mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-30 02:40:11 +08:00

Merge branch 'master' of git@github.com:LCTT/TranslateProject.git

This commit is contained in:

commit

ffe26ac1eb

README.md

published

20150820 Which Open Source Linux Distributions Would Presidential Hopefuls Run.md20151019 Gaming On Linux--All You Need To Know.md20151122 Doubly linked list in the Linux Kernel.md20151130 Useful Linux and Unix Tape Managements Commands For Sysadmins.md20151202 8 things to do after installing openSUSE Leap 42.1.md20151202 KDE vs GNOME vs XFCE Desktop.md20151227 Upheaval in the Debian Live project.md20160204 An Introduction to SELinux.md

201604

20151028 10 Tips for 10x Application Performance.md20151109 How to Configure Tripwire IDS on Debian.md20151114 How to Setup Drone - a Continuous Integration Service in Linux.md20151119 Going Beyond Hello World Containers is Hard Stuff.md20151126 Microsoft and Linux--True Romance or Toxic Love.md20160212 How to Add New Disk in Linux CentOS 7 Without Rebooting.md20160220 Make Sudo Insult User For Each Incorrect Password Attempt.md20160223 BeeGFS Parallel File System Goes Open Source.md20160226 How to use Python to hack your Eclipse IDE.md20160405 Ubuntu Budgie Could Be the New Flavor of Ubuntu Linux, as Part of Ubuntu 16.10.md20160414 Linux Kernel 3.12 to Be Supported Until 2017 Because of SUSE Linux Enterprise 12.md

sources

talk

20150806 Torvalds 2.0--Patricia Torvalds on computing college feminism and increasing diversity in tech.md20150820 Which Open Source Linux Distributions Would Presidential Hopefuls Run.md20151117 How bad a boss is Linus Torvalds.md20160505 Confessions of a cross-platform developer.md

my-open-source-story

tech

20160204 An Introduction to SELinux.md20160218 9 Key Trends in Hybrid Cloud Computing.md20160218 Tizen 3.0 Joins Growing List of Raspberry Pi 2 Distributions.md20160220 Convergence Becomes Real With First Ubuntu Tablet.md20160301 The Evolving Market for Commercial Software Built On Open Source.md20160429 Master OpenStack with 5 new tutorials.md20160502 The intersection of Drupal, IoT, and open hardware.md

LXD

translated

20151227 Upheaval in the Debian Live project.md

talk

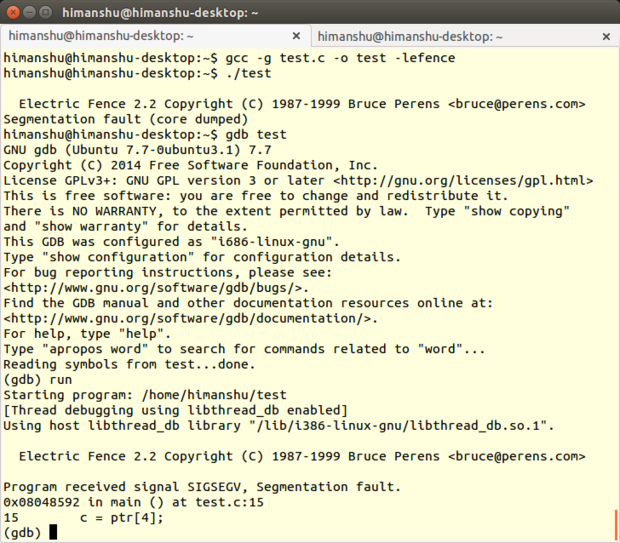

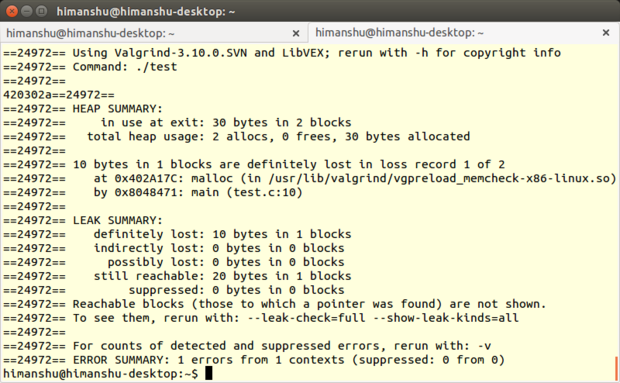

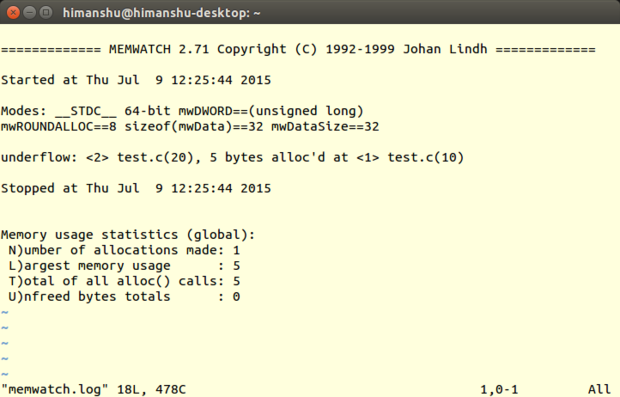

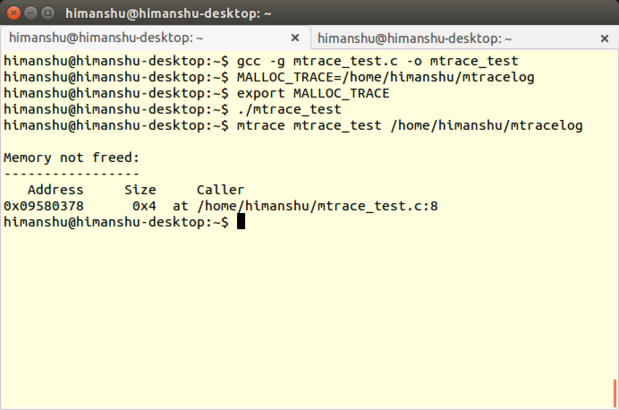

20151124 Review--5 memory debuggers for Linux coding.md20151202 KDE vs GNOME vs XFCE Desktop.md

my-open-source-story

tech

20151123 Data Structures in the Linux Kernel.md20151207 5 great Raspberry Pi projects for the classroom.md20160218 9 Key Trends in Hybrid Cloud Computing.md20160218 Top 4 open source issue tracking tools.md20160301 The Evolving Market for Commercial Software Built On Open Source.md20160304 Image processing at NASA with open source tools.md20160429 Master OpenStack with 5 new tutorials.md

LXD

76

README.md

76

README.md

@ -1,9 +1,9 @@

|

||||

简介

|

||||

-------------------------------

|

||||

|

||||

LCTT是“Linux中国”([http://linux.cn/](http://linux.cn/))的翻译组,负责从国外优秀媒体翻译Linux相关的技术、资讯、杂文等内容。

|

||||

LCTT是“Linux中国”([https://linux.cn/](https://linux.cn/))的翻译组,负责从国外优秀媒体翻译Linux相关的技术、资讯、杂文等内容。

|

||||

|

||||

LCTT已经拥有近百余名活跃成员,并欢迎更多的Linux志愿者加入我们的团队。

|

||||

LCTT已经拥有几百名活跃成员,并欢迎更多的Linux志愿者加入我们的团队。

|

||||

|

||||

|

||||

|

||||

@ -52,13 +52,15 @@ LCTT的组成

|

||||

* 2015/04/19 发起 LFS-BOOK-7.7-systemd 项目。

|

||||

* 2015/06/09 提升ictlyh和dongfengweixiao为Core Translators成员。

|

||||

* 2015/11/10 提升strugglingyouth、FSSlc、Vic020、alim0x为Core Translators成员。

|

||||

* 2016/05/09 提升PurlingNayuki为校对。

|

||||

|

||||

活跃成员

|

||||

-------------------------------

|

||||

|

||||

目前 TP 活跃成员有:

|

||||

- CORE @wxy,

|

||||

- CORE @DeadFire,

|

||||

- Leader @wxy,

|

||||

- Source @oska874,

|

||||

- Proofreader @PurlingNayuki,

|

||||

- CORE @geekpi,

|

||||

- CORE @GOLinux,

|

||||

- CORE @ictlyh,

|

||||

@ -71,6 +73,7 @@ LCTT的组成

|

||||

- CORE @Vic020,

|

||||

- CORE @dongfengweixiao,

|

||||

- CORE @alim0x,

|

||||

- Senior @DeadFire,

|

||||

- Senior @reinoir,

|

||||

- Senior @tinyeyeser,

|

||||

- Senior @vito-L,

|

||||

@ -80,41 +83,42 @@ LCTT的组成

|

||||

- ZTinoZ,

|

||||

- theo-l,

|

||||

- luoxcat,

|

||||

- disylee,

|

||||

- martin2011qi,

|

||||

- wi-cuckoo,

|

||||

- disylee,

|

||||

- haimingfg,

|

||||

- KayGuoWhu,

|

||||

- wwy-hust,

|

||||

- martin2011qi,

|

||||

- cvsher,

|

||||

- felixonmars,

|

||||

- su-kaiyao,

|

||||

- ivo-wang,

|

||||

- GHLandy,

|

||||

- cvsher,

|

||||

- wyangsun,

|

||||

- DongShuaike,

|

||||

- flsf,

|

||||

- SPccman,

|

||||

- Stevearzh

|

||||

- mr-ping,

|

||||

- Linchenguang,

|

||||

- oska874

|

||||

- Linux-pdz,

|

||||

- 2q1w2007,

|

||||

- felixonmars,

|

||||

- wyangsun,

|

||||

- MikeCoder,

|

||||

- mr-ping,

|

||||

- xiqingongzi

|

||||

- H-mudcup,

|

||||

- zhangboyue,

|

||||

- cposture,

|

||||

- xiqingongzi,

|

||||

- goreliu,

|

||||

- DongShuaike,

|

||||

- NearTan,

|

||||

- TxmszLou,

|

||||

- ZhouJ-sh,

|

||||

- wangjiezhe,

|

||||

- NearTan,

|

||||

- icybreaker,

|

||||

- shipsw,

|

||||

- johnhoow,

|

||||

- soooogreen,

|

||||

- linuhap,

|

||||

- boredivan,

|

||||

- blueabysm,

|

||||

- liaoishere,

|

||||

- boredivan,

|

||||

- name1e5s,

|

||||

- yechunxiao19,

|

||||

- l3b2w1,

|

||||

- XLCYun,

|

||||

@ -122,43 +126,55 @@ LCTT的组成

|

||||

- tenght,

|

||||

- coloka,

|

||||

- luoyutiantang,

|

||||

- yupmoon,

|

||||

- sonofelice,

|

||||

- jiajia9linuxer,

|

||||

- scusjs,

|

||||

- tnuoccalanosrep,

|

||||

- woodboow,

|

||||

- 1w2b3l,

|

||||

- JonathanKang,

|

||||

- crowner,

|

||||

- mtunique,

|

||||

- dingdongnigetou,

|

||||

- CNprober,

|

||||

- JonathanKang,

|

||||

- Medusar,

|

||||

- hyaocuk,

|

||||

- szrlee,

|

||||

- KnightJoker,

|

||||

- Xuanwo,

|

||||

- nd0104,

|

||||

- jerryling315,

|

||||

- xiaoyu33,

|

||||

- guodongxiaren,

|

||||

- zzlyzq,

|

||||

- yujianxuechuan,

|

||||

- ailurus1991,

|

||||

- ynmlml,

|

||||

- kylepeng93,

|

||||

- ggaaooppeenngg,

|

||||

- Ricky-Gong,

|

||||

- zky001,

|

||||

- Flowsnow,

|

||||

- lfzark,

|

||||

- 213edu,

|

||||

- Tanete,

|

||||

- liuaiping,

|

||||

- jerryling315,

|

||||

- bestony,

|

||||

- Timeszoro,

|

||||

- rogetfan,

|

||||

- itsang,

|

||||

- JeffDing,

|

||||

- Yuking-net,

|

||||

|

||||

- MikeCoder,

|

||||

- zhangboyue,

|

||||

- liaoishere,

|

||||

- yupmoon,

|

||||

- Medusar,

|

||||

- zzlyzq,

|

||||

- yujianxuechuan,

|

||||

- ailurus1991,

|

||||

- tomatoKiller,

|

||||

- stduolc,

|

||||

- shaohaolin,

|

||||

- Timeszoro,

|

||||

- rogetfan,

|

||||

- FineFan,

|

||||

- kingname,

|

||||

- jasminepeng,

|

||||

- JeffDing,

|

||||

- CHINAANSHE,

|

||||

|

||||

(按提交行数排名前百)

|

||||

@ -173,7 +189,7 @@ LFS 项目活跃成员有:

|

||||

- @KevinSJ

|

||||

- @Yuking-net

|

||||

|

||||

(更新于2015/11/29)

|

||||

(更新于2016/05/09)

|

||||

|

||||

谢谢大家的支持!

|

||||

|

||||

|

||||

@ -0,0 +1,53 @@

|

||||

如果总统候选人们要使用 Linux 发行版,他们会选择哪个?

|

||||

================================================================================

|

||||

|

||||

|

||||

*共和党总统候选人 Donald Trump【译者注:唐纳德·特朗普,美国地产大亨、作家、主持人】*

|

||||

|

||||

如果要竞选总统的人们使用 Linux 或其他的开源操作系统,那么会使用哪个发行版呢?问题的关键是存在许多其它的因素,比如,一些“政治立场”问题,或者是给一个发行版的名字添加上感叹号是否合适——而这问题一直被忽视。先不管这些忽视:接下来是时事新闻工作者关于总统大选和 Linux 发行版的报道。

|

||||

|

||||

对于那些已经看了很多年我的文字的人来说(除了我亲爱的的编辑之外,他们一直听我的瞎扯是不是倒霉到家了?),这篇文章听起来很熟悉,这是因为我在去年的总统选举期间写了一篇[类似的文章][1]。一些读者把这篇文章的内容看的比我想象的还要严肃,所以我会花点时间阐述我的观点:事实上,我不认为开源软件和政治运动彼此之间有多大的关系。我写那样的文章仅仅是新的一周的自我消遣罢了。

|

||||

|

||||

当然,你也可以认为它们彼此相关,毕竟你才是读者。

|

||||

|

||||

### Linux 发行版之选:共和党人们 ###

|

||||

|

||||

今天,我只是谈及一些有关共和党人们的话题,我甚至只会谈论他们的其中一部分。因为共和党的提名人太多了,以至于我写满了整篇文章。由此开始:

|

||||

|

||||

如果 **Jeb (Jeb!?) Bush** 使用 Linux,它一定是 [Debian][2]。Debian 属于一个相当无趣的分支,它是为真正意义上的、成熟的黑客设计的,这些人将清理那些由经验不甚丰富的开源爱好者所造成的混乱视为一大使命。当然,这也使得 Debian 显得很枯燥,所以它已有的用户基数一直在缩减。

|

||||

|

||||

**Scott Walker** ,对于他来说,应该是一个 [Damn Small Linux][3] (DSL) 用户。这个系统仅仅需要 50MB 的硬盘空间和 16MB 的 RAM 便可运行。DSL 可以使一台 20 年前的 486 计算机焕发新春,而这恰好符合了 **Scott Walker** 所主张的消减成本计划。当然,你在 DSL 上的用户体验也十分原始,这个系统平台只能够运行一个浏览器。但是至少你你不用浪费钱财购买新的电脑硬件,你那台 1993 年购买的机器仍然可以为你好好的工作。

|

||||

|

||||

**Chris Christie** 会使用哪种系统呢?他肯定会使用 [Relax-and-Recover Linux][4],它号称“一次搞定(Setup-and-forget)的裸机 Linux 灾难恢复方案” 。从那次不幸的华盛顿大桥事故后,“一次搞定(Setup-and-forget)”基本上便成了 Christie 的政治主张。不管灾难恢复是否能够让 Christie 最终挽回一切,但是当他的电脑死机的时候,至少可以找到一两封意外丢失的机密邮件。

|

||||

|

||||

至于 **Carly Fiorina**,她无疑将要使用 [惠普][6] (HPQ)为“[The Machine][5]”开发的操作系统,她在 1999 年到 2005 年这 6 年期间管理的这个公司。事实上,The Machine 可以运行几种不同的操作系统,也许是基于 Linux 的,也许不是,我们并不太清楚,它的开发始于 **Carly Fiorina** 在惠普公司的任期结束后。不管怎么说,作为 IT 圈里一个成功的管理者,这是她履历里面重要的组成部分,同时这也意味着她很难与惠普彻底断绝关系。

|

||||

|

||||

最后,但并不是不重要,你也猜到了——**Donald Trump**。他显然会动用数百万美元去雇佣一个精英黑客团队去定制属于自己的操作系统——尽管他原本是想要免费获得一个完美的、现成的操作系统——然后还能向别人炫耀自己的财力。他可能会吹嘘自己的操作系统是目前最好的系统,虽然它可能没有兼容 POSIX 或者一些其它的标准,因为那样的话就需要花掉更多的钱。同时这个系统也将根本不会提供任何文档,因为如果 **Donald Trump** 向人们解释他的系统的实际运行方式,他会冒着所有机密被泄露至伊斯兰国家的风险,绝对是这样的。

|

||||

|

||||

另外,如果 **Donald Trump** 非要选择一种已有的 Linux 平台的话, [Ubuntu][7] 应该是明智的选择。就像 **Donald Trump** 一样, Ubuntu 的开发者秉承“我们做自己想要做的”原则,通过他们自己的实现来构建开源软件。自由软件纯化论者却很反感 Ubuntu 这一点,但是很多普通用户却更喜欢一些。当然,无论你是不是一个纯粹论者,无论是在软件领域还是政治领域,还需要时间才能知道分晓。

|

||||

|

||||

### 敬请期待 ###

|

||||

|

||||

如果你想知道为什么我还没有提到民主党候选人,别想多了。我没有在这篇文章中提及他们,是因为我对民主党并不比共和党喜欢更多或更少一点(我个人认为,这种只有两个政党的美国特色是不荒谬的,根本不能体现民主,我也不相信这些党派候选人)。

|

||||

|

||||

另一方面,也可能会有很多人关心民主党候选人使用的 Linux 发行版。后续的帖子中我会提及的,请拭目以待。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://thevarguy.com/open-source-application-software-companies/081715/which-open-source-linux-distributions-would-presidential-

|

||||

|

||||

作者:[Christopher Tozzi][a]

|

||||

译者:[vim-kakali](https://github.com/vim-kakali)

|

||||

校对:[PurlingNayuki](https://github.com/PurlingNayuki), [wxy](https://github.com/wxy/)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://thevarguy.com/author/christopher-tozzi

|

||||

[1]:http://thevarguy.com/open-source-application-software-companies/aligning-linux-distributions-presidential-hopefuls

|

||||

[2]:http://debian.org/

|

||||

[3]:http://www.damnsmalllinux.org/

|

||||

[4]:http://relax-and-recover.org/

|

||||

[5]:http://thevarguy.com/open-source-application-software-companies/061614/hps-machine-open-source-os-truly-revolutionary

|

||||

[6]:http://hp.com/

|

||||

[7]:http://ubuntu.com/

|

||||

@ -2,29 +2,29 @@ Linux上的游戏:所有你需要知道的

|

||||

================================================================================

|

||||

|

||||

|

||||

** 我能在 Linux 上玩游戏吗 ?**

|

||||

**我能在 Linux 上玩游戏吗 ?**

|

||||

|

||||

这是打算[投奔 Linux 阵营][1]的人最经常问的问题之一。毕竟,在 Linux 上面玩游戏经常被认为有点难以实现。事实上,一些人甚至考虑他们能不能在 Linux 上看电影或者听音乐。考虑到这些,关于 Linux 的平台的游戏的问题是很现实的。「

|

||||

这是打算[投奔 Linux 阵营][1]的人最经常问的问题之一。毕竟,在 Linux 上面玩游戏经常被认为有点难以实现。事实上,一些人甚至考虑他们能不能在 Linux 上看电影或者听音乐。考虑到这些,关于 Linux 的平台的游戏的问题是很现实的。

|

||||

|

||||

在本文中,我将解答大多数 Linux 新手关于在 Linux 打游戏的问题。例如 Linux 下能不能玩游戏,如果能的话,在**哪里下载游戏**或者如何获取有关游戏的信息。

|

||||

在本文中,我将解答大多数 Linux 新手关于在 Linux 中打游戏的问题。例如 Linux 下能不能玩游戏,如果能的话,在哪里**下载游戏**或者如何获取有关游戏的信息。

|

||||

|

||||

但是在此之前,我需要说明一下。我不是一个 PC 上的玩家或者说我不认为我是一个在 Linux 桌面上完游玩戏的家伙。我更喜欢在 PS4 上玩游戏并且我不关心 PC 上的游戏甚至也不关心手机上的游戏(我没有给我的任何一个朋友安利糖果传奇)。这也就是你很少在 It's FOSS 上很少看见关于 [Linux 上的游戏][2]的部分。

|

||||

但是在此之前,我需要说明一下。我不是一个 PC 上的玩家或者说我不认为我是一个在 Linux 桌面游戏玩家。我更喜欢在 PS4 上玩游戏并且我不关心 PC 上的游戏甚至也不关心手机上的游戏(我没有给我的任何一个朋友安利糖果传奇)。这也就是你很少能在 It's FOSS 上很少看见关于 [Linux 上的游戏][2]的原因。

|

||||

|

||||

所以我为什么要写这个主题?

|

||||

所以我为什么要提到这个主题?

|

||||

|

||||

因为别人问过我几次有关 Linux 上的游戏的问题并且我想要写出来一个能解答这些问题的 Linux 上的游戏指南。注意,在这里我不只是讨论 Ubuntu 上的游戏。我讨论的是在所有的 Linux 上的游戏。

|

||||

因为别人问过我几次有关 Linux 上的游戏的问题并且我想要写出来一个能解答这些问题的 Linux 游戏指南。注意,在这里我不只是讨论在 Ubuntu 上玩游戏。我讨论的是在所有的 Linux 上的游戏。

|

||||

|

||||

### 我能在 Linux 上玩游戏吗 ? ###

|

||||

|

||||

是,但不是完全是。

|

||||

|

||||

“是”,是指你能在Linux上玩游戏;“不完全是”,是指你不能在 Linux 上玩 ’所有的游戏‘。

|

||||

“是”,是指你能在Linux上玩游戏;“不完全是”,是指你不能在 Linux 上玩 ‘所有的游戏’。

|

||||

|

||||

什么?你是拒绝的?不必这样。我的意思是你能在 Linux 上玩很多流行的游戏,比如[反恐精英以及地铁:最后的曙光][3]等。但是你可能不能玩到所有在 Windows 上流行的最新游戏,比如[实况足球2015][4]。

|

||||

感到迷惑了吗?不必这样。我的意思是你能在 Linux 上玩很多流行的游戏,比如[反恐精英以及地铁:最后的曙光][3]等。但是你可能不能玩到所有在 Windows 上流行的最新游戏,比如[实况足球 2015 ][4]。

|

||||

|

||||

在我看来,造成这种情况的原因是 Linux 在桌面系统中仅占不到 2%,这占比使得大多数开发者没有在 Linux 上发布他们的游戏的打算。

|

||||

在我看来,造成这种情况的原因是 Linux 在桌面系统中仅占不到 2%,这样的占比使得大多数开发者没有开发其游戏的 Linux 版的动力。

|

||||

|

||||

这就意味指大多数近年来被提及的比较多的游戏很有可能不能在 Linux 上玩。不要灰心。我们能以某种方式在 Linux 上玩这些游戏,我们将在下面的章节中讨论这些方法。但是,在此之前,让我们看看在 Linux 上能玩的游戏的种类。

|

||||

这就意味指大多数近年来被提及的比较多的游戏很有可能不能在 Linux 上玩。不要灰心。还有别的方式在 Linux 上玩这些游戏,我们将在下面的章节中讨论这些方法。但是,在此之前,让我们看看在 Linux 上能玩的游戏的种类。

|

||||

|

||||

要我说的话,我会把那些游戏分为四类:

|

||||

|

||||

@ -33,7 +33,7 @@ Linux上的游戏:所有你需要知道的

|

||||

3. 浏览器里的游戏

|

||||

4. 终端里的游戏

|

||||

|

||||

让我们以最重要的 Linux 的原生游戏开始。

|

||||

让我们以最重要的一类, Linux 的原生游戏开始。

|

||||

|

||||

---------

|

||||

|

||||

@ -41,15 +41,15 @@ Linux上的游戏:所有你需要知道的

|

||||

|

||||

原生游戏指的是官方支持 Linux 的游戏。这些游戏有原生的 Linux 客户端并且能像在 Linux 上的其他软件一样不需要附加的步骤就能安装在 Linux 上面(我们将在下一节讨论)。

|

||||

|

||||

所以,如你所见,这里有一些为 Linux 开发的游戏,下一个问题就是在哪能找到这些游戏以及如何安装。我将列出来一些让你玩到游戏的渠道了。

|

||||

所以,如你所见,有一些为 Linux 开发的游戏,下一个问题就是在哪能找到这些游戏以及如何安装。我将列出一些让你玩到游戏的渠道。

|

||||

|

||||

#### Steam ####

|

||||

|

||||

|

||||

|

||||

“[Steam][5] 是一个游戏的分发平台。就如同 Kindle 是电子书的分发平台,iTunes 是音乐的分发平台一样,Steam 也具有那样的功能。它给了你购买和安装游戏,玩多人游戏以及在它的平台上关注其他游戏的选项。这些游戏被[ DRM ][6]所保护。”

|

||||

“[Steam][5] 是一个游戏的分发平台。就如同 Kindle 是电子书的分发平台, iTunes 是音乐的分发平台一样, Steam 也具有那样的功能。它提供购买和安装游戏,玩多人游戏以及在它的平台上关注其他游戏的选项。其上的游戏被[ DRM ][6]所保护。”

|

||||

|

||||

两年以前,游戏平台 Steam 宣布支持 Linux,这在当时是一个大新闻。这是 Linux 上玩游戏被严肃的对待的一个迹象。尽管这个决定更多地影响了他们自己的基于 Linux 游戏平台[ Steam OS][7]。这仍然是令人欣慰的事情,因为它给 Linux 带来了一大堆游戏。

|

||||

两年以前,游戏平台 Steam 宣布支持 Linux ,这在当时是一个大新闻。这是 Linux 上玩游戏被严肃对待的一个迹象。尽管这个决定更多地影响了他们自己的基于 Linux 游戏平台以及一个独立 Linux 发行版[ Steam OS][7] ,这仍然是令人欣慰的事情,因为它给 Linux 带来了一大堆游戏。

|

||||

|

||||

我已经写了一篇详细的关于安装以及使用 Steam 的文章。如果你想开始使用 Steam 的话,读读那篇文章。

|

||||

|

||||

@ -57,23 +57,23 @@ Linux上的游戏:所有你需要知道的

|

||||

|

||||

#### GOG.com ####

|

||||

|

||||

[GOG.com][9] 失灵一个与 Steam 类似的平台。与 Steam 一样,你能在这上面找到数以百计的 Linux 游戏,你可以购买和安装它们。如果游戏支持好几个平台,尼卡一在多个操作系统上安装他们。你买到你账户的游戏你可以随时玩。捏可以在你想要下载的任何时间下载。

|

||||

[GOG.com][9] 是另一个与 Steam 类似的平台。与 Steam 一样,你能在这上面找到数以百计的 Linux 游戏,并购买和安装它们。如果游戏支持好几个平台,你可以在多个操作系统上安装他们。你可以随时游玩使用你的账户购买的游戏。你也可以在任何时间下载。

|

||||

|

||||

GOG.com 与 Steam 不同的是前者仅提供没有 DRM 保护的游戏以及电影。而且,GOG.com 完全是基于网页的,所以你不需要安装类似 Steam 的客户端。你只需要用浏览器下载游戏然后安装到你的系统上。

|

||||

|

||||

#### Portable Linux Games ####

|

||||

|

||||

[Portable Linux Games][10] 是一个集聚了不少 Linux 游戏的网站。这家网站最特别以及最好的就是你能离线安装这些游戏。

|

||||

[Portable Linux Games][10] 是一个集聚了不少 Linux 游戏的网站。这家网站最特别以及最好的点就是你能离线安装这些游戏。

|

||||

|

||||

你下载到的文件包含所有的依赖(仅需 Wine 以及 Perl)并且他们也是与平台无关的。你所需要的仅仅是下载文件并且双击来启动安装程序。你也可以把文件储存起来以用于将来的安装,如果你网速不够快的话我很推荐您这样做。

|

||||

你下载到的文件包含所有的依赖(仅需 Wine 以及 Perl)并且他们也是与平台无关的。你所需要的仅仅是下载文件并且双击来启动安装程序。你也可以把文件储存起来以用于将来的安装。如果你网速不够快的话,我很推荐你这样做。

|

||||

|

||||

#### Game Drift 游戏商店 ####

|

||||

|

||||

[Game Drift][11] 是一个只专注于游戏的基于 Ubuntu 的 Linux 发行版。但是如果你不想只为游戏就去安装这个发行版的话,你也可以经常上线看哪个游戏可以在 Linux 上运行并且安装他们。

|

||||

[Game Drift][11] 是一个只专注于游戏的基于 Ubuntu 的 Linux 发行版。但是如果你不想只为游戏就去安装这个发行版的话,你也可以经常去它的在线游戏商店去看哪个游戏可以在 Linux 上运行并且安装他们。

|

||||

|

||||

#### Linux Game Database ####

|

||||

|

||||

如其名字所示,[Linux Game Database][12]是一个收集了很多 Linux 游戏的网站。你能在这里浏览诸多类型的游戏并从游戏开发者的网站下载/安装这些游戏。作为这家网站的会员,你甚至可以为游戏打分。LGDB,有点像 Linux 游戏界的 IMDB 或者 IGN.

|

||||

如其名字所示,[Linux Game Database][12]是一个收集了很多 Linux 游戏的网站。你能在这里浏览诸多类型的游戏并从游戏开发者的网站下载/安装这些游戏。作为这家网站的会员,你甚至可以为游戏打分。 LGDB 有点像 Linux 游戏界的 IMDB 或者 IGN.

|

||||

|

||||

#### Penguspy ####

|

||||

|

||||

@ -81,7 +81,7 @@ GOG.com 与 Steam 不同的是前者仅提供没有 DRM 保护的游戏以及电

|

||||

|

||||

#### 软件源 ####

|

||||

|

||||

看看你自己的发行版的软件源。那里可能有一些游戏。如果你用 Ubuntu 的话,它的软件中心里有一个游戏的分类。在一些其他的发行版里也有,比如 Liux Mint 等。

|

||||

看看你自己的发行版的软件源。其中可能有一些游戏。如果你用 Ubuntu 的话,它的软件中心里有一个游戏的分类。在一些其他的发行版里也有,比如 Linux Mint 等。

|

||||

|

||||

----------

|

||||

|

||||

@ -89,19 +89,19 @@ GOG.com 与 Steam 不同的是前者仅提供没有 DRM 保护的游戏以及电

|

||||

|

||||

|

||||

|

||||

到现在为止,我们一直在讨论 Linux 的原生游戏。但是并没有很多 Linux 上的原生游戏,或者说,火的不要不要的游戏大多不支持 Linux,但是都支持 Windows PC。所以,如何在 Linux 上玩 Wendows 的游戏?

|

||||

到现在为止,我们一直在讨论 Linux 的原生游戏。但是并没有很多 Linux 上的原生游戏,或者更准确地说,火的不要不要的游戏大多不支持 Linux,但是都支持 Windows PC 。所以,如何在 Linux 上玩 Windows 的游戏?

|

||||

|

||||

幸好,由于我们有 Wine, PlayOnLinux 和 CrossOver 等工具,我们能在 Linux 上玩不少的 Wendows 游戏。

|

||||

幸好,由于我们有 Wine 、 PlayOnLinux 和 CrossOver 等工具,我们能在 Linux 上玩不少的 Windows 游戏。

|

||||

|

||||

#### Wine ####

|

||||

|

||||

Wine 是一个能使 Wendows 应用在类似 Linux, BSD 和 OS X 上运行的兼容层。在 Wine 的帮助下,你可以在 Linux 下安装以及使用很多 Windows 下的应用。

|

||||

Wine 是一个能使 Windows 应用在类似 Linux , BSD 和 OS X 上运行的兼容层。在 Wine 的帮助下,你可以在 Linux 下安装以及使用很多 Windows 下的应用。

|

||||

|

||||

[在 Ubuntu 上安装 Wine][14]或者在其他 Linux 上安装 Wine 是很简单的,因为大多数发行版的软件源里都有它。这里也有一个很大的[ Wine 支持的应用的数据库][15]供您浏览。

|

||||

|

||||

#### CrossOver ####

|

||||

|

||||

[CrossOver][16] 是 Wine 的增强版,它给 Wine 提供了专业的技术上的支持。但是与 Wine 不同, CrossOver 不是免费的。你需要购买许可。好消息是它会把更新也贡献到 Wine 的开发者那里并且事实上加速了 Wine 的开发使得 Wine 能支持更多的 Windows 上的游戏和应用。如果你可以一年支付 48 美元,你可以购买 CrossOver 并得到他们提供的技术支持。

|

||||

[CrossOver][16] 是 Wine 的增强版,它给 Wine 提供了专业的技术上的支持。但是与 Wine 不同, CrossOver 不是免费的。你需要购买许可。好消息是它会把更新也贡献到 Wine 的开发者那里并且事实上加速了 Wine 的开发使得 Wine 能支持更多的 Windows 上的游戏和应用。如果你可以接受每年支付 48 美元,你可以购买 CrossOver 并得到他们提供的技术支持。

|

||||

|

||||

### PlayOnLinux ###

|

||||

|

||||

@ -113,9 +113,9 @@ PlayOnLinux 也基于 Wine 但是执行程序的方式略有不同。它有着

|

||||

|

||||

|

||||

|

||||

不必说你也应该知道有非常多的基于网页的游戏,这些游戏都可以在任何操作系统里运行,无论是 Windows,Linux,还是 OS X。大多数让人上瘾的手机游戏,比如[帝国之战][18]就有官方的网页版。

|

||||

不必说你也应该知道有非常多的基于网页的游戏,这些游戏都可以在任何操作系统里运行,无论是 Windows ,Linux ,还是 OS X 。大多数让人上瘾的手机游戏,比如[帝国之战][18]就有官方的网页版。

|

||||

|

||||

除了这些,还有 [Google Chrome在线商店][19],你可以在 Linux 上玩更多的这些游戏。这些 Chrome 上的游戏可以像一个单独的应用一样安装并从应用菜单中打开,一些游戏就算是离线也能运行。

|

||||

除了这些,还有 [Google Chrome 在线商店][19],你可以在 Linux 上玩更多的这些游戏。这些 Chrome 上的游戏可以像一个单独的应用一样安装并从应用菜单中打开,一些游戏就算是离线也能运行。

|

||||

|

||||

----------

|

||||

|

||||

@ -123,7 +123,7 @@ PlayOnLinux 也基于 Wine 但是执行程序的方式略有不同。它有着

|

||||

|

||||

|

||||

|

||||

使用 Linux 的一个附加优势就是可以使用命令行终端玩游戏。我知道这不是最好的玩游戏的 方法,但是在终端里玩[贪吃蛇][20]或者 [2048][21] 很有趣。在[这个博客][21]中有一些好玩的的终端游戏。你可以浏览并安装你喜欢的游戏。

|

||||

使用 Linux 的一个附加优势就是可以使用命令行终端玩游戏。我知道这不是最好的玩游戏的方法,但是在终端里玩[贪吃蛇][20]或者 [2048][21] 很有趣。在[这个博客][21]中有一些好玩的的终端游戏。你可以浏览并安装你喜欢的游戏。

|

||||

|

||||

----------

|

||||

|

||||

@ -131,21 +131,21 @@ PlayOnLinux 也基于 Wine 但是执行程序的方式略有不同。它有着

|

||||

|

||||

当你了解了不少的在 Linux 上你可以玩到的游戏以及你如何使用他们,下一个问题就是如何保持游戏的版本是最新的。对于这件事,我建议你看看下面的博客,这些博客能告诉你 Linux 游戏世界的最新消息:

|

||||

|

||||

- [Gaming on Linux][23]:我认为我把它叫做 Linux 游戏的门户并没有错误。在这你可以得到关于 Linux 的游戏的最新的传言以及新闻。最近, Gaming on Linux 有了一个由 Linux 游戏爱好者组成的漂亮的社区。

|

||||

- [Gaming on Linux][23]:我认为我把它叫做 Linux 游戏专业门户并没有错误。在这你可以得到关于 Linux 的游戏的最新的传言以及新闻。它经常更新, 还有由 Linux 游戏爱好者组成的优秀社区。

|

||||

- [Free Gamer][24]:一个专注于免费开源的游戏的博客。

|

||||

- [Linux Game News][25]:一个提供很多的 Linux 游戏的升级的 Tumbler 博客。

|

||||

|

||||

#### 还有别的要说的吗? ####

|

||||

|

||||

我认为让你知道如何开始在 Linux 上的游戏人生是一个好事。如果你仍然不能被说服。我推荐你做个[双系统][26],把 Linux 作为你的主要桌面系统,当你想玩游戏时,重启到 Windows。这是一个对游戏妥协的解决办法。

|

||||

我认为让你知道如何开始在 Linux 上的游戏人生是一个好事。如果你仍然不能被说服,我推荐你做个[双系统][26],把 Linux 作为你的主要桌面系统,当你想玩游戏时,重启到 Windows。这是一个对游戏妥协的解决办法。

|

||||

|

||||

现在,这里是你说出你自己的状况的时候了。你在 Linux 上玩游戏吗?你最喜欢什么游戏?你关注了哪些游戏博客?

|

||||

现在,这里是你说出你自己的想法的时候了。你在 Linux 上玩游戏吗?你最喜欢什么游戏?你关注了哪些游戏博客?

|

||||

|

||||

|

||||

投票项目:

|

||||

你怎样在 Linux 上玩游戏?

|

||||

|

||||

- 我玩原生 Linux 游戏,我也用 Wine 以及 PlayOnLinux 运行 Windows 游戏

|

||||

- 我玩原生 Linux 游戏,也用 Wine 以及 PlayOnLinux 运行 Windows 游戏

|

||||

- 我喜欢网页游戏

|

||||

- 我喜欢终端游戏

|

||||

- 我只玩原生 Linux 游戏

|

||||

@ -167,7 +167,7 @@ via: http://itsfoss.com/linux-gaming-guide/

|

||||

|

||||

作者:[Abhishek][a]

|

||||

译者:[name1e5s](https://github.com/name1e5s)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[PurlingNayuki](https://github.com/PurlingNayuki)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -4,10 +4,9 @@ Linux 内核里的数据结构——双向链表

|

||||

双向链表

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

Linux 内核中自己实现了双向链表,可以在 [include/linux/list.h](https://github.com/torvalds/linux/blob/master/include/linux/list.h) 找到定义。我们将会首先从双向链表数据结构开始介绍**内核里的数据结构**。为什么?因为它在内核里使用的很广泛,你只需要在 [free-electrons.com](http://lxr.free-electrons.com/ident?i=list_head) 检索一下就知道了。

|

||||

|

||||

Linux 内核自己实现了双向链表,可以在[include/linux/list.h](https://github.com/torvalds/linux/blob/master/include/linux/list.h)找到定义。我们将会从双向链表数据结构开始`内核的数据结构`。为什么?因为它在内核里使用的很广泛,你只需要在[free-electrons.com](http://lxr.free-electrons.com/ident?i=list_head) 检索一下就知道了。

|

||||

|

||||

首先让我们看一下在[include/linux/types.h](https://github.com/torvalds/linux/blob/master/include/linux/types.h) 里的主结构体:

|

||||

首先让我们看一下在 [include/linux/types.h](https://github.com/torvalds/linux/blob/master/include/linux/types.h) 里的主结构体:

|

||||

|

||||

```C

|

||||

struct list_head {

|

||||

@ -15,7 +14,7 @@ struct list_head {

|

||||

};

|

||||

```

|

||||

|

||||

你可能注意到这和你以前见过的双向链表的实现方法是不同的。举个例子来说,在[glib](http://www.gnu.org/software/libc/) 库里是这样实现的:

|

||||

你可能注意到这和你以前见过的双向链表的实现方法是不同的。举个例子来说,在 [glib](http://www.gnu.org/software/libc/) 库里是这样实现的:

|

||||

|

||||

```C

|

||||

struct GList {

|

||||

@ -25,7 +24,7 @@ struct GList {

|

||||

};

|

||||

```

|

||||

|

||||

通常来说一个链表会包含一个指向某个项目的指针。但是内核的实现并没有这样做。所以问题来了:`链表在哪里保存数据呢?`。实际上内核里实现的链表实际上是`侵入式链表`。侵入式链表并不在节点内保存数据-节点仅仅包含指向前后节点的指针,然后把数据是附加到链表的。这就使得这个数据结构是通用的,使用起来就不需要考虑节点数据的类型了。

|

||||

通常来说一个链表结构会包含一个指向某个项目的指针。但是 Linux 内核中的链表实现并没有这样做。所以问题来了:**链表在哪里保存数据呢?**。实际上,内核里实现的链表是**侵入式链表(Intrusive list)**。侵入式链表并不在节点内保存数据-它的节点仅仅包含指向前后节点的指针,以及指向链表节点数据部分的指针——数据就是这样附加在链表上的。这就使得这个数据结构是通用的,使用起来就不需要考虑节点数据的类型了。

|

||||

|

||||

比如:

|

||||

|

||||

@ -36,7 +35,7 @@ struct nmi_desc {

|

||||

};

|

||||

```

|

||||

|

||||

让我们看几个例子来理解一下在内核里是如何使用`list_head` 的。如上所述,在内核里有实在很多不同的地方用到了链表。我们来看一个在杂项字符驱动里面的使用的例子。在 [drivers/char/misc.c](https://github.com/torvalds/linux/blob/master/drivers/char/misc.c) 的杂项字符驱动API 被用来编写处理小型硬件和虚拟设备的小驱动。这些驱动共享相同的主设备号:

|

||||

让我们看几个例子来理解一下在内核里是如何使用 `list_head` 的。如上所述,在内核里有很多很多不同的地方都用到了链表。我们来看一个在杂项字符驱动里面的使用的例子。在 [drivers/char/misc.c](https://github.com/torvalds/linux/blob/master/drivers/char/misc.c) 的杂项字符驱动 API 被用来编写处理小型硬件或虚拟设备的小驱动。这些驱动共享相同的主设备号:

|

||||

|

||||

```C

|

||||

#define MISC_MAJOR 10

|

||||

@ -68,7 +67,7 @@ crw------- 1 root root 10, 63 Mar 21 12:01 vga_arbiter

|

||||

crw------- 1 root root 10, 137 Mar 21 12:01 vhci

|

||||

```

|

||||

|

||||

现在让我们看看它是如何使用链表的。首先看一下结构体`miscdevice`:

|

||||

现在让我们看看它是如何使用链表的。首先看一下结构体 `miscdevice`:

|

||||

|

||||

```C

|

||||

struct miscdevice

|

||||

@ -84,7 +83,7 @@ struct miscdevice

|

||||

};

|

||||

```

|

||||

|

||||

可以看到结构体的第四个变量`list` 是所有注册过的设备的链表。在源代码文件的开始可以看到这个链表的定义:

|

||||

可以看到结构体`miscdevice`的第四个变量`list` 是所有注册过的设备的链表。在源代码文件的开始可以看到这个链表的定义:

|

||||

|

||||

```C

|

||||

static LIST_HEAD(misc_list);

|

||||

@ -97,13 +96,13 @@ static LIST_HEAD(misc_list);

|

||||

struct list_head name = LIST_HEAD_INIT(name)

|

||||

```

|

||||

|

||||

然后使用宏`LIST_HEAD_INIT` 进行初始化,这会使用变量`name` 的地址来填充`prev`和`next` 结构体的两个变量。

|

||||

然后使用宏 `LIST_HEAD_INIT` 进行初始化,这会使用变量`name` 的地址来填充`prev`和`next` 结构体的两个变量。

|

||||

|

||||

```C

|

||||

#define LIST_HEAD_INIT(name) { &(name), &(name) }

|

||||

```

|

||||

|

||||

现在来看看注册杂项设备的函数`misc_register`。它在开始就用 `INIT_LIST_HEAD` 初始化了`miscdevice->list`。

|

||||

现在来看看注册杂项设备的函数`misc_register`。它在一开始就用函数 `INIT_LIST_HEAD` 初始化了`miscdevice->list`。

|

||||

|

||||

```C

|

||||

INIT_LIST_HEAD(&misc->list);

|

||||

@ -119,13 +118,13 @@ static inline void INIT_LIST_HEAD(struct list_head *list)

|

||||

}

|

||||

```

|

||||

|

||||

在函数`device_create` 创建了设备后我们就用下面的语句将设备添加到设备链表:

|

||||

接下来,在函数`device_create` 创建了设备后,我们就用下面的语句将设备添加到设备链表:

|

||||

|

||||

```

|

||||

list_add(&misc->list, &misc_list);

|

||||

```

|

||||

|

||||

内核文件`list.h` 提供了项链表添加新项的API 接口。我们来看看它的实现:

|

||||

内核文件`list.h` 提供了向链表添加新项的 API 接口。我们来看看它的实现:

|

||||

|

||||

|

||||

```C

|

||||

@ -138,8 +137,8 @@ static inline void list_add(struct list_head *new, struct list_head *head)

|

||||

实际上就是使用3个指定的参数来调用了内部函数`__list_add`:

|

||||

|

||||

* new - 新项。

|

||||

* head - 新项将会被添加到`head`之前.

|

||||

* head->next - `head` 之后的项。

|

||||

* head - 新项将会插在`head`的后面

|

||||

* head->next - 插入前,`head` 后面的项。

|

||||

|

||||

`__list_add`的实现非常简单:

|

||||

|

||||

@ -155,9 +154,9 @@ static inline void __list_add(struct list_head *new,

|

||||

}

|

||||

```

|

||||

|

||||

我们会在`prev`和`next` 之间添加一个新项。所以我们用宏`LIST_HEAD_INIT`定义的`misc` 链表会包含指向`miscdevice->list` 的向前指针和向后指针。

|

||||

这里,我们在`prev`和`next` 之间添加了一个新项。所以我们开始时用宏`LIST_HEAD_INIT`定义的`misc` 链表会包含指向`miscdevice->list` 的向前指针和向后指针。

|

||||

|

||||

这里有一个问题:如何得到列表的内容呢?这里有一个特殊的宏:

|

||||

这儿还有一个问题:如何得到列表的内容呢?这里有一个特殊的宏:

|

||||

|

||||

```C

|

||||

#define list_entry(ptr, type, member) \

|

||||

@ -166,7 +165,7 @@ static inline void __list_add(struct list_head *new,

|

||||

|

||||

使用了三个参数:

|

||||

|

||||

* ptr - 指向链表头的指针;

|

||||

* ptr - 指向结构 `list_head` 的指针;

|

||||

* type - 结构体类型;

|

||||

* member - 在结构体内类型为`list_head` 的变量的名字;

|

||||

|

||||

@ -205,9 +204,9 @@ int main() {

|

||||

}

|

||||

```

|

||||

|

||||

最终会打印`2`

|

||||

最终会打印出`2`

|

||||

|

||||

下一点就是`typeof`,它也很简单。就如你从名字所理解的,它仅仅返回了给定变量的类型。当我第一次看到宏`container_of`的实现时,让我觉得最奇怪的就是`container_of`中的0.实际上这个指针巧妙的计算了从结构体特定变量的偏移,这里的`0`刚好就是位宽里的零偏移。让我们看一个简单的例子:

|

||||

下一点就是`typeof`,它也很简单。就如你从名字所理解的,它仅仅返回了给定变量的类型。当我第一次看到宏`container_of`的实现时,让我觉得最奇怪的就是表达式`((type *)0)`中的0。实际上这个指针巧妙的计算了从结构体特定变量的偏移,这里的`0`刚好就是位宽里的零偏移。让我们看一个简单的例子:

|

||||

|

||||

```C

|

||||

#include <stdio.h>

|

||||

@ -226,33 +225,35 @@ int main() {

|

||||

|

||||

结果显示`0x5`。

|

||||

|

||||

下一个宏`offsetof` 会计算从结构体的某个变量的相对于结构体起始地址的偏移。它的实现和上面类似:

|

||||

下一个宏`offsetof`会计算从结构体起始地址到某个给定结构字段的偏移。它的实现和上面类似:

|

||||

|

||||

```C

|

||||

#define offsetof(TYPE, MEMBER) ((size_t) &((TYPE *)0)->MEMBER)

|

||||

```

|

||||

|

||||

现在我们来总结一下宏`container_of`。只需要知道结构体里面类型为`list_head` 的变量的名字和结构体容器的类型,它可以通过结构体的变量`list_head`获得结构体的起始地址。在宏定义的第一行,声明了一个指向结构体成员变量`ptr`的指针`__mptr`,并且把`ptr` 的地址赋给它。现在`ptr` 和`__mptr` 指向了同一个地址。从技术上讲我们并不需要这一行,但是它可以方便的进行类型检查。第一行保证了特定的结构体(参数`type`)包含成员变量`member`。第二行代码会用宏`offsetof`计算成员变量相对于结构体起始地址的偏移,然后从结构体的地址减去这个偏移,最后就得到了结构体。

|

||||

现在我们来总结一下宏`container_of`。只需给定结构体中`list_head`类型 字段的地址、名字和结构体容器的类型,它就可以返回结构体的起始地址。在宏定义的第一行,声明了一个指向结构体成员变量`ptr`的指针`__mptr`,并且把`ptr` 的地址赋给它。现在`ptr` 和`__mptr` 指向了同一个地址。从技术上讲我们并不需要这一行,但是它可以方便地进行类型检查。第一行保证了特定的结构体(参数`type`)包含成员变量`member`。第二行代码会用宏`offsetof`计算成员变量相对于结构体起始地址的偏移,然后从结构体的地址减去这个偏移,最后就得到了结构体。

|

||||

|

||||

当然了`list_add` 和 `list_entry`不是`<linux/list.h>`提供的唯一功能。双向链表的实现还提供了如下API:

|

||||

|

||||

* list_add

|

||||

* list_add_tail

|

||||

* list_del

|

||||

* list_replace

|

||||

* list_move

|

||||

* list_is_last

|

||||

* list_empty

|

||||

* list_cut_position

|

||||

* list_splice

|

||||

* list_for_each

|

||||

* list_for_each_entry

|

||||

* list\_add

|

||||

* list\_add\_tail

|

||||

* list\_del

|

||||

* list\_replace

|

||||

* list\_move

|

||||

* list\_is\_last

|

||||

* list\_empty

|

||||

* list\_cut\_position

|

||||

* list\_splice

|

||||

* list\_for\_each

|

||||

* list\_for\_each\_entry

|

||||

|

||||

等等很多其它API。

|

||||

|

||||

via: https://github.com/0xAX/linux-insides/edit/master/DataStructures/dlist.md

|

||||

----

|

||||

|

||||

via: https://github.com/0xAX/linux-insides/blob/master/DataStructures/dlist.md

|

||||

|

||||

译者:[Ezio](https://github.com/oska874)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[Mr小眼儿](https://github.com/tinyeyeser)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

@ -1,6 +1,6 @@

|

||||

15条给系统管理员的实用 Linux/Unix 磁带管理命令

|

||||

给系统管理员的15条实用 Linux/Unix 磁带管理命令

|

||||

================================================================================

|

||||

磁带设备应只用于定期的文件归档或将数据从一台服务器传送至另一台。通常磁带设备与 Unix 机器连接,用 mt 或 mtx 控制。你可以将所有的数据备份到磁盘(也许是云中)和磁带设备。在这个教程中你将会了解到:

|

||||

磁带设备应只用于定期的文件归档或将数据从一台服务器传送至另一台。通常磁带设备与 Unix 机器连接,用 mt 或 mtx 控制。强烈建议您将所有的数据同时备份到磁盘(也许是云中)和磁带设备中。在本教程中你将会了解到:

|

||||

|

||||

- 磁带设备名

|

||||

- 管理磁带驱动器的基本命令

|

||||

@ -8,12 +8,13 @@

|

||||

|

||||

### 为什么备份? ###

|

||||

|

||||

一个备份设备是很重要的:

|

||||

一个备份计划对定期备份文件来说很有必要,如果你宁愿选择不备份,那么丢失重要数据的风险会大大增加。有了备份,你就有了从磁盘故障中恢复的能力。备份还可以帮助你抵御:

|

||||

|

||||

- 从磁盘故障中恢复的能力

|

||||

- 意外的文件删除

|

||||

- 文件或文件系统损坏

|

||||

- 服务器完全毁坏,包括由于火灾或其他问题导致的同盘备份毁坏

|

||||

- 硬盘或 SSD 崩溃

|

||||

- 病毒或勒索软件破坏或删除文件

|

||||

|

||||

你可以使用磁带归档备份整个服务器并将其离线存储。

|

||||

|

||||

@ -21,15 +22,15 @@

|

||||

|

||||

|

||||

|

||||

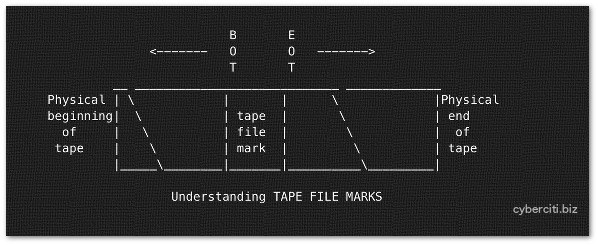

图01:磁带文件标记

|

||||

*图01:磁带文件标记*

|

||||

|

||||

每个磁带设备能存储多个备份文件。磁带备份文件通过 cpio,tar,dd 等命令创建。但是,磁带设备可以由各种程序打开,写入数据,并关闭。你可以存储若干备份(磁带文件)到一个物理磁带上。在每个磁带文件之间有个“磁带文件标记”。这个是用来指示一个物理磁带上磁带文件的结尾以及另一个文件的开始。你需要使用 mt 命令来定位磁带(快进,倒带和标记)。

|

||||

每个磁带设备能存储多个备份文件。磁带备份文件通过 cpio,tar,dd 等命令创建。同时,磁带设备可以由多种程序打开、写入数据、及关闭。你可以存储若干备份(磁带文件)到一个物理磁带上。在每个磁带文件之间有个“磁带文件标记”。这用来指示一个物理磁带上磁带文件的结尾以及另一个文件的开始。你需要使用 mt 命令来定位磁带(快进,倒带和标记)。

|

||||

|

||||

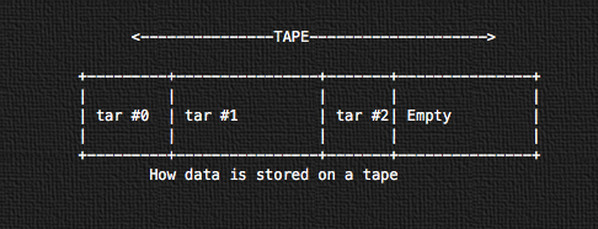

#### 磁带上的数据是如何存储的 ####

|

||||

|

||||

|

||||

|

||||

图02:磁带上的数据是如何存储的

|

||||

*图02:磁带上的数据是如何存储的*

|

||||

|

||||

所有的数据使用 tar 以连续磁带存储格式连续地存储。第一个磁带归档会从磁带的物理开始端开始存储(tar #0)。接下来的就是 tar #1,以此类推。

|

||||

|

||||

@ -59,22 +60,22 @@

|

||||

|

||||

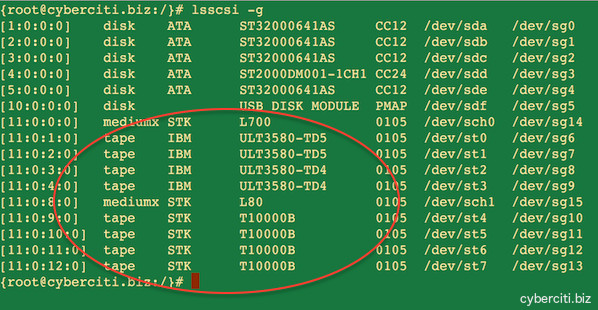

输入下列命令:

|

||||

|

||||

## Linux(更多信息参阅 man) ##

|

||||

### Linux(更多信息参阅 man) ###

|

||||

lsscsi

|

||||

lsscsi -g

|

||||

|

||||

## IBM AIX ##

|

||||

### IBM AIX ###

|

||||

lsdev -Cc tape

|

||||

lsdev -Cc adsm

|

||||

lscfg -vl rmt*

|

||||

|

||||

## Solaris Unix ##

|

||||

### Solaris Unix ###

|

||||

cfgadm –a

|

||||

cfgadm -al

|

||||

luxadm probe

|

||||

iostat -En

|

||||

|

||||

## HP-UX Unix ##

|

||||

### HP-UX Unix ###

|

||||

ioscan Cf

|

||||

ioscan -funC tape

|

||||

ioscan -fnC tape

|

||||

@ -85,11 +86,11 @@

|

||||

|

||||

|

||||

|

||||

图03:Linux 服务器上已安装的磁带设备

|

||||

*图03:Linux 服务器上已安装的磁带设备*

|

||||

|

||||

### mt 命令实例 ###

|

||||

### mt 命令示例 ###

|

||||

|

||||

在 Linux 和类Unix系统上,mt 命令用来控制磁带驱动器的操作,比如查看状态或查找磁带上的文件或写入磁带控制标记。下列大多数命令需要作为 root 用户执行。语法如下:

|

||||

在 Linux 和类 Unix 系统上,mt 命令用来控制磁带驱动器的操作,比如查看状态或查找磁带上的文件或写入磁带控制标记。下列大多数命令需要作为 root 用户执行。语法如下:

|

||||

|

||||

mt -f /tape/device/name operation

|

||||

|

||||

@ -97,7 +98,7 @@

|

||||

|

||||

你可以设置 TAPE shell 变量。这是磁带驱动器的路径名。在 FreeBSD 上默认的(如果变量没有设置,而不是 null)是 /dev/nsa0。可以通过 mt 命令的 -f 参数传递变量覆盖它,就像下面解释的那样。

|

||||

|

||||

## 添加到你的 shell 配置文件 ##

|

||||

### 添加到你的 shell 配置文件 ###

|

||||

TAPE=/dev/st1 #Linux

|

||||

TAPE=/dev/rmt/2 #Unix

|

||||

TAPE=/dev/nsa3 #FreeBSD

|

||||

@ -105,13 +106,13 @@

|

||||

|

||||

### 1:显示磁带/驱动器状态 ###

|

||||

|

||||

mt status #Use default

|

||||

mt -f /dev/rmt/0 status #Unix

|

||||

mt -f /dev/st0 status #Linux

|

||||

mt -f /dev/nsa0 status #FreeBSD

|

||||

mt -f /dev/rmt/1 status #Unix unity 1 也就是 tape device no. 1

|

||||

mt status ### Use default

|

||||

mt -f /dev/rmt/0 status ### Unix

|

||||

mt -f /dev/st0 status ### Linux

|

||||

mt -f /dev/nsa0 status ### FreeBSD

|

||||

mt -f /dev/rmt/1 status ### Unix unity 1 也就是 tape device no. 1

|

||||

|

||||

你可以像下面一样使用 shell 循环调查系统并定位所有的磁带驱动器:

|

||||

你可以像下面一样使用 shell 循环语句遍历一个系统并定位其所有的磁带驱动器:

|

||||

|

||||

for d in 0 1 2 3 4 5

|

||||

do

|

||||

@ -133,7 +134,7 @@

|

||||

mt -f /dev/mt/0 off

|

||||

mt -f /dev/st0 eject

|

||||

|

||||

### 4:擦除磁带(倒带,在可以的情况下卸载磁带) ###

|

||||

### 4:擦除磁带(倒带,在支持的情况下卸载磁带) ###

|

||||

|

||||

mt erase

|

||||

mt -f /dev/st0 erase #Linux

|

||||

@ -179,7 +180,7 @@

|

||||

|

||||

bsfm 后退指定的文件标记数目。磁带定位在下一个文件的第一块。

|

||||

|

||||

asf The tape is positioned at the beginning of the count file. Positioning is done by first rewinding the tape and then spacing forward over count filemarks.磁带定位在

|

||||

asf 磁带定位在指定文件标记数目的开始位置。定位通过先倒带,再前进指定的文件标记数目来实现。

|

||||

|

||||

fsr 前进指定的记录数。

|

||||

|

||||

@ -207,7 +208,7 @@

|

||||

|

||||

mt -f /dev/st0 rewind; dd if=/dev/st0 of=-

|

||||

|

||||

## tar 格式 ##

|

||||

### tar 格式 ###

|

||||

tar tvf {DEVICE} {Directory-FileName}

|

||||

tar tvf /dev/st0

|

||||

tar tvf /dev/st0 desktop

|

||||

@ -215,40 +216,40 @@

|

||||

|

||||

### 12:使用 dump 或 ufsdump 备份分区 ###

|

||||

|

||||

## Unix 备份 c0t0d0s2 分区 ##

|

||||

### Unix 备份 c0t0d0s2 分区 ###

|

||||

ufsdump 0uf /dev/rmt/0 /dev/rdsk/c0t0d0s2

|

||||

|

||||

## Linux 备份 /home 分区 ##

|

||||

### Linux 备份 /home 分区 ###

|

||||

dump 0uf /dev/nst0 /dev/sda5

|

||||

dump 0uf /dev/nst0 /home

|

||||

|

||||

## FreeBSD 备份 /usr 分区 ##

|

||||

### FreeBSD 备份 /usr 分区 ###

|

||||

dump -0aL -b64 -f /dev/nsa0 /usr

|

||||

|

||||

### 12:使用 ufsrestore 或 restore 恢复分区 ###

|

||||

|

||||

## Unix ##

|

||||

### Unix ###

|

||||

ufsrestore xf /dev/rmt/0

|

||||

## Unix 交互式恢复 ##

|

||||

### Unix 交互式恢复 ###

|

||||

ufsrestore if /dev/rmt/0

|

||||

|

||||

## Linux ##

|

||||

### Linux ###

|

||||

restore rf /dev/nst0

|

||||

## 从磁带媒介上的第6个备份交互式恢复 ##

|

||||

### 从磁带媒介上的第6个备份交互式恢复 ###

|

||||

restore isf 6 /dev/nst0

|

||||

|

||||

## FreeBSD 恢复 ufsdump 格式 ##

|

||||

### FreeBSD 恢复 ufsdump 格式 ###

|

||||

restore -i -f /dev/nsa0

|

||||

|

||||

### 13:从磁带开头开始写入(见图02) ###

|

||||

|

||||

## 这会覆盖磁带上的所有数据 ##

|

||||

### 这会覆盖磁带上的所有数据 ###

|

||||

mt -f /dev/st1 rewind

|

||||

|

||||

### 备份 home ##

|

||||

### 备份 home ###

|

||||

tar cvf /dev/st1 /home

|

||||

|

||||

## 离线并卸载磁带 ##

|

||||

### 离线并卸载磁带 ###

|

||||

mt -f /dev/st0 offline

|

||||

|

||||

从磁带开头开始恢复:

|

||||

@ -259,22 +260,22 @@

|

||||

|

||||

### 14:从最后一个 tar 后开始写入(见图02) ###

|

||||

|

||||

## 这会保留之前写入的数据 ##

|

||||

### 这会保留之前写入的数据 ###

|

||||

mt -f /dev/st1 eom

|

||||

|

||||

### 备份 home ##

|

||||

### 备份 home ###

|

||||

tar cvf /dev/st1 /home

|

||||

|

||||

## 卸载 ##

|

||||

### 卸载 ###

|

||||

mt -f /dev/st0 offline

|

||||

|

||||

### 15:从 tar number 2 后开始写入(见图02) ###

|

||||

|

||||

## 在 tar number 2 之后写入(应该是 2+1)

|

||||

### 在 tar number 2 之后写入(应该是 2+1)###

|

||||

mt -f /dev/st0 asf 3

|

||||

tar cvf /dev/st0 /usr

|

||||

|

||||

## asf 等效于 fsf ##

|

||||

### asf 等效于 fsf ###

|

||||

mt -f /dev/sf0 rewind

|

||||

mt -f /dev/st0 fsf 2

|

||||

|

||||

@ -413,7 +414,7 @@ via: http://www.cyberciti.biz/hardware/unix-linux-basic-tape-management-commands

|

||||

|

||||

作者:Vivek Gite

|

||||

译者:[alim0x](https://github.com/alim0x)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[Mr小眼儿](https://github.com/tinyeyeser)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,28 +1,30 @@

|

||||

装好 openSUSE Leap 42.1 之后要做的 8 件事

|

||||

安装 openSUSE Leap 42.1 之后要做的 8 件事

|

||||

================================================================================

|

||||

|

||||

致谢:[Metropolitan Transportation/Flicrk][1]

|

||||

|

||||

> 你已经在你的电脑上安装了 openSUSE。这是你接下来要做的。

|

||||

*致谢:[Metropolitan Transportation/Flicrk][1]*

|

||||

|

||||

[openSUSE Leap 确实是个巨大的飞跃][2],它允许用户运行一个和 SUSE Linux 企业版拥有一样基因的发行版。和其它系统一样,在使用它之前需要做些优化设置。

|

||||

> 如果你已经在你的电脑上安装了 openSUSE,这就是你接下来要做的。

|

||||

|

||||

下面是一些我在安装 openSUSE 到我的电脑上之后做的一些事情(不适用于服务器)。这里面没有强制性要求的设置,基本安装对来说你也可能足够了。但如果你想获得更好的 openSUSE Leap 体验,那就跟着我往下看吧。

|

||||

[openSUSE Leap 确实是个巨大的飞跃][2],它允许用户运行一个和 SUSE Linux 企业版拥有同样基因的发行版。和其它系统一样,为了实现最佳的使用效果,在使用它之前需要做些优化设置。

|

||||

|

||||

下面是一些我在我的电脑上安装 openSUSE Leap 之后做的一些事情(不适用于服务器)。这里面没有强制性的设置,基本安装对你来说也可能足够了。但如果你想获得更好的 openSUSE Leap 体验,那就跟着我往下看吧。

|

||||

|

||||

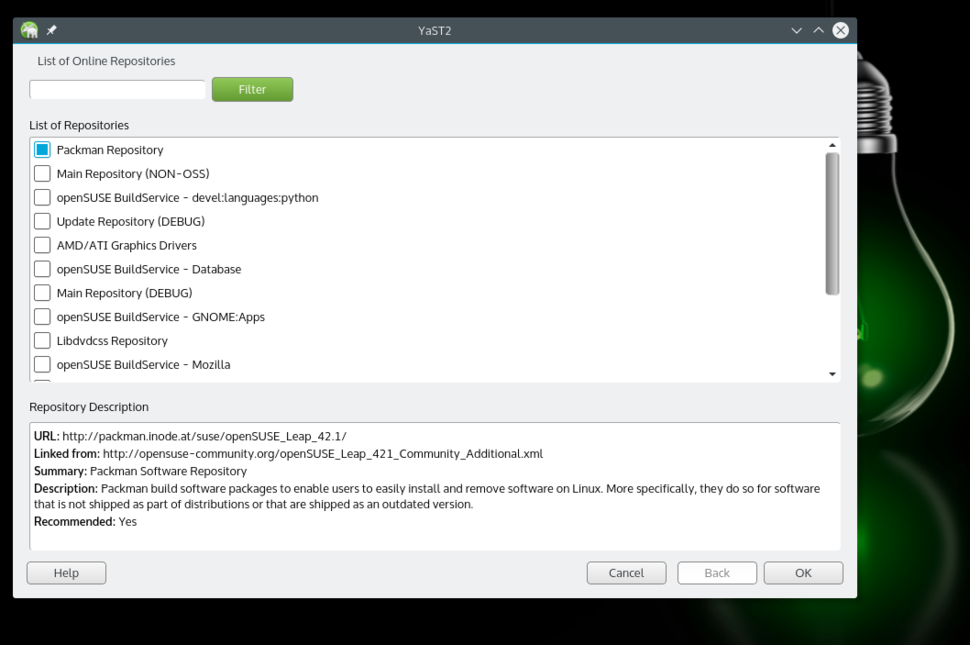

### 1. 添加 Packman 仓库 ###

|

||||

|

||||

由于专利和授权等原因,openSUSE 和许多 Linux 发行版一样,不通过官方仓库(repos)提供一些软件,解码器,以及驱动等。取而代之的是通过第三方或社区仓库来提供。第一个也是最重要的仓库是“Packman”。因为这些仓库不是默认启用的,我们需要添加它们。你可以通过 YaST (openSUSE 的特色之一)或者命令行完成(如下方介绍)。

|

||||

由于专利和授权等原因,openSUSE 和许多 Linux 发行版一样,不通过官方仓库(repos)提供一些软件、解码器,以及驱动等。取而代之的是通过第三方或社区仓库来提供。第一个也是最重要的仓库是“Packman”。因为这些仓库不是默认启用的,我们需要添加它们。你可以通过 YaST(openSUSE 的特色之一)或者命令行完成(如下方介绍)。

|

||||

|

||||

|

||||

添加 Packman 仓库。

|

||||

|

||||

使用 YsST,打开软件源部分。点击“添加”按钮并选择“社区仓库(Community Repositories)”。点击“下一步”。一旦仓库列表加载出来了,选择 Packman 仓库。点击“确认”,然后点击“信任”导入信任的 GnuPG 密钥。

|

||||

*添加 Packman 仓库。*

|

||||

|

||||

使用 YaST,打开软件源部分。点击“添加”按钮并选择“社区仓库(Community Repositories)”。点击“下一步”。一旦仓库列表加载出来了,选择 Packman 仓库。点击“确认”,然后点击“信任”导入信任的 GnuPG 密钥。

|

||||

|

||||

或者在终端里使用以下命令添加并启用 Packman 仓库:

|

||||

|

||||

zypper ar -f -n packmanhttp://ftp.gwdg.de/pub/linux/misc/packman/suse/openSUSE_Leap_42.1/ packman

|

||||

|

||||

仓库添加之后,你就能接触到更多的包了。想安装任意软件或包,打开 YaST 软件管理器,搜索并安装即可。

|

||||

仓库添加之后,你就可以使用更多的包了。想安装任意软件或包,打开 YaST 软件管理器,搜索并安装即可。

|

||||

|

||||

### 2. 安装 VLC ###

|

||||

|

||||

@ -34,7 +36,7 @@ VLC 是媒体播放器里的瑞士军刀,几乎可以播放任何媒体文件

|

||||

|

||||

### 3. 安装 Handbrake ###

|

||||

|

||||

如果你需要转码或转换视频文件格式,[Handbrake 是你的不二之选][3]。Handbrake 就在我们启用的仓库中,所以只要在 YaST 中搜索并安装它。

|

||||

如果你需要转码或转换视频文件格式,[Handbrake 是你的不二之选][3]。Handbrake 就在我们启用的仓库中,所以只需要在 YaST 中搜索并安装它即可。

|

||||

|

||||

如果你用终端,运行以下命令:

|

||||

|

||||

@ -44,7 +46,7 @@ VLC 是媒体播放器里的瑞士军刀,几乎可以播放任何媒体文件

|

||||

|

||||

### 4. 安装 Chrome ###

|

||||

|

||||

openSUSE 的默认浏览器是 Firefox。但是因为 Firefox 不能胜任播放专有媒体,比如 Netflix,我推荐安装 Chrome。这需要额外的工作。首先你需要从谷歌导入信任密钥。打开终端执行“wget”命令下载密钥:

|

||||

openSUSE 的默认浏览器是 Firefox。但是因为 Firefox 不能够播放专有媒体,比如 Netflix,我推荐安装 Chrome。这需要额外的工作。首先你需要从谷歌导入信任密钥。打开终端执行“wget”命令下载密钥:

|

||||

|

||||

wget https://dl.google.com/linux/linux_signing_key.pub

|

||||

|

||||

@ -58,7 +60,7 @@ openSUSE 的默认浏览器是 Firefox。但是因为 Firefox 不能胜任播放

|

||||

|

||||

### 5. 安装 Nvidia 驱动 ###

|

||||

|

||||

即便你有 Nvidia 或 ATI 显卡,openSUSE Leap 也能够开箱即用。但是,如果你需要专有驱动来游戏或其它目的,你可以安装这些驱动,但需要一点额外的工作。

|

||||

即便你使用 Nvidia 或 ATI 显卡,openSUSE Leap 也能够开箱即用。但是,如果你需要专有驱动来游戏或其它目的,你可以安装这些驱动,但需要一点额外的工作。

|

||||

|

||||

首先你需要添加 Nvidia 源;它的步骤和使用 YaST 添加 Packman 仓库是一样的。唯一的不同是你需要在社区仓库部分选择 Nvidia。添加好了之后,到 **软件管理 > 附加** 去并选择“附加/安装所有匹配的推荐包”。

|

||||

|

||||

@ -72,20 +74,21 @@ openSUSE 的默认浏览器是 Firefox。但是因为 Firefox 不能胜任播放

|

||||

|

||||

### 6. 安装媒体解码器 ###

|

||||

|

||||

你安装 VLC 之后就不需要安装媒体解码器了,但如果你要使用其它软件来播放媒体的话就需要安装了。一些开发者写了脚本/工具来简化这个过程。打开[这个页面][5]并点击合适的按钮安装完整的包。他会打开 YaST 并自动安装包(当然通常你还需要提供 root 权限密码并信任 GnuPG 密钥)。

|

||||

你安装 VLC 之后就不需要安装媒体解码器了,但如果你要使用其它软件来播放媒体的话就需要安装了。一些开发者写了脚本/工具来简化这个过程。打开[这个页面][5]并点击合适的按钮安装完整的包。它会打开 YaST 并自动安装包(当然通常你还需要提供 root 权限密码并信任 GnuPG 密钥)。

|

||||

|

||||

### 7. 安装你偏好的电子邮件客户端 ###

|

||||

### 7. 安装你喜欢的电子邮件客户端 ###

|

||||

|

||||

openSUSE 自带 Kmail 或 Evolution,这取决于你安装的桌面环境。我用的是 Plasma,自带 Kmail,这个邮件客户端还有许多地方有待改进。我建议可以试试 Thunderbird 或 Evolution。所有主要的邮件客户端都能在官方仓库找到。你还可以看看我的[精心挑选的 Linux 最佳邮件客户端][7]。

|

||||

openSUSE 自带 Kmail 或 Evolution,这取决于你安装的桌面环境。我用的是 KDE Plasma 自带的 Kmail,这个邮件客户端还有许多地方有待改进。我建议可以试试 Thunderbird 或 Evolution。所有主要的邮件客户端都能在官方仓库找到。你还可以看看我[精心挑选的 Linux 最佳邮件客户端][7]。

|

||||

|

||||

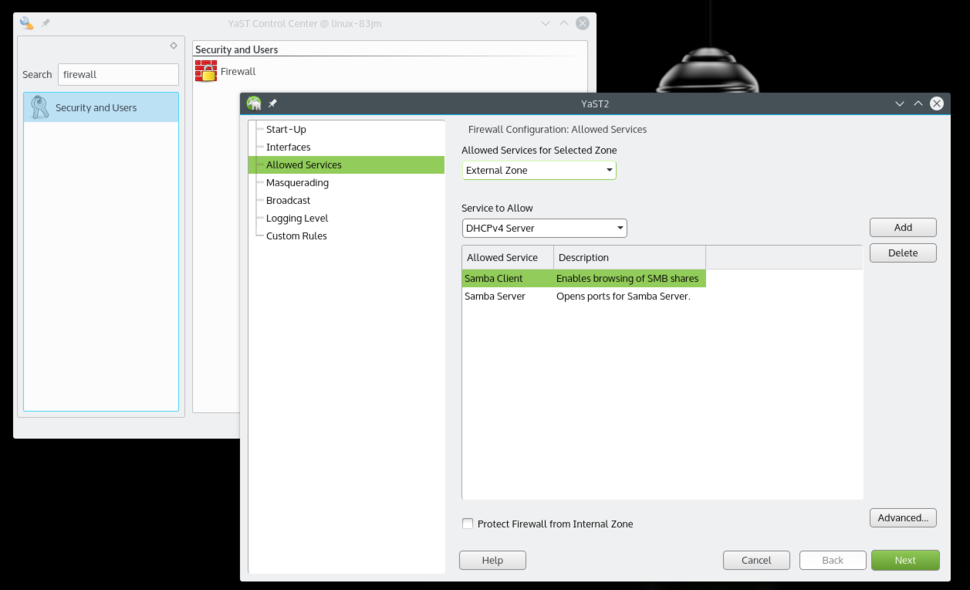

### 8. 在防火墙允许 Samba 服务 ###

|

||||

|

||||

相比于其它发行版,openSUSE 默认提供了更加安全的系统。但对新用户来说它也需要一点设置。如果你正在使用 Samba 协议分享文件到本地网络的话,你需要在防火墙允许该服务。

|

||||

|

||||

|

||||

在防火墙设置里允许 Samba 客户端和服务端

|

||||

|

||||

打开 YaST 并搜索 Firewall。在防火墙设置里,到“允许的服务”那里你会在“要允许的服务”下面看到一个下拉列表。选择“Samba 客户端”,然后点击“添加”。对“Samba 服务端”也一样地添加。都添加了之后,点击“下一步”,然后点击“完成”,现在你就可以通过本地网络从你的 openSUSE 分享文件以及访问其它机器了。

|

||||

*在防火墙设置里允许 Samba 客户端和服务端*

|

||||

|

||||

打开 YaST 并搜索 Firewall。在防火墙设置里,进入到“允许的服务(Allowed Services)”,你会在“要允许的服务(Service to allow)”下面看到一个下拉列表。选择“Samba 客户端”,然后点击“添加”。同样方法添加“Samba 服务器”。都添加了之后,点击“下一步”,然后点击“完成”,现在你就可以通过本地网络从你的 openSUSE 分享文件以及访问其它机器了。

|

||||

|

||||

这差不多就是我以我喜欢的方式对我的新 openSUSE 系统做的所有设置了。如果你有任何问题,欢迎在评论区提问。

|

||||

|

||||

@ -95,7 +98,7 @@ via: http://www.itworld.com/article/3003865/open-source-tools/8-things-to-do-aft

|

||||

|

||||

作者:[Swapnil Bhartiya][a]

|

||||

译者:[alim0x](https://github.com/alim0x)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[Caroline](https://github.com/carolinewuyan)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

53

published/20151202 KDE vs GNOME vs XFCE Desktop.md

Normal file

53

published/20151202 KDE vs GNOME vs XFCE Desktop.md

Normal file

@ -0,0 +1,53 @@

|

||||

KDE、GNOME 和 XFCE 桌面比较

|

||||

================================================================================

|

||||

|

||||

|

||||

这么多年来,很多人一直都在他们的 linux 桌面端使用 KDE 或者 GNOME 桌面环境。在这两个桌面环境多年不断发展的同时,其它的桌面也在持续增加它们的用户规模。举个例子说,在轻量级桌面环境下,XFCE 一举成为了最受欢迎的桌面环境,相较于 LXDE 缺少的优美视觉效果,默认配置下的 XFCE 在这方面就可以打败前者。XFCE 提供的功能特性都能在 GNOME2 下得到,然而,在一些较老的计算机上,它的轻量级的特性却能取得更好的效果。

|

||||

|

||||

### 桌面主题定制 ###

|

||||

|

||||

用户完成安装之后,XFCE 看起来可能会有一点无趣,因为它在视觉上还缺少一些吸引力。但是,请不要误解我的话, XFCE 仍然拥有漂亮的桌面,但是对于大多数刚刚接触 XFCE 桌面环境的人来说,可能它看起来像香草一样普普通通。不过好消息是当我们想要给 XFCE 安装新的主题的时候,这会是一个十分轻松的过程,因为你能够快速的找到你喜欢的 XFCE 主题,之后你就可以将它解压到一个合适的目录中。从这一点上来说,XFCE 自带的一个放在“外观”下的重要的图形界面工具可以帮助用户更加容易的选择中意的主题,这可能是目前在 XFCE 上这方面最好用的工具了。如果用户按照上面的建议去做的话,对于想要尝试使用 XFCE 的任何用户来说都将不存在困难。

|

||||

|

||||

在 GNOME 桌面上,用户也可以按照类似上面的方法去做。不过,其中最主要的不同点就是在你做之前,用户必须手动下载并安装 GNOME Tweak Tool。当然,对于使用来说都不会有什么障碍,但是对于用户来说,使用 XFCE 安装和激活主题并不需要去额外去下载安装各种调整工具,这可能是他们无法忽略的一个优势。而在 GNOME 上,尤其是在用户已经下载并安装了 GNOME Tweak tool 之后,你仍将必须确保你已经安装了“用户主题扩展”。

|

||||

|

||||

同 XFCE 一样,用户需要去搜索并下载自己喜欢的主题,然后,用户可以再次使用 GNOME Tweak tool,并点击该工具界面左边的“外观”按钮,接着用户便可以直接查看页面底部并点击文件浏览按钮,然后浏览到那个压缩的文件夹并打开。当完成这些之后,用户将会看到一个告诉用户已经成功应用了主题的对话框,这样你的主题便已经安装完成。然后用户就可以简单的使用下拉菜单来选择他们想要的主题。和 XFCE 一样,主题激活的过程也是十分简单的,然而,对于因为要使用一个新的主题而去下载一个没有预先安装到系统里面的应用,这种情况也是需要考虑的。

|

||||

|

||||

最后,就是 KDE 桌面主题定制的过程了。和 XFCE 一样,不需要去下载额外的工具来安装主题。从这点来看,让人有种XFCE 可能要被 KDE 战胜了的感觉。不仅在 KDE 上可以完全使用图形用户界面来安装主题,而且甚至只需要用户点击获取新主题的按钮就可以找到、查看新的主题,并且最后自动安装。

|

||||

|

||||

然而,我们应该注意到 KDE 相比 XFCE 而言,是一个更加健壮完善的桌面环境。当然,对于主要以极简设计为目的的桌面来说,缺失一些更多的功能是有一定的道理的。为此,我们要为这样优秀的功能给 KDE 加分。

|

||||

|

||||

### MATE 不是一个轻量级的桌面环境 ###

|

||||

|

||||

在继续比较 XFCE、GNOME3 和 KDE 之前,对于老手我们需要澄清一下,我们没有将 MATE 桌面环境加入到我们的比较中。MATE 可被看作是 GNOME2 的另一个衍生品,但是它并没有主要作为一款轻量级或者快捷桌面出现。相反,它的主要目的是成为一款更加传统和舒适的桌面环境,并使它的用户在使用它时就像在家里一样舒适。

|

||||

|

||||

另一方面,XFCE 生来就是要实现他自己的一系列使命。XFCE 给它的用户提供了一个更轻量而仍保持吸引人的视觉体验的桌面环境。然后,对于一些认为 MATE 也是一款轻量级的桌面环境的人来说,其实 MATE 真正的目标并不是成为一款轻量级的桌面环境。这两种选择在各自安装了一款好的主题之后看起来都会让人觉得非常具有吸引力。

|

||||

|

||||

### 桌面导航 ###

|

||||

|

||||

XFCE 除了桌面,还提供了一个醒目的导航器。任何使用过传统的 Windows 或者 GNOME 2/MATE 桌面环境的用户都可以在没有任何帮助的情况下自如的使用新安装的 XFCE 桌面环境的导航器。紧接着,添加小程序到面板中也是很显眼的。就像找一个已经安装的应用程序一样,直接使用启动器并点击你想要运行的应用程序图标就行。除了 LXDE 和 MATE 之外,还没有其他的桌面的导航器可以做到如此简单。不仅如此,更好的是控制面板的使用是非常容易使用的,对于刚刚使用这个新桌面的用户来说这是一个非常大的好处。如果用户更喜欢通过老式的方法去使用他们的桌面,那么 GNOME 就不合适。通过热角而取代了最小化按钮,加上其他的应用排布方式,这可以让大多数新用户易于使用它。

|

||||

|

||||

如果用户来自类似 Windows 这样的桌面环境,那么这些用户需要摒弃这些习惯,不能简单的通过鼠标右击一下就将一个小程序添加到他们的工作空间顶部。与此相反,它可以通过使用扩展来实现。GNOME 是可以安装拓展的,并且是非常的容易,这些容易之处体现在只需要用户简单的使用位于 GNOME 扩展页面上的 on/off 开关即可。不过,用户必须知道这个东西,才能真正使用上这个功能。

|

||||

|

||||

另一方面,GNOME 正在它的外观中体现它的设计理念,即为用户提供一个直观和易用的控制面板。你可能认为那并不是什么大事,但是,在我看来,它确实是我认为值得称赞并且有必要被提及的方面。KDE 给它的用户提供了更多的传统桌面使用体验,并通过提供相似的启动器和一种更加类似的获取软件的方式的能力来迎合来自 Windows 的用户。添加小部件或者小程序到 KDE 桌面是件非常简单的事情,只需要在桌面上右击即可。唯一的问题是 KDE 中这个功能不好发现,就像 KDE 中的其它东西一样,对于用户来说好像是隐藏的。KDE 的用户可能不同意我的观点,但我仍然坚持我的说法。

|

||||

|

||||

要增加一个小部件,只要在“我的面板”上右击就可以看见面板选项,但是并不是安装小部件的一个直观的方法。你并不能看见“添加部件”,除非你选择了“面板选项”,然后才能看见“添加部件”。这对我来说不是个问题,但是对于一些用户来说,它变成了不必要的困惑。而使事情变得更复杂的是,在用户能够找到部件区域后,他们后来发现一种称为“活动”的新术语。它和部件在同一个地方,可是它在自己的区域却是另外一种行为。

|

||||

|

||||

现在请不要误解我,KDE 中的活动特性是很不错的,也是很有价值的,但是从可用性的角度看,为了不让新手感到困惑,它更加适合于放在另一个菜单项。用户各有不同,但是让新用户多测试一段时间可以让它不断改进。对“活动”的批评先放一边,KDE 添加新部件的方法的确很棒。与 KDE 的主题一样,用户不能通过使用提供的图形用户界面浏览和自动安装部件。这是一个有点神奇的功能,但是它这样也可以工作。KDE 的控制面板可能和用户希望的样子不一样,它不是足够的简单。但是有一点很清楚,这将是他们致力于改进的地方。

|

||||

|

||||

### 因此,XFCE 是最好的桌面环境,对吗? ###

|

||||

|

||||

就我自己而言,我在我的计算机上使用 GNOME、KDE,并在我的办公室和家里的电脑上使用 Xfce。我也有一些老机器在使用 Openbox 和 LXDE。每一个桌面的体验都可以给我提供一些有用的东西,可以帮助我以适合的方式使用每台机器。对我来说,Xfce 是我的心中的挚爱,因为 Xfce 是一个我使用了多年的桌面环境。但对于这篇文章,我是用我日常使用的机器来撰写的,事实上,它用的是 GNOME。

|

||||

|

||||

这篇文章的主要思想是,对于那些正在寻找稳定的、传统的、容易理解的桌面环境的用户来说,我还是觉得 Xfce 能提供好一点的用户体验。欢迎您在评论部分和我们分享你的意见。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.unixmen.com/kde-vs-gnome-vs-xfce-desktop/

|

||||

|

||||

作者:[M.el Khamlichi][a]

|

||||

译者:[kylepeng93](https://github.com/kylepeng93)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.unixmen.com/author/pirat9/

|

||||

67

published/20151227 Upheaval in the Debian Live project.md

Normal file

67

published/20151227 Upheaval in the Debian Live project.md

Normal file

@ -0,0 +1,67 @@

|

||||

Debian Live项目的剧变

|

||||

==================================================================================

|

||||

|

||||

尽管围绕 Debian Live 项目发生了很多戏剧性事件,关于 [Debian Live 项目][1]结束的[公告][2]的影响力甚至小于该项目首次出现时的公告。主要开发者的离开是最显而易见的损失,而社区对他本人及其项目的态度是很令人困惑的,但是这个项目也许还是会以其他的形式继续下去。所以 Debian 仍然会有更多的工具去创造启动光盘和其他介质。尽管是用这样一种有遗憾的方式,项目创始人 Dabiel Baumann 和 Debian CD 团队以及安装检测团队之间出现的长期争论已经被「解决」了。

|

||||

在 11 月 9 日, Baumann 发表了题为「 Debian Live 项目的突然结束」的一篇公告。在那篇短文中,他一一列举出了自从这个和他有关的[项目被发起][3]以来近 10 年间发生的不同的事件,这些事件可以表明他在 Debian Live 项目上的努力一直没有被重视或没有被足够重视。最具决定性的因素是因为在「包的含义」上存在冲突, R.Learmonth [申请][4]了新的包名,而这侵犯了在 Debian Live 上使用的命名空间。

|

||||

|

||||

考虑到最主要的 Debian Live 包之一被命名为 live-build ,而 R.Learmonth 申请的新包名却是 live-build-ng ,这简直是对 live-build 的挑战。 live-build-ng 意为一种围绕 [vmdebootstrap][5]【译者注:创造真实的和虚拟机Debian的磁盘映像】工具的外部包装,这种包装是为了创造 live 介质(光盘和USB的插入),也是 Debian Live 最需要的的部分。但是当 Baumann Learmonth [要求][6]为他的包换一个不同的名字的时候,他得到了一个「有趣」的[回复][7]:

|

||||

|

||||

```

|

||||

应该注意到, live-build 不是一个 Debian 项目,它是一个声称自己是官方 Debian 项目的外部项目,这是一个需要我们解决的问题。

|

||||

这不是命名空间的问题,我们要将以目前维护的 live-config 和 live-boot 包为基础,把它们加入到 Debian 的本地项目。如果迫不得已的话,这将会有很多分支,但是我希望它不要发生,这样的话我们就可以把这些包整合到 Debian 中并继续以一种协作的方式去开发。

|

||||

live-build 已经被 debian-cd 放弃,live-build-ng 将会取代它。至少在一个精简的 Debian 环境中,live-build 会被放弃。我们(开发团队)正在与 debian-cd 和 Debian Installer 团队合作开发 live-build-ng 。

|

||||

```

|

||||

|

||||

Debian Live 是一个「官方的」 Debian 项目(也可以是狭义的「官方」),尽管它因为思路上的不同产生过争论。除此之外, vmdebootstrap 的维护者 Neil Willians 为脱离 Debian Live 项目[提供了如下的解释][8]:

|

||||

|

||||

```

|

||||

为了更好的支持 live-build 的代替者, vmdebootstrap 肯定会被推广。为了能够用 live-build 解决目前存在的问题,这项工作会由 debian-cd 团队来负责。这些问题包括可靠性问题,以及不能很好的支持多种机器和 UEFI 等。 vmdebootstrap 也存在着这些问题,我们用来自于对 live-boot 和 live-config 的支持情况来确定 vmdebootstrap 的功能。

|

||||

```

|

||||

|

||||

这些抱怨听起来合情合理,但是它们可能已经在目前的项目中得到了解决。然而一些秘密的项目有很明显的取代 live-build 的意图。正如 Baumann [指出][9]的,这些计划没有被发布到 debian-live 的邮件列表中。人们首次从 Debian Live 项目中获知这些计划正是因为这一次的ITP事件,所以它看起来像是一个「秘密计划」——有些事情在像 Debian 这样的项目中得不到很好的安排。

|

||||

|

||||

人们可能已经猜到了,有很多帖子都支持 Baumann [重命名][10] live-build-ng 的请求,但是紧接着,人们就因为他要停止继续在 Debian Live 上工作的决定而变得沮丧。然而 Learmonth 和 Williams 却坚持认为取代 live-build 很有必要。Learmonth 给 live-build-ng 换了一个争议性也许小一些的名字: live-wrapper 。他说他的目标是为 Debian Live 项目加入新的工具(并且「把 Debian Live 项目引入 Debian 里面」),但是完成这件事还需要很大的努力。

|

||||

|

||||

```

|

||||

我向已经被 ITP 问题所困扰的每个人道歉。我们已经告知大家 live-wrapper 还不足以完全替代 live-build 且开发工作仍在进行以收集反馈。尽管有了这部分的工作,我们收到的反馈缺并不是我们所需要的。

|

||||

```

|

||||

|

||||

这种对于取代 live-build 的强烈反对或许已经被预知到了。自由软件社区的沟通和交流很关键,所以,计划去替换一个项目的核心很容易引起争议——更何况是一个一直不为人所知的计划。从 Banumann 的角度来说,他当然不是完美的,他因为上传个不合适的 [syslinux 包][11]导致了 wheezy 的延迟发布,并且从那以后他被从 Debian 开发者暂时[降级][12]为 Debian 维护者。但是这不意味着他应该受到这种对待。当然,这个项目还有其他人参与,所以不仅仅是 Baumann 受到了影响。

|

||||

|

||||

Ben Armstrong 是其他参与者中的一位,在这个事件中,他很圆滑地处理了一些事,并且想从这个事件中全身而退。他从一封邮件[13]开始,这个邮件是为了庆祝这个项目,以及他和他的团队在过去几年取得的成果。正如他所说, Debian Live 的[下游项目列表][14]是很令人振奋的。在另一封邮件中,他也[指出][15]了这个项目不是没有生命力的:

|

||||

|

||||

```

|

||||

如果 Debian CD 开发团队通过他们的努力开发出可行的、可靠的、经过完善测试替代品,以及一个合适的取代 live-build 的候选者,这对于 Debian 项目有利无害。如果他们继续做这件事,他们不会「用一个官方改良,但不可靠且几乎没有经过测试的待选者取代 live-build 」。到目前为止,我还没有看到他们那样做的迹象。其间, live-build 仍保留在存档中——它仍然处于良好状态,且没有一种经过改良的继任者来取代它,因此开发团队没有必要尽快删除它。

|

||||

```

|

||||

|

||||

11 月 24 号, Armstrong 也在[他的博客][16]上[发布][17]了一个有关 Debian Live 的新消息。它展示了从 Baumann 退出起两周内的令人高兴的进展。甚至有迹象表明 Debian Live 项目与 live-wrapper 开发者开展了合作。博客上也有了一个[计划表][18],同时不可避免地寻求更多的帮助。这让人们有理由相信围绕项目发生的戏剧性事件仅仅是一个小摩擦——也许不可避免,但绝不是像现在看起来这么糟糕。

|

||||

|

||||

---------------------------------

|

||||

|

||||

via: https://lwn.net/Articles/665839/

|

||||

|

||||

作者:Jake Edge

|

||||

译者:[vim-kakali](https://github.com/vim-kakali)

|

||||

校对:[PurlingNayuki](https://github.com/PurlingNayuki)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

|

||||

[1]: https://lwn.net/Articles/666127/

|

||||

[2]: http://live.debian.net/

|

||||

[3]: https://www.debian.org/News/weekly/2006/08/

|

||||

[4]: https://bugs.debian.org/cgi-bin/bugreport.cgi?bug=804315

|

||||

[5]: http://liw.fi/vmdebootstrap/

|

||||

[6]: https://lwn.net/Articles/666173/

|

||||

[7]: https://lwn.net/Articles/666176/

|

||||

[8]: https://lwn.net/Articles/666181/

|

||||

[9]: https://lwn.net/Articles/666208/

|

||||

[10]: https://lwn.net/Articles/666321/

|

||||

[11]: https://bugs.debian.org/cgi-bin/bugreport.cgi?bug=699808

|

||||

[12]: https://nm.debian.org/public/process/14450

|

||||

[13]: https://lwn.net/Articles/666336/

|

||||

[14]: http://live.debian.net/project/downstream/

|

||||

[15]: https://lwn.net/Articles/666338/

|

||||

[16]: https://lwn.net/Articles/666340/

|

||||

[17]: http://syn.theti.ca/2015/11/24/debian-live-after-debian-live/

|

||||

[18]: https://wiki.debian.org/DebianLive/TODO

|

||||

127

published/20160204 An Introduction to SELinux.md

Normal file

127

published/20160204 An Introduction to SELinux.md

Normal file

@ -0,0 +1,127 @@

|

||||

SELinux 入门

|

||||

===============================

|

||||

|

||||

回到 Kernel 2.6 时代,那时候引入了一个新的安全系统,用以提供访问控制安全策略的机制。这个系统就是 [Security Enhanced Linux (SELinux)][1],它是由[美国国家安全局(NSA)][2]贡献的,它为 Linux 内核子系统引入了一个健壮的强制控制访问(Mandatory Access Control)架构。

|

||||

|

||||

如果你在之前的 Linux 生涯中都禁用或忽略了 SELinux,这篇文章就是专门为你写的:这是一篇对存在于你的 Linux 桌面或服务器之下的 SELinux 系统的介绍,它能够限制权限,甚至消除程序或守护进程的脆弱性而造成破坏的可能性。

|

||||

|

||||

在我开始之前,你应该已经了解的是 SELinux 主要是红帽 Red Hat Linux 以及它的衍生发行版上的一个工具。类似地, Ubuntu 和 SUSE(以及它们的衍生发行版)使用的是 AppArmor。SELinux 和 AppArmor 有显著的不同。你可以在 SUSE,openSUSE,Ubuntu 等等发行版上安装 SELinux,但这是项难以置信的挑战,除非你十分精通 Linux。

|

||||

|

||||

说了这么多,让我来向你介绍 SELinux。

|

||||

|

||||

### DAC vs. MAC

|

||||

|

||||

Linux 上传统的访问控制标准是自主访问控制(Discretionary Access Control,DAC)。在这种形式下,一个软件或守护进程以 User ID(UID)或 Set owner User ID(SUID)的身份运行,并且拥有该用户的目标(文件、套接字、以及其它进程)权限。这使得恶意代码很容易运行在特定权限之下,从而取得访问关键的子系统的权限。

|

||||

|

||||

另一方面,强制访问控制(Mandatory Access Control,MAC)基于保密性和完整性强制信息的隔离以限制破坏。该限制单元独立于传统的 Linux 安全机制运作,并且没有超级用户的概念。

|

||||

|

||||

### SELinux 如何工作

|

||||

|

||||

考虑一下 SELinux 的相关概念:

|

||||

|

||||

- 主体(Subjects)

|

||||

- 目标(Objects)

|

||||

- 策略(Policy)

|

||||

- 模式(Mode)

|

||||

|

||||

当一个主体(Subject,如一个程序)尝试访问一个目标(Object,如一个文件),SELinux 安全服务器(SELinux Security Server,在内核中)从策略数据库(Policy Database)中运行一个检查。基于当前的模式(mode),如果 SELinux 安全服务器授予权限,该主体就能够访问该目标。如果 SELinux 安全服务器拒绝了权限,就会在 /var/log/messages 中记录一条拒绝信息。

|

||||

|

||||

听起来相对比较简单是不是?实际上过程要更加复杂,但为了简化介绍,只列出了重要的步骤。

|

||||

|

||||

### 模式

|

||||

|

||||

SELinux 有三个模式(可以由用户设置)。这些模式将规定 SELinux 在主体请求时如何应对。这些模式是:

|

||||

|

||||

- Enforcing (强制)— SELinux 策略强制执行,基于 SELinux 策略规则授予或拒绝主体对目标的访问

|

||||

- Permissive (宽容)— SELinux 策略不强制执行,不实际拒绝访问,但会有拒绝信息写入日志

|

||||

- Disabled (禁用)— 完全禁用 SELinux

|

||||

|

||||

|

||||

|

||||

*图 1:getenforce 命令显示 SELinux 的状态是 Enforcing 启用状态。*

|

||||

|

||||

默认情况下,大部分系统的 SELinux 设置为 Enforcing。你要如何知道你的系统当前是什么模式?你可以使用一条简单的命令来查看,这条命令就是 `getenforce`。这个命令用起来难以置信的简单(因为它仅仅用来报告 SELinux 的模式)。要使用这个工具,打开一个终端窗口并执行 `getenforce` 命令。命令会返回 Enforcing、Permissive,或者 Disabled(见上方图 1)。

|

||||

|

||||

设置 SELinux 的模式实际上很简单——取决于你想设置什么模式。记住:**永远不推荐关闭 SELinux**。为什么?当你这么做了,就会出现这种可能性:你磁盘上的文件可能会被打上错误的权限标签,需要你重新标记权限才能修复。而且你无法修改一个以 Disabled 模式启动的系统的模式。你的最佳模式是 Enforcing 或者 Permissive。

|

||||

|

||||

你可以从命令行或 `/etc/selinux/config` 文件更改 SELinux 的模式。要从命令行设置模式,你可以使用 `setenforce` 工具。要设置 Enforcing 模式,按下面这么做:

|

||||

|

||||

1. 打开一个终端窗口

|

||||

2. 执行 `su` 然后输入你的管理员密码

|

||||

3. 执行 `setenforce 1`

|

||||

4. 执行 `getenforce` 确定模式已经正确设置(图 2)

|

||||

|

||||

|

||||

|

||||

*图 2:设置 SELinux 模式为 Enforcing。*

|

||||

|

||||

要设置模式为 Permissive,这么做:

|

||||

|

||||

1. 打开一个终端窗口

|

||||

2. 执行 `su` 然后输入你的管理员密码

|

||||

3. 执行 `setenforce 0`

|

||||

4. 执行 `getenforce` 确定模式已经正确设置(图 3)

|

||||

|

||||

|

||||

|

||||

*图 3:设置 SELinux 模式为 Permissive。*

|

||||

|

||||

注:通过命令行设置模式会覆盖 SELinux 配置文件中的设置。

|

||||

|

||||

如果你更愿意在 SELinux 命令文件中设置模式,用你喜欢的编辑器打开那个文件找到这一行:

|

||||

|

||||

SELINUX=permissive

|

||||

|

||||

你可以按你的偏好设置模式,然后保存文件。

|

||||

|

||||

还有第三种方法修改 SELinux 的模式(通过 bootloader),但我不推荐新用户这么做。

|

||||

|

||||

### 策略类型

|

||||

|

||||

SELinux 策略有两种:

|

||||

|

||||

- Targeted — 只有目标网络进程(dhcpd,httpd,named,nscd,ntpd,portmap,snmpd,squid,以及 syslogd)受保护

|

||||

- Strict — 对所有进程完全的 SELinux 保护

|

||||

|

||||

你可以在 `/etc/selinux/config` 文件中修改策略类型。用你喜欢的编辑器打开这个文件找到这一行:

|

||||

|

||||

SELINUXTYPE=targeted

|

||||

|

||||

修改这个选项为 targeted 或 strict 以满足你的需求。

|

||||

|

||||

### 检查完整的 SELinux 状态

|

||||

|

||||

有个方便的 SELinux 工具,你可能想要用它来获取你启用了 SELinux 的系统的详细状态报告。这个命令在终端像这样运行:

|

||||

|

||||

sestatus -v

|

||||

|

||||

你可以看到像图 4 那样的输出。

|

||||

|

||||

|

||||

|

||||

*图 4:sestatus -v 命令的输出。*

|

||||

|

||||

### 仅是皮毛

|

||||

|

||||

和你预想的一样,我只介绍了 SELinux 的一点皮毛。SELinux 的确是个复杂的系统,想要更扎实地理解它是如何工作的,以及了解如何让它更好地为你的桌面或服务器工作需要更加地深入学习。我的内容还没有覆盖到疑难解答和创建自定义 SELinux 策略。

|

||||

|

||||

SELinux 是所有 Linux 管理员都应该知道的强大工具。现在已经向你介绍了 SELinux,我强烈推荐你回到 Linux.com(当有更多关于此话题的文章发表的时候)或看看 [NSA SELinux 文档][3] 获得更加深入的指南。

|

||||

|

||||

LCTT - 相关阅读:[鸟哥的 Linux 私房菜——程序管理与 SELinux 初探][4]

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.linux.com/learn/docs/ldp/883671-an-introduction-to-selinux

|

||||

|

||||

作者:[Jack Wallen][a]

|

||||

译者:[alim0x](https://github.com/alim0x)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.linux.com/community/forums/person/93

|

||||

[1]: http://selinuxproject.org/page/Main_Page

|

||||

[2]: https://www.nsa.gov/research/selinux/

|

||||

[3]: https://www.nsa.gov/research/selinux/docs.shtml

|

||||

[4]: http://vbird.dic.ksu.edu.tw/linux_basic/0440processcontrol_5.php

|

||||

@ -78,4 +78,4 @@ via: http://opensource.com/life/15/8/patricia-torvalds-interview

|

||||

[4]:https://www.facebook.com/guerrillafeminism

|

||||

[5]:https://modelviewculture.com/

|

||||

[6]:https://www.aspirations.org/

|

||||

[7]:https://www.facebook.com/groups/LadiesStormHackathons/

|

||||

[7]:https://www.facebook.com/groups/LadiesStormHackathons/

|

||||

|

||||

@ -1,53 +0,0 @@

|

||||

Which Open Source Linux Distributions Would Presidential Hopefuls Run?

|

||||

================================================================================

|

||||

|

||||

|

||||

Republican presidential candidate Donald Trump

|

||||

|

||||

If people running for president used Linux or another open source operating system, which distribution would it be? That's a key question that the rest of the press—distracted by issues of questionable relevance such as "policy platforms" and whether it's appropriate to add an exclamation point to one's Christian name—has been ignoring. But the ignorance ends here: Read on for this sometime-journalist's take on presidential elections and Linux distributions.

|

||||

|

||||

If this sounds like a familiar topic to those of you who have been reading my drivel for years (is anyone, other than my dear editor, unfortunate enough to have actually done that?), it's because I wrote a [similar post][1] during the last presidential election cycle. Some kind readers took that article more seriously than I intended, so I'll take a moment to point out that I don't actually believe that open source software and political campaigns have anything meaningful to do with one another. I am just trying to amuse myself at the start of a new week.

|

||||

|

||||

But you can make of this what you will. You're the reader, after all.

|

||||

|

||||

### Linux Distributions of Choice: Republicans ###

|

||||

|

||||

Today, I'll cover just the Republicans. And I won't even discuss all of them, since the candidates hoping for the Republican party's nomination are too numerous to cover fully here in one post. But for starters:

|

||||

|

||||

If **Jeb (Jeb!?) Bush** ran Linux, it would be [Debian][2]. It's a relatively boring distribution designed for serious, grown-up hackers—the kind who see it as their mission to be the adults in the pack and clean up the messes that less-experienced open source fans create. Of course, this also makes Debian relatively unexciting, and its user base remains perennially small as a result.

|

||||

|

||||

**Scott Walker**, for his part, would be a [Damn Small Linux][3] (DSL) user. Requiring merely 50MB of disk space and 16MB of RAM to run, DSL can breathe new life into 20-year-old 486 computers—which is exactly what a cost-cutting guru like Walker would want. Of course, the user experience you get from DSL is damn primitive; the platform barely runs a browser. But at least you won't be wasting money on new computer hardware when the stuff you bought in 1993 can still serve you perfectly well.

|

||||

|

||||

How about **Chris Christie**? He'd obviously be clinging to [Relax-and-Recover Linux][4], which bills itself as a "setup-and-forget Linux bare metal disaster recovery solution." "Setup-and-forget" has basically been Christie's political strategy ever since that unfortunate incident on the George Washington Bridge stymied his political momentum. Disaster recovery may or may not bring back everything for Christie in the end, but at least he might succeed in recovering a confidential email or two that accidentally disappeared when his computer crashed.

|

||||

|

||||

As for **Carly Fiorina**, she'd no doubt be using software developed for "[The Machine][5]" operating system from [Hewlett-Packard][6] (HPQ), the company she led from 1999 to 2005. The Machine actually may run several different operating systems, which may or may not be based on Linux—details remain unclear—and its development began well after Fiorina's tenure at HP came to a conclusion. Still, her roots as a successful executive in the IT world form an important part of her profile today, meaning that her ties to HP have hardly been severed fully.

|

||||

|

||||

Last but not least—and you knew this was coming—there's **Donald Trump**. He'd most likely pay a team of elite hackers millions of dollars to custom-build an operating system just for him—even though he could obtain a perfectly good, ready-made operating system for free—to show off how much money he has to waste. He'd then brag about it being the best operating system ever made, though it would of course not be compliant with POSIX or anything else, because that would mean catering to the establishment. The platform would also be totally undocumented, since, if Trump explained how his operating system actually worked, he'd risk giving away all his secrets to the Islamic State—obviously.

|

||||

|

||||

Alternatively, if Trump had to go with a Linux platform already out there, [Ubuntu][7] seems like the most obvious choice. Like Trump, the Ubuntu developers have taken a we-do-what-we-want approach to building open source software by implementing their own, sometimes proprietary applications and interfaces. Free-software purists hate Ubuntu for that, but plenty of ordinary people like it a lot. Of course, whether playing purely by your own rules—in the realms of either software or politics—is sustainable in the long run remains to be seen.

|

||||

|

||||

### Stay Tuned ###

|

||||

|

||||

If you're wondering why I haven't yet mentioned the Democratic candidates, worry not. I am not leaving them out of today's writing because I like them any more or less than the Republicans. (Personally, I think the peculiar American practice of having only two viable political parties—which virtually no other functioning democracy does—is ridiculous, and I am suspicious of all of these candidates as a result.)

|

||||

|

||||