diff --git a/published/20151118 Fabric – Automate Your Linux Administration Tasks and Application Deployments Over SSH.md b/published/20151118 Fabric – Automate Your Linux Administration Tasks and Application Deployments Over SSH.md

new file mode 100644

index 0000000000..fdd53956c4

--- /dev/null

+++ b/published/20151118 Fabric – Automate Your Linux Administration Tasks and Application Deployments Over SSH.md

@@ -0,0 +1,257 @@

+Fabric - 通过 SSH 来自动化管理 Linux 任务和布署应用

+===========================

+

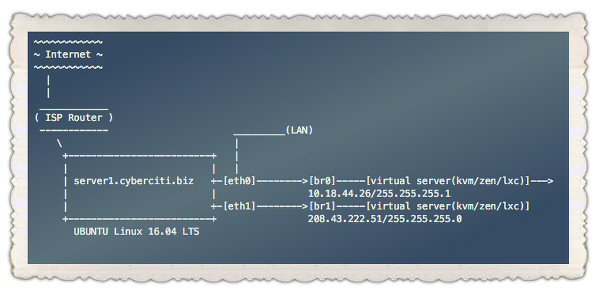

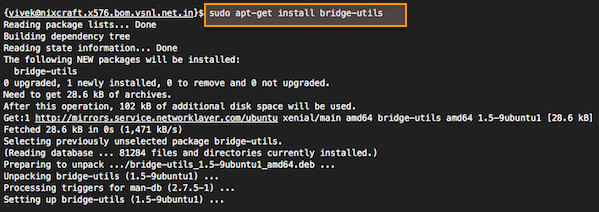

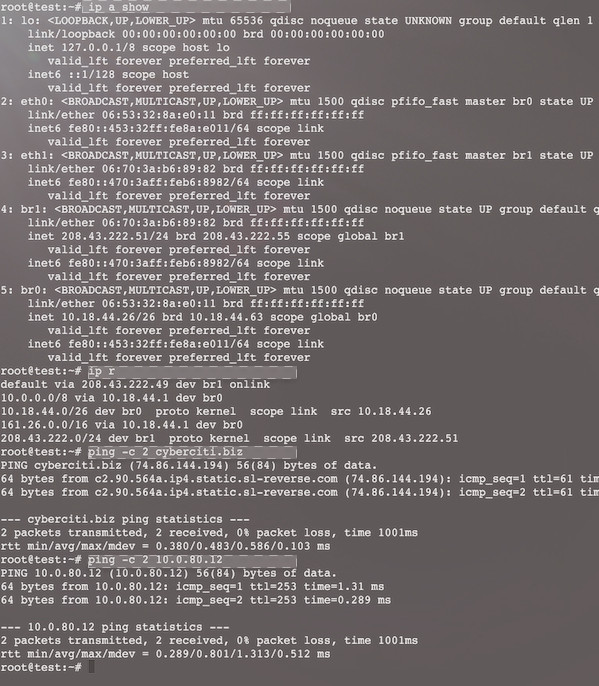

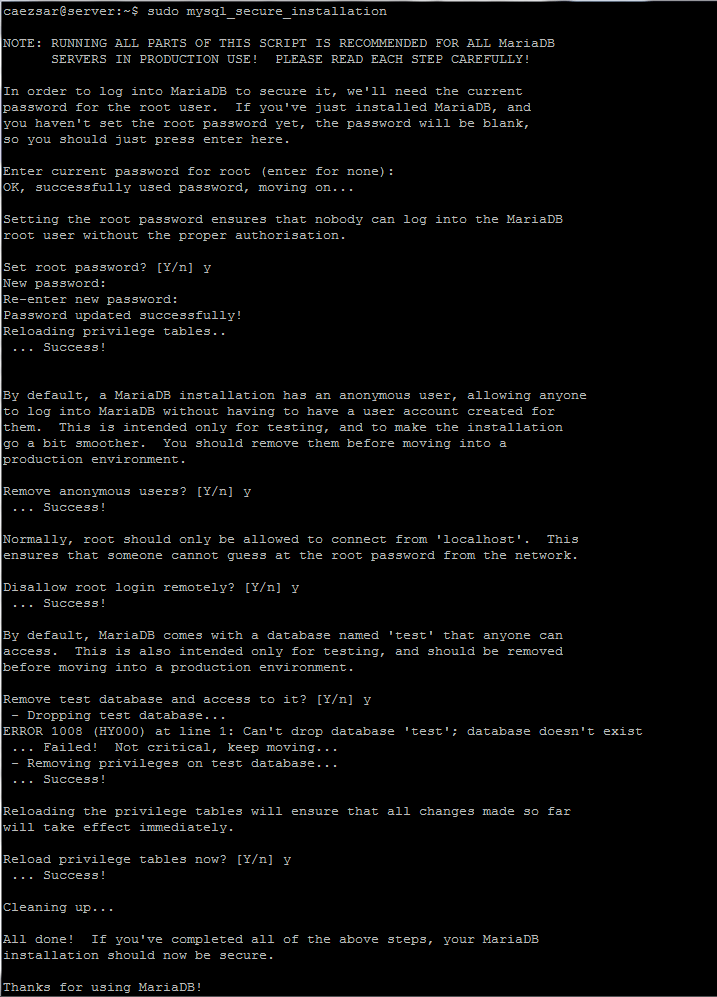

+当要管理远程机器或者要布署应用时,虽然你有多种命令行工具可以选择,但是其中很多工具都缺少详细的使用文档。

+

+在这篇教程中,我们将会一步一步地向你介绍如何使用 fabric 来帮助你更好得管理多台服务器。

+

+

+

+*使用 Fabric 来自动化地管理 Linux 任务*

+

+Fabric 是一个用 Python 编写的命令行工具库,它可以帮助系统管理员高效地执行某些任务,比如通过 SSH 到多台机器上执行某些命令,远程布署应用等。

+

+在使用之前,如果你拥有使用 Python 的经验能帮你更好的使用 Fabric。当然,如果没有那也不影响使用 Fabric。

+

+我们为什么要选择 Fabric:

+

+- 简单

+- 完备的文档

+- 如果你会 Python,不用增加学习其他语言的成本

+- 易于安装使用

+- 使用便捷

+- 支持多台机器并行操作

+

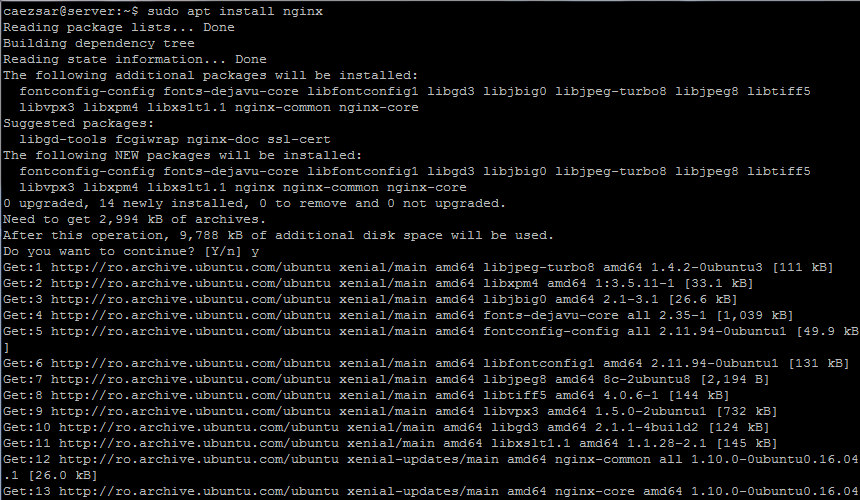

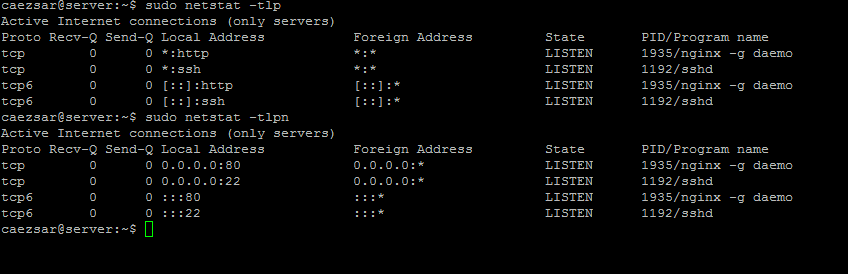

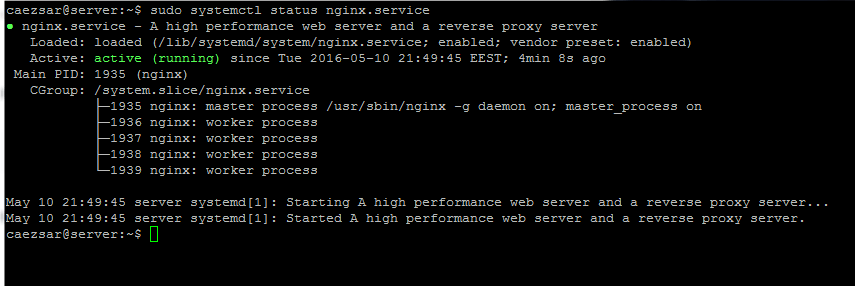

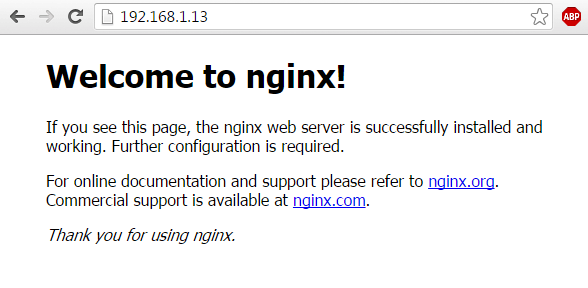

+### 在 Linux 上如何安装 Fabric

+

+Fabric 有一个特点就是要远程操作的机器只需要支持标准的 OpenSSH 服务即可。只要保证在机器上安装并开启了这个服务就能使用 Fabric 来管理机器。

+

+#### 依赖

+

+- Python 2.5 或更新版本,以及对应的开发组件

+- Python-setuptools 和 pip(可选,但是非常推荐)gcc

+

+我们推荐使用 pip 安装 Fabric,但是你也可以使用系统自带的包管理器如 `yum`, `dnf` 或 `apt-get` 来安装,包名一般是 `fabric` 或 `python-fabric`。

+

+如果是基于 RHEL/CentOS 的发行版本的系统,你可以使用系统自带的 [EPEL 源][1] 来安装 fabric。

+

+```

+# yum install fabric [适用于基于 RedHat 系统]

+# dnf install fabric [适用于 Fedora 22+ 版本]

+```

+

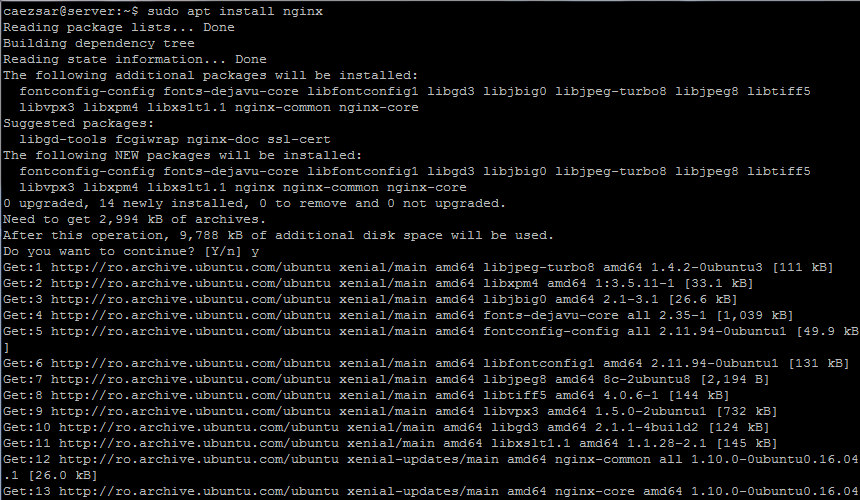

+如果你是 Debian 或者其派生的系统如 Ubuntu 和 Mint 的用户,你可以使用 apt-get 来安装,如下所示:

+

+```

+# apt-get install fabric

+```

+

+如果你要安装开发版的 Fabric,你需要安装 pip 来安装 master 分支上最新版本。

+

+```

+# yum install python-pip [适用于基于 RedHat 系统]

+# dnf install python-pip [适用于Fedora 22+ 版本]

+# apt-get install python-pip [适用于基于 Debian 系统]

+```

+

+安装好 pip 后,你可以使用 pip 获取最新版本的 Fabric。

+

+```

+# pip install fabric

+```

+

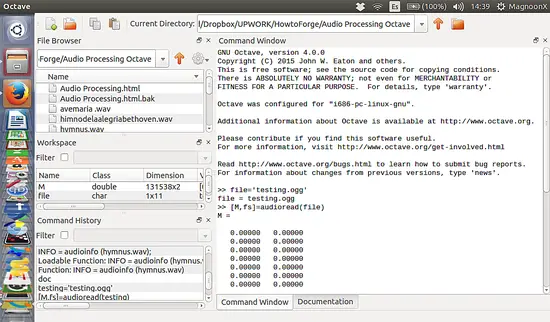

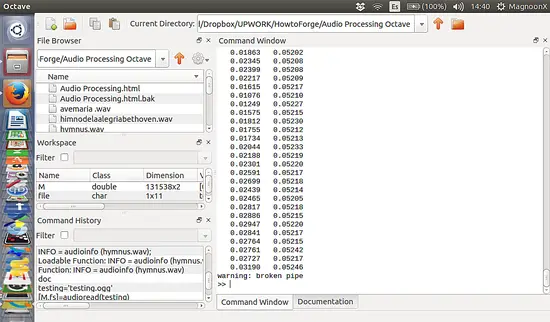

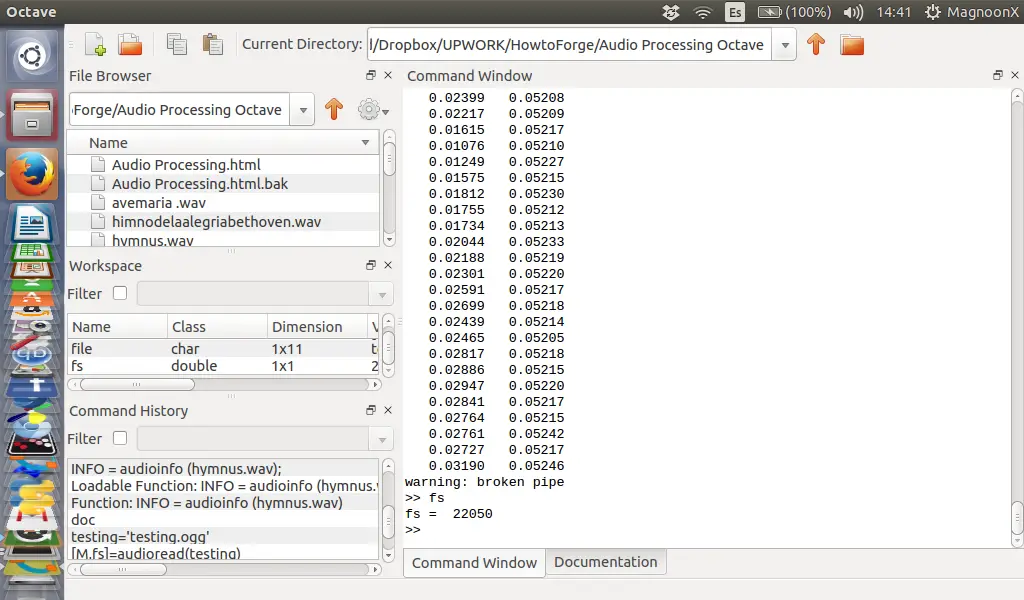

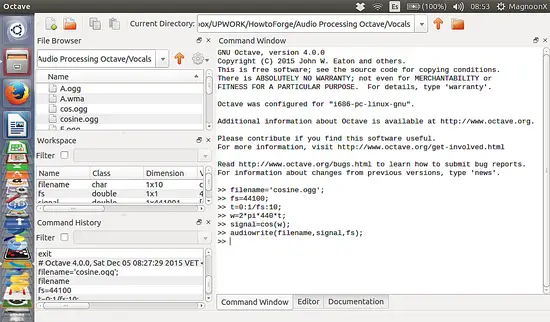

+### 如何使用 Fabric 来自动化管理 Linux 任务

+

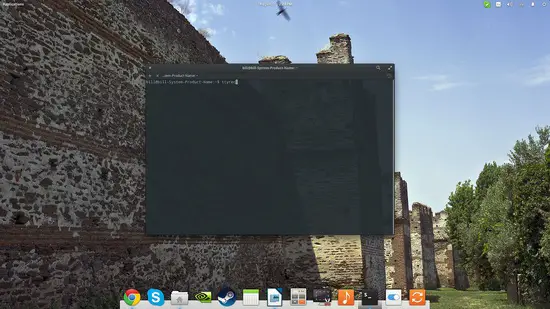

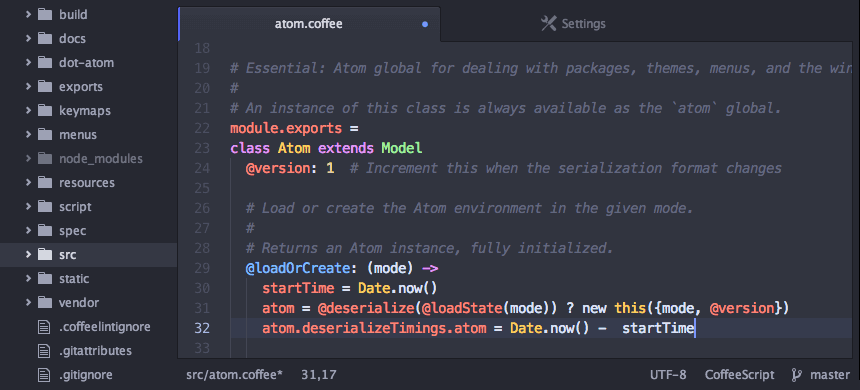

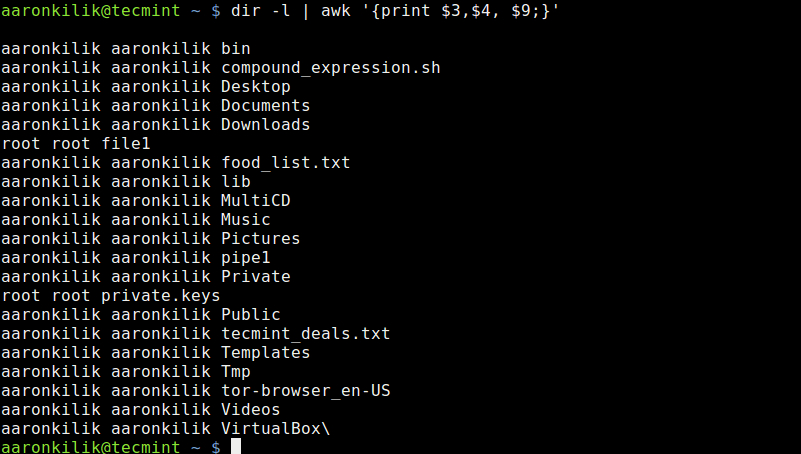

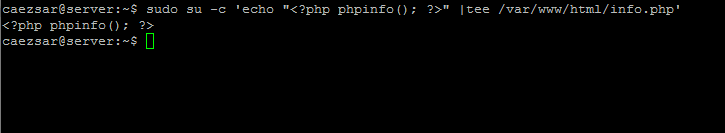

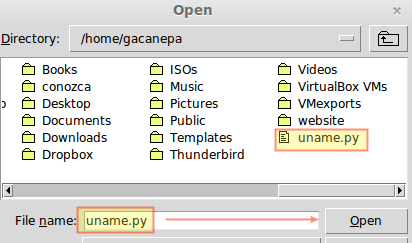

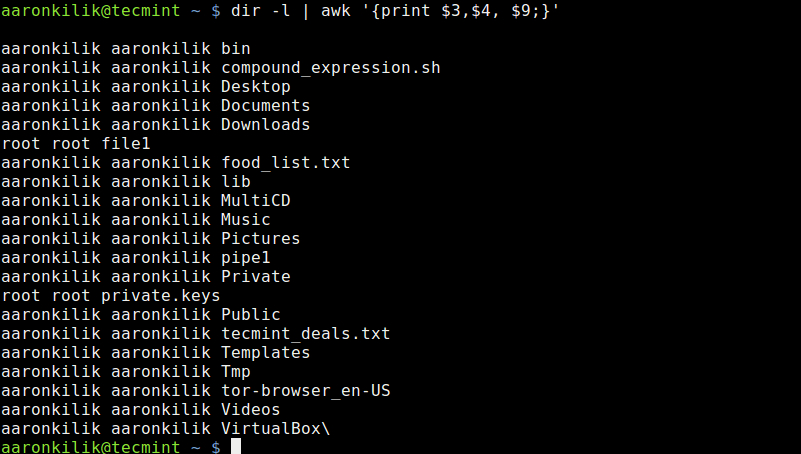

+现在我们来开始使用 Fabric,在之前的安装的过程中,Fabric Python 脚本已经被放到我们的系统目录,当我们要运行 Fabric 时输入 `fab` 命令即可。

+

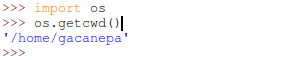

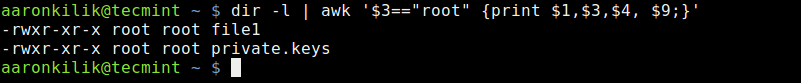

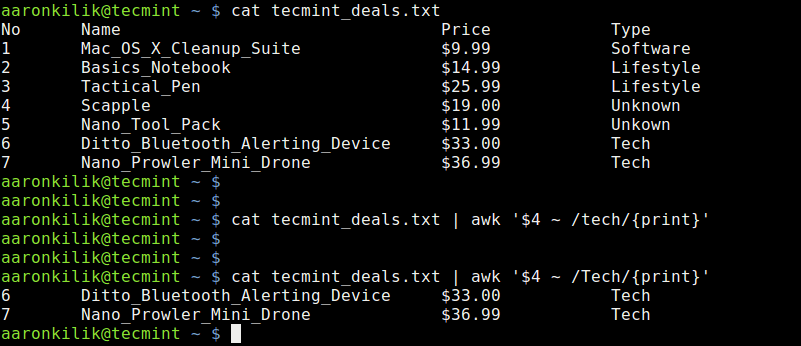

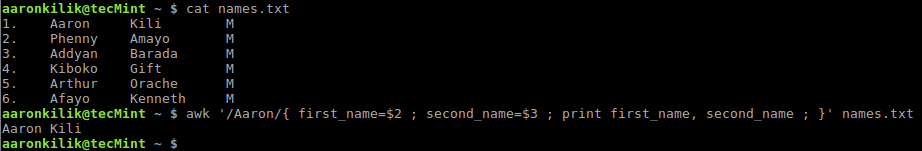

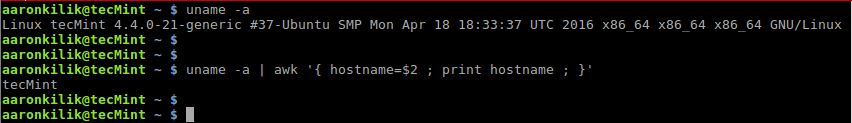

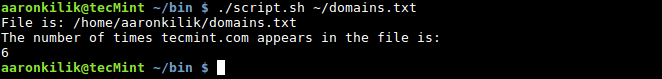

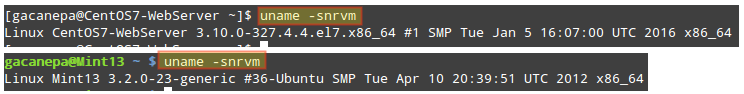

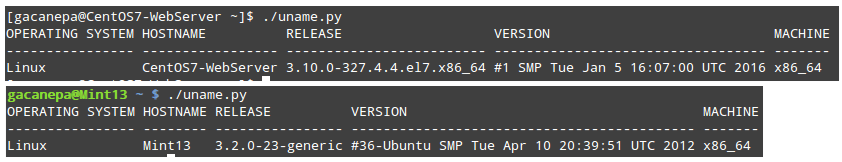

+#### 在本地 Linux 机器上运行命令行

+

+按照惯例,先用你喜欢的编辑器创建一个名为 fabfile.py 的 Python 脚本。你可以使用其他名字来命名脚本,但是就需要指定这个脚本的路径,如下所示:

+

+```

+# fabric --fabfile /path/to/the/file.py

+```

+

+Fabric 使用 `fabfile.py` 来执行任务,这个文件应该放在你执行 Fabric 命令的目录里面。

+

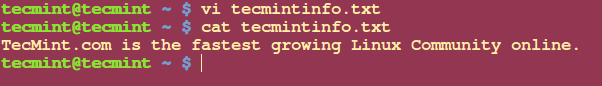

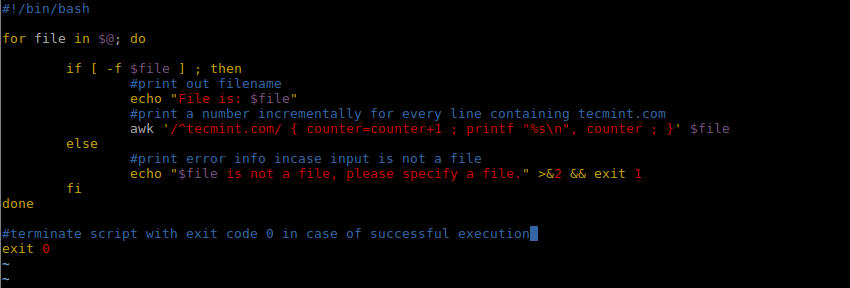

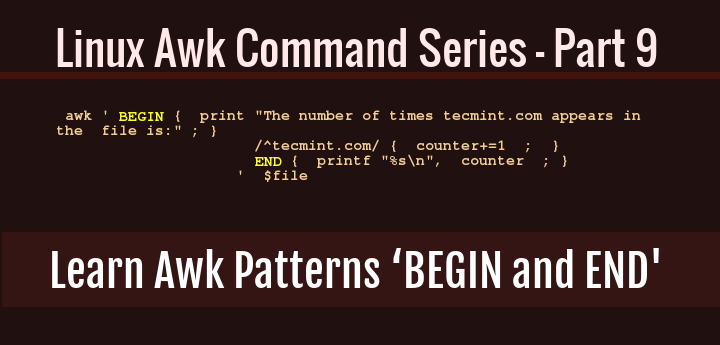

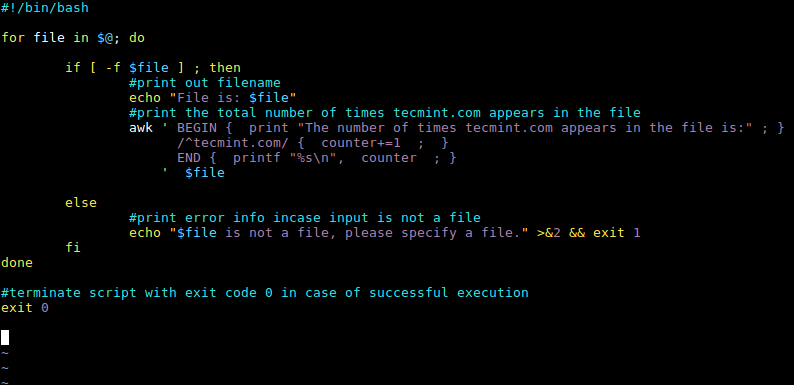

+**例子 1**:创建入门的 `Hello World` 任务:

+

+```

+# vi fabfile.py

+```

+

+在文件内输入如下内容:

+

+```

+def hello():

+ print('Hello world, Tecmint community')

+```

+

+保存文件并执行以下命令:

+

+```

+# fab hello

+```

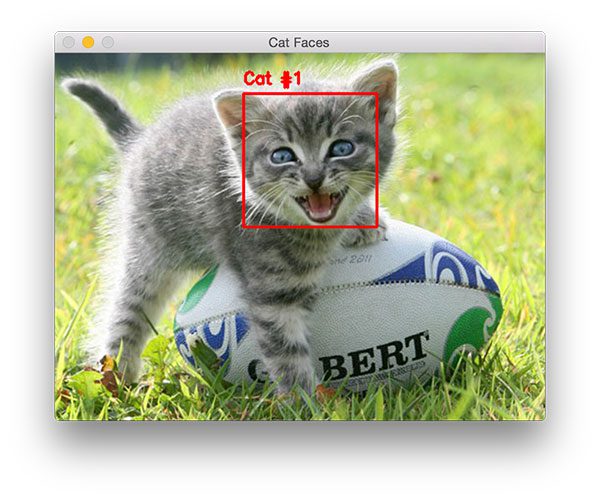

+

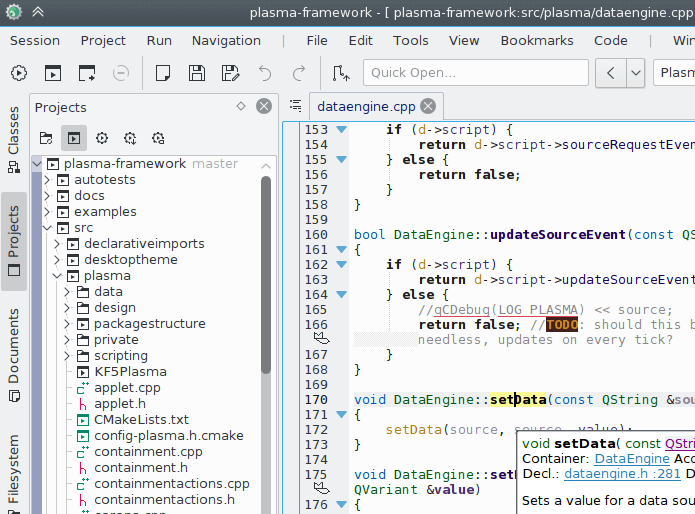

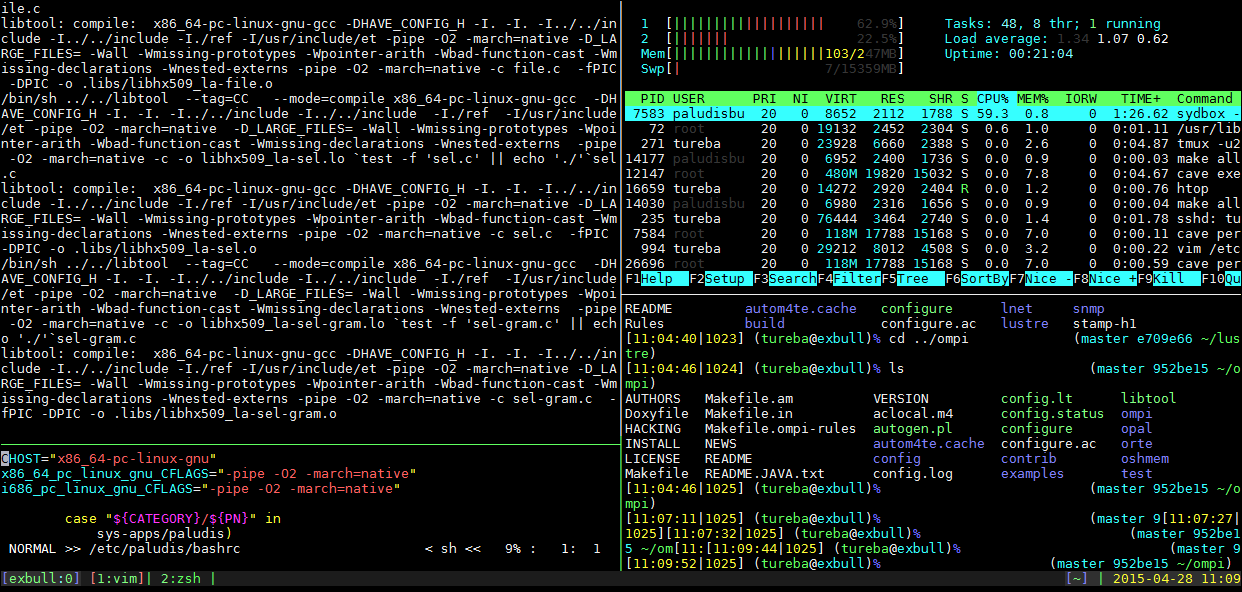

+

+

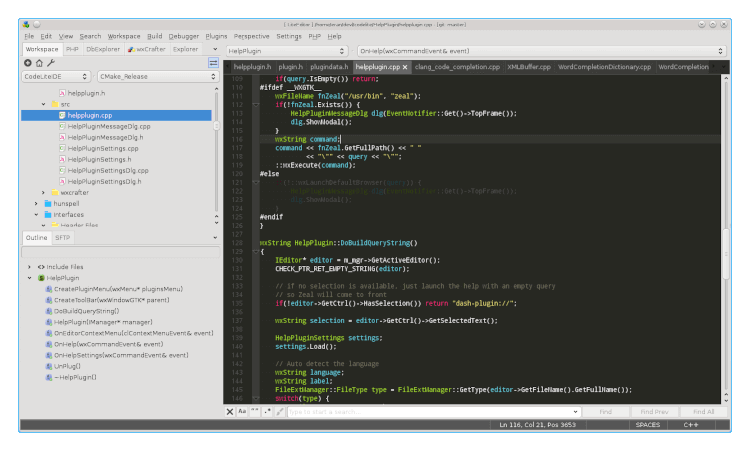

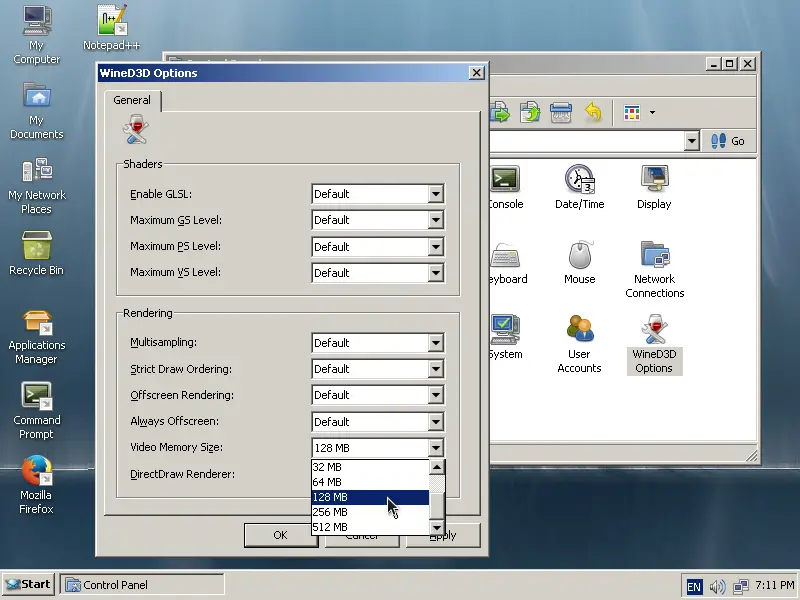

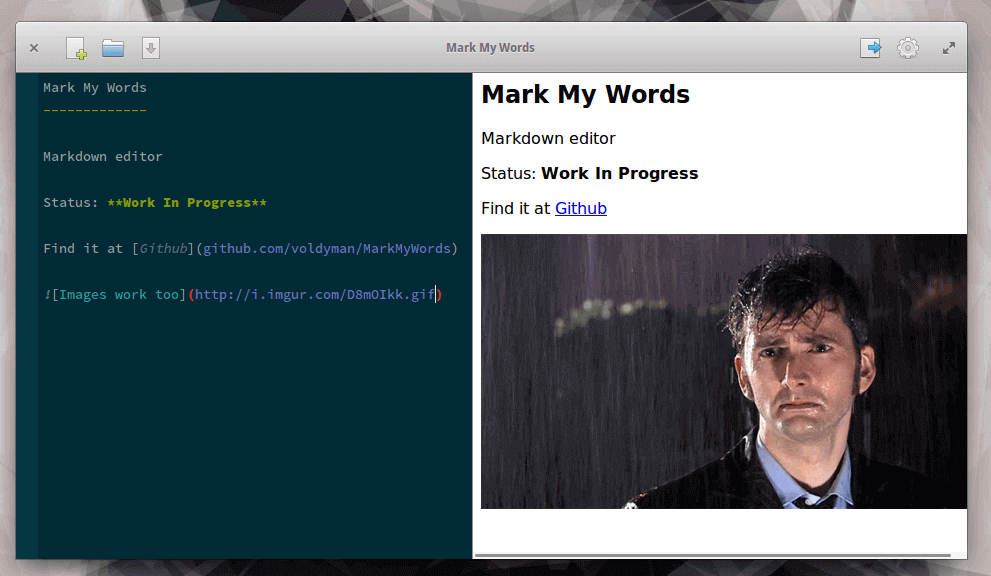

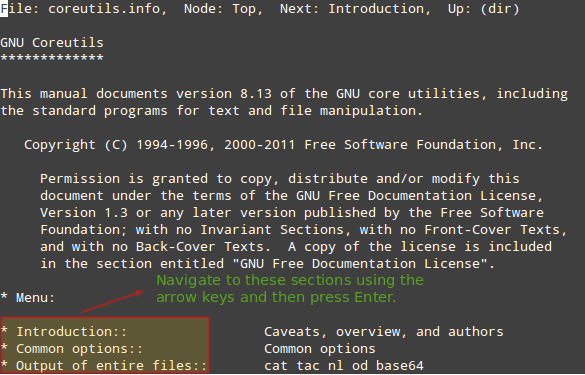

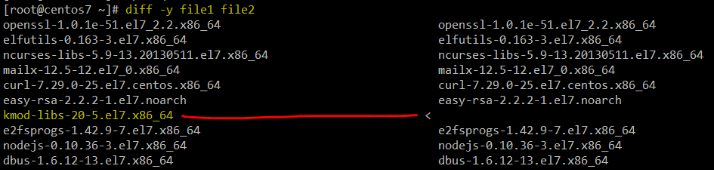

+*Fabric 工具使用说明*

+

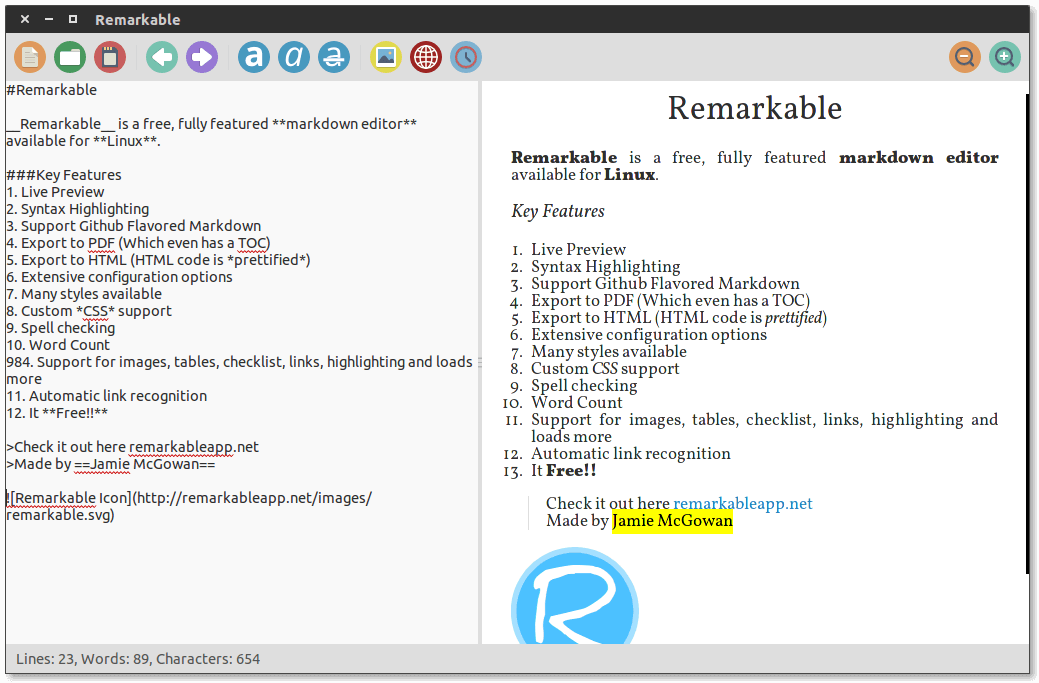

+**例子 2**:新建一个名为 fabfile.py 的文件并打开:

+

+粘贴以下代码至文件:

+

+```

+#! /usr/bin/env python

+from fabric.api import local

+def uptime():

+ local('uptime')

+```

+

+保存文件并执行以下命令:

+

+```

+# fab uptime

+```

+

+

+

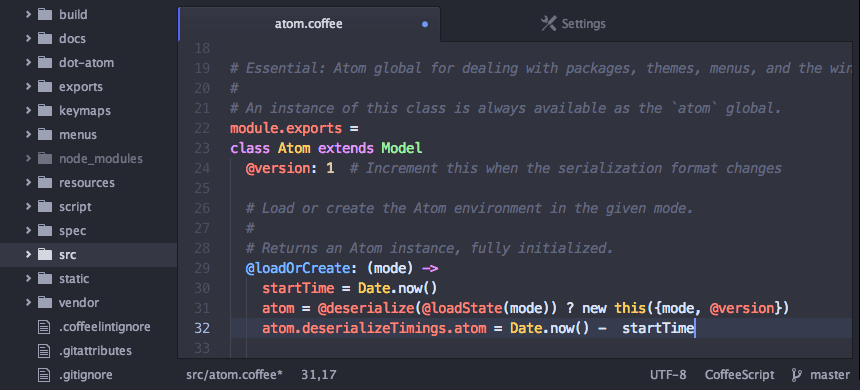

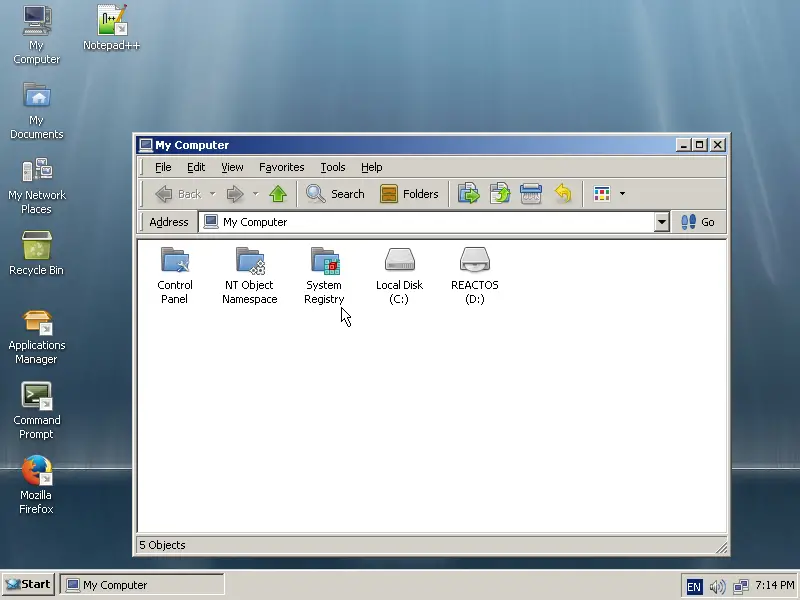

+*Fabric: 检查系统运行时间*

+

+让我们看看这个例子,fabfile.py 文件在本机执行了 uptime 这个命令。

+

+#### 在远程 Linux 机器上运行命令来执行自动化任务

+

+Fabric API 使用了一个名为 `env` 的关联数组(Python 中的词典)作为配置目录,来储存 Fabric 要控制的机器的相关信息。

+

+`env.hosts` 是一个用来存储你要执行 Fabric 任务的机器的列表,如果你的 IP 地址是 192.168.0.0,想要用 Fabric 来管理地址为 192.168.0.2 和 192.168.0.6 的机器,需要的配置如下所示:

+

+```

+#!/usr/bin/env python

+from fabric.api import env

+ env.hosts = [ '192.168.0.2', '192.168.0.6' ]

+```

+

+上面这几行代码只是声明了你要执行 Fabric 任务的主机地址,但是实际上并没有执行任何任务,下面我们就来定义一些任务。Fabric 提供了一系列可以与远程服务器交互的方法。

+

+Fabric 提供了众多的方法,这里列出几个经常会用到的:

+

+- run - 可以在远程机器上运行的 shell 命令

+- local - 可以在本机上运行的 shell 命令

+- sudo - 使用 root 权限在远程机器上运行的 shell 命令

+- get - 从远程机器上下载一个或多个文件

+- put - 上传一个或多个文件到远程机器

+

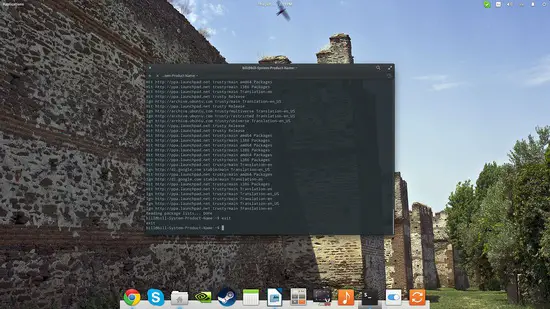

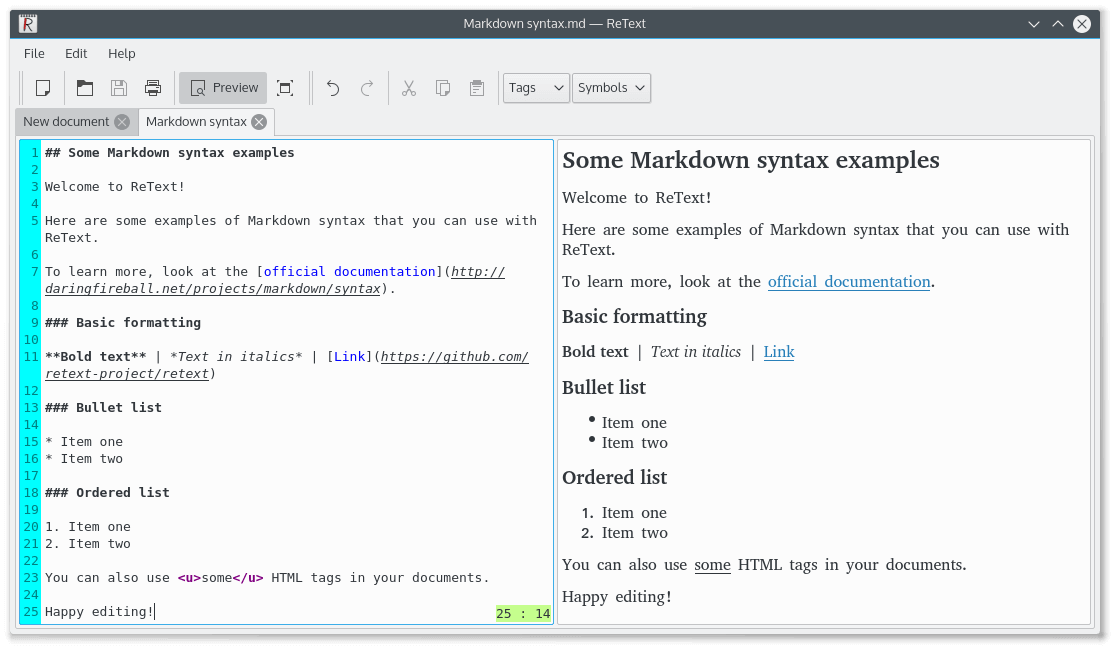

+**例子 3**:在多台机子上输出信息,新建新的 fabfile.py 文件如下所示

+

+```

+#!/usr/bin/env python

+from fabric.api import env, run

+env.hosts = ['192.168.0.2','192.168.0.6']

+def echo():

+ run("echo -n 'Hello, you are tuned to Tecmint ' ")

+```

+

+运行以下命令执行 Fabric 任务

+

+```

+# fab echo

+```

+

+

+

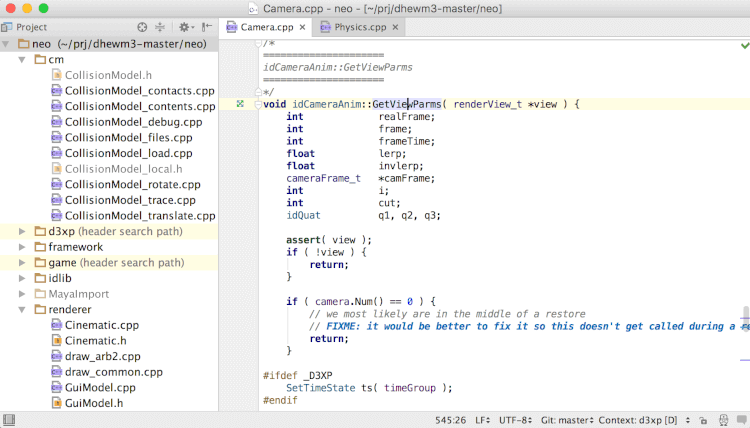

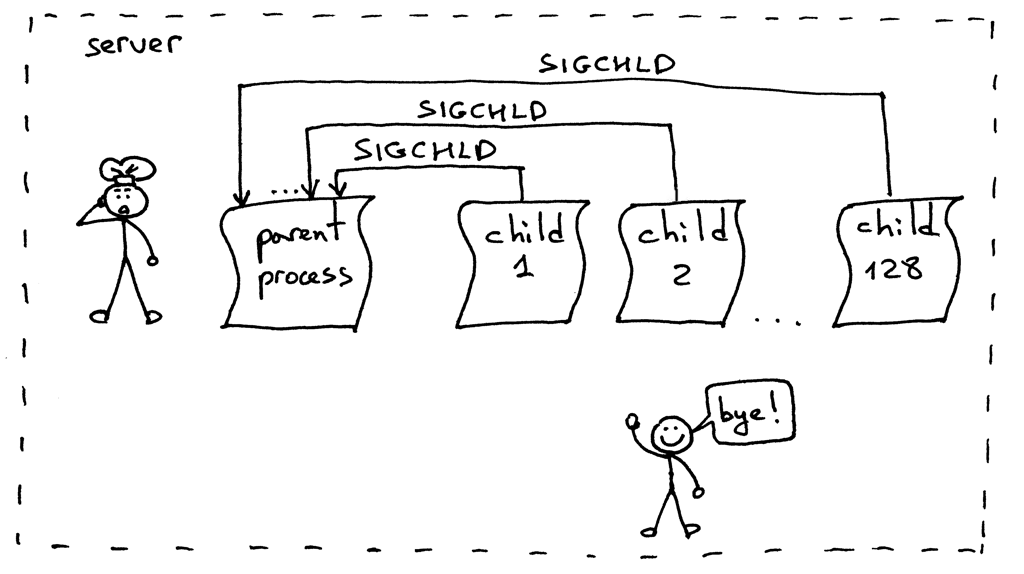

+*fabric: 自动在远程 Linux 机器上执行任务*

+

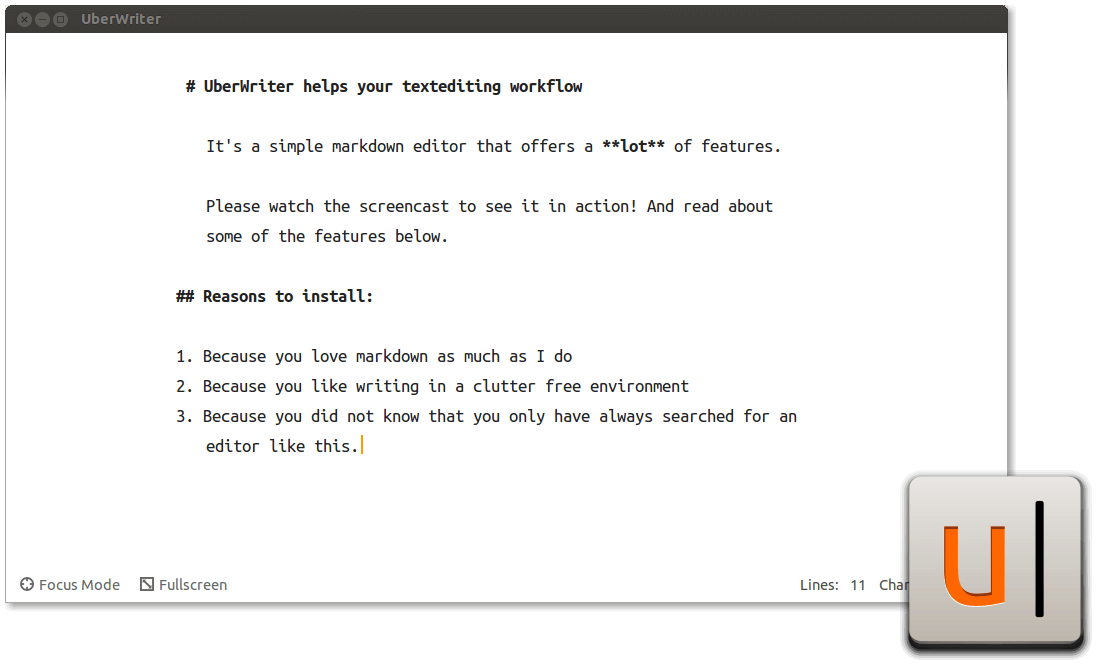

+**例子 4**:你可以继续改进之前创建的执行 uptime 任务的 fabfile.py 文件,让它可以在多台服务器上运行 uptime 命令,也可以检查其磁盘使用情况,如下所示:

+

+```

+#!/usr/bin/env python

+from fabric.api import env, run

+env.hosts = ['192.168.0.2','192.168.0.6']

+def uptime():

+ run('uptime')

+def disk_space():

+ run('df -h')

+```

+

+保存并执行以下命令

+

+```

+# fab uptime

+# fab disk_space

+```

+

+

+

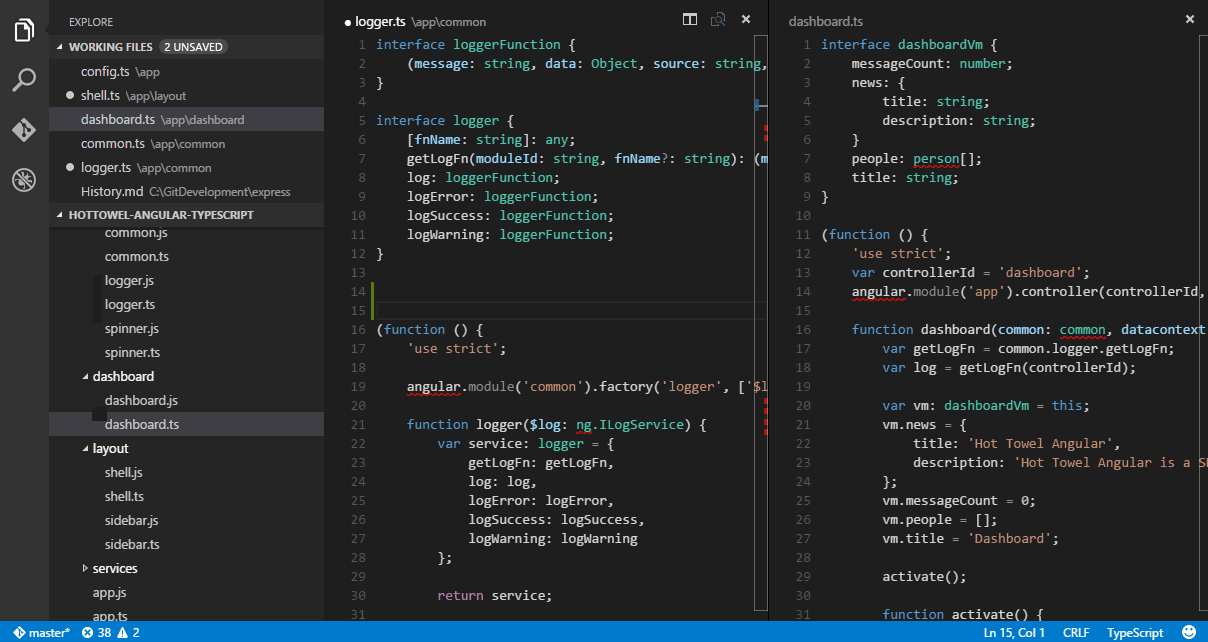

+*Fabric:自动在多台服务器上执行任务*

+

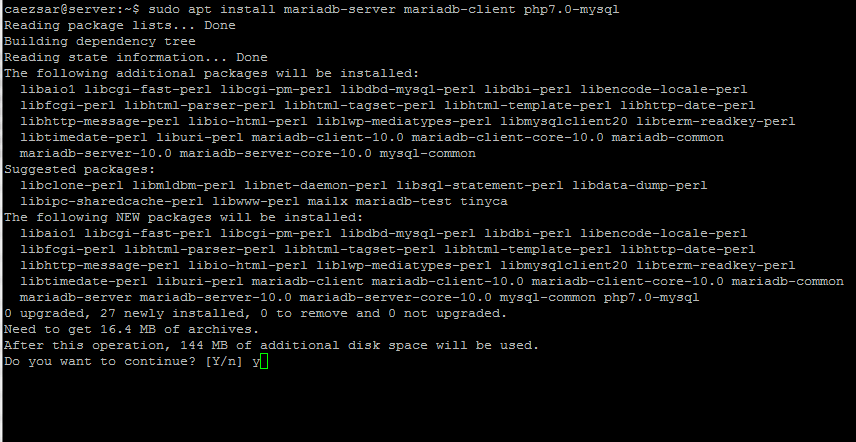

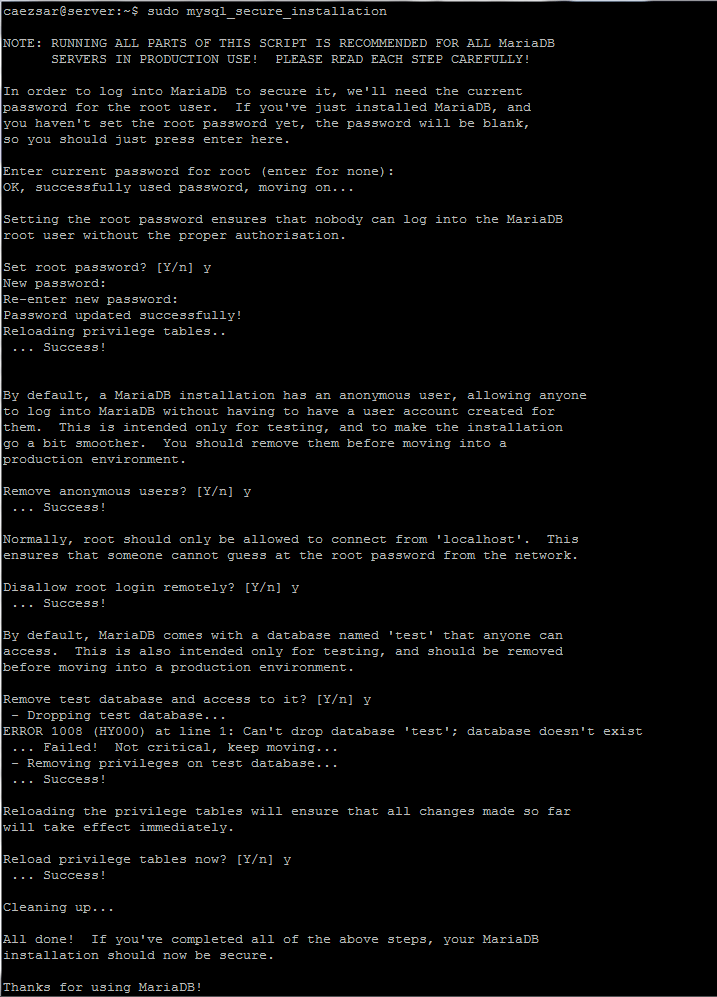

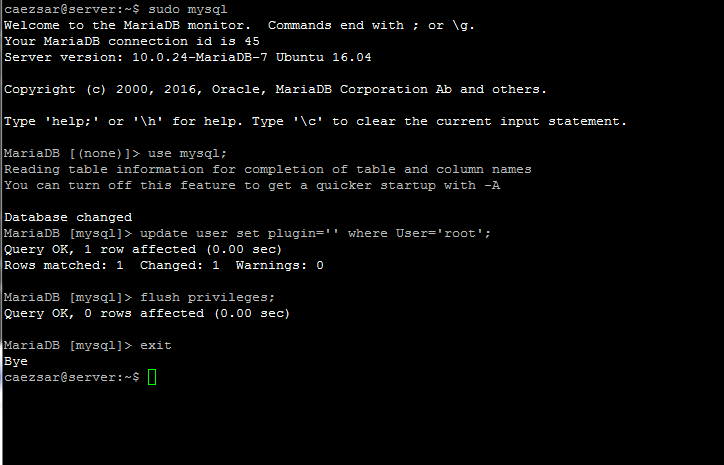

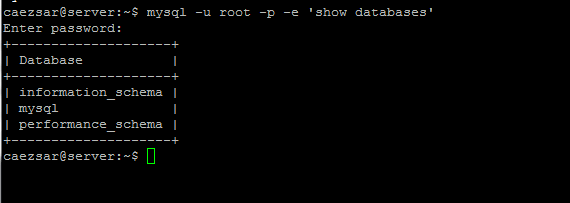

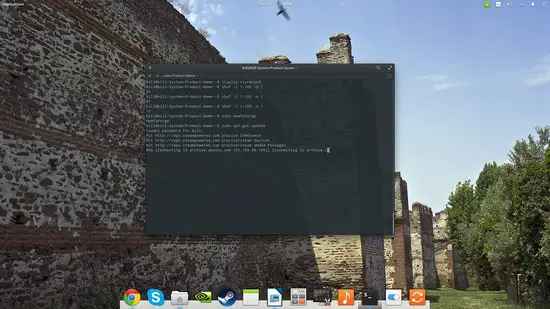

+#### 在远程服务器上自动化布署 LAMP

+

+**例子 5**:我们来尝试一下在远程服务器上布署 LAMP(Linux, Apache, MySQL/MariaDB and PHP)

+

+我们要写个函数在远程使用 root 权限安装 LAMP。

+

+##### 在 RHEL/CentOS 或 Fedora 上

+

+```

+#!/usr/bin/env python

+from fabric.api import env, run

+env.hosts = ['192.168.0.2','192.168.0.6']

+def deploy_lamp():

+ run ("yum install -y httpd mariadb-server php php-mysql")

+```

+

+##### 在 Debian/Ubuntu 或 Linux Mint 上

+

+```

+#!/usr/bin/env python

+from fabric.api import env, run

+env.hosts = ['192.168.0.2','192.168.0.6']

+def deploy_lamp():

+ sudo("apt-get install -q apache2 mysql-server libapache2-mod-php5 php5-mysql")

+```

+

+保存并执行以下命令:

+

+```

+# fab deploy_lamp

+```

+

+注:由于安装时会输出大量信息,这个例子我们就不提供屏幕 gif 图了

+

+现在你可以使用 Fabric 和上文例子所示的功能来[自动化的管理 Linux 服务器上的任务][2]了。

+

+#### 一些 Fabric 有用的选项

+

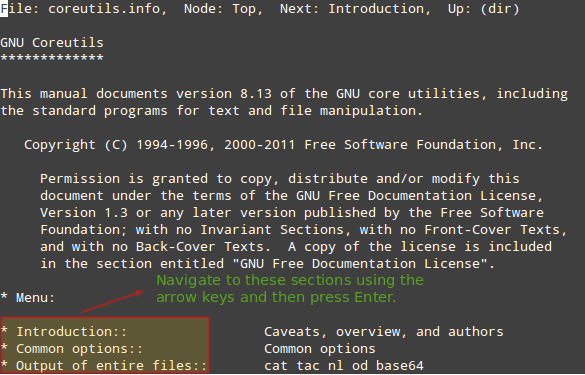

+- 你可以运行 `fab -help` 输出帮助信息,里面列出了所有可以使用的命令行信息

+- `–fabfile=PATH` 选项可以让你定义除了名为 fabfile.py 之外的模块

+- 如果你想用指定的用户名登录远程主机,请使用 `-user=USER` 选项

+- 如果你需要密码进行验证或者 sudo 提权,请使用 `–password=PASSWORD` 选项

+- 如果需要输出某个命令的详细信息,请使用 `–display=命令名` 选项

+- 使用 `--list` 输出所有可用的任务

+- 使用 `--list-format=FORMAT` 选项能格式化 `-list` 选项输出的信息,可选的有 short、normal、 nested

+- `--config=PATH` 选项可以指定读取配置文件的地址

+- `-–colorize-errors` 能显示彩色的错误输出信息

+- `--version` 输出当前版本

+

+### 总结

+

+Fabric 是一个强大并且文档完备的工具,对于新手来说也能很快上手,阅读提供的文档能帮助你更好的了解它。如果你在安装和使用 Fabric 时发现什么问题可以在评论区留言,我们会及时回复。

+

+参考:[Fabric 文档][3]

+

+

+--------------------------------------------------------------------------------

+

+via: http://www.tecmint.com/automating-linux-system-administration-tasks/

+

+作者:[Aaron Kili][a]

+译者:[NearTan](https://github.com/NearTan)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: http://www.tecmint.com/author/aaronkili/

+[1]: https://linux.cn/article-2324-1.html

+[2]: http://www.tecmint.com/use-ansible-playbooks-to-automate-complex-tasks-on-multiple-linux-servers/

+[3]: http://docs.fabfile.org/en/1.4.0/usage/env.html

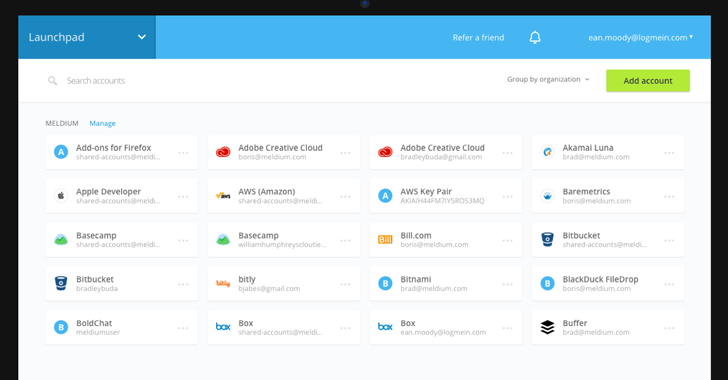

diff --git a/published/20151208 6 creative ways to use ownCloud.md b/published/20151208 6 creative ways to use ownCloud.md

new file mode 100644

index 0000000000..02824a4255

--- /dev/null

+++ b/published/20151208 6 creative ways to use ownCloud.md

@@ -0,0 +1,96 @@

+ownCloud 的六大神奇用法

+================================================================================

+

+

+

+(图片来源:Opensource.com)

+

+[ownCloud][1] 是一个自行托管的开源文件同步和共享服务器。就像“行业老大” Dropbox、Google Drive、Box 和其他的同类服务一样,ownCloud 也可以让你访问自己的文件、日历、联系人和其他数据。你可以在自己设备之间同步任意数据(或部分数据)并分享给其他人。然而,ownCloud 要比其它的商业解决方案更棒,可以[将 ownCloud 运行在自己的服务器][2]而不是其它人的服务器上。

+

+现在,让我们一起来看看在 ownCloud 上的六个创造性的应用方式。其中一些是由于 ownCloud 的开源才得以完成,而另外的则是 ownCloud 自身特有的功能。

+

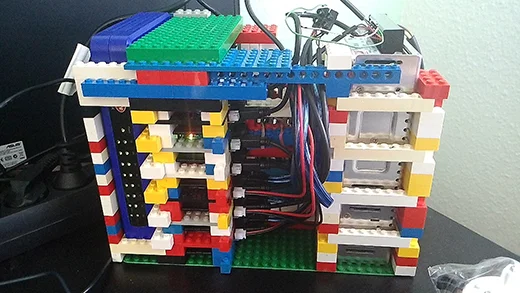

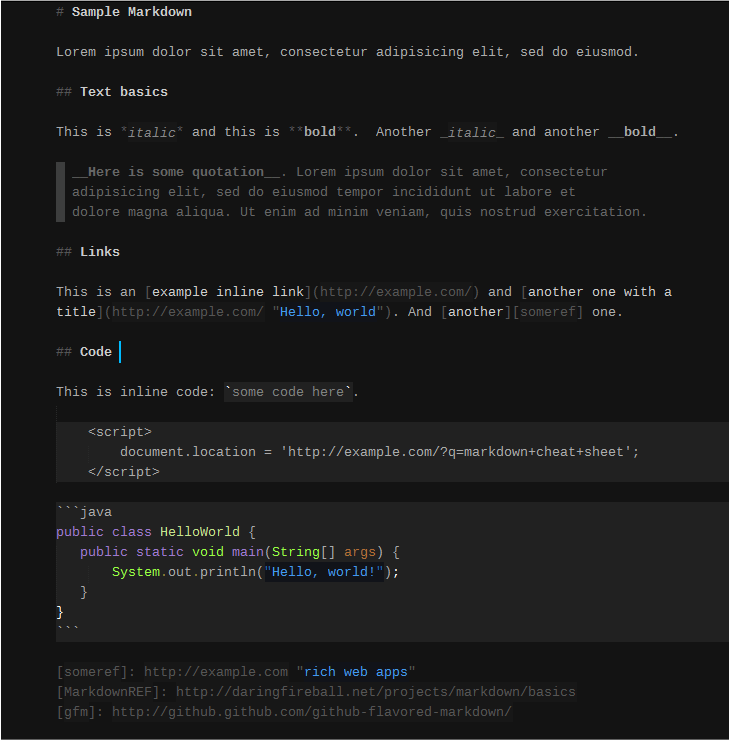

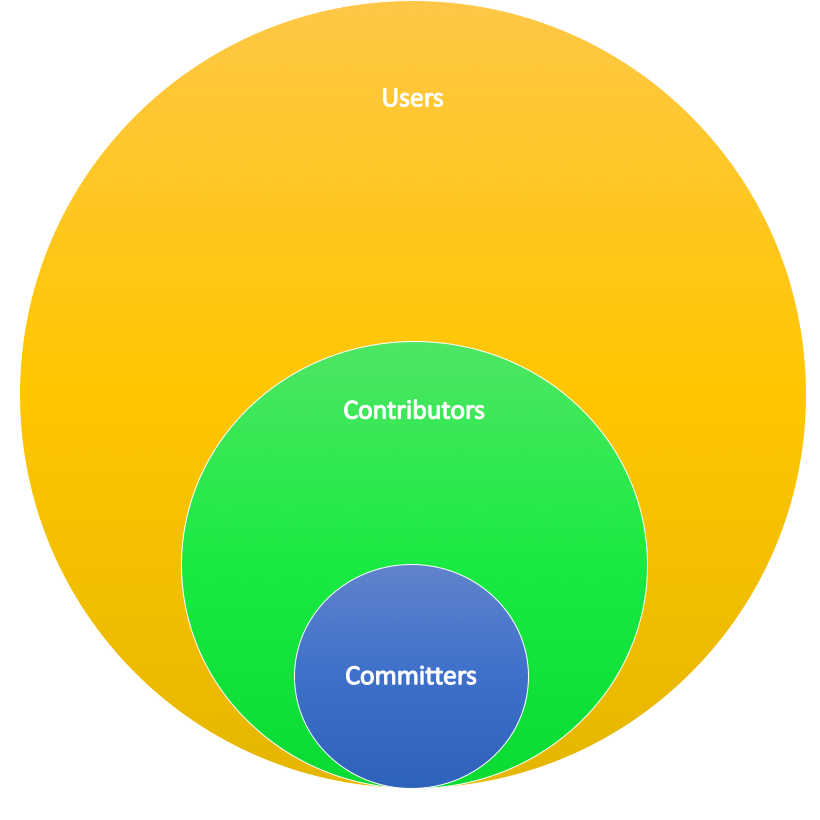

+### 1. 可扩展的 ownCloud “派”集群 ###

+

+由于 ownCloud 是开源的,你可以选择将它运行在自己的服务器中,或者从你信任的服务商那里获取空间——没必要将你的文件存储在那些大公司的服务器中,谁知他们将你的文件存储到哪里去。[点击此处查看部分 ownCloud 服务商][3],或者下载该服务软件到你的虚拟主机中[搭建自己的服务器][4].

+

+

+

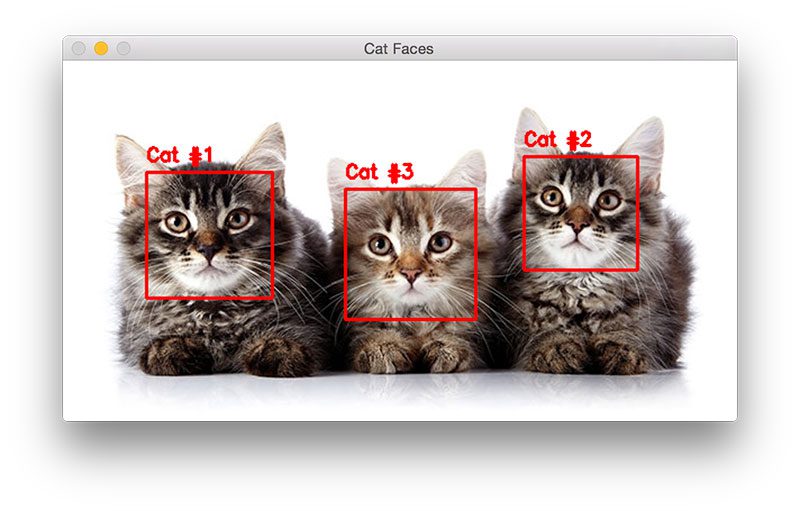

+*拍摄: Jörn Friedrich Dreyer. [CC BY-SA 4.0.][5]*

+

+我们见过最具创意的事情就是架设[香蕉派集群][6]和[树莓派集群][7]。ownCloud 的扩展性通常用于支持成千上万的用户,但有些人则将它往不同方向发展,通过将多个微型系统集群在一起,就可以创建出运行速度超快的 ownCloud。酷毙了!

+

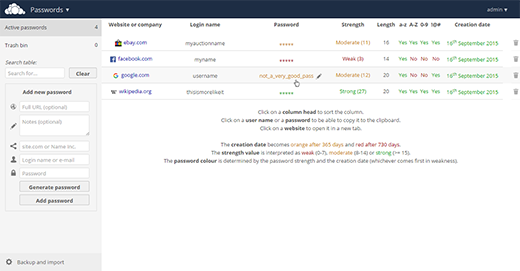

+### 2. 密码同步 ###

+

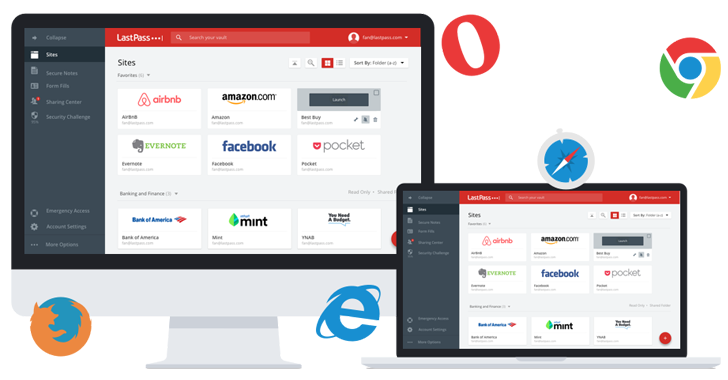

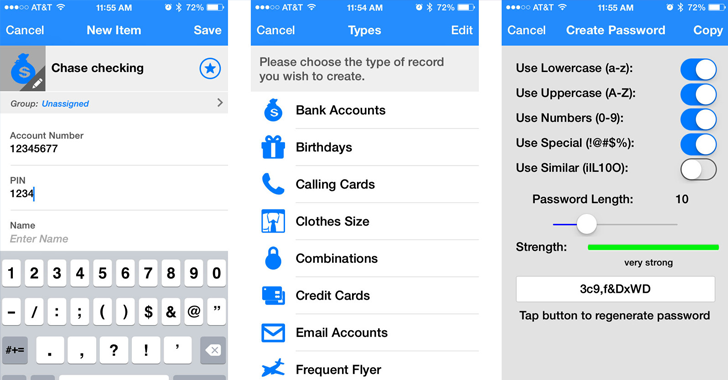

+为了让 ownCloud 更容易扩展,我们将它变得超级的模块化,甚至还有一个 [ownCloud 应用商店][8]。你可以在里边找到音乐和视频播放器、日历、联系人、生产力应用、游戏、应用模板(sketching app)等等。

+

+从近 200 多个应用中仅挑选一个是一件非常困难的事,但密码管理则是一个很独特的功能。只有不超过三个应用提供这个功能:[Passwords][9]、[Secure Container][10] 和 [Passman][11]。

+

+

+

+### 3. 随心所欲地存储文件 ###

+

+外部存储可以让你将现有数据挂载到 ownCloud 上,让你通过一个界面来访问存储在 FTP、WebDAV、Amazon S3,甚至 Dropbox 和 Google Drive 的文件。

+

+注:youtube 视频

+

+

+行业老大们喜欢创建自己的 “藩篱花园”,Box 的用户只能和其它的 Box 用户协作;假如你想从 Google Drive 分享你的文件,你的同伴也必须要有一个 Google 账号才可以访问的分享。通过 ownCloud 的外部存储功能,你可以轻松打破这些。

+

+最有创意的就是把 Google Drive 和 Dropbox 添加为外部存储。这样你就可以无缝连接它们,通过一个简单的链接即可分享给其它人——并不需要账户。

+

+### 4. 获取上传的文件 ###

+

+由于 ownCloud 是开源开,人们可以不受公司需求的制约而向它贡献感兴趣的功能。我们的贡献者总是很在意安全和隐私,所以 ownCloud 引入的通过密码保护公共链接并[设置失效期限][12]的功能要比其它人早很多。

+

+现在,ownCloud 可以配置分享链接的读写权限了,这就是说链接的访问者可以无缝的编辑你分享给他们的文件(可以有密码保护,也可以没有),或者将文件上传到服务器前不用强制他们提供私人信息来注册服务。

+

+注:youtube 视频

+

+

+对于有人想给你分享大体积的文件时,这个特性就非常有用了。相比于上传到第三方站点、然后给你发送一个连接、你再去下载文件(通常需要登录),ownCloud 仅需要上传文件到你提供的分享文件夹,你就可以马上获取到文件了。

+

+### 5. 免费却又安全的存储空间 ###

+

+之前就强调过,我们的代码贡献者最关注的就是安全和隐私,这就是 ownCloud 中有用于加密和解密存储数据的应用的原因。

+

+通过使用 ownCloud 将你的文件存储到 Dropbox 或者 Google Drive,则会违背夺回数据的控制权并保持数据隐私的初衷。但是加密应用则可以改变这个状况。在发送数据给这些提供商前进行数据加密,并在取回数据的时候进行解密,你的数据就会变得很安全。

+

+### 6. 在你的可控范围内分享文件 ###

+

+作为开源项目,ownCloud 没有必要自建 “藩篱花园”。通过“联邦云共享(Federated Cloud Sharing)”:这个[由 ownCloud 开发和发布的][13]协议使不同的文件同步和共享服务器可以彼此之间进行通信,并能够安全地传输文件。联邦云共享本身来自一个有趣的事情:有 [22 所德国大学][14] 想要为自身的 50 万名学生建立一个庞大的云服务,但是每个大学都想控制自己学生的数据。于是乎,我们需要一个创造性的解决方案:也就是联邦云服务。该解决方案可以连接全部的大学,使得学生们可以无缝的协同工作。同时,每个大学的系统管理员保持着对自己学生创建的文件的控制权,并可采用自己的策略,如限制限额,或者限制什么人、什么文件以及如何共享。

+

+注:youtube 视频

+

+

+并且,这项神奇的技术并没有限制于德国的大学之间,每个 ownCloud 用户都能在自己的用户设置中找到自己的[联邦云 ID][15],并将之分享给同伴。

+

+现在你明白了吧。通过这六个方式,ownCloud 就能让人们做一些特殊而独特的事。而使这一切成为可能的,就是 ownCloud 是开源的,其设计目标就是让你的数据自由。

+

+你有其它的 ownCloud 的创意用法吗?请发表评论让我们知道。

+

+--------------------------------------------------------------------------------

+

+via: https://opensource.com/life/15/12/6-creative-ways-use-owncloud

+

+作者:[Jos Poortvliet][a]

+译者:[GHLandy](https://github.com/GHLandy)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]:https://opensource.com/users/jospoortvliet

+[1]:https://owncloud.com/

+[2]:https://blogs.fsfe.org/mk/new-stickers-and-leaflets-no-cloud-and-e-mail-self-defense/

+[3]:https://owncloud.org/providers

+[4]:https://owncloud.org/install/#instructions-server

+[5]:https://creativecommons.org/licenses/by-sa/4.0/

+[6]:http://www.owncluster.de/

+[7]:https://christopherjcoleman.wordpress.com/2013/01/05/host-your-owncloud-on-a-raspberry-pi-cluster/

+[8]:https://apps.owncloud.com/

+[9]:https://apps.owncloud.com/content/show.php/Passwords?content=170480

+[10]:https://apps.owncloud.com/content/show.php/Secure+Container?content=167268

+[11]:https://apps.owncloud.com/content/show.php/Passman?content=166285

+[12]:https://owncloud.com/owncloud45-community/

+[13]:http://karlitschek.de/2015/08/announcing-the-draft-federated-cloud-sharing-api/

+[14]:https://owncloud.com/customer/sciebo/

+[15]:https://owncloud.org/federation/

diff --git a/published/20151220 GCC-Inline-Assembly-HOWTO.md b/published/20151220 GCC-Inline-Assembly-HOWTO.md

new file mode 100644

index 0000000000..e89e7fa256

--- /dev/null

+++ b/published/20151220 GCC-Inline-Assembly-HOWTO.md

@@ -0,0 +1,498 @@

+* * *

+

+# GCC 内联汇编 HOWTO

+

+v0.1, 01 March 2003.

+* * *

+

+_本 HOWTO 文档将讲解 GCC 提供的内联汇编特性的用途和用法。对于阅读这篇文章,这里只有两个前提要求,很明显,就是 x86 汇编语言和 C 语言的基本认识。_

+

+* * *

+

+## 1. 简介

+

+### 1.1 版权许可

+

+Copyright (C)2003 Sandeep S.

+

+本文档自由共享;你可以重新发布它,并且/或者在遵循自由软件基金会发布的 GNU 通用公共许可证下修改它;也可以是该许可证的版本 2 或者(按照你的需求)更晚的版本。

+

+发布这篇文档是希望它能够帮助别人,但是没有任何担保;甚至不包括可售性和适用于任何特定目的的担保。关于更详细的信息,可以查看 GNU 通用许可证。

+

+### 1.2 反馈校正

+

+请将反馈和批评一起提交给 [Sandeep.S](mailto:busybox@sancharnet.in) 。我将感谢任何一个指出本文档中错误和不准确之处的人;一被告知,我会马上改正它们。

+

+### 1.3 致谢

+

+我对提供如此棒的特性的 GNU 人们表示真诚的感谢。感谢 Mr.Pramode C E 所做的所有帮助。感谢在 Govt Engineering College 和 Trichur 的朋友们的精神支持和合作,尤其是 Nisha Kurur 和 Sakeeb S 。 感谢在 Gvot Engineering College 和 Trichur 的老师们的合作。

+

+另外,感谢 Phillip , Brennan Underwood 和 colin@nyx.net ;这里的许多东西都厚颜地直接取自他们的工作成果。

+

+* * *

+

+## 2. 概览

+

+在这里,我们将学习 GCC 内联汇编。这里内联(inline)表示的是什么呢?

+

+我们可以要求编译器将一个函数的代码插入到调用者代码中函数被实际调用的地方。这样的函数就是内联函数。这听起来和宏差不多?这两者确实有相似之处。

+

+内联函数的优点是什么呢?

+

+这种内联方法可以减少函数调用开销。同时如果所有实参的值为常量,它们的已知值可以在编译期允许简化,因此并非所有的内联函数代码都需要被包含进去。代码大小的影响是不可预测的,这取决于特定的情况。为了声明一个内联函数,我们必须在函数声明中使用 `inline` 关键字。

+

+现在我们正处于一个猜测内联汇编到底是什么的点上。它只不过是一些写为内联函数的汇编程序。在系统编程上,它们方便、快速并且极其有用。我们主要集中学习(GCC)内联汇编函数的基本格式和用法。为了声明内联汇编函数,我们使用 `asm` 关键词。

+

+内联汇编之所以重要,主要是因为它可以操作并且使其输出通过 C 变量显示出来。正是因为此能力, "asm" 可以用作汇编指令和包含它的 C 程序之间的接口。

+

+* * *

+

+## 3. GCC 汇编语法

+

+Linux上的 GNU C 编译器 GCC ,使用 **AT&T** / **UNIX** 汇编语法。在这里,我们将使用 AT&T 语法 进行汇编编码。如果你对 AT&T 语法不熟悉的话,请不要紧张,我会教你的。AT&T 语法和 Intel 语法的差别很大。我会给出主要的区别。

+

+1. 源操作数和目的操作数顺序

+

+ AT&T 语法的操作数方向和 Intel 语法的刚好相反。在Intel 语法中,第一操作数为目的操作数,第二操作数为源操作数,然而在 AT&T 语法中,第一操作数为源操作数,第二操作数为目的操作数。也就是说,

+

+ Intel 语法中的 `Op-code dst src` 变为

+

+ AT&T 语法中的 `Op-code src dst`。

+

+2. 寄存器命名

+

+ 寄存器名称有 `%` 前缀,即如果必须使用 `eax`,它应该用作 `%eax`。

+

+3. 立即数

+

+ AT&T 立即数以 `$` 为前缀。静态 "C" 变量也使用 `$` 前缀。在 Intel 语法中,十六进制常量以 `h` 为后缀,然而 AT&T 不使用这种语法,这里我们给常量添加前缀 `0x`。所以,对于十六进制,我们首先看到一个 `$`,然后是 `0x`,最后才是常量。

+

+4. 操作数大小

+

+ 在 AT&T 语法中,存储器操作数的大小取决于操作码名字的最后一个字符。操作码后缀 ’b’ 、’w’、’l’ 分别指明了字节(byte)(8位)、字(word)(16位)、长型(long)(32位)存储器引用。Intel 语法通过给存储器操作数添加 `byte ptr`、 `word ptr` 和 `dword ptr` 前缀来实现这一功能。

+

+ 因此,Intel的 `mov al, byte ptr foo` 在 AT&T 语法中为 `movb foo, %al`。

+

+5. 存储器操作数

+

+ 在 Intel 语法中,基址寄存器包含在 `[` 和 `]` 中,然而在 AT&T 中,它们变为 `(` 和 `)`。另外,在 Intel 语法中, 间接内存引用为

+

+ `section:[base + index*scale + disp]`,在 AT&T中变为 `section:disp(base, index, scale)`。

+

+ 需要牢记的一点是,当一个常量用于 disp 或 scale,不能添加 `$` 前缀。

+

+现在我们看到了 Intel 语法和 AT&T 语法之间的一些主要差别。我仅仅写了它们差别的一部分而已。关于更完整的信息,请参考 GNU 汇编文档。现在为了更好地理解,我们可以看一些示例。

+

+```

++------------------------------+------------------------------------+

+| Intel Code | AT&T Code |

++------------------------------+------------------------------------+

+| mov eax,1 | movl $1,%eax |

+| mov ebx,0ffh | movl $0xff,%ebx |

+| int 80h | int $0x80 |

+| mov ebx, eax | movl %eax, %ebx |

+| mov eax,[ecx] | movl (%ecx),%eax |

+| mov eax,[ebx+3] | movl 3(%ebx),%eax |

+| mov eax,[ebx+20h] | movl 0x20(%ebx),%eax |

+| add eax,[ebx+ecx*2h] | addl (%ebx,%ecx,0x2),%eax |

+| lea eax,[ebx+ecx] | leal (%ebx,%ecx),%eax |

+| sub eax,[ebx+ecx*4h-20h] | subl -0x20(%ebx,%ecx,0x4),%eax |

++------------------------------+------------------------------------+

+```

+* * *

+

+## 4. 基本内联

+

+基本内联汇编的格式非常直接了当。它的基本格式为

+

+`asm("汇编代码");`

+

+示例

+

+```

+asm("movl %ecx %eax"); /* 将 ecx 寄存器的内容移至 eax */

+__asm__("movb %bh (%eax)"); /* 将 bh 的一个字节数据 移至 eax 寄存器指向的内存 */

+```

+

+你可能注意到了这里我使用了 `asm ` 和 `__asm__`。这两者都是有效的。如果关键词 `asm` 和我们程序的一些标识符冲突了,我们可以使用 `__asm__`。如果我们的指令多于一条,我们可以每个一行,并用双引号圈起,同时为每条指令添加 ’\n’ 和 ’\t’ 后缀。这是因为 gcc 将每一条当作字符串发送给 **as**(GAS)(LCTT 译注: GAS 即 GNU 汇编器),并且通过使用换行符/制表符发送正确格式化后的行给汇编器。

+

+示例

+

+```

+__asm__ ("movl %eax, %ebx\n\t"

+ "movl $56, %esi\n\t"

+ "movl %ecx, $label(%edx,%ebx,$4)\n\t"

+ "movb %ah, (%ebx)");

+```

+

+如果在代码中,我们涉及到一些寄存器(即改变其内容),但在没有恢复这些变化的情况下从汇编中返回,这将会导致一些意想不到的事情。这是因为 GCC 并不知道寄存器内容的变化,这会导致问题,特别是当编译器做了某些优化。在没有告知 GCC 的情况下,它将会假设一些寄存器存储了一些值——而我们可能已经改变却没有告知 GCC——它会像什么事都没发生一样继续运行(LCTT 译注:什么事都没发生一样是指GCC不会假设寄存器装入的值是有效的,当退出改变了寄存器值的内联汇编后,寄存器的值不会保存到相应的变量或内存空间)。我们所可以做的是使用那些没有副作用的指令,或者当我们退出时恢复这些寄存器,要不就等着程序崩溃吧。这是为什么我们需要一些扩展功能,扩展汇编给我们提供了那些功能。

+

+* * *

+

+## 5. 扩展汇编

+

+在基本内联汇编中,我们只有指令。然而在扩展汇编中,我们可以同时指定操作数。它允许我们指定输入寄存器、输出寄存器以及修饰寄存器列表。GCC 不强制用户必须指定使用的寄存器。我们可以把头疼的事留给 GCC ,这可能可以更好地适应 GCC 的优化。不管怎么说,基本格式为:

+

+```

+asm ( 汇编程序模板

+ : 输出操作数 /* 可选的 */

+ : 输入操作数 /* 可选的 */

+ : 修饰寄存器列表 /* 可选的 */

+ );

+```

+

+汇编程序模板由汇编指令组成。每一个操作数由一个操作数约束字符串所描述,其后紧接一个括弧括起的 C 表达式。冒号用于将汇编程序模板和第一个输出操作数分开,另一个(冒号)用于将最后一个输出操作数和第一个输入操作数分开(如果存在的话)。逗号用于分离每一个组内的操作数。总操作数的数目限制在 10 个,或者机器描述中的任何指令格式中的最大操作数数目,以较大者为准。

+

+如果没有输出操作数但存在输入操作数,你必须将两个连续的冒号放置于输出操作数原本会放置的地方周围。

+

+示例:

+

+```

+asm ("cld\n\t"

+ "rep\n\t"

+ "stosl"

+ : /* 无输出寄存器 */

+ : "c" (count), "a" (fill_value), "D" (dest)

+ : "%ecx", "%edi"

+ );

+```

+

+现在来看看这段代码是干什么的?以上的内联汇编是将 `fill_value` 值连续 `count` 次拷贝到寄存器 `edi` 所指位置(LCTT 译注:每执行 stosl 一次,寄存器 edi 的值会递增或递减,这取决于是否设置了 direction 标志,因此以上代码实则初始化一个内存块)。 它也告诉 gcc 寄存器 `ecx` 和 `edi` 一直无效(LCTT 译注:原文为 eax ,但代码修饰寄存器列表中为 ecx,因此这可能为作者的纰漏。)。为了更加清晰地说明,让我们再看一个示例。

+

+```

+int a=10, b;

+asm ("movl %1, %%eax;

+ movl %%eax, %0;"

+ :"=r"(b) /* 输出 */

+ :"r"(a) /* 输入 */

+ :"%eax" /* 修饰寄存器 */

+ );

+```

+

+这里我们所做的是使用汇编指令使 ’b’ 变量的值等于 ’a’ 变量的值。一些有意思的地方是:

+

+* "b" 为输出操作数,用 %0 引用,并且 "a" 为输入操作数,用 %1 引用。

+* "r" 为操作数约束。之后我们会更详细地了解约束(字符串)。目前,"r" 告诉 GCC 可以使用任一寄存器存储操作数。输出操作数约束应该有一个约束修饰符 "=" 。这修饰符表明它是一个只读的输出操作数。

+* 寄存器名字以两个 % 为前缀。这有利于 GCC 区分操作数和寄存器。操作数以一个 % 为前缀。

+* 第三个冒号之后的修饰寄存器 %eax 用于告诉 GCC %eax 的值将会在 "asm" 内部被修改,所以 GCC 将不会使用此寄存器存储任何其他值。

+

+当 “asm” 执行完毕, "b" 变量会映射到更新的值,因为它被指定为输出操作数。换句话说, “asm” 内 "b" 变量的修改应该会被映射到 “asm” 外部。

+

+现在,我们可以更详细地看看每一个域。

+

+### 5.1 汇编程序模板

+

+汇编程序模板包含了被插入到 C 程序的汇编指令集。其格式为:每条指令用双引号圈起,或者整个指令组用双引号圈起。同时每条指令应以分界符结尾。有效的分界符有换行符(`\n`)和分号(`;`)。`\n` 可以紧随一个制表符(`\t`)。我们应该都明白使用换行符或制表符的原因了吧(LCTT 译注:就是为了排版和分隔)?和 C 表达式对应的操作数使用 %0、%1 ... 等等表示。

+

+### 5.2 操作数

+

+C 表达式用作 “asm” 内的汇编指令操作数。每个操作数前面是以双引号圈起的操作数约束。对于输出操作数,在引号内还有一个约束修饰符,其后紧随一个用于表示操作数的 C 表达式。即,“操作数约束”(C 表达式)是一个通用格式。对于输出操作数,还有一个额外的修饰符。约束字符串主要用于决定操作数的寻址方式,同时也用于指定使用的寄存器。

+

+如果我们使用的操作数多于一个,那么每一个操作数用逗号隔开。

+

+在汇编程序模板中,每个操作数用数字引用。编号方式如下。如果总共有 n 个操作数(包括输入和输出操作数),那么第一个输出操作数编号为 0 ,逐项递增,并且最后一个输入操作数编号为 n - 1 。操作数的最大数目在前一节我们讲过。

+

+输出操作数表达式必须为左值。输入操作数的要求不像这样严格。它们可以为表达式。扩展汇编特性常常用于编译器所不知道的机器指令 ;-)。如果输出表达式无法直接寻址(即,它是一个位域),我们的约束字符串必须给定一个寄存器。在这种情况下,GCC 将会使用该寄存器作为汇编的输出,然后存储该寄存器的内容到输出。

+

+正如前面所陈述的一样,普通的输出操作数必须为只写的; GCC 将会假设指令前的操作数值是死的,并且不需要被(提前)生成。扩展汇编也支持输入-输出或者读-写操作数。

+

+所以现在我们来关注一些示例。我们想要求一个数的5次方结果。为了计算该值,我们使用 `lea` 指令。

+

+```

+asm ("leal (%1,%1,4), %0"

+ : "=r" (five_times_x)

+ : "r" (x)

+ );

+```

+

+这里我们的输入为 x。我们不指定使用的寄存器。 GCC 将会选择一些输入寄存器,一个输出寄存器,来做我们预期的工作。如果我们想要输入和输出放在同一个寄存器里,我们也可以要求 GCC 这样做。这里我们使用那些读-写操作数类型。这里我们通过指定合适的约束来实现它。

+

+```

+asm ("leal (%0,%0,4), %0"

+ : "=r" (five_times_x)

+ : "0" (x)

+ );

+```

+

+现在输出和输出操作数位于同一个寄存器。但是我们无法得知是哪一个寄存器。现在假如我们也想要指定操作数所在的寄存器,这里有一种方法。

+

+```

+asm ("leal (%%ecx,%%ecx,4), %%ecx"

+ : "=c" (x)

+ : "c" (x)

+ );

+```

+

+在以上三个示例中,我们并没有在修饰寄存器列表里添加任何寄存器,为什么?在头两个示例, GCC 决定了寄存器并且它知道发生了什么改变。在最后一个示例,我们不必将 'ecx' 添加到修饰寄存器列表(LCTT 译注: 原文修饰寄存器列表这个单词拼写有错,这里已修正),gcc 知道它表示 x。因此,因为它可以知道 `ecx` 的值,它就不被当作修饰的(寄存器)了。

+

+### 5.3 修饰寄存器列表

+

+一些指令会破坏一些硬件寄存器内容。我们不得不在修饰寄存器中列出这些寄存器,即汇编函数内第三个 ’**:**’ 之后的域。这可以通知 gcc 我们将会自己使用和修改这些寄存器,这样 gcc 就不会假设存入这些寄存器的值是有效的。我们不用在这个列表里列出输入、输出寄存器。因为 gcc 知道 “asm” 使用了它们(因为它们被显式地指定为约束了)。如果指令隐式或显式地使用了任何其他寄存器,(并且寄存器没有出现在输出或者输出约束列表里),那么就需要在修饰寄存器列表中指定这些寄存器。

+

+如果我们的指令可以修改条件码寄存器(cc),我们必须将 "cc" 添加进修饰寄存器列表。

+

+如果我们的指令以不可预测的方式修改了内存,那么需要将 "memory" 添加进修饰寄存器列表。这可以使 GCC 不会在汇编指令间保持缓存于寄存器的内存值。如果被影响的内存不在汇编的输入或输出列表中,我们也必须添加 **volatile** 关键词。

+

+我们可以按我们的需求多次读写修饰寄存器。参考一下模板内的多指令示例;它假设子例程 _foo 接受寄存器 `eax` 和 `ecx` 里的参数。

+

+```

+asm ("movl %0,%%eax;

+ movl %1,%%ecx;

+ call _foo"

+ : /* no outputs */

+ : "g" (from), "g" (to)

+ : "eax", "ecx"

+ );

+```

+

+### 5.4 Volatile ...?

+

+如果你熟悉内核源码或者类似漂亮的代码,你一定见过许多声明为 `volatile` 或者 `__volatile__`的函数,其跟着一个 `asm` 或者 `__asm__`。我之前提到过关键词 `asm` 和 `__asm__`。那么什么是 `volatile` 呢?

+

+如果我们的汇编语句必须在我们放置它的地方执行(例如,不能为了优化而被移出循环语句),将关键词 `volatile` 放置在 asm 后面、()的前面。以防止它被移动、删除或者其他操作,我们将其声明为 `asm volatile ( ... : ... : ... : ...);`

+

+如果担心发生冲突,请使用 `__volatile__`。

+

+如果我们的汇编只是用于一些计算并且没有任何副作用,不使用 `volatile` 关键词会更好。不使用 `volatile` 可以帮助 gcc 优化代码并使代码更漂亮。

+

+

+在“一些实用的诀窍”一节中,我提供了多个内联汇编函数的例子。那里我们可以了解到修饰寄存器列表的细节。

+

+* * *

+

+## 6. 更多关于约束

+

+到这个时候,你可能已经了解到约束和内联汇编有很大的关联。但我们对约束讲的还不多。约束用于表明一个操作数是否可以位于寄存器和位于哪种寄存器;操作数是否可以为一个内存引用和哪种地址;操作数是否可以为一个立即数和它可能的取值范围(即值的范围),等等。

+

+### 6.1 常用约束

+

+在许多约束中,只有小部分是常用的。我们来看看这些约束。

+

+1. **寄存器操作数约束(r)**

+

+ 当使用这种约束指定操作数时,它们存储在通用寄存器(GPR)中。请看下面示例:

+

+ `asm ("movl %%eax, %0\n" :"=r"(myval));`

+

+ 这里,变量 myval 保存在寄存器中,寄存器 eax 的值被复制到该寄存器中,并且 myval 的值从寄存器更新到了内存。当指定 "r" 约束时, gcc 可以将变量保存在任何可用的 GPR 中。要指定寄存器,你必须使用特定寄存器约束直接地指定寄存器的名字。它们为:

+

+ ```

+ +---+--------------------+

+ | r | Register(s) |

+ +---+--------------------+

+ | a | %eax, %ax, %al |

+ | b | %ebx, %bx, %bl |

+ | c | %ecx, %cx, %cl |

+ | d | %edx, %dx, %dl |

+ | S | %esi, %si |

+ | D | %edi, %di |

+ +---+--------------------+

+ ```

+

+2. **内存操作数约束(m)**

+

+ 当操作数位于内存时,任何对它们的操作将直接发生在内存位置,这与寄存器约束相反,后者首先将值存储在要修改的寄存器中,然后将它写回到内存位置。但寄存器约束通常用于一个指令必须使用它们或者它们可以大大提高处理速度的地方。当需要在 “asm” 内更新一个 C 变量,而又不想使用寄存器去保存它的值,使用内存最为有效。例如,IDTR 寄存器的值存储于内存位置 loc 处:

+

+ `asm("sidt %0\n" : :"m"(loc));`

+

+3. **匹配(数字)约束**

+

+ 在某些情况下,一个变量可能既充当输入操作数,也充当输出操作数。可以通过使用匹配约束在 "asm" 中指定这种情况。

+

+ `asm ("incl %0" :"=a"(var):"0"(var));`

+

+ 在操作数那一节中,我们也看到了一些类似的示例。在这个匹配约束的示例中,寄存器 "%eax" 既用作输入变量,也用作输出变量。 var 输入被读进 %eax,并且等递增后更新的 %eax 再次被存储进 var。这里的 "0" 用于指定与第 0 个输出变量相同的约束。也就是,它指定 var 输出实例应只被存储在 "%eax" 中。该约束可用于:

+ - 在输入从变量读取或变量修改后且修改被写回同一变量的情况

+ - 在不需要将输入操作数实例和输出操作数实例分开的情况

+

+ 使用匹配约束最重要的意义在于它们可以有效地使用可用寄存器。

+

+其他一些约束:

+

+1. "m" : 允许一个内存操作数,可以使用机器普遍支持的任一种地址。

+2. "o" : 允许一个内存操作数,但只有当地址是可偏移的。即,该地址加上一个小的偏移量可以得到一个有效地址。

+3. "V" : 一个不允许偏移的内存操作数。换言之,任何适合 "m" 约束而不适合 "o" 约束的操作数。

+4. "i" : 允许一个(带有常量)的立即整形操作数。这包括其值仅在汇编时期知道的符号常量。

+5. "n" : 允许一个带有已知数字的立即整形操作数。许多系统不支持汇编时期的常量,因为操作数少于一个字宽。对于此种操作数,约束应该使用 'n' 而不是'i'。

+6. "g" : 允许任一寄存器、内存或者立即整形操作数,不包括通用寄存器之外的寄存器。

+

+以下约束为 x86 特有。

+

+1. "r" : 寄存器操作数约束,查看上面给定的表格。

+2. "q" : 寄存器 a、b、c 或者 d。

+3. "I" : 范围从 0 到 31 的常量(对于 32 位移位)。

+4. "J" : 范围从 0 到 63 的常量(对于 64 位移位)。

+5. "K" : 0xff。

+6. "L" : 0xffff。

+7. "M" : 0、1、2 或 3 (lea 指令的移位)。

+8. "N" : 范围从 0 到 255 的常量(对于 out 指令)。

+9. "f" : 浮点寄存器

+10. "t" : 第一个(栈顶)浮点寄存器

+11. "u" : 第二个浮点寄存器

+12. "A" : 指定 `a` 或 `d` 寄存器。这主要用于想要返回 64 位整形数,使用 `d` 寄存器保存最高有效位和 `a` 寄存器保存最低有效位。

+

+### 6.2 约束修饰符

+

+当使用约束时,对于更精确的控制超过了对约束作用的需求,GCC 给我们提供了约束修饰符。最常用的约束修饰符为:

+

+1. "=" : 意味着对于这条指令,操作数为只写的;旧值会被忽略并被输出数据所替换。

+2. "&" : 意味着这个操作数为一个早期改动的操作数,其在该指令完成前通过使用输入操作数被修改了。因此,这个操作数不可以位于一个被用作输出操作数或任何内存地址部分的寄存器。如果在旧值被写入之前它仅用作输入而已,一个输入操作数可以为一个早期改动操作数。

+

+上述的约束列表和解释并不完整。示例可以让我们对内联汇编的用途和用法更好的理解。在下一节,我们会看到一些示例,在那里我们会发现更多关于修饰寄存器列表的东西。

+

+* * *

+

+## 7. 一些实用的诀窍

+

+现在我们已经介绍了关于 GCC 内联汇编的基础理论,现在我们将专注于一些简单的例子。将内联汇编函数写成宏的形式总是非常方便的。我们可以在 Linux 内核代码里看到许多汇编函数。(usr/src/linux/include/asm/*.h)。

+

+1. 首先我们从一个简单的例子入手。我们将写一个两个数相加的程序。

+

+ ```

+ int main(void)

+ {

+ int foo = 10, bar = 15;

+ __asm__ __volatile__("addl %%ebx,%%eax"

+ :"=a"(foo)

+ :"a"(foo), "b"(bar)

+ );

+ printf("foo+bar=%d\n", foo);

+ return 0;

+ }

+ ```

+

+ 这里我们要求 GCC 将 foo 存放于 %eax,将 bar 存放于 %ebx,同时我们也想要在 %eax 中存放结果。'=' 符号表示它是一个输出寄存器。现在我们可以以其他方式将一个整数加到一个变量。

+

+ ```

+ __asm__ __volatile__(

+ " lock ;\n"

+ " addl %1,%0 ;\n"

+ : "=m" (my_var)

+ : "ir" (my_int), "m" (my_var)

+ : /* 无修饰寄存器列表 */

+ );

+ ```

+

+ 这是一个原子加法。为了移除原子性,我们可以移除指令 'lock'。在输出域中,"=m" 表明 my_var 是一个输出且位于内存。类似地,"ir" 表明 my_int 是一个整型,并应该存在于其他寄存器(回想我们上面看到的表格)。没有寄存器位于修饰寄存器列表中。

+

+2. 现在我们将在一些寄存器/变量上展示一些操作,并比较值。

+

+ ```

+ __asm__ __volatile__( "decl %0; sete %1"

+ : "=m" (my_var), "=q" (cond)

+ : "m" (my_var)

+ : "memory"

+ );

+ ```

+

+ 这里,my_var 的值减 1 ,并且如果结果的值为 0,则变量 cond 置 1。我们可以通过将指令 "lock;\n\t" 添加为汇编模板的第一条指令以增加原子性。

+

+ 以类似的方式,为了增加 my_var,我们可以使用 "incl %0" 而不是 "decl %0"。

+

+ 这里需要注意的地方是(i)my_var 是一个存储于内存的变量。(ii)cond 位于寄存器 eax、ebx、ecx、edx 中的任何一个。约束 "=q" 保证了这一点。(iii)同时我们可以看到 memory 位于修饰寄存器列表中。也就是说,代码将改变内存中的内容。

+

+3. 如何置 1 或清 0 寄存器中的一个比特位。作为下一个诀窍,我们将会看到它。

+

+ ```

+ __asm__ __volatile__( "btsl %1,%0"

+ : "=m" (ADDR)

+ : "Ir" (pos)

+ : "cc"

+ );

+ ```

+

+ 这里,ADDR 变量(一个内存变量)的 'pos' 位置上的比特被设置为 1。我们可以使用 'btrl' 来清除由 'btsl' 设置的比特位。pos 的约束 "Ir" 表明 pos 位于寄存器,并且它的值为 0-31(x86 相关约束)。也就是说,我们可以设置/清除 ADDR 变量上第 0 到 31 位的任一比特位。因为条件码会被改变,所以我们将 "cc" 添加进修饰寄存器列表。

+

+4. 现在我们看看一些更为复杂而有用的函数。字符串拷贝。

+

+ ```

+ static inline char * strcpy(char * dest,const char *src)

+ {

+ int d0, d1, d2;

+ __asm__ __volatile__( "1:\tlodsb\n\t"

+ "stosb\n\t"

+ "testb %%al,%%al\n\t"

+ "jne 1b"

+ : "=&S" (d0), "=&D" (d1), "=&a" (d2)

+ : "0" (src),"1" (dest)

+ : "memory");

+ return dest;

+ }

+ ```

+

+ 源地址存放于 esi,目标地址存放于 edi,同时开始拷贝,当我们到达 **0** 时,拷贝完成。约束 "&S"、"&D"、"&a" 表明寄存器 esi、edi 和 eax 早期修饰寄存器,也就是说,它们的内容在函数完成前会被改变。这里很明显可以知道为什么 "memory" 会放在修饰寄存器列表。

+

+ 我们可以看到一个类似的函数,它能移动双字块数据。注意函数被声明为一个宏。

+

+ ```

+ #define mov_blk(src, dest, numwords) \

+ __asm__ __volatile__ ( \

+ "cld\n\t" \

+ "rep\n\t" \

+ "movsl" \

+ : \

+ : "S" (src), "D" (dest), "c" (numwords) \

+ : "%ecx", "%esi", "%edi" \

+ )

+ ```

+

+ 这里我们没有输出,寄存器 ecx、esi和 edi 的内容发生了改变,这是块移动的副作用。因此我们必须将它们添加进修饰寄存器列表。

+

+5. 在 Linux 中,系统调用使用 GCC 内联汇编实现。让我们看看如何实现一个系统调用。所有的系统调用被写成宏(linux/unistd.h)。例如,带有三个参数的系统调用被定义为如下所示的宏。

+

+ ```

+ type name(type1 arg1,type2 arg2,type3 arg3) \

+ { \

+ long __res; \

+ __asm__ volatile ( "int $0x80" \

+ : "=a" (__res) \

+ : "0" (__NR_##name),"b" ((long)(arg1)),"c" ((long)(arg2)), \

+ "d" ((long)(arg3))); \

+ __syscall_return(type,__res); \

+ }

+ ```

+

+ 无论何时调用带有三个参数的系统调用,以上展示的宏就会用于执行调用。系统调用号位于 eax 中,每个参数位于 ebx、ecx、edx 中。最后 "int 0x80" 是一条用于执行系统调用的指令。返回值被存储于 eax 中。

+

+ 每个系统调用都以类似的方式实现。Exit 是一个单一参数的系统调用,让我们看看它的代码看起来会是怎样。它如下所示。

+

+ ```

+ {

+ asm("movl $1,%%eax; /* SYS_exit is 1 */

+ xorl %%ebx,%%ebx; /* Argument is in ebx, it is 0 */

+ int $0x80" /* Enter kernel mode */

+ );

+ }

+ ```

+

+ Exit 的系统调用号是 1,同时它的参数是 0。因此我们分配 eax 包含 1,ebx 包含 0,同时通过 `int $0x80` 执行 `exit(0)`。这就是 exit 的工作原理。

+

+* * *

+

+## 8. 结束语

+

+这篇文档已经将 GCC 内联汇编过了一遍。一旦你理解了基本概念,你就可以按照自己的需求去使用它们了。我们看了许多例子,它们有助于理解 GCC 内联汇编的常用特性。

+

+GCC 内联是一个极大的主题,这篇文章是不完整的。更多关于我们讨论过的语法细节可以在 GNU 汇编器的官方文档上获取。类似地,要获取完整的约束列表,可以参考 GCC 的官方文档。

+

+当然,Linux 内核大量地使用了 GCC 内联。因此我们可以在内核源码中发现许多各种各样的例子。它们可以帮助我们很多。

+

+如果你发现任何的错别字,或者本文中的信息已经过时,请告诉我们。

+

+* * *

+

+## 9. 参考

+

+1. [Brennan’s Guide to Inline Assembly](http://www.delorie.com/djgpp/doc/brennan/brennan_att_inline_djgpp.html)

+2. [Using Assembly Language in Linux](http://linuxassembly.org/articles/linasm.html)

+3. [Using as, The GNU Assembler](http://www.gnu.org/manual/gas-2.9.1/html_mono/as.html)

+4. [Using and Porting the GNU Compiler Collection (GCC)](http://gcc.gnu.org/onlinedocs/gcc_toc.html)

+5. [Linux Kernel Source](http://ftp.kernel.org/)

+

+* * *

+

+via: http://www.ibiblio.org/gferg/ldp/GCC-Inline-Assembly-HOWTO.html

+

+ 作者:[Sandeep.S](mailto:busybox@sancharnet.in) 译者:[cposture](https://github.com/cposture) 校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

diff --git a/published/20160306 5 Favorite Open Source Django Packages.md b/published/20160306 5 Favorite Open Source Django Packages.md

new file mode 100644

index 0000000000..8c73c702e1

--- /dev/null

+++ b/published/20160306 5 Favorite Open Source Django Packages.md

@@ -0,0 +1,161 @@

+5 个最受人喜爱的开源 Django 包

+================================================================================

+

+

+

+图片来源:Opensource.com

+

+_Jacob Kaplan-Moss 和 Frank Wiles 也参与了本文的写作。_

+

+Django 围绕“[可重用应用][1]”的思想建立:自包含的包提供了可重复使用的特性。你可以将这些可重用应用组装起来,在加上适用于你的网站的特定代码,来搭建你自己的网站。Django 具有一个丰富多样的、由可供你使用的可重用应用组建起来的生态系统——PyPI 列出了[超过 8000个 Django 应用][2]——可你该如何知道哪些是最好的呢?

+

+为了节省你的时间,我们总结了五个最受喜爱的 Django 应用。它们是:

+

+- [Cookiecutter][3]: 建立 Django 网站的最佳方式。

+- [Whitenoise][4]: 最棒的静态资源服务器。

+- [Django Rest Framework][5]: 使用 Django 开发 REST API 的最佳方式。

+- [Wagtail][6]: 基于 Django 的最佳内容管理系统(CMS)。

+- [django-allauth][7]: 提供社交账户登录的最佳应用(如 Twitter, Facebook, GitHub 等)。

+

+我们同样推荐你看看 [Django Packages][8],这是一个可重用 Django 应用的目录。Django Packages 将 Django 应用组织成“表格”,你可以在功能相似的不同应用之间进行比较并做出选择。你可以查看每个包中提供的特性和使用统计情况。(比如:这是[ REST 工具的表格][9],也许可以帮助你理解我们为何推荐 Django REST Framework。

+

+### 为什么你应该相信我们?

+

+我们使用 Django 的时间几乎比任何人都长。在 Django 发布之前,我们当中的两个人(Frank 和 Jacob)就在 [Lawrence Journal-World][10] (Django 的发源地)工作(事实上,是他们两人推动了 Django 开源发布的进程)。我们在过去的八年当中运行着一个咨询公司,来建议公司怎样最好地应用 Django。

+

+所以,我们见证了 Django 项目和社群的完整历史,我们见证了那些流行的软件包的兴起和没落。在我们三个之中,我们个人可能试用了 8000 个应用中至少一半以上,或者我们知道谁试用过这些。我们对如何使应用变得坚实可靠有着深刻的理解,并且我们对给予这些应用持久力量的来源也有着深入的了解。

+

+### 建立 Django 网站的最佳方式:[Cookiecutter][3]

+

+建立一个新项目或应用总是有些痛苦。你可以用 Django 内建的 `startproject`。不过,如果你像我们一样,对如何做事比较挑剔。Cookiecutter 为你提供了一个快捷简单的方式来构建项目或易于重用的应用模板,从而解决了这个问题。一个简单的例子:键入 `pip install cookiecutter`,然后在命令行中运行以下命令:

+

+```bash

+$ cookiecutter https://github.com/marcofucci/cookiecutter-simple-django

+```

+

+接下来你需要回答几个简单的问题,比如你的项目名称、目录(repo)、作者名字、E-Mail 和其他几个关于配置的小问题。这些能够帮你补充项目相关的细节。我们使用最最原始的 “_foo_” 作为我们的目录名称。所以 cokkiecutter 在子目录 “_foo_” 下建立了一个简单的 Django 项目。

+

+如果你在 “_foo_” 项目中闲逛,你会看见你刚刚选择的其它设置已通过模板,连同所需的子目录一同嵌入到文件当中。这个“模板”在我们刚刚在执行 `cookiecutter` 命令时输入的唯一一个参数 Github 仓库 URL 中定义。这个样例工程使用了一个 Github 远程仓库作为模板;不过你也可以使用本地的模板,这在建立非重用项目时非常有用。

+

+我们认为 cookiecutter 是一个极棒的 Django 包,但是,事实上其实它在面对纯 Python 甚至非 Python 相关需求时也极为有用。你能够将所有文件以一种可重复的方式精确地摆放在任何位置上,使得 cookiecutter 成为了一个简化(DRY)工作流程的极佳工具。

+

+### 最棒的静态资源服务器:[Whitenoise][4]

+

+多年来,托管网站的静态资源——图片、Javascript、CSS——都是一件很痛苦的事情。Django 内建的 [django.views.static.serve][11] 视图,就像 Django 文章所述的那样,“在生产环境中不可靠,所以只应为开发环境的提供辅助功能。”但使用一个“真正的” Web 服务器,如 NGINX 或者借助 CDN 来托管媒体资源,配置起来会比较困难。

+

+Whitenoice 很简洁地解决了这个问题。它可以像在开发环境那样轻易地在生产环境中设置静态服务器,并且针对生产环境进行了加固和优化。它的设置方法极为简单:

+

+1. 确保你在使用 Django 的 [contrib.staticfiles][12] 应用,并确认你在配置文件中正确设置了 `STATIC_ROOT` 变量。

+

+2. 在 `wsgi.py` 文件中启用 Whitenoise:

+

+ ```python

+ from django.core.wsgi import get_wsgi_application

+ from whitenoise.django import DjangoWhiteNoise

+

+ application = get_wsgi_application()

+ application = DjangoWhiteNoise(application)

+ ```

+

+配置它真的就这么简单!对于大型应用,你可能想要使用一个专用的媒体服务器和/或一个 CDN,但对于大多数小型或中型 Django 网站,Whitenoise 已经足够强大。

+

+如需查看更多关于 Whitenoise 的信息,[请查看文档][13]。

+

+### 开发 REST API 的最佳工具:[Django REST Framework][5]

+

+REST API 正在迅速成为现代 Web 应用的标准功能。 API 就是简单的使用 JSON 对话而不是 HTML,当然你可以只用 Django 做到这些。你可以制作自己的视图,设置合适的 `Content-Type`,然后返回 JSON 而不是渲染后的 HTML 响应。这是在像 [Django Rest Framework][14](下称 DRF)这样的 API 框架发布之前,大多数人所做的。

+

+如果你对 Django 的视图类很熟悉,你会觉得使用 DRF 构建 REST API 与使用它们很相似,不过 DRF 只针对特定 API 使用场景而设计。一般的 API 设置只需要一点代码,所以我们没有提供一份让你兴奋的示例代码,而是强调了一些可以让你生活的更舒适的 DRF 特性:

+

+* 可自动预览的 API 可以使你的开发和人工测试轻而易举。你可以查看 DRF 的[示例代码][15]。你可以查看 API 响应,并且不需要你做任何事就可以支持 POST/PUT/DELETE 类型的操作。

+* 便于集成各种认证方式,如 OAuth, Basic Auth, 或API Tokens。

+* 内建请求速率限制。

+* 当与 [django-rest-swagger][16] 组合使用时,API 文档几乎可以自动生成。

+* 广泛的第三方库生态。

+

+当然,你可以不依赖 DRF 来构建 API,但我们无法想象你不去使用 DRF 的原因。就算你不使用 DRF 的全部特性,使用一个成熟的视图库来构建你自己的 API 也会使你的 API 更加一致、完全,更能提高你的开发速度。如果你还没有开始使用 DRF, 你应该找点时间去体验一下。

+

+### 基于 Django 的最佳 CMS:[Wagtail][6]

+

+Wagtail 是当下 Django CMS(内容管理系统)世界中最受人青睐的应用,并且它的热门有足够的理由。就像大多数的 CMS 一样,它具有极佳的灵活性,可以通过简单的 Django 模型来定义不同类型的页面及其内容。使用它,你可以从零开始在几个小时而不是几天之内来和建造一个基本可以运行的内容管理系统。举一个小例子,为你公司的员工定义一个员工页面类型可以像下面一样简单:

+

+```python

+from wagtail.wagtailcore.models import Page

+from wagtail.wagtailcore.fields import RichTextField

+from wagtail.wagtailadmin.edit_handlers import FieldPanel, MultiFieldPanel

+from wagtail.wagtailimages.edit_handlers import ImageChooserPanel

+

+class StaffPage(Page):

+ name = models.CharField(max_length=100)

+ hire_date = models.DateField()

+ bio = models.RichTextField()

+ email = models.EmailField()

+ headshot = models.ForeignKey('wagtailimages.Image', null=True, blank=True)

+ content_panels = Page.content_panels + [

+ FieldPanel('name'),

+ FieldPanel('hire_date'),

+ FieldPanel('email'),

+ FieldPanel('bio',classname="full"),

+ ImageChoosePanel('headshot'),

+ ]

+```

+

+然而,Wagtail 真正出彩的地方在于它的灵活性及其易于使用的现代化管理页面。你可以控制不同类型的页面在哪网站的哪些区域可以访问,为页面添加复杂的附加逻辑,还天生就支持标准的适应/审批工作流。在大多数 CMS 系统中,你会在开发时在某些点上遇到困难。而使用 Wagtail 时,我们经过不懈努力找到了一个突破口,使得让我们轻易地开发出一套简洁稳定的系统,使得程序完全依照我们的想法运行。如果你对此感兴趣,我们写了一篇[深入理解 Wagtail][17。

+

+### 提供社交账户登录的最佳工具:[django-allauth][7]

+

+django-allauth 是一个能够解决你的注册和认证需求的、可重用的 Django 应用。无论你需要构建本地注册系统还是社交账户注册系统,django-allauth 都能够帮你做到。

+

+这个应用支持多种认证体系,比如用户名或电子邮件。一旦用户注册成功,它还可以提供从无需认证到电子邮件认证的多种账户验证的策略。同时,它也支持多种社交账户和电子邮件账户。它还支持插拔式注册表单,可让用户在注册时回答一些附加问题。

+

+django-allauth 支持多于 20 种认证提供者,包括 Facebook、Github、Google 和 Twitter。如果你发现了一个它不支持的社交网站,很有可能通过第三方插件提供该网站的接入支持。这个项目还支持自定义后端,可以支持自定义的认证方式,对每个有定制认证需求的人来说这都很棒。

+

+django-allauth 易于配置,且有[完善的文档][18]。该项目通过了很多测试,所以你可以相信它的所有部件都会正常运作。

+

+你有最喜爱的 Django 包吗?请在评论中告诉我们。

+

+### 关于作者

+

+

+

+*Jeff Triplett 劳伦斯,堪萨斯州 *

+

+我在 2007 年搬到了堪萨斯州的劳伦斯,在 Django 的发源地—— Lawrence Journal-World 工作。我现在在劳伦斯市的 [Revolution Systems (Revsys)][19] 工作,做一位开发者兼顾问。

+

+我是[北美 Django 运动基金会(DEFNA)][20]的联合创始人,2015 和 2016 年 [DjangoCon US][21] 的会议主席,而且我在 Django 的发源地劳伦斯参与组织了 [Django Birthday][22] 来庆祝 Django 的 10 岁生日。

+

+我是当地越野跑小组的成员,我喜欢篮球,我还喜欢梦见自己随着一道气流游遍美国。

+

+--------------------------------------------------------------------------------

+

+via: https://opensource.com/business/15/12/5-favorite-open-source-django-packages

+

+作者:[Jeff Triplett][a]

+译者:[StdioA](https://github.com/StdioA)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]:https://opensource.com/users/jefftriplett

+[1]:https://docs.djangoproject.com/en/1.8/intro/reusable-apps/

+[2]:https://pypi.python.org/pypi?:action=browse&c=523

+[3]:https://github.com/audreyr/cookiecutter

+[4]:http://whitenoise.evans.io/en/latest/base.html

+[5]:http://www.django-rest-framework.org/

+[6]:https://wagtail.io/

+[7]:http://www.intenct.nl/projects/django-allauth/

+[8]:https://www.djangopackages.com/

+[9]:https://www.djangopackages.com/grids/g/rest/

+[10]:http://www2.ljworld.com/news/2015/jul/09/happy-birthday-django/

+[11]:https://docs.djangoproject.com/en/1.8/ref/views/#django.views.static.serve

+[12]:https://docs.djangoproject.com/en/1.8/ref/contrib/staticfiles/

+[13]:http://whitenoise.evans.io/en/latest/index.html

+[14]:http://www.django-rest-framework.org/

+[15]:http://restframework.herokuapp.com/

+[16]:http://django-rest-swagger.readthedocs.org/en/latest/index.html

+[17]:https://opensource.com/business/15/5/wagtail-cms

+[18]:http://django-allauth.readthedocs.org/en/latest/

+[19]:http://www.revsys.com/

+[20]:http://defna.org/

+[21]:https://2015.djangocon.us/

+[22]:https://djangobirthday.com/

diff --git a/published/20160309 Let’s Build A Web Server. Part 1.md b/published/20160309 Let’s Build A Web Server. Part 1.md

new file mode 100644

index 0000000000..d55d5720d2

--- /dev/null

+++ b/published/20160309 Let’s Build A Web Server. Part 1.md

@@ -0,0 +1,150 @@

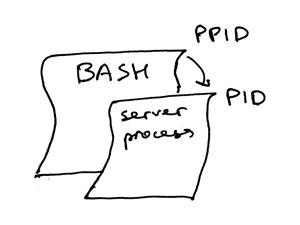

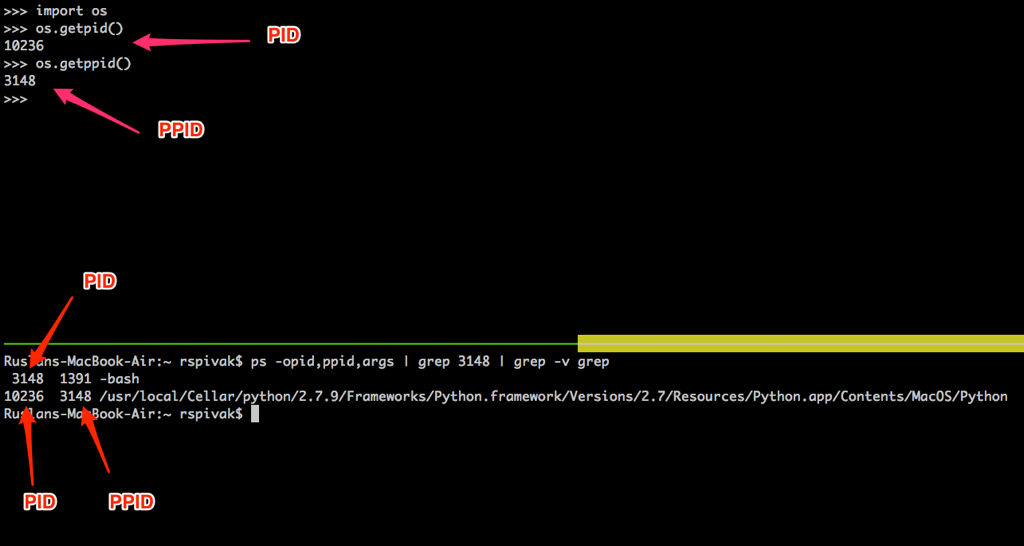

+搭个 Web 服务器(一)

+=====================================

+

+一天,有一个正在散步的妇人恰好路过一个建筑工地,看到三个正在工作的工人。她问第一个人:“你在做什么?”第一个人没好气地喊道:“你没看到我在砌砖吗?”妇人对这个答案不满意,于是问第二个人:“你在做什么?”第二个人回答说:“我在建一堵砖墙。”说完,他转向第一个人,跟他说:“嗨,你把墙砌过头了。去把刚刚那块砖弄下来!”然而,妇人对这个答案依然不满意,于是又问了第三个人相同的问题。第三个人仰头看着天,对她说:“我在建造世界上最大的教堂。”当他回答时,第一个人和第二个人在为刚刚砌错的砖而争吵。他转向那两个人,说:“不用管那块砖了。这堵墙在室内,它会被水泥填平,没人会看见它的。去砌下一层吧。”

+

+这个故事告诉我们:如果你能够理解整个系统的构造,了解系统的各个部件如何相互结合(如砖、墙还有整个教堂),你就能够更快地定位及修复问题(那块砌错的砖)。

+

+如果你想从头开始创造一个 Web 服务器,那么你需要做些什么呢?

+

+我相信,如果你想成为一个更好的开发者,你**必须**对日常使用的软件系统的内部结构有更深的理解,包括编程语言、编译器与解释器、数据库及操作系统、Web 服务器及 Web 框架。而且,为了更好更深入地理解这些系统,你**必须**从头开始,用一砖一瓦来重新构建这个系统。

+

+荀子曾经用这几句话来表达这种思想:

+

+>“不闻不若闻之。(I hear and I forget.)”

+

+

+

+>“闻之不若见之。(I see and I remember.)”

+

+

+

+>“知之不若行之。(I do and I understand.)”

+

+

+

+我希望你现在能够意识到,重新建造一个软件系统来了解它的工作方式是一个好主意。

+

+在这个由三篇文章组成的系列中,我将会教你构建你自己的 Web 服务器。我们开始吧~

+

+先说首要问题:Web 服务器是什么?

+

+

+

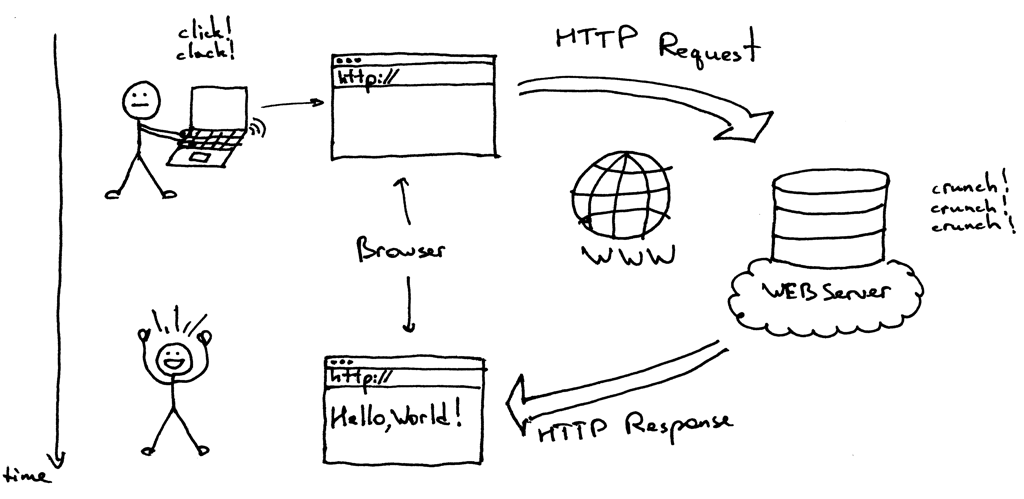

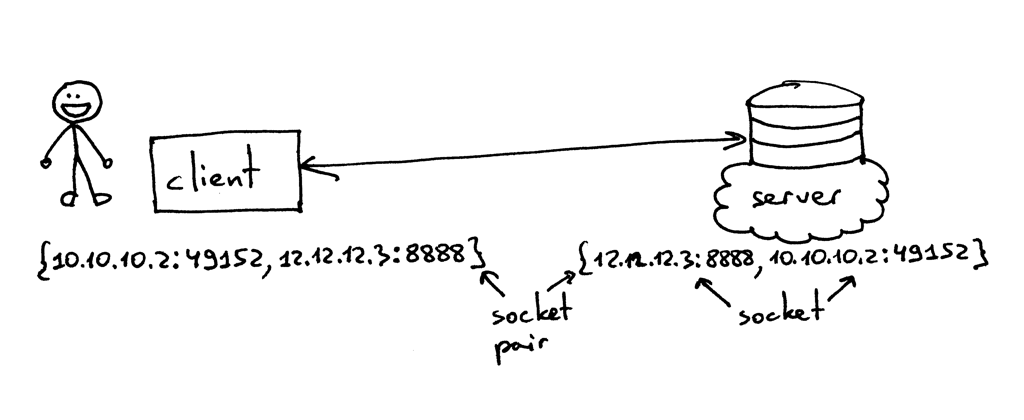

+简而言之,它是一个运行在一个物理服务器上的网络服务器(啊呀,服务器套服务器),等待客户端向其发送请求。当它接收请求后,会生成一个响应,并回送至客户端。客户端和服务端之间通过 HTTP 协议来实现相互交流。客户端可以是你的浏览器,也可以是使用 HTTP 协议的其它任何软件。

+

+最简单的 Web 服务器实现应该是什么样的呢?这里我给出我的实现。这个例子由 Python 写成,即使你没听说过 Python(它是一门超级容易上手的语言,快去试试看!),你也应该能够从代码及注释中理解其中的理念:

+

+```

+import socket

+

+HOST, PORT = '', 8888

+

+listen_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

+listen_socket.setsockopt(socket.SOL_SOCKET, socket.SO_REUSEADDR, 1)

+listen_socket.bind((HOST, PORT))

+listen_socket.listen(1)

+print 'Serving HTTP on port %s ...' % PORT

+while True:

+ client_connection, client_address = listen_socket.accept()

+ request = client_connection.recv(1024)

+ print request

+

+ http_response = """\

+HTTP/1.1 200 OK

+

+Hello, World!

+"""

+ client_connection.sendall(http_response)

+ client_connection.close()

+```

+

+将以上代码保存为 webserver1.py,或者直接从 [GitHub][1] 上下载这个文件。然后,在命令行中运行这个程序。像这样:

+

+```

+$ python webserver1.py

+Serving HTTP on port 8888 …

+```

+

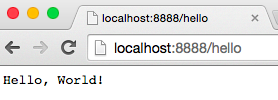

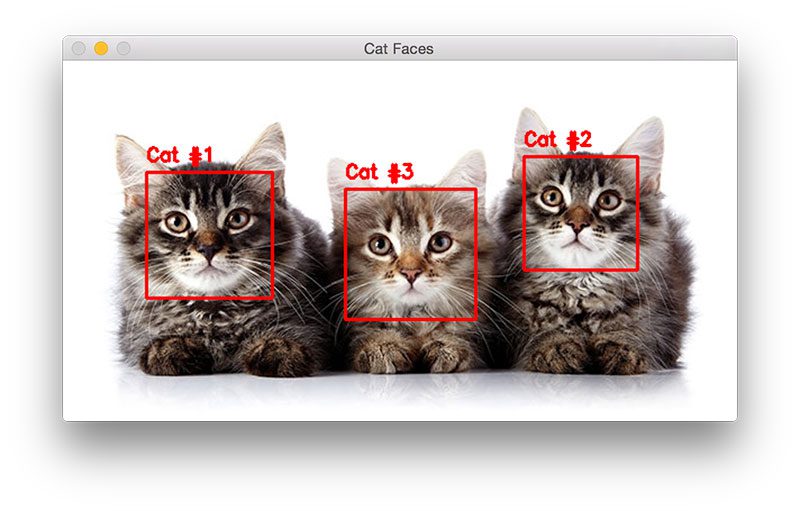

+现在,在你的网页浏览器的地址栏中输入 URL:http://localhost:8888/hello ,敲一下回车,然后来见证奇迹。你应该看到“Hello, World!”显示在你的浏览器中,就像下图那样:

+

+

+

+说真的,快去试一试。你做实验的时候,我会等着你的。

+

+完成了?不错!现在我们来讨论一下它实际上是怎么工作的。

+

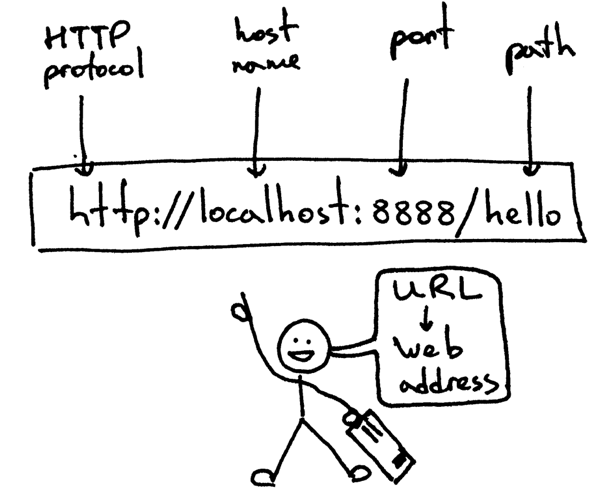

+首先我们从你刚刚输入的 Web 地址开始。它叫 [URL][2],这是它的基本结构:

+

+

+

+URL 是一个 Web 服务器的地址,浏览器用这个地址来寻找并连接 Web 服务器,并将上面的内容返回给你。在你的浏览器能够发送 HTTP 请求之前,它需要与 Web 服务器建立一个 TCP 连接。然后会在 TCP 连接中发送 HTTP 请求,并等待服务器返回 HTTP 响应。当你的浏览器收到响应后,就会显示其内容,在上面的例子中,它显示了“Hello, World!”。

+

+我们来进一步探索在发送 HTTP 请求之前,客户端与服务器建立 TCP 连接的过程。为了建立链接,它们使用了所谓“套接字(socket)”。我们现在不直接使用浏览器发送请求,而在命令行中使用 `telnet` 来人工模拟这个过程。

+

+在你运行 Web 服务器的电脑上,在命令行中建立一个 telnet 会话,指定一个本地域名,使用端口 8888,然后按下回车:

+

+```

+$ telnet localhost 8888

+Trying 127.0.0.1 …

+Connected to localhost.

+```

+

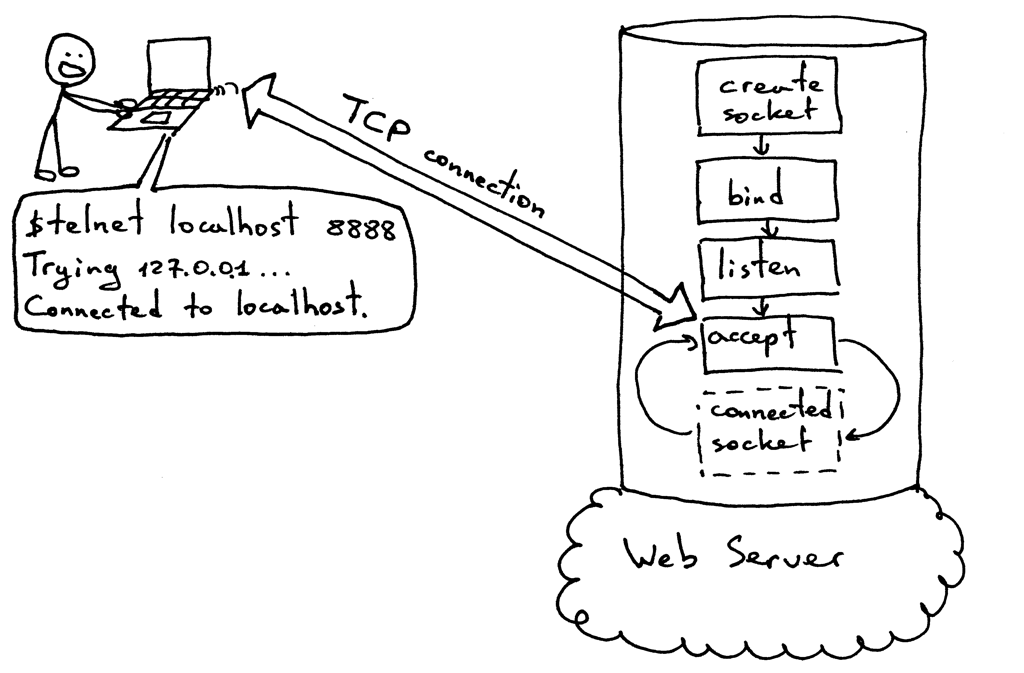

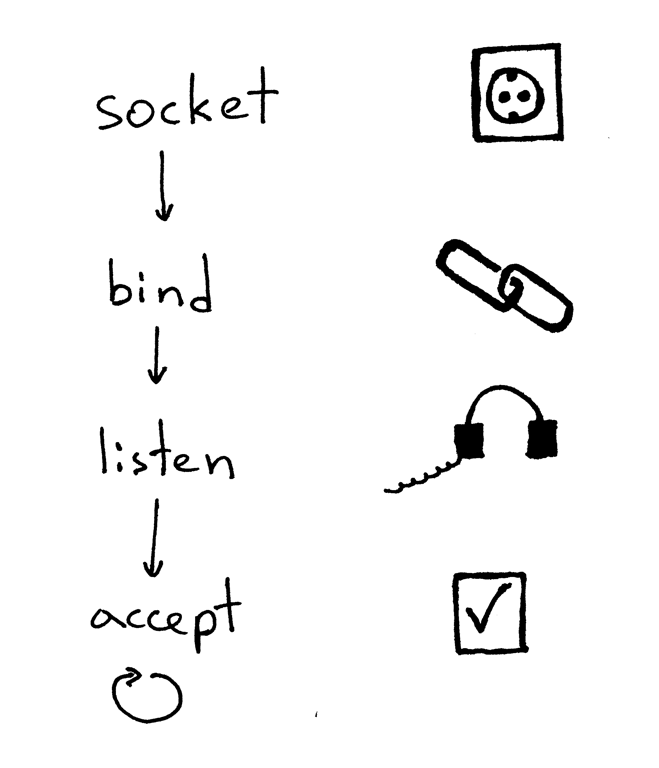

+这个时候,你已经与运行在你本地主机的服务器建立了一个 TCP 连接。在下图中,你可以看到一个服务器从头开始,到能够建立 TCP 连接的基本过程。

+

+

+

+在同一个 telnet 会话中,输入 `GET /hello HTTP/1.1`,然后输入回车:

+

+```

+$ telnet localhost 8888

+Trying 127.0.0.1 …

+Connected to localhost.

+GET /hello HTTP/1.1

+

+HTTP/1.1 200 OK

+Hello, World!

+```

+

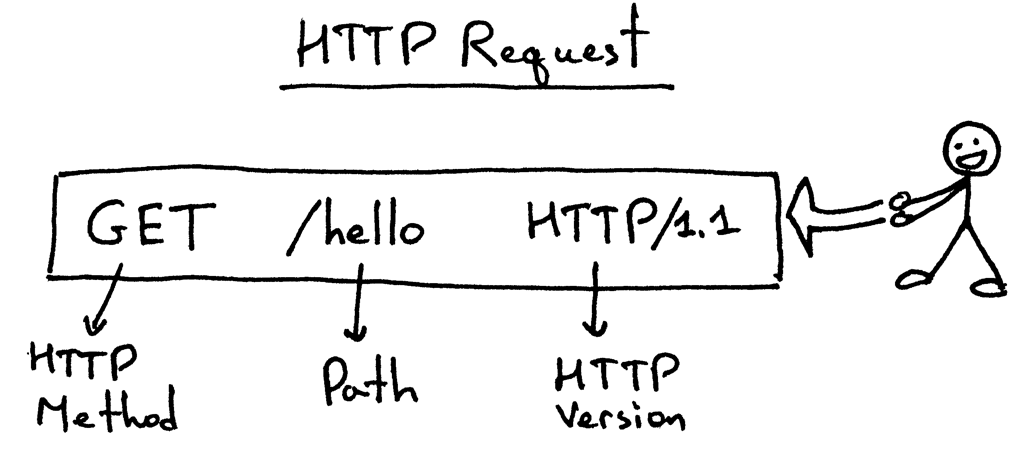

+你刚刚手动模拟了你的浏览器(的工作)!你发送了 HTTP 请求,并且收到了一个 HTTP 应答。下面是一个 HTTP 请求的基本结构:

+

+

+

+HTTP 请求的第一行由三部分组成:HTTP 方法(`GET`,因为我们想让我们的服务器返回一些内容),以及标明所需页面的路径 `/hello`,还有协议版本。

+

+为了简单一些,我们刚刚构建的 Web 服务器完全忽略了上面的请求内容。你也可以试着输入一些无用内容而不是“GET /hello HTTP/1.1”,但你仍然会收到一个“Hello, World!”响应。

+

+一旦你输入了请求行并敲了回车,客户端就会将请求发送至服务器;服务器读取请求行,就会返回相应的 HTTP 响应。

+

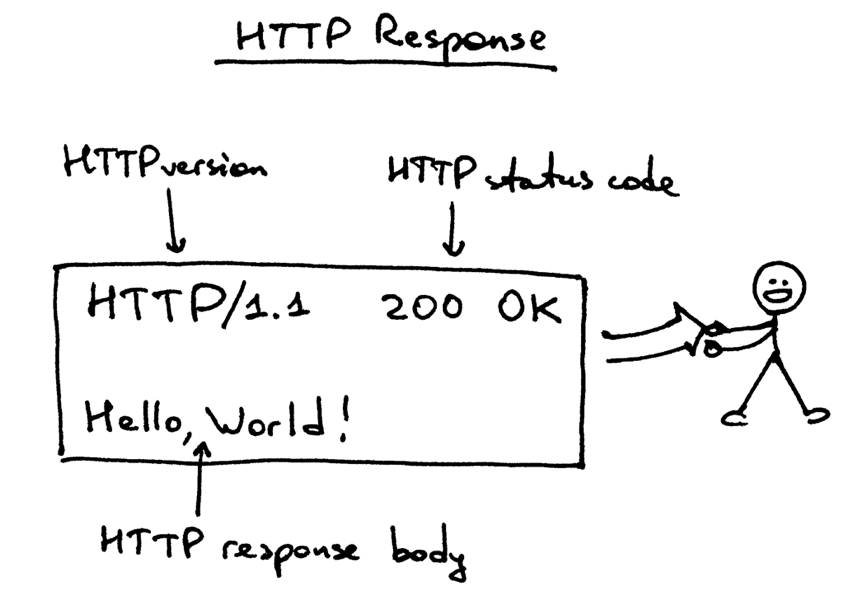

+下面是服务器返回客户端(在上面的例子里是 telnet)的响应内容:

+

+

+

+我们来解析它。这个响应由三部分组成:一个状态行 `HTTP/1.1 200 OK`,后面跟着一个空行,再下面是响应正文。

+

+HTTP 响应的状态行 HTTP/1.1 200 OK 包含了 HTTP 版本号,HTTP 状态码以及 HTTP 状态短语“OK”。当浏览器收到响应后,它会将响应正文显示出来,这也就是为什么你会在浏览器中看到“Hello, World!”。

+

+以上就是 Web 服务器的基本工作模型。总结一下:Web 服务器创建一个处于监听状态的套接字,循环接收新的连接。客户端建立 TCP 连接成功后,会向服务器发送 HTTP 请求,然后服务器会以一个 HTTP 响应做应答,客户端会将 HTTP 的响应内容显示给用户。为了建立 TCP 连接,客户端和服务端均会使用套接字。

+

+现在,你应该了解了 Web 服务器的基本工作方式,你可以使用浏览器或其它 HTTP 客户端进行试验。如果你尝试过、观察过,你应该也能够使用 telnet,人工编写 HTTP 请求,成为一个“人形” HTTP 客户端。

+

+现在留一个小问题:“你要如何在不对程序做任何改动的情况下,在你刚刚搭建起来的 Web 服务器上适配 Django, Flask 或 Pyramid 应用呢?”

+

+我会在本系列的第二部分中来详细讲解。敬请期待。

+

+顺便,我在撰写一本名为《搭个 Web 服务器:从头开始》的书。这本书讲解了如何从头开始编写一个基本的 Web 服务器,里面包含本文中没有的更多细节。订阅邮件列表,你就可以获取到这本书的最新进展,以及发布日期。

+

+--------------------------------------------------------------------------------

+

+via: https://ruslanspivak.com/lsbaws-part1/

+

+作者:[Ruslan][a]

+译者:[StdioA](https://github.com/StdioA)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://linkedin.com/in/ruslanspivak/

+[1]: https://github.com/rspivak/lsbaws/blob/master/part1/webserver1.py

+[2]: http://en.wikipedia.org/wiki/Uniform_resource_locator

+

diff --git a/published/20160316 Growing a career alongside Linux.md b/published/20160316 Growing a career alongside Linux.md

new file mode 100644

index 0000000000..d536dea1bb

--- /dev/null

+++ b/published/20160316 Growing a career alongside Linux.md

@@ -0,0 +1,49 @@

+伴随 Linux 成长的职业生涯

+==================================

+

+

+

+我与 Linux 的故事开始于 1998 年,一直延续到今天。 当时我在 Gap 公司工作,管理着成千台运行着 [OS/2][1] 系统的台式机 ( 在随后的几年里变成了 [Warp 3.0][2])。 作为一个 OS/2 的粉丝,那时我非常喜欢那个时候。 随着这些台式机的嗡鸣,我们使用 Gap 开发的工具轻而易举地就能支撑起对成千的用户的服务支持。 然而,一切都将改变了。

+

+在 1998 年的 11 月, 我收到邀请加入一个新成立的公司,这家公司将专注于企业级 Linux 上。 这就是后来非常出名的 [Linuxcare][2]。

+

+### 我在 Linuxcare 的时光

+

+我曾经接触过一些 Linux , 但我从未想过要把它提供给企业客户。仅仅几个月后 ( 从这里开始成为了空间和时间上的转折点 ), 我就在管理一整条线的业务,让企业获得他们的软件,硬件,甚至是证书认证等各种在当时非常盛行的 Linux 服务。

+

+我支持的客户包括像 IBM ,Dell ,HP 这样的厂商以确保他们的硬件能够成功的运行 Linux 。 今天你们应该都听过许多关于在硬件上预装 Linux 的事, 但当时 Dell 邀请我去讨论为即将到来的贸易展上将 Linux 运行在认证的笔记本电脑上。 这是多么激动人心的时刻 !同时我们在之后几年内也支持了 IBM 和 HP 等多项认证工作。

+

+Linux 变化得非常快,并且它总是这样。 它也获得了更多的关键设备的支持,比如声音,网络和图形。在这段时间, 我把个人使用的系统从基于 RPM 的系统换成了 [Debian][3] 。

+

+### 使用 Linux 的这些年

+

+几年前我在一些做 Linux 硬件设备、Linux 定制软件以及 Linux 数据中心的公司工作。而在二十世纪中期的时候,那时我正在忙为那些在雷蒙德附近(微软公司所在地)的大一些的软件公司做咨询工作,为他们对比 Linux 解决方案及其自己的解决方案做分析和验证。 我个人使用的系统一直没有改变,我仍会在尽可能的情况下运行 Debian 测试系统。

+

+我真的非常欣赏发行版的灵活性和永久更新状态。 Debian 是我所使用过的最有趣且拥有良好支持的发行版,并且它拥有最好的社区,而我是社区的一份子。

+

+当我回首我使用 Linux 的这几年,我仍记得大约在二十世纪前期和中期的时候在圣何塞,旧金山,波士顿和纽约召开的那些 Linux Expo 大会。在 Linuxcare 时我们总是会摆一些有趣而且时髦的展位,在那边逛的时候总会碰到一些老朋友。这一切工作都是需要付出代价的,所有的这一切都是在努力地强调使用 Linux 的乐趣。

+

+随着虚拟化和云的崛起也让 Linux 变得更加有趣。 当我在 Linuxcare 的时候, 我们常和斯坦福大学附近的帕洛阿尔托的一个约 30 人左右的小公司在一块。我们会开车到他们的办公处,然后帮他们准备和我们一起参加展览的东西。 谁会想得到这个小小的初创公司会成就后来的 VMware ?

+

+我还有许多的故事,能认识这些人并和他们一起工作我感到很幸运。 Linux 在各方面都不断发展且变得尤为重要。 并且甚至随着它重要性的提升,它使用起来仍然非常有趣。 我认为它的开放性和可定制能力给它带来了大量的新用户,这也是让我感到非常震惊的一点。

+

+### 现在

+

+在过去的五年里我的工作重心逐渐离开 Linux。 我所管理的大规模基础设施项目中包含着许多不同的操作系统 ( 包括非开源的和开源的 ), 但我的心一直以来都是和 Linux 在一起的。

+

+在使用 Linux 过程中的乐趣和不断进步是在过去的 18 年里一直驱动我的动力。我从 Linux 2.0 内核开始看着它变成现在的这样。 Linux 是一个卓越的、生机勃勃的且非常酷的东西。

+

+--------------------------------------------------------------------------------

+

+via: https://opensource.com/life/16/3/my-linux-story-michael-perry

+

+作者:[Michael Perry][a]

+译者:[chenxinlong](https://github.com/chenxinlong)

+校对:[wxy](https://github.com/wxy)

+

+[a]: https://opensource.com/users/mpmilestogo

+[1]: https://en.wikipedia.org/wiki/OS/2

+[2]: https://archive.org/details/IBMOS2Warp3Collection

+[3]: https://en.wikipedia.org/wiki/Linuxcare

+[4]: https://www.debian.org/

+[5]:

diff --git a/published/20160406 Let’s Build A Web Server. Part 2.md b/published/20160406 Let’s Build A Web Server. Part 2.md

new file mode 100644

index 0000000000..38c09e9915

--- /dev/null

+++ b/published/20160406 Let’s Build A Web Server. Part 2.md

@@ -0,0 +1,430 @@

+搭个 Web 服务器(二)

+===================================

+

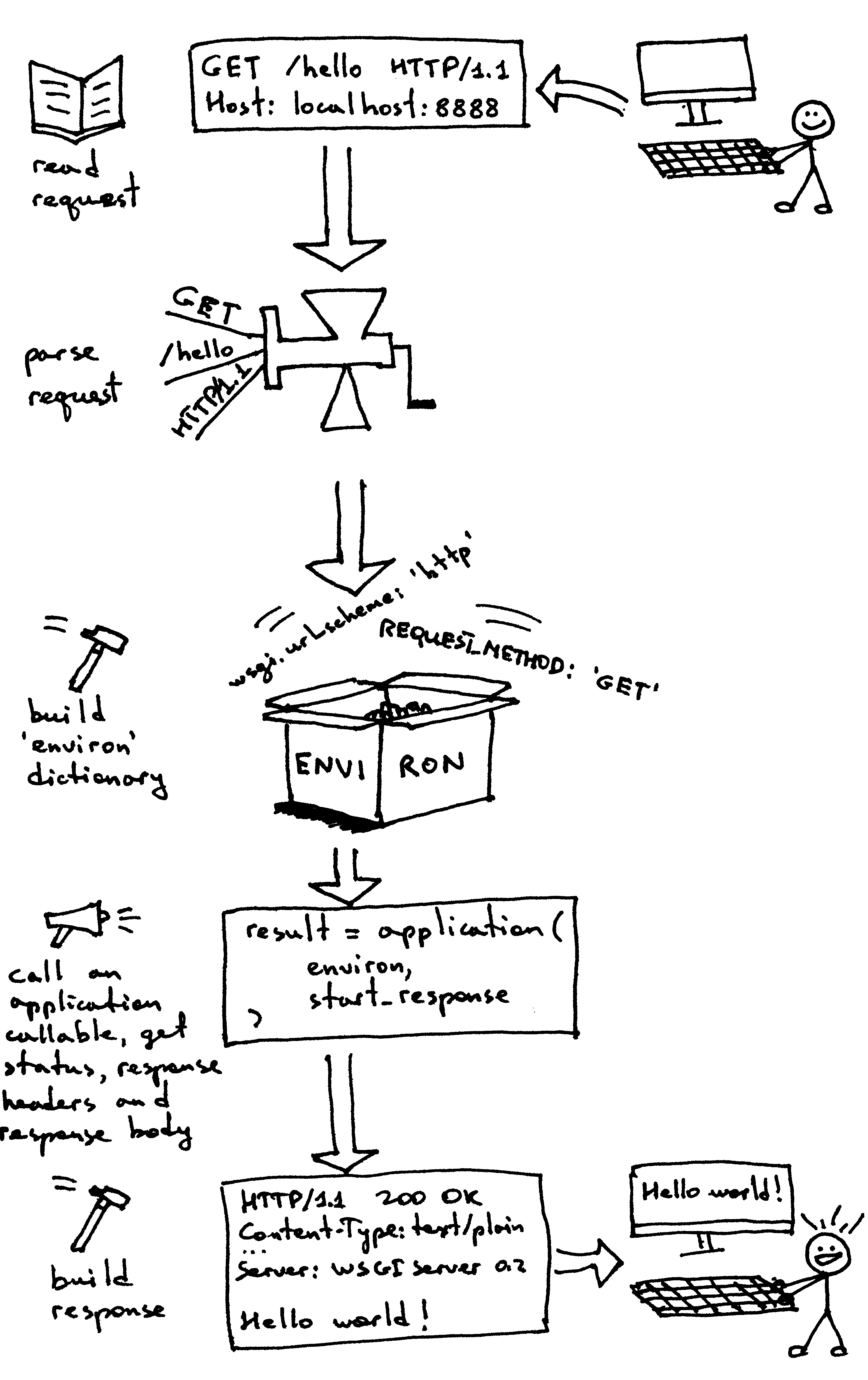

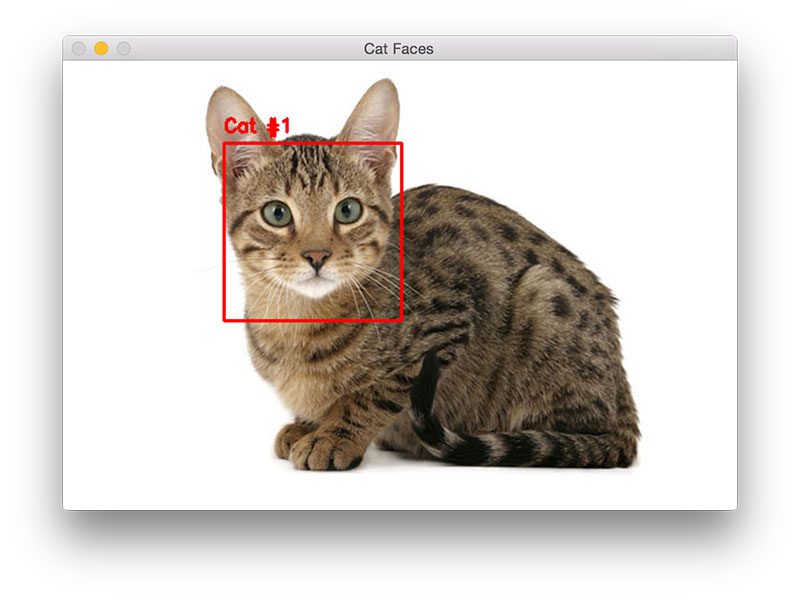

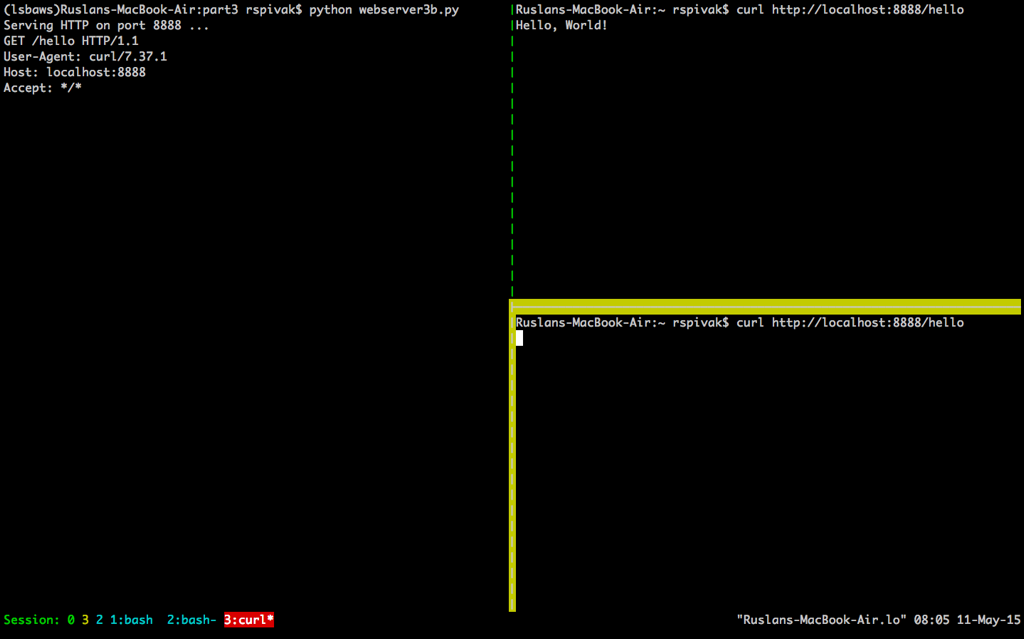

+在[第一部分][1]中,我提出了一个问题:“如何在你刚刚搭建起来的 Web 服务器上适配 Django, Flask 或 Pyramid 应用,而不用单独对 Web 服务器做做出改动以适应各种不同的 Web 框架呢?”我们可以从这一篇中找到答案。

+

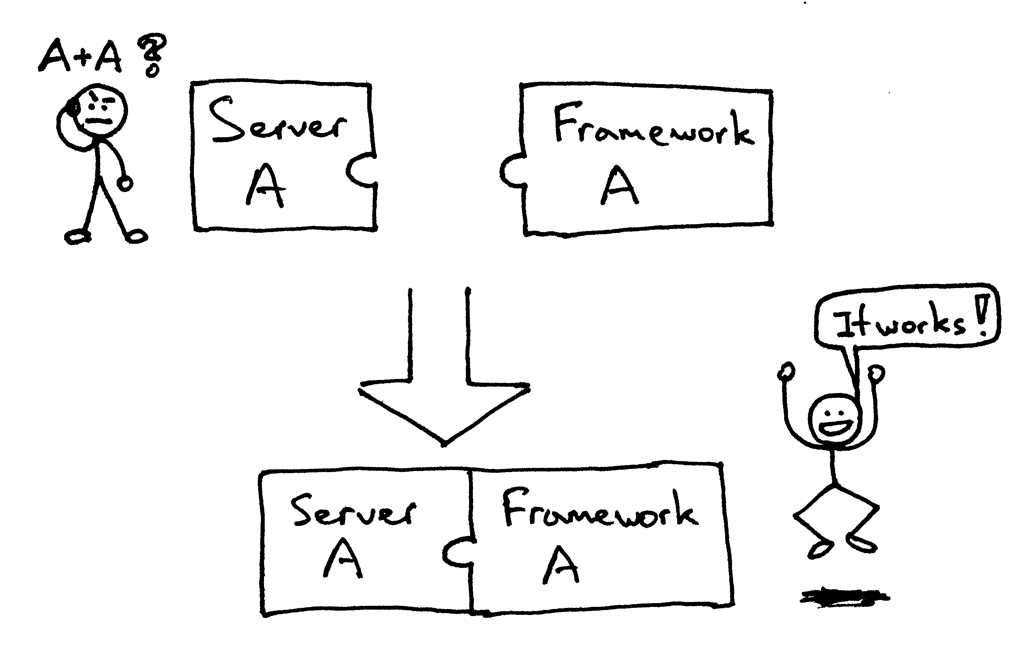

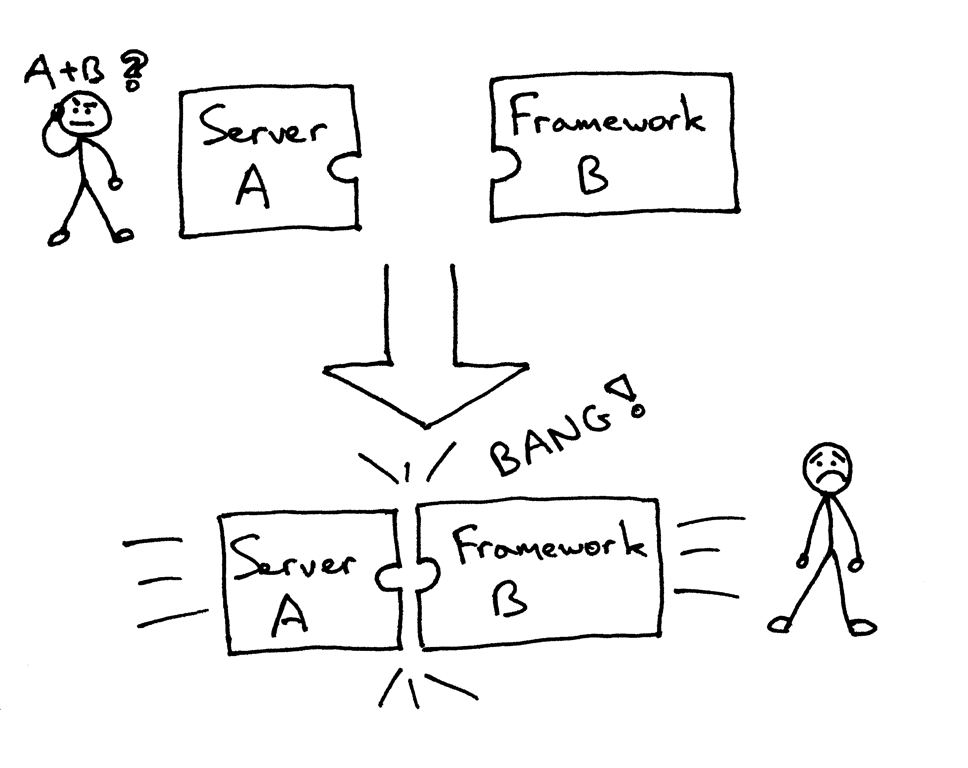

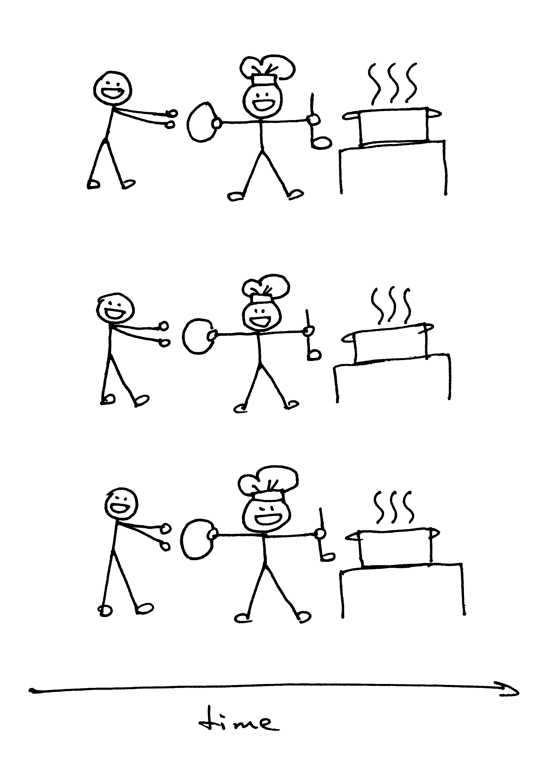

+曾几何时,你所选择的 Python Web 框架会限制你所可选择的 Web 服务器,反之亦然。如果某个框架及服务器设计用来协同工作的,那么一切正常:

+

+

+

+但你可能正面对着(或者曾经面对过)尝试将一对无法适配的框架和服务器搭配在一起的问题:

+

+

+

+基本上,你需要选择那些能够一起工作的框架和服务器,而不能选择你想用的那些。

+

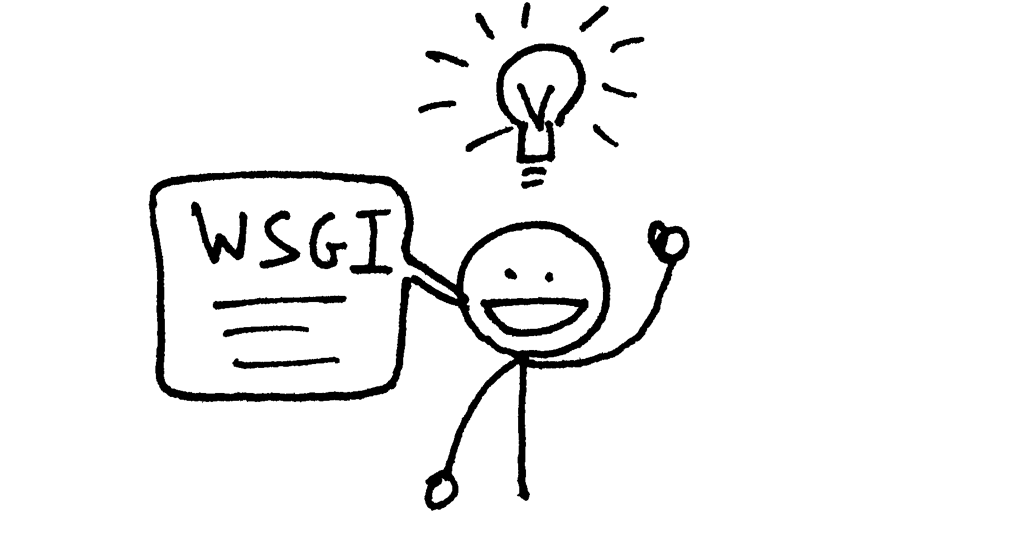

+所以,你该如何确保在不对 Web 服务器或框架的代码做任何更改的情况下,让你的 Web 服务器和多个不同的 Web 框架一同工作呢?这个问题的答案,就是 Python Web 服务器网关接口(Web Server Gateway Interface )(缩写为 [WSGI][2],念做“wizgy”)。

+

+

+

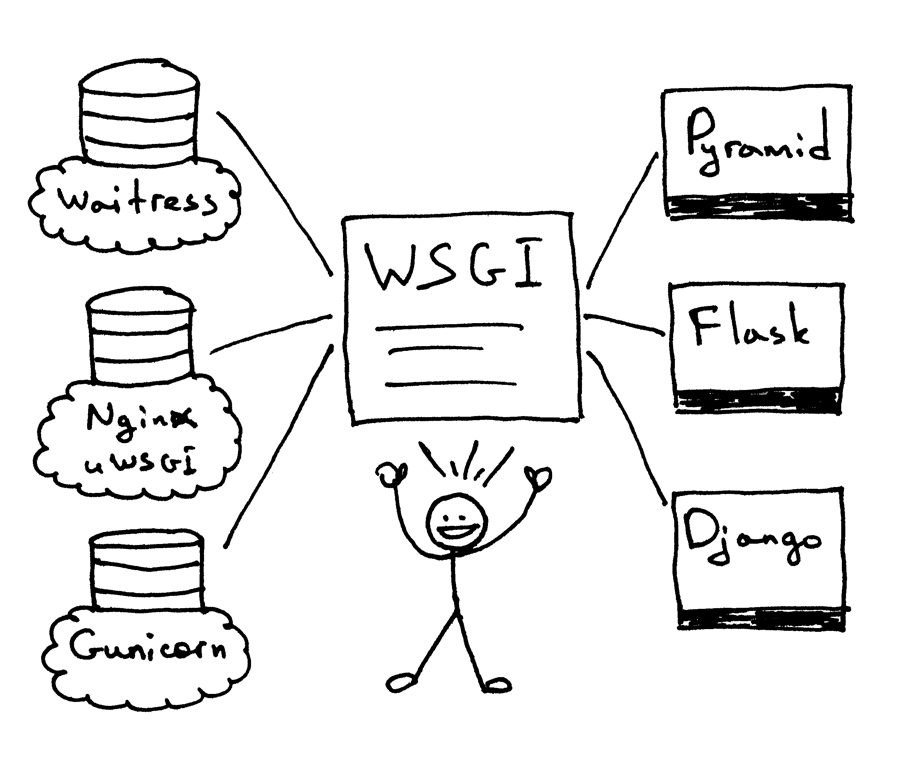

+WSGI 允许开发者互不干扰地选择 Web 框架及 Web 服务器的类型。现在,你可以真正将 Web 服务器及框架任意搭配,然后选出你最中意的那对组合。比如,你可以使用 [Django][3],[Flask][4] 或者 [Pyramid][5],与 [Gunicorn][6],[Nginx/uWSGI][7] 或 [Waitress][8] 进行结合。感谢 WSGI 同时对服务器与框架的支持,我们可以真正随意选择它们的搭配了。

+

+

+

+所以,WSGI 就是我在第一部分中提出,又在本文开头重复了一遍的那个问题的答案。你的 Web 服务器必须实现 WSGI 接口的服务器部分,而现代的 Python Web 框架均已实现了 WSGI 接口的框架部分,这使得你可以直接在 Web 服务器中使用任意框架,而不需要更改任何服务器代码,以对特定的 Web 框架实现兼容。

+

+现在,你已经知道 Web 服务器及 Web 框架对 WSGI 的支持使得你可以选择最合适的一对来使用,而且它也有利于服务器和框架的开发者,这样他们只需专注于其擅长的部分来进行开发,而不需要触及另一部分的代码。其它语言也拥有类似的接口,比如:Java 拥有 Servlet API,而 Ruby 拥有 Rack。

+

+这些理论都不错,但是我打赌你在说:“Show me the code!” 那好,我们来看看下面这个很小的 WSGI 服务器实现:

+

+```

+### 使用 Python 2.7.9,在 Linux 及 Mac OS X 下测试通过

+import socket

+import StringIO

+import sys

+

+

+class WSGIServer(object):

+

+ address_family = socket.AF_INET

+ socket_type = socket.SOCK_STREAM

+ request_queue_size = 1

+

+ def __init__(self, server_address):

+ ### 创建一个监听的套接字

+ self.listen_socket = listen_socket = socket.socket(

+ self.address_family,

+ self.socket_type

+ )

+ ### 允许复用同一地址

+ listen_socket.setsockopt(socket.SOL_SOCKET, socket.SO_REUSEADDR, 1)

+ ### 绑定地址

+ listen_socket.bind(server_address)

+ ### 激活套接字

+ listen_socket.listen(self.request_queue_size)

+ ### 获取主机的名称及端口

+ host, port = self.listen_socket.getsockname()[:2]

+ self.server_name = socket.getfqdn(host)

+ self.server_port = port

+ ### 返回由 Web 框架/应用设定的响应头部字段

+ self.headers_set = []

+

+ def set_app(self, application):

+ self.application = application

+

+ def serve_forever(self):

+ listen_socket = self.listen_socket

+ while True:

+ ### 获取新的客户端连接

+ self.client_connection, client_address = listen_socket.accept()

+ ### 处理一条请求后关闭连接,然后循环等待另一个连接建立

+ self.handle_one_request()

+

+ def handle_one_request(self):

+ self.request_data = request_data = self.client_connection.recv(1024)

+ ### 以 'curl -v' 的风格输出格式化请求数据

+ print(''.join(

+ '< {line}\n'.format(line=line)

+ for line in request_data.splitlines()

+ ))

+

+ self.parse_request(request_data)

+

+ ### 根据请求数据构建环境变量字典

+ env = self.get_environ()

+

+ ### 此时需要调用 Web 应用来获取结果,

+ ### 取回的结果将成为 HTTP 响应体

+ result = self.application(env, self.start_response)

+

+ ### 构造一个响应,回送至客户端

+ self.finish_response(result)

+

+ def parse_request(self, text):

+ request_line = text.splitlines()[0]

+ request_line = request_line.rstrip('\r\n')

+ ### 将请求行分成几个部分

+ (self.request_method, # GET

+ self.path, # /hello

+ self.request_version # HTTP/1.1

+ ) = request_line.split()

+

+ def get_environ(self):

+ env = {}

+ ### 以下代码段没有遵循 PEP8 规则,但这样排版,是为了通过强调

+ ### 所需变量及它们的值,来达到其展示目的。

+ ###

+ ### WSGI 必需变量

+ env['wsgi.version'] = (1, 0)

+ env['wsgi.url_scheme'] = 'http'

+ env['wsgi.input'] = StringIO.StringIO(self.request_data)

+ env['wsgi.errors'] = sys.stderr

+ env['wsgi.multithread'] = False

+ env['wsgi.multiprocess'] = False

+ env['wsgi.run_once'] = False

+ ### CGI 必需变量

+ env['REQUEST_METHOD'] = self.request_method # GET

+ env['PATH_INFO'] = self.path # /hello

+ env['SERVER_NAME'] = self.server_name # localhost

+ env['SERVER_PORT'] = str(self.server_port) # 8888

+ return env

+

+ def start_response(self, status, response_headers, exc_info=None):

+ ### 添加必要的服务器头部字段

+ server_headers = [

+ ('Date', 'Tue, 31 Mar 2015 12:54:48 GMT'),

+ ('Server', 'WSGIServer 0.2'),

+ ]

+ self.headers_set = [status, response_headers + server_headers]

+ ### 为了遵循 WSGI 协议,start_response 函数必须返回一个 'write'

+ ### 可调用对象(返回值.write 可以作为函数调用)。为了简便,我们

+ ### 在这里无视这个细节。

+ ### return self.finish_response

+

+ def finish_response(self, result):

+ try:

+ status, response_headers = self.headers_set

+ response = 'HTTP/1.1 {status}\r\n'.format(status=status)

+ for header in response_headers:

+ response += '{0}: {1}\r\n'.format(*header)

+ response += '\r\n'

+ for data in result:

+ response += data

+ ### 以 'curl -v' 的风格输出格式化请求数据

+ print(''.join(

+ '> {line}\n'.format(line=line)

+ for line in response.splitlines()

+ ))

+ self.client_connection.sendall(response)

+ finally:

+ self.client_connection.close()

+

+SERVER_ADDRESS = (HOST, PORT) = '', 8888

+

+def make_server(server_address, application):

+ server = WSGIServer(server_address)

+ server.set_app(application)

+ return server

+

+if __name__ == '__main__':

+ if len(sys.argv) < 2:

+ sys.exit('Provide a WSGI application object as module:callable')

+ app_path = sys.argv[1]

+ module, application = app_path.split(':')

+ module = __import__(module)

+ application = getattr(module, application)

+ httpd = make_server(SERVER_ADDRESS, application)

+ print('WSGIServer: Serving HTTP on port {port} ...\n'.format(port=PORT))

+ httpd.serve_forever()

+```

+

+当然,这段代码要比第一部分的服务器代码长不少,但它仍然很短(只有不到 150 行),你可以轻松理解它,而不需要深究细节。上面的服务器代码还可以做更多——它可以用来运行一些你喜欢的框架写出的 Web 应用,可以是 Pyramid,Flask,Django 或其它 Python WSGI 框架。

+

+不相信吗?自己来试试看吧。把以上的代码保存为 `webserver2.py`,或直接从 [Github][9] 上下载它。如果你打算不加任何参数而直接运行它,它会抱怨一句,然后退出。

+

+```

+$ python webserver2.py

+Provide a WSGI application object as module:callable

+```

+

+它想做的其实是为你的 Web 应用服务,而这才是重头戏。为了运行这个服务器,你唯一需要的就是安装好 Python。不过,如果你希望运行 Pyramid,Flask 或 Django 应用,你还需要先安装那些框架。那我们把这三个都装上吧。我推荐的安装方式是通过 `virtualenv` 安装。按照以下几步来做,你就可以创建并激活一个虚拟环境,并在其中安装以上三个 Web 框架。

+

+```

+$ [sudo] pip install virtualenv

+$ mkdir ~/envs

+$ virtualenv ~/envs/lsbaws/

+$ cd ~/envs/lsbaws/

+$ ls

+bin include lib

+$ source bin/activate

+(lsbaws) $ pip install pyramid

+(lsbaws) $ pip install flask

+(lsbaws) $ pip install django

+```

+

+现在,你需要创建一个 Web 应用。我们先从 Pyramid 开始吧。把以下代码保存为 `pyramidapp.py`,并与刚刚的 `webserver2.py` 放置在同一目录,或直接从 [Github][10] 下载该文件:

+

+```

+from pyramid.config import Configurator

+from pyramid.response import Response

+

+

+def hello_world(request):

+ return Response(

+ 'Hello world from Pyramid!\n',

+ content_type='text/plain',

+ )

+

+config = Configurator()

+config.add_route('hello', '/hello')

+config.add_view(hello_world, route_name='hello')

+app = config.make_wsgi_app()

+```

+

+现在,你可以用你自己的 Web 服务器来运行你的 Pyramid 应用了:

+

+```

+(lsbaws) $ python webserver2.py pyramidapp:app

+WSGIServer: Serving HTTP on port 8888 ...

+```

+

+你刚刚让你的服务器去加载 Python 模块 `pyramidapp` 中的可执行对象 `app`。现在你的服务器可以接收请求,并将它们转发到你的 Pyramid 应用中了。在浏览器中输入 http://localhost:8888/hello ,敲一下回车,然后看看结果:

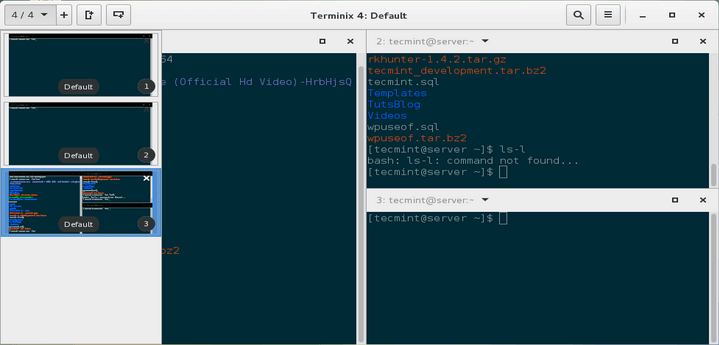

+

+

+

+你也可以使用命令行工具 `curl` 来测试服务器:

+

+```

+$ curl -v http://localhost:8888/hello

+...

+```

+

+看看服务器和 `curl` 向标准输出流打印的内容吧。

+

+现在来试试 `Flask`。运行步骤跟上面的一样。

+

+```

+from flask import Flask

+from flask import Response

+flask_app = Flask('flaskapp')

+

+

+@flask_app.route('/hello')

+def hello_world():

+ return Response(

+ 'Hello world from Flask!\n',

+ mimetype='text/plain'

+ )

+

+app = flask_app.wsgi_app

+```

+

+将以上代码保存为 `flaskapp.py`,或者直接从 [Github][11] 下载,然后输入以下命令运行服务器:

+

+```

+(lsbaws) $ python webserver2.py flaskapp:app

+WSGIServer: Serving HTTP on port 8888 ...

+```

+

+现在在浏览器中输入 http://localhost:8888/hello ,敲一下回车:

+

+

+

+同样,尝试一下 `curl`,然后你会看到服务器返回了一条 `Flask` 应用生成的信息:

+

+```

+$ curl -v http://localhost:8888/hello

+...

+```

+

+这个服务器能处理 Django 应用吗?试试看吧!不过这个任务可能有点复杂,所以我建议你将整个仓库克隆下来,然后使用 [Github][13] 仓库中的 [djangoapp.py][12] 来完成这个实验。这里的源代码主要是将 Django 的 helloworld 工程(已使用 `Django` 的 `django-admin.py startproject` 命令创建完毕)添加到了当前的 Python 路径中,然后导入了这个工程的 WSGI 应用。(LCTT 译注:除了这里展示的代码,还需要一个配合的 helloworld 工程才能工作,代码可以参见 [Github][13] 仓库。)

+

+```

+import sys

+sys.path.insert(0, './helloworld')

+from helloworld import wsgi

+

+

+app = wsgi.application

+```

+

+将以上代码保存为 `djangoapp.py`,然后用你的 Web 服务器运行这个 Django 应用:

+

+```

+(lsbaws) $ python webserver2.py djangoapp:app

+WSGIServer: Serving HTTP on port 8888 ...

+```

+

+输入以下链接,敲回车:

+

+

+

+你这次也可以在命令行中测试——你之前应该已经做过两次了——来确认 Django 应用处理了你的请求:

+

+```

+$ curl -v http://localhost:8888/hello

+...

+```

+

+你试过了吗?你确定这个服务器可以与那三个框架搭配工作吗?如果没试,请去试一下。阅读固然重要,但这个系列的内容是**重新搭建**,这意味着你需要亲自动手干点活。去试一下吧。别担心,我等着你呢。不开玩笑,你真的需要试一下,亲自尝试每一步,并确保它像预期的那样工作。

+

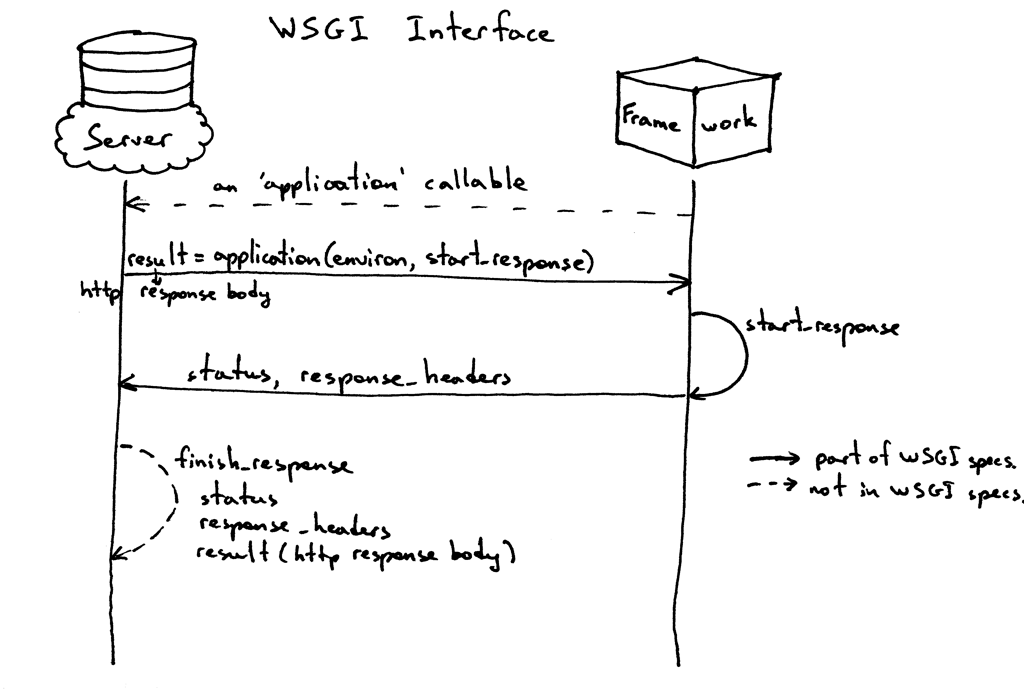

+好,你已经体验到了 WSGI 的威力:它可以使 Web 服务器及 Web 框架随意搭配。WSGI 在 Python Web 服务器及框架之间提供了一个微型接口。它非常简单,而且在服务器和框架端均可以轻易实现。下面的代码片段展示了 WSGI 接口的服务器及框架端实现:

+

+```

+def run_application(application):

+ """服务器端代码。"""

+ ### Web 应用/框架在这里存储 HTTP 状态码以及 HTTP 响应头部,

+ ### 服务器会将这些信息传递给客户端

+ headers_set = []

+ ### 用于存储 WSGI/CGI 环境变量的字典

+ environ = {}

+

+ def start_response(status, response_headers, exc_info=None):

+ headers_set[:] = [status, response_headers]

+

+ ### 服务器唤醒可执行变量“application”,获得响应头部

+ result = application(environ, start_response)

+ ### 服务器组装一个 HTTP 响应,将其传送至客户端

+ …

+

+def app(environ, start_response):

+ """一个空的 WSGI 应用"""

+ start_response('200 OK', [('Content-Type', 'text/plain')])

+ return ['Hello world!']

+

+run_application(app)

+```

+

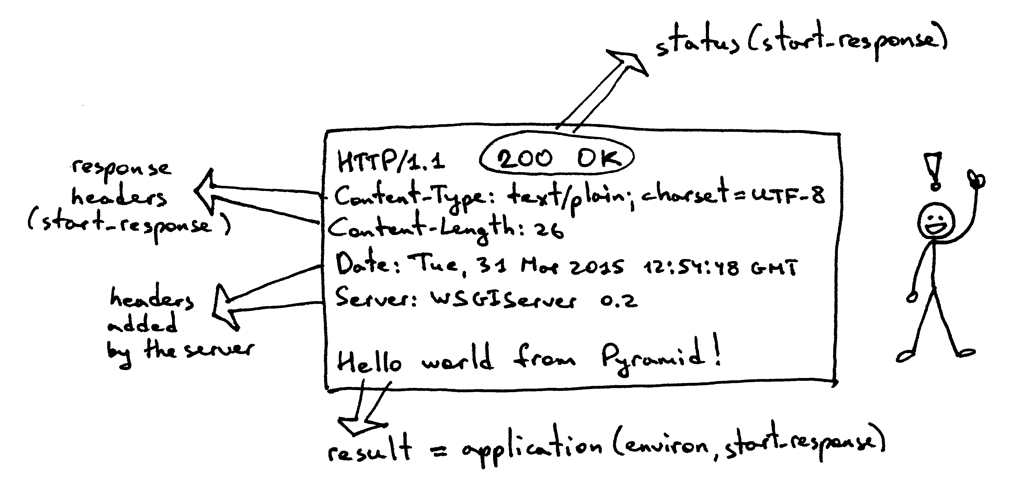

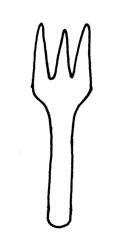

+这是它的工作原理:

+

+1. Web 框架提供一个可调用对象 `application` (WSGI 规范没有规定它的实现方式)。

+2. Web 服务器每次收到来自客户端的 HTTP 请求后,会唤醒可调用对象 `applition`。它会向该对象传递一个包含 WSGI/CGI 变量的环境变量字典 `environ`,以及一个可调用对象 `start_response`。

+3. Web 框架或应用生成 HTTP 状态码和 HTTP 响应头部,然后将它传给 `start_response` 函数,服务器会将其存储起来。同时,Web 框架或应用也会返回 HTTP 响应正文。

+4. 服务器将状态码、响应头部及响应正文组装成一个 HTTP 响应,然后将其传送至客户端(这一步并不在 WSGI 规范中,但从逻辑上讲,这一步应该包含在工作流程之中。所以为了明确这个过程,我把它写了出来)

+

+这是这个接口规范的图形化表达:

+

+

+

+到现在为止,你已经看过了用 Pyramid、Flask 和 Django 写出的 Web 应用的代码,你也看到了一个 Web 服务器如何用代码来实现另一半(服务器端的) WSGI 规范。你甚至还看到了我们如何在不使用任何框架的情况下,使用一段代码来实现一个最简单的 WSGI Web 应用。

+

+其实,当你使用上面的框架编写一个 Web 应用时,你只是在较高的层面工作,而不需要直接与 WSGI 打交道。但是我知道你一定也对 WSGI 接口的框架部分感兴趣,因为你在看这篇文章呀。所以,我们不用 Pyramid、Flask 或 Django,而是自己动手来创造一个最朴素的 WSGI Web 应用(或 Web 框架),然后将它和你的服务器一起运行:

+

+```

+def app(environ, start_response):

+ """一个最简单的 WSGI 应用。

+

+ 这是你自己的 Web 框架的起点 ^_^

+ """

+ status = '200 OK'

+ response_headers = [('Content-Type', 'text/plain')]

+ start_response(status, response_headers)

+ return ['Hello world from a simple WSGI application!\n']

+```

+

+同样,将上面的代码保存为 `wsgiapp.py` 或直接从 [Github][14] 上下载该文件,然后在 Web 服务器上运行这个应用,像这样:

+

+```

+(lsbaws) $ python webserver2.py wsgiapp:app

+WSGIServer: Serving HTTP on port 8888 ...

+```

+

+在浏览器中输入下面的地址,然后按下回车。这是你应该看到的结果:

+

+

+

+你刚刚在学习如何创建一个 Web 服务器的过程中自己编写了一个最朴素的 WSGI Web 框架!棒极了!

+

+现在,我们再回来看看服务器传给客户端的那些东西。这是在使用 HTTP 客户端调用你的 Pyramid 应用时,服务器生成的 HTTP 响应内容:

+

+

+

+这个响应和你在本系列第一部分中看到的 HTTP 响应有一部分共同点,但它还多出来了一些内容。比如说,它拥有四个你曾经没见过的 [HTTP 头部][15]:`Content-Type`, `Content-Length`, `Date` 以及 `Server`。这些头部内容基本上在每个 Web 服务器返回的响应中都会出现。不过,它们都不是被严格要求出现的。这些 HTTP 请求/响应头部字段的目的在于它可以向你传递一些关于 HTTP 请求/响应的额外信息。

+

+既然你对 WSGI 接口了解的更深了一些,那我再来展示一下上面那个 HTTP 响应中的各个部分的信息来源:

+

+

+

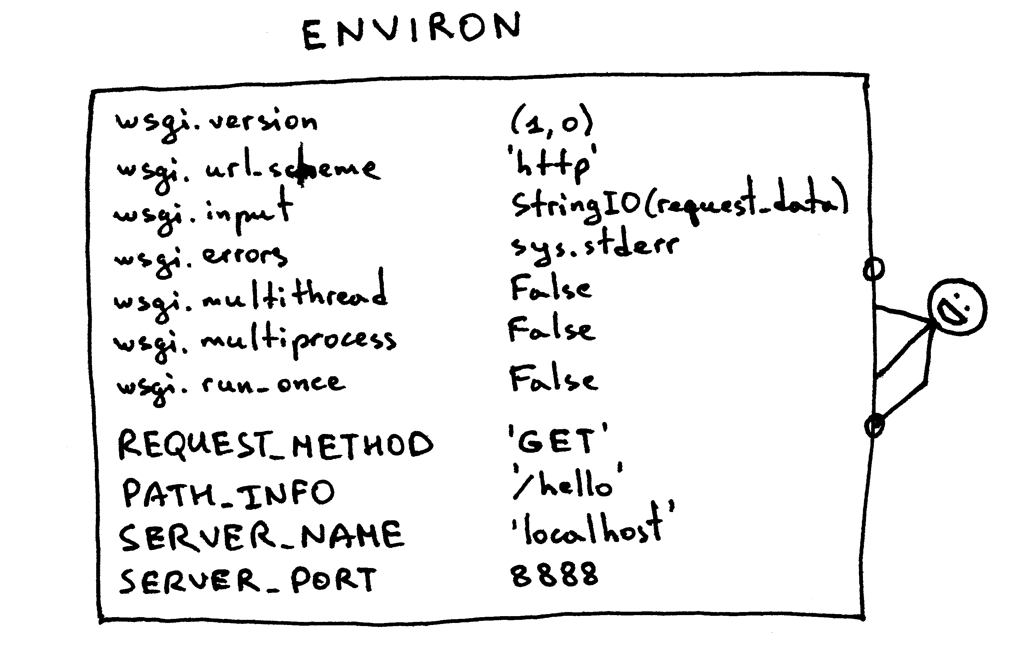

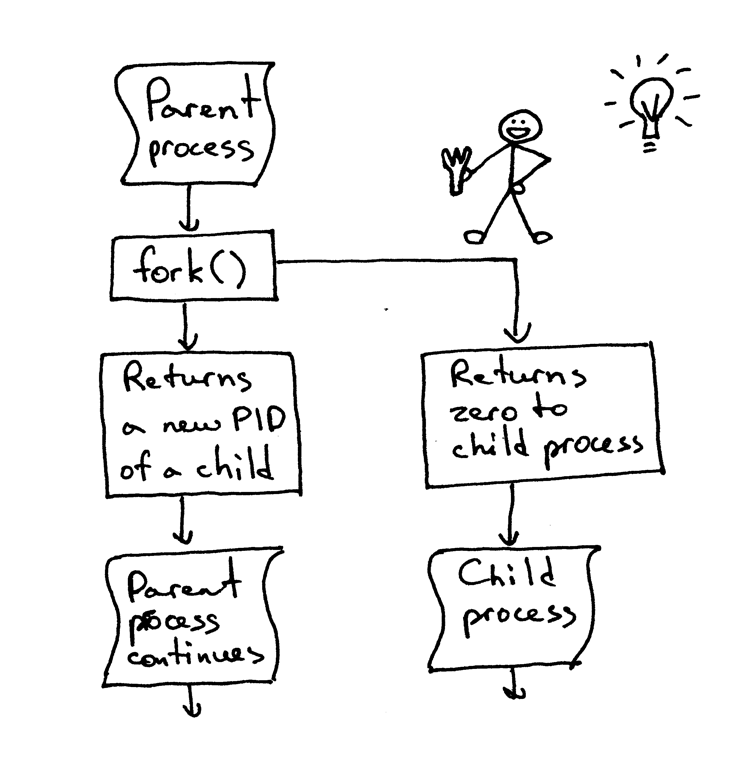

+我现在还没有对上面那个 `environ` 字典做任何解释,不过基本上这个字典必须包含那些被 WSGI 规范事先定义好的 WSGI 及 CGI 变量值。服务器在解析 HTTP 请求时,会从请求中获取这些变量的值。这是 `environ` 字典应该有的样子:

+

+

+

+Web 框架会利用以上字典中包含的信息,通过字典中的请求路径、请求动作等等来决定使用哪个视图来处理响应、在哪里读取请求正文、在哪里输出错误信息(如果有的话)。

+

+现在,你已经创造了属于你自己的 WSGI Web 服务器,你也使用不同 Web 框架做了几个 Web 应用。而且,你在这个过程中也自己创造出了一个朴素的 Web 应用及框架。这个过程真是累人。现在我们来回顾一下,你的 WSGI Web 服务器在服务请求时,需要针对 WSGI 应用做些什么:

+

+- 首先,服务器开始工作,然后会加载一个可调用对象 `application`,这个对象由你的 Web 框架或应用提供

+- 然后,服务器读取一个请求

+- 然后,服务器会解析这个请求

+- 然后,服务器会使用请求数据来构建一个 `environ` 字典

+- 然后,它会用 `environ` 字典及一个可调用对象 `start_response` 作为参数,来调用 `application`,并获取响应体内容。

+- 然后,服务器会使用 `application` 返回的响应体,和 `start_response` 函数设置的状态码及响应头部内容,来构建一个 HTTP 响应。

+- 最终,服务器将 HTTP 响应回送给客户端。

+

+

+

+这基本上是服务器要做的全部内容了。你现在有了一个可以正常工作的 WSGI 服务器,它可以为使用任何遵循 WSGI 规范的 Web 框架(如 Django、Flask、Pyramid,还有你刚刚自己写的那个框架)构建出的 Web 应用服务。最棒的部分在于,它可以在不用更改任何服务器代码的情况下,与多个不同的 Web 框架一起工作。真不错。

+

+在结束之前,你可以想想这个问题:“你该如何让你的服务器在同一时间处理多个请求呢?”

+

+敬请期待,我会在第三部分向你展示一种解决这个问题的方法。干杯!

+

+顺便,我在撰写一本名为《搭个 Web 服务器:从头开始》的书。这本书讲解了如何从头开始编写一个基本的 Web 服务器,里面包含本文中没有的更多细节。[订阅邮件列表][16],你就可以获取到这本书的最新进展,以及发布日期。

+

+--------------------------------------------------------------------------------

+

+via: https://ruslanspivak.com/lsbaws-part2/

+

+作者:[Ruslan][a]

+译者:[StdioA](https://github.com/StdioA)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://github.com/rspivak/

+[1]: https://linux.cn/article-7662-1.html

+[2]: https://www.python.org/dev/peps/pep-0333/

+[3]: https://www.djangoproject.com/

+[4]: http://flask.pocoo.org/

+[5]: http://trypyramid.com/

+[6]: http://gunicorn.org/

+[7]: http://uwsgi-docs.readthedocs.org/

+[8]: http://waitress.readthedocs.org/

+[9]: https://github.com/rspivak/lsbaws/blob/master/part2/webserver2.py

+[10]: https://github.com/rspivak/lsbaws/blob/master/part2/pyramidapp.py

+[11]: https://github.com/rspivak/lsbaws/blob/master/part2/flaskapp.py

+[12]: https://github.com/rspivak/lsbaws/blob/master/part2/flaskapp.py

+[13]: https://github.com/rspivak/lsbaws/

+[14]: https://github.com/rspivak/lsbaws/blob/master/part2/wsgiapp.py

+[15]: http://en.wikipedia.org/wiki/List_of_HTTP_header_fields

+[16]: https://ruslanspivak.com/lsbaws-part2/

\ No newline at end of file

diff --git a/published/20160416 A newcomer's guide to navigating OpenStack Infrastructure.md b/published/20160416 A newcomer's guide to navigating OpenStack Infrastructure.md

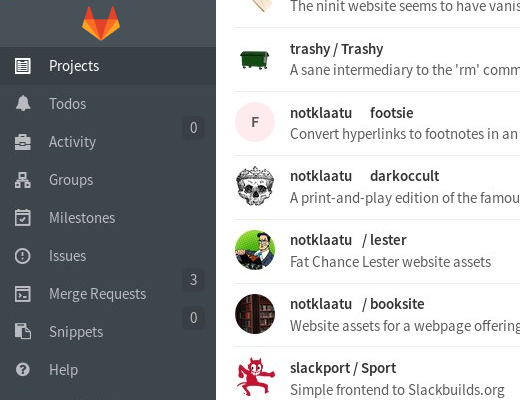

new file mode 100644

index 0000000000..952fc6f594

--- /dev/null

+++ b/published/20160416 A newcomer's guide to navigating OpenStack Infrastructure.md

@@ -0,0 +1,94 @@

+给学习 OpenStack 架构的新手入门指南

+===========================================================

+

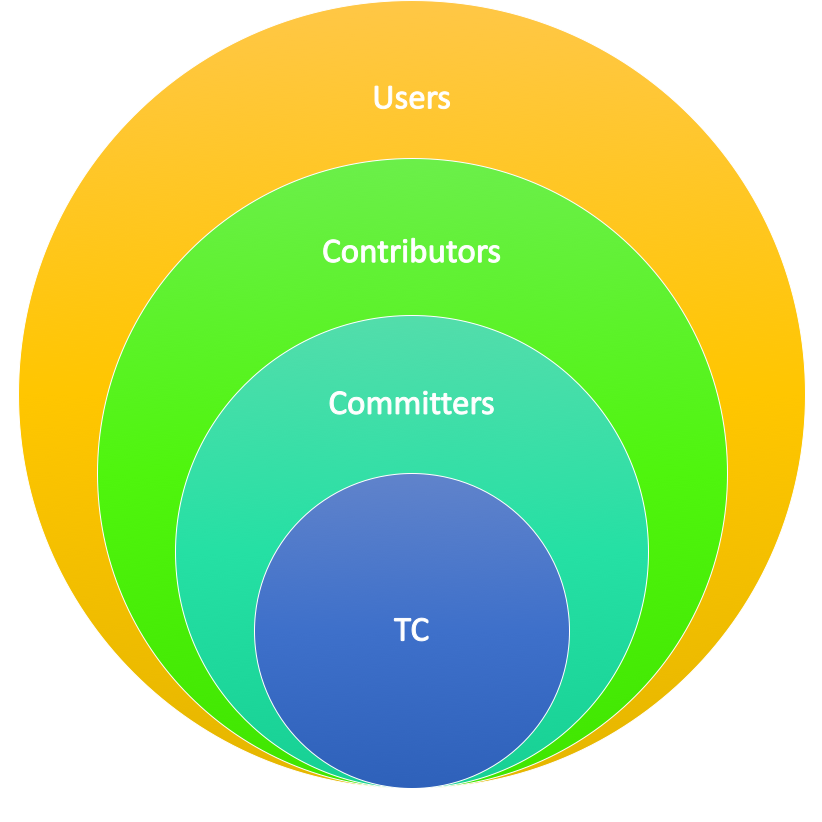

+OpenStack 欢迎新成员的到来,但是,对于这个发展趋近成熟并且快速迭代的开源社区而言,能够拥有一个新手指南并不是件坏事。在奥斯汀举办的 OpenStack 峰会上,[Paul Belanger][1] (来自红帽公司)、 [Elizabeth K. Joseph][2] (来自 HPE 公司)和 [Christopher Aedo][3] (来自 IBM 公司)就[针对新人的 OpenStack 架构][4]作了一场专门的讲演。在这次采访中,他们提供了一些建议和资源来帮助新人成为 OpenStack 贡献者中的一员。

+

+

+

+**你的讲演介绍中说你将“深入架构核心,并解释你需要知道的关于让 OpenStack 工作起来的每一件事情”。这对于 40 分钟的讲演来说是一个艰巨的任务。那么,对于学习 OpenStack 架构的新手来说最需要知道那些事情呢?**

+

+**Elizabeth K. Joseph (EKJ)**: 我们没有为 OpenStack 使用 GitHub 这种提交补丁的方式,这是因为这样做会对新手造成巨大的困扰,尽管由于历史原因我们还是在 GitHub 上维护了所有库的一个镜像。相反,我们使用了一种完全开源的评审形式,而且持续集成(CI)是由 OpenStack 架构团队维护的。与之有关的,自从我们使用了 CI 系统,每一个提交给 OpenStack 的改变都会在被合并之前进行测试。

+

+**Paul Belanger (PB)**: 这个项目中的大多数都是富有激情的人,因此当你提交的补丁被某个人否定时不要感到沮丧。

+

+**Christopher Aedo (CA)**:社区会帮助你取得成功,因此不要害怕提问或者寻求更多的那些能够促进你理解某些事物的引导者。

+

+**在你的讲话中,对于一些你无法涉及到的方面,你会向新手推荐哪些在线资源来让他们更加容易入门?**

+

+**PB**:当然是我们的 [OpenStack 项目架构文档][5]。我们已经花了足够大的努力来尽可能让这些文档能够随时保持最新状态。在 OpenStack 运行中使用的每个系统都作为一个项目,都制作了专门的页面来进行说明。甚至于连 OpenStack 云这种架构团队也会放到线上。

+

+**EKJ**:我对于架构文档这件事上的观点和 Paul 是一致的,另外,我们十分乐意看到来自那些正在学习项目的人们提交上来的补丁。我们通常不会意识到我们忽略了文档中的某些内容,除非它们恰好被人问起。因此,阅读、学习,会帮助我们修补这些知识上的漏洞。你可以在 [OpenStack 架构邮件清单]提出你的问题,或者在我们位于 FreeNode 上的 #OpenStack-infra 的 IRC 专栏发起你的提问。

+

+**CA**:我喜欢[这个详细的帖子][7],它是由 Ian Wienand 写的一篇关于构建镜像的文章。

+

+**"gotchas" 会是 OpenStack 新的贡献者们所寻找的吗?**

+

+**EKJ**:向项目作出贡献并不仅仅是提交新的代码和新的特性;OpenStack 社区高度重视代码评审。如果你想要别人查看你的补丁,那你最好先看看其他人是如何做的,然后参考他们的风格,最后一步步做到你也能够向其他人一样提交清晰且结构分明的代码补丁。你越是能让你的同伴了解你的工作并知道你正在做的评审,那他们也就越有可能及时评审你的代码。

+

+**CA**:我看到过大量的新手在面对 [Gerrit][8] 时受挫,阅读开发者引导中的[开发者工作步骤][9],有可能的话多读几遍。如果你没有用过 Gerrit,那你最初对它的感觉可能是困惑和无力的。但是,如果你随后做了一些代码评审的工作,那么你就能轻松应对它。此外,我是 IRC 的忠实粉丝,它可能是一个获得帮助的好地方,但是,你最好保持一个长期在线的状态,这样,尽管你在某个时候没有出现,人们也可以回答你的问题。(阅读 [IRC,开源成功的秘诀][10])你不必总是在线,但是你最好能够轻松的在一个频道中回溯之前信息,以此来跟上最新的动态,这种能力非常重要。

+

+**PB**:我同意 Elizabeth 和 Chris 的观点, Gerrit 是需要花点精力的,它将汇聚你的开发方面的努力。你不仅仅要提交代码给别人去评审,同时,你也要能够评审其他人的代码。看到 Gerrit 的界面,你可能一时会变的很困惑。我推荐新手去尝试 [Gertty][11],它是一个基于控制台的终端界面,用于 Gerrit 代码评审系统,而它恰好也是 OpenStack 架构所驱动的一个项目。

+

+**你对于 OpenStack 新手如何通过网络与其他贡献者交流方面有什么好的建议?**

+

+**PB**:对我来说,是通过 IRC 并在 Freenode 上参加 #OpenStack-infra 频道([IRC 日志][12])。这频道上面有很多对新手来说很有价值的资源。你可以看到 OpenStack 项目日复一日的运作情况,同时,一旦你知道了 OpenStack 项目的工作原理,你将更好的知道如何为 OpenStack 的未来发展作出贡献。

+

+**CA**:我想要为 IRC 再次说明一点,在 IRC 上保持全天在线记录对我来说有非常重大的意义,因为我会时刻保持连接并随时接到提醒。这也是一种非常好的获得帮助的方式,特别是当你和某人卡在了项目中出现的某一个难题的时候,而在一个活跃的 IRC 频道中,总会有一些人很乐意为你解决问题。

+

+**EKJ**:[OpenStack 开发邮件列表][13]对于能够时刻查看到你所致力于的 OpenStack 项目的最新情况是非常重要的。因此,我推荐一定要订阅它。邮件列表使用主题标签来区分项目,因此你可以设置你的邮件客户端来使用它来专注于你所关心的项目。除了在线资源之外,全世界范围内也成立了一些 OpenStack 小组,他们被用来为 OpenStack 的用户和贡献者提供服务。这些小组可能会定期要求 OpenStack 主要贡献者们举办座谈和活动。你可以在 MeetUp.com 上搜素你所在地域的贡献者活动聚会,或者在 [groups.openstack.org][14] 上查看你所在的地域是否存在 OpenStack 小组。最后,还有一个每六个月举办一次的 [OpenStack 峰会][15],这个峰会上会作一些关于架构的演说。当前状态下,这个峰会包含了用户会议和开发者会议,会议内容都是和 OpenStack 相关的东西,包括它的过去,现在和未来。

+

+**OpenStack 需要在那些方面得到提升来让新手更加容易学会并掌握?**

+

+**PB**: 我认为我们的 [account-setup][16] 环节对于新的贡献者已经做的比较容易了,特别是教他们如何提交他们的第一个补丁。真正参与到 OpenStack 开发者模式中是需要花费很大的努力的,相比贡献者来说已经显得非常多了;然而,一旦融入进去了,这个模式将会运转的十分高效和令人满意。

+

+**CA**: 我们拥有一个由专业开发者组成的社区,而且我们的关注点都是发展 OpenStack 本身,同时,我们致力于让用户付出更小的代价去使用 OpenStack 云架构平台。我们需要发掘更多的应用开发者,并且鼓励更多的人去开发能在 OpenStack 云上完美运行的云应用程序,我们还鼓励他们在[社区 App 目录][17]上去贡献那些由他们开发的应用。我们可以通过不断提升我们的 API 标准和保证我们不同的库(比如 libcloud,phpopencloud 以及其他一些库)持续地为开发者提供可信赖的支持来实现这一目标。还有一点就是通过举办更多的 OpenStack 黑客比赛。所有的这些事情都可以降低新人的学习门槛,这样也能引导他们与这个社区之间的关系更加紧密。

+

+**EKJ**: 我已经致力于开源软件很多年了。但是,对于大量的 OpenStack 开发者而言,这是一个他们自己所从事的第一个开源项目。我发现他们之前使用私有软件的背景并没有为他们塑造开源的观念、方法论,以及在开源项目中需要具备的合作技巧。我乐于看到我们能够让那些曾经一直在使用私有软件工作的人能够真正的明白他们在开源如软件社区所从事的事情的巨大价值。

+

+**我想把 2016 年打造成开源俳句之年。请用俳句来向新手解释 OpenStack 一下。**

+

+(LCTT 译注:俳句(Haiku)是一种日本古典短诗,以5-7-5音节为三句,校对者不揣浅陋,诌了几句歪诗,勿笑 :D,另外 OpenStack 本身音节太长,就捏造了一个中文译名“开栈”——明白就好。)

+

+**PB**: 开栈在云上//倘钟情自由软件//先当造补丁(OpenStack runs clouds

+If you enjoy free software

+Submit your first patch)

+

+**CA**:时光不必久//开栈将支配世界//协力早来到(In the near future

+OpenStack will rule the world

+Help make it happen!)

+

+**EKJ**:开栈有自由//放在自家服务器//运行你的云(OpenStack is free

+Deploy on your own servers

+And run your own cloud!)

+

+*Paul、Elizabeth 和 Christopher 在 4 月 25 号星期一上午 11:15 于奥斯汀举办的 OpenStack 峰会发表了[演说][18]。

+

+------------------------------------------------------------------------------

+

+via: https://opensource.com/business/16/4/interview-openstack-infrastructure-beginners

+

+作者:[Rikki Endsley][a]

+译者:[kylepeng93](https://github.com/kylepeng93)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: http://rikkiendsley.com/

+[1]: https://twitter.com/pabelanger

+[2]: https://twitter.com/pleia2

+[3]: https://twitter.com/docaedo

+[4]: https://www.openstack.org/summit/austin-2016/summit-schedule/events/7337

+[5]: http://docs.openstack.org/infra/system-config/

+[6]: http://lists.openstack.org/cgi-bin/mailman/listinfo/openstack-infra

+[7]: https://www.technovelty.org/openstack/image-building-in-openstack-ci.html

+[8]: https://code.google.com/p/gerrit/

+[9]: http://docs.openstack.org/infra/manual/developers.html#development-workflow

+[10]: https://developer.ibm.com/opentech/2015/12/20/irc-the-secret-to-success-in-open-source/

+[11]: https://pypi.python.org/pypi/gertty

+[12]: http://eavesdrop.openstack.org/irclogs/%23openstack-infra/

+[13]: http://lists.openstack.org/cgi-bin/mailman/listinfo/openstack-dev

+[14]: https://groups.openstack.org/

+[15]: https://www.openstack.org/summit/

+[16]: http://docs.openstack.org/infra/manual/developers.html#account-setup

+[17]: https://apps.openstack.org/

+[18]: https://www.openstack.org/summit/austin-2016/summit-schedule/events/7337

diff --git a/published/20160502 The intersection of Drupal, IoT, and open hardware.md b/published/20160502 The intersection of Drupal, IoT, and open hardware.md

new file mode 100644

index 0000000000..168bbce778

--- /dev/null

+++ b/published/20160502 The intersection of Drupal, IoT, and open hardware.md

@@ -0,0 +1,61 @@

+Drupal、IoT 和开源硬件之间的交集

+=======================================================

+

+

+

+

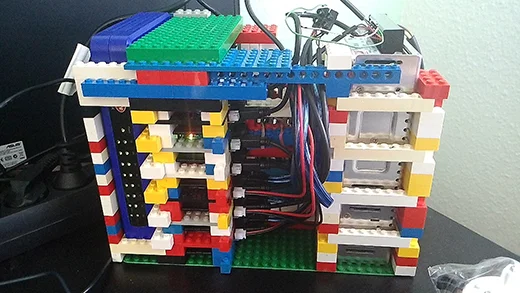

+来认识一下 [Amber Matz][1],她是来自 Lullabot Education 旗下的 [Drupalize.Me][3] 的产品经理以及培训师。当她没有倒腾 Arduino、Raspberry Pi 以及电子穿戴设备时,通常会在波特兰 Drupal 用户组里担任辩论主持人。

+

+在即将举行的 [DrupalCon NOLA][3] 大会上,Amber 将主持一个关于 Drupal 和 IoT 的主题。如果你会去参加,也想了解下开源硬件,IoT 和 Drupal 之间的交集,那这个将很合适。如果你去不了新奥尔良的现场也没关系,Amber 还分享了许多很酷的事情。在这次采访中,她讲述了自己参与 Drupal 的原因,一些她自己喜欢的开源硬件项目,以及 IoT 和 Drupal 的未来。

+

+

+

+**你是怎么加入 Drupal 社区的?**

+

+在这之前,我在一家大型非盈利性机构市场部的“网站管理部”工作,飞快地批量生产出各种定制 PHP/MySQL 表单。最终我厌烦了这一切,并开始在网上寻找更好的方式。然后我找到了 Drupal 6 并开始沉迷进去。过了几年,在一次跳槽之后,我发现了波特兰 Drupal 用户组,然后在里面找了一份全职的 Drupal 开发者工作。我一直经常参加在波特兰的聚会,在那里我找到了大量的社区、朋友和专业方面的发展。一个偶然的机会,我在 Lullabot 找了一份培训师的工作,为 Drupalize.Me 提供内容。现在,我管理着 Drupalize.Me 的内容输出,负责编撰 Drupal 8 相关的内容,还很大程度地参与到波特兰 Drupal 社区中。我是今年的协调员,寻找并安排演讲者们。

+

+**我们想知道:什么是 Arduino 原型,你是怎么找到它的,以及你用 Arduino 做过的最酷的事是什么?**

+

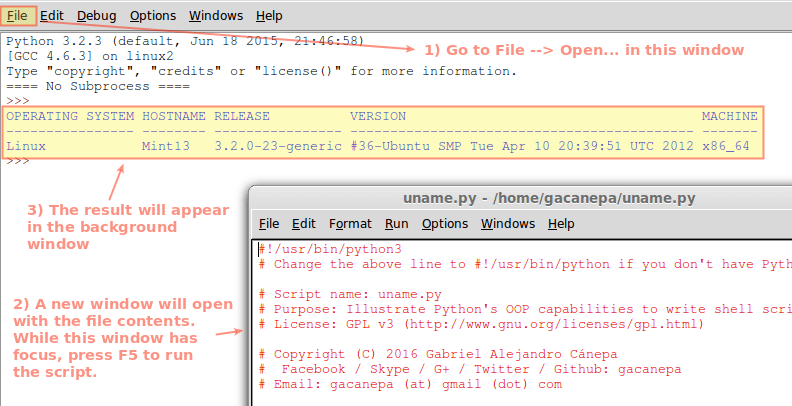

+Arduino,Raspberry Pi,以及可穿戴电子设备,这些年到处都能听到这些术语。我在几年前通过 Becky Stern 的 YouTube 秀(最近由 Becky 继续主持,每周三播出)发现了 [Adafruit 的可穿戴电子设备][4]。我被那些可穿戴设备迷住了,还订了一套 LED 缝制工具,不过没做出任何东西。我不太适合它。我没有任何电子相关的背景,而且在我被那些项目吸引的时候,我根本不知道怎么做出那样的东西,它似乎看上去太遥远了。

+

+后来,我在 Coursera 上找到了一个“物联网”专题。(很时髦,对吧?)我很快就喜欢上了。我最终找到了 Arduino 是什么的解释,以及所有这些其他的重要术语和概念。我订了一套推荐的 Arduino 初学者套件,还附带了一本如何上手的小册子。当我第一次让 LED 闪烁的时候,开心极了。我在圣诞节以及之后有两个星期的假期,然而我什么都没干,就一直根据初学者小册子给 Arduino 电路编程。很奇怪我觉得很放松!我太喜欢了。

+

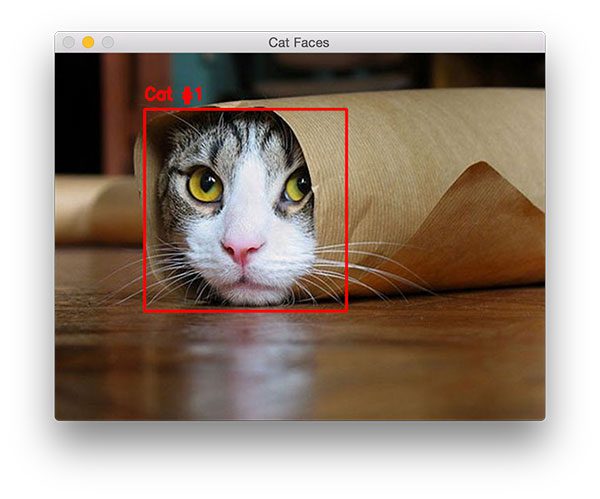

+在一月份的时候,我开始构思我自己的原型设备。在知道我需要主持公司培训的开场白时,我用五个 LED 灯和 Arduino 搭建了一个开场白视觉计时器的原型。

+

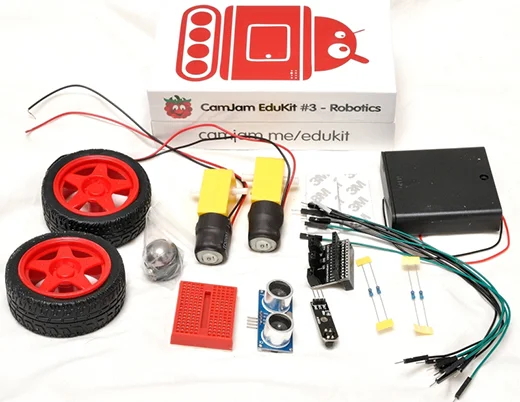

+

+

+这是一次巨大的成功。我还做了我的第一个可穿戴项目,一件会发光的连帽衫,使用了和 Arduino IDE 兼容的 Gemma 微控制器,一个小的圆形可缝制部件,然后用可导电的线缝起来,将一个滑动可变电阻和衣服帽口的收缩绳连在一起,用来控制缝到帽子里的五个 NeoPixel 灯的颜色。这就是我对原型设计的看法:做一些很好玩也可能会有点实际用途的疯狂项目。

+

+**Drupal 和 IoT 带来的最大机遇是什么??**

+

+IoT 与 Web Service 以及 Drupal 分层趋势实际并没有太大差别。就是将数据从一个东西传送到另一个东西,然后将数据转换成一些有用的东西。但数据是如何送达?能用来做点什么?你觉得现在就有一大堆现成的解决方案、应用、中间层,以及 API 吗?采用 IoT,这只会继续成几何指数级的增长。我觉得,给我任何一个设备或“东西”,总有办法来将它连接到互联网上,有很多办法。而且有大量现成的代码库来帮助创客们将他们的数据从一个东西传到另一个东西。

+

+那么 Drupal 在这里处于什么位置?首先,Web services 将是第一个明显的地方。但作为一个创客,我不希望将时间花在编写 Drupal 的订制模块上。我想要的是即插即用!所以我很高兴出现这样的模块能连接 IoT 云端 API 和服务,比如 ThingSpeak,Adafruit.io,IFTTT,以及其他的。我觉得也有一个很好的商业机会,在 Drupal 里构建一套 IoT 云服务,允许用户发送和存储他们的传感器数据,并可以制成表格和图像,还可以写一些插件可以响应特定数据或阙值。每一个 IoT 云 API 服务都是一个细分的机会,所以能留下很大空间给其他人。

+

+**这次 DrupalCon 你有哪些期待?**

+

+我喜欢与 Drupal 上的朋友重逢,认识一些新的人,还能见到 Lullabot 和 Drupalize.Me 的同事(我们是分布式的公司)!Drupal 8 有太多东西可以去探索了,我们给我们的客户们提供了海量的培训资料。所以,我很期待参与一些 Drupal 8 相关的主题,以及跟上最新的开发进度。最后,我对新奥尔良也很感兴趣!我曾经在 2004 年去过,很期待将这次将看到哪些改变。

+

+**谈一谈你这次 DrupalCon 上的演讲:“超越闪烁:将 Drupal 加到你的 IoT 游乐场中”。别人为什么要参加?他们最重要的收获会是什么?**

+

+我的主题的标题是,“超越闪烁:将 Drupal 加到你的 IoT 游乐场中”,假设我们所有人都处在同一进度和层次,你不需要了解任何关于 Arduino、物联网、甚至是 Drupal,都能跟上。我将从用 Arduino 让 LED 灯闪烁开始,然后我会谈一下我自己在这里面的最大收获:玩、学、教和做。我会列出一些曾经激励过我的例子,它们也很有希望能激发和鼓励其他听众去尝试一下。然后,就是展示时间!

+

+首先,第一个东西。它是一个建筑提醒信号灯。在这个展示里,我会说明如何将信号灯连到互联网上,以及如何响应从云 API 服务收到的数据。然后,第二个东西。它是一个蒸汽朋克风格 iPhone 外壳形式的“天气手表”。有一个小型 LED 矩阵用来显示我的天气的图标,一个气压和温度传感器,一个 GPS 模块,以及一个 Bluetooth LE 模块,都连接到一个 Adafruit Flora 微控制器上。第二个东西能通过蓝牙连接到我的 iPhone 上的一个应用,并将天气和位置数据通过 MQTT 协议发到 Adafruit.io 的服务器!然后,在 Drupal 这边,我会从云端下载这些数据,更新天气信息,然后更新地图。所以大家也能体验一下通过web service、地图和 Drupal 8 的功能块所能做的事情。

+

+学习和制作这些展示原型是一次烧脑的探险,我也希望有人能参与这个主题并感染一点我对这种技术交叉的传染性热情!我很兴奋能分享一些我的发现。

+

+------------------------------------------------------------------------------

+

+via: https://opensource.com/business/16/5/drupalcon-interview-amber-matz

+

+作者:[Jason Hibbets][a]

+译者:[zpl1025](https://github.com/zpl1025)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://opensource.com/users/jhibbets

+[1]: https://www.drupal.org/u/amber-himes-matz

+[2]: https://drupalize.me/

+[3]: https://events.drupal.org/neworleans2016/

+[4]: https://www.adafruit.com/beckystern

diff --git a/published/20160506 Linus Torvalds Talks IoT Smart Devices Security Concerns and More.md b/published/20160506 Linus Torvalds Talks IoT Smart Devices Security Concerns and More.md

new file mode 100644

index 0000000000..78af0dc3de

--- /dev/null

+++ b/published/20160506 Linus Torvalds Talks IoT Smart Devices Security Concerns and More.md

@@ -0,0 +1,49 @@

+Linus Torvalds 谈及物联网、智能设备、安全连接等问题

+===========================================================================

+

+

+

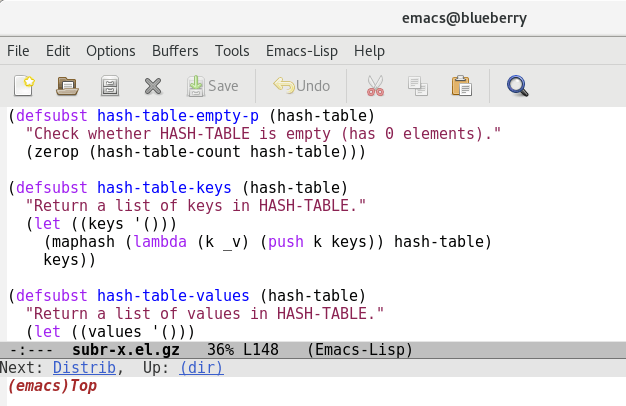

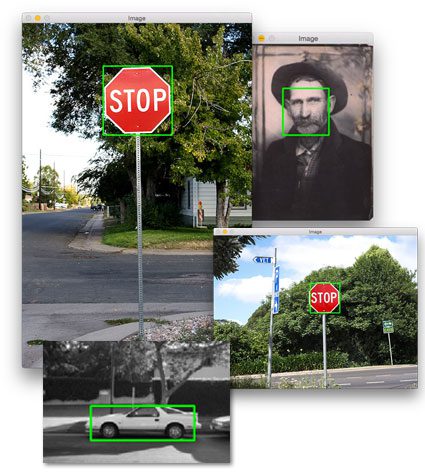

+*Dirk Hohndel 在嵌入式大会上采访 Linus Torvalds 。*

+

+

+4 月 4 日到 6 日,在圣迭戈召开的[嵌入式 Linux 大会(Embedded Linux Conference)][0](ELC) 从首次举办到现在已经有 11 年了,该会议包括了与 Linus Torvalds 的主题讨论。作为 Linux 内核的缔造者和最高决策者——用采访他的英特尔 Linux 和开源技术总监 Dirk Hohndel 的话说,“(他是)我们聚在一起的理由”——他对 Linux 在嵌入式和物联网应用程序领域的发展表示乐观。Torvalds 很明确地力挺了嵌入式 Linux,它被 Linux 桌面、服务器和云技术这些掩去光芒已经很多年了。

+

+

+

+*Linus Torvalds 在嵌入式 Linux 大会上的演讲。*

+

+物联网是嵌入式大会的主题,在 OpenIoT 峰会讲演中谈到了,在 Torvalds 的访谈中也是主要话题。

+

+Torvalds 对 Hohndel 说到,“或许你不会在物联网末端设备上看到 Linux 的影子,但是在你有一个中心设备的时候,你就会需要它。尤其是物联网标准都有 23 个的时候,你就更需要智能设备了。如果你全部使用的是低级设备,它们没必要一定运行 Linux;如果它们采用的标准稍有差异,你就需要很多的智能设备。我们将来也不会有一个完全开放的标准来将这些物联网设备统一到一起,但是我们会有 3/4 的主要协议是一样的,然后那些智能的中心设备就可以对它们进行互相转换。”

+

+当 Hohndel 问及在物联网的巨大安全漏洞的时候,Torvalds 神情如常。他说:“我不担心安全问题因为我们能做的不是很多,物联网(设备)是不能更新的,这是我们面对的事实。"

+

+Linux 缔造者看起来更关心的是一次性嵌入式项目缺少对上游的及时贡献,尽管他注意到近年来这些有了一些显著改善,特别是在硬件整合方面。

+

+“嵌入式领域历来就很难与开源开发者有所联系,但是我认为这些都在发生改变。”Torvalds 说:“ARM 社区变得越来越好了。内核维护者实际上现在也能跟上了一些硬件的更新换代。一切都在变好,但是还不够。”

+

+Torvalds 承认他在家经常使用桌面系统而不是嵌入式系统,并且对硬件不是很熟悉。

+

+“我已经用电烙铁弄坏了很多东西。”他说到。“我真的不适合搞硬件开发。”另一方面,Torvalds 设想如果他现在是个年轻人,他可能也在摆弄 Raspberry Pi 和 BeagleBone(猎兔犬板)。“最棒的是你不需要精通焊接,你只需要买个新的板子就行。”

+

+同时,Torvalds 也承诺他要为 Linux 桌面再奋斗一个 25 年。他笑着说:“我要为它工作一生。”

+

+下面,请看完整[视频](https://youtu.be/tQKUWkR-wtM)。

+

+

+要获取关于嵌入式 Linux 和物联网的最新信息,请访问 2016 年嵌入式 Linux 大会 150+ 分钟的会议全程。[现在观看][1]。

+

+--------------------------------------------------------------------------------

+

+via: https://www.linux.com/news/linus-torvalds-talks-iot-smart-devices-security-concerns-and-more-video

+

+作者:[ERIC BROWN][a]

+译者:[vim-kakali](https://github.com/vim-kakali)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://www.linux.com/users/ericstephenbrown

+[0]: http://events.linuxfoundation.org/events/embedded-linux-conference

+[1]: http://go.linuxfoundation.org/elc-openiot-summit-2016-videos?utm_source=lf&utm_medium=blog&utm_campaign=linuxcom

+

diff --git a/published/20160512 Bitmap in Linux Kernel.md b/published/20160512 Bitmap in Linux Kernel.md

new file mode 100644

index 0000000000..3c4117aece

--- /dev/null

+++ b/published/20160512 Bitmap in Linux Kernel.md

@@ -0,0 +1,399 @@

+Linux 内核里的数据结构——位数组

+================================================================================

+

+Linux 内核中的位数组和位操作

+--------------------------------------------------------------------------------

+

+除了不同的基于[链式](https://en.wikipedia.org/wiki/Linked_data_structure)和[树](https://en.wikipedia.org/wiki/Tree_%28data_structure%29)的数据结构以外,Linux 内核也为[位数组](https://en.wikipedia.org/wiki/Bit_array)(或称为位图(bitmap))提供了 [API](https://en.wikipedia.org/wiki/Application_programming_interface)。位数组在 Linux 内核里被广泛使用,并且在以下的源代码文件中包含了与这样的结构搭配使用的通用 `API`:

+

+* [lib/bitmap.c](https://github.com/torvalds/linux/blob/master/lib/bitmap.c)

+* [include/linux/bitmap.h](https://github.com/torvalds/linux/blob/master/include/linux/bitmap.h)

+

+除了这两个文件之外,还有体系结构特定的头文件,它们为特定的体系结构提供优化的位操作。我们将探讨 [x86_64](https://en.wikipedia.org/wiki/X86-64) 体系结构,因此在我们的例子里,它会是

+

+* [arch/x86/include/asm/bitops.h](https://github.com/torvalds/linux/blob/master/arch/x86/include/asm/bitops.h)

+

+头文件。正如我上面所写的,`位图`在 Linux 内核中被广泛地使用。例如,`位数组`常常用于保存一组在线/离线处理器,以便系统支持[热插拔](https://www.kernel.org/doc/Documentation/cpu-hotplug.txt)的 CPU(你可以在 [cpumasks](https://0xax.gitbooks.io/linux-insides/content/Concepts/cpumask.html) 部分阅读更多相关知识 ),一个位数组(bit array)可以在 Linux 内核初始化等期间保存一组已分配的[中断处理](https://en.wikipedia.org/wiki/Interrupt_request_%28PC_architecture%29)。

+

+因此,本部分的主要目的是了解位数组(bit array)是如何在 Linux 内核中实现的。让我们现在开始吧。

+

+位数组声明

+================================================================================

+

+在我们开始查看`位图`操作的 `API` 之前,我们必须知道如何在 Linux 内核中声明它。有两种声明位数组的通用方法。第一种简单的声明一个位数组的方法是,定义一个 `unsigned long` 的数组,例如:

+

+```C

+unsigned long my_bitmap[8]

+```

+

+第二种方法,是使用 `DECLARE_BITMAP` 宏,它定义于 [include/linux/types.h](https://github.com/torvalds/linux/blob/master/include/linux/types.h) 头文件:

+

+```C

+#define DECLARE_BITMAP(name,bits) \

+ unsigned long name[BITS_TO_LONGS(bits)]

+```

+

+我们可以看到 `DECLARE_BITMAP` 宏使用两个参数:

+

+* `name` - 位图名称;

+* `bits` - 位图中位数;

+

+并且只是使用 `BITS_TO_LONGS(bits)` 元素展开 `unsigned long` 数组的定义。 `BITS_TO_LONGS` 宏将一个给定的位数转换为 `long` 的个数,换言之,就是计算 `bits` 中有多少个 `8` 字节元素:

+

+```C

+#define BITS_PER_BYTE 8

+#define DIV_ROUND_UP(n,d) (((n) + (d) - 1) / (d))

+#define BITS_TO_LONGS(nr) DIV_ROUND_UP(nr, BITS_PER_BYTE * sizeof(long))

+```

+

+因此,例如 `DECLARE_BITMAP(my_bitmap, 64)` 将产生:

+

+```python

+>>> (((64) + (64) - 1) / (64))

+1

+```

+

+与:

+

+```C

+unsigned long my_bitmap[1];

+```

+

+在能够声明一个位数组之后,我们便可以使用它了。

+

+体系结构特定的位操作

+================================================================================

+