mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-12 01:40:10 +08:00

Merge branch 'master' of https://github.com/LCTT/TranslateProject into new

This commit is contained in:

commit

f42ebd43d2

@ -29,7 +29,7 @@

|

||||

|

||||

### 云即资本

|

||||

|

||||

就像我们的 CEO Zac Smith 多次跟我说的:都是钱的问题。不仅要制造它,还要消费它!在云中,数十亿美元的投入才能让数据中心出现计算机,这样才能让开发者消费它。换句话说(根本没云,它只是别人的电脑而已):

|

||||

就像我们的 CEO Zac Smith 多次跟我说的:一切都是钱的事。不仅要制造它,还要消费它!在云中,数十亿美元的投入才能让数据中心出现计算机,这样才能让开发者消费它。换句话说(根本没云,它只是别人的电脑而已):

|

||||

|

||||

![][4]

|

||||

|

||||

@ -45,7 +45,7 @@

|

||||

|

||||

因为我们花费大量的时间去研究数据中心和连通性,需要注意的一件事情是,这一部分的变化非常快,尤其是在 5G 正式商用时,某些负载开始不再那么依赖中心化的基础设施了。

|

||||

|

||||

边缘接入即将到来!:-)

|

||||

边缘计算即将到来!:-)

|

||||

|

||||

![][6]

|

||||

|

||||

@ -53,7 +53,7 @@

|

||||

|

||||

居于“连通”和“动力”之上的这一层,我们爱称为“处理器层”。这是奇迹发生的地方 —— 我们将来自下层的创新和实物投资转变成一个 API 终端的某些东西。

|

||||

|

||||

由于这是纽约的一个大楼,我们让在这里的云供应商处于纽约的中心。这就是为什么你会看到([Digital Ocean][Digital Ocean] 系的)鲨鱼 Sammy 和在 Google 之上的 “meet me” 的房间中和我打招呼的原因了。

|

||||

由于这是纽约的一个大楼,我们让在这里的云供应商处于纽约的中心。这就是为什么你会看到([Digital Ocean][Digital Ocean] 系的)鲨鱼 Sammy 和对 “meet me” 房间里面的 Google 标志的致意的原因了。

|

||||

|

||||

正如你所见,这个场景是非常写实的。它是由多层机架堆叠起来的。尽管我们爱 EWR1 的设备经理(Michael Pedrazzini),我们努力去尽可能减少这种体力劳动。毕竟布线专业的博士学位是很难拿到的。

|

||||

|

||||

@ -61,7 +61,7 @@

|

||||

|

||||

### 供给

|

||||

|

||||

再上一层,在基础设施层之上是供给层。这是我们最喜欢的地方之一,它以前被我们称为<ruby>配置管理<rt>confing management</rt></ruby>。但是现在到处都是一开始就是<ruby>不可变基础设施<rt>immutable infrastructure</rt></ruby>和自动化:[Terraform][Terraform]、[Ansible][Ansible]、[Quay.io][Quay.io] 等等类似的东西。你可以看出软件是按它的方式来工作的,对吗?

|

||||

再上一层,在基础设施层之上是供给层。这是我们最喜欢的地方之一,它以前被我们称为<ruby>配置管理<rt>config management</rt></ruby>。但是现在到处都是一开始就是<ruby>不可变基础设施<rt>immutable infrastructure</rt></ruby>和自动化:[Terraform][Terraform]、[Ansible][Ansible]、[Quay.io][Quay.io] 等等类似的东西。你可以看出软件是按它的方式来工作的,对吗?

|

||||

|

||||

Kelsey Hightower 最近写道“呆在无聊的基础设施中是一个让人兴奋的时刻”,我不认为这说的是物理部分(虽然我们认为它非常让人兴奋),但是由于软件持续侵入到栈的所有层,那必将是一个疯狂的旅程。

|

||||

|

||||

@ -152,7 +152,7 @@ via: https://www.packet.net/blog/splicing-the-cloud-native-stack/

|

||||

作者:[Zoe Allen][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[qhwdw](https://github.com/qhwdw)

|

||||

校对:[wxy](https://github.com/wxy)、[pityonline](https://github.com/pityonline)

|

||||

校对:[wxy](https://github.com/wxy), [pityonline](https://github.com/pityonline)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,154 @@

|

||||

|

||||

如何确定你的Linux发行版中有没有某个软件包

|

||||

======

|

||||

|

||||

|

||||

|

||||

|

||||

有时,你可能会想知道如何在你的 Linux 发行版上寻找一个特定的软件包。或者,你仅仅只是想知道安装在你的 Linux 上的软件包有什么版本。如果这就是你想知道的信息,你今天走运了。我正好知道一个小工具能帮你抓到上述信息,下面隆重推荐—— Whohas:这是一个命令行工具,它能一次查询好几个软件包列表,以检查的你软件包是否存在。目前,whohas 支持 Arch、Debian、Fedora、Gentoo、Mandriva、openSUSE、Slackware、Source Mage、Ubuntu、FreeBSD、NetBSD、OpenBSD(LCTT 译注:*BSD 不是 Linux)、Fink、MacPorts 和 Cygwin。使用这个小工具,软件包的维护者能轻而易举从别的 Linux 发行版里找到 ebuilds、 pkgbuilds 等等类似的包定义文件。

|

||||

|

||||

Whohas 是用 Perl 语言开发的自由、开源的工具。

|

||||

|

||||

### 在你的 Linux 中寻找一个特定的包

|

||||

|

||||

#### 安装 Whohas

|

||||

|

||||

Whohas 在 Debian、Ubuntu、Linux Mint 的默认软件仓库里提供。如果你正在使用某种基于 DEB 的系统,你可以用如下命令安装:

|

||||

|

||||

```

|

||||

$ sudo apt-get install whohas

|

||||

```

|

||||

|

||||

对基于 Arch 的系统,[AUR][1] 里就有提供 whohas。你能使用任何的 AUR 助手程序来安装。

|

||||

|

||||

使用 [Packer][2]:

|

||||

|

||||

```

|

||||

$ packer -S whohas

|

||||

```

|

||||

|

||||

或使用[Trizen][3]:

|

||||

|

||||

```

|

||||

$ trizen -S whohas

|

||||

```

|

||||

|

||||

使用[Yay][4]:

|

||||

|

||||

```

|

||||

$ yay -S whohas

|

||||

```

|

||||

|

||||

使用 [Yaourt][5]:

|

||||

|

||||

```

|

||||

$ yaourt -S whohas

|

||||

```

|

||||

|

||||

在别的 Linux 发行版上,从[这里][6]下载源代码并手工编译安装。

|

||||

|

||||

#### 使用方法

|

||||

|

||||

Whohas 的主要目标是想让你知道:

|

||||

|

||||

* 哪个 Linux 发布版提供了用户依赖的包。

|

||||

* 对于各个 Linux 发行版,指定的软件包是什么版本,或者在这个 Linux 发行版的各个不同版本上,指定的软件包是什么版本。

|

||||

|

||||

让我们试试看上面的的功能,比如说,哪个 Linux 发行版里有 vim 这个软件?我们可以运行如下命令:

|

||||

|

||||

```

|

||||

$ whohas vim

|

||||

```

|

||||

|

||||

|

||||

这个命令将会显示所有包含可安装的 vim 的 Linux 发行版的信息,包括包的大小,仓库地址和下载URL。

|

||||

|

||||

![][8]

|

||||

|

||||

你甚至可以通过管道将输出的结果按照发行版的字母排序,只需加入 `sort` 命令即可。

|

||||

|

||||

```

|

||||

$ whohas vim | sort

|

||||

```

|

||||

|

||||

请注意上述命令将会显示所有以 vim 开头的软件包,包括 vim-spell、vimcommander、vimpager 等等。你可以继续使用 Linux 的 `grep` 命令在 “vim” 的前后加上空格来缩小你的搜索范围,直到满意为止。

|

||||

|

||||

```

|

||||

$ whohas vim | sort | grep " vim"

|

||||

$ whohas vim | sort | grep "vim "

|

||||

$ whohas vim | sort | grep " vim "

|

||||

```

|

||||

|

||||

所有将空格放在包名字前面的搜索将会显示以包名字结尾的包。所有将空格放在包名字后面的搜索将会显示以包名字开头的包。前后都有空格将会严格匹配。

|

||||

|

||||

又或者,你就使用 `--strict` 来严格限制结果。

|

||||

|

||||

```

|

||||

$ whohas --strict vim

|

||||

```

|

||||

|

||||

有时,你想知道一个包在不在一个特定的 Linux 发行版里。例如,你想知道 vim 是否在 Arch Linux 里,请运行:

|

||||

|

||||

```

|

||||

$ whohas vim | grep "^Arch"

|

||||

```

|

||||

|

||||

(LCTT译注:在结果里搜索以 Arch 开头的 Linux)

|

||||

|

||||

Linux 发行版的命名缩写为:'archlinux'、'cygwin'、'debian'、'fedora'、 'fink'、'freebsd'、'gentoo'、'mandriva'、'macports'、'netbsd'、'openbsd'、'opensuse'、'slackware'、'sourcemage' 和 'ubuntu'。

|

||||

|

||||

你也可以用 `-d` 选项来得到同样的结果。

|

||||

|

||||

```

|

||||

$ whohas -d archlinux vim

|

||||

```

|

||||

|

||||

这个命令将在仅仅 Arch Linux 发行版下搜索 vim 包。

|

||||

|

||||

如果要在多个 Linux 发行版下搜索,如 'archlinux'、'ubuntu',请使用如下命令。

|

||||

|

||||

```

|

||||

$ whohas -d archlinux,ubuntu vim

|

||||

```

|

||||

|

||||

|

||||

你甚至可以用 `whohas` 来查找哪个发行版有 whohas 包。

|

||||

|

||||

```

|

||||

$ whohas whohas

|

||||

```

|

||||

|

||||

更详细的信息,请参照手册。

|

||||

|

||||

```

|

||||

$ man whohas

|

||||

```

|

||||

|

||||

#### 最后的话

|

||||

|

||||

当然,任何一个 Linux 发行版的包管理器都能轻松的在对应的软件仓库里找到自己管理的包。不过,whohas 帮你整合并比较了在不同的 Linux 发行版下指定的软件包信息,这样你能轻易的跨平台之间进行比较。试一下 whohas,你一定不会失望的。

|

||||

|

||||

好了,今天就到这里吧,希望前面讲的对你有用,下次我还会带来更多好东西!!

|

||||

|

||||

欧耶!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.ostechnix.com/find-if-a-package-is-available-for-your-linux-distribution/

|

||||

|

||||

作者:[SK][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[DavidChenLiang](https://github.com/davidchenliang)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.ostechnix.com/author/sk/

|

||||

[1]:https://aur.archlinux.org/packages/whohas/

|

||||

[2]:https://www.ostechnix.com/install-packer-arch-linux-2/

|

||||

[3]:https://www.ostechnix.com/trizen-lightweight-aur-package-manager-arch-based-systems/

|

||||

[4]:https://www.ostechnix.com/yay-found-yet-another-reliable-aur-helper/

|

||||

[5]:https://www.ostechnix.com/install-yaourt-arch-linux/

|

||||

[6]:http://www.philippwesche.org/200811/whohas/intro.html

|

||||

[7]:data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7

|

||||

[8]:http://www.ostechnix.com/wp-content/uploads/2018/06/whohas-1.png

|

||||

@ -1,11 +1,11 @@

|

||||

逃离 Google,重获自由(与君共勉)

|

||||

======

|

||||

|

||||

原名:How I Fully Quit Google (And You Can, Too)

|

||||

|

||||

> 寻求挣脱科技巨头的一次开创性尝试

|

||||

|

||||

在过去的六个月里,难以想象我到底经历了些什么。艰难的、时间密集的、启发性的探索,为的只是完全摒弃一家公司 —— Google(谷歌)—— 的产品。本该是件简简单单的任务,但真要去做,花费在研究和测试上的又何止几个小时。但我成功了。现在,我已经不需要 Google 了,作为西方世界中极其少数的群体中的一份子,不再使用世界上最有价值的两家科技公司的产品(是的,我也不用 [Facebook(脸书)][6])。

|

||||

|

||||

|

||||

在过去的六个月里,难以想象我到底经历了些什么。艰难的、耗时的、开创性的探索,为的只是完全摒弃一家公司 —— Google(谷歌)—— 的产品。本该是件简简单单的任务,但真要去做,花费在研究和测试上的又何止几个小时。但我成功了。现在,我已经不需要 Google 了,作为西方世界中极其少数的群体中的一份子,不再使用世界上最有价值的两家科技公司的产品(是的,我也不用 [Facebook(脸书)][6])。

|

||||

|

||||

本篇指南将向你展示我逃离 Google 生态的始末。以及根据本人的研究和个人需求,选择的替代方案。我不是技术方面的专家,或者说程序员,但作为记者,我的工作要求我对安全和隐私的问题保持警惕。

|

||||

|

||||

@ -17,17 +17,17 @@

|

||||

|

||||

Google 很快就从仅提供检索服务转向提供其它服务,其中许多都是我欣然拥抱的服务。早在 2005 年,当时你们可能还只能[通过邀请][7]加入 Gmail 的时候,我就已经是早期使用者了。Gmail 采用了线程对话、归档、标签,毫无疑问是我使用过的最好的电子邮件服务。当 Google 在 2006 年推出其日历工具时,那种对操作的改进绝对是革命性的。针对不同日历使用不同的颜色进行编排、检索事件、以及发送可共享的邀请,操作极其简单。2007 年推出的 Google Docs 同样令人惊叹。在我的第一份全职工作期间,我还促成我们团队使用支持多人同时编辑的 Google 电子表格、文档和演示文稿来完成日常工作。

|

||||

|

||||

和许多人样,我也是 Google 开疆拓土过程中的受害者。从搜索(引擎)到电子邮件、文档、分析、再到照片,许多其它服务都建立在彼此之上,相互勾连。Google 从一家发布实用产品的公司转变成诱困用户公司,与此同时将整个互联网转变为牟利和数据采集的机器。Google 在我们的数字生活中几乎无处不在,这种程度的存在远非其他公司可以比拟。与之相比使用其他科技巨头的产品想要抽身就相对容易。对于 Apple(苹果),你要么身处 iWorld 之中,要么是局外人。亚马逊亦是如此,甚至连 Facebook 也不过是拥有少数的几个平台,不用(Facebook)更多的是[心理挑战][8],实际上并没有多么困难。

|

||||

和许多人一样,我也是 Google 开疆拓土过程中的受害者。从搜索(引擎)到电子邮件、文档、分析、再到照片,许多其它服务都建立在彼此之上,相互勾连。Google 从一家发布实用产品的公司转变成诱困用户的公司,与此同时将整个互联网转变为牟利和数据采集的机器。Google 在我们的数字生活中几乎无处不在,这种程度的存在远非其他公司可以比拟。与之相比使用其他科技巨头的产品想要抽身就相对容易。对于 Apple(苹果),你要么身处 iWorld 之中,要么是局外人。亚马逊亦是如此,甚至连 Facebook 也不过是拥有少数的几个平台,不用(Facebook)更多的是[心理挑战][8],实际上并没有多么困难。

|

||||

|

||||

然而,Google 无处不在。无论是笔记本电脑、智能手机或者平板电脑,我猜其中至少会有那么一个 Google 的应用程序。Google 就是搜索(引擎)、地图、电子邮件、浏览器和大多数智能手机操作系统的代名词。甚至还有些应用有赖于其提供的“[服务][9]”和分析,比方说 Uber 便需要采用 Google Maps 来运营其乘车服务。

|

||||

然而,Google 无处不在。无论是笔记本电脑、智能手机或者平板电脑,我猜其中至少会有那么一个 Google 的应用程序。Google 就是搜索(引擎)、地图、电子邮件、浏览器和大多数智能手机操作系统的代名词。甚至还有些应用有赖于其提供的“[服务][9]”和分析,比方说 Uber 便需要采用 Google 地图来运营其乘车服务。

|

||||

|

||||

Google 现在俨然已是许多语言中的单词,但彰显其超然全球统治地位的方面显然不止于此。可以说只要你不是极其注重个人隐私,那其庞大而成套的工具几乎没有多少众所周知或广泛使用的替代品。这恰好也是大家选择 Google 的原因,在很多方面能更好的替代现有的产品。但现在,使我们的难以割舍的主要原因其实是 Google 已经成为了默认选择,或者说由于其主导地位导致替代品无法对我们构成足够的吸引。

|

||||

|

||||

事实上,替代方案是存在的,这些年自 Edward Snowden(爱德华·斯诺登)披露 Google 涉事 [Prism(棱镜)][10]以来,又陆续涌现了许多替代品。我从去年年底开始着手这个项目。经过六个月的研究、测评以及大量的尝试和失败,我终于找到了所有我正在使用的 Google 产品对应的注重个人隐私的替代品。令我感到吃惊的是,其中的一些替代品比 Google 的做的还要好。

|

||||

事实上,替代方案是存在的,这些年自<ruby>爱德华·斯诺登<rt>Edward Snowden</rt></ruby>披露 Google 涉事 <ruby>[棱镜][10]<rt>Prism</rt></ruby>以来,又陆续涌现了许多替代品。我从去年年底开始着手这个项目。经过六个月的研究、测评以及大量的尝试和失败,我终于找到了所有我正在使用的 Google 产品对应的注重个人隐私的替代品。令我感到吃惊的是,其中的一些替代品比 Google 的做的还要好。

|

||||

|

||||

### 一些注意事项

|

||||

|

||||

过程中需要面临的几个挑战之一便是,大多数的替代方案,特别是那些注重隐私空间的开源替代方案,确实对用户不太友好。我不是技术人员,但是自己有一个网站,了解如何管理 Wordpress,可以排除一些基本的故障,但我用不来命令行,也做不来任何需要编码的事。

|

||||

这个过程中需要面临的几个挑战之一便是,大多数的替代方案,特别是那些注重隐私空间的开源替代方案,确实对用户不太友好。我不是技术人员,但是自己有一个网站,了解如何管理 Wordpress,可以排除一些基本的故障,但我用不来命令行,也做不来任何需要编码的事。

|

||||

|

||||

提供的这些替代方案中的大多数,即便不能完整替代 Google 产品的功能,但至少可以轻松上手。不过有些还是需要你有自己的 Web 主机或服务器的。

|

||||

|

||||

@ -39,7 +39,7 @@ Google 现在俨然已是许多语言中的单词,但彰显其超然全球统

|

||||

|

||||

[DuckDuckGo][12] 和 [startpage][13] 都是以保护个人隐私为中心的搜索引擎,不收集任何搜索数据。我用这两个搜索引擎来负责之前用 Google 搜索的所有需求。

|

||||

|

||||

其它的替代方案:实际上并不多,Google 坐拥全球 74% 的市场份额时,剩下的那些主要是因为中国的封锁。不过还有 Ask.com,以及 Bing……

|

||||

其它的替代方案:实际上并不多,Google 坐拥全球 74% 的市场份额时,剩下的那些主要是因为中国的原因。不过还有 Ask.com,以及 Bing……

|

||||

|

||||

#### Chrome

|

||||

|

||||

@ -129,11 +129,11 @@ Google 现在俨然已是许多语言中的单词,但彰显其超然全球统

|

||||

|

||||

有些确实更好!Jitsi Meet 运行更顺畅,需要的带宽更少,并且比 Hangouts 跨平台支持好。Firefox 比 Chrome 更稳定,占用的内存更少。Fastmail 的日历具有更好的时区集成。

|

||||

|

||||

还有些旗鼓相当。ProtonMail 具有 Gmail 的大部分功能,但缺少一些好用的集成,例如我之前使用的 Boomerang 邮件日程功能。还缺少联系人界面,但我正在使用 Nextcloud。说到 Nextcloud,它非常适合托管文件,联系人,还包含了一个漂亮的笔记工具(以及诸多其它插件)。但它没有 Google Docs 丰富的多人编辑功能。在我的预算中,还没有找到可行的替代方案。虽然还有 Collabora Office,但这需要升级我的服务器,这对我来说不能算切实可行。

|

||||

还有些旗鼓相当。ProtonMail 具有 Gmail 的大部分功能,但缺少一些好用的集成,例如我之前使用的 Boomerang 邮件日程功能。还缺少联系人界面,但我正在使用 Nextcloud。说到 Nextcloud,它非常适合托管文件、联系人,还包含了一个漂亮的笔记工具(以及诸多其它插件)。但它没有 Google Docs 丰富的多人编辑功能。在我的预算中,还没有找到可行的替代方案。虽然还有 Collabora Office,但这需要升级我的服务器,这对我来说不能算切实可行。

|

||||

|

||||

一些取决于位置。在一些国家(如印度尼西亚),MAPS.ME 实际上比 Google 地图更好用,而在另一些国家(包括美国)就差了许多。

|

||||

|

||||

还有些要求用户牺牲一些特性或功能。Piwic 是一个穷人的 Google Analytics,缺乏前者的许多详细报告和搜索功能。DuckDuckGo 适用于一般搜索,但是在特定的搜索方面还存在问题,当我搜索非英文内容时,它和 startpage 时常都会检索失败。

|

||||

还有些要求用户牺牲一些特性或功能。Piwic 是一个穷人版的 Google Analytics,缺乏前者的许多详细报告和搜索功能。DuckDuckGo 适用于一般搜索,但是在特定的搜索方面还存在问题,当我搜索非英文内容时,它和 startpage 时常都会检索失败。

|

||||

|

||||

### 最后,我不再心念 Google

|

||||

|

||||

@ -141,7 +141,7 @@ Google 现在俨然已是许多语言中的单词,但彰显其超然全球统

|

||||

|

||||

如果我们别无选择,只能使用 Google 的产品,那我们便失去了作为消费者的最后一丝力量。

|

||||

|

||||

我希望 Google,Facebook,Apple 和其他科技巨头在对待用户时不要这么理所当然,不要试图强迫我们进入其无所不包的生态系统。我也期待新选手能够出现并与之竞争,就像以前一样,Google 的新搜索工具可以与当时的行业巨头 Altavista 和 Yahoo 竞争,或者说 Facebook 的社交网络能够与 MySpace 和 Friendster 竞争。Google 给出了更好的搜索方案,使互联网变得更加美好。有选择是个好事,可移植也是。

|

||||

我希望 Google、Facebook、Apple 和其他科技巨头在对待用户时不要这么理所当然,不要试图强迫我们进入其无所不包的生态系统。我也期待新选手能够出现并与之竞争,就像以前一样,Google 的新搜索工具可以与当时的行业巨头 Altavista 和 Yahoo 竞争,或者说 Facebook 的社交网络能够与 MySpace 和 Friendster 竞争。Google 给出了更好的搜索方案,使互联网变得更加美好。有选择是个好事,可移植也是。

|

||||

|

||||

如今,我们很少有人哪怕只是尝试其它产品,因为我们已经习惯了 Google。我们不再更改邮箱地址,因为这太难了。我们甚至不尝试使用 Facebook 以外的替代品,因为我们所有的朋友都在 Facebook 上。这些我明白。

|

||||

|

||||

@ -1,19 +1,19 @@

|

||||

打包更多有用的 Unix 实用程序

|

||||

一套有用的 Unix 实用程序

|

||||

======

|

||||

|

||||

|

||||

|

||||

我们都了解 **<ruby>GNU 核心实用程序<rt>GNU Core Utilities</rt></ruby>**,所有类 Unix 操作系统都预装了它们。它们是 GNU 操作系统中与文件、Shell 和 文本处理相关的基础实用工具。GNU 核心实用程序包括很多日常操作命令,例如 `cat`,`ls`, `rm`,`mkdir`,`rmdir`,`touch`,`tail` 和 `wc` 等。除了这些实用程序,还有更多有用的实用程序没有预装在类 Unix 操作系统中,它们汇集起来构成了 `moreutilis` 这个日益增长的集合。`moreutils` 可以在 GNU/Linux 和包括 FreeBSD,openBSD 及 Mac OS 在内的多种 Unix 类型操作系统上安装。

|

||||

我们都了解 <ruby>GNU 核心实用程序<rt>GNU Core Utilities</rt></ruby>,所有类 Unix 操作系统都预装了它们。它们是 GNU 操作系统中与文件、Shell 和 文本处理相关的基础实用工具。GNU 核心实用程序包括很多日常操作命令,例如 `cat`、`ls`、`rm`、`mkdir`、`rmdir`、`touch`、`tail` 和 `wc` 等。除了这些实用程序,还有更多有用的实用程序没有预装在类 Unix 操作系统中,它们汇集起来构成了 `moreutilis` 这个日益增长的集合。`moreutils` 可以在 GNU/Linux 和包括 FreeBSD,openBSD 及 Mac OS 在内的多种 Unix 类型操作系统上安装。

|

||||

|

||||

截至到编写这份指南时, `moreutils` 提供如下实用程序:

|

||||

|

||||

* `chronic` – 运行程序并忽略正常运行的输出

|

||||

* `combine` – 使用布尔操作合并文件

|

||||

* `combine` – 使用布尔操作合并文件的行

|

||||

* `errno` – 查询 errno 名称及描述

|

||||

* `ifdata` – 获取网络接口信息,无需解析 `ifconfig` 的结果

|

||||

* `ifne` – 在标准输入非空的情况下运行程序

|

||||

* `isutf8` – 检查文件或标准输入是否采用 UTF-8 编码

|

||||

* `lckdo` – 运行程序时考虑文件锁

|

||||

* `lckdo` – 带锁运行程序

|

||||

* `mispipe` – 使用管道连接两个命令,返回第一个命令的退出状态

|

||||

* `parallel` – 同时运行多个任务

|

||||

* `pee` – 将标准输入传递给多个管道

|

||||

@ -56,7 +56,7 @@ $ sudo apt-get install moreutils

|

||||

|

||||

让我们看一下几个 `moreutils` 工具的用法细节。

|

||||

|

||||

##### combine 实用程序

|

||||

#### combine 实用程序

|

||||

|

||||

正如 `combine` 名称所示,moreutils 中的这个实用程序可以使用包括 `and`,`not`,`or` 和 `xor` 在内的布尔操作,合并两个文件中的行。

|

||||

|

||||

@ -102,7 +102,7 @@ where

|

||||

|

||||

从上面的输出中可以看出,`not` 操作输出 `file1` 包含但 `file2` 不包含的行。

|

||||

|

||||

##### ifdata 实用程序

|

||||

#### ifdata 实用程序

|

||||

|

||||

`ifdata` 实用程序可用于检查网络接口是否存在,也可用于获取网络接口的信息,例如 IP 地址等。与预装的 `ifconfig` 和 `ip` 命令不同,`ifdata` 的输出更容易解析,这种设计的初衷是便于在 Shell 脚本中使用。

|

||||

|

||||

@ -134,7 +134,7 @@ $ ifdata -pe wlp9s0

|

||||

yes

|

||||

```

|

||||

|

||||

##### pee 命令

|

||||

#### pee 命令

|

||||

|

||||

该命令某种程度上类似于 `tee` 命令。

|

||||

|

||||

@ -157,7 +157,7 @@ Welcome to OSTechNIx

|

||||

|

||||

从上面的命令输出中可以看出,有两个 `cat` 命令实例获取 `echo` 命令的输出并执行,因而终端中出现两个同样的输出。

|

||||

|

||||

##### sponge 实用程序

|

||||

#### sponge 实用程序

|

||||

|

||||

这是 `moreutils` 软件包中的另一个有用的实用程序。`sponge` 读取标准输入并写入到指定的文件中。与 Shell 中的重定向不同,`sponge` 接收到完整输入后再写入输出文件。

|

||||

|

||||

@ -197,7 +197,7 @@ You

|

||||

|

||||

看到了吧?并不需要创建新文件。在脚本编程中,这非常有用。另一个好消息是,如果待写入的文件已经存在,`sponge` 会保持其<ruby>权限信息<rt>permissions</rt></ruby>不变。

|

||||

|

||||

##### ts 实用程序

|

||||

#### ts 实用程序

|

||||

|

||||

正如名称所示,`ts` 命令在每一行输出的行首增加<ruby>时间戳<rt>timestamp</rt></ruby>。

|

||||

|

||||

@ -238,7 +238,7 @@ Aug 21 13:34:25 drwxr-xr-x 24 sk users 12288 Aug 21 13:06 Downloads

|

||||

[...]

|

||||

```

|

||||

|

||||

##### vidir 实用程序

|

||||

#### vidir 实用程序

|

||||

|

||||

`vidir` 实用程序可以让你使用 `vi` 编辑器(或其它 `$EDITOR` 环境变量指定的编辑器)编辑指定目录的内容。如果没有指定目录,`vidir` 会默认编辑你当前的目录。

|

||||

|

||||

@ -274,7 +274,7 @@ $ vidir *.png

|

||||

|

||||

这时命令只会编辑当前目录下以 `.PNG` 为后缀的文件。

|

||||

|

||||

##### vipe 实用程序

|

||||

#### vipe 实用程序

|

||||

|

||||

`vipe` 命令可以让你使用默认编辑器接收 Unix 管道输入,编辑之后使用管道输出供下一个程序使用。

|

||||

|

||||

@ -285,7 +285,7 @@ $ echo "Welcome to OSTechNIx" | vipe

|

||||

Hello World

|

||||

```

|

||||

|

||||

从上面的输出可以看出,我通过管道将“Welcome to OSTechNix”输入到 `vi` 编辑器中,将内容编辑为“Hello World”,最后显示该内容。

|

||||

从上面的输出可以看出,我通过管道将 “Welcome to OSTechNix” 输入到 `vi` 编辑器中,将内容编辑为 “Hello World”,最后显示该内容。

|

||||

|

||||

好了,就介绍这么多吧。我只介绍了一小部分实用程序,而 `moreutils` 包含更多有用的实用程序。我在文章开始的时候已经列出目前 `moreutils` 软件包内包含的实用程序,你可以通过 `man` 帮助页面获取更多相关命令的细节信息。举个例子,如果你想了解 `vidir` 命令,请运行:

|

||||

|

||||

@ -304,7 +304,7 @@ via: https://www.ostechnix.com/moreutils-collection-useful-unix-utilities/

|

||||

作者:[SK][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[pinewall](https://github.com/pinewall)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,104 @@

|

||||

15 command-line aliases to save you time

|

||||

======

|

||||

|

||||

|

||||

|

||||

Linux command-line aliases are great for helping you work more efficiently. Better still, some are included by default in your installed Linux distro.

|

||||

|

||||

This is an example of a command-line alias in Fedora 27:

|

||||

|

||||

|

||||

|

||||

The command `alias` shows the list of existing aliases. Setting an alias is as simple as typing:

|

||||

|

||||

`alias new_name="command"`

|

||||

|

||||

Here are 15 command-line aliases that will save you time:

|

||||

|

||||

1. To install any utility/application:

|

||||

|

||||

`alias install="sudo yum install -y"`

|

||||

|

||||

Here, `sudo` and `-y` are optional as per user’s preferences:

|

||||

|

||||

|

||||

![install alias.png][2]

|

||||

|

||||

2. To update the system:

|

||||

|

||||

`alias update="sudo yum update -y"`

|

||||

|

||||

3. To upgrade the system:

|

||||

|

||||

`alias upgrade="sudo yum upgrade -y"`

|

||||

|

||||

4. To change to the root user:

|

||||

|

||||

`alias root="sudo su -"`

|

||||

|

||||

5. To change to "user," where "user" is set as your username:

|

||||

|

||||

`alias user="su user"`

|

||||

|

||||

6. To display the list of all available ports, their status, and IP:

|

||||

|

||||

`alias myip="ip -br -c a"`

|

||||

|

||||

7. To `ssh` to the server `myserver`:

|

||||

|

||||

`alias myserver="ssh user@my_server_ip”`

|

||||

|

||||

8. To list all processes in the system:

|

||||

|

||||

`alias process="ps -aux"`

|

||||

|

||||

9. To check the status of any system service:

|

||||

|

||||

`alias sstatus="sudo systemctl status"`

|

||||

|

||||

10. To restart any system service:

|

||||

|

||||

`alias srestart="sudo systemctl restart"`

|

||||

|

||||

11. To kill any process by its name:

|

||||

|

||||

`alias kill="sudo pkill"`

|

||||

|

||||

![kill process alias.png][4]

|

||||

|

||||

12. To display the total used and free memory of the system:

|

||||

|

||||

`alias mem="free -h"`

|

||||

|

||||

13. To display the CPU architecture, number of CPUs, threads, etc. of the system:

|

||||

|

||||

`alias cpu="lscpu"`

|

||||

|

||||

14. To display the total disk size of the system:

|

||||

|

||||

`alias disk="df -h"`

|

||||

|

||||

15. To display the current system Linux distro (for CentOS, Fedora, and Red Hat):

|

||||

|

||||

`alias os="cat /etc/redhat-release"`

|

||||

|

||||

![system_details alias.png][6]

|

||||

|

||||

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/8/time-saving-command-line-aliases

|

||||

|

||||

作者:[Aarchit Modi][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/architmodi

|

||||

[2]:https://opensource.com/sites/default/files/uploads/install.png (install alias.png)

|

||||

[4]:https://opensource.com/sites/default/files/uploads/kill.png (kill process alias.png)

|

||||

[6]:https://opensource.com/sites/default/files/uploads/system_details.png (system_details alias.png)

|

||||

@ -1,316 +0,0 @@

|

||||

pinewall is translating

|

||||

|

||||

Anatomy of a Linux DNS Lookup – Part III

|

||||

============================================================

|

||||

|

||||

In [Anatomy of a Linux DNS Lookup – Part I][1] I covered:

|

||||

|

||||

* `nsswitch`

|

||||

|

||||

* `/etc/hosts`

|

||||

|

||||

* `/etc/resolv.conf`

|

||||

|

||||

* `ping` vs `host` style lookups

|

||||

|

||||

and in [Anatomy of a Linux DNS Lookup – Part II][2] I covered:

|

||||

|

||||

* `systemd` and its `networking` service

|

||||

|

||||

* `ifup` and `ifdown`

|

||||

|

||||

* `dhclient`

|

||||

|

||||

* `resolvconf`

|

||||

|

||||

and ended up here:

|

||||

|

||||

* * *

|

||||

|

||||

|

||||

|

||||

_A (roughly) accurate map of what’s going on_

|

||||

|

||||

Unfortunately, that’s not the end of the story. There’s still more things that can get involved. In Part III, I’m going to cover NetworkManager and dnsmasq and briefly show how they play a part.

|

||||

|

||||

* * *

|

||||

|

||||

# 1) NetworkManager

|

||||

|

||||

As mentioned in Part II, we are now well away from POSIX standards and into Linux distribution-specific areas of DNS resolution management.

|

||||

|

||||

In my preferred distribution (Ubuntu), there is a service that’s available and often installed for me as a dependency of some other package I install called [NetworkManager][3]. It’s actually a service developed by RedHat in 2004 to help manage network interfaces for you.

|

||||

|

||||

What does this have to do with DNS? Install it to find out:

|

||||

|

||||

```

|

||||

$ apt-get install -y network-manager

|

||||

```

|

||||

|

||||

In my distribution, I get a config file.

|

||||

|

||||

```

|

||||

$ cat /etc/NetworkManager/NetworkManager.conf

|

||||

[main]

|

||||

plugins=ifupdown,keyfile,ofono

|

||||

dns=dnsmasq

|

||||

|

||||

[ifupdown]

|

||||

managed=false

|

||||

```

|

||||

|

||||

See that `dns=dnsmasq` there? That means that NetworkManager will use `dnsmasq` to manage DNS on the host.

|

||||

|

||||

* * *

|

||||

|

||||

# 2) dnsmasq

|

||||

|

||||

The dnsmasq program is that now-familiar thing: yet another level of indirection for `/etc/resolv.conf`.

|

||||

|

||||

Technically, dnsmasq can do a few things, but is primarily it acts as a DNS server that can cache requests to other DNS servers. It runs on port 53 (the standard DNS port), on all local network interfaces.

|

||||

|

||||

So where is `dnsmasq` running? NetworkManager is running:

|

||||

|

||||

```

|

||||

$ ps -ef | grep NetworkManager

|

||||

root 15048 1 0 16:39 ? 00:00:00 /usr/sbin/NetworkManager --no-daemon

|

||||

```

|

||||

|

||||

But no `dnsmasq` process exists:

|

||||

|

||||

```

|

||||

$ ps -ef | grep dnsmasq

|

||||

$

|

||||

```

|

||||

|

||||

Although it’s configured to be used, confusingly it’s not actually installed! So you’re going to install it.

|

||||

|

||||

Before you install it though, let’s check the state of `/etc/resolv.conf`.

|

||||

|

||||

```

|

||||

$ cat /etc/resolv.conf

|

||||

# Dynamic resolv.conf(5) file for glibc resolver(3) generated by resolvconf(8)

|

||||

# DO NOT EDIT THIS FILE BY HAND -- YOUR CHANGES WILL BE OVERWRITTEN

|

||||

nameserver 10.0.2.2

|

||||

search home

|

||||

```

|

||||

|

||||

It’s not been changed by NetworkManager.

|

||||

|

||||

If `dnsmasq` is installed:

|

||||

|

||||

```

|

||||

$ apt-get install -y dnsmasq

|

||||

```

|

||||

|

||||

Then `dnsmasq` is up and running:

|

||||

|

||||

```

|

||||

$ ps -ef | grep dnsmasq

|

||||

dnsmasq 15286 1 0 16:54 ? 00:00:00 /usr/sbin/dnsmasq -x /var/run/dnsmasq/dnsmasq.pid -u dnsmasq -r /var/run/dnsmasq/resolv.conf -7 /etc/dnsmasq.d,.dpkg-dist,.dpkg-old,.dpkg-new --local-service --trust-anchor=.,19036,8,2,49AAC11D7B6F6446702E54A1607371607A1A41855200FD2CE1CDDE32F24E8FB5

|

||||

```

|

||||

|

||||

And `/etc/resolv.conf` has changed again!

|

||||

|

||||

```

|

||||

root@linuxdns1:~# cat /etc/resolv.conf

|

||||

# Dynamic resolv.conf(5) file for glibc resolver(3) generated by resolvconf(8)

|

||||

# DO NOT EDIT THIS FILE BY HAND -- YOUR CHANGES WILL BE OVERWRITTEN

|

||||

nameserver 127.0.0.1

|

||||

search home

|

||||

```

|

||||

|

||||

And `netstat` shows `dnsmasq` is serving on all interfaces at port 53:

|

||||

|

||||

```

|

||||

$ netstat -nlp4

|

||||

Active Internet connections (only servers)

|

||||

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

|

||||

tcp 0 0 127.0.0.1:53 0.0.0.0:* LISTEN 15286/dnsmasq

|

||||

tcp 0 0 10.0.2.15:53 0.0.0.0:* LISTEN 15286/dnsmasq

|

||||

tcp 0 0 172.28.128.11:53 0.0.0.0:* LISTEN 15286/dnsmasq

|

||||

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 1237/sshd

|

||||

udp 0 0 127.0.0.1:53 0.0.0.0:* 15286/dnsmasq

|

||||

udp 0 0 10.0.2.15:53 0.0.0.0:* 15286/dnsmasq

|

||||

udp 0 0 172.28.128.11:53 0.0.0.0:* 15286/dnsmasq

|

||||

udp 0 0 0.0.0.0:68 0.0.0.0:* 10758/dhclient

|

||||

udp 0 0 0.0.0.0:68 0.0.0.0:* 10530/dhclient

|

||||

udp 0 0 0.0.0.0:68 0.0.0.0:* 10185/dhclient

|

||||

```

|

||||

|

||||

* * *

|

||||

|

||||

# 3) Unpicking dnsmasq

|

||||

|

||||

Now we are in a situation where all DNS queries are going to `127.0.0.1:53` and from there what happens?

|

||||

|

||||

We can get a clue from looking again at the `/var/run` folder. The `resolv.conf` in `resolvconf` has been changed to point to where `dnsmasq` is being served:

|

||||

|

||||

```

|

||||

$ cat /var/run/resolvconf/resolv.conf

|

||||

# Dynamic resolv.conf(5) file for glibc resolver(3) generated by resolvconf(8)

|

||||

# DO NOT EDIT THIS FILE BY HAND -- YOUR CHANGES WILL BE OVERWRITTEN

|

||||

nameserver 127.0.0.1

|

||||

search home

|

||||

```

|

||||

|

||||

while there’s a new `dnsmasq` folder with its own `resolv.conf`.

|

||||

|

||||

```

|

||||

$ cat /run/dnsmasq/resolv.conf

|

||||

nameserver 10.0.2.2

|

||||

```

|

||||

|

||||

which has the nameserver given to us by `DHCP`.

|

||||

|

||||

We can reason about this without looking too deeply, but what if we really want to know what’s going on?

|

||||

|

||||

* * *

|

||||

|

||||

# 4) Debugging Dnsmasq

|

||||

|

||||

Frequently I’ve found myself wondering what dnsmasq’s state is. Fortunately, you can get a good amount of information out of it if you set change this line in `/etc/dnsmasq.conf`:

|

||||

|

||||

```

|

||||

#log-queries

|

||||

```

|

||||

|

||||

to:

|

||||

|

||||

```

|

||||

log-queries

|

||||

```

|

||||

|

||||

and restart `dnsmasq`

|

||||

|

||||

Now, if you do a simple:

|

||||

|

||||

```

|

||||

$ ping -c1 bbc.co.uk

|

||||

```

|

||||

|

||||

you will see something like this in `/var/log/syslog` (the `[...]` indicates that the line’s start is the same as the previous one):

|

||||

|

||||

```

|

||||

Jul 3 19:56:07 ubuntu-xenial dnsmasq[15372]: query[A] bbc.co.uk from 127.0.0.1

|

||||

[...] forwarded bbc.co.uk to 10.0.2.2

|

||||

[...] reply bbc.co.uk is 151.101.192.81

|

||||

[...] reply bbc.co.uk is 151.101.0.81

|

||||

[...] reply bbc.co.uk is 151.101.64.81

|

||||

[...] reply bbc.co.uk is 151.101.128.81

|

||||

[...] query[PTR] 81.192.101.151.in-addr.arpa from 127.0.0.1

|

||||

[...] forwarded 81.192.101.151.in-addr.arpa to 10.0.2.2

|

||||

[...] reply 151.101.192.81 is NXDOMAIN

|

||||

```

|

||||

|

||||

which shows what `dnsmasq` received, where the query was forwarded to, and what reply was received.

|

||||

|

||||

If the query is returned from the cache (or, more exactly, the local ‘time-to-live’ for the query has not expired), then it looks like this in the logs:

|

||||

|

||||

```

|

||||

[...] query[A] bbc.co.uk from 127.0.0.1

|

||||

[...] cached bbc.co.uk is 151.101.64.81

|

||||

[...] cached bbc.co.uk is 151.101.128.81

|

||||

[...] cached bbc.co.uk is 151.101.192.81

|

||||

[...] cached bbc.co.uk is 151.101.0.81

|

||||

[...] query[PTR] 81.64.101.151.in-addr.arpa from 127.0.0.1

|

||||

```

|

||||

|

||||

and if you ever want to know what’s in your cache, you can provoke dnsmasq into sending it to the same log file by sending the `USR1` signal to the dnsmasq process id:

|

||||

|

||||

```

|

||||

$ kill -SIGUSR1 <(cat /run/dnsmasq/dnsmasq.pid)

|

||||

```

|

||||

|

||||

and the output of the dump looks like this:

|

||||

|

||||

```

|

||||

Jul 3 15:08:08 ubuntu-xenial dnsmasq[15697]: time 1530630488

|

||||

[...] cache size 150, 0/5 cache insertions re-used unexpired cache entries.

|

||||

[...] queries forwarded 2, queries answered locally 0

|

||||

[...] queries for authoritative zones 0

|

||||

[...] server 10.0.2.2#53: queries sent 2, retried or failed 0

|

||||

[...] Host Address Flags Expires

|

||||

[...] linuxdns1 172.28.128.8 4FRI H

|

||||

[...] ip6-localhost ::1 6FRI H

|

||||

[...] ip6-allhosts ff02::3 6FRI H

|

||||

[...] ip6-localnet fe00:: 6FRI H

|

||||

[...] ip6-mcastprefix ff00:: 6FRI H

|

||||

[...] ip6-loopback : 6F I H

|

||||

[...] ip6-allnodes ff02: 6FRI H

|

||||

[...] bbc.co.uk 151.101.64.81 4F Tue Jul 3 15:11:41 2018

|

||||

[...] bbc.co.uk 151.101.192.81 4F Tue Jul 3 15:11:41 2018

|

||||

[...] bbc.co.uk 151.101.0.81 4F Tue Jul 3 15:11:41 2018

|

||||

[...] bbc.co.uk 151.101.128.81 4F Tue Jul 3 15:11:41 2018

|

||||

[...] 151.101.64.81 4 R NX Tue Jul 3 15:34:17 2018

|

||||

[...] localhost 127.0.0.1 4FRI H

|

||||

[...] <Root> 19036 8 2 SF I

|

||||

[...] ip6-allrouters ff02::2 6FRI H

|

||||

```

|

||||

|

||||

In the above output, I believe (but don’t know, and ‘?’ indicates a relatively wild guess on my part) that:

|

||||

|

||||

* ‘4’ means IPv4

|

||||

|

||||

* ‘6’ means IPv6

|

||||

|

||||

* ‘H’ means address was read from an `/etc/hosts` file

|

||||

|

||||

* ‘I’ ? ‘Immortal’ DNS value? (ie no time-to-live value?)

|

||||

|

||||

* ‘F’ ?

|

||||

|

||||

* ‘R’ ?

|

||||

|

||||

* ‘S’?

|

||||

|

||||

* ‘N’?

|

||||

|

||||

* ‘X’

|

||||

|

||||

#### Alternatives to dnsmasq

|

||||

|

||||

`dnsmasq` is not the only option that can be passed to dns in NetworkManager. There’s `none` which does nothing to `/etc/resolv,conf`, `default`, which claims to ‘update `resolv.conf` to reflect currently active connections’, and `unbound`, which communicates with the `unbound` service and `dnssec-triggerd`, which is concerned with DNS security and is not covered here.

|

||||

|

||||

* * *

|

||||

|

||||

### End of Part III

|

||||

|

||||

That’s the end of Part III, where we covered the NetworkManager service, and its `dns=dnsmasq` setting.

|

||||

|

||||

Let’s briefly list some of the things we’ve come across so far:

|

||||

|

||||

* `nsswitch`

|

||||

|

||||

* `/etc/hosts`

|

||||

|

||||

* `/etc/resolv.conf`

|

||||

|

||||

* `/run/resolvconf/resolv.conf`

|

||||

|

||||

* `systemd` and its `networking` service

|

||||

|

||||

* `ifup` and `ifdown`

|

||||

|

||||

* `dhclient`

|

||||

|

||||

* `resolvconf`

|

||||

|

||||

* `NetworkManager`

|

||||

|

||||

* `dnsmasq`

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://zwischenzugs.com/2018/07/06/anatomy-of-a-linux-dns-lookup-part-iii/

|

||||

|

||||

作者:[ZWISCHENZUGS][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://zwischenzugs.com/

|

||||

[1]:https://zwischenzugs.com/2018/06/08/anatomy-of-a-linux-dns-lookup-part-i/

|

||||

[2]:https://zwischenzugs.com/2018/06/18/anatomy-of-a-linux-dns-lookup-part-ii/

|

||||

[3]:https://en.wikipedia.org/wiki/NetworkManager

|

||||

@ -1,3 +1,5 @@

|

||||

translating---geekpi

|

||||

|

||||

An introduction to pipes and named pipes in Linux

|

||||

======

|

||||

|

||||

|

||||

59

sources/tech/20180827 A sysadmin-s guide to containers.md

Normal file

59

sources/tech/20180827 A sysadmin-s guide to containers.md

Normal file

@ -0,0 +1,59 @@

|

||||

A sysadmin's guide to containers

|

||||

======

|

||||

|

||||

|

||||

|

||||

The term "containers" is heavily overused. Also, depending on the context, it can mean different things to different people.

|

||||

|

||||

Traditional Linux containers are really just ordinary processes on a Linux system. These groups of processes are isolated from other groups of processes using resource constraints (control groups [cgroups]), Linux security constraints (Unix permissions, capabilities, SELinux, AppArmor, seccomp, etc.), and namespaces (PID, network, mount, etc.).

|

||||

|

||||

If you boot a modern Linux system and took a look at any process with `cat /proc/PID/cgroup`, you see that the process is in a cgroup. If you look at `/proc/PID/status`, you see capabilities. If you look at `/proc/self/attr/current`, you see SELinux labels. If you look at `/proc/PID/ns`, you see the list of namespaces the process is in. So, if you define a container as a process with resource constraints, Linux security constraints, and namespaces, by definition every process on a Linux system is in a container. This is why we often say [Linux is containers, containers are Linux][1]. **Container runtimes** are tools that modify these resource constraints, security, and namespaces and launch the container.

|

||||

|

||||

Docker introduced the concept of a **container image** , which is a standard TAR file that combines:

|

||||

|

||||

* **Rootfs (container root filesystem):** A directory on the system that looks like the standard root (`/`) of the operating system. For example, a directory with `/usr`, `/var`, `/home`, etc.

|

||||

* **JSON file (container configuration):** Specifies how to run the rootfs; for example, what **command** or **entrypoint** to run in the rootfs when the container starts; **environment variables** to set for the container; the container's **working directory** ; and a few other settings.

|

||||

|

||||

|

||||

|

||||

Docker "`tar`'s up" the rootfs and the JSON file to create the **base image**. This enables you to install additional content on the rootfs, create a new JSON file, and `tar` the difference between the original image and the new image with the updated JSON file. This creates a **layered image**.

|

||||

|

||||

The definition of a container image was eventually standardized by the [Open Container Initiative (OCI)][2] standards body as the [OCI Image Specification][3].

|

||||

|

||||

Tools used to create container images are called **container image builders**. Sometimes container engines perform this task, but several standalone tools are available that can build container images.

|

||||

|

||||

Docker took these container images ( **tarballs** ) and moved them to a web service from which they could be pulled, developed a protocol to pull them, and called the web service a **container registry**.

|

||||

|

||||

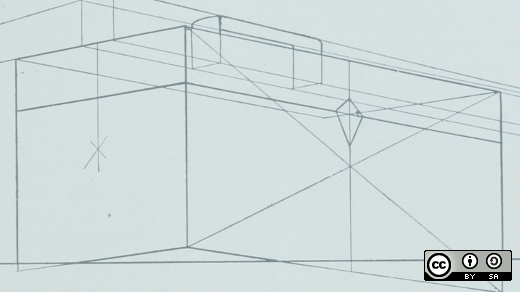

**Container engines** are programs that can pull container images from container registries and reassemble them onto **container storage**. Container engines also launch **container runtimes** (see below).

|

||||

|

||||

|

||||

|

||||

Container storage is usually a **copy-on-write** (COW) layered filesystem. When you pull down a container image from a container registry, you first need to untar the rootfs and place it on disk. If you have multiple layers that make up your image, each layer is downloaded and stored on a different layer on the COW filesystem. The COW filesystem allows each layer to be stored separately, which maximizes sharing for layered images. Container engines often support multiple types of container storage, including `overlay`, `devicemapper`, `btrfs`, `aufs`, and `zfs`.

|

||||

|

||||

|

||||

After the container engine downloads the container image to container storage, it needs to create aThe runtime configuration combines input from the caller/user along with the content of the container image specification. For example, the caller might want to specify modifications to a running container's security, add additional environment variables, or mount volumes to the container.

|

||||

|

||||

The layout of the container runtime configuration and the exploded rootfs have also been standardized by the OCI standards body as the [OCI Runtime Specification][4].

|

||||

|

||||

Finally, the container engine launches a **container runtime** that reads the container runtime specification; modifies the Linux cgroups, Linux security constraints, and namespaces; and launches the container command to create the container's **PID 1**. At this point, the container engine can relay `stdin`/`stdout` back to the caller and control the container (e.g., stop, start, attach).

|

||||

|

||||

Note that many new container runtimes are being introduced to use different parts of Linux to isolate containers. People can now run containers using KVM separation (think mini virtual machines) or they can use other hypervisor strategies (like intercepting all system calls from processes in containers). Since we have a standard runtime specification, these tools can all be launched by the same container engines. Even Windows can use the OCI Runtime Specification for launching Windows containers.

|

||||

|

||||

At a much higher level are **container orchestrators.** Container orchestrators are tools used to coordinate the execution of containers on multiple different nodes. Container orchestrators talk to container engines to manage containers. Orchestrators tell the container engines to start containers and wire their networks together. Orchestrators can monitor the containers and launch additional containers as the load increases.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/8/sysadmins-guide-containers

|

||||

|

||||

作者:[Daniel J Walsh][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/rhatdan

|

||||

[1]:https://www.redhat.com/en/blog/containers-are-linux

|

||||

[2]:https://www.opencontainers.org/

|

||||

[3]:https://github.com/opencontainers/image-spec/blob/master/spec.md

|

||||

[4]:https://github.com/opencontainers/runtime-spec

|

||||

@ -0,0 +1,167 @@

|

||||

A Cat Clone With Syntax Highlighting And Git Integration

|

||||

======

|

||||

|

||||

|

||||

|

||||

In Unix-like systems, we use **‘cat’** command to print and concatenate files. Using cat command, we can print the contents of a file to the standard output, concatenate several files into the target file, and append several files into the target file. Today, I stumbled upon a similar utility named **“Bat”** , a clone to the cat command, with some additional cool features such as syntax highlighting, git integration and automatic paging etc. In this brief guide, we will how to install and use Bat command in Linux.

|

||||

|

||||

### Installation

|

||||

|

||||

Bat is available in the default repositories of Arch Linux. So, you can install it using pacman on any arch-based systems.

|

||||

```

|

||||

$ sudo pacman -S bat

|

||||

|

||||

```

|

||||

|

||||

On Debian, Ubuntu, Linux Mint systems, download the **.deb** file from the [**Releases page**][1] and install it as shown below.

|

||||

```

|

||||

$ sudo apt install gdebi

|

||||

|

||||

$ sudo gdebi bat_0.5.0_amd64.deb

|

||||

|

||||

```

|

||||

|

||||

For other systems, you may need to compile and install from source. Make sure you have installed Rust 1.26 or higher.

|

||||

|

||||

|

||||

|

||||

Then, run the following command to install Bat:

|

||||

```

|

||||

$ cargo install bat

|

||||

|

||||

```

|

||||

|

||||

Alternatively, you can install it using [**Linuxbrew**][2] package manager.

|

||||

```

|

||||

$ brew install bat

|

||||

|

||||

```

|

||||

|

||||

### Bat command Usage

|

||||

|

||||

The Bat command’s usage is very similar to cat command.

|

||||

|

||||

To create a new file using bat command, do:

|

||||

```

|

||||

$ bat > file.txt

|

||||

|

||||

```

|

||||

|

||||

To view the contents of a file using bat command, just do:

|

||||

```

|

||||

$ bat file.txt

|

||||

|

||||

```

|

||||

|

||||

You can also view multiple files at once:

|

||||

```

|

||||

$ bat file1.txt file2.txt

|

||||

|

||||

```

|

||||

|

||||

To append the contents of the multiple files in a single file:

|

||||

```

|

||||

$ bat file1.txt file2.txt file3.txt > document.txt

|

||||

|

||||

```

|

||||

|

||||

Like I already mentioned, apart from viewing and editing files, the Bat command has some additional cool features though.

|

||||

|

||||

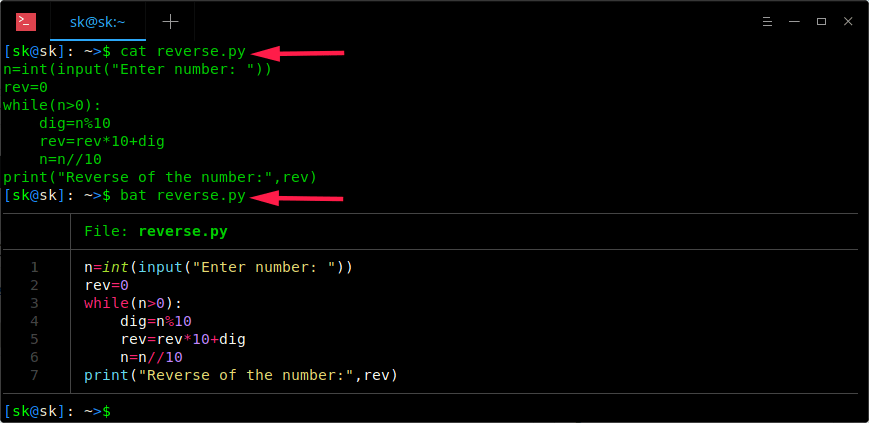

The bat command supports **syntax highlighting** for large number of programming and markup languages. For instance, look at the following example. I am going to display the contents of the **reverse.py** file using both cat and bat commands.

|

||||

|

||||

|

||||

|

||||

Did you notice the difference? Cat command shows the contents of the file in plain text format, whereas bat command shows output with syntax highlighting, order number in a neat tabular column format. Much better, isn’t it?

|

||||

|

||||

If you want to display only the line numbers (not the tabular column), use **-n** flag.

|

||||

```

|

||||

$ bat -n reverse.py

|

||||

|

||||

```

|

||||

|

||||

**Sample output:**

|

||||

|

||||

|

||||

Another notable feature of Bat command is it supports **automatic paging**. That means if output of a file is too large for one screen, the bat command automatically pipes its own output to **less** command, so you can view the output page by page.

|

||||

|

||||

Let me show you an example. When you view the contents of a file which spans multiple pages using cat command, the prompt quickly jumps to the last page of the file, and you do not see the content in the beginning or in the middle.

|

||||

|

||||

Have a look at the following output:

|

||||

|

||||

|

||||

|

||||

As you can see, the cat command displays last page of the file.

|

||||

|

||||

So, you may need to pipe the output of the cat command to **less** command to view it’s contents page by page from the beginning.

|

||||

```

|

||||

$ cat reverse.py | less

|

||||

|

||||

```

|

||||

|

||||

Now, you can view output page by page by hitting the ENTER key. However, it is not necessary if you use bat command. The bat command will automatically pipe the output of a file which spans multiple pages.

|

||||

```

|

||||

$ bat reverse.py

|

||||

|

||||

```

|

||||

|

||||

**Sample output:**

|

||||

|

||||

|

||||

|

||||

Now hit the ENTER key to go to the next page.

|

||||

|

||||

The bat command also supports **GIT integration** , so you can view/edit the files in your Git repository without much hassle. It communicates with git to show modifications with respect to the index (see left side bar).

|

||||

|

||||

|

||||

|

||||

**Customizing Bat**

|

||||

|

||||

If you don’t like the default themes, you can change it too. Bat has option for that too.

|

||||

|

||||

To list the available themes, just run:

|

||||

```

|

||||

$ bat --list-themes

|

||||

1337

|

||||

DarkNeon

|

||||

Default

|

||||

GitHub

|

||||

Monokai Extended

|

||||

Monokai Extended Bright

|

||||

Monokai Extended Light

|

||||

Monokai Extended Origin

|

||||

TwoDark

|

||||

|

||||

```

|

||||

|

||||

To use a different theme, for example TwoDark, run:

|

||||

```

|

||||

$ bat --theme=TwoDark file.txt

|

||||

|

||||

```

|

||||

|

||||

If you want to make the theme permanent, use `export BAT_THEME="TwoDark"` in your shells startup file.

|

||||

|

||||

Bat also have the option to control the appearance of the output. To do so, use the `--style` option. To show only Git changes and line numbers but no grid and no file header, use `--style=numbers,changes`.

|

||||

|

||||

For more details, refer the Bat project GitHub Repository (Link at the end).

|

||||

|

||||

And, that’s all for now. Hope this was useful. More good stuffs to come. Stay tuned!

|

||||

|

||||

Cheers!

|

||||

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.ostechnix.com/bat-a-cat-clone-with-syntax-highlighting-and-git-integration/

|

||||

|

||||

作者:[SK][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.ostechnix.com/author/sk/

|

||||

[1]:https://github.com/sharkdp/bat/releases

|

||||

[2]:https://www.ostechnix.com/linuxbrew-common-package-manager-linux-mac-os-x/

|

||||

@ -0,0 +1,228 @@

|

||||

An Introduction to Quantum Computing with Open Source Cirq Framework

|

||||

======

|

||||

As the title suggests what we are about to begin discussing, this article is an effort to understand how far we have come in Quantum Computing and where we are headed in the field in order to accelerate scientific and technological research, through an Open Source perspective with Cirq.

|

||||

|

||||

First, we will introduce you to the world of Quantum Computing. We will try our best to explain the basic idea behind the same before we look into how Cirq would be playing a significant role in the future of Quantum Computing. Cirq, as you might have heard of recently, has been breaking news in the field and in this Open Science article, we will try to find out why.

|

||||

|

||||

<https://www.youtube.com/embed/WVv5OAR4Nik?enablejsapi=1&autoplay=0&cc_load_policy=0&iv_load_policy=1&loop=0&modestbranding=1&rel=0&showinfo=0&fs=1&playsinline=0&autohide=2&theme=dark&color=red&controls=2&>

|

||||

|

||||

Before we start with what Quantum Computing is, it is essential to get to know about the term Quantum, that is, a [subatomic particle][1] referring to the smallest known entity. The word [Quantum][2] is based on the Latin word Quantus, meaning, “how little”, as described in this short video:

|

||||

|

||||

<https://www.youtube.com/embed/-pUOxVsxu3o?enablejsapi=1&autoplay=0&cc_load_policy=0&iv_load_policy=1&loop=0&modestbranding=1&rel=0&showinfo=0&fs=1&playsinline=0&autohide=2&theme=dark&color=red&controls=2&>

|

||||

|

||||

It will be easier for us to understand Quantum Computing by comparing it first to Classical Computing. Classical Computing refers to how today’s conventional computers are designed to work. The device with which you are reading this article right now, can also be referred to as a Classical Computing Device.

|

||||

|

||||

### Classical Computing

|

||||

|

||||

Classical Computing is just another way to describe how a conventional computer works. They work via a binary system, i.e, information is stored using either 1 or 0. Our Classical computers cannot understand any other form.

|

||||

|

||||

In literal terms inside the computer, a transistor can be either on (1) or off (0). Whatever information we provide input to, is translated into 0s and 1s, so that the computer can understand and store that information. Everything is represented only with the help of a combination of 0s and 1s.

|

||||

|

||||

<https://www.youtube.com/embed/Xpk67YzOn5w?enablejsapi=1&autoplay=0&cc_load_policy=0&iv_load_policy=1&loop=0&modestbranding=1&rel=0&showinfo=0&fs=1&playsinline=0&autohide=2&theme=dark&color=red&controls=2&>

|

||||

|

||||

### Quantum Computing

|

||||

|

||||

Quantum Computing, on the other hand, does not follow an “on or off” model like Classical Computing. Instead, it can simultaneously handle multiple states of information with help of two phenomena called [superimposition and entanglement][3], thus accelerating computing at a much faster rate and also facilitating greater productivity in information storage.

|

||||

|

||||

Please note that superposition and entanglement are [not the same phenomena][4].

|

||||

|

||||

<https://www.youtube.com/embed/jiXuVIEg10Q?enablejsapi=1&autoplay=0&cc_load_policy=0&iv_load_policy=1&loop=0&modestbranding=1&rel=0&showinfo=0&fs=1&playsinline=0&autohide=2&theme=dark&color=red&controls=2&>

|

||||

|

||||

![][5]

|

||||

|

||||

So, if we have bits in Classical Computing, then in the case of Quantum Computing, we would have qubits (or Quantum bits) instead. To know more about the vast difference between the two, check this [page][6] from where the above pic was obtained for explanation.

|

||||

|

||||

Quantum Computers are not going to replace our Classical Computers. But, there are certain humongous tasks that our Classical Computers will never be able to accomplish and that is when Quantum Computers would prove extremely resourceful. The following video describes the same in detail while also describing how Quantum Computers work:

|

||||

|

||||

<https://www.youtube.com/embed/JhHMJCUmq28?enablejsapi=1&autoplay=0&cc_load_policy=0&iv_load_policy=1&loop=0&modestbranding=1&rel=0&showinfo=0&fs=1&playsinline=0&autohide=2&theme=dark&color=red&controls=2&>

|

||||

|

||||

A comprehensive video on the progress in Quantum Computing so far:

|

||||

|

||||

<https://www.youtube.com/embed/CeuIop_j2bI?enablejsapi=1&autoplay=0&cc_load_policy=0&iv_load_policy=1&loop=0&modestbranding=1&rel=0&showinfo=0&fs=1&playsinline=0&autohide=2&theme=dark&color=red&controls=2&>

|

||||

|

||||

### Noisy Intermediate Scale Quantum

|

||||

|

||||

According to the very recently updated research paper (31st July 2018), the term “Noisy” refers to inaccuracy because of producing an incorrect value caused by imperfect control over qubits. This inaccuracy is why there will be serious limitations on what Quantum devices can achieve in the near term.

|

||||

|

||||

“Intermediate Scale” refers to the size of Quantum Computers which will be available in the next few years, where the number of qubits can range from 50 to a few hundred. 50 qubits is a significant milestone because that’s beyond what can be simulated by [brute force][7] using the most powerful existing digital [supercomputers][8]. Read more in the paper [here][9].

|

||||

|

||||

With the advent of Cirq, a lot is about to change.

|

||||

|

||||

### What is Cirq?

|

||||

|

||||

Cirq is a python framework for creating, editing, and invoking Noisy Intermediate Scale Quantum (NISQ) circuits that we just talked about. In other words, Cirq can address challenges to improve accuracy and reduce noise in Quantum Computing.

|

||||

|

||||

Cirq does not necessarily require an actual Quantum Computer for execution. Cirq can also use a simulator-like interface to perform Quantum circuit simulations.

|

||||

|

||||

Cirq is gradually grabbing a lot of pace, with one of its first users being [Zapata][10], formed last year by a [group of scientists][11] from Harvard University focused on Quantum Computing.

|

||||

|

||||

### Getting started with Cirq on Linux

|

||||

|

||||

The developers of the Open Source [Cirq library][12] recommend the installation in a [virtual python environment][13] like [virtualenv][14]. The developers’ installation guide for Linux can be found [here][15].

|

||||

|

||||

However, we successfully installed and tested Cirq directly for Python3 on an Ubuntu 16.04 system via the following steps:

|

||||

|

||||

#### Installing Cirq on Ubuntu

|

||||

|

||||

![Cirq Framework for Quantum Computing in Linux][16]

|

||||

|

||||

First, we would require pip or pip3 to install Cirq. [Pip][17] is a tool recommended for installing and managing Python packages.

|

||||

|

||||

For Python 3.x versions, Pip can be installed with:

|

||||

```

|

||||

sudo apt-get install python3-pip

|

||||

|

||||

```

|

||||

|

||||

Python3 packages can be installed via:

|

||||

```

|

||||

pip3 install <package-name>

|

||||

|

||||

```

|

||||

|

||||

We went ahead and installed the Cirq library with Pip3 for Python3:

|

||||

```

|

||||

pip3 install cirq

|

||||

|

||||

```

|

||||

|

||||

#### Enabling Plot and PDF generation (optional)

|

||||

|

||||

Optional system dependencies not install-able with pip can be installed with:

|

||||

```

|

||||

sudo apt-get install python3-tk texlive-latex-base latexmk

|

||||

|

||||

```

|

||||

|

||||

* python3-tk is Python’s own graphic library which enables plotting functionality.

|

||||

* texlive-latex-base and latexmk enable PDF writing functionality.

|

||||

|

||||

|

||||

|

||||

Later, we successfully tested Cirq with the following command and code:

|

||||

```

|

||||

python3 -c 'import cirq; print(cirq.google.Foxtail)'

|

||||

|

||||

```

|

||||

|

||||

We got the resulting output as:

|

||||

|

||||

![][18]

|

||||

|

||||

#### Configuring Pycharm IDE for Cirq

|

||||

|

||||

We also configured a Python IDE [PyCharm on Ubuntu][19] to test the same results:

|

||||

|

||||

Since we installed Cirq for Python3 on our Linux system, we set the path to the project interpreter in the IDE settings to be:

|

||||

```

|

||||

/usr/bin/python3

|

||||

|

||||

```

|

||||

|

||||

![][20]

|

||||

|

||||

In the output above, you can note that the path to the project interpreter that we just set, is shown along with the path to the test program file (test.py). An exit code of 0 shows that the program has finished executing successfully without errors.

|

||||

|

||||

So, that’s a ready-to-use IDE environment where you can import the Cirq library to start programming with Python and simulate Quantum circuits.

|

||||

|

||||

#### Get started with Cirq

|

||||

|

||||

A good place to start are the [examples][21] that have been made available on Cirq’s Github page.

|

||||

|

||||

The developers have included this [tutorial][22] on GitHub to get started with learning Cirq. If you are serious about learning Quantum Computing, they recommend an excellent book called [“Quantum Computation and Quantum Information” by Nielsen and Chuang][23].

|

||||

|

||||

#### OpenFermion-Cirq

|

||||

|

||||

[OpenFermion][24] is an open source library for obtaining and manipulating representations of fermionic systems (including Quantum Chemistry) for simulation on Quantum Computers. Fermionic systems are related to the generation of [fermions][25], which according to [particle physics][26], follow [Fermi-Dirac statistics][27].

|

||||

|

||||

OpenFermion has been hailed as [a great practice tool][28] for chemists and researchers involved with [Quantum Chemistry][29]. The main focus of Quantum Chemistry is the application of [Quantum Mechanics][30] in physical models and experiments of chemical systems. Quantum Chemistry is also referred to as [Molecular Quantum Mechanics][31].

|

||||

|

||||

The advent of Cirq has now made it possible for OpenFermion to extend its functionality by providing routines and tools for using Cirq to compile and compose circuits for Quantum simulation algorithms.

|

||||

|

||||

#### Google Bristlecone

|

||||

|

||||

On March 5, 2018, Google presented [Bristlecone][32], their new Quantum processor, at the annual [American Physical Society meeting][33] in Los Angeles. The [gate-based superconducting system][34] provides a test platform for research into [system error rates][35] and [scalability][36] of Google’s [qubit technology][37], along-with applications in Quantum [simulation][38], [optimization][39], and [machine learning.][40]

|

||||

|

||||

In the near future, Google wants to make its 72 qubit Bristlecone Quantum processor [cloud accessible][41]. Bristlecone will gradually become quite capable to perform a task that a Classical Supercomputer would not be able to complete in a reasonable amount of time.

|

||||

|

||||

Cirq would make it easier for researchers to directly write programs for Bristlecone on the cloud, serving as a very convenient interface for real-time Quantum programming and testing.

|

||||

|

||||

Cirq will allow us to:

|

||||

|

||||

* Fine tune control over Quantum circuits,

|

||||

* Specify [gate][42] behavior using native gates,

|

||||

* Place gates appropriately on the device &

|

||||

* Schedule the timing of these gates.

|

||||

|

||||

|

||||

|

||||

### The Open Science Perspective on Cirq

|

||||

|

||||

As we all know Cirq is Open Source on GitHub, its addition to the Open Source Scientific Communities, especially those which are focused on Quantum Research, can now efficiently collaborate to solve the current challenges in Quantum Computing today by developing new ways to reduce error rates and improve accuracy in the existing Quantum models.

|

||||

|

||||

Had Cirq not followed an Open Source model, things would have definitely been a lot more challenging. A great initiative would have been missed out and we would not have been one step closer in the field of Quantum Computing.

|

||||

|

||||

### Summary

|

||||

|

||||

To summarize in the end, we first introduced you to the concept of Quantum Computing by comparing it to existing Classical Computing techniques followed by a very important video on recent developmental updates in Quantum Computing since last year. We then briefly discussed Noisy Intermediate Scale Quantum, which is what Cirq is specifically built for.

|

||||

|

||||

We saw how we can install and test Cirq on an Ubuntu system. We also tested the installation for usability on an IDE environment with some resources to get started to learn the concept.

|

||||

|

||||

Finally, we also saw two examples of how Cirq would be an essential advantage in the development of research in Quantum Computing, namely OpenFermion and Bristlecone. We concluded the discussion by highlighting some thoughts on Cirq with an Open Science Perspective.

|

||||

|

||||

We hope we were able to introduce you to Quantum Computing with Cirq in an easy to understand manner. If you have any feedback related to the same, please let us know in the comments section. Thank you for reading and we look forward to see you in our next Open Science article.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://itsfoss.com/qunatum-computing-cirq-framework/

|

||||

|

||||

作者:[Avimanyu Bandyopadhyay][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://itsfoss.com/author/avimanyu/

|

||||

[1]:https://en.wikipedia.org/wiki/Subatomic_particle

|

||||

[2]:https://en.wikipedia.org/wiki/Quantum

|

||||

[3]:https://www.clerro.com/guide/491/quantum-superposition-and-entanglement-explained

|

||||

[4]:https://physics.stackexchange.com/questions/148131/can-quantum-entanglement-and-quantum-superposition-be-considered-the-same-phenom

|

||||

[5]:https://4bds6hergc-flywheel.netdna-ssl.com/wp-content/uploads/2018/08/bit-vs-qubit.jpg

|

||||

[6]:http://www.rfwireless-world.com/Terminology/Difference-between-Bit-and-Qubit.html

|

||||

[7]:https://en.wikipedia.org/wiki/Proof_by_exhaustion

|

||||

[8]:https://www.explainthatstuff.com/how-supercomputers-work.html

|

||||

[9]:https://arxiv.org/abs/1801.00862

|

||||

[10]:https://www.xconomy.com/san-francisco/2018/07/19/google-partners-with-zapata-on-open-source-quantum-computing-effort/

|

||||

[11]:https://www.zapatacomputing.com/about/

|

||||

[12]:https://github.com/quantumlib/Cirq

|

||||

[13]:https://itsfoss.com/python-setup-linux/

|

||||

[14]:https://virtualenv.pypa.io

|

||||

[15]:https://cirq.readthedocs.io/en/latest/install.html#installing-on-linux

|

||||

[16]:https://4bds6hergc-flywheel.netdna-ssl.com/wp-content/uploads/2018/08/cirq-framework-linux.jpeg

|

||||

[17]:https://pypi.org/project/pip/

|

||||

[18]:https://4bds6hergc-flywheel.netdna-ssl.com/wp-content/uploads/2018/08/cirq-test-output.jpg

|

||||

[19]:https://itsfoss.com/install-pycharm-ubuntu/

|

||||