mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-21 02:10:11 +08:00

commit

ee81de8e63

@ -0,0 +1,136 @@

|

||||

在 Linux 中用 nmcli 命令绑定多块网卡

|

||||

================================================================================

|

||||

今天,我们来学习一下在 CentOS 7.x 中如何用 nmcli(Network Manager Command Line Interface:网络管理命令行接口)进行网卡绑定。

|

||||

|

||||

网卡(接口)绑定是将多块 **网卡** 逻辑地连接到一起从而允许故障转移或者提高吞吐率的方法。提高服务器网络可用性的一个方式是使用多个网卡。Linux 绑定驱动程序提供了一种将多个网卡聚合到一个逻辑的绑定接口的方法。这是个新的实现绑定的方法,并不影响 linux 内核中旧绑定驱动。

|

||||

|

||||

**网卡绑定为我们提供了两个主要的好处:**

|

||||

|

||||

1. **高带宽**

|

||||

1. **冗余/弹性**

|

||||

|

||||

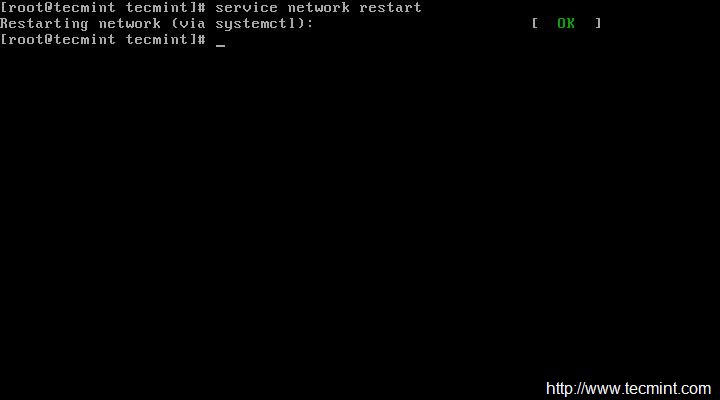

现在让我们在 CentOS 7 上配置网卡绑定吧。我们需要决定选取哪些接口配置成一个组接口(Team interface)。

|

||||

|

||||

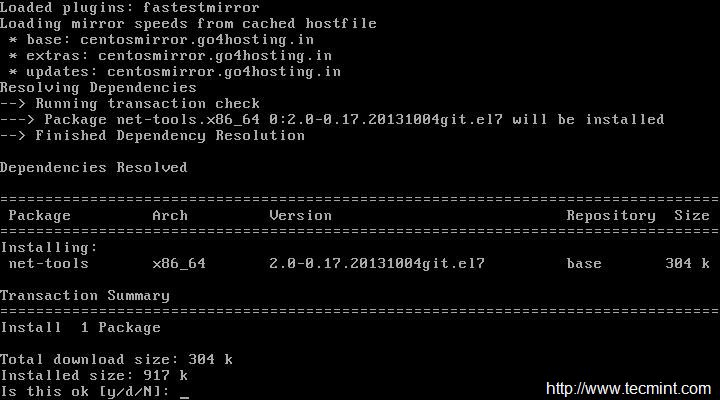

运行 **ip link** 命令查看系统中可用的接口。

|

||||

|

||||

$ ip link

|

||||

|

||||

|

||||

|

||||

这里我们使用 **eno16777736** 和 **eno33554960** 网卡在 “主动备份” 模式下创建一个组接口。(译者注:关于不同模式可以参考:<a href="http://support.huawei.com/ecommunity/bbs/10155553.html">多网卡的7种bond模式原理</a>)

|

||||

|

||||

按照下面的语法,用 **nmcli** 命令为网络组接口创建一个连接。

|

||||

|

||||

# nmcli con add type team con-name CNAME ifname INAME [config JSON]

|

||||

|

||||

**CNAME** 指代连接的名称,**INAME** 是接口名称,**JSON** (JavaScript Object Notation) 指定所使用的处理器(runner)。**JSON** 语法格式如下:

|

||||

|

||||

'{"runner":{"name":"METHOD"}}'

|

||||

|

||||

**METHOD** 是以下的其中一个:**broadcast、activebackup、roundrobin、loadbalance** 或者 **lacp**。

|

||||

|

||||

### 1. 创建组接口 ###

|

||||

|

||||

现在让我们来创建组接口。这是我们创建组接口所使用的命令。

|

||||

|

||||

# nmcli con add type team con-name team0 ifname team0 config '{"runner":{"name":"activebackup"}}'

|

||||

|

||||

|

||||

|

||||

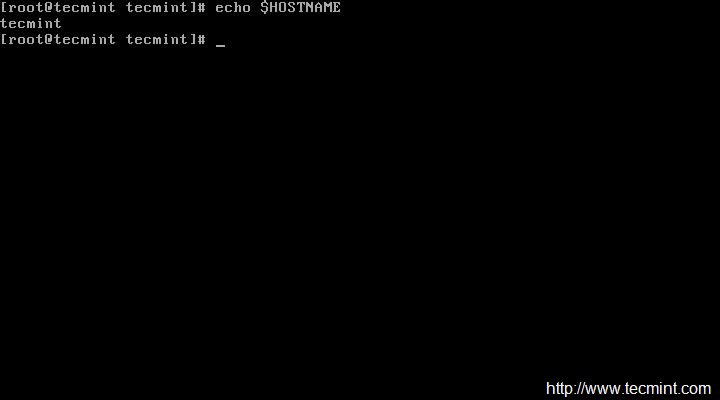

运行 **# nmcli con show** 命令验证组接口配置。

|

||||

|

||||

# nmcli con show

|

||||

|

||||

|

||||

|

||||

### 2. 添加从设备 ###

|

||||

|

||||

现在让我们添加从设备到主设备 team0。这是添加从设备的语法:

|

||||

|

||||

# nmcli con add type team-slave con-name CNAME ifname INAME master TEAM

|

||||

|

||||

在这里我们添加 **eno16777736** 和 **eno33554960** 作为 **team0** 接口的从设备。

|

||||

|

||||

# nmcli con add type team-slave con-name team0-port1 ifname eno16777736 master team0

|

||||

|

||||

# nmcli con add type team-slave con-name team0-port2 ifname eno33554960 master team0

|

||||

|

||||

|

||||

|

||||

再次用命令 **#nmcli con show** 验证连接配置。现在我们可以看到从设备配置信息。

|

||||

|

||||

#nmcli con show

|

||||

|

||||

|

||||

|

||||

### 3. 分配 IP 地址 ###

|

||||

|

||||

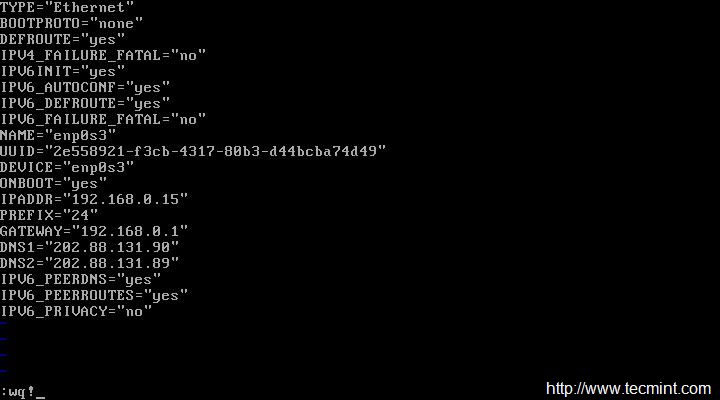

上面的命令会在 **/etc/sysconfig/network-scripts/** 目录下创建需要的配置文件。

|

||||

|

||||

现在让我们为 team0 接口分配一个 IP 地址并启用这个连接。这是进行 IP 分配的命令。

|

||||

|

||||

# nmcli con mod team0 ipv4.addresses "192.168.1.24/24 192.168.1.1"

|

||||

# nmcli con mod team0 ipv4.method manual

|

||||

# nmcli con up team0

|

||||

|

||||

|

||||

|

||||

### 4. 验证绑定 ###

|

||||

|

||||

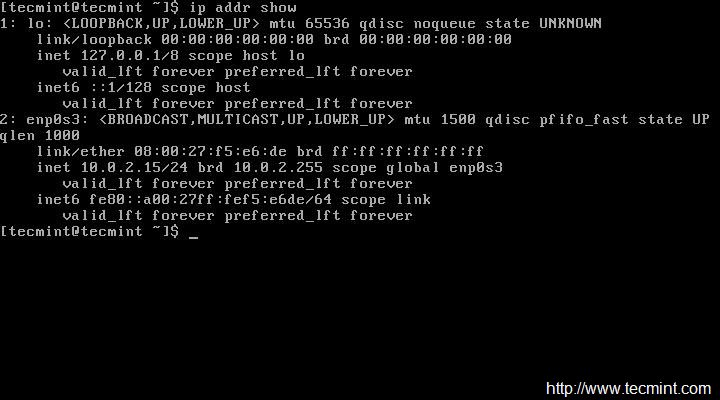

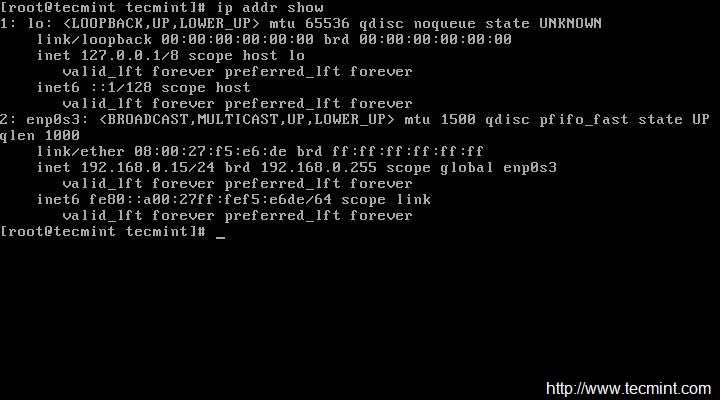

用 **#ip add show team0** 命令验证 IP 地址信息。

|

||||

|

||||

#ip add show team0

|

||||

|

||||

|

||||

|

||||

现在用 **teamdctl** 命令检查 **主动备份** 配置功能。

|

||||

|

||||

# teamdctl team0 state

|

||||

|

||||

|

||||

|

||||

现在让我们把激活的端口断开连接并再次检查状态来确认主动备份配置是否像希望的那样工作。

|

||||

|

||||

# nmcli dev dis eno33554960

|

||||

|

||||

|

||||

|

||||

断开激活端口后再次用命令 **#teamdctl team0 state** 检查状态。

|

||||

|

||||

# teamdctl team0 state

|

||||

|

||||

|

||||

|

||||

是的,它运行良好!!我们会使用下面的命令连接回到 team0 的断开的连接。

|

||||

|

||||

#nmcli dev con eno33554960

|

||||

|

||||

|

||||

|

||||

我们还有一个 **teamnl** 命令可以显示 **teamnl** 命令的一些选项。

|

||||

|

||||

用下面的命令检查在 team0 运行的端口。

|

||||

|

||||

# teamnl team0 ports

|

||||

|

||||

|

||||

|

||||

显示 **team0** 当前活动的端口。

|

||||

|

||||

# teamnl team0 getoption activeport

|

||||

|

||||

|

||||

|

||||

好了,我们已经成功地配置了网卡绑定 :-) ,如果有任何反馈,请告诉我们。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://linoxide.com/linux-command/interface-nics-bonding-linux/

|

||||

|

||||

作者:[Arun Pyasi][a]

|

||||

译者:[ictlyh](https://github.com/ictlyh)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://linoxide.com/author/arunp/

|

||||

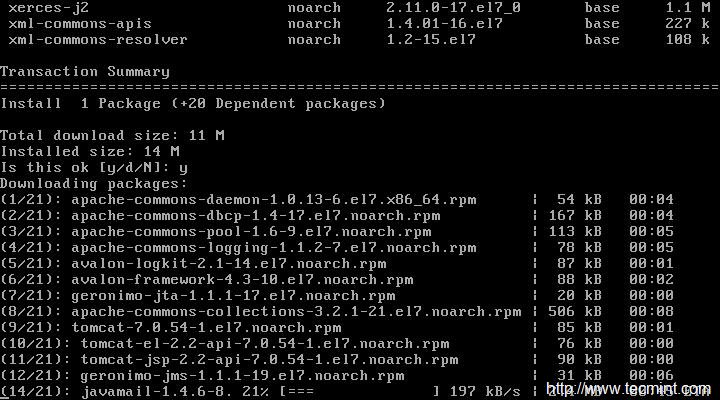

@ -0,0 +1,236 @@

|

||||

搭建一个私有的Docker registry

|

||||

================================================================================

|

||||

|

||||

|

||||

[TL;DR] 这是系列的第二篇文章,这系列讲述了我的公司如何把基础服务从PaaS迁移到Docker上

|

||||

|

||||

- [第一篇文章][1]: 我谈到了接触Docker之前的经历;

|

||||

- [第三篇文章][2]: 我展示如何使创建镜像的过程自动化以及如何用Docker部署一个Rails应用。

|

||||

|

||||

----------

|

||||

|

||||

为什么需要搭建一个私有的registry呢?嗯,对于新手来说,Docker Hub(一个Docker公共仓库)只允许你拥有一个免费的私有版本库(repo)。其他的公司也开始提供类似服务,但是价格可不便宜。另外,如果你需要用Docker部署一个用于生产环境的应用,恐怕你不希望将这些镜像放在公开的Docker Hub上吧!

|

||||

|

||||

这篇文章提供了一个非常务实的方法来处理搭建私有Docker registry时出现的各种错综复杂的情况。我们将会使用一个运行于DigitalOcean(之后简称为DO)的非常小巧的512MB VPS 实例。并且我会假定你已经了解了Docker的基本概念,因为我必须集中精力在复杂的事情上!

|

||||

|

||||

###本地搭建###

|

||||

|

||||

首先你需要安装**boot2docker**以及docker CLI。如果你已经搭建好了基本的Docker环境,你可以直接跳过这一步。

|

||||

|

||||

从终端运行以下命令(我假设你使用OS X,使用 HomeBrew 来安装相关软件,你可以根据你的环境使用不同的包管理软件来安装):

|

||||

|

||||

brew install boot2docker docker

|

||||

|

||||

如果一切顺利(想要了解搭建docker环境的完整指南,请参阅 [http://boot2docker.io/][10]) ,你现在就能够通过如下命令启动一个 Docker 运行于其中的虚拟机:

|

||||

|

||||

boot2docker up

|

||||

|

||||

按照屏幕显示的说明,复制粘贴book2docker在终端输出的命令。如果你现在运行`docker ps`命令,终端将有以下显示。

|

||||

|

||||

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

|

||||

|

||||

好了,Docker已经准备就绪,这就够了,我们回过头去搭建registry。

|

||||

|

||||

###创建服务器###

|

||||

|

||||

登录进你的DO账号,选择一个预安装了Docker的镜像文件,创建一个新的Drople。(本文写成时选择的是 Image > Applications > Docker 1.4.1 on 14.04)

|

||||

|

||||

|

||||

|

||||

你将会以邮件的方式收到一个根用户凭证。登录进去,然后运行`docker ps`命令来查看系统状态。

|

||||

|

||||

### 搭建AWS S3 ###

|

||||

|

||||

我们现在将使用Amazo Simple Storage Service(S3)作为我们registry/repository的存储层。我们将需要创建一个桶(bucket)以及用户凭证(user credentials)来允许我们的docker容器访问它。

|

||||

|

||||

登录到我们的AWS账号(如果没有,就申请一个[http://aws.amazon.com/][5]),在控制台选择S3(Simpole Storage Service)。

|

||||

|

||||

|

||||

|

||||

点击 **Create Bucket**,为你的桶输入一个名字(把它记下来,我们一会需要用到它),然后点击**Create**。

|

||||

|

||||

|

||||

|

||||

OK!我们已经搭建好存储部分了。

|

||||

|

||||

### 设置AWS访问凭证###

|

||||

|

||||

我们现在将要创建一个新的用户。退回到AWS控制台然后选择IAM(Identity & Access Management)。

|

||||

|

||||

|

||||

|

||||

在dashboard的左边,点击Users。然后选择 **Create New Users**。

|

||||

|

||||

如图所示:

|

||||

|

||||

|

||||

|

||||

输入一个用户名(例如 docker-registry)然后点击Create。写下(或者下载csv文件)你的Access Key以及Secret Access Key。回到你的用户列表然后选择你刚刚创建的用户。

|

||||

|

||||

在Permission section下面,点击Attach User Policy。之后在下一屏,选择Custom Policy。

|

||||

|

||||

|

||||

|

||||

custom policy的内容如下:

|

||||

|

||||

{

|

||||

"Version": "2012-10-17",

|

||||

"Statement": [

|

||||

{

|

||||

"Sid": "SomeStatement",

|

||||

"Effect": "Allow",

|

||||

"Action": [

|

||||

"s3:*"

|

||||

],

|

||||

"Resource": [

|

||||

"arn:aws:s3:::docker-registry-bucket-name/*",

|

||||

"arn:aws:s3:::docker-registry-bucket-name"

|

||||

]

|

||||

}

|

||||

]

|

||||

}

|

||||

|

||||

这个配置将允许用户(也就是regitstry)来对桶上的内容进行操作(读/写)(确保使用你之前创建AWS S3时使用的桶名)。总结一下:当你想把你的Docker镜像从你的本机推送到仓库中时,服务器就会将他们上传到S3。

|

||||

|

||||

### 安装registry ###

|

||||

|

||||

现在回过头来看我们的DO服务器,SSH登录其上。我们将要[使用][11]一个[官方Docker registry镜像][6]。

|

||||

|

||||

输入如下命令,开启registry。

|

||||

|

||||

docker run \

|

||||

-e SETTINGS_FLAVOR=s3 \

|

||||

-e AWS_BUCKET=bucket-name \

|

||||

-e STORAGE_PATH=/registry \

|

||||

-e AWS_KEY=your_aws_key \

|

||||

-e AWS_SECRET=your_aws_secret \

|

||||

-e SEARCH_BACKEND=sqlalchemy \

|

||||

-p 5000:5000 \

|

||||

--name registry \

|

||||

-d \

|

||||

registry

|

||||

|

||||

Docker将会从Docker Hub上拉取所需的文件系统分层(fs layers)并启动守护容器(daemonised container)。

|

||||

|

||||

### 测试registry ###

|

||||

|

||||

如果上述操作奏效,你可以通过ping命令,或者查找它的内容来测试registry(虽然这个时候容器还是空的)。

|

||||

|

||||

我们的registry非常基础,而且没有提供任何“验明正身”的方式。因为添加身份验证可不是一件轻松事(至少我认为没有一种部署方法是简单的,像是为了证明你努力过似的),我觉得“查询/拉取/推送”仓库内容的最简单方法就是通过SSH通道的未加密连接(通过HTTP)。

|

||||

|

||||

打开SSH通道的操作非常简单:

|

||||

|

||||

ssh -N -L 5000:localhost:5000 root@your_registry.com

|

||||

|

||||

这条命令建立了一条从registry服务器(前面执行`docker run`命令的时候我们见过它)的5000号端口到本机的5000号端口之间的 SSH 管道连接。

|

||||

|

||||

如果你现在用浏览器访问 [http://localhost:5000/v1/_ping][7],将会看到下面这个非常简短的回复。

|

||||

|

||||

{}

|

||||

|

||||

这个意味着registry工作正常。你还可以通过登录 [http://localhost:5000/v1/search][8] 来查看registry内容,内容相似:

|

||||

|

||||

{

|

||||

"num_results": 2,

|

||||

"query": "",

|

||||

"results": [

|

||||

{

|

||||

"description": "",

|

||||

"name": "username/first-repo"

|

||||

},

|

||||

{

|

||||

"description": "",

|

||||

"name": "username/second-repo"

|

||||

}

|

||||

]

|

||||

}

|

||||

|

||||

### 创建一个镜像 ###

|

||||

|

||||

我们现在创建一个非常简单的Docker镜像,来检验我们新弄好的registry。在我们的本机上,用如下内容创建一个Dockerfile(这里只有一点代码,在下一篇文章里我将会展示给你如何将一个Rails应用绑定进Docker容器中。):

|

||||

|

||||

# ruby 2.2.0 的基础镜像

|

||||

FROM ruby:2.2.0

|

||||

|

||||

MAINTAINER Michelangelo Chasseur <michelangelo.chasseur@touchwa.re>

|

||||

|

||||

并创建它:

|

||||

|

||||

docker build -t localhost:5000/username/repo-name .

|

||||

|

||||

`localhost:5000`这个部分非常重要:Docker镜像名的最前面一个部分将告知`docker push`命令我们将要把我们的镜像推送到哪里。在我们这个例子当中,因为我们要通过SSH管道连接远程的私有registry,`localhost:5000`精确地指向了我们的registry。

|

||||

|

||||

如果一切顺利,当命令执行完成返回后,你可以输入`docker images`命令来列出新近创建的镜像。执行它看看会出现什么现象?

|

||||

|

||||

### 推送到仓库 ###

|

||||

|

||||

接下来是更好玩的部分。实现我所描述的东西着实花了我一点时间,所以如果你第一次读的话就耐心一点吧,跟着我一起操作。我知道接下来的东西会非常复杂(如果你不自动化这个过程就一定会这样),但是我保证到最后你一定都能明白。在下一篇文章里我将会使用到一大波shell脚本和Rake任务,通过它们实现自动化并且用简单的命令实现部署Rails应用。

|

||||

|

||||

你在终端上运行的docker命令实际上都是使用boot2docker虚拟机来运行容器及各种东西。所以当你执行像`docker push some_repo`这样的命令时,是boot2docker虚拟机在与registry交互,而不是我们自己的机器。

|

||||

|

||||

接下来是一个非常重要的点:为了将Docker镜像推送到远端的私有仓库,SSH管道需要在boot2docker虚拟机上配置好,而不是在你的本地机器上配置。

|

||||

|

||||

有许多种方法实现它。我给你展示最简短的一种(可能不是最容易理解的,但是能够帮助你实现自动化)

|

||||

|

||||

在这之前,我们需要对 SSH 做最后一点工作。

|

||||

|

||||

### 设置 SSH ###

|

||||

|

||||

让我们把boot2docker 的 SSH key添加到远端服务器的“已知主机”里面。我们可以使用ssh-copy-id工具完成,通过下面的命令就可以安装上它了:

|

||||

|

||||

brew install ssh-copy-id

|

||||

|

||||

然后运行:

|

||||

|

||||

ssh-copy-id -i /Users/username/.ssh/id_boot2docker root@your-registry.com

|

||||

|

||||

用你ssh key的真实路径代替`/Users/username/.ssh/id_boot2docker`。

|

||||

|

||||

这样做能够让我们免密码登录SSH。

|

||||

|

||||

现在我们来测试以下:

|

||||

|

||||

boot2docker ssh "ssh -o 'StrictHostKeyChecking no' -i /Users/michelangelo/.ssh/id_boot2docker -N -L 5000:localhost:5000 root@registry.touchwa.re &" &

|

||||

|

||||

分开阐述:

|

||||

|

||||

- `boot2docker ssh`允许你以参数的形式传递给boot2docker虚拟机一条执行的命令;

|

||||

- 最后面那个`&`表明这条命令将在后台执行;

|

||||

- `ssh -o 'StrictHostKeyChecking no' -i /Users/michelangelo/.ssh/id_boot2docker -N -L 5000:localhost:5000 root@registry.touchwa.re &`是boot2docker虚拟机实际运行的命令;

|

||||

- `-o 'StrictHostKeyChecking no'`——不提示安全问题;

|

||||

- `-i /Users/michelangelo/.ssh/id_boot2docker`指出虚拟机使用哪个SSH key来进行身份验证。(注意这里的key应该是你前面添加到远程仓库的那个)

|

||||

- 最后我们将打开一条端口5000映射到localhost:5000的SSH通道。

|

||||

|

||||

### 从其他服务器上拉取 ###

|

||||

|

||||

你现在将可以通过下面的简单命令将你的镜像推送到远端仓库:

|

||||

|

||||

docker push localhost:5000/username/repo_name

|

||||

|

||||

在下一篇[文章][9]中,我们将会了解到如何自动化处理这些事务,并且真正地容器化一个Rails应用。请继续收听!

|

||||

|

||||

如有错误,请不吝指出。祝你Docker之路顺利!

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://cocoahunter.com/2015/01/23/docker-2/

|

||||

|

||||

作者:[Michelangelo Chasseur][a]

|

||||

译者:[DongShuaike](https://github.com/DongShuaike)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://cocoahunter.com/author/michelangelo/

|

||||

[1]:https://linux.cn/article-5339-1.html

|

||||

[2]:http://cocoahunter.com/2015/01/23/docker-3/

|

||||

[3]:http://cocoahunter.com/2015/01/23/docker-2/#fn:1

|

||||

[4]:http://cocoahunter.com/2015/01/23/docker-2/#fn:2

|

||||

[5]:http://aws.amazon.com/

|

||||

[6]:https://registry.hub.docker.com/_/registry/

|

||||

[7]:http://localhost:5000/v1/_ping

|

||||

[8]:http://localhost:5000/v1/search

|

||||

[9]:http://cocoahunter.com/2015/01/23/docker-3/

|

||||

[10]:http://boot2docker.io/

|

||||

[11]:https://github.com/docker/docker-registry/

|

||||

@ -0,0 +1,246 @@

|

||||

自动化部署基于Docker的Rails应用

|

||||

================================================================================

|

||||

|

||||

|

||||

[TL;DR] 这是系列文章的第三篇,讲述了我的公司是如何将基础设施从PaaS移植到Docker上的。

|

||||

|

||||

- [第一部分][1]:谈论了我接触Docker之前的经历;

|

||||

- [第二部分][2]:一步步搭建一个安全而又私有的registry。

|

||||

|

||||

----------

|

||||

|

||||

在系列文章的最后一篇里,我们将用一个实例来学习如何自动化整个部署过程。

|

||||

|

||||

### 基本的Rails应用程序###

|

||||

|

||||

现在让我们启动一个基本的Rails应用。为了更好的展示,我使用Ruby 2.2.0和Rails 4.1.1

|

||||

|

||||

在终端运行:

|

||||

|

||||

$ rvm use 2.2.0

|

||||

$ rails new && cd docker-test

|

||||

|

||||

创建一个基本的控制器:

|

||||

|

||||

$ rails g controller welcome index

|

||||

|

||||

……,然后编辑 `routes.rb` ,以便让该项目的根指向我们新创建的welcome#index方法:

|

||||

|

||||

root 'welcome#index'

|

||||

|

||||

在终端运行 `rails s` ,然后打开浏览器,登录[http://localhost:3000][3],你会进入到索引界面当中。我们不准备给应用加上多么神奇的东西,这只是一个基础的实例,当我们将要创建并部署容器的时候,用它来验证一切是否运行正常。

|

||||

|

||||

### 安装webserver ###

|

||||

|

||||

我们打算使用Unicorn当做我们的webserver。在Gemfile中添加 `gem 'unicorn'`和 `gem 'foreman'`然后将它bundle起来(运行 `bundle install`命令)。

|

||||

|

||||

启动Rails应用时,需要先配置好Unicorn,所以我们将一个**unicorn.rb**文件放在**config**目录下。[这里有一个Unicorn配置文件的例子][4],你可以直接复制粘贴Gist的内容。

|

||||

|

||||

接下来,在项目的根目录下添加一个Procfile,以便可以使用foreman启动应用,内容为下:

|

||||

|

||||

web: bundle exec unicorn -p $PORT -c ./config/unicorn.rb

|

||||

|

||||

现在运行**foreman start**命令启动应用,一切都将正常运行,并且你将能够在[http://localhost:5000][5]上看到一个正在运行的应用。

|

||||

|

||||

### 构建一个Docker镜像 ###

|

||||

|

||||

现在我们构建一个镜像来运行我们的应用。在这个Rails项目的根目录下,创建一个名为**Dockerfile**的文件,然后粘贴进以下内容:

|

||||

|

||||

# 基于镜像 ruby 2.2.0

|

||||

FROM ruby:2.2.0

|

||||

|

||||

# 安装所需的库和依赖

|

||||

RUN apt-get update && apt-get install -qy nodejs postgresql-client sqlite3 --no-install-recommends && rm -rf /var/lib/apt/lists/*

|

||||

|

||||

# 设置 Rails 版本

|

||||

ENV RAILS_VERSION 4.1.1

|

||||

|

||||

# 安装 Rails

|

||||

RUN gem install rails --version "$RAILS_VERSION"

|

||||

|

||||

# 创建代码所运行的目录

|

||||

RUN mkdir -p /usr/src/app

|

||||

WORKDIR /usr/src/app

|

||||

|

||||

# 使 webserver 可以在容器外面访问

|

||||

EXPOSE 3000

|

||||

|

||||

# 设置环境变量

|

||||

ENV PORT=3000

|

||||

|

||||

# 启动 web 应用

|

||||

CMD ["foreman","start"]

|

||||

|

||||

# 安装所需的 gems

|

||||

ADD Gemfile /usr/src/app/Gemfile

|

||||

ADD Gemfile.lock /usr/src/app/Gemfile.lock

|

||||

RUN bundle install --without development test

|

||||

|

||||

# 将 rails 项目(和 Dockerfile 同一个目录)添加到项目目录

|

||||

ADD ./ /usr/src/app

|

||||

|

||||

# 运行 rake 任务

|

||||

RUN RAILS_ENV=production rake db:create db:migrate

|

||||

|

||||

使用上述Dockerfile,执行下列命令创建一个镜像(确保**boot2docker**已经启动并在运行当中):

|

||||

|

||||

$ docker build -t localhost:5000/your_username/docker-test .

|

||||

|

||||

然后,如果一切正常,长长的日志输出的最后一行应该类似于:

|

||||

|

||||

Successfully built 82e48769506c

|

||||

$ docker images

|

||||

REPOSITORY TAG IMAGE ID CREATED VIRTUAL SIZE

|

||||

localhost:5000/your_username/docker-test latest 82e48769506c About a minute ago 884.2 MB

|

||||

|

||||

让我们运行一下容器试试!

|

||||

|

||||

$ docker run -d -p 3000:3000 --name docker-test localhost:5000/your_username/docker-test

|

||||

|

||||

通过你的boot2docker虚拟机的3000号端口(我的是[http://192.168.59.103:3000][6]),你可以观察你的Rails应用。(如果不清楚你的boot2docker虚拟地址,输入` $ boot2docker ip`命令查看。)

|

||||

|

||||

### 使用shell脚本进行自动化部署 ###

|

||||

|

||||

前面的文章(指文章1和文章2)已经告诉了你如何将新创建的镜像推送到私有registry中,并将其部署在服务器上,所以我们跳过这一部分直接开始自动化进程。

|

||||

|

||||

我们将要定义3个shell脚本,然后最后使用rake将它们捆绑在一起。

|

||||

|

||||

### 清除 ###

|

||||

|

||||

每当我们创建镜像的时候,

|

||||

|

||||

- 停止并重启boot2docker;

|

||||

- 去除Docker孤儿镜像(那些没有标签,并且不再被容器所使用的镜像们)。

|

||||

|

||||

在你的工程根目录下的**clean.sh**文件中输入下列命令。

|

||||

|

||||

echo Restarting boot2docker...

|

||||

boot2docker down

|

||||

boot2docker up

|

||||

|

||||

echo Exporting Docker variables...

|

||||

sleep 1

|

||||

export DOCKER_HOST=tcp://192.168.59.103:2376

|

||||

export DOCKER_CERT_PATH=/Users/user/.boot2docker/certs/boot2docker-vm

|

||||

export DOCKER_TLS_VERIFY=1

|

||||

|

||||

sleep 1

|

||||

echo Removing orphaned images without tags...

|

||||

docker images | grep "<none>" | awk '{print $3}' | xargs docker rmi

|

||||

|

||||

给脚本加上执行权限:

|

||||

|

||||

$ chmod +x clean.sh

|

||||

|

||||

### 构建 ###

|

||||

|

||||

构建的过程基本上和之前我们所做的(docker build)内容相似。在工程的根目录下创建一个**build.sh**脚本,填写如下内容:

|

||||

|

||||

docker build -t localhost:5000/your_username/docker-test .

|

||||

|

||||

记得给脚本执行权限。

|

||||

|

||||

### 部署 ###

|

||||

|

||||

最后,创建一个**deploy.sh**脚本,在里面填进如下内容:

|

||||

|

||||

# 打开 boot2docker 到私有注册库的 SSH 连接

|

||||

boot2docker ssh "ssh -o 'StrictHostKeyChecking no' -i /Users/username/.ssh/id_boot2docker -N -L 5000:localhost:5000 root@your-registry.com &" &

|

||||

|

||||

# 在推送前先确认该 SSH 通道是开放的。

|

||||

echo Waiting 5 seconds before pushing image.

|

||||

|

||||

echo 5...

|

||||

sleep 1

|

||||

echo 4...

|

||||

sleep 1

|

||||

echo 3...

|

||||

sleep 1

|

||||

echo 2...

|

||||

sleep 1

|

||||

echo 1...

|

||||

sleep 1

|

||||

|

||||

# Push image onto remote registry / repo

|

||||

echo Starting push!

|

||||

docker push localhost:5000/username/docker-test

|

||||

|

||||

如果你不理解这其中的含义,请先仔细阅读这部分[第二部分][2]。

|

||||

|

||||

给脚本加上执行权限。

|

||||

|

||||

### 使用rake将以上所有绑定 ###

|

||||

|

||||

现在的情况是,每次你想要部署你的应用时,你都需要单独运行这三个脚本。

|

||||

|

||||

1. clean

|

||||

1. build

|

||||

1. deploy / push

|

||||

|

||||

这一点都不费工夫,可是事实上开发者比你想象的要懒得多!那么咱们就索性再懒一点!

|

||||

|

||||

我们最后再把工作好好整理一番,我们现在要将三个脚本通过rake捆绑在一起。

|

||||

|

||||

为了更简单一点,你可以在工程根目录下已经存在的Rakefile中添加几行代码,打开Rakefile文件,把下列内容粘贴进去。

|

||||

|

||||

namespace :docker do

|

||||

desc "Remove docker container"

|

||||

task :clean do

|

||||

sh './clean.sh'

|

||||

end

|

||||

|

||||

desc "Build Docker image"

|

||||

task :build => [:clean] do

|

||||

sh './build.sh'

|

||||

end

|

||||

|

||||

desc "Deploy Docker image"

|

||||

task :deploy => [:build] do

|

||||

sh './deploy.sh'

|

||||

end

|

||||

end

|

||||

|

||||

即使你不清楚rake的语法(其实你真应该去了解一下,这玩意太酷了!),上面的内容也是很显然的吧。我们在一个命名空间(docker)里声明了三个任务。

|

||||

|

||||

三个任务是:

|

||||

|

||||

- rake docker:clean

|

||||

- rake docker:build

|

||||

- rake docker:deploy

|

||||

|

||||

Deploy独立于build,build独立于clean。所以每次我们输入命令运行的时候。

|

||||

|

||||

$ rake docker:deploy

|

||||

|

||||

所有的脚本都会按照顺序执行。

|

||||

|

||||

### 测试 ###

|

||||

|

||||

现在我们来看看是否一切正常,你只需要在app的代码里做一个小改动:

|

||||

|

||||

$ rake docker:deploy

|

||||

|

||||

接下来就是见证奇迹的时刻了。一旦镜像文件被上传(第一次可能花费较长的时间),你就可以ssh登录产品服务器,并且(通过SSH管道)把docker镜像拉取到服务器并运行了。多么简单!

|

||||

|

||||

也许你需要一段时间来习惯,但是一旦成功,它几乎与用Heroku部署一样简单。

|

||||

|

||||

备注:像往常一样,请让我了解到你的意见。我不敢保证这种方法是最好,最快,或者最安全的Docker开发的方法,但是这东西对我们确实奏效。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://cocoahunter.com/2015/01/23/docker-3/

|

||||

|

||||

作者:[Michelangelo Chasseur][a]

|

||||

译者:[DongShuaike](https://github.com/DongShuaike)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://cocoahunter.com/author/michelangelo/

|

||||

[1]:https://linux.cn/article-5339-1.html

|

||||

[2]:https://linux.cn/article-5379-1.html

|

||||

[3]:http://localhost:3000/

|

||||

[4]:https://gist.github.com/chasseurmic/0dad4d692ff499761b20

|

||||

[5]:http://localhost:5000/

|

||||

[6]:http://192.168.59.103:3000/

|

||||

|

||||

@ -1,6 +1,6 @@

|

||||

25个给git熟手的技巧

|

||||

25个 Git 进阶技巧

|

||||

================================================================================

|

||||

我已经使用git差不多18个月了,觉得自己对它应该已经非常了解。然后来自GitHub的[Scott Chacon][1]过来给LVS做培训,[LVS是一个赌博软件供应商和开发商][2](从2013年开始的合同),而我在第一天里就学到了很多。

|

||||

我已经使用git差不多18个月了,觉得自己对它应该已经非常了解。然后来自GitHub的[Scott Chacon][1]过来给LVS做培训([LVS是一个赌博软件供应商和开发商][2],从2013年开始的合同),而我在第一天里就学到了很多。

|

||||

|

||||

作为一个对git感觉良好的人,我觉得分享从社区里掌握的一些有价值的信息,也许能帮某人解决问题而不用做太深入研究。

|

||||

|

||||

@ -15,21 +15,21 @@

|

||||

|

||||

#### 2. Git是基于指针的 ####

|

||||

|

||||

保存在git里的一切都是文件。当你创建一个提交的时候,会建立一个包含你的提交信息和相关数据(名字,邮件地址,日期/时间,前一个提交,等等)的文件,并把它链接到一个文件树中。文件树中包含了对象或其他树的列表。对象或容器是和本次提交相关的实际内容(也是一个文件,你想了解的话,尽管文件名并没有包含在对象里,而是在树中)。所有这些文件都使用对象的SHA-1哈希值作为文件名。

|

||||

保存在git里的一切都是文件。当你创建一个提交的时候,会建立一个包含你的提交信息和相关数据(名字,邮件地址,日期/时间,前一个提交,等等)的文件,并把它链接到一个树文件中。这个树文件中包含了对象或其他树的列表。这里的提到的对象(或二进制大对象)是和本次提交相关的实际内容(它也是一个文件,另外,尽管文件名并没有包含在对象里,但是存储在树中)。所有这些文件都使用对象的SHA-1哈希值作为文件名。

|

||||

|

||||

用这种方式,分支和标签就是简单的文件(基本上是这样),包含指向实际提交的SHA-1哈希值。使用这些索引会带来优秀的灵活性和速度,比如创建一个新分支就只要简单地创建一个包含分支名字和所分出的那个提交的SHA-1索引的文件。当然,你不需要自己做这些,而只要使用Git命令行工具(或者GUI),但是实际上就是这么简单。

|

||||

用这种方式,分支和标签就是简单的文件(基本上是这样),包含指向该提交的SHA-1哈希值。使用这些索引会带来优秀的灵活性和速度,比如创建一个新分支就是简单地用分支名字和所分出的那个提交的SHA-1索引来创建一个文件。当然,你不需要自己做这些,而只要使用Git命令行工具(或者GUI),但是实际上就是这么简单。

|

||||

|

||||

你也许听说过叫HEAD的索引。这只是简单的一个文件,包含了你当前指向的那个提交的SHA-1索引值。如果你正在解决一次合并冲突然后看到了HEAD,这并不是一个特别的分支或分值上一个必须的特殊点,只是标明你当前所在位置。

|

||||

你也许听说过叫HEAD的索引。这只是简单的一个文件,包含了你当前指向的那个提交的SHA-1索引值。如果你正在解决一次合并冲突然后看到了HEAD,这并不是一个特别的分支或分支上的一个必需的特殊位置,只是标明你当前所在位置。

|

||||

|

||||

所有的分支指针都保存在.git/refs/heads里,HEAD在.git/HEAD里,而标签保存在.git/refs/tags里 - 自己可以放心地进去看看。

|

||||

所有的分支指针都保存在.git/refs/heads里,HEAD在.git/HEAD里,而标签保存在.git/refs/tags里 - 自己可以随便进去看看。

|

||||

|

||||

#### 3. 两个父节点 - 当然! ####

|

||||

#### 3. 两个爸爸(父节点) - 你没看错! ####

|

||||

|

||||

在历史中查看一个合并提交的信息时,你将看到有两个父节点(相对于一般工作上的常规提交的情况)。第一个父节点是你所在的分支,第二个是你合并过来的分支。

|

||||

在历史中查看一个合并提交的信息时,你将看到有两个父节点(不同于工作副本上的常规提交的情况)。第一个父节点是你所在的分支,第二个是你合并过来的分支。

|

||||

|

||||

#### 4. 合并冲突 ####

|

||||

|

||||

目前我相信你碰到过合并冲突并且解决过。通常是编辑一下文件,去掉<<<<,====,>>>>标志,保留需要留下的代码。有时能够看到这两个修改之前的代码会很不错,比如,在这两个分支上有冲突的改动之前。下面是一种方式:

|

||||

目前我相信你碰到过合并冲突并且解决过。通常是编辑一下文件,去掉<<<<,====,>>>>标志,保留需要留下的代码。有时能够看到这两个修改之前的代码会很不错,比如,在这两个现在冲突的分支之前的改动。下面是一种方式:

|

||||

|

||||

$ git diff --merge

|

||||

diff --cc dummy.rb

|

||||

@ -45,14 +45,14 @@

|

||||

end

|

||||

end

|

||||

|

||||

如果是二进制文件,比较差异就没那么简单了...通常你要做的就是测试这个二进制文件的两个版本来决定保留哪个(或者在二进制文件编辑器里手工复制冲突部分)。从一个特定分支获取文件拷贝(比如说你在合并master和feature123):

|

||||

如果是二进制文件,比较差异就没那么简单了...通常你要做的就是测试这个二进制文件的两个版本来决定保留哪个(或者在二进制文件编辑器里手工复制冲突部分)。从一个特定分支获取文件拷贝(比如说你在合并master和feature123两个分支):

|

||||

|

||||

$ git checkout master flash/foo.fla # 或者...

|

||||

$ git checkout feature132 flash/foo.fla

|

||||

$ # 然后...

|

||||

$ git add flash/foo.fla

|

||||

|

||||

另一种方式是通过git输出文件 - 你可以输出到另外的文件名,然后再重命名正确的文件(当你决定了要用哪个)为正常的文件名:

|

||||

另一种方式是通过git输出文件 - 你可以输出到另外的文件名,然后当你决定了要用哪个后,再将选定的正确文件复制为正常的文件名:

|

||||

|

||||

$ git show master:flash/foo.fla > master-foo.fla

|

||||

$ git show feature132:flash/foo.fla > feature132-foo.fla

|

||||

@ -71,7 +71,7 @@

|

||||

|

||||

#### 5. 远端服务器 ####

|

||||

|

||||

git的一个超强大的功能就是可以有不止一个远端服务器(实际上你一直都在一个本地仓库上工作)。你并不是一定都要有写权限,你可以有多个可以读取的服务器(用来合并他们的工作)然后写入其他仓库。添加一个新的远端服务器很简单:

|

||||

git的一个超强大的功能就是可以有不止一个远端服务器(实际上你一直都在一个本地仓库上工作)。你并不是一定都要有这些服务器的写权限,你可以有多个可以读取的服务器(用来合并他们的工作)然后写入到另外一个仓库。添加一个新的远端服务器很简单:

|

||||

|

||||

$ git remote add john git@github.com:johnsomeone/someproject.git

|

||||

|

||||

@ -87,10 +87,10 @@ git的一个超强大的功能就是可以有不止一个远端服务器(实

|

||||

|

||||

$ git diff master..john/master

|

||||

|

||||

你也可以查看不在远端分支的HEAD的改动:

|

||||

你也可以查看没有在远端分支上的HEAD的改动:

|

||||

|

||||

$ git log remote/branch..

|

||||

# 注意:..后面没有结束的refspec

|

||||

# 注意:..后面没有结束的特定引用

|

||||

|

||||

#### 6. 标签 ####

|

||||

|

||||

@ -99,7 +99,7 @@ git的一个超强大的功能就是可以有不止一个远端服务器(实

|

||||

建立这两种类型的标签都很简单(只有一个命令行开关的差异)

|

||||

|

||||

$ git tag to-be-tested

|

||||

$ git tag -a v1.1.0 # 会提示输入标签信息

|

||||

$ git tag -a v1.1.0 # 会提示输入标签的信息

|

||||

|

||||

#### 7. 建立分支 ####

|

||||

|

||||

@ -108,7 +108,7 @@ git的一个超强大的功能就是可以有不止一个远端服务器(实

|

||||

$ git branch feature132

|

||||

$ git checkout feature132

|

||||

|

||||

当然,如果你确定自己要新建分支并直接切换过去,可以用一个命令实现:

|

||||

当然,如果你确定自己直接切换到新建的分支,可以用一个命令实现:

|

||||

|

||||

$ git checkout -b feature132

|

||||

|

||||

@ -117,20 +117,20 @@ git的一个超强大的功能就是可以有不止一个远端服务器(实

|

||||

$ git checkout -b twitter-experiment feature132

|

||||

$ git branch -d feature132

|

||||

|

||||

更新:你也可以(像Brian Palmer在原博客文章的评论里提出的)只用“git branch”的-m开关在一个命令里实现(像Mike提出的,如果你只有一个分支参数,就会重命名当前分支):

|

||||

更新:你也可以(像Brian Palmer在原博客文章的评论里提出的)只用“git branch”的-m开关在一个命令里实现(像Mike提出的,如果你只指定了一个分支参数,就会重命名当前分支):

|

||||

|

||||

$ git branch -m twitter-experiment

|

||||

$ git branch -m feature132 twitter-experiment

|

||||

|

||||

#### 8. 合并分支 ####

|

||||

|

||||

在将来什么时候,你希望合并改动。有两种方式:

|

||||

也许在将来的某个时候,你希望将改动合并。有两种方式:

|

||||

|

||||

$ git checkout master

|

||||

$ git merge feature83 # 或者...

|

||||

$ git rebase feature83

|

||||

|

||||

merge和rebase之间的差别是merge会尝试处理改动并建立一个新的混合了两者的提交。rebase会尝试把你从一个分支最后一次分离后的所有改动,一个个加到该分支的HEAD上。不过,在已经将分支推到远端服务器后不要再rebase了 - 这回引起冲突/问题。

|

||||

merge和rebase之间的差别是merge会尝试处理改动并建立一个新的混合了两者的提交。rebase会尝试把你从一个分支最后一次分离后的所有改动,一个个加到该分支的HEAD上。不过,在已经将分支推到远端服务器后不要再rebase了 - 这会引起冲突/问题。

|

||||

|

||||

如果你不确定在哪些分支上还有独有的工作 - 所以你也不知道哪些分支需要合并而哪些可以删除,git branch有两个开关可以帮你:

|

||||

|

||||

@ -147,7 +147,7 @@ merge和rebase之间的差别是merge会尝试处理改动并建立一个新的

|

||||

$ git push origin twitter-experiment:refs/heads/twitter-experiment

|

||||

# origin是我们服务器的名字,而twitter-experiment是分支名字

|

||||

|

||||

更新:感谢Erlend在原博客文章上的评论 - 这个实际上和`git push origin twitter-experiment`效果一样,不过使用完整的语法,你可以在两者之间使用不同的分知名(这样本地分支可以是`add-ssl-support`而远端是`issue-1723`)。

|

||||

更新:感谢Erlend在原博客文章上的评论 - 这个实际上和`git push origin twitter-experiment`效果一样,不过使用完整的语法,你可以在两者之间使用不同的分支名(这样本地分支可以是`add-ssl-support`而远端是`issue-1723`)。

|

||||

|

||||

如果你想在远端服务器上删除一个分支(注意分支名前面的冒号):

|

||||

|

||||

@ -210,7 +210,7 @@ git会基于当前的提交信息自动创建评论。如果你更希望有自

|

||||

|

||||

这会让你进入一个基于菜单的交互式提示。你可以使用命令中的数字或高亮的字母(如果你在终端里打开了高亮的话)来进入相应的模式。然后就只是输入你希望操作的文件的数字了(你可以使用这样的格式,1或者1-4或2,4,7)。

|

||||

|

||||

如果你想进入补丁模式(交互式模式下的‘p’或‘5’),你也可以直接进入:

|

||||

如果你想进入补丁模式(交互式模式下按‘p’或‘5’),你也可以直接进入:

|

||||

|

||||

$ git add -p

|

||||

diff --git a/dummy.rb b/dummy.rb

|

||||

@ -226,11 +226,11 @@ git会基于当前的提交信息自动创建评论。如果你更希望有自

|

||||

end

|

||||

Stage this hunk [y,n,q,a,d,/,e,?]?

|

||||

|

||||

你可以看到下方会有一些选项供选择用来添加该文件的这个改动,该文件的所有改动,等等。使用‘?’命令可以详细解释这些选项。

|

||||

你可以看到下方会有一些选项供选择用来添加该文件的这个改动、该文件的所有改动,等等。使用‘?’命令可以详细解释这些选项。

|

||||

|

||||

#### 12. 从文件系统里保存/取回改动 ####

|

||||

|

||||

有些项目(比如git项目本身)在git文件系统中直接保存额外文件而并没有将它们加入到版本控制中。

|

||||

有些项目(比如Git项目本身)在git文件系统中直接保存额外文件而并没有将它们加入到版本控制中。

|

||||

|

||||

让我们从在git中存储一个随机文件开始:

|

||||

|

||||

@ -251,7 +251,7 @@ git会基于当前的提交信息自动创建评论。如果你更希望有自

|

||||

|

||||

#### 13. 查看日志 ####

|

||||

|

||||

如果不用‘git log’来查看最近的提交你git用不了多久。不过,有一些技巧来更好地应用。比如,你可以使用下面的命令来查看每次提交的具体改动:

|

||||

长时间使用 Git 的话,不会没用过‘git log’来查看最近的提交。不过,有一些技巧来更好地应用。比如,你可以使用下面的命令来查看每次提交的具体改动:

|

||||

|

||||

$ git log -p

|

||||

|

||||

@ -268,7 +268,7 @@ git会基于当前的提交信息自动创建评论。如果你更希望有自

|

||||

|

||||

#### 14. 搜索日志 ####

|

||||

|

||||

如果你想找特定作者可以这样做:

|

||||

如果你想找特定提交者可以这样做:

|

||||

|

||||

$ git log --author=Andy

|

||||

|

||||

@ -278,7 +278,7 @@ git会基于当前的提交信息自动创建评论。如果你更希望有自

|

||||

|

||||

$ git log --grep="Something in the message"

|

||||

|

||||

也有一个更强大的叫做pickaxe的命令用来查找删除或添加某个特定内容的提交(比如,该文件第一次出现或被删除)。这可以告诉你什么时候增加了一行(但这一行里的某个字符后面被改动过就不行了):

|

||||

也有一个更强大的叫做pickaxe的命令用来查找包含了删除或添加的某个特定内容的提交(比如,该内容第一次出现或被删除)。这可以告诉你什么时候增加了一行(但这一行里的某个字符后面被改动过就不行了):

|

||||

|

||||

$ git log -S "TODO: Check for admin status"

|

||||

|

||||

@ -294,7 +294,7 @@ git会基于当前的提交信息自动创建评论。如果你更希望有自

|

||||

|

||||

$ git log --since=2.months.ago --until=1.day.ago

|

||||

|

||||

默认情况下会用OR来组合查询,但你可以轻易地改为AND(如果你有超过一条的标准)

|

||||

默认情况下会用OR来组合查询,但你可以轻易地改为AND(如果你有超过一条的查询标准)

|

||||

|

||||

$ git log --since=2.months.ago --until=1.day.ago --author=andy -S "something" --all-match

|

||||

|

||||

@ -310,7 +310,7 @@ git会基于当前的提交信息自动创建评论。如果你更希望有自

|

||||

$ git show feature132@{yesterday} # 时间相关

|

||||

$ git show feature132@{2.hours.ago} # 时间相关

|

||||

|

||||

注意和之前部分有些不同,末尾的插入符号意思是该提交的父节点 - 开始位置的插入符号意思是不在这个分支。

|

||||

注意和之前部分有些不同,末尾的^的意思是该提交的父节点 - 开始位置的^的意思是不在这个分支。

|

||||

|

||||

#### 16. 选择范围 ####

|

||||

|

||||

@ -321,7 +321,7 @@ git会基于当前的提交信息自动创建评论。如果你更希望有自

|

||||

|

||||

你也可以省略[new],将使用当前的HEAD。

|

||||

|

||||

### Rewinding Time & Fixing Mistakes ###

|

||||

### 时光回溯和后悔药 ###

|

||||

|

||||

#### 17. 重置改动 ####

|

||||

|

||||

@ -329,7 +329,7 @@ git会基于当前的提交信息自动创建评论。如果你更希望有自

|

||||

|

||||

$ git reset HEAD lib/foo.rb

|

||||

|

||||

通常会使用‘unstage’的别名,因为看上去有些不直观。

|

||||

通常会使用‘unstage’的别名,因为上面的看上去有些不直观。

|

||||

|

||||

$ git config --global alias.unstage "reset HEAD"

|

||||

$ git unstage lib/foo.rb

|

||||

@ -369,11 +369,11 @@ git会基于当前的提交信息自动创建评论。如果你更希望有自

|

||||

|

||||

#### 19. 交互式切换基础 ####

|

||||

|

||||

这是一个我之前看过展示却没真正理解过的很赞的功能,现在很简单。假如说你提交了3次但是你希望更改顺序或编辑(或者合并):

|

||||

这是一个我之前看过展示却没真正理解过的很赞的功能,现在觉得它就很简单了。假如说你提交了3次但是你希望更改顺序或编辑(或者合并):

|

||||

|

||||

$ git rebase -i master~3

|

||||

|

||||

然后会启动你的编辑器并带有一些指令。你所要做的就是修改这些指令来选择/插入/编辑(或者删除)提交和保存/退出。然后在编辑完后你可以用`git rebase --continue`命令来让每一条指令生效。

|

||||

然后这会启动你的编辑器并带有一些指令。你所要做的就是修改这些指令来选择/插入/编辑(或者删除)提交和保存/退出。然后在编辑完后你可以用`git rebase --continue`命令来让每一条指令生效。

|

||||

|

||||

如果你有修改,将会切换到你提交时所处的状态,之后你需要使用命令git commit --amend来编辑。

|

||||

|

||||

@ -446,7 +446,7 @@ git会基于当前的提交信息自动创建评论。如果你更希望有自

|

||||

|

||||

$ git branch experimental SHA1_OF_HASH

|

||||

|

||||

如果你访问过的话,你通常可以用git reflog来找到SHA1哈希值。

|

||||

如果你最近访问过的话,你通常可以用git reflog来找到SHA1哈希值。

|

||||

|

||||

另一种方式是使用`git fsck —lost-found`。其中一个dangling的提交就是丢失的HEAD(它只是已删除分支的HEAD,而HEAD^被引用为当前的HEAD所以它并不处于dangling状态)

|

||||

|

||||

@ -460,7 +460,7 @@ via: https://www.andyjeffries.co.uk/25-tips-for-intermediate-git-users/

|

||||

|

||||

作者:[Andy Jeffries][a]

|

||||

译者:[zpl1025](https://github.com/zpl1025)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,14 +1,14 @@

|

||||

Linux有问必答时间--如何在Linux下禁用IPv6

|

||||

Linux有问必答:如何在Linux下禁用IPv6

|

||||

================================================================================

|

||||

> **问题**:我发现我的一个应用程序在尝试通过IPv6建立连接,但是由于我们本地网络不允许分配IPv6的流量,IPv6连接会超时,应用程序的连接会退回到IPv4,这样就会造成不必要的延迟。由于我目前对IPv6没有任何需求,所以我想在我的Linux主机上禁用IPv6。有什么比较合适的方法呢?

|

||||

> **问题**:我发现我的一个应用程序在尝试通过IPv6建立连接,但是由于我们本地网络不允许分配IPv6的流量,IPv6连接会超时,应用程序的连接会回退到IPv4,这样就会造成不必要的延迟。由于我目前对IPv6没有任何需求,所以我想在我的Linux主机上禁用IPv6。有什么比较合适的方法呢?

|

||||

|

||||

IPv6被认为是IPv4——互联网上的传统32位地址空间的替代产品,它为了解决现有IPv4地址空间即将耗尽的问题。然而,由于IPv4已经被每台主机或设备连接到了互联网上,所以想在一夜之间将它们全部切换到IPv6几乎是不可能的。许多IPv4到IPv6的转换机制(例如:双协议栈、网络隧道、代理) 已经被提出来用来促进IPv6能被采用,并且很多应用也正在进行重写,就像我们所说的,来增加对IPv6的支持。有一件事情能确定,就是在可预见的未来里IPv4和IPv6势必将共存。

|

||||

IPv6被认为是IPv4——互联网上的传统32位地址空间——的替代产品,它用来解决现有IPv4地址空间即将耗尽的问题。然而,由于已经有大量主机、设备用IPv4连接到了互联网上,所以想在一夜之间将它们全部切换到IPv6几乎是不可能的。许多IPv4到IPv6的转换机制(例如:双协议栈、网络隧道、代理) 已经被提出来用来促进IPv6能被采用,并且很多应用也正在进行重写,如我们所提倡的,来增加对IPv6的支持。有一件事情可以确定,就是在可预见的未来里IPv4和IPv6势必将共存。

|

||||

|

||||

理想情况下,[向IPv6过渡的进程][1]不应该被最终的用户所看见,但是IPv4/IPv6混合环境有时会让你碰到各种源于IPv4和IPv6之间不经意间的相互作用的问题。举个例子,你会碰到应用程序超时的问题比如apt-get或ssh尝试通过IPv6连接失败、DNS服务器意外清空了IPv6的AAAA记录、或者你支持IPv6的设备不兼容你的互联网服务提供商遗留下的IPv4网络等等等等。

|

||||

理想情况下,[向IPv6过渡的进程][1]不应该被最终的用户所看见,但是IPv4/IPv6混合环境有时会让你碰到各种源于IPv4和IPv6之间不经意间的相互碰撞的问题。举个例子,你会碰到应用程序超时的问题,比如apt-get或ssh尝试通过IPv6连接失败、DNS服务器意外清空了IPv6的AAAA记录、或者你支持IPv6的设备不兼容你的互联网服务提供商遗留下的IPv4网络,等等等等。

|

||||

|

||||

当然这不意味着你应该盲目地在你的Linux机器上禁用IPv6。鉴于IPv6许诺的种种好处,作为社会的一份子我们最终还是要充分拥抱它的,但是作为给最终用户进行故障排除过程的一部分,如果IPv6确实是罪魁祸首那你可以尝试去关闭它。

|

||||

当然这不意味着你应该盲目地在你的Linux机器上禁用IPv6。鉴于IPv6许诺的种种好处,作为社会的一份子我们最终还是要充分拥抱它的,但是作为给最终用户进行故障排除过程的一部分,如果IPv6确实是罪魁祸首,那你可以尝试去关闭它。

|

||||

|

||||

这里有一些让你在Linux中部分或全部禁用IPv6的小技巧(例如:为一个已经确定的网络接口)。这些小贴士应该适用于所有主流的Linux发行版包括Ubuntu、Debian、Linux Mint、CentOS、Fedora、RHEL以及Arch Linux。

|

||||

这里有一些让你在Linux中部分(例如:对于某个特定的网络接口)或全部禁用IPv6的小技巧。这些小贴士应该适用于所有主流的Linux发行版包括Ubuntu、Debian、Linux Mint、CentOS、Fedora、RHEL以及Arch Linux。

|

||||

|

||||

### 查看IPv6在Linux中是否被启用 ###

|

||||

|

||||

@ -24,7 +24,7 @@ IPv6被认为是IPv4——互联网上的传统32位地址空间的替代产品

|

||||

|

||||

### 临时禁用IPv6 ###

|

||||

|

||||

如果你想要在你的Linux系统上临时关闭IPv6,你可以用 /proc 文件系统。"临时",意思是我们所做的禁用IPv6的更改在系统重启后将不被保存。IPv6会在你的Linux机器重启后再次被启用。

|

||||

如果你想要在你的Linux系统上临时关闭IPv6,你可以用 /proc 文件系统。"临时"的意思是我们所做的禁用IPv6的更改在系统重启后将不被保存。IPv6会在你的Linux机器重启后再次被启用。

|

||||

|

||||

要将一个特定的网络接口禁用IPv6,使用以下命令:

|

||||

|

||||

@ -50,7 +50,7 @@ IPv6被认为是IPv4——互联网上的传统32位地址空间的替代产品

|

||||

|

||||

#### 方法一 ####

|

||||

|

||||

第一种方法是请求以上提到的 /proc 对 /etc/sysctl.conf 文件进行修改。

|

||||

第一种方法是通过 /etc/sysctl.conf 文件对 /proc 进行永久修改。

|

||||

|

||||

换句话说,就是用文本编辑器打开 /etc/sysctl.conf 然后添加以下内容:

|

||||

|

||||

@ -69,7 +69,7 @@ IPv6被认为是IPv4——互联网上的传统32位地址空间的替代产品

|

||||

|

||||

#### 方法二 ####

|

||||

|

||||

另一个永久禁用IPv6的方法是在开机的时候执行一个必要的内核参数。

|

||||

另一个永久禁用IPv6的方法是在开机的时候传递一个必要的内核参数。

|

||||

|

||||

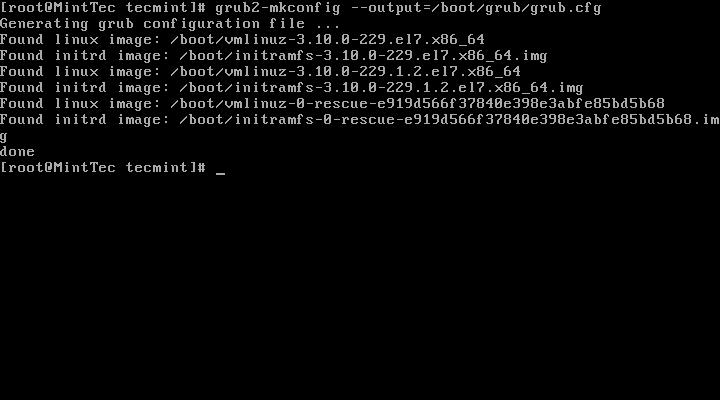

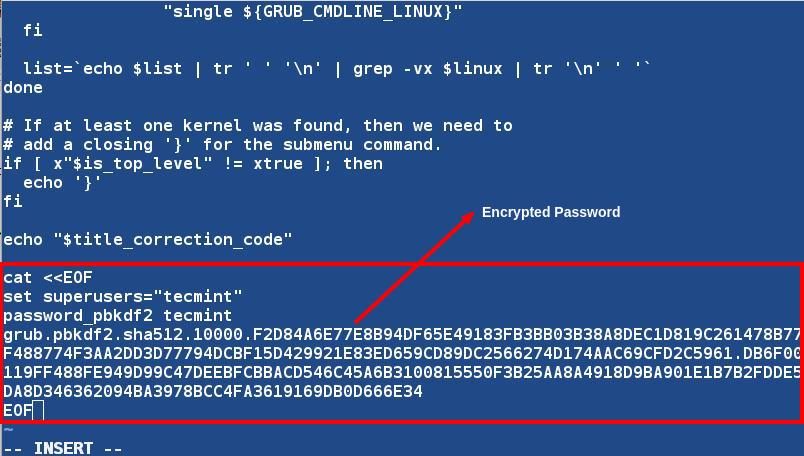

用文本编辑器打开 /etc/default/grub 并给GRUB_CMDLINE_LINUX变量添加"ipv6.disable=1"。

|

||||

|

||||

@ -79,7 +79,7 @@ IPv6被认为是IPv4——互联网上的传统32位地址空间的替代产品

|

||||

|

||||

GRUB_CMDLINE_LINUX="xxxxx ipv6.disable=1"

|

||||

|

||||

上面的"xxxxx"代表任意存在着的内核参数,在它后面添加"ipv6.disable=1"。

|

||||

上面的"xxxxx"代表任何已有的内核参数,在它后面添加"ipv6.disable=1"。

|

||||

|

||||

|

||||

|

||||

@ -97,7 +97,7 @@ Fedora、CentOS/RHEL系统:

|

||||

|

||||

### 禁用IPv6之后的其它可选步骤 ###

|

||||

|

||||

这里有一些可选步骤在你禁用IPv6后需要考虑,这是因为当你在内核里禁用IPv6后,其它程序仍然会尝试使用IPv6。在大多数情况下,例如应用程序的运转状态不太会遭到破坏,但是出于效率或安全方面的原因,你要为他们禁用IPv6。

|

||||

这里有一些在你禁用IPv6后需要考虑的可选步骤,这是因为当你在内核里禁用IPv6后,其它程序也许仍然会尝试使用IPv6。在大多数情况下,应用程序的这种行为不太会影响到什么,但是出于效率或安全方面的原因,你可以为他们禁用IPv6。

|

||||

|

||||

#### /etc/hosts ####

|

||||

|

||||

@ -124,7 +124,7 @@ Fedora、CentOS/RHEL系统:

|

||||

|

||||

默认情况下,OpenSSH服务(sshd)会去尝试捆绑IPv4和IPv6的地址。

|

||||

|

||||

要强制sshd只捆绑IPv4地址,用文本编辑器打开 /etc/ssh/sshd_config 并添加以下脚本行。inet只适用于IPv4,而inet6是适用于IPv6的。

|

||||

要强制sshd只捆绑IPv4地址,用文本编辑器打开 /etc/ssh/sshd_config 并添加以下行。inet只适用于IPv4,而inet6是适用于IPv6的。

|

||||

|

||||

$ sudo vi /etc/ssh/sshd_config

|

||||

|

||||

@ -140,7 +140,7 @@ via: http://ask.xmodulo.com/disable-ipv6-linux.html

|

||||

|

||||

作者:[Dan Nanni][a]

|

||||

译者:[ZTinoZ](https://github.com/ZTinoZ)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,4 +1,4 @@

|

||||

如何修复:apt-get update无法添加新的CD-ROM

|

||||

如何修复 apt-get update 无法添加新的 CD-ROM 的错误

|

||||

================================================================================

|

||||

|

||||

|

||||

@ -63,8 +63,8 @@

|

||||

via: http://itsfoss.com/fix-failed-fetch-cdrom-aptget-update-add-cdroms/

|

||||

|

||||

作者:[Abhishek][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -53,11 +53,11 @@ Budgie是为Linux发行版定制的旗舰桌面,也是一个定制工程。为

|

||||

|

||||

|

||||

|

||||

**注意点**

|

||||

**注意**

|

||||

|

||||

这是一个活跃的开发版本,一些主要的特点可能还不是特别的完善,如:网络管理器,为数不多的控制组件,无通知系统斌并且无法将app锁定到任务栏。

|

||||

这是一个活跃的开发版本,一些主要的功能可能还不是特别的完善,如:没有网络管理器,没有音量控制组件(可以使用键盘控制),无通知系统并且无法将app锁定到任务栏。

|

||||

|

||||

作为工作区你能够禁用滚动栏,通过设置一个默认的主题并且通过下面的命令退出当前的会话

|

||||

有一个临时解决方案可以禁用叠加滚动栏:设置另外一个默认主题,然后从终端退出当前会话:

|

||||

|

||||

$ gnome-session-quit

|

||||

|

||||

@ -65,7 +65,7 @@ Budgie是为Linux发行版定制的旗舰桌面,也是一个定制工程。为

|

||||

|

||||

### 登录Budgie会话 ###

|

||||

|

||||

安装完成之后,我们能在登录时选择机进入budgie桌面。

|

||||

安装完成之后,我们能在登录时选择进入budgie桌面。

|

||||

|

||||

|

||||

|

||||

@ -79,8 +79,7 @@ Budgie是为Linux发行版定制的旗舰桌面,也是一个定制工程。为

|

||||

|

||||

### 结论 ###

|

||||

|

||||

Hurray! We have successfully installed our Lightweight Budgie Desktop Environment in our Ubuntu 14.04 LTS "Trusty" box. As we know, Budgie Desktop is still underdevelopment which makes it a lot of stuffs missing. Though it’s based on Gnome’s GTK3, it’s not a fork. The desktop is written completely from scratch, and the design is elegant and well thought out. If you have any questions, comments, feedback please do write on the comment box below and let us know what stuffs needs to be added or improved. Thank You! Enjoy Budgie Desktop 0.8 :-)

|

||||

Budgie桌面当前正在开发过程中,因此有目前有很多功能的缺失。虽然它是基于Gnome,但不是完全的复制。Budgie是完全从零开始实现,它的设计是优雅的并且正在不断的完善。

|

||||

嗨,现在我们已经成功的在 Ubuntu 14.04 LTS 上安装了轻量级 Budgie 桌面环境。Budgie桌面当前正在开发过程中,因此有目前有很多功能的缺失。虽然它是基于Gnome 的 GTK3,但不是完全的复制。Budgie是完全从零开始实现,它的设计是优雅的并且正在不断的完善。如果你有任何问题、评论,请在下面的评论框发表。愿你喜欢 Budgie 桌面 0.8 。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -88,7 +87,7 @@ via: http://linoxide.com/ubuntu-how-to/install-lightweight-budgie-v8-desktop-ubu

|

||||

|

||||

作者:[Arun Pyasi][a]

|

||||

译者:[johnhoow](https://github.com/johnhoow)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,4 +1,4 @@

|

||||

Linux 基础:如何修复Ubuntu上“E: /var/cache/apt/archives/ subprocess new pre-removal script returned error exit status 1 ”的错误

|

||||

如何修复 Ubuntu 上“...script returned error exit status 1”的错误

|

||||

================================================================================

|

||||

|

||||

|

||||

@ -6,11 +6,11 @@ Linux 基础:如何修复Ubuntu上“E: /var/cache/apt/archives/ subprocess ne

|

||||

|

||||

> E: /var/cache/apt/archives/ subprocess new pre-removal script returned error exit status 1

|

||||

|

||||

|

||||

|

||||

|

||||

### 解决: ###

|

||||

|

||||

我google了以下并找到了方法。下面是我解决的方法。

|

||||

我google了一下并找到了方法。下面是我解决的方法。

|

||||

|

||||

sudo apt-get clean

|

||||

sudo apt-get update && sudo apt-get upgrade

|

||||

@ -33,11 +33,11 @@ Linux 基础:如何修复Ubuntu上“E: /var/cache/apt/archives/ subprocess ne

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.unixmen.com/linux-basics-how-to-fix-e-varcacheaptarchives-subprocess-new-pre-removal-script-returned-error-exit-status-1-in-ubuntu/

|

||||

via: http://www.unixmen.com/linux-basics-how-to-fix-e-varcacheaptarchives-subprocess-new-pre-removal-script-returned-error-exit-status-1-in-ubuntu/

|

||||

|

||||

作者:[SK][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -54,7 +54,7 @@ via: http://www.unixmen.com/install-mate-desktop-freebsd-10-1/

|

||||

|

||||

作者:[M.el Khamlichi][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,14 +1,14 @@

|

||||

Ubuntu中,使用Prey定位被盗的笔记本与手机

|

||||

使用Prey定位被盗的Ubuntu笔记本与智能电话

|

||||

===============================================================================

|

||||

Prey是一款跨平台的开源工具,可以帮助你找回被盗的笔记本,台式机,平板和智能手机。它已经获得了广泛的流行,声称帮助召回了成百上千台丢失的笔记本和智能手机。Prey的使用特别简单,首先安装在你的笔记本或者手机上,当你的设备不见了,用你的账号登入Prey网站,并且标记你的设备为“丢失”。只要小偷将设备接入网络,Prey就会马上发送设备的地理位置给你。如果你的笔记本有摄像头,它还会拍下小偷。

|

||||

Prey是一款跨平台的开源工具,可以帮助你找回被盗的笔记本,台式机,平板和智能手机。它已经获得了广泛的流行,声称帮助找回了成百上千台丢失的笔记本和智能手机。Prey的使用特别简单,首先安装在你的笔记本或者手机上,当你的设备不见了,用你的账号登入Prey网站,并且标记你的设备为“丢失”。只要小偷将设备接入网络,Prey就会马上发送设备的地理位置给你。如果你的笔记本有摄像头,它还会拍下该死的贼。

|

||||

|

||||

Prey占用很小的系统资源;你不会对你的设备运行有任何影响。你也可以配合其他你已经在设备上安装的防盗软件使用。Prey采用安全加密的通道,在你的设备与Prey服务器之间进行数据传输。

|

||||

Prey占用很小的系统资源;你不会对你的设备运行有任何影响。你也可以配合其他你已经在设备上安装的防盗软件使用。Prey在你的设备与Prey服务器之间采用安全加密的通道进行数据传输。

|

||||

|

||||

### 在Ubuntu上安装并配置Prey ###

|

||||

|

||||

让我们来看看如何在Ubuntu上安装和配置Prey,需要提醒的是,在配置过程中,我们必须到Prey官网进行账号注册。一旦完成上述工作,Prey将会开始监视的设备了。免费的账号最多可以监视三个设备,如果你需要添加更多的设备,你就需要购买合适的的套餐了。

|

||||

让我们来看看如何在Ubuntu上安装和配置Prey,需要提醒的是,在配置过程中,我们必须到Prey官网进行账号注册。一旦完成上述工作,Prey将会开始监视你的设备了。免费的账号最多可以监视三个设备,如果你需要添加更多的设备,你就需要购买合适的的套餐了。

|

||||

|

||||

想象一下Prey多么流行与被广泛使用,它现在已经被添加到了官方的软件库中了。这意味着你不要往软件包管理器添加任何PPA。很简单地,登录你的终端,运行以下的命令来安装它:

|

||||

可以想象Prey多么流行与被广泛使用,它现在已经被添加到了官方的软件库中了。这意味着你不要往软件包管理器添加任何PPA。很简单,登录你的终端,运行以下的命令来安装它:

|

||||

|

||||

sudo apt-get install prey

|

||||

|

||||

@ -54,7 +54,7 @@ Prey有一个明显的不足。它需要你的设备接入互联网才会发送

|

||||

|

||||

### 结论 ###

|

||||

|

||||

这是一款小巧,非常有用的安全保护应用,可以让你在一个地方追踪你所有的设备,尽管不完美,但是仍然提供了找回被盗设备的机会。它在Linux,Windows和Mac平台上无缝运行。以上就是Prey完整使用的所有细节。

|

||||

这是一款小巧,非常有用的安全保护应用,可以让你在一个地方追踪你所有的设备,尽管不完美,但是仍然提供了找回被盗设备的机会。它在Linux,Windows和Mac平台上无缝运行。以上就是[Prey][2]完整使用的所有细节。

|

||||

|

||||

-------------------------------------------------------------------------------

|

||||

|

||||

@ -62,9 +62,10 @@ via: http://linoxide.com/ubuntu-how-to/anti-theft-application-prey-ubuntu/

|

||||

|

||||

作者:[Aun Raza][a]

|

||||

译者:[wi-cuckoo](https://github.com/wi-cuckoo)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://linoxide.com/author/arunrz/

|

||||

[1]:https://preyproject.com/

|

||||

[2]:https://preyproject.com/plans

|

||||

@ -1,4 +1,4 @@

|

||||

Moving to Docker

|

||||

走向 Docker

|

||||

================================================================================

|

||||

|

||||

|

||||

@ -8,11 +8,11 @@ Moving to Docker

|

||||

|

||||

上个月,我一直在折腾开发环境。这是我个人故事和经验,关于尝试用Docker简化Rails应用的部署过程。

|

||||

|

||||

当我在2012年创建我的公司 – [Touchware][1]时,我还是一个独立开发者。很多事情很小,不复杂,不他们需要很多维护,他们也不需要不部署到很多机器上。经过过去一年的发展,我们成长了很多(我们现在是是拥有10个人团队)而且我们的服务端的程序和API无论在范围和规模方面都有增长。

|

||||

当我在2012年创建我的公司 – [Touchware][1]时,我还是一个独立开发者。很多事情很小,不复杂,他们不需要很多维护,他们也不需要部署到很多机器上。经过过去一年的发展,我们成长了很多(我们现在是是拥有10个人的团队)而且我们的服务端的程序和API无论在范围和规模方面都有增长。

|

||||

|

||||

### 第1步 - Heroku ###

|

||||

|

||||

我们还是个小公司,我们需要让事情运行地尽可能平稳。当我们寻找可行的解决方案时,我们打算坚持用那些可以帮助我们减轻对硬件依赖负担的工具。由于我们主要开发Rails应用,而Heroku对RoR,常用的数据库和缓存(Postgres/Mongo/Redis等)有很好的支持,最明智的选择就是用[Heroku][2] 。我们就是这样做的。

|

||||

我们还是个小公司,我们需要让事情运行地尽可能平稳。当我们寻找可行的解决方案时,我们打算坚持用那些可以帮助我们减轻对硬件依赖负担的工具。由于我们主要开发Rails应用,而Heroku对RoR、常用的数据库和缓存(Postgres/Mongo/Redis等)有很好的支持,最明智的选择就是用[Heroku][2] 。我们就是这样做的。

|

||||

|

||||

Heroku有很好的技术支持和文档,使得部署非常轻松。唯一的问题是,当你处于起步阶段,你需要很多开销。这不是最好的选择,真的。

|

||||

|

||||

@ -20,18 +20,18 @@ Heroku有很好的技术支持和文档,使得部署非常轻松。唯一的

|

||||

|

||||

为了尝试并降低成本,我们决定试试Dokku。[Dokku][3],引用GitHub上的一句话

|

||||

|

||||

> Docker powered mini-Heroku in around 100 lines of Bash

|

||||

> Docker 驱动的 mini-Heroku,只用了一百来行的 bash 脚本

|

||||

|

||||

我们启用的[DigitalOcean][4]上的很多台机器,都预装了Dokku。Dokku非常像Heroku,但是当你有复杂的项目需要调整配置参数或者是需要特殊的依赖时,它就不能胜任了。我们有一个应用,它需要对图片进行多次转换,我们无法安装一个适合版本的imagemagick到托管我们Rails应用的基于Dokku的Docker容器内。尽管我们还有很多应用运行在Dokku上,但我们还是不得不把一些迁移回Heroku。

|

||||

我们启用的[DigitalOcean][4]上的很多台机器,都预装了Dokku。Dokku非常像Heroku,但是当你有复杂的项目需要调整配置参数或者是需要特殊的依赖时,它就不能胜任了。我们有一个应用,它需要对图片进行多次转换,我们把我们Rails应用的托管到基于Dokku的Docker容器,但是无法安装一个适合版本的imagemagick到里面。尽管我们还有很多应用运行在Dokku上,但我们还是不得不把一些迁移回Heroku。

|

||||

|

||||

### 第3步 - Docker ###

|

||||

|

||||

几个月前,由于开发环境和生产环境的问题重新出现,我决定试试Docker。简单来说,Docker让开发者容器化应用,简化部署。由于一个Docker容器本质上已经包含项目运行所需要的所有依赖,只要它能在你的笔记本上运行地很好,你就能确保它将也能在任何一个别的远程服务器的生产环境上运行,包括Amazon的EC2和DigitalOcean上的VPS。

|

||||

几个月前,由于开发环境和生产环境的问题重新出现,我决定试试Docker。简单来说,Docker让开发者容器化应用、简化部署。由于一个Docker容器本质上已经包含项目运行所需要的所有依赖,只要它能在你的笔记本上运行地很好,你就能确保它将也能在任何一个别的远程服务器的生产环境上运行,包括Amazon的EC2和DigitalOcean上的VPS。

|

||||

|

||||

Docker IMHO特别有意思的原因是:

|

||||

就我个人的看法来说,Docker 特别有意思的原因是:

|

||||

|

||||

- 它促进了模块化和分离关注点:你只需要去考虑应用的逻辑部分(负载均衡:1个容器;数据库:1个容器;web服务器:1个容器);

|

||||

- 在部署的配置上非常灵活:容器可以被部署在大量的HW上,也可以容易地重新部署在不同的服务器或者提供商那;

|

||||

- 它促进了模块化和关注点分离:你只需要去考虑应用的逻辑部分(负载均衡:1个容器;数据库:1个容器;web服务器:1个容器);

|

||||

- 在部署的配置上非常灵活:容器可以被部署在各种硬件上,也可以容易地重新部署在不同的服务器和不同的提供商;

|

||||

- 它允许非常细粒度地优化应用的运行环境:你可以利用你的容器来创建镜像,所以你有很多选择来配置环境。

|

||||

|

||||

它也有一些缺点:

|

||||

@ -54,15 +54,15 @@ via: http://cocoahunter.com/2015/01/23/docker-1/

|

||||

|

||||

作者:[Michelangelo Chasseur][a]

|

||||

译者:[mtunique](https://github.com/mtunique)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://cocoahunter.com/author/michelangelo/

|

||||

[1]:http://www.touchwa.re/

|

||||

[2]:http://cocoahunter.com/2015/01/23/docker-1/www.heroku.com

|

||||

[2]:http://www.heroku.com

|

||||

[3]:https://github.com/progrium/dokku

|

||||

[4]:http://cocoahunter.com/2015/01/23/docker-1/www.digitalocean.com

|

||||

[4]:http://www.digitalocean.com

|

||||

[5]:http://www.docker.com/

|

||||

[6]:http://cocoahunter.com/2015/01/23/docker-2/

|

||||

[7]:http://cocoahunter.com/2015/01/23/docker-3/

|

||||

@ -78,4 +78,3 @@ via: http://cocoahunter.com/2015/01/23/docker-1/

|

||||

[17]:

|

||||

[18]:

|

||||

[19]:

|

||||

[20]:

|

||||

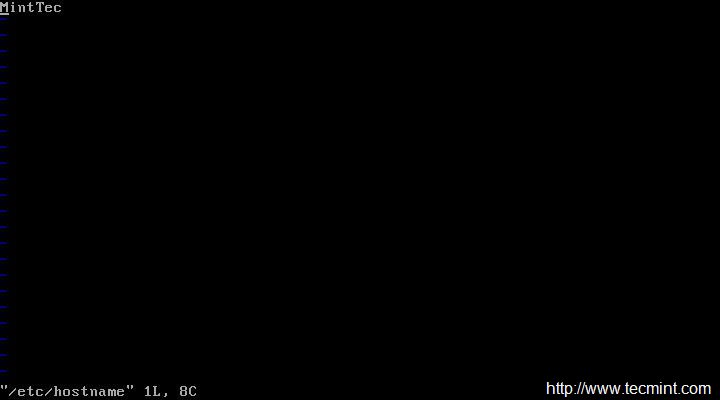

@ -0,0 +1,144 @@

|

||||

在 Linux 中以交互方式实时查看Apache web访问统计

|

||||

================================================================================

|

||||

|

||||

无论你是在网站托管业务,还是在自己的VPS上运行几个网站,你总会有需要显示访客统计信息,例如前几的访客、访问请求的文件(无论动态或者静态)、所用的带宽、客户端的浏览器,和访问的来源网站,等等。

|

||||

|

||||

[GoAccess][1] 是一款用于Apache或者Nginx的命令行日志分析器和交互式查看器。使用这款工具,你不仅可以浏览到之前提及的相关数据,还可以通过分析网站服务器日志来进一步挖掘数据 - 而且**这一切都是在一个终端窗口实时输出的**。由于今天的[大多数web服务器][2]都使用Debian的衍生版或者基于RedHat的发行版来作为底层操作系统,所以本文中我告诉你如何在Debian和CentOS中安装和使用GoAccess。

|

||||

|

||||

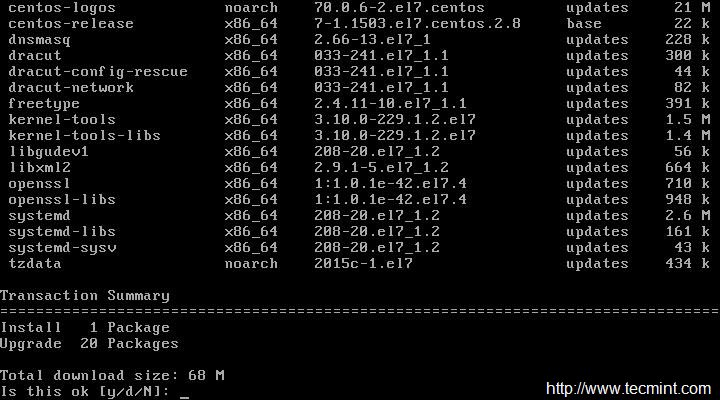

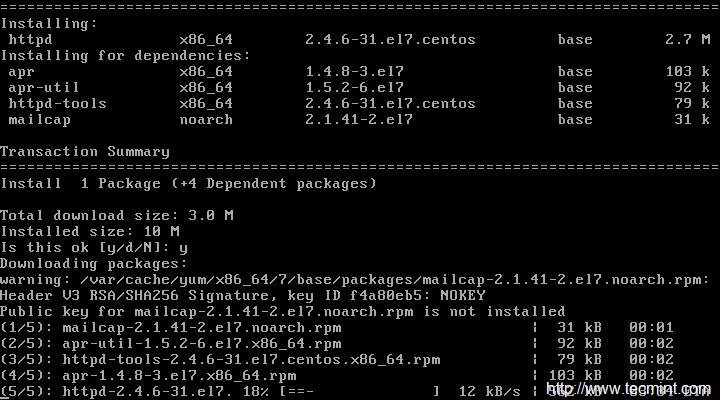

### 在Linux系统安装GoAccess ###

|

||||

|

||||

在Debian,Ubuntu及其衍生版本,运行以下命令来安装GoAccess:

|

||||

|

||||

# aptitude install goaccess

|

||||

|

||||

在CentOS中,你将需要使你的[EPEL 仓库][3]可用然后执行以下命令:

|

||||

|

||||

# yum install goaccess

|

||||

|

||||

在Fedora,同样使用yum命令:

|

||||

|

||||

# yum install goaccess

|

||||

|

||||

|

||||

如果你想从源码安装GoAccess来使用更多功能(例如 GeoIP 定位功能),需要在你的操作系统安装[必需的依赖包][4],然后按以下步骤进行:

|

||||

|

||||

# wget http://tar.goaccess.io/goaccess-0.8.5.tar.gz

|

||||

# tar -xzvf goaccess-0.8.5.tar.gz

|

||||

# cd goaccess-0.8.5/

|

||||

# ./configure --enable-geoip

|

||||

# make

|

||||

# make install

|

||||

|

||||

以上安装的版本是 0.8.5,但是你也可以在该软件的网站[下载页][5]确认是否是最新版本。

|

||||

|

||||

由于GoAccess不需要后续的配置,一旦安装你就可以马上使用。

|

||||

|

||||

### 运行 GoAccess ###

|

||||

|

||||

开始使用GoAccess,只需要对它指定你的Apache访问日志。

|

||||

|

||||

对于Debian及其衍生版本:

|

||||

|

||||

# goaccess -f /var/log/apache2/access.log

|

||||

|

||||

基于红帽的发行版:

|

||||

|

||||

# goaccess -f /var/log/httpd/access_log

|

||||

|

||||

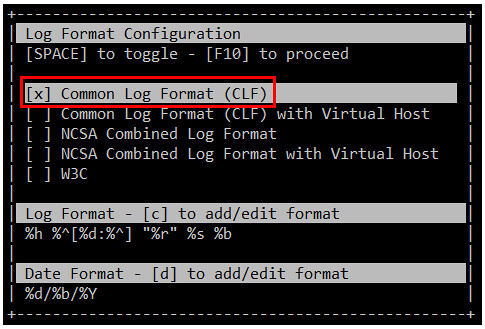

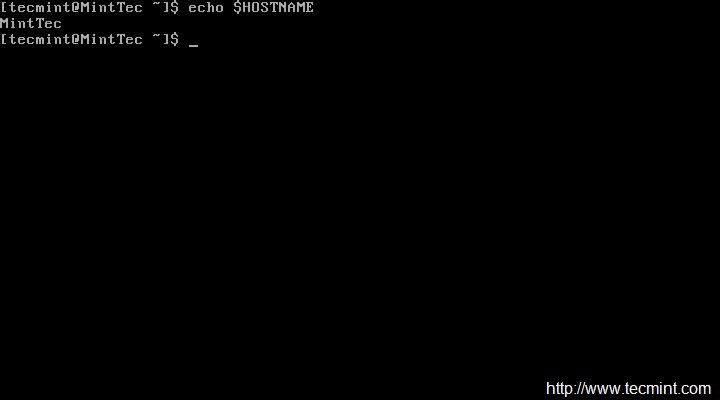

当你第一次启动GoAccess,你将会看到如下的屏幕中选择日期和日志格式。正如前面所述,你可以按空格键进行选择,并按F10确认。至于日期和日志格式,你可能需要参考[Apache 文档][6]来刷新你的记忆。

|

||||

|

||||

在这个例子中,选择常见日志格式(Common Log Format(CLF)):

|

||||

|

||||

|

||||

|

||||

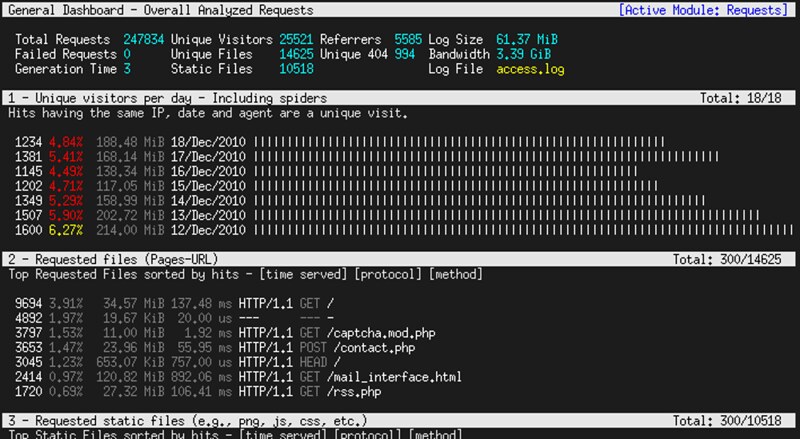

然后按F10 确认。你将会从屏幕上看到统计数据。为了简洁起见,这里只显示了首部,也就是日志文件的摘要,如下图所示:

|

||||

|

||||

|

||||

|

||||

### 通过 GoAccess来浏览网站服务器统计数据 ###

|

||||

|

||||

你可以按向下的箭头滚动页面,你会发现以下区域,它们是按请求排序的。这里提及的目录顺序可能会根据你的发行版或者你所选的安装方式(从源和库)不同而不同:

|

||||

|

||||

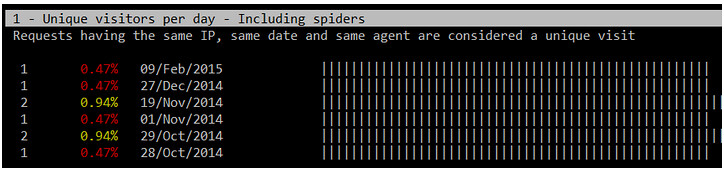

1. 每天唯一访客(来自同样IP、同一日期和同一浏览器的请求被认为是是唯一访问)

|

||||

|

||||

|

||||

|

||||

2. 请求的文件(网页URL)

|

||||

|

||||

|

||||

|

||||

3. 请求的静态文件(例如,.png文件,.js文件等等)

|

||||

|

||||

4. 来源的URLs(每一个URL请求的出处)

|

||||

|

||||

5. HTTP 404 未找到的响应代码

|

||||

|

||||

|

||||

|

||||

6. 操作系统

|

||||

|

||||

7. 浏览器

|

||||

|

||||

8. 主机地址(客户端IP地址)

|

||||

|

||||

|

||||

|

||||

9. HTTP 状态代码

|

||||

|

||||

|

||||

|

||||

10. 前几位的来源站点

|

||||

|

||||

11. 来自谷歌搜索引擎的前几位的关键字

|

||||

|

||||

如果你想要检查已经存档的日志,你可以通过管道将它们发送给GoAccess,如下:

|

||||

|

||||

在Debian及其衍生版本:

|

||||

|

||||

# zcat -f /var/log/apache2/access.log* | goaccess

|

||||

|

||||

在基于红帽的发行版:

|

||||

|

||||

# cat /var/log/httpd/access* | goaccess

|

||||

|

||||

如果你需要上述部分的详细报告(1至11项),直接按下其序号再按O(大写o),就可以显示出你需要的详细视图。下面的图像显示5-O的输出(先按5,再按O)

|

||||

|

||||

|

||||

|

||||

如果要显示GeoIP位置信息,打开主机部分的详细视图,如前面所述,你将会看到正在请求你的服务器的客户端IP地址所在的位置。

|

||||

|

||||

|

||||

|

||||

如果你的系统还不是很忙碌,以上提及的章节将不会显示大量的信息,但是这种情形可以通过在你网站服务器越来越多的请求发生改变。

|

||||

|

||||

### 保存用于离线分析的报告 ###

|

||||

|

||||

有时候你不想每次都实时去检查你的系统状态,可以保存一份在线的分析文件或打印出来。要生成一个HTML报告,只需要通过之前提到GoAccess命令,将输出来重定向到一个HTML文件即可。然后,用web浏览器来将这份报告打开即可。

|

||||

|

||||

# zcat -f /var/log/apache2/access.log* | goaccess > /var/www/webserverstats.html

|

||||

|

||||

一旦报告生成,你将需要点击展开的链接来显示每个类别详细的视图信息:

|

||||

|

||||

|

||||

|

||||

可以查看youtube视频:https://youtu.be/UVbLuaOpYdg 。

|

||||

|

||||

正如我们通过这篇文章讨论,GoAccess是一个非常有价值的工具,它能给系统管理员实时提供可视的HTTP 统计分析。虽然GoAccess的默认输出是标准输出,但是你也可以将他们保存到JSON,HTML或者CSV文件。这种转换可以让 GoAccess在监控和显示网站服务器的统计数据时更有用。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://xmodulo.com/interactive-apache-web-server-log-analyzer-linux.html

|

||||

|

||||

作者:[Gabriel Cánepa][a]

|

||||

译者:[disylee](https://github.com/disylee)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://xmodulo.com/author/gabriel

|

||||

[1]:http://goaccess.io/

|

||||

[2]:http://w3techs.com/technologies/details/os-linux/all/all

|

||||

[3]:http://linux.cn/article-2324-1.html

|

||||

[4]:http://goaccess.io/download#dependencies

|

||||

[5]:http://goaccess.io/download

|

||||

[6]:http://httpd.apache.org/docs/2.4/logs.html

|

||||

@ -1,154 +1,169 @@

|

||||

10个有用的‘ls’命令面试问题-第二部分

|

||||

10 个‘ls’命 令面试的问题(二)

|

||||

================================================================================

|

||||

这是关于文件列表命令的第二篇文章,继续探讨‘ls’命令的其他方面。该系列的第一篇文章收到了Tecmint社区的高度关注,如果你错过了该系列的第一部分,你可能会访问以下地址:

|

||||

这是关于文件列表命令的第二篇文章,继续探讨‘ls’命令的其他方面。该系列的第一篇文章受到了社区的高度关注,如果你错过了该系列的第一部分,可以访问以下地址:

|

||||

|

||||

- [15 Interview Questions on “ls” Command – Part 1][1]

|

||||

- [15 个‘ls’命令的面试问题(一)][1]

|

||||

|

||||

这篇文章通过样例来很好地展现‘ls’命令的深入应用,我们加倍小心地来写这篇文章来保持其简洁可理解性,同时又能提供最全面的服务。

|

||||

|

||||

|

||||

10 Interview Questions on ls Command

|

||||

|

||||

### 1. 假如你想要以长列表的形式列出目录中的内容,但是不打印文件创建者名称以及文件所属组。同时在输出中显示其不同之处。###

|

||||

*10 ‘ls’ 命令面试的问题*

|

||||

|

||||

### 16. 假如你想要以长列表的形式列出目录中的内容,但是不打印文件创建者名称以及文件所属组。看看输出有何不同之处。###

|

||||

|

||||

a. ls 命令在与‘-l’选项一起使用时会将文件以长列表格式输出。

|

||||

|

||||

# ls -l

|

||||

|

||||

|

||||

List Files in- Long List Format

|

||||

|

||||

*以长格式列出文件*

|

||||

|

||||

b. ls 命令在与‘-l’和‘--author’一起使用时,会将文件以长列表格式输出并带有文件创建者的名称信息。

|

||||

|

||||

# ls -l --author

|

||||

|

||||

|

||||

List Files By Author

|

||||

|

||||

*列出文件的创建者*

|

||||

|

||||

c. ls 命令在与‘-g’选项 一起将会列出文件名但是不带属主名称。

|

||||

|

||||

# ls -g

|

||||

|

||||

|

||||

List Files Without Printing Owner Name

|

||||

|

||||

d. ls 命令在与'-G'和‘-l’选项一起将会使用长列表格式列出文件名称带式不带文件所属组名称。

|

||||

*列出文件但不列出属主*

|

||||

|

||||

d. ls 命令在与'-G'和‘-l’选项一起将会使用长列表格式列出文件名称但是不带文件所属组名称。

|

||||

|

||||

# ls -Gl

|

||||

|

||||

|

||||

List Files Without Printing Group

|

||||

|

||||

### 2. 使用用户友好的格式打印出当前目录中的文件以及文件夹的大小,你会如何做?###

|

||||

*列出文件但是不列出所属组*

|

||||

|

||||

### 17. 使用易读格式打印出当前目录中的文件以及文件夹的大小,你会如何做?###

|

||||

|

||||

这里我们需要使用'-h'选项(人类可阅读的、易读的)同‘-l’或‘-s’选项与ls命令一起使用来得到想要的输出。

|

||||

|

||||

这里我们需要使用'-h'选项(人类可阅读的)同‘-l’或‘-s’选项与ls命令一起使用来得到想要的输出。

|

||||

# ls -hl

|

||||

|

||||

|

||||

List Files in Human Readable Format

|

||||

|

||||

*以易读格式的长列表列出文件*

|

||||

|

||||

# ls -hs

|

||||

|

||||

|

||||

List File Sizes in Long List Format

|

||||

|

||||

*以易读格式的短列表列出文件*

|

||||

|

||||

**注意**: ‘-h’选项使用1024(计算机中的标准)的幂,文件或文件夹的大小分别以K,M和G作为输出单位。

|

||||

|

||||

### 3. 既然‘-h’选项是使用1024的幂作为标准来输出大小,那么ls命令还支持其他的幂值呢?###

|

||||

### 18. 既然‘-h’选项是使用1024的幂作为标准来输出大小,那么ls命令是否还支持其他的幂值呢?###

|

||||

|

||||

存在一个选项 ‘-si’与选项‘-h’相似,不同之处在于前者以使用1000的幂,后者使用1024的幂。

|

||||

存在一个选项 ‘--si’与选项‘-h’相似,不同之处在于前者以使用1000的幂,后者使用1024的幂。

|

||||

|

||||

# ls -si

|

||||

# ls --si

|

||||

|

||||

|

||||

Supported Power Values of ls Command

|

||||

所以'--si'也可以与‘-l’选项一起使用来按照1000的幂来输出文件夹的大小,并且以长列表格式显示。

|

||||

|

||||

所以'-si'也可以与‘-l’选项一起使用来按照1000的幂来输出文件夹的大小,并且以长列表格式显示。

|

||||

# ls --si -l

|

||||

|

||||

# ls -si -l

|

||||

(LCTT 译注:此处原文参数有误,附图也不对,因此删除之)

|

||||

|

||||

|

||||

List Files by Power Values

|

||||

### 19. 假如要你使用逗号‘,’作为分隔符来打印一个目录中的内容,可以吗? 对于长列表形式也可行吗?###

|

||||

|

||||

### 4. 假如要你使用逗号‘,’作为分隔符来打印一个目录中的内容,可以吗? 对于长列表形式也可行吗?###

|

||||

|

||||

当然!linux的ls命令当与其选项‘-m’一起使用时可以在打印目录内容时以逗号‘,’分割。由于逗号分割的内容是水平填充的,ls命令不能在垂直列出内容时使用逗号来分割内容。

|

||||

当然!linux的ls命令当与其选项‘-m’一起使用时可以在打印目录内容时以逗号‘,’分割。由于逗号分割的内容是水平填充的,ls命令不能在垂直列出内容时使用逗号来分割内容。

|

||||

|

||||

# ls -m

|

||||

|

||||

|

||||

Print Contents of Directory by Comma

|

||||

|

||||

*以逗号分隔显示内容*

|

||||

|

||||

当使用长列表格式时,‘-m’选项就没有什么效果了。

|

||||

|

||||

# ls -ml

|

||||

|

||||

|

||||

Listing Content Horizontally

|

||||

|

||||

### 5. 有办法将目录的内容逆序打印出来吗?###

|

||||

*长列表不能使用逗号分隔列表*

|

||||

|

||||

### 20. 有办法将目录的内容逆序打印出来吗?###

|

||||

|

||||

可以!上面的情形可以轻松地通过'-r'选项搞定,该选项将输出顺序倒置。这个选项也可以与‘-l’选项一起使用。

|

||||

|

||||

# ls -r

|

||||

|

||||

|

||||

List Content in Reverse Order

|

||||

|

||||

*逆序列出*

|

||||

|

||||

# ls -rl

|

||||

|

||||

|

||||

Long List Content in Reverse Order

|

||||

|

||||

### 6. 如果你被分配一个任务,来递归地打印各个子目录,你会如何应付?注意哟,只针对子目录而不是文件哦。###

|

||||

*逆序长列表*

|

||||

|

||||

### 21. 如果你被分配一个任务,来递归地打印各个子目录,你会如何应付?注意,只针对子目录而不是文件哦。###

|

||||

|

||||

小意思!使用“-R”选项就可以轻轻松松拿下,它也可以更进一步地与其他选项如‘-l’和‘-m’选项等组合使用。

|

||||

|

||||

# ls -R

|

||||

|

||||

|

||||

Print Sub Directories in Recursively

|

||||

|

||||

### 7. 如何按照文件大小对其进行排序?###

|

||||

*递归列出子目录*

|

||||

|

||||

### 22. 如何按照文件大小对其进行排序?###

|

||||

|

||||

linux命令行选项'-S'赋予了ls命令这个超能力。按照文件大小从大到小的顺序排序:

|

||||

|

||||

# ls -S

|

||||

|

||||

|

||||

Sort Files with ls Command

|

||||

*按文件大小排序*

|

||||

|

||||

按照文件大小从小到大的顺序排序。

|

||||

|

||||

# ls -Sr

|

||||

|

||||

|

||||

Sort Files in Descending Order

|

||||

|

||||

### 8. 列出目录中的内容按照一行一个文件并且不带额外信息的方式 ###

|

||||

*从小到大的排序*

|

||||

|

||||

选项‘-l’在此可以解决这个问题,使用‘-l’选项来使用ls命令可以将目录中的内容按照一行一个文件并且不带额外信息的方式进行输出。

|

||||

### 23. 按照一行一个文件列出目录中的内容,并且不带额外信息的方式 ###

|

||||

|

||||

选项‘-1’在此可以解决这个问题,使用‘-1’选项来使用ls命令可以将目录中的内容按照一行一个文件并且不带额外信息的方式进行输出。

|

||||

|

||||

# ls -1

|

||||

|

||||

|

||||

List Files Without Information

|

||||

|

||||

### 9. 现在委派给你一个任务,你必须将目录中的内容输出到终端而且需要使用双引号引起来,你会如何做?###

|

||||

*不带其他信息,一行一个列出文件*

|

||||

|

||||

存在一个选项‘-Q’会将ls命令的输出内容用双引号引起来。

|

||||

### 24. 现在委派给你一个任务,你必须将目录中的内容输出到终端而且需要使用双引号引起来,你会如何做?###

|

||||

|

||||

有一个选项‘-Q’会将ls命令的输出内容用双引号引起来。

|

||||

|

||||

# ls -Q

|

||||

|

||||

|

||||

Print Files with Double Quotes

|

||||

|

||||

### 10. 想象一下你正在与一个包含有很多文件和文件夹的目录打交道,你需要使目录名显示在文件名之前,你如何做?###

|

||||

*输出的文件名用引号引起来*

|

||||

|

||||

### 25. 想象一下你正在与一个包含有很多文件和文件夹的目录打交道,你需要使目录名显示在文件名之前,你如何做?###

|

||||

|

||||

# ls --group-directories-first

|

||||

|

||||

|

||||

Print Directories First

|

||||

|

||||

先点到为止,我们会马上提供该系列文章的下一部分。别换频道,关注Tecmint。 另外别忘了在下面的评论中提出你们宝贵的反馈信息,喜欢就分享,帮助我们得到更好的传播吧!

|

||||

*目录优先显示*

|

||||

|

||||

先点到为止,我们会马上提供该系列文章的下一部分。别换频道,关注我们。 另外别忘了在下面的评论中提出你们宝贵的反馈信息,喜欢就分享,帮助我们得到更好的传播吧!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -156,9 +171,9 @@ via: http://www.tecmint.com/ls-interview-questions/

|

||||

|

||||

作者:[Ravi Saive][a]

|

||||

译者:[theo-l](https://github.com/theo-l)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.tecmint.com/author/admin/

|

||||

[1]:http://www.tecmint.com/ls-command-interview-questions/

|

||||

[1]:http://linux.cn/article-5349-1.html

|

||||

@ -1,85 +1,91 @@

|

||||

关于linux中的“ls”命令的15个面试问题 - 第一部分

|

||||

15 个‘ls’命令的面试问题(一)

|

||||

================================================================================

|

||||