mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-27 02:30:10 +08:00

commit

eaef6a28cd

2

.gitignore

vendored

2

.gitignore

vendored

@ -3,3 +3,5 @@ members.md

|

||||

*.html

|

||||

*.bak

|

||||

.DS_Store

|

||||

sources/*/.*

|

||||

translated/*/.*

|

||||

3

.gitmodules

vendored

3

.gitmodules

vendored

@ -1,3 +0,0 @@

|

||||

[submodule "comic"]

|

||||

path = comic

|

||||

url = https://wxy@github.com/LCTT/comic.git

|

||||

29

.travis.yml

29

.travis.yml

@ -1,2 +1,27 @@

|

||||

language: c

|

||||

script: make -s check

|

||||

language: minimal

|

||||

install:

|

||||

- sudo apt-get install jq

|

||||

- git clone --depth=1 -b gh-pages https://github.com/LCTT/TranslateProject/ build && rm -rf build/.git

|

||||

script:

|

||||

- 'if [ "$TRAVIS_PULL_REQUEST" != "false" ]; then sh ./scripts/check.sh; fi'

|

||||

- 'if [ "$TRAVIS_PULL_REQUEST" = "false" ]; then sh ./scripts/badge.sh; fi'

|

||||

- 'if [ "$TRAVIS_EVENT_TYPE" = "cron" ]; then sh ./scripts/status.sh; fi'

|

||||

|

||||

branches:

|

||||

only:

|

||||

- master

|

||||

# - status

|

||||

except:

|

||||

- gh-pages

|

||||

git:

|

||||

submodules: false

|

||||

depth: false

|

||||

deploy:

|

||||

provider: pages

|

||||

skip_cleanup: true

|

||||

github_token: $GITHUB_TOKEN

|

||||

local_dir: build

|

||||

on:

|

||||

branch:

|

||||

- master

|

||||

# - status

|

||||

|

||||

@ -1,4 +0,0 @@

|

||||

# Linux中国翻译规范

|

||||

1. 翻译中出现的专有名词,可参见Dict.md中的翻译。

|

||||

2. 英文人名,如无中文对应译名,一般不译。

|

||||

2. 缩写词,一般不须翻译,可考虑旁注中文全名。

|

||||

51

Makefile

51

Makefile

@ -1,51 +0,0 @@

|

||||

DIR_PATTERN := (news|talk|tech)

|

||||

NAME_PATTERN := [0-9]{8} [a-zA-Z0-9_.,() -]*\.md

|

||||

|

||||

RULES := rule-source-added \

|

||||

rule-translation-requested \

|

||||

rule-translation-completed \

|

||||

rule-translation-revised \

|

||||

rule-translation-published

|

||||

.PHONY: check match $(RULES)

|

||||

|

||||

CHANGE_FILE := /tmp/changes

|

||||

|

||||

check: $(CHANGE_FILE)

|

||||

echo 'PR #$(TRAVIS_PULL_REQUEST) Changes:'

|

||||

cat $(CHANGE_FILE)

|

||||

echo

|

||||

echo 'Check for rules...'

|

||||

make -k $(RULES) 2>/dev/null | grep '^Rule Matched: '

|

||||

|

||||

$(CHANGE_FILE):

|

||||

git --no-pager diff $(TRAVIS_BRANCH) FETCH_HEAD --no-renames --name-status > $@

|

||||

|

||||

rule-source-added:

|

||||

echo 'Unmatched Files:'

|

||||

egrep -v '^A\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) || true

|

||||

echo '[End of Unmatched Files]'

|

||||

[ $(shell egrep '^A\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) -ge 1 ]

|

||||

[ $(shell egrep -v '^A\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 0 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

|

||||

rule-translation-requested:

|

||||

[ $(shell egrep '^M\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell cat $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

|

||||

rule-translation-completed:

|

||||

[ $(shell egrep '^D\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell egrep '^A\s*"?translated/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell cat $(CHANGE_FILE) | wc -l) = 2 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

|

||||

rule-translation-revised:

|

||||

[ $(shell egrep '^M\s*"?translated/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell cat $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

|

||||

rule-translation-published:

|

||||

[ $(shell egrep '^D\s*"?translated/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell egrep '^A\s*"?published/$(NAME_PATTERN)' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell cat $(CHANGE_FILE) | wc -l) = 2 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

117

README.md

117

README.md

@ -1,34 +1,40 @@

|

||||

|

||||

[](https://lctt.github.io/new)

|

||||

[](https://lctt.github.io/translating)

|

||||

[](https://github.com/LCTT/TranslateProject/tree/master/translated)

|

||||

[](https://github.com/LCTT/TranslateProject/tree/master/published)

|

||||

|

||||

[](https://travis-ci.com/LCTT/TranslateProject)

|

||||

[](https://github.com/LCTT/TranslateProject/graphs/contributors)

|

||||

[](https://github.com/LCTT/TranslateProject/pulls?q=is%3Apr+is%3Aclosed)

|

||||

|

||||

简介

|

||||

-------------------------------

|

||||

|

||||

LCTT 是“Linux中国”([https://linux.cn/](https://linux.cn/))的翻译组,负责从国外优秀媒体翻译 Linux 相关的技术、资讯、杂文等内容。

|

||||

[LCTT](https://linux.cn/lctt/) 是“Linux 中国”([https://linux.cn/](https://linux.cn/))的翻译组,负责从国外优秀媒体翻译 Linux 相关的技术、资讯、杂文等内容。

|

||||

|

||||

LCTT 已经拥有几百名活跃成员,并欢迎更多的Linux志愿者加入我们的团队。

|

||||

LCTT 已经拥有几百名活跃成员,并欢迎更多的 Linux 志愿者加入我们的团队。

|

||||

|

||||

|

||||

|

||||

|

||||

LCTT 的组成

|

||||

-------------------------------

|

||||

|

||||

**选题**,负责选择合适的内容,并将原文转换为 markdown 格式,提交到 LCTT 的 [TranslateProject](https://github.com/LCTT/TranslateProject) 库中。

|

||||

|

||||

**译者**,负责从选题中选择内容进行翻译。

|

||||

|

||||

**校对**,负责将初译的文章进行文字润色、技术校对等工作。

|

||||

|

||||

**发布**,负责将校对后的文章,排版进行发布。

|

||||

- LCTT 官网: [https://linux.cn/lctt/](https://linux.cn/lctt/)

|

||||

- LCTT 状态: [https://lctt.github.io/](https://lctt.github.io/)

|

||||

|

||||

加入我们

|

||||

-------------------------------

|

||||

|

||||

请首先加入翻译组的 QQ 群,群号是:198889102,加群时请说明是“志愿者”。加入后记得修改您的群名片为您的 GitHub 的 ID。

|

||||

请首先加入翻译组的 QQ 群,群号是:**198889102**,加群时请说明是“*志愿者*”。

|

||||

|

||||

加入的成员,请先阅读 [WIKI 如何开始](https://github.com/LCTT/TranslateProject/wiki/01-如何开始)。

|

||||

加入的成员,请:

|

||||

|

||||

1. 修改你的 QQ 群名片为“译者-您的_GitHub_ID”。

|

||||

2. 阅读 [WIKI](https://lctt.github.io/wiki) 了解如何开始。

|

||||

3. 遇到不解之处,请在群内发问。

|

||||

|

||||

如何开始

|

||||

-------------------------------

|

||||

|

||||

请阅读 [WIKI](https://github.com/LCTT/TranslateProject/wiki)。

|

||||

请阅读 [WIKI](https://lctt.github.io/wiki)。如需要协助,请在群内发问。

|

||||

|

||||

历史

|

||||

-------------------------------

|

||||

@ -65,43 +71,56 @@ LCTT 的组成

|

||||

* 2018/01/11 提升 lujun9972 成为核心成员,并加入选题组。

|

||||

* 2018/02/20 遭遇 DMCA 仓库被封。

|

||||

* 2018/05/15 提升 MjSeven 为核心成员。

|

||||

* 2018/08/01 [发布 Linux 中国通证:LCCN](https://linux.cn/article-9886-1.html)。

|

||||

* 2018/08/17 提升 pityonline 为核心成员,担任校对,并接受他的建议采用 PR 审核模式。

|

||||

* 2018/09/10 [LCTT 五周年](https://linux.cn/article-9999-1.html)。

|

||||

* 2018/10/25 重构了 CI,感谢 vizv、lujun9972、bestony。

|

||||

* 2018/11/13 [成立了项目管理委员会(PMC)](https://linux.cn/article-10279-1.html),初始成员为:@wxy (主席)、@oska874、@lujun9972、@bestony、@pityonline、@geekpi、@qhwdw。

|

||||

|

||||

核心成员

|

||||

|

||||

项目管理委员及核心成员

|

||||

-------------------------------

|

||||

|

||||

目前 LCTT 核心成员有:

|

||||

LCTT 现由项目管理委员会(PMC)进行管理,成员如下:

|

||||

|

||||

- 组长 @wxy,

|

||||

- 选题 @oska874,

|

||||

- 校对 @jasminepeng,

|

||||

- 钻石译者 @geekpi,

|

||||

- 钻石译者 @GOLinux,

|

||||

- 钻石译者 @ictlyh,

|

||||

- 技术组长 @bestony,

|

||||

- 漫画组长 @GHLandy,

|

||||

- LFS 组长 @martin2011qi,

|

||||

- 核心成员 @strugglingyouth,

|

||||

- 核心成员 @FSSlc,

|

||||

- 核心成员 @zpl1025,

|

||||

- 核心成员 @runningwater,

|

||||

- 核心成员 @bazz2,

|

||||

- 核心成员 @Vic020,

|

||||

- 核心成员 @alim0x,

|

||||

- 核心成员 @tinyeyeser,

|

||||

- 核心成员 @Locez,

|

||||

- 核心成员 @ucasFL,

|

||||

- 核心成员 @rusking,

|

||||

- 核心成员 @qhwdw,

|

||||

- 核心成员 @lujun9972

|

||||

- 核心成员 @MjSeven

|

||||

- 前任选题 @DeadFire,

|

||||

- 前任校对 @reinoir222,

|

||||

- 前任校对 @PurlingNayuki,

|

||||

- 前任校对 @carolinewuyan,

|

||||

- 功勋成员 @vito-L,

|

||||

- 功勋成员 @willqian,

|

||||

- 功勋成员 @vizv,

|

||||

- 功勋成员 @dongfengweixiao,

|

||||

- 🎩 主席 @wxy

|

||||

- 🎩 选题 @oska874

|

||||

- 🎩 选题 @lujun9972

|

||||

- 🎩 技术 @bestony

|

||||

- 🎩 校对 @pityonline

|

||||

- 🎩 译者 @geekpi

|

||||

- 🎩 译者 @qhwdw

|

||||

|

||||

目前 LCTT 核心成员有:

|

||||

|

||||

- ❤️ 核心成员 @vizv

|

||||

- ❤️ 核心成员 @zpl1025

|

||||

- ❤️ 核心成员 @runningwater

|

||||

- ❤️ 核心成员 @FSSlc

|

||||

- ❤️ 核心成员 @Vic020

|

||||

- ❤️ 核心成员 @alim0x

|

||||

- ❤️ 核心成员 @martin2011qi

|

||||

- ❤️ 核心成员 @Locez

|

||||

- ❤️ 核心成员 @ucasFL

|

||||

- ❤️ 核心成员 @MjSeven

|

||||

|

||||

曾经做出了巨大贡献的核心成员,被列入荣誉榜:

|

||||

|

||||

- 🏆 前任选题 @DeadFire

|

||||

- 🏆 前任校对 @reinoir222

|

||||

- 🏆 前任校对 @PurlingNayuki

|

||||

- 🏆 前任校对 @carolinewuyan

|

||||

- 🏆 前任校对 @jasminepeng

|

||||

- 🏆 功勋成员 @tinyeyeser

|

||||

- 🏆 功勋成员 @vito-L

|

||||

- 🏆 功勋成员 @willqian

|

||||

- 🏆 功勋成员 @GOLinux

|

||||

- 🏆 功勋成员 @bazz2

|

||||

- 🏆 功勋成员 @ictlyh

|

||||

- 🏆 功勋成员 @dongfengweixiao

|

||||

- 🏆 功勋成员 @strugglingyouth

|

||||

- 🏆 功勋成员 @GHLandy

|

||||

- 🏆 功勋成员 @rusking

|

||||

|

||||

全部成员列表请参见: https://linux.cn/lctt-list/ 。

|

||||

|

||||

|

||||

1

comic

1

comic

@ -1 +0,0 @@

|

||||

Subproject commit e5db5b880dac1302ee0571ecaaa1f8ea7cf61901

|

||||

75

lctt2018.md

Normal file

75

lctt2018.md

Normal file

@ -0,0 +1,75 @@

|

||||

LCTT 2018:五周年纪念日

|

||||

======

|

||||

|

||||

我是老王,可能大家有不少人知道我,由于历史原因,我有好几个生日(;o),但是这些年来,我又多了一个生日,或者说纪念日——每过两年,我就要严肃认真地写一篇 [LCTT](https://linux.cn/lctt) 生日纪念文章。

|

||||

|

||||

喏,这一篇,就是今年的了,LCTT 如今已经五岁了!

|

||||

|

||||

或许如同小孩子过生日总是比较快乐,而随着年岁渐长,过生日往往有不少负担——比如说,每次写这篇纪念文章时,我就需要回忆、反思这两年的做了些什么,往往颇为汗颜。

|

||||

|

||||

不过不管怎么说,总要总结一下这两年我们做了什么,有什么不足,也发一些展望吧。

|

||||

|

||||

### 江山代有英豪出

|

||||

|

||||

LCTT,如同一般的开源贡献组织,总是有不断的新老传承。我们的翻译组,也有不少成员,由于工作学习的原因,慢慢淡出,但同时,也不断有新的成员加入并接过前辈手中的旗帜(就是没人接我的)。

|

||||

|

||||

> **加入方式**

|

||||

|

||||

> 请首先加入翻译组的 QQ 群,群号是:**198889102**,加群时请说明是“**志愿者**”。加入后记得修改您的群名片为您的 GitHub 的 ID。

|

||||

|

||||

> 加入的成员,请先阅读 [WIKI 如何开始](https://github.com/LCTT/TranslateProject/wiki/01-%E5%A6%82%E4%BD%95%E5%BC%80%E5%A7%8B)。

|

||||

|

||||

比如说,我们这两年来,oska874 承担了主要的选题工作,然后 lujun9972 适时的出现接过了不少选题工作;再比如说,qhwdw 出现后承担了大量繁难文章的翻译,pityonline 则专注于校对,甚至其校对的严谨程度让我都甘拜下风。还有 MjSeven 也同 qhwdw 一样,以极高的翻译频率从一星译者迅速登顶五星译者。当然,还有 Bestony、Locez、VizV 等人为 LCTT 提供了不少技术支持和开发工作。

|

||||

|

||||

### 硕果累累

|

||||

|

||||

我们并没有特别的招新渠道,但是总是时不时会有新的成员慕名而来,到目前为止,我们已经有 [331](https://linux.cn/lctt-list) 位做过贡献的成员,已经翻译发布了 3885 篇译文,合计字节达 33MB 之多!

|

||||

|

||||

这两年,我们不但翻译了很多技术、新闻和评论类文章,也新增了新的翻译类型:[漫画](https://linux.cn/talk/comic/),其中一些漫画得到了很多好评。

|

||||

|

||||

我们发布的文章有一些达到了 100000+ 的访问量,这对于我们这种技术垂直内容可不容易。

|

||||

|

||||

而同时,[Linux 中国](https://linux.cn/)也发布了近万篇文章,而这一篇,应该就是第 [9999](https://linux.cn/article-9999-1.html) 篇文章,我们将在明天,进入新的篇章。

|

||||

|

||||

### 贡献者主页和贡献者证书

|

||||

|

||||

为了彰显诸位贡献者的贡献,我们为每位贡献者创立的自己的专页,并据此建立了[排行榜](https://linux.cn/lctt-list)。

|

||||

|

||||

同时,我们还特意请 Bestony 和“一一”设计开发和”贡献者证书”,大家可以在 [LCTT 贡献平台](https://lctt.linux.cn/)中领取。

|

||||

|

||||

### 规则进化

|

||||

|

||||

LCTT 最初创立时,甚至都没有采用 PR 模式。但是随着贡献者的增多,我们也逐渐在改善我们的流程、方法。

|

||||

|

||||

之前采用了很粗糙的 PR 模式,对 PR 中的文件、提交乃至于信息都没有进行硬性约束。后来在 VizV 的帮助下,建立了对 PR 的合规性检查;又在 pityonline 的督促下,采用了更为严格的 PR 审查机制。

|

||||

|

||||

LCTT 创立几年来,我们的一些流程和规范,已经成为其它一些翻译组的参考范本,我们也希望我们的这些经验,可以进一步帮助到其它的开源社区。

|

||||

|

||||

### 仓库重建和版权问题

|

||||

|

||||

今年还发生一次严重的事故,由于对选题来源把控不严和对版权问题没有引起足够的重视,我们引用的一篇文章违背了原文的版权规定,结果被原文作者投诉到 GitHub。而我并没有及时看到 GitHub 给我发的 DMCA 处理邮件,因此错过了处理窗口期,从而被 GitHub 将整个库予以删除。

|

||||

|

||||

出现这样的重大失误之后,经过大家的帮助,我们历经周折才将仓库基本恢复。这要特别感谢 VizV 的辛苦工作。

|

||||

|

||||

在此之后,我们对译文选文的规则进行了梳理,并全面清查了文章版权。这个教训对我们来说弥足沉重。

|

||||

|

||||

### 通证时代

|

||||

|

||||

在 Linux 中国及 LCTT 发展过程中,我一直小心翼翼注意商业化的问题。严格来说,没有经济支持的开源组织如同无根之木,无源之水,是长久不了的。而商业化的技术社区又难免为了三斗米而折腰。所以往往很多技术社区要么渐渐凋零,要么就变成了商业机构。

|

||||

|

||||

从中国电信辞职后,我专职运营 Linux 中国这个开源社区已经近三年了,其间也有一些商业性收入,但是仅能勉强承担基本的运营费用。

|

||||

|

||||

这种尴尬的局面,使我,以及其它的开源社区同仁们纷纷寻求更好的发展之路。

|

||||

|

||||

去年参加中国开源年会时,在闭门会上,大家的讨论启发了我和诸位同仁,我们认为,开源社区结合通证经济,似乎是一条可行的开源社区发展之路。

|

||||

|

||||

今年 8 月 1 日,我们经过了半年的论证和实验,[发布了社区通证 LCCN](https://linux.cn/article-9886-1.html),并已经初步发放到了各位译者手中。我们还在继续建设通证生态各种工具,如合约、交易商城等。

|

||||

|

||||

我们希望能够通过通证为开源社区转入新的活力,也愿意将在探索道路上遇到的问题和解决的思路、工具链分享给更多的社区。

|

||||

|

||||

### 总结

|

||||

|

||||

从上一次总结以来,这又是七百多天,时光荏苒,而 LCTT 的创立也近两千天了。我希望,我们的翻译组以及更多的贡献者可以在通证经济的推动下,找到自洽、自治的发展道路;也希望能有更多的贡献者涌现出来接过我们的大旗,将开源发扬光大。

|

||||

|

||||

wxy

|

||||

2018/9/9 夜

|

||||

77

published/201309/20190204 7 Best VPN Services For 2019.md

Normal file

77

published/201309/20190204 7 Best VPN Services For 2019.md

Normal file

@ -0,0 +1,77 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (Modrisco)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-10691-1.html)

|

||||

[#]: subject: (7 Best VPN Services For 2019)

|

||||

[#]: via: (https://www.ostechnix.com/7-best-opensource-vpn-services-for-2019/)

|

||||

[#]: author: (Editor https://www.ostechnix.com/author/editor/)

|

||||

|

||||

2019 年最好的 7 款虚拟私人网络服务

|

||||

======

|

||||

|

||||

在过去三年中,全球至少有 67% 的企业面临着数据泄露,亿万用户受到影响。研究表明,如果事先对数据安全采取最基本的保护措施,那么预计有 93% 的安全问题是可以避免的。

|

||||

|

||||

糟糕的数据安全会带来极大的代价,特别是对企业而言。它会大致大规模的破坏并影响你的品牌声誉。尽管有些企业可以艰难地收拾残局,但仍有一些企业无法从事故中完全恢复。不过现在,你很幸运地可以得到数据及网络安全软件。

|

||||

|

||||

|

||||

|

||||

到了 2019 年,你可以通过**虚拟私人网络**,也就是我们熟知的 **VPN** 来保护你免受网络攻击。当涉及到在线隐私和安全时,常常存在许多不确定因素。有数百个不同的 VPN 提供商,选择合适的供应商也同时意味着在定价、服务和易用性之间谋取恰当的平衡。

|

||||

|

||||

如果你正在寻找一个可靠的 100% 经过测试和安全的 VPN,你可能需要进行详尽的调查并作出最佳选择。这里为你提供在 2019 年 7 款最好用并经过测试的 VPN 服务。

|

||||

|

||||

### 1、Vpnunlimitedapp

|

||||

|

||||

通过 VPN Unlimited,你的数据安全将得到全面的保障。此 VPN 允许你连接任何 WiFi ,而无需担心你的个人数据可能被泄露。你的数据通过 AES-256 算法加密,保护你不受第三方和黑客的窥探。无论你身处何处,这款 VPN 都可确保你在所有网站上保持匿名且不受跟踪。它提供 7 天的免费试用和多种协议支持:openvpn、IKEv2 和 KeepSolidWise。有特殊需求的用户会获得特殊的额外服务,如个人服务器、终身 VPN 订阅和个人 IP 选项。

|

||||

|

||||

### 2、VPN Lite

|

||||

|

||||

VPN Lite 是一款易于使用而且**免费**的用于上网的 VPN 服务。你可以通过它在网络上保持匿名并保护你的个人隐私。它会模糊你的 IP 并加密你的数据,这意味着第三方无法跟踪你的所有线上活动。你还可以访问网络上的全部内容。使用 VPN Lite,你可以访问在被拦截的网站。你还放心地可以访问公共 WiFi 而不必担心敏感信息被间谍软件窃取和来自黑客的跟踪和攻击。

|

||||

|

||||

### 3、HotSpot Shield

|

||||

|

||||

这是一款在 2005 年推出的大受欢迎的 VPN。这套 VPN 协议至少被全球 70% 的数据安全公司所集成,并在全球有数千台服务器。它提供两种免费模式:一种为完全免费,但会有线上广告;另一种则为七天试用。它提供军事级的数据加密和恶意软件防护。HotSpot Shield 保证网络安全并保证高速网络。

|

||||

|

||||

### 4、TunnelBear

|

||||

|

||||

如果你是一名 VPN 新手,那么 TunnelBear 将是你的最佳选择。它带有一个用户友好的界面,并配有动画熊引导。你可以在 TunnelBear 的帮助下以极快的速度连接至少 22 个国家的服务器。它使用 **AES 256-bit** 加密算法,保证无日志记录,这意味着你的数据将得到保护。你还可以在最多五台设备上获得无限流量。

|

||||

|

||||

### 5、ProtonVPN

|

||||

|

||||

这款 VPN 为你提供强大的优质服务。你的连接速度可能会受到影响,但你也可以享受到无限流量。它具有易于使用的用户界面,提供多平台兼容。 ProtonVPN 的服务据说是因为为种子下载提供了优化因而无法访问 Netflix。你可以获得如协议和加密等安全功能来保证你的网络安全。

|

||||

|

||||

### 6、ExpressVPN

|

||||

|

||||

ExpressVPN 被认为是最好的用于接触封锁和保护隐私的离岸 VPN。凭借强大的客户支持和快速的速度,它已成为全球顶尖的 VPN 服务。它提供带有浏览器扩展和自定义固件的路由。 ExpressVPN 拥有一系列令人赞叹高质量应用程序,配有大量的服务器,并且最多只能支持三台设备。

|

||||

|

||||

ExpressVPN 并不是完全免费的,恰恰相反,正是由于它所提供的高质量服务而使之成为了市场上最贵的 VPN 之一。ExpressVPN 有 30 天内退款保证,因此你可以免费试用一个月。好消息是,这是完全没有风险的。例如,如果你在短时间内需要 VPN 来绕过在线审查,这可能是你的首选解决方案。用过它之后,你就不会随意想给一个会发送垃圾邮件、缓慢的免费的程序当成试验品。

|

||||

|

||||

ExpressVPN 也是享受在线流媒体和户外安全的最佳方式之一。如果你需要继续使用它,你只需要续订或取消你的免费试用。ExpressVPN 在 90 多个国家架设有 2000 多台服务器,可以解锁 Netflix,提供快速连接,并为用户提供完全隐私。

|

||||

|

||||

### 7、PureVPN

|

||||

|

||||

虽然 PureVPN 可能不是完全免费的,但它却是此列表中最实惠的一个。用户可以注册获得 7 天的免费试用,并在之后选择任一付费计划。通过这款 VPN,你可以访问到至少 140 个国家中的 750 余台服务器。它还可以在几乎所有设备上轻松安装。它的所有付费特性仍然可以在免费试用期间使用。包括无限数据流量、IP 泄漏保护和 ISP 不可见性。它支持的系统有 iOS、Android、Windows、Linux 和 macOS。

|

||||

|

||||

### 总结

|

||||

|

||||

如今,可用的免费 VPN 服务越来越多,为什么不抓住这个机会来保护你自己和你的客户呢?在了解到有那么多优秀的 VPN 服务后,我们知道即使是最安全的免费服务也不一定就完全没有风险。你可能需要付费升级到高级版以增强保护。高级版的 VPN 为你提供了免费试用,提供无风险退款保证。无论你打算花钱购买 VPN 还是准备使用免费 VPN,我们都强烈建议你使用一个。

|

||||

|

||||

**关于作者:**

|

||||

|

||||

**Renetta K. Molina** 是一个技术爱好者和健身爱好者。她撰写有关技术、应用程序、 WordPress 和其他任何领域的文章。她喜欢在空余时间打高尔夫球和读书。她喜欢学习和尝试新事物。

|

||||

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.ostechnix.com/7-best-opensource-vpn-services-for-2019/

|

||||

|

||||

作者:[Editor][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[Modrisco](https://github.com/Modrisco)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://www.ostechnix.com/author/editor/

|

||||

[b]: https://github.com/lujun9972

|

||||

@ -104,10 +104,10 @@ Arch Linux 也因其丰富的 Wiki 帮助文档而大受推崇。该系统基于

|

||||

][23]

|

||||

|

||||

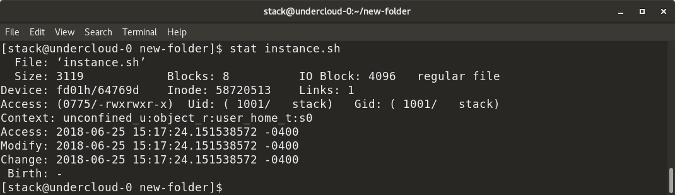

输入下面的命令来检查网络连接。

|

||||

|

||||

|

||||

```

|

||||

ping google.com

|

||||

```

|

||||

```

|

||||

|

||||

这个单词 ping 表示网路封包搜寻。你将会看到下面的返回信息,表明 Arch Linux 已经连接到外网了。这是执行安装过程中的很关键的一点。(LCTT 译注:或许你 ping 不到那个不存在的网站,你选个存在的吧。)

|

||||

|

||||

@ -117,8 +117,8 @@ ping google.com

|

||||

|

||||

输入如下命令清屏:

|

||||

|

||||

```

|

||||

clear

|

||||

```

|

||||

clear

|

||||

```

|

||||

|

||||

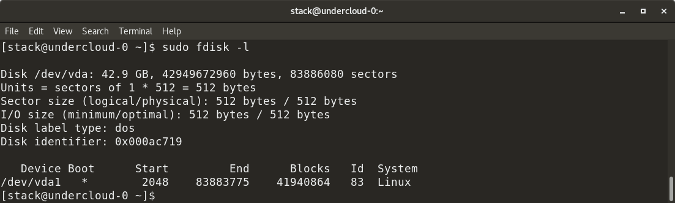

在开始安装之前,你得先为硬盘分区。输入 `fdisk -l` ,你将会看到当前系统的磁盘分区情况。注意一开始你给 Arch Linux 系统分配的 20 GB 存储空间。

|

||||

@ -137,8 +137,8 @@ clear

|

||||

|

||||

输入下面的命令:

|

||||

|

||||

```

|

||||

cfdisk

|

||||

```

|

||||

cfdisk

|

||||

```

|

||||

|

||||

你将看到 `gpt`、`dos`、`sgi` 和 `sun` 类型,选择 `dos` 选项,然后按回车。

|

||||

@ -185,8 +185,8 @@ cfdisk

|

||||

|

||||

以同样的方式创建逻辑分区。在“退出(quit)”选项按回车键,然后输入下面的命令来清屏:

|

||||

|

||||

```

|

||||

clear

|

||||

```

|

||||

clear

|

||||

```

|

||||

|

||||

[

|

||||

@ -195,21 +195,21 @@ clear

|

||||

|

||||

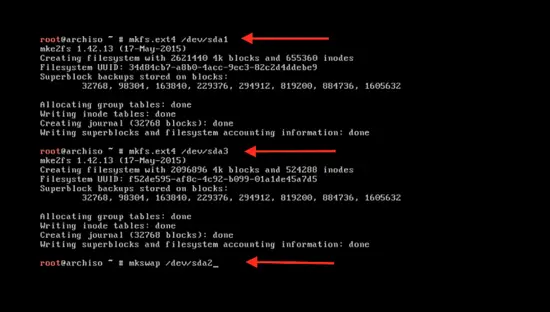

输入下面的命令来格式化新建的分区:

|

||||

|

||||

```

|

||||

```

|

||||

mkfs.ext4 /dev/sda1

|

||||

```

|

||||

```

|

||||

|

||||

这里的 `sda1` 是分区名。使用同样的命令来格式化第二个分区 `sda3` :

|

||||

|

||||

```

|

||||

```

|

||||

mkfs.ext4 /dev/sda3

|

||||

```

|

||||

```

|

||||

|

||||

格式化 swap 分区:

|

||||

|

||||

```

|

||||

```

|

||||

mkswap /dev/sda2

|

||||

```

|

||||

```

|

||||

|

||||

[

|

||||

|

||||

@ -217,14 +217,14 @@ mkswap /dev/sda2

|

||||

|

||||

使用下面的命令来激活 swap 分区:

|

||||

|

||||

```

|

||||

swapon /dev/sda2

|

||||

```

|

||||

swapon /dev/sda2

|

||||

```

|

||||

|

||||

输入 clear 命令清屏:

|

||||

|

||||

```

|

||||

clear

|

||||

```

|

||||

clear

|

||||

```

|

||||

|

||||

[

|

||||

@ -233,9 +233,9 @@ clear

|

||||

|

||||

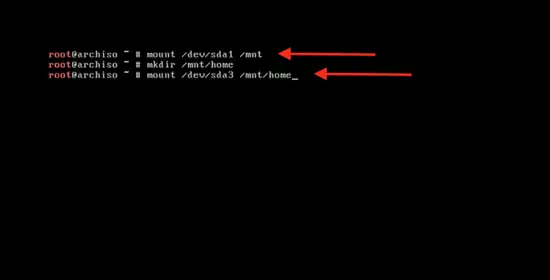

输入下面的命令来挂载主分区以开始系统安装:

|

||||

|

||||

```

|

||||

mount /dev/sda1 / mnt

|

||||

```

|

||||

```

|

||||

mount /dev/sda1 /mnt

|

||||

```

|

||||

|

||||

[

|

||||

|

||||

@ -245,9 +245,9 @@ mount /dev/sda1 / mnt

|

||||

|

||||

输入下面的命令来引导系统启动:

|

||||

|

||||

```

|

||||

```

|

||||

pacstrap /mnt base base-devel

|

||||

```

|

||||

```

|

||||

|

||||

可以看到系统正在同步数据包。

|

||||

|

||||

@ -263,9 +263,9 @@ pacstrap /mnt base base-devel

|

||||

|

||||

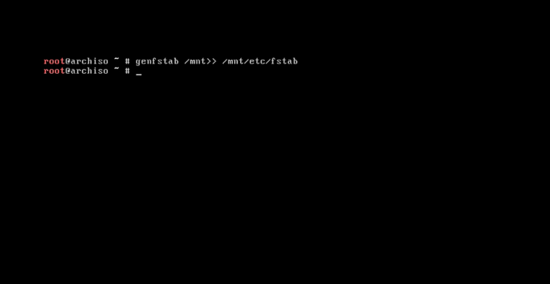

系统基本软件安装完成后,输入下面的命令来创建 fstab 文件:

|

||||

|

||||

```

|

||||

```

|

||||

genfstab /mnt>> /mnt/etc/fstab

|

||||

```

|

||||

```

|

||||

|

||||

[

|

||||

|

||||

@ -275,14 +275,14 @@ genfstab /mnt>> /mnt/etc/fstab

|

||||

|

||||

输入下面的命令来更改系统的根目录为 Arch Linux 的安装目录:

|

||||

|

||||

```

|

||||

```

|

||||

arch-chroot /mnt /bin/bash

|

||||

```

|

||||

```

|

||||

|

||||

现在来更改语言配置:

|

||||

|

||||

```

|

||||

nano /etc/local.gen

|

||||

```

|

||||

nano /etc/locale.gen

|

||||

```

|

||||

|

||||

[

|

||||

@ -297,9 +297,9 @@ nano /etc/local.gen

|

||||

|

||||

输入下面的命令来激活它:

|

||||

|

||||

```

|

||||

```

|

||||

locale-gen

|

||||

```

|

||||

```

|

||||

|

||||

按回车。

|

||||

|

||||

@ -309,8 +309,8 @@ locale-gen

|

||||

|

||||

使用下面的命令来创建 `/etc/locale.conf` 配置文件:

|

||||

|

||||

```

|

||||

nano /etc/locale.conf

|

||||

```

|

||||

nano /etc/locale.conf

|

||||

```

|

||||

|

||||

然后按回车。现在你就可以在配置文件中输入下面一行内容来为系统添加语言:

|

||||

@ -326,9 +326,9 @@ LANG=en_US.UTF-8

|

||||

][44]

|

||||

|

||||

输入下面的命令来同步时区:

|

||||

|

||||

|

||||

```

|

||||

ls user/share/zoneinfo

|

||||

ls /usr/share/zoneinfo

|

||||

```

|

||||

|

||||

下面你将看到整个世界的时区列表。

|

||||

@ -339,9 +339,9 @@ ls user/share/zoneinfo

|

||||

|

||||

输入下面的命令来选择你所在的时区:

|

||||

|

||||

```

|

||||

```

|

||||

ln –s /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

|

||||

```

|

||||

```

|

||||

|

||||

或者你可以从下面的列表中选择其它名称。

|

||||

|

||||

@ -351,8 +351,8 @@ ln –s /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

|

||||

|

||||

使用下面的命令来设置标准时间:

|

||||

|

||||

```

|

||||

hwclock --systohc –utc

|

||||

```

|

||||

hwclock --systohc --utc

|

||||

```

|

||||

|

||||

硬件时钟已同步。

|

||||

@ -363,8 +363,8 @@ hwclock --systohc –utc

|

||||

|

||||

设置 root 帐号密码:

|

||||

|

||||

```

|

||||

passwd

|

||||

```

|

||||

passwd

|

||||

```

|

||||

|

||||

按回车。 然而输入你想设置的密码,按回车确认。

|

||||

@ -377,9 +377,9 @@ passwd

|

||||

|

||||

使用下面的命令来设置主机名:

|

||||

|

||||

```

|

||||

```

|

||||

nano /etc/hostname

|

||||

```

|

||||

```

|

||||

|

||||

然后按回车。输入你想设置的主机名称,按 `control + x` ,按 `y` ,再按回车 。

|

||||

|

||||

@ -389,9 +389,9 @@ nano /etc/hostname

|

||||

|

||||

启用 dhcpcd :

|

||||

|

||||

```

|

||||

```

|

||||

systemctl enable dhcpcd

|

||||

```

|

||||

```

|

||||

|

||||

这样在下一次系统启动时, dhcpcd 将会自动启动,并自动获取一个 IP 地址:

|

||||

|

||||

@ -403,9 +403,9 @@ systemctl enable dhcpcd

|

||||

|

||||

最后一步,输入以下命令来初始化 grub 安装。输入以下命令:

|

||||

|

||||

```

|

||||

```

|

||||

pacman –S grub os-rober

|

||||

```

|

||||

```

|

||||

|

||||

然后按 `y` ,将会下载相关程序。

|

||||

|

||||

@ -415,14 +415,14 @@ pacman –S grub os-rober

|

||||

|

||||

使用下面的命令来将启动加载程序安装到硬盘上:

|

||||

|

||||

```

|

||||

```

|

||||

grub-install /dev/sda

|

||||

```

|

||||

```

|

||||

|

||||

然后进行配置:

|

||||

|

||||

```

|

||||

grub-mkconfig -o /boot/grub/grub.cfg

|

||||

```

|

||||

grub-mkconfig -o /boot/grub/grub.cfg

|

||||

```

|

||||

|

||||

[

|

||||

@ -431,9 +431,9 @@ grub-mkconfig -o /boot/grub/grub.cfg

|

||||

|

||||

最后重启系统:

|

||||

|

||||

```

|

||||

```

|

||||

reboot

|

||||

```

|

||||

```

|

||||

|

||||

然后按回车 。

|

||||

|

||||

@ -459,7 +459,7 @@ reboot

|

||||

|

||||

via: https://www.howtoforge.com/tutorial/install-arch-linux-on-virtualbox/

|

||||

|

||||

译者简介:

|

||||

译者简介:

|

||||

|

||||

rusking:春城初春/春水初生/春林初盛/春風十裏不如妳

|

||||

|

||||

|

||||

171

published/20180116 Command Line Heroes- Season 1- OS Wars_2.md

Normal file

171

published/20180116 Command Line Heroes- Season 1- OS Wars_2.md

Normal file

@ -0,0 +1,171 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (lujun9972)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-11296-1.html)

|

||||

[#]: subject: (Command Line Heroes: Season 1: OS Wars)

|

||||

[#]: via: (https://www.redhat.com/en/command-line-heroes/season-1/os-wars-part-2-rise-of-linux)

|

||||

[#]: author: (redhat https://www.redhat.com)

|

||||

|

||||

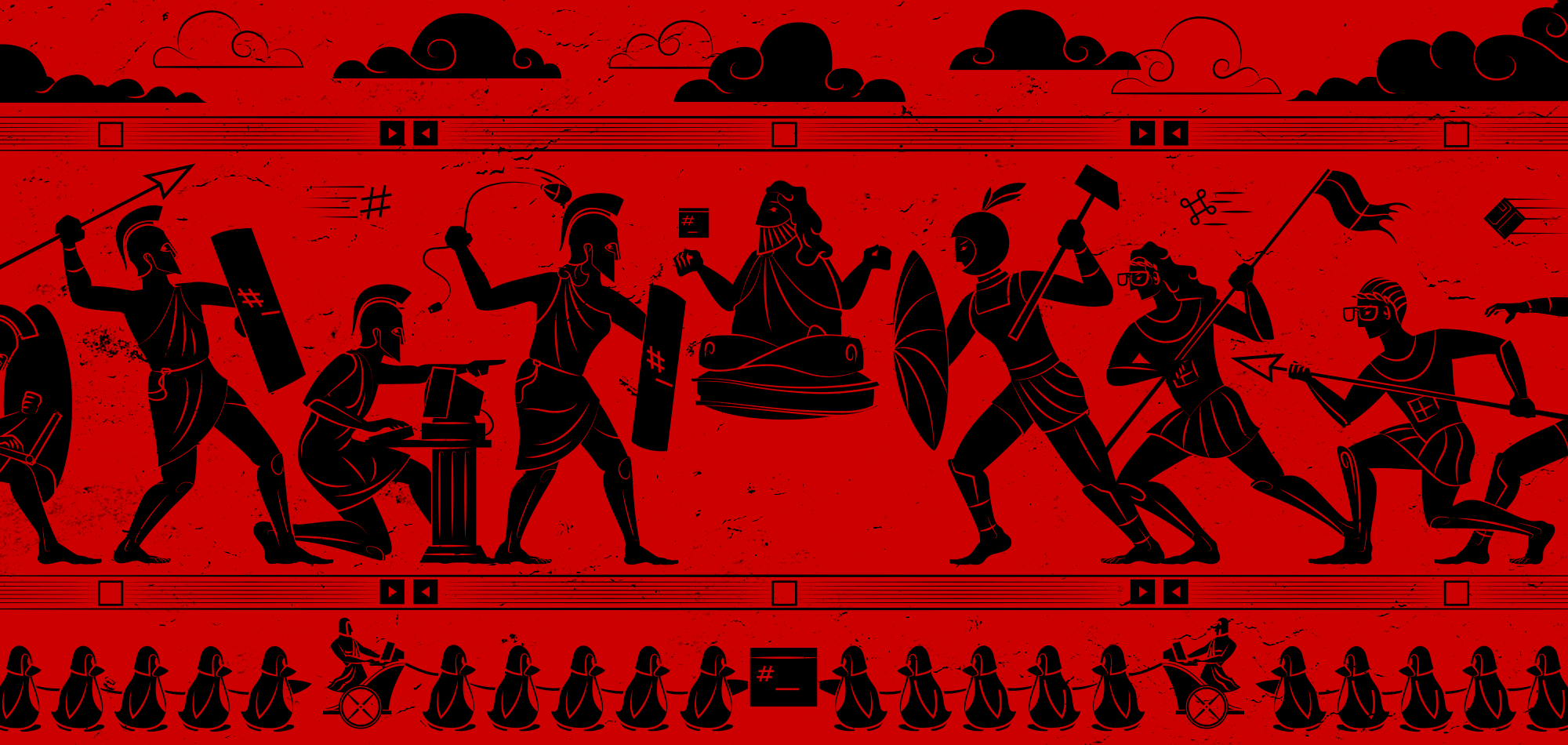

《代码英雄》第一季(2):操作系统战争(下)Linux 崛起

|

||||

======

|

||||

|

||||

> 代码英雄讲述了开发人员、程序员、黑客、极客和开源反叛者如何彻底改变技术前景的真实史诗故事。

|

||||

|

||||

|

||||

|

||||

本文是《[代码英雄](https://www.redhat.com/en/command-line-heroes)》系列播客[第一季(2):操作系统战争(下)](https://www.redhat.com/en/command-line-heroes/season-1/os-wars-part-2-rise-of-linux) 的[音频](https://dts.podtrac.com/redirect.mp3/audio.simplecast.com/2199861a.mp3)脚本。

|

||||

|

||||

> 微软帝国控制着 90% 的用户。操作系统的完全标准化似乎是板上钉钉的事了。但是一个不太可能的英雄出现在开源反叛组织中。戴着眼镜,温文尔雅的<ruby>林纳斯·托瓦兹<rt>Linus Torvalds</rt></ruby>免费发布了他的 Linux® 程序。微软打了个趔趄,并且开始重整旗鼓而来,战场从个人电脑转向互联网。

|

||||

|

||||

**Saron Yitbarek:** 这玩意开着的吗?让我们进一段史诗般的星球大战的开幕吧,开始了。

|

||||

|

||||

配音:第二集:Linux® 的崛起。微软帝国控制着 90% 的桌面用户。操作系统的全面标准化似乎是板上钉钉的事了。然而,互联网的出现将战争的焦点从桌面转向了企业,在该领域,所有商业组织都争相构建自己的服务器。*[00:00:30]*与此同时,一个不太可能的英雄出现在开源反叛组织中。固执、戴着眼镜的 <ruby>林纳斯·托瓦兹<rt>Linus Torvalds</rt></ruby>免费发布了他的 Linux 系统。微软打了个趔趄,并且开始重整旗鼓而来。

|

||||

|

||||

**Saron Yitbarek:** 哦,我们书呆子就是喜欢那样。上一次我们讲到哪了?苹果和微软互相攻伐,试图在一场争夺桌面用户的战争中占据主导地位。*[00:01:00]* 在第一集的结尾,我们看到微软获得了大部分的市场份额。很快,由于互联网的兴起以及随之而来的开发者大军,整个市场都经历了一场地震。互联网将战场从在家庭和办公室中的个人电脑用户转移到拥有数百台服务器的大型商业客户中。

|

||||

|

||||

这意味着巨量资源的迁移。突然间,所有相关企业不仅被迫为服务器空间和网站建设付费,而且还必须集成软件来进行资源跟踪和数据库监控等工作。*[00:01:30]* 你需要很多开发人员来帮助你。至少那时候大家都是这么做的。

|

||||

|

||||

在操作系统之战的第二部分,我们将看到优先级的巨大转变,以及像林纳斯·托瓦兹和<ruby>理查德·斯托尔曼<rt>Richard Stallman</rt></ruby>这样的开源反逆者是如何成功地在微软和整个软件行业的核心地带引发恐惧的。

|

||||

|

||||

我是 Saron Yitbarek,你现在收听的是代码英雄,一款红帽公司原创的播客节目。*[00:02:00]* 每一集,我们都会给你带来“从码开始”改变技术的人的故事。

|

||||

|

||||

好。想象一下你是 1991 年时的微软。你自我感觉良好,对吧?满怀信心。确立了全球主导的地位感觉不错。你已经掌握了与其他企业合作的艺术,但是仍然将大部分开发人员、程序员和系统管理员排除在联盟之外,而他们才是真正的步兵。*[00:02:30]* 这时出现了个叫林纳斯·托瓦兹的芬兰极客。他和他的开源程序员团队正在开始发布 Linux,这个操作系统内核是由他们一起编写出来的。

|

||||

|

||||

坦白地说,如果你是微软公司,你并不会太在意 Linux,甚至不太关心开源运动,但是最终,Linux 的规模变得如此之大,以至于微软不可能不注意到。*[00:03:00]* Linux 第一个版本出现在 1991 年,当时大概有 1 万行代码。十年后,变成了 300 万行代码。如果你想知道,今天则是 2000 万行代码。

|

||||

|

||||

*[00:03:30]* 让我们停留在 90 年代初一会儿。那时 Linux 还没有成为我们现在所知道的庞然大物。这个奇怪的病毒式的操作系统只是正在这个星球上蔓延,全世界的极客和黑客都爱上了它。那时候我还太年轻,但有点希望我曾经经历过那个时候。在那个时候,发现 Linux 就如同进入了一个秘密社团一样。就像其他人分享地下音乐混音带一样,程序员与朋友们分享 Linux CD 集。

|

||||

|

||||

开发者 Tristram Oaten *[00:03:40]* 讲讲你 16 岁时第一次接触 Linux 的故事吧。

|

||||

|

||||

**Tristram Oaten:** 我和我的家人去了红海的 Hurghada 潜水度假。那是一个美丽的地方,强烈推荐。第一天,我喝了自来水。也许,我妈妈跟我说过不要这么做。我整个星期都病得很厉害,没有离开旅馆房间。*[00:04:00]* 当时我只带了一台新安装了 Slackware Linux 的笔记本电脑,我听说过这玩意并且正在尝试使用它。所有的东西都在 8 张 cd 里面。这种情况下,我只能整个星期都去了解这个外星一般的系统。我阅读手册,摆弄着终端。我记得当时我甚至不知道一个点(表示当前目录)和两个点(表示前一个目录)之间的区别。

|

||||

|

||||

*[00:04:30]* 我一点头绪都没有。犯过很多错误,但慢慢地,在这种强迫的孤独中,我突破了障碍,开始理解并明白命令行到底是怎么回事。假期结束时,我没有看过金字塔、尼罗河等任何埃及遗址,但我解锁了现代世界的一个奇迹。我解锁了 Linux,接下来的事大家都知道了。

|

||||

|

||||

**Saron Yitbarek:** 你会从很多人那里听到关于这个故事的不同说法。访问 Linux 命令行是一种革命性的体验。

|

||||

|

||||

**David Cantrell:** *[00:05:00]* 它给了我源代码。我当时的感觉是,“太神奇了。”

|

||||

|

||||

**Saron Yitbarek:** 我们正在参加一个名为 Flock to Fedora 的 2017 年 Linux 开发者大会。

|

||||

|

||||

**David Cantrell:** ……非常有吸引力。我觉得我对这个系统有了更多的控制力,它越来越吸引我。我想,从 1995 年我第一次编译 Linux 内核那时起,我就迷上了它。

|

||||

|

||||

**Saron Yitbarek:** 开发者 David Cantrell 与 Joe Brockmire。

|

||||

|

||||

**Joe Brockmeier:** *[00:05:30]* 我在 Cheap Software 转的时候发现了一套四张 CD 的 Slackware Linux。它看起来来非常令人兴奋而且很有趣,所以我把它带回家,安装在第二台电脑上,开始摆弄它,有两件事情让我感到很兴奋:一个是,我运行的不是 Windows,另一个是 Linux 的开源特性。

|

||||

|

||||

**Saron Yitbarek:** *[00:06:00]* 某种程度上来说,对命令行的使用总是存在的。在开源真正开始流行还要早的几十年前,人们(至少在开发人员中是这样)总是希望能够做到完全控制。让我们回到操作系统大战之前的那个时代,在苹果和微软为他们的 GUI 而战之前。那时也有代码英雄。<ruby>保罗·琼斯<rt>Paul Jones</rt></ruby>教授(在线图书馆 ibiblio.org 的负责人)在那个古老的时代,就是一名开发人员。

|

||||

|

||||

**Paul Jones:** *[00:06:30]* 从本质上讲,互联网在那个时候客户端-服务器架构还是比较少的,而更多的是点对点架构的。确实,我们会说,某种 VAX 到 VAX 的连接(LCTT 译注:DEC 的一种操作系统),某种科学工作站到科学工作站的连接。这并不意味着没有客户端-服务端的架构及应用程序,但这的确意味着,最初的设计是思考如何实现点对点,*[00:07:00]* 它与 IBM 一直在做的东西相对立。IBM 给你的只有哑终端,这种终端只能让你管理用户界面,却无法让你像真正的终端一样为所欲为。

|

||||

|

||||

**Saron Yitbarek:** 图形用户界面在普通用户中普及的同时,在工程师和开发人员中总是存在着一股相反的力量。早在 Linux 出现之前的二十世纪七八十年代,这股力量就存在于 Emacs 和 GNU 中。有了斯托尔曼的自由软件基金会后,总有某些人想要使用命令行,但上世纪 90 年代的 Linux 提供了前所未有的东西。

|

||||

|

||||

*[00:07:30]* Linux 和其他开源软件的早期爱好者是都是先驱。我正站在他们的肩膀上。我们都是。

|

||||

|

||||

你现在收听的是代码英雄,一款由红帽公司原创的播客。这是操作系统大战的第二部分:Linux 崛起。

|

||||

|

||||

**Steven Vaughan-Nichols:** 1998 年的时候,情况发生了变化。

|

||||

|

||||

**Saron Yitbarek:** *[00:08:00]* Steven Vaughan-Nichols 是 zdnet.com 的特约编辑,他已经写了几十年关于技术商业方面的文章了。他将向我们讲述 Linux 是如何慢慢变得越来越流行,直到自愿贡献者的数量远远超过了在 Windows 上工作的微软开发人员的数量的。不过,Linux 从未真正追上微软桌面客户的数量,这也许就是微软最开始时忽略了 Linux 及其开发者的原因。Linux 真正大放光彩的地方是在服务器机房。当企业开始线上业务时,每个企业都需要一个满足其需求的独特编程解决方案。

|

||||

|

||||

*[00:08:30]* WindowsNT 于 1993 年问世,当时它已经在与其他的服务器操作系统展开竞争了,但是许多开发人员都在想,“既然我可以通过 Apache 构建出基于 Linux 的廉价系统,那我为什么要购买 AIX 设备或大型 Windows 设备呢?”关键点在于,Linux 代码已经开始渗透到几乎所有网上的东西中。

|

||||

|

||||

**Steven Vaughan-Nichols:** *[00:09:00]* 令微软感到惊讶的是,它开始意识到,Linux 实际上已经开始有一些商业应用,不是在桌面环境,而是在商业服务器上。因此,他们发起了一场运动,我们称之为 FUD - <ruby>恐惧、不确定和怀疑<rt>fear, uncertainty and double</rt></ruby>。他们说,“哦,Linux 这玩意,真的没有那么好。它不太可靠。你一点都不能相信它”。

|

||||

|

||||

**Saron Yitbarek:** 这种软宣传式的攻击持续了一段时间。微软也不是唯一一个对 Linux 感到紧张的公司。这其实是整个行业在对抗这个奇怪新人的挑战。*[00:09:30]* 例如,任何与 UNIX 有利害关系的人都可能将 Linux 视为篡夺者。有一个案例很著名,那就是 SCO 组织(它发行过一种 UNIX 版本)在过去 10 多年里发起一系列的诉讼,试图阻止 Linux 的传播。SCO 最终失败而且破产了。与此同时,微软一直在寻找机会,他们必须要采取动作,只是不清楚具体该怎么做。

|

||||

|

||||

**Steven Vaughan-Nichols:** *[00:10:00]* 让微软真正担心的是,第二年,在 2000 年的时候,IBM 宣布,他们将于 2001 年投资 10 亿美元在 Linux 上。现在,IBM 已经不再涉足个人电脑业务。(那时)他们还没有走出去,但他们正朝着这个方向前进,他们将 Linux 视为服务器和大型计算机的未来,在这一点上,剧透警告,IBM 是正确的。*[00:10:30]* Linux 将主宰服务器世界。

|

||||

|

||||

**Saron Yitbarek:** 这已经不再仅仅是一群黑客喜欢他们对命令行的绝地武士式的控制了。金钱的投入对 Linux 助力极大。<ruby>Linux 国际<rt>Linux International</rt></ruby>的执行董事 John “Mad Dog” Hall 有一个故事可以解释为什么会这样。我们通过电话与他取得了联系。

|

||||

|

||||

**John Hall:** *[00:11:00]* 我有一个名叫 Dirk Holden 的朋友,他是德国德意志银行的系统管理员,他也参与了个人电脑上早期 X Windows 系统图形项目的工作。有一天我去银行拜访他,我说:“Dirk,你银行里有 3000 台服务器,用的都是 Linux。为什么不用 Microsoft NT 呢?”*[00:11:30]* 他看着我说:“是的,我有 3000 台服务器,如果使用微软的 Windows NT 系统,我需要 2999 名系统管理员。”他继续说道:“而使用 Linux,我只需要四个。”这真是完美的答案。

|

||||

|

||||

**Saron Yitbarek:** 程序员们着迷的这些东西恰好对大公司也极具吸引力。但由于 FUD 的作用,一些企业对此持谨慎态度。*[00:12:00]* 他们听到开源,就想:“开源。这看起来不太可靠,很混乱,充满了 BUG”。但正如那位银行经理所指出的,金钱有一种有趣的方式,可以说服人们克服困境。甚至那些只需要网站的小公司也加入了 Linux 阵营。与一些昂贵的专有选择相比,使用一个廉价的 Linux 系统在成本上是无法比拟的。如果你是一家雇佣专业人员来构建网站的商店,那么你肯定想让他们使用 Linux。

|

||||

|

||||

让我们快进几年。Linux 运行每个人的网站上。Linux 已经征服了服务器世界,然后智能手机也随之诞生。*[00:12:30]* 当然,苹果和他们的 iPhone 占据了相当大的市场份额,而且微软也希望能进入这个市场,但令人惊讶的是,Linux 也在那,已经做好准备了,迫不及待要大展拳脚。

|

||||

|

||||

作家兼记者 James Allworth。

|

||||

|

||||

**James Allworth:** 肯定还有容纳第二个竞争者的空间,那本可以是微软,但是实际上却是 Android,而 Andrid 基本上是基于 Linux 的。众所周知,Android 被谷歌所收购,现在运行在世界上大部分的智能手机上,谷歌在 Linux 的基础上创建了 Android。*[00:13:00]* Linux 使他们能够以零成本从一个非常复杂的操作系统开始。他们成功地实现了这一目标,最终将微软挡在了下一代设备之外,至少从操作系统的角度来看是这样。

|

||||

|

||||

**Saron Yitbarek:** *[00:13:30]* 这可是个大地震,很大程度上,微软有被埋没的风险。John Gossman 是微软 Azure 团队的首席架构师。他还记得当时困扰公司的困惑。

|

||||

|

||||

**John Gossman:** 像许多公司一样,微软也非常担心知识产权污染。他们认为,如果允许开发人员使用开源代码,那么他们可能只是将一些代码复制并粘贴到某些产品中,就会让某种病毒式的许可证生效从而引发未知的风险……他们也很困惑,*[00:14:00]* 我认为,这跟公司文化有关,很多公司,包括微软,都对开源开发的意义和商业模式之间的分歧感到困惑。有一种观点认为,开源意味着你所有的软件都是免费的,人们永远不会付钱。

|

||||

|

||||

**Saron Yitbarek:** 任何投资于旧的、专有软件模型的人都会觉得这里发生的一切对他们构成了威胁。当你威胁到像微软这样的大公司时,是的,他们一定会做出反应。*[00:14:30]* 他们推动所有这些 FUD —— 恐惧、不确定性和怀疑是有道理的。当时,商业运作的方式基本上就是相互竞争。不过,如果是其他公司的话,他们可能还会一直怀恨在心,抱残守缺,但到了 2013 年的微软,一切都变了。

|

||||

|

||||

微软的云计算服务 Azure 上线了,令人震惊的是,它从第一天开始就提供了 Linux 虚拟机。*[00:15:00]* <ruby>史蒂夫·鲍尔默<rt>Steve Ballmer</rt></ruby>,这位把 Linux 称为癌症的首席执行官,已经离开了,代替他的是一位新的有远见的首席执行官<ruby>萨提亚·纳德拉<rt>Satya Nadella</rt></ruby>。

|

||||

|

||||

**John Gossman:** 萨提亚有不同的看法。他属于另一个世代。比保罗、比尔和史蒂夫更年轻的世代,他对开源有不同的看法。

|

||||

|

||||

**Saron Yitbarek:** 还是来自微软 Azure 团队的 John Gossman。

|

||||

|

||||

**John Gossman:** *[00:15:30]* 大约四年前,处于实际需要,我们在 Azure 中添加了 Linux 支持。如果访问任何一家企业客户,你都会发现他们并不会才试着决定是使用 Windows 还是使用 Linux、 使用 .net 还是使用 Java ^TM 。他们在很久以前就做出了决定 —— 大约 15 年前才有这样的一些争论。*[00:16:00]* 现在,我见过的每一家公司都混合了 Linux 和 Java、Windows 和 .net、SQL Server、Oracle 和 MySQL —— 基于专有源代码的产品和开放源代码的产品。

|

||||

|

||||

如果你打算运维一个云服务,允许这些公司在云上运行他们的业务,那么你根本不能告诉他们,“你可以使用这个软件,但你不能使用那个软件。”

|

||||

|

||||

**Saron Yitbarek:** *[00:16:30]* 这正是萨提亚·纳德拉采纳的哲学思想。2014 年秋季,他站在舞台上,希望传递一个重要信息。“微软爱 Linux”。他接着说,“20% 的 Azure 业务量已经是 Linux 了,微软将始终对 Linux 发行版提供一流的支持。”没有哪怕一丝对开源的宿怨。

|

||||

|

||||

为了说明这一点,在他们的背后有一个巨大的标志,上面写着:“Microsoft ❤️ Linux”。哇噢。对我们中的一些人来说,这种转变有点令人震惊,但实际上,无需如此震惊。下面是 Steven Levy,一名科技记者兼作家。

|

||||

|

||||

**Steven Levy:** *[00:17:00]* 当你在踢足球的时候,如果草坪变滑了,那么你也许会换一种不同的鞋子。他们当初就是这么做的。*[00:17:30]* 他们不能否认现实,而且他们里面也有聪明人,所以他们必须意识到,这就是这个世界的运行方式,不管他们早些时候说了什么,即使他们对之前的言论感到尴尬,但是让他们之前关于开源多么可怕的言论影响到现在明智的决策那才真的是疯了。

|

||||

|

||||

**Saron Yitbarek:** 微软低下了它高傲的头。你可能还记得苹果公司,经过多年的孤立无援,最终转向与微软构建合作伙伴关系。现在轮到微软进行 180 度转变了。*[00:18:00]* 经过多年的与开源方式的战斗后,他们正在重塑自己。要么改变,要么死亡。Steven Vaughan-Nichols。

|

||||

|

||||

**Steven Vaughan-Nichols:** 即使是像微软这样规模的公司也无法与数千个开发着包括 Linux 在内的其它大项目的开源开发者竞争。很长时间以来他们都不愿意这么做。前微软首席执行官史蒂夫·鲍尔默对 Linux 深恶痛绝。*[00:18:30]* 由于它的 GPL 许可证,他视 Linux 为一种癌症,但一旦鲍尔默被扫地出门,新的微软领导层说,“这就好像试图命令潮流不要过来,但潮水依然会不断涌进来。我们应该与 Linux 合作,而不是与之对抗。”

|

||||

|

||||

**Saron Tiebreak:** 事实上,互联网技术史上最大的胜利之一就是微软最终决定做出这样的转变。*[00:19:00]* 当然,当微软出现在开源圈子时,老一代的铁杆 Linux 支持者是相当怀疑的。他们不确定自己是否能接受这些家伙,但正如 Vaughan-Nichols 所指出的,今天的微软已经不是以前的微软了。

|

||||

|

||||

**Steven Vaughan-Nichols:** 2017 年的微软既不是史蒂夫·鲍尔默的微软,也不是比尔·盖茨的微软。这是一家完全不同的公司,有着完全不同的方法,而且,一旦使用了开源,你就无法退回到之前。*[00:19:30]* 开源已经吞噬了整个技术世界。从未听说过 Linux 的人可能对它并不了解,但是每次他们访问 Facebook,他们都在运行 Linux。每次执行谷歌搜索时,你都在运行 Linux。

|

||||

|

||||

*[00:20:00]* 每次你用 Android 手机,你都在运行 Linux。它确实无处不在,微软无法阻止它,而且我认为以为微软能以某种方式接管它的想法,太天真了。

|

||||

|

||||

**Saron Yitbarek:** 开源支持者可能一直担心微软会像混入羊群中的狼一样,但事实是,开源软件的本质保护了它无法被完全控制。*[00:20:30]* 没有一家公司能够拥有 Linux 并以某种特定的方式控制它。Greg Kroah-Hartman 是 Linux 基金会的一名成员。

|

||||

|

||||

**Greg Kroah-Hartman:** 每个公司和个人都以自私的方式为 Linux 做出贡献。他们之所以这样做是因为他们想要解决他们所面临的问题,可能是硬件无法工作,或者是他们想要添加一个新功能来做其他事情,又或者想在他们的产品中使用它。这很棒,因为他们会把代码贡献回去,此后每个人都会从中受益,这样每个人都可以用到这份代码。正是因为这种自私,所有的公司,所有的人都能从中受益。

|

||||

|

||||

**Saron Yitbarek:** *[00:21:00]* 微软已经意识到,在即将到来的云战争中,与 Linux 作战就像与空气作战一样。Linux 和开源不是敌人,它们是空气。如今,微软以白金会员的身份加入了 Linux 基金会。他们成为 GitHub 开源项目的头号贡献者。*[00:21:30]* 2017 年 9 月,他们甚至加入了<ruby>开源促进联盟<rt>Open Source Initiative</rt></ruby>。现在,微软在开源许可证下发布了很多代码。微软的 John Gossman 描述了他们开源 .net 时所发生的事情。起初,他们并不认为自己能得到什么回报。

|

||||

|

||||

**John Gossman:** 我们本没有指望来自社区的贡献,然而,三年后,超过 50% 的对 .net 框架库的贡献来自于微软之外。这包括大量的代码。*[00:22:00]* 三星为 .net 提供了 ARM 支持。Intel 和 ARM 以及其他一些芯片厂商已经为 .net 框架贡献了特定于他们处理器的代码生成,以及数量惊人的修复、性能改进等等 —— 既有单个贡献者也有社区。

|

||||

|

||||

**Saron Yitbarek:** 直到几年前,今天的这个微软,这个开放的微软,还是不可想象的。

|

||||

|

||||

*[00:22:30]* 我是 Saron Yitbarek,这里是代码英雄。好吧,我们已经看到了为了赢得数百万桌面用户的爱而战的激烈场面。我们已经看到开源软件在专有软件巨头的背后悄然崛起,并攫取了巨大的市场份额。*[00:23:00]* 我们已经看到了一批批的代码英雄将编程领域变成了我你今天看到的这个样子。如今,大企业正在吸收开源软件,通过这一切,每个人都从他人那里受益。

|

||||

|

||||

在技术的西部荒野,一贯如此。苹果受到施乐的启发,微软受到苹果的启发,Linux 受到 UNIX 的启发。进化、借鉴、不断成长。如果比喻成大卫和歌利亚(LCTT 译注:西方经典的以弱胜强战争中的两个主角)的话,开源软件不再是大卫,但是,你知道吗?它也不是歌利亚。*[00:23:30]* 开源已经超越了传统。它已经成为其他人战斗的战场。随着开源道路变得不可避免,新的战争,那些在云计算中进行的战争,那些在开源战场上进行的战争正在加剧。

|

||||

|

||||

这是 Steven Levy,他是一名作者。

|

||||

|

||||

**Steven Levy:** 基本上,到目前为止,包括微软在内,有四到五家公司,正以各种方式努力把自己打造成为全方位的平台,比如人工智能领域。你能看到智能助手之间的战争,你猜怎么着?*[00:24:00]* 苹果有一个智能助手,叫 Siri。微软有一个,叫 Cortana。谷歌有谷歌助手。三星也有一个智能助手。亚马逊也有一个,叫 Alexa。我们看到这些战斗遍布各地。也许,你可以说,最热门的人工智能平台将控制我们生活中所有的东西,而这五家公司就是在为此而争斗。

|

||||

|

||||

**Saron Yitbarek:** *[00:24:30]* 如果你正在寻找另一个反叛者,它们就像 Linux 奇袭微软那样,偷偷躲在 Facebook、谷歌或亚马逊身后,你也许要等很久,因为正如作家 James Allworth 所指出的,成为一个真正的反叛者只会变得越来越难。

|

||||

|

||||

**James Allworth:** 规模一直以来都是一种优势,但规模优势本质上……怎么说呢,我认为以前它们在本质上是线性的,现在它们在本质上是指数型的了,所以,一旦你开始以某种方法走在前面,另一个新玩家要想赶上来就变得越来越难了。*[00:25:00]* 我认为在互联网时代这大体来说来说是正确的,无论是因为规模,还是数据赋予组织的竞争力的重要性和优势。一旦你走在前面,你就会吸引更多的客户,这就给了你更多的数据,让你能做得更好,这之后,客户还有什么理由选择排名第二的公司呢,难道是因为因为他们落后了这么远么?*[00:25:30]* 我认为在云的时代这个逻辑也不会有什么不同。

|

||||

|

||||

**Saron Yitbarek:** 这个故事始于史蒂夫·乔布斯和比尔·盖茨这样的非凡的英雄,但科技的进步已经呈现出一种众包、有机的感觉。我认为据说我们的开源英雄林纳斯·托瓦兹在第一次发明 Linux 内核时甚至没有一个真正的计划。他无疑是一位才华横溢的年轻开发者,但他也像潮汐前的一滴水一样。*[00:26:00]* 变革是不可避免的。据估计,对于一家专有软件公司来说,用他们老式的、专有的方式创建一个 Linux 发行版将花费他们超过 100 亿美元。这说明了开源的力量。

|

||||

|

||||

最后,这并不是一个专有模型所能与之竞争的东西。成功的公司必须保持开放。这是最大、最终极的教训。*[00:26:30]* 还有一点要记住:当我们连接在一起的时候,我们在已有基础上成长和建设的能力是无限的。不管这些公司有多大,我们都不必坐等他们给我们更好的东西。想想那些为了纯粹的创造乐趣而学习编码的新开发者,那些自己动手丰衣足食的人。

|

||||

|

||||

未来的优秀程序员无管来自何方,只要能够访问代码,他们就能构建下一个大项目。

|

||||

|

||||

*[00:27:00]* 以上就是我们关于操作系统战争的两个故事。这场战争塑造了我们的数字生活。争夺主导地位的斗争从桌面转移到了服务器机房,最终进入了云计算领域。过去的敌人难以置信地变成了盟友,众包的未来让一切都变得开放。*[00:27:30]* 听着,我知道,在这段历史之旅中,还有很多英雄我们没有提到,所以给我们写信吧。分享你的故事。[Redhat.com/commandlineheroes](https://www.redhat.com/commandlineheroes) 。我恭候佳音。

|

||||

|

||||

在本季剩下的时间里,我们将学习今天的英雄们在创造什么,以及他们要经历什么样的战斗才能将他们的创造变为现实。让我们从壮丽的编程一线回来看看更多的传奇故事吧。我们每两周放一集新的博客。几周后,我们将为你带来第三集:敏捷革命。

|

||||

|

||||

*[00:28:00]* 代码英雄是一款红帽公司原创的播客。要想免费自动获得新一集的代码英雄,请订阅我们的节目。只要在苹果播客、Spotify、谷歌 Play,或其他应用中搜索“Command Line Heroes”。然后点击“订阅”。这样你就会第一个知道什么时候有新剧集了。

|

||||

|

||||

我是 Saron Yitbarek。感谢收听。继续编码。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.redhat.com/en/command-line-heroes/season-1/os-wars-part-2-rise-of-linux

|

||||

|

||||

作者:[redhat][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[lujun9972](https://github.com/lujun9972)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://www.redhat.com

|

||||

[b]: https://github.com/lujun9972

|

||||

@ -0,0 +1,75 @@

|

||||

使用 Ledger 记录(财务)情况

|

||||

======

|

||||

|

||||

自 2005 年搬到加拿大以来,我使用 [Ledger CLI][1] 来跟踪我的财务状况。我喜欢纯文本的方式,它支持虚拟信封意味着我可以同时将我的银行帐户余额和我的虚拟分配到不同的目录下。以下是我们如何使用这些虚拟信封分别管理我们的财务状况。

|

||||

|

||||

每个月,我都有一个条目将我生活开支分配到不同的目录中,包括家庭开支的分配。W- 不要求太多, 所以我要谨慎地处理这两者之间的差别和我自己的生活费用。我们处理它的方式是我支付固定金额,这是贷记我支付的杂货。由于我们的杂货总额通常低于我预算的家庭开支,因此任何差异都会留在标签上。我过去常常给他写支票,但最近我只是支付偶尔额外的大笔费用。

|

||||

|

||||

这是个示例信封分配:

|

||||

|

||||

```

|

||||

2014.10.01 * Budget

|

||||

[Envelopes:Living]

|

||||

[Envelopes:Household] $500

|

||||

;; More lines go here

|

||||

```

|

||||

|

||||

这是设置的信封规则之一。它鼓励我正确地分类支出。所有支出都从我的 “Play” 信封中取出。

|

||||

|

||||

```

|

||||

= /^Expenses/

|

||||

(Envelopes:Play) -1.0

|

||||

```

|

||||

|

||||

这个为家庭支出报销 “Play” 信封,将金额从 “Household” 信封转移到 “Play” 信封。

|

||||

|

||||

```

|

||||

= /^Expenses:House$/

|

||||

(Envelopes:Play) 1.0

|

||||

(Envelopes:Household) -1.0

|

||||

```

|

||||

|

||||

我有一套定期的支出来模拟我的预算中的家庭开支。例如,这是 10 月份的。

|

||||

|

||||

```

|

||||

2014.10.1 * House

|

||||

Expenses:House

|

||||

Assets:Household $-500

|

||||

```

|

||||

|

||||

这是杂货交易的形式:

|

||||

|

||||

```

|

||||

2014.09.28 * No Frills

|

||||

Assets:Household:Groceries $70.45

|

||||

Liabilities:MBNA:September $-70.45

|

||||

|

||||

```

|

||||

|

||||

接着 `ledger bal Assets:Household` 就会告诉我是否欠他钱(负余额)。如果我支付大笔费用(例如:机票、通管道),那么正常家庭开支预算会逐渐减少余额。

|

||||

|

||||

我从 W- 那找到了一个为我的信用卡交易添加一个月标签的技巧,他还使用 Ledger 跟踪他的交易。它允许我再次检查条目的余额,看看前一个条目是否已被正确清除。

|

||||

|

||||

这个资产分类使用有点奇怪,但它在精神上对我有用。

|

||||

|

||||

使用 Ledger 以这种方式跟踪它可以让我跟踪我们的杂货费用以及我实际支付费用和我预算费用之间的差额。如果我最终支出超出预期,我可以从更多可自由支配的信封中移动虚拟货币,因此我的预算始终保持平衡。

|

||||

|

||||

Ledger 是一个强大的工具。相当极客,但也许更多的工作流描述可能会帮助那些正在搞清楚它的人!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://sachachua.com/blog/2014/11/keeping-financial-score-ledger/

|

||||

|

||||

作者:[Sacha Chua][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://sachachua.com

|

||||

[1]:http://www.ledger-cli.org/

|

||||

[2]:http://sachachua.com/blog/category/finance/

|

||||

[3]:http://sachachua.com/blog/tag/ledger/

|

||||

[4]:http://pages.sachachua.com/sharing/blog.html?url=http://sachachua.com/blog/2014/11/keeping-financial-score-ledger/

|

||||

[5]:http://sachachua.com/blog/2014/11/keeping-financial-score-ledger/#comments

|

||||

@ -1,49 +1,45 @@

|

||||

使用 Ftrace 跟踪内核

|

||||

使用 ftrace 跟踪内核

|

||||

============================================================

|

||||

|

||||

标签: [ftrace][8],[kernel][9],[kernel profiling][10],[kernel tracing][11],[linux][12],[tracepoints][13]

|

||||

|

||||

|

||||

|

||||

在内核级别上分析事件有很多的工具:[SystemTap][14],[ktap][15],[Sysdig][16],[LTTNG][17]等等,并且你也可以在网络上找到关于这些工具的大量介绍文章和资料。

|

||||

在内核层面上分析事件有很多的工具:[SystemTap][14]、[ktap][15]、[Sysdig][16]、[LTTNG][17] 等等,你也可以在网络上找到关于这些工具的大量介绍文章和资料。

|

||||

|

||||

而对于使用 Linux 原生机制去跟踪系统事件以及检索/分析故障信息的方面的资料却很少找的到。这就是 [ftrace][18],它是添加到内核中的第一款跟踪工具,今天我们来看一下它都能做什么,让我们从它的一些重要术语开始吧。

|

||||

|

||||

### 内核跟踪和分析

|

||||

|

||||

内核分析可以发现性能“瓶颈”。分析能够帮我们发现在一个程序中性能损失的准确位置。特定的程序生成一个概述 — 一个事件的总结 — 它能够用于帮我们找出哪个函数占用了大量的运行时间。尽管这些程序并不能识别出为什么会损失性能。

|

||||

<ruby>内核分析<rt>Kernel profiling</rt></ruby>可以发现性能“瓶颈”。分析能够帮我们发现在一个程序中性能损失的准确位置。特定的程序生成一个<ruby>概述<rt>profile</rt></ruby> — 这是一个事件总结 — 它能够用于帮我们找出哪个函数占用了大量的运行时间。尽管这些程序并不能识别出为什么会损失性能。

|

||||

|

||||

瓶颈经常发生在无法通过分析来识别的情况下。去推断出为什么会发生事件,去保存发生事件时的相关上下文,这就需要去跟踪。

|

||||

瓶颈经常发生在无法通过分析来识别的情况下。要推断出为什么会发生事件,就必须保存发生事件时的相关上下文,这就需要去<ruby>跟踪<rt>tracing</rt></ruby>。

|

||||

|

||||

跟踪可以理解为在一个正常工作的系统上活动的信息收集进程。它使用特定的工具来完成这项工作,就像录音机来记录声音一样,用它来记录各种注册的系统事件。

|

||||

跟踪可以理解为在一个正常工作的系统上活动的信息收集过程。它使用特定的工具来完成这项工作,就像录音机来记录声音一样,用它来记录各种系统事件。

|

||||

|

||||

跟踪程序能够同时跟踪应用级和操作系统级的事件。它们收集的信息能够用于诊断多种系统问题。

|

||||

|

||||

有时候会将跟踪与日志比较。它们两者确时很相似,但是也有不同的地方。

|

||||

|

||||

对于跟踪,记录的信息都是些低级别事件。它们的数量是成百上千的,甚至是成千上万的。对于日志,记录的信息都是些高级别事件,数量上通常少多了。这些包含用户登陆系统、应用程序错误、数据库事务等等。

|

||||

对于跟踪,记录的信息都是些低级别事件。它们的数量是成百上千的,甚至是成千上万的。对于日志,记录的信息都是些高级别事件,数量上通常少多了。这些包含用户登录系统、应用程序错误、数据库事务等等。

|

||||

|

||||

就像日志一样,跟踪数据可以被原样读取,但是用特定的应用程序提取的信息更有用。所有的跟踪程序都能这样做。

|

||||

|

||||

在内核跟踪和分析方面,Linux 内核有三个主要的机制:

|

||||

|

||||

* 跟踪点 —— 一种基于静态测试代码的工作机制

|

||||

|

||||

* 探针 —— 一种动态跟踪机制,用于在任意时刻中断内核代码的运行,调用它自己的处理程序,在完成需要的操作之后再返回。

|

||||

|

||||

* perf_events —— 一个访问 PMU(性能监视单元)的接口

|

||||

* <ruby>跟踪点<rt>tracepoint</rt></ruby>:一种基于静态测试代码的工作机制

|

||||

* <ruby>探针<rt>kprobe</rt></ruby>:一种动态跟踪机制,用于在任意时刻中断内核代码的运行,调用它自己的处理程序,在完成需要的操作之后再返回

|

||||

* perf_events —— 一个访问 PMU(<ruby>性能监视单元<rt>Performance Monitoring Unit</rt></ruby>)的接口

|

||||

|

||||

我并不想在这里写关于这些机制方面的内容,任何对它们感兴趣的人可以去访问 [Brendan Gregg 的博客][19]。

|

||||

|

||||

使用 ftrace,我们可以与这些机制进行交互,并可以从用户空间直接得到调试信息。下面我们将讨论这方面的详细内容。示例中的所有命令行都是在内核版本为 3.13.0-24 的 Ubuntu 14.04 中运行的。

|

||||

|

||||

### Ftrace:常用信息

|

||||

### ftrace:常用信息

|

||||

|

||||

Ftrace 是函数 Trace 的简写,但它能做的远不止这些:它可以跟踪上下文切换、测量进程阻塞时间、计算高优先级任务的活动时间等等。

|

||||

ftrace 是 Function Trace 的简写,但它能做的远不止这些:它可以跟踪上下文切换、测量进程阻塞时间、计算高优先级任务的活动时间等等。

|

||||

|

||||

Ftrace 是由 Steven Rostedt 开发的,从 2008 年发布的内核 2.6.27 中开始就内置了。这是为记录数据提供的一个调试 `Ring` 缓冲区的框架。这些数据由集成到内核中的跟踪程序来采集。

|

||||

ftrace 是由 Steven Rostedt 开发的,从 2008 年发布的内核 2.6.27 中开始就内置了。这是为记录数据提供的一个调试 Ring 缓冲区的框架。这些数据由集成到内核中的跟踪程序来采集。

|

||||

|

||||

Ftrace 工作在 debugfs 文件系统上,这是在大多数现代 Linux 分发版中默认挂载的文件系统。为开始使用 ftrace,你将进入到 `sys/kernel/debug/tracing` 目录(仅对 root 用户可用):

|

||||

ftrace 工作在 debugfs 文件系统上,在大多数现代 Linux 发行版中都默认挂载了。要开始使用 ftrace,你将进入到 `sys/kernel/debug/tracing` 目录(仅对 root 用户可用):

|

||||

|

||||

```

|

||||

# cd /sys/kernel/debug/tracing

|

||||

@ -70,16 +66,13 @@ kprobe_profile stack_max_size uprobe_profile

|

||||

我不想去描述这些文件和子目录;它们的描述在 [官方文档][20] 中已经写的很详细了。我只想去详细介绍与我们这篇文章相关的这几个文件:

|

||||

|

||||

* available_tracers —— 可用的跟踪程序

|

||||

|

||||

* current_tracer —— 正在运行的跟踪程序

|

||||

|

||||

* tracing_on —— 负责启用或禁用数据写入到 `Ring` 缓冲区的系统文件(如果启用它,在文件中添加数字 1,禁用它,添加数字 0)

|

||||

|

||||

* tracing_on —— 负责启用或禁用数据写入到 Ring 缓冲区的系统文件(如果启用它,数字 1 被添加到文件中,禁用它,数字 0 被添加)

|

||||

* trace —— 以人类友好格式保存跟踪数据的文件

|

||||

|

||||

### 可用的跟踪程序

|

||||

|

||||

我们可以使用如下的命令去查看可用的跟踪程序的一个列表

|

||||

我们可以使用如下的命令去查看可用的跟踪程序的一个列表:

|

||||

|

||||

```

|

||||

root@andrei:/sys/kernel/debug/tracing#: cat available_tracers

|

||||

@ -89,18 +82,14 @@ blk mmiotrace function_graph wakeup_rt wakeup function nop

|

||||

我们来快速浏览一下每个跟踪程序的特性:

|

||||

|

||||

* function —— 一个无需参数的函数调用跟踪程序

|

||||

|

||||

* function_graph —— 一个使用子调用的函数调用跟踪程序

|

||||

|

||||

* blk —— 一个与块 I/O 跟踪相关的调用和事件跟踪程序(它是 blktrace 的用途)

|

||||

|

||||

* blk —— 一个与块 I/O 跟踪相关的调用和事件跟踪程序(它是 blktrace 使用的)

|

||||

* mmiotrace —— 一个内存映射 I/O 操作跟踪程序

|

||||

|

||||

* nop —— 简化的跟踪程序,就像它的名字所暗示的那样,它不做任何事情(尽管在某些情况下可能会派上用场,我们将在后文中详细解释)

|

||||

* nop —— 最简单的跟踪程序,就像它的名字所暗示的那样,它不做任何事情(尽管在某些情况下可能会派上用场,我们将在后文中详细解释)

|

||||

|

||||

### 函数跟踪程序

|

||||

|

||||

在开始介绍函数跟踪程序 ftrace 之前,我们先看一下测试脚本:

|

||||

在开始介绍函数跟踪程序 ftrace 之前,我们先看一个测试脚本:

|

||||

|

||||

```

|

||||

#!/bin/sh

|

||||

@ -117,7 +106,7 @@ less ${dir}/trace

|

||||

|

||||

这个脚本是非常简单的,但是还有几个需要注意的地方。命令 `sysctl ftrace.enabled=1` 启用了函数跟踪程序。然后我们通过写它的名字到 `current_tracer` 文件来启用 `current tracer`。

|

||||

|

||||

接下来,我们写入一个 `1` 到 `tracing_on`,它启用了 `Ring` 缓冲区。这些语法都要求在 `1` 和 `>` 符号前后有一个空格;写成像 `echo1> tracing_on` 这样将不能工作。一行之后我们禁用它(如果 `0` 写入到 `tracing_on`, 缓冲区不会被清除并且 ftrace 并不会被禁用)。

|

||||

接下来,我们写入一个 `1` 到 `tracing_on`,它启用了 Ring 缓冲区。这些语法都要求在 `1` 和 `>` 符号前后有一个空格;写成像 `echo 1> tracing_on` 这样将不能工作。一行之后我们禁用它(如果 `0` 写入到 `tracing_on`, 缓冲区不会被清除并且 ftrace 并不会被禁用)。

|

||||

|

||||

我们为什么这样做呢?在两个 `echo` 命令之间,我们看到了命令 `sleep 1`。我们启用了缓冲区,运行了这个命令,然后禁用它。这将使跟踪程序采集了这个命令运行期间发生的所有系统调用的信息。

|

||||

|

||||

@ -156,21 +145,18 @@ less ${dir}/trace

|

||||

trace.sh-1295 [000] d... 90.502879: __acct_update_integrals <-acct_account_cputime

|

||||

```

|

||||

|

||||

这个输出以缓冲区中的信息条目数量和写入的条目数量开始。这两者的数据差异是缓冲区中事件的丢失数量(在我们的示例中没有发生丢失)。

|

||||

这个输出以“缓冲区中的信息条目数量”和“写入的全部条目数量”开始。这两者的数据差异是缓冲区中事件的丢失数量(在我们的示例中没有发生丢失)。

|

||||

|

||||

在这里有一个包含下列信息的函数列表:

|

||||

|

||||

* 进程标识符(PID)

|

||||

|

||||

* 运行这个进程的 CPU(CPU#)

|

||||

|

||||

* 进程开始时间(TIMESTAMP)

|

||||

|

||||

* 被跟踪函数的名字以及调用它的父级函数;例如,在我们输出的第一行,`rb_simple_write` 调用了 `mutex-unlock` 函数。

|

||||

|

||||

### Function_graph 跟踪程序

|

||||

### function_graph 跟踪程序

|

||||

|

||||

`function_graph` 跟踪程序的工作和函数一样,但是它更详细:它显示了每个函数的进入和退出点。使用这个跟踪程序,我们可以跟踪函数的子调用并且测量每个函数的运行时间。

|

||||

function_graph 跟踪程序的工作和函数跟踪程序一样,但是它更详细:它显示了每个函数的进入和退出点。使用这个跟踪程序,我们可以跟踪函数的子调用并且测量每个函数的运行时间。

|

||||

|

||||

我们来编辑一下最后一个示例的脚本:

|

||||

|

||||

@ -215,11 +201,11 @@ less ${dir}/trace

|

||||

0) ! 208.154 us | } /* ip_local_deliver_finish */

|

||||

```

|

||||

|

||||

在这个图中,`DURATION` 展示了花费在每个运行的函数上的时间。注意使用 `+` 和 `!` 符号标记的地方。加号(+)意思是这个函数花费的时间超过 10 毫秒;而感叹号(!)意思是这个函数花费的时间超过了 100 毫秒。

|

||||

在这个图中,`DURATION` 展示了花费在每个运行的函数上的时间。注意使用 `+` 和 `!` 符号标记的地方。加号(`+`)意思是这个函数花费的时间超过 10 毫秒;而感叹号(`!`)意思是这个函数花费的时间超过了 100 毫秒。

|

||||

|

||||

在 `FUNCTION_CALLS` 下面,我们可以看到每个函数调用的信息。

|

||||

|

||||

和 C 语言一样使用了花括号({)标记每个函数的边界,它展示了每个函数的开始和结束,一个用于开始,一个用于结束;不能调用其它任何函数的叶子函数用一个分号(;)标记。

|

||||

和 C 语言一样使用了花括号(`{`)标记每个函数的边界,它展示了每个函数的开始和结束,一个用于开始,一个用于结束;不能调用其它任何函数的叶子函数用一个分号(`;`)标记。

|

||||

|

||||

### 函数过滤器

|

||||

|

||||

@ -249,13 +235,13 @@ ftrace 还有很多过滤选项。对于它们更详细的介绍,你可以去

|

||||

|

||||

### 跟踪事件

|

||||

|

||||

我们在上面提到到跟踪点机制。跟踪点是插入的由系统事件触发的特定代码。跟踪点可以是动态的(意味着可能会在它们上面附加几个检查),也可以是静态的(意味着不会附加任何检查)。

|

||||

我们在上面提到到跟踪点机制。跟踪点是插入的触发系统事件的特定代码。跟踪点可以是动态的(意味着可能会在它们上面附加几个检查),也可以是静态的(意味着不会附加任何检查)。

|

||||

|

||||

静态跟踪点不会对系统有任何影响;它们只是增加几个字节用于调用测试函数以及在一个独立的节上增加一个数据结构。

|

||||

静态跟踪点不会对系统有任何影响;它们只是在测试的函数末尾增加几个字节的函数调用以及在一个独立的节上增加一个数据结构。

|

||||

|

||||

当相关代码片断运行时,动态跟踪点调用一个跟踪函数。跟踪数据是写入到 `Ring` 缓冲区。

|

||||

当相关代码片断运行时,动态跟踪点调用一个跟踪函数。跟踪数据是写入到 Ring 缓冲区。

|

||||

|

||||

跟踪点可以设置在代码的任何位置;事实上,它们确实可以在许多的内核函数中找到。我们来看一下 `kmem_cache_alloc` 函数(它在 [这里][22]):

|

||||

跟踪点可以设置在代码的任何位置;事实上,它们确实可以在许多的内核函数中找到。我们来看一下 `kmem_cache_alloc` 函数(取自 [这里][22]):

|

||||

|

||||

```

|

||||

{

|

||||

@ -294,7 +280,7 @@ fs kvm power scsi vfs

|

||||

ftrace kvmmmu printk signal vmscan

|

||||

```

|

||||

|

||||

所有可能的事件都按子系统分组到子目录中。在我们开始跟踪事件之前,我们要先确保启用了 `Ring` 缓冲区写入:

|

||||

所有可能的事件都按子系统分组到子目录中。在我们开始跟踪事件之前,我们要先确保启用了 Ring 缓冲区写入:

|

||||

|

||||

```

|

||||

root@andrei:/sys/kernel/debug/tracing# cat tracing_on

|

||||

@ -306,25 +292,25 @@ root@andrei:/sys/kernel/debug/tracing# cat tracing_on

|

||||

root@andrei:/sys/kernel/debug/tracing# echo 1 > tracing_on

|

||||

```

|

||||

|

||||

在我们上一篇的文章中,我们写了关于 `chroot()` 系统调用的内容;我们来跟踪访问一下这个系统调用。为了跟踪,我们使用 `nop` 因为函数跟踪程序和 `function_graph` 跟踪程序记录的信息太多,它包含了我们不感兴趣的事件信息。

|

||||

在我们上一篇的文章中,我们写了关于 `chroot()` 系统调用的内容;我们来跟踪访问一下这个系统调用。对于我们的跟踪程序,我们使用 `nop` 因为函数跟踪程序和 `function_graph` 跟踪程序记录的信息太多,它包含了我们不感兴趣的事件信息。

|

||||

|

||||

```

|

||||

root@andrei:/sys/kernel/debug/tracing# echo nop > current_tracer

|

||||

```

|

||||

|

||||

所有事件相关的系统调用都保存在系统调用目录下。在这里我们将找到一个进入和退出多个系统调用的目录。我们需要在相关的文件中通过写入数字 `1` 来激活跟踪点:

|

||||

所有事件相关的系统调用都保存在系统调用目录下。在这里我们将找到一个进入和退出各种系统调用的目录。我们需要在相关的文件中通过写入数字 `1` 来激活跟踪点:

|

||||

|

||||

```

|

||||

root@andrei:/sys/kernel/debug/tracing# echo 1 > events/syscalls/sys_enter_chroot/enable

|

||||

```

|

||||

|

||||

然后我们使用 `chroot` 来创建一个独立的文件系统(更多内容,请查看 [这篇文章][23])。在我们执行完我们需要的命令之后,我们将禁用跟踪程序,以便于不需要的信息或者过量信息出现在输出中:

|

||||

然后我们使用 `chroot` 来创建一个独立的文件系统(更多内容,请查看 [之前这篇文章][23])。在我们执行完我们需要的命令之后,我们将禁用跟踪程序,以便于不需要的信息或者过量信息不会出现在输出中:

|

||||

|

||||

```

|

||||

root@andrei:/sys/kernel/debug/tracing# echo 0 > tracing_on

|

||||

```

|

||||

|

||||

然后,我们去查看 `Ring` 缓冲区的内容。在输出的结束部分,我们找到了有关的系统调用信息(这里只是一个节选)。

|

||||

然后,我们去查看 Ring 缓冲区的内容。在输出的结束部分,我们找到了有关的系统调用信息(这里只是一个节选)。

|

||||

|

||||

```

|

||||

root@andrei:/sys/kernel/debug/tracing# сat trace

|

||||

@ -343,15 +329,10 @@ root@andrei:/sys/kernel/debug/tracing# сat trace

|

||||

在这篇文篇中,我们做了一个 ftrace 的功能概述。我们非常感谢你的任何意见或者补充。如果你想深入研究这个主题,我们为你推荐下列的资源:

|

||||

|

||||

* [https://www.kernel.org/doc/Documentation/trace/tracepoints.txt][1] — 一个跟踪点机制的详细描述

|

||||

|

||||

* [https://www.kernel.org/doc/Documentation/trace/events.txt][2] — 在 Linux 中跟踪系统事件的指南

|

||||

|

||||

* [https://www.kernel.org/doc/Documentation/trace/ftrace.txt][3] — ftrace 的官方文档

|

||||

|

||||

* [https://lttng.org/files/thesis/desnoyers-dissertation-2009-12-v27.pdf][4] — Mathieu Desnoyers(作者是跟踪点和 LTTNG 的创建者)的关于内核跟踪和分析的学术论文。

|

||||

|

||||

* [https://lwn.net/Articles/370423/][5] — Steven Rostedt 的关于 ftrace 功能的文章

|

||||

|

||||

* [http://alex.dzyoba.com/linux/profiling-ftrace.html][6] — 用 ftrace 分析实际案例的一个概述

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

@ -360,7 +341,7 @@ via:https://blog.selectel.com/kernel-tracing-ftrace/

|

||||

|

||||

作者:[Andrej Yemelianov][a]

|

||||

译者:[qhwdw](https://github.com/qhwdw)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,129 @@

|

||||

Ubunsys:面向 Ubuntu 资深用户的一个高级系统配置工具

|

||||

======

|

||||

|

||||

|

||||

|

||||

|

||||

**Ubunsys** 是一个面向 Ubuntu 及其衍生版的基于 Qt 的高级系统工具。高级用户可以使用命令行轻松完成大多数配置。不过为了以防万一某天,你突然不想用命令行了,就可以用 Ubnusys 这个程序来配置你的系统或其衍生系统,如 Linux Mint、Elementary OS 等。Ubunsys 可用来修改系统配置,安装、删除、更新包和旧内核,启用或禁用 `sudo` 权限,安装主线内核,更新软件安装源,清理垃圾文件,将你的 Ubuntu 系统升级到最新版本等等。以上提到的所有功能都可以通过鼠标点击完成。你不需要再依赖于命令行模式,下面是你能用 Ubunsys 做到的事:

|

||||

|

||||

* 安装、删除、更新包

|

||||

* 更新和升级软件源

|

||||

* 安装主线内核

|

||||

* 删除旧的和不再使用的内核

|

||||

* 系统整体更新

|

||||

* 将系统升级到下一个可用的版本

|

||||

* 将系统升级到最新的开发版本

|

||||

* 清理系统垃圾文件

|

||||

* 在不输入密码的情况下启用或者禁用 `sudo` 权限

|

||||

* 当你在终端输入密码时使 `sudo` 密码可见

|

||||

* 启用或禁用系统休眠

|

||||

* 启用或禁用防火墙

|

||||

* 打开、备份和导入 `sources.list.d` 和 `sudoers` 文件

|

||||

* 显示或者隐藏启动项

|

||||

* 启用或禁用登录音效

|

||||

* 配置双启动

|

||||

* 启用或禁用锁屏

|

||||

* 智能系统更新

|

||||

* 使用脚本管理器更新/一次性执行脚本

|

||||

* 从 `git` 执行常规用户安装脚本

|

||||

* 检查系统完整性和缺失的 GPG 密钥

|

||||

* 修复网络

|

||||

* 修复已破损的包

|

||||

* 还有更多功能在开发中

|

||||

|

||||

**重要提示:** Ubunsys 不适用于 Ubuntu 新手。它很危险并且仍然不是稳定版。它可能会使你的系统崩溃。如果你刚接触 Ubuntu 不久,不要使用。但如果你真的很好奇这个应用能做什么,仔细浏览每一个选项,并确定自己能承担风险。在使用这一应用之前记着备份你自己的重要数据。

|

||||

|

||||

### 安装 Ubunsys

|

||||

|

||||

Ubunsys 开发者制作了一个 PPA 来简化安装过程,Ubunsys 现在可以在 Ubuntu 16.04 LTS、 Ubuntu 17.04 64 位版本上使用。

|

||||

|

||||

逐条执行下面的命令,将 Ubunsys 的 PPA 添加进去,并安装它。

|

||||

|

||||

```

|

||||

sudo add-apt-repository ppa:adgellida/ubunsys

|

||||

sudo apt-get update

|

||||

sudo apt-get install ubunsys

|

||||

```

|

||||

|

||||

如果 PPA 无法使用,你可以在[发布页面][1]根据你自己当前系统,选择正确的安装包,直接下载并安装 Ubunsys。

|

||||

|

||||

### 用途

|

||||

|

||||

一旦安装完成,从菜单栏启动 Ubunsys。下图是 Ubunsys 主界面。

|

||||

|

||||

![][3]

|

||||

|

||||

你可以看到,Ubunsys 有四个主要部分,分别是 Packages、Tweaks、System 和 Repair。在每一个标签项下面都有一个或多个子标签项以对应不同的操作。

|

||||

|

||||

**Packages**

|

||||

|

||||

这一部分允许你安装、删除和更新包。

|

||||

|

||||

![][4]

|

||||

|

||||

**Tweaks**

|

||||

|

||||

在这一部分,我们可以对系统进行多种调整,例如:

|

||||

|

||||

* 打开、备份和导入 `sources.list.d` 和 `sudoers` 文件;

|

||||

* 配置双启动;

|

||||

* 启用或禁用登录音效、防火墙、锁屏、系统休眠、`sudo` 权限(在不需要密码的情况下)同时你还可以针对某一用户启用或禁用 `sudo` 权限(在不需要密码的情况下);

|

||||

* 在终端中输入密码时可见(禁用星号)。

|

||||

|

||||

![][5]

|

||||

|

||||

**System**

|

||||

|

||||

这一部分被进一步分成 3 个部分,每个都是针对某一特定用户类型。

|

||||

|

||||

**Normal user** 这一标签下的选项可以:

|

||||

|

||||

* 更新、升级包和软件源

|

||||

* 清理系统

|

||||

* 执行常规用户安装脚本

|

||||

|

||||

**Advanced user** 这一标签下的选项可以:

|

||||

|

||||

* 清理旧的/无用的内核

|

||||

* 安装主线内核

|

||||

* 智能包更新

|

||||

* 升级系统

|

||||

|

||||

**Developer** 这一部分可以将系统升级到最新的开发版本。

|

||||

|

||||

![][6]

|

||||

|

||||

**Repair**

|

||||

|

||||

这是 Ubunsys 的第四个也是最后一个部分。正如名字所示,这一部分能让我们修复我们的系统、网络、缺失的 GPG 密钥,和已经缺失的包。

|

||||

|

||||

![][7]

|

||||

|

||||

正如你所见,Ubunsys 可以在几次点击下就能完成诸如系统配置、系统维护和软件维护之类的任务。你不需要一直依赖于终端。Ubunsys 能帮你完成任何高级任务。再次声明,我警告你,这个应用不适合新手,而且它并不稳定。所以当你使用的时候,能会出现 bug 或者系统崩溃。在仔细研究过每一个选项的影响之后再使用它。

|

||||

|

||||

谢谢阅读!

|

||||

|

||||

### 参考资源

|

||||

|

||||

- [Ubunsys GitHub Repository][8]

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.ostechnix.com/ubunsys-advanced-system-configuration-utility-ubuntu-power-users/

|

||||

|

||||

作者:[SK][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[wenwensnow](https://github.com/wenwensnow)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.ostechnix.com/author/sk/

|

||||

[1]:https://github.com/adgellida/ubunsys/releases

|

||||

[2]:data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7

|

||||

[3]:http://www.ostechnix.com/wp-content/uploads/2017/08/Ubunsys-1.png

|

||||

[4]:http://www.ostechnix.com/wp-content/uploads/2017/08/Ubunsys-2.png

|

||||

[5]:http://www.ostechnix.com/wp-content/uploads/2017/08/Ubunsys-5.png

|

||||

[6]:http://www.ostechnix.com/wp-content/uploads/2017/08/Ubunsys-9.png

|

||||

[7]:http://www.ostechnix.com/wp-content/uploads/2017/08/Ubunsys-11.png

|

||||

[8]:https://github.com/adgellida/ubunsys

|

||||

@ -0,0 +1,183 @@

|

||||

Streams:一个新的 Redis 通用数据结构

|

||||

======

|

||||

|

||||

直到几个月以前,对于我来说,在消息传递的环境中,<ruby>流<rt>streams</rt></ruby>只是一个有趣且相对简单的概念。这个概念在 Kafka 流行之后,我主要研究它们在 Disque 案例中的应用,Disque 是一个消息队列,它将在 Redis 4.2 中被转换为 Redis 的一个模块。后来我决定让 Disque 都用 AP 消息(LCTT 译注:参见 [CAP 定理][1]) ,也就是说,它将在不需要客户端过多参与的情况下实现容错和可用性,这样一来,我更加确定地认为流的概念在那种情况下并不适用。

|

||||

|

||||

然而在那时 Redis 有个问题,那就是缺省情况下导出数据结构并不轻松。它在 Redis <ruby>列表<rt>list</rt></ruby>、<ruby>有序集<rt>sorted list</rt></ruby>、<ruby>发布/订阅<rt>Pub/Sub</rt></ruby>功能之间有某些缺陷。你可以权衡使用这些工具对一系列消息或事件建模。

|

||||

|

||||

有序集是内存消耗大户,那自然就不能对投递的相同消息进行一次又一次的建模,客户端不能阻塞新消息。因为有序集并不是一个序列化的数据结构,它是一个元素可以根据它们量的变化而移动的集合:所以它不像时序性的数据那样。

|

||||

|

||||

列表有另外的问题,它在某些特定的用例中会产生类似的适用性问题:你无法浏览列表中间的内容,因为在那种情况下,访问时间是线性的。此外,没有任何指定输出的功能,列表上的阻塞操作仅为单个客户端提供单个元素。列表中没有固定的元素标识,也就是说,不能指定从哪个元素开始给我提供内容。

|

||||

|

||||

对于一对多的工作任务,有发布/订阅机制,它在大多数情况下是非常好的,但是,对于某些不想<ruby>“即发即弃”<rt>fire-and-forget</rt></ruby>的东西:保留一个历史是很重要的,不只是因为是断开之后会重新获得消息,也因为某些如时序性的消息列表,用范围查询浏览是非常重要的:比如在这 10 秒范围内温度读数是多少?

|

||||

|

||||

我试图解决上述问题,我想规划一个通用的有序集合,并列入一个独特的、更灵活的数据结构,然而,我的设计尝试最终以生成一个比当前的数据结构更加矫揉造作的结果而告终。Redis 有个好处,它的数据结构导出更像自然的计算机科学的数据结构,而不是 “Salvatore 发明的 API”。因此,我最终停止了我的尝试,并且说,“ok,这是我们目前能提供的”,或许我会为发布/订阅增加一些历史信息,或者为列表访问增加一些更灵活的方式。然而,每次在会议上有用户对我说 “你如何在 Redis 中模拟时间系列” 或者类似的问题时,我的脸就绿了。

|

||||

|

||||

### 起源

|

||||

|

||||

在 Redis 4.0 中引入模块之后,用户开始考虑他们自己怎么去修复这些问题。其中一个用户 Timothy Downs 通过 IRC 和我说道:

|

||||

|

||||

\<forkfork> 我计划给这个模块增加一个事务日志式的数据类型 —— 这意味着大量的订阅者可以在不导致 redis 内存激增的情况下做一些像发布/订阅那样的事情

|

||||

\<forkfork> 订阅者持有他们在消息队列中的位置,而不是让 Redis 必须维护每个消费者的位置和为每个订阅者复制消息

|

||||

|

||||

他的思路启发了我。我想了几天,并且意识到这可能是我们马上同时解决上面所有问题的契机。我需要去重新构思 “日志” 的概念是什么。日志是个基本的编程元素,每个人都使用过它,因为它只是简单地以追加模式打开一个文件,并以一定的格式写入数据。然而 Redis 数据结构必须是抽象的。它们在内存中,并且我们使用内存并不是因为我们懒,而是因为使用一些指针,我们可以概念化数据结构并把它们抽象,以使它们摆脱明确的限制。例如,一般来说日志有几个问题:偏移不是逻辑化的,而是真实的字节偏移,如果你想要与条目插入的时间相关的逻辑偏移应该怎么办?我们有范围查询可用。同样,日志通常很难进行垃圾回收:在一个只能进行追加操作的数据结构中怎么去删除旧的元素?好吧,在我们理想的日志中,我们只需要说,我想要数字最大的那个条目,而旧的元素一个也不要,等等。

|

||||

|

||||

当我从 Timothy 的想法中受到启发,去尝试着写一个规范的时候,我使用了 Redis 集群中的 radix 树去实现,优化了它内部的某些部分。这为实现一个有效利用空间的日志提供了基础,而且仍然有可能在<ruby>对数时间<rt>logarithmic time</rt></ruby>内访问范围。同时,我开始去读关于 Kafka 的流相关的内容以获得另外的灵感,它也非常适合我的设计,最后借鉴了 Kafka <ruby>消费组<rt>consumer groups</rt></ruby>的概念,并且再次针对 Redis 进行优化,以适用于 Redis 在内存中使用的情况。然而,该规范仅停留在纸面上,在一段时间后我几乎把它从头到尾重写了一遍,以便将我与别人讨论的所得到的许多建议一起增加到 Redis 升级中。我希望 Redis 流能成为对于时间序列有用的特性,而不仅是一个常见的事件和消息类的应用程序。

|

||||

|

||||

### 让我们写一些代码吧

|

||||

|

||||

从 Redis 大会回来后,整个夏天我都在实现一个叫 listpack 的库。这个库是 `ziplist.c` 的继任者,那是一个表示在单个分配中的字符串元素列表的数据结构。它是一个非常特殊的序列化格式,其特点在于也能够以逆序(从右到左)解析:以便在各种用例中替代 ziplists。

|

||||

|

||||

结合 radix 树和 listpacks 的特性,它可以很容易地去构建一个空间高效的日志,并且还是可索引的,这意味着允许通过 ID 和时间进行随机访问。自从这些就绪后,我开始去写一些代码以实现流数据结构。我还在完成这个实现,不管怎样,现在在 Github 上的 Redis 的 streams 分支里它已经可以跑起来了。我并没有声称那个 API 是 100% 的最终版本,但是,这有两个有意思的事实:一,在那时只有消费群组是缺失的,加上一些不太重要的操作流的命令,但是,所有的大的方面都已经实现了。二,一旦各个方面比较稳定了之后,我决定大概用两个月的时间将所有的流的特性<ruby>向后移植<rt>backport</rt></ruby>到 4.0 分支。这意味着 Redis 用户想要使用流,不用等待 Redis 4.2 发布,它们在生产环境马上就可用了。这是可能的,因为作为一个新的数据结构,几乎所有的代码改变都出现在新的代码里面。除了阻塞列表操作之外:该代码被重构了,我们对于流和列表阻塞操作共享了相同的代码,而极大地简化了 Redis 内部实现。

|

||||

|

||||

### 教程:欢迎使用 Redis 的 streams

|

||||

|

||||

在某些方面,你可以认为流是 Redis 列表的一个增强版本。流元素不再是一个单一的字符串,而是一个<ruby>字段<rt>field</rt></ruby>和<ruby>值<rt>value</rt></ruby>组成的对象。范围查询更适用而且更快。在流中,每个条目都有一个 ID,它是一个逻辑偏移量。不同的客户端可以<ruby>阻塞等待<rt>blocking-wait</rt></ruby>比指定的 ID 更大的元素。Redis 流的一个基本的命令是 `XADD`。是的,所有的 Redis 流命令都是以一个 `X` 为前缀的。

|

||||

|

||||

```

|

||||

> XADD mystream * sensor-id 1234 temperature 10.5

|

||||

1506871964177.0

|

||||

```

|

||||

|

||||

这个 `XADD` 命令将追加指定的条目作为一个指定的流 —— “mystream” 的新元素。上面示例中的这个条目有两个字段:`sensor-id` 和 `temperature`,每个条目在同一个流中可以有不同的字段。使用相同的字段名可以更好地利用内存。有意思的是,字段的排序是可以保证顺序的。`XADD` 仅返回插入的条目的 ID,因为在第三个参数中是星号(`*`),表示由命令自动生成 ID。通常这样做就够了,但是也可以去强制指定一个 ID,这种情况用于复制这个命令到<ruby>从服务器<rt>slave server</rt></ruby>和 <ruby>AOF<rt>append-only file</rt></ruby> 文件。

|

||||

|

||||

这个 ID 是由两部分组成的:一个毫秒时间和一个序列号。`1506871964177` 是毫秒时间,它只是一个毫秒级的 UNIX 时间戳。圆点(`.`)后面的数字 `0` 是一个序号,它是为了区分相同毫秒数的条目增加上去的。这两个数字都是 64 位的无符号整数。这意味着,我们可以在流中增加所有想要的条目,即使是在同一毫秒中。ID 的毫秒部分使用 Redis 服务器的当前本地时间生成的 ID 和流中的最后一个条目 ID 两者间的最大的一个。因此,举例来说,即使是计算机时间回跳,这个 ID 仍然是增加的。在某些情况下,你可以认为流条目的 ID 是完整的 128 位数字。然而,事实上它们与被添加到的实例的本地时间有关,这意味着我们可以在毫秒级的精度的范围随意查询。

|

||||

|

||||

正如你想的那样,快速添加两个条目后,结果是仅一个序号递增了。我们可以用一个 `MULTI`/`EXEC` 块来简单模拟“快速插入”:

|

||||

|

||||

```

|

||||

> MULTI

|

||||

OK

|

||||

> XADD mystream * foo 10

|

||||

QUEUED

|

||||

> XADD mystream * bar 20

|

||||

QUEUED

|

||||

> EXEC

|

||||

1) 1506872463535.0

|

||||

2) 1506872463535.1

|

||||

```

|

||||

|

||||