mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-01-13 22:30:37 +08:00

commit

e2b6845f8e

4

LCTT翻译规范.md

Normal file

4

LCTT翻译规范.md

Normal file

@ -0,0 +1,4 @@

|

||||

# Linux中国翻译规范

|

||||

1. 翻译中出现的专有名词,可参见Dict.md中的翻译。

|

||||

2. 英文人名,如无中文对应译名,一般不译。

|

||||

2. 缩写词,一般不须翻译,可考虑旁注中文全名。

|

||||

@ -7,7 +7,7 @@

|

||||

|

||||

|

||||

|

||||

使用这种方式的明显好处就是你可以通过使用他们各自的官方应用访问你的各种云存储。目前,提供官方Linux客户端的服务提供商有[SpiderOak](1), [Dropbox](2), [Ubuntu One](3),[Copy](5)。[Ubuntu One](3)虽不出名但的确是[一个不错的云存储竞争着](4)。[Copy][5]则提供比Dropbox更多的空间,是[Dropbox的替代选择之一](6)。使用这些官方Linux客户端可以保持你的电脑与他们的服务器之间的通信,还可以让你进行属性设置,如选择性同步。

|

||||

使用这种方式的明显好处就是你可以通过使用他们各自的官方应用访问你的各种云存储。目前,提供官方Linux客户端的服务提供商有[SpiderOak][1], [Dropbox][2], [Ubuntu One][3],[Copy][5]。[Ubuntu One][3]虽不出名但的确是[一个不错的云存储竞争着][4]。[Copy][5]则提供比Dropbox更多的空间,是[Dropbox的替代选择之一][6]。使用这些官方Linux客户端可以保持你的电脑与他们的服务器之间的通信,还可以让你进行属性设置,如选择性同步。

|

||||

|

||||

对于普通桌面用户,使用官方客户端是最好的选择,因为官方客户端可以提供最多的功能和最好的兼容性。使用它们也很简单,只需要下载他们对应你的发行版的软件包,然后安装安装完后在运行一下就Ok了。安装客户端时,它一般会指导你完成这些简单的过程。

|

||||

|

||||

@ -25,9 +25,9 @@

|

||||

|

||||

当你运行最后一条命令后,脚本会提醒你这是你第一次运行这个脚本。它将告诉你去浏览一个Dropbox的特定网页以便访问你的账户。它还会告诉你所有你需要放入网站的信息,这是为了让Dropbox给你App Key和App Secret以及赋予这个脚本你给予的访问权限。现在脚本就拥有了访问你账户的合法授权了。

|

||||

|

||||

这些一旦完成,你就可以这个脚本执行各种任务了,例如上传、下载、删除、移动、复制、创建文件夹、查看文件、共享文件、查看文件信息和取消共享。对于全部的语法解释,你可以查看一下[这个页面](9)。

|

||||

这些一旦完成,你就可以这个脚本执行各种任务了,例如上传、下载、删除、移动、复制、创建文件夹、查看文件、共享文件、查看文件信息和取消共享。对于全部的语法解释,你可以查看一下[这个页面][9]。

|

||||

|

||||

###通过[Storage Made Easy](7)将SkyDrive带到Linux上

|

||||

###通过[Storage Made Easy][7]将SkyDrive带到Linux上

|

||||

|

||||

微软并没有提供SkyDrive的官方Linux客户端,这一点也不令人惊讶。但是你并不意味着你不能在Linux上访问SkyDrive,记住:SkyDrive的web版本是可用的。

|

||||

|

||||

@ -41,7 +41,7 @@

|

||||

|

||||

第一次启动时。它会要求你登录,还有询问你要把云存储挂载到什么地方。在你做完了这些后,你就可以浏览你选择的文件夹,你还可以访问你的Storage Made Easy空间以及你的SkyDrive空间了!这种方法对于那些想在Linux上使用SkyDrive的人来说非常好,对于想把他们的多个云存储服务整合到一个地方的人来说也很不错。这种方法的缺点是你无法使用他们各自官方客户端中可以使用的特殊功能。

|

||||

|

||||

因为现在在你的Linux桌面上也可以使用SkyDrive,接下来你可能需要阅读一下我写的[SkyDrive与Google Drive的比较](8)以便于知道究竟哪种更适合于你。

|

||||

因为现在在你的Linux桌面上也可以使用SkyDrive,接下来你可能需要阅读一下我写的[SkyDrive与Google Drive的比较][8]以便于知道究竟哪种更适合于你。

|

||||

|

||||

###结论

|

||||

|

||||

|

||||

@ -2,8 +2,6 @@

|

||||

================================================================================

|

||||

|

||||

|

||||

图片来源 : opensource.com

|

||||

|

||||

经过了一整天的Opensource.com[社区版主][1]年会,最后一项日程提了上来,内容只有“特邀嘉宾:待定”几个字。作为[Opensource.com][3]的项目负责人和社区管理员,[Jason Hibbets][2]起身解释道,“因为这个嘉宾有可能无法到场,因此我不想提前说是谁。在几个月前我问他何时有空过来,他给了我两个时间点,我选了其中一个。今天是这三周中Jim唯一能来的一天”。(译者注:Jim是指下文中提到的Jim Whitehurst,即红帽公司总裁兼首席执行官)

|

||||

|

||||

这句话在版主们(Moderators)中引起一阵轰动,他们从世界各地赶来参加此次的[拥抱开源大会(All Things Open Conference)][4]。版主们纷纷往前挪动椅子,仔细聆听。

|

||||

@ -14,7 +12,7 @@

|

||||

|

||||

“大家好!”,这个家伙开口了。他没穿正装,只是衬衫和休闲裤。

|

||||

|

||||

这时会场中第二高个子的人,红帽全球意识部门(Global Awareness)的高级主管[Jeff Mackanic][5],告诉他大部分社区版本今天都在场,然后让每个人开始作简单的自我介绍。

|

||||

这时会场中第二高个子的人,红帽全球意识部门(Global Awareness)的高级主管[Jeff Mackanic][5],告诉他大部分社区版主今天都在场,然后让每个人开始作简单的自我介绍。

|

||||

|

||||

“我叫[Jen Wike Huger][6],负责Opensource.com的内容管理,很高兴见到大家。”

|

||||

|

||||

@ -22,13 +20,13 @@

|

||||

|

||||

“我叫[Robin][9],从2013年开始参与版主项目。我在OSDC做了一些事情,工作是在[City of the Hague][10]维护[网站][11]。”

|

||||

|

||||

“我叫[Marcus Hanwell][12],来自英格兰,在[Kitware][13]工作。同时,我是FOSS科学软件的技术总监,和国家实验室在[Titan][14] Z和[Gpu programming][15]方面合作。我主要使用[Gentoo][16]和[KDE][17]。最后,我很激动能加入FOSS和开源科学。”

|

||||

“我叫[Marcus Hanwell][12],来自英格兰,在[Kitware][13]工作。同时,我是FOSS science software的技术总监,和国家实验室在[Titan][14] Z和[Gpu programming][15]方面合作。我主要使用[Gentoo][16]和[KDE][17]。最后,我很激动能参与到FOSS和开源科学。”

|

||||

|

||||

“我叫[Phil Shapiro][18],是华盛顿的一个小图书馆28个Linux工作站的管理员。我视各位为我的同事。非常高兴能一起交流分享,贡献力量。我主要关注FOSS和自豪感的关系,以及FOSS如何提升自豪感。”

|

||||

“我叫[Phil Shapiro][18],是华盛顿的一个小图书馆的28个Linux工作站的管理员。我视各位为我的同事。非常高兴能一起交流分享,贡献力量。我主要关注FOSS和自豪感的关系,以及FOSS如何提升自豪感。”

|

||||

|

||||

“我叫[Joshua Holm][19]。我大多数时间都在关注系统更新,以及帮助人们在网上找工作。”

|

||||

|

||||

“我叫[Mel Chernoff][20],在红帽工作,和[Jason Hibbets]和[Mark Bohannon]一起主要关注政府渠道方面。”

|

||||

“我叫[Mel Chernoff][20],在红帽工作,和[Jason Hibbets][22]和[Mark Bohannon][23]一起主要关注[政府][21]渠道方面。”

|

||||

|

||||

“我叫[Scott Nesbitt][24],写过很多东西,使用FOSS很久了。我是个普通人,不是系统管理员,也不是程序员,只希望能更加高效工作。我帮助人们在商业和生活中使用FOSS。”

|

||||

|

||||

@ -38,41 +36,41 @@

|

||||

|

||||

“你在[新FOSS Minor][30]教书?!”,Jim说道,“很酷!”

|

||||

|

||||

“我叫[Jason Baker][31]。我是红慢的一个云专家,主要做[OpenStack][32]方面的工作。”

|

||||

“我叫[Jason Baker][31]。我是红帽的一个云专家,主要做[OpenStack][32]方面的工作。”

|

||||

|

||||

“我叫[Mark Bohannan][33],是红帽全球开放协议的一员,在华盛顿外工作。和Mel一样,我花了相当多时间写作,也从法律和政府部门中找合作者。我做了一个很好的小册子来讨论正在发生在政府中的积极变化。”

|

||||

|

||||

“我叫[Jason Hibbets][34],我组织了这次会议。”

|

||||

“我叫[Jason Hibbets][34],我组织了这次讨论。”

|

||||

|

||||

会场中一片笑声。

|

||||

|

||||

“我也组织了这片讨论,可以这么说,”这个棕红色头发笑容灿烂的家伙说道。笑声持续一会逐渐平息。

|

||||

“我也组织了这个讨论,可以这么说,”这个棕红色头发笑容灿烂的家伙说道。笑声持续一会逐渐平息。

|

||||

|

||||

我当时在他左边,时不时从转录空隙中抬头看一眼,然后从眼神中注意到微笑背后暗示的那个自2008年1月起开始领导公司的人,红帽的CEO[Jim Whitehurst][35]。

|

||||

我当时在他左边,时不时从记录的间隙中抬头看一眼,我注意到淡淡微笑背后的那个令人瞩目的人,是自2008年1月起开始领导红帽公司的CEO [Jim Whitehurst][35]。

|

||||

|

||||

“我有世界上最好的工作,”稍稍向后靠、叉腿抱头,Whitehurst开始了演讲。“我开始领导红帽,在世界各地旅行到处看看情况。在这里的七年中,FOSS和广泛的开源创新所发生的美好的事情是开源已经脱离了条条框框。我现在认为,IT正处在FOSS之前所在的位置。我们可以预见FOSS从一个替代走向创新驱动力。”用户也看到了这一点。他们用FOSS并不是因为它便宜,而是因为它能提供和创新的解决方案。这也十一个全球现象。比如,我刚才还在印度,然后发现那里的用户拥抱开源的两个理由:一个是创新,另一个是那里的市场有些特殊,需要完全的控制。

|

||||

“我有世界上最好的工作,”稍稍向后靠、叉腿抱头,Whitehurst开始了演讲。“我开始领导红帽,在世界各地旅行到处看看情况。在这里的七年中,FOSS和广泛的开源创新所发生的最美好的事情是开源已经脱离了条条框框。我现在认为,信息技术正处在FOSS之前所在的位置。我们可以预见FOSS从一个替代品走向创新驱动力。我们的用户也看到了这一点。他们用FOSS并不是因为它便宜,而是因为它能带来可控和创新的解决方案。这也是个全球现象。比如,我刚才还在印度,然后发现那里的用户拥抱开源的两个理由:一个是创新,另一个是那里的市场有些特殊,需要完全的可控。”

|

||||

|

||||

“[孟买证券交易所][36]想得到源代码并加以控制,五年前这在证券交易领域闻所未闻。那时FOSS正在重复发明轮子。今天看来,FOSS正在做几乎所有的结合了大数据的事物。几乎所有的新框架,语言和方法论,包括流动(尽管不包括设备),都首先发生在开源世界。”

|

||||

“[孟买证券交易所][36]想得到源代码并加以控制,五年前这种事情在证券交易领域就没有听说过。那时FOSS正在重复发明轮子。今天看来,实际上大数据的每件事情都出现在FOSS领域。几乎所有的新框架,语言和方法论,包括移动通讯(尽管不包括设备),都首先发生在开源世界。”

|

||||

|

||||

“这是因为用户数量已经达到了相当的规模。这不只是红帽遇到的情况,[Google][37],[Amazon][38],[Facebook][39]等也出现这样的情况。他们想解决自己的问题,用开源的方式。忘掉协议吧,开源绝不仅如此。我们建立了一个交通工具,一套规则,例如[Hadoop][40],[Cassandra][41]和其他工具。事实上,开源驱动创新。例如,Hadoop在厂商们意识的规模带来的问题。他们实际上有足够的资和资源金来解决自己的问题。”开源是许多领域的默认技术方案。这在一个更加注重内容的世界中更是如此,例如[3D打印][42]和其他使用信息内容的物理产品。”

|

||||

“这是因为用户数量已经达到了相当的规模。这不只是红帽遇到的情况,[Google][37],[Amazon][38],[Facebook][39]等也出现这样的情况。他们想解决自己的问题,用开源的方式。忘掉许可协议吧,开源绝不仅如此。我们建立了一个交通工具,一套规则,例如[Hadoop][40],[Cassandra][41]和其他工具。事实上,开源驱动创新。例如,Hadoop是在厂商们意识到规模带来的问题时的一个解决方案。他们实际上有足够的资金和资源来解决自己的问题。开源是许多领域的默认技术方案。这在一个更加注重内容的世界中更是如此,例如[3D打印][42]和其他使用信息内容的实体产品。”

|

||||

|

||||

“源代码的开源确实很酷,但开源不应当仅限于此。在各行各业不同领域开源仍有可以用武之地。我们要问下自己:‘开源能够为教育,政府,法律带来什么?其它的呢?其它的领域如何能学习我们?’”

|

||||

|

||||

“还有内容的问题。内容在现在是免费的,当然我们可以投资更多的免费内容,不过我们也需要商业模式围绕的内容。这是我们更应该关注的。如果你相信开放的创新能带来更好,那么我们需要更多的商业模式。”

|

||||

“还有内容的问题。内容在现在是免费的,当然我们可以投资更多的免费内容,不过我们也需要商业模式围绕的内容。这是我们更应该关注的。如果你相信开放的创新更好,那么我们需要更多的商业模式。”

|

||||

|

||||

“教育让我担心其相比与‘社区’它更关注‘内容’。例如,无论我走到哪里,大学校长们都会说,‘等等,难道教育将会免费?!’对于下游来说FOSS免费很棒,但别忘了上游很强大。免费课程很棒,但我们同样需要社区来不断迭代和完善。这是很多人都在做的事情,Opensource.com是一个提供交流的社区。问题不是‘我们如何控制内容’,也不是‘如何建立和分发内容’,而是要确保它处在不断的完善当中,而且能给其他领域提供有价值的参考。”

|

||||

“教育让我担心,其相比与‘社区’它更关注‘内容’。例如,无论我走到哪里,大学的校长们都会说,‘等等,难道教育将会免费?!’对于下游来说FOSS免费很棒,但别忘了上游很强大。免费课程很棒,但我们同样需要社区来不断迭代和完善。这是很多人都在做的事情,Opensource.com是一个提供交流的社区。问题不是‘我们如何控制内容’,也不是‘如何建立和分发内容’,而是要确保它处在不断的完善当中,而且能给其他领域提供有价值的参考。”

|

||||

|

||||

“改变世界的潜力是无穷无尽的,我们已经取得了很棒的进步。”六年前我们痴迷于制定宣言,我们说‘我们是领导者’。我们用错词了,因为那潜在意味着控制。积极的参与者们同样也不能很好理解……[Máirín Duffy][43]提出了[催化剂][44]这个词。然后我们组成了红帽,不断地促进行动,指引方向。”

|

||||

|

||||

“Opensource.com也是其他领域的催化剂,而这正是它的本义所在,我希望你们也这样认为。当时的内容质量和现在比起来都令人难以置信。你可以看到每季度它都在进步。谢谢你们的时间!谢谢成为了催化剂!这是一个让世界变得更好的机会。我想听听你们的看法。”

|

||||

“Opensource.com也是其他领域的催化剂,而这正是它的本义所在,我希望你们也这样认为。当时的内容质量和现在比起来都令人难以置信。你可以看到每季度它都在进步。谢谢你们付出的时间!谢谢成为了催化剂!这是一个让世界变得更好的机会。我想听听你们的看法。”

|

||||

|

||||

我瞥了一下桌子,发现几个人眼中带泪。

|

||||

|

||||

然后Whitehurst又回顾了大会的开放教育议题。“极端一点看,如果你有一门[Ulysses][45]的公开课。在这里你能和一群人一起合作体验课堂。这样就和代码块一样的:大家一起努力,代码随着时间不断改进。”

|

||||

|

||||

在这一点上,我有发言权。当谈论其FOSS和学术团体之间的差异,向基础和可能的不调和这些词语都跳了出来。

|

||||

在这一点上,我有发言权。当谈论其FOSS和学术团体之间的差异,像“基础”和“可能不调和”这些词语都跳了出来。

|

||||

|

||||

**Remy**: “倒退带来死亡。如果你在论文或者发布的代码中烦了一个错误,有可能带来十分严重的后果。学校一直都是避免失败寻求正确答案的地方。复制意味着抄袭。轮子在一遍遍地教条地被发明。FOSS你能快速失败,但在学术界,你只能带来无效的结果。”

|

||||

**Remy**: “倒退带来死亡。如果你在论文或者发布的代码中犯了一个错误,有可能带来十分严重的后果。学校一直都是避免失败寻求正确答案的地方。复制意味着抄袭。轮子在一遍遍地教条地被发明。FOSS让你能快速失败,但在学术界,你只能带来无效的结果。”

|

||||

|

||||

**Nicole**: “学术界有太多自我的家伙,你们需要一个发布经理。”

|

||||

|

||||

@ -80,20 +78,21 @@

|

||||

|

||||

**Luis**: “团队和分享应该优先考虑,红帽可以多向它们强调这一点。”

|

||||

|

||||

**Jim**: “还有公司在其中扮演积极角色吗?”

|

||||

**Jim**: “还有公司在其中扮演积极角色了吗?”

|

||||

|

||||

[Phil Shapiro][46]: “我对FOSS的临界点感兴趣。联邦没有改用[LibreOffice][47]把我逼疯了。我们没有在软件上花税款,也不应当在字处理软件或者微软的Office上浪费税钱。”

|

||||

[Phil Shapiro][46]: “我对FOSS的临界点感兴趣。Fed没有改用[LibreOffice][47]把我逼疯了。我们没有在软件上花税款,也不应当在字处理软件或者微软的Office上浪费税钱。”

|

||||

|

||||

**Jim**: “我们经常提倡这一点。我们能做更多吗?这是个问题。首先,我们在我们的产品涉足的地方取得了进步。我们在政府中有坚实的专营权。我们比私有公司平均话费更多。银行和电信业都和政府挨着。我们在欧洲做的更好,我认为在那工作又更低的税。下一代计算就像‘终结者’,我们到处取得了进步,但仍然需要忧患意识。”

|

||||

**Jim**: “我们经常提倡这一点。我们能做更多吗?这是个问题。首先,我们在我们的产品涉足的地方取得了进步。我们在政府中有坚实的专营权。我们比私有公司平均花费更多。银行和电信业都和政府挨着。我们在欧洲做的更好,我认为在那工作有更低的税。下一代计算就像‘终结者’,我们到处取得了进步,但仍然需要忧患意识。”

|

||||

|

||||

突然,门开了。Jim转身向门口站着的执行助理点头。他要去参加下一场会了。他并拢双腿,站着向前微倾。然后,他再次向每个人的工作和奉献表示感谢,微笑着出了门……留给我们更多的激励。

|

||||

|

||||

突然,门开了。Jim转身向门口站着的执行助理点头。他要去参加下一场会了。他并拢双腿,站着向前微倾。然后,他再次向每个人的工作和奉献表示感谢,微笑着除了门……留给我们更多的激励。

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/business/14/12/jim-whitehurst-inspiration-open-source

|

||||

|

||||

作者:[Remy][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

译者:[fyh](https://github.com/fyh)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,86 @@

|

||||

7 个驱动开源发展的社区

|

||||

================================================================================

|

||||

不久前,开源模式还被成熟的工业级厂商以怀疑的态度认作是叛逆小孩的玩物。如今,开源的促进会和基金会在一长列的供应商提供者的支持下正蓬勃发展,而他们将开源模式视作创新的关键。

|

||||

|

||||

|

||||

|

||||

### 技术的开放发展驱动着创新 ###

|

||||

|

||||

在过去的 20 几年间,技术的开源推进已被视作驱动创新的关键因素。即使那些以前将开源视作威胁的公司也开始接受这个观点 — 例如微软,如今它在一系列的开源的促进会中表现活跃。到目前为止,大多数的开源推进都集中在软件方面,但甚至这个也正在改变,因为社区已经开始向开源硬件倡议方面聚拢。这里介绍 7 个成功地在硬件和软件方面同时促进和发展开源技术的组织。

|

||||

|

||||

### OpenPOWER 基金会 ###

|

||||

|

||||

|

||||

|

||||

[OpenPOWER 基金会][2] 由 IBM, Google, Mellanox, Tyan 和 NVIDIA 于 2013 年共同创建,在与开源软件发展相同的精神下,旨在驱动开放协作硬件的发展,在过去的 20 几年间,开源软件发展已经找到了肥沃的土壤。

|

||||

|

||||

IBM 通过开放其基于 Power 架构的硬件和软件技术,向使用 Power IP 的独立硬件产品提供许可证等方式为基金会的建立播下种子。如今超过 70 个成员共同协作来为基于 Linux 的数据中心提供自定义的开放服务器,组件和硬件。

|

||||

|

||||

去年四月,在比最新基于 x86 系统快 50 倍的数据分析能力的新的 POWER8 处理器的服务器的基础上, OpenPOWER 推出了一个技术路线图。七月, IBM 和 Google 发布了一个固件堆栈。去年十月见证了 NVIDIA GPU 带来加速 POWER8 系统的能力和来自 Tyan 的第一个 OpenPOWER 参考服务器。

|

||||

|

||||

### Linux 基金会 ###

|

||||

|

||||

|

||||

|

||||

于 2000 年建立的 [Linux 基金会][2] 如今成为掌控着历史上最大的开源协同开发成果,它有着超过 180 个合作成员和许多独立成员及学生成员。它赞助 Linux 核心开发者的工作并促进、保护和推进 Linux 操作系统,并协调软件的协作开发。

|

||||

|

||||

它最为成功的协作项目包括 Code Aurora Forum (一个拥有为移动无线产业服务的企业财团),MeeGo (一个为移动设备和 IVI [注:指的是车载消息娱乐设备,为 In-Vehicle Infotainment 的简称] 构建一个基于 Linux 内核的操作系统的项目) 和 Open Virtualization Alliance (开放虚拟化联盟,它促进自由和开源软件虚拟化解决方案的采用)。

|

||||

|

||||

### 开放虚拟化联盟 ###

|

||||

|

||||

|

||||

|

||||

[开放虚拟化联盟(OVA)][3] 的存在目的为:通过提供使用案例和对具有互操作性的通用接口和 API 的发展提供支持,来促进自由、开源软件的虚拟化解决方案,例如 KVM 的采用。KVM 将 Linux 内核转变为一个虚拟机管理程序。

|

||||

|

||||

如今, KVM 已成为和 OpenStack 共同使用的最为常见的虚拟机管理程序。

|

||||

|

||||

### OpenStack 基金会 ###

|

||||

|

||||

|

||||

|

||||

原本作为一个 IaaS(基础设施即服务) 产品由 NASA 和 Rackspace 于 2010 年启动,[OpenStack 基金会][4] 已成为最大的开源项目聚居地之一。它拥有超过 200 家公司成员,其中包括 AT&T, AMD, Avaya, Canonical, Cisco, Dell 和 HP。

|

||||

|

||||

大约以 6 个月为一个发行周期,基金会的 OpenStack 项目开发用于通过一个基于 Web 的仪表盘,命令行工具或一个 RESTful 风格的 API 来控制或调配流经一个数据中心的处理存储池和网络资源。至今为止,基金会支持的协同开发已经孕育出了一系列 OpenStack 组件,其中包括 OpenStack Compute(一个云计算网络控制器,它是一个 IaaS 系统的主要部分),OpenStack Networking(一个用以管理网络和 IP 地址的系统) 和 OpenStack Object Storage(一个可扩展的冗余存储系统)。

|

||||

|

||||

### OpenDaylight ###

|

||||

|

||||

|

||||

|

||||

作为来自 Linux 基金会的另一个协作项目, [OpenDaylight][5] 是一个由诸如 Dell, HP, Oracle 和 Avaya 等行业厂商于 2013 年 4 月建立的联合倡议。它的任务是建立一个由社区主导、开源、有工业支持的针对软件定义网络( SDN: Software-Defined Networking)的包含代码和蓝图的框架。其思路是提供一个可直接部署的全功能 SDN 平台,而不需要其他组件,供应商可提供附件组件和增强组件。

|

||||

|

||||

### Apache 软件基金会 ###

|

||||

|

||||

|

||||

|

||||

[Apache 软件基金会 (ASF)][7] 是将近 150 个顶级项目的聚居地,这些项目涵盖从开源的企业级自动化软件到与 Apache Hadoop 相关的分布式计算的整个生态系统。这些项目分发企业级、可免费获取的软件产品,而 Apache 协议则是为了让无论是商业用户还是个人用户更方便地部署 Apache 的产品。

|

||||

|

||||

ASF 是 1999 年成立的一个会员制,非盈利公司,以精英为其核心 — 要成为它的成员,你必须首先在基金会的一个或多个协作项目中做出积极贡献。

|

||||

|

||||

### 开放计算项目 ###

|

||||

|

||||

|

||||

|

||||

作为 Facebook 重新设计其 Oregon 数据中心的副产物, [开放计算项目][7] 旨在发展针对数据中心的开源硬件解决方案。 OCP 是一个由廉价无浪费的服务器、针对 Open Rack(为数据中心设计的机架标准,来让机架集成到数据中心的基础设施中) 的模块化 I/O 存储和一个相对 "绿色" 的数据中心设计方案等构成。

|

||||

|

||||

OCP 董事会成员包括来自 Facebook,Intel,Goldman Sachs,Rackspace 和 Microsoft 的代表。

|

||||

|

||||

OCP 最近宣布了有两种可选的许可证: 一个类似 Apache 2.0 的允许衍生工作的许可证,和一个更规范的鼓励将更改回馈到原有软件的许可证。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.networkworld.com/article/2866074/opensource-subnet/7-communities-driving-open-source-development.html

|

||||

|

||||

作者:[Thor Olavsrud][a]

|

||||

译者:[FSSlc](https://github.com/FSSlc)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.networkworld.com/author/Thor-Olavsrud/

|

||||

[1]:http://openpowerfoundation.org/

|

||||

[2]:http://www.linuxfoundation.org/

|

||||

[3]:https://openvirtualizationalliance.org/

|

||||

[4]:http://www.openstack.org/foundation/

|

||||

[5]:http://www.opendaylight.org/

|

||||

[6]:http://www.apache.org/

|

||||

[7]:http://www.opencompute.org/

|

||||

@ -0,0 +1,114 @@

|

||||

安装 Strongswan :Linux 上一个基于 IPsec 的 VPN 工具

|

||||

================================================================================

|

||||

|

||||

IPsec是一个提供网络层安全的标准。它包含认证头(AH)和安全负载封装(ESP)组件。AH提供包的完整性,ESP组件提供包的保密性。IPsec确保了在网络层的安全特性。

|

||||

|

||||

- 保密性

|

||||

- 数据包完整性

|

||||

- 来源不可抵赖性

|

||||

- 重放攻击防护

|

||||

|

||||

[Strongswan][1]是一个IPsec协议的开源代码实现,Strongswan的意思是强安全广域网(StrongS/WAN)。它支持IPsec的VPN中的两个版本的密钥自动交换(网络密钥交换(IKE)V1和V2)。

|

||||

|

||||

Strongswan基本上提供了在VPN的两个节点/网关之间自动交换密钥的共享,然后它使用了Linux内核的IPsec(AH和ESP)实现。密钥共享使用了之后用于ESP数据加密的IKE 机制。在IKE阶段,strongswan使用OpenSSL的加密算法(AES,SHA等等)和其他加密类库。无论如何,IPsec中的ESP组件使用的安全算法是由Linux内核实现的。Strongswan的主要特性如下:

|

||||

|

||||

- x.509证书或基于预共享密钥认证

|

||||

- 支持IKEv1和IKEv2密钥交换协议

|

||||

- 可选的,对于插件和库的内置完整性和加密测试

|

||||

- 支持椭圆曲线DH群和ECDSA证书

|

||||

- 在智能卡上存储RSA私钥和证书

|

||||

|

||||

它能被使用在客户端/服务器(road warrior模式)和网关到网关的情景。

|

||||

|

||||

### 如何安装 ###

|

||||

|

||||

几乎所有的Linux发行版都支持Strongswan的二进制包。在这个教程,我们会从二进制包安装strongswan,也会从源代码编译带有合适的特性的strongswan。

|

||||

|

||||

### 使用二进制包 ###

|

||||

|

||||

可以使用以下命令安装Strongswan到Ubuntu 14.04 LTS

|

||||

|

||||

$ sudo aptitude install strongswan

|

||||

|

||||

|

||||

|

||||

strongswan的全局配置(strongswan.conf)文件和ipsec配置(ipsec.conf/ipsec.secrets)文件都在/etc/目录下。

|

||||

|

||||

### strongswan源码编译安装的依赖包 ###

|

||||

|

||||

- GMP(strongswan使用的高精度数学库)

|

||||

- OpenSSL(加密算法来自这个库)

|

||||

- PKCS(1,7,8,11,12)(证书编码和智能卡集成)

|

||||

|

||||

#### 步骤 ####

|

||||

|

||||

**1)** 在终端使用下面命令到/usr/src/目录

|

||||

|

||||

$ cd /usr/src

|

||||

|

||||

**2)** 用下面命令从strongswan网站下载源代码

|

||||

|

||||

$ sudo wget http://download.strongswan.org/strongswan-5.2.1.tar.gz

|

||||

|

||||

(strongswan-5.2.1.tar.gz 是当前最新版。)

|

||||

|

||||

|

||||

|

||||

**3)** 用下面命令提取下载的软件,然后进入目录。

|

||||

|

||||

$ sudo tar –xvzf strongswan-5.2.1.tar.gz; cd strongswan-5.2.1

|

||||

|

||||

**4)** 使用configure命令配置strongswan每个想要的选项。

|

||||

|

||||

$ ./configure --prefix=/usr/local -–enable-pkcs11 -–enable-openssl

|

||||

|

||||

|

||||

|

||||

如果GMP库没有安装,配置脚本将会发生下面的错误。

|

||||

|

||||

|

||||

|

||||

因此,首先,使用下面命令安装GMP库然后执行配置脚本。

|

||||

|

||||

|

||||

|

||||

不过,如果GMP已经安装还报上述错误的话,在Ubuntu上使用如下命令,给在路径 /usr/lib,/lib/,/usr/lib/x86_64-linux-gnu/ 下的libgmp.so库创建软连接。

|

||||

|

||||

$ sudo ln -s /usr/lib/x86_64-linux-gnu/libgmp.so.10.1.3 /usr/lib/x86_64-linux-gnu/libgmp.so

|

||||

|

||||

|

||||

|

||||

创建libgmp.so软连接后,再执行./configure脚本也许就找到gmp库了。然而,如果gmp头文件发生其他错误,像下面这样。

|

||||

|

||||

|

||||

|

||||

为解决上面的错误,使用下面命令安装libgmp-dev包

|

||||

|

||||

$ sudo aptitude install libgmp-dev

|

||||

|

||||

|

||||

|

||||

安装gmp的开发库后,在运行一遍配置脚本,如果没有发生错误,则将看见下面的这些输出。

|

||||

|

||||

|

||||

|

||||

使用下面的命令编译安装strongswan。

|

||||

|

||||

$ sudo make ; sudo make install

|

||||

|

||||

安装strongswan后,全局配置(strongswan.conf)和ipsec策略/密码配置文件(ipsec.conf/ipsec.secretes)被放在**/usr/local/etc**目录。

|

||||

|

||||

根据我们的安全需要Strongswan可以用作隧道或者传输模式。它提供众所周知的site-2-site模式和road warrior模式的VPN。它很容易使用在Cisco,Juniper设备上。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://linoxide.com/security/install-strongswan/

|

||||

|

||||

作者:[nido][a]

|

||||

译者:[wyangsun](https://github.com/wyangsun)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://linoxide.com/author/naveeda/

|

||||

[1]:https://www.strongswan.org/

|

||||

@ -0,0 +1,150 @@

|

||||

在 Debian 中安装 OpenQRM 云计算平台

|

||||

================================================================================

|

||||

|

||||

### 简介 ###

|

||||

|

||||

**openQRM**是一个基于 Web 的开源云计算和数据中心管理平台,可灵活地与企业数据中心的现存组件集成。

|

||||

|

||||

它支持下列虚拟技术:

|

||||

|

||||

- KVM

|

||||

- XEN

|

||||

- Citrix XenServer

|

||||

- VMWare ESX

|

||||

- LXC

|

||||

- OpenVZ

|

||||

|

||||

openQRM 中的混合云连接器支持 **Amazon AWS**, **Eucalyptus** 或 **OpenStack** 等一系列的私有或公有云提供商,以此来按需扩展你的基础设施。它也可以自动地进行资源调配、 虚拟化、 存储和配置管理,且保证高可用性。集成的计费系统的自服务云门户可使终端用户按需请求新的服务器和应用堆栈。

|

||||

|

||||

openQRM 有两种不同风格的版本可获取:

|

||||

|

||||

- 企业版

|

||||

- 社区版

|

||||

|

||||

你可以在[这里][1]查看这两个版本间的区别。

|

||||

|

||||

### 特点 ###

|

||||

|

||||

- 私有/混合的云计算平台

|

||||

- 可管理物理或虚拟的服务器系统

|

||||

- 集成了所有主流的开源或商业的存储技术

|

||||

- 跨平台: Linux, Windows, OpenSolaris 和 BSD

|

||||

- 支持 KVM, XEN, Citrix XenServer, VMWare ESX(i), lxc, OpenVZ 和 VirtualBox

|

||||

- 支持使用额外的 Amazon AWS, Eucalyptus, Ubuntu UEC 等云资源来进行混合云设置

|

||||

- 支持 P2V, P2P, V2P, V2V 迁移和高可用性

|

||||

- 集成最好的开源管理工具 – 如 puppet, nagios/Icinga 或 collectd

|

||||

- 有超过 50 个插件来支持扩展功能并与你的基础设施集成

|

||||

- 针对终端用户的自服务门户

|

||||

- 集成了计费系统

|

||||

|

||||

### 安装 ###

|

||||

|

||||

在这里我们将在 Debian 7.5 上安装 openQRM。你的服务器必须至少满足以下要求:

|

||||

|

||||

- 1 GB RAM

|

||||

- 100 GB Hdd(硬盘驱动器)

|

||||

- 可选: Bios 支持虚拟化(Intel CPUs 的 VT 或 AMD CPUs AMD-V)

|

||||

|

||||

首先,安装 `make` 软件包来编译 openQRM 源码包:

|

||||

|

||||

sudo apt-get update

|

||||

sudo apt-get upgrade

|

||||

sudo apt-get install make

|

||||

|

||||

然后,逐次运行下面的命令来安装 openQRM。

|

||||

|

||||

从[这里][2]下载最新的可用版本:

|

||||

|

||||

wget http://sourceforge.net/projects/openqrm/files/openQRM-Community-5.1/openqrm-community-5.1.tgz

|

||||

|

||||

tar -xvzf openqrm-community-5.1.tgz

|

||||

|

||||

cd openqrm-community-5.1/src/

|

||||

|

||||

sudo make

|

||||

|

||||

sudo make install

|

||||

|

||||

sudo make start

|

||||

|

||||

安装期间,会要求你更新文件 `php.ini`

|

||||

|

||||

|

||||

|

||||

输入 mysql root 用户密码。

|

||||

|

||||

|

||||

|

||||

再次输入密码:

|

||||

|

||||

|

||||

|

||||

选择邮件服务器配置类型:

|

||||

|

||||

|

||||

|

||||

假如你不确定该如何选择,可选择 `Local only`。在我们的这个示例中,我选择了 **Local only** 选项。

|

||||

|

||||

|

||||

|

||||

输入你的系统邮件名称,并最后输入 Nagios 管理员密码。

|

||||

|

||||

|

||||

|

||||

根据你的网络连接状态,上面的命令可能将花费很长的时间来下载所有运行 openQRM 所需的软件包,请耐心等待。

|

||||

|

||||

最后你将得到 openQRM 配置 URL 地址以及相关的用户名和密码。

|

||||

|

||||

|

||||

|

||||

### 配置 ###

|

||||

|

||||

在安装完 openQRM 后,打开你的 Web 浏览器并转到 URL: **http://ip-address/openqrm**

|

||||

|

||||

例如,在我的示例中为 http://192.168.1.100/openqrm 。

|

||||

|

||||

默认的用户名和密码是: **openqrm/openqrm** 。

|

||||

|

||||

|

||||

|

||||

选择一个网卡来给 openQRM 管理网络使用。

|

||||

|

||||

|

||||

|

||||

选择一个数据库类型,在我们的示例中,我选择了 mysql。

|

||||

|

||||

|

||||

|

||||

现在,配置数据库连接并初始化 openQRM, 在这里,我使用 **openQRM** 作为数据库名称, **root** 作为用户的身份,并将 debian 作为数据库的密码。 请小心,你应该输入先前在安装 openQRM 时创建的 mysql root 用户密码。

|

||||

|

||||

|

||||

|

||||

祝贺你! openQRM 已经安装并配置好了。

|

||||

|

||||

|

||||

|

||||

### 更新 openQRM ###

|

||||

|

||||

在任何时候可以使用下面的命令来更新 openQRM:

|

||||

|

||||

cd openqrm/src/

|

||||

make update

|

||||

|

||||

到现在为止,我们做的只是在我们的 Debian 服务器中安装和配置 openQRM, 至于 创建、运行虚拟,管理存储,额外的系统集成和运行你自己的私有云等内容,我建议你阅读 [openQRM 管理员指南][3]。

|

||||

|

||||

就是这些了,欢呼吧!周末快乐!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.unixmen.com/install-openqrm-cloud-computing-platform-debian/

|

||||

|

||||

作者:[SK][a]

|

||||

译者:[FSSlc](https://github.com/FSSlc)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.unixmen.com/author/sk/

|

||||

[1]:http://www.openqrm-enterprise.com/products/edition-comparison.html

|

||||

[2]:http://sourceforge.net/projects/openqrm/files/?source=navbar

|

||||

[3]:http://www.openqrm-enterprise.com/fileadmin/Documents/Whitepaper/openQRM-Enterprise-Administrator-Guide-5.2.pdf

|

||||

@ -1,20 +1,20 @@

|

||||

如何在 Ubuntu 中管理和使用 LVM(Logical Volume Management,逻辑卷管理)

|

||||

如何在 Ubuntu 中管理和使用 逻辑卷管理 LVM

|

||||

================================================================================

|

||||

|

||||

|

||||

在我们之前的文章中,我们介绍了[什么是 LVM 以及能用 LVM 做什么][1],今天我们会给你介绍一些 LVM 的主要管理工具,使得你在设置和扩展安装时更游刃有余。

|

||||

|

||||

正如之前所述,LVM 是介于你的操作系统和物理硬盘驱动器之间的抽象层。这意味着你的物理硬盘驱动器和分区不再依赖于他们所在的硬盘驱动和分区。而是,你的操作系统所见的硬盘驱动和分区可以是由任意数目的独立硬盘驱动汇集而成或是一个软件磁盘阵列。

|

||||

正如之前所述,LVM 是介于你的操作系统和物理硬盘驱动器之间的抽象层。这意味着你的物理硬盘驱动器和分区不再依赖于他们所在的硬盘驱动和分区。而是你的操作系统所见的硬盘驱动和分区可以是由任意数目的独立硬盘汇集而成的或是一个软件磁盘阵列。

|

||||

|

||||

要管理 LVM,这里有很多可用的 GUI 工具,但要真正理解 LVM 配置发生的事情,最好要知道一些命令行工具。这当你在一个服务器或不提供 GUI 工具的发行版上管理 LVM 时尤为有用。

|

||||

|

||||

LVM 的大部分命令和彼此都非常相似。每个可用的命令都由以下其中之一开头:

|

||||

|

||||

- Physical Volume = pv

|

||||

- Volume Group = vg

|

||||

- Logical Volume = lv

|

||||

- Physical Volume (物理卷) = pv

|

||||

- Volume Group (卷组)= vg

|

||||

- Logical Volume (逻辑卷)= lv

|

||||

|

||||

物理卷命令用于在卷组中添加或删除硬盘驱动。卷组命令用于为你的逻辑卷操作更改显示的物理分区抽象集。逻辑卷命令会以分区形式显示卷组使得你的操作系统能使用指定的空间。

|

||||

物理卷命令用于在卷组中添加或删除硬盘驱动。卷组命令用于为你的逻辑卷操作更改显示的物理分区抽象集。逻辑卷命令会以分区形式显示卷组,使得你的操作系统能使用指定的空间。

|

||||

|

||||

### 可下载的 LVM 备忘单 ###

|

||||

|

||||

@ -26,7 +26,7 @@ LVM 的大部分命令和彼此都非常相似。每个可用的命令都由以

|

||||

|

||||

### 如何查看当前 LVM 信息 ###

|

||||

|

||||

你首先需要做的事情是检查你的 LVM 设置。s 和 display 命令和物理卷(pv)、卷组(vg)以及逻辑卷(lv)一起使用,是一个找出当前设置好的开始点。

|

||||

你首先需要做的事情是检查你的 LVM 设置。s 和 display 命令可以和物理卷(pv)、卷组(vg)以及逻辑卷(lv)一起使用,是一个找出当前设置的好起点。

|

||||

|

||||

display 命令会格式化输出信息,因此比 s 命令更易于理解。对每个命令你会看到名称和 pv/vg 的路径,它还会给出空闲和已使用空间的信息。

|

||||

|

||||

@ -40,17 +40,17 @@ display 命令会格式化输出信息,因此比 s 命令更易于理解。对

|

||||

|

||||

#### 创建物理卷 ####

|

||||

|

||||

我们会从一个完全新的没有任何分区和信息的硬盘驱动开始。首先找出你将要使用的磁盘。(/dev/sda, sdb, 等)

|

||||

我们会从一个全新的没有任何分区和信息的硬盘开始。首先找出你将要使用的磁盘。(/dev/sda, sdb, 等)

|

||||

|

||||

> 注意:记住所有的命令都要以 root 身份运行或者在命令前面添加 'sudo' 。

|

||||

|

||||

fdisk -l

|

||||

|

||||

如果之前你的硬盘驱动从没有格式化或分区,在 fdisk 的输出中你很可能看到类似下面的信息。这完全正常,因为我们会在下面的步骤中创建需要的分区。

|

||||

如果之前你的硬盘从未格式化或分区过,在 fdisk 的输出中你很可能看到类似下面的信息。这完全正常,因为我们会在下面的步骤中创建需要的分区。

|

||||

|

||||

|

||||

|

||||

我们的新磁盘位置是 /dev/sdb,让我们用 fdisk 命令在驱动上创建一个新的分区。

|

||||

我们的新磁盘位置是 /dev/sdb,让我们用 fdisk 命令在磁盘上创建一个新的分区。

|

||||

|

||||

这里有大量能创建新分区的 GUI 工具,包括 [Gparted][2],但由于我们已经打开了终端,我们将使用 fdisk 命令创建需要的分区。

|

||||

|

||||

@ -62,9 +62,9 @@ display 命令会格式化输出信息,因此比 s 命令更易于理解。对

|

||||

|

||||

|

||||

|

||||

以指定的顺序输入命令创建一个使用新硬盘驱动 100% 空间的主分区并为 LVM 做好了准备。如果你需要更改分区的大小或相应多个分区,我建议使用 GParted 或自己了解关于 fdisk 命令的使用。

|

||||

以指定的顺序输入命令创建一个使用新硬盘 100% 空间的主分区并为 LVM 做好了准备。如果你需要更改分区的大小或想要多个分区,我建议使用 GParted 或自己了解一下关于 fdisk 命令的使用。

|

||||

|

||||

**警告:下面的步骤会格式化你的硬盘驱动。确保在进行下面步骤之前你的硬盘驱动中没有任何信息。**

|

||||

**警告:下面的步骤会格式化你的硬盘驱动。确保在进行下面步骤之前你的硬盘驱动中没有任何有用的信息。**

|

||||

|

||||

- n = 创建新分区

|

||||

- p = 创建主分区

|

||||

@ -79,9 +79,9 @@ display 命令会格式化输出信息,因此比 s 命令更易于理解。对

|

||||

- t = 更改分区类型

|

||||

- 8e = 更改为 LVM 分区类型

|

||||

|

||||

核实并将信息写入硬盘驱动器。

|

||||

核实并将信息写入硬盘。

|

||||

|

||||

- p = 查看分区设置使得写入更改到磁盘之前可以回看

|

||||

- p = 查看分区设置使得在写入更改到磁盘之前可以回看

|

||||

- w = 写入更改到磁盘

|

||||

|

||||

|

||||

@ -102,7 +102,7 @@ display 命令会格式化输出信息,因此比 s 命令更易于理解。对

|

||||

|

||||

|

||||

|

||||

Vgpool 是新创建的卷组的名称。你可以使用任何你喜欢的名称,但建议标签以 vg 开头,以便后面你使用它时能意识到这是一个卷组。

|

||||

vgpool 是新创建的卷组的名称。你可以使用任何你喜欢的名称,但建议标签以 vg 开头,以便后面你使用它时能意识到这是一个卷组。

|

||||

|

||||

#### 创建逻辑卷 ####

|

||||

|

||||

@ -112,7 +112,7 @@ Vgpool 是新创建的卷组的名称。你可以使用任何你喜欢的名称

|

||||

|

||||

|

||||

|

||||

-L 命令指定逻辑卷的大小,在该情况中是 3 GB,-n 命令指定卷的名称。 指定 vgpool 所以 lvcreate 命令知道从什么卷获取空间。

|

||||

-L 命令指定逻辑卷的大小,在该情况中是 3 GB,-n 命令指定卷的名称。 指定 vgpool 以便 lvcreate 命令知道从什么卷获取空间。

|

||||

|

||||

#### 格式化并挂载逻辑卷 ####

|

||||

|

||||

@ -131,7 +131,7 @@ Vgpool 是新创建的卷组的名称。你可以使用任何你喜欢的名称

|

||||

|

||||

#### 重新设置逻辑卷大小 ####

|

||||

|

||||

逻辑卷的一个好处是你能使你的共享物理变大或变小而不需要移动所有东西到一个更大的硬盘驱动。另外,你可以添加新的硬盘驱动并同时扩展你的卷组。或者如果你有一个不使用的硬盘驱动,你可以从卷组中移除它使得逻辑卷变小。

|

||||

逻辑卷的一个好处是你能使你的存储物理地变大或变小,而不需要移动所有东西到一个更大的硬盘。另外,你可以添加新的硬盘并同时扩展你的卷组。或者如果你有一个不使用的硬盘,你可以从卷组中移除它使得逻辑卷变小。

|

||||

|

||||

这里有三个用于使物理卷、卷组和逻辑卷变大或变小的基础工具。

|

||||

|

||||

@ -147,9 +147,9 @@ Vgpool 是新创建的卷组的名称。你可以使用任何你喜欢的名称

|

||||

|

||||

按照上面创建新分区并更改分区类型为 LVM(8e) 的步骤安装一个新硬盘驱动。然后用 pvcreate 命令创建一个 LVM 能识别的物理卷。

|

||||

|

||||

#### 添加新硬盘驱动到卷组 ####

|

||||

#### 添加新硬盘到卷组 ####

|

||||

|

||||

要添加新的硬盘驱动到一个卷组,你只需要知道你的新分区,在我们的例子中是 /dev/sdc1,以及想要添加到的卷组的名称。

|

||||

要添加新的硬盘到一个卷组,你只需要知道你的新分区,在我们的例子中是 /dev/sdc1,以及想要添加到的卷组的名称。

|

||||

|

||||

这会添加新物理卷到已存在的卷组中。

|

||||

|

||||

@ -189,7 +189,7 @@ Vgpool 是新创建的卷组的名称。你可以使用任何你喜欢的名称

|

||||

|

||||

1. 调整文件系统大小 (调整之前确保已经移动文件到硬盘驱动安全的地方)

|

||||

1. 减小逻辑卷 (除了 + 可以扩展大小,你也可以用 - 压缩大小)

|

||||

1. 用 vgreduce 从卷组中移除硬盘驱动

|

||||

1. 用 vgreduce 从卷组中移除硬盘

|

||||

|

||||

#### 备份逻辑卷 ####

|

||||

|

||||

@ -197,7 +197,7 @@ Vgpool 是新创建的卷组的名称。你可以使用任何你喜欢的名称

|

||||

|

||||

|

||||

|

||||

LVM 获取快照的时候,会有一张和逻辑卷完全相同的照片,该照片可以用于在不同的硬盘驱动上进行备份。生成一个备份的时候,任何需要添加到逻辑卷的新信息会如往常一样写入磁盘,但会跟踪更改使得原始快照永远不会损毁。

|

||||

LVM 获取快照的时候,会有一张和逻辑卷完全相同的“照片”,该“照片”可以用于在不同的硬盘上进行备份。生成一个备份的时候,任何需要添加到逻辑卷的新信息会如往常一样写入磁盘,但会跟踪更改使得原始快照永远不会损毁。

|

||||

|

||||

要创建一个快照,我们需要创建拥有足够空闲空间的逻辑卷,用于保存我们备份的时候会写入该逻辑卷的任何新信息。如果驱动并不是经常写入,你可以使用很小的一个存储空间。备份完成的时候我们只需要移除临时逻辑卷,原始逻辑卷会和往常一样。

|

||||

|

||||

@ -209,7 +209,7 @@ LVM 获取快照的时候,会有一张和逻辑卷完全相同的照片,该

|

||||

|

||||

|

||||

|

||||

这里我们创建了一个只有 512MB 的逻辑卷,因为驱动实际上并不会使用。512MB 的空间会保存备份时产生的任何新数据。

|

||||

这里我们创建了一个只有 512MB 的逻辑卷,因为该硬盘实际上并不会使用。512MB 的空间会保存备份时产生的任何新数据。

|

||||

|

||||

#### 挂载新快照 ####

|

||||

|

||||

@ -222,7 +222,7 @@ LVM 获取快照的时候,会有一张和逻辑卷完全相同的照片,该

|

||||

|

||||

#### 复制快照和删除逻辑卷 ####

|

||||

|

||||

你剩下需要做的是从 /mnt/lvstuffbackup/ 中复制所有文件到一个外部的硬盘驱动或者打包所有文件到一个文件。

|

||||

你剩下需要做的是从 /mnt/lvstuffbackup/ 中复制所有文件到一个外部的硬盘或者打包所有文件到一个文件。

|

||||

|

||||

**注意:tar -c 会创建一个归档文件,-f 要指出归档文件的名称和路径。要获取 tar 命令的帮助信息,可以在终端中输入 man tar。**

|

||||

|

||||

@ -230,7 +230,7 @@ LVM 获取快照的时候,会有一张和逻辑卷完全相同的照片,该

|

||||

|

||||

|

||||

|

||||

记住备份发生的时候写到 lvstuff 的所有文件都会在我们之前创建的临时逻辑卷中被跟踪。确保备份的时候你有足够的空闲空间。

|

||||

记住备份时候写到 lvstuff 的所有文件都会在我们之前创建的临时逻辑卷中被跟踪。确保备份的时候你有足够的空闲空间。

|

||||

|

||||

备份完成后,卸载卷并移除临时快照。

|

||||

|

||||

@ -259,10 +259,10 @@ LVM 获取快照的时候,会有一张和逻辑卷完全相同的照片,该

|

||||

via: http://www.howtogeek.com/howto/40702/how-to-manage-and-use-lvm-logical-volume-management-in-ubuntu/

|

||||

|

||||

译者:[ictlyh](https://github.com/ictlyh)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[1]:http://www.howtogeek.com/howto/36568/what-is-logical-volume-management-and-how-do-you-enable-it-in-ubuntu/

|

||||

[1]:https://linux.cn/article-5953-1.html

|

||||

[2]:http://www.howtogeek.com/howto/17001/how-to-format-a-usb-drive-in-ubuntu-using-gparted/

|

||||

[3]:http://www.howtogeek.com/howto/33552/htg-explains-which-linux-file-system-should-you-choose/

|

||||

@ -0,0 +1,67 @@

|

||||

Ubuntu 上使用 LVM 轻松调整分区并制作快照

|

||||

================================================================================

|

||||

|

||||

|

||||

Ubuntu的安装器提供了一个轻松“使用LVM”的复选框。它的描述中说,启用逻辑卷管理可以让你制作快照,并更容易地调整硬盘分区大小——这里将为大家讲述如何完成这些操作。

|

||||

|

||||

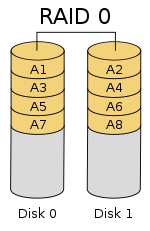

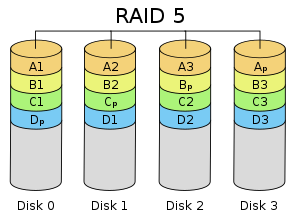

LVM是一种技术,某种程度上和[RAID阵列][1]或[Windows上的“存储空间”][2]类似。虽然该技术在服务器上更为有用,但是它也可以在桌面端PC上使用。

|

||||

|

||||

### 你应该在新安装Ubuntu时使用LVM吗? ###

|

||||

|

||||

第一个问题是,你是否想要在安装Ubuntu时使用LVM?如果是,那么Ubuntu让这一切变得很简单,只需要轻点鼠标就可以完成,但是该选项默认是不启用的。正如安装器所说的,它允许你调整分区、创建快照、将多个磁盘合并到一个逻辑卷等等——所有这一切都可以在系统运行时完成。不同于传统分区,你不需要关掉你的系统,从Live CD或USB驱动,然后[当这些分区不使用时才能调整][3]。

|

||||

|

||||

完全坦率地说,普通Ubuntu桌面用户可能不会意识到他们是否正在使用LVM。但是,如果你想要在今后做一些更高深的事情,那么LVM就会有所帮助了。LVM可能更复杂,可能会在你今后恢复数据时会导致问题——尤其是在你经验不足时。这里不会有显著的性能损失——LVM是彻底地在Linux内核中实现的。

|

||||

|

||||

|

||||

|

||||

### 逻辑卷管理说明 ###

|

||||

|

||||

前面,我们已经[说明了何谓LVM][4]。概括来讲,它在你的物理磁盘和呈现在你系统中的分区之间提供了一个抽象层。例如,你的计算机可能装有两个硬盘驱动器,它们的大小都是 1 TB。你必须得在这些磁盘上至少分两个区,每个区大小 1 TB。

|

||||

|

||||

LVM就在这些分区上提供了一个抽象层。用于取代磁盘上的传统分区,LVM将在你对这些磁盘初始化后,将它们当作独立的“物理卷”来对待。然后,你就可以基于这些物理卷创建“逻辑卷”。例如,你可以将这两个 1 TB 的磁盘组合成一个 2 TB 的分区,你的系统将只看到一个 2 TB 的卷,而LVM将会在后台处理这一切。一组物理卷以及一组逻辑卷被称之为“卷组”,一个典型的系统只会有一个卷组。

|

||||

|

||||

该抽象层使得调整分区、将多个磁盘组合成单个卷、甚至为一个运行着的分区的文件系统创建“快照”变得十分简单,而完成所有这一切都无需先卸载分区。

|

||||

|

||||

注意,如果你没有创建备份,那么将多个磁盘合并成一个卷将会是个糟糕的想法。它就像RAID 0——如果你将两个 1 TB 的卷组合成一个 2 TB 的卷,只要其中一个硬盘失败,你将丢失该卷上的重要数据。所以,如果你要走这条路,那么备份就及其重要。

|

||||

|

||||

### 管理LVM卷的图形化工具 ###

|

||||

|

||||

通常,[LVM通过Linux终端命令来管理][5]。这在Ubuntu上也行得通,但是有个更简单的图形化方法可供大家采用。如果你是一个Linux用户,对GParted或者与其类似的分区管理器熟悉,算了,别瞎掰了——GParted根本不支持LVM磁盘。

|

||||

|

||||

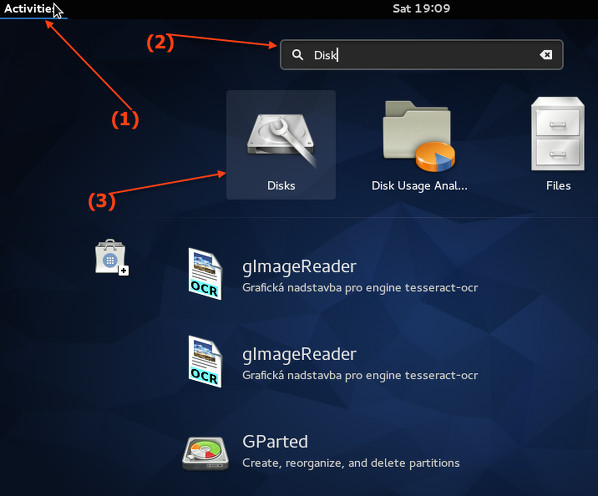

然而,你可以使用Ubuntu附带的磁盘工具。该工具也被称之为GNOME磁盘工具,或者叫Palimpsest。点击dash中的图标来开启它吧,搜索“磁盘”然后敲击回车。不像GParted,该磁盘工具将会在“其它设备”下显示LVM分区,因此你可以根据需要格式化这些分区,也可以调整其它选项。该工具在Live CD或USB 驱动下也可以使用。

|

||||

|

||||

|

||||

|

||||

不幸的是,该磁盘工具不支持LVM的大多数强大的特性,没有管理卷组、扩展分区,或者创建快照等选项。对于这些操作,你可以通过终端来实现,但是没有那个必要。相反,你可以打开Ubuntu软件中心,搜索关键字LVM,然后安装逻辑卷管理工具,你可以在终端窗口中运行**sudo apt-get install system-config-lvm**命令来安装它。安装完之后,你就可以从dash上打开逻辑卷管理工具了。

|

||||

|

||||

这个图形化配置工具是由红帽公司开发的,虽然有点陈旧了,但却是唯一的图形化方式,你可以通过它来完成上述操作,将那些终端命令抛诸脑后了。

|

||||

|

||||

比如说,你想要添加一个新的物理卷到卷组中。你可以打开该工具,选择未初始化条目下的新磁盘,然后点击“初始化条目”按钮。然后,你就可以在未分配卷下找到新的物理卷了,你可以使用“添加到现存卷组”按钮来将它添加到“ubuntu-vg”卷组,这是Ubuntu在安装过程中创建的卷组。

|

||||

|

||||

|

||||

|

||||

卷组视图会列出你所有的物理卷和逻辑卷的总览。这里,我们有两个横跨两个独立硬盘驱动器的物理分区,我们有一个交换分区和一个根分区,这是Ubuntu默认设置的分区图表。由于我们从另一个驱动器添加了第二个物理分区,现在那里有大量未使用空间。

|

||||

|

||||

|

||||

|

||||

要扩展逻辑分区到物理空间,你可以在逻辑视图下选择它,点击编辑属性,然后修改大小来扩大分区。你也可以在这里缩小分区。

|

||||

|

||||

|

||||

|

||||

system-config-lvm的其它选项允许你设置快照和镜像。对于传统桌面而言,你或许不需要这些特性,但是在这里也可以通过图形化处理。记住,你也可以[使用终端命令完成这一切][6]。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.howtogeek.com/211937/how-to-use-lvm-on-ubuntu-for-easy-partition-resizing-and-snapshots/

|

||||

|

||||

译者:[GOLinux](https://github.com/GOLinux)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[1]:http://www.howtogeek.com/162676/how-to-use-multiple-disks-intelligently-an-introduction-to-raid/

|

||||

[2]:http://www.howtogeek.com/109380/how-to-use-windows-8s-storage-spaces-to-mirror-combine-drives/

|

||||

[3]:http://www.howtogeek.com/114503/how-to-resize-your-ubuntu-partitions/

|

||||

[4]:http://www.howtogeek.com/howto/40702/how-to-manage-and-use-lvm-logical-volume-management-in-ubuntu/

|

||||

[5]:http://www.howtogeek.com/howto/40702/how-to-manage-and-use-lvm-logical-volume-management-in-ubuntu/

|

||||

[6]:http://www.howtogeek.com/howto/40702/how-to-manage-and-use-lvm-logical-volume-management-in-ubuntu/

|

||||

@ -0,0 +1,89 @@

|

||||

如何在树莓派 2 运行 ubuntu Snappy Core

|

||||

================================================================================

|

||||

物联网(Internet of Things, IoT) 时代即将来临。很快,过不了几年,我们就会问自己当初是怎么在没有物联网的情况下生存的,就像我们现在怀疑过去没有手机的年代。Canonical 就是一个物联网快速发展却还是开放市场下的竞争者。这家公司宣称自己把赌注压到了IoT 上,就像他们已经在“云”上做过的一样。在今年一月底,Canonical 启动了一个基于Ubuntu Core 的小型操作系统,名字叫做 [Ubuntu Snappy Core][1] 。

|

||||

|

||||

Snappy 代表了两种意思,它是一种用来替代 deb 的新的打包格式;也是一个用来更新系统的前端,从CoreOS、红帽子和其他系统借鉴了**原子更新**这个想法。自从树莓派 2 投入市场,Canonical 很快就发布了用于树莓派的Snappy Core 版本。而第一代树莓派因为是基于ARMv6 ,Ubuntu 的ARM 镜像是基于ARMv7 ,所以不能运行ubuntu 。不过这种状况现在改变了,Canonical 通过发布 Snappy Core 的RPI2 镜像,抓住机会证明了Snappy 就是一个用于云计算,特别是用于物联网的系统。

|

||||

|

||||

Snappy 同样可以运行在其它像Amazon EC2, Microsofts Azure, Google的 Compute Engine 这样的云端上,也可以虚拟化在 KVM、Virtuabox 和vagrant 上。Canonical Ubuntu 已经拥抱了微软、谷歌、Docker、OpenStack 这些重量级选手,同时也与一些小项目达成合作关系。除了一些创业公司,比如 Ninja Sphere、Erle Robotics,还有一些开发板生产商,比如 Odroid、Banana Pro, Udoo, PCDuino 和 Parallella 、全志,Snappy 也提供了支持。Snappy Core 同时也希望尽快运行到路由器上来帮助改进路由器生产商目前很少更新固件的策略。

|

||||

|

||||

接下来,让我们看看怎么样在树莓派 2 上运行 Ubuntu Snappy Core。

|

||||

|

||||

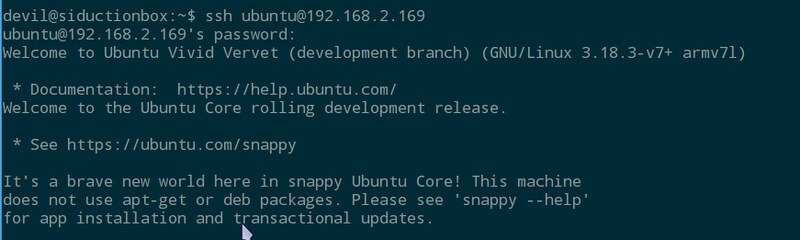

用于树莓派2 的Snappy 镜像可以从 [Raspberry Pi 网站][2] 上下载。解压缩出来的镜像必须[写到一个至少8GB 大小的SD 卡][3]。尽管原始系统很小,但是原子升级和回滚功能会占用不小的空间。使用 Snappy 启动树莓派 2 后你就可以使用默认用户名和密码(都是ubuntu)登录系统。

|

||||

|

||||

|

||||

|

||||

sudo 已经配置好了可以直接用,安全起见,你应该使用以下命令来修改你的用户名

|

||||

|

||||

$ sudo usermod -l <new name> <old name>

|

||||

|

||||

或者也可以使用`adduser` 为你添加一个新用户。

|

||||

|

||||

因为RPI缺少硬件时钟,而 Snappy Core 镜像并不知道这一点,所以系统会有一个小 bug:处理某些命令时会报很多错。不过这个很容易解决:

|

||||

|

||||

使用这个命令来确认这个bug 是否影响:

|

||||

|

||||

$ date

|

||||

|

||||

如果输出类似 "Thu Jan 1 01:56:44 UTC 1970", 你可以这样做来改正:

|

||||

|

||||

$ sudo date --set="Sun Apr 04 17:43:26 UTC 2015"

|

||||

|

||||

改成你的实际时间。

|

||||

|

||||

|

||||

|

||||

现在你可能打算检查一下,看看有没有可用的更新。注意通常使用的命令是不行的:

|

||||

|

||||

$ sudo apt-get update && sudo apt-get distupgrade

|

||||

|

||||

这时系统不会让你通过,因为 Snappy 使用它自己精简过的、基于dpkg 的包管理系统。这么做的原因是 Snappy 会运行很多嵌入式程序,而同时你也会试图所有事情尽可能的简化。

|

||||

|

||||

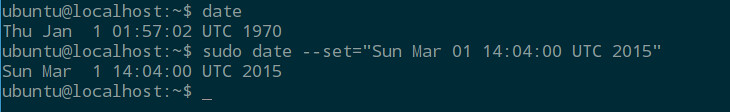

让我们来看看最关键的部分,理解一下程序是如何与 Snappy 工作的。运行 Snappy 的SD 卡上除了 boot 分区外还有3个分区。其中的两个构成了一个重复的文件系统。这两个平行文件系统被固定挂载为只读模式,并且任何时刻只有一个是激活的。第三个分区是一个部分可写的文件系统,用来让用户存储数据。通过更新系统,标记为'system-a' 的分区会保持一个完整的文件系统,被称作核心,而另一个平行的文件系统仍然会是空的。

|

||||

|

||||

|

||||

|

||||

如果我们运行以下命令:

|

||||

|

||||

$ sudo snappy update

|

||||

|

||||

系统将会在'system-b' 上作为一个整体进行更新,这有点像是更新一个镜像文件。接下来你将会被告知要重启系统来激活新核心。

|

||||

|

||||

重启之后,运行下面的命令可以检查你的系统是否已经更新到最新版本,以及当前被激活的是哪个核心

|

||||

|

||||

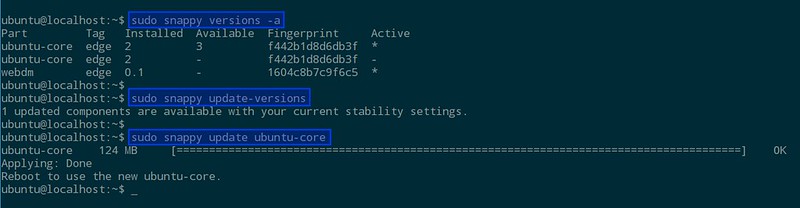

$ sudo snappy versions -a

|

||||

|

||||

经过更新-重启两步操作,你应该可以看到被激活的核心已经被改变了。

|

||||

|

||||

因为到目前为止我们还没有安装任何软件,所以可以用下面的命令更新:

|

||||

|

||||

$ sudo snappy update ubuntu-core

|

||||

|

||||

如果你打算仅仅更新特定的OS 版本这就够了。如果出了问题,你可以使用下面的命令回滚:

|

||||

|

||||

$ sudo snappy rollback ubuntu-core

|

||||

|

||||

这将会把系统状态回滚到更新之前。

|

||||

|

||||

|

||||

|

||||

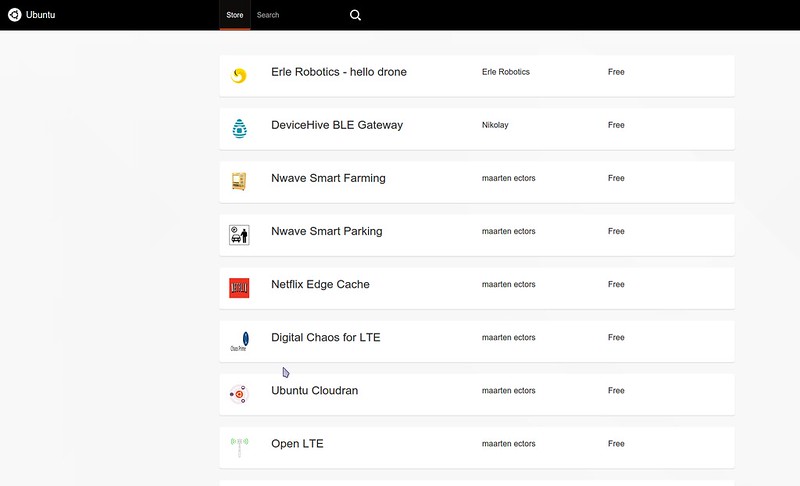

再来说说那些让 Snappy 变得有用的软件。这里不会讲的太多关于如何构建软件、向 Snappy 应用商店添加软件的基础知识,但是你可以通过 Freenode 上的IRC 频道 #snappy 了解更多信息,那个上面有很多人参与。你可以通过浏览器访问http://\<ip-address>:4200 来浏览应用商店,然后从商店安装软件,再在浏览器里访问 http://webdm.local 来启动程序。如何构建用于 Snappy 的软件并不难,而且也有了现成的[参考文档][4] 。你也可以很容易的把 DEB 安装包使用Snappy 格式移植到Snappy 上。

|

||||

|

||||

|

||||

|

||||

尽管 Ubuntu Snappy Core 吸引了我们去研究新型的 Snappy 安装包格式和 Canonical 式的原子更新操作,但是因为有限的可用应用,它现在在生产环境里还不是很有用。但是既然搭建一个 Snappy 环境如此简单,这看起来是一个学点新东西的好机会。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://xmodulo.com/ubuntu-snappy-core-raspberry-pi-2.html

|

||||

|

||||

作者:[Ferdinand Thommes][a]

|

||||

译者:[Ezio](https://github.com/oska874)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://xmodulo.com/author/ferdinand

|

||||

[1]:http://www.ubuntu.com/things

|

||||

[2]:http://www.raspberrypi.org/downloads/

|

||||

[3]:http://xmodulo.com/write-raspberry-pi-image-sd-card.html

|

||||

[4]:https://developer.ubuntu.com/en/snappy/

|

||||

@ -0,0 +1,131 @@

|

||||

如何通过反向 SSH 隧道访问 NAT 后面的 Linux 服务器

|

||||

================================================================================

|

||||

你在家里运行着一台 Linux 服务器,它放在一个 NAT 路由器或者限制性防火墙后面。现在你想在外出时用 SSH 登录到这台服务器。你如何才能做到呢?SSH 端口转发当然是一种选择。但是,如果你需要处理多级嵌套的 NAT 环境,端口转发可能会变得非常棘手。另外,在多种 ISP 特定条件下可能会受到干扰,例如阻塞转发端口的限制性 ISP 防火墙、或者在用户间共享 IPv4 地址的运营商级 NAT。

|

||||

|

||||

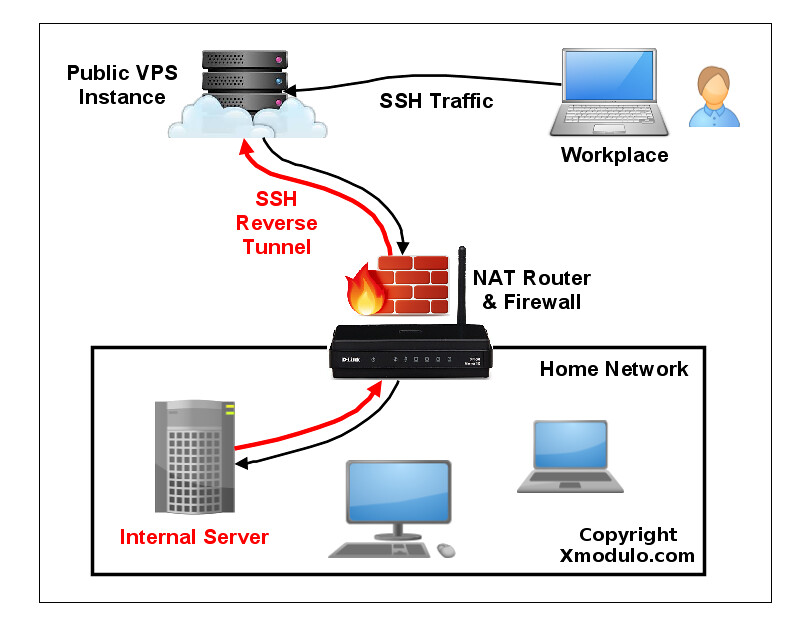

### 什么是反向 SSH 隧道? ###

|

||||

|

||||

SSH 端口转发的一种替代方案是 **反向 SSH 隧道**。反向 SSH 隧道的概念非常简单。使用这种方案,在你的受限的家庭网络之外你需要另一台主机(所谓的“中继主机”),你能从当前所在地通过 SSH 登录到它。你可以用有公网 IP 地址的 [VPS 实例][1] 配置一个中继主机。然后要做的就是从你的家庭网络服务器中建立一个到公网中继主机的永久 SSH 隧道。有了这个隧道,你就可以从中继主机中连接“回”家庭服务器(这就是为什么称之为 “反向” 隧道)。不管你在哪里、你的家庭网络中的 NAT 或 防火墙限制多么严格,只要你可以访问中继主机,你就可以连接到家庭服务器。

|

||||

|

||||

|

||||

|

||||

### 在 Linux 上设置反向 SSH 隧道 ###

|

||||

|

||||

让我们来看看怎样创建和使用反向 SSH 隧道。我们做如下假设:我们会设置一个从家庭服务器(homeserver)到中继服务器(relayserver)的反向 SSH 隧道,然后我们可以通过中继服务器从客户端计算机(clientcomputer) SSH 登录到家庭服务器。本例中的**中继服务器** 的公网 IP 地址是 1.1.1.1。

|

||||

|

||||

在家庭服务器上,按照以下方式打开一个到中继服务器的 SSH 连接。

|

||||

|

||||

homeserver~$ ssh -fN -R 10022:localhost:22 relayserver_user@1.1.1.1

|

||||

|

||||

这里端口 10022 是任何你可以使用的端口数字。只需要确保中继服务器上不会有其它程序使用这个端口。

|

||||

|

||||

“-R 10022:localhost:22” 选项定义了一个反向隧道。它转发中继服务器 10022 端口的流量到家庭服务器的 22 号端口。

|

||||

|

||||

用 “-fN” 选项,当你成功通过 SSH 服务器验证时 SSH 会进入后台运行。当你不想在远程 SSH 服务器执行任何命令,就像我们的例子中只想转发端口的时候非常有用。

|

||||

|

||||

运行上面的命令之后,你就会回到家庭主机的命令行提示框中。

|

||||

|

||||

登录到中继服务器,确认其 127.0.0.1:10022 绑定到了 sshd。如果是的话就表示已经正确设置了反向隧道。

|

||||

|

||||

relayserver~$ sudo netstat -nap | grep 10022

|

||||

|

||||

----------

|

||||

|

||||

tcp 0 0 127.0.0.1:10022 0.0.0.0:* LISTEN 8493/sshd

|

||||

|

||||

现在就可以从任何其它计算机(客户端计算机)登录到中继服务器,然后按照下面的方法访问家庭服务器。

|

||||

|

||||

relayserver~$ ssh -p 10022 homeserver_user@localhost

|

||||

|

||||

需要注意的一点是你在上面为localhost输入的 SSH 登录/密码应该是家庭服务器的,而不是中继服务器的,因为你是通过隧道的本地端点登录到家庭服务器,因此不要错误输入中继服务器的登录/密码。成功登录后,你就在家庭服务器上了。

|

||||

|

||||

### 通过反向 SSH 隧道直接连接到网络地址变换后的服务器 ###

|

||||

|

||||

上面的方法允许你访问 NAT 后面的 **家庭服务器**,但你需要登录两次:首先登录到 **中继服务器**,然后再登录到**家庭服务器**。这是因为中继服务器上 SSH 隧道的端点绑定到了回环地址(127.0.0.1)。

|

||||

|

||||

事实上,有一种方法可以只需要登录到中继服务器就能直接访问NAT之后的家庭服务器。要做到这点,你需要让中继服务器上的 sshd 不仅转发回环地址上的端口,还要转发外部主机的端口。这通过指定中继服务器上运行的 sshd 的 **GatewayPorts** 实现。

|

||||

|

||||

打开**中继服务器**的 /etc/ssh/sshd_conf 并添加下面的行。

|

||||

|

||||

relayserver~$ vi /etc/ssh/sshd_conf

|

||||

|

||||

----------

|

||||

|

||||

GatewayPorts clientspecified

|

||||

|

||||

重启 sshd。

|

||||

|

||||

基于 Debian 的系统:

|

||||

|

||||

relayserver~$ sudo /etc/init.d/ssh restart

|

||||

|

||||

基于红帽的系统:

|

||||

|

||||

relayserver~$ sudo systemctl restart sshd

|

||||

|

||||

现在在家庭服务器中按照下面方式初始化一个反向 SSH 隧道。

|

||||

|

||||

homeserver~$ ssh -fN -R 1.1.1.1:10022:localhost:22 relayserver_user@1.1.1.1

|

||||

|

||||

登录到中继服务器然后用 netstat 命令确认成功建立的一个反向 SSH 隧道。

|

||||

|

||||

relayserver~$ sudo netstat -nap | grep 10022

|

||||

|

||||

----------

|

||||

|

||||

tcp 0 0 1.1.1.1:10022 0.0.0.0:* LISTEN 1538/sshd: dev

|

||||

|

||||

不像之前的情况,现在隧道的端点是 1.1.1.1:10022(中继服务器的公网 IP 地址),而不是 127.0.0.1:10022。这就意味着从外部主机可以访问隧道的另一端。

|

||||

|

||||

现在在任何其它计算机(客户端计算机),输入以下命令访问网络地址变换之后的家庭服务器。

|

||||

|

||||

clientcomputer~$ ssh -p 10022 homeserver_user@1.1.1.1

|

||||

|

||||

在上面的命令中,1.1.1.1 是中继服务器的公共 IP 地址,homeserver_user必须是家庭服务器上的用户账户。这是因为你真正登录到的主机是家庭服务器,而不是中继服务器。后者只是中继你的 SSH 流量到家庭服务器。

|

||||

|

||||

### 在 Linux 上设置一个永久反向 SSH 隧道 ###

|

||||

|

||||

现在你已经明白了怎样创建一个反向 SSH 隧道,然后把隧道设置为 “永久”,这样隧道启动后就会一直运行(不管临时的网络拥塞、SSH 超时、中继主机重启,等等)。毕竟,如果隧道不是一直有效,你就不能可靠的登录到你的家庭服务器。

|

||||

|

||||

对于永久隧道,我打算使用一个叫 autossh 的工具。正如名字暗示的,这个程序可以让你的 SSH 会话无论因为什么原因中断都会自动重连。因此对于保持一个反向 SSH 隧道非常有用。

|

||||

|

||||

第一步,我们要设置从家庭服务器到中继服务器的[无密码 SSH 登录][2]。这样的话,autossh 可以不需要用户干预就能重启一个损坏的反向 SSH 隧道。

|

||||

|

||||

下一步,在建立隧道的家庭服务器上[安装 autossh][3]。

|

||||

|

||||

在家庭服务器上,用下面的参数运行 autossh 来创建一个连接到中继服务器的永久 SSH 隧道。

|

||||

|

||||

homeserver~$ autossh -M 10900 -fN -o "PubkeyAuthentication=yes" -o "StrictHostKeyChecking=false" -o "PasswordAuthentication=no" -o "ServerAliveInterval 60" -o "ServerAliveCountMax 3" -R 1.1.1.1:10022:localhost:22 relayserver_user@1.1.1.1

|

||||

|

||||

“-M 10900” 选项指定中继服务器上的监视端口,用于交换监视 SSH 会话的测试数据。中继服务器上的其它程序不能使用这个端口。

|

||||

|

||||

“-fN” 选项传递给 ssh 命令,让 SSH 隧道在后台运行。

|

||||

|

||||

“-o XXXX” 选项让 ssh:

|

||||

|

||||

- 使用密钥验证,而不是密码验证。

|

||||

- 自动接受(未知)SSH 主机密钥。

|

||||

- 每 60 秒交换 keep-alive 消息。

|

||||

- 没有收到任何响应时最多发送 3 条 keep-alive 消息。

|

||||

|

||||

其余 SSH 隧道相关的选项和之前介绍的一样。

|

||||

|

||||

如果你想系统启动时自动运行 SSH 隧道,你可以将上面的 autossh 命令添加到 /etc/rc.local。

|

||||

|

||||

### 总结 ###

|

||||

|

||||

在这篇博文中,我介绍了你如何能从外部通过反向 SSH 隧道访问限制性防火墙或 NAT 网关之后的 Linux 服务器。这里我介绍了家庭网络中的一个使用事例,但在企业网络中使用时你尤其要小心。这样的一个隧道可能被视为违反公司政策,因为它绕过了企业的防火墙并把企业网络暴露给外部攻击。这很可能被误用或者滥用。因此在使用之前一定要记住它的作用。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://xmodulo.com/access-linux-server-behind-nat-reverse-ssh-tunnel.html

|

||||

|

||||

作者:[Dan Nanni][a]

|

||||

译者:[ictlyh](https://github.com/ictlyh)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://xmodulo.com/author/nanni

|

||||

[1]:http://xmodulo.com/go/digitalocean

|

||||

[2]:https://linux.cn/article-5444-1.html

|

||||

[3]:https://linux.cn/article-5459-1.html

|

||||

@ -0,0 +1,199 @@

|

||||

如何配置 MongoDB 副本集

|

||||

================================================================================

|

||||

|

||||

MongoDB 已经成为市面上最知名的 NoSQL 数据库。MongoDB 是面向文档的,它的无模式设计使得它在各种各样的WEB 应用当中广受欢迎。最让我喜欢的特性之一是它的副本集(Replica Set),副本集将同一数据的多份拷贝放在一组 mongod 节点上,从而实现数据的冗余以及高可用性。

|

||||

|

||||

这篇教程将向你介绍如何配置一个 MongoDB 副本集。

|

||||

|

||||

副本集的最常见配置需要一个主节点以及多个副节点。这之后启动的复制行为会从这个主节点到其他副节点。副本集不止可以针对意外的硬件故障和停机事件对数据库提供保护,同时也因为提供了更多的节点从而提高了数据库客户端数据读取的吞吐量。

|

||||

|

||||

### 配置环境 ###

|

||||

|

||||

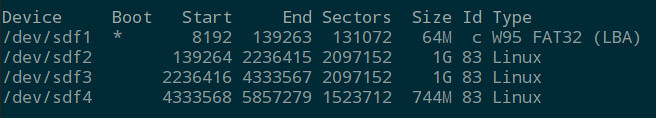

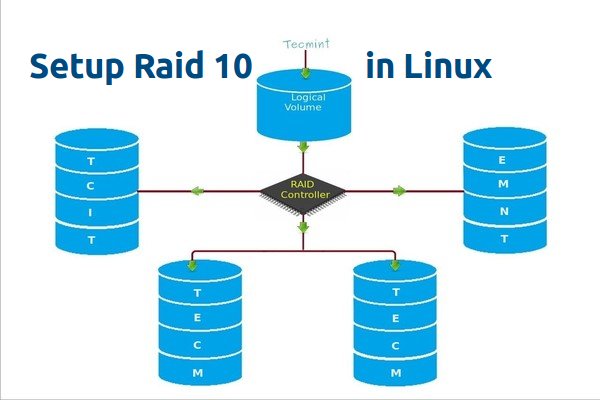

这个教程里,我们会配置一个包括一个主节点以及两个副节点的副本集。

|

||||

|

||||

|

||||

|

||||

为了达到这个目的,我们使用了3个运行在 VirtualBox 上的虚拟机。我会在这些虚拟机上安装 Ubuntu 14.04,并且安装 MongoDB 官方包。

|

||||

|

||||

我会在一个虚拟机实例上配置好所需的环境,然后将它克隆到其他的虚拟机实例上。因此,选择一个名为 master 的虚拟机,执行以下安装过程。

|

||||

|

||||

首先,我们需要给 apt 增加一个 MongoDB 密钥:

|

||||

|

||||

$ sudo apt-key adv --keyserver hkp://keyserver.ubuntu.com:80 --recv 7F0CEB10

|

||||

|

||||

然后,将官方的 MongoDB 仓库添加到 source.list 中:

|

||||

|

||||

$ sudo su

|

||||

# echo "deb http://repo.mongodb.org/apt/ubuntu "$(lsb_release -sc)"/mongodb-org/3.0 multiverse" | sudo tee /etc/apt/sources.list.d/mongodb-org-3.0.list

|

||||

|

||||

接下来更新 apt 仓库并且安装 MongoDB。

|

||||

|

||||

$ sudo apt-get update

|

||||

$ sudo apt-get install -y mongodb-org

|

||||

|

||||

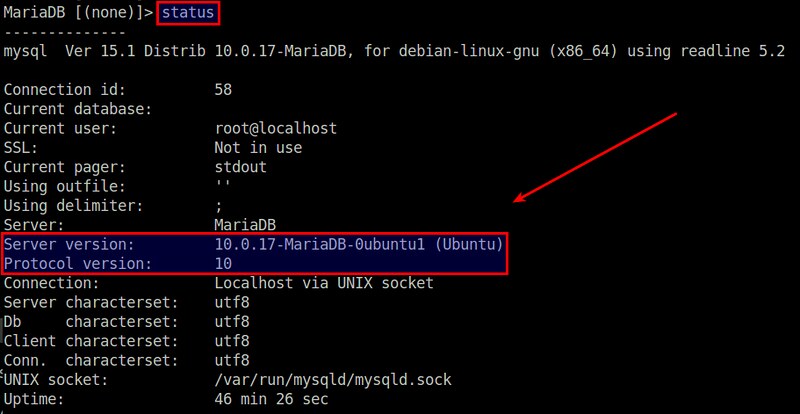

现在对 /etc/mongodb.conf 做一些更改

|

||||

|

||||

auth = true

|

||||

dbpath=/var/lib/mongodb

|

||||

logpath=/var/log/mongodb/mongod.log

|

||||

logappend=true

|

||||

keyFile=/var/lib/mongodb/keyFile

|

||||

replSet=myReplica

|

||||

|

||||

第一行的作用是表明我们的数据库需要验证才可以使用。keyfile 配置用于 MongoDB 节点间复制行为的密钥文件。replSet 为副本集设置一个名称。

|

||||

|

||||

接下来我们创建一个用于所有实例的密钥文件。

|

||||

|

||||

$ echo -n "MyRandomStringForReplicaSet" | md5sum > keyFile

|

||||

|

||||

这将会创建一个含有 MD5 字符串的密钥文件,但是由于其中包含了一些噪音,我们需要对他们清理后才能正式在 MongoDB 中使用。

|

||||

|

||||

$ echo -n "MyReplicaSetKey" | md5sum|grep -o "[0-9a-z]\+" > keyFile

|

||||

|

||||

grep 命令的作用的是把将空格等我们不想要的内容过滤掉之后的 MD5 字符串打印出来。

|

||||

|

||||

现在我们对密钥文件进行一些操作,让它真正可用。

|

||||

|

||||

$ sudo cp keyFile /var/lib/mongodb

|

||||

$ sudo chown mongodb:nogroup keyFile

|

||||

$ sudo chmod 400 keyFile

|

||||

|

||||

接下来,关闭此虚拟机。将其 Ubuntu 系统克隆到其他虚拟机上。

|

||||

|

||||

|

||||

|

||||

这是克隆后的副节点1和副节点2。确认你已经将它们的MAC地址重新初始化,并且克隆整个硬盘。

|

||||

|

||||

|

||||

|

||||

请注意,三个虚拟机示例需要在同一个网络中以便相互通讯。因此,我们需要它们弄到“互联网"上去。

|

||||

|

||||

这里推荐给每个虚拟机设置一个静态 IP 地址,而不是使用 DHCP。这样它们就不至于在 DHCP 分配IP地址给他们的时候失去连接。

|

||||

|

||||

像下面这样编辑每个虚拟机的 /etc/networks/interfaces 文件。

|

||||

|

||||

在主节点上:

|

||||

|

||||

auto eth1

|

||||

iface eth1 inet static

|

||||

address 192.168.50.2

|

||||

netmask 255.255.255.0

|

||||

|

||||

在副节点1上:

|

||||

|

||||

auto eth1

|

||||

iface eth1 inet static

|

||||

address 192.168.50.3

|

||||

netmask 255.255.255.0

|

||||

|

||||

在副节点2上:

|

||||

|

||||

auto eth1

|

||||

iface eth1 inet static

|

||||

address 192.168.50.4

|

||||

netmask 255.255.255.0

|

||||

|

||||

由于我们没有 DNS 服务,所以需要设置设置一下 /etc/hosts 这个文件,手工将主机名称放到此文件中。

|

||||

|

||||

在主节点上:

|

||||

|

||||

127.0.0.1 localhost primary

|

||||

192.168.50.2 primary

|

||||

192.168.50.3 secondary1

|

||||

192.168.50.4 secondary2

|

||||

|

||||

在副节点1上:

|

||||

|

||||

127.0.0.1 localhost secondary1

|

||||

192.168.50.2 primary

|

||||

192.168.50.3 secondary1

|

||||

192.168.50.4 secondary2

|

||||

|

||||

在副节点2上:

|

||||

|

||||

127.0.0.1 localhost secondary2

|

||||

192.168.50.2 primary

|

||||

192.168.50.3 secondary1

|

||||

192.168.50.4 secondary2

|

||||

|

||||

使用 ping 命令检查各个节点之间的连接。

|

||||

|

||||

$ ping primary

|

||||

$ ping secondary1

|

||||

$ ping secondary2

|

||||

|

||||

### 配置副本集 ###

|

||||

|

||||

验证各个节点可以正常连通后,我们就可以新建一个管理员用户,用于之后的副本集操作。

|

||||

|

||||

在主节点上,打开 /etc/mongodb.conf 文件,将 auth 和 replSet 两项注释掉。

|

||||

|

||||

dbpath=/var/lib/mongodb

|

||||

logpath=/var/log/mongodb/mongod.log

|

||||

logappend=true

|

||||

#auth = true

|

||||

keyFile=/var/lib/mongodb/keyFile

|

||||

#replSet=myReplica

|

||||

|

||||

在一个新安装的 MongoDB 上配置任何用户或副本集之前,你需要注释掉 auth 行。默认情况下,MongoDB 并没有创建任何用户。而如果在你创建用户前启用了 auth,你就不能够做任何事情。你可以在创建一个用户后再次启用 auth。

|

||||

|

||||

修改 /etc/mongodb.conf 之后,重启 mongod 进程。

|

||||

|

||||

$ sudo service mongod restart

|

||||

|

||||

现在连接到 MongoDB master:

|

||||

|

||||

$ mongo <master-ip-address>:27017

|

||||

|

||||

连接 MongoDB 后,新建管理员用户。

|

||||

|

||||

> use admin

|

||||

> db.createUser({

|

||||

user:"admin",

|

||||

pwd:"

|

||||

})

|

||||

|

||||

重启 MongoDB:

|

||||

|

||||

$ sudo service mongod restart

|

||||

|

||||

再次连接到 MongoDB,用以下命令将 副节点1 和副节点2节点添加到我们的副本集中。

|

||||

|

||||

> use admin

|

||||

> db.auth("admin","myreallyhardpassword")

|

||||

> rs.initiate()

|

||||

> rs.add ("secondary1:27017")

|

||||

> rs.add("secondary2:27017")

|

||||

|

||||

|

||||

现在副本集到手了,可以开始我们的项目了。参照 [官方驱动文档][1] 来了解如何连接到副本集。如果你想要用 Shell 来请求数据,那么你需要连接到主节点上来插入或者请求数据,副节点不行。如果你执意要尝试用副本集操作,那么以下错误信息就蹦出来招呼你了。

|

||||

|

||||

myReplica:SECONDARY>

|

||||

myReplica:SECONDARY> show databases

|

||||

2015-05-10T03:09:24.131+0000 E QUERY Error: listDatabases failed:{ "note" : "from execCommand", "ok" : 0, "errmsg" : "not master" }

|

||||

at Error ()

|

||||

at Mongo.getDBs (src/mongo/shell/mongo.js:47:15)

|

||||

at shellHelper.show (src/mongo/shell/utils.js:630:33)

|

||||

at shellHelper (src/mongo/shell/utils.js:524:36)

|

||||

at (shellhelp2):1:1 at src/mongo/shell/mongo.js:47

|

||||

|

||||

如果你要从 shell 连接到整个副本集,你可以安装如下命令。在副本集中的失败切换是自动的。

|

||||

|

||||

$ mongo primary,secondary1,secondary2:27017/?replicaSet=myReplica

|

||||

|

||||

如果你使用其它驱动语言(例如,JavaScript、Ruby 等等),格式也许不同。

|

||||

|

||||

希望这篇教程能对你有所帮助。你可以使用Vagrant来自动完成你的本地环境配置,并且加速你的代码。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://xmodulo.com/setup-replica-set-mongodb.html

|

||||

|

||||

作者:[Christopher Valerio][a]

|

||||

译者:[mr-ping](https://github.com/mr-ping)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://xmodulo.com/author/valerio

|

||||

[1]:http://docs.mongodb.org/ecosystem/drivers/

|

||||

@ -0,0 +1,113 @@

|

||||

在 VirtualBox 中使用 Docker Machine 管理主机

|

||||

================================================================================

|

||||

大家好,今天我们学习在 VirtualBox 中使用 Docker Machine 来创建和管理 Docker 主机。Docker Machine 是一个可以帮助我们在电脑上、在云端、在数据中心内创建 Docker 主机的应用。它为根据用户的配置和需求创建服务器并在其上安装 Docker和客户端提供了一个轻松的解决方案。这个 API 可以用于在本地主机、或数据中心的虚拟机、或云端的实例提供 Docker 服务。Docker Machine 支持 Windows、OSX 和 Linux,并且是以一个独立的二进制文件包形式安装的。仍然使用(与现有 Docker 工具)相同的接口,我们就可以充分利用已经提供 Docker 基础框架的生态系统。只要一个命令,用户就能快速部署 Docker 容器。

|

||||

|

||||

本文列出一些简单的步骤用 Docker Machine 来部署 docker 容器。

|

||||

|

||||

### 1. 安装 Docker Machine ###

|

||||

|

||||

Docker Machine 完美支持所有 Linux 操作系统。首先我们需要从 [github][1] 下载最新版本的 Docker Machine,本文使用 curl 作为下载工具,Docker Machine 版本为 0.2.0。

|

||||

|

||||

**64 位操作系统**

|

||||

|

||||

# curl -L https://github.com/docker/machine/releases/download/v0.2.0/docker-machine_linux-amd64 > /usr/local/bin/docker-machine

|

||||

|

||||

**32 位操作系统**

|

||||

|

||||

# curl -L https://github.com/docker/machine/releases/download/v0.2.0/docker-machine_linux-i386 > /usr/local/bin/docker-machine

|

||||

|

||||

下载完成后,找到 **/usr/local/bin** 目录下的 **docker-machine** 文件,让其可以执行:

|

||||

|

||||

# chmod +x /usr/local/bin/docker-machine

|

||||

|

||||

确认是否成功安装了 docker-machine,可以运行下面的命令,它会打印 Docker Machine 的版本信息:

|

||||

|

||||

# docker-machine -v

|

||||

|

||||

|

||||

|

||||

运行下面的命令,安装 Docker 客户端,以便于在我们自己的电脑止运行 Docker 命令:

|

||||

|

||||

# curl -L https://get.docker.com/builds/linux/x86_64/docker-latest > /usr/local/bin/docker

|

||||

# chmod +x /usr/local/bin/docker

|

||||

|

||||

### 2. 创建 VirtualBox 虚拟机 ###

|

||||

|

||||

在 Linux 系统上安装完 Docker Machine 后,接下来我们可以安装 VirtualBox 虚拟机,运行下面的就可以了。`--driver virtualbox` 选项表示我们要在 VirtualBox 的虚拟机里面部署 docker,最后的参数“linux” 是虚拟机的名称。这个命令会下载 [boot2docker][2] iso,它是个基于 Tiny Core Linux 的轻量级发行版,自带 Docker 程序,然后 `docker-machine` 命令会创建一个 VirtualBox 虚拟机(LCTT译注:当然,我们也可以选择其他的虚拟机软件)来运行这个 boot2docker 系统。

|

||||

|

||||

# docker-machine create --driver virtualbox linux

|

||||

|

||||

|

||||

|

||||

测试下有没有成功运行 VirtualBox 和 Docker,运行命令:

|

||||

|

||||

# docker-machine ls

|

||||

|

||||

|

||||

|

||||

如果执行成功,我们可以看到在 ACTIVE 那列下面会出现一个星号“*”。

|

||||

|

||||

### 3. 设置环境变量 ###

|

||||

|

||||

现在我们需要让 docker 与 docker-machine 通信,运行 `docker-machine env <虚拟机名称>` 来实现这个目的。

|

||||

|

||||

# eval "$(docker-machine env linux)"

|

||||

# docker ps

|

||||

|

||||

这个命令会设置 TLS 认证的环境变量,每次重启机器或者重新打开一个会话都需要执行一下这个命令,我们可以看到它的输出内容:

|

||||

|

||||

# docker-machine env linux

|

||||

|

||||

export DOCKER_TLS_VERIFY=1

|

||||

export DOCKER_CERT_PATH=/Users/<your username>/.docker/machine/machines/dev

|

||||

export DOCKER_HOST=tcp://192.168.99.100:2376

|

||||

|

||||

### 4. 运行 Docker 容器 ###

|

||||

|

||||

完成配置后我们就可以在 VirtualBox 上运行 docker 容器了。测试一下,我们可以运行虚拟机 `docker run busybox` ,并在里面里执行 `echo hello world` 命令,我们可以看到容器的输出信息。

|

||||

|

||||

# docker run busybox echo hello world

|

||||

|

||||

|

||||

|

||||

### 5. 拿到 Docker 主机的 IP ###

|

||||

|

||||

我们可以执行下面的命令获取运行 Docker 的主机的 IP 地址。我们可以看到在 Docker 主机的 IP 地址上的任何暴露出来的端口。

|

||||

|

||||

# docker-machine ip

|

||||

|

||||

|

||||

|

||||

### 6. 管理主机 ###

|

||||

|

||||

现在我们可以随心所欲地使用上述的 docker-machine 命令来不断创建主机了。

|

||||

|

||||

当你使用完 docker 时,可以运行 **docker-machine stop** 来停止所有主机,如果想开启所有主机,运行 **docker-machine start**。

|

||||

|

||||

# docker-machine stop

|

||||

# docker-machine start

|

||||

|

||||

你也可以只停止或开启一台主机:

|

||||

|

||||

$ docker-machine stop linux

|

||||

$ docker-machine start linux

|

||||

|

||||

### 总结 ###

|

||||

|

||||

最后,我们使用 Docker Machine 成功在 VirtualBox 上创建并管理一台 Docker 主机。Docker Machine 确实能让用户快速地在不同的平台上部署 Docker 主机,就像我们这里部署在 VirtualBox 上一样。这个 virtualbox 驱动可以在本地机器上使用,也可以在数据中心的虚拟机上使用。Docker Machine 驱动除了支持本地的 VirtualBox 之外,还支持远端的 Digital Ocean、AWS、Azure、VMware 以及其它基础设施。

|

||||

|

||||

如果你有任何疑问,或者建议,请在评论栏中写出来,我们会不断改进我们的内容。谢谢,祝愉快。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://linoxide.com/linux-how-to/host-virtualbox-docker-machine/

|

||||

|

||||

作者:[Arun Pyasi][a]

|

||||

译者:[bazz2](https://github.com/bazz2)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://linoxide.com/author/arunp/

|

||||

[1]:https://github.com/docker/machine/releases

|

||||

[2]:https://github.com/boot2docker/boot2docker

|

||||

@ -0,0 +1,205 @@

|

||||

关于Linux防火墙'iptables'的面试问答

|

||||

================================================================================

|

||||

Nishita Agarwal是Tecmint的用户,她将分享关于她刚刚经历的一家公司(印度的一家私人公司Pune)的面试经验。在面试中她被问及许多不同的问题,但她是iptables方面的专家,因此她想分享这些关于iptables的问题和相应的答案给那些以后可能会进行相关面试的人。

|

||||

|

||||

|

||||

|

||||

所有的问题和相应的答案都基于Nishita Agarwal的记忆并经过了重写。

|

||||

|

||||

> “嗨,朋友!我叫**Nishita Agarwal**。我已经取得了理学学士学位,我的专业集中在UNIX和它的变种(BSD,Linux)。它们一直深深的吸引着我。我在存储方面有1年多的经验。我正在寻求职业上的变化,并将供职于印度的Pune公司。”

|

||||

|

||||

下面是我在面试中被问到的问题的集合。我已经把我记忆中有关iptables的问题和它们的答案记录了下来。希望这会对您未来的面试有所帮助。

|

||||

|

||||

### 1. 你听说过Linux下面的iptables和Firewalld么?知不知道它们是什么,是用来干什么的? ###

|

||||

|

||||

**答案** : iptables和Firewalld我都知道,并且我已经使用iptables好一段时间了。iptables主要由C语言写成,并且以GNU GPL许可证发布。它是从系统管理员的角度写的,最新的稳定版是iptables 1.4.21。iptables通常被用作类UNIX系统中的防火墙,更准确的说,可以称为iptables/netfilter。管理员通过终端/GUI工具与iptables打交道,来添加和定义防火墙规则到预定义的表中。Netfilter是内核中的一个模块,它执行包过滤的任务。

|

||||

|

||||

Firewalld是RHEL/CentOS 7(也许还有其他发行版,但我不太清楚)中最新的过滤规则的实现。它已经取代了iptables接口,并与netfilter相连接。

|

||||

|

||||

### 2. 你用过一些iptables的GUI或命令行工具么? ###

|

||||

|

||||

**答案** : 虽然我既用过GUI工具,比如与[Webmin][1]结合的Shorewall;以及直接通过终端访问iptables,但我必须承认通过Linux终端直接访问iptables能给予用户更高级的灵活性、以及对其背后工作更好的理解的能力。GUI适合初级管理员,而终端适合有经验的管理员。

|

||||

|

||||

### 3. 那么iptables和firewalld的基本区别是什么呢? ###

|

||||

|

||||

**答案** : iptables和firewalld都有着同样的目的(包过滤),但它们使用不同的方式。iptables与firewalld不同,在每次发生更改时都刷新整个规则集。通常iptables配置文件位于‘/etc/sysconfig/iptables‘,而firewalld的配置文件位于‘/etc/firewalld/‘。firewalld的配置文件是一组XML文件。以XML为基础进行配置的firewalld比iptables的配置更加容易,但是两者都可以完成同样的任务。例如,firewalld可以在自己的命令行界面以及基于XML的配置文件下使用iptables。

|

||||

|

||||

### 4. 如果有机会的话,你会在你所有的服务器上用firewalld替换iptables么? ###

|

||||

|

||||

**答案** : 我对iptables很熟悉,它也工作的很好。如果没有任何需求需要firewalld的动态特性,那么没有理由把所有的配置都从iptables移动到firewalld。通常情况下,目前为止,我还没有看到iptables造成什么麻烦。IT技术的通用准则也说道“为什么要修一件没有坏的东西呢?”。上面是我自己的想法,但如果组织愿意用firewalld替换iptables的话,我不介意。

|

||||

|

||||

### 5. 你看上去对iptables很有信心,巧的是,我们的服务器也在使用iptables。 ###

|

||||

|

||||

iptables使用的表有哪些?请简要的描述iptables使用的表以及它们所支持的链。

|

||||

|

||||

**答案** : 谢谢您的赞赏。至于您问的问题,iptables使用的表有四个,它们是:

|

||||

|

||||

- Nat 表

|

||||

- Mangle 表

|

||||

- Filter 表

|

||||

- Raw 表

|

||||

|

||||

Nat表 : Nat表主要用于网络地址转换。根据表中的每一条规则修改网络包的IP地址。流中的包仅遍历一遍Nat表。例如,如果一个通过某个接口的包被修饰(修改了IP地址),该流中其余的包将不再遍历这个表。通常不建议在这个表中进行过滤,由NAT表支持的链称为PREROUTING 链,POSTROUTING 链和OUTPUT 链。

|

||||

|

||||

Mangle表 : 正如它的名字一样,这个表用于校正网络包。它用来对特殊的包进行修改。它能够修改不同包的头部和内容。Mangle表不能用于地址伪装。支持的链包括PREROUTING 链,OUTPUT 链,Forward 链,Input 链和POSTROUTING 链。

|

||||

|

||||

Filter表 : Filter表是iptables中使用的默认表,它用来过滤网络包。如果没有定义任何规则,Filter表则被当作默认的表,并且基于它来过滤。支持的链有INPUT 链,OUTPUT 链,FORWARD 链。

|

||||

|

||||

Raw表 : Raw表在我们想要配置之前被豁免的包时被使用。它支持PREROUTING 链和OUTPUT 链。

|

||||

|

||||

### 6. 简要谈谈什么是iptables中的目标值(能被指定为目标),他们有什么用 ###

|

||||

|

||||

**答案** : 下面是在iptables中可以指定为目标的值:

|

||||

|

||||

- ACCEPT : 接受包

|

||||

- QUEUE : 将包传递到用户空间 (应用程序和驱动所在的地方)

|

||||

- DROP : 丢弃包

|

||||

- RETURN : 将控制权交回调用的链并且为当前链中的包停止执行下一调用规则

|

||||

|

||||

### 7. 让我们来谈谈iptables技术方面的东西,我的意思是说实际使用方面 ###

|

||||

|

||||

你怎么检测在CentOS中安装iptables时需要的iptables的rpm?

|

||||

|

||||

**答案** : iptables已经被默认安装在CentOS中,我们不需要单独安装它。但可以这样检测rpm:

|

||||

|

||||

# rpm -qa iptables

|

||||

|

||||

iptables-1.4.21-13.el7.x86_64

|

||||

|

||||

如果您需要安装它,您可以用yum来安装。

|

||||

|

||||

# yum install iptables-services

|

||||

|

||||

### 8. 怎样检测并且确保iptables服务正在运行? ###

|

||||

|

||||

**答案** : 您可以在终端中运行下面的命令来检测iptables的状态。

|

||||

|

||||

# service status iptables [On CentOS 6/5]

|

||||

# systemctl status iptables [On CentOS 7]

|

||||

|

||||

如果iptables没有在运行,可以使用下面的语句

|

||||

|

||||

---------------- 在CentOS 6/5下 ----------------

|

||||

# chkconfig --level 35 iptables on

|

||||

# service iptables start

|

||||

|

||||

---------------- 在CentOS 7下 ----------------

|

||||

# systemctl enable iptables

|

||||

# systemctl start iptables

|

||||

|

||||

我们还可以检测iptables的模块是否被加载:

|

||||

|

||||

# lsmod | grep ip_tables

|

||||

|

||||

### 9. 你怎么检查iptables中当前定义的规则呢? ###

|

||||

|

||||

**答案** : 当前的规则可以简单的用下面的命令查看:

|

||||

|

||||

# iptables -L

|

||||

|

||||

示例输出

|

||||

|

||||

Chain INPUT (policy ACCEPT)

|

||||

target prot opt source destination

|

||||

ACCEPT all -- anywhere anywhere state RELATED,ESTABLISHED

|

||||

ACCEPT icmp -- anywhere anywhere

|

||||

ACCEPT all -- anywhere anywhere

|

||||

ACCEPT tcp -- anywhere anywhere state NEW tcp dpt:ssh

|

||||

REJECT all -- anywhere anywhere reject-with icmp-host-prohibited

|

||||

|

||||

Chain FORWARD (policy ACCEPT)

|

||||

target prot opt source destination

|

||||

REJECT all -- anywhere anywhere reject-with icmp-host-prohibited

|

||||

|

||||

Chain OUTPUT (policy ACCEPT)

|

||||

target prot opt source destination

|

||||

|

||||

### 10. 你怎样刷新所有的iptables规则或者特定的链呢? ###

|

||||

|

||||

**答案** : 您可以使用下面的命令来刷新一个特定的链。

|

||||

|

||||

# iptables --flush OUTPUT

|

||||

|

||||

要刷新所有的规则,可以用:

|

||||

|

||||

# iptables --flush

|

||||

|

||||

### 11. 请在iptables中添加一条规则,接受所有从一个信任的IP地址(例如,192.168.0.7)过来的包。 ###

|

||||

|

||||

**答案** : 上面的场景可以通过运行下面的命令来完成。

|

||||

|

||||

# iptables -A INPUT -s 192.168.0.7 -j ACCEPT

|

||||

|

||||

我们还可以在源IP中使用标准的斜线和子网掩码:

|

||||

|

||||

# iptables -A INPUT -s 192.168.0.7/24 -j ACCEPT

|

||||

# iptables -A INPUT -s 192.168.0.7/255.255.255.0 -j ACCEPT

|

||||

|

||||

### 12. 怎样在iptables中添加规则以ACCEPT,REJECT,DENY和DROP ssh的服务? ###

|

||||

|

||||

**答案** : 但愿ssh运行在22端口,那也是ssh的默认端口,我们可以在iptables中添加规则来ACCEPT ssh的tcp包(在22号端口上)。

|

||||

|

||||

# iptables -A INPUT -s -p tcp --dport 22 -j ACCEPT

|

||||

|

||||

REJECT ssh服务(22号端口)的tcp包。

|

||||

|

||||