mirror of

https://github.com/LCTT/TranslateProject.git

synced 2024-12-26 21:30:55 +08:00

commit

c406226926

183

published/20150522 Analyzing Linux Logs.md

Normal file

183

published/20150522 Analyzing Linux Logs.md

Normal file

@ -0,0 +1,183 @@

|

||||

如何分析 Linux 日志

|

||||

==============================================================================

|

||||

|

||||

|

||||

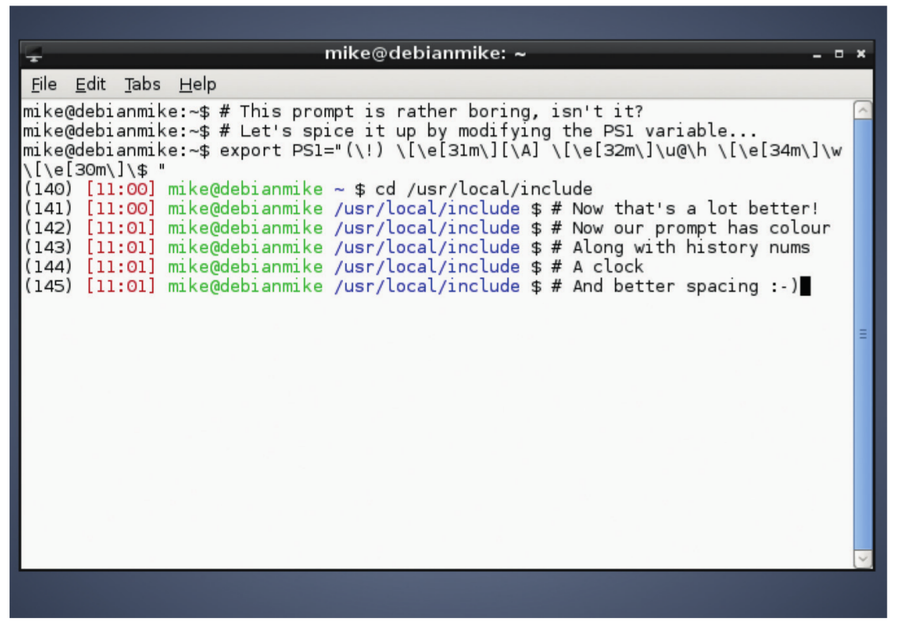

日志中有大量的信息需要你处理,尽管有时候想要提取并非想象中的容易。在这篇文章中我们会介绍一些你现在就能做的基本日志分析例子(只需要搜索即可)。我们还将涉及一些更高级的分析,但这些需要你前期努力做出适当的设置,后期就能节省很多时间。对数据进行高级分析的例子包括生成汇总计数、对有效值进行过滤,等等。

|

||||

|

||||

我们首先会向你展示如何在命令行中使用多个不同的工具,然后展示了一个日志管理工具如何能自动完成大部分繁重工作从而使得日志分析变得简单。

|

||||

|

||||

### 用 Grep 搜索 ###

|

||||

|

||||

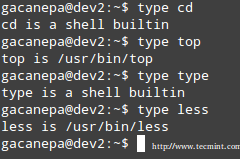

搜索文本是查找信息最基本的方式。搜索文本最常用的工具是 [grep][1]。这个命令行工具在大部分 Linux 发行版中都有,它允许你用正则表达式搜索日志。正则表达式是一种用特殊的语言写的、能识别匹配文本的模式。最简单的模式就是用引号把你想要查找的字符串括起来。

|

||||

|

||||

#### 正则表达式 ####

|

||||

|

||||

这是一个在 Ubuntu 系统的认证日志中查找 “user hoover” 的例子:

|

||||

|

||||

$ grep "user hoover" /var/log/auth.log

|

||||

Accepted password for hoover from 10.0.2.2 port 4792 ssh2

|

||||

pam_unix(sshd:session): session opened for user hoover by (uid=0)

|

||||

pam_unix(sshd:session): session closed for user hoover

|

||||

|

||||

构建精确的正则表达式可能很难。例如,如果我们想要搜索一个类似端口 “4792” 的数字,它可能也会匹配时间戳、URL 以及其它不需要的数据。Ubuntu 中下面的例子,它匹配了一个我们不想要的 Apache 日志。

|

||||

|

||||

$ grep "4792" /var/log/auth.log

|

||||

Accepted password for hoover from 10.0.2.2 port 4792 ssh2

|

||||

74.91.21.46 - - [31/Mar/2015:19:44:32 +0000] "GET /scripts/samples/search?q=4972 HTTP/1.0" 404 545 "-" "-”

|

||||

|

||||

#### 环绕搜索 ####

|

||||

|

||||

另一个有用的小技巧是你可以用 grep 做环绕搜索。这会向你展示一个匹配前面或后面几行是什么。它能帮助你调试导致错误或问题的东西。`B` 选项展示前面几行,`A` 选项展示后面几行。举个例子,我们知道当一个人以管理员员身份登录失败时,同时他们的 IP 也没有反向解析,也就意味着他们可能没有有效的域名。这非常可疑!

|

||||

|

||||

$ grep -B 3 -A 2 'Invalid user' /var/log/auth.log

|

||||

Apr 28 17:06:20 ip-172-31-11-241 sshd[12545]: reverse mapping checking getaddrinfo for 216-19-2-8.commspeed.net [216.19.2.8] failed - POSSIBLE BREAK-IN ATTEMPT!

|

||||

Apr 28 17:06:20 ip-172-31-11-241 sshd[12545]: Received disconnect from 216.19.2.8: 11: Bye Bye [preauth]

|

||||

Apr 28 17:06:20 ip-172-31-11-241 sshd[12547]: Invalid user admin from 216.19.2.8

|

||||

Apr 28 17:06:20 ip-172-31-11-241 sshd[12547]: input_userauth_request: invalid user admin [preauth]

|

||||

Apr 28 17:06:20 ip-172-31-11-241 sshd[12547]: Received disconnect from 216.19.2.8: 11: Bye Bye [preauth]

|

||||

|

||||

#### Tail ####

|

||||

|

||||

你也可以把 grep 和 [tail][2] 结合使用来获取一个文件的最后几行,或者跟踪日志并实时打印。这在你做交互式更改的时候非常有用,例如启动服务器或者测试代码更改。

|

||||

|

||||

$ tail -f /var/log/auth.log | grep 'Invalid user'

|

||||

Apr 30 19:49:48 ip-172-31-11-241 sshd[6512]: Invalid user ubnt from 219.140.64.136

|

||||

Apr 30 19:49:49 ip-172-31-11-241 sshd[6514]: Invalid user admin from 219.140.64.136

|

||||

|

||||

关于 grep 和正则表达式的详细介绍并不在本指南的范围,但 [Ryan’s Tutorials][3] 有更深入的介绍。

|

||||

|

||||

日志管理系统有更高的性能和更强大的搜索能力。它们通常会索引数据并进行并行查询,因此你可以很快的在几秒内就能搜索 GB 或 TB 的日志。相比之下,grep 就需要几分钟,在极端情况下可能甚至几小时。日志管理系统也使用类似 [Lucene][4] 的查询语言,它提供更简单的语法来检索数字、域以及其它。

|

||||

|

||||

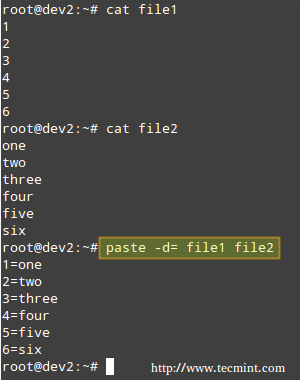

### 用 Cut、 AWK、 和 Grok 解析 ###

|

||||

|

||||

#### 命令行工具 ####

|

||||

|

||||

Linux 提供了多个命令行工具用于文本解析和分析。当你想要快速解析少量数据时非常有用,但处理大量数据时可能需要很长时间。

|

||||

|

||||

#### Cut ####

|

||||

|

||||

[cut][5] 命令允许你从有分隔符的日志解析字段。分隔符是指能分开字段或键值对的等号或逗号等。

|

||||

|

||||

假设我们想从下面的日志中解析出用户:

|

||||

|

||||

pam_unix(su:auth): authentication failure; logname=hoover uid=1000 euid=0 tty=/dev/pts/0 ruser=hoover rhost= user=root

|

||||

|

||||

我们可以像下面这样用 cut 命令获取用等号分割后的第八个字段的文本。这是一个 Ubuntu 系统上的例子:

|

||||

|

||||

$ grep "authentication failure" /var/log/auth.log | cut -d '=' -f 8

|

||||

root

|

||||

hoover

|

||||

root

|

||||

nagios

|

||||

nagios

|

||||

|

||||

#### AWK ####

|

||||

|

||||

另外,你也可以使用 [awk][6],它能提供更强大的解析字段功能。它提供了一个脚本语言,你可以过滤出几乎任何不相干的东西。

|

||||

|

||||

例如,假设在 Ubuntu 系统中我们有下面的一行日志,我们想要提取登录失败的用户名称:

|

||||

|

||||

Mar 24 08:28:18 ip-172-31-11-241 sshd[32701]: input_userauth_request: invalid user guest [preauth]

|

||||

|

||||

你可以像下面这样使用 awk 命令。首先,用一个正则表达式 /sshd.*invalid user/ 来匹配 sshd invalid user 行。然后用 { print $9 } 根据默认的分隔符空格打印第九个字段。这样就输出了用户名。

|

||||

|

||||

$ awk '/sshd.*invalid user/ { print $9 }' /var/log/auth.log

|

||||

guest

|

||||

admin

|

||||

info

|

||||

test

|

||||

ubnt

|

||||

|

||||

你可以在 [Awk 用户指南][7] 中阅读更多关于如何使用正则表达式和输出字段的信息。

|

||||

|

||||

#### 日志管理系统 ####

|

||||

|

||||

日志管理系统使得解析变得更加简单,使用户能快速的分析很多的日志文件。他们能自动解析标准的日志格式,比如常见的 Linux 日志和 Web 服务器日志。这能节省很多时间,因为当处理系统问题的时候你不需要考虑自己写解析逻辑。

|

||||

|

||||

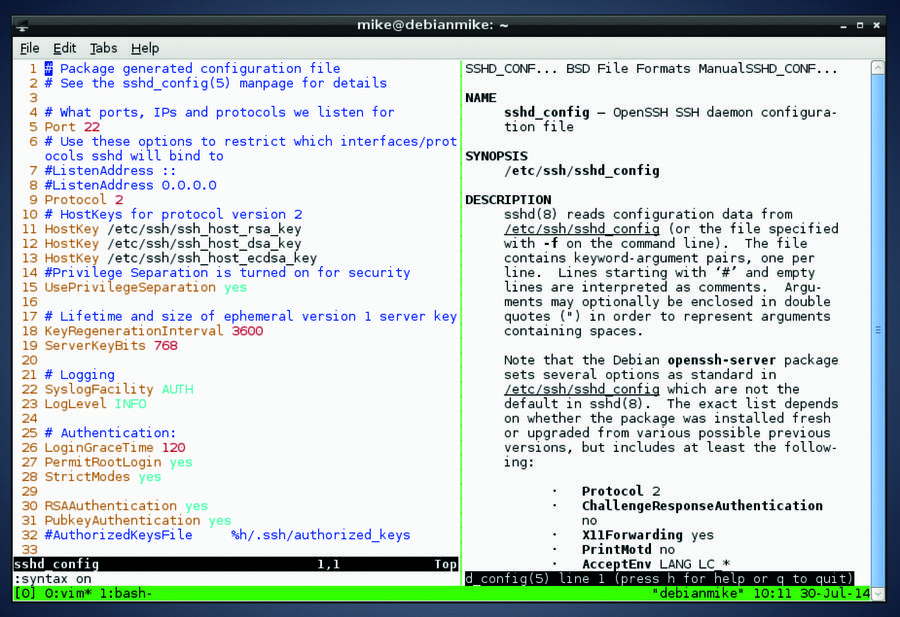

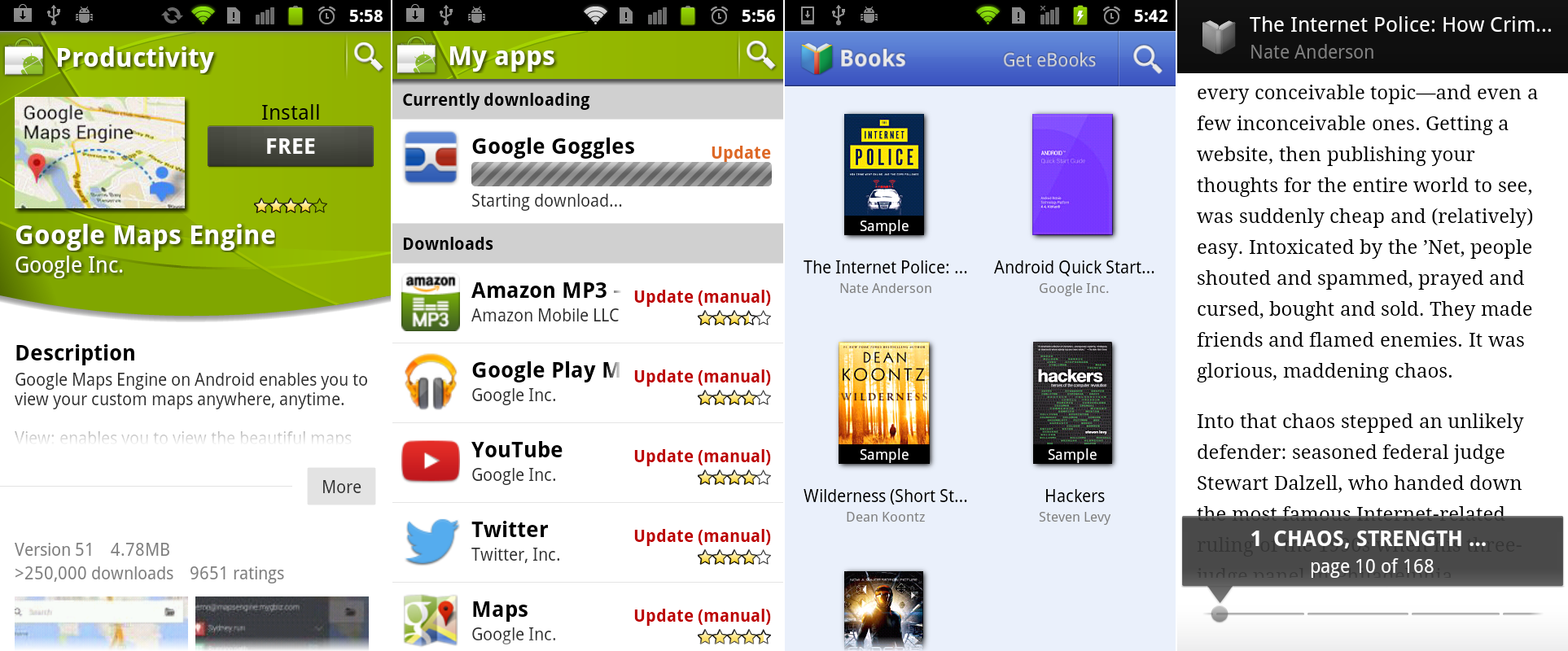

下面是一个 sshd 日志消息的例子,解析出了每个 remoteHost 和 user。这是 Loggly 中的一张截图,它是一个基于云的日志管理服务。

|

||||

|

||||

|

||||

|

||||

你也可以对非标准格式自定义解析。一个常用的工具是 [Grok][8],它用一个常见正则表达式库,可以解析原始文本为结构化 JSON。下面是一个 Grok 在 Logstash 中解析内核日志文件的事例配置:

|

||||

|

||||

filter{

|

||||

grok {

|

||||

match => {"message" => "%{CISCOTIMESTAMP:timestamp} %{HOST:host} %{WORD:program}%{NOTSPACE} %{NOTSPACE}%{NUMBER:duration}%{NOTSPACE} %{GREEDYDATA:kernel_logs}"

|

||||

}

|

||||

}

|

||||

|

||||

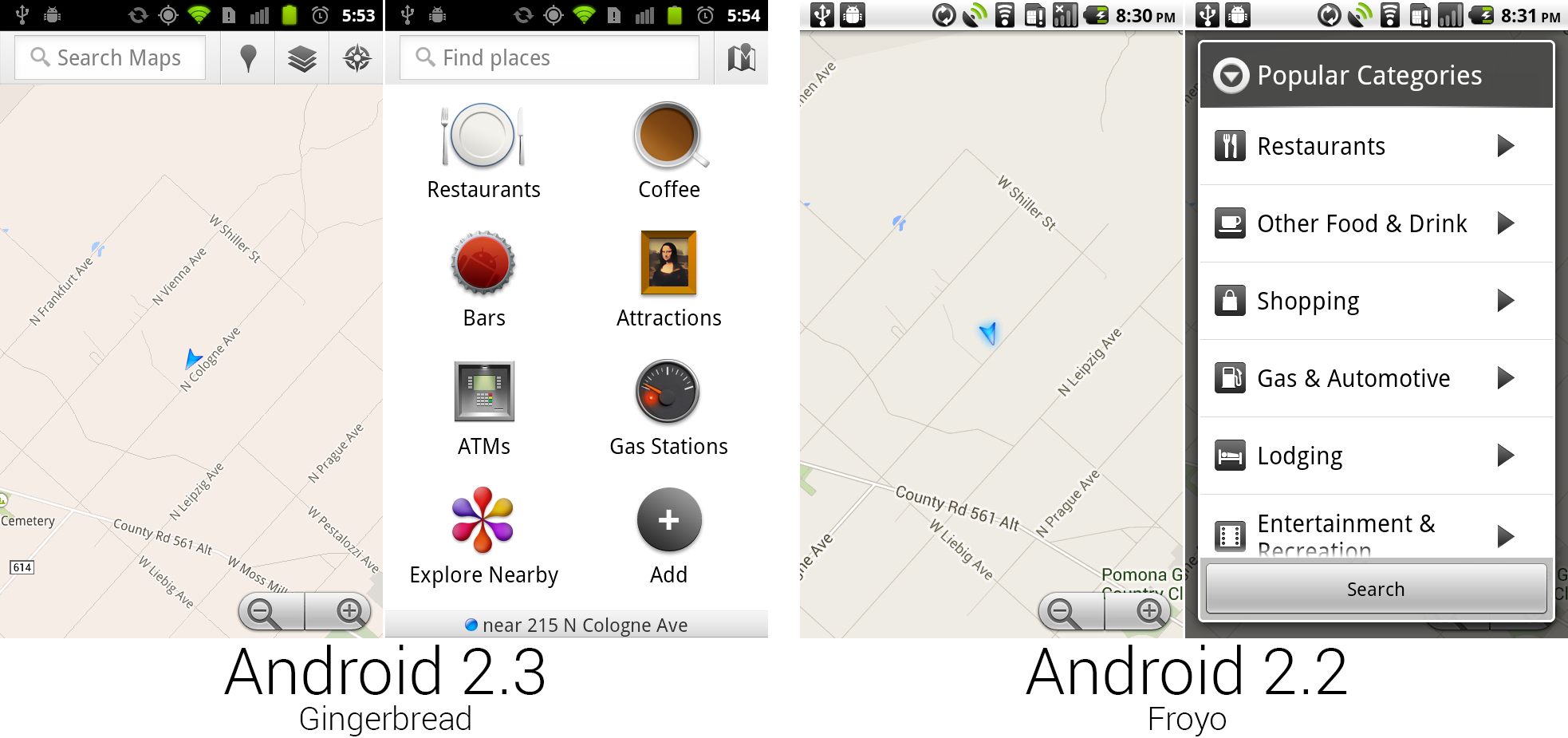

下图是 Grok 解析后输出的结果:

|

||||

|

||||

|

||||

|

||||

### 用 Rsyslog 和 AWK 过滤 ###

|

||||

|

||||

过滤使得你能检索一个特定的字段值而不是进行全文检索。这使你的日志分析更加准确,因为它会忽略来自其它部分日志信息不需要的匹配。为了对一个字段值进行搜索,你首先需要解析日志或者至少有对事件结构进行检索的方式。

|

||||

|

||||

#### 如何对应用进行过滤 ####

|

||||

|

||||

通常,你可能只想看一个应用的日志。如果你的应用把记录都保存到一个文件中就会很容易。如果你需要在一个聚集或集中式日志中过滤一个应用就会比较复杂。下面有几种方法来实现:

|

||||

|

||||

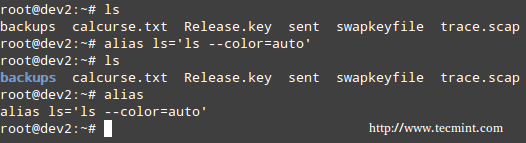

1. 用 rsyslog 守护进程解析和过滤日志。下面的例子将 sshd 应用的日志写入一个名为 sshd-message 的文件,然后丢弃事件以便它不会在其它地方重复出现。你可以将它添加到你的 rsyslog.conf 文件中测试这个例子。

|

||||

|

||||

:programname, isequal, “sshd” /var/log/sshd-messages

|

||||

&~

|

||||

|

||||

2. 用类似 awk 的命令行工具提取特定字段的值,例如 sshd 用户名。下面是 Ubuntu 系统中的一个例子。

|

||||

|

||||

$ awk '/sshd.*invalid user/ { print $9 }' /var/log/auth.log

|

||||

guest

|

||||

admin

|

||||

info

|

||||

test

|

||||

ubnt

|

||||

|

||||

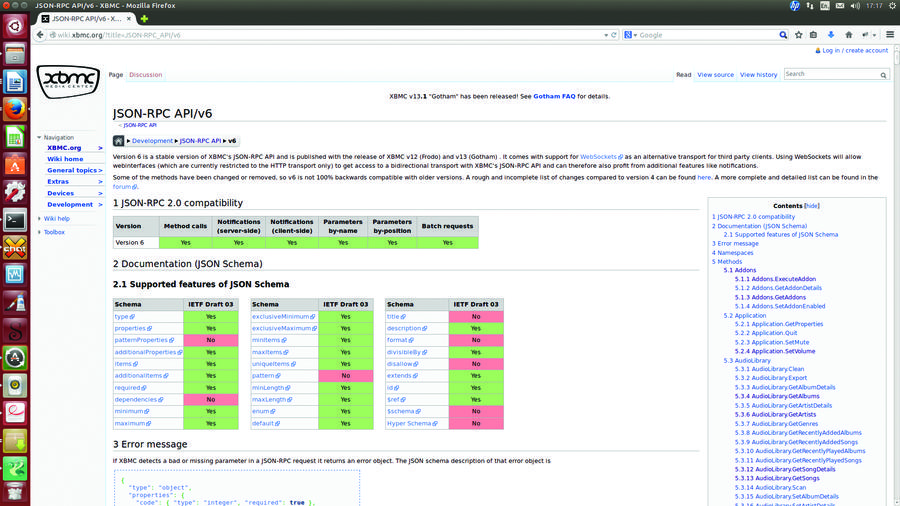

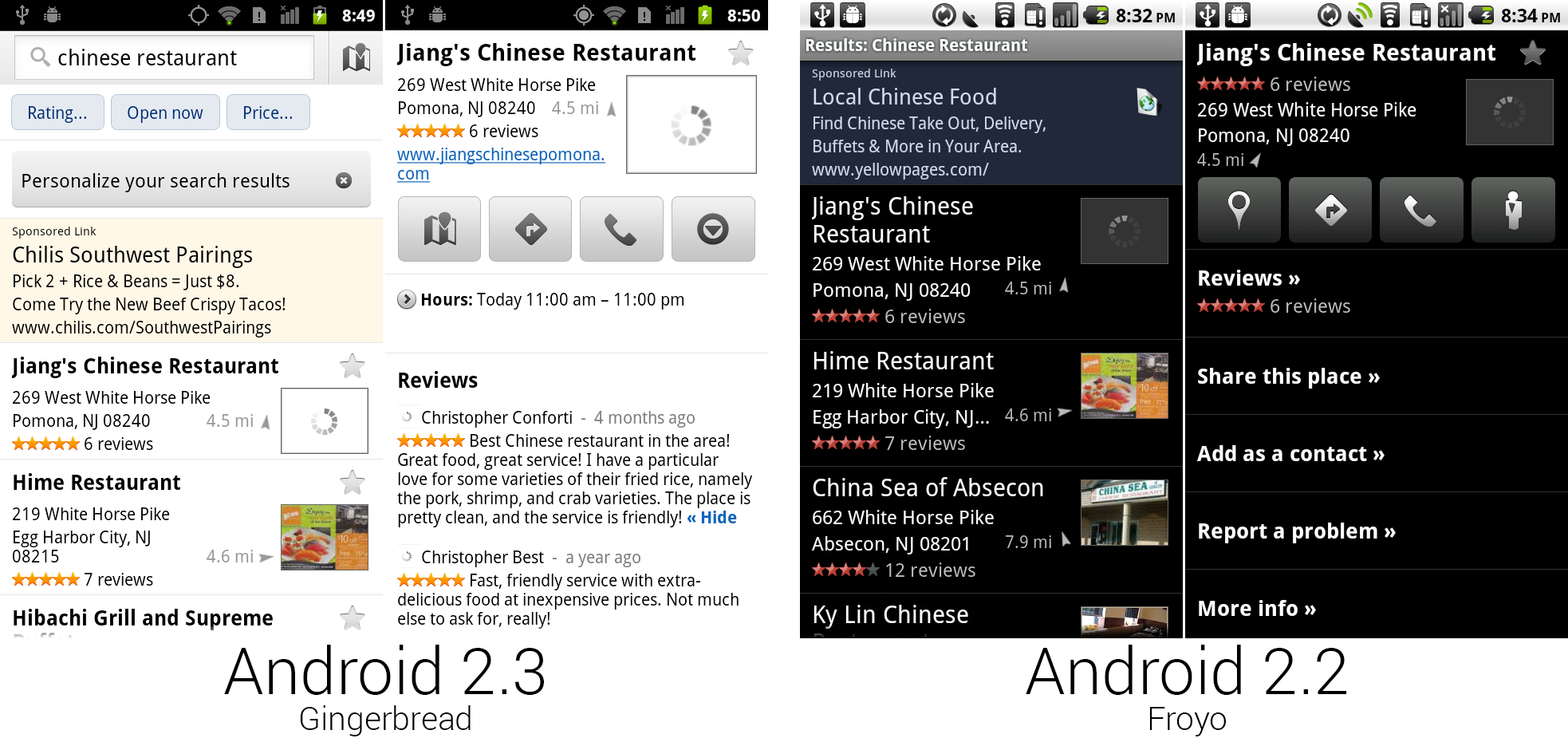

3. 用日志管理系统自动解析日志,然后在需要的应用名称上点击过滤。下面是在 Loggly 日志管理服务中提取 syslog 域的截图。我们对应用名称 “sshd” 进行过滤,如维恩图图标所示。

|

||||

|

||||

|

||||

|

||||

#### 如何过滤错误 ####

|

||||

|

||||

一个人最希望看到日志中的错误。不幸的是,默认的 syslog 配置不直接输出错误的严重性,也就使得难以过滤它们。

|

||||

|

||||

这里有两个解决该问题的方法。首先,你可以修改你的 rsyslog 配置,在日志文件中输出错误的严重性,使得便于查看和检索。在你的 rsyslog 配置中你可以用 pri-text 添加一个 [模板][9],像下面这样:

|

||||

|

||||

"<%pri-text%> : %timegenerated%,%HOSTNAME%,%syslogtag%,%msg%n"

|

||||

|

||||

这个例子会按照下面的格式输出。你可以看到该信息中指示错误的 err。

|

||||

|

||||

<authpriv.err> : Mar 11 18:18:00,hoover-VirtualBox,su[5026]:, pam_authenticate: Authentication failure

|

||||

|

||||

你可以用 awk 或者 grep 检索错误信息。在 Ubuntu 中,对这个例子,我们可以用一些语法特征,例如 . 和 >,它们只会匹配这个域。

|

||||

|

||||

$ grep '.err>' /var/log/auth.log

|

||||

<authpriv.err> : Mar 11 18:18:00,hoover-VirtualBox,su[5026]:, pam_authenticate: Authentication failure

|

||||

|

||||

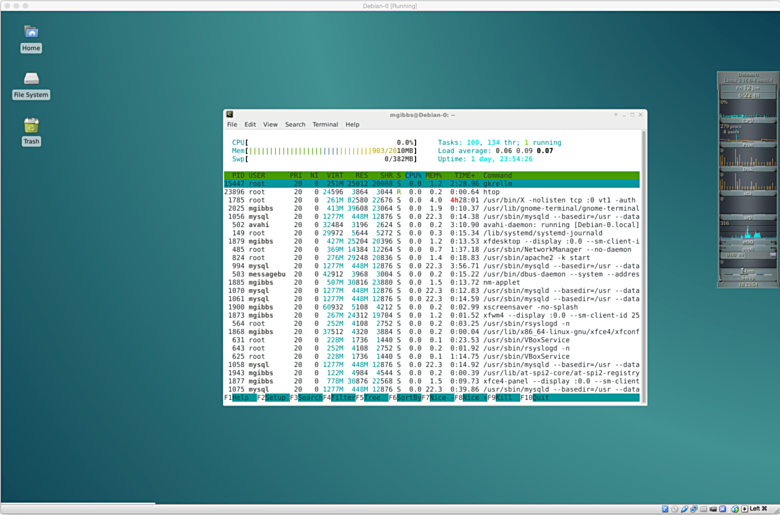

你的第二个选择是使用日志管理系统。好的日志管理系统能自动解析 syslog 消息并抽取错误域。它们也允许你用简单的点击过滤日志消息中的特定错误。

|

||||

|

||||

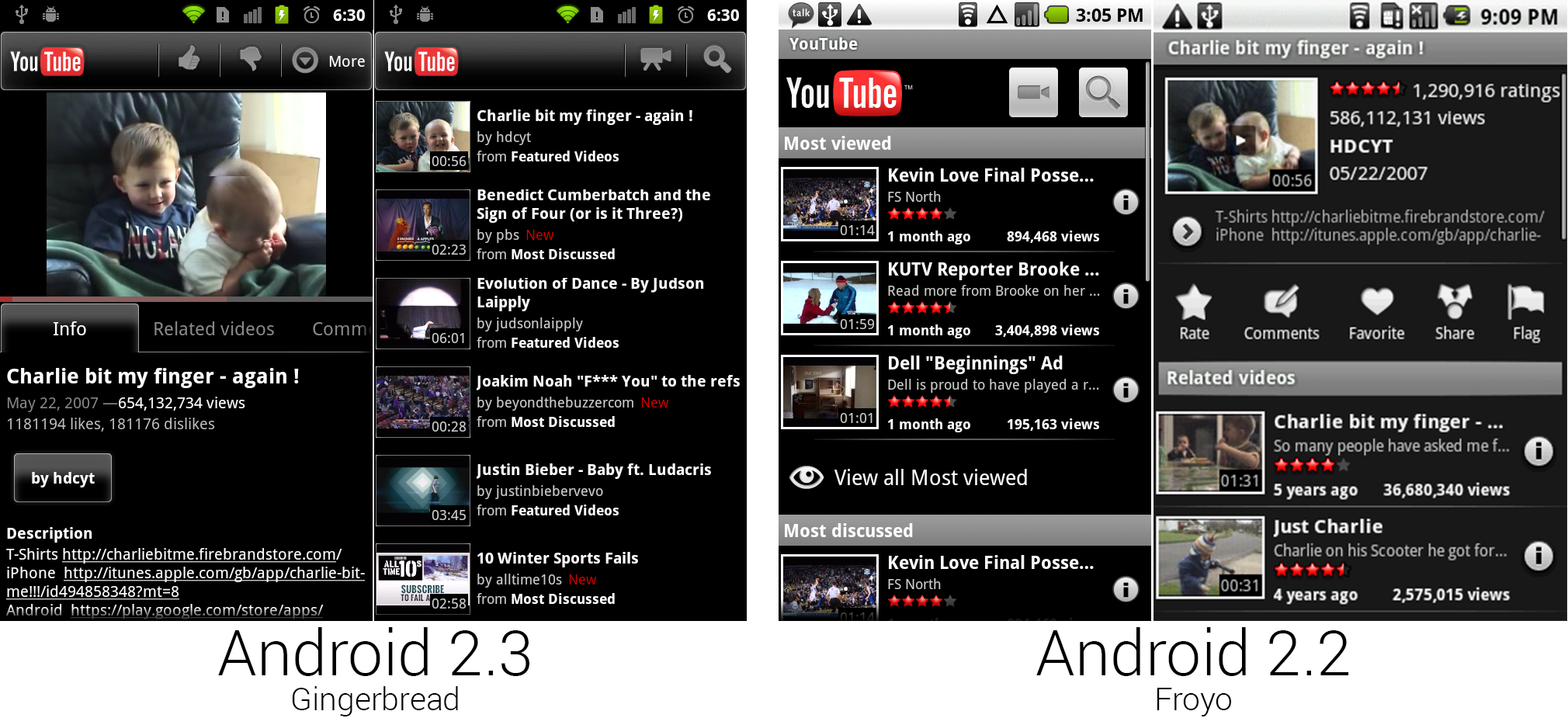

下面是 Loggly 中一个截图,显示了高亮错误严重性的 syslog 域,表示我们正在过滤错误:

|

||||

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.loggly.com/ultimate-guide/logging/analyzing-linux-logs/

|

||||

|

||||

作者:[Jason Skowronski][a],[Amy Echeverri][b],[ Sadequl Hussain][c]

|

||||

译者:[ictlyh](https://github.com/ictlyh)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.linkedin.com/in/jasonskowronski

|

||||

[b]:https://www.linkedin.com/in/amyecheverri

|

||||

[c]:https://www.linkedin.com/pub/sadequl-hussain/14/711/1a7

|

||||

[1]:http://linux.die.net/man/1/grep

|

||||

[2]:http://linux.die.net/man/1/tail

|

||||

[3]:http://ryanstutorials.net/linuxtutorial/grep.php

|

||||

[4]:https://lucene.apache.org/core/2_9_4/queryparsersyntax.html

|

||||

[5]:http://linux.die.net/man/1/cut

|

||||

[6]:http://linux.die.net/man/1/awk

|

||||

[7]:http://www.delorie.com/gnu/docs/gawk/gawk_26.html#IDX155

|

||||

[8]:http://logstash.net/docs/1.4.2/filters/grok

|

||||

[9]:http://www.rsyslog.com/doc/v8-stable/configuration/templates.html

|

||||

@ -1,18 +1,18 @@

|

||||

Ubuntu 15.04上配置OpenVPN服务器-客户端

|

||||

在 Ubuntu 15.04 上配置 OpenVPN 服务器和客户端

|

||||

================================================================================

|

||||

虚拟专用网(VPN)是几种用于建立与其它网络连接的网络技术中常见的一个名称。它被称为虚拟网,因为各个节点的连接不是通过物理线路实现的。而由于没有网络所有者的正确授权是不能通过公共线路访问到网络,所以它是专用的。

|

||||

虚拟专用网(VPN)常指几种通过其它网络建立连接技术。它之所以被称为“虚拟”,是因为各个节点间的连接不是通过物理线路实现的,而“专用”是指如果没有网络所有者的正确授权是不能被公开访问到。

|

||||

|

||||

|

||||

|

||||

[OpenVPN][1]软件通过TUN/TAP驱动的帮助,使用TCP和UDP协议来传输数据。UDP协议和TUN驱动允许NAT后的用户建立到OpenVPN服务器的连接。此外,OpenVPN允许指定自定义端口。它提额外提供了灵活的配置,可以帮助你避免防火墙限制。

|

||||

[OpenVPN][1]软件借助TUN/TAP驱动使用TCP和UDP协议来传输数据。UDP协议和TUN驱动允许NAT后的用户建立到OpenVPN服务器的连接。此外,OpenVPN允许指定自定义端口。它提供了更多的灵活配置,可以帮助你避免防火墙限制。

|

||||

|

||||

OpenVPN中,由OpenSSL库和传输层安全协议(TLS)提供了安全和加密。TLS是SSL协议的一个改进版本。

|

||||

|

||||

OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示了如何配置OpenVPN的服务器端,以及如何预备使用带有公共密钥非对称加密和TLS协议基础结构(PKI)。

|

||||

OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示了如何配置OpenVPN的服务器端,以及如何配置使用带有公共密钥基础结构(PKI)的非对称加密和TLS协议。

|

||||

|

||||

### 服务器端配置 ###

|

||||

|

||||

首先,我们必须安装OpenVPN。在Ubuntu 15.04和其它带有‘apt’报管理器的Unix系统中,可以通过如下命令安装:

|

||||

首先,我们必须安装OpenVPN软件。在Ubuntu 15.04和其它带有‘apt’包管理器的Unix系统中,可以通过如下命令安装:

|

||||

|

||||

sudo apt-get install openvpn

|

||||

|

||||

@ -20,7 +20,7 @@ OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示

|

||||

|

||||

sudo apt-get unstall easy-rsa

|

||||

|

||||

**注意**: 所有接下来的命令要以超级用户权限执行,如在“sudo -i”命令后;此外,你可以使用“sudo -E”作为接下来所有命令的前缀。

|

||||

**注意**: 所有接下来的命令要以超级用户权限执行,如在使用`sudo -i`命令后执行,或者你可以使用`sudo -E`作为接下来所有命令的前缀。

|

||||

|

||||

开始之前,我们需要拷贝“easy-rsa”到openvpn文件夹。

|

||||

|

||||

@ -32,15 +32,15 @@ OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示

|

||||

|

||||

cd /etc/openvpn/easy-rsa/2.0

|

||||

|

||||

这里,我们开启了一个密钥生成进程。

|

||||

这里,我们开始密钥生成进程。

|

||||

|

||||

首先,我们编辑一个“var”文件。为了简化生成过程,我们需要在里面指定数据。这里是“var”文件的一个样例:

|

||||

首先,我们编辑一个“vars”文件。为了简化生成过程,我们需要在里面指定数据。这里是“vars”文件的一个样例:

|

||||

|

||||

export KEY_COUNTRY="US"

|

||||

export KEY_PROVINCE="CA"

|

||||

export KEY_CITY="SanFrancisco"

|

||||

export KEY_ORG="Fort-Funston"

|

||||

export KEY_EMAIL="my@myhost.mydomain"

|

||||

export KEY_COUNTRY="CN"

|

||||

export KEY_PROVINCE="BJ"

|

||||

export KEY_CITY="Beijing"

|

||||

export KEY_ORG="Linux.CN"

|

||||

export KEY_EMAIL="open@vpn.linux.cn"

|

||||

export KEY_OU=server

|

||||

|

||||

希望这些字段名称对你而言已经很清楚,不需要进一步说明了。

|

||||

@ -61,7 +61,7 @@ OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示

|

||||

|

||||

./build-ca

|

||||

|

||||

在对话中,我们可以看到默认的变量,这些变量是我们先前在“vars”中指定的。我们可以检查以下,如有必要进行编辑,然后按回车几次。对话如下

|

||||

在对话中,我们可以看到默认的变量,这些变量是我们先前在“vars”中指定的。我们可以检查一下,如有必要进行编辑,然后按回车几次。对话如下

|

||||

|

||||

Generating a 2048 bit RSA private key

|

||||

.............................................+++

|

||||

@ -75,14 +75,14 @@ OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示

|

||||

For some fields there will be a default value,

|

||||

If you enter '.', the field will be left blank.

|

||||

-----

|

||||

Country Name (2 letter code) [US]:

|

||||

State or Province Name (full name) [CA]:

|

||||

Locality Name (eg, city) [SanFrancisco]:

|

||||

Organization Name (eg, company) [Fort-Funston]:

|

||||

Organizational Unit Name (eg, section) [MyOrganizationalUnit]:

|

||||

Common Name (eg, your name or your server's hostname) [Fort-Funston CA]:

|

||||

Country Name (2 letter code) [CN]:

|

||||

State or Province Name (full name) [BJ]:

|

||||

Locality Name (eg, city) [Beijing]:

|

||||

Organization Name (eg, company) [Linux.CN]:

|

||||

Organizational Unit Name (eg, section) [Tech]:

|

||||

Common Name (eg, your name or your server's hostname) [Linux.CN CA]:

|

||||

Name [EasyRSA]:

|

||||

Email Address [me@myhost.mydomain]:

|

||||

Email Address [open@vpn.linux.cn]:

|

||||

|

||||

接下来,我们需要生成一个服务器密钥

|

||||

|

||||

@ -102,14 +102,14 @@ OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示

|

||||

For some fields there will be a default value,

|

||||

If you enter '.', the field will be left blank.

|

||||

-----

|

||||

Country Name (2 letter code) [US]:

|

||||

State or Province Name (full name) [CA]:

|

||||

Locality Name (eg, city) [SanFrancisco]:

|

||||

Organization Name (eg, company) [Fort-Funston]:

|

||||

Organizational Unit Name (eg, section) [MyOrganizationalUnit]:

|

||||

Common Name (eg, your name or your server's hostname) [server]:

|

||||

Country Name (2 letter code) [CN]:

|

||||

State or Province Name (full name) [BJ]:

|

||||

Locality Name (eg, city) [Beijing]:

|

||||

Organization Name (eg, company) [Linux.CN]:

|

||||

Organizational Unit Name (eg, section) [Tech]:

|

||||

Common Name (eg, your name or your server's hostname) [Linux.CN server]:

|

||||

Name [EasyRSA]:

|

||||

Email Address [me@myhost.mydomain]:

|

||||

Email Address [open@vpn.linux.cn]:

|

||||

|

||||

Please enter the following 'extra' attributes

|

||||

to be sent with your certificate request

|

||||

@ -119,14 +119,14 @@ OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示

|

||||

Check that the request matches the signature

|

||||

Signature ok

|

||||

The Subject's Distinguished Name is as follows

|

||||

countryName :PRINTABLE:'US'

|

||||

stateOrProvinceName :PRINTABLE:'CA'

|

||||

localityName :PRINTABLE:'SanFrancisco'

|

||||

organizationName :PRINTABLE:'Fort-Funston'

|

||||

organizationalUnitName:PRINTABLE:'MyOrganizationalUnit'

|

||||

commonName :PRINTABLE:'server'

|

||||

countryName :PRINTABLE:'CN'

|

||||

stateOrProvinceName :PRINTABLE:'BJ'

|

||||

localityName :PRINTABLE:'Beijing'

|

||||

organizationName :PRINTABLE:'Linux.CN'

|

||||

organizationalUnitName:PRINTABLE:'Tech'

|

||||

commonName :PRINTABLE:'Linux.CN server'

|

||||

name :PRINTABLE:'EasyRSA'

|

||||

emailAddress :IA5STRING:'me@myhost.mydomain'

|

||||

emailAddress :IA5STRING:'open@vpn.linux.cn'

|

||||

Certificate is to be certified until May 22 19:00:25 2025 GMT (3650 days)

|

||||

Sign the certificate? [y/n]:y

|

||||

1 out of 1 certificate requests certified, commit? [y/n]y

|

||||

@ -143,7 +143,7 @@ OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示

|

||||

|

||||

Generating DH parameters, 2048 bit long safe prime, generator 2

|

||||

This is going to take a long time

|

||||

................................+................<and many many dots>

|

||||

................................+................<许多的点>

|

||||

|

||||

在漫长的等待之后,我们可以继续生成最后的密钥了,该密钥用于TLS验证。命令如下:

|

||||

|

||||

@ -176,7 +176,7 @@ OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示

|

||||

|

||||

### Unix的客户端配置 ###

|

||||

|

||||

假定我们有一台装有类Unix操作系统的设备,比如Ubuntu 15.04,并安装有OpenVPN。我们想要从先前的部分连接到OpenVPN服务器。首先,我们需要为客户端生成密钥。为了生成该密钥,请转到服务器上的目录中:

|

||||

假定我们有一台装有类Unix操作系统的设备,比如Ubuntu 15.04,并安装有OpenVPN。我们想要连接到前面建立的OpenVPN服务器。首先,我们需要为客户端生成密钥。为了生成该密钥,请转到服务器上的对应目录中:

|

||||

|

||||

cd /etc/openvpn/easy-rsa/2.0

|

||||

|

||||

@ -211,7 +211,7 @@ OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示

|

||||

dev tun

|

||||

proto udp

|

||||

|

||||

# IP and Port of remote host with OpenVPN server

|

||||

# 远程 OpenVPN 服务器的 IP 和 端口号

|

||||

remote 111.222.333.444 1194

|

||||

|

||||

resolv-retry infinite

|

||||

@ -243,7 +243,7 @@ OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示

|

||||

|

||||

安卓设备上的OpenVPN配置和Unix系统上的十分类似,我们需要一个含有配置文件、密钥和证书的包。文件列表如下:

|

||||

|

||||

- configuration file (.ovpn),

|

||||

- 配置文件 (扩展名 .ovpn),

|

||||

- ca.crt,

|

||||

- dh2048.pem,

|

||||

- client.crt,

|

||||

@ -257,7 +257,7 @@ OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示

|

||||

dev tun

|

||||

proto udp

|

||||

|

||||

# IP and Port of remote host with OpenVPN server

|

||||

# 远程 OpenVPN 服务器的 IP 和 端口号

|

||||

remote 111.222.333.444 1194

|

||||

|

||||

resolv-retry infinite

|

||||

@ -274,21 +274,21 @@ OpenSSL提供了两种加密方法:对称和非对称。下面,我们展示

|

||||

|

||||

所有这些文件我们必须移动我们设备的SD卡上。

|

||||

|

||||

然后,我们需要安装[OpenVPN连接][2]。

|

||||

然后,我们需要安装一个[OpenVPN Connect][2] 应用。

|

||||

|

||||

接下来,配置过程很是简单:

|

||||

|

||||

open setting of OpenVPN and select Import options

|

||||

select Import Profile from SD card option

|

||||

in opened window go to folder with prepared files and select .ovpn file

|

||||

application offered us to create a new profile

|

||||

tap on the Connect button and wait a second

|

||||

- 打开 OpenVPN 并选择“Import”选项

|

||||

- 选择“Import Profile from SD card”

|

||||

- 在打开的窗口中导航到我们放置好文件的目录,并选择那个 .ovpn 文件

|

||||

- 应用会要求我们创建一个新的配置文件

|

||||

- 点击“Connect”按钮并稍等一下

|

||||

|

||||

搞定。现在,我们的安卓设备已经通过安全的VPN连接连接到我们的专用网。

|

||||

|

||||

### 尾声 ###

|

||||

|

||||

虽然OpenVPN初始配置花费不少时间,但是简易客户端配置为我们弥补了时间上的损失,也提供了从任何设备连接的能力。此外,OpenVPN提供了一个很高的安全等级,以及从不同地方连接的能力,包括位于NAT后面的客户端。因此,OpenVPN可以同时在家和在企业中使用。

|

||||

虽然OpenVPN初始配置花费不少时间,但是简易的客户端配置为我们弥补了时间上的损失,也提供了从任何设备连接的能力。此外,OpenVPN提供了一个很高的安全等级,以及从不同地方连接的能力,包括位于NAT后面的客户端。因此,OpenVPN可以同时在家和企业中使用。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -296,7 +296,7 @@ via: http://linoxide.com/ubuntu-how-to/configure-openvpn-server-client-ubuntu-15

|

||||

|

||||

作者:[Ivan Zabrovskiy][a]

|

||||

译者:[GOLinux](https://github.com/GOLinux)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,10 +1,10 @@

|

||||

Syncthing: 一个跨计算机的私人的文件/文件夹安全同步工具

|

||||

Syncthing: 一个在计算机之间同步文件/文件夹的私密安全同步工具

|

||||

================================================================================

|

||||

### 简介 ###

|

||||

|

||||

**Syncthing** 是一个免费开源的工具,它能在你的各个网络计算机间同步文件/文件夹。它不像其它的同步工具,如**BitTorrent Sync**和**Dropbox**那样,它的同步数据是直接从一个系统中直接传输到另一个系统的,并且它是完全开源的,安全且私有的。你所有的珍贵数据都会被存储在你的系统中,这样你就能对你的文件和文件夹拥有全面的控制权,没有任何的文件或文件夹会被存储在第三方系统中。此外,你有权决定这些数据该存于何处,是否要分享到第三方,或这些数据在互联网上的传输方式。

|

||||

**Syncthing**是一个免费开源的工具,它能在你的各个网络计算机间同步文件/文件夹。它不像其它的同步工具,如**BitTorrent Sync**和**Dropbox**那样,它的同步数据是直接从一个系统中直接传输到另一个系统的,并且它是完全开源的,安全且私密的。你所有的珍贵数据都会被存储在你的系统中,这样你就能对你的文件和文件夹拥有全面的控制权,没有任何的文件或文件夹会被存储在第三方系统中。此外,你有权决定这些数据该存于何处,是否要分享到第三方,或这些数据在互联网上的传输方式。

|

||||

|

||||

所有的信息通讯都使用TLS进行加密,这样你的数据便能十分安全地逃离窥探。Syncthing有一个强大的响应式的网页管理界面(WebGUI,下同),它能够帮助用户简便地添加,删除和管理那些通过网络进行同步的文件夹。通过使用Syncthing,你可以在多个系统上一次同步多个文件夹。在安装和使用上,Syncthing是一个可移植的,简单但强大的工具。即然文件或文件夹是从一部计算机中直接传输到另一计算机中的,那么你就无需考虑向云服务供应商支付金钱来获取额外的云空间。你所需要的仅仅是非常稳定的LAN/WAN连接和你的系统中足够的硬盘空间。它支持所有的现代操作系统,包括GNU/Linux, Windows, Mac OS X, 当然还有Android。

|

||||

所有的信息通讯都使用TLS进行加密,这样你的数据便能十分安全地逃离窥探。Syncthing有一个强大的响应式的网页管理界面(WebGUI,下同),它能够帮助用户简便地添加、删除和管理那些通过网络进行同步的文件夹。通过使用Syncthing,你可以在多个系统上一次同步多个文件夹。在安装和使用上,Syncthing是一个可移植的、简单而强大的工具。即然文件或文件夹是从一部计算机中直接传输到另一计算机中的,那么你就无需考虑向云服务供应商支付金钱来获取额外的云空间。你所需要的仅仅是非常稳定的LAN/WAN连接以及在你的系统中有足够的硬盘空间。它支持所有的现代操作系统,包括GNU/Linux, Windows, Mac OS X, 当然还有Android。

|

||||

|

||||

### 安装 ###

|

||||

|

||||

@ -13,7 +13,7 @@ Syncthing: 一个跨计算机的私人的文件/文件夹安全同步工具

|

||||

### 系统1细节: ###

|

||||

|

||||

- **操作系统**: Ubuntu 14.04 LTS server;

|

||||

- **主机名**: server1.unixmen.local;

|

||||

- **主机名**: **server1**.unixmen.local;

|

||||

- **IP地址**: 192.168.1.150.

|

||||

- **系统用户**: sk (你可以使用你自己的系统用户)

|

||||

- **同步文件夹**: /home/Sync/ (Syncthing会默认创建)

|

||||

@ -21,7 +21,7 @@ Syncthing: 一个跨计算机的私人的文件/文件夹安全同步工具

|

||||

### 系统2细节 ###

|

||||

|

||||

- **操作系统**: Ubuntu 14.10 server;

|

||||

- **主机名**: server.unixmen.local;

|

||||

- **主机名**: **server**.unixmen.local;

|

||||

- **IP地址**: 192.168.1.151.

|

||||

- **系统用户**: sk (你可以使用你自己的系统用户)

|

||||

- **同步文件夹**: /home/Sync/ (Syncthing会默认创建)

|

||||

@ -49,7 +49,7 @@ Syncthing: 一个跨计算机的私人的文件/文件夹安全同步工具

|

||||

|

||||

cd syncthing-linux-amd64-v0.10.20/

|

||||

|

||||

复制可执行文件"Syncthing"到**$PATH**:

|

||||

复制可执行文件"syncthing"到**$PATH**:

|

||||

|

||||

sudo cp syncthing /usr/local/bin/

|

||||

|

||||

@ -57,7 +57,7 @@ Syncthing: 一个跨计算机的私人的文件/文件夹安全同步工具

|

||||

|

||||

syncthing

|

||||

|

||||

当你执行上述命令后,syncthing会生成一个配置以及一些关键值(keys),并且在你的浏览器上打开一个管理界面。,

|

||||

当你执行上述命令后,syncthing会生成一个配置以及一些配置键值,并且在你的浏览器上打开一个管理界面。

|

||||

|

||||

输入示例:

|

||||

|

||||

@ -78,11 +78,11 @@ Syncthing: 一个跨计算机的私人的文件/文件夹安全同步工具

|

||||

[BQXVO] 15:41:07 INFO: Device BQXVO3D-VEBIDRE-MVMMGJI-ECD2PC3-T5LT3JB-OK4Z45E-MPIDWHI-IRW3NAZ is "server1" at [dynamic]

|

||||

[BQXVO] 15:41:07 INFO: Completed initial scan (rw) of folder default

|

||||

|

||||

Syncthing已经被成功地初始化了,网页管理接口也可以通过浏览器在URL: **http://localhost:8080**进行访问了。如上面输入所看到的,Syncthing在你的**home**目录中的Sync目录**下自动为你创建了一个名为**default**的文件夹。

|

||||

Syncthing已经被成功地初始化了,网页管理接口也可以通过浏览器访问URL: **http://localhost:8080**。如上面输入所看到的,Syncthing在你的**home**目录中的Sync目录**下自动为你创建了一个名为**default**的文件夹。

|

||||

|

||||

默认情况下,Syncthing的网页管理界面(WebGUI)只能在本地端口(localhost)中进行访问,你需要在两个系统中进行以下操作:

|

||||

默认情况下,Syncthing的网页管理界面只能在本地端口(localhost)中进行访问,要从远程进行访问,你需要在两个系统中进行以下操作:

|

||||

|

||||

首先,按下CTRL+C键来停止Syncthing初始化进程。现在你回到了终端界面。

|

||||

首先,按下CTRL+C键来终止Syncthing初始化进程。现在你回到了终端界面。

|

||||

|

||||

编辑**config.xml**文件,

|

||||

|

||||

@ -115,17 +115,18 @@ Syncthing已经被成功地初始化了,网页管理接口也可以通过浏

|

||||

现在,在你的浏览器上打开**http://ip-address:8080/**。你会看到下面的界面:

|

||||

|

||||

|

||||

|

||||

网页管理界面分为两个窗格,在左窗格中,你应该可以看到同步的文件夹列表。如前所述,文件夹**default**在你初始化Syncthing时被自动创建。如果你想同步更多文件夹,点击**Add Folder**按钮。

|

||||

|

||||

在右窗格中,你可以看到已连接的设备数。现在这里只有一个,就是你现在正在操作的计算机。

|

||||

|

||||

### 网页管理界面(WebGUI)上设置Syncthing ###

|

||||

### 网页管理界面上设置Syncthing ###

|

||||

|

||||

为了提高安全性,让我们启用TLS,并且设置访问网页管理界面的管理员用户和密码。要做到这点,点击右上角的齿轮按钮,然后选择**Settings**

|

||||

|

||||

|

||||

|

||||

输入管理员的帐户名/密码。我设置的是admin/Ubuntu。你可以使用一些更复杂的密码。

|

||||

输入管理员的帐户名/密码。我设置的是admin/Ubuntu。你应该使用一些更复杂的密码。

|

||||

|

||||

|

||||

|

||||

@ -155,7 +156,7 @@ Syncthing已经被成功地初始化了,网页管理接口也可以通过浏

|

||||

|

||||

|

||||

|

||||

接着会出现下面的界面。在Device区域粘贴**系统1 ID **。输入设备名称(可选)。在地址区域,你可以输入其它系统(译者注:即粘贴的ID所属的系统,此应为系统1)的IP地址,或者使用默认值。默认值为**dynamic**。最后,选择要同步的文件夹。在我们的例子中,同步文件夹为**default**。

|

||||

接着会出现下面的界面。在Device区域粘贴**系统1 ID **。输入设备名称(可选)。在地址区域,你可以输入其它系统( LCTT 译注:即粘贴的ID所属的系统,此应为系统1)的IP地址,或者使用默认值。默认值为**dynamic**。最后,选择要同步的文件夹。在我们的例子中,同步文件夹为**default**。

|

||||

|

||||

|

||||

|

||||

@ -181,7 +182,7 @@ Syncthing已经被成功地初始化了,网页管理接口也可以通过浏

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

现在,在任一个系统中的“**default**”文件夹中放进任意文件或文件夹。你应该可以看到这些文件/文件夹被自动同步到其它系统。

|

||||

|

||||

@ -197,7 +198,7 @@ via: http://www.unixmen.com/syncthing-private-secure-tool-sync-filesfolders-comp

|

||||

|

||||

作者:[SK][a]

|

||||

译者:[XLCYun](https://github.com/XLCYun)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,89 @@

|

||||

修复Linux中的“提供类似行编辑的袖珍BASH...”的GRUB错误

|

||||

================================================================================

|

||||

|

||||

这两天我[安装了Elementary OS和Windows双系统][1],在启动的时候遇到了一个Grub错误。命令行中呈现如下信息:

|

||||

|

||||

**Minimal BASH like line editing is supported. For the first word, TAB lists possible command completions. anywhere else TAB lists possible device or file completions.**

|

||||

|

||||

**提供类似行编辑的袖珍 BASH。TAB键补全第一个词,列出可以使用的命令。除此之外,TAB键补全可以列出可用的设备或文件。**

|

||||

|

||||

|

||||

|

||||

事实上这并不是Elementary OS独有的错误。这是常见的[Grub][2]错误,会在Ubuntu,Fedora,Linux Mint等Linux操作系统上发生。

|

||||

|

||||

通过这篇文章里我们可以学到基于Linux系统**如何修复Ubuntu中出现的“minimal BASH like line editing is supported” Grub错误**。

|

||||

|

||||

> 你可以参阅这篇教程来修复类似的常见问题,[错误:分区未找到Linux grub救援模式][3]。

|

||||

|

||||

### 先决条件 ###

|

||||

|

||||

要修复这个问题,你需要达成以下的条件:

|

||||

|

||||

- 一个包含相同版本、相同OS的LiveUSB或磁盘

|

||||

- 当前会话的Internet连接正常工作

|

||||

|

||||

在确认了你拥有先决条件了之后,让我们看看如何修复Linux的死亡黑屏(如果我可以这样的称呼它的话 ;) )。

|

||||

|

||||

### 如何在基于Ubuntu的Linux中修复“minimal BASH like line editing is supported” Grub错误 ###

|

||||

|

||||

我知道你一定疑问这种Grub错误并不局限于在基于Ubuntu的Linux发行版上发生,那为什么我要强调在基于Ubuntu的发行版上呢?原因是,在这里我们将采用一个简单的方法,用个叫做**Boot Repair**的工具来修复我们的问题。我并不确定在其他的诸如Fedora的发行版中是否有这个工具可用。不再浪费时间,我们来看如何修复“minimal BASH like line editing is supported” Grub错误。

|

||||

|

||||

### 步骤 1: 引导进入lives会话 ###

|

||||

|

||||

插入live USB,引导进入live会话。

|

||||

|

||||

### 步骤 2: 安装 Boot Repair ###

|

||||

|

||||

等你进入了lives会话后,打开终端使用以下命令来安装Boot Repair:

|

||||

|

||||

sudo add-apt-repository ppa:yannubuntu/boot-repair

|

||||

sudo apt-get update

|

||||

sudo apt-get install boot-repair

|

||||

|

||||

注意:推荐这篇教程[如何修复 apt-get update 无法添加新的 CD-ROM 的错误][4],如果你在运行以上命令是遭遇同样的问题。

|

||||

|

||||

### 步骤 3: 使用Boot Repair修复引导 ###

|

||||

|

||||

装完Boot Repair后,在命令行运行如下命令启动:

|

||||

|

||||

boot-repair &

|

||||

|

||||

其实操作非常简单直接,你仅需按照Boot Repair工具提供的说明操作即可。首先,点击Boot Repair中的**Recommended repair**选项。

|

||||

|

||||

|

||||

|

||||

Boot Repair需要花费一些时间来分析引导和Grub中存在的问题。然后,它会提供一些可在命令行中直接运行的命令。将这些命令一个个在终端中执行。我这边屏幕上显示的是:

|

||||

|

||||

|

||||

|

||||

在输入了这些命令之后,它会执行执行一段时间:

|

||||

|

||||

|

||||

|

||||

在这一过程结束后,它会提供一个由boot repair的日志组成的网页网址。如果你的引导问题这样都没有修复,你就可以去社区或是发邮件给开发团队并提交该网址作为参考。很酷!不是吗?

|

||||

|

||||

|

||||

|

||||

在boot repair成功完成后,关闭你的电脑,移除USB并再次引导。我这就能成功的引导了,但是在Grub画面上会多出额外的两行。相比于看到系统能够再次正常引导的喜悦这些对我来说并不重要。

|

||||

|

||||

|

||||

|

||||

### 对你有效吗? ###

|

||||

|

||||

这就是我修复**Elementary OS Freya中的minimal BASH like line editing is supported Grub 错误**的方法。怎么样?是否对你也有效呢?请自由的在下方的评论区提出你的问题和建议。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://itsfoss.com/fix-minimal-bash-line-editing-supported-grub-error-linux/

|

||||

|

||||

作者:[Abhishek][a]

|

||||

译者:[martin2011qi](https://github.com/martin2011qi)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://itsfoss.com/author/abhishek/

|

||||

[1]:http://itsfoss.com/guide-install-elementary-os-luna/

|

||||

[2]:http://www.gnu.org/software/grub/

|

||||

[3]:http://itsfoss.com/solve-error-partition-grub-rescue-ubuntu-linux/

|

||||

[4]:http://itsfoss.com/fix-failed-fetch-cdrom-aptget-update-add-cdroms/

|

||||

@ -0,0 +1,101 @@

|

||||

FreeBSD 和 Linux 有什么不同?

|

||||

================================================================================

|

||||

|

||||

|

||||

|

||||

### 简介 ###

|

||||

|

||||

BSD最初从UNIX继承而来,目前,有许多的类Unix操作系统是基于BSD的。FreeBSD是使用最广泛的开源的伯克利软件发行版(即 BSD 发行版)。就像它隐含的意思一样,它是一个自由开源的类Unix操作系统,并且是公共服务器平台。FreeBSD源代码通常以宽松的BSD许可证发布。它与Linux有很多相似的地方,但我们得承认它们在很多方面仍有不同。

|

||||

|

||||

本文的其余部分组织如下:FreeBSD的描述在第一部分,FreeBSD和Linux的相似点在第二部分,它们的区别将在第三部分讨论,对他们功能的讨论和总结在最后一节。

|

||||

|

||||

### FreeBSD描述 ###

|

||||

|

||||

#### 历史 ####

|

||||

|

||||

- FreeBSD的第一个版本发布于1993年,它的第一张CD-ROM是FreeBSD1.0,发行于1993年12月。接下来,FreeBSD 2.1.0在1995年发布,并且获得了所有用户的青睐。实际上许多IT公司都使用FreeBSD并且很满意,我们可以列出其中的一些:IBM、Nokia、NetApp和Juniper Network。

|

||||

|

||||

#### 许可证 ####

|

||||

|

||||

- 关于它的许可证,FreeBSD以多种开源许可证进行发布,它的名为Kernel的最新代码以两句版BSD许可证进行了发布,给予使用和重新发布FreeBSD的绝对自由。其它的代码则以三句版或四句版BSD许可证进行发布,有些是以GPL和CDDL的许可证发布的。

|

||||

|

||||

(LCTT 译注:BSD 许可证与 GPL 许可证相比,相当简短,最初只有四句规则;1999年应 RMS 请求,删除了第三句,新的许可证称作“新 BSD”或三句版BSD;原来的 BSD 许可证称作“旧 BSD”、“修订的 BSD”或四句版BSD;也有一种删除了第三、第四两句的版本,称之为两句版 BSD,等价于 MIT 许可证。)

|

||||

|

||||

#### 用户 ####

|

||||

|

||||

- FreeBSD的重要特点之一就是它的用户多样性。实际上,FreeBSD可以作为邮件服务器、Web 服务器、FTP 服务器以及路由器等,您只需要在它上运行服务相关的软件即可。而且FreeBSD还支持ARM、PowerPC、MIPS、x86、x86-64架构。

|

||||

|

||||

### FreeBSD和Linux的相似处 ###

|

||||

|

||||

FreeBSD和Linux是两个自由开源的软件。实际上,它们的用户可以很容易的检查并修改源代码,用户拥有绝对的自由。而且,FreeBSD和Linux都是类Unix系统,它们的内核、内部组件、库程序都使用从历史上的AT&T Unix继承来的算法。FreeBSD从根基上更像Unix系统,而Linux是作为自由的类Unix系统发布的。许多工具应用都可以在FreeBSD和Linux中找到,实际上,他们几乎有同样的功能。

|

||||

|

||||

此外,FreeBSD能够运行大量的Linux应用。它可以安装一个Linux的兼容层,这个兼容层可以在编译FreeBSD时加入AAC Compact Linux得到,或通过下载已编译了Linux兼容层的FreeBSD系统,其中会包括兼容程序:aac_linux.ko。不同于FreeBSD的是,Linux无法运行FreeBSD的软件。

|

||||

|

||||

最后,我们注意到虽然二者有同样的目标,但二者还是有一些不同之处,我们在下一节中列出。

|

||||

|

||||

### FreeBSD和Linux的区别 ###

|

||||

|

||||

目前对于大多数用户来说并没有一个选择FreeBSD还是Linux的明确的准则。因为他们有着很多同样的应用程序,因为他们都被称作类Unix系统。

|

||||

|

||||

在这一章,我们将列出这两种系统的一些重要的不同之处。

|

||||

|

||||

#### 许可证 ####

|

||||

|

||||

- 两个系统的区别首先在于它们的许可证。Linux以GPL许可证发行,它为用户提供阅读、发行和修改源代码的自由,GPL许可证帮助用户避免仅仅发行二进制。而FreeBSD以BSD许可证发布,BSD许可证比GPL更宽容,因为其衍生著作不需要仍以该许可证发布。这意味着任何用户能够使用、发布、修改代码,并且不需要维持之前的许可证。

|

||||

- 您可以依据您的需求,在两种许可证中选择一种。首先是BSD许可证,由于其特殊的条款,它更受用户青睐。实际上,这个许可证使用户在保证源代码的封闭性的同时,可以售卖以该许可证发布的软件。再说说GPL,它需要每个使用以该许可证发布的软件的用户多加注意。

|

||||

- 如果想在以不同许可证发布的两种软件中做出选择,您需要了解他们各自的许可证,以及他们开发中的方法论,从而能了解他们特性的区别,来选择更适合自己需求的。

|

||||

|

||||

#### 控制 ####

|

||||

|

||||

- 由于FreeBSD和Linux是以不同的许可证发布的,Linus Torvalds控制着Linux的内核,而FreeBSD却与Linux不同,它并未被控制。我个人更倾向于使用FreeBSD而不是Linux,这是因为FreeBSD才是绝对自由的软件,没有任何控制许可证的存在。Linux和FreeBSD还有其他的不同之处,我建议您先不急着做出选择,等读完本文后再做出您的选择。

|

||||

|

||||

#### 操作系统 ####

|

||||

|

||||

- Linux主要指内核系统,这与FreeBSD不同,FreeBSD的整个系统都被维护着。FreeBSD的内核和一组由FreeBSD团队开发的软件被作为一个整体进行维护。实际上,FreeBSD开发人员能够远程且高效的管理核心操作系统。

|

||||

- 而Linux方面,在管理系统方面有一些困难。由于不同的组件由不同的源维护,Linux开发者需要将它们汇集起来,才能达到同样的功能。

|

||||

- FreeBSD和Linux都给了用户大量的可选软件和发行版,但他们管理的方式不同。FreeBSD是统一的管理方式,而Linux需要被分别维护。

|

||||

|

||||

#### 硬件支持 ####

|

||||

|

||||

- 说到硬件支持,Linux比FreeBSD做的更好。但这不意味着FreeBSD没有像Linux那样支持硬件的能力。他们只是在管理的方式不同,这通常还依赖于您的需求。因此,如果您在寻找最新的解决方案,FreeBSD更适应您;但如果您在寻找更多的普适性,那最好使用Linux。

|

||||

|

||||

#### 原生FreeBSD Vs 原生Linux ####

|

||||

|

||||

- 两者的原生系统的区别又有不同。就像我之前说的,Linux是一个Unix的替代系统,由Linux Torvalds编写,并由网络上的许多极客一起协助实现的。Linux有一个现代系统所需要的全部功能,诸如虚拟内存、共享库、动态加载、优秀的内存管理等。它以GPL许可证发布。

|

||||

- FreeBSD也继承了Unix的许多重要的特性。FreeBSD作为在加州大学开发的BSD的一种发行版。开发BSD的最重要的原因是用一个开源的系统来替代AT&T操作系统,从而给用户无需AT&T许可证便可使用的能力。

|

||||

- 许可证的问题是开发者们最关心的问题。他们试图提供一个最大化克隆Unix的开源系统。这影响了用户的选择,由于FreeBSD使用BSD许可证进行发布,因而相比Linux更加自由。

|

||||

|

||||

#### 支持的软件包 ####

|

||||

|

||||

- 从用户的角度来看,另一个二者不同的地方便是软件包以及从源码安装的软件的可用性和支持。Linux只提供了预编译的二进制包,这与FreeBSD不同,它不但提供预编译的包,而且还提供从源码编译和安装的构建系统。使用它的 ports 工具,FreeBSD给了您选择使用预编译的软件包(默认)和在编译时定制您软件的能力。(LCTT 译注:此处说明有误。Linux 也提供了源代码方式的包,并支持自己构建。)

|

||||

- 这些 ports 允许您构建所有支持FreeBSD的软件。而且,它们的管理还是层次化的,您可以在/usr/ports下找到源文件的地址以及一些正确使用FreeBSD的文档。

|

||||

- 这些提到的 ports给予你产生不同软件包版本的可能性。FreeBSD给了您通过源代码构建以及预编译的两种软件,而不是像Linux一样只有预编译的软件包。您可以使用两种安装方式管理您的系统。

|

||||

|

||||

#### FreeBSD 和 Linux 常用工具比较 ####

|

||||

|

||||

- 有大量的常用工具在FreeBSD上可用,并且有趣的是他们由FreeBSD的团队所拥有。相反的,Linux工具来自GNU,这就是为什么在使用中有一些限制。(LCTT 译注:这也是 Linux 正式的名称被称作“GNU/Linux”的原因,因为本质上 Linux 其实只是指内核。)

|

||||

- 实际上FreeBSD采用的BSD许可证非常有益且有用。因此,您有能力维护核心操作系统,控制这些应用程序的开发。有一些工具类似于它们的祖先 - BSD和Unix的工具,但不同于GNU的套件,GNU套件只想做到最小的向后兼容。

|

||||

|

||||

#### 标准 Shell ####

|

||||

|

||||

- FreeBSD默认使用tcsh。它是csh的评估版,由于FreeBSD以BSD许可证发行,因此不建议您在其中使用GNU的组件 bash shell。bash和tcsh的区别仅仅在于tcsh的脚本功能。实际上,我们更推荐在FreeBSD中使用sh shell,因为它更加可靠,可以避免一些使用tcsh和csh时出现的脚本问题。

|

||||

|

||||

#### 一个更加层次化的文件系统 ####

|

||||

|

||||

- 像之前提到的一样,使用FreeBSD时,基础操作系统以及可选组件可以被很容易的区别开来。这导致了一些管理它们的标准。在Linux下,/bin,/sbin,/usr/bin或者/usr/sbin都是存放可执行文件的目录。FreeBSD不同,它有一些附加的对其进行组织的规范。基础操作系统被放在/usr/local/bin或者/usr/local/sbin目录下。这种方法可以帮助管理和区分基础操作系统和可选组件。

|

||||

|

||||

### 结论 ###

|

||||

|

||||

FreeBSD和Linux都是自由且开源的系统,他们有相似点也有不同点。上面列出的内容并不能说哪个系统比另一个更好。实际上,FreeBSD和Linux都有自己的特点和技术规格,这使它们与别的系统区别开来。那么,您有什么看法呢?您已经有在使用它们中的某个系统了么?如果答案为是的话,请给我们您的反馈;如果答案是否的话,在读完我们的描述后,您怎么看?请在留言处发表您的观点。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.unixmen.com/comparative-introduction-freebsd-linux-users/

|

||||

|

||||

作者:[anismaj][a]

|

||||

译者:[wwy-hust](https://github.com/wwy-hust)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.unixmen.com/author/anis/

|

||||

@ -1,4 +1,4 @@

|

||||

ZMap 文档

|

||||

互联网扫描器 ZMap 完全手册

|

||||

================================================================================

|

||||

1. 初识 ZMap

|

||||

1. 最佳扫描习惯

|

||||

@ -21,7 +21,7 @@ ZMap 文档

|

||||

|

||||

### 初识 ZMap ###

|

||||

|

||||

ZMap被设计用来针对IPv4所有地址或其中的大部分实施综合扫描的工具。ZMap是研究者手中的利器,但在运行ZMap时,请注意,您很有可能正在以每秒140万个包的速度扫描整个IPv4地址空间 。我们建议用户在实施即使小范围扫描之前,也联系一下本地网络的管理员并参考我们列举的最佳扫描习惯。

|

||||

ZMap被设计用来针对整个IPv4地址空间或其中的大部分实施综合扫描的工具。ZMap是研究者手中的利器,但在运行ZMap时,请注意,您很有可能正在以每秒140万个包的速度扫描整个IPv4地址空间 。我们建议用户即使在实施小范围扫描之前,也联系一下本地网络的管理员并参考我们列举的[最佳扫描体验](#bestpractices)。

|

||||

|

||||

默认情况下,ZMap会对于指定端口实施尽可能大速率的TCP SYN扫描。较为保守的情况下,对10,000个随机的地址的80端口以10Mbps的速度扫描,如下所示:

|

||||

|

||||

@ -42,11 +42,13 @@ ZMap也可用于扫描特定子网或CIDR地址块。例如,仅扫描10.0.0.0/

|

||||

0% (1h50m left); send: 39676 535 Kp/s (555 Kp/s avg); recv: 1663 220 p/s (232 p/s avg); hits: 0.04%

|

||||

0% (1h50m left); send: 45372 570 Kp/s (557 Kp/s avg); recv: 1890 226 p/s (232 p/s avg); hits: 0.04%

|

||||

|

||||

这些更新信息提供了扫描的即时状态并表示成:完成进度% (剩余时间); send: 发出包的数量 即时速率 (平均发送速率); recv: 接收包的数量 接收率 (平均接收率); hits: 成功率

|

||||

这些更新信息提供了扫描的即时状态并表示成:

|

||||

|

||||

如果您不知道您所在网络支持的扫描速率,您可能要尝试不同的扫描速率和带宽限制直到扫描效果开始下降,借此找出当前网络能够支持的最快速度。

|

||||

完成进度% (剩余时间); send: 发出包的数量 即时速率 (平均发送速率); recv: 接收包的数量 接收率 (平均接收率); hits: 命中率

|

||||

|

||||

默认情况下,ZMap会输出不同IP地址的列表(例如,SYN ACK数据包的情况)像下面这样。还有几种附加的格式(如,JSON和Redis)作为其输出结果,以及生成程序可解析的扫描统计选项。 同样,可以指定附加的输出字段并使用输出过滤来过滤输出的结果。

|

||||

如果您不知道您所在网络能支持的扫描速率,您可能要尝试不同的扫描速率和带宽限制直到扫描效果开始下降,借此找出当前网络能够支持的最快速度。

|

||||

|

||||

默认情况下,ZMap会输出不同IP地址的列表(例如,根据SYN ACK数据包的情况),像下面这样。其[输出结果](#output)还有几种附加的格式(如,JSON和Redis),可以用作生成[程序可解析的扫描统计](#verbosity)。 同样,可以指定附加的[输出字段](#outputfields)并使用[输出过滤](#outputfilter)来过滤输出的结果。

|

||||

|

||||

115.237.116.119

|

||||

23.9.117.80

|

||||

@ -54,52 +56,49 @@ ZMap也可用于扫描特定子网或CIDR地址块。例如,仅扫描10.0.0.0/

|

||||

217.120.143.111

|

||||

50.195.22.82

|

||||

|

||||

我们强烈建议您使用黑名单文件,以排除预留的/未分配的IP地址空间(如,组播地址,RFC1918),以及网络中需要排除在您扫描之外的地址。默认情况下,ZMap将采用位于 `/etc/zmap/blacklist.conf`的这个简单的黑名单文件中所包含的预留和未分配地址。如果您需要某些特定设置,比如每次运行ZMap时的最大带宽或黑名单文件,您可以在文件`/etc/zmap/zmap.conf`中指定或使用自定义配置文件。

|

||||

我们强烈建议您使用[黑名单文件](#blacklisting),以排除预留的/未分配的IP地址空间(如,RFC1918 规定的私有地址、组播地址),以及网络中需要排除在您扫描之外的地址。默认情况下,ZMap将采用位于 `/etc/zmap/blacklist.conf`的这个简单的[黑名单文件](#blacklisting)中所包含的预留和未分配地址。如果您需要某些特定设置,比如每次运行ZMap时的最大带宽或[黑名单文件](#blacklisting),您可以在文件`/etc/zmap/zmap.conf`中指定或使用自定义[配置文件](#config)。

|

||||

|

||||

如果您正试图解决扫描的相关问题,有几个选项可以帮助您调试。首先,您可以通过添加`--dryrun`实施预扫,以此来分析包可能会发送到网络的何处。此外,还可以通过设置'--verbosity=n`来更改日志详细程度。

|

||||

如果您正试图解决扫描的相关问题,有几个选项可以帮助您调试。首先,您可以通过添加`--dryrun`实施[预扫](#dryrun),以此来分析包可能会发送到网络的何处。此外,还可以通过设置'--verbosity=n`来更改[日志详细程度](#verbosity)。

|

||||

|

||||

----------

|

||||

### 最佳扫描体验 ###

|

||||

<a name="bestpractices" ></a>

|

||||

|

||||

### 最佳扫描习惯 ###

|

||||

|

||||

我们为针对互联网进行扫描的研究者提供了一些建议,以此来引导养成良好的互联网合作氛围

|

||||

我们为针对互联网进行扫描的研究者提供了一些建议,以此来引导养成良好的互联网合作氛围。

|

||||

|

||||

- 密切协同本地的网络管理员,以减少风险和调查

|

||||

- 确认扫描不会使本地网络或上游供应商瘫痪

|

||||

- 标记出在扫描中呈良性的网页和DNS条目的源地址

|

||||

- 明确注明扫描中所有连接的目的和范围

|

||||

- 提供一个简单的退出方法并及时响应请求

|

||||

- 在发起扫描的源地址的网页和DNS条目中申明你的扫描是善意的

|

||||

- 明确解释你的扫描中所有连接的目的和范围

|

||||

- 提供一个简单的退出扫描的方法并及时响应请求

|

||||

- 实施扫描时,不使用比研究对象需求更大的扫描范围或更快的扫描频率

|

||||

- 如果可以通过时间或源地址来传播扫描流量

|

||||

- 如果可以,将扫描流量分布到不同的时间或源地址上

|

||||

|

||||

即使不声明,使用扫描的研究者也应该避免利用漏洞或访问受保护的资源,并遵守其辖区内任何特殊的法律规定。

|

||||

|

||||

----------

|

||||

|

||||

### 命令行参数 ###

|

||||

<a name="args" ></a>

|

||||

|

||||

#### 通用选项 ####

|

||||

|

||||

这些选项是实施简单扫描时最常用的选项。我们注意到某些选项取决于所使用的探测模块或输出模块(如,在实施ICMP Echo扫描时是不需要使用目的端口的)。

|

||||

|

||||

这些选项是实施简单扫描时最常用的选项。我们注意到某些选项取决于所使用的[探测模块](#probemodule)或[输出模块](#outputmodule)(如,在实施ICMP Echo扫描时是不需要使用目的端口的)。

|

||||

|

||||

**-p, --target-port=port**

|

||||

|

||||

用来扫描的TCP端口号(例如,443)

|

||||

要扫描的目标TCP端口号(例如,443)

|

||||

|

||||

**-o, --output-file=name**

|

||||

|

||||

使用标准输出将结果写入该文件。

|

||||

将结果写入该文件,使用`-`代表输出到标准输出。

|

||||

|

||||

**-b, --blacklist-file=path**

|

||||

|

||||

文件中被排除的子网使用CIDR表示法(如192.168.0.0/16),一个一行。建议您使用此方法排除RFC 1918地址,组播地址,IANA预留空间等IANA专用地址。在conf/blacklist.example中提供了一个以此为目的示例黑名单文件。

|

||||

文件中被排除的子网使用CIDR表示法(如192.168.0.0/16),一个一行。建议您使用此方法排除RFC 1918地址、组播地址、IANA预留空间等IANA专用地址。在conf/blacklist.example中提供了一个以此为目的示例黑名单文件。

|

||||

|

||||

#### 扫描选项 ####

|

||||

|

||||

**-n, --max-targets=n**

|

||||

|

||||

限制探测目标的数量。后面跟的可以是一个数字(例如'-n 1000`)或百分比(例如,`-n 0.1%`)当然都是针对可扫描地址空间而言的(不包括黑名单)

|

||||

限制探测目标的数量。后面跟的可以是一个数字(例如'-n 1000`),或可扫描地址空间的百分比(例如,`-n 0.1%`,不包括黑名单)

|

||||

|

||||

**-N, --max-results=n**

|

||||

|

||||

@ -111,7 +110,7 @@ ZMap也可用于扫描特定子网或CIDR地址块。例如,仅扫描10.0.0.0/

|

||||

|

||||

**-r, --rate=pps**

|

||||

|

||||

设置传输速率,以包/秒为单位

|

||||

设置发包速率,以包/秒为单位

|

||||

|

||||

**-B, --bandwidth=bps**

|

||||

|

||||

@ -119,7 +118,7 @@ ZMap也可用于扫描特定子网或CIDR地址块。例如,仅扫描10.0.0.0/

|

||||

|

||||

**-c, --cooldown-time=secs**

|

||||

|

||||

发送完成后多久继续接收(默认值= 8)

|

||||

发送完成后等待多久继续接收回包(默认值= 8)

|

||||

|

||||

**-e, --seed=n**

|

||||

|

||||

@ -127,7 +126,7 @@ ZMap也可用于扫描特定子网或CIDR地址块。例如,仅扫描10.0.0.0/

|

||||

|

||||

**--shards=n**

|

||||

|

||||

将扫描分片/区在使其可多个ZMap中执行(默认值= 1)。启用分片时,`--seed`参数是必需的。

|

||||

将扫描分片/区,使其可多个ZMap中执行(默认值= 1)。启用分片时,`--seed`参数是必需的。

|

||||

|

||||

**--shard=n**

|

||||

|

||||

@ -165,7 +164,7 @@ ZMap也可用于扫描特定子网或CIDR地址块。例如,仅扫描10.0.0.0/

|

||||

|

||||

#### 探测选项 ####

|

||||

|

||||

ZMap允许用户指定并添加自己所需要探测的模块。 探测模块的职责就是生成主机回复的响应包。

|

||||

ZMap允许用户指定并添加自己所需要的[探测模块](#probemodule)。 探测模块的职责就是生成要发送的探测包,并处理主机回复的响应包。

|

||||

|

||||

**--list-probe-modules**

|

||||

|

||||

@ -173,7 +172,7 @@ ZMap允许用户指定并添加自己所需要探测的模块。 探测模块的

|

||||

|

||||

**-M, --probe-module=name**

|

||||

|

||||

选择探探测模块(默认值= tcp_synscan)

|

||||

选择[探测模块](#probemodule)(默认值= tcp_synscan)

|

||||

|

||||

**--probe-args=args**

|

||||

|

||||

@ -185,7 +184,7 @@ ZMap允许用户指定并添加自己所需要探测的模块。 探测模块的

|

||||

|

||||

#### 输出选项 ####

|

||||

|

||||

ZMap允许用户选择指定的输出模块。输出模块负责处理由探测模块返回的字段,并将它们交给用户。用户可以指定输出的范围,并过滤相应字段。

|

||||

ZMap允许用户指定和编写他们自己的[输出模块](#outputmodule)。输出模块负责处理由探测模块返回的字段,并将它们输出给用户。用户可以指定输出的字段,并过滤相应字段。

|

||||

|

||||

**--list-output-modules**

|

||||

|

||||

@ -193,7 +192,7 @@ ZMap允许用户选择指定的输出模块。输出模块负责处理由探测

|

||||

|

||||

**-O, --output-module=name**

|

||||

|

||||

选择输出模块(默认值为csv)

|

||||

选择[输出模块](#outputmodule)(默认值为csv)

|

||||

|

||||

**--output-args=args**

|

||||

|

||||

@ -201,21 +200,21 @@ ZMap允许用户选择指定的输出模块。输出模块负责处理由探测

|

||||

|

||||

**-f, --output-fields=fields**

|

||||

|

||||

输出列表,以逗号分割

|

||||

输出的字段列表,以逗号分割

|

||||

|

||||

**--output-filter**

|

||||

|

||||

通过指定相应的探测模块来过滤输出字段

|

||||

指定输出[过滤器](#outputfilter)对[探测模块](#probemodule)定义字段进行过滤

|

||||

|

||||

#### 附加选项 ####

|

||||

|

||||

**-C, --config=filename**

|

||||

|

||||

加载配置文件,可以指定其他路径。

|

||||

加载[配置文件](#config),可以指定其他路径。

|

||||

|

||||

**-q, --quiet**

|

||||

|

||||

不再是每秒刷新输出

|

||||

不必每秒刷新输出

|

||||

|

||||

**-g, --summary**

|

||||

|

||||

@ -233,13 +232,12 @@ ZMap允许用户选择指定的输出模块。输出模块负责处理由探测

|

||||

|

||||

打印版本并退出

|

||||

|

||||

----------

|

||||

|

||||

### 附加信息 ###

|

||||

<a name="additional"></a>

|

||||

|

||||

#### TCP SYN 扫描 ####

|

||||

|

||||

在执行TCP SYN扫描时,ZMap需要指定一个目标端口和以供扫描的源端口范围。

|

||||

在执行TCP SYN扫描时,ZMap需要指定一个目标端口,也支持指定发起扫描的源端口范围。

|

||||

|

||||

**-p, --target-port=port**

|

||||

|

||||

@ -249,27 +247,27 @@ ZMap允许用户选择指定的输出模块。输出模块负责处理由探测

|

||||

|

||||

发送扫描数据包的源端口(例如 40000-50000)

|

||||

|

||||

**警示!** ZMAP基于Linux内核使用SYN/ACK包应答,RST包关闭扫描打开的连接。ZMap是在Ethernet层完成包的发送的,这样做时为了减少跟踪打开的TCP连接和路由寻路带来的内核开销。因此,如果您有跟踪连接建立的防火墙规则,如netfilter的规则类似于`-A INPUT -m state --state RELATED,ESTABLISHED -j ACCEPT`,将阻止SYN/ACK包到达内核。这不会妨碍到ZMap记录应答,但它会阻止RST包被送回,最终连接会在超时后断开。我们强烈建议您在执行ZMap时,选择一组主机上未使用且防火墙允许访问的端口,加在`-s`后(如 `-s '50000-60000' ` )。

|

||||

**警示!** ZMap基于Linux内核使用RST包来应答SYN/ACK包响应,以关闭扫描器打开的连接。ZMap是在Ethernet层完成包的发送的,这样做是为了减少跟踪打开的TCP连接和路由寻路带来的内核开销。因此,如果您有跟踪连接建立的防火墙规则,如类似于`-A INPUT -m state --state RELATED,ESTABLISHED -j ACCEPT`的netfilter规则,将阻止SYN/ACK包到达内核。这不会妨碍到ZMap记录应答,但它会阻止RST包被送回,最终被扫描主机的连接会一直打开,直到超时后断开。我们强烈建议您在执行ZMap时,选择一组主机上未使用且防火墙允许访问的端口,加在`-s`后(如 `-s '50000-60000' ` )。

|

||||

|

||||

#### ICMP Echo 请求扫描 ####

|

||||

|

||||

虽然在默认情况下ZMap执行的是TCP SYN扫描,但它也支持使用ICMP echo请求扫描。在这种扫描方式下ICMP echo请求包被发送到每个主机,并以收到ICMP 应答包作为答复。实施ICMP扫描可以通过选择icmp_echoscan扫描模块来执行,如下:

|

||||

虽然在默认情况下ZMap执行的是TCP SYN扫描,但它也支持使用ICMP echo请求扫描。在这种扫描方式下ICMP echo请求包被发送到每个主机,并以收到ICMP应答包作为答复。实施ICMP扫描可以通过选择icmp_echoscan扫描模块来执行,如下:

|

||||

|

||||

$ zmap --probe-module=icmp_echoscan

|

||||

|

||||

#### UDP 数据报扫描 ####

|

||||

|

||||

ZMap还额外支持UDP探测,它会发出任意UDP数据报给每个主机,并能在无论UDP或是ICMP任何一个不可达的情况下接受应答。ZMap支持通过使用--probe-args命令行选择四种不同的UDP payload方式。这些都有可列印payload的‘文本’,用于命令行的十六进制payload的‘hex’,外部文件中包含payload的‘file’,和需要动态区域生成的payload的‘template’。为了得到UDP响应,请使用-f参数确保您指定的“data”领域处于汇报范围。

|

||||

ZMap还额外支持UDP探测,它会发出任意UDP数据报给每个主机,并接收UDP或ICMP不可达的应答。ZMap可以通过使用--probe-args命令行选项来设置四种不同的UDP载荷。这些是:可在命令行设置可打印的ASCII 码的‘text’载荷和十六进制载荷的‘hex’,外部文件中包含载荷的‘file’,和通过动态字段生成的载荷的‘template’。为了得到UDP响应,请使用-f参数确保您指定的“data”字段处于输出范围。

|

||||

|

||||

下面的例子将发送两个字节'ST',即PC的'status'请求,到UDP端口5632。

|

||||

下面的例子将发送两个字节'ST',即PCAnwywhere的'status'请求,到UDP端口5632。

|

||||

|

||||

$ zmap -M udp -p 5632 --probe-args=text:ST -N 100 -f saddr,data -o -

|

||||

|

||||

下面的例子将发送字节“0X02”,即SQL服务器的 'client broadcast'请求,到UDP端口1434。

|

||||

下面的例子将发送字节“0X02”,即SQL Server的'client broadcast'请求,到UDP端口1434。

|

||||

|

||||

$ zmap -M udp -p 1434 --probe-args=hex:02 -N 100 -f saddr,data -o -

|

||||

|

||||

下面的例子将发送一个NetBIOS状态请求到UDP端口137。使用一个ZMap自带的payload文件。

|

||||

下面的例子将发送一个NetBIOS状态请求到UDP端口137。使用一个ZMap自带的载荷文件。

|

||||

|

||||

$ zmap -M udp -p 1434 --probe-args=file:netbios_137.pkt -N 100 -f saddr,data -o -

|

||||

|

||||

@ -277,9 +275,9 @@ ZMap还额外支持UDP探测,它会发出任意UDP数据报给每个主机,

|

||||

|

||||

$ zmap -M udp -p 1434 --probe-args=file:sip_options.tpl -N 100 -f saddr,data -o -

|

||||

|

||||

UDP payload 模板仍处于实验阶段。当您在更多的使用一个以上的发送线程(-T)时可能会遇到崩溃和一个明显的相比静态payload性能降低的表现。模板仅仅是一个由一个或多个使用$ {}将字段说明封装成序列构成的payload文件。某些协议,特别是SIP,需要payload来反射包中的源和目的地址。其他协议,如端口映射和DNS,包含范围伴随每一次请求随机生成或Zamp扫描的多宿主系统将会抛出危险警告。

|

||||

UDP载荷模板仍处于实验阶段。当您在更多的使用一个以上的发送线程(-T)时可能会遇到崩溃和一个明显的相比静态载荷性能降低的表现。模板仅仅是一个由一个或多个使用${}将字段说明封装成序列构成的载荷文件。某些协议,特别是SIP,需要载荷来反射包中的源和目的包。其他协议,如portmapper和DNS,每个请求包含的字段应该是随机的,或降低被Zamp扫描的多宿主系统的风险。

|

||||

|

||||

以下的payload模板将发送SIP OPTIONS请求到每一个目的地:

|

||||

以下的载荷模板将发送SIP OPTIONS请求到每一个目的地:

|

||||

|

||||

OPTIONS sip:${RAND_ALPHA=8}@${DADDR} SIP/2.0

|

||||

Via: SIP/2.0/UDP ${SADDR}:${SPORT};branch=${RAND_ALPHA=6}.${RAND_DIGIT=10};rport;alias

|

||||

@ -293,10 +291,9 @@ UDP payload 模板仍处于实验阶段。当您在更多的使用一个以上

|

||||

User-Agent: ${RAND_ALPHA=8}

|

||||

Accept: text/plain

|

||||

|

||||

就像在上面的例子中展示的那样,对于大多数SIP正常的实现会在在每行行末添加\r\n,并且在请求的末尾一定包含\r\n\r\n。一个可以使用的在ZMap的examples/udp-payloads目录下的例子 (sip_options.tpl).

|

||||

|

||||

下面的字段正在如今的模板中实施:

|

||||

就像在上面的例子中展示的那样,注意每行行末以\r\n结尾,请求以\r\n\r\n结尾,大多数SIP实现都可以正确处理它。一个可以工作的例子放在ZMap的examples/udp-payloads目录下 (sip_options.tpl).

|

||||

|

||||

当前实现了下面的模板字段:

|

||||

|

||||

- **SADDR**: 源IP地址的点分十进制格式

|

||||

- **SADDR_N**: 源IP地址的网络字节序格式

|

||||

@ -306,14 +303,15 @@ UDP payload 模板仍处于实验阶段。当您在更多的使用一个以上

|

||||

- **SPORT_N**: 源端口的网络字节序格式

|

||||

- **DPORT**: 目的端口的ascii格式

|

||||

- **DPORT_N**: 目的端口的网络字节序格式

|

||||

- **RAND_BYTE**: 随机字节(0-255),长度由=(长度) 参数决定

|

||||

- **RAND_DIGIT**: 随机数字0-9,长度由=(长度) 参数决定

|

||||

- **RAND_ALPHA**: 随机大写字母A-Z,长度由=(长度) 参数决定

|

||||

- **RAND_ALPHANUM**: 随机大写字母A-Z和随机数字0-9,长度由=(长度) 参数决定

|

||||

- **RAND_BYTE**: 随机字节(0-255),长度由=(length) 参数决定

|

||||

- **RAND_DIGIT**: 随机数字0-9,长度由=(length) 参数决定

|

||||

- **RAND_ALPHA**: 随机大写字母A-Z,长度由=(length) 参数决定

|

||||

- **RAND_ALPHANUM**: 随机大写字母A-Z和随机数字0-9,长度由=(length) 参数决定

|

||||

|

||||

### 配置文件 ###

|

||||

<a name="config"></a>

|

||||

|

||||

ZMap支持使用配置文件代替在命令行上指定所有的需求选项。配置中可以通过每行指定一个长名称的选项和对应的值来创建:

|

||||

ZMap支持使用配置文件来代替在命令行上指定所有要求的选项。配置中可以通过每行指定一个长名称的选项和对应的值来创建:

|

||||

|

||||

interface "eth1"

|

||||

source-ip 1.1.1.4-1.1.1.8

|

||||

@ -324,11 +322,12 @@ ZMap支持使用配置文件代替在命令行上指定所有的需求选项。

|

||||

quiet

|

||||

summary

|

||||

|

||||

然后ZMap就可以按照配置文件和一些必要的附加参数运行了:

|

||||

然后ZMap就可以按照配置文件并指定一些必要的附加参数运行了:

|

||||

|

||||

$ zmap --config=~/.zmap.conf --target-port=443

|

||||

|

||||

### 详细 ###

|

||||

<a name="verbosity" ></a>

|

||||

|

||||

ZMap可以在屏幕上生成多种类型的输出。默认情况下,Zmap将每隔1秒打印出相似的基本进度信息。可以通过设置`--quiet`来禁用。

|

||||

|

||||

@ -377,8 +376,9 @@ ZMap还支持在扫描之后打印出一个的可grep的汇总信息,类似于

|

||||

adv permutation-gen 4215763218

|

||||

|

||||

### 结果输出 ###

|

||||

<a name="output" />

|

||||

|

||||

ZMap可以通过**输出模块**生成不同格式的结果。默认情况下,ZMap只支持**csv**的输出,但是可以通过编译支持**redis**和**json** 。可以使用**输出过滤**来过滤这些发送到输出模块上的结果。输出模块的范围由用户指定。默认情况如果没有指定输出文件,ZMap将以csv格式返回结果,ZMap不会产生特定结果。也可以编写自己的输出模块;请参阅编写输出模块。

|

||||

ZMap可以通过**输出模块**生成不同格式的结果。默认情况下,ZMap只支持**csv**的输出,但是可以通过编译支持**redis**和**json** 。可以使用**输出过滤**来过滤这些发送到输出模块上的结果。输出模块输出的字段由用户指定。默认情况如果没有指定输出文件,ZMap将以csv格式返回结果,而不会生成特定结果。也可以编写自己的输出模块;请参阅[编写输出模块](#exteding)。

|

||||

|

||||

**-o, --output-file=p**

|

||||

|

||||

@ -388,14 +388,13 @@ ZMap可以通过**输出模块**生成不同格式的结果。默认情况下,

|

||||

|

||||

调用自定义输出模块

|

||||

|

||||

|

||||

**-f, --output-fields=p**

|

||||

|

||||

输出以逗号分隔各字段的列表

|

||||

以逗号分隔的输出的字段列表

|

||||

|

||||

**--output-filter=filter**

|

||||

|

||||

在给定的探测区域实施输出过滤

|

||||

对给定的探测指定字段输出过滤

|

||||

|

||||

**--list-output-modules**

|

||||

|

||||

@ -403,17 +402,17 @@ ZMap可以通过**输出模块**生成不同格式的结果。默认情况下,

|

||||

|

||||

**--list-output-fields**

|

||||

|

||||

列出可用的给定探测区域

|

||||

列出给定的探测的可用输出字段

|

||||

|

||||

#### 输出字段 ####

|

||||

|

||||

ZMap有很多区域,它可以基于IP地址输出。这些区域可以通过在给定探测模块上运行`--list-output-fields`来查看。

|

||||

除了IP地址之外,ZMap有很多字段。这些字段可以通过在给定探测模块上运行`--list-output-fields`来查看。

|

||||

|

||||

$ zmap --probe-module="tcp_synscan" --list-output-fields

|

||||

saddr string: 应答包中的源IP地址

|

||||

saddr-raw int: 网络提供的整形形式的源IP地址

|

||||

saddr-raw int: 网络字节格式的源IP地址

|

||||

daddr string: 应答包中的目的IP地址

|

||||

daddr-raw int: 网络提供的整形形式的目的IP地址

|

||||

daddr-raw int: 网络字节格式的目的IP地址

|

||||

ipid int: 应答包中的IP识别号

|

||||

ttl int: 应答包中的ttl(存活时间)值

|

||||

sport int: TCP 源端口

|

||||

@ -426,7 +425,7 @@ ZMap有很多区域,它可以基于IP地址输出。这些区域可以通过

|

||||

repeat int: 是否是来自主机的重复响应

|

||||

cooldown int: 是否是在冷却时间内收到的响应

|

||||

timestamp-str string: 响应抵达时的时间戳使用ISO8601格式

|

||||

timestamp-ts int: 响应抵达时的时间戳使用纪元开始的秒数

|

||||

timestamp-ts int: 响应抵达时的时间戳使用UNIX纪元开始的秒数

|

||||

timestamp-us int: 时间戳的微秒部分(例如 从'timestamp-ts'的几微秒)

|

||||

|

||||

可以通过使用`--output-fields=fields`或`-f`来选择选择输出字段,任意组合的输出字段可以被指定为逗号分隔的列表。例如:

|

||||

@ -435,31 +434,32 @@ ZMap有很多区域,它可以基于IP地址输出。这些区域可以通过

|

||||

|

||||

#### 过滤输出 ####

|

||||

|

||||

在传到输出模块之前,探测模块生成的结果可以先过滤。过滤被实施在探测模块的输出字段上。过滤使用简单的过滤语法写成,类似于SQL,通过ZMap的**--output-filter**选项来实施。输出过滤通常用于过滤掉重复的结果或仅传输成功的响应到输出模块。

|

||||

在传到输出模块之前,探测模块生成的结果可以先过滤。过滤是针对探测模块的输出字段的。过滤使用类似于SQL的简单过滤语法写成,通过ZMap的**--output-filter**选项来指定。输出过滤通常用于过滤掉重复的结果,或仅传输成功的响应到输出模块。

|

||||

|

||||

过滤表达式的形式为`<字段名> <操作> <值>`。`<值>`的类型必须是一个字符串或一串无符号整数并且匹配`<字段名>`类型。对于整数比较有效的操作是`= !=, <, >, <=, >=`。字符串比较的操作是=,!=。`--list-output-fields`会打印那些可供探测模块选择的字段和类型,然后退出。

|

||||

过滤表达式的形式为`<字段名> <操作符> <值>`。`<值>`的类型必须是一个字符串或一串无符号整数并且匹配`<字段名>`类型。对于整数比较有效的操作符是`= !=, <, >, <=, >=`。字符串比较的操作是=,!=。`--list-output-fields`可以打印那些可供探测模块选择的字段和类型,然后退出。

|

||||

|

||||

复合型的过滤操作,可以通过使用`&&`(逻辑与)和`||`(逻辑或)这样的运算符来组合出特殊的过滤操作。

|

||||

|

||||

**示例**

|

||||

|

||||

书写一则过滤仅显示成功,过滤重复应答

|

||||

书写一则过滤仅显示成功的、不重复的应答

|

||||

|

||||

--output-filter="success = 1 && repeat = 0"

|

||||

|

||||

过滤出包中含RST并且TTL大于10的分类,或者包中含SYNACK的分类

|

||||

过滤出RST分类并且TTL大于10的包,或者SYNACK分类的包

|

||||

|

||||

--output-filter="(classification = rst && ttl > 10) || classification = synack"

|

||||

|

||||

#### CSV ####

|

||||

|

||||

csv模块将会生成以逗号分隔各输出请求字段的文件。例如,以下的指令将生成下面的CSV至名为`output.csv`的文件。

|

||||

csv模块将会生成以逗号分隔各个要求输出的字段的文件。例如,以下的指令将生成名为`output.csv`的CSV文件。

|

||||

|

||||

$ zmap -p 80 -f "response,saddr,daddr,sport,seq,ack,in_cooldown,is_repeat,timestamp" -o output.csv

|

||||

|

||||

----------

|

||||

|

||||

响应, 源地址, 目的地址, 源端口, 目的端口, 序列号, 应答, 是否是冷却模式, 是否重复, 时间戳

|

||||

#响应, 源地址, 目的地址, 源端口, 目的端口, 序列号, 应答, 是否是冷却模式, 是否重复, 时间戳

|

||||

response, saddr, daddr, sport, dport, seq, ack, in_cooldown, is_repeat, timestamp

|

||||

synack, 159.174.153.144, 10.0.0.9, 80, 40555, 3050964427, 3515084203, 0, 0,2013-08-15 18:55:47.681

|

||||

rst, 141.209.175.1, 10.0.0.9, 80, 40136, 0, 3272553764, 0, 0,2013-08-15 18:55:47.683

|

||||

rst, 72.36.213.231, 10.0.0.9, 80, 56642, 0, 2037447916, 0, 0,2013-08-15 18:55:47.691

|

||||

@ -472,13 +472,20 @@ csv模块将会生成以逗号分隔各输出请求字段的文件。例如,

|

||||

|

||||

#### Redis ####

|

||||

|

||||

Redis的输出模块允许地址被添加到一个Redis的队列,不是被保存到文件,允许ZMap将它与之后的处理工具结合使用。

|

||||

Redis的输出模块允许地址被添加到一个Redis的队列,而不是保存到文件,允许ZMap将它与之后的处理工具结合使用。

|

||||

|

||||

**注意!** ZMap默认不会编译Redis功能。如果您想要将Redis功能编译进ZMap源码中,可以在CMake的时候加上`-DWITH_REDIS=ON`。

|

||||

**注意!** ZMap默认不会编译Redis功能。如果你从源码构建ZMap,可以在CMake的时候加上`-DWITH_REDIS=ON`来增加Redis支持。

|

||||

|

||||

#### JSON ####

|

||||

|

||||

JSON输出模块用起来类似于CSV模块,只是以JSON格式写入到文件。JSON文件能轻松地导入到其它可以读取JSON的程序中。

|

||||

|

||||

**注意!**,ZMap默认不会编译JSON功能。如果你从源码构建ZMap,可以在CMake的时候加上`-DWITH_JSON=ON`来增加JSON支持。

|

||||

|

||||

### 黑名单和白名单 ###

|

||||

<a name="blacklisting"></a>

|

||||

|

||||

ZMap同时支持对网络前缀做黑名单和白名单。如果ZMap不加黑名单和白名单参数,他将会扫描所有的IPv4地址(包括本地的,保留的以及组播地址)。如果指定了黑名单文件,那么在黑名单中的网络前缀将不再扫描;如果指定了白名单文件,只有那些网络前缀在白名单内的才会扫描。白名单和黑名单文件可以协同使用;黑名单运用于白名单上(例如:如果您在白名单中指定了10.0.0.0/8并在黑名单中指定了10.1.0.0/16,那么10.1.0.0/16将不会扫描)。白名单和黑名单文件可以在命令行中指定,如下所示:

|

||||

ZMap同时支持对网络前缀做黑名单和白名单。如果ZMap不加黑名单和白名单参数,他将会扫描所有的IPv4地址(包括本地的,保留的以及组播地址)。如果指定了黑名单文件,那么在黑名单中的网络前缀将不再扫描;如果指定了白名单文件,只有那些网络前缀在白名单内的才会扫描。白名单和黑名单文件可以协同使用;黑名单优先于白名单(例如:如果您在白名单中指定了10.0.0.0/8并在黑名单中指定了10.1.0.0/16,那么10.1.0.0/16将不会扫描)。白名单和黑名单文件可以在命令行中指定,如下所示:

|

||||

|

||||

**-b, --blacklist-file=path**

|

||||

|

||||

@ -488,7 +495,7 @@ ZMap同时支持对网络前缀做黑名单和白名单。如果ZMap不加黑名

|

||||

|

||||

文件用于记录限制扫描的子网,以CIDR的表示法,例如192.168.0.0/16

|

||||

|

||||

黑名单文件的每行都需要以CIDR的表示格式书写一个单一的网络前缀。允许使用`#`加以备注。例如:

|

||||

黑名单文件的每行都需要以CIDR的表示格式书写,一行单一的网络前缀。允许使用`#`加以备注。例如:

|

||||

|

||||

# IANA(英特网编号管理局)记录的用于特殊目的的IPv4地址

|

||||

# http://www.iana.org/assignments/iana-ipv4-special-registry/iana-ipv4-special-registry.xhtml

|

||||

@ -501,14 +508,14 @@ ZMap同时支持对网络前缀做黑名单和白名单。如果ZMap不加黑名

|

||||

169.254.0.0/16 # RFC3927: 本地链路地址

|

||||

172.16.0.0/12 # RFC1918: 私有地址

|

||||

192.0.0.0/24 # RFC6890: IETF协议预留

|

||||

192.0.2.0/24 # RFC5737: 测试地址

|

||||

192.88.99.0/24 # RFC3068: IPv6转换到IPv4的任意播

|

||||

192.0.2.0/24 # RFC5737: 测试地址1

|

||||

192.88.99.0/24 # RFC3068: IPv6转换到IPv4的任播

|

||||

192.168.0.0/16 # RFC1918: 私有地址

|

||||

192.18.0.0/15 # RFC2544: 检测地址

|

||||

198.51.100.0/24 # RFC5737: 测试地址

|

||||

203.0.113.0/24 # RFC5737: 测试地址

|

||||

198.51.100.0/24 # RFC5737: 测试地址2

|

||||

203.0.113.0/24 # RFC5737: 测试地址3

|

||||

240.0.0.0/4 # RFC1112: 预留地址

|

||||

255.255.255.255/32 # RFC0919: 广播地址

|

||||

255.255.255.255/32 # RFC0919: 限制广播地址

|

||||

|

||||

# IANA记录的用于组播的地址空间

|

||||

# http://www.iana.org/assignments/multicast-addresses/multicast-addresses.xhtml

|

||||

@ -516,13 +523,14 @@ ZMap同时支持对网络前缀做黑名单和白名单。如果ZMap不加黑名

|

||||

|

||||

224.0.0.0/4 # RFC5771: 组播/预留地址ed

|

||||

|

||||

如果您只是想扫描因特网中随机的一部分地址,使用采样检出,来代替使用白名单和黑名单。

|

||||

如果您只是想扫描因特网中随机的一部分地址,使用[抽样](#ratelimiting)检出,来代替使用白名单和黑名单。

|

||||

|

||||

**注意!**ZMap默认设置使用`/etc/zmap/blacklist.conf`作为黑名单文件,其中包含有本地的地址空间和预留的IP空间。通过编辑`/etc/zmap/zmap.conf`可以改变默认的配置。

|

||||

|

||||

### 速度限制与抽样 ###

|

||||

<a name="ratelimiting"></a>

|

||||

|

||||

默认情况下,ZMap将以您当前网络所能支持的最快速度扫描。以我们对于常用硬件的经验,这普遍是理论上Gbit以太网速度的95-98%,这可能比您的上游提供商可处理的速度还要快。ZMap是不会自动的根据您的上游提供商来调整发送速率的。您可能需要手动的调整发送速率来减少丢包和错误结果。

|

||||

默认情况下,ZMap将以您当前网卡所能支持的最快速度扫描。以我们对于常用硬件的经验,这通常是理论上Gbit以太网速度的95-98%,这可能比您的上游提供商可处理的速度还要快。ZMap是不会自动的根据您的上游提供商来调整发送速率的。您可能需要手动的调整发送速率来减少丢包和错误结果。

|

||||

|

||||

**-r, --rate=pps**

|

||||

|

||||

@ -530,9 +538,9 @@ ZMap同时支持对网络前缀做黑名单和白名单。如果ZMap不加黑名

|

||||

|

||||

**-B, --bandwidth=bps**

|

||||

|

||||

设置发送速率以比特/秒(支持G,M和K后缀)。也同样作用于--rate的参数。

|

||||

设置发送速率以比特/秒(支持G,M和K后缀)。这会覆盖--rate参数。

|

||||

|

||||

ZMap同样支持对IPv4地址空间进行指定最大目标数和/或最长运行时间的随机采样。由于针对主机的扫描是通过随机排序生成的实例,限制扫描的主机个数为N就会随机抽选N个主机。命令选项如下:

|

||||

ZMap同样支持对IPv4地址空间进行指定最大目标数和/或最长运行时间的随机采样。由于每次对主机的扫描是通过随机排序生成的,限制扫描的主机个数为N就会随机抽选N个主机。命令选项如下:

|

||||

|

||||

**-n, --max-targets=n**

|

||||

|

||||

@ -540,7 +548,7 @@ ZMap同样支持对IPv4地址空间进行指定最大目标数和/或最长运

|

||||

|

||||

**-N, --max-results=n**

|

||||

|

||||

结果上限数量(累积收到这么多结果后推出)

|

||||

结果上限数量(累积收到这么多结果后退出)

|

||||

|

||||

**-t, --max-runtime=s**

|

||||

|

||||

@ -554,48 +562,46 @@ ZMap同样支持对IPv4地址空间进行指定最大目标数和/或最长运

|

||||

|

||||

zmap -p 443 -s 3 -n 1000000 -o results

|

||||

|

||||

为了确定哪一百万主机将要被扫描,您可以执行预扫,只列印数据包而非发送,并非真的实施扫描。

|

||||

为了确定哪一百万主机将要被扫描,您可以执行预扫,只打印数据包而非发送,并非真的实施扫描。

|

||||

|

||||

zmap -p 443 -s 3 -n 1000000 --dryrun | grep daddr

|

||||

| awk -F'daddr: ' '{print $2}' | sed 's/ |.*//;'

|

||||

|

||||

### 发送多个数据包 ###

|

||||

|

||||

ZMap支持想每个主机发送多个扫描。增加这个数量既增加了扫描时间又增加了到达的主机数量。然而,我们发现,增加扫描时间(每个额外扫描的增加近100%)远远大于到达的主机数量(每个额外扫描的增加近1%)。

|

||||

ZMap支持向每个主机发送多个探测。增加这个数量既增加了扫描时间又增加了到达的主机数量。然而,我们发现,增加的扫描时间(每个额外扫描的增加近100%)远远大于到达的主机数量(每个额外扫描的增加近1%)。

|

||||

|

||||

**-P, --probes=n**

|

||||

|

||||

向每个IP发出的独立扫描个数(默认值=1)

|

||||

向每个IP发出的独立探测个数(默认值=1)

|

||||

|

||||

----------

|

||||

### 示例应用 ###

|

||||

|

||||

### 示例应用程序 ###

|

||||

|

||||

ZMap专为向大量主机发启连接并寻找那些正确响应而设计。然而,我们意识到许多用户需要执行一些后续处理,如执行应用程序级别的握手。例如,用户在80端口实施TCP SYN扫描可能只是想要实施一个简单的GET请求,还有用户扫描443端口可能是对TLS握手如何完成感兴趣。

|

||||

ZMap专为向大量主机发起连接并寻找那些正确响应而设计。然而,我们意识到许多用户需要执行一些后续处理,如执行应用程序级别的握手。例如,用户在80端口实施TCP SYN扫描也许想要实施一个简单的GET请求,还有用户扫描443端口可能希望完成TLS握手。

|

||||

|

||||

#### Banner获取 ####

|

||||

|

||||

我们收录了一个示例程序,banner-grab,伴随ZMap使用可以让用户从监听状态的TCP服务器上接收到消息。Banner-grab连接到服务上,任意的发送一个消息,然后打印出收到的第一个消息。这个工具可以用来获取banners例如HTTP服务的回复的具体指令,telnet登陆提示,或SSH服务的字符串。

|

||||

我们收录了一个示例程序,banner-grab,伴随ZMap使用可以让用户从监听状态的TCP服务器上接收到消息。Banner-grab连接到提供的服务器上,发送一个可选的消息,然后打印出收到的第一个消息。这个工具可以用来获取banner,例如HTTP服务的回复的具体指令,telnet登陆提示,或SSH服务的字符串。

|

||||

|

||||

这个例子寻找了1000个监听80端口的服务器,并向每个发送一个简单的GET请求,存储他们的64位编码响应至http-banners.out

|

||||

下面的例子寻找了1000个监听80端口的服务器,并向每个发送一个简单的GET请求,存储他们的64位编码响应至http-banners.out

|

||||

|

||||

$ zmap -p 80 -N 1000 -B 10M -o - | ./banner-grab-tcp -p 80 -c 500 -d ./http-req > out

|

||||

|

||||

如果想知道更多使用`banner-grab`的细节,可以参考`examples/banner-grab`中的README文件。

|

||||

|

||||

**注意!** ZMap和banner-grab(如例子中)同时运行可能会比较显著的影响对方的表现和精度。确保不让ZMap充满banner-grab-tcp的并发连接,不然banner-grab将会落后于标准输入的读入,导致屏蔽编写标准输出。我们推荐使用较慢扫描速率的ZMap,同时提升banner-grab-tcp的并发性至3000以内(注意 并发连接>1000需要您使用`ulimit -SHn 100000`和`ulimit -HHn 100000`来增加每个问进程的最大文件描述)。当然,这些参数取决于您服务器的性能,连接成功率(hit-rate);我们鼓励开发者在运行大型扫描之前先进行小样本的试验。

|

||||

**注意!** ZMap和banner-grab(如例子中)同时运行可能会比较显著的影响对方的表现和精度。确保不让ZMap占满banner-grab-tcp的并发连接,不然banner-grab将会落后于标准输入的读入,导致阻塞ZMap的输出写入。我们推荐使用较慢扫描速率的ZMap,同时提升banner-grab-tcp的并发性至3000以内(注意 并发连接>1000需要您使用`ulimit -SHn 100000`和`ulimit -HHn 100000`来增加每个进程的最大文件描述符数量)。当然,这些参数取决于您服务器的性能、连接成功率(hit-rate);我们鼓励开发者在运行大型扫描之前先进行小样本的试验。

|

||||

|

||||

#### 建立套接字 ####

|

||||

|

||||

我们也收录了另一种形式的banner-grab,就是forge-socket, 重复利用服务器发出的SYN-ACK,连接并最终取得banner。在`banner-grab-tcp`中,ZMap向每个服务器发送一个SYN,并监听服务器发回的带有SYN+ACK的应答。运行ZMap主机的内核接受应答后发送RST,因为有没有处于活动状态的连接与该包关联。程序banner-grab必须在这之后创建一个新的TCP连接到从服务器获取数据。

|

||||

我们也收录了另一种形式的banner-grab,就是forge-socket, 重复利用服务器发出的SYN-ACK,连接并最终取得banner。在`banner-grab-tcp`中,ZMap向每个服务器发送一个SYN,并监听服务器发回的带有SYN+ACK的应答。运行ZMap主机的内核接受应答后发送RST,这样就没有与该包关联活动连接。程序banner-grab必须在这之后创建一个新的TCP连接到从服务器获取数据。

|

||||

|

||||

在forge-socket中,我们以同样的名字利用内核模块,这使我们可以创建任意参数的TCP连接。这样可以抑制内核的RST包,并且通过创建套接字取代它可以重用SYN+ACK的参数,通过这个套接字收发数据和我们平时使用的连接套接字并没有什么不同。

|

||||

在forge-socket中,我们利用内核中同名的模块,使我们可以创建任意参数的TCP连接。可以通过抑制内核的RST包,并重用SYN+ACK的参数取代该包而创建套接字,通过这个套接字收发数据和我们平时使用的连接套接字并没有什么不同。

|

||||

|

||||

要使用forge-socket,您需要forge-socket内核模块,从[github][1]上可以获得。您需要git clone `git@github.com:ewust/forge_socket.git`至ZMap源码根目录,然后cd进入forge_socket 目录,运行make。以root身份安装带有`insmod forge_socket.ko` 的内核模块。

|

||||

要使用forge-socket,您需要forge-socket内核模块,从[github][1]上可以获得。您需要`git clone git@github.com:ewust/forge_socket.git`至ZMap源码根目录,然后cd进入forge_socket目录,运行make。以root身份运行`insmod forge_socket.ko` 来安装该内核模块。

|

||||

|

||||

您也需要告知内核不要发送RST包。一个简单的在全系统禁用RST包的方法是**iptables**。以root身份运行`iptables -A OUTPUT -p tcp -m tcp --tcp-flgas RST,RST RST,RST -j DROP`即可,当然您也可以加上一项--dport X将禁用局限于所扫描的端口(X)上。扫描完成后移除这项设置,以root身份运行`iptables -D OUTPUT -p tcp -m tcp --tcp-flags RST,RST RST,RST -j DROP`即可。

|

||||

您也需要告知内核不要发送RST包。一个简单的在全系统禁用RST包的方法是使用**iptables**。以root身份运行`iptables -A OUTPUT -p tcp -m tcp --tcp-flgas RST,RST RST,RST -j DROP`即可,当然您也可以加上一项`--dport X`将禁用局限于所扫描的端口(X)上。扫描完成后移除这项设置,以root身份运行`iptables -D OUTPUT -p tcp -m tcp --tcp-flags RST,RST RST,RST -j DROP`即可。

|

||||

|

||||

现在应该可以建立forge-socket的ZMap示例程序了。运行需要使用**extended_file**ZMap输出模块:

|

||||

现在应该可以建立forge-socket的ZMap示例程序了。运行需要使用**extended_file**ZMap[输出模块](#outputmodule):

|

||||

|

||||

$ zmap -p 80 -N 1000 -B 10M -O extended_file -o - | \

|

||||

./forge-socket -c 500 -d ./http-req > ./http-banners.out

|

||||

@ -605,8 +611,9 @@ ZMap专为向大量主机发启连接并寻找那些正确响应而设计。然

|

||||

----------

|

||||

|

||||

### 编写探测和输出模块 ###

|

||||

<a name="extending"></a>

|

||||

|

||||

ZMap可以通过**probe modules**扩展支持不同类型的扫描,通过**output modules**追加不同类型的输出结果。注册过的探测和输出模块可以在命令行中列出:

|

||||

ZMap可以通过**探测模块**来扩展支持不同类型的扫描,通过**输出模块**增加不同类型的输出结果。注册过的探测和输出模块可以在命令行中列出:

|

||||

|

||||

**--list-probe-modules**

|

||||

|

||||

@ -617,95 +624,95 @@ ZMap可以通过**probe modules**扩展支持不同类型的扫描,通过**out

|

||||

列出安装过的输出模块

|

||||

|

||||

#### 输出模块 ####

|

||||

<a name="outputmodule"></a>

|

||||

|

||||

ZMap的输出和输出后处理可以通过执行和注册扫描的**output modules**来扩展。输出模块在接收每一个应答包时都会收到一个回调。然而提供的默认模块仅提供简单的输出,这些模块同样支持扩展扫描后处理(例如:重复跟踪或输出AS号码来代替IP地址)

|

||||

ZMap的输出和输出后处理可以通过实现和注册扫描器的**输出模块**来扩展。输出模块在接收每一个应答包时都会收到一个回调。然而默认提供的模块仅提供简单的输出,这些模块同样支持更多的输出后处理(例如:重复跟踪或输出AS号码来代替IP地址)。

|

||||

|

||||

通过定义一个新的output_module机构体来创建输出模块,并在[output_modules.c][2]中注册:

|

||||

通过定义一个新的output_module结构来创建输出模块,并在[output_modules.c][2]中注册:

|

||||

|

||||

typedef struct output_module {

|

||||

const char *name; // 在命令行如何引出输出模块

|

||||

const char *name; // 在命令行如何引用输出模块

|

||||

unsigned update_interval; // 以秒为单位的更新间隔

|

||||

|

||||

output_init_cb init; // 在扫描初始化的时候调用

|

||||

output_update_cb start; // 在开始的扫描的时候调用

|

||||

output_init_cb init; // 在扫描器初始化的时候调用

|

||||

output_update_cb start; // 在扫描器开始的时候调用

|

||||

output_update_cb update; // 每次更新间隔调用,秒为单位

|

||||

output_update_cb close; // 扫描终止后调用

|

||||

|

||||

output_packet_cb process_ip; // 接收到应答时调用

|

||||

|

||||

const char *helptext; // 会在--list-output-modules时打印在屏幕啥

|

||||

const char *helptext; // 会在--list-output-modules时打印在屏幕上

|

||||

|

||||

} output_module_t;

|

||||

|

||||

输出模块必须有名称,通过名称可以在命令行、普遍实施的`success_ip`和常见的`other_ip`回调中使用模块。process_ip的回调由每个收到的或经由**probe module**过滤的应答包调用。应答是否被认定为成功并不确定(比如,他可以是一个TCP的RST)。这些回调必须定义匹配`output_packet_cb`定义的函数:

|

||||

输出模块必须有名称,通过名称可以在命令行调用,并且通常会实现`success_ip`和常见的`other_ip`回调。process_ip的回调由每个收到并经由**probe module**过滤的应答包调用。应答是否被认定为成功并不确定(比如,它可以是一个TCP的RST)。这些回调必须定义匹配`output_packet_cb`定义的函数:

|

||||

|

||||

int (*output_packet_cb) (

|

||||

|

||||

ipaddr_n_t saddr, // network-order格式的扫描主机IP地址

|

||||

ipaddr_n_t daddr, // network-order格式的目的IP地址

|

||||

ipaddr_n_t saddr, // 网络字节格式的发起扫描主机IP地址

|

||||

ipaddr_n_t daddr, // 网络字节格式的目的IP地址

|

||||

|

||||

const char* response_type, // 发送模块的数据包分类

|

||||

|

||||

int is_repeat, // {0: 主机的第一个应答, 1: 后续的应答}

|

||||

int in_cooldown, // {0: 非冷却状态, 1: 扫描处于冷却中}

|

||||

int in_cooldown, // {0: 非冷却状态, 1: 扫描器处于冷却中}

|

||||

|

||||

const u_char* packet, // 指向结构体iphdr中IP包的指针

|

||||

size_t packet_len // 包的长度以字节为单位

|

||||

const u_char* packet, // 指向IP包的iphdr结构体的指针

|

||||