mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-02-03 23:40:14 +08:00

commit

b808184cf7

@ -1,17 +1,21 @@

|

||||

怎样在桌面上安装 Docker CE?

|

||||

=====

|

||||

|

||||

[在上一篇文章中][1],我们学习了容器世界的一些基本术语。当我们运行命令并在后续文章中使用其中一些术语时,这些背景信息将会派上用场,包括这篇文章。本文将介绍在桌面 Linux, macOS 和 Windows 上安装 Docker,它适用于想要开始使用 Docker 容器的初学者。唯一的先决条件是你对命令行界面满意。

|

||||

> 按照这些简单的步骤在你的 Linux、Mac 或 Windows 桌面上安装 Docker CE。

|

||||

|

||||

|

||||

|

||||

[在上一篇文章中][1],我们学习了容器世界的一些基本术语。当我们运行命令并在后续文章中使用其中一些术语时,这些背景信息将会派上用场,包括这篇文章。本文将介绍在桌面 Linux、 macOS 和 Windows 上安装 Docker,它适用于想要开始使用 Docker 容器的初学者。唯一的先决条件是你对命令行界面满意。

|

||||

|

||||

### 为什么我在本地机器上需要 Docker CE?

|

||||

|

||||

作为一个新用户,你很可能想知道为什么你在本地系统上需要容器。难道它们不是作为微服务在云和服务器中运行吗?尽管容器长期以来一直是 Linux 世界的一部分,但 Docker 使它们真正可以使用它的工具和技术。(to 校正者:这句话它们意义似乎不明确)

|

||||

作为一个新用户,你很可能想知道为什么你在本地系统上需要容器。难道它们不是作为微服务在云和服务器中运行吗?尽管容器长期以来一直是 Linux 世界的一部分,但 Docker 才真正使容器的工具和技术步入使用。

|

||||

|

||||

Docker 容器最大的优点是可以使用本地机器进行开发和测试。你在本地系统上创建的容器映像可以在“任何位置”运行。就应用程序在开发系统上运行良好但生产环境中出现问题这一点,开发人员和操作人员之间不会起冲突。

|

||||

Docker 容器最大的优点是可以使用本地机器进行开发和测试。你在本地系统上创建的容器映像可以在“任何位置”运行。开发人员和操作人员之间不再会为应用程序在开发系统上运行良好但生产环境中出现问题而产生纷争。

|

||||

|

||||

关键是,为了创建容器化的应用程序,你必须能够在本地系统上运行和创建容器。

|

||||

而这个关键是,要创建容器化的应用程序,你必须能够在本地系统上运行和创建容器。

|

||||

|

||||

你可以使用以下三个平台中的任何一个 -- 桌面 Linux, Windows 或 macOS 作为容器的开发平台。一旦 Docker 在这些系统上成功运行,你将可以在不同的平台上使用相同的命令。因此,接下来你运行的操作系统无关紧要。

|

||||

你可以使用以下三个平台中的任何一个 —— 桌面 Linux、 Windows 或 macOS 作为容器的开发平台。一旦 Docker 在这些系统上成功运行,你将可以在不同的平台上使用相同的命令。因此,接下来你运行的操作系统无关紧要。

|

||||

|

||||

这就是 Docker 之美。

|

||||

|

||||

@ -21,149 +25,152 @@ Docker 容器最大的优点是可以使用本地机器进行开发和测试。

|

||||

|

||||

Docker CE 有两个版本:stable 和 edge。顾名思义,stable(稳定)版本会为你提供经过充分测试的季度更新,而 edge 版本每个月都会提供新的更新。经过进一步的测试之后,这些边缘特征将被添加到稳定版本中。我建议新用户使用 stable 版本。

|

||||

|

||||

Docker CE 支持 macOS, Windows 10, Ubuntu 14.04, 16.04, 17.04 和 17.10,以及 Debian 7.7, 8, 9 和 10, Fedora 25, 26, 27 和 centOS。虽然你可以下载 Docker CE 二进制文件并安装到桌面 Linux 上,但我建议添加仓库源以便继续获得修补程序和更新。

|

||||

Docker CE 支持 macOS、 Windows 10、 Ubuntu 14.04/16.04/17.04/17.10、 Debian 7.7/8/9/10、 Fedora 25/26/27 和 CentOS。虽然你可以下载 Docker CE 二进制文件并安装到桌面 Linux 上,但我建议添加仓库源以便继续获得修补程序和更新。

|

||||

|

||||

### 在桌面 Linux 上安装 Docker CE

|

||||

|

||||

你不需要一个完整的桌面 Linux 来运行 Docker,你也可以将它安装在最小的 Linux 服务器上,即你可以在一个虚拟机中运行。在本教程中,我将在我的主系统 Fedora 27 和 Ubuntu 17.04 上运行它(to 校正者:这句话搞不清主要是什么系统)。

|

||||

你不需要一个完整的桌面 Linux 来运行 Docker,你也可以将它安装在最小的 Linux 服务器上,即你可以在一个虚拟机中运行。在本教程中,我将在我的主系统的 Fedora 27 和 Ubuntu 17.04 上运行它。

|

||||

|

||||

### 在 Ubuntu 上安装

|

||||

|

||||

首先,运行系统更新,以便你的 Ubuntu 软件包完全更新:

|

||||

|

||||

```

|

||||

$ sudo apt-get update

|

||||

|

||||

```

|

||||

|

||||

现在运行系统升级:

|

||||

|

||||

```

|

||||

$ sudo apt-get dist-upgrade

|

||||

|

||||

```

|

||||

|

||||

然后安装 Docker PGP 密钥:

|

||||

|

||||

```

|

||||

sudo add-apt-repository "deb [arch=amd64] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable"

|

||||

|

||||

```

|

||||

```

|

||||

Update the repository info again:

|

||||

$ sudo apt-get update

|

||||

|

||||

```

|

||||

|

||||

现在安装 Docker CE:

|

||||

|

||||

```

|

||||

$ sudo apt-get install docker-ce

|

||||

|

||||

```

|

||||

|

||||

一旦安装,Docker CE 就会在基于 Ubuntu 的系统上自动运行,让我们来检查它是否在运行:

|

||||

一旦安装完成,Docker CE 就会在基于 Ubuntu 的系统上自动运行,让我们来检查它是否在运行:

|

||||

|

||||

```

|

||||

$ sudo systemctl status docker

|

||||

|

||||

```

|

||||

|

||||

你应该得到以下输出:

|

||||

|

||||

```

|

||||

docker.service - Docker Application Container Engine

|

||||

Loaded: loaded (/lib/systemd/system/docker.service; enabled; vendor preset: enabled)

|

||||

Active: active (running) since Thu 2017-12-28 15:06:35 EST; 19min ago

|

||||

Docs: https://docs.docker.com

|

||||

Loaded: loaded (/lib/systemd/system/docker.service; enabled; vendor preset: enabled)

|

||||

Active: active (running) since Thu 2017-12-28 15:06:35 EST; 19min ago

|

||||

Docs: https://docs.docker.com

|

||||

Main PID: 30539 (dockerd)

|

||||

|

||||

```

|

||||

|

||||

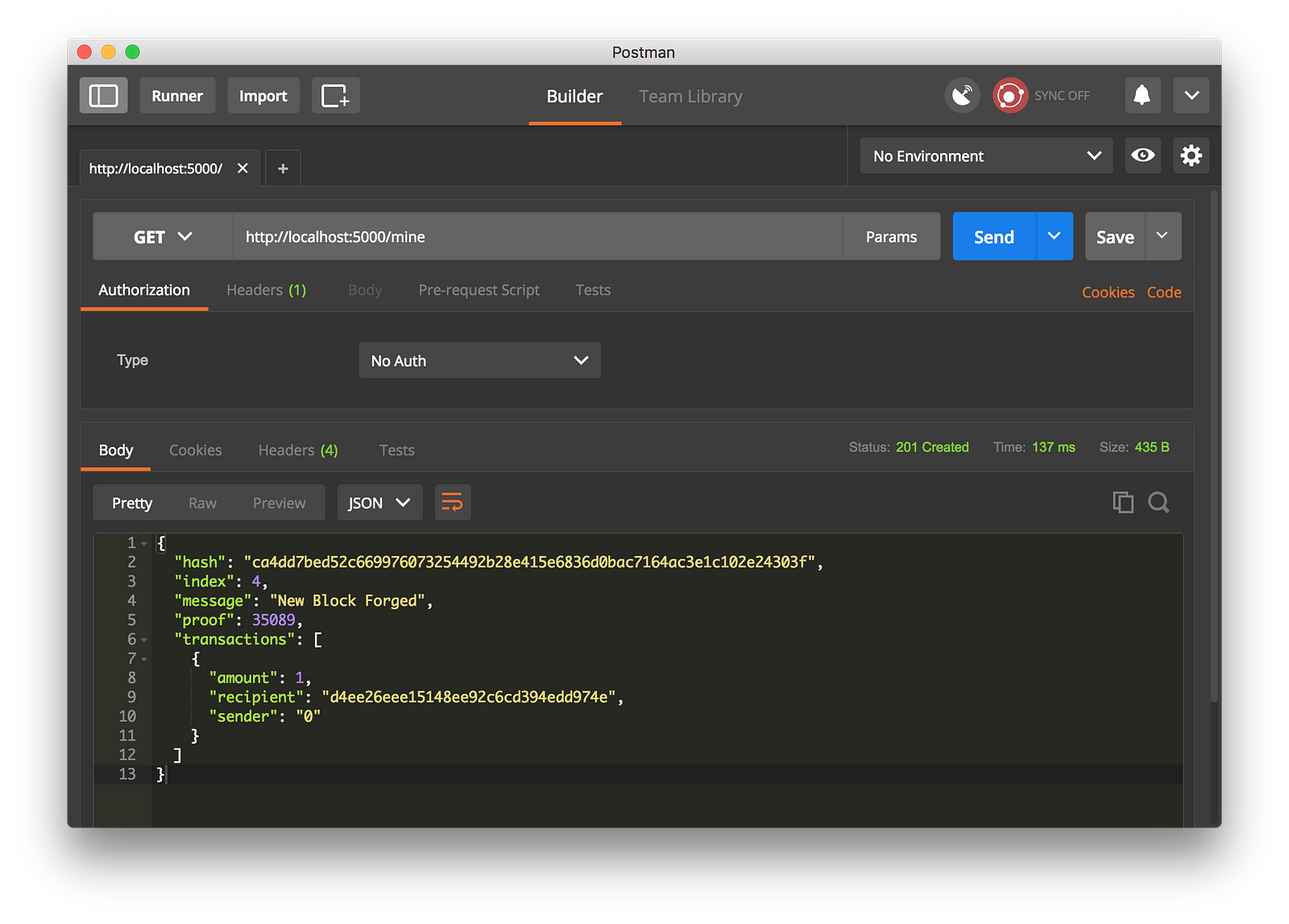

由于 Docker 安装在你的系统上,你现在可以使用 Docker CLI(命令行界面)运行 Docker 命令。像往常一样,我们运行 ‘Hello World’ 命令:

|

||||

|

||||

```

|

||||

$ sudo docker run hello-world

|

||||

|

||||

```

|

||||

|

||||

![YMChR_7xglpYBT91rtXnqQc6R1Hx9qMX_iO99vL8][2]

|

||||

|

||||

恭喜!在你的 Ubuntu 系统上正在运行着 Docker。

|

||||

|

||||

### 在 Fedora 上安装 Docker CE

|

||||

|

||||

Fedora 27 上的情况有些不同。在 Fedora 上,你首先需要安装 def-plugins-core 包,这将允许你从 CLI 管理你的 DNF 包。

|

||||

Fedora 27 上的情况有些不同。在 Fedora 上,你首先需要安装 `def-plugins-core` 包,这将允许你从 CLI 管理你的 DNF 包。

|

||||

|

||||

```

|

||||

$ sudo dnf -y install dnf-plugins-core

|

||||

|

||||

```

|

||||

|

||||

现在在你的系统上安装 Docker 仓库:

|

||||

|

||||

```

|

||||

$ sudo dnf config-manager \

|

||||

--add-repo \

|

||||

https://download.docker.com/linux/fedora/docker-ce.repo

|

||||

--add-repo \

|

||||

https://download.docker.com/linux/fedora/docker-ce.repo

|

||||

It’s time to install Docker CE:

|

||||

|

||||

$ sudo dnf install docker-ce

|

||||

|

||||

```

|

||||

|

||||

```

|

||||

$ sudo dnf install docker-ce

|

||||

```

|

||||

与 Ubuntu 不同,Docker 不会在 Fedora 上自动启动。那么让我们启动它:

|

||||

|

||||

```

|

||||

$ sudo systemctl start docker

|

||||

|

||||

```

|

||||

|

||||

你必须在每次重新启动后手动启动 Docker,因此让我们将其配置为在重新启动后自动启动。$ systemctl enable docker 就行。现在该运行 Hello World 命令了:

|

||||

你必须在每次重新启动后手动启动 Docker,因此让我们将其配置为在重新启动后自动启动。`$ systemctl enable docker` 就行。现在该运行 Hello World 命令了:

|

||||

|

||||

```

|

||||

$ sudo docker run hello-world

|

||||

|

||||

```

|

||||

|

||||

恭喜,在你的 Fedora 27 系统上正在运行着 Docker。

|

||||

|

||||

### 解除 root

|

||||

|

||||

你可能已经注意到你必须使用 sudo 来运行 Docker 命令。这是因为 Docker 守护进程与 UNIX 套接字绑定,而不是 TCP 端口,套接字由 root 用户拥有。所以,你需要 sudo 权限才能运行 docker 命令。你可以将系统用户添加到 docker 组,这样它就不需要 sudo 了:

|

||||

你可能已经注意到你必须使用 `sudo` 来运行 `docker` 命令。这是因为 Docker 守护进程与 UNIX 套接字绑定,而不是 TCP 端口,套接字由 root 用户拥有。所以,你需要 `sudo` 权限才能运行 `docker` 命令。你可以将系统用户添加到 docker 组,这样它就不需要 `sudo` 了:

|

||||

|

||||

```

|

||||

$ sudo groupadd docker

|

||||

|

||||

```

|

||||

|

||||

在大多数情况下,在安装 Docker CE 时会自动创建 Docker 用户组,因此你只需将用户添加到该组中即可:

|

||||

|

||||

```

|

||||

$ sudo usermod -aG docker $USER

|

||||

|

||||

```

|

||||

|

||||

为了测试组是否已经成功添加,根据用户名运行 groups 命令:

|

||||

为了测试该组是否已经成功添加,根据用户名运行 `groups` 命令:

|

||||

|

||||

```

|

||||

$ groups swapnil

|

||||

|

||||

```

|

||||

|

||||

(这里,swapnil 是用户名。)

|

||||

(这里,`swapnil` 是用户名。)

|

||||

|

||||

这是在我系统上的输出:

|

||||

```

|

||||

$ swapnil : swapnil adm cdrom sudo dip plugdev lpadmin sambashare docker

|

||||

|

||||

```

|

||||

swapnil : swapnil adm cdrom sudo dip plugdev lpadmin sambashare docker

|

||||

```

|

||||

|

||||

你可以看到该用户也属于 docker 组。注销系统,这样组就会生效。一旦你再次登录,在不使用 sudo 的情况下试试 Hello World 命令:

|

||||

你可以看到该用户也属于 docker 组。注销系统,这样组就会生效。一旦你再次登录,在不使用 `sudo` 的情况下试试 Hello World 命令:

|

||||

|

||||

```

|

||||

$ docker run hello-world

|

||||

|

||||

```

|

||||

|

||||

你可以通过运行以下命令来查看关于 Docker 的安装版本以及更多系统信息:

|

||||

|

||||

```

|

||||

$ docker info

|

||||

|

||||

```

|

||||

|

||||

### 在 macOS 和 Windows 上安装 Docker CE

|

||||

|

||||

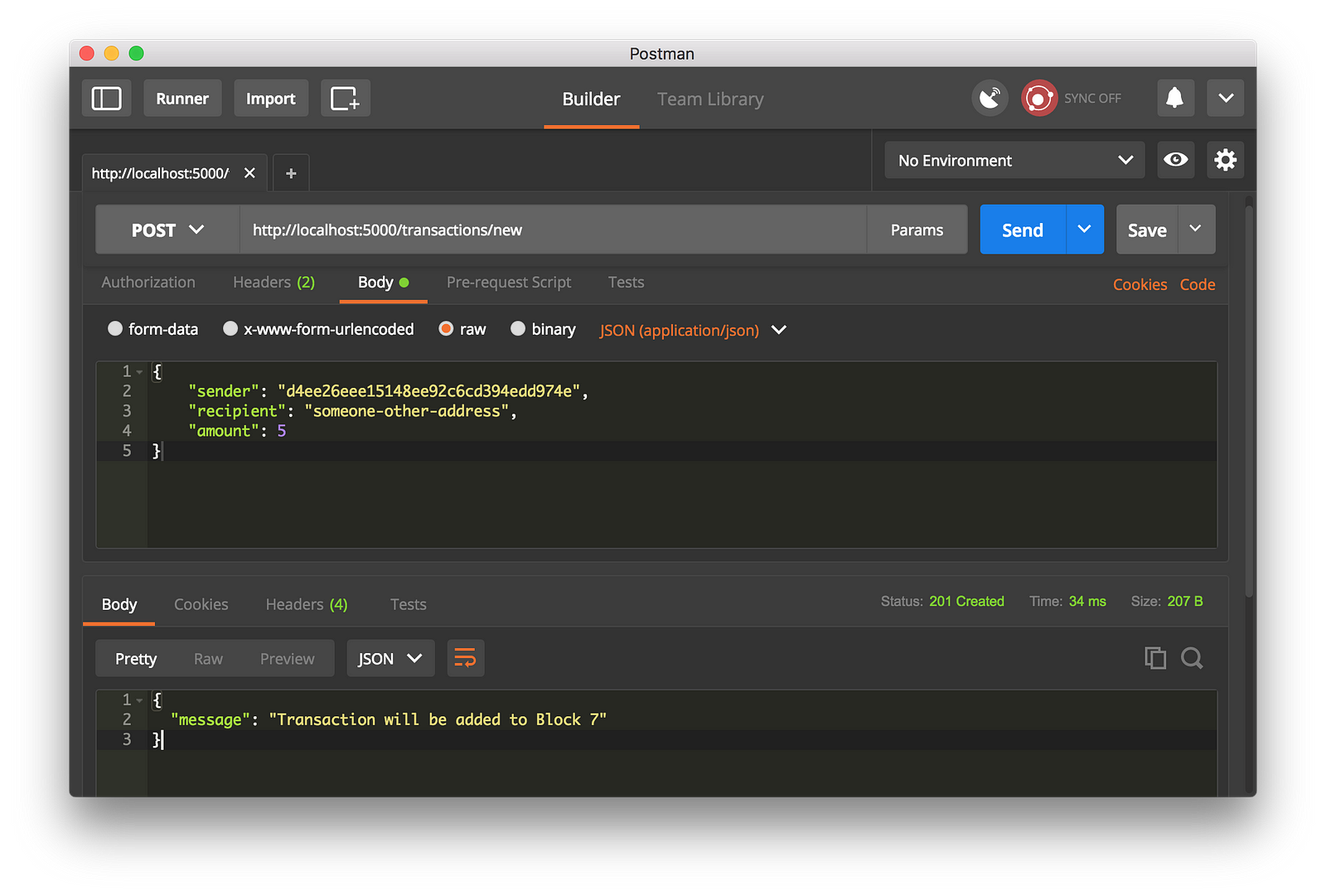

你可以在 macOS 和 Windows 上很轻松地安装 Docker CE(和 EE)。下载官方为 macOS 提供的 Docker 安装包,在 macOS 上安装应用程序的方式是只需将它们拖到 Applications 目录即可。一旦文件被复制,从 spotlight(译者注:mac 下的搜索)下打开 Docker 开始安装。一旦安装,Docker 将自动启动,你可以在 macOS 的顶部看到它。

|

||||

你可以在 macOS 和 Windows 上很轻松地安装 Docker CE(和 EE)。下载官方为 macOS 提供的 Docker 安装包,在 macOS 上安装应用程序的方式是只需将它们拖到 Applications 目录即可。一旦文件被复制,从 spotlight(LCTT 译注:mac 下的搜索功能)下打开 Docker 开始安装。一旦安装,Docker 将自动启动,你可以在 macOS 的顶部看到它。

|

||||

|

||||

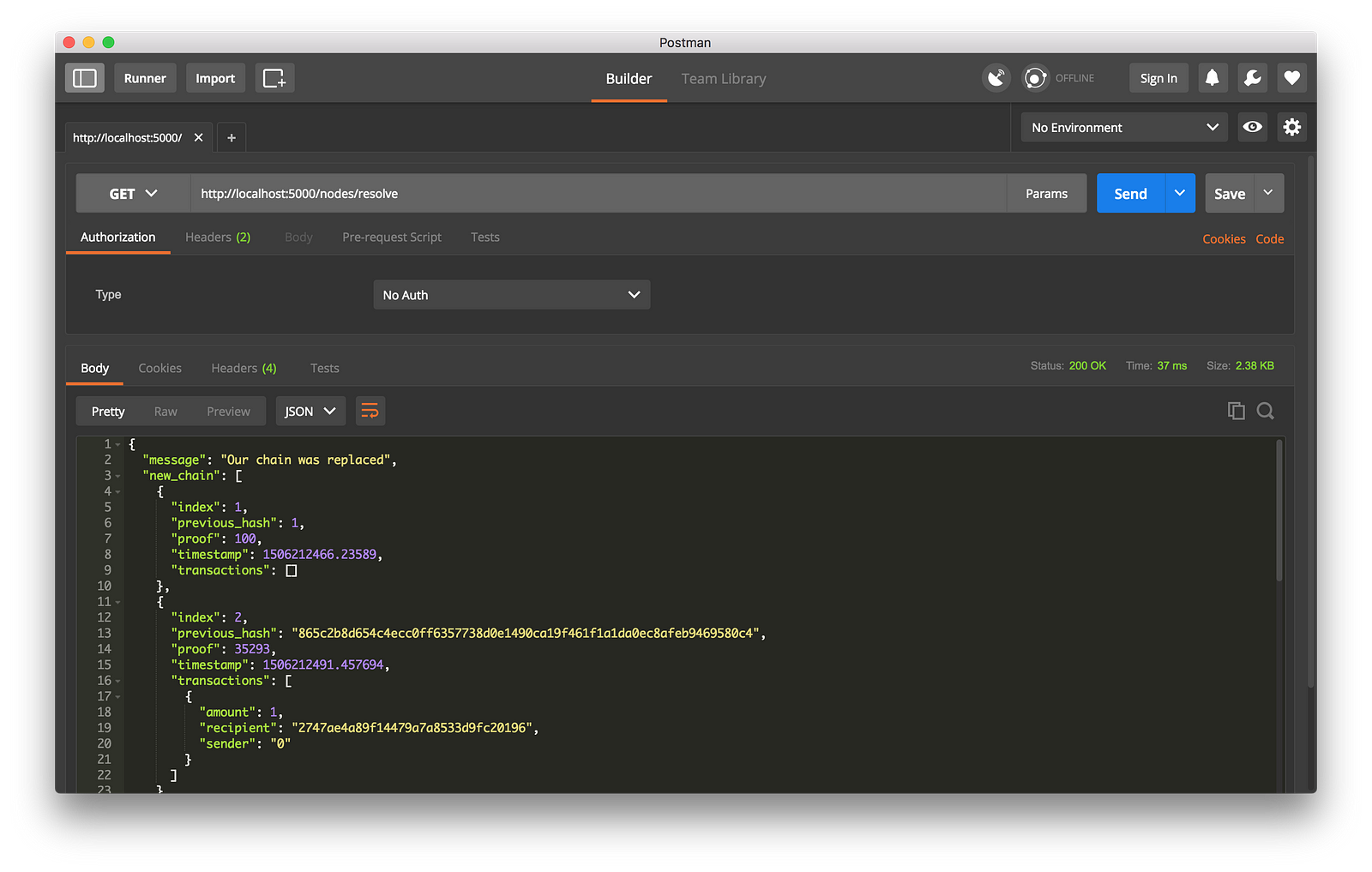

![IEX23j65zYlF8mZ1c-T_vFw_i1B1T1hibw_AuhEA][3]

|

||||

|

||||

macOS 是类 UNIX,所以你可以简单地打开终端应用程序,并开始使用 Docker 命令。测试 hello world 应用:

|

||||

macOS 是类 UNIX 系统,所以你可以简单地打开终端应用程序,并开始使用 Docker 命令。测试 hello world 应用:

|

||||

|

||||

```

|

||||

$ docker run hello-world

|

||||

|

||||

```

|

||||

|

||||

恭喜,你已经在你的 macOS 上运行了 Docker。

|

||||

@ -173,9 +180,9 @@ $ docker run hello-world

|

||||

你需要最新版本的 Windows 10 Pro 或 Server 才能在它上面安装或运行 Docker。如果你没有完全更新,Windows 将不会安装 Docker。我在 Windows 10 系统上遇到了错误,必须运行系统更新。我的版本还很落后,我出现了[这个][14] bug。所以,如果你无法在 Windows 上安装 Docker,只要知道并不是只有你一个。仔细检查该 bug 以找到解决方案。

|

||||

|

||||

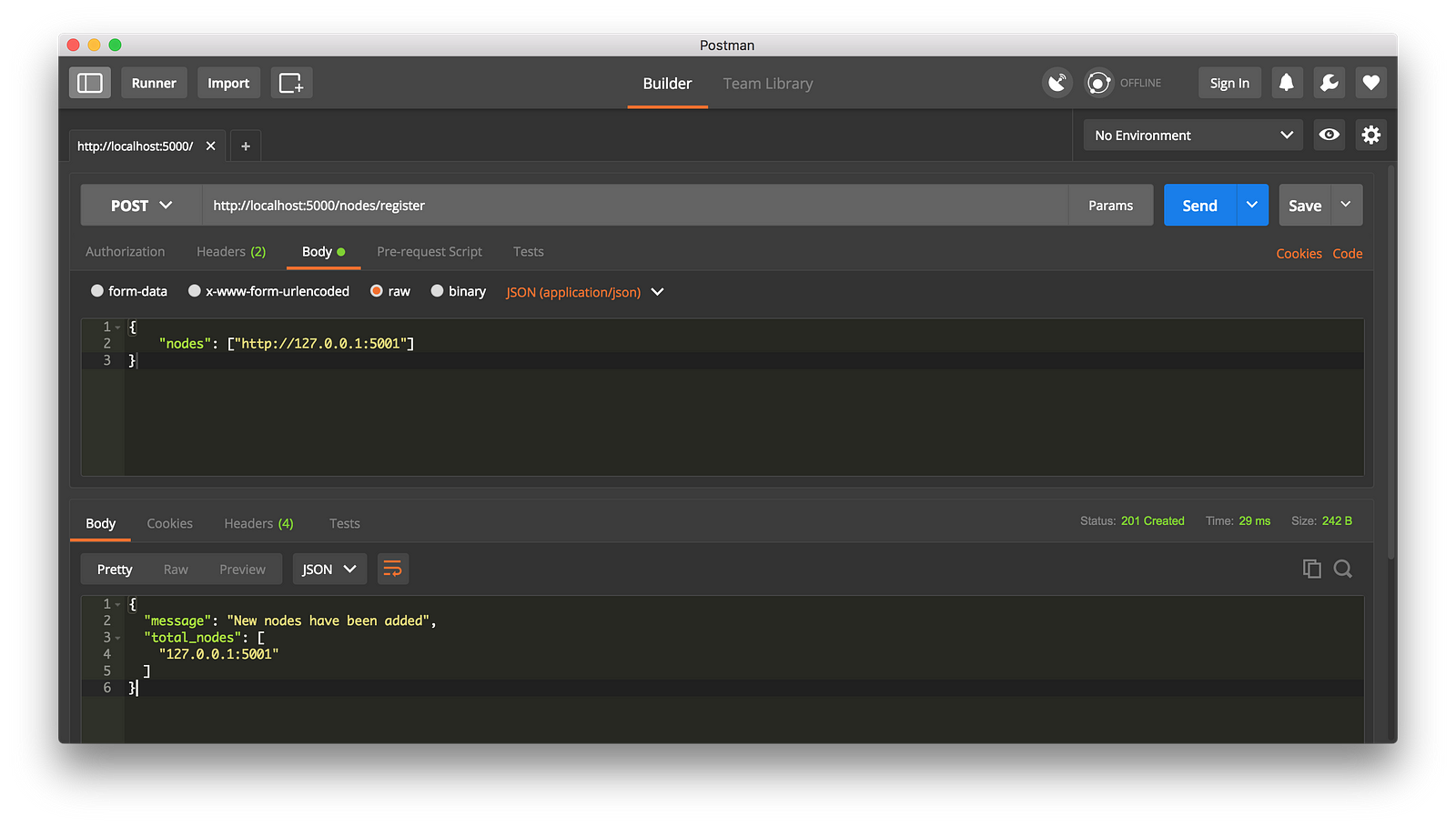

一旦你在 Windows 上安装 Docker 后,你可以通过 WSL 使用 bash shell,或者使用 PowerShell 来运行 Docker 命令。让我们在 PowerShell 中测试 “Hello World” 命令:

|

||||

|

||||

```

|

||||

PS C:\Users\swapnil> docker run hello-world

|

||||

|

||||

```

|

||||

|

||||

恭喜,你已经在 Windows 上运行了 Docker。

|

||||

@ -188,9 +195,9 @@ PS C:\Users\swapnil> docker run hello-world

|

||||

via: https://www.linux.com/blog/learn/intro-to-linux/how-install-docker-ce-your-desktop

|

||||

|

||||

作者:[SWAPNIL BHARTIYA][a]

|

||||

译者:[MjSeven](https://github.com/MjSeven)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[MjSeven](https://github.com/MjSeven)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,50 @@

|

||||

DevOps 如何帮助你将很酷的应用交付给用户

|

||||

======

|

||||

|

||||

> 想要在今天的快节奏的商业环境中获得成功?要么选择 DevOps,要么死亡。

|

||||

|

||||

|

||||

|

||||

在很久之前,遥远的银河系中,在 DevOps 成为主流实践之前,软件开发的过程是极其缓慢、单调和按部就班的。当一个应用准备要部署的时候,就已经为下一个主要版本迭代积累了一长串的变更和修复。每次为新版本迭代所花费的准备时间都需要花费数个月的时间去回顾和贯穿整个开发周期。请记住这个过程将会在交付更新给用户的过程中不断的

|

||||

重复。

|

||||

|

||||

今天一切都是瞬间和实时完成的,这个概念似乎很原始。这场移动革命已经极大的改变了我们和软件之间的交互。那些早期采用 DevOps 的公司已经彻底改变了对软件开发和部署的期望。

|

||||

|

||||

让我们看看 Facebook:这个移动应用每两周更新和刷新一次,像钟表一样。这就是新的标准,因为现在的用户期望软件持续的被修复和更新。任何一家要花费一个月或者更多的时间来部署新的功能或者修复 bug 的公司将会逐渐走向没落。如果你不能交付用户所期待的,他们将会去寻找那些能够满足他们需求的。

|

||||

|

||||

Facebook,以及一些工业巨头如亚马逊、Netfix、谷歌以及其他公司,都已经强制要求企业变得更快速、更有效的来满足今天的顾客们的需求。

|

||||

|

||||

### 为什么是 DevOps?

|

||||

|

||||

敏捷和 DevOps 对于移动应用开发领域是相当重要的,因为开发周期正变得如闪电般的快。现在是一个密集、快节奏的环境,公司必须加紧步伐赶超,思考的更深入,运用策略来去完成,从而生存下去。在应用商店中,排名前十的应用平均能够保持的时间只有一个月左右。

|

||||

|

||||

为了说明老式的瀑布方法,回想一下你第一次学习驾驶。起先,你专注于每个独立的层面,使用一套方法论的过程:你上车;系上安全带;调整座椅、镜子,控制方向盘;发动汽车,将你的手放在 10 点和 2 点钟的方向,等等。完成一个换车道一样简单的任务需要付出艰苦的努力,以一个特定的顺序执行多个步骤。

|

||||

|

||||

DevOps,正好相反,是在你有了几年的经验之后如何去驾驶的。一切都是靠直觉同时发生的,你可以不用过多的思考就很平滑的从 A 点移动到 B 点。

|

||||

|

||||

移动 app 的世界对越老式的 app 开发环境来说太快节奏了。DevOps 被设计用来快速交付有效、稳定的 app,而不需要增加资源。然而你不能像购买一件普通的商品或者服务一样去购买 DevOps。DevOps 是用来指导改变团队如何一起工作的文化和活动的。

|

||||

|

||||

不是只有像亚马逊和 Facebook 这样的大公司才拥抱 DevOps 文化;小的移动应用公司也在很好的使用。“缩短迭代周期,同时保持生产事故处于一个较低水平,以及满足顾客追求的整体故障成本。”来自移动产品代理 [Reinvently][1]的工程部的负责人,Oleg Reshetnyak 说道。

|

||||

|

||||

### DevOps: 不是如果,而是什么时候

|

||||

|

||||

在今天的快节奏的商业环境中,选在了 DevOps 就像是选择了呼吸:要么去[做要么就死亡][2]。

|

||||

|

||||

根据[美国小企业管理局][3]的报道,现在只有 16% 的公司能够持续一代人的时间。不采用 DevOps 的移动应用公司将冒着逐渐走向灭绝的风险。而且,同样的研究表明采用 DevOps 的公司组织可能能够获得两倍的盈利能力、生产目标以及市场份额。

|

||||

|

||||

更快速、更安全的革新需要做到三点:云、自动化和 DevOps。根据你对 DevOps 的定义的不同,这三个要点之间的界限是不清晰的。然而,有一点是确定的:DevOps 围绕着更快、更少风险地交付高质量的软件的共同目标将组织内的每个人都统一起来。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/2/devops-delivers-cool-apps-users

|

||||

|

||||

作者:[Stanislav Ivaschenko][a]

|

||||

译者:[FelixYFZ](https://github.com/FelixYFZ)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/ilyadudkin

|

||||

[1]:https://reinvently.com/

|

||||

[2]:https://squadex.com/insights/devops-or-die/

|

||||

[3]:https://www.sba.gov/

|

||||

@ -0,0 +1,119 @@

|

||||

学习用 Thonny 写代码: 一个面向初学者的Python IDE

|

||||

======

|

||||

|

||||

|

||||

|

||||

学习编程很难。即使当你最终怎么正确使用你的冒号和括号,但仍然有很大的可能你的程序不会如果所想的工作。 通常,这意味着你忽略了某些东西或者误解了语言结构,你需要在代码中找到你的期望与现实存在分歧的地方。

|

||||

|

||||

程序员通常使用被叫做<ruby>调试器<rt>debugger</rt></ruby>的工具来处理这种情况,它允许一步一步地运行他们的程序。不幸的是,大多数调试器都针对专业用途进行了优化,并假设用户已经很好地了解了语言结构的语义(例如:函数调用)。

|

||||

|

||||

Thonny 是一个适合初学者的 Python IDE,由爱沙尼亚的 [Tartu 大学][1] 开发,它采用了不同的方法,因为它的调试器是专为学习和教学编程而设计的。

|

||||

|

||||

虽然 Thonny 适用于像小白一样的初学者,但这篇文章面向那些至少具有 Python 或其他命令式语言经验的读者。

|

||||

|

||||

### 开始

|

||||

|

||||

从第 Fedora 27 开始,Thonny 就被包含在 Fedora 软件库中。 使用 `sudo dnf install thonny` 或者你选择的图形工具(比如“<ruby>软件<rt>Software</rt></ruby>”)安装它。

|

||||

|

||||

当第一次启动 Thonny 时,它会做一些准备工作,然后呈现一个空白的编辑器和 Python shell 。将下列程序文本复制到编辑器中,并将其保存到文件中(`Ctrl+S`)。

|

||||

|

||||

```

|

||||

n = 1

|

||||

while n < 5:

|

||||

print(n * "*")

|

||||

n = n + 1

|

||||

```

|

||||

|

||||

我们首先运行该程序。 为此请按键盘上的 `F5` 键。 你应该看到一个由星号组成的三角形出现在 shell 窗格中。

|

||||

|

||||

![一个简单的 Thonny 程序][2]

|

||||

|

||||

Python 分析了你的代码并理解了你想打印一个三角形了吗?让我们看看!

|

||||

|

||||

首先从“<ruby>查看<rt>View</rt></ruby>”菜单中选择“<ruby>变量<rt>Variables</rt></ruby>”。这将打开一张表格,向我们展示 Python 是如何管理程序的变量的。现在通过按 `Ctrl + F5`(在 XFCE 中是 `Ctrl + Shift + F5`)以调试模式运行程序。在这种模式下,Thonny 使 Python 在每一步所需的步骤之前暂停。你应该看到程序的第一行被一个框包围。我们将这称为焦点,它表明 Python 将接下来要执行的部分代码。

|

||||

|

||||

![ Thonny 调试器焦点 ][3]

|

||||

|

||||

你在焦点框中看到的一段代码段被称为赋值语句。 对于这种声明,Python 应该计算右边的表达式,并将值存储在左边显示的名称下。按 `F7` 进行下一步。你将看到 Python 将重点放在语句的正确部分。在这个例子中,表达式实际上很简单,但是为了通用性,Thonny 提供了表达式计算框,它允许将表达式转换为值。再次按 `F7` 将文字 `1` 转换为值 `1`。现在 Python 已经准备好执行实际的赋值—再次按 `F7`,你应该会看到变量 `n` 的值为 `1` 的变量出现在变量表中。

|

||||

|

||||

![Thonny 变量表][4]

|

||||

|

||||

继续按 `F7` 并观察 Python 如何以非常小的步骤前进。它看起来像是理解你的代码的目的或者更像是一个愚蠢的遵循简单规则的机器?

|

||||

|

||||

### 函数调用

|

||||

|

||||

<ruby>函数调用<rt>Function Call</rt></ruby>是一种编程概念,它常常给初学者带来很大的困惑。从表面上看,没有什么复杂的事情——给代码命名,然后在代码中的其他地方引用它(调用它)。传统的调试器告诉我们,当你进入调用时,焦点跳转到函数定义中(然后稍后神奇地返回到原来的位置)。这是整件事吗?这需要我们关心吗?

|

||||

|

||||

结果证明,“跳转模型” 只对最简单的函数是足够的。理解参数传递、局部变量、返回和递归都得理解堆栈框架的概念。幸运的是,Thonny 可以直观地解释这个概念,而无需在厚厚的掩盖下搜索重要的细节。

|

||||

|

||||

将以下递归程序复制到 Thonny 并以调试模式(`Ctrl+F5` 或 `Ctrl+Shift+F5`)运行。

|

||||

|

||||

```

|

||||

def factorial(n):

|

||||

if n == 0:

|

||||

return 1

|

||||

else:

|

||||

return factorial(n-1) * n

|

||||

|

||||

print(factorial(4))

|

||||

```

|

||||

|

||||

重复按 `F7`,直到你在对话框中看到表达式 `factorial(4)`。 当你进行下一步时,你会看到 Thonny 打开一个包含了函数代码、另一个变量表和另一个焦点框的新窗口(移动窗口以查看旧的焦点框仍然存在)。

|

||||

|

||||

![通过递归函数的 Thonny][5]

|

||||

|

||||

此窗口表示堆栈帧,即用于解析函数调用的工作区。几个放在彼此顶部的这样的窗口称为<ruby>调用堆栈<rt>call stack</rt></ruby>。注意调用位置的参数 `4` 与 “局部变量” 表中的输入 `n` 之间的关系。继续按 `F7` 步进, 观察在每次调用时如何创建新窗口并在函数代码完成时被销毁,以及如何用返回值替换了调用位置。

|

||||

|

||||

### 值与参考

|

||||

|

||||

现在,让我们在 Python shell 中进行一个实验。首先输入下面屏幕截图中显示的语句:

|

||||

|

||||

![Thonny shell 显示列表突变][6]

|

||||

|

||||

正如你所看到的, 我们追加到列表 `b`, 但列表 `a` 也得到了更新。你可能知道为什么会发生这种情况, 但是对初学者来说,什么才是最好的解释呢?

|

||||

|

||||

当教我的学生列表时,我告诉他们我一直欺骗了他们关于 Python 内存模型。实际上,它并不像变量表所显示的那样简单。我告诉他们重新启动解释器(工具栏上的红色按钮),从“<ruby>查看<rt>View</rt></ruby>”菜单中选择“<ruby>堆<rt>Heap</rt></ruby>”,然后再次进行相同的实验。如果这样做,你就会发现变量表不再包含值——它们实际上位于另一个名为“<ruby>堆<rt>Heap</rt></ruby>”的表中。变量表的作用实际上是将变量名映射到地址(或称 ID),地址又指向了<ruby>堆<rt>Heap</rt></ruby>表中的行。由于赋值仅更改变量表,因此语句 `b = a` 只复制对列表的引用,而不是列表本身。这解释了为什么我们通过这两个变量看到了变化。

|

||||

|

||||

![在堆模式中的 Thonny][7]

|

||||

|

||||

(为什么我要在教列表的主题之前推迟说出内存模型的事实?Python 存储的列表是否有所不同?请继续使用 Thonny 的堆模式来找出结果!在评论中告诉我你认为怎么样!)

|

||||

|

||||

如果要更深入地了解参考系统, 请将以下程序通过打开堆表复制到 Thonny 并进行小步调试(`F7`) 中。

|

||||

|

||||

```

|

||||

def do_something(lst, x):

|

||||

lst.append(x)

|

||||

|

||||

a = [1,2,3]

|

||||

n = 4

|

||||

do_something(a, n)

|

||||

print(a)

|

||||

```

|

||||

|

||||

即使“堆模式”向我们显示真实的图片,但它使用起来也相当不方便。 因此,我建议你现在切换回普通模式(取消选择“<ruby>查看<rt>View</rt></ruby>”菜单中的“<ruby>堆<rt>Heap</rt></ruby>”),但请记住,真实模型包含变量、参考和值。

|

||||

|

||||

### 结语

|

||||

|

||||

我在这篇文章中提及到的特性是创建 Thonny 的主要原因。很容易对函数调用和引用形成错误的理解,但传统的调试器并不能真正帮助减少混淆。

|

||||

|

||||

除了这些显著的特性,Thonny 还提供了其他几个初学者友好的工具。 请查看 [Thonny的主页][8] 以了解更多信息!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://fedoramagazine.org/learn-code-thonny-python-ide-beginners/

|

||||

|

||||

作者:[Aivar Annamaa][a]

|

||||

译者:[Auk7F7](https://github.com/Auk7F7)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://fedoramagazine.org/

|

||||

[1]:https://www.ut.ee/en

|

||||

[2]:https://fedoramagazine.org/wp-content/uploads/2017/12/scr1.png

|

||||

[3]:https://fedoramagazine.org/wp-content/uploads/2017/12/thonny-scr2.png

|

||||

[4]:https://fedoramagazine.org/wp-content/uploads/2017/12/thonny-scr3.png

|

||||

[5]:https://fedoramagazine.org/wp-content/uploads/2017/12/thonny-scr4.png

|

||||

[6]:https://fedoramagazine.org/wp-content/uploads/2017/12/thonny-scr5.png

|

||||

[7]:https://fedoramagazine.org/wp-content/uploads/2017/12/thonny-scr6.png

|

||||

[8]:http://thonny.org

|

||||

@ -1,8 +1,11 @@

|

||||

在 Linux 上用 DNS 实现简单的负载均衡

|

||||

======

|

||||

|

||||

> DNS 轮询将多个服务器映射到同一个主机名,并没有为这里展示的魔法做更多的工作。

|

||||

|

||||

|

||||

如果你的后端服务器是由多台服务器构成的,比如集群化或者镜像的 Web 或者文件服务器,通过一个负载均衡器提供了单一的入口点。业务繁忙的大型电商花费大量的资金在高端负载均衡器上,用它来执行各种各样的任务:代理、缓存、状况检查、SSL 处理、可配置的优先级、流量整形等很多任务。

|

||||

|

||||

如果你的后端服务器是由多台服务器构成的,比如集群化或者镜像的 Web 或者文件服务器,通过负载均衡器提供了单一的入口点。业务繁忙的大型电商在高端负载均衡器上花费了大量的资金,用它来执行各种各样的任务:代理、缓存、状况检查、SSL 处理、可配置的优先级、流量整形等很多任务。

|

||||

|

||||

但是你并不需要做那么多工作的负载均衡器。你需要的是一个跨服务器分发负载的简单方法,它能够提供故障切换,并且不太在意它是否高效和完美。DNS 轮询和使用轮询的子域委派是实现这个目标的两种简单方法。

|

||||

|

||||

@ -12,11 +15,12 @@ DNS 轮询是将多台服务器映射到同一个主机名上,当用户访问

|

||||

|

||||

### DNS 轮询

|

||||

|

||||

轮询和旅鸫鸟(robins)没有任何关系,据我喜欢的图书管理员说,它最初是一个法语短语,_`ruban rond`_、或者 `round ribbon`。很久以前,法国政府官员以不分级的圆形、波浪形、或者辐条形状去签署请愿书以掩盖请愿书的发起人。

|

||||

轮询和<ruby>旅鸫鸟<rt>robins</rt></ruby>没有任何关系,据我相熟的图书管理员说,它最初是一个法语短语,_ruban rond_、或者 _round ribbon_。很久以前,法国政府官员以不分级的圆形、波浪线、或者直线形状来在请愿书上签字,以盖住原来的发起人。

|

||||

|

||||

DNS 轮询也是不分级的,简单配置一个服务器列表,然后将请求转到每个服务器上。它并不做真正的负载均衡,因为它根本就不测量负载,也没有状况检查,因此如果一个服务器宕机,请求仍然会发送到那个宕机的服务器上。它的优点就是简单。如果你有一个小的文件或者 Web 服务器集群,想通过一个简单的方法在它们之间分散负载,那么 DNS 轮询很适合你。

|

||||

|

||||

你所做的全部配置就是创建多条 A 或者 AAAA 记录,映射多台服务器到单个的主机名。这个 BIND 示例同时使用了 IPv4 和 IPv6 私有地址类:

|

||||

|

||||

```

|

||||

fileserv.example.com. IN A 172.16.10.10

|

||||

fileserv.example.com. IN A 172.16.10.11

|

||||

@ -25,10 +29,10 @@ fileserv.example.com. IN A 172.16.10.12

|

||||

fileserv.example.com. IN AAAA fd02:faea:f561:8fa0:1::10

|

||||

fileserv.example.com. IN AAAA fd02:faea:f561:8fa0:1::11

|

||||

fileserv.example.com. IN AAAA fd02:faea:f561:8fa0:1::12

|

||||

|

||||

```

|

||||

|

||||

Dnsmasq 在 _/etc/hosts_ 文件中保存 A 和 AAAA 记录:

|

||||

Dnsmasq 在 `/etc/hosts` 文件中保存 A 和 AAAA 记录:

|

||||

|

||||

```

|

||||

172.16.1.10 fileserv fileserv.example.com

|

||||

172.16.1.11 fileserv fileserv.example.com

|

||||

@ -36,15 +40,14 @@ Dnsmasq 在 _/etc/hosts_ 文件中保存 A 和 AAAA 记录:

|

||||

fd02:faea:f561:8fa0:1::10 fileserv fileserv.example.com

|

||||

fd02:faea:f561:8fa0:1::11 fileserv fileserv.example.com

|

||||

fd02:faea:f561:8fa0:1::12 fileserv fileserv.example.com

|

||||

|

||||

```

|

||||

|

||||

请注意这些示例都是很简化的,解析完全合格域名有多种方法,因此,关于如何配置 DNS 请自行学习。

|

||||

|

||||

使用 `dig` 命令去检查你的配置能否按预期工作。将 `ns.example.com` 替换为你的域名服务器:

|

||||

|

||||

```

|

||||

$ dig @ns.example.com fileserv A fileserv AAA

|

||||

|

||||

```

|

||||

|

||||

它将同时显示出 IPv4 和 IPv6 的轮询记录。

|

||||

@ -56,6 +59,7 @@ $ dig @ns.example.com fileserv A fileserv AAA

|

||||

这种方法需要多台域名服务器。在最简化的场景中,你需要一台主域名服务器和两个子域,每个子域都有它们自己的域名服务器。在子域服务器上配置你的轮询记录,然后在你的主域名服务器上配置委派。

|

||||

|

||||

在主域名服务器上的 BIND 中,你至少需要两个额外的配置,一个区声明以及在区数据文件中的 A/AAAA 记录。主域名服务器中的委派应该像如下的内容:

|

||||

|

||||

```

|

||||

ns1.sub.example.com. IN A 172.16.1.20

|

||||

ns1.sub.example.com. IN AAAA fd02:faea:f561:8fa0:1::20

|

||||

@ -64,64 +68,65 @@ ns2.sub.example.com. IN AAA fd02:faea:f561:8fa0:1::21

|

||||

|

||||

sub.example.com. IN NS ns1.sub.example.com.

|

||||

sub.example.com. IN NS ns2.sub.example.com.

|

||||

|

||||

```

|

||||

|

||||

接下来的每台子域服务器上有它们自己的区文件。在这里它的关键点是每个服务器去返回它**自己的** IP 地址。在 `named.conf` 中的区声明,所有的服务上都是一样的:

|

||||

|

||||

```

|

||||

zone "sub.example.com" {

|

||||

type master;

|

||||

file "db.sub.example.com";

|

||||

type master;

|

||||

file "db.sub.example.com";

|

||||

};

|

||||

|

||||

```

|

||||

|

||||

然后数据文件也是相同的,除了那个 A/AAAA 记录使用的是各个服务器自己的 IP 地址。SOA 记录都指向到主域名服务器:

|

||||

|

||||

```

|

||||

; first subdomain name server

|

||||

$ORIGIN sub.example.com.

|

||||

$TTL 60

|

||||

sub.example.com IN SOA ns1.example.com. admin.example.com. (

|

||||

2018123456 ; serial

|

||||

3H ; refresh

|

||||

15 ; retry

|

||||

3600000 ; expire

|

||||

sub.example.com IN SOA ns1.example.com. admin.example.com. (

|

||||

2018123456 ; serial

|

||||

3H ; refresh

|

||||

15 ; retry

|

||||

3600000 ; expire

|

||||

)

|

||||

|

||||

sub.example.com. IN NS ns1.sub.example.com.

|

||||

sub.example.com. IN A 172.16.1.20

|

||||

ns1.sub.example.com. IN AAAA fd02:faea:f561:8fa0:1::20

|

||||

|

||||

sub.example.com. IN A 172.16.1.20

|

||||

ns1.sub.example.com. IN AAAA fd02:faea:f561:8fa0:1::20

|

||||

; second subdomain name server

|

||||

$ORIGIN sub.example.com.

|

||||

$TTL 60

|

||||

sub.example.com IN SOA ns1.example.com. admin.example.com. (

|

||||

2018234567 ; serial

|

||||

3H ; refresh

|

||||

15 ; retry

|

||||

3600000 ; expire

|

||||

sub.example.com IN SOA ns1.example.com. admin.example.com. (

|

||||

2018234567 ; serial

|

||||

3H ; refresh

|

||||

15 ; retry

|

||||

3600000 ; expire

|

||||

)

|

||||

|

||||

sub.example.com. IN NS ns1.sub.example.com.

|

||||

sub.example.com. IN A 172.16.1.21

|

||||

ns2.sub.example.com. IN AAAA fd02:faea:f561:8fa0:1::21

|

||||

|

||||

sub.example.com. IN A 172.16.1.21

|

||||

ns2.sub.example.com. IN AAAA fd02:faea:f561:8fa0:1::21

|

||||

```

|

||||

|

||||

接下来生成子域服务器上的轮询记录,方法和前面一样。现在你已经有了多个域名服务器来处理到你的子域的请求。再说一次,BIND 是很复杂的,做同一件事情它有多种方法,因此,给你留的家庭作业是找出适合你使用的最佳配置方法。

|

||||

|

||||

在 Dnsmasq 中做子域委派很容易。在你的主域名服务器上的 `dnsmasq.conf` 文件中添加如下的行,去指向到子域的域名服务器:

|

||||

|

||||

```

|

||||

server=/sub.example.com/172.16.1.20

|

||||

server=/sub.example.com/172.16.1.21

|

||||

server=/sub.example.com/fd02:faea:f561:8fa0:1::20

|

||||

server=/sub.example.com/fd02:faea:f561:8fa0:1::21

|

||||

|

||||

```

|

||||

|

||||

然后在子域的域名服务器上的 `/etc/hosts` 中配置轮询。

|

||||

|

||||

获取配置方法的详细内容和帮助,请参考这些资源:~~(致校对:这里的资源链接全部丢失了!!)~~

|

||||

获取配置方法的详细内容和帮助,请参考这些资源:

|

||||

|

||||

- [Dnsmasq][2]

|

||||

- [DNS and BIND, 5th Edition][3]

|

||||

|

||||

通过来自 Linux 基金会和 edX 的免费课程 ["Linux 入门" ][1] 学习更多 Linux 的知识。

|

||||

|

||||

@ -131,9 +136,11 @@ via: https://www.linux.com/learn/intro-to-linux/2018/3/simple-load-balancing-dns

|

||||

|

||||

作者:[CARLA SCHRODER][a]

|

||||

译者:[qhwdw](https://github.com/qhwdw)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.linux.com/users/cschroder

|

||||

[1]:https://training.linuxfoundation.org/linux-courses/system-administration-training/introduction-to-linux

|

||||

[2]:http://www.thekelleys.org.uk/dnsmasq/doc.html

|

||||

[3]:http://shop.oreilly.com/product/9780596100575.do

|

||||

@ -1,11 +1,15 @@

|

||||

可以考虑的 9 个开源 ERP 系统

|

||||

值得考虑的 9 个开源 ERP 系统

|

||||

======

|

||||

|

||||

> 有一些使用灵活、功能丰富而物有所值的开源 ERP 系统,这里有 9 个值得你看看。

|

||||

|

||||

|

||||

拥有一定数量员工的企业就需要大量的协调工作,包括价格、生产计划、帐务和财务、管理支出、管理存货等等。把一套截然不同的工具拼接到一起去处理这些工作,是一种粗制滥造和无价值的做法。

|

||||

|

||||

拥有一定数量员工的企业就需要大量的协调工作,包括制定价格、计划生产、会计和财务、管理支出、管理存货等等。把一套截然不同的工具拼接到一起去处理这些工作,是一种粗制滥造和无价值的做法。

|

||||

|

||||

那种方法没有任何弹性。并且那样在各种各样的自组织系统之间高效移动数据是非常困难的。同样,它也很难维护。

|

||||

|

||||

因此,大多数成长型企业都转而使用一个 [企业资源计划][1] (ERP) 系统。

|

||||

因此,大多数成长型企业都转而使用一个 [企业资源计划][1] (ERP)系统。

|

||||

|

||||

在这个行业中的大咖有 Oracle、SAP、以及 Microsoft Dynamics。它们都提供了一个综合的系统,但同时也很昂贵。如果你的企业支付不起如此昂贵的大系统,或者你仅需要一个简单的系统,怎么办呢?你可以使用开源的产品来作为替代。

|

||||

|

||||

@ -21,23 +25,23 @@

|

||||

|

||||

### ADempiere

|

||||

|

||||

像大多数其它开源 ERP 解决方案,[ADempiere][2] 的目标客户是中小企业。它已经存在一段时间了— 这个项目出现于 2006,它是 Compiere ERP 软件的一个分支。

|

||||

像大多数其它开源 ERP 解决方案,[ADempiere][2] 的目标客户是中小企业。它已经存在一段时间了 — 这个项目出现于 2006,它是 Compiere ERP 软件的一个分支。

|

||||

|

||||

它的意大利语名字的意思是“实现”或者“满足”,它“涉及多个方面”的 ERP 特性旨在帮企业去满足各种需求。它在 ERP 中增加了供应链管理(SCM)和客户关系管理(CRM)功能,能够让 ERP 套件在一个软件中去管理销售、采购、库存、以及帐务处理。它的最新版本是 v.3.9.0,更新了用户界面、销售点、人力资源、工资、以及其它的特性。

|

||||

它的意大利语名字的意思是“实现”或者“满足”,它“涉及多个方面”的 ERP 特性,旨在帮企业去满足各种需求。它在 ERP 中增加了供应链管理(SCM)和客户关系管理(CRM)功能,能够让该 ERP 套件在一个软件中去管理销售、采购、库存以及帐务处理。它的最新版本是 v.3.9.0,更新了用户界面、POS、人力资源、工资以及其它的特性。

|

||||

|

||||

因为是一个跨平台的、基于 Java 的云解决方案,ADempiere 可以运行在Linux、Unix、Windows、MacOS、智能手机、平板电脑上。它使用 [GPLv2][3] 授权。如果你想了解更多信息,这里有一个用于测试的 [demo][4],或者也可以在 GitHub 上查看它的 [源代码][5]。

|

||||

|

||||

### Apache OFBiz

|

||||

|

||||

[Apache OFBiz][6] 的业务相关的套件是构建在通用的架构上的,它允许企业根据自己的需要去定制 ERP。因此,它是有内部开发资源的大中型企业去修改和集成它到它们现有的 IT 和业务流程的最佳套件。

|

||||

[Apache OFBiz][6] 的业务相关的套件是构建在通用的架构上的,它允许企业根据自己的需要去定制 ERP。因此,它是有内部开发资源的大中型企业的最佳套件,可以去修改和集成它到它们现有的 IT 和业务流程。

|

||||

|

||||

OFBiz 是一个成熟的开源 ERP 系统;它的网站上说它是一个有十年历史的顶级 Apache 项目。可用的 [模块][7] 有帐务、生产制造、人力资源、存货管理、目录管理、客户关系管理、以及电子商务。你可以在它的 [demo 页面][8] 上试用电子商务的网上商店以及后端的 ERP 应用程序。

|

||||

OFBiz 是一个成熟的开源 ERP 系统;它的网站上说它是一个有十年历史的顶级 Apache 项目。可用的 [模块][7] 有会计、生产制造、人力资源、存货管理、目录管理、客户关系管理,以及电子商务。你可以在它的 [demo 页面][8] 上试用电子商务的网上商店以及后端的 ERP 应用程序。

|

||||

|

||||

Apache OFBiz 的源代码能够在它的 [项目仓库][9] 中找到。它是用 Java 写的,它在 [Apache 2.0 license][10] 下可用。

|

||||

|

||||

### Dolibarr

|

||||

|

||||

[Dolibarr][11] 提供了中小型企业端到端的业务管理,从发票跟踪、合同、存货、订单、以及支付,到文档管理和电子化 POS 系统支持。它的全部功能封装在一个清晰的界面中。

|

||||

[Dolibarr][11] 提供了中小型企业端到端的业务管理,从发票跟踪、合同、存货、订单,以及支付,到文档管理和电子化 POS 系统支持。它的全部功能封装在一个清晰的界面中。

|

||||

|

||||

如果你担心不会使用 Dolibarr,[这里有一些关于它的文档][12]。

|

||||

|

||||

@ -45,15 +49,15 @@ Apache OFBiz 的源代码能够在它的 [项目仓库][9] 中找到。它是用

|

||||

|

||||

### ERPNext

|

||||

|

||||

[ERPNext][17] 是这类开源项目中的其中一个;实际上它最初 [出现在 Opensource.com][18]。它被设计用于打破一个陈旧而昂贵的专用 ERP 系统的垄断局面。

|

||||

[ERPNext][17] 是这类开源项目中的其中一个;实际上它最初在 2014 年就被 [Opensource.com 推荐了][18]。它被设计用于打破一个陈旧而昂贵的专用 ERP 系统的垄断局面。

|

||||

|

||||

ERPNext 适合于中小型企业。它包含的模块有帐务、存货管理、销售、采购、以及项目管理。ERPNext 是表单驱动的应用程序 — 你可以在一组字段中填入信息,然后让应用程序去完成剩余部分。整个套件非常易用。

|

||||

ERPNext 适合于中小型企业。它包含的模块有会计、存货管理、销售、采购、以及项目管理。ERPNext 是表单驱动的应用程序 — 你可以在一组字段中填入信息,然后让应用程序去完成剩余部分。整个套件非常易用。

|

||||

|

||||

如果你感兴趣,在你考虑参与之前,你可以请求获取一个 [demo][19],去 [下载它][20] 或者在托管服务上 [购买一个订阅][21]。

|

||||

|

||||

### Metasfresh

|

||||

|

||||

[Metasfresh][22] 的名字表示它承诺软件的代码始终保持“新鲜”。它自 2015 年以来每周发行一个更新版本,那时,它的代码是由创始人从 ADempiere 项目中 fork 的。与 ADempiere 一样,它是一个基于 Java 的开源 ERP,目标客户是中小型企业。

|

||||

[Metasfresh][22] 的名字表示它承诺软件的代码始终保持“新鲜”。它自 2015 年以来每周发行一个更新版本,那时,它的代码是由创始人从 ADempiere 项目中分叉的。与 ADempiere 一样,它是一个基于 Java 的开源 ERP,目标客户是中小型企业。

|

||||

|

||||

虽然,相比在这里介绍的其它软件来说,它是一个很 “年青的” 项目,但是它早早就引起了一起人的注意,获得很多积极的评价,比如,被提名为“最佳开源”的 IT 创新奖入围者。

|

||||

|

||||

@ -71,7 +75,7 @@ Odoo 是基于 web 的工具。按单个模块来订阅的话,每个模块每

|

||||

|

||||

[Opentaps][30] 是专为大型业务设计的几个开源 ERP 解决方案之一,它的功能强大而灵活。这并不奇怪,因为它是在 Apache OFBiz 基础之上构建的。

|

||||

|

||||

你可以得到你所希望的模块组合,来帮你管理存货、生产制造、财务、以及采购。它也有分析功能,帮你去分析业务的各个方面。你可以借助这些信息让未来的计划做的更好。Opentaps 也包含一个强大的报表功能。

|

||||

你可以得到你所希望的模块组合,来帮你管理存货、生产制造、财务,以及采购。它也有分析功能,帮你去分析业务的各个方面。你可以借助这些信息让未来的计划做的更好。Opentaps 也包含一个强大的报表功能。

|

||||

|

||||

在它的基础之上,你还可以 [购买一些插件和附加模块][31] 去增强 Opentaps 的功能。包括与 Amazon Marketplace Services 和 FedEx 的集成等。在你 [下载 Opentaps][32] 之前,你可以到 [在线 demo][33] 上试用一下。它遵守 [GPLv3][34] 许可。

|

||||

|

||||

@ -87,7 +91,7 @@ WebERP 正在积极地进行开发,并且它有一个活跃的 [论坛][37],

|

||||

|

||||

如果你的生产制造、分销、电子商务业务已经从小规模业务成长起来了,并且正在寻找一个适合你的成长型企业的 ERP 系统,那么,你可以去了解一下 [xTuple PostBooks][41]。它是围绕核心 ERP 功能、帐务、以及可以添加存货、分销、采购、以及供应商报告等 CRM 功能构建的全面解决方案的系统。

|

||||

|

||||

xTuple 在通用公共属性许可证([CPAL][42])下使用,并且这个项目欢迎开发者去 fork 它,然后为基于存货的生产制造型企业开发其它的业务软件。它的基于 web 的核心是用 JavaScript 写的,它的 [源代码][43] 可以在 GitHub 上找到。你可以去在 xTuple 的网站上注册一个免费的 [demo][44] 去了解它。

|

||||

xTuple 在通用公共属性许可证([CPAL][42])下使用,并且这个项目欢迎开发者去分叉它,然后为基于存货的生产制造型企业开发其它的业务软件。它的基于 web 的核心是用 JavaScript 写的,它的 [源代码][43] 可以在 GitHub 上找到。你可以去在 xTuple 的网站上注册一个免费的 [demo][44] 去了解它。

|

||||

|

||||

还有许多其它的开源 ERP 可供你选择 — 另外你可以去了解的还有 [Tryton][45],它是用 Python 写的,并且使用的是 PostgreSQL 数据库引擎,或者基于 Java 的 [Axelor][46],它的好处是用户可以使用拖放界面来创建或者修改业务应用。如果还有在这里没有列出的你喜欢的开源 ERP 解决方案,请在下面的评论区共享出来。你也可以去查看我们的 [供应链管理工具][47] 榜单。

|

||||

|

||||

@ -98,9 +102,9 @@ xTuple 在通用公共属性许可证([CPAL][42])下使用,并且这个项

|

||||

via: https://opensource.com/tools/enterprise-resource-planning

|

||||

|

||||

作者:[Opensource.com][a]

|

||||

译者:[qhwdw](https://github.com/qhwdw)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[qhwdw](https://github.com/qhwdw)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,83 +1,86 @@

|

||||

如何在 Linux 和 Windows 之间共享文件?

|

||||

如何在 Linux 和 Windows 之间共享文件?

|

||||

=====

|

||||

|

||||

> 用一些来自 Linux 社区的工具,在 Linux 和 Windows 之间共享文件是超容易的。让我们看看可以做这件事的两种不同方法。

|

||||

|

||||

|

||||

|

||||

现代很多人都在混合网络上工作,Linux 和 Windows 系统都扮演着重要的结束。在两者之间共享文件有时是非常关键的,并且使用正确的工具非常容易。只需很少的功夫,你就可以将文件从 Windows 复制到 Linux 或从 Linux 到 Windows。在这篇文章中,我们将讨论配置 Linux 和 Windows 系统所需的东西,以允许你轻松地将文件从一个操作系统转移到另一个。

|

||||

|

||||

### 在 Linux 和 Windows 之间复制文件

|

||||

|

||||

在 Windows 和 Linux 之间移动文件的第一步是下载并安装诸如 PuTTY 的 pscp 之类的工具。你可以从 [putty.org][1] 获得它,并轻松将其设置在 Windows 系统上。PuTTY 带有一个终端仿真器(putty)以及像 **pscp** 这样的工具,用于在 Linux 和 Windows 系统之间安全地复制文件。当你进入 PuTTY 站点时,你可以选择安装所有工具,或选择安装你想要的工具,也可以选择单个 .exe 文件。

|

||||

在 Windows 和 Linux 之间移动文件的第一步是下载并安装诸如 PuTTY 的 `pscp` 之类的工具。你可以从 [putty.org][1] 获得它(LCTT 译注:切记从官方网站下载,并最好对比其 md5/sha1 指纹),并轻松将其设置在 Windows 系统上。PuTTY 带有一个终端仿真器(`putty`)以及像 `pscp` 这样的工具,用于在 Linux 和 Windows 系统之间安全地复制文件。当你进入 PuTTY 站点时,你可以选择安装所有工具,或选择安装你想要的工具,也可以选择单个 .exe 文件。

|

||||

|

||||

你还需要在你的 Linux 系统上设置并运行 ssh 服务器。这允许它支持客户端(Windows 端)连接请求。如果你还没有安装 ssh 服务器,那么以下步骤可以在 Debian 系统上运行(包括 Ubuntu 等):

|

||||

|

||||

你还需要在你的 Linux 系统上设置并运行 ssh-server。这允许它支持客户端(Windows 端)连接请求。如果你还没有安装 ssh 服务器,那么以下步骤可以在 Debian 系统上运行(包括 Ubuntu 等):

|

||||

```

|

||||

sudo apt update

|

||||

sudo apt install ssh-server

|

||||

sudo service ssh start

|

||||

|

||||

```

|

||||

|

||||

对于 Red Hat 及其相关的 Linux 系统,使用类似的命令:

|

||||

|

||||

```

|

||||

sudo yum install openssh-server

|

||||

sudo systemctl start sshd

|

||||

|

||||

```

|

||||

注意,如果你正在运行防火墙(例如 ufw),则可能需要打开 22 端口以允许连接。

|

||||

|

||||

使用 **pscp** 命令,你可以将文件从 Windows 移到 Linux,反之亦然。它的 “copy from to” 命令的语法非常简单。

|

||||

使用 `pscp` 命令,你可以将文件从 Windows 移到 Linux,反之亦然。它的 “copy from to” 命令的语法非常简单。

|

||||

|

||||

#### 从 Windows 到 Linux

|

||||

|

||||

在下面显示的命令中,我们将 Windows 系统上用户账户中的文件复制到 Linux 系统下的 /tmp 目录。

|

||||

|

||||

```

|

||||

C:\Program Files\PuTTY>pscp \Users\shs\copy_me.txt shs@192.168.0.18:/tmp

|

||||

shs@192.168.0.18's password:

|

||||

copy_me.txt | 0 kB | 0.1 kB/s | ETA: 00:00:00 | 100%

|

||||

|

||||

```

|

||||

|

||||

#### 从 Linux 到 Windows

|

||||

|

||||

将文件从 Linux 转移到 Windows 也同样简单。只要反向参数即可。

|

||||

将文件从 Linux 转移到 Windows 也同样简单。只要颠倒参数即可。

|

||||

|

||||

```

|

||||

C:\Program Files\PuTTY>pscp shs@192.168.0.18:/tmp/copy_me.txt \Users\shs

|

||||

shs@192.168.0.18's password:

|

||||

copy_me.txt | 0 kB | 0.1 kB/s | ETA: 00:00:00 | 100%

|

||||

|

||||

```

|

||||

|

||||

如果 1) pscp 位于 Windows 搜索路径中,并且 2) 你的 Linux 系统在 Windows hosts 文件中,则该过程可以变得更加顺畅和轻松。(to 校正者:这句话不怎么明白)

|

||||

如果 1) `pscp` 位于 Windows 搜索路径中,并且 2) 你的 Linux 系统在 Windows 的 hosts 文件中,则该过程可以变得更加顺畅和轻松。

|

||||

|

||||

#### Windows 搜索路径

|

||||

|

||||

如果你使用 PuTTY 安装程序安装 PuTTY 工具,你可能会发现 **C:\Program files\PuTTY** 位于 Windows 搜索路径中。你可以通过在 Windows 命令提示符下键入 **echo %path%** 来检查是否属于这种情况(在搜索栏中键入 “cmd” 来打开命令提示符)。如果是这样,你不需要关心文件系统中相对于 pscp 可执行文件的位置。进入到包含你想要移动文件的文件夹可能会更容易。

|

||||

如果你使用 PuTTY 安装程序安装 PuTTY 工具,你可能会发现 `C:\Program files\PuTTY` 位于 Windows 搜索路径中。你可以通过在 Windows 命令提示符下键入 `echo %path%` 来检查是否属于这种情况(在搜索栏中键入 `cmd` 来打开命令提示符)。如果是这样,你不需要关心文件系统中相对于 `pscp` 可执行文件的位置。进入到包含你想要移动文件的文件夹可能会更容易。

|

||||

|

||||

```

|

||||

C:\Users\shs>pscp copy_me.txt shs@192.168.0.18:/tmp

|

||||

shs@192.168.0.18's password:

|

||||

copy_me.txt | 0 kB | 0.1 kB/s | ETA: 00:00:00 | 100%

|

||||

|

||||

```

|

||||

|

||||

#### 更新你的 Windows hosts 文件

|

||||

#### 更新你的 Windows 的 hosts 文件

|

||||

|

||||

这是另一个小修补。使用管理员权限,你可以将 Linux 系统添加到 Windows 的 hosts 文件中(`C:\Windows\System32\drivers\etc\hosts`),然后使用其主机名代替其 IP 地址。请记住,如果你的 Linux 系统的 IP 地址是动态分配的,那么它不会一直发挥作用。

|

||||

|

||||

这是另一个小修补。使用管理员权限,你可以将 Linux 系统添加到 Windows hosts 文件(C:\Windows\System32\drivers\etc\hosts),然后使用其主机名代替其 IP 地址。请记住,如果你的 Linux 系统的 IP 地址是动态分配的,那么它不会一直发挥作用。

|

||||

```

|

||||

C:\Users\shs>pscp copy_me.txt shs@stinkbug:/tmp

|

||||

shs@192.168.0.18's password:

|

||||

hosts | 0 kB | 0.8 kB/s | ETA: 00:00:00 | 100%

|

||||

|

||||

```

|

||||

|

||||

请注意,Windows hosts 文件与 Linux 系统上的 /etc/hosts 文件格式相同 -- IP 地址,空格,主机名。注释以 pound(to 校正者:这个符号是英镑符??) 符号来表示的。

|

||||

请注意,Windows 的 hosts 文件与 Linux 系统上的 `/etc/hosts` 文件格式相同 -- IP 地址、空格、主机名。注释以 `#` 符号来表示的。

|

||||

|

||||

```

|

||||

# Linux systems

|

||||

192.168.0.18 stinkbug

|

||||

|

||||

```

|

||||

|

||||

#### 讨厌的行结尾符

|

||||

|

||||

请记住,Windows 上文本文件中的行以回车符和换行符结束。pscp 工具不会删除回车符,使文件看起来像 Linux 文本文件。相反,它只是完整地复制文件。你可以考虑安装 **tofrodos** 包,这使你能够在 Linux 系统上使用 **fromdos** 和 **todos** 命令来调整在平台之间移动的文件。

|

||||

请记住,Windows 上文本文件中的行以回车符和换行符结束。`pscp` 工具不会删除回车符,以使文件看起来像 Linux 文本文件。相反,它只是完整地复制文件。你可以考虑安装 `tofrodos` 包,这使你能够在 Linux 系统上使用 `fromdos` 和 `todos` 命令来调整在平台之间移动的文件。

|

||||

|

||||

### 在 Windows 和 Linux 之间共享文件夹

|

||||

|

||||

@ -96,7 +99,7 @@ via: https://www.networkworld.com/article/3269189/linux/sharing-files-between-li

|

||||

作者:[Sandra Henry-Stocker][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[MjSeven](https://github.com/MjSeven)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,61 +1,56 @@

|

||||

# 在命令行中整理数据

|

||||

如何在命令行中整理数据

|

||||

=========

|

||||

|

||||

> 命令行审计不会影响数据库,因为它使用从数据库中释放的数据。

|

||||

|

||||

|

||||

|

||||

我兼职做数据审计。把我想象成一个校对者,处理数据表格而不是一页一页的文章。这些表是从关系数据库导出的,并且规模相当小:100,000 到 1,000,000条记录,50 到 200个字段。

|

||||

我兼职做数据审计。把我想象成一个校对者,校对的是数据表格而不是一页一页的文章。这些表是从关系数据库导出的,并且规模相当小:100,000 到 1,000,000条记录,50 到 200 个字段。

|

||||

|

||||

我从来没有见过没有错误的数据表。您可能认为,这种混乱并不局限于重复记录、拼写和格式错误以及放置在错误字段中的数据项。我还发现:

|

||||

我从来没有见过没有错误的数据表。如你所能想到的,这种混乱并不局限于重复记录、拼写和格式错误以及放置在错误字段中的数据项。我还发现:

|

||||

|

||||

* 损坏的记录分布在几行上,因为数据项具有内嵌的换行符

|

||||

* 损坏的记录分布在几行上,因为数据项具有内嵌的换行符

|

||||

* 在同一记录中一个字段中的数据项与另一个字段中的数据项不一致

|

||||

* 使用截断数据项的记录,通常是因为非常长的字符串被硬塞到具有50或100字符限制的字段中

|

||||

* 字符编码失败产生称为[乱码][1]

|

||||

* 使用截断数据项的记录,通常是因为非常长的字符串被硬塞到具有 50 或 100 字符限制的字段中

|

||||

* 字符编码失败产生称为[乱码][1]的垃圾

|

||||

* 不可见的[控制字符][2],其中一些会导致数据处理错误

|

||||

* 由上一个程序插入的[替换字符][3]和神秘的问号,这导致了不知道数据的编码是什么

|

||||

* 由上一个程序插入的[替换字符][3]和神秘的问号,这是由于不知道数据的编码是什么

|

||||

|

||||

解决这些问题并不困难,但找到它们存在非技术障碍。首先,每个人都不愿处理数据错误。在我看到表格之前,数据所有者或管理人员可能已经经历了数据悲伤的所有五个阶段:

|

||||

解决这些问题并不困难,但找到它们存在非技术障碍。首先,每个人都不愿处理数据错误。在我看到表格之前,数据所有者或管理人员可能已经经历了<ruby>数据悲伤<rt>Data Grief</rt></ruby>的所有五个阶段:

|

||||

|

||||

1. 我们的数据没有错误。

|

||||

2. 好吧,也许有一些错误,但它们并不重要。

|

||||

3. 好的,有很多错误;我们会让我们的内部人员处理它们。

|

||||

4. 我们已经开始修复一些错误,但这很耗时间;我们将在迁移到新的数据库软件时执行此操作。

|

||||

5. 移至新数据库时,我们没有时间整理数据; 我们需要一些帮助。

|

||||

|

||||

1. 好吧,也许有一些错误,但它们并不重要。

|

||||

2. 好的,有很多错误; 我们会让我们的内部人员处理它们。

|

||||

3. 我们已经开始修复一些错误,但这很耗时间; 我们将在迁移到新的数据库软件时执行此操作。

|

||||

4. 1.移至新数据库时,我们没有时间整理数据; 我们可以使用一些帮助。

|

||||

|

||||

第二个阻碍进展的是相信数据整理需要专用的应用程序——要么是昂贵的专有程序,要么是优秀的开源程序 [OpenRefine][4] 。为了解决专用应用程序无法解决的问题,数据管理人员可能会向程序员寻求帮助,比如擅长 [Python][5] 或 [R][6] 的人。

|

||||

第二个阻碍进展的是相信数据整理需要专用的应用程序——要么是昂贵的专有程序,要么是优秀的开源程序 [OpenRefine][4] 。为了解决专用应用程序无法解决的问题,数据管理人员可能会向程序员寻求帮助,比如擅长 [Python][5] 或 [R][6] 的人。

|

||||

|

||||

但是数据审计和整理通常不需要专用的应用程序。纯文本数据表已经存在了几十年,文本处理工具也是如此。打开 Bash shell,您将拥有一个工具箱,其中装载了强大的文本处理器,如 `grep`、`cut`、`paste`、`sort`、`uniq`、`tr` 和 `awk`。它们快速、可靠、易于使用。

|

||||

|

||||

我在命令行上执行所有的数据审计工作,并且在 “[cookbook][7]” 网站上发布了许多数据审计技巧。我经常将操作存储为函数和 shell 脚本(参见下面的示例)。

|

||||

|

||||

是的,命令行方法要求将要审计的数据从数据库中导出。 是的,审计结果需要稍后在数据库中进行编辑,或者(数据库允许)整理的数据项作为替换杂乱的数据项导入其中。

|

||||

是的,命令行方法要求将要审计的数据从数据库中导出。而且,审计结果需要稍后在数据库中进行编辑,或者(数据库允许)将整理的数据项导入其中,以替换杂乱的数据项。

|

||||

|

||||

但其优势是显著的。awk 将在普通的台式机或笔记本电脑上以几秒钟的时间处理数百万条记录。不复杂的正则表达式将找到您可以想象的所有数据错误。所有这些都将安全地发生在数据库结构之外:命令行审计不会影响数据库,因为它使用从数据库中释放的数据。

|

||||

|

||||

受过 Unix 培训的读者此时会沾沾自喜。他们还记得许多年前用这些方法操纵命令行上的数据。从那时起,计算机的处理能力和 RAM 得到了显著提高,标准命令行工具的效率大大提高。数据审计从来都不是更快或更容易的。现在微软的 Windows 10 可以运行 Bash 和 GNU/Linux 程序了,Windows 用户也可以用 Unix 和 Linux 的座右铭来处理混乱的数据:保持冷静,打开一个终端。

|

||||

受过 Unix 培训的读者此时会沾沾自喜。他们还记得许多年前用这些方法操纵命令行上的数据。从那时起,计算机的处理能力和 RAM 得到了显著提高,标准命令行工具的效率大大提高。数据审计从来没有这么快、这么容易过。现在微软的 Windows 10 可以运行 Bash 和 GNU/Linux 程序了,Windows 用户也可以用 Unix 和 Linux 的座右铭来处理混乱的数据:保持冷静,打开一个终端。

|

||||

|

||||

|

||||

![Tshirt, Keep Calm and Open A Terminal][9]

|

||||

|

||||

图片:Robert Mesibov,CC BY

|

||||

### 例子

|

||||

|

||||

### 例子:

|

||||

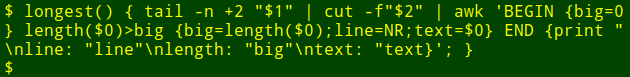

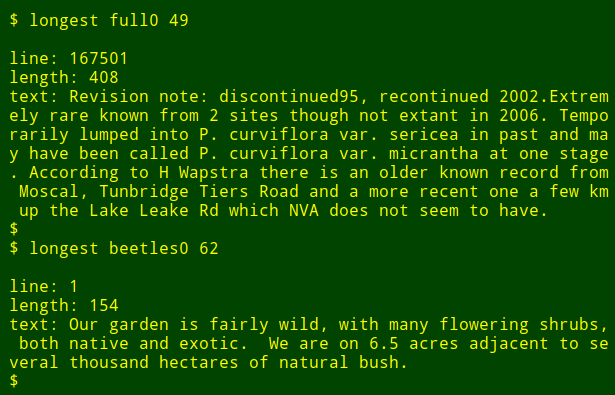

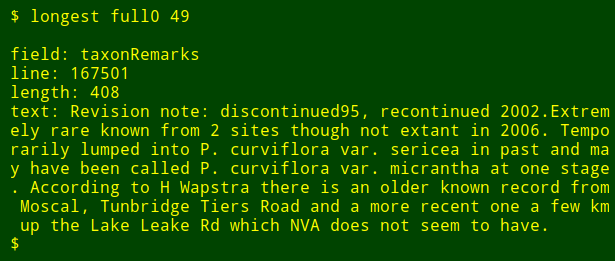

假设我想在一个大的表中的特定字段中找到最长的数据项。 这不是一个真正的数据审计任务,但它会显示 shell 工具的工作方式。 为了演示目的,我将使用制表符分隔的表 `full0` ,它有 1,122,023 条记录(加上一个标题行)和 49 个字段,我会查看 36 号字段。(我得到字段编号的函数在我的[网站][10]上有解释)

|

||||

|

||||

假设我想在一个大的表中的特定字段中找到最长的数据项。 这不是一个真正的数据审计任务,但它会显示 shell 工具的工作方式。 为了演示目的,我将使用制表符分隔的表 `full0` ,它有 1,122,023 条记录(加上一个标题行)和 49 个字段,我会查看 36 号字段.(我得到字段编号的函数在我的[网站][10]上有解释)

|

||||

|

||||

首先,使用 `tail` 命令从表 `full0` 移除标题行,结果管道至 `cut` 命令,截取第 36 个字段,接下来,管道至 `awk` ,这里有一个初始化为 0 的变量 `big` ,然后 `awk` 开始检测第一行数据项的长度,如果长度大于 0 , `awk` 将会设置 `big` 变量为新的长度,同时存储行数到变量 `line` 中。整个数据项存储在变量 `text` 中。然后 `awk` 开始轮流处理剩余的 1,122,022 记录项。同时,如果发现更长的数据项时,更新 3 个变量。最后,它打印出行号,数据项的长度,以及最长数据项的内容。(在下面的代码中,为了清晰起见,将代码分为几行)

|

||||

首先,使用 `tail` 命令从表 `full0` 移除标题行,结果管道至 `cut` 命令,截取第 36 个字段,接下来,管道至 `awk` ,这里有一个初始化为 0 的变量 `big` ,然后 `awk` 开始检测第一行数据项的长度,如果长度大于 0 ,`awk` 将会设置 `big` 变量为新的长度,同时存储行数到变量 `line` 中。整个数据项存储在变量 `text` 中。然后 `awk` 开始轮流处理剩余的 1,122,022 记录项。同时,如果发现更长的数据项时,更新 3 个变量。最后,它打印出行号、数据项的长度,以及最长数据项的内容。(在下面的代码中,为了清晰起见,将代码分为几行)

|

||||

|

||||

```

|

||||

<code>tail -n +2 full0 \

|

||||

|

||||

tail -n +2 full0 \

|

||||

> | cut -f36 \

|

||||

|

||||

> | awk 'BEGIN {big=0} length($0)>big \

|

||||

|

||||

> {big=length($0);line=NR;text=$0} \

|

||||

|

||||

> END {print "\nline: "line"\nlength: "big"\ntext: "text}' </code>

|

||||

|

||||

> END {print "\nline: "line"\nlength: "big"\ntext: "text}'

|

||||

```

|

||||

|

||||

大约花了多长时间?我的电脑大约用了 4 秒钟(core i5,8GB RAM);

|

||||

@ -66,25 +61,19 @@

|

||||

|

||||

|

||||

|

||||

现在,我重新运行这个命令,在另一个文件中找另一个字段中最长的数据项而不需要去记忆命令是如何写的:

|

||||

现在,我可以以函数的方式重新运行这个命令,在另一个文件中的另一个字段中找最长的数据项,而不需要去记忆这个命令是如何写的:

|

||||

|

||||

|

||||

|

||||

最后调整一下,我还可以输出我要查询字段的名称,我只需要使用 `head` 命令抽取表格第一行的标题行,然后将结果管道至 `tr` 命令,将制表位转换为换行,然后将结果管道至 `tail` 和 `head` 命令,打印出第二个参数在列表中名称,第二个参数就是字段号。字段的名字就存储到变量 `field` 中,然后将他传向 `awk` ,通过变量 `fld` 打印出来。(译者注:按照下面的代码,编号的方式应该是从右向左)

|

||||

最后调整一下,我还可以输出我要查询字段的名称,我只需要使用 `head` 命令抽取表格第一行的标题行,然后将结果管道至 `tr` 命令,将制表位转换为换行,然后将结果管道至 `tail` 和 `head` 命令,打印出第二个参数在列表中名称,第二个参数就是字段号。字段的名字就存储到变量 `field` 中,然后将它传向 `awk` ,通过变量 `fld` 打印出来。(LCTT 译注:按照下面的代码,编号的方式应该是从右向左)

|

||||

|

||||

```

|

||||

<code>longest() { field=$(head -n 1 "$1" | tr '\t' '\n' | tail -n +"$2" | head -n 1); \

|

||||

|

||||

longest() { field=$(head -n 1 "$1" | tr '\t' '\n' | tail -n +"$2" | head -n 1); \

|

||||

tail -n +2 "$1" \

|

||||

|

||||

| cut -f"$2" | \

|

||||

|

||||

awk -v fld="$field" 'BEGIN {big=0} length($0)>big \

|

||||

|

||||

{big=length($0);line=NR;text=$0}

|

||||

|

||||

END {print "\nfield: "fld"\nline: "line"\nlength: "big"\ntext: "text}'; }</code>

|

||||

|

||||

END {print "\nfield: "fld"\nline: "line"\nlength: "big"\ntext: "text}'; }

|

||||

```

|

||||

|

||||

|

||||

@ -98,7 +87,7 @@ via: https://opensource.com/article/18/5/command-line-data-auditing

|

||||

作者:[Bob Mesibov][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[amwps290](https://github.com/amwps290)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

120

published/20180529 Copying and renaming files on Linux.md

Normal file

120

published/20180529 Copying and renaming files on Linux.md

Normal file

@ -0,0 +1,120 @@

|

||||

在 Linux 上复制和重命名文件

|

||||

======

|

||||

|

||||

> cp 和 mv 之外,在 Linux 上有更多的复制和重命名文件的命令。试试这些命令或许会惊艳到你,并能节省一些时间。

|

||||

|

||||

|

||||

|

||||

Linux 用户数十年来一直在使用简单的 `cp` 和 `mv` 命令来复制和重命名文件。这些命令是我们大多数人首先学到的,每天可能有数百万人在使用它们。但是还有其他技术、方便的方法和另外的命令,这些提供了一些独特的选项。

|

||||

|

||||

首先,我们来思考为什么你想要复制一个文件。你可能需要在另一个位置使用同一个文件,或者因为你要编辑该文件而需要一个副本,并且希望确保备有便利的备份以防万一需要恢复原始文件。这样做的显而易见的方式是使用像 `cp myfile myfile-orig` 这样的命令。

|

||||

|

||||

但是,如果你想复制大量的文件,那么这个策略可能就会变得很老。更好的选择是:

|

||||

|

||||

* 在开始编辑之前,使用 `tar` 创建所有要备份的文件的存档。

|

||||

* 使用 `for` 循环来使备份副本更容易。

|

||||

|

||||

使用 `tar` 的方式很简单。对于当前目录中的所有文件,你可以使用如下命令:

|

||||

|

||||

```

|

||||

$ tar cf myfiles.tar *

|

||||

```

|

||||

|

||||

对于一组可以用模式标识的文件,可以使用如下命令:

|

||||

|

||||

```

|

||||

$ tar cf myfiles.tar *.txt

|

||||

```

|

||||

|

||||

在每种情况下,最终都会生成一个 `myfiles.tar` 文件,其中包含目录中的所有文件或扩展名为 .txt 的所有文件。

|

||||

|

||||

一个简单的循环将允许你使用修改后的名称来制作备份副本:

|

||||

|

||||

```

|

||||

$ for file in *

|

||||

> do

|

||||

> cp $file $file-orig

|

||||

> done

|

||||

```

|

||||

|

||||

当你备份单个文件并且该文件恰好有一个长名称时,可以依靠使用 `tab` 来补全文件名(在输入足够的字母以便唯一标识该文件后点击 `Tab` 键)并使用像这样的语法将 `-orig` 附加到副本的名字后。

|

||||

|

||||

```

|

||||

$ cp file-with-a-very-long-name{,-orig}

|

||||

```

|

||||

|

||||

然后你有一个 `file-with-a-very-long-name` 和一个 `file-with-a-very-long-name-orig`。

|

||||

|

||||

### 在 Linux 上重命名文件

|

||||

|

||||

重命名文件的传统方法是使用 `mv` 命令。该命令将文件移动到不同的目录,或原地更改其名称,或者同时执行这两个操作。

|

||||

|

||||

```

|

||||

$ mv myfile /tmp

|

||||

$ mv myfile notmyfile

|

||||

$ mv myfile /tmp/notmyfile

|

||||

```

|

||||

|

||||

但我们也有 `rename` 命令来做重命名。使用 `rename` 命令的窍门是习惯它的语法,但是如果你了解一些 Perl,你可能发现它并不棘手。

|

||||

|

||||

有个非常有用的例子。假设你想重新命名一个目录中的文件,将所有的大写字母替换为小写字母。一般来说,你在 Unix 或 Linux 系统上找不到大量大写字母的文件,但你可以有。这里有一个简单的方法来重命名它们,而不必为它们中的每一个使用 `mv` 命令。 `/A-Z/a-z/` 告诉 `rename` 命令将范围 `A-Z` 中的任何字母更改为 `a-z` 中的相应字母。

|

||||

|

||||

```

|

||||

$ ls

|

||||

Agenda Group.JPG MyFile

|

||||

$ rename 'y/A-Z/a-z/' *

|

||||

$ ls

|

||||

agenda group.jpg myfile

|

||||

```

|

||||

|

||||

你也可以使用 `rename` 来删除文件扩展名。也许你厌倦了看到带有 .txt 扩展名的文本文件。简单删除这些扩展名 —— 用一个命令。

|

||||

|

||||

```

|

||||

$ ls

|

||||

agenda.txt notes.txt weekly.txt

|

||||

$ rename 's/.txt//' *

|

||||

$ ls

|

||||

agenda notes weekly

|

||||

```

|

||||

|

||||

现在让我们想象一下,你改变了心意,并希望把这些扩展名改回来。没问题。只需修改命令。窍门是理解第一个斜杠前的 `s` 意味着“替代”。前两个斜线之间的内容是我们想要改变的东西,第二个斜线和第三个斜线之间是改变后的东西。所以,`$` 表示文件名的结尾,我们将它改为 `.txt`。

|

||||

```

|

||||

$ ls

|

||||

agenda notes weekly

|

||||

$ rename 's/$/.txt/' *

|

||||

$ ls

|

||||

agenda.txt notes.txt weekly.txt

|

||||

```

|

||||

|

||||

你也可以更改文件名的其他部分。牢记 `s/旧内容/新内容/` 规则。

|

||||

|

||||

```

|

||||

$ ls

|

||||

draft-minutes-2018-03 draft-minutes-2018-04 draft-minutes-2018-05

|

||||

$ rename 's/draft/approved/' *minutes*

|

||||

$ ls

|

||||

approved-minutes-2018-03 approved-minutes-2018-04 approved-minutes-2018-05

|

||||

```

|

||||

|

||||

在上面的例子中注意到,当我们在 `s/old/new/` 中使用 `s` 时,我们用另一个名称替换名称的一部分。当我们使用 `y` 时,我们就是直译(将字符从一个范围替换为另一个范围)。

|

||||

|

||||

### 总结

|

||||

|

||||

现在有很多复制和重命名文件的方法。我希望其中的一些会让你在使用命令行时更愉快。

|

||||

|

||||

在 [Facebook][1] 和 [LinkedIn][2] 上加入 Network World 社区来对热门主题评论。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.networkworld.com/article/3276349/linux/copying-and-renaming-files-on-linux.html

|

||||

|

||||

作者:[Sandra Henry-Stocker][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.networkworld.com/author/Sandra-Henry_Stocker/

|

||||

[1]:https://www.facebook.com/NetworkWorld/

|

||||

[2]:https://www.linkedin.com/company/network-world

|

||||

@ -1,88 +1,63 @@

|

||||

如何在 Linux 中使用 history 命令

|

||||

======

|

||||

|

||||

> 用强大的 history 命令使你的命令行提示符更有效率。

|

||||

|

||||

|

||||

|

||||

随着我在终端中花费越来越多的时间,我感觉就像不断地寻找新的命令,使我的日常任务更加高效。GNU 的 `history` 命令是一个真正改变我日常工作的命令。

|

||||

随着我在终端中花费越来越多的时间,我感觉就像在不断地寻找新的命令,以使我的日常任务更加高效。GNU 的 `history` 命令是一个真正改变我日常工作的命令。

|

||||

|

||||

GNU `history` 命令保存了从该终端会话运行的所有其他命令的列表,然后允许你重放或者重用这些命令,而不用重新输入它们。如果你是一个老玩家,你知道 `history` 的力量,但对于我们这些半吊子或新手系统管理员来说, `history` 是一个立竿见影的生产力增益。

|

||||

|

||||

### History 101

|

||||

### 历史 101

|

||||

|

||||

要查看命令历史,请在 Linux 中打开终端程序,然后输入:

|

||||

|

||||

要查看 `history`,请在 Linux 中打开终端程序,然后输入:

|

||||

```

|

||||

$ history

|

||||

|

||||

```

|

||||

|

||||

这是我得到的响应:

|

||||

|

||||

```

|

||||

1 clear

|

||||

|

||||

|

||||

|

||||

2 ls -al

|

||||

|

||||

|

||||

|

||||

3 sudo dnf update -y

|

||||

|

||||

|

||||

|

||||

4 history

|

||||

|

||||

```

|

||||

|

||||

`history` 命令显示自开始会话后输入的命令列表。 `history` 有趣的地方是你可以使用以下命令重放任意一个命令:

|

||||

|

||||

```

|

||||

$ !3

|

||||

|

||||

```

|

||||

|

||||

提示符中的 `!3` 告诉 shell 重新运行历史列表中第 3 个命令。我还可以输入以下命令来使用:

|

||||

|

||||

```

|

||||

linuser@my_linux_box: !sudo dnf

|

||||

|

||||

```

|

||||

|

||||

`history` 将搜索与你提供的模式相匹配的最后一个命令并运行它。

|

||||

`history` 将搜索与你提供的模式相匹配的最后一个命令,并运行它。

|

||||

|

||||

### 搜索历史

|

||||

|

||||

你还可以输入 `!!` 重新运行 `history` 的最后一条命令。而且,通过与` grep` 配对,你可以搜索与文本模式相匹配的命令,或者通过与 `tail` 一起使用,你可以找到你最后几条执行的命令。例如:

|

||||

你还可以输入 `!!` 重新运行命令历史中的最后一条命令。而且,通过与` grep` 配对,你可以搜索与文本模式相匹配的命令,或者通过与 `tail` 一起使用,你可以找到你最后几条执行的命令。例如:

|

||||

|

||||

```

|

||||

$ history | grep dnf

|

||||

|

||||

|

||||

|

||||

3 sudo dnf update -y

|

||||

|

||||

|

||||

|

||||

5 history | grep dnf

|

||||

|

||||

|

||||

|

||||

$ history | tail -n 3

|

||||

|

||||

|

||||

|

||||

4 history

|

||||

|

||||

|

||||

|

||||

5 history | grep dnf

|

||||

|

||||

|

||||

|

||||

6 history | tail -n 3

|

||||

|

||||

```

|

||||

|

||||

另一种实现这个功能的方法是输入 `Ctrl-R` 来调用你的命令历史记录的递归搜索。输入后,提示变为:

|

||||

|

||||

```

|

||||

(reverse-i-search)`':

|

||||

|

||||

```

|

||||

|

||||

现在你可以开始输入一个命令,并且会显示匹配的命令,按回车键执行。

|

||||

@ -90,9 +65,9 @@ $ history | tail -n 3

|

||||

### 更改已执行的命令

|

||||

|

||||

`history` 还允许你使用不同的语法重新运行命令。例如,如果我想改变我以前的命令 `history | grep dnf` 成 `history | grep ssh`,我可以在提示符下执行以下命令:

|

||||

|

||||

```

|

||||

$ ^dnf^ssh^

|

||||

|

||||

```

|

||||

|

||||

`history` 将重新运行该命令,但用 `ssh` 替换 `dnf`,并执行它。

|

||||

@ -111,8 +86,6 @@ $ ^dnf^ssh^

|

||||

* 记录历史中每行的日期和时间

|

||||

* 防止某些命令被记录在历史记录中

|

||||

|

||||

|

||||

|

||||

有关 `history` 命令的更多信息和其他有趣的事情,请参考[ GNU Bash 手册][1]。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

@ -122,7 +95,7 @@ via: https://opensource.com/article/18/6/history-command

|

||||

作者:[Steve Morris][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,29 +1,32 @@

|

||||

不像 MySQL 的 MySQL:MySQL 文档存储介绍

|

||||

======

|

||||

|

||||

> MySQL 文档存储 可以跳过底层数据结构创建、数据规范化和其它使用传统数据库时需要做的工作,直接存储数据。

|

||||

|

||||

|

||||

|

||||

MySQL 可以提供 NoSQL JSON <ruby>文档存储<rt>Document Store</rt></ruby>了,这样开发者保存数据前无需<ruby>规范化<rt>normalize</rt></ruby>数据、创建数据库,也无需在开发之前就制定好数据样式。从 MySQL 5.7 版本和 MySQL 8.0 版本开始,开发者可以在表的一列中存储 JSON 文档。由于引入 X DevAPI,你可以从你的代码中移除令人不爽的结构化查询字符串,改为使用支持现代编程设计的 API 调用。

|

||||

|

||||

系统学习过结构化查询语言(SQL)、<ruby>关系理论<rt>relational theory</rt></ruby>和其它关系数据库底层理论的开发者并不多,但他们需要一个安全可靠的数据存储。如果数据库管理人员不足,事情很快就会变得一团糟,

|

||||

系统学习过结构化查询语言(SQL)、<ruby>关系理论<rt>relational theory</rt></ruby>、<ruby>集合<rt>set</rt></ruby>和其它关系数据库底层理论的开发者并不多,但他们需要一个安全可靠的数据存储。如果数据库管理人员不足,事情很快就会变得一团糟,

|

||||

|

||||

[MySQL 文档存储][1] 允许开发者跳过底层数据结构创建、数据规范化和其它使用传统数据库时需要做的工作,直接存储数据。只需创建一个 JSON <ruby>文档集合<rt>document collection</rt></ruby>,接着就可以使用了。

|

||||

|

||||

### JSON 数据类型

|

||||

|

||||

所有这一切都基于多年前 MySQL 5.7 引入的 JSON 数据类型。允许在表的一行中提供大约 1GB 的列。数据必须是有效的 JSON,否则服务器会报错;但开发者可以自由使用这些空间。

|

||||

所有这一切都基于多年前 MySQL 5.7 引入的 JSON 数据类型。它允许在表的一行中提供大约 1GB 大小的列。数据必须是有效的 JSON,否则服务器会报错;但开发者可以自由使用这些空间。

|

||||

|

||||

### X DevAPI

|

||||

|

||||

旧的 MySQL 协议已经历经差不多四分之一个世纪,已经显现出疲态,因此新的协议被开发出来,协议名为 [X DevAPI][2]。协议引入高级会话概念,允许代码从单台服务器扩展到多台,使用符合<ruby>通用主机编程语言样式<rt>common host-language programming patterns</rt></ruby>的非阻塞异步 I/O。需要关注的是如何遵循现代实践和编码风格,同时使用 CRUD (create, replace, update, delete) 样式。换句话说,你不再需要在你精美、淳朴的代码中嵌入丑陋的 SQL 语句字符串。

|

||||

旧的 MySQL 协议已经历经差不多四分之一个世纪,已经显现出疲态,因此新的协议被开发出来,协议名为 [X DevAPI][2]。协议引入高级会话概念,允许代码从单台服务器扩展到多台,使用符合<ruby>通用主机编程语言样式<rt>common host-language programming patterns</rt></ruby>的非阻塞异步 I/O。需要关注的是如何遵循现代实践和编码风格,同时使用 CRUD (Create、 Replace、 Update、 Delete)样式。换句话说,你不再需要在你精美、纯洁的代码中嵌入丑陋的 SQL 语句字符串。

|

||||

|

||||

一个新的 shell 支持这种新协议,即所谓的 [MySQL Shell][3]。该 shell 可用于设置<ruby>高可用集群<rt>high-availability cluster</rt></ruby>、检查服务器<ruby>升级就绪状态<rt>upgrade readiness</rt></ruby>以及与 MySQL 服务器交互。支持的交互方式有以下三种:JavaScript,Python 和 SQL。

|

||||

|

||||

### 代码示例

|

||||

|

||||

一个新的 shell 支持这种新协议,即所谓的 [MySQL Shell][3]。该 shell 可用于设置<ruby>高可用集群<rt>high-availability clusters</rt></ruby>、检查服务器<ruby>升级就绪状态<rt>upgrade readiness</rt></ruby>以及与 MySQL 服务器交互。支持的交互方式有以下三种:JavaScript,Python 和 SQL。

|

||||

|

||||

下面的代码示例基于 JavaScript 方式使用 MySQL Shell,可以从 `JS>` 提示符看出。

|

||||

|

||||

下面,我们将使用用户 `dstokes` 、密码 `password` 登录本地系统上的 `demo` 库。`db` 是一个指针,指向 demo 库。

|

||||

下面,我们将使用用户 `dstokes` 、密码 `password` 登录本地系统上的 `demo` 库。`db` 是一个指针,指向 `demo` 库。

|

||||

|

||||

```

|

||||

$ mysqlsh dstokes:password@localhost/demo

|

||||

JS> db.createCollection("example")

|

||||

@ -35,14 +38,14 @@ JS> db.example.add(

|

||||

}

|

||||

)

|

||||

JS>

|

||||

|

||||

```

|

||||

|

||||

在上面的示例中,我们登录服务器,连接到 `demo` 库,创建了一个名为 `example` 的集合,最后插入一条记录;整个过程无需创建表,也无需使用 SQL。只要你能想象的到,你可以使用甚至滥用这些数据。这不是一种代码对象与关系语句之间的映射器,因为并没有将代码映射为 SQL;新协议直接与服务器层打交道。

|

||||

|

||||

### Node.js 支持

|

||||

|

||||

新 shell 看起来挺不错,你可以用其完成很多工作;但你可能更希望使用你选用的编程语言。下面的例子使用 `world_x` 示例数据库,搜索 `_id` 字段匹配 "CAN." 的记录。我们指定数据库中的特定集合,使用特定参数调用 `find` 命令。同样地,操作也不涉及 SQL。

|

||||

新 shell 看起来挺不错,你可以用其完成很多工作;但你可能更希望使用你选用的编程语言。下面的例子使用 `world_x` 示例数据库,搜索 `_id` 字段匹配 `CAN.` 的记录。我们指定数据库中的特定集合,使用特定参数调用 `find` 命令。同样地,操作也不涉及 SQL。

|

||||

|

||||

```

|

||||

var mysqlx = require('@mysql/xdevapi');

|

||||

mysqlx.getSession({ //Auth to server

|

||||

@ -62,10 +65,10 @@ collection // Get row for 'CAN'

|

||||

|

||||

session.close();

|

||||

})

|

||||

|

||||

```

|

||||

|

||||

下面例子使用 PHP,搜索 `_id` 字段匹配 "USA" 的记录:

|

||||

下面例子使用 PHP,搜索 `_id` 字段匹配 `USA` 的记录:

|

||||

|

||||

```

|

||||

<?PHP

|

||||

// Connection parameters

|

||||

@ -88,19 +91,16 @@ collection // Get row for 'CAN'

|

||||

$data = $result->fetchAll();

|

||||

var_dump($data);

|

||||

?>

|

||||

|

||||

```

|

||||

|

||||

可以看出,在上面两个使用不同编程语言的例子中,`find` 操作符的用法基本一致。这种一致性对跨语言编程的开发者有很大帮助,对试图降低新语言学习成本的开发者也不无裨益。

|

||||

|

||||

支持的语言还包括 C,Java,Python 和 JavaScript 等,未来还会有更多支持的语言。

|

||||

支持的语言还包括 C、Java、Python 和 JavaScript 等,未来还会有更多支持的语言。

|

||||

|

||||

### 从两种方式受益

|

||||

|

||||

我会告诉你使用 NoSQL 方式录入的数据也可以用 SQL 方式使用?换句话说,我会告诉你新引入的 NoSQL 方式可以访问旧式关系型表中的数据?现在使用 MySQL 服务器有多种方式,作为 SQL 服务器,作为 NoSQL 服务器或者同时作为两者。

|

||||

|

||||

Dave Stokes 将于 6 月 8-10 日在北卡罗来纳州 Charlotte 市举行的 [Southeast LinuxFest][4] 大会上做”不用 SQL 的 MySQL,我的天哪!“主题演讲。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/6/mysql-document-store

|

||||

@ -108,7 +108,7 @@ via: https://opensource.com/article/18/6/mysql-document-store

|

||||

作者:[Dave Stokes][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[pinewall](https://github.com/pinewall)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

149

published/20180611 How to partition a disk in Linux.md

Normal file

149

published/20180611 How to partition a disk in Linux.md

Normal file

@ -0,0 +1,149 @@

|

||||

如何在 Linux 中使用 parted 对磁盘分区

|

||||

==========

|

||||

|

||||

> 学习如何在 Linux 中使用 parted 命令来对存储设备分区。

|

||||

|

||||

|

||||

|

||||

在 Linux 中创建和删除分区是一种常见的操作,因为存储设备(如硬盘驱动器和 USB 驱动器)在使用之前必须以某种方式进行结构化。在大多数情况下,大型存储设备被分为称为<ruby>分区<rt>partition</rt></ruby>的独立部分。分区操作允许您将硬盘分割成独立的部分,每个部分都像是一个硬盘驱动器一样。如果您运行多个操作系统,那么分区是非常有用的。

|

||||

|

||||

在 Linux 中有许多强大的工具可以创建、删除和操作磁盘分区。在本文中,我将解释如何使用 `parted` 命令,这对于大型磁盘设备和许多磁盘分区尤其有用。`parted` 与更常见的 `fdisk` 和 `cfdisk` 命令之间的区别包括:

|

||||

|

||||

* **GPT 格式:**`parted` 命令可以创建全局惟一的标识符分区表 [GPT][1],而 `fdisk` 和 `cfdisk` 则仅限于 DOS 分区表。

|

||||

* **更大的磁盘:** DOS 分区表可以格式化最多 2TB 的磁盘空间,尽管在某些情况下最多可以达到 16TB。然而,一个 GPT 分区表可以处理最多 8ZiB 的空间。

|

||||

* **更多的分区:** 使用主分区和扩展分区,DOS 分区表只允许 16 个分区。在 GPT 中,默认情况下您可以得到 128 个分区,并且可以选择更多的分区。

|

||||

* **可靠性:** 在 DOS 分区表中,只保存了一份分区表备份,在 GPT 中保留了两份分区表的备份(在磁盘的起始和结束部分),同时 GPT 还使用了 [CRC][2] 校验和来检查分区表的完整性,在 DOS 分区中并没有实现。

|

||||

|

||||

由于现在的磁盘更大,需要更灵活地使用它们,建议使用 `parted` 来处理磁盘分区。大多数时候,磁盘分区表是作为操作系统安装过程的一部分创建的。在向现有系统添加存储设备时,直接使用 `parted` 命令非常有用。

|

||||

|

||||

### 尝试一下 parted

|

||||

|

||||

下面解释了使用 `parted` 命令对存储设备进行分区的过程。为了尝试这些步骤,我强烈建议使用一块全新的存储设备或一种您不介意将其内容删除的设备。

|

||||

|

||||

#### 1、列出分区

|

||||

|

||||

使用 `parted -l` 来标识你要进行分区的设备。一般来说,第一个硬盘 (`/dev/sda` 或 `/dev/vda` )保存着操作系统, 因此要寻找另一个磁盘,以找到你想要分区的磁盘 (例如,`/dev/sdb`、`/dev/sdc`、 `/dev/vdb `、`/dev/vdc` 等)。

|

||||

|

||||

```

|

||||

$ sudo parted -l

|

||||

[sudo] password for daniel:

|

||||

Model: ATA RevuAhn_850X1TU5 (scsi)

|

||||

Disk /dev/vdc: 512GB

|

||||

Sector size (logical/physical): 512B/512B

|

||||

Partition Table: msdos

|

||||

Disk Flags:

|

||||

|

||||

Number Start End Size Type File system Flags

|

||||

1 1049kB 525MB 524MB primary ext4 boot

|

||||

2 525MB 512GB 512GB primary lvm

|

||||

```

|

||||

|

||||

#### 2、打开存储设备

|

||||

|

||||

使用 `parted` 选中您要分区的设备。在这里例子中,是虚拟系统上的第三个磁盘(`/dev/vdc`)。指明你要使用哪一个设备非常重要。 如果你仅仅输入了 `parted` 命令而没有指定设备名字, 它会**随机**选择一个设备进行操作。

|

||||

|

||||

```

|

||||

$ sudo parted /dev/vdc

|

||||

GNU Parted 3.2

|

||||

Using /dev/vdc

|

||||

Welcome to GNU Parted! Type 'help' to view a list of commands.

|

||||

(parted)

|

||||

```

|

||||

|

||||

#### 3、 设定分区表

|

||||

|

||||

设置分区表为 GPT ,然后输入 `Yes` 开始执行。

|

||||

|

||||

```

|

||||

(parted) mklabel gpt

|

||||

Warning: the existing disk label on /dev/vdc will be destroyed

|

||||

and all data on this disk will be lost. Do you want to continue?

|

||||

Yes/No? Yes

|

||||

```

|

||||

|

||||

`mklabel` 和 `mktable` 命令用于相同的目的(在存储设备上创建分区表)。支持的分区表有:aix、amiga、bsd、dvh、gpt、mac、ms-dos、pc98、sun 和 loop。记住 `mklabel` 不会创建一个分区,而是创建一个分区表。

|

||||

|

||||

#### 4、 检查分区表

|

||||

|

||||

查看存储设备信息:

|

||||

|

||||

```

|

||||

(parted) print

|

||||

Model: Virtio Block Device (virtblk)

|

||||

Disk /dev/vdc: 1396MB

|

||||

Sector size (logical/physical): 512B/512B

|

||||

Partition Table: gpt

|

||||

Disk Flags:

|

||||

Number Start End Size File system Name Flags

|

||||

```

|

||||

|

||||

#### 5、 获取帮助

|

||||

|

||||

为了知道如何去创建一个新分区,输入: `(parted) help mkpart` 。

|

||||

|

||||

```

|

||||

(parted) help mkpart

|

||||

mkpart PART-TYPE [FS-TYPE] START END make a partition

|

||||

|

||||

PART-TYPE is one of: primary, logical, extended

|

||||

FS-TYPE is one of: btrfs, nilfs2, ext4, ext3, ext2, fat32, fat16, hfsx, hfs+, hfs, jfs, swsusp,

|

||||

linux-swap(v1), linux-swap(v0), ntfs, reiserfs, hp-ufs, sun-ufs, xfs, apfs2, apfs1, asfs, amufs5,

|

||||

amufs4, amufs3, amufs2, amufs1, amufs0, amufs, affs7, affs6, affs5, affs4, affs3, affs2, affs1,

|

||||

affs0, linux-swap, linux-swap(new), linux-swap(old)

|

||||

START and END are disk locations, such as 4GB or 10%. Negative values count from the end of the

|

||||

disk. For example, -1s specifies exactly the last sector.

|

||||

|

||||

'mkpart' makes a partition without creating a new file system on the partition. FS-TYPE may be

|

||||

specified to set an appropriate partition ID.

|

||||

```

|

||||

|

||||

#### 6、 创建分区

|

||||

|

||||

为了创建一个新分区(在这个例子中,分区 0 有 1396MB),输入下面的命令:

|

||||

|

||||

```

|

||||

(parted) mkpart primary 0 1396MB

|

||||

|

||||

Warning: The resulting partition is not properly aligned for best performance

|

||||

Ignore/Cancel? I

|

||||

|

||||

(parted) print

|

||||

Model: Virtio Block Device (virtblk)

|

||||

Disk /dev/vdc: 1396MB

|

||||

Sector size (logical/physical): 512B/512B

|

||||

Partition Table: gpt

|

||||

Disk Flags:

|

||||

Number Start End Size File system Name Flags

|

||||

1 17.4kB 1396MB 1396MB primary

|

||||

```

|

||||

|

||||

文件系统类型(`fstype`)并不是在 `/dev/vdc1`上创建 ext4 文件系统。 DOS 分区表的分区类型是<ruby>主分区<rt>primary</rt></ruby>、<ruby>逻辑分区<rt>logical</rt></ruby>和<ruby>扩展分区<rt>extended</rt></ruby>。 在 GPT 分区表中,分区类型用作分区名称。 在 GPT 下必须提供分区名称;在上例中,`primary` 是分区名称,而不是分区类型。

|

||||

|

||||

#### 7、 保存退出

|

||||

|

||||

当你退出 `parted` 时,修改会自动保存。退出请输入如下命令:

|

||||

|

||||

```

|

||||

(parted) quit

|

||||

Information: You may need to update /etc/fstab.

|

||||

$

|

||||

```

|

||||

|

||||

### 谨记

|

||||

|

||||

当您添加新的存储设备时,请确保在开始更改其分区表之前确定正确的磁盘。如果您错误地更改了包含计算机操作系统的磁盘分区,会使您的系统无法启动。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/6/how-partition-disk-linux

|

||||

|

||||

作者:[Daniel Oh][a]