mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-01-25 23:11:02 +08:00

commit

b78249f002

171

published/20180116 Command Line Heroes- Season 1- OS Wars_2.md

Normal file

171

published/20180116 Command Line Heroes- Season 1- OS Wars_2.md

Normal file

@ -0,0 +1,171 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (lujun9972)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-11296-1.html)

|

||||

[#]: subject: (Command Line Heroes: Season 1: OS Wars)

|

||||

[#]: via: (https://www.redhat.com/en/command-line-heroes/season-1/os-wars-part-2-rise-of-linux)

|

||||

[#]: author: (redhat https://www.redhat.com)

|

||||

|

||||

《代码英雄》第一季(2):操作系统战争(下)Linux 崛起

|

||||

======

|

||||

|

||||

> 代码英雄讲述了开发人员、程序员、黑客、极客和开源反叛者如何彻底改变技术前景的真实史诗故事。

|

||||

|

||||

|

||||

|

||||

本文是《[代码英雄](https://www.redhat.com/en/command-line-heroes)》系列播客[第一季(2):操作系统战争(下)](https://www.redhat.com/en/command-line-heroes/season-1/os-wars-part-2-rise-of-linux) 的[音频](https://dts.podtrac.com/redirect.mp3/audio.simplecast.com/2199861a.mp3)脚本。

|

||||

|

||||

> 微软帝国控制着 90% 的用户。操作系统的完全标准化似乎是板上钉钉的事了。但是一个不太可能的英雄出现在开源反叛组织中。戴着眼镜,温文尔雅的<ruby>林纳斯·托瓦兹<rt>Linus Torvalds</rt></ruby>免费发布了他的 Linux® 程序。微软打了个趔趄,并且开始重整旗鼓而来,战场从个人电脑转向互联网。

|

||||

|

||||

**Saron Yitbarek:** 这玩意开着的吗?让我们进一段史诗般的星球大战的开幕吧,开始了。

|

||||

|

||||

配音:第二集:Linux® 的崛起。微软帝国控制着 90% 的桌面用户。操作系统的全面标准化似乎是板上钉钉的事了。然而,互联网的出现将战争的焦点从桌面转向了企业,在该领域,所有商业组织都争相构建自己的服务器。*[00:00:30]*与此同时,一个不太可能的英雄出现在开源反叛组织中。固执、戴着眼镜的 <ruby>林纳斯·托瓦兹<rt>Linus Torvalds</rt></ruby>免费发布了他的 Linux 系统。微软打了个趔趄,并且开始重整旗鼓而来。

|

||||

|

||||

**Saron Yitbarek:** 哦,我们书呆子就是喜欢那样。上一次我们讲到哪了?苹果和微软互相攻伐,试图在一场争夺桌面用户的战争中占据主导地位。*[00:01:00]* 在第一集的结尾,我们看到微软获得了大部分的市场份额。很快,由于互联网的兴起以及随之而来的开发者大军,整个市场都经历了一场地震。互联网将战场从在家庭和办公室中的个人电脑用户转移到拥有数百台服务器的大型商业客户中。

|

||||

|

||||

这意味着巨量资源的迁移。突然间,所有相关企业不仅被迫为服务器空间和网站建设付费,而且还必须集成软件来进行资源跟踪和数据库监控等工作。*[00:01:30]* 你需要很多开发人员来帮助你。至少那时候大家都是这么做的。

|

||||

|

||||

在操作系统之战的第二部分,我们将看到优先级的巨大转变,以及像林纳斯·托瓦兹和<ruby>理查德·斯托尔曼<rt>Richard Stallman</rt></ruby>这样的开源反逆者是如何成功地在微软和整个软件行业的核心地带引发恐惧的。

|

||||

|

||||

我是 Saron Yitbarek,你现在收听的是代码英雄,一款红帽公司原创的播客节目。*[00:02:00]* 每一集,我们都会给你带来“从码开始”改变技术的人的故事。

|

||||

|

||||

好。想象一下你是 1991 年时的微软。你自我感觉良好,对吧?满怀信心。确立了全球主导的地位感觉不错。你已经掌握了与其他企业合作的艺术,但是仍然将大部分开发人员、程序员和系统管理员排除在联盟之外,而他们才是真正的步兵。*[00:02:30]* 这时出现了个叫林纳斯·托瓦兹的芬兰极客。他和他的开源程序员团队正在开始发布 Linux,这个操作系统内核是由他们一起编写出来的。

|

||||

|

||||

坦白地说,如果你是微软公司,你并不会太在意 Linux,甚至不太关心开源运动,但是最终,Linux 的规模变得如此之大,以至于微软不可能不注意到。*[00:03:00]* Linux 第一个版本出现在 1991 年,当时大概有 1 万行代码。十年后,变成了 300 万行代码。如果你想知道,今天则是 2000 万行代码。

|

||||

|

||||

*[00:03:30]* 让我们停留在 90 年代初一会儿。那时 Linux 还没有成为我们现在所知道的庞然大物。这个奇怪的病毒式的操作系统只是正在这个星球上蔓延,全世界的极客和黑客都爱上了它。那时候我还太年轻,但有点希望我曾经经历过那个时候。在那个时候,发现 Linux 就如同进入了一个秘密社团一样。就像其他人分享地下音乐混音带一样,程序员与朋友们分享 Linux CD 集。

|

||||

|

||||

开发者 Tristram Oaten *[00:03:40]* 讲讲你 16 岁时第一次接触 Linux 的故事吧。

|

||||

|

||||

**Tristram Oaten:** 我和我的家人去了红海的 Hurghada 潜水度假。那是一个美丽的地方,强烈推荐。第一天,我喝了自来水。也许,我妈妈跟我说过不要这么做。我整个星期都病得很厉害,没有离开旅馆房间。*[00:04:00]* 当时我只带了一台新安装了 Slackware Linux 的笔记本电脑,我听说过这玩意并且正在尝试使用它。所有的东西都在 8 张 cd 里面。这种情况下,我只能整个星期都去了解这个外星一般的系统。我阅读手册,摆弄着终端。我记得当时我甚至不知道一个点(表示当前目录)和两个点(表示前一个目录)之间的区别。

|

||||

|

||||

*[00:04:30]* 我一点头绪都没有。犯过很多错误,但慢慢地,在这种强迫的孤独中,我突破了障碍,开始理解并明白命令行到底是怎么回事。假期结束时,我没有看过金字塔、尼罗河等任何埃及遗址,但我解锁了现代世界的一个奇迹。我解锁了 Linux,接下来的事大家都知道了。

|

||||

|

||||

**Saron Yitbarek:** 你会从很多人那里听到关于这个故事的不同说法。访问 Linux 命令行是一种革命性的体验。

|

||||

|

||||

**David Cantrell:** *[00:05:00]* 它给了我源代码。我当时的感觉是,“太神奇了。”

|

||||

|

||||

**Saron Yitbarek:** 我们正在参加一个名为 Flock to Fedora 的 2017 年 Linux 开发者大会。

|

||||

|

||||

**David Cantrell:** ……非常有吸引力。我觉得我对这个系统有了更多的控制力,它越来越吸引我。我想,从 1995 年我第一次编译 Linux 内核那时起,我就迷上了它。

|

||||

|

||||

**Saron Yitbarek:** 开发者 David Cantrell 与 Joe Brockmire。

|

||||

|

||||

**Joe Brockmeier:** *[00:05:30]* 我在 Cheap Software 转的时候发现了一套四张 CD 的 Slackware Linux。它看起来来非常令人兴奋而且很有趣,所以我把它带回家,安装在第二台电脑上,开始摆弄它,有两件事情让我感到很兴奋:一个是,我运行的不是 Windows,另一个是 Linux 的开源特性。

|

||||

|

||||

**Saron Yitbarek:** *[00:06:00]* 某种程度上来说,对命令行的使用总是存在的。在开源真正开始流行还要早的几十年前,人们(至少在开发人员中是这样)总是希望能够做到完全控制。让我们回到操作系统大战之前的那个时代,在苹果和微软为他们的 GUI 而战之前。那时也有代码英雄。<ruby>保罗·琼斯<rt>Paul Jones</rt></ruby>教授(在线图书馆 ibiblio.org 的负责人)在那个古老的时代,就是一名开发人员。

|

||||

|

||||

**Paul Jones:** *[00:06:30]* 从本质上讲,互联网在那个时候客户端-服务器架构还是比较少的,而更多的是点对点架构的。确实,我们会说,某种 VAX 到 VAX 的连接(LCTT 译注:DEC 的一种操作系统),某种科学工作站到科学工作站的连接。这并不意味着没有客户端-服务端的架构及应用程序,但这的确意味着,最初的设计是思考如何实现点对点,*[00:07:00]* 它与 IBM 一直在做的东西相对立。IBM 给你的只有哑终端,这种终端只能让你管理用户界面,却无法让你像真正的终端一样为所欲为。

|

||||

|

||||

**Saron Yitbarek:** 图形用户界面在普通用户中普及的同时,在工程师和开发人员中总是存在着一股相反的力量。早在 Linux 出现之前的二十世纪七八十年代,这股力量就存在于 Emacs 和 GNU 中。有了斯托尔曼的自由软件基金会后,总有某些人想要使用命令行,但上世纪 90 年代的 Linux 提供了前所未有的东西。

|

||||

|

||||

*[00:07:30]* Linux 和其他开源软件的早期爱好者是都是先驱。我正站在他们的肩膀上。我们都是。

|

||||

|

||||

你现在收听的是代码英雄,一款由红帽公司原创的播客。这是操作系统大战的第二部分:Linux 崛起。

|

||||

|

||||

**Steven Vaughan-Nichols:** 1998 年的时候,情况发生了变化。

|

||||

|

||||

**Saron Yitbarek:** *[00:08:00]* Steven Vaughan-Nichols 是 zdnet.com 的特约编辑,他已经写了几十年关于技术商业方面的文章了。他将向我们讲述 Linux 是如何慢慢变得越来越流行,直到自愿贡献者的数量远远超过了在 Windows 上工作的微软开发人员的数量的。不过,Linux 从未真正追上微软桌面客户的数量,这也许就是微软最开始时忽略了 Linux 及其开发者的原因。Linux 真正大放光彩的地方是在服务器机房。当企业开始线上业务时,每个企业都需要一个满足其需求的独特编程解决方案。

|

||||

|

||||

*[00:08:30]* WindowsNT 于 1993 年问世,当时它已经在与其他的服务器操作系统展开竞争了,但是许多开发人员都在想,“既然我可以通过 Apache 构建出基于 Linux 的廉价系统,那我为什么要购买 AIX 设备或大型 Windows 设备呢?”关键点在于,Linux 代码已经开始渗透到几乎所有网上的东西中。

|

||||

|

||||

**Steven Vaughan-Nichols:** *[00:09:00]* 令微软感到惊讶的是,它开始意识到,Linux 实际上已经开始有一些商业应用,不是在桌面环境,而是在商业服务器上。因此,他们发起了一场运动,我们称之为 FUD - <ruby>恐惧、不确定和怀疑<rt>fear, uncertainty and double</rt></ruby>。他们说,“哦,Linux 这玩意,真的没有那么好。它不太可靠。你一点都不能相信它”。

|

||||

|

||||

**Saron Yitbarek:** 这种软宣传式的攻击持续了一段时间。微软也不是唯一一个对 Linux 感到紧张的公司。这其实是整个行业在对抗这个奇怪新人的挑战。*[00:09:30]* 例如,任何与 UNIX 有利害关系的人都可能将 Linux 视为篡夺者。有一个案例很著名,那就是 SCO 组织(它发行过一种 UNIX 版本)在过去 10 多年里发起一系列的诉讼,试图阻止 Linux 的传播。SCO 最终失败而且破产了。与此同时,微软一直在寻找机会,他们必须要采取动作,只是不清楚具体该怎么做。

|

||||

|

||||

**Steven Vaughan-Nichols:** *[00:10:00]* 让微软真正担心的是,第二年,在 2000 年的时候,IBM 宣布,他们将于 2001 年投资 10 亿美元在 Linux 上。现在,IBM 已经不再涉足个人电脑业务。(那时)他们还没有走出去,但他们正朝着这个方向前进,他们将 Linux 视为服务器和大型计算机的未来,在这一点上,剧透警告,IBM 是正确的。*[00:10:30]* Linux 将主宰服务器世界。

|

||||

|

||||

**Saron Yitbarek:** 这已经不再仅仅是一群黑客喜欢他们对命令行的绝地武士式的控制了。金钱的投入对 Linux 助力极大。<ruby>Linux 国际<rt>Linux International</rt></ruby>的执行董事 John “Mad Dog” Hall 有一个故事可以解释为什么会这样。我们通过电话与他取得了联系。

|

||||

|

||||

**John Hall:** *[00:11:00]* 我有一个名叫 Dirk Holden 的朋友,他是德国德意志银行的系统管理员,他也参与了个人电脑上早期 X Windows 系统图形项目的工作。有一天我去银行拜访他,我说:“Dirk,你银行里有 3000 台服务器,用的都是 Linux。为什么不用 Microsoft NT 呢?”*[00:11:30]* 他看着我说:“是的,我有 3000 台服务器,如果使用微软的 Windows NT 系统,我需要 2999 名系统管理员。”他继续说道:“而使用 Linux,我只需要四个。”这真是完美的答案。

|

||||

|

||||

**Saron Yitbarek:** 程序员们着迷的这些东西恰好对大公司也极具吸引力。但由于 FUD 的作用,一些企业对此持谨慎态度。*[00:12:00]* 他们听到开源,就想:“开源。这看起来不太可靠,很混乱,充满了 BUG”。但正如那位银行经理所指出的,金钱有一种有趣的方式,可以说服人们克服困境。甚至那些只需要网站的小公司也加入了 Linux 阵营。与一些昂贵的专有选择相比,使用一个廉价的 Linux 系统在成本上是无法比拟的。如果你是一家雇佣专业人员来构建网站的商店,那么你肯定想让他们使用 Linux。

|

||||

|

||||

让我们快进几年。Linux 运行每个人的网站上。Linux 已经征服了服务器世界,然后智能手机也随之诞生。*[00:12:30]* 当然,苹果和他们的 iPhone 占据了相当大的市场份额,而且微软也希望能进入这个市场,但令人惊讶的是,Linux 也在那,已经做好准备了,迫不及待要大展拳脚。

|

||||

|

||||

作家兼记者 James Allworth。

|

||||

|

||||

**James Allworth:** 肯定还有容纳第二个竞争者的空间,那本可以是微软,但是实际上却是 Android,而 Andrid 基本上是基于 Linux 的。众所周知,Android 被谷歌所收购,现在运行在世界上大部分的智能手机上,谷歌在 Linux 的基础上创建了 Android。*[00:13:00]* Linux 使他们能够以零成本从一个非常复杂的操作系统开始。他们成功地实现了这一目标,最终将微软挡在了下一代设备之外,至少从操作系统的角度来看是这样。

|

||||

|

||||

**Saron Yitbarek:** *[00:13:30]* 这可是个大地震,很大程度上,微软有被埋没的风险。John Gossman 是微软 Azure 团队的首席架构师。他还记得当时困扰公司的困惑。

|

||||

|

||||

**John Gossman:** 像许多公司一样,微软也非常担心知识产权污染。他们认为,如果允许开发人员使用开源代码,那么他们可能只是将一些代码复制并粘贴到某些产品中,就会让某种病毒式的许可证生效从而引发未知的风险……他们也很困惑,*[00:14:00]* 我认为,这跟公司文化有关,很多公司,包括微软,都对开源开发的意义和商业模式之间的分歧感到困惑。有一种观点认为,开源意味着你所有的软件都是免费的,人们永远不会付钱。

|

||||

|

||||

**Saron Yitbarek:** 任何投资于旧的、专有软件模型的人都会觉得这里发生的一切对他们构成了威胁。当你威胁到像微软这样的大公司时,是的,他们一定会做出反应。*[00:14:30]* 他们推动所有这些 FUD —— 恐惧、不确定性和怀疑是有道理的。当时,商业运作的方式基本上就是相互竞争。不过,如果是其他公司的话,他们可能还会一直怀恨在心,抱残守缺,但到了 2013 年的微软,一切都变了。

|

||||

|

||||

微软的云计算服务 Azure 上线了,令人震惊的是,它从第一天开始就提供了 Linux 虚拟机。*[00:15:00]* <ruby>史蒂夫·鲍尔默<rt>Steve Ballmer</rt></ruby>,这位把 Linux 称为癌症的首席执行官,已经离开了,代替他的是一位新的有远见的首席执行官<ruby>萨提亚·纳德拉<rt>Satya Nadella</rt></ruby>。

|

||||

|

||||

**John Gossman:** 萨提亚有不同的看法。他属于另一个世代。比保罗、比尔和史蒂夫更年轻的世代,他对开源有不同的看法。

|

||||

|

||||

**Saron Yitbarek:** 还是来自微软 Azure 团队的 John Gossman。

|

||||

|

||||

**John Gossman:** *[00:15:30]* 大约四年前,处于实际需要,我们在 Azure 中添加了 Linux 支持。如果访问任何一家企业客户,你都会发现他们并不会才试着决定是使用 Windows 还是使用 Linux、 使用 .net 还是使用 Java ^TM 。他们在很久以前就做出了决定 —— 大约 15 年前才有这样的一些争论。*[00:16:00]* 现在,我见过的每一家公司都混合了 Linux 和 Java、Windows 和 .net、SQL Server、Oracle 和 MySQL —— 基于专有源代码的产品和开放源代码的产品。

|

||||

|

||||

如果你打算运维一个云服务,允许这些公司在云上运行他们的业务,那么你根本不能告诉他们,“你可以使用这个软件,但你不能使用那个软件。”

|

||||

|

||||

**Saron Yitbarek:** *[00:16:30]* 这正是萨提亚·纳德拉采纳的哲学思想。2014 年秋季,他站在舞台上,希望传递一个重要信息。“微软爱 Linux”。他接着说,“20% 的 Azure 业务量已经是 Linux 了,微软将始终对 Linux 发行版提供一流的支持。”没有哪怕一丝对开源的宿怨。

|

||||

|

||||

为了说明这一点,在他们的背后有一个巨大的标志,上面写着:“Microsoft ❤️ Linux”。哇噢。对我们中的一些人来说,这种转变有点令人震惊,但实际上,无需如此震惊。下面是 Steven Levy,一名科技记者兼作家。

|

||||

|

||||

**Steven Levy:** *[00:17:00]* 当你在踢足球的时候,如果草坪变滑了,那么你也许会换一种不同的鞋子。他们当初就是这么做的。*[00:17:30]* 他们不能否认现实,而且他们里面也有聪明人,所以他们必须意识到,这就是这个世界的运行方式,不管他们早些时候说了什么,即使他们对之前的言论感到尴尬,但是让他们之前关于开源多么可怕的言论影响到现在明智的决策那才真的是疯了。

|

||||

|

||||

**Saron Yitbarek:** 微软低下了它高傲的头。你可能还记得苹果公司,经过多年的孤立无援,最终转向与微软构建合作伙伴关系。现在轮到微软进行 180 度转变了。*[00:18:00]* 经过多年的与开源方式的战斗后,他们正在重塑自己。要么改变,要么死亡。Steven Vaughan-Nichols。

|

||||

|

||||

**Steven Vaughan-Nichols:** 即使是像微软这样规模的公司也无法与数千个开发着包括 Linux 在内的其它大项目的开源开发者竞争。很长时间以来他们都不愿意这么做。前微软首席执行官史蒂夫·鲍尔默对 Linux 深恶痛绝。*[00:18:30]* 由于它的 GPL 许可证,他视 Linux 为一种癌症,但一旦鲍尔默被扫地出门,新的微软领导层说,“这就好像试图命令潮流不要过来,但潮水依然会不断涌进来。我们应该与 Linux 合作,而不是与之对抗。”

|

||||

|

||||

**Saron Tiebreak:** 事实上,互联网技术史上最大的胜利之一就是微软最终决定做出这样的转变。*[00:19:00]* 当然,当微软出现在开源圈子时,老一代的铁杆 Linux 支持者是相当怀疑的。他们不确定自己是否能接受这些家伙,但正如 Vaughan-Nichols 所指出的,今天的微软已经不是以前的微软了。

|

||||

|

||||

**Steven Vaughan-Nichols:** 2017 年的微软既不是史蒂夫·鲍尔默的微软,也不是比尔·盖茨的微软。这是一家完全不同的公司,有着完全不同的方法,而且,一旦使用了开源,你就无法退回到之前。*[00:19:30]* 开源已经吞噬了整个技术世界。从未听说过 Linux 的人可能对它并不了解,但是每次他们访问 Facebook,他们都在运行 Linux。每次执行谷歌搜索时,你都在运行 Linux。

|

||||

|

||||

*[00:20:00]* 每次你用 Android 手机,你都在运行 Linux。它确实无处不在,微软无法阻止它,而且我认为以为微软能以某种方式接管它的想法,太天真了。

|

||||

|

||||

**Saron Yitbarek:** 开源支持者可能一直担心微软会像混入羊群中的狼一样,但事实是,开源软件的本质保护了它无法被完全控制。*[00:20:30]* 没有一家公司能够拥有 Linux 并以某种特定的方式控制它。Greg Kroah-Hartman 是 Linux 基金会的一名成员。

|

||||

|

||||

**Greg Kroah-Hartman:** 每个公司和个人都以自私的方式为 Linux 做出贡献。他们之所以这样做是因为他们想要解决他们所面临的问题,可能是硬件无法工作,或者是他们想要添加一个新功能来做其他事情,又或者想在他们的产品中使用它。这很棒,因为他们会把代码贡献回去,此后每个人都会从中受益,这样每个人都可以用到这份代码。正是因为这种自私,所有的公司,所有的人都能从中受益。

|

||||

|

||||

**Saron Yitbarek:** *[00:21:00]* 微软已经意识到,在即将到来的云战争中,与 Linux 作战就像与空气作战一样。Linux 和开源不是敌人,它们是空气。如今,微软以白金会员的身份加入了 Linux 基金会。他们成为 GitHub 开源项目的头号贡献者。*[00:21:30]* 2017 年 9 月,他们甚至加入了<ruby>开源促进联盟<rt>Open Source Initiative</rt></ruby>。现在,微软在开源许可证下发布了很多代码。微软的 John Gossman 描述了他们开源 .net 时所发生的事情。起初,他们并不认为自己能得到什么回报。

|

||||

|

||||

**John Gossman:** 我们本没有指望来自社区的贡献,然而,三年后,超过 50% 的对 .net 框架库的贡献来自于微软之外。这包括大量的代码。*[00:22:00]* 三星为 .net 提供了 ARM 支持。Intel 和 ARM 以及其他一些芯片厂商已经为 .net 框架贡献了特定于他们处理器的代码生成,以及数量惊人的修复、性能改进等等 —— 既有单个贡献者也有社区。

|

||||

|

||||

**Saron Yitbarek:** 直到几年前,今天的这个微软,这个开放的微软,还是不可想象的。

|

||||

|

||||

*[00:22:30]* 我是 Saron Yitbarek,这里是代码英雄。好吧,我们已经看到了为了赢得数百万桌面用户的爱而战的激烈场面。我们已经看到开源软件在专有软件巨头的背后悄然崛起,并攫取了巨大的市场份额。*[00:23:00]* 我们已经看到了一批批的代码英雄将编程领域变成了我你今天看到的这个样子。如今,大企业正在吸收开源软件,通过这一切,每个人都从他人那里受益。

|

||||

|

||||

在技术的西部荒野,一贯如此。苹果受到施乐的启发,微软受到苹果的启发,Linux 受到 UNIX 的启发。进化、借鉴、不断成长。如果比喻成大卫和歌利亚(LCTT 译注:西方经典的以弱胜强战争中的两个主角)的话,开源软件不再是大卫,但是,你知道吗?它也不是歌利亚。*[00:23:30]* 开源已经超越了传统。它已经成为其他人战斗的战场。随着开源道路变得不可避免,新的战争,那些在云计算中进行的战争,那些在开源战场上进行的战争正在加剧。

|

||||

|

||||

这是 Steven Levy,他是一名作者。

|

||||

|

||||

**Steven Levy:** 基本上,到目前为止,包括微软在内,有四到五家公司,正以各种方式努力把自己打造成为全方位的平台,比如人工智能领域。你能看到智能助手之间的战争,你猜怎么着?*[00:24:00]* 苹果有一个智能助手,叫 Siri。微软有一个,叫 Cortana。谷歌有谷歌助手。三星也有一个智能助手。亚马逊也有一个,叫 Alexa。我们看到这些战斗遍布各地。也许,你可以说,最热门的人工智能平台将控制我们生活中所有的东西,而这五家公司就是在为此而争斗。

|

||||

|

||||

**Saron Yitbarek:** *[00:24:30]* 如果你正在寻找另一个反叛者,它们就像 Linux 奇袭微软那样,偷偷躲在 Facebook、谷歌或亚马逊身后,你也许要等很久,因为正如作家 James Allworth 所指出的,成为一个真正的反叛者只会变得越来越难。

|

||||

|

||||

**James Allworth:** 规模一直以来都是一种优势,但规模优势本质上……怎么说呢,我认为以前它们在本质上是线性的,现在它们在本质上是指数型的了,所以,一旦你开始以某种方法走在前面,另一个新玩家要想赶上来就变得越来越难了。*[00:25:00]* 我认为在互联网时代这大体来说来说是正确的,无论是因为规模,还是数据赋予组织的竞争力的重要性和优势。一旦你走在前面,你就会吸引更多的客户,这就给了你更多的数据,让你能做得更好,这之后,客户还有什么理由选择排名第二的公司呢,难道是因为因为他们落后了这么远么?*[00:25:30]* 我认为在云的时代这个逻辑也不会有什么不同。

|

||||

|

||||

**Saron Yitbarek:** 这个故事始于史蒂夫·乔布斯和比尔·盖茨这样的非凡的英雄,但科技的进步已经呈现出一种众包、有机的感觉。我认为据说我们的开源英雄林纳斯·托瓦兹在第一次发明 Linux 内核时甚至没有一个真正的计划。他无疑是一位才华横溢的年轻开发者,但他也像潮汐前的一滴水一样。*[00:26:00]* 变革是不可避免的。据估计,对于一家专有软件公司来说,用他们老式的、专有的方式创建一个 Linux 发行版将花费他们超过 100 亿美元。这说明了开源的力量。

|

||||

|

||||

最后,这并不是一个专有模型所能与之竞争的东西。成功的公司必须保持开放。这是最大、最终极的教训。*[00:26:30]* 还有一点要记住:当我们连接在一起的时候,我们在已有基础上成长和建设的能力是无限的。不管这些公司有多大,我们都不必坐等他们给我们更好的东西。想想那些为了纯粹的创造乐趣而学习编码的新开发者,那些自己动手丰衣足食的人。

|

||||

|

||||

未来的优秀程序员无管来自何方,只要能够访问代码,他们就能构建下一个大项目。

|

||||

|

||||

*[00:27:00]* 以上就是我们关于操作系统战争的两个故事。这场战争塑造了我们的数字生活。争夺主导地位的斗争从桌面转移到了服务器机房,最终进入了云计算领域。过去的敌人难以置信地变成了盟友,众包的未来让一切都变得开放。*[00:27:30]* 听着,我知道,在这段历史之旅中,还有很多英雄我们没有提到,所以给我们写信吧。分享你的故事。[Redhat.com/commandlineheroes](https://www.redhat.com/commandlineheroes) 。我恭候佳音。

|

||||

|

||||

在本季剩下的时间里,我们将学习今天的英雄们在创造什么,以及他们要经历什么样的战斗才能将他们的创造变为现实。让我们从壮丽的编程一线回来看看更多的传奇故事吧。我们每两周放一集新的博客。几周后,我们将为你带来第三集:敏捷革命。

|

||||

|

||||

*[00:28:00]* 代码英雄是一款红帽公司原创的播客。要想免费自动获得新一集的代码英雄,请订阅我们的节目。只要在苹果播客、Spotify、谷歌 Play,或其他应用中搜索“Command Line Heroes”。然后点击“订阅”。这样你就会第一个知道什么时候有新剧集了。

|

||||

|

||||

我是 Saron Yitbarek。感谢收听。继续编码。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.redhat.com/en/command-line-heroes/season-1/os-wars-part-2-rise-of-linux

|

||||

|

||||

作者:[redhat][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[lujun9972](https://github.com/lujun9972)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://www.redhat.com

|

||||

[b]: https://github.com/lujun9972

|

||||

480

published/20180330 Go on very small hardware Part 1.md

Normal file

480

published/20180330 Go on very small hardware Part 1.md

Normal file

@ -0,0 +1,480 @@

|

||||

Go 语言在极小硬件上的运用(一)

|

||||

=========

|

||||

|

||||

Go 语言,能在多低下的配置上运行并发挥作用呢?

|

||||

|

||||

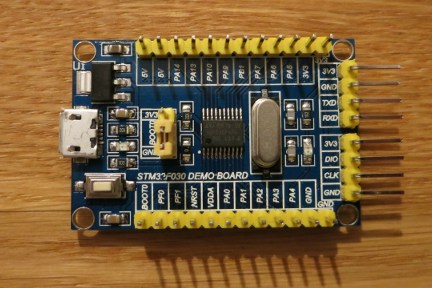

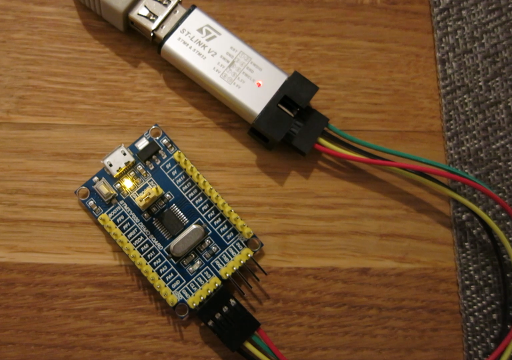

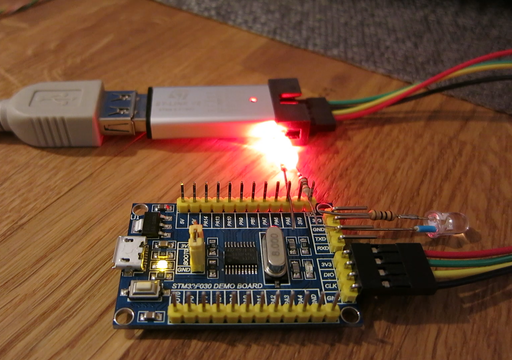

我最近购买了一个特别便宜的开发板:

|

||||

|

||||

|

||||

|

||||

我购买它的理由有三个。首先,我(作为程序员)从未接触过 STM320 系列的开发板。其次,STM32F10x 系列使用也有点少了。STM320 系列的 MCU 很便宜,有更新一些的外设,对系列产品进行了改进,问题修复也做得更好了。最后,为了这篇文章,我选用了这一系列中最低配置的开发板,整件事情就变得有趣起来了。

|

||||

|

||||

### 硬件部分

|

||||

|

||||

[STM32F030F4P6][3] 给人留下了很深的印象:

|

||||

|

||||

* CPU: [Cortex M0][1] 48 MHz(最低配置,只有 12000 个逻辑门电路)

|

||||

* RAM: 4 KB,

|

||||

* Flash: 16 KB,

|

||||

* ADC、SPI、I2C、USART 和几个定时器

|

||||

|

||||

以上这些采用了 TSSOP20 封装。正如你所见,这是一个很小的 32 位系统。

|

||||

|

||||

### 软件部分

|

||||

|

||||

如果你想知道如何在这块开发板上使用 [Go][4] 编程,你需要反复阅读硬件规范手册。你必须面对这样的真实情况:在 Go 编译器中给 Cortex-M0 提供支持的可能性很小。而且,这还仅仅只是第一个要解决的问题。

|

||||

|

||||

我会使用 [Emgo][5],但别担心,之后你会看到,它如何让 Go 在如此小的系统上尽可能发挥作用。

|

||||

|

||||

在我拿到这块开发板之前,对 [stm32/hal][6] 系列下的 F0 MCU 没有任何支持。在简单研究[参考手册][7]后,我发现 STM32F0 系列是 STM32F3 削减版,这让在新端口上开发的工作变得容易了一些。

|

||||

|

||||

如果你想接着本文的步骤做下去,需要先安装 Emgo

|

||||

|

||||

```

|

||||

cd $HOME

|

||||

git clone https://github.com/ziutek/emgo/

|

||||

cd emgo/egc

|

||||

go install

|

||||

```

|

||||

|

||||

然后设置一下环境变量

|

||||

|

||||

```

|

||||

export EGCC=path_to_arm_gcc # eg. /usr/local/arm/bin/arm-none-eabi-gcc

|

||||

export EGLD=path_to_arm_linker # eg. /usr/local/arm/bin/arm-none-eabi-ld

|

||||

export EGAR=path_to_arm_archiver # eg. /usr/local/arm/bin/arm-none-eabi-ar

|

||||

|

||||

export EGROOT=$HOME/emgo/egroot

|

||||

export EGPATH=$HOME/emgo/egpath

|

||||

|

||||

export EGARCH=cortexm0

|

||||

export EGOS=noos

|

||||

export EGTARGET=f030x6

|

||||

```

|

||||

|

||||

更详细的说明可以在 [Emgo][8] 官网上找到。

|

||||

|

||||

要确保 `egc` 在你的 `PATH` 中。 你可以使用 `go build` 来代替 `go install`,然后把 `egc` 复制到你的 `$HOME/bin` 或 `/usr/local/bin` 中。

|

||||

|

||||

现在,为你的第一个 Emgo 程序创建一个新文件夹,随后把示例中链接器脚本复制过来:

|

||||

|

||||

```

|

||||

mkdir $HOME/firstemgo

|

||||

cd $HOME/firstemgo

|

||||

cp $EGPATH/src/stm32/examples/f030-demo-board/blinky/script.ld .

|

||||

```

|

||||

|

||||

### 最基本程序

|

||||

|

||||

在 `main.go` 文件中创建一个最基本的程序:

|

||||

|

||||

```

|

||||

package main

|

||||

|

||||

func main() {

|

||||

}

|

||||

```

|

||||

|

||||

文件编译没有出现任何问题:

|

||||

|

||||

```

|

||||

$ egc

|

||||

$ arm-none-eabi-size cortexm0.elf

|

||||

text data bss dec hex filename

|

||||

7452 172 104 7728 1e30 cortexm0.elf

|

||||

```

|

||||

|

||||

第一次编译可能会花点时间。编译后产生的二进制占用了 7624 个字节的 Flash 空间(文本 + 数据)。对于一个什么都没做的程序来说,占用的空间有些大。还剩下 8760 字节,可以用来做些有用的事。

|

||||

|

||||

不妨试试传统的 “Hello, World!” 程序:

|

||||

|

||||

```

|

||||

package main

|

||||

|

||||

import "fmt"

|

||||

|

||||

func main() {

|

||||

fmt.Println("Hello, World!")

|

||||

}

|

||||

```

|

||||

|

||||

不幸的是,这次结果有些糟糕:

|

||||

|

||||

```

|

||||

$ egc

|

||||

/usr/local/arm/bin/arm-none-eabi-ld: /home/michal/P/go/src/github.com/ziutek/emgo/egpath/src/stm32/examples/f030-demo-board/blog/cortexm0.elf section `.text' will not fit in region `Flash'

|

||||

/usr/local/arm/bin/arm-none-eabi-ld: region `Flash' overflowed by 10880 bytes

|

||||

exit status 1

|

||||

```

|

||||

|

||||

“Hello, World!” 需要 STM32F030x6 上至少 32KB 的 Flash 空间。

|

||||

|

||||

`fmt` 包强制包含整个 `strconv` 和 `reflect` 包。这三个包,即使在精简版本中的 Emgo 中,占用空间也很大。我们不能使用这个例子了。有很多的应用不需要好看的文本输出。通常,一个或多个 LED,或者七段数码管显示就足够了。不过,在第二部分,我会尝试使用 `strconv` 包来格式化,并在 UART 上显示一些数字和文本。

|

||||

|

||||

### 闪烁

|

||||

|

||||

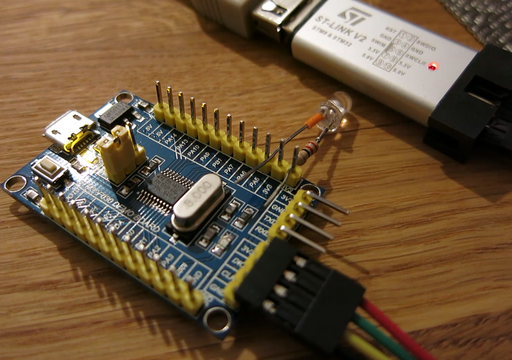

我们的开发板上有一个与 PA4 引脚和 VCC 相连的 LED。这次我们的代码稍稍长了一些:

|

||||

|

||||

```

|

||||

package main

|

||||

|

||||

import (

|

||||

"delay"

|

||||

|

||||

"stm32/hal/gpio"

|

||||

"stm32/hal/system"

|

||||

"stm32/hal/system/timer/systick"

|

||||

)

|

||||

|

||||

var led gpio.Pin

|

||||

|

||||

func init() {

|

||||

system.SetupPLL(8, 1, 48/8)

|

||||

systick.Setup(2e6)

|

||||

|

||||

gpio.A.EnableClock(false)

|

||||

led = gpio.A.Pin(4)

|

||||

|

||||

cfg := &gpio.Config{Mode: gpio.Out, Driver: gpio.OpenDrain}

|

||||

led.Setup(cfg)

|

||||

}

|

||||

|

||||

func main() {

|

||||

for {

|

||||

led.Clear()

|

||||

delay.Millisec(100)

|

||||

led.Set()

|

||||

delay.Millisec(900)

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

按照惯例,`init` 函数用来初始化和配置外设。

|

||||

|

||||

`system.SetupPLL(8, 1, 48/8)` 用来配置 RCC,将外部的 8 MHz 振荡器的 PLL 作为系统时钟源。PLL 分频器设置为 1,倍频数设置为 48/8 =6,这样系统时钟频率为 48MHz。

|

||||

|

||||

`systick.Setup(2e6)` 将 Cortex-M SYSTICK 时钟作为系统时钟,每隔 2e6 次纳秒运行一次(每秒钟 500 次)。

|

||||

|

||||

`gpio.A.EnableClock(false)` 开启了 GPIO A 口的时钟。`False` 意味着这一时钟在低功耗模式下会被禁用,但在 STM32F0 系列中并未实现这一功能。

|

||||

|

||||

`led.Setup(cfg)` 设置 PA4 引脚为开漏输出。

|

||||

|

||||

`led.Clear()` 将 PA4 引脚设为低,在开漏设置中,打开 LED。

|

||||

|

||||

`led.Set()` 将 PA4 设为高电平状态,关掉LED。

|

||||

|

||||

编译这个代码:

|

||||

|

||||

```

|

||||

$ egc

|

||||

$ arm-none-eabi-size cortexm0.elf

|

||||

text data bss dec hex filename

|

||||

9772 172 168 10112 2780 cortexm0.elf

|

||||

```

|

||||

|

||||

正如你所看到的,这个闪烁程序占用了 2320 字节,比最基本程序占用空间要大。还有 6440 字节的剩余空间。

|

||||

|

||||

看看代码是否能运行:

|

||||

|

||||

```

|

||||

$ openocd -d0 -f interface/stlink.cfg -f target/stm32f0x.cfg -c 'init; program cortexm0.elf; reset run; exit'

|

||||

Open On-Chip Debugger 0.10.0+dev-00319-g8f1f912a (2018-03-07-19:20)

|

||||

Licensed under GNU GPL v2

|

||||

For bug reports, read

|

||||

http://openocd.org/doc/doxygen/bugs.html

|

||||

debug_level: 0

|

||||

adapter speed: 1000 kHz

|

||||

adapter_nsrst_delay: 100

|

||||

none separate

|

||||

adapter speed: 950 kHz

|

||||

target halted due to debug-request, current mode: Thread

|

||||

xPSR: 0xc1000000 pc: 0x0800119c msp: 0x20000da0

|

||||

adapter speed: 4000 kHz

|

||||

** Programming Started **

|

||||

auto erase enabled

|

||||

target halted due to breakpoint, current mode: Thread

|

||||

xPSR: 0x61000000 pc: 0x2000003a msp: 0x20000da0

|

||||

wrote 10240 bytes from file cortexm0.elf in 0.817425s (12.234 KiB/s)

|

||||

** Programming Finished **

|

||||

adapter speed: 950 kHz

|

||||

```

|

||||

|

||||

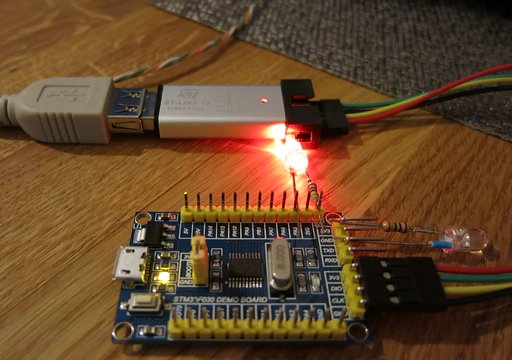

在这篇文章中,这是我第一次,将一个短视频转换成[动画 PNG][9]。我对此印象很深,再见了 YouTube。 对于 IE 用户,我很抱歉,更多信息请看 [apngasm][10]。我本应该学习 HTML5,但现在,APNG 是我最喜欢的,用来播放循环短视频的方法了。

|

||||

|

||||

|

||||

|

||||

### 更多的 Go 语言编程

|

||||

|

||||

如果你不是一个 Go 程序员,但你已经听说过一些关于 Go 语言的事情,你可能会说:“Go 语法很好,但跟 C 比起来,并没有明显的提升。让我看看 Go 语言的通道和协程!”

|

||||

|

||||

接下来我会一一展示:

|

||||

|

||||

```

|

||||

import (

|

||||

"delay"

|

||||

|

||||

"stm32/hal/gpio"

|

||||

"stm32/hal/system"

|

||||

"stm32/hal/system/timer/systick"

|

||||

)

|

||||

|

||||

var led1, led2 gpio.Pin

|

||||

|

||||

func init() {

|

||||

system.SetupPLL(8, 1, 48/8)

|

||||

systick.Setup(2e6)

|

||||

|

||||

gpio.A.EnableClock(false)

|

||||

led1 = gpio.A.Pin(4)

|

||||

led2 = gpio.A.Pin(5)

|

||||

|

||||

cfg := &gpio.Config{Mode: gpio.Out, Driver: gpio.OpenDrain}

|

||||

led1.Setup(cfg)

|

||||

led2.Setup(cfg)

|

||||

}

|

||||

|

||||

func blinky(led gpio.Pin, period int) {

|

||||

for {

|

||||

led.Clear()

|

||||

delay.Millisec(100)

|

||||

led.Set()

|

||||

delay.Millisec(period - 100)

|

||||

}

|

||||

}

|

||||

|

||||

func main() {

|

||||

go blinky(led1, 500)

|

||||

blinky(led2, 1000)

|

||||

}

|

||||

|

||||

```

|

||||

|

||||

代码改动很小: 添加了第二个 LED,上一个例子中的 `main` 函数被重命名为 `blinky` 并且需要提供两个参数。 `main` 在新的协程中先调用 `blinky`,所以两个 LED 灯在并行使用。值得一提的是,`gpio.Pin` 可以同时访问同一 GPIO 口的不同引脚。

|

||||

|

||||

Emgo 还有很多不足。其中之一就是你需要提前规定 `goroutines(tasks)` 的最大执行数量。是时候修改 `script.ld` 了:

|

||||

|

||||

```

|

||||

ISRStack = 1024;

|

||||

MainStack = 1024;

|

||||

TaskStack = 1024;

|

||||

MaxTasks = 2;

|

||||

|

||||

INCLUDE stm32/f030x4

|

||||

INCLUDE stm32/loadflash

|

||||

INCLUDE noos-cortexm

|

||||

```

|

||||

|

||||

栈的大小需要靠猜,现在还不用关心这一点。

|

||||

|

||||

```

|

||||

$ egc

|

||||

$ arm-none-eabi-size cortexm0.elf

|

||||

text data bss dec hex filename

|

||||

10020 172 172 10364 287c cortexm0.elf

|

||||

```

|

||||

|

||||

另一个 LED 和协程一共占用了 248 字节的 Flash 空间。

|

||||

|

||||

|

||||

|

||||

### 通道

|

||||

|

||||

通道是 Go 语言中协程之间相互通信的一种[推荐方式][11]。Emgo 甚至能允许通过*中断处理*来使用缓冲通道。下一个例子就展示了这种情况。

|

||||

|

||||

```

|

||||

package main

|

||||

|

||||

import (

|

||||

"delay"

|

||||

"rtos"

|

||||

|

||||

"stm32/hal/gpio"

|

||||

"stm32/hal/irq"

|

||||

"stm32/hal/system"

|

||||

"stm32/hal/system/timer/systick"

|

||||

"stm32/hal/tim"

|

||||

)

|

||||

|

||||

var (

|

||||

leds [3]gpio.Pin

|

||||

timer *tim.Periph

|

||||

ch = make(chan int, 1)

|

||||

)

|

||||

|

||||

func init() {

|

||||

system.SetupPLL(8, 1, 48/8)

|

||||

systick.Setup(2e6)

|

||||

|

||||

gpio.A.EnableClock(false)

|

||||

leds[0] = gpio.A.Pin(4)

|

||||

leds[1] = gpio.A.Pin(5)

|

||||

leds[2] = gpio.A.Pin(9)

|

||||

|

||||

cfg := &gpio.Config{Mode: gpio.Out, Driver: gpio.OpenDrain}

|

||||

for _, led := range leds {

|

||||

led.Set()

|

||||

led.Setup(cfg)

|

||||

}

|

||||

|

||||

timer = tim.TIM3

|

||||

pclk := timer.Bus().Clock()

|

||||

if pclk < system.AHB.Clock() {

|

||||

pclk *= 2

|

||||

}

|

||||

freq := uint(1e3) // Hz

|

||||

timer.EnableClock(true)

|

||||

timer.PSC.Store(tim.PSC(pclk/freq - 1))

|

||||

timer.ARR.Store(700) // ms

|

||||

timer.DIER.Store(tim.UIE)

|

||||

timer.CR1.Store(tim.CEN)

|

||||

|

||||

rtos.IRQ(irq.TIM3).Enable()

|

||||

}

|

||||

|

||||

func blinky(led gpio.Pin, period int) {

|

||||

for range ch {

|

||||

led.Clear()

|

||||

delay.Millisec(100)

|

||||

led.Set()

|

||||

delay.Millisec(period - 100)

|

||||

}

|

||||

}

|

||||

|

||||

func main() {

|

||||

go blinky(leds[1], 500)

|

||||

blinky(leds[2], 500)

|

||||

}

|

||||

|

||||

func timerISR() {

|

||||

timer.SR.Store(0)

|

||||

leds[0].Set()

|

||||

select {

|

||||

case ch <- 0:

|

||||

// Success

|

||||

default:

|

||||

leds[0].Clear()

|

||||

}

|

||||

}

|

||||

|

||||

//c:__attribute__((section(".ISRs")))

|

||||

var ISRs = [...]func(){

|

||||

irq.TIM3: timerISR,

|

||||

}

|

||||

```

|

||||

|

||||

与之前例子相比较下的不同:

|

||||

|

||||

1. 添加了第三个 LED,并连接到 PA9 引脚(UART 头的 TXD 引脚)。

|

||||

2. 时钟(`TIM3`)作为中断源。

|

||||

3. 新函数 `timerISR` 用来处理 `irq.TIM3` 的中断。

|

||||

4. 新增容量为 1 的缓冲通道是为了 `timerISR` 和 `blinky` 协程之间的通信。

|

||||

5. `ISRs` 数组作为*中断向量表*,是更大的*异常向量表*的一部分。

|

||||

6. `blinky` 中的 `for` 语句被替换成 `range` 语句。

|

||||

|

||||

为了方便起见,所有的 LED,或者说它们的引脚,都被放在 `leds` 这个数组里。另外,所有引脚在被配置为输出之前,都设置为一种已知的初始状态(高电平状态)。

|

||||

|

||||

在这个例子里,我们想让时钟以 1 kHz 的频率运行。为了配置 TIM3 预分频器,我们需要知道它的输入时钟频率。通过参考手册我们知道,输入时钟频率在 `APBCLK = AHBCLK` 时,与 `APBCLK` 相同,反之等于 2 倍的 `APBCLK`。

|

||||

|

||||

如果 CNT 寄存器增加 1 kHz,那么 ARR 寄存器的值等于*更新事件*(重载事件)在毫秒中的计数周期。 为了让更新事件产生中断,必须要设置 DIER 寄存器中的 UIE 位。CEN 位能启动时钟。

|

||||

|

||||

时钟外设在低功耗模式下必须启用,为了自身能在 CPU 处于休眠时保持运行: `timer.EnableClock(true)`。这在 STM32F0 中无关紧要,但对代码可移植性却十分重要。

|

||||

|

||||

`timerISR` 函数处理 `irq.TIM3` 的中断请求。`timer.SR.Store(0)` 会清除 SR 寄存器里的所有事件标志,无效化向 [NVIC][12] 发出的所有中断请求。凭借经验,由于中断请求无效的延时性,需要在程序一开始马上清除所有的中断标志。这避免了无意间再次调用处理。为了确保万无一失,需要先清除标志,再读取,但是在我们的例子中,清除标志就已经足够了。

|

||||

|

||||

下面的这几行代码:

|

||||

|

||||

```

|

||||

select {

|

||||

case ch <- 0:

|

||||

// Success

|

||||

default:

|

||||

leds[0].Clear()

|

||||

}

|

||||

```

|

||||

|

||||

是 Go 语言中,如何在通道上非阻塞地发送消息的方法。中断处理程序无法一直等待通道中的空余空间。如果通道已满,则执行 `default`,开发板上的LED就会开启,直到下一次中断。

|

||||

|

||||

`ISRs` 数组包含了中断向量表。`//c:__attribute__((section(".ISRs")))` 会导致链接器将数组插入到 `.ISRs` 节中。

|

||||

|

||||

`blinky` 的 `for` 循环的新写法:

|

||||

|

||||

```

|

||||

for range ch {

|

||||

led.Clear()

|

||||

delay.Millisec(100)

|

||||

led.Set()

|

||||

delay.Millisec(period - 100)

|

||||

}

|

||||

```

|

||||

|

||||

等价于:

|

||||

|

||||

```

|

||||

for {

|

||||

_, ok := <-ch

|

||||

if !ok {

|

||||

break // Channel closed.

|

||||

}

|

||||

led.Clear()

|

||||

delay.Millisec(100)

|

||||

led.Set()

|

||||

delay.Millisec(period - 100)

|

||||

}

|

||||

```

|

||||

|

||||

注意,在这个例子中,我们不在意通道中收到的值,我们只对其接受到的消息感兴趣。我们可以在声明时,将通道元素类型中的 `int` 用空结构体 `struct{}` 来代替,发送消息时,用 `struct{}{}` 结构体的值代替 0,但这部分对新手来说可能会有些陌生。

|

||||

|

||||

让我们来编译一下代码:

|

||||

|

||||

```

|

||||

$ egc

|

||||

$ arm-none-eabi-size cortexm0.elf

|

||||

text data bss dec hex filename

|

||||

11096 228 188 11512 2cf8 cortexm0.elf

|

||||

```

|

||||

|

||||

新的例子占用了 11324 字节的 Flash 空间,比上一个例子多占用了 1132 字节。

|

||||

|

||||

采用现在的时序,两个闪烁协程从通道中获取数据的速度,比 `timerISR` 发送数据的速度要快。所以它们在同时等待新数据,你还能观察到 `select` 的随机性,这也是 [Go 规范][13]所要求的。

|

||||

|

||||

|

||||

|

||||

开发板上的 LED 一直没有亮起,说明通道从未出现过溢出。

|

||||

|

||||

我们可以加快消息发送的速度,将 `timer.ARR.Store(700)` 改为 `timer.ARR.Store(200)`。 现在 `timerISR` 每秒钟发送 5 条消息,但是两个接收者加起来,每秒也只能接受 4 条消息。

|

||||

|

||||

|

||||

|

||||

正如你所看到的,`timerISR` 开启黄色 LED 灯,意味着通道上已经没有剩余空间了。

|

||||

|

||||

第一部分到这里就结束了。你应该知道,这一部分并未展示 Go 中最重要的部分,接口。

|

||||

|

||||

协程和通道只是一些方便好用的语法。你可以用自己的代码来替换它们,这并不容易,但也可以实现。接口是Go 语言的基础。这是文章中 [第二部分][14]所要提到的.

|

||||

|

||||

在 Flash 上我们还有些剩余空间。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://ziutek.github.io/2018/03/30/go_on_very_small_hardware.html

|

||||

|

||||

作者:[Michał Derkacz][a]

|

||||

译者:[wenwensnow](https://github.com/wenwensnow)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://ziutek.github.io/

|

||||

[1]:https://en.wikipedia.org/wiki/ARM_Cortex-M#Cortex-M0

|

||||

[2]:https://ziutek.github.io/2018/03/30/go_on_very_small_hardware.html

|

||||

[3]:http://www.st.com/content/st_com/en/products/microcontrollers/stm32-32-bit-arm-cortex-mcus/stm32-mainstream-mcus/stm32f0-series/stm32f0x0-value-line/stm32f030f4.html

|

||||

[4]:https://golang.org/

|

||||

[5]:https://github.com/ziutek/emgo

|

||||

[6]:https://github.com/ziutek/emgo/tree/master/egpath/src/stm32/hal

|

||||

[7]:http://www.st.com/resource/en/reference_manual/dm00091010.pdf

|

||||

[8]:https://github.com/ziutek/emgo

|

||||

[9]:https://en.wikipedia.org/wiki/APNG

|

||||

[10]:http://apngasm.sourceforge.net/

|

||||

[11]:https://blog.golang.org/share-memory-by-communicating

|

||||

[12]:http://infocenter.arm.com/help/topic/com.arm.doc.ddi0432c/Cihbecee.html

|

||||

[13]:https://golang.org/ref/spec#Select_statements

|

||||

[14]:https://ziutek.github.io/2018/04/14/go_on_very_small_hardware2.html

|

||||

115

published/20180704 BASHing data- Truncated data items.md

Normal file

115

published/20180704 BASHing data- Truncated data items.md

Normal file

@ -0,0 +1,115 @@

|

||||

如何发现截断的数据项

|

||||

======

|

||||

|

||||

**截断**(形容词):缩写、删节、缩减、剪切、剪裁、裁剪、修剪……

|

||||

|

||||

数据项被截断的一种情况是将其输入到数据库字段中,该字段的字符限制比数据项的长度要短。例如,字符串:

|

||||

|

||||

```

|

||||

Yarrow Ravine Rattlesnake Habitat Area, 2 mi ENE of Yermo CA

|

||||

```

|

||||

|

||||

是 60 个字符长。如果你将其输入到具有 50 个字符限制的“位置”字段,则可以获得:

|

||||

|

||||

```

|

||||

Yarrow Ravine Rattlesnake Habitat Area, 2 mi ENE #末尾带有一个空格

|

||||

```

|

||||

|

||||

截断也可能导致数据错误,比如你打算输入:

|

||||

|

||||

```

|

||||

Sally Ann Hunter (aka Sally Cleveland)

|

||||

```

|

||||

|

||||

但是你忘记了闭合的括号:

|

||||

|

||||

```

|

||||

Sally Ann Hunter (aka Sally Cleveland

|

||||

```

|

||||

|

||||

这会让使用数据的用户觉得 Sally 是否有被修剪掉了数据项的其它的别名。

|

||||

|

||||

截断的数据项很难检测。在审核数据时,我使用三种不同的方法来查找可能的截断,但我仍然可能会错过一些。

|

||||

|

||||

**数据项的长度分布。**第一种方法是捕获我在各个字段中找到的大多数截断的数据。我将字段传递给 `awk` 命令,该命令按字段宽度计算数据项,然后我使用 `sort` 以宽度的逆序打印计数。例如,要检查以 `tab` 分隔的文件 `midges` 中的第 33 个字段:

|

||||

|

||||

```

|

||||

awk -F"\t" 'NR>1 {a[length($33)]++} \

|

||||

END {for (i in a) print i FS a[i]}' midges | sort -nr

|

||||

```

|

||||

|

||||

![distro1][1]

|

||||

|

||||

最长的条目恰好有 50 个字符,这是可疑的,并且在该宽度处存在数据项的“凸起”,这更加可疑。检查这些 50 个字符的项目会发现截断:

|

||||

|

||||

![distro2][2]

|

||||

|

||||

我用这种方式检查的其他数据表有 100、200 和 255 个字符的“凸起”。在每种情况下,这种“凸起”都包含明显的截断。

|

||||

|

||||

**未匹配的括号。**第二种方法查找类似 `...(Sally Cleveland` 的数据项。一个很好的起点是数据表中所有标点符号的统计。这里我检查文件 `mag2`:

|

||||

|

||||

```

|

||||

grep -o "[[:punct:]]" file | sort | uniqc

|

||||

```

|

||||

|

||||

![punct][3]

|

||||

|

||||

请注意,`mag2` 中的开括号和闭括号的数量不相等。要查看发生了什么,我使用 `unmatched` 函数,它接受三个参数并检查数据表中的所有字段。第一个参数是文件名,第二个和第三个是开括号和闭括号,用引号括起来。

|

||||

|

||||

```

|

||||

unmatched()

|

||||

{

|

||||

awk -F"\t" -v start="$2" -v end="$3" \

|

||||

'{for (i=1;i<=NF;i++) \

|

||||

if (split($i,a,start) != split($i,b,end)) \

|

||||

print "line "NR", field "i":\n"$i}' "$1"

|

||||

}

|

||||

```

|

||||

|

||||

如果在字段中找到开括号和闭括号之间不匹配,则 `unmatched` 会报告行号和字段号。这依赖于 `awk` 的 `split` 函数,它返回由分隔符分隔的元素数(包括空格)。这个数字总是比分隔符的数量多一个:

|

||||

|

||||

![split][4]

|

||||

|

||||

这里 `ummatched` 检查 `mag2` 中的圆括号并找到一些可能的截断:

|

||||

|

||||

![unmatched][5]

|

||||

|

||||

我使用 `unmatched` 来找到不匹配的圆括号 `()`、方括号 `[]`、花括号 `{}` 和尖括号 `<>`,但该函数可用于任何配对的标点字符。

|

||||

|

||||

**意外的结尾。**第三种方法查找以尾随空格或非终止标点符号结尾的数据项,如逗号或连字符。这可以在单个字段上用 `cut` 用管道输入到 `grep` 完成,或者用 `awk` 一步完成。在这里,我正在检查以制表符分隔的表 `herp5` 的字段 47,并提取可疑数据项及其行号:

|

||||

|

||||

```

|

||||

cut -f47 herp5 | grep -n "[ ,;:-]$"

|

||||

或

|

||||

awk -F"\t" '$47 ~ /[ ,;:-]$/ {print NR": "$47}' herp5

|

||||

```

|

||||

|

||||

![herps5][6]

|

||||

|

||||

用于制表符分隔文件的 awk 命令的全字段版本是:

|

||||

|

||||

```

|

||||

awk -F"\t" '{for (i=1;i<=NF;i++) if ($i ~ /[ ,;:-]$/) \

|

||||

print "line "NR", field "i":\n"$i}' file

|

||||

```

|

||||

|

||||

**谨慎的想法。**在我对字段进行的验证测试期间也会出现截断。例如,我可能会在“年”的字段中检查合理的 4 位数条目,并且有个 `198` 可能是 198n?还是 1898 年?带有丢失字符的截断数据项是个谜。 作为数据审计员,我只能报告(可能的)字符损失,并建议数据编制者或管理者恢复(可能)丢失的字符。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.polydesmida.info/BASHing/2018-07-04.html

|

||||

|

||||

作者:[polydesmida][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[wxy](https://github.com/wxy)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.polydesmida.info/

|

||||

[1]:https://www.polydesmida.info/BASHing/img1/2018-07-04_1.png

|

||||

[2]:https://www.polydesmida.info/BASHing/img1/2018-07-04_2.png

|

||||

[3]:https://www.polydesmida.info/BASHing/img1/2018-07-04_3.png

|

||||

[4]:https://www.polydesmida.info/BASHing/img1/2018-07-04_4.png

|

||||

[5]:https://www.polydesmida.info/BASHing/img1/2018-07-04_5.png

|

||||

[6]:https://www.polydesmida.info/BASHing/img1/2018-07-04_6.png

|

||||

@ -0,0 +1,141 @@

|

||||

Linux 上 5 个最好 CAD 软件

|

||||

======

|

||||

|

||||

[计算机辅助设计 (CAD)][1] 是很多工程流程的必不可少的部分。CAD 用于建筑、汽车零部件设计、航天飞机研究、航空、桥梁施工、室内设计,甚至服装和珠宝设计等专业领域。

|

||||

|

||||

在 Linux 上并不原生支持一些专业级 CAD 软件,如 SolidWorks 和 Autodesk AutoCAD。因此,今天,我们将看看排名靠前的 Linux 上可用的 CAD 软件。预知详情,请看下文。

|

||||

|

||||

### Linux 可用的最好的 CAD 软件

|

||||

|

||||

![CAD Software for Linux][2]

|

||||

|

||||

在我们查看这份 Linux 的 CAD 软件列表前,你应该记住一件事,在这里不是所有的应用程序都是开源软件。我们也将包含一些非自由和开源软件的 CAD 软件来帮助普通的 Linux 用户。

|

||||

|

||||

我们为基于 Ubuntu 的 Linux 发行版提供了安装操作指南。对于其它发行版,你可以检查相应的网站来了解安装程序步骤。

|

||||

|

||||

该列表没有任何特殊顺序。在第一顺位的 CAD 应用程序不能认为比在第三顺位的好,以此类推。

|

||||

|

||||

#### 1、FreeCAD

|

||||

|

||||

对于 3D 建模,FreeCAD 是一个极好的选择,它是自由 (免费和自由) 和开源软件。FreeCAD 坚持以构建机械工程和产品设计为目标。FreeCAD 是多平台的,可用于 Windows、Mac OS X+ 以及 Linux。

|

||||

|

||||

![freecad][3]

|

||||

|

||||

尽管 FreeCAD 已经是很多 Linux 用户的选择,应该注意到,FreeCAD 仍然是 0.17 版本,因此,不适用于重要的部署。但是最近开发加速了。

|

||||

|

||||

- [FreeCAD][4]

|

||||

|

||||

FreeCAD 并不专注于 direct-2D 绘图和真实形状的动画,但是它对机械工程相关的设计极好。FreeCAD 的 0.15 版本在 Ubuntu 存储库中可用。你可以通过运行下面的命令安装。

|

||||

|

||||

```

|

||||

sudo apt install freecad

|

||||

```

|

||||

|

||||

为获取新的每日构建(目前 0.17),打开一个终端(`ctrl+alt+t`),并逐个运行下面的命令。

|

||||

|

||||

```

|

||||

sudo add-apt-repository ppa:freecad-maintainers/freecad-daily

|

||||

sudo apt update

|

||||

sudo apt install freecad-daily

|

||||

```

|

||||

|

||||

#### 2、LibreCAD

|

||||

|

||||

LibreCAD 是一个自由开源的、2D CAD 解决方案。一般来说,CAD 是一个资源密集型任务,如果你有一个相当普通的硬件,那么我建议你使用 LibreCAD ,因为它在资源使用方面真的轻量化。LibreCAD 是几何图形结构方面的一个极好的候选者。

|

||||

|

||||

![librecad][5]

|

||||

|

||||

作为一个 2D 工具,LibreCAD 是好的,但是它不能在 3D 模型和渲染上工作。它有时可能不稳定,但是,它有一个可靠的自动保存,它不会让你的工作浪费。

|

||||

|

||||

- [LibreCAD][6]

|

||||

|

||||

你可以通过运行下面的命令安装 LibreCAD。

|

||||

|

||||

```

|

||||

sudo apt install librecad

|

||||

```

|

||||

|

||||

#### 3、OpenSCAD

|

||||

|

||||

OpenSCAD 是一个自由的 3D CAD 软件。OpenSCAD 非常轻量和灵活。OpenSCAD 不是交互式的。你需要‘编程’模型,OpenSCAD 来解释这些代码来渲染一个可视化模型。在某种意义上说,它是一个编译器。你不能直接绘制模型,而是描述模型。

|

||||

|

||||

![openscad][7]

|

||||

|

||||

OpenSCAD 是这个列表上最复杂的工具,但是,一旦你了解它,它将提供一个令人愉快的工作经历。

|

||||

|

||||

- [OpenSCAD][8]

|

||||

|

||||

你可以使用下面的命令来安装 OpenSCAD。

|

||||

|

||||

```

|

||||

sudo apt-get install openscad

|

||||

```

|

||||

|

||||

#### 4、BRL-CAD

|

||||

|

||||

BRL-CAD 是最老的 CAD 工具之一。它也深受 Linux/UNIX 用户喜爱,因为它与模块化和自由的 *nix 哲学相一致。

|

||||

|

||||

![BRL-CAD rendering by Sean][9]

|

||||

|

||||

BRL-CAD 始于 1979 年,并且,它仍然在积极开发。现在,BRL-CAD 不是 AutoCAD,但是对于像热穿透和弹道穿透等等的运输研究仍然是一个极好的选择。BRL-CAD 构成 CSG 的基础,而不是边界表示。在选择 BRL-CAD 时,你可能需要记住这一点。你可以从它的官方网站下载 BRL-CAD 。

|

||||

|

||||

- [BRL-CAD][10]

|

||||

|

||||

#### 5、DraftSight (非开源)

|

||||

|

||||

如果你习惯在 AutoCAD 上作业。那么,DraftSight 将是完美的替代。

|

||||

|

||||

DraftSight 是一个在 Linux 上可用的极好的 CAD 工具。它有相当类似于 AutoCAD 的工作流,这使得迁移更容易。它甚至提供一种类似的外观和感觉。DrafSight 也兼容 AutoCAD 的 .dwg 文件格式。 但是,DrafSight 是一个 2D CAD 软件。截至当前,它不支持 3D CAD 。

|

||||

|

||||

![draftsight][11]

|

||||

|

||||

尽管 DrafSight 是一款起价 149 美元的商业软件。在 [DraftSight 网站][12]上可获得一个免费版本。你可以下载 .deb 软件包,并在基于 Ubuntu 的发行版上安装它。为了开始使用 DraftSight ,你需要使用你的电子邮件 ID 来注册你的免费版本。

|

||||

|

||||

- [DraftSight][12]

|

||||

|

||||

#### 荣誉提名

|

||||

|

||||

* 随着云计算技术的巨大发展,像 [OnShape][13] 的云 CAD 解决方案已经变得日渐流行。

|

||||

* [SolveSpace][14] 是另一个值得一提的开源软件项目。它支持 3D 模型。

|

||||

* 西门子 NX 是一个在 Windows、Mac OS 及 Linux 上可用的工业级 CAD 解决方案,但是它贵得离谱,所以,在这个列表中被忽略。

|

||||

* 接下来,你有 [LeoCAD][15],它是一个 CAD 软件,在软件中你使用乐高积木来构建东西。你使用这些信息做些什么取决于你。

|

||||

|

||||

### 我对 Linux 上的 CAD 的看法

|

||||

|

||||

尽管在 Linux 上游戏变得流行,我总是告诉我的铁杆游戏朋友坚持使用 Windows。类似地,如果你是一名在你是课程中使用 CAD 的工科学生,我建议你使用学校规定的软件 (AutoCAD、SolidEdge、Catia),这些软件通常只在 Windows 上运行。

|

||||

|

||||

对于高级专业人士来说,当我们讨论行业标准时,这些工具根本达不到标准。

|

||||

|

||||

对于想在 WINE 中运行 AutoCAD 的那些人来说,尽管一些较旧版本的 AutoCAD 可以安装在 WINE 上,它们根本不执行工作,小故障和崩溃严重损害这些体验。

|

||||

|

||||

话虽如此,我高度尊重上述列表中软件的开发者的工作。他们丰富了 FOSS 世界。很高兴看到像 FreeCAD 一样的软件在近些年中加速开发速度。

|

||||

|

||||

好了,今天到此为止。使用下面的评论区与我们分享你的想法,不用忘记分享这篇文章。谢谢。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://itsfoss.com/cad-software-linux/

|

||||

|

||||

作者:[Aquil Roshan][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[robsean](https://github.com/robsean)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://itsfoss.com/author/aquil/

|

||||

[1]:https://en.wikipedia.org/wiki/Computer-aided_design

|

||||

[2]:https://i1.wp.com/itsfoss.com/wp-content/uploads/2018/08/cad-software-linux.jpeg

|

||||

[3]:https://i1.wp.com/itsfoss.com/wp-content/uploads/2018/07/freecad.jpg

|

||||

[4]:https://www.freecadweb.org/

|

||||

[5]:https://i1.wp.com/itsfoss.com/wp-content/uploads/2018/07/librecad.jpg

|

||||

[6]:https://librecad.org/

|

||||

[7]:https://i1.wp.com/itsfoss.com/wp-content/uploads/2018/07/openscad.jpg

|

||||

[8]:http://www.openscad.org/

|

||||

[9]:https://i1.wp.com/itsfoss.com/wp-content/uploads/2018/07/brlcad.jpg

|

||||

[10]:https://brlcad.org/

|

||||

[11]:https://i1.wp.com/itsfoss.com/wp-content/uploads/2018/07/draftsight.jpg

|

||||

[12]:https://www.draftsight2018.com/

|

||||

[13]:https://www.onshape.com/

|

||||

[14]:http://solvespace.com/index.pl

|

||||

[15]:https://www.leocad.org/

|

||||

@ -0,0 +1,89 @@

|

||||

区块链能如何补充开源

|

||||

======

|

||||

|

||||

> 了解区块链如何成为去中心化的开源补贴模型。

|

||||

|

||||

|

||||

|

||||

《<ruby>[大教堂与集市][1]<rt>The Cathedral and The Bazaar</rt></ruby>》是 20 年前由<ruby>埃里克·史蒂文·雷蒙德<rt>Eric Steven Raymond<rt></ruby>(ESR)撰写的经典开源故事。在这个故事中,ESR 描述了一种新的革命性的软件开发模型,其中复杂的软件项目是在没有(或者很少的)集中管理的情况下构建的。这个新模型就是<ruby>开源<rt>open source</rt></ruby>。

|

||||

|

||||

ESR 的故事比较了两种模式:

|

||||

|

||||

* 经典模型(由“大教堂”所代表),其中软件由一小群人在封闭和受控的环境中通过缓慢而稳定的发布制作而成。

|

||||

* 以及新模式(由“集市”所代表),其中软件是在开放的环境中制作的,个人可以自由参与,但仍然可以产生一个稳定和连贯的系统。

|

||||

|

||||

开源如此成功的一些原因可以追溯到 ESR 所描述的创始原则。尽早发布、经常发布,并接受许多头脑必然比一个更好的事实,让开源项目进入全世界的人才库(很少有公司能够使用闭源模式与之匹敌)。

|

||||

|

||||

在 ESR 对黑客社区的反思分析 20 年后,我们看到开源成为占据主导地位的的模式。它不再仅仅是为了满足开发人员的个人喜好,而是创新发生的地方。甚至是全球[最大][2]软件公司也正在转向这种模式,以便继续占据主导地位。

|

||||

|

||||

### 易货系统

|

||||

|

||||

如果我们仔细研究开源模型在实践中的运作方式,我们就会意识到它是一个封闭系统,只对开源开发者和技术人员开放。影响项目方向的唯一方法是加入开源社区,了解成文和不成文的规则,学习如何贡献、编码标准等,并自己亲力完成。

|

||||

|

||||

这就是集市的运作方式,也是这个易货系统类比的来源。易货系统是一种交换服务和货物以换取其他服务和货物的方法。在市场中(即软件的构建地)这意味着为了获取某些东西,你必须自己也是一个生产者并回馈一些东西——那就是通过交换你的时间和知识来完成任务。集市是开源开发者与其他开源开发者交互并以开源方式生成开源软件的地方。

|

||||

|

||||

易货系统向前迈出了一大步,从自给自足的状态演变而来,而在自给自足的状态下,每个人都必须成为所有行业的杰出人选。使用易货系统的集市(开源模式)允许具有共同兴趣和不同技能的人们收集、协作和创造个人无法自行创造的东西。易货系统简单,没有现代货币系统那么复杂,但也有一些局限性,例如:

|

||||

|

||||

* 缺乏可分性:在没有共同的交换媒介的情况下,不能将较大的不可分割的商品/价值兑换成较小的商品/价值。例如,如果你想在开源项目中进行一些哪怕是小的更改,有时你可能仍需要经历一个高进入门槛。

|

||||

* 存储价值:如果一个项目对贵公司很重要,你可能需要投入大量投资/承诺。但由于它是开源开发者之间的易货系统,因此拥有强大发言权的唯一方法是雇佣许多开源贡献者,但这并非总是可行的。

|

||||

* 转移价值:如果你投资了一个项目(受过培训的员工、雇用开源开发者)并希望将重点转移到另一个项目,却不可能快速转移(你在上一个项目中拥有的)专业知识、声誉和影响力。

|

||||

* 时间脱钩:易货系统没有为延期或提前承诺提供良好的机制。在开源世界中,这意味着用户无法提前或在未来期间以可衡量的方式表达对项目的承诺或兴趣。

|

||||

|

||||

下面,我们将探讨如何使用集市的后门解决这些限制。

|

||||

|

||||

### 货币系统

|

||||

|

||||

人们因为不同的原因勾连于集市上:有些人在那里学习,有些是出于满足开发者个人的喜好,有些人为大型软件工厂工作。因为在集市中拥有发言权的唯一方法是成为开源社区的一份子并加入这个易货系统,为了在开源世界获得信誉,许多大型软件公司雇用这些开发者并以货币方式支付薪酬。这代表可以使用货币系统来影响集市,开源不再只是为了满足开发者个人的喜好,它也占据全球整体软件生产的重要部分,并且有许多人想要施加影响。

|

||||

|

||||

开源设定了开发人员交互的指导原则,并以分布式方式构建一致的系统。它决定了项目的治理方式、软件的构建方式以及其成果如何分发给用户。它是分散的实体共同构建高质量软件的开放共识模型。但是开源模型并没有包括如何补贴开源的部分,无论是直接还是间接地,通过内在或外在动机的赞助,都与集市无关。

|

||||

|

||||

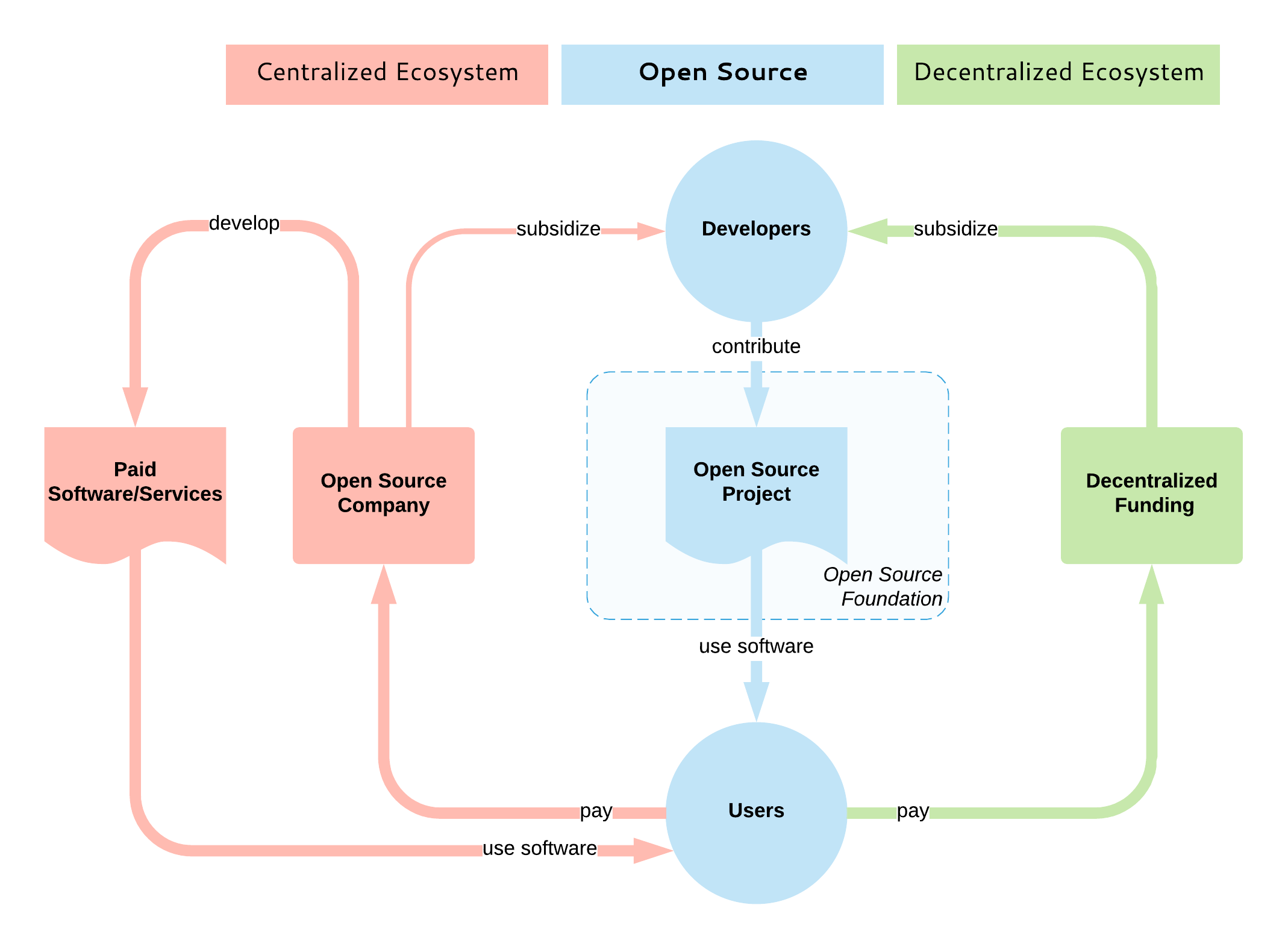

|

||||

|

||||

目前,没有相当于以补贴为目的的去中心化式开源开发模型。大多数开源补贴都是集中式的,通常一家公司通过雇用该项目的主要开源开发者来主导该项目。说实话,这是目前最好的状况,因为它保证了开发人员将长期获得报酬,项目也将继续蓬勃发展。

|

||||

|

||||

项目垄断情景也有例外情况:例如,一些云原生计算基金会(CNCF)项目是由大量的竞争公司开发的。此外,Apache 软件基金会(ASF)旨在通过鼓励不同的贡献者来使他们管理的项目不被单一供应商所主导,但实际上大多数受欢迎的项目仍然是单一供应商项目。

|

||||

|

||||

我们缺少的是一个开放的、去中心化的模式,就像一个没有集中协调和所有权的集市一样,消费者(开源用户)和生产者(开源开发者)在市场力量和开源价值的驱动下相互作用。为了补充开源,这样的模型也必须是开放和去中心化的,这就是为什么我认为区块链技术[最适合][3]的原因。

|

||||

|

||||

旨在补贴开源开发的大多数现有区块链(和非区块链)平台主要针对的是漏洞赏金、小型和零碎的任务。少数人还专注于资助新的开源项目。但并没有多少平台旨在提供维持开源项目持续开发的机制 —— 基本上,这个系统可以模仿开源服务提供商公司或开放核心、基于开源的 SaaS 产品公司的行为:确保开发人员可以获得持续和可预测的激励,并根据激励者(即用户)的优先事项指导项目开发。这种模型将解决上面列出的易货系统的局限性:

|

||||

|

||||

* 允许可分性:如果你想要一些小的修复,你可以支付少量费用,而不是成为项目的开源开发者的全部费用。

|

||||

* 存储价值:你可以在项目中投入大量资金,并确保其持续发展和你的发言权。

|

||||

* 转移价值:在任何时候,你都可以停止投资项目并将资金转移到其他项目中。

|

||||

* 时间脱钩:允许定期定期付款和订阅。

|

||||

|

||||

还有其他好处,纯粹是因为这种基于区块链的系统是透明和去中心化的:根据用户的承诺、开放的路线图承诺、去中心化决策等来量化项目的价值/实用性。

|

||||

|

||||

### 总结

|

||||

|

||||

一方面,我们看到大公司雇用开源开发者并收购开源初创公司甚至基础平台(例如微软收购 GitHub)。许多(甚至大多数)能够长期成功运行的开源项目都集中在单个供应商周围。开源的重要性及其集中化是一个事实。

|

||||

|

||||

另一方面,[维持开源软件][4]的挑战正变得越来越明显,许多人正在更深入地研究这个领域及其基本问题。有一些项目具有很高的知名度和大量的贡献者,但还有许多其他也重要的项目缺乏足够的贡献者和维护者。

|

||||

|

||||

有[许多努力][3]试图通过区块链来解决开源的挑战。这些项目应提高透明度、去中心化和补贴,并在开源用户和开发人员之间建立直接联系。这个领域还很年轻,但是进展很快,随着时间的推移,集市将会有一个加密货币系统。

|

||||

|

||||

如果有足够的时间和足够的技术,去中心化就会发生在很多层面:

|

||||

|

||||

* 互联网是一种去中心化的媒介,它释放了全球分享和获取知识的潜力。

|

||||

* 开源是一种去中心化的协作模式,它释放了全球的创新潜力。

|

||||

* 同样,区块链可以补充开源,成为去中心化的开源补贴模式。

|

||||

|

||||

请在[推特][5]上关注我在这个领域的其他帖子。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/9/barter-currency-system

|

||||

|

||||

作者:[Bilgin lbryam][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[wxy](https://github.com/wxy)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://opensource.com/users/bibryam

|

||||

[1]: http://catb.org/

|

||||

[2]: http://oss.cash/

|

||||

[3]: https://opensource.com/article/18/8/open-source-tokenomics

|

||||

[4]: https://www.youtube.com/watch?v=VS6IpvTWwkQ

|

||||

[5]: http://twitter.com/bibryam

|

||||

48

published/20181113 Eldoc Goes Global.md

Normal file

48

published/20181113 Eldoc Goes Global.md

Normal file

@ -0,0 +1,48 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (lujun9972)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-11306-1.html)

|

||||

[#]: subject: (Eldoc Goes Global)

|

||||

[#]: via: (https://emacsredux.com/blog/2018/11/13/eldoc-goes-global/)

|

||||

[#]: author: (Bozhidar Batsov https://emacsredux.com)

|

||||

|

||||

Emacs:Eldoc 全局化了

|

||||

======

|

||||

|

||||

|

||||

|

||||

最近我注意到 Emacs 25.1 增加了一个名为 `global-eldoc-mode` 的模式,它是流行的 `eldoc-mode` 的一个全局化的变体。而且与 `eldoc-mode` 不同的是,`global-eldoc-mode` 默认是开启的!

|

||||

|

||||

这意味着你可以删除 Emacs 配置中为主模式开启 `eldoc-mode` 的代码了:

|

||||

|

||||

```

|

||||

;; That code is now redundant

|

||||

(add-hook 'emacs-lisp-mode-hook #'eldoc-mode)

|

||||

(add-hook 'ielm-mode-hook #'eldoc-mode)

|

||||

(add-hook 'cider-mode-hook #'eldoc-mode)

|

||||

(add-hook 'cider-repl-mode-hook #'eldoc-mode)

|

||||

```

|

||||

|

||||

[有人说][1] `global-eldoc-mode` 在某些不支持的模式中会有性能问题。我自己从未遇到过,但若你像禁用它则只需要这样:

|

||||

|

||||

```

|

||||

(global-eldoc-mode -1)

|

||||

```

|

||||

|

||||

现在是时候清理我的配置了!删除代码就是这么爽!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://emacsredux.com/blog/2018/11/13/eldoc-goes-global/

|

||||

|

||||

作者:[Bozhidar Batsov][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[lujun9972](https://github.com/lujun9972)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://emacsredux.com

|

||||

[b]: https://github.com/lujun9972

|

||||

[1]: https://emacs.stackexchange.com/questions/31414/how-to-globally-disable-eldoc

|

||||

252

published/20181227 Linux commands for measuring disk activity.md

Normal file

252

published/20181227 Linux commands for measuring disk activity.md

Normal file

@ -0,0 +1,252 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (laingke)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-11387-1.html)

|

||||

[#]: subject: (Linux commands for measuring disk activity)

|

||||

[#]: via: (https://www.networkworld.com/article/3330497/linux/linux-commands-for-measuring-disk-activity.html)

|

||||

[#]: author: (Sandra Henry-Stocker https://www.networkworld.com/author/Sandra-Henry_Stocker/)

|

||||

|

||||

用于测量磁盘活动的 Linux 命令

|

||||

======

|

||||

> Linux 发行版提供了几个度量磁盘活动的有用命令。让我们了解一下其中的几个。

|

||||

|

||||

|

||||

|

||||

Linux 系统提供了一套方便的命令,帮助你查看磁盘有多忙,而不仅仅是磁盘有多满。在本文中,我们将研究五个非常有用的命令,用于查看磁盘活动。其中两个命令(`iostat` 和 `ioping`)可能必须添加到你的系统中,这两个命令一样要求你使用 sudo 特权,所有这五个命令都提供了查看磁盘活动的有用方法。

|

||||

|

||||

这些命令中最简单、最直观的一个可能是 `dstat` 了。

|

||||

|

||||

### dtstat

|

||||

|

||||

尽管 `dstat` 命令以字母 “d” 开头,但它提供的统计信息远远不止磁盘活动。如果你只想查看磁盘活动,可以使用 `-d` 选项。如下所示,你将得到一个磁盘读/写测量值的连续列表,直到使用 `CTRL-c` 停止显示为止。注意,在第一个报告信息之后,显示中的每个后续行将在接下来的时间间隔内报告磁盘活动,缺省值仅为一秒。

|

||||

|

||||

```

|

||||

$ dstat -d

|

||||

-dsk/total-

|

||||

read writ

|

||||

949B 73k

|

||||

65k 0 <== first second

|

||||

0 24k <== second second

|

||||

0 16k

|

||||

0 0 ^C

|

||||

```

|

||||

|

||||

在 `-d` 选项后面包含一个数字将把间隔设置为该秒数。

|

||||

|

||||

```

|

||||

$ dstat -d 10

|

||||

-dsk/total-

|

||||

read writ

|

||||

949B 73k

|

||||

65k 81M <== first five seconds

|

||||

0 21k <== second five second

|

||||

0 9011B ^C

|

||||

```

|

||||

|

||||

请注意,报告的数据可能以许多不同的单位显示——例如,M(Mb)、K(Kb)和 B(字节)。

|

||||

|

||||

如果没有选项,`dstat` 命令还将显示许多其他信息——指示 CPU 如何使用时间、显示网络和分页活动、报告中断和上下文切换。

|

||||

|

||||

```

|

||||

$ dstat

|

||||

You did not select any stats, using -cdngy by default.

|

||||

--total-cpu-usage-- -dsk/total- -net/total- ---paging-- ---system--

|

||||

usr sys idl wai stl| read writ| recv send| in out | int csw

|

||||

0 0 100 0 0| 949B 73k| 0 0 | 0 3B| 38 65

|

||||

0 0 100 0 0| 0 0 | 218B 932B| 0 0 | 53 68

|

||||

0 1 99 0 0| 0 16k| 64B 468B| 0 0 | 64 81 ^C

|

||||

```

|

||||

|

||||

`dstat` 命令提供了关于整个 Linux 系统性能的有价值的见解,几乎可以用它灵活而功能强大的命令来代替 `vmstat`、`netstat`、`iostat` 和 `ifstat` 等较旧的工具集合,该命令结合了这些旧工具的功能。要深入了解 `dstat` 命令可以提供的其它信息,请参阅这篇关于 [dstat][1] 命令的文章。

|

||||

|

||||

### iostat

|

||||

|

||||

`iostat` 命令通过观察设备活动的时间与其平均传输速率之间的关系,帮助监视系统输入/输出设备的加载情况。它有时用于评估磁盘之间的活动平衡。

|

||||

|

||||

```

|

||||

$ iostat

|

||||

Linux 4.18.0-041800-generic (butterfly) 12/26/2018 _x86_64_ (2 CPU)

|

||||

|

||||

avg-cpu: %user %nice %system %iowait %steal %idle

|

||||

0.07 0.01 0.03 0.05 0.00 99.85

|

||||

|

||||

Device tps kB_read/s kB_wrtn/s kB_read kB_wrtn

|

||||

loop0 0.00 0.00 0.00 1048 0

|

||||

loop1 0.00 0.00 0.00 365 0

|

||||

loop2 0.00 0.00 0.00 1056 0

|

||||

loop3 0.00 0.01 0.00 16169 0

|

||||

loop4 0.00 0.00 0.00 413 0

|

||||

loop5 0.00 0.00 0.00 1184 0

|

||||

loop6 0.00 0.00 0.00 1062 0

|

||||

loop7 0.00 0.00 0.00 5261 0

|

||||

sda 1.06 0.89 72.66 2837453 232735080

|

||||

sdb 0.00 0.02 0.00 48669 40

|

||||

loop8 0.00 0.00 0.00 1053 0

|

||||

loop9 0.01 0.01 0.00 18949 0

|

||||

loop10 0.00 0.00 0.00 56 0

|

||||

loop11 0.00 0.00 0.00 7090 0

|

||||

loop12 0.00 0.00 0.00 1160 0

|

||||

loop13 0.00 0.00 0.00 108 0

|

||||

loop14 0.00 0.00 0.00 3572 0

|

||||

loop15 0.01 0.01 0.00 20026 0

|

||||

loop16 0.00 0.00 0.00 24 0

|

||||

```

|

||||

|

||||

当然,当你只想关注磁盘时,Linux 回环设备上提供的所有统计信息都会使结果显得杂乱无章。不过,该命令也确实提供了 `-p` 选项,该选项使你可以仅查看磁盘——如以下命令所示。

|

||||

|

||||

```

|

||||

$ iostat -p sda

|

||||

Linux 4.18.0-041800-generic (butterfly) 12/26/2018 _x86_64_ (2 CPU)

|

||||

|

||||

avg-cpu: %user %nice %system %iowait %steal %idle

|

||||

0.07 0.01 0.03 0.05 0.00 99.85

|

||||

|

||||

Device tps kB_read/s kB_wrtn/s kB_read kB_wrtn

|

||||

sda 1.06 0.89 72.54 2843737 232815784

|

||||

sda1 1.04 0.88 72.54 2821733 232815784

|

||||

```

|

||||

|

||||

请注意 `tps` 是指每秒的传输量。

|

||||

|

||||

你还可以让 `iostat` 提供重复的报告。在下面的示例中,我们使用 `-d` 选项每五秒钟进行一次测量。

|

||||

|

||||

```

|

||||

$ iostat -p sda -d 5

|

||||

Linux 4.18.0-041800-generic (butterfly) 12/26/2018 _x86_64_ (2 CPU)

|

||||

|

||||

Device tps kB_read/s kB_wrtn/s kB_read kB_wrtn

|

||||

sda 1.06 0.89 72.51 2843749 232834048

|

||||

sda1 1.04 0.88 72.51 2821745 232834048

|

||||

|

||||

Device tps kB_read/s kB_wrtn/s kB_read kB_wrtn

|

||||

sda 0.80 0.00 11.20 0 56

|

||||

sda1 0.80 0.00 11.20 0 56

|

||||

```

|

||||

|

||||

如果你希望省略第一个(自启动以来的统计信息)报告,请在命令中添加 `-y`。

|

||||

|

||||

```

|

||||

$ iostat -p sda -d 5 -y

|

||||

Linux 4.18.0-041800-generic (butterfly) 12/26/2018 _x86_64_ (2 CPU)

|

||||

|

||||

Device tps kB_read/s kB_wrtn/s kB_read kB_wrtn

|

||||

sda 0.80 0.00 11.20 0 56

|

||||

sda1 0.80 0.00 11.20 0 56

|

||||

```

|

||||

|

||||

接下来,我们看第二个磁盘驱动器。

|

||||

|

||||

```

|

||||

$ iostat -p sdb

|

||||

Linux 4.18.0-041800-generic (butterfly) 12/26/2018 _x86_64_ (2 CPU)

|

||||

|

||||

avg-cpu: %user %nice %system %iowait %steal %idle

|

||||

0.07 0.01 0.03 0.05 0.00 99.85

|

||||

|

||||

Device tps kB_read/s kB_wrtn/s kB_read kB_wrtn

|

||||

sdb 0.00 0.02 0.00 48669 40

|

||||

sdb2 0.00 0.00 0.00 4861 40

|

||||

sdb1 0.00 0.01 0.00 35344 0

|

||||

```

|

||||

|

||||

### iotop

|

||||

|

||||

`iotop` 命令是类似 `top` 的实用程序,用于查看磁盘 I/O。它收集 Linux 内核提供的 I/O 使用信息,以便你了解哪些进程在磁盘 I/O 方面的要求最高。在下面的示例中,循环时间被设置为 5 秒。显示将自动更新,覆盖前面的输出。

|

||||

|

||||

```

|

||||

$ sudo iotop -d 5

|

||||

Total DISK READ: 0.00 B/s | Total DISK WRITE: 1585.31 B/s

|

||||

Current DISK READ: 0.00 B/s | Current DISK WRITE: 12.39 K/s

|

||||

TID PRIO USER DISK READ DISK WRITE SWAPIN IO> COMMAND

|

||||

32492 be/4 root 0.00 B/s 0.00 B/s 0.00 % 0.12 % [kworker/u8:1-ev~_power_efficient]

|

||||

208 be/3 root 0.00 B/s 1585.31 B/s 0.00 % 0.11 % [jbd2/sda1-8]

|

||||

1 be/4 root 0.00 B/s 0.00 B/s 0.00 % 0.00 % init splash

|

||||

2 be/4 root 0.00 B/s 0.00 B/s 0.00 % 0.00 % [kthreadd]

|

||||

3 be/0 root 0.00 B/s 0.00 B/s 0.00 % 0.00 % [rcu_gp]

|

||||

4 be/0 root 0.00 B/s 0.00 B/s 0.00 % 0.00 % [rcu_par_gp]

|

||||

8 be/0 root 0.00 B/s 0.00 B/s 0.00 % 0.00 % [mm_percpu_wq]

|

||||

```

|

||||

|

||||

### ioping

|

||||

|

||||

`ioping` 命令是一种完全不同的工具,但是它可以报告磁盘延迟——也就是磁盘响应请求需要多长时间,而这有助于诊断磁盘问题。

|

||||

|

||||

```

|

||||

$ sudo ioping /dev/sda1

|

||||

4 KiB <<< /dev/sda1 (block device 111.8 GiB): request=1 time=960.2 us (warmup)

|

||||

4 KiB <<< /dev/sda1 (block device 111.8 GiB): request=2 time=841.5 us

|

||||

4 KiB <<< /dev/sda1 (block device 111.8 GiB): request=3 time=831.0 us

|

||||

4 KiB <<< /dev/sda1 (block device 111.8 GiB): request=4 time=1.17 ms

|

||||

^C

|

||||

--- /dev/sda1 (block device 111.8 GiB) ioping statistics ---

|

||||

3 requests completed in 2.84 ms, 12 KiB read, 1.05 k iops, 4.12 MiB/s

|

||||

generated 4 requests in 3.37 s, 16 KiB, 1 iops, 4.75 KiB/s

|

||||

min/avg/max/mdev = 831.0 us / 947.9 us / 1.17 ms / 158.0 us

|

||||

```

|

||||

|

||||

### atop

|

||||

|

||||

`atop` 命令,像 `top` 一样提供了大量有关系统性能的信息,包括有关磁盘活动的一些统计信息。

|

||||

|

||||

```

|

||||

ATOP - butterfly 2018/12/26 17:24:19 37d3h13m------ 10ed

|

||||

PRC | sys 0.03s | user 0.01s | #proc 179 | #zombie 0 | #exit 6 |

|

||||

CPU | sys 1% | user 0% | irq 0% | idle 199% | wait 0% |

|

||||

cpu | sys 1% | user 0% | irq 0% | idle 99% | cpu000 w 0% |

|

||||

CPL | avg1 0.00 | avg5 0.00 | avg15 0.00 | csw 677 | intr 470 |

|

||||

MEM | tot 5.8G | free 223.4M | cache 4.6G | buff 253.2M | slab 394.4M |

|

||||

SWP | tot 2.0G | free 2.0G | | vmcom 1.9G | vmlim 4.9G |

|

||||

DSK | sda | busy 0% | read 0 | write 7 | avio 1.14 ms |

|

||||

NET | transport | tcpi 4 | tcpo stall 8 | udpi 1 | udpo 0swout 2255 |

|

||||

NET | network | ipi 10 | ipo 7 | ipfrw 0 | deliv 60.67 ms |

|

||||

NET | enp0s25 0% | pcki 10 | pcko 8 | si 1 Kbps | so 3 Kbp0.73 ms |

|

||||

|

||||

PID SYSCPU USRCPU VGROW RGROW ST EXC THR S CPUNR CPU CMD 1/1673e4 |

|

||||

3357 0.01s 0.00s 672K 824K -- - 1 R 0 0% atop

|

||||

3359 0.01s 0.00s 0K 0K NE 0 0 E - 0% <ps>

|

||||

3361 0.00s 0.01s 0K 0K NE 0 0 E - 0% <ps>

|

||||

3363 0.01s 0.00s 0K 0K NE 0 0 E - 0% <ps>

|

||||

31357 0.00s 0.00s 0K 0K -- - 1 S 1 0% bash

|

||||

3364 0.00s 0.00s 8032K 756K N- - 1 S 1 0% sleep

|

||||

2931 0.00s 0.00s 0K 0K -- - 1 I 1 0% kworker/u8:2-e

|

||||

3356 0.00s 0.00s 0K 0K -E 0 0 E - 0% <sleep>

|

||||

3360 0.00s 0.00s 0K 0K NE 0 0 E - 0% <sleep>

|

||||

3362 0.00s 0.00s 0K 0K NE 0 0 E - 0% <sleep>

|

||||

```

|

||||

|

||||

如果你*只*想查看磁盘统计信息,则可以使用以下命令轻松进行管理:

|

||||

|

||||

```

|

||||

$ atop | grep DSK

|

||||

DSK | sda | busy 0% | read 122901 | write 3318e3 | avio 0.67 ms |

|

||||

DSK | sdb | busy 0% | read 1168 | write 103 | avio 0.73 ms |

|

||||

DSK | sda | busy 2% | read 0 | write 92 | avio 2.39 ms |

|

||||

DSK | sda | busy 2% | read 0 | write 94 | avio 2.47 ms |

|

||||

DSK | sda | busy 2% | read 0 | write 99 | avio 2.26 ms |

|

||||

DSK | sda | busy 2% | read 0 | write 94 | avio 2.43 ms |

|

||||

DSK | sda | busy 2% | read 0 | write 94 | avio 2.43 ms |

|

||||

DSK | sda | busy 2% | read 0 | write 92 | avio 2.43 ms |

|

||||

^C

|

||||

```

|

||||

|

||||

### 了解磁盘 I/O

|

||||

|

||||

Linux 提供了足够的命令,可以让你很好地了解磁盘的工作强度,并帮助你关注潜在的问题或减缓。希望这些命令中的一个可以告诉你何时需要质疑磁盘性能。偶尔使用这些命令将有助于确保当你需要检查磁盘,特别是忙碌或缓慢的磁盘时可以显而易见地发现它们。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.networkworld.com/article/3330497/linux/linux-commands-for-measuring-disk-activity.html

|

||||

|

||||

作者:[Sandra Henry-Stocker][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[laingke](https://github.com/laingke)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://www.networkworld.com/author/Sandra-Henry_Stocker/

|

||||

[b]: https://github.com/lujun9972

|

||||

[1]: https://www.networkworld.com/article/3291616/linux/examining-linux-system-performance-with-dstat.html

|

||||

[2]: https://www.facebook.com/NetworkWorld/

|

||||

[3]: https://www.linkedin.com/company/network-world

|

||||

@ -0,0 +1,227 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (laingke)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-11373-1.html)

|

||||

[#]: subject: (Create an online store with this Java-based framework)

|

||||

[#]: via: (https://opensource.com/article/19/1/scipio-erp)

|

||||

[#]: author: (Paul Piper https://opensource.com/users/madppiper)

|

||||

|

||||

使用 Java 框架 Scipio ERP 创建一个在线商店

|

||||

======

|

||||

|

||||

> Scipio ERP 具有包罗万象的应用程序和功能。

|

||||

|

||||

|

||||

|

||||

如果,你想在网上销售产品或服务,但要么找不到合适的软件,要么觉得定制成本太高?那么,[Scipio ERP][1] 也许正是你想要的。

|

||||

|

||||

Scipio ERP 是一个基于 Java 的开源的电子商务框架,具有包罗万象的应用程序和功能。这个项目于 2014 年从 [Apache OFBiz][2] 分叉而来,侧重于更好的定制和更现代的吸引力。这个电子商务组件非常丰富,可以在多商店环境中工作,同时支持国际化,具有琳琅满目的产品配置,而且它还兼容现代 HTML 框架。该软件还为许多其他业务场景提供标准应用程序,例如会计、仓库管理或销售团队自动化。它都是高度标准化的,因此易于定制,如果你想要的不仅仅是一个虚拟购物车,这是非常棒的。

|

||||

|

||||

该系统也使得跟上现代 Web 标准变得非常容易。所有界面都是使用系统的“[模板工具包][3]”构建的,这是一个易于学习的宏集,可以将 HTML 与所有应用程序分开。正因为如此,每个应用程序都已经标准化到核心。听起来令人困惑?它真的不是 HTML——它看起来很像 HTML,但你写的内容少了很多。

|

||||

|

||||

### 初始安装

|

||||

|

||||

在你开始之前,请确保你已经安装了 Java 1.8(或更高版本)的 SDK 以及一个 Git 客户端。完成了?太棒了!接下来,切换到 Github 上的主分支:

|

||||

|

||||

```

|

||||

git clone https://github.com/ilscipio/scipio-erp.git

|

||||

cd scipio-erp

|

||||

git checkout master

|

||||

```

|

||||

|

||||

要安装该系统,只需要运行 `./install.sh` 并从命令行中选择任一选项。在开发过程中,最好一直使用 “installation for development”(选项 1),它还将安装一系列演示数据。对于专业安装,你可以修改初始配置数据(“种子数据”),以便自动为你设置公司和目录数据。默认情况下,系统将使用内部数据库运行,但是它[也可以配置][4]使用各种关系数据库,比如 PostgreSQL 和 MariaDB 等。

|

||||

|

||||

![安装向导][6]

|

||||

|

||||

*按照安装向导完成初始配置*

|

||||

|

||||

通过命令 `./start.sh` 启动系统然后打开链接 <https://localhost:8443/setup/> 完成配置。如果你安装了演示数据, 你可以使用用户名 `admin` 和密码 `scipio` 进行登录。在安装向导中,你可以设置公司简介、会计、仓库、产品目录、在线商店和额外的用户配置信息。暂时在产品商店配置界面上跳过网站实体的配置。系统允许你使用不同的底层代码运行多个在线商店;除非你想这样做,一直选择默认值是最简单的。

|

||||

|

||||

祝贺你,你刚刚安装了 Scipio ERP!在界面上操作一两分钟,感受一下它的功能。

|

||||

|

||||

### 捷径

|

||||

|

||||

在你进入自定义之前,这里有一些方便的命令可以帮助你:

|

||||

|

||||

* 创建一个 shop-override:`./ant create-component-shop-override`

|

||||

* 创建一个新组件:`./ant create-component`

|

||||

* 创建一个新主题组件:`./ant create-theme`

|

||||

* 创建管理员用户:`./ant create-admin-user-login`

|

||||

* 各种其他实用功能:`./ant -p`

|

||||

* 用于安装和更新插件的实用程序:`./git-addons help`

|

||||

|

||||

另外,请记下以下位置:

|

||||

|

||||

* 将 Scipio 作为服务运行的脚本:`/tools/scripts/`

|

||||

* 日志输出目录:`/runtime/logs`

|

||||

* 管理应用程序:`<https://localhost:8443/admin/>`

|

||||

* 电子商务应用程序:`<https://localhost:8443/shop/>`

|

||||

|

||||

最后,Scipio ERP 在以下五个主要目录中构建了所有代码:

|

||||

|

||||

* `framework`: 框架相关的源,应用程序服务器,通用界面和配置

|

||||

* `applications`: 核心应用程序

|

||||

* `addons`: 第三方扩展

|

||||

* `themes`: 修改界面外观

|

||||

* `hot-deploy`: 你自己的组件

|

||||

|

||||

除了一些配置,你将在 `hot-deploy` 和 `themes` 目录中进行开发。

|

||||

|

||||

### 在线商店定制

|

||||

|

||||