`。 例如,要将文件 `example.txt` 移到你的 `Documents` 目录中:

+

+```

+$ touch example.txt

+$ mv example.txt ~/Documents

+$ ls ~/Documents

+example.txt

+```

+

+就像你通过将文件拖放到文件夹图标上来移动文件一样,此命令不会将 `Documents` 替换为 `example.txt`。相反,`mv` 会检测到 `Documents` 是一个文件夹,并将 `example.txt` 文件放入其中。

+

+你还可以方便地在移动文件时重命名该文件:

+

+```

+$ touch example.txt

+$ mv example.txt ~/Documents/foo.txt

+$ ls ~/Documents

+foo.txt

+```

+

+这很重要,这使你不用将文件移动到另一个位置,也可以重命名文件,例如:

+

+```

+$ touch example.txt

+$ mv example.txt foo2.txt

+$ ls foo2.txt`

+```

+

+#### 移动目录

+

+不像 [cp][8] 命令,`mv` 命令处理文件和目录没有什么不同,你可以用同样的格式移动目录或文件:

+

+```

+$ touch file.txt

+$ mkdir foo_directory

+$ mv file.txt foo_directory

+$ mv foo_directory ~/Documents

+```

+

+#### 安全地移动文件

+

+如果你移动一个文件到一个已有同名文件的地方,默认情况下,`mv` 会用你移动的文件替换目标文件。这种行为被称为清除,有时候这就是你想要的结果,而有时则不是。

+

+一些发行版将 `mv` 别名定义为 `mv --interactive`(你也可以[自己写一个][9]),这会提醒你确认是否覆盖。而另外一些发行版没有这样做,那么你可以使用 `--interactive` 或 `-i` 选项来确保当两个文件有一样的名字而发生冲突时让 `mv` 请你来确认。

+

+```

+$ mv --interactive example.txt ~/Documents

+mv: overwrite '~/Documents/example.txt'?

+```

+

+如果你不想手动干预,那么可以使用 `--no-clobber` 或 `-n`。该选项会在发生冲突时静默拒绝移动操作。在这个例子当中,一个名为 `example.txt` 的文件以及存在于 `~/Documents`,所以它不会如命令要求从当前目录移走。

+

+```

+$ mv --no-clobber example.txt ~/Documents

+$ ls

+example.txt

+```

+

+#### 带备份的移动

+

+如果你使用 GNU `mv`,有一个备份选项提供了另外一种安全移动的方式。要为任何冲突的目标文件创建备份文件,可以使用 `-b` 选项。

+

+```

+$ mv -b example.txt ~/Documents

+$ ls ~/Documents

+example.txt example.txt~

+```

+

+这个选项可以确保 `mv` 完成移动操作,但是也会保护目录位置的已有文件。

+

+另外的 GNU 备份选项是 `--backup`,它带有一个定义了备份文件如何命名的参数。

+

+* `existing`:如果在目标位置已经存在了编号备份文件,那么会创建编号备份。否则,会使用 `simple` 方式。

+* `none`:即使设置了 `--backup`,也不会创建备份。当 `mv` 被别名定义为带有备份选项时,这个选项可以覆盖这种行为。

+* `numbered`:给目标文件名附加一个编号。

+* `simple`:给目标文件附加一个 `~`,当你日常使用带有 `--ignore-backups` 选项的 [ls][2] 时,这些文件可以很方便地隐藏起来。

+

+简单来说:

+

+```

+$ mv --backup=numbered example.txt ~/Documents

+$ ls ~/Documents

+-rw-rw-r--. 1 seth users 128 Aug 1 17:23 example.txt

+-rw-rw-r--. 1 seth users 128 Aug 1 17:20 example.txt.~1~

+```

+

+可以使用环境变量 `VERSION_CONTROL` 设置默认的备份方案。你可以在 `~/.bashrc` 文件中设置该环境变量,也可以在命令前动态设置:

+

+```

+$ VERSION_CONTROL=numbered mv --backup example.txt ~/Documents

+$ ls ~/Documents

+-rw-rw-r--. 1 seth users 128 Aug 1 17:23 example.txt

+-rw-rw-r--. 1 seth users 128 Aug 1 17:20 example.txt.~1~

+-rw-rw-r--. 1 seth users 128 Aug 1 17:22 example.txt.~2~

+```

+

+`--backup` 选项仍然遵循 `--interactive` 或 `-i` 选项,因此即使它在执行备份之前创建了备份,它仍会提示你覆盖目标文件:

+

+```

+$ mv --backup=numbered example.txt ~/Documents

+mv: overwrite '~/Documents/example.txt'? y

+$ ls ~/Documents

+-rw-rw-r--. 1 seth users 128 Aug 1 17:24 example.txt

+-rw-rw-r--. 1 seth users 128 Aug 1 17:20 example.txt.~1~

+-rw-rw-r--. 1 seth users 128 Aug 1 17:22 example.txt.~2~

+-rw-rw-r--. 1 seth users 128 Aug 1 17:23 example.txt.~3~

+```

+

+你可以使用 `--force` 或 `-f` 选项覆盖 `-i`。

+

+```

+$ mv --backup=numbered --force example.txt ~/Documents

+$ ls ~/Documents

+-rw-rw-r--. 1 seth users 128 Aug 1 17:26 example.txt

+-rw-rw-r--. 1 seth users 128 Aug 1 17:20 example.txt.~1~

+-rw-rw-r--. 1 seth users 128 Aug 1 17:22 example.txt.~2~

+-rw-rw-r--. 1 seth users 128 Aug 1 17:24 example.txt.~3~

+-rw-rw-r--. 1 seth users 128 Aug 1 17:25 example.txt.~4~

+```

+

+`--backup` 选项在 BSD `mv` 中不可用。

+

+#### 一次性移动多个文件

+

+移动多个文件时,`mv` 会将最终目录视为目标:

+

+```

+$ mv foo bar baz ~/Documents

+$ ls ~/Documents

+foo bar baz

+```

+

+如果最后一个项目不是目录,则 `mv` 返回错误:

+

+```

+$ mv foo bar baz

+mv: target 'baz' is not a directory

+```

+

+GNU `mv` 的语法相当灵活。如果无法把目标目录作为提供给 `mv` 命令的最终参数,请使用 `--target-directory` 或 `-t` 选项:

+

+```

+$ mv --target-directory=~/Documents foo bar baz

+$ ls ~/Documents

+foo bar baz

+```

+

+当从某些其他命令的输出构造 `mv` 命令时(例如 `find` 命令、`xargs` 或 [GNU Parallel][10]),这特别有用。

+

+#### 基于修改时间移动

+

+使用 GNU `mv`,你可以根据要移动的文件是否比要替换的目标文件新来定义移动动作。该方式可以通过 `--update` 或 `-u` 选项使用,在BSD `mv` 中不可用:

+

+```

+$ ls -l ~/Documents

+-rw-rw-r--. 1 seth users 128 Aug 1 17:32 example.txt

+$ ls -l

+-rw-rw-r--. 1 seth users 128 Aug 1 17:42 example.txt

+$ mv --update example.txt ~/Documents

+$ ls -l ~/Documents

+-rw-rw-r--. 1 seth users 128 Aug 1 17:42 example.txt

+$ ls -l

+```

+

+此结果仅基于文件的修改时间,而不是两个文件的差异,因此请谨慎使用。只需使用 `touch` 命令即可愚弄 `mv`:

+

+```

+$ cat example.txt

+one

+$ cat ~/Documents/example.txt

+one

+two

+$ touch example.txt

+$ mv --update example.txt ~/Documents

+$ cat ~/Documents/example.txt

+one

+```

+

+显然,这不是最智能的更新功能,但是它提供了防止覆盖最新数据的基本保护。

+

+### 移动

+

+除了 `mv` 命令以外,还有更多的移动数据的方法,但是作为这项任务的默认程序,`mv` 是一个很好的通用选择。现在你知道了有哪些可以使用的选项,可以比以前更智能地使用 `mv` 了。

+

+--------------------------------------------------------------------------------

+

+via: https://opensource.com/article/19/8/moving-files-linux-depth

+

+作者:[Seth Kenlon][a]

+选题:[lujun9972][b]

+译者:[wxy](https://github.com/wxy)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://opensource.com/users/sethhttps://opensource.com/users/doni08521059

+[b]: https://github.com/lujun9972

+[1]: https://opensource.com/sites/default/files/styles/image-full-size/public/lead-images/files_documents_paper_folder.png?itok=eIJWac15 (Files in a folder)

+[2]: https://opensource.com/article/19/7/master-ls-command

+[3]: https://opensource.com/sites/default/files/uploads/gnome-mv.jpg (Moving a file in GNOME.)

+[4]: https://opensource.com/sites/default/files/uploads/kde-mv.jpg (Moving a file in KDE.)

+[5]: https://opensource.com/article/19/7/understanding-file-paths-and-how-use-them

+[6]: https://opensource.com/article/19/7/navigating-filesystem-relative-paths

+[7]: https://opensource.com/article/19/7/what-posix-richard-stallman-explains

+[8]: https://opensource.com/article/19/7/copying-files-linux

+[9]: https://opensource.com/article/19/7/bash-aliases

+[10]: https://opensource.com/article/18/5/gnu-parallel

diff --git a/published/20190823 How To Check Your IP Address in Ubuntu -Beginner-s Tip.md b/published/20190823 How To Check Your IP Address in Ubuntu -Beginner-s Tip.md

new file mode 100644

index 0000000000..33084aaa52

--- /dev/null

+++ b/published/20190823 How To Check Your IP Address in Ubuntu -Beginner-s Tip.md

@@ -0,0 +1,112 @@

+[#]: collector: (lujun9972)

+[#]: translator: (geekpi)

+[#]: reviewer: (wxy)

+[#]: publisher: (wxy)

+[#]: url: (https://linux.cn/article-11308-1.html)

+[#]: subject: (How To Check Your IP Address in Ubuntu [Beginner’s Tip])

+[#]: via: (https://itsfoss.com/check-ip-address-ubuntu/)

+[#]: author: (Sergiu https://itsfoss.com/author/sergiu/)

+

+如何在 Ubuntu 中检查你的 IP 地址

+======

+

+不知道你的 IP 地址是什么?以下是在 Ubuntu 和其他 Linux 发行版中检查 IP 地址的几种方法。

+

+![][1]

+

+### 什么是 IP 地址?

+

+**互联网协议地址**(通常称为 **IP 地址**)是分配给连接到计算机网络的每个设备(使用互联网协议)的数字标签。IP 地址用于识别和定位机器。

+

+**IP 地址**在网络中是*唯一的*,使得所有连接设备能够通信。

+

+你还应该知道有两种**类型的 IP 地址**:**公有**和**私有**。**公有 IP 地址**是用于互联网通信的地址,这与你用于邮件的物理地址相同。但是,在本地网络(例如使用路由器的家庭)的环境中,会为每个设备分配在该子网内唯一的**私有 IP 地址**。这在本地网络中使用,而不直接暴露公有 IP(路由器用它与互联网通信)。

+

+另外还有区分 **IPv4** 和 **IPv6** 协议。**IPv4** 是经典的 IP 格式,它由基本的 4 部分结构组成,四个字节用点分隔(例如 127.0.0.1)。但是,随着设备数量的增加,IPv4 很快就无法提供足够的地址。这就是 **IPv6** 被发明的原因,它使用 **128 位地址**的格式(与 **IPv4** 使用的 **32 位地址**相比)。

+

+### 在 Ubuntu 中检查你的 IP 地址(终端方式)

+

+检查 IP 地址的最快和最简单的方法是使用 `ip` 命令。你可以按以下方式使用此命令:

+

+```

+ip addr show

+```

+

+它将同时显示 IPv4 和 IPv6 地址:

+

+![Display IP Address in Ubuntu Linux][2]

+

+实际上,你可以进一步缩短这个命令 `ip a`。它会给你完全相同的结果。

+

+```

+ip a

+```

+

+如果你希望获得最少的细节,也可以使用 `hostname`:

+

+```

+hostname -I

+```

+

+还有一些[在 Linux 中检查 IP 地址的方法][3],但是这两个命令足以满足这个目的。

+

+`ifconfig` 如何?

+

+老用户可能会想要使用 `ifconfig`(net-tools 软件包的一部分),但该程序已被弃用。一些较新的 Linux 发行版不再包含此软件包,如果你尝试运行它,你将看到 ifconfig 命令未找到的错误。

+

+### 在 Ubuntu 中检查你的 IP 地址(GUI 方式)

+

+如果你对命令行不熟悉,你还可以使用图形方式检查 IP 地址。

+

+打开 Ubuntu 应用菜单(在屏幕左下角**显示应用**)并搜索**Settings**,然后单击图标:

+

+![Applications Menu Settings][5]

+

+这应该会打开**设置菜单**。进入**网络**:

+

+![Network Settings Ubuntu][6]

+

+按下连接旁边的**齿轮图标**会打开一个窗口,其中包含更多设置和有关你网络链接的信息,其中包括你的 IP 地址:

+

+![IP Address GUI Ubuntu][7]

+

+### 额外提示:检查你的公共 IP 地址(适用于台式计算机)

+

+首先,要检查你的**公有 IP 地址**(用于与服务器通信),你可以[使用 curl 命令][8]。打开终端并输入以下命令:

+

+```

+curl ifconfig.me

+```

+

+这应该只会返回你的 IP 地址而没有其他多余信息。我建议在分享这个地址时要小心,因为这相当于公布你的个人地址。

+

+**注意:** 如果 `curl` 没有安装,只需使用 `sudo apt install curl -y` 来解决问题,然后再试一次。

+

+另一种可以查看公共 IP 地址的简单方法是在 Google 中搜索 “ip address”。

+

+### 总结

+

+在本文中,我介绍了在 Uuntu Linux 中找到 IP 地址的不同方法,并向你概述了 IP 地址的用途以及它们对我们如此重要的原因。

+

+我希望你喜欢这篇文章。如果你觉得文章有用,请在评论栏告诉我们!

+

+--------------------------------------------------------------------------------

+

+via: https://itsfoss.com/check-ip-address-ubuntu/

+

+作者:[Sergiu][a]

+选题:[lujun9972][b]

+译者:[geekpi](https://github.com/geekpi)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://itsfoss.com/author/sergiu/

+[b]: https://github.com/lujun9972

+[1]: https://i1.wp.com/itsfoss.com/wp-content/uploads/2019/08/checking-ip-address-ubuntu.png?resize=800%2C450&ssl=1

+[2]: https://i1.wp.com/itsfoss.com/wp-content/uploads/2019/08/ip_addr_show.png?fit=800%2C493&ssl=1

+[3]: https://linuxhandbook.com/find-ip-address/

+[5]: https://i2.wp.com/itsfoss.com/wp-content/uploads/2019/08/applications_menu_settings.jpg?fit=800%2C309&ssl=1

+[6]: https://i1.wp.com/itsfoss.com/wp-content/uploads/2019/08/network_settings_ubuntu.jpg?fit=800%2C591&ssl=1

+[7]: https://i1.wp.com/itsfoss.com/wp-content/uploads/2019/08/ip_address_gui_ubuntu.png?fit=800%2C510&ssl=1

+[8]: https://linuxhandbook.com/curl-command-examples/

diff --git a/published/20190823 The Linux kernel- Top 5 innovations.md b/published/20190823 The Linux kernel- Top 5 innovations.md

new file mode 100644

index 0000000000..486270ccfd

--- /dev/null

+++ b/published/20190823 The Linux kernel- Top 5 innovations.md

@@ -0,0 +1,104 @@

+[#]: collector: (lujun9972)

+[#]: translator: (heguangzhi)

+[#]: reviewer: (wxy)

+[#]: publisher: (wxy)

+[#]: url: (https://linux.cn/article-11368-1.html)

+[#]: subject: (The Linux kernel: Top 5 innovations)

+[#]: via: (https://opensource.com/article/19/8/linux-kernel-top-5-innovations)

+[#]: author: (Seth Kenlon https://opensource.com/users/seth)

+

+Linux 内核的五大创新

+======

+

+> 想知道什么是 Linux 内核上真正的(不是那种时髦的)创新吗?

+

+

+

+在科技行业,*创新*这个词几乎和*革命*一样到处泛滥,所以很难将那些夸张的东西与真正令人振奋的东西区分开来。Linux 内核被称为创新,但它又被称为现代计算中最大的奇迹,一个微观世界中的庞然大物。

+

+撇开营销和模式不谈,Linux 可以说是开源世界中最受欢迎的内核,它在近 30 年的生命时光当中引入了一些真正的规则改变者。

+

+### Cgroups(2.6.24)

+

+早在 2007 年,Paul Menage 和 Rohit Seth 就在内核中添加了深奥的[控制组(cgroups)][2]功能(cgroups 的当前实现是由 Tejun Heo 重写的)。这种新技术最初被用作一种方法,从本质上来说,是为了确保一组特定任务的服务质量。

+

+例如,你可以为与你的 WEB 服务相关联的所有任务创建一个控制组定义(cgroup),为例行备份创建另一个 cgroup ,再为一般操作系统需求创建另一个 cgroup。然后,你可以控制每个组的资源百分比,这样你的操作系统和 WEB 服务就可以获得大部分系统资源,而你的备份进程可以访问剩余的资源。

+

+然而,cgroups 如今变得这么著名是因其作为驱动云技术的角色:容器。事实上,cgroups 最初被命名为[进程容器][3]。当它们被 [LXC][4]、[CoreOS][5] 和 Docker 等项目采用时,这并不奇怪。

+

+就像闸门打开后一样,“容器” 一词就像成为了 Linux 的同义词一样,微服务风格的基于云的“应用”概念很快成为了规范。如今,已经很难摆脱 cgroups 了,它们是如此普遍。每一个大规模的基础设施(如果你运行 Linux 的话,可能还有你的笔记本电脑)都以一种合理的方式使用了 cgroups,这使得你的计算体验比以往任何时候都更加易于管理和灵活。

+

+例如,你可能已经在电脑上安装了 [Flathub][6] 或 [Flatpak][7],或者你已经在工作中使用 [Kubernetes][8] 和/或 [OpenShift][9]。不管怎样,如果“容器”这个术语对你来说仍然模糊不清,则可以 [通过 Linux 容器从背后][10]获得对容器的实际理解。

+

+### LKMM(4.17)

+

+2018 年,Jade Alglave、Alan Stern、Andrea Parri、Luc Maranget、Paul McKenney 以及其他几个人的辛勤工作的成果被合并到主线 Linux 内核中,以提供正式的内存模型。Linux 内核内存[一致性]模型(LKMM)子系统是一套描述 Linux 内存一致性模型的工具,同时也产生用于测试的用例(特别命名为 klitmus)。

+

+随着系统在物理设计上变得越来越复杂(增加了更多的中央处理器内核,高速缓存和内存增长,等等),它们就越难知道哪个中央处理器需要哪个地址空间,以及何时需要。例如,如果 CPU0 需要将数据写入内存中的共享变量,并且 CPU1 需要读取该值,那么 CPU0 必须在 CPU1 尝试读取之前写入。类似地,如果值是以一种顺序方式写入内存的,那么期望它们也以同样的顺序被读取,而不管哪个或哪些 CPU 正在读取。

+

+即使在单个处理器上,内存管理也需要特定的任务顺序。像 `x = y` 这样的简单操作需要处理器从内存中加载 `y` 的值,然后将该值存储在 `x` 中。在处理器从内存中读取值之前,是不能将存储在 `y` 中的值放入 `x` 变量的。此外还有地址依赖:`x[n] = 6` 要求在处理器能够存储值 `6` 之前加载 `n`。

+

+LKMM 可以帮助识别和跟踪代码中的这些内存模式。它部分是通过一个名为 `herd` 的工具来实现的,该工具(以逻辑公式的形式)定义了内存模型施加的约束,然后列举了与这些约束一致性的所有可能的结果。

+

+### 低延迟补丁(2.6.38)

+

+很久以前,在 2011 年之前,如果你想[在 Linux 上进行多媒体工作][11],你必须得有一个低延迟内核。这主要适用于[录音][12]时添加了许多实时效果(如对着麦克风唱歌和添加混音,以及在耳机中无延迟地听到你的声音)。有些发行版,如 [Ubuntu Studio][13],可靠地提供了这样一个内核,所以实际上这没有什么障碍,这只不过是当艺术家选择发行版时的一个重要提醒。

+

+然而,如果你没有使用 Ubuntu Studio,或者你需要在你的发行版提供之前更新你的内核,你必须跳转到 rt-patches 网页,下载内核补丁,将它们应用到你的内核源代码,编译,然后手动安装。

+

+后来,随着内核版本 2.6.38 的发布,这个过程结束了。Linux 内核突然像变魔术一样默认内置了低延迟代码(根据基准测试,延迟至少降低了 10 倍)。不再需要下载补丁,不用编译。一切都很顺利,这都是因为 Mike Galbraith 编写了一个 200 行的小补丁。

+

+对于全世界的开源多媒体艺术家来说,这是一个规则改变者。从 2011 年开始事情变得如此美好,到 2016 年我自己做了一个挑战,[在树莓派 v1(型号 B)上建造一个数字音频工作站(DAW)][14],结果发现它运行得出奇地好。

+

+### RCU(2.5)

+

+RCU,即读-拷贝-更新,是计算机科学中定义的一个系统,它允许多个处理器线程从共享内存中读取数据。它通过延迟更新但也将它们标记为已更新来做到这一点,以确保数据读取为最新内容。实际上,这意味着读取与更新同时发生。

+

+典型的 RCU 循环有点像这样:

+

+1. 删除指向数据的指针,以防止其他读操作引用它。

+2. 等待读操作完成它们的关键处理。

+3. 回收内存空间。

+

+将更新阶段划分为删除和回收阶段意味着更新程序会立即执行删除,同时推迟回收直到所有活动读取完成(通过阻止它们或注册一个回调以便在完成时调用)。

+

+虽然 RCU 的概念不是为 Linux 内核发明的,但它在 Linux 中的实现是该技术的一个定义性的例子。

+

+### 合作(0.01)

+

+对于 Linux 内核创新的问题的最终答案永远是协作。你可以说这是一个好时机,也可以称之为技术优势,称之为黑客能力,或者仅仅称之为开源,但 Linux 内核及其支持的许多项目是协作与合作的光辉范例。

+

+它远远超出了内核范畴。各行各业的人都对开源做出了贡献,可以说都是因为 Linux 内核。Linux 曾经是,现在仍然是[自由软件][15]的主要力量,激励人们把他们的代码、艺术、想法或者仅仅是他们自己带到一个全球化的、有生产力的、多样化的人类社区中。

+

+### 你最喜欢的创新是什么?

+

+这个列表偏向于我自己的兴趣:容器、非统一内存访问(NUMA)和多媒体。无疑,列表中肯定缺少你最喜欢的内核创新。在评论中告诉我。

+

+--------------------------------------------------------------------------------

+

+via: https://opensource.com/article/19/8/linux-kernel-top-5-innovations

+

+作者:[Seth Kenlon][a]

+选题:[lujun9972][b]

+译者:[heguangzhi](https://github.com/heguangzhi)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://opensource.com/users/seth

+[b]: https://github.com/lujun9972

+[1]: https://opensource.com/sites/default/files/styles/image-full-size/public/lead-images/linux_penguin_green.png?itok=ENdVzW22 (Penguin with green background)

+[2]: https://en.wikipedia.org/wiki/Cgroups

+[3]: https://lkml.org/lkml/2006/10/20/251

+[4]: https://linuxcontainers.org

+[5]: https://coreos.com/

+[6]: http://flathub.org

+[7]: http://flatpak.org

+[8]: http://kubernetes.io

+[9]: https://www.redhat.com/sysadmin/learn-openshift-minishift

+[10]: https://opensource.com/article/18/11/behind-scenes-linux-containers

+[11]: http://slackermedia.info

+[12]: https://opensource.com/article/17/6/qtractor-audio

+[13]: http://ubuntustudio.org

+[14]: https://opensource.com/life/16/3/make-music-raspberry-pi-milkytracker

+[15]: http://fsf.org

diff --git a/published/20190825 Top 5 IoT networking security mistakes.md b/published/20190825 Top 5 IoT networking security mistakes.md

new file mode 100644

index 0000000000..237d81b266

--- /dev/null

+++ b/published/20190825 Top 5 IoT networking security mistakes.md

@@ -0,0 +1,62 @@

+[#]: collector: (lujun9972)

+[#]: translator: (Morisun029)

+[#]: reviewer: (wxy)

+[#]: publisher: (wxy)

+[#]: url: (https://linux.cn/article-11299-1.html)

+[#]: subject: (Top 5 IoT networking security mistakes)

+[#]: via: (https://www.networkworld.com/article/3433476/top-5-iot-networking-security-mistakes.html)

+[#]: author: (Fredric Paul https://www.networkworld.com/author/Fredric-Paul/)

+

+五大物联网网络安全错误

+======

+

+> IT 供应商兄弟国际公司分享了五种最常见的物联网安全错误,这是从它们的打印机和多功能设备买家中看到的。

+

+![Getty Images][1]

+

+尽管[兄弟国际公司][2]是许多 IT 产品的供应商,从[机床][3]到[头戴式显示器][4]再到[工业缝纫机][5],但它最知名的产品是打印机。在当今世界,这些打印机不再是独立的设备,而是物联网的组成部分。

+

+这也是我为什么对罗伯特•伯内特提供的这份列表感兴趣的原因。伯内特是兄弟公司的总监,负责 B2B 产品和提供解决方案。基本上是该公司负责大客户实施的关键人物。所以他对打印机相关的物联网安全错误非常关注,并且分享了兄弟国际公司对于处理这五大错误的建议。

+

+### #5:不控制访问和授权

+

+伯内特说:“过去,成本控制是管理谁可以使用机器、何时结束工作背后的推动力。”当然,这在今天也仍然很重要,但他指出安全性正迅速成为管理控制打印和扫描设备的关键因素。这不仅适用于大型企业,也适用于各种规模的企业。

+

+### #4:无法定期更新固件

+

+让我们来面对这一现实,大多数 IT 专业人员都忙于保持服务器和其他网络基础设施设备的更新,确保其基础设施尽可能的安全高效。“在这日常的流程中,像打印机这样的设备经常被忽视。”但过时的固件可能会使基础设施面临新的威胁。

+

+### #3:设备意识不足

+

+伯内特说:“正确理解谁在使用什么设备,以及整套设备中所有连接设备的功能是什么,这是至关重要的。使用端口扫描技术、协议分析和其他检测技术检查这些设备应作为你的网络基础设施整体安全审查中的一部分。 他常常提醒人们说:“处理打印设备的方法是:如果没有损坏,就不要修理!”但即使是可靠运行多年的设备也应该成为安全审查的一部分。这是因为旧设备可能无法提供更强大的安全设置,或者可能需要更新其配置才能满足当今更高的安全要求,这其中包括设备的监控/报告功能。

+

+### #2:用户培训不足

+

+“应该把培训团队在工作过程中管理文档的最佳实践作为强有力的安全计划中的一部分。”伯内特说道,“然而,事实却是,无论你如何努力地去保护物联网设备,人为因素通常是一家企业在保护重要和敏感信息方面最薄弱的环节。像这些简单的事情,如无意中将重要文件留在打印机上供任何人查看,或者将文件扫描到错误的目的地,不仅会给企业带来经济损失和巨大的负面影响,还会影响企业的知识产权、声誉,引起合规性/监管问题。”

+

+### #1:使用默认密码

+

+“只是因为它很方便并不意味着它不重要!”伯内特说,“保护打印机和多功能设备免受未经授权的管理员访问不仅有助于保护敏感的机器配置设置和报告信息,还可以防止访问个人信息,例如,像可能用于网络钓鱼攻击的用户名。”

+

+--------------------------------------------------------------------------------

+

+via: https://www.networkworld.com/article/3433476/top-5-iot-networking-security-mistakes.html

+

+作者:[Fredric Paul][a]

+选题:[lujun9972][b]

+译者:[Morisun029](https://github.com/Morisun029)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://www.networkworld.com/author/Fredric-Paul/

+[b]: https://github.com/lujun9972

+[1]: https://images.idgesg.net/images/article/2019/02/iot_security_tablet_conference_digital-100787102-large.jpg

+[2]: https://www.brother-usa.com/business

+[3]: https://www.brother-usa.com/machinetool/default?src=default

+[4]: https://www.brother-usa.com/business/hmd#sort=%40productcatalogsku%20ascending

+[5]: https://www.brother-usa.com/business/industrial-sewing

+[6]: https://www.networkworld.com/article/2855207/internet-of-things/5-ways-to-prepare-for-internet-of-things-security-threats.html#tk.nww-infsb

+[7]: https://pluralsight.pxf.io/c/321564/424552/7490?u=https%3A%2F%2Fwww.pluralsight.com%2Fpaths%2Fcertified-information-systems-security-professional-cisspr

+[8]: https://www.facebook.com/NetworkWorld/

+[9]: https://www.linkedin.com/company/network-world

diff --git a/published/20190826 5 ops tasks to do with Ansible.md b/published/20190826 5 ops tasks to do with Ansible.md

new file mode 100644

index 0000000000..de7916b81d

--- /dev/null

+++ b/published/20190826 5 ops tasks to do with Ansible.md

@@ -0,0 +1,95 @@

+[#]: collector: (lujun9972)

+[#]: translator: (geekpi)

+[#]: reviewer: (wxy)

+[#]: publisher: (wxy)

+[#]: url: (https://linux.cn/article-11312-1.html)

+[#]: subject: (5 ops tasks to do with Ansible)

+[#]: via: (https://opensource.com/article/19/8/ops-tasks-ansible)

+[#]: author: (Mark Phillips https://opensource.com/users/markphttps://opensource.com/users/adminhttps://opensource.com/users/alsweigarthttps://opensource.com/users/belljennifer43)

+

+5 个 Ansible 运维任务

+======

+

+> 让 DevOps 少一点,OpsDev 多一点。

+

+![gears and lightbulb to represent innovation][1]

+

+在这个 DevOps 世界中,看起来开发(Dev)这一半成为了关注的焦点,而运维(Ops)则是这个关系中被遗忘的另一半。这几乎就好像是领头的开发告诉尾随的运维做什么,几乎所有的“运维”都是开发说要做的。因此,运维被抛到后面,降级到了替补席上。

+

+我想看到更多的 OpsDev。因此,让我们来看看 Ansible 在日常的运维中可以帮助你什么。

+

+![Job templates][2]

+

+我选择在 [Ansible Tower][3] 中展示这些方案,因为我认为用户界面 (UI) 可以增色大多数的任务。如果你想模拟测试,你可以在 Tower 的上游开源版本 [AWX][4] 中测试它。

+

+### 管理用户

+

+在大规模环境中,你的用户将集中在活动目录或 LDAP 等系统中。但我敢打赌,仍然存在许多包含大量的静态用户的全负荷环境。Ansible 可以帮助你将这些分散的环境集中到一起。*社区*已为我们解决了这个问题。看看 [Ansible Galaxy][5] 中的 [users][6] 角色。

+

+这个角色的聪明之处在于它允许我们通过*数据*管理用户,而无需更改运行逻辑。

+

+![User data][7]

+

+通过简单的数据结构,我们可以在系统上添加、删除和修改静态用户。这很有用。

+

+### 管理 sudo

+

+提权有[多种形式][8],但最流行的是 [sudo][9]。通过每个 `user`、`group` 等离散文件来管理 sudo 相对容易。但一些人对给予特权感到紧张,并倾向于有时限地给予提权。因此[下面是一种方案][10],它使用简单的 `at` 命令对授权访问设置时间限制。

+

+![Managing sudo][11]

+

+### 管理服务

+

+给入门级运维团队提供[菜单][12]以便他们可以重启某些服务不是很好吗?看下面!

+

+![Managing services][13]

+

+### 管理磁盘空间

+

+这有[一个简单的角色][14],可在特定目录中查找字节大于某个大小的文件。在 Tower 中这么做时,启用[回调][15]有额外的好处。想象一下,你的监控方案发现文件系统已超过 X% 并触发 Tower 中的任务以找出是什么文件导致的。

+

+![Managing disk space][16]

+

+### 调试系统性能问题

+

+[这个角色][17]相当简单:它运行一些命令并打印输出。细节在最后输出,让你 —— 系统管理员快速浏览一眼。另外可以使用 [正则表达式][18] 在输出中找到某些条件(比如说 CPU 占用率超过 80%)。

+

+![Debugging system performance][19]

+

+### 总结

+

+我已经录制了这五个任务的简短视频。你也可以在 Github 上找到[所有代码][20]!

+

+--------------------------------------------------------------------------------

+

+via: https://opensource.com/article/19/8/ops-tasks-ansible

+

+作者:[Mark Phillips][a]

+选题:[lujun9972][b]

+译者:[geekpi](https://github.com/geekpi)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://opensource.com/users/markphttps://opensource.com/users/adminhttps://opensource.com/users/alsweigarthttps://opensource.com/users/belljennifer43

+[b]: https://github.com/lujun9972

+[1]: https://opensource.com/sites/default/files/styles/image-full-size/public/lead-images/innovation_lightbulb_gears_devops_ansible.png?itok=TSbmp3_M (gears and lightbulb to represent innovation)

+[2]: https://opensource.com/sites/default/files/uploads/00_templates.png (Job templates)

+[3]: https://www.ansible.com/products/tower

+[4]: https://github.com/ansible/awx

+[5]: https://galaxy.ansible.com

+[6]: https://galaxy.ansible.com/singleplatform-eng/users

+[7]: https://opensource.com/sites/default/files/uploads/01_users_data.png (User data)

+[8]: https://docs.ansible.com/ansible/latest/plugins/become.html

+[9]: https://www.sudo.ws/intro.html

+[10]: https://github.com/phips/ansible-demos/tree/master/roles/sudo

+[11]: https://opensource.com/sites/default/files/uploads/02_sudo.png (Managing sudo)

+[12]: https://docs.ansible.com/ansible-tower/latest/html/userguide/job_templates.html#surveys

+[13]: https://opensource.com/sites/default/files/uploads/03_services.png (Managing services)

+[14]: https://github.com/phips/ansible-demos/tree/master/roles/disk

+[15]: https://docs.ansible.com/ansible-tower/latest/html/userguide/job_templates.html#provisioning-callbacks

+[16]: https://opensource.com/sites/default/files/uploads/04_diskspace.png (Managing disk space)

+[17]: https://github.com/phips/ansible-demos/tree/master/roles/gather_debug

+[18]: https://docs.ansible.com/ansible/latest/user_guide/playbooks_filters.html#regular-expression-filters

+[19]: https://opensource.com/sites/default/files/uploads/05_debug.png (Debugging system performance)

+[20]: https://github.com/phips/ansible-demos

diff --git a/published/20190826 How to rename a group of files on Linux.md b/published/20190826 How to rename a group of files on Linux.md

new file mode 100644

index 0000000000..e80d1bc31d

--- /dev/null

+++ b/published/20190826 How to rename a group of files on Linux.md

@@ -0,0 +1,128 @@

+[#]: collector: (lujun9972)

+[#]: translator: (geekpi)

+[#]: reviewer: (wxy)

+[#]: publisher: (wxy)

+[#]: url: (https://linux.cn/article-11300-1.html)

+[#]: subject: (How to rename a group of files on Linux)

+[#]: via: (https://www.networkworld.com/article/3433865/how-to-rename-a-group-of-files-on-linux.html)

+[#]: author: (Sandra Henry-Stocker https://www.networkworld.com/author/Sandra-Henry_Stocker/)

+

+如何在 Linux 上重命名一组文件

+======

+

+> 要用单个命令重命名一组文件,请使用 rename 命令。它需要使用正则表达式,并且可以在开始前告诉你会有什么更改。

+

+

+

+几十年来,Linux 用户一直使用 `mv` 命令重命名文件。它很简单,并且能做到你要做的。但有时你需要重命名一大组文件。在这种情况下,`rename` 命令可以使这个任务更容易。它只需要一些正则表达式的技巧。

+

+与 `mv` 命令不同,`rename` 不允许你简单地指定旧名称和新名称。相反,它使用类似于 Perl 中的正则表达式。在下面的例子中,`s` 指定我们将第一个字符串替换为第二个字符串(旧的),从而将 `this.new` 变为 `this.old`。

+

+```

+$ rename 's/new/old/' this.new

+$ ls this*

+this.old

+```

+

+使用 `mv this.new this.old` 可以更容易地进行更改一个,但是将字符串 `this` 变成通配符 `*`,你可以用一条命令将所有的 `*.new` 文件重命名为 `*.old`:

+

+```

+$ ls *.new

+report.new schedule.new stats.new this.new

+$ rename 's/new/old/' *.new

+$ ls *.old

+report.old schedule.old stats.old this.old

+```

+

+正如你所料,`rename` 命令不限于更改文件扩展名。如果你需要将名为 `report.*` 的文件更改为 `review.*`,那么可以使用以下命令做到:

+

+```

+$ rename 's/report/review/' *

+```

+

+正则表达式中的字符串可以更改文件名的任何部分,无论是文件名还是扩展名。

+

+```

+$ rename 's/123/124/' *

+$ ls *124*

+status.124 report124.txt

+```

+

+如果你在 `rename` 命令中添加 `-v` 选项,那么该命令将提供一些反馈,以便你可以看到所做的更改,或许会包含你没注意的。这让你注意到并按需还原更改。

+

+```

+$ rename -v 's/123/124/' *

+status.123 renamed as status.124

+report123.txt renamed as report124.txt

+```

+

+另一方面,使用 `-n`(或 `--nono`)选项会使 `rename` 命令告诉你将要做的但不会实际做的更改。这可以让你免于执行不不想要的操作,然后再还原更改。

+

+```

+$ rename -n 's/old/save/' *

+rename(logger.man-old, logger.man-save)

+rename(lyrics.txt-old, lyrics.txt-save)

+rename(olderfile-, saveerfile-)

+rename(oldfile, savefile)

+rename(review.old, review.save)

+rename(schedule.old, schedule.save)

+rename(stats.old, stats.save)

+rename(this.old, this.save)

+```

+

+如果你对这些更改满意,那么就可以运行不带 `-n` 选项的命令来更改文件名。

+

+但请注意,正则表达式中的 `.` **不会**被视为句点,而是作为匹配任何字符的通配符。上面和下面的示例中的一些更改可能不是输入命令的人希望的。

+

+```

+$ rename -n 's/.old/.save/' *

+rename(logger.man-old, logger.man.save)

+rename(lyrics.txt-old, lyrics.txt.save)

+rename(review.old, review.save)

+rename(schedule.old, schedule.save)

+rename(stats.old, stats.save)

+rename(this.old, this.save)

+```

+

+为确保句点按照字面意思执行,请在它的前面加一个反斜杠。这将使其不被解释为通配符并匹配任何字符。请注意,进行此更改时,仅选择了 `.old` 文件。

+

+```

+$ rename -n 's/\.old/.save/' *

+rename(review.old, review.save)

+rename(schedule.old, schedule.save)

+rename(stats.old, stats.save)

+rename(this.old, this.save)

+```

+

+下面的命令会将文件名中的所有大写字母更改为小写,除了使用 `-n` 选项来确保我们在命令执行之前检查将做的修改。注意在正则表达式中使用了 `y`,这是改变大小写所必需的。

+

+```

+$ rename -n 'y/A-Z/a-z/' W*

+rename(WARNING_SIGN.pdf, warning_sign.pdf)

+rename(Will_Gardner_buttons.pdf, will_gardner_buttons.pdf)

+rename(Wingding_Invites.pdf, wingding_invites.pdf)

+rename(WOW-buttons.pdf, wow-buttons.pdf)

+```

+

+在上面的例子中,我们将所有大写字母更改为了小写,但这仅对以大写字母 `W` 开头的文件名。

+

+### 总结

+

+当你需要重命名大量文件时,`rename` 命令非常有用。请注意不要做比预期更多的更改。请记住,`-n`(或者 `--nono`)选项可以帮助你避免耗时的错误。

+

+--------------------------------------------------------------------------------

+

+via: https://www.networkworld.com/article/3433865/how-to-rename-a-group-of-files-on-linux.html

+

+作者:[Sandra Henry-Stocker][a]

+选题:[lujun9972][b]

+译者:[geekpi](https://github.com/geekpi)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://www.networkworld.com/author/Sandra-Henry_Stocker/

+[b]: https://github.com/lujun9972

+[1]: https://images.idgesg.net/images/article/2019/08/card-catalog-machester_city_library-100809242-large.jpg

+[4]: https://www.facebook.com/NetworkWorld/

+[5]: https://www.linkedin.com/company/network-world

diff --git a/published/20190828 Managing Ansible environments on MacOS with Conda.md b/published/20190828 Managing Ansible environments on MacOS with Conda.md

new file mode 100644

index 0000000000..24e8d65fa0

--- /dev/null

+++ b/published/20190828 Managing Ansible environments on MacOS with Conda.md

@@ -0,0 +1,168 @@

+[#]: collector: (lujun9972)

+[#]: translator: (heguangzhi)

+[#]: reviewer: (wxy)

+[#]: publisher: (wxy)

+[#]: url: (https://linux.cn/article-11356-1.html)

+[#]: subject: (Managing Ansible environments on MacOS with Conda)

+[#]: via: (https://opensource.com/article/19/8/using-conda-ansible-administration-macos)

+[#]: author: (James Farrell https://opensource.com/users/jamesf)

+

+

+使用 Conda 管理 MacOS 上的 Ansible 环境

+=====

+

+> Conda 将 Ansible 所需的一切都收集到虚拟环境中并将其与其他项目分开。

+

+

+

+如果你是一名使用 MacOS 并涉及到 Ansible 管理的 Python 开发人员,你可能希望使用 Conda 包管理器将 Ansible 的工作内容与核心操作系统和其他本地项目分开。

+

+Ansible 基于 Python。要让 Ansible 在 MacOS 上工作,Conda 并不是必须要的,但是它确实让你管理 Python 版本和包依赖变得更加容易。这允许你在 MacOS 上使用升级的 Python 版本,并在你的系统中、Ansible 和其他编程项目之间保持 Python 包的依赖性相互独立。

+

+在 MacOS 上安装 Ansible 还有其他方法。你可以使用 [Homebrew][2],但是如果你对 Python 开发(或 Ansible 开发)感兴趣,你可能会发现在一个独立 Python 虚拟环境中管理 Ansible 可以减少一些混乱。我觉得这更简单;与其试图将 Python 版本和依赖项加载到系统或 `/usr/local` 目录中 ,还不如使用 Conda 帮助我将 Ansible 所需的一切都收集到一个虚拟环境中,并将其与其他项目完全分开。

+

+本文着重于使用 Conda 作为 Python 项目来管理 Ansible,以保持它的干净并与其他项目分开。请继续阅读,并了解如何安装 Conda、创建新的虚拟环境、安装 Ansible 并对其进行测试。

+

+### 序幕

+

+最近,我想学习 [Ansible][3],所以我需要找到安装它的最佳方法。

+

+我通常对在我的日常工作站上安装东西很谨慎。我尤其不喜欢对供应商的默认操作系统安装应用手动更新(这是我多年作为 Unix 系统管理的习惯)。我真的很想使用 Python 3.7,但是 MacOS 的 Python 包是旧的 2.7,我不会安装任何可能干扰核心 MacOS 系统的全局 Python 包。

+

+所以,我使用本地 Ubuntu 18.04 虚拟机上开始了我的 Ansible 工作。这提供了真正意义上的的安全隔离,但我很快发现管理它是非常乏味的。所以我着手研究如何在本机 MacOS 上获得一个灵活但独立的 Ansible 系统。

+

+由于 Ansible 基于 Python,Conda 似乎是理想的解决方案。

+

+### 安装 Conda

+

+Conda 是一个开源软件,它提供方便的包和环境管理功能。它可以帮助你管理多个版本的 Python、安装软件包依赖关系、执行升级和维护项目隔离。如果你手动管理 Python 虚拟环境,Conda 将有助于简化和管理你的工作。浏览 [Conda 文档][4]可以了解更多细节。

+

+我选择了 [Miniconda][5] Python 3.7 安装在我的工作站中,因为我想要最新的 Python 版本。无论选择哪个版本,你都可以使用其他版本的 Python 安装新的虚拟环境。

+

+要安装 Conda,请下载 PKG 格式的文件,进行通常的双击,并选择 “Install for me only” 选项。安装在我的系统上占用了大约 158 兆的空间。

+

+安装完成后,调出一个终端来查看你有什么了。你应该看到:

+

+ * 在你的家目录中的 `miniconda3` 目录

+ * shell 提示符被修改为 `(base)`

+ * `.bash_profile` 文件更新了一些 Conda 特有的设置内容

+

+现在基础已经安装好了,你有了第一个 Python 虚拟环境。运行 Python 版本检查可以证明这一点,你的 `PATH` 将指向新的位置:

+

+```

+(base) $ which python

+/Users/jfarrell/miniconda3/bin/python

+(base) $ python --version

+Python 3.7.1

+```

+

+现在安装了 Conda,下一步是建立一个虚拟环境,然后安装 Ansible 并运行。

+

+### 为 Ansible 创建虚拟环境

+

+我想将 Ansible 与我的其他 Python 项目分开,所以我创建了一个新的虚拟环境并切换到它:

+

+```

+(base) $ conda create --name ansible-env --clone base

+(base) $ conda activate ansible-env

+(ansible-env) $ conda env list

+```

+

+第一个命令将 Conda 库克隆到一个名为 `ansible-env` 的新虚拟环境中。克隆引入了 Python 3.7 版本和一系列默认的 Python 模块,你可以根据需要添加、删除或升级这些模块。

+

+第二个命令将 shell 上下文更改为这个新的环境。它为 Python 及其包含的模块设置了正确的路径。请注意,在 `conda activate ansible-env` 命令后,你的 shell 提示符会发生变化。

+

+第三个命令不是必须的;它列出了安装了哪些 Python 模块及其版本和其他数据。

+

+你可以随时使用 Conda 的 `activate` 命令切换到另一个虚拟环境。这将带你回到基本环境:`conda base`。

+

+### 安装 Ansible

+

+安装 Ansible 有多种方法,但是使用 Conda 可以将 Ansible 版本和所有需要的依赖项打包在一个地方。Conda 提供了灵活性,既可以将所有内容分开,又可以根据需要添加其他新环境(我将在后面演示)。

+

+要安装 Ansible 的相对较新版本,请使用:

+

+```

+(base) $ conda activate ansible-env

+(ansible-env) $ conda install -c conda-forge ansible

+```

+

+由于 Ansible 不是 Conda 默认通道的一部分,因此 `-c` 用于从备用通道搜索和安装。Ansible 现已安装到 `ansible-env` 虚拟环境中,可以使用了。

+

+### 使用 Ansible

+

+既然你已经安装了 Conda 虚拟环境,就可以使用它了。首先,确保要控制的节点已将工作站的 SSH 密钥安装到正确的用户帐户。

+

+调出一个新的 shell 并运行一些基本的 Ansible 命令:

+

+```

+(base) $ conda activate ansible-env

+(ansible-env) $ ansible --version

+ansible 2.8.1

+ config file = None

+ configured module search path = ['/Users/jfarrell/.ansible/plugins/modules', '/usr/share/ansible/plugins/modules']

+ ansible python module location = /Users/jfarrell/miniconda3/envs/ansibleTest/lib/python3.7/site-packages/ansible

+ executable location = /Users/jfarrell/miniconda3/envs/ansibleTest/bin/ansible

+ python version = 3.7.1 (default, Dec 14 2018, 13:28:58) [Clang 4.0.1 (tags/RELEASE_401/final)]

+(ansible-env) $ ansible all -m ping -u ansible

+192.168.99.200 | SUCCESS => {

+ "ansible_facts": {

+ "discovered_interpreter_python": "/usr/bin/python"

+ },

+ "changed": false,

+ "ping": "pong"

+}

+```

+

+现在 Ansible 工作了,你可以在控制台中抽身,并从你的 MacOS 工作站中使用它们。

+

+### 克隆新的 Ansible 进行 Ansible 开发

+

+这部分完全是可选的;只有当你想要额外的虚拟环境来修改 Ansible 或者安全地使用有问题的 Python 模块时,才需要它。你可以通过以下方式将主 Ansible 环境克隆到开发副本中:

+

+```

+(ansible-env) $ conda create --name ansible-dev --clone ansible-env

+(ansible-env) $ conda activte ansible-dev

+(ansible-dev) $

+```

+

+### 需要注意的问题

+

+偶尔你可能遇到使用 Conda 的麻烦。你通常可以通过以下方式删除不良环境:

+

+```

+$ conda activate base

+$ conda remove --name ansible-dev --all

+```

+

+如果出现无法解决的错误,通常可以通过在 `~/miniconda3/envs` 中找到该环境并删除整个目录来直接删除环境。如果基础环境损坏了,你可以删除整个 `~/miniconda3`,然后从 PKG 文件中重新安装。只要确保保留 `~/miniconda3/envs` ,或使用 Conda 工具导出环境配置并在以后重新创建即可。

+

+MacOS 上不包括 `sshpass` 程序。只有当你的 Ansible 工作要求你向 Ansible 提供 SSH 登录密码时,才需要它。你可以在 SourceForge 上找到当前的 [sshpass 源代码][6]。

+

+最后,基础的 Conda Python 模块列表可能缺少你工作所需的一些 Python 模块。如果你需要安装一个模块,首选命令是 `conda install package`,但是需要的话也可以使用 `pip`,Conda 会识别安装的模块。

+

+### 结论

+

+Ansible 是一个强大的自动化工具,值得我们去学习。Conda 是一个简单有效的 Python 虚拟环境管理工具。

+

+在你的 MacOS 环境中保持软件安装分离是保持日常工作环境的稳定性和健全性的谨慎方法。Conda 尤其有助于升级你的 Python 版本,将 Ansible 从其他项目中分离出来,并安全地使用 Ansible。

+

+--------------------------------------------------------------------------------

+

+via: https://opensource.com/article/19/8/using-conda-ansible-administration-macos

+

+作者:[James Farrell][a]

+选题:[lujun9972][b]

+译者:[heguangzhi](https://github.com/heguangzhi)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://opensource.com/users/jamesf

+[b]: https://github.com/lujun9972

+[1]: https://opensource.com/sites/default/files/styles/image-full-size/public/lead-images/cicd_continuous_delivery_deployment_gears.png?itok=kVlhiEkc (CICD with gears)

+[2]: https://brew.sh/

+[3]: https://docs.ansible.com/?extIdCarryOver=true&sc_cid=701f2000001OH6uAAG

+[4]: https://conda.io/projects/conda/en/latest/index.html

+[5]: https://docs.conda.io/en/latest/miniconda.html

+[6]: https://sourceforge.net/projects/sshpass/

diff --git a/published/20190829 Getting started with HTTPie for API testing.md b/published/20190829 Getting started with HTTPie for API testing.md

new file mode 100644

index 0000000000..c85c165df5

--- /dev/null

+++ b/published/20190829 Getting started with HTTPie for API testing.md

@@ -0,0 +1,334 @@

+[#]: collector: (lujun9972)

+[#]: translator: (geekpi)

+[#]: reviewer: (wxy)

+[#]: publisher: (wxy)

+[#]: url: (https://linux.cn/article-11333-1.html)

+[#]: subject: (Getting started with HTTPie for API testing)

+[#]: via: (https://opensource.com/article/19/8/getting-started-httpie)

+[#]: author: (Moshe Zadka https://opensource.com/users/moshezhttps://opensource.com/users/mkalindepauleduhttps://opensource.com/users/jamesf)

+

+使用 HTTPie 进行 API 测试

+======

+

+> 使用 HTTPie 调试 API,这是一个用 Python 写的易用的命令行工具。

+

+

+

+[HTTPie][2] 是一个非常易用、易于升级的 HTTP 客户端。它的发音为 “aitch-tee-tee-pie” 并以 `http` 命令运行,它是一个用 Python 编写的来用于访问 Web 的命令行工具。

+

+由于这是一篇关于 HTTP 客户端的指导文章,因此你需要一个 HTTP 服务器来试用它。在这里,访问 [httpbin.org][3],它是一个简单的开源 HTTP 请求和响应服务。httpbin.org 网站是一种测试 Web API 的强大方式,并能仔细管理并显示请求和响应内容,不过现在让我们专注于 HTTPie 的强大功能。

+

+### Wget 和 cURL 的替代品

+

+你可能听说过古老的 [Wget][4] 或稍微新一些的 [cURL][5] 工具,它们允许你从命令行访问 Web。它们是为访问网站而编写的,而 HTTPie 则用于访问 Web API。

+

+网站请求发生在计算机和正在阅读并响应它所看到的内容的最终用户之间,这并不太依赖于结构化的响应。但是,API 请求会在两台计算机之间进行*结构化*调用,人并不是该流程内的一部分,像 HTTPie 这样的命令行工具的参数可以有效地处理这个问题。

+

+### 安装 HTTPie

+

+有几种方法可以安装 HTTPie。你可以通过包管理器安装,无论你使用的是 `brew`、`apt`、`yum` 还是 `dnf`。但是,如果你已配置 [virtualenvwrapper][6],那么你可以用自己的方式安装:

+

+

+```

+$ mkvirtualenv httpie

+...

+(httpie) $ pip install httpie

+...

+(httpie) $ deactivate

+$ alias http=~/.virtualenvs/httpie/bin/http

+$ http -b GET https://httpbin.org/get

+{

+ "args": {},

+ "headers": {

+ "Accept": "*/*",

+ "Accept-Encoding": "gzip, deflate",

+ "Host": "httpbin.org",

+ "User-Agent": "HTTPie/1.0.2"

+ },

+ "origin": "104.220.242.210, 104.220.242.210",

+ "url": "https://httpbin.org/get"

+}

+```

+

+通过将 `http` 别名指向为虚拟环境中的命令,即使虚拟环境在非活动状态,你也可以运行它。你可以将 `alias` 命令放在 `.bash_profile` 或 `.bashrc` 中,这样你就可以使用以下命令升级 HTTPie:

+

+

+```

+$ ~/.virtualenvs/httpie/bin/pip install -U pip

+```

+

+### 使用 HTTPie 查询网站

+

+HTTPie 可以简化查询和测试 API。上面使用了一个选项,`-b`(即 `--body`)。没有它,HTTPie 将默认打印整个响应,包括响应头:

+

+```

+$ http GET https://httpbin.org/get

+HTTP/1.1 200 OK

+Access-Control-Allow-Credentials: true

+Access-Control-Allow-Origin: *

+Connection: keep-alive

+Content-Encoding: gzip

+Content-Length: 177

+Content-Type: application/json

+Date: Fri, 09 Aug 2019 20:19:47 GMT

+Referrer-Policy: no-referrer-when-downgrade

+Server: nginx

+X-Content-Type-Options: nosniff

+X-Frame-Options: DENY

+X-XSS-Protection: 1; mode=block

+

+{

+ "args": {},

+ "headers": {

+ "Accept": "*/*",

+ "Accept-Encoding": "gzip, deflate",

+ "Host": "httpbin.org",

+ "User-Agent": "HTTPie/1.0.2"

+ },

+ "origin": "104.220.242.210, 104.220.242.210",

+ "url": "https://httpbin.org/get"

+}

+```

+

+这在调试 API 服务时非常重要,因为大量信息在响应头中发送。例如,查看发送的 cookie 通常很重要。httpbin.org 提供了通过 URL 路径设置 cookie(用于测试目的)的方式。以下设置一个标题为 `opensource`, 值为 `awesome` 的 cookie:

+

+```

+$ http GET https://httpbin.org/cookies/set/opensource/awesome

+HTTP/1.1 302 FOUND

+Access-Control-Allow-Credentials: true

+Access-Control-Allow-Origin: *

+Connection: keep-alive

+Content-Length: 223

+Content-Type: text/html; charset=utf-8

+Date: Fri, 09 Aug 2019 20:22:39 GMT

+Location: /cookies

+Referrer-Policy: no-referrer-when-downgrade

+Server: nginx

+Set-Cookie: opensource=awesome; Path=/

+X-Content-Type-Options: nosniff

+X-Frame-Options: DENY

+X-XSS-Protection: 1; mode=block

+

+

+Redirecting...

+Redirecting...

+You should be redirected automatically to target URL:

+/cookies. If not click the link.

+```

+

+注意 `Set-Cookie: opensource=awesome; Path=/` 的响应头。这表明你预期设置的 cookie 已正确设置,路径为 `/`。另请注意,即使你得到了 `302` 重定向,`http` 也不会遵循它。如果你想要遵循重定向,则需要明确使用 `--follow` 标志请求:

+

+```

+$ http --follow GET https://httpbin.org/cookies/set/opensource/awesome

+HTTP/1.1 200 OK

+Access-Control-Allow-Credentials: true

+Access-Control-Allow-Origin: *

+Connection: keep-alive

+Content-Encoding: gzip

+Content-Length: 66

+Content-Type: application/json

+Date: Sat, 10 Aug 2019 01:33:34 GMT

+Referrer-Policy: no-referrer-when-downgrade

+Server: nginx

+X-Content-Type-Options: nosniff

+X-Frame-Options: DENY

+X-XSS-Protection: 1; mode=block

+

+{

+ "cookies": {

+ "opensource": "awesome"

+ }

+}

+```

+

+但此时你无法看到原来的 `Set-Cookie` 头。为了看到中间响应,你需要使用 `--all`:

+

+

+```

+$ http --headers --all --follow GET https://httpbin.org/cookies/set/opensource/awesome

+HTTP/1.1 302 FOUND

+Access-Control-Allow-Credentials: true

+Access-Control-Allow-Origin: *

+Content-Type: text/html; charset=utf-8

+Date: Sat, 10 Aug 2019 01:38:40 GMT

+Location: /cookies

+Referrer-Policy: no-referrer-when-downgrade

+Server: nginx

+Set-Cookie: opensource=awesome; Path=/

+X-Content-Type-Options: nosniff

+X-Frame-Options: DENY

+X-XSS-Protection: 1; mode=block

+Content-Length: 223

+Connection: keep-alive

+

+HTTP/1.1 200 OK

+Access-Control-Allow-Credentials: true

+Access-Control-Allow-Origin: *

+Content-Encoding: gzip

+Content-Type: application/json

+Date: Sat, 10 Aug 2019 01:38:41 GMT

+Referrer-Policy: no-referrer-when-downgrade

+Server: nginx

+X-Content-Type-Options: nosniff

+X-Frame-Options: DENY

+X-XSS-Protection: 1; mode=block

+Content-Length: 66

+Connection: keep-alive

+```

+

+打印响应体并不有趣,因为你大多数时候只关心 cookie。如果你想看到中间请求的响应头,而不是最终请求中的响应体,你可以使用:

+

+```

+$ http --print hb --history-print h --all --follow GET https://httpbin.org/cookies/set/opensource/awesome

+HTTP/1.1 302 FOUND

+Access-Control-Allow-Credentials: true

+Access-Control-Allow-Origin: *

+Content-Type: text/html; charset=utf-8

+Date: Sat, 10 Aug 2019 01:40:56 GMT

+Location: /cookies

+Referrer-Policy: no-referrer-when-downgrade

+Server: nginx

+Set-Cookie: opensource=awesome; Path=/

+X-Content-Type-Options: nosniff

+X-Frame-Options: DENY

+X-XSS-Protection: 1; mode=block

+Content-Length: 223

+Connection: keep-alive

+

+HTTP/1.1 200 OK

+Access-Control-Allow-Credentials: true

+Access-Control-Allow-Origin: *

+Content-Encoding: gzip

+Content-Type: application/json

+Date: Sat, 10 Aug 2019 01:40:56 GMT

+Referrer-Policy: no-referrer-when-downgrade

+Server: nginx

+X-Content-Type-Options: nosniff

+X-Frame-Options: DENY

+X-XSS-Protection: 1; mode=block

+Content-Length: 66

+Connection: keep-alive

+

+{

+ "cookies": {

+ "opensource": "awesome"

+ }

+}

+```

+

+你可以使用 `--print` 精确控制打印的内容(`h`:响应头;`b`:响应体),并使用 `--history-print` 覆盖中间请求的打印内容设置。

+

+### 使用 HTTPie 下载二进制文件

+

+有时响应体并不是文本形式,它需要发送到可被不同应用打开的文件:

+

+```

+$ http GET https://httpbin.org/image/jpeg

+HTTP/1.1 200 OK

+Access-Control-Allow-Credentials: true

+Access-Control-Allow-Origin: *

+Connection: keep-alive

+Content-Length: 35588

+Content-Type: image/jpeg

+Date: Fri, 09 Aug 2019 20:25:49 GMT

+Referrer-Policy: no-referrer-when-downgrade

+Server: nginx

+X-Content-Type-Options: nosniff

+X-Frame-Options: DENY

+X-XSS-Protection: 1; mode=block

+

+

++-----------------------------------------+

+| NOTE: binary data not shown in terminal |

++-----------------------------------------+

+```

+

+要得到正确的图片,你需要保存到文件:

+

+```

+$ http --download GET https://httpbin.org/image/jpeg

+HTTP/1.1 200 OK

+Access-Control-Allow-Credentials: true

+Access-Control-Allow-Origin: *

+Connection: keep-alive

+Content-Length: 35588

+Content-Type: image/jpeg

+Date: Fri, 09 Aug 2019 20:28:13 GMT

+Referrer-Policy: no-referrer-when-downgrade

+Server: nginx

+X-Content-Type-Options: nosniff

+X-Frame-Options: DENY

+X-XSS-Protection: 1; mode=block

+

+Downloading 34.75 kB to "jpeg.jpe"

+Done. 34.75 kB in 0.00068s (50.05 MB/s)

+```

+

+试一下!图片很可爱。

+

+### 使用 HTTPie 发送自定义请求

+

+你可以发送指定的请求头。这对于需要非标准头的自定义 Web API 很有用:

+

+```

+$ http GET https://httpbin.org/headers X-Open-Source-Com:Awesome

+{

+ "headers": {

+ "Accept": "*/*",

+ "Accept-Encoding": "gzip, deflate",

+ "Host": "httpbin.org",

+ "User-Agent": "HTTPie/1.0.2",

+ "X-Open-Source-Com": "Awesome"

+ }

+}

+```

+

+最后,如果要发送 JSON 字段(尽管可以指定确切的内容),对于许多嵌套较少的输入,你可以使用快捷方式:

+

+

+```

+$ http --body PUT https://httpbin.org/anything open-source=awesome author=moshez

+{

+ "args": {},

+ "data": "{\"open-source\": \"awesome\", \"author\": \"moshez\"}",

+ "files": {},

+ "form": {},

+ "headers": {

+ "Accept": "application/json, */*",

+ "Accept-Encoding": "gzip, deflate",

+ "Content-Length": "46",

+ "Content-Type": "application/json",

+ "Host": "httpbin.org",

+ "User-Agent": "HTTPie/1.0.2"

+ },

+ "json": {

+ "author": "moshez",

+ "open-source": "awesome"

+ },

+ "method": "PUT",

+ "origin": "73.162.254.113, 73.162.254.113",

+ "url": "https://httpbin.org/anything"

+}

+```

+

+下次在调试 Web API 时,无论是你自己的还是别人的,记得放下 cURL,试试 HTTPie 这个命令行工具。

+

+--------------------------------------------------------------------------------

+

+via: https://opensource.com/article/19/8/getting-started-httpie

+

+作者:[Moshe Zadka][a]

+选题:[lujun9972][b]

+译者:[geekpi](https://github.com/geekpi)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://opensource.com/users/moshezhttps://opensource.com/users/mkalindepauleduhttps://opensource.com/users/jamesf

+[b]: https://github.com/lujun9972

+[1]: https://opensource.com/sites/default/files/styles/image-full-size/public/lead-images/pie-raspberry-bake-make-food.png?itok=QRV_R8Fa (Raspberry pie with slice missing)

+[2]: https://httpie.org/

+[3]: https://github.com/postmanlabs/httpbin

+[4]: https://en.wikipedia.org/wiki/Wget

+[5]: https://en.wikipedia.org/wiki/CURL

+[6]: https://opensource.com/article/19/6/virtual-environments-python-macos

diff --git a/published/20190829 Three Ways to Exclude Specific-Certain Packages from Yum Update.md b/published/20190829 Three Ways to Exclude Specific-Certain Packages from Yum Update.md

new file mode 100644

index 0000000000..f0d1ba9087

--- /dev/null

+++ b/published/20190829 Three Ways to Exclude Specific-Certain Packages from Yum Update.md

@@ -0,0 +1,138 @@

+[#]: collector: (lujun9972)

+[#]: translator: (geekpi)

+[#]: reviewer: (wxy)

+[#]: publisher: (wxy)

+[#]: url: (https://linux.cn/article-11315-1.html)

+[#]: subject: (Three Ways to Exclude Specific/Certain Packages from Yum Update)

+[#]: via: (https://www.2daygeek.com/redhat-centos-yum-update-exclude-specific-packages/)

+[#]: author: (Magesh Maruthamuthu https://www.2daygeek.com/author/magesh/)

+

+从 Yum 更新中排除特定/某些包的三种方法

+======

+

+

+

+作为系统更新的一部分,你也许需要在基于 Red Hat 系统中由于应用依赖排除一些软件包。

+

+如果是,如何排除?可以采取多少种方式?有三种方式可以做到,我们会在本篇中教你这三种方法。

+

+包管理器是一组工具,它允许用户在 Linux 系统中轻松管理包。它能让用户在 Linux 系统中安装、更新/升级、删除、查询、重新安装和搜索软件包。

+

+对于基于 Red Hat 的系统,我们使用 [yum 包管理器][1] 和 [rpm 包管理器][2] 进行包管理。

+

+### 什么是 yum?

+

+yum 代表 “Yellowdog Updater, Modified”。Yum 是用于 rpm 系统的自动更新程序和包安装/卸载器。

+

+它在安装包时自动解决依赖关系。

+

+### 什么是 rpm?

+

+rpm 代表 “Red Hat Package Manager”,它是一款用于 Red Hat 系统的功能强大的包管理工具。

+

+RPM 指的是 `.rpm` 文件格式,它包含已编译的软件和必要的库。

+

+你可能有兴趣阅读以下与本主题相关的文章。如果是的话,请进入相应的链接。

+

+ * [如何检查 Red Hat(RHEL)和 CentOS 系统上的可用安全更新][3]

+ * [在 Red Hat(RHEL)和 CentOS 系统上安装安全更新的四种方法][4]

+ * [在 Redhat(RHEL)和 CentOS 系统上检查或列出已安装的安全更新的两种方法][5]

+

+### 方法 1:手动或临时用 yum 命令排除包

+

+我们可以在 yum 中使用 `--exclude` 或 `-x` 开关来阻止 yum 命令获取特定包的更新。

+

+我可以说,这是一种临时方法或按需方法。如果你只想将特定包排除一次,那么我们可以使用此方法。

+

+以下命令将更新除 kernel 之外的所有软件包。

+

+要排除单个包:

+

+```

+# yum update --exclude=kernel

+或者

+# yum update -x 'kernel'

+```

+

+要排除多个包。以下命令将更新除 kernel 和 php 之外的所有软件包。

+

+```

+# yum update --exclude=kernel* --exclude=php*

+或者

+# yum update --exclude httpd,php

+```

+

+### 方法 2:在 yum 命令中永久排除软件包

+

+这是永久性方法,如果你经常执行修补程序更新,那么可以使用此方法。

+

+为此,请在 `/etc/yum.conf` 中添加相应的软件包以永久禁用软件包更新。

+

+添加后,每次运行 `yum update` 命令时都不需要指定这些包。此外,这可以防止任何意外更新这些包。

+

+```

+# vi /etc/yum.conf

+

+[main]

+cachedir=/var/cache/yum/$basearch/$releasever

+keepcache=0

+debuglevel=2

+logfile=/var/log/yum.log

+exactarch=1

+obsoletes=1

+gpgcheck=1

+plugins=1

+installonly_limit=3

+exclude=kernel* php*

+```

+

+### 方法 3:使用 Yum versionlock 插件排除包

+

+这也是与上面类似的永久方法。Yum versionlock 插件允许用户通过 `yum` 命令锁定指定包的更新。

+

+为此,请运行以下命令。以下命令将从 `yum update` 中排除 freetype 包。

+

+或者,你可以直接在 `/etc/yum/pluginconf.d/versionlock.list` 中添加条目。

+

+```

+# yum versionlock add freetype

+

+Loaded plugins: changelog, package_upload, product-id, search-disabled-repos, subscription-manager, verify, versionlock

+Adding versionlock on: 0:freetype-2.8-12.el7

+versionlock added: 1

+```

+

+运行以下命令来检查被 versionlock 插件锁定的软件包列表。

+

+```

+# yum versionlock list

+

+Loaded plugins: changelog, package_upload, product-id, search-disabled-repos, subscription-manager, verify, versionlock

+0:freetype-2.8-12.el7.*

+versionlock list done

+```

+

+运行以下命令清空该列表。

+

+```

+# yum versionlock clear

+```

+

+--------------------------------------------------------------------------------

+

+via: https://www.2daygeek.com/redhat-centos-yum-update-exclude-specific-packages/

+

+作者:[Magesh Maruthamuthu][a]

+选题:[lujun9972][b]

+译者:[geekpi](https://github.com/geekpi)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://www.2daygeek.com/author/magesh/

+[b]: https://github.com/lujun9972

+[1]: https://www.2daygeek.com/yum-command-examples-manage-packages-rhel-centos-systems/

+[2]: https://www.2daygeek.com/rpm-command-examples/

+[3]: https://www.2daygeek.com/check-list-view-find-available-security-updates-on-redhat-rhel-centos-system/

+[4]: https://www.2daygeek.com/install-security-updates-on-redhat-rhel-centos-system/

+[5]: https://www.2daygeek.com/check-installed-security-updates-on-redhat-rhel-and-centos-system/

diff --git a/published/20190830 Change your Linux terminal color theme.md b/published/20190830 Change your Linux terminal color theme.md

new file mode 100644

index 0000000000..321dc40997

--- /dev/null

+++ b/published/20190830 Change your Linux terminal color theme.md

@@ -0,0 +1,86 @@

+[#]: collector: (lujun9972)

+[#]: translator: (geekpi)

+[#]: reviewer: (wxy)

+[#]: publisher: (wxy)

+[#]: url: (https://linux.cn/article-11310-1.html)

+[#]: subject: (Change your Linux terminal color theme)

+[#]: via: (https://opensource.com/article/19/8/add-color-linux-terminal)

+[#]: author: (Seth Kenlon https://opensource.com/users/seth)

+

+如何更改 Linux 终端颜色主题

+======

+

+> 你可以用丰富的选项来定义你的终端主题。

+

+

+

+如果你大部分时间都盯着终端,那么你很自然地希望它看起来能赏心悦目。美与不美,全在观者,自 CRT 串口控制台以来,终端已经经历了很多变迁。因此,你的软件终端窗口有丰富的选项,可以用来定义你看到的主题,不管你如何定义美,这总是件好事。

+

+### 设置

+

+包括 GNOME、KDE 和 Xfce 在内的流行的软件终端应用,它们都提供了更改其颜色主题的选项。调整主题就像调整应用首选项一样简单。Fedora、RHEL 和 Ubuntu 默认使用 GNOME,因此本文使用该终端作为示例,但对 Konsole、Xfce 终端和许多其他终端的设置流程类似。

+

+首先,进入到应用的“首选项”或“设置”面板。在 GNOME 终端中,你可以通过屏幕顶部或窗口右上角的“应用”菜单访问它。

+

+在“首选项”中,单击“配置文件” 旁边的加号(“+”)来创建新的主题配置文件。在新配置文件中,单击“颜色”选项卡。

+

+![GNOME Terminal preferences][2]

+

+在“颜色”选项卡中,取消选择“使用系统主题中的颜色”选项,以使窗口的其余部分变为可选状态。最开始,你可以选择内置的颜色方案。这些包括浅色主题,它有明亮的背景和深色的前景文字;还有深色主题,它有深色背景和浅色前景文字。

+

+当没有其他设置(例如 `dircolors` 命令的设置)覆盖它们时,“默认颜色”色板将同时定义前景色和背景色。“调色板”设置 `dircolors` 命令定义的颜色。这些颜色由终端以 `LS_COLORS` 环境变量的形式使用,以在 [ls][3] 命令的输出中添加颜色。如果这些颜色不吸引你,请在此更改它们。

+

+如果对主题感到满意,请关闭“首选项”窗口。

+

+要将终端更改为新的配置文件,请单击“应用”菜单,然后选择“配置文件”。选择新的配置文件,接着享受自定义主题。

+

+![GNOME Terminal profile selection][4]

+

+### 命令选项

+

+如果你的终端没有合适的设置窗口,它仍然可以在启动命令中提供颜色选项。xterm 和 rxvt 终端(旧的和启用 Unicode 的变体,有时称为 urxvt 或 rxvt-unicode)都提供了这样的选项,因此即使没有桌面环境和大型 GUI 框架,你仍然可以设置终端模拟器的主题。

+

+两个明显的选项是前景色和背景色,分别用 `-fg` 和 `-bg` 定义。每个选项的参数是*颜色名*而不是它的 ANSI 编号。例如:

+

+```

+$ urxvt -bg black -fg green

+```

+

+这些会设置默认的前景和背景。如果有任何其他规则会控制特定文件或设备类型的颜色,那么就使用这些颜色。有关如何设置它们的信息,请参阅 [dircolors][5] 命令。

+

+你还可以使用 `-cr` 设置文本光标(而不是鼠标光标)的颜色:

+

+```

+$ urxvt -bg black -fg green -cr teal

+```

+

+![Setting color in urxvt][6]

+

+你的终端模拟器可能还有更多选项,如边框颜色(rxvt 中的 `-bd`)、光标闪烁(urxvt 中的 `-bc` 和 `+bc`),甚至背景透明度。请参阅终端的手册页,了解更多的功能。

+

+要使用你选择的颜色启动终端,你可以将选项添加到用于启动终端的命令或菜单中(例如,在你的 Fluxbox 菜单文件、`$HOME/.local/share/applications` 目录中的 `.desktop` 或者类似的)。或者,你可以使用 [xrdb][7] 工具来管理与 X 相关的资源(但这超出了本文的范围)。

+

+### 家是可定制的地方

+

+自定义 Linux 机器并不意味着你需要学习如何编程。你可以而且应该进行小而有意义的更改,来使你的数字家庭感觉更舒适。而且没有比终端更好的起点了!

+

+--------------------------------------------------------------------------------

+

+via: https://opensource.com/article/19/8/add-color-linux-terminal

+

+作者:[Seth Kenlon][a]

+选题:[lujun9972][b]

+译者:[geekpi](https://github.com/geekpi)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://opensource.com/users/seth

+[b]: https://github.com/lujun9972

+[1]: https://opensource.com/sites/default/files/styles/image-full-size/public/lead-images/terminal_command_linux_desktop_code.jpg?itok=p5sQ6ODE (Terminal command prompt on orange background)

+[2]: https://opensource.com/sites/default/files/uploads/gnome-terminal-preferences.jpg (GNOME Terminal preferences)

+[3]: https://opensource.com/article/19/7/master-ls-command

+[4]: https://opensource.com/sites/default/files/uploads/gnome-terminal-profile-select.jpg (GNOME Terminal profile selection)

+[5]: http://man7.org/linux/man-pages/man1/dircolors.1.html

+[6]: https://opensource.com/sites/default/files/uploads/urxvt-color.jpg (Setting color in urxvt)

+[7]: https://www.x.org/releases/X11R7.7/doc/man/man1/xrdb.1.xhtml

diff --git a/published/20190830 How to Create and Use Swap File on Linux.md b/published/20190830 How to Create and Use Swap File on Linux.md

new file mode 100644

index 0000000000..d8db4b5623

--- /dev/null

+++ b/published/20190830 How to Create and Use Swap File on Linux.md

@@ -0,0 +1,254 @@

+[#]: collector: (lujun9972)

+[#]: translator: (heguangzhi)

+[#]: reviewer: (wxy)

+[#]: publisher: (wxy)

+[#]: url: (https://linux.cn/article-11341-1.html)

+[#]: subject: (How to Create and Use Swap File on Linux)

+[#]: via: (https://itsfoss.com/create-swap-file-linux/)

+[#]: author: (Abhishek Prakash https://itsfoss.com/author/abhishek/)

+

+如何在 Linux 上创建和使用交换文件

+======

+

+本教程讨论了 Linux 中交换文件的概念,为什么使用它以及它相对于传统交换分区的优势。你将学习如何创建交换文件和调整其大小。

+

+### 什么是 Linux 的交换文件?

+

+交换文件允许 Linux 将磁盘空间模拟为内存。当你的系统开始耗尽内存时,它会使用交换空间将内存的一些内容交换到磁盘空间上。这样释放了内存,为更重要的进程服务。当内存再次空闲时,它会从磁盘交换回数据。我建议[阅读这篇文章,了解 Linux 上的交换空间的更多内容][1]。

+

+传统上,交换空间是磁盘上的一个独立分区。安装 Linux 时,只需创建一个单独的分区进行交换。但是这种趋势在最近几年发生了变化。

+

+使用交换文件,你不再需要单独的分区。你会根目录下创建一个文件,并告诉你的系统将其用作交换空间就行了。

+

+使用专用的交换分区,在许多情况下,调整交换空间的大小是一个可怕而不可能的任务。但是有了交换文件,你可以随意调整它们的大小。

+

+最新版本的 Ubuntu 和其他一些 Linux 发行版已经开始 [默认使用交换文件][2]。甚至如果你没有创建交换分区,Ubuntu 也会自己创建一个 1GB 左右的交换文件。

+

+让我们看看交换文件的更多信息。

+

+

+

+### 检查 Linux 的交换空间

+

+在你开始添加交换空间之前,最好检查一下你的系统中是否已经有了交换空间。

+

+你可以用[Linux 上的 free 命令][4]检查它。就我而言,我的[戴尔 XPS][5]有 14GB 的交换容量。

+

+```

+free -h

+ total used free shared buff/cache available

+Mem: 7.5G 4.1G 267M 971M 3.1G 2.2G

+Swap: 14G 0B 14G

+```

+

+`free` 命令给出了交换空间的大小,但它并没有告诉你它是真实的交换分区还是交换文件。`swapon` 命令在这方面会更好。

+

+```

+swapon --show

+NAME TYPE SIZE USED PRIO

+/dev/nvme0n1p4 partition 14.9G 0B -2

+```

+

+如你所见,我有 14.9GB 的交换空间,它在一个单独的分区上。如果是交换文件,类型应该是 `file` 而不是 `partition`。

+

+```

+swapon --show

+NAME TYPE SIZE USED PRIO

+/swapfile file 2G 0B -2

+```

+

+如果你的系统上没有交换空间,它应该显示如下内容:

+

+```

+free -h

+ total used free shared buff/cache available

+Mem: 7.5G 4.1G 267M 971M 3.1G 2.2G

+Swap: 0B 0B 0B

+```

+

+而 `swapon` 命令不会显示任何输出。

+

+

+### 在 Linux 上创建交换文件

+

+如果你的系统没有交换空间,或者你认为交换空间不足,你可以在 Linux 上创建交换文件。你也可以创建多个交换文件。

+

+让我们看看如何在 Linux 上创建交换文件。我在本教程中使用 Ubuntu 18.04,但它也应该适用于其他 Linux 发行版本。

+

+#### 步骤 1:创建一个新的交换文件

+

+首先,创建一个具有所需交换空间大小的文件。假设我想给我的系统增加 1GB 的交换空间。使用`fallocate` 命令创建大小为 1GB 的文件。

+

+```

+sudo fallocate -l 1G /swapfile

+```

+

+建议只允许 `root` 用户读写该交换文件。当你尝试将此文件用于交换区域时,你甚至会看到类似“不安全权限 0644,建议 0600”的警告。

+

+```

+sudo chmod 600 /swapfile

+```

+

+请注意,交换文件的名称可以是任意的。如果你需要多个交换空间,你可以给它任何合适的名称,如 `swap_file_1`、`swap_file_2` 等。它们只是一个预定义大小的文件。

+

+#### 步骤 2:将新文件标记为交换空间

+

+你需要告诉 Linux 系统该文件将被用作交换空间。你可以用 [mkswap][7] 工具做到这一点。

+

+```

+sudo mkswap /swapfile

+```

+

+你应该会看到这样的输出:

+

+```

+Setting up swapspace version 1, size = 1024 MiB (1073737728 bytes)

+no label, UUID=7e1faacb-ea93-4c49-a53d-fb40f3ce016a

+```

+

+#### 步骤 3:启用交换文件

+

+现在,你的系统知道文件 `swapfile` 可以用作交换空间。但是还没有完成。你需要启用该交换文件,以便系统可以开始使用该文件作为交换。

+

+```

+sudo swapon /swapfile

+```

+

+现在,如果你检查交换空间,你应该会看到你的 Linux 系统会识别并使用它作为交换空间:

+

+```

+swapon --show

+NAME TYPE SIZE USED PRIO

+/swapfile file 1024M 0B -2

+```

+

+#### 步骤 4:让改变持久化

+

+迄今为止你所做的一切都是暂时的。重新启动系统,所有更改都将消失。

+

+你可以通过将新创建的交换文件添加到 `/etc/fstab` 文件来使更改持久化。

+

+对 `/etc/fstab` 文件进行任何更改之前,最好先进行备份。

+

+```

+sudo cp /etc/fstab /etc/fstab.back

+```

+

+现在将以下行添加到 `/etc/fstab` 文件的末尾:

+

+```

+/swapfile none swap sw 0 0

+```

+

+你可以使用[命令行文本编辑器][8]手动操作,或者使用以下命令:

+

+```

+echo '/swapfile none swap sw 0 0' | sudo tee -a /etc/fstab

+```

+

+现在一切都准备好了。即使在重新启动你的 Linux 系统后,你的交换文件也会被使用。

+

+### 调整 swappiness 参数

+

+`swappiness` 参数决定了交换空间的使用频率。`swappiness` 值的范围从 0 到 100。较高的值意味着交换空间将被更频繁地使用。

+

+Ubuntu 桌面的默认的 `swappiness` 是 60,而服务器的默认 `swappiness` 是 1。你可以使用以下命令检查 `swappiness`:

+

+```

+cat /proc/sys/vm/swappiness

+```

+

+为什么服务器应该使用低的 `swappiness` 值?因为交换空间比内存慢,为了获得更好的性能,应该尽可能多地使用内存。在服务器上,性能因素至关重要,因此 `swappiness` 应该尽可能低。

+

+你可以使用以下系统命令动态更改 `swappiness`:

+

+```

+sudo sysctl vm.swappiness=25

+```

+

+这种改变只是暂时的。如果要使其永久化,可以编辑 `/etc/sysctl.conf` 文件,并在文件末尾添加`swappiness` 值:

+

+```

+vm.swappiness=25

+```

+

+### 在 Linux 上调整交换空间的大小

+

+在 Linux 上有几种方法可以调整交换空间的大小。但是在你看到这一点之前,你应该了解一些关于它的事情。

+

+当你要求系统停止将交换文件用于交换空间时,它会将所有数据(确切地说是内存页)传输回内存。所以你应该有足够的空闲内存,然后再停止交换。

+

+这就是为什么创建和启用另一个临时交换文件是一个好的做法的原因。这样,当你关闭原来的交换空间时,你的系统将使用临时交换文件。现在你可以调整原来的交换空间的大小。你可以手动删除临时交换文件或留在那里,下次启动时会自动删除(LCTT 译注:存疑?)。

+

+如果你有足够的可用内存或者创建了临时交换空间,那就关闭你原来的交换文件。

+

+```

+sudo swapoff /swapfile

+```

+

+现在你可以使用 `fallocate` 命令来更改文件的大小。比方说,你将其大小更改为 2GB:

+

+```

+sudo fallocate -l 2G /swapfile

+```

+

+现在再次将文件标记为交换空间:

+

+```

+sudo mkswap /swapfile

+```

+

+并再次启用交换文件:

+

+```

+sudo swapon /swapfile

+```

+

+你也可以选择同时拥有多个交换文件。

+

+### 删除 Linux 中的交换文件

+

+你可能有不在 Linux 上使用交换文件的原因。如果你想删除它,该过程类似于你刚才看到的调整交换大小的过程。

+

+首先,确保你有足够的空闲内存。现在关闭交换文件:

+

+```

+sudo swapoff /swapfile

+```

+

+下一步是从 `/etc/fstab` 文件中删除相应的条目。

+

+最后,你可以删除该文件来释放空间:

+

+```

+sudo rm /swapfile

+```

+

+### 你用了交换空间了吗?

+

+我想你现在已经很好地理解了 Linux 中的交换文件概念。现在,你可以根据需要轻松创建交换文件或调整它们的大小。

+

+如果你对这个话题有什么要补充的或者有任何疑问,请在下面留下评论。

+

+--------------------------------------------------------------------------------

+

+via: https://itsfoss.com/create-swap-file-linux/

+

+作者:[Abhishek Prakash][a]

+选题:[lujun9972][b]

+译者:[heguangzhi](https://github.com/heguangzhi)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://itsfoss.com/author/abhishek/

+[b]: https://github.com/lujun9972

+[1]: https://itsfoss.com/swap-size/

+[2]: https://help.ubuntu.com/community/SwapFaq

+[3]: https://i2.wp.com/itsfoss.com/wp-content/uploads/2019/08/swap-file-linux.png?resize=800%2C450&ssl=1

+[4]: https://linuxhandbook.com/free-command/

+[5]: https://itsfoss.com/dell-xps-13-ubuntu-review/

+[6]: https://itsfoss.com/fix-missing-system-settings-ubuntu-1404-quick-tip/

+[7]: http://man7.org/linux/man-pages/man8/mkswap.8.html

+[8]: https://itsfoss.com/command-line-text-editors-linux/

+[9]: https://itsfoss.com/replace-linux-from-dual-boot/

diff --git a/published/20190830 git exercises- navigate a repository.md b/published/20190830 git exercises- navigate a repository.md

new file mode 100644

index 0000000000..2c7899d172

--- /dev/null

+++ b/published/20190830 git exercises- navigate a repository.md

@@ -0,0 +1,82 @@

+[#]: collector: (lujun9972)

+[#]: translator: (wxy)

+[#]: reviewer: (wxy)

+[#]: publisher: (wxy)

+[#]: url: (https://linux.cn/article-11379-1.html)

+[#]: subject: (git exercises: navigate a repository)

+[#]: via: (https://jvns.ca/blog/2019/08/30/git-exercises--navigate-a-repository/)

+[#]: author: (Julia Evans https://jvns.ca/)

+

+Git 练习:存储库导航

+======

+

+我觉得前几天的 [curl 练习][1]进展顺利,所以今天我醒来后,想尝试编写一些 Git 练习。Git 是一大块需要学习的技能,可能要花几个小时才能学会,所以我分解练习的第一个思路是从“导航”一个存储库开始的。

+

+我本来打算使用一个玩具测试库,但后来我想,为什么不使用真正的存储库呢?这样更有趣!因此,我们将浏览 Ruby 编程语言的存储库。你无需了解任何 C 即可完成此练习,只需熟悉一下存储库中的文件随时间变化的方式即可。

+

+### 克隆存储库

+

+开始之前,需要克隆存储库:

+

+```

+git clone https://github.com/ruby/ruby

+```

+

+与实际使用的大多数存储库相比,该存储库的最大不同之处在于它没有分支,但是它有很多标签,它们与分支相似,因为它们都只是指向一个提交的指针而已。因此,我们将使用标签而不是分支进行练习。*改变*标签的方式和分支非常不同,但*查看*标签和分支的方式完全相同。

+

+### Git SHA 总是引用同一个代码

+

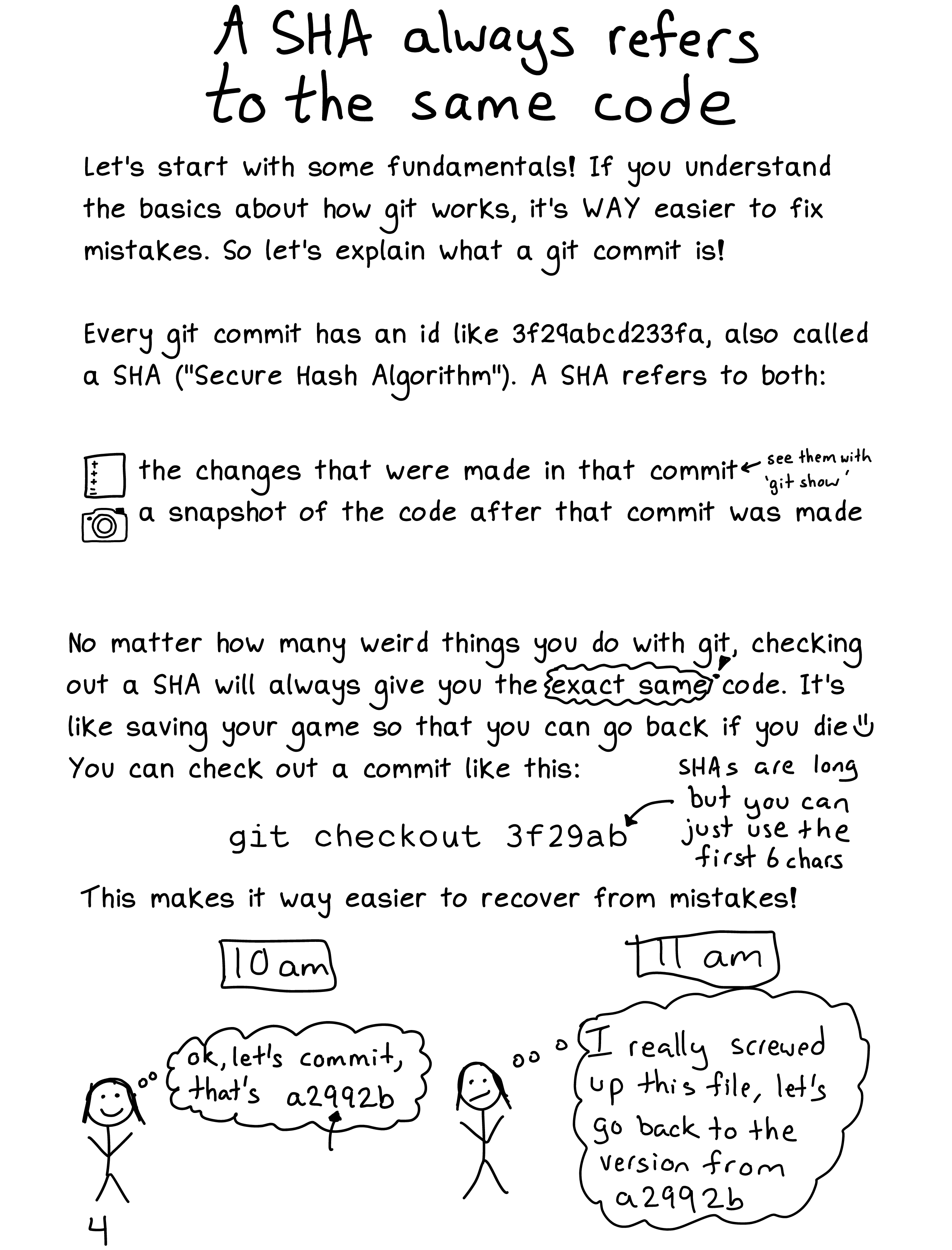

+执行这些练习时要记住的最重要的一点是,如本页面所述,像`9e3d9a2a009d2a0281802a84e1c5cc1c887edc71` 这样的 Git SHA 始终引用同一个的代码。下图摘自我与凯蒂·西勒·米勒撰写的一本杂志,名为《[Oh shit, git!][2]》。(她还有一个名为 的很棒的网站,启发了该杂志。)

+

+

+

+我们将在练习中大量使用 Git SHA,以使你习惯于使用它们,并帮助你了解它们与标签和分支的对应关系。

+

+### 我们将要使用的 Git 子命令

+

+所有这些练习仅使用这 5 个 Git 子命令:

+

+```

+git checkout

+git log (--oneline, --author, and -S will be useful)

+git diff (--stat will be useful)

+git show

+git status

+```

+

+### 练习

+

+1. 查看 matz 从 1998 年开始的 Ruby 提交。提交 ID 为 ` 3db12e8b236ac8f88db8eb4690d10e4a3b8dbcd4`。找出当时 Ruby 的代码行数。

+2. 检出当前的 master 分支。

+3. 查看文件 `hash.c` 的历史记录。更改该文件的最后一个提交 ID 是什么?

+4. 了解最近 20 年来 `hash.c` 的变化:将 master 分支上的文件与提交 `3db12e8b236ac8f88db8eb4690d10e4a3b8dbcd4` 的文件进行比较。

+5. 查找最近更改了 `hash.c` 的提交,并查看该提交的差异。

+6. 对于每个 Ruby 版本,该存储库都有一堆**标签**。获取所有标签的列表。

+7. 找出在标签 `v1_8_6_187` 和标签 `v1_8_6_188` 之间更改了多少文件。

+8. 查找 2015 年的提交(任何一个提交)并将其检出,简单地查看一下文件,然后返回 master 分支。

+9. 找出标签 `v1_8_6_187` 对应的提交。

+10. 列出目录 `.git/refs/tags`。运行 `cat .git/refs/tags/v1_8_6_187` 来查看其中一个文件的内容。

+11. 找出当前 `HEAD` 对应的提交 ID。

+12. 找出已经对 `test/` 目录进行了多少次提交。

+13. 提交 `65a5162550f58047974793cdc8067a970b2435c0` 和 `9e3d9a2a009d2a0281802a84e1c5cc1c887edc71` 之间的 `lib/telnet.rb` 的差异。该文件更改了几行?

+14. 在 Ruby 2.5.1 和 2.5.2 之间进行了多少次提交(标记为 `v2_5_1` 和 `v2_5_3`)(这一步有点棘手,步骤不只一步)

+15. “matz”(Ruby 的创建者)作了多少提交?

+16. 最近包含 “tkutil” 一词的提交是什么?

+17. 检出提交 `e51dca2596db9567bd4d698b18b4d300575d3881` 并创建一个指向该提交的新分支。

+18. 运行 `git reflog` 以查看你到目前为止完成的所有存储库导航操作。

+

+--------------------------------------------------------------------------------

+

+via: https://jvns.ca/blog/2019/08/30/git-exercises--navigate-a-repository/

+

+作者:[Julia Evans][a]

+选题:[lujun9972][b]

+译者:[wxy](https://github.com/wxy)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://jvns.ca/

+[b]: https://github.com/lujun9972

+[1]: https://jvns.ca/blog/2019/08/27/curl-exercises/

+[2]: https://wizardzines.com/zines/oh-shit-git/

diff --git a/published/20190831 Google opens Android speech transcription and gesture tracking, Twitter-s telemetry tooling, Blender-s growing adoption, and more news.md b/published/20190831 Google opens Android speech transcription and gesture tracking, Twitter-s telemetry tooling, Blender-s growing adoption, and more news.md

new file mode 100644

index 0000000000..c6370eb975

--- /dev/null

+++ b/published/20190831 Google opens Android speech transcription and gesture tracking, Twitter-s telemetry tooling, Blender-s growing adoption, and more news.md

@@ -0,0 +1,88 @@

+[#]: collector: (lujun9972)

+[#]: translator: (wxy)

+[#]: reviewer: (wxy)

+[#]: publisher: (wxy)

+[#]: url: (https://linux.cn/article-11292-1.html)

+[#]: subject: (Google opens Android speech transcription and gesture tracking, Twitter's telemetry tooling, Blender's growing adoption, and more news)

+[#]: via: (https://opensource.com/19/8/news-august-31)

+[#]: author: (Scott Nesbitt https://opensource.com/users/scottnesbitt)

+

+开源新闻综述:谷歌开源 Android 语音转录和手势追踪、Twitter 的遥测工具

+======

+

+> 不要错过两周以来最大的开源头条新闻。

+

+![Weekly news roundup with TV][1]

+

+在本期的开源新闻综述中,我们来看看谷歌发布的两个开源软件、Twitter 的最新可观测性工具、动漫工作室对 Blender 的采用在增多等等新闻!

+

+### 谷歌的开源双响炮

+

+搜索引擎巨头谷歌的开发人员最近一直忙于开源。在过去的两周里,他们以开源的方式发布了两个截然不同的软件。

+

+第一个是 Android 的语音识别和转录工具 Live Transcribe 的[语音引擎][2],它可以“在移动设备上使用机器学习算法将音频变成实时字幕”。谷歌的声明称,它正在开源 Live Transcribe 以“让所有开发人员可以为长篇对话提供字幕”。你可以[在 GitHub 上][3]浏览或下载 Live Transcribe 的源代码。

+

+谷歌还为 Android 和 iOS 开源了[手势跟踪软件][4],它建立在其 [MediaPipe][5] 机器学习框架之上。该软件结合了三种人工智能组件:手掌探测器、“返回 3D 手点”的模型和手势识别器。据谷歌研究人员称,其目标是改善“跨各种技术领域和平台的用户体验”。该软件的源代码和文档[可在 GitHub 上获得][6]。

+

+### Twitter 开源 Rezolus 遥测工具

+

+当想到网络中断时,我们想到的是影响站点或服务性能的大崩溃或减速。让我们感到惊讶的是性能慢慢被吃掉的小尖峰的重要性。为了更容易地检测这些尖峰,Twitter 开发了一个名为 Rezolus 的工具,该公司[已将其开源][7]。

+

+> 我们现有的按分钟采样的遥测技术未能反映出这些异常现象。这是因为相对于该异常发生的长度,较低的采样率掩盖了这些持续时间大约为 10 秒的异常。这使得很难理解正在发生的事情并调整系统以获得更高的性能。

+

+Rezolus 旨在检测“非常短暂但有时显著的性能异常”——仅持续几秒钟。Twitter 已经运行了 Rezolus 大约一年,并且一直在使用它收集的内容“与后端服务日志来确定峰值的来源”。

+

+如果你对将 Rezolus 添加到可观测性堆栈中的结果感到好奇,请查看 Twitter 的 [GitHub 存储库][8]中的源代码。

+

+### 日本的 Khara 动画工作室采用 Blender

+

+Blender 被认为是开源的动画和视觉效果软件的黄金标准。它被几家制作公司采用,其中最新的是[日本动漫工作室 Khara][9]。

+

+Khara 正在使用 Blender 开发 Evangelion: 3.0+1.0,这是基于流行动漫系列《Neon Genesis Evangelion》的电影系列的最新版本。虽然该电影的工作不能在 Blender 中全部完成,但 Khara 的员工“将从 2020 年 6 月开始使用 Blender 进行大部分工作”。为了强调其对 Blender 和开源的承诺,“Khara 宣布它将作为企业会员加入 Blender 基金会的发展基金。“

+

+### NSA 分享其固件安全工具

+

+继澳大利亚同行[共享他们的一个工具][10]之后,美国国家安全局(NSA)正在[提供][11]的一个项目的成果“可以更好地保护机器免受固件攻击“。这个最新的软件以及其他保护固件的开源工作可以在 [Coreboot Gerrit 存储库][12]下找到。

+

+这个名为“具有受保护执行的 SMI 传输监视器”(STM-PE)的软件“将与运行 Coreboot 的 x86 处理器配合使用”以防止固件攻击。根据 NSA 高级网络安全实验室的 Eugene Meyers 的说法,STM-PE 采用低级操作系统代码“并将其置于一个盒子中,以便它只能访问它需要访问的设备系统”。这有助于防止篡改,Meyers 说,“这将提高系统的安全性。”

+

+### 其它新闻

+

+* [Linux 内核中的 exFAT?是的!][13]

+* [瓦伦西亚继续支持 Linux 学校发行版][14]

+* [西班牙首个开源卫星][15]

+* [Western Digital 从开放标准到开源芯片的长途旅行][16]

+* [用于自动驾驶汽车多模传感器的 Waymo 开源数据集][17]

+

+一如既往地感谢 Opensource.com 的工作人员和主持人本周的帮助。

+

+--------------------------------------------------------------------------------

+

+via: https://opensource.com/19/8/news-august-31

+

+作者:[Scott Nesbitt][a]

+选题:[lujun9972][b]

+译者:[wxy](https://github.com/wxy)

+校对:[wxy](https://github.com/wxy)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://opensource.com/users/scottnesbitt

+[b]: https://github.com/lujun9972

+[1]: https://opensource.com/sites/default/files/styles/image-full-size/public/lead-images/weekly_news_roundup_tv.png?itok=B6PM4S1i (Weekly news roundup with TV)

+[2]: https://venturebeat.com/2019/08/16/google-open-sources-live-transcribes-speech-engine/

+[3]: https://github.com/google/live-transcribe-speech-engine

+[4]: https://venturebeat.com/2019/08/19/google-open-sources-gesture-tracking-ai-for-mobile-devices/

+[5]: https://github.com/google/mediapipe

+[6]: https://github.com/google/mediapipe/blob/master/mediapipe/docs/hand_tracking_mobile_gpu.md

+[7]: https://blog.twitter.com/engineering/en_us/topics/open-source/2019/introducing-rezolus.html

+[8]: https://github.com/twitter/rezolus

+[9]: https://www.neowin.net/news/anime-studio-khara-is-planning-to-use-open-source-blender-software/

+[10]: https://linux.cn/article-11241-1.html

+[11]: https://www.cyberscoop.com/nsa-firmware-open-source-coreboot-stm-pe-eugene-myers/

+[12]: https://review.coreboot.org/admin/repos

+[13]: https://cloudblogs.microsoft.com/opensource/2019/08/28/exfat-linux-kernel/

+[14]: https://joinup.ec.europa.eu/collection/open-source-observatory-osor/news/120000-lliurex-desktops

+[15]: https://hackaday.com/2019/08/15/spains-first-open-source-satellite/

+[16]: https://www.datacenterknowledge.com/open-source/western-digitals-long-trip-open-standards-open-source-chips

+[17]: https://venturebeat.com/2019/08/21/waymo-open-sources-data-set-for-autonomous-vehicle-multimodal-sensors/

diff --git a/published/20190901 Different Ways to Configure Static IP Address in RHEL 8.md b/published/20190901 Different Ways to Configure Static IP Address in RHEL 8.md

new file mode 100644

index 0000000000..d67e035961

--- /dev/null

+++ b/published/20190901 Different Ways to Configure Static IP Address in RHEL 8.md

@@ -0,0 +1,237 @@

+[#]: collector: (lujun9972)

+[#]: translator: (heguangzhi)

+[#]: reviewer: (wxy)

+[#]: publisher: (wxy)

+[#]: url: (https://linux.cn/article-11390-1.html)

+[#]: subject: (Different Ways to Configure Static IP Address in RHEL 8)

+[#]: via: (https://www.linuxtechi.com/configure-static-ip-address-rhel8/)

+[#]: author: (Pradeep Kumar https://www.linuxtechi.com/author/pradeep/)

+

+在 RHEL8 配置静态 IP 地址的不同方法

+======

+

+在 Linux 服务器上工作时,在网卡/以太网卡上分配静态 IP 地址是每个 Linux 工程师的常见任务之一。如果一个人在 Linux 服务器上正确配置了静态地址,那么他/她就可以通过网络远程访问它。在本文中,我们将演示在 RHEL 8 服务器网卡上配置静态 IP 地址的不同方法。

+

+

+

+以下是在网卡上配置静态IP的方法:

+

+ * `nmcli`(命令行工具)

+ * 网络脚本文件(`ifcfg-*`)

+ * `nmtui`(基于文本的用户界面)

+

+### 使用 nmcli 命令行工具配置静态 IP 地址

+

+每当我们安装 RHEL 8 服务器时,就会自动安装命令行工具 `nmcli`,它是由网络管理器使用的,可以让我们在以太网卡上配置静态 IP 地址。

+

+运行下面的 `ip addr` 命令,列出 RHEL 8 服务器上的以太网卡

+

+```

+[root@linuxtechi ~]# ip addr

+```

+

+正如我们在上面的命令输出中看到的,我们有两个网卡 `enp0s3` 和 `enp0s8`。当前分配给网卡的 IP 地址是通过 DHCP 服务器获得的。

+

+假设我们希望在第一个网卡 (`enp0s3`) 上分配静态 IP 地址,具体内容如下:

+

+ * IP 地址 = 192.168.1.4

+ * 网络掩码 = 255.255.255.0

+ * 网关 = 192.168.1.1

+ * DNS = 8.8.8.8

+

+依次运行以下 `nmcli` 命令来配置静态 IP,

+

+使用 `nmcli connection` 命令列出当前活动的以太网卡,

+

+```

+[root@linuxtechi ~]# nmcli connection

+NAME UUID TYPE DEVICE

+enp0s3 7c1b8444-cb65-440d-9bf6-ea0ad5e60bae ethernet enp0s3

+virbr0 3020c41f-6b21-4d80-a1a6-7c1bd5867e6c bridge virbr0

+[root@linuxtechi ~]#

+```

+

+使用下面的 `nmcli` 给 `enp0s3` 分配静态 IP。

+

+**命令语法:**

+

+```

+# nmcli connection modify ipv4.address

+```

+

+**注意:** 为了简化语句,在 `nmcli` 命令中,我们通常用 `con` 关键字替换 `connection`,并用 `mod` 关键字替换 `modify`。

+

+将 IPv4 地址 (192.168.1.4) 分配给 `enp0s3` 网卡上,

+

+```

+[root@linuxtechi ~]# nmcli con mod enp0s3 ipv4.addresses 192.168.1.4/24

+```

+

+使用下面的 `nmcli` 命令设置网关,

+

+```

+[root@linuxtechi ~]# nmcli con mod enp0s3 ipv4.gateway 192.168.1.1

+```

+

+设置手动配置(从 dhcp 到 static),

+

+```

+[root@linuxtechi ~]# nmcli con mod enp0s3 ipv4.method manual

+```

+

+设置 DNS 值为 “8.8.8.8”,

+

+```

+[root@linuxtechi ~]# nmcli con mod enp0s3 ipv4.dns "8.8.8.8"

+```

+

+要保存上述更改并重新加载,请执行如下 `nmcli` 命令,

+

+```

+[root@linuxtechi ~]# nmcli con up enp0s3

+Connection successfully activated (D-Bus active path: /org/freedesktop/NetworkManager/ActiveConnection/4)

+```

+

+以上命令显示网卡 `enp0s3` 已成功配置。我们使用 `nmcli` 命令做的那些更改都将永久保存在文件 `etc/sysconfig/network-scripts/ifcfg-enp0s3` 里。

+

+```

+[root@linuxtechi ~]# cat /etc/sysconfig/network-scripts/ifcfg-enp0s3

+```

+

+![ifcfg-enp0s3-file-rhel8][2]

+

+要确认 IP 地址是否分配给了 `enp0s3` 网卡了,请使用以下 IP 命令查看,

+

+```

+[root@linuxtechi ~]#ip addr show enp0s3

+```

+

+### 使用网络脚本文件(ifcfg-*)手动配置静态 IP 地址

+

+我们可以使用配置以太网卡的网络脚本或 `ifcfg-*` 文件来配置以太网卡的静态 IP 地址。假设我们想在第二个以太网卡 `enp0s8` 上分配静态 IP 地址:

+

+* IP 地址 = 192.168.1.91

+* 前缀 = 24

+* 网关 =192.168.1.1

+* DNS1 =4.2.2.2

+

+

+转到目录 `/etc/sysconfig/network-scripts`,查找文件 `ifcfg-enp0s8`,如果它不存在,则使用以下内容创建它,

+

+```

+[root@linuxtechi ~]# cd /etc/sysconfig/network-scripts/

+[root@linuxtechi network-scripts]# vi ifcfg-enp0s8

+TYPE="Ethernet"

+DEVICE="enp0s8"

+BOOTPROTO="static"

+ONBOOT="yes"

+NAME="enp0s8"

+IPADDR="192.168.1.91"

+PREFIX="24"

+GATEWAY="192.168.1.1"

+DNS1="4.2.2.2"

+```

+

+保存并退出文件,然后重新启动网络管理器服务以使上述更改生效,

+

+```

+[root@linuxtechi network-scripts]# systemctl restart NetworkManager

+```

+

+现在使用下面的 `ip` 命令来验证 IP 地址是否分配给网卡,

+

+```

+[root@linuxtechi ~]# ip add show enp0s8

+3: enp0s8: mtu 1500 qdisc fq_codel state UP group default qlen 1000

+ link/ether 08:00:27:7c:bb:cb brd ff:ff:ff:ff:ff:ff

+ inet 192.168.1.91/24 brd 192.168.1.255 scope global noprefixroute enp0s8

+ valid_lft forever preferred_lft forever

+ inet6 fe80::a00:27ff:fe7c:bbcb/64 scope link

+ valid_lft forever preferred_lft forever

+[root@linuxtechi ~]#

+```

+

+以上输出内容确认静态 IP 地址已在网卡 `enp0s8` 上成功配置了。

+

+### 使用 nmtui 实用程序配置静态 IP 地址

+

+`nmtui` 是一个基于文本用户界面的,用于控制网络的管理器,当我们执行 `nmtui` 时,它将打开一个基于文本的用户界面,通过它我们可以添加、修改和删除连接。除此之外,`nmtui` 还可以用来设置系统的主机名。

+

+假设我们希望通过以下细节将静态 IP 地址分配给网卡 `enp0s3` ,

+

+* IP 地址 = 10.20.0.72

+* 前缀 = 24

+* 网关 = 10.20.0.1

+* DNS1 = 4.2.2.2

+

+运行 `nmtui` 并按照屏幕说明操作,示例如下所示,

+

+```

+[root@linuxtechi ~]# nmtui

+```

+

+![nmtui-rhel8][3]

+