mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-02-28 01:01:09 +08:00

commit

b6a6cdac22

95

README.md

95

README.md

@ -5,7 +5,7 @@ LCTT 是“Linux中国”([https://linux.cn/](https://linux.cn/))的翻译

|

||||

|

||||

LCTT 已经拥有几百名活跃成员,并欢迎更多的Linux志愿者加入我们的团队。

|

||||

|

||||

|

||||

|

||||

|

||||

LCTT 的组成

|

||||

-------------------------------

|

||||

@ -38,7 +38,7 @@ LCTT 的组成

|

||||

* 2013/09/16 公开发布了翻译组成立消息后,又有新的成员申请加入了。并从此建立见习成员制度。

|

||||

* 2013/09/24 鉴于大家使用 GitHub 的水平不一,容易导致主仓库的一些错误,因此换成了常规的 fork+PR 的模式来进行翻译流程。

|

||||

* 2013/10/11 根据对 LCTT 的贡献,划分了 Core Translators 组,最先的加入成员是 vito-L 和 tinyeyeser。

|

||||

* 2013/10/12 取消对 LINUX.CN 注册用户的依赖,在 QQ 群内、文章内都采用 GitHub 的注册 ID。

|

||||

* 2013/10/12 取消对 LINUX.CN 注册用户的关联,在 QQ 群内、文章内都采用 GitHub 的注册 ID。

|

||||

* 2013/10/18 正式启动 man 翻译计划。

|

||||

* 2013/11/10 举行第一次北京线下聚会。

|

||||

* 2014/01/02 增加了 Core Translators 成员: geekpi。

|

||||

@ -52,7 +52,11 @@ LCTT 的组成

|

||||

* 2015/04/19 发起 LFS-BOOK-7.7-systemd 项目。

|

||||

* 2015/06/09 提升 ictlyh 和 dongfengweixiao 为 Core Translators 成员。

|

||||

* 2015/11/10 提升 strugglingyouth、FSSlc、Vic020、alim0x 为 Core Translators 成员。

|

||||

* 2016/02/18 由于选题 DeadFire 重病,任命 oska874 接手选题工作。

|

||||

* 2016/02/29 选题 DeadFire 病逝。

|

||||

* 2016/05/09 提升 PurlingNayuki 为校对。

|

||||

* 2016/09/10 LCTT 三周年。

|

||||

* 2016/12/24 拟定 LCTT [Core 规则](core.md),并增加新的 Core 成员: @ucasFL、@martin2011qi,及调整一些组。

|

||||

|

||||

活跃成员

|

||||

-------------------------------

|

||||

@ -60,121 +64,108 @@ LCTT 的组成

|

||||

目前 TP 活跃成员有:

|

||||

- Leader @wxy,

|

||||

- Source @oska874,

|

||||

- Proofreader @PurlingNayuki,

|

||||

- Proofreaders @jasminepeng,

|

||||

- CORE @geekpi,

|

||||

- CORE @GOLinux,

|

||||

- CORE @ictlyh,

|

||||

- CORE @carolinewuyan,

|

||||

- CORE @strugglingyouth,

|

||||

- CORE @FSSlc

|

||||

- CORE @zpl1025,

|

||||

- CORE @runningwater,

|

||||

- CORE @bazz2,

|

||||

- CORE @Vic020,

|

||||

- CORE @dongfengweixiao,

|

||||

- CORE @alim0x,

|

||||

- CORE @tinyeyeser,

|

||||

- CORE @Locez,

|

||||

- CORE @ucasFL

|

||||

- CORE @martin2011qi

|

||||

- Senior @DeadFire,

|

||||

- Senior @reinoir222,

|

||||

- Senior @tinyeyeser,

|

||||

- Senior @vito-L,

|

||||

- Senior @jasminepeng,

|

||||

- Senior @willqian,

|

||||

- Senior @vizv,

|

||||

- Senior @dongfengweixiao,

|

||||

- Senior @PurlingNayuki,

|

||||

- Senior @carolinewuyan,

|

||||

- cposture,

|

||||

- ZTinoZ,

|

||||

- martin2011qi,

|

||||

- theo-l,

|

||||

- Luoxcat,

|

||||

- GHLandy,

|

||||

- wi-cuckoo,

|

||||

- StdioA,

|

||||

- disylee,

|

||||

- haimingfg,

|

||||

- KayGuoWhu,

|

||||

- wwy-hust,

|

||||

- felixonmars,

|

||||

- KayGuoWhu,

|

||||

- mr-ping,

|

||||

- wyangsun,

|

||||

- su-kaiyao,

|

||||

- GHLandy,

|

||||

- ivo-wang,

|

||||

- cvsher,

|

||||

- wyangsun,

|

||||

- OneNewLife

|

||||

- DongShuaike,

|

||||

- flsf,

|

||||

- SPccman,

|

||||

- Stevearzh

|

||||

- mr-ping,

|

||||

- Stevearzh,

|

||||

- bestony,

|

||||

- Linchenguang,

|

||||

- Linux-pdz,

|

||||

- 2q1w2007,

|

||||

- NearTan,

|

||||

- H-mudcup,

|

||||

- cposture,

|

||||

- GitFuture,

|

||||

- MikeCoder,

|

||||

- xiqingongzi,

|

||||

- goreliu,

|

||||

- NearTan,

|

||||

- rusking,

|

||||

- jiajia9linuxer,

|

||||

- name1e5s,

|

||||

- TxmszLou,

|

||||

- ZhouJ-sh,

|

||||

- wangjiezhe,

|

||||

- icybreaker,

|

||||

- zky001,

|

||||

- vim-kakali,

|

||||

- shipsw,

|

||||

- LinuxBars,

|

||||

- Moelf,

|

||||

- Chao-zhi

|

||||

- johnhoow,

|

||||

- soooogreen,

|

||||

- kokialoves,

|

||||

- linuhap,

|

||||

- ChrisLeeGit,

|

||||

- blueabysm,

|

||||

- yangmingming,

|

||||

- boredivan,

|

||||

- name1e5s,

|

||||

- StdioA,

|

||||

- yechunxiao19,

|

||||

- l3b2w1,

|

||||

- XLCYun,

|

||||

- KevinSJ,

|

||||

- l3b2w1,

|

||||

- tenght,

|

||||

- firstadream,

|

||||

- coloka,

|

||||

- luoyutiantang,

|

||||

- sonofelice,

|

||||

- jiajia9linuxer,

|

||||

- scusjs,

|

||||

- tnuoccalanosrep,

|

||||

- woodboow,

|

||||

- 1w2b3l,

|

||||

- JonathanKang,

|

||||

- crowner,

|

||||

- dingdongnigetou,

|

||||

- mtunique,

|

||||

- CNprober,

|

||||

- hyaocuk,

|

||||

- szrlee,

|

||||

- KnightJoker,

|

||||

- Xuanwo,

|

||||

- nd0104,

|

||||

- Moelf,

|

||||

- xiaoyu33,

|

||||

- guodongxiaren,

|

||||

- ynmlml,

|

||||

- vim-kakali,

|

||||

- ggaaooppeenngg,

|

||||

- Ricky-Gong,

|

||||

- zky001,

|

||||

- lfzark,

|

||||

- 213edu,

|

||||

- bestony,

|

||||

- mudongliang,

|

||||

- chenzhijun,

|

||||

- frankatlingingdigital,

|

||||

- willcoderwang,

|

||||

- liuaiping,

|

||||

- Timeszoro,

|

||||

- rogetfan,

|

||||

- JeffDing,

|

||||

- Yuking-net,

|

||||

|

||||

|

||||

(按增加行数排名前百)

|

||||

|

||||

LFS 项目活跃成员有:

|

||||

|

||||

- @ictlyh

|

||||

- @dongfengweixiao

|

||||

- @wxy

|

||||

- @H-mudcup

|

||||

- @zpl1025

|

||||

- @KevinSJ

|

||||

- @Yuking-net

|

||||

|

||||

(更新于2016/06/20)

|

||||

(按增加行数排名前百,更新于2016/12/24)

|

||||

|

||||

谢谢大家的支持!

|

||||

|

||||

|

||||

39

core.md

Normal file

39

core.md

Normal file

@ -0,0 +1,39 @@

|

||||

给核心成员的一封信

|

||||

===================

|

||||

|

||||

鉴于您的卓越贡献,我邀请您成为 LCTT 的核心(Core)成员。

|

||||

|

||||

作为核心成员,您拥有如下权利:

|

||||

|

||||

- 您能够合并您以及其它普通成员的 PR

|

||||

- 您能够校对其它普通成员的文章,并提交校对 PR

|

||||

- 您能够建议或反对将某位普通成员升级为核心成员

|

||||

- 您能够自主添加符合 LCTT 定位的选题并翻译

|

||||

- 您能够以 LCTT 核心成员名义宣称、署名

|

||||

- 在得到 LCTT 同意后,以 LCTT 身份出席活动

|

||||

- 在得到 LCTT 同意后,创建 LCTT 名下的其它仓库并管理(及邀请其它成员参与)

|

||||

- 成为 LinuxCN 管理团队的一员

|

||||

- 参与 LCTT 及 LinuxCN 决策投票

|

||||

|

||||

以下是不允许的行为,虽然您可能有这样的权限:

|

||||

|

||||

- 直接在 LCTT 主仓库上提交修改

|

||||

- 在 LCTT 主仓库上创建分支

|

||||

|

||||

除此以外,您有以下义务:

|

||||

|

||||

- 为您的 GitHub 账户创建安全的密码

|

||||

- 为您的 GitHub 账户创建 2FA 验证

|

||||

- 不得外借您的 GitHub 账户,您需要为您的账户负责

|

||||

- 保持参与度,如长期不能参与,会转换身份为荣誉成员,并放弃相应权限

|

||||

- 接待新加入的成员,并做好引导个工作

|

||||

- 维护 Wiki

|

||||

|

||||

作为核心成员,您会执行一些管理工作,以下是一些惯例:

|

||||

|

||||

- 合并 PR 时,要按时间顺序,从最早的(最下方)的开始合并

|

||||

- 合并 PR 时,如果与仓库或前面的 PR 冲突,则关闭该 PR,并提醒 PR 发起人修改处理

|

||||

- 除非必要,合并 PR 时不要 squash-merge

|

||||

|

||||

wxy@LCTT

|

||||

2016/12/24

|

||||

42

lctt2016.md

Normal file

42

lctt2016.md

Normal file

@ -0,0 +1,42 @@

|

||||

LCTT 2016:LCTT 成立三周年了!

|

||||

===========================

|

||||

|

||||

不知不觉,LCTT 已经成立三年了,对于我这样已经迈过四张的人来说,愈发的感觉时间过得真快。

|

||||

|

||||

这三年来,我们 LCTT 经历了很多事情,有些事情想起来仍恍如昨日。

|

||||

|

||||

三年前的这一天,我的一个偶发的想法促使我在 Linux 中国的 QQ 群里面发了一则消息,具体的消息内容已经不可考了,大意是鉴于英文 man 手册的中文翻译太差,想组织一些人来重新翻译。不料发出去之后很快赢得一些有热情、有理想的小伙伴们的响应。于是我匆匆建了一个群,拉了一些人进来,甚至当时连翻译组的名称都没有确定。LCTT (Linux.Cn Translation Team)这个名称都是后来逐步定下来的。

|

||||

|

||||

关于 LCTT 的早期发展情况,可以参考 LCTT 2014 年周年[总结](http://linux.cn/article-3784-1.html)。

|

||||

|

||||

虽然说“翻译 man 手册”这个最初建群的目标因为种种原因搁浅而一直未能重启,但是,这三年来,我们组织了 [213 位志愿者](https://github.com/LCTT/TranslateProject/graphs/contributors)翻译了 2155 篇文章,接受了 [4263 个 PR](https://github.com/LCTT/TranslateProject/pulls?q=is%3Apr+is%3Aclosed),得到了 476 个星。

|

||||

|

||||

这三年来,我们经历了 man 项目的流产、 LFS 手册的翻译发布、选题 DeadFire 的离去。得益于 Linux 中国的网站和微博,乃至微信的兴起后的传播,志愿者们的译文传播很广,切实的为国内的开源社区做出了贡献(当然,与此同时,Linux 中国社区也随之更加壮大)。

|

||||

|

||||

这些年间,LCTT 来了很多人,也有人慢慢淡出,这里面涌现了不少做出了卓越贡献的人,比如:

|

||||

|

||||

- geekpi,作为整个 LCTT 项目中翻译量最大贡献者,却鲜少在群内说话,偶尔露面,被戏称为“鸡排兄”。

|

||||

- GOLinux,紧追“鸡排兄”的第二位强人,嗯,群内大部分人的昵称都是他起的,包括楼上。

|

||||

- tinyeyeser,“小眼儿”以翻译风趣幽默著称,是 LCTT 早期初创成员之一。

|

||||

- Vito-L,早期成员,LCTT 的多数 Wiki 出自于其手。

|

||||

- DeadFire,创始成员,从最开始到其离世,一直负责 LCTT 的所有选题工作。

|

||||

- oska874,在接过选题工作的重任后,全面主持 LCTT 的工作。

|

||||

- carolinewuyan,承担了相当多的校对工作。

|

||||

- alim0x,独立完成了 Android 编年史系列的翻译(多达 26 篇,现在还没发布完)等等。

|

||||

|

||||

其它还有 ictlyh、strugglingyouth、FSSlc、zpl1025、runningwater、bazz2、Vic020、dongfengweixiao、jasminepeng、willqian、vizv、ZTinoZ、martin2011qi、felixonmars、su-kaiyao、GHLandy、flsf、H-mudcup、StdioA、crowner、vim-kakali 等等,以及还有很多这里没有提到名字的人,都对 LCTT 做出不可磨灭的贡献。

|

||||

|

||||

具体的贡献排行榜,可以看[这里](https://github.com/LCTT/TranslateProject/graphs/contributors)。

|

||||

|

||||

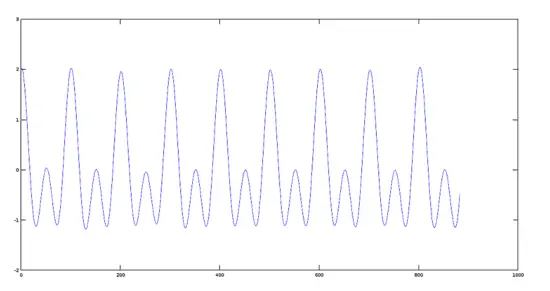

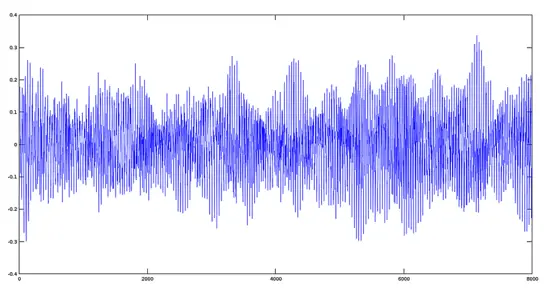

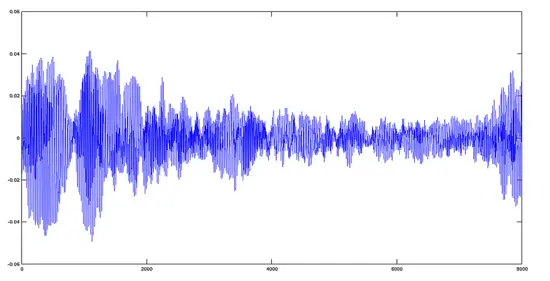

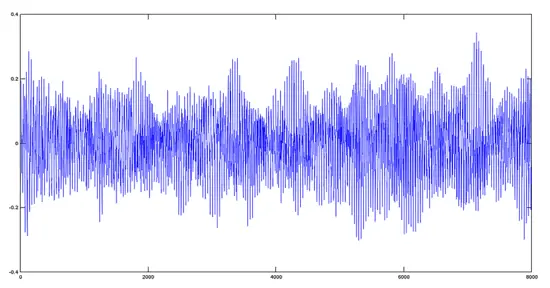

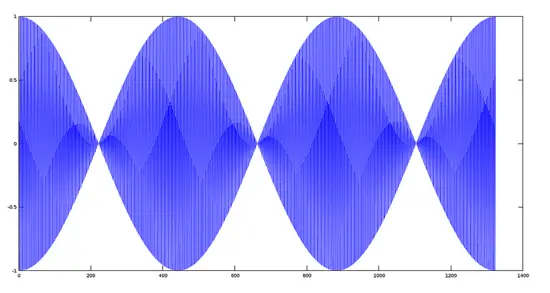

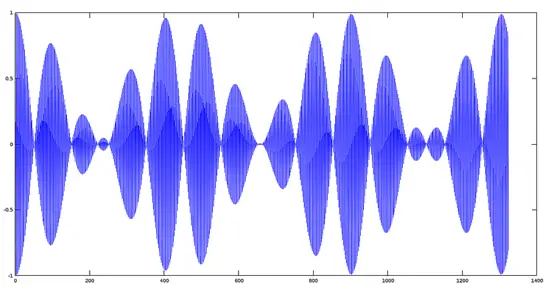

每年写总结时,我都需要和 gource 以及 ffmpeg 搏斗半天,今年,我又用 gource 重新制作了一份 LCTT 的 GitHub 版本仓库的变迁视频,以飨众人。

|

||||

|

||||

本来想写很多,或许 LCTT 和 Linux 中国已经成了我的生活的一部分,竟然不知道该写点什么了,那就此搁笔罢。

|

||||

|

||||

另外,为 LCTT 的诸位兄弟姐妹们献上我及管理团队的祝福,也欢迎更多的志愿者加入 LCTT ,传送门在此:

|

||||

|

||||

- 项目网站:https://lctt.github.io/ ,请先访问此处了解情况。

|

||||

- “Linux中国”开源社区:https://linux.cn/ ,所有翻译的文章都在这里以及它的同名微博、微信发布。

|

||||

|

||||

LCTT 组长 wxy

|

||||

|

||||

2016/9/10

|

||||

@ -0,0 +1,59 @@

|

||||

浅谈 Linux 容器和镜像签名

|

||||

====================

|

||||

|

||||

|

||||

|

||||

从根本上说,几乎所有的主要软件,即使是开源软件,都是在基于镜像的容器技术出现之前设计的。这意味着把软件放到容器中相当于是一次平台移植。这也意味着一些程序可以很容易就迁移,[而一些就更困难][1]。

|

||||

|

||||

我大约在三年半前开展基于镜像的容器相关工作。到目前为止,我已经容器化了大量应用。我了解到什么是现实情况,什么是迷信。今天,我想简要介绍一下 Linux 容器是如何设计的,以及谈谈镜像签名。

|

||||

|

||||

### Linux 容器是如何设计的

|

||||

|

||||

对于基于镜像的 Linux 容器,让大多数人感到困惑的是,它把操作系统分割成两个部分:[内核空间与用户空间][2]。在传统操作系统中,内核运行在硬件上,你无法直接与其交互。用户空间才是你真正能交互的,这包括所有你可以通过文件浏览器或者运行`ls`命令能看到的文件、类库、程序。当你使用`ifconfig`命令调整 IP 地址时,你实际上正在借助用户空间的程序来使内核根据 TCP 协议栈改变。这点经常让没有研究过 [Linux/Unix 基础][3]的人大吃一惊。

|

||||

|

||||

过去,用户空间中的类库支持了与内核交互的程序(比如 ifconfig、sysctl、tuned-adm)以及如网络服务器和数据库之类的面向用户的程序。这些所有的东西都堆积在一个单一的文件系统结构中。用户可以在 /sbin 或者 /lib 文件夹中找到所有操作系统本身支持的程序和类库,或者可以在 /usr/sbin 或 /usr/lib 文件夹中找到所有面向用户的程序或类库(参阅[文件系统层次结构标准][4])。这个模型的问题在于操作系统程序和业务支持程序没有绝对的隔离。/usr/bin 中的程序可能依赖 /lib 中的类库。如果一个应用所有者需要改变一些东西,就很有可能破坏操作系统。相反地,如果负责安全更新的团队需要改变一个类库,就(常常)有可能破坏面向业务的应用。这真是一团糟。

|

||||

|

||||

借助基于镜像的容器,比如 Docker、LXD、RKT,应用程序所有者可以打包和调整所有放在 /sbin、/lib、/usr/bin 和 /usr/lib 中的依赖部分,而不用担心破坏底层操作系统。本质上讲,容器技术再次干净地将操作系统隔离为两部分:内核空间与用户空间。现在开发人员和运维人员可以分别独立地更新各自的东西。

|

||||

|

||||

然而还是有些令人困扰的地方。通常,每个应用所有者(或开发者)并不想负责更新这些应用依赖:像 openssl、glibc,或很底层的基础组件,比如,XML 解析器、JVM,再或者处理与性能相关的设置。过去,这些问题都委托给运维团队来处理。由于我们在容器中打包了很多依赖,对于很多组织来讲,对容器内的所有东西负责仍是个严峻的问题。

|

||||

|

||||

### 迁移现有应用到 Linux 容器

|

||||

|

||||

把应用放到容器中算得上是平台移植,我准备突出介绍究竟是什么让移植某些应用到容器当中这么困难。

|

||||

|

||||

(通过容器,)开发者现在对 /sbin 、/lib、 /usr/bin、 /usr/lib 中的内容有完全的控制权。但是,他们面临的挑战是,他们仍需要将数据和配置放到 /etc 或者 /var/lib 文件夹中。对于基于镜像的容器来说,这是一个糟糕的想法。我们真正需要的是代码、配置以及数据的隔离。我们希望开发者把代码放在容器当中,而数据和配置通过不同的环境(比如,开发、测试或生产环境)来获得。

|

||||

|

||||

这意味着我们(或者说平台)在实例化容器时,需要挂载 /etc 或 /var/lib 中的一些文件或文件夹。这会允许我们到处移动容器并仍能从环境中获得数据和配置。听起来很酷吧?这里有个问题,我们需要能够干净地隔离配置和数据。很多现代开源软件比如 Apache、MySQL、MongoDB、Nginx 默认就这么做了。[但很多自产的、历史遗留的、或专有程序并未默认这么设计][5]。对于很多组织来讲,这是主要的痛点。对于开发者来讲的最佳实践是,开始架构新的应用,移植遗留代码,以完成配置和数据的完全隔离。

|

||||

|

||||

### 镜像签名简介

|

||||

|

||||

信任机制是容器的重要议题。容器镜像签名允许用户添加数字指纹到镜像中。这个指纹随后可被加密算法测试验证。这使得容器镜像的用户可以验证其来源并信任。

|

||||

|

||||

容器社区经常使用“容器镜像”这个词组,但这个命名方法会让人相当困惑。Docker、LXD 和 RKT 推行获取远程文件来当作容器运行这样的概念。这些技术各自通过不同的方式处理容器镜像。LXD 用单独的一层来获取单独一个容器,而 Docker 和 RKT 使用基于开放容器镜像(OCI)格式,可由多层组成。糟糕的是,会出现不同团队和组织对容器镜像中的不同层负责的情况。容器镜像概念下隐含的是容器镜像格式的概念。拥有标准的镜像格式比如 OCI 会让容器生态系统围绕着镜像扫描、签名,和在不同云服务提供商间转移而繁荣发展。

|

||||

|

||||

现在谈到签名了。

|

||||

|

||||

容器存在一个问题,我们把一堆代码、二进制文件和类库放入其中。一旦我们打包了代码,我们就要把它和必要的文件服务器(注册服务器)共享。代码只要被共享,它基本上就是不具名的,缺少某种密文签名。更糟糕的是,容器镜像经常由不同人或团队控制的各个镜像层组成。每个团队都需要能够检查上一个团队的工作,增加他们自己的工作内容,并在上面添加他们自己的批准印记。然后他们需要继续把工作交给下个团队。

|

||||

|

||||

(由很多镜像组成的)容器镜像的最终用户需要检查监管链。他们需要验证每个往其中添加文件的团队的可信度。对于最终用户而言,对容器镜像中的每一层都有信心是极其重要的。

|

||||

|

||||

*作者 Scott McCarty 于 8 月 24 日在 ContainerCon 会议上作了题为 [Containers for Grownups: Migrating Traditional & Existing Applications][6] 的报告,更多内容请参阅报告[幻灯片][7]。*

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/bus/16/8/introduction-linux-containers-and-image-signing

|

||||

|

||||

作者:[Scott McCarty][a]

|

||||

译者:[Tanete](https://github.com/Tanete)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://opensource.com/users/fatherlinux

|

||||

[1]: http://rhelblog.redhat.com/2016/04/21/architecting-containers-part-4-workload-characteristics-and-candidates-for-containerization/

|

||||

[2]: http://rhelblog.redhat.com/2015/07/29/architecting-containers-part-1-user-space-vs-kernel-space/

|

||||

[3]: http://rhelblog.redhat.com/tag/architecting-containers/

|

||||

[4]: https://linux.cn/article-6132-1.html

|

||||

[5]: http://rhelblog.redhat.com/2016/04/21/architecting-containers-part-4-workload-characteristics-and-candidates-for-containerization/

|

||||

[6]: https://lcccna2016.sched.org/event/7JUc/containers-for-grownups-migrating-traditional-existing-applications-scott-mccarty-red-hat

|

||||

[7]: http://schd.ws/hosted_files/lcccna2016/91/Containers%20for%20Grownups_%20Migrating%20Traditional%20%26%20Existing%20Applications.pdf

|

||||

@ -0,0 +1,276 @@

|

||||

忘记技术债务 —— 教你如何创造技术财富

|

||||

===============

|

||||

|

||||

电视里正播放着《老屋》节目,[Andrea Goulet][58] 和她的商业合作伙伴正悠闲地坐在客厅里,商讨着他们的战略计划。那正是大家思想的火花碰撞出创新事物的时刻。他们正在寻求一种能够实现自身价值的方式 —— 为其它公司清理<ruby>遗留代码<rt>legacy code</rt></ruby>及科技债务。他们此刻的情景,像极了电视里的场景。(LCTT 译注:《老屋》电视节目提供专业的家装、家庭改建、重新装饰、创意等等信息,与软件的改造有异曲同工之处)。

|

||||

|

||||

“我们意识到我们现在做的工作不仅仅是清理遗留代码,实际上我们是在用重建老屋的方式来重构软件,让系统运行更持久、更稳定、更高效,”Goulet 说。“这让我开始思考公司如何花钱来改善他们的代码,以便让他们的系统运行更高效。就好比为了让屋子变得更有价值,你不得不使用一个全新的屋顶。这并不吸引人,但却是至关重要的,然而很多人都搞错了。“

|

||||

|

||||

如今,她是 [Corgibytes][57] 公司的 CEO —— 这是一家提高软件现代化和进行系统重构方面的咨询公司。她曾经见过各种各样糟糕的系统、遗留代码,以及严重的科技债务事件。Goulet 认为**创业公司需要转变思维模式,不是偿还债务,而是创造科技财富,不是要铲除旧代码,而是要逐步修复代码**。她解释了这种新的方法,以及如何完成这些看似不可能完成的事情 —— 实际上是聘用优秀的工程师来完成这些工作。

|

||||

|

||||

### 反思遗留代码

|

||||

|

||||

关于遗留代码最常见的定义是由 Michael Feathers 在他的著作[<ruby>《高效利用遗留代码》<rt>Working Effectively with Legacy Code</rt></ruby>][56]一书中提出:遗留代码就是没有被测试所覆盖的代码。这个定义比大多数人所认为的 —— 遗留代码仅指那些古老、陈旧的系统这个说法要妥当得多。但是 Goulet 认为这两种定义都不够明确。“遗留代码与软件的年头儿毫无关系。一个两年的应用程序,其代码可能已经进入遗留状态了,”她说。“**关键要看软件质量提高的难易程度。**”

|

||||

|

||||

这意味着写得不够清楚、缺少解释说明的代码,是没有包含任何关于代码构思和决策制定的流程的成果。单元测试就是这样的一种成果,但它并没有包括了写那部分代码的原因以及逻辑推理相关的所有文档。如果想要提升代码,但没办法搞清楚原开发者的意图 —— 那些代码就属于遗留代码了。

|

||||

|

||||

> **遗留代码不是技术问题,而是沟通上的问题。**

|

||||

|

||||

|

||||

|

||||

如果你像 Goulet 所说的那样迷失在遗留代码里,你会发现每一次的沟通交流过程都会变得像那条[<ruby>康威定律<rt>Conway’s Law</rt></ruby>][54]所描述的一样。

|

||||

|

||||

Goulet 说:“这个定律认为你的代码能反映出整个公司的组织沟通结构,如果想修复公司的遗留代码,而没有一个好的组织沟通方式是不可能完成的。那是很多人都没注意到的一个重要环节。”

|

||||

|

||||

Goulet 和她的团队成员更像是考古学家一样来研究遗留系统项目。他们根据前开发者写的代码构件相关的线索来推断出他们的思想意图。然后再根据这些构件之间的关系来做出新的决策。

|

||||

|

||||

代码构件最重要的什么呢?**良好的代码结构、清晰的思想意图、整洁的代码**。例如,如果使用通用的名称如 “foo” 或 “bar” 来命名一个变量,半年后再返回来看这段代码时,根本就看不出这个变量的用途是什么。

|

||||

|

||||

如果代码读起来很困难,可以使用源代码控制系统,这是一个非常有用的工具,因为它可以提供代码的历史修改信息,并允许软件开发者写明他们作出本次修改的原因。

|

||||

|

||||

Goulet 说:“我一个朋友认为提交代码时附带的信息,每一个概要部分的内容应该有半条推文那么长(几十个字),如需要的话,代码的描述信息应该有一篇博客那么长。你得用这个方式来为你修改的代码写一个合理的说明。这不会浪费太多额外的时间,并且能给后期的项目开发者提供非常多的有用信息,但是让人惊讶的是很少有人会这么做。我们经常能看到一些开发人员在被一段代码激怒之后,要用 `git blame` 扒代码库找出这些垃圾是谁干的,结果最后发现是他们自己干的。”

|

||||

|

||||

使用自动化测试对于理解程序的流程非常有用。Goulet 解释道:“很多人都比较认可 Michael Feathers 提出的关于遗留代码的定义。测试套件对于理解开发者的意图来说是非常有用的工具,尤其当用来与[<ruby>行为驱动开发模式<rt>Behavior Driven Development</rt></ruby>][53]相结合时,比如编写测试场景。”

|

||||

|

||||

理由很简单,如果你想将遗留代码限制在一定程度下,注意到这些细节将使代码更易于理解,便于在以后也能工作。编写并运行一个代码单元,接受、认可,并且集成测试。写清楚注释的内容,方便以后你自己或是别人来理解你写的代码。

|

||||

|

||||

尽管如此,由于很多已知的和不可意料的原因,遗留代码仍然会出现。

|

||||

|

||||

在创业公司刚成立初期,公司经常会急于推出很多新的功能。开发人员在巨大的交付压力下,测试常常半途而废。Corgibytes 团队就遇到过好多公司很多年都懒得对系统做详细的测试了。

|

||||

|

||||

确实如此,当你急于开发出系统原型的时候,强制性地去做太多的测试也许意义不大。但是,一旦产品开发完成并投入使用后,你就需要投入时间精力来维护及完善系统了。Goulet 说:“很多人说,‘别在维护上费心思,重要的是功能!’ **如果真这样,当系统规模到一定程序的时候,就很难再扩展了。同时也就失去市场竞争力了。**”

|

||||

|

||||

最后才明白过来,原来热力学第二定律对代码也同样适用:**你所面临的一切将向熵增的方向发展。**你需要与混乱无序的技术债务进行一场无休无止的战斗。随着时间的推移,遗留代码也逐渐变成一种债务。

|

||||

|

||||

她说:“我们再次拿家来做比喻。你必须坚持每天收拾餐具、打扫卫生、倒垃圾。如果你不这么做,情况将来越来越糟糕,直到有一天你不得不向 HazMat 团队求助。”(LCTT 译注:HazMat 团队,危害物质专队)

|

||||

|

||||

就跟这种情况一样,Corgibytes 团队接到很多公司 CEO 的求助电话,比如 Features 公司的 CEO 在电话里抱怨道:“现在我们公司的开发团队工作效率太低了,三年前只需要两个星期就完成的工作,现在却要花费12个星期。”

|

||||

|

||||

> **技术债务往往反映出公司运作上的问题。**

|

||||

|

||||

很多公司的 CTO 明知会发生技术债务的问题,但是他们很难说服其它同事相信花钱来修复那些已经存在的问题是值得的。这看起来像是在走回头路,很乏味,也不是新的产品。有些公司直到系统已经严重影响了日常工作效率时,才着手去处理这些技术债务方面的问题,那时付出的代价就太高了。

|

||||

|

||||

### 忘记债务,创造技术财富

|

||||

|

||||

如果你想把[<ruby>重构技术债务<rt>reframe your technical debt</rt></ruby>][52] — [敏捷开发讲师 Declan Whelan 最近造出的一个术语][51] — 作为一个积累技术财富的机会,你很可能要先说服你们公司的 CEO、投资者和其它的股东接受并为之共同努力。

|

||||

|

||||

“我们没必要把技术债务想像得很可怕。当产品处于开发设计初期,技术债务反而变得非常有用,”Goulet 说。“当你解决一些系统遗留的技术问题时,你会充满成就感。例如,当你在自己家里安装新窗户时,你确实会花费一笔不少的钱,但是之后你每个月就可以节省 100 美元的电费。程序代码亦是如此。虽然暂时没有提高工作效率,但随时时间推移将提高生产力。”

|

||||

|

||||

一旦你意识到项目团队工作不再富有成效时,就需要确认下是哪些技术债务在拖后腿了。

|

||||

|

||||

“我跟很多不惜一切代价招募英才的初创公司交流过,他们高薪聘请一些工程师来只为了完成更多的工作。”她说。“与此相反,他们应该找出如何让原有的每个工程师能更高效率工作的方法。你需要去解决什么样的技术债务以增加额外的生产率?”

|

||||

|

||||

如果你改变自己的观点并且专注于创造技术财富,你将会看到产能过剩的现象,然后重新把多余的产能投入到修复更多的技术债务和遗留代码的良性循环中。你们的产品将会走得更远,发展得更好。

|

||||

|

||||

> **别把你们公司的软件当作一个项目来看。从现在起,把它想象成一栋自己要长久居住的房子。**

|

||||

|

||||

“这是一个极其重要的思想观念的转变,”Goulet 说。“这将带你走出短浅的思维模式,并让你比之前更加关注产品的维护工作。”

|

||||

|

||||

这就像对一栋房子,要实现其现代化及维护的方式有两种:小动作,表面上的更改(“我买了一块新的小地毯!”)和大改造,需要很多年才能偿还所有债务(“我想我们应替换掉所有的管道...”)。你必须考虑好两者,才能让你们已有的产品和整个团队顺利地运作起来。

|

||||

|

||||

这还需要提前预算好 —— 否则那些较大的花销将会是硬伤。定期维护是最基本的预期费用。让人震惊的是,很多公司都没把维护当成商务成本预算进来。

|

||||

|

||||

这就是 Goulet 提出“**<ruby>软件重构<rt>software remodeling</rt></ruby>**”这个术语的原因。当你房子里的一些东西损坏的时候,你并不是铲除整个房子,从头开始重建。同样的,当你们公司出现老的、损坏的代码时,重写代码通常不是最明智的选择。

|

||||

|

||||

下面是 Corgibytes 公司在重构客户代码用到的一些方法:

|

||||

|

||||

* 把大型的应用系统分解成轻量级的更易于维护的微服务。

|

||||

* 让功能模块彼此解耦以便于扩展。

|

||||

* 更新形象和提升用户前端界面体验。

|

||||

* 集合自动化测试来检查代码可用性。

|

||||

* 代码库可以让重构或者修改更易于操作。

|

||||

|

||||

系统重构也进入到 DevOps 领域。比如,Corgibytes 公司经常推荐新客户使用 [Docker][50],以便简单快速的部署新的开发环境。当你们团队有 30 个工程师的时候,把初始化配置时间从 10 小时减少到 10 分钟对完成更多的工作很有帮助。系统重构不仅仅是应用于软件开发本身,也包括如何进行系统重构。

|

||||

|

||||

如果你知道做些什么能让你们的代码管理起来更容易更高效,就应该把这它们写入到每年或季度的项目规划中。别指望它们会自动呈现出来。但是也别给自己太大的压力来马上实施它们。Goulets 看到很多公司从一开始就致力于 100% 测试覆盖率而陷入困境。

|

||||

|

||||

**具体来说,每个公司都应该把以下三种类型的重构工作规划到项目建设中来:**

|

||||

|

||||

* 自动测试

|

||||

* 持续交付

|

||||

* 文化提升

|

||||

|

||||

咱们来深入的了解下每一项内容。

|

||||

|

||||

#### 自动测试

|

||||

|

||||

“有一位客户即将进行第二轮融资,但是他们没办法在短期内招聘到足够的人才。我们帮助他们引进了一种自动化测试框架,这让他们的团队在 3 个月的时间内工作效率翻了一倍,”Goulets 说。“这样他们就可以在他们的投资人面前自豪的说,‘我们一个精英团队完成的任务比两个普通的团队要多。’”

|

||||

|

||||

自动化测试从根本上来讲就是单个测试的组合,就是可以再次检查某一行代码的单元测试。可以使用集成测试来确保系统的不同部分都正常运行。还可以使用验收性测试来检验系统的功能特性是否跟你想像的一样。当你把这些测试写成测试脚本后,你只需要简单地用鼠标点一下按钮就可以让系统自行检验了,而不用手工的去梳理并检查每一项功能。

|

||||

|

||||

在产品市场尚未打开之前就来制定自动化测试机制有些言之过早。但是一旦你有一款感到满意,并且客户也很依赖的产品,就应该把这件事付诸实施了。

|

||||

|

||||

#### 持续交付

|

||||

|

||||

这是与自动化交付相关的工作,过去是需要人工完成。目的是当系统部分修改完成时可以迅速进行部署,并且短期内得到反馈。这使公司在其它竞争对手面前有很大的优势,尤其是在客户服务行业。

|

||||

|

||||

“比如说你每次部署系统时环境都很复杂。熵值无法有效控制,”Goulets 说。“我们曾经见过花 12 个小时甚至更多的时间来部署一个很大的集群环境。在这种情况下,你不会愿意频繁部署了。因为太折腾人了,你还会推迟系统功能上线的时间。这样,你将落后于其它公司并失去竞争力。”

|

||||

|

||||

**在持续性改进的过程中常见的其它自动化任务包括:**

|

||||

|

||||

* 在提交完成之后检查构建中断部分。

|

||||

* 在出现故障时进行回滚操作。

|

||||

* 自动化审查代码的质量。

|

||||

* 根据需求增加或减少服务器硬件资源。

|

||||

* 让开发、测试及生产环境配置简单易懂。

|

||||

|

||||

举一个简单的例子,比如说一个客户提交了一个系统 Bug 报告。开发团队越高效解决并修复那个 Bug 越好。对于开发人员来说,修复 Bug 的挑战根本不是个事儿,这本来也是他们的强项,主要是系统设置上不够完善导致他们浪费太多的时间去处理 bug 以外的其它问题。

|

||||

|

||||

使用持续改进的方式时,你要严肃地决定决定哪些工作应该让机器去做,哪些交给研发去完成更好。如果机器更擅长,那就使其自动化完成。这样也能让研发愉快地去解决其它有挑战性的问题。同时客户也会很高兴地看到他们报怨的问题被快速处理了。你的待修复的未完成任务数减少了,之后你就可以把更多的时间投入到运用新的方法来提高产品的质量上了。**这是创造科技财富的一种转变。**因为开发人员可以修复 bug 后立即发布新代码,这样他们就有时间和精力做更多事。

|

||||

|

||||

“你必须时刻问自己,‘我应该如何为我们的客户改善产品功能?如何做得更好?如何让产品运行更高效?’不过还要不止于此。”Goulets 说。“一旦你回答完这些问题后,你就得询问下自己,如何自动去完成那些需要改善的功能。”

|

||||

|

||||

#### 文化提升

|

||||

|

||||

Corgibytes 公司每天都会看到同样的问题:一家创业公司建立了一个对开发团队毫无推动的文化环境。公司 CEO 抱着双臂思考着为什么这样的环境对员工没多少改变。然而事实却是公司的企业文化对工作并不利。为了激励工程师,你必须全面地了解他们的工作环境。

|

||||

|

||||

为了证明这一点,Goulet 引用了作者 Robert Henry 说过的一段话:

|

||||

|

||||

> **目的不是创造艺术,而是在最美妙的状态下让艺术应运而生。**

|

||||

|

||||

“你们也要开始这样思考一下你们的软件,”她说。“你们的企业文件就类似那个状态。你们的目标就是创造一个让艺术品应运而生的环境,这件艺术品就是你们公司的代码、一流的售后服务、充满幸福感的开发者、良好的市场预期、盈利能力等等。这些都息息相关。”

|

||||

|

||||

优先考虑解决公司的技术债务和遗留代码也是一种文化。那是真正为开发团队清除障碍,以制造影响的方法。同时,这也会让你将来有更多的时间精力去完成更重要的工作。如果你不从根本上改变固有的企业文化环境,你就不可能重构公司产品。改变对产品维护及现代化的投资的态度是开始实施变革的第一步,最理想情况是从公司的 CEO 开始自顶向下转变。

|

||||

|

||||

以下是 Goulet 关于建立那种流态文化方面提出的建议:

|

||||

|

||||

* 反对公司嘉奖那些加班到深夜的“英雄”。提倡高效率的工作方式。

|

||||

* 了解协同开发技术,比如 Woody Zuill 提出的[<ruby>合作编程<rt>Mob Programming</rt></ruby>][44]模式。

|

||||

* 遵从 4 个[现代敏捷开发][42]原则:用户至上、实践及快速学习、把安全放在首位、持续交付价值。

|

||||

* 每周为研发人员提供项目外的职业发展时间。

|

||||

* 把[日工作记录][43]作为一种驱动开发团队主动解决问题的方式。

|

||||

* 把同情心放在第一位。Corgibytes 公司让员工参加 [Brene Brown 勇气工厂][40]的培训是非常有用的。

|

||||

|

||||

“如果公司高管和投资者不支持这种升级方式,你得从客户服务的角度去说服他们,”Goulet 说,“告诉他们通过这次调整后,最终产品将如何给公司的大多数客户提高更好的体验。这是你能做的一个很有力的论点。”

|

||||

|

||||

### 寻找最具天才的代码重构者

|

||||

|

||||

整个行业都认为顶尖的工程师不愿意干修复遗留代码的工作。他们只想着去开发新的东西。大家都说把他们留在维护部门真是太浪费人才了。

|

||||

|

||||

**其实这些都是误解。如果你知道去哪里和如何找工程师,并为他们提供一个愉快的工作环境,你就可以找到技术非常精湛的工程师,来帮你解决那些最棘手的技术债务问题。**

|

||||

|

||||

“每次在会议上,我们都会问现场的同事‘谁喜欢去在遗留代码上工作?’每次只有不到 10% 的与会者会举手。”Goulet 说。“但是我跟这些人交流后,我发现这些工程师恰好是喜欢最具挑战性工作的人才。”

|

||||

|

||||

有一位客户来寻求她的帮助,他们使用国产的数据库,没有任何相关文档,也没有一种有效的方法来弄清楚他们公司的产品架构。她称修理这种情况的一类工程师为“修正者”。在 Corgibytes 公司,她有一支这样的修正者团队由她支配,热衷于通过研究二进制代码来解决技术问题。

|

||||

|

||||

|

||||

|

||||

那么,如何才能找到这些技术人才呢? Goulet 尝试过各种各样的方法,其中有一些方法还是富有成效的。

|

||||

|

||||

她创办了一个社区网站 [legacycode.rocks][49] 并且在招聘启示上写道:“长期招聘那些喜欢重构遗留代码的另类开发人员...如果你以从事处理遗留代码的工作为自豪,欢迎加入!”

|

||||

|

||||

“我开始收到很多人发来邮件说,‘噢,天呐,我也属于这样的开发人员!’”她说。“只需要发布这条信息,并且告诉他们这份工作是非常有意义的,就吸引了合适的人才。”

|

||||

|

||||

在招聘的过程中,她也会使用持续性交付的经验来回答那些另类开发者想知道的信息:包括详细的工作内容以及明确的要求。“我这么做的原因是因为我讨厌重复性工作。如果我收到多封邮件来咨询同一个问题,我会把答案发布在网上,我感觉自己更像是在写说明文档一样。”

|

||||

|

||||

但是随着时间的推移,她发现可以重新定义招聘流程来帮助她识别出更出色的候选人。比如说,她在应聘要求中写道,“公司 CEO 将会重新审查你的简历,因此请确保求职信中致意时不用写明性别。所有以‘尊敬的先生’或‘先生’开头的信件将会被当垃圾处理掉”。这些只是她的招聘初期策略。

|

||||

|

||||

“我开始这么做是因为很多申请人把我当成男性,因为我是一家软件公司的男性 CEO,我必须是男性!?”Goulet 说。“所以,有一天我想我应该它当作应聘要求放到网上,看有多少人注意到这个问题。令我惊讶的是,这让我过滤掉一些不太严谨的申请人。还突显出了很多擅于从事遗留代码方面工作的人。”

|

||||

|

||||

Goulet 想起一个应聘者发邮件给我说,“我查看了你们网站的代码(我喜欢这个网站,这也是我的工作)。你们的网站架构很奇特,好像是用 PHP 写的,但是你们却运行在用 Ruby 语言写的 Jekyll 下。我真的很好奇那是什么呢。”

|

||||

|

||||

Goulet 从她的设计师那里得知,原来,在 HTML、CSS 和 JavaScript 文件中有一个未使用的 PHP 类名,她一直想解决这个问题,但是一直没机会。Goulet 的回复是:“你正在找工作吗?”

|

||||

|

||||

另外一名候选人注意到她曾经在一篇说明文档中使用 CTO 这个词,但是她的团队里并没有这个头衔(她的合作伙伴是 Chief Code Whisperer)。这些注重细节、充满求知欲、积极主动的候选者更能引起她的注意。

|

||||

|

||||

> **代码修正者不仅需要注重细节,而且这也是他们必备的品质。**

|

||||

|

||||

让人吃惊的是,Goulet 从来没有为招募最优秀的代码修正者而感到厌烦过。“大多数人都是通过我们的网站直接投递简历,但是当我们想扩大招聘范围的时候,我们会通过 [PowerToFly][48] 和 [WeWorkRemotely][47] 网站进行招聘。我现在确实不需要招募新人马了。他们需要经历一段很艰难的时期才能理解代码修正者的意义是什么。”

|

||||

|

||||

如果他们通过首轮面试,Goulet 将会让候选者阅读一篇 Arlo Belshee 写的文章“[<ruby>命名是一个过程<rt>Naming is a Process</rt></ruby>][46]”。它讲的是非常详细的处理遗留代码的的过程。她最经典的指导方法是:“阅读完这段代码并且告诉我,你是怎么理解的。”

|

||||

|

||||

她将找出对问题的理解很深刻并且也愿意接受文章里提出的观点的候选者。这对于区分有深刻理解的候选者和仅仅想获得工作的候选者来说,是极其有用的办法。她强烈要求候选者找出一段与他操作相关的代码,来证明他是充满激情的、有主见的及善于分析问题的人。

|

||||

|

||||

最后,她会让候选者跟公司里当前的团队成员一起使用 [Exercism.io][45] 工具进行编程。这是一个开源项目,它允许开发者学习如何在不同的编程语言环境下使用一系列的测试驱动开发的练习进行编程。结对编程课程的第一部分允许候选者选择其中一种语言来使用。下一个练习中,面试官可以选择一种语言进行编程。他们总能看到那些人处理异常的方法、随机应便的能力以及是否愿意承认某些自己不了解的技术。

|

||||

|

||||

“当一个人真正的从执业者转变为大师的时候,他会毫不犹豫的承认自己不知道的东西,”Goulet说。

|

||||

|

||||

让他们使用自己不熟悉的编程语言来写代码,也能衡量其坚韧不拔的毅力。“我们想听到某个人说,‘我会深入研究这个问题直到彻底解决它。’也许第二天他们仍然会跑过来跟我们说,‘我会一直留着这个问题直到我找到答案为止。’那是作为一个成功的修正者表现出来的一种气质。”

|

||||

|

||||

> **产品开发人员在我们这个行业很受追捧,因此很多公司也想让他们来做维护工作。这是一个误解。最优秀的维护修正者并不是最好的产品开发工程师。**

|

||||

|

||||

如果一个有天赋的修正者在眼前,Goulet 懂得如何让他走向成功。下面是如何让这种类型的开发者感到幸福及高效工作的一些方式:

|

||||

|

||||

* 给他们高度的自主权。把问题解释清楚,然后安排他们去完成,但是永不命令他们应该如何去解决问题。

|

||||

* 如果他们要求升级他们的电脑配置和相关工具,尽管去满足他们。他们明白什么样的需求才能最大限度地提高工作效率。

|

||||

* 帮助他们[避免分心][39]。他们喜欢全身心投入到某一个任务直至完成。

|

||||

|

||||

总之,这些方法已经帮助 Corgibytes 公司培养出二十几位对遗留代码充满激情的专业开发者。

|

||||

|

||||

### 稳定期没什么不好

|

||||

|

||||

大多数创业公司都都不想跳过他们的成长期。一些公司甚至认为成长期应该是永无止境的。而且,他们觉得也没这个必要跳过成长期,即便他们已经进入到了下一个阶段:稳定期。**完全进入到稳定期意味着你拥有人力资源及管理方法来创造技术财富,同时根据优先权适当支出。**

|

||||

|

||||

“在成长期和稳定期之间有个转折点,就是维护人员必须要足够壮大,并且相对于专注新功能的产品开发人员,你开始更公平的对待维护人员,”Goulet 说。“你们公司的产品开发完成了。现在你得让他们更加稳定地运行。”

|

||||

|

||||

这就意味着要把公司更多的预算分配到产品维护及现代化方面。“你不应该把产品维护当作是一个不值得关注的项目,”她说。“这必须成为你们公司固有的一种企业文化 —— 这将帮助你们公司将来取得更大的成功。“

|

||||

|

||||

最终,你通过这些努力创建的技术财富,将会为你的团队带来一大批全新的开发者:他们就像侦查兵一样,有充足的时间和资源去探索新的领域,挖掘新客户资源并且给公司创造更多的机遇。当你们在新的市场领域做得更广泛并且不断取得进展 —— 那么你们公司已经真正地进入到繁荣发展的状态了。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://firstround.com/review/forget-technical-debt-heres-how-to-build-technical-wealth/

|

||||

|

||||

作者:[http://firstround.com/][a]

|

||||

译者:[rusking](https://github.com/rusking)

|

||||

校对:[jasminepeng](https://github.com/jasminepeng)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: http://firstround.com/

|

||||

[1]:http://corgibytes.com/blog/2016/04/15/inception-layers/

|

||||

[2]:http://www.courageworks.com/

|

||||

[3]:http://corgibytes.com/blog/2016/08/02/how-we-use-daily-journals/

|

||||

[4]:https://www.industriallogic.com/blog/modern-agile/

|

||||

[5]:http://mobprogramming.org/

|

||||

[6]:http://exercism.io/

|

||||

[7]:http://arlobelshee.com/good-naming-is-a-process-not-a-single-step/

|

||||

[8]:https://weworkremotely.com/

|

||||

[9]:https://www.powertofly.com/

|

||||

[10]:http://legacycode.rocks/

|

||||

[11]:https://www.docker.com/

|

||||

[12]:http://legacycoderocks.libsyn.com/technical-wealth-with-declan-wheelan

|

||||

[13]:https://www.agilealliance.org/resources/initiatives/technical-debt/

|

||||

[14]:https://en.wikipedia.org/wiki/Behavior-driven_development

|

||||

[15]:https://en.wikipedia.org/wiki/Conway%27s_law

|

||||

[16]:https://www.amazon.com/Working-Effectively-Legacy-Michael-Feathers/dp/0131177052

|

||||

[17]:http://corgibytes.com/

|

||||

[18]:https://www.linkedin.com/in/andreamgoulet

|

||||

[19]:http://corgibytes.com/blog/2016/04/15/inception-layers/

|

||||

[20]:http://www.courageworks.com/

|

||||

[21]:http://corgibytes.com/blog/2016/08/02/how-we-use-daily-journals/

|

||||

[22]:https://www.industriallogic.com/blog/modern-agile/

|

||||

[23]:http://mobprogramming.org/

|

||||

[24]:http://mobprogramming.org/

|

||||

[25]:http://exercism.io/

|

||||

[26]:http://arlobelshee.com/good-naming-is-a-process-not-a-single-step/

|

||||

[27]:https://weworkremotely.com/

|

||||

[28]:https://www.powertofly.com/

|

||||

[29]:http://legacycode.rocks/

|

||||

[30]:https://www.docker.com/

|

||||

[31]:http://legacycoderocks.libsyn.com/technical-wealth-with-declan-wheelan

|

||||

[32]:https://www.agilealliance.org/resources/initiatives/technical-debt/

|

||||

[33]:https://en.wikipedia.org/wiki/Behavior-driven_development

|

||||

[34]:https://en.wikipedia.org/wiki/Conway%27s_law

|

||||

[35]:https://www.amazon.com/Working-Effectively-Legacy-Michael-Feathers/dp/0131177052

|

||||

[36]:https://www.amazon.com/Working-Effectively-Legacy-Michael-Feathers/dp/0131177052

|

||||

[37]:http://corgibytes.com/

|

||||

[38]:https://www.linkedin.com/in/andreamgoulet

|

||||

[39]:http://corgibytes.com/blog/2016/04/15/inception-layers/

|

||||

[40]:http://www.courageworks.com/

|

||||

[41]:http://corgibytes.com/blog/2016/08/02/how-we-use-daily-journals/

|

||||

[42]:https://www.industriallogic.com/blog/modern-agile/

|

||||

[43]:http://corgibytes.com/blog/2016/08/02/how-we-use-daily-journals/

|

||||

[44]:http://mobprogramming.org/

|

||||

[45]:http://exercism.io/

|

||||

[46]:http://arlobelshee.com/good-naming-is-a-process-not-a-single-step/

|

||||

[47]:https://weworkremotely.com/

|

||||

[48]:https://www.powertofly.com/

|

||||

[49]:http://legacycode.rocks/

|

||||

[50]:https://www.docker.com/

|

||||

[51]:http://legacycoderocks.libsyn.com/technical-wealth-with-declan-wheelan

|

||||

[52]:https://www.agilealliance.org/resources/initiatives/technical-debt/

|

||||

[53]:https://en.wikipedia.org/wiki/Behavior-driven_development

|

||||

[54]:https://en.wikipedia.org/wiki/Conway%27s_law

|

||||

[56]:https://www.amazon.com/Working-Effectively-Legacy-Michael-Feathers/dp/0131177052

|

||||

[57]:http://corgibytes.com/

|

||||

[58]:https://www.linkedin.com/in/andreamgoulet

|

||||

@ -1,21 +1,15 @@

|

||||

|

||||

|

||||

【flankershen翻译中】

|

||||

|

||||

|

||||

|

||||

How to Set Nginx as Reverse Proxy on Centos7 CPanel

|

||||

如何在 CentOS 7 用 cPanel 配置 Nginx 反向代理

|

||||

================================================================================

|

||||

|

||||

Nginx is one of the fastest and most powerful web-server. It is known for its high performance and low resource utilization. It can be installed as both a standalone and a Reverse Proxy Web-server. In this article, I'm discussing about the installation of Nginx as a reverse proxy along with Apache on a CPanel server with latest CentOS 7 installed.

|

||||

Nginx 是最快和最强大的 Web 服务器之一,以其高性能和低资源占用率而闻名。它既可以被安装为一个独立的 Web 服务器,也可以安装成反向代理 Web 服务器。在这篇文章,我将讨论在安装了 cPanel 管理系统的 Centos 7 服务器上安装 Nginx 作为 Apache 的反向代理服务器。

|

||||

|

||||

Nginx as a reverse proxy will work as a frontend webserver serving static contents along with Apache serving the dynamic files in backend. This setup will boost up the overall server performance.

|

||||

Nginx 作为前端服务器用反向代理为静态文件提供服务,Apache 作为后端为动态文件提供服务。这个设置将整体提高服务器的性能。

|

||||

|

||||

Let's walk through the installation steps for Nginx as reverse proxy in CentOS7 x86_64 bit server with cPanel 11.52 installed.

|

||||

让我们过一遍在已经安装好 cPanel 11.52 的 CentOS 7 x86_64 服务器上配置 Nginx 作为反向代理的安装过程。

|

||||

|

||||

First of all, we need to install the EPEL repo to start-up with the process.

|

||||

首先,我们需要安装 EPEL 库来启动这个进程

|

||||

|

||||

### Step 1: Install the EPEL repo. ###

|

||||

### 第一步: 安装 EPEL 库###

|

||||

|

||||

root@server1 [/usr]# yum -y install epel-release

|

||||

Loaded plugins: fastestmirror, tsflags, universal-hooks

|

||||

@ -31,13 +25,13 @@ First of all, we need to install the EPEL repo to start-up with the process.

|

||||

|

||||

Dependencies Resolved

|

||||

|

||||

===============================================================================================================================================

|

||||

Package Arch Version Repository Size

|

||||

===============================================================================================================================================

|

||||

========================================================================================

|

||||

Package Arch Version Repository Size

|

||||

========================================================================================

|

||||

Installing:

|

||||

epel-release noarch 7-5 extras 14 k

|

||||

|

||||

### Step 2: After installing the repo, we can start with the installation of the nDeploy RPM repo for CentOS to install our required nDeploy Webstack and Nginx plugin. ###

|

||||

### 第二步: 可以安装 nDeploy 的 CentOS RPM 库来安装我们所需的 nDeploy Web 类软件和 Nginx 插件 ###

|

||||

|

||||

root@server1 [/usr]# yum -y install http://rpm.piserve.com/nDeploy-release-centos-1.0-1.noarch.rpm

|

||||

Loaded plugins: fastestmirror, tsflags, universal-hooks

|

||||

@ -51,13 +45,13 @@ First of all, we need to install the EPEL repo to start-up with the process.

|

||||

|

||||

Dependencies Resolved

|

||||

|

||||

===============================================================================================================================================

|

||||

========================================================================================

|

||||

Package Arch Version Repository Size

|

||||

===============================================================================================================================================

|

||||

========================================================================================

|

||||

Installing:

|

||||

nDeploy-release-centos noarch 1.0-1 /nDeploy-release-centos-1.0-1.noarch 110

|

||||

|

||||

### Step 3: Install the nDeploy and Nginx nDeploy plugins. ###

|

||||

### 第三步:安装 nDeploy 和 Nginx nDeploy 插件 ###

|

||||

|

||||

root@server1 [/usr]# yum --enablerepo=ndeploy install nginx-nDeploy nDeploy

|

||||

Loaded plugins: fastestmirror, tsflags, universal-hooks

|

||||

@ -70,9 +64,9 @@ First of all, we need to install the EPEL repo to start-up with the process.

|

||||

|

||||

Dependencies Resolved

|

||||

|

||||

===============================================================================================================================================

|

||||

========================================================================================

|

||||

Package Arch Version Repository Size

|

||||

===============================================================================================================================================

|

||||

========================================================================================

|

||||

Installing:

|

||||

nDeploy noarch 2.0-11.el7 ndeploy 80 k

|

||||

nginx-nDeploy x86_64 1.8.0-34.el7 ndeploy 36 M

|

||||

@ -84,12 +78,12 @@ First of all, we need to install the EPEL repo to start-up with the process.

|

||||

python-lxml x86_64 3.2.1-4.el7 base 758 k

|

||||

|

||||

Transaction Summary

|

||||

===============================================================================================================================================

|

||||

========================================================================================

|

||||

Install 2 Packages (+5 Dependent packages)

|

||||

|

||||

With these steps, we've completed with the installation of Nginx plugin in our server. Now we need to configure Nginx as reverse proxy and create the virtualhost for the existing cPanel user accounts. For that we can run the following script.

|

||||

通过以上这些步骤,我们完成了在我们的服务器上 Nginx 插件的安装。现在我们可以配置 Nginx 作为反向代理和为已有的 cPanel 用户账户创建虚拟主机,为此我们可以运行如下脚本。

|

||||

|

||||

### Step 4: To enable Nginx as a front end Web Server and create the default configuration files. ###

|

||||

### 第四步:启动 Nginx 作为默认的前端 Web 服务器,并创建默认的配置文件###

|

||||

|

||||

root@server1 [/usr]# /opt/nDeploy/scripts/cpanel-nDeploy-setup.sh enable

|

||||

Modifying apache http and https port in cpanel

|

||||

@ -101,9 +95,9 @@ With these steps, we've completed with the installation of Nginx plugin in our s

|

||||

ConfGen:: saheetha

|

||||

ConfGen:: satest

|

||||

|

||||

As you can see these script will modify the Apache port from 80 to another port to make Nginx run as a front end web server and create the virtual host configuration files for the existing cPanel accounts. Once it is done, confirm the status of both Apache and Nginx.

|

||||

你可以看到这个脚本将修改 Apache 的端口从 80 到另一个端口来让 Nginx 作为前端 Web 服务器,并为现有的 cPanel 用户创建虚拟主机配置文件。一旦完成,确认 Apache 和 Nginx 的状态。

|

||||

|

||||

### Apache Status: ###

|

||||

#### Apache 状态:####

|

||||

|

||||

root@server1 [/var/run/httpd]# systemctl status httpd

|

||||

● httpd.service - Apache Web Server

|

||||

@ -118,7 +112,7 @@ As you can see these script will modify the Apache port from 80 to another port

|

||||

Jan 18 06:34:23 server1.centos7-test.com apachectl[25606]: httpd (pid 24760) already running

|

||||

Jan 18 06:34:23 server1.centos7-test.com systemd[1]: Started Apache Web Server.

|

||||

|

||||

### Nginx Status: ###

|

||||

#### Nginx 状态:####

|

||||

|

||||

root@server1 [~]# systemctl status nginx

|

||||

● nginx.service - nginx-nDeploy - high performance web server

|

||||

@ -137,7 +131,7 @@ As you can see these script will modify the Apache port from 80 to another port

|

||||

Jan 17 17:18:29 server1.centos7-test.com nginx[3804]: nginx: configuration file /etc/nginx/nginx.conf test is successful

|

||||

Jan 17 17:18:29 server1.centos7-test.com systemd[1]: Started nginx-nDeploy - high performance web server.

|

||||

|

||||

Nginx act as a frontend webserver running on port 80 and Apache configuration is modified to listen on http port 9999 and https port 4430. Please see their status below:

|

||||

Nginx 作为前端服务器运行在 80 端口,Apache 配置被更改为监听 http 端口 9999 和 https 端口 4430。请看他们的情况:

|

||||

|

||||

root@server1 [/usr/local/src]# netstat -plan | grep httpd

|

||||

tcp 0 0 0.0.0.0:4430 0.0.0.0:* LISTEN 17270/httpd

|

||||

@ -151,13 +145,13 @@ Nginx act as a frontend webserver running on port 80 and Apache configuration is

|

||||

tcp 0 0 127.0.0.1:80 0.0.0.0:* LISTEN 17802/nginx: master

|

||||

tcp 0 0 45.79.183.73:80 0.0.0.0:* LISTEN 17802/nginx: master

|

||||

|

||||

The virtualhost entries created for the existing users as located in the folder "**/etc/nginx/sites-enabled**". This file path is included in the Nginx main configuration file.

|

||||

为已有用户创建的虚拟主机的配置文件在 "**/etc/nginx/sites-enabled**"。 这个文件路径包含了 Nginx 主要配置文件。

|

||||

|

||||

root@server1 [/etc/nginx/sites-enabled]# ll | grep .conf

|

||||

-rw-r--r-- 1 root root 311 Jan 17 09:02 saheetha.com.conf

|

||||

-rw-r--r-- 1 root root 336 Jan 17 09:02 saheethastest.com.conf

|

||||

|

||||

### Sample Vhost for a domain: ###

|

||||

#### 一个域名的示例虚拟主机:###

|

||||

|

||||

server {

|

||||

|

||||

@ -173,7 +167,7 @@ The virtualhost entries created for the existing users as located in the folder

|

||||

|

||||

}

|

||||

|

||||

We can confirm the working of the web server status by calling a website in the browser. Please see the web server information on my server after the installation.

|

||||

我们可以启动浏览器查看网站来确定 Web 服务器的工作状态。安装后,请阅读服务器上的 web 服务信息。

|

||||

|

||||

root@server1 [/home]# ip a | grep -i eth0

|

||||

3: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

|

||||

@ -183,24 +177,24 @@ We can confirm the working of the web server status by calling a website in the

|

||||

|

||||

|

||||

|

||||

Nginx will create the virtual host automatically for any newly created accounts in cPanel. With these simple steps we can configure Nginx as reverse proxy on a CentOS 7/CPanel server.

|

||||

Nginx 将会为任何最新在 cPanel 中创建的账户创建虚拟主机。通过这些简单的的步骤,我们能够在一台 CentOS 7 / cPanel 的服务器上配置 Nginx 作为反向代理。

|

||||

|

||||

### Advantages of Nginx as Reverse Proxy: ###

|

||||

### Nginx 作为反向代理的优势###

|

||||

|

||||

1. Easy to install and configure

|

||||

2. Performance and efficiency

|

||||

3. Prevent DDOS attacks

|

||||

4. Allows .htaccess PHP rewrite rules

|

||||

1. 便于安装和配置。

|

||||

2. 效率高、性能好。

|

||||

3. 防止 Ddos 攻击。

|

||||

4. 支持使用 .htaccess 作为 PHP 的重写规则。

|

||||

|

||||

I hope this article is useful for you guys. Thank you for referring to this. I would appreciate your valuable comments and suggestions on this for further improvements.

|

||||

我希望这篇文章对你们有用。感谢你看它。我非常高兴收到你的宝贵意见和建议,并进一步改善。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://linoxide.com/linux-how-to/set-nginx-reverse-proxy-centos-7-cpanel/

|

||||

|

||||

作者:[Saheetha Shameer][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

译者:[bestony](https://github.com/bestony)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,73 @@

|

||||

一位跨平台开发者的自白

|

||||

=============================================

|

||||

|

||||

|

||||

|

||||

[Andreia Gaita][1] 在 OSCON 开源大会上发表了一个题为[跨平台开发者的自白][2]的演讲。她长期从事于开源工作,并且为 [Mono][3] 工程(LCTT 译注:一个致力于开创 .NET 在 Linux 上使用的开源工程)做着贡献,主要以 C#/C++ 开发。Andreia 任职于 GitHub,她的工作是专注构建 Visual Studio 的 GitHub 扩展管理器。

|

||||

|

||||

我在她发表演讲前就迫不及待的想要问她一些关于跨平台开发的事,问问她作为一名跨平台开发者在这 16 年之中学习到了什么。

|

||||

|

||||

|

||||

|

||||

**在你开发跨平台代码中,你使用过的最简单的和最难的代码语言是什么?**

|

||||

|

||||

我很少讨论某种语言的好坏,更多是讨论是那些语言有哪些库和工具。语言的编译器、解释器以及构建系统决定了用它们做跨平台开发的难易程度(或者它们是否可能做跨平台开发),可用的 UI 库和对本地系统的访问能力决定了与该操作系统集成的紧密程度。按照我的观点,我认为 C# 最适合完成跨平台开发工作。这种语言自身包括了允许快速的本地调用和精确的内存映射的功能,如果你希望你的代码能够与系统和本地函数库进行交互就需要这些功能。而当我需要非常特殊的系统功能时,我就会切换到 C 或者 C++。

|

||||

|

||||

**你使用的跨平台开发工具或者抽象层有哪些?**

|

||||

|

||||

我的大部分跨平台工作都是为其它需要开发跨平台应用的人开发工具、库和绑定(binding),一般是用 MONO/C# 和 C/C++。在抽象的层面我用的不多,更多是在 glib 库和友元(friends)方面。大多数时候,我用 Mono 去完成各种跨平台应用的,包括 UI,或者偶然在游戏开发中用到 Unity3D 的部分。我经常使用 Electron(LCTT 译注:Atom 编辑器的兄弟项目,可以用 Electron 开发桌面应用)。

|

||||

|

||||

**你接触过哪些构建系统?它们之间的区别是由于语言还是平台的不同?**

|

||||

|

||||

我试着选择适合我使用的语言的构建系统。那样,就会很少遇到让我头疼的问题(希望如此)。它需要支持平台和体系结构间的选择、构建输出结果位置可以智能些(多个并行构建),以及易配置性等。大多数时候,我的项目会结合使用 C/C++ 和 C#,我要从同一源代码同时构建不同的配置环境(调试、发布、Windows、OSX、Linux、Android、iOS 等等),这通常需要为每个构建的输出结果选择带有不同参数的不同编译器。构建系统可以帮我做到这一切而不用让我(太)费心。我时常尝试着用不同的构建系统,看看有些什么新的变化,但是最终,我还是回到了使用 makefile 的情况,并结合使用 shell 和批处理脚本或 Perl 脚本来完成工作(因为如果我希望用户来构建我的软件,我还是最好选择一种到处都可以用的命令行脚本语言)。

|

||||

|

||||

**你怎样平衡在这种使用统一的用户界面下提供原生的外观和体验的需求呢?**

|

||||

|

||||

跨平台的用户界面的实现很困难。在过去几年中我已经使用了一些跨平台 GUI,并且我认为这些事情上并没有最优解。基本上有两种选择。你可以选择一个跨平台工具去做一个并不是完全适合你所有支持的平台的 UI,但是代码库比较小,维护成本比较低。或者你可以选择去开发针对平台的 UI,那样看起来更原生,集成的也更好,但是需要更大的代码库和更高的维护成本。这种决定完全取决于 APP 的类型、它有多少功能、你有多少资源,以及你要把它运行在多少平台上?

|

||||

|

||||

最后,我认为用户比较接受这种“一个 UI 打通关”了,就比如 Electron 框架。我有个 Chromium+C+C# 的框架侧项目,有一天我希望可以用 C# 构建 Electron 型的 app,这样的话我就可以做到两全其美了。

|

||||

|

||||

**构建/打包系统的依赖性对你有影响吗 ?**

|

||||

|

||||

我依赖的使用方面很保守,我被崩溃的 ABI(LCTT 译注:应用程序二进制接口)、冲突的符号、以及丢失的包等问题困扰了太多次。我决定我要针对的操作系统版本,并选择最低的公有部分来使问题最小化。通常这就意味着有五种不同的 Xcode 和 OSX 框架库,要在同样的机器上相应安装五种不同的 Visual Studio 版本,多种 clang(LCTT 译注:C语言、C++、Object-C、C++ 语言的轻量级编译器)和 gcc 版本,一系列的运行着各种发行版的虚拟机。如果我不能确定我要使用的操作系统的包的状态,我有时就会静态连接库,有时会子模块化依赖以确保它们一直可用。大多时候,我会避免这些很棘手的问题,除非我非常需要使用他们。

|

||||

|

||||

**你使用持续集成(CI)、代码审查以及相关的工具吗?**

|

||||

|

||||

基本每天都用。这是保持高效的唯一方式。我在一个项目中做的第一件事情是配置跨平台构建脚本,保证每件事尽可能自动化完成。当你面向多平台开发的时候,持续集成是至关重要的。没有人能在一个机器上构建各种平台的不同组合,并且一旦你的构建过程没有包含所有的平台,你就不会注意到你搞砸的事情。在一个共享式的多平台代码库中,不同的人拥有不同的平台和功能,所以保证质量的唯一的方法是跨团队代码审查结合持续集成和其他分析工具。这不同于其他的软件项目,如果不使用相关的工具就会面临失败。

|

||||

|

||||

**你依赖于自动构建测试,或者倾向于在每个平台上构建并且进行本地测试吗?**

|

||||

|

||||

对于不包括 UI 的工具和库,我通常使用自动构建测试。如果有 UI,两种方法我都会用到——针对已有的 GUI 工具的可靠的、可脚本化的 UI 自动化少到几乎没有,所以我要么我去针对我要跨我所支持的平台创建 UI 自动化工具,要么手动进行测试。如果一个项目使用了定制的 UI 库(比如说一个类似 Unity3D 的 OpenGL UI),开发可编程的自动化工具并自动化大多数工作就相当容易。不过,没有什么东西会像人一样双击就测试出问题。

|

||||

|

||||

**如果你要做跨平台开发,你喜欢用跨编辑器的构建系统,比如在 Windows 上使用 Visual Studio,在 Linux 上使用 Qt Creator,在 Mac 上使用 XCode 吗?还是你更趋向于使用 Eclipse 这样的可以在所有平台上使用的单一平台?**

|

||||

|

||||

我喜欢使用跨编辑器的构建系统。我更喜欢在不同的IDE上保存项目文件(这样可以使增加 IDE 变得更容易),通过使用构建脚本让 IDE 在它们支持的平台上去构建。对于一个开发者来说编辑器是最重要的工具,学习它们是需要花费时间和精力的,而它们是不可相互替代的。我有我自己喜欢的编辑器和工具,每个人也可以使用他们最喜爱的工具。

|

||||

|

||||

**在跨平台开发的时候,你更喜欢使用什么样的编辑器、开发环境和 IDE 呢?**

|

||||

|

||||

跨平台开发者被限制在只能选择可以在多数平台上工作的所共有的不多选择之一。我爱用 Visual Studio,但是我不能依赖它完成除 Windows 平台之外的工作(你可能不想让 Windows 成为你的主要的交叉编译平台),所以我不会使用它作为我的主要 IDE。即使可以,跨平台开发者的核心技能也是尽可能的了解和使用大量的平台。这就意味着必须很熟悉它们——使用该平台上的编辑器和库,了解这种操作系统及其适用场景、运行方式以及它的局限性等。做这些事情就需要头脑清醒(我的捷径是加强记忆),我必须依赖跨平台的编辑器。所以我使用 Emacs 和 Sublime。

|

||||

|

||||

**你之前和现在最喜欢的跨平台项目是什么?**

|

||||

|

||||

我一直很喜欢 Mono,并且得心应手,其它的项目大部分都是以某种方式围绕着它进行的。Gluezilla 是我在多年前开发的一个 Mozilla 绑定(binding),可以把 C# 开发的应用嵌入到 Web 浏览器页面中,并且看起来很有特色。我开发过一个 Winform 应用,它是在 linux 上开发的,它可以在 Windows 上运行在一个 Mozilla 浏览器页面里嵌入的 GTK 视图中。CppSharp 项目(以前叫做 Cxxi,更早时叫做 CppInterop)是一个我开始为 C++ 库生成 C# 绑定(binding)的项目,这样就可以在 C# 中调用、创建实例、子类化 C++ 类。这样,它在运行的时候就能够检测到所使用的平台,以及用来创建本地运行库的是什么编译器,并为它生成正确的 C# 绑定(binding)。这多么有趣啊。

|

||||

|

||||

**你怎样看跨平台开发的未来趋势呢?**

|

||||

|

||||

我们构建本地应用程序的方式已经改变了,我感觉在各种桌面操作系统的明显差异在慢慢变得模糊;所以构建跨平台的应用程序将会更加容易,而且对系统的集成也不需要完全本地化。不好的是,这可能意味着应用程序易用性更糟,并且在发挥操作系统特性方面所能做的更少。库、工具以及运行环境的跨平台开发是一种我们知道怎样做的更好,但是跨平台应用程序的开发仍然需要我们的努力。

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/business/16/5/oscon-interview-andreia-gaita

|

||||

|

||||

作者:[Marcus D. Hanwell][a]

|

||||

译者:[vim-kakali](https://github.com/vim-kakali)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://opensource.com/users/mhanwell

|

||||

[1]: https://twitter.com/sh4na

|

||||

[2]: http://conferences.oreilly.com/oscon/open-source-us/public/schedule/detail/48702

|

||||

[3]: http://www.mono-project.com/

|

||||

|

||||

85

published/201609/20160506 Setup honeypot in Kali Linux.md

Normal file

85

published/201609/20160506 Setup honeypot in Kali Linux.md

Normal file

@ -0,0 +1,85 @@

|

||||

在 Kali Linux 环境下设置蜜罐

|

||||

=========================

|

||||

|

||||

Pentbox 是一个包含了许多可以使渗透测试工作变得简单流程化的工具的安全套件。它是用 Ruby 编写并且面向 GNU / Linux,同时也支持 Windows、MacOS 和其它任何安装有 Ruby 的系统。在这篇短文中我们将讲解如何在 Kali Linux 环境下设置蜜罐。如果你还不知道什么是蜜罐(honeypot),“蜜罐是一种计算机安全机制,其设置用来发现、转移、或者以某种方式,抵消对信息系统的非授权尝试。"

|

||||

|

||||

### 下载 Pentbox:

|

||||

|

||||

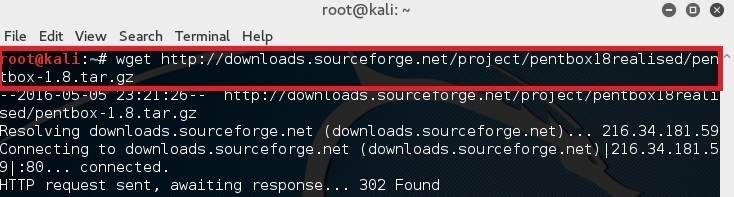

在你的终端中简单的键入下面的命令来下载 pentbox-1.8。

|

||||

|

||||

```

|

||||

root@kali:~# wget http://downloads.sourceforge.net/project/pentbox18realised/pentbox-1.8.tar.gz

|

||||

```

|

||||

|

||||

|

||||

|

||||

### 解压 pentbox 文件

|

||||

|

||||

使用如下命令解压文件:

|

||||

|

||||

```

|

||||

root@kali:~# tar -zxvf pentbox-1.8.tar.gz

|

||||

```

|

||||

|

||||

|

||||

|

||||

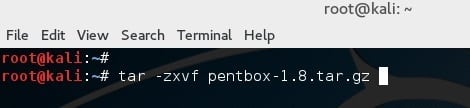

### 运行 pentbox 的 ruby 脚本

|

||||

|

||||

改变目录到 pentbox 文件夹:

|

||||

|

||||

```

|

||||

root@kali:~# cd pentbox-1.8/

|

||||

```

|

||||

|

||||

|

||||

|

||||

使用下面的命令来运行 pentbox:

|

||||

|

||||

```

|

||||

root@kali:~# ./pentbox.rb

|

||||

```

|

||||

|

||||

|

||||

|

||||

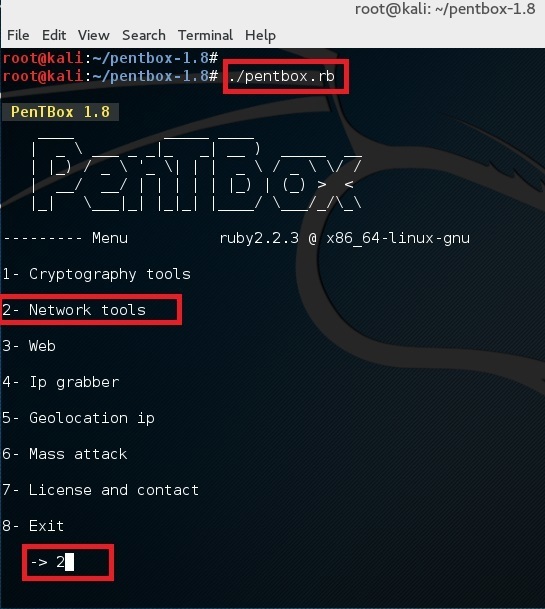

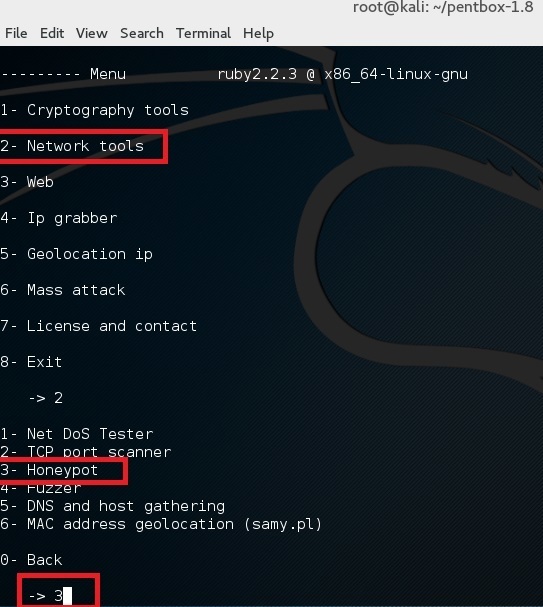

### 设置一个蜜罐

|

||||

|

||||

使用选项 2 (Network Tools) 然后是其中的选项 3 (Honeypot)。

|

||||

|

||||

|

||||

|

||||

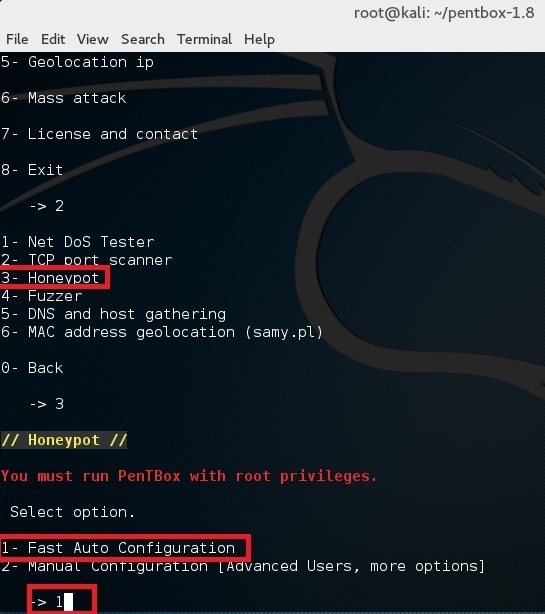

完成让我们执行首次测试,选择其中的选项 1 (Fast Auto Configuration)

|

||||

|

||||

|

||||

|

||||

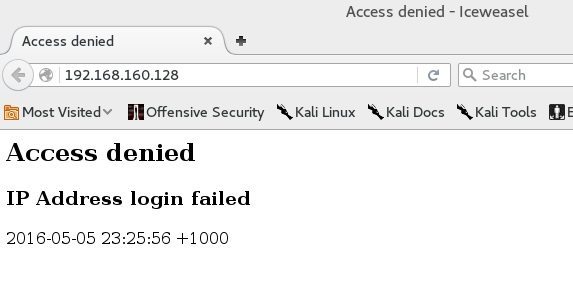

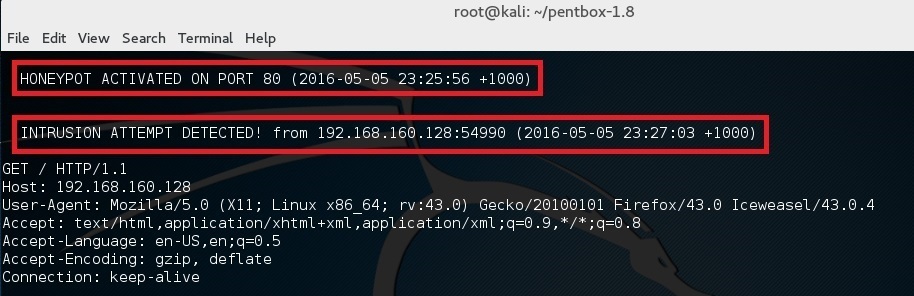

这样就在 80 端口上开启了一个蜜罐。打开浏览器并且打开链接 http://192.168.160.128 (这里的 192.168.160.128 是你自己的 IP 地址。)你应该会看到一个 Access denied 的报错。

|

||||

|

||||

|

||||

|

||||

|

||||

并且在你的终端应该会看到 “HONEYPOT ACTIVATED ON PORT 80” 和跟着的 “INTRUSION ATTEMPT DETECTED”。

|

||||

|

||||

|

||||

|

||||

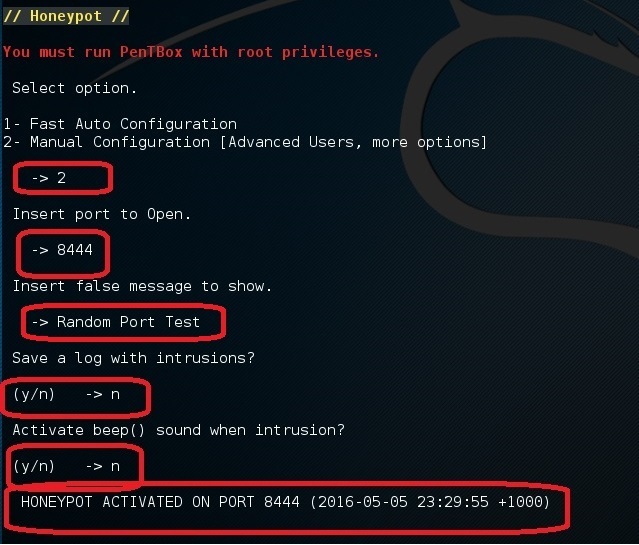

现在,如果你在同一步选择了选项 2 (Manual Configuration), 你应该看见更多的其它选项:

|

||||

|

||||

|

||||

|

||||

执行相同的步骤但是这次选择 22 端口 (SSH 端口)。接着在你家里的路由器上做一个端口转发,将外部的 22 端口转发到这台机器的 22 端口上。或者,把这个蜜罐设置在你的云端服务器的一个 VPS 上。

|

||||

|

||||

你将会被有如此多的机器在持续不断地扫描着 SSH 端口而震惊。 你知道你接着应该干什么么? 你应该黑回它们去!桀桀桀!

|

||||

|

||||

如果视频是你的菜的话,这里有一个设置蜜罐的视频:

|

||||

|

||||

<https://youtu.be/NufOMiktplA>

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.blackmoreops.com/2016/05/06/setup-honeypot-in-kali-linux/

|

||||

|

||||

作者:[blackmoreops.com][a]

|

||||

译者:[wcnnbdk1](https://github.com/wcnnbdk1)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: blackmoreops.com

|

||||

@ -0,0 +1,89 @@

|

||||

对比 Android 和 iPhone 的优缺点

|

||||

===================================

|

||||

|

||||

>当我们比较 Android 与 iPhone 的时候,很显然 Android 具有一定的优势,而 iPhone 则在一些关键方面更好。但是,究竟哪个比较好呢?

|

||||

|

||||

对 Android 与 iPhone 比较是个个人的问题。

|

||||

|

||||

就好比我来说,我两个都用。我深知这两个平台的优缺点。所以,我决定分享我关于这两个移动平台的观点。另外,然后谈谈我对新的 Ubuntu 移动平台的印象和它的优势。

|

||||

|

||||

### iPhone 的优点

|

||||

|

||||

虽然这些天我是个十足的 Android 用户,但我必须承认 iPhone 在某些方面做的是不错。首先,苹果公司在他们的设备更新方面有更好的成绩。这对于运行着 iOS 的旧设备来说尤其是这样。反观 Android ,如果不是谷歌亲生的 Nexus,它最好也不过是一个更高端的运营商支持的手机,你将发现它们的更新少的可怜或者根本没有。

|

||||

|

||||

其中 iPhone 做得很好的另一个领域是应用程序的可用性。展开来说,iPhone 应用程序几乎总是有一个简洁的外观。这并不是说 Android 应用程序就是丑陋的,而是,它们可能只是没有像 iOS 上一样的保持不变的操控习惯和一以贯之的用户体验。两个典型的例子, [Dark Sky][1] (天气)和 [Facebook Paper][2] 很好表现了 iOS 独有的布局。

|

||||

|

||||

再有就是备份过程。 Android 可以备份,默认情况下是备份到谷歌。但是对应用数据起不了太大作用。对比 iPhone ,iCloud 基本上可以对你的 iOS 设备进行了完整备份。

|

||||

|

||||

### iPhone 令我失望的地方

|

||||

|

||||

对 iPhone 来说,最无可争辩的问题是它的硬件限制要比软件限制更大,换句话来说,就是存储容量问题。

|

||||

|

||||

你看,对于大多数 Android 手机,我可以买一个容量较小的手机,然后以后可以添加 SD 卡。这意味着两件事:第一,我可以使用 SD 卡来存储大量的媒体文件。其次,我甚至可以用 SD 卡来存储“一些”我的应用程序。而苹果完全不能这么做。

|

||||

|

||||

另一个 iPhone 让我失望的地方是它提供的选择很少。备份您的设备?希望你喜欢 iTunes 或 iCloud 吧。但对一些像我一样用 Linux 的人,那就意味着,我唯一的选择便是使用 iCloud。

|

||||

|

||||

要公平的说,如果你愿意越狱,你的 iPhone 还有一些其他解决方案的,但这并不是这篇文章所讲的。 Android 的 解锁 root 也一样。本文章针对的是两个平台的原生设置。

|

||||

|

||||

最后,让我们不要忘记这件看起来很小的事—— [iTunes 会删掉用户的音乐][3],因为它认为和苹果音乐的内容重复了……或者因为一些其它的类似规定。这不是 iPhone 特有的情况?我不同意,因为那些音乐最终就是在 iPhone 上没有了。我能十分肯定地这么说,是因为不管在哪里我都不会说这种谎话。

|

||||

|

||||

|

||||

|

||||

*Android 和 iPhone 的对决取决于什么功能对你来说最重要。*

|

||||

|

||||

### Android 的优点

|

||||

|

||||

Android 给我最大的好处就是 iPhone 所提供不了的:选择。这包括对应用程序、设备以及手机是整体如何工作的选择。

|

||||

|

||||

我爱桌面小工具!对于 iPhone 用户来说,它们也许看上去很蠢。但我可以告诉你,它们可以让我不用打开应用程序就可以看到所需的数据,而无需额外的麻烦。另一个类似的功能,我喜欢安装定制的桌面界面,而不是我的手机默认的那个!

|

||||

|

||||

最后,我可以通过像 [Airdroid][4] 和 [Tasker][5] 这样的工具给我的智能手机添加计算机级的完整功能。AirDroid 可以让我把我的 Android 手机当成带有一个文件管理和通信功能的计算机——这可以让我可以轻而易举的使用鼠标和键盘。Tasker 更厉害,我可以用它让我手机根据环境变得可联系或不可联系,当我设置好了之后,当我到会议室之后我的手机就会自己进入会议模式,甚至变成省电模式。我还可以设置它当我到达特定的目的地时自动启动某个应用程序。

|

||||

|

||||

### Android 让我失望的地方

|

||||

|

||||

Android 备份选项仅限于特定的用户数据,而不是手机的完整克隆。如果不解锁 root,要么你只能听之任之,要么你必须用 Android SDK 来解决。期望普通用户会解锁 root 或运行 SDK 来完成备份(我的意思是一切都备份)显然是一个笑话。

|

||||

|

||||

是的,谷歌的备份服务会备份谷歌应用程序的数据、以及其他相关的自定义设置。但它是远不及我们所看到的苹果服务一样完整。为了完成类似于苹果那样的功能,我发现你就要么必须解锁 root ,要么将其连接到一个在 PC 机上使用一些不知道是什么的软件来干这个。

|

||||

|

||||

不过,公平的说,我知道使用 Nexus 的人能从该设备特有的[完整备份服务][6]中得到帮助。对不起,但是谷歌的默认备份方案是不行的。对于通过在 PC 上使用 adb (Android Debug Bridge) 来备份也是一样的——不会总是如预期般的恢复。

|

||||

|

||||

等吧,它会变好的。经过了很多失败的失望和挫折之后,我发现有一个应用程序,看起来它“可能”提供了一点点微小的希望,它叫 Helium 。它不像我发现的其他应用程序那样拥有误导性的和令人沮丧的局限性,[Helium][7] 最初看起来像是谷歌应该一直提供的备份应用程序——注意,只是“看起来像”。可悲的是,它绊了我一跤。第一次运行时,我不仅需要将它连接到我的计算机上,甚至使用他们提供的 Linux 脚本都不工作。在删除他们的脚本后,我弄了一个很好的老式 adb 来备份到我的 Linux PC 上。你可能要知道的是:你需要在开发工具里打开一箩筐东西,而且如果你运行 Twilight 应用的话还要关闭它。当 adb 的备份选项在我的手机上不起作用时,我花了一点时间把这个搞好了。

|

||||

|

||||

最后,Android 为非 root 用户也提供了可以轻松备份一些如联系人、短信等简单东西的选择。但是,要深度手机备份的话,以我经验还是通过有线连接和 adb。

|

||||

|

||||

### Ubuntu 能拯救我们吗?

|

||||

|

||||

在手机领域,通过对这两大玩家之间的优劣比较,我们很期望从 Ubuntu 看到更好的表现。但是,迄今为止,它的表现相当低迷。

|

||||

|

||||

我喜欢开发人员基于这个操作系统正在做的那些努力,我当然想在 iPhone 和 Android 手机之外有第三种选择。但是不幸的是,它在手机和平板上并不受欢迎,而且由于硬件的低端以及在 YouTube 上的糟糕的演示,有很多不好的传闻。

|

||||

|

||||

公平来说,我在以前也用过 iPhone 和 Android 的低端机,所以这不是对 Ubuntu 的挖苦。但是它要表现出准备与 iPhone 和 Android 相竞争的功能生态时,那就另说了,这还不是我现在特别感兴趣的东西。在以后的日子里,也许吧,我会觉得 Ubuntu 手机可以满足我的需要了。

|

||||

|

||||

###Android 与 iPhone 之争:为什么 Android 将终究赢得胜利

|

||||

|

||||

忽视 Android 那些痛苦的缺点,它起码给我了选择。它并没有把我限制在只有两种备份数据的方式上。是的,一些 Android 的限制事实上是由于它的关注点在于让我选择如何处理我的数据。但是,我可以选择我自己的设备,想加内存就加内存。Android 可以我让做很多很酷的东西,而 iPhone 根本就没有能力这些事情。

|

||||

|

||||

从根本上来说, Android 给非 root 用户提供了访问手机功能的更大自由。无论是好是坏,这是人们想要的一种自由。现在你们其中有很多 iPhone 的粉丝应该感谢像 [libimobiledevice][8] 这样项目带来的影响。看看苹果阻止 Linux 用户所做的事情……然后问问你自己:作为一个 Linux 用户这真的值得吗?

|

||||

|

||||

发表下评论吧,分享你对 iPhone 、Android 或 Ubuntu 的看法。

|

||||

|

||||

------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.datamation.com/mobile-wireless/android-vs.-iphone-pros-and-cons.html

|

||||

|

||||

作者:[Matt Hartley][a]

|

||||

译者:[jovov](https://github.com/jovov)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: http://www.datamation.com/author/Matt-Hartley-3080.html

|

||||

[1]: http://darkskyapp.com/

|

||||

[2]: https://www.facebook.com/paper/

|

||||

[3]: https://blog.vellumatlanta.com/2016/05/04/apple-stole-my-music-no-seriously/

|

||||

[4]: https://www.airdroid.com/

|

||||

[5]: http://tasker.dinglisch.net/

|

||||

[6]: https://support.google.com/nexus/answer/2819582?hl=en

|

||||

[7]: https://play.google.com/store/apps/details?id=com.koushikdutta.backup&hl=en

|

||||

[8]: http://www.libimobiledevice.org/

|

||||

|

||||

@ -1,24 +1,25 @@

|

||||

Linux 将成为21世纪汽车的主要操作系统

|

||||

Linux 将成为 21 世纪汽车的主要操作系统

|

||||

===============================================================

|

||||

|

||||

>汽车可不单单是由引擎和华丽外壳组成的,汽车里还有许许多多的计算部件,而 Linux 就在它们里面跑着。

|

||||

> 汽车可不单单是由引擎和华丽外壳组成的,汽车里还有许许多多的计算部件,而 Linux 就在它们里面跑着。

|

||||

|

||||

Linux 不只运行在你的服务器和手机(安卓)上。它还运行在你的车里。当然了,没人会因为某个车载系统而去买辆车。但是 Linux 已经为像丰田,日产,捷豹路虎,马自达,三菱,斯巴鲁,这些大型汽车制造商改进了信息娱乐系统、平视显示以及其联网汽车(connected car)的 4G 与 Wi-Fi 系统,而且 [Linux 即将登陆福特汽车][1]。

|

||||

Linux 不只运行在你的服务器和手机(安卓)上。它还运行在你的车里。当然了,没人会因为某个车载系统而去买辆车。但是 Linux 已经为像丰田、日产、捷豹路虎这些大型汽车制造商提供了信息娱乐系统、平视显示以及其联网汽车(connected car)的 4G 与 Wi-Fi 系统,而且 [Linux 即将登陆福特汽车][1]、马自达、三菱、斯巴鲁。

|

||||

|

||||

|

||||

>如今,所有的 Linux 和开源汽车软件的成果都已经在 Automotive Grade Linux 项目下统一标准化了。

|

||||

|

||||

传统软件公司也进入了移动物联网领域。 Movimento, Oracle, Qualcomm, Texas Instruments, UIEvolution 和 VeriSilicon 都已经 [加入 Automotive Grade Linux(AGL)项目][2]。 [AGL][3] 是一个相互协作的开源项目,志在于为联网汽车打造一个基于 Linux 的通用软件栈。

|

||||

*如今,所有的 Linux 和开源汽车软件的成果都已经在 Linux 基金会的 Automotive Grade Linux (AGL)项目下统一标准化了。*

|

||||

|

||||

传统软件公司也进入了移动物联网领域。 Movimento、甲骨文、高通、Texas Instruments、UIEvolution 和 VeriSilicon 都已经[加入 Automotive Grade Linux(AGL)项目][2]。 [AGL][3] 是一个相互协作的开源项目,志在于为联网汽车打造一个基于 Linux 的通用软件栈。

|

||||

|

||||

“随着联网汽车技术和信息娱乐系统需求的快速增长,AGL 过去几年中得到了极大的发展,” Linux 基金会汽车总经理 Dan Cauchy 如是说。

|

||||

|

||||

Cauchy 又补充道,“我们的会员基础不单单只是迅速壮大,而且通过横跨不同的业界实现多元化,从半导体和车载软件到 IoT 和连接云服务。这是一个明显的迹象,即联网汽车的革命已经间接影响到许多行业纵向市场。”

|

||||

Cauchy 又补充道,“我们的会员基础不单单只是迅速壮大,而且通过横跨不同的业界实现了多元化,从半导体和车载软件到 IoT 和连接云服务。这是一个明显的迹象,即联网汽车的革命已经间接影响到许多行业纵向市场。”

|

||||

|

||||

这些公司在 AGL 发布了新的 AGL Unified Code Base (UCB) 之后加入了 AGL 项目。这个新的 Linux 发行版基于 AGL 和另外两个汽车开源项目: [Tizen][4] 和 [GENIVI Alliance][5] 。 UCB 是第二代 Linux 汽车系统。它从底层开始开发,一直到特定的汽车应用软件。它能处理导航,通信,安全,安保和信息娱乐系统,

|

||||

这些公司在 AGL 发布了新的 AGL Unified Code Base (UCB) 之后加入了 AGL 项目。这个新的 Linux 发行版基于 AGL 和另外两个汽车开源项目: [Tizen][4] 和 [GENIVI Alliance][5] 。 UCB 是第二代 Linux 汽车系统。它从底层开始开发,一直到特定的汽车应用软件。它能处理导航、通信、安全、安保和信息娱乐系统。

|

||||

|

||||

“汽车行业需要一个标准的开源系统和框架来让汽车制造商和供应商能够快速地将类似智能手机的功能带入到汽车中来。” Cauchy 说。“这个新的发行版将 AGL, Tizen, GENIVI 项目和相关开源代码中的精华部分整合进 AGL Unified Code Base ( UCB ) 中,使得汽车制造商能够利用一个通用平台进行快速创新。 在汽车中采用基于 Linux 的系统来实现所有功能时, AGL 的 UCB 发行版将扮演一个重大的角色。”

|

||||

“汽车行业需要一个标准的开源系统和框架来让汽车制造商和供应商能够快速地将类似智能手机的功能带入到汽车中来。” Cauchy 说。“这个新的发行版将 AGL、Tizen、GENIVI 项目和相关开源代码中的精华部分整合进 AGL Unified Code Base (UCB)中,使得汽车制造商能够利用一个通用平台进行快速创新。 在汽车中采用基于 Linux 的系统来实现所有功能时, AGL 的 UCB 发行版将扮演一个重大的角色。”

|

||||

|

||||

他说得对。自从 2016 年 1 月发布以来,已有四个汽车公司和十个新的软件厂商加入了 AGL。Esso, 如今的 Exxon, 曾让 “把老虎装入油箱” 这条广告语出了名。我怀疑 “把企鹅装到引擎盖下” 这样的广告语是否也会变得家喻户晓,但是它却道出了事实。 Linux 正在慢慢成为 21 世纪汽车的主要操作系统。

|

||||

他说得对。自从 2016 年 1 月发布以来,已有四个汽车公司和十个新的软件厂商加入了 AGL。Esso,如今的 Exxon, 曾让 “把老虎装入油箱” 这条广告语出了名。我怀疑 “把企鹅装到引擎盖下” 这样的广告语是否也会变得家喻户晓,但是它却道出了事实。 Linux 正在慢慢成为 21 世纪汽车的主要操作系统。

|

||||

|

||||

------------------------------------------------------------------------------

|

||||

|

||||

@ -26,7 +27,7 @@ via: http://www.zdnet.com/article/the-linux-in-your-car-movement-gains-momentum/

|

||||

|

||||

作者:[Steven J. Vaughan-Nichols][a]

|

||||

译者:[XLCYun](https://github.com/XLCYun)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,74 @@

|

||||

使用 Python 和 Asyncio 编写在线多人游戏(一)

|

||||

===================================================================

|

||||

|

||||

你在 Python 中用过异步编程吗?本文中我会告诉你怎样做,而且用一个[能工作的例子][1]来展示它:这是一个流行的贪吃蛇游戏,而且是为多人游戏而设计的。

|

||||

|

||||

- [游戏入口在此,点此体验][2]。

|

||||

|

||||

###1、简介

|

||||

|

||||

在技术和文化领域,大规模多人在线游戏(MMO)毋庸置疑是我们当今世界的潮流之一。很长时间以来,为一个 MMO 游戏写一个服务器这件事总是会涉及到大量的预算与复杂的底层编程技术,不过在最近这几年,事情迅速发生了变化。基于动态语言的现代框架允许在中档的硬件上面处理大量并发的用户连接。同时,HTML5 和 WebSockets 标准使得创建基于实时图形的游戏的直接运行至浏览器上的客户端成为可能,而不需要任何的扩展。

|

||||

|

||||

对于创建可扩展的非堵塞性的服务器来说,Python 可能不是最受欢迎的工具,尤其是和在这个领域里最受欢迎的 Node.js 相比而言。但是最近版本的 Python 正在改变这种现状。[asyncio][3] 的引入和一个特别的 [async/await][4] 语法使得异步代码看起来像常规的阻塞代码一样,这使得 Python 成为了一个值得信赖的异步编程语言,所以我将尝试利用这些新特点来创建一个多人在线游戏。

|

||||

|

||||

###2、异步

|

||||

|

||||

一个游戏服务器应该可以接受尽可能多的用户并发连接,并实时处理这些连接。一个典型的解决方案是创建线程,然而在这种情况下并不能解决这个问题。运行上千的线程需要 CPU 在它们之间不停的切换(这叫做上下文切换),这将导致开销非常大,效率很低下。更糟糕的是使用进程来实现,因为,不但如此,它们还会占用大量的内存。在 Python 中,甚至还有一个问题,Python 的解释器(CPython)并不是针对多线程设计的,相反它主要针对于单线程应用实现最大的性能。这就是为什么它使用 GIL(global interpreter lock),这是一个不允许同时运行多线程 Python 代码的架构,以防止同一个共享对象出现使用不可控。正常情况下,在当前线程正在等待的时候,解释器会转换到另一个线程,通常是等待一个 I/O 的响应(举例说,比如等待 Web 服务器的响应)。这就允许在你的应用中实现非阻塞 I/O 操作,因为每一个操作仅仅阻塞一个线程而不是阻塞整个服务器。然而,这也使得通常的多线程方案变得几近无用,因为它不允许你并发执行 Python 代码,即使是在多核心的 CPU 上也是这样。而与此同时,在一个单一线程中拥有非阻塞 I/O 是完全有可能的,因而消除了经常切换上下文的需要。

|

||||

|

||||

实际上,你可以用纯 Python 代码来实现一个单线程的非阻塞 I/O。你所需要的只是标准的 [select][5] 模块,这个模块可以让你写一个事件循环来等待未阻塞的 socket 的 I/O。然而,这个方法需要你在一个地方定义所有 app 的逻辑,用不了多久,你的 app 就会变成非常复杂的状态机。有一些框架可以简化这个任务,比较流行的是 [tornade][6] 和 [twisted][7]。它们被用来使用回调方法实现复杂的协议(这和 Node.js 比较相似)。这种框架运行在它自己的事件循环中,按照定义的事件调用你的回调函数。并且,这或许是一些情况的解决方案,但是它仍然需要使用回调的方式编程,这使你的代码变得碎片化。与写同步代码并且并发地执行多个副本相比,这就像我们在普通的线程上做的一样。在单个线程上这为什么是不可能的呢?

|

||||

|

||||

这就是为什么出现微线程(microthread)概念的原因。这个想法是为了在一个线程上并发执行任务。当你在一个任务中调用阻塞的方法时,有一个叫做“manager” (或者“scheduler”)的东西在执行事件循环。当有一些事件准备处理的时候,一个 manager 会转移执行权给一个任务,并等着它执行完毕。任务将一直执行,直到它遇到一个阻塞调用,然后它就会将执行权返还给 manager。

|

||||

|

||||

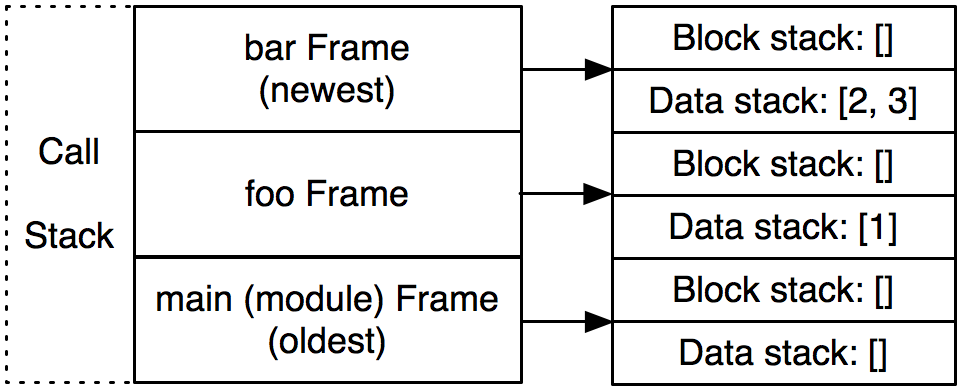

> 微线程也称为轻量级线程(lightweight threads)或绿色线程(green threads)(来自于 Java 中的一个术语)。在伪线程中并发执行的任务叫做 tasklets、greenlets 或者协程(coroutines)。

|

||||

|

||||

Python 中的微线程最早的实现之一是 [Stackless Python][8]。它之所以这么知名是因为它被用在了一个叫 [EVE online][9] 的非常有名的在线游戏中。这个 MMO 游戏自称说在一个持久的“宇宙”中,有上千个玩家在做不同的活动,这些都是实时发生的。Stackless 是一个独立的 Python 解释器,它代替了标准的函数栈调用,并且直接控制程序运行流程来减少上下文切换的开销。尽管这非常有效,这个解决方案不如在标准解释器中使用“软”库更流行,像 [eventlet][10] 和 [gevent][11] 的软件包配备了修补过的标准 I/O 库,I/O 函数会将执行权传递到内部事件循环。这使得将正常的阻塞代码转变成非阻塞的代码变得简单。这种方法的一个缺点是从代码上看这并不分明,它的调用是非阻塞的。新版本的 Python 引入了本地协程作为生成器的高级形式。在 Python 的 3.4 版本之后,引入了 asyncio 库,这个库依赖于本地协程来提供单线程并发。但是仅仅到了 Python 3.5 ,协程就变成了 Python 语言的一部分,使用新的关键字 async 和 await 来描述。这是一个简单的例子,演示了使用 asyncio 来运行并发任务。

|

||||

|

||||

```

|

||||

import asyncio

|

||||

|

||||

async def my_task(seconds):

|

||||

print("start sleeping for {} seconds".format(seconds))

|

||||

await asyncio.sleep(seconds)

|

||||

print("end sleeping for {} seconds".format(seconds))

|

||||

|

||||

all_tasks = asyncio.gather(my_task(1), my_task(2))

|

||||

loop = asyncio.get_event_loop()

|

||||

loop.run_until_complete(all_tasks)

|

||||

loop.close()

|

||||

```

|

||||

|

||||

我们启动了两个任务,一个睡眠 1 秒钟,另一个睡眠 2 秒钟,输出如下:

|

||||

|

||||

```

|

||||

start sleeping for 1 seconds

|

||||

start sleeping for 2 seconds

|

||||

end sleeping for 1 seconds

|

||||

end sleeping for 2 seconds

|

||||

```

|

||||

|

||||

正如你所看到的,协程不会阻塞彼此——第二个任务在第一个结束之前启动。这发生的原因是 asyncio.sleep 是协程,它会返回执行权给调度器,直到时间到了。

|

||||

|

||||

在下一节中,我们将会使用基于协程的任务来创建一个游戏循环。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://7webpages.com/blog/writing-online-multiplayer-game-with-python-asyncio-getting-asynchronous/

|

||||

|

||||

作者:[Kyrylo Subbotin][a]

|

||||

译者:[xinglianfly](https://github.com/xinglianfly)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://7webpages.com/blog/writing-online-multiplayer-game-with-python-asyncio-getting-asynchronous/

|

||||

[1]: http://snakepit-game.com/

|

||||

[2]: http://snakepit-game.com/

|

||||

[3]: https://docs.python.org/3/library/asyncio.html

|

||||

[4]: https://docs.python.org/3/whatsnew/3.5.html#whatsnew-pep-492

|

||||

[5]: https://docs.python.org/2/library/select.html

|

||||

[6]: http://www.tornadoweb.org/

|

||||

[7]: http://twistedmatrix.com/

|

||||

[8]: http://www.stackless.com/

|

||||

[9]: http://www.eveonline.com/

|

||||

[10]: http://eventlet.net/

|

||||

[11]: http://www.gevent.org/

|

||||

@ -0,0 +1,59 @@

|

||||

Linux 发行版们应该禁用 IPv4 映射的 IPv6 地址吗?

|

||||

=============================================

|

||||

|

||||

从各方面来看,互联网向 IPv6 的过渡是件很缓慢的事情。不过在最近几年,可能是由于 IPv4 地址资源的枯竭,IPv6 的使用处于[上升态势][1]。相应的,开发者也有兴趣确保软件能在 IPv4 和 IPv6 下工作。但是,正如近期 OpenBSD 邮件列表的讨论所关注的,一个使得向 IPv6 转换更加轻松的机制设计同时也可能导致网络更不安全——并且 Linux 发行版们的默认配置可能并不安全。

|

||||

|

||||

### 地址映射

|

||||

|

||||

IPv6 在很多方面看起来可能很像 IPv4,但它是一个不同地址空间的不同的协议。服务器程序想要接受使用二者之中任意一个协议的连接,必须给两个不同的地址族分别打开一个套接字——IPv4 的 `AF_INET` 和 IPv6 的 `AF_INET6`。特别是一个程序希望在主机的使用两种地址协议的任意接口都接受连接的话,需要创建一个绑定到全零通配符地址(`0.0.0.0`)的 `AF_INET` 套接字和一个绑定到 IPv6 等效地址(写作 `::`)的 `AF_INET6` 套接字。它必须在两个套接字上都监听连接——或者有人会这么认为。

|

||||

|

||||

多年前,在 [RFC 3493][2],IETF 指定了一个机制,程序可以使用一个单独的 IPv6 套接字工作在两个协议之上。有了一个启用这个行为的套接字,程序只需要绑定到 `::` 来在所有接口上接受使用这两个协议连接。当创建了一个 IPv4 连接到该绑定端口,源地址会像 [RFC 2373][3] 中描述的那样映射到 IPv6。所以,举个例子,一个使用了这个模式的程序会将一个 `192.168.1.1` 的传入连接看作来自 `::ffff:192.168.1.1`(这个混合的写法就是这种地址通常的写法)。程序也能通过相同的映射方法打开一个到 IPv4 地址的连接。

|

||||

|

||||

RFC 要求这个行为要默认实现,所以大多数系统这么做了。不过也有些例外,OpenBSD 就是其中之一;在那里,希望在两种协议下工作的程序能做的只能是创建两个独立的套接字。但一个在 Linux 中打开两个套接字的程序会遇到麻烦:IPv4 和 IPv6 套接字都会尝试绑定到 IPv4 地址,所以不论是哪个后者都会失败。换句话说,一个绑定到 `::` 指定端口的套接字的程序会同时绑定到 IPv6 `::` 和 IPv4 `0.0.0.0` 地址的那个端口上。如果程序之后尝试绑定一个 IPv4 套接字到 `0.0.0.0` 的相同端口上时,这个操作会失败,因为这个端口已经被绑定了。

|

||||

|

||||

当然有个办法可以解决这个问题;程序可以调用 `setsockopt()` 来打开 `IPV6_V6ONLY` 选项。一个打开两个套接字并且设置了 `IPV6_V6ONLY` 的程序应该可以在所有的系统间移植。

|

||||

|

||||

读者们可能对不是每个程序都能正确处理这一问题没那么震惊。事实证明,这些程序的其中之一是网络时间协议(Network Time Protocol)的 [OpenNTPD][4] 实现。Brent Cook 最近给上游 OpenNTPD 源码[提交了一个小补丁][5],添加了必要的 `setsockopt()` 调用,它也被提交到了 OpenBSD 中了。不过那个补丁看起来不大可能被接受,最可能是因为 OpenBSD 式的理由(LCTT 译注:如前文提到的,OpenBSD 并不受这个问题的影响)。

|

||||

|

||||

### 安全担忧

|

||||

|

||||

正如上文所提到,OpenBSD 根本不支持 IPv4 映射的 IPv6 套接字。即使一个程序试着通过将 `IPV6_V6ONLY` 选项设置为 0 显式地启用地址映射,它的作者会感到沮丧,因为这个设置在 OpenBSD 系统中无效。这个决定背后的原因是这个映射带来了一些安全担忧。攻击打开的接口的攻击类型有很多种,但它们最后都会回到规定的两个途径到达相同的端口,每个端口都有它自己的控制规则。

|

||||

|

||||