mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-18 02:00:18 +08:00

commit

a8bed2001d

@ -1,34 +1,30 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (qhwdw)

|

||||

[#]: reviewer: ( )

|

||||

[#]: publisher: ( )

|

||||

[#]: url: ( )

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-10585-1.html)

|

||||

[#]: subject: (Computer Laboratory – Raspberry Pi: Lesson 8 Screen03)

|

||||

[#]: via: (https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/screen03.html)

|

||||

[#]: author: (Alex Chadwick https://www.cl.cam.ac.uk)

|

||||

|

||||

计算机实验室 – 树莓派:课程 8 屏幕03

|

||||

计算机实验室之树莓派:课程 8 屏幕03

|

||||

======

|

||||

|

||||

屏幕03 课程基于屏幕02 课程来构建,它教你如何绘制文本,和一个操作系统命令行参数上的一个小特性。假设你已经有了[课程 7:屏幕02][1] 的操作系统代码,我们将以它为基础来构建。

|

||||

|

||||

### 1、字符串的理论知识

|

||||

|

||||

是的,我们的任务是为这个操作系统绘制文本。我们有几个问题需要去处理,最紧急的那个可能是如何去保存文本。令人难以置信的是,文本是迄今为止在计算机上最大的缺陷之一。原本应该是简单的数据类型却导致了操作系统的崩溃,破坏了完美的加密,并给使用不同字母表的用户带来了许多问题。尽管如此,它仍然是极其重要的数据类型,因为它将计算机和用户很好地连接起来。文本是计算机能够理解的非常好的结构,同时人类使用它时也有足够的可读性。

|

||||

是的,我们的任务是为这个操作系统绘制文本。我们有几个问题需要去处理,最紧急的那个可能是如何去保存文本。令人难以置信的是,文本是迄今为止在计算机上最大的缺陷之一。原本应该是简单的数据类型却导致了操作系统的崩溃,从而削弱其他方面的加密效果,并给使用其它字母表的用户带来了许多问题。尽管如此,它仍然是极其重要的数据类型,因为它将计算机和用户很好地连接起来。文本是计算机能够理解的非常好的结构,同时人类使用它时也有足够的可读性。

|

||||

|

||||

```

|

||||

可变数据类型,比如文本要求能够进行很复杂的处理。

|

||||

```

|

||||

那么,文本是如何保存的呢?非常简单,我们使用一种方法,给每个字母分配一个唯一的编号,然后我们保存一系列的这种编号。看起来很容易吧。问题是,那个编号的数量是不固定的。一些文本段可能比其它的长。保存普通数字,我们有一些固有的限制,即:32 位,我们不能超过这个限制,我们要添加方法去使用该长度的数字等等。“文本”这个术语,我们经常也叫它“字符串”,我们希望能够写一个可用于可变长度字符串的函数,否则就需要写很多函数!对于一般的数字来说,这不是个问题,因为只有几种通用的数字格式(字节、字、半字节、双字节)。

|

||||

|

||||

那么,文本是如何保存的呢?非常简单,我们使用一种方法,给每个字母分配一个唯一的编号,然后我们保存一系列的这种编号。看起来很容易吧。问题是,那个编号的数字是不固定的。一些文本片断可能比其它的长。与保存普通数字一样,我们有一些固有的限制,即:3 位,我们不能超过这个限制,我们添加方法去使用那种长数字等等。“文本”这个术语,我们经常也叫它“字符串”,我们希望能够写一个可用于变长字符串的函数,否则就需要写很多函数!对于一般的数字来说,这不是个问题,因为只有几种通用的数字格式(字节、字、半字节、双字节)。

|

||||

> 可变数据类型(比如文本)要求能够进行很复杂的处理。

|

||||

|

||||

```

|

||||

缓冲区溢出攻击祸害计算机由来已久。最近,Wii、Xbox 和 Playstation 2、以及大型系统如 Microsoft 的 Web 和数据库服务器,都遭受到缓冲区溢出攻击。

|

||||

```

|

||||

因此,如何判断字符串长度?我想显而易见的答案是存储字符串的长度,然后去存储组成字符串的字符。这称为长度前缀,因为长度位于字符串的前面。不幸的是,计算机科学家的先驱们不同意这么做。他们认为使用一个称为空终止符(`NULL`)的特殊字符(用 `\0` 表示)来表示字符串结束更有意义。这样确定简化了许多字符串算法,因为你只需要持续操作直到遇到空终止符为止。不幸的是,这成为了许多安全问题的根源。如果一个恶意用户给你一个特别长的字符串会发生什么状况?如果没有足够的空间去保存这个特别长的字符串会发生什么状况?你可以使用一个字符串复制函数来做复制,直到遇到空终止符为止,但是因为字符串特别长,而覆写了你的程序,怎么办?这看上去似乎有些较真,但是,缓冲区溢出攻击还是经常发生。长度前缀可以很容易地缓解这种问题,因为它可以很容易地推算出保存这个字符串所需要的缓冲区的长度。作为一个操作系统开发者,我留下这个问题,由你去决定如何才能更好地存储文本。

|

||||

|

||||

因此,如何判断字符串长度?我想显而易见的答案是存储多长的字符串,然后去存储组成字符串的字符。这称为长度前缀,因为长度位于字符串的前面。不幸的是,计算机科学家的先驱们不同意这么做。他们认为使用一个称为空终止符(NULL)的特殊字符(用 \0表示)来表示字符串结束更有意义。这样确定简化了许多字符串算法,因为你只需要持续操作直到遇到空终止符为止。不幸的是,这成为了许多安全问题的根源。如果一个恶意用户给你一个特别长的字符串会发生什么状况?如果没有足够的空间去保存这个特别长的字符串会发生什么状况?你可以使用一个字符串复制函数来做复制,直到遇到空终止符为止,但是因为字符串特别长,而覆写了你的程序,怎么办?这看上去似乎有些较真,但尽管如此,缓冲区溢出攻击还是经常发生。长度前缀可以很容易地缓解这种问题,因为它可以很容易地推算出保存这个字符串所需要的缓冲区的长度。作为一个操作系统开发者,我留下这个问题,由你去决定如何才能更好地存储文本。

|

||||

> 缓冲区溢出攻击祸害计算机由来已久。最近,Wii、Xbox 和 Playstation 2、以及大型系统如 Microsoft 的 Web 和数据库服务器,都遭受到缓冲区溢出攻击。

|

||||

|

||||

接下来的事情是,我们需要去维护一个很好的从字符到数字的映射。幸运的是,这是高度标准化的,我们有两个主要的选择,Unicode 和 ASCII。Unicode 几乎将每个单个的有用的符号都映射为数字,作为交换,我们得到的是很多很多的数字,和一个更复杂的编码方法。ASCII 为每个字符使用一个字节,因此它仅保存拉丁字母、数字、少数符号和少数特殊字符。因此,ASCII 是非常易于实现的,与 Unicode 相比,它的每个字符占用的空间并不相同,这使得字符串算法更棘手。一般操作系统上字符使用 ASCII,并不是为了显示给最终用户的(开发者和专家用户除外),给终端用户显示信息使用 Unicode,因为 Unicode 能够支持像日语字符这样的东西,并且因此可以实现本地化。

|

||||

接下来的事情是,我们需要确定的是如何最好地将字符映射到数字。幸运的是,这是高度标准化的,我们有两个主要的选择,Unicode 和 ASCII。Unicode 几乎将每个有用的符号都映射为数字,作为代价,我们需要有很多很多的数字,和一个更复杂的编码方法。ASCII 为每个字符使用一个字节,因此它仅保存拉丁字母、数字、少数符号和少数特殊字符。因此,ASCII 是非常易于实现的,与之相比,Unicode 的每个字符占用的空间并不相同,这使得字符串算法更棘手。通常,操作系统上字符使用 ASCII,并不是为了显示给最终用户的(开发者和专家用户除外),给终端用户显示信息使用 Unicode,因为 Unicode 能够支持像日语字符这样的东西,并且因此可以实现本地化。

|

||||

|

||||

幸运的是,在这里我们不需要去做选择,因为它们的前 128 个字符是完全相同的,并且编码也是完全一样的。

|

||||

|

||||

@ -45,27 +41,27 @@

|

||||

| 60 | ` | a | b | c | d | e | f | g | h | i | j | k | l | m | n | o | |

|

||||

| 70 | p | q | r | s | t | u | v | w | x | y | z | { | | | } | ~ | DEL |

|

||||

|

||||

这个表显示了前 128 个符号。一个符号的十六进制表示是行的值加上列的值,比如 A 是 41~16~。你可以惊奇地发现前两行和最后的值。这 33 个特殊字符是不可打印字符。事实上,许多人都忽略了它们。它们之所以存在是因为 ASCII 最初设计是基于计算机网络来传输数据的一种方法。因此它要发送的信息不仅仅是符号。你应该学习的重要的特殊字符是 `NUL`,它就是我们前面提到的空终止符。`HT` 水平制表符就是我们经常说的 `tab`,而 `LF` 换行符用于生成一个新行。你可能想研究和使用其它特殊字符在你的操行系统中的意义。

|

||||

这个表显示了前 128 个符号。一个符号的十六进制表示是行的值加上列的值,比如 A 是 41<sub>16</sub>。你可以惊奇地发现前两行和最后的值。这 33 个特殊字符是不可打印字符。事实上,许多人都忽略了它们。它们之所以存在是因为 ASCII 最初设计是基于计算机网络来传输数据的一种方法。因此它要发送的信息不仅仅是符号。你应该学习的重要的特殊字符是 `NUL`,它就是我们前面提到的空终止符。`HT` 水平制表符就是我们经常说的 `tab`,而 `LF` 换行符用于生成一个新行。你可能想研究和使用其它特殊字符在你的操行系统中的意义。

|

||||

|

||||

### 2、字符

|

||||

|

||||

到目前为止,我们已经知道了一些关于字符串的知识,我们可以开始想想它们是如何显示的。为了显示一个字符串,我们需要做的最基础的事情是能够显示一个字符。我们的第一个任务是编写一个 `DrawCharacter` 函数,给它一个要绘制的字符和一个位置,然后它将这个字符绘制出来。

|

||||

|

||||

```markdown

|

||||

在许多操作系统中使用的 `truetype` 字体格式是很强大的,它内置有它自己的汇编语言,以确保在任何分辨率下字母看起来都是正确的。

|

||||

```

|

||||

这就很自然地引出关于字体的讨论。我们已经知道有许多方式去按照选定的字体去显示任何给定的字母。那么字体又是如何工作的呢?在计算机科学的早期阶段,字体就是所有字母的一系列小图片而已,这种字体称为位图字体,而所有的字符绘制方法就是将图片复制到屏幕上。当人们想去调整字体大小时就出问题了。有时我们需要大的字母,而有时我们需要的是小的字母。尽管我们可以为每个字体、每种大小、每个字符都绘制新图片,但这种作法过于单调乏味。所以,发明了矢量字体。矢量字体不包含字体的图像,它包含的是如何去绘制字符的描述,即:一个 `o` 可能是最大字母高度的一半为半径绘制的圆。现代操作系统都几乎仅使用这种字体,因为这种字体在任何分辨率下都很完美。

|

||||

|

||||

这就很自然地引出关于字体的讨论。我们已经知道有许多方式去按照选定的字体去显示任何给定的字母。那么字体又是如何工作的呢?在计算机科学的早期阶段,一种字体就是所有字母的一系列小图片而已,这种字体称为位图字体,而所有的字符绘制方法就是将图片复制到屏幕上。当人们想去调整字体大小时就出问题了。有时我们需要大的字母,而有时我们需要的是小的字母。尽管我们可以为每个字体、每种大小、每个字符都绘制新图片,但这种作法过于单调乏味。所以,发明了矢量字体。矢量字体不包含字体的图像,它包含的是如何去绘制字符的描述,即:一个 `o` 可能是最大字母高度的一半为半径绘制的圆。现代操作系统都几乎仅使用这种字体,因为这种字体在任何分辨率下都很完美。

|

||||

> 在许多操作系统中使用的 TrueType 字体格式是很强大的,它内置有它自己的汇编语言,以确保在任何分辨率下字母看起来都是正确的。

|

||||

|

||||

不幸的是,虽然我很想包含一个矢量字体的格式的实现,但它的内容太多了,将占用这个站点的剩余部分。所以,我们将去实现一个位图字体,可是,如果你想去做一个正宗的图形化的操作系统,那么矢量字体将是很有用的。

|

||||

不幸的是,虽然我很想包含一个矢量字体的格式的实现,但它的内容太多了,将占用这个网站的剩余部分。所以,我们将去实现一个位图字体,可是,如果你想去做一个像样的图形操作系统,那么矢量字体将是很有用的。

|

||||

|

||||

在下载页面上的字体节中,我们提供了几个 `.bin` 文件。这些只是字体的原始二进制数据文件。为完成本教程,从等宽、单色、8x16 节中挑选你喜欢的字体。然后下载它并保存到 `source` 目录中并命名为 `font.bin` 文件。这些文件只是每个字母的单色图片,它们每个字母刚好是 8 x 16 个像素。所以,每个字母占用 16 字节,第一个字节是第一行,第二个字节是第二行,依此类推。

|

||||

|

||||

|

||||

|

||||

这个示意图展示了等宽、单色、8x16 的字符 A 的 `Bitstream Vera Sans Mono`。在这个文件中,我们可以找到,它从第 41~16~ × 10~16~ = 410~16~ 字节开始的十六进制序列:

|

||||

这个示意图展示了等宽、单色、8x16 的字符 A 的 “Bitstream Vera Sans Mono” 字体。在这个文件中,我们可以找到,它从第 41<sub>16</sub> × 10<sub>16</sub> = 410<sub>16</sub> 字节开始的十六进制序列:

|

||||

|

||||

```

|

||||

00, 00, 00, 10, 28, 28, 28, 44, 44, 7C, C6, 82, 00, 00, 00, 00

|

||||

```

|

||||

|

||||

在这里我们将使用等宽字体,因为等宽字体的每个字符大小是相同的。不幸的是,大多数字体的复杂之处就是因为它的宽度不同,从而导致它的显示代码更复杂。在下载页面上还包含有几个其它的字体,并包含了这种字体的存储格式介绍。

|

||||

|

||||

@ -77,9 +73,7 @@ font:

|

||||

.incbin "font.bin"

|

||||

```

|

||||

|

||||

```assembly

|

||||

.incbin "file" 插入来自文件 “file” 中的二进制数据。

|

||||

```

|

||||

> `.incbin "file"` 插入来自文件 “file” 中的二进制数据。

|

||||

|

||||

这段代码复制文件中的字体数据到标签为 `font` 的地址。我们在这里使用了一个 `.align 4` 去确保每个字符都是从 16 字节的倍数开始,这是一个以后经常用到的用于加快访问速度的技巧。

|

||||

|

||||

@ -98,8 +92,8 @@ function drawCharacter(r0 is character, r1 is x, r2 is y)

|

||||

next

|

||||

return r0 = 8, r1 = 16

|

||||

end function

|

||||

|

||||

```

|

||||

|

||||

如果直接去实现它,这显然不是个高效率的做法。像绘制字符这样的事情,效率是最重要的。因为我们要频繁使用它。我们来探索一些改善的方法,使其成为最优化的汇编代码。首先,因为我们有一个 `× 16`,你应该会马上想到它等价于逻辑左移 4 位。紧接着我们有一个变量 `row`,它只与 `charAddress` 和 `y` 相加。所以,我们可以通过增加替代变量来消除它。现在唯一的问题是如何判断我们何时完成。这时,一个很好用的 `.align 4` 上场了。我们知道,`charAddress` 将从包含 0 的低位半字节开始。这意味着我们可以通过检查低位半字节来看到进入字符数据的程度。

|

||||

|

||||

虽然我们可以消除对 `bit` 的需求,但我们必须要引入新的变量才能实现,因此最好还是保留它。剩下唯一的改进就是去除嵌套的 `bits >> bit`。

|

||||

@ -189,7 +183,7 @@ pop {r4,r5,r6,r7,r8,pc}

|

||||

|

||||

### 3、字符串

|

||||

|

||||

现在,我们可以绘制字符了,我们可以绘制文本了。我们需要去写一个方法,给它一个字符串为输入,它通过递增位置来绘制出每个字符。为了做的更好,我们应该去实现新的行和制表符。是时候决定关于空终止符的问题了,如果你想让你的操作系统使用它们,可以按需来修改下面的代码。为避免这个问题,我将给 `DrawString` 函数传递一个字符串长度,以及字符串的地址,和 x 和 y 的坐标作为参数。

|

||||

现在,我们可以绘制字符了,我们可以绘制文本了。我们需要去写一个方法,给它一个字符串为输入,它通过递增位置来绘制出每个字符。为了做的更好,我们应该去实现新的行和制表符。是时候决定关于空终止符的问题了,如果你想让你的操作系统使用它们,可以按需来修改下面的代码。为避免这个问题,我将给 `DrawString` 函数传递一个字符串长度,以及字符串的地址,和 `x` 和 `y` 的坐标作为参数。

|

||||

|

||||

```c

|

||||

function drawString(r0 is string, r1 is length, r2 is x, r3 is y)

|

||||

@ -215,7 +209,7 @@ end function

|

||||

|

||||

同样,这个函数与汇编代码还有很大的差距。你可以随意去尝试实现它,即可以直接实现它,也可以简化它。我在下面给出了简化后的函数和汇编代码。

|

||||

|

||||

很明显,写这个函数的人并不很有效率(感到奇怪吗?它就是我写的)。再说一次,我们有一个 `pos` 变量,它用于递增和与其它东西相加,这是完全没有必要的。我们可以去掉它,而同时进行长度递减,直到减到 0 为止,这样就少用了一个寄存器。除了那个烦人的乘以 5 以外,函数的其余部分还不错。在这里要做的一个重要事情是,将乘法移到循环外面;即便使用位移运算,乘法仍然是很慢的,由于我们总是加一个乘以 5 的相同的常数,因此没有必要重新计算它。实际上,在汇编代码中它可以在一个操作数中通过参数移位来实现,因此我将代码改变为下面这样。

|

||||

很明显,写这个函数的人并不很有效率(感到奇怪吗?它就是我写的)。再说一次,我们有一个 `pos` 变量,它用于递增及与其它东西相加,这是完全没有必要的。我们可以去掉它,而同时进行长度递减,直到减到 0 为止,这样就少用了一个寄存器。除了那个烦人的乘以 5 以外,函数的其余部分还不错。在这里要做的一个重要事情是,将乘法移到循环外面;即便使用位移运算,乘法仍然是很慢的,由于我们总是加一个乘以 5 的相同的常数,因此没有必要重新计算它。实际上,在汇编代码中它可以在一个操作数中通过参数移位来实现,因此我将代码改变为下面这样。

|

||||

|

||||

```c

|

||||

function drawString(r0 is string, r1 is length, r2 is x, r3 is y)

|

||||

@ -307,22 +301,20 @@ pop {r4,r5,r6,r7,r8,r9,pc}

|

||||

.unreq length

|

||||

```

|

||||

|

||||

```assembly

|

||||

subs reg,#val 从寄存器 reg 中减去 val,然后将结果与 0 进行比较。

|

||||

```

|

||||

|

||||

这个代码中非常聪明地使用了一个新运算,`subs` 是从一个操作数中减去另一个数,保存结果,然后将结果与 0 进行比较。实现上,所有的比较都可以实现为减法后的结果与 0 进行比较,但是结果通常会丢弃。这意味着这个操作与 `cmp` 一样快。

|

||||

|

||||

### 4、你的愿意是我的命令行

|

||||

> `subs reg,#val` 从寄存器 `reg` 中减去 `val`,然后将结果与 `0` 进行比较。

|

||||

|

||||

### 4、你的意愿是我的命令行

|

||||

|

||||

现在,我们可以输出字符串了,而挑战是找到一个有意思的字符串去绘制。一般在这样的教程中,人们都希望去绘制 “Hello World!”,但是到目前为止,虽然我们已经能做到了,我觉得这有点“君临天下”的感觉(如果喜欢这种感觉,请随意!)。因此,作为替代,我们去继续绘制我们的命令行。

|

||||

|

||||

有一个限制是我们所做的操作系统是用在 ARM 架构的计算机上。最关键的是,在它们引导时,给它一些信息告诉它有哪些可用资源。几乎所有的处理器都有某些方式来确定这些信息,而在 ARM 上,它是通过位于地址 100<sub>16</sub> 处的数据来确定的,这个数据的格式如下:

|

||||

|

||||

1. 数据是可分解的一系列的标签。

|

||||

2. 这里有九种类型的标签:`core`,`mem`,`videotext`,`ramdisk`,`initrd2`,`serial`,`revision`,`videolfb`,`cmdline`。

|

||||

3. 每个标签只能出现一次,除了 'core’ 标签是必不可少的之外,其它的都是可有可无的。

|

||||

4. 所有标签都依次放置在地址 0x100 处。

|

||||

2. 这里有九种类型的标签:`core`、`mem`、`videotext`、`ramdisk`、`initrd2`、`serial`、`revision`、`videolfb`、`cmdline`。

|

||||

3. 每个标签只能出现一次,除了 `core` 标签是必不可少的之外,其它的都是可有可无的。

|

||||

4. 所有标签都依次放置在地址 `0x100` 处。

|

||||

5. 标签列表的结束处总是有两个<ruby>字<rt>word</rt></ruby>,它们全为 0。

|

||||

6. 每个标签的字节数都是 4 的倍数。

|

||||

7. 每个标签都是以标签中(以字为单位)的标签大小开始(标签包含这个数字)。

|

||||

@ -334,11 +326,9 @@ subs reg,#val 从寄存器 reg 中减去 val,然后将结果与 0 进行比较

|

||||

13. 一个 `cmdline` 标签包含一个 `null` 终止符字符串,它是个内核参数。

|

||||

|

||||

|

||||

```markdown

|

||||

几乎所有的操作系统都支持一个`命令行`的程序。它的想法是为选择一个程序所期望的行为而提供一个通用的机制。

|

||||

```

|

||||

在目前的树莓派版本中,只提供了 `core`、`mem` 和 `cmdline` 标签。你可以在后面找到它们的用法,更全面的参考资料在树莓派的参考页面上。现在,我们感兴趣的是 `cmdline` 标签,因为它包含一个字符串。我们继续写一些搜索这个命令行(`cmdline`)标签的代码,如果找到了,以每个条目一个新行的形式输出它。命令行只是图形处理器或用户认为操作系统应该知道的东西的一个列表。在树莓派上,这包含了 MAC 地址、序列号和屏幕分辨率。字符串本身也是一个由空格隔开的表达式(像 `key.subkey=value` 这样的)的列表。

|

||||

|

||||

在目前的树莓派版本中,只提供了 `core`、`mem` 和 `cmdline` 标签。你可以在后面找到它们的用法,更全面的参考资料在树莓派的参考页面上。现在,我们感兴趣的是 `cmdline` 标签,因为它包含一个字符串。我们继续写一些搜索命令行标签的代码,如果找到了,以每个条目一个新行的形式输出它。命令行只是为了让操作系统理解图形处理器或用户认为的很好的事情的一个列表。在树莓派上,这包含了 MAC 地址,序列号和屏幕分辨率。字符串本身也是一个像 `key.subkey=value` 这样的由空格隔开的表达式列表。

|

||||

> 几乎所有的操作系统都支持一个“命令行”的程序。它的想法是为选择一个程序所期望的行为而提供一个通用的机制。

|

||||

|

||||

我们从查找 `cmdline` 标签开始。将下列的代码复制到一个名为 `tags.s` 的新文件中。

|

||||

|

||||

@ -355,7 +345,7 @@ tag_videolfb: .int 0

|

||||

tag_cmdline: .int 0

|

||||

```

|

||||

|

||||

通过标签列表来查找是一个很慢的操作,因为这涉及到许多内存访问。因此,我们只是想实现它一次。代码创建一些数据,用于保存每个类型的第一个标签的内存地址。接下来,用下面的伪代码就可以找到一个标签了。

|

||||

通过标签列表来查找是一个很慢的操作,因为这涉及到许多内存访问。因此,我们只想做一次。代码创建一些数据,用于保存每个类型的第一个标签的内存地址。接下来,用下面的伪代码就可以找到一个标签了。

|

||||

|

||||

```c

|

||||

function FindTag(r0 is tag)

|

||||

@ -373,7 +363,8 @@ function FindTag(r0 is tag)

|

||||

end loop

|

||||

end function

|

||||

```

|

||||

这段代码已经是优化过的,并且很接近汇编了。它尝试直接加载标签,第一次这样做是有些乐观的,但是除了第一次之外 的其它所有情况都是可以这样做的。如果失败了,它将去检查 `core` 标签是否有地址。因为 `core` 标签是必不可少的,如果它没有地址,唯一可能的原因就是它不存在。如果它有地址,那就是我们没有找到我们要找的标签。如果没有找到,那我们就需要查找所有标签的地址。这是通过读取标签编号来做的。如果标签编号为 0,意味着已经到了标签列表的结束位置。这意味着我们已经查找了目录中所有的标签。所以,如果我们再次运行我们的函数,现在它应该能够给出一个答案。如果标签编号不为 0,我们检查这个标签类型是否已经有一个地址。如果没有,我们在目录中保存这个标签的地址。然后增加这个标签的长度(以字节为单位)到标签地址中,然后去查找下一个标签。

|

||||

|

||||

这段代码已经是优化过的,并且很接近汇编了。它尝试直接加载标签,第一次这样做是有些乐观的,但是除了第一次之外的其它所有情况都是可以这样做的。如果失败了,它将去检查 `core` 标签是否有地址。因为 `core` 标签是必不可少的,如果它没有地址,唯一可能的原因就是它不存在。如果它有地址,那就是我们没有找到我们要找的标签。如果没有找到,那我们就需要查找所有标签的地址。这是通过读取标签编号来做的。如果标签编号为 0,意味着已经到了标签列表的结束位置。这意味着我们已经查找了目录中所有的标签。所以,如果我们再次运行我们的函数,现在它应该能够给出一个答案。如果标签编号不为 0,我们检查这个标签类型是否已经有一个地址。如果没有,我们在目录中保存这个标签的地址。然后增加这个标签的长度(以字节为单位)到标签地址中,然后去查找下一个标签。

|

||||

|

||||

尝试去用汇编实现这段代码。你将需要简化它。如果被卡住了,下面是我的答案。不要忘了 `.section .text`!

|

||||

|

||||

@ -459,11 +450,11 @@ via: https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/screen03.html

|

||||

作者:[Alex Chadwick][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[qhwdw](https://github.com/qhwdw)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://www.cl.cam.ac.uk

|

||||

[b]: https://github.com/lujun9972

|

||||

[1]: https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/screen02.html

|

||||

[1]: https://linux.cn/article-10551-1.html

|

||||

[2]: https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/screen04.html

|

||||

@ -0,0 +1,149 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (lujun9972)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-10582-1.html)

|

||||

[#]: subject: (Use Emacs to create OAuth 2.0 UML sequence diagrams)

|

||||

[#]: via: (https://www.onwebsecurity.com/configuration/use-emacs-to-create-oauth-2-0-uml-sequence-diagrams.html)

|

||||

[#]: author: (Peter Mosmans https://www.onwebsecurity.com)

|

||||

|

||||

使用 Emacs 创建 OAuth 2.0 的 UML 序列图

|

||||

======

|

||||

|

||||

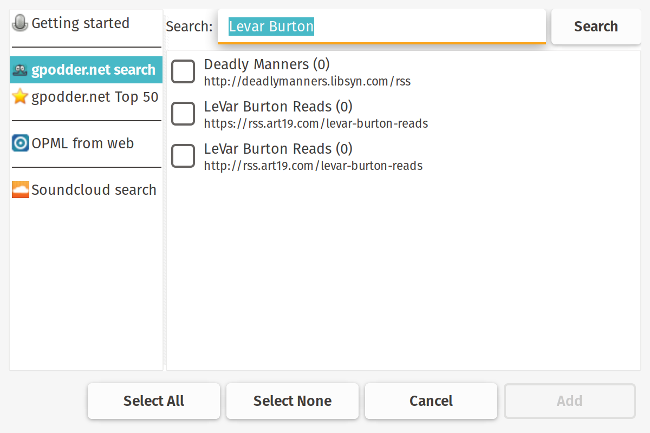

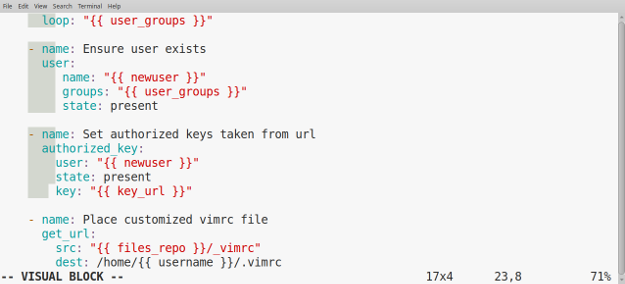

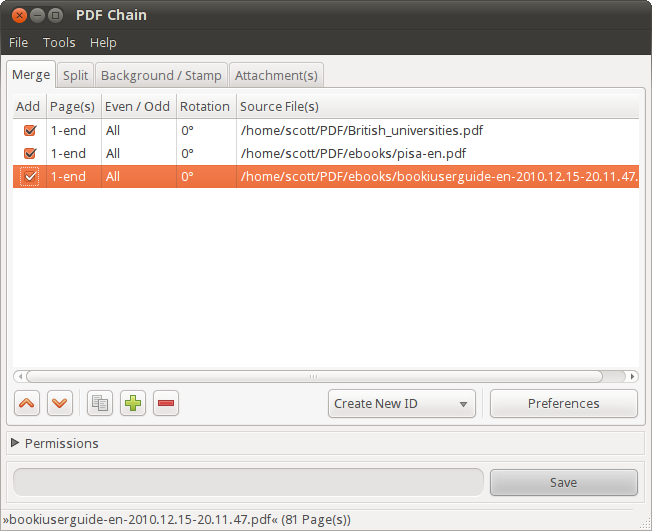

![OAuth 2.0 abstract protocol flow][6]

|

||||

|

||||

看起来 [OAuth 2.0 框架][7] 已经越来越广泛地应用于 web (和 移动) 应用。太棒了!

|

||||

|

||||

虽然协议本身并不复杂,但有很多的使用场景、流程和实现可供选择。正如生活中的大多数事物一样,魔鬼在于细节之中。

|

||||

|

||||

在审查 OAuth 2.0 实现或编写渗透测试报告时我习惯画出 UML 图。这方便让人理解发生了什么事情,并发现潜在的问题。毕竟,一图抵千言。

|

||||

|

||||

使用基于 GPL 开源协议 [Emacs][8] 编辑器来实现,再加上基于 GPL 开源协议的工具 [PlantUML][9] (也可以选择基于 Eclipse Public 协议的 [Graphviz][10]) 很容易做到这一点。

|

||||

|

||||

Emacs 是世界上最万能的编辑器。在这种场景中,我们用它来编辑文本,并自动将文本转换成图片。PlantUML 是一个允许你用人类可读的文本来写 UML 并完成该转换的工具。Graphviz 是一个可视化的软件,这里我们可以用它来显示图片。

|

||||

|

||||

下载 [预先编译好了的 PlantUML jar 文件 ][11],[Emacs][12] 还可以选择下载并安装 [Graphviz][13]。

|

||||

|

||||

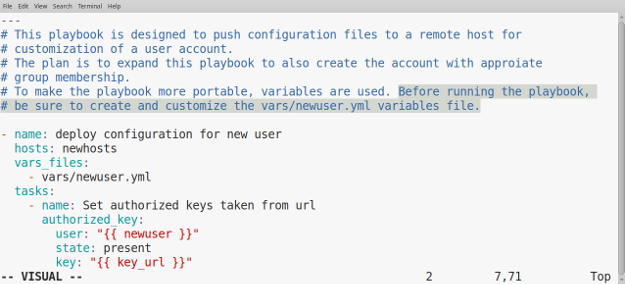

安装并启动 Emacs,然后将下面 Lisp 代码(实际上是配置)写入你的启动文件中(`~/.emacs.d/init.d`),这段代码将会:

|

||||

|

||||

* 配置 org 模式(一种用来组织并编辑文本文件的模式)来使用 PlantUML

|

||||

* 将 `plantuml` 添加到可识别的 “org-babel” 语言中(这让你可以在文本文件中执行源代码)

|

||||

* 将 PlantUML 代码标注为安全的,从而允许执行

|

||||

* 自动显示生成的结果图片

|

||||

|

||||

```elisp

|

||||

;; tell org-mode where to find the plantuml JAR file (specify the JAR file)

|

||||

(setq org-plantuml-jar-path (expand-file-name "~/plantuml.jar"))

|

||||

|

||||

;; use plantuml as org-babel language

|

||||

(org-babel-do-load-languages 'org-babel-load-languages '((plantuml . t)))

|

||||

|

||||

;; helper function

|

||||

(defun my-org-confirm-babel-evaluate (lang body)

|

||||

"Do not ask for confirmation to evaluate code for specified languages."

|

||||

(member lang '("plantuml")))

|

||||

|

||||

;; trust certain code as being safe

|

||||

(setq org-confirm-babel-evaluate 'my-org-confirm-babel-evaluate)

|

||||

|

||||

;; automatically show the resulting image

|

||||

(add-hook 'org-babel-after-execute-hook 'org-display-inline-images)

|

||||

```

|

||||

|

||||

如果你还没有启动文件,那么将该代码加入到 `~/.emacs.d/init.el` 文件中然后重启 Emacs。

|

||||

|

||||

提示:`Control-c Control-f` 可以让你创建/打开(新)文件。`Control-x Control-s` 保存文件,而 `Control-x Control-c` 退出 Emacs。

|

||||

|

||||

这就结了!

|

||||

|

||||

要测试该配置,可以创建/打开(`Control-c Control-f`)后缀为 `.org` 的文件,例如 `test.org`。这会让 Emacs 切换到 org 模式并识别 “org-babel” 语法。

|

||||

|

||||

输入下面代码,然后在代码中输入 `Control-c Control-c` 来测试是否安装正常:

|

||||

|

||||

```

|

||||

#+BEGIN_SRC plantuml :file test.png

|

||||

@startuml

|

||||

version

|

||||

@enduml

|

||||

#+END_SRC

|

||||

```

|

||||

|

||||

一切顺利的话,你会在 Emacs 中看到文本下面显示了一张图片。

|

||||

|

||||

> **注意:**

|

||||

|

||||

> 要快速插入类似 `#+BEGIN_SRC` 和 `#+END_SRC` 这样的代码片段,你可以使用内置的 Easy Templates 系统:输入 `<s` 然后按下 `TAB`,它就会自动为你插入模板。

|

||||

|

||||

还有更复杂的例子,下面是生成上面图片的 UML 源代码:

|

||||

|

||||

```

|

||||

#+BEGIN_SRC plantuml :file t:/oauth2-abstract-protocol-flow.png

|

||||

@startuml

|

||||

hide footbox

|

||||

title Oauth 2.0 Abstract protocol flow

|

||||

autonumber

|

||||

actor user as "resource owner (user)"

|

||||

box "token stays secure" #FAFAFA

|

||||

participant client as "client (application)"

|

||||

participant authorization as "authorization server"

|

||||

database resource as "resource server"

|

||||

end box

|

||||

|

||||

group user authorizes client

|

||||

client -> user : request authorization

|

||||

note left

|

||||

**grant types**:

|

||||

# authorization code

|

||||

# implicit

|

||||

# password

|

||||

# client_credentials

|

||||

end note

|

||||

user --> client : authorization grant

|

||||

end

|

||||

|

||||

group token is generated

|

||||

client -> authorization : request token\npresent authorization grant

|

||||

authorization --> client :var: access token

|

||||

note left

|

||||

**response types**:

|

||||

# code

|

||||

# token

|

||||

end note

|

||||

end group

|

||||

|

||||

group resource can be accessed

|

||||

client -> resource : request resource\npresent token

|

||||

resource --> client : resource

|

||||

end group

|

||||

@enduml

|

||||

#+END_SRC

|

||||

```

|

||||

|

||||

你难道会不喜欢 Emacs 和开源工具的多功能性吗?

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.onwebsecurity.com/configuration/use-emacs-to-create-oauth-2-0-uml-sequence-diagrams.html

|

||||

|

||||

作者:[Peter Mosmans][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[lujun9972](https://github.com/lujun9972)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://www.onwebsecurity.com

|

||||

[b]: https://github.com/lujun9972

|

||||

[1]: https://www.onwebsecurity.com/category/configuration.html

|

||||

[2]: https://www.onwebsecurity.com/tag/emacs.html

|

||||

[3]: https://www.onwebsecurity.com/tag/oauth2.html

|

||||

[4]: https://www.onwebsecurity.com/tag/pentesting.html

|

||||

[5]: https://www.onwebsecurity.com/tag/security.html

|

||||

[6]: https://www.onwebsecurity.com/images/oauth2-abstract-protocol-flow.png

|

||||

[7]: https://tools.ietf.org/html/rfc6749

|

||||

[8]: https://www.gnu.org/software/emacs/

|

||||

[9]: https://plantuml.com

|

||||

[10]: http://www.graphviz.org/

|

||||

[11]: http://plantuml.com/download

|

||||

[12]: https://www.gnu.org/software/emacs/download.html

|

||||

[13]: http://www.graphviz.org/Download.php

|

||||

121

published/20170721 Firefox and org-protocol URL Capture.md

Normal file

121

published/20170721 Firefox and org-protocol URL Capture.md

Normal file

@ -0,0 +1,121 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (lujun9972)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-10586-1.html)

|

||||

[#]: subject: (Firefox and org-protocol URL Capture)

|

||||

[#]: via: (http://www.mediaonfire.com/blog/2017_07_21_org_protocol_firefox.html)

|

||||

[#]: author: (Andreas Viklund http://andreasviklund.com/)

|

||||

|

||||

在 Firefox 上使用 Org 协议捕获 URL

|

||||

======

|

||||

|

||||

### 介绍

|

||||

|

||||

作为一名 Emacs 人,我尽可能让所有的工作流都在 <ruby>[Org 模式][1]<rt>Org-mode</rt></ruby> 上进行 —— 我比较喜欢文本。

|

||||

|

||||

我倾向于将书签记录在 [Org 模式][1] 代办列表中,而 <ruby>[Org 协议][2]<rt>Org-protocol</rt></ruby> 则允许外部进程利用 [Org 模式][1] 的某些功能。然而,要做到这一点配置起来很麻烦。([搜索引擎上][3])有很多教程,Firefox 也有这类 [扩展][4],然而我对它们都不太满意。

|

||||

|

||||

因此我决定将我现在的配置记录在这篇博客中,方便其他有需要的人使用。

|

||||

|

||||

### 配置 Emacs Org 模式

|

||||

|

||||

启用 Org 协议:

|

||||

|

||||

```

|

||||

(require 'org-protocol)

|

||||

```

|

||||

|

||||

添加一个<ruby>捕获模板<rt>capture template</rt></ruby> —— 我的配置是这样的:

|

||||

|

||||

```

|

||||

(setq org-capture-templates

|

||||

(quote (...

|

||||

("w" "org-protocol" entry (file "~/org/refile.org")

|

||||

"* TODO Review %a\n%U\n%:initial\n" :immediate-finish)

|

||||

...)))

|

||||

```

|

||||

|

||||

你可以从 [Org 模式][1] 手册中 [捕获模板][5] 章节中获取帮助。

|

||||

|

||||

设置默认使用的模板:

|

||||

|

||||

```

|

||||

(setq org-protocol-default-template-key "w")

|

||||

```

|

||||

|

||||

执行这些新增配置让它们在当前 Emacs 会话中生效。

|

||||

|

||||

### 快速测试

|

||||

|

||||

在下一步开始前,最好测试一下配置:

|

||||

|

||||

```

|

||||

emacsclient -n "org-protocol:///capture?url=http%3a%2f%2fduckduckgo%2ecom&title=DuckDuckGo"

|

||||

```

|

||||

|

||||

基于的配置的模板,可能会弹出一个捕获窗口。请确保正常工作,否则后面的操作没有任何意义。如果工作不正常,检查刚才的配置并且确保你执行了这些代码块。

|

||||

|

||||

如果你的 [Org 模式][1] 版本比较老(老于 7 版本),测试的格式会有点不同:这种 URL 编码后的格式需要改成用斜杠来分割 url 和标题。在网上搜一下很容易找出这两者的不同。

|

||||

|

||||

### Firefox 协议

|

||||

|

||||

现在开始设置 Firefox。浏览 `about:config`。右击配置项列表,选择 “New -> Boolean”,然后输入 `network.protocol-handler.expose.org-protocol` 作为名字并且将值设置为 `true`。

|

||||

|

||||

有些教程说这一步是可以省略的 —— 配不配因人而异。

|

||||

|

||||

### 添加 Desktop 文件

|

||||

|

||||

大多数的教程都有这一步:

|

||||

|

||||

增加一个文件 `~/.local/share/applications/org-protocol.desktop`:

|

||||

|

||||

```

|

||||

[Desktop Entry]

|

||||

Name=org-protocol

|

||||

Exec=/path/to/emacsclient -n %u

|

||||

Type=Application

|

||||

Terminal=false

|

||||

Categories=System;

|

||||

MimeType=x-scheme-handler/org-protocol;

|

||||

```

|

||||

|

||||

然后运行更新器。对于 i3 窗口管理器我使用下面命令(跟 gnome 一样):

|

||||

|

||||

```

|

||||

update-desktop-database ~/.local/share/applications/

|

||||

```

|

||||

|

||||

KDE 的方法不太一样……你可以查询其他相关教程。

|

||||

|

||||

### 在 FireFox 中设置捕获按钮

|

||||

|

||||

创建一个书签(我是在工具栏上创建这个书签的),地址栏输入下面内容:

|

||||

|

||||

```

|

||||

javascript:location.href="org-protocol:///capture?url="+encodeURIComponent(location.href)+"&title="+encodeURIComponent(document.title||"[untitled page]")

|

||||

```

|

||||

|

||||

保存该书签后,再次编辑该书签,你应该会看到其中的所有空格都被替换成了 `%20` —— 也就是空格的 URL 编码形式。

|

||||

|

||||

现在当你点击该书签,你就会在某个 Emacs 框架中,可能是一个任意的框架中,打开一个窗口,显示你预定的模板。

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.mediaonfire.com/blog/2017_07_21_org_protocol_firefox.html

|

||||

|

||||

作者:[Andreas Viklund][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[lujun9972](https://github.com/lujun9972)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: http://andreasviklund.com/

|

||||

[b]: https://github.com/lujun9972

|

||||

[1]: http://orgmode.org/

|

||||

[2]: http://orgmode.org/worg/org-contrib/org-protocol.html

|

||||

[3]: https://duckduckgo.com/?q=org-protocol+firefox&t=ffab&ia=qa

|

||||

[4]: https://addons.mozilla.org/en-US/firefox/search/?q=org-protocol&cat=1,0&appver=53.0&platform=linux

|

||||

[5]: http://orgmode.org/manual/Capture-templates.html

|

||||

67

published/20180122 Ick- a continuous integration system.md

Normal file

67

published/20180122 Ick- a continuous integration system.md

Normal file

@ -0,0 +1,67 @@

|

||||

ick:一个持续集成系统

|

||||

======

|

||||

|

||||

> ick 是一个持续集成(CI)系统。访问 <http://ick.liw.fi/> 获取更多信息。

|

||||

|

||||

更加详细的内容如下:

|

||||

|

||||

### 首个公开版本发行

|

||||

|

||||

这个世界可能并不需要又一个持续集成系统(CI),但是我需要。我对我尝试过或者看过的持续集成系统感到不满意。更重要的是,有几样我感兴趣的东西比我所听说过的持续集成系统要强大得多。因此我开始编写我自己的 CI 系统。

|

||||

|

||||

我的新个人业余项目叫做 ick。它是一个 CI 系统,这意味着它可以运行自动化的步骤来构建、测试软件。它的主页是 <http://ick.liw.fi/>,[下载][1]页面有指向源代码、.deb 包和用来安装的 Ansible 脚本的链接。

|

||||

|

||||

我现已发布了首个公开版本,绰号 ALPHA-1,版本号 0.23。(LCTT 译注:截止至本译文发布,已经更新到 ALPHA-6)它现在是 alpha 品质,这意味着它并没拥有期望的全部特性,如果任何一个它已有的特性工作的话,那真是运气好。

|

||||

|

||||

### 诚邀贡献

|

||||

|

||||

ick 目前是我的个人项目。我希望能让它不仅限于此,同时我也诚邀更多贡献。访问[治理][2]页面查看章程,[入门][3]页面查看如何开始贡献的的小建议,[联系][4]页面查看如何联络。

|

||||

|

||||

### 架构

|

||||

|

||||

ick 拥有一个由几个通过 HTTPS 协议通信使用 RESTful API 和 JSON 处理结构化数据的部分组成的架构。访问[架构][5]页面了解细节。

|

||||

|

||||

### 宣告

|

||||

|

||||

持续集成(CI)是用于软件开发的强大工具。它不应枯燥、易溃或恼人。它构建起来应简单快速,除非正在测试、构建的代码中有问题,不然它应在后台安静地工作。

|

||||

|

||||

一个持续集成系统应该简单、易用、清楚、干净、可扩展、快速、综合、透明、可靠,并推动你的生产力。构建它不应花大力气、不应需要专门为 CI 而造的硬件、不应需要频繁留意以使其保持工作、开发者永远不必思考为什么某样东西不工作。

|

||||

|

||||

一个持续集成系统应该足够灵活以适应你的构建、测试需求。只要 CPU 架构和操作系统版本没问题,它应该支持各种操作者。

|

||||

|

||||

同时像所有软件一样,CI 应该彻彻底底的免费,你的 CI 应由你做主。

|

||||

|

||||

(目前的 ick 仅稍具雏形,但是它会尝试着有朝一日变得完美 —— 在最理想的情况下。)

|

||||

|

||||

### 未来的梦想

|

||||

|

||||

长远来看,我希望 ick 拥有像下面所描述的特性。落实全部特性可能需要一些时间。

|

||||

|

||||

* 各种事件都可以触发构建。时间是一个明显的事件,因为项目的源代码仓库改变了。更强大的是任何依赖的改变,不管依赖是来自于 ick 构建的另一个项目,或者是包(比如说来自 Debian):ick 应当跟踪所有安装进一个项目构建环境中的包,如果任何一个包的版本改变,都应再次触发项目构建和测试。

|

||||

* ick 应该支持构建于(或针对)任何合理的目标平台,包括任何 Linux 发行版,任何自由的操作系统,以及任何一息尚存的不自由的操作系统。

|

||||

* ick 应该自己管理构建环境,并且能够执行与构建主机或网络隔离的构建。这部分工作:可以要求 ick 构建容器并在容器中运行构建。容器使用 systemd-nspawn 实现。 然而,这可以改进。(如果您认为 Docker 是唯一的出路,请为此提供支持。)

|

||||

* ick 应当不需要安装任何专门的代理,就能支持各种它能够通过 ssh 或者串口或者其它这种中性的交流管道控制的<ruby>操作者<rt>worker</rt></ruby>。ick 不应默认它可以有比如说一个完整的 Java Runtime,如此一来,操作者就可以是一个微控制器了。

|

||||

* ick 应当能轻松掌控一大批项目。我觉得不管一个新的 Debian 源包何时上传,ick 都应该要能够跟得上在 Debian 中构建所有东西的进度。(明显这可行与否取决于是否有足够的资源确实用在构建上,但是 ick 自己不应有瓶颈。)

|

||||

* 如果有需要的话 ick 应当有选择性地补给操作者。如果所有特定种类的操作者处于忙碌中,且 ick 被设置成允许使用更多资源的话,它就应该这么做。这看起来用虚拟机、容器、云提供商等做可能会简单一些。

|

||||

* ick 应当灵活提醒感兴趣的团体,特别是关于其失败的方面。它应允许感兴趣的团体通过 IRC、Matrix、Mastodon、Twitter、email、SMS 甚至电话和语音合成来接受通知。例如“您好,感兴趣的团体。现在是四点钟您想被通知 hello 包什么时候为 RISC-V 构建好。”

|

||||

|

||||

### 请提供反馈

|

||||

|

||||

如果你尝试过 ick 或者甚至你仅仅是读到这,请在上面分享你的想法。在[联系][4]页面查看如何发送反馈。相比私下反馈我更偏爱公开反馈。但如果你偏爱私下反馈,那也行。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://blog.liw.fi/posts/2018/01/22/ick_a_continuous_integration_system/

|

||||

|

||||

作者:[Lars Wirzenius][a]

|

||||

译者:[tomjlw](https://github.com/tomjlw)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://blog.liw.fi/

|

||||

[1]:http://ick.liw.fi/download/

|

||||

[2]:http://ick.liw.fi/governance/

|

||||

[3]:http://ick.liw.fi/getting-started/

|

||||

[4]:http://ick.liw.fi/contact/

|

||||

[5]:http://ick.liw.fi/architecture/

|

||||

@ -0,0 +1,80 @@

|

||||

3 款用于学术出版的开源工具

|

||||

======

|

||||

> 学术出版业每年的价值超过 260 亿美元。

|

||||

|

||||

|

||||

|

||||

有一个行业在采用数字化或开源工具方面已落后其它行业,那就是竞争与利润并存的学术出版业。根据 Stephen Buranyi 去年在 [卫报][1] 上发表的一份图表,这个估值超过 190 亿英镑(260 亿美元)的行业,即使是最重要的科学研究方面,至今其系统在选题、出版甚至分享方面仍受限于印刷媒介的诸多限制。全新的数字时代科技展现了一个巨大机遇,可以加速探索、推动科学协作而非竞争,以及将投入从基础建设导向有益于社会的研究。

|

||||

|

||||

非盈利性的 [eLife 倡议][2] 是由研究资金赞助方建立,旨在通过使用数字或者开源技术来走出上述僵局。除了为生命科学和生物医疗方面的重大成就出版开放式获取的期刊,eLife 已将自己变成了一个在研究交流方面的实验和展示创新的平台 —— 而大部分的实验都是基于开源精神的。

|

||||

|

||||

致力于开放出版基础设施项目给予我们加速接触、采用科学技术、提升用户体验的机会。我们认为这种机会对于推动学术出版行业是重要的。大而化之地说,开源产品的用户体验经常是有待开发的,而有时候这种情况会阻止其他人去使用它。作为我们在 OSS(开源软件)开发中投入的一部分,为了鼓励更多用户使用这些产品,我们十分注重用户体验。

|

||||

|

||||

我们所有的代码都是开源的,并且我们也积极鼓励社区参与进我们的项目中。这对我们来说意味着更快的迭代、更多的实验、更大的透明度,同时也拓宽了我们工作的外延。

|

||||

|

||||

我们现在参与的项目,例如 Libero (之前称作 [eLife Continuum][3])和 <ruby>[可重现文档栈][4]<rt>Reproducible Document Stack</rt></ruby> 的开发,以及我们最近和 [Hypothesis][5] 的合作,展示了 OSS 是如何在评估、出版以及新发现的沟通方面带来正面影响的。

|

||||

|

||||

### Libero

|

||||

|

||||

Libero 是面向出版商的服务及应用套餐,它包括一个后期制作出版系统、整套前端用户界面样式套件、Libero 的镜头阅读器、一个 Open API 以及一个搜索及推荐引擎。

|

||||

|

||||

去年我们采取了用户驱动的方式重新设计了 Libero 的前端,可以使用户较少地分心于网站的“陈设”,而是更多地集中关注于研究文章上。我们和 eLife 社区成员测试并迭代了该站点所有的核心功能,以确保给所有人最好的阅读体验。该网站的新 API 也为机器阅读能力提供了更简单的访问途径,其中包括文本挖掘、机器学习以及在线应用开发。

|

||||

|

||||

我们网站上的内容以及引领新设计的样式都是开源的,以鼓励 eLife 和其它想要使用它的出版商后续的产品开发。

|

||||

|

||||

### 可重现文档栈

|

||||

|

||||

在与 [Substance][6] 和 [Stencila][7] 的合作下,eLife 也参与了一个项目来创建可重现文档栈(RDS)—— 一个开放式的创作、编纂以及在线出版可重现的计算型手稿的工具栈。

|

||||

|

||||

今天越来越多的研究人员能够通过 [R Markdown][8] 和 [Python][9] 等语言记录他们的计算实验。这些可以作为实验记录的重要部分,但是尽管它们可以独立于最终的研究文章或与之一同分享,但传统出版流程经常将它们视为次级内容。为了发表论文,使用这些语言的研究人员除了将他们的计算结果用图片的形式“扁平化”提交外别无他法。但是这导致了许多实验价值和代码和计算数据可重复利用性的流失。诸如 [Jupyter][10] 这样的电子笔记本解决方案确实可以使研究员以一种可重复利用、可执行的简单形式发布,但是这种方案仍然是出版的手稿的补充,而不是不可或缺的一部分。

|

||||

|

||||

[可重现文档栈][11] 项目旨在通过开发、发布一个可重现原稿的产品原型来解决这些挑战,该原型将代码和数据视为文档的组成部分,并展示了从创作到出版的完整端对端技术栈。它将最终允许用户以一种包含嵌入代码块和计算结果(统计结果、图表或图形)的形式提交他们的手稿,并在出版过程中保留这些可视、可执行的部分。那时出版商就可以将这些做为出版的在线文章的组成部分而保存。

|

||||

|

||||

### 用 Hypothesis 进行开放式注解

|

||||

|

||||

最近,我们与 [Hypothesis][12] 合作引进了开放式注解,使得我们网站的用户们可以写评语、高亮文章重要部分以及与在线阅读的群体互动。

|

||||

|

||||

通过这样的合作,开源的 Hypothesis 软件被定制得更具有现代化的特性,如单次登录验证、用户界面定制,给予了出版商在他们自己网站上实现更多的控制。这些提升正引导着关于出版学术内容的高质量讨论。

|

||||

|

||||

这个工具可以无缝集成到出版商的网站,学术出版平台 [PubFactory][13] 和内容解决方案供应商 [Ingenta][14] 已经利用了它优化后的特性集。[HighWire][15] 和 [Silverchair][16] 也为他们的出版商提供了实施这套方案的机会。

|

||||

|

||||

### 其它产业和开源软件

|

||||

|

||||

随着时间的推移,我们希望看到更多的出版商采用 Hypothesis、Libero 以及其它开源项目去帮助他们促进重要科学研究的发现以及循环利用。但是 eLife 的创新机遇也能被其它行业所利用,因为这些软件和其它 OSS 技术在其他行业也很普遍。

|

||||

|

||||

数据科学的世界离不开高质量、良好支持的开源软件和围绕它们形成的社区;[TensorFlow][17] 就是这样一个好例子。感谢 OSS 以及其社区,AI 和机器学习的所有领域相比于计算机的其它领域的提升和发展更加迅猛。与之类似的是以 Linux 作为云端 Web 主机的爆炸性增长、接着是 Docker 容器、以及现在 GitHub 上最流行的开源项目之一的 Kubernetes 的增长。

|

||||

|

||||

所有的这些技术使得机构们能够用更少的资源做更多的事情,并专注于创新而不是重新发明轮子上。最后,这就是 OSS 真正的好处:它使得我们从互相的失败中学习,在互相的成功中成长。

|

||||

|

||||

我们总是在寻找与研究和科技界面方面最好的人才和想法交流的机会。你可以在 [eLife Labs][18] 上或者联系 [innovation@elifesciences.org][19] 找到更多这种交流的信息。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/3/scientific-publishing-software

|

||||

|

||||

作者:[Paul Shanno][a]

|

||||

译者:[tomjlw](https://github.com/tomjlw)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/pshannon

|

||||

[1]:https://www.theguardian.com/science/2017/jun/27/profitable-business-scientific-publishing-bad-for-science

|

||||

[2]:https://elifesciences.org/about

|

||||

[3]:https://elifesciences.org/inside-elife/33e4127f/elife-introduces-continuum-a-new-open-source-tool-for-publishing

|

||||

[4]:https://elifesciences.org/for-the-press/e6038800/elife-supports-development-of-open-technology-stack-for-publishing-reproducible-manuscripts-online

|

||||

[5]:https://elifesciences.org/for-the-press/81d42f7d/elife-enhances-open-annotation-with-hypothesis-to-promote-scientific-discussion-online

|

||||

[6]:https://github.com/substance

|

||||

[7]:https://github.com/stencila/stencila

|

||||

[8]:https://rmarkdown.rstudio.com/

|

||||

[9]:https://www.python.org/

|

||||

[10]:http://jupyter.org/

|

||||

[11]:https://elifesciences.org/labs/7dbeb390/reproducible-document-stack-supporting-the-next-generation-research-article

|

||||

[12]:https://github.com/hypothesis

|

||||

[13]:http://www.pubfactory.com/

|

||||

[14]:http://www.ingenta.com/

|

||||

[15]:https://github.com/highwire

|

||||

[16]:https://www.silverchair.com/community/silverchair-universe/hypothesis/

|

||||

[17]:https://www.tensorflow.org/

|

||||

[18]:https://elifesciences.org/labs

|

||||

[19]:mailto:innovation@elifesciences.org

|

||||

166

published/20181220 7 CI-CD tools for sysadmins.md

Normal file

166

published/20181220 7 CI-CD tools for sysadmins.md

Normal file

@ -0,0 +1,166 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (jdh8383)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-10578-1.html)

|

||||

[#]: subject: (7 CI/CD tools for sysadmins)

|

||||

[#]: via: (https://opensource.com/article/18/12/cicd-tools-sysadmins)

|

||||

[#]: author: (Dan Barker https://opensource.com/users/barkerd427)

|

||||

|

||||

系统管理员的 7 个 CI/CD 工具

|

||||

======

|

||||

|

||||

> 本文是一篇简单指南:介绍一些顶级的开源的持续集成、持续交付和持续部署(CI/CD)工具。

|

||||

|

||||

|

||||

|

||||

虽然持续集成、持续交付和持续部署(CI/CD)在开发者社区里已经存在很多年,一些机构在其运维部门也有实施经验,但大多数公司并没有做这样的尝试。对于很多机构来说,让运维团队能够像他们的开发同行一样熟练操作 CI/CD 工具,已经变得十分必要了。

|

||||

|

||||

无论是基础设施、第三方应用还是内部开发的应用,都可以开展 CI/CD 实践。尽管你会发现有很多不同的工具,但它们都有着相似的设计模型。而且可能最重要的一点是:通过带领你的公司进行这些实践,会让你在公司内部变得举足轻重,成为他人学习的榜样。

|

||||

|

||||

一些机构在自己的基础设施上已有多年的 CI/CD 实践经验,常用的工具包括 [Ansible][1]、[Chef][2] 或者 [Puppet][3]。另一些工具,比如 [Test Kitchen][4],允许在最终要部署应用的基础设施上运行测试。事实上,如果使用更高级的配置方法,你甚至可以将应用部署到有真实负载的仿真“生产环境”上,来运行应用级别的测试。然而,单单是能够测试基础设施就是一项了不起的成就了。配置管理工具 Terraform 可以通过 Test Kitchen 来快速创建更[短暂][5]和[冥等的][6]的基础设施配置,这比它的前辈要强不少。再加上 Linux 容器和 Kubernetes,在数小时内,你就可以创建一套类似于生产环境的配置参数和系统资源,来测试整个基础设施和其上部署的应用,这在以前可能需要花费几个月的时间。而且,删除和再次创建整个测试环境也非常容易。

|

||||

|

||||

当然,作为初学者,你也可以把网络配置和 DDL(<ruby>数据定义语言<rt>data definition language</rt></ruby>)文件加入版本控制,然后开始尝试一些简单的 CI/CD 流程。虽然只能帮你检查一下语义语法或某些最佳实践,但实际上大多数开发的管道都是这样起步的。只要你把脚手架搭起来,建造就容易得多了。而一旦起步,你就会发现各种管道的使用场景。

|

||||

|

||||

举个例子,我经常会在公司内部写新闻简报,我使用 [MJML][7] 制作邮件模板,然后把它加入版本控制。我一般会维护一个 web 版本,但是一些同事喜欢 PDF 版,于是我创建了一个[管道][8]。每当我写好一篇新闻稿,就在 Gitlab 上提交一个合并请求。这样做会自动创建一个 index.html 文件,生成这篇新闻稿的 HTML 和 PDF 版链接。HTML 和 PDF 文件也会在该管道里同时生成。除非有人来检查确认,这些文件不会被直接发布出去。使用 GitLab Pages 发布这个网站后,我就可以下载一份 HTML 版,用来发送新闻简报。未来,我会修改这个流程,当合并请求成功或者在某个审核步骤后,自动发出对应的新闻稿。这些处理逻辑并不复杂,但的确为我节省了不少时间。实际上这些工具最核心的用途就是替你节省时间。

|

||||

|

||||

关键是要在抽象层创建出工具,这样稍加修改就可以处理不同的问题。值得留意的是,我创建的这套流程几乎不需要任何代码,除了一些[轻量级的 HTML 模板][9],一些[把 HTML 文件转换成 PDF 的 nodejs 代码][10],还有一些[生成索引页面的 nodejs 代码][11]。

|

||||

|

||||

这其中一些东西可能看起来有点复杂,但其中大部分都源自我使用的不同工具的教学文档。而且很多开发人员也会乐意跟你合作,因为他们在完工时会发现这些东西也挺有用。上面我提供的那些代码链接是给 [DevOps KC][12](LCTT 译注:一个地方性 DevOps 组织) 发送新闻简报用的,其中大部分用来创建网站的代码来自我在内部新闻简报项目上所作的工作。

|

||||

|

||||

下面列出的大多数工具都可以提供这种类型的交互,但是有些工具提供的模型略有不同。这一领域新兴的模型是用声明式的方法例如 YAML 来描述一个管道,其中的每个阶段都是短暂而幂等的。许多系统还会创建[有向无环图(DAG)][13],来确保管道上不同的阶段排序的正确性。

|

||||

|

||||

这些阶段一般运行在 Linux 容器里,和普通的容器并没有区别。有一些工具,比如 [Spinnaker][14],只关注部署组件,而且提供一些其他工具没有的操作特性。[Jenkins][15] 则通常把管道配置存成 XML 格式,大部分交互都可以在图形界面里完成,但最新的方案是使用[领域专用语言(DSL)][16](如 [Groovy][17])。并且,Jenkins 的任务(job)通常运行在各个节点里,这些节点上会装一个专门的 Java 代理,还有一堆混杂的插件和预装组件。

|

||||

|

||||

Jenkins 在自己的工具里引入了管道的概念,但使用起来却并不轻松,甚至包含一些禁区。最近,Jenkins 的创始人决定带领社区向新的方向前进,希望能为这个项目注入新的活力,把 CI/CD 真正推广开(LCTT 译注:详见后面的 Jenkins 章节)。我认为其中最有意思的想法是构建一个云原生 Jenkins,能把 Kubernetes 集群转变成 Jenkins CI/CD 平台。

|

||||

|

||||

当你更多地了解这些工具并把实践带入你的公司和运维部门,你很快就会有追随者,因为你有办法提升自己和别人的工作效率。我们都有多年积累下来的技术债要解决,如果你能给同事们提供足够的时间来处理这些积压的工作,他们该会有多感激呢?不止如此,你的客户也会开始看到应用变得越来越稳定,管理层会把你看作得力干将,你也会在下次谈薪资待遇或参加面试时更有底气。

|

||||

|

||||

让我们开始深入了解这些工具吧,我们将对每个工具做简短的介绍,并分享一些有用的链接。

|

||||

|

||||

### GitLab CI

|

||||

|

||||

- [项目主页](https://about.gitlab.com/product/continuous-integration/)

|

||||

- [源代码](https://gitlab.com/gitlab-org/gitlab-ce/)

|

||||

- 许可证:MIT

|

||||

|

||||

GitLab 可以说是 CI/CD 领域里新登场的玩家,但它却在权威调研机构 [Forrester 的 CI 集成工具的调查报告][20]中位列第一。在一个高水平、竞争充分的领域里,这是个了不起的成就。是什么让 GitLab CI 这么成功呢?它使用 YAML 文件来描述整个管道。另有一个功能叫做 Auto DevOps,可以为较简单的项目用多种内置的测试单元自动生成管道。这套系统使用 [Herokuish buildpacks][21] 来判断语言的种类以及如何构建应用。有些语言也可以管理数据库,它真正改变了构建新应用程序和从开发的开始将它们部署到生产环境的过程。它原生集成于 Kubernetes,可以根据不同的方案将你的应用自动部署到 Kubernetes 集群,比如灰度发布、蓝绿部署等。

|

||||

|

||||

除了它的持续集成功能,GitLab 还提供了许多补充特性,比如:将 Prometheus 和你的应用一同部署,以提供操作监控功能;通过 GitLab 提供的 Issues、Epics 和 Milestones 功能来实现项目评估和管理;管道中集成了安全检测功能,多个项目的检测结果会聚合显示;你可以通过 GitLab 提供的网页版 IDE 在线编辑代码,还可以快速查看管道的预览或执行状态。

|

||||

|

||||

### GoCD

|

||||

|

||||

- [项目主页](https://www.gocd.org/)

|

||||

- [源代码](https://github.com/gocd/gocd)

|

||||

- 许可证:Apache 2.0

|

||||

|

||||

GoCD 是由老牌软件公司 Thoughtworks 出品,这已经足够证明它的能力和效率。对我而言,GoCD 最具亮点的特性是它的[价值流视图(VSM)][22]。实际上,一个管道的输出可以变成下一个管道的输入,从而把管道串联起来。这样做有助于提高不同开发团队在整个开发流程中的独立性。比如在引入 CI/CD 系统时,有些成立较久的机构希望保持他们各个团队相互隔离,这时候 VSM 就很有用了:让每个人都使用相同的工具就很容易在 VSM 中发现工作流程上的瓶颈,然后可以按图索骥调整团队或者想办法提高工作效率。

|

||||

|

||||

为公司的每个产品配置 VSM 是非常有价值的;GoCD 可以使用 [JSON 或 YAML 格式存储配置][23],还能以可视化的方式展示数据等待时间,这让一个机构能有效减少学习它的成本。刚开始使用 GoCD 创建你自己的流程时,建议使用人工审核的方式。让每个团队也采用人工审核,这样你就可以开始收集数据并且找到可能的瓶颈点。

|

||||

|

||||

### Travis CI

|

||||

|

||||

- [项目主页](https://docs.travis-ci.com/)

|

||||

- [源代码](https://github.com/travis-ci/travis-ci)

|

||||

- 许可证:MIT

|

||||

|

||||

我使用的第一个软件既服务(SaaS)类型的 CI 系统就是 Travis CI,体验很不错。管道配置以源码形式用 YAML 保存,它与 GitHub 等工具无缝整合。我印象中管道从来没有失效过,因为 Travis CI 的在线率很高。除了 SaaS 版之外,你也可以使用自行部署的版本。我还没有自行部署过,它的组件非常多,要全部安装的话,工作量就有点吓人了。我猜更简单的办法是把它部署到 Kubernetes 上,[Travis CI 提供了 Helm charts][26],这些 charts 目前不包含所有要部署的组件,但我相信以后会越来越丰富的。如果你不想处理这些细枝末节的问题,还有一个企业版可以试试。

|

||||

|

||||

假如你在开发一个开源项目,你就能免费使用 SaaS 版的 Travis CI,享受顶尖团队提供的优质服务!这样能省去很多麻烦,你可以在一个相对通用的平台上(如 GitHub)研发开源项目,而不用找服务器来运行任何东西。

|

||||

|

||||

### Jenkins

|

||||

|

||||

- [项目主页](https://jenkins.io/)

|

||||

- [源代码](https://github.com/jenkinsci/jenkins)

|

||||

- 许可证:MIT

|

||||

|

||||

Jenkins 在 CI/CD 界绝对是元老级的存在,也是事实上的标准。我强烈建议你读一读这篇文章:“[Jenkins: Shifting Gears][27]”,作者 Kohsuke 是 Jenkins 的创始人兼 CloudBees 公司 CTO。这篇文章契合了我在过去十年里对 Jenkins 及其社区的感受。他在文中阐述了一些这几年呼声很高的需求,我很乐意看到 CloudBees 引领这场变革。长期以来,Jenkins 对于非开发人员来说有点难以接受,并且一直是其管理员的重担。还好,这些问题正是他们想要着手解决的。

|

||||

|

||||

[Jenkins 配置既代码][28](JCasC)应该可以帮助管理员解决困扰了他们多年的配置复杂性问题。与其他 CI/CD 系统类似,只需要修改一个简单的 YAML 文件就可以完成 Jenkins 主节点的配置工作。[Jenkins Evergreen][29] 的出现让配置工作变得更加轻松,它提供了很多预设的使用场景,你只管套用就可以了。这些发行版会比官方的标准版本 Jenkins 更容易维护和升级。

|

||||

|

||||

Jenkins 2 引入了两种原生的管道功能,我在 LISA(LCTT 译注:一个系统架构和运维大会) 2017 年的研讨会上已经[讨论过了][30]。这两种功能都没有 YAML 简便,但在处理复杂任务时它们很好用。

|

||||

|

||||

[Jenkins X][31] 是 Jenkins 的一个全新变种,用来实现云端原生 Jenkins(至少在用户看来是这样)。它会使用 JCasC 及 Evergreen,并且和 Kubernetes 整合的更加紧密。对于 Jenkins 来说这是个令人激动的时刻,我很乐意看到它在这一领域的创新,并且继续发挥领袖作用。

|

||||

|

||||

### Concourse CI

|

||||

|

||||

- [项目主页](https://concourse-ci.org/)

|

||||

- [源代码](https://github.com/concourse/concourse)

|

||||

- 许可证:Apache 2.0

|

||||

|

||||

我第一次知道 Concourse 是通过 Pivotal Labs 的伙计们介绍的,当时它处于早期 beta 版本,而且那时候也很少有类似的工具。这套系统是基于微服务构建的,每个任务运行在一个容器里。它独有的一个优良特性是能够在你本地系统上运行任务,体现你本地的改动。这意味着你完全可以在本地开发(假设你已经连接到了 Concourse 的服务器),像在真实的管道构建流程一样从你本地构建项目。而且,你可以在修改过代码后从本地直接重新运行构建,来检验你的改动结果。

|

||||

|

||||

Concourse 还有一个简单的扩展系统,它依赖于“资源”这一基础概念。基本上,你想给管道添加的每个新功能都可以用一个 Docker 镜像实现,并作为一个新的资源类型包含在你的配置中。这样可以保证每个功能都被封装在一个不可变的独立工件中,方便对其单独修改和升级,改变其中一个时不会影响其他构建。

|

||||

|

||||

### Spinnaker

|

||||

|

||||

- [项目主页](https://www.spinnaker.io/)

|

||||

- [源代码](https://github.com/spinnaker/spinnaker)

|

||||

- 许可证:Apache 2.0

|

||||

|

||||

Spinnaker 出自 Netflix,它更关注持续部署而非持续集成。它可以与其他工具整合,比如 Travis 和 Jenkins,来启动测试和部署流程。它也能与 Prometheus、Datadog 这样的监控工具集成,参考它们提供的指标来决定如何部署。例如,在<ruby>金丝雀发布<rt>canary deployment</rt></ruby>里,我们可以根据收集到的相关监控指标来做出判断:最近的这次发布是否导致了服务降级,应该立刻回滚;还是说看起来一切 OK,应该继续执行部署。

|

||||

|

||||

谈到持续部署,一些另类但却至关重要的问题往往被忽略掉了,说出来可能有点让人困惑:Spinnaker 可以帮助持续部署不那么“持续”。在整个应用部署流程期间,如果发生了重大问题,它可以让流程停止执行,以阻止可能发生的部署错误。但它也可以在最关键的时刻让人工审核强制通过,发布新版本上线,使整体收益最大化。实际上,CI/CD 的主要目的就是在商业模式需要调整时,能够让待更新的代码立即得到部署。

|

||||

|

||||

### Screwdriver

|

||||

|

||||

- [项目主页](http://screwdriver.cd/)

|

||||

- [源代码](https://github.com/screwdriver-cd/screwdriver)

|

||||

- 许可证:BSD

|

||||

|

||||

Screwdriver 是个简单而又强大的软件。它采用微服务架构,依赖像 Nomad、Kubernetes 和 Docker 这样的工具作为执行引擎。官方有一篇很不错的[部署教学文档][34],介绍了如何将它部署到 AWS 和 Kubernetes 上,但如果正在开发中的 [Helm chart][35] 也完成的话,就更完美了。

|

||||

|

||||

Screwdriver 也使用 YAML 来描述它的管道,并且有很多合理的默认值,这样可以有效减少各个管道重复的配置项。用配置文件可以组织起高级的工作流,来描述各个任务间复杂的依赖关系。例如,一项任务可以在另一个任务开始前或结束后运行;各个任务可以并行也可以串行执行;更赞的是你可以预先定义一项任务,只在特定的拉取请求时被触发,而且与之有依赖关系的任务并不会被执行,这能让你的管道具有一定的隔离性:什么时候被构造的工件应该被部署到生产环境,什么时候应该被审核。

|

||||

|

||||

---

|

||||

|

||||

以上只是我对这些 CI/CD 工具的简单介绍,它们还有许多很酷的特性等待你深入探索。而且它们都是开源软件,可以自由使用,去部署一下看看吧,究竟哪个才是最适合你的那个。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/12/cicd-tools-sysadmins

|

||||

|

||||

作者:[Dan Barker][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[jdh8383](https://github.com/jdh8383)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://opensource.com/users/barkerd427

|

||||

[b]: https://github.com/lujun9972

|

||||

[1]: https://www.ansible.com/

|

||||

[2]: https://www.chef.io/

|

||||

[3]: https://puppet.com/

|

||||

[4]: https://github.com/test-kitchen/test-kitchen

|

||||

[5]: https://www.merriam-webster.com/dictionary/ephemeral

|

||||

[6]: https://en.wikipedia.org/wiki/Idempotence

|

||||

[7]: https://mjml.io/

|

||||

[8]: https://gitlab.com/devopskc/newsletter/blob/master/.gitlab-ci.yml

|

||||

[9]: https://gitlab.com/devopskc/newsletter/blob/master/index/index.html

|

||||

[10]: https://gitlab.com/devopskc/newsletter/blob/master/html-to-pdf.js

|

||||

[11]: https://gitlab.com/devopskc/newsletter/blob/master/populate-index.js

|

||||

[12]: https://devopskc.com/

|

||||

[13]: https://en.wikipedia.org/wiki/Directed_acyclic_graph

|

||||

[14]: https://www.spinnaker.io/

|

||||

[15]: https://jenkins.io/

|

||||

[16]: https://martinfowler.com/books/dsl.html

|

||||

[17]: http://groovy-lang.org/

|

||||

[18]: https://about.gitlab.com/product/continuous-integration/

|

||||

[19]: https://gitlab.com/gitlab-org/gitlab-ce/

|

||||

[20]: https://about.gitlab.com/2017/09/27/gitlab-leader-continuous-integration-forrester-wave/

|

||||

[21]: https://github.com/gliderlabs/herokuish

|

||||

[22]: https://www.gocd.org/getting-started/part-3/#value_stream_map

|

||||

[23]: https://docs.gocd.org/current/advanced_usage/pipelines_as_code.html

|

||||

[24]: https://docs.travis-ci.com/

|

||||

[25]: https://github.com/travis-ci/travis-ci

|

||||

[26]: https://github.com/travis-ci/kubernetes-config

|

||||

[27]: https://jenkins.io/blog/2018/08/31/shifting-gears/

|

||||

[28]: https://jenkins.io/projects/jcasc/

|

||||

[29]: https://github.com/jenkinsci/jep/blob/master/jep/300/README.adoc

|

||||

[30]: https://danbarker.codes/talk/lisa17-becoming-plumber-building-deployment-pipelines/

|

||||

[31]: https://jenkins-x.io/

|

||||

[32]: https://concourse-ci.org/

|

||||

[33]: https://github.com/concourse/concourse

|

||||

[34]: https://docs.screwdriver.cd/cluster-management/kubernetes

|

||||

[35]: https://github.com/screwdriver-cd/screwdriver-chart

|

||||

@ -0,0 +1,84 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (geekpi)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-10579-1.html)

|

||||

[#]: subject: (Mind map yourself using FreeMind and Fedora)

|

||||

[#]: via: (https://fedoramagazine.org/mind-map-yourself-using-freemind-and-fedora/)

|

||||

[#]: author: (Paul W. Frields https://fedoramagazine.org/author/pfrields/)

|

||||

|

||||

在 Fedora 中使用 FreeMind 介绍你自己

|

||||

======

|

||||

|

||||

|

||||

|

||||

介绍你自己的思维导图,一开始听起来有些牵强。它是关于神经通路么?还是心灵感应?完全不是。相反,自己的思维导图是一种在视觉上向他人描述自己的方式。它还展示了你拿来描述自己的特征之间的联系。这是一种以聪明又同时可控的与他人分享信息的有用方式。你可以使用任何思维导图应用来做到。本文向你展示如何使用 Fedora 中提供的 [FreeMind][1]。

|

||||

|

||||

### 获取应用

|

||||

|

||||

FreeMind 已经出现有一段时间了。虽然 UI 有点过时,应该做一些更新了,但它是一个功能强大的应用,提供了许多构建思维导图的选项。当然,它是 100% 开源的。还有其他思维导图应用可供 Fedora 和 Linux 用户使用。查看[此前一篇涵盖多个思维导图选择的文章][2]。

|

||||

|

||||

如果你运行的是 Fedora Workstation,请使用“软件”应用从 Fedora 仓库安装 FreeMind。或者在终端中使用这个 [sudo][3] 命令:

|

||||

|

||||

```

|

||||

$ sudo dnf install freemind

|

||||

```

|

||||

|

||||

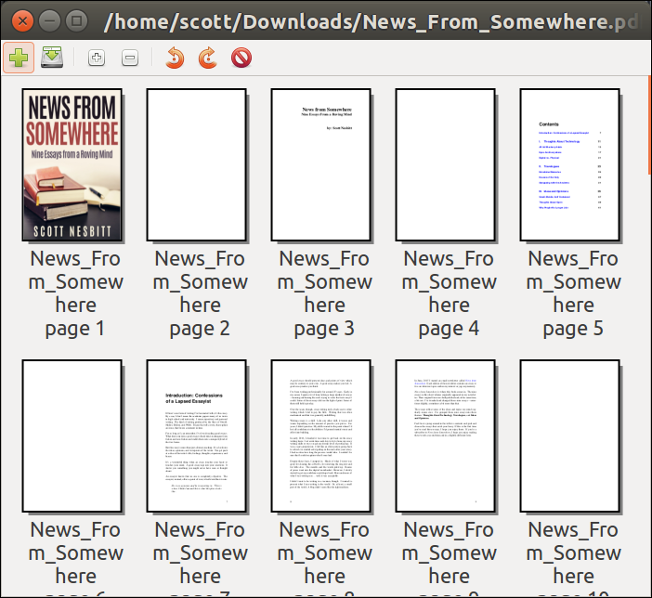

你可以从 Fedora Workstation 中的 GNOME Shell Overview 启动应用。或者使用桌面环境提供的应用启动服务。默认情况下,FreeMind 会显示一个新的空白脑图:

|

||||

|

||||

![][4]

|

||||

|

||||

*FreeMind 初始(空白)思维导图*

|

||||

|

||||

脑图由链接的项目或描述(节点)组成。当你想到与节点相关的内容时,只需创建一个与其连接的新节点即可。

|

||||

|

||||

### 做你自己的脑图

|

||||

|

||||

单击初始节点。编辑文本并按回车将其替换为你的姓名。你就能开始你的思维导图。

|

||||

|

||||

如果你必须向某人充分描述自己,你会怎么想?可能会有很多东西。你平时做什么?你喜欢什么?你不喜欢什么?你有什么价值?你有家庭吗?所有这些都可以在节点中体现。

|

||||

|

||||

要添加节点连接,请选择现有节点,然后单击“Insert”,或使用“灯泡”图标作为新的子节点。要在与新子级相同的层级添加另一个节点,请使用回车。

|

||||

|

||||

如果你弄错了,别担心。你可以使用 `Delete` 键删除不需要的节点。内容上没有规则。但是最好是短节点。它们能让你在创建导图时思维更快。简洁的节点还能让其他浏览者更轻松地查看和理解。

|

||||

|

||||

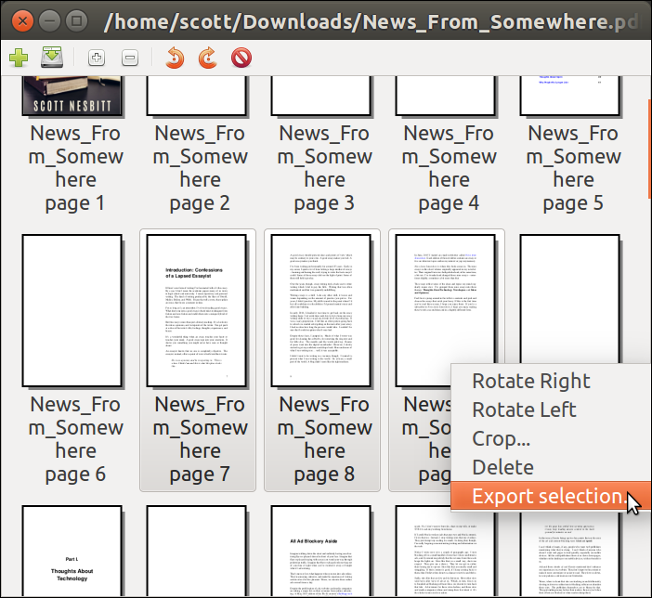

该示例使用节点规划了每个主要类别:

|

||||

|

||||

![][5]

|

||||

|

||||

*个人思维导图,第一级*

|

||||

|

||||

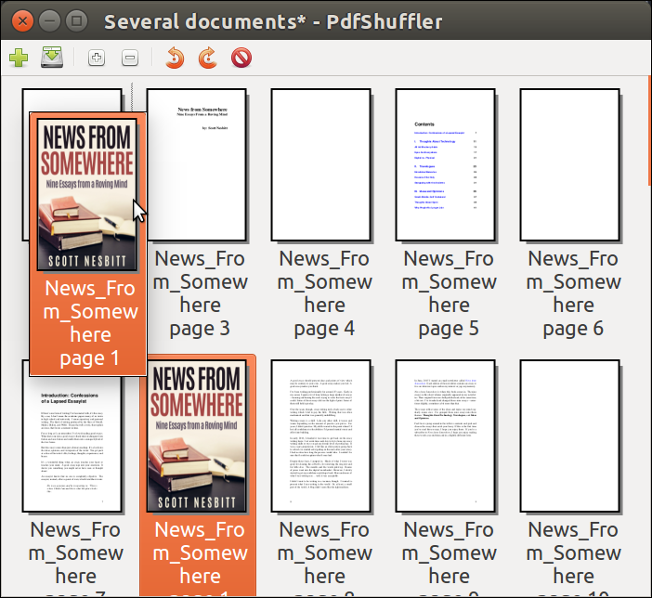

你可以为这些区域中的每个区域另外迭代一次。让你的思想自由地连接想法以生成导图。不要担心“做得正确“。最好将所有内容从头脑中移到显示屏上。这是下一级导图的样子。

|

||||

|

||||

![][6]

|

||||

|

||||

*个人思维导图,第二级*

|

||||

|

||||

你可以以相同的方式扩展任何这些节点。请注意你在示例中可以了解多少有关 “John Q. Public” 的信息。

|

||||

|

||||

### 如何使用你的个人思维导图

|

||||

|

||||

这是让团队或项目成员互相介绍的好方法。你可以将各种格式和颜色应用于导图以赋予其个性。当然,这些在纸上做很有趣。但是在 Fedora 中安装一个就意味着你可以随时修复错误,甚至可以在你改变的时候做出修改。

|

||||

|

||||

祝你在探索个人思维导图上玩得开心!

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://fedoramagazine.org/mind-map-yourself-using-freemind-and-fedora/

|

||||

|

||||

作者:[Paul W. Frields][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://fedoramagazine.org/author/pfrields/

|

||||

[b]: https://github.com/lujun9972

|

||||

[1]: http://freemind.sourceforge.net/wiki/index.php/Main_Page

|

||||

[2]: https://fedoramagazine.org/three-mind-mapping-tools-fedora/

|

||||

[3]: https://fedoramagazine.org/howto-use-sudo/

|

||||

[4]: https://fedoramagazine.org/wp-content/uploads/2019/01/Screenshot-from-2019-01-19-15-17-04-1024x736.png

|

||||

[5]: https://fedoramagazine.org/wp-content/uploads/2019/01/Screenshot-from-2019-01-19-15-32-38-1024x736.png

|

||||

[6]: https://fedoramagazine.org/wp-content/uploads/2019/01/Screenshot-from-2019-01-19-15-38-00-1024x736.png

|

||||

@ -0,0 +1,156 @@

|

||||

每个 Linux 游戏玩家都绝不想要的恼人体验

|

||||

===================

|

||||

|

||||

[][10]

|

||||

|

||||

(LCTT 译注:本文原文发表于 2016 年,可能有些信息已经过时。)

|

||||

|

||||

[在 Linux 平台上玩游戏][12] 并不是什么新鲜事,现在甚至有专门的 [Linux 游戏发行版][13],但是这不意味着在 Linux 上打游戏的体验和在 Windows 上一样顺畅。

|

||||

|

||||

为了确保我们和 Windows 用户同样地享受游戏乐趣,哪些问题是我们应该考虑的呢?

|

||||

|

||||

[Wine][14]、[PlayOnLinux][15] 和其它类似软件不总是能够让我们玩所有流行的 Windows 游戏。在这篇文章里,我想讨论一下为了拥有最好的 Linux 游戏体验所必须处理好的若干因素。

|

||||

|

||||

### #1 SteamOS 是开源平台,但 Steam for Linux 并不是

|

||||

|

||||

正如 [StemOS 主页][16]所说, 即便 SteamOS 是一个开源平台,但 Steam for Linux 仍然是专有的软件。如果 Steam for Linux 也开源,那么它从开源社区得到的支持将会是巨大的。既然它不是,那么 [Ascension 计划的诞生自然是不可避免的][17]:

|

||||

|

||||

- [Destination: Project Ascension • UI Design Mockups Reveal](https://youtu.be/07UiS5iAknA)

|

||||

|

||||

Ascension 是一个开源的游戏启动器,旨在能够启动从任何平台购买、下载的游戏。这些游戏可以是 Steam 平台的、[Origin 游戏][18]平台的、Uplay 平台的,以及直接从游戏开发者主页下载的,或者来自 DVD、CD-ROM 的。

|

||||

|

||||

Ascension 计划的开端是这样:[某个观点的分享][19]激发了一场与游戏社区读者之间有趣的讨论,在这场讨论中读者们纷纷发表了自己的观点并给出建议。

|

||||

|

||||

### #2 与 Windows 平台的性能比较

|

||||

|

||||

在 Linux 平台上运行 Windows 游戏并不总是一件轻松的任务。但是得益于一个叫做 [CSMT][20](多线程命令流)的特性,尽管离 Windows 级别的性能还有相当长的路要走,PlayOnLinux 现在依旧可以更好地解决这些性能方面的问题。

|

||||

|

||||

Linux 对游戏的原生支持在过去发行的游戏中从未尽如人意。

|

||||

|

||||

去年,有报道说 SteamOS 比 Windows 在游戏方面的表现要[差得多][21]。古墓丽影去年在 SteamOS 及 Steam for Linux 上发行,然而其基准测试的结果与 Windows 上的性能无法抗衡。

|

||||

|

||||

- [Destination: Tomb Raider benchmark video comparison, Linux vs Windows 10](https://youtu.be/nkWUBRacBNE)

|

||||

|

||||

这明显是因为游戏是基于 [DirectX][23] 而不是 [OpenGL][24] 开发的缘故。

|

||||

|

||||

古墓丽影是[第一个使用 TressFX 的游戏][25]。下面这个视频包涵了 TressFX 的比较:

|

||||

|

||||

- [Destination: Tomb Raider Benchmark - Ubuntu 15.10 vs Windows 8.1 + Ubuntu 16.04 vs Windows 10](https://youtu.be/-IeY5ZS-LlA)

|

||||

|

||||

下面是另一个有趣的比较,它显示出使用 Wine + CSMT 带来的游戏性能比 Steam 上原生的 Linux 版游戏带来的游戏性能要好得多!这就是开源的力量!

|

||||

|

||||

- [Destination: [LinuxBenchmark] Tomb Raider Linux vs Wine comparison](https://youtu.be/sCJkC6oJ08A)

|

||||

|

||||

以防 FPS 损失,TressFX 已经被关闭。

|

||||

|

||||

以下是另一个有关在 Linux 上最新发布的 “[Life is Strange][27]” 在 Linux 与 Windows 上的比较:

|

||||

|

||||

- [Destination: Life is Strange on radeonsi (Linux nine_csmt vs Windows 10)](https://youtu.be/Vlflu-pIgIY)

|

||||

|

||||

[Steam for Linux][28] 开始在这个新游戏上展示出比 Windows 更好的游戏性能,这是一件好事。

|

||||

|

||||

在发布任何 Linux 版的游戏前,开发者都应该考虑优化游戏,特别是基于 DirectX 并需要进行 OpenGL 转制的游戏。我们十分希望 Linux 上的<ruby>[杀出重围:人类分裂][29]<rt>Deus Ex: Mankind Divided</rt></ruby> 在正式发行时能有一个好的基准测试结果。由于它是基于 DirectX 的游戏,我们希望它能良好地移植到 Linux 上。[该游戏执行总监说过这样的话][30]。

|

||||

|

||||

### #3 专有的 NVIDIA 驱动

|

||||

|

||||

相比于 [NVIDIA][32],[AMD 对于开源的支持][31]绝对是值得称赞的。尽管 [AMD][33] 因其更好的开源驱动在 Linux 上的驱动支持挺不错,而 NVIDIA 显卡用户由于开源版本的 NVIDIA 显卡驱动 “Nouveau” 有限的能力,仍不得不用专有的 NVIDIA 驱动。

|

||||

|

||||

曾经,Linus Torvalds 大神也分享过他关于“来自 NVIDIA 的 Linux 支持完全不可接受”的想法。

|

||||

|

||||

- [Destination: Linus Torvalds Publicly Attacks NVidia for lack of Linux & Android Support](https://youtu.be/O0r6Pr_mdio)

|

||||

|

||||

你可以在这里观看完整的[谈话][35],尽管 NVIDIA 回应 [承诺更好的 Linux 平台支持][36],但其开源显卡驱动仍如之前一样毫无起色。

|

||||

|

||||

### #4 需要 Linux 平台上的 Uplay 和 Origin 的 DRM 支持

|

||||

|

||||

- [Destination: Uplay #1 Rayman Origins em Linux - como instalar - ago 2016](https://youtu.be/rc96NFwyxWU)

|

||||

|

||||

以上的视频描述了如何在 Linux 上安装 [Uplay][37] DRM。视频上传者还建议说并不推荐使用 Wine 作为 Linux 上的主要的应用和游戏支持软件。相反,更鼓励使用原生的应用。

|

||||

|

||||

以下视频是一个关于如何在 Linux 上安装 [Origin][38] DRM 的教程。

|

||||

|

||||

- [Destination: Install EA Origin in Ubuntu with PlayOnLinux (Updated)](https://youtu.be/ga2lNM72-Kw)

|

||||

|

||||

数字版权管理(DRM)软件给游戏运行又加了一层阻碍,使得在 Linux 上良好运行 Windows 游戏这一本就充满挑战性的任务更有难度。因此除了使游戏能够运行之外,W.I.N.E 不得不同时负责运行像 Uplay 或 Origin 之类的 DRM 软件。如果能像 Steam 一样,Linux 也能够有自己原生版本的 Uplay 和 Origin 那就好了。

|

||||

|

||||

### #5 DirectX 11 对于 Linux 的支持

|

||||

|

||||

尽管我们在 Linux 平台上有可以运行 Windows 应用的工具,每个游戏为了能在 Linux 上运行都带有自己的配套调整需求。尽管去年在 Code Weavers 有一篇关于 [DirectX 11 对于 Linux 的支持][40] 的公告,在 Linux 上畅玩新发大作仍是长路漫漫。

|

||||

|

||||

现在你可以[从 Codweavers 购买 Crossover][41] 以获得可得到的最佳 DirectX 11 支持。这个在 Arch Linux 论坛上的[频道][42]清楚展现了将这个梦想成真需要多少的努力。以下是一个 [Reddit 频道][44] 上的有趣 [发现][43]。这个发现提到了[来自 Codeweavers 的 DirectX 11 补丁][45],现在看来这无疑是好消息。

|

||||

|

||||

### #6 不是全部的 Steam 游戏都可跑在 Linux 上

|

||||

|

||||

随着 Linux 游戏玩家一次次错过主要游戏的发行,这是需要考虑的一个重点,因为大部分主要游戏都在 Windows 上发行。这是[如何在 Linux 上安装 Windows 版的 Steam 的教程][46]。

|

||||

|

||||

### #7 游戏发行商对 OpenGL 更好的支持

|

||||

|

||||

目前开发者和发行商主要着眼于用 DirectX 而不是 OpenGL 来开发游戏。现在随着 Steam 正式登录 Linux,开发者应该同样考虑在 OpenGL 下开发。

|

||||

|

||||

[Direct3D][47] 仅仅是为 Windows 平台而打造。而 OpenGL API 拥有开放性标准,并且它不仅能在 Windows 上同样也能在其它各种各样的平台上实现。

|

||||

|

||||

尽管是一篇很老的文章,但[这个很有价值的资源][48]分享了许多有关 OpenGL 和 DirectX 现状的很有想法的信息。其所提出的观点确实十分明智,基于按时间排序的事件也能给予读者启迪。

|

||||

|

||||

在 Linux 平台上发布大作的发行商绝不应该忽视一个事实:在 OpenGL 下直接开发游戏要比从 DirectX 移植到 OpenGL 合算得多。如果必须进行平台转制,移植必须被仔细优化并谨慎研究。发布游戏可能会有延迟,但这绝对值得。

|

||||

|

||||

有更多的烦恼要分享?务必在评论区让我们知道。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://itsfoss.com/linux-gaming-problems/

|

||||

|

||||

作者:[Avimanyu Bandyopadhyay][a]

|

||||

译者:[tomjlw](https://github.com/tomjlw)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://itsfoss.com/author/avimanyu/

|

||||

[1]:https://itsfoss.com/author/avimanyu/

|

||||

[2]:https://itsfoss.com/linux-gaming-problems/#comments

|

||||

[3]:https://www.facebook.com/share.php?u=https%3A%2F%2Fitsfoss.com%2Flinux-gaming-problems%2F%3Futm_source%3Dfacebook%26utm_medium%3Dsocial%26utm_campaign%3DSocialWarfare

|

||||

[4]:https://twitter.com/share?original_referer=/&text=Annoying+Experiences+Every+Linux+Gamer+Never+Wanted%21&url=https://itsfoss.com/linux-gaming-problems/%3Futm_source%3Dtwitter%26utm_medium%3Dsocial%26utm_campaign%3DSocialWarfare&via=itsfoss2

|

||||

[5]:https://plus.google.com/share?url=https%3A%2F%2Fitsfoss.com%2Flinux-gaming-problems%2F%3Futm_source%3DgooglePlus%26utm_medium%3Dsocial%26utm_campaign%3DSocialWarfare

|

||||

[6]:https://www.linkedin.com/cws/share?url=https%3A%2F%2Fitsfoss.com%2Flinux-gaming-problems%2F%3Futm_source%3DlinkedIn%26utm_medium%3Dsocial%26utm_campaign%3DSocialWarfare

|

||||

[7]:http://www.stumbleupon.com/submit?url=https://itsfoss.com/linux-gaming-problems/&title=Annoying+Experiences+Every+Linux+Gamer+Never+Wanted%21

|

||||

[8]:https://www.reddit.com/submit?url=https://itsfoss.com/linux-gaming-problems/&title=Annoying+Experiences+Every+Linux+Gamer+Never+Wanted%21

|

||||

[9]:https://itsfoss.com/wp-content/uploads/2016/09/Linux-Gaming-Problems.jpg

|

||||

[10]:https://itsfoss.com/wp-content/uploads/2016/09/Linux-Gaming-Problems.jpg

|

||||

[11]:http://pinterest.com/pin/create/bookmarklet/?media=https://itsfoss.com/wp-content/uploads/2016/09/Linux-Gaming-Problems.jpg&url=https://itsfoss.com/linux-gaming-problems/&is_video=false&description=Linux%20gamer%27s%20problem

|

||||

[12]:https://itsfoss.com/linux-gaming-guide/

|

||||

[13]:https://itsfoss.com/linux-gaming-distributions/

|

||||

[14]:https://itsfoss.com/use-windows-applications-linux/

|

||||

[15]:https://www.playonlinux.com/en/

|

||||

[16]:http://store.steampowered.com/steamos/

|

||||

[17]:http://www.ibtimes.co.uk/reddit-users-want-replace-steam-open-source-game-launcher-project-ascension-1498999

|

||||

[18]:https://www.origin.com/

|

||||

[19]:https://www.reddit.com/r/pcmasterrace/comments/33xcvm/we_hate_valves_monopoly_over_pc_gaming_why/

|

||||

[20]:https://github.com/wine-compholio/wine-staging/wiki/CSMT

|

||||

[21]:http://arstechnica.com/gaming/2015/11/ars-benchmarks-show-significant-performance-hit-for-steamos-gaming/

|

||||

[22]:https://www.gamingonlinux.com/articles/tomb-raider-benchmark-video-comparison-linux-vs-windows-10.7138

|

||||

[23]:https://en.wikipedia.org/wiki/DirectX

|

||||

[24]:https://en.wikipedia.org/wiki/OpenGL

|

||||

[25]:https://www.gamingonlinux.com/articles/tomb-raider-released-for-linux-video-thoughts-port-report-included-the-first-linux-game-to-use-tresfx.7124

|

||||

[26]:https://itsfoss.com/osu-new-linux/

|

||||

[27]:http://lifeisstrange.com/

|

||||

[28]:https://itsfoss.com/install-steam-ubuntu-linux/

|

||||

[29]:https://itsfoss.com/deus-ex-mankind-divided-linux/

|

||||

[30]:http://wccftech.com/deus-ex-mankind-divided-director-console-ports-on-pc-is-disrespectful/

|

||||

[31]:http://developer.amd.com/tools-and-sdks/open-source/

|

||||

[32]:http://nvidia.com/

|

||||

[33]:http://amd.com/

|

||||

[34]:http://www.makeuseof.com/tag/open-source-amd-graphics-now-awesome-heres-get/

|

||||

[35]:https://youtu.be/MShbP3OpASA

|

||||

[36]:https://itsfoss.com/nvidia-optimus-support-linux/

|

||||

[37]:http://uplay.com/

|

||||

[38]:http://origin.com/

|

||||

[39]:https://itsfoss.com/linux-foundation-head-uses-macos/

|

||||

[40]:http://www.pcworld.com/article/2940470/hey-gamers-directx-11-is-coming-to-linux-thanks-to-codeweavers-and-wine.html

|

||||

[41]:https://itsfoss.com/deal-run-windows-software-and-games-on-linux-with-crossover-15-66-off/

|

||||

[42]:https://bbs.archlinux.org/viewtopic.php?id=214771

|

||||

[43]:https://ghostbin.com/paste/sy3e2

|

||||

[44]:https://www.reddit.com/r/linux_gaming/comments/3ap3uu/directx_11_support_coming_to_codeweavers/

|

||||

[45]:https://www.codeweavers.com/about/blogs/caron/2015/12/10/directx-11-really-james-didnt-lie

|

||||

[46]:https://itsfoss.com/linux-gaming-guide/

|

||||

[47]:https://en.wikipedia.org/wiki/Direct3D

|

||||

[48]:http://blog.wolfire.com/2010/01/Why-you-should-use-OpenGL-and-not-DirectX

|

||||

@ -7,23 +7,23 @@

|

||||

|

||||

你能够轻松地配置 Plasma 桌面并且使用它大量方便且节省时间的特性来加速你的工作,拥有一个能够帮助你而非阻碍你的桌面环境。

|

||||

|

||||

这些提示并没有特定顺序,因此你无需按次序阅读。你只需要挑出最适合你的工作流的那几个即可。

|

||||

以下这些提示并没有特定顺序,因此你无需按次序阅读。你只需要挑出最适合你的工作流的那几个即可。

|

||||

|

||||

**相关阅读** : [10 个你应该尝试的最佳 KDE Plasma 应用][1]

|

||||

**相关阅读**:[10 个你应该尝试的最佳 KDE Plasma 应用][1]

|

||||

|

||||

### 1. 多媒体控制

|

||||

### 1、多媒体控制

|

||||

|

||||

这点算不太上是一条提示,因为它是很容易被记在脑海里的。Plasma 可在各处进行多媒体控制。当你需要暂停、继续或跳过一首歌时,你不需要每次都打开你的媒体播放器。你能够通过将鼠标移至最小化窗口之上,甚至通过锁屏进行控制。当你需要切换歌曲或忘了暂停时,你也不必麻烦地登录再进行操作。

|

||||

这点不太算得上是一条提示,因为它是很容易被记在脑海里的。Plasma 可在各处进行多媒体控制。当你需要暂停、继续或跳过一首歌时,你不需要每次都打开你的媒体播放器。你能够通过将鼠标移至那个最小化窗口之上,甚至通过锁屏进行控制。当你需要切换歌曲或忘了暂停时,你也不必麻烦地登录再进行操作。

|

||||

|

||||

### 2. KRunner

|

||||

### 2、KRunner

|

||||

|

||||

![KDE Plasma KRunner][2]

|

||||

|

||||

KRunner 是 Plasma 桌面中一个经常受到赞誉的特性。大部分人习惯于深挖应用启动菜单来找到想要启动的程序。当你使用 KRunner 时就不需要这么做。

|

||||

KRunner 是 Plasma 桌面中一个经常受到赞誉的特性。大部分人习惯于穿过层层的应用启动菜单来找到想要启动的程序。当你使用 KRunner 时就不需要这么做。

|

||||

|

||||

为了使用 KRunner,确保你当前的焦点在桌面本身(点击桌面而不是窗口)。然后开始输入你想要启动的应用名称,KRunner 将会带着建议项从你的屏幕顶部自动下拉。在你寻找的匹配项上点击或敲击 Enter 键。这比记住你每个应用所属的类别要更快。

|

||||

为了使用 KRunner,确保你当前的活动焦点在桌面本身(点击桌面而不是窗口)。然后开始输入你想要启动的应用名称,KRunner 将会带着建议项从你的屏幕顶部自动下拉。在你寻找的匹配项上点击或敲击回车键。这比记住你每个应用所属的类别要更快。

|

||||

|

||||

### 3. 跳转列表

|

||||

### 3、跳转列表

|

||||

|

||||

![KDE Plasma 的跳转列表][3]

|

||||

|

||||

@ -31,7 +31,7 @@ KRunner 是 Plasma 桌面中一个经常受到赞誉的特性。大部分人习

|

||||

|

||||

因此如果你在菜单栏上有一个应用启动图标,你可以通过右键得到可跳转位置的列表。选择你想要跳转的位置,然后就可以“起飞”了。

|

||||

|

||||

### 4. KDE Connect

|

||||

### 4、KDE Connect

|

||||

|

||||

![KDE Connect Android 客户端菜单][4]

|

||||

|

||||

@ -41,15 +41,15 @@ KRunner 是 Plasma 桌面中一个经常受到赞誉的特性。大部分人习

|

||||

|

||||

KDE Connect 也允许你在手机和电脑间发送文件或共享网页。你可以轻松地从一个设备转移至另一设备,而无需烦恼或打乱思绪。

|

||||

|

||||

### 5. Plasma Vaults

|

||||

### 5、Plasma Vaults

|

||||

|

||||

![KDE Plasma Vault][7]

|

||||

|

||||

Plasma Vaults 是 Plasma 桌面的另一个新功能。它的 KDE 为加密文件和文件夹提供的简单解决方案。如果你不使用加密文件,此项功能不会为你节省时间。如果你使用,Vaults是一个更简单的途径。

|

||||

Plasma Vaults 是 Plasma 桌面的另一个新功能。它的 KDE 为加密文件和文件夹提供的简单解决方案。如果你不使用加密文件,此项功能不会为你节省时间。如果你使用,Vaults 是一个更简单的途径。

|

||||

|

||||

Plasma Vaults 允许你以无 root 权限的普通用户创建加密目录,并通过你的任务栏来管理它们。你能够快速地挂载或卸载目录,而无需外部程序或附加权限。

|

||||

|

||||

### 6. Pager 控件

|

||||

### 6、Pager 控件

|

||||

|

||||

![KDE Plasma Pager][8]

|

||||

|

||||

@ -57,19 +57,19 @@ Plasma Vaults 允许你以无 root 权限的普通用户创建加密目录,并

|

||||

|

||||

将控件添加到你的菜单栏上,然后你就可以在多个工作区间滑动切换。每个工作区都与你原桌面的尺寸相同,因此你能够得到数倍于完整屏幕的空间。这就使你能够排布更多的窗口,而不必受到一堆混乱的最小化窗口的困扰。

|

||||

|

||||

### 7. 创建一个 Dock

|

||||

### 7、创建一个 Dock

|

||||

|

||||

![KDE Plasma Dock][9]

|

||||

|

||||

Plasma 以其灵活性和可配置性出名,同时也是它的优势。如果你有常用的程序,你可以考虑将常用程序设置为 OS X 风格的 dock。你能够通过单击启动,而不必深入菜单或输入它们的名字。

|

||||

|

||||

### 8. 为 Dolphin 添加文件树

|

||||

### 8、为 Dolphin 添加文件树

|

||||

|

||||

![Plasma Dolphin 目录][10]

|

||||

|

||||

通过目录树来浏览文件夹会更加简单。Dolphin 作为 Plasma 的默认文件管理器,具有在文件夹窗口一侧,以树的形式展示目录列表的内置功能。

|

||||

|

||||

为了启用目录树,点击“控制”标签,然后“配置 Dolphin”,“显示模式”,“详细”,最后选择“可展开文件夹”。

|

||||

为了启用目录树,点击“控制”标签,然后“配置 Dolphin”、“显示模式”、“详细”,最后选择“可展开文件夹”。

|

||||

|

||||

记住这些仅仅是提示,不要强迫自己做阻碍自己的事情。你可能讨厌在 Dolphin 中使用文件树,你也可能从不使用 Pager,这都没关系。当然也可能会有你喜欢但是此处没列举出来的功能。选择对你有用处的,也就是说,这些技巧中总有一些能帮助你度过日常工作中的艰难时刻。

|

||||

|

||||

@ -79,7 +79,7 @@ via: https://www.maketecheasier.com/kde-plasma-tips-tricks-improve-productivity/

|

||||

|

||||

作者:[Nick Congleton][a]

|

||||

译者:[cycoe](https://github.com/cycoe)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,79 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (lujun9972)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-10574-1.html)

|

||||

[#]: subject: (Get started with Org mode without Emacs)

|

||||

[#]: via: (https://opensource.com/article/19/1/productivity-tool-org-mode)

|

||||

[#]: author: (Kevin Sonney https://opensource.com/users/ksonney (Kevin Sonney))

|

||||

|

||||

开始使用 Org 模式吧,在没有 Emacs 的情况下

|

||||

======

|

||||

|

||||

> 不,你不需要 Emacs 也能用 Org,这是我开源工具系列的第 16 集,将会让你在 2019 年变得更加有生产率。

|

||||

|

||||

|

||||

|

||||

每到年初似乎总有这么一个疯狂的冲动来寻找提高生产率的方法。新年决心,正确地开始一年的冲动,以及“向前看”的态度都是这种冲动的表现。软件推荐通常都会选择闭源和专利软件。但这不是必须的。

|

||||

|

||||

这是我 2019 年改进生产率的 19 个新工具中的第 16 个。

|

||||

|

||||

### Org (非 Emacs)

|

||||

|

||||

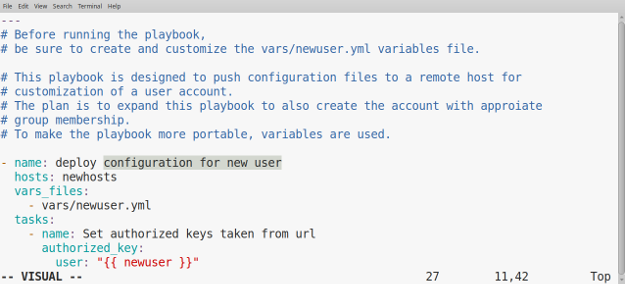

[Org 模式][1] (或者就称为 Org) 并不是新鲜货,但依然有许多人没有用过。他们很乐意试用一下以体验 Org 是如何改善生产率的。但最大的障碍来自于 Org 是与 Emacs 相关联的,而且很多人都认为两者缺一不可。并不是这样的!一旦你理解了其基础,Org 就可以与各种其他工具和编辑器一起使用。

|

||||

|

||||

|

||||

|

||||

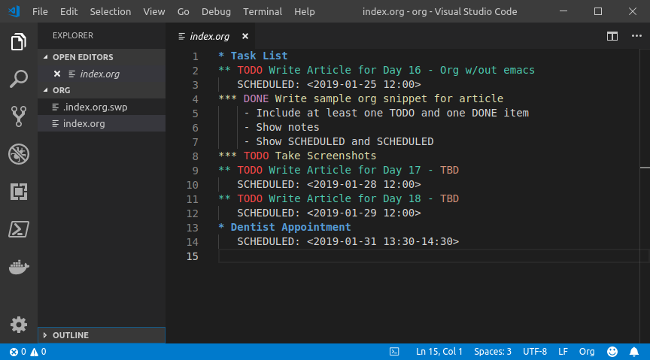

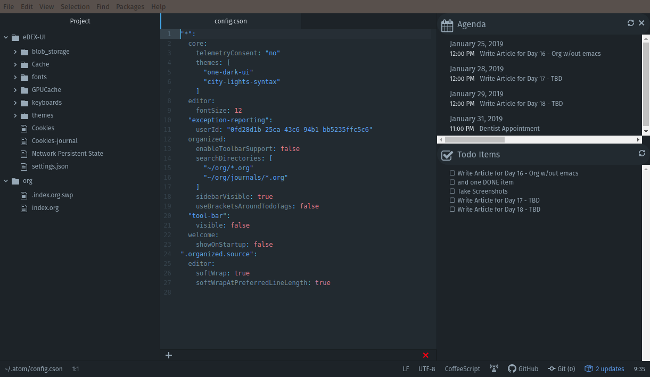

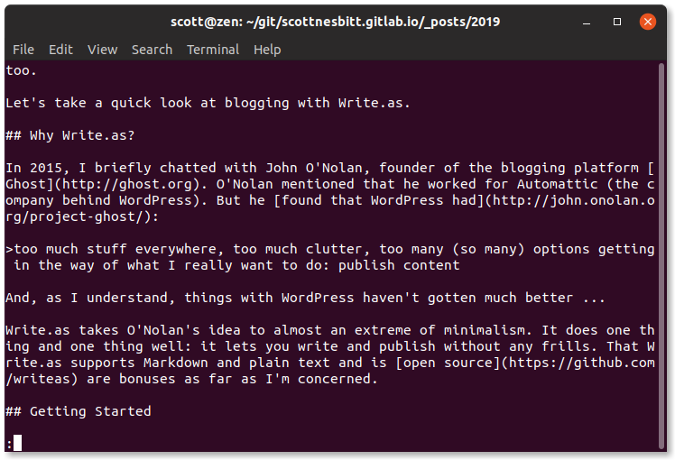

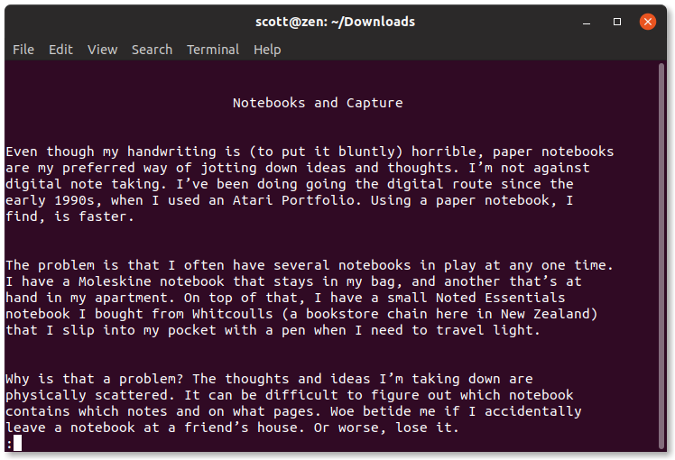

Org,本质上,是一个结构化的文本文件。它有标题、子标题,以及各种关键字,其他工具可以根据这些关键字将文件解析成日程表和代办列表。Org 文件可以被任何纯文本编辑器编辑(例如,[Vim][2]、[Atom][3] 或 [Visual Studio Code][4]),而且很多编辑器都有插件可以帮你创建和管理 Org 文件。

|

||||

|

||||

一个基础的 Org 文件看起来是这样的:

|

||||

|

||||

```

|

||||

* Task List

|

||||

** TODO Write Article for Day 16 - Org w/out emacs

|

||||

DEADLINE: <2019-01-25 12:00>

|

||||

*** DONE Write sample org snippet for article

|

||||

- Include at least one TODO and one DONE item

|

||||

- Show notes

|

||||

- Show SCHEDULED and DEADLINE

|

||||

*** TODO Take Screenshots

|

||||

** Dentist Appointment

|

||||

SCHEDULED: <2019-01-31 13:30-14:30>

|

||||

```

|

||||

|

||||

Org 是一种大纲格式,它使用 `*` 作为标识指明事项的级别。任何以 `TODO`(是的,全大些)开头的事项都是代办事项。标注为 `DONE` 的工作表示该工作已经完成。`SCHEDULED` 和 `DEADLINE` 标识与该事务相关的日期和时间。如何任何地方都没有时间,则该事务被视为全天活动。

|

||||

|

||||

使用正确的插件,你喜欢的文本编辑器可以成为一个充满生产率和组织能力的强大工具。例如,[vim-orgmode][5] 插件包括创建 Org 文件、语法高亮的功能,以及各种用来生成跨文件的日程和综合代办事项列表的关键命令。

|

||||

|

||||

|

||||

|

||||

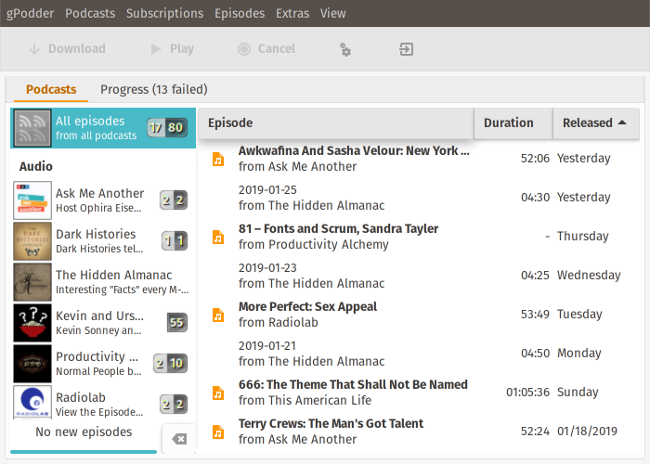

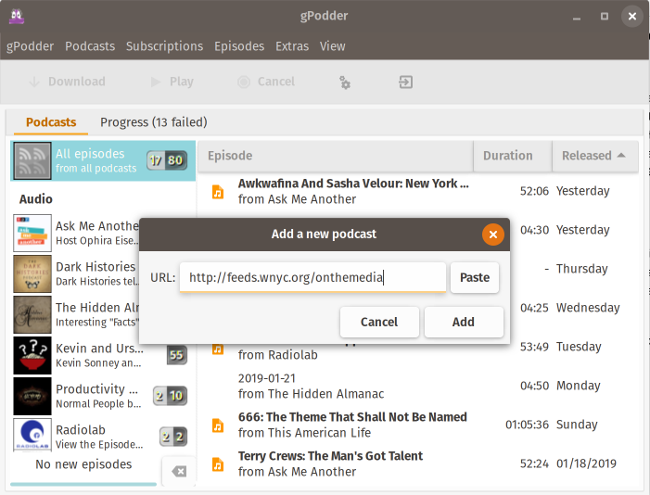

Atom 的 [Organized][6] 插件可以在屏幕右边添加一个侧边栏,用来显示 Org 文件中的日程和代办事项。默认情况下它从配置项中设置的路径中读取多个 Org 文件。Todo 侧边栏允许你通过点击未完事项来将其标记为已完成,它会自动更新源 Org 文件。

|

||||

|

||||

|

||||

|

||||

还有一大堆 Org 工具可以帮助你保持生产率。使用 Python、Perl、PHP、NodeJS 等库,你可以开发自己的脚本和工具。当然,少不了 [Emacs][7],它的核心功能就包括支持 Org。

|

||||

|

||||

|

||||

|

||||