mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-24 02:20:09 +08:00

Merge remote-tracking branch 'upstream/master'

This commit is contained in:

commit

9f71da54e1

22

Makefile

22

Makefile

@ -1,3 +1,6 @@

|

||||

DIR_PATTERN := (news|talk|tech)

|

||||

NAME_PATTERN := [0-9]{8} [a-zA-Z0-9_.,() -]*\.md

|

||||

|

||||

RULES := rule-source-added \

|

||||

rule-translation-requested \

|

||||

rule-translation-completed \

|

||||

@ -18,28 +21,31 @@ $(CHANGE_FILE):

|

||||

git --no-pager diff $(TRAVIS_BRANCH) FETCH_HEAD --no-renames --name-status > $@

|

||||

|

||||

rule-source-added:

|

||||

[ $(shell grep '^A\s*sources/[^\/]*/[a-zA-Z0-9_.,\(\) \-]*\.md' $(CHANGE_FILE) | wc -l) -ge 1 ]

|

||||

[ $(shell grep -v '^A\s*sources/[^\/]*/[a-zA-Z0-9_.,\(\) \-]*\.md' $(CHANGE_FILE) | wc -l) = 0 ]

|

||||

echo 'Unmatched Files:'

|

||||

egrep -v '^A\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) || true

|

||||

echo '[End of Unmatched Files]'

|

||||

[ $(shell egrep '^A\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) -ge 1 ]

|

||||

[ $(shell egrep -v '^A\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 0 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

|

||||

rule-translation-requested:

|

||||

[ $(shell grep '^M\s*sources/[^\/]*/[a-zA-Z0-9_.,\(\) \-]*\.md' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell egrep '^M\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell cat $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

|

||||

rule-translation-completed:

|

||||

[ $(shell grep '^D\s*sources/[^\/]*/[a-zA-Z0-9_.,\(\) \-]*\.md' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell grep '^A\s*translated/[^\/]*/[a-zA-Z0-9_.,\(\) \-]*\.md' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell egrep '^D\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell egrep '^A\s*"?translated/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell cat $(CHANGE_FILE) | wc -l) = 2 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

|

||||

rule-translation-revised:

|

||||

[ $(shell grep '^M\s*translated/[^\/]*/[a-zA-Z0-9_.,\(\) \-]*\.md' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell egrep '^M\s*"?translated/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell cat $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

|

||||

rule-translation-published:

|

||||

[ $(shell grep '^D\s*translated/[^\/]*/[a-zA-Z0-9_.,\(\) \-]*\.md' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell grep '^A\s*published/[a-zA-Z0-9_.,\(\) \-]*\.md' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell egrep '^D\s*"?translated/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell egrep '^A\s*"?published/$(NAME_PATTERN)' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell cat $(CHANGE_FILE) | wc -l) = 2 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

|

||||

@ -61,6 +61,8 @@ LCTT 的组成

|

||||

* 2017/03/16 提升 GHLandy、bestony、rusking 为新的 Core 成员。创建 Comic 小组。

|

||||

* 2017/04/11 启用头衔制,为各位重要成员颁发头衔。

|

||||

* 2017/11/21 鉴于 qhwdw 快速而上佳的翻译质量,提升 qhwdw 为新的 Core 成员。

|

||||

* 2017/11/19 wxy 在上海交大举办的 2017 中国开源年会上做了演讲:《[如何以翻译贡献参与开源社区](https://linux.cn/article-9084-1.html)》。

|

||||

* 2018/01/11 提升 lujun9972 成为核心成员,并加入选题组。

|

||||

|

||||

核心成员

|

||||

-------------------------------

|

||||

@ -88,6 +90,7 @@ LCTT 的组成

|

||||

- 核心成员 @ucasFL,

|

||||

- 核心成员 @rusking,

|

||||

- 核心成员 @qhwdw,

|

||||

- 核心成员 @lujun9972

|

||||

- 前任选题 @DeadFire,

|

||||

- 前任校对 @reinoir222,

|

||||

- 前任校对 @PurlingNayuki,

|

||||

|

||||

84

published/20090127 Anatomy of a Program in Memory.md

Normal file

84

published/20090127 Anatomy of a Program in Memory.md

Normal file

@ -0,0 +1,84 @@

|

||||

剖析内存中的程序之秘

|

||||

============================================================

|

||||

|

||||

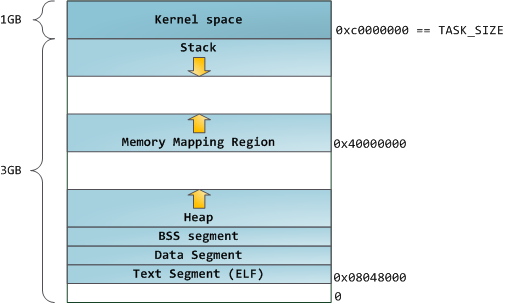

内存管理是操作系统的核心任务;它对程序员和系统管理员来说也是至关重要的。在接下来的几篇文章中,我将从实践出发着眼于内存管理,并深入到它的内部结构。虽然这些概念很通用,但示例大都来自于 32 位 x86 架构的 Linux 和 Windows 上。这第一篇文章描述了在内存中程序如何分布。

|

||||

|

||||

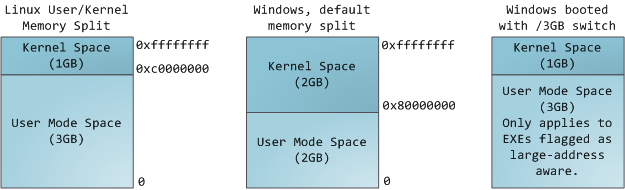

在一个多任务操作系统中的每个进程都运行在它自己的内存“沙箱”中。这个沙箱是一个<ruby>虚拟地址空间<rt>virtual address space</rt></ruby>,在 32 位的模式中它总共有 4GB 的内存地址块。这些虚拟地址是通过内核<ruby>页表<rt>page table</rt></ruby>映射到物理地址的,并且这些虚拟地址是由操作系统内核来维护,进而被进程所消费的。每个进程都有它自己的一组页表,但是这里有点玄机。一旦虚拟地址被启用,这些虚拟地址将被应用到这台电脑上的 _所有软件_,_包括内核本身_。因此,一部分虚拟地址空间必须保留给内核使用:

|

||||

|

||||

|

||||

|

||||

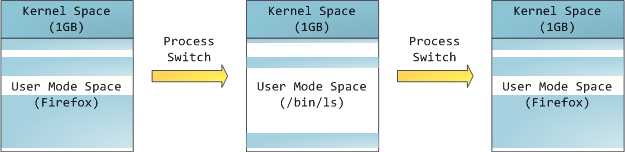

但是,这并**不是**说内核就使用了很多的物理内存,恰恰相反,它只使用了很少一部分可用的地址空间映射到其所需要的物理内存。内核空间在内核页表中被标记为独占使用于 [特权代码][1] (ring 2 或更低),因此,如果一个用户模式的程序尝试去访问它,将触发一个页面故障错误。在 Linux 中,内核空间是始终存在的,并且在所有进程中都映射相同的物理内存。内核代码和数据总是可寻址的,准备随时去处理中断或者系统调用。相比之下,用户模式中的地址空间,在每次进程切换时都会发生变化:

|

||||

|

||||

|

||||

|

||||

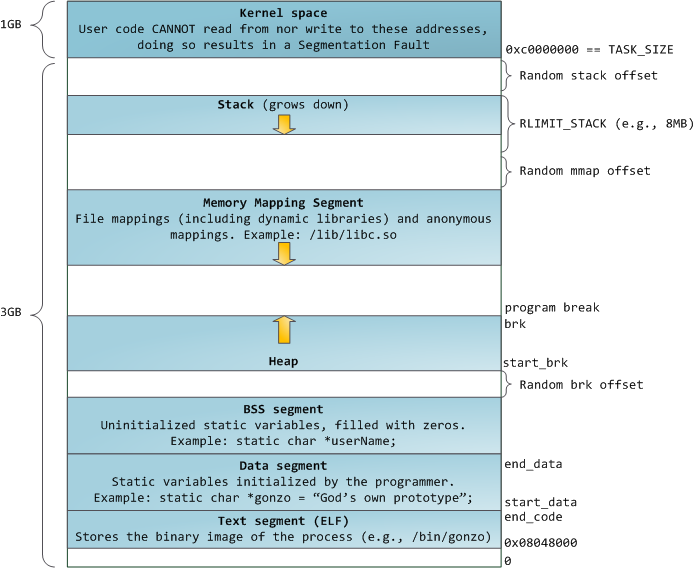

蓝色的区域代表映射到物理地址的虚拟地址空间,白色的区域是尚未映射的部分。在上面的示例中,众所周知的内存“饕餮” Firefox 使用了大量的虚拟内存空间。在地址空间中不同的条带对应了不同的内存段,像<ruby>堆<rt>heap</rt></ruby>、<ruby>栈<rt>stack</rt></ruby>等等。请注意,这些段只是一系列内存地址的简化表示,它与 [Intel 类型的段][2] _并没有任何关系_ 。不过,这是一个在 Linux 进程的标准段布局:

|

||||

|

||||

|

||||

|

||||

当计算机还是快乐、安全的时代时,在机器中的几乎每个进程上,那些段的起始虚拟地址都是**完全相同**的。这将使远程挖掘安全漏洞变得容易。漏洞利用经常需要去引用绝对内存位置:比如在栈中的一个地址,一个库函数的地址,等等。远程攻击可以闭着眼睛选择这个地址,因为地址空间都是相同的。当攻击者们这样做的时候,人们就会受到伤害。因此,地址空间随机化开始流行起来。Linux 会通过在其起始地址上增加偏移量来随机化[栈][3]、[内存映射段][4]、以及[堆][5]。不幸的是,32 位的地址空间是非常拥挤的,为地址空间随机化留下的空间不多,因此 [妨碍了地址空间随机化的效果][6]。

|

||||

|

||||

在进程地址空间中最高的段是栈,在大多数编程语言中它存储本地变量和函数参数。调用一个方法或者函数将推送一个新的<ruby>栈帧<rt>stack frame</rt></ruby>到这个栈。当函数返回时这个栈帧被删除。这个简单的设计,可能是因为数据严格遵循 [后进先出(LIFO)][7] 的次序,这意味着跟踪栈内容时不需要复杂的数据结构 —— 一个指向栈顶的简单指针就可以做到。推入和弹出也因此而非常快且准确。也可能是,持续的栈区重用往往会在 [CPU 缓存][8] 中保持活跃的栈内存,这样可以加快访问速度。进程中的每个线程都有它自己的栈。

|

||||

|

||||

向栈中推送更多的而不是刚合适的数据可能会耗尽栈的映射区域。这将触发一个页面故障,在 Linux 中它是通过 [`expand_stack()`][9] 来处理的,它会去调用 [`acct_stack_growth()`][10] 来检查栈的增长是否正常。如果栈的大小低于 `RLIMIT_STACK` 的值(一般是 8MB 大小),那么这是一个正常的栈增长和程序的合理使用,否则可能是发生了未知问题。这是一个栈大小按需调节的常见机制。但是,栈的大小达到了上述限制,将会发生一个栈溢出,并且,程序将会收到一个<ruby>段故障<rt>Segmentation Fault</rt></ruby>错误。当映射的栈区为满足需要而扩展后,在栈缩小时,映射区域并不会收缩。就像美国联邦政府的预算一样,它只会扩张。

|

||||

|

||||

动态栈增长是 [唯一例外的情况][11] ,当它去访问一个未映射的内存区域,如上图中白色部分,是允许的。除此之外的任何其它访问未映射的内存区域将触发一个页面故障,导致段故障。一些映射区域是只读的,因此,尝试去写入到这些区域也将触发一个段故障。

|

||||

|

||||

在栈的下面,有内存映射段。在这里,内核将文件内容直接映射到内存。任何应用程序都可以通过 Linux 的 [`mmap()`][12] 系统调用( [代码实现][13])或者 Windows 的 [`CreateFileMapping()`][14] / [`MapViewOfFile()`][15] 来请求一个映射。内存映射是实现文件 I/O 的方便高效的方式。因此,它经常被用于加载动态库。有时候,也被用于去创建一个并不匹配任何文件的匿名内存映射,这种映射经常被用做程序数据的替代。在 Linux 中,如果你通过 [`malloc()`][16] 去请求一个大的内存块,C 库将会创建这样一个匿名映射而不是使用堆内存。这里所谓的“大”表示是超过了`MMAP_THRESHOLD` 设置的字节数,它的缺省值是 128 kB,可以通过 [`mallopt()`][17] 去调整这个设置值。

|

||||

|

||||

接下来讲的是“堆”,就在我们接下来的地址空间中,堆提供运行时内存分配,像栈一样,但又不同于栈的是,它分配的数据生存期要长于分配它的函数。大多数编程语言都为程序提供了堆管理支持。因此,满足内存需要是编程语言运行时和内核共同来做的事情。在 C 中,堆分配的接口是 [`malloc()`][18] 一族,然而在支持垃圾回收的编程语言中,像 C#,这个接口使用 `new` 关键字。

|

||||

|

||||

如果在堆中有足够的空间可以满足内存请求,它可以由编程语言运行时来处理内存分配请求,而无需内核参与。否则将通过 [`brk()`][19] 系统调用([代码实现][20])来扩大堆以满足内存请求所需的大小。堆管理是比较 [复杂的][21],在面对我们程序的混乱分配模式时,它通过复杂的算法,努力在速度和内存使用效率之间取得一种平衡。服务一个堆请求所需要的时间可能是非常可观的。实时系统有一个 [特定用途的分配器][22] 去处理这个问题。堆也会出现 _碎片化_ ,如下图所示:

|

||||

|

||||

|

||||

|

||||

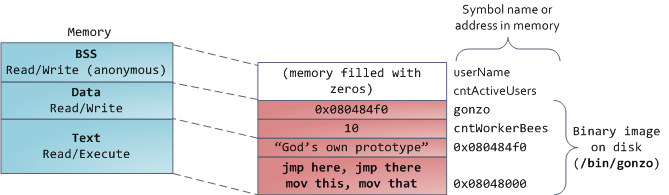

最后,我们抵达了内存的低位段:BSS、数据、以及程序文本。在 C 中,静态(全局)变量的内容都保存在 BSS 和数据中。它们之间的不同之处在于,BSS 保存 _未初始化的_ 静态变量的内容,它的值在源代码中并没有被程序员设置。BSS 内存区域是 _匿名_ 的:它没有映射到任何文件上。如果你在程序中写这样的语句 `static int cntActiveUsers`,`cntActiveUsers` 的内容就保存在 BSS 中。

|

||||

|

||||

反过来,数据段,用于保存在源代码中静态变量 _初始化后_ 的内容。这个内存区域是 _非匿名_ 的。它映射了程序的二进值镜像上的一部分,包含了在源代码中给定初始化值的静态变量内容。因此,如果你在程序中写这样的语句 `static int cntWorkerBees = 10`,那么,`cntWorkerBees` 的内容就保存在数据段中,并且初始值为 `10`。尽管可以通过数据段映射到一个文件,但是这是一个私有内存映射,意味着,如果改变内存,它并不会将这种变化反映到底层的文件上。必须是这样的,否则,分配的全局变量将会改变你磁盘上的二进制文件镜像,这种做法就太不可思议了!

|

||||

|

||||

用图去展示一个数据段是很困难的,因为它使用一个指针。在那种情况下,指针 `gonzo` 的_内容_(一个 4 字节的内存地址)保存在数据段上。然而,它并没有指向一个真实的字符串。而这个字符串存在于文本段中,文本段是只读的,它用于保存你的代码中的类似于字符串常量这样的内容。文本段也会在内存中映射你的二进制文件,但是,如果你的程序写入到这个区域,将会触发一个段故障错误。尽管在 C 中,它比不上从一开始就避免这种指针错误那么有效,但是,这种机制也有助于避免指针错误。这里有一个展示这些段和示例变量的图:

|

||||

|

||||

|

||||

|

||||

你可以通过读取 `/proc/pid_of_process/maps` 文件来检查 Linux 进程中的内存区域。请记住,一个段可以包含很多的区域。例如,每个内存映射的文件一般都在 mmap 段中的它自己的区域中,而动态库有类似于 BSS 和数据一样的额外的区域。下一篇文章中我们将详细说明“<ruby>区域<rt>area</rt></ruby>”的真正含义是什么。此外,有时候人们所说的“<ruby>数据段<rt>data segment</rt></ruby>”是指“<ruby>数据<rt>data</rt></ruby> + BSS + 堆”。

|

||||

|

||||

你可以使用 [nm][23] 和 [objdump][24] 命令去检查二进制镜像,去显示它们的符号、地址、段等等。最终,在 Linux 中上面描述的虚拟地址布局是一个“弹性的”布局,这就是这几年来的缺省情况。它假设 `RLIMIT_STACK` 有一个值。如果没有值的话,Linux 将恢复到如下所示的“经典” 布局:

|

||||

|

||||

|

||||

|

||||

这就是虚拟地址空间布局。接下来的文章将讨论内核如何对这些内存区域保持跟踪、内存映射、文件如何读取和写入、以及内存使用数据的意义。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://duartes.org/gustavo/blog/post/anatomy-of-a-program-in-memory/

|

||||

|

||||

作者:[Gustavo Duarte][a]

|

||||

译者:[qhwdw](https://github.com/qhwdw)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://duartes.org/gustavo/blog/about/

|

||||

[1]:http://duartes.org/gustavo/blog/post/cpu-rings-privilege-and-protection

|

||||

[2]:http://duartes.org/gustavo/blog/post/memory-translation-and-segmentation

|

||||

[3]:http://lxr.linux.no/linux+v2.6.28.1/fs/binfmt_elf.c#L542

|

||||

[4]:http://lxr.linux.no/linux+v2.6.28.1/arch/x86/mm/mmap.c#L84

|

||||

[5]:http://lxr.linux.no/linux+v2.6.28.1/arch/x86/kernel/process_32.c#L729

|

||||

[6]:http://www.stanford.edu/~blp/papers/asrandom.pdf

|

||||

[7]:http://en.wikipedia.org/wiki/Lifo

|

||||

[8]:http://duartes.org/gustavo/blog/post/intel-cpu-caches

|

||||

[9]:http://lxr.linux.no/linux+v2.6.28/mm/mmap.c#L1716

|

||||

[10]:http://lxr.linux.no/linux+v2.6.28/mm/mmap.c#L1544

|

||||

[11]:http://lxr.linux.no/linux+v2.6.28.1/arch/x86/mm/fault.c#L692

|

||||

[12]:http://www.kernel.org/doc/man-pages/online/pages/man2/mmap.2.html

|

||||

[13]:http://lxr.linux.no/linux+v2.6.28.1/arch/x86/kernel/sys_i386_32.c#L27

|

||||

[14]:http://msdn.microsoft.com/en-us/library/aa366537(VS.85).aspx

|

||||

[15]:http://msdn.microsoft.com/en-us/library/aa366761(VS.85).aspx

|

||||

[16]:http://www.kernel.org/doc/man-pages/online/pages/man3/malloc.3.html

|

||||

[17]:http://www.kernel.org/doc/man-pages/online/pages/man3/undocumented.3.html

|

||||

[18]:http://www.kernel.org/doc/man-pages/online/pages/man3/malloc.3.html

|

||||

[19]:http://www.kernel.org/doc/man-pages/online/pages/man2/brk.2.html

|

||||

[20]:http://lxr.linux.no/linux+v2.6.28.1/mm/mmap.c#L248

|

||||

[21]:http://g.oswego.edu/dl/html/malloc.html

|

||||

[22]:http://rtportal.upv.es/rtmalloc/

|

||||

[23]:http://manpages.ubuntu.com/manpages/intrepid/en/man1/nm.1.html

|

||||

[24]:http://manpages.ubuntu.com/manpages/intrepid/en/man1/objdump.1.html

|

||||

@ -0,0 +1,231 @@

|

||||

在不重启的情况下为 Vmware Linux 客户机添加新硬盘

|

||||

======

|

||||

|

||||

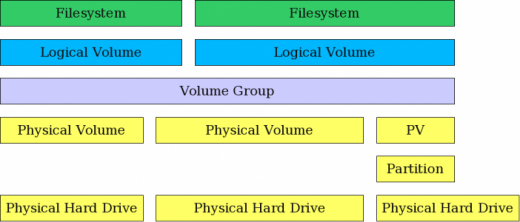

作为一名系统管理员,我经常需要用额外的硬盘来扩充存储空间或将系统数据从用户数据中分离出来。我将告诉你在将物理块设备加到虚拟主机的这个过程中,如何将一个主机上的硬盘加到一台使用 VMWare 软件虚拟化的 Linux 客户机上。

|

||||

|

||||

你可以显式的添加或删除一个 SCSI 设备,或者重新扫描整个 SCSI 总线而不用重启 Linux 虚拟机。本指南在 Vmware Server 和 Vmware Workstation v6.0 中通过测试(更老版本应该也支持)。所有命令在 RHEL、Fedora、CentOS 和 Ubuntu Linux 客户机 / 主机操作系统下都经过了测试。

|

||||

|

||||

### 步骤 1:添加新硬盘到虚拟客户机

|

||||

|

||||

首先,通过 vmware 硬件设置菜单添加硬盘。点击 “VM > Settings”

|

||||

|

||||

![Fig.01:Vmware Virtual Machine Settings ][1]

|

||||

|

||||

或者你也可以按下 `CTRL + D` 也能进入设置对话框。

|

||||

|

||||

点击 “Add” 添加新硬盘到客户机:

|

||||

|

||||

![Fig.02:VMWare adding a new hardware][2]

|

||||

|

||||

选择硬件类型为“Hard disk”然后点击 “Next”:

|

||||

|

||||

![Fig.03 VMware Adding a new disk wizard ][3]

|

||||

|

||||

选择 “create a new virtual disk” 然后点击 “Next”:

|

||||

|

||||

![Fig.04:Vmware Wizard Disk ][4]

|

||||

|

||||

设置虚拟磁盘类型为 “SCSI” ,然后点击 “Next”:

|

||||

|

||||

![Fig.05:Vmware Virtual Disk][5]

|

||||

|

||||

按需要设置最大磁盘大小,然后点击 “Next”

|

||||

|

||||

![Fig.06:Finalizing Disk Virtual Addition ][6]

|

||||

|

||||

最后,选择文件存放位置然后点击 “Finish”。

|

||||

|

||||

### 步骤 2:重新扫描 SCSI 总线,在不重启虚拟机的情况下添加 SCSI 设备

|

||||

|

||||

输入下面命令重新扫描 SCSI 总线:

|

||||

|

||||

```

|

||||

echo "- - -" > /sys/class/scsi_host/host# /scan

|

||||

fdisk -l

|

||||

tail -f /var/log/message

|

||||

```

|

||||

|

||||

输出为:

|

||||

|

||||

![Linux Vmware Rescan New Scsi Disk Without Reboot][7]

|

||||

|

||||

你需要将 `host#` 替换成真实的值,比如 `host0`。你可以通过下面命令来查出这个值:

|

||||

|

||||

`# ls /sys/class/scsi_host`

|

||||

|

||||

输出:

|

||||

|

||||

```

|

||||

host0

|

||||

```

|

||||

|

||||

然后输入下面过命令来请求重新扫描:

|

||||

|

||||

```

|

||||

echo "- - -" > /sys/class/scsi_host/host0/scan

|

||||

fdisk -l

|

||||

tail -f /var/log/message

|

||||

```

|

||||

|

||||

输出为:

|

||||

|

||||

```

|

||||

Jul 18 16:29:39 localhost kernel: Vendor: VMware, Model: VMware Virtual S Rev: 1.0

|

||||

Jul 18 16:29:39 localhost kernel: Type: Direct-Access ANSI SCSI revision: 02

|

||||

Jul 18 16:29:39 localhost kernel: target0:0:1: Beginning Domain Validation

|

||||

Jul 18 16:29:39 localhost kernel: target0:0:1: Domain Validation skipping write tests

|

||||

Jul 18 16:29:39 localhost kernel: target0:0:1: Ending Domain Validation

|

||||

Jul 18 16:29:39 localhost kernel: target0:0:1: FAST-40 WIDE SCSI 80.0 MB/s ST (25 ns, offset 127)

|

||||

Jul 18 16:29:39 localhost kernel: SCSI device sdb: 2097152 512-byte hdwr sectors (1074 MB)

|

||||

Jul 18 16:29:39 localhost kernel: sdb: Write Protect is off

|

||||

Jul 18 16:29:39 localhost kernel: sdb: cache data unavailable

|

||||

Jul 18 16:29:39 localhost kernel: sdb: assuming drive cache: write through

|

||||

Jul 18 16:29:39 localhost kernel: SCSI device sdb: 2097152 512-byte hdwr sectors (1074 MB)

|

||||

Jul 18 16:29:39 localhost kernel: sdb: Write Protect is off

|

||||

Jul 18 16:29:39 localhost kernel: sdb: cache data unavailable

|

||||

Jul 18 16:29:39 localhost kernel: sdb: assuming drive cache: write through

|

||||

Jul 18 16:29:39 localhost kernel: sdb: unknown partition table

|

||||

Jul 18 16:29:39 localhost kernel: sd 0:0:1:0: Attached scsi disk sdb

|

||||

Jul 18 16:29:39 localhost kernel: sd 0:0:1:0: Attached scsi generic sg1 type 0

|

||||

Jul 18 16:29:39 localhost kernel: Vendor: VMware, Model: VMware Virtual S Rev: 1.0

|

||||

Jul 18 16:29:39 localhost kernel: Type: Direct-Access ANSI SCSI revision: 02

|

||||

Jul 18 16:29:39 localhost kernel: target0:0:2: Beginning Domain Validation

|

||||

Jul 18 16:29:39 localhost kernel: target0:0:2: Domain Validation skipping write tests

|

||||

Jul 18 16:29:39 localhost kernel: target0:0:2: Ending Domain Validation

|

||||

Jul 18 16:29:39 localhost kernel: target0:0:2: FAST-40 WIDE SCSI 80.0 MB/s ST (25 ns, offset 127)

|

||||

Jul 18 16:29:39 localhost kernel: SCSI device sdc: 2097152 512-byte hdwr sectors (1074 MB)

|

||||

Jul 18 16:29:39 localhost kernel: sdc: Write Protect is off

|

||||

Jul 18 16:29:39 localhost kernel: sdc: cache data unavailable

|

||||

Jul 18 16:29:39 localhost kernel: sdc: assuming drive cache: write through

|

||||

Jul 18 16:29:39 localhost kernel: SCSI device sdc: 2097152 512-byte hdwr sectors (1074 MB)

|

||||

Jul 18 16:29:39 localhost kernel: sdc: Write Protect is off

|

||||

Jul 18 16:29:39 localhost kernel: sdc: cache data unavailable

|

||||

Jul 18 16:29:39 localhost kernel: sdc: assuming drive cache: write through

|

||||

Jul 18 16:29:39 localhost kernel: sdc: unknown partition table

|

||||

Jul 18 16:29:39 localhost kernel: sd 0:0:2:0: Attached scsi disk sdc

|

||||

Jul 18 16:29:39 localhost kernel: sd 0:0:2:0: Attached scsi generic sg2 type 0

|

||||

```

|

||||

|

||||

#### 如何删除 /dev/sdc 这块设备?

|

||||

|

||||

除了重新扫描整个总线外,你也可以使用下面命令添加或删除指定磁盘:

|

||||

|

||||

```

|

||||

# echo 1 > /sys/block/devName/device/delete

|

||||

# echo 1 > /sys/block/sdc/device/delete

|

||||

```

|

||||

|

||||

#### 如何添加 /dev/sdc 这块设备?

|

||||

|

||||

使用下面语法添加指定设备:

|

||||

|

||||

```

|

||||

# echo "scsi add-single-device <H> <B> <T> <L>" > /proc/scsi/scsi

|

||||

```

|

||||

|

||||

这里,

|

||||

|

||||

* <H>:主机

|

||||

* <B>:总线(通道)

|

||||

* <T>:目标 (Id)

|

||||

* <L>:LUN 号

|

||||

|

||||

例如。使用参数 `host#0`,`bus#0`,`target#2`,以及 `LUN#0` 来添加 `/dev/sdc`,则输入:

|

||||

|

||||

```

|

||||

# echo "scsi add-single-device 0 0 2 0">/proc/scsi/scsi

|

||||

# fdisk -l

|

||||

# cat /proc/scsi/scsi

|

||||

```

|

||||

|

||||

结果输出:

|

||||

|

||||

```

|

||||

Attached devices:

|

||||

Host: scsi0 Channel: 00 Id: 00 Lun: 00

|

||||

Vendor: VMware, Model: VMware Virtual S Rev: 1.0

|

||||

Type: Direct-Access ANSI SCSI revision: 02

|

||||

Host: scsi0 Channel: 00 Id: 01 Lun: 00

|

||||

Vendor: VMware, Model: VMware Virtual S Rev: 1.0

|

||||

Type: Direct-Access ANSI SCSI revision: 02

|

||||

Host: scsi0 Channel: 00 Id: 02 Lun: 00

|

||||

Vendor: VMware, Model: VMware Virtual S Rev: 1.0

|

||||

Type: Direct-Access ANSI SCSI revision: 02

|

||||

```

|

||||

|

||||

### 步骤 #3:格式化新磁盘

|

||||

|

||||

现在使用 [fdisk 并通过 mkfs.ext3][8] 命令创建分区:

|

||||

|

||||

```

|

||||

# fdisk /dev/sdc

|

||||

### [if you want ext3 fs] ###

|

||||

# mkfs.ext3 /dev/sdc3

|

||||

### [if you want ext4 fs] ###

|

||||

# mkfs.ext4 /dev/sdc3

|

||||

```

|

||||

|

||||

### 步骤 #4:创建挂载点并更新 /etc/fstab

|

||||

|

||||

```

|

||||

# mkdir /disk3

|

||||

```

|

||||

|

||||

打开 `/etc/fstab` 文件,输入:

|

||||

|

||||

```

|

||||

# vi /etc/fstab

|

||||

```

|

||||

|

||||

加入下面这行:

|

||||

|

||||

```

|

||||

/dev/sdc3 /disk3 ext3 defaults 1 2

|

||||

```

|

||||

|

||||

若是 ext4 文件系统则加入:

|

||||

|

||||

```

|

||||

/dev/sdc3 /disk3 ext4 defaults 1 2

|

||||

```

|

||||

|

||||

保存并关闭文件。

|

||||

|

||||

#### 可选操作:为分区加标签

|

||||

|

||||

[你可以使用 e2label 命令为分区加标签 ][9]。假设,你想要为 `/backupDisk` 这块新分区加标签,则输入:

|

||||

|

||||

```

|

||||

# e2label /dev/sdc1 /backupDisk

|

||||

```

|

||||

|

||||

详情参见 "[Linux 分区的重要性 ][10]。

|

||||

|

||||

### 关于作者

|

||||

|

||||

作者是 nixCraft 的创始人,也是一名经验丰富的系统管理员,还是 Linux 操作系统 /Unix shell 脚本培训师。他曾服务过全球客户并与多个行业合作过,包括 IT,教育,国防和空间研究,以及非盈利机构。你可以在 [Twitter][11],[Facebook][12],[Google+][13] 上关注他。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.cyberciti.biz/tips/vmware-add-a-new-hard-disk-without-rebooting-guest.html

|

||||

|

||||

作者:[Vivek Gite][a]

|

||||

译者:[lujun9972](https://github.com/lujun9972)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.cyberciti.biz

|

||||

[1]:https://www.cyberciti.biz/media/new/tips/2009/07/virtual-machine-settings-1.png (Vmware Virtual Machine Settings )

|

||||

[2]:https://www.cyberciti.biz/media/new/tips/2009/07/vmware-add-hardware-wizard-2.png (VMWare adding a new hardware)

|

||||

[3]:https://www.cyberciti.biz/media/new/tips/2009/07/vmware-add-hardware-anew-disk-3.png (VMware Adding a new disk wizard )

|

||||

[4]:https://www.cyberciti.biz/media/new/tips/2009/07/vmware-add-hardware-4.png (Vmware Wizard Disk )

|

||||

[5]:https://www.cyberciti.biz/media/new/tips/2009/07/add-hardware-5.png (Vmware Virtual Disk)

|

||||

[6]:https://www.cyberciti.biz/media/new/tips/2009/07/vmware-final-disk-file-add-hdd-6.png (Finalizing Disk Virtual Addition)

|

||||

[7]:https://www.cyberciti.biz/media/new/tips/2009/07/vmware-linux-rescan-hard-disk.png (Linux Vmware Rescan New Scsi Disk Without Reboot)

|

||||

[8]:https://www.cyberciti.biz/faq/linux-disk-format/

|

||||

[9]:https://www.cyberciti.biz/faq/linux-modify-partition-labels-command-to-change-diskname/

|

||||

[10]:https://www.cyberciti.biz/faq/linux-partition-howto-set-labels/>how%20to%20label%20a%20Linux%20partition</a>%E2%80%9D%20for%20more%20info.</p><h2>Conclusion</h2><p>The%20VMware%20guest%20now%20has%20an%20additional%20virtualized%20storage%20device.%20%20The%20procedure%20works%20for%20all%20physical%20block%20devices,%20this%20includes%20CD-ROM,%20DVD%20and%20floppy%20devices.%20Next,%20time%20I%20will%20write%20about%20adding%20an%20additional%20virtualized%20storage%20device%20using%20XEN%20software.</p><h2>See%20also</h2><ul><li><a%20href=

|

||||

[11]:https://twitter.com/nixcraft

|

||||

[12]:https://facebook.com/nixcraft

|

||||

[13]:https://plus.google.com/+CybercitiBiz

|

||||

@ -0,0 +1,584 @@

|

||||

30 个方便的 Bash shell 别名

|

||||

======

|

||||

|

||||

bash <ruby>别名<rt>alias</rt></ruby>只不过是指向命令的快捷方式而已。`alias` 命令允许用户只输入一个单词就运行任意一个命令或一组命令(包括命令选项和文件名)。执行 `alias` 命令会显示一个所有已定义别名的列表。你可以在 [~/.bashrc][1] 文件中自定义别名。使用别名可以在命令行中减少输入的时间,使工作更流畅,同时增加生产率。

|

||||

|

||||

本文通过 30 个 bash shell 别名的实际案例演示了如何创建和使用别名。

|

||||

|

||||

![30 Useful Bash Shell Aliase For Linux/Unix Users][2]

|

||||

|

||||

### bash alias 的那些事

|

||||

|

||||

bash shell 中的 alias 命令的语法是这样的:

|

||||

|

||||

```

|

||||

alias [alias-name[=string]...]

|

||||

```

|

||||

|

||||

#### 如何列出 bash 别名

|

||||

|

||||

输入下面的 [alias 命令][3]:

|

||||

|

||||

```

|

||||

alias

|

||||

```

|

||||

|

||||

结果为:

|

||||

|

||||

```

|

||||

alias ..='cd ..'

|

||||

alias amazonbackup='s3backup'

|

||||

alias apt-get='sudo apt-get'

|

||||

...

|

||||

```

|

||||

|

||||

`alias` 命令默认会列出当前用户定义好的别名。

|

||||

|

||||

#### 如何定义或者创建一个 bash shell 别名

|

||||

|

||||

使用下面语法 [创建别名][4]:

|

||||

|

||||

```

|

||||

alias name =value

|

||||

alias name = 'command'

|

||||

alias name = 'command arg1 arg2'

|

||||

alias name = '/path/to/script'

|

||||

alias name = '/path/to/script.pl arg1'

|

||||

```

|

||||

|

||||

举个例子,输入下面命令并回车就会为常用的 `clear`(清除屏幕)命令创建一个别名 `c`:

|

||||

|

||||

```

|

||||

alias c = 'clear'

|

||||

```

|

||||

|

||||

然后输入字母 `c` 而不是 `clear` 后回车就会清除屏幕了:

|

||||

|

||||

```

|

||||

c

|

||||

```

|

||||

|

||||

#### 如何临时性地禁用 bash 别名

|

||||

|

||||

下面语法可以[临时性地禁用别名][5]:

|

||||

|

||||

```

|

||||

## path/to/full/command

|

||||

/usr/bin/clear

|

||||

## call alias with a backslash ##

|

||||

\c

|

||||

## use /bin/ls command and avoid ls alias ##

|

||||

command ls

|

||||

```

|

||||

|

||||

#### 如何删除 bash 别名

|

||||

|

||||

使用 [unalias 命令来删除别名][6]。其语法为:

|

||||

|

||||

```

|

||||

unalias aliasname

|

||||

unalias foo

|

||||

```

|

||||

|

||||

例如,删除我们之前创建的别名 `c`:

|

||||

|

||||

```

|

||||

unalias c

|

||||

```

|

||||

|

||||

你还需要用文本编辑器删掉 [~/.bashrc 文件][1] 中的别名定义(参见下一部分内容)。

|

||||

|

||||

#### 如何让 bash shell 别名永久生效

|

||||

|

||||

别名 `c` 在当前登录会话中依然有效。但当你登出或重启系统后,别名 `c` 就没有了。为了防止出现这个问题,将别名定义写入 [~/.bashrc file][1] 中,输入:

|

||||

|

||||

```

|

||||

vi ~/.bashrc

|

||||

```

|

||||

|

||||

输入下行内容让别名 `c` 对当前用户永久有效:

|

||||

|

||||

```

|

||||

alias c = 'clear'

|

||||

```

|

||||

|

||||

保存并关闭文件就行了。系统级的别名(也就是对所有用户都生效的别名)可以放在 `/etc/bashrc` 文件中。请注意,`alias` 命令内建于各种 shell 中,包括 ksh,tcsh/csh,ash,bash 以及其他 shell。

|

||||

|

||||

#### 关于特权权限判断

|

||||

|

||||

可以将下面代码加入 `~/.bashrc`:

|

||||

|

||||

```

|

||||

# if user is not root, pass all commands via sudo #

|

||||

if [ $UID -ne 0 ]; then

|

||||

alias reboot='sudo reboot'

|

||||

alias update='sudo apt-get upgrade'

|

||||

fi

|

||||

```

|

||||

|

||||

#### 定义与操作系统类型相关的别名

|

||||

|

||||

可以将下面代码加入 `~/.bashrc` [使用 case 语句][7]:

|

||||

|

||||

```

|

||||

### Get os name via uname ###

|

||||

_myos="$(uname)"

|

||||

|

||||

### add alias as per os using $_myos ###

|

||||

case $_myos in

|

||||

Linux) alias foo='/path/to/linux/bin/foo';;

|

||||

FreeBSD|OpenBSD) alias foo='/path/to/bsd/bin/foo' ;;

|

||||

SunOS) alias foo='/path/to/sunos/bin/foo' ;;

|

||||

*) ;;

|

||||

esac

|

||||

```

|

||||

|

||||

### 30 个 bash shell 别名的案例

|

||||

|

||||

你可以定义各种类型的别名来节省时间并提高生产率。

|

||||

|

||||

#### #1:控制 ls 命令的输出

|

||||

|

||||

[ls 命令列出目录中的内容][8] 而你可以对输出进行着色:

|

||||

|

||||

```

|

||||

## Colorize the ls output ##

|

||||

alias ls = 'ls --color=auto'

|

||||

|

||||

## Use a long listing format ##

|

||||

alias ll = 'ls -la'

|

||||

|

||||

## Show hidden files ##

|

||||

alias l.= 'ls -d . .. .git .gitignore .gitmodules .travis.yml --color=auto'

|

||||

```

|

||||

|

||||

#### #2:控制 cd 命令的行为

|

||||

|

||||

```

|

||||

## get rid of command not found ##

|

||||

alias cd..= 'cd ..'

|

||||

|

||||

## a quick way to get out of current directory ##

|

||||

alias ..= 'cd ..'

|

||||

alias ...= 'cd ../../../'

|

||||

alias ....= 'cd ../../../../'

|

||||

alias .....= 'cd ../../../../'

|

||||

alias .4= 'cd ../../../../'

|

||||

alias .5= 'cd ../../../../..'

|

||||

```

|

||||

|

||||

#### #3:控制 grep 命令的输出

|

||||

|

||||

[grep 命令是一个用于在纯文本文件中搜索匹配正则表达式的行的命令行工具][9]:

|

||||

|

||||

```

|

||||

## Colorize the grep command output for ease of use (good for log files)##

|

||||

alias grep = 'grep --color=auto'

|

||||

alias egrep = 'egrep --color=auto'

|

||||

alias fgrep = 'fgrep --color=auto'

|

||||

```

|

||||

|

||||

#### #4:让计算器默认开启 math 库

|

||||

|

||||

```

|

||||

alias bc = 'bc -l'

|

||||

```

|

||||

|

||||

#### #4:生成 sha1 数字签名

|

||||

|

||||

```

|

||||

alias sha1 = 'openssl sha1'

|

||||

```

|

||||

|

||||

#### #5:自动创建父目录

|

||||

|

||||

[mkdir 命令][10] 用于创建目录:

|

||||

|

||||

```

|

||||

alias mkdir = 'mkdir -pv'

|

||||

```

|

||||

|

||||

#### #6:为 diff 输出着色

|

||||

|

||||

你可以[使用 diff 来一行行第比较文件][11] 而一个名为 `colordiff` 的工具可以为 diff 输出着色:

|

||||

|

||||

```

|

||||

# install colordiff package :)

|

||||

alias diff = 'colordiff'

|

||||

```

|

||||

|

||||

#### #7:让 mount 命令的输出更漂亮,更方便人类阅读

|

||||

|

||||

```

|

||||

alias mount = 'mount |column -t'

|

||||

```

|

||||

|

||||

#### #8:简化命令以节省时间

|

||||

|

||||

```

|

||||

# handy short cuts #

|

||||

alias h = 'history'

|

||||

alias j = 'jobs -l'

|

||||

```

|

||||

|

||||

#### #9:创建一系列新命令

|

||||

|

||||

```

|

||||

alias path = 'echo -e ${PATH//:/\\n}'

|

||||

alias now = 'date +"%T"'

|

||||

alias nowtime =now

|

||||

alias nowdate = 'date +"%d-%m-%Y"'

|

||||

```

|

||||

|

||||

#### #10:设置 vim 为默认编辑器

|

||||

|

||||

```

|

||||

alias vi = vim

|

||||

alias svi = 'sudo vi'

|

||||

alias vis = 'vim "+set si"'

|

||||

alias edit = 'vim'

|

||||

```

|

||||

|

||||

#### #11:控制网络工具 ping 的输出

|

||||

|

||||

```

|

||||

# Stop after sending count ECHO_REQUEST packets #

|

||||

alias ping = 'ping -c 5'

|

||||

|

||||

# Do not wait interval 1 second, go fast #

|

||||

alias fastping = 'ping -c 100 -s.2'

|

||||

```

|

||||

|

||||

#### #12:显示打开的端口

|

||||

|

||||

使用 [netstat 命令][12] 可以快速列出服务区中所有的 TCP/UDP 端口:

|

||||

|

||||

```

|

||||

alias ports = 'netstat -tulanp'

|

||||

```

|

||||

|

||||

#### #13:唤醒休眠的服务器

|

||||

|

||||

[Wake-on-LAN (WOL) 是一个以太网标准][13],可以通过网络消息来开启服务器。你可以使用下面别名来[快速激活 nas 设备][14] 以及服务器:

|

||||

|

||||

```

|

||||

## replace mac with your actual server mac address #

|

||||

alias wakeupnas01 = '/usr/bin/wakeonlan 00:11:32:11:15:FC'

|

||||

alias wakeupnas02 = '/usr/bin/wakeonlan 00:11:32:11:15:FD'

|

||||

alias wakeupnas03 = '/usr/bin/wakeonlan 00:11:32:11:15:FE'

|

||||

```

|

||||

|

||||

#### #14:控制防火墙 (iptables) 的输出

|

||||

|

||||

[Netfilter 是一款 Linux 操作系统上的主机防火墙][15]。它是 Linux 发行版中的一部分,且默认情况下是激活状态。[这里列出了大多数 Liux 新手防护入侵者最常用的 iptables 方法][16]。

|

||||

|

||||

```

|

||||

## shortcut for iptables and pass it via sudo#

|

||||

alias ipt = 'sudo /sbin/iptables'

|

||||

|

||||

# display all rules #

|

||||

alias iptlist = 'sudo /sbin/iptables -L -n -v --line-numbers'

|

||||

alias iptlistin = 'sudo /sbin/iptables -L INPUT -n -v --line-numbers'

|

||||

alias iptlistout = 'sudo /sbin/iptables -L OUTPUT -n -v --line-numbers'

|

||||

alias iptlistfw = 'sudo /sbin/iptables -L FORWARD -n -v --line-numbers'

|

||||

alias firewall =iptlist

|

||||

```

|

||||

|

||||

#### #15:使用 curl 调试 web 服务器 / CDN 上的问题

|

||||

|

||||

```

|

||||

# get web server headers #

|

||||

alias header = 'curl -I'

|

||||

|

||||

# find out if remote server supports gzip / mod_deflate or not #

|

||||

alias headerc = 'curl -I --compress'

|

||||

```

|

||||

|

||||

#### #16:增加安全性

|

||||

|

||||

```

|

||||

# do not delete / or prompt if deleting more than 3 files at a time #

|

||||

alias rm = 'rm -I --preserve-root'

|

||||

|

||||

# confirmation #

|

||||

alias mv = 'mv -i'

|

||||

alias cp = 'cp -i'

|

||||

alias ln = 'ln -i'

|

||||

|

||||

# Parenting changing perms on / #

|

||||

alias chown = 'chown --preserve-root'

|

||||

alias chmod = 'chmod --preserve-root'

|

||||

alias chgrp = 'chgrp --preserve-root'

|

||||

```

|

||||

|

||||

#### #17:更新 Debian Linux 服务器

|

||||

|

||||

[apt-get 命令][17] 用于通过因特网安装软件包 (ftp 或 http)。你也可以一次性升级所有软件包:

|

||||

|

||||

```

|

||||

# distro specific - Debian / Ubuntu and friends #

|

||||

# install with apt-get

|

||||

alias apt-get= "sudo apt-get"

|

||||

alias updatey = "sudo apt-get --yes"

|

||||

|

||||

# update on one command

|

||||

alias update = 'sudo apt-get update && sudo apt-get upgrade'

|

||||

```

|

||||

|

||||

#### #18:更新 RHEL / CentOS / Fedora Linux 服务器

|

||||

|

||||

[yum 命令][18] 是 RHEL / CentOS / Fedora Linux 以及其他基于这些发行版的 Linux 上的软件包管理工具:

|

||||

|

||||

```

|

||||

## distrp specifc RHEL/CentOS ##

|

||||

alias update = 'yum update'

|

||||

alias updatey = 'yum -y update'

|

||||

```

|

||||

|

||||

#### #19:优化 sudo 和 su 命令

|

||||

|

||||

```

|

||||

# become root #

|

||||

alias root = 'sudo -i'

|

||||

alias su = 'sudo -i'

|

||||

```

|

||||

|

||||

#### #20:使用 sudo 执行 halt/reboot 命令

|

||||

|

||||

[shutdown 命令][19] 会让 Linux / Unix 系统关机:

|

||||

```

|

||||

# reboot / halt / poweroff

|

||||

alias reboot = 'sudo /sbin/reboot'

|

||||

alias poweroff = 'sudo /sbin/poweroff'

|

||||

alias halt = 'sudo /sbin/halt'

|

||||

alias shutdown = 'sudo /sbin/shutdown'

|

||||

```

|

||||

|

||||

#### #21:控制 web 服务器

|

||||

|

||||

```

|

||||

# also pass it via sudo so whoever is admin can reload it without calling you #

|

||||

alias nginxreload = 'sudo /usr/local/nginx/sbin/nginx -s reload'

|

||||

alias nginxtest = 'sudo /usr/local/nginx/sbin/nginx -t'

|

||||

alias lightyload = 'sudo /etc/init.d/lighttpd reload'

|

||||

alias lightytest = 'sudo /usr/sbin/lighttpd -f /etc/lighttpd/lighttpd.conf -t'

|

||||

alias httpdreload = 'sudo /usr/sbin/apachectl -k graceful'

|

||||

alias httpdtest = 'sudo /usr/sbin/apachectl -t && /usr/sbin/apachectl -t -D DUMP_VHOSTS'

|

||||

```

|

||||

|

||||

#### #22:与备份相关的别名

|

||||

|

||||

```

|

||||

# if cron fails or if you want backup on demand just run these commands #

|

||||

# again pass it via sudo so whoever is in admin group can start the job #

|

||||

# Backup scripts #

|

||||

alias backup = 'sudo /home/scripts/admin/scripts/backup/wrapper.backup.sh --type local --taget /raid1/backups'

|

||||

alias nasbackup = 'sudo /home/scripts/admin/scripts/backup/wrapper.backup.sh --type nas --target nas01'

|

||||

alias s3backup = 'sudo /home/scripts/admin/scripts/backup/wrapper.backup.sh --type nas --target nas01 --auth /home/scripts/admin/.authdata/amazon.keys'

|

||||

alias rsnapshothourly = 'sudo /home/scripts/admin/scripts/backup/wrapper.rsnapshot.sh --type remote --target nas03 --auth /home/scripts/admin/.authdata/ssh.keys --config /home/scripts/admin/scripts/backup/config/adsl.conf'

|

||||

alias rsnapshotdaily = 'sudo /home/scripts/admin/scripts/backup/wrapper.rsnapshot.sh --type remote --target nas03 --auth /home/scripts/admin/.authdata/ssh.keys --config /home/scripts/admin/scripts/backup/config/adsl.conf'

|

||||

alias rsnapshotweekly = 'sudo /home/scripts/admin/scripts/backup/wrapper.rsnapshot.sh --type remote --target nas03 --auth /home/scripts/admin/.authdata/ssh.keys --config /home/scripts/admin/scripts/backup/config/adsl.conf'

|

||||

alias rsnapshotmonthly = 'sudo /home/scripts/admin/scripts/backup/wrapper.rsnapshot.sh --type remote --target nas03 --auth /home/scripts/admin/.authdata/ssh.keys --config /home/scripts/admin/scripts/backup/config/adsl.conf'

|

||||

alias amazonbackup =s3backup

|

||||

```

|

||||

|

||||

#### #23:桌面应用相关的别名 - 按需播放的 avi/mp3 文件

|

||||

|

||||

```

|

||||

## play video files in a current directory ##

|

||||

# cd ~/Download/movie-name

|

||||

# playavi or vlc

|

||||

alias playavi = 'mplayer *.avi'

|

||||

alias vlc = 'vlc *.avi'

|

||||

|

||||

# play all music files from the current directory #

|

||||

alias playwave = 'for i in *.wav; do mplayer "$i"; done'

|

||||

alias playogg = 'for i in *.ogg; do mplayer "$i"; done'

|

||||

alias playmp3 = 'for i in *.mp3; do mplayer "$i"; done'

|

||||

|

||||

# play files from nas devices #

|

||||

alias nplaywave = 'for i in /nas/multimedia/wave/*.wav; do mplayer "$i"; done'

|

||||

alias nplayogg = 'for i in /nas/multimedia/ogg/*.ogg; do mplayer "$i"; done'

|

||||

alias nplaymp3 = 'for i in /nas/multimedia/mp3/*.mp3; do mplayer "$i"; done'

|

||||

|

||||

# shuffle mp3/ogg etc by default #

|

||||

alias music = 'mplayer --shuffle *'

|

||||

```

|

||||

|

||||

#### #24:设置系统管理相关命令的默认网卡

|

||||

|

||||

[vnstat 一款基于终端的网络流量检测器][20]。[dnstop 是一款分析 DNS 流量的终端工具][21]。[tcptrack 和 iftop 命令显示][22] TCP/UDP 连接方面的信息,它监控网卡并显示其消耗的带宽。

|

||||

|

||||

```

|

||||

## All of our servers eth1 is connected to the Internets via vlan / router etc ##

|

||||

alias dnstop = 'dnstop -l 5 eth1'

|

||||

alias vnstat = 'vnstat -i eth1'

|

||||

alias iftop = 'iftop -i eth1'

|

||||

alias tcpdump = 'tcpdump -i eth1'

|

||||

alias ethtool = 'ethtool eth1'

|

||||

|

||||

# work on wlan0 by default #

|

||||

# Only useful for laptop as all servers are without wireless interface

|

||||

alias iwconfig = 'iwconfig wlan0'

|

||||

```

|

||||

|

||||

#### #25:快速获取系统内存,cpu 使用,和 gpu 内存相关信息

|

||||

|

||||

```

|

||||

## pass options to free ##

|

||||

alias meminfo = 'free -m -l -t'

|

||||

|

||||

## get top process eating memory

|

||||

alias psmem = 'ps auxf | sort -nr -k 4'

|

||||

alias psmem10 = 'ps auxf | sort -nr -k 4 | head -10'

|

||||

|

||||

## get top process eating cpu ##

|

||||

alias pscpu = 'ps auxf | sort -nr -k 3'

|

||||

alias pscpu10 = 'ps auxf | sort -nr -k 3 | head -10'

|

||||

|

||||

## Get server cpu info ##

|

||||

alias cpuinfo = 'lscpu'

|

||||

|

||||

## older system use /proc/cpuinfo ##

|

||||

##alias cpuinfo='less /proc/cpuinfo' ##

|

||||

|

||||

## get GPU ram on desktop / laptop##

|

||||

alias gpumeminfo = 'grep -i --color memory /var/log/Xorg.0.log'

|

||||

```

|

||||

|

||||

#### #26:控制家用路由器

|

||||

|

||||

`curl` 命令可以用来 [重启 Linksys 路由器][23]。

|

||||

|

||||

```

|

||||

# Reboot my home Linksys WAG160N / WAG54 / WAG320 / WAG120N Router / Gateway from *nix.

|

||||

alias rebootlinksys = "curl -u 'admin:my-super-password' 'http://192.168.1.2/setup.cgi?todo=reboot'"

|

||||

|

||||

# Reboot tomato based Asus NT16 wireless bridge

|

||||

alias reboottomato = "ssh admin@192.168.1.1 /sbin/reboot"

|

||||

```

|

||||

|

||||

#### #27 wget 默认断点续传

|

||||

|

||||

[GNU wget 是一款用来从 web 下载文件的自由软件][25]。它支持 HTTP,HTTPS,以及 FTP 协议,而且它也支持断点续传:

|

||||

|

||||

```

|

||||

## this one saved by butt so many times ##

|

||||

alias wget = 'wget -c'

|

||||

```

|

||||

|

||||

#### #28 使用不同浏览器来测试网站

|

||||

|

||||

```

|

||||

## this one saved by butt so many times ##

|

||||

alias ff4 = '/opt/firefox4/firefox'

|

||||

alias ff13 = '/opt/firefox13/firefox'

|

||||

alias chrome = '/opt/google/chrome/chrome'

|

||||

alias opera = '/opt/opera/opera'

|

||||

|

||||

#default ff

|

||||

alias ff =ff13

|

||||

|

||||

#my default browser

|

||||

alias browser =chrome

|

||||

```

|

||||

|

||||

#### #29:关于 ssh 别名的注意事项

|

||||

|

||||

不要创建 ssh 别名,代之以 `~/.ssh/config` 这个 OpenSSH SSH 客户端配置文件。它的选项更加丰富。下面是一个例子:

|

||||

|

||||

```

|

||||

Host server10

|

||||

Hostname 1.2.3.4

|

||||

IdentityFile ~/backups/.ssh/id_dsa

|

||||

user foobar

|

||||

Port 30000

|

||||

ForwardX11Trusted yes

|

||||

TCPKeepAlive yes

|

||||

```

|

||||

|

||||

然后你就可以使用下面语句连接 server10 了:

|

||||

|

||||

```

|

||||

$ ssh server10

|

||||

```

|

||||

|

||||

#### #30:现在该分享你的别名了

|

||||

|

||||

```

|

||||

## set some other defaults ##

|

||||

alias df = 'df -H'

|

||||

alias du = 'du -ch'

|

||||

|

||||

# top is atop, just like vi is vim

|

||||

alias top = 'atop'

|

||||

|

||||

## nfsrestart - must be root ##

|

||||

## refresh nfs mount / cache etc for Apache ##

|

||||

alias nfsrestart = 'sync && sleep 2 && /etc/init.d/httpd stop && umount netapp2:/exports/http && sleep 2 && mount -o rw,sync,rsize=32768,wsize=32768,intr,hard,proto=tcp,fsc natapp2:/exports /http/var/www/html && /etc/init.d/httpd start'

|

||||

|

||||

## Memcached server status ##

|

||||

alias mcdstats = '/usr/bin/memcached-tool 10.10.27.11:11211 stats'

|

||||

alias mcdshow = '/usr/bin/memcached-tool 10.10.27.11:11211 display'

|

||||

|

||||

## quickly flush out memcached server ##

|

||||

alias flushmcd = 'echo "flush_all" | nc 10.10.27.11 11211'

|

||||

|

||||

## Remove assets quickly from Akamai / Amazon cdn ##

|

||||

alias cdndel = '/home/scripts/admin/cdn/purge_cdn_cache --profile akamai'

|

||||

alias amzcdndel = '/home/scripts/admin/cdn/purge_cdn_cache --profile amazon'

|

||||

|

||||

## supply list of urls via file or stdin

|

||||

alias cdnmdel = '/home/scripts/admin/cdn/purge_cdn_cache --profile akamai --stdin'

|

||||

alias amzcdnmdel = '/home/scripts/admin/cdn/purge_cdn_cache --profile amazon --stdin'

|

||||

```

|

||||

|

||||

### 总结

|

||||

|

||||

本文总结了 *nix bash 别名的多种用法:

|

||||

|

||||

1. 为命令设置默认的参数(例如通过 `alias ethtool='ethtool eth0'` 设置 ethtool 命令的默认参数为 eth0)。

|

||||

2. 修正错误的拼写(通过 `alias cd..='cd ..'`让 `cd..` 变成 `cd ..`)。

|

||||

3. 缩减输入。

|

||||

4. 设置系统中多版本命令的默认路径(例如 GNU/grep 位于 `/usr/local/bin/grep` 中而 Unix grep 位于 `/bin/grep` 中。若想默认使用 GNU grep 则设置别名 `grep='/usr/local/bin/grep'` )。

|

||||

5. 通过默认开启命令(例如 `rm`,`mv` 等其他命令)的交互参数来增加 Unix 的安全性。

|

||||

6. 为老旧的操作系统(比如 MS-DOS 或者其他类似 Unix 的操作系统)创建命令以增加兼容性(比如 `alias del=rm`)。

|

||||

|

||||

我已经分享了多年来为了减少重复输入命令而使用的别名。若你知道或使用的哪些 bash/ksh/csh 别名能够减少输入,请在留言框中分享。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.cyberciti.biz/tips/bash-aliases-mac-centos-linux-unix.html

|

||||

|

||||

作者:[nixCraft][a]

|

||||

译者:[lujun9972](https://github.com/lujun9972)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.cyberciti.biz

|

||||

[1]:https://bash.cyberciti.biz/guide/~/.bashrc

|

||||

[2]:https://www.cyberciti.biz/tips/wp-content/uploads/2012/06/Getting-Started-With-Bash-Shell-Aliases-For-Linux-Unix.jpg

|

||||

[3]:https://www.cyberciti.biz/tips/bash-aliases-mac-centos-linux-unix.html (See Linux/Unix alias command examples for more info)

|

||||

[4]:https://bash.cyberciti.biz/guide/Create_and_use_aliases

|

||||

[5]:https://www.cyberciti.biz/faq/bash-shell-temporarily-disable-an-alias/

|

||||

[6]:https://bash.cyberciti.biz/guide/Create_and_use_aliases#How_do_I_remove_the_alias.3F

|

||||

[7]:https://bash.cyberciti.biz/guide/The_case_statement

|

||||

[8]:https://www.cyberciti.biz/faq/ls-command-to-examining-the-filesystem/

|

||||

[9]:https://www.cyberciti.biz/faq/howto-use-grep-command-in-linux-unix/

|

||||

[10]:https://www.cyberciti.biz/faq/linux-make-directory-command/

|

||||

[11]:https://www.cyberciti.biz/faq/how-do-i-compare-two-files-under-linux-or-unix/

|

||||

[12]:https://www.cyberciti.biz/faq/how-do-i-find-out-what-ports-are-listeningopen-on-my-linuxfreebsd-server/

|

||||

[13]:https://www.cyberciti.biz/tips/linux-send-wake-on-lan-wol-magic-packets.html

|

||||

[14]:https://bash.cyberciti.biz/misc-shell/simple-shell-script-to-wake-up-nas-devices-computers/

|

||||

[15]:https://www.cyberciti.biz/faq/rhel-fedorta-linux-iptables-firewall-configuration-tutorial/ (iptables CentOS/RHEL/Fedora tutorial)

|

||||

[16]:https://www.cyberciti.biz/tips/linux-iptables-examples.html

|

||||

[17]:https://www.cyberciti.biz/tips/linux-debian-package-management-cheat-sheet.html

|

||||

[18]:https://www.cyberciti.biz/faq/rhel-centos-fedora-linux-yum-command-howto/

|

||||

[19]:https://www.cyberciti.biz/faq/howto-shutdown-linux/

|

||||

[20]:https://www.cyberciti.biz/tips/keeping-a-log-of-daily-network-traffic-for-adsl-or-dedicated-remote-linux-box.html

|

||||

[21]:https://www.cyberciti.biz/faq/dnstop-monitor-bind-dns-server-dns-network-traffic-from-a-shell-prompt/

|

||||

[22]:https://www.cyberciti.biz/faq/check-network-connection-linux/

|

||||

[23]:https://www.cyberciti.biz/faq/reboot-linksys-wag160n-wag54-wag320-wag120n-router-gateway/

|

||||

[24]:https:/cdn-cgi/l/email-protection

|

||||

[25]:https://www.cyberciti.biz/tips/wget-resume-broken-download.html

|

||||

113

published/20140210 Three steps to learning GDB.md

Normal file

113

published/20140210 Three steps to learning GDB.md

Normal file

@ -0,0 +1,113 @@

|

||||

三步上手 GDB

|

||||

===============

|

||||

|

||||

调试 C 程序,曾让我很困扰。然而当我之前在写我的[操作系统][2]时,我有很多的 Bug 需要调试。我很幸运的使用上了 qemu 模拟器,它允许我将调试器附加到我的操作系统。这个调试器就是 `gdb`。

|

||||

|

||||

我得解释一下,你可以使用 `gdb` 先做一些小事情,因为我发现初学它的时候真的很混乱。我们接下来会在一个小程序中,设置断点,查看内存。.

|

||||

|

||||

### 1、 设断点

|

||||

|

||||

如果你曾经使用过调试器,那你可能已经会设置断点了。

|

||||

|

||||

下面是一个我们要调试的程序(虽然没有任何 Bug):

|

||||

|

||||

```

|

||||

#include <stdio.h>

|

||||

void do_thing() {

|

||||

printf("Hi!\n");

|

||||

}

|

||||

int main() {

|

||||

do_thing();

|

||||

}

|

||||

```

|

||||

|

||||

另存为 `hello.c`. 我们可以使用 `dbg` 调试它,像这样:

|

||||

|

||||

```

|

||||

bork@kiwi ~> gcc -g hello.c -o hello

|

||||

bork@kiwi ~> gdb ./hello

|

||||

```

|

||||

|

||||

以上是带调试信息编译 `hello.c`(为了 `gdb` 可以更好工作),并且它会给我们醒目的提示符,就像这样:

|

||||

|

||||

```

|

||||

(gdb)

|

||||

```

|

||||

|

||||

我们可以使用 `break` 命令设置断点,然后使用 `run` 开始调试程序。

|

||||

|

||||

```

|

||||

(gdb) break do_thing

|

||||

Breakpoint 1 at 0x4004f8

|

||||

(gdb) run

|

||||

Starting program: /home/bork/hello

|

||||

|

||||

Breakpoint 1, 0x00000000004004f8 in do_thing ()

|

||||

```

|

||||

|

||||

程序暂停在了 `do_thing` 开始的地方。

|

||||

|

||||

我们可以通过 `where` 查看我们所在的调用栈。

|

||||

|

||||

```

|

||||

(gdb) where

|

||||

#0 do_thing () at hello.c:3

|

||||

#1 0x08050cdb in main () at hello.c:6

|

||||

(gdb)

|

||||

```

|

||||

|

||||

### 2、 阅读汇编代码

|

||||

|

||||

使用 `disassemble` 命令,我们可以看到这个函数的汇编代码。棒级了,这是 x86 汇编代码。虽然我不是很懂它,但是 `callq` 这一行是 `printf` 函数调用。

|

||||

|

||||

```

|

||||

(gdb) disassemble do_thing

|

||||

Dump of assembler code for function do_thing:

|

||||

0x00000000004004f4 <+0>: push %rbp

|

||||

0x00000000004004f5 <+1>: mov %rsp,%rbp

|

||||

=> 0x00000000004004f8 <+4>: mov $0x40060c,%edi

|

||||

0x00000000004004fd <+9>: callq 0x4003f0

|

||||

0x0000000000400502 <+14>: pop %rbp

|

||||

0x0000000000400503 <+15>: retq

|

||||

```

|

||||

|

||||

你也可以使用 `disassemble` 的缩写 `disas`。

|

||||

|

||||

### 3、 查看内存

|

||||

|

||||

当调试我的内核时,我使用 `gdb` 的主要原因是,以确保内存布局是如我所想的那样。检查内存的命令是 `examine`,或者使用缩写 `x`。我们将使用`x`。

|

||||

|

||||

通过阅读上面的汇编代码,似乎 `0x40060c` 可能是我们所要打印的字符串地址。我们来试一下。

|

||||

|

||||

```

|

||||

(gdb) x/s 0x40060c

|

||||

0x40060c: "Hi!"

|

||||

```

|

||||

|

||||

的确是这样。`x/s` 中 `/s` 部分,意思是“把它作为字符串展示”。我也可以“展示 10 个字符”,像这样:

|

||||

|

||||

```

|

||||

(gdb) x/10c 0x40060c

|

||||

0x40060c: 72 'H' 105 'i' 33 '!' 0 '\000' 1 '\001' 27 '\033' 3 '\003' 59 ';'

|

||||

0x400614: 52 '4' 0 '\000'

|

||||

```

|

||||

|

||||

你可以看到前四个字符是 `H`、`i`、`!` 和 `\0`,并且它们之后的是一些不相关的东西。

|

||||

|

||||

我知道 `gdb` 很多其他的东西,但是我仍然不是很了解它,其中 `x` 和 `break` 让我获得很多。你还可以阅读 [do umentation for examining memory][4]。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://jvns.ca/blog/2014/02/10/three-steps-to-learning-gdb/

|

||||

|

||||

作者:[Julia Evans][a]

|

||||

译者:[Torival](https://github.com/Torival)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://jvns.ca

|

||||

[1]:https://jvns.ca/categories/spytools

|

||||

[2]:https://jvns.ca/blog/categories/kernel

|

||||

[3]:https://twitter.com/mgedmin

|

||||

[4]:https://ftp.gnu.org/old-gnu/Manuals/gdb-5.1.1/html_chapter/gdb_9.html#SEC56

|

||||

@ -0,0 +1,176 @@

|

||||

如何让 curl 命令通过代理访问

|

||||

======

|

||||

|

||||

我的系统管理员给我提供了如下代理信息:

|

||||

|

||||

```

|

||||

IP: 202.54.1.1

|

||||

Port: 3128

|

||||

Username: foo

|

||||

Password: bar

|

||||

```

|

||||

|

||||

该设置在 Google Chrome 和 Firefox 浏览器上很容易设置。但是我要怎么把它应用到 `curl` 命令上呢?我要如何让 curl 命令使用我在 Google Chrome 浏览器上的代理设置呢?

|

||||

|

||||

很多 Linux 和 Unix 命令行工具(比如 `curl` 命令,`wget` 命令,`lynx` 命令等)使用名为 `http_proxy`,`https_proxy`,`ftp_proxy` 的环境变量来获取代理信息。它允许你通过代理服务器(使用或不使用用户名/密码都行)来连接那些基于文本的会话和应用。

|

||||

|

||||

本文就会演示一下如何让 `curl` 通过代理服务器发送 HTTP/HTTPS 请求。

|

||||

|

||||

### 让 curl 命令使用代理的语法

|

||||

|

||||

语法为:

|

||||

|

||||

```

|

||||

## Set the proxy address of your uni/company/vpn network ##

|

||||

export http_proxy=http://your-ip-address:port/

|

||||

|

||||

## http_proxy with username and password

|

||||

export http_proxy=http://user:password@your-proxy-ip-address:port/

|

||||

|

||||

## HTTPS version ##

|

||||

export https_proxy=https://your-ip-address:port/

|

||||

export https_proxy=https://user:password@your-proxy-ip-address:port/

|

||||

```

|

||||

|

||||

另一种方法是使用 `curl` 命令的 `-x` 选项:

|

||||

|

||||

```

|

||||

curl -x <[protocol://][user:password@]proxyhost[:port]> url

|

||||

--proxy <[protocol://][user:password@]proxyhost[:port]> url

|

||||

--proxy http://user:password@Your-Ip-Here:Port url

|

||||

-x http://user:password@Your-Ip-Here:Port url

|

||||

```

|

||||

|

||||

### 在 Linux 上的一个例子

|

||||

|

||||

首先设置 `http_proxy`:

|

||||

|

||||

```

|

||||

## proxy server, 202.54.1.1, port: 3128, user: foo, password: bar ##

|

||||

export http_proxy=http://foo:bar@202.54.1.1:3128/

|

||||

export https_proxy=$http_proxy

|

||||

## Use the curl command ##

|

||||

curl -I https://www.cyberciti.biz

|

||||

curl -v -I https://www.cyberciti.biz

|

||||

```

|

||||

|

||||

输出为:

|

||||

|

||||

```

|

||||

* Rebuilt URL to: www.cyberciti.biz/

|

||||

* Trying 202.54.1.1...

|

||||

* Connected to 1202.54.1.1 (202.54.1.1) port 3128 (#0)

|

||||

* Proxy auth using Basic with user 'foo'

|

||||

> HEAD HTTP://www.cyberciti.biz/ HTTP/1.1

|

||||

> Host: www.cyberciti.biz

|

||||

> Proxy-Authorization: Basic x9VuUml2xm0vdg93MtIz

|

||||

> User-Agent: curl/7.43.0

|

||||

> Accept: */*

|

||||

> Proxy-Connection: Keep-Alive

|

||||

>

|

||||

< HTTP/1.1 200 OK

|

||||

HTTP/1.1 200 OK

|

||||

< Server: nginx

|

||||

Server: nginx

|

||||

< Date: Sun, 17 Jan 2016 11:49:21 GMT

|

||||

Date: Sun, 17 Jan 2016 11:49:21 GMT

|

||||

< Content-Type: text/html; charset=UTF-8

|

||||

Content-Type: text/html; charset=UTF-8

|

||||

< Vary: Accept-Encoding

|

||||

Vary: Accept-Encoding

|

||||

< X-Whom: Dyno-l1-com-cyber

|

||||

X-Whom: Dyno-l1-com-cyber

|

||||

< Vary: Cookie

|

||||

Vary: Cookie

|

||||

< Link: <http://www.cyberciti.biz/wp-json/>; rel="https://api.w.org/"

|

||||

Link: <http://www.cyberciti.biz/wp-json/>; rel="https://api.w.org/"

|

||||

< X-Frame-Options: SAMEORIGIN

|

||||

X-Frame-Options: SAMEORIGIN

|

||||

< X-Content-Type-Options: nosniff

|

||||

X-Content-Type-Options: nosniff

|

||||

< X-XSS-Protection: 1; mode=block

|

||||

X-XSS-Protection: 1; mode=block

|

||||

< X-Cache: MISS from server1

|

||||

X-Cache: MISS from server1

|

||||

< X-Cache-Lookup: MISS from server1:3128

|

||||

X-Cache-Lookup: MISS from server1:3128

|

||||

< Connection: keep-alive

|

||||

Connection: keep-alive

|

||||

|

||||

<

|

||||

* Connection #0 to host 10.12.249.194 left intact

|

||||

```

|

||||

|

||||

本例中,我来下载一个 pdf 文件:

|

||||

|

||||

```

|

||||

$ export http_proxy="vivek:myPasswordHere@10.12.249.194:3128/"

|

||||

$ curl -v -O http://dl.cyberciti.biz/pdfdownloads/b8bf71be9da19d3feeee27a0a6960cb3/569b7f08/cms/631.pdf

|

||||

```

|

||||

|

||||

也可以使用 `-x` 选项:

|

||||

|

||||

```

|

||||

curl -x 'http://vivek:myPasswordHere@10.12.249.194:3128' -v -O https://dl.cyberciti.biz/pdfdownloads/b8bf71be9da19d3feeee27a0a6960cb3/569b7f08/cms/631.pdf

|

||||

```

|

||||

|

||||

输出为:

|

||||

|

||||

![Fig.01:curl in action \(click to enlarge\)][2]

|

||||

|

||||

### Unix 上的一个例子

|

||||

|

||||

```

|

||||

$ curl -x http://prox_server_vpn:3128/ -I https://www.cyberciti.biz/faq/howto-nginx-customizing-404-403-error-page/

|

||||

```

|

||||

|

||||

### socks 协议怎么办呢?

|

||||

|

||||

语法也是一样的:

|

||||

|

||||

```

|

||||

curl -x socks5://[user:password@]proxyhost[:port]/ url

|

||||

curl --socks5 192.168.1.254:3099 https://www.cyberciti.biz/

|

||||

```

|

||||

|

||||

### 如何让代理设置永久生效?

|

||||

|

||||

编辑 `~/.curlrc` 文件:

|

||||

|

||||

```

|

||||

$ vi ~/.curlrc

|

||||

```

|

||||

|

||||

添加下面内容:

|

||||

|

||||

```

|

||||

proxy = server1.cyberciti.biz:3128

|

||||

proxy-user = "foo:bar"

|

||||

```

|

||||

|

||||

保存并关闭该文件。另一种方法是在你的 `~/.bashrc` 文件中创建一个别名:

|

||||

|

||||

```

|

||||

## alias for curl command

|

||||

## set proxy-server and port, the syntax is

|

||||

## alias curl="curl -x {your_proxy_host}:{proxy_port}"

|

||||

alias curl = "curl -x server1.cyberciti.biz:3128"

|

||||

```

|

||||

|

||||

记住,代理字符串中可以使用 `protocol://` 前缀来指定不同的代理协议。使用 `socks4://`,`socks4a://`,`socks5:// `或者 `socks5h://` 来指定使用的 SOCKS 版本。若没有指定协议或者使用 `http://` 表示 HTTP 协议。若没有指定端口号则默认为 `1080`。`-x` 选项的值要优先于环境变量设置的值。若不想走代理,而环境变量总设置了代理,那么可以通过设置代理为空值(`""`)来覆盖环境变量的值。[详细信息请参阅 `curl` 的 man 页 ][3]。

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.cyberciti.biz/faq/linux-unix-curl-command-with-proxy-username-password-http-options/

|

||||

|

||||

作者:[Vivek Gite][a]

|

||||

译者:[lujun9972](https://github.com/lujun9972)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.cyberciti.biz

|

||||

[1]:https://www.cyberciti.biz/media/new/faq/2016/01/curl-download-output-300x141.jpg

|

||||

[2]:https://www.cyberciti.biz/media/new/faq/2016/01/curl-download-output.jpg

|

||||

[3]:https://curl.haxx.se/docs/manpage.html

|

||||

239

published/20160625 Trying out LXD containers on our Ubuntu.md

Normal file

239

published/20160625 Trying out LXD containers on our Ubuntu.md

Normal file

@ -0,0 +1,239 @@

|

||||

在 Ubuntu 上体验 LXD 容器

|

||||

======

|

||||

|

||||

本文的主角是容器,一种类似虚拟机但更轻量级的构造。你可以轻易地在你的 Ubuntu 桌面系统中创建一堆容器!

|

||||

|

||||

虚拟机会虚拟出整个电脑让你来安装客户机操作系统。**相比之下**,容器**复用**了主机的 Linux 内核,只是简单地 **包容** 了我们选择的根文件系统(也就是运行时环境)。Linux 内核有很多功能可以将运行的 Linux 容器与我们的主机分割开(也就是我们的 Ubuntu 桌面)。

|

||||

|

||||

Linux 本身需要一些手工操作来直接管理他们。好在,有 LXD(读音为 Lex-deeh),这是一款为我们管理 Linux 容器的服务。

|

||||

|

||||

我们将会看到如何:

|

||||

|

||||

1. 在我们的 Ubuntu 桌面上配置容器,

|

||||

2. 创建容器,

|

||||

3. 安装一台 web 服务器,

|

||||

4. 测试一下这台 web 服务器,以及

|

||||

5. 清理所有的东西。

|

||||

|

||||

### 设置 Ubuntu 容器

|

||||

|

||||

如果你安装的是 Ubuntu 16.04,那么你什么都不用做。只要安装下面所列出的一些额外的包就行了。若你安装的是 Ubuntu 14.04.x 或 Ubuntu 15.10,那么按照 [LXD 2.0 系列(二):安装与配置][1] 来进行一些操作,然后再回来。

|

||||

|

||||

确保已经更新了包列表:

|

||||

|

||||

```

|

||||

sudo apt update

|

||||

sudo apt upgrade

|

||||

```

|

||||

|

||||

安装 `lxd` 包:

|

||||

|

||||

```

|

||||

sudo apt install lxd

|

||||

```

|

||||

|

||||

若你安装的是 Ubuntu 16.04,那么还可以让你的容器文件以 ZFS 文件系统的格式进行存储。Ubuntu 16.04 的 Linux kernel 包含了支持 ZFS 必要的内核模块。若要让 LXD 使用 ZFS 进行存储,我们只需要安装 ZFS 工具包。没有 ZFS,容器会在主机文件系统中以单独的文件形式进行存储。通过 ZFS,我们就有了写入时拷贝等功能,可以让任务完成更快一些。

|

||||

|

||||

安装 `zfsutils-linux` 包(若你安装的是 Ubuntu 16.04.x):

|

||||

|

||||

```

|

||||

sudo apt install zfsutils-linux

|

||||

```

|

||||

|

||||

安装好 LXD 后,包安装脚本应该会将你加入 `lxd` 组。该组成员可以使你无需通过 `sudo` 就能直接使用 LXD 管理容器。根据 Linux 的习惯,**你需要先登出桌面会话然后再登录** 才能应用 `lxd` 的组成员关系。(若你是高手,也可以通过在当前 shell 中执行 `newgrp lxd` 命令,就不用重登录了)。

|

||||

|

||||

在开始使用前,LXD 需要初始化存储和网络参数。

|

||||

|

||||

运行下面命令:

|

||||

|

||||

```

|

||||

$ sudo lxd init

|

||||

Name of the storage backend to use (dir or zfs): zfs

|

||||

Create a new ZFS pool (yes/no)? yes

|

||||

Name of the new ZFS pool: lxd-pool

|

||||

Would you like to use an existing block device (yes/no)? no

|

||||

Size in GB of the new loop device (1GB minimum): 30

|

||||

Would you like LXD to be available over the network (yes/no)? no

|

||||

Do you want to configure the LXD bridge (yes/no)? yes

|

||||

> You will be asked about the network bridge configuration. Accept all defaults and continue.

|

||||

Warning: Stopping lxd.service, but it can still be activated by:

|

||||

lxd.socket

|

||||

LXD has been successfully configured.

|

||||

$ _

|

||||

```

|

||||

|

||||

我们在一个(单独)的文件而不是块设备(即分区)中构建了一个文件系统来作为 ZFS 池,因此我们无需进行额外的分区操作。在本例中我指定了 30GB 大小,这个空间取之于根(`/`) 文件系统中。这个文件就是 `/var/lib/lxd/zfs.img`。

|

||||

|

||||

行了!最初的配置完成了。若有问题,或者想了解其他信息,请阅读 https://www.stgraber.org/2016/03/15/lxd-2-0-installing-and-configuring-lxd-212/ 。

|

||||

|

||||

### 创建第一个容器

|

||||

|

||||

所有 LXD 的管理操作都可以通过 `lxc` 命令来进行。我们通过给 `lxc` 不同参数来管理容器。

|

||||

|

||||

```

|

||||

lxc list

|

||||

```

|

||||

|

||||

可以列出所有已经安装的容器。很明显,这个列表现在是空的,但这表示我们的安装是没问题的。

|

||||

|

||||

```

|

||||

lxc image list

|

||||

```

|

||||

|

||||

列出可以用来启动容器的(已经缓存的)镜像列表。很明显这个列表也是空的,但这也说明我们的安装是没问题的。

|

||||

|

||||

```

|

||||

lxc image list ubuntu:

|

||||

```

|

||||

|

||||

列出可以下载并启动容器的远程镜像。而且指定了显示 Ubuntu 镜像。

|

||||

|

||||

```

|

||||

lxc image list images:

|

||||

```

|

||||

|

||||

列出可以用来启动容器的(已经缓存的)各种发行版的镜像列表。这会列出各种发行版的镜像比如 Alpine、Debian、Gentoo、Opensuse 以及 Fedora。

|

||||

|

||||

让我们启动一个 Ubuntu 16.04 容器,并称之为 `c1`:

|

||||

|

||||

```

|

||||

$ lxc launch ubuntu:x c1

|

||||

Creating c1

|

||||

Starting c1

|

||||

$

|

||||

```

|

||||

|

||||

我们使用 `launch` 动作,然后选择镜像 `ubuntu:x` (`x` 表示 Xenial/16.04 镜像),最后我们使用名字 `c1` 作为容器的名称。

|

||||

|

||||

让我们来看看安装好的首个容器,

|

||||

|

||||

```

|

||||

$ lxc list

|

||||

|

||||

+---------|---------|----------------------|------|------------|-----------+

|

||||

| NAME | STATE | IPV4 | IPV6 | TYPE | SNAPSHOTS |

|

||||

+---------|---------|----------------------|------|------------|-----------+

|

||||

| c1 | RUNNING | 10.173.82.158 (eth0) | | PERSISTENT | 0 |

|

||||

+---------|---------|----------------------|------|------------|-----------+

|

||||

```

|

||||

|

||||

我们的首个容器 c1 已经运行起来了,它还有自己的 IP 地址(可以本地访问)。我们可以开始用它了!

|

||||

|

||||

### 安装 web 服务器

|

||||

|

||||

我们可以在容器中运行命令。运行命令的动作为 `exec`。

|

||||

|

||||

```

|

||||

$ lxc exec c1 -- uptime

|

||||

11:47:25 up 2 min,0 users,load average:0.07,0.05,0.04

|

||||

$ _

|

||||

```

|

||||

|

||||

在 `exec` 后面,我们指定容器、最后输入要在容器中运行的命令。该容器的运行时间只有 2 分钟,这是个新出炉的容器:-)。

|

||||

|

||||

命令行中的 `--` 跟我们 shell 的参数处理过程有关。若我们的命令没有任何参数,则完全可以省略 `-`。

|

||||

|

||||

```

|

||||

$ lxc exec c1 -- df -h

|

||||

```

|

||||

|

||||

这是一个必须要 `-` 的例子,由于我们的命令使用了参数 `-h`。若省略了 `-`,会报错。

|

||||

|

||||

然后我们运行容器中的 shell 来更新包列表。

|

||||

|

||||

```

|

||||

$ lxc exec c1 bash

|

||||

root@c1:~# apt update

|

||||

Ign http://archive.ubuntu.com trusty InRelease

|

||||

Get:1 http://archive.ubuntu.com trusty-updates InRelease [65.9 kB]

|

||||

Get:2 http://security.ubuntu.com trusty-security InRelease [65.9 kB]

|

||||

...

|

||||

Hit http://archive.ubuntu.com trusty/universe Translation-en

|

||||

Fetched 11.2 MB in 9s (1228 kB/s)

|

||||

Reading package lists... Done

|

||||

root@c1:~# apt upgrade

|

||||

Reading package lists... Done

|

||||

Building dependency tree

|

||||

...

|

||||

Processing triggers for man-db (2.6.7.1-1ubuntu1) ...

|

||||

Setting up dpkg (1.17.5ubuntu5.7) ...

|

||||

root@c1:~# _

|

||||

```

|

||||

|

||||

我们使用 nginx 来做 web 服务器。nginx 在某些方面要比 Apache web 服务器更酷一些。

|

||||

|

||||

```

|

||||

root@c1:~# apt install nginx

|

||||

Reading package lists... Done

|

||||

Building dependency tree

|

||||

...

|

||||

Setting up nginx-core (1.4.6-1ubuntu3.5) ...

|

||||

Setting up nginx (1.4.6-1ubuntu3.5) ...

|

||||