mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-24 02:20:09 +08:00

commit

94820e60b2

@ -1,5 +1,6 @@

|

||||

如何设置在Quagga BGP路由器中设置IPv6的BGP对等体和过滤

|

||||

如何设置在 Quagga BGP 路由器中设置 IPv6 的 BGP 对等体和过滤

|

||||

================================================================================

|

||||

|

||||

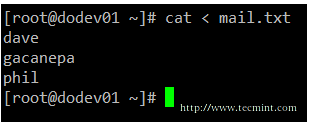

在之前的教程中,我们演示了如何使用Quagga建立一个[完备的BGP路由器][1]和配置[前缀过滤][2]。在本教程中,我们会向你演示如何创建IPv6 BGP对等体并通过BGP通告IPv6前缀。同时我们也将演示如何使用前缀列表和路由映射特性来过滤通告的或者获取到的IPv6前缀。

|

||||

|

||||

### 拓扑 ###

|

||||

@ -47,7 +48,7 @@ Quagga内部提供一个叫作vtysh的shell,其界面与那些主流路由厂

|

||||

|

||||

# vtysh

|

||||

|

||||

提示将改为:

|

||||

提示符将改为:

|

||||

|

||||

router-a#

|

||||

|

||||

@ -65,7 +66,7 @@ Quagga内部提供一个叫作vtysh的shell,其界面与那些主流路由厂

|

||||

|

||||

router-a# configure terminal

|

||||

|

||||

提示将变更成:

|

||||

提示符将变更成:

|

||||

|

||||

router-a(config)#

|

||||

|

||||

@ -246,13 +247,13 @@ Quagga内部提供一个叫作vtysh的shell,其界面与那些主流路由厂

|

||||

via: http://xmodulo.com/ipv6-bgp-peering-filtering-quagga-bgp-router.html

|

||||

|

||||

作者:[Sarmed Rahman][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

译者:[martin2011qi](https://github.com/martin2011qi)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://xmodulo.com/author/sarmed

|

||||

[1]:http://xmodulo.com/centos-bgp-router-quagga.html

|

||||

[1]:https://linux.cn/article-4232-1.html

|

||||

[2]:http://xmodulo.com/filter-bgp-routes-quagga-bgp-router.html

|

||||

[3]:http://ask.xmodulo.com/open-port-firewall-centos-rhel.html

|

||||

[4]:http://xmodulo.com/filter-bgp-routes-quagga-bgp-router.html

|

||||

@ -1,8 +1,9 @@

|

||||

如何在 Docker 中通过 Kitematic 交互式执行任务

|

||||

如何在 Windows 上通过 Kitematic 使用 Docker

|

||||

================================================================================

|

||||

在本篇文章中,我们会学习如何在 Windows 操作系统上安装 Kitematic 以及部署一个 Hello World Nginx Web 服务器。Kitematic 是一个自由开源软件,它有现代化的界面设计使得允许我们在 Docker 中交互式执行任务。Kitematic 设计非常漂亮、界面也很不错。我们可以简单快速地开箱搭建我们的容器而不需要输入命令,我们可以在图形用户界面中通过简单的点击从而在容器上部署我们的应用。Kitematic 集成了 Docker Hub,允许我们搜索、拉取任何需要的镜像,并在上面部署应用。它同时也能很好地切换到命令行用户接口模式。目前,它包括了自动映射端口、可视化更改环境变量、配置卷、精简日志以及其它功能。

|

||||

|

||||

下面是在 Windows 上安装 Kitematic 并部署 Hello World Nginx Web 服务器的 3 个简单步骤。

|

||||

在本篇文章中,我们会学习如何在 Windows 操作系统上安装 Kitematic 以及部署一个测试性的 Nginx Web 服务器。Kitematic 是一个具有现代化的界面设计的自由开源软件,它可以让我们在 Docker 中交互式执行任务。Kitematic 设计的非常漂亮、界面美观。使用它,我们可以简单快速地开箱搭建我们的容器而不需要输入命令,可以在图形用户界面中通过简单的点击从而在容器上部署我们的应用。Kitematic 集成了 Docker Hub,允许我们搜索、拉取任何需要的镜像,并在上面部署应用。它同时也能很好地切换到命令行用户接口模式。目前,它包括了自动映射端口、可视化更改环境变量、配置卷、流式日志以及其它功能。

|

||||

|

||||

下面是在 Windows 上安装 Kitematic 并部署测试性 Nginx Web 服务器的 3 个简单步骤。

|

||||

|

||||

### 1. 下载 Kitematic ###

|

||||

|

||||

@ -16,15 +17,15 @@

|

||||

|

||||

### 2. 安装 Kitematic ###

|

||||

|

||||

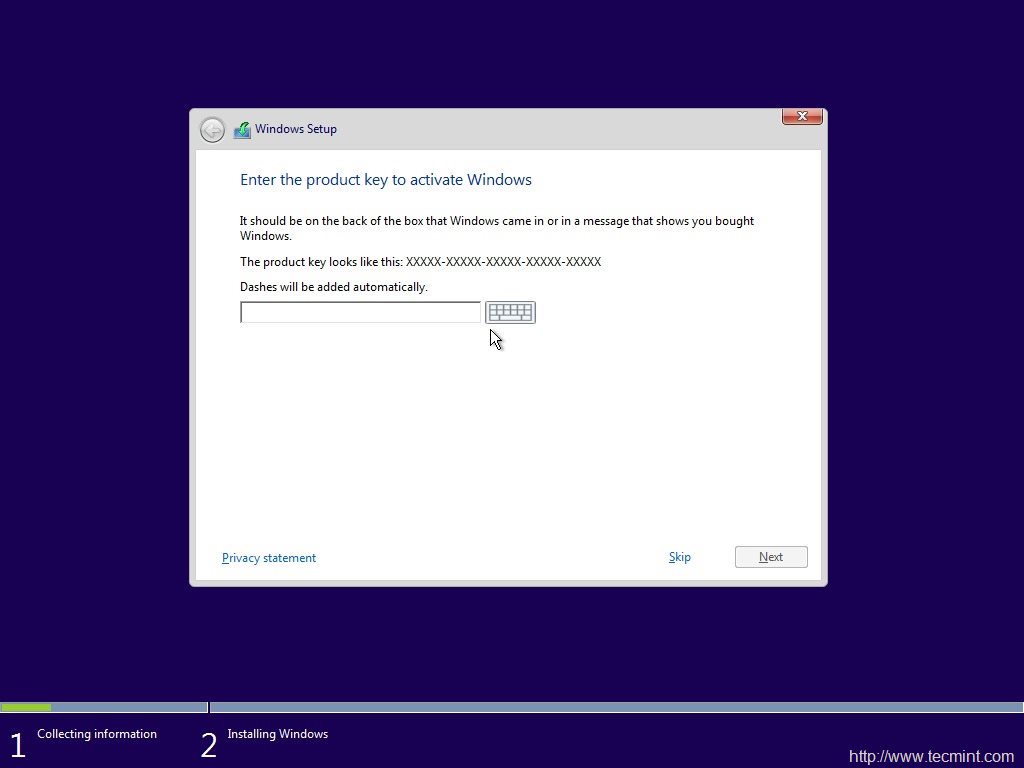

下载好可执行安装程序之后,我们现在打算在我们的 Windows 操作系统上安装 Kitematic。安装程序现在会开始下载并安装运行 Kitematic 需要的依赖,包括 Virtual Box 和 Docker。如果已经在系统上安装了 Virtual Box,它会把它升级到最新版本。安装程序会在几分钟内完成,但取决于你网络和系统的速度。如果你还没有安装 Virtual Box,它会问你是否安装 Virtual Box 网络驱动。建议安装它,因为它有助于 Virtual Box 的网络。

|

||||

下载好可执行安装程序之后,我们现在就可以在我们的 Windows 操作系统上安装 Kitematic了。安装程序现在会开始下载并安装运行 Kitematic 需要的依赖软件,包括 Virtual Box 和 Docker。如果已经在系统上安装了 Virtual Box,它会把它升级到最新版本。安装程序会在几分钟内完成,但取决于你网络和系统的速度。如果你还没有安装 Virtual Box,它会问你是否安装 Virtual Box 网络驱动。建议安装它,因为它用于 Virtual Box 的网络功能。

|

||||

|

||||

|

||||

|

||||

需要的依赖 Docker 和 Virtual Box 安装完成并运行后,会让我们登录到 Docker Hub。如果我们还没有账户或者还不想登录,可以点击 **SKIP FOR NOW** 继续后面的步骤。

|

||||

所需的依赖 Docker 和 Virtual Box 安装完成并运行后,会让我们登录到 Docker Hub。如果我们还没有账户或者还不想登录,可以点击 **SKIP FOR NOW** 继续后面的步骤。

|

||||

|

||||

|

||||

|

||||

如果你还没有账户,你可以在应用程序上点击注册链接并在 Docker Hub 上创建账户。

|

||||

如果你还没有账户,你可以在应用程序上点击注册(Sign Up)链接并在 Docker Hub 上创建账户。

|

||||

|

||||

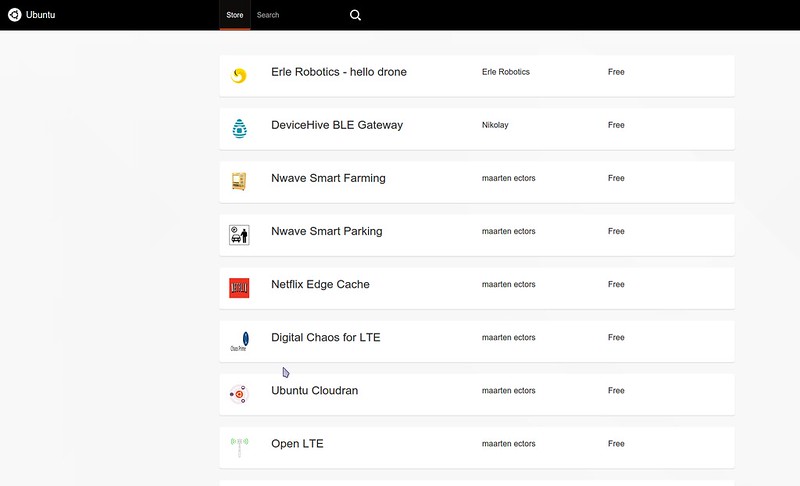

完成之后,就会出现 Kitematic 应用程序的第一个界面。正如下面看到的这样。我们可以搜索可用的 docker 镜像。

|

||||

|

||||

@ -50,7 +51,11 @@

|

||||

|

||||

### 总结 ###

|

||||

|

||||

我们终于成功在 Windows 操作系统上安装了 Kitematic 并部署了一个 Hello World Ngnix 服务器。总是推荐下载安装 Kitematic 最新的发行版,因为会增加很多新的高级功能。由于 Docker 运行在 64 位平台,当前 Kitematic 也是为 64 位操作系统构建。它只能在 Windows 7 以及更高版本上运行。在这篇教程中,我们部署了一个 Nginx Web 服务器,类似地我们可以在 Kitematic 中简单的点击就能通过镜像部署任何 docker 容器。Kitematic 已经有可用的 Mac OS X 和 Windows 版本,Linux 版本也在开发中很快就会发布。如果你有任何疑问、建议或者反馈,请在下面的评论框中写下来以便我们更改地改进或更新我们的内容。非常感谢!Enjoy :-)

|

||||

我们终于成功在 Windows 操作系统上安装了 Kitematic 并部署了一个 Hello World Ngnix 服务器。推荐下载安装 Kitematic 最新的发行版,因为会增加很多新的高级功能。由于 Docker 运行在 64 位平台,当前 Kitematic 也是为 64 位操作系统构建。它只能在 Windows 7 以及更高版本上运行。

|

||||

|

||||

在这篇教程中,我们部署了一个 Nginx Web 服务器,类似地我们可以在 Kitematic 中简单的点击就能通过镜像部署任何 docker 容器。Kitematic 已经有可用的 Mac OS X 和 Windows 版本,Linux 版本也在开发中很快就会发布。

|

||||

|

||||

如果你有任何疑问、建议或者反馈,请在下面的评论框中写下来以便我们更改地改进或更新我们的内容。非常感谢!Enjoy :-)

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -58,7 +63,7 @@ via: http://linoxide.com/linux-how-to/interactively-docker-kitematic/

|

||||

|

||||

作者:[Arun Pyasi][a]

|

||||

译者:[ictlyh](https://github.com/ictlyh)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,129 @@

|

||||

如何使用 Weave 以及 Docker 搭建 Nginx 反向代理/负载均衡服务器

|

||||

================================================================================

|

||||

|

||||

Hi, 今天我们将会学习如何使用 Weave 和 Docker 搭建 Nginx 的反向代理/负载均衡服务器。Weave 可以创建一个虚拟网络将 Docker 容器彼此连接在一起,支持跨主机部署及自动发现。它可以让我们更加专注于应用的开发,而不是基础架构。Weave 提供了一个如此棒的环境,仿佛它的所有容器都属于同个网络,不需要端口/映射/连接等的配置。容器中的应用提供的服务在 weave 网络中可以轻易地被外部世界访问,不论你的容器运行在哪里。在这个教程里我们将会使用 weave 快速并且简单地将 nginx web 服务器部署为一个负载均衡器,反向代理一个运行在 Amazon Web Services 里面多个节点上的 docker 容器中的简单 php 应用。这里我们将会介绍 WeaveDNS,它提供一个不需要改变代码就可以让容器利用主机名找到的简单方式,并且能够让其他容器通过主机名连接彼此。

|

||||

|

||||

在这篇教程里,我们将使用 nginx 来将负载均衡分配到一个运行 Apache 的容器集合。最简单轻松的方法就是使用 Weave 来把运行在 ubuntu 上的 docker 容器中的 nginx 配置成负载均衡服务器。

|

||||

|

||||

### 1. 搭建 AWS 实例 ###

|

||||

|

||||

首先,我们需要搭建 Amzaon Web Service 实例,这样才能在 ubuntu 下用 weave 跑 docker 容器。我们将会使用[AWS 命令行][1] 来搭建和配置两个 AWS EC2 实例。在这里,我们使用最小的可用实例,t1.micro。我们需要一个有效的**Amazon Web Services 账户**使用 AWS 命令行界面来搭建和配置。我们先在 AWS 命令行界面下使用下面的命令将 github 上的 weave 仓库克隆下来。

|

||||

|

||||

$ git clone http://github.com/fintanr/weave-gs

|

||||

$ cd weave-gs/aws-nginx-ubuntu-simple

|

||||

|

||||

在克隆完仓库之后,我们执行下面的脚本,这个脚本将会部署两个 t1.micro 实例,每个实例中都是 ubuntu 作为操作系统并用 weave 跑着 docker 容器。

|

||||

|

||||

$ sudo ./demo-aws-setup.sh

|

||||

|

||||

在这里,我们将会在以后用到这些实例的 IP 地址。这些地址储存在一个 weavedemo.env 文件中,这个文件创建于执行 demo-aws-setup.sh 脚本期间。为了获取这些 IP 地址,我们需要执行下面的命令,命令输出类似下面的信息。

|

||||

|

||||

$ cat weavedemo.env

|

||||

|

||||

export WEAVE_AWS_DEMO_HOST1=52.26.175.175

|

||||

export WEAVE_AWS_DEMO_HOST2=52.26.83.141

|

||||

export WEAVE_AWS_DEMO_HOSTCOUNT=2

|

||||

export WEAVE_AWS_DEMO_HOSTS=(52.26.175.175 52.26.83.141)

|

||||

|

||||

请注意这些不是固定的 IP 地址,AWS 会为我们的实例动态地分配 IP 地址。

|

||||

|

||||

我们在 bash 下执行下面的命令使环境变量生效。

|

||||

|

||||

. ./weavedemo.env

|

||||

|

||||

### 2. 启动 Weave 和 WeaveDNS ###

|

||||

|

||||

在安装完实例之后,我们将会在每台主机上启动 weave 以及 weavedns。Weave 以及 weavedns 使得我们能够轻易地将容器部署到一个全新的基础架构以及配置中, 不需要改变代码,也不需要去理解像 Ambassador 容器以及 Link 机制之类的概念。下面是在第一台主机上启动 weave 以及 weavedns 的命令。

|

||||

|

||||

ssh -i weavedemo-key.pem ubuntu@$WEAVE_AWS_DEMO_HOST1

|

||||

$ sudo weave launch

|

||||

$ sudo weave launch-dns 10.2.1.1/24

|

||||

|

||||

下一步,我也准备在第二台主机上启动 weave 以及 weavedns。

|

||||

|

||||

ssh -i weavedemo-key.pem ubuntu@$WEAVE_AWS_DEMO_HOST2

|

||||

$ sudo weave launch $WEAVE_AWS_DEMO_HOST1

|

||||

$ sudo weave launch-dns 10.2.1.2/24

|

||||

|

||||

### 3. 启动应用容器 ###

|

||||

|

||||

现在,我们准备跨两台主机启动六个容器,这两台主机都用 Apache2 Web 服务实例跑着简单的 php 网站。为了在第一个 Apache2 Web 服务器实例跑三个容器, 我们将会使用下面的命令。

|

||||

|

||||

ssh -i weavedemo-key.pem ubuntu@$WEAVE_AWS_DEMO_HOST1

|

||||

$ sudo weave run --with-dns 10.3.1.1/24 -h ws1.weave.local fintanr/weave-gs-nginx-apache

|

||||

$ sudo weave run --with-dns 10.3.1.2/24 -h ws2.weave.local fintanr/weave-gs-nginx-apache

|

||||

$ sudo weave run --with-dns 10.3.1.3/24 -h ws3.weave.local fintanr/weave-gs-nginx-apache

|

||||

|

||||

在那之后,我们将会在第二个实例上启动另外三个容器,请使用下面的命令。

|

||||

|

||||

ssh -i weavedemo-key.pem ubuntu@$WEAVE_AWS_DEMO_HOST2

|

||||

$ sudo weave run --with-dns 10.3.1.4/24 -h ws4.weave.local fintanr/weave-gs-nginx-apache

|

||||

$ sudo weave run --with-dns 10.3.1.5/24 -h ws5.weave.local fintanr/weave-gs-nginx-apache

|

||||

$ sudo weave run --with-dns 10.3.1.6/24 -h ws6.weave.local fintanr/weave-gs-nginx-apache

|

||||

|

||||

注意: 在这里,--with-dns 选项告诉容器使用 weavedns 来解析主机名,-h x.weave.local 则使得 weavedns 能够解析该主机。

|

||||

|

||||

### 4. 启动 Nginx 容器 ###

|

||||

|

||||

在应用容器如预期的运行后,我们将会启动 nginx 容器,它将会在六个应用容器服务之间轮询并提供反向代理或者负载均衡。 为了启动 nginx 容器,请使用下面的命令。

|

||||

|

||||

ssh -i weavedemo-key.pem ubuntu@$WEAVE_AWS_DEMO_HOST1

|

||||

$ sudo weave run --with-dns 10.3.1.7/24 -ti -h nginx.weave.local -d -p 80:80 fintanr/weave-gs-nginx-simple

|

||||

|

||||

因此,我们的 nginx 容器在 $WEAVE_AWS_DEMO_HOST1 上公开地暴露成为一个 http 服务器。

|

||||

|

||||

### 5. 测试负载均衡服务器 ###

|

||||

|

||||

为了测试我们的负载均衡服务器是否可以工作,我们执行一段可以发送 http 请求给 nginx 容器的脚本。我们将会发送6个请求,这样我们就能看到 nginx 在一次的轮询中服务于每台 web 服务器之间。

|

||||

|

||||

$ ./access-aws-hosts.sh

|

||||

|

||||

{

|

||||

"message" : "Hello Weave - nginx example",

|

||||

"hostname" : "ws1.weave.local",

|

||||

"date" : "2015-06-26 12:24:23"

|

||||

}

|

||||

{

|

||||

"message" : "Hello Weave - nginx example",

|

||||

"hostname" : "ws2.weave.local",

|

||||

"date" : "2015-06-26 12:24:23"

|

||||

}

|

||||

{

|

||||

"message" : "Hello Weave - nginx example",

|

||||

"hostname" : "ws3.weave.local",

|

||||

"date" : "2015-06-26 12:24:23"

|

||||

}

|

||||

{

|

||||

"message" : "Hello Weave - nginx example",

|

||||

"hostname" : "ws4.weave.local",

|

||||

"date" : "2015-06-26 12:24:23"

|

||||

}

|

||||

{

|

||||

"message" : "Hello Weave - nginx example",

|

||||

"hostname" : "ws5.weave.local",

|

||||

"date" : "2015-06-26 12:24:23"

|

||||

}

|

||||

{

|

||||

"message" : "Hello Weave - nginx example",

|

||||

"hostname" : "ws6.weave.local",

|

||||

"date" : "2015-06-26 12:24:23"

|

||||

}

|

||||

|

||||

### 结束语 ###

|

||||

|

||||

我们最终成功地将 nginx 配置成一个反向代理/负载均衡服务器,通过使用 weave 以及运行在 AWS(Amazon Web Service)EC2 里面的 ubuntu 服务器中的 docker。从上面的步骤输出可以清楚的看到我们已经成功地配置了 nginx。我们可以看到请求在一次轮询中被发送到6个应用容器,这些容器在 Apache2 Web 服务器中跑着 PHP 应用。在这里,我们部署了一个容器化的 PHP 应用,使用 nginx 横跨多台在 AWS EC2 上的主机而不需要改变代码,利用 weavedns 使得每个容器连接在一起,只需要主机名就够了,眼前的这些便捷, 都要归功于 weave 以及 weavedns。

|

||||

|

||||

如果你有任何的问题、建议、反馈,请在评论中注明,这样我们才能够做得更好,谢谢:-)

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://linoxide.com/linux-how-to/nginx-load-balancer-weave-docker/

|

||||

|

||||

作者:[Arun Pyasi][a]

|

||||

译者:[dingdongnigetou](https://github.com/dingdongnigetou)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://linoxide.com/author/arunp/

|

||||

[1]:http://console.aws.amazon.com/

|

||||

@ -0,0 +1,114 @@

|

||||

安装 Strongswan :Linux 上一个基于 IPsec 的 VPN 工具

|

||||

================================================================================

|

||||

|

||||

IPsec是一个提供网络层安全的标准。它包含认证头(AH)和安全负载封装(ESP)组件。AH提供包的完整性,ESP组件提供包的保密性。IPsec确保了在网络层的安全特性。

|

||||

|

||||

- 保密性

|

||||

- 数据包完整性

|

||||

- 来源不可抵赖性

|

||||

- 重放攻击防护

|

||||

|

||||

[Strongswan][1]是一个IPsec协议的开源代码实现,Strongswan的意思是强安全广域网(StrongS/WAN)。它支持IPsec的VPN中的两个版本的密钥自动交换(网络密钥交换(IKE)V1和V2)。

|

||||

|

||||

Strongswan基本上提供了在VPN的两个节点/网关之间自动交换密钥的共享,然后它使用了Linux内核的IPsec(AH和ESP)实现。密钥共享使用了之后用于ESP数据加密的IKE 机制。在IKE阶段,strongswan使用OpenSSL的加密算法(AES,SHA等等)和其他加密类库。无论如何,IPsec中的ESP组件使用的安全算法是由Linux内核实现的。Strongswan的主要特性如下:

|

||||

|

||||

- x.509证书或基于预共享密钥认证

|

||||

- 支持IKEv1和IKEv2密钥交换协议

|

||||

- 可选的,对于插件和库的内置完整性和加密测试

|

||||

- 支持椭圆曲线DH群和ECDSA证书

|

||||

- 在智能卡上存储RSA私钥和证书

|

||||

|

||||

它能被使用在客户端/服务器(road warrior模式)和网关到网关的情景。

|

||||

|

||||

### 如何安装 ###

|

||||

|

||||

几乎所有的Linux发行版都支持Strongswan的二进制包。在这个教程,我们会从二进制包安装strongswan,也会从源代码编译带有合适的特性的strongswan。

|

||||

|

||||

### 使用二进制包 ###

|

||||

|

||||

可以使用以下命令安装Strongswan到Ubuntu 14.04 LTS

|

||||

|

||||

$ sudo aptitude install strongswan

|

||||

|

||||

|

||||

|

||||

strongswan的全局配置(strongswan.conf)文件和ipsec配置(ipsec.conf/ipsec.secrets)文件都在/etc/目录下。

|

||||

|

||||

### strongswan源码编译安装的依赖包 ###

|

||||

|

||||

- GMP(strongswan使用的高精度数学库)

|

||||

- OpenSSL(加密算法来自这个库)

|

||||

- PKCS(1,7,8,11,12)(证书编码和智能卡集成)

|

||||

|

||||

#### 步骤 ####

|

||||

|

||||

**1)** 在终端使用下面命令到/usr/src/目录

|

||||

|

||||

$ cd /usr/src

|

||||

|

||||

**2)** 用下面命令从strongswan网站下载源代码

|

||||

|

||||

$ sudo wget http://download.strongswan.org/strongswan-5.2.1.tar.gz

|

||||

|

||||

(strongswan-5.2.1.tar.gz 是当前最新版。)

|

||||

|

||||

|

||||

|

||||

**3)** 用下面命令提取下载的软件,然后进入目录。

|

||||

|

||||

$ sudo tar –xvzf strongswan-5.2.1.tar.gz; cd strongswan-5.2.1

|

||||

|

||||

**4)** 使用configure命令配置strongswan每个想要的选项。

|

||||

|

||||

$ ./configure --prefix=/usr/local -–enable-pkcs11 -–enable-openssl

|

||||

|

||||

|

||||

|

||||

如果GMP库没有安装,配置脚本将会发生下面的错误。

|

||||

|

||||

|

||||

|

||||

因此,首先,使用下面命令安装GMP库然后执行配置脚本。

|

||||

|

||||

|

||||

|

||||

不过,如果GMP已经安装还报上述错误的话,在Ubuntu上使用如下命令,给在路径 /usr/lib,/lib/,/usr/lib/x86_64-linux-gnu/ 下的libgmp.so库创建软连接。

|

||||

|

||||

$ sudo ln -s /usr/lib/x86_64-linux-gnu/libgmp.so.10.1.3 /usr/lib/x86_64-linux-gnu/libgmp.so

|

||||

|

||||

|

||||

|

||||

创建libgmp.so软连接后,再执行./configure脚本也许就找到gmp库了。然而,如果gmp头文件发生其他错误,像下面这样。

|

||||

|

||||

|

||||

|

||||

为解决上面的错误,使用下面命令安装libgmp-dev包

|

||||

|

||||

$ sudo aptitude install libgmp-dev

|

||||

|

||||

|

||||

|

||||

安装gmp的开发库后,在运行一遍配置脚本,如果没有发生错误,则将看见下面的这些输出。

|

||||

|

||||

|

||||

|

||||

使用下面的命令编译安装strongswan。

|

||||

|

||||

$ sudo make ; sudo make install

|

||||

|

||||

安装strongswan后,全局配置(strongswan.conf)和ipsec策略/密码配置文件(ipsec.conf/ipsec.secretes)被放在**/usr/local/etc**目录。

|

||||

|

||||

根据我们的安全需要Strongswan可以用作隧道或者传输模式。它提供众所周知的site-2-site模式和road warrior模式的VPN。它很容易使用在Cisco,Juniper设备上。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://linoxide.com/security/install-strongswan/

|

||||

|

||||

作者:[nido][a]

|

||||

译者:[wyangsun](https://github.com/wyangsun)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://linoxide.com/author/naveeda/

|

||||

[1]:https://www.strongswan.org/

|

||||

@ -1,48 +1,49 @@

|

||||

在 Debian 中安装 OpenQRM 云计算平台

|

||||

================================================================================

|

||||

|

||||

### 简介 ###

|

||||

|

||||

**openQRM**是一个基于 Web 的开源云计算和数据中心管理平台,可灵活地与企业数据中心的现存组件集成。

|

||||

|

||||

它支持下列虚拟技术:

|

||||

|

||||

- KVM,

|

||||

- XEN,

|

||||

- Citrix XenServer,

|

||||

- VMWare ESX,

|

||||

- LXC,

|

||||

- OpenVZ.

|

||||

- KVM

|

||||

- XEN

|

||||

- Citrix XenServer

|

||||

- VMWare ESX

|

||||

- LXC

|

||||

- OpenVZ

|

||||

|

||||

openQRM 中的杂交云连接器通过 **Amazon AWS**, **Eucalyptus** 或 **OpenStack** 来支持一系列的私有或公有云提供商,以此来按需扩展你的基础设施。它也自动地进行资源调配、 虚拟化、 存储和配置管理,且关注高可用性。集成计费系统的自助服务云门户可使终端用户按需请求新的服务器和应用堆栈。

|

||||

openQRM 中的混合云连接器支持 **Amazon AWS**, **Eucalyptus** 或 **OpenStack** 等一系列的私有或公有云提供商,以此来按需扩展你的基础设施。它也可以自动地进行资源调配、 虚拟化、 存储和配置管理,且保证高可用性。集成的计费系统的自服务云门户可使终端用户按需请求新的服务器和应用堆栈。

|

||||

|

||||

openQRM 有两种不同风格的版本可获取:

|

||||

|

||||

- 企业版

|

||||

- 社区版

|

||||

|

||||

你可以在[这里][1] 查看这两个版本间的区别。

|

||||

你可以在[这里][1]查看这两个版本间的区别。

|

||||

|

||||

### 特点 ###

|

||||

|

||||

- 私有/杂交的云计算平台;

|

||||

- 可管理物理或虚拟的服务器系统;

|

||||

- 可与所有主流的开源或商业的存储技术集成;

|

||||

- 跨平台: Linux, Windows, OpenSolaris, and BSD;

|

||||

- 支持 KVM, XEN, Citrix XenServer, VMWare ESX(i), lxc, OpenVZ 和 VirtualBox;

|

||||

- 支持使用额外的 Amazon AWS, Eucalyptus, Ubuntu UEC 等云资源来进行杂交云设置;

|

||||

- 支持 P2V, P2P, V2P, V2V 迁移和高可用性;

|

||||

- 集成最好的开源管理工具 – 如 puppet, nagios/Icinga 或 collectd;

|

||||

- 有超过 50 个插件来支持扩展功能并与你的基础设施集成;

|

||||

- 针对终端用户的自助门户;

|

||||

- 集成计费系统.

|

||||

- 私有/混合的云计算平台

|

||||

- 可管理物理或虚拟的服务器系统

|

||||

- 集成了所有主流的开源或商业的存储技术

|

||||

- 跨平台: Linux, Windows, OpenSolaris 和 BSD

|

||||

- 支持 KVM, XEN, Citrix XenServer, VMWare ESX(i), lxc, OpenVZ 和 VirtualBox

|

||||

- 支持使用额外的 Amazon AWS, Eucalyptus, Ubuntu UEC 等云资源来进行混合云设置

|

||||

- 支持 P2V, P2P, V2P, V2V 迁移和高可用性

|

||||

- 集成最好的开源管理工具 – 如 puppet, nagios/Icinga 或 collectd

|

||||

- 有超过 50 个插件来支持扩展功能并与你的基础设施集成

|

||||

- 针对终端用户的自服务门户

|

||||

- 集成了计费系统

|

||||

|

||||

### 安装 ###

|

||||

|

||||

在这里我们将在 in Debian 7.5 上安装 openQRM。你的服务器必须至少满足以下要求:

|

||||

在这里我们将在 Debian 7.5 上安装 openQRM。你的服务器必须至少满足以下要求:

|

||||

|

||||

- 1 GB RAM;

|

||||

- 100 GB Hdd(硬盘驱动器);

|

||||

- 可选: Bios 支持虚拟化(Intel CPUs 的 VT 或 AMD CPUs AMD-V).

|

||||

- 1 GB RAM

|

||||

- 100 GB Hdd(硬盘驱动器)

|

||||

- 可选: Bios 支持虚拟化(Intel CPUs 的 VT 或 AMD CPUs AMD-V)

|

||||

|

||||

首先,安装 `make` 软件包来编译 openQRM 源码包:

|

||||

|

||||

@ -52,7 +53,7 @@ openQRM 有两种不同风格的版本可获取:

|

||||

|

||||

然后,逐次运行下面的命令来安装 openQRM。

|

||||

|

||||

从[这里][2] 下载最新的可用版本:

|

||||

从[这里][2]下载最新的可用版本:

|

||||

|

||||

wget http://sourceforge.net/projects/openqrm/files/openQRM-Community-5.1/openqrm-community-5.1.tgz

|

||||

|

||||

@ -66,35 +67,35 @@ openQRM 有两种不同风格的版本可获取:

|

||||

|

||||

sudo make start

|

||||

|

||||

安装期间,你将被询问去更新文件 `php.ini`

|

||||

安装期间,会要求你更新文件 `php.ini`

|

||||

|

||||

|

||||

|

||||

|

||||

输入 mysql root 用户密码。

|

||||

|

||||

|

||||

|

||||

|

||||

再次输入密码:

|

||||

|

||||

|

||||

|

||||

|

||||

选择邮件服务器配置类型。

|

||||

选择邮件服务器配置类型:

|

||||

|

||||

|

||||

|

||||

|

||||

假如你不确定该如何选择,可选择 `Local only`。在我们的这个示例中,我选择了 **Local only** 选项。

|

||||

|

||||

|

||||

|

||||

|

||||

输入你的系统邮件名称,并最后输入 Nagios 管理员密码。

|

||||

|

||||

|

||||

|

||||

|

||||

根据你的网络连接状态,上面的命令可能将花费很长的时间来下载所有运行 openQRM 所需的软件包,请耐心等待。

|

||||

|

||||

最后你将得到 openQRM 配置 URL 地址以及相关的用户名和密码。

|

||||

|

||||

|

||||

|

||||

|

||||

### 配置 ###

|

||||

|

||||

@ -104,23 +105,23 @@ openQRM 有两种不同风格的版本可获取:

|

||||

|

||||

默认的用户名和密码是: **openqrm/openqrm** 。

|

||||

|

||||

|

||||

|

||||

|

||||

选择一个网卡来给 openQRM 管理网络使用。

|

||||

|

||||

|

||||

|

||||

|

||||

选择一个数据库类型,在我们的示例中,我选择了 mysql。

|

||||

|

||||

|

||||

|

||||

|

||||

现在,配置数据库连接并初始化 openQRM, 在这里,我使用 **openQRM** 作为数据库名称, **root** 作为用户的身份,并将 debian 作为数据库的密码。 请小心,你应该输入先前在安装 openQRM 时创建的 mysql root 用户密码。

|

||||

|

||||

|

||||

|

||||

|

||||

祝贺你!! openQRM 已经安装并配置好了。

|

||||

祝贺你! openQRM 已经安装并配置好了。

|

||||

|

||||

|

||||

|

||||

|

||||

### 更新 openQRM ###

|

||||

|

||||

@ -129,16 +130,17 @@ openQRM 有两种不同风格的版本可获取:

|

||||

cd openqrm/src/

|

||||

make update

|

||||

|

||||

到现在为止,我们做的只是在我们的 Ubuntu 服务器中安装和配置 openQRM, 至于 创建、运行虚拟,管理存储,额外的系统集成和运行你自己的私有云等内容,我建议你阅读 [openQRM 管理员指南][3]。

|

||||

到现在为止,我们做的只是在我们的 Debian 服务器中安装和配置 openQRM, 至于 创建、运行虚拟,管理存储,额外的系统集成和运行你自己的私有云等内容,我建议你阅读 [openQRM 管理员指南][3]。

|

||||

|

||||

就是这些了,欢呼吧!周末快乐!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.unixmen.com/install-openqrm-cloud-computing-platform-debian/

|

||||

|

||||

作者:[SK][a]

|

||||

译者:[FSSlc](https://github.com/FSSlc)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,14 +1,14 @@

|

||||

Ubuntu上使用LVM轻松调整分区并制作快照

|

||||

Ubuntu 上使用 LVM 轻松调整分区并制作快照

|

||||

================================================================================

|

||||

|

||||

|

||||

Ubuntu的安装器提供了一个轻松“使用LVM”的复选框。说明中说,它启用了逻辑卷管理,因此你可以制作快照,并更容易地调整硬盘分区大小——这里将为大家讲述如何完成这些操作。

|

||||

Ubuntu的安装器提供了一个轻松“使用LVM”的复选框。它的描述中说,启用逻辑卷管理可以让你制作快照,并更容易地调整硬盘分区大小——这里将为大家讲述如何完成这些操作。

|

||||

|

||||

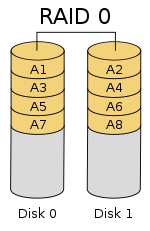

LVM是一种技术,某种程度上和[RAID阵列][1]或[Windows上的存储空间][2]类似。虽然该技术在服务器上更为有用,但是它也可以在桌面端PC上使用。

|

||||

LVM是一种技术,某种程度上和[RAID阵列][1]或[Windows上的“存储空间”][2]类似。虽然该技术在服务器上更为有用,但是它也可以在桌面端PC上使用。

|

||||

|

||||

### 你应该在新安装Ubuntu时使用LVM吗? ###

|

||||

|

||||

第一个问题是,你是否想要在安装Ubuntu时使用LVM?如果是,那么Ubuntu让这一切变得很简单,只需要轻点鼠标就可以完成,但是该选项默认是不启用的。正如安装器所说的,它允许你调整分区、创建快照、合并多个磁盘到一个逻辑卷等等——所有这一切都可以在系统运行时完成。不同于传统分区,你不需要关掉你的系统,从Live CD或USB驱动,然后[调整这些不使用的分区][3]。

|

||||

第一个问题是,你是否想要在安装Ubuntu时使用LVM?如果是,那么Ubuntu让这一切变得很简单,只需要轻点鼠标就可以完成,但是该选项默认是不启用的。正如安装器所说的,它允许你调整分区、创建快照、将多个磁盘合并到一个逻辑卷等等——所有这一切都可以在系统运行时完成。不同于传统分区,你不需要关掉你的系统,从Live CD或USB驱动,然后[当这些分区不使用时才能调整][3]。

|

||||

|

||||

完全坦率地说,普通Ubuntu桌面用户可能不会意识到他们是否正在使用LVM。但是,如果你想要在今后做一些更高深的事情,那么LVM就会有所帮助了。LVM可能更复杂,可能会在你今后恢复数据时会导致问题——尤其是在你经验不足时。这里不会有显著的性能损失——LVM是彻底地在Linux内核中实现的。

|

||||

|

||||

@ -18,7 +18,7 @@ LVM是一种技术,某种程度上和[RAID阵列][1]或[Windows上的存储空

|

||||

|

||||

前面,我们已经[说明了何谓LVM][4]。概括来讲,它在你的物理磁盘和呈现在你系统中的分区之间提供了一个抽象层。例如,你的计算机可能装有两个硬盘驱动器,它们的大小都是 1 TB。你必须得在这些磁盘上至少分两个区,每个区大小 1 TB。

|

||||

|

||||

LVM就在这些分区上提供了一个抽象层。用于取代磁盘上的传统分区,LVM将在你对这些磁盘初始化后,将它们当作独立的“物理卷”来对待。然后,你就可以基于这些物理卷创建“逻辑卷”。例如,你可以将这两个 1 TB 的磁盘组合成一个 2 TB 的分区,你的系统将只看到一个 2 TB 的卷,而LVM将会在后台处理这一切。一组物理卷以及一组逻辑卷被称之为“卷组”,一个标准的系统只会有一个卷组。

|

||||

LVM就在这些分区上提供了一个抽象层。用于取代磁盘上的传统分区,LVM将在你对这些磁盘初始化后,将它们当作独立的“物理卷”来对待。然后,你就可以基于这些物理卷创建“逻辑卷”。例如,你可以将这两个 1 TB 的磁盘组合成一个 2 TB 的分区,你的系统将只看到一个 2 TB 的卷,而LVM将会在后台处理这一切。一组物理卷以及一组逻辑卷被称之为“卷组”,一个典型的系统只会有一个卷组。

|

||||

|

||||

该抽象层使得调整分区、将多个磁盘组合成单个卷、甚至为一个运行着的分区的文件系统创建“快照”变得十分简单,而完成所有这一切都无需先卸载分区。

|

||||

|

||||

@ -28,11 +28,11 @@ LVM就在这些分区上提供了一个抽象层。用于取代磁盘上的传

|

||||

|

||||

通常,[LVM通过Linux终端命令来管理][5]。这在Ubuntu上也行得通,但是有个更简单的图形化方法可供大家采用。如果你是一个Linux用户,对GParted或者与其类似的分区管理器熟悉,算了,别瞎掰了——GParted根本不支持LVM磁盘。

|

||||

|

||||

然而,你可以使用Ubuntu附带的磁盘工具。该工具也被称之为GNOME磁盘工具,或者叫Palimpsest。点击停靠盘上的图标来开启它吧,搜索磁盘然后敲击回车。不像GParted,该磁盘工具将会在“其它设备”下显示LVM分区,因此你可以根据需要格式化这些分区,也可以调整其它选项。该工具在Live CD或USB 驱动下也可以使用。

|

||||

然而,你可以使用Ubuntu附带的磁盘工具。该工具也被称之为GNOME磁盘工具,或者叫Palimpsest。点击dash中的图标来开启它吧,搜索“磁盘”然后敲击回车。不像GParted,该磁盘工具将会在“其它设备”下显示LVM分区,因此你可以根据需要格式化这些分区,也可以调整其它选项。该工具在Live CD或USB 驱动下也可以使用。

|

||||

|

||||

|

||||

|

||||

不幸的是,该磁盘工具不支持LVM的大多数强大的特性,没有管理卷组、扩展分区,或者创建快照等选项。对于这些操作,你可以通过终端来实现,但是你没有那个必要。相反,你可以打开Ubuntu软件中心,搜索关键字LVM,然后安装逻辑卷管理工具,你可以在终端窗口中运行**sudo apt-get install system-config-lvm**命令来安装它。安装完之后,你就可以从停靠盘上打开逻辑卷管理工具了。

|

||||

不幸的是,该磁盘工具不支持LVM的大多数强大的特性,没有管理卷组、扩展分区,或者创建快照等选项。对于这些操作,你可以通过终端来实现,但是没有那个必要。相反,你可以打开Ubuntu软件中心,搜索关键字LVM,然后安装逻辑卷管理工具,你可以在终端窗口中运行**sudo apt-get install system-config-lvm**命令来安装它。安装完之后,你就可以从dash上打开逻辑卷管理工具了。

|

||||

|

||||

这个图形化配置工具是由红帽公司开发的,虽然有点陈旧了,但却是唯一的图形化方式,你可以通过它来完成上述操作,将那些终端命令抛诸脑后了。

|

||||

|

||||

@ -40,11 +40,11 @@ LVM就在这些分区上提供了一个抽象层。用于取代磁盘上的传

|

||||

|

||||

|

||||

|

||||

卷组视图会列出你所有物理卷和逻辑卷的总览。这里,我们有两个横跨两个独立硬盘驱动器的物理分区,我们有一个交换分区和一个根分区,就像Ubuntu默认设置的分区图表。由于我们从另一个驱动器添加了第二个物理分区,现在那里有大量未使用空间。

|

||||

卷组视图会列出你所有的物理卷和逻辑卷的总览。这里,我们有两个横跨两个独立硬盘驱动器的物理分区,我们有一个交换分区和一个根分区,这是Ubuntu默认设置的分区图表。由于我们从另一个驱动器添加了第二个物理分区,现在那里有大量未使用空间。

|

||||

|

||||

|

||||

|

||||

要扩展逻辑分区到物理空间,你可以在逻辑视图下选择它,点击编辑属性,然后修改大小来扩大分区。你也可以在这里缩减分区。

|

||||

要扩展逻辑分区到物理空间,你可以在逻辑视图下选择它,点击编辑属性,然后修改大小来扩大分区。你也可以在这里缩小分区。

|

||||

|

||||

|

||||

|

||||

@ -55,7 +55,7 @@ system-config-lvm的其它选项允许你设置快照和镜像。对于传统桌

|

||||

via: http://www.howtogeek.com/211937/how-to-use-lvm-on-ubuntu-for-easy-partition-resizing-and-snapshots/

|

||||

|

||||

译者:[GOLinux](https://github.com/GOLinux)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,89 @@

|

||||

如何在树莓派 2 运行 ubuntu Snappy Core

|

||||

================================================================================

|

||||

物联网(Internet of Things, IoT) 时代即将来临。很快,过不了几年,我们就会问自己当初是怎么在没有物联网的情况下生存的,就像我们现在怀疑过去没有手机的年代。Canonical 就是一个物联网快速发展却还是开放市场下的竞争者。这家公司宣称自己把赌注压到了IoT 上,就像他们已经在“云”上做过的一样。在今年一月底,Canonical 启动了一个基于Ubuntu Core 的小型操作系统,名字叫做 [Ubuntu Snappy Core][1] 。

|

||||

|

||||

Snappy 代表了两种意思,它是一种用来替代 deb 的新的打包格式;也是一个用来更新系统的前端,从CoreOS、红帽子和其他系统借鉴了**原子更新**这个想法。自从树莓派 2 投入市场,Canonical 很快就发布了用于树莓派的Snappy Core 版本。而第一代树莓派因为是基于ARMv6 ,Ubuntu 的ARM 镜像是基于ARMv7 ,所以不能运行ubuntu 。不过这种状况现在改变了,Canonical 通过发布 Snappy Core 的RPI2 镜像,抓住机会证明了Snappy 就是一个用于云计算,特别是用于物联网的系统。

|

||||

|

||||

Snappy 同样可以运行在其它像Amazon EC2, Microsofts Azure, Google的 Compute Engine 这样的云端上,也可以虚拟化在 KVM、Virtuabox 和vagrant 上。Canonical Ubuntu 已经拥抱了微软、谷歌、Docker、OpenStack 这些重量级选手,同时也与一些小项目达成合作关系。除了一些创业公司,比如 Ninja Sphere、Erle Robotics,还有一些开发板生产商,比如 Odroid、Banana Pro, Udoo, PCDuino 和 Parallella 、全志,Snappy 也提供了支持。Snappy Core 同时也希望尽快运行到路由器上来帮助改进路由器生产商目前很少更新固件的策略。

|

||||

|

||||

接下来,让我们看看怎么样在树莓派 2 上运行 Ubuntu Snappy Core。

|

||||

|

||||

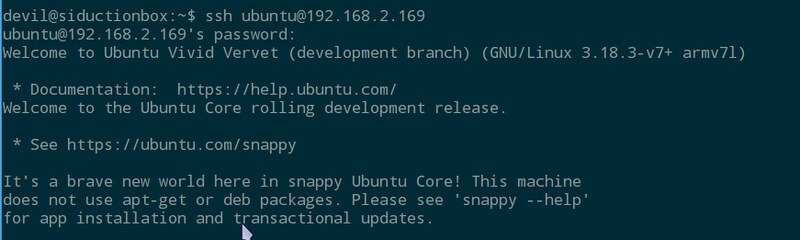

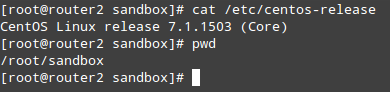

用于树莓派2 的Snappy 镜像可以从 [Raspberry Pi 网站][2] 上下载。解压缩出来的镜像必须[写到一个至少8GB 大小的SD 卡][3]。尽管原始系统很小,但是原子升级和回滚功能会占用不小的空间。使用 Snappy 启动树莓派 2 后你就可以使用默认用户名和密码(都是ubuntu)登录系统。

|

||||

|

||||

|

||||

|

||||

sudo 已经配置好了可以直接用,安全起见,你应该使用以下命令来修改你的用户名

|

||||

|

||||

$ sudo usermod -l <new name> <old name>

|

||||

|

||||

或者也可以使用`adduser` 为你添加一个新用户。

|

||||

|

||||

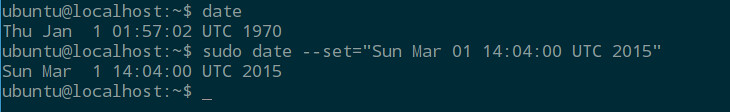

因为RPI缺少硬件时钟,而 Snappy Core 镜像并不知道这一点,所以系统会有一个小 bug:处理某些命令时会报很多错。不过这个很容易解决:

|

||||

|

||||

使用这个命令来确认这个bug 是否影响:

|

||||

|

||||

$ date

|

||||

|

||||

如果输出类似 "Thu Jan 1 01:56:44 UTC 1970", 你可以这样做来改正:

|

||||

|

||||

$ sudo date --set="Sun Apr 04 17:43:26 UTC 2015"

|

||||

|

||||

改成你的实际时间。

|

||||

|

||||

|

||||

|

||||

现在你可能打算检查一下,看看有没有可用的更新。注意通常使用的命令是不行的:

|

||||

|

||||

$ sudo apt-get update && sudo apt-get distupgrade

|

||||

|

||||

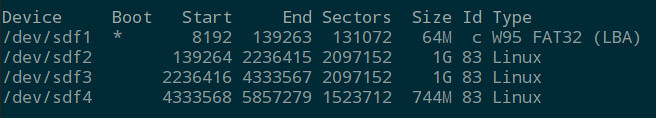

这时系统不会让你通过,因为 Snappy 使用它自己精简过的、基于dpkg 的包管理系统。这么做的原因是 Snappy 会运行很多嵌入式程序,而同时你也会试图所有事情尽可能的简化。

|

||||

|

||||

让我们来看看最关键的部分,理解一下程序是如何与 Snappy 工作的。运行 Snappy 的SD 卡上除了 boot 分区外还有3个分区。其中的两个构成了一个重复的文件系统。这两个平行文件系统被固定挂载为只读模式,并且任何时刻只有一个是激活的。第三个分区是一个部分可写的文件系统,用来让用户存储数据。通过更新系统,标记为'system-a' 的分区会保持一个完整的文件系统,被称作核心,而另一个平行的文件系统仍然会是空的。

|

||||

|

||||

|

||||

|

||||

如果我们运行以下命令:

|

||||

|

||||

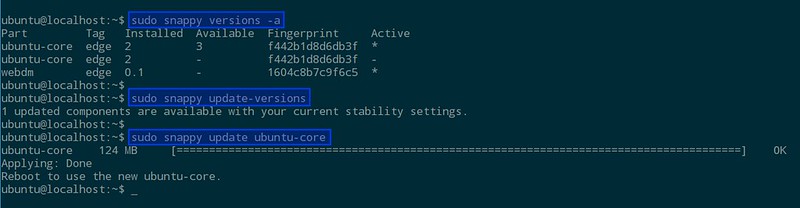

$ sudo snappy update

|

||||

|

||||

系统将会在'system-b' 上作为一个整体进行更新,这有点像是更新一个镜像文件。接下来你将会被告知要重启系统来激活新核心。

|

||||

|

||||

重启之后,运行下面的命令可以检查你的系统是否已经更新到最新版本,以及当前被激活的是哪个核心

|

||||

|

||||

$ sudo snappy versions -a

|

||||

|

||||

经过更新-重启两步操作,你应该可以看到被激活的核心已经被改变了。

|

||||

|

||||

因为到目前为止我们还没有安装任何软件,所以可以用下面的命令更新:

|

||||

|

||||

$ sudo snappy update ubuntu-core

|

||||

|

||||

如果你打算仅仅更新特定的OS 版本这就够了。如果出了问题,你可以使用下面的命令回滚:

|

||||

|

||||

$ sudo snappy rollback ubuntu-core

|

||||

|

||||

这将会把系统状态回滚到更新之前。

|

||||

|

||||

|

||||

|

||||

再来说说那些让 Snappy 变得有用的软件。这里不会讲的太多关于如何构建软件、向 Snappy 应用商店添加软件的基础知识,但是你可以通过 Freenode 上的IRC 频道 #snappy 了解更多信息,那个上面有很多人参与。你可以通过浏览器访问http://\<ip-address>:4200 来浏览应用商店,然后从商店安装软件,再在浏览器里访问 http://webdm.local 来启动程序。如何构建用于 Snappy 的软件并不难,而且也有了现成的[参考文档][4] 。你也可以很容易的把 DEB 安装包使用Snappy 格式移植到Snappy 上。

|

||||

|

||||

|

||||

|

||||

尽管 Ubuntu Snappy Core 吸引了我们去研究新型的 Snappy 安装包格式和 Canonical 式的原子更新操作,但是因为有限的可用应用,它现在在生产环境里还不是很有用。但是既然搭建一个 Snappy 环境如此简单,这看起来是一个学点新东西的好机会。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://xmodulo.com/ubuntu-snappy-core-raspberry-pi-2.html

|

||||

|

||||

作者:[Ferdinand Thommes][a]

|

||||

译者:[Ezio](https://github.com/oska874)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://xmodulo.com/author/ferdinand

|

||||

[1]:http://www.ubuntu.com/things

|

||||

[2]:http://www.raspberrypi.org/downloads/

|

||||

[3]:http://xmodulo.com/write-raspberry-pi-image-sd-card.html

|

||||

[4]:https://developer.ubuntu.com/en/snappy/

|

||||

@ -1,10 +1,11 @@

|

||||

如何配置MongoDB副本集(Replica Set)

|

||||

如何配置 MongoDB 副本集

|

||||

================================================================================

|

||||

MongoDB已经成为市面上最知名的NoSQL数据库。MongoDB是面向文档的,它的无模式设计使得它在各种各样的WEB应用当中广受欢迎。最让我喜欢的特性之一是它的副本集,副本集将同一数据的多份拷贝放在一组mongod节点上,从而实现数据的冗余以及高可用性。

|

||||

|

||||

这篇教程将向你介绍如何配置一个MongoDB副本集。

|

||||

MongoDB 已经成为市面上最知名的 NoSQL 数据库。MongoDB 是面向文档的,它的无模式设计使得它在各种各样的WEB 应用当中广受欢迎。最让我喜欢的特性之一是它的副本集(Replica Set),副本集将同一数据的多份拷贝放在一组 mongod 节点上,从而实现数据的冗余以及高可用性。

|

||||

|

||||

副本集的最常见配置涉及到一个主节点以及多个副节点。这之后启动的复制行为会从这个主节点到其他副节点。副本集不止可以针对意外的硬件故障和停机事件对数据库提供保护,同时也因为提供了更多的结点从而提高了数据库客户端数据读取的吞吐量。

|

||||

这篇教程将向你介绍如何配置一个 MongoDB 副本集。

|

||||

|

||||

副本集的最常见配置需要一个主节点以及多个副节点。这之后启动的复制行为会从这个主节点到其他副节点。副本集不止可以针对意外的硬件故障和停机事件对数据库提供保护,同时也因为提供了更多的节点从而提高了数据库客户端数据读取的吞吐量。

|

||||

|

||||

### 配置环境 ###

|

||||

|

||||

@ -12,25 +13,25 @@ MongoDB已经成为市面上最知名的NoSQL数据库。MongoDB是面向文档

|

||||

|

||||

|

||||

|

||||

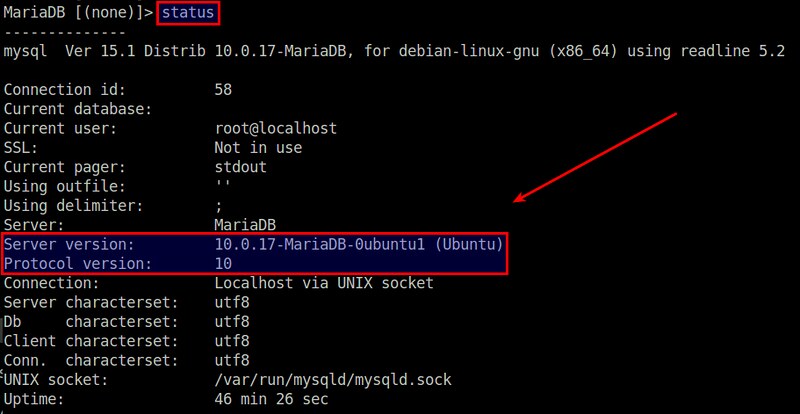

为了达到这个目的,我们使用了3个运行在VirtualBox上的虚拟机。我会在这些虚拟机上安装Ubuntu 14.04,并且安装MongoDB官方包。

|

||||

为了达到这个目的,我们使用了3个运行在 VirtualBox 上的虚拟机。我会在这些虚拟机上安装 Ubuntu 14.04,并且安装 MongoDB 官方包。

|

||||

|

||||

我会在一个虚拟机实例上配置好需要的环境,然后将它克隆到其他的虚拟机实例上。因此,选择一个名为master的虚拟机,执行以下安装过程。

|

||||

我会在一个虚拟机实例上配置好所需的环境,然后将它克隆到其他的虚拟机实例上。因此,选择一个名为 master 的虚拟机,执行以下安装过程。

|

||||

|

||||

首先,我们需要在apt中增加一个MongoDB密钥:

|

||||

首先,我们需要给 apt 增加一个 MongoDB 密钥:

|

||||

|

||||

$ sudo apt-key adv --keyserver hkp://keyserver.ubuntu.com:80 --recv 7F0CEB10

|

||||

|

||||

然后,将官方的MongoDB仓库添加到source.list中:

|

||||

然后,将官方的 MongoDB 仓库添加到 source.list 中:

|

||||

|

||||

$ sudo su

|

||||

# echo "deb http://repo.mongodb.org/apt/ubuntu "$(lsb_release -sc)"/mongodb-org/3.0 multiverse" | sudo tee /etc/apt/sources.list.d/mongodb-org-3.0.list

|

||||

|

||||

接下来更新apt仓库并且安装MongoDB。

|

||||

接下来更新 apt 仓库并且安装 MongoDB。

|

||||

|

||||

$ sudo apt-get update

|

||||

$ sudo apt-get install -y mongodb-org

|

||||

|

||||

现在对/etc/mongodb.conf做一些更改

|

||||

现在对 /etc/mongodb.conf 做一些更改

|

||||

|

||||

auth = true

|

||||

dbpath=/var/lib/mongodb

|

||||

@ -39,17 +40,17 @@ MongoDB已经成为市面上最知名的NoSQL数据库。MongoDB是面向文档

|

||||

keyFile=/var/lib/mongodb/keyFile

|

||||

replSet=myReplica

|

||||

|

||||

第一行的作用是确认我们的数据库需要验证才可以使用的。keyfile用来配置用于MongoDB结点间复制行为的密钥文件。replSet用来为副本集设置一个名称。

|

||||

第一行的作用是表明我们的数据库需要验证才可以使用。keyfile 配置用于 MongoDB 节点间复制行为的密钥文件。replSet 为副本集设置一个名称。

|

||||

|

||||

接下来我们创建一个用于所有实例的密钥文件。

|

||||

|

||||

$ echo -n "MyRandomStringForReplicaSet" | md5sum > keyFile

|

||||

|

||||

这将会创建一个含有MD5字符串的密钥文件,但是由于其中包含了一些噪音,我们需要对他们清理后才能正式在MongoDB中使用。

|

||||

这将会创建一个含有 MD5 字符串的密钥文件,但是由于其中包含了一些噪音,我们需要对他们清理后才能正式在 MongoDB 中使用。

|

||||

|

||||

$ echo -n "MyReplicaSetKey" | md5sum|grep -o "[0-9a-z]\+" > keyFile

|

||||

|

||||

grep命令的作用的是把将空格等我们不想要的内容过滤掉之后的MD5字符串打印出来。

|

||||

grep 命令的作用的是把将空格等我们不想要的内容过滤掉之后的 MD5 字符串打印出来。

|

||||

|

||||

现在我们对密钥文件进行一些操作,让它真正可用。

|

||||

|

||||

@ -57,7 +58,7 @@ grep命令的作用的是把将空格等我们不想要的内容过滤掉之后

|

||||

$ sudo chown mongodb:nogroup keyFile

|

||||

$ sudo chmod 400 keyFile

|

||||

|

||||

接下来,关闭此虚拟机。将其Ubuntu系统克隆到其他虚拟机上。

|

||||

接下来,关闭此虚拟机。将其 Ubuntu 系统克隆到其他虚拟机上。

|

||||

|

||||

|

||||

|

||||

@ -67,55 +68,55 @@ grep命令的作用的是把将空格等我们不想要的内容过滤掉之后

|

||||

|

||||

请注意,三个虚拟机示例需要在同一个网络中以便相互通讯。因此,我们需要它们弄到“互联网"上去。

|

||||

|

||||

这里推荐给每个虚拟机设置一个静态IP地址,而不是使用DHCP。这样它们就不至于在DHCP分配IP地址给他们的时候失去连接。

|

||||

这里推荐给每个虚拟机设置一个静态 IP 地址,而不是使用 DHCP。这样它们就不至于在 DHCP 分配IP地址给他们的时候失去连接。

|

||||

|

||||

像下面这样编辑每个虚拟机的/etc/networks/interfaces文件。

|

||||

像下面这样编辑每个虚拟机的 /etc/networks/interfaces 文件。

|

||||

|

||||

在主结点上:

|

||||

在主节点上:

|

||||

|

||||

auto eth1

|

||||

iface eth1 inet static

|

||||

address 192.168.50.2

|

||||

netmask 255.255.255.0

|

||||

|

||||

在副结点1上:

|

||||

在副节点1上:

|

||||

|

||||

auto eth1

|

||||

iface eth1 inet static

|

||||

address 192.168.50.3

|

||||

netmask 255.255.255.0

|

||||

|

||||

在副结点2上:

|

||||

在副节点2上:

|

||||

|

||||

auto eth1

|

||||

iface eth1 inet static

|

||||

address 192.168.50.4

|

||||

netmask 255.255.255.0

|

||||

|

||||

由于我们没有DNS服务,所以需要设置设置一下/etc/hosts这个文件,手工将主机名称放到次文件中。

|

||||

由于我们没有 DNS 服务,所以需要设置设置一下 /etc/hosts 这个文件,手工将主机名称放到此文件中。

|

||||

|

||||

在主结点上:

|

||||

在主节点上:

|

||||

|

||||

127.0.0.1 localhost primary

|

||||

192.168.50.2 primary

|

||||

192.168.50.3 secondary1

|

||||

192.168.50.4 secondary2

|

||||

|

||||

在副结点1上:

|

||||

在副节点1上:

|

||||

|

||||

127.0.0.1 localhost secondary1

|

||||

192.168.50.2 primary

|

||||

192.168.50.3 secondary1

|

||||

192.168.50.4 secondary2

|

||||

|

||||

在副结点2上:

|

||||

在副节点2上:

|

||||

|

||||

127.0.0.1 localhost secondary2

|

||||

192.168.50.2 primary

|

||||

192.168.50.3 secondary1

|

||||

192.168.50.4 secondary2

|

||||

|

||||

使用ping命令检查各个结点之间的连接。

|

||||

使用 ping 命令检查各个节点之间的连接。

|

||||

|

||||

$ ping primary

|

||||

$ ping secondary1

|

||||

@ -123,9 +124,9 @@ grep命令的作用的是把将空格等我们不想要的内容过滤掉之后

|

||||

|

||||

### 配置副本集 ###

|

||||

|

||||

验证各个结点可以正常连通后,我们就可以新建一个管理员用户,用于之后的副本集操作。

|

||||

验证各个节点可以正常连通后,我们就可以新建一个管理员用户,用于之后的副本集操作。

|

||||

|

||||

在主节点上,打开/etc/mongodb.conf文件,将auth和replSet两项注释掉。

|

||||

在主节点上,打开 /etc/mongodb.conf 文件,将 auth 和 replSet 两项注释掉。

|

||||

|

||||

dbpath=/var/lib/mongodb

|

||||

logpath=/var/log/mongodb/mongod.log

|

||||

@ -133,21 +134,30 @@ grep命令的作用的是把将空格等我们不想要的内容过滤掉之后

|

||||

#auth = true

|

||||

keyFile=/var/lib/mongodb/keyFile

|

||||

#replSet=myReplica

|

||||

|

||||

在一个新安装的 MongoDB 上配置任何用户或副本集之前,你需要注释掉 auth 行。默认情况下,MongoDB 并没有创建任何用户。而如果在你创建用户前启用了 auth,你就不能够做任何事情。你可以在创建一个用户后再次启用 auth。

|

||||

|

||||

重启mongod进程。

|

||||

修改 /etc/mongodb.conf 之后,重启 mongod 进程。

|

||||

|

||||

$ sudo service mongod restart

|

||||

|

||||

连接MongoDB后,新建管理员用户。

|

||||

现在连接到 MongoDB master:

|

||||

|

||||

$ mongo <master-ip-address>:27017

|

||||

|

||||

连接 MongoDB 后,新建管理员用户。

|

||||

|

||||

> use admin

|

||||

> db.createUser({

|

||||

user:"admin",

|

||||

pwd:"

|

||||

})

|

||||

|

||||

重启 MongoDB:

|

||||

|

||||

$ sudo service mongod restart

|

||||

|

||||

连接到MongoDB,用以下命令将secondary1和secondary2节点添加到我们的副本集中。

|

||||

再次连接到 MongoDB,用以下命令将 副节点1 和副节点2节点添加到我们的副本集中。

|

||||

|

||||

> use admin

|

||||

> db.auth("admin","myreallyhardpassword")

|

||||

@ -156,7 +166,7 @@ grep命令的作用的是把将空格等我们不想要的内容过滤掉之后

|

||||

> rs.add("secondary2:27017")

|

||||

|

||||

|

||||

现在副本集到手了,可以开始我们的项目了。参照 [official driver documentation][1] 来了解如何连接到副本集。如果你想要用Shell来请求数据,那么你需要连接到主节点上来插入或者请求数据,副节点不行。如果你执意要尝试用附件点操作,那么以下错误信息就蹦出来招呼你了。

|

||||

现在副本集到手了,可以开始我们的项目了。参照 [官方驱动文档][1] 来了解如何连接到副本集。如果你想要用 Shell 来请求数据,那么你需要连接到主节点上来插入或者请求数据,副节点不行。如果你执意要尝试用副本集操作,那么以下错误信息就蹦出来招呼你了。

|

||||

|

||||

myReplica:SECONDARY>

|

||||

myReplica:SECONDARY> show databases

|

||||

@ -166,6 +176,12 @@ grep命令的作用的是把将空格等我们不想要的内容过滤掉之后

|

||||

at shellHelper.show (src/mongo/shell/utils.js:630:33)

|

||||

at shellHelper (src/mongo/shell/utils.js:524:36)

|

||||

at (shellhelp2):1:1 at src/mongo/shell/mongo.js:47

|

||||

|

||||

如果你要从 shell 连接到整个副本集,你可以安装如下命令。在副本集中的失败切换是自动的。

|

||||

|

||||

$ mongo primary,secondary1,secondary2:27017/?replicaSet=myReplica

|

||||

|

||||

如果你使用其它驱动语言(例如,JavaScript、Ruby 等等),格式也许不同。

|

||||

|

||||

希望这篇教程能对你有所帮助。你可以使用Vagrant来自动完成你的本地环境配置,并且加速你的代码。

|

||||

|

||||

@ -175,7 +191,7 @@ via: http://xmodulo.com/setup-replica-set-mongodb.html

|

||||

|

||||

作者:[Christopher Valerio][a]

|

||||

译者:[mr-ping](https://github.com/mr-ping)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,113 @@

|

||||

在 VirtualBox 中使用 Docker Machine 管理主机

|

||||

================================================================================

|

||||

大家好,今天我们学习在 VirtualBox 中使用 Docker Machine 来创建和管理 Docker 主机。Docker Machine 是一个可以帮助我们在电脑上、在云端、在数据中心内创建 Docker 主机的应用。它为根据用户的配置和需求创建服务器并在其上安装 Docker和客户端提供了一个轻松的解决方案。这个 API 可以用于在本地主机、或数据中心的虚拟机、或云端的实例提供 Docker 服务。Docker Machine 支持 Windows、OSX 和 Linux,并且是以一个独立的二进制文件包形式安装的。仍然使用(与现有 Docker 工具)相同的接口,我们就可以充分利用已经提供 Docker 基础框架的生态系统。只要一个命令,用户就能快速部署 Docker 容器。

|

||||

|

||||

本文列出一些简单的步骤用 Docker Machine 来部署 docker 容器。

|

||||

|

||||

### 1. 安装 Docker Machine ###

|

||||

|

||||

Docker Machine 完美支持所有 Linux 操作系统。首先我们需要从 [github][1] 下载最新版本的 Docker Machine,本文使用 curl 作为下载工具,Docker Machine 版本为 0.2.0。

|

||||

|

||||

**64 位操作系统**

|

||||

|

||||

# curl -L https://github.com/docker/machine/releases/download/v0.2.0/docker-machine_linux-amd64 > /usr/local/bin/docker-machine

|

||||

|

||||

**32 位操作系统**

|

||||

|

||||

# curl -L https://github.com/docker/machine/releases/download/v0.2.0/docker-machine_linux-i386 > /usr/local/bin/docker-machine

|

||||

|

||||

下载完成后,找到 **/usr/local/bin** 目录下的 **docker-machine** 文件,让其可以执行:

|

||||

|

||||

# chmod +x /usr/local/bin/docker-machine

|

||||

|

||||

确认是否成功安装了 docker-machine,可以运行下面的命令,它会打印 Docker Machine 的版本信息:

|

||||

|

||||

# docker-machine -v

|

||||

|

||||

|

||||

|

||||

运行下面的命令,安装 Docker 客户端,以便于在我们自己的电脑止运行 Docker 命令:

|

||||

|

||||

# curl -L https://get.docker.com/builds/linux/x86_64/docker-latest > /usr/local/bin/docker

|

||||

# chmod +x /usr/local/bin/docker

|

||||

|

||||

### 2. 创建 VirtualBox 虚拟机 ###

|

||||

|

||||

在 Linux 系统上安装完 Docker Machine 后,接下来我们可以安装 VirtualBox 虚拟机,运行下面的就可以了。`--driver virtualbox` 选项表示我们要在 VirtualBox 的虚拟机里面部署 docker,最后的参数“linux” 是虚拟机的名称。这个命令会下载 [boot2docker][2] iso,它是个基于 Tiny Core Linux 的轻量级发行版,自带 Docker 程序,然后 `docker-machine` 命令会创建一个 VirtualBox 虚拟机(LCTT译注:当然,我们也可以选择其他的虚拟机软件)来运行这个 boot2docker 系统。

|

||||

|

||||

# docker-machine create --driver virtualbox linux

|

||||

|

||||

|

||||

|

||||

测试下有没有成功运行 VirtualBox 和 Docker,运行命令:

|

||||

|

||||

# docker-machine ls

|

||||

|

||||

|

||||

|

||||

如果执行成功,我们可以看到在 ACTIVE 那列下面会出现一个星号“*”。

|

||||

|

||||

### 3. 设置环境变量 ###

|

||||

|

||||

现在我们需要让 docker 与 docker-machine 通信,运行 `docker-machine env <虚拟机名称>` 来实现这个目的。

|

||||

|

||||

# eval "$(docker-machine env linux)"

|

||||

# docker ps

|

||||

|

||||

这个命令会设置 TLS 认证的环境变量,每次重启机器或者重新打开一个会话都需要执行一下这个命令,我们可以看到它的输出内容:

|

||||

|

||||

# docker-machine env linux

|

||||

|

||||

export DOCKER_TLS_VERIFY=1

|

||||

export DOCKER_CERT_PATH=/Users/<your username>/.docker/machine/machines/dev

|

||||

export DOCKER_HOST=tcp://192.168.99.100:2376

|

||||

|

||||

### 4. 运行 Docker 容器 ###

|

||||

|

||||

完成配置后我们就可以在 VirtualBox 上运行 docker 容器了。测试一下,我们可以运行虚拟机 `docker run busybox` ,并在里面里执行 `echo hello world` 命令,我们可以看到容器的输出信息。

|

||||

|

||||

# docker run busybox echo hello world

|

||||

|

||||

|

||||

|

||||

### 5. 拿到 Docker 主机的 IP ###

|

||||

|

||||

我们可以执行下面的命令获取运行 Docker 的主机的 IP 地址。我们可以看到在 Docker 主机的 IP 地址上的任何暴露出来的端口。

|

||||

|

||||

# docker-machine ip

|

||||

|

||||

|

||||

|

||||

### 6. 管理主机 ###

|

||||

|

||||

现在我们可以随心所欲地使用上述的 docker-machine 命令来不断创建主机了。

|

||||

|

||||

当你使用完 docker 时,可以运行 **docker-machine stop** 来停止所有主机,如果想开启所有主机,运行 **docker-machine start**。

|

||||

|

||||

# docker-machine stop

|

||||

# docker-machine start

|

||||

|

||||

你也可以只停止或开启一台主机:

|

||||

|

||||

$ docker-machine stop linux

|

||||

$ docker-machine start linux

|

||||

|

||||

### 总结 ###

|

||||

|

||||

最后,我们使用 Docker Machine 成功在 VirtualBox 上创建并管理一台 Docker 主机。Docker Machine 确实能让用户快速地在不同的平台上部署 Docker 主机,就像我们这里部署在 VirtualBox 上一样。这个 virtualbox 驱动可以在本地机器上使用,也可以在数据中心的虚拟机上使用。Docker Machine 驱动除了支持本地的 VirtualBox 之外,还支持远端的 Digital Ocean、AWS、Azure、VMware 以及其它基础设施。

|

||||

|

||||

如果你有任何疑问,或者建议,请在评论栏中写出来,我们会不断改进我们的内容。谢谢,祝愉快。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://linoxide.com/linux-how-to/host-virtualbox-docker-machine/

|

||||

|

||||

作者:[Arun Pyasi][a]

|

||||

译者:[bazz2](https://github.com/bazz2)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://linoxide.com/author/arunp/

|

||||

[1]:https://github.com/docker/machine/releases

|

||||

[2]:https://github.com/boot2docker/boot2docker

|

||||

@ -1,24 +1,24 @@

|

||||

Trickr:一个开源的Linux桌面RSS新闻速递

|

||||

Tickr:一个开源的 Linux 桌面 RSS 新闻速递应用

|

||||

================================================================================

|

||||

|

||||

|

||||

**最新的!最新的!阅读关于它的一切!**

|

||||

|

||||

好了,所以我们今天要强调的应用程序不是相当于旧报纸的二进制版本—而是它会以一个伟大的方式,将最新的新闻推送到你的桌面上。

|

||||

好了,我们今天要推荐的应用程序可不是旧式报纸的二进制版本——它会以一种漂亮的方式将最新的新闻推送到你的桌面上。

|

||||

|

||||

Tick是一个基于GTK的Linux桌面新闻速递,能够在水平带滚动显示最新头条新闻,以及你最爱的RSS资讯文章标题,当然你可以放置在你桌面的任何地方。

|

||||

Tickr 是一个基于 GTK 的 Linux 桌面新闻速递应用,能够以横条方式滚动显示最新头条新闻以及你最爱的RSS资讯文章标题,当然你可以放置在你桌面的任何地方。

|

||||

|

||||

请叫我Joey Calamezzo;我把我的放在底部,有电视新闻台的风格。

|

||||

请叫我 Joey Calamezzo;我把它放在底部,就像电视新闻台的滚动字幕一样。 (LCTT 译注: Joan Callamezzo 是 Pawnee Today 的主持人,一位 Pawnee 的本地新闻/脱口秀主持人。而本文作者是 Joey。)

|

||||

|

||||

“到你了,子标题”

|

||||

“到你了,副标题”。

|

||||

|

||||

### RSS -还记得吗? ###

|

||||

|

||||

“谢谢段落结尾。”

|

||||

“谢谢,这段结束了。”

|

||||

|

||||

在一个推送通知,社交媒体,以及点击诱饵的时代,哄骗我们阅读最新的令人惊奇的,人人都爱读的清单,RSS看起来有一点过时了。

|

||||

在一个充斥着推送通知、社交媒体、标题党,以及哄骗人们点击的清单体的时代,RSS看起来有一点过时了。

|

||||

|

||||

对我来说?恩,RSS是名副其实的真正简单的聚合。这是将消息通知给我的最简单,最易于管理的方式。我可以在我愿意的时候,管理和阅读一些东西;没必要匆忙的去看,以防这条微博消失在信息流中,或者推送通知消失。

|

||||

对我来说呢?恩,RSS是名副其实的真正简单的聚合(RSS : Really Simple Syndication)。这是将消息通知给我的最简单、最易于管理的方式。我可以在我愿意的时候,管理和阅读一些东西;没必要匆忙的去看,以防这条微博消失在信息流中,或者推送通知消失。

|

||||

|

||||

tickr的美在于它的实用性。你可以不断地有新闻滚动在屏幕的底部,然后不时地瞥一眼。

|

||||

|

||||

@ -32,31 +32,30 @@ tickr的美在于它的实用性。你可以不断地有新闻滚动在屏幕的

|

||||

|

||||

尽管虽然tickr可以从Ubuntu软件中心安装,然而它已经很久没有更新了。当你打开笨拙的不直观的控制面板的时候,没有什么能够比这更让人感觉被遗弃的了。

|

||||

|

||||

打开它:

|

||||

要打开它:

|

||||

|

||||

1. 右键单击tickr条

|

||||

1. 转至编辑>首选项

|

||||

1. 调整各种设置

|

||||

|

||||

选项和设置行的后面,有些似乎是容易理解的。但是知己知彼你能够几乎掌控一切,包括:

|

||||

选项和设置行的后面,有些似乎是容易理解的。但是详细了解这些你才能够掌握一切,包括:

|

||||

|

||||

- 设置滚动速度

|

||||

- 选择鼠标经过时的行为

|

||||

- 资讯更新频率

|

||||

- 字体,包括字体大小和颜色

|

||||

- 分隔符(“delineator”)

|

||||

- 消息分隔符(“delineator”)

|

||||

- tickr在屏幕上的位置

|

||||

- tickr条的颜色和不透明度

|

||||

- 选择每种资讯显示多少文章

|

||||

|

||||

有个值得一提的“怪癖”是,当你点击“应用”按钮,只会更新tickr的屏幕预览。当您退出“首选项”窗口时,请单击“确定”。

|

||||

|

||||

想要滚动条在你的显示屏上水平显示,也需要公平一点的调整,特别是统一显示。

|

||||

想要得到完美的显示效果, 你需要一点点调整,特别是在 Unity 上。

|

||||

|

||||

按下“全宽按钮”,能够让应用程序自动检测你的屏幕宽度。默认情况下,当放置在顶部或底部时,会留下25像素的间距(应用程序被创建在过去的GNOME2.x桌面)。只需添加额外的25像素到输入框,来弥补这个问题。

|

||||

按下“全宽按钮”,能够让应用程序自动检测你的屏幕宽度。默认情况下,当放置在顶部或底部时,会留下25像素的间距(应用程序以前是在GNOME2.x桌面上创建的)。只需添加额外的25像素到输入框,来弥补这个问题。

|

||||

|

||||

其他可供选择的选项包括:选择文章在哪个浏览器打开;tickr是否以一个常规的窗口出现;

|

||||

是否显示一个时钟;以及应用程序多久检查一次文章资讯。

|

||||

其他可供选择的选项包括:选择文章在哪个浏览器打开;tickr是否以一个常规的窗口出现;是否显示一个时钟;以及应用程序多久检查一次文章资讯。

|

||||

|

||||

#### 添加资讯 ####

|

||||

|

||||

@ -76,9 +75,9 @@ tickr自带的有超过30种不同的资讯列表,从技术博客到主流新

|

||||

|

||||

### 在Ubuntu 14.04 LTS或更高版本上安装Tickr ###

|

||||

|

||||

在Ubuntu 14.04 LTS或更高版本上安装Tickr

|

||||

这就是 Tickr,它不会改变世界,但是它能让你知道世界上发生了什么。

|

||||

|

||||

在Ubuntu 14.04 LTS或更高版本中安装,转到Ubuntu软件中心,但要点击下面的按钮。

|

||||

在Ubuntu 14.04 LTS或更高版本中安装,点击下面的按钮转到Ubuntu软件中心。

|

||||

|

||||

- [点击此处进入Ubuntu软件中心安装tickr][1]

|

||||

|

||||

@ -88,7 +87,7 @@ via: http://www.omgubuntu.co.uk/2015/06/tickr-open-source-desktop-rss-news-ticke

|

||||

|

||||

作者:[Joey-Elijah Sneddon][a]

|

||||

译者:[xiaoyu33](https://github.com/xiaoyu33)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -7,7 +7,7 @@

|

||||

|

||||

这是一个基本扯平的方面。每一个桌面环境都有一些非常好的应用,也有一些不怎么样的。再次强调,Gnome 把那些 KDE 完全错失的小细节给做对了。我不是想说 KDE 中有哪些应用不好。他们都能工作,但仅此而已。也就是说:它们合格了,但确实还没有达到甚至接近100分。

|

||||

|

||||

Gnome 是一个样子,KDE 是另外一种。Dragon 播放器运行得很好,清晰的标出了播放文件、URL或和光盘的按钮,正如你在 Gnome Videos 中能做到的一样……但是在便利的文件名和用户的友好度方面,Gnome 多走了一小步。它默认显示了在你的电脑上检测到的所有影像文件,不需要你做任何事情。KDE 有 [Baloo][](正如之前的 [Nepomuk][2],LCTT 译注:这是 KDE 中一种文件索引服务框架)为什么不使用它们?它们能列出可读取的影像文件……但却没被使用。

|

||||

Gnome 在左,KDE 在右。Dragon 播放器运行得很好,清晰的标出了播放文件、URL或和光盘的按钮,正如你在 Gnome Videos 中能做到的一样……但是在便利的文件名和用户的友好度方面,Gnome 多走了一小步。它默认显示了在你的电脑上检测到的所有影像文件,不需要你做任何事情。KDE 有 [Baloo][](正如之前的 [Nepomuk][2],LCTT 译注:这是 KDE 中一种文件索引服务框架)为什么不使用它们?它们能列出可读取的影像文件……但却没被使用。

|

||||

|

||||

下一步……音乐播放器

|

||||

|

||||

@ -0,0 +1,52 @@

|

||||

一周 GNOME 之旅:品味它和 KDE 的是是非非(第四节 GNOME设置)

|

||||

================================================================================

|

||||

|

||||

### 设置 ###

|

||||

|

||||

在这我要挑一挑几个特定 KDE 控制模块的毛病,大部分原因是因为相比它们的对手GNOME来说,糟糕得太可笑,实话说,真是悲哀。

|

||||

|

||||

第一个接招的?打印机。

|

||||

|

||||

|

||||

|

||||

GNOME 在左,KDE 在右。你知道左边跟右边的打印程序有什么区别吗?当我在 GNOME 控制中心打开“打印机”时,程序窗口弹出来了,然后这样就可以使用了。而当我在 KDE 系统设置打开“打印机”时,我得到了一条密码提示。甚至我都没能看一眼打印机呢,我就必须先交出 ROOT 密码。

|

||||

|

||||

让我再重复一遍。在今天这个有了 PolicyKit 和 Logind 的日子里,对一个应该是 sudo 的操作,我依然被询问要求 ROOT 的密码。我安装系统的时候甚至都没设置 root 密码。所以我必须跑到 Konsole 去,接着运行 'sudo passwd root' 命令,这样我才能给 root 设一个密码,然后我才能回到系统设置中的打印程序,再交出 root 密码,然后仅仅是看一看哪些打印机可用。完成了这些工作后,当我点击“添加打印机”时,我再次得到请求 ROOT 密码的提示,当我解决了它后再选择一个打印机和驱动时,我再次得到请求 ROOT 密码的提示。仅仅是为了添加一个打印机到系统我就收到三次密码请求!

|

||||

|

||||

而在 GNOME 下添加打印机,在点击打印机程序中的“解锁”之前,我没有得到任何请求 SUDO 密码的提示。整个过程我只被请求过一次,仅此而已。KDE,求你了……采用 GNOME 的“解锁”模式吧。不到一定需要的时候不要发出提示。还有,不管是哪个库,只要它允许 KDE 应用程序绕过 PolicyKit/Logind(如果有的话)并直接请求 ROOT 权限……那就把它封进箱里吧。如果这是个多用户系统,那我要么必须交出 ROOT 密码,要么我必须时时刻刻待命,以免有一个用户需要升级、更改或添加一个新的打印机。而这两种情况都是完全无法接受的。

|

||||

|

||||

有还一件事……

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

这个问题问大家:怎么样看起来更简洁?我在写这篇文章时意识到:当有任何附加的打印机准备好时,Gnome 打印机程序会把过程做得非常简洁,它们在左边上放了一个竖直栏来列出这些打印机。而我在 KDE 中添加第二台打印机时,它突然增加出一个左边栏来。而在添加之前,我脑海中已经有了一个恐怖的画面,它会像图片文件夹显示预览图一样直接在界面里插入另外一个图标。我很高兴也很惊讶的看到我是错的。但是事实是它直接“长出”另外一个从未存在的竖直栏,彻底改变了它的界面布局,而这样也称不上“好”。终究还是一种令人困惑,奇怪而又不直观的设计。

|

||||

|

||||

打印机说得够多了……下一个接受我公开石刑的 KDE 系统设置是?多媒体,即 Phonon。

|

||||

|

||||

|

||||

|

||||

一如既往,GNOME 在左边,KDE 在右边。让我们先看看 GNOME 的系统设置先……眼睛移动是从左到右,从上到下,对吧?来吧,就这样做。首先:音量控制滑条。滑条中的蓝色条与空条百分百清晰地消除了哪边是“音量增加”的困惑。在音量控制条后马上就是一个 On/Off 开关,用来开关静音功能。Gnome 的再次得分在于静音后能记住当前设置的音量,而在点击音量增加按钮取消静音后能回到原来设置的音量中来。Kmixer,你个健忘的垃圾,我真的希望我能多讨论你一下。

|

||||

|

||||

继续!输入输出和应用程序的标签选项?每一个应用程序的音量随时可控?Gnome,每过一秒,我爱你越深。音量均衡选项、声音配置、和清晰地标上标志的“测试麦克风”选项。

|

||||

|

||||

我不清楚它能否以一种更干净更简洁的设计实现。是的,它只是一个 Gnome 化的 Pavucontrol,但我想这就是重要的地方。Pavucontrol 在这方面几乎完全做对了,Gnome 控制中心中的“声音”应用程序的改善使它向完美更进了一步。

|

||||

|

||||

Phonon,该你上了。但开始前我想说:我 TM 看到的是什么?!我知道我看到的是音频设备的优先级列表,但是它呈现的方式有点太坑。还有,那些用户可能关心的那些东西哪去了?拥有一个优先级列表当然很好,它也应该存在,但问题是优先级列表属于那种用户乱搞一两次之后就不会再碰的东西。它还不够重要,或者说不够常用到可以直接放在正中间位置的程度。音量控制滑块呢?对每个应用程序的音量控制功能呢?那些用户使用最频繁的东西呢?好吧,它们在 Kmix 中,一个分离的程序,拥有它自己的配置选项……而不是在系统设置下……这样真的让“系统设置”这个词变得有点用词不当。

|

||||

|

||||

|

||||

|

||||

上面展示的 Gnome 的网络设置。KDE 的没有展示,原因就是我接下来要吐槽的内容了。如果你进入 KDE 的系统设置里,然后点击“网络”区域中三个选项中的任何一个,你会得到一大堆的选项:蓝牙设置、Samba 分享的默认用户名和密码(说真的,“连通性(Connectivity)”下面只有两个选项:SMB 的用户名和密码。TMD 怎么就配得上“连通性”这么大的词?),浏览器身份验证控制(只有 Konqueror 能用……一个已经倒闭的项目),代理设置,等等……我的 wifi 设置哪去了?它们没在这。哪去了?好吧,它们在网络应用程序的设置里面……而不是在网络设置里……

|

||||

|

||||

KDE,你这是要杀了我啊,你有“系统设置”当凶器,拿着它动手吧!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.phoronix.com/scan.php?page=article&item=gnome-week-editorial&num=4

|

||||

|

||||

作者:Eric Griffith

|

||||

译者:[XLCYun](https://github.com/XLCYun)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

@ -0,0 +1,40 @@

|

||||

一周 GNOME 之旅:品味它和 KDE 的是是非非(第三节 总结)

|

||||

================================================================================

|

||||

|

||||

### 用户体验和最后想法 ###

|

||||

|

||||

当 Gnome 2.x 和 KDE 4.x 要正面交锋时……我在它们之间左右逢源。我对它们爱恨交织,但总的来说它们使用起来还算是一种乐趣。然后 Gnome 3.x 来了,带着一场 Gnome Shell 的戏剧。那时我就放弃了 Gnome,我尽我所能的避开它。当时它对用户是不友好的,而且不直观,它打破了原有的设计典范,只为平板的统治世界做准备……而根据平板下跌的销量来看,这样的未来不可能实现。

|

||||

|

||||

在 Gnome 3 后续发布了八个版本后,奇迹发生了。Gnome 变得对对用户友好了,变得直观了。它完美吗?当然不。我还是很讨厌它想推动的那种设计范例,我讨厌它总想给我强加一种工作流(work flow),但是在付出时间和耐心后,这两都能被接受。只要你能够回头去看看 Gnome Shell 那外星人一样的界面,然后开始跟 Gnome 的其它部分(特别是控制中心)互动,你就能发现 Gnome 绝对做对了:细节,对细节的关注!

|

||||

|

||||

人们能适应新的界面设计范例,能适应新的工作流—— iPhone 和 iPad 都证明了这一点——但真正让他们操心的一直是“纸割”——那些不完美的细节。

|

||||

|

||||

它带出了 KDE 和 Gnome 之间最重要的一个区别。Gnome 感觉像一个产品,像一种非凡的体验。你用它的时候,觉得它是完整的,你要的东西都触手可及。它让人感觉就像是一个拥有 Windows 或者 OS X 那样桌面体验的 Linux 桌面版:你要的都在里面,而且它是被同一个目标一致的团队中的同一个人写出来的。天,即使是一个应用程序发出的 sudo 请求都感觉是 Gnome 下的一个特意设计的部分,就像在 Windows 下的一样。而在 KDE 下感觉就是随便一个应用程序都能创建的那种各种外观的弹窗。它不像是以系统本身这样的正式身份停下来说“嘿,有个东西要请求管理员权限!你要给它吗?”。

|

||||

|

||||

KDE 让人体验不到有凝聚力的体验。KDE 像是在没有方向地打转,感觉没有完整的体验。它就像是一堆东西往不同的的方向移动,只不过恰好它们都有一个共同享有的工具包而已。如果开发者对此很开心,那么好吧,他们开心就好,但是如果他们想提供最好体验的话,那么就需要多关注那些小地方了。用户体验跟直观应当做为每一个应用程序的设计中心,应当有一个视野,知道 KDE 要提供什么——并且——知道它看起来应该是什么样的。

|

||||

|

||||

是不是有什么原因阻止我在 KDE 下使用 Gnome 磁盘管理? Rhythmbox 呢? Evolution 呢? 没有,没有,没有。但是这样说又错过了关键。Gnome 和 KDE 都称它们自己为“桌面环境”。那么它们就应该是完整的环境,这意味着他们的各个部件应该汇集并紧密结合在一起,意味着你应该使用它们环境下的工具,因为它们说“您在一个完整的桌面中需要的任何东西,我们都支持。”说真的?只有 Gnome 看起来能符合完整的要求。KDE 在“汇集在一起”这一方面感觉就像个半成品,更不用说提供“完整体验”中你所需要的东西。Gnome 磁盘管理没有相应的对手—— kpartionmanage 要求 ROOT 权限。KDE 不运行“首次用户注册”的过程(原文:No 'First Time User' run through。可能是指系统安装过程中KDE没有创建新用户的过程,译注) ,现在也不过是在 Kubuntu 下引入了一个用户管理器。老天,Gnome 甚至提供了地图、笔记、日历和时钟应用。这些应用都是百分百要紧的吗?不,当然不了。但是正是这些应用帮助 Gnome 推动“Gnome 是一种完整丰富的体验”的想法。

|

||||

|

||||

我吐槽的 KDE 问题并非不可能解决,决对不是这样的!但是它需要人去关心它。它需要开发者为他们的作品感到自豪,而不仅仅是为它们实现的功能而感到自豪——组织的价值可大了去了。别夺走用户设置选项的能力—— GNOME 3.x 就是因为缺乏配置选项的能力而为我所诟病,但别把“好吧,你想怎么设置就怎么设置”作为借口而不提供任何理智的默认设置。默认设置是用户将看到的东西,它们是用户从打开软件的第一刻开始进行评判的关键。给用户留个好印象吧。

|

||||

|

||||

我知道 KDE 开发者们知道设计很重要,这也是为什么VDG(Visual Design Group 视觉设计组)存在的原因,但是感觉好像他们没有让 VDG 充分发挥,所以 KDE 里存在组织上的缺陷。不是 KDE 没办法完整,不是它没办法汇集整合在一起然后解决衰败问题,只是开发者们没做到。他们瞄准了靶心……但是偏了。

|

||||

|

||||

还有,在任何人说这句话之前……千万别说“欢迎给我们提交补丁啊"。因为当我开心的为某个人提交补丁时,只要开发者坚持以他们喜欢的却不直观的方式干事,更多这样的烦人事就会不断发生。这不关 Muon 有没有中心对齐。也不关 Amarok 的界面太丑。也不关每次我敲下快捷键后,弹出的音量和亮度调节窗口占用了我一大块的屏幕“地皮”(说真的,有人会把这些东西缩小)。

|

||||

|

||||

这跟心态的冷漠有关,跟开发者们在为他们的应用设计 UI 时根本就不多加思考有关。KDE 团队做的东西都工作得很好。Amarok 能播放音乐。Dragon 能播放视频。Kwin 或 Qt 和 kdelibs 似乎比 Mutter/gtk 更有力更效率(仅根据我的电池电量消耗计算。非科学性测试)。这些都很好,很重要……但是它们呈现的方式也很重要。甚至可以说,呈现方式是最重要的,因为它是用户看到的并与之交互的东西。

|

||||

|

||||

KDE 应用开发者们……让 VDG 参与进来吧。让 VDG 审查并核准每一个“核心”应用,让一个 VDG 的 UI/UX 专家来设计应用的使用模式和使用流程,以此保证其直观性。真见鬼,不管你们在开发的是啥应用,仅仅把它的模型发到 VDG 论坛寻求反馈甚至都可能都能得到一些非常好的指点跟反馈。你有这么好的资源在这,现在赶紧用吧。

|

||||

|

||||

我不想说得好像我一点都不懂感恩。我爱 KDE,我爱那些志愿者们为了给 Linux 用户一个可视化的桌面而付出的工作与努力,也爱可供选择的 Gnome。正是因为我关心我才写这篇文章。因为我想看到更好的 KDE,我想看到它走得比以前更加遥远。而这样做需要每个人继续努力,并且需要人们不再躲避批评。它需要人们对系统互动及系统崩溃的地方都保持诚实。如果我们不能直言批评,如果我们不说“这真垃圾!”,那么情况永远不会变好。

|

||||

|

||||

这周后我会继续使用 Gnome 吗?可能不。应该不。Gnome 还在试着强迫我接受其工作流,而我不想追随,也不想遵循,因为我在使用它的时候感觉变得不够高效,因为它并不遵循我的思维模式。可是对于我的朋友们,当他们问我“我该用哪种桌面环境?”我可能会推荐 Gnome,特别是那些不大懂技术,只要求“能工作”就行的朋友。根据目前 KDE 的形势来看,这可能是我能说出的最狠毒的评估了。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.phoronix.com/scan.php?page=article&item=gnome-week-editorial&num=5

|

||||

|

||||

作者:Eric Griffith

|

||||

译者:[XLCYun](https://github.com/XLCYun)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

@ -0,0 +1,146 @@

|

||||

如何使用 Datadog 监控 NGINX(第三篇)

|

||||

================================================================================

|

||||

|

||||

|

||||

如果你已经阅读了前面的[如何监控 NGINX][1],你应该知道从你网络环境的几个指标中可以获取多少信息。而且你也看到了从 NGINX 特定的基础中收集指标是多么容易的。但要实现全面,持续的监控 NGINX,你需要一个强大的监控系统来存储并将指标可视化,当异常发生时能提醒你。在这篇文章中,我们将向你展示如何使用 Datadog 安装 NGINX 监控,以便你可以在定制的仪表盘中查看这些指标:

|

||||

|

||||

|

||||

|

||||

Datadog 允许你以单个主机、服务、流程和度量来构建图形和警告,或者使用它们的几乎任何组合构建。例如,你可以监控你的所有主机,或者某个特定可用区域的所有NGINX主机,或者您可以监视具有特定标签的所有主机的一个关键指标。本文将告诉您如何:

|

||||

|

||||

- 在 Datadog 仪表盘上监控 NGINX 指标,就像监控其他系统一样

|

||||

- 当一个关键指标急剧变化时设置自动警报来通知你

|

||||

|

||||

### 配置 NGINX ###

|

||||

|

||||

为了收集 NGINX 指标,首先需要确保 NGINX 已启用 status 模块和一个 报告 status 指标的 URL。一步步的[配置开源 NGINX][2] 和 [NGINX Plus][3] 请参见之前的相关文章。

|

||||

|

||||

### 整合 Datadog 和 NGINX ###

|

||||

|

||||

#### 安装 Datadog 代理 ####

|

||||

|

||||

Datadog 代理是[一个开源软件][4],它能收集和报告你主机的指标,这样就可以使用 Datadog 查看和监控他们。安装这个代理通常[仅需要一个命令][5]

|

||||

|

||||

只要你的代理启动并运行着,你会看到你主机的指标报告[在你 Datadog 账号下][6]。

|

||||

|

||||

|

||||

|

||||

#### 配置 Agent ####

|

||||

|

||||

接下来,你需要为代理创建一个简单的 NGINX 配置文件。在你系统中代理的配置目录应该[在这儿][7]找到。

|

||||

|

||||

在目录里面的 conf.d/nginx.yaml.example 中,你会发现[一个简单的配置文件][8],你可以编辑并提供 status URL 和可选的标签为每个NGINX 实例:

|

||||

|

||||

init_config:

|

||||

|

||||

instances:

|

||||

|

||||

- nginx_status_url: http://localhost/nginx_status/

|

||||

tags:

|

||||

- instance:foo

|

||||

|

||||

当你提供了 status URL 和任意 tag,将配置文件保存为 conf.d/nginx.yaml。

|

||||

|

||||

#### 重启代理 ####

|

||||

|

||||

你必须重新启动代理程序来加载新的配置文件。重新启动命令[在这里][9],根据平台的不同而不同。

|

||||

|

||||

#### 检查配置文件 ####

|

||||

|

||||

要检查 Datadog 和 NGINX 是否正确整合,运行 Datadog 的 info 命令。每个平台使用的命令[看这儿][10]。

|

||||

|

||||

如果配置是正确的,你会看到这样的输出:

|

||||

|

||||

Checks

|

||||

======

|

||||

|

||||

[...]

|

||||

|

||||

nginx

|

||||

-----

|

||||

- instance #0 [OK]

|

||||

- Collected 8 metrics & 0 events

|

||||

|

||||

#### 安装整合 ####

|

||||

|

||||

最后,在你的 Datadog 帐户打开“Nginx 整合”。这非常简单,你只要在 [NGINX 整合设置][11]中点击“Install Integration”按钮。

|

||||

|

||||

|

||||

|

||||

### 指标! ###

|

||||

|

||||

一旦代理开始报告 NGINX 指标,你会看到[一个 NGINX 仪表盘][12]出现在在你 Datadog 可用仪表盘的列表中。

|

||||

|

||||

基本的 NGINX 仪表盘显示有用的图表,囊括了几个[我们的 NGINX 监控介绍][13]中的关键指标。 (一些指标,特别是请求处理时间要求进行日志分析,Datadog 不支持。)

|

||||

|

||||

你可以通过增加 NGINX 之外的重要指标的图表来轻松创建一个全面的仪表盘,以监控你的整个网站设施。例如,你可能想监视你 NGINX 的主机级的指标,如系统负载。要构建一个自定义的仪表盘,只需点击靠近仪表盘的右上角的选项并选择“Clone Dash”来克隆一个默认的 NGINX 仪表盘。

|

||||

|

||||

|

||||

|

||||

你也可以使用 Datadog 的[主机地图][14]在更高层面监控你的 NGINX 实例,举个例子,用颜色标示你所有的 NGINX 主机的 CPU 使用率来辨别潜在热点。

|

||||

|

||||

|

||||

|

||||

### NGINX 指标警告 ###

|

||||

|

||||

一旦 Datadog 捕获并可视化你的指标,你可能会希望建立一些监控自动地密切关注你的指标,并当有问题提醒你。下面将介绍一个典型的例子:一个提醒你 NGINX 吞吐量突然下降时的指标监控器。

|

||||

|

||||

#### 监控 NGINX 吞吐量 ####

|

||||

|

||||

Datadog 指标警报可以是“基于吞吐量的”(当指标超过设定值会警报)或“基于变化幅度的”(当指标的变化超过一定范围会警报)。在这个例子里,我们会采取后一种方式,当每秒传入的请求急剧下降时会提醒我们。下降往往意味着有问题。

|

||||

|

||||

1. **创建一个新的指标监控**。从 Datadog 的“Monitors”下拉列表中选择“New Monitor”。选择“Metric”作为监视器类型。

|

||||

|

||||

|

||||

|

||||

2. **定义你的指标监视器**。我们想知道 NGINX 每秒总的请求量下降的数量,所以我们在基础设施中定义我们感兴趣的 nginx.net.request_per_s 之和。

|

||||

|

||||

|

||||

|

||||

3. **设置指标警报条件**。我们想要在变化时警报,而不是一个固定的值,所以我们选择“Change Alert”。我们设置监控为无论何时请求量下降了30%以上时警报。在这里,我们使用一个一分钟的数据窗口来表示 “now” 指标的值,对横跨该间隔内的平均变化和之前 10 分钟的指标值作比较。

|

||||

|

||||

|

||||

|

||||

4. **自定义通知**。如果 NGINX 的请求量下降,我们想要通知我们的团队。在这个例子中,我们将给 ops 团队的聊天室发送通知,并给值班工程师发送短信。在“Say what’s happening”中,我们会为监控器命名,并添加一个伴随该通知的短消息,建议首先开始调查的内容。我们会 @ ops 团队使用的 Slack,并 @pagerduty [将警告发给短信][15]。

|

||||

|

||||

|

||||

|

||||

5. **保存集成监控**。点击页面底部的“Save”按钮。你现在在监控一个关键的 NGINX [工作指标][16],而当它快速下跌时会给值班工程师发短信。

|

||||

|

||||

### 结论 ###

|

||||

|

||||

在这篇文章中,我们谈到了通过整合 NGINX 与 Datadog 来可视化你的关键指标,并当你的网络基础架构有问题时会通知你的团队。

|

||||

|

||||

如果你一直使用你自己的 Datadog 账号,你现在应该可以极大的提升你的 web 环境的可视化,也有能力对你的环境、你所使用的模式、和对你的组织最有价值的指标创建自动监控。

|

||||

|

||||

如果你还没有 Datadog 帐户,你可以注册[免费试用][17],并开始监视你的基础架构,应用程序和现在的服务。

|

||||

|

||||

------------------------------------------------------------

|

||||

|

||||

via: https://www.datadoghq.com/blog/how-to-monitor-nginx-with-datadog/

|

||||

|

||||

作者:K Young

|

||||

译者:[strugglingyouth](https://github.com/strugglingyouth)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[1]:https://linux.cn/article-5970-1.html

|

||||

[2]:https://linux.cn/article-5985-1.html#open-source

|

||||

[3]:https://linux.cn/article-5985-1.html#plus

|

||||

[4]:https://github.com/DataDog/dd-agent

|

||||

[5]:https://app.datadoghq.com/account/settings#agent

|

||||

[6]:https://app.datadoghq.com/infrastructure

|

||||

[7]:http://docs.datadoghq.com/guides/basic_agent_usage/

|

||||

[8]:https://github.com/DataDog/dd-agent/blob/master/conf.d/nginx.yaml.example

|

||||

[9]:http://docs.datadoghq.com/guides/basic_agent_usage/

|

||||

[10]:http://docs.datadoghq.com/guides/basic_agent_usage/

|

||||

[11]:https://app.datadoghq.com/account/settings#integrations/nginx

|

||||

[12]:https://app.datadoghq.com/dash/integration/nginx

|

||||

[13]:https://linux.cn/article-5970-1.html

|

||||

[14]:https://www.datadoghq.com/blog/introducing-host-maps-know-thy-infrastructure/

|

||||

[15]:https://www.datadoghq.com/blog/pagerduty/

|

||||

[16]:https://www.datadoghq.com/blog/monitoring-101-collecting-data/#metrics

|

||||

[17]:https://www.datadoghq.com/blog/how-to-monitor-nginx-with-datadog/#sign-up

|

||||

[18]:https://github.com/DataDog/the-monitor/blob/master/nginx/how_to_monitor_nginx_with_datadog.md

|

||||

[19]:https://github.com/DataDog/the-monitor/issues

|

||||

@ -2,7 +2,7 @@ Ubuntu 14.04中修复“update information is outdated”错误

|

||||

================================================================================

|

||||

|

||||

|

||||

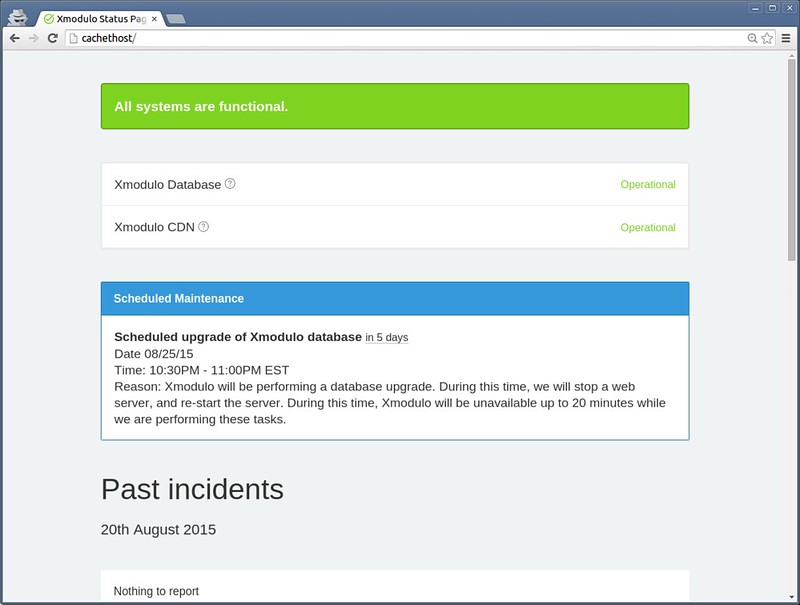

看到Ubuntu 14.04的顶部面板上那个显示下面这个错误的红色三角形了吗?

|

||||

看到过Ubuntu 14.04的顶部面板上那个显示下面这个错误的红色三角形了吗?

|

||||

|

||||

> 更新信息过时。该错误可能是由网络问题,或者某个仓库不再可用而造成的。请通过从指示器菜单中选择‘显示更新’来手动更新,然后查看是否存在有失败的仓库。

|

||||

>

|

||||

@ -25,7 +25,7 @@ Ubuntu 14.04中修复“update information is outdated”错误

|

||||

|

||||

### 修复‘update information is outdated’错误 ###

|

||||

|

||||

这里讨论的‘解决方案’可能对Ubuntu的这些版本有用:Ubuntu 14.04,12.04或14.04。你所要做的仅仅是打开终端(Ctrl+Alt+T),然后使用下面的命令:

|

||||

这里讨论的‘解决方案’可能对Ubuntu的这些版本有用:Ubuntu 14.04,12.04。你所要做的仅仅是打开终端(Ctrl+Alt+T),然后使用下面的命令:

|

||||

|

||||

sudo apt-get update

|

||||

|

||||

@ -47,7 +47,7 @@ via: http://itsfoss.com/fix-update-information-outdated-ubuntu/

|

||||

|

||||

作者:[Abhishek][a]

|

||||

译者:[GOLinux](https://github.com/GOLinux)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -56,4 +56,4 @@ via: http://itsfoss.com/fix-update-information-outdated-ubuntu/

|

||||

[2]:http://itsfoss.com/notification-terminal-command-completion-ubuntu/

|

||||

[3]:http://itsfoss.com/solve-gpg-error-signatures-verified-ubuntu/

|

||||

[4]:http://itsfoss.com/install-spotify-ubuntu-1504/

|

||||

[5]:http://itsfoss.com/fix-update-errors-ubuntu-1404/

|

||||

[5]:https://linux.cn/article-5603-1.html

|

||||

@ -1,10 +1,11 @@

|

||||

在 Linux 中使用日志来排错

|

||||

================================================================================

|

||||

人们创建日志的主要原因是排错。通常你会诊断为什么问题发生在你的 Linux 系统或应用程序中。错误信息或一些列事件可以给你提供造成根本原因的线索,说明问题是如何发生的,并指出如何解决它。这里有几个使用日志来解决的样例。

|

||||

|

||||

人们创建日志的主要原因是排错。通常你会诊断为什么问题发生在你的 Linux 系统或应用程序中。错误信息或一系列的事件可以给你提供找出根本原因的线索,说明问题是如何发生的,并指出如何解决它。这里有几个使用日志来解决的样例。

|

||||

|

||||

### 登录失败原因 ###

|

||||

|