mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-01-28 23:20:10 +08:00

commit

92417b03e0

@ -0,0 +1,80 @@

|

||||

让决策更透明的三步

|

||||

======

|

||||

|

||||

> 当您使用这种决策技巧时,可以使你作为一个开源领导人做出决策时更透明。

|

||||

|

||||

|

||||

|

||||

要让你的领导工作更加透明,其中一个最有效的方法就是将一个现有的流程开放给你的团队进行反馈,然后根据反馈去改变流程。下面这些练习能让透明度更加切实,并且它有助于让你在持续评估并调整你的工作的透明度时形成“肌肉记忆”。

|

||||

|

||||

我想说,你可以通过任何流程来完成这项工作 —— 即使有些流程看起来像是“禁区”流程,比如晋升或者调薪。但是如果第一次它对于初步实践来说太大了,那么你可能需要从一个不那么敏感的流程开始,比如旅行批准流程或者为你的团队寻找空缺候选人的系统。(举个例子,我在我们的招聘和晋升流程中使用了这种方式)

|

||||

|

||||

开放流程并使其更加透明可以建立你的信誉并增强团队成员对你的信任。它会使你以一种可能超乎你设想和舒适程度的方式“走在透明的路上”。以这种方式工作确实会产生额外的工作,尤其是在过程的开始阶段 —— 但是,最终这种方法对于让管理者(比如我)对团队成员更具责任,而且它会更加相容。

|

||||

|

||||

### 阶段一:选择一个流程

|

||||

|

||||

**第一步** 想想你的团队使用的一个普通的或常规的流程,但是这个流程通常不需要仔细检查。下面有一些例子:

|

||||

|

||||

* 招聘:如何创建职位描述、如何挑选面试团队、如何筛选候选人以及如何做出最终的招聘决定。

|

||||

* 规划:你的团队或组织如何确定年度或季度目标。

|

||||

* 升职:你如何选择并考虑升职候选人,并决定谁升职。

|

||||

* 经理绩效评估:谁有机会就经理绩效提供反馈,以及他们是如何反馈。

|

||||

* 旅游:旅游预算如何分配,以及你如何决定是否批准旅行(或提名某人是否旅行)。

|

||||

|

||||

上面的某个例子可能会引起你的共鸣,或者你可能会发现一些你觉得更合适的流程。也许你已经收到了关于某个特定流程的问题,又或者你发现自己屡次解释某个特定决策的逻辑依据。选择一些你能够控制或影响的东西 —— 一些你认为你的成员所关心的东西。

|

||||

|

||||

**第二步** 现在回答以下关于这个流程的问题:

|

||||

|

||||

* 该流程目前是否记录在一个所有成员都知道并可以访问的地方?如果没有,现在就开始创建文档(不必太详细;只需要解释这个流程的不同步骤以及它是如何工作的)。你可能会发现这个过程不够清晰或一致,无法记录到文档。在这种情况下,用你*认为*理想情况下所应该的方式去记录它。

|

||||

* 完成流程的文档是否说明了在不同的点上是如何做出决定?例如,在旅行批准流程中,它是否解释了如何批准或拒绝请求。

|

||||

* 流程的*输入信息*是什么?例如,在确定部门年度目标时,哪些数据用于关键绩效指标,查找或者采纳谁的反馈,谁有机会审查或“签字”。

|

||||

* 这个过程会做出什么*假设*?例如,在升职决策中,你是否认为所有的晋升候选人都会在适当的时间被他们的经理提出。

|

||||

* 流程的*输出物*是什么?例如,在评估经理的绩效时,评估的结果是否会与经理共享,该审查报告的任何方面是否会与经理的直接报告更广泛地共享(例如,改进的领域)?

|

||||

|

||||

回答上述问题时,避免作出判断。如果这个流程不能清楚地解释一个决定是如何做出的,那也可以接受。这些问题只是评估现状的一个机会。

|

||||

|

||||

接下来,修改流程的文档,直到你对它充分说明了流程并预测潜在的问题感到满意。

|

||||

|

||||

### 阶段二:收集反馈

|

||||

|

||||

下一个阶段涉及到与你的成员分享这个流程并要求反馈。分享说起来容易做起来难。

|

||||

|

||||

**第一步** 鼓励人们提供反馈。考虑一下实现此目的的各种机制:

|

||||

|

||||

* 把这个流程公布在人们可以在内部找到的地方,并提示他们可以在哪里发表评论或提供反馈。谷歌文档可以很好地评论特定的文本或直接提议文本中的更改。

|

||||

* 通过电子邮件分享过程文档,邀请反馈。

|

||||

* 提及流程文档,在团队会议或一对一的谈话时要求反馈。

|

||||

* 给人们一个他们可以提供反馈的时间窗口,并在此窗口内定期发送提醒。

|

||||

|

||||

如果你得不到太多的反馈,不要认为沉默就等于认可。你可以试着直接询问人们,他们为什么没有反馈。是因为他们太忙了吗?这个过程对他们来说不像你想的那么重要吗?你清楚地表达了你的要求吗?

|

||||

|

||||

**第二步** 迭代。当你获得关于流程的反馈时,鼓励团队对流程进行修改和迭代。加入改进的想法和建议,并要求确认预期的反馈已经被应用。如果你不同意某个建议,那就接受讨论,问问自己为什么不同意,以及一种方法和另一种方法的优点是什么。

|

||||

|

||||

设置一个收集反馈和迭代的时间窗口有助于向前推进。一旦收集和审查了反馈,你应当讨论和应用它,并且发布最终的流程供团队审查。

|

||||

|

||||

### 阶段三:实现

|

||||

|

||||

实现一个流程通常是计划中最困难的阶段。但如果你在修改过程中考虑了反馈意见,人们应该已经预料到了,并且可能会更支持你。从上面迭代过程中获得的文档是一个很好的工具,可以让你对实现负责。

|

||||

|

||||

**第一步** 审查实施需求。许多可以从提高透明度中获益的流程只需要做一点不同的事情,但是你确实需要检查你是否需要其他支持(例如工具)。

|

||||

|

||||

**第二步** 设置实现的时间表。与成员一起回顾时间表,这样他们就知道会发生什么。如果新流程需要对其他流程进行更改,请确保为人们提供足够的时间去适应新方式,并提供沟通和提醒。

|

||||

|

||||

**第三步** 跟进。在使用该流程 3-6 个月后,与你的成员联系,看看进展如何。新流程是否更加透明、更有效、更可预测?你有什么经验教训可以用来进一步改进这个流程吗?

|

||||

|

||||

### 关于作者

|

||||

|

||||

Sam Knuth —— 我有幸在 Red Hat 领导客户内容服务团队;我们生成提供给我们的客户的所有文档。我们的目标是为客户提供他们在企业中使用开源技术取得成功所需要的洞察力。在 Twitter 上与我联系([@samfw][1])。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/open-organization/17/9/exercise-in-transparent-decisions

|

||||

|

||||

作者:[Sam Knuth][a]

|

||||

译者:[MarineFish](https://github.com/MarineFish)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://opensource.com/users/samfw

|

||||

[1]: https://twitter.com/samfw

|

||||

@ -1,67 +1,71 @@

|

||||

在 Linux 上使用 Lutries 管理你的游戏

|

||||

======

|

||||

|

||||

|

||||

|

||||

让我们用游戏开始 2018 的第一天吧!今天我们要讨论的是 **Lutris**,一个 Linux 上的开源游戏平台。你可以使用 Lutries 安装、移除、配置、启动和管理你的游戏。它可以以一个界面帮你管理你的 Linux 游戏、Windows 游戏、仿真控制台游戏和浏览器游戏。它还包含社区编写的安装脚本,使得游戏的安装过程更加简单。

|

||||

今天我们要讨论的是 **Lutris**,一个 Linux 上的开源游戏平台。你可以使用 Lutries 安装、移除、配置、启动和管理你的游戏。它可以在一个单一界面中帮你管理你的 Linux 游戏、Windows 游戏、仿真控制台游戏和浏览器游戏。它还包含社区编写的安装脚本,使得游戏的安装过程更加简单。

|

||||

|

||||

Lutries 自动安装(或者你可以单击点击安装)了超过 20 个模拟器,它提供了从七十年代到现在的大多数游戏系统。目前支持的游戏系统如下:

|

||||

|

||||

* Native Linux

|

||||

* Linux 原生

|

||||

* Windows

|

||||

* Steam (Linux and Windows)

|

||||

* Steam (Linux 和 Windows)

|

||||

* MS-DOS

|

||||

* 街机

|

||||

* Amiga 电脑

|

||||

* Atari 8 和 16 位计算机和控制器

|

||||

* 浏览器 (Flash 或者 HTML5 游戏)

|

||||

* Commmodore 8 位计算机

|

||||

* 基于 SCUMM 的游戏和其他点击冒险游戏

|

||||

* Magnavox Odyssey², Videopac+

|

||||

* 基于 SCUMM 的游戏和其他点击式冒险游戏

|

||||

* Magnavox Odyssey²、Videopac+

|

||||

* Mattel Intellivision

|

||||

* NEC PC-Engine Turbographx 16, Supergraphx, PC-FX

|

||||

* Nintendo NES, SNES, Game Boy, Game Boy Advance, DS

|

||||

* Game Cube and Wii

|

||||

* Sega Master Sytem, Game Gear, Genesis, Dreamcast

|

||||

* SNK Neo Geo, Neo Geo Pocket

|

||||

* NEC PC-Engine Turbographx 16、Supergraphx、PC-FX

|

||||

* Nintendo NES、SNES、Game Boy、Game Boy Advance、DS

|

||||

* Game Cube 和 Wii

|

||||

* Sega Master Sytem、Game Gear、Genesis、Dreamcast

|

||||

* SNK Neo Geo、Neo Geo Pocket

|

||||

* Sony PlayStation

|

||||

* Sony PlayStation 2

|

||||

* Sony PSP

|

||||

* 像 Zork 这样的 Z-Machine 游戏

|

||||

* 还有更多

|

||||

|

||||

|

||||

|

||||

### 安装 Lutris

|

||||

|

||||

就像 Steam 一样,Lutries 包含两部分:网站和客户端程序。从网站你可以浏览可用的游戏,添加最喜欢的游戏到个人库,以及使用安装链接安装他们。

|

||||

|

||||

首先,我们还是来安装客户端。它目前支持 Arch Linux、Debian、Fedroa、Gentoo、openSUSE 和 Ubuntu。

|

||||

|

||||

对于 Arch Linux 和它的衍生版本,像是 Antergos, Manjaro Linux,都可以在 [**AUR**][1] 中找到。因此,你可以使用 AUR 帮助程序安装它。

|

||||

对于 **Arch Linux** 和它的衍生版本,像是 Antergos, Manjaro Linux,都可以在 [AUR][1] 中找到。因此,你可以使用 AUR 帮助程序安装它。

|

||||

|

||||

使用 [Pacaur][2]:

|

||||

|

||||

使用 [**Pacaur**][2]:

|

||||

```

|

||||

pacaur -S lutris

|

||||

```

|

||||

|

||||

使用 **[Packer][3]** :

|

||||

使用 [Packer][3]:

|

||||

|

||||

```

|

||||

packer -S lutris

|

||||

```

|

||||

|

||||

使用 [**Yaourt**][4]:

|

||||

使用 [Yaourt][4]:

|

||||

|

||||

```

|

||||

yaourt -S lutris

|

||||

```

|

||||

|

||||

使用 [**Yay**][5]:

|

||||

使用 [Yay][5]:

|

||||

|

||||

```

|

||||

yay -S lutris

|

||||

```

|

||||

|

||||

**Debian:**

|

||||

|

||||

在 **Debian 9.0** 上以 **root** 身份运行以下命令:

|

||||

在 **Debian 9.0** 上以 **root** 身份运行以下命令:

|

||||

|

||||

```

|

||||

echo 'deb http://download.opensuse.org/repositories/home:/strycore/Debian_9.0/ /' > /etc/apt/sources.list.d/lutris.list

|

||||

wget -nv https://download.opensuse.org/repositories/home:strycore/Debian_9.0/Release.key -O Release.key

|

||||

@ -71,6 +75,7 @@ apt-get install lutris

|

||||

```

|

||||

|

||||

在 **Debian 8.0** 上以 **root** 身份运行以下命令:

|

||||

|

||||

```

|

||||

echo 'deb http://download.opensuse.org/repositories/home:/strycore/Debian_8.0/ /' > /etc/apt/sources.list.d/lutris.list

|

||||

wget -nv https://download.opensuse.org/repositories/home:strycore/Debian_8.0/Release.key -O Release.key

|

||||

@ -79,19 +84,22 @@ apt-get update

|

||||

apt-get install lutris

|

||||

```

|

||||

|

||||

在 **Fedora 27** 上以 **root** 身份运行以下命令: r

|

||||

在 **Fedora 27** 上以 **root** 身份运行以下命令:

|

||||

|

||||

```

|

||||

dnf config-manager --add-repo https://download.opensuse.org/repositories/home:strycore/Fedora_27/home:strycore.repo

|

||||

dnf install lutris

|

||||

```

|

||||

|

||||

在 **Fedora 26** 上以 **root** 身份运行以下命令:

|

||||

在 **Fedora 26** 上以 **root** 身份运行以下命令:

|

||||

|

||||

```

|

||||

dnf config-manager --add-repo https://download.opensuse.org/repositories/home:strycore/Fedora_26/home:strycore.repo

|

||||

dnf install lutris

|

||||

```

|

||||

|

||||

在 **openSUSE Tumbleweed** 上以 **root** 身份运行以下命令:

|

||||

|

||||

```

|

||||

zypper addrepo https://download.opensuse.org/repositories/home:strycore/openSUSE_Tumbleweed/home:strycore.repo

|

||||

zypper refresh

|

||||

@ -99,13 +107,15 @@ zypper install lutris

|

||||

```

|

||||

|

||||

在 **openSUSE Leap 42.3** 上以 **root** 身份运行以下命令:

|

||||

|

||||

```

|

||||

zypper addrepo https://download.opensuse.org/repositories/home:strycore/openSUSE_Leap_42.3/home:strycore.repo

|

||||

zypper refresh

|

||||

zypper install lutris

|

||||

```

|

||||

|

||||

**Ubuntu 17.10**:

|

||||

**Ubuntu 17.10**:

|

||||

|

||||

```

|

||||

sudo sh -c "echo 'deb http://download.opensuse.org/repositories/home:/strycore/xUbuntu_17.10/ /' > /etc/apt/sources.list.d/lutris.list"

|

||||

wget -nv https://download.opensuse.org/repositories/home:strycore/xUbuntu_17.10/Release.key -O Release.key

|

||||

@ -114,7 +124,8 @@ sudo apt-get update

|

||||

sudo apt-get install lutris

|

||||

```

|

||||

|

||||

**Ubuntu 17.04**:

|

||||

**Ubuntu 17.04**:

|

||||

|

||||

```

|

||||

sudo sh -c "echo 'deb http://download.opensuse.org/repositories/home:/strycore/xUbuntu_17.04/ /' > /etc/apt/sources.list.d/lutris.list"

|

||||

wget -nv https://download.opensuse.org/repositories/home:strycore/xUbuntu_17.04/Release.key -O Release.key

|

||||

@ -123,7 +134,8 @@ sudo apt-get update

|

||||

sudo apt-get install lutris

|

||||

```

|

||||

|

||||

**Ubuntu 16.10**:

|

||||

**Ubuntu 16.10**:

|

||||

|

||||

```

|

||||

sudo sh -c "echo 'deb http://download.opensuse.org/repositories/home:/strycore/xUbuntu_16.10/ /' > /etc/apt/sources.list.d/lutris.list"

|

||||

wget -nv https://download.opensuse.org/repositories/home:strycore/xUbuntu_16.10/Release.key -O Release.key

|

||||

@ -132,7 +144,8 @@ sudo apt-get update

|

||||

sudo apt-get install lutris

|

||||

```

|

||||

|

||||

**Ubuntu 16.04**:

|

||||

**Ubuntu 16.04**:

|

||||

|

||||

```

|

||||

sudo sh -c "echo 'deb http://download.opensuse.org/repositories/home:/strycore/xUbuntu_16.04/ /' > /etc/apt/sources.list.d/lutris.list"

|

||||

wget -nv https://download.opensuse.org/repositories/home:strycore/xUbuntu_16.04/Release.key -O Release.key

|

||||

@ -141,71 +154,75 @@ sudo apt-get update

|

||||

sudo apt-get install lutris

|

||||

```

|

||||

|

||||

对于其他平台,参考 [**Lutris 下载链接**][6].

|

||||

对于其他平台,参考 [Lutris 下载链接][6]。

|

||||

|

||||

### 使用 Lutris 管理你的游戏

|

||||

|

||||

安装完成后,从菜单或者应用启动器里打开 Lutries。首次启动时,Lutries 的默认界面像下面这样:

|

||||

|

||||

[![][7]][8]

|

||||

![][8]

|

||||

|

||||

**登录你的 Lutris.net 账号**

|

||||

#### 登录你的 Lutris.net 账号

|

||||

|

||||

为了能同步你个人库中的游戏,下一步你需要在客户端中登录你的 Lutris.net 账号。如果你没有,先 [**注册一个新的账号**][9]。然后点击 **"连接到你的 Lutirs.net 账号同步你的库 "** 连接到 Lutries 客户端。

|

||||

为了能同步你个人库中的游戏,下一步你需要在客户端中登录你的 Lutris.net 账号。如果你没有,先 [注册一个新的账号][9]。然后点击 “Connecting to your Lutirs.net account to sync your library” 连接到 Lutries 客户端。

|

||||

|

||||

输入你的账号信息然后点击 **继续**。

|

||||

输入你的账号信息然后点击 “Connect”。

|

||||

|

||||

[![][7]][10]

|

||||

![][10]

|

||||

|

||||

现在你已经连接到你的 Lutries.net 账号了。

|

||||

|

||||

[![][7]][11]**Browse Games**

|

||||

![][11]

|

||||

|

||||

#### 浏览游戏

|

||||

|

||||

点击工具栏里的浏览图标(游戏控制器图标)可以搜索任何游戏。它会自动定向到 Lutries 网站的游戏页。你可以以字母顺序查看所有可用的游戏。Lutries 现在已经有了很多游戏,而且还有更多的不断添加进来。

|

||||

|

||||

[![][7]][12]

|

||||

![][12]

|

||||

|

||||

任选一个游戏,添加到你的库中。

|

||||

|

||||

[![][7]][13]

|

||||

![][13]

|

||||

|

||||

然后返回到你的 Lutries 客户端,点击 **菜单 - > Lutris -> 同步库**。现在你可以在本地的 Lutries 客户端中看到所有在库中的游戏了。

|

||||

然后返回到你的 Lutries 客户端,点击 “Menu -> Lutris -> Synchronize library”。现在你可以在本地的 Lutries 客户端中看到所有在库中的游戏了。

|

||||

|

||||

[![][7]][14]

|

||||

![][14]

|

||||

|

||||

如果你没有看到游戏,只需要重启一次。

|

||||

|

||||

**安装游戏**

|

||||

#### 安装游戏

|

||||

|

||||

安装游戏,只需要点击游戏,然后点击 **安装** 按钮。例如,我想在我的系统安装 [**2048**][15],就像你在底下的截图中看到的,它要求我选择一个版本去安装。因为它只有一个版本(例如,在线),它就会自动选择这个版本。点击 **继续**。

|

||||

安装游戏,只需要点击游戏,然后点击 “Install” 按钮。例如,我想在我的系统安装 [2048][15],就像你在底下的截图中看到的,它要求我选择一个版本去安装。因为它只有一个版本(例如,在线),它就会自动选择这个版本。点击 “Continue”。

|

||||

|

||||

[![][7]][16]Click Install:

|

||||

![][16]

|

||||

|

||||

[![][7]][17]

|

||||

点击“Install”:

|

||||

|

||||

![][17]

|

||||

|

||||

安装完成之后,你可以启动新安装的游戏或是关闭这个窗口,继续从你的库中安装其他游戏。

|

||||

|

||||

**导入 Steam 库**

|

||||

#### 导入 Steam 库

|

||||

|

||||

你也可以导入你的 Steam 库。在你的头像处点击 **"通过 Steam 登录"** 按钮。接下来你将被重定向到 Steam,输入你的账号信息。填写正确后,你的 Steam 账号将被连接到 Lutries 账号。请注意,为了同步库中的游戏,这里你的 Steam 账号将被公开。你可以在同步完成之后将其重新设为私密状态。

|

||||

你也可以导入你的 Steam 库。在你的头像处点击 “Sign in through Steam” 按钮。接下来你将被重定向到 Steam,输入你的账号信息。填写正确后,你的 Steam 账号将被连接到 Lutries 账号。请注意,为了同步库中的游戏,这里你的 Steam 账号将被公开。你可以在同步完成之后将其重新设为私密状态。

|

||||

|

||||

**手动添加游戏**

|

||||

#### 手动添加游戏

|

||||

|

||||

Lutries 有手动添加游戏的选项。在工具栏中点击 + 号登录。

|

||||

Lutries 有手动添加游戏的选项。在工具栏中点击 “+” 号登录。

|

||||

|

||||

[![][7]][18]

|

||||

![][18]

|

||||

|

||||

在下一个窗口,输入游戏名,在游戏信息栏选择一个运行器。运行器是指 Linux 上类似 wine,Steam 之类的程序,它们可以帮助你启动这个游戏。你可以从 菜单 -> 管理运行器 中安装运行器。

|

||||

在下一个窗口,输入游戏名,在游戏信息栏选择一个运行器。运行器是指 Linux 上类似 wine、Steam 之类的程序,它们可以帮助你启动这个游戏。你可以从 “Menu -> Manage” 中安装运行器。

|

||||

|

||||

[![][7]][19]

|

||||

![][19]

|

||||

|

||||

然后在下一栏中选择可执行文件或者 ISO。最后点击保存。有一个好消息是,你可以添加一个游戏的多个版本。

|

||||

|

||||

**移除游戏**

|

||||

#### 移除游戏

|

||||

|

||||

移除任何已安装的游戏,只需在 Lutries 客户端的本地库中点击对应的游戏。选择 **移除** 然后 **应用**。

|

||||

移除任何已安装的游戏,只需在 Lutries 客户端的本地库中点击对应的游戏。选择 “Remove” 然后 “Apply”。

|

||||

|

||||

[![][7]][20]

|

||||

![][20]

|

||||

|

||||

Lutries 就像 Steam。只是从网站向你的库中添加游戏,并在客户端中为你安装它们。

|

||||

|

||||

@ -215,15 +232,13 @@ Lutries 就像 Steam。只是从网站向你的库中添加游戏,并在客户

|

||||

|

||||

:)

|

||||

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.ostechnix.com/manage-games-using-lutris-linux/

|

||||

|

||||

作者:[SK][a]

|

||||

译者:[dianbanjiu](https://github.com/dianbanjiu)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -234,17 +249,16 @@ via: https://www.ostechnix.com/manage-games-using-lutris-linux/

|

||||

[4]:https://www.ostechnix.com/install-yaourt-arch-linux/

|

||||

[5]:https://www.ostechnix.com/yay-found-yet-another-reliable-aur-helper/

|

||||

[6]:https://lutris.net/downloads/

|

||||

[7]:data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7

|

||||

[8]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-1-1.png ()

|

||||

[8]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-1-1.png

|

||||

[9]:https://lutris.net/user/register/

|

||||

[10]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-2.png ()

|

||||

[11]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-3.png ()

|

||||

[12]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-15-1.png ()

|

||||

[13]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-16.png ()

|

||||

[14]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-6.png ()

|

||||

[10]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-2.png

|

||||

[11]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-3.png

|

||||

[12]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-15-1.png

|

||||

[13]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-16.png

|

||||

[14]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-6.png

|

||||

[15]:https://www.ostechnix.com/let-us-play-2048-game-terminal/

|

||||

[16]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-12.png ()

|

||||

[17]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-13.png ()

|

||||

[18]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-18-1.png ()

|

||||

[19]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-19.png ()

|

||||

[20]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-14-1.png ()

|

||||

[16]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-12.png

|

||||

[17]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-13.png

|

||||

[18]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-18-1.png

|

||||

[19]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-19.png

|

||||

[20]:http://www.ostechnix.com/wp-content/uploads/2018/01/Lutris-14-1.png

|

||||

@ -3,17 +3,18 @@

|

||||

|

||||

|

||||

|

||||

如你所知,Linux 支持非常多的文件系统,例如 Ext4、ext3、ext2、sysfs、securityfs、FAT16、FAT32、NTFS 等等,当前被使用最多的文件系统是 Ext4。你曾经疑惑过你的 Linux 系统使用的是什么类型的文件系统吗?没有疑惑过?不用担心!我们将帮助你。本指南将解释如何在类 Unix 的操作系统中查看已挂载的文件系统类型。

|

||||

如你所知,Linux 支持非常多的文件系统,例如 ext4、ext3、ext2、sysfs、securityfs、FAT16、FAT32、NTFS 等等,当前被使用最多的文件系统是 ext4。你曾经疑惑过你的 Linux 系统使用的是什么类型的文件系统吗?没有疑惑过?不用担心!我们将帮助你。本指南将解释如何在类 Unix 的操作系统中查看已挂载的文件系统类型。

|

||||

|

||||

### 在 Linux 中查看已挂载的文件系统类型

|

||||

|

||||

有很多种方法可以在 Linux 中查看已挂载的文件系统类型,下面我将给出 8 种不同的方法。那现在就让我们开始吧!

|

||||

|

||||

#### 方法 1 – 使用 `findmnt` 命令

|

||||

#### 方法 1 – 使用 findmnt 命令

|

||||

|

||||

这是查出文件系统类型最常使用的方法。**findmnt** 命令将列出所有已挂载的文件系统或者搜索出某个文件系统。`findmnt` 命令能够在 `/etc/fstab`、`/etc/mtab` 或 `/proc/self/mountinfo` 这几个文件中进行搜索。

|

||||

这是查出文件系统类型最常使用的方法。`findmnt` 命令将列出所有已挂载的文件系统或者搜索出某个文件系统。`findmnt` 命令能够在 `/etc/fstab`、`/etc/mtab` 或 `/proc/self/mountinfo` 这几个文件中进行搜索。

|

||||

|

||||

`findmnt` 预装在大多数的 Linux 发行版中,因为它是 `util-linux` 包的一部分。如果 `findmnt` 命令不可用,你可以安装这个软件包。例如,你可以使用下面的命令在基于 Debian 的系统中安装 `util-linux` 包:

|

||||

|

||||

`findmnt` 预装在大多数的 Linux 发行版中,因为它是 **util-linux** 包的一部分。为了防止 `findmnt` 命令不可用,你可以安装这个软件包。例如,你可以使用下面的命令在基于 Debian 的系统中安装 **util-linux** 包:

|

||||

```

|

||||

$ sudo apt install util-linux

|

||||

```

|

||||

@ -21,24 +22,27 @@ $ sudo apt install util-linux

|

||||

下面让我们继续看看如何使用 `findmnt` 来找出已挂载的文件系统。

|

||||

|

||||

假如你只敲 `findmnt` 命令而不带任何的参数或选项,它将像下面展示的那样以树状图形式列举出所有已挂载的文件系统。

|

||||

|

||||

```

|

||||

$ findmnt

|

||||

```

|

||||

|

||||

**示例输出:**

|

||||

示例输出:

|

||||

|

||||

![][2]

|

||||

|

||||

正如你看到的那样,`findmnt` 展示出了目标挂载点(TARGET)、源设备(SOURCE)、文件系统类型(FSTYPE)以及相关的挂载选项(OPTIONS),例如文件系统是否是可读可写或者只读的。以我的系统为例,我的根(`/`)文件系统的类型是 EXT4 。

|

||||

正如你看到的那样,`findmnt` 展示出了目标挂载点(`TARGET`)、源设备(`SOURCE`)、文件系统类型(`FSTYPE`)以及相关的挂载选项(`OPTIONS`),例如文件系统是否是可读可写或者只读的。以我的系统为例,我的根(`/`)文件系统的类型是 EXT4 。

|

||||

|

||||

假如你不想以树状图的形式来展示输出,可以使用 `-l` 选项来以简单平凡的形式来展示输出:

|

||||

|

||||

假如你不想以树状图的形式来展示输出,可以使用 **-l** 选项来以简单平凡的形式来展示输出:

|

||||

```

|

||||

$ findmnt -l

|

||||

```

|

||||

|

||||

![][3]

|

||||

|

||||

你还可以使用 **-t** 选项来列举出特定类型的文件系统,例如下面展示的 **ext4** 文件系统类型:

|

||||

你还可以使用 `-t` 选项来列举出特定类型的文件系统,例如下面展示的 `ext4` 文件系统类型:

|

||||

|

||||

```

|

||||

$ findmnt -t ext4

|

||||

TARGET SOURCE FSTYPE OPTIONS

|

||||

@ -47,15 +51,18 @@ TARGET SOURCE FSTYPE OPTIONS

|

||||

```

|

||||

|

||||

`findmnt` 还可以生成 `df` 类型的输出,使用命令

|

||||

|

||||

```

|

||||

$ findmnt --df

|

||||

```

|

||||

|

||||

或

|

||||

|

||||

```

|

||||

$ findmnt -D

|

||||

```

|

||||

|

||||

**示例输出:**

|

||||

示例输出:

|

||||

|

||||

```

|

||||

SOURCE FSTYPE SIZE USED AVAIL USE% TARGET

|

||||

@ -75,6 +82,7 @@ gvfsd-fuse fuse.gvfsd-fuse 0 0 0 - /run/user/1000/gvfs

|

||||

你还可以展示某个特定设备或者挂载点的文件系统类型。

|

||||

|

||||

查看某个特定的设备:

|

||||

|

||||

```

|

||||

$ findmnt /dev/sda1

|

||||

TARGET SOURCE FSTYPE OPTIONS

|

||||

@ -82,6 +90,7 @@ TARGET SOURCE FSTYPE OPTIONS

|

||||

```

|

||||

|

||||

查看某个特定的挂载点:

|

||||

|

||||

```

|

||||

$ findmnt /

|

||||

TARGET SOURCE FSTYPE OPTIONS

|

||||

@ -89,34 +98,38 @@ TARGET SOURCE FSTYPE OPTIONS

|

||||

```

|

||||

|

||||

你甚至还可以查看某个特定标签的文件系统的类型:

|

||||

|

||||

```

|

||||

$ findmnt LABEL=Storage

|

||||

```

|

||||

|

||||

更多详情,请参考其 man 手册。

|

||||

|

||||

```

|

||||

$ man findmnt

|

||||

```

|

||||

|

||||

`findmnt` 命令已足够完成在 Linux 中查看已挂载文件系统类型的任务,这个命令就是为了这个特定任务而生的。然而,还存在其他方法来查看文件系统的类型,假如你感兴趣的话,请接着让下看。

|

||||

`findmnt` 命令已足够完成在 Linux 中查看已挂载文件系统类型的任务,这个命令就是为了这个特定任务而生的。然而,还存在其他方法来查看文件系统的类型,假如你感兴趣的话,请接着往下看。

|

||||

|

||||

#### 方法 2 – 使用 `blkid` 命令

|

||||

#### 方法 2 – 使用 blkid 命令

|

||||

|

||||

**blkid** 命令被用来查找和打印块设备的属性。它也是 **util-linux** 包的一部分,所以你不必再安装它。

|

||||

`blkid` 命令被用来查找和打印块设备的属性。它也是 `util-linux` 包的一部分,所以你不必再安装它。

|

||||

|

||||

为了使用 `blkid` 命令来查看某个文件系统的类型,可以运行:

|

||||

|

||||

```

|

||||

$ blkid /dev/sda1

|

||||

```

|

||||

|

||||

#### 方法 3 – 使用 `df` 命令

|

||||

#### 方法 3 – 使用 df 命令

|

||||

|

||||

在类 Unix 的操作系统中,`df` 命令被用来报告文件系统的磁盘空间使用情况。为了查看所有已挂载文件系统的类型,只需要运行:

|

||||

|

||||

在类 Unix 的操作系统中, **df** 命令被用来报告文件系统的磁盘空间使用情况。为了查看所有已挂载文件系统的类型,只需要运行:

|

||||

```

|

||||

$ df -T

|

||||

```

|

||||

|

||||

**示例输出:**

|

||||

示例输出:

|

||||

|

||||

![][4]

|

||||

|

||||

@ -125,15 +138,17 @@ $ df -T

|

||||

- [针对新手的 df 命令教程](https://www.ostechnix.com/the-df-command-tutorial-with-examples-for-beginners/)

|

||||

|

||||

同样也可以参考其 man 手册:

|

||||

|

||||

```

|

||||

$ man df

|

||||

```

|

||||

|

||||

#### 方法 4 – 使用 `file` 命令

|

||||

#### 方法 4 – 使用 file 命令

|

||||

|

||||

**file** 命令可以判读出某个特定文件的类型,即便该文件没有文件后缀名也同样适用。

|

||||

`file` 命令可以判读出某个特定文件的类型,即便该文件没有文件后缀名也同样适用。

|

||||

|

||||

运行下面的命令来找出某个特定分区的文件系统类型:

|

||||

|

||||

```

|

||||

$ sudo file -sL /dev/sda1

|

||||

[sudo] password for sk:

|

||||

@ -141,13 +156,14 @@ $ sudo file -sL /dev/sda1

|

||||

```

|

||||

|

||||

查看其 man 手册可以知晓更多细节:

|

||||

|

||||

```

|

||||

$ man file

|

||||

```

|

||||

|

||||

#### 方法 5 – 使用 `fsck` 命令

|

||||

#### 方法 5 – 使用 fsck 命令

|

||||

|

||||

**fsck** 命令被用来检查某个文件系统是否健全或者修复它。你可以像下面那样通过将分区名字作为 `fsck` 的参数来查看该分区的文件系统类型:

|

||||

`fsck` 命令被用来检查某个文件系统是否健全或者修复它。你可以像下面那样通过将分区名字作为 `fsck` 的参数来查看该分区的文件系统类型:

|

||||

|

||||

```

|

||||

$ fsck -N /dev/sda1

|

||||

@ -156,15 +172,17 @@ fsck from util-linux 2.32

|

||||

```

|

||||

|

||||

如果想知道更多的内容,请查看其 man 手册:

|

||||

|

||||

```

|

||||

$ man fsck

|

||||

```

|

||||

|

||||

#### 方法 6 – 使用 `fstab` 命令

|

||||

#### 方法 6 – 使用 fstab 命令

|

||||

|

||||

**fstab** 是一个包含文件系统静态信息的文件。这个文件通常包含了挂载点、文件系统类型和挂载选项等信息。

|

||||

`fstab` 是一个包含文件系统静态信息的文件。这个文件通常包含了挂载点、文件系统类型和挂载选项等信息。

|

||||

|

||||

要查看某个文件系统的类型,只需要运行:

|

||||

|

||||

```

|

||||

$ cat /etc/fstab

|

||||

```

|

||||

@ -172,15 +190,17 @@ $ cat /etc/fstab

|

||||

![][5]

|

||||

|

||||

更多详情,请查看其 man 手册:

|

||||

|

||||

```

|

||||

$ man fstab

|

||||

```

|

||||

|

||||

#### 方法 7 – 使用 `lsblk` 命令

|

||||

#### 方法 7 – 使用 lsblk 命令

|

||||

|

||||

**lsblk** 命令可以展示设备的信息。

|

||||

`lsblk` 命令可以展示设备的信息。

|

||||

|

||||

要展示已挂载文件系统的信息,只需运行:

|

||||

|

||||

```

|

||||

$ lsblk -f

|

||||

NAME FSTYPE LABEL UUID MOUNTPOINT

|

||||

@ -193,15 +213,17 @@ sr0

|

||||

```

|

||||

|

||||

更多细节,可以参考它的 man 手册:

|

||||

|

||||

```

|

||||

$ man lsblk

|

||||

```

|

||||

|

||||

#### 方法 8 – 使用 `mount` 命令

|

||||

#### 方法 8 – 使用 mount 命令

|

||||

|

||||

**mount** 被用来在类 Unix 系统中挂载本地或远程的文件系统。

|

||||

`mount` 被用来在类 Unix 系统中挂载本地或远程的文件系统。

|

||||

|

||||

要使用 `mount` 命令查看文件系统的类型,可以像下面这样做:

|

||||

|

||||

```

|

||||

$ mount | grep "^/dev"

|

||||

/dev/sda2 on / type ext4 (rw,relatime,commit=360)

|

||||

@ -209,6 +231,7 @@ $ mount | grep "^/dev"

|

||||

```

|

||||

|

||||

更多详情,请参考其 man 手册的内容:

|

||||

|

||||

```

|

||||

$ man mount

|

||||

```

|

||||

@ -224,7 +247,7 @@ via: https://www.ostechnix.com/how-to-find-the-mounted-filesystem-type-in-linux/

|

||||

作者:[SK][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[FSSlc](https://github.com/FSSlc)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,34 +1,32 @@

|

||||

如何在 Ubuntu 服务器中禁用终端欢迎消息中的广告

|

||||

如何禁用 Ubuntu 服务器中终端欢迎消息中的广告

|

||||

======

|

||||

|

||||

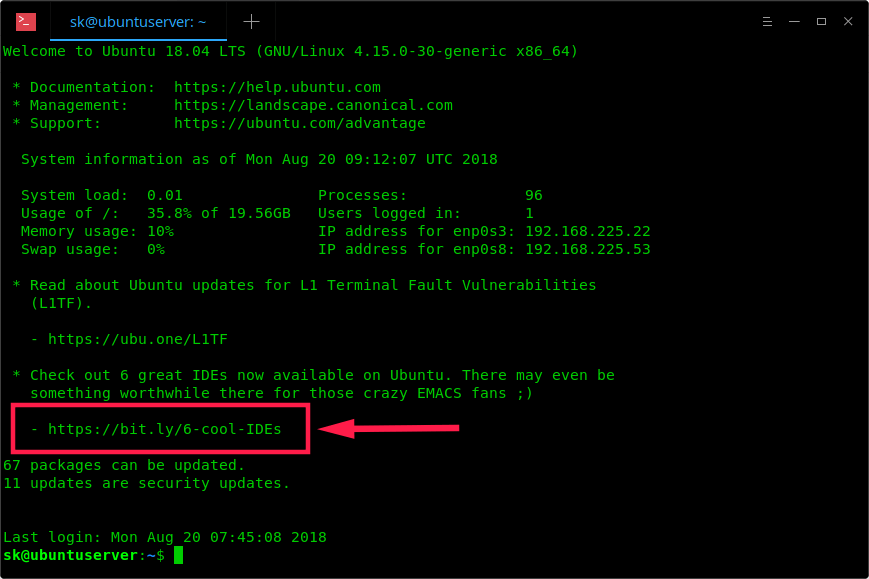

如果你正在使用最新的 Ubuntu 服务器版本,你可能已经注意到欢迎消息中有一些与 Ubuntu 服务器平台无关的促销链接。你可能已经知道 **MOTD**,即 **M**essage **O**f **T**he **D**ay 的开头首字母,在 Linux 系统每次登录时都会显示欢迎信息。通常,欢迎消息包含操作系统版本,基本系统信息,官方文档链接以及有关最新安全更新等的链接。这些是我们每次通过 SSH 或本地登录时通常会看到的内容。但是,最近在终端欢迎消息中出现了一些其他链接。我已经几次注意到这些链接,但我并在意,也从未点击过。以下是我的 Ubuntu 18.04 LTS 服务器上显示的终端欢迎消息。

|

||||

|

||||

|

||||

|

||||

正如你在上面截图中所看到的,欢迎消息中有一个 bit.ly 链接和 Ubuntu wiki 链接。有些人可能会惊讶并想知道这是什么。其实欢迎信息中的链接无需担心。它可能看起来像广告,但并不是商业广告。链接实际上指的是 [**Ubuntu 官方博客**][1] 和 [**Ubuntu wiki**][2]。正如我之前所说,其中的一个链接是不相关的,没有任何与 Ubuntu 服务器相关的细节,这就是为什么我开头称它们为广告。

|

||||

(to 校正:这里是其中一个链接不相关还是两个链接都不相关)

|

||||

正如你在上面截图中所看到的,欢迎消息中有一个 bit.ly 链接和 Ubuntu wiki 链接。有些人可能会惊讶并想知道这是什么。其实欢迎信息中的链接无需担心。它可能看起来像广告,但并不是商业广告。链接实际上指向到了 [Ubuntu 官方博客][1] 和 [Ubuntu wiki][2]。正如我之前所说,其中的一个链接是不相关的,没有任何与 Ubuntu 服务器相关的细节,这就是为什么我开头称它们为广告。

|

||||

|

||||

虽然我们大多数人都不会访问 bit.ly 链接,但是有些人可能出于好奇去访问这些链接,结果失望地发现它只是指向一个外部链接。你可以使用任何 URL 短网址服务,例如 unshorten.it,在访问真正链接之前,查看它会指向哪里。或者,你只需在 bit.ly 链接的末尾输入加号(**+**)即可查看它们的实际位置以及有关链接的一些统计信息。

|

||||

虽然我们大多数人都不会访问 bit.ly 链接,但是有些人可能出于好奇去访问这些链接,结果失望地发现它只是指向一个外部链接。你可以使用任何 URL 去短网址服务,例如 unshorten.it,在访问真正链接之前,查看它会指向哪里。或者,你只需在 bit.ly 链接的末尾输入加号(`+`)即可查看它们的实际位置以及有关链接的一些统计信息。

|

||||

|

||||

|

||||

|

||||

### 什么是 MOTD 以及它是如何工作的?

|

||||

|

||||

2009 年,来自 Canonical 的 **Dustin Kirkland** 在 Ubuntu 中引入了 MOTD 的概念。它是一个灵活的框架,使管理员或发行包能够在 /etc/update-motd.d/* 位置添加可执行脚本,目的是生成在登录时显示有益的,有趣的消息。它最初是为 Landscape(Canonical 的商业服务)实现的,但是其它发行版维护者发现它很有用,并且在他们自己的发行版中也采用了这个特性。

|

||||

2009 年,来自 Canonical 的 Dustin Kirkland 在 Ubuntu 中引入了 MOTD 的概念。它是一个灵活的框架,使管理员或发行包能够在 `/etc/update-motd.d/` 位置添加可执行脚本,目的是生成在登录时显示有益的、有趣的消息。它最初是为 Landscape(Canonical 的商业服务)实现的,但是其它发行版维护者发现它很有用,并且在他们自己的发行版中也采用了这个特性。

|

||||

|

||||

如果你在 Ubuntu 系统中查看 **/etc/update-motd.d/**,你会看到一组脚本。一个是打印通用的 “ Welcome” 横幅。下一个打印 3 个链接,显示在哪里可以找到操作系统的帮助。另一个计算并显示本地系统包可以更新的数量。另一个脚本告诉你是否需要重新启动等等。

|

||||

如果你在 Ubuntu 系统中查看 `/etc/update-motd.d/`,你会看到一组脚本。一个是打印通用的 “欢迎” 横幅。下一个打印 3 个链接,显示在哪里可以找到操作系统的帮助。另一个计算并显示本地系统包可以更新的数量。另一个脚本告诉你是否需要重新启动等等。

|

||||

|

||||

从 Ubuntu 17.04 起,开发人员添加了 **/etc/update-motd.d/50-motd-news**,这是一个脚本用来在欢迎消息中包含一些附加信息。这些附加信息是:

|

||||

|

||||

1. 重要的关键信息,例如 ShellShock, Heartbleed 等

|

||||

从 Ubuntu 17.04 起,开发人员添加了 `/etc/update-motd.d/50-motd-news`,这是一个脚本用来在欢迎消息中包含一些附加信息。这些附加信息是:

|

||||

|

||||

1. 重要的关键信息,例如 ShellShock、Heartbleed 等

|

||||

2. 生命周期(EOL)消息,新功能可用性等

|

||||

|

||||

3. 在 Ubuntu 官方博客和其他有关 Ubuntu 的新闻中发布的一些有趣且有益的帖子

|

||||

|

||||

另一个特点是异步,启动后约 60 秒,systemd 计时器运行 “/etc/update-motd.d/50-motd-news –force” 脚本。它提供了 /etc/default/motd-news 脚本中定义的 3 个配置变量。默认值为:ENABLED=1, URLS=”<https://motd.ubuntu.com”>, WAIT=”5″。

|

||||

另一个特点是异步,启动后约 60 秒,systemd 计时器运行 `/etc/update-motd.d/50-motd-news –force` 脚本。它提供了 `/etc/default/motd-news` 脚本中定义的 3 个配置变量。默认值为:`ENABLED=1, URLS="https://motd.ubuntu.com", WAIT="5"`。

|

||||

|

||||

以下是 `/etc/default/motd-news` 文件的内容:

|

||||

|

||||

以下是 /etc/default/motd-news 文件的内容:

|

||||

```

|

||||

$ cat /etc/default/motd-news

|

||||

# Enable/disable the dynamic MOTD news service

|

||||

@ -50,20 +48,20 @@ URLS="https://motd.ubuntu.com"

|

||||

# Note that news messages are fetched in the background by

|

||||

# a systemd timer, so this should never block boot or login

|

||||

WAIT=5

|

||||

|

||||

```

|

||||

|

||||

好事情是 MOTD 是完全可定制的,所以你可以彻底禁用它(ENABLED=0),根据你的意愿更改或添加脚本,并以秒为单位更改等待时间。

|

||||

好事情是 MOTD 是完全可定制的,所以你可以彻底禁用它(`ENABLED=0`)、根据你的意愿更改或添加脚本、以秒为单位更改等待时间等等。

|

||||

|

||||

如果启用了 MOTD,那么 systemd 计时器作业将循环遍历每个 URL,将它们缩减到每行 80 个字符,最多 10 行,并将它们连接(to 校正:也可能是链接?)到 /var/cache/motd-news 中的缓存文件。此 systemd 计时器作业将每隔 12 小时运行并更新 /var/cache/motd-news。用户登录后,/var/cache/motd-news 的内容会打印到屏幕上。这就是 MOTD 的工作原理。

|

||||

如果启用了 MOTD,那么 systemd 计时器作业将循环遍历每个 URL,将它们的内容缩减到每行 80 个字符、最多 10 行,并将它们连接到 `/var/cache/motd-news` 中的缓存文件。此 systemd 计时器作业将每隔 12 小时运行并更新 `/var/cache/motd-news`。用户登录后,`/var/cache/motd-news` 的内容会打印到屏幕上。这就是 MOTD 的工作原理。

|

||||

|

||||

此外,`/etc/update-motd.d/50-motd-news` 文件中包含自定义的用户代理字符串,以报告有关计算机的信息。如果你查看 `/etc/update-motd.d/50-motd-news` 文件,你会看到:

|

||||

|

||||

此外,**/etc/update-motd.d/50-motd-news** 文件中包含自定义用户代理字符串,以报告有关计算机的信息。如果你查看 **/etc/update-motd.d/50-motd-news** 文件,你会看到

|

||||

```

|

||||

# Piece together the user agent

|

||||

USER_AGENT="curl/$curl_ver $lsb $platform $cpu $uptime"

|

||||

```

|

||||

|

||||

这意味着,MOTD 检索器将向 Canonical 报告你的**操作系统版本**,**硬件平台**,**CPU 类型**和**正常运行时间**。

|

||||

这意味着,MOTD 检索器将向 Canonical 报告你的操作系统版本、硬件平台、CPU 类型和正常运行时间。

|

||||

|

||||

到这里,希望你对 MOTD 有了一个基本的了解。

|

||||

|

||||

@ -72,11 +70,13 @@ USER_AGENT="curl/$curl_ver $lsb $platform $cpu $uptime"

|

||||

### 在 Ubuntu 服务器中禁用终端欢迎消息中的广告

|

||||

|

||||

要禁用这些广告,编辑文件:

|

||||

|

||||

```

|

||||

$ sudo vi /etc/default/motd-news

|

||||

```

|

||||

|

||||

找到以下行并将其值设置为 0(零)。

|

||||

找到以下行并将其值设置为 `0`(零)。

|

||||

|

||||

```

|

||||

[...]

|

||||

ENABLED=0

|

||||

@ -101,7 +101,7 @@ via: https://www.ostechnix.com/how-to-disable-ads-in-terminal-welcome-message-in

|

||||

作者:[SK][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[MjSeven](https://github.com/MjSeven)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,12 +1,13 @@

|

||||

推动 DevOps 变革的三个方面

|

||||

======

|

||||

推动大规模的组织变革是一个痛苦的过程。对于 DevOps 来说,尽管也有阵痛,但变革带来的价值则相当可观。

|

||||

|

||||

> 推动大规模的组织变革是一个痛苦的过程。对于 DevOps 来说,尽管也有阵痛,但变革带来的价值则相当可观。

|

||||

|

||||

|

||||

|

||||

避免痛苦是一种强大的动力。一些研究表明,[植物也会通过遭受疼痛的过程][1]以采取措施来保护自己。我们人类有时也会刻意让自己受苦——在剧烈运动之后,身体可能会发生酸痛,但我们仍然坚持运动。那是因为当人认为整个过程利大于弊时,几乎可以忍受任何事情。

|

||||

|

||||

推动大规模的组织变革得过程确实是痛苦的。有人可能会因难以改变价值观和行为而感到痛苦,有人可能会因难以带领团队而感到痛苦,也有人可能会因难以开展工作而感到痛苦。但就 DevOps 而言,我可以说这些痛苦都是值得的。

|

||||

推动大规模的组织变革的过程确实是痛苦的。有人可能会因难以改变价值观和行为而感到痛苦,有人可能会因难以带领团队而感到痛苦,也有人可能会因难以开展工作而感到痛苦。但就 DevOps 而言,我可以说这些痛苦都是值得的。

|

||||

|

||||

我也曾经关注过一个团队耗费大量时间优化技术流程的过程,在这个过程中,团队逐渐将流程进行自动化改造,并最终获得了成功。

|

||||

|

||||

@ -14,60 +15,64 @@

|

||||

|

||||

图片来源:Lee Eason. CC BY-SA 4.0

|

||||

|

||||

这张图表充分表明了变革的价值。一家公司在我主导实行了 DevOps 转型之后,60 多个团队每月提交了超过 900 个发布请求。这些工作量的原耗时高达每个月 350 天,而这么多的工作量对于任何公司来说都是不可忽视的。除此以外,他们每月的部署次数从 100 次增加到了 9000 次,高危 bug 减少了 24%,工程师们更轻松了,<ruby>净推荐值<rt>Net Promoter Score</rt></ruby>(NPS)也提高了,而 NPS 提高反过来也让团队的 DevOps 转型更加顺利。正如 [Puppet 发布的 DevOps 报告][4]所预测的,用在技术流程改进上的投资可以在业务成果上明显地体现出来。

|

||||

这张图表充分表明了变革的价值。一家公司在我主导实行了 DevOps 转型之后,60 多个团队每月提交了超过 900 个发布请求。这些工作量的原耗时高达每个月 350 人/天,而这么多的工作量对于任何公司来说都是不可忽视的。除此以外,他们每月的部署次数从 100 次增加到了 9000 次,高危 bug 减少了 24%,工程师们更轻松了,<ruby>净推荐值<rt>Net Promoter Score</rt></ruby>(NPS)也提高了,而 NPS 提高反过来也让团队的 DevOps 转型更加顺利。正如 [Puppet 发布的 DevOps 报告][4]所预测的,用在技术流程改进上的投入可以在业务成果上明显地体现出来。

|

||||

|

||||

而 DevOps 主导者在推动变革是必须关注这三个方面:团队管理,团队文化和团队活力。

|

||||

而 DevOps 主导者在推动变革时必须关注这三个方面:团队管理,团队文化和团队活力。

|

||||

|

||||

### 团队管理

|

||||

|

||||

最重要的是,改进对技术流程的投入可以转化为更好的业务成果。

|

||||

|

||||

组织架构越大,业务领导与一线员工之间的距离就会越大,当然发生误解的可能性也会越大。而且各种技术工具和实际应用都在以日新月异的速度变化,这就导致业务领导几乎不可能对 DevOps 或敏捷开发的转型方向有一个亲身的了解。

|

||||

|

||||

DevOps 主导者必须和管理层密切合作,在进行决策的时候给出相关的意见,以帮助他们做出正确的决策。

|

||||

|

||||

公司的管理层只是知道 DevOps 会对产品部署的方式进行改进,而并不了解其中的具体过程。当管理层发现你在和软件团队执行自动化部署失败时,就会想要了解这件事情的细节。如果管理层了解到进行部署的是软件团队而不是专门的发布管理团队,就可能会坚持使用传统的变更流程来保证业务的正常运作。你可能会失去团队的信任,团队也可能不愿意作出进一步的改变。

|

||||

公司的管理层只是知道 DevOps 会对产品部署的方式进行改进,而并不了解其中的具体过程。假设你正在帮助一个软件开发团队实现自动化部署,当管理层得知某次部署失败时(这种情况是有的),就会想要了解这件事情的细节。如果管理层了解到进行部署的是软件团队而不是专门的发布管理团队,就可能会坚持使用传统的变更流程来保证业务的正常运作。你可能会失去团队的信任,团队也可能不愿意做出进一步的改变。

|

||||

|

||||

如果没有和管理层做好心理上的预期,一旦发生意外的生产事件,都会对你和管理层之间的信任造成难以消除的影响。所以,最好事先和管理层之间在各方面协调好,这会让你在后续的工作中避免很多麻烦。

|

||||

如果没有和管理层做好心理上的预期,一旦发生意外的生产事件,重建管理层的信任并得到他们的支持比事先对他们进行教育需要更长的时间。所以,最好事先和管理层在各方面协调好,这会让你在后续的工作中避免很多麻烦。

|

||||

|

||||

对于和管理层之间的协调,这里有两条建议:

|

||||

|

||||

* 一是**重视所有规章制度**。如果管理层对合同、安全等各方面有任何疑问,你都可以向法务或安全负责人咨询,这样做可以避免犯下后果严重的错误。

|

||||

* 二是**将管理层的重点关注的方面输出为量化指标**。举个例子,如果公司的目标是减少客户流失,而你调查得出计划外的停机是造成客户流失的主要原因,那么就可以让团队对故障的<ruby>平均检测时间<rt>Mean Time To Detection</rt></ruby>(MTTD)和<ruby>平均解决时间<rt>Mean Time To Resolution</rt></ruby>(MTTR)实行重点优化。你可以使用这些关键指标来量化团队的工作成果,而管理层对此也可以有一个直观的了解。

|

||||

|

||||

|

||||

* 一是**重视所有规章制度**。如果管理层对合同、安全等各方面有任何疑问,你都可以向法务或安全负责人咨询,这样做可以避免犯下后果严重的错误。

|

||||

* 二是**将管理层重点关注的方面输出为量化指标**。举个例子,如果公司的目标是减少客户流失,而你调查得出计划外的服务宕机是造成客户流失的主要原因,那么就可以让团队对故障的<ruby>平均排查时间<rt>Mean Time To Detection</rt></ruby>(MTTD)和<ruby>平均解决时间<rt>Mean Time To Resolution</rt></ruby>(MTTR)实行重点优化。你可以使用这些关键指标来量化团队的工作成果,而管理层对此也可以有一个直观的了解。

|

||||

|

||||

### 团队文化

|

||||

|

||||

DevOps 是一种专注于持续改进代码、构建、部署和操作流程的文化,而团队文化代表了团队的价值观和行为。从本质上说,团队文化是要塑造团队成员的行为方式,而这并不是一件容易的事。

|

||||

|

||||

我推荐一本叫做《[披着狼皮的 CIO][5]》的书。另外,研究心理学、阅读《[Drive][6]》、观看 Daniel Pink 的 [TED 演讲][7]、阅读《[千面英雄][7]》、了解每个人的心路历程,以上这些都是你推动公司技术变革所应该尝试去做的事情。

|

||||

我推荐一本叫做《[披着狼皮的 CIO][5]》的书。另外,研究心理学、阅读《[Drive][6]》、观看 Daniel Pink 的 [TED 演讲][7]、阅读《[千面英雄][7]》、了解每个人的心路历程,以上这些都是你推动公司技术变革所应该尝试去做的事情。如果这些你都没兴趣,说明你不是那个推动公司变革的人。如果你想成为那个人,那就开始学习吧!

|

||||

|

||||

理性的人大多都按照自己的价值观工作,然而团队通常没有让每个人都能达成共识的明确价值观。因此,你需要明确团队目前的价值观,包括价值观的形成过程和价值观的目标导向。也不能将这些价值观强加到团队成员身上,只需要让团队成员在目前的硬件条件下力所能及地做到最好就可以了

|

||||

从本质上说,改变一个人真不是件容易的事。

|

||||

|

||||

同时需要向团队成员阐明,公司正在发生组织上的变化,团队的价值观也随之改变,最好也厘清整个过程中将会作出什么变化。例如,公司以往或许是由于资金有限,一直将节约成本的原则放在首位,在研发新产品的时候,基础架构团队不得不通过共享数据库集群或服务器,从而导致了服务之间的紧密耦合。然而随着时间的推移,这种做法会产生难以维护的混乱,即使是一个小小的变化也可能造成无法预料的后果。这就导致交付团队难以执行变更控制流程,进而令变更停滞不前。

|

||||

理性的人大多都按照自己的价值观工作,然而团队通常没有让每个人都能达成共识的明确价值观。因此,你需要明确团队目前的价值观,包括价值观的形成过程和价值观的目标导向。但不能将这些价值观强加到团队成员身上,只需要让团队成员在现有条件下力所能及地做到最好就可以了。

|

||||

|

||||

如果这种状况持续多年,最终的结果将会是毫无创新、技术老旧、问题繁多以及产品品质低下,公司的发展到达了瓶颈,原本的价值观已经不再适用。所以,工作效率的优先级必须高于节约成本。

|

||||

同时需要向团队成员阐明,公司正在发生组织和团队目标的变化,团队的价值观也随之改变,最好也厘清整个过程中将会作出什么变化。例如,公司以往或许是由于资金有限,一直将节约成本的原则放在首位,在研发新产品的时候,基础架构团队不得不共享数据库集群或服务器,从而导致了服务之间的紧密耦合。然而随着时间的推移,这种做法会产生难以维护的混乱,即使是一个小小的变化也可能造成无法预料的后果。这就导致交付团队难以执行变更控制流程,进而令变更停滞不前。

|

||||

|

||||

你必须强调团队的价值观。每当团队按照价值观取得了一定的工作进展,都应该对团队作出激励。在团队部署出现失败时,鼓励他们承担风险、继续学习,同时指导团队如何改进他们的工作并表示支持。长此下来,团队成员就会对你产生信任,并逐渐切合团队的价值观。

|

||||

如果这种状况持续几年,最终的结果将会是毫无创新、技术老旧、问题繁多以及产品品质低下,公司的发展到达了瓶颈,原本的价值观已经不再适用。所以,工作效率的优先级必须高于节约成本。如果一个选择能让团队运作更好,另一个选择只是短期来看成本便宜,那你应该选择前者。

|

||||

|

||||

你必须反复强调团队的价值观。每当团队取得了一定的工作进展(即使探索创新时出现一些小的失误),都应该对团队作出激励。在团队部署出现失败时,鼓励他们承担风险、吸取教训,同时指导团队如何改进他们的工作并表示支持。长此下来,团队成员就会对你产生信任,不再顾虑为切合团队的价值观而做出改变。

|

||||

|

||||

### 团队活力

|

||||

|

||||

你有没有在会议上听过类似这样的话?“在张三度假回来之前,我们无法对这件事情做出评估。他是唯一一个了解代码的人”,或者是“我们完成不了这项任务,它在网络上需要跨团队合作,而防火墙管理员刚好请病假了”,又或者是“张三最清楚这个系统最好,他说是怎么样,通常就是怎么样”。那么如果团队在处理工作时,谁才是主力?就是张三。而且也一直会是他。

|

||||

你有没有在会议上听过类似这样的话?“在张三度假回来之前,我们无法对这件事情做出评估。他是唯一一个了解代码的人”,或者是“我们完成不了这项任务,它在网络上需要跨团队合作,而防火墙管理员刚好请病假了”,又或者是“张三最清楚这个系统,他说是怎么样,通常就是怎么样”。那么如果团队在处理工作时,谁才是主力?就是张三。而且也一直会是他。

|

||||

|

||||

我们一直都认为这就是软件开发的本质。但是如果我们不作出改变,这种循环就会一直保持下去。

|

||||

我们一直都认为这就是软件开发的自带属性。但是如果我们不作出改变,这种循环就会一直持续下去。

|

||||

|

||||

熵的存在会让团队自发地变得混乱和缺乏活力,团队的成员和主导者的都有责任控制这个熵并保持团队的活力。DevOps、敏捷开发、上云、代码重构这些行为都会令熵增加速,这是因为转型让团队需要学习更多新技能和专业知识以开展新工作。

|

||||

熵的存在会让团队自发地变得混乱和缺乏活力,团队的成员和主导者的都有责任控制这个熵并保持团队的活力。DevOps、敏捷开发、上云、代码重构这些行为都会令熵加速增长,这是因为转型让团队需要学习更多新技能和专业知识以开展新工作。

|

||||

|

||||

我们来看一个产品团队重构遗留代码的例子。像往常一样,他们在 AWS 上构建新的服务。而传统的系统则在数据中心部署,并由 IT 部门进行监控和备份。IT 部门会确保在基础架构的层面上满足应用的安全需求、进行灾难恢复测试、系统补丁、安装配置了入侵检测和防病毒代理,而且 IT 部门还保留了年度审计流程所需的变更控制记录。

|

||||

我们来看一个产品团队重构历史代码的例子。像往常一样,他们在 AWS 上构建新的服务。而传统的系统则在数据中心部署,并由 IT 部门进行监控和备份。IT 部门会确保在基础架构的层面上满足应用的安全需求、进行灾难恢复测试、系统补丁、安装配置了入侵检测和防病毒代理,而且 IT 部门还保留了年度审计流程所需的变更控制记录。

|

||||

|

||||

产品团队经常会犯一个致命的错误,就是认为 IT 部门是需要突破的瓶颈。他们希望脱离已有的 IT 部门并使用公有云,但实际上是他们忽视了 IT 部门提供的关键服务。迁移到云上只是以不同的方式实现这些关键服务,因为 AWS 也是一个数据中心,团队即使使用 AWS 也需要完成 IT 运维任务。

|

||||

产品团队经常会犯一个致命的错误,就是认为 IT 是消耗资源的部门,是需要突破的瓶颈。他们希望脱离已有的 IT 部门并使用公有云,但实际上是他们忽视了 IT 部门提供的关键服务。迁移到云上只是以不同的方式实现这些关键服务,因为 AWS 也是一个数据中心,团队即使使用 AWS 也需要完成 IT 运维任务。

|

||||

|

||||

实际上,产品团队在迁移到云时候也必须学习如何使用这些 IT 服务。因此,当产品团队开始重构遗留的代码并部署到云上时,也需要学习大量的技能才能正常运作。这些技能不会无师自通,必须自行学习或者聘用相关的人员,团队的主导者也必须积极进行管理。

|

||||

实际上,产品团队在向云迁移的时候也必须学习如何使用这些 IT 服务。因此,当产品团队开始重构历史代码并部署到云上时,也需要学习大量的技能才能正常运作。这些技能不会无师自通,必须自行学习或者聘用相关的人员,团队的主导者也必须积极进行管理。

|

||||

|

||||

在带领团队时,我找不到任何适合我的工具,因此我建立了 [Tekita.io][9] 这个项目。Tekata 免费而且容易使用。但相比起来,把注意力集中在人员和流程上更为重要,你需要不断学习,持续关注团队的弱项,因为它们会影响团队的交付能力,而修补这些弱项往往需要学习大量的新知识,这就需要团队成员之间有一个很好的协作。因此 76% 的年轻人都认为个人发展机会是公司文化[最重要的的一环][10]。

|

||||

在带领团队时,我找不到任何适合我的工具,因此我建立了 [Tekita.io][9] 这个项目。Tekata 免费而且容易使用。但相比起来,把注意力集中在人员和流程上更为重要,你需要不断学习,持续关注团队的短板,因为它们会影响团队的交付能力,而弥补这些短板往往需要学习大量的新知识,这就需要团队成员之间有一个很好的协作。因此 76% 的年轻人都认为个人发展机会是公司文化[最重要的的一环][10]。

|

||||

|

||||

### 效果就是最好的证明

|

||||

|

||||

DevOps 转型会改变团队的工作方式和文化,这需要得到管理层的支持和理解。同时,工作方式的改变意味着新技术的引入,所以在管理上也必须谨慎。但转型的最终结果是团队变得更高效、成员变得更积极、产品变得更优质,客户也变得更快乐。

|

||||

DevOps 转型会改变团队的工作方式和文化,这需要得到管理层的支持和理解。同时,工作方式的改变意味着新技术的引入,所以在管理上也必须谨慎。但转型的最终结果是团队变得更高效、成员变得更积极、产品变得更优质,客户也变得更满意。

|

||||

|

||||

Lee Eason 将于 10 月 21-23 日在北卡罗来纳州 Raleigh 举行的 [All Things Open][12] 上讲述 [DevOps 转型的故事][11]。

|

||||

|

||||

免责声明:本文中的内容仅为 Lee Eason 的个人立场,不代表 Ipreo 或 IHS Markit。

|

||||

|

||||

@ -78,7 +83,7 @@ via: https://opensource.com/article/18/10/tales-devops-transformation

|

||||

作者:[Lee Eason][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[HankChow](https://github.com/HankChow)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[pityonline](https://github.com/pityonline)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -96,4 +101,3 @@ via: https://opensource.com/article/18/10/tales-devops-transformation

|

||||

[10]: https://www.execu-search.com/~/media/Resources/pdf/2017_Hiring_Outlook_eBook

|

||||

[11]: https://allthingsopen.org/talk/tales-from-a-devops-transformation/

|

||||

[12]: https://allthingsopen.org/

|

||||

|

||||

@ -1,71 +1,74 @@

|

||||

Kali Linux:在开始使用之前你必须知道的 – FOSS Post

|

||||

在你开始使用 Kali Linux 之前必须知道的事情

|

||||

======

|

||||

|

||||

|

||||

|

||||

Kali Linux 在渗透测试和白帽子方面,是业界领先的 Linux 发行版。默认情况下,该发行版附带了大量黑客和渗透工具和软件,并且在全世界都得到了广泛认可。即使在那些甚至可能不知道 Linux 是什么的 Windows 用户中也是如此。

|

||||

Kali Linux 在渗透测试和白帽子方面是业界领先的 Linux 发行版。默认情况下,该发行版附带了大量入侵和渗透的工具和软件,并且在全世界都得到了广泛认可。即使在那些甚至可能不知道 Linux 是什么的 Windows 用户中也是如此。

|

||||

|

||||

由于后者的原因,许多人都试图单独使用 Kali Linux,尽管他们甚至不了解 Linux 系统的基础知识。原因可能各不相同,有的为了玩乐,有的是为了取悦女友而伪装成黑客,有的仅仅是试图破解邻居的 WiFi 网络以免费上网。如果你打算使用 Kali Linux,所有的这些都是不好的事情。

|

||||

由于后者的原因(LCTT 译注:Windows 用户),许多人都试图单独使用 Kali Linux,尽管他们甚至不了解 Linux 系统的基础知识。原因可能各不相同,有的为了玩乐,有的是为了取悦女友而伪装成黑客,有的仅仅是试图破解邻居的 WiFi 网络以免费上网。如果你打算使用 Kali Linux,记住,所有的这些都是不好的事情。

|

||||

|

||||

在计划使用 Kali Linux 之前,你应该了解一些提示。

|

||||

|

||||

### Kali Linux 不适合初学者

|

||||

|

||||

|

||||

Kali Linux 默认 GNOME 桌面

|

||||

|

||||

如果你是几个月前刚开始使用 Linux 的人,或者你认为自己的知识水平低于平均水平,那么 Kali Linux 就不适合你。如果你打算问“如何在 Kali 上安装 Stream?如何让我的打印机在 Kali 上工作?如何解决 Kali 上的 APT 源错误?”这些东西,那么 Kali Linux 并不适合你。

|

||||

*Kali Linux 默认 GNOME 桌面*

|

||||

|

||||

Kali Linux 主要面向想要运行渗透测试的专家或想要学习成为白帽子和数字取证的人。但即使你来自后者,普通的 Kali Linux 用户在日常使用时也会遇到很多麻烦。他还被要求以非常谨慎的方式使用工具和软件,而不仅仅是“让我们安装并运行一切”。每一个工具必须小心使用,你安装的每一个软件都必须仔细检查。

|

||||

如果你是几个月前刚开始使用 Linux 的人,或者你认为自己的知识水平低于平均水平,那么 Kali Linux 就不适合你。如果你打算问“如何在 Kali 上安装 Steam?如何让我的打印机在 Kali 上工作?如何解决 Kali 上的 APT 源错误?”这些东西,那么 Kali Linux 并不适合你。

|

||||

|

||||

**建议阅读:** [Linux 系统的组件是什么?][1]

|

||||

Kali Linux 主要面向想要运行渗透测试套件的专家或想要学习成为白帽子和数字取证的人。但即使你属于后者,普通的 Kali Linux 用户在日常使用时也会遇到很多麻烦。他还被要求以非常谨慎的方式使用工具和软件,而不仅仅是“让我们安装并运行一切”。每一个工具必须小心使用,你安装的每一个软件都必须仔细检查。

|

||||

|

||||

普通 Linux 用户无法做正常的事情。(to 校正:这里什么意思呢?)一个更好的方法是花几周时间学习 Linux 及其守护进程,服务,软件,发行版及其工作方式,然后观看几十个关于白帽子攻击的视频和课程,然后再尝试使用 Kali 来应用你学习到的东西。

|

||||

**建议阅读:** [Linux 系统的组件有什么?][1]

|

||||

|

||||

普通 Linux 用户都无法自如地使用它。一个更好的方法是花几周时间学习 Linux 及其守护进程、服务、软件、发行版及其工作方式,然后观看几十个关于白帽子攻击的视频和课程,然后再尝试使用 Kali 来应用你学习到的东西。

|

||||

|

||||

### 它会让你被黑客攻击

|

||||

|

||||

|

||||

Kali Linux 入侵和测试工具

|

||||

|

||||

*Kali Linux 入侵和测试工具*

|

||||

|

||||

在普通的 Linux 系统中,普通用户有一个账户,而 root 用户也有一个单独的账号。但在 Kali Linux 中并非如此。Kali Linux 默认使用 root 账户,不提供普通用户账户。这是因为 Kali 中几乎所有可用的安全工具都需要 root 权限,并且为了避免每分钟要求你输入 root 密码,所以这样设计。

|

||||

|

||||

当然,你可以简单地创建一个普通用户账户并开始使用它。但是,这种方式仍然不推荐,因为这不是 Kali Linux 系统设计的工作方式。然后,在使用程序,打开端口,调试软件时,你会遇到很多问题,你会发现为什么这个东西不起作用,最终却发现它是一个奇怪的权限错误。另外每次在系统上做任何事情时,你会被每次运行工具都要求输入密码而烦恼。

|

||||

当然,你可以简单地创建一个普通用户账户并开始使用它。但是,这种方式仍然不推荐,因为这不是 Kali Linux 系统设计的工作方式。使用普通用户在使用程序,打开端口,调试软件时,你会遇到很多问题,你会发现为什么这个东西不起作用,最终却发现它是一个奇怪的权限错误。另外每次在系统上做任何事情时,你会被每次运行工具都要求输入密码而烦恼。

|

||||

|

||||

现在,由于你被迫以 root 用户身份使用它,因此你在系统上运行的所有软件也将以 root 权限运行。如果你不知道自己在做什么,那么这很糟糕,因为如果 Firefox 中存在漏洞,并且你访问了一个受感染的网站,那么黑客能够在你的 PC 上获得全部 root 权限并入侵你。如果你使用的是普通用户账户,则会收到限制。此外,你安装和使用的某些工具可能会在你不知情的情况下打开端口并泄露信息,因此如果你不是非常小心,人们可能会以你尝试入侵他们的方式入侵你。

|

||||

现在,由于你被迫以 root 用户身份使用它,因此你在系统上运行的所有软件也将以 root 权限运行。如果你不知道自己在做什么,那么这很糟糕,因为如果 Firefox 中存在漏洞,并且你访问了一个受感染的网站,那么黑客能够在你的 PC 上获得全部 root 权限并入侵你。如果你使用的是普通用户账户,则会受到限制。此外,你安装和使用的某些工具可能会在你不知情的情况下打开端口并泄露信息,因此如果你不是非常小心,人们可能会以你尝试入侵他们的方式入侵你。

|

||||

|

||||

如果你在一些情况下访问于与 Kali Linux 相关的 Facebook 群组,你会发现这些群组中几乎有四分之一的帖子是人们在寻求帮助,因为有人入侵了他们。

|

||||

如果你曾经访问过与 Kali Linux 相关的 Facebook 群组,你会发现这些群组中几乎有四分之一的帖子是人们在寻求帮助,因为有人入侵了他们。

|

||||

|

||||

### 它可以让你入狱

|

||||

|

||||

Kali Linux 仅提供软件。那么,如何使用它们完全是你自己的责任。

|

||||

Kali Linux 只是提供了软件。那么,如何使用它们完全是你自己的责任。

|

||||

|

||||

在世界上大多数发达国家,使用针对公共 WiFi 网络或其他设备的渗透测试工具很容易让你入狱。现在不要以为你使用了 Kali 就无法被跟踪,许多系统都配置了复杂的日志记录设备来简单地跟踪试图监听或入侵其网络的人,你可能无意间成为其中的一个,那么它会毁掉你的生活。

|

||||

|

||||

永远不要对不属于你的设备或网络使用 Kali Linux 系统,也不要明确允许对它们进行入侵。如果你说你不知道你在做什么,在法庭上它不会被当作借口来接受。

|

||||

|

||||

### 修改了内核和软件

|

||||

### 修改了的内核和软件

|

||||

|

||||

Kali [基于][2] Debian(测试分支,这意味着 Kali Linux 使用滚动发布模型),因此它使用了 Debian 的大部分软件体系结构,你会发现 Kali Linux 中的大部分软件跟 Debian 中的没什么区别。

|

||||

Kali [基于][2] Debian(“测试”分支,这意味着 Kali Linux 使用滚动发布模型),因此它使用了 Debian 的大部分软件体系结构,你会发现 Kali Linux 中的大部分软件跟 Debian 中的没什么区别。

|

||||

|

||||

但是,Kali 修改了一些包来加强安全性并修复了一些可能的漏洞。例如,Kali 使用的 Linux 内核被打了补丁,允许在各种设备上进行无线注入。这些补丁通常在普通内核中不可用。此外,Kali Linux 不依赖于 Debian 服务器和镜像,而是通过自己的服务器构建软件包。以下是最新版本中的默认软件源:

|

||||

|

||||

```

|

||||

deb http://http.kali.org/kali kali-rolling main contrib non-free

|

||||

deb-src http://http.kali.org/kali kali-rolling main contrib non-free

|

||||

deb http://http.kali.org/kali kali-rolling main contrib non-free

|

||||

deb-src http://http.kali.org/kali kali-rolling main contrib non-free

|

||||

```

|

||||

|

||||

这就是为什么,对于某些特定的软件,当你在 Kali Linux 和 Fedora 中使用相同的程序时,你会发现不同的行为。你可以从 [git.kali.org][3] 中查看 Kali Linux 软件的完整列表。你还可以在 Kali Linux(GNOME)上找到我们[自己生成的已安装包列表][4]。

|

||||

|

||||

更重要的是,Kali Linux 官方文档极力建议不要添加任何其他第三方软件仓库,因为 Kali Linux 是一个滚动发行版,并且依赖于 Debian 测试,由于依赖关系冲突和包钩子,所以你很可能只是添加一个新的仓库源就会破坏系统。

|

||||

更重要的是,Kali Linux 官方文档极力建议不要添加任何其他第三方软件仓库,因为 Kali Linux 是一个滚动发行版,并且依赖于 Debian 测试分支,由于依赖关系冲突和包钩子,所以你很可能只是添加一个新的仓库源就会破坏系统。

|

||||

|

||||

### 不要安装 Kali Linux

|

||||

|

||||

|

||||

|

||||

使用 Kali Linux 在 fosspost.org 上运行 wpscan

|

||||

*使用 Kali Linux 在 fosspost.org 上运行 wpscan*

|

||||

|

||||

我在极少数情况下使用 Kali Linux 来测试我部署的软件和服务器。但是,我永远不敢安装它并将其用作主系统。

|

||||

|

||||

如果你要将其用作主系统,那么你必须保留自己的个人文件,密码,数据以及系统上的所有内容。你还需要安装大量日常使用的软件,以解放你的生活。但正如我们上面提到的,使用 Kali Linux 是非常危险的,应该非常小心地进行,如果你被入侵了,你将丢失所有数据,并且可能会暴露给更多的人。如果你在做一些不合法的事情,你的个人信息也可用于跟踪你。如果你不小心使用这些工具,那么你甚至可能会毁掉自己的数据。

|

||||

如果你要将其用作主系统,那么你必须保留自己的个人文件、密码、数据以及系统上的所有内容。你还需要安装大量日常使用的软件,以解放你的生活。但正如我们上面提到的,使用 Kali Linux 是非常危险的,应该非常小心地进行,如果你被入侵了,你将丢失所有数据,并且可能会暴露给更多的人。如果你在做一些不合法的事情,你的个人信息也可用于跟踪你。如果你不小心使用这些工具,那么你甚至可能会毁掉自己的数据。

|

||||

|

||||

即使是专业的白帽子也不建议将其作为主系统安装,而是通过 USB 使用它来进行渗透测试工作,然后再回到普通的 Linux 发行版。

|

||||

|

||||

@ -83,7 +86,7 @@ via: https://fosspost.org/articles/must-know-before-using-kali-linux

|

||||

作者:[M.Hanny Sabbagh][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[MjSeven](https://github.com/MjSeven)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,9 +1,11 @@

|

||||

使用极简浏览器 Min 浏览网页

|

||||

======

|

||||

|

||||

> 并非所有 web 浏览器都要做到无所不能,Min 就是一个极简主义风格的浏览器。

|

||||

|

||||

|

||||

|

||||

现在还有开发新的网络浏览器的需要吗?即使现在浏览器领域已经成为了寡头市场,但仍然不断涌现出各种前所未有的浏览器产品。

|

||||

现在还有开发新的 Web 浏览器的需要吗?即使现在浏览器领域已经成为了寡头市场,但仍然不断涌现出各种前所未有的浏览器产品。

|

||||

|

||||

[Min][1] 就是其中一个。顾名思义,Min 是一个小的浏览器,也是一个极简主义的浏览器。但它麻雀虽小五脏俱全,而且还是一个开源的浏览器,它的 Apache 2.0 许可证引起了我的注意。

|

||||

|

||||

@ -29,7 +31,7 @@ Min 号称是更智能、更快速的浏览器。经过尝试以后,我觉得

|

||||

|

||||

Min 和其它浏览器一样,支持页面选项卡。它还有一个称为 Tasks 的功能,可以对打开的选项卡进行分组。

|

||||

|

||||

[DuckDuckGo][6]是我最喜欢的搜索引擎,而 Min 的默认搜索引擎恰好就是它,这正合我意。当然,如果你喜欢另一个搜索引擎,也可以在 Min 的偏好设置中配置你喜欢的搜索引擎作为默认搜索引擎。

|

||||

[DuckDuckGo][6] 是我最喜欢的搜索引擎,而 Min 的默认搜索引擎恰好就是它,这正合我意。当然,如果你喜欢另一个搜索引擎,也可以在 Min 的偏好设置中配置你喜欢的搜索引擎作为默认搜索引擎。

|

||||

|

||||

Min 没有使用类似 AdBlock 这样的插件来过滤你不想看到的内容,而是使用了一个名为 [EasyList][7] 的内置的广告拦截器,你可以使用它来屏蔽脚本和图片。另外 Min 还带有一个内置的防跟踪软件。

|

||||

|

||||

@ -54,7 +56,7 @@ Min 确实也有自己的缺点,例如它无法将网站添加为书签。替

|

||||

### 总结

|

||||

|

||||

Min 算是一个中规中矩的浏览器,它可以凭借轻量、快速的优点吸引很多极简主义的用户。但是对于追求多功能的用户来说,Min 就显得相当捉襟见肘了。

|

||||

.

|

||||

|

||||

所以,如果你想摆脱当今多功能浏览器的束缚,我觉得可以试用一下 Min。

|

||||

|

||||

|

||||

@ -65,7 +67,7 @@ via: https://opensource.com/article/18/10/min-web-browser

|

||||

作者:[Scott Nesbitt][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[HankChow](https://github.com/HankChow)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,260 +0,0 @@

|

||||

Translating by cielllll

|

||||

|

||||

Three Alternatives for Enabling Two Factor Authentication For SSH On Ubuntu 16.04 And Debian Jessie

|

||||

======

|

||||

Security is now more important than ever and securing your SSH server is one of the most important things that you can do as a systems administrator. Traditionally this has meant disabling password authentication and instead using SSH keys. Whilst this is absolutely the first thing you should do that doesn't mean that SSH can't be made even more secure.

|

||||

|

||||

Two-factor authentication simply means that two means of identification are required to log in. These could be a password and an SSH key, or a key and a 3rd party service like Google. It means that the compromise of a single authentication method does not compromise the server.

|

||||

|

||||

The following guides are three ways to enable two-factor authentication for SSH.

|

||||

|

||||

Whenever you are modifying the configuration of SSH always ensure that you have a second terminal open to the server. The second terminal means that you will be able to fix any mistakes you make with the SSH configuration. Open terminals will stay open even through SSH restarts.

|

||||

|

||||

### SSH Key and Password

|

||||

|

||||

SSH supports the ability to require more than a single authentication method for logins.

|

||||

|

||||

The authentication methods are set with the `AuthenticationMethods` option in the SSH server's configuration file at `/etc/ssh/sshd_config`.

|

||||

|

||||

When the following line is added into `/etc/ssh/sshd_config` SSH requires an SSH key to be submitted and then a password is prompted for:

|

||||

```

|

||||

AuthenticationMethods "publickey,password"

|

||||

|

||||

```

|

||||

|

||||

If you want to set these methods on a per use basis then use the following additional configuration:

|

||||

```

|

||||

Match User jsmith

|

||||

AuthenticationMethods "publickey,password"

|

||||

|

||||

```

|

||||

|

||||

When you have edited and saved the new `sshd_config` file you should check that you did not make any errors by running this command:

|

||||

```

|

||||

sshd -t

|

||||

|

||||

```

|

||||

|

||||

Any syntax or other errors that would stop SSH from starting will be flagged here. When `ssh -t` runs without error use `systemctl` to restart SSH"

|

||||

```

|

||||

systemctl restart sshd

|

||||

|

||||

```

|

||||

|

||||

Now you can log in with a new terminal to check that you are prompted for a password and your SSH key is required. If you use `ssh -v` e.g.:

|

||||

```

|

||||

ssh -v jsmith@example.com

|

||||

|

||||

```

|

||||

|

||||

you will be able to see every step of the login.

|

||||

|

||||

Note, if you do set `password` as a required authentication method then you will need to ensure that `PasswordAuthentication` option is set to `yes`.

|

||||

|

||||

### SSH With Google Authenticator

|

||||

|

||||

Google's two-factor authentication system that is used on Google's own products can be integrated into your SSH server. This makes this method very convenient if you already have use the Google Authenticator app.

|

||||

|

||||

Although the `libpam-google-authenticator` is written by Google it is [open source][1]. Also, the Google Authenticator app is written by Google but does not require a Google account to work. Thanks to [Sitaram Chamarty][2] for the heads up on that.

|

||||

|

||||

If you don't already have the Google Authenticator app installed and configured on your phone please see the instructions [here][3].

|

||||

|

||||

First, we need to install the Google Authenticator package on the server. The following commands will update your system and install the needed packages:

|

||||

```

|

||||

apt-get update

|

||||

apt-get upgrade

|

||||

apt-get install libpam-google-authenticator

|

||||

|

||||

```

|

||||

|

||||

Now, we need to register the server with the Google Authenticator app on your phone. This is done by first running the program we just installed:

|

||||

```

|

||||

google-authenticator

|

||||

|

||||

```

|

||||

|

||||

You will be asked a few questions when you run this. You should answer in the way that suits your setup, however, the most secure options are to answer `y` to every question. If you need to change these later you can simply re-run `google-authenticator` and select different options.

|

||||

|

||||

When you run `google-authenticator` a QR code will be printed to the terminal and some codes that look like:

|

||||

```

|

||||

Your new secret key is: VMFY27TYDFRDNKFY

|

||||

Your verification code is 259652

|

||||

Your emergency scratch codes are:

|

||||

96915246

|

||||

70222983

|

||||

31822707

|

||||

25181286

|

||||

28919992

|

||||

|

||||

```

|

||||

|

||||

You should record all of these codes to a secure location like a password manager. The scratch codes are single use codes that will always allow you access even if your phone is unavailable.

|

||||

|

||||

All you need to do to register your server with the Authenticator app is to open the app and hit the red plus symbol on the bottom right. Then select the **Scan a barcode** option and scan the QR code that was printed to the terminal. Your server and the app are now linked.

|

||||

|

||||

Back on the server, we now need to edit the PAM (Pluggable Authentication Module) for SSH so that it uses the authenticator package we just installed. PAM is the standalone system that takes care of most authentication on a Linux server.

|

||||

|

||||

The PAM file for SSH that needs modifying is located at `/etc/pam.d/sshd` and edited with the following command:

|

||||

```

|

||||

nano /etc/pam.d/sshd

|

||||

|

||||

```

|

||||

|

||||

Add the following line to the top of the file:

|

||||

```

|

||||

auth required pam_google_authenticator.so

|

||||

|

||||

```

|

||||

|

||||

In addition, we also need to comment out a line so that PAM will not prompt for a password. Change this line:

|

||||

```

|

||||

# Standard Un*x authentication.

|

||||

@include common-auth

|

||||

|

||||

```

|

||||

|

||||

To this:

|

||||

```

|

||||

# Standard Un*x authentication.

|

||||

# @include common-auth

|

||||

|

||||

```

|

||||

|

||||

Next, we need to edit the SSH server configuration file:

|

||||

```

|

||||

nano /etc/ssh/sshd_config

|

||||

|

||||

```

|

||||

|

||||

And change this line:

|

||||

```

|

||||

ChallengeResponseAuthentication no

|

||||

|

||||

```

|

||||

|

||||

To:

|

||||

```

|

||||

ChallengeResponseAuthentication yes

|

||||

|

||||

```

|

||||

|

||||

Next, add the following line to enable two authentication schemes; SSH keys and Google Authenticator (keyboard-interactive):

|

||||

```

|

||||

AuthenticationMethods "publickey,keyboard-interactive"

|

||||

|

||||

```

|

||||

|

||||

Before we reload the SSH server it is a good idea to check that we did not make any errors in the configuration. This is done with the following command:

|

||||

```

|

||||

sshd -t

|

||||

|

||||

```

|

||||

|

||||

If this does not flag any errors, reload SSH with the new configuration:

|

||||

```

|

||||

systemctl reload sshd.service

|

||||

|

||||

```

|

||||

|

||||

Everything should now be working. Now, when you log into to your server you will need to use your SSH keys and when you are prompted for the:

|

||||

```

|

||||

Verification code:

|

||||

|

||||

```

|

||||

|

||||

open the Authenticator app and enter the 6 digit code that is displaying for your server.

|

||||

|

||||

### Authy

|

||||

|

||||

[Authy][4] is a two-factor authentication service that, like Google, offers time-based codes. However, Authy does not require a phone as they provide desktop and tables clients. They also enable offline authentication and do not require a Google account.

|

||||

|

||||

You will need to install the Authy app from your app store, or the desktop client all of which are linked to from the Authy [download page][5].

|

||||

|

||||

After you have installed the app you will need an API key that will be used on the server. This process requires a few steps:

|

||||

|

||||

1. Sign up for an account [here][6].

|

||||

2. Scroll down to the **Authy** section.

|

||||

3. Enable 2FA on the account.

|

||||

4. Return to the **Authy** section.

|

||||

5. Create a new Application for your server.

|

||||

6. Obtain the API key from the top of the `General Settings` page for the new Application. You need to click the eye symbol next to the `PRODUCTION API KEY` line to reveal the key. Shown here:

|

||||

|

||||

|

||||

|

||||

![][7]

|

||||

|

||||

Take a note of the API key somewhere secure.

|

||||

|

||||

Now, go back to your server and run the following commands as root:

|

||||

```

|

||||

curl -O 'https://raw.githubusercontent.com/authy/authy-ssh/master/authy-ssh'

|

||||

bash authy-ssh install /usr/local/bin

|

||||

|

||||

```

|

||||

|

||||

Enter the API key when prompted. If you input it incorrectly you can always edit `/usr/local/bin/authy-ssh.conf` and add it again.

|

||||

|

||||

Authy is now installed. However, it will not start working until it is enabled for a user. The command to enable Authy has the form:

|

||||

```

|

||||

/usr/local/bin/authy-ssh enable <system-user> <your-email> <your-phone-country-code> <your-phone-number>

|

||||

|

||||

```

|

||||

|

||||

With some example details for **root** logins:

|

||||

```

|

||||

/usr/local/bin/authy-ssh enable root john@example.com 44 20822536476

|

||||

|

||||

```

|

||||

|

||||

If everything was successful you will see:

|

||||

```

|

||||

User was registered

|

||||

|

||||

```

|

||||

|

||||

You can test Authy now by running the command:

|

||||

```

|

||||

authy-ssh test

|

||||

|

||||

```

|

||||

|

||||

Finally, reload SSH to implement the new configuration:

|

||||

```

|

||||

systemctl reload sshd.service

|

||||

|

||||

```

|

||||

|

||||

Authy is now working and will be required for SSH logins.

|

||||

|

||||

Now, when you log in you will see the following prompt:

|

||||

```

|

||||

Authy Token (type 'sms' to request a SMS token):

|

||||

|

||||

```

|

||||

|

||||

You can either enter the code from the Authy app on your phone or desktop client. Or you can type `sms` and Authy will send you an SMS message with a login code.

|

||||

|

||||

Authy is uninstalled by running the following:

|

||||

```

|

||||

/usr/local/bin/authy-ssh uninstall

|

||||

|

||||

```

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://bash-prompt.net/guides/ssh-2fa/

|

||||

|

||||

作者:[Elliot Cooper][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://bash-prompt.net

|

||||

[1]:https://github.com/google/google-authenticator-libpam

|

||||

[2]:https://plus.google.com/115609618223925128756

|

||||

[3]:https://support.google.com/accounts/answer/1066447?hl=en

|

||||

[4]:https://authy.com/

|

||||

[5]:https://authy.com/download/

|

||||

[6]:https://www.authy.com/signup

|

||||

[7]:/images/guides/2FA/twilio-authy-api.png

|

||||

@ -1,177 +0,0 @@

|

||||

(translating by runningwater)

|

||||

How To Determine Which System Manager Is Running On Linux System

|

||||

======

|

||||

We all are heard about this word many times but only few of us know what is this exactly. We will show you how to identify the system manager.

|

||||

|

||||

I will try my best to let you know about this. Most of us know about System V and systemd system manager. System V (Sysv) is an old and traditional init system and system manager for old systems.

|

||||

|

||||

Systemd is a new init system and system manager which was adapted by most of the major distribution.

|

||||

|

||||

There are three major init systems are available in Linux which are very famous and still in use. Most of the Linux distribution falls under in one of the below init system.

|

||||

|

||||

### What is init System Manager?

|

||||

|

||||

In Linux/Unix based operating systems, init (short for initialization) is the first process that started during the system boot up by the kernel.

|

||||

|

||||

It’s holding a process id (PID) of 1. It will be running in the background continuously until the system is shut down.

|

||||

|

||||

Init looks at the `/etc/inittab` file to decide the Linux run level then it starts all other processes & applications in the background as per the run level.

|

||||

|

||||

BIOS, MBR, GRUB and Kernel processes were kicked up before hitting init process as part of Linux booting process.

|

||||

|

||||

Below are the available run levels for Linux (There are seven runlevels exist, from zero to six).

|

||||

|

||||

* **`0:`** halt

|

||||

* **`1:`** Single user mode

|

||||

* **`2:`** Multiuser, without NFS

|

||||

* **`3:`** Full multiuser mode

|

||||

* **`4:`** Unused

|

||||

* **`5:`** X11 (GUI – Graphical User Interface)

|

||||

* **`:`** reboot

|

||||

|

||||

|

||||

|

||||

Below three init systems are widely used in Linux.

|

||||

|

||||

* **`System V (Sys V):`** System V (Sys V) is one of the first and traditional init system for Unix like operating system.

|

||||

* **`Upstart:`** Upstart is an event-based replacement for the /sbin/init daemon.

|

||||

* **`systemd:`** Systemd is a new init system and system manager which was implemented/adapted into all the major Linux distributions over the traditional SysV init systems.

|

||||

|

||||

|

||||

|

||||

### What is System V (Sys V)?

|

||||

|

||||

System V (Sys V) is one of the first and traditional init system for Unix like operating system. init is the first process that started during the system boot up by the kernel and it’s a parent process for everything.

|

||||

|

||||

Most of the Linux distributions started using traditional init system called System V (Sys V) first. Over the years, several replacement init systems were released to address design limitations in the standard versions such as launchd, the Service Management Facility, systemd and Upstart.

|

||||

|

||||