mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-01-10 22:21:11 +08:00

commit

867c27e370

@ -60,6 +60,7 @@ LCTT 的组成

|

|||||||

* 2017/03/13 制作了 LCTT 主页、成员列表和成员主页,LCTT 主页将移动至 https://linux.cn/lctt 。

|

* 2017/03/13 制作了 LCTT 主页、成员列表和成员主页,LCTT 主页将移动至 https://linux.cn/lctt 。

|

||||||

* 2017/03/16 提升 GHLandy、bestony、rusking 为新的 Core 成员。创建 Comic 小组。

|

* 2017/03/16 提升 GHLandy、bestony、rusking 为新的 Core 成员。创建 Comic 小组。

|

||||||

* 2017/04/11 启用头衔制,为各位重要成员颁发头衔。

|

* 2017/04/11 启用头衔制,为各位重要成员颁发头衔。

|

||||||

|

* 2017/11/21 鉴于 qhwdw 快速而上佳的翻译质量,提升 qhwdw 为新的 Core 成员。

|

||||||

|

|

||||||

核心成员

|

核心成员

|

||||||

-------------------------------

|

-------------------------------

|

||||||

@ -86,6 +87,7 @@ LCTT 的组成

|

|||||||

- 核心成员 @Locez,

|

- 核心成员 @Locez,

|

||||||

- 核心成员 @ucasFL,

|

- 核心成员 @ucasFL,

|

||||||

- 核心成员 @rusking,

|

- 核心成员 @rusking,

|

||||||

|

- 核心成员 @qhwdw,

|

||||||

- 前任选题 @DeadFire,

|

- 前任选题 @DeadFire,

|

||||||

- 前任校对 @reinoir222,

|

- 前任校对 @reinoir222,

|

||||||

- 前任校对 @PurlingNayuki,

|

- 前任校对 @PurlingNayuki,

|

||||||

|

|||||||

@ -0,0 +1,347 @@

|

|||||||

|

理解多区域配置中的 firewalld

|

||||||

|

============================================================

|

||||||

|

|

||||||

|

现在的新闻里充斥着服务器被攻击和数据失窃事件。对于一个阅读过安全公告博客的人来说,通过访问错误配置的服务器,利用最新暴露的安全漏洞或通过窃取的密码来获得系统控制权,并不是件多困难的事情。在一个典型的 Linux 服务器上的任何互联网服务都可能存在漏洞,允许未经授权的系统访问。

|

||||||

|

|

||||||

|

因为在应用程序层面上强化系统以防范任何可能的威胁是不可能做到的事情,而防火墙可以通过限制对系统的访问提供了安全保证。防火墙基于源 IP、目标端口和协议来过滤入站包。因为这种方式中,仅有几个 IP/端口/协议的组合与系统交互,而其它的方式做不到过滤。

|

||||||

|

|

||||||

|

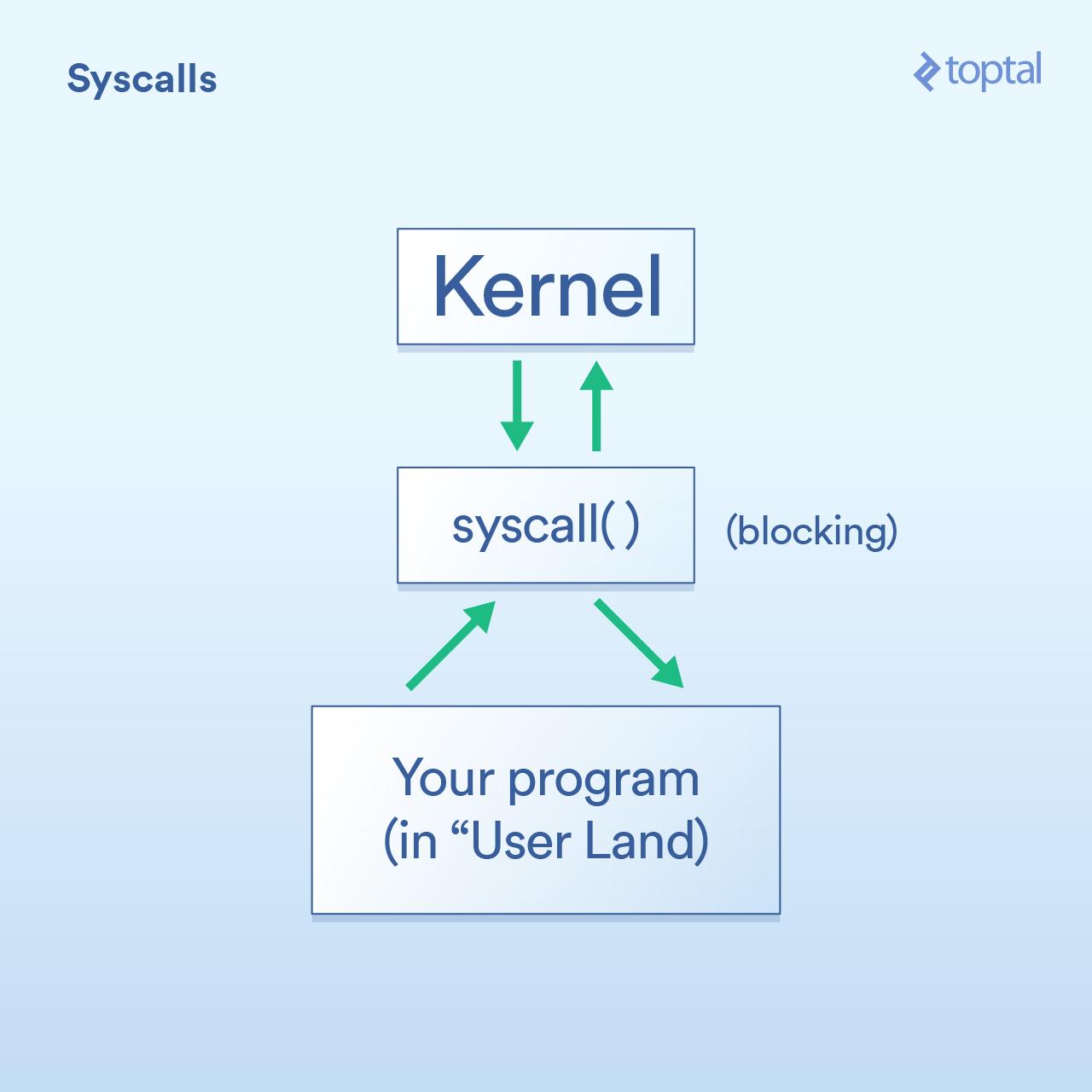

Linux 防火墙是通过 netfilter 来处理的,它是内核级别的框架。这十几年来,iptables 被作为 netfilter 的用户态抽象层(LCTT 译注: userland,一个基本的 UNIX 系统是由 kernel 和 userland 两部分构成,除 kernel 以外的称为 userland)。iptables 将包通过一系列的规则进行检查,如果包与特定的 IP/端口/协议的组合匹配,规则就会被应用到这个包上,以决定包是被通过、拒绝或丢弃。

|

||||||

|

|

||||||

|

Firewalld 是最新的 netfilter 用户态抽象层。遗憾的是,由于缺乏描述多区域配置的文档,它强大而灵活的功能被低估了。这篇文章提供了一个示例去改变这种情况。

|

||||||

|

|

||||||

|

### Firewalld 的设计目标

|

||||||

|

|

||||||

|

firewalld 的设计者认识到大多数的 iptables 使用案例仅涉及到几个单播源 IP,仅让每个符合白名单的服务通过,而其它的会被拒绝。这种模式的好处是,firewalld 可以通过定义的源 IP 和/或网络接口将入站流量分类到不同<ruby>区域<rt>zone</rt></ruby>。每个区域基于指定的准则按自己配置去通过或拒绝包。

|

||||||

|

|

||||||

|

另外的改进是基于 iptables 进行语法简化。firewalld 通过使用服务名而不是它的端口和协议去指定服务,使它更易于使用,例如,是使用 samba 而不是使用 UDP 端口 137 和 138 和 TCP 端口 139 和 445。它进一步简化语法,消除了 iptables 中对语句顺序的依赖。

|

||||||

|

|

||||||

|

最后,firewalld 允许交互式修改 netfilter,允许防火墙独立于存储在 XML 中的永久配置而进行改变。因此,下面的的临时修改将在下次重新加载时被覆盖:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd <some modification>

|

||||||

|

```

|

||||||

|

|

||||||

|

而,以下的改变在重加载后会永久保存:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --permanent <some modification>

|

||||||

|

# firewall-cmd --reload

|

||||||

|

```

|

||||||

|

|

||||||

|

### 区域

|

||||||

|

|

||||||

|

在 firewalld 中最上层的组织是区域。如果一个包匹配区域相关联的网络接口或源 IP/掩码 ,它就是区域的一部分。可用的几个预定义区域:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --get-zones

|

||||||

|

block dmz drop external home internal public trusted work

|

||||||

|

```

|

||||||

|

|

||||||

|

任何配置了一个**网络接口**和/或一个**源**的区域就是一个<ruby>活动区域<rt>active zone</rt></ruby>。列出活动的区域:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --get-active-zones

|

||||||

|

public

|

||||||

|

interfaces: eno1 eno2

|

||||||

|

```

|

||||||

|

|

||||||

|

**Interfaces** (接口)是系统中的硬件和虚拟的网络适配器的名字,正如你在上面的示例中所看到的那样。所有的活动的接口都将被分配到区域,要么是默认的区域,要么是用户指定的一个区域。但是,一个接口不能被分配给多于一个的区域。

|

||||||

|

|

||||||

|

在缺省配置中,firewalld 设置所有接口为 public 区域,并且不对任何区域设置源。其结果是,`public` 区域是唯一的活动区域。

|

||||||

|

|

||||||

|

**Sources** (源)是入站 IP 地址的范围,它也可以被分配到区域。一个源(或重叠的源)不能被分配到多个区域。这样做的结果是产生一个未定义的行为,因为不清楚应该将哪些规则应用于该源。

|

||||||

|

|

||||||

|

因为指定一个源不是必需的,任何包都可以通过接口匹配而归属于一个区域,而不需要通过源匹配来归属一个区域。这表示通过使用优先级方式,优先到达多个指定的源区域,稍后将详细说明这种情况。首先,我们来检查 `public` 区域的配置:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --zone=public --list-all

|

||||||

|

public (default, active)

|

||||||

|

interfaces: eno1 eno2

|

||||||

|

sources:

|

||||||

|

services: dhcpv6-client ssh

|

||||||

|

ports:

|

||||||

|

masquerade: no

|

||||||

|

forward-ports:

|

||||||

|

icmp-blocks:

|

||||||

|

rich rules:

|

||||||

|

# firewall-cmd --permanent --zone=public --get-target

|

||||||

|

default

|

||||||

|

```

|

||||||

|

|

||||||

|

逐行说明如下:

|

||||||

|

|

||||||

|

* `public (default, active)` 表示 `public` 区域是默认区域(当接口启动时会自动默认),并且它是活动的,因为,它至少有一个接口或源分配给它。

|

||||||

|

* `interfaces: eno1 eno2` 列出了这个区域上关联的接口。

|

||||||

|

* `sources:` 列出了这个区域的源。现在这里什么都没有,但是,如果这里有内容,它们应该是这样的格式 xxx.xxx.xxx.xxx/xx。

|

||||||

|

* `services: dhcpv6-client ssh` 列出了允许通过这个防火墙的服务。你可以通过运行 `firewall-cmd --get-services` 得到一个防火墙预定义服务的详细列表。

|

||||||

|

* `ports:` 列出了一个允许通过这个防火墙的目标端口。它是用于你需要去允许一个没有在 firewalld 中定义的服务的情况下。

|

||||||

|

* `masquerade: no` 表示这个区域是否允许 IP 伪装。如果允许,它将允许 IP 转发,它可以让你的计算机作为一个路由器。

|

||||||

|

* `forward-ports:` 列出转发的端口。

|

||||||

|

* `icmp-blocks:` 阻塞的 icmp 流量的黑名单。

|

||||||

|

* `rich rules:` 在一个区域中优先处理的高级配置。

|

||||||

|

* `default` 是目标区域,它决定了与该区域匹配而没有由上面设置中显式处理的包的动作。

|

||||||

|

|

||||||

|

### 一个简单的单区域配置示例

|

||||||

|

|

||||||

|

如果只是简单地锁定你的防火墙。简单地在删除公共区域上当前允许的服务,并重新加载:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --permanent --zone=public --remove-service=dhcpv6-client

|

||||||

|

# firewall-cmd --permanent --zone=public --remove-service=ssh

|

||||||

|

# firewall-cmd --reload

|

||||||

|

```

|

||||||

|

|

||||||

|

在下面的防火墙上这些命令的结果是:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --zone=public --list-all

|

||||||

|

public (default, active)

|

||||||

|

interfaces: eno1 eno2

|

||||||

|

sources:

|

||||||

|

services:

|

||||||

|

ports:

|

||||||

|

masquerade: no

|

||||||

|

forward-ports:

|

||||||

|

icmp-blocks:

|

||||||

|

rich rules:

|

||||||

|

# firewall-cmd --permanent --zone=public --get-target

|

||||||

|

default

|

||||||

|

```

|

||||||

|

|

||||||

|

本着尽可能严格地保证安全的精神,如果发生需要在你的防火墙上临时开放一个服务的情况(假设是 ssh),你可以增加这个服务到当前会话中(省略 `--permanent`),并且指示防火墙在一个指定的时间之后恢复修改:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --zone=public --add-service=ssh --timeout=5m

|

||||||

|

```

|

||||||

|

|

||||||

|

这个 `timeout` 选项是一个以秒(`s`)、分(`m`)或小时(`h`)为单位的时间值。

|

||||||

|

|

||||||

|

### 目标

|

||||||

|

|

||||||

|

当一个区域处理它的源或接口上的一个包时,但是,没有处理该包的显式规则时,这时区域的<ruby>目标<rt>target</rt></ruby>决定了该行为:

|

||||||

|

|

||||||

|

* `ACCEPT`:通过这个包。

|

||||||

|

* `%%REJECT%%`:拒绝这个包,并返回一个拒绝的回复。

|

||||||

|

* `DROP`:丢弃这个包,不回复任何信息。

|

||||||

|

* `default`:不做任何事情。该区域不再管它,把它踢到“楼上”。

|

||||||

|

|

||||||

|

在 firewalld 0.3.9 中有一个 bug (已经在 0.3.10 中修复),对于一个目标是除了“default”以外的源区域,不管允许的服务是什么,这的目标都会被应用。例如,一个使用目标 `DROP` 的源区域,将丢弃所有的包,甚至是白名单中的包。遗憾的是,这个版本的 firewalld 被打包到 RHEL7 和它的衍生版中,使它成为一个相当常见的 bug。本文中的示例避免了可能出现这种行为的情况。

|

||||||

|

|

||||||

|

### 优先权

|

||||||

|

|

||||||

|

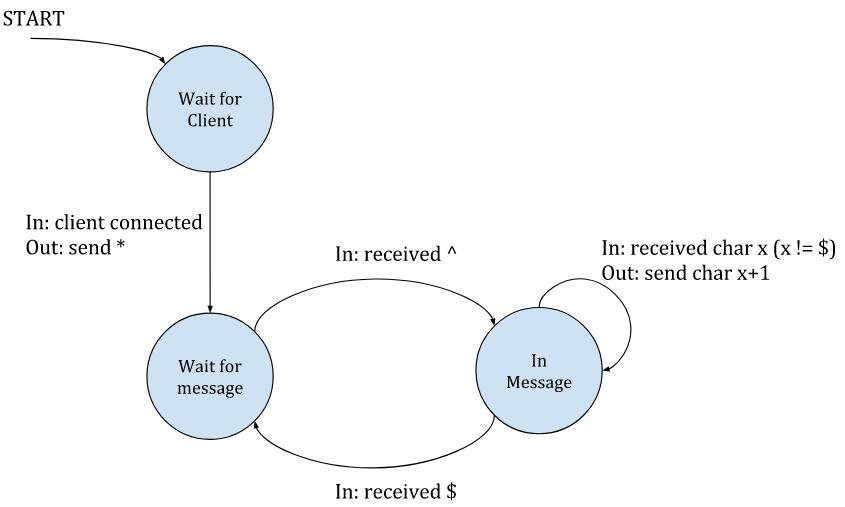

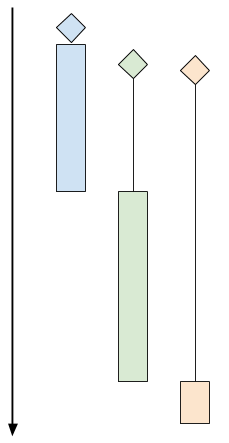

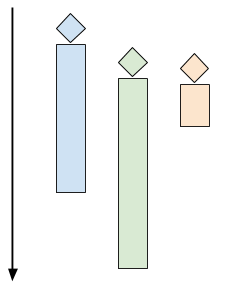

活动区域中扮演两个不同的角色。关联接口行为的区域作为接口区域,并且,关联源行为的区域作为源区域(一个区域能够扮演两个角色)。firewalld 按下列顺序处理一个包:

|

||||||

|

|

||||||

|

1. 相应的源区域。可以存在零个或一个这样的区域。如果这个包满足一个<ruby>富规则<rt>rich rule</rt></ruby>、服务是白名单中的、或者目标没有定义,那么源区域处理这个包,并且在这里结束。否则,向上传递这个包。

|

||||||

|

2. 相应的接口区域。肯定有一个这样的区域。如果接口处理这个包,那么到这里结束。否则,向上传递这个包。

|

||||||

|

3. firewalld 默认动作。接受 icmp 包并拒绝其它的一切。

|

||||||

|

|

||||||

|

这里的关键信息是,源区域优先于接口区域。因此,对于多区域的 firewalld 配置的一般设计模式是,创建一个优先源区域来允许指定的 IP 对系统服务的提升访问,并在一个限制性接口区域限制其它访问。

|

||||||

|

|

||||||

|

### 一个简单的多区域示例

|

||||||

|

|

||||||

|

为演示优先权,让我们在 `public` 区域中将 `http` 替换成 `ssh`,并且为我们喜欢的 IP 地址,如 1.1.1.1,设置一个默认的 `internal` 区域。以下的命令完成这个任务:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --permanent --zone=public --remove-service=ssh

|

||||||

|

# firewall-cmd --permanent --zone=public --add-service=http

|

||||||

|

# firewall-cmd --permanent --zone=internal --add-source=1.1.1.1

|

||||||

|

# firewall-cmd --reload

|

||||||

|

```

|

||||||

|

|

||||||

|

这些命令的结果是生成如下的配置:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --zone=public --list-all

|

||||||

|

public (default, active)

|

||||||

|

interfaces: eno1 eno2

|

||||||

|

sources:

|

||||||

|

services: dhcpv6-client http

|

||||||

|

ports:

|

||||||

|

masquerade: no

|

||||||

|

forward-ports:

|

||||||

|

icmp-blocks:

|

||||||

|

rich rules:

|

||||||

|

# firewall-cmd --permanent --zone=public --get-target

|

||||||

|

default

|

||||||

|

# firewall-cmd --zone=internal --list-all

|

||||||

|

internal (active)

|

||||||

|

interfaces:

|

||||||

|

sources: 1.1.1.1

|

||||||

|

services: dhcpv6-client mdns samba-client ssh

|

||||||

|

ports:

|

||||||

|

masquerade: no

|

||||||

|

forward-ports:

|

||||||

|

icmp-blocks:

|

||||||

|

rich rules:

|

||||||

|

# firewall-cmd --permanent --zone=internal --get-target

|

||||||

|

default

|

||||||

|

```

|

||||||

|

|

||||||

|

在上面的配置中,如果有人尝试从 1.1.1.1 去 `ssh`,这个请求将会成功,因为这个源区域(`internal`)被首先应用,并且它允许 `ssh` 访问。

|

||||||

|

|

||||||

|

如果有人尝试从其它的地址,如 2.2.2.2,去访问 `ssh`,它不是这个源区域的,因为和这个源区域不匹配。因此,这个请求被直接转到接口区域(`public`),它没有显式处理 `ssh`,因为,public 的目标是 `default`,这个请求被传递到默认动作,它将被拒绝。

|

||||||

|

|

||||||

|

如果 1.1.1.1 尝试进行 `http` 访问会怎样?源区域(`internal`)不允许它,但是,目标是 `default`,因此,请求将传递到接口区域(`public`),它被允许访问。

|

||||||

|

|

||||||

|

现在,让我们假设有人从 3.3.3.3 拖你的网站。要限制从那个 IP 的访问,简单地增加它到预定义的 `drop` 区域,正如其名,它将丢弃所有的连接:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --permanent --zone=drop --add-source=3.3.3.3

|

||||||

|

# firewall-cmd --reload

|

||||||

|

```

|

||||||

|

|

||||||

|

下一次 3.3.3.3 尝试去访问你的网站,firewalld 将转发请求到源区域(`drop`)。因为目标是 `DROP`,请求将被拒绝,并且它不会被转发到接口区域(`public`)。

|

||||||

|

|

||||||

|

### 一个实用的多区域示例

|

||||||

|

|

||||||

|

假设你为你的组织的一台服务器配置防火墙。你希望允许全世界使用 `http` 和 `https` 的访问,你的组织(1.1.0.0/16)和工作组(1.1.1.0/8)使用 `ssh` 访问,并且你的工作组可以访问 `samba` 服务。使用 firewalld 中的区域,你可以用一个很直观的方式去实现这个配置。

|

||||||

|

|

||||||

|

`public` 这个命名,它的逻辑似乎是把全世界访问指定为公共区域,而 `internal` 区域用于为本地使用。从在 `public` 区域内设置使用 `http` 和 `https` 替换 `dhcpv6-client` 和 `ssh` 服务来开始:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --permanent --zone=public --remove-service=dhcpv6-client

|

||||||

|

# firewall-cmd --permanent --zone=public --remove-service=ssh

|

||||||

|

# firewall-cmd --permanent --zone=public --add-service=http

|

||||||

|

# firewall-cmd --permanent --zone=public --add-service=https

|

||||||

|

```

|

||||||

|

|

||||||

|

然后,取消 `internal` 区域的 `mdns`、`samba-client` 和 `dhcpv6-client` 服务(仅保留 `ssh`),并增加你的组织为源:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --permanent --zone=internal --remove-service=mdns

|

||||||

|

# firewall-cmd --permanent --zone=internal --remove-service=samba-client

|

||||||

|

# firewall-cmd --permanent --zone=internal --remove-service=dhcpv6-client

|

||||||

|

# firewall-cmd --permanent --zone=internal --add-source=1.1.0.0/16

|

||||||

|

```

|

||||||

|

|

||||||

|

为容纳你提升的 `samba` 的权限,增加一个富规则:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --permanent --zone=internal --add-rich-rule='rule family=ipv4 source address="1.1.1.0/8" service name="samba" accept'

|

||||||

|

```

|

||||||

|

|

||||||

|

最后,重新加载,把这些变化拉取到会话中:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --reload

|

||||||

|

```

|

||||||

|

|

||||||

|

仅剩下少数的细节了。从一个 `internal` 区域以外的 IP 去尝试通过 `ssh` 到你的服务器,结果是回复一个拒绝的消息。它是 firewalld 默认的。更为安全的作法是去显示不活跃的 IP 行为并丢弃该连接。改变 `public` 区域的目标为 `DROP`,而不是 `default` 来实现它:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --permanent --zone=public --set-target=DROP

|

||||||

|

# firewall-cmd --reload

|

||||||

|

```

|

||||||

|

|

||||||

|

但是,等等,你不再可以 ping 了,甚至是从内部区域!并且 icmp (ping 使用的协议)并不在 firewalld 可以列入白名单的服务列表中。那是因为,icmp 是第 3 层的 IP 协议,它没有端口的概念,不像那些捆绑了端口的服务。在设置公共区域为 `DROP` 之前,ping 能够通过防火墙是因为你的 `default` 目标通过它到达防火墙的默认动作(default),即允许它通过。但现在它已经被删除了。

|

||||||

|

|

||||||

|

为恢复内部网络的 ping,使用一个富规则:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --permanent --zone=internal --add-rich-rule='rule protocol value="icmp" accept'

|

||||||

|

# firewall-cmd --reload

|

||||||

|

```

|

||||||

|

|

||||||

|

结果如下,这里是两个活动区域的配置:

|

||||||

|

|

||||||

|

```

|

||||||

|

# firewall-cmd --zone=public --list-all

|

||||||

|

public (default, active)

|

||||||

|

interfaces: eno1 eno2

|

||||||

|

sources:

|

||||||

|

services: http https

|

||||||

|

ports:

|

||||||

|

masquerade: no

|

||||||

|

forward-ports:

|

||||||

|

icmp-blocks:

|

||||||

|

rich rules:

|

||||||

|

# firewall-cmd --permanent --zone=public --get-target

|

||||||

|

DROP

|

||||||

|

# firewall-cmd --zone=internal --list-all

|

||||||

|

internal (active)

|

||||||

|

interfaces:

|

||||||

|

sources: 1.1.0.0/16

|

||||||

|

services: ssh

|

||||||

|

ports:

|

||||||

|

masquerade: no

|

||||||

|

forward-ports:

|

||||||

|

icmp-blocks:

|

||||||

|

rich rules:

|

||||||

|

rule family=ipv4 source address="1.1.1.0/8" service name="samba" accept

|

||||||

|

rule protocol value="icmp" accept

|

||||||

|

# firewall-cmd --permanent --zone=internal --get-target

|

||||||

|

default

|

||||||

|

```

|

||||||

|

|

||||||

|

这个设置演示了一个三层嵌套的防火墙。最外层,`public`,是一个接口区域,包含全世界的访问。紧接着的一层,`internal`,是一个源区域,包含你的组织,它是 `public` 的一个子集。最后,一个富规则增加到最内层,包含了你的工作组,它是 `internal` 的一个子集。

|

||||||

|

|

||||||

|

这里的关键信息是,当在一个场景中可以突破到嵌套层,最外层将使用接口区域,接下来的将使用一个源区域,并且在源区域中额外使用富规则。

|

||||||

|

|

||||||

|

### 调试

|

||||||

|

|

||||||

|

firewalld 采用直观范式来设计防火墙,但比它的前任 iptables 更容易产生歧义。如果产生无法预料的行为,或者为了更好地理解 firewalld 是怎么工作的,则可以使用 iptables 描述 netfilter 是如何配置操作的。前一个示例的输出如下,为了简单起见,将输出和日志进行了修剪:

|

||||||

|

|

||||||

|

```

|

||||||

|

# iptables -S

|

||||||

|

-P INPUT ACCEPT

|

||||||

|

... (forward and output lines) ...

|

||||||

|

-N INPUT_ZONES

|

||||||

|

-N INPUT_ZONES_SOURCE

|

||||||

|

-N INPUT_direct

|

||||||

|

-N IN_internal

|

||||||

|

-N IN_internal_allow

|

||||||

|

-N IN_internal_deny

|

||||||

|

-N IN_public

|

||||||

|

-N IN_public_allow

|

||||||

|

-N IN_public_deny

|

||||||

|

-A INPUT -m conntrack --ctstate RELATED,ESTABLISHED -j ACCEPT

|

||||||

|

-A INPUT -i lo -j ACCEPT

|

||||||

|

-A INPUT -j INPUT_ZONES_SOURCE

|

||||||

|

-A INPUT -j INPUT_ZONES

|

||||||

|

-A INPUT -p icmp -j ACCEPT

|

||||||

|

-A INPUT -m conntrack --ctstate INVALID -j DROP

|

||||||

|

-A INPUT -j REJECT --reject-with icmp-host-prohibited

|

||||||

|

... (forward and output lines) ...

|

||||||

|

-A INPUT_ZONES -i eno1 -j IN_public

|

||||||

|

-A INPUT_ZONES -i eno2 -j IN_public

|

||||||

|

-A INPUT_ZONES -j IN_public

|

||||||

|

-A INPUT_ZONES_SOURCE -s 1.1.0.0/16 -g IN_internal

|

||||||

|

-A IN_internal -j IN_internal_deny

|

||||||

|

-A IN_internal -j IN_internal_allow

|

||||||

|

-A IN_internal_allow -p tcp -m tcp --dport 22 -m conntrack --ctstate NEW -j ACCEPT

|

||||||

|

-A IN_internal_allow -s 1.1.1.0/8 -p udp -m udp --dport 137 -m conntrack --ctstate NEW -j ACCEPT

|

||||||

|

-A IN_internal_allow -s 1.1.1.0/8 -p udp -m udp --dport 138 -m conntrack --ctstate NEW -j ACCEPT

|

||||||

|

-A IN_internal_allow -s 1.1.1.0/8 -p tcp -m tcp --dport 139 -m conntrack --ctstate NEW -j ACCEPT

|

||||||

|

-A IN_internal_allow -s 1.1.1.0/8 -p tcp -m tcp --dport 445 -m conntrack --ctstate NEW -j ACCEPT

|

||||||

|

-A IN_internal_allow -p icmp -m conntrack --ctstate NEW -j ACCEPT

|

||||||

|

-A IN_public -j IN_public_deny

|

||||||

|

-A IN_public -j IN_public_allow

|

||||||

|

-A IN_public -j DROP

|

||||||

|

-A IN_public_allow -p tcp -m tcp --dport 80 -m conntrack --ctstate NEW -j ACCEPT

|

||||||

|

-A IN_public_allow -p tcp -m tcp --dport 443 -m conntrack --ctstate NEW -j ACCEPT

|

||||||

|

```

|

||||||

|

|

||||||

|

在上面的 iptables 输出中,新的链(以 `-N` 开始的行)是被首先声明的。剩下的规则是附加到(以 `-A` 开始的行) iptables 中的。已建立的连接和本地流量是允许通过的,并且入站包被转到 `INPUT_ZONES_SOURCE` 链,在那里如果存在相应的区域,IP 将被发送到那个区域。从那之后,流量被转到 `INPUT_ZONES` 链,从那里它被路由到一个接口区域。如果在那里它没有被处理,icmp 是允许通过的,无效的被丢弃,并且其余的都被拒绝。

|

||||||

|

|

||||||

|

### 结论

|

||||||

|

|

||||||

|

firewalld 是一个文档不足的防火墙配置工具,它的功能远比大多数人认识到的更为强大。以创新的区域范式,firewalld 允许系统管理员去分解流量到每个唯一处理它的分类中,简化了配置过程。因为它直观的设计和语法,它在实践中不但被用于简单的单一区域中也被用于复杂的多区域配置中。

|

||||||

|

|

||||||

|

--------------------------------------------------------------------------------

|

||||||

|

|

||||||

|

via: https://www.linuxjournal.com/content/understanding-firewalld-multi-zone-configurations?page=0,0

|

||||||

|

|

||||||

|

作者:[Nathan Vance][a]

|

||||||

|

译者:[qhwdw](https://github.com/qhwdw)

|

||||||

|

校对:[wxy](https://github.com/wxy)

|

||||||

|

|

||||||

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||

|

[a]:https://www.linuxjournal.com/users/nathan-vance

|

||||||

|

[1]:https://www.linuxjournal.com/tag/firewalls

|

||||||

|

[2]:https://www.linuxjournal.com/tag/howtos

|

||||||

|

[3]:https://www.linuxjournal.com/tag/networking

|

||||||

|

[4]:https://www.linuxjournal.com/tag/security

|

||||||

|

[5]:https://www.linuxjournal.com/tag/sysadmin

|

||||||

|

[6]:https://www.linuxjournal.com/users/william-f-polik

|

||||||

|

[7]:https://www.linuxjournal.com/users/nathan-vance

|

||||||

@ -1,36 +1,28 @@

|

|||||||

Translating By LHRchina

|

使用 LXD 容器运行 Ubuntu Core

|

||||||

|

|

||||||

|

|

||||||

Ubuntu Core in LXD containers

|

|

||||||

============================================================

|

============================================================

|

||||||

|

|

||||||

|

|

||||||

### Share or save

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

### What’s Ubuntu Core?

|

### Ubuntu Core 是什么?

|

||||||

|

|

||||||

Ubuntu Core is a version of Ubuntu that’s fully transactional and entirely based on snap packages.

|

Ubuntu Core 是完全基于 snap 包构建,并且完全事务化的 Ubuntu 版本。

|

||||||

|

|

||||||

Most of the system is read-only. All installed applications come from snap packages and all updates are done using transactions. Meaning that should anything go wrong at any point during a package or system update, the system will be able to revert to the previous state and report the failure.

|

该系统大部分是只读的,所有已安装的应用全部来自 snap 包,完全使用事务化更新。这意味着不管在系统更新还是安装软件的时候遇到问题,整个系统都可以回退到之前的状态并且记录这个错误。

|

||||||

|

|

||||||

The current release of Ubuntu Core is called series 16 and was released in November 2016.

|

最新版是在 2016 年 11 月发布的 Ubuntu Core 16。

|

||||||

|

|

||||||

Note that on Ubuntu Core systems, only snap packages using confinement can be installed (no “classic” snaps) and that a good number of snaps will not fully work in this environment or will require some manual intervention (creating user and groups, …). Ubuntu Core gets improved on a weekly basis as new releases of snapd and the “core” snap are put out.

|

注意,Ubuntu Core 限制只能够安装 snap 包(而非 “传统” 软件包),并且有相当数量的 snap 包在当前环境下不能正常运行,或者需要人工干预(创建用户和用户组等)才能正常运行。随着新版的 snapd 和 “core” snap 包发布,Ubuntu Core 每周都会得到改进。

|

||||||

|

|

||||||

### Requirements

|

### 环境需求

|

||||||

|

|

||||||

As far as LXD is concerned, Ubuntu Core is just another Linux distribution. That being said, snapd does require unprivileged FUSE mounts and AppArmor namespacing and stacking, so you will need the following:

|

就 LXD 而言,Ubuntu Core 仅仅相当于另一个 Linux 发行版。也就是说,snapd 需要挂载无特权的 FUSE 和 AppArmor 命名空间以及软件栈,像下面这样:

|

||||||

|

|

||||||

* An up to date Ubuntu system using the official Ubuntu kernel

|

* 一个新版的使用 Ubuntu 官方内核的系统

|

||||||

|

* 一个新版的 LXD

|

||||||

|

|

||||||

* An up to date version of LXD

|

### 创建一个 Ubuntu Core 容器

|

||||||

|

|

||||||

### Creating an Ubuntu Core container

|

当前 Ubuntu Core 镜像发布在社区的镜像服务器。你可以像这样启动一个新的容器:

|

||||||

|

|

||||||

The Ubuntu Core images are currently published on the community image server.

|

|

||||||

You can launch a new container with:

|

|

||||||

|

|

||||||

```

|

```

|

||||||

stgraber@dakara:~$ lxc launch images:ubuntu-core/16 ubuntu-core

|

stgraber@dakara:~$ lxc launch images:ubuntu-core/16 ubuntu-core

|

||||||

@ -38,9 +30,9 @@ Creating ubuntu-core

|

|||||||

Starting ubuntu-core

|

Starting ubuntu-core

|

||||||

```

|

```

|

||||||

|

|

||||||

The container will take a few seconds to start, first executing a first stage loader that determines what read-only image to use and setup the writable layers. You don’t want to interrupt the container in that stage and “lxc exec” will likely just fail as pretty much nothing is available at that point.

|

这个容器启动需要一点点时间,它会先执行第一阶段的加载程序,加载程序会确定使用哪一个镜像(镜像是只读的),并且在系统上设置一个可读层,你不要在这一阶段中断容器执行,这个时候什么都没有,所以执行 `lxc exec` 将会出错。

|

||||||

|

|

||||||

Seconds later, “lxc list” will show the container IP address, indicating that it’s booted into Ubuntu Core:

|

几秒钟之后,执行 `lxc list` 将会展示容器的 IP 地址,这表明已经启动了 Ubuntu Core:

|

||||||

|

|

||||||

```

|

```

|

||||||

stgraber@dakara:~$ lxc list

|

stgraber@dakara:~$ lxc list

|

||||||

@ -51,7 +43,7 @@ stgraber@dakara:~$ lxc list

|

|||||||

+-------------+---------+----------------------+----------------------------------------------+------------+-----------+

|

+-------------+---------+----------------------+----------------------------------------------+------------+-----------+

|

||||||

```

|

```

|

||||||

|

|

||||||

You can then interact with that container the same way you would any other:

|

之后你就可以像使用其他的交互一样和这个容器进行交互:

|

||||||

|

|

||||||

```

|

```

|

||||||

stgraber@dakara:~$ lxc exec ubuntu-core bash

|

stgraber@dakara:~$ lxc exec ubuntu-core bash

|

||||||

@ -63,11 +55,11 @@ pc-kernel 4.4.0-45-4 37 canonical -

|

|||||||

root@ubuntu-core:~#

|

root@ubuntu-core:~#

|

||||||

```

|

```

|

||||||

|

|

||||||

### Updating the container

|

### 更新容器

|

||||||

|

|

||||||

If you’ve been tracking the development of Ubuntu Core, you’ll know that those versions above are pretty old. That’s because the disk images that are used as the source for the Ubuntu Core LXD images are only refreshed every few months. Ubuntu Core systems will automatically update once a day and then automatically reboot to boot onto the new version (and revert if this fails).

|

如果你一直关注着 Ubuntu Core 的开发,你应该知道上面的版本已经很老了。这是因为被用作 Ubuntu LXD 镜像的代码每隔几个月才会更新。Ubuntu Core 系统在重启时会检查更新并进行自动更新(更新失败会回退)。

|

||||||

|

|

||||||

If you want to immediately force an update, you can do it with:

|

如果你想现在强制更新,你可以这样做:

|

||||||

|

|

||||||

```

|

```

|

||||||

stgraber@dakara:~$ lxc exec ubuntu-core bash

|

stgraber@dakara:~$ lxc exec ubuntu-core bash

|

||||||

@ -81,7 +73,7 @@ series 16

|

|||||||

root@ubuntu-core:~#

|

root@ubuntu-core:~#

|

||||||

```

|

```

|

||||||

|

|

||||||

And then reboot the system and check the snapd version again:

|

然后重启一下 Ubuntu Core 系统,然后看看 snapd 的版本。

|

||||||

|

|

||||||

```

|

```

|

||||||

root@ubuntu-core:~# reboot

|

root@ubuntu-core:~# reboot

|

||||||

@ -95,7 +87,7 @@ series 16

|

|||||||

root@ubuntu-core:~#

|

root@ubuntu-core:~#

|

||||||

```

|

```

|

||||||

|

|

||||||

You can get an history of all snapd interactions with

|

你也可以像下面这样查看所有 snapd 的历史记录:

|

||||||

|

|

||||||

```

|

```

|

||||||

stgraber@dakara:~$ lxc exec ubuntu-core snap changes

|

stgraber@dakara:~$ lxc exec ubuntu-core snap changes

|

||||||

@ -105,9 +97,9 @@ ID Status Spawn Ready Summary

|

|||||||

3 Done 2017-01-31T05:21:30Z 2017-01-31T05:22:45Z Refresh all snaps in the system

|

3 Done 2017-01-31T05:21:30Z 2017-01-31T05:22:45Z Refresh all snaps in the system

|

||||||

```

|

```

|

||||||

|

|

||||||

### Installing some snaps

|

### 安装 Snap 软件包

|

||||||

|

|

||||||

Let’s start with the simplest snaps of all, the good old Hello World:

|

以一个最简单的例子开始,经典的 Hello World:

|

||||||

|

|

||||||

```

|

```

|

||||||

stgraber@dakara:~$ lxc exec ubuntu-core bash

|

stgraber@dakara:~$ lxc exec ubuntu-core bash

|

||||||

@ -117,7 +109,7 @@ root@ubuntu-core:~# hello-world

|

|||||||

Hello World!

|

Hello World!

|

||||||

```

|

```

|

||||||

|

|

||||||

And then move on to something a bit more useful:

|

接下来让我们看一些更有用的:

|

||||||

|

|

||||||

```

|

```

|

||||||

stgraber@dakara:~$ lxc exec ubuntu-core bash

|

stgraber@dakara:~$ lxc exec ubuntu-core bash

|

||||||

@ -125,9 +117,9 @@ root@ubuntu-core:~# snap install nextcloud

|

|||||||

nextcloud 11.0.1snap2 from 'nextcloud' installed

|

nextcloud 11.0.1snap2 from 'nextcloud' installed

|

||||||

```

|

```

|

||||||

|

|

||||||

Then hit your container over HTTP and you’ll get to your newly deployed Nextcloud instance.

|

之后通过 HTTP 访问你的容器就可以看到刚才部署的 Nextcloud 实例。

|

||||||

|

|

||||||

If you feel like testing the latest LXD straight from git, you can do so with:

|

如果你想直接通过 git 测试最新版 LXD,你可以这样做:

|

||||||

|

|

||||||

```

|

```

|

||||||

stgraber@dakara:~$ lxc config set ubuntu-core security.nesting true

|

stgraber@dakara:~$ lxc config set ubuntu-core security.nesting true

|

||||||

@ -156,7 +148,7 @@ What IPv6 address should be used (CIDR subnet notation, “auto” or “none”

|

|||||||

LXD has been successfully configured.

|

LXD has been successfully configured.

|

||||||

```

|

```

|

||||||

|

|

||||||

And because container inception never gets old, lets run Ubuntu Core 16 inside Ubuntu Core 16:

|

已经设置过的容器不能回退版本,但是可以在 Ubuntu Core 16 中运行另一个 Ubuntu Core 16 容器:

|

||||||

|

|

||||||

```

|

```

|

||||||

root@ubuntu-core:~# lxc launch images:ubuntu-core/16 nested-core

|

root@ubuntu-core:~# lxc launch images:ubuntu-core/16 nested-core

|

||||||

@ -170,28 +162,29 @@ root@ubuntu-core:~# lxc list

|

|||||||

+-------------+---------+---------------------+-----------------------------------------------+------------+-----------+

|

+-------------+---------+---------------------+-----------------------------------------------+------------+-----------+

|

||||||

```

|

```

|

||||||

|

|

||||||

### Conclusion

|

### 写在最后

|

||||||

|

|

||||||

If you ever wanted to try Ubuntu Core, this is a great way to do it. It’s also a great tool for snap authors to make sure their snap is fully self-contained and will work in all environments.

|

如果你只是想试用一下 Ubuntu Core,这是一个不错的方法。对于 snap 包开发者来说,这也是一个不错的工具来测试你的 snap 包能否在不同的环境下正常运行。

|

||||||

|

|

||||||

Ubuntu Core is a great fit for environments where you want to ensure that your system is always up to date and is entirely reproducible. This does come with a number of constraints that may or may not work for you.

|

如果你希望你的系统总是最新的,并且整体可复制,Ubuntu Core 是一个很不错的方案,不过这也会带来一些相应的限制,所以可能不太适合你。

|

||||||

|

|

||||||

And lastly, a word of warning. Those images are considered as good enough for testing, but aren’t officially supported at this point. We are working towards getting fully supported Ubuntu Core LXD images on the official Ubuntu image server in the near future.

|

最后是一个警告,对于测试来说,这些镜像是足够的,但是当前并没有被正式的支持。在不久的将来,官方的 Ubuntu server 可以完整的支持 Ubuntu Core LXD 镜像。

|

||||||

|

|

||||||

### Extra information

|

### 附录

|

||||||

|

|

||||||

The main LXD website is at: [https://linuxcontainers.org/lxd][2] Development happens on Github at: [https://github.com/lxc/lxd][3]

|

- LXD 主站:[https://linuxcontainers.org/lxd][2]

|

||||||

Mailing-list support happens on: [https://lists.linuxcontainers.org][4]

|

- Github:[https://github.com/lxc/lxd][3]

|

||||||

IRC support happens in: #lxcontainers on irc.freenode.net

|

- 邮件列表:[https://lists.linuxcontainers.org][4]

|

||||||

Try LXD online: [https://linuxcontainers.org/lxd/try-it][5]

|

- IRC:#lxcontainers on irc.freenode.net

|

||||||

|

- 在线试用:[https://linuxcontainers.org/lxd/try-it][5]

|

||||||

|

|

||||||

--------------------------------------------------------------------------------

|

--------------------------------------------------------------------------------

|

||||||

|

|

||||||

via: https://insights.ubuntu.com/2017/02/27/ubuntu-core-in-lxd-containers/

|

via: https://insights.ubuntu.com/2017/02/27/ubuntu-core-in-lxd-containers/

|

||||||

|

|

||||||

作者:[Stéphane Graber ][a]

|

作者:[Stéphane Graber][a]

|

||||||

译者:[译者ID](https://github.com/译者ID)

|

译者:[aiwhj](https://github.com/aiwhj)

|

||||||

校对:[校对者ID](https://github.com/校对者ID)

|

校对:[wxy](https://github.com/wxy)

|

||||||

|

|

||||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||

@ -0,0 +1,48 @@

|

|||||||

|

肯特·贝克:改变人生的代码整理魔法

|

||||||

|

==========

|

||||||

|

|

||||||

|

> 本文作者<ruby>肯特·贝克<rt>Kent Beck</rt></ruby>,是最早研究软件开发的模式和重构的人之一,是敏捷开发的开创者之一,更是极限编程和测试驱动开发的创始人,同时还是 Smalltalk 和 JUnit 的作者,对当今世界的软件开发影响深远。现在 Facebook 工作。

|

||||||

|

|

||||||

|

本周我一直在整理 Facebook 代码,而且我喜欢这个工作。我的职业生涯中已经整理了数千小时的代码,我有一套使这种整理更加安全、有趣和高效的规则。

|

||||||

|

|

||||||

|

整理工作是通过一系列短小而安全的步骤进行的。事实上,规则一就是**如果这很难,那就不要去做**。我以前在晚上做填字游戏。如果我卡住那就去睡觉,第二天晚上那些没有发现的线索往往很容易发现。与其想要一心搞个大的,不如在遇到阻力的时候停下来。

|

||||||

|

|

||||||

|

整理会陷入这样一种感觉:你错失的要比你从一个个成功中获得的更多(稍后会细说)。第二条规则是**当你充满活力时开始,当你累了时停下来**。起来走走。如果还没有恢复精神,那这一天的工作就算做完了。

|

||||||

|

|

||||||

|

只有在仔细追踪其它变化的时候(我把它和最新的差异搞混了),整理工作才可以与开发同步进行。第三条规则是**立即完成每个环节的工作**。与功能开发所不同的是,功能开发只有在完成一大块工作时才有意义,而整理是基于时间一点点完成的。

|

||||||

|

|

||||||

|

整理在任何步骤中都只需要付出不多的努力,所以我会在任何步骤遇到麻烦的时候放弃。所以,规则四是**两次失败后恢复**。如果我整理代码,运行测试,并遇到测试失败,那么我会立即修复它。如果我修复失败,我会立即恢复到上次已知最好的状态。

|

||||||

|

|

||||||

|

即便没有闪亮的新设计的愿景,整理也是有用的。不过,有时候我想看看事情会如何发展,所以第五条就是**实践**。执行一系列的整理和还原。第二次将更快,你会更加熟悉避免哪些坑。

|

||||||

|

|

||||||

|

只有在附带损害的风险较低,审查整理变化的成本也较低的时候整理才有用。规则六是**隔离整理**。如果你错过了在编写代码中途整理的机会,那么接下来可能很困难。要么完成并接着整理,要么还原、整理并进行修改。

|

||||||

|

|

||||||

|

试试这些。将临时申明的变量移动到它第一次使用的位置,简化布尔表达式(`return expression == True`?),提取一个 helper,将逻辑或状态的范围缩小到实际使用的位置。

|

||||||

|

|

||||||

|

### 规则

|

||||||

|

|

||||||

|

- 规则一、 如果这很难,那就不要去做

|

||||||

|

- 规则二、 当你充满活力时开始,当你累了时停下来

|

||||||

|

- 规则三、 立即完成每个环节工作

|

||||||

|

- 规则四、 两次失败后恢复

|

||||||

|

- 规则五、 实践

|

||||||

|

- 规则六、 隔离整理

|

||||||

|

|

||||||

|

### 尾声

|

||||||

|

|

||||||

|

我通过严格地整理改变了架构、提取了框架。这种方式可以安全地做出重大改变。我认为这是因为,虽然每次整理的成本是不变的,但回报是指数级的,但我需要数据和模型来解释这个假说。

|

||||||

|

|

||||||

|

--------------------------------------------------------------------------------

|

||||||

|

|

||||||

|

via: https://www.facebook.com/notes/kent-beck/the-life-changing-magic-of-tidying-up-code/1544047022294823/

|

||||||

|

|

||||||

|

作者:[KENT BECK][a]

|

||||||

|

译者:[geekpi](https://github.com/geekpi)

|

||||||

|

校对:[wxy](https://github.com/wxy)

|

||||||

|

|

||||||

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||

|

[a]:https://www.facebook.com/kentlbeck

|

||||||

|

[1]:https://www.facebook.com/notes/kent-beck/the-life-changing-magic-of-tidying-up-code/1544047022294823/?utm_source=wanqu.co&utm_campaign=Wanqu+Daily&utm_medium=website#

|

||||||

|

[2]:https://www.facebook.com/kentlbeck

|

||||||

|

[3]:https://www.facebook.com/notes/kent-beck/the-life-changing-magic-of-tidying-up-code/1544047022294823/

|

||||||

@ -0,0 +1,33 @@

|

|||||||

|

Let’s Encrypt :2018 年 1 月发布通配证书

|

||||||

|

============================================================

|

||||||

|

|

||||||

|

Let’s Encrypt 将于 2018 年 1 月开始发放通配证书。通配证书是一个经常需要的功能,并且我们知道在一些情况下它可以使 HTTPS 部署更简单。我们希望提供通配证书有助于加速网络向 100% HTTPS 进展。

|

||||||

|

|

||||||

|

Let’s Encrypt 目前通过我们的全自动 DV 证书颁发和管理 API 保护了 4700 万个域名。自从 Let's Encrypt 的服务于 2015 年 12 月发布以来,它已经将加密网页的数量从 40% 大大地提高到了 58%。如果你对通配证书的可用性以及我们达成 100% 的加密网页的使命感兴趣,我们请求你为我们的[夏季筹款活动][1](LCTT 译注:之前的夏季活动,原文发布于今年夏季)做出贡献。

|

||||||

|

|

||||||

|

通配符证书可以保护基本域的任何数量的子域名(例如 *.example.com)。这使得管理员可以为一个域及其所有子域使用单个证书和密钥对,这可以使 HTTPS 部署更加容易。

|

||||||

|

|

||||||

|

通配符证书将通过我们[即将发布的 ACME v2 API 终端][2]免费提供。我们最初只支持通过 DNS 进行通配符证书的基础域验证,但是随着时间的推移可能会探索更多的验证方式。我们鼓励人们在我们的[社区论坛][3]上提出任何关于通配证书支持的问题。

|

||||||

|

|

||||||

|

我们决定在夏季筹款活动中宣布这一令人兴奋的进展,因为我们是一个非营利组织,这要感谢使用我们服务的社区的慷慨支持。如果你想支持一个更安全和保密的网络,[现在捐赠吧][4]!

|

||||||

|

|

||||||

|

我们要感谢我们的[社区][5]和我们的[赞助者][6],使我们所做的一切成为可能。如果你的公司或组织能够赞助 Let's Encrypt,请发送电子邮件至 [sponsor@letsencrypt.org][7]。

|

||||||

|

|

||||||

|

--------------------------------------------------------------------------------

|

||||||

|

|

||||||

|

via: https://letsencrypt.org/2017/07/06/wildcard-certificates-coming-jan-2018.html

|

||||||

|

|

||||||

|

作者:[Josh Aas][a]

|

||||||

|

译者:[geekpi](https://github.com/geekpi)

|

||||||

|

校对:[wxy](https://github.com/wxy)

|

||||||

|

|

||||||

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||

|

[a]:https://letsencrypt.org/2017/07/06/wildcard-certificates-coming-jan-2018.html

|

||||||

|

[1]:https://letsencrypt.org/donate/

|

||||||

|

[2]:https://letsencrypt.org/2017/06/14/acme-v2-api.html

|

||||||

|

[3]:https://community.letsencrypt.org/

|

||||||

|

[4]:https://letsencrypt.org/donate/

|

||||||

|

[5]:https://letsencrypt.org/getinvolved/

|

||||||

|

[6]:https://letsencrypt.org/sponsors/

|

||||||

|

[7]:mailto:sponsor@letsencrypt.org

|

||||||

@ -0,0 +1,149 @@

|

|||||||

|

Linux 用户的手边工具:Guide to Linux

|

||||||

|

============================================================

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

> “Guide to Linux” 这个应用并不完美,但它是一个非常好的工具,可以帮助你学习 Linux 命令。

|

||||||

|

|

||||||

|

还记得你初次使用 Linux 时的情景吗?对于有些人来说,他的学习曲线可能有些挑战性。比如,在 `/usr/bin` 中能找到许多命令。在我目前使用的 Elementary OS 系统中,命令的数量是 1944 个。当然,这并不全是真实的命令(或者,我会使用到的命令数量),但这个数目是很多的。

|

||||||

|

|

||||||

|

正因为如此(并且不同平台不一样),现在,新用户(和一些已经熟悉的用户)需要一些帮助。

|

||||||

|

|

||||||

|

对于每个管理员来说,这些技能是必须具备的:

|

||||||

|

|

||||||

|

* 熟悉平台

|

||||||

|

* 理解命令

|

||||||

|

* 编写 Shell 脚本

|

||||||

|

|

||||||

|

当你寻求帮助时,有时,你需要去“阅读那些该死的手册”(Read the Fine/Freaking/Funky Manual,LCTT 译注:一个网络用语,简写为 RTFM),但是当你自己都不知道要找什么的时候,它就没办法帮到你了。在那个时候,你就会为你拥有像 [Guide to Linux][15] 这样的手机应用而感到高兴。

|

||||||

|

|

||||||

|

不像你在 Linux.com 上看到的那些大多数的内容,这篇文章只是介绍一个 Android 应用的。为什么呢?因为这个特殊的 应用是用来帮助用户学习 Linux 的。

|

||||||

|

|

||||||

|

而且,它做的很好。

|

||||||

|

|

||||||

|

关于这个应用我清楚地告诉你 —— 它并不完美。Guide to Linux 里面充斥着很烂的英文,糟糕的标点符号,并且(如果你是一个纯粹主义者),它从来没有提到过 GNU。在这之上,它有一个特别的功能(通常它对用户非常有用)功能不是很有用(LCTT 译注:是指终端模拟器,后面会详细解释)。除此之外,我敢说 Guide to Linux 可能是 Linux 平台上最好的一个移动端的 “口袋指南”。

|

||||||

|

|

||||||

|

对于这个应用,你可能会喜欢它的如下特性:

|

||||||

|

|

||||||

|

* 离线使用

|

||||||

|

* Linux 教程

|

||||||

|

* 基础的和高级的 Linux 命令的详细介绍

|

||||||

|

* 包含了命令示例和语法

|

||||||

|

* 专用的 Shell 脚本模块

|

||||||

|

|

||||||

|

除此以外,Guide to Linux 是免费提供的(尽管里面有一些广告)。如果你想去除广告,它有一个应用内的购买,($2.99 USD/年)可以去消除广告。

|

||||||

|

|

||||||

|

让我们来安装这个应用,来看一看它的构成。

|

||||||

|

|

||||||

|

### 安装

|

||||||

|

|

||||||

|

像所有的 Android 应用一样,安装 Guide to Linux 是非常简单的。按照以下简单的几步就可以安装它了:

|

||||||

|

|

||||||

|

1. 打开你的 Android 设备上的 Google Play 商店

|

||||||

|

2. 搜索 Guide to Linux

|

||||||

|

3. 找到 Essence Infotech 的那个,并轻触进入

|

||||||

|

4. 轻触 Install

|

||||||

|

5. 允许安装

|

||||||

|

|

||||||

|

安装完成后,你可以在你的<ruby>应用抽屉<rt>App Drawer</rt></ruby>或主屏幕上(或者两者都有)上找到它去启动 Guide to Linux 。轻触图标去启动这个应用。

|

||||||

|

|

||||||

|

### 使用

|

||||||

|

|

||||||

|

让我们看一下 Guide to Linux 的每个功能。我发现某些功能比其它的更有帮助,或许你的体验会不一样。在我们分别讲解之前,我将重点提到其界面。开发者在为这个应用创建一个易于使用的界面方面做的很好。

|

||||||

|

|

||||||

|

从主窗口中(图 1),你可以获取四个易于访问的功能。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

*图 1: The Guide to Linux 主窗口。[已获授权][1]*

|

||||||

|

|

||||||

|

轻触四个图标中的任何一个去启动一个功能,然后,准备去学习。

|

||||||

|

|

||||||

|

### 教程

|

||||||

|

|

||||||

|

让我们从这个应用教程的最 “新手友好” 的功能开始。打开“Tutorial”功能,然后,将看到该教程的欢迎部分,“Linux 操作系统介绍”(图 2)。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

*图 2:教程开始。[已获授权][2]*

|

||||||

|

|

||||||

|

如果你轻触 “汉堡包菜单” (左上角的三个横线),显示了内容列表(图 3),因此,你可以在教程中选择任何一个可用部分。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

*图 3:教程的内容列表。[已获授权][3]*

|

||||||

|

|

||||||

|

如果你现在还没有注意到,Guide to Linux 教程部分是每个主题的一系列短文的集合。短文包含图片和链接(有时候),链接将带你到指定的 web 网站(根据主题的需要)。这里没有交互,仅仅只能阅读。但是,这是一个很好的起点,由于开发者在描述各个部分方面做的很好(虽然有语法问题)。

|

||||||

|

|

||||||

|

尽管你可以在窗口的顶部看到一个搜索选项,但是,我还是没有发现这一功能的任何效果 —— 但是,你可以试一下。

|

||||||

|

|

||||||

|

对于 Linux 新手来说,如果希望获得 Linux 管理的技能,你需要去阅读整个教程。完成之后,转到下一个主题。

|

||||||

|

|

||||||

|

### 命令

|

||||||

|

|

||||||

|

命令功能类似于手机上的 man 页面一样,是大量的频繁使用的 Linux 命令。当你首次打开它,欢迎页面将详细解释使用命令的益处。

|

||||||

|

|

||||||

|

读完之后,你可以轻触向右的箭头(在屏幕底部)或轻触 “汉堡包菜单” ,然后从侧边栏中选择你想去学习的其它命令。(图 4)

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

*图 4:命令侧边栏允许你去查看列出的命令。[已获授权][4]*

|

||||||

|

|

||||||

|

轻触任意一个命令,你可以阅读这个命令的解释。每个命令解释页面和它的选项都提供了怎么去使用的示例。

|

||||||

|

|

||||||

|

### Shell 脚本

|

||||||

|

|

||||||

|

在这个时候,你开始熟悉 Linux 了,并对命令已经有一定程序的掌握。现在,是时候去熟悉 shell 脚本了。这个部分的设置方式与教程部分和命令部分相同。

|

||||||

|

|

||||||

|

你可以打开内容列表的侧边栏,然后打开包含 shell 脚本教程的任意部分(图 5)。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

*图 5:Shell 脚本节看上去很熟悉。[已获授权][5]*

|

||||||

|

|

||||||

|

开发者在解释如何最大限度地利用 shell 脚本方面做的很好。对于任何有兴趣学习 shell 脚本细节的人来说,这是个很好的起点。

|

||||||

|

|

||||||

|

### 终端

|

||||||

|

|

||||||

|

现在我们到了一个新的地方,开发者在这个应用中包含了一个终端模拟器。遗憾的是,当你在一个没有 “root” 权限的 Android 设备上安装这个应用时,你会发现你被限制在一个只读文件系统中,在那里,大部分命令根本无法工作。但是,我在一台 Pixel 2 (通过 Android 应用商店)安装的 Guide to Linux 中,可以使用更多的这个功能(还只是较少的一部分)。在一台 OnePlus 3 (非 root 过的)上,不管我改变到哪个目录,我都是得到相同的错误信息 “permission denied”,甚至是一个简单的命令也如此。

|

||||||

|

|

||||||

|

在 Chromebook 上,不管怎么操作,它都是正常的(图 6)。可以说,它可以一直很好地工作在一个只读操作系统中(因此,你不能用它进行真正的工作或创建新文件)。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

*图 6: 可以完美地(可以这么说)用一个终端模拟器去工作。[已获授权][6]*

|

||||||

|

|

||||||

|

记住,这并不是真实的成熟终端,但却是一个新用户去熟悉终端是怎么工作的一种方法。遗憾的是,大多数用户只会发现自己对这个工具的终端功能感到沮丧,仅仅是因为,它们不能使用他们在其它部分学到的东西。开发者可能将这个终端功能打造成了一个 Linux 文件系统沙箱,因此,用户可以真实地使用它去学习。每次用户打开那个工具,它将恢复到原始状态。这只是我一个想法。

|

||||||

|

|

||||||

|

### 写在最后…

|

||||||

|

|

||||||

|

尽管终端功能被一个只读文件系统所限制(几乎到了没法使用的程序),Guide to Linux 仍然是一个新手学习 Linux 的好工具。在 guide to Linux 中,你将学习关于 Linux、命令、和 shell 脚本的很多知识,以便在你安装你的第一个发行版之前,让你学习 Linux 有一个好的起点。

|

||||||

|

|

||||||

|

--------------------------------------------------------------------------------

|

||||||

|

|

||||||

|

via: https://www.linux.com/learn/intro-to-linux/2017/8/guide-linux-app-handy-tool-every-level-linux-user

|

||||||

|

|

||||||

|

作者:[JACK WALLEN][a]

|

||||||

|

译者:[qhwdw](https://github.com/qhwdw)

|

||||||

|

校对:[wxy](https://github.com/wxy)

|

||||||

|

|

||||||

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||

|

[a]:https://www.linux.com/users/jlwallen

|

||||||

|

[1]:https://www.linux.com/licenses/category/used-permission

|

||||||

|

[2]:https://www.linux.com/licenses/category/used-permission

|

||||||

|

[3]:https://www.linux.com/licenses/category/used-permission

|

||||||

|

[4]:https://www.linux.com/licenses/category/used-permission

|

||||||

|

[5]:https://www.linux.com/licenses/category/used-permission

|

||||||

|

[6]:https://www.linux.com/licenses/category/used-permission

|

||||||

|

[7]:https://www.linux.com/licenses/category/used-permission

|

||||||

|

[8]:https://www.linux.com/files/images/guidetolinux1jpg

|

||||||

|

[9]:https://www.linux.com/files/images/guidetolinux2jpg

|

||||||

|

[10]:https://www.linux.com/files/images/guidetolinux3jpg-0

|

||||||

|

[11]:https://www.linux.com/files/images/guidetolinux4jpg

|

||||||

|

[12]:https://www.linux.com/files/images/guidetolinux-5-newjpg

|

||||||

|

[13]:https://www.linux.com/files/images/guidetolinux6jpg-0

|

||||||

|

[14]:https://www.linux.com/files/images/guide-linuxpng

|

||||||

|

[15]:https://play.google.com/store/apps/details?id=com.essence.linuxcommands

|

||||||

|

[16]:https://training.linuxfoundation.org/linux-courses/system-administration-training/introduction-to-linux

|

||||||

|

[17]:https://www.addtoany.com/share#url=https%3A%2F%2Fwww.linux.com%2Flearn%2Fintro-to-linux%2F2017%2F8%2Fguide-linux-app-handy-tool-every-level-linux-user&title=Guide%20to%20Linux%20App%20Is%20a%20Handy%20Tool%20for%20Every%20Level%20of%20Linux%20User

|

||||||

@ -0,0 +1,85 @@

|

|||||||

|

放弃你的代码,而不是你的时间

|

||||||

|

============================================================

|

||||||

|

|

||||||

|

作为软件开发人员,我认为我们可以认同开源代码^注1 已经[改变了世界][9]。它的公共性质去除了壁垒,可以让软件可以变的最好。但问题是,太多有价值的项目由于领导者的精力耗尽而停滞不前:

|

||||||

|

|

||||||

|

>“我没有时间和精力去投入开源了。我在开源上没有得到任何收入,所以我在那上面花的时间,我可以用在‘生活上的事’,或者写作上……正因为如此,我决定现在结束我所有的开源工作。”

|

||||||

|

>

|

||||||

|

>—[Ryan Bigg,几个 Ruby 和 Elixir 项目的前任维护者][1]

|

||||||

|

>

|

||||||

|

>“这也是一个巨大的机会成本,由于我无法同时学习或者完成很多事情,FubuMVC 占用了我很多的时间,这是它现在必须停下来的主要原因。”

|

||||||

|

>

|

||||||

|

>—[前 FubuMVC 项目负责人 Jeremy Miller][2]

|

||||||

|

>

|

||||||

|

>“当我们决定要孩子的时候,我可能会放弃开源,我预计最终解决我问题的方案将是:核武器。”

|

||||||

|

>

|

||||||

|

>—[Nolan Lawson,PouchDB 的维护者之一][3]

|

||||||

|

|

||||||

|

我们需要的是一种新的行业规范,即项目领导者将_总是_能获得(其付出的)时间上的补偿。我们还需要抛弃的想法是, 任何提交问题或合并请求的开发人员都自动会得到维护者的注意。

|

||||||

|

|

||||||

|

我们先来回顾一下开源代码在市场上的作用。它是一个积木。它是[实用软件][10],是企业为了在别处获利而必须承担的成本。如果用户能够理解该代码的用途并且发现它比替代方案(闭源专用、定制的内部解决方案等)更有价值,那么围绕该软件的社区就会不断增长。它可以更好,更便宜,或两者兼而有之。

|

||||||

|

|

||||||

|

如果一个组织需要改进该代码,他们可以自由地聘请任何他们想要的开发人员。通常情况下[为了他们的利益][11]会将改进贡献给社区,因为由于代码合并的复杂性,这是他们能够轻松地从其他用户获得未来改进的唯一方式。这种“引力”倾向于把社区聚集在一起。

|

||||||

|

|

||||||

|

但是它也会加重项目维护者的负担,因为他们必须对这些改进做出反应。他们得到了什么回报?最好的情况是,这些社区贡献可能是他们将来可以使用的东西,但现在不是。最坏的情况下,这只不过是一个带着利他主义面具的自私请求罢了。

|

||||||

|

|

||||||

|

有一类开源项目避免了这个陷阱。Linux、MySQL、Android、Chromium 和 .NET Core 除了有名,有什么共同点么?他们都对一个或多个大型企业具有_战略性重要意义_,因为它们满足了这些利益。[聪明的公司商品化他们的商品][12],没有什么比开源软件便宜的商品了。红帽需要那些使用 Linux 的公司来销售企业级 Linux,Oracle 使用 MySQL 作为销售 MySQL Enterprise 的引子,谷歌希望世界上每个人都拥有电话和浏览器,而微软则试图将开发者锁定在平台上然后将它们拉入 Azure 云。这些项目全部由各自公司直接资助。

|

||||||

|

|

||||||

|

但是那些其他的项目呢,那些不是大玩家核心战略的项目呢?

|

||||||

|

|

||||||

|

如果你是其中一个项目的负责人,请向社区成员收取年费。_开放的源码,封闭的社区_。给用户的信息应该是“尽你所愿地使用代码,但如果你想影响项目的未来,请_为我们的时间支付_。”将非付费用户锁定在论坛和问题跟踪之外,并忽略他们的电子邮件。不支付的人应该觉得他们错过了派对。

|

||||||

|

|

||||||

|

还要向贡献者收取合并非普通的合并请求的时间花费。如果一个特定的提交不会立即给你带来好处,请为你的时间收取全价。要有原则并[记住 YAGNI][13]。

|

||||||

|

|

||||||

|

这会导致一个极小的社区和更多的分支么?绝对。但是,如果你坚持不懈地构建自己的愿景,并为其他人创造价值,他们会尽快为要做的贡献而支付。_合并贡献的意愿是[稀缺资源][4]_。如果没有它,用户必须反复地将它们的变化与你发布的每个新版本进行协调。

|

||||||

|

|

||||||

|

如果你想在代码库中保持高水平的[概念完整性][14],那么限制社区是特别重要的。有[自由贡献政策][15]的无领导者项目没有必要收费。

|

||||||

|

|

||||||

|

为了实现更大的愿景,而不是单独为自己的业务支付成本,而是可能使其他人受益,去[众筹][16]吧。有许多成功的故事:

|

||||||

|

|

||||||

|

- [Font Awesome 5][5]

|

||||||

|

- [Ruby enVironment Management (RVM)][6]

|

||||||

|

- [Django REST framework 3][7]

|

||||||

|

|

||||||

|

[众筹有局限性][17]。它[不适合][18][大型项目][19]。但是,开源代码也是实用软件,它不需要雄心勃勃、冒险的破局者。它已经一点点地[渗透到每个行业][20]。

|

||||||

|

|

||||||

|

这些观点代表着一条可持续发展的道路,也可以解决[开源的多样性问题][21],这可能源于其历史上无偿的性质。但最重要的是,我们要记住,[我们一生中只留下那么多的按键次数][22],而且我们总有一天会后悔那些我们浪费的东西。

|

||||||

|

|

||||||

|

- 注 1 :当我说“开源”时,我的意思是代码[许可][8]以某种方式来构建专有的东西。这通常意味着一个宽松许可证(MIT 或 Apache 或 BSD),但并非总是如此。Linux 是当今科技行业的核心,但是是以 GPL 授权的。_

|

||||||

|

|

||||||

|

感谢 Jason Haley、Don McNamara、Bryan Hogan 和 Nadia Eghbal 阅读了这篇文章的草稿。

|

||||||

|

|

||||||

|

--------------------------------------------------------------------------------

|

||||||

|

|

||||||

|

via: http://wgross.net/essays/give-away-your-code-but-never-your-time

|

||||||

|

|

||||||

|

作者:[William Gross][a]

|

||||||

|

译者:[geekpi](https://github.com/geekpi)

|

||||||

|

校对:[wxy](https://github.com/wxy)

|

||||||

|

|

||||||

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||

|

[a]:http://wgross.net/#about-section

|

||||||

|

[1]:http://ryanbigg.com/2015/11/open-source-work

|

||||||

|

[2]:https://jeremydmiller.com/2014/04/03/im-throwing-in-the-towel-in-fubumvc/

|

||||||

|

[3]:https://nolanlawson.com/2017/03/05/what-it-feels-like-to-be-an-open-source-maintainer/

|

||||||

|

[4]:https://hbr.org/2010/11/column-to-win-create-whats-scarce

|

||||||

|

[5]:https://www.kickstarter.com/projects/232193852/font-awesome-5

|

||||||

|

[6]:https://www.bountysource.com/teams/rvm/fundraiser

|

||||||

|

[7]:https://www.kickstarter.com/projects/tomchristie/django-rest-framework-3

|

||||||

|

[8]:https://choosealicense.com/

|

||||||

|

[9]:https://www.wired.com/insights/2013/07/in-a-world-without-open-source/

|

||||||

|

[10]:https://martinfowler.com/bliki/UtilityVsStrategicDichotomy.html

|

||||||

|

[11]:https://tessel.io/blog/67472869771/monetizing-open-source

|

||||||

|

[12]:https://www.joelonsoftware.com/2002/06/12/strategy-letter-v/

|

||||||

|

[13]:https://martinfowler.com/bliki/Yagni.html

|

||||||

|

[14]:http://wiki.c2.com/?ConceptualIntegrity

|

||||||

|

[15]:https://opensource.com/life/16/5/growing-contributor-base-modern-open-source

|

||||||

|

[16]:https://poststatus.com/kickstarter-open-source-project/

|

||||||

|

[17]:http://blog.felixbreuer.net/2013/04/24/crowdfunding-for-open-source.html

|

||||||

|

[18]:https://www.indiegogo.com/projects/geary-a-beautiful-modern-open-source-email-client#/

|

||||||

|

[19]:http://www.itworld.com/article/2708360/open-source-tools/canonical-misses-smartphone-crowdfunding-goal-by--19-million.html

|

||||||

|

[20]:http://www.infoworld.com/article/2914643/open-source-software/rise-and-rise-of-open-source.html

|

||||||

|

[21]:http://readwrite.com/2013/12/11/open-source-diversity/

|

||||||

|

[22]:http://keysleft.com/

|

||||||

|

[23]:http://wgross.net/essays/give-away-your-code-but-never-your-time

|

||||||

98

published/20170928 3 Python web scrapers and crawlers.md

Normal file

98

published/20170928 3 Python web scrapers and crawlers.md

Normal file

@ -0,0 +1,98 @@

|

|||||||

|

三种 Python 网络内容抓取工具与爬虫

|

||||||

|

============================================================

|

||||||

|

|

||||||

|

> 运用这些很棒的 Python 爬虫工具来获取你需要的数据。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

在一个理想的世界里,你需要的所有数据都将以公开而文档完备的格式清晰地展现,你可以轻松地下载并在任何你需要的地方使用。

|

||||||

|

|

||||||

|

然而,在真实世界里,数据是凌乱的,极少被打包成你需要的样子,要么经常是过期的。

|

||||||

|

|

||||||

|

你所需要的信息经常是潜藏在一个网站里。相比一些清晰地、有调理地呈现数据的网站,更多的网站则不是这样的。<ruby>[爬取数据][33]<rt>crawling</rt></ruby>、<ruby>[挖掘数据][34]<rt>scraping</rt></ruby>、加工数据、整理数据这些是获取整个网站结构来绘制网站拓扑来收集数据所必须的活动,这些可以是以网站的格式储存的或者是储存在一个专有数据库中。

|

||||||

|

|

||||||

|

也许在不久的将来,你需要通过爬取和挖掘来获得一些你需要的数据,当然你几乎肯定需要进行一点点的编程来正确的获取。你要怎么做取决于你自己,但是我发现 Python 社区是一个很好的提供者,它提供了工具、框架以及文档来帮助你从网站上获取数据。

|

||||||

|

|

||||||

|

在我们进行之前,这里有一个小小的请求:在你做事情之前请思考,以及请耐心。抓取这件事情并不简单。不要把网站爬下来只是复制一遍,并其它人的工作当成是你自己的东西(当然,没有许可)。要注意版权和许可,以及你所爬行的内容应用哪一个标准。尊重 [robots.txt][15] 文件。不要频繁的针对一个网站,这将导致真实的访问者会遇到访问困难的问题。

|

||||||

|

|

||||||

|

在知晓这些警告之后,这里有一些很棒的 Python 网站爬虫工具,你可以用来获得你需要的数据。

|

||||||

|

|

||||||

|

### Pyspider

|

||||||

|

|

||||||

|

让我们先从 [pyspider][16] 开始介绍。这是一个带有 web 界面的网络爬虫,让与使之容易跟踪多个爬虫。其具有扩展性,支持多个后端数据库和消息队列。它还具有一些方便的特性,从优先级到再次访问抓取失败的页面,此外还有通过时间顺序来爬取和其他的一些特性。Pyspider 同时支持 Python 2 和 Python 3。为了实现一个更快的爬取,你可以在分布式的环境下一次使用多个爬虫进行爬取。

|

||||||

|

|

||||||

|

Pyspyder 的基本用法都有良好的 [文档说明][17] ,包括简单的代码片段。你能通过查看一个 [在线的样例][18] 来体验用户界面。它在 Apache 2 许可证下开源,Pyspyder 仍然在 GitHub 上积极地开发。

|

||||||

|

|

||||||

|

### MechanicalSoup

|

||||||

|

|

||||||

|

[MechanicalSoup][19] 是一个基于极其流行而异常多能的 HTML 解析库 [Beautiful Soup][20] 建立的爬虫库。如果你的爬虫需要相当的简单,但是又要求检查一些选择框或者输入一些文字,而你又不想为这个任务单独写一个爬虫,那么这会是一个值得考虑的选择。

|

||||||

|

|

||||||

|

MechanicalSoup 在 MIT 许可证下开源。查看 GitHub 上该项目的 [example.py][21] 样例文件来获得更多的用法。不幸的是,到目前为止,这个项目还没有一个很好的文档。

|

||||||

|

|

||||||

|

### Scrapy

|

||||||

|

|

||||||

|

[Scrapy][22] 是一个有着活跃社区支持的抓取框架,在那里你可以建造自己的抓取工具。除了爬取和解析工具,它还能将它收集的数据以 JSON 或者 CSV 之类的格式轻松输出,并存储在一个你选择的后端数据库。它还有许多内置的任务扩展,例如 cookie 处理、代理欺骗、限制爬取深度等等,同时还可以建立你自己附加的 API。

|

||||||

|

|

||||||

|

要了解 Scrapy,你可以查看[网上的文档][23]或者是访问它诸多的[社区][24]资源,包括一个 IRC 频道、Reddit 子版块以及关注他们的 StackOverflow 标签。Scrapy 的代码在 3 句版 BSD 许可证下开源,你可以在 [GitHub][25] 上找到它们。

|

||||||

|

|

||||||

|

如果你完全不熟悉编程,[Portia][26] 提供了一个易用的可视化的界面。[scrapinghub.com][27] 则提供一个托管的版本。

|

||||||

|

|

||||||

|

### 其它

|

||||||

|

|

||||||

|

* [Cola][6] 自称它是个“高级的分布式爬取框架”,如果你在寻找一个 Python 2 的方案,这也许会符合你的需要,但是注意它已经有超过两年没有更新了。

|

||||||

|

* [Demiurge][7] 是另一个可以考虑的潜在候选者,它同时支持 Python 2和 Python 3,虽然这个项目的发展较为缓慢。

|

||||||

|

* 如果你要解析一些 RSS 和 Atom 数据,[Feedparser][8] 或许是一个有用的项目。

|

||||||

|

* [Lassie][9] 让从网站检索像说明、标题、关键词或者是图片一类的基本内容变得简单。

|

||||||

|

* [RoboBrowser][10] 是另一个简单的库,它基于 Python 2 或者 Python 3,它具有按钮点击和表格填充的基本功能。虽然它有一段时间没有更新了,但是它仍然是一个不错的选择。

|

||||||

|

|

||||||

|

* * *

|

||||||

|

|

||||||

|

这远不是一个完整的列表,当然,如果你是一个编程专家,你可以选择采取你自己的方法而不是使用这些框架中的一个。或者你发现一个用其他语言编写的替代品。例如 Python 编程者可能更喜欢 [Python 附带的][28] [Selenium][29],它可以在不使用实际浏览器的情况下进行爬取。如果你有喜欢的爬取和挖掘工具,请在下面评论让我们知道。

|

||||||

|

|

||||||

|

(题图:[You as a Machine][13]. Modified by Rikki Endsley. [CC BY-SA 2.0][14])

|

||||||

|

|

||||||

|

--------------------------------------------------------------------------------

|

||||||

|

|

||||||

|

via: https://opensource.com/resources/python/web-scraper-crawler

|

||||||

|

|

||||||

|

作者:[Jason Baker][a]

|

||||||

|

译者:[ZH1122](https://github.com/ZH1122)

|

||||||

|

校对:[wxy](https://github.com/wxy)

|

||||||

|

|

||||||

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||

|

[a]:https://opensource.com/users/jason-baker

|

||||||

|

[1]:https://opensource.com/resources/python?intcmp=7016000000127cYAAQ

|

||||||

|

[2]:https://opensource.com/resources/python/ides?intcmp=7016000000127cYAAQ

|

||||||

|

[3]:https://opensource.com/resources/python/gui-frameworks?intcmp=7016000000127cYAAQ

|

||||||

|

[4]:https://opensource.com/tags/python?intcmp=7016000000127cYAAQ

|

||||||

|

[5]:https://developers.redhat.com/?intcmp=7016000000127cYAAQ

|

||||||

|

[6]:https://github.com/chineking/cola

|

||||||

|

[7]:https://github.com/matiasb/demiurge

|

||||||

|

[8]:https://github.com/kurtmckee/feedparser

|

||||||

|

[9]:https://github.com/michaelhelmick/lassie

|

||||||

|

[10]:https://github.com/jmcarp/robobrowser

|

||||||

|

[11]:https://opensource.com/resources/python/web-scraper-crawler?imm_mid=0f7103&cmp=em-prog-na-na-newsltr_20171007&rate=Wn1vUb9FpPK-IGQ1waRzgdIsDN3pXBH6rO2xnjoK_t4

|

||||||

|

[12]:https://opensource.com/user/19894/feed

|

||||||

|

[13]:https://www.flickr.com/photos/youasamachine/8025582590/in/photolist-decd6C-7pkccp-aBfN9m-8NEffu-3JDbWb-aqf5Tx-7Z9MTZ-rnYTRu-3MeuPx-3yYwA9-6bSLvd-irmvxW-5Asr4h-hdkfCA-gkjaSQ-azcgct-gdV5i4-8yWxCA-9G1qDn-5tousu-71V8U2-73D4PA-iWcrTB-dDrya8-7GPuxe-5pNb1C-qmnLwy-oTxwDW-3bFhjL-f5Zn5u-8Fjrua-bxcdE4-ddug5N-d78G4W-gsYrFA-ocrBbw-pbJJ5d-682rVJ-7q8CbF-7n7gDU-pdfgkJ-92QMx2-aAmM2y-9bAGK1-dcakkn-8rfyTz-aKuYvX-hqWSNP-9FKMkg-dyRPkY

|

||||||

|

[14]:https://creativecommons.org/licenses/by/2.0/

|

||||||

|

[15]:http://www.robotstxt.org/

|

||||||

|

[16]:https://github.com/binux/pyspider

|

||||||

|

[17]:http://docs.pyspider.org/en/latest/

|

||||||

|

[18]:http://demo.pyspider.org/

|

||||||

|

[19]:https://github.com/hickford/MechanicalSoup

|

||||||

|

[20]:https://www.crummy.com/software/BeautifulSoup/

|

||||||

|

[21]:https://github.com/hickford/MechanicalSoup/blob/master/example.py

|

||||||

|

[22]:https://scrapy.org/

|

||||||

|

[23]:https://doc.scrapy.org/en/latest/

|

||||||

|

[24]:https://scrapy.org/community/

|

||||||

|

[25]:https://github.com/scrapy/scrapy

|

||||||

|

[26]:https://github.com/scrapinghub/portia

|

||||||

|

[27]:https://portia.scrapinghub.com/

|

||||||

|

[28]:https://selenium-python.readthedocs.io/

|

||||||

|

[29]:https://github.com/SeleniumHQ/selenium

|

||||||

|

[30]:https://opensource.com/users/jason-baker

|

||||||

|

[31]:https://opensource.com/users/jason-baker

|

||||||

|

[32]:https://opensource.com/resources/python/web-scraper-crawler?imm_mid=0f7103&cmp=em-prog-na-na-newsltr_20171007#comments

|

||||||

|

[33]:https://en.wikipedia.org/wiki/Web_crawler

|

||||||

|

[34]:https://en.wikipedia.org/wiki/Web_scraping

|

||||||

95

published/201710/20160511 LEDE and OpenWrt.md

Normal file

95

published/201710/20160511 LEDE and OpenWrt.md

Normal file

@ -0,0 +1,95 @@

|

|||||||

|

LEDE 和 OpenWrt 分裂之争

|

||||||

|

===================

|

||||||

|

|

||||||

|

对于家用 WiFi 路由器和接入点来说,[OpenWrt][1] 项目可能是最广为人知的 Linux 发行版;在 12 年以前,它产自现在有名的 Linksys WRT54G 路由器的源代码。(2016 年)五月初,当一群 OpenWrt 核心开发者 [宣布][2] 他们将开始着手 OpenWrt 的一个副产品 (或者,可能算一个分支)叫 [Linux 嵌入开发环境][3] (LEDE)时,OpenWrt 用户社区陷入一片巨大的混乱中。为什么产生分裂对公众来说并不明朗,而且 LEDE 宣言惊到了一些其他 OpenWrt 开发者也暗示这团队的内部矛盾。

|

||||||

|

|

||||||

|

LEDE 宣言被 Jo-Philipp Wich 于五月三日发往所有 OpenWrt 开发者列表和新 LEDE 开发者列表。它将 LEDE 描述为“OpenWrt 社区的一次重启” 和 “OpenWrt 项目的一个副产品” ,希望产生一个 “注重透明性、合作和权利分散”的 Linux 嵌入式开发社区。

|

||||||

|

|

||||||

|

给出的重启的原因是 OpenWrt 遭受着长期以来存在且不能从内部解决的问题 —— 换句话说,关于内部处理方式和政策。例如,宣言称,开发者的数目在不断减少,却没有接纳新开发者的方式(而且貌似没有授权委托访问给新开发者的方法)。宣言说到,项目的基础设施不可靠(例如,去年服务器挂掉在这个项目中也引发了相当多的矛盾),但是内部不合和单点错误阻止了修复它。内部和从这个项目到外面世界也存在着“交流、透明度和合作”的普遍缺失。最后,一些技术缺陷被引述:不充分的测试、缺乏常规维护,以及窘迫的稳固性与文档。

|

||||||

|

|

||||||

|

该宣言继续描述 LEDE 重启将怎样解决这些问题。所有交流频道都会打开供公众使用,决策将在项目范围内的投票决出,合并政策将放宽等等。更详细的说明可以在 LEDE 站点的[规则][4]页找到。其他细节中,它说贡献者将只有一个阶级(也就是,没有“核心开发者”这样拥有额外权利的群体),简单的少数服从多数投票作出决定,并且任何被这个项目管理的基础设施必须有三个以上管理员账户。在 LEDE 邮件列表, Hauke Mehrtens [补充][5]到,该项目将会努力把补丁投递到上游项目 —— 这是过去 OpenWrt 被批判的一点,尤其是对 Linux 内核。

|

||||||

|

|

||||||

|

除了 Wich,这个宣言被 OpenWrt 贡献者 John Crispin、 Daniel Golle、 Felix Fietkau、 Mehrtens、 Matthias Schiffer 和 Steven Barth 共同签署,并以给其他有兴趣参与的人访问 LEDE 站点的邀请作为了宣言结尾。

|

||||||

|

|

||||||

|

### 回应和问题

|

||||||

|

|

||||||

|

有人可能会猜想 LEDE 组织者预期他们的宣言会有或积极或消极的反响。毕竟,细读宣言中批判 OpenWrt 项目暗示了 LEDE 阵营发现有一些 OpenWrt 项目成员难以共事(例如,“单点错误” 或 “内部不和”阻止了基础设施的修复)。

|

||||||

|

|

||||||

|

并且,确实,有很多消极回应。OpenWrt 创立者之一 Mike Baker [回应][6] 了一些警告,反驳所有 LEDE 宣言中的结论并称“像‘重启’这样的词语都是含糊不清的,且具有误导性的,而且 LEDE 项目未能揭晓其真实本质。”与此同时,有人关闭了那些在 LEDE 宣言上署名的开发者的 @openwrt.org 邮件入口;当 Fietkau [提出反对][7], Baker [回复][8]账户“暂时停用”是因为“还不确定 LEDE 能不能代表 OpenWrt。” 另一个 OpenWrt 核心成员 Imre Kaloz [写][9]到,他们现在所抱怨的 OpenWrt 的“大多数[破]事就是 LEDE 团队弄出来的”。

|

||||||

|

|

||||||

|

但是大多数 OpenWrt 列表的回应对该宣言表示困惑。邮件列表成员不明确 LEDE 团队是否将对 OpenWrt [继续贡献][10],或导致了这次分裂的架构和内部问题的[确切本质][11]是什么。 Baker 的第一反应是对宣言中引述的那些问题缺乏公开讨论表示难过:“我们意识到当前的 OpenWrt 项目遭受着许多的问题,”但“我们希望有机会去讨论并尝试着解决”它们。 Baker 作出结论:

|

||||||

|

|

||||||

|

> 我们想强调,我们确实希望能够公开的讨论,并解决掉手头事情。我们的目标是与所有能够且希望对 OpenWrt 作出贡献的参与者共事,包括 LEDE 团队。

|

||||||

|

|

||||||

|

除了有关新项目的初心的问题之外,一些邮件列表订阅者提出了 LEDE 是否与 OpenWrt 有相同的使用场景定位,给新项目取一个听起来更一般的名字的疑惑。此外,许多人,像 Roman Yeryomin,对为什么这些问题需要 LEDE 团队的离开(来解决)[表示了疑惑][12],特别是,与此同时,LEDE 团队由大部分活跃核心 OpenWrt 开发者构成。一些列表订阅者,像 Michael Richardson,甚至不清楚[谁还会继续开发][13] OpenWrt。

|

||||||

|

|

||||||

|

### 澄清

|

||||||

|

|

||||||

|

LEDE 团队尝试着深入阐释他们的境况。在 Fietkau 给 Baker 的回复中,他说在 OpenWrt 内部关于有目的地改变的讨论会很快变得“有毒,”因此导致没有进展。而且:

|

||||||

|

|

||||||

|

> 这些讨论的要点在于那些掌握着基础设施关键部分的人精力有限却拒绝他人的加入和帮助,甚至是面对无法及时解决的重要问题时也是这样。

|

||||||

|

|

||||||

|

> 这种像单点错误一样的事已经持续了很多年了,没有任何有意义的进展来解决它。

|

||||||

|

|

||||||

|

Wich 和 Fietkau 都没有明显指出具体的人,虽然在列表的其他人可能会想到这个基础设施和 OpenWrt 的内部决策问题要归咎于某些人。 Daniel Dickinson [陈述][14]到:

|

||||||

|

|

||||||

|

> 我的印象是 Kaloz (至少) 以基础设施为胁来保持控制,并且根本性的问题是 OpenWrt 是*不*民主的,而且忽视那些真正在 OpenWrt 工作的人想要的是什么,无视他们的愿望,因为他/他们把控着要害。

|

||||||

|

|

||||||

|

另一方面, Luka Perkov [指出][15] 很多 OpemWrt 开发者想从 Subversion 转移到 Git,但 Fietkau 却阻止这种变化。

|

||||||

|

|

||||||

|

看起来是 OpenWrt 的管理结构并非如预期般发挥作用,其结果导致个人冲突爆发,而且由于没有完好定义的流程,某些人能够简单的忽视或阻止提议的变化。明显,这不是一个能长期持续的模式。

|

||||||

|

|

||||||

|

五月六日,Crispin 在一个新的帖子中[写给][16] OpenWrt 列表,尝试着重构 LEDE 项目宣言。他说,这并不是意味着“敌对或分裂”行为,只是与结构失衡的 OpenWrt 做个清晰的划分并以新的方式开始。问题在于“不要归咎于一次单独的事件、一个人或者一次口水战”,他说,“我们想与过去自己造成的错误和多次作出的错误管理决定分开”。 Crispin 也承认宣言没有把握好,说 LEDE 团队 “弄糟了发起纲领。”

|

||||||

|

|

||||||

|

Crispin 的邮件似乎没能使 Kaloz 满意,她[坚持认为][17] Crispin(作为发行经理)和 Fietkau(作为领头开发者)可以轻易地在 OpenWrt 内部作出想要的改变。但是讨论的下文后来变得沉寂;之后 LEDE 或者 OpenWrt 哪边会发生什么还有待观察。

|

||||||

|

|

||||||

|

### 目的

|

||||||

|

|

||||||

|

对于那些想要探究 LEDE 所认为有问题的事情的更多细节的 OpenWrt 成员来说,有更多的信息来源可以为这个问题提供线索。在公众宣言之前,LEDE 组织花了几周谈论他们的计划,会议的 IRC 日志现已[发布][18]。特别有趣的是,三月三十日的[会议][19]包含了这个项目目标的细节讨论。

|

||||||

|

|

||||||

|

其中包括一些针对 OpenWrt 的基础设施的抱怨,像项目的 Trac 工单追踪器的缺点。它充斥着不完整的漏洞报告和“我也是”的评论,Wich 说,结果几乎没有贡献者使用它。此外,他们也在 Github 上追踪 bug,人们对这件事感到困惑,这使得工单应该在哪里讨论不明了。

|

||||||

|

|

||||||

|

这些 IRC 讨论也定下了开发流程本身。LEDE 团队想作出些改变,以使用会合并到主干的阶段开发分支为开端,与 OpenWrt 所使用的“直接提交到主干”方式不同。该项目也将提供基于时间的发行版,并通过只发行已被成功测试的二进制模块来鼓励用户测试,由社区而不是核心开发者在实际的硬件上进行测试。

|

||||||

|

|

||||||

|

最后,这些 IRC 讨论也确定了 LEDE 团队的目的不是用它的宣言吓唬 OpenWrt。Crispin 提到 LEDE 首先是“半公开的”并渐渐做得更公开。 Wich 解释说他希望 LEDE 是“中立的、专业的,并打开大门欢迎 OpenWrt 以便将来的合并”。不幸的是,前期发起工作并不是做得很好。

|

||||||

|

|

||||||

|

在一封邮件中, Fietkau 补充到 OpenWrt 核心开发者确实在任务中遇到瓶颈,像补丁复审和基础设施维护这些事情让他们完成不了其他工作,比如配置下载镜像和改良构建系统。在 LEDE 宣言之后短短几天内,他说,团队成功解决了镜像和构建系统任务,而这些已被搁置多年。

|

||||||

|

|

||||||

|

> 我们在 LEDE 所做的事情很多是基于转移到 Github 的去中心化软件包开发经验,并放弃了软件包应如何被维护的许多控制。这样最终有效减少了我们的工作量,而且我们有了很多更活跃的开发者。

|

||||||

|

|

||||||

|

> 我们真的希望为核心开发做一些类似的事,但是基于我们想作出更大改变的经验,我们觉得在 OpenWrt 项目内做不到。

|

||||||

|

|

||||||

|

修复基础设施也将收获其他好处,他说,就比如改进了用于管理签署发布版本的密码的系统。团队正在考虑在某些情况下非上游补丁的规则,像需要补丁的描述和为什么没有发送到上游的解释。他也提到很多留下的 OpenWrt 开发者表示有兴趣加入 LEDE,相关当事人正试图弄清楚他们是否会重新合并该项目。

|

||||||

|

|

||||||

|

有人希望 LEDE 更为扁平的管理模式和更为透明的分工会在困扰 OpenWrt 的方面取得成功。解决最初的宣言中被诟病的沟通方面的问题会是最大的障碍。如果那个过程处理得好,那么,未来 LEDE 和 OpenWrt 可能能够求同存异并协作。否则,之后两个团队可能一起被迫发展到比以前拥有更少资源的方向,这也许不是开发者或用户想看到的。

|

||||||

|

|

||||||

|

--------------------------------------------------------------------------------

|

||||||

|

|

||||||

|

via: https://lwn.net/Articles/686767/

|

||||||

|

|

||||||

|

作者:[Nathan Willis][a]

|

||||||

|

译者:[XYenChi](https://github.com/XYenChi)

|

||||||

|

校对:[wxy](https://github.com/wxy)

|

||||||

|

|

||||||

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||