mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-06 01:20:12 +08:00

Merge branch 'master' of https://github.com/LCTT/TranslateProject

This commit is contained in:

commit

7cf37b53d5

@ -1,14 +1,14 @@

|

||||

使用IBM Bluemix构建,部署和管理自定义应用程序

|

||||

使用 IBM Bluemix 构建,部署和管理自定义应用程序

|

||||

============================================================

|

||||

|

||||

|

||||

|

||||

|

||||

IBM Bluemix 为开发人员提供了构建,部署和管理自定义应用程序的机会。Bluemix 建立在 Cloud Foundry 上。它支持多种编程语言,包括 IBM 的 OpenWhisk ,还允许开发人员无需资源管理就调用任何函数。

|

||||

IBM Bluemix 为开发人员提供了构建、部署和管理自定义应用程序的机会。Bluemix 建立在 Cloud Foundry 上。它支持多种编程语言,包括 IBM 的 OpenWhisk ,还允许开发人员无需资源管理就调用任何函数。

|

||||

|

||||

Bluemix 是由 IBM 实现的开放标准的基于云的平台。它具有开放的架构,其允许组织能够在云上创建,开发和管理其应用程序。它基于 Cloud Foundry ,因此可以被视为平台即服务(PaaS)。使用 Bluemix,开发人员不必关心云端配置,可以专注于他们的应用程序。 云端配置将由 Bluemix 自动完成。

|

||||

Bluemix 是由 IBM 实现的基于开放标准的云平台。它具有开放的架构,其允许组织能够在云上创建、开发和管理其应用程序。它基于 Cloud Foundry ,因此可以被视为平台即服务(PaaS)。使用 Bluemix,开发人员不必关心云端配置,可以专注于他们的应用程序。 云端配置将由 Bluemix 自动完成。

|

||||

|

||||

Bluemix 还提供了一个仪表板,通过它,开发人员可以创建,管理和查看服务和应用程序,同时还可以监控资源使用情况。

|

||||

|

||||

它支持以下编程语言:

|

||||

|

||||

* Java

|

||||

@ -21,143 +21,132 @@ Bluemix 还提供了一个仪表板,通过它,开发人员可以创建,管

|

||||

|

||||

|

||||

|

||||

图1 IBM Bluemix 概述

|

||||

*图1 IBM Bluemix 概述*

|

||||

|

||||

|

||||

|

||||

图2 IBM Bluemix 体系结构

|

||||

*图2 IBM Bluemix 体系结构*

|

||||

|

||||

|

||||

|

||||

图3 在 IBM Bluemix 中创建组织

|

||||

*图3 在 IBM Bluemix 中创建组织*

|

||||

|

||||

**IBM Bluemix 如何工作**

|

||||

### IBM Bluemix 如何工作

|

||||

|

||||

Bluemix 构建在 IBM 的 SoftLayer IaaS(基础架构即服务)之上。它使用 Cloud Foundry 作为开源 PaaS 平台。一切起于通过 Cloud Foundry 来推送代码,它扮演着整合代码和根据编写应用所使用的编程语言所适配的运行时环境的角色。IBM 服务、第三方服务或社区构建的服务可用于不同的功能。安全连接器可用于连接本地系统到云。

|

||||

Bluemix 构建在 IBM 的 SoftLayer IaaS(基础架构即服务)之上。它使用 Cloud Foundry 作为开源 PaaS 平台。一切起于通过 Cloud Foundry 来推送代码,它扮演着将代码和编写应用所使用的编程语言运行时环境整合起来的角色。IBM 服务、第三方服务或社区构建的服务可用于不同的功能。安全连接器可用于将本地系统连接到云。

|

||||

|

||||

|

||||

|

||||

图4 在 IBM Bluemix 中设置空间

|

||||

*图4 在 IBM Bluemix 中设置空间*

|

||||

|

||||

|

||||

|

||||

图5 应用程序模板

|

||||

*图5 应用程序模板*

|

||||

|

||||

|

||||

|

||||

图6 IBM Bluemix 支持的编程语言

|

||||

*图6 IBM Bluemix 支持的编程语言*

|

||||

|

||||

### 在 Bluemix 中创建应用程序

|

||||

|

||||

**在 Bluemix 中创建应用程序**

|

||||

在本文中,我们将使用 Liberty for Java 的入门包在 IBM Bluemix 中创建一个示例“Hello World”应用程序,只需几个简单的步骤。

|

||||

|

||||

1. 打开 [_https://console.ng.bluemix.net/registration/_][2]

|

||||

1、 打开 [https://console.ng.bluemix.net/registration/][2]

|

||||

|

||||

2. 注册 Bluemix 帐户

|

||||

2、 注册 Bluemix 帐户

|

||||

|

||||

3. 点击邮件中的确认链接完成注册过程

|

||||

3、 点击邮件中的确认链接完成注册过程

|

||||

|

||||

4. 输入您的电子邮件 ID,然后点击 _Continue_ 进行登录

|

||||

4、 输入您的电子邮件 ID,然后点击 Continue 进行登录

|

||||

|

||||

5. 输入密码并点击 _Log in_

|

||||

5、 输入密码并点击 Log in

|

||||

|

||||

6. 进入 _Set up_ -> _Environment_ 设置特定区域中的资源共享

|

||||

6、 进入 Set up -> Environment 设置特定区域中的资源共享

|

||||

|

||||

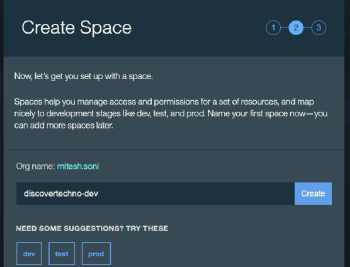

7. 创建空间方便管理访问控制和在 Bluemix 中回滚操作。 我们可以将空间映射到多个开发阶段,如 dev, test,uat,pre-prod 和 prod

|

||||

7、 创建空间方便管理访问控制和在 Bluemix 中回滚操作。 我们可以将空间映射到多个开发阶段,如 dev, test,uat,pre-prod 和 prod

|

||||

|

||||

|

||||

|

||||

图7 命名应用程序

|

||||

*图7 命名应用程序*

|

||||

|

||||

|

||||

|

||||

图8 了解应用程序何时准备就绪

|

||||

*图8 了解应用程序何时准备就绪*

|

||||

|

||||

|

||||

|

||||

图9 IBM Bluemix Java 应用程序

|

||||

*图9 IBM Bluemix Java 应用程序*

|

||||

|

||||

8. 完成初始配置后,单击 _I'm ready_ -> _Good to Go_ !

|

||||

8、 完成初始配置后,单击 I'm ready -> Good to Go !

|

||||

|

||||

9. 成功登录后,此时检查 IBM Bluemix 仪表板,特别是 Cloud Foundry Apps(其中2GB可用)和 Virtual Server(其中0个实例可用)的部分

|

||||

9、 成功登录后,此时检查 IBM Bluemix 仪表板,特别是 Cloud Foundry Apps(其中 2GB 可用)和 Virtual Server(其中 0 个实例可用)的部分

|

||||

|

||||

10. 点击 _Create app_,选择应用创建模板。在我们的例子中,我们将使用一个 Web 应用程序

|

||||

10、 点击 Create app,选择应用创建模板。在我们的例子中,我们将使用一个 Web 应用程序

|

||||

|

||||

11. 如何开始?单击 Liberty for Java ,然后查看其描述

|

||||

11、 如何开始?单击 Liberty for Java ,然后查看其描述

|

||||

|

||||

12. 单击 _Continue_

|

||||

12、 单击 Continue

|

||||

|

||||

13. 为新应用命名。对于本文,让我们使用 osfy-bluemix-tutorial 命名然后单击 _Finish_

|

||||

13、 为新应用命名。对于本文,让我们使用 osfy-bluemix-tutorial 命名然后单击 Finish

|

||||

|

||||

14. 在 Bluemix 上创建资源和托管应用程序需要等待一些时间。

|

||||

14、 在 Bluemix 上创建资源和托管应用程序需要等待一些时间

|

||||

|

||||

15. 几分钟后,应用程式就会开始运作。注意应用程序的URL。

|

||||

15、 几分钟后,应用程式就会开始运作。注意应用程序的URL

|

||||

|

||||

16. 访问应用程序的URL _http://osfy-bluemix-tutorial.au-syd.mybluemix.net/_, Bingo,我们的第一个在 IBM Bluemix 上的 Java 应用程序成功运行。

|

||||

16、 访问应用程序的URL http://osfy-bluemix-tutorial.au-syd.mybluemix.net/, 不错,我们的第一个在 IBM Bluemix 上的 Java 应用程序成功运行

|

||||

|

||||

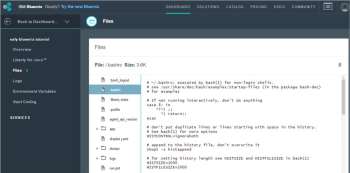

17. 为了检查源代码,请单击 _Files_ 并在门户中导航到不同文件和文件夹

|

||||

17、 为了检查源代码,请单击 Files 并在门户中导航到不同文件和文件夹

|

||||

|

||||

18. _Logs_ 部分提供包括从应用程序的创建时起的所有活动日志。

|

||||

18、 Logs 部分提供包括从应用程序的创建时起的所有活动日志。

|

||||

|

||||

19. _Environment Variables_ 部分提供关于 VCAP_Services 的所有环境变量以及用户定义的环境变量的详细信息

|

||||

19、 Environment Variables 部分提供关于 VCAP\_Services 的所有环境变量以及用户定义的环境变量的详细信息

|

||||

|

||||

20. 要检查应用程序的资源消耗,需要到 Liberty for Java 那一部分。

|

||||

20、 要检查应用程序的资源消耗,需要到 Liberty for Java 那一部分。

|

||||

|

||||

21. 默认情况下,每个应用程序的 _Overview_ 部分包含资源,应用程序的运行状况和活动日志的详细信息

|

||||

21、 默认情况下,每个应用程序的 Overview 部分包含资源,应用程序的运行状况和活动日志的详细信息

|

||||

|

||||

22. 打开 Eclipse,转到帮助菜单,然后单击 _Eclipse Marketplace_

|

||||

22、 打开 Eclipse,转到帮助菜单,然后单击 _Eclipse Marketplace_

|

||||

|

||||

23. 查找 _IBM Eclipse tools for Bluemix_ 并单击 _Install_

|

||||

23、 查找 IBM Eclipse tools for Bluemix 并单击 Install

|

||||

|

||||

24. 确认所选的功能并将其安装在 Eclipse 中

|

||||

24、 确认所选的功能并将其安装在 Eclipse 中

|

||||

|

||||

25. 下载应用程序启动器代码。点击 _File Menu_,将它导入到 Eclipse 中,选择 _Import Existing Projects_ -> _Workspace_, 然后开始修改代码

|

||||

25、 下载应用程序启动器代码。点击 File Menu,将它导入到 Eclipse 中,选择 Import Existing Projects -> Workspace, 然后开始修改代码

|

||||

|

||||

|

||||

|

||||

图10 Java 应用程序源文件

|

||||

*图10 Java 应用程序源文件*

|

||||

|

||||

|

||||

|

||||

图11 Java 应用程序日志

|

||||

*图11 Java 应用程序日志*

|

||||

|

||||

|

||||

|

||||

图12 Java 应用程序 - Liberty for Java

|

||||

*图12 Java 应用程序 - Liberty for Java*

|

||||

|

||||

### 为什么选择 IBM Bluemix?

|

||||

|

||||

**为什么选择 IBM Bluemix?**

|

||||

以下是使用 IBM Bluemix 的一些令人信服的理由:

|

||||

|

||||

* 支持多种语言和平台

|

||||

* 免费试用

|

||||

|

||||

1. 简化的注册过程

|

||||

|

||||

2. 不需要信用卡

|

||||

|

||||

3. 30 天试用期 - 配额 2GB 的运行时,支持 20 个服务,500 个 route

|

||||

|

||||

4. 无限制地访问标准支持

|

||||

|

||||

5. 没有生产使用限制

|

||||

|

||||

* 仅为每个使用的运行时和服务付费

|

||||

* 快速设置 - 从而加快上架时间

|

||||

* 持续交付新功能

|

||||

* 与本地资源的安全集成

|

||||

* 用例

|

||||

|

||||

1. Web 应用程序和移动后端

|

||||

|

||||

2. API 和内部集成

|

||||

|

||||

* DevOps 服务可部署在云上的 SaaS ,并支持持续交付:

|

||||

|

||||

1. Web IDE

|

||||

|

||||

2. SCM

|

||||

|

||||

3. 敏捷规划

|

||||

|

||||

4. 交货管道服务

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

@ -1,38 +1,39 @@

|

||||

使用 Exercism 提升你的编程技巧

|

||||

============================================================

|

||||

|

||||

### 这些练习目前已经支持 33 种编程语言了。

|

||||

> 这些练习目前已经支持 33 种编程语言了。

|

||||

|

||||

|

||||

|

||||

>图片提供: opensource.com

|

||||

|

||||

我们中的很多人有 2017 年的目标,将提高编程能力或学习如何编程放在第一位。虽然我们有许多资源可以访问,但练习独立于特定职业的代码开发的艺术还是需要一些规划。[Exercism.io][1] 就是为此目的而设计的一种资源。

|

||||

我们中的很多人的 2017 年目标,将提高编程能力或学习如何编程放在第一位。虽然我们有许多资源可以访问,但练习独立于特定职业的代码开发的艺术还是需要一些规划。[Exercism.io][1] 就是为此目的而设计的一种资源。

|

||||

|

||||

Exercism 是一个 [开源][2] 项目和服务,通过发现和协作,帮助人们提高他们的编程技能。Exercism 提供了几十种不同编程语言的练习。实践者完成每个练习,并获得反馈,从而可以从他们的同行小组的经验中学习。

|

||||

Exercism 是一个 [开源][2] 的项目和服务,通过发现和协作,帮助人们提高他们的编程技能。Exercism 提供了几十种不同编程语言的练习。实践者完成每个练习,并获得反馈,从而可以从他们的同行小组的经验中学习。

|

||||

|

||||

这里有这么多同行! Exercism 在 2016 年留下了一些令人印象深刻的统计:

|

||||

|

||||

* 有来自201个不同国家的参与者

|

||||

* 有来自 201 个不同国家的参与者

|

||||

* 自 2013 年 6 月以来,29,000 名参与者提交了练习,其中仅在 2016 年就有 15,500 名参加者提交练习

|

||||

* 自 2013 年 6 月以来,15,000 名参与者就练习解决方案提供反馈,其中 2016 年有 5,500 人提供反馈

|

||||

* 每月 50,000 名访客,每周超过 12,000 名访客

|

||||

* 目前练习支持 33 种编程语言,另外 22 种语言在筹备工作中

|

||||

* 目前的练习已经支持 33 种编程语言,另外 22 种语言在筹备工作中

|

||||

|

||||

该项目为所有级别的参与者提供了一系列小小的胜利,使他们能够“即使在低水平也能发展到高度流利”,Exercism 的创始人 [Katrina Owen][3] 这样说到。Exercism 并不旨在教导学员成为一名职业程序员,但它的练习使他们对一种语言及其瑕疵有深刻的了解。这种熟悉性消除了学习者对语言的认知负担(流利),使他们能够专注于更困难的架构和最佳实践(熟练)的问题。

|

||||

该项目为各种级别的参与者提供了一系列小小的挑战,使他们能够“即使在低水平也能发展到高度谙熟”,Exercism 的创始人 [Katrina Owen][3] 这样说到。Exercism 并不旨在教导学员成为一名职业程序员,但它的练习使他们对一种语言及其瑕疵有深刻的了解。这种熟悉性消除了学习者对语言的认知负担(使之更谙熟),使他们能够专注于更困难的架构和最佳实践的问题。

|

||||

|

||||

Exercism 通过一系列练习(还有什么?)来做到这一点。程序员下载[命令行客户端][4],检索第一个练习,添加完成练习的代码,然后提交解决方案。提交解决方案后,程序员可以研究他人的解决方案,并学习到对同一个问题不同的解决方式。更重要的是,每个解决方案都会收到来自其他参与者的反馈。

|

||||

Exercism 通过一系列练习(或者还有别的?)来做到这一点。程序员下载[命令行客户端][4],检索第一个练习,添加完成练习的代码,然后提交解决方案。提交解决方案后,程序员可以研究他人的解决方案,并学习到对同一个问题不同的解决方式。更重要的是,每个解决方案都会收到来自其他参与者的反馈。

|

||||

|

||||

反馈是 Exercism 的超级力量。鼓励所有参与者不仅接收反馈而且提供反馈。根据 Owen 说的,Exercism 的社区成员提供反馈比完成练习学到更多。她说:“这是一个强大的学习经验,你被迫发表内心感受,并检查你的假设、习惯和偏见”。她还指出,反馈可以有多种形式。

|

||||

反馈是 Exercism 的超级力量。鼓励所有参与者不仅接收反馈而且提供反馈。根据 Owen 说的,Exercism 的社区成员提供反馈比完成练习学到更多。她说:“这是一个强大的学习经验,你需要发表内心感受,并检查你的假设、习惯和偏见”。她还指出,反馈可以有多种形式。

|

||||

|

||||

欧文说:“只需进入,观察并问问题”。

|

||||

欧文说:“只需进入,观察并发问”。

|

||||

|

||||

那些刚刚接触编程,甚至只是一种特定语言的人,可以通过质疑假设来提供有价值的反馈,同时通过协作和对话来学习。

|

||||

那些刚刚接触编程,甚至只是接触了一种特定语言的人,可以通过预设好的问题来提供有价值的反馈,同时通过协作和对话来学习。

|

||||

|

||||

除了对新语言的 <ruby>“微课”学习<rt>bite-sized learning</rt></ruby> 之外,Exercism 本身还强烈支持和鼓励项目的新贡献者。在 [SitePoint.com][5] 的一篇文章中,欧文强调:“如果你想为开源贡献代码,你所需要的技能水平只要‘够用’即可。” Exercism 不仅鼓励新的贡献者,它还尽可能地帮助新贡献者发布他们项目中的第一个补丁。到目前为止,有近 1000 人是[ Exercism 项目][6]的贡献者。

|

||||

除了对新语言的 <ruby>“微课”学习<rt>bite-sized learning</rt></ruby> 之外,Exercism 本身还强烈支持和鼓励项目的新贡献者。在 [SitePoint.com][5] 的一篇文章中,欧文强调:“如果你想为开源贡献代码,你所需要的技能水平只要‘够用’即可。” Exercism 不仅鼓励新的贡献者,它还尽可能地帮助新贡献者发布他们项目中的第一个补丁。到目前为止,有近 1000 人成为 [Exercism 项目][6]的贡献者。

|

||||

|

||||

新贡献者会有大量工作让他们忙碌。 Exercism 目前正在审查[其语言轨道的健康状况][7],目的是使所有轨道可持续并避免维护者的倦怠。它还在寻求[捐赠][8]和赞助,聘请设计师提高网站的可用性。

|

||||

新贡献者会有大量工作让他们忙碌。 Exercism 目前正在审查[其语言发展轨迹的健康状况][7],目的是使所有发展轨迹可持续并避免维护者的倦怠。它还在寻求[捐赠][8]和赞助,聘请设计师提高网站的可用性。

|

||||

|

||||

Owen 说:“这些改进对于网站的健康以及为了 Exercism 参与者的发展是有必要的,这些变化还鼓励新贡献者加入并简化了加入的途径。” 她说:“如果我们可以重新设计,产品方面将更加可维护。。。当用户体验一团糟,华丽的代码一点用也没有”。该项目有一个非常活跃的[讨论仓库][9],这里社区成员合作来发现最好的新方法和功能。

|

||||

Owen 说:“这些改进对于网站的健康以及为了 Exercism 参与者的发展是有必要的,这些变化还鼓励新贡献者加入并简化了加入的途径。” 她说:“如果我们可以重新设计,产品方面将更加可维护……当用户体验一团糟时,华丽的代码一点用也没有”。该项目有一个非常活跃的[讨论仓库][9],这里社区成员合作来发现最好的新方法和功能。

|

||||

|

||||

那些想关注项目但还没有参与的人可以关注[邮件列表][10]。

|

||||

|

||||

@ -42,10 +43,12 @@ Owen 说:“这些改进对于网站的健康以及为了 Exercism 参与者

|

||||

|

||||

|

||||

|

||||

VM(Vicky)Brasseur - VM(也称为 Vicky)是技术人员、项目、流程、产品和 p^Hbusinesses 的经理。在她超过 18 年的科技行业从业中,她曾是分析师、程序员、产品经理、软件工程经理和软件工程总监。 目前,她是 Hewlett Packard Enterprise 上游开源开发团队的高级工程经理。 VM 的博客在 anonymoushash.vmbrasseur.com,tweets 在 @vmbrasseur。

|

||||

VM(Vicky)Brasseur - VM(也称为 Vicky)是技术人员、项目、流程、产品和 p\^Hbusinesses 的经理。在她超过 18 年的科技行业从业中,她曾是分析师、程序员、产品经理、软件工程经理和软件工程总监。 目前,她是 Hewlett Packard Enterprise 上游开源开发团队的高级工程经理。 VM 的博客在 anonymoushash.vmbrasseur.com,tweets 在 @vmbrasseur。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/17/1/exercism-learning-programming

|

||||

|

||||

作者:[VM (Vicky) Brasseur][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[jasminepeng](https://github.com/jasminepeng)

|

||||

@ -1,26 +1,24 @@

|

||||

|

||||

What engineers and marketers can learn from each other

|

||||

============================================================

|

||||

工程师和市场营销人员之间能够相互学习什么?

|

||||

============================================================

|

||||

|

||||

### 营销人员觉得工程师在工作中都太严谨了;而工程师则认为营销人员都很懒散。但是他们都错了。

|

||||

> 营销人员觉得工程师在工作中都太严谨了;而工程师则认为营销人员毫无用处。但是他们都错了。

|

||||

|

||||

|

||||

图片来源 :

|

||||

|

||||

opensource.com

|

||||

|

||||

图片来源:opensource.com

|

||||

|

||||

在 B2B 行业从事多年的销售实践过程中,我经常听到工程师对营销人员的各种误解。下面这些是比较常见的:

|

||||

|

||||

* ”搞市场营销真是浪费钱,还不如把更多的资金投入到实际的产品开发中来。“

|

||||

* ”那些营销人员只是一个劲儿往墙上贴各种广告,还祈祷着它们不要掉下来。这么做有啥科学依据啊?“

|

||||

* ”谁愿意去看哪些广告啊?“

|

||||

* ”对待一个营销人员最好的办法就是不订阅,不关注,也不理睬。“

|

||||

* “搞市场营销真是浪费钱,还不如把更多的资金投入到实际的产品开发中来。”

|

||||

* “那些营销人员只是一个劲儿往墙上贴各种广告,还祈祷着它们不要掉下来。这么做有啥科学依据啊?”

|

||||

* “谁愿意去看哪些广告啊?”

|

||||

* “对待一个营销人员最好的办法就是不听,不看,也不理睬。”

|

||||

|

||||

这是我最感兴趣的一点:

|

||||

_“营销人员都很懒散。”_

|

||||

|

||||

_“市场营销无足轻重。”_

|

||||

|

||||

最后一点说的不对,不够全面,懒散实际上是阻碍一个公司发展的巨大绊脚石。

|

||||

最后一点说的不对,而且不仅如此,它实际上是阻碍一个公司创新的巨大绊脚石。

|

||||

|

||||

我来跟大家解释一下原因吧。

|

||||

|

||||

@ -28,27 +26,27 @@ _“营销人员都很懒散。”_

|

||||

|

||||

这些工程师的的评论让我十分的苦恼,因为我从中看到了自己当年的身影。

|

||||

|

||||

你们知道吗?我曾经也跟你们一样是一位自豪的技术极客。我在 Rensselaer Polytechnic 学院的电气工程专业本科毕业后便在美国空军开始了我的职业生涯,而且美国空军在那段时间还发动了军事上的沙漠风暴行动。在那里我主要负责开发并部属一套智能的实时战况分析系统,用于根据各种各样的数据源来构建出战场上的画面。

|

||||

你们知道吗?我曾经也跟你们一样是一位自豪的技术极客。我在 Rensselaer Polytechnic 学院的电气工程专业本科毕业后便在美国空军担任军官开始了我的职业生涯,而且美国空军在那段时间还发动了沙漠风暴行动。在那里我主要负责开发并部属一套智能的实时战况分析系统,用于综合几个的数据源来构建出战场态势。

|

||||

|

||||

在我离开空军之后,我本打算去麻省理工学院攻读博士学位。但是上校强烈建议我去报读这个学校的商学院。“你真的想一辈子待实验室里吗?”他问我。“你想就这么去大学里当个教书匠吗? Jackie ,你在组织管理那些复杂的工作中比较有天赋。我觉得你非常有必要去了解下 MIT 的斯隆商学院。”

|

||||

在我离开空军之后,我本打算去麻省理工学院攻读博士学位。但是上校强烈建议我去报读这个学校的商学院。“你真的想一辈子待实验室里吗?”他问我。“你想就这么去大学里当个教书匠吗?Jackie ,你在组织管理那些复杂的工作中比较有天赋。我觉得你非常有必要去了解下 MIT 的斯隆商学院。”

|

||||

|

||||

我觉得自己也可以同时参加一些 MIT 技术方面的课程,因此我采纳了他的建议。但是,如果要参加市场营销管理方面的课程,我还有很长的路要走,这完全是在浪费时间。因此,在日常工作学习中,我始终是用自己所擅长的分析能力去解决一切问题。

|

||||

我觉得自己也可以同时参加一些 MIT 技术方面的课程,因此我采纳了他的建议。然而,如果要参加市场营销管理方面的课程,我还有很长的路要走,这完全是在浪费时间。因此,在日常工作学习中,我始终是用自己所擅长的分析能力去解决一切问题。

|

||||

|

||||

不久后,我在波士顿咨询集团公司做咨询顾问工作。在那六年的时间里,我经常听到大家对我的评论: Jackie ,你太没远见了。考虑问题也不够周全。你总是通过自己的分析数据去找答案。“

|

||||

不久后,我在波士顿咨询集团公司做咨询顾问工作。在那六年的时间里,我经常听到大家对我的评论: “Jackie ,你太没远见了。考虑问题也不够周全。你总是通过自己的分析去找答案。”

|

||||

|

||||

确实如此啊,我很赞同他们的想法——因为这个世界的工作方式本该如此,任何问题都要基于数据进行分析,不对吗?直到现在我才意识到(我多么希望自己早一些发现自己的问题)自己以前惯用的分析问题的方法遗漏了很多重要的东西:开放的心态,艺术修养,情感——人和创造性思维相关的因素。

|

||||

确实如此啊,我很赞同他们的想法——因为这个世界的工作方式本该如此,任何问题都要基于数据进行分析,不对吗?直到现在我才意识到(我多么希望自己早一些发现自己的问题)自己以前惯用的分析问题的方法遗漏了很多重要的东西:开放的心态、艺术修养、情感——人和创造性思维相关的因素。

|

||||

|

||||

我在 2001 年 9 月 11 日加入达美航空公司不久后,被调去管理消费者市场部门,之前我意识到的所有问题变得更加明显。这本来不是我的强项,但是在公司需要的情况下,我也愿意出手相肋。

|

||||

我在 2001 年 9 月 11 日加入达美航空公司不久后,被调去管理消费者市场部门,之前我意识到的所有问题变得更加明显。市场方面本来不是我的强项,但是在公司需要的情况下,我也愿意出手相肋。

|

||||

|

||||

但是突然之间,我一直惯用的方法获取到的常规数据分析结果却与实际情况完全相反。这个问题导致上千人(包括航线内外的人)受到影响。我忽略了一个很重要的人本身的情感因素。我所面临的问题需要各种各样的解决方案才能处理,而不是简单的从那些死板的分析数据中就能得到答案。

|

||||

但是突然之间,我一直惯用的方法获取到的分析结果却与实际情况完全相反。这个问题导致上千人(包括航线内外的人)受到影响。我忽略了一个很重要的人本身的情感因素。我所面临的问题需要各种各样的解决方案才能处理,而不是简单的从那些死板的数据中就能得到答案。

|

||||

|

||||

那段时间,我快速地学到了很多东西,因为如果我们想把达美航空公司恢复到正常状态,还需要做很多的工作——市场营销更像是一个以解决问题为导向,以用户为中心的充满挑战性的大工程,只是销售人员和工程师这两大阵营都没有迅速地意识到这个问题。

|

||||

那段时间,我快速地学到了很多东西,因为如果我们想把达美航空公司恢复到正常状态,还需要做很多的工作——市场营销更像是一个以解决问题为导向、以用户为中心的充满挑战性的大工程,只是销售人员和工程师这两大阵营都没有迅速地意识到这个问题。

|

||||

|

||||

### 两大文化差异

|

||||

|

||||

工程管理和市场营销之间的这个“巨大鸿沟”确实是根深蒂固的,这跟 C.P. Snow (英语物理化学家和小说家)提出的[“两大文化差异"问题][1]很相似。具有科学素质的工程师和具有艺术细胞的营销人员操着不同的语言,不同的文化观念导致他们不同的价值取向。

|

||||

工程管理和市场营销之间的这个“巨大鸿沟”确实是根深蒂固的,这跟(著名的科学家、小说家) C.P. Snow 提出的[“两大文化差异”问题][1]很相似。具有科学素质的工程师和具有艺术细胞的营销人员操着不同的语言,不同的文化观念导致他们不同的价值取向。

|

||||

|

||||

但是,事实上他们比想象中有更多的相似之处。华盛顿大学[最新研究][2](由微软、谷歌和美国国家科学基金会共同赞助)发现”一个伟大软件工程师必须具备哪些优秀的素质,“毫无疑问,一个伟大的销售人员同样也应该具备这些素质。例如,专家们给出的一些优秀品质如下:

|

||||

但是,事实上他们比想象中有更多的相似之处。一个由微软、谷歌和美国国家科学基金会共同赞助的华盛顿大学的[最新研究][2]发现了“一个伟大软件工程师必须具备哪些优秀的素质”,毫无疑问,一个伟大的销售人员同样也应该具备这些素质。例如,专家们给出的一些优秀品质如下:

|

||||

|

||||

* 充满激情

|

||||

* 性格开朗

|

||||

@ -56,29 +54,29 @@ _“营销人员都很懒散。”_

|

||||

* 技艺精湛

|

||||

* 解决复杂难题的能力

|

||||

|

||||

这些只是其中很小的一部分!当然,并不是所有的素质都适用于市场营销人员,但是如果用文氏图来表示这“两大文化“的交集,就很容易看出营销人员和工程师之间的关系要远比我们想象中密切得多。他们都是竭力去解决与用户或客户相关的难题,只是他们所采取的方式和角度不一致罢了。

|

||||

这些只是其中很小的一部分!当然,并不是所有的素质都适用于市场营销人员,但是如果用文氏图来表示这“两大文化”的交集,就很容易看出营销人员和工程师之间的关系要远比我们想象中密切得多。他们都是竭力去解决与用户或客户相关的难题,只是他们所采取的方式和角度不一致罢了。

|

||||

|

||||

看到上面的那几点后,我深深的陷入思考:_要是这两类员工彼此之间再多了解对方一些会怎样呢?这会给公司带来很强大的动力吧?_

|

||||

|

||||

确实如此。我在红帽公司就亲眼看到过样的情形,我身边都是一些“思想极端”的员工,要是之前,肯定早被我炒鱿鱼了。我相信公司里绝对发生过很多次类似这样的事情,一个销售人员看完工程师递交上来的分析报表后,心想,“这些书呆子,思想太局限了。真是一叶障目,不见泰山;两豆塞耳,不闻雷霆。”

|

||||

确实如此。我在红帽公司就亲眼看到过样的情形,我身边都是一些早些年肯定被我当成“想法疯狂”而无视的人。而且我猜销售人员看到工程师后(同时或某一次),心想,“这些数据呆瓜,真是只见树木不见森林。”

|

||||

|

||||

现在我才明白了公司里有这两种人才的重要性。在现实工作当中,工程师和营销人员都是围绕着客户、创新及数据分析来完成工作。如果他们能够懂得相互尊重、彼此理解、相辅相成,那么我们将会看到公司里所产生的那种积极强大的动力,这种超乎寻常的革新力量要远比两个独立的团队强大得多。

|

||||

|

||||

### 听一听他们的想法

|

||||

### 听一听疯子(和呆瓜)的想法

|

||||

|

||||

成功案例:_建立开放式组织_

|

||||

成功案例:《开放式组织》

|

||||

|

||||

在红帽任职期间,我的主要工作就是想办法提升公司的品牌影响力——但是我从未想过让公司的 CEO 去写一本书。我把公司多个部门的“想法极端”的同事召集在一起,希望他们帮我设计出一个新颖的解决方案来提升公司的影响力,结果他们提出让公司的 CEO 写书这样一个想法。

|

||||

在红帽任职期间,我的主要工作就是想办法提升公司的品牌影响力——但是就是给我一百万年我也不会想到让公司的 CEO 去写一本书。我把公司多个部门的“想法疯狂”的同事召集在一起,希望他们帮我设计出一个新颖的解决方案来提升公司的影响力,结果他们提出让公司的 CEO 写书这样一个想法。

|

||||

|

||||

当我听到这个想法的时候,我很快意识到应该把红帽公司一些经典的管理模式写入到这本书里:它将对整个开源社区的创业者带来很重要的参考价值,同时也有助于宣扬开源精神。通过优先考虑这两方面的作用,我们提升了红帽在整个开源软件世界中的品牌价值,红帽是一个可靠的随时准备着为客户在[数字化颠覆][3]年代指明方向的公司。

|

||||

当我听到这个想法的时候,我很快意识到这正是典型的红帽方式:它将对整个开源社区的从业者带来很重要的参考价值,同时也有助于宣扬开源精神。通过优先考虑这两方面的作用,我们提升了红帽在整个开源软件世界中的品牌价值——红帽是一个可靠的随时准备着为客户在[数字化颠覆][3]年代指明方向的公司。

|

||||

|

||||

这一点才是主要的:确切的说是指导红帽工程师解决代码问题的共同精神力量。 Red Hatters 小组一直在催着我赶紧把开放式组织的模式在全公司推广起来,以显示出内外部程序员共同推动整个开源社区发展的强大动力之一:那就是强烈的共享欲望。

|

||||

这一点才是主要的:确切的说是指导红帽工程师解决代码问题的共同精神力量。 Red Hatters 小组敦促我出版《开放式组织》,这显示出来自内部和外部社区的程序员共同推动整个开源社区发展的强大动力之一:那就是强烈的共享欲望。

|

||||

|

||||

最后,要把开放式组织的管理模式完全推广起来,还需要大家的共同能力,包括工程师们强大的数据分析能力和营销人员美好的艺术素养。这个项目让我更加坚定自己的想法,工程师和营销人员有更多的相似之处。

|

||||

最后,要把《开放式组织》这本书完成,还需要大家的共同能力,包括工程师们强大的数据分析能力和营销人员美好的艺术素养。这个项目让我更加坚定自己的想法,工程师和营销人员有更多的相似之处。

|

||||

|

||||

但是,有些东西我还得强调下:开放模式的实现,要求公司上下没有任何偏见,不能偏袒工程师和市场营销人员任何一方文化。一个更加理想的开放式环境能够促使员工之间和平共处,并在这个组织规定的范围内点燃大家的热情。

|

||||

|

||||

所以,这绝对不是我听到大家所说的懒散之意。

|

||||

这对我来说如春风拂面。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -94,7 +92,7 @@ via: https://opensource.com/open-organization/17/1/engineers-marketers-can-learn

|

||||

|

||||

作者:[Jackie Yeaney][a]

|

||||

译者:[rusking](https://github.com/rusking)

|

||||

校对:[Bestony](https://github.com/Bestony)

|

||||

校对:[Bestony](https://github.com/Bestony), [wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,20 +1,17 @@

|

||||

使用AWS的GO SDK获取区域与终端节点信息

|

||||

使用 AWS 的 GO SDK 获取区域与终端节点信息

|

||||

============================================================

|

||||

|

||||

<section itemprop="articleBody" style="font-family: HelveticaNeue, Helvetica, Helvetica, Arial, sans-serif;">

|

||||

LCTT 译注: 终端节点(Endpoint),详情请见: [http://docs.amazonaws.cn/general/latest/gr/rande.html](http://docs.amazonaws.cn/general/latest/gr/rande.html)

|

||||

|

||||

译注: Endpoint(终端节点)[详情请见: http://docs.amazonaws.cn/general/latest/gr/rande.html](http://docs.amazonaws.cn/general/latest/gr/rande.html)

|

||||

最新发布的 GO 的 SDK [v1.6.0][1] 版本,加入了获取区域与终端节点信息的功能。它可以很方便地列出区域、服务和终端节点的相关信息。可以通过 [github.com/aws/aws-sdk-go/aws/endpoints][3] 包使用这些功能。

|

||||

|

||||

最新发布的GO的SDK[v1.6.0][1]版本, 加入了获取区域与终端节点信息的功能. 它可以很方便地列出区域, 服务 和终端节点的相关信息.可以通过[github.com/aws/aws-sdk-go/aws/endpoints][3]包使用这些功能.

|

||||

|

||||

endpoints包提供了一个易用的接口,可以获取到一个服务的终端节点的url列表和区域列表信息.并且我们将相关信息根据AWS服务区域进行了分组,如 AWS 标准, AWS 中国, and AWS GovCloud (美国).

|

||||

endpoints 包提供了一个易用的接口,可以获取到一个服务的终端节点的 url 列表和区域列表信息。并且我们将相关信息根据 AWS 服务区域进行了分组,如 AWS 标准、AWS 中国和 AWS GovCloud(美国)。

|

||||

|

||||

### 解析终端节点

|

||||

|

||||

设置SDK的默认配置时, SDK会自动地使用endpoints.DefaultResolver函数. 你也可以自己调用包中的EndpointFor方法来解析终端节点.

|

||||

设置 SDK 的默认配置时, SDK 会自动地使用 `endpoints.DefaultResolver` 函数。你也可以自己调用包中的`EndpointFor` 方法来解析终端节点。

|

||||

|

||||

Go

|

||||

```

|

||||

```Go

|

||||

// 解析在us-west-2区域的S3服务的终端节点

|

||||

resolver := endpoints.DefaultResolver()

|

||||

endpoint, err := resolver.EndpointFor(endpoints.S3ServiceID, endpoints.UsWest2RegionID)

|

||||

@ -26,12 +23,12 @@ if err != nil {

|

||||

fmt.Println("Resolved URL:", endpoint.URL)

|

||||

```

|

||||

|

||||

如果你需要自定义终端节点的解析逻辑,你可以实现endpoints.Resolver接口, 并传值给aws.Config.EndpointResolver. 当你打算编写自定义的终端节点逻辑,让sdk可以用来解析服务的终端节点时候,这个功能就会很有用.

|

||||

如果你需要自定义终端节点的解析逻辑,你可以实现 `endpoints.Resolver` 接口,并传值给`aws.Config.EndpointResolver`。当你打算编写自定义的终端节点逻辑,让 SDK 可以用来解析服务的终端节点时候,这个功能就会很有用。

|

||||

|

||||

以下示例, 创建了一个配置好的Session, 然后[Amazon S3][4]服务的客服端就可以使用这个自定义的终端节点.

|

||||

以下示例,创建了一个配置好的 Session,然后 [Amazon S3][4] 服务的客户端就可以使用这个自定义的终端节点。

|

||||

|

||||

Go

|

||||

```

|

||||

|

||||

```Go

|

||||

s3CustResolverFn := func(service, region string, optFns ...func(*endpoints.Options)) (endpoints.ResolvedEndpoint, error) {

|

||||

if service == "s3" {

|

||||

return endpoints.ResolvedEndpoint{

|

||||

@ -52,10 +49,9 @@ sess := session.Must(session.NewSessionWithOptions(session.Options{

|

||||

|

||||

### 分区

|

||||

|

||||

endpoints.DefaultResolver函数的返回值可以被endpoints.EnumPartitions接口使用.这样就可以获取SDK使用的分区片段,也可以列出每个分区的分区信息。

|

||||

`endpoints.DefaultResolver` 函数的返回值可以被 `endpoints.EnumPartitions`接口使用。这样就可以获取 SDK 使用的分区片段,也可以列出每个分区的分区信息。

|

||||

|

||||

Go

|

||||

```

|

||||

```Go

|

||||

// 迭代所有分区表打印每个分区的ID

|

||||

resolver := endpoints.DefaultResolver()

|

||||

partitions := resolver.(endpoints.EnumPartitions).Partitions()

|

||||

@ -65,10 +61,9 @@ for _, p := range partitions {

|

||||

}

|

||||

```

|

||||

|

||||

除了分区表之外, endpoints包也提供了每个分区组的getter函数. 这些工具函数可以方便列出指定分区,而不用执行默认解析器列出所有的分区.

|

||||

除了分区表之外,endpoints 包也提供了每个分区组的 getter 函数。这些工具函数可以方便列出指定分区,而不用执行默认解析器列出所有的分区。

|

||||

|

||||

Go

|

||||

```

|

||||

```Go

|

||||

partition := endpoints.AwsPartition()

|

||||

region := partition.Regions()[endpoints.UsWest2RegionID]

|

||||

|

||||

@ -78,19 +73,18 @@ for id, _ := range region.Services() {

|

||||

}

|

||||

```

|

||||

|

||||

当你获取区域和服务值后, 可以调用ResolveEndpoint. 这样解析端点时,就可以提供分区的过滤视图.

|

||||

当你获取区域和服务值后,可以调用 `ResolveEndpoint`。这样解析端点时,就可以提供分区的过滤视图。

|

||||

|

||||

获取更多AWS SDK for GO信息, 请关注[开源库][5]. 若你有更好的看法,请留言评论.

|

||||

获取更多 AWS SDK for GO 信息, 请关注[其开源仓库][5]。若你有更好的看法,请留言评论。

|

||||

|

||||

</section>

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://aws.amazon.com/cn/blogs/developer/using-the-aws-sdk-for-gos-regions-and-endpoints-metadata

|

||||

|

||||

作者:[ Jason Del Ponte][a]

|

||||

作者:[Jason Del Ponte][a]

|

||||

译者:[Vic020](http://vicyu.com)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,24 +1,17 @@

|

||||

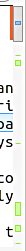

Linux 系统可视化的比较与合并工具 Meld 的新手使用教程

|

||||

Linux 系统上的可视化比较与合并工具 Meld

|

||||

============================================================

|

||||

|

||||

### 本页内容

|

||||

|

||||

1. [关于 Meld][1]

|

||||

2. [安装 Meld][2]

|

||||

3. [使用 Meld][3]

|

||||

4. [总结][4]

|

||||

|

||||

我们已经[讲过][5] Linux 中[一些][6]基于命令行的比较和合并工具,再来讲解该系统的一些可视化的比较与合并工具也很合理。首要的原因是,不是每个人都习惯使用命令行,而且对于某些人来说,基于命令行的比较工具可能很难学习和理解。

|

||||

我们已经[讲过][5] Linux 中[一些][6]基于命令行的比较和合并工具,再来讲解该系统的一些可视化的比较与合并工具也很合理。首要的原因是,不是每个人都习惯使用命令行,而且对于某些人来说,基于命令行的比较工具可能很难学习和理解。

|

||||

|

||||

因此,我们将会推出关于可视化工具 **Meld** 的系列文章。

|

||||

|

||||

在跳到安装和介绍部分前,分享这篇教程所有指令和用例是很有用的,而且它们已经在 Ubuntu 14.04 中测试过了,我们使用的 Meld 版本是 3.14.2。

|

||||

在跳到安装和介绍部分前,我需要说明这篇教程里所有的指令和用例是都是可用的,而且它们已经在 Ubuntu 14.04 中测试过了,我们使用的 Meld 版本是 3.14.2。

|

||||

|

||||

### 关于 Meld

|

||||

|

||||

[Meld][7] 主要是一个可视化的比较和合并的工具,目标人群是开发者(当然,我们将要讲到的其它部分也会考虑到终端用户)。这个工具同时支持双向和三向的比较,不仅仅是比较文件,还可以比较目录,以及版本控制的项目。

|

||||

[Meld][7] 主要是一个可视化的比较和合并的工具,目标人群是开发者(当然,我们将要讲到的其它部分也会考虑到最终用户)。这个工具同时支持双向和三向的比较,不仅仅是比较文件,还可以比较目录,以及版本控制的项目。

|

||||

|

||||

“Meld 帮你回顾代码改动,理解补丁,”官网如是说。“它甚至可以告知你如果你不进行合并将会发生什么事情。”该工具使用 GPL v2 协议进行授权。

|

||||

“Meld 可以帮你回顾代码改动,理解补丁,”其官网如是说。“它甚至可以告知你如果你不进行合并将会发生什么事情。”该工具使用 GPL v2 协议进行授权。

|

||||

|

||||

### 安装 Meld

|

||||

|

||||

@ -28,11 +21,13 @@ Linux 系统可视化的比较与合并工具 Meld 的新手使用教程

|

||||

sudo apt-get install meld

|

||||

```

|

||||

|

||||

或者你也可以用系统自带的包管理软件下载这个工具。比如在 Ubuntu 上,你可以用 Ubuntu 软件中心(Ubuntu Software Center),或者用 [Ubuntu Software][8],Ubuntu Software 从 Ubuntu 16.04 版本开始取代了软件中心。

|

||||

或者你也可以用系统自带的包管理软件下载这个工具。比如在 Ubuntu 上,你可以用 Ubuntu 软件中心(Ubuntu Software Center),或者用 [Ubuntu 软件][8],它从 Ubuntu 16.04 版本开始取代了 Ubuntu 软件中心。

|

||||

|

||||

当然,Ubuntu 官方仓库里的 Meld 版本很有可能比较陈旧。因此如果你想要用更新的版本,你可以在[这里][9]下载软件包。如果你要用这个方法,你要做的就是解压下载好的软件包,然后运行 “bin” 目录下的 “meld” 程序。

|

||||

当然,Ubuntu 官方仓库里的 Meld 版本很有可能比较陈旧。因此如果你想要用更新的版本,你可以在[这里][9]下载软件包。如果你要用这个方法,你要做的就是解压下载好的软件包,然后运行 `bin` 目录下的 `meld` 程序。

|

||||

|

||||

~/Downloads/meld-3.14.2/bin$ **./meld**

|

||||

```

|

||||

~/Downloads/meld-3.14.2/bin$ ./meld

|

||||

```

|

||||

|

||||

以下是 Meld 依赖的软件,仅供参考:

|

||||

|

||||

@ -67,9 +62,9 @@ sudo apt-get install meld

|

||||

|

||||

][12]

|

||||

|

||||

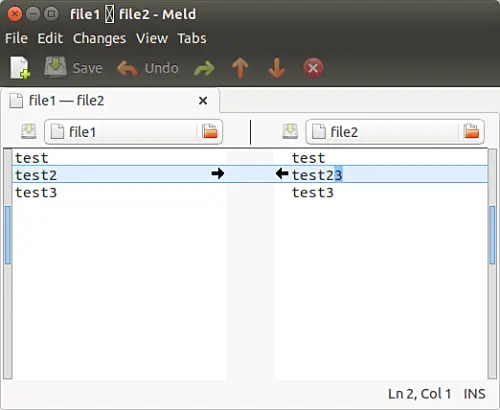

两个文件的不同之处在第二行,差别在于 “file2” 文件的第二行多了一个 “3”。你看到的黑色箭头是用来进行合并或修改的操作的。该例中,向右的箭头将会把 “file2” 文件的第二行改成文件 “file1” 中对应行的内容。左向箭头做的事情相反。

|

||||

两个文件的不同之处在第二行,差别在于 `file2` 文件的第二行多了一个 `3`。你看到的黑色箭头是用来进行合并或修改的操作的。该例中,向右的箭头将会把 `file2` 文件的第二行改成文件 `file1` 中对应行的内容。左向箭头做的事情相反。

|

||||

|

||||

做完修改后,按下 Ctrl+s 来保存。

|

||||

做完修改后,按下 `Ctrl+s` 来保存。

|

||||

|

||||

这个简单的例子,让你知道 Meld 的基本用法。让我们看一看稍微复杂一点的比较:

|

||||

|

||||

@ -77,13 +72,13 @@ sudo apt-get install meld

|

||||

|

||||

][13]

|

||||

|

||||

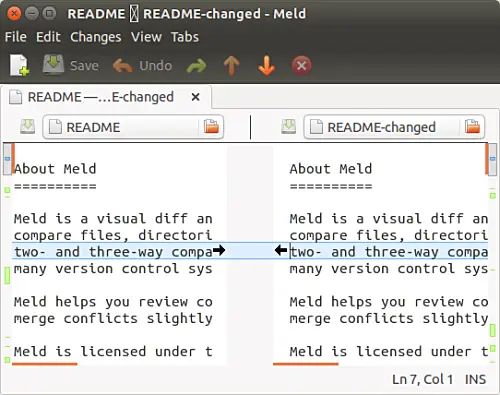

在讨论这些变化前,这里提一下, Meld GUI 中有几个区域,可以给出文件之间的差异,让概况变得直观。这里特别需要注意窗口的左右两边垂直的栏。比如下面这个截图:

|

||||

在讨论这些变化前,这里提一下, Meld 的界面中有几个区域,可以给出文件之间的差异,让概况变得直观。这里特别需要注意窗口的左右两边垂直的栏。比如下面这个截图:

|

||||

|

||||

[

|

||||

|

||||

][14]

|

||||

|

||||

仔细观察,图中的这个栏包含几个不同颜色的区块。这些区块是用来让你对文件之间的差异有个大概的了解。“每一个上色的区块表示一个部分,这个部分可能是插入、删除、修改或者有差别的,取决于区块所用的颜色。”官方文档是这样说的。

|

||||

仔细观察,图中的这个栏包含几个不同颜色的区块。这些区块是用来让你对文件之间的差异有个大概的了解。“每一个着色的区块表示一个部分,这个部分可能是插入、删除、修改或者有差别的,取决于区块所用的颜色。”官方文档是这样说的。

|

||||

|

||||

现在,让我们回到我们之前讨论的例子中。接下来的截图展示了用 Meld 理解文件的改动是很简单的(以及合并这些改动):

|

||||

|

||||

@ -105,19 +100,19 @@ sudo apt-get install meld

|

||||

|

||||

][18]

|

||||

|

||||

这些是你使用 Meld 时做的一般性的事情:可以用标准的 “Ctrl+f” 组合键在编辑区域内进行查找,按 “F11” 键让软件进入全屏模式,再按 “Ctrl+f” 来刷新(通常在所有要比较的文件改变的时候使用)。

|

||||

这些是你使用 Meld 时做的一般性的事情:可以用标准的 `Ctrl+f` 组合键在编辑区域内进行查找,按 `F11` 键让软件进入全屏模式,再按 `Ctrl+r` 来刷新(通常在所有要比较的文件改变的时候使用)。

|

||||

|

||||

以下是 Meld 官方网站宣传的重要特性:

|

||||

|

||||

* 文件和目录的双向及三向比较

|

||||

* 输入即更新文件的比较

|

||||

* 自动合并模式,改动区块的动作让合并更加简单

|

||||

* 自动合并模式,按块改动的动作让合并更加简单

|

||||

* 可视化让比较文件更简单

|

||||

* 支持 Git,Bazaar,Mercurial,Subversion 等等

|

||||

|

||||

注意还不仅仅只有以上所列的。网站上有个专门的[特性页面][19],里面提到了 Meld 提供的所有特性。这个页面列出的所有特性分为几个部分,以该软件是用来做文件比较,目录比较,版本控制还是处于合并模式下为基础进行划分。

|

||||

注意还不仅仅只有以上所列的。网站上有个专门的[特性页面][19],里面提到了 Meld 提供的所有特性。这个页面列出的所有特性分为几个部分,以该软件是用来做文件比较、目录比较、版本控制还是处于合并模式下为基础进行划分。

|

||||

|

||||

和其它软件相似,有些事情 Meld 做不到。官方网站上列出了其中的一部分:“当 Meld 展示文件之间的差异时,它同时显示两个文件,看起来就像在普通的文本编辑器中。它不会添加额外的行,让左右两边文件的特殊改动是同样的行数。没有做这个事情的选项。”

|

||||

和其它软件相似,有些事情 Meld 做不到。官方网站上列出了其中的一部分:“当 Meld 展示文件之间的差异时,它同时显示两个文件,看起来就像在普通的文本编辑器中。它不会添加额外的行,让左右两边文件的特殊改动处于同样的行数。没有做这个事情的选项。”

|

||||

|

||||

### 总结

|

||||

|

||||

@ -129,7 +124,7 @@ via: https://www.howtoforge.com/tutorial/beginners-guide-to-visual-merge-tool-me

|

||||

|

||||

作者:[Ansh][a]

|

||||

译者:[GitFuture](https://github.com/GitFuture)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,24 +1,25 @@

|

||||

印度社区如何支持隐私和软件自由

|

||||

印度的社区如何支持隐私和软件自由

|

||||

============================================================

|

||||

|

||||

|

||||

|

||||

图片提供: opensource.com

|

||||

|

||||

印度的自由和开源社区,特别是 Mozilla 和 Wikimedia 社区,它们正在引领两个独特的全球性活动,以提高隐私及支持自由软件。

|

||||

印度的自由和开源社区,特别是 Mozilla 和 Wikimedia 社区,它们正在引领两个独特的全球性活动,以提高隐私保护及支持自由软件。

|

||||

|

||||

[1 月份的隐私月][3]是由印度 Mozilla 社区领导,通过在线和线下活动向群众教育网络隐私。而[ 2 月份的自由月][4]是由[互联网与社会中心][5]领导,教育内容创作者如博主和摄影师就如何在[开放许可证][6]下捐赠内容。

|

||||

|

||||

### 1 月隐私月

|

||||

|

||||

从[去年开始][7]的 Mozilla “1 月隐私月”用来帮助庆祝年度[数据隐私日][8]。在 2016 年,该活动举办了几场涉及[全球 10 个国家 14,339,443 人][9]的线下和线上活动。其中一个核心组织者,[Ankit Gadgil][10]这样说到:“每天分享一个隐私提示,持续一个月 31 天是有可能的。今年,我们共有三个重点领域,首先是我们让这个运动更加开放和全球化。巴西、意大利、捷克共和国的 Mozilla 社区今年正在积极参与,所有的必要文件都是本地化的,所以我们可以针对更多的用户。其次,我们在线下活动中教导用户营销 Firefox 以及 Mozilla 的其他产品,以便用户可以亲身体验使用这些工具来帮助保护他们的隐私。第三点,我们鼓励大家参加线下活动并记录他们的学习,例如,最近在印度古吉拉特邦的一个节目中,他们使用 Mozilla 产品来教授隐私。”

|

||||

从[去年开始][7]的 Mozilla “1 月隐私月”用来帮助庆祝年度[数据隐私日(Data Privacy Day)][8]。在 2016 年,该活动举办了几场涉及到[全球 10 个国家 14,339,443 人][9]的线下和线上活动。其中一个核心组织者,[Ankit Gadgil][10] 这样说到:“每天分享一个隐私提示,持续一个月就能分享 31 天。”今年,我们共有三个重点领域,首先是我们让这个运动更加开放和全球化。巴西、意大利、捷克共和国的 Mozilla 社区今年正在积极参与,所有必要的文档都是本地化的,所以我们可以针对更多的用户。其次,我们在线下活动中教导用户推广 Firefox 以及 Mozilla 的其他产品,以便用户可以亲身体验使用这些工具来帮助保护他们的隐私。第三点,我们鼓励大家参加线下活动并把他们的学习写到博客里面去,例如,最近在印度古吉拉特邦的一个节目中,他们使用 Mozilla 产品来教授隐私方面的知识。”

|

||||

|

||||

今年的活动继续有线下和线上活动。关注 #PrivacyAware 参加。

|

||||

|

||||

### 安全提示

|

||||

#### 安全提示

|

||||

|

||||

像 Firefox 这样的 Mozilla 产品具有安全性设置-同时还有[内建][11]还有附加的对残疾人完全[可用][12]的库-这有助于保护用户的隐私和安全性,这些都是协同构建的并且是开源的。

|

||||

像 Firefox 这样的 Mozilla 产品具有安全性设置-有[内置的][11]还有对残疾人完全[可用][12]的附件库-这有助于保护用户的隐私和安全性,这些都是协同构建的并且是开源的。

|

||||

|

||||

[Chrome][14] 和[ Opera][15] 中的 [HTTPS Everywhere][13] 可用于加密用户通信,使外部网站无法查看用户信息。该项目由 [Tor Project][16]以及[电子前沿基金会][17]合作建成。

|

||||

[Chrome][14] 和[ Opera][15] 中的 [HTTPS Everywhere][13] 插件可用于加密用户通信,使外部网站无法查看用户信息。该项目由 [Tor Project][16] 以及[电子前沿基金会][17]合作建成。

|

||||

|

||||

### 2 月自由月

|

||||

|

||||

@ -27,15 +28,15 @@

|

||||

** 参加规则:**

|

||||

|

||||

* 你在二月份制作或出版的作品必须获得[自由许可证][1]许可。

|

||||

* 内容类型包括博客帖子、其他文字和图像。

|

||||

* 内容类型包括博客文章、其他文字和图像。

|

||||

|

||||

多媒体,基于文本的内容,艺术和设计等创意作品可以通过多个[知识共享许可证][20](CC)进行许可,其他类型的文档可以根据[ GNU 免费文档许可][21](GFDL)许可。Wikipedia 上可以找到很好的例子,其内容根据 CC 和 GFDL 许可证获得许可,允许人们使用、分享、混合和分发衍生用于商业上和非商业性的作品。此外,还有允许开发人员共享他们的软件和软件相关文档的[自由软件许可证][22]。

|

||||

多媒体,基于文本的内容,艺术和设计等创意作品可以通过多个[知识共享许可证][20](CC)进行许可,其他类型的文档可以根据 [GNU 免费文档许可][21](GFDL)许可。Wikipedia 上可以找到很好的例子,其内容根据 CC 和 GFDL 许可证获得许可,允许人们使用、分享、混合和分发衍生用于商业上和非商业性的作品。此外,还有允许开发人员共享他们的软件和软件相关文档的[自由软件许可证][22]。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

作者简介:

|

||||

|

||||

Subhashish Panigrahi - Subhashish Panigrahi(@shhapa)是 Mozilla 参与团队的亚洲社区催化师,并从 Wikimedia 基金会印度计划的早期扮演了互联网及社会知识获取中心项目官的角色,另外他是一名印度教育者,

|

||||

Subhashish Panigrahi(@shhapa)是 Mozilla 参与团队的亚洲社区催化师,并在 Wikimedia 基金会印度计划的早期扮演了互联网及社会知识获取中心项目官的角色,另外他是一名印度教育工作者,

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -43,7 +44,7 @@ via: https://opensource.com/article/17/1/how-communities-india-support-privacy-s

|

||||

|

||||

作者:[Subhashish Panigrahi][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,38 +1,30 @@

|

||||

### 在Linux上使用Nginx和Gunicorn托管Django

|

||||

在 Linux 上使用 Nginx 和 Gunicorn 托管 Django 应用

|

||||

==========

|

||||

|

||||

|

||||

|

||||

内容

|

||||

|

||||

* * [1. 介绍][4]

|

||||

* [2. Gunicorn][5]

|

||||

* [2.1. 安装][1]

|

||||

* [2.2. 配置][2]

|

||||

* [2.3. 运行][3]

|

||||

* [3. Nginx][6]

|

||||

* [4. 结语][7]

|

||||

|

||||

### 介绍

|

||||

|

||||

托管Django Web应用程序相当简单,虽然它比标准的PHP应用程序更复杂一些。 处理带Web服务器的Django接口的方法有很多。 Gunicorn就是其中最简单的一个。

|

||||

托管 Django Web 应用程序相当简单,虽然它比标准的 PHP 应用程序更复杂一些。 让 Web 服务器对接 Django 的方法有很多。 Gunicorn 就是其中最简单的一个。

|

||||

|

||||

Gunicorn(Green Unicorn的缩写)在你的Web服务器Django之间作为中间服务器使用,在这里,Web服务器就是Nginx。 Gunicorn服务于应用程序,而Nginx处理静态内容。

|

||||

Gunicorn(Green Unicorn 的缩写)在你的 Web 服务器 Django 之间作为中间服务器使用,在这里,Web 服务器就是 Nginx。 Gunicorn 服务于应用程序,而 Nginx 处理静态内容。

|

||||

|

||||

### Gunicorn

|

||||

|

||||

### 安装

|

||||

#### 安装

|

||||

|

||||

使用Pip安装Gunicorn是超级简单的。 如果你已经使用virtualenv搭建好了你的Django项目,那么你就有了Pip,并且应该熟悉Pip的工作方式。 所以,在你的virtualenv中安装Gunicorn。

|

||||

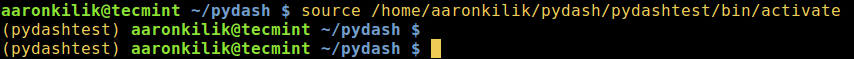

使用 Pip 安装 Gunicorn 是超级简单的。 如果你已经使用 virtualenv 搭建好了你的 Django 项目,那么你就有了 Pip,并且应该熟悉 Pip 的工作方式。 所以,在你的 virtualenv 中安装 Gunicorn。

|

||||

|

||||

```

|

||||

$ pip install gunicorn

|

||||

```

|

||||

|

||||

### 配置

|

||||

#### 配置

|

||||

|

||||

Gunicorn 最有吸引力的一个地方就是它的配置非常简单。处理配置最好的方法就是在Django项目的根目录下创建一个名叫Gunicorn的文件夹。然后 在该文件夹内,创建一个配置文件。

|

||||

Gunicorn 最有吸引力的一个地方就是它的配置非常简单。处理配置最好的方法就是在 Django 项目的根目录下创建一个名叫 `Gunicorn` 的文件夹。然后在该文件夹内,创建一个配置文件。

|

||||

|

||||

在本篇教程中,配置文件名称是`gunicorn-conf.py`。在改文件中,创建类似于下面的配置

|

||||

在本篇教程中,配置文件名称是 `gunicorn-conf.py`。在该文件中,创建类似于下面的配置:

|

||||

|

||||

```

|

||||

import multiprocessing

|

||||

@ -42,25 +34,27 @@ workers = multiprocessing.cpu_count() * 2 + 1

|

||||

reload = True

|

||||

daemon = True

|

||||

```

|

||||

在上述配置的情况下,Gunicorn会在`/tmp/`目录下创建一个名为`gunicorn1.sock`的Unix套接字。 还会启动一些工作进程,进程数量相当于CPU内核数量的2倍。 它还会自动重新加载并作为守护进程运行。

|

||||

|

||||

### 运行

|

||||

在上述配置的情况下,Gunicorn 会在 `/tmp/` 目录下创建一个名为 `gunicorn1.sock` 的 Unix 套接字。 还会启动一些工作进程,进程数量相当于 CPU 内核数量的 2 倍。 它还会自动重新加载并作为守护进程运行。

|

||||

|

||||

Gunicorn的运行命令有点长,指定了一些附加的配置项。 最重要的部分是将Gunicorn指向你项目的`.wsgi`文件。

|

||||

#### 运行

|

||||

|

||||

Gunicorn 的运行命令有点长,指定了一些附加的配置项。 最重要的部分是将 Gunicorn 指向你项目的 `.wsgi` 文件。

|

||||

|

||||

```

|

||||

gunicorn -c gunicorn/gunicorn-conf.py -D --error-logfile gunicorn/error.log yourproject.wsgi

|

||||

```

|

||||

上面的命令应该从项目的根目录运行。 Gunicorn会使用你用`-c`选项创建的配置。 `-D`再次指定gunicorn为守护进程。 最后一部分指定Gunicorn的错误日志文件在`Gunicorn`文件夹中的位置。 命令结束部分就是为Gunicorn指定`.wsgi`file的位置。

|

||||

|

||||

上面的命令应该从项目的根目录运行。 `-c` 选项告诉 Gunicorn 使用你创建的配置文件。 `-D` 再次指定 gunicorn 为守护进程。 最后一部分指定 Gunicorn 的错误日志文件在你创建 `Gunicorn` 文件夹中的位置。 命令结束部分就是为 Gunicorn 指定 `.wsgi` 文件的位置。

|

||||

|

||||

### Nginx

|

||||

|

||||

现在Gunicorn配置好了并且已经开始运行了,你可以设置Nginx连接它,为你的静态文件提供服务。 本指南假定你已经配置了Nginx,而且你通过它托管的站点使用了单独的服务块。 它还将包括一些SSL信息。

|

||||

现在 Gunicorn 配置好了并且已经开始运行了,你可以设置 Nginx 连接它,为你的静态文件提供服务。 本指南假定你已经配置好了 Nginx,而且你通过它托管的站点使用了单独的 server 块。 它还将包括一些 SSL 信息。

|

||||

|

||||

如果你想知道如何让你的网站获得免费的SSL证书,请查看我们的[LetsEncrypt指南][8]。

|

||||

如果你想知道如何让你的网站获得免费的 SSL 证书,请查看我们的 [Let'sEncrypt 指南][8]。

|

||||

|

||||

```nginx

|

||||

# 连接到Gunicorn

|

||||

# 连接到 Gunicorn

|

||||

upstream yourproject-gunicorn {

|

||||

server unix:/tmp/gunicorn1.sock fail_timeout=0;

|

||||

}

|

||||

@ -83,7 +77,7 @@ server {

|

||||

access_log /var/log/nginx/yourwebsite.access_log main;

|

||||

error_log /var/log/nginx/yourwebsite.error_log info;

|

||||

|

||||

# 将nginx指向你的ssl证书

|

||||

# 告诉 nginx 你的 ssl 证书

|

||||

ssl on;

|

||||

ssl_certificate /etc/letsencrypt/live/yourwebsite.com/fullchain.pem;

|

||||

ssl_certificate_key /etc/letsencrypt/live/yourwebsite.com/privkey.pem;

|

||||

@ -91,7 +85,7 @@ server {

|

||||

# 设置根目录

|

||||

root /var/www/yourvirtualenv/yourproject;

|

||||

|

||||

# 为Nginx指定静态文件路径

|

||||

# 为 Nginx 指定静态文件路径

|

||||

location /static/ {

|

||||

# Autoindex the files to make them browsable if you want

|

||||

autoindex on;

|

||||

@ -104,7 +98,7 @@ server {

|

||||

proxy_ignore_headers "Set-Cookie";

|

||||

}

|

||||

|

||||

# 为Nginx指定你上传文件的路径

|

||||

# 为 Nginx 指定你上传文件的路径

|

||||

location /media/ {

|

||||

Autoindex if you want

|

||||

autoindex on;

|

||||

@ -122,7 +116,7 @@ server {

|

||||

try_files $uri @proxy_to_app;

|

||||

}

|

||||

|

||||

# 将请求传递给Gunicorn

|

||||

# 将请求传递给 Gunicorn

|

||||

location @proxy_to_app {

|

||||

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

|

||||

proxy_set_header Host $http_host;

|

||||

@ -130,7 +124,7 @@ server {

|

||||

proxy_pass http://njc-gunicorn;

|

||||

}

|

||||

|

||||

# 缓存HTML,XML和JSON

|

||||

# 缓存 HTML、XML 和 JSON

|

||||

location ~* \.(html?|xml|json)$ {

|

||||

expires 1h;

|

||||

}

|

||||

@ -144,18 +138,19 @@ server {

|

||||

}

|

||||

}

|

||||

```

|

||||

配置文件有点长,但是还可以更长一些。其中重点是指向 Gunicorn 的`upstream`块以及将流量传递给 Gunicorn 的`location`块。大多数其他的配置项都是可选,但是你应该按照一定的形式来配置。配置中的注释应该可以帮助你了解具体细节。

|

||||

配置文件有点长,但是还可以更长一些。其中重点是指向 Gunicorn 的 `upstream` 块以及将流量传递给 Gunicorn 的 `location` 块。大多数其他的配置项都是可选,但是你应该按照一定的形式来配置。配置中的注释应该可以帮助你了解具体细节。

|

||||

|

||||

保存文件之后,你可以重启Nginx,让修改的配置生效。

|

||||

保存文件之后,你可以重启 Nginx,让修改的配置生效。

|

||||

|

||||

```

|

||||

# systemctl restart nginx

|

||||

```

|

||||

一旦Nginx在线生效,你的站点就可以通过域名访问了。

|

||||

|

||||

一旦 Nginx 在线生效,你的站点就可以通过域名访问了。

|

||||

|

||||

### 结语

|

||||

|

||||

如果你想深入研究,Nginx可以做很多事情。但是,上面提供的配置是一个很好的开始,并且你可以用于实践中。 如果你习惯于Apache和臃肿的PHP应用程序,像这样的服务器配置的速度应该是一个惊喜。

|

||||

如果你想深入研究,Nginx 可以做很多事情。但是,上面提供的配置是一个很好的开始,并且你可以用于实践中。 如果你见惯了 Apache 和臃肿的 PHP 应用程序,像这样的服务器配置的速度应该是一个惊喜。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -163,7 +158,7 @@ via: https://linuxconfig.org/hosting-django-with-nginx-and-gunicorn-on-linux

|

||||

|

||||

作者:[Nick Congleton][a]

|

||||

译者:[Flowsnow](https://github.com/Flowsnow)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,38 +1,25 @@

|

||||

理解 sudo 与 su 之间的区别

|

||||

深入理解 sudo 与 su 之间的区别

|

||||

============================================================

|

||||

|

||||

### 本文导航

|

||||

|

||||

1. [Linux su 命令][7]

|

||||

1. [su -][1]

|

||||

2. [su -c][2]

|

||||

2. [Sudo vs Su][8]

|

||||

2. [Sudo vs Su][8]

|

||||

1. [关于密码][3]

|

||||

2. [默认行为][4]

|

||||

3. [日志记录][5]

|

||||

4. [灵活性][6]

|

||||

3. [Sudo su][9]

|

||||

|

||||

在[早前的一篇文章][11]中,我们深入讨论了 `sudo` 命令的相关内容。同时,在该文章的末尾有提到相关的命令 `su` 的部分内容。本文,我们将详细讨论关于 su 命令与 sudo 命令之间的区别。

|

||||

在[早前的一篇文章][11]中,我们深入讨论了 `sudo` 命令的相关内容。同时,在该文章的末尾有提到相关的命令 `su` 的部分内容。本文,我们将详细讨论关于 `su` 命令与 `sudo` 命令之间的区别。

|

||||

|

||||

在开始之前有必要说明一下,文中所涉及到的示例教程都已经在 Ubuntu 14.04 LTS 上测试通过。

|

||||

|

||||

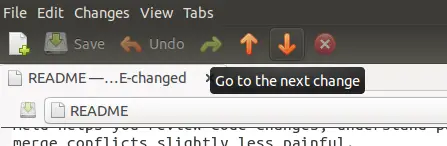

### Linux su 命令

|

||||

|

||||

su 命令的主要作用是让你可以在已登录的会话中切换到另外一个用户。换句话说,这个工具可以让你在不登出当前用户的情况下登录另外一个用户(以该用户的身份)。

|

||||

`su` 命令的主要作用是让你可以在已登录的会话中切换到另外一个用户。换句话说,这个工具可以让你在不登出当前用户的情况下登录为另外一个用户。

|

||||

|

||||

su 命令经常被用于切换到超级用户或 root 用户(因为在命令行下工作,经常需要 root 权限),但是 - 正如前面所提到的 - su 命令也可以用于切换到任意非 root 用户。

|

||||

`su` 命令经常被用于切换到超级用户或 root 用户(因为在命令行下工作,经常需要 root 权限),但是 - 正如前面所提到的 - su 命令也可以用于切换到任意非 root 用户。

|

||||

|

||||

如何使用 su 命令切换到 root 用户,如下:

|

||||

如何使用 `su` 命令切换到 root 用户,如下:

|

||||

|

||||

[

|

||||

|

||||

][12]

|

||||

|

||||

如上,su 命令要求输入的密码是 root 用户密码。所以,一般 su 命令需要输入目标用户的密码。在输入正确的密码之后,su 命令会在终端的当前会话中打开一个子会话。

|

||||

如上,`su` 命令要求输入的密码是 root 用户的密码。所以,一般 `su` 命令需要输入目标用户的密码。在输入正确的密码之后,`su` 命令会在终端的当前会话中打开一个子会话。

|

||||

|

||||

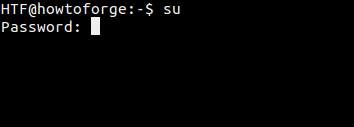

### su -

|

||||

#### su -

|

||||

|

||||

还有一种方法可以切换到 root 用户:运行 `su -` 命令,如下:

|

||||

|

||||

@ -40,41 +27,36 @@ su 命令经常被用于切换到超级用户或 root 用户(因为在命令

|

||||

|

||||

][13]

|

||||

|

||||

那么,`su` 命令与 `su -` 命令之间有什么区别呢?前者在切换到 root 用户之后仍然保持旧的或原始用户的环境,而后者则是创建一个新的环境(由 root 用户 ~/.bashrc 文件所设置的环境),相当于使用 root 用户正常登录(从登录屏幕显示登录)。

|

||||

那么,`su` 命令与 `su -` 命令之间有什么区别呢?前者在切换到 root 用户之后仍然保持旧的(或者说原始用户的)环境,而后者则是创建一个新的环境(由 root 用户 `~/.bashrc` 文件所设置的环境),相当于使用 root 用户正常登录(从登录屏幕登录)。

|

||||

|

||||

`su` 命令手册页很清楚地说明了这一点:

|

||||

|

||||

```

|

||||

可选参数 `-` 可提供的环境为用户在直接登录时的环境。

|

||||

```

|

||||

> 可选参数 `-` 可提供的环境为用户在直接登录时的环境。

|

||||

|

||||

因此,你会觉得使用 `su -` 登录更有意义。但是,同时存在 `su` 命令,那么大家可能会想知道它在什么时候用到。以下内容摘自[ArchLinux wiki website][14] - 关于 `su` 命令的好处和坏处:

|

||||

因此,你会觉得使用 `su -` 登录更有意义。但是, `su` 命令也是有用的,那么大家可能会想知道它在什么时候用到。以下内容摘自 [ArchLinux wiki 网站][14] - 关于 `su` 命令的好处和坏处:

|

||||

|

||||

* 有的时候,对于系统管理员来讲,使用其他普通用户的 Shell 账户而不是自己的 Shell 账户更会好一些。尤其是在处理用户问题时,最有效的方法就是是:登录目标用户以便重现以及调试问题。

|

||||

* 有的时候,对于系统管理员(root)来讲,使用其他普通用户的 Shell 账户而不是自己的 root Shell 账户更会好一些。尤其是在处理用户问题时,最有效的方法就是是:登录目标用户以便重现以及调试问题。

|

||||

* 然而,在多数情况下,当从普通用户切换到 root 用户进行操作时,如果还使用普通用户的环境变量的话,那是不可取甚至是危险的操作。因为是在无意间切换使用普通用户的环境,所以当使用 root 用户进行程序安装或系统更改时,会产生与正常使用 root 用户进行操作时不相符的结果。例如,以普通用户安装程序会给普通用户意外损坏系统或获取对某些数据的未授权访问的能力。

|

||||

|

||||

* 然而,在多数情况下,当从普通用户切换到 root 用户进行操作时,如果还使用普通用户的环境变量的话,那是不可取甚至是危险的操作。因为是在无意间切换使用普通用户的环境,所以当使用 root 用户进行程序安装或系统更改时,会产生与正常使用 root 用户进行操作时不相符的结果。例如,可以给普通用户安装电源意外损坏系统的程序或获取对某些数据的未授权访问的程序。

|

||||

注意:如果你想在 `su -` 命令的 `-` 后面传递更多的参数,那么你必须使用 `su -l` 而不是 `su -`。以下是 `-` 和 `-l` 命令行选项的说明:

|

||||

|

||||

注意:如果你想在 `su -` 命令后面传递更多的参数,那么你必须使用 `su -l` 来实现。以下是 `-` 和 `-l` 命令行选项的说明:

|

||||

> `-`, `-l`, `--login`

|

||||

|

||||

```

|

||||

-, -l, --login

|

||||

提供相当于用户在直接登录时所期望的环境。

|

||||

> 提供相当于用户在直接登录时所期望的环境。

|

||||

|

||||

当使用 - 时,必须放在 su 命令的最后一个选项。其他选项(-l 和 --login)无此限制。

|

||||

```

|

||||

> 当使用 - 时,必须放在 `su` 命令的最后一个选项。其他选项(`-l` 和 `--login`)无此限制。

|

||||

|

||||

### su -c

|

||||

#### su -c

|

||||

|

||||

还有一个值得一提的 `su` 命令行选项为:`-c`。该选项允许你提供在切换到目标用户之后要运行的命令。

|

||||

|

||||

`su` 命令手册页是这样说明:

|

||||

|

||||

```

|

||||

-c, --command COMMAND

|

||||

使用 -c 选项指定由 Shell 调用的命令。

|

||||

> `-c`, `--command COMMAND`

|

||||

|

||||

被执行的命令无法控制终端。所以,此选项不能用于执行需要控制 TTY 的交互式程序。

|

||||

```

|

||||

> 使用 `-c` 选项指定由 Shell 调用的命令。

|

||||

|

||||

> 被执行的命令无法控制终端。所以,此选项不能用于执行需要控制 TTY 的交互式程序。

|

||||

|

||||

参考示例:

|

||||

|

||||

@ -90,11 +72,11 @@ su [target-user] -c [command-to-run]

|

||||

|

||||

示例中的 `shell` 类型将会被目标用户在 `/etc/passwd` 文件中定义的登录 shell 类型所替代。

|

||||

|

||||

### Sudo vs Su

|

||||

### sudo vs. su

|

||||

|

||||

现在,我们已经讨论了关于 `su` 命令的基础知识,是时候来探讨一下 `sudo` 和 `su` 命令之间的区别了。

|

||||

|

||||

### 关于密码

|

||||

#### 关于密码

|

||||

|

||||

两个命令的最大区别是:`sudo` 命令需要输入当前用户的密码,`su` 命令需要输入 root 用户的密码。

|

||||

|

||||

@ -102,28 +84,27 @@ su [target-user] -c [command-to-run]

|

||||

|

||||

此外,如果要撤销特定用户的超级用户/root 用户的访问权限,唯一的办法就是更改 root 密码,然后再告知所有其他用户新的 root 密码。

|

||||

|

||||

而使用 `sudo` 命令就不一样了,你可以很好的处理以上的两种情况。鉴于 `sudo` 命令要求输入的是其他用户的密码,所以,不需要共享 root 密码。同时,想要阻止特定用户访问 root 权限,只需要调整 `sudoers` 文件中的相应配置即可。

|

||||

而使用 `sudo` 命令就不一样了,你可以很好的处理以上的两种情况。鉴于 `sudo` 命令要求输入的是其他用户自己的密码,所以,不需要共享 root 密码。同时,想要阻止特定用户访问 root 权限,只需要调整 `sudoers` 文件中的相应配置即可。

|

||||

|

||||

### 默认行为

|

||||

#### 默认行为

|

||||

|

||||

两个命令之间的另外一个区别是默认行为。`sudo` 命令只允许使用提升的权限运行单个命令,而 `su` 命令会启动一个新的 shell,同时允许使用 root 权限运行尽可能多的命令,直到显示退出登录。

|

||||

两个命令之间的另外一个区别是其默认行为。`sudo` 命令只允许使用提升的权限运行单个命令,而 `su` 命令会启动一个新的 shell,同时允许使用 root 权限运行尽可能多的命令,直到明确退出登录。

|

||||

|

||||

因此,`su` 命令的默认行为是有风险的,因为用户很有可能会忘记他们正在以 root 用户身份进行工作,于是,无意中做出了一些不可恢复的更改(例如:对错误的目录运行 `rm -rf` 命令)。关于为什么不鼓励以 root 用户身份进行工作的详细内容,请参考[这里][10]

|

||||

因此,`su` 命令的默认行为是有风险的,因为用户很有可能会忘记他们正在以 root 用户身份进行工作,于是,无意中做出了一些不可恢复的更改(例如:对错误的目录运行 `rm -rf` 命令!)。关于为什么不鼓励以 root 用户身份进行工作的详细内容,请参考[这里][10]。

|

||||

|

||||

### 日志记录

|

||||

#### 日志记录

|

||||

|

||||

尽管 `sudo` 命令是以目标用户(默认情况下是 root 用户)的身份执行命令,但是他们会使用 sudoer 所配置的用户名来记录是谁执行命令。而 `su` 命令是无法直接跟踪记录用户切换到 root 用户之后执行了什么操作。

|

||||

尽管 `sudo` 命令是以目标用户(默认情况下是 root 用户)的身份执行命令,但是它们会使用 `sudoer` 所配置的用户名来记录是谁执行命令。而 `su` 命令是无法直接跟踪记录用户切换到 root 用户之后执行了什么操作。

|

||||

|

||||

### 灵活性

|

||||

#### 灵活性

|

||||

|

||||

`sudo` 命令会比 `su` 命令灵活很多,因为你甚至可以限制 sudo 用户可以访问哪些命令。换句话说,用户通过 `sudo` 命令只能访问他们工作需要的命令。而 `su` 命令让用户有权限做任何事情。

|

||||

`sudo` 命令比 `su` 命令灵活很多,因为你甚至可以限制 sudo 用户可以访问哪些命令。换句话说,用户通过 `sudo` 命令只能访问他们工作需要的命令。而 `su` 命令让用户有权限做任何事情。

|

||||

|

||||

### Sudo su

|

||||

#### sudo su

|

||||

|

||||

大概是因为使用 `su` 命令或直接以 root 用户身份登录有风险,所以,一些 Linux 发行版(如 Ubuntu)默认禁用 root 用户帐户。鼓励用户在需要 root 权限时使用 `sudo` 命令。

|

||||

|

||||

However, you can still do 'su' successfully, i.e, without entering the root password. All you need to do is to run the following command:

|

||||

然而,您还是可以成功执行 `su` 命令,即不用输入 root 用户的密码。运行以下命令:

|

||||

然而,您还是可以成功执行 `su` 命令,而不用输入 root 用户的密码。运行以下命令:

|

||||

|

||||

```

|

||||

sudo su

|

||||

@ -131,7 +112,7 @@ sudo su

|

||||

|

||||

由于你使用 `sudo` 运行命令,你只需要输入当前用户的密码。所以,一旦完成操作,`su` 命令将会以 root 用户身份运行,这意味着它不会再要求输入任何密码。

|

||||

|

||||

** PS **:如果你想在系统中启用 root 用户帐户(虽然强烈反对,但你还是可以使用 `sudo` 命令或 `sudo su` 命令),你必须手动设置 root 用户密码 可以使用以下命令:

|

||||

**PS**:如果你想在系统中启用 root 用户帐户(强烈反对,因为你可以使用 `sudo` 命令或 `sudo su` 命令),你必须手动设置 root 用户密码,可以使用以下命令:

|

||||

|

||||

```

|

||||

sudo passwd root

|

||||

@ -139,7 +120,7 @@ sudo passwd root

|

||||

|

||||

### 结论

|

||||

|

||||

这篇文章以及之前的教程(其中侧重于 `sudo` 命令)应该能给你一个比较好的建议,当你需要可用的工具来提升(或一组完全不同的)权限来执行任务时。 如果您也想分享关于 `su` 或 `sudo` 的相关内容或者经验,欢迎您在下方进行评论。

|

||||

当你需要可用的工具来提升(或一组完全不同的)权限来执行任务时,这篇文章以及之前的教程(其中侧重于 `sudo` 命令)应该能给你一个比较好的建议。 如果您也想分享关于 `su` 或 `sudo` 的相关内容或者经验,欢迎您在下方进行评论。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -147,7 +128,7 @@ via: https://www.howtoforge.com/tutorial/sudo-vs-su/

|

||||

|

||||

作者:[Himanshu Arora][a]

|

||||

译者:[zhb127](https://github.com/zhb127)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,14 +1,13 @@

|

||||

Create a Shared Directory on Samba AD DC and Map to Windows/Linux Clients – Part 7

|

||||

Samba 系列(七):在 Samba AD DC 服务器上创建共享目录并映射到 Windows/Linux 客户机

|

||||

============================================================

|

||||

在 Samba AD DC 服务器上创建共享目录并映射到 Windows/Linux 客户机 ——(七)

|

||||

|

||||

这篇文章将指导你如何在 Samba AD DC 服务器上创建共享目录,然后通过 GPO 把共享目录挂载到域中的其它 Windows 成员机,并且从 Windows 域控的角度来管理共享权限。

|

||||

|

||||

这篇文章也包括在加入域的 Linux 机器上如何使用 Samba4 域帐号来访问及挂载共享文件。

|

||||

|

||||

#### 需求:

|

||||

### 需求:

|

||||

|

||||

1. [在 Ubuntu 系统上使用 Samba4 创建活动目录架构][1]

|

||||

1. [在 Ubuntu 系统上使用 Samba4 创建活动目录架构][1]

|

||||

|

||||

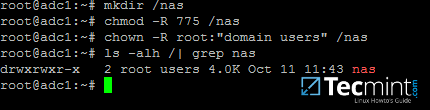

### 第一步:创建 Samba 文件共享

|

||||

|

||||

@ -21,12 +20,13 @@ Create a Shared Directory on Samba AD DC and Map to Windows/Linux Clients – Pa

|

||||

# chmod -R 775 /nas

|

||||

# chown -R root:"domain users" /nas

|

||||

# ls -alh | grep nas

|

||||

```

|

||||

```

|

||||

|

||||

[

|

||||

|

||||

|

||||

][2]

|

||||

|

||||

创建 Samba 共享目录

|

||||

*创建 Samba 共享目录*

|

||||

|

||||

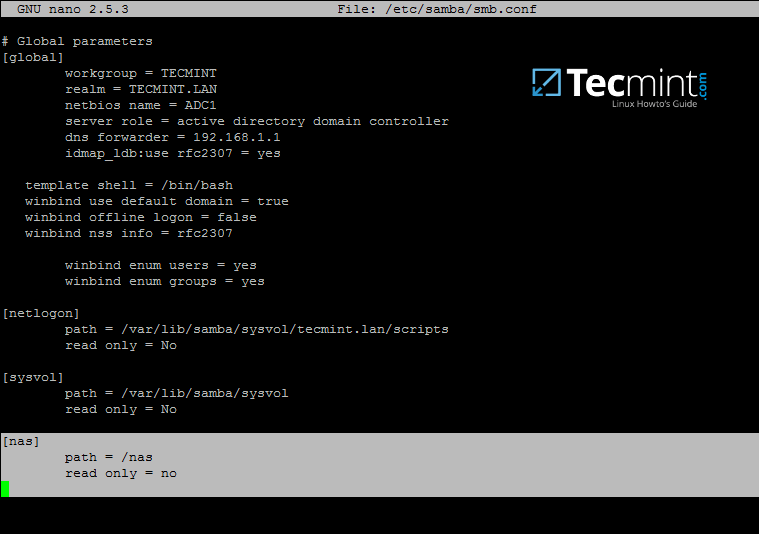

2、当你在 Samba4 AD DC 服务器上创建完成共享目录之后,你还得修改 samba 配置文件,添加下面的参数以允许通过 SMB 协议来共享文件。

|

||||

|

||||

@ -41,11 +41,12 @@ Create a Shared Directory on Samba AD DC and Map to Windows/Linux Clients – Pa

|

||||

path = /nas

|

||||

read only = no

|

||||

```

|

||||

|

||||

[

|

||||

|

||||

|

||||

][3]

|

||||

|

||||

配置 Samba 共享目录

|

||||

*配置 Samba 共享目录*

|

||||

|

||||

3、最后,你需要通过下面的命令重启 Samba AD DC 服务,以让修改的配置生效:

|

||||

|

||||

@ -57,117 +58,119 @@ read only = no

|

||||

|

||||

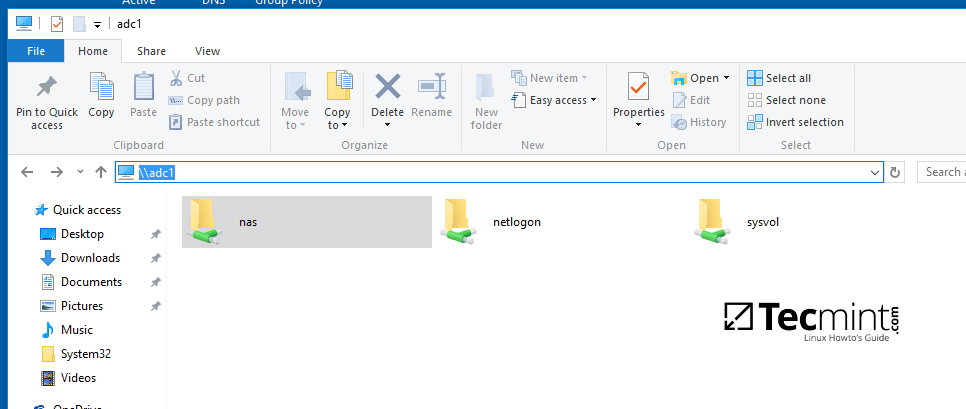

4、我们准备使用在 Samba AD DC 服务器上创建的域帐号(包括用户和组)来访问这个共享目录(禁止 Linux 系统用户访问共享目录)。

|

||||

|

||||

可以直接通过 Windows 资源管理器来完成 Samba 共享权限的管理,就跟你在 Windows 资源管理器中设置其它文件夹权限的方法一样。

|

||||

可以直接通过 Windows 资源管理器来完成 Samba 共享权限的管理,就跟你在 Windows 资源管理器中设置其它文件夹权限的方法一样。

|

||||

|

||||

首先,使用具有管理员权限的 Samba4 AD 域帐号登录到 Windows 机器。然而在 Windows 机器上的资源管理器中输入双斜杠和 Samba AD DC 服务器的 IP 地址或主机名或者是 FQDN 来访问共享文件和设置权限。

|

||||

|

||||

```

|

||||

\\adc1

|

||||

Or

|

||||

或

|

||||

\\192.168.1.254

|

||||

Or

|

||||

或

|

||||

\\adc1.tecmint.lan

|

||||

```

|

||||

```

|

||||

|

||||

[

|

||||

|

||||

|

||||

][4]

|

||||

|

||||

从 Windows 机器访问 Samba 共享目录

|

||||

*从 Windows 机器访问 Samba 共享目录*

|

||||

|

||||

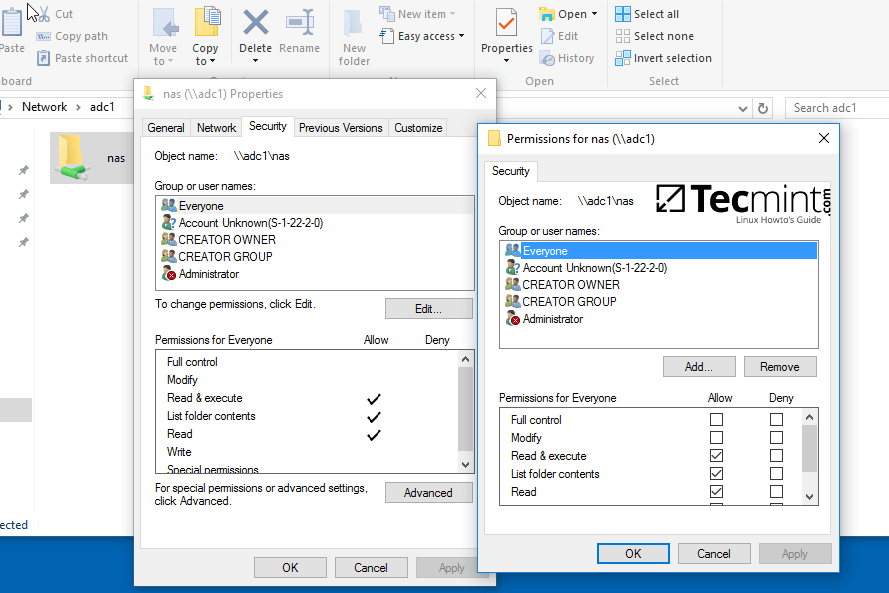

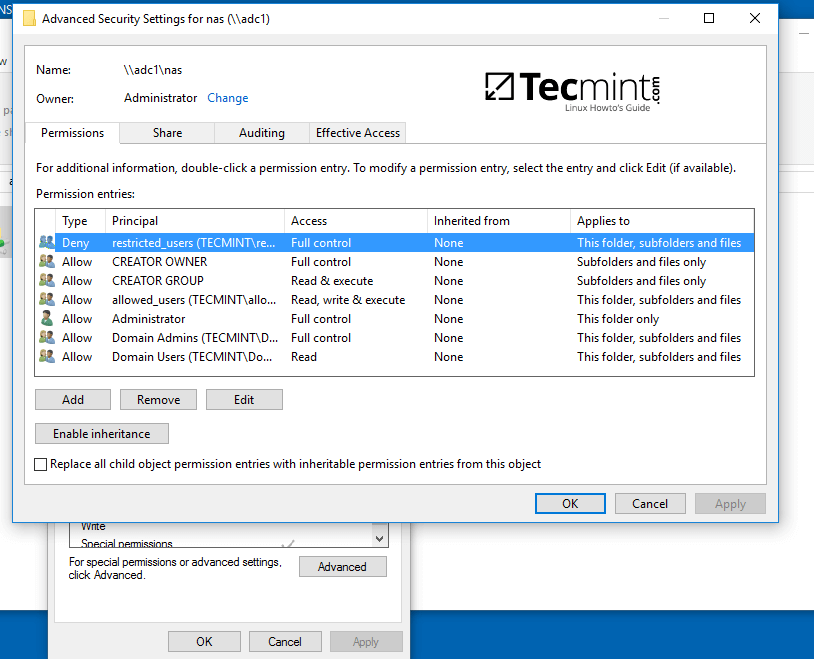

5、右键单击共享文件,选择属性来设置权限。打开安全选项卡,依次修改域账号和组权限。使用高级选项来调整权限。

|

||||

|

||||

[

|

||||

|

||||

|

||||

][5]

|

||||

|

||||

配置 Samba 共享目录权限

|

||||

*配置 Samba 共享目录权限*

|

||||

|

||||

可参考下面的截图来为指定 Samba AD DC 认证用户设置权限。

|

||||

可参考下面的截图来为指定 Samba AD DC 认证用户设置权限。

|

||||

|

||||

[

|

||||

|

||||

|

||||

][6]

|

||||

|

||||

设置 Samba 共享目录用户权限

|

||||

*设置 Samba 共享目录用户权限*

|

||||

|

||||

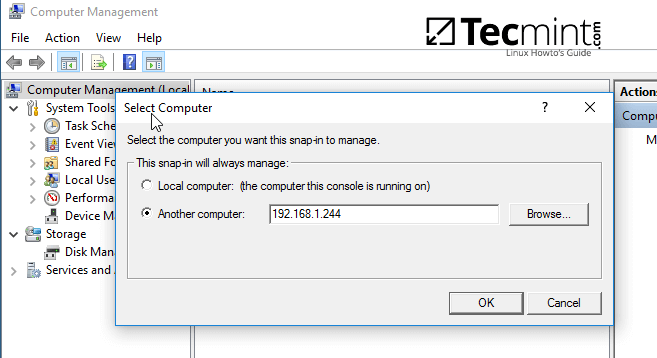

6、你也可以使用其它方法来设置共享权限,打开计算机管理-->连接到另外一台计算机。

|

||||

|

||||

找到共享目录,右键单击你想修改权限的目录,选择属性,打开安全选项卡。你可以在这里修改任何权限,就跟上图的修改共享文件夹权限的方法一样。

|

||||

|

||||

[

|

||||

|

||||

|

||||

][7]

|

||||

|

||||

连接到 Samba 共享目录服务器

|

||||

*连接到 Samba 共享目录服务器*

|

||||

|

||||

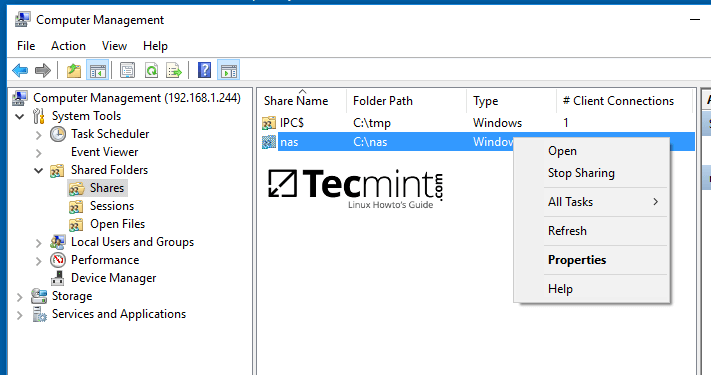

[

|

||||

|

||||

|

||||

][8]

|

||||

|

||||

管理 Samba 共享目录属性

|

||||

*管理 Samba 共享目录属性*

|

||||

|

||||

[

|

||||

|

||||

|

||||

][9]

|

||||

|

||||

为域用户授予共享目录权限

|

||||

*为域用户授予共享目录权限*

|

||||

|

||||

### 第三步:通过 GPO 来映射 Samba 文件共享

|

||||

|

||||

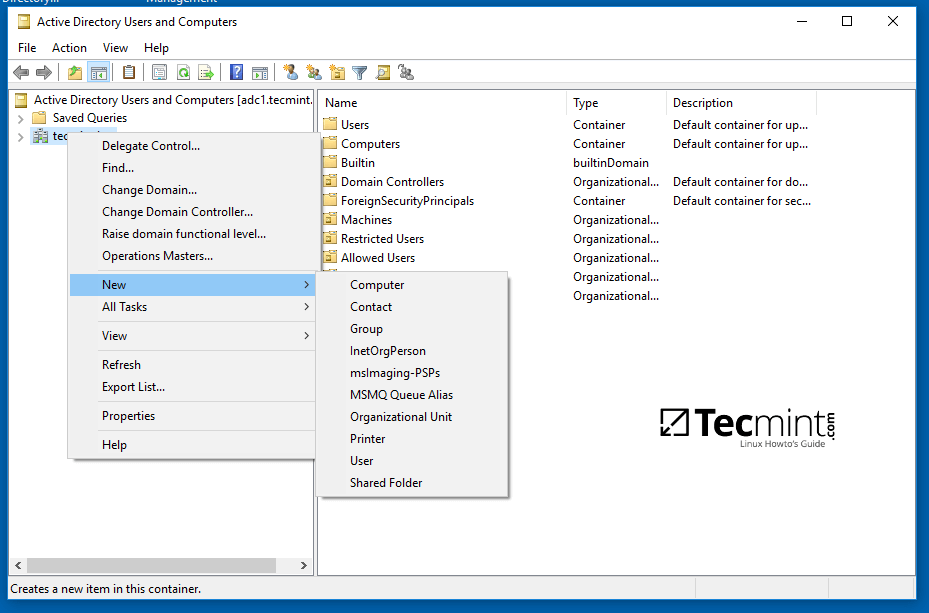

7、要想通过域组策略来挂载 Samba 共享的目录,你得先到一台[已安装了 RSAT 工具][10] 的服务器上,打开 AD DC 工具,右键单击域名,选择新建-->共享文件平。

|

||||

7、要想通过域组策略来挂载 Samba 共享的目录,你得先到一台[已安装了 RSAT 工具][10] 的服务器上,打开 AD DC 工具,右键单击域名,选择新建-->共享文件夹。

|

||||

|

||||

[

|

||||

|

||||

|

||||

][11]

|

||||

|

||||

映射 Samba 共享文件夹

|

||||

*映射 Samba 共享文件夹*

|

||||

|

||||

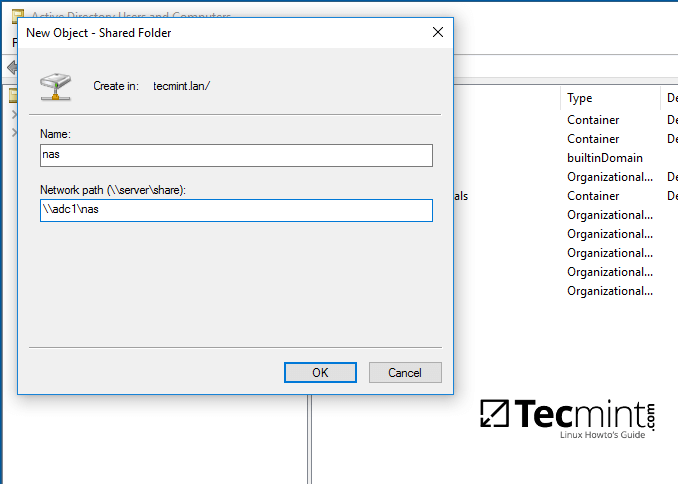

8、为共享文件夹添加一个名字,然后输入共享文件夹的网络路径,如下图所示。完成后单击 OK 按钮,你就可以在右侧看到文件夹了。

|

||||

|

||||

[

|

||||

|

||||

|

||||

][12]

|

||||

|

||||

设置 Samba 共享文件夹名称及路径

|

||||

*设置 Samba 共享文件夹名称及路径*

|

||||

|

||||

9、下一步,打开组策略管理控制台,找到当前域的默认域策略脚本,然后打开并编辑该文件。

|

||||

|

||||

在 GPM 编辑器界面,打开 GPM 编辑器,找到用户配置 --> 首选项 --> Windows 设置,然而右键单击驱动器映射,选择新建 --> 映射驱动。

|

||||

|

||||

[

|

||||

|

||||

|

||||

][13]

|

||||

|

||||

在 Windows 机器上映射 Samba 共享文件夹

|

||||

*在 Windows 机器上映射 Samba 共享文件夹*

|

||||

|

||||

10、通过单击右边的三个小点,在新窗口中查询并添加共享目录的网络位置,勾选重新连接复选框,为该目录添加一个标签,选择驱动盘符,然后单击 OK 按钮来保存和应用配置。

|

||||

|

||||

[

|

||||

|

||||

|

||||

][14]

|

||||

|

||||

配置 Samba 共享目录的网络位置

|

||||

*配置 Samba 共享目录的网络位置*

|

||||

|

||||

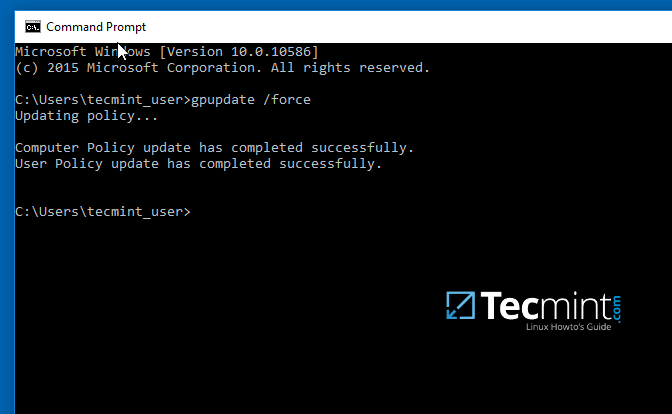

11、最后,为了在本地机器上强制应用 GPO 更改而不重启系统,打开命令行提示符,然而执行下面的命令。

|

||||

|

||||

```

|

||||

gpupdate /force

|

||||

```

|

||||

```

|

||||

|

||||

[

|

||||

|

||||

|

||||

][15]

|

||||

|

||||

应用 GPO 更改

|

||||

*应用 GPO 更改*

|

||||

|

||||

12、当你在本地机器上成功应用策略后,打开 Windows 资源管理器,你就可以看到并访问共享的网络文件夹了,能否正常访问共享目录取决于你在前一步的授权操作。

|

||||

|

||||

如果没有在命令行下强制应用组策略,你网络中的其它客户机需要重启或重新登录系统才可以看到共享目录。

|

||||

|

||||

[

|

||||

|

||||

|

||||

][16]

|

||||

|

||||

Windows 机器上挂载的 Samba 网络磁盘

|

||||

*Windows 机器上挂载的 Samba 网络磁盘*

|

||||

|

||||

### 第四步:从 Linux 客户端访问 Samba 共享目录

|

||||

|

||||

@ -183,14 +186,15 @@ $ sudo apt-get install smbclient cifs-utils

|

||||

|

||||

```

|

||||

$ smbclient –L your_domain_controller –U%

|

||||

or

|

||||

或

|

||||

$ smbclient –L \\adc1 –U%

|

||||

```

|

||||

```

|

||||

|

||||

[

|

||||

|

||||

|

||||

][17]

|

||||

|

||||

在 Linux 机器上列出 Samba 共享目录

|

||||

*在 Linux 机器上列出 Samba 共享目录*

|

||||

|

||||

15、在命令行下使用域帐号以交互试方式连接到 Samba 共享目录:

|

||||

|

||||

@ -198,13 +202,13 @@ $ smbclient –L \\adc1 –U%

|

||||

$ sudo smbclient //adc/share_name -U domain_user

|

||||

```

|

||||

|

||||

在命令行下,你可以列出共享目录内容,下载或上传文件到共享目录,或者执行其它操作。使用 ? 来查询所有可用的 smbclient 命令。

|

||||

在命令行下,你可以列出共享目录内容,下载或上传文件到共享目录,或者执行其它操作。使用 `?` 来查询所有可用的 smbclient 命令。

|

||||

|

||||

[

|

||||

|

||||

|

||||

][18]

|

||||

|

||||

在 Linux 机器上连接 Samba 共享目录

|

||||

*在 Linux 机器上连接 Samba 共享目录*

|

||||

|

||||

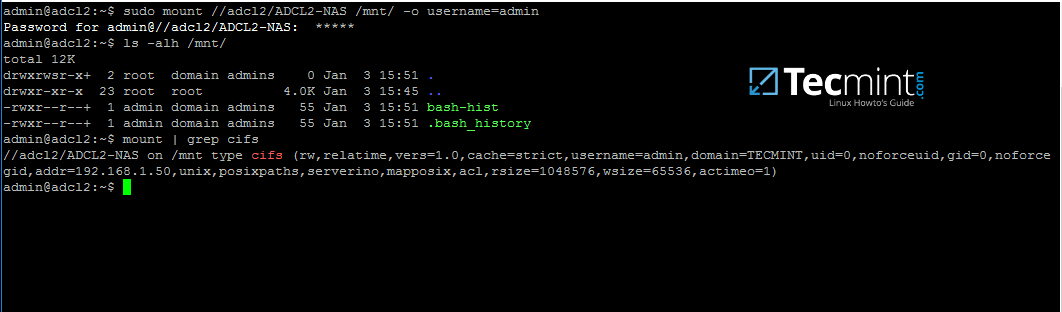

16、在 Linux 机器上使用下面的命令来挂载 samba 共享目录。

|

||||

|

||||

@ -212,16 +216,16 @@ $ sudo smbclient //adc/share_name -U domain_user

|

||||

$ sudo mount //adc/share_name /mnt -o username=domain_user

|

||||

```

|

||||

[

|

||||

|

||||

|

||||

][19]

|

||||

|

||||

在 Linux 机器上挂载 samba 共享目录

|

||||

*在 Linux 机器上挂载 samba 共享目录*

|

||||

|

||||

根据实际情况,依次替换主机名、共享目录名、挂载点和域帐号。使用 mount 命令加上管道符和 grep 参数来过滤出 cifs 类型的文件系统。

|

||||

根据实际情况,依次替换主机名、共享目录名、挂载点和域帐号。使用 `mount` 命令加上管道符和 `grep` 命令来过滤出 cifs 类型的文件系统。

|

||||

|

||||

通过上面的测试,我们可以看出,在 Samba4 AD DC 服务器上配置共享目录仅使用 Windows 访问控制列表( ACL ),而不是 POSIX ACL 。

|

||||

|

||||

通过文件共享把 Samba 配置为域成员以使用其它网络共享功能。同时,在另一个域控制器上[配置 Windbindd 服务][20] ——第二步——在你开始发起网络共享文件之前。

|

||||

通过文件共享把 Samba 配置为域成员以使用其它网络共享功能。同时,在另一个域控制器上[配置 Windbindd 服务][20] ——在你开始发起网络共享文件之前。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -230,6 +234,7 @@ $ sudo mount //adc/share_name /mnt -o username=domain_user

|

||||

我是一个电脑迷,开源 Linux 系统和软件爱好者,有 4 年多的 Linux 桌面、服务器系统使用和 Base 编程经验。

|

||||

|

||||

译者简介:

|

||||

|

||||

春城初春/春水初生/春林初盛/春風十裏不如妳

|

||||

[rusking](https://github.com/rusking)

|

||||

|

||||

@ -239,7 +244,7 @@ via: http://www.tecmint.com/create-shared-directory-on-samba-ad-dc-and-map-to-wi

|

||||

|

||||

作者:[Matei Cezar][a]

|

||||

译者:[rusking](https://github.com/rusking)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -254,7 +259,7 @@ via: http://www.tecmint.com/create-shared-directory-on-samba-ad-dc-and-map-to-wi

|

||||

[7]:http://www.tecmint.com/wp-content/uploads/2017/02/Connect-to-Samba-Share-Directory-Machine.png

|

||||

[8]:http://www.tecmint.com/wp-content/uploads/2017/02/Manage-Samba-Share-Directory-Properties.png

|

||||

[9]:http://www.tecmint.com/wp-content/uploads/2017/02/Assign-Samba-Share-Directory-Permissions-to-Users.png

|

||||

[10]:http://www.tecmint.com/manage-samba4-ad-from-windows-via-rsat/

|

||||

[10]:https://linux.cn/article-8097-1.html

|

||||

[11]:http://www.tecmint.com/wp-content/uploads/2017/02/Map-Samba-Share-Folder.png

|

||||

[12]:http://www.tecmint.com/wp-content/uploads/2017/02/Set-Samba-Shared-Folder-Name-Location.png

|

||||

[13]:http://www.tecmint.com/wp-content/uploads/2017/02/Map-Samba-Share-Folder-in-Windows.png

|

||||

@ -264,7 +269,7 @@ via: http://www.tecmint.com/create-shared-directory-on-samba-ad-dc-and-map-to-wi

|

||||

[17]:http://www.tecmint.com/wp-content/uploads/2017/02/List-Samba-Share-Directory-in-Linux.png

|

||||

[18]:http://www.tecmint.com/wp-content/uploads/2017/02/Connect-Samba-Share-Directory-in-Linux.png

|

||||

[19]:http://www.tecmint.com/wp-content/uploads/2017/02/Mount-Samba-Share-Directory-in-Linux.png

|

||||

[20]:http://www.tecmint.com/manage-samba4-active-directory-linux-command-line/

|

||||

[20]:https://linux.cn/article-8070-1.html

|

||||

[21]:http://www.tecmint.com/author/cezarmatei/

|

||||

[22]:http://www.tecmint.com/10-useful-free-linux-ebooks-for-newbies-and-administrators/

|

||||

[23]:http://www.tecmint.com/free-linux-shell-scripting-books/

|

||||

@ -0,0 +1,127 @@

|

||||

如何在 Ubuntu 和 Linux Mint 上启用桌面共享

|

||||

============================================================

|

||||

|

||||

桌面共享是指通过图形终端仿真器在计算机桌面上实现远程访问和远程协作的技术。桌面共享允许两个或多个连接到网络的计算机用户在不同位置对同一个文件进行操作。

|

||||

|

||||

在这篇文章中,我将向你展示如何在 Ubuntu 和 Linux Mint 中启用桌面共享,并展示一些重要的安全特性。

|

||||

|

||||

### 在 Ubuntu 和 Linux Mint 上启用桌面共享

|

||||

|

||||

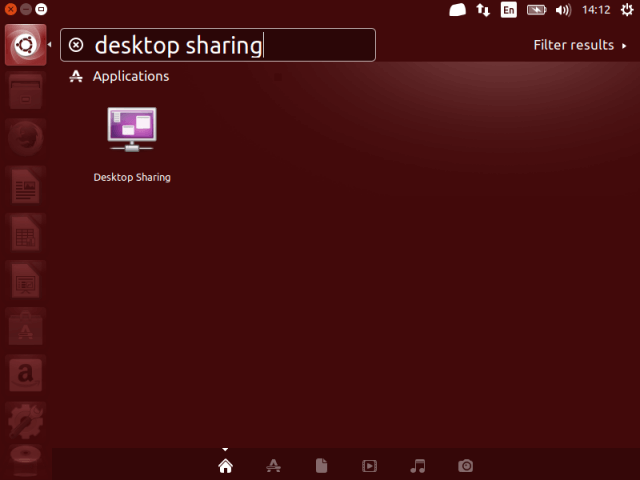

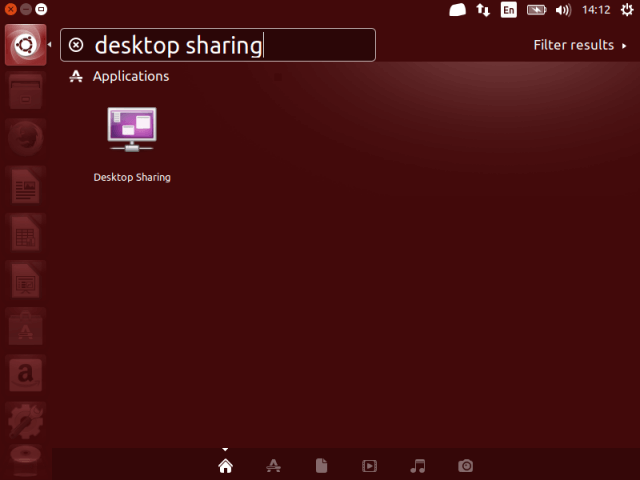

1、在 Ubuntu Dash 或 Linux Mint 菜单中,像下面的截图这样搜索 `desktop sharing`,搜索到以后,打开它。

|

||||

|

||||

[

|

||||

|

||||

][1]

|

||||

|

||||

*在 Ubuntu 中搜索 Desktop sharing*

|

||||

|

||||

2、打开 Desktop sharing 以后,有三个关于桌面共享设置的选项:共享、安全以及通知设置。

|

||||

|

||||

在共享选项下面,选中选项“允许其他用户查看桌面”来启用桌面共享。另外,你还可以选中选项“允许其他用户控制你的桌面”,从而允许其他用户远程控制你的桌面。

|

||||

|

||||

[

|

||||

|

||||

][2]

|

||||

|

||||

*桌面共享偏好*

|

||||

|

||||

3、接下来,在“安全”部分,你可以通过勾选选项“你必须确认任何对该计算机的访问”来手动确认每个远程连接。

|

||||

|

||||

另外,另一个有用的安全特性是通过选项“需要用户输入密码”创建一个确定的共享密码。这样当用户每次想要访问你的桌面时需要知道并输入密码。

|

||||

|

||||

4、对于通知,你可以勾选“仅当有人连接上时”来监视远程连接,这样每次当有人远程连接到你的桌面时,可以在通知区域查看。

|

||||

|

||||

[

|

||||

|

||||

][3]

|

||||

|

||||

*配置桌面共享设置*

|

||||

|

||||

当所有的桌面共享选项都设置好以后,点击“关闭”。现在,你已经在你的 Ubuntu 或 Linux Mint 上成功启用了桌面共享。

|

||||

|

||||

### 测试 Ubuntu 的远程桌面共享

|

||||

|

||||

你可以通过使用一个远程连接应用来进行测试,从而确保桌面共享可用。在这个例子中,我将展示上面设置的一些选项是如何工作的。

|

||||

|

||||

5、我将使用 VNC(虚拟网络计算)协议通过 [remmina 远程连接应用][4]连接到我的 Ubuntu PC。

|

||||

|

||||

[

|

||||

|

||||

][5]

|

||||

|

||||

*Remmina 桌面共享工具*

|

||||

|

||||

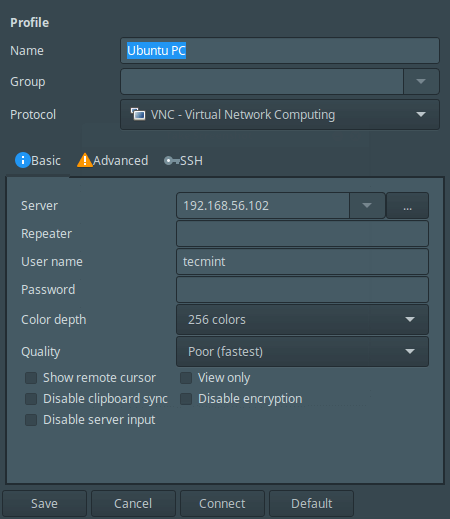

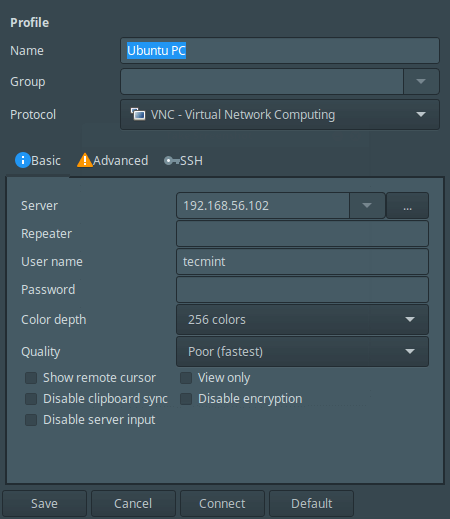

6、在点击 Ubuntu PC 以后,将会出现下面这个配置连接设置的界面,

|

||||

|

||||

[

|

||||

|

||||

][6]

|

||||

|

||||

*Remmina 桌面共享偏好*

|

||||

|

||||

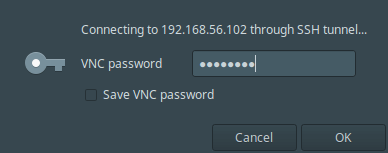

7、当执行好所有设置以后,点击连接。然后,给用户名提供 SSH 密码并点击 OK 。

|

||||

|

||||

[

|

||||

|

||||

][7]

|

||||

|

||||

*输入 SSH 用户密码*

|

||||

|

||||

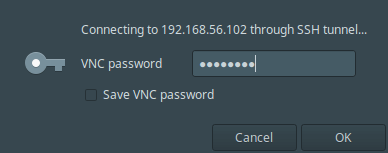

点击确定以后,出现下面这个黑屏,这是因为在远程机器上,连接还没有确认。

|

||||

|

||||

[

|

||||

|

||||

][8]

|

||||

|

||||

*连接确认前的黑屏*

|

||||

|

||||

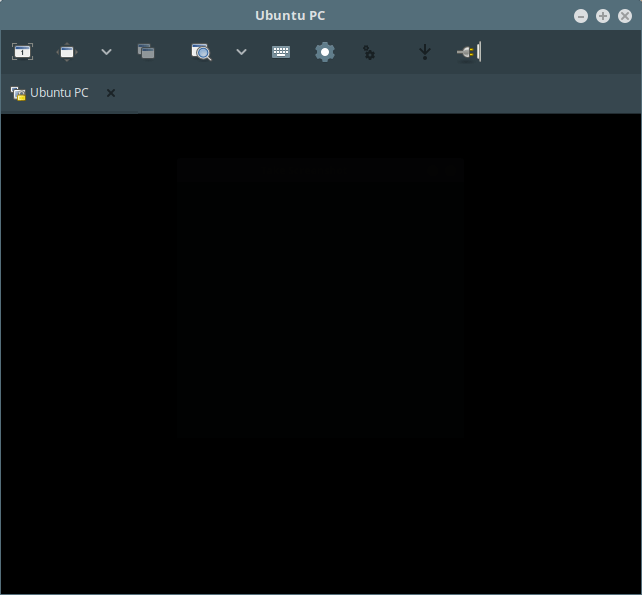

8、现在,在远程机器上,我需要如下一个屏幕截图显示的那样点击 `Allow` 来接受远程访问请求。

|

||||

|

||||

[

|

||||

|

||||

][9]

|

||||

|

||||

*允许远程桌面共享*

|

||||

|

||||

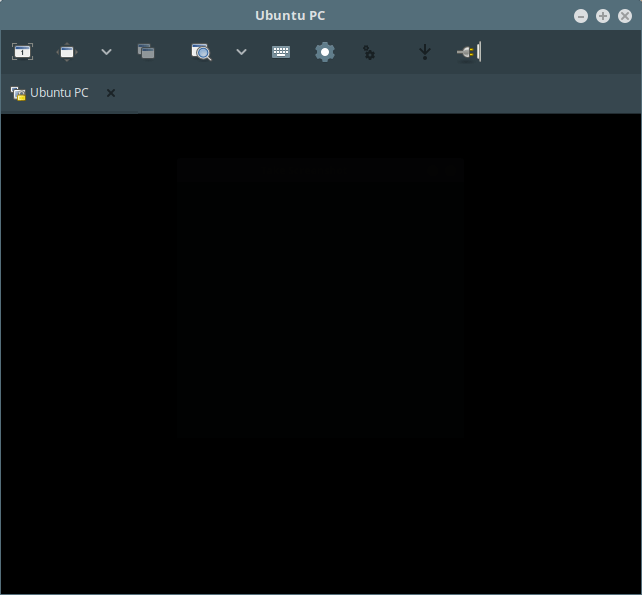

9、在接受请求以后,我就成功地连接到了远程 Ubuntu 机器的桌面。

|

||||

|

||||

[

|

||||

|

||||

][10]

|

||||

|

||||

*远程 Ubuntu 桌面*

|

||||

|

||||

这就是全部内容了,在这篇文章中,我们讲解了如何在 Ubuntu 和 Linux Mint 中启用桌面共享。你使用评论部分给我们写反馈。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

|

||||

作者简介:

|

||||

|

||||

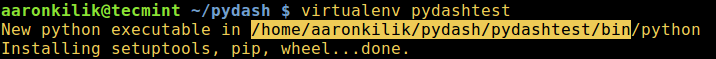

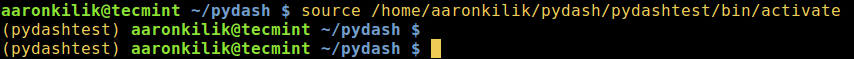

Aaron Kili 是 Linux 和 F.O.S.S 爱好者,将来的 Linux 系统管理员和网络开发人员,目前是 TecMint 的内容创作者,他喜欢用电脑工作,并坚信分享知识。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.tecmint.com/enable-desktop-sharing-in-ubuntu-linux-mint/

|

||||

|

||||

作者:[Aaron Kili][a]

|

||||

译者:[ucasFL](https://github.com/ucasFL)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.tecmint.com/author/aaronkili/

|

||||

|

||||

[1]:http://www.tecmint.com/wp-content/uploads/2017/03/search-for-desktop-sharing.png

|

||||

[2]:http://www.tecmint.com/wp-content/uploads/2017/03/desktop-sharing-settings-inte.png

|

||||

[3]:http://www.tecmint.com/wp-content/uploads/2017/03/Configure-Desktop-Sharing-Set.png

|

||||

[4]:http://www.tecmint.com/remmina-remote-desktop-sharing-and-ssh-client

|

||||

[5]:http://www.tecmint.com/wp-content/uploads/2017/03/Remmina-Desktop-Sharing-Tool.png

|

||||

[6]:http://www.tecmint.com/wp-content/uploads/2017/03/Remmina-Configure-Remote-Desk.png

|

||||

[7]:http://www.tecmint.com/wp-content/uploads/2017/03/shared-pass.png

|

||||

[8]:http://www.tecmint.com/wp-content/uploads/2017/03/black-screen-before-confirmat.png

|

||||

[9]:http://www.tecmint.com/wp-content/uploads/2017/03/accept-remote-access-request.png

|

||||

[10]:http://www.tecmint.com/wp-content/uploads/2017/03/successfully-connected-to-rem.png

|

||||

[11]:http://www.tecmint.com/author/aaronkili/

|

||||

[12]:http://www.tecmint.com/10-useful-free-linux-ebooks-for-newbies-and-administrators/

|

||||

[13]:http://www.tecmint.com/free-linux-shell-scripting-books/

|

||||

@ -1,233 +0,0 @@