mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-01-19 22:51:41 +08:00

commit

71ff532ae5

64

lctt2020.md

Normal file

64

lctt2020.md

Normal file

@ -0,0 +1,64 @@

|

||||

# Linux 中国旗下贡献者组织 LCTT 七年回顾和展望

|

||||

|

||||

> 这是一篇 LCTT 七周年的纪念文章,也是 LCTT 承前启后的一个里程碑。

|

||||

|

||||

### 写在 LCTT 七年之际

|

||||

|

||||

在 7 年前的今天,我并没有想到,在一个偶然的机会下诞生的 LCTT,它能走过这么长的时间,留下这么多的印痕。是的,一些老朋友或许记得,LCTT 这个 Linux 中国旗下的最主要的开源活动/组成部分,最初只是我发心想完善 man 的中文翻译而产生的副产品。结果,man 中文翻译项目没有做成,而 LCTT 却持续地运营了下来。

|

||||

|

||||

虽然,这些年 LCTT 屡有改进和完善,但是总体来说还是相对保守。当然,LCTT 这些年已经陆续有 400 多位贡献者实质性的参与了贡献,并在此基础上创建了几个 SIG(特别兴趣小组),如[红帽代码英雄 SIG](https://linux.cn/article-12436-1.html)、漫画 SIG、LFS SIG 等。

|

||||

|

||||

作为回顾,我来介绍一下 LCTT 这 7 年间在主项目(TranslateProject)上取得的成就:

|

||||

|

||||

- 贡献者: [435 位](https://linux.cn/lctt-list)

|

||||

- 翻译文章:[5687 篇](https://linux.cn/)

|

||||

- GitHub 提交:[54629 次](https://github.com/LCTT/TranslateProject)

|

||||

- GitHub 拉取请求:[19243 次](https://github.com/LCTT/TranslateProject/pulls)

|

||||

|

||||

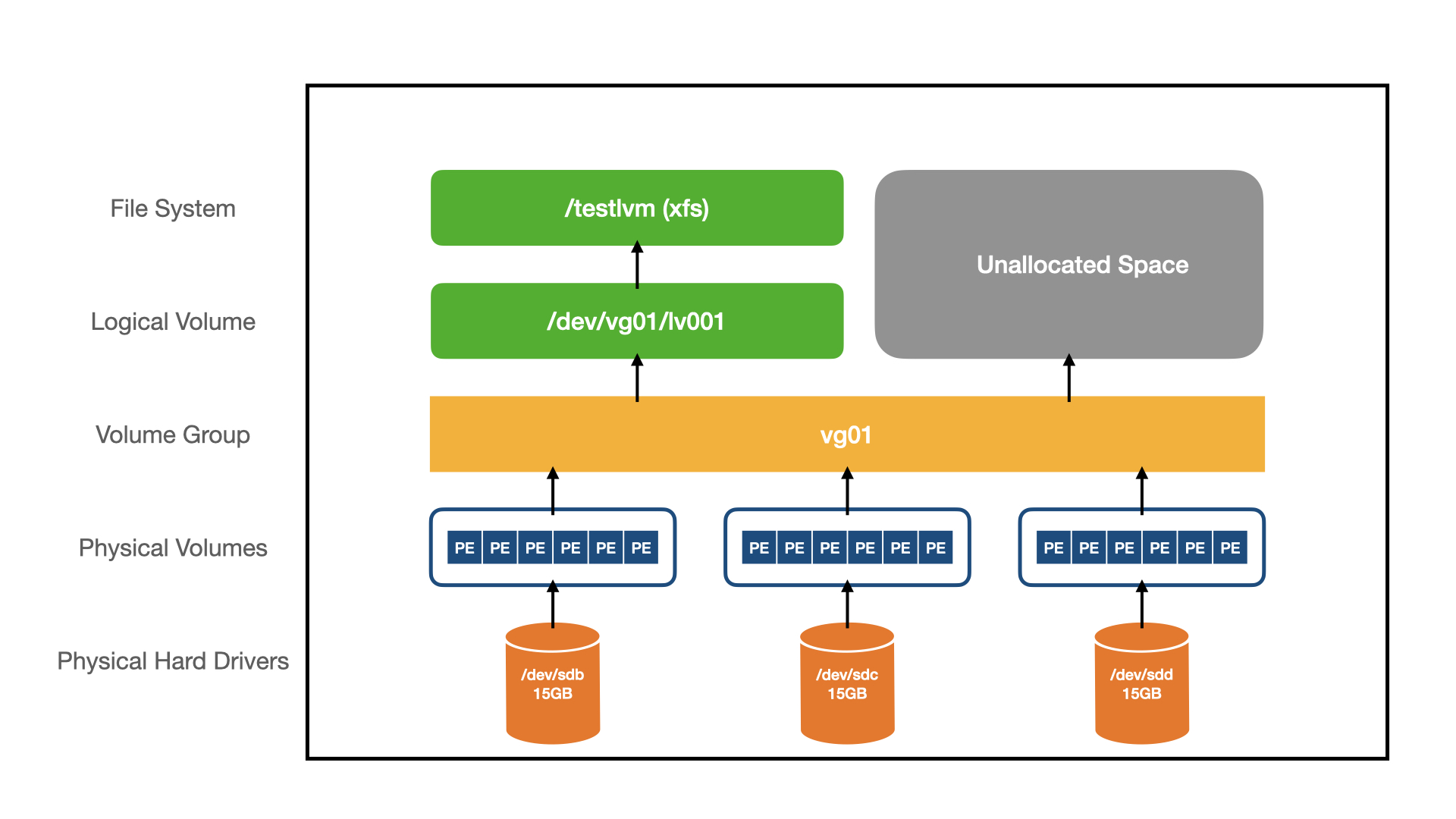

这是 LCTT 主项目的提交图:

|

||||

|

||||

|

||||

|

||||

这其中,[钻石级的贡献者有 5 名,五星级贡献者有 6 名,13 位 4 星贡献者](https://linux.cn/lctt-list)。那么,请让我来用一段视频展示一下 LCTT 七年来的历程:

|

||||

|

||||

|

||||

|

||||

当然,整体的贡献水平呈现长尾分布,大部分贡献者浅尝辄止,我想除了贡献者存在着体验的心态之外,也与 LCTT 没有建立起来合适的社区引导和激励机制有关。此外,就开源社区/开源项目而言,我们也存在一些不足,比如,按 GitHub 建议,我们在如下社区建设方面还缺乏:

|

||||

|

||||

- 社区行为准则

|

||||

- 贡献指南

|

||||

- 议题模板

|

||||

- 拉取请求模板

|

||||

|

||||

因此,在写这篇文章时,我也要宣布一件事,就是我会逐渐淡出 LCTT 的日常管理,改组 LCTT 管理团队,将更多未来的可能交给社区成员来建设,也希望新的社区管理团队可以为 LCTT 创造出一个不同的明天。

|

||||

|

||||

以下,请我们的 Linux 中国的核心合伙人 Bestony 来介绍一下今后 LCTT 的发展计划。

|

||||

|

||||

---

|

||||

|

||||

大家好,我是 Bestony,感谢老王数年来的坚持不懈的投入,正是有老王的坚守,才能有我们如今的成就。在接下来的时间里,我将会帮助老王,更好的运作 LCTT,让老王可以喘口气,也为 LCTT 带来一些新的气象。

|

||||

|

||||

在过去的七年里,我们 LCTT 做了很多事情,我们翻译了数千篇文章,有数百位技能精湛的贡献者。如今,到了 7 年的这个节点上,我也在思考,我们下一步应该怎么走。

|

||||

|

||||

其实,在过去的一年里,LCTT 的问题在不断的浮现:选题方向单一、译者进入门槛较高、大家翻译的质量水平参差不齐、校对的人手不足、译稿外发的反馈不足,这些问题都是我们在过去遇见,但一直没有足够的精力和人力来解决的问题。不过,如今我将加入到 LCTT 的管理团队中,配合老王,一起一个个的解决这些过去遇见的问题。

|

||||

|

||||

|

||||

|

||||

对于这些问题,有一些我们已经在解决,比如“**选题方向单一**”,在今年的年初,LCTT 与红帽公司(RedHat)[联合建立了 LCRH SIG](https://linux.cn/article-12436-1.html),面向红帽旗下的原创播客《<ruby>[代码英雄](https://www.redhat.com/en/command-line-heroes) <rt>Command Line Heroes</rt></ruby>》进行定向的翻译,目前,第一季度的翻译成功已经全部在 Linux 中国公众号上发布,而第二、三季度的内容,也正在不断的发布过程中。

|

||||

|

||||

|

||||

|

||||

LCTT - SIG 将是后续的新的发展方向。**我们将会在保留 LCTT 主体的基础上,鼓励各位译者探索更多的兴趣方向,通过建立起不同的 SIG,引入更多的翻译内容,来帮助大家更好的达成自己想要的翻译目标。** 并且,通过 LCTT 的技术和经验,赋能每一位译者,帮助译者更好的学习、了解各种不同领域的知识。

|

||||

|

||||

而在“**进入门槛较高**”方面,一直以来 Github 的访问慢问题、Git 的概念不熟悉等问题,都是困扰不少新同学的点。而也正是这些点,在不断制约着 LCTT 的发展。在将来,我希望 LCTT 可以打造出自己的翻译工具(也将会为之而奋斗),通过工具辅助的方式,帮助更多人走上翻译的道路,让更多的爱好者们,可以为中文的技术环境贡献一份力。

|

||||

|

||||

|

||||

|

||||

后续,我们将会引入翻译工具、自建关键词表、多轮校对手段等方案,帮助更多的译者完成自己的翻译文章,通过翻译,学到自己想要的知识。

|

||||

|

||||

当然,问题并不止我点出来的这些,我们能发展到今天,一定有很多做对了的地方,但同样,我们也有做错了的地方。欢迎你随时联系我,讨论你对于 LCTT 下一步的想法,我相信,你的意见能够帮助 LCTT 变得更好。

|

||||

|

||||

|

||||

|

||||

最后,**千里之行,始于足下**,刚刚走过 7 年的 LCTT, 希望我们可以在下一个七年,再次相遇。

|

||||

|

||||

0

published/201610/20160604 How to Build Your First Slack Bot with Python.md

Executable file → Normal file

0

published/201610/20160604 How to Build Your First Slack Bot with Python.md

Executable file → Normal file

0

published/201610/20160724 Terminator A Linux Terminal Emulator With Multiple Terminals In One Window.md

Executable file → Normal file

0

published/201610/20160724 Terminator A Linux Terminal Emulator With Multiple Terminals In One Window.md

Executable file → Normal file

0

published/201610/20160811 How to Mount Remote Linux Filesystem or Directory Using SSHFS Over SSH.md

Executable file → Normal file

0

published/201610/20160811 How to Mount Remote Linux Filesystem or Directory Using SSHFS Over SSH.md

Executable file → Normal file

0

published/201610/20160812 What is copyleft.md

Executable file → Normal file

0

published/201610/20160812 What is copyleft.md

Executable file → Normal file

0

published/201611/20160513 aria2 (Command Line Downloader) command examples.md

Executable file → Normal file

0

published/201611/20160513 aria2 (Command Line Downloader) command examples.md

Executable file → Normal file

0

published/201611/20160914 Down and dirty with Windows Nano Server 2016.md

Executable file → Normal file

0

published/201611/20160914 Down and dirty with Windows Nano Server 2016.md

Executable file → Normal file

0

published/201611/20161025 3 Ways to Delete All Files in a Directory Except One or Few Files with Extensions.md

Executable file → Normal file

0

published/201611/20161025 3 Ways to Delete All Files in a Directory Except One or Few Files with Extensions.md

Executable file → Normal file

0

published/201611/20161025 How to Start Linux Command in Background and Detach Process in Terminal.md

Executable file → Normal file

0

published/201611/20161025 How to Start Linux Command in Background and Detach Process in Terminal.md

Executable file → Normal file

0

published/201701/20160610 Setting Up Real-Time Monitoring with Ganglia.md

Executable file → Normal file

0

published/201701/20160610 Setting Up Real-Time Monitoring with Ganglia.md

Executable file → Normal file

0

published/201804/20180206 Programming in Color with ncurses.md

Executable file → Normal file

0

published/201804/20180206 Programming in Color with ncurses.md

Executable file → Normal file

523

published/20190115 Linux Desktop Setup - HookRace Blog.md

Normal file

523

published/20190115 Linux Desktop Setup - HookRace Blog.md

Normal file

@ -0,0 +1,523 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (chenmu-kk)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-12883-1.html)

|

||||

[#]: subject: (Linux Desktop Setup · HookRace Blog)

|

||||

[#]: via: (https://hookrace.net/blog/linux-desktop-setup/)

|

||||

[#]: author: (Dennis Felsing http://felsin9.de/nnis/)

|

||||

|

||||

十年 Linux 桌面生存指南

|

||||

======

|

||||

|

||||

|

||||

|

||||

从 2006 年开始转战 Linux 系统后,经过几年的实践,我的软件设置在过去十年内出人意料的固定。再过十年回顾一下,看看发生了什么,也许会非常有趣。在写这篇推文时,我迅速回顾了正在运行的内容:

|

||||

|

||||

![htop overview][2]

|

||||

|

||||

### 动机

|

||||

|

||||

我的软件介绍排序不分先后:

|

||||

|

||||

* 程序应该运行在本地系统中以便我可以控制它,这其中并不包括云解决方案。

|

||||

* 程序应在终端中运行,以便于在任何地方连贯地使用它们,包括性能稍差的电脑或手机。

|

||||

* 通过使用终端软件,可以实现自动聚焦键盘。只有在一些有意义的地方,我会更喜欢使用鼠标,因为在打字期间一直伸手去拿鼠标感觉像在浪费时间。有时候过了一个小时我才注意到甚至还没有插鼠标。

|

||||

* 最好使用快速高效的软件,我不喜欢听到风扇的声音和感到房间在变热。我还可以继续长久地运行旧硬件,已经使用了 10 年的 Thinkpad x200s 还能很好地支持我所使用的软件。

|

||||

* 组合。我不想手动执行每个步骤,而是在需要时自动执行更多操作,这时自然是支持 shell。

|

||||

|

||||

### 操作系统

|

||||

|

||||

十二年前移除 Windows 系统后,我在 Linux 系统上经历了一个艰难的开始,当时我手上只有 [Gentoo Linux][3] 系统的安装光盘和一本打印的说明书,要用它们来实现一个可运行的 Linux 系统。虽然花费了几天的时间去编译和修整,但最终还是觉得自己受益颇多。

|

||||

|

||||

自此我再也没有转回 Windows 系统,但在持续的编译压力导致风扇失灵后,我将我的电脑系统切换到 [Arch Linux][4]。之后我将其他的电脑和私人服务器也切换到了 Arch Linux。作为一个滚动发布发行版,你可以随时升级软件包,但 [Arch Linux News][5] 已经详细报道了其中最主要的漏洞。

|

||||

|

||||

不过,令人烦恼的是一旦你更新了旧的内核模组,Arch Linux 就会移除旧版的相关信息。我经常注意到一旦我试着插入一个 USB 闪存盘,内核就无法加载相关组件。相反,每次内核升级后都应该进行重启。有一些 [方法][6] 可以解决这个问题,但我还没有实际地使用它们。

|

||||

|

||||

其他程序也会出现类似的情况,通常 Firefox 、 cron 或者 Samba 在升级后都需要重启,但恼人的是,它们没有警告你存在这种情况。我在工作中使用的 [SUSE][7] 很好地提醒了这种情况。

|

||||

|

||||

对于 [DDNet][8] 产品服务器,相较于 Arch Linux ,我更倾向于 [Debian][9] 系统,这样在每次升级时出现故障的几率更低。我的防火墙和路由器使用了 [OpenBSD][10] ,它拥有干净系统、文档和强大的 [pf 防火墙][11],而我现在不需要一个单独的路由器。

|

||||

|

||||

### 窗口管理器

|

||||

|

||||

从我开始使用 Gentoo 后,我很快注意到 KDE 的编译时间非常长,这让我没办法继续使用它。我四处寻找更简单的解决方案,最初使用了 [Openbox][12] 和 [Fluxbox][13]。某次,为了能更多进行纯键盘操作,我开始尝试转入平铺窗口管理器,并在研究其初始版本的时候学习了 [dwm][14] 和 [awesome][15]。

|

||||

|

||||

最终,由于 [xmonad][16]的灵活性、可扩展性以及使用纯 [Haskell][17](一种出色的函数编程语言)编写和配置,最终选择了它。一个例子是,我在家中运行一个 40" 4K 的屏幕,但经常会将它分为四个虚拟屏幕,每个虚拟屏幕显示一个工作区,每个工作区自动排列在我的窗口上。当然, xmonad 有一个对应的 [模块][18]。

|

||||

|

||||

[dzen][19] 和 [conky][20] 对我来说是一个非常简单的状态栏。我的整体 conky 配置看起来是这样的:

|

||||

|

||||

```

|

||||

out_to_console yes

|

||||

update_interval 1

|

||||

total_run_times 0

|

||||

|

||||

TEXT

|

||||

${downspeed eth0} ${upspeed eth0} | $cpu% ${loadavg 1} ${loadavg 2} ${loadavg 3} $mem/$memmax | ${time %F %T}

|

||||

```

|

||||

|

||||

输入命令直接通过管道输入 dzen2:

|

||||

|

||||

```

|

||||

conky | dzen2 -fn '-xos4-terminus-medium-r-normal-*-12-*-*-*-*-*-*-*' -bg '#000000' -fg '#ffffff' -p -e '' -x 1000 -w 920 -xs 1 -ta r

|

||||

```

|

||||

|

||||

对我而言,一项重要功能是在完成工作后使终端发出蜂鸣声。只需要简单地在 zsh 中的 `PR_TITLEBAR` 变量中添加一个 `\a` 字符就可以做到,只要工作完成就可以发出蜂鸣声。当然,我使用了命令:

|

||||

|

||||

```

|

||||

echo "blacklist pcspkr" > /etc/modprobe.d/nobeep.conf

|

||||

```

|

||||

|

||||

将 `pcspkr` 内核模块列入黑名单来禁用实际的蜂鸣声。相反 urxvt 的 `URxvt.urgentOnBell: true` 设置会将声音变为尖锐。之后 xmonad 有一个 urgency 钩子来捕捉这类信号,并且我可以使用组合键自动聚焦到当前的发出紧急信号的窗口。在 dzen 中我可以看到一个漂亮且明亮的 `#ff0000` 紧急窗口。

|

||||

|

||||

在我笔记本上所得到的最终成品是:

|

||||

|

||||

![Laptop screenshot][22]

|

||||

|

||||

我听说前几年 [i3][23] 变得非常流行,但它要求更多的手动窗口对齐而不是自动对齐。

|

||||

|

||||

我意识到也有像 [tmux][24] 那样的终端多路复用器,但我仍想要一些图形化应用程序,因此最终我没有有效地使用它们。

|

||||

|

||||

### 终端连续性

|

||||

|

||||

为了使终端保持活跃状态,我使用了 [dtach][25] ,它只是模拟屏幕分离功能。为了使计算机上的每个终端都可连接和断开,我编写了一个小的封装脚本。 这意味着,即使必须重新启动 X 服务器,我也可以使所有终端都运行良好,包括本地和远程终端。

|

||||

|

||||

### Shell & 编程

|

||||

|

||||

对于 shell,我使用 [zsh][28] 而不是 [bash][27],因为它有众多的功能。

|

||||

|

||||

作为终端模拟,我发现 [urxvt][29] 足够轻巧,支持 Unicode 编码和 256 色,具有出色的性能。另一个重要的功能是可以分别运行 urxvt 客户端和守护进程。因此,即使大量终端也几乎不占用任何内存(回滚缓冲区除外)。

|

||||

|

||||

对我而言,只有一种字体看起来绝对干净和完美: [Terminus][30]。 由于它是位图字体,因此所有内容都是完美像素,渲染速度极快且 CPU 使用率低。为了能使用 `CTRL-WIN-[1-7]` 在每个终端按需切换字体,我的 `~/.Xdefaults` 包含:

|

||||

|

||||

```

|

||||

URxvt.font: -xos4-terminus-medium-r-normal-*-14-*-*-*-*-*-*-*

|

||||

dzen2.font: -xos4-terminus-medium-r-normal-*-14-*-*-*-*-*-*-*

|

||||

|

||||

URxvt.keysym.C-M-1: command:\033]50;-xos4-terminus-medium-r-normal-*-12-*-*-*-*-*-*-*\007

|

||||

URxvt.keysym.C-M-2: command:\033]50;-xos4-terminus-medium-r-normal-*-14-*-*-*-*-*-*-*\007

|

||||

URxvt.keysym.C-M-3: command:\033]50;-xos4-terminus-medium-r-normal-*-18-*-*-*-*-*-*-*\007

|

||||

URxvt.keysym.C-M-4: command:\033]50;-xos4-terminus-medium-r-normal-*-22-*-*-*-*-*-*-*\007

|

||||

URxvt.keysym.C-M-5: command:\033]50;-xos4-terminus-medium-r-normal-*-24-*-*-*-*-*-*-*\007

|

||||

URxvt.keysym.C-M-6: command:\033]50;-xos4-terminus-medium-r-normal-*-28-*-*-*-*-*-*-*\007

|

||||

URxvt.keysym.C-M-7: command:\033]50;-xos4-terminus-medium-r-normal-*-32-*-*-*-*-*-*-*\007

|

||||

|

||||

URxvt.keysym.C-M-n: command:\033]10;#ffffff\007\033]11;#000000\007\033]12;#ffffff\007\033]706;#00ffff\007\033]707;#ffff00\007

|

||||

URxvt.keysym.C-M-b: command:\033]10;#000000\007\033]11;#ffffff\007\033]12;#000000\007\033]706;#0000ff\007\033]707;#ff0000\007

|

||||

```

|

||||

|

||||

对于编程和书写,我使用 [Vim][31] 语法高亮显示和 [ctags][32] 进行索引,以及一些带有 `grep` 、`sed` 和其他用于搜索和操作的常用终端窗口。这可能不像 IDE 那样舒适,但可以实现更多的自动化。

|

||||

|

||||

Vim 的一个问题是你已经习惯了它的键映射,因此希望在任何地方都使用它们。

|

||||

|

||||

在 shell 功能不够强大时,[Python][33] 和 [Nim][34] 作为脚本语言也不错。

|

||||

|

||||

### 系统监控

|

||||

|

||||

[htop][35] (查看当前站点的后台运行,是托管服务器的实时视图)非常适合快速了解软件的当前运行状态。 [lm_sensors][36] 可以监控硬件温度、风扇和电压。 [powertop][37] 是一款由 Intel 发布的优秀省电小工具。 [ncdu][38] 可以交互式分析磁盘使用情况。

|

||||

|

||||

[nmap][39]、 iptraf-ng、 [tcpdump][40] 和 [Wireshark][41] 都是分析网络问题的基本工具。

|

||||

|

||||

当然还有很多更优秀的工具。

|

||||

|

||||

### 邮件 & 同步

|

||||

|

||||

在我的家庭服务器上,我为自己所有的邮箱账号运行了 [fetchmail][42] 守护进程。fetchmail 只是检索收到的邮件并调用 [procmail][43]:

|

||||

|

||||

```

|

||||

#!/bin/sh

|

||||

for i in /home/deen/.fetchmail/*; do

|

||||

FETCHMAILHOME=$i /usr/bin/fetchmail -m 'procmail -d %T' -d 60

|

||||

done

|

||||

```

|

||||

|

||||

配置非常简单,然后等待服务器通知我们有新的邮件:

|

||||

|

||||

```

|

||||

poll imap.1und1.de protocol imap timeout 120 user "dennis@felsin9.de" password "XXX" folders INBOX keep ssl idle

|

||||

```

|

||||

|

||||

我的 `.procmailrc` 配置包含一些备份全部邮件的规则,并将邮件整理在对应的目录下面。例如,基于邮件列表名或者邮件标题:

|

||||

|

||||

```

|

||||

MAILDIR=/home/deen/shared/Maildir

|

||||

LOGFILE=$HOME/.procmaillog

|

||||

LOGABSTRACT=no

|

||||

VERBOSE=off

|

||||

FORMAIL=/usr/bin/formail

|

||||

NL="

|

||||

"

|

||||

|

||||

:0wc

|

||||

* ! ? test -d /media/mailarchive/`date +%Y`

|

||||

| mkdir -p /media/mailarchive/`date +%Y`

|

||||

|

||||

# Make backups of all mail received in format YYYY/YYYY-MM

|

||||

:0c

|

||||

/media/mailarchive/`date +%Y`/`date +%Y-%m`

|

||||

|

||||

:0

|

||||

* ^From: .*(.*@.*.kit.edu|.*@.*.uka.de|.*@.*.uni-karlsruhe.de)

|

||||

$MAILDIR/.uni/

|

||||

|

||||

:0

|

||||

* ^list-Id:.*lists.kit.edu

|

||||

$MAILDIR/.uni-ml/

|

||||

|

||||

[...]

|

||||

```

|

||||

|

||||

我使用 [msmtp][44] 来发送邮件,它也很好配置:

|

||||

|

||||

```

|

||||

account default

|

||||

host smtp.1und1.de

|

||||

tls on

|

||||

tls_trust_file /etc/ssl/certs/ca-certificates.crt

|

||||

auth on

|

||||

from dennis@felsin9.de

|

||||

user dennis@felsin9.de

|

||||

password XXX

|

||||

|

||||

[...]

|

||||

```

|

||||

|

||||

但是到目前为止,邮件还在服务器上。 我的文档全部存储在一个目录中,我使用 [Unison][45] 在所有计算机之间进行同步。Unison 可以视为双向交互式 [rsync][46],我的邮件是这个文件目录下的一部分,因此它们最终存储在我的电脑上。

|

||||

|

||||

这也意味着,尽管邮件会立即到达我的邮箱,但我只是按需拿取,而不是邮件一到达时就立即收到通知。

|

||||

|

||||

从此我使用 [mutt][47] 阅读邮件,使用侧边栏显示我的邮件目录。 `/etc/mailcap` 文件对于显示非纯文本邮件( HTML, Word 或者 PDF)不可或缺:

|

||||

|

||||

```

|

||||

text/html;w3m -I %{charset} -T text/html; copiousoutput

|

||||

application/msword; antiword %s; copiousoutput

|

||||

application/pdf; pdftotext -layout /dev/stdin -; copiousoutput

|

||||

```

|

||||

|

||||

### 新闻 & 通讯

|

||||

|

||||

[Newsboat][48] 是一个非常棒的终端 RSS/Atom 阅读器。我在一个有约 150 个提要的 `tach` 会话服务器上运行它。也可以在本地选择提要,例如:

|

||||

|

||||

```

|

||||

ignore-article "https://forum.ddnet.tw/feed.php" "title =~ \"Map Testing •\" or title =~ \"Old maps •\" or title =~ \"Map Bugs •\" or title =~ \"Archive •\" or title =~ \"Waiting for mapper •\" or title =~ \"Other mods •\" or title =~ \"Fixes •\""

|

||||

```

|

||||

|

||||

我以同样的方式使用 [Irssi][49] 进行 IRC 通讯。

|

||||

|

||||

### 日历

|

||||

|

||||

[remind][50] 是一个可以从命令行获取的日历。通过编辑 `rem` 文件可以设置新的提醒:

|

||||

|

||||

```

|

||||

# One time events

|

||||

REM 2019-01-20 +90 Flight to China %b

|

||||

|

||||

# Recurring Holidays

|

||||

REM 1 May +90 Holiday "Tag der Arbeit" %b

|

||||

REM [trigger(easterdate(year(today()))-2)] +90 Holiday "Karfreitag" %b

|

||||

|

||||

# Time Change

|

||||

REM Nov Sunday 1 --7 +90 Time Change (03:00 -> 02:00) %b

|

||||

REM Apr Sunday 1 --7 +90 Time Change (02:00 -> 03:00) %b

|

||||

|

||||

# Birthdays

|

||||

FSET birthday(x) "'s " + ord(year(trigdate())-x) + " birthday is %b"

|

||||

REM 16 Apr +90 MSG Andreas[birthday(1994)]

|

||||

|

||||

# Sun

|

||||

SET $LatDeg 49

|

||||

SET $LatMin 19

|

||||

SET $LatSec 49

|

||||

SET $LongDeg -8

|

||||

SET $LongMin -40

|

||||

SET $LongSec -24

|

||||

|

||||

MSG Sun from [sunrise(trigdate())] to [sunset(trigdate())]

|

||||

[...]

|

||||

```

|

||||

|

||||

遗憾的是,目前 remind 中还没有中国农历的提醒功能,因此中国的节日不易计算。

|

||||

|

||||

我给提醒设置了两个名字:

|

||||

|

||||

```

|

||||

rem -m -b1 -q -g

|

||||

```

|

||||

|

||||

按时间顺序查看待办事项清单

|

||||

|

||||

```

|

||||

rem -m -b1 -q -cuc12 -w$(($(tput cols)+1)) | sed -e "s/\f//g" | less

|

||||

```

|

||||

|

||||

显示适应终端宽度的日历:

|

||||

|

||||

![remcal][51]

|

||||

|

||||

### 字典

|

||||

|

||||

[rdictcc][52] 是鲜为人知的字典工具,它可以使用 [dict.cc][53] 很棒的词典并将他们转存在本地数据库中:

|

||||

|

||||

```

|

||||

$ rdictcc rasch

|

||||

====================[ A => B ]====================

|

||||

rasch:

|

||||

- apace

|

||||

- brisk [speedy]

|

||||

- cursory

|

||||

- in a timely manner

|

||||

- quick

|

||||

- quickly

|

||||

- rapid

|

||||

- rapidly

|

||||

- sharpish [Br.] [coll.]

|

||||

- speedily

|

||||

- speedy

|

||||

- swift

|

||||

- swiftly

|

||||

rasch [gehen]:

|

||||

- smartly [quickly]

|

||||

Rasch {n} [Zittergras-Segge]:

|

||||

- Alpine grass [Carex brizoides]

|

||||

- quaking grass sedge [Carex brizoides]

|

||||

Rasch {m} [regional] [Putzrasch]:

|

||||

- scouring pad

|

||||

====================[ B => A ]====================

|

||||

Rasch model:

|

||||

- Rasch-Modell {n}

|

||||

```

|

||||

|

||||

### 记录和阅读

|

||||

|

||||

我有一个简单记录任务的备忘录,在 Vim 会话中基本上一直处于打开状态。我也使用备忘录作为工作中“已完成”工作的记录,这样就可以检查自己每天完成了哪些任务。

|

||||

|

||||

对于写文件、信件和演示文稿,我会使用 [LaTeX][54] 进行高级排版。德式的简单信件可以这样设置,例如:

|

||||

|

||||

```

|

||||

\documentclass[paper = a4, fromalign = right]{scrlttr2}

|

||||

\usepackage{german}

|

||||

\usepackage{eurosym}

|

||||

\usepackage[utf8]{inputenc}

|

||||

\setlength{\parskip}{6pt}

|

||||

\setlength{\parindent}{0pt}

|

||||

|

||||

\setkomavar{fromname}{Dennis Felsing}

|

||||

\setkomavar{fromaddress}{Meine Str. 1\\69181 Leimen}

|

||||

\setkomavar{subject}{Titel}

|

||||

|

||||

\setkomavar*{enclseparator}{Anlagen}

|

||||

|

||||

\makeatletter

|

||||

\@setplength{refvpos}{89mm}

|

||||

\makeatother

|

||||

|

||||

\begin{document}

|

||||

\begin{letter} {Herr Soundso\\Deine Str. 2\\69121 Heidelberg}

|

||||

\opening{Sehr geehrter Herr Soundso,}

|

||||

|

||||

Sie haben bei mir seit dem Bla Bla Bla.

|

||||

|

||||

Ich fordere Sie hiermit zu Bla Bla Bla auf.

|

||||

|

||||

\closing{Mit freundlichen Grüßen}

|

||||

|

||||

\end{letter}

|

||||

\end{document}

|

||||

```

|

||||

|

||||

在 [我的私人网站][55] 上可以找到更多的示例文档和演示文稿。

|

||||

|

||||

[Zathura][56] 读取 PDF 文件速度很快,支持 Vim 类控件,还支持两种不同的 PDF 后端: Poppler 和 MuPDF。另一方面,在偶尔遇到 Zathura 无法打开的文件时,[Evince][57] 则显得更全能一些。

|

||||

|

||||

### 图片编辑

|

||||

|

||||

简便的选择是,[GIMP][58] 和 [Inkscape][59] 分别用于照片编辑和交互式向量图形。

|

||||

|

||||

有时 [Imagemagick][60] 已经足够好了,它可以从命令行直接使用,从而自动编辑图片。同样 [Graphviz][61] 和 [TikZ][62] 可以用来绘制曲线图和其他图表。

|

||||

|

||||

### Web 浏览器

|

||||

|

||||

对于 Web 浏览器,我一直在使用 [Firefox][63]。相较于 Chrome,它的可扩展性更好,资源使用率更低。

|

||||

|

||||

不幸的是,在 Firefox 完全改用 Chrome 风格的扩展之后, [Pentadactyl][64] 扩展的开发就停止了,所以我的浏览器中再也没有令人满意的 Vim 类控件了。

|

||||

|

||||

### 媒体播放器

|

||||

|

||||

通过设置 `vo=gpu` 以及 `hwdec=vaapi`,具有硬件解码功能的 [mpv][65] 在播放期间 CPU 的占用率保持在 5%。相较于默认的 PulseAudio,mpv 中的 `audio-channels=2` 似乎可以使我的立体扬声器/耳机获得更清晰的降级混频。一个很棒的小功能是用 `Shift-Q` 退出,而不是只用 `Q` 来保存回放位置。当你与母语是其他语言的人一起看视频时,你可以使用 `--secondary-sid=` 同时显示两种字幕,主字幕位于底部,次字幕位于屏幕顶部。

|

||||

|

||||

我的无线鼠标可以简单地通过一个小的配置文件( `~/.config/mpv/input.conf` )实现远程控制 mpv :

|

||||

|

||||

```

|

||||

MOUSE_BTN5 run "mixer" "pcm" "-2"

|

||||

MOUSE_BTN6 run "mixer" "pcm" "+2"

|

||||

MOUSE_BTN1 cycle sub-visibility

|

||||

MOUSE_BTN7 add chapter -1

|

||||

MOUSE_BTN8 add chapter 1

|

||||

```

|

||||

|

||||

[youtube-dl][66] 非常适合观看在线托管的视频,使用 `-f bestvideo+bestaudio/best --all-subs --embed-subs` 命令可获得最高质量的视频。

|

||||

|

||||

作为音乐播放器, [MOC][67] 不再活跃开发,但它仍是一个简易的播放器,可以播放各种可能的格式,包括最不常用的 Chiptune 格式。在 AUR 中有一个 [补丁][68] 增加了 PulseAudio 支持。即使在 CPU 时钟频率降到 800 MHz, MOC 也只使用了单核 CPU 的 1-2% 。

|

||||

|

||||

![moc][69]

|

||||

|

||||

我的音乐收藏夹保存在我的家庭服务器上,因此我可以从任何地方访问它。它使用 [SSHFS][70] 挂载并自动安装在 `/etc/fstab/` 目录下:

|

||||

|

||||

```

|

||||

root@server:/media/media /mnt/media fuse.sshfs noauto,x-systemd.automount,idmap=user,IdentityFile=/root/.ssh/id_rsa,allow_other,reconnect 0 0

|

||||

```

|

||||

|

||||

### 跨平台构建

|

||||

|

||||

除了 Linux 本身,它对于构建任何主流操作系统的软件包都很优秀! 一开始,我使用 [QEMU][71] 与旧版 Debian、 Windows 以及 Mac OS X VM 一起构建这些平台。

|

||||

|

||||

现在我在旧版 Debian 发行版上转而使用 chroot (以获得最大的 Linux 兼容性),在 Windows 上使用 [MinGW][72] 进行交叉编译,在 Mac OS X 上则使用 [OSXCross][73]。

|

||||

|

||||

用于 [构建 DDNet][74] 的脚本以及 [更新库构建的说明][75] 的脚本都基于这个。

|

||||

|

||||

### 备份

|

||||

|

||||

通常,我们都会忘记备份。即使这是最后一节,它也不应该成为事后诸葛。

|

||||

|

||||

十年前我写了 [rrb][76] (反向 rsync 备份)重新封装了 `rsync` ,因此我只需要将备份服务器的 root SSH 权限授予正在备份的计算机。令人惊讶地是,尽管我一直在使用 rrb ,但它在过去十年里没有任何改变。

|

||||

|

||||

备份文件直接存储在文件系统中。使用硬链接实现增量备份(`--link-dest`)。一个简单的 [配置][77] 定义了备份保存时间,默认为:

|

||||

|

||||

```

|

||||

KEEP_RULES=( \

|

||||

7 7 \ # One backup a day for the last 7 days

|

||||

31 8 \ # 8 more backups for the last month

|

||||

365 11 \ # 11 more backups for the last year

|

||||

1825 4 \ # 4 more backups for the last 5 years

|

||||

)

|

||||

```

|

||||

|

||||

因为我的一些计算机没有静态 IP / DNS 但仍想使用 rrb 备份,那我会使用反向安全隧道(作为 systemd 服务):

|

||||

|

||||

```

|

||||

[Unit]

|

||||

Description=Reverse SSH Tunnel

|

||||

After=network.target

|

||||

|

||||

[Service]

|

||||

ExecStart=/usr/bin/ssh -N -R 27276:localhost:22 -o "ExitOnForwardFailure yes" server

|

||||

KillMode=process

|

||||

Restart=always

|

||||

|

||||

[Install]

|

||||

WantedBy=multi-user.target

|

||||

```

|

||||

|

||||

现在,隧道运行备份时,服务器可以通过 `ssh -p 27276 localhost` 命令或者使用 `.ssh/config` 到达服务器端。

|

||||

|

||||

```

|

||||

Host cr-remote

|

||||

HostName localhost

|

||||

Port 27276

|

||||

```

|

||||

|

||||

在谈及 SSH 技巧时,有时由于某些中断的路由会很难访问到服务器。在那种情况下你可以借道其他服务器的 SSH 连接,以获得更好的路由。在这种情况下,你可能通过美国连接访问到我的中国服务器,而来自德国的不可靠连接可能需要几个周:

|

||||

|

||||

```

|

||||

Host chn.ddnet.tw

|

||||

ProxyCommand ssh -q usa.ddnet.tw nc -q0 chn.ddnet.tw 22

|

||||

Port 22

|

||||

```

|

||||

|

||||

### 结语

|

||||

|

||||

感谢阅读我工具的收藏。这其中我也许遗漏了许多日常中自然成习惯的步骤。让我们来看看我的软件设置在下一年里能多稳定吧。如果你有任何问题,随时联系我 [dennis@felsin9.de][78] 。

|

||||

|

||||

在 [Hacker News][79] 下评论吧。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://hookrace.net/blog/linux-desktop-setup/

|

||||

|

||||

作者:[Dennis Felsing][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[chenmu-kk](https://github.com/chenmu-kk)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: http://felsin9.de/nnis/

|

||||

[b]: https://github.com/lujun9972

|

||||

[1]: https://hookrace.net/public/linux-desktop/htop_small.png

|

||||

[2]: https://hookrace.net/public/linux-desktop/htop.png

|

||||

[3]: https://gentoo.org/

|

||||

[4]: https://www.archlinux.org/

|

||||

[5]: https://www.archlinux.org/news/

|

||||

[6]: https://www.reddit.com/r/archlinux/comments/4zrsc3/keep_your_system_fully_functional_after_a_kernel/

|

||||

[7]: https://www.suse.com/

|

||||

[8]: https://ddnet.tw/

|

||||

[9]: https://www.debian.org/

|

||||

[10]: https://www.openbsd.org/

|

||||

[11]: https://www.openbsd.org/faq/pf/

|

||||

[12]: http://openbox.org/wiki/Main_Page

|

||||

[13]: http://fluxbox.org/

|

||||

[14]: https://dwm.suckless.org/

|

||||

[15]: https://awesomewm.org/

|

||||

[16]: https://xmonad.org/

|

||||

[17]: https://www.haskell.org/

|

||||

[18]: http://hackage.haskell.org/package/xmonad-contrib-0.15/docs/XMonad-Layout-LayoutScreens.html

|

||||

[19]: http://robm.github.io/dzen/

|

||||

[20]: https://github.com/brndnmtthws/conky

|

||||

[21]: https://hookrace.net/public/linux-desktop/laptop_small.png

|

||||

[22]: https://hookrace.net/public/linux-desktop/laptop.png

|

||||

[23]: https://i3wm.org/

|

||||

[24]: https://github.com/tmux/tmux/wiki

|

||||

[25]: http://dtach.sourceforge.net/

|

||||

[26]: https://github.com/def-/tach/blob/master/tach

|

||||

[27]: https://www.gnu.org/software/bash/

|

||||

[28]: http://www.zsh.org/

|

||||

[29]: http://software.schmorp.de/pkg/rxvt-unicode.html

|

||||

[30]: http://terminus-font.sourceforge.net/

|

||||

[31]: https://www.vim.org/

|

||||

[32]: http://ctags.sourceforge.net/

|

||||

[33]: https://www.python.org/

|

||||

[34]: https://nim-lang.org/

|

||||

[35]: https://hisham.hm/htop/

|

||||

[36]: http://lm-sensors.org/

|

||||

[37]: https://01.org/powertop/

|

||||

[38]: https://dev.yorhel.nl/ncdu

|

||||

[39]: https://nmap.org/

|

||||

[40]: https://www.tcpdump.org/

|

||||

[41]: https://www.wireshark.org/

|

||||

[42]: http://www.fetchmail.info/

|

||||

[43]: http://www.procmail.org/

|

||||

[44]: https://marlam.de/msmtp/

|

||||

[45]: https://www.cis.upenn.edu/~bcpierce/unison/

|

||||

[46]: https://rsync.samba.org/

|

||||

[47]: http://www.mutt.org/

|

||||

[48]: https://newsboat.org/

|

||||

[49]: https://irssi.org/

|

||||

[50]: https://www.roaringpenguin.com/products/remind

|

||||

[51]: https://hookrace.net/public/linux-desktop/remcal.png

|

||||

[52]: https://github.com/tsdh/rdictcc

|

||||

[53]: https://www.dict.cc/

|

||||

[54]: https://www.latex-project.org/

|

||||

[55]: http://felsin9.de/nnis/research/

|

||||

[56]: https://pwmt.org/projects/zathura/

|

||||

[57]: https://wiki.gnome.org/Apps/Evince

|

||||

[58]: https://www.gimp.org/

|

||||

[59]: https://inkscape.org/

|

||||

[60]: https://imagemagick.org/Usage/

|

||||

[61]: https://www.graphviz.org/

|

||||

[62]: https://sourceforge.net/projects/pgf/

|

||||

[63]: https://www.mozilla.org/en-US/firefox/new/

|

||||

[64]: https://github.com/5digits/dactyl

|

||||

[65]: https://mpv.io/

|

||||

[66]: https://rg3.github.io/youtube-dl/

|

||||

[67]: http://moc.daper.net/

|

||||

[68]: https://aur.archlinux.org/packages/moc-pulse/

|

||||

[69]: https://hookrace.net/public/linux-desktop/moc.png

|

||||

[70]: https://github.com/libfuse/sshfs

|

||||

[71]: https://www.qemu.org/

|

||||

[72]: http://www.mingw.org/

|

||||

[73]: https://github.com/tpoechtrager/osxcross

|

||||

[74]: https://github.com/ddnet/ddnet-scripts/blob/master/ddnet-release.sh

|

||||

[75]: https://github.com/ddnet/ddnet-scripts/blob/master/ddnet-lib-update.sh

|

||||

[76]: https://github.com/def-/rrb/blob/master/rrb

|

||||

[77]: https://github.com/def-/rrb/blob/master/config.example

|

||||

[78]: mailto:dennis@felsin9.de

|

||||

[79]: https://news.ycombinator.com/item?id=18979731

|

||||

103

published/20190524 Dual booting Windows and Linux using UEFI.md

Normal file

103

published/20190524 Dual booting Windows and Linux using UEFI.md

Normal file

@ -0,0 +1,103 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (robsean)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-12891-1.html)

|

||||

[#]: subject: (Dual booting Windows and Linux using UEFI)

|

||||

[#]: via: (https://opensource.com/article/19/5/dual-booting-windows-linux-uefi)

|

||||

[#]: author: (Alan Formy-Duval https://opensource.com/users/alanfdoss/users/ckrzen)

|

||||

|

||||

使用 UEFI 双启动 Windows 和 Linux

|

||||

======

|

||||

|

||||

> 这是一份在同一台机器上设置 Linux 和 Windows 双重启动的速成解释,使用统一可扩展固件接口(UEFI)。

|

||||

|

||||

|

||||

|

||||

我将强调一些重要点,而不是一步一步地指导你来如何配置你的系统以实现双重启动。作为一个示例,我将提到我在几个月之前新买的笔记本计算机。我先是安装 [Ubuntu Linux][2] 到整个硬盘中,这就摧毁了预装的 [Windows 10][3] 环境。几个月后,我决定安装一个不同的 Linux 发行版 [Fedora Linux][4],也决定在双重启动配置中与它一起再次安装 Windows 10 。我将强调一些极其重要的实际情况。让我们开始吧!

|

||||

|

||||

### 固件

|

||||

|

||||

双重启动不仅仅是软件问题。或者说它算是软件的问题,因为它需要更改你的固件,以告诉你的机器如何开始启动程序。这里有一些和固件相关的重要事项要铭记于心。

|

||||

|

||||

#### UEFI vs BIOS

|

||||

|

||||

在尝试安装前,确保你的固件配置是最佳的。现在出售的大多数计算机有一个名为 <ruby>[统一可扩展固件接口][5]<rt>Unified Extensible Firmware Interface</rt></ruby> (UEFI)的新类型固件,UEFI 差不多取代了另一个名为 <ruby>[基本输入输出系统][6]<rt>Basic Input Output System</rt></ruby>(BIOS)的固件类型,(包括很多固件供应商在内的很多人)通常称 BIOS 为<ruby>传统启动模式<rt>Legacy Boot</rt></ruby>。

|

||||

|

||||

我不需要 BIOS,所以我选择了 UEFI 模式。

|

||||

|

||||

#### 安全启动

|

||||

|

||||

另一个重要的设置是<ruby>安全启动<rt>Secure Boot</rt></ruby>。这个功能将检测启动路径是否被篡改,并阻止未经批准的操作系统的启动。现在,我禁用这个选项来确保我能够安装 Fedora Linux 。依据 Fedora 项目维基“[功能/安全启动][7]”部分的介绍可知:Fedora Linux 在安全启动选项启用的时候也可以工作。这对其它的 Linux 发行版来说可能有所不同 — 我打算今后重新研究这项设置。

|

||||

|

||||

简而言之,如果你发现在这项设置启用时你不能安装你的 Linux 操作系统,那么禁用安全启动并再次重新尝试安装。

|

||||

|

||||

### 对启动驱动器进行分区

|

||||

|

||||

如果你选择双重启动并且两个操作系统都在同一个驱动器上,那么你必须将它分成多个分区。即使你使用两个不同的驱动器进行双重启动,出于各种各样的原因,大多数 Linux 环境也最好分成几个基本的分区。这里有一些选项值得考虑。

|

||||

|

||||

#### GPT vs MBR

|

||||

|

||||

如果你决定手动分区你的启动驱动器,在动手前,我建议使用<ruby>[GUID 分区表][8]<rt>GUID Partition Table</rt></ruby>(GPT),而不是使用旧的<ruby>[主启动记录][9]<rt>Master Boot Record</rt></ruby>(MBR) 。这种更改的原因之一是:MBR 有两个特定的限制,而 GPT 却没有:

|

||||

|

||||

* MBR 可以最多拥有 15 个分区,而 GPT 可以最多拥有 128 个分区。

|

||||

* MBR 最多仅支持 2 TB 磁盘,而 GPT 使用 64 位地址,这使得它最多支持 800 万 TB 的磁盘。

|

||||

|

||||

如果你最近购买过硬盘,那么你可能会知道现代的很多硬盘都超过了 2 TB 的限制。

|

||||

|

||||

#### EFI 系统分区

|

||||

|

||||

如果你正在进行一次全新的安装或使用一块新的驱动器,那么这里可能没有可以开始的分区。在这种情况下,操作系统安装程序将先创建一个分区,即<ruby>[EFI 系统分区][10]<rt>EFI System Partition</rt></ruby>(ESP)。如果你选择使用一个诸如 [gdisk][11] 之类的工具来手动分区你的驱动器,你将需要使用一些参数来创建这个分区。基于现有的 ESP ,我设置它为约 500 MB 的大小,并分配它为 `ef00`( EFI 系统 )分区类型。UEFI 规范要求格式化为 FAT32/msdos ,很可能是因为这种格式被大量的操作系统所支持。

|

||||

|

||||

![分区][12]

|

||||

|

||||

### 操作系统安装

|

||||

|

||||

在你完成先前的两个任务后,你就可以安装你的操作系统了。虽然我在这里关注的是 Windows 10 和 Fedora Linux ,当安装其它组合时的过程也是非常相似。

|

||||

|

||||

#### Windows 10

|

||||

|

||||

我开始 Windows 10 的安装,并创建了一个 20 GB 的 Windows 分区。因为我先前在我的笔记本计算机上安装了 Linux ,所以驱动器已经有了一个 ESP ,我选择保留它。我删除所有的现有 Linux 和交换分区来开始一次全新安装,然后开始我的 Windows 安装。Windows 安装程序自动创建另一个 16 MB 的小分区,称为 <ruby>[微软保留分区][13]<rt>Microsoft Reserved Partition</rt></ruby>(MSR)。在这完成后,在 512 GB 启动驱动器上仍然有大约 400 GB 的未分配空间。

|

||||

|

||||

接下来,我继续完成了 Windows 10 安装过程。随后我重新启动到 Windows 来确保它是工作的,在操作系统第一次启动时,创建我的用户账号,设置 Wi-Fi ,并完成其它必须的任务。

|

||||

|

||||

#### Fedora Linux

|

||||

|

||||

接下来,我将心思转移到安装 Linux 。我开始了安装过程,当安装进行到磁盘配置的步骤时,我确保不会更改 Windows NTFS 和 MSR 分区。我也不会更改 ESP ,但是我设置它的挂载点为 `/boot/efi`。然后我创建常用的 ext4 格式分区, `/`(根分区)、`/boot` 和 `/home`。我创建的最后一个分区是 Linux 的交换分区(swap)。

|

||||

|

||||

像安装 Windows 一样,我继续完成了 Linux 安装,随后重新启动。令我高兴的是,在启动时<ruby>[大一统启动加载程序][14]<rt>GRand Unified Boot Loader</rt></ruby>(GRUB)菜单提供选择 Windows 或 Linux 的选项,这意味着我不需要再做任何额外的配置。我选择 Linux 并完成了诸如创建我的用户账号等常规步骤。

|

||||

|

||||

### 总结

|

||||

|

||||

总体而言,这个过程是不难的,在过去的几年里,从 BIOS 过渡到 UEFI 有一些困难需要解决,加上诸如安全启动等功能的引入。我相信我们现在已经克服了这些障碍,可以可靠地设置多重启动系统。

|

||||

|

||||

我不再怀念 [Linux LOader][15](LILO)!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/19/5/dual-booting-windows-linux-uefi

|

||||

|

||||

作者:[Alan Formy-Duval][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[robsean](https://github.com/robsean)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://opensource.com/users/alanfdoss/users/ckrzen

|

||||

[b]: https://github.com/lujun9972

|

||||

[1]: https://opensource.com/sites/default/files/styles/image-full-size/public/lead-images/linux_keyboard_desktop.png?itok=I2nGw78_ (Linux keys on the keyboard for a desktop computer)

|

||||

[2]: https://www.ubuntu.com

|

||||

[3]: https://www.microsoft.com/en-us/windows

|

||||

[4]: https://getfedora.org

|

||||

[5]: https://en.wikipedia.org/wiki/Unified_Extensible_Firmware_Interface

|

||||

[6]: https://en.wikipedia.org/wiki/BIOS

|

||||

[7]: https://fedoraproject.org/wiki/Features/SecureBoot

|

||||

[8]: https://en.wikipedia.org/wiki/GUID_Partition_Table

|

||||

[9]: https://en.wikipedia.org/wiki/Master_boot_record

|

||||

[10]: https://en.wikipedia.org/wiki/EFI_system_partition

|

||||

[11]: https://sourceforge.net/projects/gptfdisk/

|

||||

[12]: /sites/default/files/u216961/gdisk_screenshot_s.png

|

||||

[13]: https://en.wikipedia.org/wiki/Microsoft_Reserved_Partition

|

||||

[14]: https://en.wikipedia.org/wiki/GNU_GRUB

|

||||

[15]: https://en.wikipedia.org/wiki/LILO_(boot_loader)

|

||||

82

published/20190612 When to use 5G, when to use Wi-Fi 6.md

Normal file

82

published/20190612 When to use 5G, when to use Wi-Fi 6.md

Normal file

@ -0,0 +1,82 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (chenmu-kk)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-12914-1.html)

|

||||

[#]: subject: (When to use 5G, when to use Wi-Fi 6)

|

||||

[#]: via: (https://www.networkworld.com/article/3402316/when-to-use-5g-when-to-use-wi-fi-6.html)

|

||||

[#]: author: (Lee Doyle )

|

||||

|

||||

何时使用 5G,何时使用 Wi-Fi 6

|

||||

======

|

||||

|

||||

> 5G 是一种蜂窝服务, Wi-Fi 6 则是短程无线接入技术,这两种技术都有使其在特定企业角色中发挥作用的特性。

|

||||

|

||||

![Thinkstock][1]

|

||||

|

||||

我们已经看到了关于 [5G][2] 蜂窝还是 [Wi-Fi 6][3] 将在企业使用中胜出的大肆宣传,但事实却是这两者在很大程度上互补,这将在 21 世纪 20 年代初形成一个有趣的竞争环境。

|

||||

|

||||

### 5G 在企业中的潜力

|

||||

|

||||

5G 对企业用户的承诺是在更低的延迟下提供更高的连接速度。蜂窝技术使用许可频段,可在很大程度上消除未经许可的 WiFi 频段可能会发生的潜在干涉。像当前的 4G LTE 技术一样,5G 可以由蜂窝无线运营商提供,也可以作为专用网络构建。

|

||||

|

||||

5G 的架构需要更多的无线接入点,并且在室内可能会出现连接质量较差或没有连接。因此,典型的组织需要为连接它的 PC、路由器和其他设备评估其 [当前 4G 和潜在 5G 服务配置][4]。部署室内微蜂窝、中继器以及分布式天线可以帮助解决室内 5G 服务问题。与 4G 一样,5G 最佳的企业应用案例应该是用于真正的移动连接,例如,公共安全车和非地毯式覆盖区域(如采矿,石油与天然气开采、运输、农业和一些制造业)。

|

||||

|

||||

除了广泛的移动性,5G 在漫游时的身份验证和部署速度方面也具有优势,这正好满足临时办公室或零售点的广域网连接需求。5G 将会拥有在视频直播这样的数据拥塞的情况下分流的能力。随着 5G 标准的成熟,该技术将提高其低功耗 IoT 连接的选择。

|

||||

|

||||

未来四到五年内,5G 将从大城市和特定地区开始逐步推出;4G 技术将在未来数年内继续流行。企业用户将需要新的设备、加密狗和路由器来连接 5G 服务。例如,苹果的 iPhone 预计要到 2020 年才能支持 5G,而物联网设备需要特定的蜂窝网络兼容性才能连接到 5G。(LCTT 译注:原文发表于 2019 年中)

|

||||

|

||||

Doyle Research 预计,5G 承诺的 1Gbps 和更高的带宽将对 SD-WAN 市场产生重大影响。4G LTE 已经使蜂窝服务成为主要的 WAN 连接。5G 可能比许多有线 WAN 选项(例如 MPLS 或互联网)更具成本竞争力或更便宜。5G 为企业 WAN 管理员提供了更多选择,为他们的分支站点和远程用户提供更多的带宽 —— 随着时间的推移,或将取代 MPLS。

|

||||

|

||||

### Wi-Fi 6 在企业中的潜力

|

||||

|

||||

Wi-Fi 几乎无处不在,它可以将便携式笔记本电脑、平板电脑和其他设备连接到企业网络中。Wi-Fi 6(802.11ax)是 Wi-Fi 的最新版本,并有望提高速度、降低延迟、改善聚合带宽并提供高级流量管理。虽然 Wi-Fi 6 与 5G 有一些相似之处(两者均基于正交频分多址),但 Wi-Fi 6 不太容易受到干扰,能耗更低(延长设备电池的寿命),并提高了频谱效率。

|

||||

|

||||

与典型的 Wi-Fi 相同,目前许多厂商都有 [Wi-Fi 6 早期厂商专用版本][6]。Wi-Fi 联盟计划在 2020 年获得 Wi-Fi 6 标准设备的认证。大多数企业将按照标准<ruby>接入点<rt>access-point</rt></ruby>(AP)的生命周期(三年左右)升级到 Wi-Fi 6,除非他们有特定的性能/延迟要求,这将促使它们更快地升级。

|

||||

|

||||

Wi-Fi 接入点仍然会受到干涉的影响。设计和配置接入点以提供适当的覆盖范围将会是一项挑战。企业 LAN 管理者将继续需要供应商提供的工具和合作伙伴来为组织配置最理想的 Wi-Fi 覆盖。Wi-Fi 6 解决方案必须与有线区域基础建设集成。Wi-Fi 供应商需要更好地为企业提供无线和有线解决方案的统一网络管理。

|

||||

|

||||

### 有线回程的需求

|

||||

|

||||

对于这两种技术,通过无线与有线网络基础设施相结合,可以提供端到端的高速通信。在企业中,Wi-Fi 通常与区域和一些较大分支机构的有线以太网交换机搭配使用。一些设备通过电缆连接到交换机,其他设备则通过 Wi-Fi 连接,而笔记本电脑可能会同时采用这两种方法。Wi-Fi 接入点通过企业内部的以太网连接,并通过光纤连接连接到 WAN 或 Internet。

|

||||

|

||||

5G 的架构广泛使用光纤,将分布式无线接入网络连接回 5G 网络的核心。光纤通常需要提供将 5G 端点连接到基于 SaaS 的应用程序所需的高带宽,并提供实时视频和高速互联网访问。专用 5G 网络也必须满足高速有线连接要求。

|

||||

|

||||

### 切换问题

|

||||

|

||||

随着手机在 5G 和 Wi-Fi 6 之间切换,企业 IT 管理者要注意到切换挑战。这些问题会影响到性能和用户满意度。一些组织正在努力制定标准,以促进 Wi-Fi 6 和 5G 间更好的互操作性。

|

||||

由于 Wi-Fi 6 的架构与 5G 接轨,在蜂窝网络与 Wi-Fi 网络间移动的体验应该更加顺滑。

|

||||

|

||||

### 5G 和 Wi-Fi 6 的对比取决于位置、应用和设备

|

||||

|

||||

Wi-Fi 6 和 5G 在企业环境中的特定情况下相互竞争,这取决于位置、应用程序和设备类型。IT 管理者应该仔细评估他们当前和正在出现的连接性需求。Wi-Fi 将继续占领室内环境优势,而移动蜂窝网络将赢得更为广泛的室外覆盖。

|

||||

|

||||

一些重叠的情况发生在体育场馆、酒店和其他大型活动场所,许多用户将争夺带宽。政府应用(包括智能城市方面)可适用于 Wi-Fi 和蜂窝。医疗保健设施中有许多分布式医疗设备和需要连接的用户。大型分布式制造环境具有相似的特点。新兴的物联网应用环境可能是最有趣的“重叠使用案例”。

|

||||

|

||||

### 对于 IT 领导者的建议

|

||||

|

||||

虽然支持它们的无线技术正在融合,但 Wi-Fi 6 和 5G 从根本上来说是不同的网络,在企业连接中都有各自的作用。企业 IT 领导者应关注 Wi-Fi 和蜂窝网络如何相互补足,Wi-Fi 将继续作为内置技术,连接 PC 和笔记本电脑,处理手机和平板电脑数据,并实现一些物联网连接。

|

||||

|

||||

4G LTE 升级到 5G 后,仍将是手机和平板电脑连接的真正移动技术,也是 PC 连接的一种选择(通过加密狗),并在连接一些物联网设备方面越来越受欢迎。5G WAN 链路将日益成为标准,作为提高 SD-WAN 可靠性的备份和远程办公室的主要链路。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.networkworld.com/article/3402316/when-to-use-5g-when-to-use-wi-fi-6.html

|

||||

|

||||

作者:[Lee Doyle][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[chenmu-kk](https://github.com/chenmu-kk)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://www.networkworld.com/author/Lee-Doyle/

|

||||

[b]: https://github.com/lujun9972

|

||||

[1]: https://images.idgesg.net/images/article/2017/07/wi-fi_wireless_communication_network_abstract_thinkstock_610127984_1200x800-100730107-large.jpg

|

||||

[2]: https://www.networkworld.com/article/3203489/what-is-5g-how-is-it-better-than-4g.html

|

||||

[3]: https://www.networkworld.com/article/3215907/why-80211ax-is-the-next-big-thing-in-wi-fi.html

|

||||

[4]: https://www.networkworld.com/article/3330603/5g-versus-4g-how-speed-latency-and-application-support-differ.html

|

||||

[5]: https://pluralsight.pxf.io/c/321564/424552/7490?u=https%3A%2F%2Fwww.pluralsight.com%2Fcourses%2Fmobile-device-management-big-picture

|

||||

[6]: https://www.networkworld.com/article/3309439/80211ax-preview-access-points-and-routers-that-support-the-wi-fi-6-protocol-on-tap.html

|

||||

[7]: https://www.facebook.com/NetworkWorld/

|

||||

[8]: https://www.linkedin.com/company/network-world

|

||||

@ -0,0 +1,172 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (quinbyjoe)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-12927-1.html)

|

||||

[#]: subject: (How to Use VLAN tagged NIC \(Ethernet Card\) on CentOS and RHEL Servers)

|

||||

[#]: via: (https://www.linuxtechi.com/vlan-tagged-nic-ethernet-card-centos-rhel-servers/)

|

||||

[#]: author: (Pradeep Kumar https://www.linuxtechi.com/author/pradeep/)

|

||||

|

||||

如何在 CentOS/RHEL 系统中使用带 VLAN 标记的网卡

|

||||

======

|

||||

|

||||

在某些场景中,我们希望在 Linux 服务器(CentOS/RHEL)的同一块以太网卡(NIC)上分配来自不同 VLAN 的多个 IP。这个可以通过使用 VLAN 标记接口来实现。但是要做到这一点,我们必须确保交换机的端口上连接了多个 VLAN,也就是说我们可以在交换机上添加多个 VLAN 来配置<ruby>聚合端口<rt>Trunk port</rt></ruby>(LCTT 译注:一般有<ruby>聚合端口<rt>Trunk port</rt></ruby>、<ruby>接入端口<rt>Access port</rt></ruby>、<ruby>混合端口<rt>Hybird port</rt></ruby>三种)。

|

||||

|

||||

|

||||

|

||||

假设我们有一个 Linux 服务器,我们在这里有两张以太网卡(`enp0s3` 和 `enp0s8`),第一张网卡(`enp0s3`)会用于数据传输,而第二张网卡(`enp0s8`) 会用于控制/流量管理。我会使用多个 VLAN 用于数据传输(或在数据流量网卡上从不同的 VLAN 中分配多个 IP)。

|

||||

|

||||

我假设连接到我服务器的数据网卡的端口,是通过映射多个 VLAN 来配置为聚合端口。

|

||||

|

||||

下面是映射到数据传输网卡(NIC)的 VLAN:

|

||||

|

||||

* VLAN ID (200), VLAN N/W = 172.168.10.0/24

|

||||

* VLAN ID (300), VLAN N/W = 172.168.20.0/24

|

||||

|

||||

要在 CentOS 7 / RHEL 7 / CentOS 8 / RHEL 8 系统中使用 VLAN 标记接口,必须加载[内核模块][1] `8021q` 。

|

||||

|

||||

加载内核模块 `8021q` 可以使用下面的命令:

|

||||

|

||||

```

|

||||

[root@linuxtechi ~]# lsmod | grep -i 8021q

|

||||

[root@linuxtechi ~]# modprobe --first-time 8021q

|

||||

[root@linuxtechi ~]# lsmod | grep -i 8021q

|

||||

8021q 29022 0

|

||||

garp 14384 1 8021q

|

||||

mrp 18542 1 8021q

|

||||

[root@linuxtechi ~]#

|

||||

```

|

||||

|

||||

可以使用 `modinfo` 命令显示内核模块 `8021q` 的详细信息:

|

||||

|

||||

```

|

||||

[root@linuxtechi ~]# modinfo 8021q

|

||||

filename: /lib/modules/3.10.0-327.el7.x86_64/kernel/net/8021q/8021q.ko

|

||||

version: 1.8

|

||||

license: GPL

|

||||

alias: rtnl-link-vlan

|

||||

rhelversion: 7.2

|

||||

srcversion: 2E63BD725D9DC11C7DA6190

|

||||

depends: mrp,garp

|

||||

intree: Y

|

||||

vermagic: 3.10.0-327.el7.x86_64 SMP mod_unload modversions

|

||||

signer: CentOS Linux kernel signing key

|

||||

sig_key: 79:AD:88:6A:11:3C:A0:22:35:26:33:6C:0F:82:5B:8A:94:29:6A:B3

|

||||

sig_hashalgo: sha256

|

||||

[root@linuxtechi ~]#

|

||||

```

|

||||

|

||||

现在使用 [ip 命令][2]给 `enp0s3` 网卡标记(或映射)上 `200` 和 `300` 的 VLAN 。

|

||||

|

||||

(LCTT 译注:这是先给 `enp0s3` 网卡映射上 `200` 的 VLAN 标签。)

|

||||

|

||||

```

|

||||

[root@linuxtechi ~]# ip link add link enp0s3 name enp0s3.200 type vlan id 200

|

||||

```

|

||||

|

||||

使用下面的 `ip` 命令打开接口:

|

||||

|

||||

```

|

||||

[root@linuxtechi ~]# ip link set dev enp0s3.200 up

|

||||

```

|

||||

|

||||

同理给 `enp0s3` 网卡映射上 `300` 的 VLAN 标签:

|

||||

|

||||

```

|

||||

[root@linuxtechi ~]# ip link add link enp0s3 name enp0s3.300 type vlan id 300

|

||||

[root@linuxtechi ~]# ip link set dev enp0s3.300 up

|

||||

```

|

||||

|

||||

现在使用 `ip` 命令查看标记后的接口状态:

|

||||

|

||||

![tagged-interface-ip-command][3]

|

||||

|

||||

现在我们可以使用下面的 `ip` 命令从它们各自的 VLAN 为已经标记的接口分配 IP 地址:

|

||||

|

||||

```

|

||||

[root@linuxtechi ~]# ip addr add 172.168.10.51/24 dev enp0s3.200

|

||||

[root@linuxtechi ~]# ip addr add 172.168.20.51/24 dev enp0s3.300

|

||||

```

|

||||

|

||||

使用下面的 `ip` 命令查看是否为已标记的接口分配到 IP:

|

||||

|

||||

![ip-address-tagged-nic][5]

|

||||

|

||||

重启之后,上面所有通过 `ip` 命令的更改都不会保持(LCTT 译注:修改后可保存至配置文件或数据库中,如果未进行保存处理,则只有当前环境生效,重启后配置失效)。系统重启和网络服务重启(LCTT 译注:`service network restart`,或 `down` 和 `up` 命令)之后这些标记接口将不可用。

|

||||

|

||||

因此,要使标记的接口在重启后保持不变,需要使用接口的 `ifcfg` 文件。

|

||||

|

||||

编辑接口(`enp0s3`)文件 `/etc/sysconfig/network-scripts/ifcfg-enp0s3`,并且增加下面的内容:

|

||||

|

||||

**作者提醒**:替换为你环境中的接口名称。

|

||||

|

||||

```

|

||||

[root@linuxtechi ~]# vi /etc/sysconfig/network-scripts/ifcfg-enp0s3

|

||||

TYPE=Ethernet

|

||||

DEVICE=enp0s3

|

||||

BOOTPROTO=none

|

||||

ONBOOT=yes

|

||||

```

|

||||

|

||||

保存和退出文件。

|

||||

|

||||

为 id 是 `200` 的 VLAN 创建接口文件 `/etc/sysconfig/network-scripts/ifcfg-enp0s3.200`,且增加下面的内容:

|

||||

|

||||

```

|

||||

[root@linuxtechi ~]# vi /etc/sysconfig/network-scripts/ifcfg-enp0s3.200

|

||||

DEVICE=enp0s3.200

|

||||

BOOTPROTO=none

|

||||

ONBOOT=yes

|

||||

IPADDR=172.168.10.51

|

||||

PREFIX=24

|

||||

NETWORK=172.168.10.0

|

||||

VLAN=yes

|

||||

```

|

||||

|

||||

保存并退出此文件。

|

||||

|

||||

同理为 id 是 `300` 的 VLAN 创建接口文件 `/etc/sysconfig/network-scripts/ifcfg-enp0s3.300`,且增加下面的内容:

|

||||

|

||||

```

|

||||

[root@linuxtechi ~]# vi /etc/sysconfig/network-scripts/ifcfg-enp0s3.300

|

||||

DEVICE=enp0s3.300

|

||||

BOOTPROTO=none

|

||||

ONBOOT=yes

|

||||

IPADDR=172.168.20.51

|

||||

PREFIX=24

|

||||

NETWORK=172.168.20.0

|

||||

VLAN=yes

|

||||

```

|

||||

|

||||

保存并退出文件,这时候使用下面的命令重启网络服务,

|

||||

|

||||

```

|

||||

[root@linuxtechi ~]# systemctl restart network

|

||||

```

|

||||

|

||||

现在使用下面的 `ip` 命令检验标记的接口是否已配置和启动,并且正在运行中:

|

||||

|

||||

![tagged-interface-status-ip-command-linux-server][6]

|

||||

|

||||

以上就是本文的全部内容,我希望你已经学会了在 CentOS 7 / 8 和 RHEL 7 / 8 服务器上如何去配置和启用 VLAN 标签接口的方法。请分享你的反馈和意见。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.linuxtechi.com/vlan-tagged-nic-ethernet-card-centos-rhel-servers/

|

||||

|

||||

作者:[Pradeep Kumar][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[quinbyjoe](https://github.com/quinbyjoe)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://www.linuxtechi.com/author/pradeep/

|

||||

[b]: https://github.com/lujun9972

|

||||

[1]: https://www.linuxtechi.com/how-to-manage-kernel-modules-in-linux/

|

||||

[2]: https://www.linuxtechi.com/ip-command-examples-for-linux-users/

|

||||

[3]: https://www.linuxtechi.com/wp-content/uploads/2019/06/tagged-interface-ip-command-1024x444.jpg

|

||||

[4]: https://www.linuxtechi.com/wp-content/uploads/2019/06/tagged-interface-ip-command.jpg

|

||||

[5]: https://www.linuxtechi.com/wp-content/uploads/2019/06/ip-address-tagged-nic-1024x343.jpg

|

||||

[6]: https://www.linuxtechi.com/wp-content/uploads/2019/06/tagged-interface-status-ip-command-linux-server-1024x656.jpg

|

||||

[7]: https://www.linuxtechi.com/wp-content/uploads/2019/06/VLAN-Tagged-NIC-Linux-Server.jpg

|

||||

0

published/201908/20190730 How to create a pull request in GitHub.md

Executable file → Normal file

0

published/201908/20190730 How to create a pull request in GitHub.md

Executable file → Normal file

164

published/20191118 Creating a Chat Bot with Recast.AI.md

Normal file

164

published/20191118 Creating a Chat Bot with Recast.AI.md

Normal file

@ -0,0 +1,164 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (alim0x)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-12878-1.html)

|

||||

[#]: subject: (Creating a Chat Bot with Recast.AI)

|

||||

[#]: via: (https://opensourceforu.com/2019/11/creating-a-chat-bot-with-recast-ai/)

|

||||

[#]: author: (Athira Lekshmi C.V https://opensourceforu.com/author/athira-lekshmi/)

|

||||

|

||||

用 Recast.AI 创建一个聊天机器人

|

||||

======

|

||||

|

||||

[![][1]][2]

|

||||

|

||||

> 据 Gartner 2018 年 2 月的报告,“到 2020 年,25% 的客户服务和支持业务将在参与渠道中整合虚拟客户助理(VCA)或聊天机器人技术,而 2017 年只有不到 2%。”鉴于此,读者会发现本教程对理解开源的 Recast.AI 机器人创建平台的工作原理很有帮助。

|

||||

|

||||

聊天机器人,包括基于语音的以及其他技术的,已经实际使用了有一阵子了。从让用户参与谋杀解密游戏,到帮助完成房地产交易和医疗诊断,聊天机器人已经跨越了多个领域。

|

||||

|

||||

有许多平台可以让用户创建和部署机器人。Recast.AI(在被 SAP 收购之后现在是 SAP Conversational AI)是其中的先行者。

|

||||

|

||||

酷炫的界面、协作性以及它所提供的分析工具,让它成为流行的选择。

|

||||

|

||||

正如 Recast 官方网站说的,“它是一个创建、训练、部署和监控智能机器人的终极协作平台。”

|

||||

|

||||

### 创建一个基础的机器人

|

||||

|

||||

让我们来看看如何在 Recast 创建一个基础的机器人。

|

||||

|

||||

1. 在 https://cai.tools.sap 创建一个账户。注册可以使用电子邮箱或者 Github 账户。

|

||||

2. 在你登录之后,你会进入仪表板。点击右上角 “+” 新建机器人图标新建一个机器人。

|

||||

3. 在下一个界面,你会看到一系列可选的预定义技能。暂时选择<ruby>问候<rt>Greetings</rt></ruby>”(图 1)。这个机器人已经经过训练,能够理解基本的问候。

|

||||

![图 1: 设置机器人属性][3]

|

||||

4. 给机器人提供一个名字。目前来说,你可以让机器人讲一些笑话,所以我们将它命名为 Joke Bot,选择英语作为默认语言。

|

||||

5. 因为你不会处理任何敏感信息,所以在数据策略下选择非个人数据。然后选择公共机器人选项并点击创建一个机器人。

|

||||

|

||||

所以这就是你在 Recast 平台创建的机器人。

|

||||

|

||||

### 开发一个机器人的五个阶段

|

||||

|

||||

用 Recast 官方博客的话说,在机器人的生命中有五个阶段。

|

||||

|

||||

* 训练——教授机器人需要理解的内容

|

||||

* 构建——使用机器人构建工具创建你的对话流

|

||||

* 编写代码——将机器人连接到外部 API 或数据库

|

||||

* 连接——将机器人发布到一个或多个消息平台

|

||||

* 监控——训练机器人让它更敏锐,并且了解其使用情况

|

||||

|

||||

### 通过意图训练机器人

|

||||

|

||||

你可以在仪表板上看到搜索、分叉或创建一个<ruby>意图<rt>intent</rt></ruby>的选项。“‘意图’是一系列含义相同但构造不同的表达。‘意图’是你的机器人理解能力的核心。每个‘意图’代表了机器人可以理解的一种想法。”(摘自 Recast.AI 网站)

|

||||

|

||||

![图 2: 机器人面板][4]

|

||||

|

||||

就像先前定的,你需要一个讲笑话的机器人。所以底线是这个机器人可以理解用户在要求它讲笑话,它不应该在用户仅仅说了“Hi”的情况下回复一个笑话——这可不妙。把用户可能说的话进行分组,比如:

|

||||

|

||||

```

|

||||

Tell me a joke.(给我讲个笑话。)

|

||||

Tell me a funny fact.(告诉我一个有趣的事实。)

|

||||

Can you crack a joke?(你可以讲个笑话吗?)

|

||||

What’s funny today?(今天有什么有趣的?)

|

||||

```

|

||||

……

|

||||

|

||||

在继续从头开始创建意图之前,让我们来看看搜索/分叉选项。在搜索框输入 “Joke”(图 3)。系统给出了全球的 Recast 用户创建的公开的意图清单,这就是为什么说 Recast 天然就是协作性质的。所以其实没有必要从头开始创建所有的意图,可以在已经创建的基础上进行构建。这就降低了训练具有常见意图的机器人所需的投入。

|

||||

|

||||

![图 3: 搜索一个意图][5]

|

||||

|

||||

* 选择列表中的第一个意图并将其分叉到机器人上。

|

||||

* 点击<ruby>分叉<rt>Fork</rt></ruby>按钮。这个意图就添加到了机器人中(图 4)。

|

||||

![图 4: @joke 意图][6]

|

||||

* 点击意图 @joke,会显示出这个意图中已经存在的<ruby>表达<rt>expression</rt></ruby>列表(图 5)。

|

||||

![图 5: 预定义表达][7]

|

||||

* 向其添加更多的表达(图 6)。

|

||||

![图 6: 建议的表达][8]

|

||||

|

||||

添加了一些表达之后,机器人会给出一些建议,像图 7 展示的那样。选择几个将它们添加到意图中。你还可以根据机器人的上下文,标记你自己的自定义实体来检测关键词。

|

||||

|

||||

![图 7: 建议的表达][9]

|

||||

|

||||

### 技能

|

||||

|

||||

<ruby>技能<rt>skill</rt></ruby>是一块有明确目的的对话,机器人可以据此运行并达到目标。它可以像打招呼那么简单,也可以更复杂,比如基于用户提供的信息提供电影建议。

|

||||

|

||||

技能需要的不能只是一对问答,它需要多次交互。比如考虑一个帮你学习汇率的机器人。它一开始会问原货币,然后是目标货币,最后给出准确回应。结合技能可以创建复杂的对话流。

|

||||

|

||||

下面是如何给笑话机器人创建技能:

|

||||

|

||||

* 去到 构建(Build) 页。点击 “+” 图标创建技能。

|

||||

* 给技能命名 “Joke”(图 8)

|

||||

![图 8: 技能面板][10]

|

||||

* 创建之后,点击这个技能。你会看到四个标签。<ruby>读我<rt>Read me</rt></ruby>、<ruby>触发器<rt>Triggers</rt></ruby>、<ruby>需求<rt>Requirements</rt></ruby>和 <ruby>动作<rt>Actions</rt></ruby>。

|

||||

* 切换到需求页面。只有在笑话意图存在的时候,你才应该存储信息。所以,像图 9 那样添加一个需求。

|

||||

![图 9: 添加一个触发器][11]

|

||||

|

||||

由于这个简单的使用范例,你不需要在需求选项卡中考虑任何特定的需求,但可以考虑只有当某些关键字或实体出现时才需要触发响应的情况——在这种情况下你需要需求。

|

||||

|

||||

需求是某个技能执行动作之前需要检索的意图或实体。需求是对话中机器人可以使用的重要信息。例如用户的姓名或位置。一旦一个需求完成,相关的值就会存储在机器人的内存中,供整个对话使用。

|

||||

|

||||

现在让我们转到动作页面设置<ruby>回应<rt>response</rt></ruby>(参见图 10)。

|

||||

|

||||

![图 10: 添加动作][12]

|

||||

|

||||

点击添加<ruby>新消息组<rt>new message group</rt></ruby>。然后选择<ruby>发送消息<rt>Send message</rt></ruby>并添加一条文本消息,在这个例子中可以是任何笑话。当然,你肯定不想让你的机器人每次都说一样的笑话,你可以添加多条消息,每次从中随机选择一条。

|

||||

|

||||

![图 11: 添加文本消息][13]

|

||||

|

||||

### 频道集成

|

||||

|

||||

一个成功的机器人还依赖于它的易得性。Recast 有不少的内置消息频道集成,如 Skype for Business、Kik Messenger、Telegram、Line、Facebook Messenger、Slack、Alexa 等等。除此之外,Recast 还提供了 SDK 用于开发自定义的频道。

|

||||

|

||||

此外,Recast 还提供一个可立即使用的网页聊天(在连接页面中)。你可以自定义颜色主题、标题、机器人头像等。它给你提供了一个可以添加到页面的脚本标签。你的界面现在就可以使用了(图 12)。

|

||||

|

||||

![图 12: 设置网络聊天][14]

|

||||

|

||||

网页聊天的代码是开源的,开发者可以更方便地定制外观、标准回应类型等等。面板提供了如何将机器人部署到各种频道的逐步过程说明。这个笑话机器人部署在 Telegram 和网页聊天上,就像图 13 展示的那样。

|

||||

|

||||

![图 13: 网页聊天部署][15]

|

||||

|

||||

![图 14: Telegram 中开发的机器人][16]

|

||||

|

||||

### 还有更多

|

||||

|

||||

Recast 支持多语言,创建机器人的时候选择一个语言作为基础,但之后你有选项可以添加更多你想要的语言。

|

||||

|

||||

![图 15: 多语言机器人][17]

|

||||

|

||||

这里的例子是一个简单的静态笑话机器人,实际使用中可能需要更多的和不同系统的交互。Recast 有 Web 钩子功能,用户可以连接到不同的系统来获取回应。同时它还有详细的 API 文档来帮助使用平台的每个独立功能。

|

||||

|

||||

至于分析,Recast 有一个监控面板,帮助你了解机器人的准确度以及更加深入地训练机器人。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensourceforu.com/2019/11/creating-a-chat-bot-with-recast-ai/

|

||||

|

||||

作者:[Athira Lekshmi C.V][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[alim0x](https://github.com/alim0x)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://opensourceforu.com/author/athira-lekshmi/

|

||||

[b]: https://github.com/lujun9972

|

||||

[1]: https://i0.wp.com/opensourceforu.com/wp-content/uploads/2019/04/Build-ChatBoat.jpg?resize=696%2C442&ssl=1 (Build ChatBoat)

|

||||

[2]: https://i0.wp.com/opensourceforu.com/wp-content/uploads/2019/04/Build-ChatBoat.jpg?fit=900%2C572&ssl=1

|

||||

[3]: https://i1.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-1-Setting-the-bot-properties.jpg

|

||||

[4]: https://i1.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-2-Setting-the-bot-properties.jpg

|

||||

[5]: https://i0.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-3-Searching-an-intent.jpg

|

||||

[6]: https://i0.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-4-@joke-intent.jpg

|

||||

[7]: https://i0.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-5-Predefined-expressions.jpg

|

||||

[8]: https://i2.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-6-Suggested-expressions.jpg

|

||||

[9]: https://i1.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-7-Suggested-expressions.jpg

|

||||

[10]: https://i0.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-8-Skills-dashboard.jpg

|

||||

[11]: https://i0.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-9-Adding-a-trigger.jpg

|

||||

[12]: https://i0.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-10-Adding-actions.jpg

|

||||

[13]: https://i1.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-11-Adding-text-messages.jpg

|

||||

[14]: https://i2.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-12-Setting-up-webchat.jpg

|

||||

[15]: https://i0.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-13-Webchat-deployed.jpg

|

||||

[16]: https://i2.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-14-Bot-deployed-in-Telegram.jpg

|

||||

[17]: https://i1.wp.com/opensourceforu.com/wp-content/uploads/2019/11/Figure-15-Multi-language-bot.jpg

|

||||

[18]: https://secure.gravatar.com/avatar/d24503a2a0bb8bd9eefe502587d67323?s=100&r=g

|

||||

[19]: https://opensourceforu.com/author/athira-lekshmi/

|

||||

[20]: https://opensourceforu.com/wp-content/uploads/2019/11/assoc.png

|

||||

[21]: https://feedburner.google.com/fb/a/mailverify?uri=LinuxForYou&loc=en_US

|

||||

0

published/202007/20200701 Customizing Bash.md

Executable file → Normal file

0

published/202007/20200701 Customizing Bash.md

Executable file → Normal file

78

published/20200711 scanimage- scan from the command line.md

Normal file

78

published/20200711 scanimage- scan from the command line.md

Normal file

@ -0,0 +1,78 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (geekpi)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-12886-1.html)

|

||||

[#]: subject: (scanimage: scan from the command line!)

|

||||

[#]: via: (https://jvns.ca/blog/2020/07/11/scanimage--scan-from-the-command-line/)

|

||||

[#]: author: (Julia Evans https://jvns.ca/)

|

||||

|

||||

scanimage:从命令行扫描!

|

||||

======

|

||||

|

||||

|

||||

|

||||

这又是一篇关于我很喜欢的一个命令行工具的文章。

|

||||

|

||||

昨晚,出于官僚原因,我需要扫描一些文档。我以前从来没有在 Linux 上使用过扫描仪,我担心会花上好几个小时才弄明白。我从使用 `gscan2pdf` 开始,但在用户界面上遇到了麻烦。我想同时扫描两面(我知道我们的扫描仪支持),但无法使它工作。

|

||||

|

||||

### 遇到 scanimage!

|

||||

|

||||

`scanimage` 是一个命令行工具,在 `sane-utils` Debian 软件包中。我想所有的 Linux 扫描工具都使用 `sane` (“scanner access now easy”) 库,所以我猜测它和其他扫描软件有类似的能力。在这里,我不需要 OCR,所以我不打算谈论 OCR。

|

||||

|

||||

### 用 scanimage -L 得到你的扫描仪的名字

|

||||

|

||||

`scanimage -L` 列出了你所有的扫描设备。

|

||||

|

||||

一开始我不能让它工作,我有点沮丧,但事实证明,我把扫描仪连接到了我的电脑上,但没有插上电源。

|

||||

|

||||

插上后,它马上就能工作了。显然我们的扫描仪叫 `fujitsu:ScanSnap S1500:2314`。万岁!

|

||||

|

||||

### 用 --help 列出你的扫描仪选项

|

||||

|

||||

显然每个扫描仪有不同的选项(有道理!),所以我运行这个命令来获取我的扫描仪的选项:

|

||||

|

||||

```

|

||||

scanimage --help -d 'fujitsu:ScanSnap S1500:2314'

|

||||

```

|

||||

|

||||

我发现我的扫描仪支持 `--source` 选项(我可以用它来启用双面扫描)和 `--resolution` 选项(我把它改为 150,以减少文件大小,使扫描更快)。

|

||||

|

||||

### scanimage 不支持输出 PDF 文件(但你可以写一个小脚本)

|

||||

|

||||

唯一的缺点是:我想要一个 PDF 格式的扫描文件,而 scanimage 似乎不支持 PDF 输出。

|

||||

|

||||

所以我写了这个 5 行的 shell 脚本在一个临时文件夹中扫描一堆 PNG 文件,并将结果保存到 PDF 中。

|

||||

|

||||

```

|

||||

#!/bin/bash

|

||||

set -e

|

||||

|

||||

DIR=`mktemp -d`

|

||||

CUR=$PWD

|

||||

cd $DIR

|

||||

scanimage -b --format png -d 'fujitsu:ScanSnap S1500:2314' --source 'ADF Front' --resolution 150

|

||||

convert *.png $CUR/$1

|

||||

```

|

||||

|

||||

我像这样运行脚本:`scan-single-sided output-file-to-save.pdf`

|

||||

|

||||

你可能需要为你的扫描仪设置不同的 `-d` 和 `-source`。

|

||||

|

||||

### 这真是太简单了!

|

||||

|

||||

我一直以为在 Linux 上使用打印机/扫描仪是一个噩梦,我真的很惊讶 `scanimage` 可以工作。我可以直接运行我的脚本 `scan-single-sided receipts.pdf`,它将扫描文档并将其保存到 `receipts.pdf`!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://jvns.ca/blog/2020/07/11/scanimage--scan-from-the-command-line/

|

||||

|

||||

作者:[Julia Evans][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://jvns.ca/

|

||||

[b]: https://github.com/lujun9972

|

||||

115

published/202009/20190105 Why Sorting is O(N log N).md

Normal file

115

published/202009/20190105 Why Sorting is O(N log N).md

Normal file

@ -0,0 +1,115 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (silentdawn-zz)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-12594-1.html)

|

||||

[#]: subject: (Why Sorting is O\(N log N\))

|

||||

[#]: via: (https://theartofmachinery.com/2019/01/05/sorting_is_nlogn.html)

|

||||

[#]: author: (Simon Arneaud https://theartofmachinery.com)

|

||||

|

||||

为什么排序的复杂度为 O(N log N)

|

||||

======

|

||||

|

||||

基本上所有正而八经的算法教材都会解释像<ruby>快速排序<rt>quicksort</rt></ruby>和<ruby>堆排序<rt>heapsort</rt></ruby>这样的排序算法有多快,但并不需要复杂的数学就能证明你可以逐渐趋近的速度有多快。

|

||||

|

||||

> 关于标记的一个严肃说明:

|

||||

>

|

||||

> 大多数计算机专业的科学家使用大写字母 O 标记来指代“趋近,直到到达一个常数比例因子”,这与数学专业所指代的意义是有所区别的。这里我使用的大 O 标记的含义与计算机教材所指相同,但至少不会和其他数学符号混用。

|

||||

|

||||

### 基于比较的排序

|

||||

|

||||

先来看个特例,即每次比较两个值大小的算法(快速排序、堆排序,及其它通用排序算法)。这种思想后续可以扩展至所有排序算法。

|

||||

|

||||

#### 一个简单的最差情况下的计数角度

|

||||

|

||||

假设有 4 个互不相等的数,且顺序随机,那么,可以通过只比较一对数字完成排序吗?显然不能,证明如下:根据定义,要对该数组排序,需要按照某种顺序重新排列数字。换句话说,你需要知道用哪种排列方式?有多少种可能的排列?第一个数字可以放在四个位置中的任意一个,第二个数字可以放在剩下三个位置中的任意一个,第三个数字可以放在剩下两个位置中的任意一个,最后一个数字只有剩下的一个位置可选。这样,共有 $4×3×2×1 = 4! = 24$ 种排列可供选择。通过一次比较大小,只能产生两种可能的结果。如果列出所有的排列,那么“从小到大”排序对应的可能是第 8 种排列,按“从大到小”排序对应的可能是第 24 种排列,但无法知道什么时候需要的是其它 22 种排列。

|

||||

|

||||

通过 2 次比较,可以得到 2×2=4 种可能的结果,这仍然不够。只要比较的次数少于 5(对应 $2^{5} = 32$ 种输出),就无法完成 4 个随机次序的数字的排序。如果 $W(N)$ 是最差情况下对 $N$ 个不同元素进行排序所需要的比较次数,那么,

|

||||

|

||||

$$

|

||||

2^{W(N)} \geq N!

|

||||

$$

|

||||

|

||||

两边取以 2 为底的对数,得:

|

||||

|

||||

$$

|

||||

W(N) \geq \log_{2}{N!}

|

||||

$$

|

||||

|

||||

$N!$ 的增长近似于 $N^{N}$ (参阅 [Stirling 公式][1]),那么,

|

||||

|

||||

$$

|

||||

W(N) \succeq \log N^{N} = N\log N

|

||||

$$

|

||||

|

||||

这就是最差情况下从输出计数的角度得出的 $O(N\log N)$ 上限。

|

||||

|

||||

#### 从信息论角度的平均状态的例子

|

||||

|

||||

使用一些信息论知识,就可以从上面的讨论中得到一个更有力的结论。下面,使用排序算法作为信息传输的编码器:

|

||||

|

||||

1. 任取一个数,比如 15

|

||||

2. 从 4 个数字的排列列表中查找第 15 种排列

|

||||

3. 对这种排列运行排序算法,记录所有的“大”、“小”比较结果

|

||||

4. 用二进制编码发送比较结果

|

||||

5. 接收端重新逐步执行发送端的排序算法,需要的话可以引用发送端的比较结果

|

||||

6. 现在接收端就可以知道发送端如何重新排列数字以按照需要排序,接收端可以对排列进行逆算,得到 4 个数字的初始顺序

|

||||

7. 接收端在排列表中检索发送端的原始排列,指出发送端发送的是 15

|

||||

|

||||

确实,这有点奇怪,但确实可以。这意味着排序算法遵循着与编码方案相同的定律,包括理论所证明的不存在通用的数据压缩算法。算法中每次比较发送 1 比特的比较结果编码数据,根据信息论,比较的次数至少是能表示所有数据的二进制位数。更技术语言点,[平均所需的最小比较次数是输入数据的香农熵,以比特为单位][2]。熵是衡量信息等不可预测量的数学度量。

|

||||

|

||||

包含 $N$ 个元素的数组,元素次序随机且无偏时的熵最大,其值为 $\log_{2}{N!}$ 个比特。这证明 $O(N\log N)$ 是一个基于比较的对任意输入排序的最优平均值。

|

||||

|

||||

以上都是理论说法,那么实际的排序算法如何做比较的呢?下面是一个数组排序所需比较次数均值的图。我比较的是理论值与快速排序及 [Ford-Johnson 合并插入排序][3] 的表现。后者设计目的就是最小化比较次数(整体上没比快速排序快多少,因为生活中相对于最大限度减少比较次数,还有更重要的事情)。又因为<ruby>合并插入排序<rt>merge-insertion sort</rt></ruby>是在 1959 年提出的,它一直在调整,以减少了一些比较次数,但图示说明,它基本上达到了最优状态。

|

||||

|

||||

![随机排列 100 个元素所需的平均排序次数图。最下面的线是理论值,约 1% 处的是合并插入算法,原始 quicksort 大约在 25% 处。][4]

|

||||

|

||||

一点点理论导出这么实用的结论,这感觉真棒!

|

||||

|

||||

#### 小结

|

||||

|

||||

证明了:

|

||||

|

||||

1. 如果数组可以是任意顺序,在最坏情况下至少需要 $O(N\log N)$ 次比较。

|

||||

2. 数组的平均比较次数最少是数组的熵,对随机输入而言,其值是 $O(N\log N)$ 。

|

||||

|

||||

注意,第 2 个结论允许基于比较的算法优于 $O(N\log N)$,前提是输入是低熵的(换言之,是部分可预测的)。如果输入包含很多有序的子序列,那么合并排序的性能接近 $O(N)$。如果在确定一个位之前,其输入是有序的,插入排序性能接近 $O(N)$。在最差情况下,以上算法的性能表现都不超出 $O(N\log N)$。

|

||||

|

||||

### 一般排序算法

|

||||

|

||||

基于比较的排序在实践中是个有趣的特例,但从理论上讲,计算机的 [CMP][5] 指令与其它指令相比,并没有什么特别之处。在下面两条的基础上,前面两种情形都可以扩展至任意排序算法:

|

||||

|

||||

1. 大多数计算机指令有多于两个的输出,但输出的数量仍然是有限的。

|

||||

2. 一条指令有限的输出意味着一条指令只能处理有限的熵。

|

||||

|

||||

这给出了 $O(N\log N)$ 对应的指令下限。任何物理上可实现的计算机都只能在给定时间内执行有限数量的指令,所以算法的执行时间也有对应 $O(N\log N)$ 的下限。

|

||||

|

||||

#### 什么是更快的算法?

|

||||

|

||||

一般意义上的 $O(N\log N)$ 下限,放在实践中来看,如果听人说到任何更快的算法,你要知道,它肯定以某种方式“作弊”了,其中肯定有圈套,即它不是一个可以处理任意大数组的通用排序算法。可能它是一个有用的算法,但最好看明白它字里行间隐含的东西。

|

||||

|

||||

一个广为人知的例子是<ruby>基数排序<rt>radix sort</rt></ruby>算法,它经常被称为 $O(N)$ 排序算法,但它只能处理所有数字都能放入 $k$ 比特的情况,所以实际上它的性能是 $O({kN})$。

|

||||

|

||||

什么意思呢?假如你用的 8 位计算机,那么 8 个二进制位可以表示 $2^{8} = 256$ 个不同的数字,如果数组有上千个数字,那么其中必有重复。对有些应用而言这是可以的,但对有些应用就必须用 16 个二进制位来表示,16 个二进制位可以表示 $2^{16} = 65,536$ 个不同的数字。32 个二进制位可以表示 $2^{32} = 4,294,967,296$ 不同的数字。随着数组长度的增长,所需要的二进制位数也在增长。要表示 $N$ 个不同的数字,需要 $k \geq \log_{2}N$ 个二进制位。所以,只有允许数组中存在重复的数字时,$O({kN})$ 才优于 $O(N\log N)$。

|

||||

|

||||

一般意义上输入数据的 $O(N\log N)$ 的性能已经说明了全部问题。这个讨论不那么有趣因为很少需要在 32 位计算机上对几十亿整数进行排序,[如果有谁的需求超出了 64 位计算机的极限,他一定没有告诉别人][6]。

|

||||

|

||||