mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-01-25 23:11:02 +08:00

commit

6f6bed0ff8

102

published/20090203 How the Kernel Manages Your Memory.md

Normal file

102

published/20090203 How the Kernel Manages Your Memory.md

Normal file

@ -0,0 +1,102 @@

|

||||

内核如何管理内存

|

||||

============================================================

|

||||

|

||||

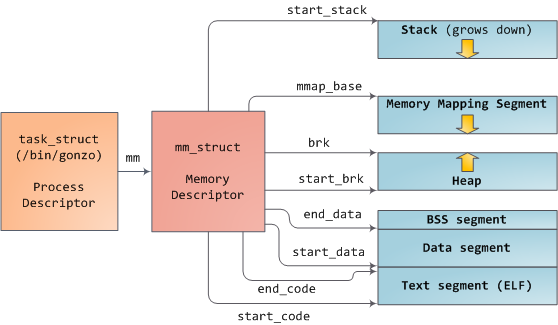

在学习了进程的 [虚拟地址布局][1] 之后,让我们回到内核,来学习它管理用户内存的机制。这里再次使用 Gonzo:

|

||||

|

||||

|

||||

|

||||

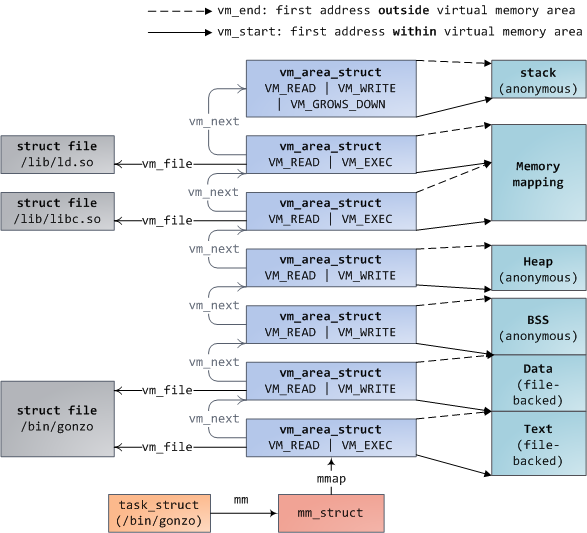

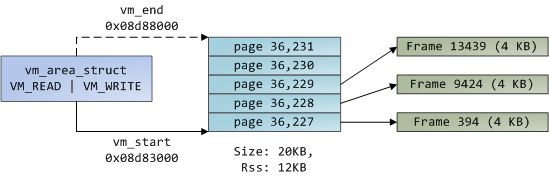

Linux 进程在内核中是作为进程描述符 [task_struct][2] (LCTT 译注:它是在 Linux 中描述进程完整信息的一种数据结构)的实例来实现的。在 task_struct 中的 [mm][3] 域指向到**内存描述符**,[mm_struct][4] 是一个程序在内存中的执行摘要。如上图所示,它保存了起始和结束内存段,进程使用的物理内存页面的 [数量][5](RSS <ruby>常驻内存大小<rt>Resident Set Size</rt></ruby> )、虚拟地址空间使用的 [总数量][6]、以及其它片断。 在内存描述符中,我们可以获悉它有两种管理内存的方式:**虚拟内存区域**集和**页面表**。Gonzo 的内存区域如下所示:

|

||||

|

||||

|

||||

|

||||

每个虚拟内存区域(VMA)是一个连续的虚拟地址范围;这些区域绝对不会重叠。一个 [vm_area_struct][7] 的实例完整地描述了一个内存区域,包括它的起始和结束地址,[flags][8] 决定了访问权限和行为,并且 [vm_file][9] 域指定了映射到这个区域的文件(如果有的话)。(除了内存映射段的例外情况之外,)一个 VMA 是不能**匿名**映射文件的。上面的每个内存段(比如,堆、栈)都对应一个单个的 VMA。虽然它通常都使用在 x86 的机器上,但它并不是必需的。VMA 也不关心它们在哪个段中。

|

||||

|

||||

一个程序的 VMA 在内存描述符中是作为 [mmap][10] 域的一个链接列表保存的,以起始虚拟地址为序进行排列,并且在 [mm_rb][12] 域中作为一个 [红黑树][11] 的根。红黑树允许内核通过给定的虚拟地址去快速搜索内存区域。在你读取文件 `/proc/pid_of_process/maps` 时,内核只是简单地读取每个进程的 VMA 的链接列表并[显示它们][13]。

|

||||

|

||||

在 Windows 中,[EPROCESS][14] 块大致类似于一个 task_struct 和 mm_struct 的结合。在 Windows 中模拟一个 VMA 的是虚拟地址描述符,或称为 [VAD][15];它保存在一个 [AVL 树][16] 中。你知道关于 Windows 和 Linux 之间最有趣的事情是什么吗?其实它们只有一点小差别。

|

||||

|

||||

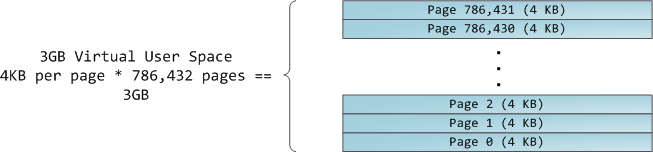

4GB 虚拟地址空间被分配到**页面**中。在 32 位模式中的 x86 处理器中支持 4KB、2MB、以及 4MB 大小的页面。Linux 和 Windows 都使用大小为 4KB 的页面去映射用户的一部分虚拟地址空间。字节 0-4095 在页面 0 中,字节 4096-8191 在页面 1 中,依次类推。VMA 的大小 _必须是页面大小的倍数_ 。下图是使用 4KB 大小页面的总数量为 3GB 的用户空间:

|

||||

|

||||

|

||||

|

||||

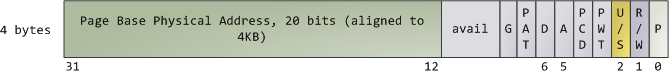

处理器通过查看**页面表**去转换一个虚拟内存地址到一个真实的物理内存地址。每个进程都有它自己的一组页面表;每当发生进程切换时,用户空间的页面表也同时切换。Linux 在内存描述符的 [pgd][17] 域中保存了一个指向进程的页面表的指针。对于每个虚拟页面,页面表中都有一个相应的**页面表条目**(PTE),在常规的 x86 页面表中,它是一个简单的如下所示的大小为 4 字节的记录:

|

||||

|

||||

|

||||

|

||||

Linux 通过函数去 [读取][18] 和 [设置][19] PTE 条目中的每个标志位。标志位 P 告诉处理器这个虚拟页面是否**在**物理内存中。如果该位被清除(设置为 0),访问这个页面将触发一个页面故障。请记住,当这个标志位为 0 时,内核可以在剩余的域上**做任何想做的事**。R/W 标志位是读/写标志;如果被清除,这个页面将变成只读的。U/S 标志位表示用户/超级用户;如果被清除,这个页面将仅被内核访问。这些标志都是用于实现我们在前面看到的只读内存和内核空间保护。

|

||||

|

||||

标志位 D 和 A 用于标识页面是否是“**脏的**”或者是已**被访问过**。一个脏页面表示已经被写入,而一个被访问过的页面则表示有一个写入或者读取发生过。这两个标志位都是粘滞位:处理器只能设置它们,而清除则是由内核来完成的。最终,PTE 保存了这个页面相应的起始物理地址,它们按 4KB 进行整齐排列。这个看起来不起眼的域是一些痛苦的根源,因为它限制了物理内存最大为 [4 GB][20]。其它的 PTE 域留到下次再讲,因为它是涉及了物理地址扩展的知识。

|

||||

|

||||

由于在一个虚拟页面上的所有字节都共享一个 U/S 和 R/W 标志位,所以内存保护的最小单元是一个虚拟页面。但是,同一个物理内存可能被映射到不同的虚拟页面,这样就有可能会出现相同的物理内存出现不同的保护标志位的情况。请注意,在 PTE 中是看不到运行权限的。这就是为什么经典的 x86 页面上允许代码在栈上被执行的原因,这样会很容易导致挖掘出栈缓冲溢出漏洞(可能会通过使用 [return-to-libc][21] 和其它技术来找出非可执行栈)。由于 PTE 缺少禁止运行标志位说明了一个更广泛的事实:在 VMA 中的权限标志位有可能或可能不完全转换为硬件保护。内核只能做它能做到的,但是,最终的架构限制了它能做的事情。

|

||||

|

||||

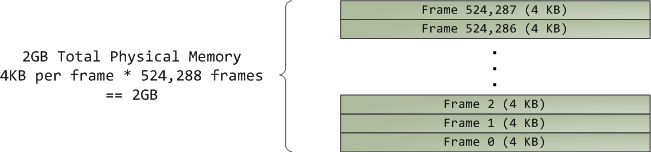

虚拟内存不保存任何东西,它只是简单地 _映射_ 一个程序的地址空间到底层的物理内存上。物理内存被当作一个称之为**物理地址空间**的巨大块而由处理器访问。虽然内存的操作[涉及到某些][22]总线,我们在这里先忽略它,并假设物理地址范围从 0 到可用的最大值按字节递增。物理地址空间被内核进一步分解为**页面帧**。处理器并不会关心帧的具体情况,这一点对内核也是至关重要的,因为,**页面帧是物理内存管理的最小单元**。Linux 和 Windows 在 32 位模式下都使用 4KB 大小的页面帧;下图是一个有 2 GB 内存的机器的例子:

|

||||

|

||||

|

||||

|

||||

在 Linux 上每个页面帧是被一个 [描述符][23] 和 [几个标志][24] 来跟踪的。通过这些描述符和标志,实现了对机器上整个物理内存的跟踪;每个页面帧的具体状态是公开的。物理内存是通过使用 [Buddy 内存分配][25] (LCTT 译注:一种内存分配算法)技术来管理的,因此,如果一个页面帧可以通过 Buddy 系统分配,那么它是**未分配的**(free)。一个被分配的页面帧可以是**匿名的**、持有程序数据的、或者它可能处于页面缓存中、持有数据保存在一个文件或者块设备中。还有其它的异形页面帧,但是这些异形页面帧现在已经不怎么使用了。Windows 有一个类似的页面帧号(Page Frame Number (PFN))数据库去跟踪物理内存。

|

||||

|

||||

我们把虚拟内存区域(VMA)、页面表条目(PTE),以及页面帧放在一起来理解它们是如何工作的。下面是一个用户堆的示例:

|

||||

|

||||

|

||||

|

||||

蓝色的矩形框表示在 VMA 范围内的页面,而箭头表示页面表条目映射页面到页面帧。一些缺少箭头的虚拟页面,表示它们对应的 PTE 的当前标志位被清除(置为 0)。这可能是因为这个页面从来没有被使用过,或者是它的内容已经被交换出去了。在这两种情况下,即便这些页面在 VMA 中,访问它们也将导致产生一个页面故障。对于这种 VMA 和页面表的不一致的情况,看上去似乎很奇怪,但是这种情况却经常发生。

|

||||

|

||||

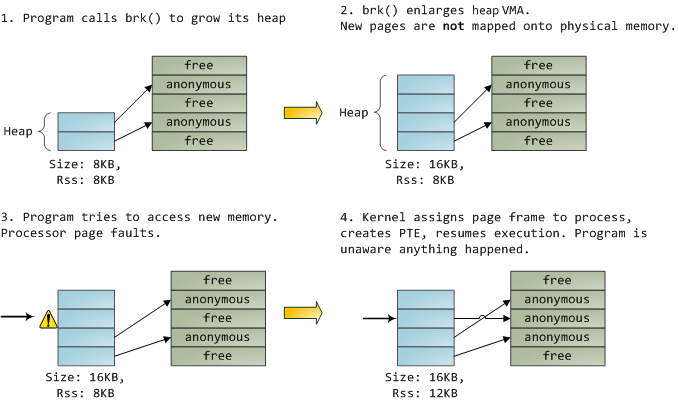

一个 VMA 像一个在你的程序和内核之间的合约。你请求它做一些事情(分配内存、文件映射、等等),内核会回应“收到”,然后去创建或者更新相应的 VMA。 但是,它 _并不立刻_ 去“兑现”对你的承诺,而是它会等待到发生一个页面故障时才去 _真正_ 做这个工作。内核是个“懒惰的家伙”、“不诚实的人渣”;这就是虚拟内存的基本原理。它适用于大多数的情况,有一些类似情况和有一些意外的情况,但是,它是规则是,VMA 记录 _约定的_ 内容,而 PTE 才反映这个“懒惰的内核” _真正做了什么_。通过这两种数据结构共同来管理程序的内存;它们共同来完成解决页面故障、释放内存、从内存中交换出数据、等等。下图是内存分配的一个简单案例:

|

||||

|

||||

|

||||

|

||||

当程序通过 [brk()][26] 系统调用来请求一些内存时,内核只是简单地 [更新][27] 堆的 VMA 并给程序回复“已搞定”。而在这个时候并没有真正地分配页面帧,并且新的页面也没有映射到物理内存上。一旦程序尝试去访问这个页面时,处理器将发生页面故障,然后调用 [do_page_fault()][28]。这个函数将使用 [find_vma()][30] 去 [搜索][29] 发生页面故障的 VMA。如果找到了,然后在 VMA 上进行权限检查以防范恶意访问(读取或者写入)。如果没有合适的 VMA,也没有所尝试访问的内存的“合约”,将会给进程返回段故障。

|

||||

|

||||

当[找到][31]了一个合适的 VMA,内核必须通过查找 PTE 的内容和 VMA 的类型去[处理][32]故障。在我们的案例中,PTE 显示这个页面是 [不存在的][33]。事实上,我们的 PTE 是全部空白的(全部都是 0),在 Linux 中这表示虚拟内存还没有被映射。由于这是匿名 VMA,我们有一个完全的 RAM 事务,它必须被 [do_anonymous_page()][34] 来处理,它分配页面帧,并且用一个 PTE 去映射故障虚拟页面到一个新分配的帧。

|

||||

|

||||

有时候,事情可能会有所不同。例如,对于被交换出内存的页面的 PTE,在当前(Present)标志位上是 0,但它并不是空白的。而是在交换位置仍有页面内容,它必须从磁盘上读取并且通过 [do_swap_page()][35] 来加载到一个被称为 [major fault][36] 的页面帧上。

|

||||

|

||||

这是我们通过探查内核的用户内存管理得出的前半部分的结论。在下一篇文章中,我们通过将文件加载到内存中,来构建一个完整的内存框架图,以及对性能的影响。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://duartes.org/gustavo/blog/post/how-the-kernel-manages-your-memory/

|

||||

|

||||

作者:[Gustavo Duarte][a]

|

||||

译者:[qhwdw](https://github.com/qhwdw)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://duartes.org/gustavo/blog/about/

|

||||

[1]:https://linux.cn/article-9255-1.html

|

||||

[2]:http://lxr.linux.no/linux+v2.6.28.1/include/linux/sched.h#L1075

|

||||

[3]:http://lxr.linux.no/linux+v2.6.28.1/include/linux/sched.h#L1129

|

||||

[4]:http://lxr.linux.no/linux+v2.6.28.1/include/linux/mm_types.h#L173

|

||||

[5]:http://lxr.linux.no/linux+v2.6.28.1/include/linux/mm_types.h#L197

|

||||

[6]:http://lxr.linux.no/linux+v2.6.28.1/include/linux/mm_types.h#L206

|

||||

[7]:http://lxr.linux.no/linux+v2.6.28.1/include/linux/mm_types.h#L99

|

||||

[8]:http://lxr.linux.no/linux+v2.6.28/include/linux/mm.h#L76

|

||||

[9]:http://lxr.linux.no/linux+v2.6.28.1/include/linux/mm_types.h#L150

|

||||

[10]:http://lxr.linux.no/linux+v2.6.28.1/include/linux/mm_types.h#L174

|

||||

[11]:http://en.wikipedia.org/wiki/Red_black_tree

|

||||

[12]:http://lxr.linux.no/linux+v2.6.28.1/include/linux/mm_types.h#L175

|

||||

[13]:http://lxr.linux.no/linux+v2.6.28.1/fs/proc/task_mmu.c#L201

|

||||

[14]:http://www.nirsoft.net/kernel_struct/vista/EPROCESS.html

|

||||

[15]:http://www.nirsoft.net/kernel_struct/vista/MMVAD.html

|

||||

[16]:http://en.wikipedia.org/wiki/AVL_tree

|

||||

[17]:http://lxr.linux.no/linux+v2.6.28.1/include/linux/mm_types.h#L185

|

||||

[18]:http://lxr.linux.no/linux+v2.6.28.1/arch/x86/include/asm/pgtable.h#L173

|

||||

[19]:http://lxr.linux.no/linux+v2.6.28.1/arch/x86/include/asm/pgtable.h#L230

|

||||

[20]:http://www.google.com/search?hl=en&amp;amp;amp;amp;q=2^20+*+2^12+bytes+in+GB

|

||||

[21]:http://en.wikipedia.org/wiki/Return-to-libc_attack

|

||||

[22]:http://duartes.org/gustavo/blog/post/getting-physical-with-memory

|

||||

[23]:http://lxr.linux.no/linux+v2.6.28/include/linux/mm_types.h#L32

|

||||

[24]:http://lxr.linux.no/linux+v2.6.28/include/linux/page-flags.h#L14

|

||||

[25]:http://en.wikipedia.org/wiki/Buddy_memory_allocation

|

||||

[26]:http://www.kernel.org/doc/man-pages/online/pages/man2/brk.2.html

|

||||

[27]:http://lxr.linux.no/linux+v2.6.28.1/mm/mmap.c#L2050

|

||||

[28]:http://lxr.linux.no/linux+v2.6.28/arch/x86/mm/fault.c#L583

|

||||

[29]:http://lxr.linux.no/linux+v2.6.28/arch/x86/mm/fault.c#L692

|

||||

[30]:http://lxr.linux.no/linux+v2.6.28/mm/mmap.c#L1466

|

||||

[31]:http://lxr.linux.no/linux+v2.6.28/arch/x86/mm/fault.c#L711

|

||||

[32]:http://lxr.linux.no/linux+v2.6.28/mm/memory.c#L2653

|

||||

[33]:http://lxr.linux.no/linux+v2.6.28/mm/memory.c#L2674

|

||||

[34]:http://lxr.linux.no/linux+v2.6.28/mm/memory.c#L2681

|

||||

[35]:http://lxr.linux.no/linux+v2.6.28/mm/memory.c#L2280

|

||||

[36]:http://lxr.linux.no/linux+v2.6.28/mm/memory.c#L2316

|

||||

@ -0,0 +1,435 @@

|

||||

使用 sar 和 kSar 来发现 Linux 性能瓶颈

|

||||

======

|

||||

|

||||

`sar` 命令用用收集、报告、或者保存 UNIX / Linux 系统的活动信息。它保存选择的计数器到操作系统的 `/var/log/sa/sadd` 文件中。从收集的数据中,你可以得到许多关于你的服务器的信息:

|

||||

|

||||

1. CPU 使用率

|

||||

2. 内存页面和使用率

|

||||

3. 网络 I/O 和传输统计

|

||||

4. 进程创建活动

|

||||

5. 所有的块设备活动

|

||||

6. 每秒中断数等等

|

||||

|

||||

`sar` 命令的输出能够用于识别服务器瓶颈。但是,分析 `sar` 命令提供的信息可能比较困难,所以要使用 kSar 工具。kSar 工具可以将 `sar` 命令的输出绘制成基于时间周期的、易于理解的图表。

|

||||

|

||||

### sysstat 包

|

||||

|

||||

`sar`、`sa1`、和 `sa2` 命令都是 sysstat 包的一部分。它是 Linux 包含的性能监视工具集合。

|

||||

|

||||

1. `sar`:显示数据

|

||||

2. `sa1` 和 `sa2`:收集和保存数据用于以后分析。`sa2` shell 脚本在 `/var/log/sa` 目录中每日写入一个报告。`sa1` shell 脚本将每日的系统活动信息以二进制数据的形式写入到文件中。

|

||||

3. sadc —— 系统活动数据收集器。你可以通过修改 `sa1` 和 `sa2` 脚本去配置各种选项。它们位于以下的目录:

|

||||

* `/usr/lib64/sa/sa1` (64 位)或者 `/usr/lib/sa/sa1` (32 位) —— 它调用 `sadc` 去记录报告到 `/var/log/sa/sadX` 格式。

|

||||

* `/usr/lib64/sa/sa2` (64 位)或者 `/usr/lib/sa/sa2` (32 位) —— 它调用 `sar` 去记录报告到 `/var/log/sa/sarX` 格式。

|

||||

|

||||

#### 如何在我的系统上安装 sar?

|

||||

|

||||

在一个基于 CentOS/RHEL 的系统上,输入如下的 [yum 命令][1] 去安装 sysstat:

|

||||

|

||||

```

|

||||

# yum install sysstat

|

||||

```

|

||||

|

||||

示例输出如下:

|

||||

|

||||

```

|

||||

Loaded plugins: downloadonly, fastestmirror, priorities,

|

||||

: protectbase, security

|

||||

Loading mirror speeds from cached hostfile

|

||||

* addons: mirror.cs.vt.edu

|

||||

* base: mirror.ash.fastserv.com

|

||||

* epel: serverbeach1.fedoraproject.org

|

||||

* extras: mirror.cogentco.com

|

||||

* updates: centos.mirror.nac.net

|

||||

0 packages excluded due to repository protections

|

||||

Setting up Install Process

|

||||

Resolving Dependencies

|

||||

--> Running transaction check

|

||||

---> Package sysstat.x86_64 0:7.0.2-3.el5 set to be updated

|

||||

--> Finished Dependency Resolution

|

||||

|

||||

Dependencies Resolved

|

||||

|

||||

====================================================================

|

||||

Package Arch Version Repository Size

|

||||

====================================================================

|

||||

Installing:

|

||||

sysstat x86_64 7.0.2-3.el5 base 173 k

|

||||

|

||||

Transaction Summary

|

||||

====================================================================

|

||||

Install 1 Package(s)

|

||||

Update 0 Package(s)

|

||||

Remove 0 Package(s)

|

||||

|

||||

Total download size: 173 k

|

||||

Is this ok [y/N]: y

|

||||

Downloading Packages:

|

||||

sysstat-7.0.2-3.el5.x86_64.rpm | 173 kB 00:00

|

||||

Running rpm_check_debug

|

||||

Running Transaction Test

|

||||

Finished Transaction Test

|

||||

Transaction Test Succeeded

|

||||

Running Transaction

|

||||

Installing : sysstat 1/1

|

||||

|

||||

Installed:

|

||||

sysstat.x86_64 0:7.0.2-3.el5

|

||||

|

||||

Complete!

|

||||

```

|

||||

|

||||

#### 为 sysstat 配置文件

|

||||

|

||||

编辑 `/etc/sysconfig/sysstat` 文件去指定日志文件保存多少天(最长为一个月):

|

||||

|

||||

```

|

||||

# vi /etc/sysconfig/sysstat

|

||||

```

|

||||

|

||||

示例输出如下 :

|

||||

|

||||

```

|

||||

# keep log for 28 days

|

||||

# the default is 7

|

||||

HISTORY=28

|

||||

```

|

||||

|

||||

保存并关闭这个文件。

|

||||

|

||||

### 找到 sar 默认的 cron 作业

|

||||

|

||||

[默认的 cron 作业位于][2] `/etc/cron.d/sysstat`:

|

||||

|

||||

```

|

||||

# cat /etc/cron.d/sysstat

|

||||

```

|

||||

|

||||

示例输出如下:

|

||||

|

||||

```

|

||||

# run system activity accounting tool every 10 minutes

|

||||

*/10 * * * * root /usr/lib64/sa/sa1 1 1

|

||||

# generate a daily summary of process accounting at 23:53

|

||||

53 23 * * * root /usr/lib64/sa/sa2 -A

|

||||

```

|

||||

|

||||

#### 告诉 sadc 去报告磁盘的统计数据

|

||||

|

||||

使用一个文本编辑器去编辑 `/etc/cron.d/sysstat` 文件,比如使用 `vim` 命令,输入如下:

|

||||

|

||||

```

|

||||

# vi /etc/cron.d/sysstat

|

||||

```

|

||||

|

||||

像下面的示例那样更新这个文件,以记录所有的硬盘统计数据(`-d` 选项强制记录每个块设备的统计数据,而 `-I` 选项强制记录所有系统中断的统计数据):

|

||||

|

||||

```

|

||||

# run system activity accounting tool every 10 minutes

|

||||

*/10 * * * * root /usr/lib64/sa/sa1 -I -d 1 1

|

||||

# generate a daily summary of process accounting at 23:53

|

||||

53 23 * * * root /usr/lib64/sa/sa2 -A

|

||||

```

|

||||

|

||||

在 CentOS/RHEL 7.x 系统上你需要传递 `-S DISK` 选项去收集块设备的数据。传递 `-S XALL` 选项去采集如下所列的数据:

|

||||

|

||||

1. 磁盘

|

||||

2. 分区

|

||||

3. 系统中断

|

||||

4. SNMP

|

||||

5. IPv6

|

||||

|

||||

```

|

||||

# Run system activity accounting tool every 10 minutes

|

||||

*/10 * * * * root /usr/lib64/sa/sa1 -S DISK 1 1

|

||||

# 0 * * * * root /usr/lib64/sa/sa1 600 6 &

|

||||

# Generate a daily summary of process accounting at 23:53

|

||||

53 23 * * * root /usr/lib64/sa/sa2 -A

|

||||

# Run system activity accounting tool every 10 minutes

|

||||

```

|

||||

|

||||

保存并关闭这个文件。

|

||||

|

||||

#### 打开 CentOS/RHEL 版本 5.x/6.x 的服务

|

||||

|

||||

输入如下命令:

|

||||

|

||||

```

|

||||

chkconfig sysstat on

|

||||

service sysstat start

|

||||

```

|

||||

|

||||

示例输出如下:

|

||||

|

||||

```

|

||||

Calling the system activity data collector (sadc):

|

||||

```

|

||||

|

||||

对于 CentOS/RHEL 7.x,运行如下的命令:

|

||||

|

||||

```

|

||||

# systemctl enable sysstat

|

||||

# systemctl start sysstat.service

|

||||

# systemctl status sysstat.service

|

||||

```

|

||||

|

||||

示例输出:

|

||||

|

||||

```

|

||||

● sysstat.service - Resets System Activity Logs

|

||||

Loaded: loaded (/usr/lib/systemd/system/sysstat.service; enabled; vendor preset: enabled)

|

||||

Active: active (exited) since Sat 2018-01-06 16:33:19 IST; 3s ago

|

||||

Process: 28297 ExecStart=/usr/lib64/sa/sa1 --boot (code=exited, status=0/SUCCESS)

|

||||

Main PID: 28297 (code=exited, status=0/SUCCESS)

|

||||

|

||||

Jan 06 16:33:19 centos7-box systemd[1]: Starting Resets System Activity Logs...

|

||||

Jan 06 16:33:19 centos7-box systemd[1]: Started Resets System Activity Logs.

|

||||

```

|

||||

|

||||

### 如何使用 sar?如何查看统计数据?

|

||||

|

||||

使用 `sar` 命令去显示操作系统中选定的累积活动计数器输出。在这个示例中,运行 `sar` 命令行,去实时获得 CPU 使用率的报告:

|

||||

|

||||

```

|

||||

# sar -u 3 10

|

||||

```

|

||||

|

||||

示例输出:

|

||||

|

||||

```

|

||||

Linux 2.6.18-164.2.1.el5 (www-03.nixcraft.in) 12/14/2009

|

||||

|

||||

09:49:47 PM CPU %user %nice %system %iowait %steal %idle

|

||||

09:49:50 PM all 5.66 0.00 1.22 0.04 0.00 93.08

|

||||

09:49:53 PM all 12.29 0.00 1.93 0.04 0.00 85.74

|

||||

09:49:56 PM all 9.30 0.00 1.61 0.00 0.00 89.10

|

||||

09:49:59 PM all 10.86 0.00 1.51 0.04 0.00 87.58

|

||||

09:50:02 PM all 14.21 0.00 3.27 0.04 0.00 82.47

|

||||

09:50:05 PM all 13.98 0.00 4.04 0.04 0.00 81.93

|

||||

09:50:08 PM all 6.60 6.89 1.26 0.00 0.00 85.25

|

||||

09:50:11 PM all 7.25 0.00 1.55 0.04 0.00 91.15

|

||||

09:50:14 PM all 6.61 0.00 1.09 0.00 0.00 92.31

|

||||

09:50:17 PM all 5.71 0.00 0.96 0.00 0.00 93.33

|

||||

Average: all 9.24 0.69 1.84 0.03 0.00 88.20

|

||||

```

|

||||

|

||||

其中:

|

||||

|

||||

* 3 表示间隔时间

|

||||

* 10 表示次数

|

||||

|

||||

查看进程创建的统计数据,输入:

|

||||

|

||||

```

|

||||

# sar -c 3 10

|

||||

```

|

||||

|

||||

查看 I/O 和传输率统计数据,输入:

|

||||

|

||||

```

|

||||

# sar -b 3 10

|

||||

```

|

||||

|

||||

查看内存页面统计数据,输入:

|

||||

|

||||

```

|

||||

# sar -B 3 10

|

||||

```

|

||||

|

||||

查看块设备统计数据,输入:

|

||||

|

||||

```

|

||||

# sar -d 3 10

|

||||

```

|

||||

|

||||

查看所有中断的统计数据,输入:

|

||||

|

||||

```

|

||||

# sar -I XALL 3 10

|

||||

```

|

||||

|

||||

查看网络设备特定的统计数据,输入:

|

||||

|

||||

```

|

||||

# sar -n DEV 3 10

|

||||

# sar -n EDEV 3 10

|

||||

```

|

||||

|

||||

查看 CPU 特定的统计数据,输入:

|

||||

|

||||

```

|

||||

# sar -P ALL

|

||||

# Only 1st CPU stats

|

||||

# sar -P 1 3 10

|

||||

```

|

||||

|

||||

查看队列长度和平均负载的统计数据,输入:

|

||||

|

||||

```

|

||||

# sar -q 3 10

|

||||

```

|

||||

|

||||

查看内存和交换空间的使用统计数据,输入:

|

||||

|

||||

```

|

||||

# sar -r 3 10

|

||||

# sar -R 3 10

|

||||

```

|

||||

|

||||

查看 inode、文件、和其它内核表统计数据状态,输入:

|

||||

|

||||

```

|

||||

# sar -v 3 10

|

||||

```

|

||||

|

||||

查看系统切换活动统计数据,输入:

|

||||

|

||||

```

|

||||

# sar -w 3 10

|

||||

```

|

||||

|

||||

查看交换统计数据,输入:

|

||||

|

||||

```

|

||||

# sar -W 3 10

|

||||

```

|

||||

|

||||

查看一个 PID 为 3256 的 Apache 进程,输入:

|

||||

|

||||

```

|

||||

# sar -x 3256 3 10

|

||||

```

|

||||

|

||||

### kSar 介绍

|

||||

|

||||

`sar` 和 `sadf` 提供了基于命令行界面的输出。这种输出可能会使新手用户/系统管理员感到无从下手。因此,你需要使用 kSar,它是一个图形化显示你的 `sar` 数据的 Java 应用程序。它也允许你以 PDF/JPG/PNG/CSV 格式导出数据。你可以用三种方式去加载数据:本地文件、运行本地命令、以及通过 SSH 远程运行的命令。kSar 可以处理下列操作系统的 `sar` 输出:

|

||||

|

||||

1. Solaris 8, 9 和 10

|

||||

2. Mac OS/X 10.4+

|

||||

3. Linux (Systat Version >= 5.0.5)

|

||||

4. AIX (4.3 & 5.3)

|

||||

5. HPUX 11.00+

|

||||

|

||||

#### 下载和安装 kSar

|

||||

|

||||

访问 [官方][3] 网站去获得最新版本的源代码。使用 [wget][4] 去下载源代码,输入:

|

||||

|

||||

```

|

||||

$ wget https://github.com/vlsi/ksar/releases/download/v5.2.4-snapshot-652bf16/ksar-5.2.4-SNAPSHOT-all.jar

|

||||

```

|

||||

|

||||

#### 如何运行 kSar?

|

||||

|

||||

首先要确保你的机器上 [JAVA jdk][5] 已安装并能够正常工作。输入下列命令去启动 kSar:

|

||||

|

||||

```

|

||||

$ java -jar ksar-5.2.4-SNAPSHOT-all.jar

|

||||

```

|

||||

|

||||

![Fig.01: kSar welcome screen][6]

|

||||

|

||||

接下来你将看到 kSar 的主窗口,和有两个菜单的面板。

|

||||

|

||||

![Fig.02: kSar - the main window][7]

|

||||

|

||||

左侧有一个列表,是 kSar 根据数据已经解析出的可用图表的列表。右侧窗口将展示你选定的图表。

|

||||

|

||||

#### 如何使用 kSar 去生成 sar 图表?

|

||||

|

||||

首先,你需要从命名为 server1 的服务器上采集 `sar` 命令的统计数据。输入如下的命令:

|

||||

|

||||

```

|

||||

[ server1 ]# LC_ALL=C sar -A > /tmp/sar.data.txt

|

||||

```

|

||||

|

||||

接下来,使用 `scp` 命令从本地桌面拷贝到远程电脑上:

|

||||

|

||||

```

|

||||

[ desktop ]$ scp user@server1.nixcraft.com:/tmp/sar.data.txt /tmp/

|

||||

```

|

||||

|

||||

切换到 kSar 窗口,点击 “Data” > “Load data from text file” > 从 `/tmp/` 中选择 `sar.data.txt` > 点击 “Open” 按钮。

|

||||

|

||||

现在,图表类型树已经出现在左侧面板中并选定了一个图形:

|

||||

|

||||

![Fig.03: Processes for server1][8]

|

||||

|

||||

![Fig.03: Disk stats (blok device) stats for server1][9]

|

||||

|

||||

![Fig.05: Memory stats for server1][10]

|

||||

|

||||

##### 放大和缩小

|

||||

|

||||

通过移动你可以交互式缩放图像的一部分。在要缩放的图像的左上角点击并按下鼠标,移动到要缩放区域的右下角,可以选定要缩放的区域。返回到未缩放状态,点击并拖动鼠标到除了右下角外的任意位置,你也可以点击并选择 zoom 选项。

|

||||

|

||||

##### 了解 kSar 图像和 sar 数据

|

||||

|

||||

我强烈建议你去阅读 `sar` 和 `sadf` 命令的 man 页面:

|

||||

|

||||

```

|

||||

$ man sar

|

||||

$ man sadf

|

||||

```

|

||||

|

||||

### 案例学习:识别 Linux 服务器的 CPU 瓶颈

|

||||

|

||||

使用 `sar` 命令和 kSar 工具,可以得到内存、CPU、以及其它子系统的详细快照。例如,如果 CPU 使用率在一个很长的时间内持续高于 80%,有可能就是出现了一个 CPU 瓶颈。使用 `sar -x ALL` 你可以找到大量消耗 CPU 的进程。

|

||||

|

||||

[mpstat 命令][11] 的输出(sysstat 包的一部分)也会帮你去了解 CPU 的使用率。但你可以使用 kSar 很容易地去分析这些信息。

|

||||

|

||||

#### 找出 CPU 瓶颈后 …

|

||||

|

||||

对 CPU 执行如下的调整:

|

||||

|

||||

1. 确保没有不需要的进程在后台运行。关闭 [Linux 上所有不需要的服务][12]。

|

||||

2. 使用 [cron][13] 在一个非高峰时刻运行任务(比如,备份)。

|

||||

3. 使用 [top 和 ps 命令][14] 去找出所有非关键的后台作业/服务。使用 [renice 命令][15] 去调整低优先级作业。

|

||||

4. 使用 [taskset 命令去设置进程使用的 CPU ][16] (卸载所使用的 CPU),即,绑定进程到不同的 CPU 上。例如,在 2# CPU 上运行 MySQL 数据库,而在 3# CPU 上运行 Apache。

|

||||

5. 确保你的系统使用了最新的驱动程序和固件。

|

||||

6. 如有可能在系统上增加额外的 CPU。

|

||||

7. 为单线程应用程序使用更快的 CPU(比如,Lighttpd web 服务器应用程序)。

|

||||

8. 为多线程应用程序使用多个 CPU(比如,MySQL 数据库服务器应用程序)。

|

||||

9. 为一个 web 应用程序使用多个计算节点并设置一个 [负载均衡器][17]。

|

||||

|

||||

### isag —— 交互式系统活动记录器(替代工具)

|

||||

|

||||

`isag` 命令图形化显示了以前运行 `sar` 命令时存储在二进制文件中的系统活动数据。`isag` 命令引用 `sar` 并提取出它的数据来绘制图形。与 kSar 相比,`isag` 的选项比较少。

|

||||

|

||||

![Fig.06: isag CPU utilization graphs][18]

|

||||

|

||||

### 关于作者

|

||||

|

||||

本文作者是 nixCraft 的创始人和一位经验丰富的 Linux 操作系统/Unix shell 脚本培训师。他与包括 IT、教育、国防和空间研究、以及非营利组织等全球各行业客户一起合作。可以在 [Twitter][19]、[Facebook][20]、[Google+][21] 上关注他。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.cyberciti.biz/tips/identifying-linux-bottlenecks-sar-graphs-with-ksar.html

|

||||

|

||||

作者:[Vivek Gite][a]

|

||||

译者:[qhwdw](https://github.com/qhwdw)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.cyberciti.biz

|

||||

[1]:https://www.cyberciti.biz/faq/rhel-centos-fedora-linux-yum-command-howto/ "See Linux/Unix yum command examples for more info"

|

||||

[2]:https://www.cyberciti.biz/faq/how-do-i-add-jobs-to-cron-under-linux-or-unix-oses/

|

||||

[3]:https://github.com/vlsi/ksar

|

||||

[4]:https://www.cyberciti.biz/tips/linux-wget-your-ultimate-command-line-downloader.html

|

||||

[5]:https://www.cyberciti.biz/faq/howto-ubuntu-linux-install-configure-jdk-jre/

|

||||

[6]:https://www.cyberciti.biz/media/new/tips/2009/12/sar-welcome.png "kSar welcome screen"

|

||||

[7]:https://www.cyberciti.biz/media/new/tips/2009/12/screenshot-kSar-a-sar-grapher-01.png "kSar - the main window"

|

||||

[8]:https://www.cyberciti.biz/media/new/tips/2009/12/cpu-ksar.png "Linux kSar Processes for server1 "

|

||||

[9]:https://www.cyberciti.biz/media/new/tips/2009/12/disk-stats-ksar.png "Linux Disk I/O Stats Using kSar"

|

||||

[10]:https://www.cyberciti.biz/media/new/tips/2009/12/memory-ksar.png "Linux Memory paging and its utilization stats"

|

||||

[11]:https://www.cyberciti.biz/tips/how-do-i-find-out-linux-cpu-utilization.html

|

||||

[12]:https://www.cyberciti.biz/faq/check-running-services-in-rhel-redhat-fedora-centoslinux/

|

||||

[13]:https://www.cyberciti.biz/faq/how-do-i-add-jobs-to-cron-under-linux-or-unix-oses/

|

||||

[14]:https://www.cyberciti.biz/faq/show-all-running-processes-in-linux/

|

||||

[15]:https://www.cyberciti.biz/faq/howto-change-unix-linux-process-priority/

|

||||

[16]:https://www.cyberciti.biz/faq/taskset-cpu-affinity-command/

|

||||

[17]:https://www.cyberciti.biz/tips/load-balancer-open-source-software.html

|

||||

[18]:https://www.cyberciti.biz/media/new/tips/2009/12/isag.cpu_.png "Fig.06: isag CPU utilization graphs"

|

||||

[19]:https://twitter.com/nixcraft

|

||||

[20]:https://facebook.com/nixcraft

|

||||

[21]:https://plus.google.com/+CybercitiBiz

|

||||

@ -1,26 +1,27 @@

|

||||

让我们做个简单的解释器(1)

|

||||

让我们做个简单的解释器(一)

|

||||

======

|

||||

|

||||

> “如果你不知道编译器是怎么工作的,那你就不知道电脑是怎么工作的。如果你不能百分百确定,那就是不知道它们是如何工作的。” --Steve Yegge

|

||||

|

||||

> **" If you don't know how compilers work, then you don't know how computers work. If you're not 100% sure whether you know how compilers work, then you don't know how they work."** -- Steve Yegge

|

||||

> **“如果你不知道编译器是怎么工作的,那你就不知道电脑是怎么工作的。如果你不能百分百确定,那就是不知道他们是如何工作的。”** --Steve Yegge

|

||||

就是这样。想一想。你是萌新还是一个资深的软件开发者实际上都无关紧要:如果你不知道<ruby>编译器<rt>compiler</rt></ruby>和<ruby>解释器<rt>interpreter</rt></ruby>是怎么工作的,那么你就不知道电脑是怎么工作的。就这么简单。

|

||||

|

||||

就是这样。想一想。你是萌新还是一个资深的软件开发者实际上都无关紧要:如果你不知道编译器和解释器是怎么工作的,那么你就不知道电脑是怎么工作的。就这么简单。

|

||||

所以,你知道编译器和解释器是怎么工作的吗?我是说,你百分百确定自己知道他们怎么工作吗?如果不知道。

|

||||

|

||||

所以,你知道编译器和解释器是怎么工作的吗?我是说,你百分百确定自己知道他们怎么工作吗?如果不知道。![][1]

|

||||

![][1]

|

||||

|

||||

或者如果你不知道但你非常想要了解它。 ![][2]

|

||||

或者如果你不知道但你非常想要了解它。

|

||||

|

||||

不用担心。如果你能坚持跟着这个系列做下去,和我一起构建一个解释器和编译器,最后你将会知道他们是怎么工作的。并且你会变成一个自信满满的快乐的人。至少我希望如此。![][3]。

|

||||

![][2]

|

||||

|

||||

不用担心。如果你能坚持跟着这个系列做下去,和我一起构建一个解释器和编译器,最后你将会知道他们是怎么工作的。并且你会变成一个自信满满的快乐的人。至少我希望如此。

|

||||

|

||||

![][3]

|

||||

|

||||

为什么要学习编译器和解释器?有三点理由。

|

||||

|

||||

1. 要写出一个解释器或编译器,你需要有很多的专业知识,并能融会贯通。写一个解释器或编译器能帮你加强这些能力,成为一个更厉害的软件开发者。而且,你要学的技能对写软件非常有用,而不是仅仅局限于解释器或编译器。

|

||||

2. 你确实想要了解电脑是怎么工作的。一般解释器和编译器看上去很魔幻。你或许不习惯这种魔力。你会想去揭开构建解释器和编译器那层神秘的面纱,了解他们的原理,把事情做好。

|

||||

3. 你想要创建自己的编程语言或者特定领域的语言。如果你创建了一个,你还要为它创建一个解释器或者编译器。最近,兴起了对新的编程语言的兴趣。你能看到几乎每天都有一门新的编程语言横空出世:Elixir,Go,Rust,还有很多。

|

||||

|

||||

|

||||

|

||||

1. 要写出一个解释器或编译器,你需要有很多的专业知识,并能融会贯通。写一个解释器或编译器能帮你加强这些能力,成为一个更厉害的软件开发者。而且,你要学的技能对编写软件非常有用,而不是仅仅局限于解释器或编译器。

|

||||

2. 你确实想要了解电脑是怎么工作的。通常解释器和编译器看上去很魔幻。你或许不习惯这种魔力。你会想去揭开构建解释器和编译器那层神秘的面纱,了解它们的原理,把事情做好。

|

||||

3. 你想要创建自己的编程语言或者特定领域的语言。如果你创建了一个,你还要为它创建一个解释器或者编译器。最近,兴起了对新的编程语言的兴趣。你能看到几乎每天都有一门新的编程语言横空出世:Elixir,Go,Rust,还有很多。

|

||||

|

||||

好,但什么是解释器和编译器?

|

||||

|

||||

@ -32,11 +33,12 @@

|

||||

|

||||

我希望你现在确信你很想学习构建一个编译器和解释器。你期望在这个教程里学习解释器的哪些知识呢?

|

||||

|

||||

你看这样如何。你和我一起做一个简单的解释器当作 [Pascal][5] 语言的子集。在这个系列结束的时候你能做出一个可以运行的 Pascal 解释器和一个像 Python 的 [pdb][6] 那样的源代码级别的调试器。

|

||||

你看这样如何。你和我一起为 [Pascal][5] 语言的一个大子集做一个简单的解释器。在这个系列结束的时候你能做出一个可以运行的 Pascal 解释器和一个像 Python 的 [pdb][6] 那样的源代码级别的调试器。

|

||||

|

||||

你或许会问,为什么是 Pascal?有一点,它不是我为了这个系列而提出的一个虚构的语言:它是真实存在的一门编程语言,有很多重要的语言结构。有些陈旧但有用的计算机书籍使用 Pascal 编程语言作为示例(我知道对于选择一门语言来构建解释器,这个理由并不令人信服,但我认为学一门非主流的语言也不错:)。

|

||||

你或许会问,为什么是 Pascal?一方面,它不是我为了这个系列而提出的一个虚构的语言:它是真实存在的一门编程语言,有很多重要的语言结构。有些陈旧但有用的计算机书籍使用 Pascal 编程语言作为示例(我知道对于选择一门语言来构建解释器,这个理由并不令人信服,但我认为学一门非主流的语言也不错 :))。

|

||||

|

||||

这有个 Pascal 中的阶乘函数示例,你将能用自己的解释器解释代码,还能够用可交互的源码级调试器进行调试,你可以这样创造:

|

||||

|

||||

这有个 Pascal 中的阶乘函数示例,你能用自己的解释器解释代码,还能够用可交互的源码级调试器进行调试,你可以这样创造:

|

||||

```

|

||||

program factorial;

|

||||

|

||||

@ -57,15 +59,14 @@ begin

|

||||

end.

|

||||

```

|

||||

|

||||

这个 Pascal 解释器的实现语言会用 Python,但你也可以用其他任何语言,因为这里展示的思想不依赖任何特殊的实现语言。好,让我们开始干活。准备好了,出发!

|

||||

|

||||

你会从编写一个简单的算术表达式解析器,也就是常说的计算器,开始学习解释器和编译器。今天的目标非常简单:让你的计算器能处理两个个位数相加,比如 **3+5**。这是你的计算器的源代码,不好意思,是解释器:

|

||||

这个 Pascal 解释器的实现语言会使用 Python,但你也可以用其他任何语言,因为这里展示的思想不依赖任何特殊的实现语言。好,让我们开始干活。准备好了,出发!

|

||||

|

||||

你会从编写一个简单的算术表达式解析器,也就是常说的计算器,开始学习解释器和编译器。今天的目标非常简单:让你的计算器能处理两个个位数相加,比如 `3+5`。下面是你的计算器的源代码——不好意思,是解释器:

|

||||

|

||||

```

|

||||

# 标记类型

|

||||

#

|

||||

# EOF (end-of-file 文件末尾) 标记是用来表示所有输入都解析完成

|

||||

# EOF (end-of-file 文件末尾)标记是用来表示所有输入都解析完成

|

||||

INTEGER, PLUS, EOF = 'INTEGER', 'PLUS', 'EOF'

|

||||

|

||||

|

||||

@ -73,7 +74,7 @@ class Token(object):

|

||||

def __init__(self, type, value):

|

||||

# token 类型: INTEGER, PLUS, MINUS, or EOF

|

||||

self.type = type

|

||||

# token 值: 0, 1, 2. 3, 4, 5, 6, 7, 8, 9, '+', 或 None

|

||||

# token 值: 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, '+', 或 None

|

||||

self.value = value

|

||||

|

||||

def __str__(self):

|

||||

@ -187,7 +188,8 @@ if __name__ == '__main__':

|

||||

```

|

||||

|

||||

|

||||

把上面的代码保存到 calc1.py 文件,或者直接从 [GitHub][7] 上下载。在你深入研究代码前,在命令行里面运行它看看效果。试一试!这是我笔记本上的示例会话(如果你想在 Python3 下运行,你要把 raw_input 换成 input):

|

||||

把上面的代码保存到 `calc1.py` 文件,或者直接从 [GitHub][7] 上下载。在你深入研究代码前,在命令行里面运行它看看效果。试一试!这是我笔记本上的示例会话(如果你想在 Python3 下运行,你要把 `raw_input` 换成 `input`):

|

||||

|

||||

```

|

||||

$ python calc1.py

|

||||

calc> 3+4

|

||||

@ -205,31 +207,32 @@ calc>

|

||||

* 此时支持的唯一一个运算符是加法

|

||||

* 输入中不允许有任何的空格符号

|

||||

|

||||

|

||||

|

||||

要让计算器变得简单,这些限制非常必要。不用担心,你很快就会让它变得很复杂。

|

||||

|

||||

好,现在让我们深入它,看看解释器是怎么工作,它是怎么评估出算术表达式的。

|

||||

|

||||

当你在命令行中输入一个表达式 3+5,解释器就获得了字符串 “3+5”。为了让解释器能够真正理解要用这个字符串做什么,它首先要把输入 “3+5” 分到叫做 **token(标记)** 的容器里。**标记** 是一个拥有类型和值的对象。比如说,对字符 “3” 而言,标记的类型是 INTEGER 整数,对应的值是 3。

|

||||

当你在命令行中输入一个表达式 `3+5`,解释器就获得了字符串 “3+5”。为了让解释器能够真正理解要用这个字符串做什么,它首先要把输入 “3+5” 分到叫做 `token`(标记)的容器里。<ruby>标记<rt>token</rt></ruby> 是一个拥有类型和值的对象。比如说,对字符 “3” 而言,标记的类型是 INTEGER 整数,对应的值是 3。

|

||||

|

||||

把输入字符串分成标记的过程叫 **词法分析**。因此解释器的需要做的第一步是读取输入字符,并将其转换成标记流。解释器中的这一部分叫做 **词法分析器**,或者简短点叫 **lexer**。你也可以给它起别的名字,诸如 **扫描器** 或者 **标记器**。他们指的都是同一个东西:解释器或编译器中将输入字符转换成标记流的那部分。

|

||||

把输入字符串分成标记的过程叫<ruby>词法分析<rt>lexical analysis</rt></ruby>。因此解释器的需要做的第一步是读取输入字符,并将其转换成标记流。解释器中的这一部分叫做<ruby>词法分析器<rt>lexical analyzer</rt></ruby>,或者简短点叫 **lexer**。你也可以给它起别的名字,诸如<ruby>扫描器<rt>scanner</rt></ruby>或者<ruby>标记器<rt>tokenizer</rt></ruby>。它们指的都是同一个东西:解释器或编译器中将输入字符转换成标记流的那部分。

|

||||

|

||||

Interpreter 类中的 get_next_token 方法就是词法分析器。每次调用它的时候,你都能从传入解释器的输入字符中获得创建的下一个标记。仔细看看这个方法,看看它是如何完成把字符转换成标记的任务的。输入被存在可变文本中,它保存了输入的字符串和关于该字符串的索引(把字符串想象成字符数组)。pos 开始时设为 0,指向 ‘3’.这个方法一开始检查字符是不是数字,如果是,就将 pos 加 1,并返回一个 INTEGER 类型的标记实例,并把字符 ‘3’ 的值设为整数,也就是整数 3:

|

||||

`Interpreter` 类中的 `get_next_token` 方法就是词法分析器。每次调用它的时候,你都能从传入解释器的输入字符中获得创建的下一个标记。仔细看看这个方法,看看它是如何完成把字符转换成标记的任务的。输入被存在可变文本中,它保存了输入的字符串和关于该字符串的索引(把字符串想象成字符数组)。`pos` 开始时设为 0,指向字符 ‘3’。这个方法一开始检查字符是不是数字,如果是,就将 `pos` 加 1,并返回一个 INTEGER 类型的标记实例,并把字符 ‘3’ 的值设为整数,也就是整数 3:

|

||||

|

||||

![][8]

|

||||

|

||||

现在 pos 指向文本中的 ‘+’ 号。下次调用这个方法的时候,它会测试 pos 位置的字符是不是个数字,然后检测下一个字符是不是个加号,就是这样。结果这个方法把 pos 加一,返回一个新创建的标记,类型是 PLUS,值为 ‘+’。

|

||||

现在 `pos` 指向文本中的 ‘+’ 号。下次调用这个方法的时候,它会测试 `pos` 位置的字符是不是个数字,然后检测下一个字符是不是个加号,就是这样。结果这个方法把 `pos` 加 1,返回一个新创建的标记,类型是 PLUS,值为 ‘+’。

|

||||

|

||||

![][9]

|

||||

|

||||

pos 现在指向字符 ‘5’。当你再调用 get_next_token 方法时,该方法会检查这是不是个数字,就是这样,然后它把 pos 加一,返回一个新的 INTEGER 标记,该标记的值被设为 5:

|

||||

`pos` 现在指向字符 ‘5’。当你再调用 `get_next_token` 方法时,该方法会检查这是不是个数字,就是这样,然后它把 `pos` 加 1,返回一个新的 INTEGER 标记,该标记的值被设为整数 5:

|

||||

|

||||

![][10]

|

||||

|

||||

因为 pos 索引现在到了字符串 “3+5” 的末尾,你每次调用 get_next_token 方法时,它将会返回 EOF 标记:

|

||||

因为 `pos` 索引现在到了字符串 “3+5” 的末尾,你每次调用 `get_next_token` 方法时,它将会返回 EOF 标记:

|

||||

|

||||

![][11]

|

||||

|

||||

自己试一试,看看计算器里的词法分析器的运行:

|

||||

|

||||

```

|

||||

>>> from calc1 import Interpreter

|

||||

>>>

|

||||

@ -248,17 +251,16 @@ Token(EOF, None)

|

||||

>>>

|

||||

```

|

||||

|

||||

既然你的解释器能够从输入字符中获取标记流,解释器需要做点什么:它需要在词法分析器 get_next_token 中获取的标记流中找出相应的结构。你的解释器应该能够找到流中的结构:INTEGER -> PLUS -> INTEGER。就是这样,它尝试找出标记的序列:整数后面要跟着加号,加号后面要跟着整数。

|

||||

既然你的解释器能够从输入字符中获取标记流,解释器需要对它做点什么:它需要在词法分析器 `get_next_token` 中获取的标记流中找出相应的结构。你的解释器应该能够找到流中的结构:INTEGER -> PLUS -> INTEGER。就是这样,它尝试找出标记的序列:整数后面要跟着加号,加号后面要跟着整数。

|

||||

|

||||

负责找出并解释结构的方法就是 expr。该方法检验标记序列确实与期望的标记序列是对应的,比如 INTEGER -> PLUS -> INTEGER。成功确认了这个结构后,就会生成加号左右两边的标记的值相加的结果,这样就成功解释你输入到解释器中的算术表达式了。

|

||||

负责找出并解释结构的方法就是 `expr`。该方法检验标记序列确实与期望的标记序列是对应的,比如 INTEGER -> PLUS -> INTEGER。成功确认了这个结构后,就会生成加号左右两边的标记的值相加的结果,这样就成功解释你输入到解释器中的算术表达式了。

|

||||

|

||||

expr 方法用了一个助手方法 eat 来检验传入的标记类型是否与当前的标记类型相匹配。在匹配到传入的标记类型后,eat 方法获取下一个标记,并将其赋给 current_token 变量,然后高效地 “吃掉” 当前匹配的标记,并将标记流的虚拟指针向后移动。如果标记流的结构与期望的 INTEGER PLUS INTEGER 标记序列不对应,eat 方法就抛出一个异常。

|

||||

`expr` 方法用了一个助手方法 `eat` 来检验传入的标记类型是否与当前的标记类型相匹配。在匹配到传入的标记类型后,`eat` 方法会获取下一个标记,并将其赋给 `current_token` 变量,然后高效地 “吃掉” 当前匹配的标记,并将标记流的虚拟指针向后移动。如果标记流的结构与期望的 INTEGER -> PLUS -> INTEGER 标记序列不对应,`eat` 方法就抛出一个异常。

|

||||

|

||||

让我们回顾下解释器做了什么来对算术表达式进行评估的:

|

||||

|

||||

* 解释器接受输入字符串,就把它当作 “3+5”

|

||||

* 解释器调用 expr 方法,在词法分析器 get_next_token 返回的标记流中找出结构。这个结构就是 INTEGER PLUS INTEGER 这样的格式。在确认了格式后,它就通过把两个整型标记相加解释输入,因为此时对于解释器来说很清楚,他要做的就是把两个整数 3 和 5 进行相加。

|

||||

|

||||

* 解释器接受输入字符串,比如说 “3+5”

|

||||

* 解释器调用 `expr` 方法,在词法分析器 `get_next_token` 返回的标记流中找出结构。这个结构就是 INTEGER -> PLUS -> INTEGER 这样的格式。在确认了格式后,它就通过把两个整型标记相加来解释输入,因为此时对于解释器来说很清楚,它要做的就是把两个整数 3 和 5 进行相加。

|

||||

|

||||

恭喜。你刚刚学习了怎么构建自己的第一个解释器!

|

||||

|

||||

@ -268,42 +270,38 @@ expr 方法用了一个助手方法 eat 来检验传入的标记类型是否与

|

||||

|

||||

看了这篇文章,你肯定觉得不够,是吗?好,准备好做这些练习:

|

||||

|

||||

1. 修改代码,允许输入多位数,比如 “12+3”

|

||||

2. 添加一个方法忽略空格符,让你的计算器能够处理带有空白的输入,比如“12 + 3”

|

||||

3. 修改代码,用 ‘-’ 号而非 ‘+’ 号去执行减法比如 “7-5”

|

||||

|

||||

1. 修改代码,允许输入多位数,比如 “12+3”

|

||||

2. 添加一个方法忽略空格符,让你的计算器能够处理带有空白的输入,比如 “12 + 3”

|

||||

3. 修改代码,用 ‘-’ 号而非 ‘+’ 号去执行减法比如 “7-5”

|

||||

|

||||

**检验你的理解**

|

||||

|

||||

1. 什么是解释器?

|

||||

2. 什么是编译器

|

||||

3. 解释器和编译器有什么差别?

|

||||

4. 什么是标记?

|

||||

5. 将输入分隔成若干个标记的过程叫什么?

|

||||

6. 解释器中进行词法分析的部分叫什么?

|

||||

7. 解释器或编译器中进行词法分析的部分有哪些其他的常见名字?

|

||||

|

||||

|

||||

1. 什么是解释器?

|

||||

2. 什么是编译器

|

||||

3. 解释器和编译器有什么差别?

|

||||

4. 什么是标记?

|

||||

5. 将输入分隔成若干个标记的过程叫什么?

|

||||

6. 解释器中进行词法分析的部分叫什么?

|

||||

7. 解释器或编译器中进行词法分析的部分有哪些其他的常见名字?

|

||||

|

||||

在结束本文前,我衷心希望你能留下学习解释器和编译器的承诺。并且现在就开始做。不要把它留到以后。不要拖延。如果你已经看完了本文,就开始吧。如果已经仔细看完了但是还没做什么练习 —— 现在就开始做吧。如果已经开始做练习了,那就把剩下的做完。你懂得。而且你知道吗?签下承诺书,今天就开始学习解释器和编译器!

|

||||

|

||||

> 本人, ______,身体健全,思想正常,在此承诺从今天开始学习解释器和编译器,直到我百分百了解它们是怎么工作的!

|

||||

|

||||

_本人, ______,身体健全,思想正常,在此承诺从今天开始学习解释器和编译器,直到我百分百了解它们是怎么工作的!_

|

||||

>

|

||||

|

||||

签字人:

|

||||

> 签字人:

|

||||

|

||||

日期:

|

||||

> 日期:

|

||||

|

||||

![][13]

|

||||

|

||||

签字,写上日期,把它放在你每天都能看到的地方,确保你能坚守承诺。谨记你的承诺:

|

||||

|

||||

> "Commitment is doing the thing you said you were going to do long after the mood you said it in has left you." -- Darren Hardy

|

||||

> “承诺就是,你说自己会去做的事,在你说完就一直陪着你的东西。” —— Darren Hardy

|

||||

|

||||

好,今天的就结束了。这个系列的下一篇文章里,你将会扩展自己的计算器,让它能够处理更复杂的算术表达式。敬请期待。

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://ruslanspivak.com/lsbasi-part1/

|

||||

@ -311,7 +309,7 @@ via: https://ruslanspivak.com/lsbasi-part1/

|

||||

|

||||

作者:[Ruslan Spivak][a]

|

||||

译者:[BriFuture](https://github.com/BriFuture)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,28 +1,21 @@

|

||||

|

||||

如何提供有帮助的回答

|

||||

=============================

|

||||

|

||||

如果你的同事问你一个不太清晰的问题,你会怎么回答?我认为提问题是一种技巧(可以看 [如何提出有意义的问题][1]) 同时,合理地回答问题也是一种技巧。他们都是非常实用的。

|

||||

如果你的同事问你一个不太清晰的问题,你会怎么回答?我认为提问题是一种技巧(可以看 [如何提出有意义的问题][1]) 同时,合理地回答问题也是一种技巧,它们都是非常实用的。

|

||||

|

||||

一开始 - 有时向你提问的人不尊重你的时间,这很糟糕。

|

||||

|

||||

理想情况下,我们假设问你问题的人是一个理性的人并且正在尽力解决问题而你想帮助他们。和我一起工作的人是这样,我所生活的世界也是这样。当然,现实生活并不是这样。

|

||||

一开始 —— 有时向你提问的人不尊重你的时间,这很糟糕。理想情况下,我们假设问你问题的人是一个理性的人并且正在尽力解决问题,而你想帮助他们。和我一起工作的人是这样,我所生活的世界也是这样。当然,现实生活并不是这样。

|

||||

|

||||

下面是有助于回答问题的一些方法!

|

||||

|

||||

|

||||

### 如果他们提问不清楚,帮他们澄清

|

||||

### 如果他们的提问不清楚,帮他们澄清

|

||||

|

||||

通常初学者不会提出很清晰的问题,或者问一些对回答问题没有必要信息的问题。你可以尝试以下方法 澄清问题:

|

||||

|

||||

* ** 重述为一个更明确的问题 ** 来回复他们(”你是想问 X 吗?“)

|

||||

|

||||

* ** 向他们了解更具体的他们并没有提供的信息 ** (”你使用 IPv6 ?”)

|

||||

|

||||

* ** 问是什么导致了他们的问题 ** 例如,有时有些人会进入我的团队频道,询问我们的服务发现(service discovery )如何工作的。这通常是因为他们试图设置/重新配置服务。在这种情况下,如果问“你正在使用哪种服务?可以给我看看你正在处理的 pull requests 吗?”是有帮助的。

|

||||

|

||||

这些方法很多来自 [如何提出有意义的问题][2]中的要点。(尽管我永远不会对某人说“噢,你得先看完 “如何提出有意义的问题”这篇文章后再来像我提问)

|

||||

* **重述为一个更明确的问题**来回复他们(“你是想问 X 吗?”)

|

||||

* **向他们了解更具体的他们并没有提供的信息** (“你使用 IPv6 ?”)

|

||||

* **问是什么导致了他们的问题**。例如,有时有些人会进入我的团队频道,询问我们的<ruby>服务发现<rt>service discovery</rt></ruby>如何工作的。这通常是因为他们试图设置/重新配置服务。在这种情况下,如果问“你正在使用哪种服务?可以给我看看你正在处理的‘拉取请求’吗?”是有帮助的。

|

||||

|

||||

这些方法很多来自[如何提出有意义的问题][2]中的要点。(尽管我永远不会对某人说“噢,你得先看完《如何提出有意义的问题》这篇文章后再来向我提问)

|

||||

|

||||

### 弄清楚他们已经知道了什么

|

||||

|

||||

@ -30,66 +23,54 @@

|

||||

|

||||

Harold Treen 给了我一个很好的例子:

|

||||

|

||||

> 前几天,有人请我解释“ Redux-Sagas ”。与其深入解释不如说“ 他们就像 worker threads 监听行为(actions),让你更新 Redux store 。

|

||||

> 前几天,有人请我解释 “Redux-Sagas”。与其深入解释,不如说 “它们就像监听 action 的工人线程,并可以让你更新 Redux store。

|

||||

|

||||

> 我开始搞清楚他们对 Redux 、行为(actions)、store 以及其他基本概念了解多少。将这些概念都联系在一起再来解释会容易得多。

|

||||

> 我开始搞清楚他们对 Redux、action、store 以及其他基本概念了解多少。将这些概念都联系在一起再来解释会容易得多。

|

||||

|

||||

弄清楚问你问题的人已经知道什么是非常重要的。因为有时他们可能会对基础概念感到疑惑(“ Redux 是什么?“),或者他们可能是专家但是恰巧遇到了微妙的极端情况(corner case)。如果答案建立在他们不知道的概念上会令他们困惑,但如果重述他们已经知道的的又会是乏味的。

|

||||

弄清楚问你问题的人已经知道什么是非常重要的。因为有时他们可能会对基础概念感到疑惑(“Redux 是什么?”),或者他们可能是专家,但是恰巧遇到了微妙的<ruby>极端情况<rt>corner case</rt></ruby>。如果答案建立在他们不知道的概念上会令他们困惑,但如果重述他们已经知道的的又会是乏味的。

|

||||

|

||||

这里有一个很实用的技巧来了解他们已经知道什么 - 比如可以尝试用“你对 X 了解多少?”而不是问“你知道 X 吗?”。

|

||||

|

||||

|

||||

### 给他们一个文档

|

||||

|

||||

“RTFM” (“去读那些他妈的手册”(Read The Fucking Manual))是一个典型的无用的回答,但事实上如果向他们指明一个特定的文档会是非常有用的!当我提问题的时候,我当然很乐意翻看那些能实际解决我的问题的文档,因为它也可能解决其他我想问的问题。

|

||||

“RTFM” (<ruby>“去读那些他妈的手册”<rt>Read The Fucking Manual</rt></ruby>)是一个典型的无用的回答,但事实上如果向他们指明一个特定的文档会是非常有用的!当我提问题的时候,我当然很乐意翻看那些能实际解决我的问题的文档,因为它也可能解决其他我想问的问题。

|

||||

|

||||

我认为明确你所给的文档的确能够解决问题是非常重要的,或者至少经过查阅后确认它对解决问题有帮助。否则,你可能将以下面这种情形结束对话(非常常见):

|

||||

|

||||

* Ali:我应该如何处理 X ?

|

||||

* Jada:\<文档链接>

|

||||

* Ali: 这个没有实际解释如何处理 X ,它仅仅解释了如何处理 Y !

|

||||

|

||||

* Jada:<文档链接>

|

||||

|

||||

* Ali: 这个并有实际解释如何处理 X ,它仅仅解释了如何处理 Y !

|

||||

|

||||

如果我所给的文档特别长,我会指明文档中那个我将会谈及的特定部分。[bash 手册][3] 有44000个字(真的!),所以如果只说“它在 bash 手册中有说明”是没有帮助的:)

|

||||

|

||||

如果我所给的文档特别长,我会指明文档中那个我将会谈及的特定部分。[bash 手册][3] 有 44000 个字(真的!),所以如果只说“它在 bash 手册中有说明”是没有帮助的 :)

|

||||

|

||||

### 告诉他们一个有用的搜索

|

||||

|

||||

在工作中,我经常发现我可以利用我所知道的关键字进行搜索找到能够解决我的问题的答案。对于初学者来说,这些关键字往往不是那么明显。所以说“这是我用来寻找这个答案的搜索”可能有用些。再次说明,回答时请经检查后以确保搜索能够得到他们所需要的答案:)

|

||||

|

||||

在工作中,我经常发现我可以利用我所知道的关键字进行搜索来找到能够解决我的问题的答案。对于初学者来说,这些关键字往往不是那么明显。所以说“这是我用来寻找这个答案的搜索”可能有用些。再次说明,回答时请经检查后以确保搜索能够得到他们所需要的答案 :)

|

||||

|

||||

### 写新文档

|

||||

|

||||

人们经常一次又一次地问我的团队同样的问题。很显然这并不是他们的错(他们怎么能够知道在他们之前已经有10个人问了这个问题,且知道答案是什么呢?)因此,我们会尝试写新文档,而不是直接回答回答问题。

|

||||

人们经常一次又一次地问我的团队同样的问题。很显然这并不是他们的错(他们怎么能够知道在他们之前已经有 10 个人问了这个问题,且知道答案是什么呢?)因此,我们会尝试写新文档,而不是直接回答回答问题。

|

||||

|

||||

1. 马上写新文档

|

||||

|

||||

2. 给他们我们刚刚写好的新文档

|

||||

|

||||

3. 公示

|

||||

|

||||

写文档有时往往比回答问题需要花很多时间,但这是值得的。写文档尤其重要,如果:

|

||||

|

||||

a. 这个问题被问了一遍又一遍

|

||||

|

||||

b. 随着时间的推移,这个答案不会变化太大(如果这个答案每一个星期或者一个月就会变化,文档就会过时并且令人受挫)

|

||||

|

||||

|

||||

### 解释你做了什么

|

||||

|

||||

对于一个话题,作为初学者来说,这样的交流会真让人沮丧:

|

||||

|

||||

* 新人:“嗨!你如何处理 X ?”

|

||||

|

||||

* 有经验的人:“我已经处理过了,而且它已经完美解决了”

|

||||

|

||||

* 新人:”...... 但是你做了什么?!“

|

||||

|

||||

如果问你问题的人想知道事情是如何进行的,这样是有帮助的:

|

||||

|

||||

* 让他们去完成任务而不是自己做

|

||||

|

||||

* 告诉他们你是如何得到你给他们的答案的。

|

||||

|

||||

这可能比你自己做的时间还要长,但对于被问的人来说这是一个学习机会,因为那样做使得他们将来能够更好地解决问题。

|

||||

@ -97,88 +78,74 @@ b. 随着时间的推移,这个答案不会变化太大(如果这个答案

|

||||

这样,你可以进行更好的交流,像这:

|

||||

|

||||

* 新人:“这个网站出现了错误,发生了什么?”

|

||||

|

||||

* 有经验的人:(2分钟后)”oh 这是因为发生了数据库故障转移“

|

||||

|

||||

* 新人: ”你是怎么知道的??!?!?“

|

||||

|

||||

* 有经验的人:“以下是我所做的!“:

|

||||

|

||||

* 有经验的人:(2分钟后)“oh 这是因为发生了数据库故障转移”

|

||||

* 新人: “你是怎么知道的??!?!?”

|

||||

* 有经验的人:“以下是我所做的!”:

|

||||

1. 通常这些错误是因为服务器 Y 被关闭了。我查看了一下 `$PLACE` 但它表明服务器 Y 开着。所以,并不是这个原因导致的。

|

||||

|

||||

2. 然后我查看 X 的仪表盘 ,仪表盘的这个部分显示这里发生了数据库故障转移。

|

||||

|

||||

3. 然后我在日志中找到了相应服务器,并且它显示连接数据库错误,看起来错误就是这里。

|

||||

|

||||

如果你正在解释你是如何调试一个问题,解释你是如何发现问题,以及如何找出问题的。尽管看起来你好像已经得到正确答案,但感觉更好的是能够帮助他们提高学习和诊断能力,并了解可用的资源。

|

||||

|

||||

|

||||

### 解决根本问题

|

||||

|

||||

这一点有点棘手。有时候人们认为他们依旧找到了解决问题的正确途径,且他们只再多一点信息就可以解决问题。但他们可能并不是走在正确的道路上!比如:

|

||||

这一点有点棘手。有时候人们认为他们依旧找到了解决问题的正确途径,且他们只要再多一点信息就可以解决问题。但他们可能并不是走在正确的道路上!比如:

|

||||

|

||||

* George:”我在处理 X 的时候遇到了错误,我该如何修复它?“

|

||||

|

||||

* Jasminda:”你是正在尝试解决 Y 吗?如果是这样,你不应该处理 X ,反而你应该处理 Z 。“

|

||||

|

||||

* George:“噢,你是对的!!!谢谢你!我回反过来处理 Z 的。“

|

||||

* George:“我在处理 X 的时候遇到了错误,我该如何修复它?”

|

||||

* Jasminda:“你是正在尝试解决 Y 吗?如果是这样,你不应该处理 X ,反而你应该处理 Z 。”

|

||||

* George:“噢,你是对的!!!谢谢你!我回反过来处理 Z 的。”

|

||||

|

||||

Jasminda 一点都没有回答 George 的问题!反而,她猜测 George 并不想处理 X ,并且她是猜对了。这是非常有用的!

|

||||

|

||||

如果你这样做可能会产生高高在上的感觉:

|

||||

|

||||

* George:”我在处理 X 的时候遇到了错误,我该如何修复它?“

|

||||

* George:“我在处理 X 的时候遇到了错误,我该如何修复它?”

|

||||

* Jasminda:“不要这样做,如果你想处理 Y ,你应该反过来完成 Z 。”

|

||||

* George:“好吧,我并不是想处理 Y 。实际上我想处理 X 因为某些原因(REASONS)。所以我该如何处理 X 。”

|

||||

|

||||

* Jasminda:不要这样做,如果你想处理 Y ,你应该反过来完成 Z 。

|

||||

|

||||

* George:“好吧,我并不是想处理 Y 。实际上我想处理 X 因为某些原因(REASONS)。所以我该如何处理 X 。

|

||||

|

||||

所以不要高高在上,且要记住有时有些提问者可能已经偏离根本问题很远了。同时回答提问者提出的问题以及他们本该提出的问题都是合理的:“嗯,如果你想处理 X ,那么你可能需要这么做,但如果你想用这个解决 Y 问题,可能通过处理其他事情你可以更好地解决这个问题,这就是为什么可以做得更好的原因。

|

||||

所以不要高高在上,且要记住有时有些提问者可能已经偏离根本问题很远了。同时回答提问者提出的问题以及他们本该提出的问题都是合理的:“嗯,如果你想处理 X ,那么你可能需要这么做,但如果你想用这个解决 Y 问题,可能通过处理其他事情你可以更好地解决这个问题,这就是为什么可以做得更好的原因。”

|

||||

|

||||

|

||||

### 询问”那个回答可以解决您的问题吗?”

|

||||

### 询问“那个回答可以解决您的问题吗?”

|

||||

|

||||

我总是喜欢在我回答了问题之后核实是否真的已经解决了问题:”这个回答解决了您的问题吗?您还有其他问题吗?“在问完这个之后最好等待一会,因为人们通常需要一两分钟来知道他们是否已经找到了答案。

|

||||

我总是喜欢在我回答了问题之后核实是否真的已经解决了问题:“这个回答解决了您的问题吗?您还有其他问题吗?”在问完这个之后最好等待一会,因为人们通常需要一两分钟来知道他们是否已经找到了答案。

|

||||

|

||||

我发现尤其是问“这个回答解决了您的问题吗”这个额外的步骤在写完文档后是非常有用的。通常,在写关于我熟悉的东西的文档时,我会忽略掉重要的东西而不会意识到它。

|

||||

|

||||

|

||||

### 结对编程和面对面交谈

|

||||

|

||||

我是远程工作的,所以我的很多对话都是基于文本的。我认为这是沟通的默认方式。

|

||||

|

||||

今天,我们生活在一个方便进行小视频会议和屏幕共享的世界!在工作时候,在任何时间我都可以点击一个按钮并快速加入与他人的视频对话或者屏幕共享的对话中!

|

||||

|

||||

例如,最近有人问如何自动调节他们的服务容量规划。我告诉他们我们有几样东西需要清理,但我还不太确定他们要清理的是什么。然后我们进行了一个简短的视屏会话并在5分钟后,我们解决了他们问题。

|

||||

例如,最近有人问如何自动调节他们的服务容量规划。我告诉他们我们有几样东西需要清理,但我还不太确定他们要清理的是什么。然后我们进行了一个简短的视频会话并在 5 分钟后,我们解决了他们问题。

|

||||

|

||||

我认为,特别是如果有人真的被困在该如何开始一项任务时,开启视频进行结对编程几分钟真的比电子邮件或者一些即时通信更有效。

|

||||

|

||||

|

||||

### 不要表现得过于惊讶

|

||||

|

||||

这是源自 Recurse Center 的一则法则:[不要故作惊讶][4]。这里有一个常见的情景:

|

||||

|

||||

* 某人1:“什么是 Linux 内核”

|

||||

* 某甲:“什么是 Linux 内核”

|

||||

* 某乙:“你竟然不知道什么是 Linux 内核?!!!!?!!!????”

|

||||

|

||||

* 某人2:“你竟然不知道什么是 Linux 内核(LINUX KERNEL)?!!!!?!!!????”

|

||||

某乙的表现(无论他们是否真的如此惊讶)是没有帮助的。这大部分只会让某甲不好受,因为他们确实不知道什么是 Linux 内核。

|

||||

|

||||

某人2表现(无论他们是否真的如此惊讶)是没有帮助的。这大部分只会让某人1不好受,因为他们确实不知道什么是 Linux 内核。

|

||||

我一直在假装不惊讶,即使我事实上确实有点惊讶那个人不知道这种东西。

|

||||

|

||||

我一直在假装不惊讶即使我事实上确实有点惊讶那个人不知道这种东西但它是令人敬畏的。

|

||||

|

||||

### 回答问题是令人敬畏的

|

||||

### 回答问题真的很棒

|

||||

|

||||

显然并不是所有方法都是合适的,但希望你能够发现这里有些是有帮助的!我发现花时间去回答问题并教导人们是其实是很有收获的。

|

||||

|

||||

特别感谢 Josh Triplett 的一些建议并做了很多有益的补充,以及感谢 Harold Treen、Vaibhav Sagar、Peter Bhat Hatkins、Wesley Aptekar Cassels 和 Paul Gowder的阅读或评论。

|

||||

特别感谢 Josh Triplett 的一些建议并做了很多有益的补充,以及感谢 Harold Treen、Vaibhav Sagar、Peter Bhat Hatkins、Wesley Aptekar Cassels 和 Paul Gowder 的阅读或评论。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://jvns.ca/blog/answer-questions-well/

|

||||

|

||||

作者:[ Julia Evans][a]

|

||||

作者:[Julia Evans][a]

|

||||

译者:[HardworkFish](https://github.com/HardworkFish)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,23 +1,34 @@

|

||||

绕过 Linux/Unix 命令别名

|

||||

4 种绕过 Linux/Unix 命令别名的方法

|

||||

======

|

||||

|

||||

我在我的 Linux 系统上定义了如下 mount 别名:

|

||||

|

||||

```

|

||||

alias mount='mount | column -t'

|

||||

```

|

||||

但是我需要在挂载文件系统和其他用途时绕过 bash 别名。我如何在 Linux、\*BSD、macOS 或者类 Unix 系统上临时禁用或者绕过 bash shell 呢?

|

||||

|

||||

但是我需要在挂载文件系统和其他用途时绕过这个 bash 别名。我如何在 Linux、*BSD、macOS 或者类 Unix 系统上临时禁用或者绕过 bash shell 呢?

|

||||

|

||||

你可以使用 `alias` 命令定义或显示 bash shell 别名。一旦创建了 bash shell 别名,它们将优先于外部或内部命令。本文将展示如何暂时绕过 bash 别名,以便你可以运行实际的内部或外部命令。

|

||||

|

||||

你可以使用 alias 命令定义或显示 bash shell 别名。一旦创建了 bash shell 别名,它们将优先于外部或内部命令。本文将展示如何暂时绕过 bash 别名,以便你可以运行实际的内部或外部命令。

|

||||

[![Bash Bypass Alias Linux BSD macOS Unix Command][1]][1]

|

||||

|

||||

## 4 种绕过 bash 别名的方法

|

||||

|

||||

### 4 种绕过 bash 别名的方法

|

||||

|

||||

尝试以下任意一种方法来运行被 bash shell 别名绕过的命令。让我们[如下定义一个别名][2]:

|

||||

`alias mount='mount | column -t'`

|

||||

|

||||

```

|

||||

alias mount='mount | column -t'

|

||||

```

|

||||

|

||||

运行如下:

|

||||

`mount `

|

||||

|

||||

```

|

||||

mount

|

||||

```

|

||||

|

||||

示例输出:

|

||||

|

||||

```

|

||||

sysfs on /sys type sysfs (rw,nosuid,nodev,noexec,relatime)

|

||||

proc on /proc type proc (rw,nosuid,nodev,noexec,relatime)

|

||||

@ -30,45 +41,83 @@ binfmt_misc on /proc/sys/fs/binfmt_misc type binfmt_m

|

||||

lxcfs on /var/lib/lxcfs type fuse.lxcfs (rw,nosuid,nodev,relatime,user_id=0,group_id=0,allow_other)

|

||||

```

|

||||

|

||||

### 方法1 - 使用 \command

|

||||

#### 方法 1 - 使用 `\command`

|

||||

|

||||

输入以下命令暂时绕过名为 mount 的 bash 别名:

|

||||

`\mount`

|

||||

输入以下命令暂时绕过名为 `mount` 的 bash 别名:

|

||||

|

||||

### 方法2 - 使用 "command" 或 'command'

|

||||

```

|

||||

\mount

|

||||

```

|

||||

|

||||

#### 方法 2 - 使用 `"command"` 或 `'command'`

|

||||

|

||||

如下引用 `mount` 命令调用实际的 `/bin/mount`:

|

||||

|

||||

```

|

||||

"mount"

|

||||

```

|

||||

|

||||

如下引用 mount 命令调用实际的 /bin/mount:

|

||||

`"mount"`

|

||||

或者

|

||||

`'mount'`

|

||||

|

||||

### Method 3 - Use full command path

|

||||

```

|

||||

'mount'

|

||||

```

|

||||

|

||||

Use full binary path such as /bin/mount:

|

||||

`/bin/mount

|

||||

/bin/mount /dev/sda1 /mnt/sda`

|

||||

#### 方法 3 - 使用命令的完全路径

|

||||

|

||||

### 方法3 - 使用完整的命令路径

|

||||

使用完整的二进制路径,如 `/bin/mount`:

|

||||

|

||||

```

|

||||

/bin/mount

|

||||

/bin/mount /dev/sda1 /mnt/sda

|

||||

```

|

||||

|

||||

#### 方法 4 - 使用内部命令 `command`

|

||||

|

||||

语法是:

|

||||

`command cmd

|

||||

command cmd arg1 arg2`

|

||||

要覆盖 .bash_aliases 中设置的别名,例如 mount:

|

||||

`command mount

|

||||

command mount /dev/sdc /mnt/pendrive/`

|

||||

[”command“ 运行命令或显示][3]关于命令的信息。它带参数运行命令会抑制 shell 函数查询或者别名,或者显示有关给定命令的信息。

|

||||

|

||||

## 关于 unalias 命令的说明

|

||||

```

|

||||

command cmd

|

||||

command cmd arg1 arg2

|

||||

```

|

||||

|

||||

要覆盖 `.bash_aliases` 中设置的别名,例如 `mount`:

|

||||

|

||||

```

|

||||

command mount

|

||||

command mount /dev/sdc /mnt/pendrive/

|

||||

```

|

||||

|

||||

[“command” 直接运行命令或显示][3]关于命令的信息。它带参数运行命令会抑制 shell 函数查询或者别名,或者显示有关给定命令的信息。

|

||||

|

||||

### 关于 unalias 命令的说明

|

||||

|

||||

要从当前会话的已定义别名列表中移除别名,请使用 `unalias` 命令:

|

||||

|

||||

```

|

||||

unalias mount

|

||||

```

|

||||

|

||||

要从当前会话的已定义别名列表中移除别名,请使用 unalias 命令:

|

||||

`unalias mount`

|

||||

要从当前 bash 会话中删除所有别名定义:

|

||||

`unalias -a`

|

||||

确保你更新你的 ~/.bashrc 或 $HOME/.bash_aliases。如果要永久删除定义的别名,则必须删除定义的别名:

|

||||

`vi ~/.bashrc`

|

||||

|

||||

```

|

||||

unalias -a

|

||||

```

|

||||

|

||||

确保你更新你的 `~/.bashrc` 或 `$HOME/.bash_aliases`。如果要永久删除定义的别名,则必须删除定义的别名:

|

||||

|

||||

```

|

||||

vi ~/.bashrc

|

||||

```

|

||||

|

||||

或者

|

||||

`joe $HOME/.bash_aliases`

|

||||

|

||||

```

|

||||

joe $HOME/.bash_aliases

|

||||

```

|

||||

|

||||

想了解更多信息,参考[这里][4]的在线手册,或者输入下面的命令查看:

|

||||

|

||||

```

|

||||

man bash

|

||||

help command

|

||||

@ -76,14 +125,13 @@ help unalias

|

||||

help alias

|

||||

```

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.cyberciti.biz/faq/bash-bypass-alias-command-on-linux-macos-unix/

|

||||

|

||||

作者:[Vivek Gite][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -12,17 +12,17 @@

|

||||

|

||||

### 使用 libuv 抽象出事件驱动循环

|

||||

|

||||

在 [第三节][11] 中,我们看到了基于 `select` 和 `epoll` 的服务器的相似之处,并且,我说过,在它们之间抽象出细微的差别是件很有吸引力的事。许多库已经做到了这些,所以在这一部分中我将去选一个并使用它。我选的这个库是 [libuv][12],它最初设计用于 Node.js 底层的可移植平台层,并且,后来发现在其它的项目中已有使用。libuv 是用 C 写的,因此,它具有很高的可移植性,非常适用嵌入到像 JavaScript 和 Python 这样的高级语言中。

|

||||

在 [第三节][11] 中,我们看到了基于 `select` 和 `epoll` 的服务器的相似之处,并且,我说过,在它们之间抽象出细微的差别是件很有吸引力的事。许多库已经做到了这些,所以在这一部分中我将去选一个并使用它。我选的这个库是 [libuv][12],它最初设计用于 Node.js 底层的可移植平台层,并且,后来发现在其它的项目中也有使用。libuv 是用 C 写的,因此,它具有很高的可移植性,非常适用嵌入到像 JavaScript 和 Python 这样的高级语言中。

|

||||

|

||||

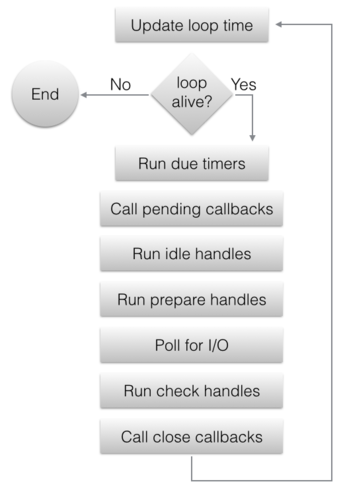

虽然 libuv 为抽象出底层平台细节已经变成了一个相当大的框架,但它仍然是以 _事件循环_ 思想为中心的。在我们第三部分的事件驱动服务器中,事件循环在 `main` 函数中是很明确的;当使用 libuv 时,该循环通常隐藏在库自身中,而用户代码仅需要注册事件句柄(作为一个回调函数)和运行这个循环。此外,libuv 会在给定的平台上使用更快的事件循环实现,对于 Linux 它是 epoll,等等。

|

||||

虽然 libuv 为了抽象出底层平台细节已经变成了一个相当大的框架,但它仍然是以 _事件循环_ 思想为中心的。在我们第三部分的事件驱动服务器中,事件循环是显式定义在 `main` 函数中的;当使用 libuv 时,该循环通常隐藏在库自身中,而用户代码仅需要注册事件句柄(作为一个回调函数)和运行这个循环。此外,libuv 会在给定的平台上使用更快的事件循环实现,对于 Linux 它是 `epoll`,等等。

|

||||

|

||||

|

||||

|

||||

libuv 支持多路事件循环,并且,因此事件循环在库中是非常重要的;它有一个句柄 —— `uv_loop_t`,和创建/杀死/启动/停止循环的函数。也就是说,在这篇文章中,我将仅需要使用 “默认的” 循环,libuv 可通过 `uv_default_loop()` 提供它;多路循环大多用于多线程事件驱动的服务器,这是一个更高级别的话题,我将留在这一系列文章的以后部分。

|

||||

libuv 支持多路事件循环,因此事件循环在库中是非常重要的;它有一个句柄 —— `uv_loop_t`,以及创建/杀死/启动/停止循环的函数。也就是说,在这篇文章中,我将仅需要使用 “默认的” 循环,libuv 可通过 `uv_default_loop()` 提供它;多路循环大多用于多线程事件驱动的服务器,这是一个更高级别的话题,我将留在这一系列文章的以后部分。

|

||||

|

||||

### 使用 libuv 的并发服务器

|

||||

|

||||

为了对 libuv 有一个更深的印象,让我们跳转到我们的可靠协议的服务器,它通过我们的这个系列已经有了一个强大的重新实现。这个服务器的结构与第三部分中的基于 select 和 epoll 的服务器有一些相似之处,因为,它也依赖回调。完整的 [示例代码在这里][13];我们开始设置这个服务器的套接字绑定到一个本地端口:

|

||||

为了对 libuv 有一个更深的印象,让我们跳转到我们的可靠协议的服务器,它通过我们的这个系列已经有了一个强大的重新实现。这个服务器的结构与第三部分中的基于 `select` 和 `epoll` 的服务器有一些相似之处,因为,它也依赖回调。完整的 [示例代码在这里][13];我们开始设置这个服务器的套接字绑定到一个本地端口:

|

||||

|

||||

```

|

||||

int portnum = 9090;

|

||||

@ -47,9 +47,9 @@ if ((rc = uv_tcp_bind(&server_stream, (const struct sockaddr*)&server_address, 0

|

||||

}

|

||||

```

|

||||

|

||||

除了它被封装进 libuv API 中之外,你看到的是一个相当标准的套接字。在它的返回中,我们取得一个可工作于任何 libuv 支持的平台上的可移植接口。

|

||||

除了它被封装进 libuv API 中之外,你看到的是一个相当标准的套接字。在它的返回中,我们取得了一个可工作于任何 libuv 支持的平台上的可移植接口。

|

||||

|

||||

这些代码也展示了很认真负责的错误处理;多数的 libuv 函数返回一个整数状态,返回一个负数意味着出现了一个错误。在我们的服务器中,我们把这些错误看做致命问题进行处理,但也可以设想为一个更优雅的错误恢复。

|

||||

这些代码也展示了很认真负责的错误处理;多数的 libuv 函数返回一个整数状态,返回一个负数意味着出现了一个错误。在我们的服务器中,我们把这些错误看做致命问题进行处理,但也可以设想一个更优雅的错误恢复。

|

||||

|

||||

现在,那个套接字已经绑定,是时候去监听它了。这里我们运行首个回调注册:

|

||||

|

||||

@ -73,7 +73,7 @@ uv_run(uv_default_loop(), UV_RUN_DEFAULT);

|

||||

return uv_loop_close(uv_default_loop());

|

||||

```

|

||||

|

||||

注意,在运行事件循环之前,只有一个回调是通过 main 注册的;我们稍后将看到怎么去添加更多的回调。在事件循环的整个运行过程中,添加和删除回调并不是一个问题 —— 事实上,大多数服务器就是这么写的。

|

||||

注意,在运行事件循环之前,只有一个回调是通过 `main` 注册的;我们稍后将看到怎么去添加更多的回调。在事件循环的整个运行过程中,添加和删除回调并不是一个问题 —— 事实上,大多数服务器就是这么写的。

|

||||

|

||||

这是一个 `on_peer_connected`,它处理到服务器的新的客户端连接:

|

||||

|

||||

@ -132,8 +132,8 @@ void on_peer_connected(uv_stream_t* server_stream, int status) {

|

||||

|

||||

这些代码都有很好的注释,但是,这里有一些重要的 libuv 语法我想去强调一下:

|

||||

|

||||

* 传入自定义数据到回调中:因为 C 还没有闭包,这可能是个挑战,libuv 在它的所有的处理类型中有一个 `void* data` 字段;这些字段可以被用于传递用户数据。例如,注意 `client->data` 是如何指向到一个 `peer_state_t` 结构上,以便于 `uv_write` 和 `uv_read_start` 注册的回调可以知道它们正在处理的是哪个客户端的数据。

|

||||

* 内存管理:在带有垃圾回收的语言中进行事件驱动编程是非常容易的,因为,回调通常运行在一个它们注册的完全不同的栈帧中,使得基于栈的内存管理很困难。它总是需要传递堆分配的数据到 libuv 回调中(当所有回调运行时,除了 main,其它的都运行在栈上),并且,为了避免泄漏,许多情况下都要求这些数据去安全释放。这些都是些需要实践的内容 [[1]][6]。

|

||||

* 传入自定义数据到回调中:因为 C 语言还没有闭包,这可能是个挑战,libuv 在它的所有的处理类型中有一个 `void* data` 字段;这些字段可以被用于传递用户数据。例如,注意 `client->data` 是如何指向到一个 `peer_state_t` 结构上,以便于 `uv_write` 和 `uv_read_start` 注册的回调可以知道它们正在处理的是哪个客户端的数据。

|

||||

* 内存管理:在带有垃圾回收的语言中进行事件驱动编程是非常容易的,因为,回调通常运行在一个与它们注册的地方完全不同的栈帧中,使得基于栈的内存管理很困难。它总是需要传递堆分配的数据到 libuv 回调中(当所有回调运行时,除了 `main`,其它的都运行在栈上),并且,为了避免泄漏,许多情况下都要求这些数据去安全释放(`free()`)。这些都是些需要实践的内容 ^注1 。

|

||||

|

||||

这个服务器上对端的状态如下:

|

||||

|

||||

@ -146,7 +146,7 @@ typedef struct {

|

||||

} peer_state_t;

|

||||

```

|

||||

|

||||

它与第三部分中的状态非常类似;我们不再需要 sendptr,因为,在调用 "done writing" 回调之前,`uv_write` 将确保去发送它提供的整个缓冲。我们也为其它的回调使用保持了一个到客户端的指针。这里是 `on_wrote_init_ack`:

|

||||

它与第三部分中的状态非常类似;我们不再需要 `sendptr`,因为,在调用 “done writing” 回调之前,`uv_write` 将确保发送它提供的整个缓冲。我们也为其它的回调使用保持了一个到客户端的指针。这里是 `on_wrote_init_ack`:

|

||||

|

||||

```

|

||||

void on_wrote_init_ack(uv_write_t* req, int status) {

|

||||

@ -171,7 +171,7 @@ void on_wrote_init_ack(uv_write_t* req, int status) {

|

||||

}

|

||||

```

|

||||

|

||||

然后,我们确信知道了这个初始的 '*' 已经被发送到对端,我们通过调用 `uv_read_start` 去监听从这个对端来的入站数据,它注册一个回调(`on_peer_read`)去被调用,不论什么时候,事件循环都在套接字上接收来自客户端的调用:

|

||||

然后,我们确信知道了这个初始的 `'*'` 已经被发送到对端,我们通过调用 `uv_read_start` 去监听从这个对端来的入站数据,它注册一个将被事件循环调用的回调(`on_peer_read`),不论什么时候,事件循环都在套接字上接收来自客户端的调用:

|

||||

|

||||

```

|

||||

void on_peer_read(uv_stream_t* client, ssize_t nread, const uv_buf_t* buf) {

|

||||

@ -236,11 +236,11 @@ void on_peer_read(uv_stream_t* client, ssize_t nread, const uv_buf_t* buf) {

|

||||

}

|

||||

```

|

||||

|

||||

这个服务器的运行时行为非常类似于第三部分的事件驱动服务器:所有的客户端都在一个单个的线程中并发处理。并且一些行为被维护在服务器代码中:服务器的逻辑实现为一个集成的回调,并且长周期运行是禁止的,因为它会阻塞事件循环。这一点也很类似。让我们进一步探索这个问题。

|

||||

这个服务器的运行时行为非常类似于第三部分的事件驱动服务器:所有的客户端都在一个单个的线程中并发处理。并且类似的,一些特定的行为必须在服务器代码中维护:服务器的逻辑实现为一个集成的回调,并且长周期运行是禁止的,因为它会阻塞事件循环。这一点也很类似。让我们进一步探索这个问题。

|

||||

|

||||

### 在事件驱动循环中的长周期运行的操作

|

||||

|

||||

单线程的事件驱动代码使它先天地对一些常见问题非常敏感:整个循环中的长周期运行的代码块。参见如下的程序:

|

||||

单线程的事件驱动代码使它先天就容易受到一些常见问题的影响:长周期运行的代码会阻塞整个循环。参见如下的程序:

|

||||

|

||||

```

|

||||

void on_timer(uv_timer_t* timer) {

|

||||

@ -280,23 +280,21 @@ on_timer [18850 ms]

|

||||

...

|

||||

```

|

||||

|

||||

`on_timer` 忠实地每秒执行一次,直到随机出现的睡眠为止。在那个时间点,`on_timer` 不再被调用,直到睡眠时间结束;事实上,_没有其它的回调_ 在这个时间帧中被调用。这个睡眠调用阻塞当前线程,它正是被调用的线程,并且也是事件循环使用的线程。当这个线程被阻塞后,事件循环也被阻塞。

|

||||

`on_timer` 忠实地每秒执行一次,直到随机出现的睡眠为止。在那个时间点,`on_timer` 不再被调用,直到睡眠时间结束;事实上,_没有其它的回调_ 会在这个时间帧中被调用。这个睡眠调用阻塞了当前线程,它正是被调用的线程,并且也是事件循环使用的线程。当这个线程被阻塞后,事件循环也被阻塞。

|

||||

|

||||

这个示例演示了在事件驱动的调用中为什么回调不能被阻塞是多少的重要。并且,同样适用于 Node.js 服务器、客户端侧的 Javascript、大多数的 GUI 编程框架、以及许多其它的异步编程模型。

|

||||

|

||||

但是,有时候运行耗时的任务是不可避免的。并不是所有任务都有一个异步 APIs;例如,我们可能使用一些仅有同步 API 的库去处理,或者,正在执行一个可能的长周期计算。我们如何用事件驱动编程去结合这些代码?线程可以帮到你!

|

||||

但是,有时候运行耗时的任务是不可避免的。并不是所有任务都有一个异步 API;例如,我们可能使用一些仅有同步 API 的库去处理,或者,正在执行一个可能的长周期计算。我们如何用事件驱动编程去结合这些代码?线程可以帮到你!

|

||||

|

||||

### “转换” 阻塞调用到异步调用的线程

|

||||

### “转换” 阻塞调用为异步调用的线程

|

||||

|

||||

一个线程池可以被用于去转换阻塞调用到异步调用,通过与事件循环并行运行,并且当任务完成时去由它去公布事件。一个给定的阻塞函数 `do_work()`,这里介绍了它是怎么运行的:

|

||||

一个线程池可以用于转换阻塞调用为异步调用,通过与事件循环并行运行,并且当任务完成时去由它去公布事件。以阻塞函数 `do_work()` 为例,这里介绍了它是怎么运行的:

|

||||

|

||||

1. 在一个回调中,用 `do_work()` 代表直接调用,我们将它打包进一个 “任务”,并且请求线程池去运行这个任务。当任务完成时,我们也为循环去调用它注册一个回调;我们称它为 `on_work_done()`。

|

||||

1. 不在一个回调中直接调用 `do_work()` ,而是将它打包进一个 “任务”,让线程池去运行这个任务。当任务完成时,我们也为循环去调用它注册一个回调;我们称它为 `on_work_done()`。

|

||||

2. 在这个时间点,我们的回调就可以返回了,而事件循环保持运行;在同一时间点,线程池中的有一个线程运行这个任务。

|

||||

3. 一旦任务运行完成,通知主线程(指正在运行事件循环的线程),并且事件循环调用 `on_work_done()`。

|

||||

|

||||

2. 在这个时间点,我们的回调可以返回并且事件循环保持运行;在同一时间点,线程池中的一个线程运行这个任务。

|

||||

|

||||

3. 一旦任务运行完成,通知主线程(指正在运行事件循环的线程),并且,通过事件循环调用 `on_work_done()`。

|

||||

|

||||

让我们看一下,使用 libuv 的工作调度 API,是怎么去解决我们前面的 timer/sleep 示例中展示的问题的:

|

||||

让我们看一下,使用 libuv 的工作调度 API,是怎么去解决我们前面的计时器/睡眠示例中展示的问题的:

|

||||

|

||||

```

|

||||

void on_after_work(uv_work_t* req, int status) {

|

||||

@ -327,7 +325,7 @@ int main(int argc, const char** argv) {

|

||||

}

|

||||

```

|

||||

|

||||

通过一个 work_req [[2]][14] 类型的句柄,我们进入一个任务队列,代替在 `on_timer` 上直接调用 sleep,这个函数在任务中(`on_work`)运行,并且,一旦任务完成(`on_after_work`),这个函数被调用一次。`on_work` 在这里是指发生的 “work”(阻塞中的/耗时的操作)。在这两个回调传递到 `uv_queue_work` 时,注意一个关键的区别:`on_work` 运行在线程池中,而 `on_after_work` 运行在事件循环中的主线程上 - 就好像是其它的回调一样。

|

||||

通过一个 `work_req` ^注2 类型的句柄,我们进入一个任务队列,代替在 `on_timer` 上直接调用 sleep,这个函数在任务中(`on_work`)运行,并且,一旦任务完成(`on_after_work`),这个函数被调用一次。`on_work` 是指 “work”(阻塞中的/耗时的操作)进行的地方。注意在这两个回调传递到 `uv_queue_work` 时的一个关键区别:`on_work` 运行在线程池中,而 `on_after_work` 运行在事件循环中的主线程上 —— 就好像是其它的回调一样。

|

||||

|

||||

让我们看一下这种方式的运行:

|

||||

|

||||

@ -347,25 +345,25 @@ on_timer [97578 ms]

|

||||

...

|

||||

```

|

||||

|

||||

即便在 sleep 函数被调用时,定时器也每秒钟滴答一下,睡眠(sleeping)现在运行在一个单独的线程中,并且不会阻塞事件循环。

|

||||

即便在 sleep 函数被调用时,定时器也每秒钟滴答一下,睡眠现在运行在一个单独的线程中,并且不会阻塞事件循环。

|

||||

|

||||

### 一个用于练习的素数测试服务器

|

||||

|

||||

因为通过睡眼去模拟工作并不是件让人兴奋的事,我有一个事先准备好的更综合的一个示例 - 一个基于套接字接受来自客户端的数字的服务器,检查这个数字是否是素数,然后去返回一个 “prime" 或者 “composite”。完整的 [服务器代码在这里][15] - 我不在这里粘贴了,因为它太长了,更希望读者在一些自己的练习中去体会它。

|

||||

因为通过睡眠去模拟工作并不是件让人兴奋的事,我有一个事先准备好的更综合的一个示例 —— 一个基于套接字接受来自客户端的数字的服务器,检查这个数字是否是素数,然后去返回一个 “prime" 或者 “composite”。完整的 [服务器代码在这里][15] —— 我不在这里粘贴了,因为它太长了,更希望读者在一些自己的练习中去体会它。

|

||||

|

||||

这个服务器使用了一个原生的素数测试算法,因此,对于大的素数可能花很长时间才返回一个回答。在我的机器中,对于 2305843009213693951,它花了 ~5 秒钟去计算,但是,你的方法可能不同。

|

||||

|

||||

练习 1:服务器有一个设置(通过一个名为 MODE 的环境变量)要么去在套接字回调(意味着在主线程上)中运行素数测试,要么在 libuv 工作队列中。当多个客户端同时连接时,使用这个设置来观察服务器的行为。当它计算一个大的任务时,在阻塞模式中,服务器将不回复其它客户端,而在非阻塞模式中,它会回复。

|

||||

练习 1:服务器有一个设置(通过一个名为 `MODE` 的环境变量)要么在套接字回调(意味着在主线程上)中运行素数测试,要么在 libuv 工作队列中。当多个客户端同时连接时,使用这个设置来观察服务器的行为。当它计算一个大的任务时,在阻塞模式中,服务器将不回复其它客户端,而在非阻塞模式中,它会回复。

|

||||

|

||||

练习 2;libuv 有一个缺省大小的线程池,并且线程池的大小可以通过环境变量配置。你可以通过使用多个客户端去实验找出它的缺省值是多少?找到线程池缺省值后,使用不同的设置去看一下,在重负载下怎么去影响服务器的响应能力。

|

||||

练习 2:libuv 有一个缺省大小的线程池,并且线程池的大小可以通过环境变量配置。你可以通过使用多个客户端去实验找出它的缺省值是多少?找到线程池缺省值后,使用不同的设置去看一下,在重负载下怎么去影响服务器的响应能力。

|

||||

|

||||

### 在非阻塞文件系统中使用工作队列

|

||||

|

||||

对于仅傻傻的演示和 CPU 密集型的计算来说,将可能的阻塞操作委托给一个线程池并不是明智的;libuv 在它的文件系统 APIs 中本身就大量使用了这种性能。通过这种方式,libuv 使用一个异步 API,在一个轻便的方式中,显示出它强大的文件系统的处理能力。

|

||||

对于只是呆板的演示和 CPU 密集型的计算来说,将可能的阻塞操作委托给一个线程池并不是明智的;libuv 在它的文件系统 API 中本身就大量使用了这种能力。通过这种方式,libuv 使用一个异步 API,以一个轻便的方式显示出它强大的文件系统的处理能力。

|

||||

|

||||

让我们使用 `uv_fs_read()`,例如,这个函数从一个文件中(以一个 `uv_fs_t` 句柄为代表)读取一个文件到一个缓冲中 [[3]][16],并且当读取完成后调用一个回调。换句话说,`uv_fs_read()` 总是立即返回,甚至如果文件在一个类似 NFS 的系统上,并且,数据到达缓冲区可能需要一些时间。换句话说,这个 API 与这种方式中其它的 libuv APIs 是异步的。这是怎么工作的呢?

|

||||

让我们使用 `uv_fs_read()`,例如,这个函数从一个文件中(表示为一个 `uv_fs_t` 句柄)读取一个文件到一个缓冲中 ^注3,并且当读取完成后调用一个回调。换句话说,`uv_fs_read()` 总是立即返回,即使是文件在一个类似 NFS 的系统上,而数据到达缓冲区可能需要一些时间。换句话说,这个 API 与这种方式中其它的 libuv API 是异步的。这是怎么工作的呢?

|

||||

|

||||

在这一点上,我们看一下 libuv 的底层;内部实际上非常简单,并且它是一个很好的练习。作为一个便携的库,libuv 对于 Windows 和 Unix 系统在它的许多函数上有不同的实现。我们去看一下在 libuv 源树中的 src/unix/fs.c。

|

||||

在这一点上,我们看一下 libuv 的底层;内部实际上非常简单,并且它是一个很好的练习。作为一个可移植的库,libuv 对于 Windows 和 Unix 系统在它的许多函数上有不同的实现。我们去看一下在 libuv 源树中的 `src/unix/fs.c`。

|

||||

|

||||

这是 `uv_fs_read` 的代码:

|

||||

|

||||

@ -400,9 +398,9 @@ int uv_fs_read(uv_loop_t* loop, uv_fs_t* req,

|

||||

}

|

||||

```

|

||||

|

||||

第一次看可能觉得很困难,因为它延缓真实的工作到 INIT 和 POST 宏中,在 POST 中与一些本地变量一起设置。这样做可以避免了文件中的许多重复代码。

|

||||

第一次看可能觉得很困难,因为它延缓真实的工作到 `INIT` 和 `POST` 宏中,以及为 `POST` 设置了一些本地变量。这样做可以避免了文件中的许多重复代码。

|

||||

|

||||

这是 INIT 宏:

|

||||

这是 `INIT` 宏:

|

||||

|

||||

```

|

||||

#define INIT(subtype) \

|

||||

@ -421,9 +419,9 @@ int uv_fs_read(uv_loop_t* loop, uv_fs_t* req,

|

||||

while (0)

|

||||

```

|

||||

|

||||

它设置了请求,并且更重要的是,设置 `req->fs_type` 域为真实的 FS 请求类型。因为 `uv_fs_read` 调用 invokes INIT(READ),它意味着 `req->fs_type` 被分配一个常数 `UV_FS_READ`。

|

||||

它设置了请求,并且更重要的是,设置 `req->fs_type` 域为真实的 FS 请求类型。因为 `uv_fs_read` 调用 `INIT(READ)`,它意味着 `req->fs_type` 被分配一个常数 `UV_FS_READ`。

|

||||

|

||||

这是 POST 宏:

|

||||

这是 `POST` 宏:

|

||||

|

||||

```

|

||||

#define POST \

|

||||

@ -440,31 +438,25 @@ int uv_fs_read(uv_loop_t* loop, uv_fs_t* req,

|

||||

while (0)

|

||||

```

|

||||

|

||||

它做什么取决于回调是否为 NULL。在 libuv 文件系统 APIs 中,一个 NULL 回调意味着我们真实地希望去执行一个 _同步_ 操作。在这种情况下,POST 直接调用 `uv__fs_work`(我们需要了解一下这个函数的功能),而对于一个 non-NULL 回调,它提交 `uv__fs_work` 作为一个工作事项到工作队列(指的是线程池),然后,注册 `uv__fs_done` 作为回调;该函数执行一些登记并调用用户提供的回调。

|

||||

它做什么取决于回调是否为 `NULL`。在 libuv 文件系统 API 中,一个 `NULL` 回调意味着我们真实地希望去执行一个 _同步_ 操作。在这种情况下,`POST` 直接调用 `uv__fs_work`(我们需要了解一下这个函数的功能),而对于一个非 `NULL` 回调,它把 `uv__fs_work` 作为一个工作项提交到工作队列(指的是线程池),然后,注册 `uv__fs_done` 作为回调;该函数执行一些登记并调用用户提供的回调。

|

||||

|

||||

如果我们去看 `uv__fs_work` 的代码,我们将看到它使用很多宏去按需路由工作到真实的文件系统调用。在我们的案例中,对于 `UV_FS_READ` 这个调用将被 `uv__fs_read` 生成,它(最终)使用普通的 POSIX APIs 去读取。这个函数可以在一个 _阻塞_ 方式中很安全地实现。因为,它通过异步 API 调用时被置于一个线程池中。

|

||||

如果我们去看 `uv__fs_work` 的代码,我们将看到它使用很多宏按照需求将工作分发到实际的文件系统调用。在我们的案例中,对于 `UV_FS_READ` 这个调用将被 `uv__fs_read` 生成,它(最终)使用普通的 POSIX API 去读取。这个函数可以在一个 _阻塞_ 方式中很安全地实现。因为,它通过异步 API 调用时被置于一个线程池中。

|

||||

|

||||