**, and notice that the paragraph line is indented automatically.

+

+```

+

+

Vim plugins are awesome !

+

+```

+

+Vim Surround has many other options. Give it a try—and consult [GitHub][7] for additional information.

+

+### 4\. Vim Gitgutter

+

+The [Vim Gitgutter][8] plugin is useful for anyone using Git for version control. It shows the output of **Git diff** as symbols in the "gutter"—the sign column where Vim presents additional information, such as line numbers. For example, consider the following as the committed version in Git:

+

+```

+ 1 package main

+ 2

+ 3 import "fmt"

+ 4

+ 5 func main() {

+ 6 x := true

+ 7 items := []string{"tv", "pc", "tablet"}

+ 8

+ 9 if x {

+ 10 for _, i := range items {

+ 11 fmt.Println(i)

+ 12 }

+ 13 }

+ 14 }

+```

+

+After making some changes, Vim Gitgutter displays the following symbols in the gutter:

+

+```

+ 1 package main

+ 2

+ 3 import "fmt"

+ 4

+_ 5 func main() {

+ 6 items := []string{"tv", "pc", "tablet"}

+ 7

+~ 8 if len(items) > 0 {

+ 9 for _, i := range items {

+ 10 fmt.Println(i)

++ 11 fmt.Println("------")

+ 12 }

+ 13 }

+ 14 }

+```

+

+The **-** symbol shows that a line was deleted between lines 5 and 6. The **~** symbol shows that line 8 was modified, and the symbol **+** shows that line 11 was added.

+

+In addition, Vim Gitgutter allows you to navigate between "hunks"—individual changes made in the file—with **[c** and **]c** , or even stage individual hunks for commit by pressing **Leader+hs**.

+

+This plugin gives you immediate visual feedback of changes, and it's a great addition to your toolbox if you use Git.

+

+### 5\. VIM Fugitive

+

+[Vim Fugitive][9] is another great plugin for anyone incorporating Git into the Vim workflow. It's a Git wrapper that allows you to execute Git commands directly from Vim and integrates with Vim's interface. This plugin has many features—check its [GitHub][10] page for more information.

+

+Here's a basic Git workflow example using Vim Fugitive. Considering the changes we've made to the Go code block on section 4, you can use **git blame** by typing the command **:Gblame** :

+

+```

+e9949066 (Ricardo Gerardi 2018-12-05 18:17:19 -0500)│ 1 package main

+e9949066 (Ricardo Gerardi 2018-12-05 18:17:19 -0500)│ 2

+e9949066 (Ricardo Gerardi 2018-12-05 18:17:19 -0500)│ 3 import "fmt"

+e9949066 (Ricardo Gerardi 2018-12-05 18:17:19 -0500)│ 4

+e9949066 (Ricardo Gerardi 2018-12-05 18:17:19 -0500)│_ 5 func main() {

+e9949066 (Ricardo Gerardi 2018-12-05 18:17:19 -0500)│ 6 items := []string{"tv", "pc", "tablet"}

+e9949066 (Ricardo Gerardi 2018-12-05 18:17:19 -0500)│ 7

+00000000 (Not Committed Yet 2018-12-05 18:55:00 -0500)│~ 8 if len(items) > 0 {

+e9949066 (Ricardo Gerardi 2018-12-05 18:17:19 -0500)│ 9 for _, i := range items {

+e9949066 (Ricardo Gerardi 2018-12-05 18:17:19 -0500)│ 10 fmt.Println(i)

+00000000 (Not Committed Yet 2018-12-05 18:55:00 -0500)│+ 11 fmt.Println("------")

+e9949066 (Ricardo Gerardi 2018-12-05 18:17:19 -0500)│ 12 }

+e9949066 (Ricardo Gerardi 2018-12-05 18:17:19 -0500)│ 13 }

+e9949066 (Ricardo Gerardi 2018-12-05 18:17:19 -0500)│ 14 }

+```

+

+You can see that lines 8 and 11 have not been committed. Check the repository status by typing **:Gstatus** :

+

+```

+ 1 # On branch master

+ 2 # Your branch is up to date with 'origin/master'.

+ 3 #

+ 4 # Changes not staged for commit:

+ 5 # (use "git add

..." to update what will be committed)

+ 6 # (use "git checkout -- ..." to discard changes in working directory)

+ 7 #

+ 8 # modified: vim-5plugins/examples/test1.go

+ 9 #

+ 10 no changes added to commit (use "git add" and/or "git commit -a")

+--------------------------------------------------------------------------------------------------------

+ 1 package main

+ 2

+ 3 import "fmt"

+ 4

+_ 5 func main() {

+ 6 items := []string{"tv", "pc", "tablet"}

+ 7

+~ 8 if len(items) > 0 {

+ 9 for _, i := range items {

+ 10 fmt.Println(i)

++ 11 fmt.Println("------")

+ 12 }

+ 13 }

+ 14 }

+```

+

+Vim Fugitive opens a split window with the result of **git status**. You can stage a file for commit by pressing the **-** key on the line with the name of the file. You can reset the status by pressing **-** again. The message updates to reflect the new status:

+

+```

+ 1 # On branch master

+ 2 # Your branch is up to date with 'origin/master'.

+ 3 #

+ 4 # Changes to be committed:

+ 5 # (use "git reset HEAD ..." to unstage)

+ 6 #

+ 7 # modified: vim-5plugins/examples/test1.go

+ 8 #

+--------------------------------------------------------------------------------------------------------

+ 1 package main

+ 2

+ 3 import "fmt"

+ 4

+_ 5 func main() {

+ 6 items := []string{"tv", "pc", "tablet"}

+ 7

+~ 8 if len(items) > 0 {

+ 9 for _, i := range items {

+ 10 fmt.Println(i)

++ 11 fmt.Println("------")

+ 12 }

+ 13 }

+ 14 }

+```

+

+Now you can use the command **:Gcommit** to commit the changes. Vim Fugitive opens another split that allows you to enter a commit message:

+

+```

+ 1 vim-5plugins: Updated test1.go example file

+ 2 # Please enter the commit message for your changes. Lines starting

+ 3 # with '#' will be ignored, and an empty message aborts the commit.

+ 4 #

+ 5 # On branch master

+ 6 # Your branch is up to date with 'origin/master'.

+ 7 #

+ 8 # Changes to be committed:

+ 9 # modified: vim-5plugins/examples/test1.go

+ 10 #

+```

+

+Save the file with **:wq** to complete the commit:

+

+```

+[master c3bf80f] vim-5plugins: Updated test1.go example file

+ 1 file changed, 2 insertions(+), 2 deletions(-)

+Press ENTER or type command to continue

+```

+

+You can use **:Gstatus** again to see the result and **:Gpush** to update the remote repository with the new commit.

+

+```

+ 1 # On branch master

+ 2 # Your branch is ahead of 'origin/master' by 1 commit.

+ 3 # (use "git push" to publish your local commits)

+ 4 #

+ 5 nothing to commit, working tree clean

+```

+

+If you like Vim Fugitive and want to learn more, the GitHub repository has links to screencasts showing additional functionality and workflows. Check it out!

+

+### What's next?

+

+These Vim plugins help developers write code in any programming language. There are two other categories of plugins to help developers: code-completion plugins and syntax-checker plugins. They are usually related to specific programming languages, so I will cover them in a follow-up article.

+

+Do you have another Vim plugin you use when writing code? Please share it in the comments below.

+

+--------------------------------------------------------------------------------

+

+via: https://opensource.com/article/19/1/vim-plugins-developers

+

+作者:[Ricardo Gerardi][a]

+选题:[lujun9972][b]

+译者:[pityonline](https://github.com/pityonline)

+校对:[校对者ID](https://github.com/校对者ID)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://opensource.com/users/rgerardi

+[b]: https://github.com/lujun9972

+[1]: https://www.vim.org/

+[2]: https://www.vim.org/scripts/script.php?script_id=3599

+[3]: https://github.com/jiangmiao/auto-pairs

+[4]: https://github.com/scrooloose/nerdcommenter

+[5]: http://vim.wikia.com/wiki/Filetype.vim

+[6]: https://www.vim.org/scripts/script.php?script_id=1697

+[7]: https://github.com/tpope/vim-surround

+[8]: https://github.com/airblade/vim-gitgutter

+[9]: https://www.vim.org/scripts/script.php?script_id=2975

+[10]: https://github.com/tpope/vim-fugitive

diff --git a/sources/tech/20190111 Build a retro gaming console with RetroPie.md b/sources/tech/20190111 Build a retro gaming console with RetroPie.md

new file mode 100644

index 0000000000..eedac575c9

--- /dev/null

+++ b/sources/tech/20190111 Build a retro gaming console with RetroPie.md

@@ -0,0 +1,82 @@

+[#]: collector: (lujun9972)

+[#]: translator: ( )

+[#]: reviewer: ( )

+[#]: publisher: ( )

+[#]: url: ( )

+[#]: subject: (Build a retro gaming console with RetroPie)

+[#]: via: (https://opensource.com/article/19/1/retropie)

+[#]: author: (Jay LaCroix https://opensource.com/users/jlacroix)

+

+Build a retro gaming console with RetroPie

+======

+Play your favorite classic Nintendo, Sega, and Sony console games on Linux.

+

+

+The most common question I get on [my YouTube channel][1] and in person is what my favorite Linux distribution is. If I limit the answer to what I run on my desktops and laptops, my answer will typically be some form of an Ubuntu-based Linux distro. My honest answer to this question may surprise many. My favorite Linux distribution is actually [RetroPie][2].

+

+As passionate as I am about Linux and open source software, I'm equally passionate about classic gaming, specifically video games produced in the '90s and earlier. I spend most of my surplus income on older games, and I now have a collection of close to a thousand games for over 20 gaming consoles. In my spare time, I raid flea markets, yard sales, estate sales, and eBay buying games for various consoles, including almost every iteration made by Nintendo, Sega, and Sony. There's something about classic games that I adore, a charm that seems lost in games released nowadays.

+

+Unfortunately, collecting retro games has its fair share of challenges. Cartridges with memory for save files will lose their charge over time, requiring the battery to be replaced. While it's not hard to replace save batteries (if you know how), it's still time-consuming. Games on CD-ROMs are subject to disc rot, which means that even if you take good care of them, they'll still lose data over time and become unplayable. Also, sometimes it's difficult to find replacement parts for some consoles. This wouldn't be so much of an issue if the majority of classic games were available digitally, but the vast majority are never re-released on a digital platform.

+

+### Gaming on RetroPie

+

+RetroPie is a great project and an asset to retro gaming enthusiasts like me. RetroPie is a Raspbian-based distribution designed for use on the Raspberry Pi (though it is possible to get it working on other platforms, such as a PC). RetroPie boots into a graphical interface that is completely controllable via a gamepad or joystick and allows you to easily manage digital copies (ROMs) of your favorite games. You can scrape information from the internet to organize your collection better and manage lists of favorite games, and the entire interface is very user-friendly and efficient. From the interface, you can launch directly into a game, then exit the game by pressing a combination of buttons on your gamepad. You rarely need a keyboard, unless you have to enter your WiFi password or manually edit configuration files.

+

+I use RetroPie to host a digital copy of every physical game I own in my collection. When I purchase a game from a local store or eBay, I also download the ROM. As a collector, this is very convenient. If I don't have a particular physical console within arms reach, I can boot up RetroPie and enjoy a game quickly without having to connect cables or clean cartridge contacts. There's still something to be said about playing a game on the original hardware, but if I'm pressed for time, RetroPie is very convenient. I also don't have to worry about dead save batteries, dirty cartridge contacts, disc rot, or any of the other issues collectors like me have to regularly deal with. I simply play the game.

+

+Also, RetroPie allows me to be very clever and utilize my technical know-how to achieve additional functionality that's not normally available. For example, I have three RetroPies set up, each of them synchronizing their files between each other by leveraging [Syncthing][3], a popular open source file synchronization tool. The synchronization happens automatically, and it means I can start a game on one television and continue in the same place on another unit since the save files are included in the synchronization. To take it a step further, I also back up my save and configuration files to [Backblaze B2][4], so I'm protected if an SD card becomes defective.

+

+### Setting up RetroPie

+

+Setting up RetroPie is very easy, and if you've ever set up a Raspberry Pi Linux distribution before (such as Raspbian) the process is essentially the same—you simply download the IMG file and flash it to your SD card by utilizing another tool, such as [Etcher][5], and insert it into your RetroPie. Then plug in an AC adapter and gamepad and hook it up to your television via HDMI. Optionally, you can buy a case to protect your RetroPie from outside elements and add visual appeal. Here is a listing of things you'll need to get started:

+

+ * Raspberry Pi board (Model 3B+ or higher recommended)

+ * SD card (16GB or larger recommended)

+ * A USB gamepad

+ * UL-listed micro USB power adapter, at least 2.5 amp

+

+

+

+If you choose to add the optional Raspberry Pi case, I recommend the Super NES and Super Famicom themed cases from [RetroFlag][6]. Not only do these cases look cool, but they also have fully functioning power and reset buttons. This means you can configure the reset and power buttons to directly trigger the operating system's halt process, rather than abruptly terminating power. This definitely makes for a more professional experience, but it does require the installation of a special script. The instructions are on [RetroFlag's GitHub page][7]. Be wary: there are many cases available on Amazon and eBay of varying quality. Some of them are cheap knock-offs of RetroFlag cases, and others are just a lower quality overall. In fact, even cases by RetroFlag vary in quality—I had some power-distribution issues with the NES-themed case that made for an unstable experience. If in doubt, I've found that RetroFlag's Super NES and Super Famicom themed cases work very well.

+

+### Adding games

+

+When you boot RetroPie for the first time, it will resize the filesystem to ensure you have full access to the available space on your SD card and allow you to set up your gamepad. I can't give you links for game ROMs, so I'll leave that part up to you to figure out. When you've found them, simply add them to the RetroPie SD card in the designated folder, which would be located under **/home/pi/RetroPie/roms/ **. You can use your favorite tool for transferring the ROMs to the Pi, such as [SCP][8] in a terminal, [WinSCP][9], [Samba][10], etc. Once you've added the games, you can rescan them by pressing start and choosing the option to restart EmulationStation. When it restarts, it should automatically add menu entries for the ROMs you've added. That's basically all there is to it.

+

+(The rescan updates EmulationStation’s game inventory. If you don’t do that, it won’t list any newly added games you copy over.)

+

+Regarding the games' performance, your mileage will vary depending on which consoles you're emulating. For example, I've noticed that Sega Dreamcast games barely run at all, and most Nintendo 64 games will run sluggishly with a bad framerate. Many PlayStation Portable (PSP) games also perform inconsistently. However, all of the 8-bit and 16-bit consoles emulate seemingly perfectly—I haven't run into a single 8-bit or 16-bit game that doesn't run well. Surprisingly, games designed for the original PlayStation run great for me, which is a great feat considering the lower-performance potential of the Raspberry Pi.

+

+Overall, RetroPie's performance is great, but the Raspberry Pi is not as powerful as a gaming PC, so adjust your expectations accordingly.

+

+### Conclusion

+

+RetroPie is a fantastic open source project dedicated to preserving classic games and an asset to game collectors everywhere. Having a digital copy of my physical game collection is extremely convenient. If I were to tell my childhood self that one day I could have an entire game collection on one device, I probably wouldn't believe it. But RetroPie has become a staple in my household and provides hours of fun and enjoyment.

+

+If you want to see the parts I mentioned as well as a quick installation overview, I have [a video][11] on [my YouTube channel][12] that goes over the process and shows off some gameplay at the end.

+

+--------------------------------------------------------------------------------

+

+via: https://opensource.com/article/19/1/retropie

+

+作者:[Jay LaCroix][a]

+选题:[lujun9972][b]

+译者:[译者ID](https://github.com/译者ID)

+校对:[校对者ID](https://github.com/校对者ID)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://opensource.com/users/jlacroix

+[b]: https://github.com/lujun9972

+[1]: https://www.youtube.com/channel/UCxQKHvKbmSzGMvUrVtJYnUA

+[2]: https://retropie.org.uk/

+[3]: https://syncthing.net/

+[4]: https://www.backblaze.com/b2/cloud-storage.html

+[5]: https://www.balena.io/etcher/

+[6]: https://www.amazon.com/shop/learnlinux.tv?listId=1N9V89LEH5S8K

+[7]: https://github.com/RetroFlag/retroflag-picase

+[8]: https://en.wikipedia.org/wiki/Secure_copy

+[9]: https://winscp.net/eng/index.php

+[10]: https://www.samba.org/

+[11]: https://www.youtube.com/watch?v=D8V-KaQzsWM

+[12]: http://www.youtube.com/c/LearnLinuxtv

diff --git a/sources/tech/20190111 Top 5 Linux Distributions for Productivity.md b/sources/tech/20190111 Top 5 Linux Distributions for Productivity.md

new file mode 100644

index 0000000000..fbd8b9d120

--- /dev/null

+++ b/sources/tech/20190111 Top 5 Linux Distributions for Productivity.md

@@ -0,0 +1,170 @@

+[#]: collector: (lujun9972)

+[#]: translator: ( )

+[#]: reviewer: ( )

+[#]: publisher: ( )

+[#]: url: ( )

+[#]: subject: (Top 5 Linux Distributions for Productivity)

+[#]: via: (https://www.linux.com/blog/learn/2019/1/top-5-linux-distributions-productivity)

+[#]: author: (Jack Wallen https://www.linux.com/users/jlwallen)

+

+Top 5 Linux Distributions for Productivity

+======

+

+

+

+I have to confess, this particular topic is a tough one to address. Why? First off, Linux is a productive operating system by design. Thanks to an incredibly reliable and stable platform, getting work done is easy. Second, to gauge effectiveness, you have to consider what type of work you need a productivity boost for. General office work? Development? School? Data mining? Human resources? You see how this question can get somewhat complicated.

+

+That doesn’t mean, however, that some distributions aren’t able to do a better job of configuring and presenting that underlying operating system into an efficient platform for getting work done. Quite the contrary. Some distributions do a much better job of “getting out of the way,” so you don’t find yourself in a work-related hole, having to dig yourself out and catch up before the end of day. These distributions help strip away the complexity that can be found in Linux, thereby making your workflow painless.

+

+Let’s take a look at the distros I consider to be your best bet for productivity. To help make sense of this, I’ve divided them into categories of productivity. That task itself was challenging, because everyone’s productivity varies. For the purposes of this list, however, I’ll look at:

+

+ * General Productivity: For those who just need to work efficiently on multiple tasks.

+

+ * Graphic Design: For those that work with the creation and manipulation of graphic images.

+

+ * Development: For those who use their Linux desktops for programming.

+

+ * Administration: For those who need a distribution to facilitate their system administration tasks.

+

+ * Education: For those who need a desktop distribution to make them more productive in an educational environment.

+

+

+

+

+Yes, there are more categories to be had, many of which can get very niche-y, but these five should fill most of your needs.

+

+### General Productivity

+

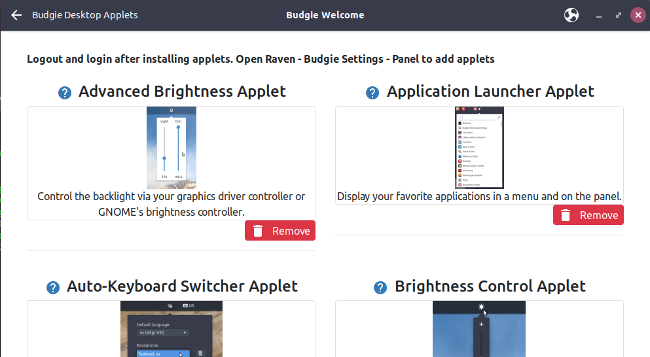

+For general productivity, you won’t get much more efficient than [Ubuntu][1]. The primary reason for choosing Ubuntu for this category is the seamless integration of apps, services, and desktop. You might be wondering why I didn’t choose Linux Mint for this category? Because Ubuntu now defaults to the GNOME desktop, it gains the added advantage of GNOME Extensions (Figure 1).

+

+![GNOME Clipboard][3]

+

+Figure 1: The GNOME Clipboard Indicator extension in action.

+

+[Used with permission][4]

+

+These extensions go a very long way to aid in boosting productivity (so Ubuntu gets the nod over Mint). But Ubuntu didn’t just accept a vanilla GNOME desktop. Instead, they tweaked it to make it slightly more efficient and user-friendly, out of the box. And because Ubuntu contains just the right mixture of default, out-of-the-box, apps (that just work), it makes for a nearly perfect platform for productivity.

+

+Whether you need to write a paper, work on a spreadsheet, code a new app, work on your company website, create marketing images, administer a server or network, or manage human resources from within your company HR tool, Ubuntu has you covered. The Ubuntu desktop distribution also doesn’t require the user to jump through many hoops to get things working … it simply works (and quite well). Finally, thanks to it’s Debian base, Ubuntu makes installing third-party apps incredibly easy.

+

+Although Ubuntu tends to be the go-to for nearly every list of “top distributions for X,” it’s very hard to argue against this particular distribution topping the list of general productivity distributions.

+

+### Graphic Design

+

+If you’re looking to up your graphic design productivity, you can’t go wrong with [Fedora Design Suite][5]. This Fedora respin was created by the team responsible for all Fedora-related art work. Although the default selection of apps isn’t a massive collection of tools, those it does include are geared specifically for the creation and manipulation of images.

+

+With apps like GIMP, Inkscape, Darktable, Krita, Entangle, Blender, Pitivi, Scribus, and more (Figure 2), you’ll find everything you need to get your image editing jobs done and done well. But Fedora Design Suite doesn’t end there. This desktop platform also includes a bevy of tutorials that cover countless subjects for many of the installed applications. For anyone trying to be as productive as possible, this is some seriously handy information to have at the ready. I will say, however, the tutorial entry in the GNOME Favorites is nothing more than a link to [this page][6].

+

+![Fedora Design Suite Favorites][8]

+

+Figure 2: The Fedora Design Suite Favorites menu includes plenty of tools for getting your graphic design on.

+

+[Used with permission][4]

+

+Those that work with a digital camera will certainly appreciate the inclusion of the Entangle app, which allows you to control your DSLR from the desktop.

+

+### Development

+

+Nearly all Linux distributions are great platforms for programmers. However, one particular distributions stands out, above the rest, as one of the most productive tools you’ll find for the task. That OS comes from [System76][9] and it’s called [Pop!_OS][10]. Pop!_OS is tailored specifically for creators, but not of the artistic type. Instead, Pop!_OS is geared toward creators who specialize in developing, programming, and making. If you need an environment that is not only perfected suited for your development work, but includes a desktop that’s sure to get out of your way, you won’t find a better option than Pop!_OS (Figure 3).

+

+What might surprise you (given how “young” this operating system is), is that Pop!_OS is also one of the single most stable GNOME-based platforms you’ll ever use. This means Pop!_OS isn’t just for creators and makers, but anyone looking for a solid operating system. One thing that many users will greatly appreciate with Pop!_OS, is that you can download an ISO specifically for your video hardware. If you have Intel hardware, [download][10] the version for Intel/AMD. If your graphics card is NVIDIA, download that specific release. Either way, you are sure go get a solid platform for which to create your masterpiece.

+

+![Pop!_OS][12]

+

+Figure 3: The Pop!_OS take on GNOME Overview.

+

+[Used with permission][4]

+

+Interestingly enough, with Pop!_OS, you won’t find much in the way of pre-installed development tools. You won’t find an included IDE, or many other dev tools. You can, however, find all the development tools you need in the Pop Shop.

+

+### Administration

+

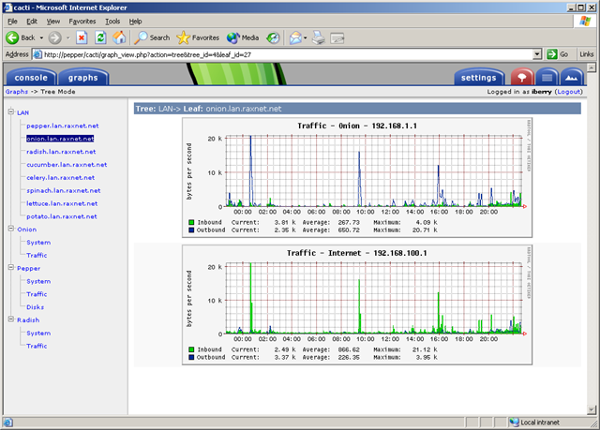

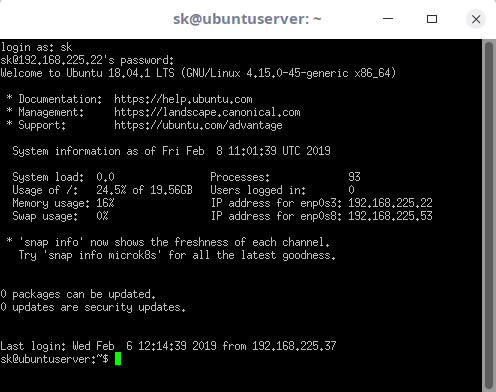

+If you’re looking to find one of the most productive distributions for admin tasks, look no further than [Debian][13]. Why? Because Debian is not only incredibly reliable, it’s one of those distributions that gets out of your way better than most others. Debian is the perfect combination of ease of use and unlimited possibility. On top of which, because this is the distribution for which so many others are based, you can bet if there’s an admin tool you need for a task, it’s available for Debian. Of course, we’re talking about general admin tasks, which means most of the time you’ll be using a terminal window to SSH into your servers (Figure 4) or a browser to work with web-based GUI tools on your network. Why bother making use of a desktop that’s going to add layers of complexity (such as SELinux in Fedora, or YaST in openSUSE)? Instead, chose simplicity.

+

+![Debian][15]

+

+Figure 4: SSH’ing into a remote server on Debian.

+

+[Used with permission][4]

+

+And because you can select which desktop you want (from GNOME, Xfce, KDE, Cinnamon, MATE, LXDE), you can be sure to have the interface that best matches your work habits.

+

+### Education

+

+If you are a teacher or student, or otherwise involved in education, you need the right tools to be productive. Once upon a time, there existed the likes of Edubuntu. That distribution never failed to be listed in the top of education-related lists. However, that distro hasn’t been updated since it was based on Ubuntu 14.04. Fortunately, there’s a new education-based distribution ready to take that title, based on openSUSE. This spin is called [openSUSE:Education-Li-f-e][16] (Linux For Education - Figure 5), and is based on openSUSE Leap 42.1 (so it is slightly out of date).

+

+openSUSE:Education-Li-f-e includes tools like:

+

+ * Brain Workshop - A dual n-back brain exercise

+

+ * GCompris - An educational software suite for young children

+

+ * gElemental - A periodic table viewer

+

+ * iGNUit - A general purpose flash card program

+

+ * Little Wizard - Development environment for children based on Pascal

+

+ * Stellarium - An astronomical sky simulator

+

+ * TuxMath - An math tutor game

+

+ * TuxPaint - A drawing program for young children

+

+ * TuxType - An educational typing tutor for children

+

+ * wxMaxima - A cross platform GUI for the computer algebra system

+

+ * Inkscape - Vector graphics program

+

+ * GIMP - Graphic image manipulation program

+

+ * Pencil - GUI prototyping tool

+

+ * Hugin - Panorama photo stitching and HDR merging program

+

+

+![Education][18]

+

+Figure 5: The openSUSE:Education-Li-f-e distro has plenty of tools to help you be productive in or for school.

+

+[Used with permission][4]

+

+Also included with openSUSE:Education-Li-f-e is the [KIWI-LTSP Server][19]. The KIWI-LTSP Server is a flexible, cost effective solution aimed at empowering schools, businesses, and organizations all over the world to easily install and deploy desktop workstations. Although this might not directly aid the student to be more productive, it certainly enables educational institutions be more productive in deploying desktops for students to use. For more information on setting up KIWI-LTSP, check out the openSUSE [KIWI-LTSP quick start guide][20].

+

+Learn more about Linux through the free ["Introduction to Linux" ][21]course from The Linux Foundation and edX.

+

+--------------------------------------------------------------------------------

+

+via: https://www.linux.com/blog/learn/2019/1/top-5-linux-distributions-productivity

+

+作者:[Jack Wallen][a]

+选题:[lujun9972][b]

+译者:[译者ID](https://github.com/译者ID)

+校对:[校对者ID](https://github.com/校对者ID)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://www.linux.com/users/jlwallen

+[b]: https://github.com/lujun9972

+[1]: https://www.ubuntu.com/

+[2]: /files/images/productivity1jpg

+[3]: https://www.linux.com/sites/lcom/files/styles/rendered_file/public/productivity_1.jpg?itok=yxez3X1w (GNOME Clipboard)

+[4]: /licenses/category/used-permission

+[5]: https://labs.fedoraproject.org/en/design-suite/

+[6]: https://fedoraproject.org/wiki/Design_Suite/Tutorials

+[7]: /files/images/productivity2jpg

+[8]: https://www.linux.com/sites/lcom/files/styles/rendered_file/public/productivity_2.jpg?itok=ke0b8qyH (Fedora Design Suite Favorites)

+[9]: https://system76.com/

+[10]: https://system76.com/pop

+[11]: /files/images/productivity3jpg-0

+[12]: https://www.linux.com/sites/lcom/files/styles/rendered_file/public/productivity_3_0.jpg?itok=8UkCUfsD (Pop!_OS)

+[13]: https://www.debian.org/

+[14]: /files/images/productivity4jpg

+[15]: https://www.linux.com/sites/lcom/files/styles/rendered_file/public/productivity_4.jpg?itok=c9yD3Xw2 (Debian)

+[16]: https://en.opensuse.org/openSUSE:Education-Li-f-e

+[17]: /files/images/productivity5jpg

+[18]: https://www.linux.com/sites/lcom/files/styles/rendered_file/public/productivity_5.jpg?itok=oAFtV8nT (Education)

+[19]: https://en.opensuse.org/Portal:KIWI-LTSP

+[20]: https://en.opensuse.org/SDB:KIWI-LTSP_quick_start

+[21]: https://training.linuxfoundation.org/linux-courses/system-administration-training/introduction-to-linux

diff --git a/sources/tech/20190113 Editing Subtitles in Linux.md b/sources/tech/20190113 Editing Subtitles in Linux.md

new file mode 100644

index 0000000000..1eaa6a68fd

--- /dev/null

+++ b/sources/tech/20190113 Editing Subtitles in Linux.md

@@ -0,0 +1,168 @@

+[#]: collector: (lujun9972)

+[#]: translator: ( )

+[#]: reviewer: ( )

+[#]: publisher: ( )

+[#]: url: ( )

+[#]: subject: (Editing Subtitles in Linux)

+[#]: via: (https://itsfoss.com/editing-subtitles)

+[#]: author: (Shirish https://itsfoss.com/author/shirish/)

+

+Editing Subtitles in Linux

+======

+

+I have been a world movie and regional movies lover for decades. Subtitles are the essential tool that have enabled me to enjoy the best movies in various languages and from various countries.

+

+If you enjoy watching movies with subtitles, you might have noticed that sometimes the subtitles are not synced or not correct.

+

+Did you know that you can edit subtitles and make them better? Let me show you some basic subtitle editing in Linux.

+

+![Editing subtitles in Linux][1]

+

+### Extracting subtitles from closed captions data

+

+Around 2012, 2013 I came to know of a tool called [CCEextractor.][2] As time passed, it has become one of the vital tools for me, especially if I come across a media file which has the subtitle embedded in it.

+

+CCExtractor analyzes video files and produces independent subtitle files from the closed captions data.

+

+CCExtractor is a cross-platform, free and open source tool. The tool has matured quite a bit from its formative years and has been part of [GSOC][3] and Google Code-in now and [then.][4]

+

+The tool, to put it simply, is more or less a set of scripts which work one after another in a serialized order to give you an extracted subtitle.

+

+You can follow the installation instructions for CCExtractor on [this page][5].

+

+After installing when you want to extract subtitles from a media file, do the following:

+

+```

+ccextractor

+```

+

+The output of the command will be something like this:

+

+It basically scans the media file. In this case, it found that the media file is in malyalam and that the media container is an [.mkv][6] container. It extracted the subtitle file with the same name as the video file adding _eng to it.

+

+CCExtractor is a wonderful tool which can be used to enhance subtitles along with Subtitle Edit which I will share in the next section.

+

+```

+Interesting Read: There is an interesting synopsis of subtitles at [vicaps][7] which tells and shares why subtitles are important to us. It goes into quite a bit of detail of movie-making as well for those interested in such topics.

+```

+

+### Editing subtitles with SubtitleEditor Tool

+

+You probably are aware that most subtitles are in [.srt format][8] . The beautiful thing about this format is and was you could load it in your text editor and do little fixes in it.

+

+A srt file looks something like this when launched into a simple text-editor:

+

+The excerpt subtitle I have shared is from a pretty Old German Movie called [The Cabinet of Dr. Caligari (1920)][9]

+

+Subtitleeditor is a wonderful tool when it comes to editing subtitles. Subtitle Editor is and can be used to manipulate time duration, frame-rate of the subtitle file to be in sync with the media file, duration of breaks in-between and much more. I’ll share some of the basic subtitle editing here.

+

+![][10]

+

+First install subtitleeditor the same way you installed ccextractor, using your favorite installation method. In Debian, you can use this command:

+

+```

+sudo apt install subtitleeditor

+```

+

+When you have it installed, let’s see some of the common scenarios where you need to edit a subtitle.

+

+#### Manipulating Frame-rates to sync with Media file

+

+If you find that the subtitles are not synced with the video, one of the reasons could be the difference between the frame rates of the video file and the subtitle file.

+

+How do you know the frame rates of these files, then?

+

+To get the frame rate of a video file, you can use the mediainfo tool. You may need to install it first using your distribution’s package manager.

+

+Using mediainfo is simple:

+

+```

+$ mediainfo somefile.mkv | grep Frame

+ Format settings : CABAC / 4 Ref Frames

+ Format settings, ReFrames : 4 frames

+ Frame rate mode : Constant

+ Frame rate : 25.000 FPS

+ Bits/(Pixel*Frame) : 0.082

+ Frame rate : 46.875 FPS (1024 SPF)

+```

+

+Now you can see that framerate of the video file is 25.000 FPS. The other Frame-rate we see is for the audio. While I can share why particular fps are used in Video-encoding, Audio-encoding etc. it would be a different subject matter. There is a lot of history associated with it.

+

+Next is to find out the frame rate of the subtitle file and this is a slightly complicated.

+

+Usually, most subtitles are in a zipped format. Unzipping the .zip archive along with the subtitle file which ends in something.srt. Along with it, there is usually also a .info file with the same name which sometime may have the frame rate of the subtitle.

+

+If not, then it usually is a good idea to go some site and download the subtitle from a site which has that frame rate information. For this specific German file, I will be using [Opensubtitle.org][11]

+

+As you can see in the link, the frame rate of the subtitle is 23.976 FPS. Quite obviously, it won’t play well with my video file with frame rate 25.000 FPS.

+

+In such cases, you can change the frame rate of the subtitle file using the Subtitle Editor tool:

+

+Select all the contents from the subtitle file by doing CTRL+A. Go to Timings -> Change Framerate and change frame rates from 23.976 fps to 25.000 fps or whatever it is that is desired. Save the changed file.

+

+![synchronize frame rates of subtitles in Linux][12]

+

+#### Changing the Starting position of a subtitle file

+

+Sometimes the above method may be enough, sometimes though it will not be enough.

+

+You might find some cases when the start of the subtitle file is different from that in the movie or a media file while the frame rate is the same.

+

+In such cases, do the following:

+

+Select all the contents from the subtitle file by doing CTRL+A. Go to Timings -> Select Move Subtitle.

+

+![Move subtitles using Subtitle Editor on Linux][13]

+

+Change the new Starting position of the subtitle file. Save the changed file.

+

+![Move subtitles using Subtitle Editor in Linux][14]

+

+If you wanna be more accurate, then use [mpv][15] to see the movie or media file and click on the timing, if you click on the timing bar which shows how much the movie or the media file has elapsed, clicking on it will also reveal the microsecond.

+

+I usually like to be accurate so I try to be as precise as possible. It is very difficult in MPV as human reaction time is imprecise. If I wanna be super accurate then I use something like [Audacity][16] but then that is another ball-game altogether as you can do so much more with it. That may be something to explore in a future blog post as well.

+

+#### Manipulating Duration

+

+Sometimes even doing both is not enough and you even have to shrink or add the duration to make it sync with the media file. This is one of the more tedious works as you have to individually fix the duration of each sentence. This can happen especially if you have variable frame rates in the media file (nowadays rare but you still get such files).

+

+In such a scenario, you may have to edit the duration manually and automation is not possible. The best way is either to fix the video file (not possible without degrading the video quality) or getting video from another source at a higher quality and then [transcode][17] it with the settings you prefer. This again, while a major undertaking I could shed some light on in some future blog post.

+

+### Conclusion

+

+What I have shared in above is more or less on improving on existing subtitle files. If you were to start a scratch you need loads of time. I haven’t shared that at all because a movie or any video material of say an hour can easily take anywhere from 4-6 hours or even more depending upon skills of the subtitler, patience, context, jargon, accents, native English speaker, translator etc. all of which makes a difference to the quality of the subtitle.

+

+I hope you find this interesting and from now onward, you’ll handle your subtitles slightly better. If you have any suggestions to add, please leave a comment below.

+

+

+--------------------------------------------------------------------------------

+

+via: https://itsfoss.com/editing-subtitles

+

+作者:[Shirish][a]

+选题:[lujun9972][b]

+译者:[译者ID](https://github.com/译者ID)

+校对:[校对者ID](https://github.com/校对者ID)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://itsfoss.com/author/shirish/

+[b]: https://github.com/lujun9972

+[1]: https://i0.wp.com/itsfoss.com/wp-content/uploads/2019/01/editing-subtitles-in-linux.jpeg?resize=800%2C450&ssl=1

+[2]: https://www.ccextractor.org/

+[3]: https://itsfoss.com/best-open-source-internships/

+[4]: https://www.ccextractor.org/public:codein:google_code-in_2018

+[5]: https://github.com/CCExtractor/ccextractor/wiki/Installation

+[6]: https://en.wikipedia.org/wiki/Matroska

+[7]: https://www.vicaps.com/blog/history-of-silent-movies-and-subtitles/

+[8]: https://en.wikipedia.org/wiki/SubRip#SubRip_text_file_format

+[9]: https://www.imdb.com/title/tt0010323/

+[10]: https://i1.wp.com/itsfoss.com/wp-content/uploads/2018/12/subtitleeditor.jpg?ssl=1

+[11]: https://www.opensubtitles.org/en/search/sublanguageid-eng/idmovie-4105

+[12]: https://i1.wp.com/itsfoss.com/wp-content/uploads/2019/01/subtitleeditor-frame-rate-sync.jpg?resize=800%2C450&ssl=1

+[13]: https://i0.wp.com/itsfoss.com/wp-content/uploads/2019/01/Move-subtitles-Caligiri.jpg?resize=800%2C450&ssl=1

+[14]: https://i2.wp.com/itsfoss.com/wp-content/uploads/2019/01/move-subtitles.jpg?ssl=1

+[15]: https://itsfoss.com/mpv-video-player/

+[16]: https://www.audacityteam.org/

+[17]: https://en.wikipedia.org/wiki/Transcoding

+[18]: https://i0.wp.com/itsfoss.com/wp-content/uploads/2019/01/editing-subtitles-in-linux.jpeg?fit=800%2C450&ssl=1

diff --git a/sources/tech/20190116 Best Audio Editors For Linux.md b/sources/tech/20190116 Best Audio Editors For Linux.md

new file mode 100644

index 0000000000..d588c886e2

--- /dev/null

+++ b/sources/tech/20190116 Best Audio Editors For Linux.md

@@ -0,0 +1,156 @@

+[#]: collector: (lujun9972)

+[#]: translator: ( )

+[#]: reviewer: ( )

+[#]: publisher: ( )

+[#]: url: ( )

+[#]: subject: (Best Audio Editors For Linux)

+[#]: via: (https://itsfoss.com/best-audio-editors-linux)

+[#]: author: (Ankush Das https://itsfoss.com/author/ankush/)

+

+Best Audio Editors For Linux

+======

+

+You’ve got a lot of choices when it comes to audio editors for Linux. No matter whether you are a professional music producer or just learning to create awesome music, the audio editors will always come in handy.

+

+Well, for professional-grade usage, a [DAW][1] (Digital Audio Workstation) is always recommended. However, not everyone needs all the functionalities, so you should know about some of the most simple audio editors as well.

+

+In this article, we will talk about a couple of DAWs and basic audio editors which are available as **free and open source** solutions for Linux and (probably) for other operating systems.

+

+### Top Audio Editors for Linux

+

+![Best audio editors and DAW for Linux][2]

+

+We will not be focusing on all the functionalities that DAWs offer – but the basic audio editing capabilities. You may still consider this as the list of best DAW for Linux.

+

+**Installation instruction:** You will find all the mentioned audio editors or DAWs in your AppCenter or Software center. In case, you do not find them listed, please head to their official website for more information.

+

+#### 1\. Audacity

+

+![audacity audio editor][3]

+

+Audacity is one of the most basic yet a capable audio editor available for Linux. It is a free and open-source cross-platform tool. A lot of you must be already knowing about it.

+

+It has improved a lot when compared to the time when it started trending. I do recall that I utilized it to “try” making karaokes by removing the voice from an audio file. Well, you can still do it – but it depends.

+

+**Features:**

+

+It also supports plug-ins that include VST effects. Of course, you should not expect it to support VST Instruments.

+

+ * Live audio recording through a microphone or a mixer

+ * Export/Import capability supporting multiple formats and multiple files at the same time

+ * Plugin support: LADSPA, LV2, Nyquist, VST and Audio Unit effect plug-ins

+ * Easy editing with cut, paste, delete and copy functions.

+ * Spectogram view mode for analyzing frequencies

+

+

+

+#### 2\. LMMS

+

+![][4]

+

+LMMS is a free and open source (cross-platform) digital audio workstation. It includes all the basic audio editing functionalities along with a lot of advanced features.

+

+You can mix sounds, arrange them, or create them using VST instruments. It does support them. Also, it comes baked in with some samples, presets, VST Instruments, and effects to get started. In addition, you also get a spectrum analyzer for some advanced audio editing.

+

+**Features:**

+

+ * Note playback via MIDI

+ * VST Instrument support

+ * Native multi-sample support

+ * Built-in compressor, limiter, delay, reverb, distortion and bass enhancer

+

+

+

+#### 3\. Ardour

+

+![Ardour audio editor][5]

+

+Ardour is yet another free and open source digital audio workstation. If you have an audio interface, Ardour will support it. Of course, you can add unlimited multichannel tracks. The multichannel tracks can also be routed to different mixer tapes for the ease of editing and recording.

+

+You can also import a video to it and edit the audio to export the whole thing. It comes with a lot of built-in plugins and supports VST plugins as well.

+

+**Features:**

+

+ * Non-linear editing

+ * Vertical window stacking for easy navigation

+ * Strip silence, push-pull trimming, Rhythm Ferret for transient and note onset-based editing

+

+

+

+#### 4\. Cecilia

+

+![cecilia audio editor][6]

+

+Cecilia is not an ordinary audio editor application. It is meant to be used by sound designers or if you are just in the process of becoming one. It is technically an audio signal processing environment. It lets you create ear-bending sound out of them.

+

+You get in-build modules and plugins for sound effects and synthesis. It is tailored for a specific use – if that is what you were looking for – look no further!

+

+**Features:**

+

+ * Modules to achieve more (UltimateGrainer – A state-of-the-art granulation processing, RandomAccumulator – Variable speed recording accumulator,

+UpDistoRes – Distortion with upsampling and resonant lowpass filter)

+ * Automatic Saving of modulations

+

+

+

+#### 5\. Mixxx

+

+![Mixxx audio DJ ][7]

+

+If you want to mix and record something while being able to have a virtual DJ tool, [Mixxx][8] would be a perfect tool. You get to know the BPM, key, and utilize the master sync feature to match the tempo and beats of a song. Also, do not forget that it is yet another free and open source application for Linux!

+

+It supports custom DJ equipment as well. So, if you have one or a MIDI – you can record your live mixes using this tool.

+

+**Features**

+

+ * Broadcast and record DJ Mixes of your song

+ * Ability to connect your equipment and perform live

+ * Key detection and BPM detection

+

+

+

+#### 6\. Rosegarden

+

+![rosegarden audio editor][9]

+

+Rosegarden is yet another impressive audio editor for Linux which is free and open source. It is neither a fully featured DAW nor a basic audio editing tool. It is a mixture of both with some scaled down functionalities.

+

+I wouldn’t recommend this for professionals but if you have a home studio or just want to experiment, this would be one of the best audio editors for Linux to have installed.

+

+**Features:**

+

+ * Music notation editing

+ * Recording, Mixing, and samples

+

+

+

+### Wrapping Up

+

+These are some of the best audio editors you could find out there for Linux. No matter whether you need a DAW, a cut-paste editing tool, or a basic mixing/recording audio editor, the above-mentioned tools should help you out.

+

+Did we miss any of your favorite? Let us know about it in the comments below.

+

+

+--------------------------------------------------------------------------------

+

+via: https://itsfoss.com/best-audio-editors-linux

+

+作者:[Ankush Das][a]

+选题:[lujun9972][b]

+译者:[译者ID](https://github.com/译者ID)

+校对:[校对者ID](https://github.com/校对者ID)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://itsfoss.com/author/ankush/

+[b]: https://github.com/lujun9972

+[1]: https://en.wikipedia.org/wiki/Digital_audio_workstation

+[2]: https://i1.wp.com/itsfoss.com/wp-content/uploads/2019/01/linux-audio-editors-800x450.jpeg?resize=800%2C450&ssl=1

+[3]: https://i2.wp.com/itsfoss.com/wp-content/uploads/2019/01/audacity-audio-editor.jpg?fit=800%2C591&ssl=1

+[4]: https://i2.wp.com/itsfoss.com/wp-content/uploads/2019/01/lmms-daw.jpg?fit=800%2C472&ssl=1

+[5]: https://i2.wp.com/itsfoss.com/wp-content/uploads/2019/01/ardour-audio-editor.jpg?fit=800%2C639&ssl=1

+[6]: https://i1.wp.com/itsfoss.com/wp-content/uploads/2019/01/cecilia.jpg?fit=800%2C510&ssl=1

+[7]: https://i0.wp.com/itsfoss.com/wp-content/uploads/2019/01/mixxx.jpg?fit=800%2C486&ssl=1

+[8]: https://itsfoss.com/dj-mixxx-2/

+[9]: https://i2.wp.com/itsfoss.com/wp-content/uploads/2019/01/rosegarden.jpg?fit=800%2C391&ssl=1

+[10]: https://i2.wp.com/itsfoss.com/wp-content/uploads/2019/01/linux-audio-editors.jpeg?fit=800%2C450&ssl=1

diff --git a/sources/tech/20190116 GameHub - An Unified Library To Put All Games Under One Roof.md b/sources/tech/20190116 GameHub - An Unified Library To Put All Games Under One Roof.md

new file mode 100644

index 0000000000..bdaae74b43

--- /dev/null

+++ b/sources/tech/20190116 GameHub - An Unified Library To Put All Games Under One Roof.md

@@ -0,0 +1,139 @@

+[#]: collector: (lujun9972)

+[#]: translator: ( )

+[#]: reviewer: ( )

+[#]: publisher: ( )

+[#]: url: ( )

+[#]: subject: (GameHub – An Unified Library To Put All Games Under One Roof)

+[#]: via: (https://www.ostechnix.com/gamehub-an-unified-library-to-put-all-games-under-one-roof/)

+[#]: author: (SK https://www.ostechnix.com/author/sk/)

+

+GameHub – An Unified Library To Put All Games Under One Roof

+======

+

+

+

+**GameHub** is an unified gaming library that allows you to view, install, run and remove games on GNU/Linux operating system. It supports both native and non-native games from various sources including Steam, GOG, Humble Bundle, and Humble Trove etc. The non-native games are supported by [Wine][1], Proton, [DOSBox][2], ScummVM and RetroArch. It also allows you to add custom emulators and download bonus content and DLCs for GOG games. Simply put, Gamehub is a frontend for Steam/GoG/Humblebundle/Retroarch. It can use steam technologies like Proton to run windows gog games. GameHub is free, open source gaming platform written in **Vala** using **GTK+3**. If you’re looking for a way to manage all games under one roof, GameHub might be a good choice.

+

+### Installing GameHub

+

+The author of GameHub has designed it specifically for elementary OS. So, you can install it on Debian, Ubuntu, elementary OS and other Ubuntu-derivatives using GameHub PPA.

+

+```

+$ sudo apt install --no-install-recommends software-properties-common

+$ sudo add-apt-repository ppa:tkashkin/gamehub

+$ sudo apt update

+$ sudo apt install com.github.tkashkin.gamehub

+```

+

+GameHub is available in [**AUR**][3], so just install it on Arch Linux and its variants using any AUR helpers, for example [**YaY**][4].

+

+```

+$ yay -S gamehub-git

+```

+

+It is also available as **AppImage** and **Flatpak** packages in [**releases page**][5].

+

+If you prefer AppImage package, do the following:

+

+```

+$ wget https://github.com/tkashkin/GameHub/releases/download/0.12.1-91-dev/GameHub-bionic-0.12.1-91-dev-cd55bb5-x86_64.AppImage -O gamehub

+```

+

+Make it executable:

+

+```

+$ chmod +x gamehub

+```

+

+And, run GameHub using command:

+

+```

+$ ./gamehub

+```

+

+If you want to use Flatpak installer, run the following commands one by one.

+

+```

+$ git clone https://github.com/tkashkin/GameHub.git

+$ cd GameHub

+$ scripts/build.sh build_flatpak

+```

+

+### Put All Games Under One Roof

+

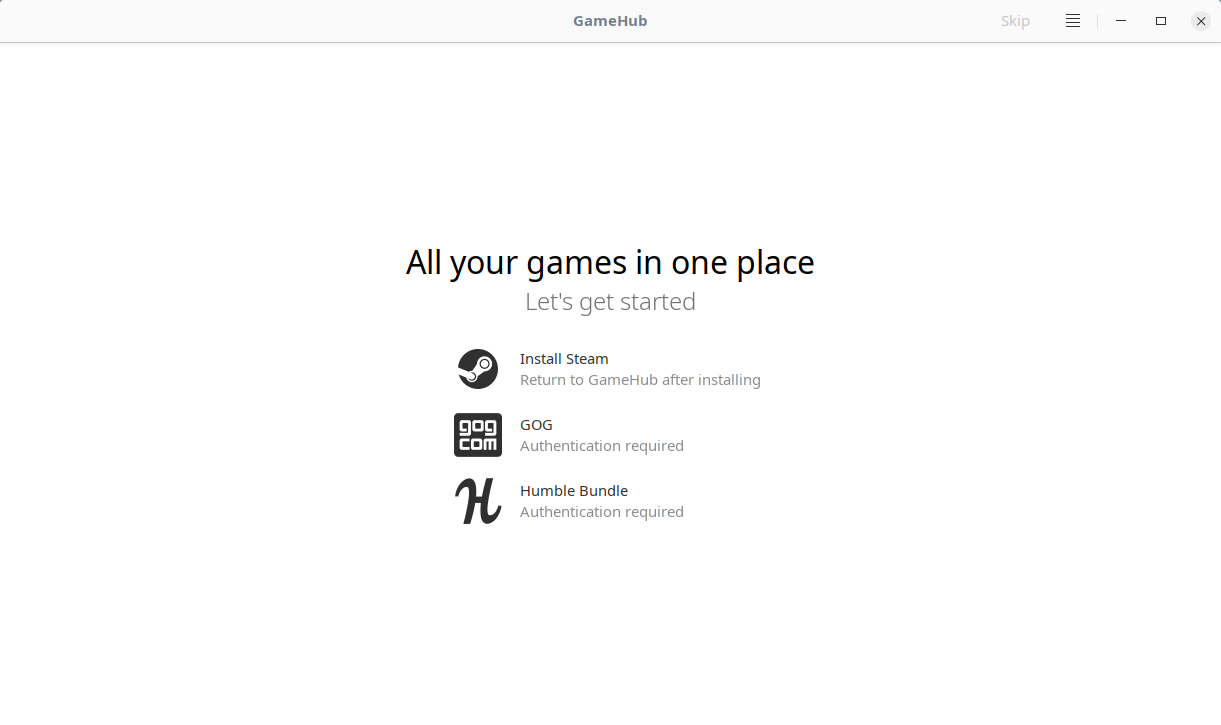

+Launch GameHub from menu or application launcher. At first launch, you will see the following welcome screen.

+

+

+

+As you can see in the above screenshot, you need to login to the given sources namely Steam, GoG or Humble Bundle. If you don’t have Steam client on your Linux system, you need to install it first to access your steam account. For GoG and Humble bundle sources, click on the icon to log in to the respective source.

+

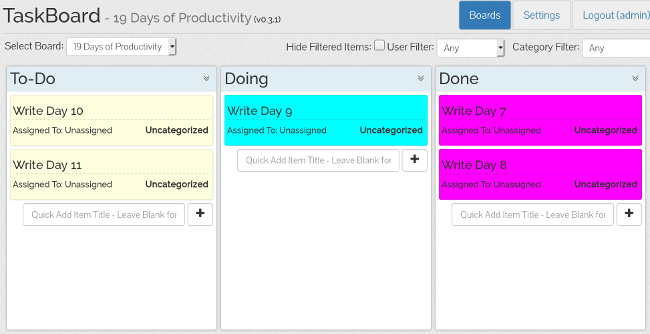

+Once you logged in to your account(s), all games from the all sources can be visible on GameHub dashboard.

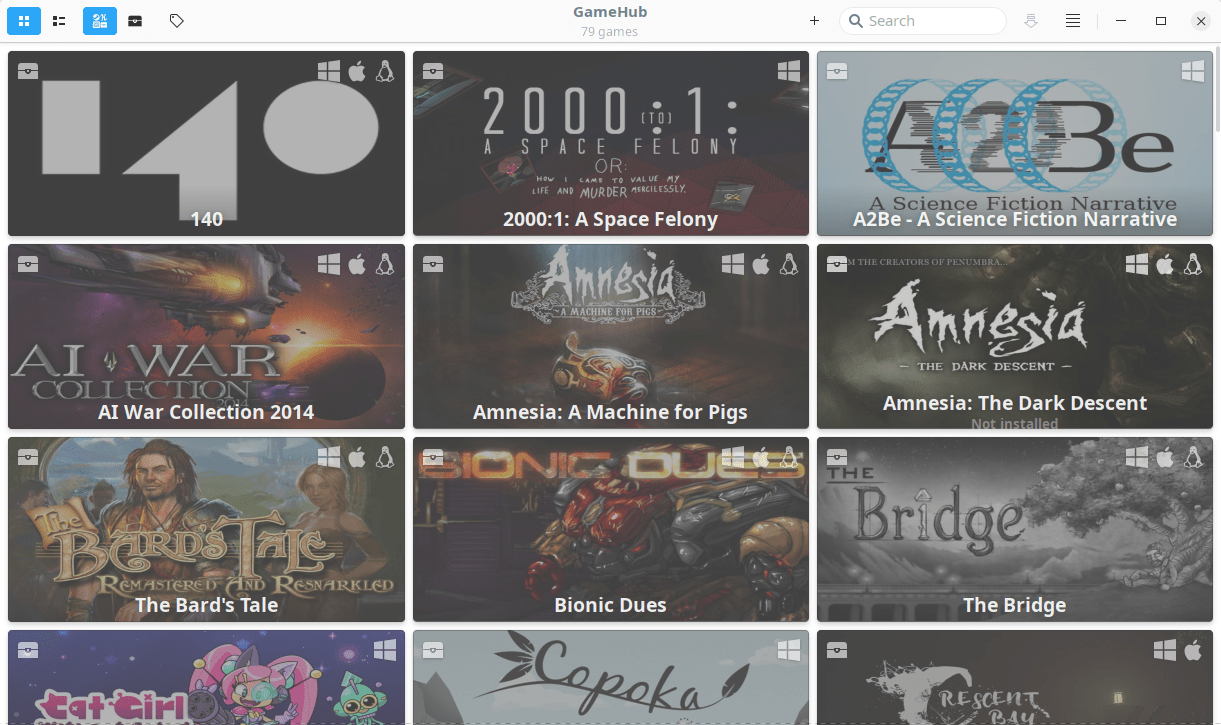

+

+

+

+You will see list of logged-in sources on the top left corner. To view the games from each source, just click on the respective icon.

+

+You can also switch between list view or grid view, sort the games by applying the filters and search games from the list in GameHub dashboard.

+

+#### Installing a game

+

+Click on the game of your choice from the list and click Install button. If the game is non-native, GameHub will automatically choose the compatibility layer (E.g Wine) that suits to run the game and install the selected game. As you see in the below screenshot, Indiana Jones game is not available for Linux platform.

+

+

+

+If it is a native game (i.e supports Linux), simply press the Install button.

+

+![][7]

+

+If you don’t want to install the game, just hit the **Download** button to save it in your games directory. It is also possible to add locally installed games to GameHub using the **Import** option.

+

+

+

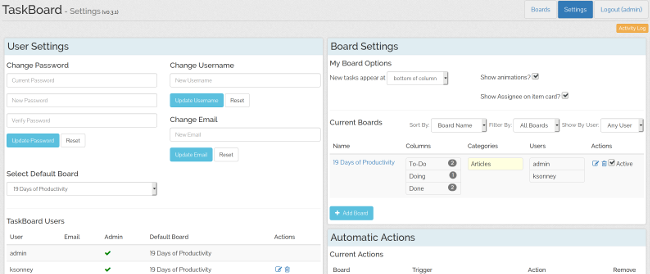

+#### GameHub Settings

+

+GameHub Settings window can be launched by clicking on the four straight lines on top right corner.

+

+From Settings section, we can enable, disable and set various settings such as,

+

+ * Switch between light/dark themes.

+ * Use Symbolic icons instead of colored icons for games.

+ * Switch to compact list.

+ * Enable/disable merging games from different sources.

+ * Enable/disable compatibility layers.

+ * Set games collection directory. The default directory for storing the collection is **$HOME/Games/_Collection**.

+ * Set games directories for each source.

+ * Add/remove emulators,

+ * And many.

+

+

+

+For more details, refer the project links given at the end of this guide.

+

+**Related read:**

+

+And, that’s all for now. Hope this helps. I will be soon here with another guide. Until then, stay tuned with OSTechNix.

+

+Cheers!

+

+

+

+--------------------------------------------------------------------------------

+

+via: https://www.ostechnix.com/gamehub-an-unified-library-to-put-all-games-under-one-roof/

+

+作者:[SK][a]

+选题:[lujun9972][b]

+译者:[译者ID](https://github.com/译者ID)

+校对:[校对者ID](https://github.com/校对者ID)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://www.ostechnix.com/author/sk/

+[b]: https://github.com/lujun9972

+[1]: https://www.ostechnix.com/run-windows-games-softwares-ubuntu-16-04/

+[2]: https://www.ostechnix.com/how-to-run-ms-dos-games-and-programs-in-linux/

+[3]: https://aur.archlinux.org/packages/gamehub-git/

+[4]: https://www.ostechnix.com/yay-found-yet-another-reliable-aur-helper/

+[5]: https://github.com/tkashkin/GameHub/releases

+[6]: data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7

+[7]: http://www.ostechnix.com/wp-content/uploads/2019/01/gamehub4.png

diff --git a/sources/tech/20190116 The Evil-Twin Framework- A tool for improving WiFi security.md b/sources/tech/20190116 The Evil-Twin Framework- A tool for improving WiFi security.md

new file mode 100644

index 0000000000..81b5d2ddf1

--- /dev/null

+++ b/sources/tech/20190116 The Evil-Twin Framework- A tool for improving WiFi security.md

@@ -0,0 +1,236 @@

+[#]: collector: (lujun9972)

+[#]: translator: ( )

+[#]: reviewer: ( )

+[#]: publisher: ( )

+[#]: url: ( )

+[#]: subject: (The Evil-Twin Framework: A tool for improving WiFi security)

+[#]: via: (https://opensource.com/article/19/1/evil-twin-framework)

+[#]: author: (André Esser https://opensource.com/users/andreesser)

+

+The Evil-Twin Framework: A tool for improving WiFi security

+======

+Learn about a pen-testing tool intended to test the security of WiFi access points for all types of threats.

+

+

+The increasing number of devices that connect over-the-air to the internet over-the-air and the wide availability of WiFi access points provide many opportunities for attackers to exploit users. By tricking users to connect to [rogue access points][1], hackers gain full control over the users' network connection, which allows them to sniff and alter traffic, redirect users to malicious sites, and launch other attacks over the network..

+

+To protect users and teach them to avoid risky online behaviors, security auditors and researchers must evaluate users' security practices and understand the reasons they connect to WiFi access points without being confident they are safe. There are a significant number of tools that can conduct WiFi audits, but no single tool can test the many different attack scenarios and none of the tools integrate well with one another.

+

+The **Evil-Twin Framework** (ETF) aims to fix these problems in the WiFi auditing process by enabling auditors to examine multiple scenarios and integrate multiple tools. This article describes the framework and its functionalities, then provides some examples to show how it can be used.

+

+### The ETF architecture

+

+The ETF framework was written in [Python][2] because the development language is very easy to read and make contributions to. In addition, many of the ETF's libraries, such as **[Scapy][3]** , were already developed for Python, making it easy to use them for ETF.

+

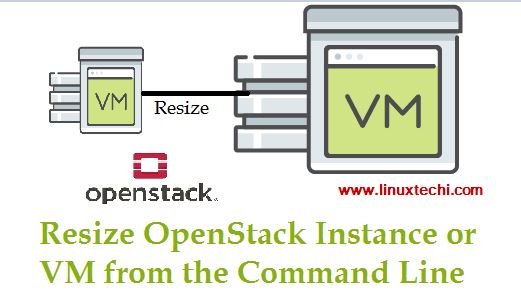

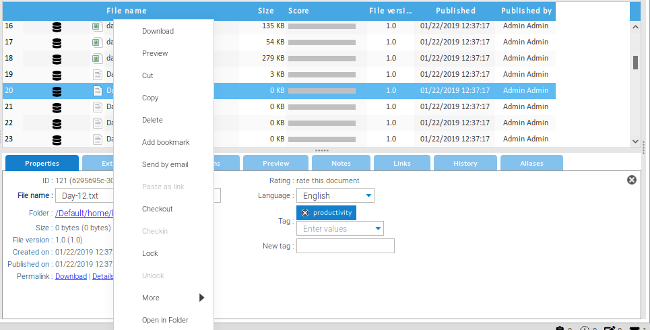

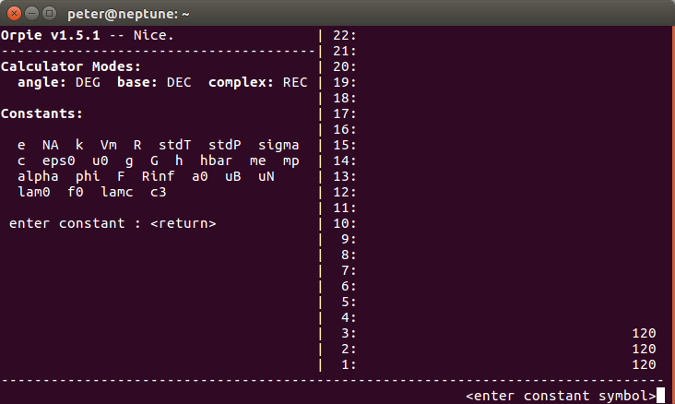

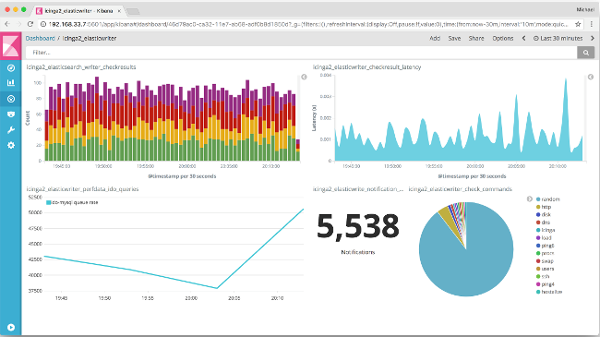

+The ETF architecture (Figure 1) is divided into different modules that interact with each other. The framework's settings are all written in a single configuration file. The user can verify and edit the settings through the user interface via the **ConfigurationManager** class. Other modules can only read these settings and run according to them.

+

+![Evil-Twin Framework Architecture][5]

+

+Figure 1: Evil-Twin framework architecture

+

+The ETF supports multiple user interfaces that interact with the framework. The current default interface is an interactive console, similar to the one on [Metasploit][6]. A graphical user interface (GUI) and a command line interface (CLI) are under development for desktop/browser use, and mobile interfaces may be an option in the future. The user can edit the settings in the configuration file using the interactive console (and eventually with the GUI). The user interface can interact with every other module that exists in the framework.

+

+The WiFi module ( **AirCommunicator** ) was built to support a wide range of WiFi capabilities and attacks. The framework identifies three basic pillars of Wi-Fi communication: **packet sniffing** , **custom packet injection** , and **access point creation**. The three main WiFi communication modules are **AirScanner** , **AirInjector** , and **AirHost** , which are responsible for packet sniffing, packet injection, and access point creation, respectively. The three classes are wrapped inside the main WiFi module, AirCommunicator, which reads the configuration file before starting the services. Any type of WiFi attack can be built using one or more of these core features.

+

+To enable man-in-the-middle (MITM) attacks, which are a common way to attack WiFi clients, the framework has an integrated module called ETFITM (Evil-Twin Framework-in-the-Middle). This module is responsible for the creation of a web proxy used to intercept and manipulate HTTP/HTTPS traffic.

+

+There are many other tools that can leverage the MITM position created by the ETF. Through its extensibility, ETF can support them—and, instead of having to call them separately, you can add the tools to the framework just by extending the Spawner class. This enables a developer or security auditor to call the program with a preconfigured argument string from within the framework.

+

+The other way to extend the framework is through plugins. There are two categories of plugins: **WiFi plugins** and **MITM plugins**. MITM plugins are scripts that can run while the MITM proxy is active. The proxy passes the HTTP(S) requests and responses through to the plugins where they can be logged or manipulated. WiFi plugins follow a more complex flow of execution but still expose a fairly simple API to contributors who wish to develop and use their own plugins. WiFi plugins can be further divided into three categories, one for each of the core WiFi communication modules.

+

+Each of the core modules has certain events that trigger the execution of a plugin. For instance, AirScanner has three defined events to which a response can be programmed. The events usually correspond to a setup phase before the service starts running, a mid-execution phase while the service is running, and a teardown or cleanup phase after a service finishes. Since Python allows multiple inheritance, one plugin can subclass more than one plugin class.

+

+Figure 1 above is a summary of the framework's architecture. Lines pointing away from the ConfigurationManager mean that the module reads information from it and lines pointing towards it mean that the module can write/edit configurations.

+

+### Examples of using the Evil-Twin Framework

+

+There are a variety of ways ETF can conduct penetration testing on WiFi network security or work on end users' awareness of WiFi security. The following examples describe some of the framework's pen-testing functionalities, such as access point and client detection, WPA and WEP access point attacks, and evil twin access point creation.

+

+These examples were devised using ETF with WiFi cards that allow WiFi traffic capture. They also utilize the following abbreviations for ETF setup commands:

+

+ * **APS** access point SSID

+ * **APB** access point BSSID

+ * **APC** access point channel

+ * **CM** client MAC address

+

+

+

+In a real testing scenario, make sure to replace these abbreviations with the correct information.

+

+#### Capturing a WPA 4-way handshake after a de-authentication attack

+

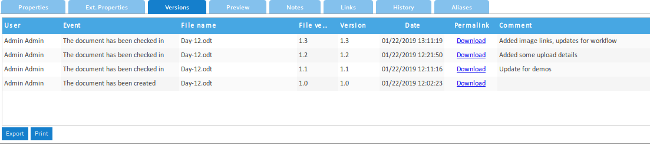

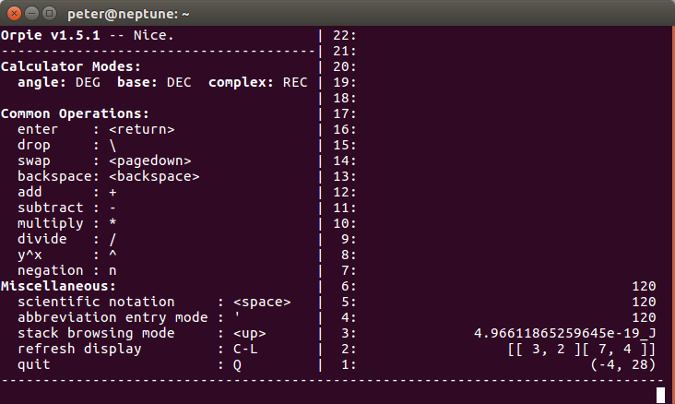

+This scenario (Figure 2) takes two aspects into consideration: the de-authentication attack and the possibility of catching a 4-way WPA handshake. The scenario starts with a running WPA/WPA2-enabled access point with one connected client device (in this case, a smartphone). The goal is to de-authenticate the client with a general de-authentication attack then capture the WPA handshake once it tries to reconnect. The reconnection will be done manually immediately after being de-authenticated.

+

+![Scenario for capturing a WPA handshake after a de-authentication attack][8]

+

+Figure 2: Scenario for capturing a WPA handshake after a de-authentication attack

+

+The consideration in this example is the ETF's reliability. The goal is to find out if the tools can consistently capture the WPA handshake. The scenario will be performed multiple times with each tool to check its reliability when capturing the WPA handshake.

+

+There is more than one way to capture a WPA handshake using the ETF. One way is to use a combination of the AirScanner and AirInjector modules; another way is to just use the AirInjector. The following scenario uses a combination of both modules.

+

+The ETF launches the AirScanner module and analyzes the IEEE 802.11 frames to find a WPA handshake. Then the AirInjector can launch a de-authentication attack to force a reconnection. The following steps must be done to accomplish this on the ETF:

+

+ 1. Enter the AirScanner configuration mode: **config airscanner**

+ 2. Configure the AirScanner to not hop channels: **config airscanner**

+ 3. Set the channel to sniff the traffic on the access point channel (APC): **set fixed_sniffing_channel = **

+ 4. Start the AirScanner module with the CredentialSniffer plugin: **start airscanner with credentialsniffer**

+ 5. Add a target access point BSSID (APS) from the sniffed access points list: **add aps where ssid = **

+ 6. Start the AirInjector, which by default lauches the de-authentication attack: **start airinjector**

+

+

+

+This simple set of commands enables the ETF to perform an efficient and successful de-authentication attack on every test run. The ETF can also capture the WPA handshake on every test run. The following code makes it possible to observe the ETF's successful execution.

+

+```

+███████╗████████╗███████╗

+██╔════╝╚══██╔══╝██╔════╝

+█████╗ ██║ █████╗

+██╔══╝ ██║ ██╔══╝

+███████╗ ██║ ██║

+╚══════╝ ╚═╝ ╚═╝

+

+

+[+] Do you want to load an older session? [Y/n]: n

+[+] Creating new temporary session on 02/08/2018

+[+] Enter the desired session name:

+ETF[etf/aircommunicator/]::> config airscanner

+ETF[etf/aircommunicator/airscanner]::> listargs

+ sniffing_interface = wlan1; (var)

+ probes = True; (var)

+ beacons = True; (var)

+ hop_channels = false; (var)

+fixed_sniffing_channel = 11; (var)

+ETF[etf/aircommunicator/airscanner]::> start airscanner with

+arpreplayer caffelatte credentialsniffer packetlogger selfishwifi

+ETF[etf/aircommunicator/airscanner]::> start airscanner with credentialsniffer

+[+] Successfully added credentialsniffer plugin.

+[+] Starting packet sniffer on interface 'wlan1'

+[+] Set fixed channel to 11

+ETF[etf/aircommunicator/airscanner]::> add aps where ssid = CrackWPA

+ETF[etf/aircommunicator/airscanner]::> start airinjector

+ETF[etf/aircommunicator/airscanner]::> [+] Starting deauthentication attack

+ - 1000 bursts of 1 packets

+ - 1 different packets

+[+] Injection attacks finished executing.

+[+] Starting post injection methods

+[+] Post injection methods finished

+[+] WPA Handshake found for client '70:3e:ac:bb:78:64' and network 'CrackWPA'

+```

+

+#### Launching an ARP replay attack and cracking a WEP network

+

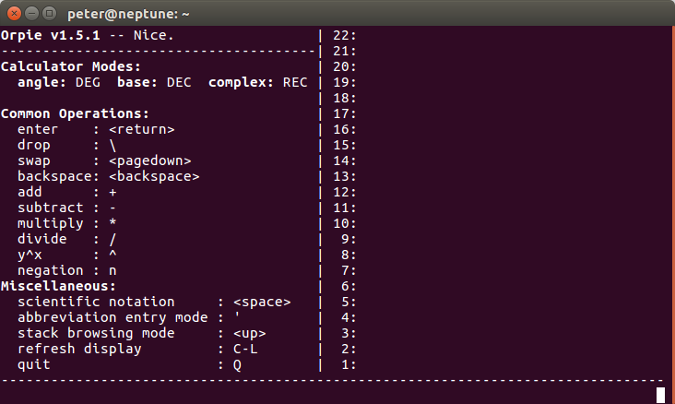

+The next scenario (Figure 3) will also focus on the [Address Resolution Protocol][9] (ARP) replay attack's efficiency and the speed of capturing the WEP data packets containing the initialization vectors (IVs). The same network may require a different number of caught IVs to be cracked, so the limit for this scenario is 50,000 IVs. If the network is cracked during the first test with less than 50,000 IVs, that number will be the new limit for the following tests on the network. The cracking tool to be used will be **aircrack-ng**.

+

+The test scenario starts with an access point using WEP encryption and an offline client that knows the key—the key for testing purposes is 12345, but it can be a larger and more complex key. Once the client connects to the WEP access point, it will send out a gratuitous ARP packet; this is the packet that's meant to be captured and replayed. The test ends once the limit of packets containing IVs is captured.

+

+![Scenario for capturing a WPA handshake after a de-authentication attack][11]

+

+Figure 3: Scenario for capturing a WPA handshake after a de-authentication attack

+

+ETF uses Python's Scapy library for packet sniffing and injection. To minimize known performance problems in Scapy, ETF tweaks some of its low-level libraries to significantly speed packet injection. For this specific scenario, the ETF uses **tcpdump** as a background process instead of Scapy for more efficient packet sniffing, while Scapy is used to identify the encrypted ARP packet.

+

+This scenario requires the following commands and operations to be performed on the ETF:

+

+ 1. Enter the AirScanner configuration mode: **config airscanner**

+ 2. Configure the AirScanner to not hop channels: **set hop_channels = false**

+ 3. Set the channel to sniff the traffic on the access point channel (APC): **set fixed_sniffing_channel = **

+ 4. Enter the ARPReplayer plugin configuration mode: **config arpreplayer**

+ 5. Set the target access point BSSID (APB) of the WEP network: **set target_ap_bssid **

+ 6. Start the AirScanner module with the ARPReplayer plugin: **start airscanner with arpreplayer**

+

+

+

+After executing these commands, ETF correctly identifies the encrypted ARP packet, then successfully performs an ARP replay attack, which cracks the network.

+

+#### Launching a catch-all honeypot

+

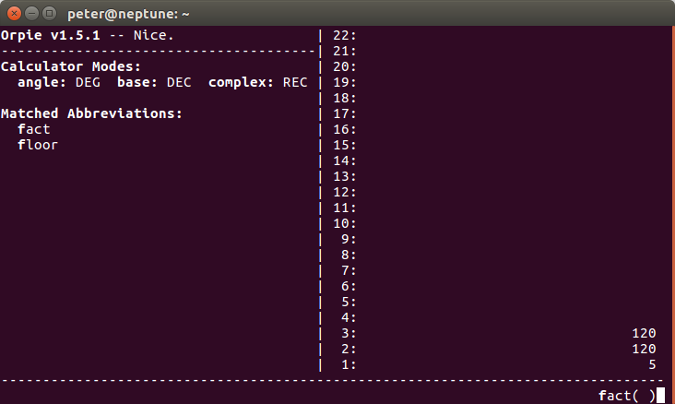

+The scenario in Figure 4 creates multiple access points with the same SSID. This technique discovers the encryption type of a network that was probed for but out of reach. By launching multiple access points with all security settings, the client will automatically connect to the one that matches the security settings of the locally cached access point information.

+

+![Scenario for capturing a WPA handshake after a de-authentication attack][13]

+

+Figure 4: Scenario for capturing a WPA handshake after a de-authentication attack

+

+Using the ETF, it is possible to configure the **hostapd** configuration file then launch the program in the background. Hostapd supports launching multiple access points on the same wireless card by configuring virtual interfaces, and since it supports all types of security configurations, a complete catch-all honeypot can be set up. For the WEP and WPA(2)-PSK networks, a default password is used, and for the WPA(2)-EAP, an "accept all" policy is configured.

+

+For this scenario, the following commands and operations must be performed on the ETF:

+

+ 1. Enter the APLauncher configuration mode: **config aplauncher**

+ 2. Set the desired access point SSID (APS): **set ssid = **

+ 3. Configure the APLauncher as a catch-all honeypot: **set catch_all_honeypot = true**

+ 4. Start the AirHost module: **start airhost**

+

+

+

+With these commands, the ETF can launch a complete catch-all honeypot with all types of security configurations. ETF also automatically launches the DHCP and DNS servers that allow clients to stay connected to the internet. ETF offers a better, faster, and more complete solution to create catch-all honeypots. The following code enables the successful execution of the ETF to be observed.

+

+```

+███████╗████████╗███████╗

+██╔════╝╚══██╔══╝██╔════╝

+█████╗ ██║ █████╗

+██╔══╝ ██║ ██╔══╝

+███████╗ ██║ ██║

+╚══════╝ ╚═╝ ╚═╝

+

+

+[+] Do you want to load an older session? [Y/n]: n

+[+] Creating ne´,cxzw temporary session on 03/08/2018

+[+] Enter the desired session name:

+ETF[etf/aircommunicator/]::> config aplauncher

+ETF[etf/aircommunicator/airhost/aplauncher]::> setconf ssid CatchMe

+ssid = CatchMe

+ETF[etf/aircommunicator/airhost/aplauncher]::> setconf catch_all_honeypot true

+catch_all_honeypot = true

+ETF[etf/aircommunicator/airhost/aplauncher]::> start airhost

+[+] Killing already started processes and restarting network services

+[+] Stopping dnsmasq and hostapd services

+[+] Access Point stopped...

+[+] Running airhost plugins pre_start

+[+] Starting hostapd background process

+[+] Starting dnsmasq service

+[+] Running airhost plugins post_start

+[+] Access Point launched successfully

+[+] Starting dnsmasq service

+```

+

+### Conclusions and future work

+

+These scenarios use common and well-known attacks to help validate the ETF's capabilities for testing WiFi networks and clients. The results also validate that the framework's architecture enables new attack vectors and features to be developed on top of it while taking advantage of the platform's existing capabilities. This should accelerate development of new WiFi penetration-testing tools, since a lot of the code is already written. Furthermore, the fact that complementary WiFi technologies are all integrated in a single tool will make WiFi pen-testing simpler and more efficient.

+

+The ETF's goal is not to replace existing tools but to complement them and offer a broader choice to security auditors when conducting WiFi pen-testing and improving user awareness.

+

+The ETF is an open source project [available on GitHub][14] and community contributions to its development are welcomed. Following are some of the ways you can help.

+

+One of the limitations of current WiFi pen-testing is the inability to log important events during tests. This makes reporting identified vulnerabilities both more difficult and less accurate. The framework could implement a logger that can be accessed by every class to create a pen-testing session report.

+

+The ETF tool's capabilities cover many aspects of WiFi pen-testing. On one hand, it facilitates the phases of WiFi reconnaissance, vulnerability discovery, and attack. On the other hand, it doesn't offer a feature that facilitates the reporting phase. Adding the concept of a session and a session reporting feature, such as the logging of important events during a session, would greatly increase the value of the tool for real pen-testing scenarios.

+

+Another valuable contribution would be extending the framework to facilitate WiFi fuzzing. The IEEE 802.11 protocol is very complex, and considering there are multiple implementations of it, both on the client and access point side, it's safe to assume these implementations contain bugs and even security flaws. These bugs could be discovered by fuzzing IEEE 802.11 protocol frames. Since Scapy allows custom packet creation and injection, a fuzzer can be implemented through it.

+

+--------------------------------------------------------------------------------

+

+via: https://opensource.com/article/19/1/evil-twin-framework

+

+作者:[André Esser][a]

+选题:[lujun9972][b]

+译者:[译者ID](https://github.com/译者ID)

+校对:[校对者ID](https://github.com/校对者ID)

+

+本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

+

+[a]: https://opensource.com/users/andreesser

+[b]: https://github.com/lujun9972

+[1]: https://en.wikipedia.org/wiki/Rogue_access_point

+[2]: https://www.python.org/

+[3]: https://scapy.net

+[4]: /file/417776

+[5]: https://opensource.com/sites/default/files/uploads/pic1.png (Evil-Twin Framework Architecture)

+[6]: https://www.metasploit.com

+[7]: /file/417781

+[8]: https://opensource.com/sites/default/files/uploads/pic2.png (Scenario for capturing a WPA handshake after a de-authentication attack)

+[9]: https://en.wikipedia.org/wiki/Address_Resolution_Protocol

+[10]: /file/417786

+[11]: https://opensource.com/sites/default/files/uploads/pic3.png (Scenario for capturing a WPA handshake after a de-authentication attack)

+[12]: /file/417791

+[13]: https://opensource.com/sites/default/files/uploads/pic4.png (Scenario for capturing a WPA handshake after a de-authentication attack)

+[14]: https://github.com/Esser420/EvilTwinFramework

diff --git a/sources/tech/20190116 Zipping files on Linux- the many variations and how to use them.md b/sources/tech/20190116 Zipping files on Linux- the many variations and how to use them.md

new file mode 100644

index 0000000000..fb98f78b06

--- /dev/null

+++ b/sources/tech/20190116 Zipping files on Linux- the many variations and how to use them.md

@@ -0,0 +1,324 @@

+[#]: collector: (lujun9972)

+[#]: translator: ( )

+[#]: reviewer: ( )