mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-02-25 00:50:15 +08:00

Merge branch 'master' of https://github.com/LCTT/TranslateProject

This commit is contained in:

commit

5efad69d01

189

published/20150708 Choosing a Linux Tracer (2015).md

Normal file

189

published/20150708 Choosing a Linux Tracer (2015).md

Normal file

@ -0,0 +1,189 @@

|

||||

Linux 跟踪器之选

|

||||

======

|

||||

|

||||

[![][1]][2]

|

||||

|

||||

> Linux 跟踪很神奇!

|

||||

|

||||

<ruby>跟踪器<rt>tracer</rt></ruby>是一个高级的性能分析和调试工具,如果你使用过 `strace(1)` 或者 `tcpdump(8)`,你不应该被它吓到 ... 你使用的就是跟踪器。系统跟踪器能让你看到很多的东西,而不仅是系统调用或者数据包,因为常见的跟踪器都可以跟踪内核或者应用程序的任何东西。

|

||||

|

||||

有大量的 Linux 跟踪器可供你选择。由于它们中的每个都有一个官方的(或者非官方的)的吉祥物,我们有足够多的选择给孩子们展示。

|

||||

|

||||

你喜欢使用哪一个呢?

|

||||

|

||||

我从两类读者的角度来回答这个问题:大多数人和性能/内核工程师。当然,随着时间的推移,这也可能会发生变化,因此,我需要及时去更新本文内容,或许是每年一次,或者更频繁。(LCTT 译注:本文最后更新于 2015 年)

|

||||

|

||||

### 对于大多数人

|

||||

|

||||

大多数人(开发者、系统管理员、运维人员、网络可靠性工程师(SRE)…)是不需要去学习系统跟踪器的底层细节的。以下是你需要去了解和做的事情:

|

||||

|

||||

#### 1. 使用 perf_events 进行 CPU 剖析

|

||||

|

||||

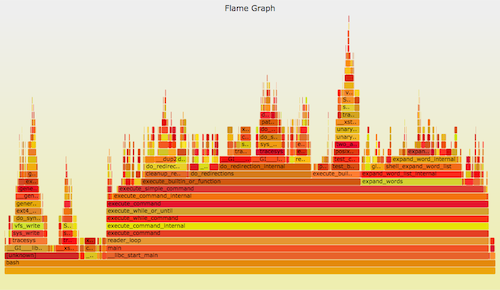

可以使用 perf_events 进行 CPU <ruby>剖析<rt>profiling</rt></ruby>。它可以用一个 [火焰图][3] 来形象地表示。比如:

|

||||

|

||||

```

|

||||

git clone --depth 1 https://github.com/brendangregg/FlameGraph

|

||||

perf record -F 99 -a -g -- sleep 30

|

||||

perf script | ./FlameGraph/stackcollapse-perf.pl | ./FlameGraph/flamegraph.pl > perf.svg

|

||||

```

|

||||

|

||||

|

||||

|

||||

Linux 的 perf_events(即 `perf`,后者是它的命令)是官方为 Linux 用户准备的跟踪器/分析器。它位于内核源码中,并且维护的非常好(而且现在它的功能还在快速变强)。它一般是通过 linux-tools-common 这个包来添加的。

|

||||

|

||||

`perf` 可以做的事情很多,但是,如果我只能建议你学习其中的一个功能的话,那就是 CPU 剖析。虽然从技术角度来说,这并不是事件“跟踪”,而是<ruby>采样<rt>sampling</rt></ruby>。最难的部分是获得完整的栈和符号,这部分在我的 [Linux Profiling at Netflix][4] 中针对 Java 和 Node.js 讨论过。

|

||||

|

||||

#### 2. 知道它能干什么

|

||||

|

||||

正如一位朋友所说的:“你不需要知道 X 光机是如何工作的,但你需要明白的是,如果你吞下了一个硬币,X 光机是你的一个选择!”你需要知道使用跟踪器能够做什么,因此,如果你在业务上确实需要它,你可以以后再去学习它,或者请会使用它的人来做。

|

||||

|

||||

简单地说:几乎任何事情都可以通过跟踪来了解它。内部文件系统、TCP/IP 处理过程、设备驱动、应用程序内部情况。阅读我在 lwn.net 上的 [ftrace][5] 的文章,也可以去浏览 [perf_events 页面][6],那里有一些跟踪(和剖析)能力的示例。

|

||||

|

||||

#### 3. 需要一个前端工具

|

||||

|

||||

如果你要购买一个性能分析工具(有许多公司销售这类产品),并要求支持 Linux 跟踪。想要一个直观的“点击”界面去探查内核的内部,以及包含一个在不同堆栈位置的延迟热力图。就像我在 [Monitorama 演讲][7] 中描述的那样。

|

||||

|

||||

我创建并开源了我自己的一些前端工具,虽然它是基于 CLI 的(不是图形界面的)。这样可以使其它人使用跟踪器更快更容易。比如,我的 [perf-tools][8],跟踪新进程是这样的:

|

||||

|

||||

```

|

||||

# ./execsnoop

|

||||

Tracing exec()s. Ctrl-C to end.

|

||||

PID PPID ARGS

|

||||

22898 22004 man ls

|

||||

22905 22898 preconv -e UTF-8

|

||||

22908 22898 pager -s

|

||||

22907 22898 nroff -mandoc -rLL=164n -rLT=164n -Tutf8

|

||||

[...]

|

||||

```

|

||||

|

||||

在 Netflix 公司,我正在开发 [Vector][9],它是一个实例分析工具,实际上它也是一个 Linux 跟踪器的前端。

|

||||

|

||||

### 对于性能或者内核工程师

|

||||

|

||||

一般来说,我们的工作都非常难,因为大多数人或许要求我们去搞清楚如何去跟踪某个事件,以及因此需要选择使用哪个跟踪器。为完全理解一个跟踪器,你通常需要花至少一百多个小时去使用它。理解所有的 Linux 跟踪器并能在它们之间做出正确的选择是件很难的事情。(我或许是唯一接近完成这件事的人)

|

||||

|

||||

在这里我建议选择如下,要么:

|

||||

|

||||

A)选择一个全能的跟踪器,并以它为标准。这需要在一个测试环境中花大量的时间来搞清楚它的细微差别和安全性。我现在的建议是 SystemTap 的最新版本(例如,从 [源代码][10] 构建)。我知道有的公司选择的是 LTTng ,尽管它并不是很强大(但是它很安全),但他们也用的很好。如果在 `sysdig` 中添加了跟踪点或者是 kprobes,它也是另外的一个候选者。

|

||||

|

||||

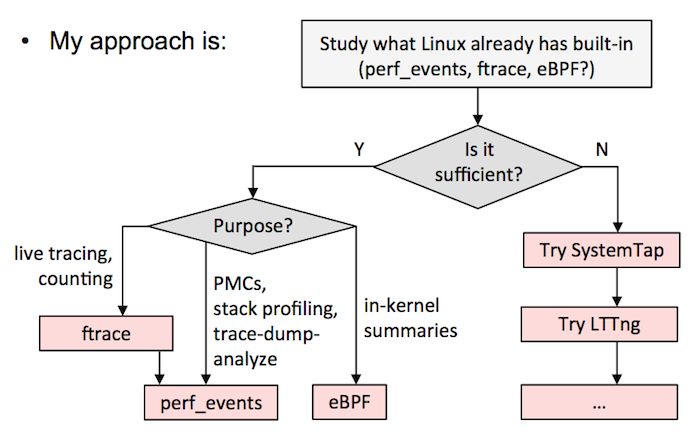

B)按我的 [Velocity 教程中][11] 的流程图。这意味着尽可能使用 ftrace 或者 perf_events,eBPF 已经集成到内核中了,然后用其它的跟踪器,如 SystemTap/LTTng 作为对 eBPF 的补充。我目前在 Netflix 的工作中就是这么做的。

|

||||

|

||||

|

||||

|

||||

以下是我对各个跟踪器的评价:

|

||||

|

||||

#### 1. ftrace

|

||||

|

||||

我爱 [ftrace][12],它是内核黑客最好的朋友。它被构建进内核中,它能够利用跟踪点、kprobes、以及 uprobes,以提供一些功能:使用可选的过滤器和参数进行事件跟踪;事件计数和计时,内核概览;<ruby>函数流步进<rt>function-flow walking</rt></ruby>。关于它的示例可以查看内核源代码树中的 [ftrace.txt][13]。它通过 `/sys` 来管理,是面向单一的 root 用户的(虽然你可以使用缓冲实例以让其支持多用户),它的界面有时很繁琐,但是它比较容易<ruby>调校<rt>hackable</rt></ruby>,并且有个前端:ftrace 的主要创建者 Steven Rostedt 设计了一个 trace-cmd,而且我也创建了 perf-tools 集合。我最诟病的就是它不是<ruby>可编程的<rt>programmable</rt></ruby>,因此,举个例子说,你不能保存和获取时间戳、计算延迟,以及将其保存为直方图。你需要转储事件到用户级以便于进行后期处理,这需要花费一些成本。它也许可以通过 eBPF 实现可编程。

|

||||

|

||||

#### 2. perf_events

|

||||

|

||||

[perf_events][14] 是 Linux 用户的主要跟踪工具,它的源代码位于 Linux 内核中,一般是通过 linux-tools-common 包来添加的。它又称为 `perf`,后者指的是它的前端,它相当高效(动态缓存),一般用于跟踪并转储到一个文件中(perf.data),然后可以在之后进行后期处理。它可以做大部分 ftrace 能做的事情。它不能进行函数流步进,并且不太容易调校(而它的安全/错误检查做的更好一些)。但它可以做剖析(采样)、CPU 性能计数、用户级的栈转换、以及使用本地变量利用<ruby>调试信息<rt>debuginfo</rt></ruby>进行<ruby>行级跟踪<rt>line tracing</rt></ruby>。它也支持多个并发用户。与 ftrace 一样,它也不是内核可编程的,除非 eBPF 支持(补丁已经在计划中)。如果只学习一个跟踪器,我建议大家去学习 perf,它可以解决大量的问题,并且它也相当安全。

|

||||

|

||||

#### 3. eBPF

|

||||

|

||||

<ruby>扩展的伯克利包过滤器<rt>extended Berkeley Packet Filter</rt></ruby>(eBPF)是一个<ruby>内核内<rt>in-kernel</rt></ruby>的虚拟机,可以在事件上运行程序,它非常高效(JIT)。它可能最终为 ftrace 和 perf_events 提供<ruby>内核内编程<rt>in-kernel programming</rt></ruby>,并可以去增强其它跟踪器。它现在是由 Alexei Starovoitov 开发的,还没有实现完全的整合,但是对于一些令人印象深刻的工具,有些内核版本(比如,4.1)已经支持了:比如,块设备 I/O 的<ruby>延迟热力图<rt>latency heat map</rt></ruby>。更多参考资料,请查阅 Alexei 的 [BPF 演示][15],和它的 [eBPF 示例][16]。

|

||||

|

||||

#### 4. SystemTap

|

||||

|

||||

[SystemTap][17] 是一个非常强大的跟踪器。它可以做任何事情:剖析、跟踪点、kprobes、uprobes(它就来自 SystemTap)、USDT、内核内编程等等。它将程序编译成内核模块并加载它们 —— 这是一种很难保证安全的方法。它开发是在内核代码树之外进行的,并且在过去出现过很多问题(内核崩溃或冻结)。许多并不是 SystemTap 的过错 —— 它通常是首次对内核使用某些跟踪功能,并率先遇到 bug。最新版本的 SystemTap 是非常好的(你需要从它的源代码编译),但是,许多人仍然没有从早期版本的问题阴影中走出来。如果你想去使用它,花一些时间去测试环境,然后,在 irc.freenode.net 的 #systemtap 频道与开发者进行讨论。(Netflix 有一个容错架构,我们使用了 SystemTap,但是我们或许比起你来说,更少担心它的安全性)我最诟病的事情是,它似乎假设你有办法得到内核调试信息,而我并没有这些信息。没有它我实际上可以做很多事情,但是缺少相关的文档和示例(我现在自己开始帮着做这些了)。

|

||||

|

||||

#### 5. LTTng

|

||||

|

||||

[LTTng][18] 对事件收集进行了优化,性能要好于其它的跟踪器,也支持许多的事件类型,包括 USDT。它的开发是在内核代码树之外进行的。它的核心部分非常简单:通过一个很小的固定指令集写入事件到跟踪缓冲区。这样让它既安全又快速。缺点是做内核内编程不太容易。我觉得那不是个大问题,由于它优化的很好,可以充分的扩展,尽管需要后期处理。它也探索了一种不同的分析技术。很多的“黑匣子”记录了所有感兴趣的事件,以便可以在 GUI 中以后分析它。我担心该记录会错失之前没有预料的事件,我真的需要花一些时间去看看它在实践中是如何工作的。这个跟踪器上我花的时间最少(没有特别的原因)。

|

||||

|

||||

#### 6. ktap

|

||||

|

||||

[ktap][19] 是一个很有前途的跟踪器,它在内核中使用了一个 lua 虚拟机,不需要调试信息和在嵌入时设备上可以工作的很好。这使得它进入了人们的视野,在某个时候似乎要成为 Linux 上最好的跟踪器。然而,由于 eBPF 开始集成到了内核,而 ktap 的集成工作被推迟了,直到它能够使用 eBPF 而不是它自己的虚拟机。由于 eBPF 在几个月过去之后仍然在集成过程中,ktap 的开发者已经等待了很长的时间。我希望在今年的晚些时间它能够重启开发。

|

||||

|

||||

#### 7. dtrace4linux

|

||||

|

||||

[dtrace4linux][20] 主要由一个人(Paul Fox)利用业务时间将 Sun DTrace 移植到 Linux 中的。它令人印象深刻,一些<ruby>供应器<rt>provider</rt></ruby>可以工作,还不是很完美,它最多应该算是实验性的工具(不安全)。我认为对于许可证的担心,使人们对它保持谨慎:它可能永远也进入不了 Linux 内核,因为 Sun 是基于 CDDL 许可证发布的 DTrace;Paul 的方法是将它作为一个插件。我非常希望看到 Linux 上的 DTrace,并且希望这个项目能够完成,我想我加入 Netflix 时将花一些时间来帮它完成。但是,我一直在使用内置的跟踪器 ftrace 和 perf_events。

|

||||

|

||||

#### 8. OL DTrace

|

||||

|

||||

[Oracle Linux DTrace][21] 是将 DTrace 移植到 Linux (尤其是 Oracle Linux)的重大努力。过去这些年的许多发布版本都一直稳定的进步,开发者甚至谈到了改善 DTrace 测试套件,这显示出这个项目很有前途。许多有用的功能已经完成:系统调用、剖析、sdt、proc、sched、以及 USDT。我一直在等待着 fbt(函数边界跟踪,对内核的动态跟踪),它将成为 Linux 内核上非常强大的功能。它最终能否成功取决于能否吸引足够多的人去使用 Oracle Linux(并为支持付费)。另一个羁绊是它并非完全开源的:内核组件是开源的,但用户级代码我没有看到。

|

||||

|

||||

#### 9. sysdig

|

||||

|

||||

[sysdig][22] 是一个很新的跟踪器,它可以使用类似 `tcpdump` 的语法来处理<ruby>系统调用<rt>syscall</rt></ruby>事件,并用 lua 做后期处理。它也是令人印象深刻的,并且很高兴能看到在系统跟踪领域的创新。它的局限性是,它的系统调用只能是在当时,并且,它转储所有事件到用户级进行后期处理。你可以使用系统调用来做许多事情,虽然我希望能看到它去支持跟踪点、kprobes、以及 uprobes。我也希望看到它支持 eBPF 以查看内核内概览。sysdig 的开发者现在正在增加对容器的支持。可以关注它的进一步发展。

|

||||

|

||||

### 深入阅读

|

||||

|

||||

我自己的工作中使用到的跟踪器包括:

|

||||

|

||||

- **ftrace** : 我的 [perf-tools][8] 集合(查看示例目录);我的 lwn.net 的 [ftrace 跟踪器的文章][5]; 一个 [LISA14][8] 演讲;以及帖子: [函数计数][23]、 [iosnoop][24]、 [opensnoop][25]、 [execsnoop][26]、 [TCP retransmits][27]、 [uprobes][28] 和 [USDT][29]。

|

||||

- **perf_events** : 我的 [perf_events 示例][6] 页面;在 SCALE 的一个 [Linux Profiling at Netflix][4] 演讲;和帖子:[CPU 采样][30]、[静态跟踪点][31]、[热力图][32]、[计数][33]、[内核行级跟踪][34]、[off-CPU 时间火焰图][35]。

|

||||

- **eBPF** : 帖子 [eBPF:一个小的进步][36],和一些 [BPF-tools][37] (我需要发布更多)。

|

||||

- **SystemTap** : 很久以前,我写了一篇 [使用 SystemTap][38] 的文章,它有点过时了。最近我发布了一些 [systemtap-lwtools][39],展示了在没有内核调试信息的情况下,SystemTap 是如何使用的。

|

||||

- **LTTng** : 我使用它的时间很短,不足以发布什么文章。

|

||||

- **ktap** : 我的 [ktap 示例][40] 页面包括一行程序和脚本,虽然它是早期的版本。

|

||||

- **dtrace4linux** : 在我的 [系统性能][41] 书中包含了一些示例,并且在过去我为了某些事情开发了一些小的修补,比如, [timestamps][42]。

|

||||

- **OL DTrace** : 因为它是对 DTrace 的直接移植,我早期 DTrace 的工作大多与之相关(链接太多了,可以去 [我的主页][43] 上搜索)。一旦它更加完美,我可以开发很多专用工具。

|

||||

- **sysdig** : 我贡献了 [fileslower][44] 和 [subsecond offset spectrogram][45] 的 chisel。

|

||||

- **其它** : 关于 [strace][46],我写了一些告诫文章。

|

||||

|

||||

不好意思,没有更多的跟踪器了! … 如果你想知道为什么 Linux 中的跟踪器不止一个,或者关于 DTrace 的内容,在我的 [从 DTrace 到 Linux][47] 的演讲中有答案,从 [第 28 张幻灯片][48] 开始。

|

||||

|

||||

感谢 [Deirdre Straughan][49] 的编辑,以及跟踪小马的创建(General Zoi 是小马的创建者)。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.brendangregg.com/blog/2015-07-08/choosing-a-linux-tracer.html

|

||||

|

||||

作者:[Brendan Gregg][a]

|

||||

译者:[qhwdw](https://github.com/qhwdw)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.brendangregg.com

|

||||

[1]:http://www.brendangregg.com/blog/images/2015/tracing_ponies.png

|

||||

[2]:http://www.slideshare.net/brendangregg/velocity-2015-linux-perf-tools/105

|

||||

[3]:http://www.brendangregg.com/FlameGraphs/cpuflamegraphs.html

|

||||

[4]:http://www.brendangregg.com/blog/2015-02-27/linux-profiling-at-netflix.html

|

||||

[5]:http://lwn.net/Articles/608497/

|

||||

[6]:http://www.brendangregg.com/perf.html

|

||||

[7]:http://www.brendangregg.com/blog/2015-06-23/netflix-instance-analysis-requirements.html

|

||||

[8]:http://www.brendangregg.com/blog/2015-03-17/linux-performance-analysis-perf-tools.html

|

||||

[9]:http://techblog.netflix.com/2015/04/introducing-vector-netflixs-on-host.html

|

||||

[10]:https://sourceware.org/git/?p=systemtap.git;a=blob_plain;f=README;hb=HEAD

|

||||

[11]:http://www.slideshare.net/brendangregg/velocity-2015-linux-perf-tools

|

||||

[12]:http://lwn.net/Articles/370423/

|

||||

[13]:https://www.kernel.org/doc/Documentation/trace/ftrace.txt

|

||||

[14]:https://perf.wiki.kernel.org/index.php/Main_Page

|

||||

[15]:http://www.phoronix.com/scan.php?page=news_item&px=BPF-Understanding-Kernel-VM

|

||||

[16]:https://github.com/torvalds/linux/tree/master/samples/bpf

|

||||

[17]:https://sourceware.org/systemtap/wiki

|

||||

[18]:http://lttng.org/

|

||||

[19]:http://ktap.org/

|

||||

[20]:https://github.com/dtrace4linux/linux

|

||||

[21]:http://docs.oracle.com/cd/E37670_01/E38608/html/index.html

|

||||

[22]:http://www.sysdig.org/

|

||||

[23]:http://www.brendangregg.com/blog/2014-07-13/linux-ftrace-function-counting.html

|

||||

[24]:http://www.brendangregg.com/blog/2014-07-16/iosnoop-for-linux.html

|

||||

[25]:http://www.brendangregg.com/blog/2014-07-25/opensnoop-for-linux.html

|

||||

[26]:http://www.brendangregg.com/blog/2014-07-28/execsnoop-for-linux.html

|

||||

[27]:http://www.brendangregg.com/blog/2014-09-06/linux-ftrace-tcp-retransmit-tracing.html

|

||||

[28]:http://www.brendangregg.com/blog/2015-06-28/linux-ftrace-uprobe.html

|

||||

[29]:http://www.brendangregg.com/blog/2015-07-03/hacking-linux-usdt-ftrace.html

|

||||

[30]:http://www.brendangregg.com/blog/2014-06-22/perf-cpu-sample.html

|

||||

[31]:http://www.brendangregg.com/blog/2014-06-29/perf-static-tracepoints.html

|

||||

[32]:http://www.brendangregg.com/blog/2014-07-01/perf-heat-maps.html

|

||||

[33]:http://www.brendangregg.com/blog/2014-07-03/perf-counting.html

|

||||

[34]:http://www.brendangregg.com/blog/2014-09-11/perf-kernel-line-tracing.html

|

||||

[35]:http://www.brendangregg.com/blog/2015-02-26/linux-perf-off-cpu-flame-graph.html

|

||||

[36]:http://www.brendangregg.com/blog/2015-05-15/ebpf-one-small-step.html

|

||||

[37]:https://github.com/brendangregg/BPF-tools

|

||||

[38]:http://dtrace.org/blogs/brendan/2011/10/15/using-systemtap/

|

||||

[39]:https://github.com/brendangregg/systemtap-lwtools

|

||||

[40]:http://www.brendangregg.com/ktap.html

|

||||

[41]:http://www.brendangregg.com/sysperfbook.html

|

||||

[42]:https://github.com/dtrace4linux/linux/issues/55

|

||||

[43]:http://www.brendangregg.com

|

||||

[44]:https://github.com/brendangregg/sysdig/commit/d0eeac1a32d6749dab24d1dc3fffb2ef0f9d7151

|

||||

[45]:https://github.com/brendangregg/sysdig/commit/2f21604dce0b561407accb9dba869aa19c365952

|

||||

[46]:http://www.brendangregg.com/blog/2014-05-11/strace-wow-much-syscall.html

|

||||

[47]:http://www.brendangregg.com/blog/2015-02-28/from-dtrace-to-linux.html

|

||||

[48]:http://www.slideshare.net/brendangregg/from-dtrace-to-linux/28

|

||||

[49]:http://www.beginningwithi.com/

|

||||

@ -0,0 +1,129 @@

|

||||

Linux 容器安全的 10 个层面

|

||||

======

|

||||

|

||||

> 应用这些策略来保护容器解决方案的各个层面和容器生命周期的各个阶段的安全。

|

||||

|

||||

|

||||

|

||||

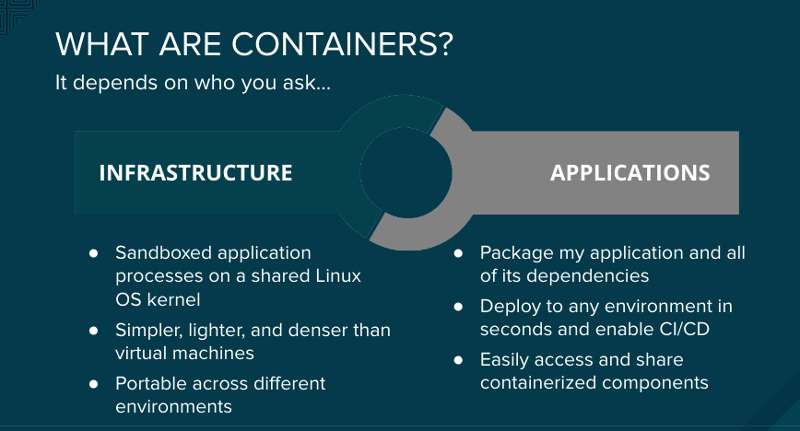

容器提供了打包应用程序的一种简单方法,它实现了从开发到测试到投入生产系统的无缝传递。它也有助于确保跨不同环境的连贯性,包括物理服务器、虚拟机、以及公有云或私有云。这些好处使得一些组织为了更方便地部署和管理为他们提升业务价值的应用程序,而快速地采用了容器技术。

|

||||

|

||||

|

||||

|

||||

企业需要高度安全,在容器中运行核心服务的任何人都会问,“容器安全吗?”以及“我们能信任运行在容器中的应用程序吗?”

|

||||

|

||||

对容器进行安全保护就像是对运行中的进程进行安全保护一样。在你部署和运行你的容器之前,你需要去考虑整个解决方案各个层面的安全。你也需要去考虑贯穿了应用程序和容器整个生命周期的安全。

|

||||

|

||||

请尝试从这十个关键的因素去确保容器解决方案栈不同层面、以及容器生命周期的不同阶段的安全。

|

||||

|

||||

### 1. 容器宿主机操作系统和多租户环境

|

||||

|

||||

由于容器将应用程序和它的依赖作为一个单元来处理,使得开发者构建和升级应用程序变得更加容易,并且,容器可以启用多租户技术将许多应用程序和服务部署到一台共享主机上。在一台单独的主机上以容器方式部署多个应用程序、按需启动和关闭单个容器都是很容易的。为完全实现这种打包和部署技术的优势,运营团队需要运行容器的合适环境。运营者需要一个安全的操作系统,它能够在边界上保护容器安全、从容器中保护主机内核,以及保护容器彼此之间的安全。

|

||||

|

||||

容器是隔离而资源受限的 Linux 进程,允许你在一个共享的宿主机内核上运行沙盒化的应用程序。保护容器的方法与保护你的 Linux 中运行的任何进程的方法是一样的。降低权限是非常重要的,也是保护容器安全的最佳实践。最好使用尽可能小的权限去创建容器。容器应该以一个普通用户的权限来运行,而不是 root 权限的用户。在 Linux 中可以使用多个层面的安全加固手段,Linux 命名空间、安全强化 Linux([SELinux][1])、[cgroups][2] 、capabilities(LCTT 译注:Linux 内核的一个安全特性,它打破了传统的普通用户与 root 用户的概念,在进程级提供更好的安全控制)、以及安全计算模式( [seccomp][3] ),这五种 Linux 的安全特性可以用于保护容器的安全。

|

||||

|

||||

### 2. 容器内容(使用可信来源)

|

||||

|

||||

在谈到安全时,首先要考虑你的容器里面有什么?例如 ,有些时候,应用程序和基础设施是由很多可用组件所构成的。它们中的一些是开源的软件包,比如,Linux 操作系统、Apache Web 服务器、Red Hat JBoss 企业应用平台、PostgreSQL,以及 Node.js。这些软件包的容器化版本已经可以使用了,因此,你没有必要自己去构建它们。但是,对于你从一些外部来源下载的任何代码,你需要知道这些软件包的原始来源,是谁构建的它,以及这些包里面是否包含恶意代码。

|

||||

|

||||

### 3. 容器注册(安全访问容器镜像)

|

||||

|

||||

你的团队的容器构建于下载的公共容器镜像,因此,访问和升级这些下载的容器镜像以及内部构建镜像,与管理和下载其它类型的二进制文件的方式是相同的,这一点至关重要。许多私有的注册库支持容器镜像的存储。选择一个私有的注册库,可以帮你将存储在它的注册中的容器镜像实现策略自动化。

|

||||

|

||||

### 4. 安全性与构建过程

|

||||

|

||||

在一个容器化环境中,软件构建过程是软件生命周期的一个阶段,它将所需的运行时库和应用程序代码集成到一起。管理这个构建过程对于保护软件栈安全来说是很关键的。遵守“一次构建,到处部署”的原则,可以确保构建过程的结果正是生产系统中需要的。保持容器的恒定不变也很重要 — 换句话说就是,不要对正在运行的容器打补丁,而是,重新构建和部署它们。

|

||||

|

||||

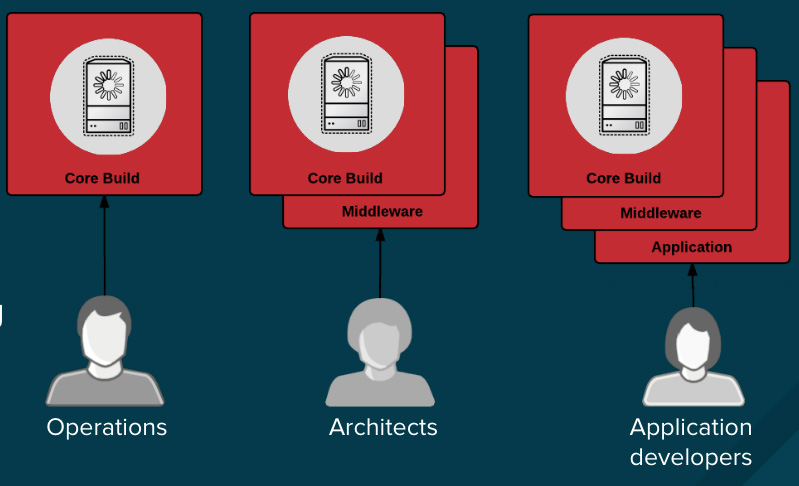

不论是因为你处于一个高强度监管的行业中,还是只希望简单地优化你的团队的成果,设计你的容器镜像管理以及构建过程,可以使用容器层的优势来实现控制分离,因此,你应该去这么做:

|

||||

|

||||

* 运营团队管理基础镜像

|

||||

* 架构师管理中间件、运行时、数据库,以及其它解决方案

|

||||

* 开发者专注于应用程序层面,并且只写代码

|

||||

|

||||

|

||||

|

||||

最后,标记好你的定制构建容器,这样可以确保在构建和部署时不会搞混乱。

|

||||

|

||||

### 5. 控制好在同一个集群内部署应用

|

||||

|

||||

如果是在构建过程中出现的任何问题,或者在镜像被部署之后发现的任何漏洞,那么,请在基于策略的、自动化工具上添加另外的安全层。

|

||||

|

||||

我们来看一下,一个应用程序的构建使用了三个容器镜像层:内核、中间件,以及应用程序。如果在内核镜像中发现了问题,那么只能重新构建镜像。一旦构建完成,镜像就会被发布到容器平台注册库中。这个平台可以自动检测到发生变化的镜像。对于基于这个镜像的其它构建将被触发一个预定义的动作,平台将自己重新构建应用镜像,合并该修复的库。

|

||||

|

||||

一旦构建完成,镜像将被发布到容器平台的内部注册库中。在它的内部注册库中,会立即检测到镜像发生变化,应用程序在这里将会被触发一个预定义的动作,自动部署更新镜像,确保运行在生产系统中的代码总是使用更新后的最新的镜像。所有的这些功能协同工作,将安全功能集成到你的持续集成和持续部署(CI/CD)过程和管道中。

|

||||

|

||||

### 6. 容器编配:保护容器平台安全

|

||||

|

||||

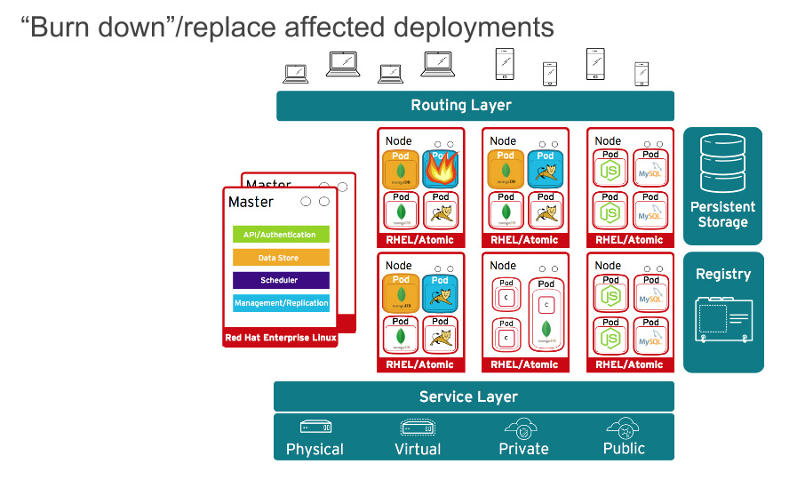

当然了,应用程序很少会以单一容器分发。甚至,简单的应用程序一般情况下都会有一个前端、一个后端、以及一个数据库。而在容器中以微服务模式部署的应用程序,意味着应用程序将部署在多个容器中,有时它们在同一台宿主机上,有时它们是分布在多个宿主机或者节点上,如下面的图所示:

|

||||

|

||||

|

||||

|

||||

在大规模的容器部署时,你应该考虑:

|

||||

|

||||

* 哪个容器应该被部署在哪个宿主机上?

|

||||

* 那个宿主机应该有什么样的性能?

|

||||

* 哪个容器需要访问其它容器?它们之间如何发现彼此?

|

||||

* 你如何控制和管理对共享资源的访问,像网络和存储?

|

||||

* 如何监视容器健康状况?

|

||||

* 如何去自动扩展性能以满足应用程序的需要?

|

||||

* 如何在满足安全需求的同时启用开发者的自助服务?

|

||||

|

||||

考虑到开发者和运营者的能力,提供基于角色的访问控制是容器平台的关键要素。例如,编配管理服务器是中心访问点,应该接受最高级别的安全检查。API 是规模化的自动容器平台管理的关键,可以用于为 pod、服务,以及复制控制器验证和配置数据;在入站请求上执行项目验证;以及调用其它主要系统组件上的触发器。

|

||||

|

||||

### 7. 网络隔离

|

||||

|

||||

在容器中部署现代微服务应用,经常意味着跨多个节点在多个容器上部署。考虑到网络防御,你需要一种在一个集群中的应用之间的相互隔离的方法。一个典型的公有云容器服务,像 Google 容器引擎(GKE)、Azure 容器服务,或者 Amazon Web 服务(AWS)容器服务,是单租户服务。他们让你在你初始化建立的虚拟机集群上运行你的容器。对于多租户容器的安全,你需要容器平台为你启用一个单一集群,并且分割流量以隔离不同的用户、团队、应用、以及在这个集群中的环境。

|

||||

|

||||

使用网络命名空间,容器内的每个集合(即大家熟知的 “pod”)都会得到它自己的 IP 和绑定的端口范围,以此来从一个节点上隔离每个 pod 网络。除使用下面所述的方式之外,默认情况下,来自不同命名空间(项目)的 pod 并不能发送或者接收其它 pod 上的包和不同项目的服务。你可以使用这些特性在同一个集群内隔离开发者环境、测试环境,以及生产环境。但是,这样会导致 IP 地址和端口数量的激增,使得网络管理更加复杂。另外,容器是被设计为反复使用的,你应该在处理这种复杂性的工具上进行投入。在容器平台上比较受欢迎的工具是使用 [软件定义网络][4] (SDN) 提供一个定义的网络集群,它允许跨不同集群的容器进行通讯。

|

||||

|

||||

### 8. 存储

|

||||

|

||||

容器即可被用于无状态应用,也可被用于有状态应用。保护外加的存储是保护有状态服务的一个关键要素。容器平台对多种受欢迎的存储提供了插件,包括网络文件系统(NFS)、AWS 弹性块存储(EBS)、GCE 持久磁盘、GlusterFS、iSCSI、 RADOS(Ceph)、Cinder 等等。

|

||||

|

||||

一个持久卷(PV)可以通过资源提供者支持的任何方式装载到一个主机上。提供者有不同的性能,而每个 PV 的访问模式被设置为特定的卷支持的特定模式。例如,NFS 能够支持多路客户端同时读/写,但是,一个特定的 NFS 的 PV 可以在服务器上被发布为只读模式。每个 PV 有它自己的一组反应特定 PV 性能的访问模式的描述,比如,ReadWriteOnce、ReadOnlyMany、以及 ReadWriteMany。

|

||||

|

||||

### 9. API 管理、终端安全、以及单点登录(SSO)

|

||||

|

||||

保护你的应用安全,包括管理应用、以及 API 的认证和授权。

|

||||

|

||||

Web SSO 能力是现代应用程序的一个关键部分。在构建它们的应用时,容器平台带来了开发者可以使用的多种容器化服务。

|

||||

|

||||

API 是微服务构成的应用程序的关键所在。这些应用程序有多个独立的 API 服务,这导致了终端服务数量的激增,它就需要额外的管理工具。推荐使用 API 管理工具。所有的 API 平台应该提供多种 API 认证和安全所需要的标准选项,这些选项既可以单独使用,也可以组合使用,以用于发布证书或者控制访问。

|

||||

|

||||

这些选项包括标准的 API key、应用 ID 和密钥对,以及 OAuth 2.0。

|

||||

|

||||

### 10. 在一个联合集群中的角色和访问管理

|

||||

|

||||

在 2016 年 7 月份,Kubernetes 1.3 引入了 [Kubernetes 联合集群][5]。这是一个令人兴奋的新特性之一,它是在 Kubernetes 上游、当前的 Kubernetes 1.6 beta 中引用的。联合是用于部署和访问跨多集群运行在公有云或企业数据中心的应用程序服务的。多个集群能够用于去实现应用程序的高可用性,应用程序可以跨多个可用区域,或者去启用部署公共管理,或者跨不同的供应商进行迁移,比如,AWS、Google Cloud、以及 Azure。

|

||||

|

||||

当管理联合集群时,你必须确保你的编配工具能够提供你所需要的跨不同部署平台的实例的安全性。一般来说,认证和授权是很关键的 —— 不论你的应用程序运行在什么地方,将数据安全可靠地传递给它们,以及管理跨集群的多租户应用程序。Kubernetes 扩展了联合集群,包括对联合的秘密数据、联合的命名空间、以及 Ingress objects 的支持。

|

||||

|

||||

### 选择一个容器平台

|

||||

|

||||

当然,它并不仅关乎安全。你需要提供一个你的开发者团队和运营团队有相关经验的容器平台。他们需要一个安全的、企业级的基于容器的应用平台,它能够同时满足开发者和运营者的需要,而且还能够提高操作效率和基础设施利用率。

|

||||

|

||||

想从 Daniel 在 [欧盟开源峰会][7] 上的 [容器安全的十个层面][6] 的演讲中学习更多知识吗?这个峰会已于 10 月 23 - 26 日在 Prague 举行。

|

||||

|

||||

### 关于作者

|

||||

|

||||

Daniel Oh;Microservives;Agile;Devops;Java Ee;Container;Openshift;Jboss;Evangelism

|

||||

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/17/10/10-layers-container-security

|

||||

|

||||

作者:[Daniel Oh][a]

|

||||

译者:[qhwdw](https://github.com/qhwdw)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/daniel-oh

|

||||

[1]:https://en.wikipedia.org/wiki/Security-Enhanced_Linux

|

||||

[2]:https://en.wikipedia.org/wiki/Cgroups

|

||||

[3]:https://en.wikipedia.org/wiki/Seccomp

|

||||

[4]:https://en.wikipedia.org/wiki/Software-defined_networking

|

||||

[5]:https://kubernetes.io/docs/concepts/cluster-administration/federation/

|

||||

[6]:https://osseu17.sched.com/mobile/#session:f2deeabfc1640d002c1d55101ce81223

|

||||

[7]:http://events.linuxfoundation.org/events/open-source-summit-europe

|

||||

@ -1,45 +1,44 @@

|

||||

# 让 “rm” 命令将文件移动到“垃圾桶”,而不是完全删除它们

|

||||

给 “rm” 命令添加个“垃圾桶”

|

||||

============

|

||||

|

||||

人类犯错误是因为我们不是一个可编程设备,所以,在使用 `rm` 命令时要额外注意,不要在任何时候使用 `rm -rf * `。当你使用 rm 命令时,它会永久删除文件,不会像文件管理器那样将这些文件移动到 `垃圾箱`。

|

||||

人类犯错误是因为我们不是一个可编程设备,所以,在使用 `rm` 命令时要额外注意,不要在任何时候使用 `rm -rf *`。当你使用 `rm` 命令时,它会永久删除文件,不会像文件管理器那样将这些文件移动到 “垃圾箱”。

|

||||

|

||||

有时我们会将不应该删除的文件删除掉,所以当错误的删除文件时该怎么办? 你必须看看恢复工具(Linux 中有很多数据恢复工具),但我们不知道是否能将它百分之百恢复,所以要如何解决这个问题?

|

||||

有时我们会将不应该删除的文件删除掉,所以当错误地删除了文件时该怎么办? 你必须看看恢复工具(Linux 中有很多数据恢复工具),但我们不知道是否能将它百分之百恢复,所以要如何解决这个问题?

|

||||

|

||||

我们最近发表了一篇关于 [Trash-Cli][1] 的文章,在评论部分,我们从用户 Eemil Lgz 那里获得了一个关于 [saferm.sh][2] 脚本的更新,它可以帮助我们将文件移动到“垃圾箱”而不是永久删除它们。

|

||||

|

||||

将文件移动到“垃圾桶”是一个好主意,当你无意中运行 rm 命令时,可以节省你的时间,但是很少有人会说这是一个坏习惯,如果你不注意“垃圾桶”,它可能会在一定的时间内被文件和文件夹堆积起来。在这种情况下,我建议你按照你的意愿去做一个定时任务。

|

||||

将文件移动到“垃圾桶”是一个好主意,当你无意中运行 `rm` 命令时,可以拯救你;但是很少有人会说这是一个坏习惯,如果你不注意“垃圾桶”,它可能会在一定的时间内被文件和文件夹堆积起来。在这种情况下,我建议你按照你的意愿去做一个定时任务。

|

||||

|

||||

这适用于服务器和桌面两种环境。 如果脚本检测到 **GNOME 、KDE、Unity 或 LXDE** 桌面环境(DE),则它将文件或文件夹安全地移动到默认垃圾箱 **\$HOME/.local/share/Trash/files**,否则会在您的主目录中创建垃圾箱文件夹 **$HOME/Trash**。

|

||||

这适用于服务器和桌面两种环境。 如果脚本检测到 GNOME 、KDE、Unity 或 LXDE 桌面环境(DE),则它将文件或文件夹安全地移动到默认垃圾箱 `$HOME/.local/share/Trash/files`,否则会在您的主目录中创建垃圾箱文件夹 `$HOME/Trash`。

|

||||

|

||||

`saferm.sh` 脚本托管在 Github 中,可以从仓库中克隆,也可以创建一个名为 `saferm.sh` 的文件并复制其上的代码。

|

||||

|

||||

saferm.sh 脚本托管在 Github 中,可以从 repository 中克隆,也可以创建一个名为 saferm.sh 的文件并复制其上的代码。

|

||||

```

|

||||

$ git clone https://github.com/lagerspetz/linux-stuff

|

||||

$ sudo mv linux-stuff/scripts/saferm.sh /bin

|

||||

$ rm -Rf linux-stuff

|

||||

|

||||

```

|

||||

|

||||

在 `bashrc` 文件中设置别名,

|

||||

在 `.bashrc` 文件中设置别名,

|

||||

|

||||

```

|

||||

alias rm=saferm.sh

|

||||

|

||||

```

|

||||

|

||||

执行下面的命令使其生效,

|

||||

|

||||

```

|

||||

$ source ~/.bashrc

|

||||

|

||||

```

|

||||

|

||||

一切就绪,现在你可以执行 rm 命令,自动将文件移动到”垃圾桶”,而不是永久删除它们。

|

||||

一切就绪,现在你可以执行 `rm` 命令,自动将文件移动到”垃圾桶”,而不是永久删除它们。

|

||||

|

||||

测试一下,我们将删除一个名为 `magi.txt` 的文件,命令行明确的提醒了 `Moving magi.txt to $HOME/.local/share/Trash/file`。

|

||||

|

||||

测试一下,我们将删除一个名为 `magi.txt` 的文件,命令行显式的说明了 `Moving magi.txt to $HOME/.local/share/Trash/file`

|

||||

|

||||

```

|

||||

$ rm -rf magi.txt

|

||||

Moving magi.txt to /home/magi/.local/share/Trash/files

|

||||

|

||||

```

|

||||

|

||||

也可以通过 `ls` 命令或 `trash-cli` 进行验证。

|

||||

@ -47,47 +46,16 @@ Moving magi.txt to /home/magi/.local/share/Trash/files

|

||||

```

|

||||

$ ls -lh /home/magi/.local/share/Trash/files

|

||||

Permissions Size User Date Modified Name

|

||||

.rw-r--r-- 32 magi 11 Oct 16:24 magi.txt

|

||||

|

||||

.rw-r--r-- 32 magi 11 Oct 16:24 magi.txt

|

||||

```

|

||||

|

||||

或者我们可以通过文件管理器界面中查看相同的内容。

|

||||

|

||||

![![][3]][4]

|

||||

|

||||

创建一个定时任务,每天清理一次“垃圾桶”,( LCTT 注:原文为每周一次,但根据下面的代码,应该是每天一次)

|

||||

(LCTT 译注:原文此处混淆了部分 trash-cli 的内容,考虑到文章衔接和逻辑,此处略。)

|

||||

|

||||

```

|

||||

$ 1 1 * * * trash-empty

|

||||

|

||||

```

|

||||

|

||||

`注意` 对于服务器环境,我们需要使用 rm 命令手动删除。

|

||||

|

||||

```

|

||||

$ rm -rf /root/Trash/

|

||||

/root/Trash/magi1.txt is on . Unsafe delete (y/n)? y

|

||||

Deleting /root/Trash/magi1.txt

|

||||

|

||||

```

|

||||

|

||||

对于桌面环境,trash-put 命令也可以做到这一点。

|

||||

|

||||

在 `bashrc` 文件中创建别名,

|

||||

|

||||

```

|

||||

alias rm=trash-put

|

||||

|

||||

```

|

||||

|

||||

执行下面的命令使其生效。

|

||||

|

||||

```

|

||||

$ source ~/.bashrc

|

||||

|

||||

```

|

||||

|

||||

要了解 saferm.sh 的其他选项,请查看帮助。

|

||||

要了解 `saferm.sh` 的其他选项,请查看帮助。

|

||||

|

||||

```

|

||||

$ saferm.sh -h

|

||||

@ -112,7 +80,7 @@ via: https://www.2daygeek.com/rm-command-to-move-files-to-trash-can-rm-alias/

|

||||

|

||||

作者:[2DAYGEEK][a]

|

||||

译者:[amwps290](https://github.com/amwps290)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,59 +1,64 @@

|

||||

使用 Showterm 录制和共享终端会话

|

||||

使用 Showterm 录制和分享终端会话

|

||||

======

|

||||

|

||||

|

||||

|

||||

你可以使用几乎所有的屏幕录制程序轻松录制终端会话。但是,你很可能会得到超大的视频文件。Linux 中有几种终端录制程序,每种录制程序都有自己的优点和缺点。Showterm 是一个可以非常容易地记录终端会话,上传,共享,并将它们嵌入到任何网页中。一个优点是,你不会有巨大的文件来处理。

|

||||

你可以使用几乎所有的屏幕录制程序轻松录制终端会话。但是,你很可能会得到超大的视频文件。Linux 中有几种终端录制程序,每种录制程序都有自己的优点和缺点。Showterm 是一个可以非常容易地记录终端会话、上传、分享,并将它们嵌入到任何网页中的工具。一个优点是,你不会有巨大的文件来处理。

|

||||

|

||||

Showterm 是开源的,该项目可以在这个[ GitHub 页面][1]上找到。

|

||||

Showterm 是开源的,该项目可以在这个 [GitHub 页面][1]上找到。

|

||||

|

||||

**相关**:[2 个简单的将你的终端会话录制为视频的 Linux 程序][2]

|

||||

|

||||

### 在 Linux 中安装 Showterm

|

||||

|

||||

Showterm 要求你在计算机上安装了 Ruby。以下是如何安装该程序。

|

||||

|

||||

```

|

||||

gem install showterm

|

||||

```

|

||||

|

||||

如果你没有在 Linux 上安装 Ruby:

|

||||

如果你没有在 Linux 上安装 Ruby,可以这样:

|

||||

|

||||

```

|

||||

sudo curl showterm.io/showterm > ~/bin/showterm

|

||||

sudo chmod +x ~/bin/showterm

|

||||

```

|

||||

|

||||

如果你只是想运行程序而不是安装:

|

||||

|

||||

```

|

||||

bash <(curl record.showterm.io)

|

||||

```

|

||||

|

||||

你可以在终端输入 `showterm --help` 得到帮助页面。如果没有出现帮助页面,那么可能是未安装 showterm。现在你已安装了 Showterm(或正在运行独立版本),让我们开始使用该工具进行录制。

|

||||

你可以在终端输入 `showterm --help` 得到帮助页面。如果没有出现帮助页面,那么可能是未安装 `showterm`。现在你已安装了 Showterm(或正在运行独立版本),让我们开始使用该工具进行录制。

|

||||

|

||||

**相关**:[如何在 Ubuntu 中录制终端会话][3]

|

||||

**相关**:[如何在 Ubuntu 中录制终端会话][3]

|

||||

|

||||

### 录制终端会话

|

||||

|

||||

![showterm terminal][4]

|

||||

|

||||

录制终端会话非常简单。从命令行运行 `showterm`。这会在后台启动终端录制。所有从命令行输入的命令都由 Showterm 记录。完成录制后,请按 Ctrl + D 或在命令行中输入`exit` 停止录制。

|

||||

录制终端会话非常简单。从命令行运行 `showterm`。这会在后台启动终端录制。所有从命令行输入的命令都由 Showterm 记录。完成录制后,请按 `Ctrl + D` 或在命令行中输入`exit` 停止录制。

|

||||

|

||||

Showterm 会上传你的视频并输出一个看起来像 http://showterm.io/<一长串字符> 的链接的视频。不幸的是,终端会话会立即上传,而没有任何提示。请不要惊慌!你可以通过输入 `showterm --delete <recording URL>` 删除任何已上传的视频。在上传视频之前,你可以通过在 showterm 命令中添加 `-e` 选项来改变计时。如果视频无法上传,你可以使用 `showterm --retry <script> <times>` 强制重试。

|

||||

Showterm 会上传你的视频并输出一个看起来像 `http://showterm.io/<一长串字符>` 的链接的视频。不幸的是,终端会话会立即上传,而没有任何提示。请不要惊慌!你可以通过输入 `showterm --delete <recording URL>` 删除任何已上传的视频。在上传视频之前,你可以通过在 `showterm` 命令中添加 `-e` 选项来改变计时。如果视频无法上传,你可以使用 `showterm --retry <script> <times>` 强制重试。

|

||||

|

||||

在查看录制内容时,还可以通过在 URL 中添加 “#slow”、“#fast” 或 “#stop” 来控制视频的计时。slow 让视频以正常速度播放、fast 是速度加倍、stop,如名称所示,停止播放视频。

|

||||

在查看录制内容时,还可以通过在 URL 中添加 `#slow`、`#fast` 或 `#stop` 来控制视频的计时。`#slow` 让视频以正常速度播放、`#fast` 是速度加倍、`#stop`,如名称所示,停止播放视频。

|

||||

|

||||

Showterm 终端录制视频可以通过 iframe 轻松嵌入到网页中。这可以通过将 iframe 源添加到 showterm 视频地址来实现,如下所示。

|

||||

|

||||

![showtermio][5]

|

||||

|

||||

作为开源工具,Showterm 允许进一步定制。例如,要运行你自己的 Showterm 服务器,你需要运行以下命令:

|

||||

|

||||

```

|

||||

export SHOWTERM_SERVER=https://showterm.myorg.local/

|

||||

```

|

||||

这样你的客户端可以和它通信。还有额外的功能只需很少的编程知识就可添加。Showterm 服务器项目可在此[ GitHub 页面][1]获得。

|

||||

|

||||

这样你的客户端可以和它通信。还有额外的功能只需很少的编程知识就可添加。Showterm 服务器项目可在此 [GitHub 页面][1]获得。

|

||||

|

||||

### 结论

|

||||

|

||||

如果你想与同事分享一些命令行教程,请务必记得 Showterm。Showterm 是基于文本的。因此,与其他屏幕录制机相比,它将产生相对较小的视频。该工具本身尺寸相当小 - 只有几千字节。

|

||||

如果你想与同事分享一些命令行教程,请务必记得 Showterm。Showterm 是基于文本的。因此,与其他屏幕录制机相比,它将产生相对较小的视频。该工具本身尺寸相当小 —— 只有几千字节。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -61,7 +66,7 @@ via: https://www.maketecheasier.com/record-terminal-session-showterm/

|

||||

|

||||

作者:[Bruno Edoh][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,138 @@

|

||||

Linux 下最好的图片截取和视频截录工具

|

||||

======

|

||||

|

||||

|

||||

|

||||

可能有一个困扰你多时的问题,当你想要获取一张屏幕截图向开发者反馈问题,或是在 Stack Overflow 寻求帮助时,你可能缺乏一个可靠的屏幕截图工具去保存和发送截图。在 GNOME 中有一些这种类型的程序和 shell 拓展工具。这里介绍的是 Linux 最好的屏幕截图工具,可以供你截取图片或截录视频。

|

||||

|

||||

### 1. Shutter

|

||||

|

||||

[][2]

|

||||

|

||||

[Shutter][3] 可以截取任意你想截取的屏幕,是 Linux 最好的截屏工具之一。得到截屏之后,它还可以在保存截屏之前预览图片。它也有一个扩展菜单,展示在 GNOME 顶部面板,使得用户进入软件变得更人性化,非常方便使用。

|

||||

|

||||

你可以截取选区、窗口、桌面、当前光标下的窗口、区域、菜单、提示框或网页。Shutter 允许用户直接上传屏幕截图到设置内首选的云服务商。它同样允许用户在保存截图之前编辑器图片;同时提供了一些可自由添加或移除的插件。

|

||||

|

||||

终端内键入下列命令安装此工具:

|

||||

|

||||

```

|

||||

sudo add-apt-repository -y ppa:shutter/ppa

|

||||

sudo apt-get update && sudo apt-get install shutter

|

||||

```

|

||||

|

||||

### 2. Vokoscreen

|

||||

|

||||

[][4]

|

||||

|

||||

[Vokoscreen][5] 是一款允许你记录和叙述屏幕活动的一款软件。它易于使用,有一个简洁的界面和顶部面板的菜单,方便用户录制视频。

|

||||

|

||||

你可以选择记录整个屏幕,或是记录一个窗口,抑或是记录一个选区。自定义记录可以让你轻松得到所需的保存类型,你甚至可以将屏幕录制记录保存为 gif 文件。当然,你也可以使用网络摄像头记录自己的情况,用于你写作教程吸引学习者。记录完成后,你还可以在该应用程序中回放视频记录,这样就不必到处去找你记录的内容。

|

||||

|

||||

[][6]

|

||||

|

||||

你可以从你的发行版仓库安装 Vocoscreen,或者你也可以在 [pkgs.org][7] 选择下载你需要的版本。

|

||||

|

||||

```

|

||||

sudo dpkg -i vokoscreen_2.5.0-1_amd64.deb

|

||||

```

|

||||

|

||||

### 3. OBS

|

||||

|

||||

[][8]

|

||||

|

||||

[OBS][9] 可以用来录制自己的屏幕亦可用来录制互联网上的流媒体。它允许你看到自己所录制的内容或你叙述的屏幕录制。它允许你根据喜好选择录制视频的品质;它也允许你选择文件的保存类型。除了视频录制功能之外,你还可以切换到 Studio 模式,不借助其他软件进行视频编辑。要在你的 Linux 系统中安装 OBS,你必须确保你的电脑已安装 FFmpeg。ubuntu 14.04 或更早的版本安装 FFmpeg 可以使用如下命令:

|

||||

|

||||

```

|

||||

sudo add-apt-repository ppa:kirillshkrogalev/ffmpeg-next

|

||||

|

||||

sudo apt-get update && sudo apt-get install ffmpeg

|

||||

```

|

||||

|

||||

ubuntu 15.04 以及之后的版本,你可以在终端中键入如下命令安装 FFmpeg:

|

||||

|

||||

```

|

||||

sudo apt-get install ffmpeg

|

||||

```

|

||||

|

||||

如果 FFmpeg 安装完成,在终端中键入如下安装 OBS:

|

||||

|

||||

```

|

||||

sudo add-apt-repository ppa:obsproject/obs-studio

|

||||

|

||||

sudo apt-get update

|

||||

|

||||

sudo apt-get install obs-studio

|

||||

```

|

||||

|

||||

### 4. Green Recorder

|

||||

|

||||

[][10]

|

||||

|

||||

[Green recorder][11] 是一款界面简单的程序,它可以让你记录屏幕。你可以选择包括视频和单纯的音频在内的录制内容,也可以显示鼠标指针,甚至可以跟随鼠标录制视频。同样,你可以选择记录窗口或是屏幕上的选区,以便于只在自己的记录中保留需要的内容;你还可以自定义最终保存的视频的帧数。如果你想要延迟录制,它提供给你一个选项可以设置出你想要的延迟时间。它还提供一个录制结束后的命令运行选项,这样,就可以在视频录制结束后立即运行。

|

||||

|

||||

在终端中键入如下命令来安装 green recorder:

|

||||

|

||||

```

|

||||

sudo add-apt-repository ppa:fossproject/ppa

|

||||

|

||||

sudo apt update && sudo apt install green-recorder

|

||||

```

|

||||

|

||||

### 5. Kazam

|

||||

|

||||

[][12]

|

||||

|

||||

[Kazam][13] 在几乎所有使用截图工具的 Linux 用户中都十分流行。这是一款简单直观的软件,它可以让你做一个屏幕截图或是视频录制,也同样允许在屏幕截图或屏幕录制之前设置延时。它可以让你选择录制区域,窗口或是你想要抓取的整个屏幕。Kazam 的界面接口安排的非常好,和其它软件相比毫无复杂感。它的特点,就是让你优雅的截图。Kazam 在系统托盘和菜单中都有图标,无需打开应用本身,你就可以开始屏幕截图。

|

||||

|

||||

终端中键入如下命令来安装 Kazam:

|

||||

|

||||

```

|

||||

sudo apt-get install kazam

|

||||

```

|

||||

|

||||

如果没有找到该 PPA,你需要使用下面的命令安装它:

|

||||

|

||||

```

|

||||

sudo add-apt-repository ppa:kazam-team/stable-series

|

||||

|

||||

sudo apt-get update && sudo apt-get install kazam

|

||||

```

|

||||

|

||||

### 6. GNOME 扩展截屏工具

|

||||

|

||||

[][1]

|

||||

|

||||

GNOME 的一个扩展软件就叫做 screenshot tool,它常驻系统面板,如果你没有设置禁用它的话。由于它是常驻系统面板的软件,所以它会一直等待你的调用,获取截图,方便和容易获取是它最主要的特点,除非你在调整工具中禁用,否则它将一直在你的系统面板中。这个工具也有用来设置首选项的选项窗口。在 extensions.gnome.org 中搜索 “_Screenshot Tool_”,在你的 GNOME 中安装它。

|

||||

|

||||

你需要安装 gnome 扩展的 chrome 扩展组件和 GNOME 调整工具才能使用这个工具。

|

||||

|

||||

[][14]

|

||||

|

||||

当你碰到一个问题,不知道怎么处理,想要在 [Linux 社区][15] 或者其他开发社区分享、寻求帮助的的时候, **Linux 截图工具** 尤其合适。学习开发、程序或者其他任何事物都会发现这些工具在分享截图的时候真的很实用。Youtube 用户和教程制作爱好者会发现视频截录工具真的很适合录制可以发表的教程。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.linuxandubuntu.com/home/best-linux-screenshot-screencasting-tools

|

||||

|

||||

作者:[linuxandubuntu][a]

|

||||

译者:[CYLeft](https://github.com/CYLeft)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.linuxandubuntu.com

|

||||

[1]:http://www.linuxandubuntu.com/uploads/2/1/1/5/21152474/gnome-screenshot-extension-compressed_orig.jpg

|

||||

[2]:http://www.linuxandubuntu.com/uploads/2/1/1/5/21152474/shutter-linux-screenshot-taking-tools_orig.jpg

|

||||

[3]:http://shutter-project.org/

|

||||

[4]:http://www.linuxandubuntu.com/uploads/2/1/1/5/21152474/vokoscreen-screencasting-tool-for-linux_orig.jpg

|

||||

[5]:https://github.com/vkohaupt/vokoscreen

|

||||

[6]:http://www.linuxandubuntu.com/uploads/2/1/1/5/21152474/vokoscreen-preferences_orig.jpg

|

||||

[7]:https://pkgs.org/download/vokoscreen

|

||||

[8]:http://www.linuxandubuntu.com/uploads/2/1/1/5/21152474/obs-linux-screencasting-tool_orig.jpg

|

||||

[9]:https://obsproject.com/

|

||||

[10]:http://www.linuxandubuntu.com/uploads/2/1/1/5/21152474/green-recording-linux-tool_orig.jpg

|

||||

[11]:https://github.com/foss-project/green-recorder

|

||||

[12]:http://www.linuxandubuntu.com/uploads/2/1/1/5/21152474/kazam-screencasting-tool-for-linux_orig.jpg

|

||||

[13]:https://launchpad.net/kazam

|

||||

[14]:http://www.linuxandubuntu.com/uploads/2/1/1/5/21152474/gnome-screenshot-extension-preferences_orig.jpg

|

||||

[15]:http://www.linuxandubuntu.com/home/top-10-communities-to-help-you-learn-linux

|

||||

@ -1,21 +1,21 @@

|

||||

Partclone - 多功能的分区和克隆免费软件

|

||||

Partclone:多功能的分区和克隆的自由软件

|

||||

======

|

||||

|

||||

|

||||

|

||||

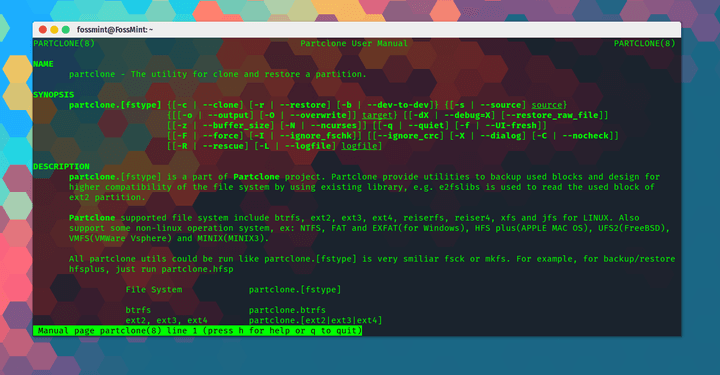

**[Partclone][1]** 是由 **Clonezilla** 开发者开发的免费开源的用于创建和克隆分区镜像的软件。实际上,**Partclone** 是基于 **Clonezilla** 的工具之一。

|

||||

[Partclone][1] 是由 Clonezilla 的开发者们开发的用于创建和克隆分区镜像的自由开源软件。实际上,Partclone 是 Clonezilla 所基于的工具之一。

|

||||

|

||||

它为用户提供了备份与恢复占用的分区块工具,并与多个文件系统的高度兼容,这要归功于它能够使用像 **e2fslibs** 这样的现有库来读取和写入分区,例如 **ext2**。

|

||||

它为用户提供了备份与恢复已用分区的工具,并与多个文件系统高度兼容,这要归功于它能够使用像 e2fslibs 这样的现有库来读取和写入分区,例如 ext2。

|

||||

|

||||

它最大的优点是支持各种格式,包括 ext2、ext3、ext4、hfs +、reiserfs、reiser4、btrfs、vmfs3、vmfs5、xfs、jfs、ufs、ntfs、fat(12/16/32)、exfat、f2fs 和 nilfs。

|

||||

它最大的优点是支持各种格式,包括 ext2、ext3、ext4、hfs+、reiserfs、reiser4、btrfs、vmfs3、vmfs5、xfs、jfs、ufs、ntfs、fat(12/16/32)、exfat、f2fs 和 nilfs。

|

||||

|

||||

它还有许多的程序,包括 **partclone.ext2**ext3&ext4)、partclone.ntfs、partclone.exfat、partclone.hfsp 和 partclone.vmfs(v3和v5) 等等。

|

||||

它还有许多的程序,包括 partclone.ext2(ext3&ext4)、partclone.ntfs、partclone.exfat、partclone.hfsp 和 partclone.vmfs(v3和v5) 等等。

|

||||

|

||||

### Partclone中的功能

|

||||

|

||||

* **免费软件:** **Partclone**免费供所有人下载和使用。

|

||||

* **开源:** **Partclone**是在 GNU GPL 许可下发布的,并在 [GitHub][2] 上公开。

|

||||

* **跨平台**:适用于 Linux、Windows、MAC、ESX 文件系统备份/恢复和 FreeBSD。

|

||||

* 免费软件: Partclone 免费供所有人下载和使用。

|

||||

* 开源: Partclone 是在 GNU GPL 许可下发布的,并在 [GitHub][2] 上公开。

|

||||

* 跨平台:适用于 Linux、Windows、MAC、ESX 文件系统备份/恢复和 FreeBSD。

|

||||

* 一个在线的[文档页面][3],你可以从中查看帮助文档并跟踪其 GitHub 问题。

|

||||

* 为初学者和专业人士提供的在线[用户手册][4]。

|

||||

* 支持救援。

|

||||

@ -25,55 +25,53 @@ Partclone - 多功能的分区和克隆免费软件

|

||||

* 支持 raw 克隆。

|

||||

* 显示传输速率和持续时间。

|

||||

* 支持管道。

|

||||

* 支持 crc32。

|

||||

* 支持 crc32 校验。

|

||||

* 支持 ESX vmware server 的 vmfs 和 FreeBSD 的文件系统 ufs。

|

||||

|

||||

Partclone 中还捆绑了更多功能,你可以在[这里][5]查看其余的功能。

|

||||

|

||||

|

||||

**Partclone** 中还捆绑了更多功能,你可以在[这里][5]查看其余的功能。

|

||||

|

||||

[下载 Linux 中的 Partclone][6]

|

||||

- [下载 Linux 中的 Partclone][6]

|

||||

|

||||

### 如何安装和使用 Partclone

|

||||

|

||||

在 Linux 上安装 Partclone。

|

||||

|

||||

```

|

||||

$ sudo apt install partclone [On Debian/Ubuntu]

|

||||

$ sudo yum install partclone [On CentOS/RHEL/Fedora]

|

||||

|

||||

```

|

||||

|

||||

克隆分区为镜像。

|

||||

|

||||

```

|

||||

# partclone.ext4 -d -c -s /dev/sda1 -o sda1.img

|

||||

|

||||

```

|

||||

|

||||

将镜像恢复到分区。

|

||||

|

||||

```

|

||||

# partclone.ext4 -d -r -s sda1.img -o /dev/sda1

|

||||

|

||||

```

|

||||

|

||||

分区到分区克隆。

|

||||

|

||||

```

|

||||

# partclone.ext4 -d -b -s /dev/sda1 -o /dev/sdb1

|

||||

|

||||

```

|

||||

|

||||

显示镜像信息。

|

||||

|

||||

```

|

||||

# partclone.info -s sda1.img

|

||||

|

||||

```

|

||||

|

||||

检查镜像。

|

||||

|

||||

```

|

||||

# partclone.chkimg -s sda1.img

|

||||

|

||||

```

|

||||

|

||||

你是 **Partclone** 的用户吗?我最近在 [**Deepin Clone**][7] 上写了一篇文章,显然,Partclone 有擅长处理的任务。你使用其他备份和恢复工具的经验是什么?

|

||||

你是 Partclone 的用户吗?我最近在 [Deepin Clone][7] 上写了一篇文章,显然,Partclone 有擅长处理的任务。你使用其他备份和恢复工具的经验是什么?

|

||||

|

||||

请在下面的评论区与我们分享你的想法和建议。

|

||||

|

||||

@ -81,13 +79,13 @@ $ sudo yum install partclone [On CentOS/RHEL/Fedora]

|

||||

|

||||

via: https://www.fossmint.com/partclone-linux-backup-clone-tool/

|

||||

|

||||

作者:[Martins D. Okoi;View All Posts;Peter Beck;Martins Divine Okoi][a]

|

||||

作者:[Martins D. Okoi][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:

|

||||

[a]:https://www.fossmint.com/author/dillivine/

|

||||

[1]:https://partclone.org/

|

||||

[2]:https://github.com/Thomas-Tsai/partclone

|

||||

[3]:https://partclone.org/help/

|

||||

@ -1,35 +1,35 @@

|

||||

5 个最好的再在视觉上最轻松的黑色主题

|

||||

5 个在视觉上最轻松的黑暗主题

|

||||

======

|

||||

|

||||

|

||||

|

||||

人们在电脑上选择黑暗主题有几个原因。有些人觉得对于眼睛轻松,而另一些人因为他们的医学条件选择黑色。特别地,程序员喜欢黑暗的主题,因为可以减少眼睛的眩光。

|

||||

|

||||

如果你是一位 Linux 用户和黑暗的主题爱好者,那么你很幸运。这里有五个最好的 Linux 黑暗主题。去看一下!

|

||||

如果你是一位 Linux 用户和黑暗主题爱好者,那么你很幸运。这里有五个最好的 Linux 黑暗主题。去看一下!

|

||||

|

||||

### 1. OSX-Arc-Shadow

|

||||

|

||||

![OSX-Arc-Shadow Theme][1]

|

||||

|

||||

顾名思义,这个主题受 OS X 的启发,它是基于 Arc 的平面主题。该主题支持 GTK 3 和 GTK 2 桌面环境,因此 Gnome、Cinnamon、Unity、Manjaro、Mate 和 XFCE 用户可以安装和使用该主题。[OSX-Arc-Shadow][2] 是 OSX-Arc 主题集合的一部分。集合还包括其他几个主题(黑暗明亮)。你可以下载整个系列并使用黑色主题。

|

||||

顾名思义,这个主题受 OS X 的启发,它是基于 Arc 的平面主题。该主题支持 GTK 3 和 GTK 2 桌面环境,因此 Gnome、Cinnamon、Unity、Manjaro、Mate 和 XFCE 用户可以安装和使用该主题。[OSX-Arc-Shadow][2] 是 OSX-Arc 主题集合的一部分。该集合还包括其他几个主题(黑暗和明亮)。你可以下载整个系列并使用黑色主题。

|

||||

|

||||

基于 Debian 和 Ubuntu 的发行版用户可以选择使用此[页面][3]中找到的 .deb 文件来安装稳定版本。压缩的源文件也位于同一页面上。Arch Linux 用户,请查看此[ AUR 链接][4]。最后,要手动安装主题,请将 zip 解压到 “~/.themes” ,并将其设置为当前主题、控件和窗口边框。

|

||||

基于 Debian 和 Ubuntu 的发行版用户可以选择使用此[页面][3]中找到的 .deb 文件来安装稳定版本。压缩的源文件也位于同一页面上。Arch Linux 用户,请查看此 [AUR 链接][4]。最后,要手动安装主题,请将 zip 解压到 `~/.themes` ,并将其设置为当前主题、控件和窗口边框。

|

||||

|

||||

### 2. Kiss-Kool-Red version 2

|

||||

|

||||

![Kiss-Kool-Red version 2 ][5]

|

||||

|

||||

主题发布不久。与 OSX-Arc-Shadow 相比它有更黑的外观和红色选择框。对于那些希望电脑屏幕上有更强对比度和更少眩光的人尤其有吸引力。因此,它可以减少在夜间使用或在光线较暗的地方使用时的注意力分散。它支持 GTK 3 和 GTK2。

|

||||

该主题发布不久。与 OSX-Arc-Shadow 相比它有更黑的外观和红色选择框。对于那些希望电脑屏幕上有更强对比度和更少眩光的人尤其有吸引力。因此,它可以减少在夜间使用或在光线较暗的地方使用时的注意力分散。它支持 GTK 3 和 GTK2。

|

||||

|

||||

前往 [gnome-looks][6],在“文件”菜单下下载主题。安装过程很简单:将主题解压到 “~/.themes” 中,并将其设置为当前主题、控件和窗口边框。

|

||||

前往 [gnome-looks][6],在“文件”菜单下下载主题。安装过程很简单:将主题解压到 `~/.themes` 中,并将其设置为当前主题、控件和窗口边框。

|

||||

|

||||

### 3. Equilux

|

||||

|

||||

![Equilux][7]

|

||||

|

||||

Equilux 是基于 Materia 主题的另一个简单的黑暗主题。它有一个中性的深色调,并不过分花哨。选择框之间的对比度也很小,并且没有 Kiss-Kool-Red 中红色的锐利。这个主题的确是为减轻眼睛疲劳而做的。

|

||||

Equilux 是另一个基于 Materia 主题的简单的黑暗主题。它有一个中性的深色调,并不过分花哨。选择框之间的对比度也很小,并且没有 Kiss-Kool-Red 中红色的锐利。这个主题的确是为减轻眼睛疲劳而做的。

|

||||

|

||||

[下载压缩文件][8]并将其解压缩到你的 “~/.themes” 中。然后,你可以将其设置为你的主题。你可以查看[它的 GitHub 页面][9]了解最新的增加内容。

|

||||

[下载压缩文件][8]并将其解压缩到你的 `~/.themes` 中。然后,你可以将其设置为你的主题。你可以查看[它的 GitHub 页面][9]了解最新的增加内容。

|

||||

|

||||

### 4. Deepin Dark

|

||||

|

||||

@ -41,7 +41,7 @@ Deepin Dark 是一个完全黑暗的主题。对于那些喜欢更黑暗的人

|

||||

|

||||

![Ambiance DS BlueSB12 ][12]

|

||||

|

||||

Ambiance DS BlueSB12 是一个简单的黑暗主题,所以它使重要细节突出。它有助于专注,因为它没必要花哨。它与 Deepin Dark 非常相似。特别与 Ubuntu 用户相关,它与 Ubuntu 17.04 兼容。你可以从[这里][13]下载并尝试。

|

||||

Ambiance DS BlueSB12 是一个简单的黑暗主题,它使得重要细节突出。它有助于专注,不花哨。它与 Deepin Dark 非常相似。特别是对于 Ubuntu 用户,它与 Ubuntu 17.04 兼容。你可以从[这里][13]下载并尝试。

|

||||

|

||||

### 总结

|

||||

|

||||

@ -53,7 +53,7 @@ via: https://www.maketecheasier.com/best-linux-dark-themes/

|

||||

|

||||

作者:[Bruno Edoh][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,95 @@

|

||||

简单介绍 ldd 命令

|

||||

=========================================

|

||||

|

||||

如果您的工作涉及到 Linux 中的可执行文件和共享库的知识,则需要了解几种命令行工具。其中之一是 `ldd` ,您可以使用它来访问共享对象依赖关系。在本教程中,我们将使用一些易于理解的示例来讨论此实用程序的基础知识。

|

||||

|

||||

请注意,这里提到的所有示例都已在 Ubuntu 16.04 LTS 上进行了测试。

|

||||

|

||||

|

||||

### Linux ldd 命令

|

||||

|

||||

正如开头已经提到的,`ldd` 命令打印共享对象依赖关系。以下是该命令的语法:

|

||||

|

||||

```

|

||||

ldd [option]... file...

|

||||

```

|

||||

|

||||

下面是该工具的手册页对它作出的解释:

|

||||

|

||||

> ldd 会输出命令行指定的每个程序或共享对象所需的共享对象(共享库)。

|

||||

|

||||

以下使用问答的方式让您更好地了解ldd的工作原理。

|

||||

|

||||

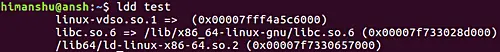

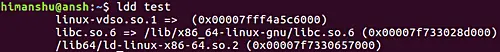

### 问题一、 如何使用 ldd 命令?

|

||||

|

||||

`ldd` 的基本用法非常简单,只需运行 `ldd` 命令以及可执行文件或共享对象的文件名称作为输入。

|

||||

|

||||

```

|

||||

ldd [object-name]

|

||||

```

|

||||

|

||||

例如:

|

||||

|

||||

```

|

||||

ldd test

|

||||

```

|

||||

|

||||

[](https://www.howtoforge.com/images/command-tutorial/big/ldd-basic.png)

|

||||

|

||||

所以你可以看到所有的共享库依赖已经在输出中产生了。

|

||||

|

||||

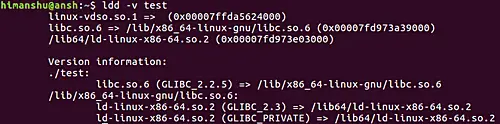

### Q2、 如何使 ldd 在输出中生成详细的信息?

|

||||

|

||||

如果您想要 `ldd` 生成详细信息,包括符号版本控制数据,则可以使用 `-v` 命令行选项。例如,该命令

|

||||

|

||||

```

|

||||

ldd -v test

|

||||

```

|

||||

|

||||

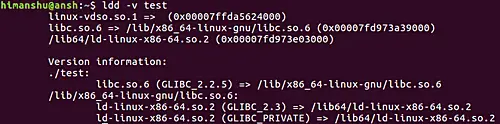

当使用 `-v` 命令行选项时,在输出中产生以下内容:

|

||||

|

||||

[](https://www.howtoforge.com/images/command-tutorial/big/ldd-v-option.png)

|

||||

|

||||

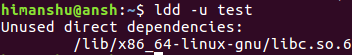

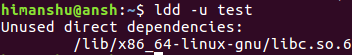

### Q3、 如何使 ldd 产生未使用的直接依赖关系?

|

||||

|

||||

对于这个信息,使用 `-u` 命令行选项。这是一个例子:

|

||||

|

||||

```

|

||||

ldd -u test

|

||||

```

|

||||

|

||||

[](https://www.howtoforge.com/images/command-tutorial/big/ldd-u-test.png)

|

||||

|

||||

### Q4、 如何让 ldd 执行重定位?

|

||||

|

||||

您可以在这里使用几个命令行选项:`-d` 和 `-r`。 前者告诉 `ldd` 执行数据重定位,后者则使 `ldd` 为数据对象和函数执行重定位。在这两种情况下,该工具都会报告丢失的 ELF 对象(如果有的话)。

|

||||

|

||||

```

|

||||

ldd -d

|

||||

ldd -r

|

||||

```

|

||||

|

||||

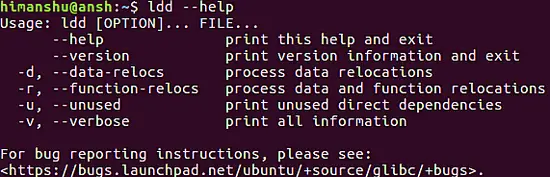

### Q5、 如何获得关于ldd的帮助?

|

||||

|

||||

`--help` 命令行选项使 `ldd` 为该工具生成有用的用法相关信息。

|

||||

|

||||

```

|

||||

ldd --help

|

||||

```

|

||||

|

||||

[](https://www.howtoforge.com/images/command-tutorial/big/ldd-help-option.png)

|

||||

|

||||

### 总结

|

||||

|

||||

`ldd` 不像 `cd`、`rm` 和 `mkdir` 这样的工具类别。这是因为它是为特定目的而构建的。该实用程序提供了有限的命令行选项,我们在这里介绍了其中的大部分。要了解更多信息,请前往 `ldd` 的[手册页](https://linux.die.net/man/1/ldd)。

|

||||

|

||||

---------

|

||||

|

||||

via: [https://www.howtoforge.com/linux-ldd-command/](https://www.howtoforge.com/linux-ldd-command/)

|

||||

|

||||

作者: [Himanshu Arora](https://www.howtoforge.com/)

|

||||

选题: [lujun9972](https://github.com/lujun9972)

|

||||

译者: [MonkeyDEcho](https://github.com/MonkeyDEcho)

|

||||

校对: [wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

149

published/20180217 The List Of Useful Bash Keyboard Shortcuts.md

Normal file

149

published/20180217 The List Of Useful Bash Keyboard Shortcuts.md

Normal file

@ -0,0 +1,149 @@

|

||||

有用的 Bash 快捷键清单

|

||||

======

|

||||

|

||||

|

||||

现如今,我在终端上花的时间更多,尝试在命令行完成比在图形界面更多的工作。随着时间推移,我学了许多 BASH 的技巧。这是一份每个 Linux 用户都应该知道的 BASH 快捷键,这样在终端做事就会快很多。我不会说这是一份完全的 BASH 快捷键清单,但是这足够让你的 BASH shell 操作比以前更快了。学习更快地使用 BASH 不仅节省了更多时间,也让你因为学到了有用的知识而感到自豪。那么,让我们开始吧。

|

||||

|

||||

### ALT 快捷键

|

||||

|

||||

1. `ALT+A` – 光标移动到行首。

|

||||

2. `ALT+B` – 光标移动到所在单词词首。

|

||||

3. `ALT+C` – 终止正在运行的命令/进程。与 `CTRL+C` 相同。

|

||||

4. `ALT+D` – 关闭空的终端(也就是它会关闭没有输入的终端)。也删除光标后的全部字符。

|

||||

5. `ALT+F` – 移动到光标所在单词词末。

|

||||

6. `ALT+T` – 交换最后两个单词。

|

||||

7. `ALT+U` – 将单词内光标后的字母转为大写。

|

||||

8. `ALT+L` – 将单词内光标后的字母转为小写。

|

||||

9. `ALT+R` – 撤销对从历史记录中带来的命令的修改。

|

||||

|

||||

正如你在上面输出所见,我使用反向搜索拉取了一个指令,并更改了那个指令的最后一个字母,并使用 `ALT+R` 撤销了更改。

|

||||

10. `ALT+.` (注意末尾的点号) – 使用上一条命令的最后一个单词。

|

||||

|

||||

如果你想要对多个命令进行相同的操作的话,你可以使用这个快捷键来获取前几个指令的最后一个单词。例如,我需要使用 `ls -r` 命令输出以文件名逆序排列的目录内容。同时,我也想使用 `uname -r` 命令来查看我的内核版本。在这两个命令中,相同的单词是 `-r` 。这就是需要 `ALT+.` 的地方。快捷键很顺手。首先运行 `ls -r` 来按文件名逆序输出,然后在其他命令,比如 `uname` 中使用最后一个单词 `-r` 。

|

||||

|

||||

### CTRL 快捷键

|

||||

|

||||

1. `CTRL+A` – 快速移动到行首。

|

||||

|

||||

我们假设你输入了像下面这样的命令。当你在第 N 行时,你发现在行首字符有一个输入错误

|

||||

|

||||

```

|

||||

$ gind . -mtime -1 -type

|

||||

```

|

||||

|

||||

注意到了吗?上面的命令中我输入了 `gind` 而不是 `find` 。你可以通过一直按着左箭头键定位到第一个字母然后用 `g` 替换 `f` 。或者,仅通过 `CTRL+A` 或 `HOME` 键来立刻定位到行首,并替换拼错的单词。这将节省你几秒钟的时间。

|

||||

|

||||

2. `CTRL+B` – 光标向前移动一个字符。

|

||||

|

||||

这个快捷键可以使光标向前移动一个字符,即光标前的一个字符。或者,你可以使用左箭头键来向前移动一个字符。

|

||||

|

||||

3. `CTRL+C` – 停止当前运行的命令。

|

||||

|

||||

如果一个命令运行时间过久,或者你误运行了,你可以通过使用 `CTRL+C` 来强制停止或退出。

|

||||

|

||||

4. `CTRL+D` – 删除光标后的一个字符。

|

||||

|

||||

如果你的系统退格键无法工作的话,你可以使用 `CTRL+D` 来删除光标后的一个字符。这个快捷键也可以让你退出当前会话,和 exit 类似。

|

||||

|

||||

5. `CTRL+E` – 移动到行末。

|

||||

|

||||

当你修正了行首拼写错误的单词,按下 `CTRL+E` 来快速移动到行末。或者,你也可以使用你键盘上的 `END` 键。

|

||||

|

||||

6. `CTRL+F` – 光标向后移动一个字符。

|

||||

|

||||

如果你想将光标向后移动一个字符的话,按 `CTRL+F` 来替代右箭头键。

|

||||

|

||||

7. `CTRL+G` – 退出历史搜索模式,不运行命令。

|

||||

|

||||

正如你在上面的截图看到的,我进行了反向搜索,但是我执行命令,并退出了历史搜索模式。

|

||||

|

||||

8. `CTRL+H` – 删除光标签的一个字符,和退格键相同。

|

||||

|

||||

9. `CTRL+J` – 和 ENTER/RETURN 键相同。

|

||||

|

||||

回车键不工作?没问题! `CTRL+J` 或 `CTRL+M` 可以用来替换回车键。

|

||||

|

||||

10. `CTRL+K` – 删除光标后的所有字符。

|

||||

|

||||

你不必一直按着删除键来删除光标后的字符。只要按 `CTRL+K` 就能删除光标后的所有字符。

|

||||

|

||||

11. `CTRL+L` – 清空屏幕并重新显示当前行。

|

||||

|

||||

别输入 `clear` 来清空屏幕了。只需按 `CTRL+M` 即可清空并重新显示当前行。

|

||||

|

||||

12. `CTRL+M` – 和 `CTRL+J` 或 RETURN键相同。

|

||||

|

||||

13. `CTRL+N` – 在命令历史中显示下一行。

|

||||

|

||||

你也可以使用下箭头键。

|

||||

|

||||

14. `CTRL+O` – 运行你使用反向搜索时发现的命令,即 CTRL+R。

|

||||

|

||||

15. `CTRL+P` – 显示命令历史的上一条命令。

|

||||

|

||||

你也可以使用上箭头键。

|

||||

|

||||

16. `CTRL+R` – 向后搜索历史记录(反向搜索)。

|

||||

|

||||

17. `CTRL+S` – 向前搜索历史记录。

|

||||

|

||||

18. `CTRL+T` – 交换最后两个字符。

|

||||

|

||||

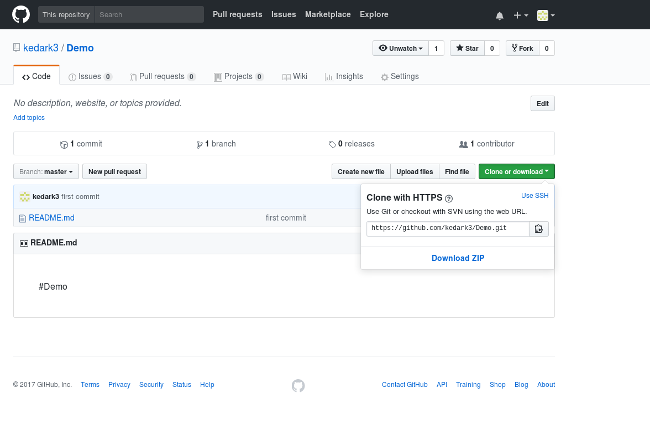

这是我最喜欢的一个快捷键。假设你输入了 `sl` 而不是 `ls` 。没问题!这个快捷键会像下面这张截图一样交换字符。

|

||||

|

||||

![][2]

|

||||

|

||||

19. `CTRL+U` – 删除光标前的所有字符(从光标后的点删除到行首)。

|

||||

|

||||

这个快捷键立刻删除前面的所有字符。

|

||||

|

||||

20. `CTRL+V` – 逐字显示输入的下一个字符。

|

||||

|

||||

21. `CTRL+W` – 删除光标前的一个单词。

|

||||

|

||||

不要和 CTRL+U 弄混了。CTRL+W 不会删除光标前的所有东西,而是只删除一个单词。

|

||||

|

||||

![][3]

|

||||

|

||||

22. `CTRL+X` – 列出当前单词可能的文件名补全。

|

||||

|

||||

23. `CTRL+XX` – 移动到行首位置(再移动回来)。

|

||||

|

||||

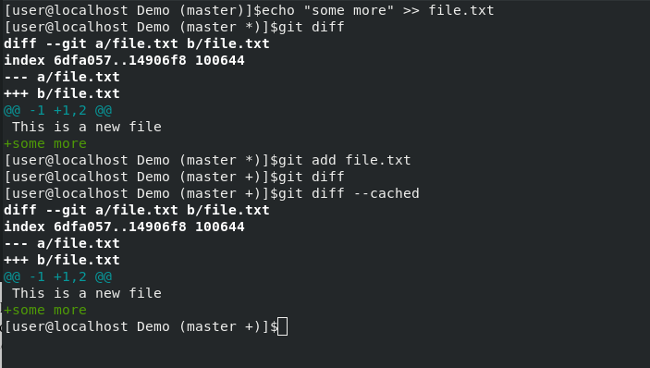

24. `CTRL+Y` – 恢复你上一个删除或剪切的条目。

|

||||

|

||||

记得吗,我们在第 21 个命令用 `CTRL+W` 删除了单词“-al”。你可以使用 `CTRL+Y` 立刻恢复。

|

||||

|

||||

![][4]

|

||||

|

||||

看见了吧?我没有输入“-al”。取而代之,我按了 `CTRL+Y` 来恢复它。

|

||||

|

||||

25. `CTRL+Z` – 停止当前的命令。

|

||||

|

||||

你也许很了解这个快捷键。它终止了当前运行的命令。你可以在前台使用 `fg` 或在后台使用 `bg` 来恢复它。

|

||||

|

||||

26. `CTRL+[` – 和 `ESC` 键等同。

|

||||

|

||||

### 杂项

|

||||

|

||||

1. `!!` – 重复上一个命令。

|

||||

|

||||

2. `ESC+t` – 交换最后两个单词。

|

||||

|

||||

这就是我所能想到的了。将来我遇到 Bash 快捷键时我会持续添加的。如果你觉得文章有错的话,请在下方的评论区留言。我会尽快更新。

|

||||

|

||||

Cheers!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.ostechnix.com/list-useful-bash-keyboard-shortcuts/

|

||||

|

||||

作者:[SK][a]

|

||||

译者:[heart4lor](https://github.com/heart4lor)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.ostechnix.com/author/sk/

|

||||

[2]:http://www.ostechnix.com/wp-content/uploads/2018/02/CTRLT-1.gif

|

||||

[3]:http://www.ostechnix.com/wp-content/uploads/2018/02/CTRLW-1.gif

|

||||

[4]:http://www.ostechnix.com/wp-content/uploads/2018/02/CTRLY-1.gif

|

||||

69

published/20180219 How Linux became my job.md

Normal file

69

published/20180219 How Linux became my job.md

Normal file

@ -0,0 +1,69 @@

|

||||

Linux 如何成为我的工作

|

||||

======

|

||||

|

||||

> IBM 工程师 Phil Estes 分享了他的 Linux 爱好如何使他成为了一位开源领袖、贡献者和维护者。

|

||||

|

||||

|

||||

|

||||

从很早很早以前起,我就一直使用开源软件。那个时候,没有所谓的社交媒体。没有火狐,没有谷歌浏览器(甚至连谷歌也没有),没有亚马逊,甚至几乎没有互联网。事实上,那个时候最热门的是最新的 Linux 2.0 内核。当时的技术挑战是什么?嗯,是 Linux 发行版本中旧的 [a.out][2] 格式被 [ELF 格式][1]代替,导致升级一些 [Linux][3] 的安装可能有些棘手。

|

||||

|

||||

我如何将我自己对这个初出茅庐的年轻操作系统的兴趣转变为开源事业是一个有趣的故事。

|

||||

|

||||

### Linux 为乐趣为生,而非利益

|

||||

|

||||

1994 年我大学毕业时,计算机实验室是 UNIX 系统的小型网络;如果你幸运的话,它们会连接到这个叫做互联网的新东西上。我知道这难以置信!(那时,)“Web”(就是所知道的那个)大多是手写的 HTML,`cgi-bin` 目录是启用动态 Web 交互的一个新平台。我们许多人对这些新技术感到兴奋,我们还自学了 shell 脚本、[Perl][4]、HTML,以及所有我们在父母的 Windows 3.1 PC 上从没有见过的简短的 UNIX 命令。

|

||||

|

||||

毕业后,我加入 IBM,工作在一个不能访问 UNIX 系统的 PC 操作系统上,不久,我的大学切断了我通往工程实验室的远程通道。我该如何继续通过 [Pine][6] 使用 `vi` 和 `ls` 读我的电子邮件的呢?我一直听说开源 Linux,但我还没有时间去研究它。

|

||||

|

||||

1996 年,我在德克萨斯大学奥斯丁分校开始读硕士学位。我知道这将涉及编程和写论文,不知道还有什么,但我不想使用专有的编辑器,编译器或者文字处理器。我想要的是我的 UNIX 体验!

|

||||

|

||||

所以我拿了一个旧电脑,找到了一个 Linux 发行版本 Slackware 3.0,在我的 IBM 办公室下载了一张又一张的软盘。可以说我在第一次安装 Linux 后就没有回过头了。在最初的那些日子里,我学习了很多关于 Makefile 和 `make` 系统、构建软件、补丁还有源码控制的知识。虽然我开始使用 Linux 只是为了兴趣和个人知识,但它最终改变了我的职业生涯。

|

||||

|

||||

虽然我是一个愉快的 Linux 用户,但我认为开源开发仍然是其他人的工作;我觉得在线邮件列表都是神秘的 [UNIX][7] 极客的。我很感激像 Linux HOWTO 这样的项目,它们在我尝试添加软件包、升级 Linux 版本,或者安装新硬件和新 PC 的设备驱动程序撞得鼻青脸肿时帮助了我。但是要处理源代码并进行修改或提交到上游……那是别人的事,不是我。

|

||||

|

||||

### Linux 如何成为我的工作

|

||||

|

||||

1999 年,我终于有理由把我对 Linux 的个人兴趣与我在 IBM 的日常工作结合起来了。我接了一个研究项目,将 IBM 的 Java 虚拟机(JVM)移植到 Linux 上。为了确保我们在法律上是安全的,IBM 购买了一个塑封的盒装的 Red Hat Linux 6.1 副本来完成这项工作。在 IBM 东京研究实验室工作时,为了编写我们的 JVM 即时编译器(JIT),参考了 AIX JVM 源代码和 Windows 及 OS/2 的 JVM 源代码,我们在几周内就有了一个可以工作在 Linux 上的 JVM,击败了 SUN 公司官方宣告花了几个月才把 Java 移植到 Linux。既然我在 Linux 平台上做得了开发,我就更喜欢它了。

|

||||

|

||||

到 2000 年,IBM 使用 Linux 的频率迅速增加。由于 [Dan Frye][8] 的远见和坚持,IBM 在 Linux 上下了“[一亿美元的赌注][9]”,在 1999 年创建了 Linux 技术中心(LTC)。在 LTC 里面有内核开发者、开源贡献者、IBM 硬件设备的驱动程序编写者,以及各种各样的针对 Linux 的开源工作。比起留在与 LTC 联系不大的部门,我更想要成为这个令人兴奋的 IBM 新天地的一份子。

|

||||

|

||||

从 2003 年到 2013 年我深度参与了 IBM 的 Linux 战略和 Linux 发行版(在 IBM 内部)的使用,最终组成了一个团队成为大约 60 个产品的信息交换所,Linux 的使用涉及了 IBM 每个部门。我参与了收购,期望每个设备、管理系统和虚拟机或者基于物理设备的中间件都能运行 Linux。我开始熟悉 Linux 发行版的构建,包括打包、选择上游来源、开发发行版维护的补丁集、做定制,并通过我们的发行版合作伙伴提供支持。

|

||||

|

||||

由于我们的下游供应商,我很少提交补丁到上游,但我通过配合 [Ulrich Drepper][10] (将一个小补丁提交到 glibc)和改变[时区数据库][11]的工作贡献了自己的力量(Arthur David Olson 在 NIH 的 FTP 站点维护它的时候接受了这个改变)。但我仍然没有把开源项目的正式贡献者的工作来当做我的工作的一部分。是该改变这种情况的时候了。

|

||||

|

||||

在 2013 年末,我加入了 IBM 在开源社区的云组织,并正在寻找一个上游社区参与进来。我会在 Cloud Foundry 工作,还是会加入 IBM 为 OpenStack 贡献的大组中呢?都不是,因为在 2014 年 Docker 席卷了全球,IBM 要我们几个参与到这个热门的新技术。我在接下来的几个月里,经历了许多的第一次:使用 GitHub,比起只是 `git clone` [学习了关于 Git 的更多知识][12],做过 Pull Request 的审查,用 Go 语言写代码,等等。在接下来的一年中,我在 Docker 引擎项目上成为一个维护者,为 Dockr 创造下一版的镜像规范(支持多个架构),并在一个关于容器技术的会议上出席和讲话。

|

||||

|

||||

### 如今的我

|

||||

|

||||

一晃几年过去,我已经成为了包括 CNCF 的 [containerd][13] 项目在内的开源项目的维护者。我还创建了项目(如 [manifest-tool][14] 和 [bucketbench][15])。我也通过 OCI 参与了开源治理,我现在是技术监督委员会的成员;而在Moby 项目,我是技术指导委员会的成员。我乐于在世界各地的会议、沙龙、IBM 内部发表关于开源的演讲。

|

||||

|

||||

开源现在是我在 IBM 职业生涯的一部分。我与工程师、开发人员和行业领袖的联系可能比我在 IBM 内认识的人的联系还要多。虽然开源与专有开发团队和供应商合作伙伴有许多相同的挑战,但据我的经验,开源与全球各地的人们的关系和联系远远超过困难。随着不同的意见、观点和经验的不断优化,可以对软件和涉及的在其中的人产生一种不断学习和改进的文化。

|

||||

|

||||

这个旅程 —— 从我第一次使用 Linux 到今天成为一个领袖、贡献者,和现在云原生开源世界的维护者 —— 我获得了极大的收获。我期待着与全球各地的人们长久的进行开源协作和互动。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/2/my-open-source-story-phil-estes

|

||||

|

||||

作者:[Phil Estes][a]

|

||||

译者:[ranchong](https://github.com/ranchong)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/estesp

|

||||

[1]:https://en.wikipedia.org/wiki/Executable_and_Linkable_Format

|

||||

[2]:https://en.wikipedia.org/wiki/A.out

|

||||

[3]:https://opensource.com/node/19796

|

||||

[4]:https://opensource.com/node/25456

|

||||

[5]:https://opensource.com/node/35141

|

||||

[6]:https://opensource.com/article/17/10/alpine-email-client

|

||||

[7]:https://opensource.com/node/22781

|

||||

[8]:https://www.linkedin.com/in/danieldfrye/

|

||||

[9]:http://www-03.ibm.com/ibm/history/ibm100/us/en/icons/linux/

|

||||

[10]:https://www.linkedin.com/in/ulrichdrepper/

|

||||

[11]:https://en.wikipedia.org/wiki/Tz_database

|

||||

[12]:https://linux.cn/article-9319-1.html

|

||||

[13]:https://github.com/containerd/containerd

|

||||

[14]:https://github.com/estesp/manifest-tool

|

||||

[15]:https://github.com/estesp/bucketbench

|

||||

@ -1,3 +1,5 @@

|

||||

lontow Translating

|

||||

|

||||

Evolutional Steps of Computer Systems

|

||||

======

|

||||

Throughout the history of the modern computer, there were several evolutional steps related to the way we interact with the system. I tend to categorize those steps as following:

|

||||

|

||||

@ -1,69 +0,0 @@

|

||||

How Linux became my job translation by ranchong

|

||||

======

|

||||

|

||||

|

||||

|

||||

I've been using open source since what seems like prehistoric times. Back then, there was nothing called social media. There was no Firefox, no Google Chrome (not even a Google), no Amazon, barely an internet. In fact, the hot topic of the day was the new Linux 2.0 kernel. The big technical challenges in those days? Well, the [ELF format][1] was replacing the old [a.out][2] format in binary [Linux][3] distributions, and the upgrade could be tricky on some installs of Linux.

|

||||

|

||||

How I transformed a personal interest in this fledgling young operating system to a [career][4] in open source is an interesting story.

|

||||

|

||||

### Linux for fun, not profit

|

||||

|

||||

I graduated from college in 1994 when computer labs were small networks of UNIX systems; if you were lucky they connected to this new thing called the internet. Hard to believe, I know! The "web" (as we knew it) was mostly handwritten HTML, and the `cgi-bin` directory was a new playground for enabling dynamic web interactions. Many of us were excited about these new technologies, and we taught ourselves shell scripting, [Perl][5], HTML, and all the terse UNIX commands that we had never seen on our parents' Windows 3.1 PCs.

|

||||

|

||||

`vi` and `ls` and reading my email via

|

||||

|

||||

After graduation, I joined IBM, working on a PC operating system with no access to UNIX systems, and soon my university cut off my remote access to the engineering lab. How was I going to keep usingandand reading my email via [Pine][6] ? I kept hearing about open source Linux, but I hadn't had time to look into it.

|

||||

|

||||

In 1996, I was about to begin a master's degree program at the University of Texas at Austin. I knew it would involve programming and writing papers, and who knows what else, and I didn't want to use proprietary editors or compilers or word processors. I wanted my UNIX experience!

|

||||

|

||||

So I took an old PC, found a Linux distribution—Slackware 3.0—and downloaded it, diskette after diskette, in my IBM office. Let's just say I've never looked back after that first install of Linux. In those early days, I learned a lot about makefiles and the `make` system, about building software, and about patches and source code control. Even though I started working with Linux for fun and personal knowledge, it ended up transforming my career.

|

||||

|

||||

While I was a happy Linux user, I thought open source development was still other people's work; I imagined an online mailing list of mystical [UNIX][7] geeks. I appreciated things like the Linux HOWTO project for helping with the bumps and bruises I acquired trying to add packages, upgrade my Linux distribution, or install device drivers for new hardware or a new PC. But working with source code and making modifications or submitting them upstream … that was for other people, not me.

|

||||

|

||||

### How Linux became my job

|

||||

|

||||

In 1999, I finally had a reason to combine my personal interest in Linux with my day job at IBM. I took on a skunkworks project to port the IBM Java Virtual Machine (JVM) to Linux. To ensure we were legally safe, IBM purchased a shrink-wrapped, boxed copy of Red Hat Linux 6.1 to do this work. Working with the IBM Tokyo Research lab, which wrote our JVM just-in-time (JIT) compiler, and both the AIX JVM source code and the Windows & OS/2 JVM source code reference, we had a working JVM on Linux within a few weeks, beating the announcement of Sun's official Java on Linux port by several months. Now that I had done development on the Linux platform, I was sold on it.

|

||||

|

||||

By 2000, IBM's use of Linux was growing rapidly. Due to the vision and persistence of [Dan Frye][8], IBM made a "[billion dollar bet][9]" on Linux, creating the Linux Technology Center (LTC) in 1999. Inside the LTC were kernel developers, open source contributors, device driver authors for IBM hardware, and all manner of Linux-focused open source work. Instead of remaining tangentially connected to the LTC, I wanted to be part of this exciting new area at IBM.

|

||||

|

||||

From 2003 to 2013 I was deeply involved in IBM's Linux strategy and use of Linux distributions, culminating with having a team that became the clearinghouse for about 60 different product uses of Linux across every division of IBM. I was involved in acquisitions where it was an expectation that every appliance, management system, and virtual or physical appliance-based middleware ran Linux. I became well-versed in the construction of Linux distributions, including packaging, selecting upstream sources, developing distro-maintained patch sets, doing customizations, and offering support through our distro partners.

|

||||

|

||||

Due to our downstream providers, I rarely got to submit patches upstream, but I got to contribute by interacting with [Ulrich Drepper][10] (including getting a small patch into glibc) and working on changes to the [timezone database][11], which Arthur David Olson accepted while he was maintaining it on the NIH FTP site. But I still hadn't worked as a regular contributor on an open source project as part of my work. It was time for that to change.

|

||||

|

||||

In late 2013, I joined IBM's cloud organization in the open source group and was looking for an upstream community in which to get involved. Would it be our work on Cloud Foundry, or would I join IBM's large group of contributors to OpenStack? It was neither, because in 2014 Docker took the world by storm, and IBM asked a few of us to get involved with this hot new technology. I experienced many firsts in the next few months: using GitHub, [learning a lot more about Git][12] than just `git clone`, having pull requests reviewed, writing in Go, and more. Over the next year, I became a maintainer in the Docker engine project, working with Docker on creating the next version of the image specification (to support multiple architectures), and attending and speaking at conferences about container technology.

|

||||

|

||||

### Where I am today

|

||||

|

||||

Fast forward a few years, and I've become a maintainer of open source projects, including the Cloud Native Computing Foundation (CNCF) [containerd][13] project. I've also created projects (such as [manifest-tool][14] and [bucketbench][15]). I've gotten involved in open source governance via the Open Containers Initiative (OCI), where I'm now a member of the Technical Oversight Board, and the Moby Project, where I'm a member of the Technical Steering Committee. And I've had the pleasure of speaking about open source at conferences around the world, to meetup groups, and internally at IBM.

|

||||

|

||||

Open source is now part of the fiber of my career at IBM. The connections I've made to engineers, developers, and leaders across the industry may rival the number of people I know and work with inside IBM. While open source has many of the same challenges as proprietary development teams and vendor partnerships have, in my experience the relationships and connections with people around the globe in open source far outweigh the difficulties. The sharpening that occurs with differing opinions, perspectives, and experiences can generate a culture of learning and improvement for both the software and the people involved.

|

||||

|

||||

This journey—from my first use of Linux to becoming a leader, contributor, and maintainer in today's cloud-native open source world—has been extremely rewarding. I'm looking forward to many more years of open source collaboration and interactions with people around the globe.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/2/my-open-source-story-phil-estes

|

||||

|

||||

作者:[Phil Estes][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/estesp

|

||||

[1]:https://en.wikipedia.org/wiki/Executable_and_Linkable_Format

|

||||

[2]:https://en.wikipedia.org/wiki/A.out

|

||||

[3]:https://opensource.com/node/19796

|

||||

[4]:https://opensource.com/node/25456

|

||||

[5]:https://opensource.com/node/35141

|

||||

[6]:https://opensource.com/article/17/10/alpine-email-client

|

||||

[7]:https://opensource.com/node/22781

|

||||

[8]:https://www.linkedin.com/in/danieldfrye/

|

||||

[9]:http://www-03.ibm.com/ibm/history/ibm100/us/en/icons/linux/

|

||||

[10]:https://www.linkedin.com/in/ulrichdrepper/

|

||||

[11]:https://en.wikipedia.org/wiki/Tz_database

|

||||