mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-03 01:10:13 +08:00

Merge remote-tracking branch 'LCTT/master'

This commit is contained in:

commit

5df858c92e

lctt2018.md

sources/tech

20180324 How To Compress And Decompress Files In Linux.md20180806 Anatomy of a Linux DNS Lookup - Part IV.md20180822 What is a Makefile and how does it work.md20180827 An introduction to diffs and patches.md20180830 How to Update Firmware on Ubuntu 18.04.md20180831 6 open source tools for making your own VPN.md20180905 8 great Python libraries for side projects.md20180906 Two open source alternatives to Flash Player.md

translated

talk

tech

20180324 How To Compress And Decompress Files In Linux.md20180806 Anatomy of a Linux DNS Lookup - Part IV.md20180822 What is a Makefile and how does it work.md20180827 An introduction to diffs and patches.md20180830 How to Update Firmware on Ubuntu 18.04.md20180831 6 open source tools for making your own VPN.md20180905 8 great Python libraries for side projects.md

75

lctt2018.md

Normal file

75

lctt2018.md

Normal file

@ -0,0 +1,75 @@

|

||||

LCTT 2018:五周年纪念日

|

||||

======

|

||||

|

||||

我是老王,可能大家有不少人知道我,由于历史原因,我有好几个生日(;o),但是这些年来,我又多了一个生日,或者说纪念日——每过两年,我就要严肃认真地写一篇 [LCTT](https://linux.cn/lctt) 生日纪念文章。

|

||||

|

||||

喏,这一篇,就是今年的了,LCTT 如今已经五岁了!

|

||||

|

||||

或许如同小孩子过生日总是比较快乐,而随着年岁渐长,过生日往往有不少负担——比如说,每次写这篇纪念文章时,我就需要回忆、反思这两年的做了些什么,往往颇为汗颜。

|

||||

|

||||

不过不管怎么说,总要总结一下这两年我们做了什么,有什么不足,也发一些展望吧。

|

||||

|

||||

### 江山代有英豪出

|

||||

|

||||

LCTT,如同一般的开源贡献组织,总是有不断的新老传承。我们的翻译组,也有不少成员,由于工作学习的原因,慢慢淡出,但同时,也不断有新的成员加入并接过前辈手中的旗帜(就是没人接我的)。

|

||||

|

||||

> **加入方式**

|

||||

|

||||

> 请首先加入翻译组的 QQ 群,群号是:**198889102**,加群时请说明是“**志愿者**”。加入后记得修改您的群名片为您的 GitHub 的 ID。

|

||||

|

||||

> 加入的成员,请先阅读 [WIKI 如何开始](https://github.com/LCTT/TranslateProject/wiki/01-%E5%A6%82%E4%BD%95%E5%BC%80%E5%A7%8B)。

|

||||

|

||||

比如说,我们这两年来,oska874 承担了主要的选题工作,然后 lujun9972 适时的出现接过了不少选题工作;再比如说,qhwdw 出现后承担了大量繁难文章的翻译,pityonline 则专注于校对,甚至其校对的严谨程度让我都甘拜下风。还有 MjSeven 也同 qhwdw 一样,以极高的翻译频率从一星译者迅速登顶五星译者。当然,还有 Bestony、Locez、VizV 等人为 LCTT 提供了不少技术支持和开发工作。

|

||||

|

||||

### 硕果累累

|

||||

|

||||

我们并没有特别的招新渠道,但是总是时不时会有新的成员慕名而来,到目前为止,我们已经有 [331](https://linux.cn/lctt-list) 位做过贡献的成员,已经翻译发布了 3885 篇译文,合计字节达 33MB 之多!

|

||||

|

||||

这两年,我们不但翻译了很多技术、新闻和评论类文章,也新增了新的翻译类型:[漫画](https://linux.cn/talk/comic/),其中一些漫画得到了很多好评。

|

||||

|

||||

我们发布的文章有一些达到了 100000+ 的访问量,这对于我们这种技术垂直内容可不容易。

|

||||

|

||||

而同时,[Linux 中国](https://linux.cn/)也发布了近万篇文章,而这一篇,应该就是第 [9999](https://linux.cn/article-9999-1.html) 篇文章,我们将在明天,进入新的篇章。

|

||||

|

||||

### 贡献者主页和贡献者证书

|

||||

|

||||

为了彰显诸位贡献者的贡献,我们为每位贡献者创立的自己的专页,并据此建立了[排行榜](https://linux.cn/lctt-list)。

|

||||

|

||||

同时,我们还特意请 Bestony 和“一一”设计开发和”贡献者证书”,大家可以在 [LCTT 贡献平台](https://lctt.linux.cn/)中领取。

|

||||

|

||||

### 规则进化

|

||||

|

||||

LCTT 最初创立时,甚至都没有采用 PR 模式。但是随着贡献者的增多,我们也逐渐在改善我们的流程、方法。

|

||||

|

||||

之前采用了很粗糙的 PR 模式,对 PR 中的文件、提交乃至于信息都没有进行硬性约束。后来在 VizV 的帮助下,建立了对 PR 的合规性检查;又在 pityonline 的督促下,采用了更为严格的 PR 审查机制。

|

||||

|

||||

LCTT 创立几年来,我们的一些流程和规范,已经成为其它一些翻译组的参考范本,我们也希望我们的这些经验,可以进一步帮助到其它的开源社区。

|

||||

|

||||

### 仓库重建和版权问题

|

||||

|

||||

今年还发生一次严重的事故,由于对选题来源把控不严和对版权问题没有引起足够的重视,我们引用的一篇文章违背了原文的版权规定,结果被原文作者投诉到 GitHub。而我并没有及时看到 GitHub 给我发的 DMCA 处理邮件,因此错过了处理窗口期,从而被 GitHub 将整个库予以删除。

|

||||

|

||||

出现这样的重大失误之后,经过大家的帮助,我们历经周折才将仓库基本恢复。这要特别感谢 VizV 的辛苦工作。

|

||||

|

||||

在此之后,我们对译文选文的规则进行了梳理,并全面清查了文章版权。这个教训对我们来说弥足沉重。

|

||||

|

||||

### 通证时代

|

||||

|

||||

在 Linux 中国及 LCTT 发展过程中,我一直小心翼翼注意商业化的问题。严格来说,没有经济支持的开源组织如同无根之木,无源之水,是长久不了的。而商业化的技术社区又难免为了三斗米而折腰。所以往往很多技术社区要么渐渐凋零,要么就变成了商业机构。

|

||||

|

||||

从中国电信辞职后,我专职运营 Linux 中国这个开源社区已经近三年了,其间也有一些商业性收入,但是仅能勉强承担基本的运营费用。

|

||||

|

||||

这种尴尬的局面,使我,以及其它的开源社区同仁们纷纷寻求更好的发展之路。

|

||||

|

||||

去年参加中国开源年会时,在闭门会上,大家的讨论启发了我和诸位同仁,我们认为,开源社区结合通证经济,似乎是一条可行的开源社区发展之路。

|

||||

|

||||

今年 8 月 1 日,我们经过了半年的论证和实验,[发布了社区通证 LCCN](https://linux.cn/article-9886-1.html),并已经初步发放到了各位译者手中。我们还在继续建设通证生态各种工具,如合约、交易商城等。

|

||||

|

||||

我们希望能够通过通证为开源社区转入新的活力,也愿意将在探索道路上遇到的问题和解决的思路、工具链分享给更多的社区。

|

||||

|

||||

### 总结

|

||||

|

||||

从上一次总结以来,这又是七百多天,时光荏苒,而 LCTT 的创立也近两千天了。我希望,我们的翻译组以及更多的贡献者可以在通证经济的推动下,找到自洽、自治的发展道路;也希望能有更多的贡献者涌现出来接过我们的大旗,将开源发扬光大。

|

||||

|

||||

wxy

|

||||

2018/9/9 夜

|

||||

@ -1,212 +0,0 @@

|

||||

ucasFL translating

|

||||

|

||||

How To Compress And Decompress Files In Linux

|

||||

======

|

||||

|

||||

|

||||

Compressing is quite useful when backing up important files and also sending large files over Internet. Please note that compressing an already compressed file adds extra overhead, hence you will get a slightly bigger file. So, stop compressing a compressed file. There are many programs to compress and decompress files in GNU/Linux. In this tutorial, we’re going to learn about two applications only.

|

||||

|

||||

### Compress and decompress files

|

||||

|

||||

The most common programs used to compress files in Unix-like systems are:

|

||||

|

||||

1. gzip

|

||||

2. bzip2

|

||||

|

||||

|

||||

|

||||

##### 1\. Compress and decompress files using Gzip program

|

||||

|

||||

The gzip is an utility to compress and decompress files using Lempel-Ziv coding (LZ77) algorithm.

|

||||

|

||||

**1.1 Compress files**

|

||||

|

||||

To compress a file named **ostechnix.txt** , replacing it with a gzipped compressed version, run:

|

||||

```

|

||||

$ gzip ostechnix.txt

|

||||

|

||||

```

|

||||

|

||||

Gzip will replace the original file **ostechnix.txt** with a gzipped compressed version named **ostechnix.txt.gz**.

|

||||

|

||||

The gzip command can also be used in other ways too. One fine example is we can create a compressed version of a specific command’s output. Look at the following command.

|

||||

```

|

||||

$ ls -l Downloads/ | gzip > ostechnix.txt.gz

|

||||

|

||||

```

|

||||

|

||||

The above command creates compressed version of the directory listing of Downloads folder.

|

||||

|

||||

**1.2 Compress files and write the output to different files (Don’t replace the original file)

|

||||

**

|

||||

|

||||

By default, gzip program will compress the given file, replacing it with a gzipped compressed version. You can, however, keep the original file and write the output to standard output. For example, the following command, compresses **ostechnix.txt** and writes the output to **output.txt.gz**.

|

||||

```

|

||||

$ gzip -c ostechnix.txt > output.txt.gz

|

||||

|

||||

```

|

||||

|

||||

Similarly, to decompress a gzipped file specifying the output filename:

|

||||

```

|

||||

$ gzip -c -d output.txt.gz > ostechnix1.txt

|

||||

|

||||

```

|

||||

|

||||

The above command decompresses the **output.txt.gz** file and writes the output to **ostechnix1.txt** file. In both cases, it won’t delete the original file.

|

||||

|

||||

**1.3 Decompress files**

|

||||

|

||||

To decompress the file **ostechnix.txt.gz** , replacing it with the original uncompressed version, we do:

|

||||

```

|

||||

$ gzip -d ostechnix.txt.gz

|

||||

|

||||

```

|

||||

|

||||

We can also use gunzip to decompress the files.

|

||||

```

|

||||

$ gunzip ostechnix.txt.gz

|

||||

|

||||

```

|

||||

|

||||

**1.4 View contents of compressed files without decompressing them**

|

||||

|

||||

To view the contents of the compressed file using gzip without decompressing it, use **-c** flag as shown below:

|

||||

```

|

||||

$ gunzip -c ostechnix1.txt.gz

|

||||

|

||||

```

|

||||

|

||||

Alternatively, use **zcat** utility like below.

|

||||

```

|

||||

$ zcat ostechnix.txt.gz

|

||||

|

||||

```

|

||||

|

||||

You can also pipe the output to “less” command to view the output page by page like below.

|

||||

```

|

||||

$ gunzip -c ostechnix1.txt.gz | less

|

||||

|

||||

$ zcat ostechnix.txt.gz | less

|

||||

|

||||

```

|

||||

|

||||

Alternatively, there is a **zless** program which performs the same function as the pipeline above.

|

||||

```

|

||||

$ zless ostechnix1.txt.gz

|

||||

|

||||

```

|

||||

|

||||

**1.5 Compress file with gzip by specifying compression level**

|

||||

|

||||

Another notable advantage of gzip is it supports compression level. It supports 3 compression levels as given below.

|

||||

|

||||

* **1** – Fastest (Worst)

|

||||

* **9** – Slowest (Best)

|

||||

* **6** – Default level

|

||||

|

||||

|

||||

|

||||

To compress a file named **ostechnix.txt** , replacing it with a gzipped compressed version with **best** compression level, we use:

|

||||

```

|

||||

$ gzip -9 ostechnix.txt

|

||||

|

||||

```

|

||||

|

||||

**1.6 Concatenate multiple compressed files**

|

||||

|

||||

It is also possible to concatenate multiple compressed files into one. How? Have a look at the following example.

|

||||

```

|

||||

$ gzip -c ostechnix1.txt > output.txt.gz

|

||||

|

||||

$ gzip -c ostechnix2.txt >> output.txt.gz

|

||||

|

||||

```

|

||||

|

||||

The above two commands will compress ostechnix1.txt and ostechnix2.txt and saves them in one file named **output.txt.gz**.

|

||||

|

||||

You can view the contents of both files (ostechnix1.txt and ostechnix2.txt) without extracting them using any one of the following commands:

|

||||

```

|

||||

$ gunzip -c output.txt.gz

|

||||

|

||||

$ gunzip -c output.txt

|

||||

|

||||

$ zcat output.txt.gz

|

||||

|

||||

$ zcat output.txt

|

||||

|

||||

```

|

||||

|

||||

For more details, refer the man pages.

|

||||

```

|

||||

$ man gzip

|

||||

|

||||

```

|

||||

|

||||

##### 2\. Compress and decompress files using bzip2 program

|

||||

|

||||

The **bzip2** is very similar to gzip program, but uses different compression algorithm named the Burrows-Wheeler block sorting text compression algorithm, and Huffman coding. The files compressed using bzip2 will end with **.bz2** extension.

|

||||

|

||||

Like I said, the usage of bzip2 is almost same as gzip. Just replace **gzip** in the above examples with **bzip2** , **gunzip** with **bunzip2** , **zcat** with **bzcat** and so on.

|

||||

|

||||

To compress a file using bzip2, replacing it with compressed version, run:

|

||||

```

|

||||

$ bzip2 ostechnix.txt

|

||||

|

||||

```

|

||||

|

||||

If you don’t want to replace the original file, use **-c** flag and write the output to a new file.

|

||||

```

|

||||

$ bzip2 -c ostechnix.txt > output.txt.bz2

|

||||

|

||||

```

|

||||

|

||||

To decompress a compressed file:

|

||||

```

|

||||

$ bzip2 -d ostechnix.txt.bz2

|

||||

|

||||

```

|

||||

|

||||

Or,

|

||||

```

|

||||

$ bunzip2 ostechnix.txt.bz2

|

||||

|

||||

```

|

||||

|

||||

To view the contents of a compressed file without decompressing it:

|

||||

```

|

||||

$ bunzip2 -c ostechnix.txt.bz2

|

||||

|

||||

```

|

||||

|

||||

Or,

|

||||

```

|

||||

$ bzcat ostechnix.txt.bz2

|

||||

|

||||

```

|

||||

|

||||

For more details, refer man pages.

|

||||

```

|

||||

$ man bzip2

|

||||

|

||||

```

|

||||

|

||||

##### Summary

|

||||

|

||||

In this tutorial, we learned what is gzip and bzip2 programs and how to use them to compress and decompress files with some examples in GNU/Linux. In this next, guide we are going to learn how to archive files and directories in Linux.

|

||||

|

||||

Cheers!

|

||||

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.ostechnix.com/how-to-compress-and-decompress-files-in-linux/

|

||||

|

||||

作者:[SK][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.ostechnix.com/author/sk/

|

||||

@ -1,182 +0,0 @@

|

||||

pinewall is translating

|

||||

|

||||

[Anatomy of a Linux DNS Lookup – Part IV][2]

|

||||

============================================

|

||||

|

||||

In [Anatomy of a Linux DNS Lookup – Part I][3], [Part II][4], and [Part III][5] I covered:

|

||||

|

||||

* `nsswitch`

|

||||

|

||||

* `/etc/hosts`

|

||||

|

||||

* `/etc/resolv.conf`

|

||||

|

||||

* `ping` vs `host` style lookups

|

||||

|

||||

* `systemd` and its `networking` service

|

||||

|

||||

* `ifup` and `ifdown`

|

||||

|

||||

* `dhclient`

|

||||

|

||||

* `resolvconf`

|

||||

|

||||

* `NetworkManager`

|

||||

|

||||

* `dnsmasq`

|

||||

|

||||

In Part IV I’ll cover how containers do DNS. Yes, that’s not simple either…

|

||||

|

||||

* * *

|

||||

|

||||

1) Docker and DNS

|

||||

============================================================

|

||||

|

||||

In [part III][6] we looked at DNSMasq, and learned that it works by directing DNS queries to the localhost address `127.0.0.1`, and a process listening on port 53 there will accept the request.

|

||||

|

||||

So when you run up a Docker container, on a host set up like this, what do you expect to see in its `/etc/resolv.conf`?

|

||||

|

||||

Have a think, and try and guess what it will be.

|

||||

|

||||

Here’s the default output if you run a default Docker setup:

|

||||

|

||||

```

|

||||

$ docker run ubuntu cat /etc/resolv.conf

|

||||

# Dynamic resolv.conf(5) file for glibc resolver(3) generated by resolvconf(8)

|

||||

# DO NOT EDIT THIS FILE BY HAND -- YOUR CHANGES WILL BE OVERWRITTEN

|

||||

# 127.0.0.53 is the systemd-resolved stub resolver.

|

||||

# run "systemd-resolve --status" to see details about the actual nameservers.

|

||||

|

||||

search home

|

||||

nameserver 8.8.8.8

|

||||

nameserver 8.8.4.4

|

||||

```

|

||||

|

||||

Hmmm.

|

||||

|

||||

#### Where did the addresses `8.8.8.8` and `8.8.4.4` come from?

|

||||

|

||||

When I pondered this question, my first thought was that the container would inherit the `/etc/resolv.conf` settings from the host. But a little thought shows that that won’t always work.

|

||||

|

||||

If you have DNSmasq set up on the host, the `/etc/resolv.conf` file will be pointed at the `127.0.0.1` loopback address. If this were passed through to the container, the container would look up DNS addresses from within its own networking context, and there’s no DNS server available within the container context, so the DNS lookups would fail.

|

||||

|

||||

‘A-ha!’ you might think: we can always use the host’s DNS server by using the _host’s_ IP address, available from within the container as the default route:

|

||||

|

||||

```

|

||||

root@79a95170e679:/# ip route

|

||||

default via 172.17.0.1 dev eth0

|

||||

172.17.0.0/16 dev eth0 proto kernel scope link src 172.17.0.2

|

||||

```

|

||||

|

||||

#### Use the host?

|

||||

|

||||

From that we can work out that the ‘host’ is on the ip address: `172.17.0.1`, so we could try manually pointing DNS at that using dig (you could also update the `/etc/resolv.conf` and then run `ping`, this just seems like a good time to introduce `dig` and its `@` flag, which points the request at the ip address you specify):

|

||||

|

||||

```

|

||||

root@79a95170e679:/# dig @172.17.0.1 google.com | grep -A1 ANSWER.SECTION

|

||||

;; ANSWER SECTION:

|

||||

google.com. 112 IN A 172.217.23.14

|

||||

```

|

||||

|

||||

However: that might work if you use DNSMasq, but if you don’t it won’t, as there’s no DNS server on the host to look up.

|

||||

|

||||

So Docker’s solution to this quandary is to bypass all that complexity and point your DNS lookups to Google’s DNS servers at `8.8.8.8` and `8.8.4.4`, ignoring whatever the host context is.

|

||||

|

||||

_Anecdote: This was the source of my first problem with Docker back in 2013\. Our corporate network blocked access to those IP addresses, so my containers couldn’t resolve URLs._

|

||||

|

||||

So that’s Docker containers, but container _orchestrators_ such as Kubernetes can do different things again…

|

||||

|

||||

# 2) Kubernetes and DNS

|

||||

|

||||

The unit of container deployment in Kubernetes is a Pod. A pod is a set of co-located containers that (among other things) share the same IP address.

|

||||

|

||||

An extra challenge with Kubernetes is to forward requests for Kubernetes services to the right resolver (eg `myservice.kubernetes.io`) to the private network allocated to those service addresses. These addresses are said to be on the ‘cluster domain’. This cluster domain is configurable by the administrator, so it might be `cluster.local` or `myorg.badger` depending on the configuration you set up.

|

||||

|

||||

In Kubernetes you have four options for configuring how DNS lookup works within your pod.

|

||||

|

||||

* Default

|

||||

|

||||

This (misleadingly-named) option takes the same DNS resolution path as the host the pod runs on, as in the ‘naive’ DNS lookup described earlier. It’s misleadingly named because it’s not the default! ClusterFirst is.

|

||||

|

||||

If you want to override the `/etc/resolv.conf` entries, you can in your config for the kubelet.

|

||||

|

||||

* ClusterFirst

|

||||

|

||||

ClusterFirst does selective forwarding on the DNS request. This is achieved in one of two ways based on the configuration.

|

||||

|

||||

In the first, older and simpler setup, a rule was followed where if the cluster domain was not found in the request, then it was forwarded to the host.

|

||||

|

||||

In the second, newer approach, you can configure selective forwarding on an internal DNS

|

||||

|

||||

Here’s what the config looks like and a diagram lifted from the [Kubernetes docs][7] which shows the flow:

|

||||

|

||||

```

|

||||

apiVersion: v1

|

||||

kind: ConfigMap

|

||||

metadata:

|

||||

name: kube-dns

|

||||

namespace: kube-system

|

||||

data:

|

||||

stubDomains: |

|

||||

{"acme.local": ["1.2.3.4"]}

|

||||

upstreamNameservers: |

|

||||

["8.8.8.8", "8.8.4.4"]

|

||||

```

|

||||

|

||||

The `stubDomains` entry defines specific DNS servers to use for specific domains. The upstream servers are the servers we defer to when nothing else has picked up the DNS request.

|

||||

|

||||

This is achieved with our old friend DNSMasq running in a pod.

|

||||

|

||||

|

||||

|

||||

The other two options are more niche:

|

||||

|

||||

* ClusterFirstWithHostNet

|

||||

|

||||

This applies if you use host network for your pods, ie you bypass the Docker networking setup to use the same network as you would directly on the host the pod is running on.

|

||||

|

||||

* None

|

||||

|

||||

None does nothing to DNS but forces you to specify the DNS settings in the `dnsConfig` field in the pod specification.

|

||||

|

||||

### CoreDNS Coming

|

||||

|

||||

And if that wasn’t enough, this is set to change again as CoreDNS comes to Kubernetes, replacing kube-dns. CoreDNS will offer a few benefits over kube-dns, being more configurabe and more efficient.

|

||||

|

||||

Find out more [here][8].

|

||||

|

||||

If you’re interested in OpenShift networking, I wrote a post on that [here][9]. But that was for 3.6 so is likely out of date now.

|

||||

|

||||

### End of Part IV

|

||||

|

||||

That’s part IV done. In it we covered.

|

||||

|

||||

* Docker DNS lookups

|

||||

|

||||

* Kubernetes DNS lookups

|

||||

|

||||

* Selective forwarding (stub domains)

|

||||

|

||||

* kube-dns

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://zwischenzugs.com/2018/08/06/anatomy-of-a-linux-dns-lookup-part-iv/

|

||||

|

||||

作者:[zwischenzugs][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://zwischenzugs.com/

|

||||

[1]:https://zwischenzugs.com/2018/08/06/anatomy-of-a-linux-dns-lookup-part-iv/

|

||||

[2]:https://zwischenzugs.com/2018/08/06/anatomy-of-a-linux-dns-lookup-part-iv/

|

||||

[3]:https://zwischenzugs.com/2018/06/08/anatomy-of-a-linux-dns-lookup-part-i/

|

||||

[4]:https://zwischenzugs.com/2018/06/18/anatomy-of-a-linux-dns-lookup-part-ii/

|

||||

[5]:https://zwischenzugs.com/2018/07/06/anatomy-of-a-linux-dns-lookup-part-iii/

|

||||

[6]:https://zwischenzugs.com/2018/07/06/anatomy-of-a-linux-dns-lookup-part-iii/

|

||||

[7]:https://kubernetes.io/docs/tasks/administer-cluster/dns-custom-nameservers/#impacts-on-pods

|

||||

[8]:https://coredns.io/

|

||||

[9]:https://zwischenzugs.com/2017/10/21/openshift-3-6-dns-in-pictures/

|

||||

@ -1,323 +0,0 @@

|

||||

Zafiry translating...

|

||||

What is a Makefile and how does it work?

|

||||

======

|

||||

|

||||

|

||||

If you want to run or update a task when certain files are updated, the `make` utility can come in handy. The `make` utility requires a file, `Makefile` (or `makefile`), which defines set of tasks to be executed. You may have used `make` to compile a program from source code. Most open source projects use `make` to compile a final executable binary, which can then be installed using `make install`.

|

||||

|

||||

In this article, we'll explore `make` and `Makefile` using basic and advanced examples. Before you start, ensure that `make` is installed in your system.

|

||||

|

||||

### Basic examples

|

||||

|

||||

Let's start by printing the classic "Hello World" on the terminal. Create a empty directory `myproject` containing a file `Makefile` with this content:

|

||||

```

|

||||

say_hello:

|

||||

|

||||

echo "Hello World"

|

||||

|

||||

```

|

||||

|

||||

Now run the file by typing `make` inside the directory `myproject`. The output will be:

|

||||

```

|

||||

$ make

|

||||

|

||||

echo "Hello World"

|

||||

|

||||

Hello World

|

||||

|

||||

```

|

||||

|

||||

In the example above, `say_hello` behaves like a function name, as in any programming language. This is called the target. The prerequisites or dependencies follow the target. For the sake of simplicity, we have not defined any prerequisites in this example. The command `echo "Hello World"` is called the recipe. The recipe uses prerequisites to make a target. The target, prerequisites, and recipes together make a rule.

|

||||

|

||||

To summarize, below is the syntax of a typical rule:

|

||||

```

|

||||

target: prerequisites

|

||||

|

||||

<TAB> recipe

|

||||

|

||||

```

|

||||

|

||||

As an example, a target might be a binary file that depends on prerequisites (source files). On the other hand, a prerequisite can also be a target that depends on other dependencies:

|

||||

```

|

||||

final_target: sub_target final_target.c

|

||||

|

||||

Recipe_to_create_final_target

|

||||

|

||||

|

||||

|

||||

sub_target: sub_target.c

|

||||

|

||||

Recipe_to_create_sub_target

|

||||

|

||||

```

|

||||

|

||||

It is not necessary for the target to be a file; it could be just a name for the recipe, as in our example. We call these "phony targets."

|

||||

|

||||

Going back to the example above, when `make` was executed, the entire command `echo "Hello World"` was displayed, followed by actual command output. We often don't want that. To suppress echoing the actual command, we need to start `echo` with `@`:

|

||||

```

|

||||

say_hello:

|

||||

|

||||

@echo "Hello World"

|

||||

|

||||

```

|

||||

|

||||

Now try to run `make` again. The output should display only this:

|

||||

```

|

||||

$ make

|

||||

|

||||

Hello World

|

||||

|

||||

```

|

||||

|

||||

Let's add a few more phony targets: `generate` and `clean` to the `Makefile`:

|

||||

```

|

||||

say_hello:

|

||||

@echo "Hello World"

|

||||

|

||||

generate:

|

||||

@echo "Creating empty text files..."

|

||||

touch file-{1..10}.txt

|

||||

|

||||

clean:

|

||||

@echo "Cleaning up..."

|

||||

rm *.txt

|

||||

```

|

||||

|

||||

If we try to run `make` after the changes, only the target `say_hello` will be executed. That's because only the first target in the makefile is the default target. Often called the default goal, this is the reason you will see `all` as the first target in most projects. It is the responsibility of `all` to call other targets. We can override this behavior using a special phony target called `.DEFAULT_GOAL`.

|

||||

|

||||

Let's include that at the beginning of our makefile:

|

||||

```

|

||||

.DEFAULT_GOAL := generate

|

||||

```

|

||||

|

||||

This will run the target `generate` as the default:

|

||||

```

|

||||

$ make

|

||||

Creating empty text files...

|

||||

touch file-{1..10}.txt

|

||||

```

|

||||

|

||||

As the name suggests, the phony target `.DEFAULT_GOAL` can run only one target at a time. This is why most makefiles include `all` as a target that can call as many targets as needed.

|

||||

|

||||

Let's include the phony target `all` and remove `.DEFAULT_GOAL`:

|

||||

```

|

||||

all: say_hello generate

|

||||

|

||||

say_hello:

|

||||

@echo "Hello World"

|

||||

|

||||

generate:

|

||||

@echo "Creating empty text files..."

|

||||

touch file-{1..10}.txt

|

||||

|

||||

clean:

|

||||

@echo "Cleaning up..."

|

||||

rm *.txt

|

||||

```

|

||||

|

||||

Before running `make`, let's include another special phony target, `.PHONY`, where we define all the targets that are not files. `make` will run its recipe regardless of whether a file with that name exists or what its last modification time is. Here is the complete makefile:

|

||||

```

|

||||

.PHONY: all say_hello generate clean

|

||||

|

||||

all: say_hello generate

|

||||

|

||||

say_hello:

|

||||

@echo "Hello World"

|

||||

|

||||

generate:

|

||||

@echo "Creating empty text files..."

|

||||

touch file-{1..10}.txt

|

||||

|

||||

clean:

|

||||

@echo "Cleaning up..."

|

||||

rm *.txt

|

||||

```

|

||||

|

||||

The `make` should call `say_hello` and `generate`:

|

||||

```

|

||||

$ make

|

||||

Hello World

|

||||

Creating empty text files...

|

||||

touch file-{1..10}.txt

|

||||

```

|

||||

|

||||

It is a good practice not to call `clean` in `all` or put it as the first target. `clean` should be called manually when cleaning is needed as a first argument to `make`:

|

||||

```

|

||||

$ make clean

|

||||

Cleaning up...

|

||||

rm *.txt

|

||||

```

|

||||

|

||||

Now that you have an idea of how a basic makefile works and how to write a simple makefile, let's look at some more advanced examples.

|

||||

|

||||

### Advanced examples

|

||||

|

||||

#### Variables

|

||||

|

||||

In the above example, most target and prerequisite values are hard-coded, but in real projects, these are replaced with variables and patterns.

|

||||

|

||||

The simplest way to define a variable in a makefile is to use the `=` operator. For example, to assign the command `gcc` to a variable `CC`:

|

||||

```

|

||||

CC = gcc

|

||||

```

|

||||

|

||||

This is also called a recursive expanded variable, and it is used in a rule as shown below:

|

||||

```

|

||||

hello: hello.c

|

||||

${CC} hello.c -o hello

|

||||

```

|

||||

|

||||

As you may have guessed, the recipe expands as below when it is passed to the terminal:

|

||||

```

|

||||

gcc hello.c -o hello

|

||||

```

|

||||

|

||||

Both `${CC}` and `$(CC)` are valid references to call `gcc`. But if one tries to reassign a variable to itself, it will cause an infinite loop. Let's verify this:

|

||||

```

|

||||

CC = gcc

|

||||

CC = ${CC}

|

||||

|

||||

all:

|

||||

@echo ${CC}

|

||||

```

|

||||

|

||||

Running `make` will result in:

|

||||

```

|

||||

$ make

|

||||

Makefile:8: *** Recursive variable 'CC' references itself (eventually). Stop.

|

||||

```

|

||||

|

||||

To avoid this scenario, we can use the `:=` operator (this is also called the simply expanded variable). We should have no problem running the makefile below:

|

||||

```

|

||||

CC := gcc

|

||||

CC := ${CC}

|

||||

|

||||

all:

|

||||

@echo ${CC}

|

||||

```

|

||||

|

||||

#### Patterns and functions

|

||||

|

||||

The following makefile can compile all C programs by using variables, patterns, and functions. Let's explore it line by line:

|

||||

```

|

||||

# Usage:

|

||||

# make # compile all binary

|

||||

# make clean # remove ALL binaries and objects

|

||||

|

||||

.PHONY = all clean

|

||||

|

||||

CC = gcc # compiler to use

|

||||

|

||||

LINKERFLAG = -lm

|

||||

|

||||

SRCS := $(wildcard *.c)

|

||||

BINS := $(SRCS:%.c=%)

|

||||

|

||||

all: ${BINS}

|

||||

|

||||

%: %.o

|

||||

@echo "Checking.."

|

||||

${CC} ${LINKERFLAG} $< -o $@

|

||||

|

||||

%.o: %.c

|

||||

@echo "Creating object.."

|

||||

${CC} -c $<

|

||||

|

||||

clean:

|

||||

@echo "Cleaning up..."

|

||||

rm -rvf *.o ${BINS}

|

||||

```

|

||||

|

||||

* Lines starting with `#` are comments.

|

||||

|

||||

* Line `.PHONY = all clean` defines phony targets `all` and `clean`.

|

||||

|

||||

* Variable `LINKERFLAG` defines flags to be used with `gcc` in a recipe.

|

||||

|

||||

* `SRCS := $(wildcard *.c)`: `$(wildcard pattern)` is one of the functions for filenames. In this case, all files with the `.c` extension will be stored in a variable `SRCS`.

|

||||

|

||||

* `BINS := $(SRCS:%.c=%)`: This is called as substitution reference. In this case, if `SRCS` has values `'foo.c bar.c'`, `BINS` will have `'foo bar'`.

|

||||

|

||||

* Line `all: ${BINS}`: The phony target `all` calls values in`${BINS}` as individual targets.

|

||||

|

||||

* Rule:

|

||||

```

|

||||

%: %.o

|

||||

@echo "Checking.."

|

||||

${CC} ${LINKERFLAG} $< -o $@

|

||||

```

|

||||

|

||||

Let's look at an example to understand this rule. Suppose `foo` is one of the values in `${BINS}`. Then `%` will match `foo`(`%` can match any target name). Below is the rule in its expanded form:

|

||||

```

|

||||

foo: foo.o

|

||||

@echo "Checking.."

|

||||

gcc -lm foo.o -o foo

|

||||

|

||||

```

|

||||

|

||||

As shown, `%` is replaced by `foo`. `$<` is replaced by `foo.o`. `$<` is patterned to match prerequisites and `$@` matches the target. This rule will be called for every value in `${BINS}`

|

||||

|

||||

* Rule:

|

||||

```

|

||||

%.o: %.c

|

||||

@echo "Creating object.."

|

||||

${CC} -c $<

|

||||

```

|

||||

|

||||

Every prerequisite in the previous rule is considered a target for this rule. Below is the rule in its expanded form:

|

||||

```

|

||||

foo.o: foo.c

|

||||

@echo "Creating object.."

|

||||

gcc -c foo.c

|

||||

```

|

||||

|

||||

* Finally, we remove all binaries and object files in target `clean`.

|

||||

|

||||

|

||||

|

||||

|

||||

Below is the rewrite of the above makefile, assuming it is placed in the directory having a single file `foo.c:`

|

||||

```

|

||||

# Usage:

|

||||

# make # compile all binary

|

||||

# make clean # remove ALL binaries and objects

|

||||

|

||||

.PHONY = all clean

|

||||

|

||||

CC = gcc # compiler to use

|

||||

|

||||

LINKERFLAG = -lm

|

||||

|

||||

SRCS := foo.c

|

||||

BINS := foo

|

||||

|

||||

all: foo

|

||||

|

||||

foo: foo.o

|

||||

@echo "Checking.."

|

||||

gcc -lm foo.o -o foo

|

||||

|

||||

foo.o: foo.c

|

||||

@echo "Creating object.."

|

||||

gcc -c foo.c

|

||||

|

||||

clean:

|

||||

@echo "Cleaning up..."

|

||||

rm -rvf foo.o foo

|

||||

```

|

||||

|

||||

For more on makefiles, refer to the [GNU Make manual][1], which offers a complete reference and examples.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/8/what-how-makefile

|

||||

|

||||

作者:[Sachin Patil][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/psachin

|

||||

[1]:https://www.gnu.org/software/make/manual/make.pdf

|

||||

@ -1,114 +0,0 @@

|

||||

Translating by DavidChenLiang

|

||||

|

||||

An introduction to diffs and patches

|

||||

======

|

||||

|

||||

|

||||

If you’ve ever worked on a large codebase with a distributed development model, you’ve probably heard people say things like “Sue just sent a patch,” or “Rajiv is checking out the diff.” Maybe those terms were new to you and you wondered what they meant. Open source has had an impact here, as the main development model of large projects from Apache web server to the Linux kernel have been “patch-based” development projects throughout their lifetime. In fact, did you know that Apache’s name originated from the set of patches that were collected and collated against the original [NCSA HTTPd server source code][1]?

|

||||

|

||||

You might think this is folklore, but an early [capture of the Apache website][2] claims that the name was derived from this original “patch” collection; hence **APA** t **CH** y server, which was then simplified to Apache.

|

||||

|

||||

But enough history trivia. What exactly are these patches and diffs that developers talk about?

|

||||

|

||||

First, for the sake of this article, let’s assume that these two terms reference one and the same thing. “Diff” is simply short for “difference;” a Unix utility by the same name reveals the difference between one or more files. We will look at a diff utility example below.

|

||||

|

||||

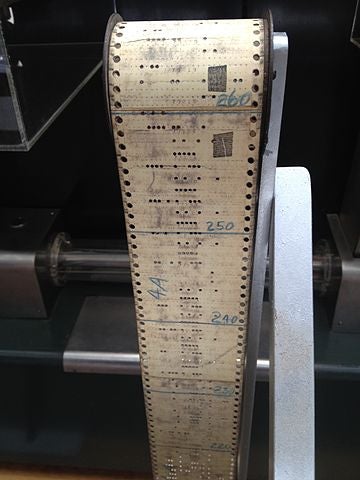

A “patch” refers to a specific collection of differences between files that can be applied to a source code tree using the Unix diff utility. So we can create diffs (or patches) using the diff tool and apply them to an unpatched version of that same source code using the patch tool. As an aside (and breaking my rule of no more history trivia), the word “patch” comes from the physical covering of punchcard holes to make software changes in the early computing days, when punchcards represented the program executed by the computer’s processor. The image below, found on this [Wikipedia page][3] describing software patches, shows this original “patching” concept:

|

||||

|

||||

|

||||

|

||||

Now that you have a basic understanding of patches and diffs, let’s explore how software developers use these tools. If you haven’t used a source code control system like [Git][4] or [Subversion][5], I will set the stage for how most non-trivial software projects are developed. If you think of the life of a software project as a set of actions along a timeline, you might visualize changes to the software—such as adding a feature or a function to a source code file or fixing a bug—appearing at different points on the timeline, with each discrete point representing the state of all the source code files at that time. We will call these points of change “commits,” using the same nomenclature that today’s most popular source code control tool, Git, uses. When you want to see the difference between the source code before and after a certain commit, or between many commits, you can use a tool to show us diffs, or differences.

|

||||

|

||||

If you are developing software using this same source code control tool, Git, you may have changes in your local system that you want to provide for others to potentially add as commits to their own tree. One way to provide local changes to others is to create a diff of your local tree's changes and send this “patch” to others who are working on the same source code. This lets others patch their tree and see the source code tree with your changes applied.

|

||||

|

||||

### Linux, Git, and GitHub

|

||||

|

||||

This model of sharing patch files is how the Linux kernel community operates regarding proposed changes today. If you look at the archives for any of the popular Linux kernel mailing lists—[LKML][6] is the primary one, but others include [linux-containers][7], [fs-devel][8], [Netdev][9], to name a few—you’ll find many developers posting patches that they wish to have others review, test, and possibly bring into the official Linux kernel Git tree at some point. It is outside of the scope of this article to discuss Git, the source code control system written by Linus Torvalds, in more detail, but it's worth noting that Git enables this distributed development model, allowing patches to live separately from a main repository, pushing and pulling into different trees and following their specific development flow.

|

||||

|

||||

Before moving on, we can’t ignore the most popular service in which patches and diffs are relevant: [GitHub][10]. Given its name, you can probably guess that GitHub is based on Git, but it offers a web- and API-based workflow around the Git tool for distributed open source project development. One of the main ways that patches are shared in GitHub is not via email, like the Linux kernel, but by creating a **pull request**. When you commit changes on your own copy of a source code tree, you can share those changes by creating a pull request against a commonly shared repository for that software project. GitHub is used by many active and popular open source projects today, such as [Kubernetes][11], [Docker][12], [the Container Network Interface (CNI)][13], [Istio][14], and many others. In the GitHub world, users tend to use the web-based interface to review the diffs or patches that comprise a pull request, but you can still access the raw patch files and use them at the command line with the patch utility.

|

||||

|

||||

### Getting down to business

|

||||

|

||||

Now that we’ve covered patches and diffs and how they are used in popular open source communities or tools, let's look at a few examples.

|

||||

|

||||

The first example includes two copies of a source tree, and one has changes that we want to visualize using the diff utility. In our examples, we will look at “unified” diffs because that is the expected view for patches in most of the modern software development world. Check the diff manual page for more information on options and ways to produce differences. The original source code is located in sources-orig and our second, modified codebase is located in a directory named sources-fixed. To show the differences in a unified diff format in your terminal, use the following command:

|

||||

```

|

||||

$ diff -Naur sources-orig/ sources-fixed/

|

||||

```

|

||||

|

||||

...which then shows the following diff command output:

|

||||

```

|

||||

diff -Naur sources-orig/officespace/interest.go sources-fixed/officespace/interest.go

|

||||

--- sources-orig/officespace/interest.go 2018-08-10 16:39:11.000000000 -0400

|

||||

+++ sources-fixed/officespace/interest.go 2018-08-10 16:39:40.000000000 -0400

|

||||

@@ -11,15 +11,13 @@

|

||||

InterestRate float64

|

||||

}

|

||||

|

||||

+// compute the rounded interest for a transaction

|

||||

func computeInterest(acct *Account, t Transaction) float64 {

|

||||

|

||||

interest := t.Amount 选题模板.txt 中文排版指北.md comic core.md Dict.md lctt2014.md lctt2016.md LCTT翻译规范.md LICENSE Makefile published README.md sign.md sources translated t.InterestRate

|

||||

roundedInterest := math.Floor(interest*100) / 100.0

|

||||

remainingInterest := interest - roundedInterest

|

||||

|

||||

- // a little extra..

|

||||

- remainingInterest *= 1000

|

||||

-

|

||||

// Save the remaining interest into an account we control:

|

||||

acct.Balance = acct.Balance + remainingInterest

|

||||

```

|

||||

|

||||

The first few lines of the diff command output could use some explanation: The three `---` signs show the original filename; any lines that exist in the original file but not in the compared new file will be prefixed with a single `-` to note that this line was “subtracted” from the sources. The `+++` signs show the opposite: The compared new file and additions found in this file are marked with a single `+` symbol to show they were added in the new version of the file. Each “hunk” (that’s what sections prefixed by `@@` are called) of the difference patch file has contextual line numbers that help the patch tool (or other processors) know where to apply this change. You can see from the "Office Space" movie reference function that we’ve corrected (by removing three lines) the greed of one of our software developers, who added a bit to the rounded-out interest calculation along with a comment to our function.

|

||||

|

||||

If you want someone else to test the changes from this tree, you could save this output from diff into a patch file:

|

||||

```

|

||||

$ diff -Naur sources-orig/ sources-fixed/ >myfixes.patch

|

||||

```

|

||||

|

||||

Now you have a patch file, myfixes.patch, which can be shared with another developer to apply and test this set of changes. A fellow developer can apply the changes using the patch tool, given that their current working directory is in the base of the source code tree:

|

||||

```

|

||||

$ patch -p1 < ../myfixes.patch

|

||||

patching file officespace/interest.go

|

||||

```

|

||||

|

||||

Now your fellow developer’s source tree is patched and ready to build and test the changes that were applied via the patch. What if this developer had made changes to interest.go separately? As long as the changes do not conflict directly—for example, change the same exact lines—the patch tool should be able to solve where to merge the changes in. As an example, an interest.go file with several other changes is used in the following example run of patch:

|

||||

```

|

||||

$ patch -p1 < ../myfixes.patch

|

||||

patching file officespace/interest.go

|

||||

Hunk #1 succeeded at 26 (offset 15 lines).

|

||||

```

|

||||

|

||||

In this case, patch warns that the changes did not apply at the original location in the file, but were offset by 15 lines. If you have heavily changed files, patch may give up trying to find where the changes fit, but it does provide options (with requisite warnings in the documentation) for turning up the matching “fuzziness” (which are beyond the scope of this article).

|

||||

|

||||

If you are using Git and/or GitHub, you will probably not use the diff or patch tools as standalone tools. Git offers much of this functionality so you can use the built-in capabilities of working on a shared source tree with merging and pulling other developer’s changes. One similar capability is to use git diff to provide the unified diff output in your local tree or between any two references (a commit identifier, the name of a tag or branch, and so on). You can even create a patch file that someone not using Git might find useful by simply piping the git diff output to a file, given that it uses the exact format of the diffcommand that patch can consume. Of course, GitHub takes these capabilities into a web-based user interface so you can view file changes on a pull request. In this view, you will note that it is effectively a unified diff view in your web browser, and GitHub allows you to download these changes as a raw patch file.

|

||||

|

||||

### Summary

|

||||

|

||||

You’ve learned what a diff and a patch are, as well as the common Unix/Linux command line tools that interact with them. Unless you are a developer on a project still using a patch file-based development method—like the Linux kernel—you will consume these capabilities primarily through a source code control system like Git. But it’s helpful to know the background and underpinnings of features many developers use daily through higher-level tools like GitHub. And who knows—they may come in handy someday when you need to work with patches from a mailing list in the Linux world.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/8/diffs-patches

|

||||

|

||||

作者:[Phil Estes][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/estesp

|

||||

[1]:https://github.com/TooDumbForAName/ncsa-httpd

|

||||

[2]:https://web.archive.org/web/19970615081902/http:/www.apache.org/info.html

|

||||

[3]:https://en.wikipedia.org/wiki/Patch_(computing)

|

||||

[4]:https://git-scm.com/

|

||||

[5]:https://subversion.apache.org/

|

||||

[6]:https://lkml.org/

|

||||

[7]:https://lists.linuxfoundation.org/pipermail/containers/

|

||||

[8]:https://patchwork.kernel.org/project/linux-fsdevel/list/

|

||||

[9]:https://www.spinics.net/lists/netdev/

|

||||

[10]:https://github.com/

|

||||

[11]:https://kubernetes.io/

|

||||

[12]:https://www.docker.com/

|

||||

[13]:https://github.com/containernetworking/cni

|

||||

[14]:https://istio.io/

|

||||

@ -1,99 +0,0 @@

|

||||

translating---geekpi

|

||||

|

||||

How to Update Firmware on Ubuntu 18.04

|

||||

======

|

||||

Usually, the default software center in Ubuntu and other Linux handle the update of the firmware of your system. But if you encounter errors with it, you can use fwupd command line tool for updating the firmware of your system.

|

||||

|

||||

I use [Dell XPS 13 Ubuntu edition][1] as my main operating system. I have done a fresh [installation of Ubuntu 18.04][2] on it and I cannot be happier with the hardware compatibility. Bluetooth, external USB headsets and speakers, multi-monitor, everything works out of the box.

|

||||

|

||||

The one thing that troubled me was one of the [firmware][3] updates that appeared in the Software Center.

|

||||

|

||||

![Updating firmware in Ubuntu][4]

|

||||

|

||||

Clicking on the Update button resulted in an error a few seconds later.

|

||||

|

||||

![Updating firmware in Ubuntu][5]

|

||||

|

||||

The error message was:

|

||||

|

||||

**Unable to update “Thunderbolt NVM for Xps Notebook 9360”: could not detect device after update: timed out while waiting for device**

|

||||

|

||||

In this quick tip, I’ll show you how to update the firmware of your system in [Ubuntu][6].

|

||||

|

||||

### Updating firmware in Ubuntu 18.04

|

||||

|

||||

![How to update firmware in Ubuntu][7]

|

||||

|

||||

One thing you should know that GNOME Software i.e. the software center in Ubuntu 18.04 is also capable of updating the firmware. But in situations when it fails for some reason, you can use the command line tool fwupd.

|

||||

|

||||

[fwupd][8] is an open source daemon that handles firmware upgrades in Linux based systems. It is created by GNOME developer [Richard Hughes][9]. Developers from Dell also contributed to the development of this open source tool.

|

||||

|

||||

Basically, it utilizes the LVFS, Linux Vendor Firmware Service. Hardware vendors upload redistributable firmware to the LVFS site and thanks to fwupd, you can upgrade those firmware from inside the operating system itself. fwupd is supported by major Linux distributions like Ubuntu and Fedora.

|

||||

|

||||

Open a terminal and update your system first:

|

||||

```

|

||||

sudo apt update && sudo apt upgrade -y

|

||||

|

||||

```

|

||||

|

||||

After that you can use the following commands one by one to start the daemon, refresh the list of available firmware updates and install the firmware updates.

|

||||

```

|

||||

sudo service fwupd start

|

||||

|

||||

```

|

||||

|

||||

Once the daemon is running, check if there are any firmware updates available.

|

||||

```

|

||||

sudo fwupdmgr refresh

|

||||

|

||||

```

|

||||

|

||||

The output should look like this:

|

||||

|

||||

Fetching metadata <https://cdn.fwupd.org/downloads/firmware.xml.gz>

|

||||

Downloading… [****************************]

|

||||

Fetching signature <https://cdn.fwupd.org/downloads/firmware.xml.gz.asc>

|

||||

|

||||

After this, run the firmware update:

|

||||

```

|

||||

sudo fwupdmgr update

|

||||

|

||||

```

|

||||

|

||||

The output of the firmware update could be similar to this:

|

||||

|

||||

```

|

||||

No upgrades for XPS 13 9360 TPM 2.0, current is 1.3.1.0: 1.3.1.0=same

|

||||

No upgrades for XPS 13 9360 System Firmware, current is 0.2.8.1: 0.2.8.1=same, 0.2.7.1=older, 0.2.6.2=older, 0.2.5.1=older, 0.2.4.2=older, 0.2.3.1=older, 0.2.2.1=older, 0.2.1.0=older, 0.1.3.7=older, 0.1.3.5=older, 0.1.3.2=older, 0.1.2.3=older

|

||||

Downloading 21.00 for XPS13 9360 Thunderbolt Controller…

|

||||

Updating 21.00 on XPS13 9360 Thunderbolt Controller…

|

||||

Decompressing… [***********]

|

||||

Authenticating… [***********]

|

||||

Restarting device… [***********]

|

||||

```

|

||||

|

||||

This should handle the firmware update in Ubuntu 18.04. I hope this quick tip helped you with firmware updates in Linux.

|

||||

|

||||

If you have questions or suggestions, please feel free to use the comment section below.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://itsfoss.com/update-firmware-ubuntu/

|

||||

|

||||

作者:[Abhishek Prakash][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://itsfoss.com/author/abhishek/

|

||||

[1]: https://itsfoss.com/dell-xps-13-ubuntu-review/

|

||||

[2]: https://itsfoss.com/install-ubuntu-dual-boot-mode-windows/

|

||||

[3]: https://en.wikipedia.org/wiki/Firmware

|

||||

[4]: https://4bds6hergc-flywheel.netdna-ssl.com/wp-content/uploads/2018/08/ubuntu-firmware-update-error-1.png

|

||||

[5]: https://4bds6hergc-flywheel.netdna-ssl.com/wp-content/uploads/2018/08/ubuntu-firmware-update-error-2.jpg

|

||||

[6]: https://www.ubuntu.com/

|

||||

[7]: https://4bds6hergc-flywheel.netdna-ssl.com/wp-content/uploads/2018/08/update-firmware-ubuntu.png

|

||||

[8]: https://fwupd.org/

|

||||

[9]: https://github.com/hughsie/fwupd

|

||||

@ -1,110 +0,0 @@

|

||||

heguangzhi Translating

|

||||

|

||||

6 open source tools for making your own VPN

|

||||

======

|

||||

|

||||

|

||||

|

||||

If you want to try your hand at building your own VPN but aren’t sure where to start, you’ve come to the right place. I’ll compare six of the best free and open source tools to set up and use a VPN on your own server. These VPNs work whether you want to set up a site-to-site VPN for your business or just create a remote access proxy to unblock websites and hide your internet traffic from ISPs.

|

||||

|

||||

Which is best depends on your needs and limitations, so take into consideration your own technical expertise, environment, and what you want to achieve with your VPN. In particular, consider the following factors:

|

||||

|

||||

* VPN protocol

|

||||

* Number of clients and types of devices

|

||||

* Server distro compatibility

|

||||

* Technical expertise required

|

||||

|

||||

|

||||

|

||||

### Algo

|

||||

|

||||

[Algo][1] was designed from the bottom up to create VPNs for corporate travelers who need a secure proxy to the internet. It “includes only the minimal software you need,” meaning you sacrifice extensibility for simplicity. Algo is based on StrongSwan but cuts out all the things that you don’t need, which has the added benefit of removing security holes that a novice might otherwise not notice.

|

||||

|

||||

As an added bonus, it even blocks ads!

|

||||

|

||||

Algo supports only the IKEv2 protocol and Wireguard. Because IKEv2 support is built into most devices these days, it doesn’t require a client app like OpenVPN. Algo can be deployed using Ansible on Ubuntu (the preferred option), Windows, RedHat, CentOS, and FreeBSD. Setup is automated using Ansible, which configures the server based on your answers to a short set of questions. It’s also very easy to tear down and re-deploy on demand.

|

||||

|

||||

Algo is probably the easiest and fastest VPN to set up and deploy on this list. It’s extremely tidy and well thought out. If you don’t need any of the more advanced features offered by other tools and just need a secure proxy, it’s a great option. Note that Algo explicitly states it’s not meant for geo-unblocking or evading censorship, and was primarily designed for confidentiality.

|

||||

|

||||

### Streisand

|

||||

|

||||

[Streisand][2] can be installed on any Ubuntu 16.04 server using a single command; the process takes about 10 minutes. It supports L2TP, OpenConnect, OpenSSH, OpenVPN, Shadowsocks, Stunnel, Tor bridge, and WireGuard. Depending on which protocol you choose, you may need to install a client app.

|

||||

|

||||

In many ways, Streisand is similar to Algo, but it offers more protocols and customization. This takes a bit more effort to manage and secure but is also more flexible. Note Streisand does not support IKEv2. I would say Streisand is more effective for bypassing censorship in places like China and Turkey due to its versatility, but Algo is easier and faster to set up.

|

||||

|

||||

The setup is automated using Ansible, so there’s not much technical expertise required. You can easily add more users by sending them custom-generated connection instructions, which include an embedded copy of the server’s SSL certificate.

|

||||

|

||||

Tearing down Streisand is a quick and painless process, and you can re-deploy on demand.

|

||||

|

||||

### OpenVPN

|

||||

|

||||

[OpenVPN][3] requires both client and server applications to set up VPN connections using the protocol of the same name. OpenVPN can be tweaked and customized to fit your needs, but it also requires the most technical expertise of the tools covered here. Both remote access and site-to-site configurations are supported; the former is what you’ll need if you plan on using your VPN as a proxy to the internet. Because client apps are required to use OpenVPN on most devices, the end user must keep them updated.

|

||||

|

||||

Server-side, you can opt to deploy in the cloud or on your Linux server. Compatible distros include CentOS, Ubuntu, Debian, and openSUSE. Client apps are available for Windows, MacOS, iOS, and Android, and there are unofficial apps for other devices. Enterprises can opt to set up an OpenVPN Access Server, but that’s probably overkill for individuals, who will want the Community Edition.

|

||||

|

||||

OpenVPN is relatively easy to configure with static key encryption, but it isn’t all that secure. Instead, I recommend setting it up with [easy-rsa][4], a key management package you can use to set up a public key infrastructure. This allows you to connect multiple devices at a time and protect them with perfect forward secrecy, among other benefits. OpenVPN uses SSL/TLS for encryption, and you can specify DNS servers in your configuration.

|

||||

|

||||

OpenVPN can traverse firewalls and NAT firewalls, which means you can use it to bypass gateways and firewalls that might otherwise block the connection. It supports both TCP and UDP transports.

|

||||

|

||||

### StrongSwan

|

||||

|

||||

You might have come across a few different VPN tools with “Swan” in the name. FreeS/WAN, OpenSwan, LibreSwan, and [strongSwan][5] are all forks of the same project, and the lattermost is my personal favorite. Server-side, strongSwan runs on Linux 2.6, 3.x, and 4x kernels, Android, FreeBSD, macOS, iOS, and Windows.

|

||||

|

||||

StrongSwan uses the IKEv2 protocol and IPSec. Compared to OpenVPN, IKEv2 connects much faster while offering comparable speed and security. This is useful if you prefer a protocol that doesn’t require installing an additional app on the client, as most newer devices manufactured today natively support IKEv2, including Windows, MacOS, iOS, and Android.

|

||||

|

||||

StrongSwan is not particularly easy to use, and despite decent documentation, it uses a different vocabulary than most other tools, which can be confusing. Its modular design makes it great for enterprises, but that also means it’s not the most streamlined. It’s certainly not as straightforward as Algo or Streisand.

|

||||

|

||||

Access control can be based on group memberships using X.509 attribute certificates, a feature unique to strongSwan. It supports EAP authentication methods for integration into other environments like Windows Active Directory. StrongSwan can traverse NAT firewalls.

|

||||

|

||||

### SoftEther

|

||||

|

||||

[SoftEther][6] started out as a project by a graduate student at the University of Tsukuba in Japan. SoftEther VPN Server and VPN Bridge run on Windows, Linux, OSX, FreeBSD, and Solaris, while the client app works on Windows, Linux, and MacOS. VPN Bridge is mainly for enterprises that need to set up site-to-site VPNs, so individual users will just need the server and client programs to set up remote access.

|

||||

|

||||

SoftEther supports the OpenVPN, L2TP, SSTP, and EtherIP protocols, but its own SoftEther protocol claims to be able to be immunized against deep packet inspection thanks to “Ethernet over HTTPS” camouflage. SoftEther also makes a few tweaks to reduce latency and increase throughput. Additionally, SoftEther includes a clone function that allows you to easily transition from OpenVPN to SoftEther.

|

||||

|

||||

SoftEther can traverse NAT firewalls and bypass firewalls. On restricted networks that permit only ICMP and DNS packets, you can utilize SoftEther’s VPN over ICMP or VPN over DNS options to penetrate the firewall. SoftEther works with both IPv4 and IPv6.

|

||||

|

||||

SoftEther is easier to set up than OpenVPN and strongSwan but is a bit more complicated than Streisand and Algo.

|

||||

|

||||

### WireGuard

|

||||

|

||||

[WireGuard][7] is the newest tool on this list; it's so new that it’s not even finished yet. That being said, it offers a fast and easy way to deploy a VPN. It aims to improve on IPSec by making it simpler and leaner like SSH.

|

||||

|

||||

Like OpenVPN, WireGuard is both a protocol and a software tool used to deploy a VPN that uses said protocol. A key feature is “crypto key routing,” which associates public keys with a list of IP addresses allowed inside the tunnel.

|

||||

|

||||

WireGuard is available for Ubuntu, Debian, Fedora, CentOS, MacOS, Windows, and Android. WireGuard works on both IPv4 and IPv6.

|

||||

|

||||

WireGuard is much lighter than most other VPN protocols, and it transmits packets only when data needs to be sent.

|

||||

|

||||

The developers say WireGuard should not yet be trusted because it hasn’t been fully audited yet, but you’re welcome to give it a spin. It could be the next big thing!

|

||||

|

||||

### Homemade VPN vs. commercial VPN

|

||||

|

||||

Making your own VPN adds a layer of privacy and security to your internet connection, but if you’re the only one using it, then it would be relatively easy for a well-equipped third party, such as a government agency, to trace activity back to you.

|

||||

|

||||

Furthermore, if you plan to use your VPN to unblock geo-locked content, a homemade VPN may not be the best option. Since you’ll only be connecting from a single IP address, your VPN server is fairly easy to block.

|

||||

|

||||

Good commercial VPNs don’t have these issues. With a provider like [ExpressVPN][8], you share the server’s IP address with dozens or even hundreds of other users, making it nigh-impossible to track a single user’s activity. You also get a huge range of hundreds or thousands of servers to choose from, so if one has been blacklisted, you can just switch to another.

|

||||

|

||||

The tradeoff of a commercial VPN, however, is that you must trust the provider not to snoop on your internet traffic. Be sure to choose a reputable provider with a clear no-logs policy.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/8/open-source-tools-vpn

|

||||

|

||||

作者:[Paul Bischoff][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:

|

||||

[1]: https://blog.trailofbits.com/2016/12/12/meet-algo-the-vpn-that-works/

|

||||

[2]: https://github.com/StreisandEffect/streisand

|

||||

[3]: https://openvpn.net/

|

||||

[4]: https://github.com/OpenVPN/easy-rsa

|

||||

[5]: https://www.strongswan.org/

|

||||

[6]: https://www.softether.org/

|

||||

[7]: https://www.wireguard.com/

|

||||

[8]: https://www.comparitech.com/vpn/reviews/expressvpn/

|

||||

@ -1,68 +0,0 @@

|

||||

ucasFL translating

|

||||

|

||||

8 great Python libraries for side projects

|

||||

======

|

||||

|

||||

|

||||

|

||||

We have a saying in the Python/Django world: We came for the language and stayed for the community. That is true for most of us, but something else that has kept us in the Python world is how easy it is to have an idea and quickly work through it over lunch or in a few hours at night.

|

||||

|

||||

This month we're diving into Python libraries we love to use to quickly scratch those side-project or lunchtime itches.

|

||||

|

||||

### To save data in a database on the fly: Dataset

|

||||

|

||||

[Dataset][1] is our go-to library when we quickly want to collect data and save it into a database before we know what our final database tables will look like. Dataset has a simple, yet powerful API that makes it easy to put data in and sort it out later.

|

||||

|

||||