mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-02-03 23:40:14 +08:00

Merge branch 'master' of https://github.com/LCTT/TranslateProject into new

This commit is contained in:

commit

4fc7fd9206

@ -1,4 +1,5 @@

|

|||||||

# KeeWeb – 一个开源且跨平台的密码管理工具

|

KeeWeb:一个开源且跨平台的密码管理工具

|

||||||

|

======

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

@ -6,64 +7,60 @@

|

|||||||

|

|

||||||

**KeePass** 就是一个这样的开源密码管理工具,它有一个官方客户端,但功能非常简单。也有许多 PC 端和手机端的其他密码管理工具,并且与 KeePass 存储加密密码的文件格式兼容。其中一个就是 **KeeWeb**。

|

**KeePass** 就是一个这样的开源密码管理工具,它有一个官方客户端,但功能非常简单。也有许多 PC 端和手机端的其他密码管理工具,并且与 KeePass 存储加密密码的文件格式兼容。其中一个就是 **KeeWeb**。

|

||||||

|

|

||||||

KeeWeb 是一个开源、跨平台的密码管理工具,具有云同步,键盘快捷键和插件等功能。KeeWeb使用 Electron 框架,这意味着它可以在 Windows,Linux 和 Mac OS 上运行。

|

KeeWeb 是一个开源、跨平台的密码管理工具,具有云同步,键盘快捷键和插件等功能。KeeWeb使用 Electron 框架,这意味着它可以在 Windows、Linux 和 Mac OS 上运行。

|

||||||

|

|

||||||

### KeeWeb 的使用

|

### KeeWeb 的使用

|

||||||

|

|

||||||

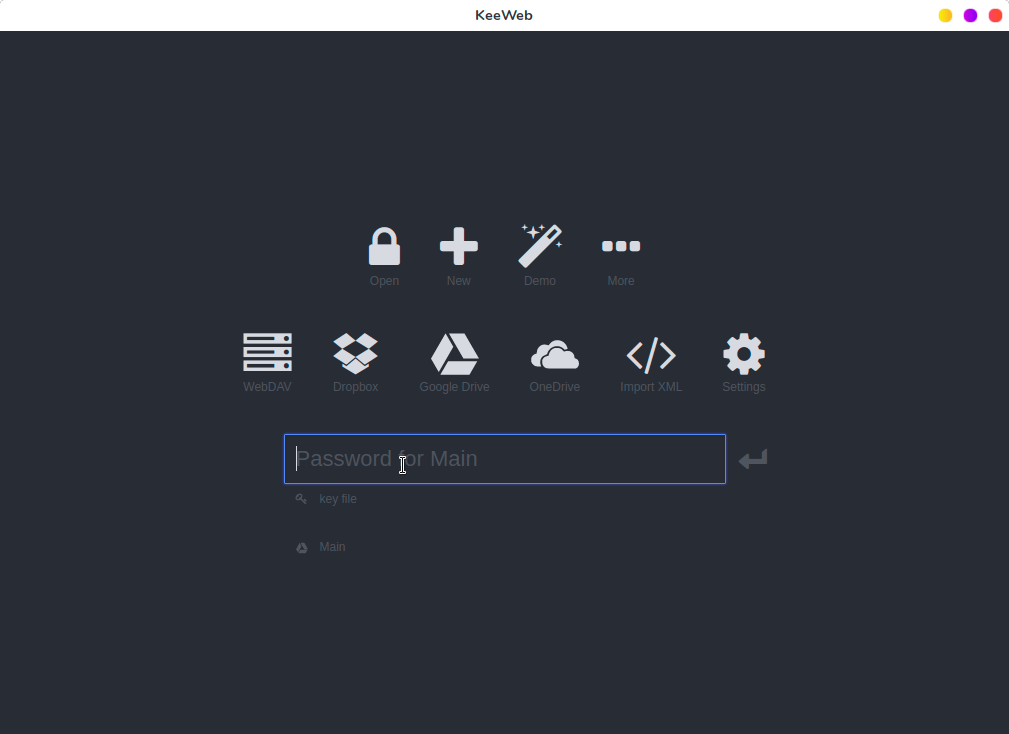

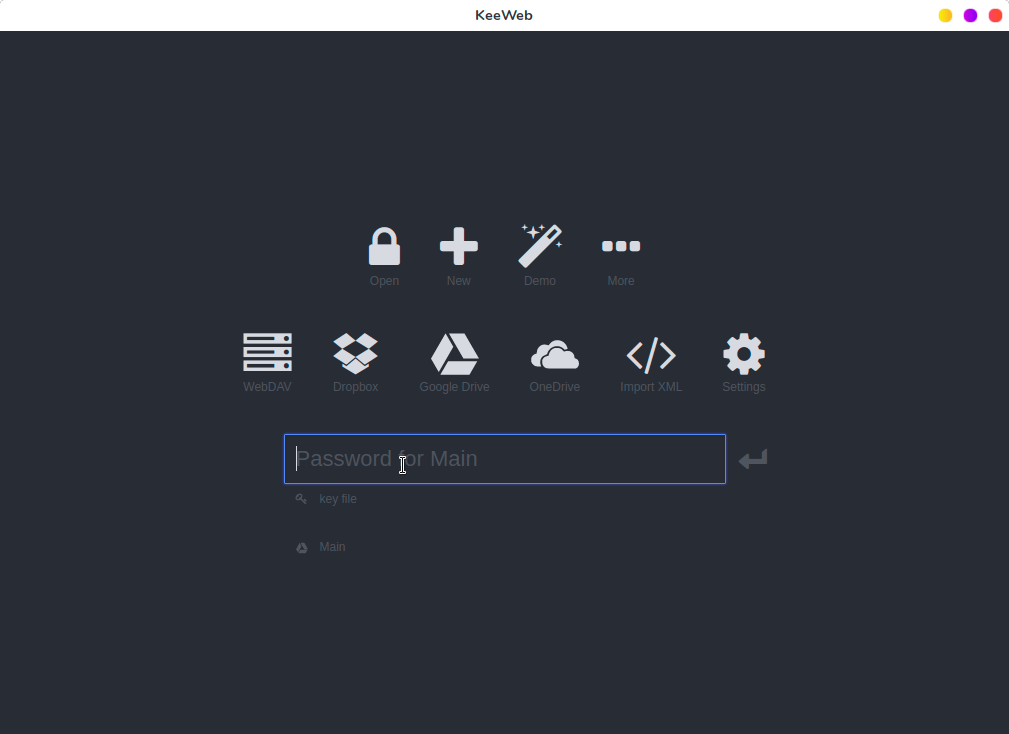

有两种方式可以使用 KeeWeb。第一种无需安装,直接在网页上使用,第二中就是在本地系统中安装 KeeWeb 客户端。

|

有两种方式可以使用 KeeWeb。第一种无需安装,直接在网页上使用,第二中就是在本地系统中安装 KeeWeb 客户端。

|

||||||

|

|

||||||

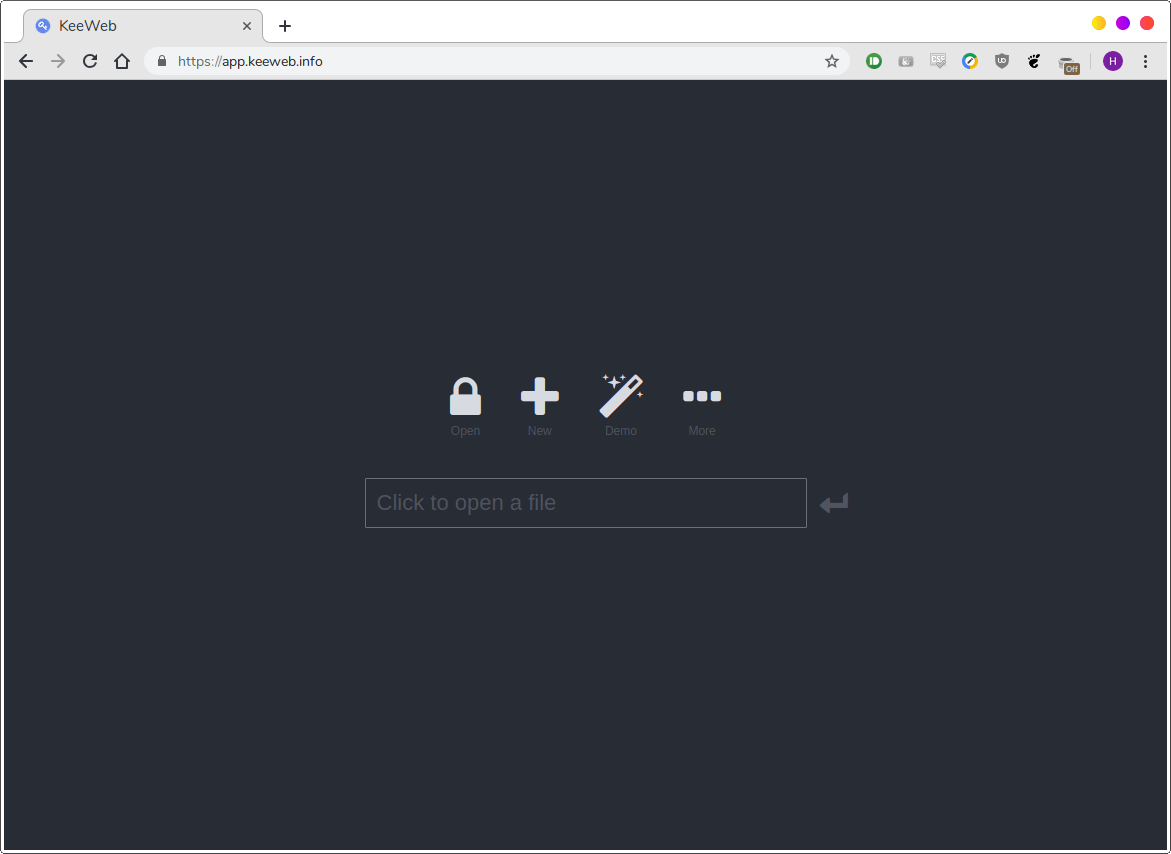

**在网页上使用 KeeWeb**

|

#### 在网页上使用 KeeWeb

|

||||||

|

|

||||||

如果不想在系统中安装应用,可以去 [**https://app.keeweb.info/**][1] 使用KeeWeb。

|

如果不想在系统中安装应用,可以去 [https://app.keeweb.info/][1] 使用KeeWeb。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

网页端具有桌面客户端的所有功能,当然也需要联网才能进行使用。

|

网页端具有桌面客户端的所有功能,当然也需要联网才能进行使用。

|

||||||

|

|

||||||

**在计算机中安装 KeeWeb**

|

#### 在计算机中安装 KeeWeb

|

||||||

|

|

||||||

如果喜欢客户端的舒适性和离线可用性,也可以将其安装在系统中。

|

如果喜欢客户端的舒适性和离线可用性,也可以将其安装在系统中。

|

||||||

|

|

||||||

如果使用Ubuntu/Debian,你可以去 [**releases pages**][2] 下载 KeeWeb 最新的 **.deb ** 文件,然后通过下面的命令进行安装:

|

如果使用 Ubuntu/Debian,你可以去 [发布页][2] 下载 KeeWeb 最新的 .deb 文件,然后通过下面的命令进行安装:

|

||||||

|

|

||||||

```

|

```

|

||||||

$ sudo dpkg -i KeeWeb-1.6.3.linux.x64.deb

|

$ sudo dpkg -i KeeWeb-1.6.3.linux.x64.deb

|

||||||

|

|

||||||

```

|

```

|

||||||

|

|

||||||

如果用的是 Arch,在 [**AUR**][3] 上也有 KeeWeb,可以使用任何 AUR 助手进行安装,例如 [**Yay**][4]:

|

如果用的是 Arch,在 [AUR][3] 上也有 KeeWeb,可以使用任何 AUR 助手进行安装,例如 [Yay][4]:

|

||||||

|

|

||||||

```

|

```

|

||||||

$ yay -S keeweb

|

$ yay -S keeweb

|

||||||

|

|

||||||

```

|

```

|

||||||

|

|

||||||

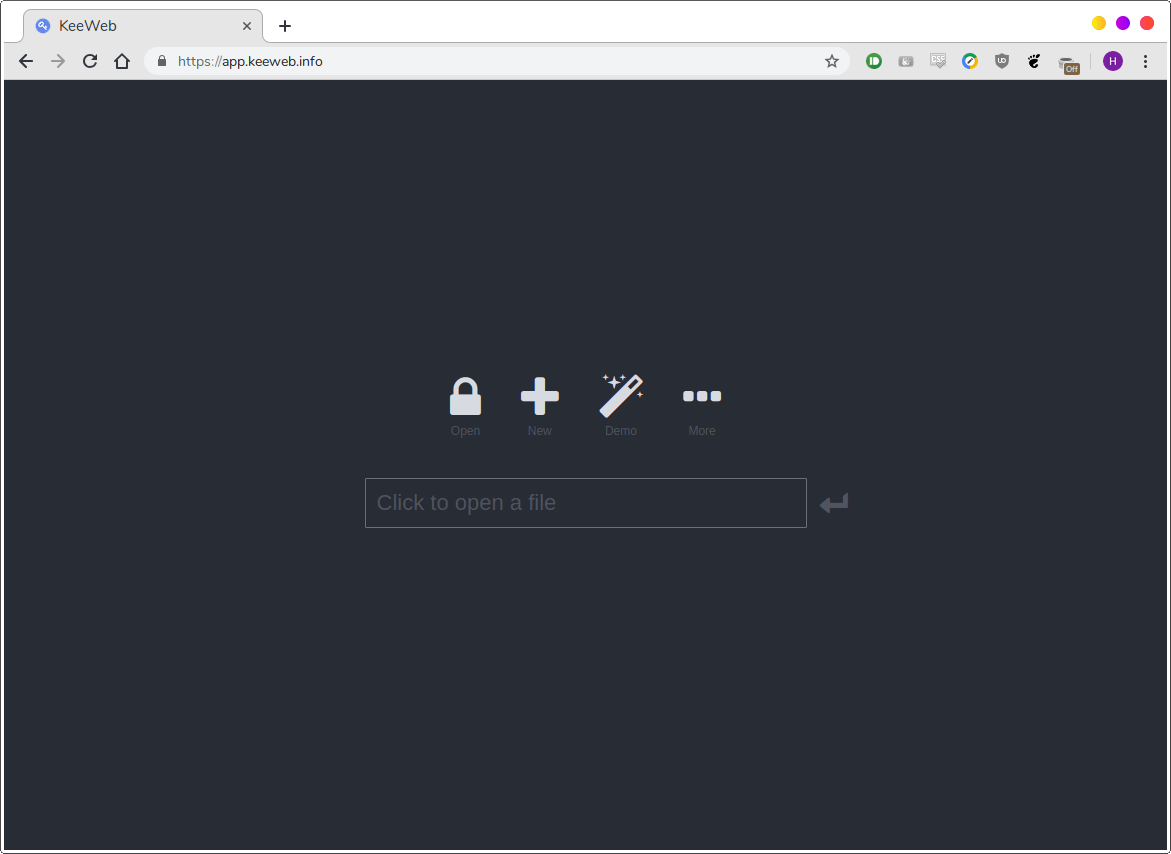

安装后,从菜单中或应用程序启动器启动 KeeWeb。默认界面长这样:

|

安装后,从菜单中或应用程序启动器启动 KeeWeb。默认界面如下:

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

### 总体布局

|

### 总体布局

|

||||||

|

|

||||||

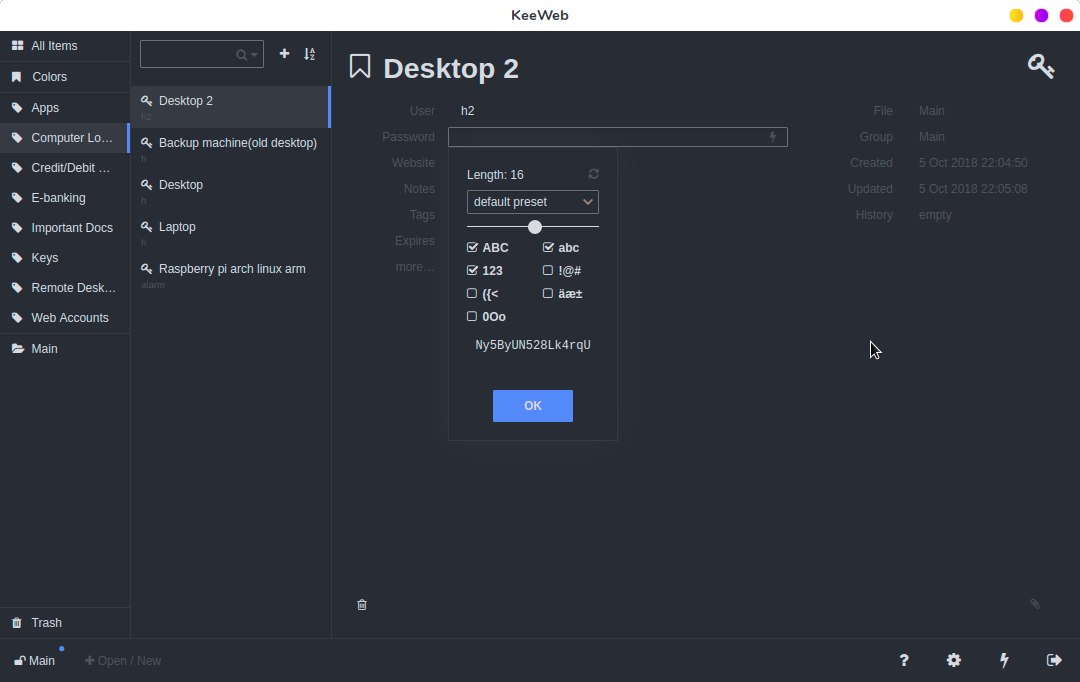

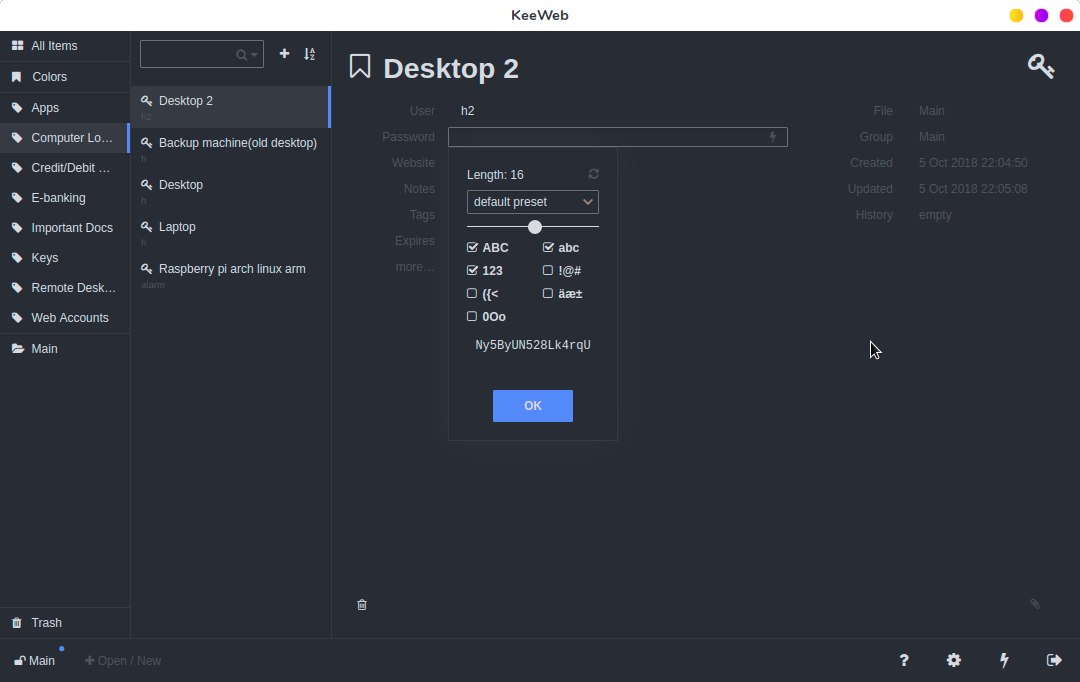

KeeWeb 界面主要显示所有密码的列表,在左侧展示所有标签。单击标签将对密码进行过滤,只显示带有那个标签的密码。在右侧,显示所选帐户的所有字段。你可以设置用户名,密码,网址,或者添加自定义的备注。你甚至可以创建自己的字段并将其标记为安全字段,这在存储信用卡信息等内容时非常有用。你只需单击即可复制密码。 KeeWeb 还显示账户的创建和修改日期。已删除的密码会保留在回收站中,可以在其中还原或永久删除。

|

KeeWeb 界面主要显示所有密码的列表,在左侧展示所有标签。单击标签将对密码进行筛选,只显示带有那个标签的密码。在右侧,显示所选帐户的所有字段。你可以设置用户名、密码、网址,或者添加自定义的备注。你甚至可以创建自己的字段并将其标记为安全字段,这在存储信用卡信息等内容时非常有用。你只需单击即可复制密码。 KeeWeb 还显示账户的创建和修改日期。已删除的密码会保留在回收站中,可以在其中还原或永久删除。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

### KeeWeb 功能

|

### KeeWeb 功能

|

||||||

|

|

||||||

**云同步**

|

#### 云同步

|

||||||

|

|

||||||

KeeWeb 的主要功能之一是支持各种远程位置和云服务。除了加载本地文件,你可以从以下位置打开文件:

|

KeeWeb 的主要功能之一是支持各种远程位置和云服务。除了加载本地文件,你可以从以下位置打开文件:

|

||||||

|

|

||||||

```

|

|

||||||

1. WebDAV Servers

|

1. WebDAV Servers

|

||||||

2. Google Drive

|

2. Google Drive

|

||||||

3. Dropbox

|

3. Dropbox

|

||||||

4. OneDrive

|

4. OneDrive

|

||||||

```

|

|

||||||

|

|

||||||

这意味着如果你使用多台计算机,就可以在它们之间同步密码文件,因此不必担心某台设备无法访问所有密码。

|

这意味着如果你使用多台计算机,就可以在它们之间同步密码文件,因此不必担心某台设备无法访问所有密码。

|

||||||

|

|

||||||

**密码生成器**

|

#### 密码生成器

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

@ -71,13 +68,13 @@ KeeWeb 的主要功能之一是支持各种远程位置和云服务。除了加

|

|||||||

|

|

||||||

为此,KeeWeb 有一个内置密码生成器,可以生成特定长度、包含指定字符的自定义密码。

|

为此,KeeWeb 有一个内置密码生成器,可以生成特定长度、包含指定字符的自定义密码。

|

||||||

|

|

||||||

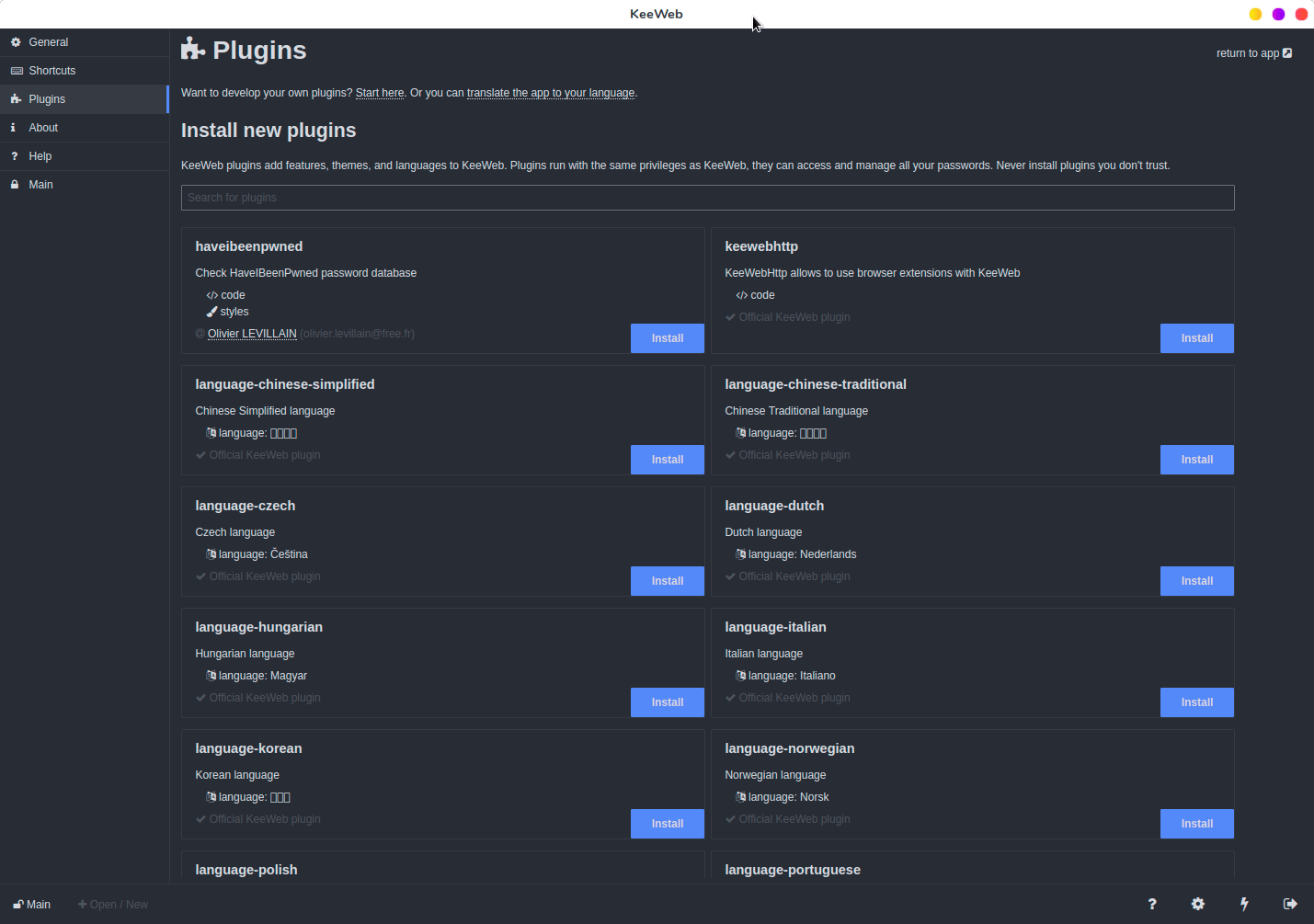

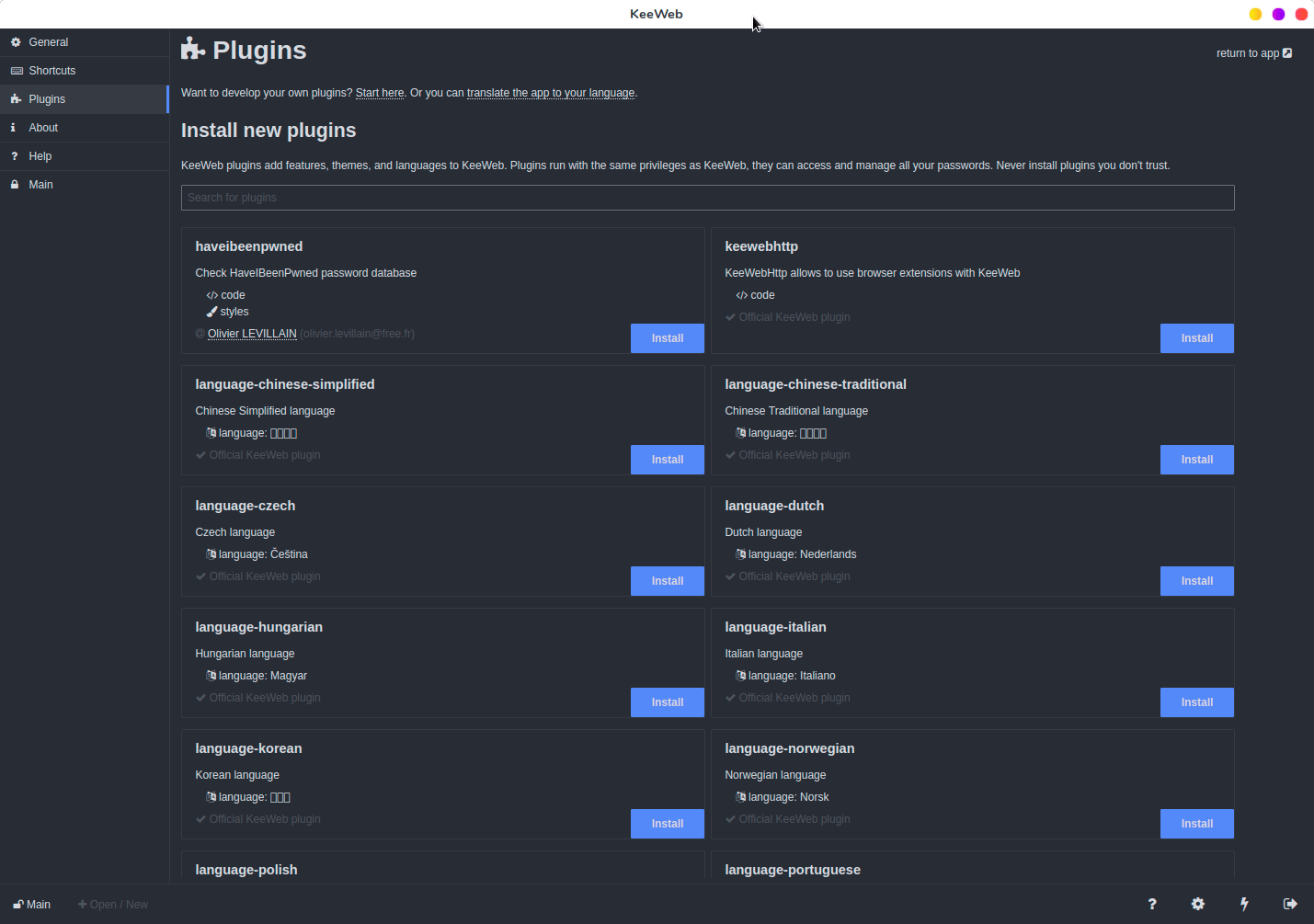

**插件**

|

#### 插件

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

你可以使用插件扩展 KeeWeb 的功能。 其中一些插件用于更改界面语言,而其他插件则添加新功能,例如访问 **<https://haveibeenpwned.com>** 以查看密码是否暴露。

|

你可以使用插件扩展 KeeWeb 的功能。其中一些插件用于更改界面语言,而其他插件则添加新功能,例如访问 https://haveibeenpwned.com 以查看密码是否暴露。

|

||||||

|

|

||||||

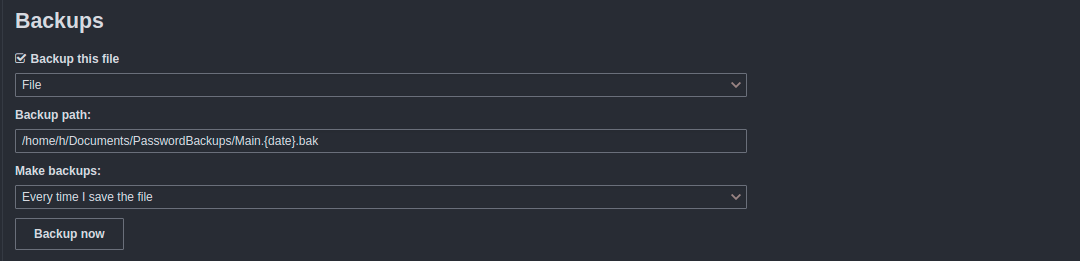

**本地备份**

|

#### 本地备份

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

@ -94,7 +91,7 @@ via: https://www.ostechnix.com/keeweb-an-open-source-cross-platform-password-man

|

|||||||

作者:[EDITOR][a]

|

作者:[EDITOR][a]

|

||||||

选题:[lujun9972](https://github.com/lujun9972)

|

选题:[lujun9972](https://github.com/lujun9972)

|

||||||

译者:[jlztan](https://github.com/jlztan)

|

译者:[jlztan](https://github.com/jlztan)

|

||||||

校对:[校对者ID](https://github.com/校对者ID)

|

校对:[wxy](https://github.com/wxy)

|

||||||

|

|

||||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||

@ -1,13 +1,13 @@

|

|||||||

理解 Linux 链接 (二)

|

理解 Linux 链接(二)

|

||||||

======

|

======

|

||||||

|

> 我们继续这个系列,来看一些你所不知道的微妙之处。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

在[本系列的第一篇文章中][1],我们认识了硬链接,软链接,知道在很多时候链接是非常有用的。链接看起来比较简单,但是也有一些不易察觉的奇怪的地方需要注意。这就是我们这篇文章中要讲的。例如,像一下我们在前一篇文章中创建的指向 `libblah` 的链接。请注意,我们是如何从目标文件夹中创建链接的。

|

在[本系列的第一篇文章中][1],我们认识了硬链接、软链接,知道在很多时候链接是非常有用的。链接看起来比较简单,但是也有一些不易察觉的奇怪的地方需要注意。这就是我们这篇文章中要讲的。例如,像一下我们在前一篇文章中创建的指向 `libblah` 的链接。请注意,我们是如何从目标文件夹中创建链接的。

|

||||||

|

|

||||||

```

|

```

|

||||||

cd /usr/local/lib

|

cd /usr/local/lib

|

||||||

|

|

||||||

ln -s /usr/lib/libblah

|

ln -s /usr/lib/libblah

|

||||||

```

|

```

|

||||||

|

|

||||||

@ -15,35 +15,32 @@ ln -s /usr/lib/libblah

|

|||||||

|

|

||||||

```

|

```

|

||||||

cd /usr/lib

|

cd /usr/lib

|

||||||

|

|

||||||

ln -s libblah /usr/local/lib

|

ln -s libblah /usr/local/lib

|

||||||

```

|

```

|

||||||

|

|

||||||

也就是说,从原始文件夹内到目标文件夹之间的链接将不起作用。

|

也就是说,从原始文件夹内到目标文件夹之间的链接将不起作用。

|

||||||

|

|

||||||

出现这种情况的原因是 `ln` 会把它当作是你在 `/usr/local/lib` 中创建一个到 `/usr/local/lib` 的链接,并在 `/usr/local/lib` 中创建了从 `libblah` 到 `libblah` 的一个链接。这是因为所有链接文件获取的是文件的名称(`libblah`),而不是文件的路径,最终的结果将会产生一个坏的链接。

|

出现这种情况的原因是 `ln` 会把它当作是你在 `/usr/local/lib` 中创建一个到 `/usr/local/lib` 的链接,并在 `/usr/local/lib` 中创建了从 `libblah` 到 `libblah` 的一个链接。这是因为所有链接文件获取的是文件的名称(`libblah),而不是文件的路径,最终的结果将会产生一个坏的链接。

|

||||||

|

|

||||||

然而,请看下面的这种情况。

|

然而,请看下面的这种情况。

|

||||||

|

|

||||||

```

|

```

|

||||||

cd /usr/lib

|

cd /usr/lib

|

||||||

|

|

||||||

ln -s /usr/lib/libblah /usr/local/lib

|

ln -s /usr/lib/libblah /usr/local/lib

|

||||||

```

|

```

|

||||||

|

|

||||||

是可以工作的。奇怪的事情又来了,不管你在文件系统的任何位置执行指令,它都可以好好的工作。使用绝对路径,也就是说,指定整个完整的路径,从根目录(`/`)开始到需要的文件或者是文件夹,是最好的实现方式。

|

是可以工作的。奇怪的事情又来了,不管你在文件系统的任何位置执行这个指令,它都可以好好的工作。使用绝对路径,也就是说,指定整个完整的路径,从根目录(`/`)开始到需要的文件或者是文件夹,是最好的实现方式。

|

||||||

|

|

||||||

其它需要注意的事情是,只要 `/usr/lib` 和 `/usr/local/lib` 在一个分区上,做一个如下的硬链接:

|

其它需要注意的事情是,只要 `/usr/lib` 和 `/usr/local/lib` 在一个分区上,做一个如下的硬链接:

|

||||||

|

|

||||||

```

|

```

|

||||||

cd /usr/lib

|

cd /usr/lib

|

||||||

|

|

||||||

ln libblah /usr/local/lib

|

ln libblah /usr/local/lib

|

||||||

```

|

```

|

||||||

|

|

||||||

也是可以工作的,因为硬链接不依赖于指向文件系统内的文件来工作。

|

也是可以工作的,因为硬链接不依赖于指向文件系统内的文件来工作。

|

||||||

|

|

||||||

如果硬链接不起作用,那么可能是你想跨分区之间建立一个硬链接。就比如说,你有分区A上有文件 `fileA` ,并且把这个分区挂载到 `/path/to/partitionA/directory` 目录,而你又想从 `fileA` 链接到分区B上 `/path/to/partitionB/directory` 目录,这样是行不通的。

|

如果硬链接不起作用,那么可能是你想跨分区之间建立一个硬链接。就比如说,你有分区 A 上有文件 `fileA` ,并且把这个分区挂载到 `/path/to/partitionA/directory` 目录,而你又想从 `fileA` 链接到分区 B 上 `/path/to/partitionB/directory` 目录,这样是行不通的。

|

||||||

|

|

||||||

```

|

```

|

||||||

ln /path/to/partitionA/directory/file /path/to/partitionB/directory

|

ln /path/to/partitionA/directory/file /path/to/partitionB/directory

|

||||||

@ -63,15 +60,15 @@ ln -s /path/to/some/directory /path/to/some/other/directory

|

|||||||

|

|

||||||

这将在 `/path/to/some/other/directory` 中创建 `/path/to/some/directory` 的链接,没有任何问题。

|

这将在 `/path/to/some/other/directory` 中创建 `/path/to/some/directory` 的链接,没有任何问题。

|

||||||

|

|

||||||

当你使用硬链接做同样的事情的时候,会提示你一个错误,说不允许那么做。而不允许这么做的原因量会导致无休止的递归:如果你在目录A中有一个目录B,然后你在目录B中链接A,就会出现同样的情况,在目录A中,目录A包含了目录B,而在目录B中又包含了A,然后又包含了B,等等无穷无尽。

|

当你使用硬链接做同样的事情的时候,会提示你一个错误,说不允许那么做。而不允许这么做的原因量会导致无休止的递归:如果你在目录 A 中有一个目录 B,然后你在目录 B 中链接 A,就会出现同样的情况,在目录 A 中,目录 A 包含了目录 B,而在目录 B 中又包含了 A,然后又包含了 B,等等无穷无尽。

|

||||||

|

|

||||||

当然你可以在递归中使用软链接,但你为什么要那样做呢?

|

当然你可以在递归中使用软链接,但你为什么要那样做呢?

|

||||||

|

|

||||||

### 我应该使用硬链接还是软链接呢?

|

### 我应该使用硬链接还是软链接呢?

|

||||||

|

|

||||||

通常,你可以在任何地方使用软链接做任何事情。实际上,在有些情况下你只能使用软软链接。话说回来,硬链接的效率要稍高一些:它们占用的磁盘空间更少,访问速度更快。在大多数的机器上, 发你可以忽略这一点点的差异,因为:在磁盘空间越来越大,访问速度越来越快的今天,空间和速度的差异可以忽略不计。不过,如果你是在一个有小存储和低功耗的处理器上使用嵌入式系统上使用 linux, 则可能需要考虑使用硬链接。

|

通常,你可以在任何地方使用软链接做任何事情。实际上,在有些情况下你只能使用软链接。话说回来,硬链接的效率要稍高一些:它们占用的磁盘空间更少,访问速度更快。在大多数的机器上,你可以忽略这一点点的差异,因为:在磁盘空间越来越大,访问速度越来越快的今天,空间和速度的差异可以忽略不计。不过,如果你是在一个有小存储和低功耗的处理器上使用嵌入式系统上使用 Linux, 则可能需要考虑使用硬链接。

|

||||||

|

|

||||||

另一个使用硬链接的原因是硬链接不容易破碎。假设你有一个软链接,而你意外的移动或者删除了它指向的文件,那么你的软链接将会破碎,并指向了一个不存在的东西。这种情况是不会发生在硬链接中的,因为硬链接直接指向的是磁盘上的数据。实际上,磁盘上的空间不不会被标记为空闲,除非最后一个指向它的硬链接把它从文件系统中擦除掉。

|

另一个使用硬链接的原因是硬链接不容易损坏。假设你有一个软链接,而你意外的移动或者删除了它指向的文件,那么你的软链接将会损坏,并指向了一个不存在的东西。这种情况是不会发生在硬链接中的,因为硬链接直接指向的是磁盘上的数据。实际上,磁盘上的空间不会被标记为空闲,除非最后一个指向它的硬链接把它从文件系统中擦除掉。

|

||||||

|

|

||||||

软链接,在另一方面比硬链接可以做更多的事情,而且可以指向任何东西,可以是文件或目录。它也可以指向不在同一个分区上的文件和目录。仅这两个不同,我们就可以做出唯一的选择了。

|

软链接,在另一方面比硬链接可以做更多的事情,而且可以指向任何东西,可以是文件或目录。它也可以指向不在同一个分区上的文件和目录。仅这两个不同,我们就可以做出唯一的选择了。

|

||||||

|

|

||||||

@ -79,7 +76,7 @@ ln -s /path/to/some/directory /path/to/some/other/directory

|

|||||||

|

|

||||||

现在我们已经介绍了文件和目录以及操作它们的工具,你是否已经准备好转到这些工具,可以浏览目录层次结构,可以查找文件中的数据,也可以检查目录。这就是我们下一期中要做的事情。下期见。

|

现在我们已经介绍了文件和目录以及操作它们的工具,你是否已经准备好转到这些工具,可以浏览目录层次结构,可以查找文件中的数据,也可以检查目录。这就是我们下一期中要做的事情。下期见。

|

||||||

|

|

||||||

你可以通过Linux 基金会和edX [Linux 简介][2]了解更多关于Linux的免费课程。

|

你可以通过 Linux 基金会和 edX “[Linux 简介][2]”了解更多关于 Linux 的免费课程。

|

||||||

|

|

||||||

--------------------------------------------------------------------------------

|

--------------------------------------------------------------------------------

|

||||||

|

|

||||||

@ -87,12 +84,12 @@ via: https://www.linux.com/blog/2018/10/understanding-linux-links-part-2

|

|||||||

|

|

||||||

作者:[Paul Brown][a]

|

作者:[Paul Brown][a]

|

||||||

选题:[lujun9972][b]

|

选题:[lujun9972][b]

|

||||||

译者:[译者ID](https://github.com/译者ID)

|

译者:[Jamkr](https://github.com/Jamkr)

|

||||||

校对:[校对者ID](https://github.com/校对者ID)

|

校对:[wxy](https://github.com/wxy)

|

||||||

|

|

||||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||

[a]: https://www.linux.com/users/bro66

|

[a]: https://www.linux.com/users/bro66

|

||||||

[b]: https://github.com/lujun9972

|

[b]: https://github.com/lujun9972

|

||||||

[1]: https://www.linux.com/blog/intro-to-linux/2018/10/linux-links-part-1

|

[1]: https://linux.cn/article-10173-1.html

|

||||||

[2]: https://training.linuxfoundation.org/linux-courses/system-administration-training/introduction-to-linux

|

[2]: https://training.linuxfoundation.org/linux-courses/system-administration-training/introduction-to-linux

|

||||||

@ -3,33 +3,34 @@

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

管道命令的作用是将一个命令/程序/进程的输出发送给另一个命令/程序/进程,以便将输出结果进行进一步的处理。我们可以通过使用管道命令把多个命令组合起来,使一个命令的标准输入或输出重定向到另一个命令。两个或多个 Linux 命令之间的竖线字符(|)表示在命令之间使用管道命令。管道命令的一般语法如下所示:

|

管道命令的作用是将一个命令/程序/进程的输出发送给另一个命令/程序/进程,以便将输出结果进行进一步的处理。我们可以通过使用管道命令把多个命令组合起来,使一个命令的标准输入或输出重定向到另一个命令。两个或多个 Linux 命令之间的竖线字符(`|`)表示在命令之间使用管道命令。管道命令的一般语法如下所示:

|

||||||

|

|

||||||

```

|

```

|

||||||

Command-1 | Command-2 | Command-3 | …| Command-N

|

Command-1 | Command-2 | Command-3 | …| Command-N

|

||||||

```

|

```

|

||||||

|

|

||||||

`Ultimate Plumber`(简称 `UP`)是一个命令行工具,它可以用于即时预览管道命令结果。如果你在使用 Linux 时经常会用到管道命令,就可以通过它更好地运用管道命令了。它可以预先显示执行管道命令后的结果,而且是即时滚动地显示,让你可以轻松构建复杂的管道。

|

Ultimate Plumber(简称 UP)是一个命令行工具,它可以用于即时预览管道命令结果。如果你在使用 Linux 时经常会用到管道命令,就可以通过它更好地运用管道命令了。它可以预先显示执行管道命令后的结果,而且是即时滚动地显示,让你可以轻松构建复杂的管道。

|

||||||

|

|

||||||

下文将会介绍如何安装 `UP` 并用它将复杂管道命令的编写变得简单。

|

下文将会介绍如何安装 UP 并用它将复杂管道命令的编写变得简单。

|

||||||

|

|

||||||

|

|

||||||

**重要警告:**

|

**重要警告:**

|

||||||

|

|

||||||

在生产环境中请谨慎使用 `UP`!在使用它的过程中,有可能会在无意中删除重要数据,尤其是搭配 `rm` 或 `dd` 命令时需要更加小心。勿谓言之不预。

|

在生产环境中请谨慎使用 UP!在使用它的过程中,有可能会在无意中删除重要数据,尤其是搭配 `rm` 或 `dd` 命令时需要更加小心。勿谓言之不预。

|

||||||

|

|

||||||

### 使用 Ultimate Plumber 即时预览管道命令

|

### 使用 Ultimate Plumber 即时预览管道命令

|

||||||

|

|

||||||

下面给出一个简单的例子介绍 `UP` 的使用方法。如果需要将 `lshw` 命令的输出传递给 `UP`,只需要在终端中输入以下命令,然后回车:

|

下面给出一个简单的例子介绍 `up` 的使用方法。如果需要将 `lshw` 命令的输出传递给 `up`,只需要在终端中输入以下命令,然后回车:

|

||||||

|

|

||||||

```

|

```

|

||||||

$ lshw |& up

|

$ lshw |& up

|

||||||

```

|

```

|

||||||

|

|

||||||

你会在屏幕顶部看到一个输入框,如下图所示。

|

你会在屏幕顶部看到一个输入框,如下图所示。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

在输入命令的过程中,输入管道符号并回车,就可以立即执行已经输入了的命令。`Ultimate Plumber` 会在下方的可滚动窗口中即时显示管道命令的输出。在这种状态下,你可以通过 `PgUp`/`PgDn` 键或 `ctrl + ←`/`ctrl + →` 组合键来查看结果。

|

在输入命令的过程中,输入管道符号并回车,就可以立即执行已经输入了的命令。Ultimate Plumber 会在下方的可滚动窗口中即时显示管道命令的输出。在这种状态下,你可以通过 `PgUp`/`PgDn` 键或 `ctrl + ←`/`ctrl + →` 组合键来查看结果。

|

||||||

|

|

||||||

当你满意执行结果之后,可以使用 `ctrl + x` 组合键退出 `UP`。而退出前编写的管道命令则会保存在当前工作目录的文件中,并命名为 `up1.sh`。如果这个文件名已经被占用,就会命名为 `up2.sh`、`up3.sh` 等等以此类推,直到第 1000 个文件。如果你不需要将管道命令保存输出,只需要使用 `ctrl + c` 组合键退出即可。

|

当你满意执行结果之后,可以使用 `ctrl + x` 组合键退出 `UP`。而退出前编写的管道命令则会保存在当前工作目录的文件中,并命名为 `up1.sh`。如果这个文件名已经被占用,就会命名为 `up2.sh`、`up3.sh` 等等以此类推,直到第 1000 个文件。如果你不需要将管道命令保存输出,只需要使用 `ctrl + c` 组合键退出即可。

|

||||||

|

|

||||||

@ -41,29 +42,29 @@ $ cat up2.sh

|

|||||||

grep network -A5 | grep : | cut -d: -f2- | paste - -

|

grep network -A5 | grep : | cut -d: -f2- | paste - -

|

||||||

```

|

```

|

||||||

|

|

||||||

如果通过管道发送到 `UP` 的命令运行时间太长,终端窗口的左上角会显示一个波浪号(~)字符,这就表示 `UP` 在等待前一个命令的输出结果作为输入。在这种情况下,你可能需要使用 `ctrl + s` 组合键暂时冻结 `UP` 的输入缓冲区大小。在需要解冻的时候,使用 `ctrl + q` 组合键即可。`Ultimate Plumber` 的输入缓冲区大小一般为 40 MB,到达这个限制之后,屏幕的左上角会显示一个加号。

|

如果通过管道发送到 `up` 的命令运行时间太长,终端窗口的左上角会显示一个波浪号(~)字符,这就表示 `up` 在等待前一个命令的输出结果作为输入。在这种情况下,你可能需要使用 `ctrl + s` 组合键暂时冻结 `up` 的输入缓冲区大小。在需要解冻的时候,使用 `ctrl + q` 组合键即可。Ultimate Plumber 的输入缓冲区大小一般为 40 MB,到达这个限制之后,屏幕的左上角会显示一个加号。

|

||||||

|

|

||||||

|

以下是 `up` 命令的一个简单演示:

|

||||||

|

|

||||||

以下是 `UP` 命令的一个简单演示:

|

|

||||||

|

|

||||||

|

|

||||||

### 安装 Ultimate Plumber

|

### 安装 Ultimate Plumber

|

||||||

|

|

||||||

喜欢这个工具的话,你可以在你的 Linux 系统上安装使用。安装过程也相当简单,只需要在终端里执行以下两个命令就可以安装 `UP` 了。

|

喜欢这个工具的话,你可以在你的 Linux 系统上安装使用。安装过程也相当简单,只需要在终端里执行以下两个命令就可以安装 `up` 了。

|

||||||

|

|

||||||

首先从 Ultimate Plumber 的[发布页面][1]下载最新的二进制文件,并将放在你系统的某个路径下,例如`/usr/local/bin/`。

|

首先从 Ultimate Plumber 的[发布页面][1]下载最新的二进制文件,并将放在你系统的某个路径下,例如 `/usr/local/bin/`。

|

||||||

|

|

||||||

```

|

```

|

||||||

$ sudo wget -O /usr/local/bin/up wget https://github.com/akavel/up/releases/download/v0.2.1/up

|

$ sudo wget -O /usr/local/bin/up wget https://github.com/akavel/up/releases/download/v0.2.1/up

|

||||||

```

|

```

|

||||||

|

|

||||||

然后向 `UP` 二进制文件赋予可执行权限:

|

然后向 `up` 二进制文件赋予可执行权限:

|

||||||

|

|

||||||

```

|

```

|

||||||

$ sudo chmod a+x /usr/local/bin/up

|

$ sudo chmod a+x /usr/local/bin/up

|

||||||

```

|

```

|

||||||

|

|

||||||

至此,你已经完成了 `UP` 的安装,可以开始编写你的管道命令了。

|

至此,你已经完成了 `up` 的安装,可以开始编写你的管道命令了。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

--------------------------------------------------------------------------------

|

--------------------------------------------------------------------------------

|

||||||

@ -73,7 +74,7 @@ via: https://www.ostechnix.com/ultimate-plumber-writing-linux-pipes-with-instant

|

|||||||

作者:[SK][a]

|

作者:[SK][a]

|

||||||

选题:[lujun9972][b]

|

选题:[lujun9972][b]

|

||||||

译者:[HankChow](https://github.com/HankChow)

|

译者:[HankChow](https://github.com/HankChow)

|

||||||

校对:[校对者ID](https://github.com/校对者ID)

|

校对:[wxy](https://github.com/wxy)

|

||||||

|

|

||||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||

@ -1,32 +1,28 @@

|

|||||||

Python 机器学习的必备技巧

|

Python 机器学习的必备技巧

|

||||||

======

|

======

|

||||||

|

|

||||||

> 尝试使用 Python 掌握机器学习、人工智能和深度学习。

|

> 尝试使用 Python 掌握机器学习、人工智能和深度学习。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

想要入门机器学习并不难。除了<ruby>大规模网络公开课<rt>Massive Open Online Courses</rt></ruby>(MOOCs)之外,还有很多其它优秀的免费资源。下面我分享一些我觉得比较有用的方法。

|

想要入门机器学习并不难。除了<ruby>大规模网络公开课<rt>Massive Open Online Courses</rt></ruby>(MOOC)之外,还有很多其它优秀的免费资源。下面我分享一些我觉得比较有用的方法。

|

||||||

|

|

||||||

1. 阅览一些关于这方面的视频、文章或者书籍,例如 [The Master Algorithm: How the Quest for the Ultimate Learning Machine Will Remake Our World][29],你肯定会喜欢这些[关于机器学习的互动页面][30]。

|

1. 从一些 YouTube 上的好视频开始,阅览一些关于这方面的文章或者书籍,例如 《[主算法:终极学习机器的探索将如何重塑我们的世界][29]》,而且我觉得你肯定会喜欢这些[关于机器学习的很酷的互动页面][30]。

|

||||||

|

2. 对于“<ruby>机器学习<rt>machine learning</rt></ruby>”、“<ruby>人工智能<rt>artificial intelligence</rt></ruby>”、“<ruby>深度学习<rt>deep learning</rt></ruby>”、“<ruby>数据科学<rt>data science</rt></ruby>”、“<ruby>计算机视觉<rt>computer vision</rt></ruby>”和“<ruby>机器人技术<rt>robotics</rt></ruby>”这一堆新名词,你需要知道它们之间的区别。你可以阅览或聆听这些领域的专家们的演讲,例如这位有影响力的[数据科学家 Brandon Rohrer 的精彩视频][1]。或者这个讲述了数据科学相关的[各种角色之间的区别][2]的视频。

|

||||||

2. 对于“机器学习”、“人工智能”、“深度学习”、“数据科学”、“计算机视觉”和“机器人技术”这一堆新名词,你需要知道它们之前的区别。你可以阅览这些领域的专家们的演讲,例如[数据科学家 Brandon Rohrer 的这个视频][1]。

|

3. 明确你自己的学习目标,并选择合适的 [Coursera 课程][3],或者参加高校的网络公开课,例如[华盛顿大学的课程][4]就很不错。

|

||||||

|

4. 关注优秀的博客:例如 [KDnuggets][32] 的博客、[Mark Meloon][33] 的博客、[Brandon Rohrer][34] 的博客、[Open AI][35] 的研究博客,这些都值得推荐。

|

||||||

3. 明确你自己的学习目标,并选择合适的 [Coursera 课程][3],或者参加高校的网络公开课。例如[华盛顿大学的课程][4]就很不错。

|

5. 如果你热衷于在线课程,后文中会有如何[正确选择 MOOC 课程][31]的指导。

|

||||||

|

6. 最重要的是,培养自己对这些技术的兴趣。加入一些优秀的社交论坛,不要被那些耸人听闻的头条和新闻所吸引,专注于阅读和了解,将这些技术的背景知识和发展方向理解透彻,并积极思考在日常生活和工作中如何应用机器学习或数据科学的原理。例如建立一个简单的回归模型来预测下一次午餐的成本,又或者是从电力公司的网站上下载历史电费数据,在 Excel 中进行简单的时序分析以发现某种规律。在你对这些技术产生了浓厚兴趣之后,可以观看以下这个视频。

|

||||||

4. 关注优秀的博客:例如 [KDnuggets][32] 的博客、[Mark Meloon][33] 的博客、[Brandon Rohrer][34] 的博客、[Open AI][35] 的博客,这些都值得推荐。

|

|

||||||

|

|

||||||

5. 如果你对在线课程有很大兴趣,后文中会有如何[正确选择 MOOC 课程][31]的指导。

|

|

||||||

|

|

||||||

6. 最重要的是,培养自己对这些技术的兴趣。加入一些优秀的社交论坛,专注于阅读和了解,将这些技术的背景知识和发展方向理解透彻,并积极思考在日常生活和工作中如何应用机器学习或数据科学的原理。例如建立一个简单的回归模型来预测下一次午餐的成本,又或者是从电力公司的网站上下载历史电费数据,在 Excel 中进行简单的时序分析以发现某种规律。在你对这些技术产生了浓厚兴趣之后,可以观看以下这个视频。

|

|

||||||

|

|

||||||

<https://www.youtube.com/embed/IpGxLWOIZy4>

|

<https://www.youtube.com/embed/IpGxLWOIZy4>

|

||||||

|

|

||||||

### Python 是机器学习和人工智能方面的最佳语言吗?

|

### Python 是机器学习和人工智能方面的最佳语言吗?

|

||||||

|

|

||||||

除非你是一名专业的研究一些复杂算法纯理论证明的研究人员,否则,对于一个机器学习的入门者来说,需要熟悉至少一种高级编程语言一家相关的专业知识。因为大多数情况下都是需要考虑如何将机器学习算法应用于解决实际问题,而这需要有一定的编程能力作为基础。

|

除非你是一名专业的研究一些复杂算法纯理论证明的研究人员,否则,对于一个机器学习的入门者来说,需要熟悉至少一种高级编程语言。因为大多数情况下都是需要考虑如何将现有的机器学习算法应用于解决实际问题,而这需要有一定的编程能力作为基础。

|

||||||

|

|

||||||

哪一种语言是数据科学的最佳语言?这个讨论一直没有停息过。对于这方面,你可以提起精神来看一下 FreeCodeCamp 上这一篇关于[数据科学语言][6]的文章,又或者是 KDnuggets 关于 [Python 和 R][7] 之间的深入探讨。

|

哪一种语言是数据科学的最佳语言?这个讨论一直没有停息过。对于这方面,你可以提起精神来看一下 FreeCodeCamp 上这一篇关于[数据科学语言][6]的文章,又或者是 KDnuggets 关于 [Python 和 R 之争][7]的深入探讨。

|

||||||

|

|

||||||

目前人们普遍认为 Python 在开发、部署、维护各方面的效率都是比较高的。与 Java、C 和 C++ 这些较为传统的语言相比,Python 的语法更为简单和高级。而且 Python 拥有活跃的社区群体、广泛的开源文化、数百个专用于机器学习的优质代码库,以及来自业界巨头(包括Google、Dropbox、Airbnb 等)的强大技术支持。

|

目前人们普遍认为 Python 在开发、部署、维护各方面的效率都是比较高的。与 Java、C 和 C++ 这些较为传统的语言相比,Python 的语法更为简单和高级。而且 Python 拥有活跃的社区群体、广泛的开源文化、数百个专用于机器学习的优质代码库,以及来自业界巨头(包括 Google、Dropbox、Airbnb 等)的强大技术支持。

|

||||||

|

|

||||||

### 基础 Python 库

|

### 基础 Python 库

|

||||||

|

|

||||||

@ -46,7 +42,7 @@ Pandas 是 Python 生态中用于进行通用数据分析的最受欢迎的库

|

|||||||

* 选择数据子集

|

* 选择数据子集

|

||||||

* 跨行列计算

|

* 跨行列计算

|

||||||

* 查找并补充缺失的数据

|

* 查找并补充缺失的数据

|

||||||

* 将操作应用于数据中的独立组

|

* 将操作应用于数据中的独立分组

|

||||||

* 按照多种格式转换数据

|

* 按照多种格式转换数据

|

||||||

* 组合多个数据集

|

* 组合多个数据集

|

||||||

* 高级时间序列功能

|

* 高级时间序列功能

|

||||||

@ -68,7 +64,7 @@ Pandas 是 Python 生态中用于进行通用数据分析的最受欢迎的库

|

|||||||

|

|

||||||

#### Scikit-learn

|

#### Scikit-learn

|

||||||

|

|

||||||

Scikit-learn 是机器学习方面通用的重要 Python 包。它实现了多种[分类][16]、[回归][17]和[聚类][18]算法,包括[支持向量机][19]、[随机森林][20]、[梯度增强][21]、[k-means 算法][22]和 [DBSCAN 算法][23],可以与 Python 的数值库 NumPy 和科学计算库 [SciPy][24] 结合使用。它通过兼容的接口提供了有监督和无监督的学习算法。Scikit-learn 的强壮性让它可以稳定运行在生产环境中,同时它在易用性、代码质量、团队协作、文档和性能等各个方面都有良好的表现。可以参考这篇基于 Scikit-learn 的[机器学习入门][25],或者这篇基于 Scikit-learn 的[简单机器学习用例演示][26]。

|

Scikit-learn 是机器学习方面通用的重要 Python 包。它实现了多种[分类][16]、[回归][17]和[聚类][18]算法,包括[支持向量机][19]、[随机森林][20]、[梯度增强][21]、[k-means 算法][22]和 [DBSCAN 算法][23],可以与 Python 的数值库 NumPy 和科学计算库 [SciPy][24] 结合使用。它通过兼容的接口提供了有监督和无监督的学习算法。Scikit-learn 的强壮性让它可以稳定运行在生产环境中,同时它在易用性、代码质量、团队协作、文档和性能等各个方面都有良好的表现。可以参考[这篇基于 Scikit-learn 的机器学习入门][25],或者[这篇基于 Scikit-learn 的简单机器学习用例演示][26]。

|

||||||

|

|

||||||

本文使用 [CC BY-SA 4.0][28] 许可,在 [Heartbeat][27] 上首发。

|

本文使用 [CC BY-SA 4.0][28] 许可,在 [Heartbeat][27] 上首发。

|

||||||

|

|

||||||

@ -79,7 +75,7 @@ via: https://opensource.com/article/18/10/machine-learning-python-essential-hack

|

|||||||

作者:[Tirthajyoti Sarkar][a]

|

作者:[Tirthajyoti Sarkar][a]

|

||||||

选题:[lujun9972][b]

|

选题:[lujun9972][b]

|

||||||

译者:[HankChow](https://github.com/HankChow)

|

译者:[HankChow](https://github.com/HankChow)

|

||||||

校对:[校对者ID](https://github.com/校对者ID)

|

校对:[wxy](https://github.com/wxy)

|

||||||

|

|

||||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||

@ -1,134 +0,0 @@

|

|||||||

translating by belitex

|

|

||||||

|

|

||||||

What breaks our systems: A taxonomy of black swans

|

|

||||||

======

|

|

||||||

|

|

||||||

Find and fix outlier events that create issues before they trigger severe production problems.

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

Black swans are a metaphor for outlier events that are severe in impact (like the 2008 financial crash). In production systems, these are the incidents that trigger problems that you didn't know you had, cause major visible impact, and can't be fixed quickly and easily by a rollback or some other standard response from your on-call playbook. They are the events you tell new engineers about years after the fact.

|

|

||||||

|

|

||||||

Black swans, by definition, can't be predicted, but sometimes there are patterns we can find and use to create defenses against categories of related problems.

|

|

||||||

|

|

||||||

For example, a large proportion of failures are a direct result of changes (code, environment, or configuration). Each bug triggered in this way is distinctive and unpredictable, but the common practice of canarying all changes is somewhat effective against this class of problems, and automated rollbacks have become a standard mitigation.

|

|

||||||

|

|

||||||

As our profession continues to mature, other kinds of problems are becoming well-understood classes of hazards with generalized prevention strategies.

|

|

||||||

|

|

||||||

### Black swans observed in the wild

|

|

||||||

|

|

||||||

All technology organizations have production problems, but not all of them share their analyses. The organizations that publicly discuss incidents are doing us all a service. The following incidents describe one class of a problem and are by no means isolated instances. We all have black swans lurking in our systems; it's just some of us don't know it yet.

|

|

||||||

|

|

||||||

#### Hitting limits

|

|

||||||

|

|

||||||

Running headlong into any sort of limit can produce very severe incidents. A canonical example of this was [Instapaper's outage in February 2017][1] . I challenge any engineer who has carried a pager to read the outage report without a chill running up their spine. Instapaper's production database was on a filesystem that, unknown to the team running the service, had a 2TB limit. With no warning, it stopped accepting writes. Full recovery took days and required migrating its database.

|

|

||||||

|

|

||||||

Limits can strike in various ways. Sentry hit [limits on maximum transaction IDs in Postgres][2] . Platform.sh hit [size limits on a pipe buffer][3] . SparkPost [triggered AWS's DDoS protection][4] . Foursquare hit a performance cliff when one of its [datastores ran out of RAM][5]

|

|

||||||

|

|

||||||

One way to get advance knowledge of system limits is to test periodically. Good load testing (on a production replica) ought to involve write transactions and should involve growing each datastore beyond its current production size. It's easy to forget to test things that aren't your main datastores (such as Zookeeper). If you hit limits during testing, you have time to fix the problems. Given that resolution of limits-related issues can involve major changes (like splitting a datastore), time is invaluable.

|

|

||||||

|

|

||||||

When it comes to cloud services, if your service generates unusual loads or uses less widely used products or features (such as older or newer ones), you may be more at risk of hitting limits. It's worth load testing these, too. But warn your cloud provider first.

|

|

||||||

|

|

||||||

Finally, where limits are known, add monitoring (with associated documentation) so you will know when your systems are approaching those ceilings. Don't rely on people still being around to remember.

|

|

||||||

|

|

||||||

#### Spreading slowness

|

|

||||||

|

|

||||||

> "The world is much more correlated than we give credit to. And so we see more of what Nassim Taleb calls 'black swan events'—rare events happen more often than they should because the world is more correlated."

|

|

||||||

> —[Richard Thaler][6]

|

|

||||||

|

|

||||||

HostedGraphite's postmortem on how an [AWS outage took down its load balancers][7] (which are not hosted on AWS) is a good example of just how much correlation exists in distributed computing systems. In this case, the load-balancer connection pools were saturated by slow connections from customers that were hosted in AWS. The same kinds of saturation can happen with application threads, locks, and database connections—any kind of resource monopolized by slow operations.

|

|

||||||

|

|

||||||

HostedGraphite's incident is an example of externally imposed slowness, but often slowness can result from saturation somewhere in your own system creating a cascade and causing other parts of your system to slow down. An [incident at Spotify][8] demonstrates such spread—the streaming service's frontends became unhealthy due to saturation in a different microservice. Enforcing deadlines for all requests, as well as limiting the length of request queues, can prevent such spread. Your service will serve at least some traffic, and recovery will be easier because fewer parts of your system will be broken.

|

|

||||||

|

|

||||||

Retries should be limited with exponential backoff and some jitter. An outage at Square, in which its [Redis datastore became overloaded][9] due to a piece of code that retried failed transactions up to 500 times with no backoff, demonstrates the potential severity of excessive retries. The [Circuit Breaker][10] design pattern can be helpful here, too.

|

|

||||||

|

|

||||||

Dashboards should be designed to clearly show [utilization, saturation, and errors][11] for all resources so problems can be found quickly.

|

|

||||||

|

|

||||||

#### Thundering herds

|

|

||||||

|

|

||||||

Often, failure scenarios arise when a system is under unusually heavy load. This can arise organically from users, but often it arises from systems. A surge of cron jobs that starts at midnight is a venerable example. Mobile clients can also be a source of coordinated demand if they are programmed to fetch updates at the same time (of course, it is much better to jitter such requests).

|

|

||||||

|

|

||||||

Events occurring at pre-configured times aren't the only source of thundering herds. Slack experienced [multiple outages][12] over a short time due to large numbers of clients being disconnected and immediately reconnecting, causing large spikes of load. CircleCI saw a [severe outage][13] when a GitLab outage ended, leading to a surge of builds queued in its database, which became saturated and very slow.

|

|

||||||

|

|

||||||

Almost any service can be the target of a thundering herd. Planning for such eventualities—and testing that your plan works as intended—is therefore a must. Client backoff and [load shedding][14] are often core to such approaches.

|

|

||||||

|

|

||||||

If your systems must constantly ingest data that can't be dropped, it's key to have a scalable way to buffer this data in a queue for later processing.

|

|

||||||

|

|

||||||

#### Automation systems are complex systems

|

|

||||||

|

|

||||||

> "Complex systems are intrinsically hazardous systems."

|

|

||||||

> —[Richard Cook, MD][15]

|

|

||||||

|

|

||||||

If your systems must constantly ingest data that can't be dropped, it's key to have a scalable way to buffer this data in a queue for later processing.

|

|

||||||

|

|

||||||

The trend for the past several years has been strongly towards more automation of software operations. Automation of anything that can reduce your system's capacity (e.g., erasing disks, decommissioning devices, taking down serving jobs) needs to be done with care. Accidents (due to bugs or incorrect invocations) with this kind of automation can take down your system very efficiently, potentially in ways that are hard to recover from.

|

|

||||||

|

|

||||||

The trend for the past several years has been strongly towards more automation of software operations. Automation of anything that can reduce your system's capacity (e.g., erasing disks, decommissioning devices, taking down serving jobs) needs to be done with care. Accidents (due to bugs or incorrect invocations) with this kind of automation can take down your system very efficiently, potentially in ways that are hard to recover from.

|

|

||||||

|

|

||||||

Christina Schulman and Etienne Perot of Google describe some examples in their talk [Help Protect Your Data Centers with Safety Constraints][16]. One incident sent Google's entire in-house content delivery network (CDN) to disk-erase.

|

|

||||||

|

|

||||||

Schulman and Perot suggest using a central service to manage constraints, which limits the pace at which destructive automation can operate, and being aware of system conditions (for example, avoiding destructive operations if the service has recently had an alert).

|

|

||||||

|

|

||||||

Automation systems can also cause havoc when they interact with operators (or with other automated systems). [Reddit][17] experienced a major outage when its automation restarted a system that operators had stopped for maintenance. Once you have multiple automation systems, their potential interactions become extremely complex and impossible to predict.

|

|

||||||

|

|

||||||

It will help to deal with the inevitable surprises if all this automation writes logs to an easily searchable, central place. Automation systems should always have a mechanism to allow them to be quickly turned off (fully or only for a subset of operations or targets).

|

|

||||||

|

|

||||||

### Defense against the dark swans

|

|

||||||

|

|

||||||

These are not the only black swans that might be waiting to strike your systems. There are many other kinds of severe problem that can be avoided using techniques such as canarying, load testing, chaos engineering, disaster testing, and fuzz testing—and of course designing for redundancy and resiliency. Even with all that, at some point your system will fail.

|

|

||||||

|

|

||||||

To ensure your organization can respond effectively, make sure your key technical staff and your leadership have a way to coordinate during an outage. For example, one unpleasant issue you might have to deal with is a complete outage of your network. It's important to have a fail-safe communications channel completely independent of your own infrastructure and its dependencies. For instance, if you run on AWS, using a service that also runs on AWS as your fail-safe communication method is not a good idea. A phone bridge or an IRC server that runs somewhere separate from your main systems is good. Make sure everyone knows what the communications platform is and practices using it.

|

|

||||||

|

|

||||||

Another principle is to ensure that your monitoring and your operational tools rely on your production systems as little as possible. Separate your control and your data planes so you can make changes even when systems are not healthy. Don't use a single message queue for both data processing and config changes or monitoring, for example—use separate instances. In [SparkPost: The Day the DNS Died][4], Jeremy Blosser presents an example where critical tools relied on the production DNS setup, which failed.

|

|

||||||

|

|

||||||

### The psychology of battling the black swan

|

|

||||||

|

|

||||||

To ensure your organization can respond effectively, make sure your key technical staff and your leadership have a way to coordinate during an outage.

|

|

||||||

|

|

||||||

Dealing with major incidents in production can be stressful. It really helps to have a structured incident-management process in place for these situations. Many technology organizations (

|

|

||||||

|

|

||||||

Dealing with major incidents in production can be stressful. It really helps to have a structured incident-management process in place for these situations. Many technology organizations ( [including Google][18] ) successfully use a version of FEMA's Incident Command System. There should be a clear way for any on-call individual to call for assistance in the event of a major problem they can't resolve alone.

|

|

||||||

|

|

||||||

For long-running incidents, it's important to make sure people don't work for unreasonable lengths of time and get breaks to eat and sleep (uninterrupted by a pager). It's easy for exhausted engineers to make a mistake or overlook something that might resolve the incident faster.

|

|

||||||

|

|

||||||

### Learn more

|

|

||||||

|

|

||||||

There are many other things that could be said about black (or formerly black) swans and strategies for dealing with them. If you'd like to learn more, I highly recommend these two books dealing with resilience and stability in production: Susan Fowler's [Production-Ready Microservices][19] and Michael T. Nygard's [Release It!][20].

|

|

||||||

|

|

||||||

Laura Nolan will present [What Breaks Our Systems: A Taxonomy of Black Swans][21] at [LISA18][22], October 29-31 in Nashville, Tennessee, USA.

|

|

||||||

|

|

||||||

--------------------------------------------------------------------------------

|

|

||||||

|

|

||||||

via: https://opensource.com/article/18/10/taxonomy-black-swans

|

|

||||||

|

|

||||||

作者:[Laura Nolan][a]

|

|

||||||

选题:[lujun9972][b]

|

|

||||||

译者:[译者ID](https://github.com/译者ID)

|

|

||||||

校对:[校对者ID](https://github.com/校对者ID)

|

|

||||||

|

|

||||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

|

||||||

|

|

||||||

[a]: https://opensource.com/users/lauranolan

|

|

||||||

[b]: https://github.com/lujun9972

|

|

||||||

[1]: https://medium.com/making-instapaper/instapaper-outage-cause-recovery-3c32a7e9cc5f

|

|

||||||

[2]: https://blog.sentry.io/2015/07/23/transaction-id-wraparound-in-postgres.html

|

|

||||||

[3]: https://medium.com/@florian_7764/technical-post-mortem-of-the-august-incident-82ab4c3d6547

|

|

||||||

[4]: https://www.usenix.org/conference/srecon18americas/presentation/blosser

|

|

||||||

[5]: https://groups.google.com/forum/#!topic/mongodb-user/UoqU8ofp134

|

|

||||||

[6]: https://en.wikipedia.org/wiki/Richard_Thaler

|

|

||||||

[7]: https://blog.hostedgraphite.com/2018/03/01/spooky-action-at-a-distance-how-an-aws-outage-ate-our-load-balancer/

|

|

||||||

[8]: https://labs.spotify.com/2013/06/04/incident-management-at-spotify/

|

|

||||||

[9]: https://medium.com/square-corner-blog/incident-summary-2017-03-16-2f65be39297

|

|

||||||

[10]: https://en.wikipedia.org/wiki/Circuit_breaker_design_pattern

|

|

||||||

[11]: http://www.brendangregg.com/usemethod.html

|

|

||||||

[12]: https://slackhq.com/this-was-not-normal-really

|

|

||||||

[13]: https://circleci.statuspage.io/incidents/hr0mm9xmm3x6

|

|

||||||

[14]: https://www.youtube.com/watch?v=XNEIkivvaV4

|

|

||||||

[15]: https://web.mit.edu/2.75/resources/random/How%20Complex%20Systems%20Fail.pdf

|

|

||||||

[16]: https://www.usenix.org/conference/srecon18americas/presentation/schulman

|

|

||||||

[17]: https://www.reddit.com/r/announcements/comments/4y0m56/why_reddit_was_down_on_aug_11/

|

|

||||||

[18]: https://landing.google.com/sre/book/chapters/managing-incidents.html

|

|

||||||

[19]: http://shop.oreilly.com/product/0636920053675.do

|

|

||||||

[20]: https://www.oreilly.com/library/view/release-it/9781680500264/

|

|

||||||

[21]: https://www.usenix.org/conference/lisa18/presentation/nolan

|

|

||||||

[22]: https://www.usenix.org/conference/lisa18

|

|

||||||

@ -1,71 +0,0 @@

|

|||||||

Excellent Free Roguelike Games

|

|

||||||

======

|

|

||||||

![Dungeon][1]

|

|

||||||

|

|

||||||

Roguelike is a sub-genre of role-playing games. It literally means "a game like Rogue". Rogue is a dungeon crawling video game, first released in 1980 by developers Michel Toy, Glenn Wichman and Ken Arnold. The game stood out from the crowd by being fiendishly addictive. The game's goal was to retrieve the Amulet of Yendor, hidden deep in the 26th level, and ascend back to the top, all set in a world based on Dungeons & Dragons.

|

|

||||||

|

|

||||||

The game is rightly considered to be a classic, formidably difficult yet compelling addictive. While it was popular in college and university campuses, it wasn't a big seller. At the time of its release, Rogue wasn't published under an open source license, which led to many clones being developed.

|

|

||||||

|

|

||||||

There is no exact definition of a roguelike, but this type of game typically has the following characteristics:

|

|

||||||

|

|

||||||

* High fantasy narrative background

|

|

||||||

* Procedural level generation. Most of the game world is generated by the game for every new gameplay session. This is meant to encourage replayability

|

|

||||||

* Turn-based dungeon exploration and combat

|

|

||||||

* Tile-based graphics that are randomly generated

|

|

||||||

* Random conflict outcomes

|

|

||||||

* Permanent death - death works realistically, once you're gone, you're gone

|

|

||||||

* High difficulty

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

This article compiles a wide selection of roguelike games available for Linux. If you enjoy addictive gameplay with real intensity, I heartily recommended downloading these games. Don't be put off by the primitive graphics offered by many of the games, you'll soon forget the visuals once you get immersed in playing. Remember, in roguelikes game mechanics tend to be the primary focus, with graphics being a welcome, but not essential, addition.

|

|

||||||

|

|

||||||

There are 16 games recommended here. All of the games are available to download without charge, and almost all are released under an open source license.

|

|

||||||

| **Roguelike Games** |

|

|

||||||

| --- |

|

|

||||||

| **[Dungeon Crawl Stone Soup][1]** | A continuation of Linley’s Dungeon Crawl |

|

|

||||||

| **[Prospector][2]** | Roguelike game set in a science fiction universe |

|

|

||||||

| **[Dwarf Fortress][3]** | Adventure and Dwarf Fortress modes |

|

|

||||||

| **[NetHack][4]** | Wonderfully silly, and addictive Dungeons and Dragons-style adventure game |

|

|

||||||

| **[Angband][5]** | Along the lines of Rogue and NetHack. It is derived from the games Moria and Umoria |

|

|

||||||

| **[Ancient Domains of Mystery][6]** | Very mature Roguelike game |

|

|

||||||

| **[Tales of Maj’Eyal][7]** | Features tactical turn-based combat and advanced character building |

|

|

||||||

| **[UnNetHack][8]** | Inspired fork of NetHack |

|

|

||||||

| **[Hydra Slayer][9]** | Roguelike game based on mathematical puzzles |

|

|

||||||

| **[Cataclysm DDA][10]** | Post-apocalyptic roguelike, set in the countryside of fictional New England |

|

|

||||||

| **[Brogue][11]** | A direct descendant of Rogue |

|

|

||||||

| **[Goblin Hack][12]** | Inspired by the likes of NetHack, but faster with fewer keys |

|

|

||||||

| **[Ascii Sector][13]** | 2D trading and space flight simulator with roguelike action |

|

|

||||||

| **[SLASH'EM][14]** | Super Lotsa Added Stuff Hack - Extended Magic |

|

|

||||||

| **[Everything Is Fodder][15]** | Seven Day Roguelike competition entry |

|

|

||||||

| **[Woozoolike][16]** | A simple space exploration roguelike for 7DRL 2017. |

|

|

||||||

|

|

||||||

|

|

||||||

--------------------------------------------------------------------------------

|

|

||||||

|

|

||||||

via: https://www.linuxlinks.com/excellent-free-roguelike-games/

|

|

||||||

|

|

||||||

作者:[Steve Emms][a]

|

|

||||||

译者:[译者ID](https://github.com/译者ID)

|

|

||||||

校对:[校对者ID](https://github.com/校对者ID)

|

|

||||||

|

|

||||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

|

||||||

|

|

||||||

[a]:https://www.linuxlinks.com/author/linuxlinks/

|

|

||||||

[1]:https://www.linuxlinks.com/dungeoncrawlstonesoup/

|

|

||||||

[2]:https://www.linuxlinks.com/Prospector-roguelike/

|

|

||||||

[3]:https://www.linuxlinks.com/dwarffortress/

|

|

||||||

[4]:https://www.linuxlinks.com/nethack/

|

|

||||||

[5]:https://www.linuxlinks.com/angband/

|

|

||||||

[6]:https://www.linuxlinks.com/ADOM/

|

|

||||||

[7]:https://www.linuxlinks.com/talesofmajeyal/

|

|

||||||

[8]:https://www.linuxlinks.com/unnethack/

|

|

||||||

[9]:https://www.linuxlinks.com/hydra-slayer/

|

|

||||||

[10]:https://www.linuxlinks.com/cataclysmdda/

|

|

||||||

[11]:https://www.linuxlinks.com/brogue/

|

|

||||||

[12]:https://www.linuxlinks.com/goblin-hack/

|

|

||||||

[13]:https://www.linuxlinks.com/asciisector/

|

|

||||||

[14]:https://www.linuxlinks.com/slashem/

|

|

||||||

[15]:https://www.linuxlinks.com/everything-is-fodder/

|

|

||||||

[16]:https://www.linuxlinks.com/Woozoolike/

|

|

||||||

[17]:https://i2.wp.com/www.linuxlinks.com/wp-content/uploads/2017/12/dungeon.jpg?resize=300%2C200&ssl=1

|

|

||||||

@ -1,3 +1,4 @@

|

|||||||

|

translating by Auk7F7

|

||||||

How to dual-boot Linux and Windows

|

How to dual-boot Linux and Windows

|

||||||

======

|

======

|

||||||

|

|

||||||

|

|||||||

@ -1,3 +1,5 @@

|

|||||||

|

translating---geekpi

|

||||||

|

|

||||||

A single-user, lightweight OS for your next home project | Opensource.com

|

A single-user, lightweight OS for your next home project | Opensource.com

|

||||||

======

|

======

|

||||||

|

|

||||||

|

|||||||

@ -0,0 +1,119 @@

|

|||||||

|

@flowsnow is translating

|

||||||

|

|

||||||

|

|

||||||

|

How I organize my knowledge as a Software Engineer

|

||||||

|

============================================================

|

||||||

|

|

||||||

|

|

||||||

|

Software Development and Technology in general are areas that evolve at a very fast pace and continuous learning is essential.

|

||||||

|

Some minutes navigating in the internet, in places like Twitter, Medium, RSS feeds, Hacker News and other specialized sites and communities, are enough to find lots of great pieces of information from articles, case studies, tutorials, code snippets, new applications and much more.

|

||||||

|

|

||||||

|

Saving and organizing all that information can be a daunting task. In this post I will present some tools tools that I use to do it.

|

||||||

|

|

||||||

|

One of the points I consider very important regarding knowledge management is to avoid lock-in in a particular platform. All the tools I use, allow to export your data in standard formats like Markdown and HTML.

|

||||||

|

|

||||||

|

Note that, My workflow is not perfect and I am constantly searching for new tools and ways to optimize it. Also everyone is different, so what works for me might not working well for you.

|

||||||

|

|

||||||

|

### Knowledge base with NotionHQ

|

||||||

|

|

||||||

|

For me, the fundamental piece of Knowledge management is to have some kind of personal Knowledge base / wiki. A place where you can save links, bookmarks, notes etc in an organized manner.

|

||||||

|

|

||||||

|

I use [NotionHQ][7] for that matter. I use it to keep notes on various topics, having lists of resources like great libraries or tutorials grouped by programming language, bookmarking interesting blog posts and tutorials, and much more, not only related to software development but also my personal life.

|

||||||

|

|

||||||

|

What I really like about Notion, is how simple it is to create new content. You write it using Markdown and it is organized as tree.

|

||||||

|

|

||||||

|

Here is my top level pages of my "Development" workspace:

|

||||||

|

|

||||||

|

[][8]

|

||||||

|

|

||||||

|

Notion has some nice other features like integrated spreadsheets / databases and Task boards.

|

||||||

|

|

||||||

|

You will need to subscribe to paid Personal Plan, if you want to use Notion seriously as the free plan is somewhat limited. I think its worth the price. Notion allows to export your entire workspace to Markdown files. The export has some important problems, like loosing the page hierarchy, but hope Notion Team can improve that.

|

||||||

|

|

||||||

|

As a free alternative I would probably use [VuePress][9] or [GitBook][10] to host my own.

|

||||||

|

|

||||||

|

### Save interesting articles with Pocket

|

||||||

|

|

||||||

|

[Pocket][11] is one of my favorite applications ever! With Pocket you can create a reading list of articles from the Internet.

|

||||||

|

Every time I see an article that looks interesting, I save it to Pocket using its Chrome Extension. Later on, I will read it and If I found it useful enough, I will use the "Archive" function of Pocket to permanently save that article and clean up my Pocket inbox.

|

||||||

|

|

||||||

|

I try to keep the Reading list small enough and keep archiving information that I have dealt with. Pocket allows you to tag articles which will make it simpler to search articles for a particular topic later in time.

|

||||||

|

|

||||||

|

You can also save a copy of the article in Pocket servers in case of the original site disappears, but you will need Pocket Premium for that.

|

||||||

|

|

||||||

|

Pocket also have a "Discover" feature which suggests similar articles based on the articles you have saved. This is a great way to find new content to read.

|

||||||

|

|

||||||

|

### Snippet Management with SnippetStore

|

||||||

|

|

||||||

|

From GitHub, to Stack Overflow answers, to blog posts, its common to find some nice code snippets that you want to save for later. It could be some nice algorithm implementation, an useful script or an example of how to do X in Y language.

|

||||||

|

|

||||||

|

I tried many apps from simple GitHub Gists to [Boostnote][12] until I discovered [SnippetStore][13].

|

||||||

|

|

||||||

|

SnippetStore is an open source snippet management app. What distinguish SnippetStore from others is its simplicity. You can organize snippets by Language or Tags and you can have multi file snippets. Its not perfect but it gets the job done. Boostnote, for example has more features, but I prefer the simpler way of organizing content of SnippetStore.

|

||||||

|

|

||||||

|

For abbreviations and snippets that I use on a daily basis, I prefer to use my Editor / IDE snippets feature as it is more convenient to use. I use SnippetStore more like a reference of coding examples.

|

||||||

|

|

||||||

|

[Cacher][14] is also an interesting alternative, since it has integrations with many editors, have a cli tool and uses GitHub Gists as backend, but 6$/month for its pro plan, its too much IMO.

|

||||||

|

|

||||||

|

### Managing cheat sheets with DevHints

|

||||||

|

|

||||||

|

[Devhints][15] is a collection of cheat sheets created by Rico Sta. Cruz. Its open source and powered by Jekyll, one of the most popular static site generator.

|

||||||

|

|

||||||

|

The cheat sheets are written in Markdown with some extra formatting goodies like support for columns.

|

||||||

|

|

||||||

|

I really like the looks of the interface and being Markdown makes in incredibly easy to add new content and keep it updated and in version control, unlike cheat sheets in PDF or Image format, that you can find on sites like [Cheatography][16].

|

||||||

|

|

||||||

|

As it is open source I have created my own fork, removed some cheat sheets that I dont need and add some more.

|

||||||

|

|

||||||

|

I use cheat sheets as reference of how to use some library or programming language or to remember some commands. Its very handy to have a single page, with all the basic syntax of a specific programming language for example.

|

||||||

|

|

||||||

|

I am still experimenting with this but its working great so far.

|

||||||

|

|

||||||

|

### Diigo

|

||||||

|

|

||||||

|

[Diigo][17] allows you to Annotate and Highlight parts of websites. I use it to annotate important information when studying new topics or to save particular paragraphs from articles, Stack Overflow answers or inspirational quotes from Twitter! ;)

|

||||||

|

|

||||||

|

* * *

|

||||||

|

|

||||||

|

And thats it. There might be some overlap in terms of functionality in some of the tools, but like I said in the beginning, this is an always evolving workflow, as I am always experimenting and searching for ways to improve and be more productive.

|

||||||

|

|

||||||

|

What about you? How to you organize your Knowledge?. Please feel free to comment below.

|

||||||

|

|

||||||

|

Thank you for reading.

|

||||||

|

|

||||||

|

------------------------------------------------------------------------

|

||||||

|

|

||||||

|

作者简介:

|

||||||

|

|

||||||

|

Bruno Paz

|

||||||

|

Web Engineer. Expert in #PHP and @Symfony Framework. Enthusiast about new technologies. Sports and @FCPorto fan!

|

||||||

|

|

||||||

|

--------------------------------------------------------------------------------

|

||||||

|

|

||||||

|

via: https://dev.to/brpaz/how-do-i-organize-my-knowledge-as-a-software-engineer-4387

|

||||||

|

|

||||||

|

作者:[ Bruno Paz][a]

|

||||||

|

译者:[译者ID](https://github.com/译者ID)

|

||||||

|

校对:[校对者ID](https://github.com/校对者ID)

|

||||||

|

选题:[oska874](https://github.com/oska874)

|

||||||

|

|

||||||

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||

|

[a]:http://brunopaz.net/

|

||||||

|

[1]:https://dev.to/brpaz

|

||||||

|

[2]:http://twitter.com/brunopaz88

|

||||||

|

[3]:http://github.com/brpaz

|

||||||

|

[4]:https://dev.to/t/knowledge

|

||||||

|

[5]:https://dev.to/t/learning

|

||||||

|

[6]:https://dev.to/t/development

|

||||||

|

[7]:https://www.notion.so/

|

||||||

|

[8]:https://res.cloudinary.com/practicaldev/image/fetch/s--uMbaRUtu--/c_limit%2Cf_auto%2Cfl_progressive%2Cq_auto%2Cw_880/http://i.imgur.com/kRnuvMV.png

|

||||||

|

[9]:https://vuepress.vuejs.org/

|

||||||

|

[10]:https://www.gitbook.com/?t=1

|

||||||

|

[11]:https://getpocket.com/

|

||||||

|

[12]:https://boostnote.io/

|

||||||

|

[13]:https://github.com/ZeroX-DG/SnippetStore

|

||||||

|

[14]:https://www.cacher.io/

|

||||||

|

[15]:https://devhints.io/

|

||||||

|

[16]:https://cheatography.com/

|

||||||

|

[17]:https://www.diigo.com/index

|

||||||

@ -1,3 +1,5 @@

|

|||||||

|

HankChow translating

|

||||||

|

|

||||||

Some Good Alternatives To ‘du’ Command

|

Some Good Alternatives To ‘du’ Command

|

||||||

======

|

======

|

||||||

|

|

||||||

|

|||||||

@ -0,0 +1,122 @@

|

|||||||

|

让系统崩溃的黑天鹅分类

|

||||||

|

======

|

||||||

|

|

||||||

|

在严重的故障发生之前,找到引起问题的异常事件,并修复它。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

黑天鹅用来比喻造成严重影响的小概率事件(比如 2008 年的金融危机)。在生产环境的系统中,黑天鹅是指这样的事情:它引发了你不知道的问题,造成了重大影响,不能快速修复或回滚,也不能用值班说明书上的其他标准响应来解决。它是事发几年后你还在给新人说起的事件。

|

||||||

|

|

||||||

|

从定义上看,黑天鹅是不可预测的,不过有时候我们能找到其中的一些模式,针对有关联的某一类问题准备防御措施。

|

||||||

|

|

||||||

|

例如,大部分故障的直接原因是变更(代码、环境或配置)。虽然这种方式触发的 bug 是独特的,不可预测的,但是常见的金丝雀发布对避免这类问题有一定的作用,而且自动回滚已经成了一种标准止损策略。

|

||||||

|

|

||||||

|

随着我们的专业性不断成熟,一些其他的问题也正逐渐变得容易理解,被归类到某种风险并有普适的预防策略。

|

||||||

|

|

||||||

|

### 公布出来的黑天鹅事件

|

||||||

|

|

||||||

|

所有科技公司都有生产环境的故障,只不过并不是所有公司都会分享他们的事故分析。那些公开讨论事故的公司帮了我们的忙。下列事故都描述了某一类问题,但它们绝对不是只属于一个类别。我们的系统中都有黑天鹅在潜伏着,只是有些人还不知道而已。

|

||||||

|

|

||||||

|

#### 达到上限

|

||||||

|

|

||||||

|

达到任何类型的限制都会引发严重事故。这类问题的一个典型例子是 2017 年 2 月 [Instapaper 的一次服务中断][1]。我把这份事故报告给任何一个运维工作者看,他们读完都会脊背发凉。Instapaper 生产环境的数据库所在的文件系统有 2 TB 的大小限制,但是数据库服务团队并不知情。在没有任何报错的情况下,数据库不再接受任何写入了。完全恢复需要好几天,而且还得迁移数据库。

|

||||||

|

|

||||||

|

资源限制有各式各样的触发场景。Sentry 遇到了 [Postgres 的最大事务 ID 限制][2]。Platform.sh 遇到了[管道缓冲区大小限制][3]。SparkPost [触发了 AWS 的 DDos 保护][4]。Foursquare 在他们的一个 [MongoDB 耗尽内存][5]时遭遇了性能骤降。

|

||||||

|

|

||||||

|

提前了解系统限制的一个办法是定期做测试。好的压力测试(在生产环境的副本上做)应该包含写入事务,并且应该把每一种数据存储都写到超过当前生产环境的容量。压力测试时很容易忽略的是次要存储(比如 Zookeeper)。如果你是在测试时遇到了资源限制,那么你还有时间去解决问题。鉴于这种资源限制问题的解决方案可能涉及重大的变更(比如数据存储拆分),所以时间是非常宝贵的。

|

||||||

|

|

||||||

|

说到云产品的使用,如果你的服务产生了异常的负载,或者你用的产品或功能还没有被广泛使用(比如老旧的或者新兴的),那么你遇到资源上限的风险很大。对这些云产品做一下压力测试是值得的。不过,做之前要提醒一下你的云服务提供商。

|

||||||

|

|

||||||

|

最后,知道了哪里有限制之后,要增加监控(和对应文档),这样你才能知道系统在什么时候接近了资源上限。不要寄希望于那些还在维护服务的人会记得。

|

||||||

|

|

||||||

|

#### 扩散的慢请求

|

||||||

|

|

||||||

|

> “这个世界的关联性远比我们想象中更大。所以我们看到了更多 Nassim Taleb 所说的‘黑天鹅事件’ —— 即罕见事件以更高的频率离谱地发生了,因为世界是相互关联的”

|

||||||

|

> — [Richard Thaler][6]

|

||||||

|

|

||||||

|

HostedGraphite 的负载均衡器并没有托管在 AWS 上,却[被 AWS 的服务中断给搞垮了][7],他们关于这次事故原因的分析报告很好地诠释了分布式计算系统之间存在多么大的关联。在这个事件里,负载均衡器的连接池被来自 AWS 上的客户访问占满了,因为这些连接很耗时。同样的现象还会发生在应用的线程、锁、数据库连接上 —— 任何能被慢操作占满的资源。

|

||||||

|

|

||||||

|

这个 HostedGraphite 的例子中,慢速连接是外部系统施加的,不过慢速连接经常是由内部某个系统的饱和所引起的,饱和与慢操作的级联,拖慢了系统中的其他部分。[Spotify 的一个事故][8]就说明了这样的传播 —— 流媒体服务的前端被另一个微服务的饱和所影响,造成健康检查失败。强制给所有请求设置超时时间,以及限制请求队列的长度,可以预防这一类故障传播。这样即使有问题,至少你的服务还能承担一些流量,而且因为整体上你的系统里故障的部分更少了,恢复起来也会更快。

|

||||||

|

|

||||||

|

重试的间隔应该用指数退避来限制一下,并加入一些时间抖动。Square 有一次服务中断是 [Redis 存储的过载][9],原因是有一段代码对失败的事务重试了 500 次,没有任何重试退避的方案,也说明了过度重试的潜在风险。另外,针对这种情况,[断路器][10]设计模式也是有用的。

|

||||||

|

|

||||||

|

应该设计出监控仪表盘来清晰地展示所有资源的[使用率,饱和度和报错][11],这样才能快速发现问题。

|

||||||

|

|

||||||

|

#### 突发的高负载

|

||||||

|

|

||||||

|

系统在异常高的负载下经常会发生故障。用户天然会引发高负载,不过也常常是由系统引发的。午夜突发的 cron 定时任务是老生常谈了。如果程序让移动客户端同时去获取更新,这些客户端也会造成突发的大流量(当然,给这种请求加入时间抖动会好很多)。

|

||||||

|

|

||||||

|

在预定时刻同时发生的事件并不是突发大流量的唯一原因。Slack 经历过一次短时间内的[多次服务中断][12],原因是非常多的客户端断开连接后立即重连,造成了突发的大负载。 CircleCI 也经历过一次[严重的服务中断][13],当时 Gitlab 从故障中恢复了,所以数据库里积累了大量的构建任务队列,服务变得饱和而且缓慢。

|

||||||

|

|

||||||

|

几乎所有的服务都会受突发的高负载所影响。所以对这类可能出现的事情做应急预案——并测试一下预案能否正常工作——是必须的。客户端退避和[减载][14]通常是这些方案的核心。

|

||||||

|

|

||||||

|

如果你的系统必须不间断地接收数据,并且数据不能被丢掉,关键是用可伸缩的方式把数据缓冲到队列中,后续再处理。

|

||||||

|

|

||||||

|

#### 自动化系统是复杂的系统

|

||||||

|

|

||||||

|

> “复杂的系统本身就是有风险的系统”

|

||||||

|

> —— [Richard Cook, MD][15]

|

||||||

|

|

||||||

|

过去几年里软件的运维操作趋势是更加自动化。任何可能降低系统容量的自动化操作(比如擦除磁盘,退役设备,关闭服务)都应该谨慎操作。这类自动化操作的故障(由于系统有 bug 或者有不正确的调用)能很快地搞垮你的系统,而且可能很难恢复。

|

||||||

|

|

||||||

|

谷歌的 Christina Schulman 和 Etienne Perot 在[用安全规约协助保护你的数据中心][16]的演讲中给了一些例子。其中一次事故是将谷歌整个内部的内容分发网络(CDN)提交给了擦除磁盘的自动化系统。

|

||||||

|

|

||||||

|

Schulman 和 Perot 建议使用一个中心服务来管理规约,限制破坏性自动化操作的速度,并能感知到系统状态(比如避免在最近有告警的服务上执行破坏性的操作)。

|

||||||

|

|

||||||

|

自动化系统在与运维人员(或其他自动化系统)交互时,也可能造成严重事故。[Reddit][17] 遭遇过一次严重的服务中断,当时他们的自动化系统重启了一个服务,但是这个服务是运维人员停掉做维护的。一旦有了多个自动化系统,它们之间潜在的交互就变得异常复杂和不可预测。

|

||||||

|

|

||||||

|

所有的自动化系统都把日志输出到一个容易搜索的中心存储上,能帮助到对这类不可避免的意外情况的处理。自动化系统总是应该具备这样一种机制,即允许快速地关掉它们(完全关掉或者只关掉其中一部分操作或一部分目标)。

|

||||||

|

|

||||||

|

### 防止黑天鹅事件

|

||||||

|

|

||||||

|

可能在等着击垮系统的黑天鹅可不止上面这些。有很多其他的严重问题是能通过一些技术来避免的,像金丝雀发布,压力测试,混沌工程,灾难测试和模糊测试——当然还有冗余性和弹性的设计。但是即使用了这些技术,有时候你的系统还是会有故障。

|

||||||

|

|

||||||

|

为了确保你的组织能有效地响应,在服务中断期间,请保证关键技术人员和领导层有办法沟通协调。例如,有一种你可能需要处理的烦人的事情,那就是网络完全中断。拥有故障时仍然可用的通信通道非常重要,这个通信通道要完全独立于你们自己的基础设施和基础设施的依赖。举个例子,假如你使用 AWS,那么把故障时可用的通信服务部署在 AWS 上就不明智了。在和你的主系统无关的地方,运行电话网桥或 IRC 服务器是比较好的方案。确保每个人都知道这个通信平台,并练习使用它。

|

||||||

|

|

||||||

|

另一个原则是,确保监控和运维工具对生产环境系统的依赖尽可能的少。将控制平面和数据平面分开,你才能在系统不健康的时候做变更。不要让数据处理和配置变更或监控使用同一个消息队列,比如——应该使用不同的消息队列实例。在 [SparkPost: DNS 挂掉的那一天][4] 这个演讲中,Jeremy Blosser 讲了一个这类例子,很关键的工具依赖了生产环境的 DNS 配置,但是生产环境的 DNS 出了问题。

|

||||||

|

|

||||||

|

### 对抗黑天鹅的心理学

|

||||||

|

|

||||||

|

处理生产环境的重大事故时会产生很大的压力。为这些场景制定结构化的事故管理流程确实是有帮助的。很多科技公司([包括谷歌][18])成功地使用了联邦应急管理局事故指挥系统的某个版本。对于每一个值班的人,遇到了他们无法独立解决的重大问题时,都应该有一个明确的寻求协助的方法。

|

||||||

|

|

||||||

|

对于那些持续很长时间的事故,有一点很重要,要确保工程师不会连续工作到不合理的时长,确保他们不会不吃不睡(没有报警打扰的睡觉)。疲惫不堪的工程师很容易犯错或者漏掉了可能更快解决故障的信息。

|

||||||

|

|

||||||

|

### 了解更多

|

||||||

|

|

||||||

|

关于黑天鹅(或者以前的黑天鹅)事件以及应对策略,还有很多其他的事情可以说。如果你想了解更多,我强烈推荐你去看这两本书,它们是关于生产环境中的弹性和稳定性的:Susan Fowler 写的[生产微服务][19],还有 Michael T. Nygard 的 [Release It!][20]。

|

||||||

|

|

||||||

|

--------------------------------------------------------------------------------

|

||||||

|

|

||||||

|

via: https://opensource.com/article/18/10/taxonomy-black-swans

|

||||||

|

|

||||||

|

作者:[Laura Nolan][a]

|

||||||

|

选题:[lujun9972][b]

|

||||||

|

译者:[BeliteX](https://github.com/belitex)

|

||||||

|

校对:[校对者ID](https://github.com/校对者ID)

|

||||||

|

|

||||||

|

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||||

|

|

||||||

|

[a]: https://opensource.com/users/lauranolan

|

||||||

|

[b]: https://github.com/lujun9972

|

||||||

|

[1]: https://medium.com/making-instapaper/instapaper-outage-cause-recovery-3c32a7e9cc5f

|

||||||

|

[2]: https://blog.sentry.io/2015/07/23/transaction-id-wraparound-in-postgres.html

|

||||||

|

[3]: https://medium.com/@florian_7764/technical-post-mortem-of-the-august-incident-82ab4c3d6547

|

||||||

|

[4]: https://www.usenix.org/conference/srecon18americas/presentation/blosser

|

||||||

|

[5]: https://groups.google.com/forum/#!topic/mongodb-user/UoqU8ofp134

|

||||||

|

[6]: https://en.wikipedia.org/wiki/Richard_Thaler

|

||||||

|

[7]: https://blog.hostedgraphite.com/2018/03/01/spooky-action-at-a-distance-how-an-aws-outage-ate-our-load-balancer/

|

||||||

|

[8]: https://labs.spotify.com/2013/06/04/incident-management-at-spotify/

|

||||||

|

[9]: https://medium.com/square-corner-blog/incident-summary-2017-03-16-2f65be39297

|

||||||

|

[10]: https://en.wikipedia.org/wiki/Circuit_breaker_design_pattern

|

||||||

|

[11]: http://www.brendangregg.com/usemethod.html

|

||||||

|

[12]: https://slackhq.com/this-was-not-normal-really

|

||||||

|

[13]: https://circleci.statuspage.io/incidents/hr0mm9xmm3x6

|

||||||

|

[14]: https://www.youtube.com/watch?v=XNEIkivvaV4

|

||||||

|

[15]: https://web.mit.edu/2.75/resources/random/How%20Complex%20Systems%20Fail.pdf

|

||||||

|

[16]: https://www.usenix.org/conference/srecon18americas/presentation/schulman

|

||||||

|

[17]: https://www.reddit.com/r/announcements/comments/4y0m56/why_reddit_was_down_on_aug_11/

|

||||||

|

[18]: https://landing.google.com/sre/book/chapters/managing-incidents.html

|

||||||

|

[19]: http://shop.oreilly.com/product/0636920053675.do

|

||||||

|

[20]: https://www.oreilly.com/library/view/release-it/9781680500264/

|

||||||

|

[21]: https://www.usenix.org/conference/lisa18/presentation/nolan

|

||||||

|

[22]: https://www.usenix.org/conference/lisa18

|

||||||

70

translated/tech/20171229 Excellent Free Roguelike Games.md

Normal file

70

translated/tech/20171229 Excellent Free Roguelike Games.md

Normal file

@ -0,0 +1,70 @@

|

|||||||

|

最棒的免费 Roguelike 游戏

|

||||||

|

======

|

||||||

|

![地牢][1]

|

||||||

|

|

||||||

|

Roguelike 属于角色扮演游戏的一个子流派,它从字面上理解就是“类 Rogue 游戏”。Rogue 是一个地牢爬行视频游戏,第一个版本由开发者 Michel Toy、Glenn Wichman 和 Ken Arnold 在 1980 年发布,由于极易上瘾使得它从一众游戏中脱颖而出。整个游戏的目标是深入第 26 层,取回 Yendor 的护身符并回到地面,所有设定都基于龙与地下城的世界观。

|

||||||

|

|

||||||

|

Rogue 被认为是一个经典、极其困难并且让人废寝忘食的游戏。虽然它在大学校园中非常受欢迎,但并不十分畅销。在 Rogue 发布时,它并没有使用开源证书,导致了爱好者们开发了许多克隆版本。

|

||||||

|

|

||||||

|

对于 Roguelike 游戏并没有一个明确的定义,但是此类游戏会拥有下述的典型特征:

|

||||||

|

|

||||||

|

* 高度魔幻的叙事背景;

|

||||||

|

* 程序化生成关卡。游戏世界中的大部分地图在每次开始游戏时重新生成,也就意味着鼓励多周目;

|

||||||

|

* 回合制的地牢探险和战斗;

|

||||||

|

* 基于图块随机生成的图形;

|

||||||

|

* 随机的战斗结果;

|

||||||

|

* 永久死亡——死亡现实地起作用,一旦死亡你就需要重新开始

|

||||||

|

* 高难度

|

||||||

|

|

||||||

|

|

||||||

|

此篇文章收集了大量 Linux 平台可玩的 Roguelike 游戏。如果你享受提供真实紧张感的上瘾游戏体验,我衷心推荐你下载这些游戏。不要被其中很多游戏的原始画面劝退,一旦你沉浸其中你会很快忽略简陋的画面。记住,在 Roguelike 游戏中应是游戏机制占主导,画面只是一个加分项而不是必需项。

|

||||||

|

|

||||||

|

此处推荐 16 款游戏。所有的游戏都可免费下载,并且大部分采用开源证书发布。

|

||||||

|

| **Roguelike 游戏** |

|

||||||

|

| --- |

|

||||||

|

| **[Dungeon Crawl Stone Soup][1]** | Linley’s Dungeon Crawl 的续作 |

|

||||||

|

| **[Prospector][2]** | 基于科幻小说世界观的 Roguelike 游戏 |

|

||||||

|

| **[Dwarf Fortress][3]** | 冒险和侏儒塔防 |

|

||||||

|

| **[NetHack][4]** | 非常怪诞并且令人上瘾的龙与地下城风格冒险游戏 |

|

||||||

|

| **[Angband][5]** | 沿着 Rogue 和 NetHack 的路线,它源于游戏 Moria 和 Umoria |

|

||||||

|

| **[Ancient Domains of Mystery][6]** | 非常成熟的 Roguelike 游戏 |

|

||||||

|

| **[Tales of Maj’Eyal][7]** | 特色的策略回合制战斗与先进的角色培养系统 |

|

||||||

|

| **[UnNetHack][8]** | NetHack 的创新复刻 |

|

||||||

|