mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-21 02:10:11 +08:00

Merge branch 'master' of https://github.com/LCTT/TranslateProject

This commit is contained in:

commit

4626949d4c

@ -1,36 +1,35 @@

|

||||

你需要知道的最佳 Linux Adobe 替代品

|

||||

Adobe 软件的最佳 Linux 替代品

|

||||

============================================================

|

||||

|

||||

|

||||

|

||||

你是一名正在寻找 Adobe 的替代品的 Linux 用户吗?那你不是一个人。如果你是一个狂热的平面设计师,那么你可能很擅长避开昂贵的 Adobe 产品。不过,对于 Adobe 来说,Linux 用户通常是其支持最不利的。因此,Adobe 的替代品是必须的 —— 但是最好的选择是什么?

|

||||

|

||||

这最终要看具体的 Adobe 程序和你希望完成的事情。幸运的是,由于需求是所有发明之母,有人响应了这些号召。其结果是出现了一系列高效的 Adobe 替代品。

|

||||

|

||||

作为一名 Linux 用户正在寻找 Adobe 的替代品?你不是一个人。如果你是一个狂热的平面设计师,那么你可能很擅长避开昂贵的 Adobe 产品。不过,对于 Adobe 来说,Linux 用户通常是不利的一面。因此,Adobe 的替代品是必须的 - 但是最好的选择是什么?

|

||||

|

||||

它最终归结到具体的 Adobe 程序和你希望完成的事情。幸运的是,由于需求是所有发明之母,有人响应了号召。其结果是出现了一系列高效的 Adobe 插件。

|

||||

|

||||

### Evince (Adobe Acrobat)

|

||||

### Evince (Adobe Acrobat Reader)

|

||||

|

||||

|

||||

|

||||

就像 Adobe Acrobat Reader 一样,[Evince][6] 是一个“支持多种文档格式的文档查看器”。例如,用户可以使用 Evince 作为 PDF 查看器。它还支持各种漫画书格式(cbr、cbz、cb7 和 cbt)。你可以在 Evince 网站上找到[支持格式的完整列表][7]。

|

||||

|

||||

Evince 没有高看或低看 Linux 用户,因为它是标准的。你可以在需要时前往官方网站进行更新。

|

||||

对于 Evince ,Linux 用户不用高估,也不用贬低,它就是个标准的查看器。你可以在需要时前往官方网站进行更新。

|

||||

|

||||

### Pixlr (Adobe Photoshop)

|

||||

|

||||

|

||||

|

||||

关于 [Pixlr][8] 的很棒的一点在于 Adobe 的各种替代工具可以在线获得。如果你有一个互联网连接,那么你就有一个强大的图像编辑工作区。

|

||||

关于 [Pixlr][8] 的很棒的一点是这个 Adobe 替代品的各种工具可以在线获得。如果你有一个互联网连接,那么你就有一个强大的图像编辑工作区。

|

||||

|

||||

[Pixlr Editor][9] 是 Photoshop 的一个功能强大的插件,因为你可以使用图层和相关效果。它还有一些漂亮的绘图和颜色编辑工具。[Pixlr Express][10] 没有这么多功能,因为它主要用于图像增强。调整颜色和清晰度,并增加一些 Instagram 友好的效果!

|

||||

[Pixlr Editor][9] 是 Photoshop 的一个功能强大的替代品,你可以使用图层和相关效果。它还有一些漂亮的绘图和颜色编辑工具。[Pixlr Express][10] 没有这么多功能,因为它主要用于图像增强、调整颜色和清晰度,并增加一些 Instagram 适用的效果!

|

||||

|

||||

你可以通过 Pixlr 完成任务,这是完全免费的。

|

||||

你可以通过 Pixlr 完成的任务简直不可置信,而且完全免费的。

|

||||

|

||||

### Inkscape (Adobe Illustrator)

|

||||

|

||||

|

||||

|

||||

[Inkscape][11]是另一个值得推荐的免费 Adobe 替代品。它主要作为一个“专业的矢量图形编辑器”。除了 Illustrator,Inkscape 也受到了 Corel Draw、Freehand 和 Xara X 的限制。

|

||||

[Inkscape][11]是另一个值得推荐的免费 Adobe 替代品。它主要作为一个“专业的矢量图形编辑器”。除了 Illustrator,Inkscape 也与 Corel Draw、Freehand 和 Xara X 的功能差不多。

|

||||

|

||||

它的矢量设计工具可用于制作 logo 和“高可伸缩性”艺术品。Inkscape 包含绘图、形状和文本工具。图层工具允许你锁定、分组或隐藏单个图层。

|

||||

|

||||

@ -38,9 +37,9 @@ Evince 没有高看或低看 Linux 用户,因为它是标准的。你可以在

|

||||

|

||||

|

||||

|

||||

[Pinegrow Web Editor][12] 是 Linux 上 Dreamweaver 的绝佳替代品。该程序可让你在桌面上直接制作 HTML 网站。

|

||||

[Pinegrow Web Editor][12] 是 Dreamweaver 在 Linux 上的绝佳替代品。该程序可让你在桌面上直接制作 HTML 网站。

|

||||

|

||||

不仅是使用代码创建(而且需要稍后预览),Pinegrow 可以提供详细的视觉编辑体验。你可以直接查看和测试你的 HTML 项目,实时了解链接是否正常工作,或者图片是否在它该在的地方。Pinegrow 还附带了 WordPress 主题构建器。

|

||||

不仅是使用代码创建(而且需要稍后预览),Pinegrow 可以提供详细的可视化编辑体验。你可以直接查看和测试你的 HTML 项目,实时了解链接是否正常工作,或者图片是否在它该在的地方。Pinegrow 还附带了 WordPress 主题构建器。

|

||||

|

||||

免费试用 30 天。如果你喜欢,你可以一次性支付 $49 购买。

|

||||

|

||||

@ -50,55 +49,55 @@ Evince 没有高看或低看 Linux 用户,因为它是标准的。你可以在

|

||||

|

||||

[Scribus][13] 可能是最接近 Adobe InDesign 的替代品。根据开发者的说法,你应该[认真考虑使用][14] Scribus,因为它是可靠和免费的。

|

||||

|

||||

实际上,Scribus 不仅仅是一个出色的桌面出版工具,也是一个很好的_自我_出版工具。当你可以自己做高质量的杂志和书籍时,为什么要依靠昂贵的商业软件来创建?Scribus 目前允许设计师使用一个 200 色的调色板,下一个稳定版中[承诺将会加倍颜色][15]。

|

||||

实际上,Scribus 不仅仅是一个出色的桌面出版工具,也是一个很好的自出版工具。当你可以自己做高质量的杂志和书籍时,为什么要依靠昂贵的商业软件来创建?Scribus 目前允许设计师使用一个 200 色的调色板,下一个稳定版中[承诺将会加倍颜色数][15]。

|

||||

|

||||

### digiKam (Adobe Lightroom)

|

||||

|

||||

|

||||

|

||||

[digiKam][16] 也许是目前 Linux 用户最好的 Lightroom 选择。功能包括导入照片、整理图片集、图像增强、创建幻灯片等功能。

|

||||

[digiKam][16] 也许是目前 Linux 用户最好的 Lightroom 替代品。功能包括导入照片、整理图片集、图像增强、创建幻灯片等功能。

|

||||

|

||||

它的时尚设计和先进的功能是真正的爱的劳动。实际上,digiKam 背后的人是摄影师。不仅如此,他们希望在 Linux 中完成在 Lightroom 能做的任何工作。

|

||||

它的时尚设计和先进的功能是真正用心之作。实际上,digiKam 背后的人是摄影师们。不仅如此,他们希望在 Linux 中完成在 Lightroom 能做的任何工作。

|

||||

|

||||

### Webflow (Adobe Muse)

|

||||

|

||||

|

||||

|

||||

[Webflow][17] 是另一个可以证明你无需下载软件而可以完成很多事的网站。一个非常方便的 Adobe Muse 替代品,Webflow 是创建高响应式网站设计的理想选择。

|

||||

[Webflow][17] 是另一个可以证明你无需下载软件而可以完成很多事的网站。这是一个非常方便的 Adobe Muse 替代品,Webflow 是创建高响应式网站设计的理想选择。

|

||||

|

||||

Webflow 的最好的一方面是你不需要自己编写代码。你只需拖放图像并写入文本。Webflow 为你做了所有杂事。你可以从头开始构建网站,也可以使用各种模板。虽然是免费的,但是高级选项还有额外的功能,如能够轻松地导出 HTML 和 CSS 以在其他地方使用。

|

||||

Webflow 的最好的一方面是你不需要自己编写代码。你只需拖放图像并写入文本。Webflow 为你做了所有杂事。你可以从头开始构建网站,也可以使用各种模板。虽然是免费的,但是其高级版本还提供了额外的功能,如能够轻松地导出 HTML 和 CSS 以在其他地方使用。

|

||||

|

||||

### Tupi (Adobe Animate)

|

||||

|

||||

|

||||

|

||||

[Tupi][18] 是 Adobe Animate 的替代品,或者那些[不太热衷于 Flash 的人][19]。当然,Tupi 的作者说这并不是与 Flash 竞争。然而,能够使用 HTML5 并不能阻止它成为理想的替代品。

|

||||

[Tupi][18] 是 Adobe Animate 的替代品,或者也可以用于那些[不太热衷于 Flash 的人][19]。当然,Tupi 的作者说这并不是与 Flash 竞争。然而,其使用 HTML5 的能力使其成为了理想的替代品。

|

||||

|

||||

在 PC 或平板电脑上绘制 2D 动画。不确定如何开始?使用网站的[ YouTube 教程][20]了解如何制作剪贴画动画以及更多。

|

||||

在 PC 或平板电脑上绘制 2D 动画。不确定如何开始?使用网站的 [YouTube 教程][20]了解如何制作剪贴画动画以及更多。

|

||||

|

||||

### Black Magic Fusion (Adobe After Effects)

|

||||

|

||||

|

||||

|

||||

[Black Magic Fusion][21]注定是 Adobe After Effects 的替代者。这个视觉效果软件有大约 25 年的开发!Fusion 通常用于在好莱坞电影和电视节目中制造令人印象深刻的效果 - 将其详细和时尚的功能带到家庭。

|

||||

[Black Magic Fusion][21] 注定是 Adobe After Effects 的替代者。这个视觉效果软件历经了大约 25 年的开发!Fusion 通常用于在好莱坞电影和电视节目中制造令人印象深刻的效果 —— 这靠的是其丰富而时尚的功能。

|

||||

|

||||

Fusion 通过使用节点,那些“代表效果、过滤器和其他处理的小图标”工作。将这些节点连接在一起,创建一系列复杂的视觉效果。该程序包括许多功能,如图片修饰、对象跟踪和令人兴奋的 3D 效果。

|

||||

Fusion 通过使用节点,即那些“代表效果、过滤器和其他处理的小图标”工作。将这些节点连接在一起,创建一系列复杂的视觉效果。该程序包括许多功能,如图片修饰、对象跟踪和令人兴奋的 3D 效果。

|

||||

|

||||

你可以选择免费版或者 $995 的 Fusion Studio。为了帮助你决定,[你可以比较][22]免费和高级版的 Fusion 功能。

|

||||

|

||||

### 总结

|

||||

|

||||

如你所见,其他的远远超过你的 Adobe 替代品。由于开源独创性,显著提升的替代品的持续发布。我们很快就会看到一个仅为 Linux 用户创建的完整套件。在此之前,你可以随意选择这些替代品。

|

||||

如你所见,这些远不止于是 Adobe 替代品。由于开源的缘故,显著提升的替代品的不断地发布。我们很快就会看到一个仅为 Linux 用户创建的完整套件。在此之前,你可以随意选择这些替代品。

|

||||

|

||||

知道这里没有提到的任何有用的 Adobe 替代品?在下面的评论区分享软件建议。

|

||||

知道这里没有提到的其它有用的 Adobe 替代品吗?在下面的评论区分享软件建议。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.maketecheasier.com/adobe-alternatives-for-linux/

|

||||

|

||||

作者:[ Toni Matthews-El][a]

|

||||

作者:[Toni Matthews-El][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,7 +1,6 @@

|

||||

详解 Ubuntu snap 包的制作过程

|

||||

============================================================

|

||||

|

||||

|

||||

> 如果你看过译者以前翻译的 snappy 文章,不知有没有感觉相关主题都是浅尝辄止,讲得不够透彻,看得也不太过瘾?如果有的话,相信这篇详细讲解如何从零开始制作一个 snap 包的文章应该不会让你失望。

|

||||

|

||||

在这篇文章中,我们将看到如何为名为 [timg][1] 的实用程序制作对应的 snap 包。如果这是你第一次听说 snap 安装包,你可以先看看 [如何创建你的第一个 snap 包][2]。

|

||||

@ -9,10 +8,8 @@

|

||||

今天我们将学习以下有关使用 snapcraft 制作 snap 包的内容:

|

||||

|

||||

* [timg][3] 源码中的 Makefile 文件是手工编写,我们需要修改一些 [make 插件参数][4]。

|

||||

|

||||

* 这个程序是用 C++ 语言写的,依赖几个额外的库文件。我们需要把相关的代码添加到 snap 包中。

|

||||

|

||||

* 严格限制还是传统限制?我们将会讨论如何在它们之间进行选择。

|

||||

* [严格限制还是传统限制][38]?我们将会讨论如何在它们之间进行选择。

|

||||

|

||||

首先,我们了解下 [timg][5] 有什么用?

|

||||

|

||||

@ -22,15 +19,15 @@ Linux 终端模拟器已经变得非常炫酷,并且还能显示颜色!

|

||||

|

||||

![1.png-19.9kB][6]

|

||||

|

||||

除了标准的颜色,大多数终端模拟器都支持真彩色(1600 万种颜色)。

|

||||

除了标准的颜色,大多数终端模拟器(如上图显示的 GNOME 终端)都支持真彩色(1600 万种颜色)。

|

||||

|

||||

![图片.png-61.9kB][7]

|

||||

|

||||

是的!终端模拟器已经支持真彩色了!从这个页面 [多个终端和终端应用程序已经支持真彩色(1600 万种颜色)][8] 可以获取 AWK 代码进行测试。你可以看到在代码中使用了一些 [转义序列][9] 来指定 RGB 的值(256 * 256 * 256 ~= 1600 万种颜色)。

|

||||

是的!终端模拟器已经支持真彩色了!从这个页面“ [多个终端和终端应用程序已经支持真彩色(1600 万种颜色)][8]” 可以获取 AWK 代码自己进行测试。你可以看到在代码中使用了一些 [转义序列][9] 来指定 RGB 的值(256 * 256 * 256 ~= 1600 万种颜色)。

|

||||

|

||||

### timg 是什么?

|

||||

|

||||

好了,言归正传,[timg][10] 有什么用?它能将输入的图片重新调整为终端窗口字符能显示范围的大小(比如:80 x 25),然后在终端窗口的任何分辨率用彩色字符显示图像。

|

||||

好了,言归正传,[timg][10] 有什么用?它能将输入的图片重新调整为终端窗口字符所能显示范围的大小(比如:80 x 25),然后在任何分辨率的终端窗口用彩色字符显示图像。

|

||||

|

||||

![图片.png-37.3kB][11]

|

||||

|

||||

@ -40,28 +37,26 @@ Linux 终端模拟器已经变得非常炫酷,并且还能显示颜色!

|

||||

|

||||

这是 [@Doug8888 拍摄的花][14]。

|

||||

|

||||

如果你通过远程连接服务器来管理自己的业务,并希望查看图像文件,那么 [timg][15] 将会特别有用。

|

||||

如果你通过远程连接服务器来管理自己的业务,并想要查看图像文件,那么 [timg][15] 将会特别有用。

|

||||

|

||||

除了静态图片,[timg][16] 同样也可以显示 gif 动图。让我们开始 snap 之旅吧!

|

||||

除了静态图片,[timg][16] 同样也可以显示 gif 动图。

|

||||

|

||||

那么让我们开始 snap 之旅吧!

|

||||

|

||||

### 熟悉 timg 的源码

|

||||

|

||||

[timg][17] 的源码可以在 [这里][18] 找到。让我们试着手动编译它,以了解它有什么需求。

|

||||

[timg][17] 的源码可以在 [https://github.com/hzeller/timg][18] 找到。让我们试着手动编译它,以了解它有什么需求。

|

||||

|

||||

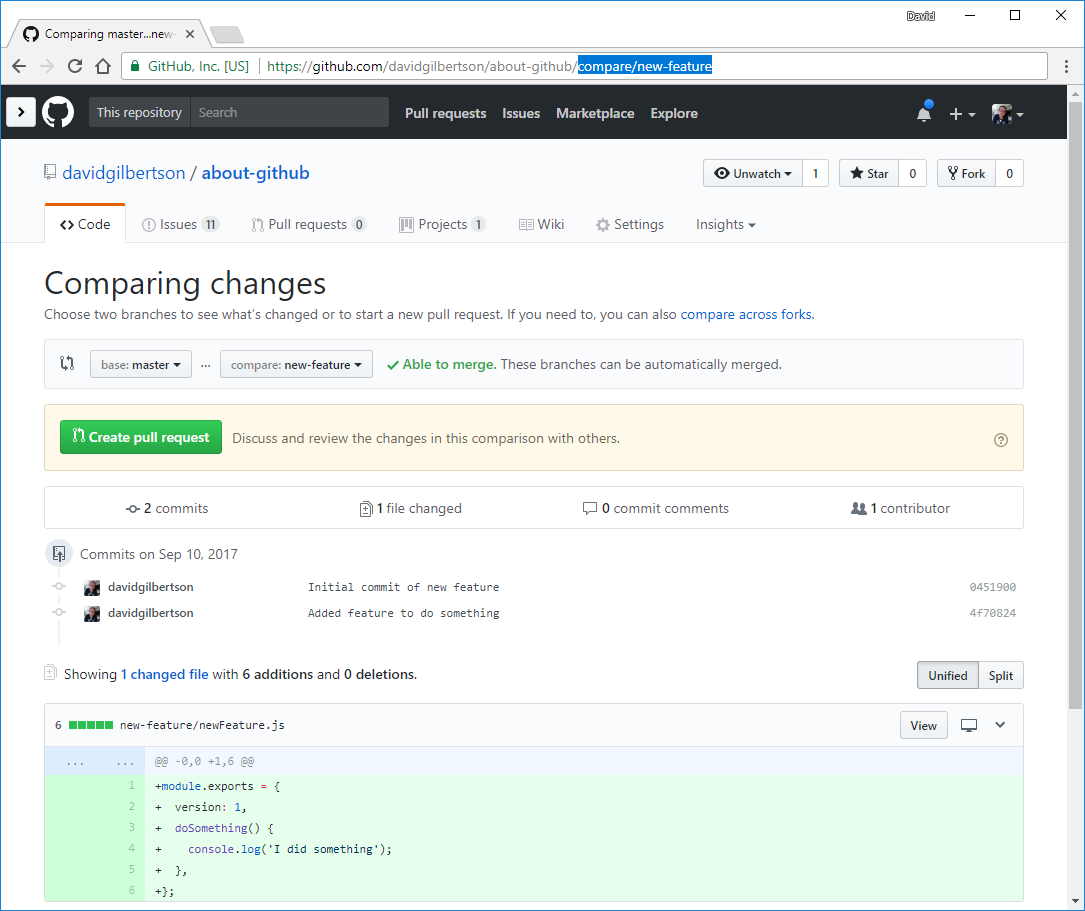

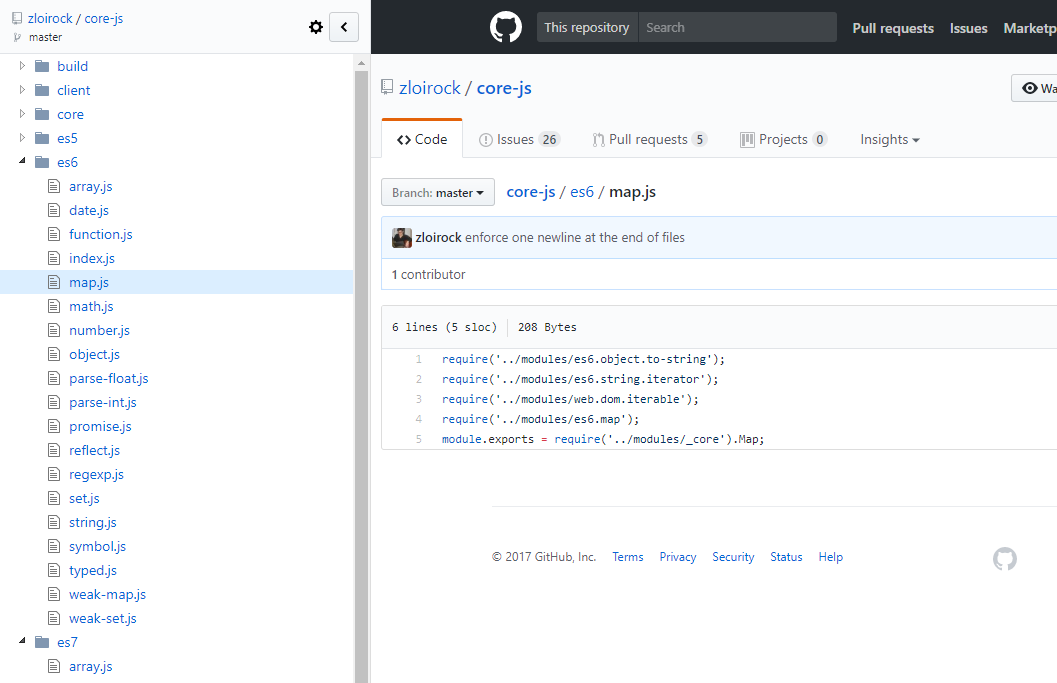

![图片.png-128.4kB][19]

|

||||

|

||||

`Makefile` 在 `src/` 子文件夹中而不是项目的根文件夹中。在 github 页面上,他们说需要安装这两个开发包(GraphicsMagic++ 和 WebP),然后使用 `make` 就能生成可执行文件。在截图中可以看到我已经将它们安装好了(在我读完相关的 Readme.md 文件后)。

|

||||

`Makefile` 在 `src/` 子文件夹中而不是项目的根文件夹中。在 github 页面上,他们说需要安装两个开发包(GraphicsMagic++ 和 WebP),然后使用 `make` 就能生成可执行文件。在截图中可以看到我已经将它们安装好了(在我读完相关的 Readme.md 文件后)。

|

||||

|

||||

因此,在编写 `snapcraft.yaml` 文件时已经有了四条腹稿:

|

||||

|

||||

因此,在编写 snapcraft.yaml 文件时已经有了四条腹稿:

|

||||

|

||||

1. Makefile 在 src/ 子文件夹中而不是项目的根文件夹中。

|

||||

|

||||

1. `Makefile` 在 `src/` 子文件夹中而不是项目的根文件夹中。

|

||||

2. 这个程序编译时需要两个开发库。

|

||||

|

||||

3. 为了让 timg 以 snap 包形式运行,我们需要将这两个库捆绑在 snap 包中(或者静态链接它们)。

|

||||

|

||||

4. [timg][20] 是用 C++ 编写的,所以需要安装 g++。在编译之前,让我们通过 snapcraft.yaml 文件来检查 `build-essential` 元包是否已经安装。

|

||||

4. [timg][20] 是用 C++ 编写的,所以需要安装 g++。在编译之前,让我们通过 `snapcraft.yaml` 文件来检查 `build-essential` 元包是否已经安装。

|

||||

|

||||

### 从 snapcraft 开始

|

||||

|

||||

@ -91,19 +86,14 @@ parts:

|

||||

|

||||

### 填充元数据

|

||||

|

||||

snapcraft.yaml 配置文件的上半部分是元数据。我们需要一个一个把它们填满,这算是比较容易的部分。元数据由以下字段组成:

|

||||

`snapcraft.yaml` 配置文件的上半部分是元数据。我们需要一个一个把它们填满,这算是比较容易的部分。元数据由以下字段组成:

|

||||

|

||||

1. `名字` —— snap 包的名字,它将公开在 Ubuntu 商店中。

|

||||

|

||||

2. `版本` —— snap 包的版本号。可以是源代码存储库中一个适当的分支或者标记,如果没有分支或标记的话,也可以是当前日期。

|

||||

|

||||

3. `摘要` —— 不超过 80 个字符的简短描述。

|

||||

|

||||

4. `描述` —— 长一点的描述, 100 个字以下.

|

||||

|

||||

5. `等级` —— 稳定或者开发。因为我们想要在 Ubuntu 商店的稳定通道中发布这个 snap 包,所以在 snap 包能正常工作后,就把它设置成稳定。

|

||||

|

||||

6. `限制` —— 我们首先设置为开发模式,这样系统将不会以任何方式限制 snap 包。一旦它在开发模式 下能正常工作,我们再考虑选择严格还是传统限制。

|

||||

1. `name` (名字)—— snap 包的名字,它将公开在 Ubuntu 商店中。

|

||||

2. `version` (版本)—— snap 包的版本号。可以是源代码存储库中一个适当的分支或者标记,如果没有分支或标记的话,也可以是当前日期。

|

||||

3. `summary` (摘要)—— 不超过 80 个字符的简短描述。

|

||||

4. `description` (描述)—— 长一点的描述, 100 个字以下。

|

||||

5. `grade` (等级)—— `stable` (稳定)或者 `devel` (开发)。因为我们想要在 Ubuntu 商店的稳定通道中发布这个 snap 包,所以在 snap 包能正常工作后,就把它设置成 `stable`。

|

||||

6. `confinement` (限制)—— 我们首先设置为 `devmode` (开发模式),这样系统将不会以任何方式限制 snap 包。一旦它在 `devmode`下能正常工作,我们再考虑选择 `strict` (严格)还是 `classic` (传统)限制。

|

||||

|

||||

我们将使用 `timg` 这个名字:

|

||||

|

||||

@ -125,11 +115,11 @@ You already own the name 'timg'.

|

||||

|

||||

然而主分支(`master`)中有两个看起来很重要的提交。因此我们使用主分支而不用 `v0.9.5` 标签的那个。我们使用今天的日期—— `20170226` 做为版本号。

|

||||

|

||||

我们从仓库中搜集了摘要和描述。其中摘要的内容为 `一个终端图像查看器`,描述的内容为 `一个能用 24 位颜色和 unicode 字符块来在终端中显示图像的查看器`。

|

||||

我们从仓库中搜集了摘要和描述。其中摘要的内容为 `A terminal image viewer`,描述的内容为 `A viewer that uses 24-Bit color capabilities and unicode character blocks to display images in the terminal`。

|

||||

|

||||

最后,将等级设置为稳定,将限制设置为开发模式(一直到 snap 包真正起作用)。

|

||||

最后,将 `grade` (等级)设置为 `stable` (稳定),将 `confinement` 限制设置为 `devmode` (开发模式)(一直到 snap 包真正起作用)。

|

||||

|

||||

这是更新后的 snapcraft.yaml,带有所有的元数据:

|

||||

这是更新后的 `snapcraft.yaml`,带有所有的元数据:

|

||||

|

||||

```

|

||||

ubuntu@snaps:~/timg-snap$ cat snap/snapcraft.yaml

|

||||

@ -148,22 +138,19 @@ parts:

|

||||

plugin: nil

|

||||

```

|

||||

|

||||

### 弄清楚 "parts:" 是什么

|

||||

### 弄清楚 `parts:` 是什么

|

||||

|

||||

现在我们需要将上面已经存在的 `parts:` 部分替换成真实的 `parts:`。

|

||||

|

||||

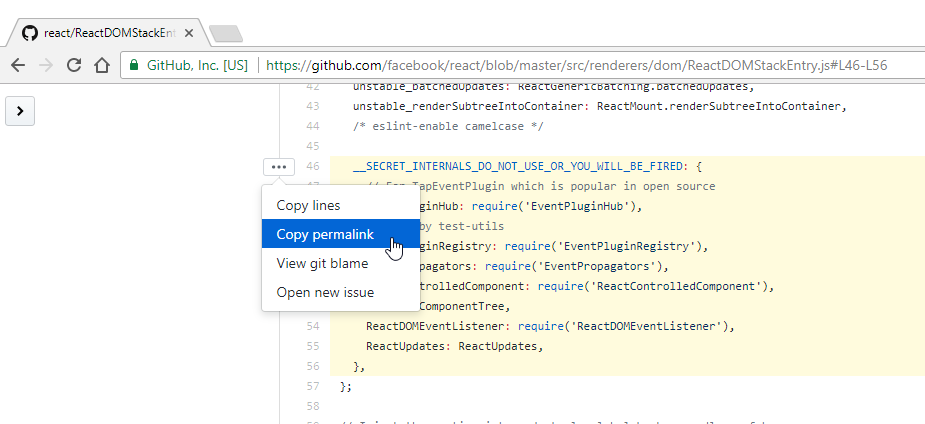

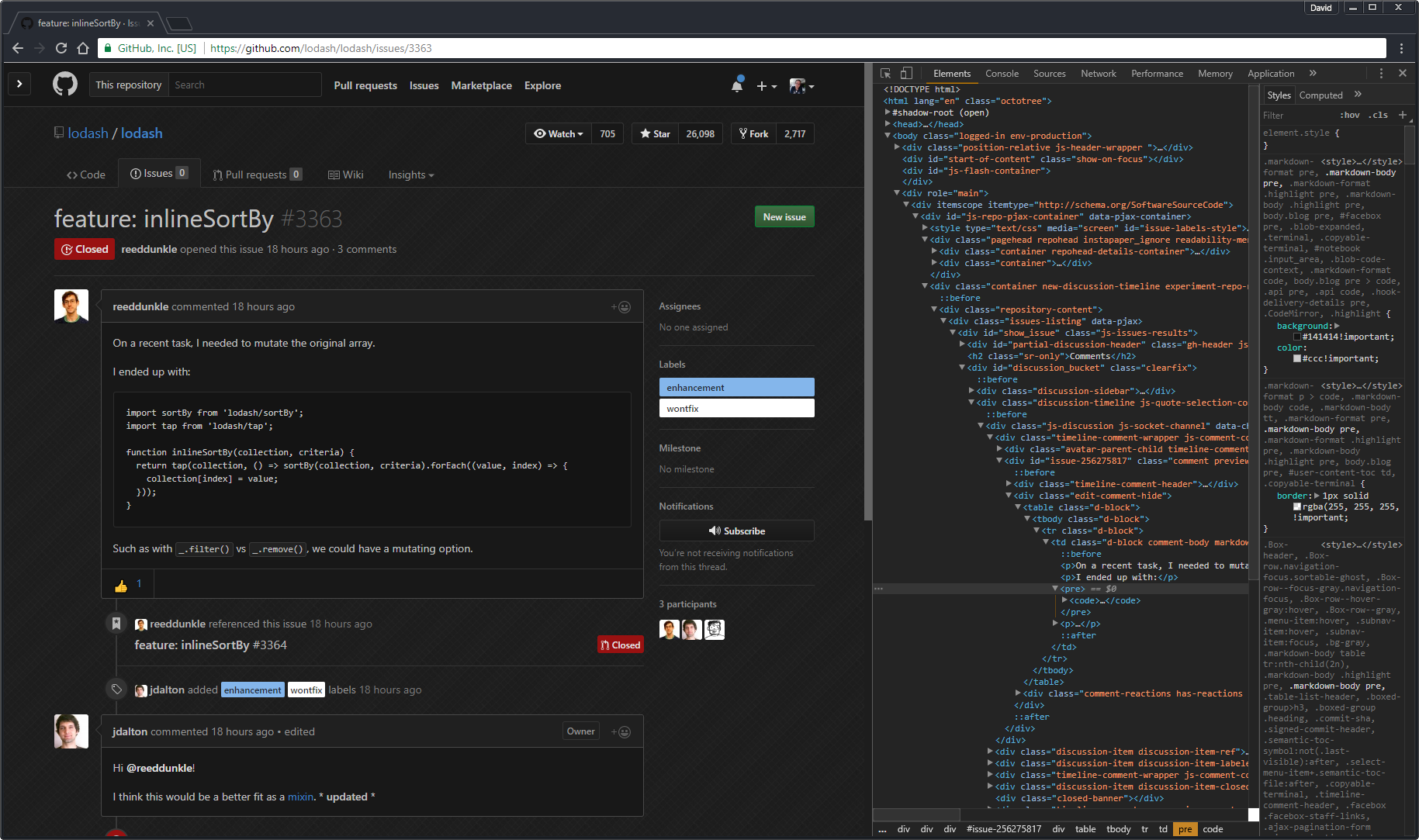

![timg-git-url.png-8kB][23]

|

||||

|

||||

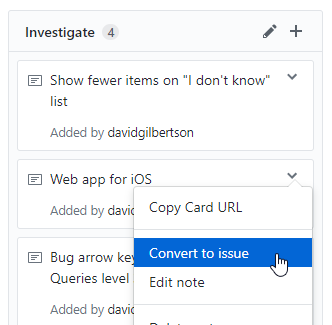

<dd> Git 仓库的 URL。 </dd>

|

||||

*Git 仓库的 URL。*

|

||||

|

||||

![图片.png-28.7kB][24]

|

||||

|

||||

<dd> 存在 Makefile,因此我们需要 make 插件。</dd>

|

||||

*存在 Makefile,因此我们需要 make 插件。*

|

||||

|

||||

(这两张图在原文中是并排显示的,在 markdown 中不知道怎么设置。。)

|

||||

|

||||

|

||||

我们已经知道 git 仓库的 URL 链接,并且 timg 源码中存在 Makefile 文件。至于 [snapcraft make 插件][25] 的 Makefile 命令,正如文档所言,这个插件总是会运行 `make` 后再运行 `make install`。为了确认 `make` 插件的用法,我查看了 [snapcraft 可用插件列表][26]。

|

||||

我们已经知道 git 仓库的 URL 链接,并且 timg 源码中已有了 `Makefile` 文件。至于 [snapcraft make 插件][25] 的 Makefile 命令,正如文档所言,这个插件总是会运行 `make` 后再运行 `make install`。为了确认 `make` 插件的用法,我查看了 [snapcraft 可用插件列表][26]。

|

||||

|

||||

因此,我们将最初的配置:

|

||||

|

||||

@ -183,7 +170,7 @@ parts:

|

||||

plugin: make

|

||||

```

|

||||

|

||||

这是当前 snapcraft.yaml 文件的内容:

|

||||

这是当前 `snapcraft.yaml` 文件的内容:

|

||||

|

||||

```

|

||||

name: timg

|

||||

@ -222,13 +209,13 @@ Command '['/bin/sh', '/tmp/tmpem97fh9d', 'make', '-j4']' returned non-zero exit

|

||||

ubuntu@snaps:~/timg-snap$

|

||||

```

|

||||

|

||||

我们可以看到 `snapcraft` 无法在源代码中找到 `Makefile` 文件,正如我们之前所暗示的,`Makefile` 只位于 `src/` 子文件夹中。那么,我们可以让 `snapcraft` 使用 `src/` 文件夹中的 `Makefile` 文件吗?

|

||||

我们可以看到 `snapcraft` 无法在源代码中找到 `Makefile` 文件,正如我们之前所暗示的,`Makefile` 位于 `src/` 子文件夹中。那么,我们可以让 `snapcraft` 使用 `src/` 文件夹中的 `Makefile` 文件吗?

|

||||

|

||||

每个 snapcraft 插件都有自己的选项,并且有一些通用选项是所有插件共享的。在本例中,我们希望研究那些[与源代码相关的 snapcraft 选项][27]。我们开始吧:

|

||||

|

||||

* source-subdir:path

|

||||

**source-subdir:path**

|

||||

|

||||

snapcraft 会检出(checkout) `source` 关键字所引用的仓库或者解压归档文件到 `parts/<part-name>/src/` 中,但是它只会将特定的子目录复制到 `parts/<part-name>/build/` 中。

|

||||

snapcraft 会<ruby>检出<rt>checkout</rt></ruby> `source` 关键字所引用的仓库或者解压归档文件到 `parts/<part-name>/src/` 中,但是它只会将特定的子目录复制到 `parts/<part-name>/build/` 中。

|

||||

|

||||

我们已经有了适当的选项,下面更新下 `parts`:

|

||||

|

||||

@ -240,7 +227,7 @@ parts:

|

||||

plugin: make

|

||||

```

|

||||

|

||||

然后再次运行 snapcraft prime:

|

||||

然后再次运行 `snapcraft prime`:

|

||||

|

||||

```

|

||||

ubuntu@snaps:~/timg-snap$ snapcraft prime

|

||||

@ -270,11 +257,11 @@ Command '['/bin/sh', '/tmp/tmpeeyxj5kw', 'make', '-j4']' returned non-zero exit

|

||||

ubuntu@snaps:~/timg-snap$

|

||||

```

|

||||

|

||||

从错误信息我们可以得知 snapcraft 找不到 GraphicsMagick++ 这个开发库文件。根据 [snapcraft 常见关键字][29] 可知,我们需要在 snapcraft.yaml 中指定这个库文件,这样 snapcraft 才能安装它。

|

||||

从错误信息我们可以得知 snapcraft 找不到 GraphicsMagick++ 这个开发库文件。根据 [snapcraft 常见关键字][29] 可知,我们需要在 `snapcraft.yaml` 中指定这个库文件,这样 snapcraft 才能安装它。

|

||||

|

||||

* `build-packages`:[deb, deb, deb…]

|

||||

**build-packages:[deb, deb, deb…]**

|

||||

|

||||

构建 part 前需要在主机中安装的 Ubuntu 包列表。这些包通常不会进入最终的 snap 包中,除非它们含有 snap 包中二进制文件直接依赖的库文件(在这种情况下,可以通过 `ldd` 发现他们),或者在 `stage-package` 中显式地指定了它们。

|

||||

列出构建 part 前需要在主机中安装的 Ubuntu 包。这些包通常不会进入最终的 snap 包中,除非它们含有 snap 包中二进制文件直接依赖的库文件(在这种情况下,可以通过 `ldd` 发现它们),或者在 `stage-package` 中显式地指定了它们。

|

||||

|

||||

让我们寻找下这个开发包的名字:

|

||||

|

||||

@ -346,7 +333,7 @@ parts:

|

||||

- libwebp-dev

|

||||

```

|

||||

|

||||

下面是更新后 snapcraft.yaml 文件的内容:

|

||||

下面是更新后的 `snapcraft.yaml` 文件的内容:

|

||||

|

||||

```

|

||||

name: timg

|

||||

@ -408,9 +395,9 @@ terminal-canvas.cc terminal-canvas.o timg.cc

|

||||

ubuntu@snaps:~/timg-snap/parts/timg$

|

||||

```

|

||||

|

||||

在 `build/` 子目录中,我们可以找到 `make` 的输出结果。由于我们设置了 `source-subdir:` 为 `src`,所以 `artifacts:` 的基目录为 `build/src`。在这里我们可以找到可执行文件 `timg`,我们需要将它设置为 `artifacts:` 的一个参数:。通过 `artifacts:`,我们可以把 `make` 输出的某些文件复制到 snap 包的安装目录(在 `prime/` 中)。

|

||||

在 `build/` 子目录中,我们可以找到 `make` 的输出结果。由于我们设置了 `source-subdir:` 为 `src`,所以 `artifacts:` 的基目录为 `build/src`。在这里我们可以找到可执行文件 `timg`,我们需要将它设置为 `artifacts:` 的一个参数。通过 `artifacts:`,我们可以把 `make` 输出的某些文件复制到 snap 包的安装目录(在 `prime/` 中)。

|

||||

|

||||

下面是更新后 snapcraft.yaml 文件 parts: 部分的内容:

|

||||

下面是更新后 `snapcraft.yaml` 文件 `parts:` 部分的内容:

|

||||

|

||||

```

|

||||

parts:

|

||||

@ -423,7 +410,9 @@ parts:

|

||||

- libwebp-dev

|

||||

artifacts: [timg]

|

||||

```

|

||||

|

||||

让我们运行 `snapcraft prime`:

|

||||

|

||||

```

|

||||

ubuntu@snaps:~/timg-snap$ snapcraft prime

|

||||

Preparing to pull timg

|

||||

@ -459,7 +448,7 @@ meta/ snap/ timg* usr/

|

||||

ubuntu@snaps:~/timg-snap$

|

||||

```

|

||||

|

||||

它在 `prime/` 子文件夹的根目录中。现在,我们已经准备好要在 snapcaft.yaml 中增加 `apps:` 的内容:

|

||||

它在 `prime/` 子文件夹的根目录中。现在,我们已经准备好要在 `snapcaft.yaml` 中增加 `apps:` 的内容:

|

||||

|

||||

```

|

||||

ubuntu@snaps:~/timg-snap$ cat snap/snapcraft.yaml

|

||||

@ -503,9 +492,9 @@ ubuntu@snaps:~/timg-snap$

|

||||

|

||||

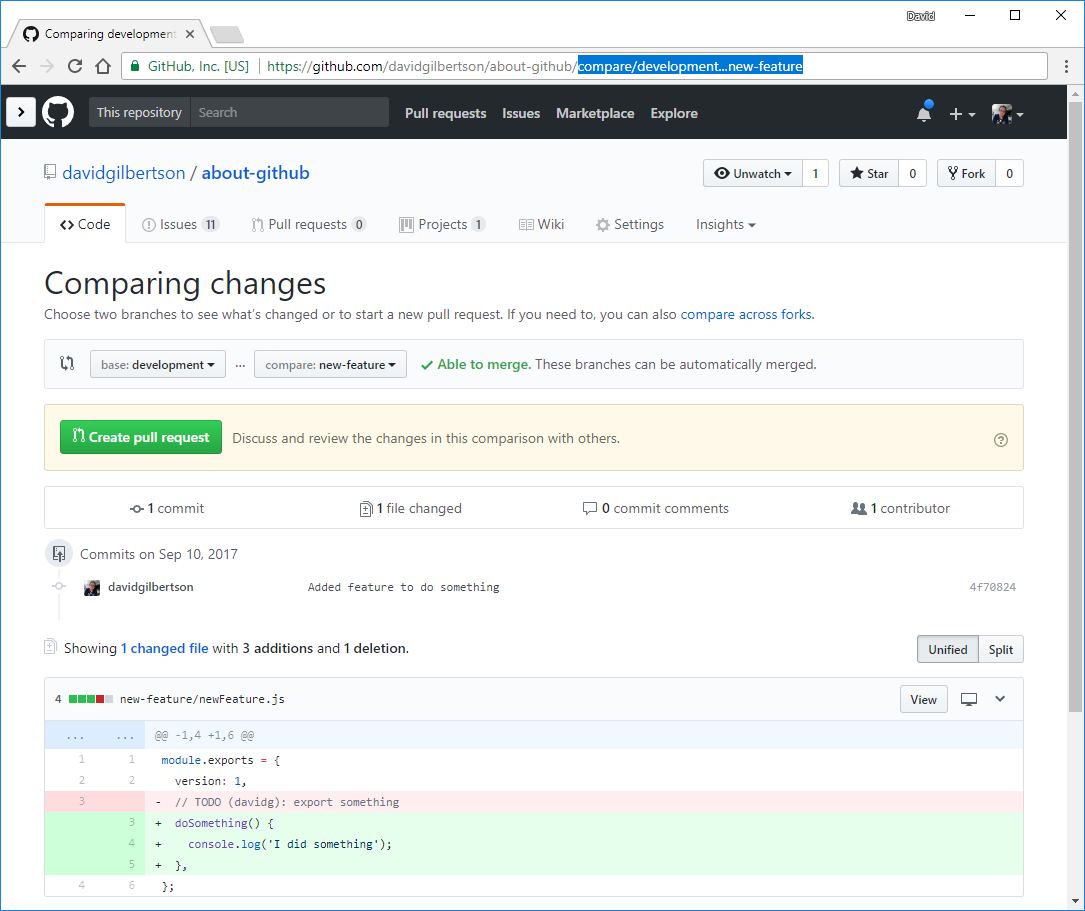

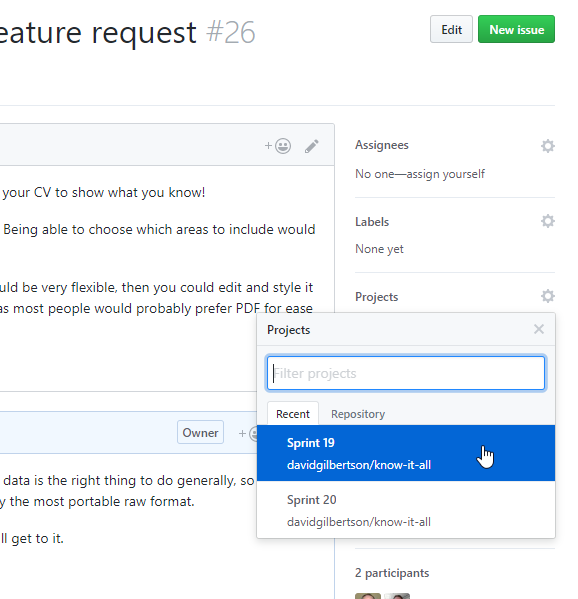

![图片.png-42.3kB][32]

|

||||

|

||||

图片来源: https://www.flickr.com/photos/mustangjoe/6091603784/

|

||||

*图片来源: https://www.flickr.com/photos/mustangjoe/6091603784/*

|

||||

|

||||

我们可以通过 `snap try --devmode prime/ ` 使能 snap 包然后测试 timg 命令。这是一种高效的测试方法,可以避免生成 .snap 文件,并且无需安装和卸载它们,因为 `snap try prime/` 直接使用了 `prime/` 文件夹中的内容。

|

||||

我们可以通过 `snap try --devmode prime/ ` 启用该 snap 包然后测试 `timg` 命令。这是一种高效的测试方法,可以避免生成 .snap 文件,并且无需安装和卸载它们,因为 `snap try prime/` 直接使用了 `prime/` 文件夹中的内容。

|

||||

|

||||

### 限制 snap

|

||||

|

||||

@ -527,9 +516,9 @@ Trouble loading pexels-photo-149813.jpeg (Magick: Unable to open file (pexels-ph

|

||||

ubuntu@snaps:~/timg-snap$

|

||||

```

|

||||

|

||||

通过这种方式,我们可以无需修改 snapcraft.yaml 文件就从开发模式切换到限制模式(confinement: strict)。正如预期的那样,timg 无法读取图像,因为我们没有开放访问文件系统的权限。

|

||||

通过这种方式,我们可以无需修改 `snapcraft.yaml` 文件就从开发模式(`devmode`)切换到限制模式(`jailmode`)(`confinement: strict`)。正如预期的那样,`timg` 无法读取图像,因为我们没有开放访问文件系统的权限。

|

||||

|

||||

现在,我们需要作出决定。使用限制模式,我们可以很容易授予某个命令访问用户 `$HOME` 目录中文件的权限,但是只能访问那里。如果图像文件位于其它地方,我们总是需要复制到 `$HOME` 目录并在 `$HOME` 的副本上运行 timg。如果我们对此感到满意,那我们可以设置 snapcraf.yaml 为:

|

||||

现在,我们需要作出决定。使用限制模式,我们可以很容易授予某个命令访问用户 `$HOME` 目录中文件的权限,但是只能访问那里。如果图像文件位于其它地方,我们总是需要复制到 `$HOME` 目录并在 `$HOME` 的副本上运行 timg。如果我们觉得可行,那我们可以设置 `snapcraf.yaml` 为:

|

||||

|

||||

```

|

||||

name: timg

|

||||

@ -558,7 +547,7 @@ parts:

|

||||

artifacts: [timg]

|

||||

```

|

||||

|

||||

另一方面,如果希望 timg snap 包能访问整个文件系统,我们可以设置 传统限制来实现。对应的 snapcraft.yaml 内容如下:

|

||||

另一方面,如果希望 timg snap 包能访问整个文件系统,我们可以设置传统限制来实现。对应的 `snapcraft.yaml` 内容如下:

|

||||

|

||||

```

|

||||

name: timg

|

||||

@ -586,7 +575,7 @@ parts:

|

||||

artifacts: [timg]

|

||||

```

|

||||

|

||||

接下来我们将选择严格约束选项。因此,图像应该只能放在 $HOME 中。

|

||||

接下来我们将选择严格(`strict`)约束选项。因此,图像应该只能放在 $HOME 中。

|

||||

|

||||

### 打包和测试

|

||||

|

||||

@ -663,9 +652,9 @@ latest amd64 16 stable 20170226 6

|

||||

The 'stable' channel is now open.

|

||||

```

|

||||

|

||||

我们把 .snap 包推送到 Ubuntu 商店后,得到了一个 `修订版本号 6`。然后,我们将 timg `修订版本 6` 发布到了 Ubuntu 商店的稳定通道。

|

||||

我们把 .snap 包推送到 Ubuntu 商店后,得到了一个 `Revision 6`。然后,我们将 timg `Revision 6` 发布到了 Ubuntu 商店的稳定通道。

|

||||

|

||||

在候选通道中没有已发布的 snap 包,他继承的是稳定通道的包,所以显示 `^` 字符。

|

||||

在候选通道中没有已发布的 snap 包,它继承的是稳定通道的包,所以显示 `^` 字符。

|

||||

|

||||

在之前的测试中,我将一些较老版本的 snap 包上传到了测试和边缘通道。这些旧版本使用了 timg 标签为 `0.9.5` 的源代码。

|

||||

|

||||

@ -688,7 +677,7 @@ latest amd64 16 stable 20170226 6

|

||||

|

||||

### 使用 timg

|

||||

|

||||

让我们不带参数运行 timg:

|

||||

让我们不带参数运行 `timg`:

|

||||

|

||||

```

|

||||

ubuntu@snaptesting:~$ timg

|

||||

@ -709,7 +698,7 @@ If both -w and -t are given for some animation/scroll, -t takes precedence

|

||||

ubuntu@snaptesting:~$

|

||||

```

|

||||

|

||||

这里说,当前我们终端模拟器的缩放级别,即分辨率为:80 × 48。

|

||||

这里提到当前我们终端模拟器的缩放级别,即分辨率为:80 × 48。

|

||||

|

||||

让我们缩小一点,并最大化 GNOME 终端窗口。

|

||||

|

||||

@ -723,13 +712,13 @@ ubuntu@snaptesting:~$

|

||||

|

||||

你所看到的是调整后的图像(1080p)。虽然它是用彩色文本字符显示的,但看起来依旧很棒。

|

||||

|

||||

接下来呢?timg 其实也可以播放 gif 动画哦!

|

||||

接下来呢?`timg` 其实也可以播放 gif 动画哦!

|

||||

|

||||

```

|

||||

$ wget https://m.popkey.co/9b7141/QbAV_f-maxage-0.gif -O JonahHillAmazed.gif$ timg JonahHillAmazed.gif

|

||||

```

|

||||

|

||||

你可以试着安装 timg 来体验 gif 动画。要是不想自己动手,可以在 [asciinema][36] 上查看相关记录 (如果视频看上去起伏不定的,请重新运行它)。

|

||||

你可以试着安装 `timg` 来体验 gif 动画。要是不想自己动手,可以在 [asciinema][36] 上查看相关记录 (如果视频看上去起伏不定的,请重新运行它)。

|

||||

|

||||

谢谢阅读!

|

||||

|

||||

@ -743,13 +732,13 @@ via:https://blog.simos.info/how-to-create-a-snap-for-timg-with-snapcraft-on-ub

|

||||

|

||||

作者:[Mi blog lah!][37]

|

||||

译者:[Snapcrafter](https://github.com/Snapcrafter)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

|

||||

[1]: https://github.com/hzeller/timg

|

||||

[2]:https://tutorials.ubuntu.com/tutorial/create-first-snap

|

||||

[2]: https://tutorials.ubuntu.com/tutorial/create-your-first-snap

|

||||

[3]: https://github.com/hzeller/timg

|

||||

[4]: https://snapcraft.io/docs/reference/plugins/make

|

||||

[5]:https://github.com/hzeller/timg

|

||||

@ -785,3 +774,4 @@ via:https://blog.simos.info/how-to-create-a-snap-for-timg-with-snapcraft-on-ub

|

||||

[35]: http://static.zybuluo.com/apollomoon/clnv44g3bwhaqog7o1jpvpcd/%E5%9B%BE%E7%89%87.png

|

||||

[36]: https://asciinema.org/a/dezbe2gpye84e0pjndp8t0pvh

|

||||

[37]: https://blog.simos.info/

|

||||

[38]:https://snapcraft.io/docs/reference/confinement

|

||||

@ -1,48 +1,50 @@

|

||||

OpenGL 与 Go 教程 第一节: Hello, OpenGL

|

||||

OpenGL 与 Go 教程(一)Hello, OpenGL

|

||||

============================================================

|

||||

|

||||

_[第一节: Hello, OpenGL][6]_ | _[第二节: 绘制游戏面板][7]_ | _[第三节: 实现游戏功能][8]_

|

||||

- [第一节: Hello, OpenGL][6]

|

||||

- [第二节: 绘制游戏面板][7]

|

||||

- [第三节: 实现游戏功能][8]

|

||||

|

||||

_这篇教程的所有源代码都可以在 [GitHub][9] 上找到。_

|

||||

这篇教程的所有源代码都可以在 [GitHub][9] 上找到。

|

||||

|

||||

### 介绍

|

||||

|

||||

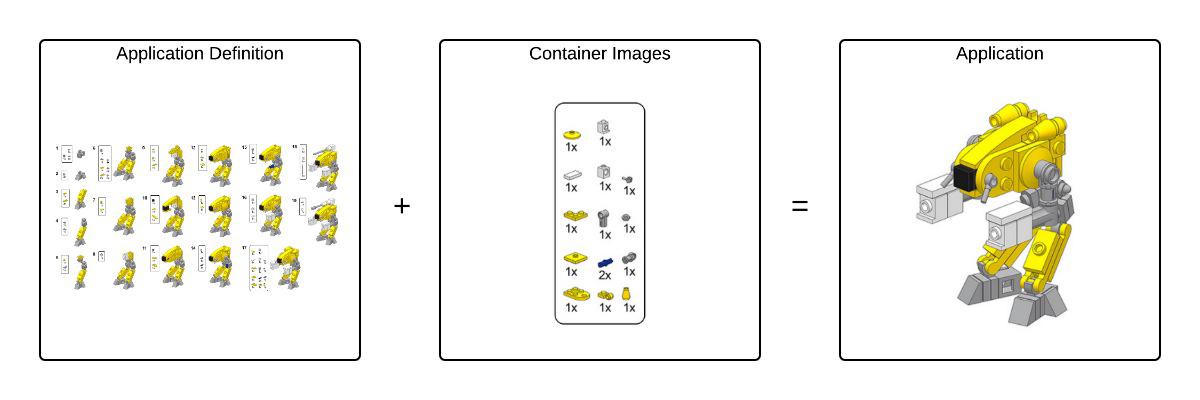

[OpenGL][19] 是一门相当好的技术,适用于多种类型的绘图工作,从桌面的 GUI 到游戏,到移动应用甚至 web 应用。我敢保证,你今天看到的图形有些就是用 OpenGL 渲染的。可是,不管 OpenGL 多受欢迎、有多好用,与学习其它高层次的绘图库相比,学习 OpenGL 是要相当足够的决心的。

|

||||

[OpenGL][19] 是一门相当好的技术,适用于从桌面的 GUI 到游戏,到移动应用甚至 web 应用的多种类型的绘图工作。我敢保证,你今天看到的图形有些就是用 OpenGL 渲染的。可是,不管 OpenGL 多受欢迎、有多好用,与学习其它高级绘图库相比,学习 OpenGL 是要相当足够的决心的。

|

||||

|

||||

这个教程的目的是给你一个切入点,让你对 OpenGL 有个基本的了解,然后教你怎么用 [Go][20] 操作它。几乎每种编程语言都有绑定 OpenGL 的库,Go 也不例外,它有 [go-gl][21] 这个包。这是一个完整的套件,可以绑定 OpenGL ,适用于多种版本的 OpenGL。

|

||||

|

||||

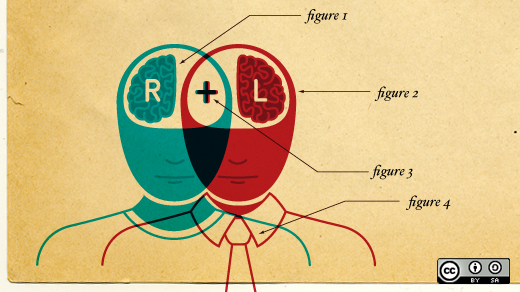

这篇教程会按照下面列出的几个阶段进行介绍,我们最终的目标是用 OpenGL 在桌面窗口绘制游戏面板,进而实现 [Conway's Game of Life][22]。完整的源代码可以在 GitHub [github.com/KyleBanks/conways-gol][23] 上获得,当你有疑惑的时候可以随时查看源代码,或者你要按照自己的方式学习也可以参考这个代码。

|

||||

这篇教程会按照下面列出的几个阶段进行介绍,我们最终的目标是用 OpenGL 在桌面窗口绘制游戏面板,进而实现[康威生命游戏][22]。完整的源代码可以在 GitHub [github.com/KyleBanks/conways-gol][23] 上获得,当你有疑惑的时候可以随时查看源代码,或者你要按照自己的方式学习也可以参考这个代码。

|

||||

|

||||

在我们开始之前,我们要先弄明白 _Conway's Game of Life_ 到底是什么。这里是 [Wikipedia][24] 上面的总结:

|

||||

在我们开始之前,我们要先弄明白<ruby>康威生命游戏<rt>Conway's Game of Life</rt></ruby> 到底是什么。这里是 [Wikipedia][24] 上面的总结:

|

||||

|

||||

> 《Game of Life》,也可以简称为 Life,是一个细胞自动变化的过程,由英国数学家 John Horton Conway 于 1970 年提出。

|

||||

> 《生命游戏》,也可以简称为 Life,是一个细胞自动变化的过程,由英国数学家 John Horton Conway 于 1970 年提出。

|

||||

>

|

||||

> 这个“游戏”没有玩家,也就是说它的发展依靠的是它的初始状态,不需要输入。用户通过创建初始配置文件、观察它如何演变,或者对于高级“玩家”可以创建特殊属性的模式,进而与《Game of Life》进行交互。

|

||||

> 这个“游戏”没有玩家,也就是说它的发展依靠的是它的初始状态,不需要输入。用户通过创建初始配置文件、观察它如何演变,或者对于高级“玩家”可以创建特殊属性的模式,进而与《生命游戏》进行交互。

|

||||

>

|

||||

> 规则

|

||||

> `规则`

|

||||

>

|

||||

> 《Game of Life》的世界是一个无穷多的二维正交的正方形细胞的格子,每一个格子都有两种可能的状态,“存活”或者“死亡”,也可以说是“填充态”或“未填充态”(区别可能很小,除非把它看作一个模拟人类/哺乳动物行为的早期模型,或者在一个人如何看待方格里的空白时)。每一个细胞与它周围的八个细胞相关联,这八个细胞分别是水平、垂直、斜对角相接的。在游戏中的每一步,下列事情中的一件将会发生:

|

||||

> 《生命游戏》的世界是一个无穷多的二维正交的正方形细胞的格子世界,每一个格子都有两种可能的状态,“存活”或者“死亡”,也可以说是“填充态”或“未填充态”(区别可能很小,可以把它看作一个模拟人类/哺乳动物行为的早期模型,这要看一个人是如何看待方格里的空白)。每一个细胞与它周围的八个细胞相关联,这八个细胞分别是水平、垂直、斜对角相接的。在游戏中的每一步,下列事情中的一件将会发生:

|

||||

>

|

||||

> 1. 任何存活着的细胞当任何一个存活的 cell 的附近少于 2 个存活的 cell 时,该 cell 将会消亡,就像人口过少所导致的结果一样

|

||||

> 2. 当任何一个存活的 cell 的附近有 2 至 3 个存活的 cell 时,该 cell 在下一代中仍然存活。

|

||||

> 3. 当任何一个存活的 cell 的附近多于 3 个存活的 cell 时,该 cell 将会消亡,就像人口过多所导致的结果一样

|

||||

> 4. 任何一个消亡的 cell 附近刚好有 3 个存活的 cell,该 cell 会变为存活的状态,就像重生一样。

|

||||

> 1. 当任何一个存活的细胞的附近少于 2 个存活的细胞时,该细胞将会消亡,就像人口过少所导致的结果一样

|

||||

> 2. 当任何一个存活的细胞的附近有 2 至 3 个存活的细胞时,该细胞在下一代中仍然存活。

|

||||

> 3. 当任何一个存活的细胞的附近多于 3 个存活的细胞时,该细胞将会消亡,就像人口过多所导致的结果一样

|

||||

> 4. 任何一个消亡的细胞附近刚好有 3 个存活的细胞,该细胞会变为存活的状态,就像重生一样。

|

||||

|

||||

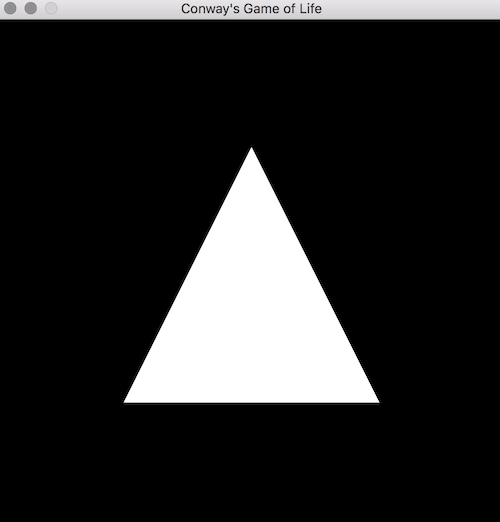

不需要其他工具,这里由一个我们将会制作的演示程序:

|

||||

不需要其他工具,这里有一个我们将会制作的演示程序:

|

||||

|

||||

|

||||

|

||||

|

||||

在我们的运行过程中,白色的细胞表示它是存活着的,黑色的细胞表示它已经死亡。

|

||||

|

||||

### 概述

|

||||

|

||||

本教程将会涉及到很多基础内容,从最基本的开始,但是你还是要对 Go 由一些最基本的了解 - 至少你应该知道变量,切片,函数和结构体,并且装了一个 Go 的运行环境。我写这篇教程用的 Go 版本是 1.8,但它应该与之前的版本兼容。这里用 Go 语言实现没有什么特别新奇的东西,因此只要你有过类似的编程经历就行。

|

||||

本教程将会涉及到很多基础内容,从最基本的开始,但是你还是要对 Go 由一些最基本的了解 —— 至少你应该知道变量、切片、函数和结构体,并且装了一个 Go 的运行环境。我写这篇教程用的 Go 版本是 1.8,但它应该与之前的版本兼容。这里用 Go 语言实现没有什么特别新奇的东西,因此只要你有过类似的编程经历就行。

|

||||

|

||||

这里是我们在这个教程里将会讲到的东西:

|

||||

|

||||

* [第一节: Hello, OpenGL][10]: 安装 OpenGL 和 [GLFW][11],在窗口上绘制一个三角形。

|

||||

* [第二节: 绘制游戏面板][12]: 用三角形拼成方形,在窗口上用方形绘成格子。

|

||||

* [第三节: 实现游戏功能][13]: 实现 Conway 游戏

|

||||

* [第一节: Hello, OpenGL][10]: 安装 OpenGL 和 [GLFW][11],在窗口上绘制一个三角形。

|

||||

* [第二节: 绘制游戏面板][12]: 用三角形拼成方形,在窗口上用方形绘成格子。

|

||||

* [第三节: 实现游戏功能][13]: 实现 Conway 游戏

|

||||

|

||||

最后的源代码可以在 [GitHub][25] 上获得,每一节的末尾有个_回顾_,包含该节相关的代码。如果有什么不清楚的地方或者是你感到疑惑的,看看每一节末尾的完整代码。

|

||||

|

||||

@ -50,9 +52,9 @@ OpenGL 与 Go 教程 第一节: Hello, OpenGL

|

||||

|

||||

### 安装 OpenGL 和 GLFW

|

||||

|

||||

我们介绍过 OpenGL,但是为了使用它,我们要有个窗口可以绘制东西。 [GLFW][26] 是一款对于 OpenGL 跨平台的 API,允许我们创建窗口并使用,而且它是 [go-gl][27] 套件中提供的。

|

||||

我们介绍过 OpenGL,但是为了使用它,我们要有个窗口可以绘制东西。 [GLFW][26] 是一款用于 OpenGL 的跨平台 API,允许我们创建并使用窗口,而且它也是 [go-gl][27] 套件中提供的。

|

||||

|

||||

我们要做的第一件事就是确定 OpenGL 的版本。为了方便本教程,我们将会使用 **OpenGL v4.1**,但你也可以用 **v2.1** 要是你的操作系统不支持最新的 OpenGL。要安装 OpenGL,我们需要做这些事:

|

||||

我们要做的第一件事就是确定 OpenGL 的版本。为了方便本教程,我们将会使用 `OpenGL v4.1`,但要是你的操作系统不支持最新的 OpenGL,你也可以用 `v2.1`。要安装 OpenGL,我们需要做这些事:

|

||||

|

||||

```

|

||||

# 对于 OpenGL 4.1

|

||||

@ -68,7 +70,7 @@ $ go get github.com/go-gl/gl/v2.1/gl

|

||||

$ go get github.com/go-gl/glfw/v3.2/glfw

|

||||

```

|

||||

|

||||

安装好这两个包之后,我们就可以开始了!先创建 **main.go** 文件,导入相应的包(我们待会儿会用到的其他东西)。

|

||||

安装好这两个包之后,我们就可以开始了!先创建 `main.go` 文件,导入相应的包(我们待会儿会用到的其它东西)。

|

||||

|

||||

```

|

||||

package main

|

||||

@ -82,8 +84,7 @@ import (

|

||||

)

|

||||

```

|

||||

|

||||

Next lets define the **main** function, the purpose of which is to initialize OpenGL and GLFW and display the window:

|

||||

接下来定义一个叫做 **main** 的函数,这是用来初始化 OpenGL 以及 GLFW,显示窗口的:

|

||||

接下来定义一个叫做 `main` 的函数,这是用来初始化 OpenGL 以及 GLFW,并显示窗口的:

|

||||

|

||||

```

|

||||

const (

|

||||

@ -124,11 +125,11 @@ func initGlfw() *glfw.Window {

|

||||

}

|

||||

```

|

||||

|

||||

好了,让我们花一分钟来运行一下这个程序,看看会发生什么。首先定义了一些常量, **width** 和 **height** - 它们决定窗口的像素大小。

|

||||

好了,让我们花一分钟来运行一下这个程序,看看会发生什么。首先定义了一些常量, `width` 和 `height` —— 它们决定窗口的像素大小。

|

||||

|

||||

然后就是 **main** 函数。这里我们使用了 **runtime** 包的 **LockOSThread()**,这能确保我们总是在操作系统的一个线程中运行代码,这对 GLFW 来说很重要,GLFW 被初始化之后需要在同一个进程里被调用多次。讲完这个,接下来我们调用 **initGlfw** 来获得一个窗口的引用,并且 defer glfw 的 terminating 方法。窗口的引用会被用在一个 for 循环中,只要窗口是打开的状态,就执行某些事情。我们待会儿会讲要做的事情是什么。

|

||||

然后就是 `main` 函数。这里我们使用了 `runtime` 包的 `LockOSThread()`,这能确保我们总是在操作系统的同一个线程中运行代码,这对 GLFW 来说很重要,GLFW 需要在其被初始化之后的线程里被调用。讲完这个,接下来我们调用 `initGlfw` 来获得一个窗口的引用,并且推迟(`defer`)其终止。窗口的引用会被用在一个 `for` 循环中,只要窗口处于打开的状态,就执行某些事情。我们待会儿会讲要做的事情是什么。

|

||||

|

||||

**initGlfw** 是另一个函数,这里我们调用 **glfw.Init()** 来初始化 GLFW 包。然后我们定义了 GLFW 的一些全局属性,包括禁用调整窗口大小和改变 OpenGL 的属性。然后创建了 **glfw.Window**,这会在稍后的绘图中用到。我们仅仅告诉它我们想要的宽度和高度,以及标题,然后调用 **window.MakeContextCurrent**,将窗口绑定到当前的进程中。最后就是返回窗口的引用了。

|

||||

`initGlfw` 是另一个函数,这里我们调用 `glfw.Init()` 来初始化 GLFW 包。然后我们定义了 GLFW 的一些全局属性,包括禁用调整窗口大小和改变 OpenGL 的属性。然后创建了 `glfw.Window`,这会在稍后的绘图中用到。我们仅仅告诉它我们想要的宽度和高度,以及标题,然后调用 `window.MakeContextCurrent`,将窗口绑定到当前的线程中。最后就是返回窗口的引用了。

|

||||

|

||||

如果你现在就构建、运行这个程序,你看不到任何东西。很合理,因为我们还没有用这个窗口做什么实质性的事。

|

||||

|

||||

@ -149,9 +150,9 @@ func initOpenGL() uint32 {

|

||||

}

|

||||

```

|

||||

|

||||

**initOpenGL** 就像之前的 **initGlfw** 函数一样,初始化 OpenGL 库,创建一个_程序_。这个程序是一个包含了着色器的引用,稍后会用于绘图。待会儿会讲这一点,现在只用知道 OpenGL 已经初始化完成了,我们有一个 **program** 的引用。我们还打印了 OpenGL 的版本,这对于 debug 很有帮助。

|

||||

`initOpenGL` 就像之前的 `initGlfw` 函数一样,初始化 OpenGL 库,创建一个<ruby>程序<rt>program</rt></ruby>。“程序”是一个包含了<ruby>着色器<rt>shader</rt></ruby>的引用,稍后会用<ruby>着色器<rt>shader</rt></ruby>绘图。待会儿会讲这一点,现在只用知道 OpenGL 已经初始化完成了,我们有一个程序的引用。我们还打印了 OpenGL 的版本,可以用于之后的调试。

|

||||

|

||||

回到 **main** 函数里,调用这个新函数:

|

||||

回到 `main` 函数里,调用这个新函数:

|

||||

|

||||

```

|

||||

func main() {

|

||||

@ -168,7 +169,7 @@ func main() {

|

||||

}

|

||||

```

|

||||

|

||||

你应该注意到了现在我们有 **program** 的引用,在我们的窗口循环中,调用新的 **draw** 函数。最终这个函数会绘制出所有细胞,让游戏状态变得可视化,但是现在它做的仅仅是情况窗口,所以我们只能看到一个全黑的屏幕:

|

||||

你应该注意到了现在我们有 `program` 的引用,在我们的窗口循环中,调用新的 `draw` 函数。最终这个函数会绘制出所有细胞,让游戏状态变得可视化,但是现在它做的仅仅是清除窗口,所以我们只能看到一个全黑的屏幕:

|

||||

|

||||

```

|

||||

func draw(window *glfw.Window, program uint32) {

|

||||

@ -180,19 +181,19 @@ func draw(window *glfw.Window, program uint32) {

|

||||

}

|

||||

```

|

||||

|

||||

我们首先做的是调用 **gl.clear** 函数来清除上一帧在窗口中绘制的东西,给我们一个干净的面板。然后我们告诉 OpenGL 去使用程序引用,这个引用还没有做什么事。最终我们告诉 GLFW 用 **PollEvents** 去检查是否有鼠标或者键盘事件(这一节里还不会对这些事件进行处理),告诉窗口 **SwapBuffers**。 [Buffer swapping][28](交换缓冲区) 很重要,因为 GLFW(像其他图形库一样)使用双缓冲,也就是说你绘制的所有东西实际上是绘制到一个不可见的画布上,当你准备好进行展示的时候就把绘制的这些东西放到可见的画布中 - 这种情况下,就需要调用 **SwapBuffers** 函数。

|

||||

我们首先做的是调用 `gl.clear` 函数来清除上一帧在窗口中绘制的东西,给我们一个干净的面板。然后我们告诉 OpenGL 去使用我们的程序引用,这个引用还没有做什么事。最终我们告诉 GLFW 用 `PollEvents` 去检查是否有鼠标或者键盘事件(这一节里还不会对这些事件进行处理),告诉窗口去交换缓冲区 `SwapBuffers`。 [交换缓冲区][28] 很重要,因为 GLFW(像其他图形库一样)使用双缓冲,也就是说你绘制的所有东西实际上是绘制到一个不可见的画布上,当你准备好进行展示的时候就把绘制的这些东西放到可见的画布中 —— 这种情况下,就需要调用 `SwapBuffers` 函数。

|

||||

|

||||

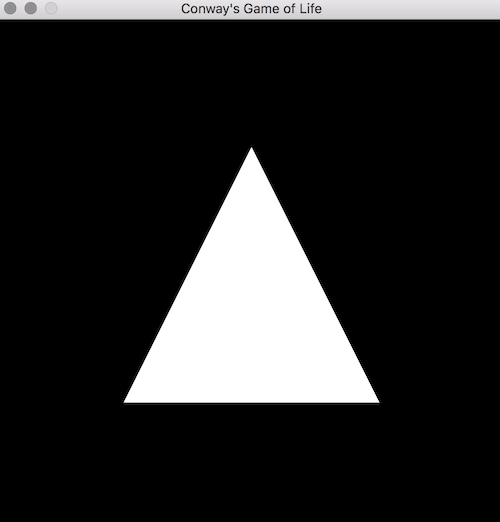

好了,到这里我们已经讲了很多东西,花一点时间看看我们的实验成果。运行这个程序,你应该可以看到你所绘制的第一个东西:

|

||||

|

||||

|

||||

|

||||

|

||||

完美!

|

||||

|

||||

### 在窗口里绘制三角形

|

||||

|

||||

我们已经完成了一些复杂的步骤,即使看上去和图片不像,但我们仍然需要绘制一些东西。我们会以三角形绘制开始,可能这第一眼看上去要比我们最终要绘制的方形更难,但你会知道这样的想法是错的。你可能不知道的是三角形或许是绘制的图形中最简单的,实际上我们最终会用某种方式把三角形拼成方形。

|

||||

我们已经完成了一些复杂的步骤,即使看起来不多,但我们仍然需要绘制一些东西。我们会以三角形绘制开始,可能这第一眼看上去要比我们最终要绘制的方形更难,但你会知道这样的想法是错的。你可能不知道的是三角形或许是绘制的图形中最简单的,实际上我们最终会用某种方式把三角形拼成方形。

|

||||

|

||||

好吧,那么我们想要绘制一个三角形,怎么做呢?我们通过定义图形的顶点来绘制图形,把它们交给 OpenGL 来进行绘制。先在 **main.go** 的顶部里定义我们的三角形:

|

||||

好吧,那么我们想要绘制一个三角形,怎么做呢?我们通过定义图形的顶点来绘制图形,把它们交给 OpenGL 来进行绘制。先在 `main.go` 的顶部里定义我们的三角形:

|

||||

|

||||

```

|

||||

var (

|

||||

@ -204,9 +205,9 @@ var (

|

||||

)

|

||||

```

|

||||

|

||||

这看上去很奇怪,让我们分开来看。首先我们用了一个 **float32** 切片(slice),这是一种我们总会在向 OpenGL 传递顶点时用到的数据类型。这个切片包含 9 个值,每三个值构成三角形的一个点。第一行, **0, 0.5, 0** 表示的是 X、Y、Z 坐标,是最上方的顶点,第二行是左边的顶点,第三行是右边的顶点。每一组的三个点都表示相对于窗口中心点的 X、Y、Z 坐标,在 **-1 和 1** 之间。因此最上面的顶点 X 坐标是 0,因为它在 X 方向上位于窗口中央,Y 坐标是 _0.5_ 意味着它会相对窗口中央上移 1/4 个单位(因为窗口的范围是 -1 到 1),Z 坐标是 0.因为我们只需要在二维空间中绘图,所以 Z 值永远是 0。现在看一看左右两边的顶点,看看你能不能理解为什么它们是这样定义的 —— 如果不能立刻就弄清楚也没关系,我们将会在屏幕上去观察它,因此我们需要一个完美的图形来进行观察。

|

||||

这看上去很奇怪,让我们分开来看。首先我们用了一个 `float32` <ruby>切片<rt>slice</rt></ruby>,这是一种我们总会在向 OpenGL 传递顶点时用到的数据类型。这个切片包含 9 个值,每三个值构成三角形的一个点。第一行, `0, 0.5, 0` 表示的是 X、Y、Z 坐标,是最上方的顶点,第二行是左边的顶点,第三行是右边的顶点。每一组的三个点都表示相对于窗口中心点的 X、Y、Z 坐标,大小在 `-1` 和 `1` 之间。因此最上面的顶点 X 坐标是 `0`,因为它在 X 方向上位于窗口中央,Y 坐标是 `0.5` 意味着它会相对窗口中央上移 1/4 个单位(因为窗口的范围是 `-1` 到 `1`),Z 坐标是 0。因为我们只需要在二维空间中绘图,所以 Z 值永远是 `0`。现在看一看左右两边的顶点,看看你能不能理解为什么它们是这样定义的 —— 如果不能立刻就弄清楚也没关系,我们将会在屏幕上去观察它,因此我们需要一个完美的图形来进行观察。

|

||||

|

||||

好了,我们定义了一个三角形,但是现在我们得把它画出来。要画出这个三角形,我们需要一个叫做 **Vertex Array Object** 或者叫 **vao** 的东西,这是由一系列的点(也就是我们定义的三角形)创造的,这个东西可以提供给 OpenGL 来进行绘制。创建一个叫做 **makeVao** 的函数,然后我们可以提供一组切片的点,让它返回一个指向 OpenGL vertex array object 的指针:

|

||||

好了,我们定义了一个三角形,但是现在我们得把它画出来。要画出这个三角形,我们需要一个叫做<ruby>顶点数组对象<rt>Vertex Array Object</rt></ruby>或者叫 vao 的东西,这是由一系列的点(也就是我们定义的三角形)创造的,这个东西可以提供给 OpenGL 来进行绘制。创建一个叫做 `makeVao` 的函数,然后我们可以提供一个点的切片,让它返回一个指向 OpenGL 顶点数组对象的指针:

|

||||

|

||||

```

|

||||

// makeVao 执行初始化并从提供的点里面返回一个顶点数组

|

||||

@ -227,11 +228,11 @@ func makeVao(points []float32) uint32 {

|

||||

}

|

||||

```

|

||||

|

||||

首先我们创造了 **Vertex Buffer Object** 或者说 **vbo** 绑定到我们的 **vao** 上,**vbo** 是通过所占空间(也就是**4 x len(points)**大小的空间)和一个指向顶点的指针(**gl.Ptr(points)**)来创建的。你也许会好奇为什么它是 **4 x len(points)** - 而不是 6 或者 3 或者 1078 呢?原因在于我们用的是 **float32** 切片,32 个 bit 的 float 浮点型变量是 4 个字节,因此我们说这个缓冲区以字节为单位的大小是点个数的 4 倍。

|

||||

首先我们创造了<ruby>顶点缓冲区对象<rt>Vertex Buffer Object</rt></ruby> 或者说 vbo 绑定到我们的 `vao` 上,`vbo` 是通过所占空间(也就是 4 倍 `len(points)` 大小的空间)和一个指向顶点的指针(`gl.Ptr(points)`)来创建的。你也许会好奇为什么它是 4 倍 —— 而不是 6 或者 3 或者 1078 呢?原因在于我们用的是 `float32` 切片,32 个位的浮点型变量是 4 个字节,因此我们说这个缓冲区以字节为单位的大小是点个数的 4 倍。

|

||||

|

||||

现在我们有缓冲区了,可以创建 **vao** 并用 **gl.BindBuffer** 把它绑定到缓冲区上,最后返回 **vao**。这个 **vao** 将会被用于绘制三角形!

|

||||

现在我们有缓冲区了,可以创建 `vao` 并用 `gl.BindBuffer` 把它绑定到缓冲区上,最后返回 `vao`。这个 `vao` 将会被用于绘制三角形!

|

||||

|

||||

回到 **main** 函数:

|

||||

回到 `main` 函数:

|

||||

|

||||

```

|

||||

func main() {

|

||||

@ -243,7 +244,7 @@ func main() {

|

||||

}

|

||||

}

|

||||

|

||||

这里我们调用了 **makeVao** ,从我们之前定义的 **triangle** 顶点中获得 **vao** 引用,将它作为一个新的参数传递给 **draw** 函数:

|

||||

这里我们调用了 `makeVao` ,从我们之前定义的 `triangle` 顶点中获得 `vao` 引用,将它作为一个新的参数传递给 `draw` 函数:

|

||||

|

||||

func draw(vao uint32, window *glfw.Window, program uint32) {

|

||||

gl.Clear(gl.COLOR_BUFFER_BIT | gl.DEPTH_BUFFER_BIT)

|

||||

@ -257,13 +258,13 @@ func draw(vao uint32, window *glfw.Window, program uint32) {

|

||||

}

|

||||

```

|

||||

|

||||

然后我们把 OpenGL 绑定到 **vao** 上,这样当我们告诉 OpenGL 三角形切片的顶点数(除以 3,是因为每一个点有 X、Y、Z 坐标),让它去 **DrawArrays** ,它就知道要画多少个顶点了。

|

||||

然后我们把 OpenGL 绑定到 `vao` 上,这样当我们告诉 OpenGL 三角形切片的顶点数(除以 3,是因为每一个点有 X、Y、Z 坐标),让它去 `DrawArrays` ,它就知道要画多少个顶点了。

|

||||

|

||||

如果你这时候运行程序,你可能希望在窗口中央看到一个美丽的三角形,但是不幸的是你还看不到。还有一件事情没做,我们告诉 OpenGL 我们要画一个三角形,但是我们还要告诉它_怎么_画出来。

|

||||

|

||||

要让它画出来,我们需要叫做片元着色器和顶点着色器的东西,这些已经超出本教程的范围了(老实说,也超出了我对 OpenGL 的了解),但 [Harold Serrano On Quora][29] 关于它们是什么给出了完美的介绍。我们只需要理解,对于这个应用来说,着色器是它内部的小程序(用 [OpenGL Shader Language or GLSL][30] 编写的),操作顶点进行绘制,也可用于确定图形的颜色。

|

||||

要让它画出来,我们需要叫做<ruby>片元着色器<rt>fragment shader</rt></ruby>和<ruby>顶点着色器<rt>vertex shader</rt></ruby>的东西,这些已经超出本教程的范围了(老实说,也超出了我对 OpenGL 的了解),但 [Harold Serrano 在 Quora][29] 上对对它们是什么给出了完美的介绍。我们只需要理解,对于这个应用来说,着色器是它内部的小程序(用 [OpenGL Shader Language 或 GLSL][30] 编写的),它操作顶点进行绘制,也可用于确定图形的颜色。

|

||||

|

||||

添加两个 imports 和一个叫做 **compileShader** 的函数:

|

||||

添加两个 `import` 和一个叫做 `compileShader` 的函数:

|

||||

|

||||

```

|

||||

import (

|

||||

@ -297,7 +298,7 @@ func compileShader(source string, shaderType uint32) (uint32, error) {

|

||||

|

||||

这个函数的目的是以字符串的形式接受着色器源代码和它的类型,然后返回一个指向这个编译好的着色器的指针。如果编译失败,我们就会获得出错的详细信息。

|

||||

|

||||

现在定义着色器,在 **makeProgram** 里编译。回到我们的 **const** 块中,我们在这里定义了 **width** 和 **hegiht**。

|

||||

现在定义着色器,在 `makeProgram` 里编译。回到我们的 `const` 块中,我们在这里定义了 `width` 和 `hegiht`。

|

||||

|

||||

```

|

||||

vertexShaderSource = `

|

||||

@ -317,11 +318,11 @@ fragmentShaderSource = `

|

||||

` + "\x00"

|

||||

```

|

||||

|

||||

你能看到这是两个着色器程序,包含了 GLSL 源代码的字符串,一个是_顶点着色器_,另一个是_片元着色器_。唯一比较特殊的地方是它们都要在末尾加上一个空终止字符,**\x00** —— OpenGL 需要它才能编译着色器。注意 **fragmentShaderSource**,这是我们用 RGBA 形式的值通过 **vec4** 来定义我们图形的颜色。你可以修改这里的值来改变这个三角形的颜色,现在的值是 **RGBA(1, 1, 1, 1)** 或者说是 _white_。

|

||||

如你所见,这是两个包含了 GLSL 源代码字符串的着色器,一个是<ruby>顶点着色器<rt>vertex shader</rt></ruby>,另一个是<ruby>片元着色器<rt>fragment shader</rt></ruby>。唯一比较特殊的地方是它们都要在末尾加上一个空终止字符,`\x00` —— OpenGL 需要它才能编译着色器。注意 `fragmentShaderSource`,这是我们用 RGBA 形式的值通过 `vec4` 来定义我们图形的颜色。你可以修改这里的值来改变这个三角形的颜色,现在的值是 `RGBA(1, 1, 1, 1)` 或者说是白色。

|

||||

|

||||

同样需要注意的是这两个程序都是运行在 **#version 410** 版本下,如果你用的是 OpenGL 2.1,那你也可以改成 **#version 120**。**120** 不是打错的,如果你用的是 OpenGL 2.1,要用 **120** 而不是 **210**!

|

||||

同样需要注意的是这两个程序都是运行在 `#version 410` 版本下,如果你用的是 OpenGL 2.1,那你也可以改成 `#version 120`。这里 `120` 不是打错的,如果你用的是 OpenGL 2.1,要用 `120` 而不是 `210`!

|

||||

|

||||

接下来在 **initOpenGL** 中我们会编译着色器,把它们附加到我们的 **program** 中。

|

||||

接下来在 `initOpenGL` 中我们会编译着色器,把它们附加到我们的 `program` 中。

|

||||

|

||||

```

|

||||

func initOpenGL() uint32 {

|

||||

@ -348,27 +349,24 @@ func initOpenGL() uint32 {

|

||||

}

|

||||

```

|

||||

|

||||

这里我们用 _顶点着色器_ 调用了 **compileShader** 函数,指定它的类型是 **gl.VERTEX_SHADER**,对 _片元着色器_ 做了同样的事情,但是指定的类型是 **gl.FRAGMENT_SHADER**。编译完成后,我们把它们附加到程序中,调用 **gl.AttachShader**,传递程序以及编译好的着色器。

|

||||

这里我们用顶点着色器(`vertexShader`)调用了 `compileShader` 函数,指定它的类型是 `gl.VERTEX_SHADER`,对片元着色器(`fragmentShader`)做了同样的事情,但是指定的类型是 `gl.FRAGMENT_SHADER`。编译完成后,我们把它们附加到程序中,调用 `gl.AttachShader`,传递程序(`prog`)以及编译好的着色器作为参数。

|

||||

|

||||

现在我们终于可以看到我们漂亮的三角形了!运行程序,如果一切顺利的话你会看到这些:

|

||||

|

||||

|

||||

|

||||

|

||||

### 总结

|

||||

|

||||

是不是很惊喜!这些代码画出了一个三角形,但我保证我们已经完成了大部分的 OpenGL 代码,在接下来的章节中我们还会用到这些代码。我十分推荐你花几分钟修改一下代码,看看你能不能移动三角形,改变三角形的大小和颜色。OpenGL 可以令人心生畏惧,有时想要理解发生了什么很困难,但是要记住,这不是魔术 - 它就是它看上去的东西。

|

||||

是不是很惊喜!这些代码画出了一个三角形,但我保证我们已经完成了大部分的 OpenGL 代码,在接下来的章节中我们还会用到这些代码。我十分推荐你花几分钟修改一下代码,看看你能不能移动三角形,改变三角形的大小和颜色。OpenGL 可以令人心生畏惧,有时想要理解发生了什么很困难,但是要记住,这不是魔法 - 它只不过看上去像魔法。

|

||||

|

||||

下一节里我们讲会用两个锐角三角形拼出一个方形 - 看看你能不能试着修改这一节的代码,再进入下一节。不能也没有关系,因为我们在 [第二节][31] 还会编写代码, 按照创建一个有许多方形的格子,我们把它当做游戏面板。

|

||||

下一节里我们讲会用两个锐角三角形拼出一个方形 - 看看你能不能在进入下一节前试着修改这一节的代码。不能也没有关系,因为我们在 [第二节][31] 还会编写代码, 接着创建一个有许多方形的格子,我们把它当做游戏面板。

|

||||

|

||||

最后,在[第三节][32] 里我们会用格子来实现 _Conway’s Game of Life_!

|

||||

|

||||

_[第一节: Hello, OpenGL][14]_ | _[第二节: 绘制游戏面板][15]_ | _[第三节:实现游戏功能][16]_

|

||||

|

||||

_本教程的完整源代码可在 [GitHub][17] 上获得。_

|

||||

|

||||

### 回顾

|

||||

|

||||

本教程 **main.go** 文件的内容如下:

|

||||

本教程 `main.go` 文件的内容如下:

|

||||

|

||||

```

|

||||

package main

|

||||

@ -528,9 +526,9 @@ func compileShader(source string, shaderType uint32) (uint32, error) {

|

||||

|

||||

via: https://kylewbanks.com/blog/tutorial-opengl-with-golang-part-1-hello-opengl

|

||||

|

||||

作者:[kylewbanks ][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

作者:[kylewbanks][a]

|

||||

译者:[GitFuture](https://github.com/GitFuture)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,9 +1,11 @@

|

||||

OpenGL 与 Go 教程第二节:绘制游戏面板

|

||||

OpenGL 与 Go 教程(二)绘制游戏面板

|

||||

============================================================

|

||||

|

||||

_[第一节: Hello, OpenGL][6]_ | _[第二节: 绘制游戏面板][7]_ | _[第三节:实现游戏功能][8]_

|

||||

- [第一节: Hello, OpenGL][6]

|

||||

- [第二节: 绘制游戏面板][7]

|

||||

- [第三节:实现游戏功能][8]

|

||||

|

||||

_这篇教程的所有源代码都可以在 [GitHub][9] 上找到._

|

||||

这篇教程的所有源代码都可以在 [GitHub][9] 上找到。

|

||||

|

||||

欢迎回到《OpenGL 与 Go 教程》。如果你还没有看过[第一节][15],那就要回过头去看看那一节。

|

||||

|

||||

@ -13,7 +15,7 @@ OpenGL 与 Go 教程第二节:绘制游戏面板

|

||||

|

||||

### 利用三角形绘制方形

|

||||

|

||||

在我们绘制方形之前,先把三角形变成直角三角形。打开 **main.go** 文件,把 **triangle** 的定义改成像这个样子:

|

||||

在我们绘制方形之前,先把三角形变成直角三角形。打开 `main.go` 文件,把 `triangle` 的定义改成像这个样子:

|

||||

|

||||

```

|

||||

triangle = []float32{

|

||||

@ -23,11 +25,11 @@ triangle = []float32{

|

||||

}

|

||||

```

|

||||

|

||||

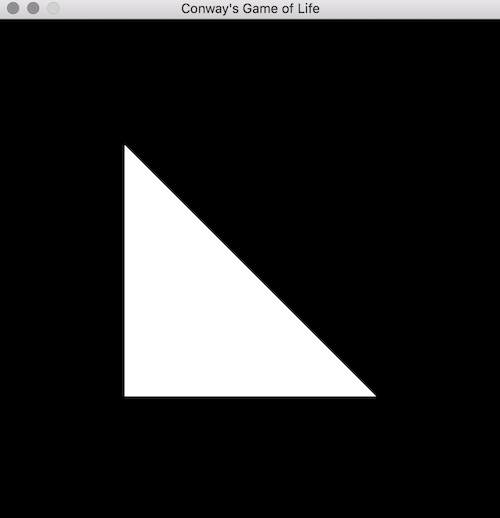

我们做的事情是,把最上面的顶点 X 坐标移动到左边(也就是变为**-0.5**),这就变成了像这样的三角形:

|

||||

我们做的事情是,把最上面的顶点 X 坐标移动到左边(也就是变为 `-0.5`),这就变成了像这样的三角形:

|

||||

|

||||

|

||||

|

||||

|

||||

很简单,对吧?现在让我们用两个这样的三角形顶点做成正方形。把 **triangle** 重命名为 **square**,然后添加第二个三角形的顶点数据,把直角三角形变成这样的:

|

||||

很简单,对吧?现在让我们用两个这样的三角形顶点做成正方形。把 `triangle` 重命名为 `square`,然后添加第二个倒置的三角形的顶点数据,把直角三角形变成这样的:

|

||||

|

||||

```

|

||||

square = []float32{

|

||||

@ -41,17 +43,17 @@ square = []float32{

|

||||

}

|

||||

```

|

||||

|

||||

注意:你也要把在 **main** 和 **draw** 里面命名的 **triangle** 改为 **square**。

|

||||

注意:你也要把在 `main` 和 `draw` 里面命名的 `triangle` 改为 `square`。

|

||||

|

||||

我们通过添加三个顶点,把顶点数增加了一倍,这三个顶点就是右上角的三角形,用来拼成方形。运行它看看效果:

|

||||

|

||||

|

||||

|

||||

|

||||

很好,现在我们能够绘制正方形了!OpenGL 一点都不难,对吧?

|

||||

|

||||

### 在窗口中绘制方形格子

|

||||

|

||||

现在我们能画一个方形,怎么画 100 个吗?我们来创建一个 **cell** 结构体,用来表示格子的每一个单元,因此我们能够很灵活的选择绘制的数量:

|

||||

现在我们能画一个方形,怎么画 100 个吗?我们来创建一个 `cell` 结构体,用来表示格子的每一个单元,因此我们能够很灵活的选择绘制的数量:

|

||||

|

||||

```

|

||||

type cell struct {

|

||||

@ -62,7 +64,7 @@ type cell struct {

|

||||

}

|

||||

```

|

||||

|

||||

**cell** 结构体包含一个 **drawable** 属性,这是一个 **Vertex Array Object(顶点数组对象)**,就像我们在之前创建的一样,这个结构体还包含 X 和 Y 坐标,用来表示这个格子的位置。

|

||||

`cell` 结构体包含一个 `drawable` 属性,这是一个顶点数组对象,就像我们在之前创建的一样,这个结构体还包含 X 和 Y 坐标,用来表示这个格子的位置。

|

||||

|

||||

我们还需要两个常量,用来设定格子的大小和形状:

|

||||

|

||||

@ -91,9 +93,9 @@ func makeCells() [][]*cell {

|

||||

}

|

||||

```

|

||||

|

||||

这里我们创建多维的 slice(注:这是 Go 语言中的一种动态数组),代表我们的游戏面板,用 **newCell** 新函数创建的 **cell** 来填充矩阵的每个元素,我们待会就来实现 **newCell** 这个函数。

|

||||

这里我们创建多维的<ruby>切片<rt>slice</rt></ruby>,代表我们的游戏面板,用名为 `newCell` 的新函数创建的 `cell` 来填充矩阵的每个元素,我们待会就来实现 `newCell` 这个函数。

|

||||

|

||||

在接着往下阅读前,我们先花一点时间来看看 **makeCells** 函数做了些什么。我们创造了一个 slice(切片),这个 slice 的长度和格子的行数相等,每一个 slice 里面都有一个用 slice 包含的一系列格子,这些格子的数量与列数相等。如果我们把 **rows** 和 **columns** 都设定成 2,那么就会创建如下的矩阵:

|

||||

在接着往下阅读前,我们先花一点时间来看看 `makeCells` 函数做了些什么。我们创造了一个切片,这个切片的长度和格子的行数相等,每一个切片里面都有一个<ruby>细胞<rt>cell</rt></ruby>的切片,这些细胞的数量与列数相等。如果我们把 `rows` 和 `columns` 都设定成 2,那么就会创建如下的矩阵:

|

||||

|

||||

```

|

||||

[

|

||||

@ -102,7 +104,7 @@ func makeCells() [][]*cell {

|

||||

]

|

||||

```

|

||||

|

||||

还可以创建一个更大的矩阵,包含 **10x10** 个格子:

|

||||

还可以创建一个更大的矩阵,包含 `10x10` 个细胞:

|

||||

|

||||

```

|

||||

[

|

||||

@ -119,7 +121,7 @@ func makeCells() [][]*cell {

|

||||

]

|

||||

```

|

||||

|

||||

现在应该理解了我们创造的矩阵的形状和表示方法。让我们看看 **newCell** 函数到底是怎么填充矩阵的:

|

||||

现在应该理解了我们创造的矩阵的形状和表示方法。让我们看看 `newCell` 函数到底是怎么填充矩阵的:

|

||||

|

||||

```

|

||||

func newCell(x, y int) *cell {

|

||||

@ -156,15 +158,15 @@ func newCell(x, y int) *cell {

|

||||

}

|

||||

```

|

||||

|

||||

这个函数里有很多内容,我们把它分成几个部分。我们做的第一件事是复制了 **square** 的定义。这让我们能够修改该定义,定制当前的格子位置,而不会影响其它使用 **square** 定义的格子。然后我们基于当前索引迭代复制后的 **points**。我们用求余数的方法来判断我们是在操作 X 坐标(**i % 3 == 0**),还是在操作 Y 坐标(**i % 3 == 1**)(跳过 Z 坐标是因为我们仅在二维层面上进行操作),跟着确定格子的大小(也就是占据整个游戏面板的比例),当然它的位置是基于格子在 **相对游戏面板的** X 和 Y 坐标。

|

||||

这个函数里有很多内容,我们把它分成几个部分。我们做的第一件事是复制了 `square` 的定义。这让我们能够修改该定义,定制当前的细胞位置,而不会影响其它使用 `square` 切片定义的细胞。然后我们基于当前索引迭代 `points` 副本。我们用求余数的方法来判断我们是在操作 X 坐标(`i % 3 == 0`),还是在操作 Y 坐标(`i % 3 == 1`)(跳过 Z 坐标是因为我们仅在二维层面上进行操作),跟着确定细胞的大小(也就是占据整个游戏面板的比例),当然它的位置是基于细胞在 `相对游戏面板的` X 和 Y 坐标。

|

||||

|

||||

接着,我们改变那些包含在 **square** slice 中定义的 **0.5**,**0**, **-0.5** 这样的点。如果点小于 0,我们就把它设置成原来的 2 倍(因为 OpenGL 坐标的范围在 **-1** 到 **1** 之间,范围大小是 2),减 1 是为了归一化 OpenGL 坐标。如果点大于等于 0,我们的做法还是一样的,不过要加上我们计算出的尺寸。

|

||||

接着,我们改变那些包含在 `square` 切片中定义的 `0.5`,`0`, `-0.5` 这样的点。如果点小于 0,我们就把它设置成原来的 2 倍(因为 OpenGL 坐标的范围在 `-1` 到 `1` 之间,范围大小是 2),减 1 是为了归一化 OpenGL 坐标。如果点大于等于 0,我们的做法还是一样的,不过要加上我们计算出的尺寸。

|

||||

|

||||

这样做是为了设置每个格子的大小,这样它就能只填充它在面板中的部分。因为我们有 10 行 10 列,每一个格子能分到游戏面板的 10% 宽度和高度。

|

||||

这样做是为了设置每个细胞的大小,这样它就能只填充它在面板中的部分。因为我们有 10 行 10 列,每一个格子能分到游戏面板的 10% 宽度和高度。

|

||||

|

||||

最后,确定了所有点的位置和大小,我们用提供的 X 和 Y 坐标创建一个格子,设置 **drawable** 字段和我们刚刚操作 **points** 得到的 **Vertex Array Object** 对象一致。

|

||||

最后,确定了所有点的位置和大小,我们用提供的 X 和 Y 坐标创建一个 `cell`,并设置 `drawable` 字段与我们刚刚操作 `points` 得到的顶点数组对象(vao)一致。

|

||||

|

||||

好了,现在我们在 **main** 函数里可以移去对 **makeVao** 的调用了,用 **makeCells** 代替。我们还修改了 **draw**,让它绘制一系列的格子而不是一个 **vao**。

|

||||

好了,现在我们在 `main` 函数里可以移去对 `makeVao` 的调用了,用 `makeCells` 代替。我们还修改了 `draw`,让它绘制一系列的细胞而不是一个 `vao`。

|

||||

|

||||

```

|

||||

func main() {

|

||||

@ -189,7 +191,7 @@ func draw(cells [][]*cell, window *glfw.Window, program uint32) {

|

||||

}

|

||||

```

|

||||

|

||||

现在我们要让每个格子知道怎么绘制出自己。在 **cell** 里面添加一个 **draw** 函数:

|

||||

现在我们要让每个细胞知道怎么绘制出自己。在 `cell` 里面添加一个 `draw` 函数:

|

||||

|

||||

```

|

||||

func (c *cell) draw() {

|

||||

@ -198,9 +200,9 @@ func (c *cell) draw() {

|

||||

}

|

||||

```

|

||||

|

||||

这看上去很熟悉,它很像我们之前在 **vao** 里写的 **draw**,唯一的区别是我们的 **BindVertexArray** 函数用的是 **c.drawable**,这是我们在 **newCell** 中创造的格子的 **vao**。

|

||||

这看上去很熟悉,它很像我们之前在 `vao` 里写的 `draw`,唯一的区别是我们的 `BindVertexArray` 函数用的是 `c.drawable`,这是我们在 `newCell` 中创造的细胞的 `vao`。

|

||||

|

||||

回到 main 中的 **draw** 函数上,我们可以循环每个格子,让它们自己绘制自己:

|

||||

回到 main 中的 `draw` 函数上,我们可以循环每个细胞,让它们自己绘制自己:

|

||||

|

||||

```

|

||||

func draw(cells [][]*cell, window *glfw.Window, program uint32) {

|

||||

@ -218,13 +220,13 @@ func draw(cells [][]*cell, window *glfw.Window, program uint32) {

|

||||

}

|

||||

```

|

||||

|

||||

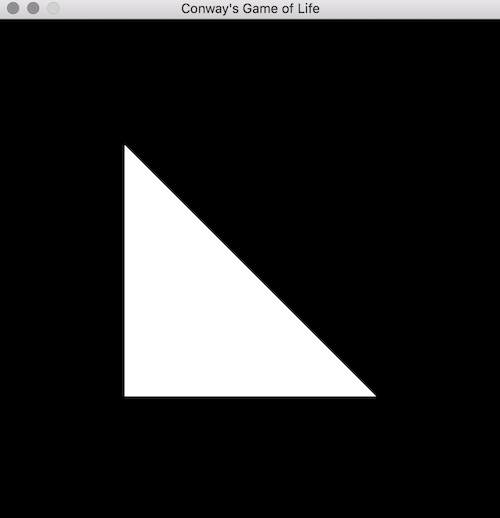

你看到了我们循环每一个格子,调用它的 **draw** 函数。如果运行这段代码,你能看到像下面这样的东西:

|

||||

如你所见,我们循环每一个细胞,调用它的 `draw` 函数。如果运行这段代码,你能看到像下面这样的东西:

|

||||

|

||||

|

||||

|

||||

|

||||

这是你想看到的吗?我们做的是在格子里为每一行每一列创建了一个方块,然后给它上色,这就填满了整个面板!

|

||||

|

||||

注释掉 for 循环,我们就可以看到分隔的格子,像这样:

|

||||

注释掉 for 循环,我们就可以看到一个明显独立的细胞,像这样:

|

||||

|

||||

```

|

||||

// for x := range cells {

|

||||

@ -236,26 +238,21 @@ func draw(cells [][]*cell, window *glfw.Window, program uint32) {

|

||||

cells[2][3].draw()

|

||||

```

|

||||

|

||||

|

||||

|

||||

|

||||

这只绘制坐标在 **(X=2, Y=3)** 的格子。你可以看到,每一个独立的格子占据着面板的一小块部分,并且会绘制自己那部分空间。我们也能看到游戏面板有自己的原点,也就是坐标为 **(X=0, Y=0)** 的点,在窗口的左下方。这仅仅是我们的 **newCell** 函数计算位置的方式,也可以用右上角,右下角,左上角,中央,或者其它任何位置当作原点。

|

||||

这只绘制坐标在 `(X=2, Y=3)` 的格子。你可以看到,每一个独立的细胞占据着面板的一小块部分,并且负责绘制自己那部分空间。我们也能看到游戏面板有自己的原点,也就是坐标为 `(X=0, Y=0)` 的点,在窗口的左下方。这仅仅是我们的 `newCell` 函数计算位置的方式,也可以用右上角,右下角,左上角,中央,或者其它任何位置当作原点。

|

||||

|

||||

接着往下做,移除 **cells[2][3].draw()** 这一行,取消 for 循环的那部分注释,变成之前那样全部绘制的样子。

|

||||

接着往下做,移除 `cells[2][3].draw()` 这一行,取消 for 循环的那部分注释,变成之前那样全部绘制的样子。

|

||||

|

||||

### 总结

|

||||

|

||||

好了,我们现在能用两个三角形画出一个正方形了,我们还有一个游戏的面板了!我们该为此自豪,目前为止我们已经接触到了很多零碎的内容,老实说,最难的部分还在前面等着我们!

|

||||

|

||||

在接下来的 [第三节],我们会实现游戏核心逻辑,看到很酷的东西!

|

||||

|

||||

_[第 1 节: Hello, OpenGL][10]_ | _[第二节: 绘制游戏面板][11]_ | _[第三节:实现游戏功能][12]_

|

||||

|

||||

_该教程的完整源代码可以在 [GitHub][13] 上获得。_

|

||||

|

||||

在接下来的第三节,我们会实现游戏核心逻辑,看到很酷的东西!

|

||||

|

||||

### 回顾

|

||||

|

||||

这是这一部分教程中 **main.go** 文件的内容:

|

||||

这是这一部分教程中 `main.go` 文件的内容:

|

||||

|

||||

```

|

||||

package main

|

||||

@ -390,7 +387,7 @@ func (c *cell) draw() {

|

||||

gl.DrawArrays(gl.TRIANGLES, 0, int32(len(square)/3))

|

||||

}

|

||||

|

||||

// initGlfw initializes glfw and returns a Window to use. 初始化 glfw,返回一个可用的 Window

|

||||

// 初始化 glfw,返回一个可用的 Window

|

||||

func initGlfw() *glfw.Window {

|

||||

if err := glfw.Init(); err != nil {

|

||||

panic(err)

|

||||

@ -410,7 +407,7 @@ func initGlfw() *glfw.Window {

|

||||

return window

|

||||

}

|

||||

|

||||

// initOpenGL initializes OpenGL and returns an intiialized program. 初始化 OpenGL 并返回一个可用的着色器程序

|

||||

// 初始化 OpenGL 并返回一个可用的着色器程序

|

||||

func initOpenGL() uint32 {

|

||||

if err := gl.Init(); err != nil {

|

||||

panic(err)

|

||||

@ -435,7 +432,7 @@ func initOpenGL() uint32 {

|

||||

return prog

|

||||

}

|

||||

|

||||

// makeVao initializes and returns a vertex array from the points provided. 初始化并返回由 points 提供的顶点数组

|

||||

// 初始化并返回由 points 提供的顶点数组

|

||||

func makeVao(points []float32) uint32 {

|

||||

var vbo uint32

|

||||

gl.GenBuffers(1, &vbo)

|

||||

@ -483,9 +480,9 @@ func compileShader(source string, shaderType uint32) (uint32, error) {

|

||||

|

||||

via: https://kylewbanks.com/blog/tutorial-opengl-with-golang-part-2-drawing-the-game-board

|

||||

|

||||

作者:[kylewbanks ][a]

|

||||

作者:[kylewbanks][a]

|

||||

译者:[GitFtuture](https://github.com/GitFuture)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -495,16 +492,16 @@ via: https://kylewbanks.com/blog/tutorial-opengl-with-golang-part-2-drawing-the-

|

||||

[3]:https://twitter.com/intent/tweet?text=OpenGL%20%26%20Go%20Tutorial%20Part%202%3A%20Drawing%20the%20Game%20Board%20https%3A%2F%2Fkylewbanks.com%2Fblog%2Ftutorial-opengl-with-golang-part-2-drawing-the-game-board%20by%20%40kylewbanks

|

||||

[4]:mailto:?subject=Check%20Out%20%22OpenGL%20%26%20Go%20Tutorial%20Part%202%3A%20Drawing%20the%20Game%20Board%22&body=https%3A%2F%2Fkylewbanks.com%2Fblog%2Ftutorial-opengl-with-golang-part-2-drawing-the-game-board

|

||||

[5]:https://www.facebook.com/sharer/sharer.php?u=https%3A%2F%2Fkylewbanks.com%2Fblog%2Ftutorial-opengl-with-golang-part-2-drawing-the-game-board

|

||||

[6]:https://kylewbanks.com/blog/tutorial-opengl-with-golang-part-1-hello-opengl

|

||||

[6]:https://linux.cn/article-8933-1.html

|

||||

[7]:https://kylewbanks.com/blog/tutorial-opengl-with-golang-part-2-drawing-the-game-board

|

||||

[8]:https://kylewbanks.com/blog/tutorial-opengl-with-golang-part-3-implementing-the-game

|

||||

[9]:https://github.com/KyleBanks/conways-gol

|

||||

[10]:https://kylewbanks.com/blog/tutorial-opengl-with-golang-part-1-hello-opengl

|

||||

[10]:https://linux.cn/article-8933-1.html

|

||||

[11]:https://kylewbanks.com/blog/tutorial-opengl-with-golang-part-2-drawing-the-game-board

|

||||

[12]:https://kylewbanks.com/blog/tutorial-opengl-with-golang-part-3-implementing-the-game

|

||||

[13]:https://github.com/KyleBanks/conways-gol

|

||||

[14]:https://twitter.com/kylewbanks

|

||||

[15]:https://kylewbanks.com/blog/tutorial-opengl-with-golang-part-1-hello-opengl

|

||||

[15]:https://linux.cn/article-8933-1.html

|

||||

[16]:https://kylewbanks.com/blog/tutorial-opengl-with-golang-part-3-implementing-the-game

|

||||

[17]:https://twitter.com/intent/tweet?text=OpenGL%20%26%20Go%20Tutorial%20Part%202%3A%20Drawing%20the%20Game%20Board%20https%3A%2F%2Fkylewbanks.com%2Fblog%2Ftutorial-opengl-with-golang-part-2-drawing-the-game-board%20by%20%40kylewbanks

|

||||

[18]:mailto:?subject=Check%20Out%20%22OpenGL%20%26%20Go%20Tutorial%20Part%202%3A%20Drawing%20the%20Game%20Board%22&body=https%3A%2F%2Fkylewbanks.com%2Fblog%2Ftutorial-opengl-with-golang-part-2-drawing-the-game-board

|

||||

115

published/20170516 What's the point of DevOps.md

Normal file

115

published/20170516 What's the point of DevOps.md

Normal file

@ -0,0 +1,115 @@

|

||||

DevOps 的意义

|

||||

========================================

|

||||

|

||||

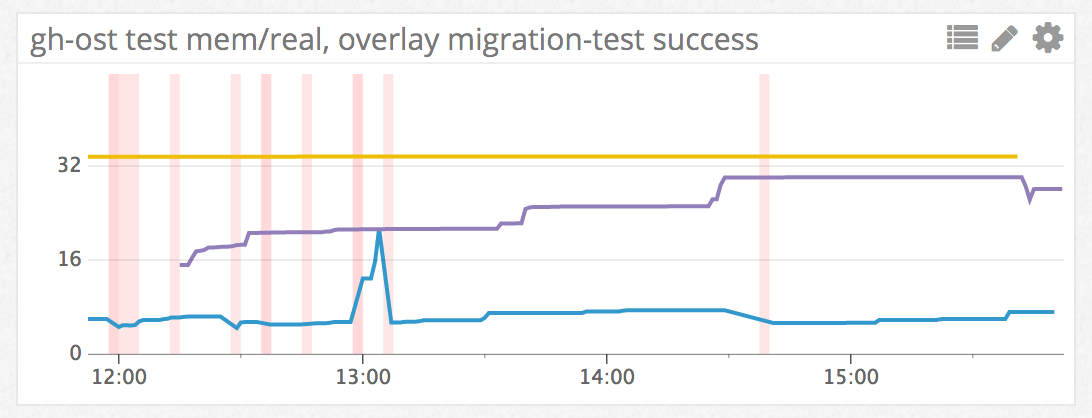

> 真正的组织文化变革有助于弥合你原以为无法跨过的鸿沟

|

||||

|

||||

|

||||

|

||||

回想一下你最近一次尝试改掉一个个人习惯的事情,你可能遇到过这样的情形,你需要改变你思考的方式并且改掉之前的习惯。这很艰难,你只能试着改变_你自己的_思维方式。

|

||||

|

||||

所以你可能会试着让自己置身于新的环境。新的环境实际上可帮助我们养成_新的_习惯,它反过来又会促成新的思维方式。

|

||||

|

||||

那就是能否成功改变的所在:思考的越多,得到的越多。你需要知道你在改变的原因以及你的目的所在(而不仅仅你要怎么做),因为改变本身往往是短暂和短视的。

|

||||

|

||||

现在想想你的 IT 组织需要做出的改变。也许你正在考虑采用像 DevOps 这样的东西。这个我们称之为 “DevOps” 的东西有三个组件:人、流程和工具。人和流程是_任何_团体组织的基础。因此,采用 DevOps 需要对大多数组织的核心进行根本性的改变,而不仅仅是学习新的工具。

|

||||

|

||||

如同其它的改变一样,它也是短视的。如果您将注意力集中在将改变作为单点解决方案 —— 例如,“获得更好的报警工具” —— 你可能只是管中窥豹。这种思维方式或许可以提供一套拥有更多铃声、口哨以及可以更好地处理呼叫轮询的工具,但是它不能解决这样的实际问题:警报不能送达到正确的团队,或者故障得不到解决,因为实际上没有人知道如何修复服务。

|

||||

|

||||

新的工具(或者至少一个新工具的想法)创造了一个讨论潜在问题的机会,可以让你的团队讨论对监控的看法。新工具让你能够做出更大的改变 —— 信仰和做法的改变 —— 它们作为你组织的基础而显得更加重要。

|

||||

|

||||

创造更深层次的变革需要一种可以全新地改变观念的方法。要找到这种方法,我们首先需要更好的理解变革的驱动力。

|

||||

|

||||

### 清除栅栏

|

||||

|

||||

> 就改革而言,它不同于推翻。这是一条直白且简单的原则,这个原则或许被视作悖论。在这种情况下,存在某种制度或法律;这么说吧,为了简单起见,在一条路上架设了一个栅栏或门。当今的改革者们来到这儿,并说:“我看不到它的用处,让我们把它清除掉。”更聪明的改革者会很好地回答:“如果你看不到它的用处,我肯定不会让你清除它,回去想想,然后你可以回来告诉我你知道了它的用处,我也许会允许你摧毁它。” — G.K Chesterton, 1929

|

||||

|

||||

为了了解对 DevOps 的需求 —— 它试图将传统意义上分开的开发部门和运维部门进行重新组合 —— 我们首先必须明白这个分开是如何产生的。一旦我们"知道了它的用处",然后我们就会知道将它们分开是为了什么,并且在必要的时候可以取消分开。

|

||||

|

||||

今天我们没有一个单一的管理理论,但是大多数现代管理理论的起源可以追溯到<ruby>弗雷德里克·温斯洛·泰勒<rt>Frederick Winslow Taylor</rt></ruby>。泰勒是一名机械工程师,他创建了一个衡量钢厂工人效率的系统。泰勒认为,他可以对工厂的劳动者运用科学分析的方法,不仅可以改进个人任务,也证明发现了有一个可以用来执行_任何_任务最佳方法。

|

||||

|

||||

我们可以很容易地画一个以泰勒为起源的历史树。从泰勒早在 18 世纪 80 年代后期的研究出现的时间运动研究和其他质量改进计划,跨越 20 世纪 20 年代一直到今天,我们可以从中看到六西格玛、精益,等等类似方法。自上而下、指导式管理,再加上研究过程的系统方法,主宰了今天主流商业文化。它主要侧重于把效率作为工人成功的测量标准。

|

||||

|

||||

如果泰勒是我们这颗历史树的根,那么我们主干上的下一个主叉将是 20 世纪 20 年代通用汽车公司的<ruby>阿尔弗雷德·斯隆<rt>Alfred P. Sloan</rt></ruby>。通用汽车公司创造的斯隆结构不仅持续强劲到 21 世纪初,而且在未来五十年的大部分时间里,都将成为该公司的主要模式。

|

||||

|

||||

1920 年,通用公司正经历一场管理危机,或者说是缺乏管理的危机。斯隆向董事会写了一份为通用汽车的多个部门提出了一个新的结构《组织研究》。这一新结构的核心概念是“集中管理下放业务”。与雪佛兰,凯迪拉克和别克等品牌相关的各个部门将独立运作,同时为中央管理层提供推动战略和控制财务的手段。

|

||||

|

||||

在斯隆的建议下(以及后来就任 CEO 的指导下),通用汽车在美国汽车工业中占据了主导地位。斯隆的计划把一个处于灾难边缘公司创造成了一个非常成功的公司。从中间来看,自治单位是黑盒子,激励和目标被设置在顶层,而团队在底层推动。

|

||||

|

||||

泰勒思想的“最佳实践” —— 标准、可互换和可重复的行为 —— 仍然在今天的管理理念中占有一席之地,与斯隆公司结构的层次模式相结合,主导了僵化部门的分裂和孤岛化以实现最大的控制。

|

||||

|

||||

我们可以指出几份管理研究来证明这一点,但商业文化不是通过阅读书籍而创造和传播的。组织文化是 *真实的* 人在 *实际的* 情形下执行推动文化规范的 *具体的* 行为的产物。这就是为何类似泰勒和斯隆这样的理论变得固化而不可动摇的原因。

|

||||

|

||||

技术部门投资就是一个例子。以下是这个周期是如何循环的:投资者只投资于他们认为可以实现 *他们的* 特定成功观点的公司。这个成功的模式并不一定源于公司本身(和它的特定的目标);它来自董事会对一家成功的公司 *应该* 如何看待的想法。许多投资者来自从经营企业的尝试和苦难中幸存下来的公司,因此他们对什么会使一个公司成功有 *不同的* 理念。他们为那些能够被教导模仿他们的成功模式的公司提供资金,希望获得资金的公司学会模仿。这样,初创公司孵化器就是一种重现理想的结构和文化的*直接的*方式。

|

||||

|

||||

“开发”和“运维”的分开不是因为人的原因,也不是因为不同的技能,或者放在新员工头上的一顶魔法分院帽;它是泰勒和斯隆的理论的副产品。责任与人员之间的清晰而不可渗透的界线是一个管理功能,同时也注重员工的工作效率。管理上的分开可以很容易的落在产品或者项目界线上,而不是技能上,但是通过今天的业务管理理论的历史告诉我们,基于技能的分组是“最好”的高效方式。

|

||||

|

||||

不幸的是,那些界线造成了紧张局势,这些紧张局势是由不同的管理链出于不同的目标设定的相反目标的直接结果。例如:

|

||||

|

||||

* 敏捷 ⟷ 稳定

|

||||

* 吸引新用户 ⟷ 现有用户的体验

|

||||

* 让应用程序增加新功能 ⟷ 让应用程序保持可用

|

||||

* 打败竞争对手 ⟷ 维持收入

|

||||

* 修复出现的问题 ⟷ 在问题出现之前就进行预防

|

||||

|

||||

今天,我们可以看到组织的高层领导人越来越认识到,现有的商业文化(并扩大了它所产生的紧张局势)是一个严重的问题。在 2016 年的 Gartner 报告中,57% 的受访者表示,文化变革是 2020 年之前企业面临的主要挑战之一。像作为一种影响组织变革的手段的敏捷和 DevOps 这样的新方法的兴起反映了这一认识。“[影子 IT][7]” 的出现更是事物的另一个方面;最近的估计有将近 30% 的 IT 支出在 IT 组织的控制之外。

|

||||

|

||||

这些只是企业正在面临的一些“文化担忧”。改变的必要性是明确的,但前进的道路仍然受到昨天的决定的约束。

|

||||

|

||||

### 抵抗并不是没用的

|

||||

|

||||

> Bert Lance 认为如果他能让政府采纳一条简单的格言“如果东西还没损坏,那就别去修理它”,他就可以为国家节省三十亿。他解释说:“这是政府的问题:‘修复没有损坏的东西,而不是修复已经损坏了的东西。’” — Nation's Business, 1977.5

|

||||

|

||||

通常,改革是组织针对所出现的错误所做的应对。在这个意义上说,如果紧张局势(即使逆境)是变革的正常催化剂,那么对变化的 *抵抗* 就是成功的指标。但是过分强调成功的道路会使组织变得僵硬、衰竭和独断。重视有效结果的政策导向是这种不断增长的僵局的症状。

|

||||

|

||||

传统 IT 部门的成功加剧了 IT 孤岛的壁垒。其他部门现在变成了“顾客”,而不是伙伴。试图将 IT 从成本中心转移出来创建一个新的操作模式,它可以将 IT 与其他业务目标断开。这反过来又会对敏捷性造成限制,增加摩擦,降低反应能力。合作被搁置转而偏向“专家方向”。结果是一个孤立主义的观点,IT 只能带来更多的伤害而不是好处。

|

||||

|

||||

正如“软件吃掉世界”,IT 越来越成为组织整体成功的核心。具有前瞻性的 IT 组织认识到这一点,并且已经对其战略规划进行了有意义的改变,而不是将改变视为恐惧。

|

||||

|

||||

例如,Facebook 与人类学家<ruby>罗宾·邓巴<rt>Robin Dunbar</rt></ruby>就社会团体的方法进行了磋商,而且意识到这一点对公司成长的内部团体(不仅仅是该网站的外部用户)的影响。<ruby>扎波斯<rt>Zappos</rt></ruby>的文化得到了很多的赞誉,该组织创立了一个部门,专注于培养他人对于核心价值观和企业文化的看法。当然,这本书是 《开放式组织》的姊妹篇,那是一本描述被应用于管理的开放原则 —— 透明度、参与度和社区 —— 可以如何为我们快节奏的互联时代重塑组织。

|

||||

|

||||

### 决心改变

|

||||

|

||||

> “如果外界的变化率超过了内部的变化率,那末日就不远了。” — Jack Welch, 2004

|

||||

|

||||

一位同事曾经告诉我他可以只用 “[信息技术基础设施库(ITIL)][9]” 框架里面的词汇向一位项目经理解释 DevOps。

|

||||

|

||||

虽然这些框架 *似乎* 是反面的,但实际上它们都集中在风险和变革管理上。它们简单地介绍了这种管理的不同流程和工具。在 IT 圈子外面谈论 DevOps 时,这一点需要注意。不要强调流程问题和故障,而是显示更小的变化引起的风险 *更小* 等等。这是强调改变团队文化的有益方式:专注于 *新的* 功能而不是老问题,是改变的有效中介,特别是当您采用别人的框架进行参考时。

|

||||

|

||||

改革不仅仅只是 *重构* 组织;它也是跨越历史上不可跨越的鸿沟的新途径 —— 通过拒绝把像“敏捷”和“稳定”这样的东西作为互相排斥的力量来解决我之前提到的那些紧张局势。建立注重 *结果* 胜过 *功能* 的跨部门团队是一个有效的策略。把不同的团队 —— 其中每个人的工作依赖于其他人 —— 聚集起来围绕一个项目或目标是最常见的方法之一。消除这些团队之间的摩擦和改善沟通能够产生巨大的改进 —— 即使在坚持铁仓管理结构时(如果可以掌握,则不需要拆除孤岛)。在这些情况下,对改革的 *抵抗* 不是成功的一个指标;而对改革的拥抱才是。

|

||||

|

||||

这些也不是“最佳实例”,它们只是一种检查你自己的栅栏的方式。每个组织都会有独特的、由他们内部人员创造的栅栏。一旦你“知道了它的用途”,你就可以决定它是需要拆解还是掌握。

|

||||

|

||||

** 本文是 Opensource.com 即将推出的关于开放组织和 IT 文化指南的一部分。[你可以在这注册以便当它发布时收到通知][5]**

|

||||

|

||||

(题图 : opensource.com)

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

|

||||

作者简介:

|

||||

|

||||

Matt Micene 是 Red Hat 公司的 Linux 和容器传播者。从架构和系统设计到数据中心设计,他在信息技术方面拥有超过 15 年的经验。他对关键技术(如容器,云计算和虚拟化)有深入的了解。他目前的重点是宣传红帽企业版 Linux,以及操作系统如何与计算环境的新时代相关。

|

||||

|

||||

------------------------------------------

|

||||

|

||||

via: https://opensource.com/open-organization/17/5/what-is-the-point-of-DevOps

|

||||

|

||||

作者:[Matt Micene][a]

|

||||

译者:[zhousiyu325](https://github.com/zhousiyu325)

|

||||

校对:[apemost](https://github.com/apemost),[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/matt-micene

|

||||

[1]:https://opensource.com/open-organization/resources/leaders-manual?src=too_resource_menu

|

||||

[2]:https://opensource.com/open-organization/resources/field-guide?src=too_resource_menu

|

||||

[3]:https://opensource.com/open-organization/resources/open-org-definition?src=too_resource_menu

|

||||

[4]:https://opensource.com/open-organization/resources/open-decision-framework?src=too_resource_menu

|

||||

[5]:https://opensource.com/open-organization/resources/book-series

|

||||

[6]:https://opensource.com/open-organization/17/5/what-is-the-point-of-DevOps?rate=gOQvGqsEbNk_RSnoU0wP3PJ71E_XDYiYo7KS2HKFfP0

|

||||

[7]:https://thenewstack.io/parity-check-dont-afraid-shadow-yet/

|

||||

[8]:http://www.npr.org/2017/01/13/509358157/is-there-a-limit-to-how-many-friends-we-can-have

|

||||

[9]:https://en.wikipedia.org/wiki/ITIL

|

||||

[10]:https://opensource.com/user/18066/feed

|

||||

[11]:https://opensource.com/open-organization/17/5/what-is-the-point-of-DevOps#comments

|

||||

[12]:https://opensource.com/users/matt-micene

|

||||

187

published/20170529 LFCS sed Command.md

Normal file

187

published/20170529 LFCS sed Command.md

Normal file

@ -0,0 +1,187 @@

|

||||

LFCS 基础:sed 命令

|

||||

=====================

|

||||

|

||||

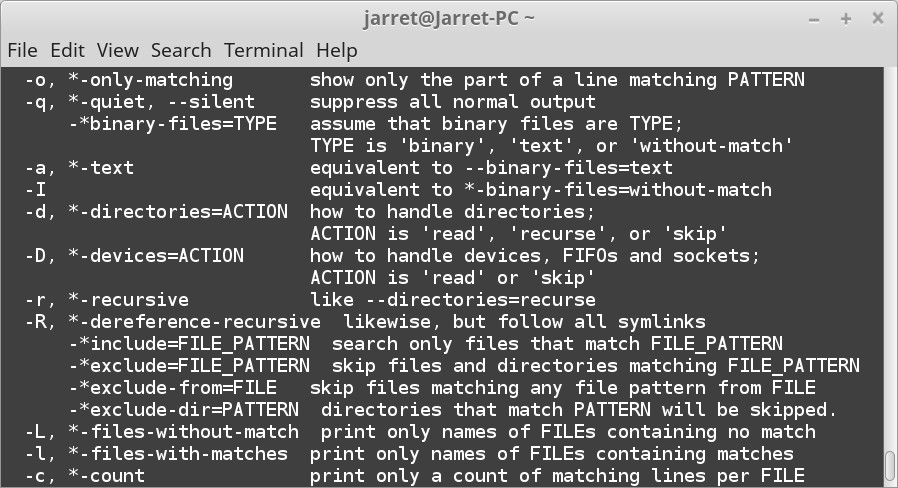

Linux 基金会认证系统管理员(LFCS)的另一个有用的命令是 “sed”,最初表示“流式编辑器” (Streaming EDitor)。

|

||||

|

||||

“sed” 命令是一个可以将文件作为流进行编辑的编辑器。流式传输文件的方法是从另一个命令使用管道(`>` 或 `|`)传递,或将其直接加载到 “sed” 中。

|

||||

|

||||

该命令的工作方式与其他编辑器相同,只是文件不显示,也不允许可视化编辑。命令被传递给 “sed” 来操纵流。

|

||||

|

||||

用 “sed” 可以做五件基本的事。当然,“sed” 如此强大,还有其他高级的功能,但你只需要集中精力在五件基本的事上。五种功能类型如下:

|

||||

|

||||

1. 搜索

|

||||

2. 替换

|

||||

3. 删除

|

||||

4. 添加

|

||||

5. 改变/变换

|

||||

|

||||

在深入命令参数之前,我们需要看看基本的语法。

|

||||

|

||||

### 语法

|

||||

|

||||

“sed” 命令的语法是:

|

||||

|

||||

```

|

||||

sed [选项] 命令 [要编辑的文件]

|

||||

```

|

||||

|

||||

本文将在适当的部分中介绍这些“选项”。“命令”可以是正则表达式的搜索和替换模式。请继续阅读了解 “sed” 如何工作的并学习基本命令。正如我之前提到的,“sed” 是一个非常强大的工具,有更多的选项可用,我将在本文中介绍。

|

||||

|

||||

### 示例文件

|

||||

|

||||

如果你打开一个终端,那你可以创建一个用于 “sed” 示例的文件。执行以下命令:

|

||||

|

||||

```

|

||||

cd ~

|

||||

grep --help >grephelp.txt

|

||||

```

|

||||

|

||||

你现在应该在 HOME 文件夹中有一个名为 `grephelp.txt` 的文件。该文件的内容是 `grep` 命令的帮助说明。

|

||||

|

||||

### 搜索

|

||||

|

||||

搜索特定字符串是编辑器的常见功能,在 “sed” 中执行搜索也不例外。

|

||||

|

||||

执行搜索以在文件中查找字符串。我们来看一下基本的搜索。

|

||||

|

||||

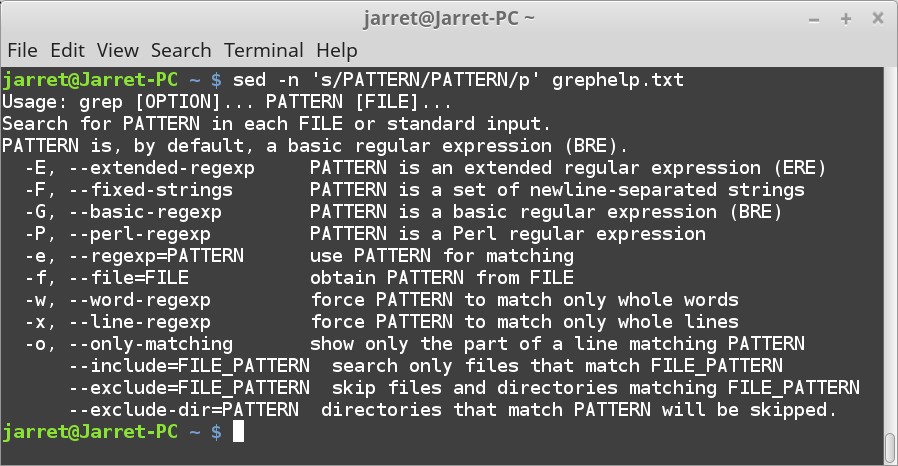

如果我们想在示例文件搜索 `PATTERN` 这个词,我们将使用如下命令:

|

||||

|

||||

```

|

||||

sed -n 's/PATTERN/PATTERN/p' grephelp.txt

|

||||

```

|

||||

|

||||

**注意:** 如果剪切粘贴命令,请确保将单引号替换为键盘上的标准单引号。

|

||||

|

||||

参数 `-n` 用于抑制每行的自动打印(除了用 `p` 命令指定的行)。默认情况下,流入 “sed” 的每一行将被打印到标准输出(stdout)。如果你不使用 “-n” 选项运行上述命令,你将看到原始文件的每一行以及匹配的行。

|

||||

|

||||

要搜索的文件名是我们在“示例文件”部分中创建的 “grephelp.txt”。

|

||||

|

||||

剩下的部分是 `'s/PATTERN/PATTERN/p'` 。这一段基本分为四个部分。第一部分的 `s` 指定执行替换,或搜索并替换。

|

||||

|

||||

剩下的第二部分和第三部分是模式。第一个是要搜索的模式,最后一个是替换流中匹配字符串的模式。此例中,我们找到字符串 `PATTERN`,并用 `PATTERN` 替换。通过查找和替换相同的字符串,我们完全不会更改文件,甚至在屏幕上也一样。

|

||||

|

||||

最后一个命令是 `p`。 它指定在替换后打印新行。当然,因为替换的是相同的字符串,所以没有改变。由于我们使用 `-n` 参数抑制打印行,所以更改的行将使用 `p` 命令打印。

|

||||

|

||||

这个完整的命令允许我们执行搜索并查看匹配的结果。

|

||||

|

||||

### 替换

|

||||

|

||||

当搜索特定字符串时,你可能希望用匹配的字符串替换新字符串。用另一个字符串替换是很常见的操作。

|

||||

|

||||

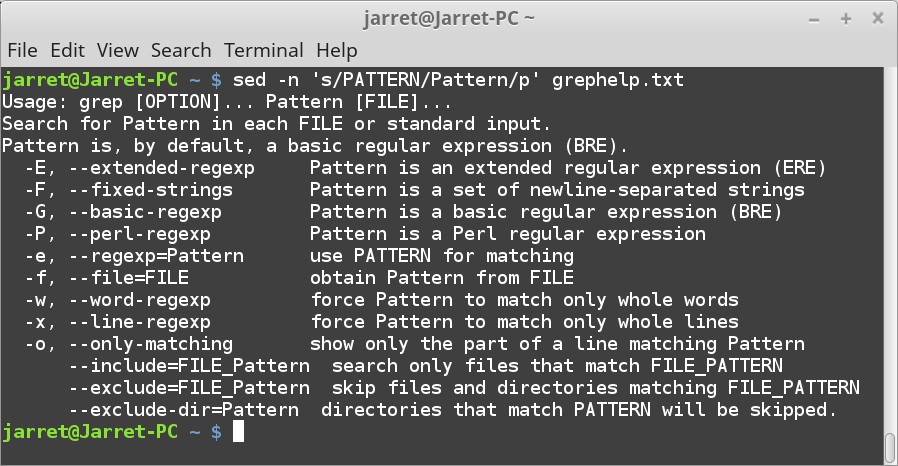

我们可以使用以下命令执行相同的搜索:

|

||||

|

||||

```

|

||||

sed -n 's/PATTERN/Pattern/p' grephelp.txt

|

||||

```

|

||||

|

||||

在这时,字符串 “PATTERN” 变为 “Pattern” 并显示。如果你使用命令 `cat grephelp.txt` 查看文件,你会看到该文件没有更改。该更改仅对屏幕上的输出进行。你可以使用以下命令将输出通过管道传输到另一个文件:

|

||||

|

||||

```

|

||||

sed 's/PATTERN/Pattern/' grephelp.txt > grephelp1.txt

|

||||

```

|

||||

|

||||

现在将存在一个名为 `grephelp1.txt` 的新文件,其中保存了更改的文件。如果 `p` 作为第四个选项留下,那么有个问题是被替换的字符串的每一行将在文件中重复两次。我们也可以删除 “-n” 参数以允许所有的行打印。

|

||||

|

||||

使用相同字符串替换字符串的另一种方法是使用 `&` 符号来表示搜索字符串。例如,命令 `s/PATTERN/&/p` 效果是一样的。我们可以添加字符串,例如添加 `S`,可以使用命令 `s/PATTERN/&S/p`。

|

||||

|

||||

如果我们希望在每一行中只替换某种模式呢?可以指定要替换的匹配项的特定出现。当然,每一行的替换都是一个特定的编号。例如,示例文件上有很多破折号。一些行至少有两条破折号,所以我们可以用另一个字符代替每一行的第二个破折号。每行用星号 `*` 替换第二个破折号 `-` 的命令将是:

|

||||

|

||||

```

|

||||

sed 's/-/*/2' grephelp.txt

|

||||

```

|

||||

|

||||

在这里,我们用最初的 `s` 来执行替换。字符 `-` 被替换为 `*`。`2` 表示我们想要替换每行上的第二个 `-`(如果存在)。如果我们忽略了命令 `2`,则替换第一次出现的破折号。只有第一个破折号而不是每行的破折号都被替换。

|

||||

|

||||

如果要搜索并替换带有星号的行上的所有破折号,请使用 `g` 命令:

|

||||

|

||||

```

|

||||

sed 's/-/*/g' grephelp.txt

|

||||

```

|

||||

|

||||

命令也可以组合。假设你想要替换从第二次开始出现的破折号,命令将是:

|

||||

|

||||

```

|

||||

sed 's/-/*/2g' grephelp.txt

|

||||

```

|

||||

|

||||

现在从第二个开始出现的破折号将被星号取代。

|

||||

|

||||

### 删除

|

||||

|

||||

搜索过程中有很多时候你可能想要完全删除搜索字符串。

|

||||

|

||||

例如,如果要从文件中删除所有破折号,你可以使用以下命令:

|

||||

|

||||

```

|

||||

sed 's/-//g' grephelp.txt

|

||||

```

|

||||

|

||||

替换字符串为空白,因此匹配的字符串将被删除。

|

||||

|

||||

### 添加

|

||||

|

||||

当找到匹配时,你可以添加一行特定的文本,来使这行在浏览或打印中突出。

|

||||

|

||||