mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-02-03 23:40:14 +08:00

Merge remote-tracking branch 'LCTT/master'

This commit is contained in:

commit

4561908be4

2

.gitignore

vendored

2

.gitignore

vendored

@ -3,3 +3,5 @@ members.md

|

||||

*.html

|

||||

*.bak

|

||||

.DS_Store

|

||||

sources/*/.*

|

||||

translated/*/.*

|

||||

95

published/20180128 Being open about data privacy.md

Normal file

95

published/20180128 Being open about data privacy.md

Normal file

@ -0,0 +1,95 @@

|

||||

对数据隐私持开放的态度

|

||||

======

|

||||

|

||||

> 尽管有包括 GDPR 在内的法规,数据隐私对于几乎所有的人来说都是很重要的事情。

|

||||

|

||||

|

||||

|

||||

今天(LCTT 译注:本文发表于 2018/1/28)是<ruby>[数据隐私日][1]<rt>Data Privacy Day</rt></ruby>,(在欧洲叫“<ruby>数据保护日<rt>Data Protection Day</rt></ruby>”),你可能会认为现在我们处于一个开源的世界中,所有的数据都应该是自由的,[就像人们想的那样][2],但是现实并没那么简单。主要有两个原因:

|

||||

|

||||

1. 我们中的大多数(不仅仅是在开源中)认为至少有些关于我们自己的数据是不愿意分享出去的(我在之前发表的一篇文章中列举了一些例子[3])

|

||||

2. 我们很多人虽然在开源中工作,但事实上是为了一些商业公司或者其他一些组织工作,也是在合法的要求范围内分享数据。

|

||||

|

||||

所以实际上,数据隐私对于每个人来说是很重要的。

|

||||

|

||||

事实证明,在美国和欧洲之间,人们和政府认为让组织使用哪些数据的出发点是有些不同的。前者通常为商业实体(特别是愤世嫉俗的人们会指出是大型的商业实体)利用他们所收集到的关于我们的数据提供了更多的自由度。在欧洲,完全是另一观念,一直以来持有的多是有更多约束限制的观念,而且在 5 月 25 日,欧洲的观点可以说取得了胜利。

|

||||

|

||||

### 通用数据保护条例(GDPR)的影响

|

||||

|

||||

那是一个相当全面的声明,其实事实上这是 2016 年欧盟通过的一项称之为<ruby>通用数据保护条例<rt>General Data Protection Regulation</rt></ruby>(GDPR)的立法的日期。数据通用保护条例在私人数据怎样才能被保存,如何才能被使用,谁能使用,能被持有多长时间这些方面设置了严格的规则。它描述了什么数据属于私人数据——而且涉及的条目范围非常广泛,从你的姓名、家庭住址到你的医疗记录以及接通你电脑的 IP 地址。

|

||||

|

||||

通用数据保护条例的重要之处是它并不仅仅适用于欧洲的公司,如果你是阿根廷人、日本人、美国人或者是俄罗斯的公司而且你正在收集涉及到欧盟居民的数据,你就要受到这个条例的约束管辖。

|

||||

|

||||

“哼!” 你可能会这样说^注1 ,“我的业务不在欧洲:他们能对我有啥约束?” 答案很简单:如果你想继续在欧盟做任何生意,你最好遵守,因为一旦你违反了通用数据保护条例的规则,你将会受到你的全球总收入百分之四的惩罚。是的,你没听错,是全球总收入,而不是仅仅在欧盟某一国家的的收入,也不只是净利润,而是全球总收入。这将会让你去叮嘱告知你的法律团队,他们就会知会你的整个团队,同时也会立即去指引你的 IT 团队,确保你的行为在相当短的时间内合规。

|

||||

|

||||

看上去这和非欧盟公民没有什么相关性,但其实不然,对大多数公司来说,对所有的他们的顾客、合作伙伴以及员工实行同样的数据保护措施是件既简单又有效的事情,而不是仅针对欧盟公民实施,这将会是一件很有利的事情。^注2

|

||||

|

||||

然而,数据通用保护条例不久将在全球实施并不意味着一切都会变的很美好^注3 :事实并非如此,我们一直在丢弃关于我们自己的信息——而且允许公司去使用它。

|

||||

|

||||

有一句话是这么说的(尽管很争议):“如果你没有在付费,那么你就是产品。”这句话的意思就是如果你没有为某一项服务付费,那么其他的人就在付费使用你的数据。你有付费使用 Facebook、推特、谷歌邮箱?你觉得他们是如何赚钱的?大部分是通过广告,一些人会争论那是他们向你提供的一项服务而已,但事实上是他们在利用你的数据从广告商里获取收益。你不是一个真正的广告的顾客——只有当你从看了广告后买了他们的商品之后你才变成了他们的顾客,但直到这个发生之前,都是广告平台和广告商的关系。

|

||||

|

||||

有些服务是允许你通过付费来消除广告的(流媒体音乐平台声破天就是这样的),但从另一方面来讲,即使你认为付费的服务也可以启用广告(例如,亚马逊正在努力让 Alexa 发广告),除非我们想要开始为这些所有的免费服务付费,我们需要清楚我们所放弃的,而且在我们暴露的和不想暴露的之间做一些选择。

|

||||

|

||||

### 谁是顾客?

|

||||

|

||||

关于数据的另一个问题一直在困扰着我们,它是产生的数据量的直接结果。有许多组织一直在产生巨量的数据,包括公共的组织比如大学、医院或者是政府部门^注4 ——而且他们没有能力去储存这些数据。如果这些数据没有长久的价值也就没什么要紧的,但事实正好相反,随着处理大数据的工具正在开发中,而且这些组织也认识到他们现在以及在不久的将来将能够去挖掘这些数据。

|

||||

|

||||

然而他们面临的是,随着数据的增长和存储量无法跟上该怎么办。幸运的是——而且我是带有讽刺意味的使用了这个词^注5 ,大公司正在介入去帮助他们。“把你们的数据给我们,”他们说,“我们将免费保存。我们甚至让你随时能够使用你所收集到的数据!”这听起来很棒,是吗?这是大公司^注6 的一个极具代表性的例子,站在慈善的立场上帮助公共组织管理他们收集到的关于我们的数据。

|

||||

|

||||

不幸的是,慈善不是唯一的理由。他们是附有条件的:作为同意保存数据的交换条件,这些公司得到了将数据访问权限出售给第三方的权利。你认为公共组织,或者是被收集数据的人在数据被出售使用权使给第三方,以及在他们如何使用上能有发言权吗?我将把这个问题当做一个练习留给读者去思考。^注7

|

||||

|

||||

### 开放和积极

|

||||

|

||||

然而并不只有坏消息。政府中有一项在逐渐发展起来的“开放数据”运动鼓励各个部门免费开放大量他们的数据给公众或者其他组织。在某些情况下,这是专门立法的。许多志愿组织——尤其是那些接受公共资金的——正在开始这样做。甚至商业组织也有感兴趣的苗头。而且,有一些技术已经可行了,例如围绕不同的隐私和多方计算上,正在允许跨越多个数据集挖掘数据,而不用太多披露个人的信息——这个计算问题从未如现在比你想象的更容易。

|

||||

|

||||

这些对我们来说意味着什么呢?我之前在网站 Opensource.com 上写过关于[开源的共享福利][4],而且我越来越相信我们需要把我们的视野从软件拓展到其他区域:硬件、组织,和这次讨论有关的,数据。让我们假设一下你是 A 公司要提向另一家公司客户 B^注8 提供一项服务 。在此有四种不同类型的数据:

|

||||

|

||||

1. 数据完全开放:对 A 和 B 都是可得到的,世界上任何人都可以得到

|

||||

2. 数据是已知的、共享的,和机密的:A 和 B 可得到,但其他人不能得到

|

||||

3. 数据是公司级别上保密的:A 公司可以得到,但 B 顾客不能

|

||||

4. 数据是顾客级别保密的:B 顾客可以得到,但 A 公司不能

|

||||

|

||||

首先,也许我们对数据应该更开放些,将数据默认放到选项 1 中。如果那些数据对所有人开放——在无人驾驶、语音识别,矿藏以及人口数据统计会有相当大的作用的。^注9 如果我们能够找到方法将数据放到选项 2、3 和 4 中,不是很好吗?——或者至少它们中的一些——在选项 1 中是可以实现的,同时仍将细节保密?这就是研究这些新技术的希望。

|

||||

然而有很长的路要走,所以不要太兴奋,同时,开始考虑将你的的一些数据默认开放。

|

||||

|

||||

### 一些具体的措施

|

||||

|

||||

我们如何处理数据的隐私和开放?下面是我想到的一些具体的措施:欢迎大家评论做出更多的贡献。

|

||||

|

||||

* 检查你的组织是否正在认真严格的执行通用数据保护条例。如果没有,去推动实施它。

|

||||

* 要默认加密敏感数据(或者适当的时候用散列算法),当不再需要的时候及时删掉——除非数据正在被处理使用,否则没有任何借口让数据清晰可见。

|

||||

* 当你注册了一个服务的时候考虑一下你公开了什么信息,特别是社交媒体类的。

|

||||

* 和你的非技术朋友讨论这个话题。

|

||||

* 教育你的孩子、你朋友的孩子以及他们的朋友。然而最好是去他们的学校和他们的老师谈谈在他们的学校中展示。

|

||||

* 鼓励你所服务和志愿贡献的组织,或者和他们沟通一些推动数据的默认开放。不是去思考为什么我要使数据开放,而是从我为什么不让数据开放开始。

|

||||

* 尝试去访问一些开源数据。挖掘使用它、开发应用来使用它,进行数据分析,画漂亮的图,^注10 制作有趣的音乐,考虑使用它来做些事。告诉组织去使用它们,感谢它们,而且鼓励他们去做更多。

|

||||

|

||||

**注:**

|

||||

|

||||

1. 我承认你可能尽管不会。

|

||||

2. 假设你坚信你的个人数据应该被保护。

|

||||

3. 如果你在思考“极好的”的寓意,在这点上你并不孤独。

|

||||

4. 事实上这些机构能够有多开放取决于你所居住的地方。

|

||||

5. 假设我是英国人,那是非常非常大的剂量。

|

||||

6. 他们可能是巨大的公司:没有其他人能够负担得起这么大的存储和基础架构来使数据保持可用。

|

||||

7. 不,答案是“不”。

|

||||

8. 尽管这个例子也同样适用于个人。看看:A 可能是 Alice,B 可能是 BOb……

|

||||

9. 并不是说我们应该暴露个人的数据或者是这样的数据应该被保密,当然——不是那类的数据。

|

||||

10. 我的一个朋友当她接孩子放学的时候总是下雨,所以为了避免确认失误,她在整个学年都访问天气信息并制作了图表分享到社交媒体上。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/1/being-open-about-data-privacy

|

||||

|

||||

作者:[Mike Bursell][a]

|

||||

译者:[FelixYFZ](https://github.com/FelixYFZ)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/mikecamel

|

||||

[1]:https://en.wikipedia.org/wiki/Data_Privacy_Day

|

||||

[2]:https://en.wikipedia.org/wiki/Information_wants_to_be_free

|

||||

[3]:https://aliceevebob.wordpress.com/2017/06/06/helping-our-governments-differently/

|

||||

[4]:https://opensource.com/article/17/11/commonwealth-open-source

|

||||

[5]:http://www.outpost9.com/reference/jargon/jargon_40.html#TAG2036

|

||||

@ -0,0 +1,40 @@

|

||||

在 Arch 用户仓库(AUR)中发现恶意软件

|

||||

======

|

||||

|

||||

7 月 7 日,有一个 AUR 软件包被改入了一些恶意代码,提醒 [Arch Linux][1] 用户(以及一般的 Linux 用户)在安装之前应该尽可能检查所有由用户生成的软件包。

|

||||

|

||||

[AUR][3](即 Arch(Linux)用户仓库)包含包描述,也称为 PKGBUILD,它使得从源代码编译包变得更容易。虽然这些包非常有用,但它们永远不应被视为安全的,并且用户应尽可能在使用之前检查其内容。毕竟,AUR 在网页中以粗体显示 “**AUR 包是用户制作的内容。任何使用该提供的文件的风险由你自行承担。**”

|

||||

|

||||

这次[发现][4]包含恶意代码的 AUR 包证明了这一点。[acroread][5] 于 7 月 7 日(看起来它以前是“孤儿”,意思是它没有维护者)被一位名为 “xeactor” 的用户修改,它包含了一行从 pastebin 使用 `curl` 下载脚本的命令。然后,该脚本下载了另一个脚本并安装了一个 systemd 单元以定期运行该脚本。

|

||||

|

||||

**看来有[另外两个][2] AUR 包以同样的方式被修改。所有违规软件包都已删除,并暂停了用于上传它们的用户帐户(它们注册在更新软件包的同一天)。**

|

||||

|

||||

这些恶意代码没有做任何真正有害的事情 —— 它只是试图上传一些系统信息,比如机器 ID、`uname -a` 的输出(包括内核版本、架构等)、CPU 信息、pacman 信息,以及 `systemctl list-units`(列出 systemd 单元信息)的输出到 pastebin.com。我说“试图”是因为第二个脚本中存在错误而没有实际上传系统信息(上传函数为 “upload”,但脚本试图使用其他名称 “uploader” 调用它)。

|

||||

|

||||

此外,将这些恶意脚本添加到 AUR 的人将脚本中的个人 Pastebin API 密钥以明文形式留下,再次证明他们真的不明白他们在做什么。(LCTT 译注:意即这是一个菜鸟“黑客”,还不懂得如何有经验地隐藏自己。)

|

||||

|

||||

尝试将此信息上传到 Pastebin 的目的尚不清楚,特别是原本可以上传更加敏感信息的情况下,如 GPG / SSH 密钥。

|

||||

|

||||

**更新:** Reddit用户 u/xanaxdroid_ [提及][6]同一个名为 “xeactor” 的用户也发布了一些加密货币挖矿软件包,因此他推测 “xeactor” 可能正计划添加一些隐藏的加密货币挖矿软件到 AUR([两个月][7]前的一些 Ubuntu Snap 软件包也是如此)。这就是 “xeactor” 可能试图获取各种系统信息的原因。此 AUR 用户上传的所有包都已删除,因此我无法检查。

|

||||

|

||||

**另一个更新:**你究竟应该在那些用户生成的软件包检查什么(如 AUR 中发现的)?情况各有不同,我无法准确地告诉你,但你可以从寻找任何尝试使用 `curl`、`wget`和其他类似工具下载内容的东西开始,看看他们究竟想要下载什么。还要检查从中下载软件包源的服务器,并确保它是官方来源。不幸的是,这不是一个确切的“科学做法”。例如,对于 Launchpad PPA,事情变得更加复杂,因为你必须懂得 Debian 如何打包,并且这些源代码是可以直接更改的,因为它托管在 PPA 中并由用户上传的。使用 Snap 软件包会变得更加复杂,因为在安装之前你无法检查这些软件包(据我所知)。在后面这些情况下,作为通用解决方案,我觉得你应该只安装你信任的用户/打包器生成的软件包。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.linuxuprising.com/2018/07/malware-found-on-arch-user-repository.html

|

||||

|

||||

作者:[Logix][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://plus.google.com/118280394805678839070

|

||||

[1]:https://www.archlinux.org/

|

||||

[2]:https://lists.archlinux.org/pipermail/aur-general/2018-July/034153.html

|

||||

[3]:https://aur.archlinux.org/

|

||||

[4]:https://lists.archlinux.org/pipermail/aur-general/2018-July/034152.html

|

||||

[5]:https://aur.archlinux.org/cgit/aur.git/commit/?h=acroread&id=b3fec9f2f16703c2dae9e793f75ad6e0d98509bc

|

||||

[6]:https://www.reddit.com/r/archlinux/comments/8x0p5z/reminder_to_always_read_your_pkgbuilds/e21iugg/

|

||||

[7]:https://www.linuxuprising.com/2018/05/malware-found-in-ubuntu-snap-store.html

|

||||

@ -2,19 +2,20 @@

|

||||

======

|

||||

|

||||

|

||||

Thunderbird 是由 [Mozilla][1] 开发的流行免费电子邮件客户端。与 Firefox 类似,Thunderbird 提供了大量加载项来用于额外功能和自定义。本文重点介绍四个加载项,以改善你的隐私。

|

||||

|

||||

Thunderbird 是由 [Mozilla][1] 开发的流行的免费电子邮件客户端。与 Firefox 类似,Thunderbird 提供了大量加载项来用于额外功能和自定义。本文重点介绍四个加载项,以改善你的隐私。

|

||||

|

||||

### Enigmail

|

||||

|

||||

使用 GPG(GNU Privacy Guard)加密电子邮件是保持其内容私密性的最佳方式。如果你不熟悉 GPG,请[查看我们在 Magazine 上的入门介绍][2]。

|

||||

使用 GPG(GNU Privacy Guard)加密电子邮件是保持其内容私密性的最佳方式。如果你不熟悉 GPG,请[查看我们在这里的入门介绍][2]。

|

||||

|

||||

[Enigmail][3] 是使用 OpenPGP 和 Thunderbird 的首选加载项。实际上,Enigmail 与 Thunderbird 集成良好,可让你加密、解密、数字签名和验证电子邮件。

|

||||

|

||||

### Paranoia

|

||||

|

||||

[Paranoia][4] 可让你查看有关收到的电子邮件的重要信息。表情符号显示电子邮件在到达收件箱之前经过的服务器之间的加密状态。

|

||||

[Paranoia][4] 可让你查看有关收到的电子邮件的重要信息。用一个表情符号显示电子邮件在到达收件箱之前经过的服务器之间的加密状态。

|

||||

|

||||

黄色,快乐的表情告诉你所有连接都已加密。蓝色,悲伤的表情意味着一个连接未加密。最后,红色的,害怕的表情表示在多个连接上该消息未加密。

|

||||

黄色、快乐的表情告诉你所有连接都已加密。蓝色、悲伤的表情意味着有一个连接未加密。最后,红色的、害怕的表情表示在多个连接上该消息未加密。

|

||||

|

||||

还有更多有关这些连接的详细信息,你可以用来检查哪台服务器用于投递邮件。

|

||||

|

||||

@ -30,9 +31,9 @@ Thunderbird 是由 [Mozilla][1] 开发的流行免费电子邮件客户端。与

|

||||

|

||||

如果你真的担心自己的隐私,[TorBirdy][6] 就是给你设计的加载项。它将 Thunderbird 配置为使用 [Tor][7] 网络。

|

||||

|

||||

据其[文档][8]所述,TorBirdy 在以前没有使用 Tor 的电子邮件帐户上提供较少的隐私。

|

||||

据其[文档][8]所述,TorBirdy 为以前没有使用 Tor 的电子邮件帐户提供了少量隐私保护。

|

||||

|

||||

>请记住,跟之前使用 Tor 访问的电子邮件帐户相比,之前没有使用 Tor 访问的电子邮件帐户提供**更少**的隐私/匿名/更弱的假名。但是,TorBirdy 仍然对现有帐户或实名电子邮件地址有用。例如,如果你正在寻求隐匿位置 - 你经常旅行并且不想通过发送电子邮件来披露你的所有位置--TorBirdy 非常有效!

|

||||

> 请记住,跟之前使用 Tor 访问的电子邮件帐户相比,之前没有使用 Tor 访问的电子邮件帐户提供**更少**的隐私/匿名/更弱的假名。但是,TorBirdy 仍然对现有帐户或实名电子邮件地址有用。例如,如果你正在寻求隐匿位置 —— 你经常旅行并且不想通过发送电子邮件来披露你的所有位置 —— TorBirdy 非常有效!

|

||||

|

||||

请注意,要使用此加载项,必须在系统上安装 Tor。

|

||||

|

||||

@ -46,7 +47,7 @@ via: https://fedoramagazine.org/4-addons-privacy-thunderbird/

|

||||

作者:[Clément Verna][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1 +0,0 @@

|

||||

lujun9972@T520.854:1532408217

|

||||

@ -1,3 +1,4 @@

|

||||

Translating by qhwdw

|

||||

# Understanding metrics and monitoring with Python

|

||||

|

||||

|

||||

|

||||

@ -1,3 +1,4 @@

|

||||

Translating by qhwdw

|

||||

Asynchronous Processing with Go using Kafka and MongoDB

|

||||

============================================================

|

||||

|

||||

|

||||

@ -1,58 +0,0 @@

|

||||

Everything old is new again: Microservices – DXC Blogs

|

||||

======

|

||||

|

||||

|

||||

If I told you about a software architecture in which components of an application provided services to other components via a communications protocol over a network you would say it was…

|

||||

|

||||

Well, it depends. If you got your start programming in the 90s, you’d say I just defined a [Service-Oriented Architecture (SOA)][1]. But, if you’re younger and cut your developer teeth on the cloud, you’d say: “Oh, you’re talking about [microservices][2].”

|

||||

|

||||

You’d both be right. To really understand the differences, you need to dive deeper into these architectures.

|

||||

|

||||

In SOA, a service is a function, which is well-defined, self-contained, and doesn’t depend on the context or state of other services. There are two kinds of services. A service consumer, which requests a service from the other type, a service provider. An SOA service can play both roles.

|

||||

|

||||

SOA services can trade data with each other. Two or more services can also coordinate with each other. These services carry out basic jobs such as creating a user account, providing login functionality, or validating a payment.

|

||||

|

||||

SOA isn’t so much about modularizing an application as it is about composing an application by integrating distributed, separately-maintained and deployed components. These components run on servers.

|

||||

|

||||

Early versions of SOA used object-oriented protocols to communicate with each other. For example, Microsoft’s [Distributed Component Object Model (DCOM)][3] and [Object Request Brokers (ORBs)][4] use the [Common Object Request Broker Architecture (CORBA)][5] specification.

|

||||

|

||||

Later versions used messaging services such as [Java Message Service (JMS)][6] or [Advanced Message Queuing Protocol (AMQP)][7]. These service connections are called Enterprise Service Buses (ESB). Over these buses, data, almost always in eXtensible Markup Language (XML) format, is transmitted and received.

|

||||

|

||||

[Microservices][2] is an architectural style where applications are made up from loosely coupled services or modules. It lends itself to the Continuous Integration/Continuous Deployment (CI/CD) model of developing large, complex applications. An application is the sum of its modules.

|

||||

|

||||

Each microservice provides an application programming interface (API) endpoint. These are connected by lightweight protocols such as [REpresentational State Transfer (REST)][8], or [gRPC][9]. Data tends to be represented by [JavaScript Object Notation (JSON)][10] or [Protobuf][11].

|

||||

|

||||

Both architectures stand as an alternative to the older, monolithic style of architecture where applications are built as single, autonomous units. For example, in a client-server model, a typical Linux, Apache, MySQL, PHP/Python/Perl (LAMP) server-side application would deal with HTTP requests, run sub-programs and retrieves/updates from the underlying MySQL database. These are all tied closely together. When you change anything, you must build and deploy a new version.

|

||||

|

||||

With SOA, you may need to change several components, but never the entire application. With microservices, though, you can make changes one service at a time. With microservices, you’re working with a true decoupled architecture.

|

||||

|

||||

Microservices are also lighter than SOA. While SOA services are deployed to servers and virtual machines (VMs), microservices are deployed in containers. The protocols are also lighter. This makes microservices more flexible than SOA. Hence, it works better with Agile shops.

|

||||

|

||||

So what does this mean? The long and short of it is that microservices are an SOA variation for container and cloud computing.

|

||||

|

||||

Old style SOA isn’t going away, but as we continue to move applications to containers, the microservice architecture will only grow more popular.

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://blogs.dxc.technology/2018/05/08/everything-old-is-new-again-microservices/

|

||||

|

||||

作者:[Cloudy Weather][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://blogs.dxc.technology/author/steven-vaughan-nichols/

|

||||

[1]:https://www.service-architecture.com/articles/web-services/service-oriented_architecture_soa_definition.html

|

||||

[2]:http://microservices.io/

|

||||

[3]:https://technet.microsoft.com/en-us/library/cc958799.aspx

|

||||

[4]:https://searchmicroservices.techtarget.com/definition/Object-Request-Broker-ORB

|

||||

[5]:http://www.corba.org/

|

||||

[6]:https://docs.oracle.com/javaee/6/tutorial/doc/bncdq.html

|

||||

[7]:https://www.amqp.org/

|

||||

[8]:https://www.service-architecture.com/articles/web-services/representational_state_transfer_rest.html

|

||||

[9]:https://grpc.io/

|

||||

[10]:https://www.json.org/

|

||||

[11]:https://github.com/google/protobuf/

|

||||

@ -1,127 +0,0 @@

|

||||

How To Check Ubuntu Version and Other System Information Easily

|

||||

======

|

||||

**Brief: Wondering which Ubuntu version are you using? Here’s how to check Ubuntu version, desktop environment and other relevant system information.**

|

||||

|

||||

You can easily find the Ubuntu version you are using in the command line or via the graphical interface. Knowing the exact Ubuntu version, desktop environment and other system information helps a lot when you are trying to follow a tutorial from the web or seeking help in various forums.

|

||||

|

||||

In this quick tip, I’ll show you various ways to check [Ubuntu][1] version and other common system information.

|

||||

|

||||

### How to check Ubuntu version in terminal

|

||||

|

||||

This is the best way to find Ubuntu version. I could have mentioned the graphical way first but then I chose this method because this one doesn’t depend on the [desktop environment][2] you are using. You can use it on any Ubuntu variant.

|

||||

|

||||

Open a terminal (Ctrl+Alt+T) and type the following command:

|

||||

```

|

||||

lsb_release -a

|

||||

|

||||

```

|

||||

|

||||

The output of the above command should be like this:

|

||||

```

|

||||

No LSB modules are available.

|

||||

Distributor ID: Ubuntu

|

||||

Description: Ubuntu 16.04.4 LTS

|

||||

Release: 16.04

|

||||

Codename: xenial

|

||||

|

||||

```

|

||||

|

||||

![How to check Ubuntu version in command line][3]

|

||||

|

||||

As you can see, the current Ubuntu installed in my system is Ubuntu 16.04 and its code name is Xenial.

|

||||

|

||||

Wait! Why does it say Ubuntu 16.04.4 in Description and 16.04 in the Release? Which one is it, 16.04 or 16.04.4? What’s the difference between the two?

|

||||

|

||||

The short answer is that you are using Ubuntu 16.04. That’s the base image. 16.04.4 signifies the fourth point release of 16.04. A point release can be thought of as a service pack in Windows era. Both 16.04 and 16.04.4 will be the correct answer here.

|

||||

|

||||

What’s Xenial in the output? That’s the codename of the Ubuntu 16.04 release. You can read this [article to know about Ubuntu naming convention][4].

|

||||

|

||||

#### Some alternate ways to find Ubuntu version

|

||||

|

||||

Alternatively, you can use either of the following commands to find Ubuntu version:

|

||||

```

|

||||

cat /etc/lsb-release

|

||||

|

||||

```

|

||||

|

||||

The output of the above command would look like this:

|

||||

```

|

||||

DISTRIB_ID=Ubuntu

|

||||

DISTRIB_RELEASE=16.04

|

||||

DISTRIB_CODENAME=xenial

|

||||

DISTRIB_DESCRIPTION="Ubuntu 16.04.4 LTS"

|

||||

|

||||

```

|

||||

|

||||

![How to check Ubuntu version in command line][5]

|

||||

|

||||

You can also use this command to know Ubuntu version

|

||||

```

|

||||

cat /etc/issue

|

||||

|

||||

```

|

||||

|

||||

The output of this command will be like this:

|

||||

```

|

||||

Ubuntu 16.04.4 LTS \n \l

|

||||

|

||||

```

|

||||

|

||||

Forget the \n \l. The Ubuntu version is 16.04.4 in this case or simply Ubuntu 16.04.

|

||||

|

||||

### How to check Ubuntu version graphically

|

||||

|

||||

Checking Ubuntu version graphically is no big deal either. I am going to use screenshots from Ubuntu 18.04 GNOME here. Things may look different if you are using Unity or some other desktop environment. This is why I recommend the command line version discussed in the previous sections because that doesn’t depend on the desktop environment.

|

||||

|

||||

I’ll show you how to find the desktop environment in the next section.

|

||||

|

||||

For now, go to System Settings and look under the Details segment.

|

||||

|

||||

![Finding Ubuntu version graphically][6]

|

||||

|

||||

You should see the Ubuntu version here along with the information about the desktop environment you are using, [GNOME][7] being the case here.

|

||||

|

||||

![Finding Ubuntu version graphically][8]

|

||||

|

||||

### How to know the desktop environment and other system information in Ubuntu

|

||||

|

||||

So you just learned how to find Ubuntu version. What about the desktop environment in use? Which Linux kernel version is being used?

|

||||

|

||||

Of course, there are various commands you can use to get all those information but I’ll recommend a command line utility called [Neofetch][9]. This will show you essential system information in the terminal beautifully with the logo of Ubuntu or any other Linux distribution you are using.

|

||||

|

||||

Install Neofetch using the command below:

|

||||

```

|

||||

sudo apt install neofetch

|

||||

|

||||

```

|

||||

|

||||

Once installed, simply run the command `neofetch` in the terminal and see a beautiful display of system information.

|

||||

|

||||

![System information in Linux terminal][10]

|

||||

|

||||

As you can see, Neofetch shows you the Linux kernel version, Ubuntu version, desktop environment in use along with its version, themes and icons in use etc.

|

||||

|

||||

I hope it helps you to find Ubuntu version and other system information. If you have suggestions to improve this article, feel free to drop it in the comment section. Ciao :)

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://itsfoss.com/how-to-know-ubuntu-unity-version/

|

||||

|

||||

作者:[Abhishek Prakash][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://itsfoss.com/author/abhishek/

|

||||

[1]:https://www.ubuntu.com/

|

||||

[2]:https://en.wikipedia.org/wiki/Desktop_environment

|

||||

[3]:https://4bds6hergc-flywheel.netdna-ssl.com/wp-content/uploads/2013/03/check-ubuntu-version-command-line-1-800x216.jpeg

|

||||

[4]:https://itsfoss.com/linux-code-names/

|

||||

[5]:https://4bds6hergc-flywheel.netdna-ssl.com/wp-content/uploads/2013/03/check-ubuntu-version-command-line-2-800x185.jpeg

|

||||

[6]:https://4bds6hergc-flywheel.netdna-ssl.com/wp-content/uploads/2013/03/ubuntu-version-system-settings.jpeg

|

||||

[7]:https://www.gnome.org/

|

||||

[8]:https://4bds6hergc-flywheel.netdna-ssl.com/wp-content/uploads/2013/03/checking-ubuntu-version-gui.jpeg

|

||||

[9]:https://itsfoss.com/display-linux-logo-in-ascii/

|

||||

[10]:https://4bds6hergc-flywheel.netdna-ssl.com/wp-content/uploads/2013/03/ubuntu-system-information-terminal-800x400.jpeg

|

||||

@ -1,3 +1,4 @@

|

||||

Translating by qhwdw

|

||||

Splicing the Cloud Native Stack, One Floor at a Time

|

||||

======

|

||||

At Packet, our value (automated infrastructure) is super fundamental. As such, we spend an enormous amount of time looking up at the players and trends in all the ecosystems above us - as well as the very few below!

|

||||

|

||||

@ -1,94 +0,0 @@

|

||||

translating---geekpi

|

||||

|

||||

Give Your Linux Desktop a Stunning Makeover With Xenlism Themes

|

||||

============================================================

|

||||

|

||||

|

||||

_Brief: Xenlism theme pack provides an aesthetically pleasing GTK theme, colorful icons, and minimalist wallpapers to transform your Linux desktop into an eye-catching setup._

|

||||

|

||||

It’s not every day that I dedicate an entire article to a theme unless I find something really awesome. I used to cover themes and icons regularly. But lately, I preferred having lists of [best GTK themes][6] and icon themes. This is more convenient for me and for you as well as you get to see many beautiful themes in one place.

|

||||

|

||||

After [Pop OS theme][7] suit, Xenlism is another theme that has left me awestruck by its look.

|

||||

|

||||

|

||||

|

||||

Xenlism GTK theme is based on the Arc theme, an inspiration behind so many themes these days. The GTK theme provides Windows buttons similar to macOS which I neither like nor dislike. The GTK theme has a flat, minimalist layout and I like that.

|

||||

|

||||

There are two icon themes in the Xenlism suite. Xenlism Wildfire is an old one and had already made to our list of [best icon themes][8].

|

||||

|

||||

|

||||

Xenlism Wildfire Icons

|

||||

|

||||

Xenlsim Storm is the relatively new icon theme but is equally beautiful.

|

||||

|

||||

|

||||

Xenlism Storm Icons

|

||||

|

||||

Xenlism themes are open source under GPL license.

|

||||

|

||||

### How to install Xenlism theme pack on Ubuntu 18.04

|

||||

|

||||

Xenlism dev provides an easier way of installing the theme pack through a PPA. Though the PPA is available for Ubuntu 16.04, I found the GTK theme wasn’t working with Unity. It works fine with the GNOME desktop in Ubuntu 18.04.

|

||||

|

||||

Open a terminal (Ctrl+Alt+T) and use the following commands one by one:

|

||||

|

||||

```

|

||||

sudo add-apt-repository ppa:xenatt/xenlism

|

||||

sudo apt update

|

||||

```

|

||||

|

||||

This PPA offers four packages:

|

||||

|

||||

* xenlism-finewalls: for a set of wallpapers that will be available directly in the wallpaper section of Ubuntu. One of the wallpapers has been used in the screenshot.

|

||||

|

||||

* xenlism-minimalism-theme: GTK theme

|

||||

|

||||

* xenlism-storm: an icon theme (see previous screenshots)

|

||||

|

||||

* xenlism-wildfire-icon-theme: another icon theme with several color variants (folder colors get changed in the variants)

|

||||

|

||||

You can decide on your own what theme component you want to install. Personally, I don’t see any harm in installing all the components.

|

||||

|

||||

```

|

||||

sudo apt install xenlism-minimalism-theme xenlism-storm-icon-theme xenlism-wildfire-icon-theme xenlism-finewalls

|

||||

```

|

||||

|

||||

You can use GNOME Tweaks for changing the theme and icons. If you are not familiar with the procedure already, I suggest reading this tutorial to learn [how to install themes in Ubuntu 18.04 GNOME][9].

|

||||

|

||||

### Getting Xenlism themes in other Linux distributions

|

||||

|

||||

You can install Xenlism themes on other Linux distributions as well. Installation instructions for various Linux distributions can be found on its website:

|

||||

|

||||

[Install Xenlism Themes][10]

|

||||

|

||||

### What do you think?

|

||||

|

||||

I know not everyone would agree with me but I loved this theme. I think you are going to see the glimpse of Xenlism theme in the screenshots in future tutorials on It’s FOSS.

|

||||

|

||||

Did you like Xenlism theme? If not, what theme do you like the most? Share your opinion in the comment section below.

|

||||

|

||||

#### 关于作者

|

||||

|

||||

I am a professional software developer, and founder of It's FOSS. I am an avid Linux lover and Open Source enthusiast. I use Ubuntu and believe in sharing knowledge. Apart from Linux, I love classic detective mysteries. I'm a huge fan of Agatha Christie's work.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://itsfoss.com/xenlism-theme/

|

||||

|

||||

作者:[Abhishek Prakash ][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://itsfoss.com/author/abhishek/

|

||||

[1]:https://itsfoss.com/author/abhishek/

|

||||

[2]:https://itsfoss.com/xenlism-theme/#comments

|

||||

[3]:https://itsfoss.com/category/desktop/

|

||||

[4]:https://itsfoss.com/tag/themes/

|

||||

[5]:https://itsfoss.com/tag/xenlism/

|

||||

[6]:https://itsfoss.com/best-gtk-themes/

|

||||

[7]:https://itsfoss.com/pop-icon-gtk-theme-ubuntu/

|

||||

[8]:https://itsfoss.com/best-icon-themes-ubuntu-16-04/

|

||||

[9]:https://itsfoss.com/install-themes-ubuntu/

|

||||

[10]:http://xenlism.github.io/minimalism/#install

|

||||

@ -1,3 +1,5 @@

|

||||

pinewall translating

|

||||

|

||||

How Graphics Cards Work

|

||||

======

|

||||

![AMD-Polaris][1]

|

||||

|

||||

@ -1,311 +0,0 @@

|

||||

pinewall translating

|

||||

|

||||

Using MQTT to send and receive data for your next project

|

||||

======

|

||||

|

||||

|

||||

|

||||

Last November we bought an electric car, and it raised an interesting question: When should we charge it? I was concerned about having the lowest emissions for the electricity used to charge the car, so this is a specific question: What is the rate of CO2 emissions per kWh at any given time, and when during the day is it at its lowest?

|

||||

|

||||

### Finding the data

|

||||

|

||||

I live in New York State. About 80% of our electricity comes from in-state generation, mostly through natural gas, hydro dams (much of it from Niagara Falls), nuclear, and a bit of wind, solar, and other fossil fuels. The entire system is managed by the [New York Independent System Operator][1] (NYISO), a not-for-profit entity that was set up to balance the needs of power generators, consumers, and regulatory bodies to keep the lights on in New York.

|

||||

|

||||

Although there is no official public API, as part of its mission, NYISO makes [a lot of open data][2] available for public consumption. This includes reporting on what fuels are being consumed to generate power, at five-minute intervals, throughout the state. These are published as CSV files on a public archive and updated throughout the day. If you know the number of megawatts coming from different kinds of fuels, you can make a reasonable approximation of how much CO2 is being emitted at any given time.

|

||||

|

||||

We should always be kind when building tools to collect and process open data to avoid overloading those systems. Instead of sending everyone to their archive service to download the files all the time, we can do better. We can create a low-overhead event stream that people can subscribe to and get updates as they happen. We can do that with [MQTT][3]. The target for my project ([ny-power.org][4]) was inclusion in the [Home Assistant][5] project, an open source home automation platform that has hundreds of thousands of users. If all of these users were hitting this CSV server all the time, NYISO might need to restrict access to it.

|

||||

|

||||

### What is MQTT?

|

||||

|

||||

MQTT is a publish/subscribe (pubsub) wire protocol designed with small devices in mind. Pubsub systems work like a message bus. You send a message to a topic, and any software with a subscription for that topic gets a copy of your message. As a sender, you never really know who is listening; you just provide your information to a set of topics and listen for any other topics you might care about. It's like walking into a party and listening for interesting conversations to join.

|

||||

|

||||

This can make for extremely efficient applications. Clients subscribe to a narrow selection of topics and only receive the information they are looking for. This saves both processing time and network bandwidth.

|

||||

|

||||

As an open standard, MQTT has many open source implementations of both clients and servers. There are client libraries for every language you could imagine, even a library you can embed in Arduino for making sensor networks. There are many servers to choose from. My go-to is the [Mosquitto][6] server from Eclipse, as it's small, written in C, and can handle tens of thousands of subscribers without breaking a sweat.

|

||||

|

||||

### Why I like MQTT

|

||||

|

||||

Over the past two decades, we've come up with tried and true models for software applications to ask questions of services. Do I have more email? What is the current weather? Should I buy this thing now? This pattern of "ask/receive" works well much of the time; however, in a world awash with data, there are other patterns we need. The MQTT pubsub model is powerful where lots of data is published inbound to the system. Clients can subscribe to narrow slices of data and receive updates instantly when that data comes in.

|

||||

|

||||

MQTT also has additional interesting features, such as "last-will-and-testament" messages, which make it possible to distinguish between silence because there is no relevant data and silence because your data collectors have crashed. MQTT also has retained messages, which provide the last message on a topic to clients when they first connect. This is extremely useful for topics that update slowly.

|

||||

|

||||

In my work with the Home Assistant project, I've found this message bus model works extremely well for heterogeneous systems. If you dive into the Internet of Things space, you'll quickly run into MQTT everywhere.

|

||||

|

||||

### Our first MQTT stream

|

||||

|

||||

One of NYSO's CSV files is the real-time fuel mix. Every five minutes, it's updated with the fuel sources and power generated (in megawatts) during that time period.

|

||||

|

||||

The CSV file looks something like this:

|

||||

|

||||

| Time Stamp | Time Zone | Fuel Category | Gen MW |

|

||||

| 05/09/2018 00:05:00 | EDT | Dual Fuel | 1400 |

|

||||

| 05/09/2018 00:05:00 | EDT | Natural Gas | 2144 |

|

||||

| 05/09/2018 00:05:00 | EDT | Nuclear | 4114 |

|

||||

| 05/09/2018 00:05:00 | EDT | Other Fossil Fuels | 4 |

|

||||

| 05/09/2018 00:05:00 | EDT | Other Renewables | 226 |

|

||||

| 05/09/2018 00:05:00 | EDT | Wind | 1 |

|

||||

| 05/09/2018 00:05:00 | EDT | Hydro | 3229 |

|

||||

| 05/09/2018 00:10:00 | EDT | Dual Fuel | 1307 |

|

||||

| 05/09/2018 00:10:00 | EDT | Natural Gas | 2092 |

|

||||

| 05/09/2018 00:10:00 | EDT | Nuclear | 4115 |

|

||||

| 05/09/2018 00:10:00 | EDT | Other Fossil Fuels | 4 |

|

||||

| 05/09/2018 00:10:00 | EDT | Other Renewables | 224 |

|

||||

| 05/09/2018 00:10:00 | EDT | Wind | 40 |

|

||||

| 05/09/2018 00:10:00 | EDT | Hydro | 3166 |

|

||||

|

||||

The only odd thing in the table is the dual-fuel category. Most natural gas plants in New York can also burn other fossil fuel to generate power. During cold snaps in the winter, the natural gas supply gets constrained, and its use for home heating is prioritized over power generation. This happens at a low enough frequency that we can consider dual fuel to be natural gas (for our calculations).

|

||||

|

||||

The file is updated throughout the day. I created a simple data pump that polls for the file every minute and looks for updates. It publishes any new entries out to the MQTT server into a set of topics that largely mirror this CSV file. The payload is turned into a JSON object that is easy to parse from nearly any programming language.

|

||||

```

|

||||

ny-power/upstream/fuel-mix/Hydro {"units": "MW", "value": 3229, "ts": "05/09/2018 00:05:00"}

|

||||

|

||||

ny-power/upstream/fuel-mix/Dual Fuel {"units": "MW", "value": 1400, "ts": "05/09/2018 00:05:00"}

|

||||

|

||||

ny-power/upstream/fuel-mix/Natural Gas {"units": "MW", "value": 2144, "ts": "05/09/2018 00:05:00"}

|

||||

|

||||

ny-power/upstream/fuel-mix/Other Fossil Fuels {"units": "MW", "value": 4, "ts": "05/09/2018 00:05:00"}

|

||||

|

||||

ny-power/upstream/fuel-mix/Wind {"units": "MW", "value": 41, "ts": "05/09/2018 00:05:00"}

|

||||

|

||||

ny-power/upstream/fuel-mix/Other Renewables {"units": "MW", "value": 226, "ts": "05/09/2018 00:05:00"}

|

||||

|

||||

ny-power/upstream/fuel-mix/Nuclear {"units": "MW", "value": 4114, "ts": "05/09/2018 00:05:00"}

|

||||

|

||||

```

|

||||

|

||||

This direct reflection is a good first step in turning open data into open events. We'll be converting this into a CO2 intensity, but other applications might want these raw feeds to do other calculations with them.

|

||||

|

||||

### MQTT topics

|

||||

|

||||

Topics and topic structures are one of MQTT's major design points. Unlike more "enterprisey" message buses, in MQTT topics are not preregistered. A sender can create topics on the fly, the only limit being that they are less than 220 characters. The `/` character is special; it's used to create topic hierarchies. As we'll soon see, you can subscribe to slices of data in these hierarchies.

|

||||

|

||||

Out of the box with Mosquitto, every client can publish to any topic. While it's great for prototyping, before going to production you'll want to add an access control list (ACL) to restrict writing to authorized applications. For example, my app's tree is accessible to everyone in read-only format, but only clients with specific credentials can publish to it.

|

||||

|

||||

There is no automatic schema around topics nor a way to discover all the possible topics that clients will publish to. You'll have to encode that understanding directly into any application that consumes the MQTT bus.

|

||||

|

||||

So how should you design your topics? The best practice is to start with an application-specific root name, in our case, `ny-power`. After that, build a hierarchy as deep as you need for efficient subscription. The `upstream` tree will contain data that comes directly from an upstream source without any processing. Our `fuel-mix` category is a specific type of data. We may add others later.

|

||||

|

||||

### Subscribing to topics

|

||||

|

||||

Subscriptions in MQTT are simple string matches. For processing efficiency, only two wildcards are allowed:

|

||||

|

||||

* `#` matches everything recursively to the end

|

||||

* `+` matches only until the next `/` character

|

||||

|

||||

|

||||

|

||||

It's easiest to explain this with some examples:

|

||||

```

|

||||

ny-power/# - match everything published by the ny-power app

|

||||

|

||||

ny-power/upstream/# - match all raw data

|

||||

|

||||

ny-power/upstream/fuel-mix/+ - match all fuel types

|

||||

|

||||

ny-power/+/+/Hydro - match everything about Hydro power that's

|

||||

|

||||

nested 2 deep (even if it's not in the upstream tree)

|

||||

|

||||

```

|

||||

|

||||

A wide subscription like `ny-power/#` is common for low-volume applications. Just get everything over the network and handle it in your own application. This works poorly for high-volume applications, as most of the network bandwidth will be wasted as you drop most of the messages on the floor.

|

||||

|

||||

To stay performant at higher volumes, applications will do some clever topic slides like `ny-power/+/+/Hydro` to get exactly the cross-section of data they need.

|

||||

|

||||

### Adding our next layer of data

|

||||

|

||||

From this point forward, everything in the application will work off existing MQTT streams. The first additional layer of data is computing the power's CO2 intensity.

|

||||

|

||||

Using the 2016 [U.S. Energy Information Administration][7] numbers for total emissions and total power by fuel type in New York, we can come up with an [average emissions rate][8] per megawatt hour of power.

|

||||

|

||||

This is encapsulated in a dedicated microservice. This has a subscription on `ny-power/upstream/fuel-mix/+`, which matches all upstream fuel-mix entries from the data pump. It then performs the calculation and publishes out to a new topic tree:

|

||||

```

|

||||

ny-power/computed/co2 {"units": "g / kWh", "value": 152.9486, "ts": "05/09/2018 00:05:00"}

|

||||

|

||||

```

|

||||

|

||||

In turn, there is another process that subscribes to this topic tree and archives that data into an [InfluxDB][9] instance. It then publishes a 24-hour time series to `ny-power/archive/co2/24h`, which makes it easy to graph the recent changes.

|

||||

|

||||

This layer model works well, as the logic for each of these programs can be distinct from each other. In a more complicated system, they may not even be in the same programming language. We don't care, because the interchange format is MQTT messages, with well-known topics and JSON payloads.

|

||||

|

||||

### Consuming from the command line

|

||||

|

||||

To get a feel for MQTT in action, it's useful to just attach it to a bus and see the messages flow. The `mosquitto_sub` program included in the `mosquitto-clients` package is a simple way to do that.

|

||||

|

||||

After you've installed it, you need to provide a server hostname and the topic you'd like to listen to. The `-v` flag is important if you want to see the topics being posted to. Without that, you'll see only the payloads.

|

||||

```

|

||||

mosquitto_sub -h mqtt.ny-power.org -t ny-power/# -v

|

||||

|

||||

```

|

||||

|

||||

Whenever I'm writing or debugging an MQTT application, I always have a terminal with `mosquitto_sub` running.

|

||||

|

||||

### Accessing MQTT directly from the web

|

||||

|

||||

We now have an application providing an open event stream. We can connect to it with our microservices and, with some command-line tooling, it's on the internet for all to see. But the web is still king, so it's important to get it directly into a user's browser.

|

||||

|

||||

The MQTT folks thought about this one. The protocol specification is designed to work over three transport protocols: [TCP][10], [UDP][11], and [WebSockets][12]. WebSockets are supported by all major browsers as a way to retain persistent connections for real-time applications.

|

||||

|

||||

The Eclipse project has a JavaScript implementation of MQTT called [Paho][13], which can be included in your application. The pattern is to connect to the host, set up some subscriptions, and then react to messages as they are received.

|

||||

```

|

||||

// ny-power web console application

|

||||

|

||||

var client = new Paho.MQTT.Client(mqttHost, Number("80"), "client-" + Math.random());

|

||||

|

||||

|

||||

|

||||

// set callback handlers

|

||||

|

||||

client.onMessageArrived = onMessageArrived;

|

||||

|

||||

|

||||

|

||||

// connect the client

|

||||

|

||||

client.reconnect = true;

|

||||

|

||||

client.connect({onSuccess: onConnect});

|

||||

|

||||

|

||||

|

||||

// called when the client connects

|

||||

|

||||

function onConnect() {

|

||||

|

||||

// Once a connection has been made, make a subscription and send a message.

|

||||

|

||||

console.log("onConnect");

|

||||

|

||||

client.subscribe("ny-power/computed/co2");

|

||||

|

||||

client.subscribe("ny-power/archive/co2/24h");

|

||||

|

||||

client.subscribe("ny-power/upstream/fuel-mix/#");

|

||||

|

||||

}

|

||||

|

||||

|

||||

|

||||

// called when a message arrives

|

||||

|

||||

function onMessageArrived(message) {

|

||||

|

||||

console.log("onMessageArrived:"+message.destinationName + message.payloadString);

|

||||

|

||||

if (message.destinationName == "ny-power/computed/co2") {

|

||||

|

||||

var data = JSON.parse(message.payloadString);

|

||||

|

||||

$("#co2-per-kwh").html(Math.round(data.value));

|

||||

|

||||

$("#co2-units").html(data.units);

|

||||

|

||||

$("#co2-updated").html(data.ts);

|

||||

|

||||

}

|

||||

|

||||

if (message.destinationName.startsWith("ny-power/upstream/fuel-mix")) {

|

||||

|

||||

fuel_mix_graph(message);

|

||||

|

||||

}

|

||||

|

||||

if (message.destinationName == "ny-power/archive/co2/24h") {

|

||||

|

||||

var data = JSON.parse(message.payloadString);

|

||||

|

||||

var plot = [

|

||||

|

||||

{

|

||||

|

||||

x: data.ts,

|

||||

|

||||

y: data.values,

|

||||

|

||||

type: 'scatter'

|

||||

|

||||

}

|

||||

|

||||

];

|

||||

|

||||

var layout = {

|

||||

|

||||

yaxis: {

|

||||

|

||||

title: "g CO2 / kWh",

|

||||

|

||||

}

|

||||

|

||||

};

|

||||

|

||||

Plotly.newPlot('co2_graph', plot, layout);

|

||||

|

||||

}

|

||||

|

||||

```

|

||||

|

||||

This application subscribes to a number of topics because we're going to display a few different kinds of data. The `ny-power/computed/co2` topic provides us a topline number of current intensity. Whenever we receive that topic, we replace the related contents on the site.

|

||||

|

||||

|

||||

![NY ISO Grid CO2 Intensity][15]

|

||||

|

||||

NY ISO Grid CO2 Intensity graph from [ny-power.org][4].

|

||||

|

||||

The `ny-power/archive/co2/24h` topic provides a time series that can be loaded into a [Plotly][16] line graph. And `ny-power/upstream/fuel-mix` provides the data needed to provide a nice bar graph of the current fuel mix.

|

||||

|

||||

|

||||

![Fuel mix on NYISO grid][18]

|

||||

|

||||

Fuel mix on NYISO grid, [ny-power.org][4].

|

||||

|

||||

This is a dynamic website that is not polling the server. It is attached to the MQTT bus and listening on its open WebSocket. The webpage is a pub/sub client just like the data pump and the archiver. This one just happens to be executing in your browser instead of a microservice in the cloud.

|

||||

|

||||

You can see the page in action at <http://ny-power.org>. That includes both the graphics and a real-time MQTT console to see the messages as they come in.

|

||||

|

||||

### Diving deeper

|

||||

|

||||

The entire ny-power.org application is [available as open source on GitHub][19]. You can also check out [this architecture overview][20] to see how it was built as a set of Kubernetes microservices deployed with [Helm][21]. You can see another interesting MQTT application example with [this code pattern][22] using MQTT and OpenWhisk to translate text messages in real time.

|

||||

|

||||

MQTT is used extensively in the Internet of Things space, and many more examples of MQTT use can be found at the [Home Assistant][23] project.

|

||||

|

||||

And if you want to dive deep into the protocol, [mqtt.org][3] has all the details for this open standard.

|

||||

|

||||

To learn more, attend Sean Dague's talk, [Adding MQTT to your toolkit][24], at [OSCON][25], which will be held July 16-19 in Portland, Oregon.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/6/mqtt

|

||||

|

||||

作者:[Sean Dague][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/sdague

|

||||

[1]:http://www.nyiso.com/public/index.jsp

|

||||

[2]:http://www.nyiso.com/public/markets_operations/market_data/reports_info/index.jsp

|

||||

[3]:http://mqtt.org/

|

||||

[4]:http://ny-power.org/#

|

||||

[5]:https://www.home-assistant.io

|

||||

[6]:https://mosquitto.org/

|

||||

[7]:https://www.eia.gov/

|

||||

[8]:https://github.com/IBM/ny-power/blob/master/src/nypower/calc.py#L1-L60

|

||||

[9]:https://www.influxdata.com/

|

||||

[10]:https://en.wikipedia.org/wiki/Transmission_Control_Protocol

|

||||

[11]:https://en.wikipedia.org/wiki/User_Datagram_Protocol

|

||||

[12]:https://en.wikipedia.org/wiki/WebSocket

|

||||

[13]:https://www.eclipse.org/paho/

|

||||

[14]:/file/400041

|

||||

[15]:https://opensource.com/sites/default/files/uploads/mqtt_nyiso-co2intensity.png (NY ISO Grid CO2 Intensity)

|

||||

[16]:https://plot.ly/

|

||||

[17]:/file/400046

|

||||

[18]:https://opensource.com/sites/default/files/uploads/mqtt_nyiso_fuel-mix.png (Fuel mix on NYISO grid)

|

||||

[19]:https://github.com/IBM/ny-power

|

||||

[20]:https://developer.ibm.com/code/patterns/use-mqtt-stream-real-time-data/

|

||||

[21]:https://helm.sh/

|

||||

[22]:https://developer.ibm.com/code/patterns/deploy-serverless-multilingual-conference-room/

|

||||

[23]:https://www.home-assistant.io/

|

||||

[24]:https://conferences.oreilly.com/oscon/oscon-or/public/schedule/speaker/77317

|

||||

[25]:https://conferences.oreilly.com/oscon/oscon-or

|

||||

@ -1,3 +1,4 @@

|

||||

Translating by qhwdw

|

||||

How to reset, revert, and return to previous states in Git

|

||||

======

|

||||

|

||||

|

||||

@ -1,3 +1,4 @@

|

||||

Translating by qhwdw

|

||||

Bitcoin is a Cult — Adam Caudill

|

||||

======

|

||||

The Bitcoin community has changed greatly over the years; from technophiles that could explain a [Merkle tree][1] in their sleep, to speculators driven by the desire for a quick profit & blockchain startups seeking billion dollar valuations led by people who don’t even know what a Merkle tree is. As the years have gone on, a zealotry has been building around Bitcoin and other cryptocurrencies driven by people who see them as something far grander than they actually are; people who believe that normal (or fiat) currencies are becoming a thing of the past, and the cryptocurrencies will fundamentally change the world’s economy.

|

||||

|

||||

@ -1,3 +1,4 @@

|

||||

Translating by qhwdw

|

||||

How to Run Windows Apps on Android with Wine

|

||||

======

|

||||

|

||||

|

||||

@ -1,3 +1,4 @@

|

||||

Translating by qhwdw

|

||||

A sysadmin's guide to network management

|

||||

======

|

||||

|

||||

|

||||

@ -1,3 +1,4 @@

|

||||

Translating by qhwdw

|

||||

15 open source applications for MacOS

|

||||

======

|

||||

|

||||

|

||||

@ -1,92 +0,0 @@

|

||||

6 open source cryptocurrency wallets

|

||||

======

|

||||

|

||||

|

||||

|

||||

Without crypto wallets, cryptocurrencies like Bitcoin and Ethereum would just be another pie-in-the-sky idea. These wallets are essential for keeping, sending, and receiving cryptocurrencies.

|

||||

|

||||

The revolutionary growth of [cryptocurrencies][1] is attributed to the idea of decentralization, where a central authority is absent from the network and everyone has a level playing field. Open source technology is at the heart of cryptocurrencies and [blockchain][2] networks. It has enabled the vibrant, nascent industry to reap the benefits of decentralization—such as immutability, transparency, and security.

|

||||

|

||||

If you're looking for a free and open source cryptocurrency wallet, read on to start exploring whether any of the following options meet your needs.

|

||||

|

||||

### 1\. Copay

|

||||

|

||||

[Copay][3] is an open source Bitcoin crypto wallet that promises convenient storage. The software is released under the [MIT License][4].

|

||||

|

||||

The Copay server is also open source. Therefore, developers and Bitcoin enthusiasts can assume complete control of their activities by deploying their own applications on the server.

|

||||

|

||||

The Copay wallet empowers you to take the security of your Bitcoin in your own hands, instead of trusting unreliable third parties. It allows you to use multiple signatories for approving transactions and supports the storage of multiple, separate wallets within the same app.

|

||||

|

||||

Copay is available for a range of platforms, such as Android, Windows, MacOS, Linux, and iOS.

|

||||

|

||||

### 2\. MyEtherWallet

|

||||

|

||||

As the name implies, [MyEtherWallet][5] (abbreviated MEW) is a wallet for Ethereum transactions. It is open source (under the [MIT License][6]) and is completely online, accessible through a web browser.

|

||||

|

||||

The wallet has a simple client-side interface, which allows you to participate in the Ethereum blockchain confidently and securely.

|

||||

|

||||

### 3\. mSIGNA

|

||||

|

||||

[mSIGNA][7] is a powerful desktop application for completing transactions on the Bitcoin network. It is released under the [MIT License][8] and is available for MacOS, Windows, and Linux.

|

||||

|

||||

The blockchain wallet provides you with complete control over your Bitcoin stash. Some of its features include user-friendliness, versatility, decentralized offline key generation capabilities, encrypted data backups, and multi-device synchronization.

|

||||

|

||||

### 4\. Armory

|

||||

|

||||

[Armory][9] is an open source wallet (released under the [GNU AGPLv3][10]) for producing and keeping Bitcoin private keys on your computer. It enhances security by providing users with cold storage and multi-signature support capabilities.

|

||||

|

||||

With Armory, you can set up a wallet on a computer that is completely offline; you'll use the watch-only feature for observing your Bitcoin details on the internet, which improves security. The wallet also allows you to create multiple addresses and use them to complete different transactions.

|

||||

|

||||

Armory is available for MacOS, Windows, and several flavors of Linux (including Raspberry Pi).

|

||||

|

||||

### 5\. Electrum

|

||||

|

||||

[Electrum][11] is a Bitcoin wallet that navigates the thin line between beginner user-friendliness and expert functionality. The open source wallet is released under the [MIT License][12].

|

||||

|

||||

Electrum encrypts your private keys locally, supports cold storage, and provides multi-signature capabilities with minimal resource usage on your machine.

|

||||

|

||||

It is available for a wide range of operating systems and devices, including Windows, MacOS, Android, iOS, and Linux, and hardware wallets such as [Trezor][13].

|

||||

|

||||

### 6\. Etherwall

|

||||

|

||||

[Etherwall][14] is the first wallet for storing and sending Ethereum on the desktop. The open source wallet is released under the [GPLv3 License][15].

|

||||

|

||||

Etherwall is intuitive and fast. What's more, to enhance the security of your private keys, you can operate it on a full node or a thin node. Running it as a full-node client will enable you to download the whole Ethereum blockchain on your local machine.

|

||||

|

||||

Etherwall is available for MacOS, Linux, and Windows, and it also supports the Trezor hardware wallet.

|

||||

|

||||

### Words to the wise

|

||||

|

||||

Open source and free crypto wallets are playing a vital role in making cryptocurrencies easily available to more people.

|

||||

|

||||

Before using any digital currency software wallet, make sure to do your due diligence to protect your security, and always remember to comply with best practices for safeguarding your finances.

|

||||

|

||||

If your favorite open source cryptocurrency wallet is not on this list, please share what you know in the comment section below.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/7/crypto-wallets

|

||||

|

||||

作者:[Dr.Michael J.Garbade][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/drmjg

|

||||

[1]:https://www.liveedu.tv/guides/cryptocurrency/

|

||||

[2]:https://opensource.com/tags/blockchain

|

||||

[3]:https://copay.io/

|

||||

[4]:https://github.com/bitpay/copay/blob/master/LICENSE

|

||||

[5]:https://www.myetherwallet.com/

|

||||

[6]:https://github.com/kvhnuke/etherwallet/blob/mercury/LICENSE.md

|

||||

[7]:https://ciphrex.com/

|

||||

[8]:https://github.com/ciphrex/mSIGNA/blob/master/LICENSE

|

||||

[9]:https://www.bitcoinarmory.com/

|

||||

[10]:https://github.com/etotheipi/BitcoinArmory/blob/master/LICENSE

|

||||

[11]:https://electrum.org/#home

|

||||

[12]:https://github.com/spesmilo/electrum/blob/master/LICENCE

|

||||

[13]:https://trezor.io/

|

||||

[14]:https://www.etherwall.com/

|

||||

[15]:https://github.com/almindor/etherwall/blob/master/LICENSE

|

||||

@ -1,3 +1,4 @@

|

||||

Translating by qhwdw

|

||||

A sysadmin's guide to SELinux: 42 answers to the big questions

|

||||

======

|

||||

|

||||

|

||||

@ -1,3 +1,5 @@

|

||||

translating---geekpi

|

||||

|

||||

Convert video using Handbrake

|

||||

======

|

||||

|

||||

|

||||

@ -0,0 +1,284 @@

|

||||

Building a network attached storage device with a Raspberry Pi

|

||||

======

|

||||

|

||||

|

||||

|

||||

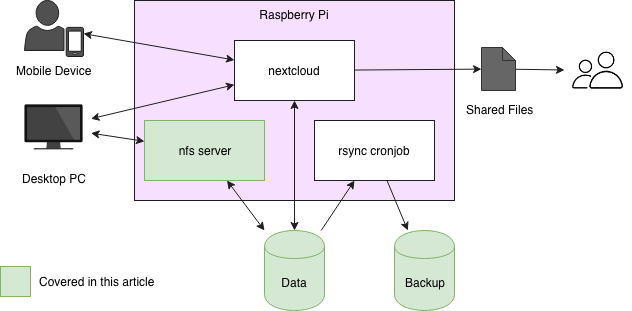

In this three-part series, I'll explain how to set up a simple, useful NAS (network attached storage) system. I use this kind of setup to store my files on a central system, creating incremental backups automatically every night. To mount the disk on devices that are located in the same network, NFS is installed. To access files offline and share them with friends, I use [Nextcloud][1].

|

||||

|

||||

This article will cover the basic setup of software and hardware to mount the data disk on a remote device. In the second article, I will discuss a backup strategy and set up a cron job to create daily backups. In the third and last article, we will install Nextcloud, a tool for easy file access to devices synced offline as well as online using a web interface. It supports multiple users and public file-sharing so you can share pictures with friends, for example, by sending a password-protected link.

|

||||

|

||||

The target architecture of our system looks like this:

|

||||

|

||||

|

||||

### Hardware

|

||||

|

||||

Let's get started with the hardware you need. You might come up with a different shopping list, so consider this one an example.

|

||||

|

||||

The computing power is delivered by a [Raspberry Pi 3][2], which comes with a quad-core CPU, a gigabyte of RAM, and (somewhat) fast ethernet. Data will be stored on two USB hard drives (I use 1-TB disks); one is used for the everyday traffic, the other is used to store backups. Be sure to use either active USB hard drives or a USB hub with an additional power supply, as the Raspberry Pi will not be able to power two USB drives.

|

||||

|

||||

### Software

|

||||

|

||||

The operating system with the highest visibility in the community is [Raspbian][3] , which is excellent for custom projects. There are plenty of [guides][4] that explain how to install Raspbian on a Raspberry Pi, so I won't go into details here. The latest official supported version at the time of this writing is [Raspbian Stretch][5] , which worked fine for me.

|

||||

|

||||

At this point, I will assume you have configured your basic Raspbian and are able to connect to the Raspberry Pi by `ssh`.

|

||||

|

||||

### Prepare the USB drives

|

||||

|

||||

To achieve good performance reading from and writing to the USB hard drives, I recommend formatting them with ext4. To do so, you must first find out which disks are attached to the Raspberry Pi. You can find the disk devices in `/dev/sd/<x>`. Using the command `fdisk -l`, you can find out which two USB drives you just attached. Please note that all data on the USB drives will be lost as soon as you follow these steps.

|

||||

```

|

||||

pi@raspberrypi:~ $ sudo fdisk -l

|

||||

|

||||

|

||||

|

||||

<...>

|

||||

|

||||

|

||||

|

||||

Disk /dev/sda: 931.5 GiB, 1000204886016 bytes, 1953525168 sectors

|

||||

|

||||

Units: sectors of 1 * 512 = 512 bytes

|

||||

|

||||

Sector size (logical/physical): 512 bytes / 512 bytes

|

||||

|

||||

I/O size (minimum/optimal): 512 bytes / 512 bytes

|

||||

|

||||

Disklabel type: dos

|

||||

|

||||

Disk identifier: 0xe8900690

|

||||

|

||||

|

||||

|

||||

Device Boot Start End Sectors Size Id Type

|

||||

|

||||

/dev/sda1 2048 1953525167 1953523120 931.5G 83 Linux

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

Disk /dev/sdb: 931.5 GiB, 1000204886016 bytes, 1953525168 sectors

|

||||

|

||||

Units: sectors of 1 * 512 = 512 bytes

|

||||

|

||||

Sector size (logical/physical): 512 bytes / 512 bytes

|

||||

|

||||

I/O size (minimum/optimal): 512 bytes / 512 bytes

|

||||

|

||||

Disklabel type: dos

|

||||

|

||||

Disk identifier: 0x6aa4f598

|

||||

|

||||

|

||||

|

||||

Device Boot Start End Sectors Size Id Type

|

||||

|

||||

/dev/sdb1 * 2048 1953521663 1953519616 931.5G 83 Linux

|

||||

|

||||

```

|

||||

|

||||

As those devices are the only 1TB disks attached to the Raspberry Pi, we can easily see that `/dev/sda` and `/dev/sdb` are the two USB drives. The partition table at the end of each disk shows how it should look after the following steps, which create the partition table and format the disks. To do this, repeat the following steps for each of the two devices by replacing `sda` with `sdb` the second time (assuming your devices are also listed as `/dev/sda` and `/dev/sdb` in `fdisk`).

|

||||

|

||||

First, delete the partition table of the disk and create a new one containing only one partition. In `fdisk`, you can use interactive one-letter commands to tell the program what to do. Simply insert them after the prompt `Command (m for help):` as follows (you can also use the `m` command anytime to get more information):

|

||||

```

|

||||

pi@raspberrypi:~ $ sudo fdisk /dev/sda

|

||||

|

||||

|

||||

|

||||

Welcome to fdisk (util-linux 2.29.2).

|

||||

|

||||

Changes will remain in memory only, until you decide to write them.

|

||||

|

||||

Be careful before using the write command.

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

Command (m for help): o

|

||||

|

||||

Created a new DOS disklabel with disk identifier 0x9c310964.

|

||||

|

||||

|

||||

|

||||

Command (m for help): n

|

||||

|

||||

Partition type

|

||||

|

||||

p primary (0 primary, 0 extended, 4 free)

|

||||

|

||||

e extended (container for logical partitions)

|

||||

|

||||

Select (default p): p

|

||||

|

||||

Partition number (1-4, default 1):

|

||||

|

||||

First sector (2048-1953525167, default 2048):

|

||||

|

||||

Last sector, +sectors or +size{K,M,G,T,P} (2048-1953525167, default 1953525167):

|

||||

|

||||

|

||||

|

||||

Created a new partition 1 of type 'Linux' and of size 931.5 GiB.

|

||||

|

||||

|

||||

|

||||

Command (m for help): p

|

||||

|

||||

|

||||

|

||||

Disk /dev/sda: 931.5 GiB, 1000204886016 bytes, 1953525168 sectors

|

||||

|

||||

Units: sectors of 1 * 512 = 512 bytes

|

||||

|

||||

Sector size (logical/physical): 512 bytes / 512 bytes

|

||||

|

||||

I/O size (minimum/optimal): 512 bytes / 512 bytes

|

||||

|

||||

Disklabel type: dos

|

||||

|

||||

Disk identifier: 0x9c310964

|

||||

|

||||

|

||||

|

||||

Device Boot Start End Sectors Size Id Type

|

||||

|

||||

/dev/sda1 2048 1953525167 1953523120 931.5G 83 Linux

|

||||

|

||||

|

||||

|

||||

Command (m for help): w

|

||||

|

||||

The partition table has been altered.

|

||||

|

||||

Syncing disks.

|

||||

|

||||

```