mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-21 02:10:11 +08:00

commit

35a2fa4a52

320

published/20140804 Group Test--Linux Text Editors.md

Normal file

320

published/20140804 Group Test--Linux Text Editors.md

Normal file

@ -0,0 +1,320 @@

|

||||

五款 Linux 文本编辑器测评

|

||||

================================================================================

|

||||

|

||||

> Mayank Sharma 测试了5款不仅仅是能处理文字的超强文本编辑器。

|

||||

|

||||

如果你使用Linux已经有很长一段时间,你知道,不管是编辑一款app的配置文件,还是修改shell脚本,或者编写/查看代码,类似LibreOffice的工具并不适合。尽管字面上看起来都是一样,但是你并不需要一个文字处理器来完成这些任务;你需要的是一个文本编辑器。

|

||||

|

||||

在这个测评中,我们将着眼于5款更能胜任繁重文本工作的轻量级的文本编辑器。他们支持语法高亮,像拼写检查一样轻松处理代码缩进。你可以像你复制/粘贴文本那样容易地使用它们记录宏以及管理代码片段。

|

||||

|

||||

得益于它们的插件,使得它们足以抗衡其它的以文本为中心的应用程序,一些简单的文本编辑器甚至超出了它们的设计目标。它们能胜任一个源代码编辑器的任务,甚至就是一个集成开发环境。

|

||||

|

||||

Emacs和Vim是两款最流行和强大的纯文本编辑器。但是,由于一些原因,我们在这个测评中并没有包括它们。首先,如果你使用它们中的任何一个,那么恭喜你:你不需要更换了。其次,它们都有陡峭的学习曲线,尤其是那些熟悉了桌面环境的用户:他们很更愿意投入其他有图形界面的文本编辑器。

|

||||

|

||||

### 目录: ###

|

||||

|

||||

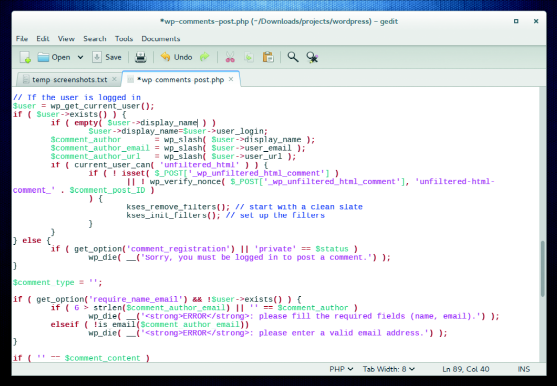

#### Gedit ####

|

||||

|

||||

- URL:http://projects.gnome.org/gedit/

|

||||

- 版本: 3.10

|

||||

- 许可证: GPL

|

||||

- Gnome的默认文本编辑器准备好挑战了吗?

|

||||

|

||||

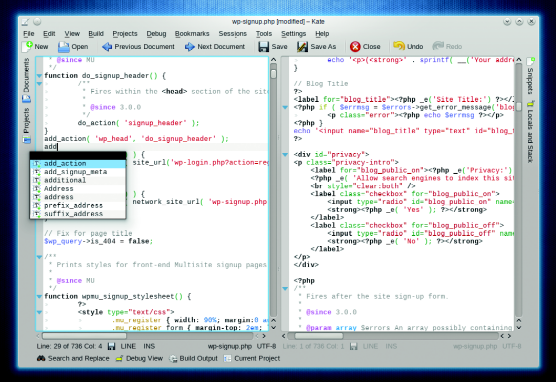

#### Kate ####

|

||||

|

||||

- URL: www.kate-editor.org

|

||||

- 版本: 3.11

|

||||

- 许可证: LGPL/GPL

|

||||

- Kate会挑战命运吗?

|

||||

|

||||

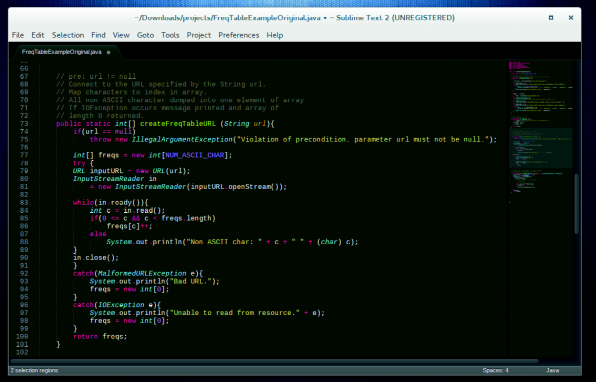

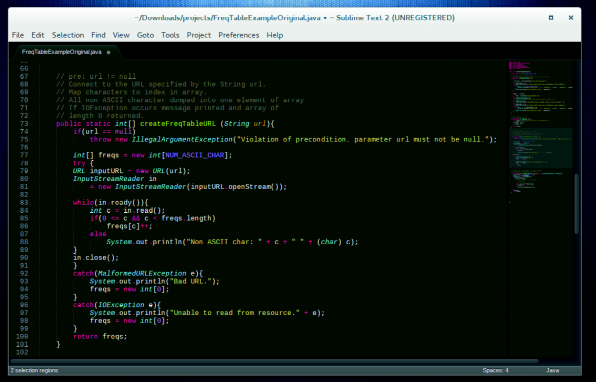

#### Sublime Text ####

|

||||

|

||||

- URL: www.sublimetext.com

|

||||

- 版本: 2.0.2

|

||||

- 许可证: Proprietary

|

||||

- 在自由的土地上的带有黄金般的心脏的专利软件。

|

||||

|

||||

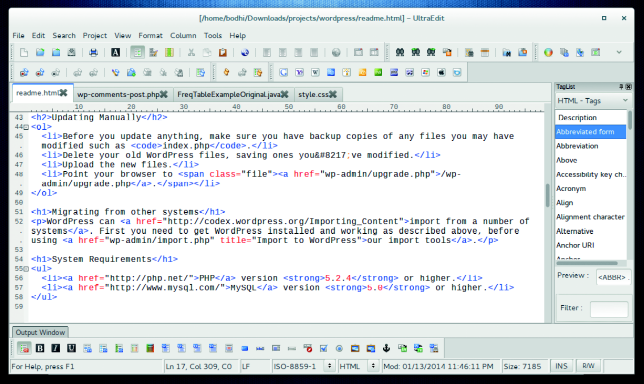

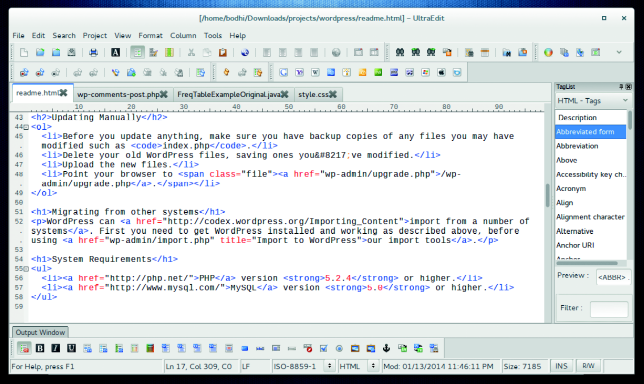

#### UltraEdit ####

|

||||

|

||||

- URL: www.ultraedit.com

|

||||

- 版本: 4.1.0.4

|

||||

- 许可证: Proprietary

|

||||

- 足够证明它的价值了吗?

|

||||

|

||||

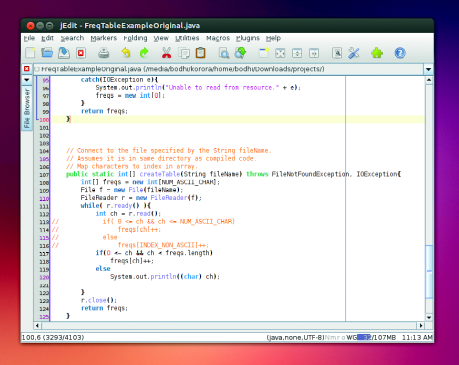

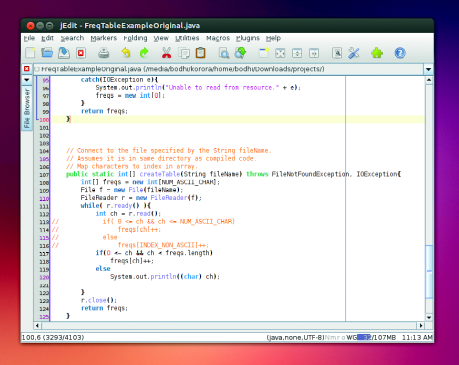

#### jEdit ####

|

||||

|

||||

- URL: www.jedit.org

|

||||

- 版本: 5.1.0

|

||||

- 许可证: GPL

|

||||

- 基于Java的编辑器是否会毁掉其他编辑器的世界?

|

||||

|

||||

|

||||

### 关键标准 ###

|

||||

|

||||

除了Gedit和jEdit以外的所有工具,都是通过其推荐的安装方法安装在Fedora和Ubuntu上。前者已经兼容默认的Gnome桌面,后者仍然固执地反对安装在Fedora上。由于这些是相对简单的应用程序,他们没有复杂的依赖,唯一例外的是jEdit,它要求要有Oracle Java。

|

||||

|

||||

得益于Gnome和KDE持续的努力,所有编辑器无论在哪个桌面上的外观看起来很好,功能也很正常。这不仅是作为评价的标准,也意味着你不再受制于你的桌面环境兼容的工具。

|

||||

|

||||

除了它们独特的功能,我们也对所有候选者测试了常规的文本编辑功能。然而,它们并没有被设计为模仿现代字处理器的所有功能,我们也不以此评判。

|

||||

|

||||

|

||||

### 编程语言支持 ###

|

||||

|

||||

UltraEdit 能进行语法高亮、代码折叠以及拥有项目管理的能力。也有一个罗列源文件中所有函数的功能列表,但并不适用于我们测试的任何代码文件。UltraEdit也支持HTML5,有一个能添加常用HTML标记的HTML工具栏。

|

||||

|

||||

即使Gnome的默认文本编辑器Gedit,也有几个面向编码的功能特性,例如括号匹配、自动缩进以及为包括C, C++, Java, HTML, XML, Python, Perl, 以及许多其它编程语言进行语法高亮。

|

||||

|

||||

如果你需要更多的编程辅助功能,看一下Sublime和Kate。

|

||||

|

||||

Sublime支持多种编程语言并且能为(那些流行的)C#, D, Dylan, Erlang, Groovy, Haskell, Lisp, Lua, MATLAB, OCaml, R, 甚至 SQL 进行语法高亮。如果这还不够,你可以下载插件以支持更多的语言。另外,它的语法高亮功能提供了多个可定制选项。这个应用程序也会进行括号匹配,确保代码段都正确,Sublime的自动补全功能也支持用户创建的变量。就像Komodo IDE,Sublime也可以显示一个全部源代码的滚动预览图,这对于长代码文件导航和在文件中的不同部分跳转很方便。Sublime最好的功能之一就是能在编辑器内部运行特定语言,例如C++, Python, Ruby等的代码,当然假设在你的电脑上安装有编译器以及其它系统工具。省时间而且不用再开终端.

|

||||

|

||||

你也可以用插件在Kate中开启构建系统功能。另外,你可以为GDB调试器添加一个简单的前端。Kate能和Git,Subversion以及Mercurial版本控制系统一起工作,也提供了一些项目管理的功能。除了能为超过180种语言进行语法高亮,它支持所有的这些辅助功能,例如括号匹配,自动补全和自动缩进。它也支持代码折叠,甚至在一个程序中折叠函数。

|

||||

|

||||

唯一的遗憾的是jEdit,它声称自己是一个程序员的文本编辑器,但它缺少其他的基本功能,例如代码折叠,它甚至不能提示或者补全函数.

|

||||

|

||||

**评分:**

|

||||

|

||||

- Gedit:3/5

|

||||

- Kate:5/5

|

||||

- Sublime:5/5

|

||||

- UltraEdit:3/5

|

||||

- jEdit:1/5

|

||||

|

||||

|

||||

### 键盘控制 ###

|

||||

|

||||

高级文本编辑器的用户希望能完全通过键盘控制和操作,一些应用程序甚至支持用户自定义快捷方式的键盘绑定。

|

||||

|

||||

你可以轻松的使用Gedit的扩展键盘快捷键。可以在编辑文件时通过工具的快捷键调用工具,例如对一个文档进行拼写检查。你可以看到应用程序内部的一系列默认快捷键,但并没有图形化的方式去自定义它们。相似的,在Sublime中自定义键盘绑定,你需要修改它的XML的键盘映射文件。Sublime由于缺少定义键盘快捷键的图形化界面而饱受批评,但长期使用的用户支持当前的基于文件的机制:这给了他们更多的控制能力。

|

||||

|

||||

UltraEdit为它"一切都可自定义"的座右铭感到自豪,这也包括键盘快捷键。你可以自定义菜单导航的热键,以及定义你自己的访问大量功能的组合键映射。

|

||||

|

||||

除了完全可自定义的键盘快捷键以外,jEdit也有为Emacs预定义的键映射。Kate在这方面尤其令人映像深刻。它有简单可访问的自定义键绑定窗口。你可以更改默认的键,或者定义替代的键。另外,Kate也有一个能使用户使用Vi键操作Kate的Vi模式。

|

||||

|

||||

**评分:**

|

||||

|

||||

- Gedit:2/5

|

||||

- Kate:5/5

|

||||

- Sublime:3/5

|

||||

- UltraEdit:4/5

|

||||

- jEdit:5/5

|

||||

|

||||

### 片段和宏 ###

|

||||

|

||||

宏通过自动化重复的步骤帮助你降低花费在编辑和组织数据上的时间,而代码片段通过创建可重用的源代码块为程序员扩展类似的功能。这两者都能节省你的时间。

|

||||

|

||||

标准的Gedit安装没有这两种功能中的任何一种,但是你可以通过独立的插件启用这些功能。片段插件随Gedit一起发布,但在Gedit内启用宏插件,则需要你手动下载和安装(被称为gedit-macropy,托管在GitHub上)。

|

||||

|

||||

Kate也同样通过插件的形式启用片段功能。一旦加入,插件也增加了PHP,Bash和Java的片段库。你可以在侧边栏中显示片段列表以便于访问。可以通过右击片段或者快捷键组合方式编辑它的内容。然而,令人惊讶的是,它不支持宏-尽管用户从2002年就不断要求!

|

||||

|

||||

jEdit也有一个启用片段的插件。它还可以从用户行为中记录宏或者你也可以用BeanShell 脚本语言(BeanShell支持像Perl和JavaScript那样将脚本对象封装为简单的方法)中写宏。jEdit也有一个可以从jEdit的网站中下载多种宏的插件。

|

||||

|

||||

Sublime有创建片段和宏的内建功能,也有为大多数编程语言经常使用的函数多种片段。

|

||||

|

||||

在UltraEdit中片段被称为智能模板,就像Sublime中一样,你可以根据正在编辑的源代码文件类型插入片段。要完成宏记录功能,UltraEdit还有集成了一个基于JavaScript的脚本语言引擎来完成自动任务。你也可以从该编辑器的网站中下载用户提交的宏和脚本。

|

||||

|

||||

**评分:**

|

||||

|

||||

- Gedit:3/5

|

||||

- Kate:1/5

|

||||

- Sublime:5/5

|

||||

- UltraEdit:5/5

|

||||

- jEdit:5/5

|

||||

|

||||

|

||||

### 易用性 ###

|

||||

|

||||

不像那些简陋的文本编辑器,这些文本编辑器在这方面可以适应从文档写作者到程序员的各种用户的需要。与精简应用程序相反,他们的开发者在寻找添加更多功能的途径。

|

||||

|

||||

尽管第一眼看上去这次测评中的大部分应用有一个很相似的布局,经过仔细的检查,你会发现一些可用性的差异。我们通过用户界面的合理使用来介绍它们的功能和特性,而不是铺天盖地地告诉读者。

|

||||

|

||||

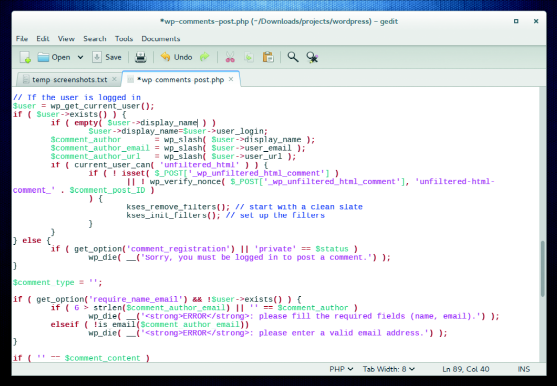

#### Gedit: 4/5 ####

|

||||

|

||||

Gedit的外观很普通,它有一个带有很少的菜单和按钮的简单界面。这是一把双刃剑,因为有些用户可能不会发现它真正的潜能。

|

||||

|

||||

Gedit可以在选项卡中打开多个文件,这些选项卡可以重排和在多个 Gedit窗口之间移动。用户可以选择通过插件来启用侧边栏来浏览文件或者在底部面板显示工具输出内容。这个应用程序会检测到被其它应用程序更改的文件并可以重新加载该文件。

|

||||

|

||||

为了适配Gnome,在应用程序的最新版本中做了大量的 UI 修改。然而修改还还不稳定,尽管包括了所有的功能,但是菜单交互的一些插件还需要升级。

|

||||

|

||||

|

||||

|

||||

*在功能与界面之间取得了良好的平衡,Gedit将其大部分功能隐藏在背后。*

|

||||

|

||||

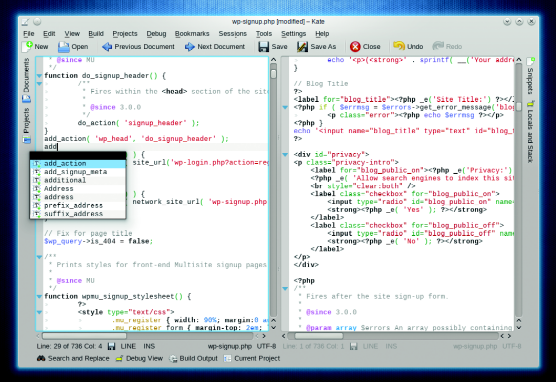

#### Kate: 5/5 ####

|

||||

|

||||

尽管用户界面的主要部分和Gedit相似,Kate可以在两边显示选项卡并且它的菜单更加丰富。该应用程序平易近人,吸引用户来挖掘它的其它功能。

|

||||

|

||||

Kate可以在KDE的KIO支持的所有协议上透明地打开和保存文件,包括通过HTTP, FTP, SSH, SMB 和 WebDAV。你可以用这个应用同时处理多个文件。但不同于大部分应用程序传统的水平选项卡选择栏,Kate在屏幕的两个方向都有选项卡。左侧的侧边栏显示打开的文件列表。需要同时查看一个文件不同部分的程序员也会感激它可以水平或者竖直分隔界面的能力。

|

||||

|

||||

|

||||

|

||||

*Kate能搭建为功能丰富的集成开发环境。*

|

||||

|

||||

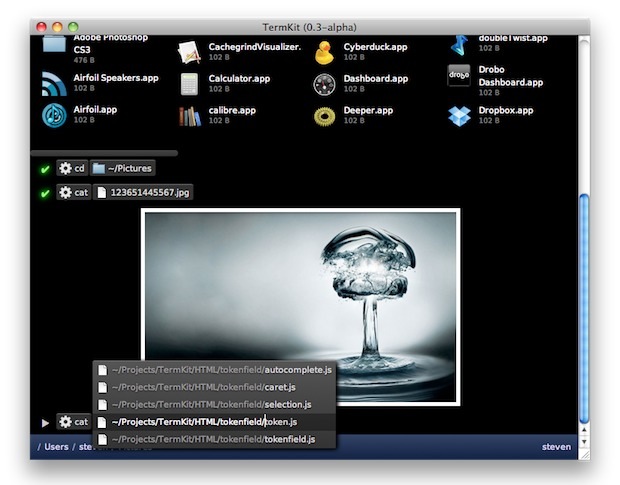

#### Sublime: 5/5 ####

|

||||

|

||||

Sublime支持你在不同方式同时查看多达四个文件。当你在集中精力编程时,它也有一个只显示文件和菜单的全屏无扰模式。

|

||||

|

||||

这个编辑器还在右边有个缩略地图,这在长文件中导航非常有用。应用程序为多种编程语言提供多种常用函数的片段,这使得它对于开发者非常有用。另一个精巧的功能是,无论你使用都是文本文档或者代码,都可以任意选择和替换。

|

||||

|

||||

|

||||

|

||||

*如果你不喜欢Sublime的Charcoal外观,你可以选择它包含的其它22种主题。*

|

||||

|

||||

#### UltraEdit: 3/5 ####

|

||||

|

||||

UltraEdit在界面的顶部和底部加载了多种工具栏。加上切换文档的选项卡、两边的面板,以及分隔区域,使得只剩下一点空间给编辑窗口。

|

||||

|

||||

使用HTML的网络开发者有很多唾手可得的帮助。你可以通过FTP和SFTP访问远程文件。高级功能,例如记录一个宏以及比较文件,也简单易用。

|

||||

|

||||

使用应用程序的偏好设置窗口,你可以调整应用程序的多个方面,包括颜色主题和类似语法高亮的其它功能。

|

||||

|

||||

|

||||

|

||||

*UltraEdit的用户界面是高度可配置的 — 你可以像改变其它许多方面那样简单的自定义工具栏和菜单的布局。*

|

||||

|

||||

#### jEdit: 3/5 ####

|

||||

|

||||

在可用性方面,首先一个不好就是jEdit不能在基于RPM的发行版上安装。导航编辑器需要一些时间来适应,因为它的菜单和其它流行的应用程序顺序不同,而且有些普通桌面用户不熟悉的名字。但是,该应用程序有详细的内部帮助,这有利于缓解学习曲线。

|

||||

|

||||

jEdit会高亮你所在的当前行,并使你能以多种查看方式分隔窗口。你可以简单地从应用程序中安装和管理插件,除了使用完整的宏,jEdit也支持你快速记录一个临时的宏。

|

||||

|

||||

|

||||

|

||||

*由于它的Java基础,jEdit在任何桌面环境中都不能给人宾至如归的感觉*

|

||||

|

||||

### 可用性和支持 ###

|

||||

|

||||

在Gedit和Kate之间有很多相似性。两个应用程序都得益于他们各自的父项目,Gnome和KDE,捆绑在各种主流的发行版中。另外两个项目都是跨平台的,有Windows和Mac OS X版本以及原生的Linux版本。

|

||||

|

||||

Gedit托管在Gnome的网站上,并有一个简单的用户指南、关于多种插件的信息,以及包括邮件列表和IRC通道在内的常用联系方式。你也可以在其它基于Gnome的发行版,例如Ubuntu中找到使用信息。相似地,Kate得益于KDE的资源,并包括详细的用户信息以及邮件列表和IRC通道。你也可以从应用程序中获取相应的离线用户指南。

|

||||

|

||||

除了Linux,UltraEdit在Windows和Mac OS X中也可用,虽然在应用程序中并没有包括,但在启动时也有详细的用户指南。为了辅助用户的使用,UltraEdit保存了一个常见问题的数据库,一系列关于多种特定功能的详细介绍,用户还可以在论坛版块彼此帮助。另外,付费用户也可以通过邮件从开发者中获取支持。

|

||||

|

||||

Sublime支持一样多的平台,但是你需要单独为每种平台购买许可证。开发者通过博客让用户了解正在进行的开发,并积极参加它的论坛。这个项目支持设施的亮点是提供免费的详细教程和视频课程。Sublime非常漂亮。

|

||||

|

||||

由于jEdit是用java编写的,所以它在多种平台中都可用。在它的网站上你可以找到一个详细的用户指南以及一些插件帮助文档的链接。然而,这里没有能使用户和其他用户或者开发者交流的途径。

|

||||

|

||||

**评分:**

|

||||

|

||||

- Gedit:4/5

|

||||

- Kate:4/5

|

||||

- Sublime:5/5

|

||||

- UltraEdit:3/5

|

||||

- jEdit:2/5

|

||||

|

||||

### 附加组件和插件 ###

|

||||

|

||||

不同的用户有不同的需求,一个简单的轻量级应用程序只能做到这么多。这就是为什么需要插件的原因。应用程序依赖于这些小部件来扩展它们的功能集并让更多的用户使用。

|

||||

|

||||

UltraEdit是一个例外。它没有第三方插件,但开发者将例如HtmlTidy这样的第三方工具集成到了UltraEdit。

|

||||

|

||||

Gedit附带了好多已安装的插件,你可以下载更多的更多gedit插件包。基于和Gedit版本的兼容性,项目网站也有到多个第三方插件的链接。

|

||||

|

||||

三个对程序员非常有用的插件是:Code Comment、在底部面板增加一个终端的Terminal Plugin以及Session Saver。当你用多个文件开发项目的时候Session Saver相当有用。你可以在选项卡中打开文件,保存会话,你可以用一键恢复,就可以按照你保存时的选项卡顺序打开所有的文件。

|

||||

|

||||

类似的,你可以通过用内部的插件管理器增加插件来扩展Kate。除了令人映像深刻的项目插件,一些开发者使用的插件包括嵌入式终端,它能编译和调试代码,以及对数据库执行SQL查询。

|

||||

|

||||

Sublime的插件是用Python写的,文本编辑器包括了一个类似于apt-get,能使用户查找,安装,升级和移除插件包的名为Package Control的工具。通过插件,你可以在Sublime中使用Git版本控制,以及美化JavaScript代码的JSLint工具。Sublime Linter能指出你代码中的错误,是编码人员必备的插件。

|

||||

|

||||

jEdit拥有最令人印象深刻的插件设施。该应用有超过200个插件,可以在它们自己的专用网站中浏览。网站通过不同的类型列出了插件,例如文件管理,版本控制,文本等。你可以在每个类型下找到很多的插件。

|

||||

|

||||

一些最好的插件是Android插件,它们提供了和Android项目协同工作的工具;你可以使用TomcatSwitch插件创建和控制外部Jakarta Tomcat服务器进程;以及类似于Vi功能的Vimulator插件。你可以通过使用jEdit的插件管理器安装这些插件。

|

||||

|

||||

**评分:**

|

||||

|

||||

- Gedit:3/5

|

||||

- Kate:4/5

|

||||

- Sublime:4/5

|

||||

- UltraEdit:1/5

|

||||

- jEdit:5/5

|

||||

|

||||

### 纯文本编辑 ###

|

||||

|

||||

尽管它们强大的额外功能甚至可能会取代几种完全成熟的应用程序,有时候可能只需要使用这些庞大的文本编辑器读、写或者编辑简单的纯文本。虽然你可以使用它们中的任何一个输入文本,我们通过普通文本编辑的方便性评价它们。

|

||||

|

||||

Gnome的默认文本编辑器Gedit,支持取消和重做机制以及搜索和替换。它可以对多种语言进行拼写检查,并能通过使用Gnome GVFS库访问和编辑远程文件。

|

||||

|

||||

你也可以使用Kate进行拼写检查,它也可以让你对任何高亮文本进行Google搜索。它还有一个能可视化告知用户文件中更改过但没有保存的行的行修改系统。另外,它通过允许用户在文件中使用书签简化长文档的导航。

|

||||

|

||||

Sublime有很多可选择的编辑命令,例如缩进文本和格式化段落。它的自动保存功能帮助防止用户丢失他们的更改。高级用户还会喜欢基于正则表达式的递归查找和替换功能,以及选择多个不连续的文本块并执行统一操作。

|

||||

|

||||

UltraEdit也允许用户在查找和替换功能中使用正则表达式,并能通过FTP编辑远程文件。

|

||||

|

||||

JEdit一个独特的功能是它支持被称为寄存器的不限数目的剪切板。你可以复制文本片段到这些寄存器中,在编辑会话过程中都可用。

|

||||

|

||||

**评分:**

|

||||

|

||||

- Gedit:4/5

|

||||

- Kate:5/5

|

||||

- Sublime:5/5

|

||||

- UltraEdit:4/5

|

||||

- jEdit:4/5

|

||||

|

||||

### 我们的评比 ###

|

||||

|

||||

在这里的所有编辑器都足以替换你已有的文本编辑器,来编辑文本和调整配置文件。事实上,没准它们会组合起来作为你的集成开发环境。这些应用程序都有各种各样功能,它们的开发者不会考虑剥离功能,而是增加越来越多的功能。

|

||||

|

||||

jEdit排在这次测试的最后面。因为它不仅坚持使用专有的Oracle Java运行时环境,不能在你的Fedora机器上安装,而且开发者并不积极和用户交互。

|

||||

|

||||

UltraEdit做的稍微好一点。这个商业专用工具专注于网络开发者,不为非开发者的高级用户提供任何功能,使得它不值得推荐为免费软件的替代品。

|

||||

|

||||

排在第三的是Gedit。作为Gnome的默认编辑器,它没有任何内在的问题,但尽管有很多积极的方面,它还是略微被Sublime和Kate超越。开诚布公地说,Kate是比Gedit更通用的编辑器,甚至考虑到他们的插件系统,评分也优于Gnome的默认编辑器。

|

||||

|

||||

Sublime和Kate都相当好。他们在我们的大多数测试中表现同样出色。Kate由于不支持宏而落后于Sublime,但键盘友好和能简单定义自定义键绑定又使Kate找回优势。

|

||||

|

||||

Kate成功的原因可以归结为它通过最小化学习曲线提供了最大化的功能。尽管使用它吧,不仅作为简单文本编辑器使用,或者容易使用语法高亮编辑配置文件,甚至得益于其项目管理能力能使用它协作一个复杂的编程项目。

|

||||

|

||||

我们不是选择Kate去替换一个类似“[XX,在这里插入你最喜欢的专业工具]”的全面的集成开发环境。但是它是一个专业工具理想的、全面的、以及完美的垫脚石。

|

||||

|

||||

Kate为能快速响应你的需要而设计,它的界面并不会使你茫然,并且和那些过于复杂的应用一样的有用。

|

||||

|

||||

### 1st Kate ###

|

||||

|

||||

- Licence LGPL/GPL Version 3.11

|

||||

- www.kate-editor.org

|

||||

- 拥有超能力,态度温和的文本编辑器。

|

||||

- Kate是KDE项目中最有用的应用程序之一。

|

||||

|

||||

### 2nd Sublime Text ###

|

||||

|

||||

- Licence 专利 Version 2.0.2

|

||||

- www.sublimetext.com

|

||||

- 值得你每分钱的专业文本编辑器 - 简单易用,功能全面而且看起来很棒。

|

||||

|

||||

### 3rd Gedit ###

|

||||

|

||||

- Licence GPL Version 3.10

|

||||

- http://projects.gnome.org/gedit

|

||||

- 在Gnome中就用它吧。这是一个奇妙的文本编辑器,确实令人钦佩的工作,但这里的竞争实在太大了。

|

||||

|

||||

### 4th UltraEdit ###

|

||||

|

||||

- Licence Proprietary Version 4.1.0.4

|

||||

- www.ultraedit.com

|

||||

- 关注于为网络开发者提供各种便利,而不为普通用户提供任何特殊功能。

|

||||

|

||||

### 5th jEdit ###

|

||||

|

||||

- Licence GPL Version 5.1.0

|

||||

- www.jedit.org

|

||||

- 缺乏支持,不支持Fedora,缺乏好看的界面,jEdit被贬低到最后。

|

||||

|

||||

### 你也许希望尝试… ###

|

||||

|

||||

随你发行版发布的默认文本编辑器也能帮助你一些高级任务。例如KDE的KWrite和Raspbian的Nano。得益于KDE的katepart组件,KWrite继承了一些Kate的功能,得益于在树莓派上的可用性,Nano也开始重现风头。

|

||||

|

||||

如果你希望跟随Linux大师的脚步,你总是可以尝试高大上的文本编辑器Emacs和Vim。想尝试Vim强大的用户首先可以考虑gVim,它通过图形界面展现了Vim的强大。

|

||||

|

||||

除了jEdit和Kate,这里还有其他模仿Emacs和Vim之类的旧式高级编辑器的编辑器,比如JED 编辑器和Joe's Own Editor,这两者都有Emacs的模拟模式。另一方面,如果你在寻找轻量级的代码编辑器,可以看看Bluefish和Geany。他们的存在是为了填补文本编辑器和全面集成的开发平台之间的空隙。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.linuxvoice.com/text-editors/

|

||||

|

||||

作者:[Ben Everard][a]

|

||||

译者:[ictlyh](https://github.com/ictlyh)

|

||||

校对:[royaso](https://github.com/royaso),[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.linuxvoice.com/author/ben_everard/

|

||||

@ -0,0 +1,136 @@

|

||||

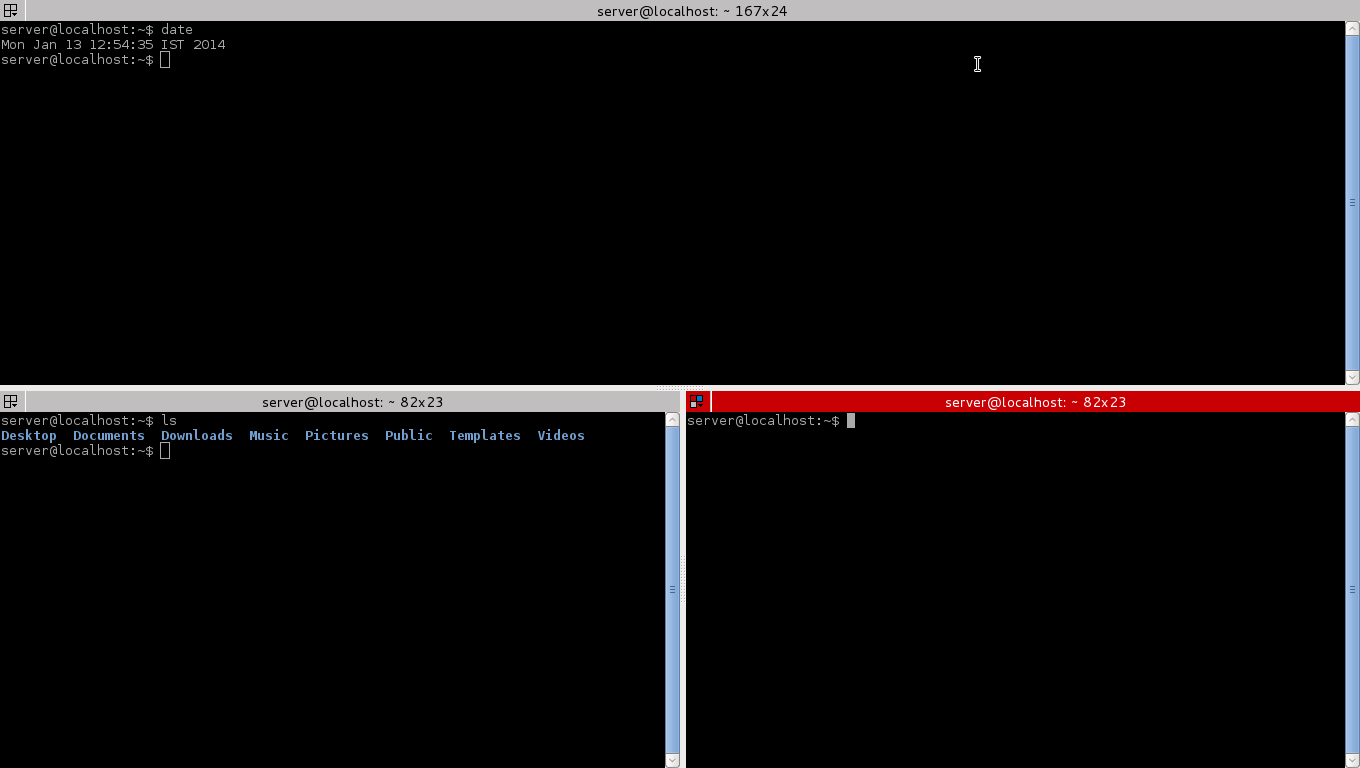

又一波你可能不知道的 Linux 命令行网络监控工具

|

||||

===============================================================================

|

||||

|

||||

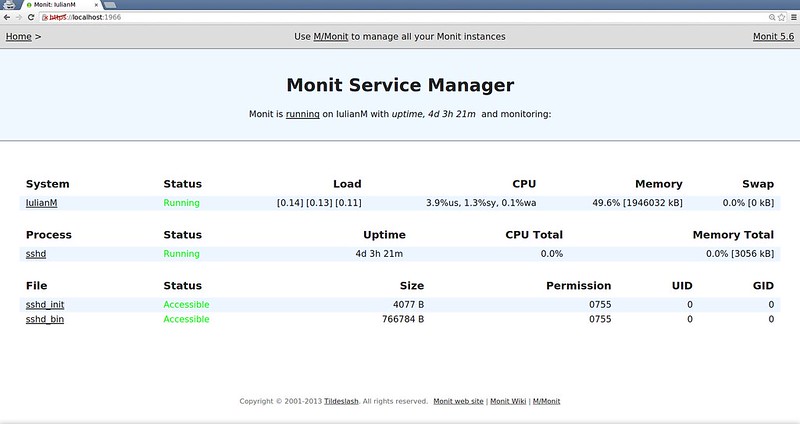

对任何规模的业务来说,网络监控工具都是一个重要的功能。网络监控的目标可能千差万别。比如,监控活动的目标可以是保证长期的网络服务、安全保护、对性能进行排查、网络使用统计等。由于它的目标不同,网络监控器使用很多不同的方式来完成任务。比如对包层面的嗅探,对数据流层面的统计数据,向网络中注入探测的流量,分析服务器日志等。

|

||||

|

||||

尽管有许多专用的网络监控系统可以365天24小时监控,但您依旧可以在特定的情况下使用命令行式的网络监控器,某些命令行式的网络监控器在某方面很有用。如果您是系统管理员,那您就应该有亲身使用一些知名的命令行式网络监控器的经历。这里有一份**Linux上流行且实用的网络监控器**列表。

|

||||

|

||||

### 包层面的嗅探器 ###

|

||||

|

||||

在这个类别下,监控工具在链路上捕捉独立的包,分析它们的内容,展示解码后的内容或者包层面的统计数据。这些工具在最底层对网络进行监控、管理,同样的也能进行最细粒度的监控,其代价是影响网络I/O和分析的过程。

|

||||

|

||||

1. **dhcpdump**:一个命令行式的DHCP流量嗅探工具,捕捉DHCP的请求/回复流量,并以用户友好的方式显示解码的DHCP协议消息。这是一款排查DHCP相关故障的实用工具。

|

||||

|

||||

2. **[dsniff][1]**:一个基于命令行的嗅探、伪造和劫持的工具合集,被设计用于网络审查和渗透测试。它可以嗅探多种信息,比如密码、NSF流量(LCTT 译注:此处疑为 NFS 流量)、email消息、网络地址等。

|

||||

|

||||

3. **[httpry][2]**:一个HTTP报文嗅探器,用于捕获、解码HTTP请求和回复报文,并以用户友好的方式显示这些信息。(LCTT 译注:[延伸阅读](https://linux.cn/article-4148-1.html)。 )

|

||||

|

||||

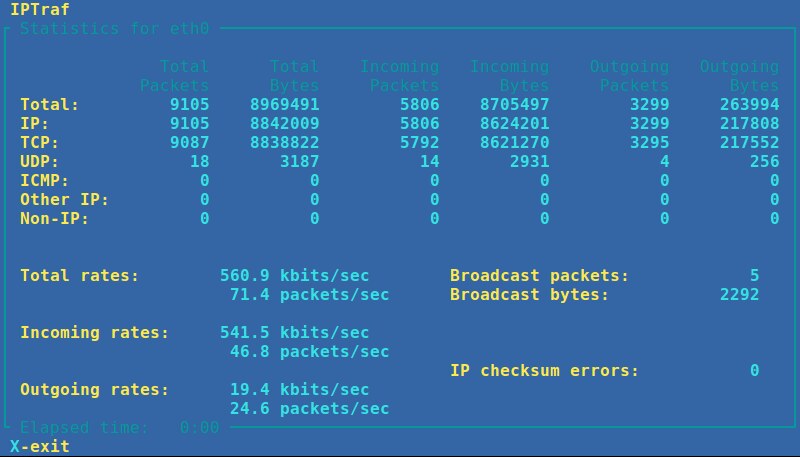

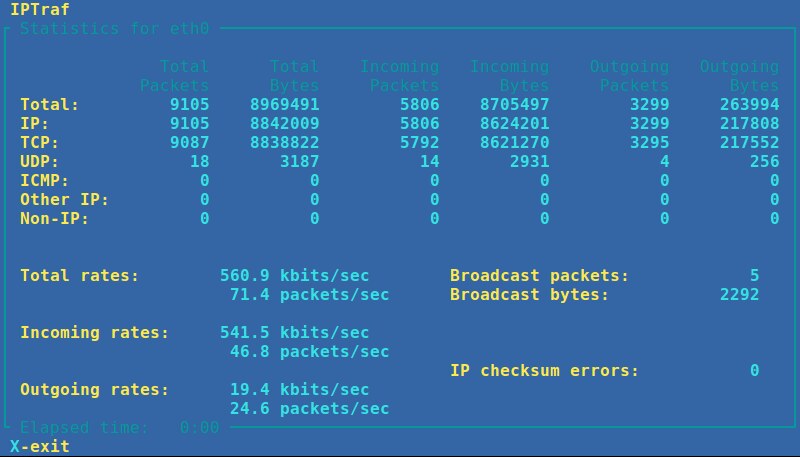

4. **IPTraf**:基于命令行的网络统计数据查看器。它实时显示包层面、连接层面、接口层面、协议层面的报文/字节数。抓包过程由协议过滤器控制,且操作过程全部是菜单驱动的。(LCTT 译注:[延伸阅读](https://linux.cn/article-5430-1.html)。)

|

||||

|

||||

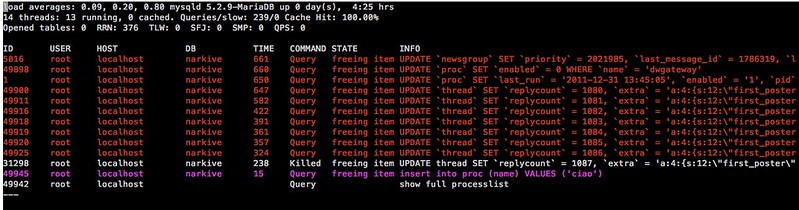

|

||||

|

||||

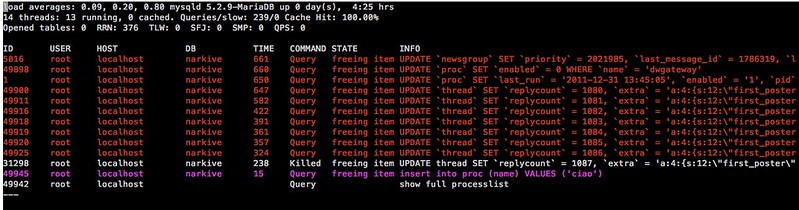

5. **[mysql-sniffer][3]**:一个用于抓取、解码MySQL请求相关的数据包的工具。它以可读的方式显示最频繁或全部的请求。

|

||||

|

||||

6. **[ngrep][4]**:在网络报文中执行grep。它能实时抓取报文,并用正则表达式或十六进制表达式的方式匹配(过滤)报文。它是一个可以对异常流量进行检测、存储或者对实时流中特定模式报文进行抓取的实用工具。

|

||||

|

||||

7. **[p0f][5]**:一个被动的基于包嗅探的指纹采集工具,可以可靠地识别操作系统、NAT或者代理设置、网络链路类型以及许多其它与活动的TCP连接相关的属性。

|

||||

|

||||

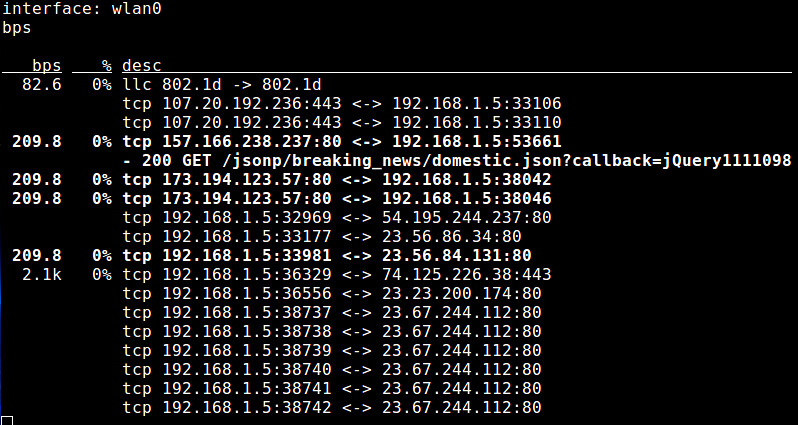

8. **pktstat**:一个命令行式的工具,通过实时分析报文,显示连接带宽使用情况以及相关的协议(例如,HTTP GET/POST、FTP、X11)等描述信息。

|

||||

|

||||

|

||||

|

||||

9. **Snort**:一个入侵检测和预防工具,通过规则驱动的协议分析和内容匹配,来检测/预防活跃流量中各种各样的后门、僵尸网络、网络钓鱼、间谍软件攻击。

|

||||

|

||||

10. **tcpdump**:一个命令行的嗅探工具,可以基于过滤表达式抓取网络中的报文,分析报文,并且在包层面输出报文内容以便于包层面的分析。他在许多网络相关的错误排查、网络程序debug、或[安全][6]监测方面应用广泛。

|

||||

|

||||

11. **tshark**:一个与Wireshark窗口程序一起使用的命令行式的嗅探工具。它能捕捉、解码网络上的实时报文,并能以用户友好的方式显示其内容。

|

||||

|

||||

### 流/进程/接口层面的监控 ###

|

||||

|

||||

在这个分类中,网络监控器通过把流量按照流、相关进程或接口分类,收集每个流、每个进程、每个接口的统计数据。其信息的来源可以是libpcap抓包库或者sysfs内核虚拟文件系统。这些工具的监控成本很低,但是缺乏包层面的检视能力。

|

||||

|

||||

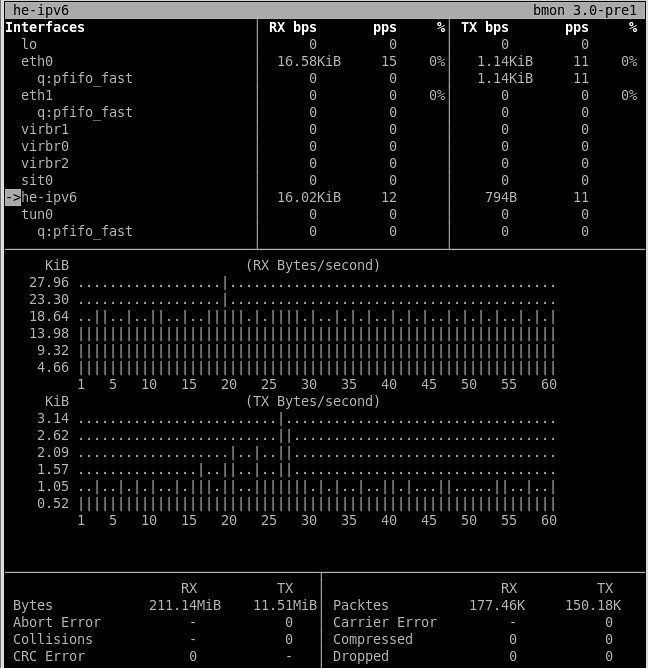

12. **bmon**:一个基于命令行的带宽监测工具,可以显示各种接口相关的信息,不但包括接收/发送的总量/平均值统计数据,而且拥有历史带宽使用视图。

|

||||

|

||||

|

||||

|

||||

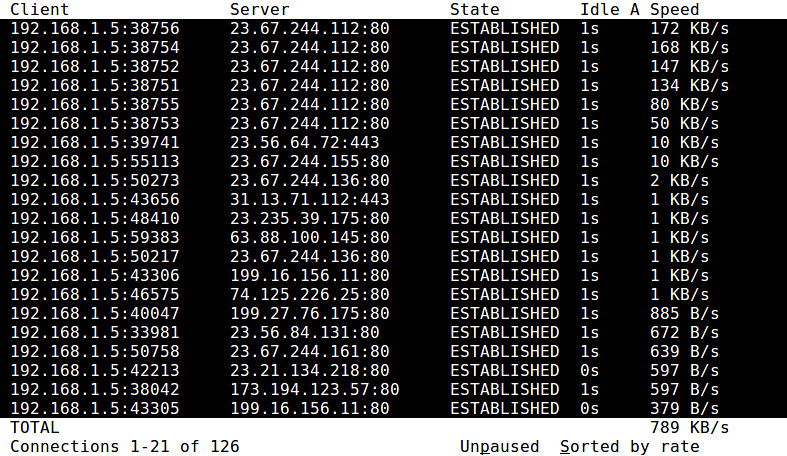

13. **[iftop][7]**:一个带宽使用监测工具,可以实时显示某个网络连接的带宽使用情况。它对所有带宽使用情况排序并通过ncurses的接口来进行可视化。他可以方便的监控哪个连接消耗了最多的带宽。(LCTT 译注:[延伸阅读](https://linux.cn/article-1843-1.html)。)

|

||||

|

||||

14. **nethogs**:一个基于ncurses显示的进程监控工具,提供进程相关的实时的上行/下行带宽使用信息。它对检测占用大量带宽的进程很有用。(LCTT 译注:[延伸阅读](https://linux.cn/article-2808-1.html)。)

|

||||

|

||||

15. **netstat**:一个显示许多TCP/UDP的网络堆栈的统计信息的工具。诸如打开的TCP/UDP连接书、网络接口发送/接收、路由表、协议/套接字的统计信息和属性。当您诊断与网络堆栈相关的性能、资源使用时它很有用。

|

||||

|

||||

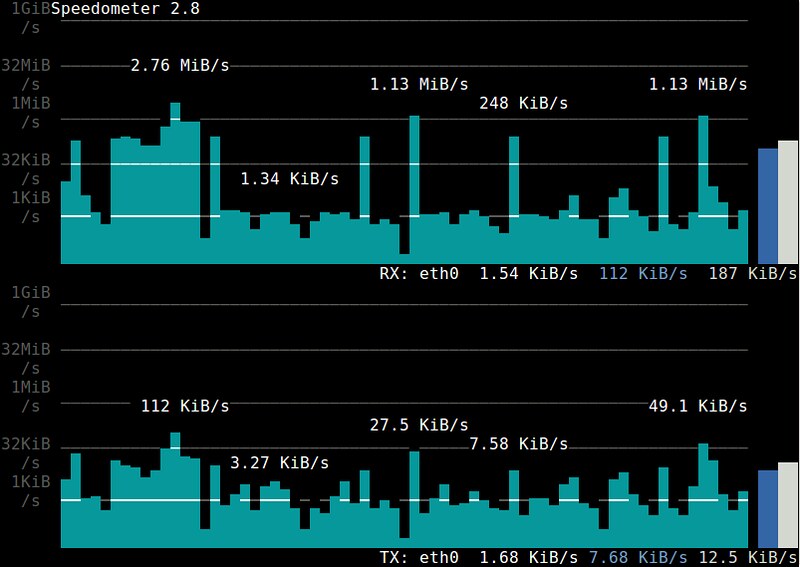

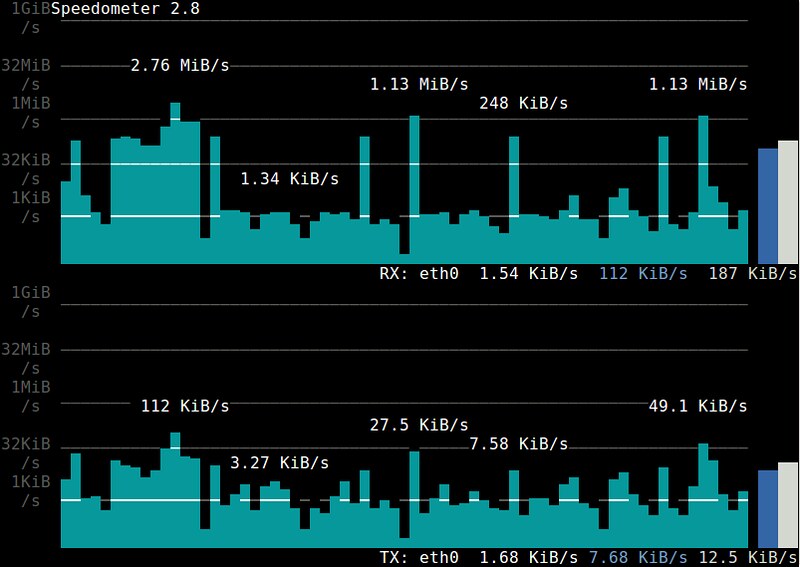

16. **[speedometer][8]**:一个可视化某个接口发送/接收的带宽使用的历史趋势,并且基于ncurses的条状图进行显示的终端工具。

|

||||

|

||||

|

||||

|

||||

17. **[sysdig][9]**:一个可以通过统一的界面对各个Linux子系统进行系统级综合性调试的工具。它的网络监控模块可以监控在线或离线、许多进程/主机相关的网络统计数据,例如带宽、连接/请求数等。(LCTT 译注:[延伸阅读](https://linux.cn/article-4341-1.html)。)

|

||||

|

||||

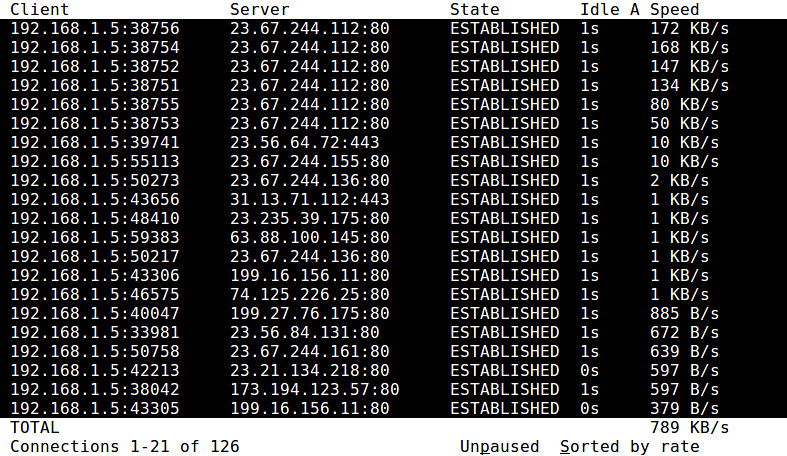

18. **tcptrack**:一个TCP连接监控工具,可以显示活动的TCP连接,包括源/目的IP地址/端口、TCP状态、带宽使用等。

|

||||

|

||||

|

||||

|

||||

19. **vnStat**:一个存储并显示每个接口的历史接收/发送带宽视图(例如,当前、每日、每月)的流量监控器。作为一个后台守护进程,它收集并存储统计数据,包括接口带宽使用率和传输字节总数。(LCTT 译注:[延伸阅读](https://linux.cn/article-5256-1.html)。)

|

||||

|

||||

### 主动网络监控器 ###

|

||||

|

||||

不同于前面提到的被动的监听工具,这个类别的工具们在监听时会主动的“注入”探测内容到网络中,并且会收集相应的反应。监听目标包括路由路径、可供使用的带宽、丢包率、延时、抖动(jitter)、系统设置或者缺陷等。

|

||||

|

||||

20. **[dnsyo][10]**:一个DNS检测工具,能够管理跨越多达1500个不同网络的开放解析器的DNS查询。它在您检查DNS传播或排查DNS设置的时候很有用。

|

||||

|

||||

21. **[iperf][11]**:一个TCP/UDP带宽测量工具,能够测量两个端点间最大可用带宽。它通过在两个主机间单向或双向的输出TCP/UDP探测流量来测量可用的带宽。它在监测网络容量、调谐网络协议栈参数时很有用。一个叫做[netperf][12]的变种拥有更多的功能及更好的统计数据。

|

||||

|

||||

22. **[netcat][13]/socat**:通用的网络调试工具,可以对TCP/UDP套接字进行读、写或监听。它通常和其他的程序或脚本结合起来在后端对网络传输或端口进行监听。(LCTT 译注:[延伸阅读](https://linux.cn/article-1171-1.html)。)

|

||||

|

||||

23. **nmap**:一个命令行的端口扫描和网络发现工具。它依赖于若干基于TCP/UDP的扫描技术来查找开放的端口、活动的主机或者在本地网络存在的操作系统。它在你审查本地主机漏洞或者建立维护所用的主机映射时很有用。[zmap][14]是一个类似的替代品,是一个用于互联网范围的扫描工具。(LCTT 译注:[延伸阅读](https://linux.cn/article-2561-1.html)。)

|

||||

|

||||

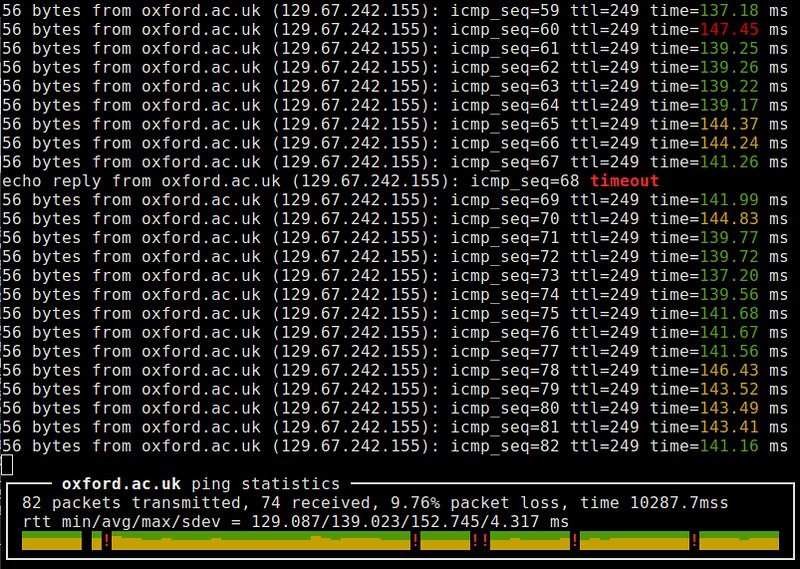

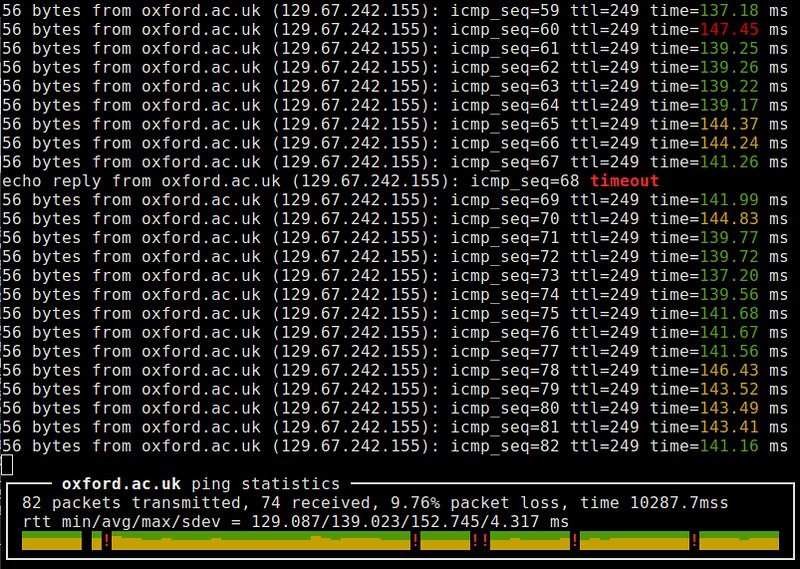

24. ping:一个常用的网络测试工具。通过交换ICMP的echo和reply报文来实现其功能。它在测量路由的RTT、丢包率以及检测远端系统防火墙规则时很有用。ping的变种有更漂亮的界面(例如,[noping][15])、多协议支持(例如,[hping][16])或者并行探测能力(例如,[fping][17])。(LCTT 译注:[延伸阅读](https://linux.cn/article-2303-1.html)。)

|

||||

|

||||

|

||||

|

||||

25. **[sprobe][18]**:一个启发式推断本地主机和任意远端IP地址之间的网络带宽瓶颈的命令行工具。它使用TCP三次握手机制来评估带宽的瓶颈。它在检测大范围网络性能和路由相关的问题时很有用。

|

||||

|

||||

26. **traceroute**:一个能发现从本地到远端主机的第三层路由/转发路径的网络发现工具。它发送限制了TTL的探测报文,收集中间路由的ICMP反馈信息。它在排查低速网络连接或者路由相关的问题时很有用。traceroute的变种有更好的RTT统计功能(例如,[mtr][19])。

|

||||

|

||||

### 应用日志解析器 ###

|

||||

|

||||

在这个类别下的网络监测器把特定的服务器应用程序作为目标(例如,web服务器或者数据库服务器)。由服务器程序产生或消耗的网络流量通过它的日志被分析和监测。不像前面提到的网络层的监控器,这个类别的工具能够在应用层面分析和监控网络流量。

|

||||

|

||||

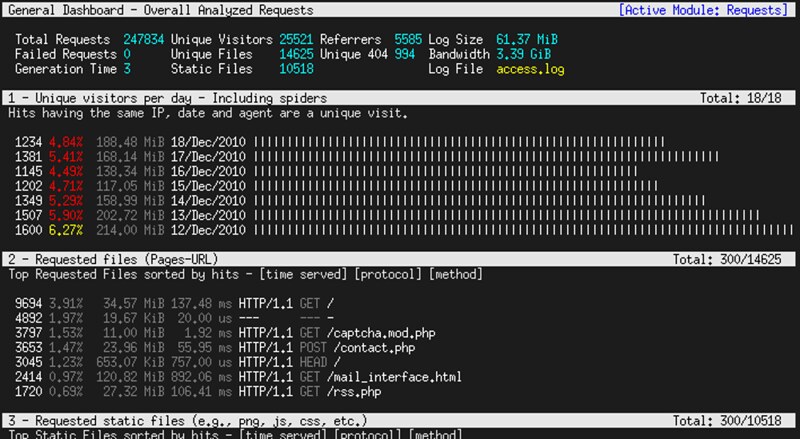

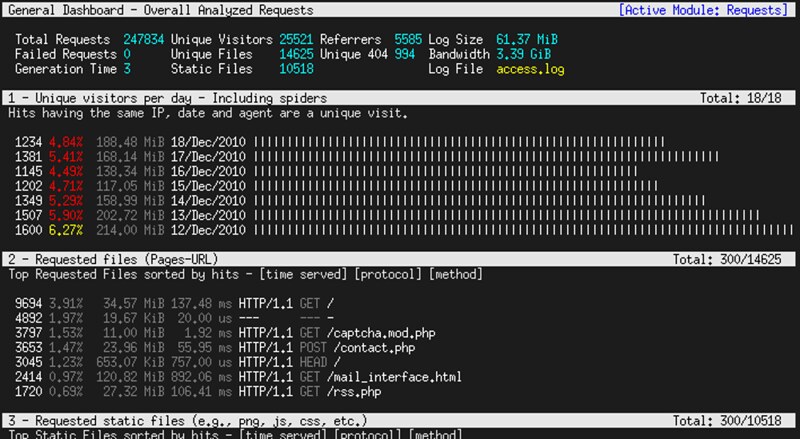

27. **[GoAccess][20]**:一个针对Apache和Nginx服务器流量的交互式查看器。基于对获取到的日志的分析,它能展示包括日访问量、最多请求、客户端操作系统、客户端位置、客户端浏览器等在内的多个实时的统计信息,并以滚动方式显示。

|

||||

|

||||

|

||||

|

||||

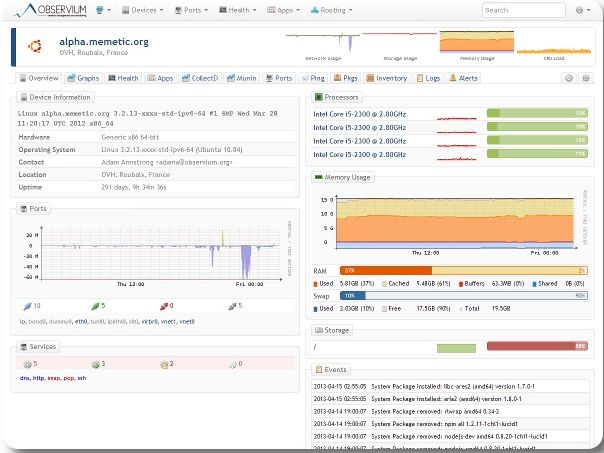

28. **[mtop][21]**:一个面向MySQL/MariaDB服务器的命令行监控器,它可以将成本最大的查询和当前数据库服务器负载以可视化的方式显示出来。它在您优化MySQL服务器性能、调谐服务器参数时很有用。

|

||||

|

||||

|

||||

|

||||

29. **[ngxtop][22]**:一个面向Nginx和Apache服务器的流量监测工具,能够以类似top指令的方式可视化的显示Web服务器的流量。它解析web服务器的查询日志文件并收集某个目的地或请求的流量统计信息。

|

||||

|

||||

### 总结 ###

|

||||

|

||||

在这篇文章中,我展示了许多命令行式监测工具,从最底层的包层面的监控器到最高层应用程序层面的网络监控器。了解那个工具的作用是一回事,选择哪个工具使用又是另外一回事。单一的一个工具不能作为您每天使用的通用的解决方案。一个好的系统管理员应该能决定哪个工具更适合当前的环境。希望这个列表对此有所帮助。

|

||||

|

||||

欢迎您通过回复来改进这个列表的内容!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://xmodulo.com/useful-command-line-network-monitors-linux.html

|

||||

|

||||

作者:[Dan Nanni][a]

|

||||

译者:[wwy-hust](https://github.com/wwy-hust)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://xmodulo.com/author/nanni

|

||||

[1]:http://www.monkey.org/~dugsong/dsniff/

|

||||

[2]:http://xmodulo.com/monitor-http-traffic-command-line-linux.html

|

||||

[3]:https://github.com/zorkian/mysql-sniffer

|

||||

[4]:http://ngrep.sourceforge.net/

|

||||

[5]:http://lcamtuf.coredump.cx/p0f3/

|

||||

[6]:http://xmodulo.com/recommend/firewallbook

|

||||

[7]:http://xmodulo.com/how-to-install-iftop-on-linux.html

|

||||

[8]:https://excess.org/speedometer/

|

||||

[9]:http://xmodulo.com/monitor-troubleshoot-linux-server-sysdig.html

|

||||

[10]:http://xmodulo.com/check-dns-propagation-linux.html

|

||||

[11]:https://iperf.fr/

|

||||

[12]:http://www.netperf.org/netperf/

|

||||

[13]:http://xmodulo.com/useful-netcat-examples-linux.html

|

||||

[14]:https://zmap.io/

|

||||

[15]:http://noping.cc/

|

||||

[16]:http://www.hping.org/

|

||||

[17]:http://fping.org/

|

||||

[18]:http://sprobe.cs.washington.edu/

|

||||

[19]:http://xmodulo.com/better-alternatives-basic-command-line-utilities.html#mtr_link

|

||||

[20]:http://goaccess.io/

|

||||

[21]:http://mtop.sourceforge.net/

|

||||

[22]:http://xmodulo.com/monitor-nginx-web-server-command-line-real-time.html

|

||||

@ -0,0 +1,58 @@

|

||||

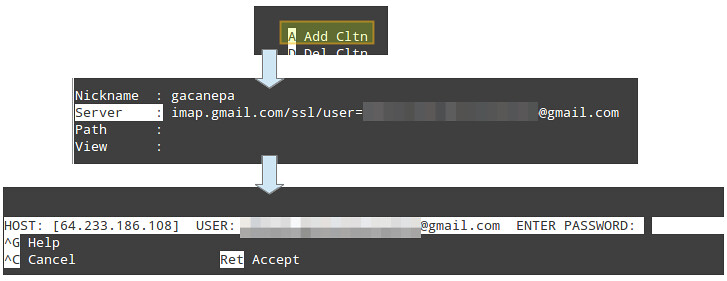

‘Unity Greeter Badges’:将丢失的会话图标带回Ubuntu登录屏幕

|

||||

================================================================================

|

||||

|

||||

|

||||

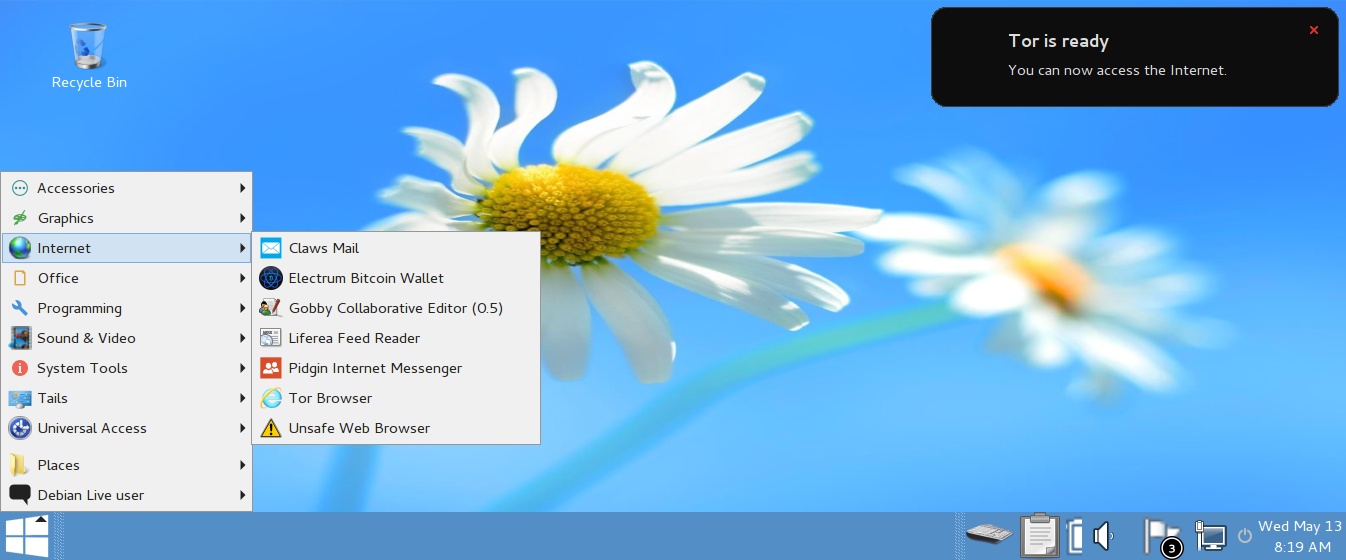

新出现在**Ubuntu 15.04中的一个软件包解决了我对Unity 欢迎屏的微词:像Cinnamon这样的其它Linux桌面会话没有徽章图标。**

|

||||

|

||||

我知道这有点吹毛求疵了;这只是对大多数人而言几乎毫无影响的视觉瑕疵罢了。但是这种不一致性时时刻刻缠绕着我,让我不胜其烦,因为Ubuntu的一些会话带有徽章图标,包括Unity、GNOME和KDE。而剩下的其它桌面环境,包括它自己的一些旁系产品,像Xubuntu,只会在会话切换列表和主用户界面显示了一个不能再简单的白点。

|

||||

|

||||

这些点点们造成的这种不一致性刺激着我的神经,即使它只是稍纵即逝,但这种刺激不仅仅来自设计,也来自可用性方面。标牌式的标志符号对于让我们知道我们即将登陆到哪个会话很有帮助。

|

||||

|

||||

例如,你能告诉我们这个是个什么会话呢?

|

||||

|

||||

|

||||

|

||||

Budgie? 也许是 MATE? 也能是 Cinnamon……我必须点开它才能知道。

|

||||

|

||||

没有必要这样做啊。构建Unity Greeter,就是为了让桌面环境开发者能够部署徽章到欢迎屏幕中(有些确实这样做了)。但在许多情况下,像MATE,它的包来自上游的Debian,想要移植一个“Ubuntu专用的补丁包”不太可取,也不太可能。

|

||||

|

||||

### 一个解决方案出炉了 ###

|

||||

|

||||

一位有经验的Debian维护者[Doug Torrance][1]有了修复该可用性瑕疵的解决方案。与其依赖桌面制造者自己来添加品牌式徽章到他们的包中,与其给Ubuntu增加维护它的责任重担,Torrance还不如自己创建了一个独立的‘unity-greeter-badges’包来收容它们。

|

||||

|

||||

承担起了直接提供会话标志的假定责任后,该包确保能同时迎合新旧窗口管理器、会话和桌面。

|

||||

|

||||

在30个左右的桌面环境列表中,它为以下桌面捆绑了新的会话徽章:

|

||||

|

||||

- Xubuntu

|

||||

- Cinnamon

|

||||

- MATE

|

||||

- Cairo-Dock

|

||||

- Xmonad

|

||||

- Awesome

|

||||

- OpenBox

|

||||

- Pantheon

|

||||

|

||||

最重要的是,‘**Unity-Greeter-Badges**’已经被Ubuntu 15.04收录进去。这就意味着Torrance的包将可以直接安装,不需要PPA,也不需要下载。没有像Unity Greeter一样成为核心包的一部分,它可以以更高效和更及时的方式更新新的图标。

|

||||

|

||||

如果你真运行着Ubuntu 15.04,在不久的将来,你就可以从软件中心获取并安装该包了。

|

||||

|

||||

不想等到15.04?Torrance已经为Ubuntu 14.04和Ubuntu 14.10用户做了个.deb安装器。

|

||||

|

||||

- [下载用于Ubuntu 14.04的unity-greeter-badges][2]

|

||||

- [下载用于Ubuntu 14.10的unity-greeter-badges][3]

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.omgubuntu.co.uk/2015/01/unity-greeter-badges-brings-missing-session-icons-ubuntu-login-screen

|

||||

|

||||

作者:[Joey-Elijah Sneddon][a]

|

||||

译者:[GOLinux](https://github.com/GOLinux)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://plus.google.com/117485690627814051450/?rel=author

|

||||

[1]:https://launchpad.net/~profzoom

|

||||

[2]:https://launchpad.net/~profzoom/+archive/ubuntu/misc/+files/unity-greeter-badges_0.1-0ubuntu1%7E201412111501%7Eubuntu14.04.1_all.deb

|

||||

[3]:https://launchpad.net/~profzoom/+archive/ubuntu/misc/+files/unity-greeter-badges_0.1-0ubuntu1%7E201412111501%7Eubuntu14.10.1_all.deb

|

||||

73

published/20150123 How to make a file immutable on Linux.md

Normal file

73

published/20150123 How to make a file immutable on Linux.md

Normal file

@ -0,0 +1,73 @@

|

||||

如何在Linux下创建一个不可变更的文件

|

||||

================================================================================

|

||||

|

||||

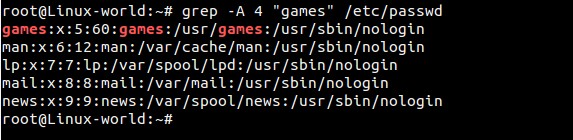

假如你想对Linux中的一些重要文件做写保护,这样它们就不能被删除或者被篡改成之前的版本或者其他东西,或者在其他情况下,你可能想避免某些配置文件被软件自动修改。使用`chown`和`chmod`命令修改文件的归属关系或者权限位是处理这种情况的一个解决方法,但这并不完美,因为这样无法避免有root权限的操作。这时`chattr`就派上用场了。

|

||||

|

||||

`chattr`是一个可以设置或取消文件的标志位的Linux命令,它和标准的文件权限(读、写、执行)是分离的。与此相关的另一个命令是`lsattr`,它可以显示文件的哪些标志位被设置上了。最初只有EXT文件系统(EXT2/3/4)支持`chattr`和`lsattr`所管理的标志位,但现在很多其他的原生的Linux文件系统都支持了,比如XFS、Btrfs、ReiserFS等等。

|

||||

|

||||

在这个教程中,我会示范如果使用`chattr`来让Linux中的文件不可变更。

|

||||

|

||||

`chattr`和`lsattr`命令是e2fsprogs包的一部分,它在所有现代Linux发行版都预装了。

|

||||

|

||||

下面是`chattr`的基本语法。

|

||||

|

||||

$ chattr [-RVf] [操作符][标志位] 文件...

|

||||

|

||||

其中操作符可以是“+”(把选定的标志位添加到标志位列表)、“-”(从标志位列表中移除选定的标志位)、或者“=”(强制使用选定的标志位)。

|

||||

|

||||

下面是一些可用的标志位。

|

||||

|

||||

- **a**: 只能以追加模式打开。

|

||||

- **A**: 不能更新atime(文件访问时间)。

|

||||

- **c**: 当被写入磁盘时被自动压缩。

|

||||

- **C**: 关掉“写时复制”。

|

||||

- **i**: 不可变更。

|

||||

- **s**: 通过自动归零来安全删除。(LCTT 译注:一般情况文件被删后内容不会被修改,改标志位会使得文件被删后原有内容被“0”取代)

|

||||

|

||||

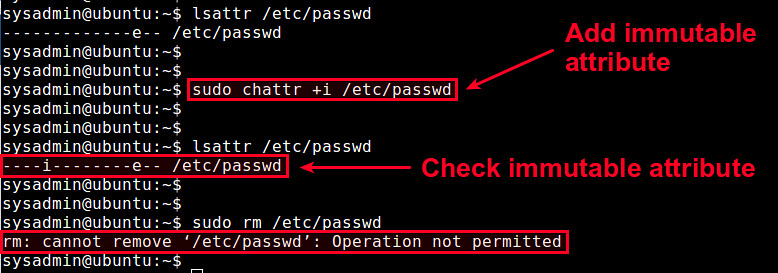

### “不可变更”标志位 ###

|

||||

|

||||

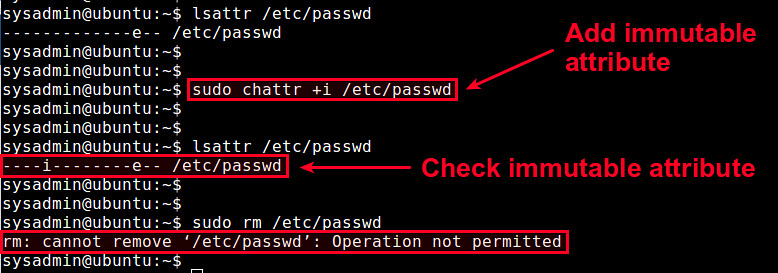

为了让一个文件不可变更,你需要按照如下方法为这个文件添加“不可变更”标志位。例如,对/etc/passwd文件做写保护:

|

||||

|

||||

$ sudo chattr +i /etc/passwd

|

||||

|

||||

注意设置或取消一个文件的“不可变更”标志位是需要root用户权限的。现在检查该文件“不可变更”标志位是否被添加上了。

|

||||

|

||||

$ lsattr /etc/passwd

|

||||

|

||||

一旦文件被设置为不可变更,任何用户都将无法修改该文件。即使是root用户也不可以修改、删除、覆盖、移动或者重命名这个文件。如果你想再次修改这个文件,需要先把“不可变更”标志位取消了。

|

||||

|

||||

用如下命令取消“不可变更”标志位:

|

||||

|

||||

$ sudo chattr -i /etc/passwd

|

||||

|

||||

|

||||

|

||||

如果你想让一个目录(比如/etc)连同它下边的所有内容不可变更,使用“-R”选项:

|

||||

|

||||

$ sudo chattr -R +i /etc

|

||||

|

||||

### “只可追加”标志位 ###

|

||||

|

||||

另一个有用的的标志位是“只可追加”,它只允许文件内容被追加的方式修改。你不能覆盖或者删除一个设置了“只可追加”标志位的文件。这个标志位在你想避免日志文件被意外清理掉的情况很有用。

|

||||

|

||||

和“不可变更”标志位类似,你可以使用如下命令让文件变成“只可追加”模式:

|

||||

|

||||

$ sudo chattr +a /var/log/syslog

|

||||

|

||||

注意当你复制一个“不可变更”或者“只可追加”的文件到其他地方后,新文件不会保留这些标志位!

|

||||

|

||||

### 结论 ###

|

||||

|

||||

在这个教程中,我展示了如何使用`chattr`和`lsattr`命令来管理额外的文件标志位,来避免文件被篡改(意外或者其他情况)的方法。注意你不能将`chattr`作为一个安全措施,因为“不可变更”标志位可以很容易被取消掉。解决这个问题的一个可能的方式是限制`chattr`命令自身的可用性,或者去掉CAP_LINUX_IMMUTABLE内核权能标志。关于`chattr`以及可用的标志位的更多细节,请参考它的man手册。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://xmodulo.com/make-file-immutable-linux.html

|

||||

|

||||

作者:[Dan Nanni][a]

|

||||

译者:[goreliu](https://github.com/goreliu)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://xmodulo.com/author/nanni

|

||||

@ -1,7 +1,7 @@

|

||||

既然float不能表示所有的int,那为什么在类型转换时C++将int转换成float?

|

||||

---------

|

||||

=============

|

||||

|

||||

#问题:

|

||||

###问题:

|

||||

|

||||

代码如下:

|

||||

|

||||

@ -13,7 +13,7 @@ if (i == f) // 执行某段代码

|

||||

|

||||

编译器会将i转换成float类型,然后比较这两个float的大小,但是float能够表示所有的int吗?为什么没有将int和float转换成double类型进行比较呢?

|

||||

|

||||

#回答:

|

||||

###回答:

|

||||

|

||||

在整型数的演变中,当`int`变成`unsigned`时,会丢掉负数部分(有趣的是,这样的话,`0u < -1`就是对的了)。

|

||||

|

||||

@ -32,11 +32,11 @@ if((double) i < (double) f)

|

||||

顺便提一下,在这个问题中有趣的是,`unsigned`的优先级高于`int`,所以把`int`和`unsigned`进行比较时,最终进行的是unsigned类型的比较(开头提到的`0u < -1`就是这个道理)。我猜测这可能是在早些时候(计算机发展初期),当时的人们认为`unsigned`比`int`在所表示的数值范围上受到的限制更小:现在还不需要符号位,所以可以使用额外的位来表示更大的数值范围。如果你觉得`int`可能会溢出,那么就使用unsigned好了——在使用16位表示的ints时这个担心会更明显。

|

||||

|

||||

----

|

||||

via:[stackoverflow](http://stackoverflow.com/questions/28010565/why-does-c-promote-an-int-to-a-float-when-a-float-cannot-represent-all-int-val/28011249#28011249)

|

||||

via: [stackoverflow](http://stackoverflow.com/questions/28010565/why-does-c-promote-an-int-to-a-float-when-a-float-cannot-represent-all-int-val/28011249#28011249)

|

||||

|

||||

作者:[wintermute][a]

|

||||

译者:[KayGuoWhu](https://github.com/KayGuoWhu)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

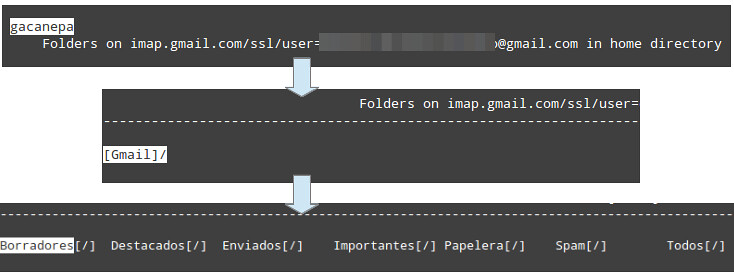

@ -0,0 +1,65 @@

|

||||

iptraf:一个实用的TCP/UDP网络监控工具

|

||||

================================================================================

|

||||

|

||||

[iptraf][1]是一个基于ncurses的IP局域网监控器,用来生成包括TCP信息、UDP计数、ICMP和OSPF信息、以太网负载信息、节点状态信息、IP校验和错误等等统计数据。

|

||||

|

||||

它基于ncurses的用户界面可以使用户免于记忆繁琐的命令行开关。

|

||||

|

||||

### 特征 ###

|

||||

|

||||

- IP流量监控器,用来显示你的网络中的IP流量变化信息。包括TCP标识信息、包以及字节计数,ICMP细节,OSPF包类型。

|

||||

- 简单的和详细的接口统计数据,包括IP、TCP、UDP、ICMP、非IP以及其他的IP包计数、IP校验和错误,接口活动、包大小计数。

|

||||

- TCP和UDP服务监控器,能够显示常见的TCP和UDP应用端口上发送的和接收的包的数量。

|

||||

- 局域网数据统计模块,能够发现在线的主机,并显示其上的数据活动统计信息。

|

||||

- TCP、UDP、及其他协议的显示过滤器,允许你只查看感兴趣的流量。

|

||||

- 日志功能。

|

||||

- 支持以太网、FDDI、ISDN、SLIP、PPP以及本地回环接口类型。

|

||||

- 利用Linux内核内置的原始套接字接口,允许它(指iptraf)能够用于各种支持的网卡上

|

||||

- 全屏,菜单式驱动的操作。

|

||||

|

||||

###安装方法###

|

||||

|

||||

**Ubuntu以及其衍生版本**

|

||||

|

||||

sudo apt-get install iptraf

|

||||

|

||||

**Arch Linux以及其衍生版本**

|

||||

|

||||

sudo pacman -S iptra

|

||||

|

||||

**Fedora以及其衍生版本**

|

||||

|

||||

sudo yum install iptraf

|

||||

|

||||

### 用法 ###

|

||||

|

||||

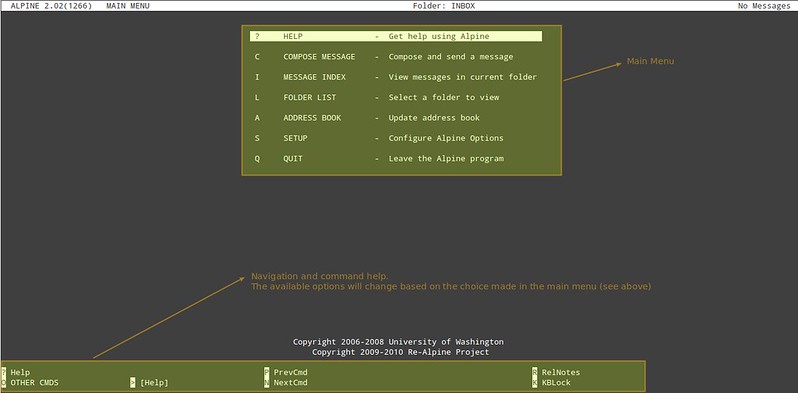

如果不加任何命令行选项地运行**iptraf**命令,程序将进入一种交互模式,通过主菜单可以访问多种功能。

|

||||

|

||||

|

||||

|

||||

简易的上手导航菜单。

|

||||

|

||||

|

||||

|

||||

选择要监控的接口。

|

||||

|

||||

|

||||

|

||||

接口**ppp0**处的流量。

|

||||

|

||||

|

||||

|

||||

试试吧!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.unixmen.com/iptraf-tcpudp-network-monitoring-utility/

|

||||

|

||||

作者:[Enock Seth Nyamador][a]

|

||||

译者:[DongShuaike](https://github.com/DongShuaike)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.unixmen.com/author/seth/

|

||||

[1]:http://iptraf.seul.org/about.html

|

||||

@ -1,171 +1,172 @@

|

||||

Inxi: Find System And Hardware Information On Linux

|

||||

================================================================================

|

||||

We already have shown different [applications][1] and ways to find the system and hardware information on Linux. In that series, today we will see how to find such details using **inxi**. It can be used for forum technical support, as a debugging tool, to quickly ascertain user system configuration and hardware.

|

||||

|

||||

**Inxi** is a command line tool that can be used to find the complete system and hardware details such as;

|

||||

|

||||

- Hardware,

|

||||

- CPU,

|

||||

- Drivers,

|

||||

- Xorg,

|

||||

- Desktop,

|

||||

- Kernel,

|

||||

- GCC version,

|

||||

- Processes,

|

||||

- RAM usage,

|

||||

- and other useful information.

|

||||

|

||||

### Installation ###

|

||||

|

||||

Inxi is available in the default repositories of most modern GNU/Linux operating systems. So, we can simply install it by running the following commands.

|

||||

|

||||

**On Debian based system:**

|

||||

|

||||

sudo apt-get install inxi

|

||||

|

||||

**On Fedora:**

|

||||

|

||||

sudo yum install inxi

|

||||

|

||||

**On RHEL based systems:**

|

||||

|

||||

Install EPEL repository:

|

||||

|

||||

sudo yum install epel-release

|

||||

|

||||

Then, install inxi using command:

|

||||

|

||||

sudo yum install inxi

|

||||

|

||||

### Usage ###

|

||||

|

||||

To find the quick view of the system information, run the following command from Terminal.

|

||||

|

||||

inxi

|

||||

|

||||

**Sample output:**

|

||||

|

||||

CPU~Dual core Intel Core i3-2350M CPU (-HT-MCP-) clocked at Min:800.000Mhz Max:1200.000Mhz Kernel~3.13.0-45-generic x86_64 Up~6:41 Mem~1537.7/3861.3MB HDD~500.1GB(52.5% used) Procs~183 Client~Shell inxi~1.9.17

|

||||

|

||||

Ofcourse, we can retrieve a particular hardware details. For example to retrieve the **Audio/Sound hardware details**, run the following command:

|

||||

|

||||

inxi -A

|

||||

|

||||

**Sample output:**

|

||||

|

||||

Audio: Card: Intel 6 Series/C200 Series Family High Definition Audio Controller driver: snd_hda_intel

|

||||

Sound: Advanced Linux Sound Architecture ver: k3.13.0-45-generic

|

||||

|

||||

Cool, isn’t it?

|

||||

|

||||

Likewise, you can retrieve the details of **Graphic card** information.

|

||||

|

||||

inxi -G

|

||||

|

||||

**Sample output:**

|

||||

|

||||

Graphics: Card: Intel 2nd Generation Core Processor Family Integrated Graphics Controller

|

||||

X.Org: 1.15.1 drivers: intel (unloaded: fbdev,vesa) Resolution: 1366x768@60.0hz

|

||||

GLX Renderer: Mesa DRI Intel Sandybridge Mobile GLX Version: 3.0 Mesa 10.3.0

|

||||

|

||||

What about harddisk information? That’s also possible. To view the full **harddisk** information, run the following command.

|

||||

|

||||

inxi -D

|

||||

|

||||

**Sample Output:**

|

||||

|

||||

Drives: HDD Total Size: 500.1GB (52.5% used) 1: id: /dev/sda model: ST9601325BD size: 500.1GB

|

||||

|

||||

To display the Bios and Motherboard details:

|

||||

|

||||

inxi -M

|

||||

|

||||

**Sample output:**

|

||||

|

||||

Machine: System: Dell (portable) product: Inspiron N5050

|

||||

Mobo: Dell model: 01HXXJ version: A05 Bios: Dell version: A05 date: 08/03/2012

|

||||

|

||||

Not only hardware details, it can also displays the **list of available repositories** in our system.

|

||||

|

||||

inxi -r

|

||||

|

||||

**Sample output:**

|

||||

|

||||

Repos: Active apt sources in file: /etc/apt/sources.list

|

||||

deb http://ubuntu.excellmedia.net/archive/ trusty main restricted

|

||||

deb-src http://ubuntu.excellmedia.net/archive/ trusty main restricted

|

||||

deb http://ubuntu.excellmedia.net/archive/ trusty-updates main restricted

|

||||

deb-src http://ubuntu.excellmedia.net/archive/ trusty-updates main restricted

|

||||

deb http://ubuntu.excellmedia.net/archive/ trusty universe

|

||||

.

|

||||

.

|

||||

Active apt sources in file: /etc/apt/sources.list.d/intellinuxgraphics.list

|

||||

deb https://download.01.org/gfx/ubuntu/14.04/main trusty main #Intel Graphics drivers

|

||||

Active apt sources in file: /etc/apt/sources.list.d/linrunner-tlp-trusty.list

|

||||

Active apt sources in file: /etc/apt/sources.list.d/wseverin-ppa-trusty.list

|

||||

deb http://ppa.launchpad.net/wseverin/ppa/ubuntu trusty main

|

||||

|

||||

Inxi will also display the Weather details of your location. Surprised? Yes, It should.

|

||||

|

||||

inxi -W Erode,Tamilnadu

|

||||

|

||||

Here **Erode** is the District and **Tamilnadu** is a state in India.

|

||||

|

||||

Sample output:

|

||||

|

||||

Weather: Conditions: 79 F (26 C) - Clear Time: February 4, 6:00 PM IST

|

||||

|

||||

### Viewing Complete Hardware details ###

|

||||

|

||||

Tired of finding each hardware details? Well, you can list all details at once using command:

|

||||

|

||||

inxi -F

|

||||

|

||||

**Sample output:**

|

||||

|

||||

System: Host: sk Kernel: 3.13.0-45-generic x86_64 (64 bit) Desktop: LXDE (Openbox 3.5.2) Distro: Ubuntu 14.04 trusty

|

||||

Machine: System: Dell (portable) product: Inspiron N5050

|

||||

Mobo: Dell model: 01HXXJ version: A05 Bios: Dell version: A05 date: 08/03/2012

|

||||

CPU: Dual core Intel Core i3-2350M CPU (-HT-MCP-) cache: 3072 KB flags: (lm nx sse sse2 sse3 sse4_1 sse4_2 ssse3 vmx)

|

||||

Clock Speeds: 1: 800.00 MHz 2: 1000.00 MHz 3: 800.00 MHz 4: 800.00 MHz

|

||||

Graphics: Card: Intel 2nd Generation Core Processor Family Integrated Graphics Controller

|

||||

X.Org: 1.15.1 drivers: intel (unloaded: fbdev,vesa) Resolution: 1366x768@60.0hz

|

||||

GLX Renderer: Mesa DRI Intel Sandybridge Mobile GLX Version: 3.0 Mesa 10.3.0

|

||||

Audio: Card: Intel 6 Series/C200 Series Family High Definition Audio Controller driver: snd_hda_intel

|

||||

Sound: Advanced Linux Sound Architecture ver: k3.13.0-45-generic

|

||||

Network: Card-1: Qualcomm Atheros AR9285 Wireless Network Adapter (PCI-Express) driver: ath9k

|

||||

IF: wlan0 state: up mac:

|

||||

Card-2: Realtek RTL8101E/RTL8102E PCI Express Fast Ethernet controller driver: r8169

|

||||

IF: eth0 state: down mac:

|

||||

Drives: HDD Total Size: 500.1GB (52.5% used) 1: id: /dev/sda model: ST9500325AS size: 500.1GB

|

||||

Partition: ID: / size: 455G used: 245G (57%) fs: ext4 ID: /boot size: 236M used: 159M (72%) fs: ext2

|

||||

ID: swap-1 size: 4.19GB used: 0.00GB (0%) fs: swap

|

||||

RAID: No RAID devices detected - /proc/mdstat and md_mod kernel raid module present

|

||||

Sensors: System Temperatures: cpu: 64.5C mobo: N/A

|

||||

Fan Speeds (in rpm): cpu: N/A

|

||||

Info: Processes: 186 Uptime: 6:52 Memory: 1547.2/3861.3MB Client: Shell (bash) inxi: 1.9.17

|

||||

|

||||

As you see in the above, inxi displays the complete hardware details.

|

||||

|

||||

For more details, refer the man pages.

|

||||

|

||||

man inxi

|

||||

|

||||

### Conclusion ###

|

||||

|

||||

Are you searching for a simple tool which displays your complete system and hardware details? Then, don’t look anywhere, inxi will give you what actually want. And, it is light weight tool available in your default repositories. What else you want more? Give it a try, you won’t be disappointed.

|

||||

|

||||

Cheers!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.unixmen.com/inxi-find-system-hardware-information-linux/

|

||||

|

||||

作者:[SK][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.unixmen.com/author/sk/

|

||||

[1]:http://www.unixmen.com/screenfetch-bash-screenshot-information-tool/

|

||||

Inxi:获取Linux的系统和硬件信息

|

||||

================================================================================

|

||||

|

||||

我们已经展示了一些不同的[应用程序][1]和方法来获取Linux的系统和硬件信息。在这一系列里,我们将看到如何使用**inxi**来获取这些详情信息。在论坛技术支持中,它可以作为调试工具,迅速确定用户的系统配置和硬件信息。

|

||||

|

||||

**Inxi**是一个可以获取完整的系统和硬件详情信息的命令行工具,内容包括:

|

||||

|

||||

- 硬件

|

||||

- CPU

|

||||

- 磁盘驱动器

|

||||

- Xorg

|

||||

- 桌面环境

|

||||

- 内核

|

||||

- GCC版本

|

||||

- 进程

|

||||

- 内存占用

|

||||

- 和其他有用的信息

|

||||

|

||||

### 安装方法 ###

|

||||

|

||||

Inxi在多数现代GNU/Linux操作系统的默认软件仓库中。所以我们可以简单地运行下列命令安装。

|

||||

|

||||

**在基于Debian的发行版:**

|

||||

|

||||

sudo apt-get install inxi

|

||||

|

||||

**在Fedora:**

|

||||

|

||||

sudo yum install inxi

|

||||

|

||||

**在基于RHEL的发行版:**

|

||||

|

||||

安装EPEL软件仓库:

|

||||

|

||||

sudo yum install epel-release

|

||||

|

||||

然后使用如下命令安装inxi:

|

||||

|

||||

sudo yum install inxi

|

||||

|

||||

### 使用方法 ###

|

||||

|

||||

在终端运行如下命令可以获取系统的概况信息。

|

||||

|

||||

inxi

|

||||

|

||||

**示例输出:**

|

||||

|

||||

CPU~Dual core Intel Core i3-2350M CPU (-HT-MCP-) clocked at Min:800.000Mhz Max:1200.000Mhz Kernel~3.13.0-45-generic x86_64 Up~6:41 Mem~1537.7/3861.3MB HDD~500.1GB(52.5% used) Procs~183 Client~Shell inxi~1.9.17

|

||||

|

||||

当然,我们可以获取一个特定硬件的详情信息。比如获取**声音/音频硬件详情信息**,可以运行如下命令:

|

||||

|

||||

inxi -A

|

||||

|

||||

**示例输出:**

|

||||

|

||||

Audio: Card: Intel 6 Series/C200 Series Family High Definition Audio Controller driver: snd_hda_intel

|

||||

Sound: Advanced Linux Sound Architecture ver: k3.13.0-45-generic

|

||||

|

||||

很酷是吧?

|

||||

|

||||

同样的,你可以获取**显卡**的详情信息。

|

||||

|

||||

inxi -G

|

||||

|

||||

**示例输出:**

|

||||

|

||||

Graphics: Card: Intel 2nd Generation Core Processor Family Integrated Graphics Controller

|

||||

X.Org: 1.15.1 drivers: intel (unloaded: fbdev,vesa) Resolution: 1366x768@60.0hz

|

||||

GLX Renderer: Mesa DRI Intel Sandybridge Mobile GLX Version: 3.0 Mesa 10.3.0

|

||||

|

||||

硬盘信息呢?也是可以的。运行如下命令来获取完整的**硬盘**信息。

|

||||

|

||||

inxi -D

|

||||

|

||||

**示例输出:**

|

||||

|

||||

Drives: HDD Total Size: 500.1GB (52.5% used) 1: id: /dev/sda model: ST9601325BD size: 500.1GB

|

||||

|

||||

显示Bios和主板详情信息:

|

||||

|

||||

inxi -M

|

||||

|

||||

**示例输出:**

|

||||

|

||||

Machine: System: Dell (portable) product: Inspiron N5050

|

||||

Mobo: Dell model: 01HXXJ version: A05 Bios: Dell version: A05 date: 08/03/2012

|

||||

|

||||

不仅是硬性详情信息,它也可以显示我们系统中的**可用软件仓库列表**。

|

||||

|

||||

inxi -r

|

||||

|

||||

**示例输出:**

|

||||

|

||||

Repos: Active apt sources in file: /etc/apt/sources.list

|

||||

deb http://ubuntu.excellmedia.net/archive/ trusty main restricted

|

||||

deb-src http://ubuntu.excellmedia.net/archive/ trusty main restricted

|

||||

deb http://ubuntu.excellmedia.net/archive/ trusty-updates main restricted

|

||||

deb-src http://ubuntu.excellmedia.net/archive/ trusty-updates main restricted

|

||||

deb http://ubuntu.excellmedia.net/archive/ trusty universe

|

||||

.

|

||||

.

|

||||

Active apt sources in file: /etc/apt/sources.list.d/intellinuxgraphics.list

|

||||

deb https://download.01.org/gfx/ubuntu/14.04/main trusty main #Intel Graphics drivers

|

||||

Active apt sources in file: /etc/apt/sources.list.d/linrunner-tlp-trusty.list

|

||||

Active apt sources in file: /etc/apt/sources.list.d/wseverin-ppa-trusty.list

|

||||

deb http://ppa.launchpad.net/wseverin/ppa/ubuntu trusty main

|

||||

|

||||

Inxi还可以显示你所在位置的天气信息。感到意外吗?是的,它可以。

|

||||

|

||||

inxi -W Erode,Tamilnadu

|

||||

|

||||

这里**Erode**是地区,**Tamilnadu**是印度的一个邦。

|

||||

|

||||

示例输出:

|

||||

|

||||

Weather: Conditions: 79 F (26 C) - Clear Time: February 4, 6:00 PM IST

|

||||

|

||||

### 查看完整的硬件详情信息 ###

|

||||

|

||||

厌倦了逐一获取每种硬件的信息?你可以使用如下命令将所有信息一次列出:

|

||||

|

||||

inxi -F

|

||||

|

||||

**示例输出:**

|

||||

|

||||

System: Host: sk Kernel: 3.13.0-45-generic x86_64 (64 bit) Desktop: LXDE (Openbox 3.5.2) Distro: Ubuntu 14.04 trusty

|

||||

Machine: System: Dell (portable) product: Inspiron N5050

|

||||

Mobo: Dell model: 01HXXJ version: A05 Bios: Dell version: A05 date: 08/03/2012

|

||||

CPU: Dual core Intel Core i3-2350M CPU (-HT-MCP-) cache: 3072 KB flags: (lm nx sse sse2 sse3 sse4_1 sse4_2 ssse3 vmx)

|

||||

Clock Speeds: 1: 800.00 MHz 2: 1000.00 MHz 3: 800.00 MHz 4: 800.00 MHz

|

||||

Graphics: Card: Intel 2nd Generation Core Processor Family Integrated Graphics Controller

|

||||

X.Org: 1.15.1 drivers: intel (unloaded: fbdev,vesa) Resolution: 1366x768@60.0hz

|

||||

GLX Renderer: Mesa DRI Intel Sandybridge Mobile GLX Version: 3.0 Mesa 10.3.0

|

||||

Audio: Card: Intel 6 Series/C200 Series Family High Definition Audio Controller driver: snd_hda_intel

|

||||

Sound: Advanced Linux Sound Architecture ver: k3.13.0-45-generic

|

||||

Network: Card-1: Qualcomm Atheros AR9285 Wireless Network Adapter (PCI-Express) driver: ath9k

|

||||

IF: wlan0 state: up mac:

|

||||

Card-2: Realtek RTL8101E/RTL8102E PCI Express Fast Ethernet controller driver: r8169

|

||||

IF: eth0 state: down mac:

|

||||

Drives: HDD Total Size: 500.1GB (52.5% used) 1: id: /dev/sda model: ST9500325AS size: 500.1GB

|

||||

Partition: ID: / size: 455G used: 245G (57%) fs: ext4 ID: /boot size: 236M used: 159M (72%) fs: ext2

|

||||

ID: swap-1 size: 4.19GB used: 0.00GB (0%) fs: swap

|

||||

RAID: No RAID devices detected - /proc/mdstat and md_mod kernel raid module present

|

||||

Sensors: System Temperatures: cpu: 64.5C mobo: N/A

|

||||

Fan Speeds (in rpm): cpu: N/A

|

||||

Info: Processes: 186 Uptime: 6:52 Memory: 1547.2/3861.3MB Client: Shell (bash) inxi: 1.9.17

|

||||

|

||||

就像上面你看到的那样,inxi显示出了完整的硬件详情信息。

|

||||

|

||||

更多的细节可以参考man手册。

|

||||

|

||||

man inxi

|

||||

|

||||

### 结论 ###

|

||||

|

||||

你在寻找一个可以显示完整的系统和硬件详情信息的简单工具吗?那么不用再找了,inxi会提供你所需要的。并且,它还是在你系统默认的软件仓库中的轻量级工具。你还想要更多东西吗?试一试它,你不会失望。

|

||||

|

||||

欢呼吧!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.unixmen.com/inxi-find-system-hardware-information-linux/

|

||||

|

||||

作者:[SK][a]

|

||||

译者:[goreliu](https://github.com/goreliu)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.unixmen.com/author/sk/

|

||||

[1]:https://linux.cn/article-1947-1.html

|

||||

@ -0,0 +1,67 @@

|

||||

在Ubuntu 14.10上安装基于Web的监控工具:Linux-Dash

|

||||

================================================================================

|

||||

|

||||

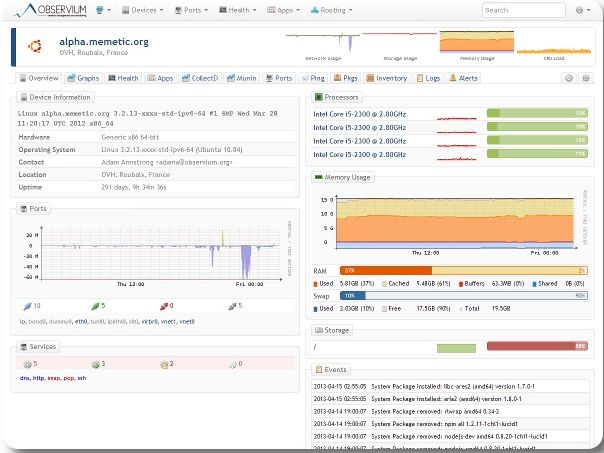

Linux-Dash是一个用于GNU/Linux机器的,低开销的监控仪表盘。您可以安装试试!Linux Dash的界面提供了您的服务器的所有关键信息的详细视图,可监测的信息包括RAM、磁盘使用率、网络、安装的软件、用户、运行的进程等。所有的信息都被分成几类,您可以通过主页工具栏中的按钮跳到任何一类中。Linux Dash并不是最先进的监测工具,但它十分适合寻找灵活、轻量级、容易部署的应用的用户。

|

||||

|

||||

### Linux-Dash的功能 ###

|

||||

|

||||

- 使用一个基于Web的漂亮的仪表盘界面来监控服务器信息

|

||||

- 实时的按照你的要求监控RAM、负载、运行时间、磁盘配置、用户和许多其他系统状态

|

||||

- 支持基于Apache2/niginx + PHP的服务器

|

||||

- 通过点击和拖动来重排列控件

|

||||

- 支持多种类型的linux服务器

|

||||

|

||||

### 当前控件列表 ###

|

||||

|

||||

- 通用信息

|

||||

- 平均负载

|

||||

- RAM

|

||||

- 磁盘使用量

|

||||

- 用户

|

||||

- 软件

|

||||

- IP

|

||||

- 网络速率

|

||||

- 在线状态

|

||||

- 处理器

|

||||

- 日志

|

||||

|

||||

### 在Ubuntu server 14.10上安装Linux-Dash ###

|

||||

|

||||

首先您需要确认您安装了[Ubuntu LAMP server 14.10][1],接下来您需要安装下面的包:

|

||||

|

||||

sudo apt-get install php5-json unzip

|

||||

|

||||

安装这个模块后,需要在apache2中启用该模块,所以您需要使用下面的命令重启apache2服务器:

|

||||

|

||||

sudo service apache2 restart

|

||||

|

||||

现在您需要下载linux-dash的安装包并安装它:

|

||||

|

||||

wget https://github.com/afaqurk/linux-dash/archive/master.zip

|

||||

|

||||

unzip master.zip

|

||||

|

||||

sudo mv linux-dash-master/ /var/www/html/linux-dash-master/

|

||||

|

||||

接下来您需要使用下面的命令来改变权限:

|

||||

|

||||

sudo chmod 755 /var/www/html/linux-dash-master/

|

||||

|

||||

现在您便可以访问http://serverip/linux-dash-master/了。您应该会看到类似下面的输出:

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.ubuntugeek.com/install-linux-dash-web-based-monitoring-tool-on-ubntu-14-10.html

|

||||

|

||||

作者:[ruchi][a]

|

||||

译者:[wwy-hust](https://github.com/wwy-hust)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.ubuntugeek.com/author/ubuntufix

|

||||

[1]:http://www.ubuntugeek.com/step-by-step-ubuntu-14-10-utopic-unicorn-lamp-server-setup.html

|

||||

@ -1,18 +1,18 @@

|

||||

领略一些最著名的 Linux 网络工具

|

||||

一大波你可能不知道的 Linux 网络工具

|

||||

================================================================================

|

||||

在你的系统上使用命令行工具来监控你的网络是非常实用的,并且对于 Linux 用户来说,有着许许多多现成的工具可以使用,如 nethogs, ntopng, nload, iftop, iptraf, bmon, slurm, tcptrack, cbm, netwatch, collectl, trafshow, cacti, etherape, ipband, jnettop, netspeed 以及 speedometer。

|

||||

如果要在你的系统上监控网络,那么使用命令行工具是非常实用的,并且对于 Linux 用户来说,有着许许多多现成的工具可以使用,如: nethogs, ntopng, nload, iftop, iptraf, bmon, slurm, tcptrack, cbm, netwatch, collectl, trafshow, cacti, etherape, ipband, jnettop, netspeed 以及 speedometer。

|

||||

|

||||

鉴于世上有着许多的 Linux 专家和开发者,显然还存在其他的网络监控工具,但在这篇教程中,我不打算将它们所有包括在内。

|

||||

|

||||

上面列出的工具都有着自己的独特之处,但归根结底,它们都做着监控网络流量的工作,且并不是只有一种方法来完成这件事。例如 nethogs 可以被用来展示每个进程的带宽使用情况,以防你想知道究竟是哪个应用在消耗了你的整个网络资源; iftop 可以被用来展示每个套接字连接的带宽使用情况,而 像 nload 这类的工具可以帮助你得到有关整个带宽的信息。

|

||||

上面列出的工具都有着自己的独特之处,但归根结底,它们都做着监控网络流量的工作,只是通过各种不同的方法。例如 nethogs 可以被用来展示每个进程的带宽使用情况,以防你想知道究竟是哪个应用在消耗了你的整个网络资源; iftop 可以被用来展示每个套接字连接的带宽使用情况,而像 nload 这类的工具可以帮助你得到有关整个带宽的信息。

|

||||

|

||||

### 1) nethogs ###

|

||||

|

||||

nethogs 是一个免费的工具,当要查找哪个 PID (注:即 process identifier,进程 ID) 给你的网络流量带来了麻烦时,它是非常方便的。它按每个进程来组织带宽,而不是像大多数的工具那样按照每个协议或每个子网来划分流量。它功能丰富,同时支持 IPv4 和 IPv6,并且我认为,若你想在你的 Linux 主机上确定哪个程序正消耗着你的全部带宽,它是来做这件事的最佳的程序。

|

||||

nethogs 是一个免费的工具,当要查找哪个 PID (注:即 process identifier,进程 ID) 给你的网络流量带来了麻烦时,它是非常方便的。它按每个进程来分组带宽,而不是像大多数的工具那样按照每个协议或每个子网来划分流量。它功能丰富,同时支持 IPv4 和 IPv6,并且我认为,若你想在你的 Linux 主机上确定哪个程序正消耗着你的全部带宽,它是来做这件事的最佳的程序。

|

||||

|

||||

一个 Linux 用户可以使用 **nethogs** 来显示每个进程的 TCP 下载和上传速率,使用命令 **nethogs eth0** 来监控一个特定的设备,上面的 eth0 是那个你想获取信息的设备的名称,你还可以得到有关正在被传输的数据的传输速率的信息。

|

||||

一个 Linux 用户可以使用 **nethogs** 来显示每个进程的 TCP 下载和上传速率,可以使用命令 **nethogs eth0** 来监控一个指定的设备,上面的 eth0 是那个你想获取信息的设备的名称,你还可以得到有关正在传输的数据的传输速率信息。

|

||||

|

||||

对我而言, nethogs 是非常容易使用的,或许是因为我非常喜欢它以至于我总是在我的 Ubuntu 12.04 LTS 机器中使用它来监控我的网络带宽。

|

||||

对我而言, nethogs 是非常容易使用的,或许是因为我非常喜欢它,以至于我总是在我的 Ubuntu 12.04 LTS 机器中使用它来监控我的网络带宽。

|

||||

|

||||

例如要想使用混杂模式来嗅探,可以像下面展示的命令那样使用选项 -p:

|

||||

|

||||

@ -20,6 +20,8 @@ nethogs 是一个免费的工具,当要查找哪个 PID (注:即 process ide

|

||||

|

||||

假如你想更多地了解 nethogs 并深入探索它,那么请毫不犹豫地阅读我们做的关于这个网络带宽监控工具的整个教程。

|

||||

|

||||

(LCTT 译注:关于 nethogs 的更多信息可以参考:https://linux.cn/article-2808-1.html )

|

||||

|

||||

### 2) nload ###

|

||||

|

||||

nload 是一个控制台应用,可以被用来实时地监控网络流量和带宽使用情况,它还通过提供两个简单易懂的图表来对流量进行可视化。这个绝妙的网络监控工具还可以在监控过程中切换被监控的设备,而这可以通过按左右箭头来完成。

|

||||

@ -28,19 +30,21 @@ nload 是一个控制台应用,可以被用来实时地监控网络流量和

|

||||

|

||||

正如你在上面的截图中所看到的那样,由 nload 提供的图表是非常容易理解的。nload 提供了有用的信息,也展示了诸如被传输数据的总量和最小/最大网络速率等信息。

|

||||

|

||||

而更酷的是你可以在下面的命令的帮助下运行 nload 这个工具,这个命令是非常的短小且易记的:

|

||||

而更酷的是你只需要直接运行 nload 这个工具就行,这个命令是非常的短小且易记的:

|

||||

|

||||

nload

|

||||

|

||||

我很确信的是:我们关于如何使用 nload 的详细教程将帮助到新的 Linux 用户,甚至可以帮助那些正寻找关于 nload 信息的老手。

|

||||

|

||||

(LCTT 译注:关于 nload 的更新信息可以参考:https://linux.cn/article-5114-1.html )

|

||||

|

||||

### 3) slurm ###

|

||||

|

||||

slurm 是另一个 Linux 网络负载监控工具,它以一个不错的 ASCII 图来显示结果,它还支持许多键值用以交互,例如 **c** 用来切换到经典模式, **s** 切换到分图模式, **r** 用来重绘屏幕, **L** 用来启用 TX/RX(注:TX,发送流量;RX,接收流量) LED,**m** 用来在经典分图模式和大图模式之间进行切换, **q** 退出 slurm。

|

||||

slurm 是另一个 Linux 网络负载监控工具,它以一个不错的 ASCII 图来显示结果,它还支持许多按键用以交互,例如 **c** 用来切换到经典模式, **s** 切换到分图模式, **r** 用来重绘屏幕, **L** 用来启用 TX/RX 灯(注:TX,发送流量;RX,接收流量) ,**m** 用来在经典分图模式和大图模式之间进行切换, **q** 退出 slurm。

|

||||

|

||||

|

||||

|

||||

在网络负载监控工具 slurm 中,还有许多其它的键值可用,你可以很容易地使用下面的命令在 man 手册中学习它们。

|

||||

在网络负载监控工具 slurm 中,还有许多其它的按键可用,你可以很容易地使用下面的命令在 man 手册中学习它们。

|

||||

|

||||

man slurm

|

||||

|

||||

@ -48,11 +52,11 @@ slurm 在 Ubuntu 和 Debian 的官方软件仓库中可以找到,所以使用

|

||||

|

||||

sudo apt-get install slurm

|

||||

|

||||

我们已经在一个教程中对 slurm 的使用做了介绍,所以请访问相关网页( 注:应该指的是[这篇文章](http://linoxide.com/ubuntu-how-to/monitor-network-load-slurm-tool/) ),并不要忘记和其它使用 Linux 的朋友分享这些知识。

|

||||

我们已经在一个[教程](http://linoxide.com/ubuntu-how-to/monitor-network-load-slurm-tool/)中对 slurm 的使用做了介绍,不要忘记和其它使用 Linux 的朋友分享这些知识。

|

||||

|

||||

### 4) iftop ###

|

||||

|

||||

当你想在一个接口上按照主机来展示带宽使用情况时,iftop 是一个非常有用的工具。根据 man 手册,**iftop** 在一个已命名的接口或在它可以找到的第一个接口(假如没有任何特殊情况,它就像一个外部的接口)上监听网络流量,并且展示出一个表格来显示当前一对主机间的带宽使用情况。

|

||||

当你想显示连接到网卡上的各个主机的带宽使用情况时,iftop 是一个非常有用的工具。根据 man 手册,**iftop** 在一个指定的接口或在它可以找到的第一个接口(假如没有任何特殊情况,它应该是一个对外的接口)上监听网络流量,并且展示出一个表格来显示当前的一对主机间的带宽使用情况。

|

||||

|

||||

通过在虚拟终端中使用下面的命令,Ubuntu 和 Debian 用户可以在他们的机器中轻易地安装 iftop:

|

||||

|

||||

@ -61,6 +65,8 @@ slurm 在 Ubuntu 和 Debian 的官方软件仓库中可以找到,所以使用

|

||||

在你的机器上,可以使用下面的命令通过 yum 来安装 iftop:

|

||||

|

||||

yum -y install iftop

|

||||

|

||||

(LCTT 译注:关于 nload 的更多信息请参考:https://linux.cn/article-1843-1.html )

|

||||

|

||||

### 5) collectl ###

|

||||

|

||||

@ -69,7 +75,7 @@ collectl 可以被用来收集描述当前系统状态的数据,并且它支

|

||||

- 记录模式

|

||||

- 回放模式

|

||||

|

||||

**记录模式** 允许从一个正在运行的系统中读取数据,然后将这些数据要么显示在终端中,要么写入一个或多个文件或套接字中。

|

||||

**记录模式** 允许从一个正在运行的系统中读取数据,然后将这些数据要么显示在终端中,要么写入一个或多个文件或一个套接字中。

|

||||

|

||||

**回放模式**

|

||||

|

||||

@ -79,13 +85,15 @@ Ubuntu 和 Debian 用户可以在他们的机器上使用他们默认的包管

|

||||

|

||||

sudo apt-get install collectl

|

||||

|

||||

还可以使用下面的命令来安装 collectl, 因为对于这些发行版本(注:这里指的是用 yum 作为包管理器的发行版本),在它们官方的软件仓库中也含有 collectl:

|

||||

还可以使用下面的命令来安装 collectl, 因为对于这些发行版本(注:这里指的是用 yum 作为包管理器的发行版本),在它们官方的软件仓库中也含有 collectl:

|

||||

|

||||

yum install collectl

|

||||

|

||||

(LCTT 译注:关于 collectl 的更多信息请参考: https://linux.cn/article-3154-1.html )

|

||||

|

||||

### 6) Netstat ###

|

||||

|

||||

Netstat 是一个用来监控**传入和传出的网络数据包统计数据**和接口统计数据的命令行工具。它为传输控制协议 TCP (包括上传和下行),路由表,及一系列的网络接口(网络接口控制器或者软件定义的网络接口) 和网络协议统计数据展示网络连接情况。

|

||||

Netstat 是一个用来监控**传入和传出的网络数据包统计数据**的接口统计数据命令行工具。它会显示 TCP 连接 (包括上传和下行),路由表,及一系列的网络接口(网卡或者SDN接口)和网络协议统计数据。

|

||||

|

||||

Ubuntu 和 Debian 用户可以在他们的机器上使用默认的包管理器来安装 netstat。Netsta 软件被包括在 net-tools 软件包中,并可以在 shell 或虚拟终端中运行下面的命令来安装它:

|

||||

|

||||

@ -107,6 +115,8 @@ CentOS, Fedora, RHEL 用户可以在他们的机器上使用默认的包管理

|

||||

|

||||

|

||||

|

||||

(LCTT 译注:关于 netstat 的更多信息请参考:https://linux.cn/article-2434-1.html )

|

||||

|

||||

### 7) Netload ###

|

||||

|

||||

netload 命令只展示一个关于当前网络荷载和自从程序运行之后传输数据总的字节数目的简要报告,它没有更多的功能。它是 netdiag 软件的一部分。

|

||||

@ -115,9 +125,9 @@ netload 命令只展示一个关于当前网络荷载和自从程序运行之后

|

||||

|

||||

# yum install netdiag

|

||||

|

||||

Netload 在默认仓库中作为 netdiag 的一部分可以被找到,我们可以轻易地使用下面的命令来利用 **apt** 包管理器安装 **netdiag**:

|

||||

Netload 是默认仓库中 netdiag 的一部分,我们可以轻易地使用下面的命令来利用 **apt** 包管理器安装 **netdiag**:

|

||||

|

||||

$ sudo apt-get install netdiag (注:这里原文为 sudo install netdiag,应该加上 apt-get)

|

||||

$ sudo apt-get install netdiag

|

||||

|

||||

为了运行 netload,我们需要确保选择了一个正在工作的网络接口的名称,如 eth0, eh1, wlan0, mon0等,然后在 shell 或虚拟终端中运行下面的命令:

|

||||

|

||||

@ -127,21 +137,23 @@ Netload 在默认仓库中作为 netdiag 的一部分可以被找到,我们可

|

||||

|

||||

### 8) Nagios ###

|

||||

|

||||

Nagios 是一个领先且功能强大的开源监控系统,它使得网络或系统管理员在服务器相关的问题影响到服务器的主要事务之前,鉴定并解决这些问题。 有了 Nagios 系统,管理员便可以在一个单一的窗口中监控远程的 Linux 、Windows 系统、交换机、路由器和打印机等。它显示出重要的警告并指示出在你的网络或服务器中是否出现某些故障,这间接地帮助你在问题发生之前,着手执行补救行动。

|

||||

Nagios 是一个领先且功能强大的开源监控系统,它使得网络或系统管理员可以在服务器的各种问题影响到服务器的主要事务之前,发现并解决这些问题。 有了 Nagios 系统,管理员便可以在一个单一的窗口中监控远程的 Linux 、Windows 系统、交换机、路由器和打印机等。它会显示出重要的警告并指出在你的网络或服务器中是否出现某些故障,这可以间接地帮助你在问题发生前就着手执行补救行动。

|

||||

|

||||

Nagios 有一个 web 界面,其中有一个图形化的活动监视器。通过浏览网页 http://localhost/nagios/ 或 http://localhost/nagios3/ 便可以登录到这个 web 界面。假如你在远程的机器上进行操作,请使用你的 IP 地址来替换 localhost,然后键入用户名和密码,我们便会看到如下图所展示的信息:

|

||||

|

||||

|

||||

|

||||

(LCTT 译注:关于 Nagios 的更多信息请参考:https://linux.cn/article-2436-1.html )

|

||||

|

||||

### 9) EtherApe ###

|

||||

|

||||

EtherApe 是一个针对 Unix 的图形化网络监控工具,它仿照了 etherman 软件。它具有链路层,IP 和 TCP 模式并支持 Ethernet, FDDI, Token Ring, ISDN, PPP, SLIP 及 WLAN 设备等接口,再加上支持一些封装的格式。主机和链接随着流量大小和被着色的协议名称展示而变化。它可以过滤要展示的流量,并可从一个文件或运行的网络中读取数据报。

|

||||

EtherApe 是一个针对 Unix 的图形化网络监控工具,它仿照了 etherman 软件。它支持链路层、IP 和 TCP 等模式,并支持以太网, FDDI, 令牌环, ISDN, PPP, SLIP 及 WLAN 设备等接口,以及一些封装格式。主机和连接随着流量和协议而改变其尺寸和颜色。它可以过滤要展示的流量,并可从一个文件或运行的网络中读取数据包。

|

||||

|

||||

在 CentOS、Fedora、RHEL 等 Linux 发行版本中安装 etherape 是一件容易的事,因为在它们的官方软件仓库中就可以找到 etherape。我们可以像下面展示的命令那样使用 yum 包管理器来安装它:

|

||||

|

||||

yum install etherape

|

||||

|

||||

我们可以使用下面的命令在 Ubuntu、Debian 及它们的衍生发行版本中使用 **apt** 包管理器来安装 EtherApe :

|

||||

我们也可以使用下面的命令在 Ubuntu、Debian 及它们的衍生发行版本中使用 **apt** 包管理器来安装 EtherApe :

|

||||

|

||||

sudo apt-get install etherape

|

||||

|

||||

@ -149,13 +161,13 @@ EtherApe 是一个针对 Unix 的图形化网络监控工具,它仿照了 ethe

|

||||

|

||||

sudo etherape

|

||||

|

||||

然后, **etherape** 的 **图形用户界面** 便会被执行。接着,在菜单上面的 **捕捉** 选项下,我们可以选择 **模式**(IP,链路层,TCP) 和 **接口**。一切设定完毕后,我们需要点击 **开始** 按钮。接着我们便会看到类似下面截图的东西:

|

||||

然后, **etherape** 的 **图形用户界面** 便会被执行。接着,在菜单上面的 **捕捉** 选项下,我们可以选择 **模式**(IP,链路层,TCP) 和 **接口**。一切设定完毕后,我们需要点击 **开始** 按钮。接着我们便会看到类似下面截图的东西:

|

||||

|

||||

|

||||

|

||||

### 10) tcpflow ###

|

||||

|

||||

tcpflow 是一个命令行工具,它可以捕捉作为 TCP 连接(流)的一部分的传输数据,并以一种方便协议分析或除错的方式来存储数据。它重建了实际的数据流并将每个流存储在不同的文件中,以备日后的分析。它理解 TCP 序列号并可以正确地重建数据流,不管是在重发或乱序发送状态下。

|

||||

tcpflow 是一个命令行工具,它可以捕捉 TCP 连接(流)的部分传输数据,并以一种方便协议分析或除错的方式来存储数据。它重构了实际的数据流并将每个流存储在不同的文件中,以备日后的分析。它能识别 TCP 序列号并可以正确地重构数据流,不管是在重发还是乱序发送状态下。

|

||||

|

||||

通过 **apt** 包管理器在 Ubuntu 、Debian 系统中安装 tcpflow 是很容易的,因为默认情况下在官方软件仓库中可以找到它。

|

||||

|

||||

@ -175,7 +187,7 @@ tcpflow 是一个命令行工具,它可以捕捉作为 TCP 连接(流)的一

|

||||

|

||||

# yum install --nogpgcheck http://pkgs.repoforge.org/tcpflow/tcpflow-0.21-1.2.el6.rf.i686.rpm

|

||||

|

||||

我们可以使用 tcpflow 来捕捉全部或部分 tcp 流量并以一种简单的方式把它们写到一个可读文件中。下面的命令执行着我们想要做的事情,但我们需要在一个空目录中运行下面的命令,因为它将创建诸如 x.x.x.x.y-a.a.a.a.z 格式的文件,做完这些之后,只需按 Ctrl-C 便可停止这个命令。

|

||||

我们可以使用 tcpflow 来捕捉全部或部分 tcp 流量,并以一种简单的方式把它们写到一个可读的文件中。下面的命令就可以完成这个事情,但我们需要在一个空目录中运行下面的命令,因为它将创建诸如 x.x.x.x.y-a.a.a.a.z 格式的文件,运行之后,只需按 Ctrl-C 便可停止这个命令。

|

||||

|

||||

$ sudo tcpflow -i eth0 port 8000

|

||||

|

||||

@ -183,49 +195,51 @@ tcpflow 是一个命令行工具,它可以捕捉作为 TCP 连接(流)的一

|

||||

|

||||

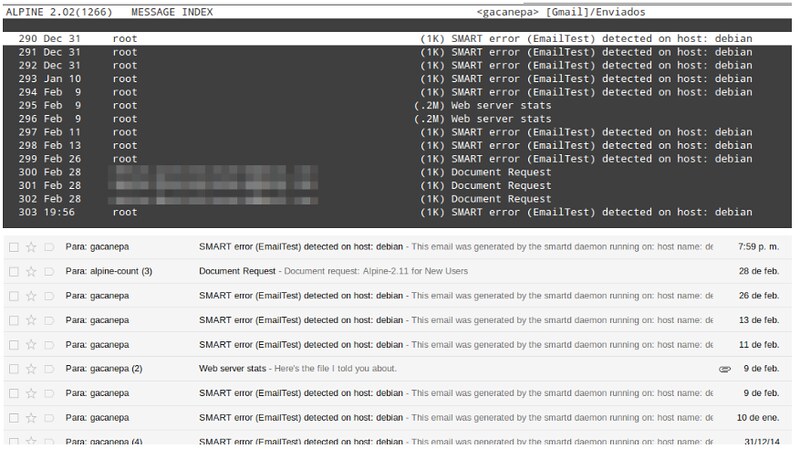

### 11) IPTraf ###

|

||||

|

||||

[IPTraf][2] 是一个针对 Linux 平台的基于控制台的网络统计应用。它生成一系列的图形,如 TCP 连接包和字节的数目、接口信息和活动指示器、 TCP/UDP 流量故障以及 LAN 状态包和字节的数目。

|

||||

[IPTraf][2] 是一个针对 Linux 平台的基于控制台的网络统计应用。它生成一系列的图形,如 TCP 连接的包/字节计数、接口信息和活动指示器、 TCP/UDP 流量故障以及局域网内设备的包/字节计数。

|

||||

|

||||

在默认的软件仓库中可以找到 IPTraf,所以我们可以使用下面的命令通过 **apt** 包管理器轻松地安装 IPTraf:

|

||||

|

||||

$ sudo apt-get install iptraf

|

||||

|

||||

在默认的软件仓库中可以找到 IPTraf,所以我们可以使用下面的命令通过 **yum** 包管理器轻松地安装 IPTraf:

|

||||

我们可以使用下面的命令通过 **yum** 包管理器轻松地安装 IPTraf:

|

||||

|

||||

# yum install iptraf

|

||||

|

||||

我们需要以管理员权限来运行 IPTraf(注:这里原文写错为 TPTraf),并带有一个可用的网络接口名。这里,我们的网络接口名为 wlan2,所以我们使用 wlan2 来作为接口的名称:

|

||||

我们需要以管理员权限来运行 IPTraf,并带有一个有效的网络接口名。这里,我们的网络接口名为 wlan2,所以我们使用 wlan2 来作为参数:

|

||||

|

||||

$ sudo iptraf wlan2 (注:这里原文为 sudo iptraf,应该加上 wlan2)

|

||||

$ sudo iptraf wlan2

|

||||

|

||||

|

||||

|

||||

开始一般的网络接口统计,键入:

|

||||

开始通常的网络接口统计,键入:

|

||||

|

||||

# iptraf -g

|

||||

|

||||

为了在一个名为 eth0 的接口设备上看详细的统计信息,使用:

|

||||

查看接口 eth0 的详细统计信息,使用:

|

||||

|

||||

# iptraf -d wlan2 (注:这里的 wlan2 和 上面的 eth0 不一致,下面的几句也是这种情况,请相应地改正)

|

||||

# iptraf -d eth0

|

||||

|

||||

为了看一个名为 eth0 的接口的 TCP 和 UDP 监控,使用:

|

||||

查看接口 eth0 的 TCP 和 UDP 监控信息,使用:

|

||||

|

||||

# iptraf -z wlan2

|

||||

# iptraf -z eth0

|

||||

|

||||

为了展示在一个名为 eth0 的接口上的包的大小和数目,使用:

|

||||

查看接口 eth0 的包的大小和数目,使用:

|

||||

|

||||

# iptraf -z wlan2

|

||||

# iptraf -z eth0

|

||||

|

||||

注意:请将上面的 wlan2 替换为你的接口名称。你可以通过运行`ip link show`命令来检查你的接口。

|

||||

注意:请将上面的 eth0 替换为你的接口名称。你可以通过运行`ip link show`命令来检查你的接口。

|

||||

|

||||

(LCTT 译注:关于 iptraf 的更多详细信息请参考:https://linux.cn/article-5430-1.html )

|

||||

|

||||

### 12) Speedometer ###

|

||||

|

||||

Speedometer 是一个小巧且简单的工具,它只绘出一幅包含有通过某个给定端口的上行、下行流量的好看的图。

|

||||

Speedometer 是一个小巧且简单的工具,它只用来绘出一幅包含有通过某个给定端口的上行、下行流量的好看的图。

|

||||

|

||||

在默认的软件仓库中可以找到 Speedometer ,所以我们可以使用下面的命令通过 **yum** 包管理器轻松地安装 Speedometer:

|

||||

|

||||

# yum install speedometer

|

||||

|

||||

在默认的软件仓库中可以找到 Speedometer ,所以我们可以使用下面的命令通过 **apt** 包管理器轻松地安装 Speedometer:

|

||||

我们可以使用下面的命令通过 **apt** 包管理器轻松地安装 Speedometer:

|

||||

|

||||

$ sudo apt-get install speedometer

|

||||

|

||||

@ -239,15 +253,15 @@ Speedometer 可以简单地通过在 shell 或虚拟终端中执行下面的命

|

||||

|

||||

### 13) Netwatch ###

|

||||

|

||||

Netwatch 是 netdiag 工具集里的一部分,并且它也显示出当前主机和其他远程主机的连接情况,以及在每个连接中数据传输的速率。

|

||||

Netwatch 是 netdiag 工具集里的一部分,它也显示当前主机和其他远程主机的连接情况,以及在每个连接中数据传输的速率。

|

||||

|

||||

我们可以使用 yum 在 fedora 中安装 Netwatch,因为它在 fedora 的默认软件仓库中。但若你运行着 CentOS 或 RHEL , 我们需要安装 [rpmforge 软件仓库][3]。

|

||||

|

||||

# yum install netwatch

|

||||

|

||||

Netwatch 作为 netdiag 的一部分可以在默认的软件仓库中找到,所以我们可以轻松地使用下面的命令来利用 **apt** 包管理器安装 **netdiag**:

|

||||

Netwatch 是 netdiag 的一部分,可以在默认的软件仓库中找到,所以我们可以轻松地使用下面的命令来利用 **apt** 包管理器安装 **netdiag**:

|

||||

|

||||

$ sudo apt-get install netdiag(注:这里应该加上 apt-get

|

||||

$ sudo apt-get install netdiag

|

||||

|

||||

为了运行 netwatch, 我们需要在虚拟终端或 shell 中执行下面的命令:

|

||||

|

||||

@ -259,15 +273,15 @@ Netwatch 作为 netdiag 的一部分可以在默认的软件仓库中找到,

|

||||

|

||||

### 14) Trafshow ###

|

||||

|

||||

Trafshow 同 netwatch 和 pktstat(注:这里原文中多了一个 trafshow)一样,可以报告当前激活的连接里使用的协议和每个连接中数据传输的速率。它可以使用 pcap 类型的滤波器来筛选出特定的连接。

|

||||

Trafshow 同 netwatch 和 pktstat 一样,可以报告当前活动的连接里使用的协议和每个连接中数据传输的速率。它可以使用 pcap 类型的过滤器来筛选出特定的连接。

|

||||

|

||||

我们可以使用 yum 在 fedora 中安装 trafshow(注:这里原文为 Netwatch,应该为 trafshow),因为它在 fedora 的默认软件仓库中。但若你正运行着 CentOS 或 RHEL , 我们需要安装 [rpmforge 软件仓库][4]。

|

||||

我们可以使用 yum 在 fedora 中安装 trafshow ,因为它在 fedora 的默认软件仓库中。但若你正运行着 CentOS 或 RHEL , 我们需要安装 [rpmforge 软件仓库][4]。

|

||||

|

||||

# yum install trafshow

|

||||

|

||||

Trafshow 在默认仓库中可以找到,所以我们可以轻松地使用下面的命令来利用 **apt** 包管理器安装它:

|