mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-02-03 23:40:14 +08:00

commit

304802f9a9

@ -1,13 +1,15 @@

|

||||

调试器到底怎样工作

|

||||

======

|

||||

|

||||

> 你也许用过调速器检查过你的代码,但你知道它们是如何做到的吗?

|

||||

|

||||

|

||||

|

||||

供图:opensource.com

|

||||

|

||||

调试器是那些大多数(即使不是每个)开发人员在软件工程职业生涯中至少使用过一次的软件之一,但是你们中有多少人知道它们到底是如何工作的?我在悉尼 [linux.conf.au 2018][1] 的演讲中,将讨论从头开始编写调试器...使用 [Rust][2]!

|

||||

调试器是大多数(即使不是每个)开发人员在软件工程职业生涯中至少使用过一次的那些软件之一,但是你们中有多少人知道它们到底是如何工作的?我在悉尼 [linux.conf.au 2018][1] 的演讲中,将讨论从头开始编写调试器……使用 [Rust][2]!

|

||||

|

||||

在本文中,术语调试器/跟踪器可以互换。 “被跟踪者”是指正在被跟踪者跟踪的进程。

|

||||

在本文中,术语<ruby>调试器<rt>debugger</rt></ruby>和<ruby>跟踪器<rt>tracer</rt></ruby>可以互换。 “<ruby>被跟踪者<rt>Tracee</rt></ruby>”是指正在被跟踪器跟踪的进程。

|

||||

|

||||

### ptrace 系统调用

|

||||

|

||||

@ -17,59 +19,46 @@

|

||||

long ptrace(enum __ptrace_request request, pid_t pid, void *addr, void *data);

|

||||

```

|

||||

|

||||

这是一个可以操纵进程几乎所有方面的系统调用;但是,在调试器可以连接到一个进程之前,“被跟踪者”必须以请求 `PTRACE_TRACEME` 调用 `ptrace`。这告诉 Linux,父进程通过 `ptrace` 连接到这个进程是合法的。但是......我们如何强制一个进程调用 `ptrace`?很简单!`fork/execve` 提供了在 `fork` 之后但在被跟踪者真正开始使用 `execve` 之前调用 `ptrace` 的简单方法。很方便地,`fork` 还会返回被跟踪者的 `pid`,这是后面使用 `ptrace` 所必需的。

|

||||

这是一个可以操纵进程几乎所有方面的系统调用;但是,在调试器可以连接到一个进程之前,“被跟踪者”必须以请求 `PTRACE_TRACEME` 调用 `ptrace`。这告诉 Linux,父进程通过 `ptrace` 连接到这个进程是合法的。但是……我们如何强制一个进程调用 `ptrace`?很简单!`fork/execve` 提供了在 `fork` 之后但在被跟踪者真正开始使用 `execve` 之前调用 `ptrace` 的简单方法。很方便地,`fork` 还会返回被跟踪者的 `pid`,这是后面使用 `ptrace` 所必需的。

|

||||

|

||||

现在被跟踪者可以被调试器追踪,重要的变化发生了:

|

||||

|

||||

* 每当一个信号被传送到被调试者时,它就会停止,并且一个可以被 `wait` 系列系统调用捕获的等待事件被传送给跟踪器。

|

||||

* 每当一个信号被传送到被跟踪者时,它就会停止,并且一个可以被 `wait` 系列的系统调用捕获的等待事件被传送给跟踪器。

|

||||

* 每个 `execve` 系统调用都会导致 `SIGTRAP` 被传递给被跟踪者。(与之前的项目相结合,这意味着被跟踪者在一个 `execve` 完全发生之前停止。)

|

||||

|

||||

这意味着,一旦我们发出 `PTRACE_TRACEME` 请求并调用 `execve` 系统调用来实际在被跟踪者(进程上下文)中启动程序时,被跟踪者将立即停止,因为 `execve` 会传递一个 `SIGTRAP`,并且会被跟踪器中的等待事件捕获。我们如何继续?正如人们所期望的那样,`ptrace` 有大量的请求可以用来告诉被跟踪者可以继续:

|

||||

|

||||

|

||||

* `PTRACE_CONT`:这是最简单的。 被跟踪者运行,直到它接收到一个信号,此时等待事件被传递给跟踪器。这是最常见的实现真实世界调试器的“继续直至断点”和“永远继续”选项的方式。断点将在下面介绍。

|

||||

* `PTRACE_SYSCALL`:与 `PTRACE_CONT` 非常相似,但在进入系统调用之前以及在系统调用返回到用户空间之前停止。它可以与其他请求(我们将在本文后面介绍)结合使用来监视和修改系统调用的参数或返回值。系统调用追踪程序 `strace` 很大程度上使用这个请求来获知进程发起了哪些系统调用。

|

||||

* `PTRACE_SINGLESTEP`:这个很好理解。如果您之前使用过调试器(你会知道),此请求会执行下一条指令,然后立即停止。

|

||||

|

||||

|

||||

|

||||

我们可以通过各种各样的请求停止进程,但我们如何获得被调试者的状态?进程的状态大多是通过其寄存器捕获的,所以当然 `ptrace` 有一个请求来获得(或修改)寄存器:

|

||||

|

||||

* `PTRACE_GETREGS`:这个请求将给出被跟踪者刚刚被停止时的寄存器的状态。

|

||||

* `PTRACE_SETREGS`:如果跟踪器之前通过调用 `PTRACE_GETREGS` 得到了寄存器的值,它可以在参数结构中修改相应寄存器的值并使用 `PTRACE_SETREGS` 将寄存器设为新值。

|

||||

* `PTRACE_SETREGS`:如果跟踪器之前通过调用 `PTRACE_GETREGS` 得到了寄存器的值,它可以在参数结构中修改相应寄存器的值,并使用 `PTRACE_SETREGS` 将寄存器设为新值。

|

||||

* `PTRACE_PEEKUSER` 和 `PTRACE_POKEUSER`:这些允许从被跟踪者的 `USER` 区读取信息,这里保存了寄存器和其他有用的信息。 这可以用来修改单一寄存器,而避免使用更重的 `PTRACE_{GET,SET}REGS` 请求。

|

||||

|

||||

|

||||

|

||||

在调试器仅仅修改寄存器是不够的。调试器有时需要读取一部分内存,甚至对其进行修改。GDB 可以使用 `print` 得到一个内存位置或变量的值。`ptrace` 通过下面的方法实现这个功能:

|

||||

|

||||

* `PTRACE_PEEKTEXT` 和 `PTRACE_POKETEXT`:这些允许读取和写入被跟踪者地址空间中的一个字。当然,使用这个功能时被跟踪者要被暂停。

|

||||

|

||||

|

||||

|

||||

真实世界的调试器也有类似断点和观察点的功能。 在接下来的部分中,我将深入体系结构对调试器支持的细节。为了清晰和简洁,本文将只考虑x86。

|

||||

真实世界的调试器也有类似断点和观察点的功能。 在接下来的部分中,我将深入体系结构对调试器支持的细节。为了清晰和简洁,本文将只考虑 x86。

|

||||

|

||||

### 体系结构的支持

|

||||

|

||||

`ptrace` 很酷,但它是如何工作? 在前面的部分中,我们已经看到 `ptrace` 跟信号有很大关系:`SIGTRAP` 可以在单步跟踪、`execve` 之前以及系统调用前后被传送。信号可以通过一些方式产生,但我们将研究两个具体的例子,以展示信号可以被调试器用来在给定的位置停止程序(有效地创建一个断点!):

|

||||

|

||||

|

||||

* **未定义的指令**:当一个进程尝试执行一个未定义的指令,CPU 将产生一个异常。此异常通过 CPU 中断处理,内核中相应的中断处理程序被调用。这将导致一个 `SIGILL` 信号被发送给进程。 这依次导致进程被停止,跟踪器通过一个等待事件被通知,然后它可以决定后面做什么。在 x86 上,指令 `ud2` 被确保始终是未定义的。

|

||||

|

||||

* **调试中断**:前面的方法的问题是,`ud2` 指令需要占用两个字节的机器码。存在一条特殊的单字节指令能够触发一个中断,它是 `int $3`,机器码是 `0xCC`。 当该中断发出时,内核向进程发送一个 `SIGTRAP`,如前所述,跟踪器被通知。

|

||||

|

||||

|

||||

|

||||

这很好,但如何做我们胁迫的被跟踪者执行这些指令? 这很简单:利用 `ptrace` 的 `PTRACE_POKETEXT` 请求,它可以覆盖内存中的一个字。 调试器将使用 `PTRACE_PEEKTEXT` 读取该位置原来的值并替换为 `0xCC` ,然后在其内部状态中记录该处原来的值,以及它是一个断点的事实。 下次被跟踪者执行到该位置时,它将被通过 `SIGTRAP` 信号自动停止。 然后调试器的最终用户可以决定如何继续(例如,检查寄存器)。

|

||||

这很好,但如何我们才能胁迫被跟踪者执行这些指令? 这很简单:利用 `ptrace` 的 `PTRACE_POKETEXT` 请求,它可以覆盖内存中的一个字。 调试器将使用 `PTRACE_PEEKTEXT` 读取该位置原来的值并替换为 `0xCC` ,然后在其内部状态中记录该处原来的值,以及它是一个断点的事实。 下次被跟踪者执行到该位置时,它将被通过 `SIGTRAP` 信号自动停止。 然后调试器的最终用户可以决定如何继续(例如,检查寄存器)。

|

||||

|

||||

好吧,我们已经讲过了断点,那观察点呢? 当一个特定的内存位置被读或写,调试器如何停止程序? 当然你不可能为了能够读或写内存而去把每一个指令都覆盖为 `int $3`。有一组调试寄存器为了更有效的满足这个目的而被设计出来:

|

||||

|

||||

|

||||

* `DR0` 到 `DR3`:这些寄存器中的每个都包含一个地址(内存位置),调试器因为某种原因希望被跟踪者在那些地址那里停止。 其原因以掩码方式被设定在 `DR7` 寄存器中。

|

||||

* `DR4` 和 `DR5`:这些分别是 `DR6` 和 `DR7`过时的别名。

|

||||

* `DR4` 和 `DR5`:这些分别是 `DR6` 和 `DR7` 过时的别名。

|

||||

* `DR6`:调试状态。包含有关 `DR0` 到 `DR3` 中的哪个寄存器导致调试异常被引发的信息。这被 Linux 用来计算与 `SIGTRAP` 信号一起传递给被跟踪者的信息。

|

||||

* `DR7`:调试控制。通过使用这些寄存器中的位,调试器可以控制如何解释DR0至DR3中指定的地址。位掩码控制监视点的尺寸(监视1,2,4或8个字节)以及是否在执行、读取、写入时引发异常,或在读取或写入时引发异常。

|

||||

|

||||

* `DR7`:调试控制。通过使用这些寄存器中的位,调试器可以控制如何解释 `DR0` 至 `DR3` 中指定的地址。位掩码控制监视点的尺寸(监视1、2、4 或 8 个字节)以及是否在执行、读取、写入时引发异常,或在读取或写入时引发异常。

|

||||

|

||||

由于调试寄存器是进程的 `USER` 区域的一部分,调试器可以使用 `PTRACE_POKEUSER` 将值写入调试寄存器。调试寄存器只与特定进程相关,因此在进程抢占并重新获得 CPU 控制权之前,调试寄存器会被恢复。

|

||||

|

||||

@ -88,7 +77,7 @@ via: https://opensource.com/article/18/1/how-debuggers-really-work

|

||||

|

||||

作者:[Levente Kurusa][a]

|

||||

译者:[stephenxs](https://github.com/stephenxs)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,13 +1,15 @@

|

||||

我们能否建立一个服务于用户而非广告商的社交网络?

|

||||

=====

|

||||

|

||||

> 找出 Human Connection 是如何将透明度和社区放在首位的。

|

||||

|

||||

|

||||

|

||||

如今,开源软件具有深远的意义,在推动数字经济创新方面发挥着关键作用。世界正在快速彻底地改变。世界各地的人们需要一个专门的,中立的,透明的在线平台来迎接我们这个时代的挑战。

|

||||

如今,开源软件具有深远的意义,在推动数字经济创新方面发挥着关键作用。世界正在快速彻底地改变。世界各地的人们需要一个专门的、中立的、透明的在线平台来迎接我们这个时代的挑战。

|

||||

|

||||

开放的原则可能会成为让我们到达那里的方法(to 校正者:这句上下文没有理解)。如果我们用开放的思维方式将数字创新与社会创新结合在一起,会发生什么?

|

||||

开放的原则也许是让我们达成这一目标的方法。如果我们用开放的思维方式将数字创新与社会创新结合在一起,会发生什么?

|

||||

|

||||

这个问题是我们在 [Human Connection][1] 工作的核心,这是一个具有前瞻性的,以德国为基础的知识和行动网络,其使命是创建一个服务于全球的真正的社交网络。我们受到这样一种观念为指引,即人类天生慷慨而富有同情心,并且他们在慈善行为上茁壮成长。但我们还没有看到一个完全支持我们自然倾向,于乐于助人和合作以促进共同利益的社交网络。Human Connection 渴望成为让每个人都成为积极变革者的平台。

|

||||

这个问题是我们在 [Human Connection][1] 工作的核心,这是一个具有前瞻性的,以德国为基础的知识和行动网络,其使命是创建一个服务于全球的真正的社交网络。我们受到这样一种观念为指引,即人类天生慷慨而富有同情心,并且他们在慈善行为上茁壮成长。但我们还没有看到一个完全支持我们的自然趋势,与乐于助人和合作以促进共同利益的社交网络。Human Connection 渴望成为让每个人都成为积极变革者的平台。

|

||||

|

||||

为了实现一个以解决方案为导向的平台的梦想,让人们通过与慈善机构、社区团体和社会变革活动人士的接触,围绕社会公益事业采取行动,Human Connection 将开放的价值观作为社会创新的载体。

|

||||

|

||||

@ -15,31 +17,28 @@

|

||||

|

||||

### 首先是透明

|

||||

|

||||

透明是 Human Connection 的指导原则之一。Human Connection 邀请世界各地的程序员通过[在 Github 上提交他们的源代码][2]共同开发平台的源代码(JavaScript, Vue, nuxt),并通过贡献代码或编程附加功能来支持真正的社交网络。

|

||||

透明是 Human Connection 的指导原则之一。Human Connection 邀请世界各地的程序员通过[在 Github 上提交他们的源代码][2]共同开发平台的源代码(JavaScript、Vue、nuxt),并通过贡献代码或编程附加功能来支持真正的社交网络。

|

||||

|

||||

但我们对透明的承诺超出了我们的发展实践。事实上,当涉及到建立一种新的社交网络,促进那些对让世界变得更好的人之间的真正联系和互动,分享源代码只是迈向透明的一步。

|

||||

但我们对透明的承诺超出了我们的发展实践。事实上,当涉及到建立一种新的社交网络,促进那些让世界变得更好的人之间的真正联系和互动,分享源代码只是迈向透明的一步。

|

||||

|

||||

为促进公开对话,Human Connection 团队举行[定期在线公开会议][3]。我们在这里回答问题,鼓励建议并对潜在的问题作出回应。我们的 Meet The Team (to 校正者:这里如果可以,请翻译得稍微优雅,我想不出来一个词)活动也会记录下来,并在事后向公众开放。通过对我们的流程,源代码和财务状况完全透明,我们可以保护自己免受批评或其他潜在的不利影响。

|

||||

为促进公开对话,Human Connection 团队举行[定期在线公开会议][3]。我们在这里回答问题,鼓励建议并对潜在的问题作出回应。我们的 Meet The Team 活动也会记录下来,并在事后向公众开放。通过对我们的流程,源代码和财务状况完全透明,我们可以保护自己免受批评或其他潜在的不利影响。

|

||||

|

||||

对透明的承诺意味着,所有在 Human Connection 上公开分享的用户贡献者将在 Creative Commons 许可下发布,最终作为数据包下载。通过让大众知识变得可用,特别是以一种分散的方式,我们创造了一个多元化社会的机会。

|

||||

|

||||

一个问题指导我们所有的组织决策:“它是否服务于人民和更大的利益?”我们用[联合国宪章(UN Charter)][4]和“世界人权宣言(Universal Declaration of Human Rights)”作为我们价值体系的基础。随着我们的规模越来越大,尤其是即将推出的公测版,我们必须对此任务负责。我甚至愿意邀请 Chaos Computer Club (译者注:这是欧洲最大的黑客联盟)或其他黑客俱乐部通过随机检查我们的平台来验证我们的代码和行为的完整性。

|

||||

有一个问题指导我们所有的组织决策:“它是否服务于人民和更大的利益?”我们用<ruby>[联合国宪章][4]<rt>UN Charter</rt></ruby>和“<ruby>世界人权宣言<rt>Universal Declaration of Human Rights</rt></ruby>”作为我们价值体系的基础。随着我们的规模越来越大,尤其是即将推出的公测版,我们必须对此任务负责。我甚至愿意邀请 Chaos Computer Club (LCTT 译注:这是欧洲最大的黑客联盟)或其他黑客俱乐部通过随机检查我们的平台来验证我们的代码和行为的完整性。

|

||||

|

||||

### 一个合作的社会

|

||||

|

||||

以一种[以社区为中心的协作方法][5]来编写 Human Connection 平台是超越社交网络实际应用理念的基础。我们的团队是通过找到问题的答案来驱动:“是什么让一个社交网络真正地社会化?”

|

||||

|

||||

一个抛弃了以利润为导向的算法,为广告商而不是最终用户服务的网络,只能通过转向对等生产和协作的过程而繁荣起来。例如,像 [Code Alliance][6] 和 [Code for America][7] 这样的组织已经证明了如何在一个开源环境中创造技术,造福人类并破坏(to 校正:这里译为改变较好)现状。社区驱动的项目,如基于地图的报告平台 [FixMyStreet][8],或者为 Humanitarian OpenStreetMap 而建立的 [Tasking Manager][9],已经将众包作为推动其使用的一种方式。

|

||||

一个抛弃了以利润为导向的算法、为最终用户而不是广告商服务的网络,只能通过转向对等生产和协作的过程而繁荣起来。例如,像 [Code Alliance][6] 和 [Code for America][7] 这样的组织已经证明了如何在一个开源环境中创造技术,造福人类并变革现状。社区驱动的项目,如基于地图的报告平台 [FixMyStreet][8],或者为 Humanitarian OpenStreetMap 而建立的 [Tasking Manager][9],已经将众包作为推动其使用的一种方式。

|

||||

|

||||

我们建立 Human Connection 的方法从一开始就是合作。为了收集关于必要功能和真正社交网络的目的的初步数据,我们与巴黎索邦大学(University Sorbonne)的国家东方语言与文明研究所(National Institute for Oriental Languages and Civilizations (INALCO) )和德国斯图加特媒体大学(Stuttgart Media University )合作。这两个项目的研究结果都被纳入了 Human Connection 的早期开发。多亏了这项研究,[用户将拥有一套全新的功能][10],让他们可以控制自己看到的内容以及他们如何与他人的互动。由于早期的支持者[被邀请到网络的 alpha 版本][10],他们可以体验到第一个可用的值得注意的功能。这里有一些:

|

||||

|

||||

* 将信息与行动联系起来是我们研究会议的一个重要主题。当前的社交网络让用户处于信息阶段。这两所大学的学生团体都认为,需要一个以行动为导向的组件,以满足人类共同解决问题的本能。所以我们在平台上构建了一个[“Can Do”功能][11]。这是一个人在阅读了某个话题后可以采取行动的一种方式。“Can Do” 是用户建议的活动,在“采取行动(Take Action)”领域,每个人都可以实现。

|

||||

|

||||

* “Versus” 功能是另一个定义结果的方式(to 校正者:这句话稍微注意一下)。在传统社交网络仅限于评论功能的地方,我们的学生团体认为需要采用更加结构化且有用的方式进行讨论和争论。“Versus” 是对公共帖子的反驳,它是单独显示的,并提供了一个机会来突出围绕某个问题的不同意见。

|

||||

我们建立 Human Connection 的方法从一开始就是合作。为了收集关于必要功能和真正社交网络的目的的初步数据,我们与巴黎<ruby>索邦大学<rt>University Sorbonne</rt></ruby>的<ruby>国家东方语言与文明研究所<rt>National Institute for Oriental Languages and Civilizations</rt></ruby>(INALCO)和德国<ruby>斯图加特媒体大学<rt>Stuttgart Media University</rt></ruby>合作。这两个项目的研究结果都被纳入了 Human Connection 的早期开发。多亏了这项研究,[用户将拥有一套全新的功能][10],让他们可以控制自己看到的内容以及他们如何与他人的互动。由于早期的支持者[被邀请到网络的 alpha 版本][10],他们可以体验到第一个可用的值得注意的功能。这里有一些:

|

||||

|

||||

* 将信息与行动联系起来是我们研究会议的一个重要主题。当前的社交网络让用户处于信息阶段。这两所大学的学生团体都认为,需要一个以行动为导向的组件,以满足人类共同解决问题的本能。所以我们在平台上构建了一个[“Can Do”功能][11]。这是一个人在阅读了某个话题后可以采取行动的一种方式。“Can Do” 是用户建议的活动,在“<ruby>采取行动<rt>Take Action</rt></ruby>”领域,每个人都可以实现。

|

||||

* “Versus” 功能是另一个成果。在传统社交网络仅限于评论功能的地方,我们的学生团体认为需要采用更加结构化且有用的方式进行讨论和争论。“Versus” 是对公共帖子的反驳,它是单独显示的,并提供了一个机会来突出围绕某个问题的不同意见。

|

||||

* 今天的社交网络并没有提供很多过滤内容的选项。研究表明,情绪过滤选项可以帮助我们根据日常情绪驾驭社交空间,并可能通过在我们希望仅看到令人振奋的内容的那一天时,不显示悲伤或难过的帖子来潜在地保护我们的情绪健康。

|

||||

|

||||

|

||||

Human Connection 邀请改革者合作开发一个网络,有可能动员世界各地的个人和团体将负面新闻变成 “Can Do”,并与慈善机构和非营利组织一起参与社会创新项目。

|

||||

|

||||

[订阅我们的每周时事通讯][12]以了解有关开放组织的更多信息。

|

||||

@ -51,7 +50,7 @@ via: https://opensource.com/open-organization/18/3/open-social-human-connection

|

||||

|

||||

作者:[Dennis Hack][a]

|

||||

译者:[MjSeven](https://github.com/MjSeven)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,60 @@

|

||||

macOS 和 Linux 的内核有什么区别

|

||||

======

|

||||

|

||||

有些人可能会认为 macOS 和 Linux 内核之间存在相似之处,因为它们可以处理类似的命令和类似的软件。有些人甚至认为苹果公司的 macOS 是基于 Linux 的。事实上是,两个内核有着截然不同的历史和特征。今天,我们来看看 macOS 和 Linux 的内核之间的区别。

|

||||

|

||||

![macOS vs Linux][1]

|

||||

|

||||

### macOS 内核的历史

|

||||

|

||||

我们将从 macOS 内核的历史开始。1985 年,由于与首席执行官 John Sculley 和董事会不和,<ruby>史蒂夫·乔布斯<rt>Steve Jobs</rt></ruby>离开了苹果公司。然后,他成立了一家名为 [NeXT][2] 的新电脑公司。乔布斯希望将一款(带有新操作系统的)新计算机快速推向市场。为了节省时间,NeXT 团队使用了卡耐基梅隆大学的 [Mach 内核][3] 和部分 BSD 代码库来创建 [NeXTSTEP 操作系统][4]。

|

||||

|

||||

NeXT 从来没有取得过财务上的成功,部分归因于乔布斯花钱的习惯,就像他还在苹果公司一样。与此同时,苹果公司曾多次试图更新其操作系统,甚至与 IBM 合作,但从未成功。1997年,苹果公司以 4.29 亿美元收购了 NeXT。作为交易的一部分,史蒂夫·乔布斯回到了苹果公司,同时 NeXTSTEP 成为了 macOS 和 iOS 的基础。

|

||||

|

||||

### Linux 内核的历史

|

||||

|

||||

与 macOS 内核不同,Linux 的创建并非源于商业尝试。相反,它是由[芬兰计算机科学专业学生<ruby>林纳斯·托瓦兹<rt>Linus Torvalds</rt></ruby>于 1991 年创建的][5]。最初,内核是按照林纳斯自己的计算机的规格编写的,因为他想利用其新的 80386 处理器(的特性)。林纳斯[于 1991 年 8 月在 Usenet 上][6]发布了他的新内核代码。很快,他就收到了来自世界各地的代码和功能建议。次年,Orest Zborowski 将 X Window 系统移植到 Linux,使其能够支持图形用户界面。

|

||||

|

||||

在过去的 27 年中,Linux 已经慢慢成长并增加了不少功能。这不再是一个学生的小型项目。现在它运行在[世界上][7]大多数的[计算设备][8]和[超级计算机][9]上。不错!

|

||||

|

||||

### macOS 内核的特性

|

||||

|

||||

macOS 内核被官方称为 XNU。这个[首字母缩写词][10]代表“XNU is Not Unix”。根据 [苹果公司的 Github 页面][10],XNU 是“将卡耐基梅隆大学开发的 Mach 内核和 FreeBSD 组件整合而成的混合内核,加上用于编写驱动程序的 C++ API”。代码的 BSD 子系统部分[“在微内核系统中通常实现为用户空间的服务”][11]。Mach 部分负责底层工作,例如多任务、内存保护、虚拟内存管理、内核调试支持和控制台 I/O。

|

||||

|

||||

### Linux 内核的特性

|

||||

|

||||

虽然 macOS 内核结合了微内核([Mach][12])和宏内核([BSD][13])的特性,但 Linux 只是一个宏内核。[宏内核][14]负责管理 CPU、内存、进程间通信、设备驱动程序、文件系统和系统服务调用( LCTT 译注:原文为 system server calls,但结合 Linux 内核的构成,译者认为这里翻译成系统服务调用更合适,即 system service calls)。

|

||||

|

||||

### 用一句话总结 Linux 和 Mac 的区别

|

||||

|

||||

macOS 内核(XNU)比 Linux 历史更悠久,并且基于两个更古老一些的代码库的结合;另一方面,Linux 新一些,是从头开始编写的,并且在更多设备上使用。

|

||||

|

||||

如果您发现这篇文章很有趣,请花一点时间在社交媒体,黑客新闻或 [Reddit][15] 上分享。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://itsfoss.com/mac-linux-difference/

|

||||

|

||||

作者:[John Paul][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[stephenxs](https://github.com/stephenxs)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://itsfoss.com/author/john/

|

||||

[1]:https://4bds6hergc-flywheel.netdna-ssl.com/wp-content/uploads/2018/07/macos-vs-linux-kernels.jpeg

|

||||

[2]:https://en.wikipedia.org/wiki/NeXT

|

||||

[3]:https://en.wikipedia.org/wiki/Mach_(kernel)

|

||||

[4]:https://en.wikipedia.org/wiki/NeXTSTEP

|

||||

[5]:https://www.cs.cmu.edu/%7Eawb/linux.history.html

|

||||

[6]:https://groups.google.com/forum/#!original/comp.os.minix/dlNtH7RRrGA/SwRavCzVE7gJ

|

||||

[7]:https://www.zdnet.com/article/sorry-windows-android-is-now-the-most-popular-end-user-operating-system/

|

||||

[8]:https://www.linuxinsider.com/story/31855.html

|

||||

[9]:https://itsfoss.com/linux-supercomputers-2017/

|

||||

[10]:https://github.com/apple/darwin-xnu

|

||||

[11]:http://osxbook.com/book/bonus/ancient/whatismacosx/arch_xnu.html

|

||||

[12]:https://en.wikipedia.org/wiki/Mach_(kernel

|

||||

[13]:https://en.wikipedia.org/wiki/FreeBSD

|

||||

[14]:https://www.howtogeek.com/howto/31632/what-is-the-linux-kernel-and-what-does-it-do/

|

||||

[15]:http://reddit.com/r/linuxusersgroup

|

||||

@ -1,3 +1,5 @@

|

||||

translating---geekpi

|

||||

|

||||

Give Your Linux Desktop a Stunning Makeover With Xenlism Themes

|

||||

============================================================

|

||||

|

||||

|

||||

@ -1,124 +0,0 @@

|

||||

**Translating by distant1219**

|

||||

|

||||

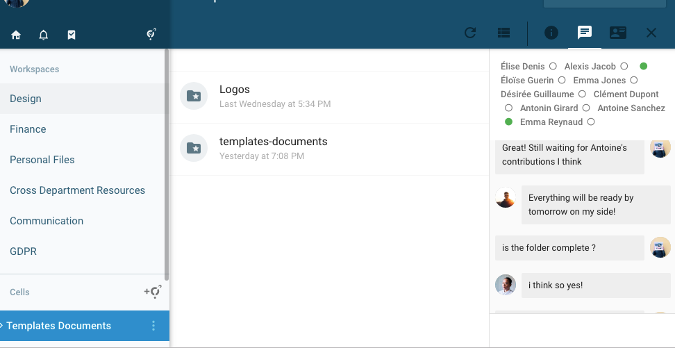

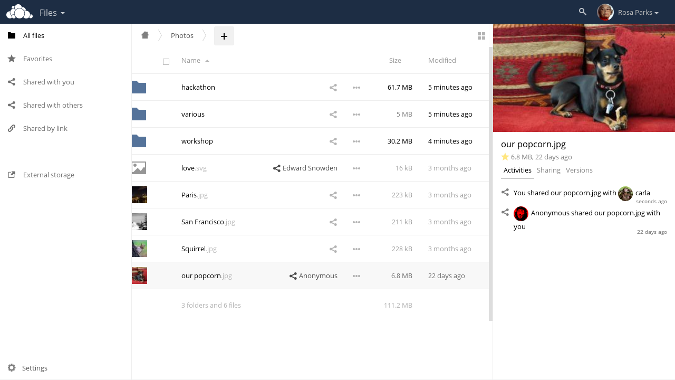

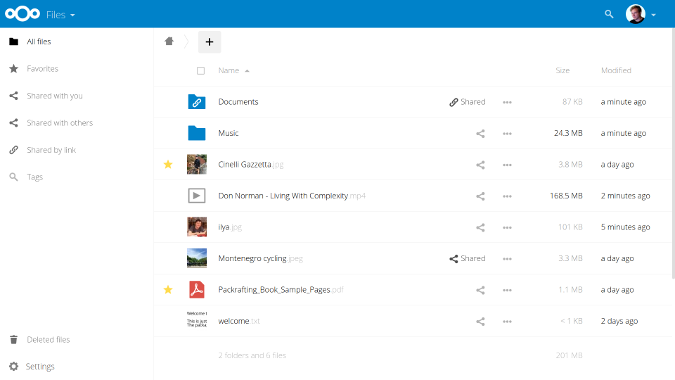

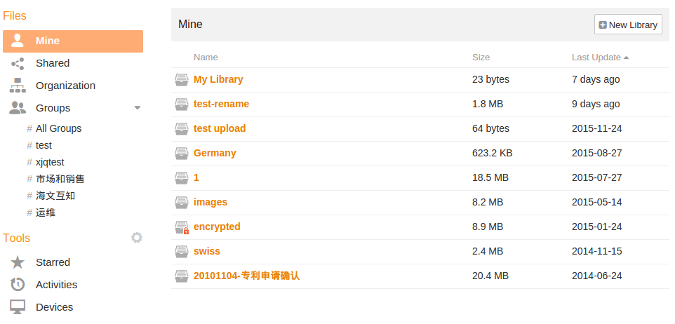

5 open source alternatives to Dropbox

|

||||

======

|

||||

|

||||

|

||||

|

||||

Dropbox is the 800-pound gorilla of filesharing applications. Even though it's a massively popular tool, you may choose to use an alternative.

|

||||

|

||||

Maybe that's because you're dedicated to the [open source way][1] for all the good reasons, including security and freedom, or possibly you've been spooked by data breaches. Or perhaps the pricing plan doesn't work out in your favor for the amount of storage you actually need.

|

||||

|

||||

Fortunately, there are a variety of open source filesharing applications out there that give you more storage, security, and control over your data at a far lower price than Dropbox charges. How much lower? Try free, if you're a bit tech savvy and have a Linux server to use.

|

||||

|

||||

Here are five of the best open source alternatives to Dropbox, plus a few others that you might want to consider.

|

||||

|

||||

### ownCloud

|

||||

|

||||

|

||||

|

||||

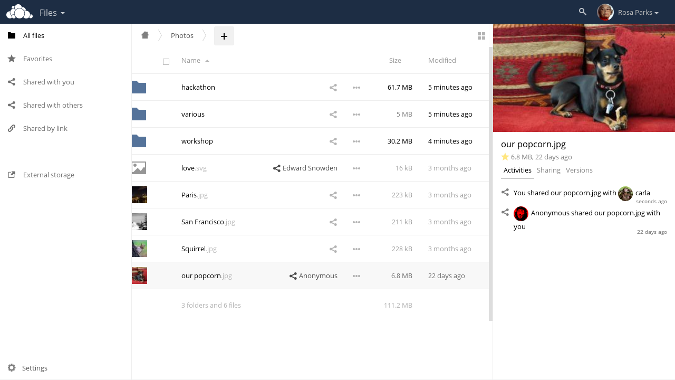

[ownCloud][2], launched in 2010, is the oldest application on this list, but don't let that fool you: It's still very popular (with over 1.5 million users, according to the company) and actively maintained by a community of 1,100 contributors, with updates released regularly.

|

||||

|

||||

Its primary features—file and folding sharing, document collaboration—are similar to Dropbox's. Its primary difference (aside from its [open source license][3]) is that your files are hosted on your private Linux server or cloud, giving users complete control over your data. (Self-hosting is a common thread among the apps on this list.)

|

||||

|

||||

With ownCloud, you can sync and access files through clients for Linux, MacOS, or Windows computers or mobile apps for Android and iOS devices, and provide password-protected links to others for collaboration or file upload/download. Data transfers are secured by end-to-end encryption (E2EE) and SSL encryption. You can also expand its functionality with a wide variety of third-party apps available in its [marketplace][4], and there is also a paid, commercially licensed enterprise edition.

|

||||

|

||||

ownCloud offers comprehensive [documentation][5], including an installation guide and manuals for users, admins, and developers, and you can access its [source code][6] in its GitHub repository.

|

||||

|

||||

### NextCloud

|

||||

|

||||

|

||||

|

||||

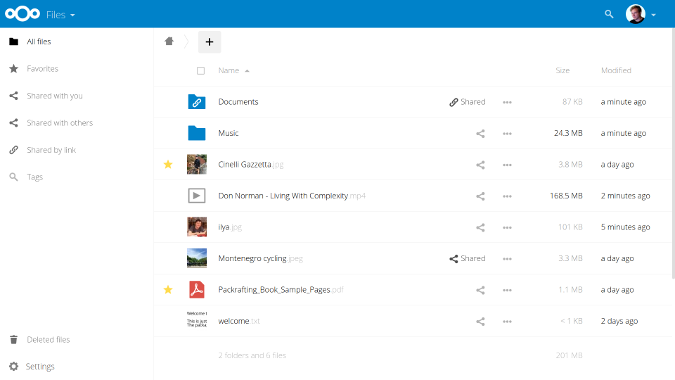

[NextCloud][7] spun out of ownCloud in 2016 and shares much of the same functionality. Nextcloud [touts][8] its high security and regulatory compliance as a distinguishing feature. It has HIPAA (healthcare) and GDPR (privacy) compliance features and offers extensive data-policy enforcement, encryption, user management, and auditing capabilities. It also encrypts data during transfer and at rest and integrates with mobile device management and authentication mechanisms (including LDAP/AD, single-sign-on, two-factor authentication, etc.).

|

||||

|

||||

Like the other solutions on this list, NextCloud is self-hosted, but if you don't want to roll your own NextCloud server on Linux, the company partners with several [providers][9] for setup and hosting and sells servers, appliances, and support. A [marketplace][10] offers numerous apps to extend its features.

|

||||

|

||||

NextCloud's [documentation][11] page offers thorough information for users, admins, and developers as well as links to its forums, IRC channel, and social media pages for community-based support. If you'd like to contribute, access its source code, report a bug, check out its (AGPLv3) license, or just learn more, visit the project's [GitHub repository][12].

|

||||

|

||||

### Seafile

|

||||

|

||||

|

||||

|

||||

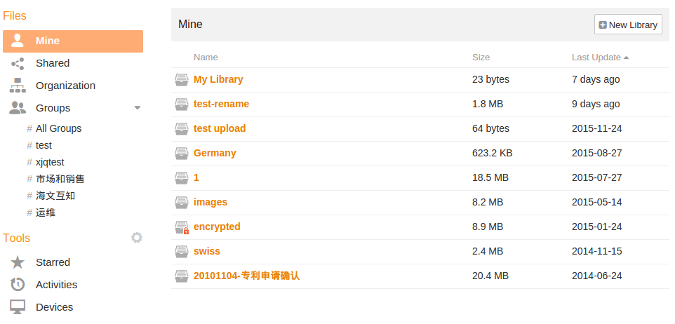

[Seafile][13] may not have the bells and whistles (or app ecosystem) of ownCloud or Nextcloud, but it gets the job done. Essentially, it acts as a virtual drive on your Linux server to extend your desktop storage and allow you to share files selectively with password protection and various levels of permission (i.e., read-only or read/write).

|

||||

|

||||

Its collaboration features include per-folder access control, password-protected download links, and Git-like version control and retention. Files are secured with two-factor authentication, file encryption, and AD/LDAP integration, and they're accessible from Windows, MacOS, Linux, iOS, or Android devices.

|

||||

|

||||

For more information, visit Seafile's [GitHub repository][14], [server manual][15], [wiki][16], and [forums][17]. Note that Seafile's community edition is licensed under [GPLv2][18], but its professional edition is not open source.

|

||||

|

||||

### OnionShare

|

||||

|

||||

|

||||

|

||||

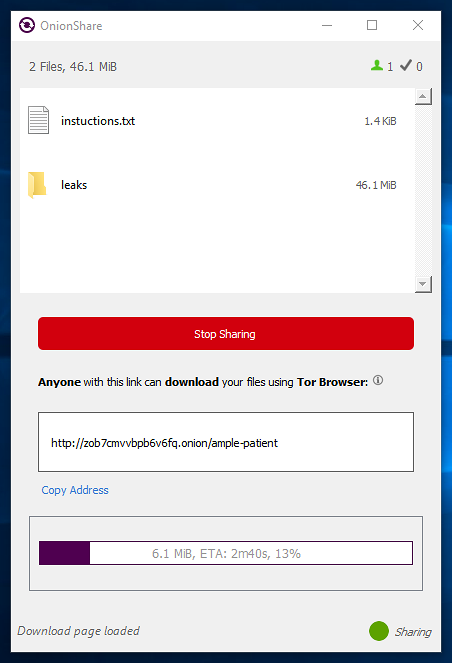

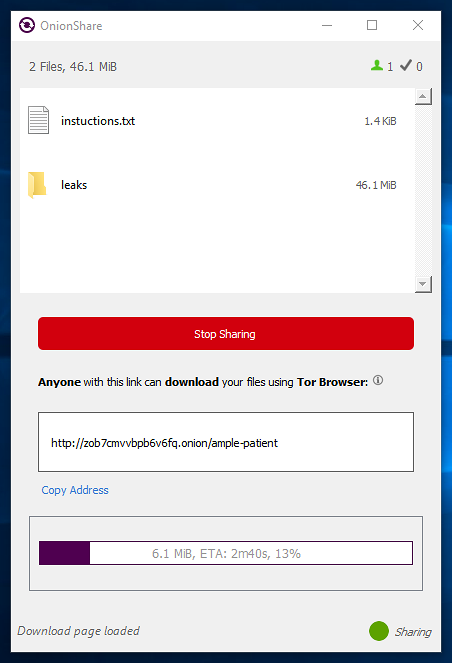

[OnionShare][19] is a cool app that does one thing: It allows you to share individual files or folders securely and, if you want, anonymously. There's no server to set up or maintain—all you need to do is [download and install][20] the app on MacOS, Windows, or Linux. Files are always hosted on your own computer; when you share a file, OnionShare creates a web server, makes it accessible as a Tor Onion service, and generates an unguessable .onion URL that allows the recipient to access the file via [Tor browser][21].

|

||||

|

||||

You can set limits on your fileshare, such as limiting the number of times it can be downloaded or using an auto-stop timer, which sets a strict expiration date/time after which the file is inaccessible (even if it hasn't been accessed yet).

|

||||

|

||||

OnionShare is licensed under [GPLv3][22]; for more information, check out its GitHub [repository][22], which also includes [documentation][23] that covers the features in this easy-to-use filesharing application.

|

||||

|

||||

### Pydio Cells

|

||||

|

||||

|

||||

|

||||

[Pydio Cells][24], which achieved stability in May 2018, is a complete overhaul of the Pydio filesharing application's core server code. Due to limitations with Pydio's PHP-based backend, the developers decided to rewrite the backend in the Go server language with a microservices architecture. (The frontend is still based on PHP.)

|

||||

|

||||

Pydio Cells includes the usual filesharing and version control features, as well as in-app messaging, mobile apps (Android and iOS), and a social network-style approach to collaboration. Security includes OpenID Connect-based authentication, encryption at rest, security policies, and more. Advanced features are included in the enterprise distribution, but there's plenty of power for most small and midsize businesses and home users in the community (or "Home") version.

|

||||

|

||||

You can [download][25] Pydio Cells for Linux and MacOS. For more information, check out the [documentation FAQ][26], [source code][27] repository, and [AGPLv3 license][28].

|

||||

|

||||

### Others to consider

|

||||

|

||||

If these choices don't meet your needs, you may want to consider these open source filesharing-type applications.

|

||||

|

||||

* If your main goal is to sync files between devices, rather than to share files, check out [Syncthing][29]).

|

||||

* If you're a Git fan and don't need a mobile app, you might appreciate [SparkleShare][30].

|

||||

* If you primarily want a place to aggregate all your personal data, take a look at [Cozy][31].

|

||||

* And, if you're looking for a lightweight or dedicated filesharing tool, peruse [Scott Nesbitt's review][32] of some lesser-known options.

|

||||

|

||||

|

||||

|

||||

What is your favorite open source filesharing application? Let us know in the comments.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/alternatives/dropbox

|

||||

|

||||

作者:[OPensource.com][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com

|

||||

[1]:https://opensource.com/open-source-way

|

||||

[2]:https://owncloud.org/

|

||||

[3]:https://www.gnu.org/licenses/agpl-3.0.html

|

||||

[4]:https://marketplace.owncloud.com/

|

||||

[5]:https://doc.owncloud.com/

|

||||

[6]:https://github.com/owncloud

|

||||

[7]:https://nextcloud.com/

|

||||

[8]:https://nextcloud.com/secure/

|

||||

[9]:https://nextcloud.com/providers/

|

||||

[10]:https://apps.nextcloud.com/

|

||||

[11]:https://nextcloud.com/support/

|

||||

[12]:https://github.com/nextcloud

|

||||

[13]:https://www.seafile.com/en/home/

|

||||

[14]:https://github.com/haiwen/seafile

|

||||

[15]:https://manual.seafile.com/

|

||||

[16]:https://seacloud.cc/group/3/wiki/

|

||||

[17]:https://forum.seafile.com/

|

||||

[18]:https://github.com/haiwen/seafile/blob/master/LICENSE.txt

|

||||

[19]:https://onionshare.org/

|

||||

[20]:https://onionshare.org/#downloads

|

||||

[21]:https://www.torproject.org/

|

||||

[22]:https://github.com/micahflee/onionshare/blob/develop/LICENSE

|

||||

[23]:https://github.com/micahflee/onionshare/wiki

|

||||

[24]:https://pydio.com/en

|

||||

[25]:https://pydio.com/download/

|

||||

[26]:https://pydio.com/en/docs/faq

|

||||

[27]:https://github.com/pydio/cells

|

||||

[28]:https://github.com/pydio/pydio-core/blob/develop/LICENSE

|

||||

[29]:https://syncthing.net/

|

||||

[30]:http://www.sparkleshare.org/

|

||||

[31]:https://cozy.io/en/

|

||||

[32]:https://opensource.com/article/17/3/file-sharing-tools

|

||||

@ -1,294 +0,0 @@

|

||||

Translating by qhwdw

|

||||

Intercepting and Emulating Linux System Calls with Ptrace « null program

|

||||

======

|

||||

|

||||

The `ptrace(2)` (“process trace”) system call is usually associated with debugging. It’s the primary mechanism through which native debuggers monitor debuggees on unix-like systems. It’s also the usual approach for implementing [strace][1] — system call trace. With Ptrace, tracers can pause tracees, [inspect and set registers and memory][2], monitor system calls, or even intercept system calls.

|

||||

|

||||

By intercept, I mean that the tracer can mutate system call arguments, mutate the system call return value, or even block certain system calls. Reading between the lines, this means a tracer can fully service system calls itself. This is particularly interesting because it also means **a tracer can emulate an entire foreign operating system**. This is done without any special help from the kernel beyond Ptrace.

|

||||

|

||||

The catch is that a process can only have one tracer attached at a time, so it’s not possible emulate a foreign operating system while also debugging that process with, say, GDB. The other issue is that emulated systems calls will have higher overhead.

|

||||

|

||||

For this article I’m going to focus on [Linux’s Ptrace][3] on x86-64, and I’ll be taking advantage of a few Linux-specific extensions. For the article I’ll also be omitting error checks, but the full source code listings will have them.

|

||||

|

||||

You can find runnable code for the examples in this article here:

|

||||

|

||||

**<https://github.com/skeeto/ptrace-examples>**

|

||||

|

||||

### strace

|

||||

|

||||

Before getting into the really interesting stuff, let’s start by reviewing a bare bones implementation of strace. It’s [no DTrace][4], but strace is still incredibly useful.

|

||||

|

||||

Ptrace has never been standardized. Its interface is similar across different operating systems, especially in its core functionality, but it’s still subtly different from system to system. The `ptrace(2)` prototype generally looks something like this, though the specific types may be different.

|

||||

```

|

||||

long ptrace(int request, pid_t pid, void *addr, void *data);

|

||||

|

||||

```

|

||||

|

||||

The `pid` is the tracee’s process ID. While a tracee can have only one tracer attached at a time, a tracer can be attached to many tracees.

|

||||

|

||||

The `request` field selects a specific Ptrace function, just like the `ioctl(2)` interface. For strace, only two are needed:

|

||||

|

||||

* `PTRACE_TRACEME`: This process is to be traced by its parent.

|

||||

* `PTRACE_SYSCALL`: Continue, but stop at the next system call entrance or exit.

|

||||

* `PTRACE_GETREGS`: Get a copy of the tracee’s registers.

|

||||

|

||||

|

||||

|

||||

The other two fields, `addr` and `data`, serve as generic arguments for the selected Ptrace function. One or both are often ignored, in which case I pass zero.

|

||||

|

||||

The strace interface is essentially a prefix to another command.

|

||||

```

|

||||

$ strace [strace options] program [arguments]

|

||||

|

||||

```

|

||||

|

||||

My minimal strace doesn’t have any options, so the first thing to do — assuming it has at least one argument — is `fork(2)` and `exec(2)` the tracee process on the tail of `argv`. But before loading the target program, the new process will inform the kernel that it’s going to be traced by its parent. The tracee will be paused by this Ptrace system call.

|

||||

```

|

||||

pid_t pid = fork();

|

||||

switch (pid) {

|

||||

case -1: /* error */

|

||||

FATAL("%s", strerror(errno));

|

||||

case 0: /* child */

|

||||

ptrace(PTRACE_TRACEME, 0, 0, 0);

|

||||

execvp(argv[1], argv + 1);

|

||||

FATAL("%s", strerror(errno));

|

||||

}

|

||||

|

||||

```

|

||||

|

||||

The parent waits for the child’s `PTRACE_TRACEME` using `wait(2)`. When `wait(2)` returns, the child will be paused.

|

||||

```

|

||||

waitpid(pid, 0, 0);

|

||||

|

||||

```

|

||||

|

||||

Before allowing the child to continue, we tell the operating system that the tracee should be terminated along with its parent. A real strace implementation may want to set other options, such as `PTRACE_O_TRACEFORK`.

|

||||

```

|

||||

ptrace(PTRACE_SETOPTIONS, pid, 0, PTRACE_O_EXITKILL);

|

||||

|

||||

```

|

||||

|

||||

All that’s left is a simple, endless loop that catches on system calls one at a time. The body of the loop has four steps:

|

||||

|

||||

1. Wait for the process to enter the next system call.

|

||||

2. Print a representation of the system call.

|

||||

3. Allow the system call to execute and wait for the return.

|

||||

4. Print the system call return value.

|

||||

|

||||

|

||||

|

||||

The `PTRACE_SYSCALL` request is used in both waiting for the next system call to begin, and waiting for that system call to exit. As before, a `wait(2)` is needed to wait for the tracee to enter the desired state.

|

||||

```

|

||||

ptrace(PTRACE_SYSCALL, pid, 0, 0);

|

||||

waitpid(pid, 0, 0);

|

||||

|

||||

```

|

||||

|

||||

When `wait(2)` returns, the registers for the thread that made the system call are filled with the system call number and its arguments. However, the operating system has not yet serviced this system call. This detail will be important later.

|

||||

|

||||

The next step is to gather the system call information. This is where it gets architecture specific. On x86-64, [the system call number is passed in `rax`][5], and the arguments (up to 6) are passed in `rdi`, `rsi`, `rdx`, `r10`, `r8`, and `r9`. Reading the registers is another Ptrace call, though there’s no need to `wait(2)` since the tracee isn’t changing state.

|

||||

```

|

||||

struct user_regs_struct regs;

|

||||

ptrace(PTRACE_GETREGS, pid, 0, ®s);

|

||||

long syscall = regs.orig_rax;

|

||||

|

||||

fprintf(stderr, "%ld(%ld, %ld, %ld, %ld, %ld, %ld)",

|

||||

syscall,

|

||||

(long)regs.rdi, (long)regs.rsi, (long)regs.rdx,

|

||||

(long)regs.r10, (long)regs.r8, (long)regs.r9);

|

||||

|

||||

```

|

||||

|

||||

There’s one caveat. For [internal kernel purposes][6], the system call number is stored in `orig_rax` rather than `rax`. All the other system call arguments are straightforward.

|

||||

|

||||

Next it’s another `PTRACE_SYSCALL` and `wait(2)`, then another `PTRACE_GETREGS` to fetch the result. The result is stored in `rax`.

|

||||

```

|

||||

ptrace(PTRACE_GETREGS, pid, 0, ®s);

|

||||

fprintf(stderr, " = %ld\n", (long)regs.rax);

|

||||

|

||||

```

|

||||

|

||||

The output from this simple program is very crude. There is no symbolic name for the system call and every argument is printed numerically, even if it’s a pointer to a buffer. A more complete strace would know which arguments are pointers and use `process_vm_readv(2)` to read those buffers from the tracee in order to print them appropriately.

|

||||

|

||||

However, this does lay the groundwork for system call interception.

|

||||

|

||||

### System call interception

|

||||

|

||||

Suppose we want to use Ptrace to implement something like OpenBSD’s [`pledge(2)`][7], in which [a process pledges to use only a restricted set of system calls][8]. The idea is that many programs typically have an initialization phase where they need lots of system access (opening files, binding sockets, etc.). After initialization they enter a main loop in which they processing input and only a small set of system calls are needed.

|

||||

|

||||

Before entering this main loop, a process can limit itself to the few operations that it needs. If [the program has a flaw][9] allowing it to be exploited by bad input, the pledge significantly limits what the exploit can accomplish.

|

||||

|

||||

Using the same strace model, rather than print out all system calls, we could either block certain system calls or simply terminate the tracee when it misbehaves. Termination is easy: just call `exit(2)` in the tracer. Since it’s configured to also terminate the tracee. Blocking the system call and allowing the child to continue is a little trickier.

|

||||

|

||||

The tricky part is that **there’s no way to abort a system call once it’s started**. When tracer returns from `wait(2)` on the entrance to the system call, the only way to stop a system call from happening is to terminate the tracee.

|

||||

|

||||

However, not only can we mess with the system call arguments, we can change the system call number itself, converting it to a system call that doesn’t exist. On return we can report a “friendly” `EPERM` error in `errno` [via the normal in-band signaling][10].

|

||||

```

|

||||

for (;;) {

|

||||

/* Enter next system call */

|

||||

ptrace(PTRACE_SYSCALL, pid, 0, 0);

|

||||

waitpid(pid, 0, 0);

|

||||

|

||||

struct user_regs_struct regs;

|

||||

ptrace(PTRACE_GETREGS, pid, 0, ®s);

|

||||

|

||||

/* Is this system call permitted? */

|

||||

int blocked = 0;

|

||||

if (is_syscall_blocked(regs.orig_rax)) {

|

||||

blocked = 1;

|

||||

regs.orig_rax = -1; // set to invalid syscall

|

||||

ptrace(PTRACE_SETREGS, pid, 0, ®s);

|

||||

}

|

||||

|

||||

/* Run system call and stop on exit */

|

||||

ptrace(PTRACE_SYSCALL, pid, 0, 0);

|

||||

waitpid(pid, 0, 0);

|

||||

|

||||

if (blocked) {

|

||||

/* errno = EPERM */

|

||||

regs.rax = -EPERM; // Operation not permitted

|

||||

ptrace(PTRACE_SETREGS, pid, 0, ®s);

|

||||

}

|

||||

}

|

||||

|

||||

```

|

||||

|

||||

This simple example only checks against a whitelist or blacklist of system calls. And there’s no nuance, such as allowing files to be opened (`open(2)`) read-only but not as writable, allowing anonymous memory maps but not non-anonymous mappings, etc. There’s also no way to the tracee to dynamically drop privileges.

|

||||

|

||||

How could the tracee communicate to the tracer? Use an artificial system call!

|

||||

|

||||

### Creating an artificial system call

|

||||

|

||||

For my new pledge-like system call — which I call `xpledge()` to distinguish it from the real thing — I picked system call number 10000, a nice high number that’s unlikely to ever be used for a real system call.

|

||||

```

|

||||

#define SYS_xpledge 10000

|

||||

|

||||

```

|

||||

|

||||

Just for demonstration purposes, I put together a minuscule interface that’s not good for much in practice. It has little in common with OpenBSD’s `pledge(2)`, which uses a [string interface][11]. Actually designing robust and secure sets of privileges is really complicated, as the `pledge(2)` manpage shows. Here’s the entire interface and implementation of the system call for the tracee:

|

||||

```

|

||||

#define _GNU_SOURCE

|

||||

#include <unistd.h>

|

||||

|

||||

#define XPLEDGE_RDWR (1 << 0)

|

||||

#define XPLEDGE_OPEN (1 << 1)

|

||||

|

||||

#define xpledge(arg) syscall(SYS_xpledge, arg)

|

||||

|

||||

```

|

||||

|

||||

If it passes zero for the argument, only a few basic system calls are allowed, including those used to allocate memory (e.g. `brk(2)`). The `PLEDGE_RDWR` bit allows [various][12] read and write system calls (`read(2)`, `readv(2)`, `pread(2)`, `preadv(2)`, etc.). The `PLEDGE_OPEN` bit allows `open(2)`.

|

||||

|

||||

To prevent privileges from being escalated back, `pledge()` blocks itself — though this also prevents dropping more privileges later down the line.

|

||||

|

||||

In the xpledge tracer, I just need to check for this system call:

|

||||

```

|

||||

/* Handle entrance */

|

||||

switch (regs.orig_rax) {

|

||||

case SYS_pledge:

|

||||

register_pledge(regs.rdi);

|

||||

break;

|

||||

}

|

||||

|

||||

```

|

||||

|

||||

The operating system will return `ENOSYS` (Function not implemented) since this isn’t a real system call. So on the way out I overwrite this with a success (0).

|

||||

```

|

||||

/* Handle exit */

|

||||

switch (regs.orig_rax) {

|

||||

case SYS_pledge:

|

||||

ptrace(PTRACE_POKEUSER, pid, RAX * 8, 0);

|

||||

break;

|

||||

}

|

||||

|

||||

```

|

||||

|

||||

I wrote a little test program that opens `/dev/urandom`, makes a read, tries to pledge, then tries to open `/dev/urandom` a second time, then confirms it can read from the original `/dev/urandom` file descriptor. Running without a pledge tracer, the output looks like this:

|

||||

```

|

||||

$ ./example

|

||||

fread("/dev/urandom")[1] = 0xcd2508c7

|

||||

XPledging...

|

||||

XPledge failed: Function not implemented

|

||||

fread("/dev/urandom")[2] = 0x0be4a986

|

||||

fread("/dev/urandom")[1] = 0x03147604

|

||||

|

||||

```

|

||||

|

||||

Making an invalid system call doesn’t crash an application. It just fails, which is a rather convenient fallback. When run under the tracer, it looks like this:

|

||||

```

|

||||

$ ./xpledge ./example

|

||||

fread("/dev/urandom")[1] = 0xb2ac39c4

|

||||

XPledging...

|

||||

fopen("/dev/urandom")[2]: Operation not permitted

|

||||

fread("/dev/urandom")[1] = 0x2e1bd1c4

|

||||

|

||||

```

|

||||

|

||||

The pledge succeeds but the second `fopen(3)` does not since the tracer blocked it with `EPERM`.

|

||||

|

||||

This concept could be taken much further, to, say, change file paths or return fake results. A tracer could effectively chroot its tracee, prepending some chroot path to the root of any path passed through a system call. It could even lie to the process about what user it is, claiming that it’s running as root. In fact, this is exactly how the [Fakeroot NG][13] program works.

|

||||

|

||||

### Foreign system emulation

|

||||

|

||||

Suppose you don’t just want to intercept some system calls, but all system calls. You’ve got [a binary intended to run on another operating system][14], so none of the system calls it makes will ever work.

|

||||

|

||||

You could manage all this using only what I’ve described so far. The tracer would always replace the system call number with a dummy, allow it to fail, then service the system call itself. But that’s really inefficient. That’s essentially three context switches for each system call: one to stop on the entrance, one to make the always-failing system call, and one to stop on the exit.

|

||||

|

||||

The Linux version of PTrace has had a more efficient operation for this technique since 2005: `PTRACE_SYSEMU`. PTrace stops only once per a system call, and it’s up to the tracer to service that system call before allowing the tracee to continue.

|

||||

```

|

||||

for (;;) {

|

||||

ptrace(PTRACE_SYSEMU, pid, 0, 0);

|

||||

waitpid(pid, 0, 0);

|

||||

|

||||

struct user_regs_struct regs;

|

||||

ptrace(PTRACE_GETREGS, pid, 0, ®s);

|

||||

|

||||

switch (regs.orig_rax) {

|

||||

case OS_read:

|

||||

/* ... */

|

||||

|

||||

case OS_write:

|

||||

/* ... */

|

||||

|

||||

case OS_open:

|

||||

/* ... */

|

||||

|

||||

case OS_exit:

|

||||

/* ... */

|

||||

|

||||

/* ... and so on ... */

|

||||

}

|

||||

}

|

||||

|

||||

```

|

||||

|

||||

To run binaries for the same architecture from any system with a stable (enough) system call ABI, you just need this `PTRACE_SYSEMU` tracer, a loader (to take the place of `exec(2)`), and whatever system libraries the binary needs (or only run static binaries).

|

||||

|

||||

In fact, this sounds like a fun weekend project.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://nullprogram.com/blog/2018/06/23/

|

||||

|

||||

作者:[Chris Wellons][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://nullprogram.com

|

||||

[1]:https://blog.plover.com/Unix/strace-groff.html

|

||||

[2]:http://nullprogram.com/blog/2016/09/03/

|

||||

[3]:http://man7.org/linux/man-pages/man2/ptrace.2.html

|

||||

[4]:http://nullprogram.com/blog/2018/01/17/

|

||||

[5]:http://nullprogram.com/blog/2015/05/15/

|

||||

[6]:https://stackoverflow.com/a/6469069

|

||||

[7]:https://man.openbsd.org/pledge.2

|

||||

[8]:http://www.openbsd.org/papers/hackfest2015-pledge/mgp00001.html

|

||||

[9]:http://nullprogram.com/blog/2017/07/19/

|

||||

[10]:http://nullprogram.com/blog/2016/09/23/

|

||||

[11]:https://www.tedunangst.com/flak/post/string-interfaces

|

||||

[12]:http://nullprogram.com/blog/2017/03/01/

|

||||

[13]:https://fakeroot-ng.lingnu.com/index.php/Home_Page

|

||||

[14]:http://nullprogram.com/blog/2017/11/30/

|

||||

@ -1,125 +0,0 @@

|

||||

translating-----geekpi

|

||||

|

||||

How To Upgrade Everything Using A Single Command In Linux

|

||||

======

|

||||

|

||||

|

||||

|

||||

As we all know already, keeping our Linux system up-to-date involves invoking more than one package manager. Say for instance, in Ubuntu you can’t upgrade everything using “sudo apt update && sudo apt upgrade” command. This command will only upgrade the applications which are installed using APT package manager. There are chances that you might have installed some other applications using **cargo** , [**pip**][1], **npm** , **snap** , **flatpak** or [**Linuxbrew**][2] package managers. You need to use the respective package manager in order to keep them all updated. Not anymore! Say hello to **“topgrade”** , an utility to upgrade all the things in your system in one go.

|

||||

|

||||

You need not to run every package manager to update the packages. The topgrade tool resolves this problem by detecting the installed packages, tools, plugins and run their appropriate package manager to update everything in your Linux box with a single command. It is free, open source and written using **rust programming language**. It supports GNU/Linux and Mac OS X.

|

||||

|

||||

### Upgrade Everything Using A Single Command In Linux

|

||||

|

||||

The topgrade is available in AUR. So, you can install it using [**Yay**][3] helper program in any Arch-based systems.

|

||||

```

|

||||

$ yay -S topgrade

|

||||

|

||||

```

|

||||

|

||||

On other Linux distributions, you can install topgrade utility using **cargo** package manager. To install cargo package manager, refer the following link.

|

||||

|

||||

And, then run the following command to install topgrade.

|

||||

```

|

||||

$ cargo install topgrade

|

||||

|

||||

```

|

||||

|

||||

Once installed, run the topgrade to upgrade all the things in your Linux system.

|

||||

```

|

||||

$ topgrade

|

||||

|

||||

```

|

||||

|

||||

Once topgrade is invoked, it will perform the following tasks one by one. You will be asked to enter root/sudo user password wherever necessary.

|

||||

|

||||

1 Run your system’s package manager:

|

||||

|

||||

* Arch: Run **yay** or fall back to [**pacman**][4]

|

||||

* CentOS/RHEL: Run `yum upgrade`

|

||||

* Fedora – Run `dnf upgrade`

|

||||

* Debian/Ubuntu: Run `apt update && apt dist-upgrade`

|

||||

* Linux/macOS: Run `brew update && brew upgrade`

|

||||

|

||||

|

||||

|

||||

2\. Check if the following paths are tracked by Git. If so, pull them:

|

||||

|

||||

* ~/.emacs.d (Should work whether you use **Spacemacs** or a custom configuration)

|

||||

* ~/.zshrc

|

||||

* ~/.oh-my-zsh

|

||||

* ~/.tmux

|

||||

* ~/.config/fish/config.fish

|

||||

* Custom defined paths

|

||||

|

||||

|

||||

|

||||

3\. Unix: Run **zplug** update

|

||||

|

||||

4\. Unix: Upgrade **tmux** plugins with **TPM**

|

||||

|

||||

5\. Run **Cargo install-update**

|

||||

|

||||

6\. Upgrade **Emacs** packages

|

||||

|

||||

7\. Upgrade Vim packages. Works with the following plugin frameworks:

|

||||

|

||||

* NeoBundle

|

||||

* [**Vundle**][5]

|

||||

* Plug

|

||||

|

||||

|

||||

|

||||

8\. Upgrade [**NPM**][6] globally installed packages

|

||||

|

||||

9\. Upgrade **Atom** packages

|

||||

|

||||

10\. Update [**Flatpak**][7] packages

|

||||

|

||||

11\. Update [**snap**][8] packages

|

||||

|

||||

12\. **Linux:** Run **fwupdmgr** to show firmware upgrade. (View only. No upgrades will actually be performed)

|

||||

|

||||

13\. Run custom defined commands.

|

||||

|

||||

Finally, topgrade utility will run **needrestart** to restart all services. In Mac OS X, it will upgrade App Store applications.

|

||||

|

||||

Sample output from my Ubuntu 18.04 LTS test box:

|

||||

|

||||

![][10]

|

||||

|

||||

The good thing is if one task is failed, it will automatically run the next task and complete all other subsequent tasks. Finally, it will display the summary with details such as how many tasks did it run, how many succeeded and how many failed etc.

|

||||

|

||||

![][11]

|

||||

|

||||

**Suggested read:**

|

||||

|

||||

Personally, I liked this idea of creating an utility like topgrade and upgrade everything installed with various package managers with a single command. I hope you find it useful too. More good stuffs to come. Stay tuned!

|

||||

|

||||

Cheers!

|

||||

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.ostechnix.com/how-to-upgrade-everything-using-a-single-command-in-linux/

|

||||

|

||||

作者:[SK][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.ostechnix.com/author/sk/

|

||||

[1]:https://www.ostechnix.com/manage-python-packages-using-pip/

|

||||

[2]:https://www.ostechnix.com/linuxbrew-common-package-manager-linux-mac-os-x/

|

||||

[3]:https://www.ostechnix.com/yay-found-yet-another-reliable-aur-helper/

|

||||

[4]:https://www.ostechnix.com/getting-started-pacman/

|

||||

[5]:https://www.ostechnix.com/manage-vim-plugins-using-vundle-linux/

|

||||

[6]:https://www.ostechnix.com/manage-nodejs-packages-using-npm/

|

||||

[7]:https://www.ostechnix.com/flatpak-new-framework-desktop-applications-linux/

|

||||

[8]:https://www.ostechnix.com/install-snap-packages-arch-linux-fedora/

|

||||

[9]:data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7

|

||||

[10]:http://www.ostechnix.com/wp-content/uploads/2018/06/topgrade-1.png

|

||||

[11]:http://www.ostechnix.com/wp-content/uploads/2018/06/topgrade-2.png

|

||||

@ -1,59 +0,0 @@

|

||||

tranWhat is the Difference Between the macOS and Linux Kernels

|

||||

======

|

||||

Some people might think that there are similarities between the macOS and the Linux kernel because they can handle similar commands and similar software. Some people even think that Apple’s macOS is based on Linux. The truth is that both kernels have very different histories and features. Today, we will take a look at the difference between macOS and Linux kernels.

|

||||

|

||||

![macOS vs Linux][1]

|

||||

|

||||

### History of macOS Kernel

|

||||

|

||||

We will start with the history of the macOS kernel. In 1985, Steve Jobs left Apple due to a falling out with CEO John Sculley and the Apple board of directors. He then founded a new computer company named [NeXT][2]. Jobs wanted to get a new computer (with a new operating system) to market quickly. To save time, the NeXT team used the [Mach kernel][3] from Carnegie Mellon and parts of the BSD code base to created the [NeXTSTEP operating system][4].

|

||||

|

||||

NeXT never became a financial success, due in part to Jobs’ habit of spending money like he was still at Apple. Meanwhile, Apple had tried unsuccessfully on several occasions to update their operating system, even going so far as to partner with IBM. In 1997, Apple purchased NeXT for $429 million. As part of the deal, Steve Jobs returned to Apple and NeXTSTEP became the foundation of macOS and iOS.

|

||||

|

||||

### History of Linux Kernel

|

||||

|

||||

Unlike the macOS kernel, Linux was not created as part of a commercial endeavor. Instead, it was [created in 1991 by Finnish computer science student Linus Torvalds][5]. Originally, the kernel was written to the specifications of Linus’ computer because he wanted to take advantage of its new 80386 processor. Linus posted the code for his new kernel to [the Usenet in August of 1991][6]. Soon, he was receiving code and feature suggestions from all over the world. The following year Orest Zborowski ported the X Window System to Linux, giving it the ability to support a graphical user interface.

|

||||

|

||||

Over the last 27 years, Linux has slowly grown and gained features. It’s no longer a student’s small-time project. Now it runs most of the [world’s][7] [computing devices][8] and the [world’s supercomputers][9]. Not too shabby.

|

||||

|

||||

### Features of the macOS Kernel

|

||||

|

||||

The macOS kernel is officially known as XNU. The [acronym][10] stands for “XNU is Not Unix.” According to [Apple’s Github page][10], XNU is “a hybrid kernel combining the Mach kernel developed at Carnegie Mellon University with components from FreeBSD and C++ API for writing drivers”. The BSD subsystem part of the code is [“typically implemented as user-space servers in microkernel systems”][11]. The Mach part is responsible for low-level work, such as multitasking, protected memory, virtual memory management, kernel debugging support, and console I/O.

|

||||

|

||||

### Features of Linux Kernel

|

||||

|

||||

While the macOS kernel combines the feature of a microkernel ([Mach][12])) and a monolithic kernel ([BSD][13]), Linux is solely a monolithic kernel. A [monolithic kernel][14] is responsible for managing the CPU, memory, inter-process communication, device drivers, file system, and system server calls.

|

||||

|

||||

### Difference between Mac and Linux kernel in one line

|

||||

|

||||

The macOS kernel (XNU) has been around longer than Linux and was based on a combination of two even older code bases. On the other hand, Linux is newer, written from scratch, and is used on many more devices.

|

||||

|

||||

If you found this article interesting, please take a minute to share it on social media, Hacker News or [Reddit][15].

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://itsfoss.com/mac-linux-difference/

|

||||

|

||||

作者:[John Paul][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://itsfoss.com/author/john/

|

||||

[1]:https://4bds6hergc-flywheel.netdna-ssl.com/wp-content/uploads/2018/07/macos-vs-linux-kernels.jpeg

|

||||

[2]:https://en.wikipedia.org/wiki/NeXT

|

||||

[3]:https://en.wikipedia.org/wiki/Mach_(kernel)

|

||||

[4]:https://en.wikipedia.org/wiki/NeXTSTEP

|

||||

[5]:https://www.cs.cmu.edu/%7Eawb/linux.history.html

|

||||

[6]:https://groups.google.com/forum/#!original/comp.os.minix/dlNtH7RRrGA/SwRavCzVE7gJ

|

||||

[7]:https://www.zdnet.com/article/sorry-windows-android-is-now-the-most-popular-end-user-operating-system/

|

||||

[8]:https://www.linuxinsider.com/story/31855.html

|

||||

[9]:https://itsfoss.com/linux-supercomputers-2017/

|

||||

[10]:https://github.com/apple/darwin-xnu

|

||||

[11]:http://osxbook.com/book/bonus/ancient/whatismacosx/arch_xnu.html

|

||||

[12]:https://en.wikipedia.org/wiki/Mach_(kernel

|

||||

[13]:https://en.wikipedia.org/wiki/FreeBSD

|

||||

[14]:https://www.howtogeek.com/howto/31632/what-is-the-linux-kernel-and-what-does-it-do/

|

||||

[15]:http://reddit.com/r/linuxusersgroup

|

||||

@ -1,98 +0,0 @@

|

||||

Translating by SunWave...

|

||||

|

||||

How to use dd in Linux without destroying your disk

|

||||

======

|

||||

|

||||

|

||||

|

||||

This article is excerpted from chapter 4 of [Linux in Action][1], published by Manning.

|

||||

|

||||

Whether you're trying to rescue data from a dying storage drive, backing up archives to remote storage, or making a perfect copy of an active partition somewhere else, you'll need to know how to safely and reliably copy drives and filesystems. Fortunately, `dd` is a simple and powerful image-copying tool that's been around, well, pretty much forever. And in all that time, nothing's come along that does the job better.

|

||||

|

||||

### Making perfect copies of drives and partitions

|

||||

|

||||

`dd` if you research hard enough, but where it shines is in the ways it lets you play with partitions. You can, of course, use `tar` or even `scp` to replicate entire filesystems by copying the files from one computer and then pasting them as-is on top of a fresh Linux install on another computer. But, because those filesystem archives aren't complete images, they'll require a running host OS at both ends to serve as a base.

|

||||

|

||||

There's all kinds of stuff you can do withif you research hard enough, but where it shines is in the ways it lets you play with partitions. You can, of course, useor evento replicate entire filesystems by copying the files from one computer and then pasting them as-is on top of a fresh Linux install on another computer. But, because those filesystem archives aren't complete images, they'll require a running host OS at both ends to serve as a base.

|

||||

|

||||

Using `dd`, on the other hand, can make perfect byte-for-byte images of, well, just about anything digital. But before you start flinging partitions from one end of the earth to the other, I should mention that there's some truth to that old Unix admin joke: "dd stands for disk destroyer." If you type even one wrong character in a `dd` command, you can instantly and permanently wipe out an entire drive of valuable data. And yes, spelling counts.

|

||||

|

||||

**Remember:** Before pressing that Enter key to invoke `dd`, pause and think very carefully!

|

||||

|

||||

### Basic dd operations

|

||||

|

||||

Now that you've been suitably warned, we'll start with something straightforward. Suppose you want to create an exact image of an entire disk of data that's been designated as `/dev/``sda`. You've plugged in an empty drive (ideally having the same capacity as your `/dev/``sda` system). The syntax is simple: `if=` defines the source drive and `of=` defines the file or location where you want your data saved:

|

||||

```

|

||||

# dd if=/dev/sda of=/dev/sdb

|

||||

|

||||

```

|

||||

|

||||

The next example will create an .img archive of the `/dev/``sda` drive and save it to the home directory of your user account:

|

||||

```

|

||||

# dd if=/dev/sda of=/home/username/sdadisk.img

|

||||

|

||||

```

|

||||

|

||||

Those commands created images of entire drives. You could also focus on a single partition from a drive. The next example does that and also uses `bs` to set the number of bytes to copy at a single time (4,096, in this case). Playing with the `bs` value can have an impact on the overall speed of a `dd` operation, although the ideal setting will depend on your hardware profile and other considerations.

|

||||

```

|

||||

# dd if=/dev/sda2 of=/home/username/partition2.img bs=4096

|

||||

|

||||

```

|

||||

|

||||

Restoring is simple: Effectively, you reverse the values of `if` and `of`. In this case, `if=` takes the image you want to restore, and `of=` takes the target drive to which you want to write the image:

|

||||

```

|

||||

# dd if=sdadisk.img of=/dev/sdb

|

||||

|

||||

```

|

||||

|

||||

You can also perform both the create and copy operations in one command. This example, for instance, will create a compressed image of a remote drive using SSH and save the resulting archive to your local machine:

|

||||

```

|

||||

# ssh username@54.98.132.10 "dd if=/dev/sda | gzip -1 -" | dd of=backup.gz

|

||||

|

||||

```

|

||||

|

||||

You should always test your archives to confirm they're working. If it's a boot drive you've created, stick it into a computer and see if it launches as expected. If it's a normal data partition, mount it to make sure the files both exist and are appropriately accessible.

|

||||

|

||||

### Wiping disks with dd

|

||||

|

||||

Years ago, I had a friend who was responsible for security at his government's overseas embassies. He once told me that each embassy under his watch was provided with an official government-issue hammer. Why? In case the facility was ever at risk of being overrun by unfriendlies, the hammer was to be used to destroy all their hard drives.

|

||||

|

||||

What's that? Why not just delete the data? You're kidding, right? Everyone knows that deleting files containing sensitive data from storage devices doesn't actually remove the data. Given enough time and motivation, nearly anything can be retrieved from virtually any digital media, with the possible exception of the ones that have been well and properly hammered.

|

||||

|

||||

You can, however, use `dd` to make it a whole lot more difficult for the bad guys to get at your old data. This command will spend some time writing millions and millions of zeros over every nook and cranny of the `/dev/sda1` partition:

|

||||

```

|

||||

# dd if=/dev/zero of=/dev/sda1

|

||||

|

||||

```

|

||||

|

||||

But it gets better. Using `/dev/``urandom` file as your source, you can write over a disk with random characters:

|

||||

```

|

||||

# dd if=/dev/urandom of=/dev/sda1

|

||||

|

||||

```

|

||||

|

||||

### Monitoring dd operations

|

||||

|

||||

Since disk or partition archiving can take a very long time, you might want to add a progress monitor to your command. Install Pipe Viewer (`sudo apt install pv` on Ubuntu) and insert it into `dd`. With `pv`, that last command might look something like this:

|

||||

```

|

||||

# dd if=/dev/urandom | pv | dd of=/dev/sda1

|

||||

|

||||

4,14MB 0:00:05 [ 98kB/s] [ <=> ]

|

||||

|

||||

```

|

||||

|

||||

Putting off backups and disk management? With dd, you aren't left with too many excuses. It's really not difficult, but be careful. Good luck!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/7/how-use-dd-linux

|

||||

|

||||

作者:[David Clinton][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/remyd

|

||||

[1]:https://www.manning.com/books/linux-in-action?a_aid=bootstrap-it&a_bid=4ca15fc9&chan=opensource

|

||||

@ -1,3 +1,5 @@

|

||||

translating---geekpi

|

||||

|

||||

Boost your typing with emoji in Fedora 28 Workstation

|

||||

======

|

||||

|

||||

|

||||

@ -1,88 +0,0 @@

|

||||

translating---geekpi

|

||||

|

||||

Getting started with Perlbrew

|

||||

======

|

||||

|

||||

|

||||

|

||||

What's better than having Perl installed on your system? Having multiple Perls installed on your system! With [Perlbrew][1] you can do just that. But why—apart from surrounding yourself in Perl—would you want to do that?

|

||||

|

||||

The short answer is that different versions of Perl are… different. Application A may depend on behavior deprecated in a newer release, while Application B needs new features that weren't available last year. If you have multiple versions of Perl installed, each script can use the version that best suits it. This also comes in handy if you're a developer—you can test your application against multiple versions of Perl so that, no matter what your users are running, you know it works.

|

||||

|

||||

### Install Perlbrew

|

||||

|

||||

The other benefit is that Perlbrew installs to the user's home directory. That means each user can manage their Perl versions (and the associated CPAN packages) without having to involve the system administrators. Self-service means quicker installation for the users and gives sysadmins more time to work on the hard problems.

|

||||

|

||||

The first step is to install Perlbrew on your system. Many Linux distributions have it in the package repo already, so you're just a `dnf install perlbrew` (or whatever is the appropriate command for your distribution) away. You can also install the `App::perlbrew` module from CPAN with `cpan App::perlbrew`. Or you can download and run the installation script at [install.perlbrew.pl][2].

|

||||

|

||||

To begin using Perlbrew, run `perlbrew init`.

|

||||

|

||||

### Install a new Perl version

|

||||

|

||||

Let's say you want to try the latest development release (5.27.11 as of this writing). First, you need to install the package:

|

||||

```

|

||||

perlbrew install 5.27.11

|

||||

|

||||

```

|

||||

|

||||

### Switch Perl version

|

||||

|

||||

Now that you have a new version installed, you can use it for just that shell:

|

||||

```

|

||||

perlbrew use 5.27.11

|

||||

|

||||

```

|

||||

|

||||

Or you can make it the default Perl version for your account (assuming you set up your profile as instructed by the output of `perlbrew init`):

|

||||

```

|

||||

perlbrew switch 5.27.11

|

||||

|

||||

```

|

||||

|

||||

### Run a single script

|

||||

|

||||

You can run a single command against a specific version of Perl, too:

|

||||

```

|

||||

perlberew exec 5.27.11 myscript.pl

|

||||

|

||||

```

|

||||

|

||||

Or you can run a command against all your installed versions. This is particularly handy if you want to run tests against a variety of versions. In this case, specify Perl as the version:

|

||||

```

|

||||

.plperlbrew exec perl myscriptpl

|

||||

|

||||

```

|

||||

|

||||

### Install CPAN modules

|

||||

|

||||

If you want to install CPAN modules, the `cpanm` package is an easy-to-use interface that works well with Perlbrew. Install it with:

|

||||

```

|

||||

perlbrew install-cpamn

|

||||

|

||||

```

|

||||

|

||||

You can then install CPAN modules with the `cpanm` command:

|

||||

```

|

||||

cpanm CGI::simple

|

||||

|

||||

```

|

||||

|

||||

### But wait, there's more!

|

||||

|

||||

This article covers basic Perlbrew usage. There are many more features and options available. Look at the output of `perlbrew help` as a starting point, or check out the [App::perlbrew documentation][3]. What other features do you love in Perlbrew? Let us know in the comments.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/7/perlbrew

|

||||

|

||||

作者:[Ben Cotton][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||