mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-30 02:40:11 +08:00

commit

28b5dfd027

published

20150104 How to debug a C or C++ program with Nemiver debugger.md20150114 Install Gitblit On Ubuntu or Fedora or CentOS.md20150115 Get back your privacy and control.md20150121 How to Monitor Network Usage with nload in Linux.md20150122 How To Recover Windows 7 And Delete Ubuntu In 3 Easy Steps.md20150126 4 lvcreate Command Examples on Linux.md20150126 CD Audio Grabbers--Graphical Based.md20150126 Improve system performance by moving your log files to RAM Using Ramlog.md20150127 How to limit network bandwidth on Linux.md20150127 LinSSID--A Graphical Wi-Fi Scanner for Linux.md20150203 How To Install KDE Plasma 5.2 In Ubuntu 14.10.md20150205 How To Use Smartphones Like Weather Conky In Linux.md20150205 Linux Basics--Assign Multiple IP Addresses To Single Network Interface Card On CentOS 7.md20150211 Best Known Linux Archive or Compress Tools.md20150211 How To Protect Ubuntu Server Against the GHOST Vulnerability.md20150309 15 Basic 'ls' Command Examples in Linux.md

sources

share

20150323 Papyrus--An Open Source Note Manager.md20150323 Red Hat Developer Toolset 3.1 beta arrives.md20150323 Square 2.0 Icon Pack Is Twice More Beautiful.md20150324 How to Install Telegram Messenger Application on Linux.md20150326 Mydumper--Mysql Database Backup tool.md

talk

tech

20150227 How to Install Lightweight Budgie v8 Desktop in Ubuntu 14.04.md20150302 How to Manage KVM Virtual Environment using Commandline Tools in Linux.md20150320 Locate Stolen laptops and Smart phones Using Prey Tool in Ubuntu.md20150323 How to enable ssh login without entering password.md20150323 How to set up networking between Docker containers.md20150323 Linux FAQs with Answers--How to install and access CentOS remote desktop on VPS.md20150324 7 Quirky' ls' Command Tricks Every Linux User Should Know.md20150324 How to Host Open Source Code Repository in github.md20150324 How to Interactively Create a Docker Container.md20150326 A Peep into Process Management Commands in Linux.md20150326 How to set up server monitoring system with Monit.md

translated

share

talk

tech

20150104 How to debug a C or C++ program with Nemiver debugger.md20150121 How to Monitor Network Usage with nload in Linux.md20150126 Improve system performance by moving your log files to RAM Using Ramlog.md20150227 How to Install Lightweight Budgie v8 Desktop in Ubuntu 14.04.md20150302 How to Manage KVM Virtual Environment using Commandline Tools in Linux.md20150320 Locate Stolen laptops and Smart phones Using Prey Tool in Ubuntu.md20150323 Linux FAQs with Answers--How to compress JPEG images from the command line on Linux.md20150324 4 Tools to Securely Delete Files from Linux.md20150324 Prips--Print IP address on a given range.md

@ -0,0 +1,110 @@

|

||||

使用Nemiver调试器来调试 C/C++ 程序

|

||||

================================================================================

|

||||

|

||||

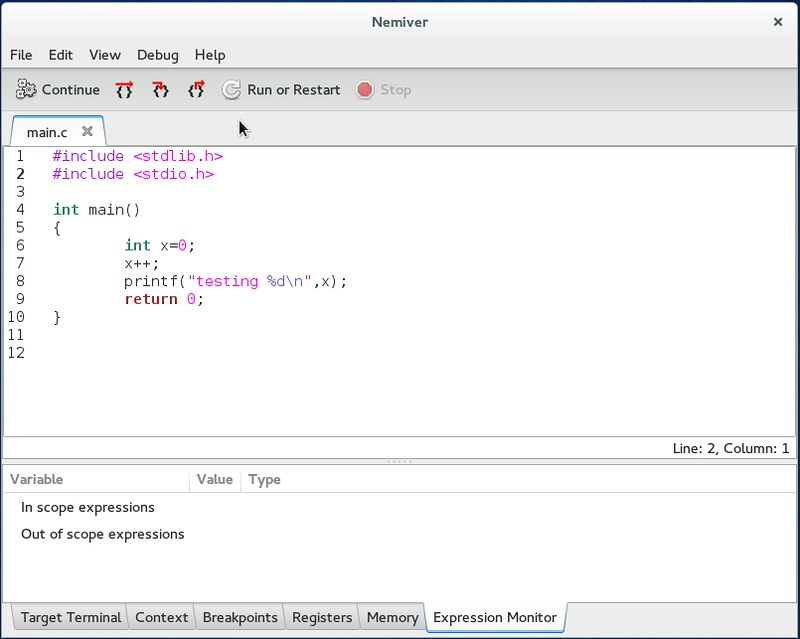

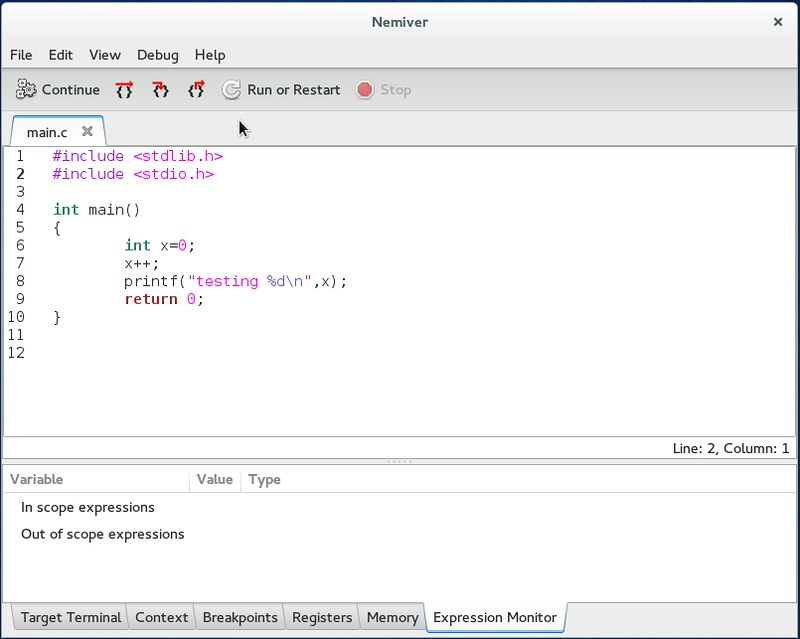

如果你读过我写的[使用GDB命令行调试器调试C/C++程序][1],你就会明白一个调试器对一段C/C++程序来说有多么的重要和有用。然而,如果一个像GDB这样的命令行对你而言听起来更像一个问题而不是一个解决方案的话,那么你也许会对Nemiver更感兴趣。[Nemiver][2] 是一款基于 GTK+ 的用于C/C++程序的图形化的独立调试器,它以GDB作为其后端。最令人赞赏的是其速度和稳定性,Nemiver是一个非常可靠,具备许多优点的调试工具。

|

||||

|

||||

### Nemiver的安装 ###

|

||||

|

||||

基于Debian发行版,它的安装时非常直接简单,如下:

|

||||

|

||||

$ sudo apt-get install nemiver

|

||||

|

||||

在Arch Linux中安装如下:

|

||||

|

||||

$ sudo pacman -S nemiver

|

||||

|

||||

在Fedora中安装如下:

|

||||

|

||||

$ sudo yum install nemiver

|

||||

|

||||

如果你选择自己编译,[GNOME 网站][3]上有最新源码包。

|

||||

|

||||

最令人欣慰的是,它能够很好地与GNOME环境像结合。

|

||||

|

||||

### Nemiver的基本用法 ###

|

||||

|

||||

启动Nemiver的命令:

|

||||

|

||||

$ nemiver

|

||||

|

||||

你也可以通过执行一下命令来启动:

|

||||

|

||||

$ nemiver [需要调试的可执行程序的路径]

|

||||

|

||||

注意,如果在调试模式下编译程序(在 GCC 中使用 -g 选项)将会对 nemiver 更有帮助。

|

||||

|

||||

还有一个优点是Nemiver的加载很快,所以你马上就可以看到主屏幕的默认布局。

|

||||

|

||||

|

||||

|

||||

默认情况下,断点通常位于主函数的第一行。这样就可以空出时间让你去认识调试器的基本功能:

|

||||

|

||||

|

||||

|

||||

- 执行到下一行 (按键是F6)

|

||||

- 执行到函数内部即停止(F7)

|

||||

- 执行到函数外部即停止(Shift+F7)

|

||||

|

||||

不过我个人喜欢“Run to cursor(运行至光标所在行)”,该选项使你的程序准确的运行至你光标所在行,它的默认按键是F11。

|

||||

|

||||

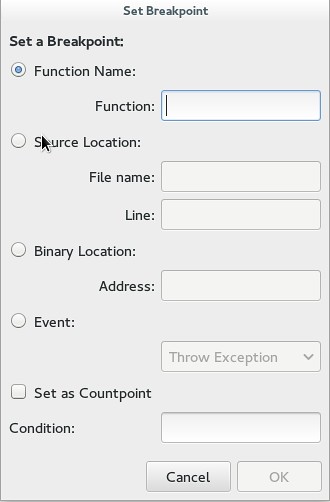

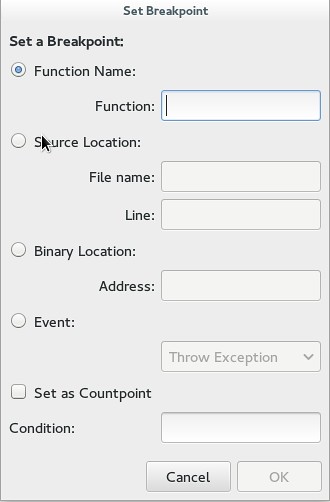

断点是很容易使用的。最快捷的方式是在一行代码上按下F8来设置一个断点。但是Nemiver在“Debug”菜单下也有一个更复杂的菜单,它允许你在一个特定的函数,某一行,二进制文件中的位置,或者类似异常、分支或者exec的事件上设置断点。

|

||||

|

||||

|

||||

|

||||

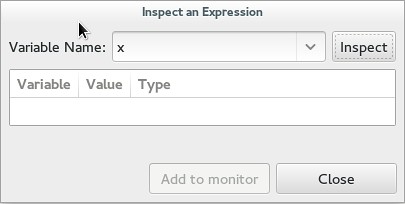

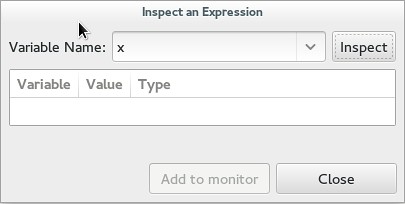

你也可以通过追踪来查看一个变量。在“Debug”中,你可以用一个表达式的名字来检查它的值,然后也可以通过将其添加到列表中以方便访问。这可能是最有用的一个功能,虽然我从未有兴趣将鼠标悬停在一个变量来获取它的值。值得注意的是,虽然鼠标悬停可以取到值,如果想要让它更好地工作,Nemiver是可以看到结构并给出所有成员的变量的赋值。

|

||||

|

||||

|

||||

|

||||

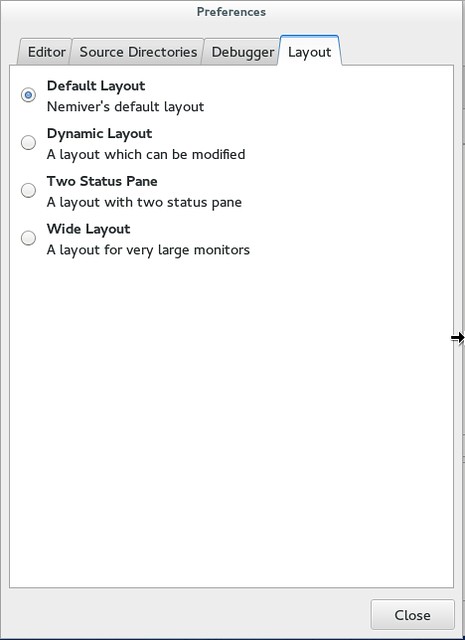

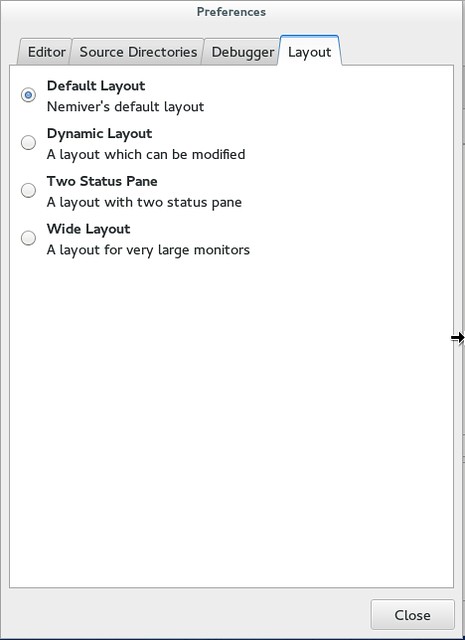

谈到方便地访问信息,我也非常欣赏这个程序的布局。默认情况下,代码在上半部分,功能区标签在下半部分。这可以让你访问终端的输出、上下文追踪器、断点列表、注册器地址、内存映射和变量控制。但是请注意在“Edit”-“Preferences”-“Layout”下你可以选择不同的布局,包括一个可以修改的动态布局。

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

自然,当你设置了全部断点,观察点和布局,您可以在“File”菜单下很方便地保存该会话,以便你下次打开时恢复。

|

||||

|

||||

### Nemiver的高级用法 ###

|

||||

|

||||

到目前为止,我们讨论的都是Nemiver的基本特征,例如,你马上开始调试一个简单的程序需要了解什么。如果你有更高的需求,特别是对于一些更加复杂的程序,你应该会对接下来提到的这些特征更感兴趣。

|

||||

|

||||

#### 调试一个正在运行的进程 ####

|

||||

|

||||

Nemiver允许你驳接到一个正在运行的进程进行调试。在“File”菜单,你可以筛选出正在运行的进程,并驳接到某个进程。

|

||||

|

||||

|

||||

|

||||

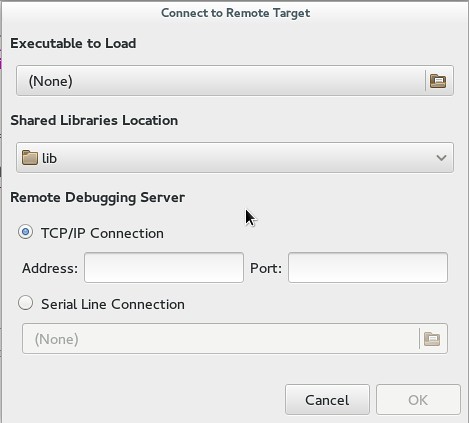

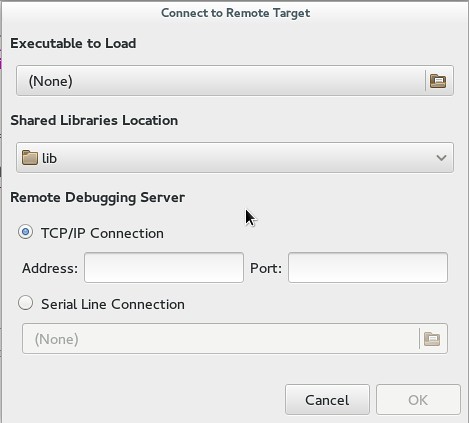

#### 通过TCP连接远程调试一个程序 ####

|

||||

|

||||

Nemiver支持远程调试,你可以在一台远程机器上设置一个轻量级调试服务器,然后你在另外一台机器上启动 nemiver 去调试运行在调试服务器上的程序。如果出于某些原因,你不能在远程机器上很好地驾驭 Nemiver或者GDB,那么远程调试对于你来说将非常有用。在“File”菜单下,指定二进制文件、共享库位置、远程地址和端口。

|

||||

|

||||

|

||||

|

||||

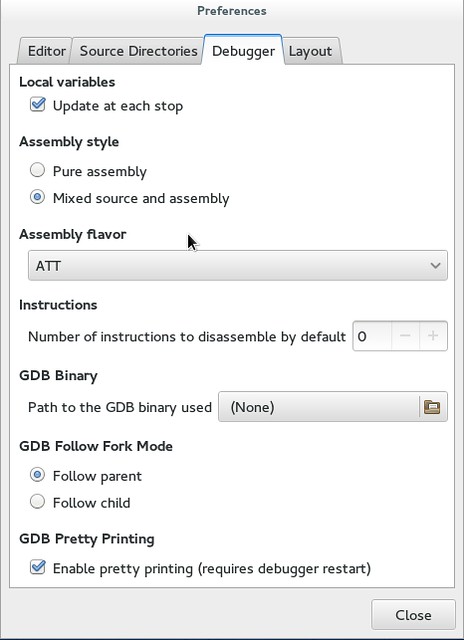

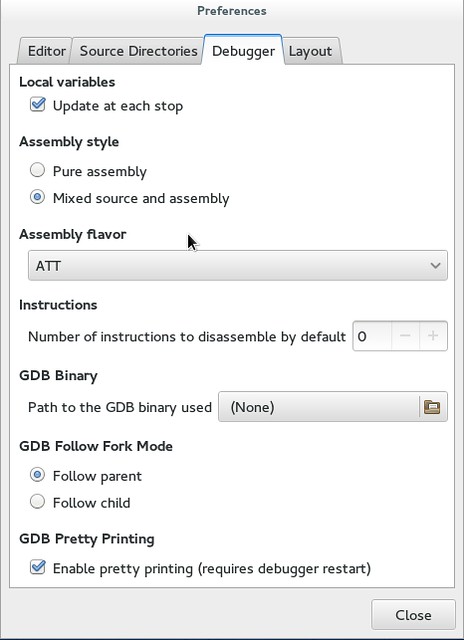

#### 使用你的GDB二进制程序进行调试 ####

|

||||

|

||||

如果你的Nemiver是自行编译的,你可以在“Edit(编辑)”-“Preferences(首选项)”-“Debug(调试)”下给GDB指定一个新的位置。如果你想在Nemiver下使用定制版本的GDB,那么这个选项对你来说是非常实用的。

|

||||

|

||||

#### 跟随一个子进程或者父进程 ####

|

||||

|

||||

当你的程序分支时,Nemiver是可以设置为跟随子进程或者父进程的。想激活这个功能,请到“Debugger”下面的“Preferences(首选项)”。

|

||||

|

||||

|

||||

|

||||

总而言之,Nemiver大概是我最喜欢的不在IDE里面的调试程序。在我看来,它甚至可以击败GDB,它和命令行程序一样深深吸引了我。所以,如果你从未使用过的话,我会强烈推荐你使用。我十分感谢它背后的开发团队给了我这么一个可靠、稳定的程序。

|

||||

|

||||

你对Nemiver有什么见解?你是否也考虑它作为独立的调试工具?或者仍然坚持使用IDE?让我们在评论中探讨吧。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://xmodulo.com/debug-program-nemiver-debugger.html

|

||||

|

||||

作者:[Adrien Brochard][a]

|

||||

译者:[disylee](https://github.com/disylee)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://xmodulo.com/author/adrien

|

||||

[1]:http://linux.cn/article-4302-1.html

|

||||

[2]:https://wiki.gnome.org/Apps/Nemiver

|

||||

[3]:https://download.gnome.org/sources/nemiver/0.9/

|

||||

[4]:http://xmodulo.com/recommend/linuxclibook

|

||||

@ -2,13 +2,13 @@

|

||||

================================================================================

|

||||

**Git**是一款注重速度、数据完整性、分布式支持和非线性工作流的分布式版本控制工具。Git最初由Linus Torvalds在2005年为Linux内核开发而设计,如今已经成为被广泛接受的版本控制系统。

|

||||

|

||||

和其他大多数分布式版本控制系统比起来,不像大多数客户端-服务端的系统,每个Git工作目录是一个完整的仓库,带有完整的历史记录和完整的版本跟踪能力,不需要依赖网络或者中心服务器。像Linux内核一样,Git意识在GPLv2许可证下的免费软件。

|

||||

和其他大多数分布式版本控制系统比起来,不像大多数客户端-服务端的系统,每个Git工作目录是一个完整的仓库,带有完整的历史记录和完整的版本跟踪能力,不需要依赖网络或者中心服务器。像Linux内核一样,Git也是在GPLv2许可证下分发的自由软件。

|

||||

|

||||

本篇教程我会演示如何安装gitlit服务器。gitlit的最新稳定版是1.6.2。[Gitblit][1]是一款开源、纯Java开发的用于管理浏览和服务的[Git][2]仓库。它被设计成一款为希望托管中心仓库的小工作组服务的工具。

|

||||

本篇教程我会演示如何安装 gitlit 服务器。gitlit的最新稳定版是1.6.2。[Gitblit][1]是一款开源、纯Java开发的用于管理、浏览和提供[Git][2]仓库服务的软件。它被设计成一款为希望托管中心仓库的小型工作组服务的工具。

|

||||

|

||||

mkdir -p /opt/gitblit; cd /opt/gitblit; wget http://dl.bintray.com/gitblit/releases/gitblit-1.6.2.tar.gz

|

||||

|

||||

### 列出目录: ###

|

||||

### 列出解压后目录内容: ###

|

||||

|

||||

root@vps124229 [/opt/gitblit]# ls

|

||||

./ docs/ gitblit-stop.sh* LICENSE service-ubuntu.sh*

|

||||

@ -21,7 +21,7 @@

|

||||

|

||||

### 启动gitlit服务: ###

|

||||

|

||||

### 通过service命令: ###

|

||||

**通过service命令:**

|

||||

|

||||

root@vps124229 [/opt/gitblit]# cp service-centos.sh /etc/init.d/gitblit

|

||||

root@vps124229 [/opt/gitblit]# chkconfig --add gitblit

|

||||

@ -29,7 +29,7 @@

|

||||

Starting gitblit server

|

||||

.

|

||||

|

||||

### 手动启动: ###

|

||||

**手动启动:**

|

||||

|

||||

root@vps124229 [/opt/gitblit]# java -jar gitblit.jar --baseFolder data

|

||||

2015-01-10 09:16:53 [INFO ] *****************************************************************

|

||||

@ -108,15 +108,15 @@

|

||||

|

||||

打开浏览器,依据你的配置进入**http://localhost:8080** 或者 **https://localhost:8443**。 输入默认的管理员授权:**admin / admin** 并点击**Login** 按钮

|

||||

|

||||

|

||||

|

||||

|

||||

### 添加用户: ###

|

||||

|

||||

|

||||

|

||||

|

||||

添加仓库:

|

||||

###添加仓库:###

|

||||

|

||||

|

||||

|

||||

|

||||

### 用命令行创建新的仓库: ###

|

||||

|

||||

@ -140,7 +140,7 @@ via: http://www.unixmen.com/install-gitblit-ubuntu-fedora-centos/

|

||||

|

||||

作者:[M.el Khamlichi][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,42 +1,42 @@

|

||||

在短短几个小时里拿回自己数据的隐私和控制权:为自己和朋友们搭建私有云

|

||||

权威指南:构建个人私有云,拿回你的数据隐私的控制权!

|

||||

================================================================================

|

||||

8年里40'000多次搜索!这是我的Google搜索历史。你的呢?(可以在[这里][1]自己找一下)有经过这么长时间积累下来的这么多数据点,Google已经能非常精确的推测你对什么感兴趣,曾经的想法,担忧过的事情,以及从你第一次获得Google帐号后这些年里所有这些的变化。

|

||||

8年里40000多次搜索!这是我的Google搜索历史。你的呢?(可以在[这里][1]自己找一下)有经过这么长时间积累下来的这么多数据点,Google已经能非常精确的推测你对什么感兴趣、曾经的想法、担忧过的事情,以及从你第一次获得Google帐号后这些年里所有这些的变化!

|

||||

|

||||

### 很多非常私人的信息不受自己控制地存储在世界范围内的服务器上 ###

|

||||

## 很多非常私人的信息不受自己控制地存储在世界范围内的服务器上 ##

|

||||

|

||||

比如说你也像我一样从2006年到2013年都是Gmail用户,意味着你收到了30'000+的电子邮件以及在这7年里写了差不多5000封电子邮件。这些发送或收到的电子邮件里有很多是非常私人的,私人到你甚至不希望自己的家人或好友能系统地查看。也许你还写过一些草稿邮件,因为最后一分钟改变主意而从没发出去。但是尽管你从未发出去,这些邮件仍然保存在服务器上的某个地方。结论是,说Google服务器比你最亲密的朋友或家人都更了解你的个人生活一点也不过分。

|

||||

比如说你也像我一样从2006年到2013年都是Gmail用户,意味着你收到了30000封以上的电子邮件,以及在这7年里写了差不多5000封电子邮件。这些发送或收到的电子邮件里有很多是非常私人的,私人到你甚至不希望自己的家人或好友可以系统地查看。也许你还写过一些草稿邮件,因为最后一分钟改变主意而从没发出去。但是尽管你从未发出去,这些邮件仍然保存在服务器上的某个地方。结论是,说Google服务器比你最亲密的朋友或家人都更了解你的个人生活一点也不过分。

|

||||

|

||||

从统计数据来看,可以很安全地赌你拥有一部智能手机。如果不使用联系人应用的话手机将基本没法用,而它默认会将你的联系人信息保存到Google服务器上的Google联系人里。所以,现在Google不仅知道了你的电子邮件,还有了你的离线联系人:你喜欢打给谁,谁来过电话,你发过短信给谁,以及发了些什么。你也不需要听我的片面之词,可以自己检查一下,看看你开放给类似Google Play服务的一些应用的权限,用来读取来电信息以及收到的短信。你是否还会用到手机里自带的日历应用?除非你在设置日程的时候明确地去掉,那么Google将精确地知道你将要做什么,一天里的每个时段,每一天,每一年。用iPhone代替Android手机也是一样的,只是Apple会代替Google来掌握你的往来邮件,联系人和日程计划。

|

||||

从统计数据来看,我可以很保险地打赌你拥有一部智能手机。如果不使用联系人应用的话手机将基本没法用,而它默认会将你的联系人信息保存到Google服务器上的Google联系人里。所以,现在Google不仅知道了你的电子邮件,还有了你的离线联系人:你喜欢打给谁、谁来过电话、你发过短信给谁,以及发了些什么。你也不需要听我的片面之词,可以自己检查一下,看看你开放给类似Google Play服务的一些应用的权限,用来读取来电信息以及收到的短信。你是否还会用到手机里自带的日历应用?除非你在设置日程的时候明确地去掉同步,那么Google将精确地知道你将要做什么,一天里的每个时段、每一天、每一年。用iPhone代替Android手机也是一样的,只是Apple会代替Google来掌握你的往来邮件、联系人和日程计划。

|

||||

|

||||

你是否还会非常小心地同步自己的联系人信息,在你朋友,同事或家人换工作或换服务商的时候更新他们的电子邮件地址和手机号?这给Google提供了一副你社交网络的非常精确的,最新的图片。还有你非常喜欢手机的GPS功能,经常配合Google地图使用。这意味着Google不仅能从日程里知道你在干什么,还知道你在哪儿,住在哪儿,在哪儿工作。然后再关联用户之间的GPS位置信息,GOogle还能知道你现在可能正在和哪些人来往。

|

||||

你是否还会非常小心地同步自己的联系人信息,在你朋友,同事或家人换工作或换服务商的时候更新他们的电子邮件地址和手机号?这给Google提供了一副你的社交网络的非常精确的、最新的描绘。还有你非常喜欢手机的GPS功能,经常配合Google地图使用。这意味着Google不仅能从日程里知道你在干什么,还知道你在哪儿、住在哪儿、在哪儿工作。然后再关联用户之间的GPS位置信息,Google还能知道你现在可能正在和哪些人来往。

|

||||

|

||||

### 这种泄漏自己私人信息的日常爱好会以一种甚至没人能够预测的方式影响你的生活 ###

|

||||

## 这种泄漏自己私人信息的日常爱好会以一种甚至没人能够预测的方式影响你的生活 ##

|

||||

|

||||

总结一下,如果你是一个普通的因特网用户,Google拥有过去差不多10年里你最新的,深度的信息,关于你的兴趣,忧虑,热情,疑问。它还收集了一些你很私人的信息(电子邮件,短信),精确到小时的你的日常活动和位置,一副你社交网络的高品质图片。关于你的如此私密的数据,很可能已经超越了你最亲密的朋友,家人或爱人对你的了解。

|

||||

总结一下,如果你是一个普通的因特网用户,Google拥有过去差不多10年里你最新的、深度的信息,关于你的兴趣、忧虑、热情、疑问。它还收集了一些你很私人的信息(电子邮件、短信),精确到小时的你的日常活动和位置,一副你社交网络的高精度的描绘。关于你的如此私密的数据,很可能已经超越了你最亲密的朋友,家人或爱人对你的了解。

|

||||

|

||||

不敢想象把这些深度的个人信息交给完全陌生的人,就好像把这些信息拷到一个U盘里,然后随便放到某个咖啡厅的桌上,留张纸条说“Olivier Martin的个人数据,请随便”。谁知道什么人会拿到它以及用来干嘛?然而,我们毫不犹豫地把自己的主要信息交给那些对我们的数据很感兴趣的IT公司的陌生人(这是他们制造面包的材料)以及[世界级的数据分析专家][2]手里,也许只是因为我们在点击那个绿色的'接受'按钮时根本没有想这么多。

|

||||

|

||||

有这么多的高质量信息,这么多年里,Google可能会比你希望自我了解的更了解你自己:尼玛,回想我过去的数字生活,我已经不记得5年前发出的邮件里的一半了。我很高兴能重新发现早在2005年对马克思主义的兴趣以及第二年加入了[ATTAC][3](一个致力于通过征收金融交易税来限制投机和改善社会公平的组织)。天知道为什么我竟然在2007年这么喜欢跳舞。这些都是无关紧要的信息(你不要指望我能爆出什么猛料,不会吧?;-)。但是,连接起这些高质量数据点,关于你生活的方方面面(做什么,什么时候,和谁一起,在哪里,...),并跨越这么长时间间隔,应该能推测出你的未来状态。比如说,根据一个17岁女孩的购物习惯,超市甚至可以在他父亲听说之前断定这个女孩怀孕了([真实故事][4])。谁知道通过像Google所掌握的这些远远超出购物习惯的高质量数据能做些什么?连接起这些点,也许有人能预测你未来几年里口味或政治观点的变化。如今,[你从未听过的公司声称拥有你500项数据点][5],包括宗教信仰,性取向和政治观点。提到政治,如果说你决定今后10年内进入政坛会怎么样?你的生活会改变,你的观点也一样,甚至你有时候会有所遗忘,但是Google不会。那你会不会担心你的对手会接触一些可以从Google访问你数据的人并会从你过去这些年里积累的个人数据深渊里挖出一些猛料呢?[就像最近Sony被黑][6]一样,多久以后会轮到Google或Facebook,以致让你的个人信息最终永远暴露?

|

||||

有这么多的高质量信息,这么多年里,Google可能会比你希望自我了解的更了解你自己:尼玛,回想我过去的数字生活,5年前发出的邮件里有一半我已经不记得了。我很高兴能重新发现早在2005年对xxx主义的兴趣以及第二年加入了[ATTAC][3](一个致力于通过征收金融交易税来限制投机和改善社会公平的组织)。天知道为什么我竟然在2007年这么喜欢跳舞。这些都是无关紧要的信息(你不指望我能爆出什么猛料,是吧?;-)。但是,连接起这些高质量数据点,关于你生活的方方面面(做什么、什么时候、和谁一起、在哪里,...),并跨越这么长时间间隔,应该能推测出你的未来状态。比如说,根据一个17岁女孩的购物习惯,超市甚至可以在他父亲听说之前断定这个女孩怀孕了(这是一个[真实的故事][4])。谁知道通过像Google所掌握的这些远远超出购物习惯的高质量数据能做些什么?连接起这些点,也许有人能预测你未来几年里口味或观点的变化。如今,[你从未听过的公司声称拥有你500项数据点][5],包括宗教信仰、性取向和政治观点。提到政治,如果说你决定今后10年内进入政坛会怎么样?你的生活会改变,你的观点也一样,甚至你有时候会有所遗忘,但是Google不会。那你会不会担心你的对手会接触一些可以从Google访问你数据的人并会从你过去这些年里积累的个人数据深渊里挖出一些猛料呢?[就像最近Sony被黑][6]一样,多久以后会轮到Google或Facebook,以致让你的个人信息最终永远暴露?

|

||||

|

||||

我们大多数人把自己的个人数据托付给这些公司的一个原因就是它们提供免费服务。但是真的免费吗?一般的Google帐号的价值根据评估方式不同会有些差别:你花在写邮件上的时间占到[1000美元/年][7],你的帐号对于广告产业的价值差不多在[220美元/年][8]到[500美元/年][9]之间。所以这些服务并不是真的免费:会通过广告和我们的数据在未来的一些未知使用来间接付费。

|

||||

|

||||

我写的最多的是Google,这是因为这是我托付个人数字信息的,以及目前我所知道做的最好的公司。但是我也提到过Apple或Facebook。这些公司通过它们在设计,工程和我们(曾经)喜欢每天使用的服务方面的神奇进步实实在在地改变了世界。但是这并不是说我们应该把所有我们最私人的个人数据堆积到它们的服务器上并把我们的数字生活托付给它们:潜在的危害实在太大了。

|

||||

我写的最多的是Google,这是因为这是我托付个人数字信息的,以及目前我所知道做的最好的公司。但是我也提到过Apple或Facebook。这些公司通过它们在设计、工程和我们(曾经)喜欢每天使用的服务方面的神奇进步实实在在地改变了世界。但是这并不是说我们应该把所有我们最私人的个人数据堆积到它们的服务器上并把我们的数字生活托付给它们:潜在的危害实在太大了。

|

||||

|

||||

### 只要5小时,拿回自己以及关心的人的隐私权 ###

|

||||

## 只要5小时,拿回自己以及关心的人的隐私权 ##

|

||||

|

||||

并不是一定要这样做。你可以生活在21世纪,拿着智能手机,每天都用电子邮件和GPS,却仍然可以保留自己的隐私。你所需要的就是拿回自己个人数据的控制权:邮件、日程、联系人、文件,等等。[Prism-Break.org][10]网站上列出了一些能帮你掌握个人数据命运的软件。除此以外,控制自己个人数据的最安全和最有效的方式是架设自己的服务器并搭建自己的云。不过你也许只是没有时间或精力去研究具体该怎么做以及如何让它能流畅工作。

|

||||

但是事实并不是一定必须这样的。你可以生活在21世纪,拿着智能手机,每天都用电子邮件和GPS,却仍然可以保留自己的隐私。你所需要的就是拿回自己个人数据的控制权:邮件、日程、联系人、文件,等等。[Prism-Break.org][10]网站上列出了一些能帮你掌握个人数据命运的软件。除此以外,控制自己个人数据的最安全和最有效的方式是架设自己的服务器并搭建自己的云。不过你也许只是没有时间或精力去研究具体该怎么做以及如何让它能流畅工作。

|

||||

|

||||

这也是这篇文章的意义所在。仅仅5个小时内,我们将配置出一台服务器来支撑你的邮件、联系人、日程表和各种文件,为你、你的朋友和你的家人。这个服务器将设计成一个个人数据中心或云,所以你能时刻保留它的完整控制。数据将自动在你的台式机/笔记本、手机和平板之间同步。从根本上来说,**我们将建立一个系统来代替Gmail、Google文件/Dropbox、Google联系人、Google日历和Picasa**。

|

||||

|

||||

为自己做这件事情已经是迈出很大一步了。但是,你个人信息的很大一部分将仍然泄漏出去并保存到硅谷的一些主机上,只是因为和你日常来往的太多人在用Gmail和使用智能手机。所以最好是带上你一些比较亲近的人加入这次探险。

|

||||

为自己做这件事情已经是迈出很大一步了。但是,你个人信息的很大一部分将仍然泄漏出去并保存到硅谷的一些主机上,只是因为和你日常来往的太多人在用Gmail和使用智能手机,所以最好是带上你一些比较亲近的人加入这次探险。

|

||||

|

||||

我们将构建的系统能够

|

||||

我们将构建的系统能够:

|

||||

|

||||

- **支持任意数目的域名和用户**。这样就能轻易地和你的家人朋友共享这台服务器,所以他们也能掌控自己的个人数据,并且还能和你一起分摊服务费用。和你一起共享服务器的人可以使用他们自己的域名或者共享你的。

|

||||

- **允许你从任意网络发送和接收电子邮件**,需要成功登录服务器之后。这样,你可以通过任意的邮件地址,任意设备(台式机、手机、平板),任意网络(家里、公司、公共网络、...)来发送电子邮件。

|

||||

- **允许你从任意网络发送和接收电子邮件**,需要成功登录服务器之后。这样,你可以通过任意的邮件地址、任意设备(台式机、手机、平板)、任意网络(家里、公司、公共网络、...)来发送电子邮件。

|

||||

- **在发送和接收邮件的时候加密网络数据**,这样,你不信任的人不能钓出你的密码,也不能看到你的私人邮件。

|

||||

- **提供最先进的反垃圾邮件技术**,结合了已知垃圾邮件黑名单,自动灰名单,和自适应垃圾邮件过滤。如果邮件被误判了只需要简单地把它拖入或拖出垃圾目录就可以重新配置垃圾邮件过滤器。而且,服务器还会为基于社区的反垃圾邮件努力做出贡献。

|

||||

- **一段时间里只需要几分钟的维护**,基本上只是安装安全更新和简单地检查一下服务器日志。添加一个新的邮件地址只需要在数据库中插入一条记录。除此之外,你可以忘记它的存在过自己的生活。我在14个月之前搭建了本文描述的这个系统,从那以后就一直顺利运行。所以我完全把它给忘了,直到我最近觉得随便按下手机上的‘检查邮件’会导致电子一路跑到冰岛(我放置服务器的地方)再回来的想法有点好笑才想起来。

|

||||

- **提供最先进的反垃圾邮件技术**,结合了已知垃圾邮件黑名单、自动灰名单、和自适应垃圾邮件过滤。如果邮件被误判了只需要简单地把它拖入或拖出垃圾目录就可以重新调校垃圾邮件过滤器。而且,服务器还会为基于社区的反垃圾邮件努力做出贡献。

|

||||

- **一段时间里只需要几分钟的维护**,基本上只是安装安全更新和简单地检查一下服务器日志。添加一个新的邮件地址只需要在数据库中插入一条记录。除此之外,你可以忘记它的存在过自己的生活。我在14个月之前搭建了本文描述的这个系统,从那以后就一直顺利运行。所以我完全把它给忘了,直到我最近觉得随便按下手机上的‘检查邮件’会导致电子信号一路跑到冰岛(我放置服务器的地方)再回来的想法有点好笑才想起来。

|

||||

|

||||

要完成这篇文章里的工作,你需要一点基本的技术能力。如果你知道SMTP和IMAP的区别,什么是DNS,以及对TCP/IP有基本了解的话,就够了。你还将需要一点基本的Unix知识(在命令行下和文件一起工作,基本的系统管理)。然后你需要花总共5小时时间来搭建。

|

||||

|

||||

@ -49,7 +49,7 @@

|

||||

- [使用Owncloud提供日历,联系人,文件服务并配置webmail][15]

|

||||

- [在云上同步你的设备][16]

|

||||

|

||||

### 这篇文章是受之前工作的启发并以之为基础 ###

|

||||

## 这篇文章是受之前工作的启发并以之为基础 ##

|

||||

|

||||

本文很大程度参考了两篇文章,由[Xavier Claude][17]和[Drew Crawford][18]写的关于架设私有邮件服务器的介绍。

|

||||

|

||||

@ -62,13 +62,13 @@

|

||||

- 我增加了webmail。

|

||||

- 我增加了设定云服务器的部分,不仅能收发邮件还能管理文件,地址本/联系人(邮件地址,电话号码,生日,等等等),日程表和图片,供所有设备访问使用。

|

||||

|

||||

### 申请一个虚拟私人服务器,一个域名,并把它们配置好 ###

|

||||

## 申请一个虚拟私人服务器,一个域名,并把它们配置好 ##

|

||||

|

||||

让我们从设置基础设施开始:我们的虚拟私人主机和我们的域名。

|

||||

|

||||

我用过[1984.is][19]和[Linode][20]提供的虚拟私人主机(VPS),体验非常好。在本文中,我们将使用**Debian Wheezy**,这个在1984和Linode都提供了已经做好的映像文件可以直接布置到你的VPS上。我喜欢1984是因为它的服务器在冰岛,也是唯一使用可再生能源(地热和水力发电)的地方,目前还没有影响过气候变化,不像[大多数美国数据中心目前大多数依赖于烧煤的火力发电站][21]。而且,他们注重[民权,透明,自由][22]以及[免费软件][23]。

|

||||

|

||||

最好是在服务器上创建一个文件用来保存后面要用到的各种密码(用户账号,邮件账号,云帐号,数据库帐号)。当然最好是加密一下(可以用[GnuPG][24]),这样就算用来设定服务器的电脑被偷了或被入侵了,你的服务器就不会那么容易被攻击。

|

||||

最好是在服务器上创建一个文件用来保存后面要用到的各种密码(用户账号、邮件账号、云帐号、数据库帐号)。当然最好是加密一下(可以用[GnuPG][24]),这样就算用来设定服务器的电脑被偷了或被入侵了,你的服务器就不会那么容易被攻击。

|

||||

|

||||

关于注册域名,我已经使用[grandi][25]的服务超过10年了,也很满意。在本文中,我们将开辟一个叫**jhausse.net**的域名。然后在上面增加一个叫**cloud.jhausse.net**的二级域名,并绑定MX纪录。在完成之后,设置比较短的纪录生存时间(TTL)比如300秒,这样你在设置服务器的时候,可以修改你的域并很快测试到结果。

|

||||

|

||||

@ -78,7 +78,7 @@

|

||||

|

||||

adduser roudy

|

||||

|

||||

然后,在文件**/etc/ssh/sshd_config**中设置

|

||||

然后,在文件**/etc/ssh/sshd\_config**中设置

|

||||

|

||||

PermitRootLogin no

|

||||

|

||||

@ -90,7 +90,7 @@

|

||||

|

||||

cloud

|

||||

|

||||

然后,编辑ssh服务的公钥文件**/etc/ssh/ssh_host_rsa_key.pub, /etc/ssh/ssh_host_dsa_key.pub, /etc/ssh/ssh_host_ecdsa_key.pub**,这样文件末尾可以反映你的主机名,比如**root@cloud**。然后重启系统保证主机名在系统的每个需要它的角落都生效了。

|

||||

然后,编辑ssh服务的公钥文件**/etc/ssh/ssh\_host\_rsa\_key.pub, /etc/ssh/ssh\_host\_dsa\_key.pub, /etc/ssh/ssh\_host\_ecdsa\_key.pub**,这样文件末尾可以反映你的主机名,比如**root@cloud**。然后重启系统保证主机名在系统的每个需要它的角落都生效了。

|

||||

|

||||

reboot

|

||||

|

||||

@ -103,15 +103,15 @@

|

||||

apt-get autoremove

|

||||

apt-get install vim

|

||||

|

||||

我喜欢使用vim远程编辑配置文件。打开自动语法高亮会很有帮助。添加下面这一行到**~/.vimrc**文件中。

|

||||

我喜欢使用vim远程编辑配置文件。打开vim 的自动语法高亮会很有帮助。添加下面这一行到**~/.vimrc**文件中。

|

||||

|

||||

syn on

|

||||

|

||||

### 设置postfix和dovecot来收发电子邮件 ###

|

||||

## 设置postfix和dovecot来收发电子邮件 ##

|

||||

|

||||

apt-get install postfix postfix-mysql dovecot-core dovecot-imapd dovecot-mysql mysql-server dovecot-lmtpd postgrey

|

||||

|

||||

在[Postfix][27]的配置菜单里,选择**因特网站点**,把系统邮件名设为**jhausse.net**。

|

||||

在[Postfix][27]的配置菜单里,选择`Internet Site`,设置这个系统的邮件名称为**jhausse.net**。

|

||||

|

||||

现在开始添加一个数据库用于保存主机上管理的域名列表,和每个域名下的用户列表(同时也包括他们各自的密码),以及邮件别名列表(用于从一个地址往另一个地址转发邮件)。

|

||||

|

||||

@ -142,14 +142,14 @@

|

||||

FOREIGN KEY (domain_id) REFERENCES virtual_domains(id) ON DELETE CASCADE

|

||||

) ENGINE=InnoDB DEFAULT CHARSET=utf8;

|

||||

|

||||

我们将承载**jhausse.net**域名。如果还需要加入其他域名,也没问题。我们也会为每个域名设置一个邮件管理地址,转寄给**roudy@jhausse.net**。

|

||||

这里我们为**jhausse.net**域名提供邮件服务。如果还需要加入其他域名,也没问题。我们也会为每个域名设置一个邮件管理地址(postmaster),转寄给**roudy@jhausse.net**。

|

||||

|

||||

mysql> INSERT INTO virtual_domains (`name`) VALUES ('jhausse.net');

|

||||

mysql> INSERT INTO virtual_domains (`name`) VALUES ('otherdomain.net');

|

||||

mysql> INSERT INTO virtual_aliases (`domain_id`, `source`, `destination`) VALUES ('1', 'postmaster', 'roudy@jhausse.net');

|

||||

mysql> INSERT INTO virtual_aliases (`domain_id`, `source`, `destination`) VALUES ('2', 'postmaster', 'roudy@jhausse.net');

|

||||

|

||||

现在已经添加了一个本地邮件账号**roudy@jhausse.net**。首先,为它生成一个哈希密码:

|

||||

现在已经添加了一个本地邮件账号**roudy@jhausse.net**。首先,为它生成一个密码的哈希串:

|

||||

|

||||

doveadm pw -s SHA512-CRYPT

|

||||

|

||||

@ -157,7 +157,7 @@

|

||||

|

||||

mysql> INSERT INTO `mailserver`.`virtual_users` (`domain_id`, `password`, `email`) VALUES ('1', '$6$YOURPASSWORDHASH', 'roudy@jhausse.net');

|

||||

|

||||

现在我们的域名,别名和用户列表都设置好了,然后开始设置postfix(SMTP服务器,用来发送邮件)。把文件**/etc/postfix/main.cf**替换为下面的内容:

|

||||

现在我们的域名、别名和用户列表都设置好了,然后开始设置postfix(这是一个SMTP服务器,用来发送邮件)。把文件**/etc/postfix/main.cf**替换为下面的内容:

|

||||

|

||||

myhostname = cloud.jhausse.net

|

||||

myorigin = /etc/mailname

|

||||

@ -239,7 +239,7 @@

|

||||

|

||||

如果一切都正常配置了的话,头两个查询应该输出1,第3个查询应该输出**roudy@jhausse.net**,而最后一个应该什么都不输出。

|

||||

|

||||

现在,让我们设置一下dovecot(一个IMAP服务程序,用来在我们的设备上从服务器获取收件箱里的邮件)。编辑文件**/etc/dovecot/dovecot.conf**设置以下参数:

|

||||

现在,让我们设置一下dovecot(一个IMAP服务程序,用来在我们的设备上从服务器获取收到的邮件)。编辑文件**/etc/dovecot/dovecot.conf**设置以下参数:

|

||||

|

||||

# Enable installed protocol

|

||||

# !include_try /usr/share/dovecot/protocols.d/*.protocol

|

||||

@ -253,7 +253,7 @@

|

||||

[...]

|

||||

first_valid_uid = 0

|

||||

|

||||

这样邮件将被保存到目录/var/mail/domainname/username下。注意下这几个选项散布在配置文件的不同位置,有时已经在那里写好了:我们只需要取消注释。文件里的其他设定选项,可以维持原样。在本文后面还有很多文件需要用同样的方式更新设置。在文件**/etc/dovecot/conf.d/10-auth.conf**里,设置以下参数:

|

||||

这样邮件将被保存到目录 /var/mail/domainname/username 下。注意下这几个选项散布在配置文件的不同位置,有时已经在那里写好了:我们只需要取消注释即可。文件里的其他设定选项,可以维持原样。在本文后面还有很多文件需要用同样的方式更新设置。在文件**/etc/dovecot/conf.d/10-auth.conf**里,设置以下参数:

|

||||

|

||||

disable_plaintext_auth = yes

|

||||

auth_mechanisms = plain

|

||||

@ -366,9 +366,10 @@

|

||||

在服务器上,尝试发送邮件给本地用户:

|

||||

|

||||

telnet localhost 25

|

||||

|

||||

EHLO cloud.jhausse.net

|

||||

MAIL FROM:youremail@domain.com

|

||||

rcpt to:roudy@jhausse.net

|

||||

RCPT TO:roudy@jhausse.net

|

||||

data

|

||||

Subject: Hallo!

|

||||

|

||||

@ -397,18 +398,18 @@

|

||||

|

||||

554 5.7.1 <bob@gmail.com>: Relay access denied

|

||||

|

||||

这个没问题:如果服务器能接受这封邮件,那意味着我们架设的postfix是一个对全世界所有垃圾邮件都开放的中继,将完全没法使用。除了'Relay access denied'消息,你也可能会收到这样的响应:

|

||||

这个没问题:如果服务器能接受这封邮件而不是返回如上的拒绝消息,那意味着我们架设的postfix是一个对全世界所有垃圾邮件都开放的中继,这将完全没法使用。除了'Relay access denied'消息,你也可能会收到这样的响应:

|

||||

|

||||

554 5.7.1 Service unavailable; Client host [87.68.61.119] blocked using zen.spamhaus.org; http://www.spamhaus.org/query/bl?ip=87.68.61.119

|

||||

|

||||

意思是你正尝试从一个被标记成垃圾邮件发送者的IP地址连接服务器。我在通过普通的因特网服务提供商(ISP)连接服务器时曾收到过这样的消息。要解决这个问题,可以试着从另一个主机发起连接,比如另外一个你可以SSH登录的主机。另外一种方式是,你可以修改postfix的**main.cf**配置文件,不要使用Spamhous的RBL,重启postfix服务,然后再检查上面的测试是否正常。不管用哪种方式,最重要的是你要确定一个能工作的,因为我们后面马上要测试其他功能。如果你选择了重新配置postfix不使用RBL,别忘了在完成本文后重新开启RBL并重启postfix,以避免收到一些不必要的垃圾邮件。

|

||||

意思是你正尝试从一个被标记成垃圾邮件发送者的IP地址连接服务器。我在通过普通的因特网服务提供商(ISP)连接服务器时曾收到过这样的消息。要解决这个问题,可以试着从另一个主机发起连接,比如另外一个你可以SSH登录的主机。另外一种方式是,你可以修改postfix的**main.cf**配置文件,不要使用Spamhous的RBL,重启postfix服务,然后再检查上面的测试是否正常。不管用哪种方式,最重要的是你要确定一个能工作的,因为我们后面马上要测试其他功能。如果你选择了重新配置postfix不使用RBL,别忘了在完成本文后重新开启RBL并重启postfix,以避免收到一些不必要的垃圾邮件。(LCTT 译者注:在国内可以使用 CASA 的 RBL:cblplus.anti-spam.org.cn,参见:http://www.anti-spam.org.cn/ 。)

|

||||

|

||||

现在,我们试一下往SMTP端口25发送一封有效的邮件,这是一般正常的邮件服务器用来彼此对话的方式:

|

||||

|

||||

openssl s_client -connect cloud.jhausse.net:25 -starttls smtp

|

||||

EHLO cloud.jhausse.net

|

||||

MAIL FROM:youremail@domain.com

|

||||

rcpt to:roudy@jhausse.net

|

||||

RCPT TO:roudy@jhausse.net

|

||||

|

||||

服务器应该有这样的响应

|

||||

|

||||

@ -425,7 +426,7 @@

|

||||

4 UID fetch 1:1 (UID RFC822.SIZE FLAGS BODY.PEEK[])

|

||||

5 LOGOUT

|

||||

|

||||

这里,你应该把mypassword替换为你自己为这个邮件账号设定的密码。如果能正常工作,基本上我们已经拥有一个能接收邮件的邮件服务器了,通过它我们可以在各种设备(PC/笔记本,平板,手机,...)上收取邮件了。但是我们不能把邮件给它发送出去,除非我们自己从服务器发送。现在我们将让postfix为我们转发邮件,但是这个只有成功登录才可以,这是为了保证邮件是由服务器上的某个有效帐号发出来的。要做到这个,我们要打开一个特殊的,全程SSL连接的,SASL鉴权的邮件提交服务。在文件**/etc/postfix/master.cf**里设置下面的参数:

|

||||

这里,你应该把*mypassword*替换为你自己为这个邮件账号设定的密码。如果能正常工作,基本上我们已经拥有一个能接收邮件的邮件服务器了,通过它我们可以在各种设备(PC/笔记本、平板、手机...)上收取邮件了。但是我们不能把邮件给它发送出去,除非我们自己从服务器发送。现在我们将让postfix为我们转发邮件,但是这个只有成功登录才可以,这是为了保证邮件是由服务器上的某个有效帐号发出来的。要做到这个,我们要打开一个特殊的,全程SSL连接的,SASL鉴权的邮件提交服务。在文件**/etc/postfix/master.cf**里设置下面的参数:

|

||||

|

||||

submission inet n - - - - smtpd

|

||||

-o syslog_name=postfix/submission

|

||||

@ -437,7 +438,7 @@

|

||||

-o smtpd_sasl_security_options=noanonymous

|

||||

-o smtpd_recipient_restrictions=permit_sasl_authenticated,reject_non_fqdn_recipient,reject_unauth_destination

|

||||

|

||||

然后重启postfix服务

|

||||

然后重启postfix服务:

|

||||

|

||||

service postfix reload

|

||||

|

||||

@ -446,7 +447,7 @@

|

||||

openssl s_client -connect cloud.jhausse.net:587 -starttls smtp

|

||||

EHLO cloud.jhausse.net

|

||||

|

||||

注意一下服务器建议的'250-AUTH PLAIN'功能,在从端口25连接的时候不会生效。

|

||||

注意一下服务器建议的'250-AUTH PLAIN'功能,在从端口25连接的时候不会出现。

|

||||

|

||||

MAIL FROM:asdf@jkl.net

|

||||

rcpt to:bob@gmail.com

|

||||

@ -494,13 +495,13 @@

|

||||

|

||||

PS:不要忘记再次[试试通过端口25往自己架设的服务器上的帐号发送邮件][29],来验证你已经没有被postgrey阻挡了。

|

||||

|

||||

### 阻止垃圾邮件进入你的收件箱 ###

|

||||

## 阻止垃圾邮件进入你的收件箱 ##

|

||||

|

||||

为了过滤垃圾邮件,我们已经使用了实时黑名单(RBLs)和灰名单(postgrey)。现在我们将增加自适应垃圾邮件过滤来让我们的垃圾邮件过滤能力提高一个等级。这意味着我们将为我们的邮件服务器增加人工智能,这样它就能从经验中学习哪些有件是垃圾哪些不是。我们将使用[dspam][30]来实现这个功能。

|

||||

为了过滤垃圾邮件,我们已经使用了实时黑名单(RBL)和灰名单(postgrey)。现在我们将增加自适应垃圾邮件过滤来让我们的垃圾邮件过滤能力提高一个等级。这意味着我们将为我们的邮件服务器增加人工智能,这样它就能从经验中学习哪些邮件是垃圾哪些不是。我们将使用[dspam][30]来实现这个功能。

|

||||

|

||||

apt-get install dspam dovecot-antispam postfix-pcre dovecot-sieve

|

||||

|

||||

dovecot-antispam是一个安装包,可以在我们发现有邮件被dspan误分类了之后让dovecot重新更新垃圾邮件过滤器。基本上,我们所需要做的就只是把邮件放进或拿出垃圾箱。dovecot-antispam将负责调用dspam来更新过滤器。至于postfix-pcre和dovecot-sieve,我们将分别用它们来把接收的邮件递给垃圾邮件过滤器以及自动把垃圾邮件放入用户的垃圾箱。

|

||||

dovecot-antispam是一个安装包,可以在我们发现有邮件被dspam误分类了之后让dovecot重新更新垃圾邮件过滤器。基本上,我们所需要做的就只是把邮件放进或拿出垃圾箱。dovecot-antispam将负责调用dspam来更新过滤器。至于postfix-pcre和dovecot-sieve,我们将分别用它们来把接收的邮件传递给垃圾邮件过滤器以及自动把垃圾邮件放入用户的垃圾箱。

|

||||

|

||||

在配置文件**/etc/dspam/dspam.conf**里,为以下参数设置相应的值:

|

||||

|

||||

@ -535,7 +536,7 @@ dovecot-antispam是一个安装包,可以在我们发现有邮件被dspan误

|

||||

dovecot unix - n n - - pipe

|

||||

flags=DRhu user=mail:mail argv=/usr/lib/dovecot/deliver -f ${sender} -d ${recipient}

|

||||

|

||||

现在我们将告诉postfix通过dspam来过滤所有提交给服务器端口25(一般的SMTP通信)的新邮件,除非该邮件是从服务器本身发出(permit_mynetworks)。注意下我们通过SASL鉴权提交给postfix的邮件不会通过dspam过滤,因为我们在前面部分里为这种方式设定了独立的提交服务。编辑文件**/etc/postfix/main.cf**将选项**smtpd_client_restrictions**改为如下内容:

|

||||

现在我们将告诉postfix通过dspam来过滤所有提交给服务器端口25(一般的SMTP通信)的新邮件,除非该邮件是从服务器本身发出(permit\_mynetworks)。注意下我们通过SASL鉴权提交给postfix的邮件不会通过dspam过滤,因为我们在前面部分里为这种方式设定了独立的提交服务。编辑文件**/etc/postfix/main.cf**将选项**smtpd\_client\_restrictions**改为如下内容:

|

||||

|

||||

smtpd_client_restrictions = permit_mynetworks, reject_rbl_client zen.spamhaus.org, check_policy_service inet:127.0.0.1:10023, check_client_access pcre:/etc/postfix/dspam_filter_access

|

||||

|

||||

@ -544,11 +545,11 @@ dovecot-antispam是一个安装包,可以在我们发现有邮件被dspan误

|

||||

# For DSPAM, only scan one mail at a time

|

||||

dspam_destination_recipient_limit = 1

|

||||

|

||||

现在我们需要指定我们定义的过滤器。基本上,我们将告诉postfix把所有邮件(/./)通过unix套接字发给dspam。创建一个新文件**/etc/postfix/dspam_filter_access**并把下面一行写进去:

|

||||

现在我们需要指定我们定义的过滤器。基本上,我们将告诉postfix把所有邮件(如下用 /./ 代表)通过unix套接字发给dspam。创建一个新文件**/etc/postfix/dspam\_filter\_access**并把下面一行写进去:

|

||||

|

||||

/./ FILTER dspam:unix:/run/dspam/dspam.sock

|

||||

|

||||

这是postfix部分的配置。现在让我们为dovecot设置垃圾过滤。在文件**/etc/dovecot/conf.d/20-imap.conf**里,修改**imap mail_plugin**插件参数为下面的方式:

|

||||

这是postfix部分的配置。现在让我们为dovecot设置垃圾过滤。在文件**/etc/dovecot/conf.d/20-imap.conf**里,修改**imap mail\_plugin**插件参数为下面的方式:

|

||||

|

||||

mail_plugins = $mail_plugins antispam

|

||||

|

||||

@ -581,7 +582,7 @@ dovecot-antispam是一个安装包,可以在我们发现有邮件被dspan误

|

||||

|

||||

sieve_default = /etc/dovecot/default.sieve

|

||||

|

||||

什么是sieve以及为什么我们需要为所有用户设置一个默认脚本?sieve可以在IMAP服务器上为我们自动处理任务。在我们的例子里,我们想让所有被确定为垃圾的邮件会被移到垃圾箱而不是收件箱里。我们希望这是服务器上所有用户的默认行为;这是为什么我们把这个脚本设为默认脚本。现在让我们来创建这个脚本,建立一个新文件**/etc/dovecot/default.sieve**并写入以下内容:

|

||||

什么是sieve以及为什么我们需要为所有用户设置一个默认脚本?sieve可以在IMAP服务器上为我们自动处理任务。在我们的例子里,我们想让所有被确定为垃圾的邮件移到垃圾箱而不是收件箱里。我们希望这是服务器上所有用户的默认行为;这是为什么我们把这个脚本设为默认脚本。现在让我们来创建这个脚本,建立一个新文件**/etc/dovecot/default.sieve**并写入以下内容:

|

||||

|

||||

require ["regex", "fileinto", "imap4flags"];

|

||||

# Catch mail tagged as Spam, except Spam retrained and delivered to the mailbox

|

||||

@ -603,7 +604,7 @@ dovecot-antispam是一个安装包,可以在我们发现有邮件被dspan误

|

||||

chmod 0640 default.sieve

|

||||

chmod 0750 default.svbin

|

||||

|

||||

最后,我们需要修改dspam要读取的两个postfix配置文件的权限:

|

||||

最后,我们需要修改dspam需要读取的两个postfix配置文件的权限:

|

||||

|

||||

chmod 0644 /etc/postfix/dynamicmaps.cf /etc/postfix/main.cf

|

||||

|

||||

@ -669,21 +670,21 @@ dovecot-antispam是一个安装包,可以在我们发现有邮件被dspan误

|

||||

|

||||

很好!你现在已经为你服务器上的用户配置好自适应垃圾邮件过滤。当然,每个用户将需要在开始的几周里培训过滤器。要标记一则信息为垃圾,只需要在你的任意设备(电脑,平板,手机)上将它移动到叫“垃圾箱”或“废纸篓”的目录里。否则它将被标记为有用。

|

||||

|

||||

### 确保你发出的邮件能通过垃圾邮件过滤器 ###

|

||||

## 确保你发出的邮件能通过垃圾邮件过滤器 ##

|

||||

|

||||

这个部分我们的目标是让我们的邮件服务器能尽量干净地出现在世界上,并让垃圾邮件发送者们更难以我们的名义发邮件。作为附加效果,这也有助于让我们的邮件能通过其他邮件服务器的垃圾邮件过滤器。

|

||||

|

||||

#### 发送者策略框架 ####

|

||||

### 发送者策略框架(SPF) ###

|

||||

|

||||

发送者策略框架(SPF)是你添加到自己服务器区域里的一份记录,声明了整个因特网上哪些邮件服务器能以你的域名发邮件。设置非常简单,使用[microsoft.com][31]上的SPF向导来生成你的SPF记录,然后作为一个TXT记录添加到自己的服务器区域里。看上去像这样:

|

||||

|

||||

jhausse.net. 300 IN TXT v=spf1 mx mx:cloud.jhausse.net -all

|

||||

|

||||

#### 反向PTR ####

|

||||

### 反向PTR ###

|

||||

|

||||

我们[之前][32]在本文里讨论过这个问题,建议你为自己的服务器正确地设置反向DNS,这样对服务器IP地址的反向查询能返回你服务器的实际名字。

|

||||

|

||||

#### OpenDKIM ####

|

||||

### OpenDKIM ###

|

||||

|

||||

当我们激活[OpenDKIM][33]后,postfix会用密钥为每封发出去的邮件签名。然后我们将把这个密钥存储在DNS域中。这样的话,世界上任意一个邮件服务器都能够检验邮件是否真的是我们发出的,或是由垃圾邮件发送者伪造的。让我们先安装opendkim:

|

||||

|

||||

@ -710,7 +711,7 @@ dovecot-antispam是一个安装包,可以在我们发现有邮件被dspan误

|

||||

UMask 022

|

||||

UserID opendkim:opendkim

|

||||

|

||||

我们还需要几个额外的文件,将保存在目录**/etc/opendkim**里:

|

||||

我们还需要几个额外的文件,需保存在目录**/etc/opendkim**里:

|

||||

|

||||

mkdir -pv /etc/opendkim/

|

||||

cd /etc/opendkim/

|

||||

@ -740,7 +741,7 @@ dovecot-antispam是一个安装包,可以在我们发现有邮件被dspan误

|

||||

|

||||

cat mail.txt

|

||||

|

||||

然后把它作为一个TXT记录添加到区域文件里,应该是这样的

|

||||

然后把它作为一个TXT记录添加到区域文件里,应该是类似这样的

|

||||

|

||||

mail._domainkey.cloud1984.net. 300 IN TXT v=DKIM1; k=rsa; p=MIGfMA0GCSqG...

|

||||

|

||||

@ -751,30 +752,30 @@ dovecot-antispam是一个安装包,可以在我们发现有邮件被dspan误

|

||||

non_smtpd_milters = $smtpd_milters

|

||||

milter_default_action = accept

|

||||

|

||||

然后重启相关服务

|

||||

然后重启相关服务:

|

||||

|

||||

service postfix reload

|

||||

service opendkim restart

|

||||

|

||||

现在让我们测试一下能找到我们的OpenDKIM公钥并和私钥匹配:

|

||||

现在让我们测试一下是否能找到我们的OpenDKIM公钥并和私钥匹配:

|

||||

|

||||

opendkim-testkey -d jhausse.net -s mail -k mail.private -vvv

|

||||

|

||||

这个应该返回

|

||||

这个应该返回:

|

||||

|

||||

opendkim-testkey: key OK

|

||||

|

||||

这个你可能需要等一会直到域名服务器重新加载该区域(对于Linode,每15分钟会更新一次)。你可以用**dig**来检查区域是否已经重新加载。

|

||||

|

||||

如果这个没问题,让我们测试一下其他服务器能验证我们的OpenDKIM签名和SPF记录。要做这个,我们可以用[Brandon Checkett的邮件测试][34]。发送一封邮件到[Brandon的网页][34]上提供的测试地址,我们可以在服务器上运行下面的命令

|

||||

如果这个没问题,让我们测试一下其他服务器能验证我们的OpenDKIM签名和SPF记录。要做这个,我们可以用[Brandon Checkett的邮件测试系统][34]。发送一封邮件到[Brandon的网页][34]上提供的测试地址,我们可以在服务器上运行下面的命令

|

||||

|

||||

mail -s CloudCheck ihAdmTBmUH@www.brandonchecketts.com

|

||||

|

||||

在Brandon的网页上,我们应该可以在'DKIM Signature'部分里看到**result = pass**的文字,以及在'SPF Information'部分看到**Result: pass**的文字。如果我们的邮件通过这个测试,只要不加-t开关重新生成OpenDKIM密钥,上传新的密钥到区域文件里,然后重新测试检查是否仍然可以通过这些测试。如果可以的话,恭喜!你已经在你的服务器上成功配置好OpenDKIM和SPF了!

|

||||

|

||||

### 使用Owncloud提供日历,联系人,文件服务并通过Roundcube配置网页邮件 ###

|

||||

## 使用Owncloud提供日历,联系人,文件服务并通过Roundcube配置网页邮件 ##

|

||||

|

||||

既然我们已经拥有了一流的邮件服务器,让我们再为它增加在云上保存通讯录,日程表和文件的能力。这些是[Owncloud][35]所提供的非常赞的服务。在这个弄好后,我们还会设置一个网页邮件,这样就算你没带任何电子设备出去旅行时,或者说在你的手机或笔记本没电的情况下,也可以检查邮件。

|

||||

既然我们已经拥有了一流的邮件服务器,让我们再为它增加在云上保存通讯录,日程表和文件的能力。这些是[Owncloud][35]所提供的非常赞的服务。在这个弄好后,我们还会设置一个网页邮件,这样就算你没带任何电子设备出去旅行时,或者说在你的手机或笔记本没电的情况下,也可以通过网吧来检查邮件。

|

||||

|

||||

安装Owncloud非常直观,而且在[这里][36]有非常好的介绍。在Debian系统里,归根结底就是把owncloud的仓库添加到apt源里,下载Owncloud的发行密钥并安装到apt钥匙链中,然后通过apt-get安装Owncloud:

|

||||

|

||||

@ -784,20 +785,20 @@ dovecot-antispam是一个安装包,可以在我们发现有邮件被dspan误

|

||||

apt-get update

|

||||

apt-get install apache2 owncloud roundcube

|

||||

|

||||

在有提示的时候,选择**dbconfig**然后说你希望**roundcube**使用**mysql**。然后,提供一下mysql的root密码并为roundcube的mysql用户设置一个漂亮的密码。然后,按如下方式编辑roundcube的配置文件**/etc/roundcube/main.inc.php**,这样登录roundcube默认会使用你的IMAP服务器:

|

||||

在有提示的时候,选择**dbconfig**并设置**roundcube**使用**mysql**。然后,提供一下mysql的root密码并为roundcube的mysql用户设置一个漂亮的密码。然后,按如下方式编辑roundcube的配置文件**/etc/roundcube/main.inc.php**,这样登录roundcube默认会使用你的IMAP服务器:

|

||||

|

||||

$rcmail_config['default_host'] = 'ssl://localhost';

|

||||

$rcmail_config['default_port'] = 993;

|

||||

|

||||

现在我们来配置一下apache2网页服务器增加SSL支持,这样我们可以和Owncloud和Roundcube对话时使用加密的方式传输我们的密码和数据。让我们打开Apache的ssl模块:

|

||||

现在我们来配置一下apache2网页服务器增加SSL支持,这样我们可以和Owncloud和Roundcube对话时使用加密的方式传输我们的密码和数据。让我们打开Apache的SSL模块:

|

||||

|

||||

a2enmod ssl

|

||||

|

||||

然后编辑文件**/etc/apache2/ports.conf**并设定以下参数:

|

||||

|

||||

NameVirtualHost *:80

|

||||

Listen 80

|

||||

ServerName www.jhausse.net

|

||||

NameVirtualHost *:80

|

||||

Listen 80

|

||||

ServerName www.jhausse.net

|

||||

|

||||

<IfModule mod_ssl.c>

|

||||

# If you add NameVirtualHost *:443 here, you will also have to change

|

||||

@ -969,9 +970,9 @@ ServerName www.jhausse.net

|

||||

a2ensite default default-ssl roundcube

|

||||

service apache2 restart

|

||||

|

||||

关于网页邮件,可以通过网址**https://webmail.jhausse.net**来访问,基本上能工作。之后使用邮箱全名(例如roudy@jhausse.net)和在本文一开始在邮件服务器数据库里设定的密码登录。第一次连接成功,浏览器会警告说证书没有可靠机构的签名。这个没什么关系,只要添加一个例外。

|

||||

关于网页邮件,可以通过网址**https://webmail.jhausse.net**来访问,基本上能工作。之后使用邮箱全名(例如roudy@jhausse.net)和在本文一开始在邮件服务器数据库里设定的密码登录。第一次连接成功,浏览器会警告说证书没有可靠机构的签名。这个没什么关系,只要添加一个例外即可。

|

||||

|

||||

最后但很重要的是,我们将通过把以下内容你哦个写入**/etc/apache2/sites-available/owncloud**来为Owncloud创建一个虚拟主机。

|

||||

最后但很重要的是,我们将通过把以下内容写入到**/etc/apache2/sites-available/owncloud**来为Owncloud创建一个虚拟主机。

|

||||

|

||||

<IfModule mod_ssl.c>

|

||||

<VirtualHost *:443>

|

||||

@ -1040,33 +1041,33 @@ ServerName www.jhausse.net

|

||||

|

||||

就这些了!现在你已经拥有自己的Google Drive,日程表,联系人,Dropbox,以及Gmail!好好享受下新鲜恢复保护的隐私吧!:-)

|

||||

|

||||

### 在云上同步你的设备 ###

|

||||

## 在云上同步你的设备 ##

|

||||

|

||||

要同步你的邮件,你可以只是用你喜欢的邮件客户端:Android或iOS自带的默认邮件应用,[k9mail][37],或者电脑上的Thunderbird。或者你也可以使用我们设置好的网页邮件。

|

||||

要同步你的邮件,你只需用你喜欢的邮件客户端即可:Android或iOS自带的默认邮件应用,[k9mail][37],或者电脑上的Thunderbird。或者你也可以使用我们设置好的网页邮件。

|

||||

|

||||

在Owncloud的文档里描述了如何与云端同步你的日程表和联系人。在Android系统中,我用的是CalDAV-Sync,CardDAV-Sync应用桥接了手机上Android自带日历以及联系人应用和Owncloud服务器。

|

||||

|

||||

对于文件,有一个叫Owncloud的Android应用可以访问你手机上的文件,然后自动把你拍的图片和视频上传到云中。在你的Mac/PC上访问云端文件也很容易,在[Owncloud文档里有很好的描述][38]。

|

||||

|

||||

### 最后一点提示 ###

|

||||

## 最后一点提示 ##

|

||||

|

||||

在上线后的前几个星期里,最好每天检查一下日志**/var/log/syslog**和**/var/log/mail.log**以保证一切都在顺利运行。在你邀请其他人(朋友,家人,等等)加入你的服务器之前这很重要。他们信任你能很好地架设个人服务器维护他们的数据,但是如果服务器突然崩溃会让他们很失望。

|

||||

|

||||

要添加另一个邮件用户,只要在数据库**mailserver**的**virtual_users**表中增加一行。

|

||||

要添加另一个邮件用户,只要在数据库**mailserver**的**virtual\_users**表中增加一行。

|

||||

|

||||

要添加一个域名,只要在**virtual_domains**表中增加一行。然后更新**/etc/opendkim/SigningTable**为发出的邮件签名,上传OpenDKIM密钥到服务器区域,然后吃哦更年期OpenDKIM服务。

|

||||

要添加一个域名,只要在**virtual_domains**表中增加一行。然后更新**/etc/opendkim/SigningTable**为发出的邮件签名,上传OpenDKIM密钥到服务器区域,然后重启OpenDKIM服务。

|

||||

|

||||

Owncloud有自己的用户数据库,在用管理员帐号登录后可以修改。

|

||||

|

||||

最后,万一在服务器临时崩溃的时候想办法找解决方案很重要。比如说,在服务器恢复之前你的邮件应该送往哪儿?一种方式是找个能帮你做备份MX的朋友,同时你也可以当他的备份MX(看下postfix的配置文件**main.cf**里**relay_domains**和**relay_recipient_maps**里的设定)。与此类似,如果你的服务器被破解然后一个坏蛋把你所有文件删了怎么办?对于这个,考虑增加一个常规备份系统就很重要了。Linode提供了备份选项。在1984.is里,我用crontabs和scp做了一个基本但管用的自动备份系统。

|

||||

最后,万一在服务器临时崩溃的时候想办法找解决方案很重要。比如说,在服务器恢复之前你的邮件应该送往哪儿?一种方式是找个能帮你做备份MX的朋友,同时你也可以当他的备份MX(看下postfix的配置文件**main.cf**里**relay\_domains**和**relay\_recipient\_maps**里的设定)。与此类似,如果你的服务器被破解然后一个坏蛋把你所有文件删了怎么办?对于这个,考虑增加一个常规备份系统就很重要了。Linode提供了备份选项。在1984.is里,我用crontabs和scp做了一个基本但管用的自动备份系统。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.howtoforge.com/tutorial/build-your-own-cloud-on-debian-wheezy/

|

||||

|

||||

作者:[Roudy Jhausse ][a]

|

||||

作者:[Roudy Jhausse][a]

|

||||

译者:[zpl1025](https://github.com/zpl1025)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,202 @@

|

||||

在linux中如何通过nload来监控网络使用情况

|

||||

================================================================================

|

||||

nload 是一个 linux 自由软件工具,通过提供两个简单的图形来帮助linux用户和系统管理员来实时监控网络流量以及宽带使用情况:一个是进入流量,一个是流出流量。

|

||||

|

||||

我真的很喜欢用**nload**来在屏幕上显示当前的下载速度、总的流入量和平均下载速度等信息。nload工具的报告图非常容易理解,最重要的是这些信息真的非常有用。

|

||||

|

||||

在其使用手册上说到,在默认情况下它会监控所有网络设备。但是你可以轻松地指定你想要监控的设备,而且可以通过方向键在不同的网络设备之间进行转换。另外还有很多的选项可用,例如 ‘-t’选项以毫秒来设定刷新显示时间间隔(默认时间间隔值是500毫秒),‘-m’选项用来同时显示多个设备(在使用该选项时不会显示流量图),‘-u’选项用来设置显示流量数字的单位,另外还有许多其他的选项将会在本教程中探索和练习。

|

||||

|

||||

### 如何将 nload安装到你的linux机器上 ###

|

||||

|

||||

**Ubuntu** 和 **Fedora** 用户可以从默认的软件仓库中容易地安装。

|

||||

|

||||

在Ubuntu上使用以下命令进行安装。

|

||||

|

||||

sudo apt-get install nload

|

||||

|

||||

在Fedora上使用以下命令进行安装。

|

||||

|

||||

sudo yum install nload

|

||||

|

||||

**CentOS**用户该怎么办呢? 只需要在你的机器上输入以下命令就可以安装成功。

|

||||

|

||||

sudo yum install nload

|

||||

|

||||

以下的命令会帮助你在OpenBSD系统中安装nload。

|

||||

|

||||

sudo pkg_add -i nload

|

||||

|

||||

在 linux 机器上的另外一个非常有效的安装软件的方式就是编译源代码,下载并安装最新的版本意味着能够获得更好地性能、更酷的特性以及更少的bug。

|

||||

|

||||

### 如何通过源代码安装nload ###

|

||||

|

||||

在从源代码安装nload之前,你需要首先下载源代码。 我通常使用wget工具来进行下载--该工具在许多linux机器上默认可用。该免费工具帮助用户以非交互式的方式从网络上下载文件,并支持以下协议:

|

||||

|

||||

- HTTP

|

||||

- HTTPS

|

||||

- FTP

|

||||

|

||||

通过以下命令来进入到**/tmp**目录中。

|

||||

|

||||

cd /tmp

|

||||

|

||||

然后在你的终端中输入以下命令就可以将最新版本的nload下载到你的linux机器上了。

|

||||

|

||||

wget http://www.roland-riegel.de/nload/nload-0.7.4.tar.gz

|

||||

|

||||

如果你不喜欢使用wget工具,也可以通过简单的一个鼠标点击轻松地从[官网][1]上下载其源代码。

|

||||

|

||||

由于该软件非常轻巧,其下载过程几乎在瞬间就会完成。接下来的步骤就是通过**tar**工具来将下载的源代码包进行解压。

|

||||

|

||||

tar归档工具可以用来从磁带或硬盘文档中存储或解压文件,该工具有许多可用的选项,但是我们只需要下面的几个选项来执行我们的操作。

|

||||

|

||||

1. **-x** 从归档中解压文件

|

||||

1. **-v** 使用繁琐模式运行--用来显示详细信息

|

||||

1. **-f** 用来指定归档文件

|

||||

|

||||

例如(LCTT 译注:tar 命令的参数前的“-”可以省略):

|

||||

|

||||

tar xvf example.tar

|

||||

|

||||

现在你学会了如何使用tar工具,我可以非常肯定你知道了如何从命令行中解压这个.tar文档。

|

||||

|

||||

tar xvf nload-0.7.4.tar.gz

|

||||

|

||||

之后使用cd命令来进入到nload*目录中:

|

||||

|

||||

cd nload*

|

||||

|

||||

在我的系统上看起来是这样的:

|

||||

|

||||

oltjano@baby:/tmp/nload-0.7.4$

|

||||

|

||||

然后运行下面这个命令来为你的系统配置该软件包:

|

||||

|

||||

./configure

|

||||

|

||||

此时会有“一大波僵尸”会在你的屏幕上显示出来,下面的一个屏幕截图描述了它的样子。

|

||||

|

||||

|

||||

|

||||

在上述命令完成之后,通过下面的命令来编译nload。

|

||||

|

||||

make

|

||||

|

||||

|

||||

|

||||

好了,终于....,通过以下命令可以将nload安装在你的机器上了。

|

||||

|

||||

sudo make install

|

||||

|

||||

|

||||

|

||||

安装好nload之后就是让你学习如何使用它的时间了。

|

||||

|

||||

###如何使用nload###

|

||||

|

||||

我喜欢探索,所以在你的终端输入以下命令.

|

||||

|

||||

nload

|

||||

|

||||

看到了什么?

|

||||

|

||||

我得到了下面的结果。

|

||||

|

||||

|

||||

|

||||

如上述截图可以看到,我得到了以下信息:

|

||||

|

||||

#### 流入量####

|

||||

|

||||

**当前下载速度**

|

||||

|

||||

|

||||

|

||||

**平均下载速度**

|

||||

|

||||

|

||||

|

||||

**最小下载速度**

|

||||

|

||||

|

||||

|

||||

**最大下载速度**

|

||||

|

||||

|

||||

|

||||

**总的流入量按字节进行显示**

|

||||

|

||||

|

||||

|

||||

#### 流出量 ####

|

||||

|

||||

类似的同样适用于流出量

|

||||

|

||||

#### 一些nload有用的选项####

|

||||

|

||||

使用选项

|

||||

|

||||

-u

|

||||

|

||||

用来设置显示流量单位。

|

||||

|

||||

下面的命令会帮助你使用MBit/s显示单元

|

||||

|

||||

nload -u m

|

||||

|

||||

下面的屏幕截图显示了上述命令的结果。

|

||||

|

||||

|

||||

|

||||

尝试以下命令然后看看有什么结果。

|

||||

|

||||

nload -u g

|

||||

|

||||

|

||||

|

||||

同时还有一个**-U**选项。根据手册描述,该选项基本上与-u选项类似,只是用在合计数据。 我测试了这个命令,老实说,当你需要检查总的流入与流出量时非常有用。

|

||||

|

||||

nload -U G

|

||||

|

||||

|

||||

|

||||

从上面的截图中可以看到,**nload -U G** 使用Gbyte来显示数据总量。

|

||||

|

||||

另外一个我喜欢使用的有用选项是 **-t**。 该选项用来设置刷新显示事件间隔,单位为毫秒,默认值为500毫秒。

|

||||

|

||||

我会通过下面的命令做一些小的实验。

|

||||

|

||||

nload -t 130

|

||||

|

||||

那么上述命令做了什么呢?它将刷新显示时间间隔设置为130毫秒。 通常推荐不要将该时间间隔值设置为小于100毫秒,因为nload在生成报告时计算错误。

|

||||

|

||||

另外的一个选项为 **-a**, 在你想要设置计算平均值的时间窗口的秒数时使用,默认该值为300秒。

|

||||

|

||||

那么当你想要监控指定的网络设备该如何呢? 非常容易, 像下面这样简单地指定设备或者列出想要监控的设备列表即可。

|

||||

|

||||

nload wlan0

|

||||

|

||||

|

||||

|

||||

下面的语法可帮助你监控指定的多个设备。

|

||||

|

||||

nload [options] device1 device2 devicen

|

||||

|

||||

例如,使用下面的命令来监控eth0和eth1。

|

||||

|

||||

nload wlan0 eth0

|

||||

|

||||

如果不带选项来运行nload,那么它会监控所有自动检测到的设备,你可以通过左右方向键来显示其中的任何一个设备的信息。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://linoxide.com/monitoring-2/monitor-network-usage-nload/

|

||||

|

||||

作者:[Oltjano Terpollari][a]

|

||||

译者:[theo-l](https://github.com/theo-l)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://linoxide.com/author/oltjano/

|

||||

[1]:http://www.roland-riegel.de/nload/nload-0.7.4.tar.gz

|

||||

@ -1,4 +1,4 @@

|

||||

如何通过简单的3步恢复Windows7同时删除Ubuntu

|

||||

如何通过简单的3步恢复Windows 7同时删除Ubuntu

|

||||

================================================================================

|

||||

### 说明 ###

|

||||

|

||||

@ -8,11 +8,11 @@

|

||||

|

||||

那么为什么我现在要写这篇文章呢?

|

||||

|

||||

到目前为止我曾经在很多场合被问到如何从一个装有Windows7或Windows8的双系统中删除Unbuntu系统,因此写这篇文章就变得有意义了。

|

||||

到目前为止我曾经在很多场合被问到如何从一个装有Windows7或Windows8的双系统中删除Ubuntu系统,因此写这篇文章就变得有意义了。

|

||||

|

||||

我在圣诞节期间浏览了人们在我文章中的留言,感觉是时候把缺失的文章写完同时更新一下那些比较老的又需要关注的文章了。

|

||||

|

||||

我打算把一月份剩下的时间都用在这上面。这是第一步。如果你的电脑上安装了Windown7和Ubuntu双系统,同时你不想通过恢复出厂设置的方式恢复Windows7系统,那么请参考该教程。(注意:对于Windows8系统,有一个独立的教程)

|

||||

我打算把一月份剩下的时间都用在这上面。这是第一步。如果你的电脑上安装了Windows7和Ubuntu双系统,同时你不想通过恢复出厂设置的方式恢复Windows7系统,那么请参考该教程。(注意:对于Windows8系统,有一个独立的教程)

|

||||

|

||||

### 删除Ubuntu系统需要的步骤 ###

|

||||

|

||||

@ -24,11 +24,10 @@

|

||||

|

||||

在你开始之前,我建议为你的系统保留一个备份。

|

||||

|

||||

我也建议不要放弃这样的机会也不要使用微软自带的工具。

|

||||

我建议你不要放弃备份的机会,但也不要使用微软自带的工具。

|

||||

|

||||

[点击查看如何使用Macrinum Reflect备份你的驱动][1]

|

||||

|

||||

|

||||

如果Ubuntu中有你希望保存的数据,现在就登录进去然后将数据保存到外部硬盘驱动器,USB驱动器或者DVD中。

|

||||

|

||||

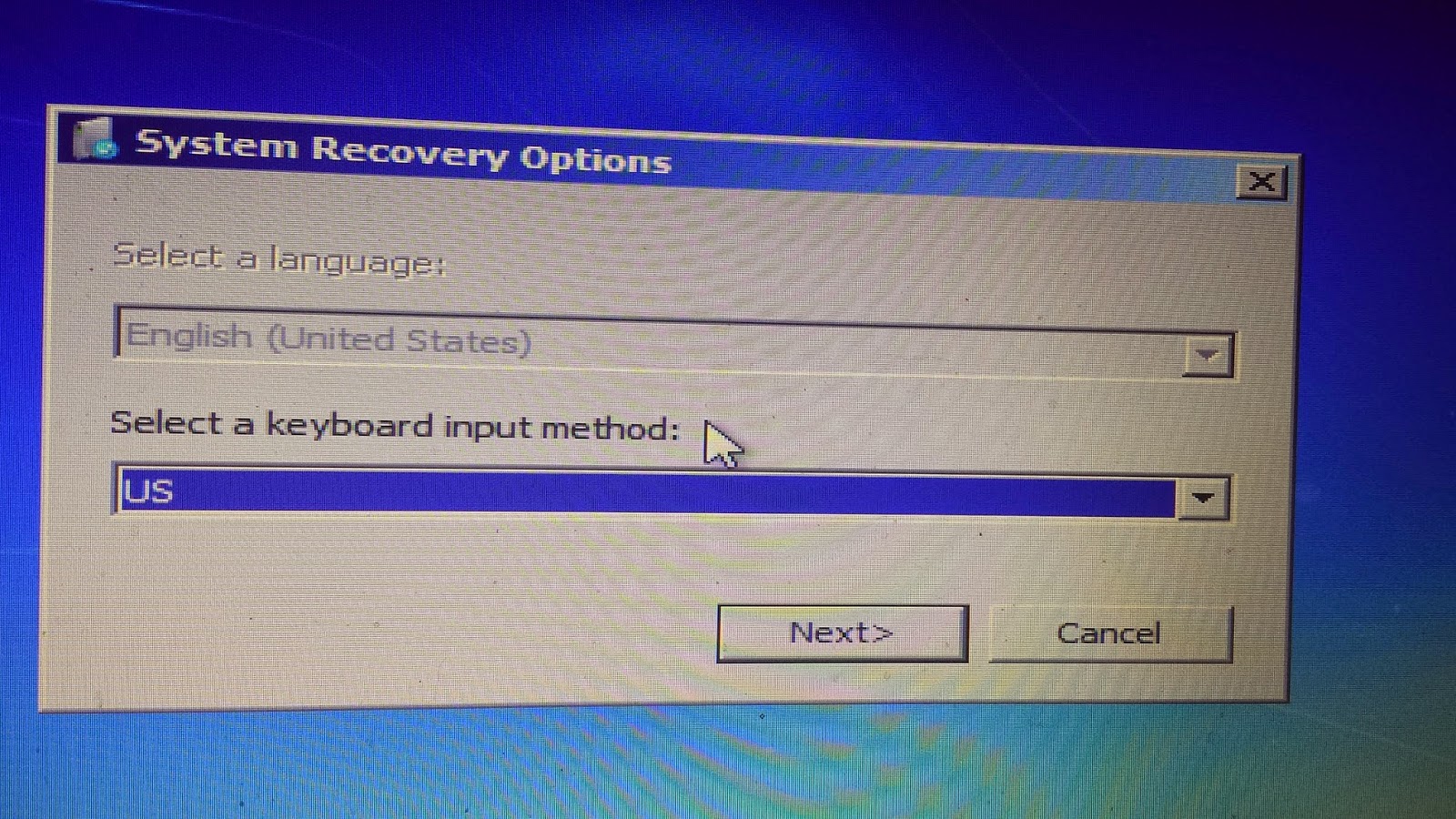

### 步骤1 - 删除Grub启动菜单 ###

|

||||

@ -57,7 +56,7 @@

|

||||

|

||||

点击“创建光盘”。

|

||||

|

||||

将光盘留在电脑中重启电脑,当出现从CD中启动的消息的时候按下键盘上的“回车”键。

|

||||

将光盘留在电脑中并重启电脑,当出现从CD中启动的消息的时候按下键盘上的“回车”键。

|

||||

|

||||

|

||||

|

||||

@ -111,13 +110,13 @@

|

||||

|

||||

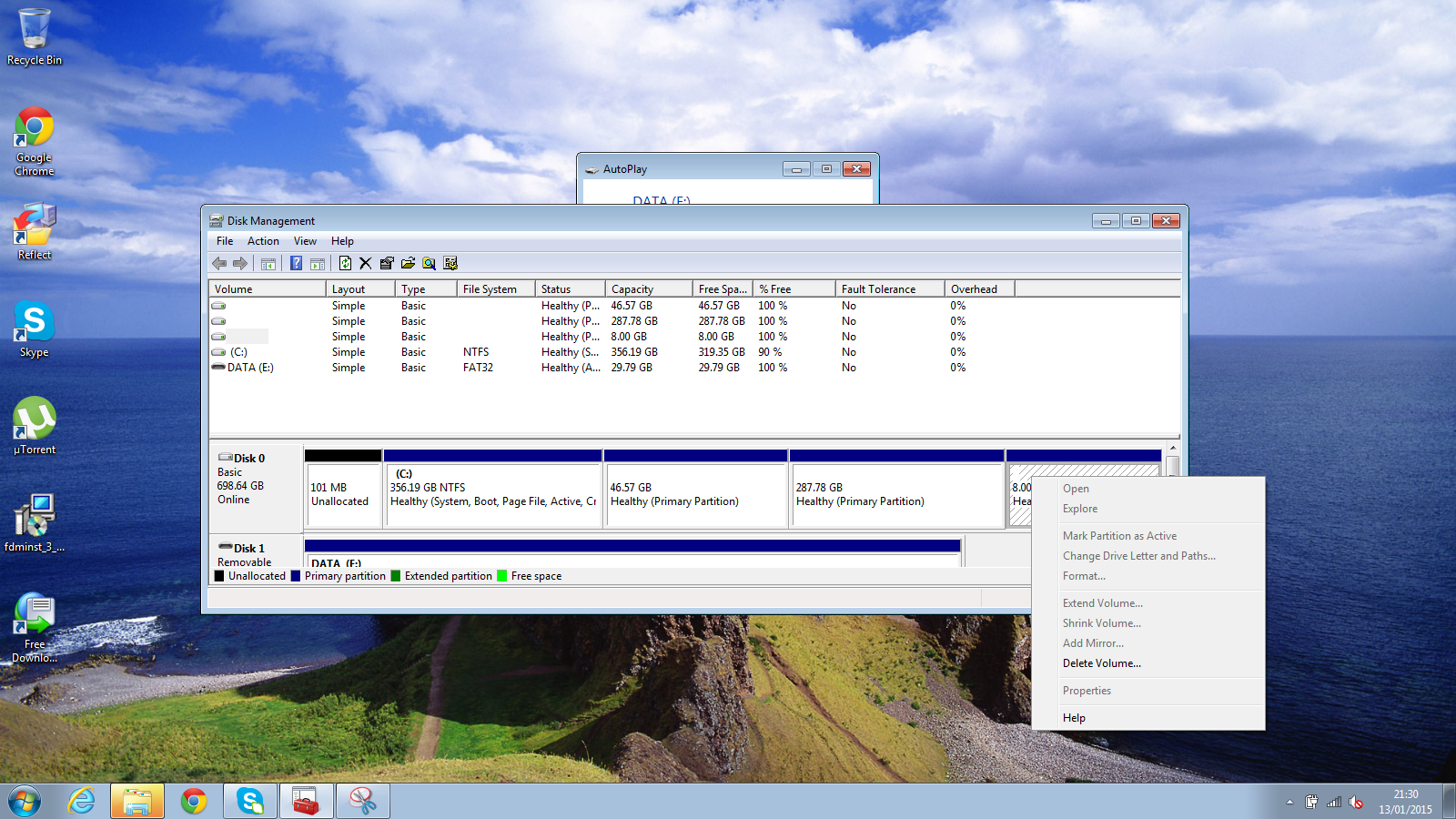

对于Windows系统来说,我们真正需要的只有驱动器C,所以剩下的是可以删掉的。

|

||||

|

||||

**注意: 注意一下.你的磁盘上可能有恢复分区。 不要删除恢复分区.。它们应该会被标记,将文件系统设置为NTFS或FAT32**

|

||||

**注意: 注意一下.你的磁盘上可能有恢复分区。 不要删除恢复分区。它们应该有专门的卷标,文件系统也许是NTFS或FAT32**

|

||||

|

||||

|

||||

|

||||

在你希望删除的分区上单击右键(例如:root,home和swap分区),然后从弹出的菜单中点击“删除卷”。

|

||||

|

||||

**(不要删除任何NTFS或者FAT32文件系统的分区)**

|

||||

**(不要删除任何NTFS或者FAT32文件系统的分区!)**

|

||||

|

||||

对于剩下的两个分区重复执行上面的操作。

|

||||

|

||||

@ -134,11 +133,12 @@

|

||||

|

||||

|

||||

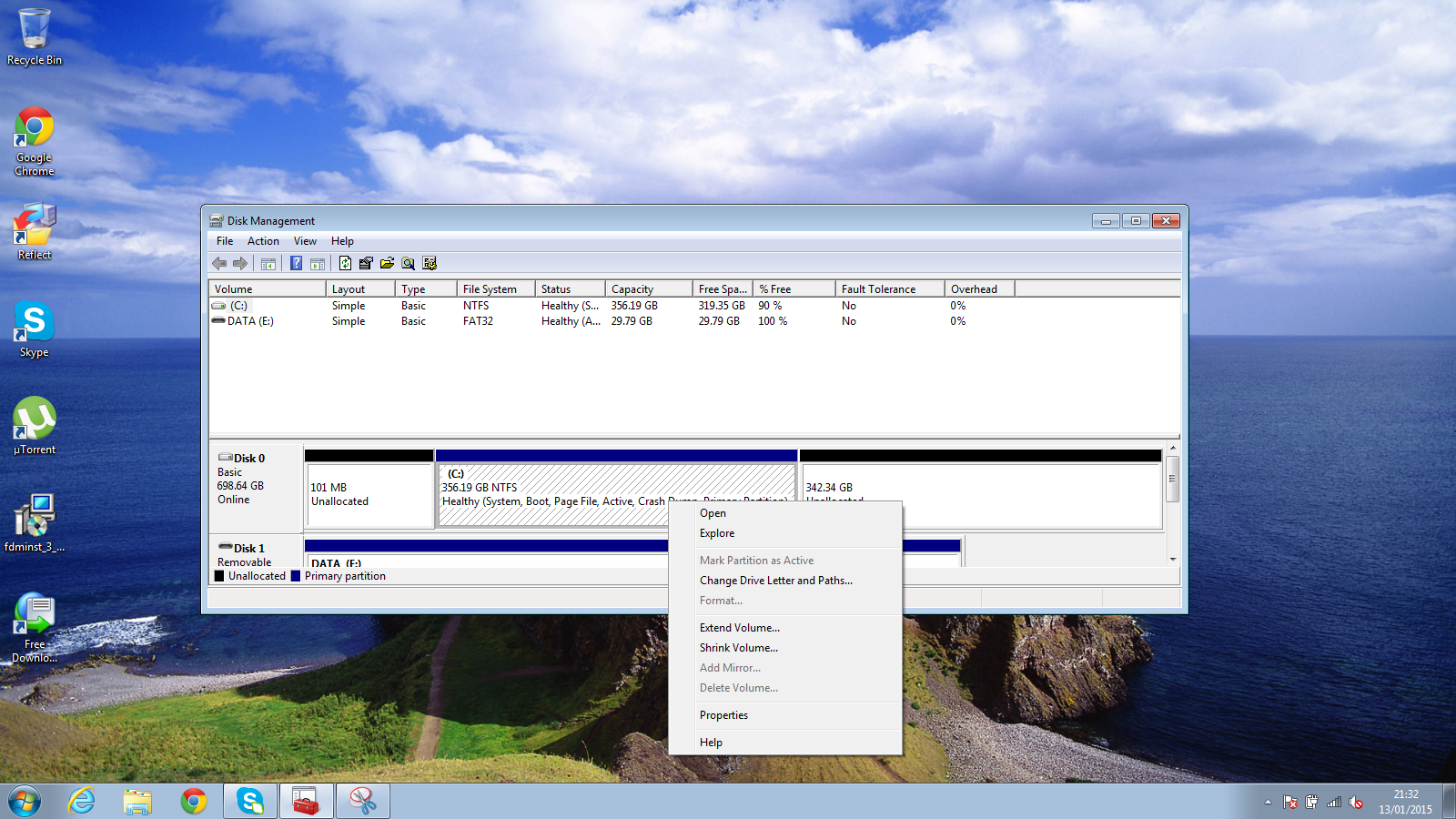

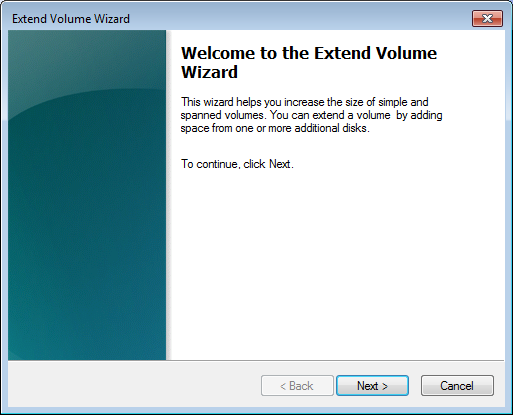

最后一步是扩展Windows以便于将它再变成一个大的分区。

|

||||

|

||||

右键点击Windows分区(C盘),然后选择“扩展卷”。

|

||||

|

||||

|

||||

|

||||

当出现左面的窗口的时候点击“下一步”,

|

||||

当出现左面的窗口的时候点击“下一步”。

|

||||

|

||||

|

||||

|

||||

@ -165,13 +165,14 @@

|

||||

这就是全部内容。一个致力于Linux的网站刚刚向你展示了如何移除Linux然后用Windows7取而代之。

|

||||

|

||||

有任何疑问可以在下面评论区留言。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.everydaylinuxuser.com/2015/01/how-to-recover-windows-7-and-delete.html

|

||||

|

||||

作者:Gary Newell

|

||||

译者:[Medusar](https://github.com/Medusar)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,39 +1,38 @@

|

||||

在linux中4个lvcreate命令例子

|

||||

4 个 lvcreate 常用命令举例

|

||||

================================================================================

|

||||

逻辑卷管理(LVM)是广泛使用的技术,并拥有极其灵活磁盘管理方案。主要包含3个基础命令:

|

||||

|

||||

a. 创建物理卷使用**pvcreate**

|

||||

b. 创建卷组并给卷组增加分区**vgcreate**

|

||||

c. 创建新的逻辑卷使用**lvcreate**

|

||||

1. 创建物理卷使用**pvcreate**

|

||||

2. 创建卷组并给卷组增加分区**vgcreate**

|

||||

3. 创建新的逻辑卷使用**lvcreate**

|

||||

|

||||

|

||||

|

||||

随后的例子着重在已经存在的卷组上使用**lvcreate**创建逻辑卷。**lvcreate**命令可以在来自自由物理扩展池的卷组分配逻辑扩展。通常,逻辑卷可以随意使用底层逻辑卷上的任意空间。修改逻辑卷将释放或重新分配在物理卷空间。这些例子已经在CentOS 5, CentOS 6, CentOS 7, RHEL 5, RHEl 6 和 RHEL 7 版本中测试通过。

|

||||

下列例子主要讲述在已经存在的卷组上使用**lvcreate**创建逻辑卷。**lvcreate**命令可以在卷组的可用物理扩展池中分配逻辑扩展。通常,逻辑卷可以随意使用底层逻辑卷上的任意空间。修改逻辑卷将释放或重新分配物理卷的空间。这些例子已经在CentOS 5, CentOS 6, CentOS 7, RHEL 5, RHEl 6 和 RHEL 7 版本中测试通过。

|

||||

|

||||

### 4个lvcreate命令例子 ###

|

||||

|

||||

1. 在名为vg_newlvm卷组中创建15G大小的逻辑卷:

|

||||

1. 在名为vg_newlvm的卷组中创建15G大小的逻辑卷:

|

||||

|

||||

[root@centos7 ~]# lvcreate -L 15G vg_newlvm

|

||||

[root@centos7 ~]# lvcreate -L 15G vg_newlvm

|

||||

|

||||

2. 在名为vg_newlvm中创建大小为2500MB的逻辑卷并命名centos7_newvol,创建块设备/dev/vg_newlvm/centos7_newvol:

|

||||

2. 在名为vg_newlvm的卷组中创建大小为2500MB的逻辑卷,并命名为centos7_newvol,这样就创建了块设备/dev/vg_newlvm/centos7_newvol:

|

||||

|

||||

[root@centos7 ~]# lvcreate -L 2500 -n centos7_newvol vg_newlvm

|

||||

[root@centos7 ~]# lvcreate -L 2500 -n centos7_newvol vg_newlvm

|

||||

|

||||

3.可以使用**lvcreate**命令的参数-l,能指定一些特别的逻辑卷扩展大小。也可以使用这个参数以卷组的大小百分比来扩展逻辑卷。这下列的命令创建了centos7_newvol卷组的50%大小的逻辑卷vg_newlvm:

|

||||

3. 可以使用**lvcreate**命令的参数-l来指定逻辑卷扩展的大小。也可以使用这个参数以卷组的大小百分比来扩展逻辑卷。这下列的命令创建了centos7_newvol卷组的50%大小的逻辑卷vg_newlvm:

|

||||

|

||||

[root@centos7 ~]# lvcreate -l 50%VG -n centos7_newvol vg_newlvm

|

||||

[root@centos7 ~]# lvcreate -l 50%VG -n centos7_newvol vg_newlvm

|

||||

|

||||

4. 使用卷组剩下的所有空间创建逻辑卷

|

||||

|

||||

[root@centos7 ~]# lvcreate --name centos7_newvol -l 100%FREE vg_newlvm

|

||||

[root@centos7 ~]# lvcreate --name centos7_newvol -l 100%FREE vg_newlvm

|

||||

|

||||

更多帮助,使用**lvcreate**命令--help选项来查看:

|

||||

|

||||

[root@centos7 ~]# lvcreate --help

|

||||

|

||||

----------

|

||||

以下空号中是帮助字面翻译

|

||||

|

||||

lvcreate: Create a logical volume(创建逻辑卷)

|

||||

|

||||

@ -46,8 +45,8 @@ c. 创建新的逻辑卷使用**lvcreate**

|

||||

[-C|--contiguous {y|n}]

|

||||

[-d|--debug]

|

||||

[-h|-?|--help]

|

||||

[--ignoremonitoring](忽略监听)

|

||||

[--monitor {y|n}](监听)

|

||||

[--ignoremonitoring](忽略监控)

|

||||

[--monitor {y|n}](监控)

|

||||

[-i|--stripes Stripes [-I|--stripesize StripeSize]]

|

||||

[-k|--setactivationskip {y|n}]

|

||||

[-K|--ignoreactivationskip]

|

||||

@ -66,7 +65,7 @@ c. 创建新的逻辑卷使用**lvcreate**

|

||||

[--discards {ignore|nopassdown|passdown}]

|

||||

[--poolmetadatasize MetadataSize[bBsSkKmMgG]]]

|

||||

[--poolmetadataspare {y|n}]

|

||||

[--thinpool ThinPoolLogicalVolume{Name|Path}]精简池逻辑卷

|

||||

[--thinpool ThinPoolLogicalVolume{Name|Path}] (精简池逻辑卷)

|

||||

[-t|--test]

|

||||

[--type VolumeType](卷类型)

|

||||

[-v|--verbose]

|

||||

@ -75,18 +74,14 @@ c. 创建新的逻辑卷使用**lvcreate**

|

||||

[--version]

|

||||

VolumeGroupName [PhysicalVolumePath...]

|

||||

|

||||

lvcreate

|

||||

{ {-s|--snapshot} OriginalLogicalVolume[Path] |

|

||||

[-s|--snapshot] VolumeGroupName[Path] -V|--virtualsize VirtualSize}

|

||||

{-T|--thin} VolumeGroupName[Path][/PoolLogicalVolume]

|

||||

-V|--virtualsize VirtualSize}(

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.ehowstuff.com/4-lvcreate-command-examples-on-linux/

|

||||

|

||||

作者:[skytech][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

译者:[Vic020](https://github.com/Vic020)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

121

published/20150126 CD Audio Grabbers--Graphical Based.md

Normal file

121

published/20150126 CD Audio Grabbers--Graphical Based.md

Normal file

@ -0,0 +1,121 @@

|

||||

4 个图形界面的 CD 音频抓取器

|

||||

================================================================================

|

||||

CD音频抓取器设计用来从光盘中提取(“RIP”)原始数字音频(通常被称为 CDDA 格式)并把它保存成文件或以其他形式输出。这类软件使用户能把数字音频编码成各种格式,并可以从在线光盘数据库 freedb 中下载或上传光盘信息。

|

||||

|

||||

复制CD合法吗?在美国版权法中,把一个原始CD转换成数字文件用于个人使用等同于‘合理使用’。然而,美国版权法并没有明确的允许或禁止拷贝私人音频CD,而且判例法还没有确立出在具体的哪种情况下可以视为合理使用。而在英国,其版权的定位则更清晰一些。从2014年开始,英国公民制造CD,MP3,DVD,蓝光和电子书的行为成为合法行为。当然,这仅适用于这个人拥有被采集的媒体的实体,并且复制品仅用于他们个人使用。对于欧盟的其他国家,成员国也允许私人复制这种特例。

|

||||

|

||||

如果你不确定在你生活的国家里这种版权是如何界定的,在你使用这篇文章中所列举的软件前请查询本地的版权法以确定你处在合法的一边。

|

||||

|

||||

在某种程度上,提取CD音轨看起来有点多余。如[Spotify][5]和Google Play Music这类流媒体服务提供了一个巨大的以通用格式的音乐的库,无需采集你的CD集。但是,如果你已将收藏了一个数量巨大的CD集。能把你的CD转换成可以在便携设备如智能手机、平板和便携式MP3播放器上播放的格式仍然是个诱人的选择。

|

||||

|

||||

这篇文章推荐了我最喜欢的音频CD抓取器。我挑了四个最好的图形界面的音频抓取器。所有这些应用程序都是在开源许可下发行的。

|

||||

|

||||

###fre:ac

|

||||

|

||||

|

||||

|

||||

fre:ac是个开源的音频转换器和CD提取器,支持很多种流行格式和编码器。目前这个应用可以在MA3、MP4/M4A、WMA、Ogg Vorbis、FLAC、AAC、WAV和Bonk格式间转换。这来源于几种不同形式的LAME编码器。

|

||||

|

||||

#### 功能包括: ####

|

||||

|

||||

- 易学易用

|

||||

- MP3、MP4/M4A、WMA、Ogg Vorbis、FLAC、AAC、WAV和Bonk格式转换器

|

||||

- 集成了CDDB/freedb标题数据库支持的CD提取器

|

||||

- 多核优化的编码器加速了现代PC上的转换速度

|

||||

- 对于标签和文件名称的全Unicode支持

|

||||

- 易学易用,而当你需要时还提供专家级选项

|

||||

- 任务列表

|

||||

- 可以使用Winamp 2输入插件

|

||||

- 多语言用户界面支持41种语言

|

||||

|

||||

- 网址: [freac.org][1]

|

||||

- 开发人员:Robert Kausch

|

||||

- 许可证: GNU GPL v2

|

||||

- 版本号: 20141005

|

||||

|

||||

###Audex

|

||||

|

||||

|

||||

|

||||

Audex是个简单易用的开源的音频CD提取应用。虽然它还处于早期开发阶段,但这个KDE桌面工具足够稳定、智能和简单易用。

|

||||

|

||||

它的助手可以为LAME、OGG Vorbis(oggenc)、FLAC、FAAC(AAC/MP4)和RIFF WAVE等格式创建配置文件。除了这个助手,你也可以定义你自己的配置文件,这意味着,Audex适用于大部分的命令行编码器。

|

||||

|

||||

#### 功能包括: ####

|

||||

|

||||

- 可提取CDDA Paranoia

|

||||

- 提取和编码同时进行

|

||||

- 文件名采用本地和远程的CDDB/FreeDB数据库

|

||||

- 可以提交到CDDB/FreeDB数据库

|

||||

- 类似capitalize的元数据纠正工具

|

||||

- 多配置文件提取(每个配置文件文件有一个命令行编码器)

|

||||

- 从互联网上抓取封面并将他们存在数据库中

|

||||

- 在目标目录中创建播放列表、封面和基于模板的信息文件

|

||||

- 创建提取和编码协议

|

||||

- 将文件传送到FTP服务器

|

||||

- 支持国际化

|

||||

|

||||

- 网址: [kde.maniatek.com/audex][2]

|

||||

- 开发人员: Marco Nelles

|

||||

- 许可证: GNU GPL v3

|

||||

- 版本号: 0.79

|

||||

|

||||

###Sound Juicer

|

||||

|

||||

|

||||

|

||||

Sound Juicer是个使用GTK+和GStreamer开发的轻量级CD提取器。它从CD中提取音频并把它转换成音频文件。Sound Juicer还可以直接播放CD中的音轨,在提取前提供预览。

|

||||

|

||||

它支持任何GStreamer插件所支持的音频编码,包括 MP3、Ogg Vorbis、FLAC和未压缩的PCM格式。

|

||||

|

||||

它是GNOME桌面环境内建的一部分。

|

||||

|

||||

#### 功能包括: ####

|

||||

|

||||

- 自动通过CDDB给音轨加标签

|

||||

- 可编码成ogg/vorbis、FLAC和原始WAV

|

||||

- 编码路径的设置很简单

|

||||

- 多种风格流派

|

||||

- 国际化支持

|

||||

|

||||

- 网址:[burtonini.com][3]

|

||||

- 开发人员: Ross Burton

|

||||

- 许可证:GNU GPL v2

|

||||

- 版本号:3.14

|

||||

|

||||

###ripperX

|

||||

|

||||

|

||||

|

||||

ripperX是个开源的图形界面的程序,用于提取CD音轨并把他们编码成Ogg、MP2、MP3或FLAC格式。它的目的是容易使用,只需要点几下鼠标就能转换整张专辑。它支持在CDDB寻找专辑和音轨信息。

|

||||

|

||||

他使用cdparanoia把CD音轨转换(也就是“提取”)成WAV文件,然后调用Vorbis/Ogg编码器oggenc把WAV文件转换成OGG文件。它还可以调用flac让WAV文件生成无损压缩的FLAC文件。

|

||||

|

||||

#### 功能包括: ####

|

||||

|

||||

- 非常简单易用

|

||||

- 可以把CD音轨提取成WAV、MP3、OGG或FLAC文件

|

||||

- 支持CDDB查找

|

||||

- 支持ID3v2标签

|

||||

- 可暂停提取进程

|

||||

|

||||

- 网址:[sourceforge.net/projects/ripperx][4]

|

||||

- 开发人员:Marc André Tanner

|

||||

- 许可证:MIT/X Consortium License

|

||||

- 版本号:2.8.0

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

转自:http://www.linuxlinks.com/article/20150125043738417/AudioGrabbersGraphical.html

|

||||

|

||||

作者:Frazer Kline

|

||||

译者:[H-mudcup](https://github.com/H-mudcup)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[1]:http://www.freac.org/

|

||||

[2]:http://kde.maniatek.com/audex/

|

||||

[3]:http://burtonini.com/blog/computers/sound-juicer

|

||||

[4]:http://sourceforge.net/projects/ripperx/

|

||||

[5]:http://linux.cn/article-3130-1.html

|

||||

@ -0,0 +1,107 @@

|

||||

性能优化:使用ramlog将日志文件转移到内存中

|

||||

================================================================================

|

||||

Ramlog 以系统守护进程的形式运行。在系统启动时它创建虚拟磁盘(ramdisk),将 /var/log 下的文件复制到虚拟磁盘中,同时把虚拟磁盘挂载为/var/log。然后所有的日志就会更新到虚拟磁盘上。而当 ramlog 重启或停止时,需要记录到硬盘上的日志就会保留在目录/var/log.hdd中。而关机的时候,(ramdisk上的)日志文件会重新保存到硬盘上,以确保日志一致性。Ramlog 2.x默认使用tmpfs文件系统,同时也可以支持ramfs和内核ramdisk。使用rsync(译注:Linux数据镜像备份工具)这个工具来同步日志。

|

||||

|

||||

注意:如果突然断电或者内核崩溃(kernel panic)时,没有保存进硬盘的日志将会丢失。

|

||||

|

||||

如果你拥有够多的可用内存,而又想把日志放进虚拟磁盘,就安装ramlog吧。它是笔记本用户、带有UPS的系统或是直接在flash中运行的系统的优良选择,可以节省日志的写入时间。

|

||||

|

||||

Ramlog的运行机制以及步骤如下:

|

||||

|

||||

1. Ramlog 由第一个守护进程(这取决于你所安装过的其它守护进程)启动。

|

||||

|

||||

2. 然后创建目录/var/log.hdd并将其硬链至/var/log。

|

||||

|

||||

3. 如果使用的是tmpfs(默认)或者ramfs 文件系统,将其挂载到/var/log上。

|

||||

|

||||

4. 而如果使用的是内核ramdisk,ramdisk会在/dev/ram9中创建,并将其挂载至/var/log。默认情况下ramlog会占用所有ramdisk的内存,其大小由内核参数"ramdisk_size"指定。

|

||||

|

||||

5. 接着其它的守护进程被启动,并在ramdisk中更新日志。Logrotate(译注:Linux日志轮替工具)和 ramdisk 配合的也很好。

|

||||

|

||||

6. 重启(默认一天一次)ramlog时,目录/var/log.hdd将借助rsync与/var/log保持同步。日志自动保存的频率可以通过cron(译注:Linux例行性工作调度)来控制。默认情况下,ramlog 的调度任务放置在目录/etc/cron.daily下。

|

||||

|

||||

7. 系统关机时,ramlog在最后一个守护进程关闭之前关闭。

|

||||

|

||||

8. 在ramlog关闭期间,/var/log.hdd中的文件将被同步至/var/log,接着/var/log和/var/log.hdd都被卸载,然后删除空目录/var/log.hdd。

|

||||

|

||||

**注意:- 此文仅面向高级用户**

|

||||

|

||||

### 在Ubuntu中安装Ramlog ###

|

||||

|

||||

首先需要用以下命令,从[这里][1]下载.deb安装包:

|

||||

|

||||

wget http://www.tremende.com/ramlog/download/ramlog_2.0.0_all.deb

|

||||

|

||||

下载ramlog\_2.0.0\_all.deb安装包完毕,使用以下命令进行安装:

|

||||

|

||||

sudo dpkg -i ramlog_2.0.0_all.deb

|

||||

|

||||

这一步会完成整个安装,现在你需要运行以下命令:

|

||||

|

||||

sudo update-rc.d ramlog start 2 2 3 4 5 . stop 99 0 1 6 .

|

||||

|

||||

现在,在更新sysklogd的初始化顺序,使之能在ramlog停止运行前正确关闭:

|

||||

|

||||

sudo update-rc.d -f sysklogd remove

|

||||

|

||||

sudo update-rc.d sysklogd start 10 2 3 4 5 . stop 90 0 1 6 .

|

||||

|

||||

然后重启系统:

|

||||

|

||||

sudo reboot

|

||||

|

||||

系统重启完毕,运行'ramlog getlogsize'来获取你当前的/var/log的空间大小。在此基础之上多分配40%的空间,确保ramdisk有足够的空间(这整个都将作为ramdisk的空间大小)。

|

||||

|

||||

编辑引导配置文件,如/etc/grub.conf,、/boot/grub/menu.lst 或/etc/lilo.conf(译注:具体哪个配置文件视不同引导加载程序而定),给你的当前内核的新增选项 'ramdisk_size=xxx' ,其中xxx是ramdisk的空间大小。

|

||||

|

||||

### 配置Ramlog ###

|

||||

|

||||

基于deb的系统中,Ramlog的配置文件位于/etc/default/ramlog,你可以在该配置文件中设置以下变量:

|

||||

|

||||

RAMDISKTYPE=0

|

||||

# 取值:

|

||||

# 0 -- tmpfs (可被交换到交换分区) -- 默认

|

||||

# 1 -- ramfs (旧内核不能设置最大空间大小,

|

||||

# 不能被交换到交换分区,和 SELinux 不兼容)

|

||||

# 2 -- 老式的内核 ramdisk

|

||||

TMPFS_RAMFS_SIZE=

|

||||

# 可以用于 tmpfs 或 ramfs 的最大内存大小

|

||||

# 这个值可以是百分比或数值(单位是 Mb),例如:

|

||||

# TMPFS_RAMFS_SIZE=40%

|

||||

# TMPFS_RAMFS_SIZE=100m

|

||||

# 该值为空表示 tmpfs/ramfs 的大小是全部内存的 50%

|

||||

# 更多选项可以参考 ‘man mount' 中的‘Mount options for tmpfs' 一节

|

||||

# (补充,在较新的内核中,ramfs 支持大小限制,

|

||||

# 虽然 man 中说没有这个挂载选项)

|

||||

# 该选项仅用于 RAMDISKTYPE=0 或 1 时

|

||||

KERNEL_RAMDISK_SIZE=MAX

|

||||

#以 kb 为单位指定的内核 ramdisk 大小,或者使用 MAX 来使用整个 ramdisk。

|

||||

#该选项仅用于 RAMDISKTYPE=2 时

|

||||

LOGGING=1

|

||||

# 0=关闭, 1=打开 。记录自身的日志到 /var/log/ramdisk

|

||||

LOGNAME=ramlog

|

||||

# 自身的日志文件名 (用于 LOGGING=1时)

|

||||

VERBOSE=1

|

||||

# 0=关闭, 1=打开 (设置为 1时,启动或停止失败时会调用 teststartstop 将细节

|

||||

# 写到日志中)

|

||||

|

||||

### 在Ubuntu中卸载ramlog ###

|

||||

|

||||

打开终端运行以下命令:

|

||||

|

||||

sudo dpkg -P ramlog

|

||||

|

||||

注意:如果ramlog卸载之前仍在运行,需要重启系统完成整个卸载工作。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.ubuntugeek.com/improve-system-performance-by-moving-your-log-files-to-ram-using-ramlog.html

|

||||

|

||||

作者:[ruchi][a]

|

||||

译者:[soooogreen](https://github.com/soooogreen)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.ubuntugeek.com/author/ubuntufix

|

||||

[1]:http://www.tremende.com/ramlog/download/ramlog_2.0.0_all.deb

|

||||

@ -1,12 +1,12 @@

|

||||

怎样在 Linux 中限制网络带宽

|

||||

怎样在 Linux 中限制网络带宽使用

|

||||

================================================================================

|

||||

假如你经常在 Linux 桌面上运行多个网络应用,或在家中让多台电脑共享带宽;(这时,)你可能想更好地控制带宽的使用。否则,当你使用下载器下载一个大文件时,交互式 SSH 会话可能会变得缓慢以至不可用;或者当你通过 Dropbox 来同步一个大文件夹时,你的室友可能会抱怨在她的电脑上,视频流变得断断续续。

|

||||

假如你经常在 Linux 桌面上运行多个网络应用,或在家中让多台电脑共享带宽;那么你可能想更好地控制带宽的使用。否则,当你使用下载器下载一个大文件时,交互式 SSH 会话可能会变得缓慢以至不可用;或者当你通过 Dropbox 来同步一个大文件夹时,你的室友可能会抱怨在她的电脑上,视频流变得断断续续。

|

||||

|

||||

在本教程中,我将为你描述两种 在 Linux 中限制网络流量速率的不同方法。

|

||||

在本教程中,我将为你描述两种在 Linux 中限制网络流量速率的不同方法。

|

||||

|

||||

### 在 Linux 中限制一个应用的速率 ###

|

||||

|

||||

限制网络流量速率的一种方法是通过一个名为[trickle][1]的命令行工具。通过在程序运行时,预先加载一个 速率限制 socket 库 的方法,trickle 命令允许你改变任意一个特定程序的流量。 关于 trickle 命令的一个很好的特征是 它仅在用户空间中运行,这意味着,你不必需要 root 权限来达到限制一个程序的带宽使用的目的。为了与 trickle 程序兼容,这个特定程序必须使用没有静态链接库的套接字接口。当你想对一个不具有内置带宽控制功能的程序进行速率限制时,trickle 可以帮得上忙。

|

||||

限制网络流量速率的一种方法是通过一个名为[trickle][1]的命令行工具。通过在程序运行时,预先加载一个速率限制 socket 库 的方法,trickle 命令允许你改变任意一个特定程序的流量。 trickle 命令有一个很好的特性是它仅在用户空间中运行,这意味着,你不必需要 root 权限就可以限制一个程序的带宽使用。要能使用 trickle 程序控制程序的带宽,这个程序就必须使用非静态链接库的套接字接口。当你想对一个不具有内置带宽控制功能的程序进行速率限制时,trickle 可以帮得上忙。

|

||||

|

||||

在 Ubuntu,Debian 及其衍生发行版中安装 trickle :

|

||||

|

||||

@ -20,10 +20,10 @@ $ sudo apt-get install trickle

|

||||

$ sudo yum install trickle

|

||||

```

|

||||

|

||||

trickle 的基本使用方法如下。仅需简单地把 trickle 命令(带有速率参数)放在你想运行的命令之前。

|

||||

trickle 的基本使用方法如下。仅需简单地把 trickle 命令(及速率参数)放在你想运行的命令之前。

|

||||

|

||||

```

|

||||

$ trickle -d <download-rate> -u <upload-rate> <command>

|

||||

$ trickle -d <download-rate> -u <upload-rate> <command>

|

||||

```

|

||||

|

||||

这就可以将 `<command>` 的下载和上传速率限定为特定值(单位 KBytes/s)。

|

||||

@ -34,27 +34,27 @@ $ trickle -d <download-rate> -u <upload-rate> <command>

|

||||

$ trickle -u 100 scp backup.tgz alice@remote_host.com:

|

||||

```

|

||||

|

||||

如若你想,你可以使用下面的命令为你的 Firefox 浏览器设定最大下载速率(e.g. , 300 KB/s),通过产生一个[自定义启动器][3]的方式。

|

||||

如若你想,你可以通过创建一个[自定义启动器][3]的方式,使用下面的命令为你的 Firefox 浏览器设定最大下载速率(例如, 300 KB/s)。

|

||||

|

||||

```

|

||||

trickle -d 300 firefox %u

|

||||

```

|

||||

|

||||

最后, trickle 也可以 以守护进程模式运行,在该模式下,它将会限制所有通过 trickle 启动且正在运行的程序的总的带宽和。 启动 trickle 使其作为一个守护进程(i.e., trickled):

|

||||

最后, trickle 也可以以守护进程模式运行,在该模式下,它将会限制所有通过 trickle 启动且正在运行的程序的总带宽之和。 启动 trickle 使其作为一个守护进程(例如, trickled):

|

||||

|

||||

```

|

||||

$ sudo trickled -d 1000

|

||||

```

|

||||

|

||||

一旦 trickled 守护进程在后台运行,你便可以通过 trickle 命令来启动其他程序。假如你通过 trickle 启动一个程序,那么这个程序的最大下载速率将是 1000 KB/s, 假如你再通过 trickle 启动了另一个程序,则每个程序的(下载)速率极限将会被限制为 500 KB/s, 等等。

|

||||

一旦 trickled 守护进程在后台运行,你便可以通过 trickle 命令来启动其他程序。假如你通过 trickle 启动一个程序,那么这个程序的最大下载速率将是 1000 KB/s, 假如你再通过 trickle 启动了另一个程序,则每个程序的(下载)速率极限将会被限制为 500 KB/s,等等。

|

||||

|

||||

### 在 Linux 中限制一个网络接口的速率 ###

|

||||

|

||||

另一种控制你的带宽资源的方式是在每一个接口上限制带宽。这在你与其他人分享你的网络连接的上行带宽时尤为实用。同其他一样,Linux 有一个工具来为你做这件事。[wondershaper][4]恰好执行限制网络接口速率的任务。

|

||||

另一种控制你的带宽资源的方式是在每一个接口上限制带宽。这在你与其他人分享你的网络连接的上行带宽时尤为实用。同其他一样,Linux 有一个工具来为你做这件事。[wondershaper][4]就是干这个的。

|

||||

|

||||

wondershaper 实际上是一个 shell 脚本,它使用 [tc][5] 来定义流量调整命令,使用 QoS 来处理特定的网络接口。通过放置被赋予不同的优先级的传出流量在一个队列中,达到限制传出流量速率的目的, 而传入流量通过丢包的方式来达到速率限制的目的。

|

||||

wondershaper 实际上是一个 shell 脚本,它使用 [tc][5] 来定义流量调整命令,使用 QoS 来处理特定的网络接口。外发流量通过放在不同优先级的队列中,达到限制传出流量速率的目的;而传入流量通过丢包的方式来达到速率限制的目的。

|

||||

|

||||

事实上, wondershaper 的既定目标不仅仅是对一个接口增加其带宽上限;当批量下载或上传正在进行时,wondershaper 还试图去保持互动性会话如SSH 的低延迟。同样的,它还确保批量上传(e.g. , Dropbox 的同步)不会使得下载“窒息”,反之亦然。

|

||||

事实上, wondershaper 的既定目标不仅仅是对一个接口增加其带宽上限;当批量下载或上传正在进行时,wondershaper 还试图去保持互动性会话如 SSH 的低延迟。同样的,它还会控制批量上传(例如, Dropbox 的同步)不会使得下载“窒息”,反之亦然。

|

||||

|

||||

在 Ubuntu Debian 及其衍生发行版本 中安装 wondershaper:

|

||||

|

||||