mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-15 01:50:08 +08:00

commit

26405f6faf

@ -1,22 +1,18 @@

|

||||

GHLandy Translated

|

||||

|

||||

LFCS 系列第五讲:如何在 Linux 中挂载/卸载本地文件系统和网络文件系统(Samba 和 NFS)

|

||||

|

||||

================================================================================

|

||||

|

||||

Linux 基金会已经发起了一个全新的 LFCS(Linux Foundation Certified Sysadmin,Linux 基金会认证系统管理员)认证,旨在让来自世界各地的人有机会参加到 LFCS 测试,获得关于有能力在 Linux 系统中执行中间系统管理任务的认证。该认证包括:维护正在运行的系统和服务的能力、全面监控和分析的能力以及何时上游团队请求支持的决策能力。

|

||||

Linux 基金会已经发起了一个全新的 LFCS(Linux Foundation Certified Sysadmin,Linux 基金会认证系统管理员)认证,旨在让来自世界各地的人有机会参加到 LFCS 测试,获得关于有能力在 Linux 系统中执行中间系统管理任务的认证。该认证包括:维护正在运行的系统和服务的能力、全面监控和分析的能力以及何时向上游团队请求支持的决策能力。

|

||||

|

||||

|

||||

|

||||

LFCS 系列第五讲

|

||||

*LFCS 系列第五讲*

|

||||

|

||||

请看以下视频,这里边介绍了 Linux 基金会认证程序。

|

||||

|

||||

注:youtube 视频

|

||||

<iframe width="720" height="405" frameborder="0" allowfullscreen="allowfullscreen" src="//www.youtube.com/embed/Y29qZ71Kicg"></iframe>

|

||||

|

||||

本讲是《十套教程》系列中的第三讲,在这一讲里边,我们会解释如何在 Linux 中挂载/卸载本地和网络文件系统。这些都是 LFCS 认证中的必备知识。

|

||||

|

||||

本讲是系列教程中的第五讲,在这一讲里边,我们会解释如何在 Linux 中挂载/卸载本地和网络文件系统。这些都是 LFCS 认证中的必备知识。

|

||||

|

||||

### 挂载文件系统 ###

|

||||

|

||||

@ -26,20 +22,19 @@ LFCS 系列第五讲

|

||||

|

||||

换句话说,管理存储设备的第一步就是把设备关联到文件系统树。要完成这一步,通常可以这样:用 mount 命令来进行临时挂载(用完的时候,使用 umount 命令来卸载),或者通过编辑 /etc/fstab 文件之后重启系统来永久性挂载,这样每次开机都会进行挂载。

|

||||

|

||||

|

||||

不带任何选项的 mount 命令,可以显示当前已挂载的文件系统。

|

||||

|

||||

# mount

|

||||

|

||||

|

||||

|

||||

检查已挂载的文件系统

|

||||

*检查已挂载的文件系统*

|

||||

|

||||

另外,mount 命令通常用来挂载文件系统。其基本语法如下:

|

||||

|

||||

# mount -t type device dir -o options

|

||||

|

||||

该命令会指引内核在设备上找到的文件系统(如已格式化为指定类型的文件系统)挂载到指定目录。像这样的形式,mount 命令不会再到 /etc/fstab 文件中进行确认。

|

||||

该命令会指引内核将在设备上找到的文件系统(如已格式化为指定类型的文件系统)挂载到指定目录。像这样的形式,mount 命令不会再到 /etc/fstab 文件中进行确认。

|

||||

|

||||

除非像下面,挂载指定的目录或者设备:

|

||||

|

||||

@ -59,20 +54,17 @@ mount 命令会尝试寻找挂载点,如果找不到就会查找设备(上

|

||||

|

||||

读作:

|

||||

|

||||

设备 dev/mapper/debian-home 的格式为 ext4,挂载在 /home 下,并且有以下挂载选项: rw,relatime,user_xattr,barrier=1,data=ordered。

|

||||

设备 dev/mapper/debian-home 挂载在 /home 下,它被格式化为 ext4,并且有以下挂载选项: rw,relatime,user_xattr,barrier=1,data=ordered。

|

||||

|

||||

**mount 命令选项**

|

||||

|

||||

下面列出 mount 命令的常用选项

|

||||

|

||||

|

||||

- async:运许在将要挂载的文件系统上进行异步 I/O 操作

|

||||

- auto:标志文件系统通过 mount -a 命令挂载,与 noauto 相反。

|

||||

|

||||

- defaults:该选项为 async,auto,dev,exec,nouser,rw,suid 的一个别名。注意,多个选项必须由逗号隔开并且中间没有空格。倘若你不小心在两个选项中间输入了一个空格,mount 命令会把后边的字符解释为另一个参数。

|

||||

- async:允许在将要挂载的文件系统上进行异步 I/O 操作

|

||||

- auto:标示该文件系统通过 mount -a 命令挂载,与 noauto 相反。

|

||||

- defaults:该选项相当于 `async,auto,dev,exec,nouser,rw,suid` 的组合。注意,多个选项必须由逗号隔开并且中间没有空格。倘若你不小心在两个选项中间输入了一个空格,mount 命令会把后边的字符解释为另一个参数。

|

||||

- loop:将镜像文件(如 .iso 文件)挂载为 loop 设备。该选项可以用来模拟显示光盘中的文件内容。

|

||||

- noexec:阻止该文件系统中可执行文件的执行。与 exec 选项相反。

|

||||

|

||||

- nouser:阻止任何用户(除 root 用户外) 挂载或卸载文件系统。与 user 选项相反。

|

||||

- remount:重新挂载文件系统。

|

||||

- ro:只读模式挂载。

|

||||

@ -91,7 +83,7 @@ mount 命令会尝试寻找挂载点,如果找不到就会查找设备(上

|

||||

|

||||

|

||||

|

||||

可读写模式挂载设备

|

||||

*可读写模式挂载设备*

|

||||

|

||||

**以默认模式挂载设备**

|

||||

|

||||

@ -102,26 +94,25 @@ mount 命令会尝试寻找挂载点,如果找不到就会查找设备(上

|

||||

|

||||

|

||||

|

||||

挂载设备

|

||||

*挂载设备*

|

||||

|

||||

在这个例子中,我们发现写入文件和命令都完美执行了。

|

||||

|

||||

### 卸载设备 ###

|

||||

|

||||

使用 umount 命令卸载设备,意味着将所有的“在使用”数据全部写入到文件系统了,然后可以安全移除文件系统。请注意,倘若你移除一个没有事先正确卸载的文件系统,就会有造成设备损坏和数据丢失的风险。

|

||||

使用 umount 命令卸载设备,意味着将所有的“在使用”数据全部写入到文件系统,然后可以安全移除文件系统。请注意,倘若你移除一个没有事先正确卸载的设备,就会有造成设备损坏和数据丢失的风险。

|

||||

|

||||

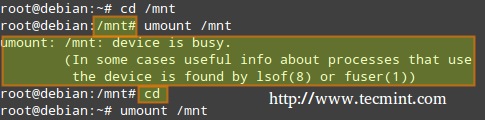

也就是说,你必须设备的盘符或者挂载点中退出,才能卸载设备。换言之,当前工作目录不能是需要卸载设备的挂载点。否则,系统将返回设备繁忙的提示信息。

|

||||

也就是说,你必须“离开”设备的块设备描述符或者挂载点,才能卸载设备。换言之,你的当前工作目录不能是需要卸载设备的挂载点。否则,系统将返回设备繁忙的提示信息。

|

||||

|

||||

|

||||

|

||||

卸载设备

|

||||

*卸载设备*

|

||||

|

||||

离开需卸载设备的挂载点最简单的方法就是,运行不带任何选项的 cd 命令,这样会回到当前用户的家目录。

|

||||

|

||||

|

||||

### 挂载常见的网络文件系统 ###

|

||||

最常用的两种网络文件系统是 SMB(Server Message Block,服务器消息块)和 NFS(Network File System,网络文件系统)。如果你只向类 Unix 客户端提供共享,用 NFS 就可以了,如果是向 Windows 和其他类 Unix客户端提供共享服务,就需要用到 Samba 了。

|

||||

|

||||

最常用的两种网络文件系统是 SMB(Server Message Block,服务器消息块)和 NFS(Network File System,网络文件系统)。如果你只向类 Unix 客户端提供共享,用 NFS 就可以了,如果是向 Windows 和其他类 Unix 客户端提供共享服务,就需要用到 Samba 了。

|

||||

|

||||

扩展阅读

|

||||

|

||||

@ -130,13 +121,13 @@ mount 命令会尝试寻找挂载点,如果找不到就会查找设备(上

|

||||

|

||||

下面的例子中,假设 Samba 和 NFS 已经在地址为 192.168.0.10 的服务器上架设好了(请注意,架设 NFS 服务器也是 LFCS 考试中需要考核的能力,我们会在后边中提到)。

|

||||

|

||||

|

||||

#### 在 Linux 中挂载 Samba 共享 ####

|

||||

|

||||

第一步:在 Red Hat 以 Debian 系发行版中安装 samba-client、samba-common 和 cifs-utils 软件包,如下:

|

||||

|

||||

# yum update && yum install samba-client samba-common cifs-utils

|

||||

# aptitude update && aptitude install samba-client samba-common cifs-utils

|

||||

|

||||

然后运行下列命令,查看服务器上可用的 Samba 共享。

|

||||

|

||||

# smbclient -L 192.168.0.10

|

||||

@ -145,7 +136,7 @@ mount 命令会尝试寻找挂载点,如果找不到就会查找设备(上

|

||||

|

||||

|

||||

|

||||

挂载 Samba 共享

|

||||

*挂载 Samba 共享*

|

||||

|

||||

上图中,已经对可以挂载到我们本地系统上的共享进行高亮显示。你只需要与一个远程服务器上的合法用户名及密码就可以访问共享了。

|

||||

|

||||

@ -164,7 +155,7 @@ mount 命令会尝试寻找挂载点,如果找不到就会查找设备(上

|

||||

|

||||

|

||||

|

||||

挂载有密码保护的 Samba 共享

|

||||

*挂载有密码保护的 Samba 共享*

|

||||

|

||||

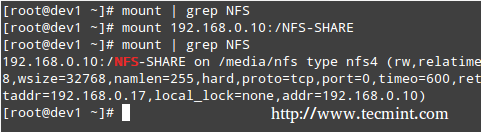

#### 在 Linux 系统中挂载 NFS 共享 ####

|

||||

|

||||

@ -185,7 +176,7 @@ mount 命令会尝试寻找挂载点,如果找不到就会查找设备(上

|

||||

|

||||

|

||||

|

||||

挂载 NFS 共享

|

||||

*挂载 NFS 共享*

|

||||

|

||||

### 永久性挂载文件系统 ###

|

||||

|

||||

@ -197,13 +188,12 @@ mount 命令会尝试寻找挂载点,如果找不到就会查找设备(上

|

||||

|

||||

其中:

|

||||

|

||||

- <file system>: 第一个字段指定挂载的设备。大多数发行版本都通过分区的标卷(label)或者 UUID 来指定。这样做可以避免分区号改变是带来的错误。

|

||||

- <mount point>: 第二字段指定挂载点。

|

||||

- <type> :文件系统的类型代码与 mount 命令挂载文件系统时使用的类型代码是一样的。通过 auto 类型代码可以让内核自动检测文件系统,这对于可移动设备来说非常方便。注意,该选项可能不是对所有文件系统可用。

|

||||

- <options>: 一个(或多个)挂载选项。

|

||||

- <dump>: 你可能把这个字段设置为 0(否则设置为 1),使得系统启动时禁用 dump 工具(dump 程序曾经是一个常用的备份工具,但现在越来越少用了)对文件系统进行备份。

|

||||

|

||||

- <pass>: 这个字段指定启动系统是是否通过 fsck 来检查文件系统的完整性。0 表示 fsck 不对文件系统进行检查。数字越大,优先级越低。因此,根分区(/)最可能使用数字 1,其他所有需要检查的分区则是以数字 2.

|

||||

- \<file system>: 第一个字段指定挂载的设备。大多数发行版本都通过分区的标卷(label)或者 UUID 来指定。这样做可以避免分区号改变时带来的错误。

|

||||

- \<mount point>: 第二个字段指定挂载点。

|

||||

- \<type> :文件系统的类型代码与 mount 命令挂载文件系统时使用的类型代码是一样的。通过 auto 类型代码可以让内核自动检测文件系统,这对于可移动设备来说非常方便。注意,该选项可能不是对所有文件系统可用。

|

||||

- \<options>: 一个(或多个)挂载选项。

|

||||

- \<dump>: 你可能把这个字段设置为 0(否则设置为 1),使得系统启动时禁用 dump 工具(dump 程序曾经是一个常用的备份工具,但现在越来越少用了)对文件系统进行备份。

|

||||

- \<pass>: 这个字段指定启动系统是是否通过 fsck 来检查文件系统的完整性。0 表示 fsck 不对文件系统进行检查。数字越大,优先级越低。因此,根分区(/)最可能使用数字 1,其他所有需要检查的分区则是以数字 2.

|

||||

|

||||

**Mount 命令例示**

|

||||

|

||||

@ -211,7 +201,7 @@ mount 命令会尝试寻找挂载点,如果找不到就会查找设备(上

|

||||

|

||||

LABEL=TECMINT /mnt ext4 rw,noexec 0 0

|

||||

|

||||

2. 若你想在系统启动时挂载 DVD 光驱中的内容,添加已下语句。

|

||||

2. 若你想在系统启动时挂载 DVD 光驱中的内容,添加以下语句。

|

||||

|

||||

/dev/sr0 /media/cdrom0 iso9660 ro,user,noauto 0 0

|

||||

|

||||

@ -219,7 +209,7 @@ mount 命令会尝试寻找挂载点,如果找不到就会查找设备(上

|

||||

|

||||

### 总结 ###

|

||||

|

||||

可以放心,在命令行中挂载/卸载本地和网络文件系统将是你作为系统管理员的日常责任的一部分。同时,你需要掌握 /etc/fstab 文件的编写。希望本文对你有帮助。随时在下边发表评论(或者提问),并分享本文到你的朋友圈。

|

||||

不用怀疑,在命令行中挂载/卸载本地和网络文件系统将是你作为系统管理员的日常责任的一部分。同时,你需要掌握 /etc/fstab 文件的编写。希望本文对你有帮助。随时在下边发表评论(或者提问),并分享本文到你的朋友圈。

|

||||

|

||||

|

||||

参考链接

|

||||

@ -234,7 +224,7 @@ via: http://www.tecmint.com/mount-filesystem-in-linux/

|

||||

|

||||

作者:[Gabriel Cánepa][a]

|

||||

译者:[GHLandy](https://github.com/GHLandy)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,110 +0,0 @@

|

||||

alim0x translating

|

||||

|

||||

8 things to do after installing openSUSE Leap 42.1

|

||||

================================================================================

|

||||

|

||||

Credit: [Metropolitan Transportation/Flicrk][1]

|

||||

|

||||

> You've installed openSUSE on your PC. Here's what to do next.

|

||||

|

||||

[openSUSE Leap is indeed a huge leap][2], allowing users to run a distro that has the same DNA of SUSE Linux Enterprise. Like any other operating system, some work is needed to get it set up for optimal use.

|

||||

|

||||

Following are some of the things that I did after installing openSUSE Leap on my PC (these are not applicable for server installations). None of them are mandatory, and you may be fine with the basic install. But if you need more out of your openSUSE Leap, follow me.

|

||||

|

||||

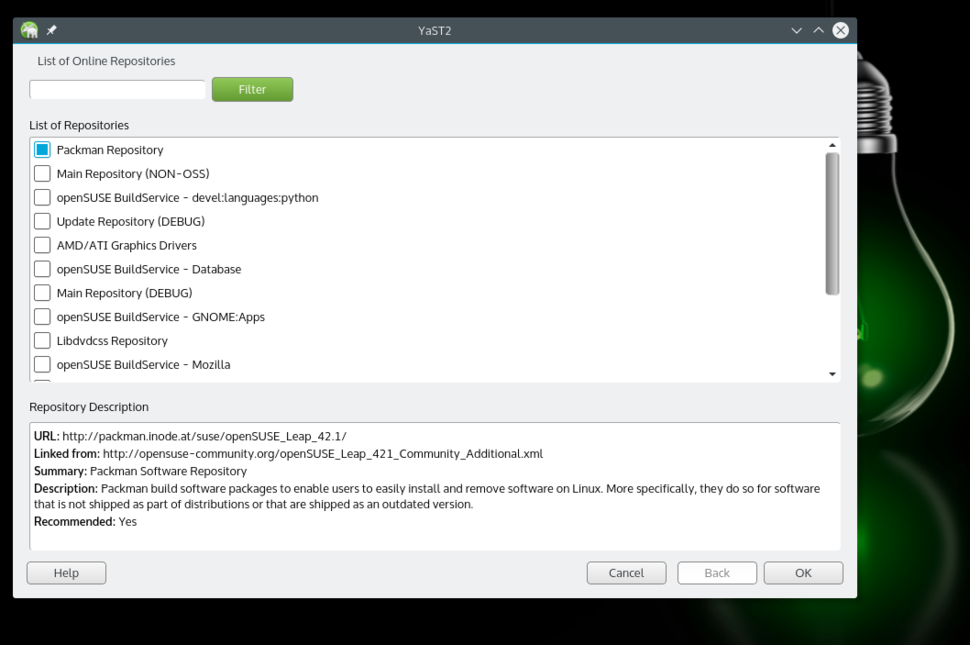

### 1. Adding Packman repository ###

|

||||

|

||||

Due to software patents and licences, openSUSE, like many Linux distributions, doesn't offer many applications, codecs, and drivers through official repositories (repos). Instead, these are made available through 3rd party or community repos. The first and most important repository is 'Packman'. Since these repos are not enabled by default, we have to add them. You can do so either using YaST (one of the gems of openSUSE) or by command line (instructions below).

|

||||

|

||||

|

||||

Adding Packman repositories.

|

||||

|

||||

Using YaST, go to the Software Repositories section. Click on the 'Add’ button and select 'Community Repositories.' Click 'next.' And once the repos are loaded, select the Packman Repository. Click 'OK,' then import the trusted GnuPG key by clicking on the 'Trust' button.

|

||||

|

||||

Or, using the terminal you can add and enable the Packman repo using the following command:

|

||||

|

||||

zypper ar -f -n packmanhttp://ftp.gwdg.de/pub/linux/misc/packman/suse/openSUSE_Leap_42.1/ packman

|

||||

|

||||

Once the repo is added, you have access to many more packages. To install any application or package, open YaST Software Manager, search for the package and install it.

|

||||

|

||||

### 2. Install VLC ###

|

||||

|

||||

VLC is the Swiss Army knife of media players and can play virtually any media file. You can install VLC from YaST Software Manager or from software.opensuse.org. You will need to install two packages: vlc and vlc-codecs.

|

||||

|

||||

If using terminal, run the following command:

|

||||

|

||||

sudo zypper install vlc vlc-codecs

|

||||

|

||||

### 3. Install Handbrake ###

|

||||

|

||||

If you need to transcode or convert your video files from one format to another, [Handbrake is the tools for you][3]. Handbrake is available through repositories we enabled, so just search for it in YaST and install.

|

||||

|

||||

If you are using the terminal, run the following command:

|

||||

|

||||

sudo zypper install handbrake-cli handbrake-gtk

|

||||

|

||||

(Pro tip: VLC can also transcode audio and video files.)

|

||||

|

||||

### 4. Install Chrome ###

|

||||

|

||||

OpenSUSE comes with Firefox as the default browser. But since Firefox isn't capable of playing restricted media such as Netflix, I recommend installing Chrome. This takes some extra work. First you need to import the trusted key from Google. Open the terminal app and run the 'wget' command to download the key:

|

||||

|

||||

wget https://dl.google.com/linux/linux_signing_key.pub

|

||||

|

||||

Then import the key:

|

||||

|

||||

sudo rpm --import linux_signing_key.pub

|

||||

|

||||

Now head over to the [Google Chrome website][4] and download the 64 bit .rpm file. Once downloaded run the following command to install the browser:

|

||||

|

||||

sudo zypper install /PATH_OF_GOOGLE_CHROME.rpm

|

||||

|

||||

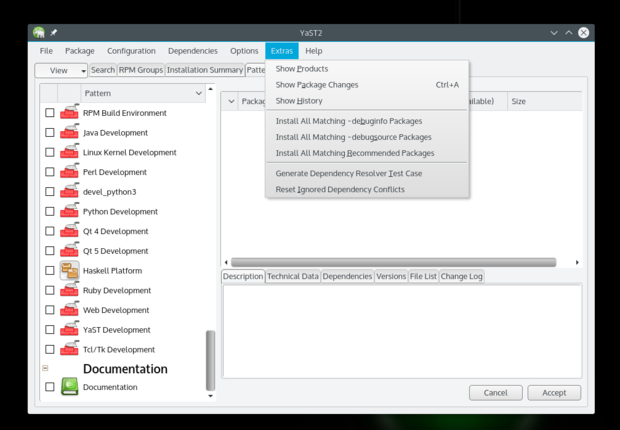

### 5. Install Nvidia drivers ###

|

||||

|

||||

OpenSUSE Leap will work out of the box even if you have Nvidia or ATI graphics cards. However, if you do need the proprietary drivers for gaming or any other purpose, you can install such drivers, but some extra work is needed.

|

||||

|

||||

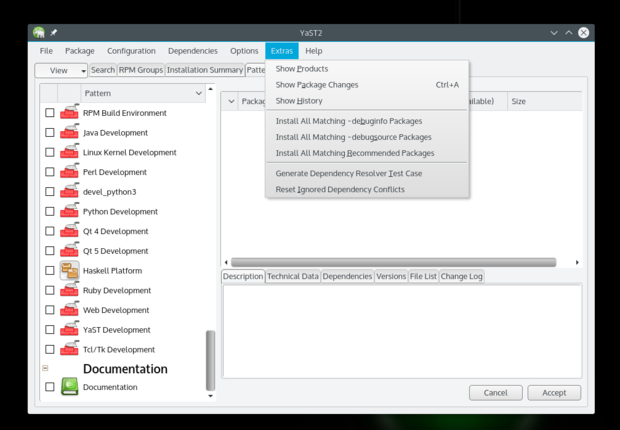

First you need to add the Nvidia repositories; it's the same procedure we used to add Packman repositories using YaST. The only difference is that you will choose Nvidia from the Community Repositories section. Once it's added, go to **Software Management > Extras** and select 'Extras/Install All Matching Recommended Packages'.

|

||||

|

||||

|

||||

|

||||

It will open a dialogue box showing all the packages it's going to install, click OK and follow the instructions. You can also run the following command after adding the Nvidia repository to install the needed Nvidia drivers:

|

||||

|

||||

sudo zypper inr

|

||||

|

||||

(Note: I have never used AMD/ATI cards so I have no experience with them.)

|

||||

|

||||

### 6. Install media codecs ###

|

||||

|

||||

Once you have VLC installed you won't need to install media codecs, but if you are using other apps for media playback you will need to install such codecs. Some developers have written scripts/tools which makes it a much easier process. Just go to [this page][5] and install the entire pack by clicking on the appropriate button. It will open YaST and install the packages automatically (of source you will have to give the root password and trust the GnuPG key, as usual).

|

||||

|

||||

### 7. Install your preferred email client ###

|

||||

|

||||

OpenSUSE comes with Kmail or Evolution, depending on the Desktop Environment you installed on the system. I run Plasma, which comes with Kmail, and this email client leaves a lot to be desired. I suggest trying Thunderbird or Evolution mail. All major email clients are available through official repositories. You can also check my [handpicked list of the best email clients for Linux][7].

|

||||

|

||||

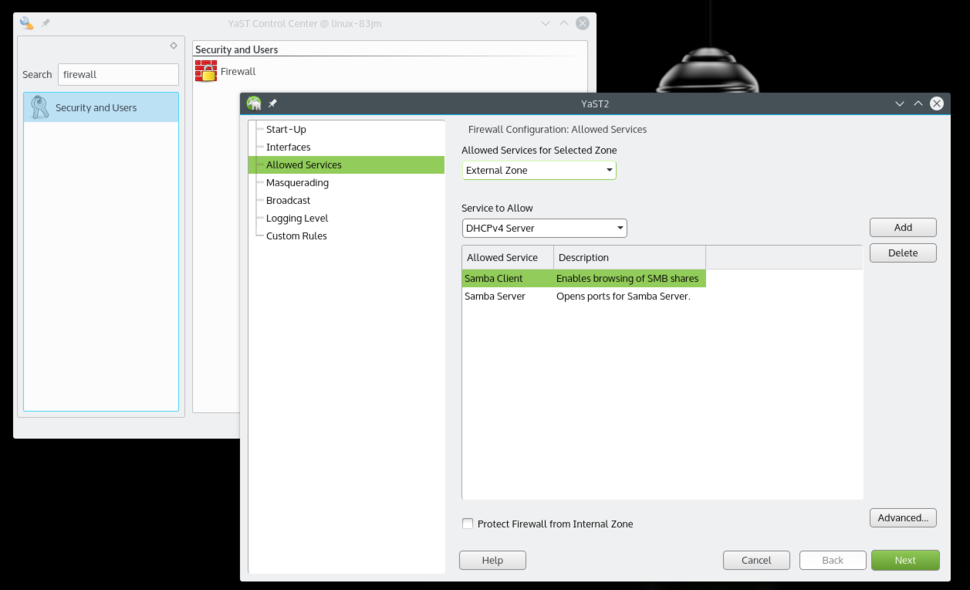

### 8. Enable Samba services from Firewall ###

|

||||

|

||||

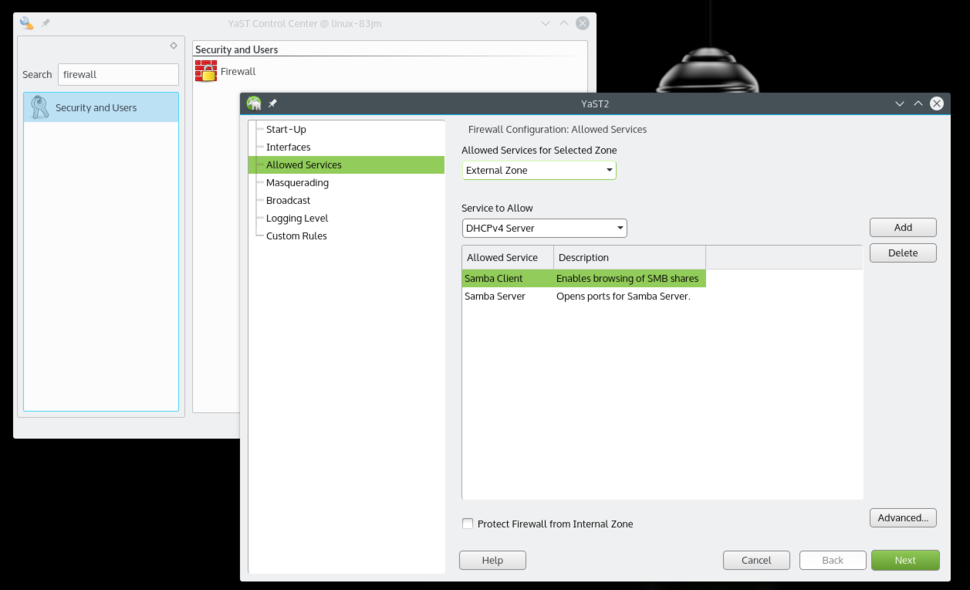

OpenSUSE offers a much more secure system out of the box, compared to other distributions. But it also requires a little bit more work for a new user. If you are using Samba protocol to share files within your local network then you will have to allow that service from the Firewall.

|

||||

|

||||

|

||||

Allow Samba Client and Server from Firewall settings.

|

||||

|

||||

Open YaST and search for Firewall. Once in Firewall settings, go to 'Allowed Services' where you will see a drop down list under 'Service to allow.' Select 'Samba Client,' then click 'Add.' Do the same with the 'Samba Server' option. Once both are added, click 'Next,' then click 'Finish,' and now you will be able to share folders from your openSUSE system and also access other machines over the local network.

|

||||

|

||||

That's pretty much all that I did on my new openSUSE system to set it up just the way I like it. If you have any questions, please feel free to ask in the comments below.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.itworld.com/article/3003865/open-source-tools/8-things-to-do-after-installing-opensuse-leap-421.html

|

||||

|

||||

作者:[Swapnil Bhartiya][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.itworld.com/author/Swapnil-Bhartiya/

|

||||

[1]:https://www.flickr.com/photos/mtaphotos/11200079265/

|

||||

[2]:https://www.linux.com/news/software/applications/865760-opensuse-leap-421-review-the-most-mature-linux-distribution

|

||||

[3]:https://www.linux.com/learn/tutorials/857788-how-to-convert-videos-in-linux-using-the-command-line

|

||||

[4]:https://www.google.com/intl/en/chrome/browser/desktop/index.html#brand=CHMB&utm_campaign=en&utm_source=en-ha-na-us-sk&utm_medium=ha

|

||||

[5]:http://opensuse-community.org/

|

||||

[6]:http://www.itworld.com/article/2875981/the-5-best-open-source-email-clients-for-linux.html

|

||||

@ -1,217 +0,0 @@

|

||||

Vic020

|

||||

|

||||

How to use Python to hack your Eclipse IDE

|

||||

==============================================

|

||||

|

||||

|

||||

|

||||

The Eclipse Advanced Scripting Environment ([EASE][1]) project is a new but powerful set of plugins that enables you to quickly hack your Eclipse IDE.

|

||||

|

||||

Eclipse is a powerful framework that can be extended in many different ways by using its built-in plugin mechanism. However, writing and deploying a new plugin can be cumbersome if all you want is a bit of additional functionality. Now, using EASE, there's a better way to do that, without having to write a single line of Java code. EASE provides a way to easily automate workbench functionality using scripting languages such as Python or Javascript.

|

||||

|

||||

In this article, based on my [talk][2] at EclipseCon North America this year, I'll cover the basics of how to set up your Eclipse environment with Python and EASE and look at a few ideas to supercharge your IDE with the power of Python.

|

||||

|

||||

### Setup and run "Hello World"

|

||||

|

||||

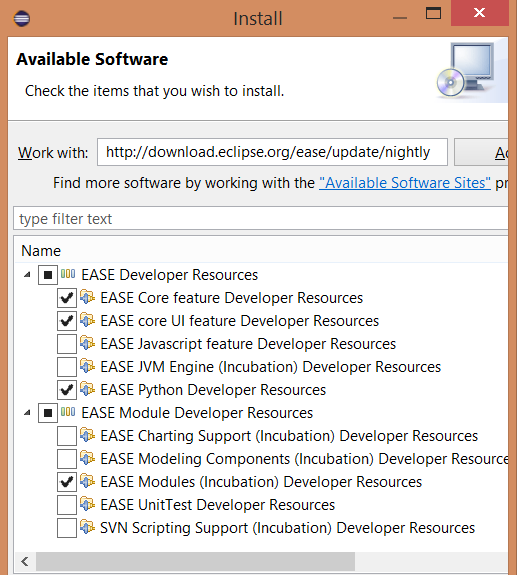

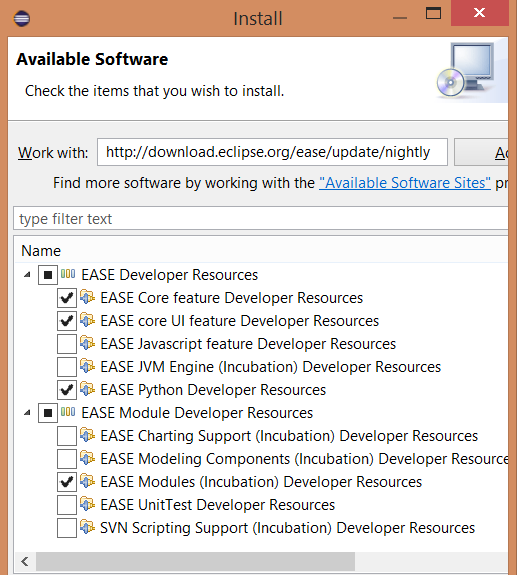

The examples in this article are based on the Java-implementation of Python, Jython. You can install EASE directly into your existing Eclipse IDE. In this example we use Eclipse [Mars][3] and install EASE itself, its modules and the Jython engine.

|

||||

|

||||

From within the Eclipse Install Dialog (`Help>Install New Software`...), install EASE: [http://download.eclipse.org/ease/update/nightly][4]

|

||||

|

||||

And, select the following components:

|

||||

|

||||

- EASE Core feature

|

||||

|

||||

- EASE core UI feature

|

||||

|

||||

- EASE Python Developer Resources

|

||||

|

||||

- EASE modules (Incubation)

|

||||

|

||||

This will give you EASE and its modules. The main one we are interested in is the Resource module that gives you access to the Eclipse workspace, projects, and files API.

|

||||

|

||||

|

||||

|

||||

|

||||

After those have been successfully installed, next install the EASE Jython engine: [https://dl.bintray.com/pontesegger/ease-jython/][5]. Once the plugins are installed, test EASE out. Create a new project and add in a new file called hello.py with this content:

|

||||

|

||||

```

|

||||

print "hello world"

|

||||

```

|

||||

|

||||

Select the file, right click, and select 'Run as -> EASE script'. You should see "Hello World" appear in the console.

|

||||

|

||||

Now you can start writing Python scripts that can access the workspace and projects. This power can be used for all sorts of hacks, below are just a few ideas.

|

||||

|

||||

### Improve your code quality

|

||||

|

||||

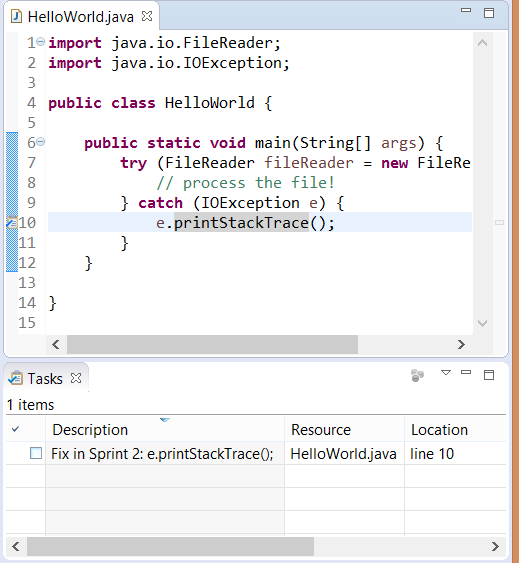

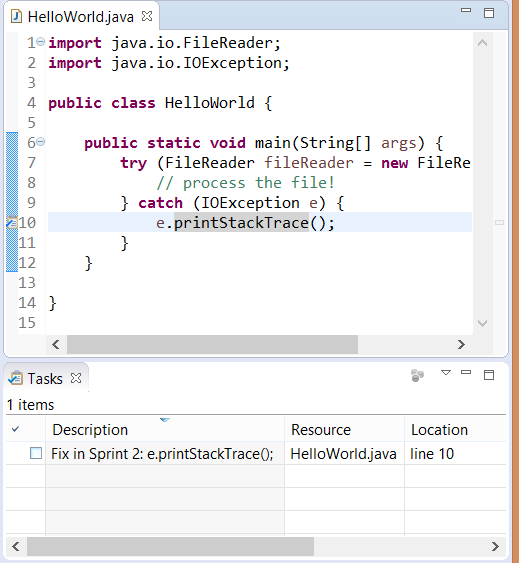

Maintaining good code quality can be a tiresome job especially when dealing with a large codebase or when lots of developers are involved. Some of this pain can be made easier with a script, such as for batch formatting for a set of files, or even fixing certain files to [remove unix line endings][6] for easy comparison in source control like git. Another nice thing to do is use a script to generate Eclipse markers to highlight code that could do with improving. Here's an example script that you could use to add task markers for all "printStackTrace" methods it detects in Java files. See the source code: [markers.py][7]

|

||||

|

||||

To run, copy the file to your workspace, then right click and select 'Run as -> EASE script'.

|

||||

|

||||

```

|

||||

loadModule('/System/Resources')

|

||||

```

|

||||

|

||||

from org.eclipse.core.resources import IMarker

|

||||

|

||||

```

|

||||

for ifile in findFiles("*.java"):

|

||||

file_name = str(ifile.getLocation())

|

||||

print "Processing " + file_name

|

||||

with open(file_name) as f:

|

||||

for line_no, line in enumerate(f, start=1):

|

||||

if "printStackTrace" in line:

|

||||

marker = ifile.createMarker(IMarker.TASK)

|

||||

marker.setAttribute(IMarker.TRANSIENT, True)

|

||||

marker.setAttribute(IMarker.LINE_NUMBER, line_no)

|

||||

marker.setAttribute(IMarker.MESSAGE, "Fix in Sprint 2: " + line.strip())

|

||||

|

||||

```

|

||||

|

||||

If you have any java files with printStackTraces you will be able to see the newly created markers in the Tasks view and in the editor margin.

|

||||

|

||||

|

||||

|

||||

### Automate tedious tasks

|

||||

|

||||

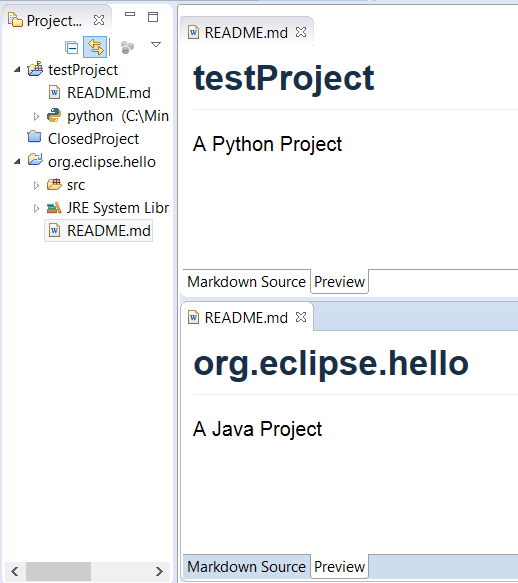

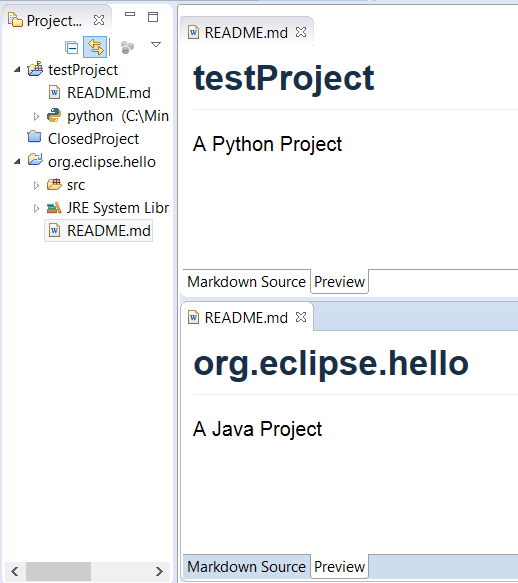

When you are working with several projects you may want to automate some tedious, repetitive tasks. Perhaps you need to add in a copyright header to the beginning of each source file, or update source files when adopting a new framework. For instance, when we first switched to using Tycho and Maven, we had to add a pom.xml to each project. This is easily done using a few lines of Python. Then when Tycho provided support for pom-less builds, we wanted to remove unnecessary pom files. Again, a few lines of Python script enabled this. As an example, here is a script which adds a README.md file to every open project in your workspace, noting if they are Java or Python projects. See the source code: [add_readme.py][8].

|

||||

|

||||

To run, copy the file to your workspace, then right click and select 'Run as -> EASE script'.

|

||||

|

||||

loadModule('/System/Resources')

|

||||

|

||||

```

|

||||

for iproject in getWorkspace().getProjects():

|

||||

if not iproject.isOpen():

|

||||

continue

|

||||

|

||||

ifile = iproject.getFile("README.md")

|

||||

|

||||

if not ifile.exists():

|

||||

contents = "# " + iproject.getName() + "\n\n"

|

||||

if iproject.hasNature("org.eclipse.jdt.core.javanature"):

|

||||

contents += "A Java Project\n"

|

||||

elif iproject.hasNature("org.python.pydev.pythonNature"):

|

||||

contents += "A Python Project\n"

|

||||

writeFile(ifile, contents)

|

||||

```

|

||||

|

||||

The result should be that every open project will have a README.md file, with Java and Python projects having an additional descriptive line.

|

||||

|

||||

|

||||

|

||||

### Prototype new features

|

||||

|

||||

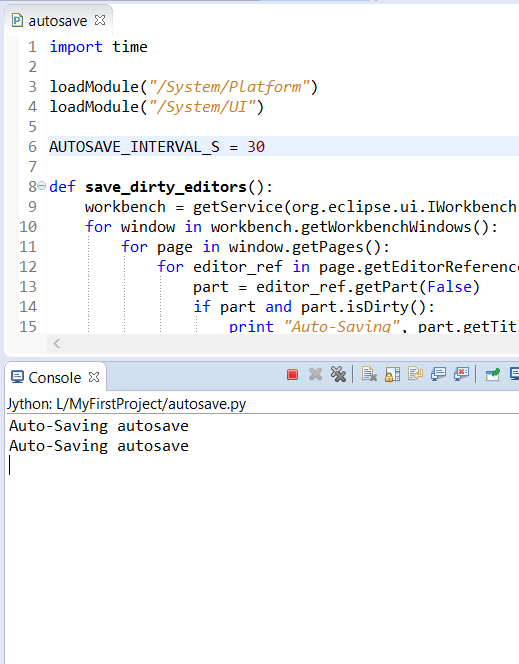

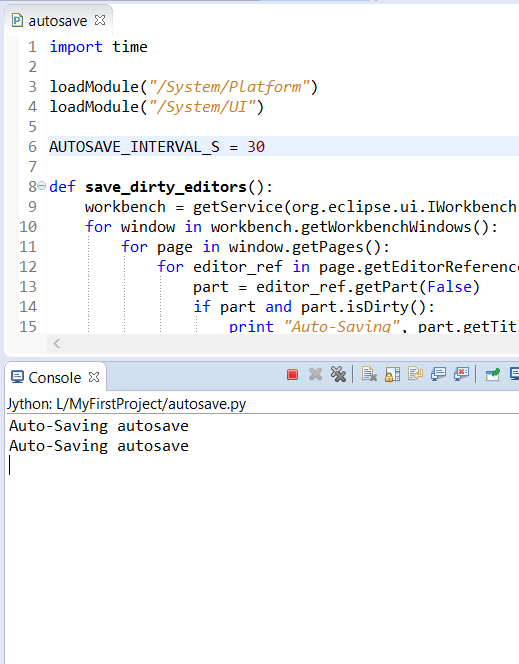

You can also use a Python script to hack a quick-fix for some much wanted functionality, or as a prototype to help demonstrate to your team or users how you envision a feature. For instance, one feature Eclipse IDE doesn't currently support is auto-save on the current file you are working on. Although this feature is in the works for future releases, you can have a quick and dirty version that autosaves every 30 seconds or when the editor is deactivated. Below is a snippet of the main method. See the full source: [autosave.py][9]

|

||||

|

||||

```

|

||||

def save_dirty_editors():

|

||||

workbench = getService(org.eclipse.ui.IWorkbench)

|

||||

for window in workbench.getWorkbenchWindows():

|

||||

for page in window.getPages():

|

||||

for editor_ref in page.getEditorReferences():

|

||||

part = editor_ref.getPart(False)

|

||||

if part and part.isDirty():

|

||||

print "Auto-Saving", part.getTitle()

|

||||

part.doSave(None)

|

||||

```

|

||||

|

||||

Before running this script you will need to turn on the 'Allow Scripts to run code in UI thread' setting by checking the box under Window > Preferences > Scripting. Then you can add the file to your workspace, right click on it and select 'Run As>EASE Script'. A save message is printed out in the Console view every time an editor is saved. To turn off the autosave just stop the script by pressing the 'Terminate' red square button in the Console view.

|

||||

|

||||

|

||||

|

||||

### Quickly extend the user interface with custom buttons, menus, etc

|

||||

|

||||

One of the best things about EASE is that it allows you to take your scripts and quickly hook them into UI elements of the IDE, for example, as a new button or new menu item. No need to write Java or have a new plugin, just add a couple of lines to your script header—it's that simple.

|

||||

|

||||

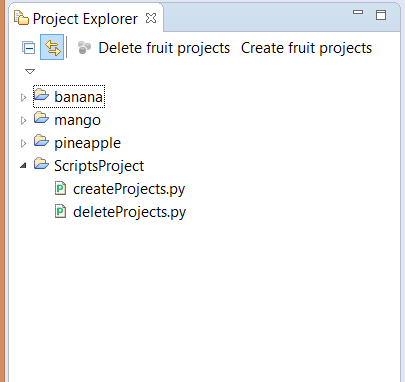

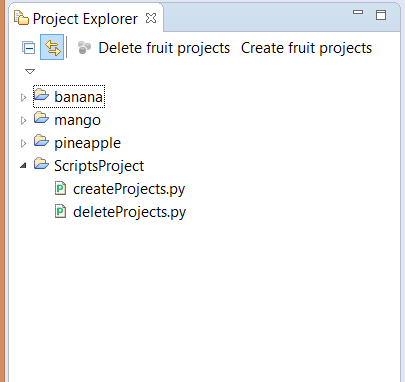

Here's an example for a simplistic script that creates us three new projects.

|

||||

|

||||

```

|

||||

# name : Create fruit projects

|

||||

# toolbar : Project Explorer

|

||||

# description : Create fruit projects

|

||||

|

||||

loadModule("/System/Resources")

|

||||

|

||||

for name in ["banana", "pineapple", "mango"]:

|

||||

createProject(name)

|

||||

```

|

||||

|

||||

The comment lines specify to EASE to add a button to the Project Explorer toolbar. Here's another script that adds a button to the same toolbar to delete those three projects. See the source files: [createProjects.py][10] and [deleteProjects.py][11]

|

||||

|

||||

```

|

||||

# name :Delete fruit projects

|

||||

# toolbar : Project Explorer

|

||||

# description : Get rid of the fruit projects

|

||||

|

||||

loadModule("/System/Resources")

|

||||

|

||||

for name in ["banana", "pineapple", "mango"]:

|

||||

project = getProject(name)

|

||||

project.delete(0, None)

|

||||

```

|

||||

|

||||

To get the buttons to appear, add the two script files to a new project—let's call it 'ScriptsProject'. Then go to Windows > Preference > Scripting > Script Locations. Click on the 'Add Workspace' button and select the ScriptsProject. This project now becomes a default location for locating script files. You should see the buttons show up in the Project Explorer without needing to restart your IDE. You should be able to quickly create and delete the projects using your newly added buttons.

|

||||

|

||||

|

||||

|

||||

### Integrate with third-party tools

|

||||

|

||||

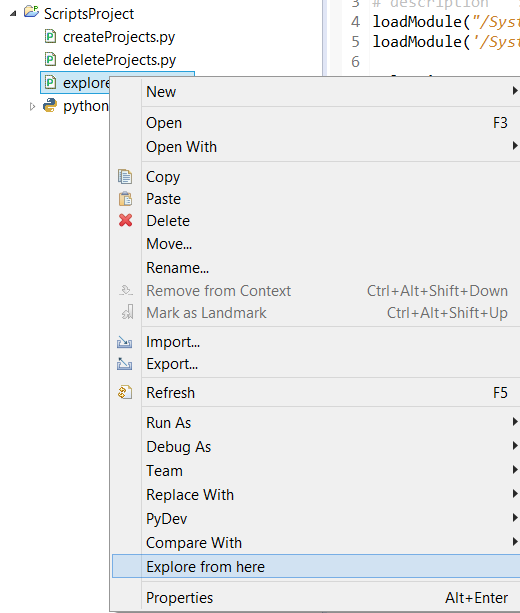

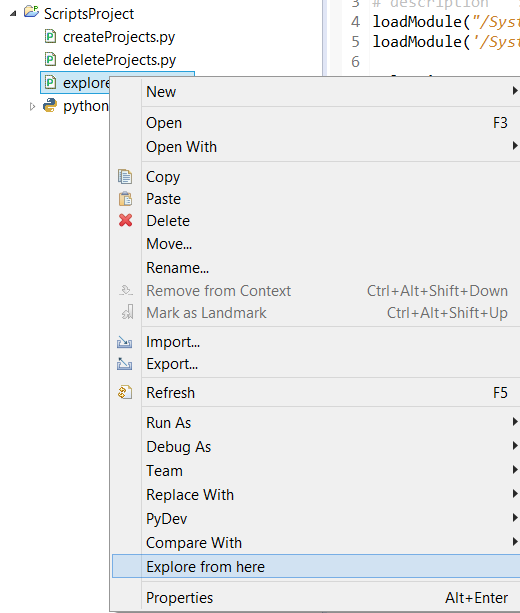

Every now and then you may need to use a tool outside the Eclipse ecosystem (sad but true, it has a lot but it does not do everything). For those occasions it might be quite handy to wrap calling that call to the tool in a script. Here's an example that allows you to integrate with explorer.exe, and add it to the content menu so you could instantly open a file browser using the current selection. See the source code: [explorer.py][12]

|

||||

|

||||

```

|

||||

# name : Explore from here

|

||||

# popup : enableFor(org.eclipse.core.resources.IResource)

|

||||

# description : Start a file browser using current selection

|

||||

loadModule("/System/Platform")

|

||||

loadModule('/System/UI')

|

||||

|

||||

selection = getSelection()

|

||||

if isinstance(selection, org.eclipse.jface.viewers.IStructuredSelection):

|

||||

selection = selection.getFirstElement()

|

||||

|

||||

if not isinstance(selection, org.eclipse.core.resources.IResource):

|

||||

selection = adapt(selection, org.eclipse.core.resources.IResource)

|

||||

|

||||

if isinstance(selection, org.eclipse.core.resources.IFile):

|

||||

selection = selection.getParent()

|

||||

|

||||

if isinstance(selection, org.eclipse.core.resources.IContainer):

|

||||

runProcess("explorer.exe", [selection.getLocation().toFile().toString()])

|

||||

```

|

||||

|

||||

To get the menu to appear, add the script to a new project—let's call it 'ScriptsProject'. Then go to Windows > Preference > Scripting > Script Locations. Click on the 'Add Workspace' button and select the ScriptsProject. You should see the new menu item show up in the context menu when you right-click on a file. Select this action to bring up a file browser. (Note this functionality already exists in Eclipse but this example is one you could adapt to other third-party tools).

|

||||

|

||||

|

||||

|

||||

The Eclipse Advanced Scripting Environment provides a great way to get more out of your Eclipse IDE by leveraging the power of Python. It is a project in its infancy so there is so much more to come. Learn more [about the project][13] and get involved by signing up for the [forum][14].

|

||||

|

||||

I'll be talking more about EASE at [Eclipsecon North America][15] 2016. My talk [Scripting Eclipse with Python][16] will go into how you can use not just Jython, but C-Python and how this functionality can be extended specifically for scientific use-cases.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/life/16/2/how-use-python-hack-your-ide

|

||||

|

||||

作者:[Tracy Miranda][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/tracymiranda

|

||||

[1]: https://eclipse.org/ease/

|

||||

[2]: https://www.eclipsecon.org/na2016/session/scripting-eclipse-python

|

||||

[3]: https://www.eclipse.org/downloads/packages/eclipse-ide-eclipse-committers-451/mars1

|

||||

[4]: http://download.eclipse.org/ease/update/nightly

|

||||

[5]: https://dl.bintray.com/pontesegger/ease-jython/

|

||||

[6]: http://code.activestate.com/recipes/66434-change-line-endings/

|

||||

[7]: https://gist.github.com/tracymiranda/6556482e278c9afc421d

|

||||

[8]: https://gist.github.com/tracymiranda/f20f233b40f1f79b1df2

|

||||

[9]: https://gist.github.com/tracymiranda/e9588d0976c46a987463

|

||||

[10]: https://gist.github.com/tracymiranda/55995daaea9a4db584dc

|

||||

[11]: https://gist.github.com/tracymiranda/baa218fc2c1a8e898194

|

||||

[12]: https://gist.github.com/tracymiranda/8aa3f0fc4bf44f4a5cd3

|

||||

[13]: https://eclipse.org/ease/

|

||||

[14]: https://dev.eclipse.org/mailman/listinfo/ease-dev

|

||||

[15]: https://www.eclipsecon.org/na2016

|

||||

[16]: https://www.eclipsecon.org/na2016/session/scripting-eclipse-python

|

||||

@ -1,3 +1,4 @@

|

||||

Translating By willowyoung

|

||||

Image processing at NASA with open source tools

|

||||

=======================================================

|

||||

|

||||

|

||||

@ -0,0 +1,206 @@

|

||||

Part 11 - How to Manage and Create LVM Using vgcreate, lvcreate and lvextend Commands

|

||||

============================================================================================

|

||||

|

||||

Because of the changes in the LFCS exam requirements effective Feb. 2, 2016, we are adding the necessary topics to the [LFCS series][1] published here. To prepare for this exam, your are highly encouraged to use the [LFCE series][2] as well.

|

||||

|

||||

|

||||

>LFCS: Manage LVM and Create LVM Partition – Part 11

|

||||

|

||||

One of the most important decisions while installing a Linux system is the amount of storage space to be allocated for system files, home directories, and others. If you make a mistake at that point, growing a partition that has run out of space can be burdensome and somewhat risky.

|

||||

|

||||

**Logical Volumes Management** (also known as **LVM**), which have become a default for the installation of most (if not all) Linux distributions, have numerous advantages over traditional partitioning management. Perhaps the most distinguishing feature of LVM is that it allows logical divisions to be resized (reduced or increased) at will without much hassle.

|

||||

|

||||

The structure of the LVM consists of:

|

||||

|

||||

* One or more entire hard disks or partitions are configured as physical volumes (PVs).

|

||||

* A volume group (**VG**) is created using one or more physical volumes. You can think of a volume group as a single storage unit.

|

||||

* Multiple logical volumes can then be created in a volume group. Each logical volume is somewhat equivalent to a traditional partition – with the advantage that it can be resized at will as we mentioned earlier.

|

||||

|

||||

In this article we will use three disks of **8 GB** each (**/dev/sdb**, **/dev/sdc**, and **/dev/sdd**) to create three physical volumes. You can either create the PVs directly on top of the device, or partition it first.

|

||||

|

||||

Although we have chosen to go with the first method, if you decide to go with the second (as explained in [Part 4 – Create Partitions and File Systems in Linux][3] of this series) make sure to configure each partition as type `8e`.

|

||||

|

||||

### Creating Physical Volumes, Volume Groups, and Logical Volumes

|

||||

|

||||

To create physical volumes on top of **/dev/sdb**, **/dev/sdc**, and **/dev/sdd**, do:

|

||||

|

||||

```

|

||||

# pvcreate /dev/sdb /dev/sdc /dev/sdd

|

||||

```

|

||||

|

||||

You can list the newly created PVs with:

|

||||

|

||||

```

|

||||

# pvs

|

||||

```

|

||||

|

||||

and get detailed information about each PV with:

|

||||

|

||||

```

|

||||

# pvdisplay /dev/sdX

|

||||

```

|

||||

|

||||

(where **X** is b, c, or d)

|

||||

|

||||

If you omit `/dev/sdX` as parameter, you will get information about all the PVs.

|

||||

|

||||

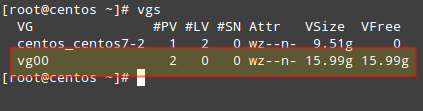

To create a volume group named `vg00` using `/dev/sdb` and `/dev/sdc` (we will save `/dev/sdd` for later to illustrate the possibility of adding other devices to expand storage capacity when needed):

|

||||

|

||||

```

|

||||

# vgcreate vg00 /dev/sdb /dev/sdc

|

||||

```

|

||||

|

||||

As it was the case with physical volumes, you can also view information about this volume group by issuing:

|

||||

|

||||

```

|

||||

# vgdisplay vg00

|

||||

```

|

||||

|

||||

Since `vg00` is formed with two **8 GB** disks, it will appear as a single **16 GB** drive:

|

||||

|

||||

|

||||

>List LVM Volume Groups

|

||||

|

||||

When it comes to creating logical volumes, the distribution of space must take into consideration both current and future needs. It is considered good practice to name each logical volume according to its intended use.

|

||||

|

||||

For example, let’s create two LVs named `vol_projects` (**10 GB**) and `vol_backups` (remaining space), which we can use later to store project documentation and system backups, respectively.

|

||||

|

||||

The `-n` option is used to indicate a name for the LV, whereas `-L` sets a fixed size and `-l` (lowercase L) is used to indicate a percentage of the remaining space in the container VG.

|

||||

|

||||

```

|

||||

# lvcreate -n vol_projects -L 10G vg00

|

||||

# lvcreate -n vol_backups -l 100%FREE vg00

|

||||

```

|

||||

|

||||

As before, you can view the list of LVs and basic information with:

|

||||

|

||||

```

|

||||

# lvs

|

||||

```

|

||||

|

||||

and detailed information with

|

||||

|

||||

```

|

||||

# lvdisplay

|

||||

```

|

||||

|

||||

To view information about a single **LV**, use **lvdisplay** with the **VG** and **LV** as parameters, as follows:

|

||||

|

||||

```

|

||||

# lvdisplay vg00/vol_projects

|

||||

```

|

||||

|

||||

|

||||

>List Logical Volume

|

||||

|

||||

In the image above we can see that the LVs were created as storage devices (refer to the LV Path line). Before each logical volume can be used, we need to create a filesystem on top of it.

|

||||

|

||||

We’ll use ext4 as an example here since it allows us both to increase and reduce the size of each LV (as opposed to xfs that only allows to increase the size):

|

||||

|

||||

```

|

||||

# mkfs.ext4 /dev/vg00/vol_projects

|

||||

# mkfs.ext4 /dev/vg00/vol_backups

|

||||

```

|

||||

|

||||

In the next section we will explain how to resize logical volumes and add extra physical storage space when the need arises to do so.

|

||||

|

||||

### Resizing Logical Volumes and Extending Volume Groups

|

||||

|

||||

Now picture the following scenario. You are starting to run out of space in `vol_backups`, while you have plenty of space available in `vol_projects`. Due to the nature of LVM, we can easily reduce the size of the latter (say **2.5 GB**) and allocate it for the former, while resizing each filesystem at the same time.

|

||||

|

||||

Fortunately, this is as easy as doing:

|

||||

|

||||

```

|

||||

# lvreduce -L -2.5G -r /dev/vg00/vol_projects

|

||||

# lvextend -l +100%FREE -r /dev/vg00/vol_backups

|

||||

```

|

||||

|

||||

|

||||

>Resize Reduce Logical Volume and Volume Group

|

||||

|

||||

It is important to include the minus `(-)` or plus `(+)` signs while resizing a logical volume. Otherwise, you’re setting a fixed size for the LV instead of resizing it.

|

||||

|

||||

It can happen that you arrive at a point when resizing logical volumes cannot solve your storage needs anymore and you need to buy an extra storage device. Keeping it simple, you will need another disk. We are going to simulate this situation by adding the remaining PV from our initial setup (`/dev/sdd`).

|

||||

|

||||

To add `/dev/sdd` to `vg00`, do

|

||||

|

||||

```

|

||||

# vgextend vg00 /dev/sdd

|

||||

```

|

||||

|

||||

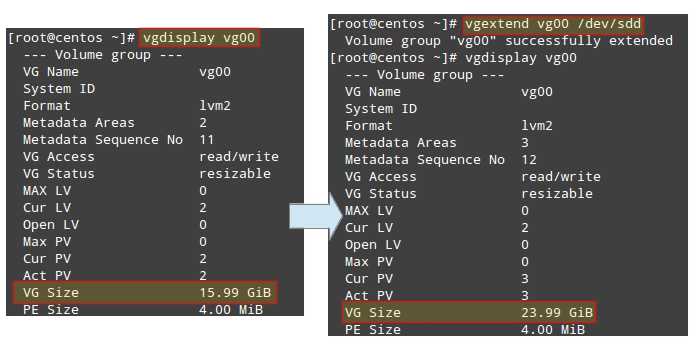

If you run vgdisplay `vg00` before and after the previous command, you will see the increase in the size of the VG:

|

||||

|

||||

```

|

||||

# vgdisplay vg00

|

||||

```

|

||||

|

||||

|

||||

>Check Volume Group Disk Size

|

||||

|

||||

Now you can use the newly added space to resize the existing LVs according to your needs, or to create additional ones as needed.

|

||||

|

||||

### Mounting Logical Volumes on Boot and on Demand

|

||||

|

||||

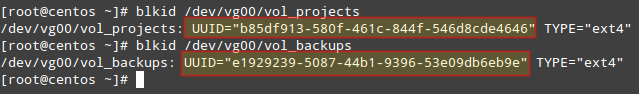

Of course there would be no point in creating logical volumes if we are not going to actually use them! To better identify a logical volume we will need to find out what its `UUID` (a non-changing attribute that uniquely identifies a formatted storage device) is.

|

||||

|

||||

To do that, use blkid followed by the path to each device:

|

||||

|

||||

```

|

||||

# blkid /dev/vg00/vol_projects

|

||||

# blkid /dev/vg00/vol_backups

|

||||

```

|

||||

|

||||

|

||||

>Find Logical Volume UUID

|

||||

|

||||

Create mount points for each LV:

|

||||

|

||||

```

|

||||

# mkdir /home/projects

|

||||

# mkdir /home/backups

|

||||

```

|

||||

|

||||

and insert the corresponding entries in `/etc/fstab` (make sure to use the UUIDs obtained before):

|

||||

|

||||

```

|

||||

UUID=b85df913-580f-461c-844f-546d8cde4646 /home/projects ext4 defaults 0 0

|

||||

UUID=e1929239-5087-44b1-9396-53e09db6eb9e /home/backups ext4 defaults 0 0

|

||||

```

|

||||

|

||||

Then save the changes and mount the LVs:

|

||||

|

||||

```

|

||||

# mount -a

|

||||

# mount | grep home

|

||||

```

|

||||

|

||||

|

||||

>Find Logical Volume UUID

|

||||

|

||||

When it comes to actually using the LVs, you will need to assign proper `ugo+rwx` permissions as explained in [Part 8 – Manage Users and Groups in Linux][4] of this series.

|

||||

|

||||

### Summary

|

||||

|

||||

In this article we have introduced [Logical Volume Management][5], a versatile tool to manage storage devices that provides scalability. When combined with RAID (which we explained in [Part 6 – Create and Manage RAID in Linux][6] of this series), you can enjoy not only scalability (provided by LVM) but also redundancy (offered by RAID).

|

||||

|

||||

In this type of setup, you will typically find `LVM` on top of `RAID`, that is, configure RAID first and then configure LVM on top of it.

|

||||

|

||||

If you have questions about this article, or suggestions to improve it, feel free to reach us using the comment form below.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.tecmint.com/linux-basic-shell-scripting-and-linux-filesystem-troubleshooting/

|

||||

|

||||

作者:[Gabriel Cánepa][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: http://www.tecmint.com/author/gacanepa/

|

||||

[1]: http://www.tecmint.com/sed-command-to-create-edit-and-manipulate-files-in-linux/

|

||||

[2]: http://www.tecmint.com/installing-network-services-and-configuring-services-at-system-boot/

|

||||

[3]: http://www.tecmint.com/create-partitions-and-filesystems-in-linux/

|

||||

[4]: http://www.tecmint.com/manage-users-and-groups-in-linux/

|

||||

[5]: http://www.tecmint.com/create-lvm-storage-in-linux/

|

||||

[6]: http://www.tecmint.com/creating-and-managing-raid-backups-in-linux/

|

||||

@ -0,0 +1,273 @@

|

||||

Part 14 - Monitor Linux Processes Resource Usage and Set Process Limits on a Per-User Basis

|

||||

=============================================================================================

|

||||

|

||||

Because of the changes in the LFCS exam requirements effective Feb. 2, 2016, we are adding the necessary topics to the [LFCS series][1] published here. To prepare for this exam, your are highly encouraged to use the [LFCE series][2] as well.

|

||||

|

||||

|

||||

>Monitor Linux Processes and Set Process Limits Per User – Part 14

|

||||

|

||||

Every Linux system administrator needs to know how to verify the integrity and availability of hardware, resources, and key processes. In addition, setting resource limits on a per-user basis must also be a part of his / her skill set.

|

||||

|

||||

In this article we will explore a few ways to ensure that the system both hardware and the software is behaving correctly to avoid potential issues that may cause unexpected production downtime and money loss.

|

||||

|

||||

### Linux Reporting Processors Statistics

|

||||

|

||||

With **mpstat** you can view the activities for each processor individually or the system as a whole, both as a one-time snapshot or dynamically.

|

||||

|

||||

In order to use this tool, you will need to install **sysstat**:

|

||||

|

||||

```

|

||||

# yum update && yum install sysstat [On CentOS based systems]

|

||||

# aptitutde update && aptitude install sysstat [On Ubuntu based systems]

|

||||

# zypper update && zypper install sysstat [On openSUSE systems]

|

||||

```

|

||||

|

||||

Read more about sysstat and it’s utilities at [Learn Sysstat and Its Utilities mpstat, pidstat, iostat and sar in Linux][3]

|

||||

|

||||

Once you have installed **mpstat**, use it to generate reports of processors statistics.

|

||||

|

||||

To display **3** global reports of CPU utilization (`-u`) for all CPUs (as indicated by `-P` ALL) at a 2-second interval, do:

|

||||

|

||||

```

|

||||

# mpstat -P ALL -u 2 3

|

||||

```

|

||||

|

||||

### Sample Output

|

||||

|

||||

```

|

||||

Linux 3.19.0-32-generic (tecmint.com) Wednesday 30 March 2016 _x86_64_ (4 CPU)

|

||||

|

||||

11:41:07 IST CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

|

||||

11:41:09 IST all 5.85 0.00 1.12 0.12 0.00 0.00 0.00 0.00 0.00 92.91

|

||||

11:41:09 IST 0 4.48 0.00 1.00 0.00 0.00 0.00 0.00 0.00 0.00 94.53

|

||||

11:41:09 IST 1 2.50 0.00 0.50 0.00 0.00 0.00 0.00 0.00 0.00 97.00

|

||||

11:41:09 IST 2 6.44 0.00 0.99 0.00 0.00 0.00 0.00 0.00 0.00 92.57

|

||||

11:41:09 IST 3 10.45 0.00 1.99 0.00 0.00 0.00 0.00 0.00 0.00 87.56

|

||||

|

||||

11:41:09 IST CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

|

||||

11:41:11 IST all 11.60 0.12 1.12 0.50 0.00 0.00 0.00 0.00 0.00 86.66

|

||||

11:41:11 IST 0 10.50 0.00 1.00 0.00 0.00 0.00 0.00 0.00 0.00 88.50

|

||||

11:41:11 IST 1 14.36 0.00 1.49 2.48 0.00 0.00 0.00 0.00 0.00 81.68

|

||||

11:41:11 IST 2 2.00 0.50 1.00 0.00 0.00 0.00 0.00 0.00 0.00 96.50

|

||||

11:41:11 IST 3 19.40 0.00 1.00 0.00 0.00 0.00 0.00 0.00 0.00 79.60

|

||||

|

||||

11:41:11 IST CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

|

||||

11:41:13 IST all 5.69 0.00 1.24 0.00 0.00 0.00 0.00 0.00 0.00 93.07

|

||||

11:41:13 IST 0 2.97 0.00 1.49 0.00 0.00 0.00 0.00 0.00 0.00 95.54

|

||||

11:41:13 IST 1 10.78 0.00 1.47 0.00 0.00 0.00 0.00 0.00 0.00 87.75

|

||||

11:41:13 IST 2 2.00 0.00 1.00 0.00 0.00 0.00 0.00 0.00 0.00 97.00

|

||||

11:41:13 IST 3 6.93 0.00 0.50 0.00 0.00 0.00 0.00 0.00 0.00 92.57

|

||||

|

||||

Average: CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

|

||||

Average: all 7.71 0.04 1.16 0.21 0.00 0.00 0.00 0.00 0.00 90.89

|

||||

Average: 0 5.97 0.00 1.16 0.00 0.00 0.00 0.00 0.00 0.00 92.87

|

||||

Average: 1 9.24 0.00 1.16 0.83 0.00 0.00 0.00 0.00 0.00 88.78

|

||||

Average: 2 3.49 0.17 1.00 0.00 0.00 0.00 0.00 0.00 0.00 95.35

|

||||

Average: 3 12.25 0.00 1.16 0.00 0.00 0.00 0.00 0.00 0.00 86.59

|

||||

```

|

||||

|

||||

To view the same statistics for a specific **CPU** (**CPU 0** in the following example), use:

|

||||

|

||||

```

|

||||

# mpstat -P 0 -u 2 3

|

||||

```

|

||||

|

||||

### Sample Output

|

||||

|

||||

```

|

||||

Linux 3.19.0-32-generic (tecmint.com) Wednesday 30 March 2016 _x86_64_ (4 CPU)

|

||||

|

||||

11:42:08 IST CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

|

||||

11:42:10 IST 0 3.00 0.00 0.50 0.00 0.00 0.00 0.00 0.00 0.00 96.50

|

||||

11:42:12 IST 0 4.08 0.00 0.00 2.55 0.00 0.00 0.00 0.00 0.00 93.37

|

||||

11:42:14 IST 0 9.74 0.00 0.51 0.00 0.00 0.00 0.00 0.00 0.00 89.74

|

||||

Average: 0 5.58 0.00 0.34 0.85 0.00 0.00 0.00 0.00 0.00 93.23

|

||||

```

|

||||

|

||||

The output of the above commands shows these columns:

|

||||

|

||||

* `CPU`: Processor number as an integer, or the word all as an average for all processors.

|

||||

* `%usr`: Percentage of CPU utilization while running user level applications.

|

||||

* `%nice`: Same as `%usr`, but with nice priority.

|

||||

* `%sys`: Percentage of CPU utilization that occurred while executing kernel applications. This does not include time spent dealing with interrupts or handling hardware.

|

||||

* `%iowait`: Percentage of time when the given CPU (or all) was idle, during which there was a resource-intensive I/O operation scheduled on that CPU. A more detailed explanation (with examples) can be found [here][4].

|

||||

* `%irq`: Percentage of time spent servicing hardware interrupts.

|

||||

* `%soft`: Same as `%irq`, but with software interrupts.

|

||||

* `%steal`: Percentage of time spent in involuntary wait (steal or stolen time) when a virtual machine, as guest, is “winning” the hypervisor’s attention while competing for the CPU(s). This value should be kept as small as possible. A high value in this field means the virtual machine is stalling – or soon will be.

|

||||

* `%guest`: Percentage of time spent running a virtual processor.

|

||||

* `%idle`: percentage of time when CPU(s) were not executing any tasks. If you observe a low value in this column, that is an indication of the system being placed under a heavy load. In that case, you will need to take a closer look at the process list, as we will discuss in a minute, to determine what is causing it.

|

||||

|

||||

To put the place the processor under a somewhat high load, run the following commands and then execute mpstat (as indicated) in a separate terminal:

|

||||

|

||||

```

|

||||

# dd if=/dev/zero of=test.iso bs=1G count=1

|

||||

# mpstat -u -P 0 2 3

|

||||

# ping -f localhost # Interrupt with Ctrl + C after mpstat below completes

|

||||

# mpstat -u -P 0 2 3

|

||||

```

|

||||

|

||||

Finally, compare to the output of **mpstat** under “normal” circumstances:

|

||||

|

||||

|

||||

>Report Linux Processors Related Statistics

|

||||

|

||||

As you can see in the image above, **CPU 0** was under a heavy load during the first two examples, as indicated by the `%idle` column.

|

||||

|

||||

In the next section we will discuss how to identify these resource-hungry processes, how to obtain more information about them, and how to take appropriate action.

|

||||

|

||||

### Reporting Linux Processes

|

||||

|

||||

To list processes sorting them by CPU usage, we will use the well known `ps` command with the `-eo` (to select all processes with user-defined format) and `--sort` (to specify a custom sorting order) options, like so:

|

||||

|

||||

```

|

||||

# ps -eo pid,ppid,cmd,%cpu,%mem --sort=-%cpu

|

||||

```

|

||||

|

||||

The above command will only show the `PID`, `PPID`, the command associated with the process, and the percentage of CPU and RAM usage sorted by the percentage of CPU usage in descending order. When executed during the creation of the .iso file, here’s the first few lines of the output:

|

||||

|

||||

|

||||

>Find Linux Processes By CPU Usage

|

||||

|

||||

Once we have identified a process of interest (such as the one with `PID=2822`), we can navigate to `/proc/PID` (`/proc/2822` in this case) and do a directory listing.

|

||||

|

||||

This directory is where several files and subdirectories with detailed information about this particular process are kept while it is running.

|

||||

|

||||

#### For example:

|

||||

|

||||

* `/proc/2822/io` contains IO statistics for the process (number of characters and bytes read and written, among others, during IO operations).

|

||||

* `/proc/2822/attr/current` shows the current SELinux security attributes of the process.

|

||||

* `/proc/2822/cgroup` describes the control groups (cgroups for short) to which the process belongs if the CONFIG_CGROUPS kernel configuration option is enabled, which you can verify with:

|

||||

|

||||

```

|

||||

# cat /boot/config-$(uname -r) | grep -i cgroups

|

||||

```

|

||||

|

||||

If the option is enabled, you should see:

|

||||

|

||||

```

|

||||

CONFIG_CGROUPS=y

|

||||

```

|

||||

|

||||

Using `cgroups` you can manage the amount of allowed resource usage on a per-process basis as explained in Chapters 1 through 4 of the [Red Hat Enterprise Linux 7 Resource Management guide][5], in Chapter 9 of the [openSUSE System Analysis and Tuning guide][6], and in the [Control Groups section of the Ubuntu 14.04 Server documentation][7].

|

||||

|

||||

The `/proc/2822/fd` is a directory that contains one symbolic link for each file descriptor the process has opened. The following image shows this information for the process that was started in tty1 (the first terminal) to create the **.iso** image:

|

||||

|

||||

|

||||

>Find Linux Process Information

|

||||

|

||||

The above image shows that **stdin** (file descriptor **0**), **stdout** (file descriptor **1**), and **stderr** (file descriptor **2**) are mapped to **/dev/zero**, **/root/test.iso**, and **/dev/tty1**, respectively.

|

||||

|

||||

More information about `/proc` can be found in “The `/proc` filesystem” document kept and maintained by Kernel.org, and in the Linux Programmer’s Manual.

|

||||

|

||||

### Setting Resource Limits on a Per-User Basis in Linux

|

||||

|

||||

If you are not careful and allow any user to run an unlimited number of processes, you may eventually experience an unexpected system shutdown or get locked out as the system enters an unusable state. To prevent this from happening, you should place a limit on the number of processes users can start.

|

||||

|

||||

To do this, edit **/etc/security/limits.conf** and add the following line at the bottom of the file to set the limit:

|

||||

|

||||

```

|

||||

* hard nproc 10

|

||||

```

|

||||

|

||||

The first field can be used to indicate either a user, a group, or all of them `(*)`, whereas the second field enforces a hard limit on the number of process (nproc) to **10**. To apply changes, logging out and back in is enough.

|

||||

|

||||

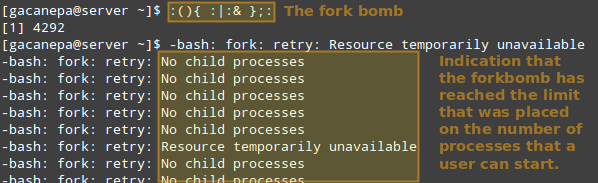

Thus, let’s see what happens if a certain user other than root (either a legitimate one or not) attempts to start a shell fork bomb. If we had not implemented limits, this would initially launch two instances of a function, and then duplicate each of them in a neverending loop. Thus, it would eventually bringing your system to a crawl.

|

||||

|

||||

However, with the above restriction in place, the fork bomb does not succeed but the user will still get locked out until the system administrator kills the process associated with it:

|

||||

|

||||

|

||||

>Run Shell Fork Bomb

|

||||

|

||||

**TIP**: Other possible restrictions made possible by **ulimit** are documented in the `limits.conf` file.

|

||||

|

||||

### Linux Other Process Management Tools

|

||||

|

||||

In addition to the tools discussed previously, a system administrator may also need to:

|

||||

|

||||

**a)** Modify the execution priority (use of system resources) of a process using **renice**. This means that the kernel will allocate more or less system resources to the process based on the assigned priority (a number commonly known as “**niceness**” in a range from `-20` to `19`).

|

||||

|

||||

The lower the value, the greater the execution priority. Regular users (other than root) can only modify the niceness of processes they own to a higher value (meaning a lower execution priority), whereas root can modify this value for any process, and may increase or decrease it.

|

||||

|

||||

The basic syntax of renice is as follows:

|

||||

|

||||

```

|

||||

# renice [-n] <new priority> <UID, GID, PGID, or empty> identifier

|

||||

```

|

||||

|

||||

If the argument after the new priority value is not present (empty), it is set to PID by default. In that case, the niceness of process with **PID=identifier** is set to `<new priority>`.

|

||||

|

||||

**b)** Interrupt the normal execution of a process when needed. This is commonly known as [“killing” the process][9]. Under the hood, this means sending the process a signal to finish its execution properly and release any used resources in an orderly manner.

|

||||

|

||||

To [kill a process][10], use the **kill** command as follows:

|

||||

|

||||

```

|

||||

# kill PID

|

||||

```

|

||||

|

||||

Alternatively, you can use [pkill to terminate all processes][11] of a given owner `(-u)`, or a group owner `(-G)`, or even those processes which have a PPID in common `(-P)`. These options may be followed by the numeric representation or the actual name as identifier:

|

||||

|

||||

```

|

||||

# pkill [options] identifier

|

||||

```

|

||||

|

||||

For example,

|

||||

|

||||

```

|

||||

# pkill -G 1000

|

||||

```

|

||||

|

||||

will kill all processes owned by group with `GID=1000`.

|

||||

|

||||

And,

|

||||

|

||||

```

|

||||

# pkill -P 4993

|

||||

```

|

||||

|

||||

will kill all processes whose `PPID is 4993`.

|

||||

|

||||

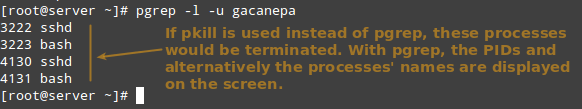

Before running a `pkill`, it is a good idea to test the results with `pgrep` first, perhaps using the `-l` option as well to list the processes’ names. It takes the same options but only returns the PIDs of processes (without taking any further action) that would be killed if `pkill` is used.

|

||||

|

||||

```

|

||||

# pgrep -l -u gacanepa

|

||||

```

|

||||

|

||||

This is illustrated in the next image:

|

||||

|

||||

|

||||

>Find User Running Processes in Linux

|

||||

|

||||

### Summary

|

||||

|

||||

In this article we have explored a few ways to monitor resource usage in order to verify the integrity and availability of critical hardware and software components in a Linux system.

|

||||

|

||||

We have also learned how to take appropriate action (either by adjusting the execution priority of a given process or by terminating it) under unusual circumstances.

|

||||

|

||||

We hope the concepts explained in this tutorial have been helpful. If you have any questions or comments, feel free to reach us using the contact form below.

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.tecmint.com/linux-basic-shell-scripting-and-linux-filesystem-troubleshooting/

|

||||

|

||||

作者:[Gabriel Cánepa][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: http://www.tecmint.com/author/gacanepa/

|

||||

[1]: http://www.tecmint.com/sed-command-to-create-edit-and-manipulate-files-in-linux/

|

||||

[2]: http://www.tecmint.com/installing-network-services-and-configuring-services-at-system-boot/

|

||||

[3]: http://www.tecmint.com/sysstat-commands-to-monitor-linux/

|

||||

[4]: http://veithen.github.io/2013/11/18/iowait-linux.html

|

||||

[5]: https://access.redhat.com/documentation/en-US/Red_Hat_Enterprise_Linux/7/html/Resource_Management_Guide/index.html

|

||||

[6]: https://doc.opensuse.org/documentation/leap/tuning/html/book.sle.tuning/cha.tuning.cgroups.html

|

||||

[7]: https://help.ubuntu.com/lts/serverguide/cgroups.html

|

||||

[8]: http://man7.org/linux/man-pages/man5/proc.5.html

|

||||

[9]: http://www.tecmint.com/kill-processes-unresponsive-programs-in-ubuntu/

|

||||

[10]: http://www.tecmint.com/find-and-kill-running-processes-pid-in-linux/

|

||||

[11]: http://www.tecmint.com/how-to-kill-a-process-in-linux/

|

||||

@ -0,0 +1,43 @@

|

||||

Ubuntu Budgie 将在 Ubuntu 16.10 中成为新官方分支发行版

|

||||

===

|

||||

|

||||

> Budgie-Remix Beta 2 已经就绪以供测试。

|

||||

|

||||

上个月我们介绍了一个新 GNU/Linux 发行版 [Budgie-Remix][1],它的终极目标是成为一个 Ubuntu 官方分支发行版,可能会使用 Ubuntu Budgie 这个名字。

|

||||

|

||||

|

||||

|

||||

今天,Budgie-Remix 的开发者 David Mohammed 向 Softpedia 通报了项目进度,以及为即将到来的 16.04 发布的第二个 Beta 版本。Cononical 的创始人 [Mark Shuttleworth 说过][2]如果能够有围绕这个包的社区,它肯定会得到支持。

|

||||

|

||||

自我们[最初的报道][3]以来,David Mohammed 似乎与 Ubuntu MATE 项目的领导者 Martin Wimpress 取得了联系,后者敦促他以 Ubuntu 16.10 作为他还未正式命名的 Ubuntu 分支的官方版本目标。这个分支发行版构建于 Budgie 桌面环境之上,它是超赞的 [Solus][4] 开发者团队创建的。

|

||||

|

||||

“我们本周完成了 Beta 2 版本的开发以及很多其它东西,而且我们还有 Martin Wimpress (Ubuntu MATE 项目领导者)的支持,”David Mohammed 对 Softpedia 独家爆料。”他还敦促我们以 16.10 作为成为官方版本的目标——那当然是个主要的挑战——并且我们还需要社区的帮助/加入我们来让这一切成为现实!”

|

||||

|

||||

### Ubuntu Budgie 16.10 可能在 2016 年 10 月到来 ###

|

||||

|

||||

4 月 21 日,Canonical 将会发布 Ubuntu Linux 的下一个 LTS(Long Term Support,长期支持)版本,Xenial Xerus 好客的非洲地松鼠,也就是 Ubuntu 16.04,并且我们有可能能够以 Budgie-Remix 16.04 的名义提前尝试将成为官方分支的 Ubuntu Budgie。但在那之前,你可以帮助开发者[测试 Beta 2 版本][5]。

|

||||

|

||||

在 Ubuntu 16.04 LTS(Xenial Xerus)发布之后,Ubuntu 的开发者们就会立即将注意力转移到下一个版本的开发上。下一个版本 Ubuntu 16.10 应该会在 10 月底到来,并且 Ubuntu Budgie 也可能宣布成为 Ubuntu 官方分支发行版。

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

----------------------------------

|

||||

|

||||

via: http://news.softpedia.com/news/ubuntu-budgie-could-be-the-new-flavor-of-ubuntu-linux-as-part-of-ubuntu-16-10-502573.shtml

|

||||

|

||||

作者:Marius Nestor

|

||||

译者:[alim0x](https://github.com/alim0x)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[1]: https://launchpad.net/budgie-remix

|

||||

[2]: https://plus.google.com/+programmerslab/posts/CSvbSvgcdcv

|

||||

[3]: http://news.softpedia.com/news/budgie-remix-could-become-ubuntu-budgie-download-and-test-it-501231.shtml

|

||||

[4]: https://solus-project.com/

|

||||

[5]: https://sourceforge.net/projects/budgie-remix/files/beta2/

|

||||

@ -1,208 +1,207 @@

|

||||

10 Tips for 10x Application Performance

|

||||

|

||||

将程序性能提高十倍的10条建议

|

||||

================================================================================

|

||||

|

||||

提高web 应用的性能从来没有比现在更关键过。网络经济的比重一直在增长;全球经济超过5% 的价值是在因特网上产生的(数据参见下面的资料)。我们的永远在线、超级连接的世界意味着用户的期望值也处于历史上的最高点。如果你的网站不能及时的响应,或者你的app 不能无延时的工作,用户会很快的投奔到你的竞争对手那里。

|

||||

提高 web 应用的性能从来没有比现在更重要过。网络经济的比重一直在增长;全球经济超过 5% 的价值是在因特网上产生的(数据参见下面的资料)。这个时刻在线的超连接世界意味着用户对其的期望值也处于历史上的最高点。如果你的网站不能及时的响应,或者你的 app 不能无延时的工作,用户会很快的投奔到你的竞争对手那里。

|

||||

|

||||

举一个例子,一份亚马逊十年前做过的研究可以证明,甚至在那个时候,网页加载时间每减少100毫秒,收入就会增加1%。另一个最近的研究特别强调一个事实,即超过一半的网站拥有着在调查中说他们会因为应用程序性能的问题流失用户。

|

||||

举一个例子,一份亚马逊十年前做过的研究可以证明,甚至在那个时候,网页加载时间每减少100毫秒,收入就会增加1%。另一个最近的研究特别强调一个事实,即超过一半的网站拥有者在调查中承认它们会因为应用程序性能的问题流失用户。

|

||||

|

||||

网站到底需要多块呢?对于页面加载,每增加1秒钟就有4%的用户放弃使用。顶级的电子商务站点的页面在第一次交互时可以做到1秒到3秒加载时间,而这是提供最高舒适度的速度。很明显这种利害关系对于web 应用来说很高,而且在不断的增加。

|

||||

网站到底需要多快呢?对于页面加载,每增加1秒钟就有4%的用户放弃使用。顶级的电子商务站点的页面在第一次交互时可以做到1秒到3秒加载时间,而这是提供最高舒适度的速度。很明显这种利害关系对于 web 应用来说很高,而且在不断的增加。

|

||||

|

||||

想要提高效率很简单,但是看到实际结果很难。要在旅途上帮助你,这篇blog 会给你提供10条最高可以10倍的提升网站性能的建议。这是系列介绍提高应用程序性能的第一篇文章,包括测试充分的优化技术和一点NGIX 的帮助。这个系列给出了潜在的提高安全性的帮助。

|

||||

想要提高效率很简单,但是看到实际结果很难。为了在你的探索之旅上帮助到你,这篇文章会给你提供10条最高可以提升10倍网站性能的建议。这是系列介绍提高应用程序性能的第一篇文章,包括充分测试的优化技术和一点 NGINX 的帮助。这个系列也给出了潜在的提高安全性的帮助。

|

||||

|

||||

### Tip #1: 通过反向代理来提高性能和增加安全性 ###

|

||||

|

||||

如果你的web 应用运行在单个机器上,那么这个办法会明显的提升性能:只需要添加一个更快的机器,更好的处理器,更多的内存,更快的磁盘阵列,等等。然后新机器就可以更快的运行你的WordPress 服务器, Node.js 程序, Java 程序,以及其它程序。(如果你的程序要访问数据库服务器,那么这个办法还是很简单:添加两个更快的机器,以及在两台电脑之间使用一个更快的链路。)

|

||||

如果你的 web 应用运行在单个机器上,那么这个办法会明显的提升性能:只需要换一个更快的机器,更好的处理器,更多的内存,更快的磁盘阵列,等等。然后新机器就可以更快的运行你的 WordPress 服务器, Node.js 程序, Java 程序,以及其它程序。(如果你的程序要访问数据库服务器,那么解决方法依然很简单:添加两个更快的机器,以及在两台电脑之间使用一个更快的链路。)

|

||||

|

||||

问题是,机器速度可能并不是问题。web 程序运行慢经常是因为计算机一直在不同的任务之间切换:和用户的成千上万的连接,从磁盘访问文件,运行代码,等等。应用服务器可能会抖动-内存不足,将内存数据写会磁盘,以及多个请求等待一个任务完成,如磁盘I/O。

|

||||

问题是,机器速度可能并不是问题。web 程序运行慢经常是因为计算机一直在不同的任务之间切换:通过成千上万的连接和用户交互,从磁盘访问文件,运行代码,等等。应用服务器可能会抖动(thrashing)-比如说内存不足、将内存数据交换到磁盘,以及有多个请求要等待某个任务完成,如磁盘I/O。

|

||||

|

||||

你可以采取一个完全不同的方案来替代升级硬件:添加一个反向代理服务器来分担部分任务。[反向代理服务器][1] 位于运行应用的机器的前端,是用来处理网络流量的。只有反向代理服务器是直接连接到互联网的;和程序的通讯都是通过一个快速的内部网络完成的。

|

||||

你可以采取一个完全不同的方案来替代升级硬件:添加一个反向代理服务器来分担部分任务。[反向代理服务器][1] 位于运行应用的机器的前端,是用来处理网络流量的。只有反向代理服务器是直接连接到互联网的;和应用服务器的通讯都是通过一个快速的内部网络完成的。

|

||||

|

||||

使用反向代理服务器可以将应用服务器从等待用户与web 程序交互解放出来,这样应用服务器就可以专注于为反向代理服务器构建网页,让其能够传输到互联网上。而应用服务器就不需要在能带客户端的响应,可以运行与接近优化过的性能水平。

|

||||

使用反向代理服务器可以将应用服务器从等待用户与 web 程序交互解放出来,这样应用服务器就可以专注于为反向代理服务器构建网页,让其能够传输到互联网上。而应用服务器就不需要等待客户端的响应,其运行速度可以接近于优化后的性能水平。

|

||||

|

||||

添加方向代理服务器还可以给你的web 服务器安装带来灵活性。比如,一个已知类型的服务器已经超载了,那么就可以轻松的添加另一个相同的服务器;如果某个机器宕机了,也可以很容易的被替代。

|

||||

添加反向代理服务器还可以给你的 web 服务器安装带来灵活性。比如,一个某种类型的服务器已经超载了,那么就可以轻松的添加另一个相同的服务器;如果某个机器宕机了,也可以很容易替代一个新的。

|

||||

|

||||

因为反向代理带来的灵活性,所以方向代理也是一些性能加速功能的必要前提,比如:

|

||||

因为反向代理带来的灵活性,所以反向代理也是一些性能加速功能的必要前提,比如:

|

||||

|

||||

- **负载均衡** (参见 [Tip #2][2]) – 负载均衡运行在方向代理服务器上,用来将流量均衡分配给一批应用。有了合适的负载均衡,你就可以在不改变程序的前提下添加应用服务器。

|

||||

- **缓存静态文件** (参见 [Tip #3][3]) – 直接读取的文件,比如图像或者代码,可以保存在方向代理服务器,然后直接发给客户端,这样就可以提高速度、分担应用服务器的负载,可以让应用运行的更快

|

||||

- **网站安全** – 反响代理服务器可以提高网站安全性,以及快速的发现和响应攻击,保证应用服务器处于被保护状态。

|

||||

- **负载均衡** (参见 [Tip #2][2]) – 负载均衡运行在反向代理服务器上,用来将流量均衡分配给一批应用。有了合适的负载均衡,你就可以添加应用服务器而根本不用修改应用。

|

||||

- **缓存静态文件** (参见 [Tip #3][3]) – 直接读取的文件,比如图片或者客户端代码,可以保存在反向代理服务器,然后直接发给客户端,这样就可以提高速度、分担应用服务器的负载,可以让应用运行的更快。

|

||||

- **网站安全** – 反向代理服务器可以提高网站安全性,以及快速的发现和响应攻击,保证应用服务器处于被保护状态。

|

||||

|

||||

NGINX 软件是一个专门设计的反响代理服务器,也包含了上述的多种功能。NGINX 使用事件驱动的方式处理问题,着回避传统的服务器更加有效率。NGINX plus 天价了更多高级的反向代理特性,比如程序[健康度检查][4],专门用来处理request 路由,高级缓冲和相关支持。

|

||||

NGINX 软件为用作反向代理服务器而专门设计,也包含了上述的多种功能。NGINX 使用事件驱动的方式处理请求,这会比传统的服务器更加有效率。NGINX plus 添加了更多高级的反向代理特性,比如应用的[健康度检查][4],专门用来处理请求路由、高级缓冲和相关支持。

|

||||

|

||||

|

||||

|

||||

### Tip #2: 添加负载平衡 ###

|

||||

|

||||

添加一个[负载均衡服务器][5] 是一个相当简单的用来提高性能和网站安全性的的方法。使用负载均衡讲流量分配到多个服务器,是用来替代只使用一个巨大且高性能web 服务器的方案。即使程序写的不好,或者在扩容方面有困难,只使用负载均衡服务器就可以很好的提高用户体验。

|

||||

添加一个[负载均衡服务器][5] 是一个相当简单的用来提高性能和网站安全性的的方法。与其将核心 Web 服务器变得越来越大和越来越强,不如使用负载均衡将流量分配到多个服务器。即使程序写的不好,或者在扩容方面有困难,仅是使用负载均衡服务器就可以很好的提高用户体验。