mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-24 02:20:09 +08:00

commit

1fb67e2b87

3

.gitmodules

vendored

Normal file

3

.gitmodules

vendored

Normal file

@ -0,0 +1,3 @@

|

||||

[submodule "comic"]

|

||||

path = comic

|

||||

url = https://wxy@github.com/LCTT/comic.git

|

||||

2

.travis.yml

Normal file

2

.travis.yml

Normal file

@ -0,0 +1,2 @@

|

||||

language: c

|

||||

script: make -s check

|

||||

84

Dict.md

84

Dict.md

@ -14,55 +14,55 @@

|

||||

### 2.

|

||||

#### B ####

|

||||

### 1. Backbone:骨干

|

||||

>是一个网络的一部分,其作为所有网络运输的一个基本通道,其需要非常高的带宽。一个骨干网络的服务提供者连接许多企业子网和较小服务提供者的网络。一个企业骨干网络连接许多局域网和数据中心。

|

||||

> 是一个网络的一部分,其作为所有网络运输的一个基本通道,其需要非常高的带宽。一个骨干网络的服务提供者连接许多企业子网和较小服务提供者的网络。一个企业骨干网络连接许多局域网和数据中心。

|

||||

|

||||

### 2. B channel(Bearer channel):承载信道

|

||||

>承载信道(Bearer Channel),也叫做B channel,是一个全双工DS0时间槽(64-kbps),其携带模拟语音或数字资料通过综合服务数字网(ISDN)。

|

||||

> 承载信道(Bearer Channel),也叫做B channel,是一个全双工DS0时间槽(64-kbps),其携带模拟语音或数字资料通过综合服务数字网(ISDN)。

|

||||

|

||||

### 3. Backchannel:反向通道

|

||||

>是指当其他实时在线会话在进行中时,习惯使用网络化的计算机来维持一个实时的在线会话。

|

||||

> 是指当其他实时在线会话在进行中时,习惯使用网络化的计算机来维持一个实时的在线会话。

|

||||

|

||||

### 4. Back End:后台

|

||||

>在一个计算机系统中,是指为一个前台作业提供服务的一个节点或软件程序。前台直接影响用户,后台可能与其他系统相连接,如数据库和其它系统。

|

||||

> 在一个计算机系统中,是指为一个前台作业提供服务的一个节点或软件程序。前台直接影响用户,后台可能与其他系统相连接,如数据库和其它系统。

|

||||

|

||||

### 5. Back-haul:回程线路

|

||||

>是一个通信信道,它使携带信息流到远于最终目的地的地方,然后将它送回。这样做是因为传输到更远的远程区域的代价要远比直接发送的代价低地多。

|

||||

> 是一个通信信道,它使携带信息流到远于最终目的地的地方,然后将它送回。这样做是因为传输到更远的远程区域的代价要远比直接发送的代价低地多。

|

||||

|

||||

### 6. Backoff:退避

|

||||

>是指当一个主机已经在有MAC 协议的网络中经历了一个冲突之后试图去重发之前的等待时期。这个退避时间通常是任意的来最小化相同节点再次冲突的可能性。在每次冲突后增加退避时期也能帮助预防重复碰撞,特别当这个网络负担很重时。

|

||||

> 是指当一个主机已经在有MAC 协议的网络中经历了一个冲突之后试图去重发之前的等待时期。这个退避时间通常是任意的来最小化相同节点再次冲突的可能性。在每次冲突后增加退避时期也能帮助预防重复碰撞,特别当这个网络负担很重时。

|

||||

|

||||

### 7. Backplane:附加卡

|

||||

>在许多网络中是一个物理接口模块,例如,连接在一个界面处理器或卡和在一个总线机箱内数据总线和功率分配总线之间的一个路由器或转换器。

|

||||

> 在许多网络中是一个物理接口模块,例如,连接在一个界面处理器或卡和在一个总线机箱内数据总线和功率分配总线之间的一个路由器或转换器。

|

||||

|

||||

### 8. Back Pressure:背压

|

||||

>在计算机系统中,是指网络拥塞信息逆流通过一个Internet网络。

|

||||

> 在计算机系统中,是指网络拥塞信息逆流通过一个Internet网络。

|

||||

|

||||

### 9. Balun(balanced-unbalanced):不平衡变压器

|

||||

>意味着平衡-非平衡。不平衡变压器是一个设计用来转换平衡和不平衡之间的电信号的设备。

|

||||

> 意味着平衡-非平衡。不平衡变压器是一个设计用来转换平衡和不平衡之间的电信号的设备。

|

||||

|

||||

### 10. Baseband:基带

|

||||

>是一种类型的网络技术,在那里仅仅一种载波频率被使用。在一个基带网中,信息在传送介质中以数字的形式被携带在一个单一的多元信号通道中。

|

||||

> 是一种类型的网络技术,在那里仅仅一种载波频率被使用。在一个基带网中,信息在传送介质中以数字的形式被携带在一个单一的多元信号通道中。

|

||||

|

||||

### 11. Bastion Host:防御主机

|

||||

>是在内部网络和外部网络之间的一个网关,它被设计来防御针对内部网络的攻击。这个系统在非武装区(DMZ)的公共一边,不被防火墙或过滤路由器保护,它对攻击是完全暴露的。

|

||||

> 是在内部网络和外部网络之间的一个网关,它被设计来防御针对内部网络的攻击。这个系统在非武装区(DMZ)的公共一边,不被防火墙或过滤路由器保护,它对攻击是完全暴露的。

|

||||

|

||||

### 12: Bc(Committed Burst):约定资讯讯务

|

||||

>是一个用在帧中继系统的术语,是一个帧中继交互网约定接受和传输和通过一个帧中继网络数据链路控制(DLC)和一个特殊的时帧的最大数据量(用比特表示)。

|

||||

> 是一个用在帧中继系统的术语,是一个帧中继交互网约定接受和传输和通过一个帧中继网络数据链路控制(DLC)和一个特殊的时帧的最大数据量(用比特表示)。

|

||||

|

||||

### 13. BCP(Best Current Practices):最优现行方法

|

||||

>是副系列的IETF RFCs,其被用于描述在Internet上的最优配置技术。

|

||||

> 是副系列的IETF RFCs,其被用于描述在Internet上的最优配置技术。

|

||||

|

||||

### 14. BCU(Balanced Configuration Unit):平衡配置单元

|

||||

>是一个综合的IBM解决方法,它由软件和硬件组成。BCUs是综合的和测试作为数据仓库系统的预配置功能块。

|

||||

> 是一个综合的IBM解决方法,它由软件和硬件组成。BCUs是综合的和测试作为数据仓库系统的预配置功能块。

|

||||

|

||||

### 15. BECN(Backward Explicit Congestion Notification):显式拥塞通知

|

||||

>是在帧中继报头的一个1比特域,其发信号到任何接收帧的事物(转换器和数据终端设备),拥塞就发生在帧的反面(后面)。帧中继转换器和数据终端设备可能遵照显式拥塞通知位来减慢那个方向的数据传输率。

|

||||

> 是在帧中继报头的一个1比特域,其发信号到任何接收帧的事物(转换器和数据终端设备),拥塞就发生在帧的反面(后面)。帧中继转换器和数据终端设备可能遵照显式拥塞通知位来减慢那个方向的数据传输率。

|

||||

|

||||

### 16. BER(Bit Error Rate):误码率

|

||||

>是接收到的位包含错误的比率。BER通常被表示成十足的负面力量。

|

||||

> 是接收到的位包含错误的比率。BER通常被表示成十足的负面力量。

|

||||

|

||||

### 17. BIP(Bit Interleaved Parity):位交叉奇偶校验

|

||||

>一个用在ATM中的术语,是一个通常用来检测链接错误的一种方法。一个检测位或字被嵌入到以前发生阻塞或帧的链接中。位错误在有效载荷中能够作为维护信息被删除和报告。

|

||||

> 一个用在ATM中的术语,是一个通常用来检测链接错误的一种方法。一个检测位或字被嵌入到以前发生阻塞或帧的链接中。位错误在有效载荷中能够作为维护信息被删除和报告。

|

||||

|

||||

#### C ####

|

||||

|

||||

@ -76,76 +76,88 @@

|

||||

#### H ####

|

||||

### 1. Home Directory:家目录

|

||||

#### I ####

|

||||

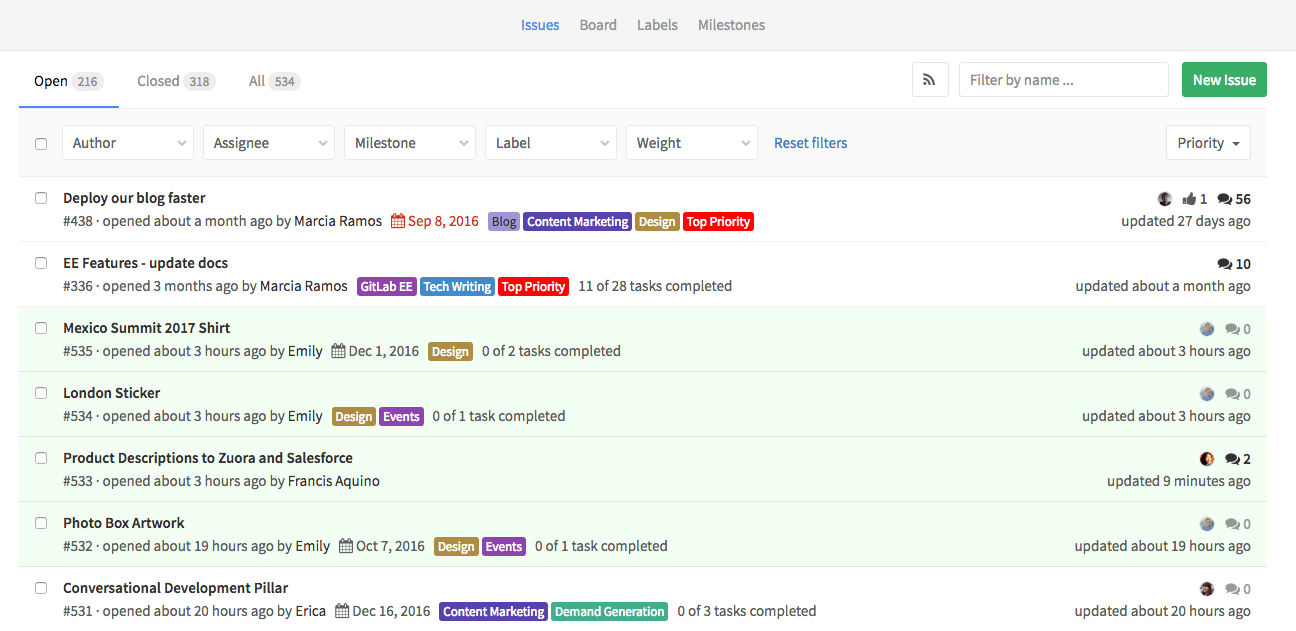

### 1. issue:工单

|

||||

> 有翻译做“问题”的,但是应该译作“工单”,尤其是用于 GitHub 中。

|

||||

|

||||

#### J ####

|

||||

|

||||

#### K ####

|

||||

|

||||

#### L ####

|

||||

### 1. LTS(Long Term Support):长期支持

|

||||

>该缩写词多见于操作系统发行版或者软件发行版名称中,表明该版本属于长期支持版。

|

||||

### 1. live CD:现场版 CD

|

||||

> 通常不翻译,但是如果翻译,可以译作“现场版”。

|

||||

### 2. live patch: 实时补丁/热补丁

|

||||

> 指 Linux 内核的 live patch 支持。

|

||||

|

||||

### 2. LTS(Long Term Support):长期支持

|

||||

> 该缩写词多见于操作系统发行版或者软件发行版名称中,表明该版本属于长期支持版。

|

||||

|

||||

#### M ####

|

||||

|

||||

#### N ####

|

||||

|

||||

#### O ####

|

||||

### 1. Orchestration:编排

|

||||

> 描述复杂计算机系统、中间件(middleware)和业务的自动化的安排、协调和管理(来自维基百科)。

|

||||

|

||||

#### P ####

|

||||

### 1.P-code(Pseudo-code):伪代码语言

|

||||

>一种解释型语言,执行方式介于编译型语言和解释型语言之间。和解释型语言一样,伪代码编程语言无需编译,在执行时自动转换成二进制形式。然而,和编译型语言不同的是,这种可执行的二进制文件是以伪代码的形式而不是机器语言的形式存储的。伪代码语言的例子有 Java、Python 和 REXX/Object REXX。

|

||||

### 1. P-code(Pseudo-code):伪代码语言

|

||||

> 一种解释型语言,执行方式介于编译型语言和解释型语言之间。和解释型语言一样,伪代码编程语言无需编译,在执行时自动转换成二进制形式。然而,和编译型语言不同的是,这种可执行的二进制文件是以伪代码的形式而不是机器语言的形式存储的。伪代码语言的例子有 Java、Python 和 REXX/Object REXX。

|

||||

|

||||

### 2. PAM(Pluggable Authentication Modules):可插拔认证模块

|

||||

>用于系统安全性的可替换的用户认证模块,它允许在不知道将使用何种认证方案的情况下进行编程。这允许将来用其它模块来替换某个模块,却无需重写软件。

|

||||

> 用于系统安全性的可替换的用户认证模块,它允许在不知道将使用何种认证方案的情况下进行编程。这允许将来用其它模块来替换某个模块,却无需重写软件。

|

||||

|

||||

### 3. Port/Ported/Porting:移植

|

||||

>一个过程,即获取为某个操作系统平台编写的程序,并对其进行修改使之能在另一 OS 上运行,并且具有类似的功能。

|

||||

> 一个过程,即获取为某个操作系统平台编写的程序,并对其进行修改使之能在另一 OS 上运行,并且具有类似的功能。

|

||||

|

||||

### 4. POSIX(Portable Operating System Interface for uniX):UNIX 可移植操作系统接口

|

||||

>一组编程接口标准,它们规定如何编写应用程序源代码以便应用程序可在操作系统之间移植。POSIX 基于 UNIX,它是 The Open Group 的 X/Open 规范的基础。

|

||||

> 一组编程接口标准,它们规定如何编写应用程序源代码以便应用程序可在操作系统之间移植。POSIX 基于 UNIX,它是 The Open Group 的 X/Open 规范的基础。

|

||||

|

||||

#### Q ####

|

||||

|

||||

#### R ####

|

||||

### 1. RCS(Revision Control System):修订控制系统

|

||||

>一组程序,它们控制组环境下文件的共享访问并跟踪文本文件的变化。常用于维护源代码模块的编码工作。

|

||||

> 一组程序,它们控制组环境下文件的共享访问并跟踪文本文件的变化。常用于维护源代码模块的编码工作。

|

||||

|

||||

### 2. RFS(Remote File Sharing):远程文件共享

|

||||

>一个程序,它让用户访问其它计算机上的文件,就好象文件在用户的系统上一样。

|

||||

> 一个程序,它让用户访问其它计算机上的文件,就好象文件在用户的系统上一样。

|

||||

|

||||

#### S ####

|

||||

### 1. shebang [ʃɪ'bæŋ]:释伴

|

||||

>Shebang(也称为Hashbang)是一个由井号和叹号构成的字符序列(#!),出现在文本文件的第一行的前两个字符,后跟解释器路径,如:#!/bin/sh,这通常是Linux中shell脚本的标准起始行。

|

||||

>长期以来,shebang都没有正式的中文名称。Linux中国翻译组将其翻译为:释伴,即解释伴随行的简称,同时又是shebang的音译。

|

||||

> Shebang(也称为Hashbang)是一个由井号和叹号构成的字符序列(#!),出现在文本文件的第一行的前两个字符,后跟解释器路径,如:#!/bin/sh,这通常是Linux中shell脚本的标准起始行。

|

||||

> 长期以来,shebang都没有正式的中文名称。Linux中国翻译组将其翻译为:释伴,即解释伴随行的简称,同时又是shebang的音译。

|

||||

|

||||

### 2. Spool(Simultaneous Peripheral Operation On-Line):假脱机

|

||||

>将数据发送给一个程序,该程序将该数据信息放入队列以备将来使用(例如,打印假脱机程序)

|

||||

> 将数据发送给一个程序,该程序将该数据信息放入队列以备将来使用(例如,打印假脱机程序)

|

||||

|

||||

### 2. Steganography:隐写术

|

||||

>将一段信息隐藏在另一段信息中的做法。一个示例是在数字化照片中放置不可见的数字水印。

|

||||

> 将一段信息隐藏在另一段信息中的做法。一个示例是在数字化照片中放置不可见的数字水印。

|

||||

|

||||

### 3. Swap:交换

|

||||

>暂时将数据(程序和/或数据文件)从随机存取存储器移到磁盘存储器(换出),或反方向移动(换入),以允许处理比物理内存所能容纳的更多的程序和数据。

|

||||

> 暂时将数据(程序和/或数据文件)从随机存取存储器移到磁盘存储器(换出),或反方向移动(换入),以允许处理比物理内存所能容纳的更多的程序和数据。

|

||||

|

||||

### 4. Scheduling:调度

|

||||

> 将任务分配至资源的过程,在计算机或生产处理中尤为重要(来自维基百科)。

|

||||

|

||||

#### T ####

|

||||

### 1. Time-sharing:分时

|

||||

>一种允许多个用户分享处理器的方法,它以时间为基础给每个用户分配一部分处理器资源,按照这些时间段轮流运行每个用户的进程。

|

||||

> 一种允许多个用户分享处理器的方法,它以时间为基础给每个用户分配一部分处理器资源,按照这些时间段轮流运行每个用户的进程。

|

||||

|

||||

### 2. TL;DR:长篇摘要

|

||||

>Too Long;Didn't Read的缩写词,即太长,未阅的意思。该词多见于互联网社区论坛中,用于指出该文太长,没有阅读,或者标示出一篇长文章的摘要。在论坛回复中,该缩写词也多作为灌水用。因此,Linux中国翻译组将其翻译为:长篇摘要。

|

||||

> Too Long;Didn't Read的缩写词,即太长,未阅的意思。该词多见于互联网社区论坛中,用于指出该文太长,没有阅读,或者标示出一篇长文章的摘要。在论坛回复中,该缩写词也多作为灌水用。因此,Linux中国翻译组将其翻译为:长篇摘要。

|

||||

|

||||

#### U ####

|

||||

|

||||

#### V ####

|

||||

### 1. VRML(Virtual Reality Modeling Language):虚拟现实建模语言

|

||||

>一种主要基于 Web 的语言,用于 3D 效果(如构建遍历)。

|

||||

> 一种主要基于 Web 的语言,用于 3D 效果(如构建遍历)。

|

||||

|

||||

#### W ####

|

||||

### 1. Wrapper:封装器

|

||||

>用于启动另一个程序的程序。

|

||||

> 用于启动另一个程序的程序。

|

||||

|

||||

#### X ####

|

||||

|

||||

#### Y ####

|

||||

|

||||

#### Z ####

|

||||

#### Z ####

|

||||

|

||||

51

Makefile

Normal file

51

Makefile

Normal file

@ -0,0 +1,51 @@

|

||||

DIR_PATTERN := (news|talk|tech)

|

||||

NAME_PATTERN := [0-9]{8} [a-zA-Z0-9_.,() -]*\.md

|

||||

|

||||

RULES := rule-source-added \

|

||||

rule-translation-requested \

|

||||

rule-translation-completed \

|

||||

rule-translation-revised \

|

||||

rule-translation-published

|

||||

.PHONY: check match $(RULES)

|

||||

|

||||

CHANGE_FILE := /tmp/changes

|

||||

|

||||

check: $(CHANGE_FILE)

|

||||

echo 'PR #$(TRAVIS_PULL_REQUEST) Changes:'

|

||||

cat $(CHANGE_FILE)

|

||||

echo

|

||||

echo 'Check for rules...'

|

||||

make -k $(RULES) 2>/dev/null | grep '^Rule Matched: '

|

||||

|

||||

$(CHANGE_FILE):

|

||||

git --no-pager diff $(TRAVIS_BRANCH) FETCH_HEAD --no-renames --name-status > $@

|

||||

|

||||

rule-source-added:

|

||||

echo 'Unmatched Files:'

|

||||

egrep -v '^A\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) || true

|

||||

echo '[End of Unmatched Files]'

|

||||

[ $(shell egrep '^A\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) -ge 1 ]

|

||||

[ $(shell egrep -v '^A\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 0 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

|

||||

rule-translation-requested:

|

||||

[ $(shell egrep '^M\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell cat $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

|

||||

rule-translation-completed:

|

||||

[ $(shell egrep '^D\s*"?sources/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell egrep '^A\s*"?translated/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell cat $(CHANGE_FILE) | wc -l) = 2 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

|

||||

rule-translation-revised:

|

||||

[ $(shell egrep '^M\s*"?translated/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell cat $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

|

||||

rule-translation-published:

|

||||

[ $(shell egrep '^D\s*"?translated/$(DIR_PATTERN)/$(NAME_PATTERN)"?' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell egrep '^A\s*"?published/$(NAME_PATTERN)' $(CHANGE_FILE) | wc -l) = 1 ]

|

||||

[ $(shell cat $(CHANGE_FILE) | wc -l) = 2 ]

|

||||

echo 'Rule Matched: $(@)'

|

||||

@ -60,6 +60,9 @@ LCTT 的组成

|

||||

* 2017/03/13 制作了 LCTT 主页、成员列表和成员主页,LCTT 主页将移动至 https://linux.cn/lctt 。

|

||||

* 2017/03/16 提升 GHLandy、bestony、rusking 为新的 Core 成员。创建 Comic 小组。

|

||||

* 2017/04/11 启用头衔制,为各位重要成员颁发头衔。

|

||||

* 2017/11/21 鉴于 qhwdw 快速而上佳的翻译质量,提升 qhwdw 为新的 Core 成员。

|

||||

* 2017/11/19 wxy 在上海交大举办的 2017 中国开源年会上做了演讲:《[如何以翻译贡献参与开源社区](https://linux.cn/article-9084-1.html)》。

|

||||

* 2018/01/11 提升 lujun9972 成为核心成员,并加入选题组。

|

||||

|

||||

核心成员

|

||||

-------------------------------

|

||||

@ -86,6 +89,8 @@ LCTT 的组成

|

||||

- 核心成员 @Locez,

|

||||

- 核心成员 @ucasFL,

|

||||

- 核心成员 @rusking,

|

||||

- 核心成员 @qhwdw,

|

||||

- 核心成员 @lujun9972

|

||||

- 前任选题 @DeadFire,

|

||||

- 前任校对 @reinoir222,

|

||||

- 前任校对 @PurlingNayuki,

|

||||

|

||||

1

comic

Submodule

1

comic

Submodule

@ -0,0 +1 @@

|

||||

Subproject commit e5db5b880dac1302ee0571ecaaa1f8ea7cf61901

|

||||

@ -0,0 +1,293 @@

|

||||

如何在 Linux 或者 UNIX 下调试 Bash Shell 脚本

|

||||

======

|

||||

|

||||

来自我的邮箱:

|

||||

|

||||

> 我写了一个 hello world 小脚本。我如何能调试运行在 Linux 或者类 UNIX 的系统上的 bash shell 脚本呢?

|

||||

|

||||

这是 Linux / Unix 系统管理员或新用户最常问的问题。shell 脚本调试可能是一项繁琐的工作(不容易阅读)。调试 shell 脚本有多种方法。

|

||||

|

||||

您需要传递 `-x` 或 `-v` 参数,以在 bash shell 中浏览每行代码。

|

||||

|

||||

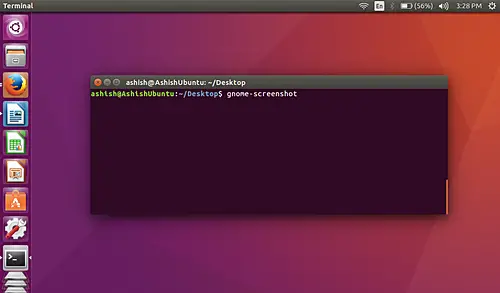

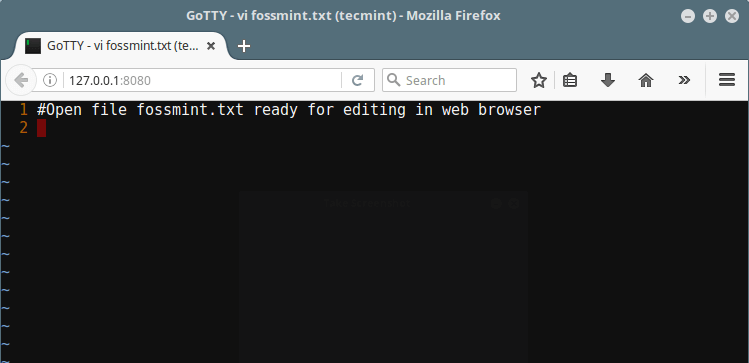

[![如何在 Linux 或者 UNIX 下调试 Bash Shell 脚本][1]][1]

|

||||

|

||||

让我们看看如何使用各种方法调试 Linux 和 UNIX 上运行的脚本。

|

||||

|

||||

### -x 选项来调试脚本

|

||||

|

||||

用 `-x` 选项来运行脚本:

|

||||

|

||||

```

|

||||

$ bash -x script-name

|

||||

$ bash -x domains.sh

|

||||

```

|

||||

### 使用 set 内置命令

|

||||

|

||||

bash shell 提供调试选项,可以打开或关闭使用 [set 命令][2]:

|

||||

|

||||

* `set -x` : 显示命令及其执行时的参数。

|

||||

* `set -v` : 显示 shell 输入行作为它们读取的

|

||||

|

||||

可以在 shell 脚本本身中使用上面的两个命令:

|

||||

|

||||

```

|

||||

#!/bin/bash

|

||||

clear

|

||||

|

||||

# turn on debug mode

|

||||

set -x

|

||||

for f in *

|

||||

do

|

||||

file $f

|

||||

done

|

||||

# turn OFF debug mode

|

||||

set +x

|

||||

ls

|

||||

# more commands

|

||||

```

|

||||

|

||||

你可以代替 [标准释伴][3] 行:

|

||||

|

||||

```

|

||||

#!/bin/bash

|

||||

```

|

||||

|

||||

用以下代码(用于调试):

|

||||

|

||||

```

|

||||

#!/bin/bash -xv

|

||||

```

|

||||

|

||||

### 使用智能调试功能

|

||||

|

||||

首先添加一个叫做 `_DEBUG` 的特殊变量。当你需要调试脚本的时候,设置 `_DEBUG` 为 `on`:

|

||||

|

||||

```

|

||||

_DEBUG="on"

|

||||

```

|

||||

|

||||

在脚本的开头放置以下函数:

|

||||

|

||||

```

|

||||

function DEBUG()

|

||||

{

|

||||

[ "$_DEBUG" == "on" ] && $@

|

||||

}

|

||||

```

|

||||

|

||||

现在,只要你需要调试,只需使用 `DEBUG` 函数如下:

|

||||

|

||||

```

|

||||

DEBUG echo "File is $filename"

|

||||

```

|

||||

|

||||

或者:

|

||||

|

||||

```

|

||||

DEBUG set -x

|

||||

Cmd1

|

||||

Cmd2

|

||||

DEBUG set +x

|

||||

```

|

||||

|

||||

当调试完(在移动你的脚本到生产环境之前)设置 `_DEBUG` 为 `off`。不需要删除调试行。

|

||||

|

||||

```

|

||||

_DEBUG="off" # 设置为非 'on' 的任何字符

|

||||

```

|

||||

|

||||

示例脚本:

|

||||

|

||||

```

|

||||

#!/bin/bash

|

||||

_DEBUG="on"

|

||||

function DEBUG()

|

||||

{

|

||||

[ "$_DEBUG" == "on" ] && $@

|

||||

}

|

||||

|

||||

DEBUG echo 'Reading files'

|

||||

for i in *

|

||||

do

|

||||

grep 'something' $i > /dev/null

|

||||

[ $? -eq 0 ] && echo "Found in $i file"

|

||||

done

|

||||

DEBUG set -x

|

||||

a=2

|

||||

b=3

|

||||

c=$(( $a + $b ))

|

||||

DEBUG set +x

|

||||

echo "$a + $b = $c"

|

||||

```

|

||||

|

||||

保存并关闭文件。运行脚本如下:

|

||||

|

||||

```

|

||||

$ ./script.sh

|

||||

```

|

||||

|

||||

输出:

|

||||

|

||||

```

|

||||

Reading files

|

||||

Found in xyz.txt file

|

||||

+ a=2

|

||||

+ b=3

|

||||

+ c=5

|

||||

+ DEBUG set +x

|

||||

+ '[' on == on ']'

|

||||

+ set +x

|

||||

2 + 3 = 5

|

||||

```

|

||||

|

||||

现在设置 `_DEBUG` 为 `off`(你需要编辑该文件):

|

||||

|

||||

```

|

||||

_DEBUG="off"

|

||||

```

|

||||

|

||||

运行脚本:

|

||||

|

||||

```

|

||||

$ ./script.sh

|

||||

```

|

||||

|

||||

输出:

|

||||

|

||||

```

|

||||

Found in xyz.txt file

|

||||

2 + 3 = 5

|

||||

```

|

||||

|

||||

以上是一个简单但非常有效的技术。还可以尝试使用 `DEBUG` 作为别名而不是函数。

|

||||

|

||||

### 调试 Bash Shell 的常见错误

|

||||

|

||||

Bash 或者 sh 或者 ksh 在屏幕上给出各种错误信息,在很多情况下,错误信息可能不提供详细的信息。

|

||||

|

||||

#### 跳过在文件上应用执行权限

|

||||

|

||||

当你 [编写你的第一个 hello world 脚本][4],您可能会得到一个错误,如下所示:

|

||||

|

||||

```

|

||||

bash: ./hello.sh: Permission denied

|

||||

```

|

||||

|

||||

设置权限使用 `chmod` 命令:

|

||||

|

||||

```

|

||||

$ chmod +x hello.sh

|

||||

$ ./hello.sh

|

||||

$ bash hello.sh

|

||||

```

|

||||

|

||||

#### 文件结束时发生意外的错误

|

||||

|

||||

如果您收到文件结束意外错误消息,请打开脚本文件,并确保它有打开和关闭引号。在这个例子中,`echo` 语句有一个开头引号,但没有结束引号:

|

||||

|

||||

```

|

||||

#!/bin/bash

|

||||

|

||||

...

|

||||

....

|

||||

|

||||

echo 'Error: File not found

|

||||

^^^^^^^

|

||||

missing quote

|

||||

```

|

||||

|

||||

还要确保你检查缺少的括号和大括号 `{}`:

|

||||

|

||||

```

|

||||

#!/bin/bash

|

||||

.....

|

||||

[ ! -d $DIRNAME ] && { echo "Error: Chroot dir not found"; exit 1;

|

||||

^^^^^^^^^^^^^

|

||||

missing brace }

|

||||

...

|

||||

```

|

||||

|

||||

#### 丢失像 fi,esac,;; 等关键字。

|

||||

|

||||

如果你缺少了结尾的关键字,如 `fi` 或 `;;` 你会得到一个错误,如 “XXX 意外”。因此,确保所有嵌套的 `if` 和 `case` 语句以适当的关键字结束。有关语法要求的页面。在本例中,缺少 `fi`:

|

||||

|

||||

```

|

||||

#!/bin/bash

|

||||

echo "Starting..."

|

||||

....

|

||||

if [ $1 -eq 10 ]

|

||||

then

|

||||

if [ $2 -eq 100 ]

|

||||

then

|

||||

echo "Do something"

|

||||

fi

|

||||

|

||||

for f in $files

|

||||

do

|

||||

echo $f

|

||||

done

|

||||

|

||||

# 注意 fi 丢失了

|

||||

```

|

||||

|

||||

#### 在 Windows 或 UNIX 框中移动或编辑 shell 脚本

|

||||

|

||||

不要在 Linux 上创建脚本并移动到 Windows。另一个问题是编辑 Windows 10上的 shell 脚本并将其移动到 UNIX 服务器上。这将由于换行符不同而导致命令没有发现的错误。你可以使用下列命令 [将 DOS 换行转换为 CR-LF 的Unix/Linux 格式][5] :

|

||||

|

||||

```

|

||||

dos2unix my-script.sh

|

||||

```

|

||||

|

||||

### 技巧

|

||||

|

||||

#### 技巧 1 - 发送调试信息输出到标准错误

|

||||

|

||||

[标准错误] 是默认错误输出设备,用于写所有系统错误信息。因此,将消息发送到默认的错误设备是个好主意:

|

||||

|

||||

```

|

||||

# 写错误到标准输出

|

||||

echo "Error: $1 file not found"

|

||||

#

|

||||

# 写错误到标准错误(注意 1>&2 在 echo 命令末尾)

|

||||

#

|

||||

echo "Error: $1 file not found" 1>&2

|

||||

```

|

||||

|

||||

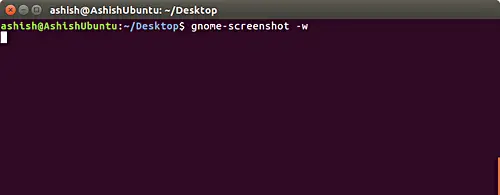

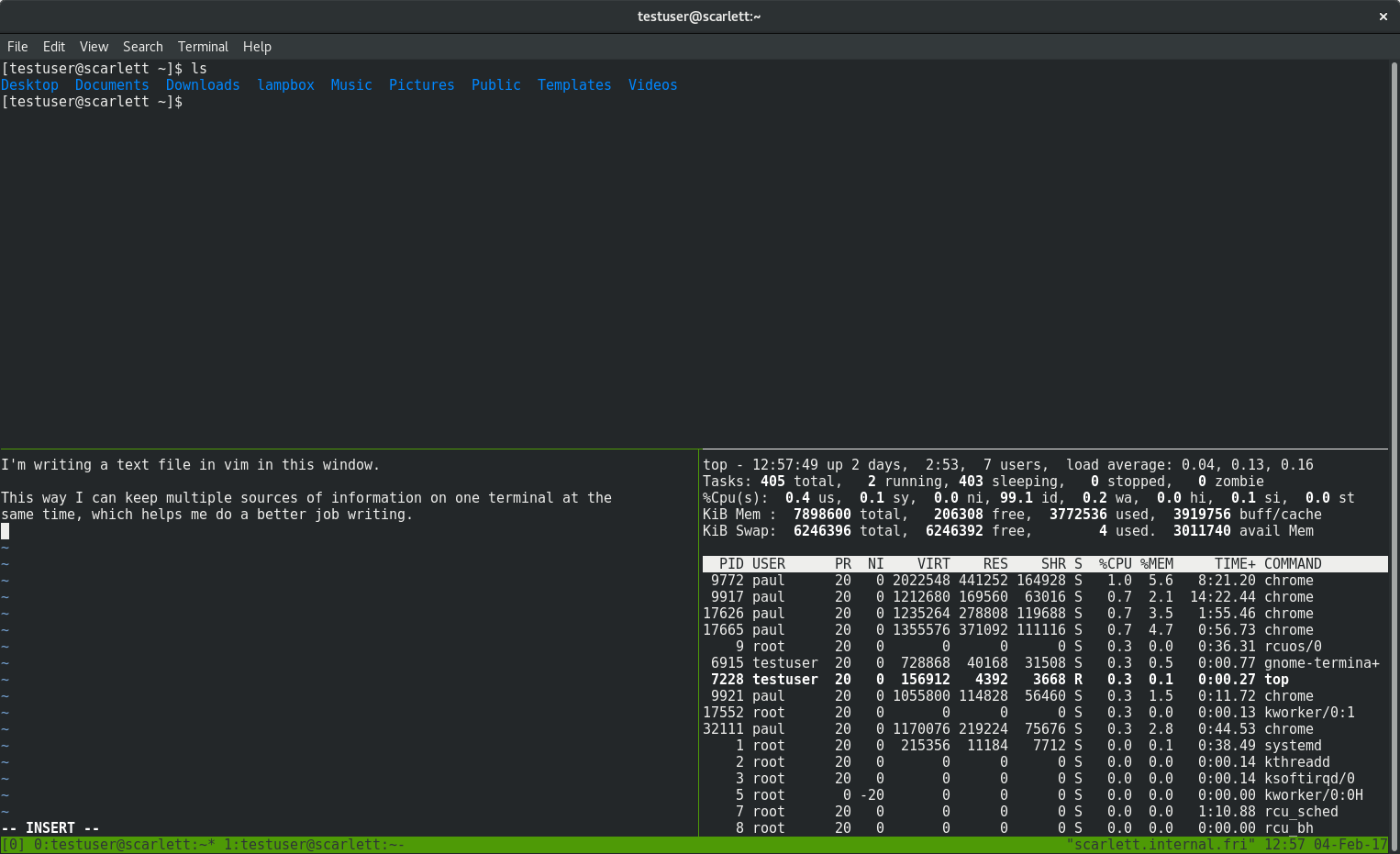

#### 技巧 2 - 在使用 vim 文本编辑器时,打开语法高亮

|

||||

|

||||

大多数现代文本编辑器允许设置语法高亮选项。这对于检测语法和防止常见错误如打开或关闭引号非常有用。你可以在不同的颜色中看到。这个特性简化了 shell 脚本结构中的编写,语法错误在视觉上截然不同。高亮不影响文本本身的意义,它只为你提示而已。在这个例子中,我的脚本使用了 vim 语法高亮:

|

||||

|

||||

[!如何调试 Bash Shell 脚本,在 Linux 或者 UNIX 使用 Vim 语法高亮特性][7]][7]

|

||||

|

||||

#### 技巧 3 - 使用 shellcheck 检查脚本

|

||||

|

||||

[shellcheck 是一个用于静态分析 shell 脚本的工具][8]。可以使用它来查找 shell 脚本中的错误。这是用 Haskell 编写的。您可以使用这个工具找到警告和建议。你可以看看如何在 Linux 或 类UNIX 系统上安装和使用 shellcheck 来改善你的 shell 脚本,避免错误和高效。

|

||||

|

||||

作者:Vivek Gite

|

||||

|

||||

作者是 nixCraft 创造者,一个经验丰富的系统管理员和一个练习 Linux 操作系统/ UNIX shell 脚本的教练。他曾与全球客户和各种行业,包括 IT,教育,国防和空间研究,以及非营利部门。关注他的 [推特][9],[脸谱网][10],[谷歌+ ][11]。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.cyberciti.biz/tips/debugging-shell-script.html

|

||||

|

||||

作者:[Vivek Gite][a]

|

||||

译者:[zjon](https://github.com/zjon)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://www.cyberciti.biz

|

||||

[1]:https://www.cyberciti.biz/tips/wp-content/uploads/2007/01/How-to-debug-a-bash-shell-script-on-Linux-or-Unix.jpg

|

||||

[2]:https://bash.cyberciti.biz/guide/Set_command

|

||||

[3]:https://bash.cyberciti.biz/guide/Shebang

|

||||

[4]:https://www.cyberciti.biz/faq/hello-world-bash-shell-script/

|

||||

[5]:https://www.cyberciti.biz/faq/howto-unix-linux-convert-dos-newlines-cr-lf-unix-text-format/

|

||||

[6]:https://bash.cyberciti.biz/guide/Standard_error

|

||||

[7]:https://www.cyberciti.biz/media/new/tips/2007/01/bash-vim-debug-syntax-highlighting.png

|

||||

[8]:https://www.cyberciti.biz/programming/improve-your-bashsh-shell-script-with-shellcheck-lint-script-analysis-tool/

|

||||

[9]:https://twitter.com/nixcraft

|

||||

[10]:https://facebook.com/nixcraft

|

||||

[11]:https://plus.google.com/+CybercitiBiz

|

||||

|

||||

|

||||

89

published/20141029 What does an idle CPU do.md

Normal file

89

published/20141029 What does an idle CPU do.md

Normal file

@ -0,0 +1,89 @@

|

||||

当 CPU 空闲时它都在做什么?

|

||||

============================================================

|

||||

|

||||

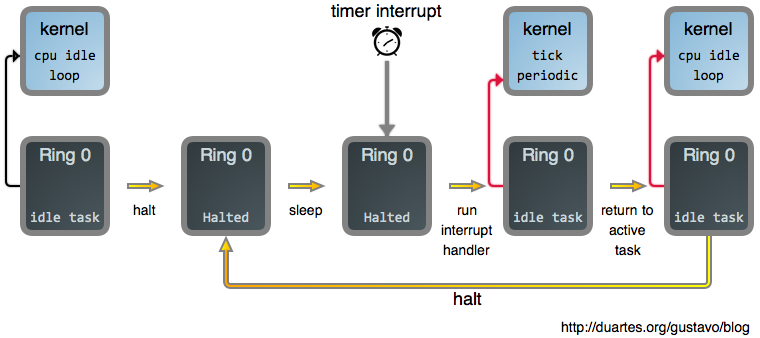

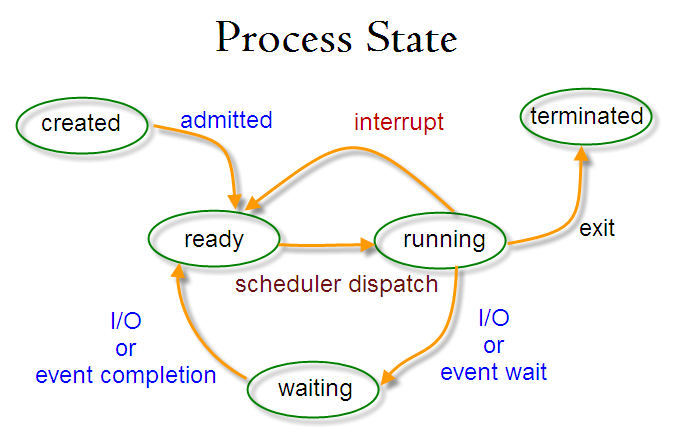

在 [上篇文章中][2] 我说了操作系统行为的基本原理是,*在任何一个给定的时刻*,在一个 CPU 上**有且只有一个任务是活动的**。但是,如果 CPU 无事可做的时候,又会是什么样的呢?

|

||||

|

||||

事实证明,这种情况是非常普遍的,对于绝大多数的个人电脑来说,这确实是一种常态:大量的睡眠进程,它们都在等待某种情况下被唤醒,差不多在 100% 的 CPU 时间中,都处于虚构的“空闲任务”中。事实上,如果一个普通用户的 CPU 处于持续的繁忙中,它可能意味着有一个错误、bug、或者运行了恶意软件。

|

||||

|

||||

因为我们不能违反我们的原理,*一些任务需要在一个 CPU 上激活*。首先是因为,这是一个良好的设计:持续很长时间去遍历内核,检查是否*有*一个活动任务,这种特殊情况是不明智的做法。最好的设计是*没有任何例外的情况*。无论何时,你写一个 `if` 语句,Nyan Cat 就会喵喵喵。其次,我们需要使用空闲的 CPU 去做*一些事情*,让它们充满活力,你懂得,就是创建天网计划呗。

|

||||

|

||||

因此,保持这种设计的连续性,并领先于那些邪恶计划一步,操作系统开发者创建了一个**空闲任务**,当没有其它任务可做时就调度它去运行。我们可以在 Linux 的 [引导过程][3] 中看到,这个空闲任务就是进程 0,它是由计算机打开电源时运行的第一个指令直接派生出来的。它在 [rest_init][4] 中初始化,在 [init_idle_bootup_task][5] 中初始化空闲<ruby>调度类<rt>scheduling class</rt></ruby>。

|

||||

|

||||

简而言之,Linux 支持像实时进程、普通用户进程等等的不同调度类。当选择一个进程变成活动任务时,这些类按优先级进行查询。通过这种方式,核反应堆的控制代码总是优先于 web 浏览器运行。尽管在通常情况下,这些类返回 `NULL`,意味着它们没有合适的任务需要去运行 —— 它们总是处于睡眠状态。但是空闲调度类,它是持续运行的,从不会失败:它总是返回空闲任务。

|

||||

|

||||

好吧,我们来看一下这个空闲任务*到底做了些什么*。下面是 [cpu_idle_loop][6],感谢开源能让我们看到它的代码:

|

||||

|

||||

```

|

||||

while (1) {

|

||||

while(!need_resched()) {

|

||||

cpuidle_idle_call();

|

||||

}

|

||||

|

||||

/*

|

||||

[Note: Switch to a different task. We will return to this loop when the idle task is again selected to run.]

|

||||

*/

|

||||

schedule_preempt_disabled();

|

||||

}

|

||||

```

|

||||

|

||||

*cpu_idle_loop*

|

||||

|

||||

我省略了很多的细节,稍后我们将去了解任务切换,但是,如果你阅读了这些源代码,你就会找到它的要点:由于这里不需要重新调度(即改变活动任务),它一直处于空闲状态。以所经历的时间来计算,这个循环和其它操作系统中它的“堂兄弟们”相比,在计算的历史上它是运行的最多的代码片段。对于 Intel 处理器来说,处于空闲状态意味着运行着一个 [halt][7] 指令:

|

||||

|

||||

```

|

||||

static inline void native_halt(void)

|

||||

{

|

||||

asm volatile("hlt": : :"memory");

|

||||

}

|

||||

```

|

||||

|

||||

*native_halt*

|

||||

|

||||

`hlt` 指令停止处理器中的代码执行,并将它置于 `halt` 的状态。奇怪的是,全世界各地数以百万计的 Intel 类的 CPU 们花费大量的时间让它们处于 `halt` 的状态,甚至它们在通电的时候也是如此。这并不是高效、节能的做法,这促使芯片制造商们去开发处理器的深度睡眠状态,以带来着更少的功耗和更长休眠时间。内核的 [cpuidle 子系统][8] 是这些节能模式能够产生好处的原因。

|

||||

|

||||

现在,一旦我们告诉 CPU 去 `halt`(睡眠)之后,我们需要以某种方式让它醒来。如果你读过 [上篇文章《你的操作系统什么时候运行?》][9] ,你可能会猜到*中断*会参与其中,而事实确实如此。中断促使 CPU 离开 `halt` 状态返回到激活状态。因此,将这些拼到一起,下图是当你阅读一个完全呈现的 web 网页时,你的系统主要做的事情:

|

||||

|

||||

|

||||

|

||||

除定时器中断外的其它中断也会使处理器再次发生变化。如果你再次点击一个 web 页面就会产生这种变化,例如:你的鼠标发出一个中断,它的驱动会处理它,并且因为它产生了一个新的输入,突然进程就可运行了。在那个时刻, `need_resched()` 返回 `true`,然后空闲任务因你的浏览器而被踢出而终止运行。

|

||||

|

||||

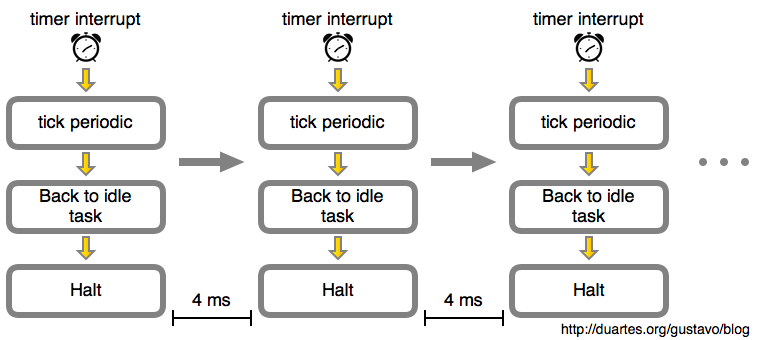

如果我们呆呆地看着这篇文章,而不做任何事情。那么随着时间的推移,这个空闲循环就像下图一样:

|

||||

|

||||

|

||||

|

||||

在这个示例中,由内核计划的定时器中断会每 4 毫秒发生一次。这就是<ruby>滴答<rt>tick</rt></ruby>周期。也就是说每秒钟将有 250 个滴答,因此,这个*滴答速率(频率)*是 250 Hz。这是运行在 Intel 处理器上的 Linux 的典型值,而其它操作系统喜欢使用 100 Hz。这是由你构建内核时在 `CONFIG_HZ` 选项中定义的。

|

||||

|

||||

对于一个*空闲 CPU* 来说,它看起来似乎是个无意义的工作。如果外部世界没有新的输入,在你的笔记本电脑的电池耗尽之前,CPU 将始终处于这种每秒钟被唤醒 250 次的地狱般折磨的小憩中。如果它运行在一个虚拟机中,那我们正在消耗着宿主机 CPU 的性能和宝贵的时钟周期。

|

||||

|

||||

在这里的解决方案是 [动态滴答][10],当 CPU 处于空闲状态时,定时器中断被 [暂停或重计划][11],直到内核*知道*将有事情要做时(例如,一个进程的定时器可能要在 5 秒内过期,因此,我们不能再继续睡眠了),定时器中断才会重新发出。这也被称为*无滴答模式*。

|

||||

|

||||

最后,假设在一个系统中你有一个*活动进程*,例如,一个长时间运行的 CPU 密集型任务。那样几乎就和一个空闲系统是相同的:这些示意图仍然是相同的,只是将空闲任务替换为这个进程,并且相应的描述也是准确的。在那种情况下,每 4 毫秒去中断一次任务仍然是无意义的:它只是操作系统的性能抖动,甚至会使你的工作变得更慢而已。Linux 也可以在这种单一进程的场景中停止这种固定速率的滴答,这被称为 [自适应滴答][12] 模式。最终,这种固定速率的滴答可能会 [完全消失][13]。

|

||||

|

||||

对于阅读一篇文章来说,CPU 基本是无事可做的。内核的这种空闲行为是操作系统难题的一个重要部分,并且它与我们看到的其它情况非常相似,因此,这将帮助我们理解一个运行中的内核。更多的内容将发布在下周的 [RSS][14] 和 [Twitter][15] 上。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://manybutfinite.com/post/what-does-an-idle-cpu-do/

|

||||

|

||||

作者:[Gustavo Duarte][a]

|

||||

译者:[qhwdw](https://github.com/qhwdw)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://duartes.org/gustavo/blog/about/

|

||||

[1]:https://manybutfinite.com/post/what-does-an-idle-cpu-do/

|

||||

[2]:https://linux.cn/article-9095-1.html

|

||||

[3]:https://manybutfinite.com/post/kernel-boot-process

|

||||

[4]:https://github.com/torvalds/linux/blob/v3.17/init/main.c#L393

|

||||

[5]:https://github.com/torvalds/linux/blob/v3.17/kernel/sched/core.c#L4538

|

||||

[6]:https://github.com/torvalds/linux/blob/v3.17/kernel/sched/idle.c#L183

|

||||

[7]:https://github.com/torvalds/linux/blob/v3.17/arch/x86/include/asm/irqflags.h#L52

|

||||

[8]:http://lwn.net/Articles/384146/

|

||||

[9]:https://linux.cn/article-9095-1.html

|

||||

[10]:https://github.com/torvalds/linux/blob/v3.17/Documentation/timers/NO_HZ.txt#L17

|

||||

[11]:https://github.com/torvalds/linux/blob/v3.17/Documentation/timers/highres.txt#L215

|

||||

[12]:https://github.com/torvalds/linux/blob/v3.17/Documentation/timers/NO_HZ.txt#L100

|

||||

[13]:http://lwn.net/Articles/549580/

|

||||

[14]:https://manybutfinite.com/feed.xml

|

||||

[15]:http://twitter.com/manybutfinite

|

||||

Binary file not shown.

|

Before Width: | Height: | Size: 247 KiB |

@ -1,21 +1,21 @@

|

||||

[调试器的工作原理:第一篇-基础][21]

|

||||

调试器的工作原理(一):基础篇

|

||||

============================================================

|

||||

|

||||

这是调试器工作原理系列文章的第一篇,我不确定这个系列会有多少篇文章,会涉及多少话题,但我仍会从这篇基础开始。

|

||||

|

||||

### 这一篇会讲什么

|

||||

|

||||

我将为大家展示 Linux 中调试器的主要构成模块 - ptrace 系统调用。这篇文章所有代码都是基于 32 位 Ubuntu 操作系统.值得注意的是,尽管这些代码是平台相关的,将他们移植到其他平台应该并不困难。

|

||||

我将为大家展示 Linux 中调试器的主要构成模块 - `ptrace` 系统调用。这篇文章所有代码都是基于 32 位 Ubuntu 操作系统。值得注意的是,尽管这些代码是平台相关的,将它们移植到其它平台应该并不困难。

|

||||

|

||||

### 缘由

|

||||

|

||||

为了理解我们要做什么,让我们先考虑下调试器为了完成调试都需要什么资源。调试器可以开始一个进程并调试这个进程,又或者将自己同某个已经存在的进程关联起来。调试器能够单步执行代码,设定断点并且将程序执行到断点,检查变量的值并追踪堆栈。许多调试器有着更高级的特性,例如在调试器的地址空间内执行表达式或者调用函数,甚至可以在进程执行过程中改变代码并观察效果。

|

||||

为了理解我们要做什么,让我们先考虑下调试器为了完成调试都需要什么资源。调试器可以开始一个进程并调试这个进程,又或者将自己同某个已经存在的进程关联起来。调试器能够单步执行代码,设定断点并且将程序执行到断点,检查变量的值并追踪堆栈。许多调试器有着更高级的特性,例如在调试器的地址空间内执行表达式或者调用函数,甚至可以在进程执行过程中改变代码并观察效果。

|

||||

|

||||

尽管现代的调试器都十分的复杂 [[1]][13],但他们的工作的原理却是十分的简单。调试器的基础是操作系统与编译器 / 链接器提供的一些基础服务,其余的部分只是[简单的编程][14]。

|

||||

尽管现代的调试器都十分的复杂(我没有检查,但我确信 gdb 的代码行数至少有六位数),但它们的工作的原理却是十分的简单。调试器的基础是操作系统与编译器 / 链接器提供的一些基础服务,其余的部分只是[简单的编程][14]而已。

|

||||

|

||||

### Linux 的调试 - ptrace

|

||||

|

||||

Linux 调试器中的瑞士军刀便是 ptrace 系统调用 [[2]][15]。这是一种复杂却强大的工具,可以允许一个进程控制另外一个进程并从内部替换被控制进程的内核镜像的值[[3]][16].。

|

||||

Linux 调试器中的瑞士军刀便是 `ptrace` 系统调用(使用 man 2 ptrace 命令可以了解更多)。这是一种复杂却强大的工具,可以允许一个进程控制另外一个进程并从<ruby>内部替换<rt>Peek and poke</rt></ruby>被控制进程的内核镜像的值(Peek and poke 在系统编程中是很知名的叫法,指的是直接读写内存内容)。

|

||||

|

||||

接下来会深入分析。

|

||||

|

||||

@ -49,7 +49,7 @@ int main(int argc, char** argv)

|

||||

}

|

||||

```

|

||||

|

||||

看起来相当的简单:我们用 fork 命令创建了一个新的子进程。if 语句的分支执行子进程(这里称之为“target”),else if 的分支执行父进程(这里称之为“debugger”)。

|

||||

看起来相当的简单:我们用 `fork` 创建了一个新的子进程(这篇文章假定读者有一定的 Unix/Linux 编程经验。我假定你知道或至少了解 fork、exec 族函数与 Unix 信号)。if 语句的分支执行子进程(这里称之为 “target”),`else if` 的分支执行父进程(这里称之为 “debugger”)。

|

||||

|

||||

下面是 target 进程的代码:

|

||||

|

||||

@ -69,18 +69,18 @@ void run_target(const char* programname)

|

||||

}

|

||||

```

|

||||

|

||||

这段代码中最值得注意的是 ptrace 调用。在 "sys/ptrace.h" 中,ptrace 是如下定义的:

|

||||

这段代码中最值得注意的是 `ptrace` 调用。在 `sys/ptrace.h` 中,`ptrace` 是如下定义的:

|

||||

|

||||

```

|

||||

long ptrace(enum __ptrace_request request, pid_t pid,

|

||||

void *addr, void *data);

|

||||

```

|

||||

|

||||

第一个参数是 _request_,这是许多预定义的 PTRACE_* 常量中的一个。第二个参数为请求分配进程 ID。第三个与第四个参数是地址与数据指针,用于操作内存。上面代码段中的ptrace调用发起了 PTRACE_TRACEME 请求,这意味着该子进程请求系统内核让其父进程跟踪自己。帮助页面上对于 request 的描述很清楚:

|

||||

第一个参数是 `_request_`,这是许多预定义的 `PTRACE_*` 常量中的一个。第二个参数为请求分配进程 ID。第三个与第四个参数是地址与数据指针,用于操作内存。上面代码段中的 `ptrace` 调用发起了 `PTRACE_TRACEME` 请求,这意味着该子进程请求系统内核让其父进程跟踪自己。帮助页面上对于 request 的描述很清楚:

|

||||

|

||||

> 意味着该进程被其父进程跟踪。任何传递给该进程的信号(除了 SIGKILL)都将通过 wait() 方法阻塞该进程并通知其父进程。**此外,该进程的之后所有调用 exec() 动作都将导致 SIGTRAP 信号发送到此进程上,使得父进程在新的程序执行前得到取得控制权的机会**。如果一个进程并不需要它的的父进程跟踪它,那么这个进程不应该发送这个请求。(pid,addr 与 data 暂且不提)

|

||||

> 意味着该进程被其父进程跟踪。任何传递给该进程的信号(除了 `SIGKILL`)都将通过 `wait()` 方法阻塞该进程并通知其父进程。**此外,该进程的之后所有调用 `exec()` 动作都将导致 `SIGTRAP` 信号发送到此进程上,使得父进程在新的程序执行前得到取得控制权的机会**。如果一个进程并不需要它的的父进程跟踪它,那么这个进程不应该发送这个请求。(pid、addr 与 data 暂且不提)

|

||||

|

||||

我高亮了这个例子中我们需要注意的部分。在 ptrace 调用后,run_target 接下来要做的就是通过 execl 传参并调用。如同高亮部分所说明,这将导致系统内核在 execl 创建进程前暂时停止,并向父进程发送信号。

|

||||

我高亮了这个例子中我们需要注意的部分。在 `ptrace` 调用后,`run_target` 接下来要做的就是通过 `execl` 传参并调用。如同高亮部分所说明,这将导致系统内核在 `execl` 创建进程前暂时停止,并向父进程发送信号。

|

||||

|

||||

是时候看看父进程做什么了。

|

||||

|

||||

@ -110,11 +110,11 @@ void run_debugger(pid_t child_pid)

|

||||

}

|

||||

```

|

||||

|

||||

如前文所述,一旦子进程调用了 exec,子进程会停止并被发送 SIGTRAP 信号。父进程会等待该过程的发生并在第一个 wait() 处等待。一旦上述事件发生了,wait() 便会返回,由于子进程停止了父进程便会收到信号(如果子进程由于信号的发送停止了,WIFSTOPPED 就会返回 true)。

|

||||

如前文所述,一旦子进程调用了 `exec`,子进程会停止并被发送 `SIGTRAP` 信号。父进程会等待该过程的发生并在第一个 `wait()` 处等待。一旦上述事件发生了,`wait()` 便会返回,由于子进程停止了父进程便会收到信号(如果子进程由于信号的发送停止了,`WIFSTOPPED` 就会返回 `true`)。

|

||||

|

||||

父进程接下来的动作就是整篇文章最需要关注的部分了。父进程会将 PTRACE_SINGLESTEP 与子进程ID作为参数调用 ptrace 方法。这就会告诉操作系统,“请恢复子进程,但在它执行下一条指令前阻塞”。周而复始地,父进程等待子进程阻塞,循环继续。当 wait() 中传出的信号不再是子进程的停止信号时,循环终止。在跟踪器(父进程)运行期间,这将会是被跟踪进程(子进程)传递给跟踪器的终止信号(如果子进程终止 WIFEXITED 将返回 true)。

|

||||

父进程接下来的动作就是整篇文章最需要关注的部分了。父进程会将 `PTRACE_SINGLESTEP` 与子进程 ID 作为参数调用 `ptrace` 方法。这就会告诉操作系统,“请恢复子进程,但在它执行下一条指令前阻塞”。周而复始地,父进程等待子进程阻塞,循环继续。当 `wait()` 中传出的信号不再是子进程的停止信号时,循环终止。在跟踪器(父进程)运行期间,这将会是被跟踪进程(子进程)传递给跟踪器的终止信号(如果子进程终止 `WIFEXITED` 将返回 `true`)。

|

||||

|

||||

icounter 存储了子进程执行指令的次数。这么看来我们小小的例子也完成了些有用的事情 - 在命令行中指定程序,它将执行该程序并记录它从开始到结束所需要的 cpu 指令数量。接下来就让我们这么做吧。

|

||||

`icounter` 存储了子进程执行指令的次数。这么看来我们小小的例子也完成了些有用的事情 - 在命令行中指定程序,它将执行该程序并记录它从开始到结束所需要的 cpu 指令数量。接下来就让我们这么做吧。

|

||||

|

||||

### 测试

|

||||

|

||||

@ -131,11 +131,11 @@ int main()

|

||||

|

||||

```

|

||||

|

||||

令我惊讶的是,跟踪器花了相当长的时间,并报告整个执行过程共有超过 100,000 条指令执行。仅仅是一条输出语句?什么造成了这种情况?答案很有趣[[5]][18]。Linux 的 gcc 默认会动态的将程序与 c 的运行时库动态地链接。这就意味着任何程序运行前的第一件事是需要动态库加载器去查找程序运行所需要的共享库。这些代码的数量很大 - 别忘了我们的跟踪器要跟踪每一条指令,不仅仅是主函数的,而是“整个过程中的指令”。

|

||||

令我惊讶的是,跟踪器花了相当长的时间,并报告整个执行过程共有超过 100,000 条指令执行。仅仅是一条输出语句?什么造成了这种情况?答案很有趣(至少你同我一样痴迷与机器/汇编语言)。Linux 的 gcc 默认会动态的将程序与 c 的运行时库动态地链接。这就意味着任何程序运行前的第一件事是需要动态库加载器去查找程序运行所需要的共享库。这些代码的数量很大 - 别忘了我们的跟踪器要跟踪每一条指令,不仅仅是主函数的,而是“整个进程中的指令”。

|

||||

|

||||

所以当我将测试程序使用静态编译时(通过比较,可执行文件会多出 500 KB 左右的大小,这部分是 C 运行时库的静态链接),跟踪器提示只有大概 7000 条指令被执行。这个数目仍然不小,但是考虑到在主函数执行前 libc 的初始化以及主函数执行后的清除代码,这个数目已经是相当不错了。此外,printf 也是一个复杂的函数。

|

||||

所以当我将测试程序使用静态编译时(通过比较,可执行文件会多出 500 KB 左右的大小,这部分是 C 运行时库的静态链接),跟踪器提示只有大概 7000 条指令被执行。这个数目仍然不小,但是考虑到在主函数执行前 libc 的初始化以及主函数执行后的清除代码,这个数目已经是相当不错了。此外,`printf` 也是一个复杂的函数。

|

||||

|

||||

仍然不满意的话,我需要的是“可以测试”的东西 - 例如可以完整记录每一个指令运行的程序执行过程。这当然可以通过汇编代码完成。所以我找到了这个版本的“Hello, world!”并编译了它。

|

||||

仍然不满意的话,我需要的是“可以测试”的东西 - 例如可以完整记录每一个指令运行的程序执行过程。这当然可以通过汇编代码完成。所以我找到了这个版本的 “Hello, world!” 并编译了它。

|

||||

|

||||

|

||||

```

|

||||

@ -168,13 +168,11 @@ len equ $ - msg

|

||||

```

|

||||

|

||||

|

||||

当然,现在跟踪器提示 7 条指令被执行了,这样一来很容易区分他们。

|

||||

|

||||

当然,现在跟踪器提示 7 条指令被执行了,这样一来很容易区分它们。

|

||||

|

||||

### 深入指令流

|

||||

|

||||

|

||||

上面那个汇编语言编写的程序使得我可以向你介绍 ptrace 的另外一个强大的用途 - 详细显示被跟踪进程的状态。下面是 run_debugger 函数的另一个版本:

|

||||

上面那个汇编语言编写的程序使得我可以向你介绍 `ptrace` 的另外一个强大的用途 - 详细显示被跟踪进程的状态。下面是 `run_debugger` 函数的另一个版本:

|

||||

|

||||

```

|

||||

void run_debugger(pid_t child_pid)

|

||||

@ -209,24 +207,16 @@ void run_debugger(pid_t child_pid)

|

||||

}

|

||||

```

|

||||

|

||||

|

||||

不同仅仅存在于 while 循环的开始几行。这个版本里增加了两个新的 ptrace 调用。第一条将进程的寄存器值读取进了一个结构体中。 sys/user.h 定义有 user_regs_struct。如果你查看头文件,头部的注释这么写到:

|

||||

不同仅仅存在于 `while` 循环的开始几行。这个版本里增加了两个新的 `ptrace` 调用。第一条将进程的寄存器值读取进了一个结构体中。 `sys/user.h` 定义有 `user_regs_struct`。如果你查看头文件,头部的注释这么写到:

|

||||

|

||||

```

|

||||

/* The whole purpose of this file is for GDB and GDB only.

|

||||

Don't read too much into it. Don't use it for

|

||||

anything other than GDB unless know what you are

|

||||

doing. */

|

||||

```

|

||||

|

||||

```

|

||||

/* 这个文件只为了GDB而创建

|

||||

/* 这个文件只为了 GDB 而创建

|

||||

不用详细的阅读.如果你不知道你在干嘛,

|

||||

不要在除了 GDB 以外的任何地方使用此文件 */

|

||||

```

|

||||

|

||||

|

||||

不知道你做何感想,但这让我觉得我们找对地方了。回到例子中,一旦我们在 regs 变量中取得了寄存器的值,我们就可以通过将 PTRACE_PEEKTEXT 作为参数、 regs.eip(x86 上的扩展指令指针)作为地址,调用 ptrace ,读取当前进程的当前指令。下面是新跟踪器所展示出的调试效果:

|

||||

不知道你做何感想,但这让我觉得我们找对地方了。回到例子中,一旦我们在 `regs` 变量中取得了寄存器的值,我们就可以通过将 `PTRACE_PEEKTEXT` 作为参数、 `regs.eip`(x86 上的扩展指令指针)作为地址,调用 `ptrace` ,读取当前进程的当前指令(警告:如同我上面所说,文章很大程度上是平台相关的。我简化了一些设定 - 例如,x86 指令集不需要调整到 4 字节,我的32位 Ubuntu unsigned int 是 4 字节。事实上,许多平台都不需要。从内存中读取指令需要预先安装完整的反汇编器。我们这里没有,但实际的调试器是有的)。下面是新跟踪器所展示出的调试效果:

|

||||

|

||||

```

|

||||

$ simple_tracer traced_helloworld

|

||||

@ -244,7 +234,7 @@ Hello, world!

|

||||

```

|

||||

|

||||

|

||||

现在,除了 icounter,我们也可以观察到指令指针与它每一步所指向的指令。怎么来判断这个结果对不对呢?使用 objdump -d 处理可执行文件:

|

||||

现在,除了 `icounter`,我们也可以观察到指令指针与它每一步所指向的指令。怎么来判断这个结果对不对呢?使用 `objdump -d` 处理可执行文件:

|

||||

|

||||

```

|

||||

$ objdump -d traced_helloworld

|

||||

@ -263,62 +253,36 @@ Disassembly of section .text:

|

||||

804809b: cd 80 int $0x80

|

||||

```

|

||||

|

||||

|

||||

这个结果和我们跟踪器的结果就很容易比较了。

|

||||

|

||||

|

||||

### 将跟踪器关联到正在运行的进程

|

||||

|

||||

|

||||

如你所知,调试器也能关联到已经运行的进程。现在你应该不会惊讶,ptrace 通过 以PTRACE_ATTACH 为参数调用也可以完成这个过程。这里我不会展示示例代码,通过上文的示例代码应该很容易实现这个过程。出于学习目的,这里使用的方法更简便(因为我们在子进程刚开始就可以让它停止)。

|

||||

|

||||

如你所知,调试器也能关联到已经运行的进程。现在你应该不会惊讶,`ptrace` 通过以 `PTRACE_ATTACH` 为参数调用也可以完成这个过程。这里我不会展示示例代码,通过上文的示例代码应该很容易实现这个过程。出于学习目的,这里使用的方法更简便(因为我们在子进程刚开始就可以让它停止)。

|

||||

|

||||

### 代码

|

||||

|

||||

|

||||

上文中的简单的跟踪器(更高级的,可以打印指令的版本)的完整c源代码可以在[这里][20]找到。它是通过 4.4 版本的 gcc 以 -Wall -pedantic --std=c99 编译的。

|

||||

|

||||

上文中的简单的跟踪器(更高级的,可以打印指令的版本)的完整c源代码可以在[这里][20]找到。它是通过 4.4 版本的 gcc 以 `-Wall -pedantic --std=c99` 编译的。

|

||||

|

||||

### 结论与计划

|

||||

|

||||

诚然,这篇文章并没有涉及很多内容 - 我们距离亲手完成一个实际的调试器还有很长的路要走。但我希望这篇文章至少可以使得调试这件事少一些神秘感。`ptrace` 是功能多样的系统调用,我们目前只展示了其中的一小部分。

|

||||

|

||||

诚然,这篇文章并没有涉及很多内容 - 我们距离亲手完成一个实际的调试器还有很长的路要走。但我希望这篇文章至少可以使得调试这件事少一些神秘感。ptrace 是功能多样的系统调用,我们目前只展示了其中的一小部分。

|

||||

|

||||

|

||||

单步调试代码很有用,但也只是在一定程度上有用。上面我通过c的“Hello World!”做了示例。为了执行主函数,可能需要上万行代码来初始化c的运行环境。这并不是很方便。最理想的是在main函数入口处放置断点并从断点处开始分步执行。为此,在这个系列的下一篇,我打算展示怎么实现断点。

|

||||

|

||||

|

||||

单步调试代码很有用,但也只是在一定程度上有用。上面我通过 C 的 “Hello World!” 做了示例。为了执行主函数,可能需要上万行代码来初始化 C 的运行环境。这并不是很方便。最理想的是在 `main` 函数入口处放置断点并从断点处开始分步执行。为此,在这个系列的下一篇,我打算展示怎么实现断点。

|

||||

|

||||

### 参考

|

||||

|

||||

|

||||

撰写此文时参考了如下文章

|

||||

|

||||

* [Playing with ptrace, Part I][11]

|

||||

* [How debugger works][12]

|

||||

|

||||

|

||||

|

||||

[1] 我没有检查,但我确信 gdb 的代码行数至少有六位数。

|

||||

|

||||

[2] 使用 man 2 ptrace 命令可以了解更多。

|

||||

|

||||

[3] Peek and poke 在系统编程中是很知名的叫法,指的是直接读写内存内容。

|

||||

|

||||

[4] 这篇文章假定读者有一定的 Unix/Linux 编程经验。我假定你知道(至少了解概念)fork,exec 族函数与 Unix 信号。

|

||||

|

||||

[5] 至少你同我一样痴迷与机器/汇编语言。

|

||||

|

||||

[6] 警告:如同我上面所说,文章很大程度上是平台相关的。我简化了一些设定 - 例如,x86指令集不需要调整到 4 字节(我的32位 Ubuntu unsigned int 是 4 字节)。事实上,许多平台都不需要。从内存中读取指令需要预先安装完整的反汇编器。我们这里没有,但实际的调试器是有的。

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://eli.thegreenplace.net/2011/01/23/how-debuggers-work-part-1

|

||||

|

||||

作者:[Eli Bendersky ][a]

|

||||

译者:[译者ID](https://github.com/YYforymj)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

作者:[Eli Bendersky][a]

|

||||

译者:[YYforymj](https://github.com/YYforymj)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

165

published/201704/20150112 Data-Oriented Hash Table.md

Normal file

165

published/201704/20150112 Data-Oriented Hash Table.md

Normal file

@ -0,0 +1,165 @@

|

||||

深入解析面向数据的哈希表性能

|

||||

============================================================

|

||||

|

||||

最近几年中,面向数据的设计已经受到了很多的关注 —— 一种强调内存中数据布局的编程风格,包括如何访问以及将会引发多少的 cache 缺失。由于在内存读取操作中缺失所占的数量级要大于命中的数量级,所以缺失的数量通常是优化的关键标准。这不仅仅关乎那些对性能有要求的 code-data 结构设计的软件,由于缺乏对内存效益的重视而成为软件运行缓慢、膨胀的一个很大因素。

|

||||

|

||||

|

||||

高效缓存数据结构的中心原则是将事情变得平滑和线性。比如,在大部分情况下,存储一个序列元素更倾向于使用普通数组而不是链表 —— 每一次通过指针来查找数据都会为 cache 缺失增加一份风险;而普通数组则可以预先获取,并使得内存系统以最大的效率运行

|

||||

|

||||

如果你知道一点内存层级如何运作的知识,下面的内容会是想当然的结果——但是有时候即便它们相当明显,测试一下任不失为一个好主意。几年前 [Baptiste Wicht 测试过了 `std::vector` vs `std::list` vs `std::deque`][4],(后者通常使用分块数组来实现,比如:一个数组的数组)。结果大部分会和你预期的保持一致,但是会存在一些违反直觉的东西。作为实例:在序列链表的中间位置做插入或者移除操作被认为会比数组快,但如果该元素是一个 POD 类型,并且不大于 64 字节或者在 64 字节左右(在一个 cache 流水线内),通过对要操作的元素周围的数组元素进行移位操作要比从头遍历链表来的快。这是由于在遍历链表以及通过指针插入/删除元素的时候可能会导致不少的 cache 缺失,相对而言,数组移位则很少会发生。(对于更大的元素,非 POD 类型,或者你已经有了指向链表元素的指针,此时和预期的一样,链表胜出)

|

||||

|

||||

|

||||

多亏了类似 Baptiste 这样的数据,我们知道了内存布局如何影响序列容器。但是关联容器,比如 hash 表会怎么样呢?已经有了些权威推荐:[Chandler Carruth 推荐的带局部探测的开放寻址][5](此时,我们没必要追踪指针),以及[Mike Acton 推荐的在内存中将 value 和 key 隔离][6](这种情况下,我们可以在每一个 cache 流水线中得到更多的 key), 这可以在我们必须查找多个 key 时提高局部性能。这些想法很有意义,但再一次的说明:测试永远是好习惯,但由于我找不到任何数据,所以只好自己收集了。

|

||||

|

||||

### 测试

|

||||

|

||||

我测试了四个不同的 quick-and-dirty 哈希表实现,另外还包括 `std::unordered_map` 。这五个哈希表都使用了同一个哈希函数 —— Bob Jenkins 的 [SpookyHash][8](64 位哈希值)。(由于哈希函数在这里不是重点,所以我没有测试不同的哈希函数;我同样也没有检测我的分析中的总内存消耗。)实现会通过简短的代码在测试结果表中标注出来。

|

||||

|

||||

* **UM**: `std::unordered_map` 。在 VS2012 和 libstdc++-v3 (libstdc++-v3: gcc 和 clang 都会用到这东西)中,UM 是以链表的形式实现,所有的元素都在链表中,bucket 数组中存储了链表的迭代器。VS2012 中,则是一个双链表,每一个 bucket 存储了起始迭代器和结束迭代器;libstdc++ 中,是一个单链表,每一个 bucket 只存储了一个起始迭代器。这两种情况里,链表节点是独立申请和释放的。最大负载因子是 1 。

|

||||

* **Ch**:分离的、链状 buket 指向一个元素节点的单链表。为了避免分开申请每一个节点,元素节点存储在普通数组池中。未使用的节点保存在一个空闲链表中。最大负载因子是 1。

|

||||

* **OL**:开地址线性探测 —— 每一个 bucket 存储一个 62 bit 的 hash 值,一个 2 bit 的状态值(包括 empty,filled,removed 三个状态),key 和 vale 。最大负载因子是 2/3。

|

||||

* **DO1**:“data-oriented 1” —— 和 OL 相似,但是哈希值、状态值和 key、values 分离在两个隔离的平滑数组中。

|

||||

* **DO2**:“data-oriented 2” —— 与 OL 类似,但是哈希/状态,keys 和 values 被分离在 3 个相隔离的平滑数组中。

|

||||

|

||||

|

||||

在我的所有实现中,包括 VS2012 的 UM 实现,默认使用尺寸为 2 的 n 次方。如果超出了最大负载因子,则扩展两倍。在 libstdc++ 中,UM 默认尺寸是一个素数。如果超出了最大负载因子,则扩展为下一个素数大小。但是我不认为这些细节对性能很重要。素数是一种对低 bit 位上没有足够熵的低劣 hash 函数的挽救手段,但是我们正在用的是一个很好的 hash 函数。

|

||||

|

||||

OL,DO1 和 DO2 的实现将共同的被称为 OA(open addressing)——稍后我们将发现它们在性能特性上非常相似。在每一个实现中,单元数从 100 K 到 1 M,有效负载(比如:总的 key + value 大小)从 8 到 4 k 字节我为几个不同的操作记了时间。 keys 和 values 永远是 POD 类型,keys 永远是 8 个字节(除了 8 字节的有效负载,此时 key 和 value 都是 4 字节)因为我的目的是为了测试内存影响而不是哈希函数性能,所以我将 key 放在连续的尺寸空间中。每一个测试都会重复 5 遍,然后记录最小的耗时。

|

||||

|

||||

测试的操作在这里:

|

||||

|

||||

* **Fill**:将一个随机的 key 序列插入到表中(key 在序列中是唯一的)。

|

||||

* **Presized fill**:和 Fill 相似,但是在插入之间我们先为所有的 key 保留足够的内存空间,以防止在 fill 过程中 rehash 或者重申请。

|

||||

* **Lookup**:执行 100 k 次随机 key 查找,所有的 key 都在 table 中。

|

||||

* **Failed lookup**: 执行 100 k 次随机 key 查找,所有的 key 都不在 table 中。

|

||||

* **Remove**:从 table 中移除随机选择的半数元素。

|

||||

* **Destruct**:销毁 table 并释放内存。

|

||||

|

||||

你可以[在这里下载我的测试代码][9]。这些代码只能在 64 机器上编译(包括Windows和Linux)。在 `main()` 函数顶部附近有一些开关,你可把它们打开或者关掉——如果全开,可能会需要一两个小时才能结束运行。我收集的结果也放在了那个打包文件里的 Excel 表中。(注意: Windows 和 Linux 在不同的 CPU 上跑的,所以时间不具备可比较性)代码也跑了一些单元测试,用来验证所有的 hash 表实现都能运行正确。

|

||||

|

||||

我还顺带尝试了附加的两个实现:Ch 中第一个节点存放在 bucket 中而不是 pool 里,二次探测的开放寻址。

|

||||

这两个都不足以好到可以放在最终的数据里,但是它们的代码仍放在了打包文件里面。

|

||||

|

||||

### 结果

|

||||

|

||||

这里有成吨的数据!!

|

||||

这一节我将详细的讨论一下结果,但是如果你对此不感兴趣,可以直接跳到下一节的总结。

|

||||

|

||||

#### Windows

|

||||

|

||||

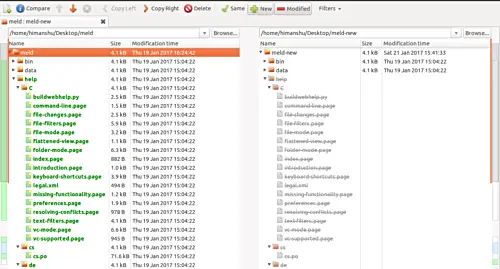

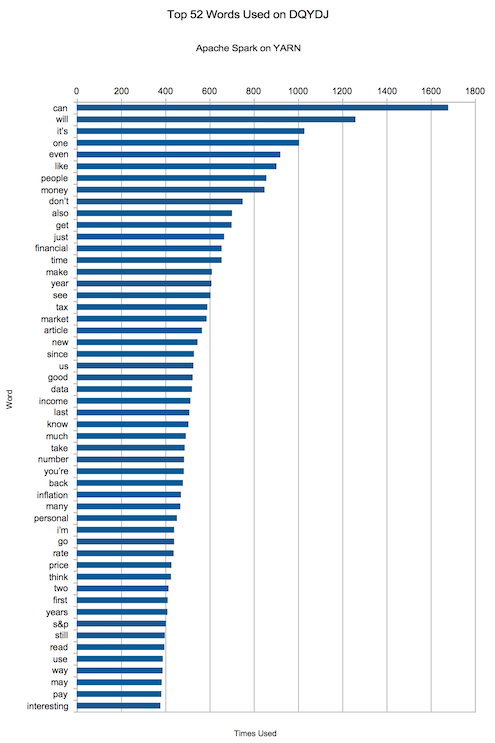

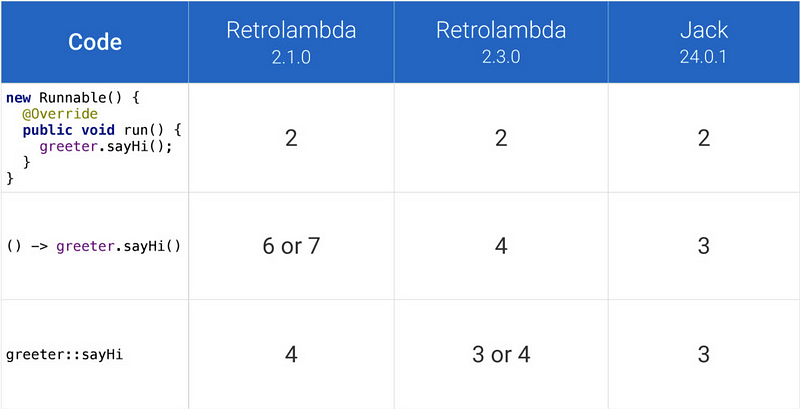

这是所有的测试的图表结果,使用 Visual Studio 2012 编译,运行于 Windows 8.1 和 Core i7-4710HQ 机器上。(点击可以放大。)

|

||||

|

||||

[

|

||||

|

||||

][12]

|

||||

|

||||

从左至右是不同的有效负载大小,从上往下是不同的操作(注意:不是所有的Y轴都是相同的比例!)我将为每一个操作总结一下主要趋向。

|

||||

|

||||

**Fill**:

|

||||

|

||||

在我的 hash 表中,Ch 稍比任何的 OA 变种要好。随着哈希表大小和有效负载的加大,差距也随之变大。我猜测这是由于 Ch 只需要从一个空闲链表中拉取一个元素,然后把它放在 bucket 前面,而 OA 不得不搜索一部分 bucket 来找到一个空位置。所有的 OA 变种的性能表现基本都很相似,当然 DO1 稍微有点优势。

|

||||

|

||||

在小负载的情况,UM 几乎是所有 hash 表中表现最差的 —— 因为 UM 为每一次的插入申请(内存)付出了沉重的代价。但是在 128 字节的时候,这些 hash 表基本相当,大负载的时候 UM 还赢了点。因为,我所有的实现都需要重新调整元素池的大小,并需要移动大量的元素到新池里面,这一点我几乎无能为力;而 UM 一旦为元素申请了内存后便不需要移动了。注意大负载中图表上夸张的跳步!这更确认了重新调整大小带来的问题。相反,UM 只是线性上升 —— 只需要重新调整 bucket 数组大小。由于没有太多隆起的地方,所以相对有效率。

|

||||

|

||||

**Presized fill**:

|

||||

|

||||

大致和 Fill 相似,但是图示结果更加的线性光滑,没有太大的跳步(因为不需要 rehash ),所有的实现差距在这一测试中要缩小了些。大负载时 UM 依然稍快于 Ch,问题还是在于重新调整大小上。Ch 仍是稳步少快于 OA 变种,但是 DO1 比其它的 OA 稍有优势。

|

||||

|

||||

**Lookup**:

|

||||

|

||||

所有的实现都相当的集中。除了最小负载时,DO1 和 OL 稍快,其余情况下 UM 和 DO2 都跑在了前面。(LCTT 译注: 你确定?)真的,我无法描述 UM 在这一步做的多么好。尽管需要遍历链表,但是 UM 还是坚守了面向数据的本性。

|

||||

|

||||

顺带一提,查找时间和 hash 表的大小有着很弱的关联,这真的很有意思。

|

||||

哈希表查找时间期望上是一个常量时间,所以在的渐进视图中,性能不应该依赖于表的大小。但是那是在忽视了 cache 影响的情况下!作为具体的例子,当我们在具有 10 k 条目的表中做 100 k 次查找时,速度会便变快,因为在第一次 10 k - 20 k 次查找后,大部分的表会处在 L3 中。

|

||||

|

||||

**Failed lookup**:

|

||||

|

||||

相对于成功查找,这里就有点更分散一些。DO1 和 DO2 跑在了前面,但 UM 并没有落下,OL 则是捉襟见肘啊。我猜测,这可能是因为 OL 整体上具有更长的搜索路径,尤其是在失败查询时;内存中,hash 值在 key 和 value 之飘来荡去的找不着出路,我也很受伤啊。DO1 和 DO2 具有相同的搜索长度,但是它们将所有的 hash 值打包在内存中,这使得问题有所缓解。

|

||||

|

||||

**Remove**:

|

||||

|

||||

DO2 很显然是赢家,但 DO1 也未落下。Ch 则落后,UM 则是差的不是一丁半点(主要是因为每次移除都要释放内存);差距随着负载的增加而拉大。移除操作是唯一不需要接触数据的操作,只需要 hash 值和 key 的帮助,这也是为什么 DO1 和 DO2 在移除操作中的表现大相径庭,而其它测试中却保持一致。(如果你的值不是 POD 类型的,并需要析构,这种差异应该是会消失的。)

|

||||

|

||||

**Destruct**:

|

||||

|

||||

Ch 除了最小负载,其它的情况都是最快的(最小负载时,约等于 OA 变种)。所有的 OA 变种基本都是相等的。注意,在我的 hash 表中所做的所有析构操作都是释放少量的内存 buffer 。但是 [在Windows中,释放内存的消耗和大小成比例关系][13]。(而且,这是一个很显著的开支 —— 申请 ~1 GB 的内存需要 ~100 ms 的时间去释放!)

|

||||

|

||||

UM 在析构时是最慢的一个(小负载时,慢的程度可以用数量级来衡量),大负载时依旧是稍慢些。对于 UM 来讲,释放每一个元素而不是释放一组数组真的是一个硬伤。

|

||||

|

||||

#### Linux

|

||||

|

||||

我还在装有 Linux Mint 17.1 的 Core i5-4570S 机器上使用 gcc 4.8 和 clang 3.5 来运行了测试。gcc 和 clang 的结果很相像,因此我只展示了 gcc 的;完整的结果集合包含在了代码下载打包文件中,链接在上面。(点击图来缩放)

|

||||

|

||||

[

|

||||

|

||||

][15]

|

||||

|

||||

大部分结果和 Windows 很相似,因此我只高亮了一些有趣的不同点。

|

||||

|

||||

**Lookup**:

|

||||

|

||||

这里 DO1 跑在前头,而在 Windows 中 DO2 更快些。(LCTT 译注: 这里原文写错了吧?)同样,UM 和 Ch 落后于其它所有的实现——过多的指针追踪,然而 OA 只需要在内存中线性的移动即可。至于 Windows 和 Linux 结果为何不同,则不是很清楚。UM 同样比 Ch 慢了不少,特别是大负载时,这很奇怪;我期望的是它们可以基本相同。

|

||||

|

||||

**Failed lookup**:

|

||||

|

||||

UM 再一次落后于其它实现,甚至比 OL 还要慢。我再一次无法理解为何 UM 比 Ch 慢这么多,Linux 和 Windows 的结果为何有着如此大的差距。

|

||||

|

||||

|

||||

**Destruct**:

|

||||

|

||||

在我的实现中,小负载的时候,析构的消耗太少了,以至于无法测量;在大负载中,线性增加的比例和创建的虚拟内存页数量相关,而不是申请到的数量?同样,要比 Windows 中的析构快上几个数量级。但是并不是所有的都和 hash 表有关;我们在这里可以看出不同系统和运行时内存系统的表现。貌似,Linux 释放大内存块是要比 Windows 快上不少(或者 Linux 很好的隐藏了开支,或许将释放工作推迟到了进程退出,又或者将工作推给了其它线程或者进程)。

|

||||

|

||||

UM 由于要释放每一个元素,所以在所有的负载中都比其它慢上几个数量级。事实上,我将图片做了剪裁,因为 UM 太慢了,以至于破坏了 Y 轴的比例。

|

||||

|

||||

### 总结

|

||||

|

||||

好,当我们凝视各种情况下的数据和矛盾的结果时,我们可以得出什么结果呢?我想直接了当的告诉你这些 hash 表变种中有一个打败了其它所有的 hash 表,但是这显然不那么简单。不过我们仍然可以学到一些东西。

|

||||

|

||||

首先,在大多数情况下我们“很容易”做的比 `std::unordered_map` 还要好。我为这些测试所写的所有实现(它们并不复杂;我只花了一两个小时就写完了)要么是符合 `unordered_map` 要么是在其基础上做的提高,除了大负载(超过128字节)中的插入性能, `unordered_map` 为每一个节点独立申请存储占了优势。(尽管我没有测试,我同样期望 `unordered_map` 能在非 POD 类型的负载上取得胜利。)具有指导意义的是,如果你非常关心性能,不要假设你的标准库中的数据结构是高度优化的。它们可能只是在 C++ 标准的一致性上做了优化,但不是性能。:P

|

||||

|

||||

其次,如果不管在小负载还是超负载中,若都只用 DO1 (开放寻址,线性探测,hashes/states 和 key/vaules分别处在隔离的普通数组中),那可能不会有啥好表现。这不是最快的插入,但也不坏(还比 `unordered_map` 快),并且在查找,移除,析构中也很快。你所知道的 —— “面向数据设计”完成了!

|

||||

|

||||

注意,我的为这些哈希表做的测试代码远未能用于生产环境——它们只支持 POD 类型,没有拷贝构造函数以及类似的东西,也未检测重复的 key,等等。我将可能尽快的构建一些实际的 hash 表,用于我的实用库中。为了覆盖基础部分,我想我将有两个变种:一个基于 DO1,用于小的,移动时不需要太大开支的负载;另一个用于链接并且避免重新申请和移动元素(就像 `unordered_map` ),用于大负载或者移动起来需要大开支的负载情况。这应该会给我带来最好的两个世界。

|

||||

|

||||

与此同时,我希望你们会有所启迪。最后记住,如果 Chandler Carruth 和 Mike Acton 在数据结构上给你提出些建议,你一定要听。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

|

||||

作者简介:

|

||||

|

||||

我是一名图形程序员,目前在西雅图做自由职业者。之前我在 NVIDIA 的 DevTech 软件团队中工作,并在美少女特工队工作室中为 PS3 和 PS4 的 Infamous 系列游戏开发渲染技术。

|

||||

|

||||

自 2002 年起,我对图形非常感兴趣,并且已经完成了一系列的工作,包括:雾、大气雾霾、体积照明、水、视觉效果、粒子系统、皮肤和头发阴影、后处理、镜面模型、线性空间渲染、和 GPU 性能测量和优化。

|

||||

|

||||

你可以在我的博客了解更多和我有关的事,处理图形,我还对理论物理和程序设计感兴趣。

|

||||

|

||||

你可以在 nathaniel.reed@gmail.com 或者在 Twitter(@Reedbeta)/Google+ 上关注我。我也会经常在 StackExchange 上回答计算机图形的问题。

|

||||

|

||||

--------------

|

||||

|

||||

via: http://reedbeta.com/blog/data-oriented-hash-table/

|

||||

|

||||

作者:[Nathan Reed][a]

|

||||

译者:[sanfusu](https://github.com/sanfusu)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://reedbeta.com/about/

|

||||

[1]:http://reedbeta.com/blog/data-oriented-hash-table/

|

||||

[2]:http://reedbeta.com/blog/category/coding/

|

||||

[3]:http://reedbeta.com/blog/data-oriented-hash-table/#comments

|

||||

[4]:http://baptiste-wicht.com/posts/2012/12/cpp-benchmark-vector-list-deque.html

|

||||

[5]:https://www.youtube.com/watch?v=fHNmRkzxHWs

|

||||

[6]:https://www.youtube.com/watch?v=rX0ItVEVjHc

|

||||

[7]:http://reedbeta.com/blog/data-oriented-hash-table/#the-tests

|

||||

[8]:http://burtleburtle.net/bob/hash/spooky.html

|

||||

[9]:http://reedbeta.com/blog/data-oriented-hash-table/hash-table-tests.zip

|

||||

[10]:http://reedbeta.com/blog/data-oriented-hash-table/#the-results

|

||||

[11]:http://reedbeta.com/blog/data-oriented-hash-table/#windows

|

||||

[12]:http://reedbeta.com/blog/data-oriented-hash-table/results-vs2012.png

|

||||

[13]:https://randomascii.wordpress.com/2014/12/10/hidden-costs-of-memory-allocation/

|

||||

[14]:http://reedbeta.com/blog/data-oriented-hash-table/#linux

|

||||

[15]:http://reedbeta.com/blog/data-oriented-hash-table/results-g++4.8.png

|

||||

[16]:http://reedbeta.com/blog/data-oriented-hash-table/#conclusions

|

||||

@ -0,0 +1,314 @@

|

||||

2016 年度顶级开源创作工具

|

||||

============================================================

|

||||

|

||||

> 无论你是想修改图片、编译音频,还是制作动画,这里的自由而开源的工具都能帮你做到。

|

||||

|

||||

|

||||

|

||||

>图片来源 : opensource.com

|

||||

|

||||

几年前,我在 Red Hat 总结会上做了一个简单的演讲,给与会者展示了 [2012 年度开源创作工具][12]。开源软件在过去几年里发展迅速,现在我们来看看 2016 年的相关领域的软件。

|

||||

|

||||

### 核心应用

|

||||

|

||||

这六款应用是开源的设计软件中的最强王者。它们做的很棒,拥有完善的功能特征集、稳定发行版以及活跃的开发者社区,是很成熟的项目。这六款应用都是跨平台的,每一个都能在 Linux、OS X 和 Windows 上使用,不过大多数情况下 Linux 版本一般都是最先更新的。这些应用广为人知,我已经把最新特性的重要部分写进来了,如果你不是非常了解它们的开发情况,你有可能会忽视这些特性。

|

||||

|

||||

如果你想要对这些软件做更深层次的了解,或许你可以帮助测试这四个软件 —— GIMP、Inkscape、Scribus,以及 MyPaint 的最新版本,在 Linux 机器上你可以用 [Flatpak][13] 软件轻松地安装它们。这些应用的每日构建版本可以[按照指令][14] 通过 Flatpak 的“每日构建的绘图应用(Nightly Graphics Apps)”得到。有一件事要注意:如果你要给每个应用的 Flatpak 版本安装笔刷或者其它扩展,用于移除这些扩展的目录将会位于相应应用的目录 **~/.var/app** 下。

|

||||

|

||||

#### GIMP

|

||||

|

||||

[GIMP][15] [在 2015 年迎来了它的 20 周岁][16],使得它成为这里资历最久的开源创造型应用之一。GIMP 是一款强大的应用,可以处理图片,创作简单的绘画,以及插图。你可以通过简单的任务来尝试 GIMP,比如裁剪、缩放图片,然后循序渐进使用它的其它功能。GIMP 可以在 Linux、Mac OS X 以及 Windows 上使用,是一款跨平台的应用,而且能够打开、导出一系列格式的文件,包括在与之相似的软件 Photoshop 上广为应用的那些格式。

|

||||

|

||||

GIMP 开发团队正在忙着 2.10 发行版的工作;[2.8.18][17] 是最新的稳定版本。更振奋人心的是非稳定版,[2.9.4][18],拥有全新的用户界面,旨在节省空间的符号式图标和黑色主题,改进了颜色管理,更多的基于 GEGL 的支持分离预览的过滤器,支持 MyPaint 笔刷(如下图所示),对称绘图,以及命令行批次处理。想了解更多信息,请关注 [完整的发行版注记][19]。

|

||||

|

||||

|

||||

|

||||

#### Inkscape

|

||||

|

||||

[Inkscape][20] 是一款富有特色的矢量绘图设计软件。可以用它来创作简单的图形、图表、布局或者图标。

|

||||

|

||||

最新的稳定版是 [0.91][21] 版本;与 GIMP 相似,能在预发布版 0.92pre3 版本中找到更多有趣的东西,其发布于 2016 年 11 月。最新推出的预发布版的突出特点是 [梯度网格特性(gradient mesh feature)][22](如下图所示);0.91 发行版里介绍的新特性包括:[强力笔触(power stroke)][23] 用于完全可配置的书法笔画(下图的 “opensource.com” 中的 “open” 用的就是强力笔触技术),画布测量工具,以及 [全新的符号对话框][24](如下图右侧所示)。(很多符号库可以从 GitHub 上获得;[Xaviju's inkscape-open-symbols set][25] 就很不错。)_对象_对话框是在改进版或每日构建中可用的新特性,整合了一个文档中的所有对象,提供工具来管理这些对象。

|

||||

|

||||

|

||||

|

||||

#### Scribus

|

||||

|

||||

[Scribus][26] 是一款强大的桌面出版和页面布局工具。Scribus 让你能够创造精致美丽的物品,包括信封、书籍、杂志以及其它印刷品。Scribus 的颜色管理工具可以处理和输出 CMYK 格式,还能给文件配色,可靠地用于印刷车间的重印。

|

||||

|

||||

[1.4.6][27] 是 Scribus 的最新稳定版本;[1.5.x][28] 系列的发行版更令人期待,因为它们是即将到来的 1.6.0 发行版的预览。1.5.3 版本包含了 Krita 文件(*.KRA)导入工具; 1.5.x 系列中其它的改进包括了表格工具、文本框对齐、脚注、导出可选 PDF 格式、改进的字典、可驻留边框的调色盘、符号工具,和丰富的文件格式支持。

|

||||

|

||||

|

||||

|

||||

#### MyPaint

|

||||

|

||||

[MyPaint][29] 是一款用于数位屏的快速绘图和插画工具。它很轻巧,界面虽小,但快捷键丰富,因此你能够不用放下数位笔而专心于绘图。

|

||||

|

||||

[MyPaint 1.2.0][30] 是其最新的稳定版本,包含了一些新特性,诸如 [直观上墨工具][31] 用来跟踪铅笔绘图的轨迹,新的填充工具,层分组,笔刷和颜色的历史面板,用户界面的改进包括暗色主题和小型符号图标,以及可编辑的矢量层。想要尝试 MyPaint 里的最新改进,我建议安装每日构建版的 Flatpak 构建,尽管自从 1.2.0 版本没有添加重要的特性。

|

||||

|

||||

|

||||

|

||||

#### Blender

|

||||

|

||||

[Blender][32] 最初发布于 1995 年 1 月,像 GIMP 一样,已经有 20 多年的历史了。Blender 是一款功能强大的开源 3D 制作套件,包含建模、雕刻、渲染、真实材质、套索、动画、影像合成、视频编辑、游戏创作以及模拟。

|

||||

|

||||

Blender 最新的稳定版是 [2.78a][33]。2.78 版本很庞大,包含的特性有:改进的 2D 蜡笔(Grease Pencil) 动画工具;针对球面立体图片的 VR 渲染支持;以及新的手绘曲线的绘图工具。

|

||||

|

||||

|

||||

|

||||

要尝试最新的 Blender 开发工具,有很多种选择,包括:

|

||||

|

||||

* Blender 基金会在官方网址提供 [非稳定版的每日构建版][2]。

|

||||

* 如果你在寻找特殊的开发中特性,[graphicall.org][3] 是一个适合社区的网站,能够提供特殊版本的 Blender(偶尔还有其它的创造型开源应用),让艺术家能够尝试体验最新的代码。

|

||||

* Mathieu Bridon 通过 Flatpak 做了 Blender 的一个开发版本。查看它的博客以了解详情:[Flatpak 上每日构建版的 Blender][4]

|

||||

|

||||

#### Krita

|

||||

|

||||

[Krita][34] 是一款拥有强大功能的数字绘图应用。这款应用贴合插画师、印象艺术家以及漫画家的需求,有很多附件,比如笔刷、调色板、图案以及模版。

|

||||

|

||||

最新的稳定版是 [Krita 3.0.1][35],于 2016 年 9 月发布。3.0.x 系列的新特性包括 2D 逐帧动画;改进的层管理器和功能;丰富的常用快捷键;改进了网格、向导和图形捕捉;还有软打样。

|

||||

|

||||

|

||||

|

||||

### 视频处理工具

|

||||

|

||||

关于开源的视频编辑工具则有很多很多。这这些工具之中,[Flowblade][36] 是新推出的,而 Kdenlive 则是构建完善、对新手友好、功能最全的竞争者。对你排除某些备选品有所帮助的主要标准是它们所支持的平台,其中一些只支持 Linux 平台。它们的软件上游都很活跃,最新的稳定版都于近期发布,发布时间相差不到一周。

|

||||

|

||||

#### Kdenlive

|

||||

|

||||

[Kdenlive][37],最初于 2002 年发布,是一款强大的非线性视频编辑器,有 Linux 和 OS X 版本(但是 OS X 版本已经过时了)。Kdenlive 有用户友好的、基于拖拽的用户界面,适合初学者,又有专业人员需要的深层次功能。

|

||||

|

||||

可以看看 Seth Kenlon 写的 [Kdenlive 系列教程][38],了解如何使用 Kdenlive。

|

||||

|

||||

* 最新稳定版: 16.08.2 (2016 年 10 月)

|

||||

|

||||

|

||||

|

||||

#### Flowblade

|

||||

|

||||

2012 年发布, [Flowblade][39],只有 Linux 版本的视频编辑器,是个相当不错的后起之秀。

|

||||

|

||||

* 最新稳定版: 1.8 (2016 年 9 月)

|

||||

|

||||

#### Pitivi

|

||||

|

||||

[Pitivi][40] 是用户友好型的自由开源视频编辑器。Pitivi 是用 [Python][41] 编写的(“Pitivi” 中的 “Pi”来源于此),使用了 [GStreamer][42] 多媒体框架,社区活跃。

|

||||

|

||||

* 最新稳定版: 0.97 (2016 年 8 月)

|

||||

* 通过 Flatpak 获取 [最新版本][5]

|

||||

|

||||

#### Shotcut

|

||||

|

||||

[Shotcut][43] 是一款自由开源的跨平台视频编辑器,[早在 2004 年]就发布了,之后由现在的主要开发者 [Dan Dennedy][45] 重写。

|

||||

|

||||

* 最新稳定版: 16.11 (2016 年 11 月)

|

||||

* 支持 4K 分辨率

|

||||

* 仅以 tar 包方式发布

|

||||

|

||||

#### OpenShot Video Editor

|

||||

|

||||

始于 2008 年,[OpenShot Video Editor][46] 是一款自由、开源、易于使用、跨平台的视频编辑器。

|

||||

|

||||

* 最新稳定版: [2.1][6] (2016 年 8 月)

|

||||

|

||||

|

||||

### 其它工具

|

||||

|

||||

#### SwatchBooker

|

||||

|

||||

[SwatchBooker][47] 是一款很方便的工具,尽管它近几年都没有更新了,但它还是很有用。SwatchBooler 能帮助用户从各大制造商那里合法地获取色卡,你可以用其它自由开源的工具处理它导出的格式,包括 Scribus。

|

||||

|

||||

#### GNOME Color Manager

|

||||

|

||||

[GNOME Color Manager][48] 是 GNOME 桌面环境内建的颜色管理器,而 GNOME 是某些 Linux 发行版的默认桌面。这个工具让你能够用色度计为自己的显示设备创建属性文件,还可以为这些设备加载/管理 ICC 颜色属性文件。

|

||||

|

||||

#### GNOME Wacom Control

|

||||

|

||||

[The GNOME Wacom controls][49] 允许你在 GNOME 桌面环境中配置自己的 Wacom 手写板;你可以修改手写板交互的很多选项,包括自定义手写板灵敏度,以及手写板映射到哪块屏幕上。

|

||||

|

||||

#### Xournal

|

||||

|

||||

[Xournal][50] 是一款简单但可靠的应用,可以让你通过手写板手写或者在笔记上涂鸦。Xournal 是一款有用的工具,可以让你签名或注解 PDF 文档。

|

||||

|

||||

#### PDF Mod

|

||||

|

||||

[PDF Mod][51] 是一款编辑 PDF 文件很方便的工具。PDF Mod 让用户可以移除页面、添加页面,将多个 PDF 文档合并成一个单独的 PDF 文件,重新排列页面,旋转页面等。

|

||||

|

||||

#### SparkleShare

|

||||

|

||||

[SparkleShare][52] 是一款基于 git 的文件分享工具,艺术家用来协作和分享资源。它会挂载在 GitLab 仓库上,你能够采用一个精妙的开源架构来进行资源管理。SparkleShare 的前端通过在顶部提供一个类似下拉框界面,避免了使用 git 的复杂性。

|

||||

|

||||

### 摄影

|

||||

|

||||

#### Darktable

|

||||

|

||||

[Darktable][53] 是一款能让你开发数位 RAW 文件的应用,有一系列工具,可以管理工作流、无损编辑图片。Darktable 支持许多流行的相机和镜头。

|

||||

|

||||

|

||||

|

||||

#### Entangle

|

||||

|

||||

[Entangle][54] 允许你将数字相机连接到电脑上,让你能从电脑上完全控制相机。

|

||||

|

||||

#### Hugin

|

||||

|

||||

[Hugin][55] 是一款工具,让你可以拼接照片,从而制作全景照片。

|

||||

|

||||

### 2D 动画

|

||||

|

||||

#### Synfig Studio

|

||||

|

||||

[Synfig Studio][56] 是基于矢量的二维动画套件,支持位图原图,在平板上用起来方便。

|

||||

|

||||

#### Blender Grease Pencil

|

||||

|

||||

我在前面讲过了 Blender,但值得注意的是,最近的发行版里[重构的蜡笔特性][57],添加了创作二维动画的功能。

|

||||

|

||||

#### Krita

|

||||

|

||||

[Krita][58] 现在同样提供了二维动画功能。

|

||||

|

||||

### 音频编辑

|

||||

|

||||

#### Audacity

|

||||

|

||||

[Audacity][59] 在编辑音频文件、记录声音方面很有名,是用户友好型的工具。

|

||||

|

||||

#### Ardour

|

||||

|

||||

[Ardour][60] 是一款数字音频工作软件,界面中间是录音,编辑和混音工作流。使用上它比 Audacity 要稍微难一点,但它允许自动操作,并且更高端。(有 Linux、Mac OS X 和 Windows 版本)

|

||||

|

||||

#### Hydrogen

|

||||

|

||||

[Hydrogen][61] 是一款开源的电子鼓,界面直观。它可以用合成的乐器创作、整理各种乐谱。

|

||||

|

||||

#### Mixxx

|

||||

|

||||

[Mixxx][62] 是四仓 DJ 套件,让你能够以强大操控来 DJ 和混音歌曲,包含节拍循环、时间延长、音高变化,还可以用 DJ 硬件控制器直播混音和衔接。

|

||||

|

||||

### Rosegarden

|

||||

|

||||

[Rosegarden][63] 是一款作曲软件,有乐谱编写和音乐作曲或编辑的功能,提供音频和 MIDI 音序器。(LCTT 译注:MIDI 即 Musical Instrument Digital Interface 乐器数字接口)

|

||||

|

||||

#### MuseScore

|

||||

|

||||

[MuseScore][64] 是乐谱创作、记谱和编辑的软件,它还有个乐谱贡献者社区。

|

||||

|

||||

### 其它具有创造力的工具

|

||||

|

||||

#### MakeHuman

|

||||

|

||||

[MakeHuman][65] 是一款三维绘图工具,可以创造人型的真实模型。

|

||||

|

||||

#### Natron

|

||||

|

||||

[Natron][66] 是基于节点的合成工具,用于视频后期制作、动态图象和设计特效。

|

||||

|

||||

#### FontForge

|

||||

|

||||

[FontForge][67] 是创作和编辑字体的工具。允许你编辑某个字体中的字形,也能够使用这些字形生成字体。

|

||||

|

||||

#### Valentina

|

||||

|

||||

[Valentina][68] 是用来设计缝纫图案的应用。

|

||||

|

||||

#### Calligra Flow

|

||||

|

||||

[Calligra Flow][69] 是一款图表工具,类似 Visio(有 Linux,Mac OS X 和 Windows 版本)。

|

||||

|

||||

### 资源

|

||||

|

||||

这里有很多小玩意和彩蛋值得尝试。需要一点灵感来探索?这些网站和论坛有很多教程和精美的成品能够激发你开始创作:

|

||||

|

||||

1、 [pixls.us][7]: 摄影师 Pat David 管理的博客,他专注于专业摄影师使用的自由开源的软件和工作流。

|

||||

2、 [David Revoy 's Blog][8]: David Revoy 的博客,热爱自由开源,非常有天赋的插画师,概念派画师和开源倡议者,对 Blender 基金会电影有很大贡献。

|

||||

3、 [The Open Source Creative Podcast][9]: 由 Opensource.com 社区版主和专栏作家 [Jason van Gumster][10] 管理,他是 Blender 和 GIMP 的专家, [《Blender for Dummies》][1] 的作者,该文章正好是面向我们这些热爱开源创作工具和这些工具周边的文化的人。

|

||||

4、 [Libre Graphics Meeting][11]: 自由开源创作软件的开发者和使用这些软件的创作者的年度会议。这是个好地方,你可以通过它找到你喜爱的开源创作软件将会推出哪些有意思的特性,还可以了解到这些软件的用户用它们在做什么。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

作者简介:

|

||||

|

||||

|

||||

|

||||

Máirín Duffy - Máirín 是 Red Hat 的首席交互设计师。她热衷于自由软件和开源工具,尤其是在创作领域:她最喜欢的应用是 [Inkscape](http://inkscape.org)。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/16/12/yearbook-top-open-source-creative-tools-2016

|

||||

|

||||

作者:[Máirín Duffy][a]

|

||||

译者:[GitFuture](https://github.com/GitFuture)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/mairin

|

||||

[1]:http://www.blenderbasics.com/

|

||||

[2]:https://builder.blender.org/download/

|

||||

[3]:http://graphicall.org/

|

||||

[4]:https://mathieu.daitauha.fr/blog/2016/09/23/blender-nightly-in-flatpak/

|

||||

[5]:https://pitivi.wordpress.com/2016/07/18/get-pitivi-directly-from-us-with-flatpak/

|

||||

[6]:http://www.openshotvideo.com/2016/08/openshot-21-released.html

|

||||

[7]:http://pixls.us/

|

||||

[8]:http://davidrevoy.com/

|

||||

[9]:http://monsterjavaguns.com/podcast/

|

||||

[10]:https://opensource.com/users/jason-van-gumster

|

||||

[11]:http://libregraphicsmeeting.org/2016/

|

||||

[12]:https://opensource.com/life/12/9/tour-through-open-source-creative-tools

|

||||

[13]:https://opensource.com/business/16/8/flatpak

|

||||

[14]:http://flatpak.org/apps.html

|

||||

[15]:https://opensource.com/tags/gimp

|

||||

[16]:https://linux.cn/article-7131-1.html

|

||||

[17]:https://www.gimp.org/news/2016/07/14/gimp-2-8-18-released/

|

||||

[18]:https://www.gimp.org/news/2016/07/13/gimp-2-9-4-released/

|

||||

[19]:https://www.gimp.org/news/2016/07/13/gimp-2-9-4-released/

|

||||

[20]:https://opensource.com/tags/inkscape

|

||||

[21]:http://wiki.inkscape.org/wiki/index.php/Release_notes/0.91

|

||||

[22]:http://wiki.inkscape.org/wiki/index.php/Mesh_Gradients

|

||||

[23]:https://www.youtube.com/watch?v=IztyV-Dy4CE

|

||||

[24]:https://inkscape.org/cs/~doctormo/%E2%98%85symbols-dialog

|

||||

[25]:https://github.com/Xaviju/inkscape-open-symbols

|

||||

[26]:https://opensource.com/tags/scribus

|

||||

[27]:https://www.scribus.net/scribus-1-4-6-released/

|

||||

[28]:https://www.scribus.net/scribus-1-5-2-released/

|

||||

[29]:http://mypaint.org/

|

||||

[30]:http://mypaint.org/blog/2016/01/15/mypaint-1.2.0-released/

|

||||

[31]:https://github.com/mypaint/mypaint/wiki/v1.2-Inking-Tool

|

||||

[32]:https://opensource.com/tags/blender

|

||||

[33]:http://www.blender.org/features/2-78/

|

||||

[34]:https://opensource.com/tags/krita

|

||||

[35]:https://krita.org/en/item/krita-3-0-1-update-brings-numerous-fixes/

|

||||

[36]:https://opensource.com/life/16/9/10-reasons-flowblade-linux-video-editor

|

||||

[37]:https://opensource.com/tags/kdenlive

|

||||

[38]:https://opensource.com/life/11/11/introduction-kdenlive

|

||||

[39]:http://jliljebl.github.io/flowblade/

|

||||

[40]:http://pitivi.org/

|

||||

[41]:http://wiki.pitivi.org/wiki/Why_Python%3F

|

||||

[42]:https://gstreamer.freedesktop.org/

|

||||

[43]:http://shotcut.org/

|

||||

[44]:http://permalink.gmane.org/gmane.comp.lib.fltk.general/2397

|

||||

[45]:http://www.dennedy.org/

|

||||

[46]:http://openshot.org/

|

||||

[47]:http://www.selapa.net/swatchbooker/

|

||||

[48]:https://help.gnome.org/users/gnome-help/stable/color.html.en

|

||||

[49]:https://help.gnome.org/users/gnome-help/stable/wacom.html.en

|

||||

[50]:http://xournal.sourceforge.net/

|

||||

[51]:https://wiki.gnome.org/Apps/PdfMod

|

||||

[52]:https://www.sparkleshare.org/

|

||||

[53]:https://opensource.com/life/16/4/how-use-darktable-digital-darkroom

|

||||

[54]:https://entangle-photo.org/

|

||||

[55]:http://hugin.sourceforge.net/

|

||||

[56]:https://opensource.com/article/16/12/synfig-studio-animation-software-tutorial

|

||||

[57]:https://wiki.blender.org/index.php/Dev:Ref/Release_Notes/2.78/GPencil

|

||||

[58]:https://opensource.com/tags/krita

|

||||

[59]:https://opensource.com/tags/audacity

|

||||

[60]:https://ardour.org/

|

||||

[61]:http://www.hydrogen-music.org/

|

||||

[62]:http://mixxx.org/

|

||||

[63]:http://www.rosegardenmusic.com/

|

||||

[64]:https://opensource.com/life/16/03/musescore-tutorial

|

||||

[65]:http://makehuman.org/

|

||||

[66]:https://natron.fr/

|

||||

[67]:http://fontforge.github.io/en-US/

|

||||

[68]:http://valentina-project.org/

|

||||

[69]:https://www.calligra.org/flow/

|

||||

@ -1,7 +1,7 @@

|

||||

工程师和市场营销人员之间能够相互学习什么?

|

||||

============================================================

|

||||

|

||||

> 营销人员觉得工程师在工作中都太严谨了;而工程师则认为营销人员都很懒散。但是他们都错了。

|

||||

> 营销人员觉得工程师在工作中都太严谨了;而工程师则认为营销人员毫无用处。但是他们都错了。

|

||||

|

||||

|

||||

|

||||

@ -1,74 +1,59 @@

|

||||

|

||||

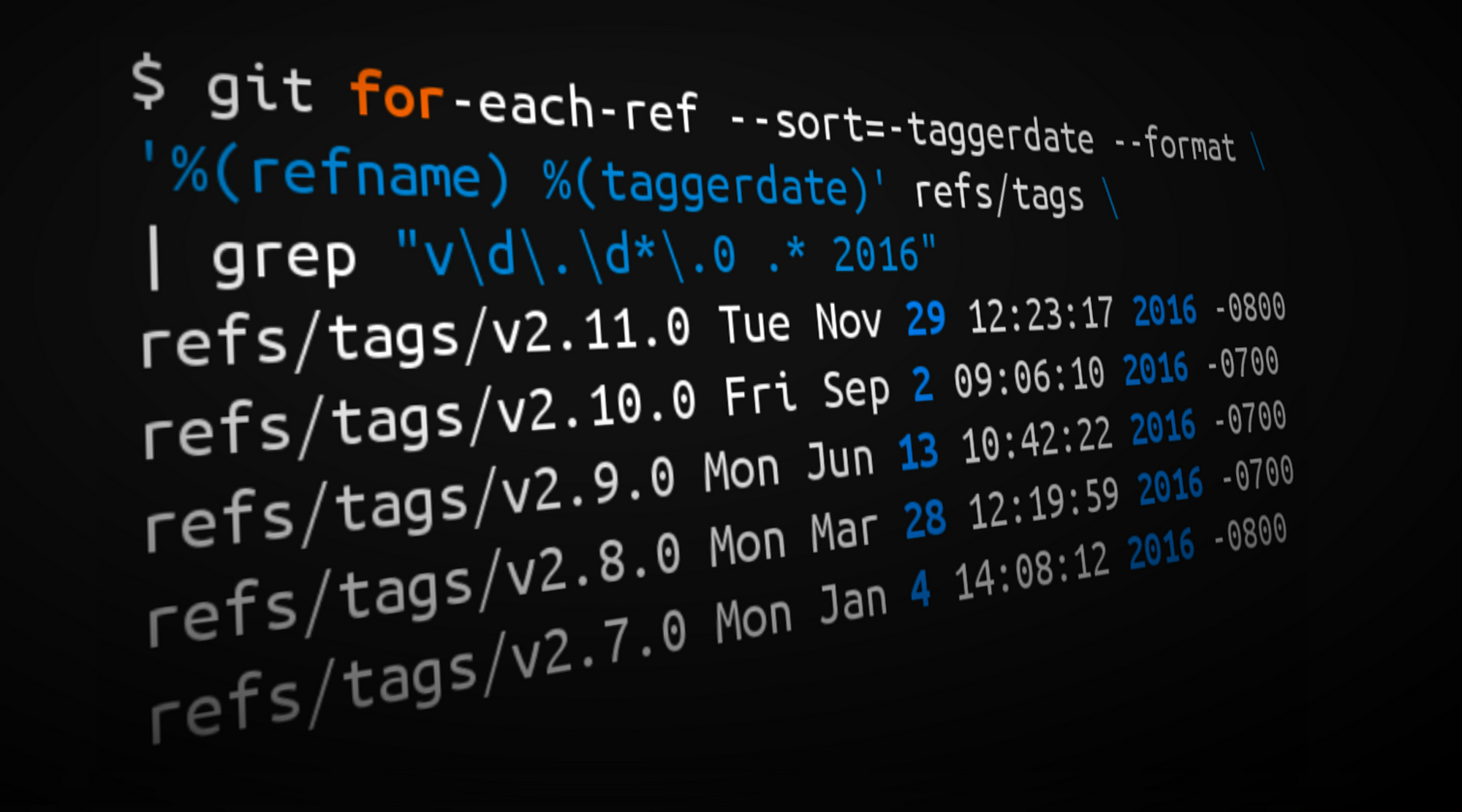

2016 Git 新视界

|

||||

============================================================

|

||||

|

||||

|

||||

|

||||

|

||||