mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-12 01:40:10 +08:00

commit

1eeaa77c19

@ -0,0 +1,69 @@

|

||||

Rowhammer:针对物理内存的攻击可以取得 Android 设备的 root 权限

|

||||

===

|

||||

|

||||

> 攻击者确实可以在物理存储单元中实现位翻转来达到侵入移动设备与计算机的目的

|

||||

|

||||

|

||||

|

||||

|

||||

研究者们发现了一种新的在不利用任何软件漏洞情况下,利用内存芯片物理设计上的弱点来侵入 Android 设备的方式。这种攻击技术同样可以影响到其它如 ARM 和 X86 架构的设备与计算机。

|

||||

|

||||

这种称之为“Rowhammer”的攻击起源于过去十多年中将更多的 DRAM(动态随机存取存储器)容量封装进越来越小的芯片中,这将导致在特定情况下存储单元电子可以从相邻两<ruby>行<rt>row</rt></ruby>的一边泄漏到另一边。(LCTT 译注:参见 https://en.wikipedia.org/wiki/Row_hammer)

|

||||

|

||||

例如,反复且快速的访问相同的物理储存位置,这种被称为 “<ruby>锤击<rt>hammering</rt></ruby>” 的行为可以导致相邻位置的位值从 0 反转成 1,或者相反。

|

||||

|

||||

虽然这样的电子干扰已经被生产商知晓并且从可靠性角度研究了一段时间了,因为内存错误能够导致系统崩溃。而研究者们现在展示了在可控方式的触发下它所存在的严重安全隐患。

|

||||

|

||||

在 2015 年 4 月,来自谷歌 Project Zero 项目的研究者公布了两份基于内存 “Rowhammer”漏洞对于 x86-64 CPU 架构的 [提权利用][7]。其中一份利用可以使代码从谷歌的 Chrome 浏览器沙盒里逃逸并且直接在系统上执行,另一份可以在 Linux 机器上获取内核级权限。

|

||||

|

||||

此后,其他的研究者进行了更深入的调查并且展示了[通过网站中 JaveScript 脚本进行利用的方式][6]甚至能够影响运行在云环境下的[虚拟服务器][5]。然而,对于这项技术是否可以应用在智能手机和移动设备大量使用的 ARM 架构中还是有疑问的。

|

||||

|

||||

现在,一队成员来自荷兰阿姆斯特丹自由大学、奥地利格拉茨技术大学和加州大学圣塔芭芭拉分校的 VUSec 小组,已经证明了 Rowhammer 不仅仅可以应用在 ARM 架构上并且甚至比在 x86 架构上更容易。

|

||||

|

||||

研究者们将他们的新攻击命名为 Drammer,代表了 Rowhammer 确实存在,并且计划于周三在维也纳举办的第 23 届 ACM 计算机与通信安全大会上展示。这种攻击建立在之前就被发现与实现的 Rowhammer 技术之上。

|

||||

|

||||

VUSec 小组的研究者已经制造了一个适用于 Android 设备的恶意应用,当它被执行的时候利用不易察觉的内存位反转在不需要任何权限的情况下就可以获取设备根权限。

|

||||

|

||||

研究者们测试了来自不同制造商的 27 款 Android 设备,21 款使用 ARMv7(32-bit)指令集架构,其它 6 款使用 ARMv8(64-bit)指令集架构。他们成功的在 17 款 ARMv7 设备和 1 款 ARMv8 设备上实现了为反转,表明了这些设备是易受攻击的。

|

||||

|

||||

此外,Drammer 能够与其它的 Android 漏洞组合使用,例如 [Stagefright][4] 或者 [BAndroid][3] 来实现无需用户手动下载恶意应用的远程攻击。

|

||||

|

||||

谷歌已经注意到了这一类型的攻击。“在研究者向谷歌漏洞奖励计划报告了这个问题之后,我们与他们进行了密切的沟通来深入理解这个问题以便我们更好的保护用户,”一位谷歌的代表在一份邮件申明中这样说到。“我们已经开发了一个缓解方案,将会包含在十一月的安全更新中。”(LCTT 译注:缓解方案,参见 https://en.wikipedia.org/wiki/Vulnerability_management)

|

||||

|

||||

VUSec 的研究者认为,谷歌的缓解方案将会使得攻击过程更为复杂,但是它不能修复潜在的问题。

|

||||

|

||||

事实上,从软件上去修复一个由硬件导致的问题是不现实的。硬件供应商正在研究相关问题并且有可能在将来的内存芯片中被修复,但是在现有设备的芯片中风险依然存在。

|

||||

|

||||

更糟的是,研究者们说,由于有许多因素会影响到攻击的成功与否并且这些因素尚未被研究透彻,因此很难去说有哪些设备会被影响到。例如,内存控制器可能会在不同的电量的情况下展现不同的行为,因此一个设备可能在满电的情况下没有风险,当它处于低电量的情况下就是有风险的。

|

||||

|

||||

同样的,在网络安全中有这样一句俗语:<ruby>攻击将变本加厉,如火如荼<rt>Attacks always get getter, they never get worse</rt></ruby>。Rowhammer 攻击已经从理论变成了现实可能,同样的,它也可能会从现在的现实可能变成确确实实的存在。这意味着今天某个设备是不被影响的,在明天就有可能被改进后的 Rowhammer 技术证明它是存在风险的。

|

||||

|

||||

Drammer 在 Android 上实现是因为研究者期望研究基于 ARM 设备的影响,但是潜在的技术可以被使用在所有的架构与操作系统上。新的攻击相较于之前建立在运气与特殊特性与特定平台之上并且十分容易失效的技术已经是一个巨大的进步了。

|

||||

|

||||

Drammer 攻击的实现依靠于被包括图形、网络、声音等大量硬件子系统所使用的 DMA(直接存储访问)缓存。Drammer 的实现采用了所有操作系统上都有的 Android 的 ION 内存分配器、接口与方法,这给我们带来的警示是该论文的主要贡献之一。

|

||||

|

||||

“破天荒的,我们成功地展示了我们可以做到,在不依赖任何特定的特性情况下完全可靠的证明了 Rowhammer”, VUSec 小组中的其中一位研究者 Cristiano Giuffrida 这样说道。“攻击所利用的内存位置并非是 Android 独有的。攻击在任何的 Linux 平台上都能工作 -- 我们甚至怀疑其它操作系统也可以 -- 因为它利用的是操作系统内核内存管理中固有的特性。”

|

||||

|

||||

“我期待我们可以看到更多针对其它平台的攻击的变种,”阿姆斯特丹自由大学的教授兼 VUSec 系统安全研究小组的领导者 Herbert Bos 补充道。

|

||||

|

||||

在他们的[论文][2]之外,研究者们也释出了一个 Android 应用来测试 Android 设备在当前所知的技术条件下受到 Rowhammer 攻击时是否会有风险。应用还没有传上谷歌应用商店,可以从 [VUSec Drammer 网站][1] 下载来手动安装。一个开源的 Rowhammer 模拟器同样能够帮助其他的研究者来更深入的研究这个问题。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via:http://www.csoonline.com/article/3134726/security/physical-ram-attack-can-root-android-and-possibly-other-devices.html

|

||||

|

||||

作者:[Lucian Constantin][a]

|

||||

译者:[wcnnbdk1](https://github.com/wcnnbdk1)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: http://www.csoonline.com/author/Lucian-Constantin/

|

||||

[1]:https://www.vusec.net/projects/drammer/

|

||||

[2]:https://vvdveen.com/publications/drammer.pdf

|

||||

[3]:https://www.vusec.net/projects/bandroid/

|

||||

[4]:http://www.csoonline.com/article/3045836/security/new-stagefright-exploit-puts-millions-of-android-devices-at-risk.html

|

||||

[5]:http://www.infoworld.com/article/3105889/security/flip-feng-shui-attack-on-cloud-vms-exploits-hardware-weaknesses.html

|

||||

[6]:http://www.computerworld.com/article/2954582/security/researchers-develop-astonishing-webbased-attack-on-a-computers-dram.html

|

||||

[7]:http://www.computerworld.com/article/2895898/google-researchers-hack-computers-using-dram-electrical-leaks.html

|

||||

[8]:http://csoonline.com/newsletters/signup.html

|

||||

@ -1,68 +1,67 @@

|

||||

该死,原生移动应用的开发成本太高了!

|

||||

============================================================

|

||||

|

||||

### 一个有价值的命题

|

||||

> 一个有价值的命题

|

||||

|

||||

我们遇到了一个临界点。除去几个比较好的用例之外,使用原生框架和原生应用开发团队构建、维护移动应用再也没有意义了。

|

||||

我们遇到了一个临界点。除去少数几个特别的的用例之外,使用原生框架和原生应用开发团队构建、维护移动应用再也没有意义了。

|

||||

|

||||

|

||||

|

||||

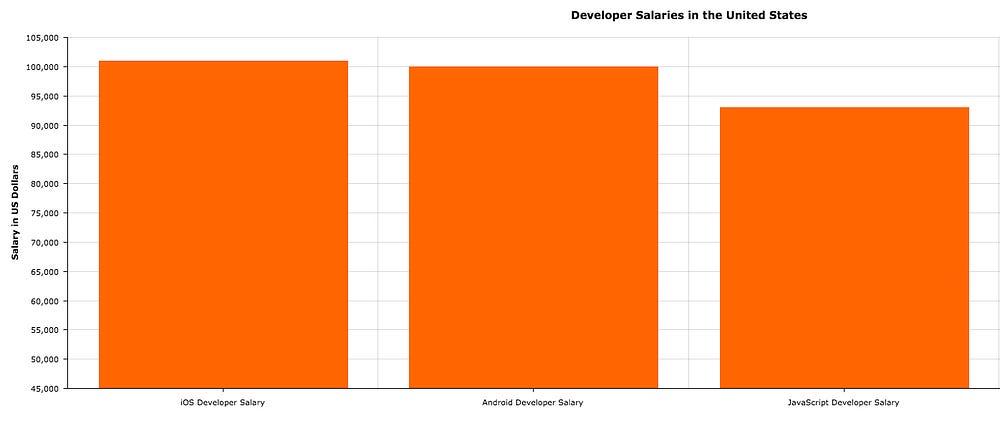

在美国,雇佣 iOS,Android,JavaScript 开发人员的平均花费([http://www.indeed.com/salary][1],[http://www.payscale.com/research/US/Skill=JavaScript/Salary][2])

|

||||

*在美国,雇佣 [iOS,Android][1],[JavaScript][2] 开发人员的平均花费*

|

||||

|

||||

在过去的几年,原生移动应用开发的费用螺旋式上升,无法控制。对没有大量资金的新创业者来说,创建原生应用、MVP 设计架构和原型的难度大大增加。现有的公司需要抓住人才,以便在现有应用上进行迭代开发或者构建一个新的应用。要尽一切努力留住最好的人才,与 [世界各地的公司][9] 拼尽全力 [争][6] 个 [高][7] [下][8]。

|

||||

在过去的几年,原生移动应用开发的费用螺旋式上升,无法控制。对没有大量资金的新创业者来说,创建原生应用、MVP 设计架构和原型的难度大大增加。现有的公司需要抓住人才,以便在现有应用上进行迭代开发或者构建一个新的应用。要尽一切努力才能留住最好的人才,与 [世界各地的公司][9] 拼尽全力[争个][6][高][7][下][8]。

|

||||

|

||||

|

||||

|

||||

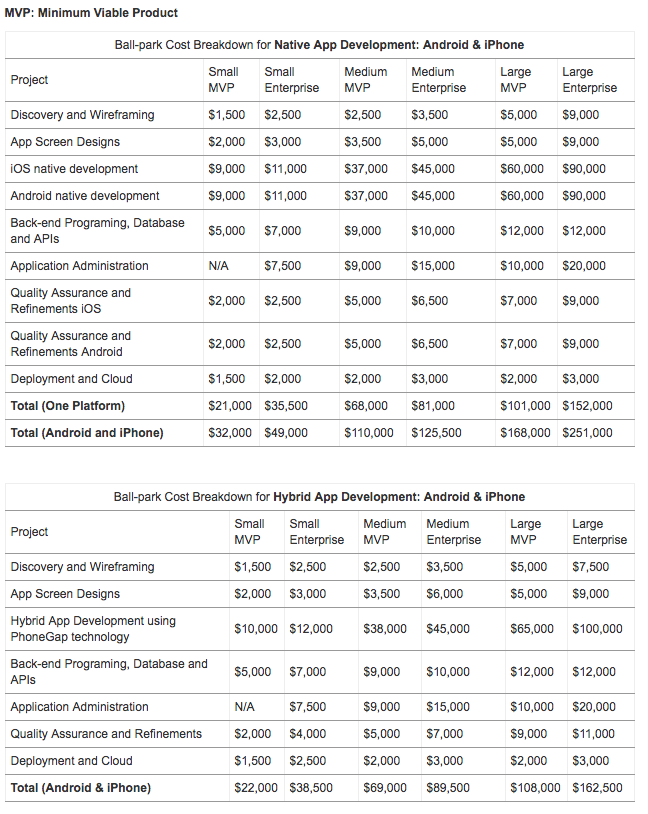

2015年初,原生方式和混合方式开发 MVP 设计架构的费用对比([Comomentum.com][3])

|

||||

*2015 年初,原生方式和混合方式开发 MVP 设计架构的费用[对比][3]*

|

||||

|

||||

### 这一切对于我们意味着什么?

|

||||

|

||||

如果你的公司很大或者有足够多的现金,旧思维是只要你在原生应用开发方面投入足够多的资金,就高枕无忧。但事实不再如此。

|

||||

|

||||

Facebook 是你最不会想到的在人才战中失败的公司(因为他们没有失败),它也遇到了原生应用方面金钱无法解决的问题。他们的移动应用庞大而又复杂,[可以看到编译它竟然需要15分钟][10]。这意味着哪怕是极小的用户界面改动,比如移动几个点,测试起来都要花费几个小时(甚至几天)。

|

||||

Facebook 是你最不会想到的在人才战中失败的公司(因为他们没有失败),它也遇到了原生应用方面金钱无法解决的问题。他们的移动应用庞大而又复杂,[他们发现编译它竟然需要 15 分钟][10]。这意味着哪怕是极小的用户界面改动,比如移动几个点,测试起来都要花费几个小时(甚至几天)。

|

||||

|

||||

除了冗长的编译时间,应用的每一个小改动在测试时都需要在两个完全不同的环境(IOS 和 Android)实施,开发团队需要使用两种语言和框架工作,这趟水更浑了。

|

||||

|

||||

Facebook 对这个问题的解决方案是 [React Native][11]。

|

||||

|

||||

### 能不能抛弃移动应用,仅面向Web呢?

|

||||

### 能不能抛弃移动应用,仅面向 Web 呢?

|

||||

|

||||

[一些人认为移动应用的末日已到。][12] 尽管我很欣赏、尊重 [Eric Elliott][13] 和他的工作,但我们还是通过考察一些近期的数据,进而讨论一下某些相反的观点:

|

||||

[一些人认为移动应用的末日已到][12]。尽管我很欣赏、尊重 [Eric Elliott][13] 和他的工作,但我们还是通过考察一些近期的数据,进而讨论一下某些相反的观点:

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

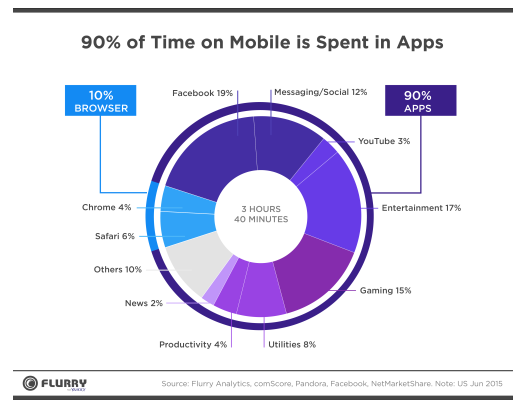

人们在移动应用上花费的时间(2016年4月,[smartinsights.com][4])

|

||||

*人们在移动应用上花费的[时间][4](2016年4月)*

|

||||

|

||||

> 人们使用 APP 的时间占使用手机总时长的 90%

|

||||

|

||||

目前世界上有 25 亿人在使用移动手机。[这个数字增长到 50 亿的速度会比我们想象的还要快。][14] 在正常情况下,丢掉 45 亿人的生意,或者抛弃有 45 亿人使用的应用程序是绝对荒唐且行不通的。

|

||||

|

||||

老问题是原生移动应用的开发成本对大多数公司来说太高了。尽管这个问题确实存在,但面向 web 的开发成本也在增加。[在美国,JavaScript 开发者的平均工资已达到 $97,000.00。][15]

|

||||

老问题是原生移动应用的开发成本对大多数公司来说太高了。然而,面向 web 的开发成本也在增加。[在美国,JavaScript 开发者的平均工资已达到 $97,000.00][15]。

|

||||

|

||||

伴随着复杂性的增加以及暴涨的高质量 web 开发需求,雇佣一个JavaScript 开发者的平均价格直逼原生应用开发者。论证 web 开发更便宜已经没用了。

|

||||

伴随着复杂性的增加以及对高质量 web 开发的需求暴涨,雇佣一个 JavaScript 开发者的平均价格直逼原生应用开发者。论证 web 开发更便宜已经没用了。

|

||||

|

||||

### 那混合开发呢?

|

||||

|

||||

混合应用是将 HTML5 应用内嵌在原生应用的容器里,并且提供实现原生平台特性所需的权限。Cordova 和 PhoneGap 就是典型的例子。

|

||||

|

||||

如果你想构建一个 MVP 设计架构、一个产品原型,或者不担心模仿原生应用的用户体验,那么混合应用会很适合你。谨记如果你最后想把它转为原生应用,整个项目都得重写。

|

||||

如果你想构建一个 MVP 设计架构、一个产品原型,或者不担心对原生应用的模仿的用户体验,那么混合应用会很适合你。但谨记如果你最后想把它转为原生应用,整个项目都得重写。

|

||||

|

||||

此领域有很多创新的东西,我最喜欢的当属 [Ionic Framework][16]。混合开发正变得越来越好,但还不如原生开发那么流畅自然。

|

||||

|

||||

有很多公司,包括最严峻的初创公司,也包括大中规模的公司,混合应用在质量上的表现似乎没有满足客户的要求,给人的感觉是活糙、不够专业。

|

||||

|

||||

[听说应用商店里的前 100 名都不是混合应用,][17]我没有证据支持这一观点。如果说有百分之零到百分之五是混合应用,我就不怀疑了。

|

||||

[听说应用商店里的前 100 名都不是混合应用][17],我没有证据支持这一观点。如果说有百分之零到百分之五是混合应用,我就不怀疑了。

|

||||

|

||||

> [我们最大的错误是在 HTML5 身上下了太多的赌注][18] — 马克 扎克伯格

|

||||

> [我们最大的错误是在 HTML5 身上下了太多的赌注][18] — 马克·扎克伯格

|

||||

|

||||

### 解决方案

|

||||

|

||||

如果你紧跟移动开发动向,那么你绝对听说过像 [NativeScript][19] 和 [React Native][20] 这样的项目。

|

||||

|

||||

通过这些项目,使用用 JavaScript 写成的基本 UI 组成块,像常规 iOS 和 Android 应用那样,就可以构建出高质量的原生移动应用。

|

||||

通过这些项目,使用由 JavaScript 写成的基本 UI 组成块,像常规 iOS 和 Android 应用那样,就可以构建出高质量的原生移动应用。

|

||||

|

||||

你可以仅用一位工程师,也可以用一个专业的工程师团队,通过 React Native 使用 [现有代码库][22] 或者 [底层技术][23] 进行跨平台移动应用开发,[原生桌面开发][21], 甚至还有 web 开发。把你的应用发布到 APP Store上, Play Store上,还有 Web 上。如此可以在保证不丧失原生应用性能和质量的同时,使成本仅占传统开发的一小部分。

|

||||

你可以仅用一位工程师,也可以用一个专业的工程师团队,通过 React Native 使用 [现有代码库][22] 或者 [底层技术][23] 进行跨平台移动应用开发、[原生桌面开发][21],甚至还有 web 开发。把你的应用发布到 APP Store 上、 Play Store 上,还有 Web 上。如此可以在保证不丧失原生应用性能和质量的同时,使成本仅占传统开发的一小部分。

|

||||

|

||||

通过 React Native 进行跨平台开发时重复使用其中 90% 的代码也不是没有的事,这个范围通常是 80% 到 90%。

|

||||

|

||||

@ -72,7 +71,7 @@ Facebook 对这个问题的解决方案是 [React Native][11]。

|

||||

|

||||

React Native 还可以使用 [Code Push][24] 和 [AppHub][25] 这样的工具来远程更新你的 JavaScript 代码。这意味着你可以向用户实时推送更新、新特性,快速修复 bug,绕过打包、发布这些工作,绕过 App Store、Google Play Store 的审核,省去了耗时 2 到 7 天的过程(App Store 一直是整个过程的痛点)。混合应用的这些优势原生应用不可能比得上。

|

||||

|

||||

如果这个领域的创新力能像刚发行时那样保持,将来你甚至可以为 [Apple Watch ][26],[Apple TV][27],和 [Tizen][28] 这样的平台开发应用。

|

||||

如果这个领域的创新力能像刚发行时那样保持,将来你甚至可以为 [Apple Watch][26]、[Apple TV][27],和 [Tizen][28] 这样的平台开发应用。

|

||||

|

||||

> NativeScript 依然是个相当年轻的框架驱动,Angular 版本 2,[上个月刚刚发布测试版][29]。但只要它保持良好的市场份额,未来就很有前途。

|

||||

|

||||

@ -84,49 +83,57 @@ React Native 还可以使用 [Code Push][24] 和 [AppHub][25] 这样的工具

|

||||

|

||||

看下面的例子,[这是一个使用 React Native 技术的著名应用列表][31]。

|

||||

|

||||

### Facebook

|

||||

#### Facebook

|

||||

|

||||

|

||||

|

||||

Facebook 公司的 React Native 应用

|

||||

*Facebook 公司的 React Native 应用*

|

||||

|

||||

Facebook 的两款应用 [Ads Manager][32] 和 [Facebook Groups][33]都在使用 React Native 技术,并且[将会应用到实现动态消息的框架上][34]。

|

||||

Facebook 的两款应用 [Ads Manager][32] 和 [Facebook Groups][33] 都在使用 React Native 技术,并且[将会应用到实现动态消息的框架上][34]。

|

||||

|

||||

Facebook 也会投入大量的资金创立和维护像 React Native 这样的开源项目,而且开源项目的开发者最近已经创建很多了不起的项目,这是很了不起的工作,像我以及全世界的业务每天都从中享受诸多好处。

|

||||

|

||||

### Instagram

|

||||

#### Instagram

|

||||

|

||||

|

||||

|

||||

Instagram

|

||||

*Instagram*

|

||||

|

||||

Instagram 应用的一部分已经使用了 React Native 技术。

|

||||

|

||||

### Airbnb

|

||||

#### Airbnb

|

||||

|

||||

|

||||

|

||||

Airbnb

|

||||

*Airbnb*

|

||||

|

||||

Airbnb 的很多东西正用 React Native 重写。(来自 [Leland Richardson][36])

|

||||

|

||||

超过 90% 的 Airbnb 旅行平台都是用 React Native 写的。(来自 [spikebrehm][37])

|

||||

|

||||

### Vogue

|

||||

#### Vogue

|

||||

|

||||

|

||||

|

||||

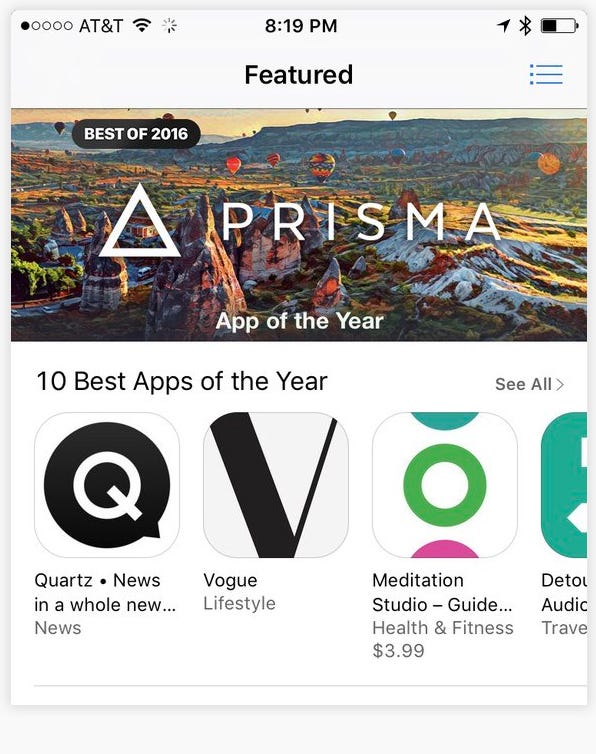

Vogue 是 2016 年度十佳应用之一

|

||||

*Vogue 是 2016 年度十佳应用之一*

|

||||

|

||||

Vogue 这么突出不仅仅因为它也用 React Native 写成,而是[因为它被苹果公司评为年度十佳应用之一][38]。

|

||||

|

||||

|

||||

|

||||

微软

|

||||

#### 沃尔玛

|

||||

|

||||

微软在 React Native 身上下的赌注很大

|

||||

|

||||

|

||||

它早已发布多个开源工具,包括 [Code Push][39],[React Native VS Code][40],以及 [React Native Windows][41],旨在帮助开发者向 React Native 领域转移。

|

||||

*Walmart Labs*

|

||||

|

||||

查看这篇 [Keerti](https://medium.com/@Keerti) 的[文章](https://medium.com/walmartlabs/react-native-at-walmartlabs-cdd140589560#.azpn97g8t)来了解沃尔玛是怎样看待 React Native 的优势的。

|

||||

|

||||

#### 微软

|

||||

|

||||

微软在 React Native 身上下的赌注很大。

|

||||

|

||||

它早已发布多个开源工具,包括 [Code Push][39]、[React Native VS Code][40],以及 [React Native Windows][41],旨在帮助开发者向 React Native 领域转移。

|

||||

|

||||

微软考虑的是那些已经使用 React Native 为 iOS 和 Android 开发应用的开发者,他们可以重用高达 90% 的代码,不用花费太多额外的时间和成本就可将应用发布到 Windows 上。

|

||||

|

||||

@ -136,11 +143,11 @@ Vogue 这么突出不仅仅因为它也用 React Native 写成,而是[因为

|

||||

|

||||

移动应用界面设计和移动应用开发要进行范式转变,下一步就是 React Native 以及与其相似的技术。

|

||||

|

||||

公司

|

||||

#### 公司

|

||||

|

||||

如果你的公司正想着削减成本、加快开发速度,而又不想在应用质量和性能上妥协,这是最适合使用 React Native 的时候,它能提高你的净利润。

|

||||

|

||||

开发者

|

||||

#### 开发者

|

||||

|

||||

如果你是一个开发者,想进入一个将来会快速发展的领域,我强烈推荐你把 React Native 列入你的学习清单。

|

||||

|

||||

@ -166,7 +173,7 @@ via: https://hackernoon.com/the-cost-of-native-mobile-app-development-is-too-dam

|

||||

|

||||

作者:[Nader Dabit][a]

|

||||

译者:[fuowang](https://github.com/fuowang)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -9,15 +9,15 @@ GraphQL 在生产环境中似乎难以使用:虽然对于建模功能来说图

|

||||

|

||||

* 三种类型的资源(用户、博文以及评论)支持多种功能(创建用户、创建博文、给博文添加评论、关注其它用户的博文和评论,等等。)

|

||||

* 使用 PostgreSQL 作为后端数据存储(选择它因为它是一个流行的关系型数据库)。

|

||||

* 使用 Golang(开发 API 的一个流行语言)进行 API 实现。

|

||||

* 使用 Golang(开发 API 的一个流行语言)实现 API。

|

||||

|

||||

我们会比较简单的 GraphQL 实现和纯 REST 替代方案,在一种普通场景(呈现博客文章页面)下对比它们的实现复杂性和效率。

|

||||

|

||||

### 介绍

|

||||

|

||||

GraphQL 是一种 IDL(Interface Definition Language,接口定义语言),设计者定义数据类型和并把数据建模为一个图。每个顶点都是一种数据类型的一个实例,边代表了节点之间的关系。这种方式非常灵活,能适应任何业务领域。然而,问题是设计过程更加复杂,而且传统的数据存储不能很好地映射到图模型。阅读_附录1_了解更多关于这个问题的详细信息。

|

||||

GraphQL 是一种 IDL(Interface Definition Language,接口定义语言),设计者定义数据类型和并把数据建模为一个图(graph)。每个顶点都是一种数据类型的一个实例,边代表了节点之间的关系。这种方式非常灵活,能适应任何业务领域。然而,问题是设计过程更加复杂,而且传统的数据存储不能很好地映射到图模型。阅读_附录1_了解更多关于这个问题的详细信息。

|

||||

|

||||

GraphQL 在 2014 年由 Facebook 的工程师团队首次提出。尽管它的优点和功能非常有趣而且引人注目,它并没有得到大规模应用。开发者需要权衡 REST 的设计简单性、熟悉性、丰富的工具和 GraphQL 不会受限于 CRUD(LCTT 译注:Create、Read、Update、Delete) 以及网络性能(它优化了往返服务器的网络)的灵活性。

|

||||

GraphQL 在 2014 年由 Facebook 的工程师团队首次提出。尽管它的优点和功能非常有趣而且引人注目,但它并没有得到大规模应用。开发者需要权衡 REST 的设计简单性、熟悉性、丰富的工具和 GraphQL 不会受限于 CRUD(LCTT 译注:Create、Read、Update、Delete) 以及网络性能(它优化了往返服务器的网络)的灵活性。

|

||||

|

||||

大部分关于 GraphQL 的教程和指南都跳过了从数据存储获取数据以便解决查询的问题。也就是,如何使用通用目的、流行存储方案(例如关系型数据库)为 GraphQL API 设计一个支持高效数据提取的数据库。

|

||||

|

||||

@ -37,7 +37,7 @@ GraphQL 在 2014 年由 Facebook 的工程师团队首次提出。尽管它的

|

||||

|

||||

### 在 GraphQL 中建模一个博客引擎

|

||||

|

||||

_列表1_包括了博客引擎 API 的全部模式。它显示了组成图的顶点的数据类型。顶点之间的关系,也就是边,被建模为指定类型的属性。

|

||||

下述_列表1_包括了博客引擎 API 的全部模式。它显示了组成图的顶点的数据类型。顶点之间的关系,也就是边,被建模为指定类型的属性。

|

||||

|

||||

```

|

||||

type User {

|

||||

@ -86,7 +86,7 @@ type Mutation {

|

||||

|

||||

_列表1_

|

||||

|

||||

模式使用 GraphQL DSL 编写,它用于定义自定义数据类型,例如 `User`、`Post` 和 `Comment`。该语言也提供了一系列原始数据类型,例如 `String`、`Boolean` 和 `ID`(是`String` 的别名,但是有顶点唯一标识符的额外语义)。

|

||||

模式使用 GraphQL DSL 编写,它用于定义自定义数据类型,例如 `User`、`Post` 和 `Comment`。该语言也提供了一系列原始数据类型,例如 `String`、`Boolean` 和 `ID`(它是`String` 的别名,但是有顶点唯一标识符的额外语义)。

|

||||

|

||||

`Query` 和 `Mutation` 是语法解析器能识别并用于查询图的可选类型。从 GraphQL API 读取数据等同于遍历图。需要提供这样一个起始顶点;该角色通过 `Query` 类型来实现。在这种情况中,所有图的查询都要从一个由 id `user(id:ID!)` 指定的用户开始。对于写数据,定义了 `Mutation` 顶点。它提供了一系列操作,建模为能遍历(并返回)新创建顶点类型的参数化属性。_列表2_是这些查询的一些例子。

|

||||

|

||||

@ -99,7 +99,7 @@ _列表1_

|

||||

* 也可以把它们组合起来,例如 `[Comment!]!` 表示一个非空 Comment 顶点链表,其中 `[]`、`[Comment]` 是有效的,但 `null, [null], [Comment, null]` 就不是。

|

||||

|

||||

|

||||

_列表2_ 包括一系列用于博客 API 的 _curl_ 命令,它们会使用 mutation 填充图然后查询图以便获取数据。要运行它们,按照 [topliceanu/graphql-go-example][3] 仓库中的指令编译并运行服务。

|

||||

_列表2_ 包括一系列用于博客 API 的 `curl` 命令,它们会使用 mutation 填充图然后查询图以便获取数据。要运行它们,按照 [topliceanu/graphql-go-example][3] 仓库中的指令编译并运行服务。

|

||||

|

||||

```

|

||||

# 创建用户 1、2 和 3 的更改。更改和查询类似,在该情景中我们检索新创建用户的 id 和 email。

|

||||

@ -143,7 +143,10 @@ _列表2_

|

||||

|

||||

### 设计 PostgreSQL 数据库

|

||||

|

||||

关系型数据库的设计,一如以往,由避免数据冗余的需求驱动。选择该方式有两个原因:1\. 表明实现 GraphQL API 不需要定制化的数据库技术或者学习和使用新的设计技巧。2\. 表明 GraphQL API 能在现有的数据库之上创建,更具体地说,最初设计用于 REST 后端甚至传统的呈现 HTML 站点的服务器端数据库。

|

||||

关系型数据库的设计,一如以往,由避免数据冗余的需求驱动。选择该方式有两个原因:

|

||||

|

||||

1. 表明实现 GraphQL API 不需要定制化的数据库技术或者学习和使用新的设计技巧。

|

||||

2. 表明 GraphQL API 能在现有的数据库之上创建,更具体地说,最初设计用于 REST 后端甚至传统的呈现 HTML 站点的服务器端数据库。

|

||||

|

||||

阅读 _附录1_ 了解关于关系型和图数据库在构建 GraphQL API 方面的区别。_列表3_ 显示了用于创建新数据库的 SQL 命令。数据库模式和 GraphQL 模式相对应。为了支持 `follow/unfollow` 更改,需要添加 `followers` 关系。

|

||||

|

||||

@ -176,7 +179,7 @@ _列表3_

|

||||

|

||||

### Golang API 实现

|

||||

|

||||

本项目使用的用 Go 实现的 GraphQL 语法解析器是 `github.com/graphql-go/graphql`。它包括一个查询解析器,但不包括模式解析器。这要求开发者利用库提供的结构使用 Go 构建 GraphQL 模式。这和 [nodejs 实现][3] 不同,后者提供了一个模式解析器并为数据获取暴露了钩子。因此 `列表1` 中的模式只是作为指导使用,需要转化为 Golang 代码。然而,这个_“限制”_提供了与抽象级别对等的机会,并且了解模式如何和用于检索数据的图遍历模型相关。_列表4_ 显示了 `Comment` 顶点类型的实现:

|

||||

本项目使用的用 Go 实现的 GraphQL 语法解析器是 `github.com/graphql-go/graphql`。它包括一个查询解析器,但不包括模式解析器。这要求开发者利用库提供的结构使用 Go 构建 GraphQL 模式。这和 [nodejs 实现][3] 不同,后者提供了一个模式解析器并为数据获取暴露了钩子。因此 _列表1_ 中的模式只是作为指导使用,需要转化为 Golang 代码。然而,这个_“限制”_提供了与抽象级别对等的机会,并且了解模式如何和用于检索数据的图遍历模型相关。_列表4_ 显示了 `Comment` 顶点类型的实现:

|

||||

|

||||

```

|

||||

var CommentType = graphql.NewObject(graphql.ObjectConfig{

|

||||

@ -348,9 +351,9 @@ _列表5_

|

||||

|

||||

对于这种情况,对数据库的查询次数是故意相同的,但是到 API 服务器的 HTTP 请求已经减少到只有一个。我们认为在这种类型的应用程序中通过互联网的 HTTP 请求是最昂贵的。

|

||||

|

||||

为了获取 GraphQL 的优势,后端并不需要进行特别设计,从 REST 到 GraphQL 的转换可以逐步完成。这使得可以测量性能提升和优化。从这一点,API 设计者可以开始优化(潜在的合并) SQL 查询从而提高性能。缓存的机会在数据库和 API 级别都大大增加。

|

||||

为了利用 GraphQL 的优势,后端并不需要进行特别设计,从 REST 到 GraphQL 的转换可以逐步完成。这使得可以测量性能提升和优化。从这一点,API 设计者可以开始优化(潜在的合并) SQL 查询从而提高性能。缓存的机会在数据库和 API 级别都大大增加。

|

||||

|

||||

SQL 之上的抽象(例如 ORM 层)通常会和 `n+1` 问题想抵触。在 REST 事例的步骤 4 中,客户端可能不得不在单独的请求中为每个评论的作者请求关注状态。这是因为在 REST 中没有标准的方式来表达两个以上资源之间的关系,而 GraphQL 旨在通过使用嵌套查询来防止这类问题。这里我们通过获取用户的所有关注者进行欺骗。我们向客户推荐确定评论和关注作者用户的逻辑。

|

||||

SQL 之上的抽象(例如 ORM 层)通常会和 `n+1` 问题相抵触。在 REST 示例的步骤 4 中,客户端可能不得不在单独的请求中为每个评论的作者请求关注状态。这是因为在 REST 中没有标准的方式来表达两个以上资源之间的关系,而 GraphQL 旨在通过使用嵌套查询来防止这类问题。这里我们通过获取用户的所有关注者来作弊。我们向客户提出了如何确定评论并关注了作者的用户的逻辑。

|

||||

|

||||

另一个区别是获取比客户端所需更多的数据,以免破坏 REST 资源抽象。这对于用于解析和存储不需要数据的带宽消耗和电池寿命非常重要。

|

||||

|

||||

@ -358,7 +361,7 @@ SQL 之上的抽象(例如 ORM 层)通常会和 `n+1` 问题想抵触。在

|

||||

|

||||

GraphQL 是 REST 的一个可用替代方案,因为:

|

||||

|

||||

* 尽管设计 API 更加困难,该过程可以逐步完成。也是由于这个原因,从 REST 转换到 GraphQL 非常容易,两个流程可以没有任何问题地共存。

|

||||

* 尽管设计 API 更加困难,但该过程可以逐步完成。也是由于这个原因,从 REST 转换到 GraphQL 非常容易,两个流程可以没有任何问题地共存。

|

||||

* 在网络请求方面更加高效,即使是类似本博客中的简单实现。它还提供了更多查询优化和结果缓存的机会。

|

||||

* 在用于解析结果的带宽消耗和 CPU 周期方面它更加高效,因为它只返回呈现页面所需的数据。

|

||||

|

||||

@ -370,15 +373,15 @@ REST 仍然非常有用,如果:

|

||||

|

||||

### 附录1:图数据库和高效数据存储

|

||||

|

||||

尽管将应用领域数据想象为一个图非常直观,正如这篇博文介绍的那样,但是支持这种接口的高效数据存储问题仍然没有解决。

|

||||

尽管将其应用领域数据想象为一个图非常直观,正如这篇博文介绍的那样,但是支持这种接口的高效数据存储问题仍然没有解决。

|

||||

|

||||

近年来图数据库变得越来越流行。通过将 GraphQL 查询转换为特定的图数据库查询语言从而延迟解决请求的复杂性似乎是一种可行的方案。

|

||||

|

||||

问题是和关系型数据库相比图并不是一种高效的数据结构。图中一个顶点可能有到任何其它顶点的连接,访问模式比较难以预测因此提供了较少的优化机会。

|

||||

问题是和关系型数据库相比,图并不是一种高效的数据结构。图中一个顶点可能有到任何其它顶点的连接,访问模式比较难以预测因此提供了较少的优化机会。

|

||||

|

||||

例如缓存的问题,为了快速访问需要将哪些顶点保存在内存中?通用缓存算法在图遍历场景中可能没那么高效。

|

||||

|

||||

数据库分片问题:把数据库切分为更小、没有交叉的数据库并保存到独立的硬件。在学术上,最小切割的图划分问题已经得到了很好的理解,但可能是次优的而且由于病态的最坏情况可能导致高度不平衡切割。

|

||||

数据库分片问题:把数据库切分为更小、没有交叉的数据库并保存到独立的硬件。在学术上,最小切割的图划分问题已经得到了很好的理解,但可能是次优的,而且由于病态的最坏情况可能导致高度不平衡切割。

|

||||

|

||||

在关系型数据库中,数据被建模为记录(行或者元组)和列,表和数据库名称都只是简单的命名空间。大部分数据库都是面向行的,意味着每个记录都是一个连续的内存块,一个表中的所有记录在磁盘上一个接一个地整齐地打包(通常按照某个关键列排序)。这非常高效,因为这是物理存储最优的工作方式。HDD 最昂贵的操作是将磁头移动到磁盘上的另一个扇区,因此最小化此类访问非常重要。

|

||||

|

||||

@ -392,7 +395,7 @@ via: http://alexandrutopliceanu.ro/post/graphql-with-go-and-postgresql

|

||||

|

||||

作者:[Alexandru Topliceanu][a]

|

||||

译者:[ictlyh](https://github.com/ictlyh)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,71 +1,47 @@

|

||||

### 如何在 Linux 终端会话中使用 Asciinema 进行录制和回放

|

||||

如何在 Linux 中使用 Asciinema 进行录制和回放终端会话

|

||||

===========

|

||||

|

||||

|

||||

|

||||

内容

|

||||

|

||||

* * [1、简介][11]

|

||||

* [2、困难][12]

|

||||

* [3、惯例][13]

|

||||

* [4、标准库安装][14]

|

||||

* [4.1、在 Arch Linux 上安装][1]

|

||||

* [4.2、在 Debian 上安装][2]

|

||||

* [4.3、在 Ubuntu 上安装][3]

|

||||

* [4.4、在 Fedora 上安装][4]

|

||||

* [5、从源代码安装][15]

|

||||

* [6、前提条件][16]

|

||||

* [6.1、在 Arch Linux 上安装 ruby][5]

|

||||

* [6.2、在 Debian 上安装 ruby][6]

|

||||

* [6.3、在 Ubuntu 安装 ruby][7]

|

||||

* [6.4、在 Fedora 安装 ruby][8]

|

||||

* [6.5、在 CentOS 安装 ruby][9]

|

||||

* [7、 安装 Linuxbrew][17]

|

||||

* [8、 安装 Asciinema][18]

|

||||

* [9、录制终端会话][19]

|

||||

* [10、回放已录制终端会话][20]

|

||||

* [11、将视频嵌入 HTML][21]

|

||||

* [12、结论][22]

|

||||

* [13、 故障排除][23]

|

||||

* [13.1、在 UTF-8 环境下运行 asciinema][10]

|

||||

|

||||

### 简介

|

||||

|

||||

Asciinema 是一个轻量并且非常高效的脚本终端会话录制器的替代品。使用它可以录制、回放和分享 JSON 格式的终端会话记录。和一些桌面录制器,比如 Recordmydesktop、Simplescreenrecorder、Vokoscreen 或 Kazam 相比,Asciinema 最主要的优点是,它能够以通过 ANSI 转义码编码的 ASCII 文本录制所有的标准终端输入、输出和错误。

|

||||

Asciinema 是一个轻量并且非常高效的终端会话录制器。使用它可以录制、回放和分享 JSON 格式的终端会话记录。与一些桌面录制器,比如 Recordmydesktop、Simplescreenrecorder、Vokoscreen 或 Kazam 相比,Asciinema 最主要的优点是,它能够以通过 ASCII 文本以及 ANSI 转义码编码来录制所有的标准终端输入、输出和错误信息。

|

||||

|

||||

事实上,即使是很长的终端会话,录制出的 JSON 格式文件也非常小。另外,JSON 格式使得用户可以利用简单的文件转化器,将输出的 JSON 格式文件嵌入到 HTML 代码中,然后分享到公共网站或者使用 asciinema 账户分享到 Asciinema.org 。最后,如果你的终端会话中有一些错误,并且你还懂一些 ASCI 转义码语法,那么你可以使用任何编辑器来修改你的已录制终端会话。

|

||||

|

||||

### 困难

|

||||

**难易程度:**

|

||||

|

||||

很简单!

|

||||

|

||||

### 惯例

|

||||

**标准终端:**

|

||||

|

||||

* **#** - 给定命令需要以 root 用户权限运行或者使用 `sudo` 命令

|

||||

* **$** - 给定命令以常规权限用户运行

|

||||

|

||||

### 标准库安装

|

||||

### 从软件库安装

|

||||

|

||||

很有可能, asciinema 可以使用你的版本库进行安装。但是,如果不可以使用系统版本库进行安装或者你想安装最新的版本,那么,你可以像下面的“从源代码安装”部分所描述的那样,使用 Linuxbrew 包管理器来执行 Asciinema 安装。

|

||||

通常, asciinema 可以使用你的发行版的软件库进行安装。但是,如果不可以使用系统的软件库进行安装或者你想安装最新的版本,那么,你可以像下面的“从源代码安装”部分所描述的那样,使用 Linuxbrew 包管理器来执行 Asciinema 安装。

|

||||

|

||||

### 在 Arch Linux 上安装

|

||||

**在 Arch Linux 上安装:**

|

||||

|

||||

```

|

||||

# pacman -S asciinema

|

||||

```

|

||||

|

||||

### 在 Debian 上安装

|

||||

**在 Debian 上安装:**

|

||||

|

||||

```

|

||||

# apt install asciinema

|

||||

```

|

||||

|

||||

### 在 Ubuntu 上安装

|

||||

**在 Ubuntu 上安装:**

|

||||

|

||||

```

|

||||

$ sudo apt install asciinema

|

||||

```

|

||||

|

||||

### 在 Fedora 上安装

|

||||

**在 Fedora 上安装:**

|

||||

|

||||

```

|

||||

$ sudo dnf install asciinema

|

||||

@ -75,7 +51,7 @@ $ sudo dnf install asciinema

|

||||

|

||||

最简单并且值得推荐的方式是使用 Linuxbrew 包管理器,从源代码安装最新版本的 Asciinema 。

|

||||

|

||||

### 前提条件

|

||||

#### 前提条件

|

||||

|

||||

下面列出的前提条件是安装 Linuxbrew 和 Asciinema 需要满足的依赖关系:

|

||||

|

||||

@ -86,61 +62,69 @@ $ sudo dnf install asciinema

|

||||

|

||||

在安装 Linuxbrew 之前,请确保上面的这些包都已经安装在了你的 Linux 系统中。

|

||||

|

||||

### 在 Arch Linux 上安装 ruby

|

||||

**在 Arch Linux 上安装 ruby:**

|

||||

|

||||

```

|

||||

# pacman -S git gcc make ruby

|

||||

```

|

||||

|

||||

### 在 Debian 上安装 ruby

|

||||

**在 Debian 上安装 ruby:**

|

||||

|

||||

```

|

||||

# apt install git gcc make ruby

|

||||

```

|

||||

|

||||

### 在 Ubuntu 上安装 ruby

|

||||

**在 Ubuntu 上安装 ruby:**

|

||||

|

||||

```

|

||||

$ sudo apt install git gcc make ruby

|

||||

```

|

||||

|

||||

### 在 Fedora 上安装 ruby

|

||||

**在 Fedora 上安装 ruby:**

|

||||

|

||||

```

|

||||

$ sudo dnf install git gcc make ruby

|

||||

```

|

||||

|

||||

### 在 CentOS 上安装 ruby

|

||||

**在 CentOS 上安装 ruby:**

|

||||

|

||||

```

|

||||

# yum install git gcc make ruby

|

||||

```

|

||||

|

||||

### 安装 Linuxbrew

|

||||

#### 安装 Linuxbrew

|

||||

|

||||

Linuxbrew 包管理器是苹果的 MacOS 操作系统很受欢迎的 Homebrew 包管理器的一个复刻版本。还没发布多久,Homebrew 就以容易使用而著称。如果你想使用 Linuxbrew 来安装 Asciinema,那么,请运行下面命令在你的 Linux 版本上安装 Linuxbrew:

|

||||

|

||||

```

|

||||

$ ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Linuxbrew/install/master/install)"

|

||||

```

|

||||

|

||||

现在,Linuxbrew 已经安装到了目录 `$HOME/.linuxbrew/` 下。剩下需要做的就是使它成为可执行 `PATH` 环境变量的一部分。

|

||||

|

||||

```

|

||||

$ echo 'export PATH="$HOME/.linuxbrew/bin:$PATH"' >>~/.bash_profile

|

||||

$ . ~/.bash_profile

|

||||

```

|

||||

|

||||

为了确认 Linuxbrew 是否已经安装好,你可以使用 `brew` 命令来查看它的版本:

|

||||

|

||||

```

|

||||

$ brew --version

|

||||

Homebrew 1.1.7

|

||||

Homebrew/homebrew-core (git revision 5229; last commit 2017-02-02)

|

||||

```

|

||||

|

||||

### 安装 Asciinema

|

||||

#### 安装 Asciinema

|

||||

|

||||

安装好 Linuxbrew 以后,安装 Asciinema 就变得无比容易了:

|

||||

|

||||

```

|

||||

$ brew install asciinema

|

||||

```

|

||||

|

||||

检查 Asciinema 是否安装正确:

|

||||

|

||||

```

|

||||

$ asciinema --version

|

||||

asciinema 1.3.0

|

||||

@ -151,10 +135,13 @@ asciinema 1.3.0

|

||||

经过一番辛苦的安装工作以后,是时候来干一些有趣的事情了。Asciinema 是一个非常容易使用的软件。事实上,目前的 1.3 版本只有很少的几个可用命令行选项,其中一个是 `--help` 。

|

||||

|

||||

我们首先使用 `rec` 选项来录制终端会话。下面的命令将会开始录制终端会话,之后,你将会有一个选项来丢弃已录制记录或者把它上传到 asciinema.org 网站以便将来参考。

|

||||

|

||||

```

|

||||

$ asciinema rec

|

||||

```

|

||||

|

||||

运行上面的命令以后,你会注意到, Asciinema 已经开始录制终端会话了,你可以按下 `CTRL+D` 快捷键或执行 `exit` 命令来停止录制。如果你使用的是 Debian/Ubuntu/Mint Linux 系统,你可以像下面这样尝试进行第一次 asciinema 录制:

|

||||

|

||||

```

|

||||

$ su

|

||||

Password:

|

||||

@ -162,7 +149,9 @@ Password:

|

||||

# exit

|

||||

$ sl

|

||||

```

|

||||

|

||||

一旦输入最后一个 `exit` 命令以后,将会询问你:

|

||||

|

||||

```

|

||||

$ exit

|

||||

~ Asciicast recording finished.

|

||||

@ -170,11 +159,15 @@ $ exit

|

||||

|

||||

https://asciinema.org/a/7lw94ys68gsgr1yzdtzwijxm4

|

||||

```

|

||||

|

||||

如果你不想上传你的私密命令行技巧到 asciinema.org 网站,那么有一个选项可以把 Asciinema 记录以 JSON 格式保存为本地文件。比如,下面的 asciinema 记录将被存为 `/tmp/my_rec.json`:

|

||||

|

||||

```

|

||||

$ asciinema rec /tmp/my_rec.json

|

||||

```

|

||||

另一个非常有用的 asciinema 特性是时间微调。如果你的键盘输入速度很慢,或者你在进行多任务,输入命令和执行命令之间的时间可以延长。Asciinema 会记录你的实时按键时间,这意味着每一个停顿都将反映在最终视频的长度上。可以使用 `-w` 选项来缩短按键的时间间隔。比如,下面的命令将按键的时间间隔缩短为 0.2 秒:

|

||||

|

||||

另一个非常有用的 asciinema 特性是时间微调。如果你的键盘输入速度很慢,或者你在进行多任务,输入命令和执行命令之间的时间会比较长。Asciinema 会记录你的实时按键时间,这意味着每一个停顿都将反映在最终视频的长度上。可以使用 `-w` 选项来缩短按键的时间间隔。比如,下面的命令将按键的时间间隔缩短为 0.2 秒:

|

||||

|

||||

```

|

||||

$ asciinema rec -w 0.2

|

||||

```

|

||||

@ -182,15 +175,19 @@ $ asciinema rec -w 0.2

|

||||

### 回放已录制终端会话

|

||||

|

||||

有两种方式可以来回放已录制会话。第一种方式是直接从 asciinema.org 网站上播放终端会话。这意味着,你之前已经把录制会话上传到了 asciinema.org 网站,并且需要提供有效链接:

|

||||

|

||||

```

|

||||

$ asciinema play https://asciinema.org/a/7lw94ys68gsgr1yzdtzwijxm4

|

||||

```

|

||||

Alternatively, use your locally stored JSON file:

|

||||

|

||||

另外,你也可以使用本地存储的 JSON 文件:

|

||||

|

||||

```

|

||||

$ asciinema play /tmp/my_rec.json

|

||||

```

|

||||

|

||||

如果要使用 `wget` 命令来下载之前的上传记录,只需在链接的后面加上 `.json`:

|

||||

|

||||

```

|

||||

$ wget -q -O steam_locomotive.json https://asciinema.org/a/7lw94ys68gsgr1yzdtzwijxm4.json

|

||||

$ asciinema play steam_locomotive.json

|

||||

@ -198,7 +195,8 @@ $ asciinema play steam_locomotive.json

|

||||

|

||||

### 将视频嵌入 HTML

|

||||

|

||||

最后,Asciinema 还带有一个独立的 JavaScript 播放器。这意味者你可以很容易的在你的网站上分享终端会话记录。下面,使用一段简单的 `index.html` 代码来说明这个方法。首先,下载所有必要的东西:

|

||||

最后,asciinema 还带有一个独立的 JavaScript 播放器。这意味者你可以很容易的在你的网站上分享终端会话记录。下面,使用一段简单的 `index.html` 代码来说明这个方法。首先,下载所有必要的东西:

|

||||

|

||||

```

|

||||

$ cd /tmp/

|

||||

$ mkdir steam_locomotive

|

||||

@ -208,6 +206,7 @@ $ wget -q https://github.com/asciinema/asciinema-player/releases/download/v2.4.0

|

||||

$ wget -q https://github.com/asciinema/asciinema-player/releases/download/v2.4.0/asciinema-player.js

|

||||

```

|

||||

之后,创建一个新的包含下面这些内容的 `/tmp/steam_locomotive/index.html` 文件:

|

||||

|

||||

```

|

||||

<html>

|

||||

<head>

|

||||

@ -219,28 +218,34 @@ $ wget -q https://github.com/asciinema/asciinema-player/releases/download/v2.4.0

|

||||

</body>

|

||||

</html>

|

||||

```

|

||||

|

||||

完成以后,打开你的网页浏览器,按下 `CTRL+O` 来打开新创建的 `/tmp/steam_locomotive/index.html` 文件。

|

||||

|

||||

### 结论

|

||||

|

||||

正如前面所说的,使用 Asciinema 录制器来录制终端会话最主要的优点是它的输出文件非常小,这使得你的视频很容易分享出去。上面的例子产生了一个包含 58472 个字符的文件,它是一个只有 58 KB 大的 22 秒终端会话视频。如果我们查看输出的 JSON 文件,会发现甚至这个数字已经非常大了,这主要是因为一个 “蒸汽机车” 已经跑过了终端。这个长度的正常终端会话会产生一个更小的输出文件。

|

||||

正如前面所说的,使用 asciinema 录制器来录制终端会话最主要的优点是它的输出文件非常小,这使得你的视频很容易分享出去。上面的例子产生了一个包含 58472 个字符的文件,它是一个只有 58 KB 大 小的 22 秒终端会话视频。如果我们查看输出的 JSON 文件,会发现甚至这个数字已经非常大了,这主要是因为一个 “蒸汽机车” 已经跑过了终端。这个长度的正常终端会话一般会产生一个更小的输出文件。

|

||||

|

||||

下次,当你想要在一个论坛上询问关于 Linux 配置的问题,并且很难描述你的问题的时候,只需运行下面的命令:

|

||||

|

||||

```

|

||||

$ asciinema rec

|

||||

```

|

||||

|

||||

然后把最后的链接贴到论坛的帖子里。

|

||||

|

||||

### 故障排除

|

||||

|

||||

### 在 UTF-8 环境下运行 asciinema

|

||||

#### 在 UTF-8 环境下运行 asciinema

|

||||

|

||||

错误信息:

|

||||

|

||||

```

|

||||

asciinema 需要在 UTF-8 环境下运行。请检查 `locale` 命令的输出。

|

||||

asciinema needs a UTF-8 native locale to run. Check the output of `locale` command.

|

||||

```

|

||||

|

||||

解决方法:

|

||||

生成并导出UTF-8语言环境。例如:

|

||||

生成并导出 UTF-8 语言环境。例如:

|

||||

|

||||

```

|

||||

$ localedef -c -f UTF-8 -i en_US en_US.UTF-8

|

||||

$ export LC_ALL=en_US.UTF-8

|

||||

@ -252,7 +257,7 @@ via: https://linuxconfig.org/record-and-replay-terminal-session-with-asciinema-o

|

||||

|

||||

作者:[Lubos Rendek][a]

|

||||

译者:[ucasFL](https://github.com/ucasFL)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,49 @@

|

||||

甲骨文的政策更改提高了其在 AWS 上的价格

|

||||

============================================================

|

||||

|

||||

> 这种改变使在 AWS 上实施甲骨文的软件的价格翻了一番,它已经安静地生效了,而几乎没有通知用户。

|

||||

|

||||

|

||||

|

||||

之前有消息传出,甲骨文使亚马逊云上的产品价格翻了一倍。它在[如何计算 AWS 的虚拟 CPU][6] 上耍了一些花招。它这么做也没有任何宣扬。该公司的新定价政策于 1 月 23 日生效,直到 1 月 28 日都几乎没有被人注意到, 甲骨文的关注者 Tim Hall 偶然发现 Big Red 公司的 [甲骨文软件云计算环境许可][7]文件并披露了出来。

|

||||

|

||||

乍一看,这一举动似乎并不太大,因为它仅将甲骨文的 AWS 定价与 Microsoft Azure 的价格相提并论。但是 Azure 只有市场领先的 AWS 体量的三分之一,所以如果你想在云中销售许可证,AWS 是合适的地方。虽然此举可能或可能不会影响已经在 AWS 上使用甲骨文产品的用户,但是尚不清楚新规则是否适用于已在使用产品的用户 - 它肯定会让一些考虑可能使用甲骨文的用户另寻它处。

|

||||

|

||||

这个举动的主要原因是显而易见的。甲骨文希望使自己的云更具吸引力 - 这让 [The Register 观察][8]到一点:“拉里·埃里森确实承诺过甲骨文的云将会更快更便宜”。更快和更便宜仍然有待看到。如果甲骨文的 SPARC 云计划启动,并且按照广告的形式执行,那么可能会更快,但是更便宜的可能性较小。甲骨文以对其价格的强硬态度而著称。

|

||||

|

||||

随着其招牌数据库和业务栈销售的下滑,并且对 Sun 公司的 74 亿美元的投资并未能按照如期那样,甲骨文将其未来赌在云计算上。但是甲骨文来晚了,迄今为止,它的努力似乎还没有结果, 一些金融预测者并没有看到甲骨文云的光明前景。他们说,云是一个拥挤的市场,而四大公司 - 亚马逊、微软、IBM 和谷歌 - 已经有了领先优势。

|

||||

|

||||

确实如此。但是甲骨文面临的最大的障碍是,好吧,就是甲骨文。它的声誉在它之前。

|

||||

|

||||

保守地说这个公司并不是因为明星客户服务而闻名。事实上,各种新闻报道将甲骨文描绘成一个恶霸和操纵者。

|

||||

|

||||

例如,早在 2015 年,甲骨文就因为它的云并不像预期那样快速增长而越来越沮丧,开始[激活业内人士称之为的“核特权”][9]。它会审核客户的数据中心,如果客户不符合规定,将发出“违规通知” - 它通常只适用于大规模滥用情况,并命令客户在 30 天内退出使用其软件。

|

||||

|

||||

或许你能想到,大量投入在甲骨文软件平台上的大公司们绝对不能在短时间内迁移到另一个解决方案。甲骨文的违规通知将会引发灾难。

|

||||

|

||||

商业内幕人士 Julie Bort 解释到:“为了使违规通知消失 - 或者减少高额的违规罚款 - 甲骨文销售代表通常希望客户向合同中添加云额度”。

|

||||

|

||||

换句话说,甲骨文正在使用审计来扭转客户去购买它的云,而无论他们是否有需要。这种策略与最近 AWS 价格翻倍之间也可能存在联系。Hall 的文章的评论者指出,围绕价格提升的秘密背后的目的可能是触发软件审计。

|

||||

|

||||

使用这些策略的麻烦迟早会出来。消息一旦传播开来,你的客户就开始寻找其他选项。对 Big Red 而言或许是时候参考微软的做法,开始建立一个更好和更温和的甲骨文,将客户的需求放在第一位。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://windowsitpro.com/cloud/oracle-policy-change-raises-prices-aws

|

||||

|

||||

作者:[Christine Hall][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://windowsitpro.com/author/christine-hall

|

||||

[1]:http://windowsitpro.com/penton_ur/nojs/user/register?path=node%2F186491&nid=186491&source=email

|

||||

[2]:http://windowsitpro.com/author/christine-hall

|

||||

[3]:http://windowsitpro.com/author/christine-hall

|

||||

[4]:http://windowsitpro.com/cloud/oracle-policy-change-raises-prices-aws#comments

|

||||

[5]:http://windowsitpro.com/cloud/oracle-policy-change-raises-prices-aws#comments

|

||||

[6]:https://oracle-base.com/blog/2017/01/28/oracles-cloud-licensing-change-be-warned/

|

||||

[7]:http://www.oracle.com/us/corporate/pricing/cloud-licensing-070579.pdf

|

||||

[8]:https://www.theregister.co.uk/2017/01/30/oracle_effectively_doubles_licence_fees_to_run_in_aws/

|

||||

[9]:http://www.businessinsider.com/oracle-is-using-the-nuclear-option-to-sell-its-cloud-software-2015-7

|

||||

132

published/20170501 Containers running Containers.md

Normal file

132

published/20170501 Containers running Containers.md

Normal file

@ -0,0 +1,132 @@

|

||||

LinuxKit:在容器中运行容器

|

||||

============================================================

|

||||

|

||||

一些令人振奋的消息引发了我对今年 DockerCon 的兴趣,在这次会议中,无可争议的容器巨头公司 Docker 发布了一个新的操作系统:LinuxKit。

|

||||

|

||||

这家容器巨头宣布的是一个灵活的、可扩展的操作系统,而为了可移植性,系统服务也是运行在容器之中。甚至,令人惊讶的是,就连 Docker 运行时环境也是运行在容器内!

|

||||

|

||||

在本文中,我们将简要介绍一下 LinuxKit 中所承诺的内容,以及如何自己尝试一下这个不断精简、优化的容器。

|

||||

|

||||

### 少即是多

|

||||

|

||||

不可否认的是,用户一直在寻找一个可以运行他们的微服务的精简版本的 Linux 。通过容器化,你会尽可能地最小化每个应用程序,使其成为一个适合于运行在其自身容器内的独立进程。但是,由于你需要对那些驻留容器的宿主机出现的问题进行修补,因此你不断地在宿主机间移动容器。实际上,如果没有像 Kubernetes 或 Docker Swarm 这样的编排系统,容器编排几乎总是会导致停机。

|

||||

|

||||

不用说,这只是让你保持操作系统尽可能小的原因之一。

|

||||

|

||||

我曾多次在不同场合重复过的最喜爱的名言,来自荷兰的天才程序员 Wietse Zweitze,他为我们提供了重要的 Email 软件 Postfix 和 TCP Wrappers 等知名软件。

|

||||

|

||||

在 [Postfix 网站][10] 指出,即使你编码和 Wietse 一样小心,“每 1000 行[你]就会在 Postfix 中引入一个额外的 bug”。从我的专业的 DevSecOps 角度看,这里提到的“bug” 可以将其大致看做安全问题。

|

||||

|

||||

从安全的角度来看,正是由于这个原因,代码世界中“少即是多”。简单地说,使用较少的代码行有很多好处,即安全性、管理时间和性能。对于初学者来说,这意味着安全漏洞较少,更新软件包的时间更短,启动时间更快。

|

||||

|

||||

### 深入观察

|

||||

|

||||

考虑下在容器内部运行你的程序。

|

||||

|

||||

一个好的起点是 [Alpine Linux][1],它是一个苗条、精简的操作系统,通常比那些笨重的系统更受喜欢,如 Ubuntu 或 CentOS 等。Alpine 还提供了一个 miniroot 文件系统(用于容器内),最近我看到的大小是惊人的 1.8M。事实上,这个完整的 Linux 操作系统下载后有 80M。

|

||||

|

||||

如果你决定使用 Alpine Linux 作为 Docker 基础镜像,那么你可以在 Docker Hub 上[找到][2]一个, 它将其描述为:“一个基于 Alpine Linux 的最小 Docker 镜像,具有完整的包索引,大小只有5 MB!”

|

||||

|

||||

据说无处不在的 “Window 开始菜单” 文件也是大致相同的大小!我没有验证过,也不会进一步评论。

|

||||

|

||||

讲真,希望你去了解一下这个创新的类 Unix 操作系统(如 Alpine Linux)的强大功能。

|

||||

|

||||

### 锁定一切

|

||||

|

||||

再说一点,Alpine Linux 是(并不惊人)基于 [BusyBox][3],这是一套著名的打包了 Linux 命令的集合,许多人不会意识到他们的宽带路由器、智能电视,当然还有他们家庭中的物联网设备就有它。

|

||||

|

||||

Alpine Linux 站点的“[关于][4]”页面的评论中指出:

|

||||

|

||||

> “Alpine Linux 的设计考虑到安全性。内核使用 grsecurity/PaX 的非官方移植进行了修补,所有用户态二进制文件都编译为具有堆栈保护的地址无关可执行文件(PIE)。 这些主动安全特性可以防止所有类别的零日漏洞和其它漏洞利用。”

|

||||

|

||||

换句话说,这些捆绑在 Alpine Linux 中的精简二进制文件提供的功能通过了那些行业级安全工具筛选,以缓解缓冲区溢出攻击所带来的危害。

|

||||

|

||||

### 多出一只袜子

|

||||

|

||||

你可能会问,为什么当我们谈及 Docker 的新操作系统时,容器的内部结构很重要?

|

||||

|

||||

那么,你可能已经猜到,当涉及容器时,他们的目标是精简。除非绝对必要,否则不包括任何东西。所以你可以放心地清理橱柜、花园棚子、车库和袜子抽屉了。

|

||||

|

||||

Docker 的确因为它们的先见而获得声望。据报道,2 月初,Docker 聘请了 Alpine Linux 的主要推动者 Nathaniel Copa,他帮助将默认的官方镜像库从 Ubuntu 切换到 Alpine。Docker Hub 从新近精简镜像节省的带宽受到了赞誉。

|

||||

|

||||

并且最新的情况是,这项工作将与最新的基于容器的操作系统相结合:Docker 的 LinuxKit。

|

||||

|

||||

要说清楚的是 LinuxKit 注定不会代替 Alpine,而是位于容器下层,并作为一个完整的操作系统出现,你可以高兴地启动你的运行时守护程序(在这种情况下,是生成你的容器的Docker 守护程序 )。

|

||||

|

||||

### 金发女郎的 Atomic

|

||||

|

||||

经过精心调试的宿主机绝对不是一件新事物(以前提到过嵌入式 Linux 的家用设备)。在过去几十年中一直在优化 Linux 的天才在某个时候意识到底层的操作系统才是快速生产含有大量容器主机的关键。

|

||||

|

||||

例如,强大的红帽长期以来一直在出售已经贡献给 [Project Atomic][6] 的 [红帽 Atomic][5]。后者继续解释:

|

||||

|

||||

> “基于 Red Hat Enterprise Linux 或 CentOS 和 Fedora 项目的成熟技术,Atomic Host 是一个轻量级的、不可变的平台,其设计目的仅在于运行容器化应用程序。”

|

||||

|

||||

将底层的、不可变的 Atomic OS 作为红帽的 OpenShift PaaS(平台即服务)产品推荐有一个很好理由:它最小化、高性能、尖端。

|

||||

|

||||

### 特性

|

||||

|

||||

在 Docker 关于 LinuxKit 的公告中,“少即是多”的口号是显而易见的。实现 LinuxKit 愿景的项目显然是不小的事业,它由 Docker 老将和 [Unikernel][7] 的主管 Justin Cormack 指导,并与 HPE、Intel、ARM、IBM 和 Microsoft LinuxKit 合作,可以运行在从大型机到基于物联网的冰柜之中。

|

||||

|

||||

LinuxKit 的可配置性、可插拔性和可扩展性将吸引许多寻求建立其服务基准的项目。通过开源项目,Docker 明智地邀请每个人全身心地投入其功能开发,随着时间的推移,它会像好的奶酪那样成熟。

|

||||

|

||||

### 布丁作证

|

||||

|

||||

按照该发布消息中所承诺的,那些急于使用新系统的人不用再等待了。如果你准备着手 LinuxKit,你可以从 GitHub 中开始:[LinuxKit][11]。

|

||||

|

||||

在 GitHub 页面上有关于如何启动和运行一些功能的指导。

|

||||

|

||||

时间允许的话我准备更加深入研究 LinuxKit。对有争议的 Kubernetes 与 Docker Swarm 编排功能对比会是有趣的尝试。此外,我还想看到内存占用、启动时间和磁盘空间使用率的基准测试。

|

||||

|

||||

如果该承诺可靠,则作为容器运行的可插拔系统服务是构建操作系统的迷人方式。Docker 在[博客][12])中提到:“因为 LinuxKit 是原生容器,它有一个非常小的尺寸 - 35MB,引导时间非常小。所有系统服务都是容器,这意味着可以删除或替换所有的内容。”

|

||||

|

||||

我不知道你觉得怎么样,但这非常符合我的胃口。

|

||||

|

||||

### 呼叫警察

|

||||

|

||||

除了我站在 DevSecOps 角度看到的功能,我会看看其对安全的承诺。

|

||||

|

||||

Docker 在他们的博客上引用来自 NIST([国家标准与技术研究所] [8])的话:

|

||||

|

||||

> “安全性是最高目标,这与 NIST 在其《应用程序容器安全指南》草案中说明的保持一致:‘使用容器专用操作系统而不是通用操作系统来减少攻击面。当使用专用容器操作系统时,攻击面通常比通用操作系统小得多,因此攻击和危及专用容器操作系统的机会较少。’”

|

||||

|

||||

可能最重要的容器到主机和主机到容器的安全创新是将系统容器(系统服务)完全地沙箱化到自己的非特权空间中,而只给它们需要的外部访问。

|

||||

|

||||

通过<ruby>内核自我保护项目<rt>Kernel Self Protection Project</rt></ruby>([KSPP][9])的协作来实现这一功能,我很满意 Docker 开始专注于一些非常值得的东西上。对于那些不熟悉的 KSPP 的人而言,它存在理由如下:

|

||||

|

||||

> “启动这个项目的的假设是内核 bug 的存在时间很长,内核必须设计成可以防止这些缺陷的危害。”

|

||||

|

||||

KSPP 网站进一步表态:

|

||||

|

||||

> “这些努力非常重要并还在进行,但如果我们要保护我们的十亿 Android 手机、我们的汽车、国际空间站,还有其他运行 Linux 的产品,我们必须在上游的 Linux 内核中建立积极的防御性技术。我们需要内核安全地出错,而不只是安全地运行。”

|

||||

|

||||

而且,如果 Docker 最初只是在 LinuxKit 前进了一小步,那么随着时间的推移,成熟度带来的好处可能会在容器领域中取得长足的进步。

|

||||

|

||||

### 离终点还远

|

||||

|

||||

像 Docker 这样不断发展壮大的巨头无论在哪个方向上取得巨大的飞跃都将会用户和其他软件带来益处。

|

||||

|

||||

我鼓励所有对 Linux 感兴趣的人密切关注这个领域。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.devsecops.cc/devsecops/containers.html

|

||||

|

||||

作者:[Chris Binnie][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.devsecops.cc/

|

||||

[1]:https://alpinelinux.org/downloads/

|

||||

[2]:https://hub.docker.com/_/alpine

|

||||

[3]:https://busybox.net/

|

||||

[4]:https://www.alpinelinux.org/about/

|

||||

[5]:https://www.redhat.com/en/resources/red-hat-enterprise-linux-atomic-host

|

||||

[6]:http://www.projectatomic.io/

|

||||

[7]:https://en.wikipedia.org/wiki/Unikernel

|

||||

[8]:https://www.nist.gov/

|

||||

[9]:https://kernsec.org/wiki/index.php/Kernel_Self_Protection_Project

|

||||

[10]:http://www.postfix.org/TLS_README.html

|

||||

[11]:https://github.com/linuxkit/linuxkit

|

||||

[12]:https://blog.docker.com/2017/04/introducing-linuxkit-container-os-toolkit

|

||||

@ -1,354 +0,0 @@

|

||||

What I Don’t Like About Error Handling in Go, and How to Work Around It

|

||||

======================

|

||||

|

||||

More often than not, people who write Go have some sort of opinion on its error handling model. Depending on your experience with other languages, you may be used to different approaches. That’s why I’ve decided to write this article, as despite being relatively opinionated, I think drawing on my experiences can be useful in the debate. The main issues I wanted to cover are that it is difficult to force good error handling practice, that errors don’t have stack traces, and that error handling itself is too verbose. However I’ve looked at some potential workarounds for these problems which could help negate the issues somewhat.

|

||||

|

||||

### Quick Comparison to Other Languages

|

||||

|

||||

|

||||

[In Go, all errors are values][1]. Because of this, a fair amount of functions end up returning an `error`, looking something like this:

|

||||

|

||||

```

|

||||

func (s *SomeStruct) Function() (string, error)

|

||||

```

|

||||

|

||||

As a result of this, the calling code will regularly have `if` statements to check for them:

|

||||

|

||||

```

|

||||

bytes, err := someStruct.Function()

|

||||

if err != nil {

|

||||

// Process error

|

||||

}

|

||||

```

|

||||

|

||||

Another approach is the `try-catch` model that is used in other languages such as Java, C#, Javascript, Objective C, Python etc. You could see the following Java code as synonymous to the previous Go examples, declaring `throws` instead of returning an `error`:

|

||||

|

||||

```

|

||||

public String function() throws Exception

|

||||

```

|

||||

|

||||

And then doing `try-catch` instead of `if err != nil`:

|

||||

|

||||

```

|

||||

try {

|

||||

String result = someObject.function()

|

||||

// continue logic

|

||||

}

|

||||

catch (Exception e) {

|

||||

// process exception

|

||||

}

|

||||

```

|

||||

|

||||

Of course, there are more differences than this. For example, an `error` can’t crash your program, whereas an `Exception` can. There are others as well, and I want to focus on them in this article.

|

||||

|

||||

### Implementing Centralised Error Handling

|

||||

|

||||

Taking a step back, let’s look at why and how we might want to have a centralised place for handling errors.

|

||||

|

||||

An example most people would be familiar with is a web service – if some unexpected server-side error were to happen, we would generate a 5xx error. At a first pass in Go you might implement this:

|

||||

|

||||

```

|

||||

func init() {

|

||||

http.HandleFunc("/users", viewUsers)

|

||||

http.HandleFunc("/companies", viewCompanies)

|

||||

}

|

||||

|

||||

func viewUsers(w http.ResponseWriter, r *http.Request) {

|

||||

user // some code

|

||||

if err := userTemplate.Execute(w, user); err != nil {

|

||||

http.Error(w, err.Error(), 500)

|

||||

}

|

||||

}

|

||||

|

||||

func viewCompanies(w http.ResponseWriter, r *http.Request) {

|

||||

companies = // some code

|

||||

if err := companiesTemplate.Execute(w, companies); err != nil {

|

||||

http.Error(w, err.Error(), 500)

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

This isn’t a good solution, as we would have to repeat the same error handling across all of our handler functions. It would be much better to do it all in one place for maintainability purposes. Fortunately, there is [an alternative by Andrew Gerrand on the Go blog][2] which works quite nicely. We can create a Type which does http error handling:

|

||||

|

||||

```

|

||||

type appHandler func(http.ResponseWriter, *http.Request) error

|

||||

|

||||

func (fn appHandler) ServeHTTP(w http.ResponseWriter, r *http.Request) {

|

||||

if err := fn(w, r); err != nil {

|

||||

http.Error(w, err.Error(), 500)

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

And then it can be used as a wrapper to decorate our handlers:

|

||||

|

||||

```

|

||||

func init() {

|

||||

http.Handle("/users", appHandler(viewUsers))

|

||||

http.Handle("/companies", appHandler(viewCompanies))

|

||||

}

|

||||

```

|

||||

|

||||

Then all we need to do is change the signature of handler functions so they return `errors`. This works nicely, as we have been able to apply the [dry][3] principle and not re-use code unnecessarily – now we return default errors in a single place.

|

||||

|

||||

### Error Context

|

||||

|

||||

In the previous example, there are many potential errors which we could receive, all of which could be generated in many parts of the call stack. This is when things start to get tricky.

|

||||

|

||||

To demonstrate this, we can expand on our handler. It’s more likely to look like this as the template execution is not the only place where an error could occur:

|

||||

|

||||

```

|

||||

func viewUsers(w http.ResponseWriter, r *http.Request) error {

|

||||

user, err := findUser(r.formValue("id"))

|

||||

if err != nil {

|

||||

return err;

|

||||

}

|

||||

return userTemplate.Execute(w, user);

|

||||

}

|

||||

```

|

||||

|

||||

The call chain could get quite deep, and throughout it, all sorts of errors could be instantiated in different places. This post by [Russ Cox][4] explains the best practice to prevent this from being too much of a problem:

|

||||

|

||||

> Part of the intended contract for error reporting in Go is that functions include relevant available context, including the operation being attempted (such as the function name and its arguments)

|

||||

|

||||

The example given is a call to the OS package:

|

||||

|

||||

```

|

||||

err := os.Remove("/tmp/nonexist")

|

||||

fmt.Println(err)

|

||||

```

|

||||

|

||||

Which prints the output:

|

||||

|

||||

```

|

||||

remove /tmp/nonexist: no such file or directory

|

||||

```

|

||||

|

||||

To summarise, you are outputting the method called, the arguments given, and the specific thing that went wrong, immediately after doing it. When creating an `Exception` message in another language you would also follow this practice. So if we stuck to these rules in our `viewUsers` handler, it could almost always be clear what the cause of an error is.

|

||||

|

||||

The problem comes from people not following this best practice, and quite often in third party Go libraries you will see messages like:

|

||||

|

||||

```

|

||||

Oh no I broke

|

||||

```

|

||||

|

||||

Which is just not helpful – you don’t know anything about the context which makes it really hard to debug. Even worse is when these sorts of errors are ignored or returned really far back up the stack until they are handled:

|

||||

|

||||

```

|

||||

if err != nil {

|

||||

return err

|

||||

}

|

||||

```

|

||||

|

||||

This means that when they happened isn’t communicated.

|

||||

|

||||

It should be noted that all these mistakes can be made in an `Exception` driven model – poor error messages, swallowing exceptions etc. So why do I think that model is more helpful?

|

||||

|

||||

If we’re dealing with a poor exception message, _we are still able to know where it occurred in the call stack_. This is because of stack traces, which raises something I don’t get about Go – you have the concept of `panic` in Go which contains a stack trace, but an `error` which does not. I think the reasoning is that a `panic` can crash your program, so requires a stack trace, whereas a handled error does not as you are supposed to do something about it where it occurs.

|

||||

|

||||

So let’s go back to our previous example – a third party library with a poor error message, which just gets propagated all the way up the call chain. Do you think debugging would be easier if you had this?

|

||||

|

||||

```

|

||||

panic: Oh no I broke

|

||||

[signal 0xb code=0x1 addr=0x0 pc=0xfc90f]

|

||||

|

||||

goroutine 1103 [running]:

|

||||

panic(0x4bed00, 0xc82000c0b0)

|

||||

/usr/local/go/src/runtime/panic.go:481 +0x3e6

|

||||

github.com/Org/app/core.(_app).captureRequest(0xc820163340, 0x0, 0x55bd50, 0x0, 0x0)

|

||||

/home/ubuntu/.go_workspace/src/github.com/Org/App/core/main.go:313 +0x12cf

|

||||

github.com/Org/app/core.(_app).processRequest(0xc820163340, 0xc82064e1c0, 0xc82002aab8, 0x1)

|

||||

/home/ubuntu/.go_workspace/src/github.com/Org/App/core/main.go:203 +0xb6

|

||||

github.com/Org/app/core.NewProxy.func2(0xc82064e1c0, 0xc820bb2000, 0xc820bb2000, 0x1)

|

||||

/home/ubuntu/.go_workspace/src/github.com/Org/App/core/proxy.go:51 +0x2a

|

||||

github.com/Org/app/core/vendor/github.com/rusenask/goproxy.FuncReqHandler.Handle(0xc820da36e0, 0xc82064e1c0, 0xc820bb2000, 0xc5001, 0xc820b4a0a0)

|

||||

/home/ubuntu/.go_workspace/src/github.com/Org/app/core/vendor/github.com/rusenask/goproxy/actions.go:19 +0x30

|

||||

```

|

||||

|

||||

I think this might be something which has been overlooked in the design of Go – not that things aren’t overlooked in all languages.

|

||||

|

||||

If we use Java as an arbitrary example, one of the silliest mistakes people make is not logging the stack trace:

|

||||

|

||||

```

|

||||

LOGGER.error(ex.getMessage()) // Doesn't log stack trace

|

||||

LOGGER.error(ex.getMessage(), ex) // Does log stack trace

|

||||

```

|

||||

|

||||

But Go seems to not have this information by design.

|

||||

|

||||

In terms of getting context information – Russ also mentions the community are talking about some potential interfaces for stripping out error contexts. It would be interesting to hear more about this.

|

||||

|

||||

### Solution to the Stack Trace Problem

|

||||

|

||||

Fortunately, after doing some searching, I found this excellent [Go Errors][5] library which helps solves the problem, by adding stack traces to errors:

|

||||

|

||||

```

|

||||

if errors.Is(err, crashy.Crashed) {

|

||||

fmt.Println(err.(*errors.Error).ErrorStack())

|

||||

}

|

||||

```

|

||||

|

||||

However, I’d think it would be an improvement for this feature to have first class citizenship in the language, so you wouldn’t have to fiddle around with types. Also, if we are working with a third party library like in the previous example then it is probably not using `crashy` – we still have the same problem.

|

||||

|

||||

### What Should We Do with an Error?

|

||||

|

||||

We also have to think about what should happen when an error occurs. [It’s definitely useful that they can’t crash your program][6], and it’s also idiomatic to handle them immediately:

|

||||

|

||||

```

|

||||

err := method()

|

||||

if err != nil {

|

||||

// some logic that I must do now in the event of an error!

|

||||

}

|

||||

```

|

||||

|

||||

But what happens if we want to call lots of methods which return errors, and then handle them all in the same place? Something like this:

|

||||

|

||||

```

|

||||

err := doSomething()

|

||||

if err != nil {

|

||||

// handle the error here

|

||||

}

|

||||

|

||||

func doSomething() error {

|

||||

err := someMethod()

|

||||

if err != nil {

|

||||

return err

|

||||

}

|

||||

err = someOther()

|

||||

if err != nil {

|

||||

return err

|

||||

}

|

||||

someOtherMethod()

|

||||

}

|

||||

```

|

||||

|

||||

It feels a little verbose, whereas in other languages you can treat multiple statements that fail as a block:

|

||||

|

||||

```

|

||||

try {

|

||||

someMethod()

|

||||

someOther()

|

||||

someOtherMethod()

|

||||

}

|

||||

catch (Exception e) {

|

||||

// process exception

|

||||

}

|

||||

```

|

||||

|

||||

Or just propagate failure in the method signature:

|

||||

|

||||

```

|

||||

public void doSomething() throws SomeErrorToPropogate {

|

||||

someMethod()

|

||||

someOther()

|

||||

someOtherMethod()

|

||||

}

|

||||

```

|

||||

|

||||

Personally I think both of these example achieve the same thing, only the `Exception` model is less verbose and more flexible. If anything, I find the `if err != nil` to feel like boilerplate. Maybe there is a way that it could be cleaned up?

|

||||

|

||||

### Treating Multiple Statements That Fail as a Block

|

||||

|

||||

To begin with, I did some more reading and found a relatively pragmatic solution on the [by Rob Pike on the Go Blog.][7]

|

||||

|

||||

He defines a struct with a method which wraps errors:

|

||||

|

||||

```

|

||||

type errWriter struct {

|

||||

w io.Writer

|

||||

err error

|

||||

}

|

||||

|

||||

func (ew *errWriter) write(buf []byte) {

|

||||

if ew.err != nil {

|

||||

return

|

||||

}

|

||||

_, ew.err = ew.w.Write(buf)

|

||||

}

|

||||

```

|

||||

|

||||

This let’s us do:

|

||||

|

||||

```

|

||||

ew := &errWriter{w: fd}

|

||||

ew.write(p0[a:b])

|

||||

ew.write(p1[c:d])

|

||||

ew.write(p2[e:f])

|

||||

// and so on

|

||||

if ew.err != nil {

|

||||

return ew.err

|

||||

}

|

||||

```

|

||||

|

||||

This is also a good solution, but I still feel like something is missing – as we can’t re-use this pattern. If we wanted a method which took a string as an argument, then we’d have to change the function signature. Or what if we didn’t want to perform a write? We could try and make it more generic:

|

||||

|

||||

```

|

||||

type errWrapper struct {

|

||||

err error

|

||||

}

|

||||

```

|

||||

|

||||

```

|

||||

func (ew *errWrapper) do(f func() error) {

|

||||

if ew.err != nil {

|

||||

return

|

||||

}

|

||||

ew.err = f();

|

||||

}

|

||||

```

|

||||

|

||||

But we have the same problem that it won’t compile if we want to call functions which have different arguments. However you simply wrap those function calls:

|

||||

|

||||

```

|

||||

w := &errWrapper{}

|

||||

|

||||

w.do(func() error {

|

||||

return someFunction(1, 2);

|

||||

})

|

||||

|

||||

w.do(func() error {

|

||||

return otherFunction("foo");

|

||||

})

|

||||

|

||||

err := w.err

|

||||

|

||||

if err != nil {

|

||||

// process error here

|

||||

}

|

||||

```

|

||||

|

||||

This works, but doesn’t help too much as it ends up being more verbose than the standard `if err != nil`checks. I would be interested to hear if anyone can offer any other solutions. Maybe the language itself needs some sort of way to propagate or group errors in a less bloated fashion – but it feels like it’s been specifically designed to not do that.

|

||||

|

||||

### Conclusion

|

||||

|

||||

After reading this, you might think that by picking on `errors` I’m opposed to Go. But that’s not the case, I’m just describing how it compares to my experience with the `try catch` model. It’s a great language for systems programming, and some outstanding tools have been produced by it. To name a few there is [Kubernetes][8], [Docker][9], [Terraform][10], [Hoverfly][11] and others. There’s also the advantage of your tiny, highly performant, native binary. But `errors` have been difficult to adjust to. I hope my reasoning makes sense, and also that some of the solutions and workarounds could be of help.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

作者简介:

|

||||

|

||||

Andrew is a Consultant for OpenCredo having Joined the company in 2015. Andrew has several years experience working in the across a number of industries, developing web-based enterprise applications.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

|

||||

via: https://opencredo.com/why-i-dont-like-error-handling-in-go

|

||||

|

||||

作者:[Andrew Morgan][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opencredo.com/author/andrew/

|

||||

[1]:https://blog.golang.org/errors-are-values

|

||||

[2]:https://blog.golang.org/error-handling-and-go

|

||||

[3]:https://en.wikipedia.org/wiki/Don't_repeat_yourself

|

||||

[4]:https://research.swtch.com/go2017

|

||||

[5]:https://github.com/go-errors/errors

|

||||

[6]:https://davidnix.io/post/error-handling-in-go/

|

||||

[7]:https://blog.golang.org/errors-are-values

|

||||

[8]:https://kubernetes.io/

|

||||

[9]:https://www.docker.com/

|

||||

[10]:https://www.terraform.io/

|

||||

[11]:http://hoverfly.io/en/latest/

|

||||

@ -1,3 +1,5 @@

|

||||

GitFuture is translating

|

||||

|

||||

OpenGL & Go Tutorial Part 2: Drawing the Game Board

|

||||

============================================================

|

||||

|

||||

|

||||

@ -0,0 +1,97 @@

|

||||

8 ways to get started with open source hardware

|

||||

============================================================

|

||||

|

||||

### Making your own hardware is easier and less expensive than ever. Here's what you need to design, build, and test your first board.

|

||||

|

||||

|

||||

|

||||

>Image by : Thomas Hawk on [Flickr][11]. [CC BY-NC 2.0][12]. Modified by Opensource.com

|

||||

|

||||

Alan Kay, famed computer scientist, once said, "People who are really serious about software should make their own hardware." I'd argue that's as true today as it was in 1982 when he said it. However, what's changed between then and now is that hardware has gotten faster, smaller, and most importantly: cheaper. it's now possible to buy a full computer for $5.

|

||||

|

||||

With big companies driving down prices for their own products, it's grown a manufacturing ecosystem capable of producing production-grade hardware that's cheap enough and accessible enough that it is now within reach of normal individuals. This accessibility and affordability are helping drive things like crowdfunding and the maker movement, but they're also giving way to more individuals being able to participate in open source through open source hardware.

|

||||

|

||||

Explore open hardware

|

||||

|

||||

* [What is open hardware?][1]

|

||||

|

||||

* [What is Raspberry Pi?][2]

|

||||

|

||||

* [What is an Arduino?][3]

|

||||

|

||||

* [Our latest open hardware articles][4]

|

||||

|

||||

There's some pretty big differences in what is or isn't open source hardware, but the Open Source Hardware Association (OSHWA) has a definition that most folks agree with, and if you're familiar with open source software this shouldn't sound too weird:

|

||||

|

||||

> "Open source hardware (OSHW) is a term for tangible artifacts—machines, devices, or other physical things—whose design has been released to the public in such a way that anyone can make, modify, distribute, and use those things."

|

||||

|

||||

There's lots of open source hardware around; you may not have noticed the boards you already use may, in fact, be open hardware. From the humble but ever versatile [Arduino][13] and all the way up through full computers like the [BeagleBone][14] family and the [C.H.I.P.][15] computer, there are lots of examples of open hardware around, and more designs are being made all the time.

|

||||

|

||||

Hardware can be complicated, and sometimes non-obvious to beginners why a design needs something. But open source hardware gives you the ability to not only see working examples, but also the ability to change those designs or strike off and replicate the pieces you need in your own designs, and it might be as simple as copy and paste.

|

||||

|

||||

### How can I get started?

|

||||

|

||||

Let's start off by pointing out that hardware is hard, it's complicated, sometimes esoteric, and the tools you may be using are not always the most user-friendly. It's also more than likely, as anyone who's played around with a microcontroller long enough can attest: you are going to fry something and let the magic smoke out at some point. It's ok, we've all done it, some of us repeatedly because we didn't learn the lesson the first 100 times we did something, but don't let this discourage you: Lessons are learned when things go wrong, and you usually get an interesting story to tell later.

|

||||

|

||||

### Modeling

|

||||

|

||||

The first thing to do is to start modeling what you want to do with an existing board, jumper wires, a breadboard, and whatever devices you want to hook up. In many cases, the simplest thing to play with is just adding more LEDs to a board and getting them to blink in novel ways. This is a great way to prototype something, and it's a fairly common thing to do. It won't look pretty, and you may find that you wire something wrong, but these are prototypes—you just want to prove things work. When things don't work, always double check everything, and don't be afraid to ask for help—sometimes a second pair of eyes will find your oddball ground short.

|

||||

|

||||

### Design

|

||||

|

||||

When you've figured out what you want to build, it's time to start taking your idea from jumper wires and breadboards to an actual design. This is where things can get a bit daunting, but start small—in fact, it's worth starting really small just to get used to the tooling and process, so why not make a printed circuit board that has a LED and a battery on it? Seriously, this might sound overly simplistic but there's a lot of new ground to cover here.

|

||||

|

||||

1. **Find an electronic design automation (EDA) tool to use.** There are some good open source software options out there, but they aren't always the most user-friendly. [Fritzing][5], [gEDA][6], and [KiCad ][7]are all open source in ascending order of approachability. There are also some options if you want to try more commercial offerings; Eagle has a free version available with some restrictions and a lot of open source hardware designs are done in it.

|

||||

|

||||

1. **Design your board in your EDA tool.** Depending on the tool you choose, this could be fairly quick, or it could be quite the exercise in learning how things work. This is one of the reasons I suggest starting small; a circuit with an LEDaan be as simple as a battery, a resistor, and an LED. The schematic capture is pretty simple, and the layout can be small and very simple.