mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-01-25 23:11:02 +08:00

commit

1a81f2409d

76

README.md

76

README.md

@ -1,9 +1,9 @@

|

||||

简介

|

||||

-------------------------------

|

||||

|

||||

LCTT是“Linux中国”([http://linux.cn/](http://linux.cn/))的翻译组,负责从国外优秀媒体翻译Linux相关的技术、资讯、杂文等内容。

|

||||

LCTT是“Linux中国”([https://linux.cn/](https://linux.cn/))的翻译组,负责从国外优秀媒体翻译Linux相关的技术、资讯、杂文等内容。

|

||||

|

||||

LCTT已经拥有近百余名活跃成员,并欢迎更多的Linux志愿者加入我们的团队。

|

||||

LCTT已经拥有几百名活跃成员,并欢迎更多的Linux志愿者加入我们的团队。

|

||||

|

||||

|

||||

|

||||

@ -52,13 +52,15 @@ LCTT的组成

|

||||

* 2015/04/19 发起 LFS-BOOK-7.7-systemd 项目。

|

||||

* 2015/06/09 提升ictlyh和dongfengweixiao为Core Translators成员。

|

||||

* 2015/11/10 提升strugglingyouth、FSSlc、Vic020、alim0x为Core Translators成员。

|

||||

* 2016/05/09 提升PurlingNayuki为校对。

|

||||

|

||||

活跃成员

|

||||

-------------------------------

|

||||

|

||||

目前 TP 活跃成员有:

|

||||

- CORE @wxy,

|

||||

- CORE @DeadFire,

|

||||

- Leader @wxy,

|

||||

- Source @oska874,

|

||||

- Proofreader @PurlingNayuki,

|

||||

- CORE @geekpi,

|

||||

- CORE @GOLinux,

|

||||

- CORE @ictlyh,

|

||||

@ -71,6 +73,7 @@ LCTT的组成

|

||||

- CORE @Vic020,

|

||||

- CORE @dongfengweixiao,

|

||||

- CORE @alim0x,

|

||||

- Senior @DeadFire,

|

||||

- Senior @reinoir,

|

||||

- Senior @tinyeyeser,

|

||||

- Senior @vito-L,

|

||||

@ -80,41 +83,42 @@ LCTT的组成

|

||||

- ZTinoZ,

|

||||

- theo-l,

|

||||

- luoxcat,

|

||||

- disylee,

|

||||

- martin2011qi,

|

||||

- wi-cuckoo,

|

||||

- disylee,

|

||||

- haimingfg,

|

||||

- KayGuoWhu,

|

||||

- wwy-hust,

|

||||

- martin2011qi,

|

||||

- cvsher,

|

||||

- felixonmars,

|

||||

- su-kaiyao,

|

||||

- ivo-wang,

|

||||

- GHLandy,

|

||||

- cvsher,

|

||||

- wyangsun,

|

||||

- DongShuaike,

|

||||

- flsf,

|

||||

- SPccman,

|

||||

- Stevearzh

|

||||

- mr-ping,

|

||||

- Linchenguang,

|

||||

- oska874

|

||||

- Linux-pdz,

|

||||

- 2q1w2007,

|

||||

- felixonmars,

|

||||

- wyangsun,

|

||||

- MikeCoder,

|

||||

- mr-ping,

|

||||

- xiqingongzi

|

||||

- H-mudcup,

|

||||

- zhangboyue,

|

||||

- cposture,

|

||||

- xiqingongzi,

|

||||

- goreliu,

|

||||

- DongShuaike,

|

||||

- NearTan,

|

||||

- TxmszLou,

|

||||

- ZhouJ-sh,

|

||||

- wangjiezhe,

|

||||

- NearTan,

|

||||

- icybreaker,

|

||||

- shipsw,

|

||||

- johnhoow,

|

||||

- soooogreen,

|

||||

- linuhap,

|

||||

- boredivan,

|

||||

- blueabysm,

|

||||

- liaoishere,

|

||||

- boredivan,

|

||||

- name1e5s,

|

||||

- yechunxiao19,

|

||||

- l3b2w1,

|

||||

- XLCYun,

|

||||

@ -122,43 +126,55 @@ LCTT的组成

|

||||

- tenght,

|

||||

- coloka,

|

||||

- luoyutiantang,

|

||||

- yupmoon,

|

||||

- sonofelice,

|

||||

- jiajia9linuxer,

|

||||

- scusjs,

|

||||

- tnuoccalanosrep,

|

||||

- woodboow,

|

||||

- 1w2b3l,

|

||||

- JonathanKang,

|

||||

- crowner,

|

||||

- mtunique,

|

||||

- dingdongnigetou,

|

||||

- CNprober,

|

||||

- JonathanKang,

|

||||

- Medusar,

|

||||

- hyaocuk,

|

||||

- szrlee,

|

||||

- KnightJoker,

|

||||

- Xuanwo,

|

||||

- nd0104,

|

||||

- jerryling315,

|

||||

- xiaoyu33,

|

||||

- guodongxiaren,

|

||||

- zzlyzq,

|

||||

- yujianxuechuan,

|

||||

- ailurus1991,

|

||||

- ynmlml,

|

||||

- kylepeng93,

|

||||

- ggaaooppeenngg,

|

||||

- Ricky-Gong,

|

||||

- zky001,

|

||||

- Flowsnow,

|

||||

- lfzark,

|

||||

- 213edu,

|

||||

- Tanete,

|

||||

- liuaiping,

|

||||

- jerryling315,

|

||||

- bestony,

|

||||

- Timeszoro,

|

||||

- rogetfan,

|

||||

- itsang,

|

||||

- JeffDing,

|

||||

- Yuking-net,

|

||||

|

||||

- MikeCoder,

|

||||

- zhangboyue,

|

||||

- liaoishere,

|

||||

- yupmoon,

|

||||

- Medusar,

|

||||

- zzlyzq,

|

||||

- yujianxuechuan,

|

||||

- ailurus1991,

|

||||

- tomatoKiller,

|

||||

- stduolc,

|

||||

- shaohaolin,

|

||||

- Timeszoro,

|

||||

- rogetfan,

|

||||

- FineFan,

|

||||

- kingname,

|

||||

- jasminepeng,

|

||||

- JeffDing,

|

||||

- CHINAANSHE,

|

||||

|

||||

(按提交行数排名前百)

|

||||

@ -173,7 +189,7 @@ LFS 项目活跃成员有:

|

||||

- @KevinSJ

|

||||

- @Yuking-net

|

||||

|

||||

(更新于2015/11/29)

|

||||

(更新于2016/05/09)

|

||||

|

||||

谢谢大家的支持!

|

||||

|

||||

|

||||

@ -0,0 +1,53 @@

|

||||

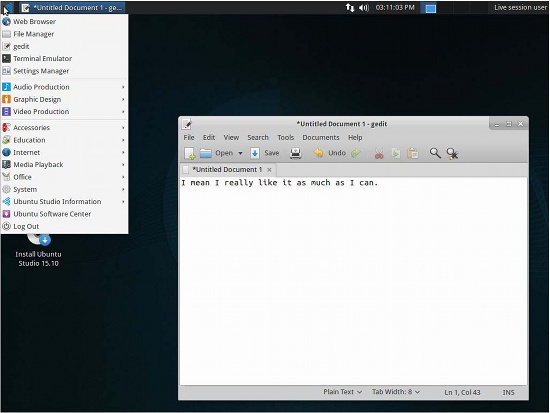

如果总统候选人们要使用 Linux 发行版,他们会选择哪个?

|

||||

================================================================================

|

||||

|

||||

|

||||

*共和党总统候选人 Donald Trump【译者注:唐纳德·特朗普,美国地产大亨、作家、主持人】*

|

||||

|

||||

如果要竞选总统的人们使用 Linux 或其他的开源操作系统,那么会使用哪个发行版呢?问题的关键是存在许多其它的因素,比如,一些“政治立场”问题,或者是给一个发行版的名字添加上感叹号是否合适——而这问题一直被忽视。先不管这些忽视:接下来是时事新闻工作者关于总统大选和 Linux 发行版的报道。

|

||||

|

||||

对于那些已经看了很多年我的文字的人来说(除了我亲爱的的编辑之外,他们一直听我的瞎扯是不是倒霉到家了?),这篇文章听起来很熟悉,这是因为我在去年的总统选举期间写了一篇[类似的文章][1]。一些读者把这篇文章的内容看的比我想象的还要严肃,所以我会花点时间阐述我的观点:事实上,我不认为开源软件和政治运动彼此之间有多大的关系。我写那样的文章仅仅是新的一周的自我消遣罢了。

|

||||

|

||||

当然,你也可以认为它们彼此相关,毕竟你才是读者。

|

||||

|

||||

### Linux 发行版之选:共和党人们 ###

|

||||

|

||||

今天,我只是谈及一些有关共和党人们的话题,我甚至只会谈论他们的其中一部分。因为共和党的提名人太多了,以至于我写满了整篇文章。由此开始:

|

||||

|

||||

如果 **Jeb (Jeb!?) Bush** 使用 Linux,它一定是 [Debian][2]。Debian 属于一个相当无趣的分支,它是为真正意义上的、成熟的黑客设计的,这些人将清理那些由经验不甚丰富的开源爱好者所造成的混乱视为一大使命。当然,这也使得 Debian 显得很枯燥,所以它已有的用户基数一直在缩减。

|

||||

|

||||

**Scott Walker** ,对于他来说,应该是一个 [Damn Small Linux][3] (DSL) 用户。这个系统仅仅需要 50MB 的硬盘空间和 16MB 的 RAM 便可运行。DSL 可以使一台 20 年前的 486 计算机焕发新春,而这恰好符合了 **Scott Walker** 所主张的消减成本计划。当然,你在 DSL 上的用户体验也十分原始,这个系统平台只能够运行一个浏览器。但是至少你不用浪费钱财购买新的电脑硬件,你那台 1993 年购买的机器仍然可以为你好好的工作。

|

||||

|

||||

**Chris Christie** 会使用哪种系统呢?他肯定会使用 [Relax-and-Recover Linux][4],它号称“一次搞定(Setup-and-forget)的裸机 Linux 灾难恢复方案” 。从那次不幸的华盛顿大桥事故后,“一次搞定(Setup-and-forget)”基本上便成了 Christie 的政治主张。不管灾难恢复是否能够让 Christie 最终挽回一切,但是当他的电脑死机的时候,至少可以找到一两封意外丢失的机密邮件。

|

||||

|

||||

至于 **Carly Fiorina**,她无疑将要使用 [惠普][6] (HPQ)为“[The Machine][5]”开发的操作系统,她在 1999 年到 2005 年这 6 年期间管理该公司。事实上,The Machine 可以运行几种不同的操作系统,也许是基于 Linux 的,也许不是,我们并不太清楚,它的开发始于 **Carly Fiorina** 在惠普公司的任期结束后。不管怎么说,作为 IT 圈里一个成功的管理者,这是她履历里面重要的组成部分,同时这也意味着她很难与惠普彻底断绝关系。

|

||||

|

||||

最后,但并不是不重要,你也猜到了——**Donald Trump**。他显然会动用数百万美元去雇佣一个精英黑客团队去定制属于自己的操作系统——尽管他原本是想要免费获得一个完美的、现成的操作系统——然后还能向别人炫耀自己的财力。他可能会吹嘘自己的操作系统是目前最好的系统,虽然它可能没有兼容 POSIX 或者一些其它的标准,因为那样的话就需要花掉更多的钱。同时这个系统也将根本不会提供任何文档,因为如果 **Donald Trump** 向人们解释他的系统的实际运行方式,他会冒着所有机密被泄露至伊斯兰国家的风险,绝对是这样的。

|

||||

|

||||

另外,如果 **Donald Trump** 非要选择一种已有的 Linux 平台的话, [Ubuntu][7] 应该是明智的选择。就像 **Donald Trump** 一样, Ubuntu 的开发者秉承“我们做自己想要做的”原则,通过他们自己的实现来构建开源软件。自由软件纯化论者却很反感 Ubuntu 这一点,但是很多普通用户却更喜欢一些。当然,无论你是不是一个纯粹论者,无论是在软件领域还是政治领域,还需要时间才能知道分晓。

|

||||

|

||||

### 敬请期待 ###

|

||||

|

||||

如果你想知道为什么我还没有提到民主党候选人,别想多了。我没有在这篇文章中提及他们,是因为我对民主党并不比共和党喜欢更多或更少一点(我个人认为,这种只有两个政党的美国特色是不荒谬的,根本不能体现民主,我也不相信这些党派候选人)。

|

||||

|

||||

另一方面,也可能会有很多人关心民主党候选人使用的 Linux 发行版。后续的帖子中我会提及的,请拭目以待。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://thevarguy.com/open-source-application-software-companies/081715/which-open-source-linux-distributions-would-presidential-

|

||||

|

||||

作者:[Christopher Tozzi][a]

|

||||

译者:[vim-kakali](https://github.com/vim-kakali)

|

||||

校对:[PurlingNayuki](https://github.com/PurlingNayuki), [wxy](https://github.com/wxy/)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://thevarguy.com/author/christopher-tozzi

|

||||

[1]:http://thevarguy.com/open-source-application-software-companies/aligning-linux-distributions-presidential-hopefuls

|

||||

[2]:http://debian.org/

|

||||

[3]:http://www.damnsmalllinux.org/

|

||||

[4]:http://relax-and-recover.org/

|

||||

[5]:http://thevarguy.com/open-source-application-software-companies/061614/hps-machine-open-source-os-truly-revolutionary

|

||||

[6]:http://hp.com/

|

||||

[7]:http://ubuntu.com/

|

||||

200

published/20151019 Gaming On Linux--All You Need To Know.md

Normal file

200

published/20151019 Gaming On Linux--All You Need To Know.md

Normal file

@ -0,0 +1,200 @@

|

||||

Linux上的游戏:所有你需要知道的

|

||||

================================================================================

|

||||

|

||||

|

||||

**我能在 Linux 上玩游戏吗 ?**

|

||||

|

||||

这是打算[投奔 Linux 阵营][1]的人最经常问的问题之一。毕竟,在 Linux 上面玩游戏经常被认为有点难以实现。事实上,一些人甚至考虑他们能不能在 Linux 上看电影或者听音乐。考虑到这些,关于 Linux 的平台的游戏的问题是很现实的。

|

||||

|

||||

在本文中,我将解答大多数 Linux 新手关于在 Linux 中打游戏的问题。例如 Linux 下能不能玩游戏,如果能的话,在哪里**下载游戏**或者如何获取有关游戏的信息。

|

||||

|

||||

但是在此之前,我需要说明一下。我不是一个 PC 上的玩家或者说我不认为我是一个在 Linux 桌面游戏玩家。我更喜欢在 PS4 上玩游戏并且我不关心 PC 上的游戏甚至也不关心手机上的游戏(我没有给我的任何一个朋友安利糖果传奇)。这也就是你很少能在 It's FOSS 上很少看见关于 [Linux 上的游戏][2]的原因。

|

||||

|

||||

所以我为什么要提到这个主题?

|

||||

|

||||

因为别人问过我几次有关 Linux 上的游戏的问题并且我想要写出来一个能解答这些问题的 Linux 游戏指南。注意,在这里我不只是讨论在 Ubuntu 上玩游戏。我讨论的是在所有的 Linux 上的游戏。

|

||||

|

||||

### 我能在 Linux 上玩游戏吗 ? ###

|

||||

|

||||

是,但不是完全是。

|

||||

|

||||

“是”,是指你能在Linux上玩游戏;“不完全是”,是指你不能在 Linux 上玩 ‘所有的游戏’。

|

||||

|

||||

感到迷惑了吗?不必这样。我的意思是你能在 Linux 上玩很多流行的游戏,比如[反恐精英以及地铁:最后的曙光][3]等。但是你可能不能玩到所有在 Windows 上流行的最新游戏,比如[实况足球 2015 ][4]。

|

||||

|

||||

在我看来,造成这种情况的原因是 Linux 在桌面系统中仅占不到 2%,这样的占比使得大多数开发者没有开发其游戏的 Linux 版的动力。

|

||||

|

||||

这就意味指大多数近年来被提及的比较多的游戏很有可能不能在 Linux 上玩。不要灰心。还有别的方式在 Linux 上玩这些游戏,我们将在下面的章节中讨论这些方法。但是,在此之前,让我们看看在 Linux 上能玩的游戏的种类。

|

||||

|

||||

要我说的话,我会把那些游戏分为四类:

|

||||

|

||||

1. Linux 原生游戏

|

||||

2. Linux 上的 Windows 游戏

|

||||

3. 浏览器里的游戏

|

||||

4. 终端里的游戏

|

||||

|

||||

让我们以最重要的一类, Linux 的原生游戏开始。

|

||||

|

||||

---------

|

||||

|

||||

### 1. 在哪里去找 Llinux 原生游戏 ?###

|

||||

|

||||

原生游戏指的是官方支持 Linux 的游戏。这些游戏有原生的 Linux 客户端并且能像在 Linux 上的其他软件一样不需要附加的步骤就能安装在 Linux 上面(我们将在下一节讨论)。

|

||||

|

||||

所以,如你所见,有一些为 Linux 开发的游戏,下一个问题就是在哪能找到这些游戏以及如何安装。我将列出一些让你玩到游戏的渠道。

|

||||

|

||||

#### Steam ####

|

||||

|

||||

|

||||

|

||||

“[Steam][5] 是一个游戏的分发平台。就如同 Kindle 是电子书的分发平台, iTunes 是音乐的分发平台一样, Steam 也具有那样的功能。它提供购买和安装游戏,玩多人游戏以及在它的平台上关注其他游戏的选项。其上的游戏被[ DRM ][6]所保护。”

|

||||

|

||||

两年以前,游戏平台 Steam 宣布支持 Linux ,这在当时是一个大新闻。这是 Linux 上玩游戏被严肃对待的一个迹象。尽管这个决定更多地影响了他们自己的基于 Linux 游戏平台以及一个独立 Linux 发行版[ Steam OS][7] ,这仍然是令人欣慰的事情,因为它给 Linux 带来了一大堆游戏。

|

||||

|

||||

我已经写了一篇详细的关于安装以及使用 Steam 的文章。如果你想开始使用 Steam 的话,读读那篇文章。

|

||||

|

||||

- [在 Linux 上安装以及使用 Steam ][8]

|

||||

|

||||

#### GOG.com ####

|

||||

|

||||

[GOG.com][9] 是另一个与 Steam 类似的平台。与 Steam 一样,你能在这上面找到数以百计的 Linux 游戏,并购买和安装它们。如果游戏支持好几个平台,你可以在多个操作系统上安装他们。你可以随时游玩使用你的账户购买的游戏。你也可以在任何时间下载。

|

||||

|

||||

GOG.com 与 Steam 不同的是前者仅提供没有 DRM 保护的游戏以及电影。而且,GOG.com 完全是基于网页的,所以你不需要安装类似 Steam 的客户端。你只需要用浏览器下载游戏然后安装到你的系统上。

|

||||

|

||||

#### Portable Linux Games ####

|

||||

|

||||

[Portable Linux Games][10] 是一个集聚了不少 Linux 游戏的网站。这家网站最特别以及最好的点就是你能离线安装这些游戏。

|

||||

|

||||

你下载到的文件包含所有的依赖(仅需 Wine 以及 Perl)并且他们也是与平台无关的。你所需要的仅仅是下载文件并且双击来启动安装程序。你也可以把文件储存起来以用于将来的安装。如果你网速不够快的话,我很推荐你这样做。

|

||||

|

||||

#### Game Drift 游戏商店 ####

|

||||

|

||||

[Game Drift][11] 是一个只专注于游戏的基于 Ubuntu 的 Linux 发行版。但是如果你不想只为游戏就去安装这个发行版的话,你也可以经常去它的在线游戏商店去看哪个游戏可以在 Linux 上运行并且安装他们。

|

||||

|

||||

#### Linux Game Database ####

|

||||

|

||||

如其名字所示,[Linux Game Database][12]是一个收集了很多 Linux 游戏的网站。你能在这里浏览诸多类型的游戏并从游戏开发者的网站下载/安装这些游戏。作为这家网站的会员,你甚至可以为游戏打分。 LGDB 有点像 Linux 游戏界的 IMDB 或者 IGN.

|

||||

|

||||

#### Penguspy ####

|

||||

|

||||

此网站由一个不想用 Windows 玩游戏的玩家创立。[Penguspy][13] 聚集了一些 Linux 下最好的游戏。在这里你也能分类浏览游戏,如果你喜欢这个游戏的话,你可以跳转到游戏开发者的网站去下载安装。

|

||||

|

||||

#### 软件源 ####

|

||||

|

||||

看看你自己的发行版的软件源。其中可能有一些游戏。如果你用 Ubuntu 的话,它的软件中心里有一个游戏的分类。在一些其他的发行版里也有,比如 Linux Mint 等。

|

||||

|

||||

----------

|

||||

|

||||

### 2. 如何在 Linux 上玩 Windows 的游戏 ?###

|

||||

|

||||

|

||||

|

||||

到现在为止,我们一直在讨论 Linux 的原生游戏。但是并没有很多 Linux 上的原生游戏,或者更准确地说,火的不要不要的游戏大多不支持 Linux,但是都支持 Windows PC 。所以,如何在 Linux 上玩 Windows 的游戏?

|

||||

|

||||

幸好,由于我们有 Wine 、 PlayOnLinux 和 CrossOver 等工具,我们能在 Linux 上玩不少的 Windows 游戏。

|

||||

|

||||

#### Wine ####

|

||||

|

||||

Wine 是一个能使 Windows 应用在类似 Linux , BSD 和 OS X 上运行的兼容层。在 Wine 的帮助下,你可以在 Linux 下安装以及使用很多 Windows 下的应用。

|

||||

|

||||

[在 Ubuntu 上安装 Wine][14]或者在其他 Linux 上安装 Wine 是很简单的,因为大多数发行版的软件源里都有它。这里也有一个很大的[ Wine 支持的应用的数据库][15]供您浏览。

|

||||

|

||||

#### CrossOver ####

|

||||

|

||||

[CrossOver][16] 是 Wine 的增强版,它给 Wine 提供了专业的技术上的支持。但是与 Wine 不同, CrossOver 不是免费的。你需要购买许可。好消息是它会把更新也贡献到 Wine 的开发者那里并且事实上加速了 Wine 的开发使得 Wine 能支持更多的 Windows 上的游戏和应用。如果你可以接受每年支付 48 美元,你可以购买 CrossOver 并得到他们提供的技术支持。

|

||||

|

||||

### PlayOnLinux ###

|

||||

|

||||

PlayOnLinux 也基于 Wine 但是执行程序的方式略有不同。它有着更好用的,不同的界面。与 Wine 一样,PlayOnLinux 也是免费使用。你可以在[开发者自己的数据库里查看它支持的应用以及游戏][17]。

|

||||

|

||||

----------

|

||||

|

||||

### 3. 网页游戏 ###

|

||||

|

||||

|

||||

|

||||

不必说你也应该知道有非常多的基于网页的游戏,这些游戏都可以在任何操作系统里运行,无论是 Windows ,Linux ,还是 OS X 。大多数让人上瘾的手机游戏,比如[帝国之战][18]就有官方的网页版。

|

||||

|

||||

除了这些,还有 [Google Chrome 在线商店][19],你可以在 Linux 上玩更多的这些游戏。这些 Chrome 上的游戏可以像一个单独的应用一样安装并从应用菜单中打开,一些游戏就算是离线也能运行。

|

||||

|

||||

----------

|

||||

|

||||

### 4. 终端游戏 ###

|

||||

|

||||

|

||||

|

||||

使用 Linux 的一个附加优势就是可以使用命令行终端玩游戏。我知道这不是最好的玩游戏的方法,但是在终端里玩[贪吃蛇][20]或者 [2048][21] 很有趣。在[这个博客][21]中有一些好玩的的终端游戏。你可以浏览并安装你喜欢的游戏。

|

||||

|

||||

----------

|

||||

|

||||

### 如何保证游戏的版本是最新的 ?###

|

||||

|

||||

当你了解了不少的在 Linux 上你可以玩到的游戏以及你如何使用他们,下一个问题就是如何保持游戏的版本是最新的。对于这件事,我建议你看看下面的博客,这些博客能告诉你 Linux 游戏世界的最新消息:

|

||||

|

||||

- [Gaming on Linux][23]:我认为我把它叫做 Linux 游戏专业门户并没有错误。在这你可以得到关于 Linux 的游戏的最新的传言以及新闻。它经常更新, 还有由 Linux 游戏爱好者组成的优秀社区。

|

||||

- [Free Gamer][24]:一个专注于免费开源的游戏的博客。

|

||||

- [Linux Game News][25]:一个提供很多的 Linux 游戏的升级的 Tumbler 博客。

|

||||

|

||||

#### 还有别的要说的吗? ####

|

||||

|

||||

我认为让你知道如何开始在 Linux 上的游戏人生是一个好事。如果你仍然不能被说服,我推荐你做个[双系统][26],把 Linux 作为你的主要桌面系统,当你想玩游戏时,重启到 Windows。这是一个对游戏妥协的解决办法。

|

||||

|

||||

现在,这里是你说出你自己的想法的时候了。你在 Linux 上玩游戏吗?你最喜欢什么游戏?你关注了哪些游戏博客?

|

||||

|

||||

|

||||

投票项目:

|

||||

你怎样在 Linux 上玩游戏?

|

||||

|

||||

- 我玩原生 Linux 游戏,也用 Wine 以及 PlayOnLinux 运行 Windows 游戏

|

||||

- 我喜欢网页游戏

|

||||

- 我喜欢终端游戏

|

||||

- 我只玩原生 Linux 游戏

|

||||

- 我用 Steam

|

||||

- 我用双系统,要玩游戏时就换到 Windows

|

||||

- 我不玩游戏

|

||||

|

||||

注:投票代码

|

||||

<div class="PDS_Poll" id="PDI_container9132962" style="display:inline-block;"></div>

|

||||

<div id="PD_superContainer"></div>

|

||||

<script type="text/javascript" charset="UTF-8" src="http://static.polldaddy.com/p/9132962.js"></script>

|

||||

<noscript><a href="http://polldaddy.com/poll/9132962">Take Our Poll</a></noscript>

|

||||

|

||||

注,发布时根据情况看怎么处理

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://itsfoss.com/linux-gaming-guide/

|

||||

|

||||

作者:[Abhishek][a]

|

||||

译者:[name1e5s](https://github.com/name1e5s)

|

||||

校对:[PurlingNayuki](https://github.com/PurlingNayuki)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://itsfoss.com/author/abhishek/

|

||||

[1]:http://itsfoss.com/reasons-switch-linux-windows-xp/

|

||||

[2]:http://itsfoss.com/category/games/

|

||||

[3]:http://blog.counter-strike.net/

|

||||

[4]:https://pes.konami.com/tag/pes-2015/

|

||||

[5]:http://store.steampowered.com/

|

||||

[6]:https://en.wikipedia.org/wiki/Digital_rights_management

|

||||

[7]:http://itsfoss.com/valve-annouces-linux-based-gaming-operating-system-steamos/

|

||||

[8]:http://itsfoss.com/install-steam-ubuntu-linux/

|

||||

[9]:http://www.gog.com/

|

||||

[10]:http://www.portablelinuxgames.org/

|

||||

[11]:http://gamedrift.org/GameStore.html

|

||||

[12]:http://www.lgdb.org/

|

||||

[13]:http://www.penguspy.com/

|

||||

[14]:http://itsfoss.com/wine-1-5-11-released-ppa-available-to-download/

|

||||

[15]:https://appdb.winehq.org/

|

||||

[16]:https://www.codeweavers.com/products/

|

||||

[17]:https://www.playonlinux.com/en/supported_apps.html

|

||||

[18]:http://empire.goodgamestudios.com/

|

||||

[19]:https://chrome.google.com/webstore/category/apps

|

||||

[20]:http://itsfoss.com/nsnake-play-classic-snake-game-linux-terminal/

|

||||

[21]:http://itsfoss.com/play-2048-linux-terminal/

|

||||

[22]:https://ttygames.wordpress.com/

|

||||

[23]:https://www.gamingonlinux.com/

|

||||

[24]:http://freegamer.blogspot.fr/

|

||||

[25]:http://linuxgamenews.com/

|

||||

[26]:http://itsfoss.com/install-ubuntu-1404-dual-boot-mode-windows-8-81-uefi/

|

||||

@ -4,10 +4,9 @@ Linux 内核里的数据结构——双向链表

|

||||

双向链表

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

Linux 内核中自己实现了双向链表,可以在 [include/linux/list.h](https://github.com/torvalds/linux/blob/master/include/linux/list.h) 找到定义。我们将会首先从双向链表数据结构开始介绍**内核里的数据结构**。为什么?因为它在内核里使用的很广泛,你只需要在 [free-electrons.com](http://lxr.free-electrons.com/ident?i=list_head) 检索一下就知道了。

|

||||

|

||||

Linux 内核自己实现了双向链表,可以在[include/linux/list.h](https://github.com/torvalds/linux/blob/master/include/linux/list.h)找到定义。我们将会从双向链表数据结构开始`内核的数据结构`。为什么?因为它在内核里使用的很广泛,你只需要在[free-electrons.com](http://lxr.free-electrons.com/ident?i=list_head) 检索一下就知道了。

|

||||

|

||||

首先让我们看一下在[include/linux/types.h](https://github.com/torvalds/linux/blob/master/include/linux/types.h) 里的主结构体:

|

||||

首先让我们看一下在 [include/linux/types.h](https://github.com/torvalds/linux/blob/master/include/linux/types.h) 里的主结构体:

|

||||

|

||||

```C

|

||||

struct list_head {

|

||||

@ -15,7 +14,7 @@ struct list_head {

|

||||

};

|

||||

```

|

||||

|

||||

你可能注意到这和你以前见过的双向链表的实现方法是不同的。举个例子来说,在[glib](http://www.gnu.org/software/libc/) 库里是这样实现的:

|

||||

你可能注意到这和你以前见过的双向链表的实现方法是不同的。举个例子来说,在 [glib](http://www.gnu.org/software/libc/) 库里是这样实现的:

|

||||

|

||||

```C

|

||||

struct GList {

|

||||

@ -25,7 +24,7 @@ struct GList {

|

||||

};

|

||||

```

|

||||

|

||||

通常来说一个链表会包含一个指向某个项目的指针。但是内核的实现并没有这样做。所以问题来了:`链表在哪里保存数据呢?`。实际上内核里实现的链表实际上是`侵入式链表`。侵入式链表并不在节点内保存数据-节点仅仅包含指向前后节点的指针,然后把数据是附加到链表的。这就使得这个数据结构是通用的,使用起来就不需要考虑节点数据的类型了。

|

||||

通常来说一个链表结构会包含一个指向某个项目的指针。但是 Linux 内核中的链表实现并没有这样做。所以问题来了:**链表在哪里保存数据呢?**。实际上,内核里实现的链表是**侵入式链表(Intrusive list)**。侵入式链表并不在节点内保存数据-它的节点仅仅包含指向前后节点的指针,以及指向链表节点数据部分的指针——数据就是这样附加在链表上的。这就使得这个数据结构是通用的,使用起来就不需要考虑节点数据的类型了。

|

||||

|

||||

比如:

|

||||

|

||||

@ -36,7 +35,7 @@ struct nmi_desc {

|

||||

};

|

||||

```

|

||||

|

||||

让我们看几个例子来理解一下在内核里是如何使用`list_head` 的。如上所述,在内核里有实在很多不同的地方用到了链表。我们来看一个在杂项字符驱动里面的使用的例子。在 [drivers/char/misc.c](https://github.com/torvalds/linux/blob/master/drivers/char/misc.c) 的杂项字符驱动API 被用来编写处理小型硬件和虚拟设备的小驱动。这些驱动共享相同的主设备号:

|

||||

让我们看几个例子来理解一下在内核里是如何使用 `list_head` 的。如上所述,在内核里有很多很多不同的地方都用到了链表。我们来看一个在杂项字符驱动里面的使用的例子。在 [drivers/char/misc.c](https://github.com/torvalds/linux/blob/master/drivers/char/misc.c) 的杂项字符驱动 API 被用来编写处理小型硬件或虚拟设备的小驱动。这些驱动共享相同的主设备号:

|

||||

|

||||

```C

|

||||

#define MISC_MAJOR 10

|

||||

@ -68,7 +67,7 @@ crw------- 1 root root 10, 63 Mar 21 12:01 vga_arbiter

|

||||

crw------- 1 root root 10, 137 Mar 21 12:01 vhci

|

||||

```

|

||||

|

||||

现在让我们看看它是如何使用链表的。首先看一下结构体`miscdevice`:

|

||||

现在让我们看看它是如何使用链表的。首先看一下结构体 `miscdevice`:

|

||||

|

||||

```C

|

||||

struct miscdevice

|

||||

@ -84,7 +83,7 @@ struct miscdevice

|

||||

};

|

||||

```

|

||||

|

||||

可以看到结构体的第四个变量`list` 是所有注册过的设备的链表。在源代码文件的开始可以看到这个链表的定义:

|

||||

可以看到结构体`miscdevice`的第四个变量`list` 是所有注册过的设备的链表。在源代码文件的开始可以看到这个链表的定义:

|

||||

|

||||

```C

|

||||

static LIST_HEAD(misc_list);

|

||||

@ -97,13 +96,13 @@ static LIST_HEAD(misc_list);

|

||||

struct list_head name = LIST_HEAD_INIT(name)

|

||||

```

|

||||

|

||||

然后使用宏`LIST_HEAD_INIT` 进行初始化,这会使用变量`name` 的地址来填充`prev`和`next` 结构体的两个变量。

|

||||

然后使用宏 `LIST_HEAD_INIT` 进行初始化,这会使用变量`name` 的地址来填充`prev`和`next` 结构体的两个变量。

|

||||

|

||||

```C

|

||||

#define LIST_HEAD_INIT(name) { &(name), &(name) }

|

||||

```

|

||||

|

||||

现在来看看注册杂项设备的函数`misc_register`。它在开始就用 `INIT_LIST_HEAD` 初始化了`miscdevice->list`。

|

||||

现在来看看注册杂项设备的函数`misc_register`。它在一开始就用函数 `INIT_LIST_HEAD` 初始化了`miscdevice->list`。

|

||||

|

||||

```C

|

||||

INIT_LIST_HEAD(&misc->list);

|

||||

@ -119,13 +118,13 @@ static inline void INIT_LIST_HEAD(struct list_head *list)

|

||||

}

|

||||

```

|

||||

|

||||

在函数`device_create` 创建了设备后我们就用下面的语句将设备添加到设备链表:

|

||||

接下来,在函数`device_create` 创建了设备后,我们就用下面的语句将设备添加到设备链表:

|

||||

|

||||

```

|

||||

list_add(&misc->list, &misc_list);

|

||||

```

|

||||

|

||||

内核文件`list.h` 提供了项链表添加新项的API 接口。我们来看看它的实现:

|

||||

内核文件`list.h` 提供了向链表添加新项的 API 接口。我们来看看它的实现:

|

||||

|

||||

|

||||

```C

|

||||

@ -138,8 +137,8 @@ static inline void list_add(struct list_head *new, struct list_head *head)

|

||||

实际上就是使用3个指定的参数来调用了内部函数`__list_add`:

|

||||

|

||||

* new - 新项。

|

||||

* head - 新项将会被添加到`head`之前.

|

||||

* head->next - `head` 之后的项。

|

||||

* head - 新项将会插在`head`的后面

|

||||

* head->next - 插入前,`head` 后面的项。

|

||||

|

||||

`__list_add`的实现非常简单:

|

||||

|

||||

@ -155,9 +154,9 @@ static inline void __list_add(struct list_head *new,

|

||||

}

|

||||

```

|

||||

|

||||

我们会在`prev`和`next` 之间添加一个新项。所以我们用宏`LIST_HEAD_INIT`定义的`misc` 链表会包含指向`miscdevice->list` 的向前指针和向后指针。

|

||||

这里,我们在`prev`和`next` 之间添加了一个新项。所以我们开始时用宏`LIST_HEAD_INIT`定义的`misc` 链表会包含指向`miscdevice->list` 的向前指针和向后指针。

|

||||

|

||||

这里有一个问题:如何得到列表的内容呢?这里有一个特殊的宏:

|

||||

这儿还有一个问题:如何得到列表的内容呢?这里有一个特殊的宏:

|

||||

|

||||

```C

|

||||

#define list_entry(ptr, type, member) \

|

||||

@ -166,7 +165,7 @@ static inline void __list_add(struct list_head *new,

|

||||

|

||||

使用了三个参数:

|

||||

|

||||

* ptr - 指向链表头的指针;

|

||||

* ptr - 指向结构 `list_head` 的指针;

|

||||

* type - 结构体类型;

|

||||

* member - 在结构体内类型为`list_head` 的变量的名字;

|

||||

|

||||

@ -205,9 +204,9 @@ int main() {

|

||||

}

|

||||

```

|

||||

|

||||

最终会打印`2`

|

||||

最终会打印出`2`

|

||||

|

||||

下一点就是`typeof`,它也很简单。就如你从名字所理解的,它仅仅返回了给定变量的类型。当我第一次看到宏`container_of`的实现时,让我觉得最奇怪的就是`container_of`中的0.实际上这个指针巧妙的计算了从结构体特定变量的偏移,这里的`0`刚好就是位宽里的零偏移。让我们看一个简单的例子:

|

||||

下一点就是`typeof`,它也很简单。就如你从名字所理解的,它仅仅返回了给定变量的类型。当我第一次看到宏`container_of`的实现时,让我觉得最奇怪的就是表达式`((type *)0)`中的0。实际上这个指针巧妙的计算了从结构体特定变量的偏移,这里的`0`刚好就是位宽里的零偏移。让我们看一个简单的例子:

|

||||

|

||||

```C

|

||||

#include <stdio.h>

|

||||

@ -226,33 +225,35 @@ int main() {

|

||||

|

||||

结果显示`0x5`。

|

||||

|

||||

下一个宏`offsetof` 会计算从结构体的某个变量的相对于结构体起始地址的偏移。它的实现和上面类似:

|

||||

下一个宏`offsetof`会计算从结构体起始地址到某个给定结构字段的偏移。它的实现和上面类似:

|

||||

|

||||

```C

|

||||

#define offsetof(TYPE, MEMBER) ((size_t) &((TYPE *)0)->MEMBER)

|

||||

```

|

||||

|

||||

现在我们来总结一下宏`container_of`。只需要知道结构体里面类型为`list_head` 的变量的名字和结构体容器的类型,它可以通过结构体的变量`list_head`获得结构体的起始地址。在宏定义的第一行,声明了一个指向结构体成员变量`ptr`的指针`__mptr`,并且把`ptr` 的地址赋给它。现在`ptr` 和`__mptr` 指向了同一个地址。从技术上讲我们并不需要这一行,但是它可以方便的进行类型检查。第一行保证了特定的结构体(参数`type`)包含成员变量`member`。第二行代码会用宏`offsetof`计算成员变量相对于结构体起始地址的偏移,然后从结构体的地址减去这个偏移,最后就得到了结构体。

|

||||

现在我们来总结一下宏`container_of`。只需给定结构体中`list_head`类型 字段的地址、名字和结构体容器的类型,它就可以返回结构体的起始地址。在宏定义的第一行,声明了一个指向结构体成员变量`ptr`的指针`__mptr`,并且把`ptr` 的地址赋给它。现在`ptr` 和`__mptr` 指向了同一个地址。从技术上讲我们并不需要这一行,但是它可以方便地进行类型检查。第一行保证了特定的结构体(参数`type`)包含成员变量`member`。第二行代码会用宏`offsetof`计算成员变量相对于结构体起始地址的偏移,然后从结构体的地址减去这个偏移,最后就得到了结构体。

|

||||

|

||||

当然了`list_add` 和 `list_entry`不是`<linux/list.h>`提供的唯一功能。双向链表的实现还提供了如下API:

|

||||

|

||||

* list_add

|

||||

* list_add_tail

|

||||

* list_del

|

||||

* list_replace

|

||||

* list_move

|

||||

* list_is_last

|

||||

* list_empty

|

||||

* list_cut_position

|

||||

* list_splice

|

||||

* list_for_each

|

||||

* list_for_each_entry

|

||||

* list\_add

|

||||

* list\_add\_tail

|

||||

* list\_del

|

||||

* list\_replace

|

||||

* list\_move

|

||||

* list\_is\_last

|

||||

* list\_empty

|

||||

* list\_cut\_position

|

||||

* list\_splice

|

||||

* list\_for\_each

|

||||

* list\_for\_each\_entry

|

||||

|

||||

等等很多其它API。

|

||||

|

||||

via: https://github.com/0xAX/linux-insides/edit/master/DataStructures/dlist.md

|

||||

----

|

||||

|

||||

via: https://github.com/0xAX/linux-insides/blob/master/DataStructures/dlist.md

|

||||

|

||||

译者:[Ezio](https://github.com/oska874)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[Mr小眼儿](https://github.com/tinyeyeser)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

198

published/20151123 Data Structures in the Linux Kernel.md

Normal file

198

published/20151123 Data Structures in the Linux Kernel.md

Normal file

@ -0,0 +1,198 @@

|

||||

Linux 内核里的数据结构 —— 基数树

|

||||

================================================================================

|

||||

|

||||

基数树 Radix tree

|

||||

--------------------------------------------------------------------------------

|

||||

正如你所知道的,Linux内核提供了许多不同的库和函数,它们实现了不同的数据结构和算法。在这部分,我们将研究其中一种数据结构——[基数树 Radix tree](http://en.wikipedia.org/wiki/Radix_tree)。在 Linux 内核中,有两个文件与基数树的实现和API相关:

|

||||

|

||||

* [include/linux/radix-tree.h](https://github.com/torvalds/linux/blob/master/include/linux/radix-tree.h)

|

||||

* [lib/radix-tree.c](https://github.com/torvalds/linux/blob/master/lib/radix-tree.c)

|

||||

|

||||

让我们先说说什么是 `基数树` 吧。基数树是一种 `压缩的字典树 (compressed trie)` ,而[字典树](http://en.wikipedia.org/wiki/Trie)是实现了关联数组接口并允许以 `键值对` 方式存储值的一种数据结构。这里的键通常是字符串,但可以使用任意数据类型。字典树因为它的节点而与 `n叉树` 不同。字典树的节点不存储键,而是存储单个字符的标签。与一个给定节点关联的键可以通过从根遍历到该节点获得。举个例子:

|

||||

|

||||

```

|

||||

+-----------+

|

||||

| |

|

||||

| " " |

|

||||

| |

|

||||

+------+-----------+------+

|

||||

| |

|

||||

| |

|

||||

+----v------+ +-----v-----+

|

||||

| | | |

|

||||

| g | | c |

|

||||

| | | |

|

||||

+-----------+ +-----------+

|

||||

| |

|

||||

| |

|

||||

+----v------+ +-----v-----+

|

||||

| | | |

|

||||

| o | | a |

|

||||

| | | |

|

||||

+-----------+ +-----------+

|

||||

|

|

||||

|

|

||||

+-----v-----+

|

||||

| |

|

||||

| t |

|

||||

| |

|

||||

+-----------+

|

||||

```

|

||||

|

||||

因此在这个例子中,我们可以看到一个有着两个键 `go` 和 `cat` 的 `字典树` 。压缩的字典树也叫做 `基数树` ,它和 `字典树` 的不同之处在于,所有只有一个子节点的中间节点都被删除。

|

||||

|

||||

Linux 内核中的基数树是把值映射到整形键的一种数据结构。[include/linux/radix-tree.h](https://github.com/torvalds/linux/blob/master/include/linux/radix-tree.h)文件中的以下结构体描述了基数树:

|

||||

|

||||

```C

|

||||

struct radix_tree_root {

|

||||

unsigned int height;

|

||||

gfp_t gfp_mask;

|

||||

struct radix_tree_node __rcu *rnode;

|

||||

};

|

||||

```

|

||||

|

||||

这个结构体描述了一个基数树的根,它包含了3个域成员:

|

||||

|

||||

* `height` - 树的高度;

|

||||

* `gfp_mask` - 告知如何执行动态内存分配;

|

||||

* `rnode` - 孩子节点指针.

|

||||

|

||||

我们第一个要讨论的字段是 `gfp_mask` :

|

||||

|

||||

底层内核的内存动态分配函数以一组标志作为 `gfp_mask` ,用于描述如何执行动态内存分配。这些控制分配进程的 `GFP_` 标志拥有以下值:( `GF_NOIO` 标志)意味着睡眠以及等待内存,( `__GFP_HIGHMEM` 标志)意味着高端内存能够被使用,( `GFP_ATOMIC` 标志)意味着分配进程拥有高优先级并不能睡眠等等。

|

||||

|

||||

* `GFP_NOIO` - 睡眠等待内存

|

||||

* `__GFP_HIGHMEM` - 高端内存能够被使用;

|

||||

* `GFP_ATOMIC` - 分配进程拥有高优先级并且不能睡眠;

|

||||

|

||||

等等。

|

||||

|

||||

下一个字段是`rnode`:

|

||||

|

||||

```C

|

||||

struct radix_tree_node {

|

||||

unsigned int path;

|

||||

unsigned int count;

|

||||

union {

|

||||

struct {

|

||||

struct radix_tree_node *parent;

|

||||

void *private_data;

|

||||

};

|

||||

struct rcu_head rcu_head;

|

||||

};

|

||||

/* For tree user */

|

||||

struct list_head private_list;

|

||||

void __rcu *slots[RADIX_TREE_MAP_SIZE];

|

||||

unsigned long tags[RADIX_TREE_MAX_TAGS][RADIX_TREE_TAG_LONGS];

|

||||

};

|

||||

```

|

||||

这个结构体包含的信息有父节点中的偏移以及到底端(叶节点)的高度、子节点的个数以及用于访问和释放节点的字段成员。这些字段成员描述如下:

|

||||

|

||||

* `path` - 父节点中的偏移和到底端(叶节点)的高度

|

||||

* `count` - 子节点的个数;

|

||||

* `parent` - 父节点指针;

|

||||

* `private_data` - 由树的用户使用;

|

||||

* `rcu_head` - 用于释放节点;

|

||||

* `private_list` - 由树的用户使用;

|

||||

|

||||

`radix_tree_node` 的最后两个成员—— `tags` 和 `slots` 非常重要且令人关注。Linux 内核基数树的每个节点都包含了一组指针槽( slots ),槽里存储着指向数据的指针。在Linux内核基数树的实现中,空槽存储的是 `NULL` 。Linux内核中的基数树也支持标签( tags ),它与 `radix_tree_node` 结构体的 `tags` 字段相关联。有了标签,我们就可以对基数树中存储的记录以单个比特位( bit )进行设置。

|

||||

|

||||

既然我们了解了基数树的结构,那么该是时候看一下它的API了。

|

||||

|

||||

Linux内核基数树API

|

||||

---------------------------------------------------------------------------------

|

||||

|

||||

我们从结构体的初始化开始。有两种方法初始化一个新的基数树。第一种是使用 `RADIX_TREE` 宏:

|

||||

|

||||

```C

|

||||

RADIX_TREE(name, gfp_mask);

|

||||

````

|

||||

|

||||

正如你所看到的,我们传递了 `name` 参数,所以通过 `RADIX_TREE` 宏,我们能够定义和初始化基数树为给定的名字。`RADIX_TREE` 的实现很简单:

|

||||

|

||||

```C

|

||||

#define RADIX_TREE(name, mask) \

|

||||

struct radix_tree_root name = RADIX_TREE_INIT(mask)

|

||||

|

||||

#define RADIX_TREE_INIT(mask) { \

|

||||

.height = 0, \

|

||||

.gfp_mask = (mask), \

|

||||

.rnode = NULL, \

|

||||

}

|

||||

```

|

||||

|

||||

在 `RADIX_TREE` 宏的开始,我们使用给定的名字定义 `radix_tree_root` 结构体实例,并使用给定的 mask 调用 `RADIX_TREE_INIT` 宏。 而 `RADIX_TREE_INIT` 宏则是使用默认值和给定的mask对 `radix_tree_root` 结构体进行了初始化。

|

||||

|

||||

第二种方法是手动定义`radix_tree_root`结构体,并且将它和mask传给 `INIT_RADIX_TREE` 宏:

|

||||

|

||||

```C

|

||||

struct radix_tree_root my_radix_tree;

|

||||

INIT_RADIX_TREE(my_tree, gfp_mask_for_my_radix_tree);

|

||||

```

|

||||

|

||||

`INIT_RADIX_TREE` 宏的定义如下:

|

||||

|

||||

```C

|

||||

#define INIT_RADIX_TREE(root, mask) \

|

||||

do { \

|

||||

(root)->height = 0; \

|

||||

(root)->gfp_mask = (mask); \

|

||||

(root)->rnode = NULL; \

|

||||

} while (0)

|

||||

```

|

||||

|

||||

和`RADIX_TREE_INIT`宏所做的初始化工作一样,`INIT_RADIX_TREE` 宏使用默认值和给定的 mask 完成初始化工作。

|

||||

|

||||

接下来是用于向基数树插入和删除数据的两个函数:

|

||||

|

||||

* `radix_tree_insert`;

|

||||

* `radix_tree_delete`;

|

||||

|

||||

第一个函数 `radix_tree_insert` 需要3个参数:

|

||||

|

||||

* 基数树的根;

|

||||

* 索引键;

|

||||

* 插入的数据;

|

||||

|

||||

`radix_tree_delete` 函数需要和 `radix_tree_insert` 一样的一组参数,但是不需要传入要删除的数据。

|

||||

|

||||

基数树的搜索以两种方法实现:

|

||||

|

||||

* `radix_tree_lookup`;

|

||||

* `radix_tree_gang_lookup`;

|

||||

* `radix_tree_lookup_slot`.

|

||||

|

||||

第一个函数`radix_tree_lookup`需要两个参数:

|

||||

|

||||

* 基数树的根;

|

||||

* 索引键;

|

||||

|

||||

这个函数尝试在树中查找给定的键,并返回和该键相关联的记录。第二个函数 `radix_tree_gang_lookup` 有以下的函数签名:

|

||||

|

||||

```C

|

||||

unsigned int radix_tree_gang_lookup(struct radix_tree_root *root,

|

||||

void **results,

|

||||

unsigned long first_index,

|

||||

unsigned int max_items);

|

||||

```

|

||||

|

||||

它返回的是记录的个数。 `results` 中的结果,按键排序,并从第一个索引开始。返回的记录个数将不会超过 `max_items` 的值。

|

||||

|

||||

最后一个函数`radix_tree_lookup_slot`将会返回包含数据的指针槽。

|

||||

|

||||

链接

|

||||

---------------------------------------------------------------------------------

|

||||

|

||||

* [Radix tree](http://en.wikipedia.org/wiki/Radix_tree)

|

||||

* [Trie](http://en.wikipedia.org/wiki/Trie)

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://github.com/0xAX/linux-insides/blob/master/DataStructures/radix-tree.md

|

||||

|

||||

作者:0xAX

|

||||

译者:[cposture](https://github.com/cposture)

|

||||

校对:[Mr小眼儿](https://github.com/tinyeyeser)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,302 @@

|

||||

点评五款用于 Linux 编程的内存调试器

|

||||

================================================================================

|

||||

|

||||

>Credit: [Moini][1]

|

||||

|

||||

作为一个程序员,我知道我肯定会犯错误——怎么可能不犯错!程序员也是人啊。有的错误能在编码过程中及时发现,而有些却得等到软件测试了才能显露出来。然而,还有一类错误并不能在这两个阶段被解决,这就导致软件不能正常运行,甚至是提前终止。

|

||||

|

||||

如果你还没猜出是那种错误,我说的就是和内存相关的错误。手动调试这些错误不仅耗时,而且很难发现并纠正。值得一提的是,这种错误很常见,特别是在用 C/C++ 这类允许[手动管理内存][2]的语言编写的软件里。

|

||||

|

||||

幸运的是,现行有一些编程工具能够帮你在软件程序中找到这些和内存相关的错误。在这些工具集中,我评估了五款支持 Linux 的、流行的、自由开源的内存调试器: Dmalloc 、 Electric Fence 、 Memcheck 、 Memwatch 以及 Mtrace 。在日常编码中,我已经用过这五个调试器了,所以这些评估是建立在我的实际体验之上的。

|

||||

|

||||

### [Dmalloc][3] ###

|

||||

|

||||

**开发者**:Gray Watson

|

||||

|

||||

**评估版本**:5.5.2

|

||||

|

||||

**支持的 Linux 版本**:所有种类

|

||||

|

||||

**许可**: CC 3.0

|

||||

|

||||

Dmalloc 是 Gray Watson 开发的一款内存调试工具。它是作为库来实现的,封装了标准内存管理函数如`malloc() , calloc() , free()`等,使程序员得以检测出有问题的代码。

|

||||

|

||||

|

||||

|

||||

*Dmalloc*

|

||||

|

||||

如同工具的网页所示,这个调试器提供的特性包括内存泄漏跟踪、[重复释放内存(double free)][4]错误跟踪、以及[越界写入(fence-post write)][5]检测。其它特性包括报告错误的文件/行号、通用的数据统计记录。

|

||||

|

||||

#### 更新内容 ####

|

||||

|

||||

5.5.2 版本是一个 [bug 修正发行版][6],修复了几个有关构建和安装的问题。

|

||||

|

||||

#### 有何优点 ####

|

||||

|

||||

Dmalloc 最大的优点就是高度可配置性。比如说,你可以配置它以支持 C++ 程序和多线程应用。 Dmalloc 还提供一个有用的功能:运行时可配置,这表示在 Dmalloc 执行时,可以轻易地启用或者禁用它提供的一些特性。

|

||||

|

||||

你还可以配合 [GNU Project Debugger (GDB)][7]来使用 Dmalloc ,只需要将`dmalloc.gdb`文件(位于 Dmalloc 源码包中的 contrib 子目录里)的内容添加到你的主目录中的`.gdbinit`文件里即可。

|

||||

|

||||

另外一个让我对 Dmalloc 爱不释手的优点是它有大量的资料文献。前往官网的 [Documentation 栏目][8],可以获取所有关于如何下载、安装、运行、怎样使用库,和 Dmalloc 所提供特性的细节描述,及其生成的输出文件的解释。其中还有一个章节介绍了一般问题的解决方法。

|

||||

|

||||

#### 注意事项 ####

|

||||

|

||||

跟 Mtrace 一样, Dmalloc 需要程序员改动他们的源代码。比如说你可以(也是必须的)添加头文件`dmalloc.h`,工具就能汇报产生问题的调用的文件或行号。这个功能非常有用,因为它节省了调试的时间。

|

||||

|

||||

除此之外,还需要在编译你的程序时,把 Dmalloc 库(编译 Dmalloc 源码包时产生的)链接进去。

|

||||

|

||||

然而,还有点更麻烦的事,需要设置一个环境变量,命名为`DMALLOC_OPTION`,以供工具在运行时配置内存调试特性,比如定义输出文件的路径。可以手动为该环境变量分配一个值,不过初学者可能会觉得这个过程有点困难,因为该值的一部分用来表示要启用的 Dmalloc 特性——以十六进制值的累加值表示。[这里][9]有详细介绍。

|

||||

|

||||

一个比较简单方法设置这个环境变量是使用 [Dmalloc 实用指令][10],这是专为这个目的设计的方法。

|

||||

|

||||

#### 总结 ####

|

||||

|

||||

Dmalloc 真正的优势在于它的可配置选项。而且高度可移植,曾经成功移植到多种操作系统如 AIX 、 BSD/OS 、 DG/UX 、 Free/Net/OpenBSD 、 GNU/Hurd 、 HPUX 、 Irix 、 Linux 、 MS-DOG 、 NeXT 、 OSF 、 SCO 、 Solaris 、 SunOS 、 Ultrix 、 Unixware 甚至 Unicos(运行在 Cray T3E 主机上)。虽然使用 Dmalloc 需要学习许多知识,但是它所提供的特性值得为之付出。

|

||||

|

||||

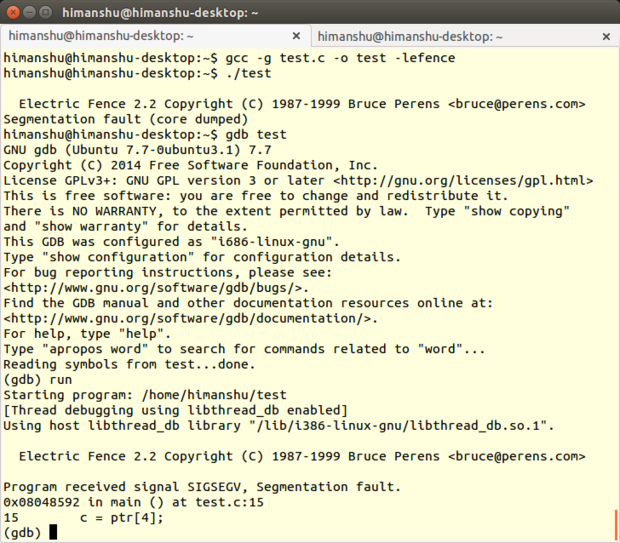

### [Electric Fence][15] ###

|

||||

|

||||

**开发者**:Bruce Perens

|

||||

|

||||

**评估版本**:2.2.3

|

||||

|

||||

**支持的 Linux 版本**:所有种类

|

||||

|

||||

**许可**:GPL v2

|

||||

|

||||

Electric Fence 是 Bruce Perens 开发的一款内存调试工具,它以库的形式实现,你的程序需要链接它。Electric Fence 能检测出[堆][11]内存溢出和访问已经释放的内存。

|

||||

|

||||

|

||||

|

||||

*Electric Fence*

|

||||

|

||||

顾名思义, Electric Fence 在每个所申请的缓存边界建立了虚拟围栏,这样一来任何非法的内存访问都会导致[段错误][12]。这个调试工具同时支持 C 和 C++ 程序。

|

||||

|

||||

#### 更新内容 ####

|

||||

|

||||

2.2.3 版本修复了工具的构建系统,使得 `-fno-builtin-malloc` 选项能真正传给 [GNU Compiler Collection (GCC)][13]。

|

||||

|

||||

#### 有何优点 ####

|

||||

|

||||

我喜欢 Electric Fence 的首要一点是它不同于 Memwatch 、 Dmalloc 和 Mtrace ,不需要对你的源码做任何的改动,你只需要在编译的时候把它的库链接进你的程序即可。

|

||||

|

||||

其次, Electric Fence 的实现保证了产生越界访问的第一个指令就会引起段错误。这比在后面再发现问题要好多了。

|

||||

|

||||

不管是否有检测出错误, Electric Fence 都会在输出产生版权信息。这一点非常有用,由此可以确定你所运行的程序已经启用了 Electric Fence 。

|

||||

|

||||

#### 注意事项 ####

|

||||

|

||||

另一方面,我对 Electric Fence 真正念念不忘的是它检测内存泄漏的能力。内存泄漏是 C/C++ 软件最常见也是最不容易发现的问题之一。不过, Electric Fence 不能检测出栈溢出,而且也不是线程安全的。

|

||||

|

||||

由于 Electric Fence 会在用户分配内存区的前后分配禁止访问的虚拟内存页,如果你过多的进行动态内存分配,将会导致你的程序消耗大量的额外内存。

|

||||

|

||||

Electric Fence 还有一个局限是不能明确指出错误代码所在的行号。它所能做只是在检测到内存相关错误时产生段错误。想要定位错误的行号,需要借助 [GDB][14]这样的调试工具来调试启用了 Electric Fence 的程序。

|

||||

|

||||

最后一点,尽管 Electric Fence 能检测出大部分的缓冲区溢出,有一个例外是,如果所申请的缓冲区大小不是系统字长的倍数,这时候溢出(即使只有几个字节)就不能被检测出来。

|

||||

|

||||

#### 总结 ####

|

||||

|

||||

尽管局限性较大, Electric Fence 的易用性仍然是加分项。只要链接一次程序, Electric Fence 就可以在监测出内存相关问题的时候报警。不过,如同前面所说, Electric Fence 需要配合像 GDB 这样的源码调试器使用。

|

||||

|

||||

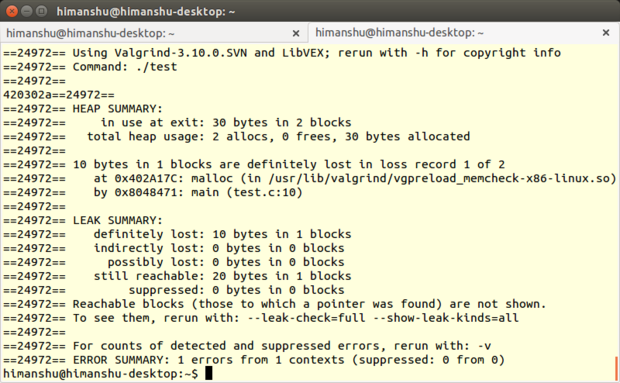

### [Memcheck][16] ###

|

||||

|

||||

**开发者**:[Valgrind 开发团队][17]

|

||||

|

||||

**评估版本**:3.10.1

|

||||

|

||||

**支持的 Linux 发行版**:所有种类

|

||||

|

||||

**许可**:GPL

|

||||

|

||||

[Valgrind][18] 是一个提供好几款调试和分析 Linux 程序性能的工具的套件。虽然 Valgrind 能和不同语言——Java 、 Perl 、 Python 、 Assembly code 、 ortran 、 Ada 等——编写的程序一起工作,但是它主要还是针对使用 C/C++ 所编写的程序。

|

||||

|

||||

Memcheck ,一款内存错误检测器,是其中最受欢迎的工具。它能够检测出如内存泄漏、无效的内存访问、未定义变量的使用以及堆内存分配和释放相关的问题等诸多问题。

|

||||

|

||||

#### 更新内容 ####

|

||||

|

||||

[工具套件( 3.10.1 )][19]主要修复了 3.10.0 版本发现的 bug 。除此之外,“从主干开发版本向后移植的一些补丁,修复了缺失的 AArch64 ARMv8 指令和系统调用”。

|

||||

|

||||

#### 有何优点 ####

|

||||

|

||||

同其它所有 Valgrind 工具一样, Memcheck 也是命令行程序。它的操作非常简单:通常我们会使用诸如 `prog arg1 arg2` 格式的命令来运行程序,而 Memcheck 只要求你多加几个值即可,如 `valgrind --leak-check=full prog arg1 arg2` 。

|

||||

|

||||

|

||||

|

||||

*Memcheck*

|

||||

|

||||

(注意:因为 Memcheck 是 Valgrind 的默认工具,所以在命令行执行命令时无需提及 Memcheck。但是,需要在编译程序之初带上 `-g` 参数选项,这一步会添加调试信息,使得 Memcheck 的错误信息会包含正确的行号。)

|

||||

|

||||

我真正倾心于 Memcheck 的是它提供了很多命令行选项(如上所述的`--leak-check`选项),如此不仅能控制工具运转还可以控制它的输出。

|

||||

|

||||

举个例子,可以开启`--track-origins`选项,以查看程序源码中未初始化的数据;可以开启`--show-mismatched-frees`选项让 Memcheck 匹配内存的分配和释放技术。对于 C 语言所写的代码, Memcheck 会确保只能使用`free()`函数来释放内存,`malloc()`函数来申请内存。而对 C++ 所写的源码, Memcheck 会检查是否使用了`delete`或`delete[]`操作符来释放内存,以及`new`或者`new[]`来申请内存。

|

||||

|

||||

Memcheck 最好的特点,尤其是对于初学者来说,是它会给用户建议使用哪个命令行选项能让输出更加有意义。比如说,如果你不使用基本的`--leak-check`选项, Memcheck 会在输出时给出建议:“使用 --leak-check=full 重新运行以查看更多泄漏内存细节”。如果程序有未初始化的变量, Memcheck 会产生信息:“使用 --track-origins=yes 以查看未初始化变量的定位”。

|

||||

|

||||

Memcheck 另外一个有用的特性是它可以[创建抑制文件( suppression files )][20],由此可以略过特定的不能修正的错误,这样 Memcheck 运行时就不会每次都报警了。值得一提的是, Memcheck 会去读取默认抑制文件来忽略系统库(比如 C 库)中的报错,这些错误在系统创建之前就已经存在了。可以选择创建一个新的抑制文件,或是编辑现有的文件(通常是`/usr/lib/valgrind/default.supp`)。

|

||||

|

||||

Memcheck 还有高级功能,比如可以使用[定制内存分配器][22]来[检测内存错误][21]。除此之外, Memcheck 提供[监控命令][23],当用到 Valgrind 内置的 gdbserver ,以及[客户端请求][24]机制(不仅能把程序的行为告知 Memcheck ,还可以进行查询)时可以使用。

|

||||

|

||||

#### 注意事项 ####

|

||||

|

||||

毫无疑问, Memcheck 可以节省很多调试时间以及省去很多麻烦。但是它使用了很多内存,导致程序执行变慢([由文档可知][25],大概会花费 20 至 30 倍时间)。

|

||||

|

||||

除此之外, Memcheck 还有其它局限。根据用户评论, Memcheck 很明显不是[线程安全][26]的;它不能检测出 [静态缓冲区溢出][27];还有就是,一些 Linux 程序如 [GNU Emacs][28] 目前还不能配合 Memcheck 工作。

|

||||

|

||||

如果有兴趣,可以在[这里][29]查看 Valgrind 局限性的详细说明。

|

||||

|

||||

#### 总结 ####

|

||||

|

||||

无论是对于初学者还是那些需要高级特性的人来说, Memcheck 都是一款便捷的内存调试工具。如果你仅需要基本调试和错误检查, Memcheck 会非常容易上手。而当你想要使用像抑制文件或者监控指令这样的特性,就需要花一些功夫学习了。

|

||||

|

||||

虽然罗列了大量的局限性,但是 Valgrind(包括 Memcheck )在它的网站上声称全球有[成千上万程序员][30]使用了此工具。开发团队称收到来自超过 30 个国家的用户反馈,而这些用户的工程代码有的高达两千五百万行。

|

||||

|

||||

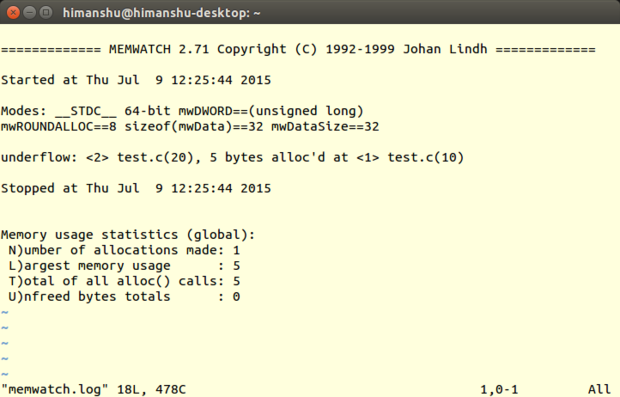

### [Memwatch][31] ###

|

||||

|

||||

**开发者**:Johan Lindh

|

||||

|

||||

**评估版本**:2.71

|

||||

|

||||

**支持的 Linux 发行版**:所有种类

|

||||

|

||||

**许可**:GNU GPL

|

||||

|

||||

Memwatch 是由 Johan Lindh 开发的内存调试工具,虽然它扮演的主要角色是内存泄漏检测器,但是(根据网页介绍)它也具有检测其它如[内存重复释放和错误释放][32]、缓冲区溢出和下溢、[野指针][33]写入等等内存相关问题的能力。

|

||||

|

||||

Memwatch 支持用 C 语言所编写的程序。也可以在 C++ 程序中使用它,但是这种做法并不提倡(由 Memwatch 源码包随附的 Q&A 文件中可知)。

|

||||

|

||||

#### 更新内容 ####

|

||||

|

||||

这个版本添加了`ULONG_LONG_MAX`以区分 32 位和 64 位程序。

|

||||

|

||||

#### 有何优点 ####

|

||||

|

||||

跟 Dmalloc 一样, Memwatch 也有优秀的文档资料。参考 USING 文件,可以学习如何使用 Memwatch ,可以了解 Memwatch 是如何初始化、如何清理以及如何进行 I/O 操作,等等。还有一个 FAQ 文件,旨在帮助用户解决使用过程遇到的一般问题。最后还有一个`test.c`文件提供工作案例参考。

|

||||

|

||||

|

||||

|

||||

*Memwatch*

|

||||

|

||||

不同于 Mtrace , Memwatch 产生的日志文件(通常是`memwatch.log`)是人类可阅读的格式。而且, Memwatch 每次运行时总会把内存调试结果拼接到输出该文件的末尾。如此便可在需要之时轻松查看之前的输出信息。

|

||||

|

||||

同样值得一提的是当你执行了启用 Memwatch 的程序, Memwatch 会在[标准输出][34]中产生一个单行输出,告知发现了错误,然后你可以在日志文件中查看输出细节。如果没有产生错误信息,就可以确保日志文件不会写入任何错误,多次运行的话确实能节省时间。

|

||||

|

||||

另一个我喜欢的优点是 Memwatch 还提供了在源码中获取其输出信息的方式,你可以获取信息,然后任由你进行处理(参考 Memwatch 源码中的`mwSetOutFunc()`函数获取更多有关的信息)。

|

||||

|

||||

#### 注意事项 ####

|

||||

|

||||

跟 Mtrace 和 Dmalloc 一样, Memwatch 也需要你往你的源文件里增加代码:你需要把`memwatch.h`这个头文件包含进你的代码。而且,编译程序的时候,你需要连同`memwatch.c`一块编译;或者你可以把已经编译好的目标模块包含起来,然后在命令行定义`MEMWATCH`和`MW_STDIO`变量。不用说,想要在输出中定位行号, -g 编译器选项也少不了。

|

||||

|

||||

此外, Memwatch 缺少一些特性。比如 Memwatch 不能检测出对一块已经被释放的内存进行写入操作,或是在分配的内存块之外的进行读取操作。而且, Memwatch 也不是线程安全的。还有一点,正如我在开始时指出,在 C++ 程序上运行 Memwatch 的结果是不能预料的。

|

||||

|

||||

#### 总结 ####

|

||||

|

||||

Memcheck 可以检测很多内存相关的问题,在处理 C 程序时是非常便捷的调试工具。因为源码小巧,所以可以从中了解 Memcheck 如何运转,有需要的话可以调试它,甚至可以根据自身需求扩展升级它的功能。

|

||||

|

||||

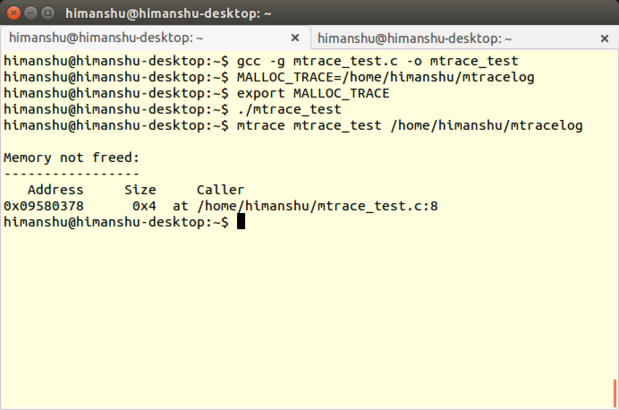

### [Mtrace][35] ###

|

||||

|

||||

**开发者**: Roland McGrath 和 Ulrich Drepper

|

||||

|

||||

**评估版本**: 2.21

|

||||

|

||||

**支持的 Linux 发行版**:所有种类

|

||||

|

||||

**许可**:GNU GPL

|

||||

|

||||

Mtrace 是 [GNU C 库][36]中的一款内存调试工具,同时支持 Linux 上的 C 和 C++ 程序,可以检测由函数`malloc()`和`free()`不匹配的调用所引起的内存泄漏问题。

|

||||

|

||||

|

||||

|

||||

*Mtrace*

|

||||

|

||||

Mtrace 实际上是实现了一个名为`mtrace()`的函数,它可以跟踪程序中所有 malloc/free 调用,并在用户指定的文件中记录相关信息。文件以一种机器可读的格式记录数据,所以有一个 Perl 脚本——同样命名为 mtrace ——用来把文件转换并为人类可读格式。

|

||||

|

||||

#### 更新内容 ####

|

||||

|

||||

[Mtrace 源码][37]和 [Perl 文件][38]同 GNU C 库( 2.21 版本)一起释出,除了更新版权日期,其它别无改动。

|

||||

|

||||

#### 有何优点 ####

|

||||

|

||||

Mtrace 最好的地方是它非常简单易学。你只需要了解在你的源码中如何以及何处添加 mtrace() 及对应的 muntrace() 函数,还有如何使用 Mtrace 的 Perl 脚本。后者非常简单,只需要运行指令`mtrace <program-executable> <log-file-generated-upon-program-execution>`(例子见开头截图最后一条指令)。

|

||||

|

||||

Mtrace 另外一个优点是它的可伸缩性,这体现在不仅可以使用它来调试完整的程序,还可以使用它来检测程序中独立模块的内存泄漏。只需在每个模块里调用`mtrace()`和`muntrace()`即可。

|

||||

|

||||

最后一点,因为 Mtrace 会在`mtrace()`——在源码中添加的函数——执行时被触发,因此可以很灵活地[使用信号][39]动态地(在程序执行时)使能 Mtrace 。

|

||||

|

||||

#### 注意事项 ####

|

||||

|

||||

因为`mtrace()`和`mauntrace()`函数 —— 声明在`mcheck.h`文件中,所以必须在源码中包含此头文件 —— 的调用是 Mtrace 工作的基础(`mauntrace()`函数并非[总是必要][40]),因此 Mtrace 要求程序员至少改动源码一次。

|

||||

|

||||

需要注意的是,在编译程序的时候带上 -g 选项( [GCC][41] 和 [G++][42] 编译器均有提供),才能使调试工具在输出结果时展示正确的行号。除此之外,有些程序(取决于源码体积有多大)可能会花很长时间进行编译。最后,带 -g 选项编译会增加了可执行文件的大小(因为提供了额外的调试信息),因此记得程序需要在测试结束后,不带 -g 选项重新进行编译。

|

||||

|

||||

使用 Mtrace ,你需要掌握 Linux 环境变量的基本知识,因为在程序执行之前,需要把用户把环境变量`MALLOC_TRACE`的值设为指定的文件(`mtrace()`函数将会记录全部信息到其中)路径。

|

||||

|

||||

Mtrace 在检测内存泄漏和试图释放未经过分配的内存方面存在局限。它不能检测其它内存相关问题如非法内存访问、使用未初始化内存。而且,[有人抱怨][43] Mtrace 不是[线程安全][44]的。

|

||||

|

||||

### 总结 ###

|

||||

|

||||

不言自明,我在此讨论的每款内存调试器都有其优点和局限。所以,哪一款适合你取决于你所需要的特性,虽然有时候容易安装和使用也是一个决定因素。

|

||||

|

||||

要想捕获软件程序中的内存泄漏, Mtrace 最适合不过了。它还可以节省时间。由于 Linux 系统已经预装了此工具,对于不能联网或者不可以下载第三方调试调试工具的情况, Mtrace 也是极有助益的。

|

||||

|

||||

另一方面,相比 Mtrace , Dmalloc 不仅能检测更多错误类型,还提供更多特性,比如运行时可配置、 GDB 集成。而且, Dmalloc 不像这里所说的其它工具,它是线程安全的。更不用说它的详细资料了,这让 Dmalloc 成为初学者的理想选择。

|

||||

|

||||

虽然 Memwatch 的资料比 Dmalloc 的更加丰富,而且还能检测更多的错误种类,但是你只能在 C 语言写就的程序中使用它。一个让 Memwatch 脱颖而出的特性是它允许在你的程序源码中处理它的输出,这对于想要定制输出格式来说是非常有用的。

|

||||

|

||||

如果改动程序源码非你所愿,那么使用 Electric Fence 吧。不过,请记住, Electric Fence 只能检测两种错误类型,而此二者均非内存泄漏。还有就是,需要基本了解 GDB 以最大化发挥这款内存调试工具的作用。

|

||||

|

||||

Memcheck 可能是其中综合性最好的了。相比这里提及的其它工具,它能检测更多的错误类型,提供更多的特性,而且不需要你的源码做任何改动。但请注意,基本功能并不难上手,但是想要使用它的高级特性,就必须学习相关的专业知识了。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.computerworld.com/article/3003957/linux/review-5-memory-debuggers-for-linux-coding.html

|

||||

|

||||

作者:[Himanshu Arora][a]

|

||||

译者:[soooogreen](https://github.com/soooogreen)

|

||||

校对:[PurlingNayuki](https://github.com/PurlingNayuki),[ezio](https://github.com/oska874)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.computerworld.com/author/Himanshu-Arora/

|

||||

[1]:https://openclipart.org/detail/132427/penguin-admin

|

||||

[2]:https://en.wikipedia.org/wiki/Manual_memory_management

|

||||

[3]:http://dmalloc.com/

|

||||

[4]:https://www.owasp.org/index.php/Double_Free

|

||||

[5]:https://stuff.mit.edu/afs/sipb/project/gnucash-test/src/dmalloc-4.8.2/dmalloc.html#Fence-Post%20Overruns

|

||||

[6]:http://dmalloc.com/releases/notes/dmalloc-5.5.2.html

|

||||

[7]:http://www.gnu.org/software/gdb/

|

||||

[8]:http://dmalloc.com/docs/

|

||||

[9]:http://dmalloc.com/docs/latest/online/dmalloc_26.html#SEC32

|

||||

[10]:http://dmalloc.com/docs/latest/online/dmalloc_23.html#SEC29

|

||||

[11]:https://en.wikipedia.org/wiki/Memory_management#Dynamic_memory_allocation

|

||||

[12]:https://en.wikipedia.org/wiki/Segmentation_fault

|

||||

[13]:https://en.wikipedia.org/wiki/GNU_Compiler_Collection

|

||||

[14]:http://www.gnu.org/software/gdb/

|

||||

[15]:https://launchpad.net/ubuntu/+source/electric-fence/2.2.3

|

||||

[16]:http://valgrind.org/docs/manual/mc-manual.html

|

||||

[17]:http://valgrind.org/info/developers.html

|

||||

[18]:http://valgrind.org/

|

||||

[19]:http://valgrind.org/docs/manual/dist.news.html

|

||||

[20]:http://valgrind.org/docs/manual/mc-manual.html#mc-manual.suppfiles

|

||||

[21]:http://valgrind.org/docs/manual/mc-manual.html#mc-manual.mempools

|

||||

[22]:http://stackoverflow.com/questions/4642671/c-memory-allocators

|

||||

[23]:http://valgrind.org/docs/manual/mc-manual.html#mc-manual.monitor-commands

|

||||

[24]:http://valgrind.org/docs/manual/mc-manual.html#mc-manual.clientreqs

|

||||

[25]:http://valgrind.org/docs/manual/valgrind_manual.pdf

|

||||

[26]:http://sourceforge.net/p/valgrind/mailman/message/30292453/

|

||||

[27]:https://msdn.microsoft.com/en-us/library/ee798431%28v=cs.20%29.aspx

|

||||

[28]:http://www.computerworld.com/article/2484425/linux/5-free-linux-text-editors-for-programming-and-word-processing.html?nsdr=true&page=2

|

||||

[29]:http://valgrind.org/docs/manual/manual-core.html#manual-core.limits

|

||||

[30]:http://valgrind.org/info/

|

||||

[31]:http://www.linkdata.se/sourcecode/memwatch/

|

||||

[32]:http://www.cecalc.ula.ve/documentacion/tutoriales/WorkshopDebugger/007-2579-007/sgi_html/ch09.html

|

||||

[33]:http://c2.com/cgi/wiki?WildPointer

|

||||

[34]:https://en.wikipedia.org/wiki/Standard_streams#Standard_output_.28stdout.29

|

||||

[35]:http://www.gnu.org/software/libc/manual/html_node/Tracing-malloc.html

|

||||

[36]:https://www.gnu.org/software/libc/

|

||||

[37]:https://sourceware.org/git/?p=glibc.git;a=history;f=malloc/mtrace.c;h=df10128b872b4adc4086cf74e5d965c1c11d35d2;hb=HEAD

|

||||

[38]:https://sourceware.org/git/?p=glibc.git;a=history;f=malloc/mtrace.pl;h=0737890510e9837f26ebee2ba36c9058affb0bf1;hb=HEAD

|

||||

[39]:http://webcache.googleusercontent.com/search?q=cache:s6ywlLtkSqQJ:www.gnu.org/s/libc/manual/html_node/Tips-for-the-Memory-Debugger.html+&cd=1&hl=en&ct=clnk&gl=in&client=Ubuntu

|

||||

[40]:http://www.gnu.org/software/libc/manual/html_node/Using-the-Memory-Debugger.html#Using-the-Memory-Debugger

|

||||

[41]:http://linux.die.net/man/1/gcc

|

||||

[42]:http://linux.die.net/man/1/g++

|

||||

[43]:https://sourceware.org/ml/libc-help/2014-05/msg00008.html

|

||||

[44]:https://en.wikipedia.org/wiki/Thread_safety

|

||||

@ -1,6 +1,6 @@

|

||||

15条给系统管理员的实用 Linux/Unix 磁带管理命令

|

||||

给系统管理员的15条实用 Linux/Unix 磁带管理命令

|

||||

================================================================================

|

||||

磁带设备应只用于定期的文件归档或将数据从一台服务器传送至另一台。通常磁带设备与 Unix 机器连接,用 mt 或 mtx 控制。你可以将所有的数据备份到磁盘(也许是云中)和磁带设备。在这个教程中你将会了解到:

|

||||

磁带设备应只用于定期的文件归档或将数据从一台服务器传送至另一台。通常磁带设备与 Unix 机器连接,用 mt 或 mtx 控制。强烈建议您将所有的数据同时备份到磁盘(也许是云中)和磁带设备中。在本教程中你将会了解到:

|

||||

|

||||

- 磁带设备名

|

||||

- 管理磁带驱动器的基本命令

|

||||

@ -8,12 +8,13 @@

|

||||

|

||||

### 为什么备份? ###

|

||||

|

||||

一个备份设备是很重要的:

|

||||

一个备份计划对定期备份文件来说很有必要,如果你宁愿选择不备份,那么丢失重要数据的风险会大大增加。有了备份,你就有了从磁盘故障中恢复的能力。备份还可以帮助你抵御:

|

||||

|

||||

- 从磁盘故障中恢复的能力

|

||||

- 意外的文件删除

|

||||

- 文件或文件系统损坏

|

||||

- 服务器完全毁坏,包括由于火灾或其他问题导致的同盘备份毁坏

|

||||

- 硬盘或 SSD 崩溃

|

||||

- 病毒或勒索软件破坏或删除文件

|

||||

|

||||

你可以使用磁带归档备份整个服务器并将其离线存储。

|

||||

|

||||

@ -21,15 +22,15 @@

|

||||

|

||||

|

||||

|

||||

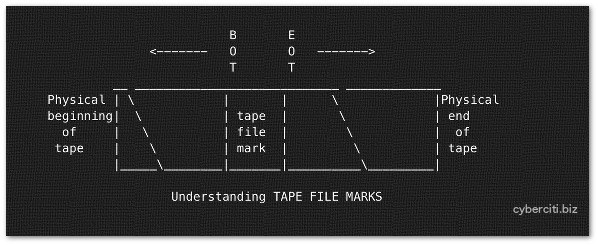

图01:磁带文件标记

|

||||

*图01:磁带文件标记*

|

||||

|

||||

每个磁带设备能存储多个备份文件。磁带备份文件通过 cpio,tar,dd 等命令创建。但是,磁带设备可以由各种程序打开,写入数据,并关闭。你可以存储若干备份(磁带文件)到一个物理磁带上。在每个磁带文件之间有个“磁带文件标记”。这个是用来指示一个物理磁带上磁带文件的结尾以及另一个文件的开始。你需要使用 mt 命令来定位磁带(快进,倒带和标记)。

|

||||

每个磁带设备能存储多个备份文件。磁带备份文件通过 cpio,tar,dd 等命令创建。同时,磁带设备可以由多种程序打开、写入数据、及关闭。你可以存储若干备份(磁带文件)到一个物理磁带上。在每个磁带文件之间有个“磁带文件标记”。这用来指示一个物理磁带上磁带文件的结尾以及另一个文件的开始。你需要使用 mt 命令来定位磁带(快进,倒带和标记)。

|

||||

|

||||

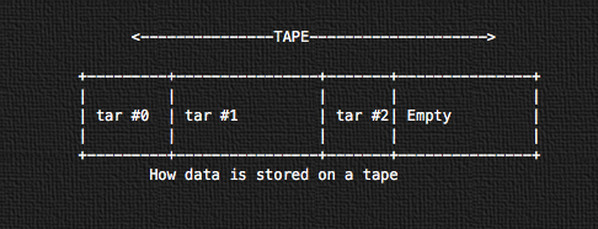

#### 磁带上的数据是如何存储的 ####

|

||||

|

||||

|

||||

|

||||

图02:磁带上的数据是如何存储的

|

||||

*图02:磁带上的数据是如何存储的*

|

||||

|

||||

所有的数据使用 tar 以连续磁带存储格式连续地存储。第一个磁带归档会从磁带的物理开始端开始存储(tar #0)。接下来的就是 tar #1,以此类推。

|

||||

|

||||

@ -59,22 +60,22 @@

|

||||

|

||||

输入下列命令:

|

||||

|

||||

## Linux(更多信息参阅 man) ##

|

||||

### Linux(更多信息参阅 man) ###

|

||||

lsscsi

|

||||

lsscsi -g

|

||||

|

||||

## IBM AIX ##

|

||||

### IBM AIX ###

|

||||

lsdev -Cc tape

|

||||

lsdev -Cc adsm

|

||||

lscfg -vl rmt*

|

||||

|

||||

## Solaris Unix ##

|

||||

### Solaris Unix ###

|

||||

cfgadm –a

|

||||

cfgadm -al

|

||||

luxadm probe

|

||||

iostat -En

|

||||

|

||||

## HP-UX Unix ##

|

||||

### HP-UX Unix ###

|

||||

ioscan Cf

|

||||

ioscan -funC tape

|

||||

ioscan -fnC tape

|

||||

@ -85,11 +86,11 @@

|

||||

|

||||

|

||||

|

||||

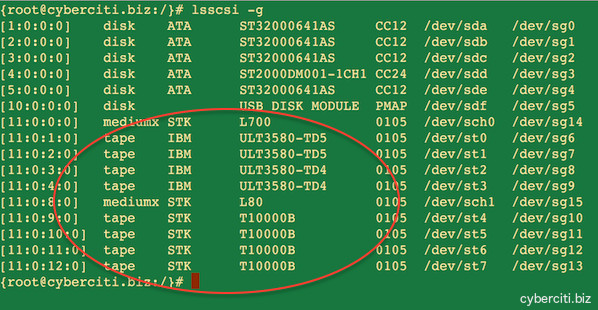

图03:Linux 服务器上已安装的磁带设备

|

||||

*图03:Linux 服务器上已安装的磁带设备*

|

||||

|

||||

### mt 命令实例 ###

|

||||

### mt 命令示例 ###

|

||||

|

||||

在 Linux 和类Unix系统上,mt 命令用来控制磁带驱动器的操作,比如查看状态或查找磁带上的文件或写入磁带控制标记。下列大多数命令需要作为 root 用户执行。语法如下:

|

||||

在 Linux 和类 Unix 系统上,mt 命令用来控制磁带驱动器的操作,比如查看状态或查找磁带上的文件或写入磁带控制标记。下列大多数命令需要作为 root 用户执行。语法如下:

|

||||

|

||||

mt -f /tape/device/name operation

|

||||

|

||||

@ -97,7 +98,7 @@

|

||||

|

||||

你可以设置 TAPE shell 变量。这是磁带驱动器的路径名。在 FreeBSD 上默认的(如果变量没有设置,而不是 null)是 /dev/nsa0。可以通过 mt 命令的 -f 参数传递变量覆盖它,就像下面解释的那样。

|

||||

|

||||

## 添加到你的 shell 配置文件 ##

|

||||

### 添加到你的 shell 配置文件 ###

|

||||

TAPE=/dev/st1 #Linux

|

||||

TAPE=/dev/rmt/2 #Unix

|

||||

TAPE=/dev/nsa3 #FreeBSD

|

||||

@ -105,13 +106,13 @@

|

||||

|

||||

### 1:显示磁带/驱动器状态 ###

|

||||

|

||||

mt status #Use default

|

||||

mt -f /dev/rmt/0 status #Unix

|

||||

mt -f /dev/st0 status #Linux

|

||||

mt -f /dev/nsa0 status #FreeBSD

|

||||

mt -f /dev/rmt/1 status #Unix unity 1 也就是 tape device no. 1

|

||||

mt status ### Use default

|

||||

mt -f /dev/rmt/0 status ### Unix

|

||||

mt -f /dev/st0 status ### Linux

|

||||

mt -f /dev/nsa0 status ### FreeBSD

|

||||

mt -f /dev/rmt/1 status ### Unix unity 1 也就是 tape device no. 1

|

||||

|

||||

你可以像下面一样使用 shell 循环调查系统并定位所有的磁带驱动器:

|

||||

你可以像下面一样使用 shell 循环语句遍历一个系统并定位其所有的磁带驱动器:

|

||||

|

||||

for d in 0 1 2 3 4 5

|

||||

do

|

||||

@ -133,7 +134,7 @@

|

||||

mt -f /dev/mt/0 off

|

||||

mt -f /dev/st0 eject

|

||||

|

||||

### 4:擦除磁带(倒带,在可以的情况下卸载磁带) ###

|

||||

### 4:擦除磁带(倒带,在支持的情况下卸载磁带) ###

|

||||

|

||||

mt erase

|

||||

mt -f /dev/st0 erase #Linux

|

||||

@ -179,7 +180,7 @@

|

||||

|

||||

bsfm 后退指定的文件标记数目。磁带定位在下一个文件的第一块。

|

||||

|

||||

asf The tape is positioned at the beginning of the count file. Positioning is done by first rewinding the tape and then spacing forward over count filemarks.磁带定位在

|

||||

asf 磁带定位在指定文件标记数目的开始位置。定位通过先倒带,再前进指定的文件标记数目来实现。

|

||||

|

||||

fsr 前进指定的记录数。

|

||||

|

||||

@ -207,7 +208,7 @@

|

||||

|

||||

mt -f /dev/st0 rewind; dd if=/dev/st0 of=-

|

||||

|

||||

## tar 格式 ##

|

||||

### tar 格式 ###

|

||||

tar tvf {DEVICE} {Directory-FileName}

|

||||

tar tvf /dev/st0

|

||||

tar tvf /dev/st0 desktop

|

||||

@ -215,40 +216,40 @@

|

||||

|

||||

### 12:使用 dump 或 ufsdump 备份分区 ###

|

||||

|

||||

## Unix 备份 c0t0d0s2 分区 ##

|

||||

### Unix 备份 c0t0d0s2 分区 ###

|

||||

ufsdump 0uf /dev/rmt/0 /dev/rdsk/c0t0d0s2

|

||||

|

||||

## Linux 备份 /home 分区 ##

|

||||

### Linux 备份 /home 分区 ###

|

||||

dump 0uf /dev/nst0 /dev/sda5

|

||||

dump 0uf /dev/nst0 /home

|

||||

|

||||

## FreeBSD 备份 /usr 分区 ##

|

||||

### FreeBSD 备份 /usr 分区 ###

|

||||

dump -0aL -b64 -f /dev/nsa0 /usr

|

||||

|

||||

### 12:使用 ufsrestore 或 restore 恢复分区 ###

|

||||

|

||||

## Unix ##

|

||||

### Unix ###

|

||||

ufsrestore xf /dev/rmt/0

|

||||

## Unix 交互式恢复 ##

|

||||

### Unix 交互式恢复 ###

|

||||

ufsrestore if /dev/rmt/0

|

||||

|

||||

## Linux ##

|

||||

### Linux ###

|

||||

restore rf /dev/nst0

|

||||

## 从磁带媒介上的第6个备份交互式恢复 ##

|

||||

### 从磁带媒介上的第6个备份交互式恢复 ###

|

||||

restore isf 6 /dev/nst0

|

||||

|

||||

## FreeBSD 恢复 ufsdump 格式 ##

|

||||

### FreeBSD 恢复 ufsdump 格式 ###

|

||||

restore -i -f /dev/nsa0

|

||||

|

||||

### 13:从磁带开头开始写入(见图02) ###

|

||||

|

||||

## 这会覆盖磁带上的所有数据 ##

|

||||

### 这会覆盖磁带上的所有数据 ###

|

||||

mt -f /dev/st1 rewind

|

||||

|

||||

### 备份 home ##

|

||||

### 备份 home ###

|

||||

tar cvf /dev/st1 /home

|

||||

|

||||

## 离线并卸载磁带 ##

|

||||

### 离线并卸载磁带 ###

|

||||

mt -f /dev/st0 offline

|

||||

|

||||

从磁带开头开始恢复:

|

||||

@ -259,22 +260,22 @@

|

||||

|

||||

### 14:从最后一个 tar 后开始写入(见图02) ###

|

||||

|

||||

## 这会保留之前写入的数据 ##

|

||||

### 这会保留之前写入的数据 ###

|

||||

mt -f /dev/st1 eom

|

||||

|

||||

### 备份 home ##

|

||||

### 备份 home ###

|

||||

tar cvf /dev/st1 /home

|

||||

|

||||

## 卸载 ##

|

||||

### 卸载 ###

|

||||

mt -f /dev/st0 offline

|

||||

|

||||

### 15:从 tar number 2 后开始写入(见图02) ###

|

||||

|

||||

## 在 tar number 2 之后写入(应该是 2+1)

|

||||

### 在 tar number 2 之后写入(应该是 2+1)###

|

||||

mt -f /dev/st0 asf 3

|

||||

tar cvf /dev/st0 /usr

|

||||

|

||||

## asf 等效于 fsf ##

|

||||

### asf 等效于 fsf ###

|

||||

mt -f /dev/sf0 rewind

|

||||

mt -f /dev/st0 fsf 2

|

||||

|

||||

@ -413,7 +414,7 @@ via: http://www.cyberciti.biz/hardware/unix-linux-basic-tape-management-commands

|

||||

|

||||

作者:Vivek Gite

|

||||

译者:[alim0x](https://github.com/alim0x)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[Mr小眼儿](https://github.com/tinyeyeser)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,44 @@

|

||||

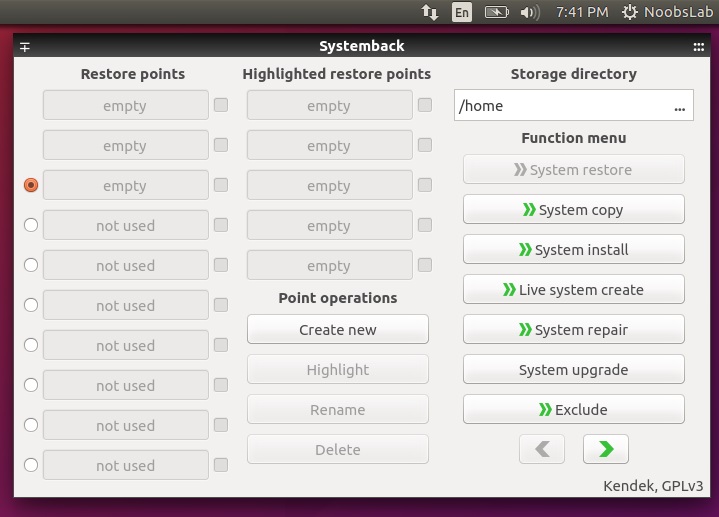

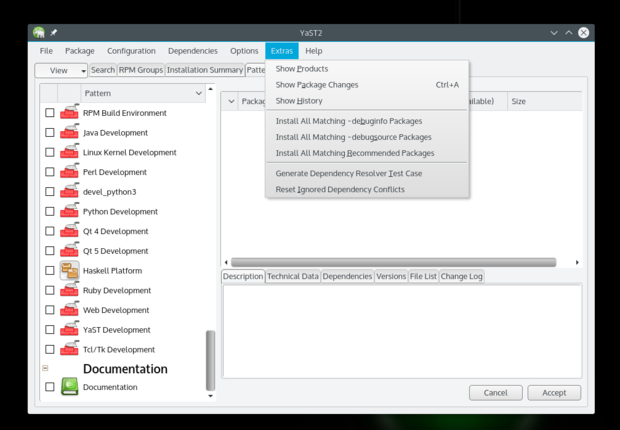

使用 SystemBack 备份/还原你的 Ubuntu/Linux Mint

|

||||

=================================================

|

||||

|

||||

对于任何一款允许用户还原电脑到之前状态(包括文件系统,安装的应用,以及系统设置)的操作系统来说,系统还原功能都是必备功能,它可以恢复系统故障以及其他的问题。

|

||||

|

||||

有的时候安装一个程序或者驱动可能让你的系统黑屏。系统还原则可以让你电脑里面的系统文件(LCTT 译注:是系统文件,并非普通文件,详情请看**注意**部分)和程序恢复到之前工作正常时候的状态,进而让你远离那让人头痛的排障过程了,而且它也不会影响你的文件,照片或者其他数据。

|

||||

|

||||

简单的系统备份还原工具 [Systemback](https://launchpad.net/systemback) 可以让你很容易地创建系统备份以及用户配置文件。一旦遇到问题,你可以简单地恢复到系统先前的状态。它还有一些额外的特征包括系统复制,系统安装以及Live系统创建。

|

||||

|

||||

**截图**

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

**注意**:使用系统还原不会还原你自己的文件、音乐、电子邮件或者其他任何类型的私人文件。对不同用户来讲,这既是优点又是缺点。坏消息是它不会还原你意外删除的文件,不过你可以通过一个文件恢复程序来解决这个问题。如果你的计算机没有创建还原点,那么系统恢复就无法奏效,所以这个工具就无法帮助你(还原系统),如果你尝试恢复一个主要问题,你将需要移步到另外的步骤来进行故障排除。

|

||||

|

||||

> 适用于 Ubuntu 15.10 Wily/16.04/15.04 Vivid/14.04 Trusty/Linux Mint 14.x/其他Ubuntu衍生版,打开终端,将下面这些命令复制过去:

|

||||

|

||||

终端命令:

|

||||

|

||||

```

|

||||

sudo add-apt-repository ppa:nemh/systemback

|

||||

sudo apt-get update

|

||||

sudo apt-get install systemback

|

||||

|

||||

```

|

||||

|

||||

大功告成。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.noobslab.com/2015/11/backup-system-restore-point-your.html

|

||||

|

||||

译者:[DongShuaike](https://github.com/DongShuaike)

|

||||

校对:[Caroline](https://github.com/carolinewuyan)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[1]:https://launchpad.net/systemback

|

||||

@ -0,0 +1,111 @@

|

||||

安装 openSUSE Leap 42.1 之后要做的 8 件事

|

||||

================================================================================

|

||||

|

||||

|

||||

*致谢:[Metropolitan Transportation/Flicrk][1]*

|

||||

|

||||

> 如果你已经在你的电脑上安装了 openSUSE,这就是你接下来要做的。

|

||||

|

||||

[openSUSE Leap 确实是个巨大的飞跃][2],它允许用户运行一个和 SUSE Linux 企业版拥有同样基因的发行版。和其它系统一样,为了实现最佳的使用效果,在使用它之前需要做些优化设置。

|

||||

|

||||

下面是一些我在我的电脑上安装 openSUSE Leap 之后做的一些事情(不适用于服务器)。这里面没有强制性的设置,基本安装对你来说也可能足够了。但如果你想获得更好的 openSUSE Leap 体验,那就跟着我往下看吧。

|

||||

|

||||

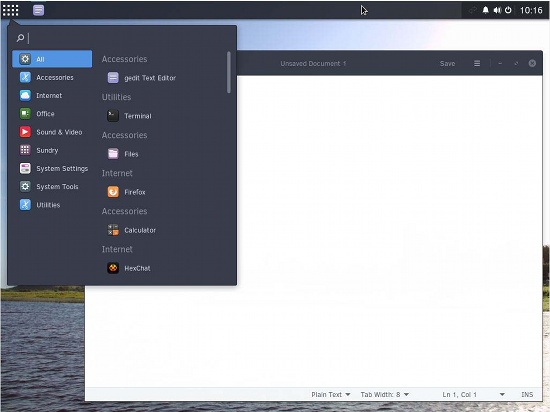

### 1. 添加 Packman 仓库 ###

|

||||

|

||||

由于专利和授权等原因,openSUSE 和许多 Linux 发行版一样,不通过官方仓库(repos)提供一些软件、解码器,以及驱动等。取而代之的是通过第三方或社区仓库来提供。第一个也是最重要的仓库是“Packman”。因为这些仓库不是默认启用的,我们需要添加它们。你可以通过 YaST(openSUSE 的特色之一)或者命令行完成(如下方介绍)。

|

||||

|

||||

|

||||

|

||||

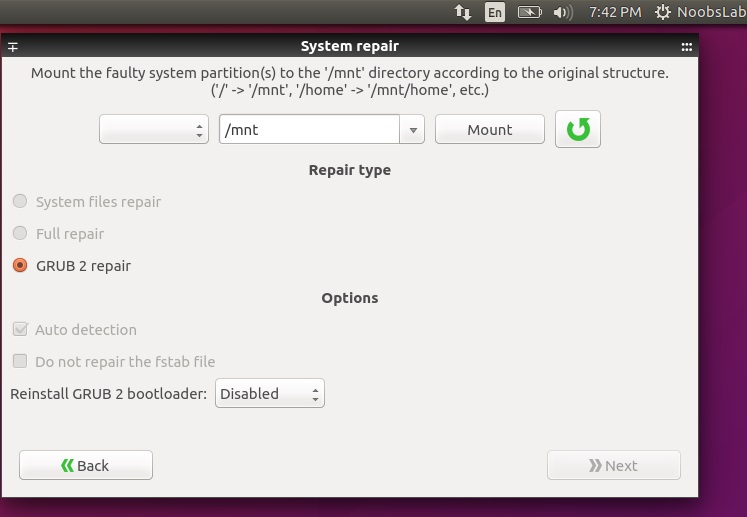

*添加 Packman 仓库。*

|

||||

|

||||

使用 YaST,打开软件源部分。点击“添加”按钮并选择“社区仓库(Community Repositories)”。点击“下一步”。一旦仓库列表加载出来了,选择 Packman 仓库。点击“确认”,然后点击“信任”导入信任的 GnuPG 密钥。

|

||||

|

||||

或者在终端里使用以下命令添加并启用 Packman 仓库:

|

||||

|

||||

zypper ar -f -n packmanhttp://ftp.gwdg.de/pub/linux/misc/packman/suse/openSUSE_Leap_42.1/ packman

|

||||

|

||||

仓库添加之后,你就可以使用更多的包了。想安装任意软件或包,打开 YaST 软件管理器,搜索并安装即可。

|

||||

|

||||

### 2. 安装 VLC ###

|

||||

|

||||

VLC 是媒体播放器里的瑞士军刀,几乎可以播放任何媒体文件。你可以从 YaST 软件管理器 或 software.opensuse.org 安装 VLC。你需要安装两个包:vlc 和 vlc-codecs。

|

||||

|

||||

如果你用终端,运行以下命令:

|

||||

|

||||

sudo zypper install vlc vlc-codecs

|

||||

|

||||

### 3. 安装 Handbrake ###

|

||||

|

||||

如果你需要转码或转换视频文件格式,[Handbrake 是你的不二之选][3]。Handbrake 就在我们启用的仓库中,所以只需要在 YaST 中搜索并安装它即可。

|

||||

|

||||

如果你用终端,运行以下命令:

|

||||

|

||||

sudo zypper install handbrake-cli handbrake-gtk

|

||||

|

||||

(提示:VLC 也能转码音频和视频文件。)

|

||||

|

||||

### 4. 安装 Chrome ###

|

||||

|

||||

openSUSE 的默认浏览器是 Firefox。但是因为 Firefox 不能够播放专有媒体,比如 Netflix,我推荐安装 Chrome。这需要额外的工作。首先你需要从谷歌导入信任密钥。打开终端执行“wget”命令下载密钥:

|

||||

|

||||

wget https://dl.google.com/linux/linux_signing_key.pub

|

||||

|

||||

然后导入密钥:

|

||||

|

||||

sudo rpm --import linux_signing_key.pub

|

||||

|

||||

现在到 [Google Chrome 网站][4] 去,下载 64 位 .rpm 文件。下载完成后执行以下命令安装浏览器:

|

||||

|

||||

sudo zypper install /PATH_OF_GOOGLE_CHROME.rpm

|

||||

|

||||