mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-15 01:50:08 +08:00

commit

150114e44a

@ -1,8 +1,8 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (qhwdw)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: ( )

|

||||

[#]: url: ( )

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-10458-1.html)

|

||||

[#]: subject: (Computer Laboratory – Raspberry Pi: Lesson 1 OK01)

|

||||

[#]: via: (https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/ok01.html)

|

||||

[#]: author: (Robert Mullins http://www.cl.cam.ac.uk/~rdm34)

|

||||

@ -196,15 +196,15 @@ b loop$

|

||||

|

||||

将这个 SD 卡插入到树莓派,并打开它的电源。这个 OK 的 LED 灯将亮起来。如果不是这样,请查看故障排除页面。如果一切如愿,恭喜你,你已经写出了你的第一个操作系统。[课程 2 OK02][12] 将指导你让 LED 灯闪烁和关闭闪烁。

|

||||

|

||||

[^1]: OK, I'm lying it tells the linker, which is another program used to link several assembled files together. It doesn't really matter.

|

||||

[^2]: Clearly they're important to you. Since the GNU toolchain is mainly used for creating programs, it expects there to be an entry point labelled `_start`. As we're making an operating system, the `_start` is always whatever comes first, which we set up with the `.section .init` command. However, if we don't say where the entry point is, the toolchain gets upset. Thus, the first line says that we are going to define a symbol called `_start` for all to see (globally), and the second line says to make the symbol `_start` the address of the next line. We will come onto addresses shortly.

|

||||

[^3]: This tutorial is designed to spare you the pain of reading it, but, if you must, it can be found here [SoC-Peripherals.pdf](https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/downloads/SoC-Peripherals.pdf). For added confusion, the manual uses a different addressing system. An address listed as 0x7E200000 would be 0x20200000 in our OS.

|

||||

[^4]: Only values which have a binary representation which only has 1s in the first 8 bits of the representation. In other words, 8 1s or 0s followed by only 0s.

|

||||

[^5]: A hardware engineer was kind enough to explain this to me as follows:

|

||||

[^1]: 是的,我说错了,它告诉的是链接器,它是另一个程序,用于将汇编器转换过的几个代码文件链接到一起。直接说是汇编器也没有大问题。

|

||||

[^2]: 其实它们对你很重要。由于 GNU 工具链主要用于开发操作系统,它要求入口点必须是名为 `_start` 的地方。由于我们是开发一个操作系统,无论什么时候,它总是从 `_start` 开时的,而我们可以使用 `.section .init` 命令去设置它。因此,如果我们没有告诉它入口点在哪里,就会使工具链困惑而产生警告消息。所以,我们先定义一个名为 `_start` 的符号,它是所有人可见的(全局的),紧接着在下一行生成符号 `_start` 的地址。我们很快就讲到这个地址了。

|

||||

[^3]: 本教程的设计减少了你阅读树莓派开发手册的难度,但是,如果你必须要阅读它,你可以在这里 [SoC-Peripherals.pdf](https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/downloads/SoC-Peripherals.pdf) 找到它。由于添加了混淆,手册中 GPIO 使用了不同的地址系统。我们的操作系统中的地址 0x20200000 对应到手册中是 0x7E200000。

|

||||

[^4]: `mov` 能够加载的值只有前 8 位是 `1` 的二进制表示的值。换句话说就是一个 0 后面紧跟着 8 个 `1` 或 `0`。

|

||||

[^5]: 一个很友好的硬件工程师是这样向我解释这个问题的:

|

||||

|

||||

原因是现在的芯片都是用一种称为 CMOS 的技术来制成的,它是互补金属氧化物半导体的简称。互补的意思是每个信号都连接到两个晶体管上,一个是使用 N 型半导体的材料制成,它用于将电压拉低,而另一个使用 P 型半导体材料制成,它用于将电压升高。在任何时刻,仅有一个半导体是打开的,否则将会短路。P 型材料的导电性能不如 N 型材料。这意味着三倍大的 P 型半导体材料才能提供与 N 型半导体材料相同的电流。这就是为什么 LED 总是通过降低为低电压来打开它,因为 N 型半导体拉低电压比 P 型半导体拉高电压的性能更强。

|

||||

|

||||

The reason is that modern chips are made of a technology called CMOS, which stands for Complementary Metal Oxide Semiconductor. The Complementary part means each signal is connected to two transistors, one made of material called N-type semiconductor which is used to pull it to a low voltage and another made of P-type material to pull it to a high voltage. Only one transistor of the pair turns on at any time, otherwise we'd get a short circuit. P-type isn't as conductive as N-type, which means the P-type transistor has to be about 3 times as big to provide the same current. This is why LEDs are often wired to turn on by pulling them low, because the N-type is stronger at pulling low than the P-type is in pulling high.

|

||||

|

||||

There's another reason. Back in the 1970s chips were made out of entirely out of N-type material ('NMOS'), with the P-type replaced by a resistor. That means that when a signal is pulled low the chip is consuming power (and getting hot) even while it isn't doing anything. Your phone getting hot and flattening the battery when it's in your pocket doing nothing wouldn't be good. So signals were designed to be 'active low' so that they're high when inactive and so don't take any power. Even though we don't use NMOS any more, it's still often quicker to pull a signal low with the N-type than to pull it high with the P-type. Often a signal that's 'active low' is marked with a bar over the top of the name, or written as SIGNAL_n or /SIGNAL. But it can still be confusing, even for hardware engineers!

|

||||

还有一个原因。早在上世纪七十年代,芯片完全是由 N 型材料制成的(NMOS),P 型材料部分使用了一个电阻来代替。这意味着当信号为低电压时,即便它什么事都没有做,芯片仍然在消耗能量(并发热)。你的电话装在口袋里什么事都不做,它仍然会发热并消耗你的电池电量,这不是好的设计。因此,信号设计成 “活动时低”,而不活动时为高电压,这样就不会消耗能源了。虽然我们现在已经不使用 NMOS 了,但由于 N 型材料的低电压信号比 P 型材料的高电压信号要快,所以仍然使用了这种设计。通常在一个 “活动时低” 信号名字上方会有一个条型标记,或者写作 `SIGNAL_n` 或 `/SIGNAL`。但是即便这样,仍然很让人困惑,那怕是硬件工程师,也不可避免这种困惑!

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -1,8 +1,10 @@

|

||||

开始使用 Turtl 这个 Evernote 的开源替代品

|

||||

Turtl:Evernote 的开源替代品

|

||||

======

|

||||

> 如果你正在寻找一个 Evernote 和 Google Keep 的替代品,那么 Turtl 是一个可靠的记笔记工具。

|

||||

|

||||

|

||||

|

||||

我认识的每个人都会记笔记,许多人使用在线笔记应用,如 Evernote、Simplenote 或 Google Keep。这些都是很好的工具,但你不得不担忧信息的安全性和隐私性 - 特别是考虑到 [Evernote 2016 年的隐私策略变更][1]。如果你想要更好地控制笔记和数据,你需要转向开源工具。

|

||||

我认识的每个人都会记笔记,许多人使用在线笔记应用,如 Evernote、Simplenote 或 Google Keep。这些都是很好的工具,但你不得不担忧信息的安全性和隐私性 —— 特别是考虑到 [Evernote 2016 年的隐私策略变更][1]。如果你想要更好地控制笔记和数据,你需要转向开源工具。

|

||||

|

||||

无论你离开 Evernote 的原因是什么,都有开源替代品。让我们来看看其中一个选择:Turtl。

|

||||

|

||||

@ -10,30 +12,25 @@

|

||||

|

||||

[Turtl][2] 背后的开发人员希望你将其视为“具有绝对隐私的 Evernote”。说实话,我不能保证 Turtl 提供的隐私级别,但它是一个非常好的笔记工具。

|

||||

|

||||

要开始使用 Turtl,[下载][3]适用于 Linux、Mac OS 或 Windows 的桌面客户端,或者获取 [Android 应用][4]。安装它,然后启动客户端或应用。系统会要求你输入用户名和密码。Turtl 使用密码来生成加密密钥,根据开发人员的说法,加密密钥会在将笔记存储在设备或服务器上之前对其进行加密。

|

||||

要开始使用 Turtl,[下载][3]适用于 Linux、Mac OS 或 Windows 的桌面客户端,或者获取它的 [Android 应用][4]。安装它,然后启动客户端或应用。系统会要求你输入用户名和密码。Turtl 使用密码来生成加密密钥,根据开发人员的说法,加密密钥会在将笔记存储在设备或服务器上之前对其进行加密。

|

||||

|

||||

### 使用 Turtl

|

||||

|

||||

你可以使用 Turtl 创建以下类型的笔记:

|

||||

|

||||

* 密码

|

||||

|

||||

* 档案

|

||||

|

||||

* 图片

|

||||

|

||||

* 书签

|

||||

|

||||

* 文字笔记

|

||||

|

||||

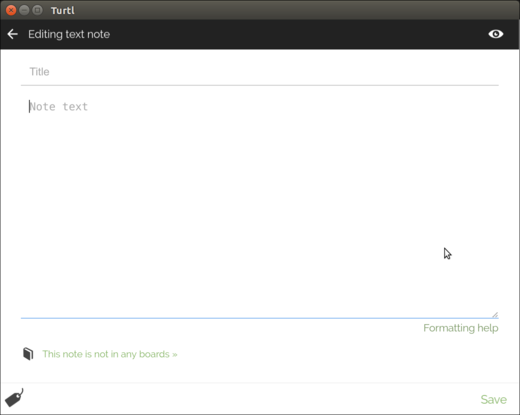

无论你选择何种类型的笔记,你都可以在类似的窗口中创建:

|

||||

|

||||

|

||||

|

||||

|

||||

在 Turtl 中创建新笔记

|

||||

*在 Turtl 中创建新笔记*

|

||||

|

||||

添加笔记标题,文字并(如果你正在创建文件或图像笔记)附加文件或图像等信息。然后单击“保存”。

|

||||

添加笔记标题、文字并(如果你正在创建文件或图像笔记)附加文件或图像等信息。然后单击“保存”。

|

||||

|

||||

你可以通过 [Markdown][6] 为你的笔记添加格式。因为没有工具栏快捷方式,所以你需要手动添加格式。

|

||||

|

||||

@ -41,9 +38,9 @@

|

||||

|

||||

|

||||

|

||||

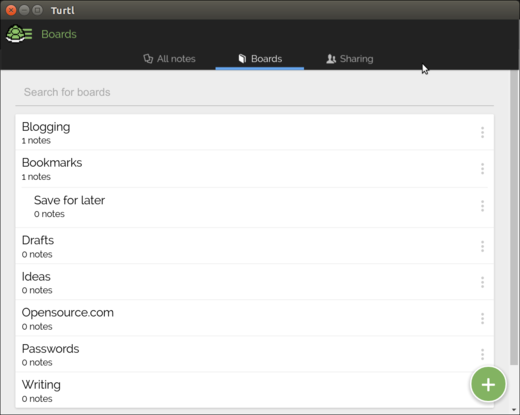

在 Turtl 中创建新的白板

|

||||

*在 Turtl 中创建新的白板*

|

||||

|

||||

要向白板添加笔记,请创建或编辑笔记,然后单击笔记底部的“此笔记不在任何白板”的链接。选择一个或多个白板,然后单击“完成”。

|

||||

要向白板中添加笔记,请创建或编辑笔记,然后单击笔记底部的“此笔记不在任何白板”的链接。选择一个或多个白板,然后单击“完成”。

|

||||

|

||||

要为笔记添加标记,请单击记事本底部的“标记”图标,输入一个或多个以逗号分隔的关键字,然后单击“完成”。

|

||||

|

||||

@ -57,14 +54,13 @@

|

||||

|

||||

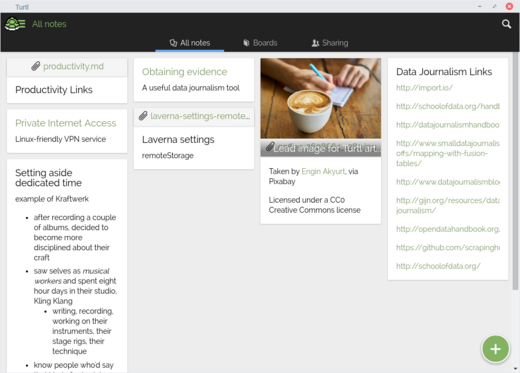

Turtl 以平铺视图显示笔记,让人想起 Google Keep:

|

||||

|

||||

|

||||

|

||||

|

||||

Turtl 中的一系列笔记

|

||||

*Turtl 中的一系列笔记*

|

||||

|

||||

无法在桌面或 Android 应用上将其更改为列表视图。这对我来说不是问题,但我听说有些人因为它没有列表视图而不喜欢 Turtl。

|

||||

|

||||

说到 Android 应用,它并不坏。但是,它没有与 Android 共享菜单集成。如果你想把在其他应用中看到或阅读的内容添加到 Turtl 笔记中,则需要手动复制并粘贴。

|

||||

说到 Android 应用,它并不差。但是,它没有与 Android 共享菜单集成。如果你想把在其他应用中看到或阅读的内容添加到 Turtl 笔记中,则需要手动复制并粘贴。

|

||||

|

||||

我已经在我的 Linux 笔记本,[运行 GalliumOS 的 Chromebook][10],还有一台 Android 手机上使用 Turtl 几个月了。对所有这些设备来说这都是一种非常无缝的体验。虽然它不是我最喜欢的开源笔记工具,但 Turtl 做得非常好。试试看它,它可能是你正在寻找的简单的笔记工具。

|

||||

|

||||

@ -74,7 +70,7 @@ via: https://opensource.com/article/17/12/using-turtl-open-source-alternative-ev

|

||||

|

||||

作者:[Scott Nesbitt][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,157 @@

|

||||

设计微服务架构前应该了解的 5 项指导原则

|

||||

======

|

||||

> 顶级 CTO 基于五个简单的原则为精心设计的微服务提供建议。

|

||||

|

||||

|

||||

|

||||

对于从微服务开始的团队来说,最大的挑战之一就是坚持<ruby>金发女孩原则<rt>The Goldilocks principle</rt></ruby>(该典故来自于童话《金发姑娘和三只熊》):不要太大,不要太小,不能太紧密耦合。之所以是挑战的部分原因是会对究竟什么是设计良好的微服务感到疑惑。

|

||||

|

||||

数十位 CTO 通过采访分享了他们的经验,这些对话说明了设计良好的微服务的五个特点。本文将帮助指导团队设计微服务。(有关详细信息,请查看即将出版的书籍 [Microservices for Startups][1],LCTT 译注:已可免费下载完整的电子版)。本文将简要介绍微服务的边界和主观的 “规则”,以避免在深入了解五个特征之前就开始指导您的微服务设计。

|

||||

|

||||

### 微服务边界

|

||||

|

||||

[使用微服务开发新系统的核心优势][2]之一是该体系结构允许开发人员独立构建和修改各个组件,但在最大限度地减少每个 API 之间的回调数量方面可能会出现问题。根据 [SparkPost][3] 工程副总裁 Chris McFadden 所说,解决方案是应用适当的服务边界。

|

||||

|

||||

关于边界,与有时难以理解和抽象的领域驱动设计(DDD,一种微服务框架)形成鲜明对比,本文重点介绍了和我们行业的一些顶级 CTO 一同建立的明确定义的微服务边界的实用原则。

|

||||

|

||||

### 避免主观的 “规则”

|

||||

|

||||

如果您阅读了足够多的关于设计和创建微服务的建议,您一定会遇到下面的一些 “规则”。 尽管将它们用作创建微服务的指南很有吸引力,但加入这些主观规则并不是思考确定微服务的边界的原则性方式。

|

||||

|

||||

#### “微服务应该有 X 行代码”

|

||||

|

||||

让我们直说:微服务中有多少行代码没有限制。微服务不会因为您写了几行额外的代码而突然变成一个独石应用。关键是要确保服务中的代码具有很高的内聚性(稍后将对此进行更多介绍)。

|

||||

|

||||

#### “将每个功能转换为微服务”

|

||||

|

||||

如果函数基于三个输入值计算某些内容并返回结果,它是否是微服务的理想候选项?它是否应该是单独可部署应用程序?这确实取决于该函数是什么以及它是如何服务于整个系统。将每个函数转换为微服务在您的情景中可能根本没有意义。

|

||||

|

||||

其他主观规则包括不考虑整个情景的规则,例如团队的经验、DevOps 能力、服务正在执行的操作以及数据的可用性需求。

|

||||

|

||||

### 精心设计的服务的 5 个特点

|

||||

|

||||

如果您读过关于微服务的文章,您无疑会遇到有关设计良好的服务的建议。简单地说,高内聚和低耦合。如果您不熟悉这些概念,有[许多][4][文章][4]关于这些概念的文章。虽然它们提供了合理的建议,但这些概念是相当抽象的。基于与经验丰富的 CTO 们的对话,下面是在创建设计良好的微服务时需要牢记的关键特征。

|

||||

|

||||

#### #1:不与其他服务共享数据库表

|

||||

|

||||

在 SparkPost 的早期,Chris McFadden 和他的团队必须解决每个 SaaS 业务需要面对的问题:它们需要提供基本服务,如身份验证、帐户管理和计费。

|

||||

|

||||

为了解决这个问题,他们创建了两个微服务:用户 API 和帐户 API。用户 API 将处理用户帐户、API 密钥和身份验证,而帐户 API 将处理所有与计费相关的逻辑。这是一个非常合乎逻辑的分离 —— 但没过多久,他们发现了一个问题。

|

||||

|

||||

McFadden 解释说,“我们有一个名为‘用户 API’的服务,还有一个名为‘帐户 API’的服务。问题是,他们之间实际上有几个来回的调用。因此,您会在帐户服务中执行一些操作,然后调用并终止于用户服务,反之亦然”

|

||||

|

||||

这两个服务的耦合太紧密了。

|

||||

|

||||

在设计微服务时,如果您有多个服务引用同一个表,则它是一个危险的信号,因为这可能意味着您的数据库是耦合的源头。

|

||||

|

||||

这确实是关于服务与数据的关系,这正是 [Swiftype SRE,Elastic][6] 的负责人 Oleksiy Kovrin 告诉我。他说,“我们在开发新服务时使用的主要基本原则之一是,它们不应跨越数据库边界。每个服务都应依赖于自己的一组底层数据存储。这使我们能够集中访问控制、审计日志记录、缓存逻辑等。”

|

||||

|

||||

Kovrin 接着解释说,如果数据库表的某个子集“与数据集的其余部分没有或很少连接,则这是一个强烈的信号,表明该组件可以被隔离到单独的 API 或单独的服务中”。

|

||||

|

||||

[Lead Honestly][7] 的联合创始人 Darby Frey 与此的观点相呼应:“每个服务都应该有自己的表并且永远不应该共享数据库表。”

|

||||

|

||||

#### #2:数据库表数量最小化

|

||||

|

||||

微服务的理想尺寸应该足够小,但不能太小。每个服务的数据库表的数量也是如此。

|

||||

|

||||

[Scaylr][8] 的工程主管 Steven Czerwinski 在接受采访时解释说 Scaylr 的最佳选择是“一个或两个服务的数据库表。”

|

||||

|

||||

SparkPost 的 Chris McFadden 表示同意:“我们有一个 suppression 微服务,它处理、跟踪数以百万计和数十亿围绕 suppression 的条目,但它们都非常专注于围绕 suppression,所以实际上只有一个或两个表。其他服务也是如此,比如 webhooks。

|

||||

|

||||

#### #3:考虑有状态和无状态

|

||||

|

||||

在设计微服务时,您需要问问自己它是否需要访问数据库,或者它是否是处理 TB 级数据 (如电子邮件或日志) 的无状态服务。

|

||||

|

||||

[Algolia][9] 的 CTO Julien Lemoine 解释说:“我们通过定义服务的输入和输出来定义服务的边界。有时服务是网络 API,但它也可能是使用文件并在数据库中生成记录的进程 (这就是我们的日志处理服务)。”

|

||||

|

||||

事先要明确是否有状态,这将引导一个更好的服务设计。

|

||||

|

||||

#### #4:考虑数据可用性需求

|

||||

|

||||

在设计微服务时,请记住哪些服务将依赖于此新服务,以及在该数据不可用时的整个系统的影响。考虑到这一点,您可以正确地设计此服务的数据备份和恢复系统。

|

||||

|

||||

Steven Czerwinski 提到,在 Scaylr 由于关键客户行空间映射数据的重要性,它将以不同的方式复制和分离。

|

||||

|

||||

相比之下,他补充说,“每个分片信息,都在自己的小分区里。如果部分客户群体因为没有可用日志而停止服务那很糟糕,但它只影响 5% 的客户,而不是100% 的客户。”

|

||||

|

||||

#### #5:单一的真实来源

|

||||

|

||||

设计服务,使其成为系统中某些内容的唯一真实来源。

|

||||

|

||||

例如,当您从电子商务网站订购内容时,则会生成订单 ID,其他服务可以使用此订单 ID 来查询订单服务,以获取有关订单的完整信息。使用 [发布/订阅模式][10],在服务之间传递的数据应该是订单 ID ,而不是订单本身的属性信息。只有订单服务具有订单的完整信息,并且是给定订单信息的唯一真实来源。

|

||||

|

||||

### 大型团队的注意事项

|

||||

|

||||

考虑到上面列出的五个注意事项,较大的团队应了解其组织结构对微服务边界的影响。

|

||||

|

||||

对于较大的组织,整个团队可以专门拥有服务,在确定服务边界时,组织性就会发挥作用。还有两个需要考虑的因素:**独立的发布计划**和**不同的正常运行时间**的重要性。

|

||||

|

||||

[Cloud66.][11] 的 CEO Khash Sajadi 说:“我们所看到的微服务最成功的实现要么基于类似领域驱动设计这样的软件设计原则 (如面向服务的体系结构),要么基于反映组织方法的设计原则。”

|

||||

|

||||

“所以 (对于) 支付团队” Sajadi 说,“他们有支付服务或信用卡验证服务,这就是他们向外界提供的服务。所以这不一定是关于软件的。这主要是关于为外界提供更多服务的业务单位。”

|

||||

|

||||

### 双披萨原理

|

||||

|

||||

Amazon 是一个拥有多个团队的大型组织的完美示例。正如在一篇发表于 [API Evangelist][12] 的文章中所提到的,Jeff Bezos 向所有员工发布一项要求,告知他们公司内的每个团队都必须通过 API 进行沟通。任何不这样做的人都会被解雇。

|

||||

|

||||

这样,所有数据和功能都通过该接口公开。Bezos 还设法让每个团队解耦,定义他们的资源,并通过 API 提供。Amazon 正在从头建立一个系统。这使得公司内的每一支团队都能成为彼此的合作伙伴。

|

||||

|

||||

我与 [Iron.io][13] 的 CTO Travis Reeder 谈到了 Bezos 的内部倡议。

|

||||

|

||||

“Jeff Bezos 规定所有团队都必须构建 API 才能与其他团队进行沟通,” Reeder 说。“他也是提出‘双披萨’规则的人:一支团队不应该比两个比萨饼能养活的大。”

|

||||

|

||||

“我认为这里也可以适用同样的方法:无论一个小型团队是否能够开发、管理和富有成效。如果它开始变得笨重或开始变慢,它可能变得太大了。” Reeder 告诉我。

|

||||

|

||||

### 最后注意事项: 您的服务是否具有合适的大小和正确的定义?

|

||||

|

||||

在微服务系统的测试和实施阶段,有一些指标需要记住。

|

||||

|

||||

#### 指标 #1: 服务之间是否存在过度依赖?

|

||||

|

||||

如果两个服务不断地相互回调,那么这就是强烈的耦合信号,也是它们可能更好地合并为一个服务的信号。

|

||||

|

||||

回到 Chris McFadden 的例子, 他有两个 API 服务,帐户服务和用户服务不断地相互通信, McFadden 提出了一个合并服务的想法,并决定将其称为 “账户用户 API”。事实证明,这是一项富有成效的战略。

|

||||

|

||||

“我们开始做的是消除这些内部 API 之间调用的链接,” McFadden 告诉我。“这有助于简化代码。”

|

||||

|

||||

#### 指标 #2: 设置服务的开销是否超过了服务独立的好处?

|

||||

|

||||

Darby Frey 解释说,“每个应用都需要将其日志聚合到某个位置,并需要进行监视。你需要设置它的警报。你需要有标准的操作程序,和在出现问题时的操作手册。您必须管理 SSH 对它的访问。只是为了让一个应用运行起来,就有大量的基础性工作必须存在。”

|

||||

|

||||

### 关键要点

|

||||

|

||||

设计微服务往往会让人感觉更像是一门艺术,而不是一门科学。对工程师来说,这可能并不顺利。有很多一般性的建议,但有时可能有点太抽象了。让我们回顾一下在设计下一组微服务时要注意的五个具体特征:

|

||||

|

||||

1. 不与其他服务共享数据库表

|

||||

2. 数据库表数量最小化

|

||||

3. 考虑有状态和无状态

|

||||

4. 考虑数据可用性需求

|

||||

5. 单一的真实来源

|

||||

|

||||

下次设计一组微服务并确定服务边界时,回顾这些原则应该会使任务变得更容易。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/4/guide-design-microservices

|

||||

|

||||

作者:[Jake Lumetta][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[lixinyuxx](https://github.com/lixinyuxx)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:https://opensource.com/users/jakelumetta

|

||||

[1]:https://buttercms.com/books/microservices-for-startups/

|

||||

[2]:https://buttercms.com/books/microservices-for-startups/should-you-always-start-with-a-monolith

|

||||

[3]:https://www.sparkpost.com/

|

||||

[4]:https://thebojan.ninja/2015/04/08/high-cohesion-loose-coupling/

|

||||

[5]:https://en.wikipedia.org/wiki/Single_responsibility_principle

|

||||

[6]:https://www.elastic.co/solutions/site-search

|

||||

[7]:https://leadhonestly.com/

|

||||

[8]:https://www.scalyr.com/

|

||||

[9]:https://www.algolia.com/

|

||||

[10]:https://en.wikipedia.org/wiki/Publish%E2%80%93subscribe_pattern

|

||||

[11]:https://www.cloud66.com/

|

||||

[12]:https://apievangelist.com/2012/01/12/the-secret-to-amazons-success-internal-apis/

|

||||

[13]:https://www.iron.io/

|

||||

@ -1,17 +1,18 @@

|

||||

[#]: collector: "lujun9972"

|

||||

[#]: translator: "jlztan"

|

||||

[#]: reviewer: " "

|

||||

[#]: publisher: " "

|

||||

[#]: url: " "

|

||||

[#]: subject: "What is PPA? Everything You Need to Know About PPA in Linux"

|

||||

[#]: via: "https://itsfoss.com/ppa-guide/"

|

||||

[#]: author: "Abhishek Prakash https://itsfoss.com/author/abhishek/"

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (jlztan)

|

||||

[#]: reviewer: (wxy)

|

||||

[#]: publisher: (wxy)

|

||||

[#]: url: (https://linux.cn/article-10456-1.html)

|

||||

[#]: subject: (What is PPA? Everything You Need to Know About PPA in Linux)

|

||||

[#]: via: (https://itsfoss.com/ppa-guide/)

|

||||

[#]: author: (Abhishek Prakash https://itsfoss.com/author/abhishek/)

|

||||

|

||||

# 什么是 PPA?你需要知道的关于 Linux 中 PPA 的一切

|

||||

Ubuntu PPA 使用指南

|

||||

======

|

||||

|

||||

**简介:一篇涵盖了在 Ubuntu 和其他 Linux 发行版中使用 PPA 的几乎所有问题的深入的文章。**

|

||||

> 一篇涵盖了在 Ubuntu 和其他 Linux 发行版中使用 PPA 的几乎所有问题的深入的文章。

|

||||

|

||||

如果你一直在使用 Ubuntu 或基于 Ubuntu 的其他 Linux 发行版,例如 Linux Mint、Linux Lite、Zorin OS 等,你可能会遇到以下三行神奇的命令:

|

||||

如果你一直在使用 Ubuntu 或基于 Ubuntu 的其他 Linux 发行版,例如 Linux Mint、Linux Lite、Zorin OS 等,你可能会遇到以下三种神奇的命令:

|

||||

|

||||

```

|

||||

sudo add-apt-repository ppa:dr-akulavich/lighttable

|

||||

@ -21,17 +22,17 @@ sudo apt-get install lighttable-installer

|

||||

|

||||

许多网站推荐使用类似于以上几行的形式 [在 Ubuntu 中安装应用程序][1]。这就是所谓的使用 PPA 安装应用程序。

|

||||

|

||||

但什么是 PPA?为什么用它?使用 PPA 安全吗?如何正确使用 PPA?如何删除 PPA?

|

||||

但什么是 PPA?为什么要用它?使用 PPA 安全吗?如何正确使用 PPA?如何删除 PPA?

|

||||

|

||||

我将在这个详细的指南中回答上述所有问题。即使你已经了解了一些关于 PPA 的事情,我相信这篇文章仍然会让你了解这方面的更多知识。

|

||||

|

||||

请注意我正在使用 Ubuntu 撰写本文。因此,我几乎可以在任何地方使用 Ubuntu 这个术语,但文中的说明和步骤也适用于其他基于 Debian/Ubuntu 的发行版。

|

||||

请注意我正在使用 Ubuntu 撰写本文。因此,我几乎在各个地方都使用了 Ubuntu 这个术语,但文中的说明和步骤也适用于其他基于 Debian/Ubuntu 的发行版。

|

||||

|

||||

### 什么是 PPA?为什么要使用 PPA?

|

||||

|

||||

![Everything you need to know about PPA in Ubuntu Linux][2]

|

||||

|

||||

PPA 表示 个人软件包存档Personal Package Archive<ruby>个人软件包存档<rt>Personal Package Archive</rt></ruby>。

|

||||

PPA 表示<ruby>个人软件包存档<rt>Personal Package Archive</rt></ruby>。

|

||||

|

||||

这样说容易理解吗?可能不是很容易。

|

||||

|

||||

@ -41,12 +42,12 @@ PPA 表示 个人软件包存档Personal Package Archive<ruby>个人软件包存

|

||||

|

||||

软件仓库是一组文件,其中包含各种软件及其版本的信息,以及校验和等其他一些详细信息。每个版本的 Ubuntu 都有自己的四个官方软件仓库:

|

||||

|

||||

- Main - Canonical 支持的免费和开源软件。

|

||||

- Universe - 社区维护的免费和开源软件。

|

||||

- Main - Canonical 支持的自由开源软件。

|

||||

- Universe - 社区维护的自由开源软件。

|

||||

- Restricted - 设备的专有驱动程序。

|

||||

- Multiverse - 受版权或法律问题限制的软件。

|

||||

|

||||

你可以在 [这里][3] 看到所有版本的 Ubuntu 的软件仓库。你可以浏览并转到各个仓库。例如,可以在 [这里][4] 找到 Ubuntu 16.04 的主存储库。

|

||||

你可以在 [这里][3] 看到所有版本的 Ubuntu 的软件仓库。你可以浏览并转到各个仓库。例如,可以在 [这里][4] 找到 Ubuntu 16.04 的主存储库(Main)。

|

||||

|

||||

所以,PPA 基本上是一个包含软件信息的网址。那你的系统又是如何知道这些仓库的位置的呢?

|

||||

|

||||

@ -80,19 +81,21 @@ Ubuntu 不会立即提供该新版本的软件。需要一个步骤来检查此

|

||||

|

||||

### 如何使用 PPA?PPA 是怎样工作的?

|

||||

|

||||

正如我已经告诉过你的那样,[PPA][7] 代表个人软件包存档Personal Package Archive<ruby>个人软件包存档<rt>Personal Package Archive</rt></ruby>。在这里注意 “个人” 这个词,它暗示了这是开发人员独有的东西,并没有得到分发的正式许可。

|

||||

正如我已经告诉过你的那样,[PPA][7] 代表<ruby>个人软件包存档<rt>Personal Package Archive</rt></ruby>。在这里注意 “个人” 这个词,它暗示了这是开发人员独有的东西,并没有得到分发的正式许可。

|

||||

|

||||

Ubuntu 提供了一个名为 Launchpad 的平台,使软件开发人员能够创建自己的软件仓库。 终端用户,也就是你,可以将 PPA 仓库添加到 `sources.list` 文件中,当你更新系统时,你的系统会知道这个新软件的可用性,然后你可以使用标准的 `sudo apt install` 命令安装它。

|

||||

Ubuntu 提供了一个名为 Launchpad 的平台,使软件开发人员能够创建自己的软件仓库。终端用户,也就是你,可以将 PPA 仓库添加到 `sources.list` 文件中,当你更新系统时,你的系统会知道这个新软件的可用性,然后你可以使用标准的 `sudo apt install` 命令安装它。

|

||||

|

||||

`sudo add-apt-repository ppa:dr-akulavich/lighttable`

|

||||

`sudo apt-get update`

|

||||

`sudo apt-get install lighttable-installer`

|

||||

```

|

||||

sudo add-apt-repository ppa:dr-akulavich/lighttable

|

||||

sudo apt-get update

|

||||

sudo apt-get install lighttable-installer

|

||||

```

|

||||

|

||||

概括一下上面三个命令:

|

||||

|

||||

- `sudo add-apt-repository <PPA_info>` < - 此命令将 PPA 仓库添加到列表中。

|

||||

- `sudo apt-get update` < - 此命令更新可以在当前系统上安装的软件包列表。

|

||||

- `sudo apt-get install <package_in_PPA>` < - 此命令安装软件包。

|

||||

- `sudo add-apt-repository <PPA_info>` <- 此命令将 PPA 仓库添加到列表中。

|

||||

- `sudo apt-get update` <- 此命令更新可以在当前系统上安装的软件包列表。

|

||||

- `sudo apt-get install <package_in_PPA>` <- 此命令安装软件包。

|

||||

|

||||

你会发现使用 `sudo apt update` 命令非常重要,否则你的系统将无法知道新软件包何时可用。

|

||||

|

||||

@ -115,17 +118,17 @@ deb-src http://ppa.launchpad.net/dr-akulavich/lighttable/ubuntu YOUR_UBUNTU_VERS

|

||||

|

||||

以上两行是将任何软件仓库添加到你系统的 `sources.list` 文件的传统方法。但 PPA 会自动为你完成这些工作,无需考虑确切的软件仓库 URL 和操作系统版本。

|

||||

|

||||

此处不那么重要的一点是,当你使用 PPA 时,它不会更改原始的 `sources.list` 文件。相反,它在 `/etc/apt/sources.d` 目录中创建了两个文件,一个 “list” 文件和一个带有 “save” 后缀的备份文件。

|

||||

此处不那么重要的一点是,当你使用 PPA 时,它不会更改原始的 `sources.list` 文件。相反,它在 `/etc/apt/sources.d` 目录中创建了两个文件,一个 `.list` 文件和一个带有 `.save` 后缀的备份文件。

|

||||

|

||||

![Using a PPA in Ubuntu][8]

|

||||

|

||||

PPA 创建了单独的 `sources.list` 文件

|

||||

*PPA 创建了单独的 `sources.list` 文件*

|

||||

|

||||

带有后缀 “list” 的文件含有添加软件仓库的信息的命令。

|

||||

带有后缀 `.list` 的文件含有添加软件仓库的信息的命令。

|

||||

|

||||

![PPA add repository information][9]

|

||||

|

||||

一个 PPA 的 `source.list` 文件的内容

|

||||

*一个 PPA 的 `source.list` 文件的内容*

|

||||

|

||||

这是一种安全措施,可以确保添加的 PPA 不会和原始的 `sources.list` 文件弄混,它还有助于移除 PPA。

|

||||

|

||||

@ -135,11 +138,11 @@ PPA 创建了单独的 `sources.list` 文件

|

||||

|

||||

答案在于更新的过程。如果使用 DEB 包安装软件,将无法保证在运行 `sudo apt update` 和 `sudo apt upgrade` 命令时,已安装的软件会被更新为较新的版本。

|

||||

|

||||

这是因为 apt 的升级过程依赖于 `sources.list` 文件。如果文件中没有相应的软件条目,则不会通过标准软件更新程序获得更新。

|

||||

这是因为 `apt` 的升级过程依赖于 `sources.list` 文件。如果文件中没有相应的软件条目,则不会通过标准软件更新程序获得更新。

|

||||

|

||||

那么这是否意味着使用 DEB 安装的软件永远不会得到更新?不是的。这取决于 DEB 包的创建方式。

|

||||

|

||||

一些开发人员会自动在 `sources.list ` 中添加一个条目,这样软件就可以像普通软件一样更新。谷歌 Chrome 浏览器就是这样一个例子。

|

||||

一些开发人员会自动在 `sources.list` 中添加一个条目,这样软件就可以像普通软件一样更新。谷歌 Chrome 浏览器就是这样一个例子。

|

||||

|

||||

某些软件会在运行时通知你有新版本可用。你必须下载新的 DEB 包并再次运行,来将当前软件更新为较新版本。Oracle Virtual Box 就是这样一个例子。

|

||||

|

||||

@ -163,11 +166,11 @@ PPA 创建了单独的 `sources.list` 文件

|

||||

|

||||

并非每个 PPA 都适用于你的特定版本。你应该知道正在使用 [哪个版本的 Ubuntu][11]。版本的开发代号很重要,因为当你访问某个 PPA 的页面时,你可以看到该 PPA 都支持哪些版本的 Ubuntu。

|

||||

|

||||

对于其他基于 Ubuntu 的发行版,你可以查看 `/etc/os-release` 的内容来 [找出 Ubuntu 版本][11] 的信息。

|

||||

对于其他基于 Ubuntu 的发行版,你可以查看 `/etc/os-release` 的内容来 [找出 Ubuntu 版本][11] 的信息。

|

||||

|

||||

![Verify PPA availability for Ubuntu version][12]

|

||||

|

||||

检查 PPA 是否适用于你的 Ubuntu 版本

|

||||

*检查 PPA 是否适用于你的 Ubuntu 版本*

|

||||

|

||||

如何知道 PPA 的网址呢?只需在网上搜索 PPA 的名称,如 `ppa:dr-akulavich/lighttable`,第一个搜索结果来自 [Launchpad][13],这是托管 PPA 的官方平台。你也可以转到 Launchpad 并直接在那里搜索所需的 PPA。

|

||||

|

||||

@ -188,9 +191,9 @@ W: Failed to fetch http://ppa.launchpad.net/venerix/pkg/ubuntu/dists/raring/main

|

||||

E: Some index files failed to download. They have been ignored, or old ones used instead.

|

||||

```

|

||||

|

||||

上面的错误提示说的很明白,是因为系统找不到当前版本对应的仓库。还记得我们之前看到的仓库结构吗?APT 将尝试在 <http://ppa.launchpad.net/\><PPA_NAME>/ubuntu/dists/Ubuntu_Version 中寻找软件信息。

|

||||

上面的错误提示说的很明白,是因为系统找不到当前版本对应的仓库。还记得我们之前看到的仓库结构吗?APT 将尝试在 `http://ppa.launchpad.net/<PPA_NAME>/ubuntu/dists/<Ubuntu_Version>` 中寻找软件信息。

|

||||

|

||||

如果特定版本的 PPA 不可用,它将永远无法打开 URL,你会看到著名的404错误。

|

||||

如果特定版本的 PPA 不可用,它将永远无法打开 URL,你会看到著名的 404 错误。

|

||||

|

||||

#### 为什么 PPA 不适用于所有 Ubuntu 发行版?

|

||||

|

||||

@ -202,7 +205,7 @@ E: Some index files failed to download. They have been ignored, or old ones used

|

||||

|

||||

比如说,你访问 Light Table 的 PPA 页面,使用刚刚学到的有关 PPA 的知识,你会发现 PPA 不适用于你的特定 Ubuntu 版本。

|

||||

|

||||

你可以点击 `查看软件包详细信息`。

|

||||

你可以点击 “查看软件包详细信息”。

|

||||

|

||||

![Get DEB file from PPA][16]

|

||||

|

||||

@ -234,11 +237,11 @@ Ubuntu 软件中心无法移除 PPA 安装的软件包,你必须使用具有

|

||||

sudo apt install synaptic

|

||||

```

|

||||

|

||||

安装后,启动 Synaptic 包管理器并选择 Origin。你会看到添加到系统的各种软件仓库。 PPA 条目将以前缀 PPA 进行标识,单击以查看 PPA 可用的包。已安装的软件前面会有恰当的符号进行标识。

|

||||

安装后,启动 Synaptic 包管理器并选择 “Origin”。你会看到添加到系统的各种软件仓库。PPA 条目将以前缀 PPA 进行标识,单击以查看 PPA 可用的包。已安装的软件前面会有恰当的符号进行标识。

|

||||

|

||||

![Managing PPA with Synaptic package manager][20]

|

||||

|

||||

查找通过 PPA 安装的软件包

|

||||

*查找通过 PPA 安装的软件包*

|

||||

|

||||

找到包后,你可以从 Synaptic 删除它们。此外,也始终可以选择使用命令行进行移除:

|

||||

|

||||

@ -264,7 +267,7 @@ sudo apt remove package_name

|

||||

|

||||

这是一个主观问题。纯粹主义者厌恶 PPA,因为大多数时候 PPA 来自第三方开发者。但与此同时,PPA 在 Debian/Ubuntu 世界中很受欢迎,因为它们提供了更简单的安装选项。

|

||||

|

||||

就安全性而言,使用 PPA 之后,你的 Linux 系统被黑客攻击或注入恶意软件的可能性较小。到目前为止,我不记得发生过这样的事件。

|

||||

就安全性而言,很少见到因为使用 PPA 之后你的 Linux 系统被黑客攻击或注入恶意软件。到目前为止,我不记得发生过这样的事件。

|

||||

|

||||

官方 PPA 可以不加考虑的使用,使用非官方 PPA 完全是你自己的决定。

|

||||

|

||||

@ -285,7 +288,7 @@ via: https://itsfoss.com/ppa-guide/

|

||||

作者:[Abhishek Prakash][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[jlztan](https://github.com/jlztan)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -300,7 +303,7 @@ via: https://itsfoss.com/ppa-guide/

|

||||

[7]: https://launchpad.net/ubuntu/+ppas

|

||||

[8]: https://i2.wp.com/itsfoss.com/wp-content/uploads/2018/01/ppa-sources-list-files.png?resize=800%2C259&ssl=1

|

||||

[9]: https://i1.wp.com/itsfoss.com/wp-content/uploads/2018/01/content-of-ppa-list.png?ssl=1

|

||||

[10]: https://itsfoss.com/install-software-from-source-code/

|

||||

[10]: https://linux.cn/article-9172-1.html

|

||||

[11]: https://itsfoss.com/how-to-know-ubuntu-unity-version/

|

||||

[12]: https://i1.wp.com/itsfoss.com/wp-content/uploads/2017/12/verify-ppa-availibility-version.jpg?resize=800%2C481&ssl=1

|

||||

[13]: https://launchpad.net/

|

||||

@ -1,78 +0,0 @@

|

||||

translating by hopefully2333

|

||||

|

||||

5 ways DevSecOps changes security

|

||||

======

|

||||

|

||||

|

||||

|

||||

There’s been an ongoing kerfuffle over whether we need to expand [DevOps][1] to explicitly bring in security. After all, the thinking goes, [DevOps][2] has always been something of a shorthand for a broad set of new practices, using new tools (often open source) and built on more collaborative cultures. Why not [DevBizOps][3] for better aligning with business needs? Or DevChatOps to emphasize better and faster communications?

|

||||

|

||||

However, [as John Willis wrote earlier this year][4] on his coming around to the [DevSecOps][5] terminology, “Hopefully, someday we will have a world where we no longer have to use the word DevSecOps and security will be an inherent part of all service delivery discussions. Until that day, and at this point, my general conclusion is that it’s just three new characters. More importantly, the name really differentiates the problem statement in a world where we as an industry are not doing a great job on information security.”

|

||||

|

||||

So why aren’t we doing a great job on [information security][6], and what does it mean to do a great job in a DevSecOps context?

|

||||

|

||||

We’ve arguably never done a great job of information security in spite of (or maybe because of) the vast industry of complex point products addressing narrow problems. But we also arguably did a good enough job during the era when defending against threats focused on securing the perimeter, network connections were limited, and most users were employees using company-provided devices.

|

||||

|

||||

Those circumstances haven’t accurately described most organizations’ reality for a number of years now. But the current era, which brings in not only DevSecOps but new application architectural patterns, development practices, and an increasing number of threats, defines a stark new normal that requires a faster pace of change. It’s not so much that DevSecOps in isolation changes security, but that infosec circa 2018 requires new approaches.

|

||||

|

||||

Consider these five areas.

|

||||

|

||||

### Automation

|

||||

|

||||

Lots of automation is a hallmark of DevOps generally. It’s partly about speed. If you’re going to move fast (and not break things), you need to have repeatable processes that execute without a lot of human intervention. Indeed, automation is one of the best entry points for DevOps, even in organizations that are still mostly working on monolithic legacy apps. Automating routine processes associated with configurations or testing with easy-to-use tools such as [Ansible][7] is a common quick hit for starting down the path to DevOps.

|

||||

|

||||

DevSecOps is no different. Security today is a continuous process rather than a discrete checkpoint in the application lifecycle, or even a weekly or monthly check. When vulnerabilities are found and fixes issued by a vendor, it’s important they be applied quickly given that exploits taking advantage of those vulnerabilities will be out soon.

|

||||

|

||||

### "Shift left"

|

||||

|

||||

Traditional security is often viewed as a gatekeeper at the end of the development process. Check all the boxes and your app goes into production. Otherwise, try again. Security teams have a reputation for saying no a lot.

|

||||

|

||||

Therefore, the thinking goes, why not move security earlier (left in a typical left-to-right drawing of a development pipeline)? Security may still say no, but the consequences of rework in early-stage development are a lot less than they are when the app is complete and ready to ship.

|

||||

|

||||

I don’t like the “shift left” term, though. It implies that security is still a one-time event that’s just been moved earlier. Security needs to be a largely automated process everywhere in the application lifecycle, from the supply chain to the development and test process all the way through deployment.

|

||||

|

||||

### Manage dependencies

|

||||

|

||||

One of the big changes we see with modern app development is that you often don’t write most of the code. Using open source libraries and frameworks is one obvious case in point. But you may also just use external services from public cloud providers or other sources. In many cases, this external code and services will dwarf what you write yourself.

|

||||

|

||||

As a result, DevSecOps needs to include a serious focus on your [software supply chain][8]. Are you getting your software from trusted sources? Is it up to date? Is it integrated into the security processes that you use for your own code? What policies do you have in place for which code and APIs you can use? Is commercial support available for the components that you are using for your own production code?

|

||||

|

||||

No set of answers are going to be appropriate in all cases. They may be different for a proof-of-concept versus an at-scale production workload. But, as has been the case in manufacturing for a long time (and DevSecOps has many analogs in how manufacturing has evolved), the integrity of the supply chain is critical.

|

||||

|

||||

### Visibility

|

||||

|

||||

I’ve talked a lot about the need for automation throughout all the stages of the application lifecycle. That makes the assumption that we can see what’s going on in each of those stages.

|

||||

|

||||

Effective DevSecOps requires effective instrumentation so that automation knows what to do. This instrumentation falls into a number of categories. There are long-term and high-level metrics that help tell us if the overall DevSecOps process is working well. There are critical alerts that require immediate human intervention (the security scanning system is down!). There are alerts, such as for a failed scan, that require remediation. And there are logs of the many parameters we capture for later analysis (what’s changing over time? What caused that failure?).

|

||||

|

||||

### Services vs. monoliths

|

||||

|

||||

While DevSecOps practices can be applied across many types of application architectures, they’re most effective with small and loosely coupled components that can be updated and reused without potentially forcing changes elsewhere in the app. In their purest form, these components can be [microservices][9] or functions, but the general principles apply wherever you have loosely coupled services communicating over a network.

|

||||

|

||||

This pattern does introduce some new security challenges. The interactions between components can be complex and the total attack surface can be larger because there are now more entry points to the application across the network.

|

||||

|

||||

On the other hand, this type of architecture also means that automated security and monitoring also has more granular visibility into the application components because they’re no longer buried deep within a monolithic application.

|

||||

|

||||

Don’t get too wrapped up in the DevSecOps term, but take it as a reminder that security is evolving because the way that we write and deploy applications is evolving.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://opensource.com/article/18/9/devsecops-changes-security

|

||||

|

||||

作者:[Gordon Haff][a]

|

||||

选题:[lujun9972](https://github.com/lujun9972)

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: https://opensource.com/users/ghaff

|

||||

[1]: https://opensource.com/resources/devops

|

||||

[2]: https://opensource.com/tags/devops

|

||||

[3]: https://opensource.com/article/18/5/steps-apply-devops-culture-beyond-it

|

||||

[4]: https://www.devsecopsdays.com/articles/its-just-a-name

|

||||

[5]: https://opensource.com/article/18/4/devsecops

|

||||

[6]: https://opensource.com/article/18/6/where-cycle-security-devops

|

||||

[7]: https://opensource.com/tags/ansible

|

||||

[8]: https://opensource.com/article/17/1/be-open-source-supply-chain

|

||||

[9]: https://opensource.com/tags/microservices

|

||||

@ -1,68 +0,0 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (qhwdw)

|

||||

[#]: reviewer: ( )

|

||||

[#]: publisher: ( )

|

||||

[#]: url: ( )

|

||||

[#]: subject: (Computer Laboratory – Raspberry Pi: Lesson 2 OK02)

|

||||

[#]: via: (https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/ok02.html)

|

||||

[#]: author: (Robert Mullins http://www.cl.cam.ac.uk/~rdm34)

|

||||

|

||||

Computer Laboratory – Raspberry Pi: Lesson 2 OK02

|

||||

======

|

||||

|

||||

The OK02 lesson builds on OK01, by causing the 'OK' or 'ACT' LED to turn on and off repeatedly. It is assumed you have the code for the [Lesson 1: OK01][1] operating system as a basis.

|

||||

|

||||

### 1 Waiting

|

||||

|

||||

Waiting is a surprisingly useful part of Operating System development. Often Operating Systems find themselves with nothing to do, and must delay. In this example, we wish to do so in order to allow the LED flashing off and on to be visible. If you just turned it off and on, it would not be visible, as the computer would be able to turn it off and on many thousands of times per second. In later lessons we will look at accurate waiting, but for now it is sufficient to simply waste time.

|

||||

|

||||

```

|

||||

mov r2,#0x3F0000

|

||||

wait1$:

|

||||

sub r2,#1

|

||||

cmp r2,#0

|

||||

bne wait1$

|

||||

```

|

||||

|

||||

```

|

||||

sub reg,#val subtracts the number val from the value in reg.

|

||||

|

||||

cmp reg,#val compares the value in reg with the number val.

|

||||

|

||||

Suffix ne causes the command to be executed only if the last comparison determined that the numbers were not equal.

|

||||

```

|

||||

|

||||

The code above is a generic piece of code that creates a delay, which thanks to every Raspberry Pi being basically the same, is roughly the same time. How it does this is using a mov command to put the value 3F000016 into r2, and then subtracting 1 from this value until it is 0. The new commands here are sub, cmp, and bne.

|

||||

|

||||

sub is the subtract command, and simply subtracts the second argument from the first.

|

||||

|

||||

cmp is a more interesting command. It compares the first argument with the second, and remembers the result of the comparison in a special register called the current processor status register. You don't really need to worry about this, suffice to say it remembers, among other things, which of the two numbers was bigger or smaller, or if they were equal.[1]

|

||||

|

||||

bne is actually just a branch command in disguise. In the ARM assembly language family, any instruction can be executed conditionally. This means that the instruction is only run if the last comparison had a certain result. We will use this extensively later for interesting tricks, but in this case we use the ne suffix on the b command to mean 'only branch if the last comparison's result was that the values were not equal'. The ne suffix can be used on any command, as can several other (16 in all) conditions such as eq for equal and lt for less than.

|

||||

|

||||

### 2 The All Together

|

||||

|

||||

I mentioned briefly last time that the status LED can be turned off again by writing to an offset of 28 from the GPIO controller instead of 40 (i.e. str r1,[r0,#28]). Thus, you need to modify the code from OK01 to turn the LED on, run the wait code, turn it off, run the wait code again, and then include a branch back to the beginning. Note, it is not necessary to re-enable the output to GPIO 16, we need only do that once. If you're being efficient, which I strongly encourage, you should be able to reuse the value of r1. As with all lessons, a full solution to this can be found on the [download page][2]. Be careful to make sure all of your labels are unique. When you write wait1$: you cannot label another line wait1$.

|

||||

|

||||

On my Raspberry Pi it flashes about twice a second. this could easily be altered by changing the value we set r2 to. However, unfortunately we can't precisely predict the speed this runs at. If you didn't manage to get this working see our trouble shooting page, otherwise, congratulations.

|

||||

|

||||

In this lesson we've learnt two more assembly commands, sub and cmp, as well as learning about conditional execution in ARM.

|

||||

|

||||

In the next lesson, [Lesson 3: OK03][3] we will evaluate how we're coding, and establish some standards so that we can reuse code, and if necessary, work with C or C++ code.

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/ok02.html

|

||||

|

||||

作者:[Robert Mullins][a]

|

||||

选题:[lujun9972][b]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]: http://www.cl.cam.ac.uk/~rdm34

|

||||

[b]: https://github.com/lujun9972

|

||||

[1]: https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/ok01.html

|

||||

[2]: https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/downloads.html

|

||||

[3]: https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/ok03.html

|

||||

@ -1,590 +0,0 @@

|

||||

[#]: collector: (lujun9972)

|

||||

[#]: translator: (MjSeven)

|

||||

[#]: reviewer: ( )

|

||||

[#]: publisher: ( )

|

||||

[#]: subject: (An introduction to the Tornado Python web app framework)

|

||||

[#]: via: (https://opensource.com/article/18/6/tornado-framework)

|

||||

[#]: author: (Nicholas Hunt-Walker https://opensource.com/users/nhuntwalker)

|

||||

[#]: url: ( )

|

||||

|

||||

An introduction to the Tornado Python web app framework

|

||||

======

|

||||

In the third part in a series comparing Python frameworks, learn about Tornado, built to handle asynchronous processes.

|

||||

|

||||

|

||||

In the first two articles in this four-part series comparing different Python web frameworks, we've covered the [Pyramid][1] and [Flask][2] web frameworks. We've built the same app twice and seen the similarities and differences between a complete DIY framework and a framework with a few more batteries included.

|

||||

|

||||

Now let's look at a somewhat different option: [the Tornado framework][3]. Tornado is, for the most part, as bare-bones as Flask, but with a major difference: Tornado is built specifically to handle asynchronous processes. That special sauce isn't terribly useful in the app we're building in this series, but we'll see where we can use it and how it works in a more general situation.

|

||||

|

||||

Let's continue the pattern we set in the first two articles and start by tackling the setup and config.

|

||||

|

||||

### Tornado startup and configuration

|

||||

|

||||

If you've been following along with this series, what we do first shouldn't come as much of a surprise.

|

||||

|

||||

```

|

||||

$ mkdir tornado_todo

|

||||

$ cd tornado_todo

|

||||

$ pipenv install --python 3.6

|

||||

$ pipenv shell

|

||||

(tornado-someHash) $ pipenv install tornado

|

||||

```

|

||||

|

||||

Create a `setup.py` for installing our application:

|

||||

|

||||

```

|

||||

(tornado-someHash) $ touch setup.py

|

||||

# setup.py

|

||||

from setuptools import setup, find_packages

|

||||

|

||||

requires = [

|

||||

'tornado',

|

||||

'tornado-sqlalchemy',

|

||||

'psycopg2',

|

||||

]

|

||||

|

||||

setup(

|

||||

name='tornado_todo',

|

||||

version='0.0',

|

||||

description='A To-Do List built with Tornado',

|

||||

author='<Your name>',

|

||||

author_email='<Your email>',

|

||||

keywords='web tornado',

|

||||

packages=find_packages(),

|

||||

install_requires=requires,

|

||||

entry_points={

|

||||

'console_scripts': [

|

||||

'serve_app = todo:main',

|

||||

],

|

||||

},

|

||||

)

|

||||

```

|

||||

|

||||

Because Tornado doesn't require any external configuration, we can dive right into writing the Python code that'll run our application. Let's make our inner `todo` directory and fill it with the first few files we'll need.

|

||||

|

||||

```

|

||||

todo/

|

||||

__init__.py

|

||||

models.py

|

||||

views.py

|

||||

```

|

||||

|

||||

Like Flask and Pyramid, Tornado has some central configuration that will go in `__init__.py`. From `tornado.web`, we'll import the `Application` object. This will handle the hookups for routing and views, including our database (when we get there) and any extra settings needed to run our Tornado app.

|

||||

|

||||

```

|

||||

# __init__.py

|

||||

from tornado.httpserver import HTTPServer

|

||||

from tornado.options import define, options

|

||||

from tornado.web import Application

|

||||

|

||||

define('port', default=8888, help='port to listen on')

|

||||

|

||||

def main():

|

||||

"""Construct and serve the tornado application."""

|

||||

app = Application()

|

||||

http_server = HTTPServer(app)

|

||||

http_server.listen(options.port)

|

||||

```

|

||||

|

||||

When we use the `define` function, we end up creating attributes on the `options` object. Anything that goes in the position of the first argument will be the attribute's name, and what's assigned to the `default` keyword argument will be the value of that attribute.

|

||||

|

||||

As an example, if we name the attribute `potato` instead of `port`, we can access its value via `options.potato`.

|

||||

|

||||

Calling `listen` on the `HTTPServer` doesn't start the server yet. We must do one more step to have a working application that can listen for requests and return responses. We need an input-output loop. Thankfully, Tornado comes with that out of the box in the form of `tornado.ioloop.IOLoop`.

|

||||

|

||||

```

|

||||

# __init__.py

|

||||

from tornado.httpserver import HTTPServer

|

||||

from tornado.ioloop import IOLoop

|

||||

from tornado.options import define, options

|

||||

from tornado.web import Application

|

||||

|

||||

define('port', default=8888, help='port to listen on')

|

||||

|

||||

def main():

|

||||

"""Construct and serve the tornado application."""

|

||||

app = Application()

|

||||

http_server = HTTPServer(app)

|

||||

http_server.listen(options.port)

|

||||

print('Listening on http://localhost:%i' % options.port)

|

||||

IOLoop.current().start()

|

||||

```

|

||||

|

||||

I like some kind of a `print` statement somewhere that tells me when I'm serving my application, but that's me. You could do without the `print` line if you so chose.

|

||||

|

||||

We begin our I/O loop with `IOLoop.current().start()`. Let's talk a little more about input, output, and asynchronicity.

|

||||

|

||||

### The basics of async in Python and the I/O loop

|

||||

|

||||

Allow me to preface by saying that I am absolutely, positively, surely, and securely not an expert in asynchronous programming. As with all things I write, what follows stems from the limits of my understanding of the concept. As I am human, it may be deeply, deeply flawed.

|

||||

|

||||

The main concerns of an asynchronous program are:

|

||||

|

||||

* How is data coming in?

|

||||

* How is data going out?

|

||||

* When can some procedure be left to run without consuming my full attention?

|

||||

|

||||

|

||||

|

||||

Due to the [global interpreter lock][4] (GIL), Python is—by design—a [single-threaded][5] language. For every task a Python program must execute, the full attention of its thread of execution is on that task for the duration of that task. Our HTTP server is written in Python. Thus, when data (e.g., an HTTP request) is received, the server's sole focus is that incoming data. This means that, in most cases, whatever procedures need to run in handling and processing that data will completely consume your server's thread of execution, blocking other potential data from being received until your server finishes whatever it needed to do.

|

||||

|

||||

In many cases this isn't too problematic; a typical web request-response cycle will take only fractions of a second. Along with that, the sockets that HTTP servers are built from can maintain a backlog of incoming requests to be handled. So, if a request comes in while that socket is handling something else, chances are it'll just wait in line a bit before being addressed. For a low to intermediate traffic site, a fraction of a second isn't that big of a deal, and you can use multiple deployed instances along with a load-balancer like [NGINX][6] to distribute traffic for the larger request loads.

|

||||

|

||||

What if, however, your average response time takes more than a fraction of a second? What if you use data from the incoming request to start some long-running process like a machine-learning algorithm or some massive database query? Now, your single-threaded web server starts to accumulate an unaddressable backlog of requests, some of which will get dropped due to simply timing out. This is not an option, especially if you want your service to be seen as reliable on a regular basis.

|

||||

|

||||

In comes the asynchronous Python program. It's important to keep in mind that because it's written in Python, the program is still a single-threaded process. Anything that would block execution in a synchronous program, unless specifically flagged, will still block execution in an asynchronous one.

|

||||

|

||||

When it's structured correctly, however, your asynchronous Python program can "shelve" long-running tasks whenever you designate that a certain function should have the ability to do so. Your async controller can then be alerted when the shelved tasks are complete and ready to resume, managing their execution only when needed without completely blocking the handling of new input.

|

||||

|

||||

That was somewhat jargony, so let's demonstrate with a human example.

|

||||

|

||||

#### Bringing it home

|

||||

|

||||

I often find myself trying to get multiple chores done at home with little time to do them. On a given day, that backlog of chores may look like:

|

||||

|

||||

* Cook a meal (20 min. prep, 40 min. cook)

|

||||

* Wash dishes (60 min.)

|

||||

* Wash and dry laundry (30 min. wash, 90 min. dry per load)

|

||||

* Vacuum floors (30 min.)

|

||||

|

||||

|

||||

|

||||

If I were acting as a traditional, synchronous program, I'd be doing each task myself, by hand. Each task would require my full attention to complete before I could consider handling anything else, as nothing would get done without my active attention. So my sequence of execution might look like:

|

||||

|

||||

1. Focus fully on preparing and cooking the meal, including waiting around for food to just… cook (60 min.).

|

||||

2. Transfer dirty dishes to sink (65 min. elapsed).

|

||||

3. Wash all the dishes (125 min. elapsed).

|

||||

4. Start laundry with my full focus on that, including waiting around for the washing machine to finish, then transferring laundry to the dryer, and waiting for the dryer to finish (250 min. elapsed).

|

||||

5. Vacuum the floors (280 min. elapsed).

|

||||

|

||||

|

||||

|

||||

That's 4 hours and 40 minutes to complete my chores from end-to-end.

|

||||

|

||||

Instead of working hard, I should work smart like an asynchronous program. My home is full of machines that can do my work for me without my continuous effort. Meanwhile, I can switch my attention to what may actively need it right now.

|

||||

|

||||

My execution sequence might instead look like:

|

||||

|

||||

1. Load clothes into and start the washing machine (5 min.).

|

||||

2. While the washing machine is running, prep food (25 min. elapsed).

|

||||

3. After prepping food, start cooking food (30 min. elapsed).

|

||||

4. While the food is cooking, move clothes from the washing machine into the dryer and start dryer (35 min. elapsed).

|

||||

5. While dryer is running and food is still cooking, vacuum the floors (65 min. elapsed).

|

||||

6. After vacuuming the floors, take food off the stove and load the dishwasher (70 min. elapsed).

|

||||

7. Run the dishwasher (130 min. when done).

|

||||

|

||||

|

||||

|

||||

Now I'm down to 2 hours and 10 minutes. Even if I allow more time for switching between jobs (10-20 more minutes total), I'm still down to about half the time I would've spent if I'd waited to perform each task in sequential order. This is the power of structuring your program to be asynchronous.

|

||||

|

||||

#### So where does the I/O loop come in?

|

||||

|

||||

An asynchronous Python program works by taking in data from some external source (input) and, should the process require it, offloading that data to some external worker (output) for processing. When that external process finishes, the main Python program is alerted. The program then picks up the result of that external processing (input) and continues on its merry way.

|

||||

|

||||

Whenever that data isn't actively in the hands of the main Python program, that main program is freed to work on just about anything else. This includes awaiting completely new inputs (e.g., HTTP requests) and handling the results of long-running processes (e.g., results of machine-learning algorithms, long-running database queries). The main program, while still single-threaded, becomes event-driven, triggered into action for specific occurrences handled by the program. The main worker that listens for those events and dictates how they should be handled is the I/O loop.

|

||||

|

||||

We traveled a long road to get to this nugget of an explanation, I know, but what I'm hoping to communicate here is that it's not magic, nor is it some type of complex parallel processing or multi-threaded work. The global interpreter lock is still in place; any long-running process within the main program will still block anything else from happening. The program is also still single-threaded; however, by externalizing tedious work, we conserve the attention of that thread to only what it needs to be attentive to.

|

||||

|

||||

This is kind of like my asynchronous chores above. When my attention is fully necessary for prepping food, that's all I'm doing. However, when I can get the stove to do work for me by cooking my food, and the dishwasher to wash my dishes, and the washing machine and dryer to handle my laundry, my attention is freed to work on other things. When I am alerted that one of my long-running tasks is finished and ready to be handled once again, if my attention is free, I can pick up the results of that task and do whatever needs to be done with it next.

|

||||

|

||||

### Tornado routes and views

|

||||

|

||||

Despite having gone through all the trouble of talking about async in Python, we're going to hold off on using it for a bit and first write a basic Tornado view.

|

||||

|

||||

Unlike the function-based views we've seen in the Flask and Pyramid implementations, Tornado's views are all class-based. This means we'll no longer use individual, standalone functions to dictate how requests are handled. Instead, the incoming HTTP request will be caught and assigned to be an attribute of our defined class. Its methods will then handle the corresponding request types.

|

||||

|

||||

Let's start with a basic view that prints "Hello, World" to the screen. Every class-based view we construct for our Tornado app must inherit from the `RequestHandler` object found in `tornado.web`. This will set up all the ground-level logic that we'll need (but don't want to write) to take in a request and construct a properly formatted HTTP response.

|

||||

|

||||

```

|

||||

from tornado.web import RequestHandler

|

||||

|

||||

class HelloWorld(RequestHandler):

|

||||

"""Print 'Hello, world!' as the response body."""

|

||||

|

||||

def get(self):

|

||||

"""Handle a GET request for saying Hello World!."""

|

||||

self.write("Hello, world!")

|

||||

```

|

||||

|

||||

Because we're looking to handle a `GET` request, we declare (really override) the `get` method. Instead of returning anything, we provide text or a JSON-serializable object to be written to the response body with `self.write`. After that, we let the `RequestHandler` take on the rest of the work that must be done before a response can be sent.

|

||||

|

||||

As it stands, this view has no actual connection to the Tornado application itself. We have to go back into `__init__.py` and update the `main` function a bit. Here's the new hotness:

|

||||

|

||||

```

|

||||

# __init__.py

|

||||

from tornado.httpserver import HTTPServer

|

||||

from tornado.ioloop import IOLoop

|

||||

from tornado.options import define, options

|

||||

from tornado.web import Application

|

||||

from todo.views import HelloWorld

|

||||

|

||||

define('port', default=8888, help='port to listen on')

|

||||

|

||||

def main():

|

||||

"""Construct and serve the tornado application."""

|

||||

app = Application([

|

||||

('/', HelloWorld)

|

||||

])

|

||||

http_server = HTTPServer(app)

|

||||

http_server.listen(options.port)

|

||||

print('Listening on http://localhost:%i' % options.port)

|

||||

IOLoop.current().start()

|

||||

```

|

||||

|

||||

#### What'd we do?

|

||||

|

||||

We imported the `HelloWorld` view from the `views.py` file into `__init__.py` at the top of the script. Then we added a list of route-view pairs as the first argument to the instantiation to `Application`. Whenever we want to declare a route in our application, it must be tied to a view. You can use the same view for multiple routes if you want, but there must always be a view for every route.

|

||||

|

||||

We can make sure this all works by running our app with the `serve_app` command we enabled in the `setup.py`. Check `http://localhost:8888/` and see that it says "Hello, world!"

|

||||

|

||||

Of course, there's more we can and will do in this space, but let's move on to models.

|

||||

|

||||

### Connecting the database

|

||||

|

||||

If we want to hold onto data, we need to connect a database. Like with Flask, we'll be using a framework-specific variant of SQLAlchemy called [tornado-sqlalchemy][7].

|

||||

|

||||

Why use this instead of just the bare [SQLAlchemy][8]? Well, `tornado-sqlalchemy` has all the goodness of straightforward SQLAlchemy, so we can still declare models with a common `Base` as well as use all the column data types and relationships to which we've grown accustomed. Alongside what we already know from habit, `tornado-sqlalchemy` provides an accessible async pattern for its database-querying functionality specifically to work with Tornado's existing I/O loop.

|

||||

|

||||

We set the stage by adding `tornado-sqlalchemy` and `psycopg2` to `setup.py` to the list of required packages and reinstall the package. In `models.py`, we declare our models. This step looks pretty much exactly like what we've already seen in Flask and Pyramid, so I'll skip the full-class declarations and just put up the necessaries of the `Task` model.

|

||||

|

||||

```

|

||||

# this is not the complete models.py, but enough to see the differences

|

||||

from tornado_sqlalchemy import declarative_base

|

||||

|

||||

Base = declarative_base

|

||||

|

||||

class Task(Base):

|

||||

# and so on, because literally everything's the same...

|

||||

```

|

||||

|

||||

We still have to connect `tornado-sqlalchemy` to the actual application. In `__init__.py`, we'll be defining the database and integrating it into the application.

|

||||

|

||||

```

|

||||

# __init__.py

|

||||

from tornado.httpserver import HTTPServer

|

||||

from tornado.ioloop import IOLoop

|

||||

from tornado.options import define, options

|

||||

from tornado.web import Application

|

||||

from todo.views import HelloWorld

|

||||

|

||||

# add these

|

||||

import os

|

||||

from tornado_sqlalchemy import make_session_factory

|

||||

|

||||

define('port', default=8888, help='port to listen on')

|

||||

factory = make_session_factory(os.environ.get('DATABASE_URL', ''))

|

||||

|

||||

def main():

|

||||

"""Construct and serve the tornado application."""

|

||||

app = Application([

|

||||

('/', HelloWorld)

|

||||

],

|

||||

session_factory=factory

|

||||

)

|

||||

http_server = HTTPServer(app)

|

||||

http_server.listen(options.port)

|

||||

print('Listening on http://localhost:%i' % options.port)

|

||||

IOLoop.current().start()

|

||||

```

|

||||

|

||||

Much like the session factory we passed around in Pyramid, we can use `make_session_factory` to take in a database URL and produce an object whose sole purpose is to provide connections to the database for our views. We then tie it into our application by passing the newly created `factory` into the `Application` object with the `session_factory` keyword argument.

|

||||

|

||||

Finally, initializing and managing the database will look the same as it did for Flask and Pyramid (i.e., separate DB management script, working with respect to the `Base` object, etc.). It'll look so similar that I'm not going to reproduce it here.

|

||||

|

||||

### Revisiting views

|

||||

|

||||

Hello, World is always nice for learning the basics, but we need some real, application-specific views.

|

||||

|

||||

Let's start with the info view.

|

||||

|

||||

```

|

||||

# views.py

|

||||

import json

|

||||

from tornado.web import RequestHandler

|

||||

|

||||

class InfoView(RequestHandler):

|

||||

"""Only allow GET requests."""

|

||||

SUPPORTED_METHODS = ["GET"]

|

||||

|

||||

def set_default_headers(self):

|

||||

"""Set the default response header to be JSON."""

|

||||

self.set_header("Content-Type", 'application/json; charset="utf-8"')

|

||||

|

||||

def get(self):

|

||||

"""List of routes for this API."""

|

||||

routes = {

|

||||

'info': 'GET /api/v1',

|

||||

'register': 'POST /api/v1/accounts',

|

||||

'single profile detail': 'GET /api/v1/accounts/<username>',

|

||||

'edit profile': 'PUT /api/v1/accounts/<username>',

|

||||

'delete profile': 'DELETE /api/v1/accounts/<username>',

|

||||

'login': 'POST /api/v1/accounts/login',

|

||||

'logout': 'GET /api/v1/accounts/logout',

|

||||

"user's tasks": 'GET /api/v1/accounts/<username>/tasks',

|

||||

"create task": 'POST /api/v1/accounts/<username>/tasks',

|

||||

"task detail": 'GET /api/v1/accounts/<username>/tasks/<id>',

|

||||

"task update": 'PUT /api/v1/accounts/<username>/tasks/<id>',

|

||||

"delete task": 'DELETE /api/v1/accounts/<username>/tasks/<id>'

|

||||

}

|

||||

self.write(json.dumps(routes))

|

||||

```

|

||||

|

||||

So what changed? Let's go from the top down.

|

||||

|

||||

The `SUPPORTED_METHODS` class attribute was added. This will be an iterable of only the request methods that are accepted by this view. Any other method will return a [405][9] status code. When we made the `HelloWorld` view, we didn't specify this, mostly out of laziness. Without this class attribute, this view would respond to any request trying to access the route tied to the view.

|

||||

|

||||

The `set_default_headers` method is declared, which sets the default headers of the outgoing HTTP response. We declare this here to ensure that any response we send back has a `"Content-Type"` of `"application/json"`.

|

||||

|

||||

We added `json.dumps(some_object)` to the argument of `self.write` because it makes it easy to construct the content for the body of the outgoing response.

|

||||

|

||||

Now that's done, and we can go ahead and connect it to the home route in `__init__.py`.

|

||||

|

||||

```

|

||||

# __init__.py

|

||||

from tornado.httpserver import HTTPServer

|

||||

from tornado.ioloop import IOLoop

|

||||

from tornado.options import define, options

|

||||

from tornado.web import Application

|

||||

from todo.views import InfoView

|

||||

|

||||

# add these

|

||||

import os

|

||||

from tornado_sqlalchemy import make_session_factory

|

||||

|

||||

define('port', default=8888, help='port to listen on')

|

||||

factory = make_session_factory(os.environ.get('DATABASE_URL', ''))

|

||||

|

||||

def main():

|

||||

"""Construct and serve the tornado application."""

|

||||

app = Application([

|

||||

('/', InfoView)

|

||||

],

|

||||

session_factory=factory

|

||||

)

|

||||

http_server = HTTPServer(app)

|

||||

http_server.listen(options.port)

|

||||

print('Listening on http://localhost:%i' % options.port)

|

||||

IOLoop.current().start()

|

||||

```

|

||||

|

||||

As we know, more views and routes will need to be written. Each one will get dropped into the `Application` route listing as needed. Each will also need a `set_default_headers` method. On top of that, we'll create our `send_response`method, whose job it will be to package our response along with any custom status codes we want to set for a given response. Since each one will need both methods, we can create a base class containing them that each of our views can inherit from. That way, we have to write them only once.

|

||||

|

||||

```

|

||||

# views.py

|

||||

import json

|

||||

from tornado.web import RequestHandler

|

||||

|

||||

class BaseView(RequestHandler):

|

||||

"""Base view for this application."""

|

||||

|

||||

def set_default_headers(self):

|

||||

"""Set the default response header to be JSON."""

|

||||

self.set_header("Content-Type", 'application/json; charset="utf-8"')

|

||||

|

||||

def send_response(self, data, status=200):

|

||||

"""Construct and send a JSON response with appropriate status code."""

|

||||

self.set_status(status)

|

||||

self.write(json.dumps(data))

|

||||

```

|

||||

|

||||

For a view like the `TaskListView` we'll soon write, we'll also need a connection to the database. We'll need `tornado_sqlalchemy`'s `SessionMixin` to add a database session within every view class. We can fold that into the `BaseView` so that, by default, every view inheriting from it has access to a database session.

|

||||

|

||||

```

|

||||

# views.py

|

||||

import json

|

||||

from tornado_sqlalchemy import SessionMixin

|

||||

from tornado.web import RequestHandler

|

||||

|

||||

class BaseView(RequestHandler, SessionMixin):

|

||||

"""Base view for this application."""

|

||||

|

||||

def set_default_headers(self):

|

||||

"""Set the default response header to be JSON."""

|

||||