mirror of

https://github.com/LCTT/TranslateProject.git

synced 2025-03-24 02:20:09 +08:00

commit

06399a5df8

@ -1,7 +1,7 @@

|

||||

如何在 Docker 容器中运行支持 OData 的 JBoss 数据虚拟化 GA

|

||||

Howto Run JBoss Data Virtualization GA with OData in Docker Container

|

||||

================================================================================

|

||||

大家好,我们今天来学习如何在一个 Docker 容器中运行支持 OData(译者注:Open Data Protocol,开放数据协议) 的 JBoss 数据虚拟化 6.0.0 GA(译者注:GA,General Availability,具体定义可以查看[WIKI][4])。JBoss 数据虚拟化是数据提供和集成解决方案平台,有多种分散的数据源时,转换为一种数据源统一对待,在正确的时间将所需数据传递给任意的应用或者用户。JBoss 数据虚拟化可以帮助我们将数据快速组合和转换为可重用的商业友好的数据模型,通过开放标准接口简单可用。它提供全面的数据抽取、联合、集成、转换,以及传输功能,将来自一个或多个源的数据组合为可重复使用和共享的灵活数据。要了解更多关于 JBoss 数据虚拟化的信息,可以查看它的[官方文档][1]。Docker 是一个提供开放平台用于打包,装载和以轻量级容器运行任何应用的开源平台。使用 Docker 容器我们可以轻松处理和启用支持 OData 的 JBoss 数据虚拟化。

|

||||

|

||||

大家好,我们今天来学习如何在一个 Docker 容器中运行支持 OData(译者注:Open Data Protocol,开放数据协议) 的 JBoss 数据虚拟化 6.0.0 GA(译者注:GA,General Availability,具体定义可以查看[WIKI][4])。JBoss 数据虚拟化是数据提供和集成解决方案平台,将多种分散的数据源转换为一种数据源统一对待,在正确的时间将所需数据传递给任意的应用或者用户。JBoss 数据虚拟化可以帮助我们将数据快速组合和转换为可重用的商业友好的数据模型,通过开放标准接口简单可用。它提供全面的数据抽取、联合、集成、转换,以及传输功能,将来自一个或多个源的数据组合为可重复使用和共享的灵活数据。要了解更多关于 JBoss 数据虚拟化的信息,可以查看它的[官方文档][1]。Docker 是一个提供开放平台用于打包,装载和以轻量级容器运行任何应用的开源平台。使用 Docker 容器我们可以轻松处理和启用支持 OData 的 JBoss 数据虚拟化。

|

||||

|

||||

下面是该指南中在 Docker 容器中运行支持 OData 的 JBoss 数据虚拟化的简单步骤。

|

||||

|

||||

@ -78,7 +78,6 @@ Howto Run JBoss Data Virtualization GA with OData in Docker Container

|

||||

"LinkLocalIPv6PrefixLen": 0,

|

||||

|

||||

### 6. Web 界面 ###

|

||||

### 6. Web Interface ###

|

||||

|

||||

现在,如果一切如期望的那样进行,当我们用浏览器打开 http://container-ip:8080/ 和 http://container-ip:9990 时会看到支持 oData 的 JBoss 数据虚拟化登录界面和 JBoss 管理界面。管理验证的用户名和密码分别是 admin 和 redhat1!数据虚拟化验证的用户名和密码都是 user。之后,我们可以通过 web 界面在内容间导航。

|

||||

|

||||

@ -94,7 +93,7 @@ via: http://linoxide.com/linux-how-to/run-jboss-data-virtualization-ga-odata-doc

|

||||

|

||||

作者:[Arun Pyasi][a]

|

||||

译者:[ictlyh](http://www.mutouxiaogui.cn/blog)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,5 +1,4 @@

|

||||

|

||||

Linux 有问必答 - 如何在 Linux 中统计一个进程的线程数

|

||||

Linux 有问必答:如何在 Linux 中统计一个进程的线程数

|

||||

================================================================================

|

||||

> **问题**: 我正在运行一个程序,它在运行时会派生出多个线程。我想知道程序在运行时会有多少线程。在 Linux 中检查进程的线程数最简单的方法是什么?

|

||||

|

||||

@ -7,11 +6,11 @@ Linux 有问必答 - 如何在 Linux 中统计一个进程的线程数

|

||||

|

||||

### 方法一: /proc ###

|

||||

|

||||

proc 伪文件系统,它驻留在 /proc 目录,这是最简单的方法来查看任何活动进程的线程数。 /proc 目录以可读文本文件形式输出,提供现有进程和系统硬件相关的信息如 CPU, interrupts, memory, disk, 等等.

|

||||

proc 伪文件系统,它驻留在 /proc 目录,这是最简单的方法来查看任何活动进程的线程数。 /proc 目录以可读文本文件形式输出,提供现有进程和系统硬件相关的信息如 CPU、中断、内存、磁盘等等.

|

||||

|

||||

$ cat /proc/<pid>/status

|

||||

|

||||

上面的命令将显示进程 <pid> 的详细信息,包括过程状态(例如, sleeping, running),父进程 PID,UID,GID,使用的文件描述符的数量,以及上下文切换的数量。输出也包括**进程创建的总线程数**如下所示。

|

||||

上面的命令将显示进程 \<pid> 的详细信息,包括过程状态(例如, sleeping, running),父进程 PID,UID,GID,使用的文件描述符的数量,以及上下文切换的数量。输出也包括**进程创建的总线程数**如下所示。

|

||||

|

||||

Threads: <N>

|

||||

|

||||

@ -23,11 +22,11 @@ Linux 有问必答 - 如何在 Linux 中统计一个进程的线程数

|

||||

|

||||

输出表明该进程有28个线程。

|

||||

|

||||

或者,你可以在 /proc/<pid>/task 中简单的统计目录的数量,如下所示。

|

||||

或者,你可以在 /proc/<pid>/task 中简单的统计子目录的数量,如下所示。

|

||||

|

||||

$ ls /proc/<pid>/task | wc

|

||||

|

||||

这是因为,对于一个进程中创建的每个线程,在 /proc/<pid>/task 中会创建一个相应的目录,命名为其线程 ID。由此在 /proc/<pid>/task 中目录的总数表示在进程中线程的数目。

|

||||

这是因为,对于一个进程中创建的每个线程,在 `/proc/<pid>/task` 中会创建一个相应的目录,命名为其线程 ID。由此在 `/proc/<pid>/task` 中目录的总数表示在进程中线程的数目。

|

||||

|

||||

### 方法二: ps ###

|

||||

|

||||

@ -35,7 +34,7 @@ Linux 有问必答 - 如何在 Linux 中统计一个进程的线程数

|

||||

|

||||

$ ps hH p <pid> | wc -l

|

||||

|

||||

如果你想监视一个进程的不同线程消耗的硬件资源(CPU & memory),请参阅[此教程][1]。(注:此文我们翻译过)

|

||||

如果你想监视一个进程的不同线程消耗的硬件资源(CPU & memory),请参阅[此教程][1]。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -43,9 +42,9 @@ via: http://ask.xmodulo.com/number-of-threads-process-linux.html

|

||||

|

||||

作者:[Dan Nanni][a]

|

||||

译者:[strugglingyouth](https://github.com/strugglingyouth)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://ask.xmodulo.com/author/nanni

|

||||

[1]:http://ask.xmodulo.com/view-threads-process-linux.html

|

||||

[1]:https://linux.cn/article-5633-1.html

|

||||

@ -1,16 +1,16 @@

|

||||

Docker Working on Security Components, Live Container Migration

|

||||

Docker 在安全组件、实时容器迁移方面的进展

|

||||

================================================================================

|

||||

|

||||

|

||||

**Docker 开发者在 Containercon 上的演讲,谈论将来的容器在安全和实时迁移方面的创新**

|

||||

**这是 Docker 开发者在 Containercon 上的演讲,谈论将来的容器在安全和实时迁移方面的创新**

|

||||

|

||||

来自西雅图的消息。当前 IT 界最热的词汇是“容器”,美国有两大研讨会:Linuxcon USA 和 Containercon,后者就是为容器而生的。

|

||||

|

||||

Docker 公司是开源 Docker 项目的商业赞助商,本次研讨会这家公司有 3 位高管带来主题演讲,但公司创始人 Solomon Hykes 没上场演讲。

|

||||

|

||||

Hykes 曾在 2014 年的 Linuxcon 上进行过一次主题演讲,但今年的 Containeron 他只坐在观众席上。而工程部高级副总裁 Marianna Tessel、Docker 首席安全员 Diogo Monica 和核心维护员 Michael Crosby 为我们演讲 Docker 新增的功能和将来会有的功能。

|

||||

Hykes 曾在 2014 年的 Linuxcon 上进行过一次主题演讲,但今年的 Containeron 他只坐在观众席上。而工程部高级副总裁 Marianna Tessel、Docker 首席安全官 Diogo Monica 和核心维护员 Michael Crosby 为我们演讲 Docker 新增的功能和将来会有的功能。

|

||||

|

||||

Tessel 强调 Docker 现在已经被很多世界上最大的组织用在生产环境中,包括美国政府。Docker 也被用在小环境中,比如树莓派,一块树莓派上可以跑 2300 个容器。

|

||||

Tessel 强调 Docker 现在已经被很多世界上大型组织用在生产环境中,包括美国政府。Docker 也被用在小环境中,比如树莓派,一块树莓派上可以跑 2300 个容器。

|

||||

|

||||

“Docker 的功能正在变得越来越强大,而部署方法变得越来越简单。”Tessel 在会上说道。

|

||||

|

||||

@ -18,9 +18,9 @@ Tessel 把 Docker 形容成一艘游轮,内部由强大而复杂的机器驱

|

||||

|

||||

Docker 试图解决的领域是简化安全配置。Tessel 认为对于大多数用户和组织来说,避免网络漏洞所涉及的安全问题是一个乏味而且复杂的过程。

|

||||

|

||||

于是 Docker Content Trust 就出现在 Docker 1.8 release 版本中了。安全项目领导 Diogo Mónica 中加入 Tessel 上台讨论,说安全是一个难题,而 Docker Content Trust 就是为解决这个难道而存在的。

|

||||

于是 Docker Content Trust 就出现在 Docker 1.8 release 版本中了。安全项目领导 Diogo Mónica 中加入了 Tessel 的台上讨论,说安全是一个难题,而 Docker Content Trust 就是为解决这个难道而存在的。

|

||||

|

||||

Docker Content Trusst 提供一种方法来验证一个 Docker 应用是否可信,以及多种方法来限制欺骗和病毒注入。

|

||||

Docker Content Trust 提供一种方法来验证一个 Docker 应用是否可信,以及多种方法来限制欺骗和病毒注入。

|

||||

|

||||

为了证明他的观点,Monica 做了个现场示范,演示 Content Trust 的效果。在一个实验中,一个网站在更新过程中其 Web App 被人为攻破,而当 Content Trust 启动后,这个黑客行为再也无法得逞。

|

||||

|

||||

@ -32,7 +32,7 @@ Docker 首席维护员 Micheal Crosby 在台上做了个实时迁移的演示,

|

||||

|

||||

一个容器也可以克隆到另一个地方,Crosby 将他的克隆容器称为“多利”,就是世界上第一只被克隆出来的羊的名字。

|

||||

|

||||

Tessel 也花了点时间聊了下 RunC 组件,这是个正在被 Open Container Initiative 作为多方开发的项目,目的是让窗口兼容 Linux、Windows 和 Solaris。

|

||||

Tessel 也花了点时间聊了下 RunC 组件,这是个正在被 Open Container Initiative 作为多方开发的项目,目的是让它可以从 Linux 扩展到包括 Windows 和 Solaris 在内的多种操作系统。

|

||||

|

||||

Tessel 总结说她不知道 Docker 的未来是什么样,但对此抱非常乐观的态度。

|

||||

|

||||

@ -46,7 +46,7 @@ via: http://www.eweek.com/virtualization/docker-working-on-security-components-l

|

||||

|

||||

作者:[Sean Michael Kerner][a]

|

||||

译者:[bazz2](https://github.com/bazz2)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,14 +1,15 @@

|

||||

网络管理命令行工具基础,Nmcli

|

||||

Nmcli 网络管理命令行工具基础

|

||||

================================================================================

|

||||

|

||||

|

||||

|

||||

### 介绍 ###

|

||||

|

||||

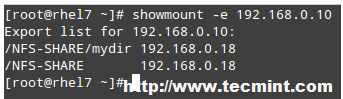

在本教程中,我们会在CentOS / RHEL 7中讨论网络管理工具,也叫**nmcli**。那些使用**ifconfig**的用户应该在CentOS 7中避免使用这个命令。

|

||||

在本教程中,我们会在CentOS / RHEL 7中讨论网络管理工具(NetworkManager command line tool),也叫**nmcli**。那些使用**ifconfig**的用户应该在CentOS 7中避免使用**ifconfig** 了。

|

||||

|

||||

让我们用nmcli工具配置一些网络设置。

|

||||

|

||||

### 要得到系统中所有接口的地址信息 ###

|

||||

#### 要得到系统中所有接口的地址信息 ####

|

||||

|

||||

[root@localhost ~]# ip addr show

|

||||

|

||||

@ -27,13 +28,13 @@

|

||||

inet6 fe80::20c:29ff:fe67:2f4c/64 scope link

|

||||

valid_lft forever preferred_lft forever

|

||||

|

||||

#### 检索与连接的接口相关的数据包统计 ####

|

||||

#### 检索与已连接的接口相关的数据包统计 ####

|

||||

|

||||

[root@localhost ~]# ip -s link show eno16777736

|

||||

|

||||

**示例输出:**

|

||||

|

||||

|

||||

|

||||

|

||||

#### 得到路由配置 ####

|

||||

|

||||

@ -50,11 +51,11 @@

|

||||

|

||||

输出像traceroute,但是更加完整。

|

||||

|

||||

|

||||

|

||||

|

||||

### nmcli 工具 ###

|

||||

|

||||

**Nmcli** 是一个非常丰富和灵活的命令行工具。nmcli使用的情况有:

|

||||

**nmcli** 是一个非常丰富和灵活的命令行工具。nmcli使用的情况有:

|

||||

|

||||

- **设备** – 正在使用的网络接口

|

||||

- **连接** – 一组配置设置,对于一个单一的设备可以有多个连接,可以在连接之间切换。

|

||||

@ -63,7 +64,7 @@

|

||||

|

||||

[root@localhost ~]# nmcli connection show

|

||||

|

||||

|

||||

|

||||

|

||||

#### 得到特定连接的详情 ####

|

||||

|

||||

@ -71,7 +72,7 @@

|

||||

|

||||

**示例输出:**

|

||||

|

||||

|

||||

|

||||

|

||||

#### 得到网络设备状态 ####

|

||||

|

||||

@ -89,7 +90,7 @@

|

||||

|

||||

这里,

|

||||

|

||||

- **Connection add** – 添加新的连接

|

||||

- **connection add** – 添加新的连接

|

||||

- **con-name** – 连接名

|

||||

- **type** – 设备类型

|

||||

- **ifname** – 接口名

|

||||

@ -100,7 +101,7 @@

|

||||

|

||||

Connection 'dhcp' (163a6822-cd50-4d23-bb42-8b774aeab9cb) successfully added.

|

||||

|

||||

#### 不同过dhcp分配IP,使用“static”添加地址 ####

|

||||

#### 不通过dhcp分配IP,使用“static”添加地址 ####

|

||||

|

||||

[root@localhost ~]# nmcli connection add con-name "static" ifname eno16777736 autoconnect no type ethernet ip4 192.168.1.240 gw4 192.168.1.1

|

||||

|

||||

@ -112,25 +113,23 @@

|

||||

|

||||

[root@localhost ~]# nmcli connection up eno1

|

||||

|

||||

Again Check, whether ip address is changed or not.

|

||||

再检查一遍,ip地址是否已经改变

|

||||

|

||||

[root@localhost ~]# ip addr show

|

||||

|

||||

|

||||

|

||||

|

||||

#### 添加DNS设置到静态连接中 ####

|

||||

|

||||

[root@localhost ~]# nmcli connection modify "static" ipv4.dns 202.131.124.4

|

||||

|

||||

#### 添加额外的DNS值 ####

|

||||

#### 添加更多的DNS ####

|

||||

|

||||

[root@localhost ~]# nmcli connection modify "static" +ipv4.dns 8.8.8.8

|

||||

[root@localhost ~]# nmcli connection modify "static" +ipv4.dns 8.8.8.8

|

||||

|

||||

**注意**:要使用额外的**+**符号,并且要是**+ipv4.dns**,而不是**ip4.dns**。

|

||||

|

||||

|

||||

添加一个额外的ip地址:

|

||||

####添加一个额外的ip地址####

|

||||

|

||||

[root@localhost ~]# nmcli connection modify "static" +ipv4.addresses 192.168.200.1/24

|

||||

|

||||

@ -138,11 +137,11 @@ Again Check, whether ip address is changed or not.

|

||||

|

||||

[root@localhost ~]# nmcli connection up eno1

|

||||

|

||||

|

||||

|

||||

|

||||

你会看见,设置生效了。

|

||||

|

||||

完结

|

||||

完结。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -150,6 +149,6 @@ via: http://www.unixmen.com/basics-networkmanager-command-line-tool-nmcli/

|

||||

|

||||

作者:Rajneesh Upadhyay

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

@ -1,44 +1,45 @@

|

||||

修复安装完 Ubuntu 后无可引导设备错误

|

||||

修复安装完 Ubuntu 后无可引导设备的错误

|

||||

================================================================================

|

||||

通常情况下,我启动 Ubuntu 和 Windows 双系统,但是这次我决定完全消除 Windows 纯净安装 Ubuntu。纯净安装 Ubuntu 完成后,结束时屏幕输出 **no bootable device found** 而不是进入 GRUB 界面。显然,安装搞砸了 UEFI 引导设置。

|

||||

|

||||

通常情况下,我会安装启动 Ubuntu 和 Windows 的双系统,但是这次我决定完全消除 Windows 纯净安装 Ubuntu。纯净安装 Ubuntu 完成后,结束时屏幕输出 **无可引导设备(no bootable device found)** 而不是进入 GRUB 界面。显然,安装搞砸了 UEFI 引导设置。

|

||||

|

||||

|

||||

|

||||

我会告诉你我是如何修复**在宏碁笔记本上安装 Ubuntu 后出现无可引导设备错误**。我声明了我使用的是宏碁灵越 R13,这很重要,因为我们需要更改固件设置,而这些设置可能因制造商和设备有所不同。

|

||||

我会告诉你我是如何修复**在宏碁笔记本上安装 Ubuntu 后出现无可引导设备错误**的。我声明了我使用的是宏碁灵越 R13,这很重要,因为我们需要更改固件设置,而这些设置可能因制造商和设备有所不同。

|

||||

|

||||

因此在你开始这里介绍的步骤之前,先看一下发生这个错误时我计算机的状态:

|

||||

|

||||

- 我的宏碁灵越 R13 预装了 Windows8.1 和 UEFI 引导管理器

|

||||

- 关闭了 Secure boot(我的笔记本刚维修过,维修人员又启用了它,直到出现了问题我才发现)。你可以阅读这篇博文了解[如何在宏碁笔记本中关闭 secure boot][1]

|

||||

- 我通过选择清除所有东西安装 Ubuntu,例如现有的 Windows 8.1,各种分区等。

|

||||

- 我的宏碁灵越 R13 预装了 Windows 8.1 和 UEFI 引导管理器

|

||||

- 安全引导( Secure boot)没有关闭,(我的笔记本刚维修过,维修人员又启用了它,直到出现了问题我才发现)。你可以阅读这篇博文了解[如何在宏碁笔记本中关闭安全引导(secure boot)][1]

|

||||

- 我选择了清除所有东西安装 Ubuntu,例如现有的 Windows 8.1,各种分区等

|

||||

- 安装完 Ubuntu 之后,从硬盘启动时我看到无可引导设备错误。但能从 USB 设备正常启动

|

||||

|

||||

在我看来,没有禁用 secure boot 可能是这个错误的原因。但是,我没有数据支撑我的观点。这仅仅是预感。有趣的是,双系统启动 Windows 和 Linux 经常会出现这两个 Grub 问题:

|

||||

在我看来,没有禁用安全引导(secure boot)可能是这个错误的原因。但是,我没有数据支撑我的观点。这仅仅是预感。有趣的是,双系统启动 Windows 和 Linux 经常会出现这两个 Grub 问题:

|

||||

|

||||

- [error: no such partition grub rescue][2]

|

||||

- [Minimal BASH like line editing is supported][3]

|

||||

- [错误:没有 grub 救援分区][2]

|

||||

- [支持最小化 BASH 式的行编辑][3]

|

||||

|

||||

如果你遇到类似的情况,你可以试试我的修复方法。

|

||||

|

||||

### 修复安装完 Ubuntu 后无可引导设备错误 ###

|

||||

|

||||

请原谅我没有丰富的图片。我的一加相机不能很好地拍摄笔记本屏幕。

|

||||

请原谅我的图片质量很差。我的一加相机不能很好地拍摄笔记本屏幕。

|

||||

|

||||

#### 第一步 ####

|

||||

|

||||

关闭电源并进入 boot 设置。我需要在宏碁灵越 R13 上快速地按 Fn+F2。如果你使用固态硬盘的话要按的非常快,因为固态硬盘启动速度很快。取决于你的制造商,你可能要用 Del 或 F10 或者 F12。

|

||||

关闭电源并进入引导设置。我需要在宏碁灵越 R13 上快速地按下 Fn+F2。如果你使用固态硬盘的话要按的非常快,因为固态硬盘启动速度很快。这取决于你的制造商,你可能要用 Del 或 F10 或者 F12。

|

||||

|

||||

#### 第二步 ####

|

||||

|

||||

在 boot 设置中,确保启用了 Secure Boot。它在 Boot 标签里。

|

||||

在引导设置中,确保启用了 Secure Boot。它在 Boot 标签里。

|

||||

|

||||

#### 第三步 ####

|

||||

|

||||

进入到 Security 标签,查找 “Select an UEFI file as trusted for executing” 并敲击回车。

|

||||

进入到 Security 标签,找到 “选择一个用于执行的可信任 UEFI 文件(Select an UEFI file as trusted for executing)” 并敲击回车。

|

||||

|

||||

|

||||

|

||||

特意说明,我们这一步是要在你的设备中添加 UEFI 设置文件(安装 Ubuntu 的时候生成)到可信 UEFI 启动。如果你记得的话,UEFI 启动的主要目的是提供安全性,由于(可能)没有禁用 Secure Boot,设备不会试图从新安装的操作系统中启动。添加它到类似白名单的可信列表,会使设备从 Ubuntu UEFI 文件启动。

|

||||

特意说明,我们这一步是要在你的设备中添加 UEFI 设置文件(安装 Ubuntu 的时候生成)到可信 UEFI 启动中。如果你记得的话,UEFI 启动的主要目的是提供安全性,由于(可能)没有禁用安全引导(Secure Boot),设备不会试图从新安装的操作系统中启动。添加它到类似白名单的可信列表,会使设备从 Ubuntu UEFI 文件启动。

|

||||

|

||||

#### 第四步 ####

|

||||

|

||||

@ -48,13 +49,13 @@

|

||||

|

||||

#### 第五步 ####

|

||||

|

||||

你应该可以看到 <EFI>,敲击回车。

|

||||

你应该可以看到 \<EFI> 了,敲击回车。

|

||||

|

||||

|

||||

|

||||

#### 第六步 ####

|

||||

|

||||

在下一个屏幕中你会看到 <Ubuntu>。耐心点,马上就好了。

|

||||

在下一个屏幕中你会看到 \<Ubuntu>。耐心点,马上就好了。

|

||||

|

||||

|

||||

|

||||

@ -71,7 +72,7 @@

|

||||

|

||||

#### 第八步 ####

|

||||

|

||||

当我们添加它到可信 EFI 文件并执行时,按 F10 保存并退出。

|

||||

当我们添加它到可信 EFI 文件并执行后,按 F10 保存并退出。

|

||||

|

||||

|

||||

|

||||

@ -87,7 +88,7 @@ via: http://itsfoss.com/no-bootable-device-found-ubuntu/

|

||||

|

||||

作者:[Abhishek][a]

|

||||

译者:[ictlyh](http://www.mutouxiaogui.cn/blog/)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,17 +1,19 @@

|

||||

为Antergos与Arch Linux添加印度语和梵文支持

|

||||

也许你需要在 Antergos 与 Arch Linux 中查看印度语和梵文?

|

||||

================================================================================

|

||||

|

||||

|

||||

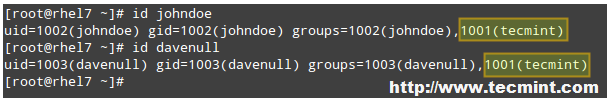

你们到目前或许知道,我最近一直在尝试体验[Antergos Linux][1]。在安装完[Antergos][2]后我所首先注意到的一些事情是在默认的Chromium浏览器中**没法正确显示印度语脚本**。

|

||||

你们到目前或许知道,我最近一直在尝试体验 [Antergos Linux][1]。在安装完[Antergos][2]后我所首先注意到的一些事情是在默认的 Chromium 浏览器中**没法正确显示印度语脚本**。

|

||||

|

||||

这是一件奇怪的事情,在我之前桌面Linux的体验中是从未遇到过的。起初,我认为是浏览器的问题,所以我安装了Firefox,然而问题依旧,Firefox也不能正确显示印度语。和Chromium不显示任何东西不同的是,Firefox确实显示了一些东西,但是毫无可读性。

|

||||

|

||||

|

||||

Chromium中的印度语显示

|

||||

|

||||

*Chromium中的印度语显示*

|

||||

|

||||

|

||||

|

||||

Firefox中的印度语显示

|

||||

|

||||

*Firefox中的印度语显示*

|

||||

|

||||

奇怪吧?那么,默认情况下基于Arch的Antergos Linux中没有印度语的支持吗?我没有去验证,但是我假设其它基于梵语脚本的印地语之类会产生同样的问题。

|

||||

|

||||

@ -37,7 +39,7 @@ via: http://itsfoss.com/display-hindi-arch-antergos/

|

||||

|

||||

作者:[Abhishek][a]

|

||||

译者:[GOLinux](https://github.com/GOLinux)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

66

published/20150826 Five Super Cool Open Source Games.md

Normal file

66

published/20150826 Five Super Cool Open Source Games.md

Normal file

@ -0,0 +1,66 @@

|

||||

五大超酷的开源游戏

|

||||

================================================================================

|

||||

|

||||

在2014年和2015年,Linux 涌入了一堆流行的付费游戏,例如备受欢迎的无主之地(Borderlands)、巫师(Witcher)、死亡岛(Dead Island) 和 CS 系列游戏。虽然这是令人激动的消息,但玩家有这个支出预算吗?付费游戏很好,但更好的是由了解玩家喜好的开发者开发的免费的替代品。

|

||||

|

||||

前段时间,我偶然看到了一个三年前发布的 YouTube 视频,标题非常的有正能量 [5个不算糟糕的开源游戏][1]。虽然视频表扬了一些开源游戏,我还是更喜欢用一个更加热情的方式来切入这个话题,至少如标题所说。所以,下面是我的一份五大超酷开源游戏的清单。

|

||||

|

||||

### Tux Racer ###

|

||||

|

||||

|

||||

|

||||

*Tux Racer*

|

||||

|

||||

[《Tux Racer》][2]是这份清单上的第一个游戏,因为我对这个游戏很熟悉。最近,我的兄弟和我为了参加[玩电脑的孩子们][4]项目,在[去墨西哥的路途中][3],Tux Racer 是孩子和教师都喜欢玩的游戏之一。在这个游戏中,玩家使用 Linux 吉祥物——企鹅 Tux——在下山雪道上以计时赛的方式进行比赛。玩家们不断挑战他们自己的最佳纪录。目前还没有多玩家版本,但这是有可能改变的。它适用于 Linux、OS X、Windows 和 Android。

|

||||

|

||||

### Warsow ###

|

||||

|

||||

|

||||

|

||||

*Warsow*

|

||||

|

||||

[《Warsow》][5]网站介绍道:“设定是有未来感的卡通世界,Warsow 是个完全开放的适用于 Windows、Linux 和 Mac OS X平台的快节奏第一人称射击游戏(FPS)。Warsow 是跨网络的尊重和体育精神的的艺术。(Warsow is the Art of Respect and Sportsmanship Over the Web. 大写回文字母组成 Warsow。)” 我很不情愿的把 FPS 类放到了这个列表中,因为很多人玩过这类的游戏,但是我的确被 Warsow 打动了。它对很多动作进行了优先级排序,游戏节奏很快,一开始就有八个武器。卡通化的风格让玩的过程变得没有那么严肃,更加的休闲,非常适合和亲友一同玩。然而,它却以充满竞争的游戏自居,并且当我体验这个游戏时,我发现周围确实有一些专家级的玩家。它适用于 Linux、Windows 和 OS X。

|

||||

|

||||

### M.A.R.S——一个荒诞的射击游戏 ###

|

||||

|

||||

|

||||

|

||||

*M.A.R.S.——一个荒诞的射击游戏*

|

||||

|

||||

[《M.A.R.S——一个荒诞的射击游戏》][6]之所以吸引人是因为它充满活力的色彩和画风。支持两个玩家使用同一个键盘,而一个在线多玩家版本目前正在开发中——这意味着想要和朋友们一起玩暂时还要等等。不论如何,它是个可以使用几个不同飞船和武器的有趣的太空射击游戏。飞船的形状不同,从普通的枪、激光、散射枪到更有趣的武器(随机出来的飞船中有一个会对敌人发射泡泡,这为这款混乱的游戏增添了很多乐趣)。游戏有几种模式,比如标准模式和对方进行殊死搏斗以获得高分或先达到某个分数线,还有其他的模式,空间球(Spaceball)、坟坑(Grave-itation Pit)和保加农炮(Cannon Keep)。它适用于 Linux、Windows 和 OS X。

|

||||

|

||||

### Valyria Tear ###

|

||||

|

||||

|

||||

|

||||

*Valyria Tear*

|

||||

|

||||

[Valyria Tear][7] 类似近年来拥有众多粉丝的角色扮演游戏(RPG)。故事设定在奇幻游戏的通用年代,充满了骑士、王国和魔法,以及主要角色 Bronann。设计团队在这个世界的设计上做的非常棒,实现了玩家对这类游戏所有的期望:隐藏的宝藏、偶遇的怪物、非玩家操纵角色(NPC)的互动以及所有 RPG 不可或缺的——在低级别的怪物上刷经验直到可以面对大 BOSS。我在试玩的时候,时间不允许我太过深入到这个游戏故事中,但是感兴趣的人可以看 YouTube 上由 Yohann Ferriera 用户发的‘[Let’s Play][8]’系列视频。它适用于 Linux、Windows 和 OS X。

|

||||

|

||||

### SuperTuxKart ###

|

||||

|

||||

|

||||

|

||||

*SuperTuxKart*

|

||||

|

||||

最后一个同样好玩的游戏是 [SuperTuxKart][9],一个效仿 Mario Kart(马里奥卡丁车)但丝毫不逊色的好游戏。它在2000年-2004年间开始以 Tux Kart 开发,但是在成品中有错误,结果开发就停止了几年。从2006年开始重新开发时起,它就一直在改进,直到四个月前0.9版首次发布。在游戏里,我们的老朋友 Tux 与马里奥和其他一些开源吉祥物一同开始。其中一个熟悉的面孔是 Suzanne,这是 Blender 的那只吉祥物猴子。画面很给力,游戏很流畅。虽然在线游戏还在计划阶段,但是分屏多玩家游戏是可以的。一个电脑最多可以供四个玩家同时玩。它适用于 Linux、Windows、OS X、AmigaOS 4、AROS 和 MorphOS。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://fossforce.com/2015/08/five-super-cool-open-source-games/

|

||||

|

||||

作者:Hunter Banks

|

||||

译者:[H-mudcup](https://github.com/H-mudcup)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[1]:https://www.youtube.com/watch?v=BEKVl-XtOP8

|

||||

[2]:http://tuxracer.sourceforge.net/download.html

|

||||

[3]:http://fossforce.com/2015/07/banks-family-values-texas-linux-fest/

|

||||

[4]:http://www.kidsoncomputers.org/an-amazing-week-in-oaxaca

|

||||

[5]:https://www.warsow.net/download

|

||||

[6]:http://mars-game.sourceforge.net/

|

||||

[7]:http://valyriatear.blogspot.com/

|

||||

[8]:https://www.youtube.com/channel/UCQ5KrSk9EqcT_JixWY2RyMA

|

||||

[9]:http://supertuxkart.sourceforge.net/

|

||||

@ -0,0 +1,110 @@

|

||||

mosh:一个基于 SSH 用于连接远程 Unix/Linux 系统的工具

|

||||

================================================================================

|

||||

Mosh 表示移动 Shell(Mobile Shell),是一个用于从客户端跨互联网连接远程服务器的命令行工具。它能用于 SSH 连接,但是比 Secure Shell 功能更多。它是一个类似于 SSH 而带有更多功能的应用。程序最初由 Keith Winstein 编写,用于类 Unix 的操作系统中,发布于GNU GPL v3协议下。

|

||||

|

||||

|

||||

|

||||

*Mosh Shell SSH 客户端*

|

||||

|

||||

#### Mosh的功能 ####

|

||||

|

||||

- 它是一个支持漫游的远程终端程序。

|

||||

- 在所有主流的类 Unix 版本中可用,如 Linux、FreeBSD、Solaris、Mac OS X 和 Android。

|

||||

- 支持不稳定连接

|

||||

- 支持智能的本地回显

|

||||

- 支持用户输入的行编辑

|

||||

- 响应式设计及在 wifi、3G、长距离连接下的鲁棒性

|

||||

- 在 IP 改变后保持连接。它使用 UDP 代替 TCP(在 SSH 中使用),当连接被重置或者获得新的 IP 后 TCP 会超时,但是 UDP 仍然保持连接。

|

||||

- 在很长的时候之后恢复会话时仍然保持连接。

|

||||

- 没有网络延迟。立即显示用户输入和删除而没有延迟

|

||||

- 像 SSH 那样支持一些旧的方式登录。

|

||||

- 包丢失处理机制

|

||||

|

||||

### Linux 中 mosh 的安装 ###

|

||||

|

||||

在 Debian、Ubuntu 和 Mint 类似的系统中,你可以很容易地用 [apt-get 包管理器][1]安装。

|

||||

|

||||

# apt-get update

|

||||

# apt-get install mosh

|

||||

|

||||

在基于 RHEL/CentOS/Fedora 的系统中,要使用 [yum 包管理器][3]安装 mosh,你需要打开第三方的 [EPEL][2]。

|

||||

|

||||

# yum update

|

||||

# yum install mosh

|

||||

|

||||

在 Fedora 22+的版本中,你需要使用 [dnf 包管理器][4]来安装 mosh。

|

||||

|

||||

# dnf install mosh

|

||||

|

||||

### 我该如何使用 mosh? ###

|

||||

|

||||

1、 让我们尝试使用 mosh 登录远程 Linux 服务器。

|

||||

|

||||

$ mosh root@192.168.0.150

|

||||

|

||||

|

||||

|

||||

*mosh远程连接*

|

||||

|

||||

**注意**:你有没有看到一个连接错误,因为我在 CentOS 7中还有打开这个端口。一个快速但是我并不建议的解决方法是:

|

||||

|

||||

# systemctl stop firewalld [在远程服务器上]

|

||||

|

||||

更好的方法是打开一个端口并更新防火墙规则。接着用 mosh 连接到预定义的端口中。至于更深入的细节,也许你会对下面的文章感兴趣。

|

||||

|

||||

- [如何配置 Firewalld][5]

|

||||

|

||||

2、 让我们假设把默认的 22 端口改到 70,这时使用 -p 选项来使用自定义端口。

|

||||

|

||||

$ mosh -p 70 root@192.168.0.150

|

||||

|

||||

3、 检查 mosh 的版本

|

||||

|

||||

$ mosh --version

|

||||

|

||||

|

||||

|

||||

*检查mosh版本*

|

||||

|

||||

4、 你可以输入`exit`来退出 mosh 会话。

|

||||

|

||||

$ exit

|

||||

|

||||

5、 mosh 支持很多选项,你可以用下面的方法看到:

|

||||

|

||||

$ mosh --help

|

||||

|

||||

|

||||

|

||||

*Mosh 选项*

|

||||

|

||||

#### mosh 的优缺点 ####

|

||||

|

||||

- mosh 有额外的需求,比如需要允许 UDP 直接连接,这在 SSH 不需要。

|

||||

- 动态分配的端口范围是 60000-61000。第一个打开的端口是分配好的。每个连接都需要一个端口。

|

||||

- 默认的端口分配是一个严重的安全问题,尤其是在生产环境中。

|

||||

- 支持 IPv6 连接,但是不支持 IPv6 漫游。

|

||||

- 不支持回滚

|

||||

- 不支持 X11 转发

|

||||

- 不支持 ssh-agent 转发

|

||||

|

||||

### 总结 ###

|

||||

|

||||

mosh是一款在大多数linux发行版的仓库中可以下载的一款小工具。虽然它有一些差异尤其是安全问题和额外的需求,它的功能,比如漫游后保持连接是一个加分点。我的建议是任何一个使用ssh的linux用户都应该试试这个程序,mosh值得一试。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.tecmint.com/install-mosh-shell-ssh-client-in-linux/

|

||||

|

||||

作者:[Avishek Kumar][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.tecmint.com/author/avishek/

|

||||

[1]:http://www.tecmint.com/useful-basic-commands-of-apt-get-and-apt-cache-for-package-management/

|

||||

[2]:https://linux.cn/article-2324-1.html

|

||||

[3]:http://www.tecmint.com/20-linux-yum-yellowdog-updater-modified-commands-for-package-mangement/

|

||||

[4]:http://www.tecmint.com/dnf-commands-for-fedora-rpm-package-management/

|

||||

[5]:http://www.tecmint.com/configure-firewalld-in-centos-7/

|

||||

63

published/20150901 Is Linux Right For You.md

Normal file

63

published/20150901 Is Linux Right For You.md

Normal file

@ -0,0 +1,63 @@

|

||||

Linux 系统是否适合于您?

|

||||

================================================================================

|

||||

> 并非人人都适合使用 Linux --对许多用户来说,Windows 或 OSX 会是更好的选择。

|

||||

|

||||

我喜欢使用 Linux 桌面系统,并不是因为软件的政治性质,也不是不喜欢其它操作系统。我喜欢 Linux 系统因为它能满足我的需求并且确实适合使用。

|

||||

|

||||

我的经验是,并非人人都适合切换至“Linux 的生活方式”。本文将帮助您通过分析使用 Linux 系统的利弊来供您自行判断使用 Linux 是否真正适合您。

|

||||

|

||||

### 什么时候更换系统? ###

|

||||

|

||||

当有充分的理由时,将系统切换到 Linux 系统是很有意义的。这对 Windows 用户将系统更换到 OSX 或类似的情况都同样适用。为让您的系统转变成功,您必须首先确定为什么要做这种转换。

|

||||

|

||||

对某些人来说,更换系统通常意味着他们不满于当前的系统操作平台。也许是最新的升级给了他们糟糕的用户体验,而他们也已准备好更换到别的系统,也许仅仅是因为对某个系统好奇。不管动机是什么,必须要有充分的理由支撑您做出更换操作系统的决定。如果没有一个充足的原因让您这样做,往往不会成功。

|

||||

|

||||

然而事事都有例外。如果您确实对 Linux 桌面非常感兴趣,或许可以选择一种折衷的方式。

|

||||

|

||||

### 放慢起步的脚步 ###

|

||||

|

||||

第一次尝试运行 Linux 系统后,我看到就有人开始批判 Windows 安装过程的费时,完全是因为他们20分钟就用闪存安装好 Ubuntu 的良好体验。但是伙伴们,这并不只是一次测验。相反,我有如下建议:

|

||||

|

||||

- 用一周的时间尝试在[虚拟机上运行 Linux 系统][1]。这意味着您将在该系统上执行所有的浏览器工作、邮箱操作和其它想要完成的任务。

|

||||

- 如果运行虚拟机资源消耗太大,您可以尝试用提供了[一些持久存储][2]的 USB 驱动器来运行 Linux,您的主操作系统将不受任何影响。与此同时,您仍可以运行 Linux 系统。

|

||||

- 运行 Linux 系统一周后,如果一切进展顺利,下一步您可以计算一下这周内登入 Windows 的次数。如果只是偶尔登录 Windows 系统,下一步就可以尝试运行 Windows 和 Linux 的[双系统][3]。对那些只运行了 Linux 系统的用户,可以考虑尝试将系统真正更换为 Linux 系统。

|

||||

- 在你完全删除 Windows 分区前,更应该购买一个新硬盘来安装 Linux 系统。这样有了充足的硬盘空间,您就可以使用双系统。如果必须要启动 Windows 系统做些事情的话,Windows 系统也是可以运行的。

|

||||

|

||||

### 使用 Linux 系统的好处是什么? ###

|

||||

|

||||

将系统更换到 Linux 有什么好处呢?一般而言,这种好处对大多数人来说可以归结到释放个性自由。在使用 Linux 系统的时候,如果您不喜欢某些设置,可以自行更改它们。同时使用 Linux 可以为用户节省大量的硬件升级开支和不必要的软件开支。另外,您不需再费力找寻已丢失的软件许可证密钥,而且如果您不喜欢即将发布的系统版本,大可轻松地更换到别的版本。

|

||||

|

||||

在 Linux 桌面方面可以选择的桌面种类是惊人的多,看起来对新手来说做这种选择非常困难。但是如果您发现了喜欢的一款 Linux 版本(Debian、Fedora、Arch等),最困难的工作其实已经完成了,您需要做的就是找到各版本的区别并选择出您最喜欢的系统版本环境。

|

||||

|

||||

如今我听到的最常见的抱怨之一是用户发现没有太多的软件能适用于 Linux 系统。然而,这并不是事实。尽管别的操作系统可能会提供更多软件,但是如今的 Linux 也已经提供了足够多应用程序满足您的各种需求,包括视频剪辑(家用和专业级)、摄影、办公管理软件、远程访问、音乐软件、等等等等。

|

||||

|

||||

### 使用 Linux 系统您会失去些什么? ###

|

||||

|

||||

虽然我喜欢使用 Linux,但我妻子的家庭办公依然依赖于 OS X。对于用 Linux 系统完成一些特定的任务她心满意足,但是她需要 OS X 来运行一些不支持 Linux 的软件。这是许多想要更换系统的用户会遇到的一个常见的问题。如果要更换系统,您需要考虑是否愿意失去一些关键的软件工具。

|

||||

|

||||

有时这个问题是因为软件的数据只能用该软件打开。别的情况下,是传统应用程序的工作流和功能并不适用于在 Linux 系统上可运行的软件。我自己并没有遇到过这类问题,但是我知道确实存在这些问题。许多 Linux 上的软件在其它操作系统上也都可以用。所以如果担心这类软件兼容问题,建议您先尝试在已有的系统上操作一下几款类似的应用程序。

|

||||

|

||||

更换成 Linux 系统后,另一件您可能会失去的是本地系统支持服务。人们通常会嘲笑这种愚蠢行径,但我知道,无数的新手在使用 Linux 时会发现解决 Linux 上各种问题的唯一资源就是来自网络另一端的陌生人提供的帮助。如果只是他们的 PC 遇到了一些问题,这将会比较麻烦。Windows 和 OS X 的用户已经习惯各城市遍布了支持他们操作系统的各项技术服务。

|

||||

|

||||

### 如何开启新旅程? ###

|

||||

|

||||

这里建议大家要记住最重要的就是总要有个回退方案。如果您将 Windows 10 从硬盘中擦除,您会发现重新安装它又会花费金钱。对那些从其它 Windows 发布版本升级的用户来说尤其会遇到这种情况。请接受这个建议,对新手来说使用闪存安装 Linux 或使用 Windows 和 Linux 双系统都是更值得提倡的做法。您也许会如鱼得水般使用 Linux系统,但是有了一份回退方案,您将高枕无忧。

|

||||

|

||||

相反,如果数周以来您一直依赖于使用双操作系统,但是已经准备好冒险去尝试一下单操作系统,那么就去做吧。格式化您的驱动器,重新安装您喜爱的 Linux 发行版。数年来我一直都是“全职” Linux 使用爱好者,这里可以确定地告诉您,使用 Linux 系统感觉棒极了。这种感觉会持续多久?我第一次的 Linux 系统使用经验还是来自早期的 Red Hat 系统,最终在2003年,我在自己的笔记本上整个安装了 Linux 系统。

|

||||

|

||||

Linux 爱好者们,你们什么时候开始使用 Linux 的?您在最初更换成 Linux 系统时是兴奋还是焦虑呢?欢迎点击评论分享你们的经验。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.datamation.com/open-source/is-linux-right-for-you.html

|

||||

|

||||

作者:[Matt Hartley][a]

|

||||

译者:[icybreaker](https://github.com/icybreaker)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.datamation.com/author/Matt-Hartley-3080.html

|

||||

[1]:http://www.psychocats.net/ubuntu/virtualbox

|

||||

[2]:http://www.howtogeek.com/howto/14912/create-a-persistent-bootable-ubuntu-usb-flash-drive/

|

||||

[3]:http://www.linuxandubuntu.com/home/dual-boot-ubuntu-15-04-14-10-and-windows-10-8-1-8-step-by-step-tutorial-with-screenshots

|

||||

@ -18,9 +18,9 @@ Elementary OS 它自己本身借鉴了 OS X,也就不奇怪它的很多第三

|

||||

|

||||

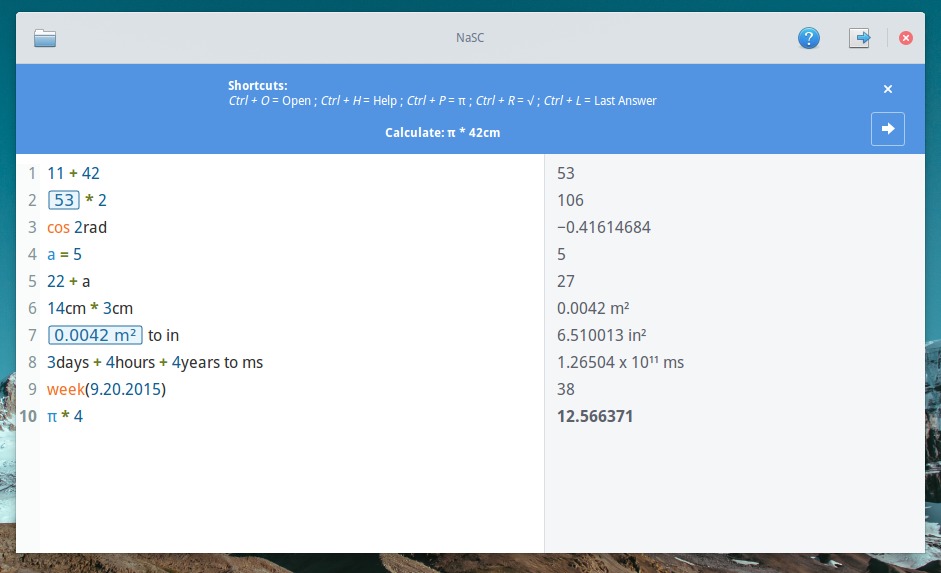

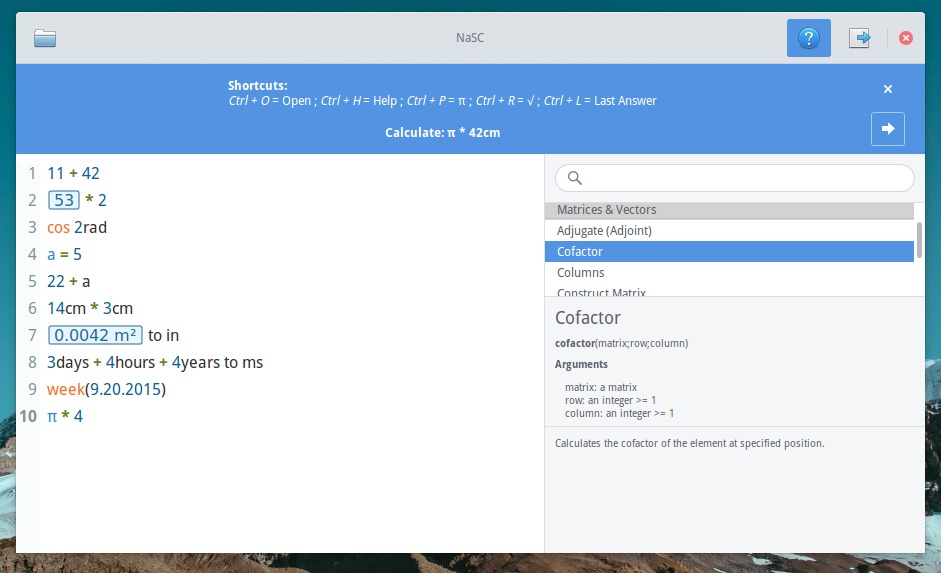

### 在 Ubuntu、Elementary OS 和 Mint 上安装 NaSC ###

|

||||

|

||||

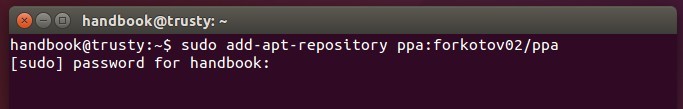

安装 NaSC 有一个可用的 PPA。PPA 中说 ‘每日’,意味着所有构建(包括不稳定),但作为我的快速测试,并没什么影响。

|

||||

安装 NaSC 有一个可用的 PPA。PPA 是 ‘每日’,意味着每日构建(意即,不稳定),但作为我的快速测试,并没什么影响。

|

||||

|

||||

打卡一个终端并运行下面的命令:

|

||||

打开一个终端并运行下面的命令:

|

||||

|

||||

sudo apt-add-repository ppa:nasc-team/daily

|

||||

sudo apt-get update

|

||||

@ -35,7 +35,7 @@ Elementary OS 它自己本身借鉴了 OS X,也就不奇怪它的很多第三

|

||||

sudo apt-get remove nasc

|

||||

sudo apt-add-repository --remove ppa:nasc-team/daily

|

||||

|

||||

如果你试用了这个软件,要分享你的经验哦。除此之外,你也可以在第三方 Elementary OS 应用中体验[Vocal podcast app for Linux][3]。

|

||||

如果你试用了这个软件,要分享你的经验哦。除此之外,你也可以在第三方 Elementary OS 应用中体验 [Vocal podcast app for Linux][3]。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

@ -43,7 +43,7 @@ via: http://itsfoss.com/math-ubuntu-nasc/

|

||||

|

||||

作者:[Abhishek][a]

|

||||

译者:[ictlyh](http://www.mutouxiaogui.cn/blog/)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,40 +1,33 @@

|

||||

在 Ubuntu 上安装 Qmmp 0.9.0 类似 Winamp 的音频播放器

|

||||

在 Ubuntu 上安装类 Winamp 的音频播放器 Qmmp 0.9.0

|

||||

================================================================================

|

||||

|

||||

|

||||

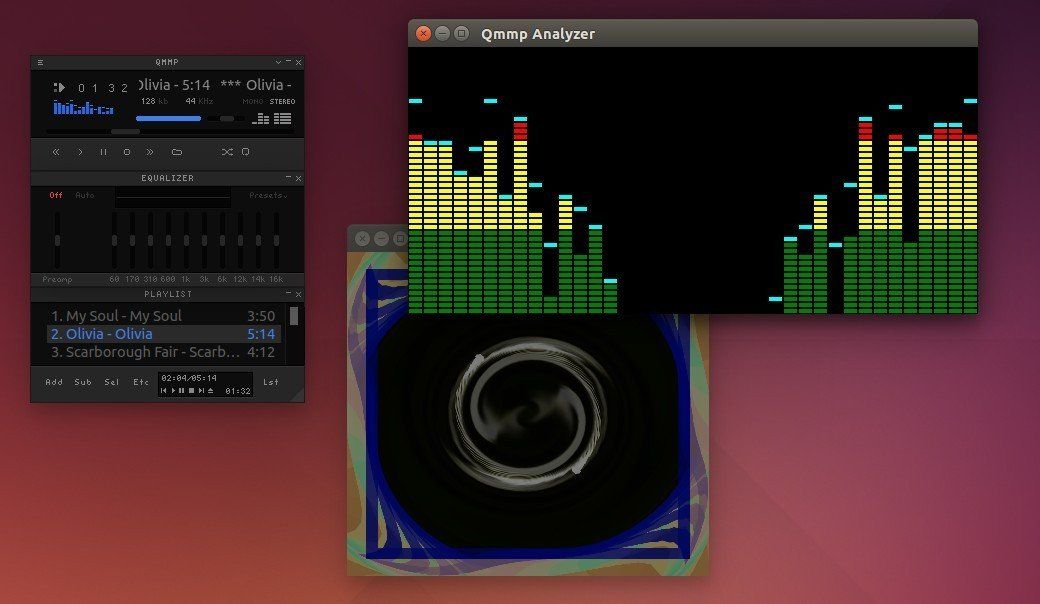

Qmmp,基于 Qt 的音频播放器,与 Winamp 或 xmms 的用户界面类似,现在最新版本是0.9.0。PPA 已经在 Ubuntu 15.10,Ubuntu 15.04,Ubuntu 14.04,Ubuntu 12.04 和其衍生物中已经更新了。

|

||||

Qmmp,一个基于 Qt 的音频播放器,与 Winamp 或 xmms 的用户界面类似,现在最新版本是0.9.0。PPA 已经在 Ubuntu 15.10,Ubuntu 15.04,Ubuntu 14.04,Ubuntu 12.04 和其衍生版本中已经更新了。

|

||||

|

||||

Qmmp 0.9.0 是一个较大的版本,有许多新的功能,有许多改进和新的转变。它添加了如下功能:

|

||||

|

||||

- 音频-信道序列转换器;

|

||||

- 9通道支持均衡器;

|

||||

- 艺术家专辑标签支持;

|

||||

- 支持艺术家专辑标签;

|

||||

- 异步排序;

|

||||

- 通过文件的修改日期排序;

|

||||

- 按艺术家专辑排序;

|

||||

- 支持多专栏;

|

||||

- 有隐藏踪迹长度功能;

|

||||

- 不用修改 qmmp.pri 来禁用插件(仅在 qmake 中)功能

|

||||

- 记住播放列表滚动位置功能;

|

||||

- 排除提示数据文件功能;

|

||||

- 排除 cue 数据文件功能;

|

||||

- 更改用户代理功能;

|

||||

- 改变窗口标题功能;

|

||||

- 复位字体功能;

|

||||

- 恢复默认快捷键功能;

|

||||

- 默认热键为“Rename List”功能;

|

||||

- 功能禁用弹出的 GME 插件;

|

||||

- 简单的用户界面(QSUI)有以下变化:

|

||||

- 增加了多列表的支持;

|

||||

- 禁用 gme 插件淡出的功能;

|

||||

- 简单用户界面(QSUI)有以下变化:

|

||||

- 增加了多列的支持;

|

||||

- 增加了按艺术家专辑排序;

|

||||

- 增加了按文件的修改日期进行排序;

|

||||

- 增加了隐藏歌曲长度功能;

|

||||

- 增加了默认热键为“Rename List”;

|

||||

- 增加了“Rename List”的默认热键;

|

||||

- 增加了“Save List”功能到标签菜单;

|

||||

- 增加了复位字体功能;

|

||||

- 增加了复位快捷键功能;

|

||||

- 改进了状态栏;

|

||||

|

||||

它还改进了播放列表的通知,播放列表容器,采样率转换器,cmake 构建脚本,标题格式,在 mpeg 插件中支持 ape 标签,fileops 插件,降低了 cpu 占用率,改变默认的皮肤(炫光)和分离播放列表。

|

||||

它还改进了播放列表的改变通知,播放列表容器,采样率转换器,cmake 构建脚本,标题格式化,在 mpeg 插件中支持 ape 标签,fileops 插件,降低了 cpu 占用率,改变默认的皮肤(炫光)和分离的播放列表。

|

||||

|

||||

|

||||

|

||||

@ -42,7 +35,7 @@ Qmmp 0.9.0 是一个较大的版本,有许多新的功能,有许多改进和

|

||||

|

||||

新版本已经制做了 PPA,适用于目前所有 Ubuntu 发行版和衍生版。

|

||||

|

||||

1. 添加 [Qmmp PPA][1].

|

||||

1、 添加 [Qmmp PPA][1].

|

||||

|

||||

从 Dash 中打开终端并启动应用,通过按 Ctrl+Alt+T 快捷键。当它打开时,运行命令:

|

||||

|

||||

@ -50,7 +43,7 @@ Qmmp 0.9.0 是一个较大的版本,有许多新的功能,有许多改进和

|

||||

|

||||

|

||||

|

||||

2. 在添加 PPA 后,通过更新软件来升级 Qmmp 播放器。刷新系统缓存,并通过以下命令安装软件:

|

||||

2、 在添加 PPA 后,通过更新软件来升级 Qmmp 播放器。刷新系统缓存,并通过以下命令安装软件:

|

||||

|

||||

sudo apt-get update

|

||||

|

||||

@ -63,8 +56,8 @@ Qmmp 0.9.0 是一个较大的版本,有许多新的功能,有许多改进和

|

||||

via: http://ubuntuhandbook.org/index.php/2015/09/qmmp-0-9-0-in-ubuntu/

|

||||

|

||||

作者:[Ji m][a]

|

||||

译者:[译者ID](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

译者:[strugglingyouth](https://github.com/strugglingyouth)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,4 +1,4 @@

|

||||

在 Ubuntu 里,如何下载,安装和配置 Plank Dock

|

||||

在 Ubuntu 里如何下载、安装和配置 Plank Dock

|

||||

=============================================================================

|

||||

一个众所周知的事实就是,Linux 是一个用户可以高度自定义的系统,有很多选项可以选择 —— 作为操作系统,有各种各样的发行版,而对于单个发行版来说,又有很多桌面环境可以选择。与其他操作系统的用户一样,Linux 用户也有不同的口味和喜好,特别是对于桌面来说。

|

||||

|

||||

@ -8,7 +8,7 @@

|

||||

|

||||

### Plank ###

|

||||

|

||||

官方的文档描述 Plank 是“这个星球上最简洁的 dock”。该项目的目的就是提供一个 dock 仅需要的功能,尽管这是很基础的一个库,却可以被扩展,创造其他的含更多高级功能的 dock 程序。

|

||||

官方的文档描述 Plank 是“这个星球上最简洁的 dock”。该项目的目的就是仅提供一个 dock 需要的功能,尽管这是很基础的一个库,却可以被扩展,创造其他的含更多高级功能的 dock 程序。

|

||||

|

||||

这里值得一提的就是,在 elementary OS 里,Plank 是预装的。并且 Plank 是 Docky 的基础,Docky 也是一个非常流行的 dock 应用,在功能上与 Mac OS X 的 Dock 非常相似。

|

||||

|

||||

@ -30,11 +30,11 @@

|

||||

|

||||

|

||||

|

||||

正如上面图片显示的那样,dock 包含许多带橙色的应用图标,这表明这些应用正处于运行状态。无需说,你可以点击一个图标来打开那个应用。同时,右击一个应用图标会给出更多的选项,你可能会感兴趣。举个例子,该下面的屏幕快照:

|

||||

正如上面图片显示的那样,dock 包含许多带橙色标示的应用图标,这表明这些应用正处于运行状态。无需说,你可以点击一个图标来打开那个应用。同时,右击一个应用图标会给出更多的选项,你可能会感兴趣。举个例子,看下面的屏幕快照:

|

||||

|

||||

|

||||

|

||||

为了获得配置的选项,你不得不右击一下 Plank 的图标(左数第一个),然后点击 Preferences 选项。这就会产生接下来的窗口。

|

||||

为了获得配置的选项,你需要右击一下 Plank 的图标(左数第一个),然后点击 Preferences 选项。这就会出现如下的窗口。

|

||||

|

||||

|

||||

|

||||

@ -58,7 +58,7 @@ via: https://www.maketecheasier.com/download-install-configure-plank-dock-ubuntu

|

||||

|

||||

作者:[Himanshu Arora][a]

|

||||

译者:[wi-cuckoo](https://github.com/wi-cuckoo)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,4 +1,4 @@

|

||||

10条真心有趣的Linux命令

|

||||

10 条真心有趣的 Linux 命令

|

||||

================================================================================

|

||||

|

||||

**在终端工作是一件很有趣的事情。今天,我们将会列举一些有趣得为你带来欢笑的Linux命令。**

|

||||

@ -29,7 +29,7 @@

|

||||

|

||||

### 3. yes ###

|

||||

|

||||

#yes <string>

|

||||

# yes <string>

|

||||

|

||||

这个命令会不停打印字符串,直到用户把这进程给结束掉。

|

||||

|

||||

@ -38,6 +38,7 @@

|

||||

|

||||

|

||||

### 4. figlet ###

|

||||

|

||||

这个命令可以用apt-get安装,安装之后,在**/usr/share/figlet**可以看到一些ascii字体文件。

|

||||

|

||||

cd /usr/share/figlet

|

||||

@ -45,26 +46,25 @@

|

||||

----------

|

||||

|

||||

#figlet -f <font> <string>

|

||||

|

||||

e.g.

|

||||

|

||||

#figlet -f big.flf unixmen

|

||||

|

||||

|

||||

|

||||

#figlet -f block.flf unixmen

|

||||

#figlet -f block.flf unixmen

|

||||

|

||||

|

||||

|

||||

当然,你也可以尝试使用其他的选项。

|

||||

|

||||

### 5. asciiquarium ###

|

||||

|

||||

这个命令会将你的终端变成一个海洋馆。

|

||||

下载term animator

|

||||

|

||||

下载term animator:

|

||||

|

||||

# wget http://search.cpan.org/CPAN/authors/id/K/KB/KBAUCOM/Term-Animation-2.4.tar.gz

|

||||

|

||||

安装并且配置这个包

|

||||

安装并且配置这个包:

|

||||

|

||||

# tar -zxvf Term-Animation-2.4.tar.gz

|

||||

# cd Term-Animation-2.4/

|

||||

@ -75,14 +75,14 @@ e.g.

|

||||

|

||||

# apt-get install libcurses-perl

|

||||

|

||||

下载并且安装asciiquarium

|

||||

下载并且安装asciiquarium:

|

||||

|

||||

# wget http://www.robobunny.com/projects/asciiquarium/asciiquarium.tar.gz

|

||||

# tar -zxvf asciiquarium.tar.gz

|

||||

# cd asciiquarium_1.0/

|

||||

# cp asciiquarium /usr/local/bin/

|

||||

|

||||

执行如下命令

|

||||

执行如下命令:

|

||||

|

||||

# /usr/local/bin/asciiquarium

|

||||

|

||||

@ -176,8 +176,8 @@ aafire能让你的终端燃起来。

|

||||

via: http://www.unixmen.com/list-10-funny-linux-commands/

|

||||

|

||||

作者:[Rajneesh Upadhyay][a]

|

||||

译者:[tnuoccalanosrep](https://github.com/译者ID)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

译者:[tnuoccalanosrep](https://github.com/tnuoccalanosrep)

|

||||

校对:[wxy](https://github.com/校对者ID)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -1,14 +1,14 @@

|

||||

Linux有问必答--如何删除Ubuntu上不再使用的老内核

|

||||

Linux有问必答:如何删除Ubuntu上不再使用的旧内核

|

||||

================================================================================

|

||||

> **提问**:过去我已经在我的Ubuntu上升级了几次内核。现在我想要删除这些旧的内核镜像来节省我的磁盘空间。如何用最简单的方法删除Ubuntu上先前版本的内核?

|

||||

|

||||

在Ubuntu上,有几个方法来升级内核。在Ubuntu桌面中,软件更新允许你每天检查并更新到最新的内核上。在Ubuntu服务器上,一个无人值守的包会自动更新内核最为一项最要的安全更新。然而,你可以手动用apt-get或者aptitude命令来更新。

|

||||

在Ubuntu上,有几个方法来升级内核。在Ubuntu桌面中,软件更新允许你每天检查并更新到最新的内核上。在Ubuntu服务器上,最为重要的安全更新项目之一就是 unattended-upgrades 软件包会自动更新内核。然而,你也可以手动用apt-get或者aptitude命令来更新。

|

||||

|

||||

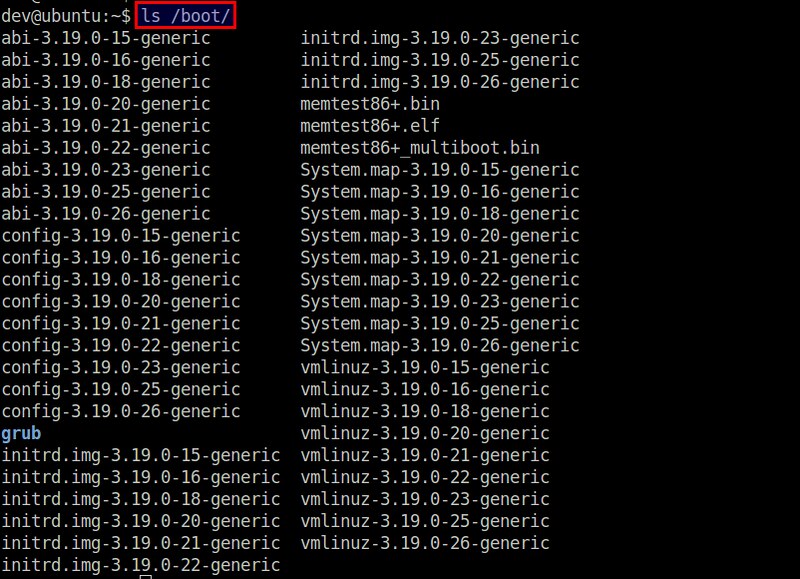

随着时间的流逝,持续的内核更新会在系统中积聚大量的不再使用的内核,浪费你的磁盘空间。每个内核镜像和其相关联的模块/头文件会占用200-400MB的磁盘空间,因此由不再使用的内核而浪费的磁盘空间会快速地增加。

|

||||

|

||||

|

||||

|

||||

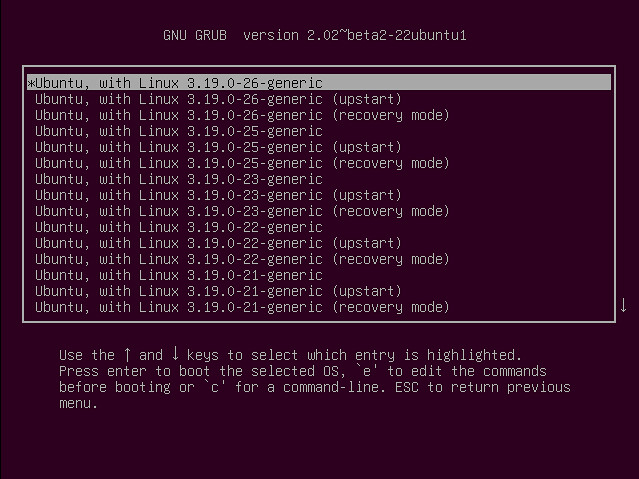

GRUB管理器为每个旧内核都维护了一个GRUB入口,防止你想要进入它们。

|

||||

GRUB管理器为每个旧内核都维护了一个GRUB入口,以备你想要使用它们。

|

||||

|

||||

|

||||

|

||||

@ -18,7 +18,7 @@ GRUB管理器为每个旧内核都维护了一个GRUB入口,防止你想要进

|

||||

|

||||

在删除旧内核之前,记住最好留有2个最近的内核(最新的和上一个版本),以防主要的版本出错。现在就让我们看看如何在Ubuntu上清理旧内核。

|

||||

|

||||

在Ubuntu内核镜像包哈了以下的包。

|

||||

在Ubuntu内核镜像包含了以下的包。

|

||||

|

||||

- **linux-image-<VERSION-NUMBER>**: 内核镜像

|

||||

- **linux-image-extra-<VERSION-NUMBER>**: 额外的内核模块

|

||||

@ -36,7 +36,6 @@ GRUB管理器为每个旧内核都维护了一个GRUB入口,防止你想要进

|

||||

|

||||

上面的命令会删除内核镜像和它相关联的内核模块和头文件。

|

||||

|

||||

updated to remove the corresponding GRUB entry from GRUB menu.

|

||||

注意如果你还没有升级内核那么删除旧内核会自动触发安装新内核。这样在删除旧内核之后,GRUB配置会自动升级来移除GRUB菜单中相关GRUB入口。

|

||||

|

||||

如果你有很多没用的内核,你可以用shell表达式来一次性地删除多个内核。注意这个括号表达式只在bash或者兼容的shell中才有效。

|

||||

@ -52,7 +51,7 @@ updated to remove the corresponding GRUB entry from GRUB menu.

|

||||

|

||||

$ sudo update-grub2

|

||||

|

||||

现在就重启来验证GRUB菜单已经正确清理了。

|

||||

现在就重启来验证GRUB菜单是否已经正确清理了。

|

||||

|

||||

|

||||

|

||||

@ -62,7 +61,7 @@ via: http://ask.xmodulo.com/remove-kernel-images-ubuntu.html

|

||||

|

||||

作者:[Dan Nanni][a]

|

||||

译者:[geekpi](https://github.com/geekpi)

|

||||

校对:[校对者ID](https://github.com/校对者ID)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

@ -0,0 +1,38 @@

|

||||

Ubuntu 开源操作系统运行在中国 42% 的 Dell PC 上

|

||||

================================================================================

|

||||

|

||||

> Dell 称它在中国市场出售的 42% 的 PC 运行的是 Kylin,这是一款 Canonical 帮助开发的基于 Ubuntu 的操作系统。

|

||||

|

||||

让开源粉丝欢喜的是:Linux 桌面年来了。或者说中国正在接近这个目标,[Dell][1] 报告称它售卖的超过 40% 的 PC 机运行的是 [Canonical][3] 帮助开发的 [Ubuntu Linux][2]。

|

||||

|

||||

特别地,Dell 称 42% 的中国电脑运行 NeoKylin(中标麒麟),一款中国本土倾力打造的用于替代 [Microsoft][4] Windows的操作系统。它也简称麒麟,这是一款从 2013 年出来的基于 Ubuntu 的操作系统,也是这年开始 Canonical 公司与中国政府合作建立一个专供中国市场的 Ubuntu 变种。

|

||||

|

||||

麒麟的早期版本出现于 2001 年左右,也是基于其他操作系统,包括 FreeBSD,这是一个开放源码但是不同于 Linux 的类 Unix 操作系统。

|

||||

|

||||

Ubuntu 麒麟的外观和感觉很像 Ubuntu 的现代版本。它拥有的 [Unity][5] 界面,并运行开源软件的标准套件,以及专门的如 Youker 助理程序,它是一个图形化的前端,帮助用户管理基本计算任务。但是麒麟的默认主题使得它看起来有点像 Windows 而不是 Ubuntu。

|

||||

|

||||

鉴于桌面 Linux PC 市场在世界上大多数国家的相对停滞,戴尔的宣布是令人吃惊的。结合中国对当前版本 windows 的轻微[敌意][6],这个消息并不看好着微软在中国市场的前景。

|

||||

|

||||

紧跟着 Dell 公司[宣布][7]在华投资1.25亿美元之后,一位决策者给华尔街杂志的评论中提到了 Dell 在中国市场上 PC 的销售。

|

||||

|

||||

|

||||

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://thevarguy.com/open-source-application-software-companies/091515/ubuntu-linux-based-open-source-os-runs-42-percent-dell-pc

|

||||

|

||||

作者:[Christopher Tozzi][a]

|

||||

译者:[geekpi](https://github.com/geeekpi)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://thevarguy.com/author/christopher-tozzi

|

||||

[1]:http://dell.com/

|

||||

[2]:http://ubuntu.com/

|

||||

[3]:http://canonical.com/

|

||||

[4]:http://microsoft.com/

|

||||

[5]:http://unity.ubuntu.com/

|

||||

[6]:http://www.wsj.com/articles/windows-8-faces-new-criticism-in-china-1401882772

|

||||

[7]:http://thevarguy.com/business-technology-solution-sales/091415/dell-125-million-directed-china-jobs-new-business-and-innovation

|

||||

@ -0,0 +1,209 @@

|

||||

RHCSA 系列(四): 编辑文本文件及分析文本

|

||||

================================================================================

|

||||

|

||||

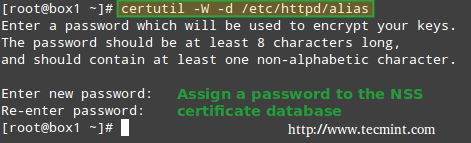

作为系统管理员的日常职责的一部分,每个系统管理员都必须处理文本文件,这包括编辑已有文件(大多可能是配置文件),或创建新的文件。有这样一个说法,假如你想在 Linux 世界中挑起一场圣战,你可以询问系统管理员们,什么是他们最喜爱的编辑器以及为什么。在这篇文章中,我们并不打算那样做,但我们将向你呈现一些技巧,这些技巧对使用两款在 RHEL 7 中最为常用的文本编辑器: nano(由于其简单和易用,特别是对于新手来说)和 vi/m(由于其自身的几个特色使得它不仅仅是一个简单的编辑器)来说都大有裨益。我确信你可以找到更多的理由来使用其中的一个或另一个,或许其他的一些编辑器如 emacs 或 pico。这完全取决于你自己。

|

||||

|

||||

|

||||

|

||||

*RHCSA: 使用 Nano 和 Vim 编辑文本文件 – Part 4*

|

||||

|

||||

### 使用 Nano 编辑器来编辑文件 ###

|

||||

|

||||

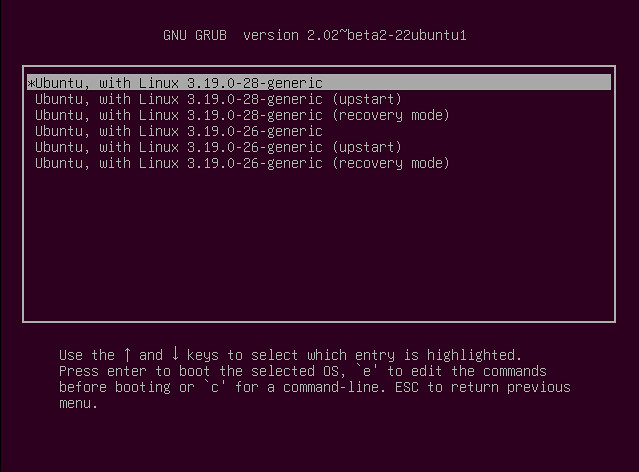

要启动 nano,你可以在命令提示符下输入 `nano`,或可选地跟上一个文件名(在这种情况下,若文件存在,它将在编辑模式中被打开)。若文件不存在,或我们省略了文件名, nano 也将在编辑模式下开启,但将为我们开启一个空白屏以便开始输入:

|

||||

|

||||

|

||||

|

||||

*Nano 编辑器*

|

||||

|

||||

正如你在上一张图片中所见的那样, nano 在屏幕的底部呈现出一些可以通过指定的快捷键来触发的功能(\^,即插入记号,代指 Ctrl 键)。它们中的一些是:

|

||||

|

||||

- Ctrl + G: 触发一个帮助菜单,带有一个关于功能和相应的描述的完整列表;

|

||||

|

||||

|

||||

|

||||

*Nano 编辑器帮助菜单*

|

||||

|

||||

- Ctrl + O: 保存更改到一个文件。它可以让你用一个与源文件相同或不同的名称来保存该文件,然后按 Enter 键来确认。

|

||||

|

||||

|

||||

|

||||

*Nano 编辑器的保存更改模式*

|

||||

|

||||

- Ctrl + X: 离开当前文件,假如更改没有被保存,则它们将被丢弃;

|

||||

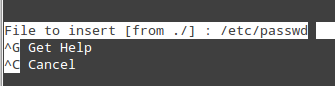

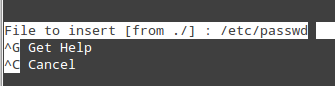

- Ctrl + R: 通过指定一个完整的文件路径,让你选择一个文件来将该文件的内容插入到当前文件中;

|

||||

|

||||

|

||||

|

||||

*Nano: 插入文件内容到主文件中*

|

||||

|

||||

上图的操作将把 `/etc/passwd` 的内容插入到当前文件中。

|

||||

|

||||

- Ctrl + K: 剪切当前行;

|

||||

- Ctrl + U: 粘贴;

|

||||

- Ctrl + C: 取消当前的操作并返回先前的屏幕;

|

||||

|

||||

为了轻松地在打开的文件中浏览, nano 提供了下面的功能:

|

||||

|

||||

- Ctrl + F 和 Ctrl + B 分别先前或向后移动光标;而 Ctrl + P 和 Ctrl + N 则分别向上或向下移动一行,功能与箭头键相同;

|

||||

- Ctrl + space 和 Alt + space 分别向前或向后移动一个单词;

|

||||

|

||||

最后,

|

||||

|

||||

- 假如你想将光标移动到文档中的特定位置,使用 Ctrl + _ (下划线) 并接着输入 X,Y 将准确地带你到 第 X 行,第 Y 列。

|

||||

|

||||

|

||||

|

||||

*在 nano 中定位到具体的行和列*

|

||||

|

||||

上面的例子将带你到当前文档的第 15 行,第 14 列。

|

||||

|

||||

假如你可以回忆起你早期的 Linux 岁月,特别是当你刚从 Windows 迁移到 Linux 中,你就可能会同意:对于一个新手来说,使用 nano 来开始学习是最好的方式。

|

||||

|

||||

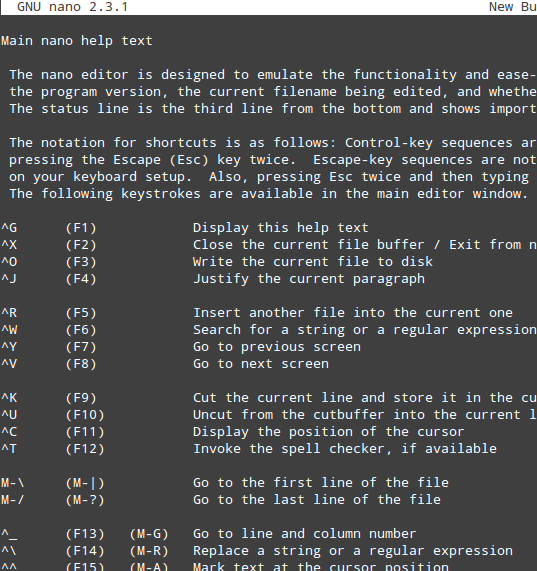

### 使用 Vim 编辑器来编辑文件 ###

|

||||

|

||||

Vim 是 vi 的加强版本,它是 Linux 中一个著名的文本编辑器,可在所有兼容 POSIX 的 *nix 系统中获取到,例如在 RHEL 7 中。假如你有机会并可以安装 Vim,请继续;假如不能,这篇文章中的大多数(若不是全部)的提示也应该可以正常工作。

|

||||

|

||||

Vim 的一个出众的特点是可以在多个不同的模式中进行操作:

|

||||

|

||||

- 命令模式(Command Mode)将允许你在文件中跳转和输入命令,这些命令是由一个或多个字母组成的简洁且大小写敏感的组合。假如你想重复执行某个命令特定次数,你可以在这个命令前加上需要重复的次数(这个规则只有极少数例外)。例如, `yy`(或 `Y`,yank 的缩写)可以复制整个当前行,而 `4yy`(或 `4Y`)则复制整个从当前行到接下来的 3 行(总共 4 行)。

|

||||

- 我们总是可以通过敲击 `Esc` 键来进入命令模式(无论我们正工作在哪个模式下)。

|

||||

- 在末行模式(Ex Mode)中,你可以操作文件(包括保存当前文件和运行外部的程序或命令)。要进入末行模式,你必须从命令模式中(换言之,输入 `Esc` + `:`)输入一个冒号(`:`),再直接跟上你想使用的末行模式命令的名称。

|

||||

- 对于插入模式(Insert Mode),可以输入字母 `i` 进入,然后只需要输入文字即可。大多数的击键结果都将出现在屏幕中的文本中。

|

||||

|

||||

现在,让我们看看如何在 vim 中执行在上一节列举的针对 nano 的相同的操作。不要忘记敲击 Enter 键来确认 vim 命令。

|

||||

|

||||

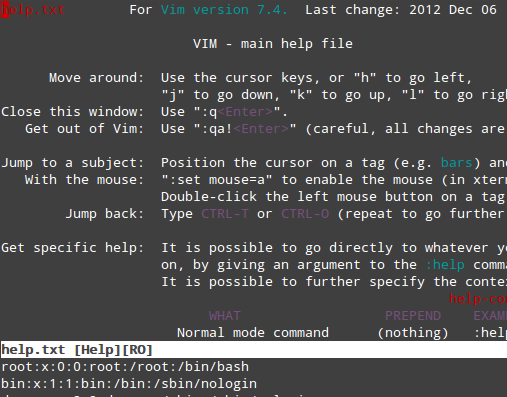

为了从命令行中获取 vim 的完整手册,在命令模式下键入 `:help` 并敲击 Enter 键:

|

||||

|

||||

|

||||

|

||||

*vim 编辑器帮助菜单*

|

||||

|

||||

上面的部分呈现出一个内容列表,这些定义的小节则描述了 Vim 的特定话题。要浏览某一个小节,可以将光标放到它的上面,然后按 `Ctrl + ]` (闭方括号)。注意,底部的小节展示的是当前文件的内容。

|

||||

|

||||

1、 要保存更改到文件,在命令模式中运行下面命令中的任意一个,就可以达到这个目的:

|

||||

|

||||

```

|

||||

:wq!

|

||||

:x!

|

||||

ZZ (是的,两个 ZZ,前面无需添加冒号)

|

||||

```

|

||||

|

||||

2、 要离开并丢弃更改,使用 `:q!`。这个命令也将允许你离开上面描述过的帮助菜单,并返回到命令模式中的当前文件。

|

||||

|

||||

3、 剪切 N 行:在命令模式中键入 `Ndd`。

|

||||

|

||||

4、 复制 M 行:在命令模式中键入 `Myy`。

|

||||

|

||||

5、 粘贴先前剪贴或复制过的行:在命令模式中按 `P`键。

|

||||

|

||||

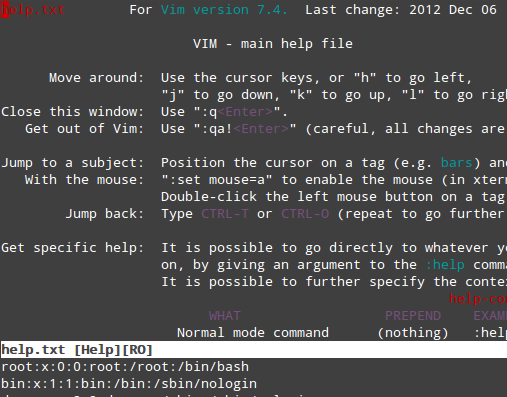

6、 要插入另一个文件的内容到当前文件:

|

||||

|

||||

:r filename

|

||||

|

||||

例如,插入 `/etc/fstab` 的内容,可以这样做:

|

||||

|

||||

[在 vi 编辑器中插入文件的内容](http://www.tecmint.com/wp-content/uploads/2015/03/Insert-Content-vi-Editor.png)

|

||||

|

||||

*在 vi 编辑器中插入文件的内容*

|

||||

|

||||

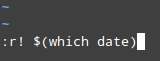

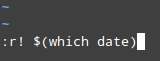

7、 插入一个命令的输出到当前文档:

|

||||

|

||||

:r! command

|

||||

|

||||

例如,要在光标所在的当前位置后面插入日期和时间:

|

||||

|

||||

|

||||

|

||||

*在 vi 编辑器中插入时间和日期*

|

||||

|

||||

在另一篇我写的文章中,([LFCS 系列(二)][1]),我更加详细地解释了在 vim 中可用的键盘快捷键和功能。或许你可以参考那个教程来查看如何使用这个强大的文本编辑器的更深入的例子。

|

||||

|

||||

### 使用 grep 和正则表达式来分析文本 ###

|

||||

|

||||

到现在为止,你已经学习了如何使用 nano 或 vim 创建和编辑文件。打个比方说,假如你成为了一个文本编辑器忍者 – 那又怎样呢? 在其他事情上,你也需要知道如何在文本中搜索正则表达式。

|

||||

|

||||

正则表达式(也称为 "regex" 或 "regexp") 是一种识别一个特定文本字符串或模式的方式,使得一个程序可以将这个模式和任意的文本字符串相比较。尽管利用 grep 来使用正则表达式值得用一整篇文章来描述,这里就让我们复习一些基本的知识:

|

||||

|

||||

**1、 最简单的正则表达式是一个由数字和字母构成的字符串(例如,单词 "svm") ,或者两个(在使用两个字符串时,你可以使用 `|`(或) 操作符):**

|

||||

|

||||

# grep -Ei 'svm|vmx' /proc/cpuinfo

|

||||

|

||||

上面命令的输出结果中若有这两个字符串之一的出现,则标志着你的处理器支持虚拟化:

|

||||

|

||||

|

||||

|

||||

*正则表达式示例*

|

||||

|

||||

**2、 第二种正则表达式是一个范围列表,由方括号包裹。**

|

||||

|

||||

例如, `c[aeiou]t` 匹配字符串 cat、cet、cit、cot 和 cut,而 `[a-z]` 和 `[0-9]` 则相应地匹配小写字母或十进制数字。假如你想重复正则表达式 X 次,在正则表达式的后面立即输入 `{X}`即可。

|

||||

|

||||

例如,让我们从 `/etc/fstab` 中析出存储设备的 UUID:

|

||||

|

||||

# grep -Ei '[0-9a-f]{8}-([0-9a-f]{4}-){3}[0-9a-f]{12}' -o /etc/fstab

|

||||

|

||||

|

||||

|

||||

*从一个文件中析出字符串*

|

||||

|

||||

方括号中的第一个表达式 `[0-9a-f]` 被用来表示小写的十六进制字符,`{8}`是一个量词,暗示前面匹配的字符串应该重复的次数(在一个 UUID 中的开头序列是一个 8 个字符长的十六进制字符串)。

|

||||

|

||||

在圆括号中,量词 `{4}`和连字符暗示下一个序列是一个 4 个字符长的十六进制字符串,接着的量词 `({3})`表示前面的表达式要重复 3 次。

|

||||

|

||||

最后,在 UUID 中的最后一个 12 个字符长的十六进制字符串可以由 `[0-9a-f]{12}` 取得, `-o` 选项表示只打印出在 `/etc/fstab`中匹配行中的匹配的(非空)部分。

|

||||

|

||||

**3、 POSIX 字符类**

|

||||

|

||||

|字符类|匹配 …|

|

||||

|-----|-----|

|

||||

| `[:alnum:]` | 任意字母或数字 [a-zA-Z0-9] |

|

||||

| `[:alpha:]` |任意字母 [a-zA-Z] |

|

||||

| `[:blank:]` |空格或制表符 |

|

||||

| `[:cntrl:]` |任意控制字符 (ASCII 码的 0 至 32) |

|

||||

| `[:digit:]` |任意数字 [0-9] |

|

||||

| `[:graph:]` |任意可见字符 |

|

||||

| `[:lower:]` |任意小写字母 [a-z] |

|

||||

| `[:print:]` |任意非控制字符 |

|

||||

| `[:space:]` |任意空格 |

|

||||

| `[:punct:]` |任意标点字符 |

|

||||

| `[:upper:]` |任意大写字母 [A-Z] |

|

||||

| `[:xdigit:]` |任意十六进制数字 [0-9a-fA-F] |

|

||||

| `[:word:]` |任意字母,数字和下划线 [a-zA-Z0-9_] |

|

||||

|

||||

例如,我们可能会对查找已添加到我们系统中给真实用户的 UID 和 GID(参考“[RHCSA 系列(二): 如何进行文件和目录管理][2]”来回忆起这些知识)感兴趣。那么,我们将在 `/etc/passwd` 文件中查找 4 个字符长的序列:

|

||||

|

||||

# grep -Ei [[:digit:]]{4} /etc/passwd

|

||||

|

||||

|

||||

|

||||

*在文件中查找一个字符串*

|

||||

|

||||

上面的示例可能不是真实世界中使用正则表达式的最好案例,但它清晰地启发了我们如何使用 POSIX 字符类来使用 grep 分析文本。

|

||||

|

||||

### 总结 ###

|

||||

|

||||

|

||||

在这篇文章中,我们已经提供了一些技巧来最大地利用针对命令行用户的两个文本编辑器 nano 和 vim,这两个工具都有相关的扩展文档可供阅读,你可以分别查询它们的官方网站(链接在下面给出)以及使用“[RHCSA 系列(一): 回顾基础命令及系统文档][3]”中给出的建议。

|

||||

|

||||

#### 参考文件链接 ####

|

||||

|

||||

- [http://www.nano-editor.org/][4]

|

||||

- [http://www.vim.org/][5]

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.tecmint.com/rhcsa-exam-how-to-use-nano-vi-editors/

|

||||

|

||||

作者:[Gabriel Cánepa][a]

|

||||

译者:[FSSlc](https://github.com/FSSlc)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.tecmint.com/author/gacanepa/

|

||||

[1]:http://www.tecmint.com/vi-editor-usage/

|

||||

[2]:https://linux.cn/article-6155-1.html

|

||||

[3]:https://linux.cn/article-6133-1-rel.html

|

||||

[4]:http://www.nano-editor.org/

|

||||

[5]:http://www.vim.org/

|

||||

[6]:http://www.tecmint.com/vi-editor-usage/

|

||||

@ -0,0 +1,152 @@

|

||||

RHCSA 系列(五): RHEL7 中的进程管理:开机,关机

|

||||

================================================================================

|

||||

我们将概括和简要地复习从你按开机按钮来打开你的 RHEL 7 服务器到呈现出命令行界面的登录屏幕之间所发生的所有事情,以此来作为这篇文章的开始。

|

||||

|

||||

|

||||

|

||||

*Linux 开机过程*

|

||||

|

||||

**请注意:**

|

||||

|

||||

1. 相同的基本原则也可以应用到其他的 Linux 发行版本中,但可能需要较小的更改,并且

|

||||

2. 下面的描述并不是旨在给出开机过程的一个详尽的解释,而只是介绍一些基础的东西

|

||||

|

||||

### Linux 开机过程 ###

|

||||

|

||||

1. 初始化 POST(加电自检)并执行硬件检查;

|

||||

|

||||

2. 当 POST 完成后,系统的控制权将移交给启动管理器的第一阶段(first stage),它存储在一个硬盘的引导扇区(对于使用 BIOS 和 MBR 的旧式的系统而言)或存储在一个专门的 (U)EFI 分区上。

|

||||

|

||||

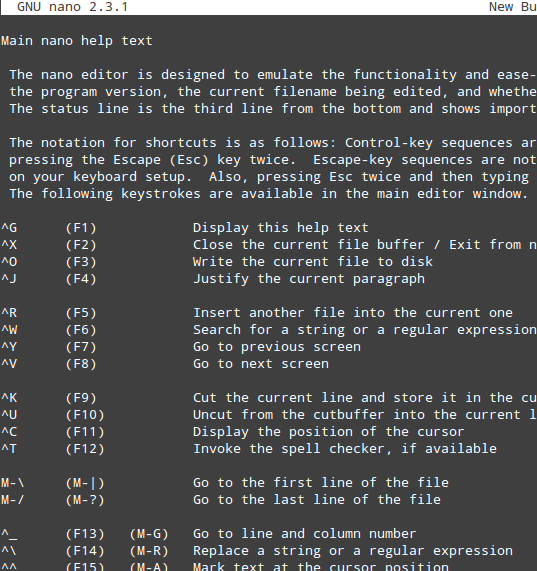

3. 启动管理器的第一阶段完成后,接着进入启动管理器的第二阶段(second stage),通常大多数使用的是 GRUB(GRand Unified Boot Loader 的简称),它驻留在 `/boot` 中,然后开始加载内核和驻留在 RAM 中的初始化文件系统(被称为 initramfs,它包含执行必要操作所需要的程序和二进制文件,以此来最终挂载真实的根文件系统)。

|

||||

|

||||

4. 接着展示了闪屏(splash)过后,呈现在我们眼前的是类似下图的画面,它允许我们选择一个操作系统和内核来启动:

|

||||

|

||||

|

||||

|

||||

*启动菜单屏幕*

|

||||

|

||||

5. 内核会对接入到系统的硬件进行设置,当根文件系统被挂载后,接着便启动 PID 为 1 的进程,这个进程将开始初始化其他的进程并最终呈现给我们一个登录提示符界面。

|

||||

|

||||

注意:假如我们想在启动后查看这些信息,我们可以使用 [dmesg 命令][1],并使用这个系列里的上一篇文章中介绍过的工具(注:即 grep)来过滤它的输出。

|

||||

|

||||

|

||||

|

||||

*登录屏幕和进程的 PID*

|

||||

|

||||

在上面的例子中,我们使用了大家熟知的 `ps` 命令来显示在系统启动过程中的一系列当前进程的信息,它们的父进程(或者换句话说,就是那个开启这些进程的进程)为 systemd(大多数现代的 Linux 发行版本已经切换到的系统和服务管理器):

|

||||

|

||||

# ps -o ppid,pid,uname,comm --ppid=1

|

||||

|

||||

记住 `-o`(为 -format 的简写)选项允许你以一个自定义的格式来显示 ps 的输出,以此来满足你的需求;这个自定义格式使用 `man ps` 里 STANDARD FORMAT SPECIFIERS 一节中的特定关键词。

|

||||

|

||||

另一个你想自定义 ps 的输出而不是使用其默认输出的情形是:当你需要找到引起 CPU 或内存消耗过多的那些进程,并按照下列方式来对它们进行排序时:

|

||||

|

||||

# ps aux --sort=+pcpu # 以 %CPU 来排序(增序)

|

||||

# ps aux --sort=-pcpu # 以 %CPU 来排序(降序)

|

||||

# ps aux --sort=+pmem # 以 %MEM 来排序(增序)

|

||||

# ps aux --sort=-pmem # 以 %MEM 来排序(降序)

|

||||

# ps aux --sort=+pcpu,-pmem # 结合 %CPU (增序) 和 %MEM (降序)来排列

|

||||

|

||||

|

||||

|

||||

*自定义 ps 命令的输出*

|

||||

|

||||

### systemd 的一个介绍 ###

|

||||

|

||||

在 Linux 世界中,很少有能比在主流的 Linux 发行版本中采用 systemd 引起更多的争论的决定。systemd 的倡导者根据以下事实来表明其主要的优势:

|

||||

|

||||

1. 在系统启动期间,systemd 允许并发地启动更多的进程(相比于先前的 SysVinit,SysVinit 似乎总是表现得更慢,因为它一个接一个地启动进程,检查一个进程是否依赖于另一个进程,然后等待守护进程启动才可以启动的更多的服务),并且

|

||||

2. 在一个运行着的系统中,它用作一个动态的资源管理器。这样在启动期间,当一个服务被需要时,才启动它(以此来避免消耗系统资源)而不是在没有一个合理的原因的情况下启动额外的服务。

|

||||

3. 向后兼容 sysvinit 的脚本。

|

||||

|

||||

另外请阅读: ['init' 和 'systemd' 背后的故事][2]

|

||||

|

||||

systemd 由 systemctl 工具控制,假如你了解 SysVinit,你将会对以下的内容感到熟悉:

|

||||

|

||||

- service 工具,在旧一点的系统中,它被用来管理 SysVinit 脚本,以及

|

||||

- chkconfig 工具,为系统服务升级和查询运行级别信息

|

||||

- shutdown 你一定使用过几次来重启或关闭一个运行的系统。

|

||||

|

||||

下面的表格展示了使用传统的工具和 systemctl 之间的相似之处:

|

||||

|

||||

|

||||

| 旧式工具 | Systemctl 等价命令 | 描述 |

|

||||

|-------------|----------------------|-------------|

|

||||

| service name start | systemctl start name | 启动 name (这里 name 是一个服务) |

|

||||

| service name stop | systemctl stop name | 停止 name |

|

||||

| service name condrestart | systemctl try-restart name | 重启 name (如果它已经运行了) |

|

||||

| service name restart | systemctl restart name | 重启 name |

|

||||

| service name reload | systemctl reload name | 重载 name 的配置 |

|

||||

| service name status | systemctl status name | 显示 name 的当前状态 |

|

||||

| service - status-all | systemctl | 显示当前所有服务的状态 |

|

||||

| chkconfig name on | systemctl enable name | 通过一个特定的单元文件,让 name 可以在系统启动时运行(这个文件是一个符号链接)。启用或禁用一个启动时的进程,实际上是增加或移除一个到 /etc/systemd/system 目录中的符号链接。 |

|

||||

| chkconfig name off | systemctl disable name | 通过一个特定的单元文件,让 name 可以在系统启动时禁止运行(这个文件是一个符号链接)。 |

|

||||

| chkconfig -list name | systemctl is-enabled name | 确定 name (一个特定的服务)当前是否启用。|

|

||||

| chkconfig - list | systemctl - type=service | 显示所有的服务及其是否启用或禁用。 |

|

||||

| shutdown -h now | systemctl poweroff | 关机 |

|

||||

| shutdown -r now | systemctl reboot | 重启系统 |

|

||||

|

||||

systemd 也引进了单元(unit)(它可能是一个服务,一个挂载点,一个设备或者一个网络套接字)和目标(target)(它们定义了 systemd 如何去管理和同时开启几个相关的进程,可以认为它们与在基于 SysVinit 的系统中的运行级别等价,尽管事实上它们并不等价)的概念。

|

||||

|

||||

### 总结归纳 ###

|

||||

|

||||

其他与进程管理相关,但并不仅限于下面所列的功能的任务有:

|

||||

|

||||

**1. 在考虑到系统资源的使用上,调整一个进程的执行优先级:**

|

||||

|

||||

这是通过 `renice` 工具来完成的,它可以改变一个或多个正在运行着的进程的调度优先级。简单来说,调度优先级是一个允许内核(当前只支持 >= 2.6 的版本)根据某个给定进程被分配的执行优先级(即友善度(niceness),从 -20 到 19)来为其分配系统资源的功能。

|

||||

|

||||

`renice` 的基本语法如下:

|

||||

|

||||

# renice [-n] priority [-gpu] identifier

|

||||

|

||||

在上面的通用命令中,第一个参数是将要使用的优先级数值,而另一个参数可以是进程 ID(这是默认的设定),进程组 ID,用户 ID 或者用户名。一个常规的用户(即除 root 以外的用户)只可以更改他或她所拥有的进程的调度优先级,并且只能增加友善度的层次(这意味着占用更少的系统资源)。

|

||||

|

||||

|

||||

|

||||

*进程调度优先级*

|

||||

|

||||

**2. 按照需要杀死一个进程(或终止其正常执行):**

|

||||

|

||||

更精确地说,杀死一个进程指的是通过 [kill 或 pkill][3] 命令给该进程发送一个信号,让它优雅地(SIGTERM=15)或立即(SIGKILL=9)结束它的执行。

|

||||

|

||||

这两个工具的不同之处在于前一个被用来终止一个特定的进程或一个进程组,而后一个则允许你通过进程的名称和其他属性,执行相同的动作。

|

||||

|

||||

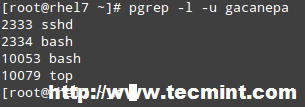

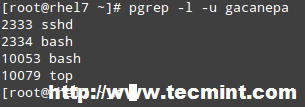

另外, pkill 与 pgrep 相捆绑,pgrep 提供将受符合的进程的 PID 给 pkill 来使用。例如,在运行下面的命令之前:

|

||||

|

||||

# pkill -u gacanepa

|

||||

|

||||

查看一眼由 gacanepa 所拥有的 PID 或许会带来点帮助:

|

||||

|

||||

# pgrep -l -u gacanepa

|

||||

|

||||

|

||||

|

||||

*找到用户拥有的 PID*

|

||||

|

||||

默认情况下,kill 和 pkiill 都发送 SIGTERM 信号给进程,如我们上面提到的那样,这个信号可以被忽略(即该进程可能会终止其自身的执行,也可能不终止),所以当你因一个合理的理由要真正地停止一个运行着的进程,则你将需要在命令行中带上特定的 SIGKILL 信号:

|

||||

|

||||

# kill -9 identifier # 杀死一个进程或一个进程组

|

||||

# kill -s SIGNAL identifier # 同上

|

||||

# pkill -s SIGNAL identifier # 通过名称或其他属性来杀死一个进程

|

||||

|

||||

### 结论 ###

|

||||

|

||||

在这篇文章中,我们解释了在 RHEL 7 系统中,有关开机启动过程的基本知识,并分析了一些可用的工具来帮助你通过使用一般的程序和 systemd 特有的命令来管理进程。

|

||||

|

||||

请注意,这个列表并不旨在涵盖有关这个话题的所有花哨的工具,请随意使用下面的评论栏来添加你自已钟爱的工具和命令。同时欢迎你的提问和其他的评论。

|

||||

|

||||

--------------------------------------------------------------------------------

|

||||

|

||||

via: http://www.tecmint.com/rhcsa-exam-boot-process-and-process-management/

|

||||

|

||||

作者:[Gabriel Cánepa][a]

|

||||

译者:[FSSlc](https://github.com/FSSlc)

|

||||

校对:[wxy](https://github.com/wxy)

|

||||

|

||||

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

|

||||

|

||||

[a]:http://www.tecmint.com/author/gacanepa/

|

||||

[1]:https://linux.cn/article-3587-1.html

|

||||

[2]:http://www.tecmint.com/systemd-replaces-init-in-linux/

|

||||

[3]:https://linux.cn/article-2116-1.html

|

||||

@ -1,28 +1,28 @@

|

||||

RHCSA 系列:使用 'Parted' 和 'SSM' 来配置和加密系统存储 – Part 6

|

||||

RHCSA 系列(六): 使用 Parted 和 SSM 来配置和加密系统存储

|

||||

================================================================================

|

||||

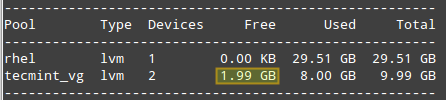

在本篇文章中,我们将讨论在 RHEL 7 中如何使用传统的工具来设置和配置本地系统存储,并介绍系统存储管理器(也称为 SSM),它将极大地简化上面的任务。

|

||||

在本篇文章中,我们将讨论在 RHEL 7 中如何使用传统的工具来设置和配置本地系统存储,并介绍系统存储管理器(也称为 SSM),它将极大地简化上面的任务。

|

||||

|

||||

|

||||

|

||||

RHCSA: 配置和加密系统存储 – Part 6

|

||||

*RHCSA: 配置和加密系统存储 – Part 6*

|

||||

|

||||

请注意,我们将在这篇文章中展开这个话题,但由于该话题的宽泛性,我们将在下一期(Part 7)中继续介绍有关它的描述和使用。

|

||||

请注意,我们将在这篇文章中展开这个话题,但由于该话题的宽泛性,我们将在下一期中继续介绍有关它的描述和使用。

|

||||

|

||||

### 在 RHEL 7 中创建和修改分区 ###

|

||||

|

||||

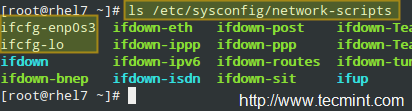

在 RHEL 7 中, parted 是默认的用来处理分区的程序,且它允许你:

|

||||

|

||||

- 展示当前的分区表

|

||||

- 操纵(增加或减少分区的大小)现有的分区

|

||||

- 操纵(扩大或缩小分区的大小)现有的分区

|

||||

- 利用空余的磁盘空间或额外的物理存储设备来创建分区

|

||||

|

||||

强烈建议你在试图增加一个新的分区或对一个现有分区进行更改前,你应当确保设备上没有任何一个分区正在使用(`umount /dev/partition`),且假如你正使用设备的一部分来作为 swap 分区,在进行上面的操作期间,你需要将它禁用(`swapoff -v /dev/partition`) 。

|

||||

强烈建议你在试图增加一个新的分区或对一个现有分区进行更改前,你应当确保该设备上没有任何一个分区正在使用(`umount /dev/分区`),且假如你正使用设备的一部分来作为 swap 分区,在进行上面的操作期间,你需要将它禁用(`swapoff -v /dev/分区`) 。

|

||||

|

||||

实施上面的操作的最简单的方法是使用一个安装介质例如一个 RHEL 7 安装 DVD 或 USB 以急救模式启动 RHEL(Troubleshooting → Rescue a Red Hat Enterprise Linux system),然后当让你选择一个选项来挂载现有的 Linux 安装时,选择'跳过'这个选项,接着你将看到一个命令行提示符,在其中你可以像下图显示的那样开始键入与在一个未被使用的物理设备上创建一个正常的分区时所用的相同的命令。

|

||||

实施上面的操作的最简单的方法是使用一个安装介质例如一个 RHEL 7 的 DVD 或 USB 安装盘以急救模式启动 RHEL(`Troubleshooting` → `Rescue a Red Hat Enterprise Linux system`),然后当让你选择一个选项来挂载现有的 Linux 安装时,选择“跳过”这个选项,接着你将看到一个命令行提示符,在其中你可以像下图显示的那样开始键入与在一个未被使用的物理设备上创建一个正常的分区时所用的相同的命令。

|

||||

|

||||

|

||||

|

||||

RHEL 7 急救模式

|

||||

*RHEL 7 急救模式*

|

||||

|

||||

要启动 parted,只需键入:

|

||||

|

||||

@ -32,17 +32,17 @@ RHEL 7 急救模式

|

||||

|

||||

|

||||

|

||||

创建新的分区

|

||||

*创建新的分区*

|

||||

|

||||

正如你所看到的那样,在这个例子中,我们正在使用一个 5 GB 的虚拟光驱。现在我们将要创建一个 4 GB 的主分区,然后将它格式化为 xfs 文件系统,它是 RHEL 7 中默认的文件系统。

|

||||

正如你所看到的那样,在这个例子中,我们正在使用一个 5 GB 的虚拟驱动器。现在我们将要创建一个 4 GB 的主分区,然后将它格式化为 xfs 文件系统,它是 RHEL 7 中默认的文件系统。

|

||||

|

||||

你可以从一系列的文件系统中进行选择。你将需要使用 mkpart 来手动地创建分区,接着和平常一样,用 mkfs.fstype 来对分区进行格式化,因为 mkpart 并不支持许多现代的文件系统以达到即开即用。

|

||||

你可以从一系列的文件系统中进行选择。你将需要使用 `mkpart` 来手动地创建分区,接着和平常一样,用 `mkfs.类型` 来对分区进行格式化,因为 `mkpart` 并不支持许多现代的文件系统的到即开即用。

|

||||

|

||||

在下面的例子中,我们将为设备设定一个标记,然后在 `/dev/sdb` 上创建一个主分区 `(p)`,它从设备的 0% 开始,并在 4000MB(4 GB) 处结束。

|

||||

|

||||

|

||||

|

||||

标记分区的名称

|

||||

*标记分区的名称*

|

||||

|

||||

接下来,我们将把分区格式化为 xfs 文件系统,然后再次打印出分区表,以此来确保更改已被应用。

|

||||

|

||||

@ -51,11 +51,11 @@ RHEL 7 急救模式

|

||||

|

||||

|

||||

|

||||

格式化分区为 XFS 文件系统

|

||||

*格式化分区为 XFS 文件系统*

|

||||

|

||||

对于旧一点的文件系统,在 parted 中你应该使用 `resize` 命令来改变分区的大小。不幸的是,这只适用于 ext2, fat16, fat32, hfs, linux-swap, 和 reiserfs (若 libreiserfs 已被安装)。

|

||||

对于旧一点的文件系统,在 parted 中你可以使用 `resize` 命令来改变分区的大小。不幸的是,这只适用于 ext2, fat16, fat32, hfs, linux-swap, 和 reiserfs (若 libreiserfs 已被安装)。

|

||||

|

||||

因此,改变分区大小的唯一方式是删除它然后再创建它(所以确保你对你的数据做了完整的备份!)。毫无疑问,在 RHEL 7 中默认的分区方案是基于 LVM 的。

|

||||

因此,改变分区大小的唯一方式是删除它然后再创建它(所以,确保你对你的数据做了完整的备份!)。毫无疑问,在 RHEL 7 中默认的分区方案是基于 LVM 的。

|

||||

|

||||

使用 parted 来移除一个分区,可以用:

|

||||

|

||||

@ -64,23 +64,23 @@ RHEL 7 急救模式

|

||||

|

||||

|

||||

|

||||

移除或删除分区

|

||||

*移除或删除分区*

|

||||

|

||||

### 逻辑卷管理(LVM) ###

|

||||

|

||||

一旦一个磁盘被分好了分区,再去更改分区的大小就是一件困难或冒险的事了。基于这个原因,假如我们计划在我们的系统上对分区的大小进行更改,我们应当考虑使用 LVM 的可能性,而不是使用传统的分区系统。这样多个物理设备可以组成一个逻辑组,以此来寄宿可自定义数目的逻辑卷,而逻辑卷的增大或减少不会带来任何麻烦。

|

||||

一旦一个磁盘被分好了分区,再去更改分区的大小就是一件困难或冒险的事了。基于这个原因,假如我们计划在我们的系统上对分区的大小进行更改,我们应当考虑使用 LVM 的可能性,而不是使用传统的分区系统。这样多个物理设备可以组成一个逻辑组,以此来存放任意数目的逻辑卷,而逻辑卷的增大或减少不会带来任何麻烦。

|

||||

|

||||

简单来说,你会发现下面的示意图对记住 LVM 的基础架构或许有用。

|

||||

|

||||

|

||||

|

||||

LVM 的基本架构

|

||||

*LVM 的基本架构*

|

||||

|

||||

#### 创建物理卷,卷组和逻辑卷 ####

|

||||

|

||||

遵循下面的步骤是为了使用传统的卷管理工具来设置 LVM。由于你可以通过阅读这个网站上的 LVM 系列来扩展这个话题,我将只是概要的介绍设置 LVM 的基本步骤,然后与使用 SSM 来实现相同功能做个比较。

|

||||

|

||||

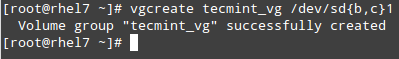

**注**: 我们将使用整个磁盘 `/dev/sdb` 和 `/dev/sdc` 来作为 PVs (物理卷),但是否执行相同的操作完全取决于你。

|

||||

**注**: 我们将使用整个磁盘 `/dev/sdb` 和 `/dev/sdc` 来作为物理卷(PV),但是否执行相同的操作完全取决于你。

|

||||

|

||||

**1. 使用 /dev/sdb 和 /dev/sdc 中 100% 的可用磁盘空间来创建分区 `/dev/sdb1` 和 `/dev/sdc1`:**

|

||||

|

||||

@ -89,7 +89,7 @@ LVM 的基本架构

|

||||

|

||||

|

||||

|

||||

创建新分区

|

||||

*创建新分区*

|

||||

|

||||

**2. 分别在 /dev/sdb1 和 /dev/sdc1 上共创建 2 个物理卷。**

|

||||

|

||||

@ -98,21 +98,21 @@ LVM 的基本架构

|

||||

|

||||

|

||||

|

||||

创建两个物理卷

|

||||

*创建两个物理卷*

|

||||

|

||||

记住,你可以使用 pvdisplay /dev/sd{b,c}1 来显示有关新建的 PV 的信息。

|

||||

记住,你可以使用 pvdisplay /dev/sd{b,c}1 来显示有关新建的物理卷的信息。

|